This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.リリースノート

新機能のハイライトおよび OpenShift Container Platform リリースの変更内容

概要

第1章 OpenShift Container Platform 4.8 リリースノート

Red Hat OpenShift Container Platform では、設定や管理のオーバーヘッドを最小限に抑えながら、セキュアでスケーラブルなリソースに新規および既存のアプリケーションをデプロイするハイブリッドクラウドアプリケーションプラットフォームを開発者や IT 組織に提供します。OpenShift Container Platform は、Java、Javascript、Python、Ruby および PHP など、幅広いプログラミング言語およびフレームワークをサポートしています。

Red Hat Enterprise Linux (RHEL) および Kubernetes にビルドされる OpenShift Container Platform は、エンタープライズレベルの最新アプリケーションに対してよりセキュアでスケーラブルなマルチテナント対応のオペレーティングシステムを提供するだけでなく、統合アプリケーションランタイムやライブラリーを提供します。OpenShift Container Platform を使用することで、組織はセキュリティー、プライバシー、コンプライアンス、ガバナンスの各種の要件を満たすことができます。

1.1. 本リリースについて

OpenShift Container Platform (RHSA-2021:2438) が公開されました。本リリースでは、CRI-O ランタイムで Kubernetes 1.21 を使用します。以下では、OpenShift Container Platform 4.8 に関連する新機能、変更点および既知の問題について説明します。

Red Hat は OpenShift Container Platform 4.8.0 を GA バージョンとしてリリースせず、OpenShift Container Platform 4.8.2 を GA バージョンとしてリリースしています。

OpenShift Container Platform 4.8 クラスターは https://console.redhat.com/openshift でご利用いただけます。OpenShift Container Platform 向けの Red Hat OpenShift Cluster Manager アプリケーションを使って、OpenShift クラスターをオンプレミスまたはクラウド環境のいずれかにデプロイすることができます。

OpenShift Container Platform 4.8 は、Red Hat Enterprise Linux (RHEL) 7.9 以降、および Red Hat Enterprise Linux CoreOS (RHCOS) 4.8 でサポートされます。

コントロールプレーンには RHCOS マシンを使用する必要があり、コンピュートマシンには RHCOS または Red Hat Enterprise Linux (RHEL) 7.9 以降のいずれかを使用できます。

RHEL 7.9 以降のみがコンピュートマシンでサポートされるため、RHEL コンピュートマシンを RHEL 8 にアップグレードすることはできません。

OpenShift Container Platform 4.8 は Extended Update Support (EUS) リリースです。Red Hat OpenShift EUS の詳細は、OpenShift ライフサイクル、および OpenShift EUS の概要 を参照してください。

OpenShift Container Platform 4.8 のリリースでは、バージョン 4.5 のライフサイクルは終了します。詳細は、Red Hat OpenShift Container Platform ライフサイクルポリシー を参照してください。

1.2. 多様性を受け入れるオープンソースの強化

Red Hat では、コード、ドキュメント、Web プロパティーにおける配慮に欠ける用語の置き換えに取り組んでいます。

この作業の一環として、本リリースでは以下の変更を実施しています。

-

OpenShift Docs GitHub リポジトリー の

masterブランチの名前がmainに変更されました。 - マスターからコントロールプレーンへの用語の置き換えを徐々に開始しています。ドキュメント全体にわたって、両方の用語を使用しているいることにお気づきいただけると思います (マスターは括弧で括っています)。たとえば、… コントロールプレーンノード (別名マスターノード) のように使用しています。今後のリリースでは、これをコントロールプレーンノードに更新します。

1.3. OpenShift ContainerPlatform のレイヤー化された依存関係にあるコンポーネントのサポートと互換性

OpenShift Container Platform のレイヤー化された依存関係にあるコンポーネントのサポート範囲は、OpenShift Container Platform のバージョンに関係なく変更されます。アドオンの現在のサポートステータスと互換性を確認するには、リリースノートを参照してください。詳細は、Red Hat OpenShift Container Platform ライフサイクルポリシー を参照してください。

1.4. 新機能および機能拡張

今回のリリースでは、以下のコンポーネントおよび概念に関連する拡張機能が追加されました。

1.4.1. Red Hat Enterprise Linux CoreOS (RHCOS)

1.4.1.1. RHCOS が RHEL 8.4 を使用するように

RHCOS は、OpenShift Container Platform 4.8 および OpenShift Container Platform 4.7.24 以降で、Red Hat Enterprise Linux (RHEL) 8.4 パッケージを使用するようになりました。これにより、最新の修正、機能、拡張機能、および最新のハードウェアサポートおよびドライバー更新を利用できます。OpenShift Container Platform 4.6 は延長更新サポート (EUS) リリースです。このリリースは、ライフサイクル全体に対して RHEL 8.2 EUS パッケージを引き続き使用します。

1.4.1.2. ブートイメージの自動化を改善するためのストリームメタデータの使用

ストリームメタデータは、OpenShift Container Platform のインストール時に、メタデータをクラスターに挿入するための標準化された JSON 形式を提供します。自動化を強化するために、新規の openshift-install coreos print-stream-json コマンドは、スクリプト可能かつ機械読み取り可能な形式でストリームメタデータを出力する方法を提供します。

ユーザーによってプロビジョニングされるインストールの場合、openshift-install バイナリーには、AWS AMI などの OpenShift Container Platform での使用がテストされている RHCOS ブートイメージのバージョンへの参照が含まれます。https://github.com/coreos/stream-metadata-go の公式の stream-metadata-go ライブラリーを使用して、Go プログラムからストリームメタデータを解析できるようになりました。

詳細は、ストリームメタデータを使用した RHCOS AMI へのアクセス を参照してください。

1.4.1.3. Butane config transpiler がマシン設定の作成を単純化する

OpenShift Container Platform には、マシン設定の生成および検証に役立つ Butane config transpiler が含まれるようになりました。ドキュメントでは、Butane を使用して LUKS ディスク暗号化、ブートディスクのミラーリング、およびカスタムカーネルモジュールのマシン設定を作成することを推奨しています。

詳細は、Butane を使用したマシン設定の作成 を参照してください。

1.4.1.4. クラウドプラットフォームにおけるカスタム chrony.conf のデフォルトへの変更

クラウド管理者がカスタムの /etc/chrony.conf 設定をすでに設定している場合、RHCOS はデフォルトで PEERNTP=no オプションをクラウドプラットフォームに設定しなくなりました。これを設定していない場合、PEERNTP=no オプションがデフォルトで設定されます。詳細は、BZ#1924869 を参照してください。

1.4.1.5. ベアメタルインストール時のマルチパスの有効化

ベアメタルインストール時のマルチパスの有効化が、OpenShift Container Platform 4.8 以降でプロビジョニングされるノードでサポートされるようになりました。マルチパスを有効にするには、coreos-installer install コマンドにカーネル引数を追加して、インストール済みシステム自体が初回起動からマルチパスを使用できるようにします。インストール後のサポートはマシン設定を使用してマルチパスをアクティベートすることで引き続き利用できますが、OpenShift Container Platform 4.8 以降では、インストール中にプロビジョニングされたノードのマルチパスを有効化することをお勧めします。

詳細は、Enabling multipathing with kernel arguments on RHCOS について参照してください。

1.4.2. インストールおよびアップグレード

1.4.2.1. クラスターの Azure の既存の空のリソースグループへのインストール

install-config.yaml ファイルの platform.azure.resourceGroupName フィールドを定義して、既存のリソースグループを定義し、クラスターを Azure にインストールできるようになりました。このリソースグループは空である必要があり、単一のクラスターにのみ使用する必要があります。クラスターのコンポーネントには、リソースグループ内のすべてのリソースの所有権があります。

インストールプログラムのサービスプリンシパルの範囲をこのリソースグループに制限する場合は、環境内でインストールプログラムが使用する他のすべてのリソースに、パブリック DNS ゾーンや仮想ネットワークなどの必要なパーミッションがあることを確認する必要があります。インストールプログラムを使用してクラスターを破棄すると、ユーザー定義のリソースグループが削除されます。

1.4.2.2. AWS でのクラスターの既存 IAM ロールの使用

install-config.yaml ファイルに compute.platform.aws.iamRole および controlPlane.platform.aws.iamRole フィールドを設定して、マシンインスタンスのプロファイルに既存の Amazon Web Services (AWS) IAM ロールを定義できるようになりました。これにより、IAM ロールについて以下を実行できます。

- 命名スキームのマッチング

- 事前に定義されたパーミッション境界の追加

1.4.2.3. AWS での既存の Route53 ホストプライベートゾーンの使用

install-config.yaml ファイルに platform.aws.hostedZone フィールドを設定して、クラスターの既存の Route 53 プライベートホストゾーンを定義できるようになりました。独自の VPC を指定する場合も、既存のホストゾーンのみを使用できます。

1.4.2.4. マシン CIDR 内の GCP サブネットサイズの拡大

Google Cloud Platform (GCP) の OpenShift Container Platform インストールプログラムは、マシン CIDR 内に可能な限り大きなサブネットを作成するようになりました。これにより、クラスターがマシン CIDR のサイズを、クラスター内のノード数に対応するように設定できます。

1.4.2.5. アップグレード期間の短縮

今回のリリースにより、デーモンセットをすべてのノードにデプロイするクラスター Operator のアップグレード期間が大幅に短縮されるようになりました。たとえば、250 ノードのテストクラスターのアップグレード期間は 7.5 時間から 1.5 時間に短縮されるため、アップグレード期間は 1 ノードの追加につき 1 分未満となります。

この変更はマシン設定プールのロールアウト期間には影響しません。

1.4.2.6. MCO は、すべてのマシン設定プールが更新を待ってから、更新の完了を報告します。

更新時に、Machine Config Operator (MCO) は、マシン設定プールの更新が完了していない場合に Upgradeable=False の状態を machine-config Cluster Operator に報告するようになりました。このステータスは今後のマイナー更新をブロックしますが、今後のパッチ更新をブロックしたり、現在の更新をブロックしたりすることはありません。以前のバージョンでは、MCO はワーカープールの更新が完了していなくても、コントロールプレーンマシンの設定プールの状態のみに基づいて、Upgradeable ステータスを報告していました。

1.4.2.7. ベアメタルノードへのインストールでの Fujitsu iRMC の使用

OpenShift Container Platform 4.8 では、インストーラーでプロビジョニングされるクラスターをベアメタルにデプロイするときに、Fujitsu ハードウェアと Fujitsu iRMC ベースボード管理コントローラープロトコルを使用できます。現在 Fujitsu は、ベアメタルへのインストーラーでプロビジョニングされるインストール用に iRMC S5 ファームウェアバージョン 3.05P 以降をサポートしています。OpenShift Container Platform 4.8 の機能拡張およびバグ修正には以下が含まれます。

- iRMC ハードウェアにおける通常の電源オフをサポートします。

- インストーラーがベアメタルノードにコントロールプレーンをデプロイすると、プロビジョニングサービスを停止します。詳細は、BZ#1949859 を参照してください。

-

ブートストラップ

keepalivedチェックに Ironic ヘルスチェックを追加します。詳細は、BZ#1949859 を参照してください。 - コントロールプレーンノードでユニキャストピアリストが空ではないことを確認します。詳細は、BZ#1957708 を参照してください。

- Bare Metal Operator を更新して、iRMC PowerInterface に合わせます。詳細は、BZ#1957869 を参照してください。

-

pyghmiライブラリーバージョンを更新します。詳細は、BZ#1920294 を参照してください。 - Bare Metal Operator を更新して、不足している IPMI 認証情報に対処します。詳細は、BZ#1965182 を参照してください。

-

enabled_bios_interfacesから iRMC を削除します。詳細は、BZ#1969212 を参照してください。 -

ironicTlsMountおよびinspectorTlsMountをベアメタル Pod 定義に追加します。詳細は、BZ#1968701 を参照してください。 - iRMC サーバーの RAID 機能を無効化します。詳細は、BZ#1969487 を参照してください。

- すべてのドライバーで RAID を無効にします。詳細は、BZ#1969487 を参照してください。

1.4.2.8. RHOSP 上でインストーラーでプロビジョニングされるインフラストラクチャーを使用するクラスターに対する SR-IOV ネットワークサポート

コンピュートマシン用に Single Root I/O Virtualization (SR-IOV) ネットワークを使用する RHOSP にクラスターをデプロイすることができるようになりました。

詳細は、SR-IOV で接続されたコンピュートマシンをサポートする OpenStack へのクラスターのインストール を参照してください。

1.4.2.9. VLAN インターフェイスに対する Ironic Python Agent のサポート

今回の更新により、Ironic Python Agent は、イントロスペクション中にインターフェイス一覧で VLAN インターフェイスを報告するようになりました。さらに、IP アドレスがインターフェイスに含まれているため、CSR を適切に作成できます。これにより、VLAN インターフェイスを含むすべてのインターフェイスで CSR を取得できます。詳細は、BZ#1888712 を参照してください。

1.4.2.10. OpenShift Update Service を使用した OTA (over-the-air) 更新

OpenShift Update Service (OSUS) は、Red Hat Enterprise Linux CoreOS (RHCOS) を含む OpenShift Container Platform に OTA (over-the-air) 更新を提供します。以前は、パブリック API の背後にある Red Hat ホストサービスとしてのみアクセス可能でしたが、現在はローカルにインストールできます。OpenShift Update Service は Operator および 1 つ以上のアプリケーションインスタンスで設定され、OpenShift Container Platform 4.6 以降で一般に利用可能になりました。

詳細は、OpenShift Update Service について を参照してください。

1.4.3. Web コンソール

1.4.3.1. カスタムコンソールルートは新規の CustomDomains クラスター API を使用する

console および downloads ルートについて、カスタムルート機能が新規 ingress 設定ルート設定 API の spec.componentRoutes を使用するようになりました。Console Operator 設定にはカスタムルートのカスタマイズがすでに含まれていますが、console ルートのみが対象です。console-operator 設定を使用したルート設定は非推奨になりました。そのため、console カスタムルートが ingress 設定と console-operator 設定の両方に設定されている場合、新規の ingress 設定のカスタムルート設定が優先されます。

詳細は、コンソールルートのカスタマイズ を参照してください。

1.4.3.2. クイックスタートからのコードスニペットへのアクセス

CLI スニペットがクイックスタートに含まれる場合、これを Web コンソールから実行できるようになりました。この機能を使用するには、まず Web ターミナル Operator をインストールする必要があります。Web ターミナルで実行する Web ターミナルおよびコードスニペットの各種アクションは、Web ターミナル Operator をインストールしない場合は表示されません。または、Web ターミナル Operator がインストールされているかどうかに関係なく、コードスニペットをクリップボードにコピーできます。

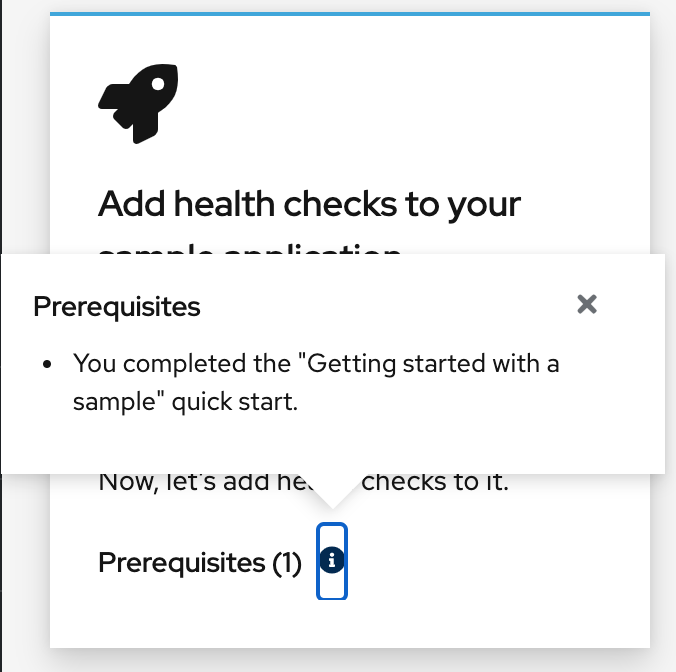

1.4.3.3. クイックスタートの前提条件の表示についての改善

以前のバージョンでは、クイックスタートの前提条件はクイックスタートカードの一覧ではなく、統合されたテキストとして表示されていました。スケーラビリティーを考慮し、前提条件はカードではなくポップアップで表示されるようになりました。

1.4.3.4. Developer パースペクティブ

このリリースにより、以下が可能になります。

- カスタムパイプラインテンプレートを使用して、Git リポジトリーからアプリケーションを作成およびデプロイします。これらのテンプレートは、OpenShift Pipelines 1.5 以降で提供されるデフォルトのパイプラインテンプレートをオーバーライドします。

- 認定レベルに基づいて Helm チャートをフィルターリングします。すべての Helm チャートは、Developer Catalog で表示できます。

- Add ページのオプションを使用して、アプリケーションと関連サービスを作成し、これらのアプリケーションとサービスを OpenShift Container Platform にデプロイします。Add ページのオプションには、Getting started resources、Creating applications using samples、Build with guided documentation、Explore new developer features が含まれます。

- パイプラインビルダーでパイプラインを作成するときにワークスペースを使用します。パイプラインにトリガーを追加して、タスクを使用してパイプラインのワークスペースをサポートすることもできます。

- Developer パースペクティブの Topology ビューで JAR ファイルを使用して、Java アプリケーションをデプロイします。

- OpenShift Container Platform で複数のイベントソースタイプを作成し、これらのソースタイプをシンクに接続します。OpenShift Container Platform クラスターに Knative サービスとしてデプロイされた機能を取得し、それらをシンクに接続できます。

-

パイプラインの

finallyタスクを使用して、コマンドを並行して実行します。 - Add Task フォームのコード支援を使用して、タスクのパラメーター値にアクセスします。パイプラインパラメーターと、その特定のパイプラインパラメーターを参照するための正しい構文を表示するには、それぞれのテキストフィールドに移動します。

-

特定の条件が満たされた後にのみ

Taskを実行します。whenフィールドを使用してタスクの実行を設定し、when式への一連の参照を一覧表示します。

1.4.4. IBM Z および LinuxONE

本リリースでは、IBM Z および LinuxONE は OpenShift Container Platform 4.8 と互換性があります。インストールは z/VM または RHEL KVM で実行できます。インストール手順については、以下のドキュメントを参照してください。

主な機能拡張

以下の新機能は、OpenShift Container Platform 4.8 の IBM Z および LinuxONE でサポートされます。

- RHEL 8.3 以降の KVM は、IBM Z および LinuxONE での OpenShift Container Platform 4.8 のユーザーによってプロビジョニングされるインストールのハイパーバイザーとしてサポートされます。静的 IP アドレスを使用したインストールや、ネットワークが制限された環境でのインストールもサポートされます。

- etcd に保存されるデータの暗号化

- 4k FCP ブロックデバイス

- 3 ノードクラスターのサポート

サポートされる機能

以下の機能が IBM Z および LinuxONE でもサポートされるようになりました。

- マルチパス化

- iSCSI を使用した永続ストレージ

- ローカルボリュームを使用した永続ストレージ (Local Storage Operator)

- hostPath を使用した永続ストレージ

- ファイバーチャネルを使用した永続ストレージ

- Raw Block を使用した永続ストレージ

- OpenShift Container Platform 4.8 の初回インストールを含む OVN-Kubernetes

- SCSI ディスク上の z/VM Emulated FBA デバイス

これらの機能は、4.8 の IBM Z の OpenShift Container Platform についてのみ利用できます。

- IBM Z/LinuxONE で有効にされている HyperPAV (FICON 接続の ECKD ストレージの仮想マシン用)。

制限

IBM Z および LinuxONE の OpenShift Container Platform については、以下の制限に注意してください。

IBM Z 向けの OpenShift Container Platform には、以下のテクノロジープレビューが含まれていません。

- Precision Time Protocol (PTP) ハードウェア

以下の OpenShift Container Platform 機能はサポートされていません。

- マシンヘルスチェックによる障害のあるマシンの自動修復

- CodeReady Containers (CRC)

- オーバーコミットの制御およびノード上のコンテナーの密度の管理

- CSI ボリュームのクローン作成

- CSI ボリュームスナップショット

- FIPS 暗号

- Helm コマンドラインインターフェイス (CLI) ツール

- Multus CNI プラグイン

- NVMe

- OpenShift Metering

- OpenShift Virtualization

- OpenShift Container Platform のデプロイメント時の Tang モードのディスク暗号化

- ワーカーノードは Red Hat Enterprise Linux CoreOS (RHCOS) を実行する必要があります。

- 永続共有ストレージは、NFS またはその他のサポートされるストレージプロトコルを使用してプロビジョニングする必要があります。

- 共有されていない永続ストレージは、iSCSI、FC、DASD、FCP または EDEV/FBA と共に LSO を使用するなど、ローカルストレージを使用してプロビジョニングする必要があります。

1.4.5. IBM Power Systems

本リリースでは、IBM Power Systems は OpenShift Container Platform 4.8 と互換性があります。インストール手順については、以下のドキュメントを参照してください。

主な機能拡張

以下の新機能は、OpenShift Container Platform 4.8 の IBM Power Systems でサポートされます。

- etcd に保存されるデータの暗号化

- 3 ノードクラスターのサポート

- Multus SR-IOV

サポートされる機能

以下の機能は、IBM Power Systems でもサポートされています。

現時点で、5 つの Operator がサポートされています。

- Cluster-Logging-Operator

- Cluster-NFD-Operator

- Elastic Search-Operator

- Local Storage Operator

- SR-IOV ネットワーク Operator

- マルチパス化

- iSCSI を使用した永続ストレージ

- ローカルボリュームを使用した永続ストレージ (Local Storage Operator)

- hostPath を使用した永続ストレージ

- ファイバーチャネルを使用した永続ストレージ

- Raw Block を使用した永続ストレージ

- OpenShift Container Platform 4.8 の初回インストールを含む OVN-Kubernetes

- 4K ディスクのサポート

- NVMe

制限

IBM Power Systems の OpenShift Container Platform については、以下の制限に注意してください。

IBM Power Systems 向けの OpenShift Container Platform には、以下のテクノロジープレビュー機能が含まれていません。

- Precision Time Protocol (PTP) ハードウェア

以下の OpenShift Container Platform 機能はサポートされていません。

- マシンヘルスチェックによる障害のあるマシンの自動修復

- CodeReady Containers (CRC)

- オーバーコミットの制御およびノード上のコンテナーの密度の管理

- FIPS 暗号

- Helm コマンドラインインターフェイス (CLI) ツール

- OpenShift Metering

- OpenShift Virtualization

- OpenShift Container Platform のデプロイメント時の Tang モードのディスク暗号化

- ワーカーノードは Red Hat Enterprise Linux CoreOS (RHCOS) を実行する必要があります。

- 永続ストレージは、ローカルボリューム、Network File System (NFS)、または Container Storage Interface (CSI) を使用する Filesystem タイプである必要があります。

1.4.6. セキュリティーおよびコンプライアンス

1.4.6.1. OAuth アクセストークンのログアウト要求についての監査ロギング

Default 監査ログポリシーは、OAuth アクセストークンの作成 (ログイン) および削除 (ログアウト) 要求の本体をログに記録するようになりました。以前のバージョンでは、削除要求の本体はログに記録されませんでした。

監査ログポリシーについての詳細は、ノード監査ログポリシーの設定 について参照してください。

1.4.6.2. ヘッドレスサービスのサービス提供証明書のワイルドカードサブジェクト

ヘッドレスサービスのサービス提供証明書を生成すると、*.<service.name>.<service.namespace>.svc 形式のワイルドカードサブジェクトが組み込まれるようになりました。これにより、これらの Pod の証明書を手動で生成しなくても、個別のステートフルセット Pod への TLS で保護される接続を使用できます。

生成された証明書にはヘッドレスサービスのワイルドカードサブジェクトが含まれるため、クライアントが個別の Pod を区別する必要がある場合はサービス CA を使用しないでください。この場合は、以下のようになります。

- 別の CA を使用して個別の TLS 証明書を生成します。

- サービス CA は、個々の Pod に送信される接続についての信頼される CA として許可することはできず、他の Pod がこの権限を借用することはできません。これらの接続は、個別の TLS 証明書の生成に使用されている CA を信頼するように設定される必要があります。

詳細は、サービス証明書の追加 を参照してください。

1.4.6.3. oc-compliance プラグインが利用可能になりました。

コンプライアンス Operator は、OpenShift Container Platform クラスターのチェックおよび修復の多くを自動化します。ただし、クラスターをコンプライアンスに準拠させる完全なプロセスでは、多くの場合、管理者がコンプライアンス Operator API や他のコンポーネントと対話する必要があります。oc-compliance プラグインが利用可能となり、プロセスが簡単になりました。

詳細は、oc-compliance プラグインの使用 を参照してください。

1.4.6.4. Kubernetes コントロールプレーンの TLS セキュリティープロファイル

Kubernetes API サーバーの TLS セキュリティープロファイル設定は、Kubernetes スケジューラーおよび Kubernetes コントローラーマネージャーでも適用されるようになりました。

詳細は、TLS セキュリティープロファイルの設定 を参照してください。

1.4.6.5. サーバーとしての kubelet の TLS セキュリティープロファイル

Kubernetes API サーバーの HTTP サーバーとして機能する場合に、kubelet の TLS セキュリティープロファイルを設定できるようになりました。

詳細は、TLS セキュリティープロファイルの設定 を参照してください。

1.4.6.6. bcrypt パスワードハッシュのサポート

以前のバージョンでは、oauth-proxy コマンドでは、認証に使用される htpasswd ファイルでの SHA-1 ハッシュ化されたパスワードの使用のみが許可されていました。oauth-proxy には、bcrypt パスワードハッシュを使用する htpasswd エントリーのサポートが含まれるようになりました。詳細は、BZ#1874322 を参照してください。

1.4.6.7. インストーラーでプロビジョニングされるクラスターでの管理対象 Secure Boot の有効化

OpenShift Container Platform 4.8 は、プロビジョニングされたコントロールプレーンおよびワーカーノードの UEFI セキュアブートモードを自動的に有効にし、ノードの削除時にオフに戻すことをサポートします。この機能を使用するには、ノードの bootMode 設定を install-config.yaml ファイルで UEFISecureBoot に設定します。Red Hat は、第 10 世代 HPE ハードウェアまたは第 13 世代 Dell ハードウェア (ファームウェアバージョン 2.75.75.75 以上を実行) で、管理対象 Secure Boot を使用したインストーラーでプロビジョニングされるインストールのみをサポートします。詳細は、Configuring managed Secure Boot in the install-config.yaml file を参照してください。

1.4.7. ネットワーク

1.4.7.1. OVN-Kubernetes クラスターネットワークプロバイダーを使用した、インストーラーでプロビジョニングされるベアメタルインフラストラクチャーでのデュアルスタックサポート

インストーラーでプロビジョニングされる ベアメタルインフラストラクチャー 上のクラスターの場合、OVN-Kubernetes クラスターネットワークプロバイダーは、IPv4 アドレスファミリーと IPv6 アドレスファミリーの両方をサポートします。

以前のバージョンの OpenShift Container Platform からアップグレードするインストーラーでプロビジョニングされるベアメタルクラスターの場合、デュアルスタックネットワークをサポートするようにクラスターを変換する必要があります。詳細は、IPv4/IPv6 デュアルスタックネットワークへの変換 を参照してください。

1.4.7.2. ユーザーによってプロビジョニングされるインフラストラクチャーでの OpenShift SDN から OVN-Kubernetes への移行

OpenShift SDN クラスターネットワークプロバイダーの OVN-Kubernetes クラスターネットワークプロバイダーへの移行は、ユーザーによってプロビジョニングされるクラスターでサポートされます。詳細は、OpenShift SDN クラスターネットワークプロバイダーからの移行 について参照してください。

1.4.7.3. OpenShift SDN クラスターネットワークプロバイダーの egress IP 機能によるノード全体での分散

OpenShift SDN の egress IP 機能は、namespace に複数の egress IP アドレスが割り当てられている場合、その指定された namespace のノード全体にほぼ均等にネットワークトラフィックを分散するようになりました。それぞれの IP アドレスは異なるノードに存在する必要があります。詳細は、OpenShift SDN の プロジェクトの egress IP の設定 を参照してください。

1.4.7.4. ネットワークポリシーによるホストネットワーク Ingress コントローラーの選択のサポート

OpenShift SDN または OVN-Kubernetes クラスターネットワークプロバイダーを使用する場合、Ingress コントローラーがクラスターネットワークまたはホストネットワークで実行されるかどうかにかかわらず、ネットワークポリシールールの Ingress コントローラーからトラフィックを選択することができます。ネットワークポリシールールでは、policy-group.network.openshift.io/ingress: "" namespace セレクターラベルが Ingress コントローラーからのトラフィックと一致します。network.openshift.io/policy-group: ingress namespace セレクターラベルは引き続き使用できますが、これはレガシーラベルであり、OpenShift Container Platform の将来のリリースで削除される可能性があります。

OpenShift Container Platform の以前のリリースでは、以下の制限がありました。

-

OpenShift SDN クラスターネットワークプロバイダーを使用するクラスターは、

network.openshift.io/policy-group: ingressラベルをdefaultnamespace に適用することによってのみ、ホストネットワーク上の Ingress コントローラーからトラフィックを選択できます。 - OVN-Kubernetes クラスターネットワークプロバイダーを使用するクラスターは、ホストネットワーク上の Ingress コントローラーからのトラフィックを選択できませんでした。

詳細は、ネットワークポリシーについて を参照してください。

1.4.7.5. ネットワークポリシーによるホストネットワークトラフィックの選択のサポート

OVN-Kubernetes クラスターネットワークプロバイダーまたは OpenShift SDN クラスターネットワークプロバイダーのいずれかを使用する場合は、policy-group.network.openshift.io/host-network: "" namespace セレクターを使用して、ネットワークポリシールールでホストネットワークトラフィックを選択できます。

1.4.7.6. ネットワークポリシー監査ログ

OVN-Kubernetes クラスターネットワークプロバイダーを使用する場合は、namespace でネットワークポリシーの監査ロギングを有効にできます。ログは syslog と互換性のある形式であり、ローカルに保存したり、UDP 接続を介して送信したり、UNIX ドメインソケットに送信したりできます。許可された接続、ドロップされた接続、または許可された接続とドロップされた接続の両方をログに記録するかどうかを指定できます。詳細は、ネットワークポリシーイベントのロギング を参照してください。

1.4.7.7. macvlan 追加ネットワークのネットワークポリシーサポート

NetworkPolicy API を実装する MultiNetworkPolicy API を使用して、macvlan の追加ネットワークに適用するネットワークポリシーを作成できます。詳細は、マルチネットワークポリシーの設定 を参照してください。

1.4.7.8. SR-IOV でサポートされるハードウェア

OpenShift Container Platform 4.8 は、追加の Intel および Mellanox ネットワークインターフェイスコントローラーのサポートを追加します。

- インテル X710、XL710、および E810

- Mellanox ConnectX-5 Ex

詳細は、サポートされるデバイス について参照してください。

1.4.7.9. SR-IOV Network Operator の機能拡張

Operator でデプロイされる Network Resources Injector は、Downward API を使用して Huge Page の要求および制限についての情報を公開するように機能強化されました。Pod 仕様に Huge Page 要求または制限が含まれる場合、情報は /etc/podnetinfo パスで公開されます。

詳細は、Downward API の Huge Page リソースの挿入 について参照してください。

1.4.7.10. ネットワークフローの追跡

OpenShift Container Platform 4.8 では、Pod ネットワーク上のネットワークフローについてのメタデータをネットワークフローコレクターに送信するためのサポートを追加します。以下のプロトコルがサポートされます。

- NetFlow

- sFlow

- IPFIX

パケットデータはネットワークフローコレクターに送信されません。プロトコル、ソースアドレス、宛先アドレス、ポート番号、バイト数、その他のパケットレベルの情報などのパケットレベルのメタデータはネットワークフローコネクターに送信されます。

詳細は、ネットワークフローの追跡 について参照してください。

1.4.7.11. CoreDNS-mDNS が IP アドレスにノード名を解決する際に使用されなくなる

OpenShift Container Platform 4.8 以降のリリースには、クラスターメンバーシップ情報を使用して A/AAAA レコードを生成する機能が含まれます。これにより、ノード名が IP アドレスに解決されます。ノードが API に登録されると、クラスターは CoreDNS-mDNS を使用せずにこれらのノード情報を分散させることができます。これにより、マルチキャスト DNS に関連付けられたネットワークトラフィックがなくなります。

1.4.7.12. OpenShift Container Platform 4.8 へのアップグレードをサポートする HTTP ヘッダー名の変換

OpenShift Container Platform は HAProxy 2.2 に対して更新されます。これはデフォルトで、Host: xyz.com を host: xyz.com に変更するなど HTTP ヘッダー名を小文字に変換します。HTTP ヘッダー名の大文字/小文字を認識するレガシーアプリケーションの場合、Ingress コントローラーの spec.httpHeaders.headerNameCaseAdjustments API フィールドを使用して、レガシーアプリケーションが修正されるまでこれらのレガシーアプリケーションに対応します。HAProxy 2.2 が利用可能な場合、OpenShift Container Platform をアップグレードする前に、spec.httpHeaders.headerNameCaseAdjustments を使用して必要な設定を追加するようにしてください。

詳細は、HTTP ヘッダーケースの変換 について参照してください。

1.4.7.13. OpenShift Container Platform 4.8 でより厳格な HTTP ヘッダー検証

OpenShift Container Platform が HAProxy 2.2 に更新され、HTTP ヘッダーにいくつかの追加の制限が適用されます。これらの制限は、アプリケーションの潜在的なセキュリティーの弱点を軽減することを目的としています。特に、HTTP 要求行でホスト名を指定する HTTP クライアント要求は、要求行と要求の HTTP host ヘッダーの両方でポート番号が指定または省略されていない場合は、拒否される可能性があります。たとえば、ヘッダー host: hostname を持つ要求 GET http://hostname:80/path は、HTTP 400 "Bad request" レスポンスで拒否されます。これは、host ヘッダーではポート番号が指定されていないのに、要求ラインではポート番号が指定されているためです。この制限の目的は、リクエストスマグリング攻撃を軽減することです。

このより厳格な HTTP ヘッダー検証は、HTTP/2 が有効化されたときに OpenShift Container Platform の以前のバージョンでも有効化されていました。これは、OpenShift Container Platform 4.7 クラスターで HTTP/2 を有効にし、HTTP 400 エラーを確認することで、問題のあるクライアント要求をテストできることを意味します。HTTP/2 を有効にする方法は、HTTP/2 Ingress 接続の有効化 を参照してください。

1.4.7.14. GCP での Ingress コントローラーのグローバルアクセスの設定

OpenShift Container Platform 4.8 では、内部ロードバランサーを使用して GCP で作成された Ingress コントローラーのグローバルアクセスオプションのサポートが追加されました。グローバルアクセスオプションが有効にされる場合、ロードバランサーと同じ VPC ネットワークおよびコンピュートリージョン内の任意のリージョンのクライアントは、クラスターで実行されるワークロードに到達できます。

詳細は、GCP での Ingress コントローラーのグローバルアクセスの設定 について参照してください。

1.4.7.15. Ingress コントローラースレッド数の設定

OpenShift Container Platform 4.8 では、スレッド数を設定し、クラスターが処理できる受信接続の量を増やすサポートを追加しています。

詳細は、Ingress コントローラースレッド数の設定 について参照してください。

1.4.7.16. Ingress コントローラーの PROXY プロトコルの設定

OpenShift Container Platform 4.8 は、とくに HostNetwork または NodePortService エンドポイント公開ストラテジーのタイプについて、クラウド以外のプラットフォームでの Ingress コントローラーの PROXY プロトコルの設定をサポートします。

詳細は、Ingress コントローラーの PROXY プロトコルの設定 について参照してください。

1.4.7.17. コントロールプレーンノード上の NTP サーバー

OpenShift Container Platform 4.8 では、インストーラーでプロビジョニングされるクラスターは、コントロールプレーンノードの Network Time Protocol (NTP) サーバーおよびワーカーノードの NTP クライアントを設定し、デプロイできます。これにより、ルーティング可能なネットワークから切断されている場合でも、ワーカーはコントロールプレーンノードの NTP サーバーから日時を取得できます。デプロイメント後に NTP サーバーおよび NTP クライアントを設定し、デプロイすることもできます。

1.4.7.18. Kuryr のデフォルト API ロードバランサー管理への変更

Kuryr-Kubernetes を使用した Red Hat OpenStack Platform (RHOSP) への OpenShift Container Platform 4.8 デプロイメントでは、default/kubernetes サービスの API ロードバランサーは Cluster Network Operator (CNO) によって管理されなくなり、kuryr-controller 自体により管理されます。これは以下を意味します。

OpenShift Container Platform 4.8 にアップグレードする場合、

default/kubernetesサービスにはダウンタイムがあります。注記Open Virtual Network (OVN) Octavia が利用できないデプロイメントでは、より多くのダウンタイムが予想されます。

-

default/kubernetesロードバランサーを Octavia Amphora ドライバーを使用するために使用する必要がなくなります。その代わりに、OVN Octavia は OpenStack クラウドで利用可能な場合にdefault/kubernetesサービスを実装するために使用されます。

1.4.7.19. インストール後のプロビジョニングネットワークの有効化

ベアメタルクラスター用の支援付きインストーラーおよびインストーラーでプロビジョニングされるインストールは、provisioning ネットワークなしでクラスターをデプロイする機能を提供します。OpenShift Container Platform 4.8 以降では、Cluster Baremetal Operator (CBO) を使用してインストール後に provisioning ネットワークを有効にすることができます。

1.4.7.20. コントロールプレーンで実行されるネットワークコンポーネントの設定

ベアメタルインストールのコントロールプレーンノードで実行する仮想 IP (VIP) アドレスが必要な場合は、コントロールプレーンノードでのみ実行する apiVIP および ingressVIP VIP アドレスを設定する必要があります。デフォルトで、OpenShift Container Platform は、ワーカーマシン設定プールの任意のノードが apiVIP および ingressVIP VIP アドレスをホストできるようにします。多くのベアメタル環境では、コントロールプレーンノードとは別のサブネットにワーカーノードをデプロイするため、コントロールプレーンノードで apiVIP および ingressVIP 仮想 IP アドレスを排他的に実行するように設定すると、ワーカーノードを別のサブネットにデプロイすることに関連して発生する問題を防ぐことができます。詳細は、コントロールプレーンで実行されるネットワークコンポーネントの設定 を参照してください。

1.4.7.21. apiVIP および ingressVIP トラフィック用の外部ロードバランサーの設定

OpenShift Container Platform 4.8 では、Red Hat OpenStack Platform (RHOSP) およびベアメタルインストーラーでプロビジョニングされたクラスターの apiVIP および ingressVIP トラフィックを処理するように外部ロードバランサーを設定できます。外部の負荷分散サービスとコントロールプレーンノードは同じ L2 ネットワークで実行する必要があります。また、VLAN を使用して負荷分散サービスとコントロールプレーンノード間のトラフィックをルーティングする際に同じ VLAN で実行する必要があります。

apiVIP および ingressVIP トラフィックを処理するためのロードバランサーの設定は、VMware インストーラーでプロビジョニングされたクラスターではサポートされていません。

1.4.7.22. デュアルスタックネットワークに対する OVN-Kubernetes IPsec のサポート

OpenShift Container Platform 4.8 では、デュアルスタックネットワークを使用するように設定されているクラスターに対して、OVN-Kubernetes IPsec サポートを追加しています。

1.4.7.23. OVN-Kubernetes の egress ルーター CNI

egress ルーター CNI プラグインは一般に利用可能です。Cluster Network Operator は、EgressRouter API オブジェクトをサポートするように強化されています。OVN-Kubernetes を使用するクラスターに egress ルーターを追加するプロセスは簡素化されます。egress ルーターオブジェクトの作成時に、Operator はネットワーク接続定義とデプロイメントを自動的に追加します。デプロイメントの Pod は egress ルーターとして機能します。

詳細は、egress ルーター Pod の使用についての考慮事項 を参照してください。

1.4.7.24. OpenShift Container Platform での IP フェイルオーバーのサポート

IP フェイルオーバーがベアメタルの OpenShift Container Platform クラスターでサポートされるようになりました。IP フェイルオーバーは keepalived を使用して、一連のホストでの外部からアクセスできる VIP アドレスのセットをホストします。各 VIP は 1 度に 1 つのホストによって提供されます。keepalived は Virtual Router Redundancy Protocol (VRRP) を使用して、(一連のホストの) どのホストがどの VIP を提供するかを判別します。ホストが利用不可の場合や keepalived が監視しているサービスが応答しない場合は、VIP は一連のホストの別のホストに切り換えられます。したがって、VIP はホストが利用可能である限り常に提供されます。

詳細は、IP フェイルオーバーの設定 を参照してください。

1.4.7.25. DNS Pod 配置の制御

OpenShift Container Platform 4.8 では、カスタムノードセレクターと容認を使用して、CoreDNS を特定のノードで実行または実行しないようにデーモンセットを設定できます。

以前のバージョンの OpenShift Container Platform は、node taints に関係なく、DNS Pod がクラスター内のすべてのノードで実行されるように、すべてのテイントを容認する CoreDNS デーモンセットを設定していました。OpenShift Container Platform 4.8 では、デフォルトですべてのテイントを容認するように設定しなくなりました。代わりに、デフォルトでは node-role.kubernetes.io/master のテイントのみ容認します。DNS Pod を他のテイントのあるノードで実行するには、カスタム容認を設定する必要があります。

詳細は、DNS Pod 配置の制御 を参照してください。

1.4.7.26. RHOSP で実行されるクラスターによるプロバイダーネットワークのサポート

Red Hat OpenStack Platform (RHOSP) の OpenShift Container Platform クラスターは、すべてのデプロイメントタイプのプロバイダーネットワークをサポートするようになりました。

1.4.7.27. HAProxy の設定可能な tune.maxrewrite および tune.bufsize

クラスター管理者は、headerBufferMaxRewriteByte および headerBufferBytes Ingress コントローラーの調整パラメーターを設定して、Ingress コントローラーごとに tune.maxrewrite および tune.bufsize HAProxy メモリーオプションを設定できるようになりました。

詳細は、Ingress コントローラー設定パラメーター を参照してください。

1.4.8. ストレージ

1.4.8.1. GCP PD CSI Driver Operator を使用した永続ストレージは一般に利用可能

Google Cloud Platform (GCP) 永続ディスク (PD) Container Storage Interface (CSI) ドライバーは、GCP 環境に自動的にデプロイされ、管理されるため、ドライバーを手動でインストールしなくてもこれらのボリュームを動的にプロビジョニングできます。この機能は以前は OpenShift Container Platform 4.7 のテクノロジープレビュー機能として導入されましたが、OpenShift Container Platform 4.8 では一般に利用可能となり、デフォルトで有効にされます。

詳細は、GCP PD CSI Driver Operator を参照してください。

1.4.8.2. Azure Disk CSI Driver Operator を使用した永続ストレージ (テクノロジープレビュー)

Azure Disk CSI Driver Operator は、永続ボリューム要求 (PVC) の作成に使用できるデフォルトのストレージクラスを提供します。このドライバーを管理する Azure Disk CSI Driver Operator はテクノロジープレビュー機能としてご利用いただけます。

詳細は、Azure Disk CSI Driver Operator を参照してください。

1.4.8.3. vSphere CSI Driver Operator を使用した永続ストレージ (テクノロジープレビュー)

vSphere CSI Driver Operator は、永続ボリューム要求 (PVC) の作成に使用できるデフォルトのストレージクラスを提供します。このドライバーを管理する vSphere CSI Driver Operator はテクノロジープレビュー機能としてご利用いただけます。

詳細は、vSphere CSI Driver Operator を参照してください。

1.4.8.4. CSI の自動移行 (テクノロジープレビュー)

OpenShift Container Platform 4.8 以降では、以下の in-tree ボリュームプラグインの同等の CSI ドライバーへの自動移行が、テクノロジープレビュー機能として利用可能になりました。

- Amazon Web Services (AWS) Elastic Block Storage (EBS)

- OpenStack Cinder

詳細は、CSI の自動移行 を参照してください。

1.4.8.5. AWS EFS (テクノロジープレビュー) 機能の外部プロビジョナーが削除される

Amazon Web Services (AWS) Elastic File System (EFS) テクノロジープレビュー機能が削除され、サポートされなくなりました。

1.4.8.6. RHOSP で実行されるクラスターの Cinder ボリュームアベイラビリティーゾーンの制御の強化

インストール時に Cinder ボリュームのアベイラビリティーゾーンを選択できるようになりました。イメージレジストリー の特定アベイラビリティーゾーンで Cinder ボリュームを使用することもできます。

1.4.9. レジストリー

1.4.10. Operator ライフサイクル

1.4.10.1. 管理者用のエラーレポートの強化

Operator Lifecycle Manager (OLM) を使用して Operator をインストールするクラスター管理者の場合、現在の API または低レベルの API に関連したエラー状態が生じる可能性があります。以前のバージョンでは、OLM が Operator をインストールしたり、更新したりする要求を満たせないことに関する洞察を得ることがほとんどできませんでした。これらのエラーは、オブジェクトプロパティーの誤字や RBAC が欠落しているなどの簡単な問題から、メタデータの解析により項目をカタログから読み込むことができないなどのより複雑な問題にまで及びます。

管理者は各種の低レベル API 間の対話プロセスへの理解や、これらの問題のデバッグのために OLM Pod ログにアクセスする必要がないため、OpenShift Container Platform 4.8 では OLM に以下の拡張機能を導入し、管理者により包括的なエラーレポートおよびメッセージが提供されるようになりました。

1.4.10.2. インストール計画の再試行

InstallPlan オブジェクトで定義されるインストール計画では、API サーバーの可用性や他のライターとの競合などによる一時的なエラーが発生する可能性があります。以前のバージョンでは、これらのエラーにより、手動クリーンアップが必要な部分的に適用されるインストール計画が終了しました。今回の機能拡張により、カタログ Operator は、インストール計画の実行中に最大 1 分間エラーを再試行するようになりました。新規の .status.message フィールドには、再試行の実行時に人間が判読できる通知が提供されます。

1.4.10.3. 無効な Operator グループの指定

以前のバージョンでは、Operator グループまたは複数の Operator グループのない namespace でサブスクリプションを作成すると、phase=Installing のままになるインストール計画と共に Operator のインストールが停止されました。今回の機能拡張により、インストール計画が phase=Failed にすぐに移行し、管理者が無効な Operator グループを修正してからサブスクリプションを再度削除し、作成できるようになりました。

1.4.10.4. Operator 候補が見つからない場合の特定レポート

ResolutionFailed イベントは、namespace での依存関係の解決に失敗すると作成されますが、namespace に参照されるカタログソースに存在しないパッケージまたはチャネルを参照するサブスクリプションが含まれる場合に、より具体的なテキストを提供するようになりました。以前のバージョンでは、このメッセージは汎用的なメッセージでした。

no candidate operators found matching the spec of subscription '<name>'

no candidate operators found matching the spec of subscription '<name>'今回の機能拡張により、メッセージがより具体的になりました。

Operator does not exist

no operators found in package <name> in the catalog referenced by subscription <name>

no operators found in package <name> in the catalog referenced by subscription <name>Catalog does not exist

no operators found from catalog <name> in namespace openshift-marketplace referenced by subscription <name>

no operators found from catalog <name> in namespace openshift-marketplace referenced by subscription <name>Channel does not exist

no operators found in channel <name> of package <name> in the catalog referenced by subscription <name>

no operators found in channel <name> of package <name> in the catalog referenced by subscription <name>Cluster service version (CSV) does not exist

no operators found with name <name>.<version> in channel <name> of package <name> in the catalog referenced by subscription <name>

no operators found with name <name>.<version> in channel <name> of package <name> in the catalog referenced by subscription <name>1.4.11. Operator の開発

1.4.11.1. Operator プロジェクトのパッケージマニフェスト形式からバンドル形式への移行

Operator のレガシーパッケージマニフェスト形式のサポートは、OpenShift Container Platform 4.8 以降で削除されます。バンドル形式は、OpenShift Container Platform 4.6 以降の Operator Lifecycle Manager (OLM) の推奨 Operator パッケージ形式です。非推奨のパッケージマニフェスト形式で最初に作成された Operator プロジェクトがある場合、Operator SDK pkgman-to-bundle コマンドを使用してプロジェクトをバンドル形式に移行できます。

詳細は、パッケージマニフェストプロジェクトのバンドル形式への移行 を参照してください。

1.4.11.2. バンドルされた Operator を含むカタログの公開

Operator をインストールおよび管理するには、Operator Lifecycle Manager (OLM) では、Operator バンドルがクラスターのカタログで参照されるインデックスイメージに一覧表示される必要があります。Operator の作成者は、Operator SDK を使用して Operator のバンドルおよびそれらのすべての依存関係を含むインデックスを作成できます。これは、リモートクラスターでのテストおよびコンテナーレジストリーへの公開に役立ちます。

詳細は、バンドルされた Operator を含むカタログの公開 を参照してください。

1.4.11.3. Operator のアップグレードテストの強化

Operator SDK の run bundle-upgrade サブコマンドは、より新しいバージョンのバンドルイメージを指定することにより、インストールされた Operator をトリガーしてそのバージョンにアップグレードするプロセスを自動化します。以前のバージョンでは、サブコマンドは、run bundle サブコマンドを使用して最初にインストールした Operator のみをアップグレードすることができました。今回の機能拡張により、run bundle-upgrade は、従来の Operator Lifecycle Manager (OLM) ワークフローで最初にインストールされた Operator でも機能するようになりました。

詳細は、Operator Lifecycle Manager での Operator アップグレードのテスト を参照してください。

1.4.11.4. OpenShift Container Platform バージョンとの Operator 互換性の制御

API が OpenShift Container Platform バージョンから削除されると、削除された API を依然として使用しているクラスターバージョンで実行されている Operator が適切に機能しなくなります。Operator の作成者は、Operator ユーザーの中断を回避するために、API の非推奨および削除に対応するように Operator プロジェクトを更新する計画を立てる必要があります。

詳細は、OpenShift Container Platform バージョンとの Operator 互換性の制御 を参照してください。

ビルド

1.4.11.5. ストラテジーごとのビルド数の新しい Telemetry メトリクス

Telemetry には新規の openshift:build_by_strategy:sum 測定メトリクスが含まれており、このメトリクスは、ストラテジータイプごとのビルド数を Telemeter クライアントに送信します。このメトリクスにより、サイト信頼性エンジニア (SRE) と製品マネージャーは、OpenShift Container Platform クラスターで実行されるビルドの種類を可視化できます。

1.4.11.6. カスタム PKI 認証局のマウント

以前のバージョンでは、ビルドは、企業アーティファクトリーポジトリーへのアクセスに必要なことがあるクラスターの PKI 認証局を使用できませんでした。現在では、mountTrustedCA を true に設定することにより、クラスターのカスタム PKI 認証局をマウントするように BuildConfig オブジェクトを設定できるようになりました。

1.4.12. イメージ

1.4.13. マシン API

1.4.13.1. クラスター Autoscaler を使用した、vSphere で実行されるマシンの 0 への/からのスケーリング

vSphere でマシンを実行している場合、MachineAutoscaler リソース定義で minReplicas 値を 0 に設定できるようになりました。この値を 0 に設定すると、クラスター Autoscaler は、マシンが使用中であるかどうかに応じてマシンセットを 0 に/からスケーリングします。詳細は、MachineAutoscaler リソース定義 を参照してください。

1.4.13.2. kubelet-ca.crt の自動ローテーションでは、ノードのドレイン (解放) または再起動は必要ありません。

/etc/kubernetes/kubelet-ca.crt 認証局 (CA) の自動ローテーションでは、ノードのドレイン (解放) またはクラスターの再起動において Machine Config Operator (MCO) は不要になりました。

この変更の一環として、以下の変更では MCO によるノードのドレイン (解放) が不要になりました。

-

マシン設定の

spec.config.ignition.passwd.users.sshAuthorizedKeysパラメーターの SSH キーへの変更 -

openshift-confignamespace でのグローバルプルシークレットまたはプルシークレットへの変更

MCO がこれらの変更のいずれかを検出すると、その変更を適用し、ノードの遮断を解除します。

詳細は、Machine Config Operator について を参照してください。

1.4.13.3. マシンセットポリシーの強化

以前のバージョンでは、マシンセットを作成するには、ホストのパフォーマンスを向上させるために、ユーザーが CPU ピニング設定、NUMA ピニング設定、および CPU トポロジーの変更を手動で設定する必要がありました。今回の機能拡張により、ユーザーは MachineSet リソースのポリシーを選択し、設定を自動的に設定できるようになりました。詳細は、BZ#1941334 を参照してください。

1.4.13.4. マシンセットの hugepage の拡張機能

hugepages プロパティーを MachineSet リソースに提供できるようになりました。今回の機能拡張により、oVirt のカスタムプロパティーで MachineSet リソースのノードが作成され、それらのノードにハイパーバイザーの hugepages を使用するように指示されるようになりました。詳細は、BZ#1948963 を参照してください。

1.4.13.5. Machine Config Operator ImageContentSourcePolicy オブジェクトの機能拡張

OpenShift Container Platform 4.8 は、一部の ImageContentSourcePolicy オブジェクト変更のワークロードの中断を防ぎます。この機能により、ユーザーおよびチームはワークロードの中断なしにミラーおよびレジストリーを追加することができます。その結果、/etc/containers/registries.conf ファイルの以下の変更に対して、ワークロードの中断は発生しなくなりました。

-

mirror-by-digest-only=trueを含むレジストリーの追加 -

mirror-by-digest-only=trueを含むレジストリーへのミラーの追加 -

unqualified-search-registries一覧への項目の追加

/etc/containers/registries.conf ファイルのその他の変更については、Machine Config Operator はデフォルトでノードをドレイン (解放) して変更を適用します。詳細は、BZ#1943315 を参照してください。

1.4.14. ノード

1.4.14.1. Descheduler operator.openshift.io/v1 API グループが利用可能になる

operator.openshift.io/v1 API グループが Descheduler で利用可能になりました。Descheduler の operator.openshift.io/v1beta1 API グループのサポートは今後のリリースで削除される可能性があります。

1.4.14.2. Descheduler の Prometheus メトリクス

Descheduler をインストールした openshift-kube-descheduler-operator namespace に openshift.io/cluster-monitoring=true ラベルを追加することで、 Descheduler の Prometheus メトリクスを有効にできるようになりました。

以下の Descheduler メトリクスを利用できます。

-

descheduler_build_info: Descheduler に関するビルド情報を提供します。 -

descheduler_pods_evicted:ストラテジー、namespace、および結果の組み合わせごとにエビクトされた Pod 数を提供します。このメトリクスを表示するには、少なくとも 1 つのエビクトされた Pod が必要です。

1.4.14.3. Downward API を使用した Huge Page のサポート

今回のリリースにより、Pod 仕様の Huge Page の要求および制限を設定する際に、Downward API を使用してコンテナー内から Pod の割り当てを表示できるようになりました。この拡張機能は DownwardAPIHugePages 機能ゲートに依存します。OpenShift Container Platform 4.8 は機能ゲートを有効にします。

詳細は、Downward API を使用した Huge Page リソースの消費 について参照してください。

1.4.14.4. Node Feature Discovery Operator の新規ラベル

Node Feature Discovery (NFD) Operator は、OpenShift Container Platform クラスターの各ノードで利用可能なハードウェア機能を検出します。次に、これはノードラベルでノードオブジェクトを変更します。これにより、NFD Operator は特定のノードの機能を公開できます。OpenShift Container Platform 4.8 は、NFD Operator の 3 つの追加のラベルをサポートします。

-

pstate intel-pstate: Intelpstateドライバーが有効であり、使用中の場合、pstate intel-pstateラベルには Intelpstateドライバーのステータスが反映されます。ステータスはactiveまたはpassiveのいずれかです。 -

pstate scaling_governor: Intelpstateドライバーのステータスがactiveの場合、pstate scaling_governorラベルには scaling governor アルゴリズムが反映されます。アルゴリズムはpowersaveまたはperformanceのいずれかです。 -

cstate status:intel_idleドライバーに C-states または idle 状態がある場合、cstate statusラベルはtrueになります。そうでない場合はfalseになります。

1.4.14.5. Poison Pill Operator による正常ではないノードの修復

Poison Pill Operator を使って、正常ではないノードが自動的に再起動するようにできます。これにより、ステートフルアプリケーションと ReadWriteOnce(RWO) ボリュームのダウンタイムを最小限に抑え、一時的な障害が発生した場合に計算能力を回復します。

Poison Pill Operator は、あらゆる種類のクラスターとハードウェアで動作します。

詳しくは、Remediating nodes with the Poison Pill Operator をご覧ください。

1.4.14.6. kubelet-ca.crt の自動ローテーションに再起動は不要になる

/etc/kubernetes/kubelet-ca.crt 認証局 (CA) の自動ローテーションでは、ノードのドレイン (解放) またはクラスターの再起動において Machine Config Operator (MCO) は不要になりました。

この変更の一環として、以下の変更では MCO によるノードのドレイン (解放) が不要になりました。

-

マシン設定の

spec.config.ignition.passwd.users.sshAuthorizedKeysパラメーターの SSH キーへの変更 -

openshift-confignamespace でのグローバルプルシークレットまたはプルシークレットへの変更

MCO がこれらの変更のいずれかを検出すると、その変更を適用し、ノードの遮断を解除します。

詳細は、Machine Config Operator について を参照してください。

1.4.14.7. Vertical Pod autoscaling が一般に利用可能になる

OpenShift Container Platform vertical pod autoscaler (VPA) が一般に利用可能になりました。VPA は、Pod 内のコンテナーの履歴および現在の CPU とメモリーリソースを自動的に確認し、確認された使用についての値に基づいてリソース制限および要求を更新できます。

以下のように VerticalPodAutoscalerController オブジェクトを変更して、1 つのレプリカのみを必要とする Pod で VPA を使用することもできます。以前のバージョンでは、VPA は 2 つ以上のレプリカを必要とする Pod でのみ機能しました。

詳細は、vertical pod autoscaler を使用した Pod リソースレベルの自動調整 について参照してください。

1.4.14.8. Vertical pod autoscaling の最小値が設定可能

デフォルトで、ワークロードオブジェクトは、VPA が Pod を自動的に更新できるようにするためにレプリカを 2 つ以上指定する必要があります。そのため、2 つ未満を指定するワークロードオブジェクトの場合 VPA は機能しません。このクラスター全体の最小値は、VerticalPodAutoscalerController オブジェクトを変更して minReplicas パラメーターを追加することで変更できます。

詳細は、vertical pod autoscaler を使用した Pod リソースレベルの自動調整 について参照してください。

1.4.14.9. ノードの CPU およびメモリーリソースの自動割り当て

OpenShift Container Platform は、ノードの起動時に system-reserved 設定の最適なサイジング値を自動的に判別できます。以前のバージョンでは、system-reserved 設定の CPU およびメモリーの割り当ては、手動で決定し、設定する必要のある固定された制限値でした。

リソースの自動割り当てが有効な場合、各ノードのスクリプトにより、ノードにインストールされている CPU およびメモリーの容量に基づいて、予約されたそれぞれのリソースに最適な値が計算されます。

詳細は、ノードのリソースの自動割り当て について参照してください。

1.4.14.10. イメージをプルするための特定のリポジトリーの追加

イメージのプルおよびプッシュ用に許可され、ブロックされるレジストリーの一覧を作成する際に、レジストリー内に個別のリポジトリーを指定できるようになりました。以前のバージョンでは、レジストリーのみを指定できました。

詳細は、特定レジストリーの追加 および 特定レジストリーのブロック を参照してください。

1.4.14.11. Cron ジョブは一般に利用可能

cron ジョブカスタムリソースが一般に利用できるようになりました。この変更の一環として、cron ジョブのパフォーマンスを大幅に向上させる新しいコントローラーが実装されました。cron ジョブの詳細は、ジョブと Cron ジョブについて を参照してください。

1.4.15. Red Hat OpenShift Logging

OpenShift Container Platform 4.7 では、Cluster Logging は Red Hat OpenShift Logging になりました。詳細は、Red Hat OpenShift Logging のリリースノート を参照してください。

1.4.16. モニタリング

1.4.16.1. アラートルールの変更

OpenShift Container Platform 4.8 には、以下のアラートルールの変更が含まれます。

例1.1 アラートルールの変更

-

ThanosSidecarPrometheusDownアラートの重大度が、重大 から 警告 に更新されました。 -

ThanosSidecarUnhealthyアラートの重大度が、重大 から 警告 に更新されました。 -

ThanosQueryHttpRequestQueryErrorRateHighアラートの重大度が、重大 から 警告 に更新されました。 -

ThanosQueryHttpRequestQueryRangeErrorRateHighアラートの重大度が、重大 から 警告 に更新されました。 -

ThanosQueryInstantLatencyHighの重大なアラートが削除されました。このアラートは、Thanos Querier のインスタントクエリーのレイテンシーが高い場合に発生しました。 -

ThanosQueryRangeLatencyHighの重大なアラートが削除されました。このアラートは、Thanos Querier のレンジクエリーのレイテンシーが高い場合に発生しました。 -

すべての Thanos Querier アラートについては、

forの期間が増え、1 時間となりました。 -

すべての Thanos サイドカーアラートについては、

forの期間が増え、1 時間となりました。

Red Hat は、メトリクス、記録ルールまたはアラートルールの後方互換性を保証しません。

1.4.16.2. 今後のリリースで削除される API が使用される際のアラートおよび情報

OpenShift Container Platform 4.8 では、次のリリースで削除される API が使用中の場合に実行される 2 つの新規アラートが導入されました。

-

APIRemovedInNextReleaseInUse: OpenShift Container Platform の次のリリースで削除される API の場合 -

APIRemovedInNextEUSReleaseInUse: 次の OpenShift Container Platform Extended Update Support (EUS) リリースで削除される API の場合

新しい APIRequestCount API を使用して、非推奨の API を使用する内容を追跡することができます。これにより、次のリリースにアップグレードするためにアクションが必要であるかどうかについて計画できます。

1.4.16.3. モニターリングスタックコンポーネントおよび依存関係のバージョン更新

OpenShift Container Platform 4.8 には、以下のモニターリングスタックコンポーネントおよび依存関係に対するバージョンの更新が含まれます。

- Prometheus Operator: バージョン 0.48.1

- Prometheus: バージョン 2.26.1

-

node-exporterエージェント: バージョン 1.1.2 - Thanos: バージョン 0.20.2

- Grafana: バージョン 7.5.5

1.4.16.4. kube-state-metrics はバージョン 2.0.0 にアップグレード

kube-state-metrics はバージョン 2.0.0 にアップグレードされました。以下のメトリクスは kube-state-metrics バージョン 1.9 で非推奨となり、バージョン 2.0.0 で事実上削除されます。

Pod の非汎用リソースメトリクス:

- kube_pod_container_resource_requests_cpu_cores

- kube_pod_container_resource_limits_cpu_cores

- kube_pod_container_resource_requests_memory_bytes

- kube_pod_container_resource_limits_memory_bytes

ノードの非汎用リソースメトリクス:

- kube_node_status_capacity_pods

- kube_node_status_capacity_cpu_cores

- kube_node_status_capacity_memory_bytes

- kube_node_status_allocatable_pods

- kube_node_status_allocatable_cpu_cores

- kube_node_status_allocatable_memory_bytes

1.4.16.5. Grafana および Alertmanager UI リンクの削除

サードパーティーの Alertmanager UI へのリンクは、OpenShift Container Platform Web コンソールの Monitoring → Alerting ページから削除されます。また、サードパーティーの Grafana UI へのリンクは、Monitoring → Dashboards ページから削除されます。openshift-monitoring プロジェクトの Networking → Routes ページに移動して、Administrator パースペクティブの Web コンソールで Grafana UI および Alertmanager UI へのルートに引き続きアクセスできます。

1.4.16.6. Web コンソールでのダッシュボードの機能拡張のモニターリング

OpenShift Container Platform Web コンソールの Monitoring → Dashboards ページで新しい拡張機能を利用できます。

- マウスで領域を選択して単一のグラフを拡大すると、他のすべてのグラフが更新され、同じ時間範囲が反映されるようになりました。

- ダッシュボードパネルはグループに分類され、展開したり折りたたんだりできるようになりました。

- 単一値パネルは、値に応じて色を変更できるようになりました。

- ダッシュボードラベルが Dashboard のドロップダウンリストに表示されるようになりました。

- Time Range ドロップダウンリストで Custom time range を選択して、ダッシュボードのカスタム時間範囲を指定できるようになりました。

- 該当する場合は、ダッシュボードフィルタードロップダウンメニューで All オプションを選択して、そのフィルター内のすべてのオプションのデータを表示できるようになりました。

1.4.17. メータリング

メータリング Operator は OpenShift Container Platform 4.6 で非推奨となり、OpenShift Container Platform の次のリリースで削除される予定です。

1.4.18. スケーリング

1.4.18.1. 単一ノードクラスターでの実行

単一ノードクラスターでテストを実行すると、SR-IOV および SCTP テストを含む特定のテストのタイムアウトが長くなり、コントロールプレーンとワーカーノードを必要とするテストは省略されます。ノードの再起動が必要な再設定では、OpenShift コントロールプレーンを含む環境全体が再起動されるため、完了するまでに時間がかかります。コントロールプレーンおよびワーカーノードを必要とするすべての PTP テストは省略されます。テストは起動時にノード数をチェックし、それに応じてテスト動作を調整するため、追加の設定は必要ありません。

PTP テストが検出モードで実行できます。このテストは、クラスター外に設定された PTP マスターを検索します。以下のパラメーターが必要です。

-

ROLE_WORKER_CNF=master: コントロールプレーン (master) は、ノードが所属する唯一のマシンプールであるため必須です。 -

XT_U32TEST_HAS_NON_CNF_WORKERS=false: モジュールが読み込まれるノードのみが存在するため、xt_u32の障害テストを省略するように指示する必要があります。 -

SCTPTEST_HAS_NON_CNF_WORKERS=false: モジュールが読み込まれるノードのみがあるため、SCTP の障害テストを省略するように指示する必要があります。

1.4.18.2. Performance Addon Operator を使用した NIC の削減

Performance Addon Operator を使用すると、パフォーマンスプロファイルを設定して、各ネットワークデバイスの Network Interface Card (NIC) キュー数を調整できます。デバイスネットワークキューを使用すると、パケットを複数の異なる物理キューに分散でき、各キューはパケット処理用に個別のスレッドを取得します。

Data Plane Development Kit (DPDK) ベースのワークロードの場合、NIC キューを予約済みまたはハウスキーピング CPU の数に制限して、必要な低レイテンシーを実現するために NIC キューを減らすことが重要です。

詳細は、Performance Addon Operator を使用した NIC キューの削減 について参照してください。

1.4.18.3. クラスターの最大数

OpenShift Container Platform 4.8 の クラスターの最大値 に関するガイダンスが更新されました。

本リリースでは、OVN-Kubernetes テストに対してパフォーマンスの大規模なスケーリングテストは実行されません。

ご使用の環境のクラスター制限を見積もるには、OpenShift Container Platform Limit Calculator を使用できます。

1.4.18.4. パフォーマンスプロファイルの作成

Performance Profile Creator (PPC) ツールを使用してパフォーマンスプロファイルを作成できるようになりました。このツールは、クラスターから must-gather データおよびいくつかのユーザー指定のプロファイル引数を消費し、この情報を使用して、ハードウェアおよびトポロジーに適したパフォーマンスプロファイルを生成します。

詳細は、コントロールプレーンプロファイルの作成 について参照してください。

1.4.18.5. Node Feature Discovery Operator

Node Feature Discovery (NFD) Operator が利用可能になりました。これを使用して、ハードウェア機能およびシステム設定を検出する Node Feature Discovery という Kubernetes アドオンをオーケストレーションしてノードレベルの情報を公開します。

1.4.18.6. ドライバーツールキット (テクノロジープレビュー)

Driver Toolkit をドライバーコンテナーのベースイメージとして使用し、Kubernetes で特別なソフトウェアおよびハードウェアデバイスを有効化できるようになりました。これは現在、テクノロジープレビュー機能です。

1.4.19. バックアップおよび復元

1.4.19.1. etcd スナップショットの強化

新規の拡張機能は、バックアップ後および復元前の etcd スナップショットのステータスを検証します。以前のバージョンでは、バックアッププロセスは、取得されたスナップショットが完了したことを検証しませんでした。また、復元プロセスは、復元されるスナップショットが有効であり、破損していないことを検証しませんでした。バックアップまたは復元中にディスクが破損している場合は、エラーが管理者に明確に報告されるようになりました。詳細は、BZ#1965024 を参照してください。

1.4.20. Insights Operator

1.4.20.1. ネットワークが制限された環境に関する Insights Advisor の推奨事項

OpenShift Container Platform 4.8 では、ネットワークが制限された環境で操作しているユーザーは、Insights Operator アーカイブを Insights Advisor に収集し、アップロードして潜在的な問題を診断できます。さらに、ユーザーはアップロード前に、Insights Operator アーカイブに含まれる機密データを難読化できます。

詳細は、限定的なネットワーク環境でのリモートヘルスレポートの使用 を参照してください。

1.4.20.2. Insights Advisor の改善

OpenShift Container Platform Web コンソールの Insights Advisor は、0 の問題が検出されたと正しく報告するようになりました。以前のバージョンでは、Insights Advisor は情報を提供していませんでした。

1.4.20.3. Insights Operator のデータ収集機能の拡張

OpenShift Container Platform 4.8 では、Insights Operator は以下の追加情報を収集します。

- 既知のセキュリティー問題とバージョンの問題を見つけるための識別できないクラスターワークロード情報。

-

MachineHealthCheckおよびMachineAutoscalerの定義。 -

virt_platformおよびvsphere_node_hw_version_totalのメトリクス。 - SAP Smart Data Integration のインストールを支援するための正常でない SAP Pod に関する情報。

-

SAP クラスターを識別するための

datahubs.installers.datahub.sap.comリソース。 -

ネットワークを強化するための失敗した

PodNetworkConnectivityChecksの概要。 -

cluster-versionOperator の問題をデバッグするためのopenshift-cluster-operatornamespace からのcluster-versionPod およびイベントに関する情報。

この追加情報により、Red Hat は Insights Advisor の改善された修復手順を提供できます。

1.4.20.4. 正常でない SAP Pod の Insights Operator の拡張機能

Insights Operator は正常でない SAP Pod についてのデータを収集できるようになりました。SDI インストールが失敗すると、どの初期化 Pod が失敗したかを確認して問題を検出できます。Insights Operator は、SAP/SDI namespace で失敗した Pod の情報を収集できるようになりました。詳細は、BZ#1930393 を参照してください。

1.4.20.5. SAP Pod データを収集するための Insights Operator の拡張機能

Insights Operator は、SAP クラスターから Datahubs リソースを収集できるようになりました。このデータにより、SAP クラスターは Insights Operator アーカイブの非 SAP クラスターと区別できます。これは、SAP クラスターのみから収集されたすべてのデータが欠落しており、クラスターに SDI インストールがあるかどうかを判別することができない場合でも同様です。詳細は、BZ#1940432 を参照してください。

1.4.21. 認証および認可

1.4.21.1. 認証情報の AWS Security Token Service (STS) を使用した OpenShift Container Platform の実行が一般に利用可能になる

Cloud Credential Operator (CCO) ユーティリティー (ccoctl) を、Amazon Web Services Security Token Service (AWS STS) を使用するように設定できるようになりました。CCO が STS を使用するように設定されている場合、短期的で権限に制限のあるセキュリティー認証情報を提供する IAM ロールをコンポーネントに割り当てます。

この機能は以前は OpenShift Container Platform 4.7 のテクノロジープレビュー機能として導入されましたが、OpenShift Container Platform 4.8 では一般に利用可能となりました。

詳細は、STS での手動モードの使用 を参照してください。

1.4.22. OpenShift サンドボックスコンテナー

1.4.22.1. OpenShift Container Platform での OpenShift サンドボックスコンテナーのサポート (テクノロジープレビュー)

OpenShift サンドボックスコンテナーの新機能、バグ修正、既知の問題、および非同期エラータ更新を確認するには、OpenShift sandboxed containers 1.0 release notes を参照してください。

1.5. 主な技術上の変更点

OpenShift Container Platform 4.8 では、主に以下のような技術的な変更点が加えられています。

Kuryr サービスサブネットの作成の変更

Kuryr を使用するように設定された Open Virtual Network を使用した Red Hat OpenStack Platform (RHOSP) への OpenShift Container Platform の新規インストールでは、networking.serviceCIDR で要求されたサイズの 2 倍の services サブネットが作成されなくなりました。作成されたサブネットは、要求されたサイズと同じになります。詳細は、BZ#1955548 を参照してください。

SHA-256 接頭辞のない OAuth トークンが使用不可になる

OpenShift Container Platform 4.6 よりも前のバージョンでは、OAuth のアクセスおよび認証トークンはオブジェクト名のシークレット情報を使用していました。

OpenShift Container Platform 4.6 以降、OAuth アクセストークンおよび認証トークンオブジェクト名は、SHA-256 接頭辞を持つ機密ではないオブジェクト名として保存されます。OpenShift Container Platform 4.8 では、SHA-256 接頭辞が含まれない OAuth トークンは使用されず、作成できなくなります。

Federal Risk and Authorization Management Program (FedRAMP) モードレート制御

OpenShift Container Platform 4.8 では、rhcos4-moderate プロファイルが完了しています。ocp4-moderate プロファイルは今後のリリースで完了されます。

Ingress コントローラーを HAProxy 2.2.13 にアップグレード

OpenShift Container Platform Ingress コントローラーが HAProxy version 2.2.13 にアップグレードされます。

CoreDNS がバージョン 1.8.1 に更新される

OpenShift Container Platform 4.8 では、CoreDNS はバージョン 1.8.1 を使用します。これには、バグ修正、名前が変更されたメトリクス、およびデュアルスタック IPv6 対応が含まれます。

etcd が zap ロガーを使用する

OpenShift Container Platform 4.8 では、etcd は capnslog ではなく、デフォルトのロガーとして zap を使用するようになりました。zap は、マシンで消費可能な JSON ログメッセージを提供する構造化ロガーです。jq を使用して、これらのログメッセージを簡単に解析することができます。

capnslog 形式の使用が予想されるログコンシューマーがある場合、zap ロガー形式に合わせてこれを調整する必要がある場合があります。

サンプル capnslog 形式 (OpenShift Container Platform 4.7)

2021-06-03 22:40:16.984470 W | etcdserver: read-only range request "key:\"/kubernetes.io/operator.openshift.io/clustercsidrivers/\" range_end:\"/kubernetes.io/operator.openshift.io/clustercsidrivers0\" count_only:true " with result "range_response_count:0 size:8" took too long (100.498102ms) to execute

2021-06-03 22:40:16.984470 W | etcdserver: read-only range request "key:\"/kubernetes.io/operator.openshift.io/clustercsidrivers/\" range_end:\"/kubernetes.io/operator.openshift.io/clustercsidrivers0\" count_only:true " with result "range_response_count:0 size:8" took too long (100.498102ms) to executeサンプル zap 形式 (OpenShift Container Platform 4.8)

{"level":"warn","ts":"2021-06-14T13:13:23.243Z","caller":"etcdserver/util.go:163","msg":"apply request took too long","took":"163.262994ms","expected-duration":"100ms","prefix":"read-only range ","request":"key:\"/kubernetes.io/namespaces/default\" serializable:true keys_only:true ","response":"range_response_count:1 size:53"}

{"level":"warn","ts":"2021-06-14T13:13:23.243Z","caller":"etcdserver/util.go:163","msg":"apply request took too long","took":"163.262994ms","expected-duration":"100ms","prefix":"read-only range ","request":"key:\"/kubernetes.io/namespaces/default\" serializable:true keys_only:true ","response":"range_response_count:1 size:53"}LSO 用にマージされた複数のデーモンセット

OpenShift Container Platform 4.8 では、複数のデーモンセットがローカルストレージオブジェクト (LSO) に対してマージされます。ローカルボリュームカスタムリソースを作成すると、daemonset.apps/diskmaker-manager のみが作成されます。

バインドされたサービスアカウントトークンボリュームが有効化されている

以前のバージョンでは、サービスアカウントトークンは Pod にマウントされたシークレットでした。OpenShift Container Platform 4.8 以降では、代わりに Projected ボリュームを使用します。この変更により、サービスアカウントトークンには基礎となる対応するシークレットが含まれなくなりました。

バインドされたサービスアカウントトークンは、オーディエンスバインドとタイムバインドです。詳細は、バインドされたサービスアカウントトークンの使用 を参照してください。

さらに、kubelet はトークンが期間の 80 パーセントに達するとトークンを自動的に更新し、client-go はトークンの変更を監視して自動的にリロードします。これら 2 つの動作の組み合わせは、バインドされたトークンのほとんどの使用法が、期限切れにならないレガシートークンの使用法と変わらないことを意味します。client-go 以外での非標準的な使用は、問題を引き起こす可能性があります。

Operator SDK v1.8.0

OpenShift Container Platform 4.8 は Operator SDK v1.8.0 をサポートします。この最新バージョンにインストールまたは更新するには、Operator SDK CLI のインストール を参照してください。

Operator SDK v1.8.0 は Kubernetes 1.20 をサポートします。

以前に Operator SDK v1.3.0 で作成または保守された Operator プロジェクトがある場合は、新しい Operator SDK バージョンのプロジェクトのアップグレード を参照してプロジェクトをアップグレードし、Operator SDK v1.8.0 との互換性が維持されていることを確認してください。

1.6. 非推奨および削除された機能

以前のリリースで利用可能であった一部の機能が非推奨になるか、または削除されました。

非推奨の機能は依然として OpenShift Container Platform に含まれており、引き続きサポートされますが、本製品の今後のリリースで削除されるため、新規デプロイメントでの使用は推奨されません。OpenShift Container Platform 4.8 で非推奨となり、削除された主な機能の最新の一覧については、以下の表を参照してください。非推奨になったか、または削除された機能の詳細情報は、表の後に記載されています。

以下の表では、機能は以下のステータスでマークされています。

- GA: 一般公開機能

- TP: テクノロジープレビュー

- DEP: 非推奨機能

- REM: 削除された機能

| 機能 | OCP 4.6 | OCP 4.7 | OCP 4.8 |

|---|---|---|---|

|

| REM | REM | REM |

| Package Manifest Format (Operator Framework) | DEP | DEP | REM |

|

| DEP | DEP | REM |

|

| GA | DEP | REM |

| v1beta1 CRD | DEP | DEP | DEP |

| Docker Registry v1 API | DEP | DEP | DEP |

| メータリング Operator | DEP | DEP | DEP |

| スケジューラーポリシー | GA | DEP | DEP |

|

Cluster Samples Operator の | GA | DEP | DEP |

|

Cluster Samples Operator の | GA | DEP | DEP |

|

OpenShift Container Platform リソースの | GA | DEP | DEP |

|

Red Hat Enterprise Linux CoreOS (RHCOS) での | DEP | DEP | DEP |

| クラスターローダー | GA | GA | DEP |

| 独自の RHEL 7 コンピュートマシンの持ち込み | DEP | DEP | DEP |

| AWS EFS の外部プロビジョナー | REM | REM | REM |

|

ビルドの | GA | GA | DEP |

| Jenkins Operator | TP | TP | DEP |

| Prometheus に基づく HPA カスタムメトリクスアダプター | TP | TP | REM |

|

Red Hat Virtualization (RHV) の | GA | DEP | DEP |

| Microsoft Azure クラスターのクレデンシャルの作成 | GA | GA |

1.6.1. 非推奨の機能

1.6.1.1. Descheduler operator.openshift.io/v1beta1 API グループが非推奨になる

Descheduler の operator.openshift.io/v1beta1 API グループは非推奨となり、今後のリリースで削除される可能性があります。代わりに operator.openshift.io/v1 API グループを使用します。

1.6.1.2. Red Hat Enterprise Linux CoreOS (RHCOS) での dhclient の使用が非推奨になる

OpenShift Container Platform 4.6 以降、Red Hat Enterprise Linux CoreOS (RHCOS) は initramfs で NetworkManager を使用し、初回の起動時にネットワークを設定するようになりました。この変更の一環として、DHCP の dhclient バイナリーの使用が非推奨になりました。その代わりに、NetworkManager の内部 DHCP クライアントをネットワーク設定に使用します。dhclient バイナリーは、今後のリリースで Red Hat Enterprise Linux CoreOS (RHCOS) から削除されます。詳細は、BZ#1908462 を参照してください。

1.6.1.3. クラスターローダーが非推奨になる

クラスターローダーが非推奨になり、今後のリリースで削除されます。

1.6.1.4. ビルドの lastTriggeredImageID パラメーターは非推奨となりました。

このリリースでは、BuildConfig 仕様で設定できる BuildTriggerPolicy タイプの 1 つである ImageChangeTrigger オブジェクトの lastTriggeredImageID が非推奨となりました。

OpenShift Container Platform の次のリリースでは、lastTriggeredImageID のサポートが削除され、これを無視します。次に、イメージ変更トリガーは、BuildConfig 仕様の lastTriggeredImageID フィールドへの変更に基づいたビルドは開始しません。その代わりに、ビルドをトリガーするイメージ ID は BuildConfig オブジェクトのステータスに記録されます。これは、ほとんどのユーザーが変更することはできません。

したがって、buildConfig.spec.triggers[i].imageChange.lastTriggeredImageID を検査するスクリプトとジョブを適切に更新します。(BUILD-213)

1.6.1.5. Jenkins Operator (テクノロジープレビュー) が非推奨となりました。

このリリースでは、テクノロジープレビュー機能であった Jenkins Operator が非推奨となりました。OpenShift Container Platform の今後のバージョンでは、OpenShift Container Platform Web コンソールインターフェイスの OperatorHub から Jenkins Operator を削除します。その後、Jenkins Operator のアップグレードは利用できなくなり、Operator はサポートされなくなります。

お客様は、Samples Operator によって提供されるテンプレートを使用して引き続き OpenShift Container Platform に Jenkins をデプロイすることができます。

1.6.1.6. Red Hat Virtualization (RHV) の instance_type_id インストール設定パラメーター

instance_type_id インストール設定パラメーターは非推奨になり、今後のリリースで削除される予定です。

1.6.2. 削除された機能

1.6.2.1. Microsoft Azure のクレデンシャルの作成のサポートが削除されました

OpenShift Container Platform 4.8.34 以降、Microsoft Azure クラスターのミントモードで Cloud Credential Operator (CCO) を使用するためのサポートが OpenShift Container Platform 4.8 から削除されました。この変更は、2022 年 6 月 30 日に Microsoft が Azure AD Graph API を廃止する予定であるためであり、z-stream 更新でサポートされているすべてのバージョンの OpenShift Container Platform にバックポートされます。

ミントモードを使用する以前にインストールされた Azure クラスターの場合、CCO は既存のシークレットを更新しようとします。シークレットに以前に作成されたアプリ登録サービスプリンシパルのクレデンシャルが含まれている場合、そのシークレットは kube-system/azure-credentials のシークレットの内容で更新されます。この動作は、パススルーモードに似ています。

クレデンシャルモードがデフォルト値の "" に設定されているクラスターの場合、更新された CCO は、ミントモードでの動作からパススルーモードでの動作に自動的に変更されます。クラスターでクレデンシャルモードが明示的にミントモード ("Mint") に設定されている場合は、値を "" または "Passthrough" に変更する必要があります。

ミントモードで必要な Contributor のロールに加えて、変更されたアプリ登録サービスプリンシパルには、パススルーモードで使用される User Access Administrator のロールが必要になりました。

Azure AD Graph API は引き続き利用可能ですが、OpenShift Container Platform のアップグレードバージョンの CCO は、以前に作成されたアプリ登録サービスプリンシパルをクリーンアップしようとします。Azure AD Graph API を廃止する前にクラスターをアップグレードすると、リソースを手動でクリーンアップする必要がなくなる場合があります。

Azure AD Graph API が廃止された後、クラスターがミントモードをサポートしなくなったバージョンの OpenShift Container Platform にアップグレードされた場合、CCO は関連する credentialsrequest に OrphanedCloudResource 条件を設定しますが、エラーを致命的なものとして扱いません。この条件には、unable to clean up App Registration / Service Principal: <app_registration_name> と類似したメッセージが含まれます。Azure AD Graph API が廃止された後のクリーンアップでは、Azure CLI ツールまたは Azure Web コンソールを使用して手動で介入し、残りのアプリ登録サービスプリンシパルを削除する必要があります。

リソースを手動でクリーンアップするには、影響を受けるリソースを見つけて削除する必要があります。

Azure CLI ツールを使用して、次のコマンドを実行し、

OrphanedCloudResource条件メッセージから<app_registration_name>を使用するアプリ登録サービスプリンシパルをフィルター処理します。az ad app list --filter "displayname eq '<app_registration_name>'" --query '[].objectId'

$ az ad app list --filter "displayname eq '<app_registration_name>'" --query '[].objectId'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

[ "038c2538-7c40-49f5-abe5-f59c59c29244" ]

[ "038c2538-7c40-49f5-abe5-f59c59c29244" ]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、アプリ登録サービスプリンシパルを削除します。

az ad app delete --id 038c2538-7c40-49f5-abe5-f59c59c29244

$ az ad app delete --id 038c2538-7c40-49f5-abe5-f59c59c29244Copy to Clipboard Copied! Toggle word wrap Toggle overflow

リソースを手動でクリーンアップした後、CCO はリソースがクリーンアップされたことを確認できないため、OrphanedCloudResource 状態が持続します。

AWS EFS (テクノロジープレビュー) 機能の外部プロビジョナーが削除される

Amazon Web Services (AWS) Elastic File System (EFS) テクノロジープレビュー機能が削除され、サポートされなくなりました。

1.6.2.2. サンプルイメージストリームから削除されたイメージ

以下のイメージは、OpenShift Container Platform で提供されるサンプルイメージストリームに含まれなくなりました。

1.6.2.3. Operator のパッケージマニフェスト形式へのサポートの削除

Operator のレガシーパッケージマニフェスト形式のサポートは、OpenShift Container Platform 4.8 以降で削除されます。このサポートの削除には、レガシー形式で構築されたカスタムカタログと、OperatorSDK を使用してレガシー形式で最初に作成された Operator プロジェクトが含まれます。バンドル形式は、OpenShift Container Platform 4.6 以降の Operator Lifecycle Manager (OLM) の推奨 Operator パッケージ形式です。

バンドル形式の使用についての詳細は、カスタムカタログの管理 および パッケージマニフェストプロジェクトのバンドル形式への移行 を参照してください。

さらに、形式に関連する以下のコマンドが OpenShift CLI (oc) および Operator SDK CLI から削除されました。

-

oc adm catalog build -

operator-sdk generate packagemanifest -

operator-sdk run packagemanifest

1.6.2.4. Prometheus に基づく HPA カスタムメトリクスアダプターのサポート

本リリースでは、テクノロジープレビューであった Prometheus アダプターが削除されます。

1.6.2.5. セキュアなトークンストレージアノテーション認識が削除される

authentication および openshift-apiserver Operator は、クラスターの監査ポリシーを選択する際に oauth-apiserver.openshift.io/secure-token-storage アノテーションを無視するようになりました。監査ポリシーは、デフォルトで secure- を使用するようになりました。詳細は、BZ#1879182 を参照してください。

1.7. バグ修正

assisted-installer

-

以前のバージョンでは、

assisted-serviceコンテナーはpostgresが起動し、接続を受け入れる準備ができるのを待ちませんでした。assisted-serviceコンテナーはデータベース接続を確立しようとして失敗し、そしてassisted-serviceコンテナーが失敗して再起動していました。この問題は、assisted-serviceコンテナーが、最大 10 秒間データベースに接続しようとすることで修正されました。postgresが起動して 10 秒以内に接続を受け入れる準備ができると、assisted-serviceコンテナーはエラー状態に進むことなく接続します。assisted-serviceコンテナーが 10 秒以内にpostgresに接続できない場合、エラー状態になり、再起動し、再度試みます。(BZ#1941859)

ベアメタルハードウェアのプロビジョニング

-

以前のバージョンでは、Ironic はデフォルトで HTTPS を使用し、正しい証明書バンドルを利用できなかったため、インストール用のイメージのダウンロードに失敗していました。この問題は、イメージのダウンロードを

Insecureに設定して、証明書なしで転送を要求することで修正されています。(BZ#1953795) - 以前のバージョンでは、デュアルスタックネットワークを使用する場合、ワーカーノードのホスト名は、デプロイメントの前に Ironic が検査するホスト名と一致しないことがありました。そのため、ノードを手動で承認する必要がありました。これは修正されています。(BZ#1955114)

-

以前のバージョンでは、UEFI モードでは、RHCOS イメージのダウンロード後に

ironic-python-agentが UEFI ブートローダーエントリーを作成していました。RHEL 8.4 に基づく RHCOS イメージを使用する場合、このエントリーを使用してイメージを起動できない可能性があります。イメージの起動時に Ironic によりインストールされたエントリーが使用された場合、起動に失敗し、BIOS エラー画面が出力される可能性があります。これは、固定のブートエントリーを使用する代わりに、イメージにある CSV ファイルに基づいてブートエントリーを設定するironic-python-agentにより修正されています。イメージはエラーなしで正常に起動します。(BZ#1972213) -

以前のバージョンでは、ノードは、起動時に誤った IP バージョンを選択することがありました (IPv4 ではなく IPv6 を選択したり、またはその逆の場合もあり)。ノードは IP アドレスを受信しなかったために起動できませんでした。これは、IP オプションを downloader (

ip=dhcporip=dhcp6) に渡す Cluster Bare Metal Operator によって修正され、これにより、起動時に正しく設定され、ノードは予想どおりに起動します。(BZ#1946079) - 以前のバージョンでは、Ironic のイメージキャッシュメカニズムが無効化され、virtualmedial iso をホストする HTTP サーバーへの直接接続を有効化し、ローカルストレージの問題を阻止していました。標準に準拠しない HTTP クライアントおよび redfish 実装により、BMC 接続でで障害が発生しました。これは、virtualmedia iso がキャッシュされ、Ironic conductor ノードから提供されるデフォルトの Ironic の動作に戻すことで修正されています。標準に準拠しない HTTP クライアントおよび redfish 実装によって生じる問題が修正されました。(BZ#1962905)

-

以前のバージョンでは、マシンインスタンスの

stateアノテーションは設定されていませんでした。その結果、STATE 列は空でした。今回の更新により、マシンインスタンスのstateアノテーションが設定され、STATE 列の情報が自動的に入力されるようになりました。(BZ#1857008) - 新しい ipmitool パッケージはデフォルトで暗号化スイート 17 を使用するため、暗号化スイート 17 をサポートしない古いハードウェアはデプロイメント中に失敗します。暗号化スイート 17 がハードウェアでサポートされない場合は、ipmitool を使用する古いハードウェアで正常にデプロイメントされるように、Ironic は暗号化スイート 3 を使用するようになりました。(BZ#1897415)

-

以前のバージョンでは、イメージキャッシュの設定前に導入が実行されたため、永続的な導入に失敗し、再試行されることはありませんでした。これにより、コントロールプレーンのベアメタルホストが

adoption failedを報告しました。この更新により、外部でプロビジョニングされるホストの導入は、導入の失敗後にコントロールプレーンホストが正しく導入されるまで自動的に再試行されます。(BZ#1905577) - 以前のバージョンでは、カスタムリソース (CR) には、ベースボード管理コントローラー (BMC) の詳細が必要でした。ただし、アシスト付きインストーラーの場合は、この情報が提供されませんでした。この更新により、Operator がノードを作成していないときに、CR が BMC の詳細をバイパスできるようになります。(BZ#1913112)

- イメージをノードにプロビジョニングする場合、qemu-image は 1G の RAM に制限されていたため、qemu-img がクラッシュする可能性がありました。この修正により、制限が 2G に引き上げられ、qemu-img がプロビジョニングを確実に完了するようになりました。(BZ#1917482)

- redfish/v1/SessionService URL には認証が必要なため、Ironic はサイトにアクセスする際に認証エラーを生成します。Ironic がこのエラーメッセージを報告した際、機能上の問題はなかったため、削除されました。(BZ#1924816)

-

一部のドライブでは、

/dev/sda1などのパーティションには読み取り専用ファイルがありませんでした。ただし、/dev/sdaなどのベースデバイスにはこのファイルがあります。そのため、Ironic はパーティションが読み取り専用であることを判断できず、そのドライブでメタデータのクリーニングが失敗する可能性がありました。この更新により、パーティションが読み取り専用として検出され、ベースデバイスの追加チェックが含まれるようになります。その結果、メタデータのクリーニングは読み取り専用パーティションで実行されず、メタデータのクリーニングが失敗しなくなりました。(BZ#1935419) -

プロキシーが設定された状態で Baremetal IPI がデプロイされると、内部の machine-os イメージのダウンロードはプロキシーを介して送信されました。これによりイメージが破損し、ダウンロードできなくなりました。この更新により、内部イメージトラフィックが

no_proxyに修正され、イメージのダウンロードでプロキシーが使用されなくなります。(BZ#1962592) - 以前のバージョンでは、Ironic と RAM ディスク間の大規模なパケット転送によって接続障害が発生した場合、ベアメタルのデプロイメントは失敗していました。今回の更新により、Ironic は、接続エラーを回避するための情報を RAM ディスクにクエリーし、デプロイメントを正常に実行できるようになりました。(BZ#1957976)

ビルド

- 以前のバージョンでは、CVE-2021-3344 が修正された後、ビルドは OpenShift Container Platform ノードにエンタイトルメントキーを自動的にマウントしませんでした。その結果、エンタイトルメント証明書がホストまたはノードに保存されていた場合は、修正により、エンタイトルメントのあるビルドがシームレスに機能しなくなりました。ホストまたはノードに保存されているエンタイトルメント証明書の取り込みの失敗は、4.7.z では BZ#1945692 で修正され、4.6.z では BZ#1946363 で修正されました。ただし、これらの修正では、Red Hat Enterprise Linux CoreOS (RHCOS) ワーカーノードで実行されているビルドに無害な警告メッセージが導入されました。現在のリリースでは、ビルドが RHEL ワーカーノードにのみエンタイトルメントを自動的にマウントできるようにし、RHCOS ワーカーノードでのマウント試行を回避することで、この問題を修正しています。これで、RHCOS ノードでビルドを実行するときに、エンタイトルメントのマウントに関する無害な警告メッセージが表示されなくなります。(BZ#1951084)

Docker Hub からイメージをプルする一部のユーザーには、以下のエラーが発生する可能性があります。

container image registry lookup failed...toomanyrequests: You have reached your pull rate limit

container image registry lookup failed...toomanyrequests: You have reached your pull rate limitCopy to Clipboard Copied! Toggle word wrap Toggle overflow このエラーは、

oc new-appの呼び出しに使用したdocker.ioログインにdocker.ioの有料サポートが十分にないために発生します。結果として得られるアプリケーションは、イメージプルスロットリングの対象となり、障害が発生する可能性があります。現在のリリースでは、oc new-appヘルプが更新され、イメージレジストリーおよびリポジトリー仕様でデフォルトがどのように機能するかをユーザーに通知します。これによりユーザーは、可能な場合、デフォルト以外のイメージ参照を使用して、同様のエラーを回避できます。(BZ#1928850)-

以前のバージョンでは、ビルドはイメージのプッシュが失敗したかどうかを確認するためのエラーチェックを実行しませんでした。その結果、ビルドは常に

Successfully pushedのメッセージをログに記録します。現在、ビルドはエラーが発生したかどうかをチェックし、イメージのプッシュが成功した後にのみ、Successfully pushedのメッセージをログに記録します。(BZ#1947164) -

以前のバージョンでは、ドキュメントおよび

oc explainヘルプテキストは、BuildConfigオブジェクト内のbuildArgsフィールドが、その基礎となる KubernetesEnvVarタイプのvalueFromフィールドをサポートしていないことを伝えていませんでした。その結果、ユーザーはそれがサポートされていると信じて使用しようとしました。現在のリリースでは、ドキュメントとヘルプテキストが更新されているため、BuildConfigオブジェクトのbuildArgsフィールドがvalueFromフィールドをサポートしていないことがより明確になっています。(BZ#1956826) - ビルドがベースイメージのプルなどのイメージレジストリーと対話する場合、断続的な通信の問題によりビルドが失敗する可能性があります。現在のリリースでは、これらの対話に対する再試行回数が増えています。現在の OpenShift Container Platform ビルドは、イメージレジストリーとの断続的な通信の問題が発生した場合、以前よりも回復力があります。(BZ#1937535)

クラウドコンピュート

-

以前のバージョンでは、

Cluster Image Registry Operatorはuser_domain_nameを不変フィールドと見なし、インストール後に変更しませんでした。これにより、user_domain_nameおよび生成される認証情報への変更を受け入れることが拒否されました。今回の更新により、user_domain_nameが変更可能としてマークされ、イメージレジストリー設定に保存されなくなりました。これにより、user_domain_nameおよびその他すべてのauthパラメーターをインストール後に変更できます。(BZ#1937464) - 以前のバージョンでは、プロキシーの更新により、継続的インテグレーション (CI) の実行中に、API サーバーの再起動を含む完全なクラスター設定の更新が発生していました。その結果、Machine API Operator の一部のクラスターは、予期しない API サーバーの停止が原因でタイムアウトになっていました。この更新により、プロキシーテストが分離され、事後条件が追加されるため、CI の実行中は Machine API Operator のクラスターが再び安定します。(BZ#1913341)

-

以前のバージョンでは、さまざまな vCenter タスクタイプの区別がなかったため、

Insufficient disk space on datastore状態のマシンを削除するには、想定外の時間がかかりました。この更新により、マシンコントローラーの削除手順で vCenter タスクタイプがチェックされたため、マシンコントローラーの削除がブロックされなくなりました。その結果、マシンコントローラーはすぐに削除されます。(BZ#1918101) - 以前のバージョンでは、インスタンスタイプがない場合でも、ゼロアノテーションからのスケーリングが再びキューに入れられていました。その結果、MachineSet コントローラーログに一定の再キューおよびエラースペースメッセージがありました。この更新では、インスタンスタイプが自動的に解決されない場合、ユーザーはアノテーションを手動で設定することができます。その結果、ユーザーが手動でアノテーションを提供した場合、不明なインスタンスタイプのゼロからのスケーリングが機能します。(BZ#1918910)

-

以前のバージョンでは、HTTP 応答は Machine API 終了ハンドラーによって適切に閉じられていませんでした。その結果、goroutine が

net.httpの読み取りおよび書き込みループでリークされ、メモリー使用量が高くなりました。今回の更新で、HTTP 応答が常に正常に閉じられるようになりました。その結果、メモリー使用量が安定するようになりました。(BZ#1934021) - 以前のバージョンでは、MachineSet コントローラー内で作成された複数のクライアントセットにより起動時間が遅くなり、一部の大規模なクラスターで Pod が readiness チェックに失敗していました。その結果、MachineSet コントローラーは無限ループでスタックします。この更新により、MachineSet コントローラーが修正され、単一のクライアントが使用されるようになります。その結果、MachineSet コントローラーは想定どおりに動作します。(BZ#1934216)

- 以前のバージョンでは、最初の起動時に Machine Config Daemon によってアップグレードが実行されたときに、インスタンスの起動に時間がかかりました。その結果、ワーカーノードが再起動ループでスタックし、ワーカーノードが適切に起動しなかったため、マシンヘルスチェック (MCH) はワーカーノードを削除しました。この更新により、MHC は正しく開始されていないノードを削除しなくなりました。代わりに、MHC は、明示的に要求された場合にのみノードを削除します。(BZ#1939054)

- 以前のバージョンでは、不明な理由で証明書署名要求 (CSR) の承認が遅れていました。その結果、インストール中にクラスターに表示される新しいマシンはすぐには承認されず、クラスターのインストールに時間がかかりました。インストールの初期段階で API サーバーがたまに使用できなくなることを減らすために、この更新により、キャッシュの再同期期間が 10 時間から 10 分に変更されます。その結果、コントロールプレーンマシンがより迅速に承認されるようになり、クラスターのインストールが長引くことはなくなりました。(BZ#1940972)

- 以前のバージョンでは、デフォルトの Google Cloud Platform (GCP) イメージは古く、新しい Ignition バージョンをサポートしない OpenShift Container Platform 4.6 リリースからのバージョンを参照していました。その結果、デフォルトの GCP イメージを使用するクラスター内の新しいマシンは、OpenShift Container Platform 4.7 以降を起動できませんでした。この更新により、GCP イメージがリリースバージョンと一致するように更新されます。その結果、新しいマシンはデフォルトの GCP イメージで起動できるようになりました。(BZ#1954597)

-

以前のバージョンでは、仮想マシン (VM) の ProvisioningState 値が厳密にチェックされていたため、存在チェック中に仮想マシンが失敗することがありました。この更新により、チェックがより寛容になり、削除されたマシンのみが存在チェック中に

Failedフェーズに入ります。(BZ#1957349) -

以前のバージョンでは、AWS クラスターで

oc delete machineを使用してコントロールプレーンマシンを削除した場合、そのマシンはロードバランサーから削除されていませんでした。その結果、ロードバランサーは、削除されたコントロールプレーンマシンへの要求を引き続き処理しました。この修正により、コントロールプレーンマシンを削除すると、ロードバランサーはマシンへの要求を処理しなくなります。(BZ#1880757) - 以前のバージョンでは、到達不能なマシンを削除すると、永続ボリューム用に作成され、ノードに接続されている vSphere 仮想マシンディスク (VMDK) が誤って削除されていました。その結果、VMDK 上のデータは回復できませんでした。この修正により、vSphere クラウドプロバイダーは、kubelet に到達できない場合に、これらのディスクをチェックしてノードからデタッチします。その結果、VMDK を失うことなく、到達不能なマシンを削除できます。(BZ#1883993)

- 以前のバージョンでは、生成された AWS インスタンスタイプのリストが古くなっていたため、レプリカがゼロの Cluster Autoscaler とマシンセットを使用すると、一部の新しい Amazon Web Services (AWS) インスタンスタイプをゼロからスケーリングできませんでした。AWS インスタンスタイプの一覧が更新され、新しいインスタンスタイプが含まれるようになりました。この修正により、レプリカがゼロからスケーリングするために、より多くのインスタンスタイプを Cluster Autoscaler Operator で使用できるようになります。(BZ#1896321)

- 以前のバージョンでは、Pod の Disruption Budget では、アップストリームのエビクション API 機能がないため、到達不能なノードで Pod をドレインしませんでした。その結果、到達不能ノード上のマシンは、削除された後に取り除かれるまでに膨大な時間がかかる可能性があります。現在は、到達不能ノード上のマシンを削除するときの猶予期間のタイムアウトが 1 秒に変更されました。この修正により、Machine API は、到達不能なノードを正常にドレインおよび削除できます。(BZ#1905709)

Cloud Credential Operator

-

以前のバージョンでは、Cloud Credential Operator は、ベアメタルプラットフォームで

unsupported platform type: BareMetal警告を繰り返していました。この更新により、ベアメタルプラットフォームは不明のプラットフォームとして扱われなくなりました。その結果、誤解を招くロギングメッセージが削減されます。(BZ#1864116) -

以前のバージョンでは、Cloud Credential Operator の

credentialsRequestカスタムリソース (CR) に保存されたエラーメッセージが繰り返し発生するため、CPU 使用率が過度に高くなり、Amazon Web Services (AWS) のレート制限などの一部のエラーシナリオにログインしていました。この更新により、クラウドプロバイダーから返されるリクエスト ID が削除され、エラーメッセージはユーザーが見つけやすい状態で保存され、credentialsRequestCR で繰り返し発生するエラーメッセージが削除されます。(BZ#1910396) - 以前のバージョンでは、CCO デプロイメントが正常ではない場合に、Cloud Credential Operator (CCO) および Cluster Version Operator (CVO) の両方が報告しました。これにより、問題がある場合に 2 つのレポートが作成されました。今回のリリースにより、CCO はデプロイメントが正常ではない場合に報告しなくなりました。(BZ#1957424)

Cluster Version Operator

-

以前のバージョンでは、Cluster Version Operator は

cluster_operator_upメトリクスの設定時にAvailableパラメーターおよびDegradedパラメーターの両方を評価していました。これにより、アラートに記載された has not been available がAvailable=Trueに一致しなかった場合でも、ClusterOperatorDownアラートがAvailable=TrueまたはDegraded=Trueの Operator に対して表示されました。今回の修正により、Cluster Version Operator はcluster_operator_upメトリクスの設定時にDegradedパラメーターを無視するようになりました。(BZ#1834551) -

以前のバージョンでは、Prometheus がクラスターにインストールされている場合、重要なプラットフォームトポロジーメトリクスは使用できず、呼び出し元で生成されたインストーラーメトリクスが

""に設定されていると、CI エラーが発生していました。エラーの原因となっているメトリクスが提供される前にインフォーマーが同期されなかった潜在的な競合状態が修正されました。(BZ#1871303) -

以前のバージョンでは、Cluster Version Operator の独自デプロイメントなど、同じキーの複数の容認を持つマニフェストは、最後に読み取られたエントリーのみを受け入れ、前のエントリーを上書きしていました。これにより、

in-cluster tolerationsがマニフェストに記載されている容認から分離されました。この更新により、Cluster Version Operator は、容認が完全に等しい場合に、容認が一致すると見なすようになりました。これにより、Cluster Version Operator はin-cluster resourceのマニフェストに存在するすべての容認を保持することができます。(BZ#1941901) -

以前のバージョンでは、Cluster Version Operator は、

envおよびenvFromを設定しなかったマニフェストのこれらのプロパティーを調整しませんでした。そのため、Cluster Version Operator はコンテナー環境を適切に管理しませんでした。今回の更新により、Cluster Version Operator が改善され、envおよびenvFromがマニフェストで未設定の場合は、これらを消去できるようになりました。これにより、クラスターは、これらのプロパティーに対するcluster-adminの無効な変更から自動的に回復できます。(BZ#1951339) -

以前のバージョンでは、

cluster-version-operatorデプロイメントオブジェクトなど、同じキーの複数の容認を持つマニフェストは、最後に読み取られたエントリーのみを受け入れ、前のエントリーを上書きしていました。これにより、クラスター内の容認がマニフェストに記載されている容認から分離されました。この更新により、Cluster Version Operator は、容認が等しい場合に、容認が一致すると見なすようになりました。これにより、Cluster Version Operator は、クラスター内リソースのマニフェストに存在するすべての容認を保持することができます。(BZ#1941901) -

以前のバージョンでは、Cluster Version Operator は、

ClusterOperatorリソースのパフォーマンスが 10 分間低下すると、ClusterOperatorDegradedアラートを報告していました。このアラートは、リソースがまだ作成中だったため、インストールの途中で発生したことがありました。今回の更新により、期間が 10 分から 30 分に変更され、ClusterOperatorDegradedアラートが途中で発生することなく、十分な時間を提供することで、インストールが進行するようになりました。(BZ#1957991)

コンプライアンス Operator

-

以前のバージョンでは、ユーザーがコンプライアンスチェックを実行し、

NON-COMPLIANTの結果が表示された場合に、ユーザーが対応するために必要な修正手順は示されていませんでした。このリリースでは、ユーザーがルールの検証に必要な手順を確認できるようにinstructionsキーが提供されています。これにより、ユーザーおよび監査担当者は Operator が正しい値をチェックしていることを確認できます。(BZ#1919367)

コンソール kubevirt プラグイン

- 以前は、ユーザーが仮想化テンプレートにブートソースを追加する際に役立つ Web コンソールフォームでは、テンプレートが使用するオペレーティングシステムに関係なく、説明テキストは Fedora に対してのみ情報を提供していました。この更新により、テンプレートのオペレーティングシステムに固有の例を提供する修正が追加され、ユーザーに関連するガイダンスを提供します。(BZ#1908169)

- 以前のバージョンでは、ユーザーの仮想マシンテンプレートの作成をサポートする Web コンソールウィザードの説明が曖昧だったことから、操作がテンプレートに適用されるのか、または仮想マシンに適用されるのか、わかりにくい点がありました。今回の修正により説明が明確になり、ユーザーは十分な情報に基づいて決定を下すことができます。(BZ#1922063)

- 以前のバージョンでは、Web コンソールの曖昧なエラーメッセージにより、テンプレートから作成している仮想マシンにネットワークインターフェイスを追加しようとした一部のユーザーに不必要な混乱が生じていました。今回の更新でエラーメッセージに詳細が追加され、ユーザーはより簡単にエラーをトラブルシューティングできるようになりました。(BZ#1924788)

- 以前のバージョンでは、Web コンソールの Red Hat Enterprise Linux (RHEL) 6 テンプレートから仮想マシンを作成しようとすると、RHEL 6 がサポートされていない場合でも、ポップアップウィンドウにサポートレベルの定義方法に関する情報が表示されていました今回の修正により、このウィンドウのテキストが変更され、RHEL 6 はサポートされていないことを明確にしました。(BZ#1926776)

-

以前のバージョンでは、Web コンソールのドロップダウンリストがボタン要素によって隠されていたため、ユーザーは仮想マシンの作成時に特定のオペレーティングシステムを選択できませんでした。今回の修正にはボタン要素の

z-index値の調整が含まれ、エラーが修正されたため、ユーザーは使用可能なオペレーティングシステムを選択できるようになります。(BZ#1930015) - 以前のバージョンでは、ストレージクラスが定義されていないクラスターで Web コンソールの新しい仮想マシンウィザードを使用した場合、Web コンソールが無限ループに陥ってクラッシュしていました。今回の修正により、ストレージクラスが定義されていないインスタンスのストレージクラスのドロップダウンリストが削除されました。その結果、Web コンソールはクラッシュしません。(BZ#1930064)

- 以前のバージョンでは、お気に入りリストから仮想マシンテンプレートを削除するというボタンの機能について、ボタン要素のテキストは明確に説明していませんでした。この修正でテキストが更新され、ボタンの機能が明確になりました。(BZ#1937941)

-

以前のバージョンでは、

RerunOnFailure実行ストラテジーを持つ仮想マシンの場合は、仮想マシンを停止すると、複数の UI 要素が応答しなくなり、ユーザーがステータス情報を読み取ったり、仮想マシンを再起動したりできなくなりました。今回の更新で、応答しない要素が修正され、ユーザーがそれらの機能を使用できるようになりました。(BZ#1951209) -

以前のバージョンでは、別の

/varパーティションを持つように設定されたクラスターの場合、ファイルシステムにクエリーを実行すると、/varパーティションのサイズを除く、root ディレクトリーにマウントされたディスクのサイズのみが返されていました。今回の修正により、クエリーの実行方法が変更され、ユーザーはクラスター上のファイルシステムの合計サイズを判断できるようになりました。(BZ#1960612)

コンソールストレージプラグイン

- 以前のバージョンでは、正しいストレージクラスが利用できない場合に OpenShift Container Storage Operator はエラーメッセージを表示していました。今回の更新によりエラーメッセージが削除され、正しいストレージクラスが利用可能になるまで Next ボタンが無効になります。(BZ#1924641)

- 以前のバージョンでは、内部接続されたストレージクラスターの作成中にユーザーがブラウザーの戻るボタンをクリックすると、インストールウィザードがプロセスを再開しました。今回の更新でこの問題が修正されています。(BZ#1928008)

- ノードをローカルボリューム検出に追加すると、既存のノードの一覧を表示できるようになりました。これにより、不要なナビゲーションが削減されます。(BZ#1947311)

- 以前のバージョンでは、Create Storage Cluster ウィザードを使用すると、未定義の値を持つ Arbiter ゾーンを有効化できました。この更新の修正では、未定義の値がフィルターに掛けられて除外され、Arbiter ゾーンは定義された値でのみ作成できるようになりました。(BZ#1926798)

- 以前のバージョンでは、製品タイトルの書き方や登録商標記号の使用方法に一貫性がなかったため、Web コンソールでクイックスタートカードが誤って表示されていました。今回の更新では、製品名が正しく表記され、登録商標記号は最初のカードでのみ一貫して表示されます。(BZ#1931760)

DNS

- 以前のバージョンでは、BZ#1936587 はグローバル CoreDNS キャッシュの最大 TTL を 900 秒に設定しました。そのため、アップストリームリゾルバーから受信される NXDOMAIN レコードが 900 秒間キャッシュされました。今回の更新により、最大 30 秒間、ネガティブな DNS 応答レコードが明示的にキャッシュされるようになりました。その結果、NXDOMAINs の解決は 900 秒間キャッシュされなくなりました。(BZ#1943578)

-

BZ#1953097 の修正は、サイズが 1232 バイトの CoreDNS

bufsizeプラグインを有効化しました。一部のプリミティブ DNS リゾルバーは、512 バイトを超える UDP 経由で DNS 応答メッセージを受信できません。その結果、Go の内部 DNS ライブラリーなどの一部の DNS リゾルバーは、DNS Operator から詳細な DNS 応答を受け取ることができません。今回の更新で、すべてのサーバーで CoreDNSbufsizeが 512 バイトに設定されました。その結果、UDP DNS メッセージが適切に受信されるようになりました。(BZ#1966116) -

以前のバージョンでは、クラスターのアップストリームリゾルバーは、UDP 経由で 512 バイトを超える DNS 応答を返しました。そのため、coreDNS は

SERVFAILまたは他のエラーメッセージを返し、クライアントに TCP 上で再試行するように強制しました。今回の更新で、UDP バッファーサイズ 1232 バイトで coreDNS bufisze プラグインが有効になりました。(BZ#1949361)

etcd

- 以前のバージョンでは、etcd Operator でトランスポートリークが発生したため、時間の経過とともにメモリー使用量が増加していました。メモリーリークは修正されました。(BZ#1925586)

-

以前のバージョンでは、

etcdInsufficientMembersアラートが誤って実行されていました。このリリースでは、アラートが更新され、インスタンスラベルに加えて Pod ラベルが含まれるようになり、クォーラムが失われた場合にのみアラートが実行されるようになりました。(BZ#1929944) - 以前のバージョンでは、SO_REUSEADDR ソケットオプションの導入により readiness プローブが正しい readiness (準備状態) を報告しませんでした。そのため、etcd-quorum-guard が失敗した場合でも etcd Pod は準備完了と表示されていました。readiness プローブチェックはこれらのオプションを考慮して更新され、etcd readiness プローブはオペランドの readiness を適切に反映するようになりました。(BZ#1946607)

以前のバージョンでは、

spec.loglevelフィールドが etcd オペランドにlog-levelフラグを設定していなかったため、ユーザーは etcd ログレベルを変更できませんでした。ユーザーは、以下のようにログレベルを設定できるようになりました。-

Debug、Trace、およびTraceAllログレベルは、etcddebugログレベルにマップします。 -

DefaultまたはNormalログレベルは、etcdinfoログレベルにマップします。

詳細は、BZ#1948553 を参照してください。

-

-

以前のバージョンでは、etcd プロセスに従うと、次のプロセスは関連するポートがリリースされるまで開始されませんでした。このプロセスに

SO_REUSEADDRを追加すると、ポートをすぐに再利用できます。詳細は、BZ#1927942 を参照してください。 -

以前のバージョンでは、

network.Status.ServiceNetworkフィールドが設定されていないと、etcd-endpoint の ConfigMap は空のままになっていました。その結果、etcd Operator はスケールアップできませんでした。OpenShift Container Platform 4.8 の新規機能により、etcd Operator はnetwork.Status.ServiceNetworkフィールドが設定されていなくてもスケールアップできるようになりました。(BZ#1902247)

イメージレジストリー

-

以前のバージョンでは、イメージプルーナーはイメージの削除に失敗した際に停止しました。その結果、2 つのイメージプルーナーがイメージの同時削除を試行する場合、それらのいずれかが

not foundエラーを出して失敗していました。今回の更新により、not foundエラーは無視され、イメージプルーナーは同時削除を容認できるようになりました。(BZ#1890828) -

以前のバージョンでは、イメージレジストリー Operator のステータス評価中にルートステータスが含まれていなかったため、ルートが

degraded状態であっても、イメージレジストリー Operator のパフォーマンスは低下しませんでした。今回の修正により、イメージレジストリー Operator は設定済みのすべてのルートを取得し、自身のステータスを評価する際にそれらのステータスを評価するようになりました。今回の更新により、ルートのいずれかがdegradedの場合、イメージレジストリー Operator はエラーメッセージと共に自身をdegradeとして報告します。(BZ#1902076) - 以前のバージョンでは、自動作成された Docker 設定シークレットには、統合された内部レジストリールートの認証情報が含まれませんでした。いずれかのルートを介してレジストリーにアクセスするための認証情報がなかったため、レジストリーへのアクセスを試行した Pod は認証情報がないために失敗しました。今回の修正では、デフォルトの Docker 認証情報シークレットに設定されたすべてのレジストリールートが含まれています。現在は、認証情報に各ルートのエントリーが含まれるようになったため、Pod は任意のルートで統合レジストリーに到達できるようになりました。(BZ#1911470)

-

以前のバージョンでは、イメージレジストリーはクラスター全体の

ImageContentSourcePolicy(ICSP) ルールを無視していました。プルスルー中にイメージのミラーは無視され、非接続クラスターでプルの失敗が生じました。今回の更新により、ICSP ルールがターゲットリポジトリーに存在する場合、レジストリーはミラーからプルするようになりました。その結果、設定されたミラーからイメージをプルしても失敗しなくなりました。(BZ#1918376) -

以前のバージョンでは、イメージレジストリー Operator は設定リソースの

.status.readyReplicasフィールドを更新しなかったため、その値は常に0でした。今回の修正により、イメージレジストリー Operator は準備状態にあるイメージレジストリーのレプリカ数をデプロイメントから設定に書き込むようになりました。現在、このフィールドには、準備ができているイメージレジストリーレプリカの数が表示されます。(BZ#1923811) -

Azure では、

v1ではなく、ストレージアカウントv2を使用するようユーザーに勧めています。特定のセキュリティープロファイルでは、管理者は Azure に対してv1ストレージアカウントの作成を許可しないように強制できます。イメージレジストリーはv1のストレージアカウントに依存するため、クラスターのインストールはこのような環境で失敗します。今回の修正により、クラスターのブートストラップ中に、イメージレジストリー Operator はV2ストレージアカウントの作成および使用を試みるようになりました。v1で実行されているクラスターは、引き続きV1ストレージアカウントを使用します。インストールは成功し、イメージレジストリー Operator がAvailableを報告するようになりました。(BZ#1929654)

ImageStreams

- 以前のバージョンでは、ストリームから複数のイメージをインポートする場合にパフォーマンスが遅くなることがありました。今回のリリースにより、イメージレジストリーへの同時要求の数が 5 から 50 に増え、パフォーマンスが向上します。(BZ#1954715)

Insights Operator

-

以前のバージョンでは、Insights Operator は

openshift-cluster-versionnamespace で Cluster Version Operator (CVO) Pod またはイベントを収集しませんでした。その結果、Insights Operator は、CVO で発生する可能性のある問題に関する情報を表示せず、ユーザーは CVO に関する診断情報を取得できませんでした。Insights Operator が更新され、openshift-cluster-operatornamespace から CVO Pod とイベントが収集されることで、CVO の問題が Insights Operator によって報告されるようになりました。(BZ#1942271)

インストーラー

- 以前は、IPv6 ネットワークが /64 以外になっている場合は、DNSmasq は接頭辞長を指定する必要がありました。その結果、コントロールプレーンのホストは PXE ブートに失敗しました。この更新には、DNSmasq 設定のサブネット接頭辞長が含まれます。その結果、コントロールプレーンホストは、任意の接頭辞長の IPv6 ネットワークで DHCP および PXE ブートを実行します。(BZ#1927068)

-

vSphere にインストールする場合、ブートストラップマシンは

/etc/resolv.confファイルのネームサーバーを正しく更新しないことがありました。その結果、ブートストラップマシンは一時的なコントロールプレーンにアクセスできず、インストールは失敗しました。この修正には、更新する適切な行の検索の信頼性を高める変更が含まれています。ブートストラップマネージャーが一時的なコントロールプレーンにアクセスできるようになったため、正常にインストールすることができます。(BZ#1967355) - 以前のバージョンでは、インストーラーはその URL の生成時にブートストラップ Ignition 設定を配置するリージョンを考慮しませんでした。その結果、ブートストラップマシンは、提供された URL が正しくないため、設定を取得できませんでした。今回の更新により、URL の生成時にユーザーのリージョンを考慮し、正しいパブリックエンドポイントを選択するようになりました。その結果、インストーラーは常に正しいブートストラップ Ignition URL を生成します。(BZ#1934123)

- 以前のバージョンでは、ストレージアカウントを作成する際、Azure の最小 TLS のデフォルトバージョンは 1.0 でした。その結果、ポリシーチェックは失敗しました。今回の更新では、ストレージアカウントの作成時に最小 TLS バージョンを 1.2 に設定するように openshift-installer Azure クライアントを設定します。その結果、ポリシーチェックに合格するようになりました。(BZ#1943157)

- 以前のバージョンでは、Azure で IPI を使用してデプロイされたプライベートクラスターには、ブートストラップノードへの SSH を許可するインバウンド NSG ルールがありました。これにより、Azure のセキュリティーポリシーがトリガーされる可能性があります。今回の更新で、NSG ルールが削除されました。(BZ#1943219)

-

以前のバージョンでは、インストーラーは

ap-northeast-3AWS リージョンを認識しませんでした。今回の更新により、インストーラーは既知のパーティションのパターンに適合する不明なリージョンへのインストールを許可します。これにより、ユーザーはap-northeast-3AWS リージョンでインフラストラクチャーを作成できるようになりました。(BZ#1944268) - 以前のバージョンでは、オンプレミスプラットフォームには内部ロードバランサーを作成する機能がありませんでした。今回の更新により、ユーザーがマニフェストを作成する際にチェックが追加され、このストラテジーが AWS、Azure、GCP などのクラウドプラットフォームでのみ使用されるようになりました。(BZ#1953035)

-

以前のバージョンでは、Google Cloud Platform リソースに名前を付ける際、フィルターによって、

Googleという単語を使用する特定の名前を使用できませんでした。この更新により、クラスター名のインストーラーにチェックが追加され、名前を設定するときにGoogleという単語のいくつかのバリエーションを使用できるようになりました。(BZ#1955336) -

以前のバージョンでは、インストーラーでプロビジョニングされるインフラストラクチャーを使用したベアメタルのインストールでは、インストーラープロセスでプロビジョニングネットワークと通信できる必要がありました。現在、インストーラープロセスは、API サーバーの仮想 IP と通信できるようになりました。この変更により、プロビジョニングネットワークがルーティング可能ではなく、インストーラープロセスが Red Hat OpenStack Platform (RHOSP) または Red Hat Advanced Cluster Management 向けの Hive などのリモートのロケーションから実行されるケースが可能になります。API サーバーの仮想 IP で TCP ポート

6385および5050との通信を許可するように、ファイアウォールルールを調整しなければならない場合があります。(BZ#1932799) 以前のリリースでは、Red Hat OpenStack Platform (RHOSP) へのインストールで、

platform.openstack.machinesSubnetフィールドに存在しないサブネットの ID が提供されると、openshift-installコマンドは SIGSEGV およびバックトレースを生成していました。openshift-installコマンドが修正され、以下のメッセージのようなエラーが生成されるようになりました。FATAL failed to fetch Metadata: failed to load asset "Install Config": platform.openstack.machinesSubnet: Not found: "<network-ID>"

FATAL failed to fetch Metadata: failed to load asset "Install Config": platform.openstack.machinesSubnet: Not found: "<network-ID>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

以前のリリースでは、RHOSP HTTPS 証明書がホスティングデバイスにインポートされない限り、Red Hat OpenStack Platform (RHOSP) へのインストールは失敗していました。

cloud.yamlのcacert値が RHOSP HTTPS 証明書に設定されている場合に、インストールが正常に実行されるようになりました。ホストへの証明書のインポートは不要になりました。(BZ#1786314) -

以前のバージョンでは、

proxy.config.openshift.ioの外部ネットワークエントリーが正しくないため、インストールが失敗する可能性がありました。検証チェックにより、これらの間違いが識別され、修正が可能になりました。(BZ#1873649) - 以前は曖昧または紛らわしかった Terraform コンポーネントの説明が、より明確な情報に置き換えられました。(BZ#1880758)

-

gophercloud/utils に対する以前の変更により、自己署名証明書を使用するカスタム HTTP クライアントが導入されました。この変更により、プロキシー環境変数の設定を含む

DefaultTransportの設定が削除されたため、自己署名証明書とプロキシーの両方を使用するインストールで失敗が発生しました。この更新では、カスタム HTTP クライアントがDefaultTransportの設定を継承するため、自己署名証明書およびプロキシーを使用して OpenShift Container Platform をインストールできるようになりました。(BZ#1925216) -

以前のバージョンでは、インストーラーは検証中にインストール設定の

defaultMachineSet値を考慮していなかったため、インストーラーが失敗していました。この更新により、デフォルト値がインストール設定に適用され、空のフィールドの検証が開始されます。(BZ#1903055) -

以前のバージョンでは、