3.2. S3 API を使用した Ceph Object Gateway へのアクセス

開発者は、Amazon S3 API の使用を開始する前に、Ceph Object Gateway および Secure Token Service (STS) へのアクセスを設定する必要があります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- 実行中の Ceph Object Gateway。

- RESTful クライアント。

3.2.1. S3 認証

Ceph Object Gateway への要求は、認証または認証解除のいずれかになります。Ceph Object Gateway は、認証されていないリクエストが匿名ユーザーによって送信されることを前提としています。Ceph Object Gateway は、固定 ACL をサポートしています。

ほとんどのユースケースでは、クライアントは、Java や Python Boto 用の Amazon SDK の AmazonS3Client などの既存のオープンソースライブラリーを使用します。オープンソースライブラリーでは、アクセスキーおよびシークレットキーを渡すだけで、ライブラリーはユーザーの要求ヘッダーおよび認証署名をビルドします。ただし、リクエストを作成して署名することもできます。

リクエストの認証には、アクセスキーとベース 64 でエンコードされたハッシュベースのメッセージ認証コード (HMAC) が Ceph Object Gateway サーバーに送信される前に要求に追加する必要があります。Ceph Object Gateway は S3 互換の認証を使用します。

例

上記の例では、ACCESS_KEY をアクセスキー ID の値に置き換え、その後にコロン (:) を追加します。HASH_OF_HEADER_AND_SECRET を、正規化されたヘッダー文字列のハッシュとアクセスキー ID に対応するシークレットに置き換えます。

ヘッダー文字列およびシークレットのハッシュの生成

ヘッダー文字列およびシークレットのハッシュを生成するには、以下を実行します。

- ヘッダー文字列の値を取得します。

- 要求ヘッダー文字列を正規形式に正規化します。

- SHA-1 ハッシュアルゴリズムを使用して HMAC を生成します。

-

hmacの結果を base-64 としてエンコードします。

ヘッダーを正規化

ヘッダーを正規の形式に正規化するには、以下を行います。

-

すべての

content-ヘッダーを取得します。 -

content-typeおよびcontent-md5以外のcontent-ヘッダーをすべて削除します。 -

content-ヘッダー名が小文字であることを確認します。 -

content-ヘッダーの辞書式で並べ替えます。 -

Dateヘッダー AND があることを確認します。指定した日付が、オフセットではなく GMT を使用していることを確認してください。 -

x-amz-で始まるヘッダーをすべて取得します。 -

x-amz-ヘッダーがすべて小文字であることを確認します。 -

x-amz-ヘッダーの辞書式で並べ替えます。 - 同じフィールド名の複数のインスタンスを単一のフィールドに組み合わせ、フィールド値をコンマで区切ります。

- ヘッダー値の空白文字および改行文字を、単一スペースに置き換えます。

- コロンの前後に空白を削除します。

- 各ヘッダーの後に新しい行を追加します。

- ヘッダーを要求ヘッダーにマージします。

HASH_OF_HEADER_AND_SECRET を、base-64 でエンコードされた HMAC 文字列に置き換えます。

関連情報

- 詳細は、Amazon Simple Storage Service ドキュメントの Signing and Authenticating REST Requests セクションを参照してください。

3.2.2. S3 サーバー側の暗号化

Ceph Object Gateway は、S3 アプリケーションプログラムインターフェイス (API) のアップロードされたオブジェクトのサーバー側の暗号化をサポートします。サーバー側の暗号化とは、S3 クライアントが暗号化されていない形式で HTTP 経由でデータを送信し、Ceph Object Gateway はそのデータを暗号化した形式で Red Hat Ceph Storage に保存することを意味します。

Red Hat は、Static Large Object (SLO) または Dynamic Large Object (DLO) の S3 オブジェクト暗号化をサポートしません。

暗号化を使用するには、クライアントリクエストは、SSL 接続上でリクエストを送信する 必要があります。Red Hat は、Ceph Object Gateway が SSL を使用しない限り、クライアントからの S3 暗号化をサポートしません。ただし、テストの目的で、管理者は ceph config set client.rgw コマンドを使用して、rgw_crypt_require_ssl 設定を false に設定してから、Ceph Object Gateway インスタンスを再起動することで、テスト中に SSL を無効にできます。

実稼働環境では、SSL 経由で暗号化された要求を送信できない場合があります。このような場合は、サーバー側の暗号化で HTTP を使用して要求を送信します。

サーバー側の暗号化で HTTP を設定する方法は、以下の関連情報セクションを参照してください。

暗号化キーの管理には、以下の 2 つのオプションがあります。

お客様提供のキー

お客様が提供する鍵を使用する場合、S3 クライアントは暗号鍵を各リクエストと共に渡して、暗号化されたデータの読み取りまたは書き込みを行います。これらのキーを管理するのは、お客様の責任です。各オブジェクトの暗号化に使用する Ceph Object Gateway の鍵を覚えておく必要があります。

Ceph Object Gateway は、Amazon SSE-C 仕様に従って、S3 API で顧客提供のキー動作を実装します。

お客様がキー管理を処理し、S3 クライアントはキーを Ceph Object Gateway に渡すため、Ceph Object Gateway ではこの暗号化モードをサポートするための特別な設定は必要ありません。

キー管理サービス

キー管理サービスを使用する場合、セキュアなキー管理サービスはキーを格納し、Ceph Object Gateway はデータの暗号化または復号の要求に対応するためにキーをオンデマンドで取得します。

Ceph Object Gateway は、Amazon SSE-KMS 仕様に従って S3 API にキー管理サービスの動作を実装します。

現時点で、テスト済み鍵管理の実装は HashiCorp Vault および OpenStack Barbican です。ただし、OpenStack Barbican はテクノロジープレビューであるため、実稼働システムでの使用はサポートされません。

3.2.3. S3 アクセス制御リスト

Ceph Object Gateway は S3 と互換性のあるアクセス制御リスト (ACL) の機能をサポートします。ACL は、ユーザーがバケットまたはオブジェクトで実行できる操作を指定するアクセス権限のリストです。それぞれの付与は、バケットに適用するか、オブジェクトに適用される場合の異なる意味を持ちます。

| パーミッション | バケット | オブジェクト |

|---|---|---|

|

| パーミッションを得たユーザーは、バケットのオブジェクトをリスト表示できます。 | パーミッションを得たユーザーは、オブジェクトを読み取りできます。 |

|

| パーミッションを得たユーザーは、バケットのオブジェクトを書き込みまたは削除できます。 | 該当なし |

|

| パーミッションを得たユーザーは、バケット ACL を読み取ることができます。 | パーミッションを得たユーザーは、オブジェクト ACL を読み取ることができます。 |

|

| パーミッションを得たユーザーは、バケット ACL を書き込めます。 | パーミッションを得たユーザーは、オブジェクト ACL に書き込めます。 |

|

| Grantee にはバケットのオブジェクトに対する完全なパーミッションがあります。 | パーミッションを得たユーザーは、オブジェクト ACL に読み取りまたは書き込みできます。 |

3.2.4. S3 を使用した Ceph Object Gateway へのアクセスの準備

ゲートウェイサーバーにアクセスする前に、Ceph Object Gateway ノードの前提条件に従う必要があります。

前提条件

- Ceph Object Gateway ソフトウェアのインストール。

- Ceph Object Gateway ノードへのルートレベルのアクセスがある。

手順

rootで、ファイアウォールのポート8080を開きます。firewall-cmd --zone=public --add-port=8080/tcp --permanent firewall-cmd --reload

[root@rgw ~]# firewall-cmd --zone=public --add-port=8080/tcp --permanent [root@rgw ~]# firewall-cmd --reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow Object Gateway 設定および管理ガイド に記載されているように、ゲートウェイに使用している DNS サーバーにワイルドカードを追加します。

ローカル DNS キャッシュ用のゲートウェイノードを設定することもできます。これを実行するには、以下の手順を実行します。

rootでdnsmasqをインストールおよび設定します。yum install dnsmasq echo "address=/.FQDN_OF_GATEWAY_NODE/IP_OF_GATEWAY_NODE" | tee --append /etc/dnsmasq.conf systemctl start dnsmasq systemctl enable dnsmasq

[root@rgw ~]# yum install dnsmasq [root@rgw ~]# echo "address=/.FQDN_OF_GATEWAY_NODE/IP_OF_GATEWAY_NODE" | tee --append /etc/dnsmasq.conf [root@rgw ~]# systemctl start dnsmasq [root@rgw ~]# systemctl enable dnsmasqCopy to Clipboard Copied! Toggle word wrap Toggle overflow IP_OF_GATEWAY_NODEおよびFQDN_OF_GATEWAY_NODEは、ゲートウェイノードの IP アドレスと FQDN に置き換えます。rootで NetworkManager を停止します。systemctl stop NetworkManager systemctl disable NetworkManager

[root@rgw ~]# systemctl stop NetworkManager [root@rgw ~]# systemctl disable NetworkManagerCopy to Clipboard Copied! Toggle word wrap Toggle overflow rootとして、ゲートウェイサーバーの IP を名前空間として設定します。echo "DNS1=IP_OF_GATEWAY_NODE" | tee --append /etc/sysconfig/network-scripts/ifcfg-eth0 echo "IP_OF_GATEWAY_NODE FQDN_OF_GATEWAY_NODE" | tee --append /etc/hosts systemctl restart network systemctl enable network systemctl restart dnsmasq

[root@rgw ~]# echo "DNS1=IP_OF_GATEWAY_NODE" | tee --append /etc/sysconfig/network-scripts/ifcfg-eth0 [root@rgw ~]# echo "IP_OF_GATEWAY_NODE FQDN_OF_GATEWAY_NODE" | tee --append /etc/hosts [root@rgw ~]# systemctl restart network [root@rgw ~]# systemctl enable network [root@rgw ~]# systemctl restart dnsmasqCopy to Clipboard Copied! Toggle word wrap Toggle overflow IP_OF_GATEWAY_NODEおよびFQDN_OF_GATEWAY_NODEは、ゲートウェイノードの IP アドレスと FQDN に置き換えます。サブドメイン要求を確認します。

ping mybucket.FQDN_OF_GATEWAY_NODE

[user@rgw ~]$ ping mybucket.FQDN_OF_GATEWAY_NODECopy to Clipboard Copied! Toggle word wrap Toggle overflow FQDN_OF_GATEWAY_NODEは、ゲートウェイノードの FQDN に置き換えます。警告ローカルの DNS キャッシュ用にゲートウェイサーバーを設定することは、テスト目的のみを目的としています。これを行った後は、外部ネットワークにはアクセスできなくなります。Red Hat Ceph Storage クラスターおよびゲートウェイノードに適切な DNS サーバーを使用することを強く推奨します。

-

Object Gateway 設定および管理ガイド に記載されているように、

S3アクセス用のradosgwユーザーを慎重に作成し、生成されたaccess_keyとsecret_keyをコピーします。S3アクセス、およびそれ以降のバケット管理タスクには、これらのキーが必要です。

3.2.5. Ruby AWS S3 を使用した Ceph Object Gateway へのアクセス

Ruby プログラミング言語は、S3 アクセスに aws-s3 gem と共に使用できます。Ruby AWS::S3 で Ceph Object Gateway サーバーにアクセスするために使用されるノードで以下の手順を実行します。

前提条件

- Ceph Object Gateway へのユーザーレベルのアクセス。

- Ceph Object Gateway にアクセスするノードへのルートレベルのアクセス。

- インターネットアクセス。

手順

rubyパッケージをインストールします。yum install ruby

[root@dev ~]# yum install rubyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記上記のコマンドは

rubyと、rubygems、ruby-libsなどの基本的な依存関係をインストールします。コマンドによってすべての依存関係がインストールされていない場合は、個別にインストールします。Ruby パッケージ

aws-s3をインストールします。gem install aws-s3

[root@dev ~]# gem install aws-s3Copy to Clipboard Copied! Toggle word wrap Toggle overflow プロジェクトディレクトリーを作成します。

mkdir ruby_aws_s3 cd ruby_aws_s3

[user@dev ~]$ mkdir ruby_aws_s3 [user@dev ~]$ cd ruby_aws_s3Copy to Clipboard Copied! Toggle word wrap Toggle overflow コネクションファイルを作成します。

vim conn.rb

[user@dev ~]$ vim conn.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow conn.rbファイルに以下のコンテンツを貼り付けます。構文

Copy to Clipboard Copied! Toggle word wrap Toggle overflow FQDN_OF_GATEWAY_NODEは、Ceph Object Gateway ノードの FQDN に置き換えます。MY_ACCESS_KEYとMY_SECRET_KEY を、Red Hat Ceph Storage Object Gateway 設定および管理ガイド に記載されているように、S3アクセス用のradosgwユーザーを作成したときに生成されたaccess_keyとsecret_keyに置き換えます。例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x conn.rb

[user@dev ~]$ chmod +x conn.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./conn.rb | echo $?

[user@dev ~]$ ./conn.rb | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルに正しく値を指定した場合は、コマンドの出力は

0になります。バケットを作成するための新規ファイルを作成します。

vim create_bucket.rb

[user@dev ~]$ vim create_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

#!/usr/bin/env ruby load 'conn.rb' AWS::S3::Bucket.create('my-new-bucket1')#!/usr/bin/env ruby load 'conn.rb' AWS::S3::Bucket.create('my-new-bucket1')Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x create_bucket.rb

[user@dev ~]$ chmod +x create_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./create_bucket.rb

[user@dev ~]$ ./create_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドの出力が

trueの場合は、バケットmy-new-bucket1が正常に作成されたことを意味します。所有されるバケットをリスト表示するために新規ファイルを作成します。

vim list_owned_buckets.rb

[user@dev ~]$ vim list_owned_buckets.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x list_owned_buckets.rb

[user@dev ~]$ chmod +x list_owned_buckets.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./list_owned_buckets.rb

[user@dev ~]$ ./list_owned_buckets.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力は以下のようになります。

my-new-bucket1 2020-01-21 10:33:19 UTC

my-new-bucket1 2020-01-21 10:33:19 UTCCopy to Clipboard Copied! Toggle word wrap Toggle overflow オブジェクトを作成するための新規ファイルを作成します。

vim create_object.rb

[user@dev ~]$ vim create_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x create_object.rb

[user@dev ~]$ chmod +x create_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./create_object.rb

[user@dev ~]$ ./create_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow これで、文字列

Hello World!でhello.txtが作成されます。バケットのコンテンツをリスト表示するための新規ファイルを作成します。

vim list_bucket_content.rb

[user@dev ~]$ vim list_bucket_content.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x list_bucket_content.rb

[user@dev ~]$ chmod +x list_bucket_content.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./list_bucket_content.rb

[user@dev ~]$ ./list_bucket_content.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力は以下のようになります。

hello.txt 12 Fri, 22 Jan 2020 15:54:52 GMT

hello.txt 12 Fri, 22 Jan 2020 15:54:52 GMTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 空のバケットを削除するために新規ファイルを作成します。

vim del_empty_bucket.rb

[user@dev ~]$ vim del_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

#!/usr/bin/env ruby load 'conn.rb' AWS::S3::Bucket.delete('my-new-bucket1')#!/usr/bin/env ruby load 'conn.rb' AWS::S3::Bucket.delete('my-new-bucket1')Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x del_empty_bucket.rb

[user@dev ~]$ chmod +x del_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./del_empty_bucket.rb | echo $?

[user@dev ~]$ ./del_empty_bucket.rb | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow バケットが正常に削除されると、コマンドは

0を出力として返します。注記create_bucket.rbファイルを編集し、空のバケットを作成します (例:my-new-bucket4、my-new-bucket5)。次に、空のバケットの削除を試みる前に、上記のdel_empty_bucket.rbファイルを適宜編集します。空でないバケットを削除する新規ファイルを作成します。

vim del_non_empty_bucket.rb

[user@dev ~]$ vim del_non_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

#!/usr/bin/env ruby load 'conn.rb' AWS::S3::Bucket.delete('my-new-bucket1', :force => true)#!/usr/bin/env ruby load 'conn.rb' AWS::S3::Bucket.delete('my-new-bucket1', :force => true)Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x del_non_empty_bucket.rb

[user@dev ~]$ chmod +x del_non_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./del_non_empty_bucket.rb | echo $?

[user@dev ~]$ ./del_non_empty_bucket.rb | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow バケットが正常に削除されると、コマンドは

0を出力として返します。オブジェクトを削除する新しいファイルを作成します。

vim delete_object.rb

[user@dev ~]$ vim delete_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

#!/usr/bin/env ruby load 'conn.rb' AWS::S3::S3Object.delete('hello.txt', 'my-new-bucket1')#!/usr/bin/env ruby load 'conn.rb' AWS::S3::S3Object.delete('hello.txt', 'my-new-bucket1')Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x delete_object.rb

[user@dev ~]$ chmod +x delete_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./delete_object.rb

[user@dev ~]$ ./delete_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、オブジェクト

hello.txtが削除されます。

3.2.6. Ruby AWS SDK を使用した Ceph Object Gateway へのアクセス

Ruby プログラミング言語は、S3 アクセスに aws-sdk gem と共に使用できます。Ruby AWS::SDK を使用して Ceph Object Gateway サーバーにアクセスするために使用されるノードで以下の手順を実行します。

前提条件

- Ceph Object Gateway へのユーザーレベルのアクセス。

- Ceph Object Gateway にアクセスするノードへのルートレベルのアクセス。

- インターネットアクセス。

手順

rubyパッケージをインストールします。yum install ruby

[root@dev ~]# yum install rubyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記上記のコマンドは

rubyと、rubygems、ruby-libsなどの基本的な依存関係をインストールします。コマンドによってすべての依存関係がインストールされていない場合は、個別にインストールします。Ruby パッケージ

aws-sdkをインストールします。gem install aws-sdk

[root@dev ~]# gem install aws-sdkCopy to Clipboard Copied! Toggle word wrap Toggle overflow プロジェクトディレクトリーを作成します。

mkdir ruby_aws_sdk cd ruby_aws_sdk

[user@dev ~]$ mkdir ruby_aws_sdk [user@dev ~]$ cd ruby_aws_sdkCopy to Clipboard Copied! Toggle word wrap Toggle overflow コネクションファイルを作成します。

vim conn.rb

[user@dev ~]$ vim conn.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow conn.rbファイルに以下のコンテンツを貼り付けます。構文

Copy to Clipboard Copied! Toggle word wrap Toggle overflow FQDN_OF_GATEWAY_NODEは、Ceph Object Gateway ノードの FQDN に置き換えます。MY_ACCESS_KEYとMY_SECRET_KEY を、Red Hat Ceph Storage Object Gateway 設定および管理ガイド に記載されているように、S3アクセス用のradosgwユーザーを作成したときに生成されたaccess_keyとsecret_keyに置き換えます。例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x conn.rb

[user@dev ~]$ chmod +x conn.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./conn.rb | echo $?

[user@dev ~]$ ./conn.rb | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルに正しく値を指定した場合は、コマンドの出力は

0になります。バケットを作成するための新規ファイルを作成します。

vim create_bucket.rb

[user@dev ~]$ vim create_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

構文

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x create_bucket.rb

[user@dev ~]$ chmod +x create_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./create_bucket.rb

[user@dev ~]$ ./create_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドの出力が

trueの場合は、バケットmy-new-bucket2が正常に作成されていることを意味します。所有されるバケットをリスト表示するために新規ファイルを作成します。

vim list_owned_buckets.rb

[user@dev ~]$ vim list_owned_buckets.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x list_owned_buckets.rb

[user@dev ~]$ chmod +x list_owned_buckets.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./list_owned_buckets.rb

[user@dev ~]$ ./list_owned_buckets.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力は以下のようになります。

my-new-bucket2 2020-01-21 10:33:19 UTC

my-new-bucket2 2020-01-21 10:33:19 UTCCopy to Clipboard Copied! Toggle word wrap Toggle overflow オブジェクトを作成するための新規ファイルを作成します。

vim create_object.rb

[user@dev ~]$ vim create_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x create_object.rb

[user@dev ~]$ chmod +x create_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./create_object.rb

[user@dev ~]$ ./create_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow これで、文字列

Hello World!でhello.txtが作成されます。バケットのコンテンツをリスト表示するための新規ファイルを作成します。

vim list_bucket_content.rb

[user@dev ~]$ vim list_bucket_content.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x list_bucket_content.rb

[user@dev ~]$ chmod +x list_bucket_content.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./list_bucket_content.rb

[user@dev ~]$ ./list_bucket_content.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力は以下のようになります。

hello.txt 12 Fri, 22 Jan 2020 15:54:52 GMT

hello.txt 12 Fri, 22 Jan 2020 15:54:52 GMTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 空のバケットを削除するために新規ファイルを作成します。

vim del_empty_bucket.rb

[user@dev ~]$ vim del_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x del_empty_bucket.rb

[user@dev ~]$ chmod +x del_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./del_empty_bucket.rb | echo $?

[user@dev ~]$ ./del_empty_bucket.rb | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow バケットが正常に削除されると、コマンドは

0を出力として返します。注記create_bucket.rbファイルを編集し、空のバケットを作成します (例:my-new-bucket6、my-new-bucket7)。次に、空のバケットの削除を試みる前に、上記のdel_empty_bucket.rbファイルを適宜編集します。空でないバケットを削除する新規ファイルを作成します。

vim del_non_empty_bucket.rb

[user@dev ~]$ vim del_non_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x del_non_empty_bucket.rb

[user@dev ~]$ chmod +x del_non_empty_bucket.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./del_non_empty_bucket.rb | echo $?

[user@dev ~]$ ./del_non_empty_bucket.rb | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow バケットが正常に削除されると、コマンドは

0を出力として返します。オブジェクトを削除する新しいファイルを作成します。

vim delete_object.rb

[user@dev ~]$ vim delete_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

ファイルを実行可能にします。

chmod +x delete_object.rb

[user@dev ~]$ chmod +x delete_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow コマンドを実行します。

./delete_object.rb

[user@dev ~]$ ./delete_object.rbCopy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、オブジェクト

hello.txtが削除されます。

3.2.7. PHP を使用した Ceph Object Gateway へのアクセス

S3 アクセスには PHP スクリプトを使用できます。この手順では、バケットやオブジェクトの削除など、さまざまなタスクを実行する PHP スクリプトの例を提供します。

以下は、php v5.4.16 および aws-sdk v2.8.24 に対してテストされています。

前提条件

- 開発ワークステーションへのルートレベルのアクセス。

- インターネットアクセス。

手順

phpパッケージをインストールします。yum install php

[root@dev ~]# yum install phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

PHP 用に

aws-sdkの zip アーカイブを ダウンロード し、デプロイメントします。 プロジェクトディレクトリーを作成します。

mkdir php_s3 cd php_s3

[user@dev ~]$ mkdir php_s3 [user@dev ~]$ cd php_s3Copy to Clipboard Copied! Toggle word wrap Toggle overflow デプロイメントした

awsディレクトリーをプロジェクトのディレクトリーにコピーします。以下に例を示します。cp -r ~/Downloads/aws/ ~/php_s3/

[user@dev ~]$ cp -r ~/Downloads/aws/ ~/php_s3/Copy to Clipboard Copied! Toggle word wrap Toggle overflow コネクションファイルを作成します。

vim conn.php

[user@dev ~]$ vim conn.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow conn.phpファイルに以下のコンテンツを貼り付けます。構文

Copy to Clipboard Copied! Toggle word wrap Toggle overflow FQDN_OF_GATEWAY_NODEは、ゲートウェイノードの FQDN に置き換えます。MY_ACCESS_KEYとMY_SECRET_KEY を、Red Hat Ceph Storage Object Gateway 設定および管理ガイド に記載されているように、S3アクセス用のradosgwユーザーを作成するときに生成されたaccess_keyとsecret_keyに置き換えます。PATH_TO_AWSは、phpプロジェクトディレクトリーにコピーした、デプロイメントしたawsディレクトリーへの絶対パスに置き換えます。ファイルを保存して、エディターを終了します。

コマンドを実行します。

php -f conn.php | echo $?

[user@dev ~]$ php -f conn.php | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルに正しく値を指定した場合は、コマンドの出力は

0になります。バケットを作成するための新規ファイルを作成します。

vim create_bucket.php

[user@dev ~]$ vim create_bucket.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 新しいファイルに以下の内容を貼り付けます。

構文

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

コマンドを実行します。

php -f create_bucket.php

[user@dev ~]$ php -f create_bucket.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 所有されるバケットをリスト表示するために新規ファイルを作成します。

vim list_owned_buckets.php

[user@dev ~]$ vim list_owned_buckets.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

構文

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

コマンドを実行します。

php -f list_owned_buckets.php

[user@dev ~]$ php -f list_owned_buckets.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力は以下のようになります。

my-new-bucket3 2020-01-21 10:33:19 UTC

my-new-bucket3 2020-01-21 10:33:19 UTCCopy to Clipboard Copied! Toggle word wrap Toggle overflow まず

hello.txtという名前のソースファイルを作成するオブジェクトを作成します。echo "Hello World!" > hello.txt

[user@dev ~]$ echo "Hello World!" > hello.txtCopy to Clipboard Copied! Toggle word wrap Toggle overflow 新しい php ファイルを作成します。

vim create_object.php

[user@dev ~]$ vim create_object.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

構文

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

コマンドを実行します。

php -f create_object.php

[user@dev ~]$ php -f create_object.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、バケット

my-new-bucket3でオブジェクトhello.txtが作成されます。バケットのコンテンツをリスト表示するための新規ファイルを作成します。

vim list_bucket_content.php

[user@dev ~]$ vim list_bucket_content.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

構文

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

コマンドを実行します。

php -f list_bucket_content.php

[user@dev ~]$ php -f list_bucket_content.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力は以下のようになります。

hello.txt 12 Fri, 22 Jan 2020 15:54:52 GMT

hello.txt 12 Fri, 22 Jan 2020 15:54:52 GMTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 空のバケットを削除するために新規ファイルを作成します。

vim del_empty_bucket.php

[user@dev ~]$ vim del_empty_bucket.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

構文

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

コマンドを実行します。

php -f del_empty_bucket.php | echo $?

[user@dev ~]$ php -f del_empty_bucket.php | echo $?Copy to Clipboard Copied! Toggle word wrap Toggle overflow バケットが正常に削除されると、コマンドは

0を出力として返します。注記create_bucket.phpファイルを編集し、空のバケットを作成します (例:my-new-bucket4、my-new-bucket5)。次に、空のバケットの削除を試みる前に、上記のdel_empty_bucket.phpファイルを適宜編集します。重要空でないバケットの削除は、現在 PHP 2 以降のバージョンの

aws-sdkではサポートされていません。オブジェクトを削除する新しいファイルを作成します。

vim delete_object.php

[user@dev ~]$ vim delete_object.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコンテンツをファイルに貼り付けます。

構文

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを保存して、エディターを終了します。

コマンドを実行します。

php -f delete_object.php

[user@dev ~]$ php -f delete_object.phpCopy to Clipboard Copied! Toggle word wrap Toggle overflow これにより、オブジェクト

hello.txtが削除されます。

3.2.8. セキュアなトークンサービス

Amazon Web Services の Secure Token Service (STS) は、ユーザーを認証するための一時セキュリティー認証情報のセットを返します。

Red Hat Ceph Storage Object Gateway は、アイデンティティーおよびアクセス管理 (IAM) 用の Amazon STS アプリケーションプログラミングインターフェイス (API) のサブセットをサポートします。

ユーザーは最初に STS に対して認証し、後続の要求で使用できる有効期間の短い S3 アクセスキーとシークレットキーを受け取ります。

Red Hat Ceph Storage は、OIDC プロバイダーを設定してシングルサインオンと統合することで、S3 ユーザーを認証できます。この機能により、Object Storage ユーザーは、ローカルの Ceph Object Gateway データベースではなく、エンタープライズアイデンティティープロバイダーに対して認証できるようになります。たとえば、SSO がバックエンドのエンタープライズ IDP に接続されている場合、Object Storage ユーザーはエンタープライズ認証情報を使用して認証して、Ceph Object Gateway S3 エンドポイントにアクセスできます。

STS を IAM ロールポリシー機能と併用することで、細かく調整された認可ポリシーを作成してデータへのアクセスを制御できます。これにより、オブジェクトストレージデータにロールベースのアクセス制御 (RBAC) または属性ベースのアクセス制御 (ABAC) 認可モデルを実装できるようになり、どのユーザーがデータにアクセスできるかを完全に制御できるようになります。

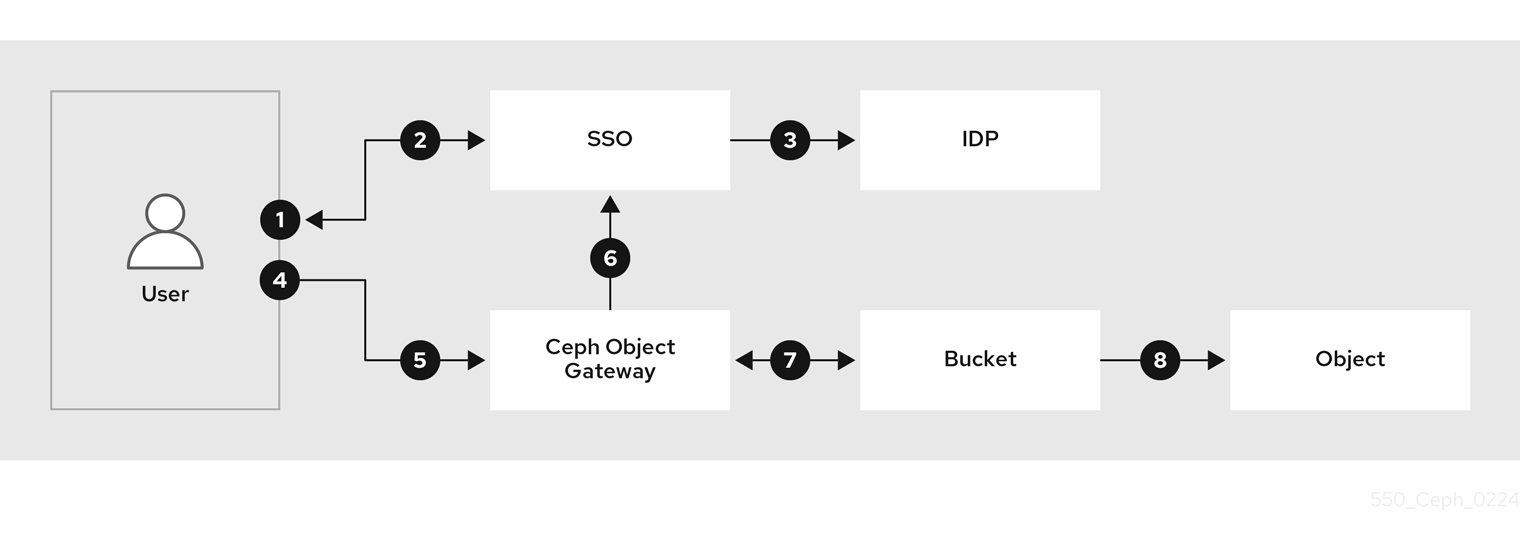

STS を使用して S3 リソースにアクセスするワークフローを簡略化する

- ユーザーは、Red Hat Ceph Storage 内の S3 リソースにアクセスしたいと考えています。

- ユーザーは SSO プロバイダーに対して認証する必要があります。

- SSO プロバイダーは IDP と統合され、ユーザーの認証情報が有効か確認し、ユーザーが認証されると SSO がユーザーにトークンを提供します。

- ユーザーは、SSO によって提供されたトークンを使用して Ceph Object Gateway STS エンドポイントにアクセスし、S3 リソースへのアクセスをユーザーに提供する IAM ロールを引き受けるように要求します。

- Red Hat Ceph Storage ゲートウェイはユーザートークンを受け取り、SSO にトークンの検証を要求します。

- SSO がトークンを検証すると、ユーザーはロールを引き受けることができます。STS を通じて、ユーザーは一時的なアクセスと秘密鍵を取得し、S3 リソースにアクセスできるようになります。

- ユーザーが引き受けた IAM ロールにアタッチされたポリシーに応じて、ユーザーは S3 リソースセットにアクセスできます。

- たとえば、バケット A を読み取り、バケット B に書き込みます。

関連情報

- Amazon Web Services Secure Token Service の Welcome ページ。

- STS Lite と Keystone の詳細は、Red Hat Ceph Storage 開発者ガイド の Keystone を使用した STS Lite の設定と使用 セクションを参照してください。

- STS Lite と Keystone の制限の詳細は、Red Hat Ceph Storage 開発者ガイド の Keystone で STS Lite を使用する場合の制限の回避 セクションを参照してください。

3.2.8.1. Secure Token Service アプリケーションのプログラミングインターフェイス

Ceph Object Gateway は、以下の Secure Token Service (STS) アプリケーションプログラミングインターフェイス (API) を実装します。

AssumeRole

この API は、アカウント間のアクセスのための一時的な認証情報のセットを返します。これらの一時的な認証情報により、Role と、AssumeRole API で割り当てられるポリシーの両方に割り当てられるパーミッションポリシーを使用することができます。RoleArn および RoleSessionName リクエストパラメーターは必須ですが、他の要求パラメーターは任意です。

RoleArn- 説明

- 長さが 20 ~ 2048 文字の Amazon Resource Name (ARN) について想定するロール。

- 型

- String

- 必須

- はい

RoleSessionName- 説明

-

仮定するロールセッション名を特定します。ロールセッション名は、異なるプリンシパルや別の理由がロールを想定する場合にセッションを一意に識別できます。このパラメーターの値は、2 文字から 64 文字までです。

=、,、.、@、および-文字は使用できますが、スペースは使用できません。 - 型

- String

- 必須

- はい

ポリシー- 説明

- インラインセッションで使用する JSON 形式の ID およびアクセス管理ポリシー (IAM)。このパラメーターの値は 1 文字から 2048 文字までです。

- 型

- String

- 必須

- いいえ

DurationSeconds- 説明

-

セッションの期間 (秒単位)。最小値は

900秒で、最大値は43200秒です。デフォルト値は3600秒です。 - 型

- Integer

- 必須

- いいえ

ExternalId- 説明

- 別のアカウントのロールを想定する場合には、利用可能な場合は一意の外部識別子を指定します。このパラメーターの値は、2 文字から 1224 文字までになります。

- 型

- String

- 必須

- いいえ

SerialNumber- 説明

- 関連付けられたマルチファクター認証 (MFA) デバイスからのユーザーの識別番号。パラメーターの値は、9 文字から 256 文字までのハードウェアデバイスまたは仮想デバイスのシリアル番号になります。

- 型

- String

- 必須

- いいえ

TokenCode- 説明

- 信頼ポリシーに MFA が必要な場合は、マルチファクター認証 (MFA) デバイスから生成された値。MFA デバイスが必要で、このパラメーターの値が空または期限切れの場合には、AssumeRole の呼び出しは "access denied" エラーメッセージを返します。このパラメーターの値には、固定長は 6 文字です。

- 型

- String

- 必須

- いいえ

AssumeRoleWithWebIdentity

この API は、OpenID Connect や OAuth 2.0 アイデンティティープロバイダーなどのアプリケーションによって認証されたユーザーの一時認証情報のセットを返します。RoleArn および RoleSessionName リクエストパラメーターは必須ですが、他の要求パラメーターは任意です。

RoleArn- 説明

- 長さが 20 ~ 2048 文字の Amazon Resource Name (ARN) について想定するロール。

- 型

- String

- 必須

- はい

RoleSessionName- 説明

-

仮定するロールセッション名を特定します。ロールセッション名は、異なるプリンシパルや別の理由がロールを想定する場合にセッションを一意に識別できます。このパラメーターの値は、2 文字から 64 文字までです。

=、,、.、@、および-文字は使用できますが、スペースは使用できません。 - 型

- String

- 必須

- はい

ポリシー- 説明

- インラインセッションで使用する JSON 形式の ID およびアクセス管理ポリシー (IAM)。このパラメーターの値は 1 文字から 2048 文字までです。

- 型

- String

- 必須

- いいえ

DurationSeconds- 説明

-

セッションの期間 (秒単位)。最小値は

900秒で、最大値は43200秒です。デフォルト値は3600秒です。 - 型

- Integer

- 必須

- いいえ

ProviderId- 説明

- アイデンティティープロバイダーからのドメイン名の完全修飾ホストコンポーネント。このパラメーターの値は、長さが 4 ~ 2048 文字の OAuth 2.0 アクセストークンでのみ有効です。

- 型

- String

- 必須

- いいえ

WebIdentityToken- 説明

- アイデンティティープロバイダーから提供される OpenID Connect アイデンティティートークンまたは OAuth 2.0 アクセストークン。このパラメーターの値は、4 文字から 2048 文字までです。

- 型

- String

- 必須

- いいえ

関連情報

- 詳細は、Red Hat Ceph Storage 開発者ガイド の Secure Token ServiceAPI を使用した例 セクションを参照してください。

- Amazon Web Services Security Token Service (AssumeRole アクション)

- Amazon Web Services Security Token Service (AssumeRoleWithWebIdentity アクション)

3.2.8.2. セキュアなトークンサービスの設定

rgw_sts_key および rgw_s3_auth_use_sts オプションを設定して、Ceph Object Gateway で使用する Ceph Object Gateway (STS) を設定します。

S3 と STS API は同じ名前空間に共存し、いずれも Ceph Object Gateway の同じエンドポイントからアクセスできます。

前提条件

- 稼働中の Red Hat Ceph Storage クラスターがある。

- 実行中の Ceph Object Gateway。

- Ceph Manager ノードへのルートレベルのアクセス。

手順

Ceph Object Gateway クライアントに以下の設定オプションを設定します。

構文

ceph config set RGW_CLIENT_NAME rgw_sts_key STS_KEY ceph config set RGW_CLIENT_NAME rgw_s3_auth_use_sts true

ceph config set RGW_CLIENT_NAME rgw_sts_key STS_KEY ceph config set RGW_CLIENT_NAME rgw_s3_auth_use_sts trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow rgw_sts_keyは、セッショントークンを暗号化または復号化するための STS キーであり、正確に 16 進数の 16 文字です。重要STS キーは英数字である必要があります。

例

ceph config set client.rgw rgw_sts_key 7f8fd8dd4700mnop ceph config set client.rgw rgw_s3_auth_use_sts true

[root@mgr ~]# ceph config set client.rgw rgw_sts_key 7f8fd8dd4700mnop [root@mgr ~]# ceph config set client.rgw rgw_s3_auth_use_sts trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 追加したキーを有効にするには、Ceph Object Gateway を再起動します。

注記NAME列のceph orch psコマンドの出力を使用して、SERVICE_TYPE.ID 情報を取得します。ストレージクラスター内の個別のノードで Ceph Object Gateway を再起動するには、以下を実行します。

構文

systemctl restart ceph-CLUSTER_ID@SERVICE_TYPE.ID.service

systemctl restart ceph-CLUSTER_ID@SERVICE_TYPE.ID.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

systemctl restart ceph-c4b34c6f-8365-11ba-dc31-529020a7702d@rgw.realm.zone.host01.gwasto.service

[root@host01 ~]# systemctl restart ceph-c4b34c6f-8365-11ba-dc31-529020a7702d@rgw.realm.zone.host01.gwasto.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow ストレージクラスター内のすべてのノードで Ceph Object Gateway を再起動するには、以下を実行します。

構文

ceph orch restart SERVICE_TYPE

ceph orch restart SERVICE_TYPECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph orch restart rgw

[ceph: root@host01 /]# ceph orch restart rgwCopy to Clipboard Copied! Toggle word wrap Toggle overflow

関連情報

- STS API の詳細は、Red Hat Ceph Storage 開発者ガイド の Secure Token Service アプリケーションプログラミングインターフェイス セクションを参照してください。

- Ceph 設定データベースの使用に関する詳細は、Red Hat Ceph Storage 設定ガイド の Ceph 設定の基本の 章を参照してください。

3.2.8.3. OpenID Connect プロバイダー用のユーザーの作成

Ceph Object Gateway と OpenID Connect Provider との間の信頼を確立するには、ユーザーエンティティーとロール信頼ポリシーを作成します。

前提条件

- Ceph Object Gateway ノードへのユーザーレベルのアクセスがある。

- セキュアなトークンサービスが設定されている。

手順

新しい Ceph ユーザーを作成します。

構文

radosgw-admin --uid USER_NAME --display-name "DISPLAY_NAME" --access_key USER_NAME --secret SECRET user create

radosgw-admin --uid USER_NAME --display-name "DISPLAY_NAME" --access_key USER_NAME --secret SECRET user createCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

radosgw-admin --uid TESTER --display-name "TestUser" --access_key TESTER --secret test123 user create

[user@rgw ~]$ radosgw-admin --uid TESTER --display-name "TestUser" --access_key TESTER --secret test123 user createCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph ユーザー機能を設定します。

構文

radosgw-admin caps add --uid="USER_NAME" --caps="oidc-provider=*"

radosgw-admin caps add --uid="USER_NAME" --caps="oidc-provider=*"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

radosgw-admin caps add --uid="TESTER" --caps="oidc-provider=*"

[user@rgw ~]$ radosgw-admin caps add --uid="TESTER" --caps="oidc-provider=*"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Secure Token Service (STS) API を使用してロール信頼ポリシーに条件を追加します。

構文

"{\"Version\":\"2020-01-17\",\"Statement\":[{\"Effect\":\"Allow\",\"Principal\":{\"Federated\":[\"arn:aws:iam:::oidc-provider/IDP_URL\"]},\"Action\":[\"sts:AssumeRoleWithWebIdentity\"],\"Condition\":{\"StringEquals\":{\"IDP_URL:app_id\":\"AUD_FIELD\"\}\}\}\]\}""{\"Version\":\"2020-01-17\",\"Statement\":[{\"Effect\":\"Allow\",\"Principal\":{\"Federated\":[\"arn:aws:iam:::oidc-provider/IDP_URL\"]},\"Action\":[\"sts:AssumeRoleWithWebIdentity\"],\"Condition\":{\"StringEquals\":{\"IDP_URL:app_id\":\"AUD_FIELD\"\}\}\}\]\}"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要上記の構文例の

app_idは、着信トークンのAUD_FIELDフィールドと一致させる必要があります。

関連情報

- Amazon の Web サイトの Obtaining the Root CA Thumbprint for an OpenID Connect Identity Provider を参照してください。

- STS API の詳細は、Red Hat Ceph Storage 開発者ガイド の Secure Token Service アプリケーションプログラミングインターフェイス セクションを参照してください。

- 詳細は、Red Hat Ceph Storage 開発者ガイド の Secure Token ServiceAPI を使用した例 セクションを参照してください。

3.2.8.4. OpenID Connect プロバイダーのサムプリントの取得

OpenID Connect プロバイダー (IDP) の設定ドキュメントを取得します。

OIDC プロトコル標準に準拠する SSO は、Ceph Object Gateway で動作すると想定されています。Red Hat は、次の SSO プロバイダーを使用してテストしました。

- Red Hat Single Sign-On

- Keycloak

前提条件

-

opensslパッケージおよびcurlパッケージがインストールされている。

手順

IDP の URL から設定ドキュメントを取得します。

構文

curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "IDP_URL:8000/CONTEXT/realms/REALM/.well-known/openid-configuration" \ | jq .curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "IDP_URL:8000/CONTEXT/realms/REALM/.well-known/openid-configuration" \ | jq .Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "http://www.example.com:8000/auth/realms/quickstart/.well-known/openid-configuration" \ | jq .[user@client ~]$ curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "http://www.example.com:8000/auth/realms/quickstart/.well-known/openid-configuration" \ | jq .Copy to Clipboard Copied! Toggle word wrap Toggle overflow IDP 証明書を取得します。

構文

curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "IDP_URL/CONTEXT/realms/REALM/protocol/openid-connect/certs" \ | jq .curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "IDP_URL/CONTEXT/realms/REALM/protocol/openid-connect/certs" \ | jq .Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "http://www.example.com/auth/realms/quickstart/protocol/openid-connect/certs" \ | jq .[user@client ~]$ curl -k -v \ -X GET \ -H "Content-Type: application/x-www-form-urlencoded" \ "http://www.example.com/auth/realms/quickstart/protocol/openid-connect/certs" \ | jq .Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記x5c証明書は、SSO プロバイダーに応じて、/certsパスまたは/jwksパスで使用できます。直前のコマンドから "x5c" 応答の結果をコピーし、それを

certificate.crtファイルに貼り付けます。冒頭に—–BEGIN CERTIFICATE—–、末尾に—–END CERTIFICATE—–を含めます。例

-----BEGIN CERTIFICATE----- MIIDYjCCAkqgAwIBAgIEEEd2CDANBgkqhkiG9w0BAQsFADBzMQkwBwYDVQQGEwAxCTAHBgNVBAgTADEJMAcGA1UEBxMAMQkwBwYDVQQKEwAxCTAHBgNVBAsTADE6MDgGA1UEAxMxYXV0aHN2Yy1pbmxpbmVtZmEuZGV2LnZlcmlmeS5pYm1jbG91ZHNlY3VyaXR5LmNvbTAeFw0yMTA3MDUxMzU2MzZaFw0zMTA3MDMxMzU2MzZaMHMxCTAHBgNVBAYTADEJMAcGA1UECBMAMQkwBwYDVQQHEwAxCTAHBgNVBAoTADEJMAcGA1UECxMAMTowOAYDVQQDEzFhdXRoc3ZjLWlubGluZW1mYS5kZXYudmVyaWZ5LmlibWNsb3Vkc2VjdXJpdHkuY29tMIIBIjANBgkqhkiG9w0BAQEFAAOCAQ8AMIIBCgKCAQEAphyu3HaAZ14JH/EXetZxtNnerNuqcnfxcmLhBz9SsTlFD59ta+BOVlRnK5SdYEqO3ws2iGEzTvC55rczF+hDVHFZEBJLVLQe8ABmi22RAtG1P0dA/Bq8ReFxpOFVWJUBc31QM+ummW0T4yw44wQJI51LZTMz7PznB0ScpObxKe+frFKd1TCMXPlWOSzmTeFYKzR83Fg9hsnz7Y8SKGxi+RoBbTLT+ektfWpR7O+oWZIf4INe1VYJRxZvn+qWcwI5uMRCtQkiMknc3Rj6Eupiqq6FlAjDs0p//EzsHAlW244jMYnHCGq0UP3oE7vViLJyiOmZw7J3rvs3m9mOQiPLoQIDAQABMA0GCSqGSIb3DQEBCwUAA4IBAQCeVqAzSh7Tp8LgaTIFUuRbdjBAKXC9Nw3+pRBHoiUTdhqO3ualyGih9m/js/clb8Vq/39zl0VPeaslWl2NNX9zaK7xo+ckVIOY3ucCaTC04ZUn1KzZu/7azlN0C5XSWg/CfXgU2P3BeMNzc1UNY1BASGyWn2lEplIVWKLaDZpNdSyyGyaoQAIBdzxeNCyzDfPCa2oSO8WH1czmFiNPqR5kdknHI96CmsQdi+DT4jwzVsYgrLfcHXmiWyIAb883hR3Pobp+Bsw7LUnxebQ5ewccjYmrJzOk5Wb5FpXBhaJH1B3AEd6RGalRUyc/zUKdvEy0nIRMDS9x2BP3NVvZSADD -----END CERTIFICATE-----

-----BEGIN CERTIFICATE----- MIIDYjCCAkqgAwIBAgIEEEd2CDANBgkqhkiG9w0BAQsFADBzMQkwBwYDVQQGEwAxCTAHBgNVBAgTADEJMAcGA1UEBxMAMQkwBwYDVQQKEwAxCTAHBgNVBAsTADE6MDgGA1UEAxMxYXV0aHN2Yy1pbmxpbmVtZmEuZGV2LnZlcmlmeS5pYm1jbG91ZHNlY3VyaXR5LmNvbTAeFw0yMTA3MDUxMzU2MzZaFw0zMTA3MDMxMzU2MzZaMHMxCTAHBgNVBAYTADEJMAcGA1UECBMAMQkwBwYDVQQHEwAxCTAHBgNVBAoTADEJMAcGA1UECxMAMTowOAYDVQQDEzFhdXRoc3ZjLWlubGluZW1mYS5kZXYudmVyaWZ5LmlibWNsb3Vkc2VjdXJpdHkuY29tMIIBIjANBgkqhkiG9w0BAQEFAAOCAQ8AMIIBCgKCAQEAphyu3HaAZ14JH/EXetZxtNnerNuqcnfxcmLhBz9SsTlFD59ta+BOVlRnK5SdYEqO3ws2iGEzTvC55rczF+hDVHFZEBJLVLQe8ABmi22RAtG1P0dA/Bq8ReFxpOFVWJUBc31QM+ummW0T4yw44wQJI51LZTMz7PznB0ScpObxKe+frFKd1TCMXPlWOSzmTeFYKzR83Fg9hsnz7Y8SKGxi+RoBbTLT+ektfWpR7O+oWZIf4INe1VYJRxZvn+qWcwI5uMRCtQkiMknc3Rj6Eupiqq6FlAjDs0p//EzsHAlW244jMYnHCGq0UP3oE7vViLJyiOmZw7J3rvs3m9mOQiPLoQIDAQABMA0GCSqGSIb3DQEBCwUAA4IBAQCeVqAzSh7Tp8LgaTIFUuRbdjBAKXC9Nw3+pRBHoiUTdhqO3ualyGih9m/js/clb8Vq/39zl0VPeaslWl2NNX9zaK7xo+ckVIOY3ucCaTC04ZUn1KzZu/7azlN0C5XSWg/CfXgU2P3BeMNzc1UNY1BASGyWn2lEplIVWKLaDZpNdSyyGyaoQAIBdzxeNCyzDfPCa2oSO8WH1czmFiNPqR5kdknHI96CmsQdi+DT4jwzVsYgrLfcHXmiWyIAb883hR3Pobp+Bsw7LUnxebQ5ewccjYmrJzOk5Wb5FpXBhaJH1B3AEd6RGalRUyc/zUKdvEy0nIRMDS9x2BP3NVvZSADD -----END CERTIFICATE-----Copy to Clipboard Copied! Toggle word wrap Toggle overflow 証明書のサムプリントを取得します。

構文

openssl x509 -in CERT_FILE -fingerprint -noout

openssl x509 -in CERT_FILE -fingerprint -nooutCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

openssl x509 -in certificate.crt -fingerprint -noout SHA1 Fingerprint=F7:D7:B3:51:5D:D0:D3:19:DD:21:9A:43:A9:EA:72:7A:D6:06:52:87

[user@client ~]$ openssl x509 -in certificate.crt -fingerprint -noout SHA1 Fingerprint=F7:D7:B3:51:5D:D0:D3:19:DD:21:9A:43:A9:EA:72:7A:D6:06:52:87Copy to Clipboard Copied! Toggle word wrap Toggle overflow - SHA1 フィンガープリントからコロンをすべて削除し、IAM 要求で IDP エンティティーを作成するための入力として使用します。

関連情報

- Amazon の Web サイトの Obtaining the Root CA Thumbprint for an OpenID Connect Identity Provider を参照してください。

- STS API の詳細は、Red Hat Ceph Storage 開発者ガイド の Secure Token Service アプリケーションプログラミングインターフェイス セクションを参照してください。

- 詳細は、Red Hat Ceph Storage 開発者ガイド の Secure Token ServiceAPI を使用した例 セクションを参照してください。

3.2.8.5. OpenID Connect プロバイダーの登録

OpenID Connect プロバイダー (IDP) の設定ドキュメントを登録します。

前提条件

-

opensslパッケージおよびcurlパッケージがインストールされている。 - セキュアなトークンサービスが設定されている。

- OIDC プロバイダー用にユーザーが作成されている。

- OIDC のサムプリントを取得している。

手順

トークンから URL を抽出します。

例

bash check_token_isv.sh | jq .iss "https://keycloak-sso.apps.ocp.example.com/auth/realms/ceph"

[root@host01 ~]# bash check_token_isv.sh | jq .iss "https://keycloak-sso.apps.ocp.example.com/auth/realms/ceph"Copy to Clipboard Copied! Toggle word wrap Toggle overflow OIDC プロバイダーを Ceph Object Gateway に登録します。

例

aws --endpoint https://cephproxy1.example.com:8443 iam create-open-id-connect-provider --url https://keycloak-sso.apps.ocp.example.com/auth/realms/ceph --thumbprint-list 00E9CFD697E0B16DD13C86B0FFDC29957E5D24DF

[root@host01 ~]# aws --endpoint https://cephproxy1.example.com:8443 iam create-open-id-connect-provider --url https://keycloak-sso.apps.ocp.example.com/auth/realms/ceph --thumbprint-list 00E9CFD697E0B16DD13C86B0FFDC29957E5D24DFCopy to Clipboard Copied! Toggle word wrap Toggle overflow OIDC プロバイダーが Ceph Object Gateway に追加されていることを確認します。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.2.8.6. IAM ロールとポリシーの作成

IAM ロールとポリシーを作成します。

前提条件

-

opensslパッケージおよびcurlパッケージがインストールされている。 - セキュアなトークンサービスが設定されている。

- OIDC プロバイダー用にユーザーが作成されている。

- OIDC のサムプリントを取得している。

- Ceph Object Gateway の OIDC プロバイダーが登録されている。

手順

JWT トークンを取得して検証します。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow トークンを確認します。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、jq フィルターがトークンのサブフィールドによって使用され、ceph に設定されます。

ロールのプロパティーを含む JSON ファイルを作成します。

StatementをAllowに設定し、ActionをAssumeRoleWithWebIdentityに設定します。sub:cephの条件に一致する JWT トークンを持つすべてのユーザーにアクセスを許可します。例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow JSON ファイルを使用して Ceph Object Gateway ロールを作成します。

例

radosgw-admin role create --role-name rgwadmins \ --assume-role-policy-doc=$(jq -rc . /root/role-rgwadmins.json)

[root@host01 ~]# radosgw-admin role create --role-name rgwadmins \ --assume-role-policy-doc=$(jq -rc . /root/role-rgwadmins.json)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

.

3.2.8.7. S3 リソースへのアクセス

S3 リソースにアクセスするには、STS 認証情報を使用して Assume ロールを確認します。

前提条件

-

opensslパッケージおよびcurlパッケージがインストールされている。 - セキュアなトークンサービスが設定されている。

- OIDC プロバイダー用にユーザーが作成されている。

- OIDC のサムプリントを取得している。

- Ceph Object Gateway の OIDC プロバイダーが登録されている。

- IAM ロールとポリシーが作成されている。

手順

以下は、一時的なアクセスとシークレットキーを取得して S3 リソースにアクセスするための、STS を使用した assume ロールの例です。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow スクリプトを実行します。

例

source ./test-assume-role.sh s3admin passw0rd rgwadmins aws s3 mb s3://testbucket aws s3 ls

[root@host01 ~]# source ./test-assume-role.sh s3admin passw0rd rgwadmins [root@host01 ~]# aws s3 mb s3://testbucket [root@host01 ~]# aws s3 lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.2.9. Keystone での STS Lite の設定および使用 (テクノロジープレビュー)

Amazon Secure Token Service (STS) と S3 API は、同じ名前空間に共存します。STS オプションは、Keystone オプションと組み合わせて設定できます。

S3 と STS の API の両方に、Ceph Object Gateway の同じエンドポイントを使用してアクセスできます。

前提条件

- Red Hat Ceph Storage 5.0 以降

- 実行中の Ceph Object Gateway。

- Boto Python モジュールのバージョン 3 以降のインストール

- Ceph Manager ノードへのルートレベルのアクセス。

- OpenStack ノードへのユーザーレベルのアクセス。

手順

Ceph Object Gateway クライアントに以下の設定オプションを設定します。

構文

ceph config set RGW_CLIENT_NAME rgw_sts_key STS_KEY ceph config set RGW_CLIENT_NAME rgw_s3_auth_use_sts true

ceph config set RGW_CLIENT_NAME rgw_sts_key STS_KEY ceph config set RGW_CLIENT_NAME rgw_s3_auth_use_sts trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow rgw_sts_keyは、セッショントークンを暗号化または復号化するための STS キーであり、正確に 16 進数の 16 文字です。重要STS キーは英数字である必要があります。

例

ceph config set client.rgw rgw_sts_key 7f8fd8dd4700mnop ceph config set client.rgw rgw_s3_auth_use_sts true

[root@mgr ~]# ceph config set client.rgw rgw_sts_key 7f8fd8dd4700mnop [root@mgr ~]# ceph config set client.rgw rgw_s3_auth_use_sts trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenStack ノードで EC2 認証情報を生成します。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 生成された認証情報を使用して、GetSessionToken API を使用して一時的なセキュリティー認証情報のセットを取得します。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 一時認証情報の取得は、S3 呼び出しの作成に使用できます。

例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 新しい S3Access ロールを作成し、ポリシーを設定します。

管理 CAPS でユーザーを割り当てます。

構文

radosgw-admin caps add --uid="USER" --caps="roles=*"

radosgw-admin caps add --uid="USER" --caps="roles=*"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

radosgw-admin caps add --uid="gwadmin" --caps="roles=*"

[root@mgr ~]# radosgw-admin caps add --uid="gwadmin" --caps="roles=*"Copy to Clipboard Copied! Toggle word wrap Toggle overflow S3Access ロールを作成します。

構文

radosgw-admin role create --role-name=ROLE_NAME --path=PATH --assume-role-policy-doc=TRUST_POLICY_DOC

radosgw-admin role create --role-name=ROLE_NAME --path=PATH --assume-role-policy-doc=TRUST_POLICY_DOCCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

radosgw-admin role create --role-name=S3Access --path=/application_abc/component_xyz/ --assume-role-policy-doc=\{\"Version\":\"2012-10-17\",\"Statement\":\[\{\"Effect\":\"Allow\",\"Principal\":\{\"AWS\":\[\"arn:aws:iam:::user/TESTER\"\]\},\"Action\":\[\"sts:AssumeRole\"\]\}\]\}[root@mgr ~]# radosgw-admin role create --role-name=S3Access --path=/application_abc/component_xyz/ --assume-role-policy-doc=\{\"Version\":\"2012-10-17\",\"Statement\":\[\{\"Effect\":\"Allow\",\"Principal\":\{\"AWS\":\[\"arn:aws:iam:::user/TESTER\"\]\},\"Action\":\[\"sts:AssumeRole\"\]\}\]\}Copy to Clipboard Copied! Toggle word wrap Toggle overflow S3Access ロールにパーミッションポリシーを割り当てます。

構文

radosgw-admin role-policy put --role-name=ROLE_NAME --policy-name=POLICY_NAME --policy-doc=PERMISSION_POLICY_DOC

radosgw-admin role-policy put --role-name=ROLE_NAME --policy-name=POLICY_NAME --policy-doc=PERMISSION_POLICY_DOCCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

radosgw-admin role-policy put --role-name=S3Access --policy-name=Policy --policy-doc=\{\"Version\":\"2012-10-17\",\"Statement\":\[\{\"Effect\":\"Allow\",\"Action\":\[\"s3:*\"\],\"Resource\":\"arn:aws:s3:::example_bucket\"\}\]\}[root@mgr ~]# radosgw-admin role-policy put --role-name=S3Access --policy-name=Policy --policy-doc=\{\"Version\":\"2012-10-17\",\"Statement\":\[\{\"Effect\":\"Allow\",\"Action\":\[\"s3:*\"\],\"Resource\":\"arn:aws:s3:::example_bucket\"\}\]\}Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

別のユーザーが

gwadminユーザーのロールを想定できるようになりました。たとえば、gwuserユーザーは、gwadminユーザーのパーミッションを想定できます。 仮定ユーザーの

access_keyおよびsecret_keyの値を書き留めておきます。例

radosgw-admin user info --uid=gwuser | grep -A1 access_key

[root@mgr ~]# radosgw-admin user info --uid=gwuser | grep -A1 access_keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow

AssumeRole API 呼び出しを使用し、仮定のユーザーから

access_keyおよびsecret_keyの値を提供します。例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要AssumeRole API には S3Access ロールが必要です。

関連情報

- Boto Python モジュールのインストールの詳細は、Red Hat Ceph Storage Object Gateway ガイド の S3 アクセスのテスト セクションを参照してください。

- 詳細は、Red Hat Ceph Storage Object Gateway ガイド の ユーザーの作成 セクションを参照してください。

3.2.10. Keystone で STS Lite を使用するための制限の回避 (テクノロジープレビュー)

Keystone の制限は、Secure Token Service (STS) 要求をサポートしないことです。もう 1 つの制限は、ペイロードハッシュがリクエストに含まれていないことです。この 2 つの制限を回避するには、Boto 認証コードを変更する必要があります。

前提条件

- 稼働中の Red Hat Ceph Storage クラスター (バージョン 5.0 以降)。

- 実行中の Ceph Object Gateway。

- Boto Python モジュールのバージョン 3 以降のインストール

手順

Boto の

auth.pyファイルを開いて編集します。以下の 4 つの行をコードブロックに追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の 2 つの行をコードブロックに追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

関連情報

- Boto Python モジュールのインストールの詳細は、Red Hat Ceph Storage Object Gateway ガイド の S3 アクセスのテスト セクションを参照してください。