네트워킹

클러스터 네트워킹 구성 및 관리

초록

1장. 네트워킹 정보

Red Hat OpenShift Networking은 클러스터가 하나 이상의 하이브리드 클러스터의 네트워크 트래픽을 관리하는 데 필요한 고급 네트워킹 관련 기능을 사용하여 Kubernetes 네트워킹을 확장하는 기능, 플러그인 및 고급 네트워킹 기능으로 구성된 에코시스템입니다. 이 네트워킹 기능의 에코시스템은 수신, 송신, 로드 밸런싱, 고성능 처리량, 보안, 클러스터 간 트래픽 관리를 통합하고, 특성 복잡성을 줄이기 위해 역할 기반 관찰 기능 툴을 제공합니다.

OpenShift SDN CNI는 OpenShift Container Platform 4.14에서 더 이상 사용되지 않습니다. OpenShift Container Platform 4.15부터 네트워크 플러그인은 새 설치를 위한 옵션이 아닙니다. 향후 릴리스에서 OpenShift SDN 네트워크 플러그인은 제거될 예정이며 더 이상 지원되지 않습니다. Red Hat은 제거될 때까지 이 기능에 대한 버그 수정 및 지원을 제공하지만 이 기능은 더 이상 개선 사항을 받지 않습니다. OpenShift SDN CNI 대신 OVN Kubernetes CNI를 대신 사용할 수 있습니다.

다음 목록은 클러스터에서 사용할 수 있는 가장 일반적으로 사용되는 Red Hat OpenShift Networking 기능 중 일부를 강조 표시합니다.

다음 CNI(Container Network Interface) 플러그인에서 제공하는 기본 클러스터 네트워크입니다.

- 인증된 타사 대체 기본 네트워크 플러그인

- 네트워크 플러그인 관리를 위한 Cluster Network Operator

- TLS 암호화 웹 트래픽용 Ingress Operator

- 이름 할당을 위한 DNS Operator

- 베어 메탈 클러스터에서 트래픽 로드 밸런싱을 위한 MetalLB Operator

- 고가용성에 대한 IP 페일오버 지원

- macvlan, ipvlan 및 SR-IOV 하드웨어 네트워크를 포함한 여러 CNI 플러그인을 통한 추가 하드웨어 네트워크 지원

- IPv4, IPv6 및 듀얼 스택 주소 지정

- Windows 기반 워크로드를 위한 하이브리드 Linux-Windows 호스트 클러스터

- 검색, 로드 밸런싱, 서비스 간 인증, 장애 복구, 메트릭 및 서비스 모니터링을 위한 Red Hat OpenShift Service Mesh

- 단일 노드 OpenShift

- 네트워크 디버깅 및 인사이트를 위한 Network Observability Operator

- 클러스터 간 네트워킹을 위한 Submariner

- 계층 7 간 네트워킹을 위한 Red Hat Service Interconnect

2장. 네트워킹 이해

클러스터 관리자에게는 클러스터 내에서 실행되는 애플리케이션을 외부 트래픽으로 노출하고 네트워크 연결 보안을 설정하는 몇 가지 옵션이 있습니다.

- 노드 포트 또는 로드 밸런서와 같은 서비스 유형

-

Ingress및Route와 같은 API 리소스

기본적으로 Kubernetes는 pod 내에서 실행되는 애플리케이션의 내부 IP 주소를 각 pod에 할당합니다. pod와 해당 컨테이너에 네트워크를 지정할 수 있지만 클러스터 외부의 클라이언트에는 네트워킹 액세스 권한이 없습니다. 애플리케이션을 외부 트래픽에 노출할 때 각 pod에 고유 IP 주소를 부여하면 포트 할당, 네트워킹, 이름 지정, 서비스 검색, 로드 밸런싱, 애플리케이션 구성 및 마이그레이션 등 다양한 업무를 할 때 pod를 물리적 호스트 또는 가상 머신처럼 취급할 수 있습니다.

일부 클라우드 플랫폼은 IPv4 169.254.0.0/16 CIDR 블록의 링크 로컬 IP 주소인 169.254.169.254 IP 주소에서 수신 대기하는 메타데이터 API를 제공합니다.

Pod 네트워크에서는 이 CIDR 블록에 접근할 수 없습니다. 이러한 IP 주소에 액세스해야 하는 pod의 경우 pod 사양의 spec.hostNetwork 필드를 true로 설정하여 호스트 네트워크 액세스 권한을 부여해야 합니다.

Pod의 호스트 네트워크 액세스를 허용하면 해당 pod에 기본 네트워크 인프라에 대한 액세스 권한이 부여됩니다.

2.1. OpenShift Container Platform DNS

여러 Pod에 사용하기 위해 프론트엔드 및 백엔드 서비스와 같은 여러 서비스를 실행하는 경우 사용자 이름, 서비스 IP 등에 대한 환경 변수를 생성하여 프론트엔드 Pod가 백엔드 서비스와 통신하도록 할 수 있습니다. 서비스를 삭제하고 다시 생성하면 새 IP 주소를 서비스에 할당할 수 있으며 서비스 IP 환경 변수의 업데이트된 값을 가져오기 위해 프론트엔드 Pod를 다시 생성해야 합니다. 또한 백엔드 서비스를 생성한 후 프론트엔드 Pod를 생성해야 서비스 IP가 올바르게 생성되고 프론트엔드 Pod에 환경 변수로 제공할 수 있습니다.

이러한 이유로 서비스 DNS는 물론 서비스 IP/포트를 통해서도 서비스를 이용할 수 있도록 OpenShift Container Platform에 DNS를 내장했습니다.

2.2. OpenShift Container Platform Ingress Operator

OpenShift Container Platform 클러스터를 생성할 때 클러스터에서 실행되는 Pod 및 서비스에는 각각 자체 IP 주소가 할당됩니다. IP 주소는 내부에서 실행되지만 외부 클라이언트가 액세스할 수 없는 다른 pod 및 서비스에 액세스할 수 있습니다. Ingress Operator는 IngressController API를 구현하며 OpenShift Container Platform 클러스터 서비스에 대한 외부 액세스를 활성화하는 구성 요소입니다.

Ingress Operator를 사용하면 라우팅을 처리하기 위해 하나 이상의 HAProxy 기반 Ingress 컨트롤러를 배포하고 관리하여 외부 클라이언트가 서비스에 액세스할 수 있습니다. Ingress Operator를 사용하여 OpenShift 컨테이너 플랫폼 Route 및 Kubernetes Ingress 리소스를 지정하면 수신 트래픽을 라우팅할 수 있습니다. endpointPublishingStrategy 유형 및 내부 로드 밸런싱을 정의하는 기능과 같은 Ingress 컨트롤러 내 구성은 Ingress 컨트롤러 끝점을 게시하는 방법을 제공합니다.

2.2.1. 경로와 Ingress 비교

OpenShift Container Platform의 Kubernetes Ingress 리소스는 클러스터 내에서 Pod로 실행되는 공유 라우터 서비스를 사용하여 Ingress 컨트롤러를 구현합니다. Ingress 트래픽을 관리하는 가장 일반적인 방법은 Ingress 컨트롤러를 사용하는 것입니다. 다른 일반 Pod와 마찬가지로 이 Pod를 확장하고 복제할 수 있습니다. 이 라우터 서비스는 오픈 소스 로드 밸런서 솔루션인 HAProxy를 기반으로 합니다.

OpenShift Container Platform 경로는 클러스터의 서비스에 대한 Ingress 트래픽을 제공합니다. 경로는 TLS 재암호화, TLS 패스스루, 블루-그린 배포를 위한 분할 트래픽등 표준 Kubernetes Ingress 컨트롤러에서 지원하지 않는 고급 기능을 제공합니다.

Ingress 트래픽은 경로를 통해 클러스터의 서비스에 액세스합니다. 경로 및 Ingress는 Ingress 트래픽을 처리하는 데 필요한 주요 리소스입니다. Ingress는 외부 요청을 수락하고 경로를 기반으로 위임하는 것과 같은 경로와 유사한 기능을 제공합니다. 그러나 Ingress를 사용하면 HTTP/2, HTTPS, SNI(서버 이름 식별) 및 인증서가 있는 TLS와 같은 특정 유형의 연결만 허용할 수 있습니다. OpenShift Container Platform에서는 Ingress 리소스에서 지정하는 조건을 충족하기 위해 경로가 생성됩니다.

2.3. OpenShift Container Platform 네트워킹의 일반 용어집

이 용어집은 네트워킹 콘텐츠에 사용되는 일반적인 용어를 정의합니다.

- 인증

- OpenShift Container Platform 클러스터에 대한 액세스를 제어하기 위해 클러스터 관리자는 사용자 인증을 구성하고 승인된 사용자만 클러스터에 액세스할 수 있는지 확인할 수 있습니다. OpenShift Container Platform 클러스터와 상호 작용하려면 OpenShift Container Platform API에 인증해야 합니다. OpenShift Container Platform API에 대한 요청에 OAuth 액세스 토큰 또는 X.509 클라이언트 인증서를 제공하여 인증할 수 있습니다.

- AWS Load Balancer Operator

-

AWS Load Balancer(ALB) Operator는

aws-load-balancer-controller인스턴스를 배포 및 관리합니다. - CNO(Cluster Network Operator)

- CNO(Cluster Network Operator)는 OpenShift Container Platform 클러스터에서 클러스터 네트워크 구성 요소를 배포하고 관리합니다. 여기에는 설치 중에 클러스터에 대해 선택된 CNI(Container Network Interface) 네트워크 플러그인 배포가 포함됩니다.

- 구성 맵

-

구성 맵에서는 구성 데이터를 Pod에 삽입하는 방법을 제공합니다. 구성 맵에 저장된 데이터를

ConfigMap유형의 볼륨에서 참조할 수 있습니다. Pod에서 실행되는 애플리케이션에서는 이 데이터를 사용할 수 있습니다. - CR(사용자 정의 리소스)

- CR은 Kubernetes API의 확장입니다. 사용자 정의 리소스를 생성할 수 있습니다.

- DNS

- 클러스터 DNS는 Kubernetes 서비스에 대한 DNS 레코드를 제공하는 DNS 서버입니다. Kubernetes로 시작한 컨테이너는 DNS 검색에 이 DNS 서버를 자동으로 포함합니다.

- DNS Operator

- DNS Operator는 CoreDNS를 배포 및 관리하여 Pod에 이름 확인 서비스를 제공합니다. 이를 통해 OpenShift Container Platform에서 DNS 기반 Kubernetes 서비스 검색을 사용할 수 있습니다.

- 배포

- 애플리케이션의 라이프사이클을 유지 관리하는 Kubernetes 리소스 오브젝트입니다.

- domain

- domain은 Ingress 컨트롤러에서 제공하는 DNS 이름입니다.

- egress

- Pod의 네트워크 아웃 바운드 트래픽을 통해 외부적으로 데이터 공유 프로세스.

- 외부 DNS Operator

- 외부 DNS Operator는 ExternalDNS를 배포 및 관리하여 외부 DNS 공급자에서 OpenShift Container Platform으로의 서비스 및 경로에 대한 이름 확인을 제공합니다.

- HTTP 기반 경로

- HTTP 기반 경로는 기본 HTTP 라우팅 프로토콜을 사용하고 안전하지 않은 애플리케이션 포트에 서비스를 노출하는 비보안 경로입니다.

- Ingress

- OpenShift Container Platform의 Kubernetes Ingress 리소스는 클러스터 내에서 Pod로 실행되는 공유 라우터 서비스를 사용하여 Ingress 컨트롤러를 구현합니다.

- Ingress 컨트롤러

- Ingress Operator는 Ingress 컨트롤러를 관리합니다. OpenShift Container Platform 클러스터에 대한 외부 액세스를 허용하는 가장 일반적인 방법은 Ingress 컨트롤러를 사용하는 것입니다.

- 설치 프로그램에서 제공하는 인프라

- 설치 프로그램은 클러스터가 실행되는 인프라를 배포하고 구성합니다.

- kubelet

- Pod에서 컨테이너가 실행 중인지 확인하기 위해 클러스터의 각 노드에서 실행되는 기본 노드 에이전트입니다.

- Kubernetes NMState Operator

- Kubernetes NMState Operator는 OpenShift Container Platform 클러스터 노드에서 NMState를 사용하여 상태 중심 네트워크 구성을 수행하는 데 필요한 Kubernetes API를 제공합니다.

- kube-proxy

- kube-proxy는 각 노드에서 실행되는 프록시 서비스로, 외부 호스트에서 서비스를 사용할 수 있도록 하는 데 도움이 됩니다. 컨테이너를 수정하도록 요청을 전달하는 데 도움이 되며 기본 로드 밸런싱을 수행할 수 있습니다.

- 로드 밸런서

- OpenShift Container Platform에서는 로드 밸런서를 사용하여 클러스터에서 실행되는 서비스와 클러스터 외부에서 통신합니다.

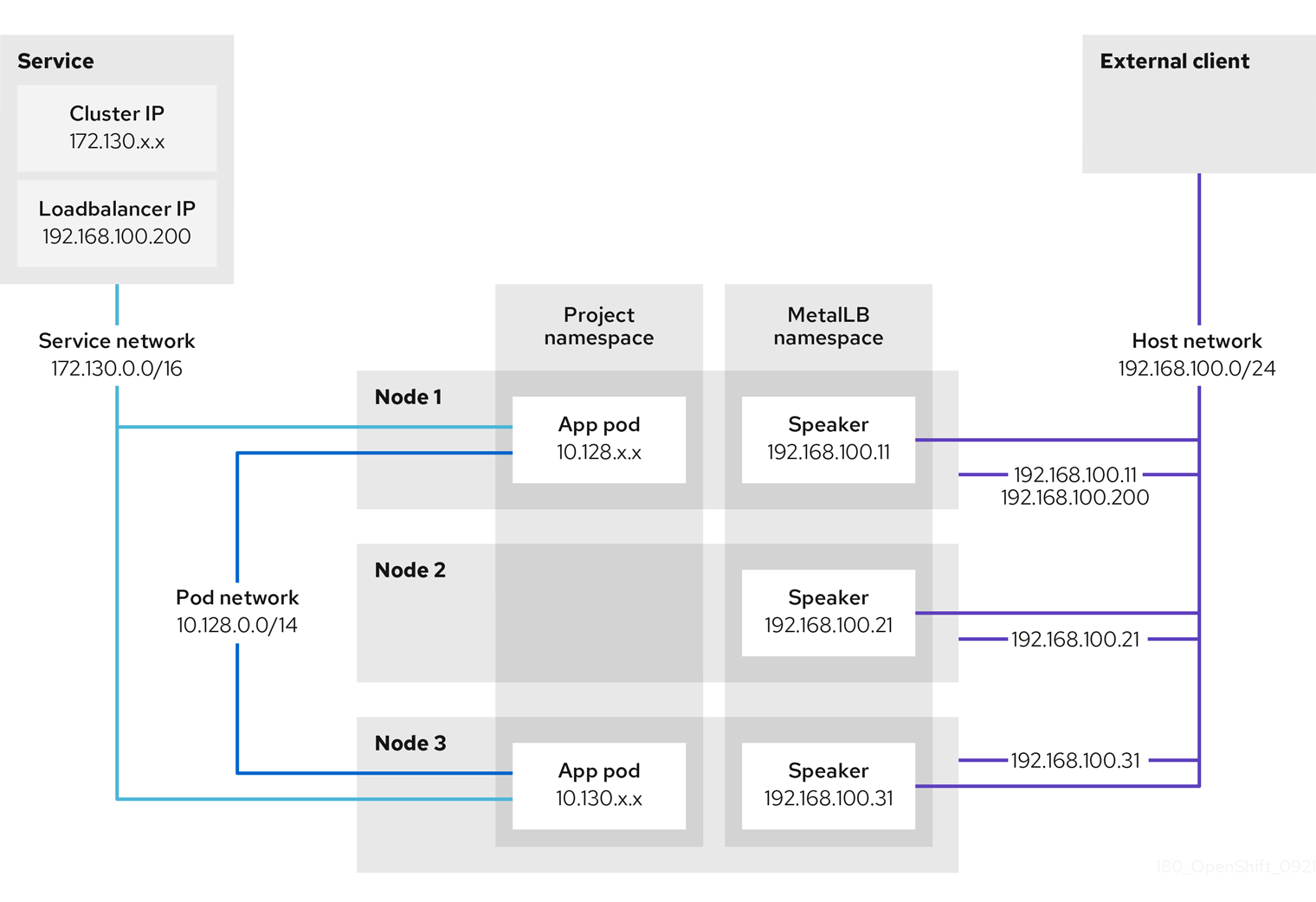

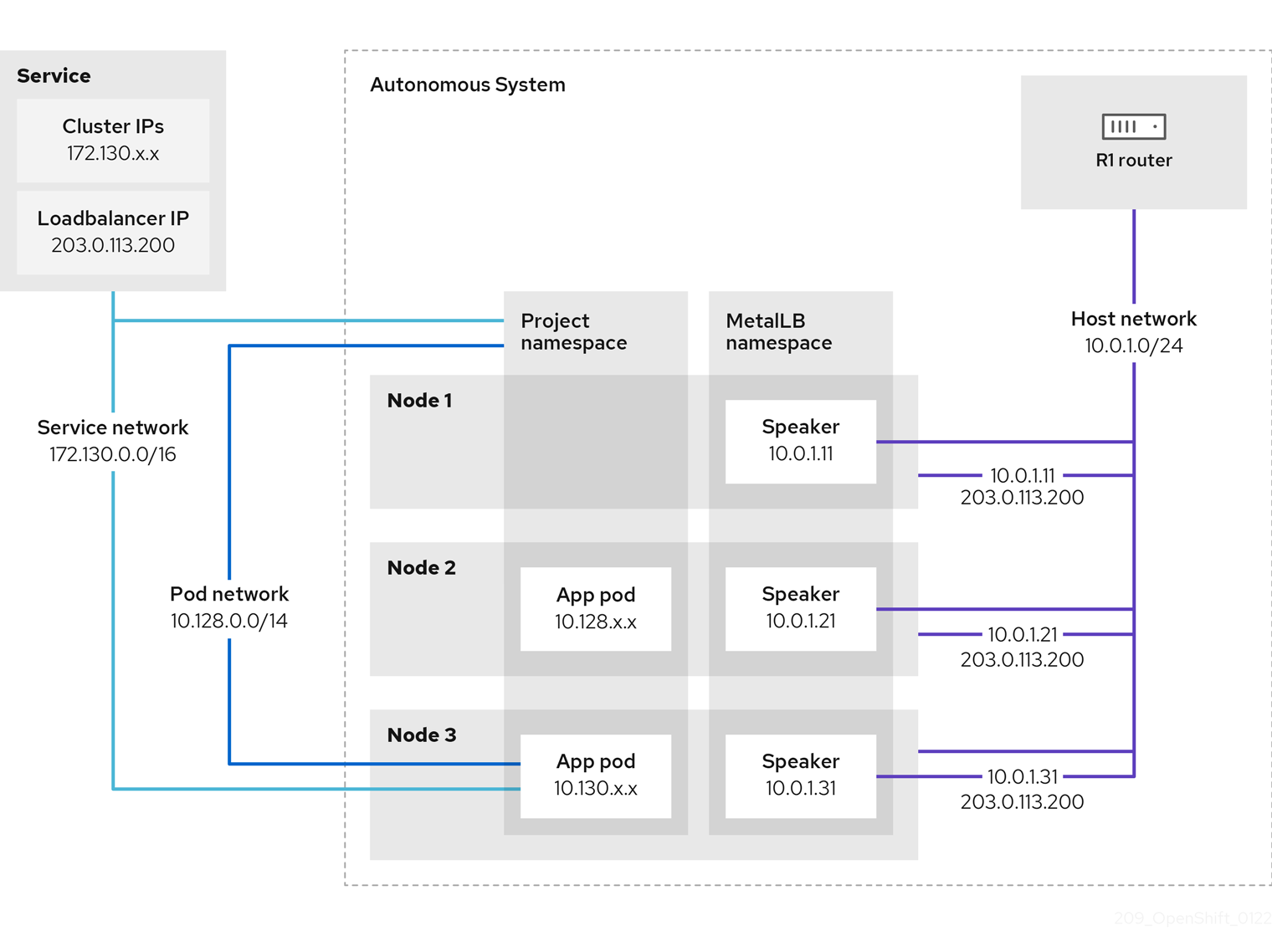

- MetalLB Operator

-

클러스터 관리자는 MetalLB Operator를 클러스터에 추가하여

LoadBalancer유형의 서비스가 클러스터에 추가되면 MetalLB에서 서비스의 외부 IP 주소를 추가할 수 있습니다. - 멀티 캐스트

- IP 멀티 캐스트를 사용하면 데이터가 여러 IP 주소로 동시에 브로드캐스트됩니다.

- 네임스페이스

- 네임스페이스는 모든 프로세스에 표시되는 특정 시스템 리소스를 격리합니다. 네임스페이스 내에서 해당 네임스페이스의 멤버인 프로세스만 해당 리소스를 볼 수 있습니다.

- 네트워킹

- OpenShift Container Platform 클러스터의 네트워크 정보.

- 노드

- OpenShift Container Platform 클러스터의 작업자 시스템입니다. 노드는 VM(가상 머신) 또는 물리적 머신입니다.

- OpenShift Container Platform Ingress Operator

-

Ingress Operator는

IngressControllerAPI를 구현하며 OpenShift Container Platform 서비스에 대한 외부 액세스를 활성화하는 구성 요소입니다. - Pod

- OpenShift Container Platform 클러스터에서 실행되는 볼륨 및 IP 주소와 같은 공유 리소스가 있는 하나 이상의 컨테이너입니다. Pod는 정의, 배포 및 관리되는 최소 컴퓨팅 단위입니다.

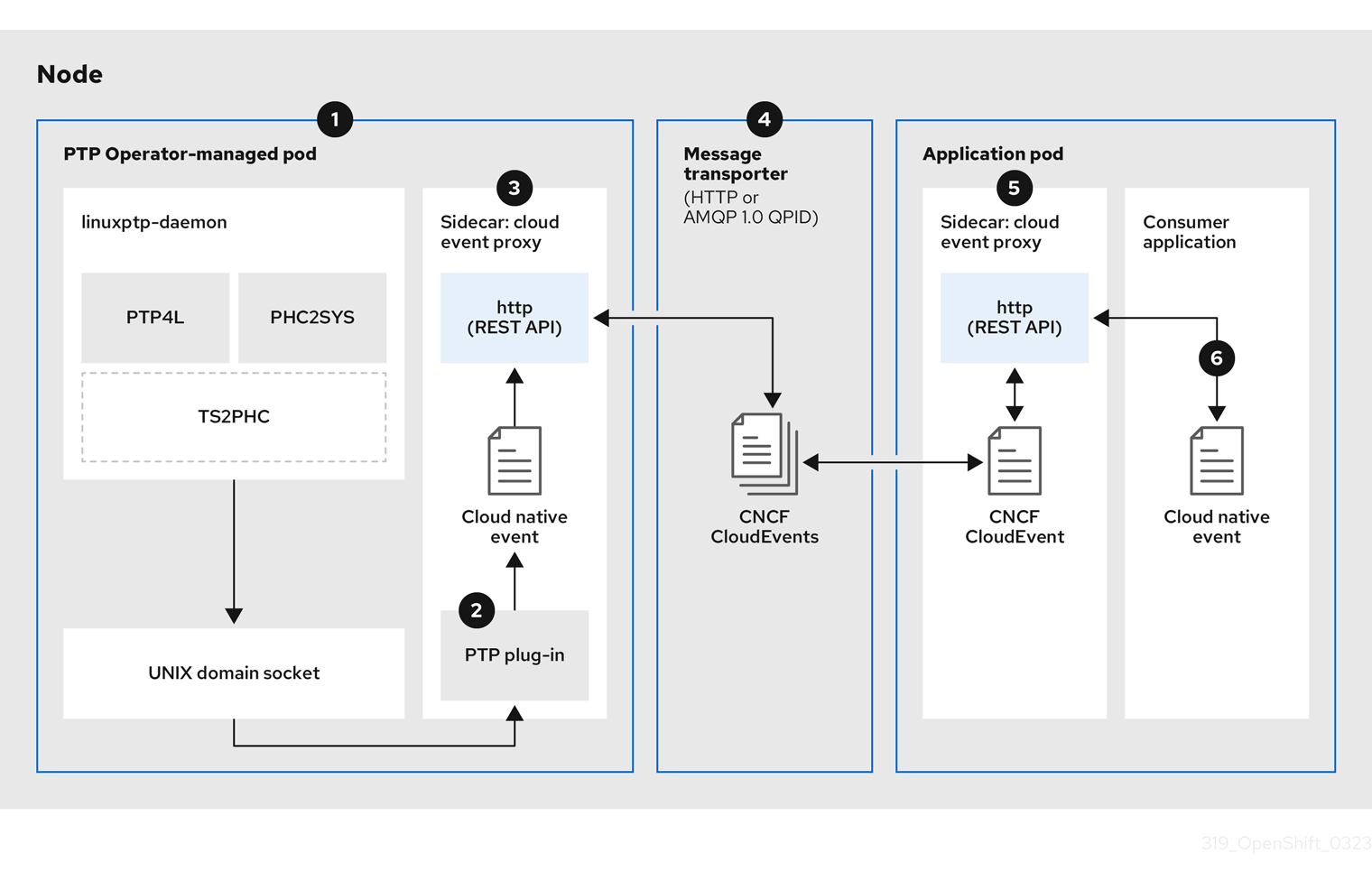

- PTP Operator

-

PTP Operator는

linuxptp서비스를 생성하고 관리합니다. - 라우트

- OpenShift Container Platform 경로는 클러스터의 서비스에 대한 Ingress 트래픽을 제공합니다. 경로는 TLS 재암호화, TLS 패스스루, 블루-그린 배포를 위한 분할 트래픽등 표준 Kubernetes Ingress 컨트롤러에서 지원하지 않는 고급 기능을 제공합니다.

- 스케일링

- 리소스 용량을 늘리거나 줄입니다.

- 서비스

- Pod 세트에 실행 중인 애플리케이션을 노출합니다.

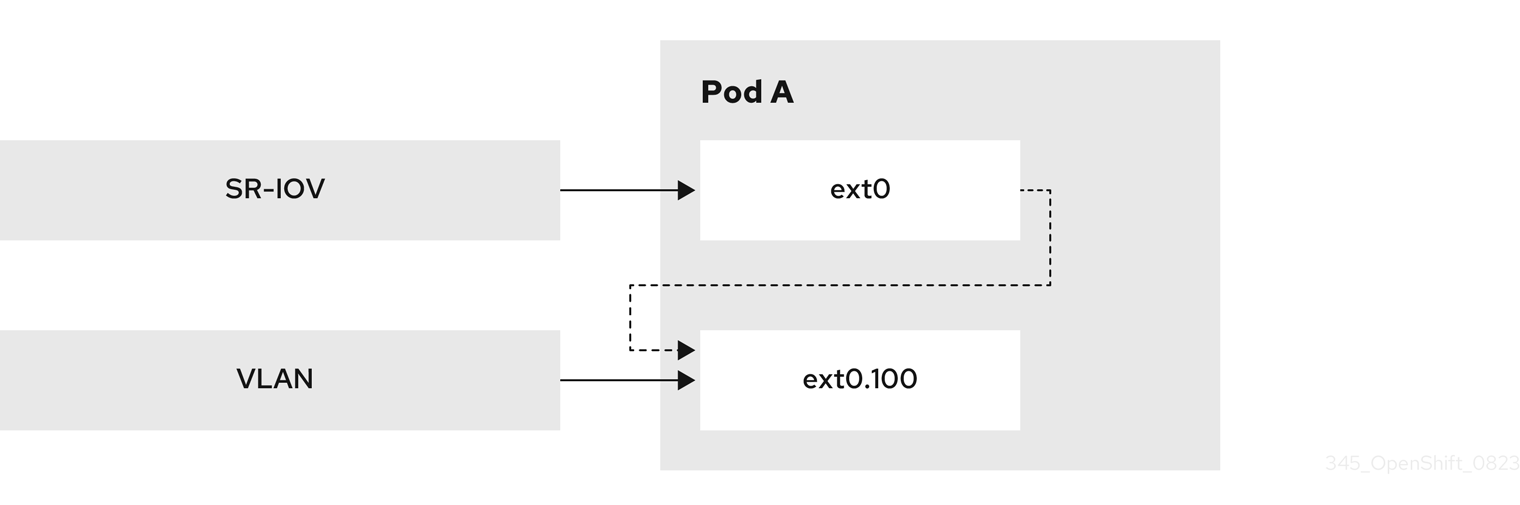

- SR-IOV(Single Root I/O Virtualization) Network Operator

- SR-IOV(Single Root I/O Virtualization) Network Operator는 클러스터의 SR-IOV 네트워크 장치 및 네트워크 첨부 파일을 관리합니다.

- 소프트웨어 정의 네트워킹(SDN)

- OpenShift Container Platform에서는 소프트웨어 정의 네트워킹(SDN) 접근법을 사용하여 OpenShift Container Platform 클러스터 전체의 pod 간 통신이 가능한 통합 클러스터 네트워크를 제공합니다.

OpenShift SDN CNI는 OpenShift Container Platform 4.14에서 더 이상 사용되지 않습니다. OpenShift Container Platform 4.15부터 네트워크 플러그인은 새 설치를 위한 옵션이 아닙니다. 향후 릴리스에서 OpenShift SDN 네트워크 플러그인은 제거될 예정이며 더 이상 지원되지 않습니다. Red Hat은 제거될 때까지 이 기능에 대한 버그 수정 및 지원을 제공하지만 이 기능은 더 이상 개선 사항을 받지 않습니다. OpenShift SDN CNI 대신 OVN Kubernetes CNI를 대신 사용할 수 있습니다.

- SCTP(스트림 제어 전송 프로토콜)

- SCTP는 IP 네트워크에서 실행되는 안정적인 메시지 기반 프로토콜입니다.

- taint

- 테인트 및 허용 오차는 Pod가 적절한 노드에 예약되도록 합니다. 노드에 하나 이상의 테인트를 적용할 수 있습니다.

- 톨러레이션

- Pod에 허용 오차를 적용할 수 있습니다. 허용 오차를 사용하면 스케줄러에서 일치하는 테인트를 사용하여 Pod를 예약할 수 있습니다.

- 웹 콘솔

- OpenShift Container Platform을 관리할 UI(사용자 인터페이스)입니다.

3장. 제로 신뢰 네트워킹

제로 신뢰는 모든 상호 작용이 신뢰할 수 없는 상태에서 시작되는 전제를 기반으로 보안 아키텍처를 설계하는 방법입니다. 이는 방화벽 내에서 통신이 시작되는지 여부에 따라 신뢰성을 결정할 수 있는 기존 아키텍처와 대조됩니다. 특히 제로 신뢰는 암시적 신뢰 모델 및 일회성 인증에 의존하는 보안 아키텍처의 격차를 없애려고 합니다.

OpenShift Container Platform은 컨테이너 또는 해당 컨테이너에서 실행되는 소프트웨어를 변경하지 않고도 플랫폼에서 실행되는 컨테이너에 일부 제로 신뢰 네트워킹 기능을 추가할 수 있습니다. Red Hat이 제공하는 여러 제품도 컨테이너의 제로 신뢰 네트워킹 기능을 추가로 보강할 수 있습니다. 컨테이너에서 실행되는 소프트웨어를 변경할 수 있는 기능이 있는 경우 Red Hat에서 추가 기능을 추가할 수 있는 다른 프로젝트가 있습니다.

제로 신뢰 네트워킹의 다음과 같은 대상 기능을 살펴봅니다.

3.1. 신뢰의 루트

공개 인증서 및 개인 키는 제로 트러스트 네트워킹에 중요합니다. 이러한 구성 요소는 서로 구성 요소를 식별하고 인증하고 트래픽을 보호하는 데 사용됩니다. 인증서는 다른 인증서에서 서명하며 루트 CA(인증 기관)에 대한 신뢰 체인이 있습니다. 네트워크에 참여하는 모든 것은 궁극적으로 신뢰 체인을 검증할 수 있도록 루트 CA의 공개 키를 보유해야 합니다. 공개 내용의 경우 일반적으로 널리 알려진 루트 CA 세트이며 운영 체제, 웹 브라우저 등과 함께 키가 배포되는 키입니다. 그러나 개인 CA의 인증서가 모든 당사자에게 배포되는 경우 클러스터 또는 법인을 위해 개인 CA를 실행할 수 있습니다.

제품 상세 정보:

- OpenShift Container Platform: OpenShift는 설치 시 클러스터 리소스를 보호하는 데 사용되는 클러스터 CA 를 생성합니다. 그러나 OpenShift Container Platform은 클러스터의 서비스에 대한 인증서를 생성하고 서명할 수 있으며 요청된 경우 클러스터 CA 번들을 Pod에 삽입할 수 있습니다. OpenShift Container Platform에서 생성 및 서명한 서비스 인증서 에는 26개월의 라이브(TTL)가 있으며 13개월에 자동으로 순환됩니다. 필요한 경우 수동으로 순환할 수도 있습니다.

- OpenShift cert-manager Operator: cert-manager를 사용하면 신뢰의 외부 루트에서 서명한 키를 요청할 수 있습니다. 위임된 서명 인증서와 함께 외부 발행자와 통합할 수 있는 구성 가능한 많은 발행자가 있습니다. cert-manager API는 제로 신뢰 네트워킹의 다른 소프트웨어에서 사용하여 필요한 인증서(예: Red Hat OpenShift Service Mesh)를 요청하거나 고객 소프트웨어에서 직접 사용할 수 있습니다.

3.2. 트래픽 인증 및 암호화

유선의 모든 트래픽이 암호화되고 엔드포인트를 확인할 수 있는지 확인합니다. 상호 TLS 또는 mTLS는 상호 인증을 위한 방법입니다.

제품 상세 정보:

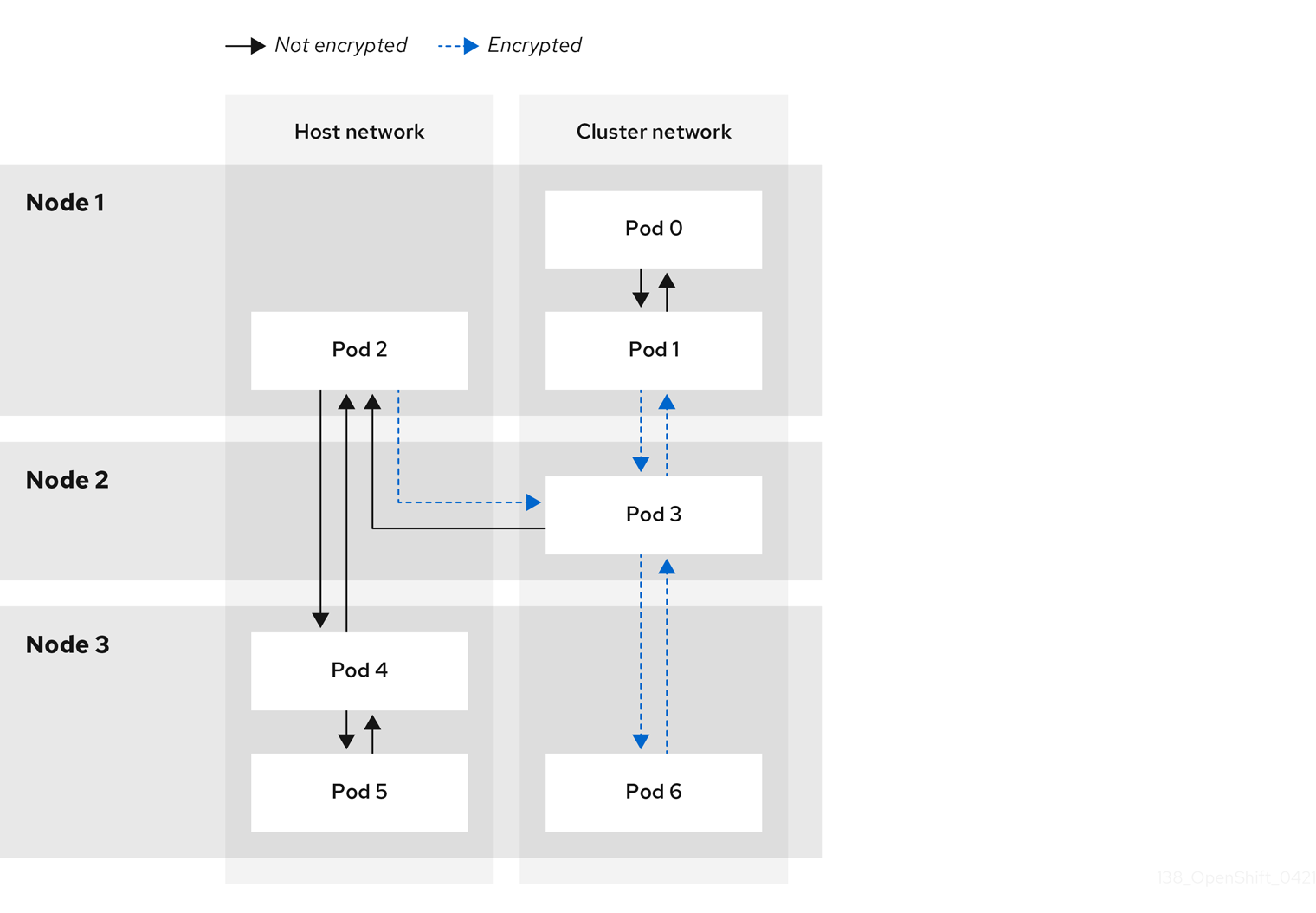

- OpenShift Container Platform: 투명한 pod-to-pod IPsec 을 사용하면 트래픽의 소스 및 대상을 IP 주소로 식별할 수 있습니다. IPsec 을 사용하여 송신 트래픽을 암호화 할 수 있는 기능이 있습니다. 송신 IP 기능을 사용하면 트래픽의 소스 IP 주소를 사용하여 클러스터 내부의 트래픽 소스를 식별할 수 있습니다.

- Red Hat OpenShift Service Mesh: Pod를 나가는 트래픽을 투명하게 보강하여 인증 및 암호화를 제공할 수 있는 강력한 mTLS 기능을 제공합니다.

- OpenShift cert-manager Operator: CRD(사용자 정의 리소스 정의)를 사용하여 프로그램에서 SSL/TLS 프로토콜에 사용할 수 있는 인증서를 요청합니다.

3.3. 식별 및 인증

CA를 사용하여 인증서를 Mint할 수 있는 기능이 있으면 이 인증서를 사용하여 사용자 또는 클라이언트 머신의 다른 쪽 끝의 ID를 확인하여 신뢰 관계를 설정할 수 있습니다. 또한 손상된 경우 사용을 제한하려면 인증서 라이프사이클을 관리해야 합니다.

제품 상세 정보:

- OpenShift Container Platform: 클라이언트가 신뢰할 수 있는 끝점과 통신할 수 있도록 클러스터 서명 서비스 인증서 입니다. 이를 위해서는 서비스에서 SSL/TLS를 사용하고 클라이언트가 클러스터 CA 를 사용해야 합니다. 클라이언트 ID는 다른 방법을 사용하여 제공해야 합니다.

- Red Hat Single Sign-On: 엔터프라이즈 사용자 디렉터리 또는 타사 ID 공급자와의 요청 인증 통합을 제공합니다.

- Red Hat OpenShift Service Mesh: mTLS에 대한 연결투명 업그레이드, 자동 순환, 사용자 정의 인증서 만료, JSON 웹 토큰(JWT)을 통한 인증 요청.

- OpenShift cert-manager Operator: 애플리케이션에서 사용할 인증서 생성 및 관리 인증서는 CRD에서 제어하고 시크릿으로 마운트하거나 cert-manager API와 직접 상호 작용하도록 애플리케이션을 변경할 수 있습니다.

3.4. 서비스 간 권한 부여

요청자의 ID를 기반으로 서비스에 대한 액세스를 제어할 수 있어야 합니다. 이 작업은 플랫폼에 의해 수행되며 각 애플리케이션을 구현할 필요가 없습니다. 이를 통해 정책의 감사 및 검사를 더 잘 수행할 수 있습니다.

제품 상세 정보:

-

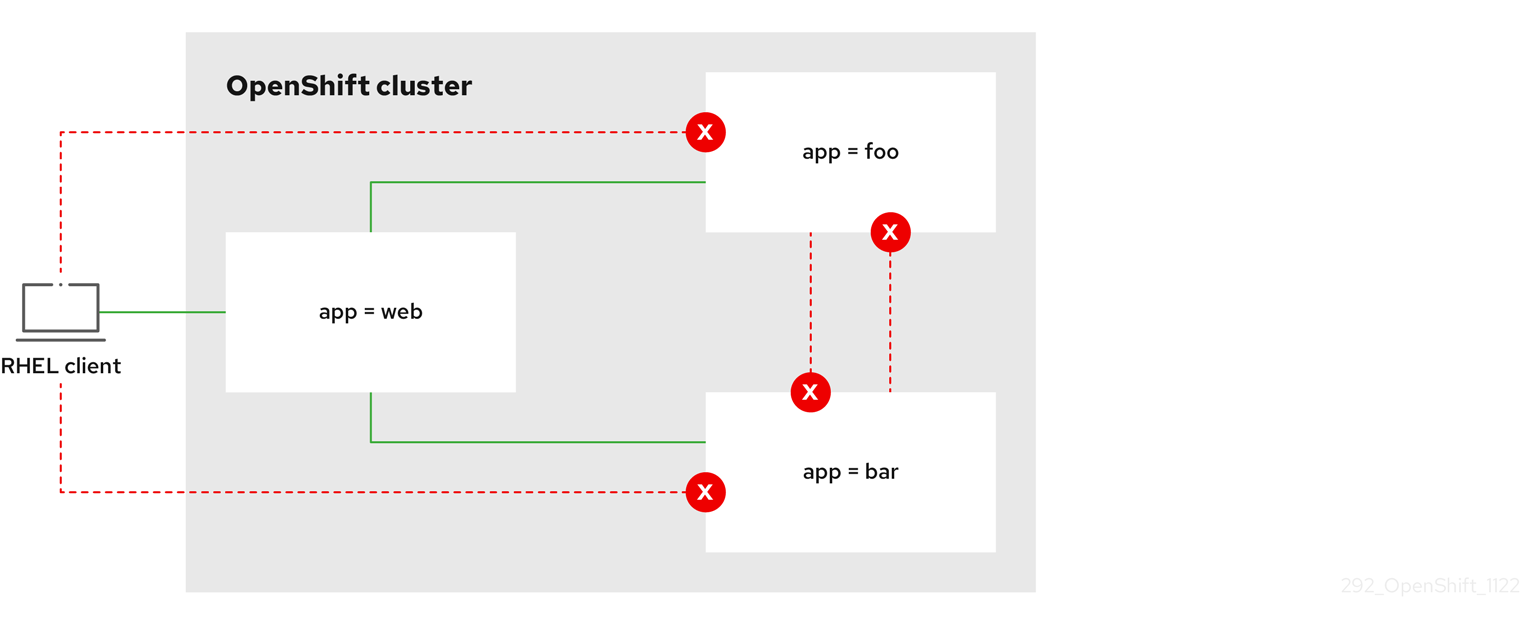

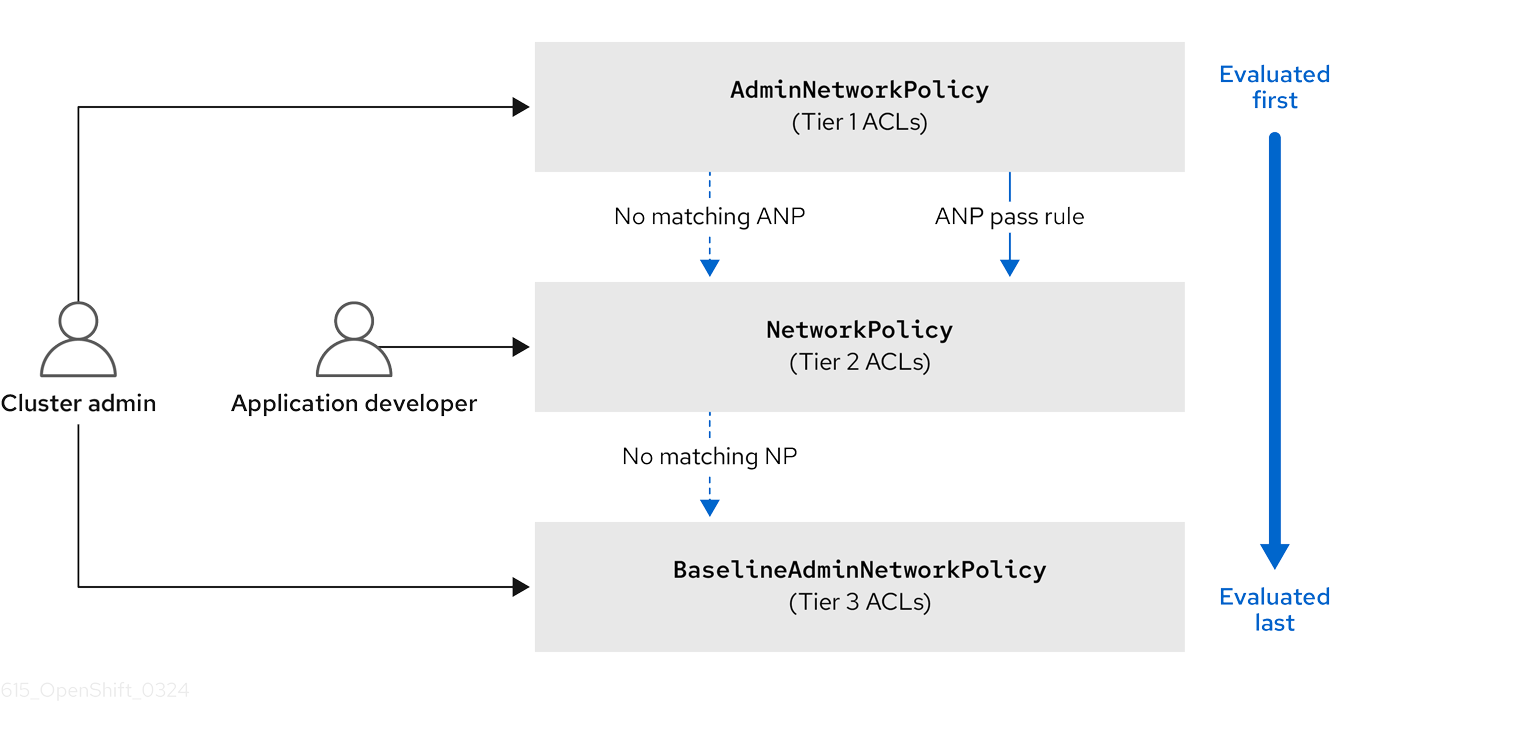

OpenShift Container Platform: Kubernetes

NetworkPolicy및AdminNetworkPolicy오브젝트를 사용하여 플랫폼의 네트워킹 계층에 격리를 적용할 수 있습니다. - Red Hat OpenShift Service Mesh: 표준 Istio 오브젝트를 사용한 트래픽 제어 및 mTLS를 사용하여 트래픽의 소스 및 대상을 확인한 다음 해당 정보를 기반으로 정책을 적용합니다.

3.5. 트랜잭션 수준 확인

연결을 식별하고 인증하는 기능 외에도 개별 트랜잭션에 대한 액세스를 제어하는 것도 유용합니다. 여기에는 소스별 속도 제한, 관찰 기능, 트랜잭션이 잘 형성되는 의미 체계 검증이 포함될 수 있습니다.

제품 상세 정보:

- Red Hat OpenShift Service Mesh: 요청에 대한 L7 검사를 수행하고 잘못된 형식의 HTTP 요청, 트랜잭션 수준의 관찰 기능 및 보고 를 거부합니다. 서비스 메시는 JWT를 사용하여 요청 기반 인증을 제공할 수도 있습니다.

3.6. 위험 평가

클러스터의 보안 정책 수가 증가함에 따라 정책 허용 및 거부에 대한 시각화가 점점 더 중요해지고 있습니다. 이러한 툴을 사용하면 클러스터 보안 정책을 보다 쉽게 생성, 시각화 및 관리할 수 있습니다.

제품 상세 정보:

-

Red Hat OpenShift Service Mesh: OpenShift 웹 콘솔 을 사용하여 Kubernetes

NetworkPolicy및AdminNetworkPolicy및 OpenShift NetworkingEgressFirewall오브젝트를 생성 및 시각화합니다. - Red Hat Advanced Cluster Security for Kubernetes: 오브젝트의 고급 시각화.

3.7. 사이트 전체 정책 시행 및 배포

클러스터에 애플리케이션을 배포한 후 보안 규칙을 구성하는 모든 오브젝트를 관리하기가 어려워집니다. 사이트 전체 정책을 적용하고 배포된 오브젝트를 감사하여 정책을 준수하는 것이 중요합니다. 이렇게 하면 정의된 범위 내의 사용자 및 클러스터 관리자에게 일부 권한을 위임할 수 있으며 필요한 경우 정책에 대한 예외를 허용해야 합니다.

제품 상세 정보:

- Red Hat OpenShift Service Mesh: 정책 오브젝트를 제어하고 제어를위임하는 RBAC입니다.

- Red Hat Advanced Cluster Security for Kubernetes:정책 시행 엔진.

- 쿠버네티스용 RHACM(Red Hat Advanced Cluster Management ): 중앙 집중식 정책 제어.

3.8. 일정 및 retrospective, evaluation에 대한 관찰 가능성

실행 중인 클러스터가 있으면 트래픽을 관찰하고 트래픽이 정의된 규칙으로 시작되는지 확인할 수 있어야 합니다. 이는 침입 감지, 법의학에 중요하며, 운영 부하 관리에 유용합니다.

제품 상세 정보:

- Network Observability Operator: 클러스터의 Pod 및 노드에 대한 네트워크 연결에 대한 검사, 모니터링 및 경고를 허용합니다.

- Red Hat Advanced Cluster Management(RHACM) for Kubernetes: 프로세스 실행, 네트워크 연결 및 흐름, 권한 에스컬레이션과 같은 시스템 수준 이벤트를 모니터링, 수집 및 평가합니다. 클러스터 기준을 확인한 다음 비정상적인 활동을 감지하고 이에 대해 경고할 수 있습니다.

- Red Hat OpenShift Service Mesh: Pod로 들어오고 나가는 트래픽을 모니터링 할 수 있습니다.

- Red Hat OpenShift distributed tracing platform: 적절하게 조정된 애플리케이션의 경우 마이크로 서비스에 대한 하위 요청으로 분할할 때 특정 작업과 관련된 모든 트래픽을 확인할 수 있습니다. 이를 통해 분산 애플리케이션 내에서 병목 현상을 식별할 수 있습니다.

3.9. 엔드포인트 보안

클러스터에서 서비스를 실행하는 소프트웨어가 손상되지 않았음을 신뢰할 수 있어야 합니다. 예를 들어 인증된 이미지가 신뢰할 수 있는 하드웨어에서 실행되고 엔드포인트 특성을 기반으로 끝점 간 연결만 허용하는 정책이 있어야 할 수 있습니다.

제품 상세 정보:

- OpenShift Container Platform: Secureboot는 클러스터의 노드가 신뢰할 수 있는 소프트웨어를 실행하도록 할 수 있으므로 플랫폼 자체(컨테이너 런타임 포함)가 변조되지 않았습니다. 특정 서명에서 서명된 이미지만 실행하도록 OpenShift Container Platform을 구성할 수 있습니다.

- Red Hat Trusted Artifact Signer: 신뢰할 수 있는 빌드 체인에서 사용할 수 있으며 서명된 컨테이너 이미지를 생성할 수 있습니다.

3.10. 클러스터 외부에서 신뢰 확장

클러스터가 하위 도메인의 CA를 Mint하도록 허용하여 클러스터 외부에서 신뢰를 확장해야 할 수 있습니다. 또는 클러스터의 워크로드 ID를 원격 끝점으로 테스트할 수 있습니다.

제품 상세 정보:

- OpenShift cert-manager Operator: cert-manager를 사용하여 다른 클러스터에 또는 조직을 통해 신뢰를 배포할 수 있도록 위임된 CA를 관리할 수 있습니다.

- Red Hat OpenShift Service Mesh: SPIFFE를 사용하여 원격 또는 로컬 클러스터에서 실행되는 엔드포인트에 워크로드의 원격 인증 정보를 제공할 수 있습니다.

4장. 호스트에 액세스

배스천 호스트(Bastion Host)를 생성하여 OpenShift Container Platform 인스턴스에 액세스하고 SSH(Secure Shell) 액세스 권한으로 컨트롤 플레인 노드에 액세스하는 방법을 알아봅니다.

4.1. 설치 관리자 프로비저닝 인프라 클러스터에서 Amazon Web Services의 호스트에 액세스

OpenShift Container Platform 설치 관리자는 OpenShift Container Platform 클러스터에 프로비저닝된 Amazon EC2(Amazon Elastic Compute Cloud) 인스턴스에 대한 퍼블릭 IP 주소를 생성하지 않습니다. OpenShift Container Platform 호스트에 SSH를 사용하려면 다음 절차를 따라야 합니다.

프로세스

-

openshift-install명령으로 생성된 가상 프라이빗 클라우드(VPC)에 SSH로 액세스할 수 있는 보안 그룹을 만듭니다. - 설치 관리자가 생성한 퍼블릭 서브넷 중 하나에 Amazon EC2 인스턴스를 생성합니다.

생성한 Amazon EC2 인스턴스와 퍼블릭 IP 주소를 연결합니다.

OpenShift Container Platform 설치와는 달리, 생성한 Amazon EC2 인스턴스를 SSH 키 쌍과 연결해야 합니다. 이 인스턴스에서 사용되는 운영 체제는 중요하지 않습니다. 그저 인터넷을 OpenShift Container Platform 클러스터의 VPC에 연결하는 SSH 베스천의 역할을 수행하기 때문입니다. 사용하는 AMI(Amazon 머신 이미지)는 중요합니다. 예를 들어, RHCOS(Red Hat Enterprise Linux CoreOS)를 사용하면 설치 프로그램과 마찬가지로 Ignition을 통해 키를 제공할 수 있습니다.

Amazon EC2 인스턴스를 프로비저닝한 후 SSH로 연결할 수 있는 경우 OpenShift Container Platform 설치와 연결된 SSH 키를 추가해야 합니다. 이 키는 베스천 인스턴스의 키와 다를 수 있지만 반드시 달라야 하는 것은 아닙니다.

참고SSH 직접 액세스는 재해 복구 시에만 권장됩니다. Kubernetes API가 응답할 때는 권한 있는 Pod를 대신 실행합니다.

-

oc get nodes를 실행하고 출력을 확인한 후 마스터 노드 중 하나를 선택합니다. 호스트 이름은ip-10-0-1-163.ec2.internal과 유사합니다. Amazon EC2에 수동으로 배포한 베스천 SSH 호스트에서 해당 컨트롤 플레인 호스트에 SSH로 연결합니다. 설치 중 지정한 것과 동일한 SSH 키를 사용해야 합니다.

ssh -i <ssh-key-path> core@<master-hostname>

$ ssh -i <ssh-key-path> core@<master-hostname>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5장. Networking Operator 개요

OpenShift Container Platform은 여러 유형의 네트워킹 Operator를 지원합니다. 이러한 네트워킹 Operator를 사용하여 클러스터 네트워킹을 관리할 수 있습니다.

5.1. CNO(Cluster Network Operator)

CNO(Cluster Network Operator)는 OpenShift Container Platform 클러스터에서 클러스터 네트워크 구성 요소를 배포하고 관리합니다. 여기에는 설치 중에 클러스터에 대해 선택된 CNI(Container Network Interface) 네트워크 플러그인 배포가 포함됩니다. 자세한 내용은 OpenShift Container Platform의 Cluster Network Operator 를 참조하십시오.

5.2. DNS Operator

DNS Operator는 CoreDNS를 배포 및 관리하여 Pod에 이름 확인 서비스를 제공합니다. 이를 통해 OpenShift Container Platform에서 DNS 기반 Kubernetes 서비스 검색을 사용할 수 있습니다. 자세한 내용은 OpenShift Container Platform의 DNS Operator 를 참조하십시오.

5.3. Ingress Operator

OpenShift Container Platform 클러스터를 생성할 때 클러스터에서 실행 중인 Pod 및 서비스가 각각 할당된 IP 주소입니다. IP 주소는 주변에서 실행되는 다른 pod 및 서비스에 액세스할 수 있지만 외부 클라이언트에는 액세스할 수 없습니다. Ingress Operator는 Ingress 컨트롤러 API를 구현하고 OpenShift Container Platform 클러스터 서비스에 대한 외부 액세스를 활성화합니다. 자세한 내용은 OpenShift Container Platform의 Ingress Operator 를 참조하십시오.

5.4. 외부 DNS Operator

외부 DNS Operator는 ExternalDNS를 배포 및 관리하여 외부 DNS 공급자에서 OpenShift Container Platform으로의 서비스 및 경로에 대한 이름 확인을 제공합니다. 자세한 내용은 외부 DNS Operator 이해를 참조하십시오.

5.5. Ingress 노드 방화벽 Operator

Ingress Node Firewall Operator는 확장된 Berkley Packet Filter(eBPF) 및 eXpress Data Path(XDP) 플러그인을 사용하여 노드 방화벽 규칙을 처리하고 통계를 업데이트하고, 트래픽의 이벤트를 생성합니다. Operator는 수신 노드 방화벽 리소스를 관리하고, 방화벽 구성을 확인하고, 클러스터 액세스를 방지할 수 있는 잘못 구성된 규칙을 허용하지 않으며, 규칙 오브젝트에서 선택한 인터페이스에 수신 노드 방화벽 XDP 프로그램을 로드합니다. 자세한 내용은 Ingress Node Firewall Operator 이해를참조하십시오.

5.6. Network Observability Operator

Network Observability Operator는 클러스터 관리자가 OpenShift Container Platform 클러스터의 네트워크 트래픽을 관찰할 수 있는 선택적 Operator입니다. Network Observability Operator는 eBPF 기술을 사용하여 네트워크 흐름을 생성합니다. 그런 다음 OpenShift Container Platform 정보로 네트워크 흐름이 강화되고 Loki에 저장됩니다. 자세한 정보 및 문제 해결을 위해 OpenShift Container Platform 콘솔에서 저장된 네트워크 흐름 정보를 보고 분석할 수 있습니다. 자세한 내용은 Network Observability Operator 정보를 참조하십시오.

6장. 네트워킹 대시보드

네트워킹 메트릭은 OpenShift Container Platform 웹 콘솔의 모니터링 → 대시보드의 대시보드에서 볼 수 있습니다.

6.1. Network Observability Operator

Network Observability Operator가 설치된 경우 Dashboards 드롭다운 목록에서 Netobserv 대시보드를 선택하여 네트워크 트래픽 지표 대시보드를 볼 수 있습니다. 이 대시보드에서 사용할 수 있는 메트릭에 대한 자세한 내용은 Network Observability 지표 대시보드를 참조하십시오.

6.2. 네트워킹 및 OVN-Kubernetes 대시보드

대시보드에서 일반 네트워킹 메트릭과 OVN-Kubernetes 지표를 모두 볼 수 있습니다.

일반 네트워킹 메트릭을 보려면 대시보드 드롭다운 목록에서 네트워킹/Linux Cryostat 통계 를 선택합니다. 대시보드에서 Network Utilization , Network Saturation , Network Saturation ) 의 다음 네트워킹 메트릭을 볼 수 있습니다.

OVN-Kubernetes 지표를 보려면 대시보드 드롭다운 목록에서 네트워킹/인프라 를 선택합니다. 네트워킹 구성,TCP Latency Probes,컨트롤 플레인 리소스, 작업자 리소스 등 OVN-Kuberenetes 메트릭을 볼 수 있습니다.

6.3. Ingress Operator 대시보드

대시보드에서 Ingress Operator가 처리하는 네트워킹 메트릭을 볼 수 있습니다. 여기에는 다음과 같은 메트릭이 포함됩니다.

- 들어오고 나가는 대역폭

- HTTP 오류율

- HTTP 서버 응답 대기 시간

이러한 Ingress 지표를 보려면 대시보드 드롭다운 목록에서 네트워킹/Ingress 를 선택합니다. 다음 카테고리에 대한 Ingress 메트릭을 볼 수 있습니다. 경로당 상위 10 개,네임스페이스당 상위 10 개, 하드 당 상위 10개.

7장. OpenShift 컨테이너 플랫폼의 Cluster Network Operator

CNO(Cluster Network Operator)를 사용하여 설치 중에 클러스터에 대해 선택한 CNI(Container Network Interface) 네트워크 플러그인을 포함하여 OpenShift Container Platform 클러스터에 클러스터 네트워크 구성 요소를 배포하고 관리할 수 있습니다.

7.1. CNO(Cluster Network Operator)

Cluster Network Operator는 operator.openshift.io API 그룹에서 네트워크 API를 구현합니다. Operator는 데몬 세트를 사용하여 OVN-Kubernetes 네트워크 플러그인 또는 클러스터 설치 중에 선택한 네트워크 공급자 플러그인을 배포합니다.

프로세스

Cluster Network Operator는 설치 중에 Kubernetes Deployment로 배포됩니다.

다음 명령을 실행하여 배포 상태를 확인합니다.

oc get -n openshift-network-operator deployment/network-operator

$ oc get -n openshift-network-operator deployment/network-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME READY UP-TO-DATE AVAILABLE AGE network-operator 1/1 1 1 56m

NAME READY UP-TO-DATE AVAILABLE AGE network-operator 1/1 1 1 56mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 Cluster Network Operator의 상태를 확인합니다.

oc get clusteroperator/network

$ oc get clusteroperator/networkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE network 4.5.4 True False False 50m

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE network 4.5.4 True False False 50mCopy to Clipboard Copied! Toggle word wrap Toggle overflow AVAILABLE,PROGRESSING및DEGRADED필드에서 Operator 상태에 대한 정보를 볼 수 있습니다. Cluster Network Operator가 사용 가능한 상태 조건을 보고하는 경우AVAILABLE필드는True로 설정됩니다.

7.2. 클러스터 네트워크 구성 보기

모든 새로운 OpenShift Container Platform 설치에는 이름이 cluster인 network.config 오브젝트가 있습니다.

프로세스

oc describe명령을 사용하여 클러스터 네트워크 구성을 확인합니다.oc describe network.config/cluster

$ oc describe network.config/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3. CNO(Cluster Network Operator) 상태 보기

oc describe 명령을 사용하여 상태를 조사하고 Cluster Network Operator의 세부 사항을 볼 수 있습니다.

프로세스

다음 명령을 실행하여 Cluster Network Operator의 상태를 확인합니다.

oc describe clusteroperators/network

$ oc describe clusteroperators/networkCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4. 전역적으로 IP 전달 활성화

OpenShift Container Platform 4.14부터는 라우터 역할을 하는 노드가 있는 클러스터 관리자에게 바람직하지 않은 영향을 방지하기 위해 OVN-Kubernetes 기반 클러스터 배포에서 글로벌 IP 주소 전달이 비활성화됩니다. 그러나 관리자가 트래픽을 전달하는 데 필요한 경우 모든 IP 트래픽을 전달할 수 있도록 새 구성 매개변수 ipForwarding 을 사용할 수 있습니다.

OVN-Kubernetes 관리 인터페이스의 모든 트래픽에 대해 IP 전달을 다시 활성화하려면 다음 절차에 따라 Cluster Network Operator의 gatewayConfig.ipForwarding 사양을 Global 으로 설정합니다.

프로세스

다음 명령을 실행하여 기존 네트워크 구성을 백업합니다.

oc get network.operator cluster -o yaml > network-config-backup.yaml

$ oc get network.operator cluster -o yaml > network-config-backup.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 기존 네트워크 구성을 수정합니다.

oc edit network.operator cluster

$ oc edit network.operator clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 예에 설명된 대로

spec에서 다음 블록을 추가하거나 업데이트합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 파일을 저장하고 닫습니다.

변경 사항을 적용한 후 OpenShift CNO(Cluster Network Operator)는 클러스터에 업데이트를 적용합니다. 다음 명령을 사용하여 진행 상황을 모니터링할 수 있습니다.

oc get clusteroperators network

$ oc get clusteroperators networkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 상태는 최종적으로

Available,Progressing=False,Degraded=False로 보고되어야 합니다.또는 다음 명령을 실행하여 IP 전달을 전역적으로 활성화할 수 있습니다.

oc patch network.operator cluster -p '{"spec":{"defaultNetwork":{"ovnKubernetesConfig":{"gatewayConfig":{"ipForwarding": "Global"}}}}}$ oc patch network.operator cluster -p '{"spec":{"defaultNetwork":{"ovnKubernetesConfig":{"gatewayConfig":{"ipForwarding": "Global"}}}}}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고이 매개변수의 다른 유효한 옵션은 이 변경 사항을 되돌리려는 경우 제한됩니다.

restricted는 기본값이며 해당 설정으로 글로벌 IP 주소 전달이 비활성화됩니다.

7.5. CNO(Cluster Network Operator) 로그 보기

oc logs 명령을 사용하여 Cluster Network Operator 로그를 확인할 수 있습니다.

프로세스

다음 명령을 실행하여 Cluster Network Operator의 로그를 확인합니다.

oc logs --namespace=openshift-network-operator deployment/network-operator

$ oc logs --namespace=openshift-network-operator deployment/network-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.6. CNO(Cluster Network Operator) 구성

클러스터 네트워크의 구성은 CNO(Cluster Network Operator) 구성의 일부로 지정되며 cluster라는 이름의 CR(사용자 정의 리소스) 오브젝트에 저장됩니다. CR은 operator.openshift.io API 그룹에서 Network API의 필드를 지정합니다.

CNO 구성은 Network.config.openshift.io API 그룹의 Network API에서 클러스터 설치 중에 다음 필드를 상속합니다.

clusterNetwork- Pod IP 주소가 할당되는 IP 주소 풀입니다.

serviceNetwork- 서비스를 위한 IP 주소 풀입니다.

defaultNetwork.type-

클러스터 네트워크 플러그인.

OVNKubernetes는 설치 중에 지원되는 유일한 플러그인입니다.

클러스터 설치 후 clusterNetwork IP 주소 범위만 수정할 수 있습니다. 기본 네트워크 유형은 마이그레이션을 통해 OpenShift SDN에서 OVN-Kubernetes로만 변경할 수 있습니다.

cluster라는 CNO 오브젝트에서 defaultNetwork 오브젝트의 필드를 설정하여 클러스터의 클러스터 네트워크 플러그인 구성을 지정할 수 있습니다.

7.6.1. CNO(Cluster Network Operator) 구성 오브젝트

CNO(Cluster Network Operator)의 필드는 다음 표에 설명되어 있습니다.

| 필드 | 유형 | 설명 |

|---|---|---|

|

|

|

CNO 개체 이름입니다. 이 이름은 항상 |

|

|

| Pod IP 주소가 할당되는 IP 주소 블록과 클러스터의 각 개별 노드에 할당된 서브넷 접두사 길이를 지정하는 목록입니다. 예를 들면 다음과 같습니다. |

|

|

| 서비스의 IP 주소 블록입니다. OpenShift SDN 및 OVN-Kubernetes 네트워크 플러그인은 서비스 네트워크에 대한 단일 IP 주소 블록만 지원합니다. 예를 들면 다음과 같습니다. spec: serviceNetwork: - 172.30.0.0/14

이 값은 준비 전용이며 클러스터 설치 중에 |

|

|

| 클러스터 네트워크의 네트워크 플러그인을 구성합니다. |

|

|

| 이 개체의 필드는 kube-proxy 구성을 지정합니다. OVN-Kubernetes 클러스터 네트워크 플러그인을 사용하는 경우 kube-proxy 구성이 적용되지 않습니다. |

defaultNetwork 오브젝트 구성

defaultNetwork 오브젝트의 값은 다음 표에 정의되어 있습니다.

| 필드 | 유형 | 설명 |

|---|---|---|

|

|

|

참고 OpenShift Container Platform은 기본적으로 OVN-Kubernetes 네트워크 플러그인을 사용합니다. OpenShift SDN은 더 이상 새 클러스터의 설치 옵션으로 사용할 수 없습니다. |

|

|

| 이 오브젝트는 OVN-Kubernetes 네트워크 플러그인에만 유효합니다. |

OpenShift SDN 네트워크 플러그인 구성

다음 표에서는 OpenShift SDN 네트워크 플러그인의 구성 필드를 설명합니다.

| 필드 | 유형 | 설명 |

|---|---|---|

|

|

| OpenShift SDN의 네트워크 격리 모드입니다. |

|

|

| VXLAN 오버레이 네트워크의 최대 전송 단위(MTU)입니다. 이 값은 일반적으로 자동 구성됩니다. |

|

|

|

모든 VXLAN 패킷에 사용할 포트입니다. 기본값은 |

OpenShift SDN 구성 예

OVN-Kubernetes 네트워크 플러그인 구성

다음 표에서는 OVN-Kubernetes 네트워크 플러그인의 구성 필드를 설명합니다.

| 필드 | 유형 | 설명 |

|---|---|---|

|

|

| Geneve(Generic Network Virtualization Encapsulation) 오버레이 네트워크의 MTU(최대 전송 단위)입니다. 이 값은 일반적으로 자동 구성됩니다. |

|

|

| Geneve 오버레이 네트워크용 UDP 포트입니다. |

|

|

| 클러스터의 IPsec 모드를 설명하는 오브젝트입니다. |

|

|

| 네트워크 정책 감사 로깅을 사용자 정의할 구성 오브젝트를 지정합니다. 설정되지 않으면 기본값 감사 로그 설정이 사용됩니다. |

|

|

| 선택 사항: 송신 트래픽이 노드 게이트웨이로 전송되는 방법을 사용자 정의할 구성 오브젝트를 지정합니다. 참고 송신 트래픽을 마이그레이션하는 동안 CNO(Cluster Network Operator)에서 변경 사항을 성공적으로 롤아웃할 때까지 워크로드 및 서비스 트래픽에 대한 일부 중단을 기대할 수 있습니다. |

|

|

기존 네트워크 인프라가 설치 후에는 이 필드를 변경할 수 없습니다. |

기본값은 |

|

|

기존 네트워크 인프라가 설치 후에는 이 필드를 변경할 수 없습니다. |

기본값은 |

| 필드 | 유형 | 설명 |

|---|---|---|

|

| integer |

노드당 1초마다 생성할 최대 메시지 수입니다. 기본값은 초당 |

|

| integer |

감사 로그의 최대 크기(바이트)입니다. 기본값은 |

|

| integer | 유지되는 최대 로그 파일 수입니다. |

|

| string | 다음 추가 감사 로그 대상 중 하나입니다.

|

|

| string |

RFC5424에 정의된 |

| 필드 | 유형 | 설명 |

|---|---|---|

|

|

|

Pod에서 호스트 네트워킹 스택으로 송신 트래픽을 보내려면 이 필드를

이 필드는 Open vSwitch 하드웨어 오프로드 기능과 상호 작용합니다. 이 필드를 |

|

|

|

|

| 필드 | 유형 | 설명 |

|---|---|---|

|

|

| IPsec 구현의 동작을 지정합니다. 다음 값 중 하나여야 합니다.

|

설치 후 활동으로 런타임 시 변경할 수 있는 gatewayConfig 필드를 제외하고 클러스터 설치 중에 클러스터 네트워크 플러그인의 구성만 변경할 수 있습니다.

IPSec가 활성화된 OVN-Kubernetes 구성의 예

OVNKubernetes를 사용하면 IBM Power®에서 스택 소진 문제가 발생할 수 있습니다.

kubeProxyConfig 오브젝트 구성 (OpenShiftSDN 컨테이너 네트워크 인터페이스만 해당)

kubeProxyConfig 오브젝트의 값은 다음 표에 정의되어 있습니다.

| 필드 | 유형 | 설명 |

|---|---|---|

|

|

|

참고

OpenShift Container Platform 4.3 이상에서는 성능이 개선되어 더 이상 |

|

|

|

kubeProxyConfig:

proxyArguments:

iptables-min-sync-period:

- 0s

|

7.6.2. CNO(Cluster Network Operator) 구성 예시

다음 예에서는 전체 CNO 구성이 지정됩니다.

CNO(Cluster Network Operator) 개체 예시

8장. OpenShift Container Platform에서의 DNS Operator

DNS Operator는 CoreDNS를 배포 및 관리하여 Pod에 이름 확인 서비스를 제공하여 OpenShift Container Platform에서 DNS 기반 Kubernetes 서비스 검색을 활성화합니다.

8.1. DNS Operator

DNS Operator는 operator.openshift.io API 그룹에서 dns API를 구현합니다. Operator는 데몬 세트를 사용하여 CoreDNS를 배포하고 데몬 세트에 대한 서비스를 생성하며 이름 확인에서 CoreDNS 서비스 IP 주소를 사용하기 위해 Pod에 명령을 내리도록 kubelet을 구성합니다.

프로세스

DNS Operator는 설치 중에 Deployment 오브젝트로 배포됩니다.

oc get명령을 사용하여 배포 상태를 확인합니다.oc get -n openshift-dns-operator deployment/dns-operator

$ oc get -n openshift-dns-operator deployment/dns-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME READY UP-TO-DATE AVAILABLE AGE dns-operator 1/1 1 1 23h

NAME READY UP-TO-DATE AVAILABLE AGE dns-operator 1/1 1 1 23hCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get명령을 사용하여 DNS Operator의 상태를 확인합니다.oc get clusteroperator/dns

$ oc get clusteroperator/dnsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE dns 4.1.0-0.11 True False False 92m

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE dns 4.1.0-0.11 True False False 92mCopy to Clipboard Copied! Toggle word wrap Toggle overflow AVAILABLE,PROGRESSING및DEGRADED는 Operator의 상태에 대한 정보를 제공합니다.AVAILABLE은 CoreDNS 데몬 세트에서 1개 이상의 포드가Available상태 조건을 보고할 때True입니다.

8.2. DNS Operator managementState 변경

DNS는 CoreDNS 구성 요소를 관리하여 클러스터의 pod 및 서비스에 대한 이름 확인 서비스를 제공합니다. DNS Operator의 managementState는 기본적으로 Managed로 설정되어 있으며 이는 DNS Operator가 리소스를 적극적으로 관리하고 있음을 의미합니다. Unmanaged로 변경할 수 있습니다. 이는 DNS Operator가 해당 리소스를 관리하지 않음을 의미합니다.

다음은 DNS Operator managementState를 변경하는 사용 사례입니다.

-

사용자가 개발자이며 구성 변경을 테스트하여 CoreDNS의 문제가 해결되었는지 확인하려고 합니다.

managementState를Unmanaged로 설정하여 DNS Operator가 수정 사항을 덮어쓰지 않도록 할 수 있습니다. -

클러스터 관리자이며 CoreDNS 관련 문제를 보고했지만 문제가 해결될 때까지 해결 방법을 적용해야 합니다. DNS Operator의

managementState필드를Unmanaged로 설정하여 해결 방법을 적용할 수 있습니다.

프로세스

managementStateDNS Operator 변경:oc patch dns.operator.openshift.io default --type merge --patch '{"spec":{"managementState":"Unmanaged"}}'oc patch dns.operator.openshift.io default --type merge --patch '{"spec":{"managementState":"Unmanaged"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

8.3. DNS Pod 배치 제어

DNS Operator에는 2개의 데몬 세트(CoreDNS 및 /etc/hosts 파일 관리용)가 있습니다. 이미지 가져오기를 지원할 클러스터 이미지 레지스트리의 항목을 추가하려면 모든 노드 호스트에서 /etc/hosts의 데몬 세트를 실행해야 합니다. 보안 정책은 CoreDNS에 대한 데몬 세트가 모든 노드에서 실행되지 않도록 하는 노드 쌍 간 통신을 금지할 수 있습니다.

클러스터 관리자는 사용자 정의 노드 선택기를 사용하여 특정 노드에서 CoreDNS를 실행하거나 실행하지 않도록 데몬 세트를 구성할 수 있습니다.

사전 요구 사항

-

ocCLI를 설치했습니다. -

cluster-admin권한이 있는 사용자로 클러스터에 로그인합니다.

프로세스

특정 노드 간 통신을 방지하려면

spec.nodePlacement.nodeSelectorAPI 필드를 구성합니다.이름이

default인 DNS Operator 오브젝트를 수정합니다.oc edit dns.operator/default

$ oc edit dns.operator/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow spec.nodePlacement.nodeSelectorAPI 필드에 컨트롤 플레인 노드만 포함하는 노드 선택기를 지정합니다.spec: nodePlacement: nodeSelector: node-role.kubernetes.io/worker: ""spec: nodePlacement: nodeSelector: node-role.kubernetes.io/worker: ""Copy to Clipboard Copied! Toggle word wrap Toggle overflow

CoreDNS의 데몬 세트가 노드에서 실행되도록 테인트 및 허용 오차를 구성합니다.

이름이

default인 DNS Operator 오브젝트를 수정합니다.oc edit dns.operator/default

$ oc edit dns.operator/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 테인트 키와 테인트에 대한 허용 오차를 지정합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 테인트가

dns-only인 경우 무기한 허용될 수 있습니다.tolerationSeconds를생략할 수 있습니다.

8.4. 기본 DNS보기

모든 새로운 OpenShift Container Platform 설치에서는 dns.operator의 이름이 default로 지정됩니다.

프로세스

oc describe명령을 사용하여 기본dns를 확인합니다.oc describe dns.operator/default

$ oc describe dns.operator/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 클러스터의 service CIDR을 찾으려면

oc get명령을 사용합니다.oc get networks.config/cluster -o jsonpath='{$.status.serviceNetwork}'$ oc get networks.config/cluster -o jsonpath='{$.status.serviceNetwork}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

출력 예

[172.30.0.0/16]

[172.30.0.0/16]8.5. DNS 전달 사용

DNS 전달을 사용하여 다음과 같은 방법으로 /etc/resolv.conf 파일의 기본 전달 구성을 덮어쓸 수 있습니다.

- 모든 영역의 이름 서버를 지정합니다. 전달된 영역이 OpenShift Container Platform에서 관리하는 Ingress 도메인인 경우 도메인에 대한 업스트림 이름 서버를 승인해야 합니다.

- 업스트림 DNS 서버 목록을 제공합니다.

- 기본 전달 정책을 변경합니다.

기본 도메인의 DNS 전달 구성에는 /etc/resolv.conf 파일과 업스트림 DNS 서버에 지정된 기본 서버가 모두 있을 수 있습니다.

프로세스

이름이

default인 DNS Operator 오브젝트를 수정합니다.oc edit dns.operator/default

$ oc edit dns.operator/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이전 명령을 실행한 후 Operator는 서버를 기반으로 추가 서버 구성 블록을 사용하여

dns-default라는 구성 맵을 생성하고 업데이트합니다.서버에 쿼리와 일치하는 영역이 없는 경우 이름 확인은 업스트림 DNS 서버로 대체됩니다.DNS 전달 구성

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

rfc6335서비스 이름 구문을 준수해야 합니다.- 2

rfc1123서비스 이름 구문의 하위 도메인 정의를 준수해야 합니다. 클러스터 도메인인cluster.local은zones필드에 대해 유효하지 않은 하위 도메인입니다.- 3

- 업스트림 리졸버를 선택하는 정책을 정의합니다. 기본값은

Random입니다.RoundRobin및Sequential값을 사용할 수도 있습니다. - 4

forwardPlugin당 최대 15개의업스트림이 허용됩니다.- 5

- 선택 사항: 이를 사용하여 기본 정책을 재정의하고 기본 도메인의 지정된 DNS 확인자(업스트림 확인자)로 DNS 확인을 전달할 수 있습니다. 업스트림 확인자를 제공하지 않으면 DNS 이름 쿼리는

/etc/resolv.conf의 서버로 이동합니다. - 6

- 쿼리용으로 선택한 업스트림 서버의 순서를 결정합니다. 이러한 값 중 하나를 지정할 수 있습니다.

Random,RoundRobin또는Sequential. 기본값은Sequential입니다. - 7

- 선택 사항: 이를 사용하여 업스트림 리졸버를 제공할 수 있습니다.

- 8

- 두 가지 유형의

업스트림(SystemResolvConf및Network)을 지정할 수 있습니다.SystemResolvConf는/etc/resolv.conf를 사용하도록 업스트림을 구성하고Network는Networkresolver를 정의합니다. 하나 또는 둘 다를 지정할 수 있습니다. - 9

- 지정된 유형이

Network인 경우 IP 주소를 제공해야 합니다.address필드는 유효한 IPv4 또는 IPv6 주소여야 합니다. - 10

- 지정된 유형이

네트워크인 경우 선택적으로 포트를 제공할 수 있습니다.port필드에는1에서65535사이의 값이 있어야 합니다. 업스트림에 대한 포트를 지정하지 않으면 기본적으로 포트 853이 시도됩니다.

선택 사항: 고도로 규제된 환경에서 작업할 때 추가 DNS 트래픽 및 데이터 개인 정보를 보장할 수 있도록 요청을 업스트림 해석기로 전달할 때 DNS 트래픽을 보호할 수 있는 기능이 필요할 수 있습니다. 클러스터 관리자는 전달된 DNS 쿼리에 대해 TLS(전송 계층 보안)를 구성할 수 있습니다.

TLS를 사용하여 DNS 전달 구성

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

rfc6335서비스 이름 구문을 준수해야 합니다.- 2

rfc1123서비스 이름 구문의 하위 도메인 정의를 준수해야 합니다. 클러스터 도메인인cluster.local은zones필드에 대해 유효하지 않은 하위 도메인입니다. 클러스터 도메인에 해당하는cluster.local은영역에 유효하지 않은하위 도메인입니다.- 3

- 전달된 DNS 쿼리에 대해 TLS를 구성할 때 값

TLS를 갖도록transport필드를 설정합니다. 기본적으로 CoreDNS는 전달된 연결을 10초 동안 캐시합니다. CoreDNS는 요청이 발행되지 않은 경우 해당 10초 동안 TCP 연결을 열린 상태로 유지합니다. 대규모 클러스터에서는 노드당 연결을 시작할 수 있으므로 DNS 서버에서 많은 새 연결을 유지할 수 있음을 알고 있는지 확인합니다. 성능 문제를 방지하기 위해 DNS 계층 구조를 적절하게 설정합니다. - 4

- 전달된 DNS 쿼리에 대해 TLS를 구성할 때 이는 업스트림 TLS 서버 인증서의 유효성을 확인하기 위해 SNI(서버 이름 표시)의 일부로 사용되는 필수 서버 이름입니다.

- 5

- 업스트림 리졸버를 선택하는 정책을 정의합니다. 기본값은

Random입니다.RoundRobin및Sequential값을 사용할 수도 있습니다. - 6

- 필수 항목입니다. 이를 사용하여 업스트림 리졸버를 제공할 수 있습니다.

forwardPlugin항목당 최대 15개의 업스트림항목이 허용됩니다. - 7

- 선택 사항: 이를 사용하여 기본 정책을 재정의하고 기본 도메인의 지정된 DNS 확인자(업스트림 확인자)로 DNS 확인을 전달할 수 있습니다. 업스트림 확인자를 제공하지 않으면 DNS 이름 쿼리는

/etc/resolv.conf의 서버로 이동합니다. - 8

네트워크유형은 이 업스트림 리졸버가/etc/resolv.conf에 나열된 업스트림 해석기와 별도로 전달된 요청을 처리해야 함을 나타냅니다. TLS를 사용할 때네트워크유형만 허용되며 IP 주소를 제공해야 합니다.- 9

address필드는 유효한 IPv4 또는 IPv6 주소여야 합니다.- 10

- 선택적으로 포트를 제공할 수 있습니다.

포트는1에서65535사이의 값이 있어야 합니다. 업스트림에 대한 포트를 지정하지 않으면 기본적으로 포트 853이 시도됩니다.

참고서버가 정의되지 않았거나 유효하지 않은 경우 구성 맵에는 기본 서버만 포함됩니다.

검증

구성 맵을 표시합니다.

oc get configmap/dns-default -n openshift-dns -o yaml

$ oc get configmap/dns-default -n openshift-dns -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이전 샘플 DNS를 기반으로 하는 샘플 DNS ConfigMap

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

forwardPlugin을 변경하면 CoreDNS 데몬 세트의 롤링 업데이트가 트리거됩니다.

8.6. DNS Operator 상태

oc describe 명령을 사용하여 상태를 확인하고 DNS Operator의 세부 사항을 볼 수 있습니다.

프로세스

DNS Operator의 상태를 확인하려면 다음을 실행합니다.

oc describe clusteroperators/dns

$ oc describe clusteroperators/dns8.7. DNS Operator 로그

oc logs 명령을 사용하여 DNS Operator 로그를 확인할 수 있습니다.

프로세스

DNS Operator의 로그를 확인합니다.

oc logs -n openshift-dns-operator deployment/dns-operator -c dns-operator

$ oc logs -n openshift-dns-operator deployment/dns-operator -c dns-operator8.8. CoreDNS 로그 수준 설정

CoreDNS 로그 수준을 구성하여 기록된 오류 메시지의 세부 정보를 확인할 수 있습니다. CoreDNS 로그 수준에 유효한 값은 Normal,Debug 및 Trace 입니다. 기본 logLevel 은 Normal 입니다.

오류 플러그인은 항상 활성화됩니다. 다음 logLevel 설정은 다른 오류 응답을 보고합니다.

-

loglevel:Normal은 "errors" 클래스를 활성화합니다.log . { class error }. -

loglevel:Debug는 "denial" 클래스를 활성화합니다.log . { class denial error}} . -

loglevel:Trace는 "all" 클래스를 활성화합니다.log . { class all }.

프로세스

logLevel을Debug로 설정하려면 다음 명령을 입력합니다.oc patch dnses.operator.openshift.io/default -p '{"spec":{"logLevel":"Debug"}}' --type=merge$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"logLevel":"Debug"}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow logLevel을Trace로 설정하려면 다음 명령을 입력합니다.oc patch dnses.operator.openshift.io/default -p '{"spec":{"logLevel":"Trace"}}' --type=merge$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"logLevel":"Trace"}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

원하는 로그 수준이 설정되었는지 확인하려면 구성 맵을 확인합니다.

oc get configmap/dns-default -n openshift-dns -o yaml

$ oc get configmap/dns-default -n openshift-dns -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

8.9. CoreDNS Operator 로그 수준 설정

클러스터 관리자는 OpenShift DNS 문제를 더 신속하게 추적하도록 Operator 로그 수준을 구성할 수 있습니다. operatorLogLevel 에 유효한 값은 Normal,Debug 및 Trace 입니다. 추적 에는 가장 자세한 정보가 있습니다. 기본 operatorlogLevel 은 Normal 입니다. 문제에 대한 로깅 수준은 추적, 디버그, 정보, 경고, 오류, Fatal 및 Panic입니다. 로깅 수준이 설정되면 해당 심각도가 있는 로그 항목 또는 그 이상의 로그 항목이 기록됩니다.

-

operatorLogLevel: "Normal"은logrus.SetLogLevel("Info")을 설정합니다. -

operatorLogLevel: "Debug"는logrus.SetLogLevel("Debug")을 설정합니다. -

operatorLogLevel: "Trace"는logrus.SetLogLevel("Trace")을 설정합니다.

프로세스

operatorLogLevel을Debug로 설정하려면 다음 명령을 입력합니다.oc patch dnses.operator.openshift.io/default -p '{"spec":{"operatorLogLevel":"Debug"}}' --type=merge$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"operatorLogLevel":"Debug"}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow operatorLogLevel을Trace로 설정하려면 다음 명령을 입력합니다.oc patch dnses.operator.openshift.io/default -p '{"spec":{"operatorLogLevel":"Trace"}}' --type=merge$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"operatorLogLevel":"Trace"}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

8.10. CoreDNS 캐시 튜닝

CoreDNS에서 수행하는 양수 또는 음수 캐싱이라고도 하는 성공 또는 실패한 캐싱의 최대 기간을 구성할 수 있습니다. DNS 쿼리 응답 캐싱 기간을 조정하면 업스트림 DNS 확인자의 부하를 줄일 수 있습니다.

프로세스

다음 명령을 실행하여

default라는 DNS Operator 오브젝트를 편집합니다.oc edit dns.operator.openshift.io/default

$ oc edit dns.operator.openshift.io/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow TTL(Time-to-live) 캐싱 값을 수정합니다.

DNS 캐싱 구성

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 주의TTL 필드를 낮은 값으로 설정하면 클러스터의 부하, 업스트림 확인자 또는 둘 다 증가할 수 있습니다.

9장. OpenShift Container Platform에서의 Ingress Operator

9.1. OpenShift Container Platform Ingress Operator

OpenShift Container Platform 클러스터를 생성할 때 클러스터에서 실행되는 Pod 및 서비스에는 각각 자체 IP 주소가 할당됩니다. IP 주소는 내부에서 실행되지만 외부 클라이언트가 액세스할 수 없는 다른 pod 및 서비스에 액세스할 수 있습니다. Ingress Operator는 IngressController API를 구현하며 OpenShift Container Platform 클러스터 서비스에 대한 외부 액세스를 활성화하는 구성 요소입니다.

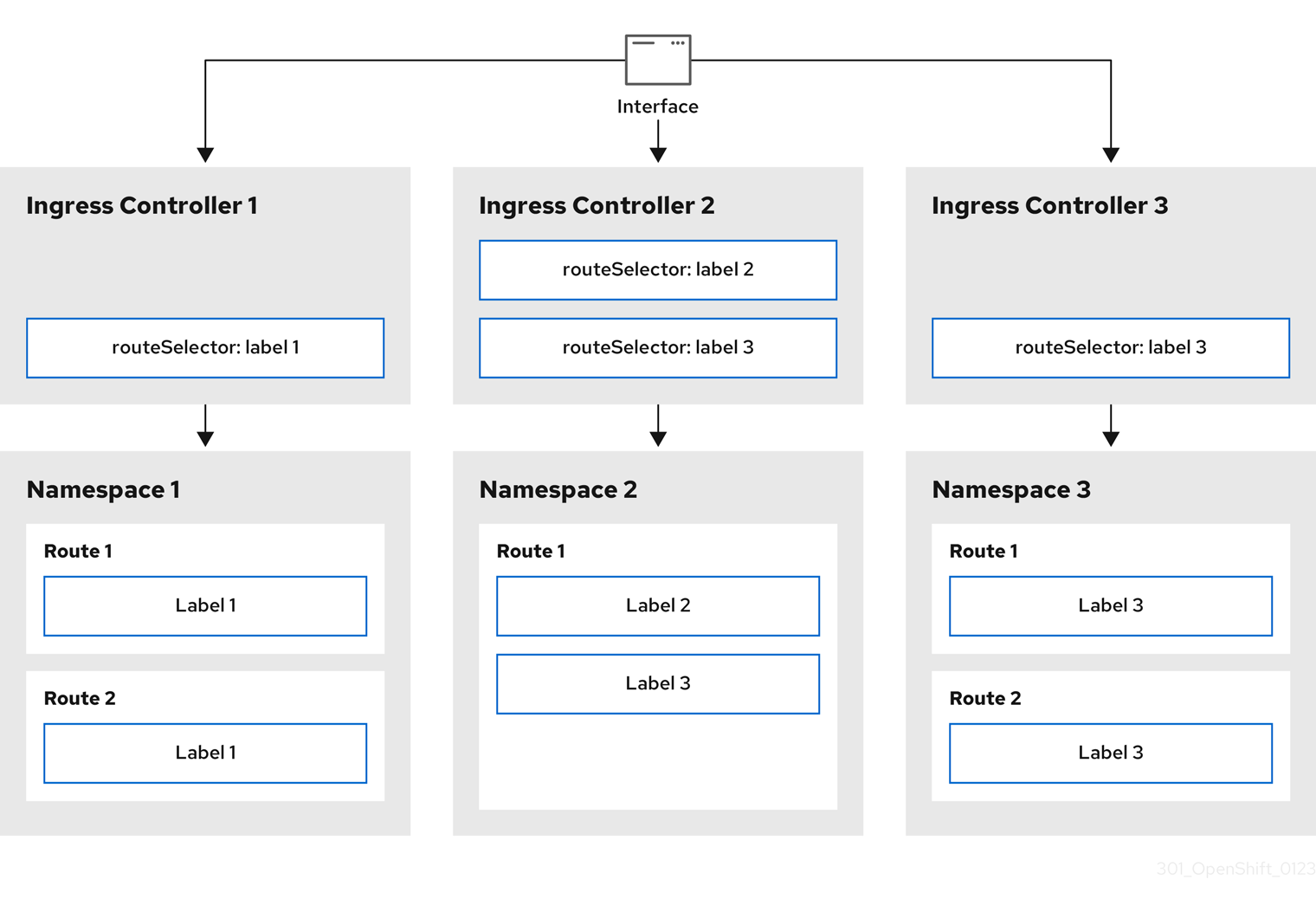

Ingress Operator를 사용하면 라우팅을 처리하기 위해 하나 이상의 HAProxy 기반 Ingress 컨트롤러를 배포하고 관리하여 외부 클라이언트가 서비스에 액세스할 수 있습니다. Ingress Operator를 사용하여 OpenShift 컨테이너 플랫폼 Route 및 Kubernetes Ingress 리소스를 지정하면 수신 트래픽을 라우팅할 수 있습니다. endpointPublishingStrategy 유형 및 내부 로드 밸런싱을 정의하는 기능과 같은 Ingress 컨트롤러 내 구성은 Ingress 컨트롤러 끝점을 게시하는 방법을 제공합니다.

9.2. Ingress 구성 자산

설치 프로그램은 config.openshift.io API 그룹인 cluster-ingress-02-config.yml에 Ingress 리소스가 포함된 자산을 생성합니다.

Ingress 리소스의 YAML 정의

설치 프로그램은 이 자산을 manifests / 디렉터리의 cluster-ingress-02-config.yml 파일에 저장합니다. 이 Ingress 리소스는 Ingress와 관련된 전체 클러스터 구성을 정의합니다. 이 Ingress 구성은 다음과 같이 사용됩니다.

- Ingress Operator는 클러스터 Ingress 구성에 설정된 도메인을 기본 Ingress 컨트롤러의 도메인으로 사용합니다.

-

OpenShift API Server Operator는 클러스터 Ingress 구성의 도메인을 사용합니다. 이 도메인은 명시적 호스트를 지정하지 않는

Route리소스에 대한 기본 호스트를 생성할 수도 있습니다.

9.3. Ingress 컨트롤러 구성 매개변수

IngressController CR(사용자 정의 리소스)에는 조직의 특정 요구 사항을 충족하도록 구성할 수 있는 선택적 구성 매개변수가 포함되어 있습니다.

| 매개변수 | 설명 |

|---|---|

|

|

비어 있는 경우 기본값은 |

|

|

|

|

|

클라우드 환경의 경우

GCP, AWS 및 Azure에서 다음

설정되지 않은 경우, 기본값은

대부분의 플랫폼의 경우

베어 메탈 플랫폼과 같은 클라우드 이외의 환경의 경우

이러한 필드 중 하나에 값을 설정하지 않으면 기본값은

클러스터가 배포된 후

|

|

|

보안에는 키와 데이터, 즉 *

설정하지 않으면 와일드카드 인증서가 자동으로 생성되어 사용됩니다. 인증서는 Ingress 컨트롤러 생성된 인증서 또는 사용자 정의 인증서는 OpenShift Container Platform 내장 OAuth 서버와 자동으로 통합됩니다. |

|

|

|

|

|

|

|

|

설정하지 않으면 기본값이 사용됩니다. 참고

|

|

|

설정되지 않으면, 기본값은

Ingress 컨트롤러의 최소 TLS 버전은 참고

구성된 보안 프로파일의 암호 및 최소 TLS 버전은 중요

Ingress Operator는 |

|

|

|

|

|

|

|

|

|

|

|

기본적으로 정책은

이러한 조정은 HTTP/1을 사용하는 경우에만 일반 텍스트, 에지 종료 및 재암호화 경로에 적용됩니다.

요청 헤더의 경우 이러한 조정은

|

|

|

|

|

|

|

|

|

캡처하려는 모든 쿠키의 경우 다음 매개변수가

예를 들면 다음과 같습니다. httpCaptureCookies:

- matchType: Exact

maxLength: 128

name: MYCOOKIE

|

|

|

|

|

|

|

|

|

|

|

|

이러한 연결은 로드 밸런서 상태 프로브 또는 웹 브라우저 추측 연결(preconnect)에서 제공되며 무시해도 됩니다. 그러나 이러한 요청은 네트워크 오류로 인해 발생할 수 있으므로 이 필드를 |

9.3.1. Ingress 컨트롤러 TLS 보안 프로필

TLS 보안 프로필은 서버가 서버에 연결할 때 연결 클라이언트가 사용할 수 있는 암호를 규제하는 방법을 제공합니다.

9.3.1.1. TLS 보안 프로필 이해

TLS(Transport Layer Security) 보안 프로필을 사용하여 다양한 OpenShift Container Platform 구성 요소에 필요한 TLS 암호를 정의할 수 있습니다. OpenShift Container Platform TLS 보안 프로필은 Mozilla 권장 구성을 기반으로 합니다.

각 구성 요소에 대해 다음 TLS 보안 프로필 중 하나를 지정할 수 있습니다.

| Profile | 설명 |

|---|---|

|

| 이 프로필은 레거시 클라이언트 또는 라이브러리와 함께 사용하기 위한 것입니다. 프로필은 이전 버전과의 호환성 권장 구성을 기반으로 합니다.

참고 Ingress 컨트롤러의 경우 최소 TLS 버전이 1.0에서 1.1로 변환됩니다. |

|

| 이 프로필은 대부분의 클라이언트에서 권장되는 구성입니다. Ingress 컨트롤러, kubelet 및 컨트롤 플레인의 기본 TLS 보안 프로필입니다. 프로필은 중간 호환성 권장 구성을 기반으로 합니다.

|

|

| 이 프로필은 이전 버전과의 호환성이 필요하지 않은 최신 클라이언트와 사용하기 위한 것입니다. 이 프로필은 최신 호환성 권장 구성을 기반으로 합니다.

|

|

| 이 프로필을 사용하면 사용할 TLS 버전과 암호를 정의할 수 있습니다. 주의

|

미리 정의된 프로파일 유형 중 하나를 사용하는 경우 유효한 프로파일 구성은 릴리스마다 변경될 수 있습니다. 예를 들어 릴리스 X.Y.Z에 배포된 중간 프로필을 사용하는 사양이 있는 경우 릴리스 X.Y.Z+1로 업그레이드하면 새 프로필 구성이 적용되어 롤아웃이 발생할 수 있습니다.

9.3.1.2. Ingress 컨트롤러의 TLS 보안 프로필 구성

Ingress 컨트롤러에 대한 TLS 보안 프로필을 구성하려면 IngressController CR(사용자 정의 리소스)을 편집하여 사전 정의된 또는 사용자 지정 TLS 보안 프로필을 지정합니다. TLS 보안 프로필이 구성되지 않은 경우 기본값은 API 서버에 설정된 TLS 보안 프로필을 기반으로 합니다.

Old TLS 보안 프로파일을 구성하는 샘플 IngressController CR

TLS 보안 프로필은 Ingress 컨트롤러의 TLS 연결에 대한 최소 TLS 버전과 TLS 암호를 정의합니다.

Status.Tls Profile 아래의 IngressController CR(사용자 정의 리소스) 및 Spec.Tls Security Profile 아래 구성된 TLS 보안 프로필에서 구성된 TLS 보안 프로필의 암호 및 최소 TLS 버전을 확인할 수 있습니다. Custom TLS 보안 프로필의 경우 특정 암호 및 최소 TLS 버전이 두 매개변수 아래에 나열됩니다.

HAProxy Ingress 컨트롤러 이미지는 TLS 1.3 및 Modern 프로필을 지원합니다.

Ingress Operator는 Old 또는 Custom 프로파일의 TLS 1.0을 1.1로 변환합니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

프로세스

openshift-ingress-operator프로젝트에서IngressControllerCR을 편집하여 TLS 보안 프로필을 구성합니다.oc edit IngressController default -n openshift-ingress-operator

$ oc edit IngressController default -n openshift-ingress-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow spec.tlsSecurityProfile필드를 추가합니다.Custom프로필에 대한IngressControllerCR 샘플Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 파일을 저장하여 변경 사항을 적용합니다.

검증

IngressControllerCR에 프로파일이 설정되어 있는지 확인합니다.oc describe IngressController default -n openshift-ingress-operator

$ oc describe IngressController default -n openshift-ingress-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

9.3.1.3. 상호 TLS 인증 구성

spec.clientTLS 값을 설정하여 mTLS(mTLS) 인증을 사용하도록 Ingress 컨트롤러를 구성할 수 있습니다. clientTLS 값은 클라이언트 인증서를 확인하도록 Ingress 컨트롤러를 구성합니다. 이 구성에는 구성 맵에 대한 참조인 clientCA 값 설정이 포함됩니다. 구성 맵에는 클라이언트의 인증서를 확인하는 데 사용되는 PEM 인코딩 CA 인증서 번들이 포함되어 있습니다. 필요한 경우 인증서 제목 필터 목록을 구성할 수도 있습니다.

clientCA 값이 X509v3 인증서 취소 목록(CRL) 배포 지점을 지정하는 경우 Ingress Operator는 각 인증서에 지정된 HTTP URI X509v3 CRL Distribution Point 를 기반으로 CRL 구성 맵을 다운로드하고 관리합니다. Ingress 컨트롤러는 mTLS/TLS 협상 중에 이 구성 맵을 사용합니다. 유효한 인증서를 제공하지 않는 요청은 거부됩니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다. - PEM 인코딩 CA 인증서 번들이 있습니다.

CA 번들이 CRL 배포 지점을 참조하는 경우 클라이언트 CA 번들에 엔드센티 또는 리프 인증서도 포함해야 합니다. RFC 5280에 설명된 대로 이 인증서에는

CRL 배포 지점아래에 HTTP URI가 포함되어 있어야 합니다. 예를 들면 다음과 같습니다.Issuer: C=US, O=Example Inc, CN=Example Global G2 TLS RSA SHA256 2020 CA1 Subject: SOME SIGNED CERT X509v3 CRL Distribution Points: Full Name: URI:http://crl.example.com/example.crlIssuer: C=US, O=Example Inc, CN=Example Global G2 TLS RSA SHA256 2020 CA1 Subject: SOME SIGNED CERT X509v3 CRL Distribution Points: Full Name: URI:http://crl.example.com/example.crlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

프로세스

openshift-config네임스페이스에서 CA 번들에서 구성 맵을 생성합니다.oc create configmap \ router-ca-certs-default \ --from-file=ca-bundle.pem=client-ca.crt \ -n openshift-config

$ oc create configmap \ router-ca-certs-default \ --from-file=ca-bundle.pem=client-ca.crt \1 -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 구성 맵 데이터 키는

ca-bundle.pem이어야 하며 데이터 값은 PEM 형식의 CA 인증서여야 합니다.

openshift-ingress-operator프로젝트에서IngressController리소스를 편집합니다.oc edit IngressController default -n openshift-ingress-operator

$ oc edit IngressController default -n openshift-ingress-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow spec.clientTLS필드 및 하위 필드를 추가하여 상호 TLS를 구성합니다.패턴 필터링을 지정하는

clientTLS프로필에 대한IngressControllerCR 샘플Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

선택 사항, 다음 명령을 입력하여

allowedSubjectPatterns에 대한 Distinguished Name (DN)을 가져옵니다.

openssl x509 -in custom-cert.pem -noout -subject subject= /CN=example.com/ST=NC/C=US/O=Security/OU=OpenShift

$ openssl x509 -in custom-cert.pem -noout -subject

subject= /CN=example.com/ST=NC/C=US/O=Security/OU=OpenShift9.4. 기본 Ingress 컨트롤러 보기

Ingress Operator는 OpenShift Container Platform의 핵심 기능이며 즉시 사용이 가능합니다.

모든 새로운 OpenShift Container Platform 설치에는 이름이 ingresscontroller로 기본으로 지정됩니다. 추가 Ingress 컨트롤러를 추가할 수 있습니다. 기본 ingresscontroller가 삭제되면 Ingress Operator가 1분 이내에 자동으로 다시 생성합니다.

프로세스

기본 Ingress 컨트롤러를 확인합니다.

oc describe --namespace=openshift-ingress-operator ingresscontroller/default

$ oc describe --namespace=openshift-ingress-operator ingresscontroller/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow

9.5. Ingress Operator 상태 보기

Ingress Operator의 상태를 확인 및 조사할 수 있습니다.

프로세스

Ingress Operator 상태를 확인합니다.

oc describe clusteroperators/ingress

$ oc describe clusteroperators/ingressCopy to Clipboard Copied! Toggle word wrap Toggle overflow

9.6. Ingress 컨트롤러 로그 보기

Ingress 컨트롤러의 로그를 확인할 수 있습니다.

프로세스

Ingress 컨트롤러 로그를 확인합니다.

oc logs --namespace=openshift-ingress-operator deployments/ingress-operator -c <container_name>

$ oc logs --namespace=openshift-ingress-operator deployments/ingress-operator -c <container_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

9.7. Ingress 컨트롤러 상태 보기

특정 Ingress 컨트롤러의 상태를 확인할 수 있습니다.

프로세스

Ingress 컨트롤러의 상태를 확인합니다.

oc describe --namespace=openshift-ingress-operator ingresscontroller/<name>

$ oc describe --namespace=openshift-ingress-operator ingresscontroller/<name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

9.8. 사용자 정의 Ingress 컨트롤러 생성

클러스터 관리자는 새 사용자 정의 Ingress 컨트롤러를 생성할 수 있습니다. 기본 Ingress 컨트롤러는 OpenShift Container Platform 업데이트 중에 변경될 수 있으므로 사용자 정의 Ingress 컨트롤러를 생성하면 클러스터 업데이트 시 구성을 수동으로 유지 관리할 때 유용할 수 있습니다.

이 예에서는 사용자 정의 Ingress 컨트롤러에 대한 최소 사양을 제공합니다. 사용자 정의 Ingress 컨트롤러를 추가로 사용자 지정하려면 " Ingress 컨트롤러 구성"을 참조하십시오.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin권한이 있는 사용자로 로그인합니다.

프로세스

사용자 지정

IngressController오브젝트를 정의하는 YAML 파일을 생성합니다.custom-ingress-controller.yaml파일 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 오브젝트를 생성합니다.

oc create -f custom-ingress-controller.yaml

$ oc create -f custom-ingress-controller.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

9.9. Ingress 컨트롤러 구성

9.9.1. 사용자 정의 기본 인증서 설정

관리자는 Secret 리소스를 생성하고 IngressController CR(사용자 정의 리소스)을 편집하여 사용자 정의 인증서를 사용하도록 Ingress 컨트롤러를 구성할 수 있습니다.

사전 요구 사항

- PEM 인코딩 파일에 인증서/키 쌍이 있어야 합니다. 이때 인증서는 신뢰할 수 있는 인증 기관 또는 사용자 정의 PKI에서 구성한 신뢰할 수 있는 개인 인증 기관의 서명을 받은 인증서입니다.

인증서가 다음 요구 사항을 충족합니다.

- 인증서가 Ingress 도메인에 유효해야 합니다.

-

인증서는

subjectAltName확장자를 사용하여*.apps.ocp4.example.com과같은 와일드카드 도메인을 지정합니다.

IngressControllerCR이 있어야 합니다. 기본 설정을 사용할 수 있어야 합니다.oc --namespace openshift-ingress-operator get ingresscontrollers

$ oc --namespace openshift-ingress-operator get ingresscontrollersCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME AGE default 10m

NAME AGE default 10mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

임시 인증서가 있는 경우 사용자 정의 기본 인증서가 포함 된 보안의 tls.crt 파일에 인증서가 포함되어 있어야 합니다. 인증서를 지정하는 경우에는 순서가 중요합니다. 서버 인증서 다음에 임시 인증서를 나열해야 합니다.

프로세스

아래에서는 사용자 정의 인증서 및 키 쌍이 현재 작업 디렉터리의 tls.crt 및 tls.key 파일에 있다고 가정합니다. 그리고 tls.crt 및 tls.key의 실제 경로 이름으로 변경합니다. Secret 리소스를 생성하고 IngressController CR에서 참조하는 경우 custom-certs-default를 다른 이름으로 변경할 수도 있습니다.

이 작업을 수행하면 롤링 배포 전략에 따라 Ingress 컨트롤러가 재배포됩니다.

tls.crt및tls.key파일을 사용하여openshift-ingress네임스페이스에 사용자 정의 인증서를 포함하는 Secret 리소스를 만듭니다.oc --namespace openshift-ingress create secret tls custom-certs-default --cert=tls.crt --key=tls.key

$ oc --namespace openshift-ingress create secret tls custom-certs-default --cert=tls.crt --key=tls.keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 새 인증서 보안 키를 참조하도록 IngressController CR을 업데이트합니다.

oc patch --type=merge --namespace openshift-ingress-operator ingresscontrollers/default \ --patch '{"spec":{"defaultCertificate":{"name":"custom-certs-default"}}}'$ oc patch --type=merge --namespace openshift-ingress-operator ingresscontrollers/default \ --patch '{"spec":{"defaultCertificate":{"name":"custom-certs-default"}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 업데이트가 적용되었는지 확인합니다.

echo Q |\ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null |\ openssl x509 -noout -subject -issuer -enddate

$ echo Q |\ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null |\ openssl x509 -noout -subject -issuer -enddateCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

<domain>- 클러스터의 기본 도메인 이름을 지정합니다.

출력 예

subject=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = *.apps.example.com issuer=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = example.com notAfter=May 10 08:32:45 2022 GM

subject=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = *.apps.example.com issuer=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = example.com notAfter=May 10 08:32:45 2022 GMCopy to Clipboard Copied! Toggle word wrap Toggle overflow 작은 정보다음 YAML을 적용하여 사용자 지정 기본 인증서를 설정할 수 있습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 인증서 보안 이름은 CR을 업데이트하는 데 사용된 값과 일치해야 합니다.

IngressController CR이 수정되면 Ingress Operator는 사용자 정의 인증서를 사용하도록 Ingress 컨트롤러의 배포를 업데이트합니다.

9.9.2. 사용자 정의 기본 인증서 제거

관리자는 사용할 Ingress 컨트롤러를 구성한 사용자 정의 인증서를 제거할 수 있습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다. -

OpenShift CLI(

oc)가 설치되어 있습니다. - 이전에는 Ingress 컨트롤러에 대한 사용자 정의 기본 인증서를 구성했습니다.

프로세스

사용자 정의 인증서를 제거하고 OpenShift Container Platform과 함께 제공되는 인증서를 복원하려면 다음 명령을 입력합니다.

oc patch -n openshift-ingress-operator ingresscontrollers/default \ --type json -p $'- op: remove\n path: /spec/defaultCertificate'

$ oc patch -n openshift-ingress-operator ingresscontrollers/default \ --type json -p $'- op: remove\n path: /spec/defaultCertificate'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 클러스터가 새 인증서 구성을 조정하는 동안 지연이 발생할 수 있습니다.

검증

원래 클러스터 인증서가 복원되었는지 확인하려면 다음 명령을 입력합니다.

echo Q | \ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null | \ openssl x509 -noout -subject -issuer -enddate

$ echo Q | \ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null | \ openssl x509 -noout -subject -issuer -enddateCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

<domain>- 클러스터의 기본 도메인 이름을 지정합니다.

출력 예

subject=CN = *.apps.<domain> issuer=CN = ingress-operator@1620633373 notAfter=May 10 10:44:36 2023 GMT

subject=CN = *.apps.<domain> issuer=CN = ingress-operator@1620633373 notAfter=May 10 10:44:36 2023 GMTCopy to Clipboard Copied! Toggle word wrap Toggle overflow

9.9.3. Ingress 컨트롤러 자동 스케일링

처리량 증가 요구와 같은 라우팅 성능 또는 가용성 요구 사항을 동적으로 충족하도록 Ingress 컨트롤러를 자동으로 확장할 수 있습니다.

다음 절차에서는 기본 Ingress 컨트롤러를 확장하는 예제를 제공합니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있어야 합니다. -

cluster-admin역할의 사용자로 OpenShift Container Platform 클러스터에 액세스할 수 있습니다. Custom Metrics Autoscaler Operator 및 관련 KEDA 컨트롤러가 설치되어 있습니다.

-

웹 콘솔에서 OperatorHub를 사용하여 Operator를 설치할 수 있습니다. Operator를 설치한 후

KedaController의 인스턴스를 생성할 수 있습니다.

-

웹 콘솔에서 OperatorHub를 사용하여 Operator를 설치할 수 있습니다. Operator를 설치한 후

프로세스

다음 명령을 실행하여 Thanos로 인증할 서비스 계정을 생성합니다.

oc create -n openshift-ingress-operator serviceaccount thanos && oc describe -n openshift-ingress-operator serviceaccount thanos

$ oc create -n openshift-ingress-operator serviceaccount thanos && oc describe -n openshift-ingress-operator serviceaccount thanosCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 선택 사항: 다음 명령을 사용하여 수동으로 서비스 계정 시크릿 토큰을 생성합니다.

중요ImageRegistry기능을 비활성화하거나 Cluster Image Registry Operator 구성에서 통합 OpenShift 이미지 레지스트리를 비활성화하는 경우 각 서비스 계정에 대해 이미지 풀 시크릿이 생성되지 않습니다. 이 경우 이 단계를 수행해야 합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 서비스 계정의 토큰을 사용하여

openshift-ingress-operator네임스페이스에TriggerAuthentication오브젝트를 정의합니다.다음 명령을 실행하여 보안이 포함된

시크릿변수를 정의합니다.secret=$(oc get secret -n openshift-ingress-operator | grep thanos-token | head -n 1 | awk '{ print $1 }')$ secret=$(oc get secret -n openshift-ingress-operator | grep thanos-token | head -n 1 | awk '{ print $1 }')Copy to Clipboard Copied! Toggle word wrap Toggle overflow TriggerAuthentication오브젝트를 생성하고secret변수 값을TOKEN매개변수에 전달합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Thanos에서 메트릭을 읽는 역할을 생성하고 적용합니다.

Pod 및 노드에서 지표를 읽는 새 역할

thanos-metrics-reader.yaml을 생성합니다.thanos-metrics-reader.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 새 역할을 적용합니다.

oc apply -f thanos-metrics-reader.yaml

$ oc apply -f thanos-metrics-reader.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

다음 명령을 입력하여 서비스 계정에 새 역할을 추가합니다.

oc adm policy -n openshift-ingress-operator add-role-to-user thanos-metrics-reader -z thanos --role-namespace=openshift-ingress-operator

$ oc adm policy -n openshift-ingress-operator add-role-to-user thanos-metrics-reader -z thanos --role-namespace=openshift-ingress-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc adm policy -n openshift-ingress-operator add-cluster-role-to-user cluster-monitoring-view -z thanos

$ oc adm policy -n openshift-ingress-operator add-cluster-role-to-user cluster-monitoring-view -z thanosCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고add-cluster-role-to-user인수는 네임스페이스 간 쿼리를 사용하는 경우에만 필요합니다. 다음 단계에서는 이 인수가 필요한kube-metrics네임스페이스의 쿼리를 사용합니다.기본 Ingress 컨트롤러 배포를 대상으로 하는 새 scaled

ObjectYAML 파일ingress-autoscaler.yaml을 만듭니다.scaled

Object정의의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow 중요네임스페이스 간 쿼리를 사용하는 경우

serverAddress필드에서 포트 9091이 아닌 포트 9091을 대상으로 지정해야 합니다. 또한 이 포트에서 메트릭을 읽을 수 있는 높은 권한이 있어야 합니다.다음 명령을 실행하여 사용자 정의 리소스 정의를 적용합니다.

oc apply -f ingress-autoscaler.yaml

$ oc apply -f ingress-autoscaler.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

다음 명령을 실행하여 기본 Ingress 컨트롤러가

kube-state-metrics쿼리에서 반환된 값과 일치하도록 확장되었는지 확인합니다.grep명령을 사용하여 Ingress 컨트롤러 YAML 파일에서 복제본을 검색합니다.oc get -n openshift-ingress-operator ingresscontroller/default -o yaml | grep replicas:

$ oc get -n openshift-ingress-operator ingresscontroller/default -o yaml | grep replicas:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

replicas: 3

replicas: 3Copy to Clipboard Copied! Toggle word wrap Toggle overflow openshift-ingress프로젝트에서 Pod를 가져옵니다.oc get pods -n openshift-ingress

$ oc get pods -n openshift-ingressCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME READY STATUS RESTARTS AGE router-default-7b5df44ff-l9pmm 2/2 Running 0 17h router-default-7b5df44ff-s5sl5 2/2 Running 0 3d22h router-default-7b5df44ff-wwsth 2/2 Running 0 66s

NAME READY STATUS RESTARTS AGE router-default-7b5df44ff-l9pmm 2/2 Running 0 17h router-default-7b5df44ff-s5sl5 2/2 Running 0 3d22h router-default-7b5df44ff-wwsth 2/2 Running 0 66sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

9.9.4. Ingress 컨트롤러 확장

처리량 증가 요구 등 라우팅 성능 또는 가용성 요구 사항을 충족하도록 Ingress 컨트롤러를 수동으로 확장할 수 있습니다. IngressController 리소스를 확장하려면 oc 명령을 사용합니다. 다음 절차는 기본 IngressController를 확장하는 예제입니다.

원하는 수의 복제본을 만드는 데에는 시간이 걸리기 때문에 확장은 즉시 적용되지 않습니다.

프로세스

기본

IngressController의 현재 사용 가능한 복제본 개수를 살펴봅니다.oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'$ oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

2

2Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc patch명령을 사용하여 기본IngressController의 복제본 수를 원하는 대로 조정합니다. 다음 예제는 기본IngressController를 3개의 복제본으로 조정합니다.oc patch -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"replicas": 3}}' --type=merge$ oc patch -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"replicas": 3}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

ingresscontroller.operator.openshift.io/default patched

ingresscontroller.operator.openshift.io/default patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 기본

IngressController가 지정한 복제본 수에 맞게 조정되었는지 확인합니다.oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'$ oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

3

3Copy to Clipboard Copied! Toggle word wrap Toggle overflow 작은 정보또는 다음 YAML을 적용하여 Ingress 컨트롤러를 세 개의 복제본으로 확장할 수 있습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 다른 양의 복제본이 필요한 경우

replicas값을 변경합니다.

9.9.5. 수신 액세스 로깅 구성

Ingress 컨트롤러가 로그에 액세스하도록 구성할 수 있습니다. 수신 트래픽이 많지 않은 클러스터의 경우 사이드카에 로그를 기록할 수 있습니다. 트래픽이 많은 클러스터가 있는 경우 로깅 스택의 용량을 초과하지 않거나 OpenShift Container Platform 외부의 로깅 인프라와 통합하기 위해 사용자 정의 syslog 끝점으로 로그를 전달할 수 있습니다. 액세스 로그의 형식을 지정할 수도 있습니다.

컨테이너 로깅은 기존 Syslog 로깅 인프라가 없는 경우 트래픽이 적은 클러스터에서 액세스 로그를 활성화하거나 Ingress 컨트롤러의 문제를 진단하는 동안 단기적으로 사용하는 데 유용합니다.

액세스 로그가 OpenShift 로깅 스택 용량을 초과할 수 있는 트래픽이 많은 클러스터 또는 로깅 솔루션이 기존 Syslog 로깅 인프라와 통합되어야 하는 환경에는 Syslog가 필요합니다. Syslog 사용 사례는 중첩될 수 있습니다.

사전 요구 사항

-

cluster-admin권한이 있는 사용자로 로그인합니다.

프로세스

사이드카에 Ingress 액세스 로깅을 구성합니다.

수신 액세스 로깅을 구성하려면

spec.logging.access.destination을 사용하여 대상을 지정해야 합니다. 사이드카 컨테이너에 로깅을 지정하려면Containerspec.logging.access.destination.type을 지정해야 합니다. 다음 예제는Container대상에 로그를 기록하는 Ingress 컨트롤러 정의입니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 사이드카에 로그를 기록하도록 Ingress 컨트롤러를 구성하면 Operator는 Ingress 컨트롤러 Pod에

logs라는 컨테이너를 만듭니다.oc -n openshift-ingress logs deployment.apps/router-default -c logs

$ oc -n openshift-ingress logs deployment.apps/router-default -c logsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

2020-05-11T19:11:50.135710+00:00 router-default-57dfc6cd95-bpmk6 router-default-57dfc6cd95-bpmk6 haproxy[108]: 174.19.21.82:39654 [11/May/2020:19:11:50.133] public be_http:hello-openshift:hello-openshift/pod:hello-openshift:hello-openshift:10.128.2.12:8080 0/0/1/0/1 200 142 - - --NI 1/1/0/0/0 0/0 "GET / HTTP/1.1"

2020-05-11T19:11:50.135710+00:00 router-default-57dfc6cd95-bpmk6 router-default-57dfc6cd95-bpmk6 haproxy[108]: 174.19.21.82:39654 [11/May/2020:19:11:50.133] public be_http:hello-openshift:hello-openshift/pod:hello-openshift:hello-openshift:10.128.2.12:8080 0/0/1/0/1 200 142 - - --NI 1/1/0/0/0 0/0 "GET / HTTP/1.1"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Syslog 끝점에 대한 Ingress 액세스 로깅을 구성합니다.

수신 액세스 로깅을 구성하려면

spec.logging.access.destination을 사용하여 대상을 지정해야 합니다. Syslog 끝점 대상에 로깅을 지정하려면spec.logging.access.destination.type에 대한Syslog를 지정해야 합니다. 대상 유형이Syslog인 경우,spec.logging.access.destination.syslog.endpoint를 사용하여 대상 끝점을 지정해야 하며spec.logging.access.destination.syslog.facility를 사용하여 장치를 지정할 수 있습니다. 다음 예제는Syslog대상에 로그를 기록하는 Ingress 컨트롤러 정의입니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고syslog대상 포트는 UDP여야 합니다.

특정 로그 형식으로 Ingress 액세스 로깅을 구성합니다.

spec.logging.access.httpLogFormat을 지정하여 로그 형식을 사용자 정의할 수 있습니다. 다음 예제는 IP 주소 1.2.3.4 및 포트 10514를 사용하여syslog끝점에 로그하는 Ingress 컨트롤러 정의입니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Ingress 액세스 로깅을 비활성화합니다.

Ingress 액세스 로깅을 비활성화하려면

spec.logging또는spec.logging.access를 비워 둡니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

사이드카를 사용할 때 Ingress 컨트롤러에서 HAProxy 로그 길이를 수정할 수 있도록 허용합니다.

spec.logging.access.destination.destination.를 사용합니다.type: Syslog를 사용하는 경우 spec.logging.access.destination.maxLengthCopy to Clipboard Copied! Toggle word wrap Toggle overflow spec.logging.access.destination.destination.를 사용합니다.type: Container를 사용하는 경우 spec.logging.access.destination.maxLengthCopy to Clipboard Copied! Toggle word wrap Toggle overflow

9.9.6. Ingress 컨트롤러 스레드 수 설정

클러스터 관리자는 클러스터에서 처리할 수 있는 들어오는 연결의 양을 늘리기 위해 스레드 수를 설정할 수 있습니다. 기존 Ingress 컨트롤러에 패치하여 스레드의 양을 늘릴 수 있습니다.

사전 요구 사항

- 다음은 Ingress 컨트롤러를 이미 생성했다고 가정합니다.

프로세스

스레드 수를 늘리도록 Ingress 컨트롤러를 업데이트합니다.

oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"threadCount": 8}}}'$ oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"threadCount": 8}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고많은 리소스를 실행할 수 있는 노드가 있는 경우 원하는 노드의 용량과 일치하는 라벨을 사용하여

spec.nodePlacement.nodeSelector를 구성하고spec.tuningOptions.threadCount를 적절하게 높은 값으로 구성할 수 있습니다.

9.9.7. 내부 로드 밸런서를 사용하도록 Ingress 컨트롤러 구성

클라우드 플랫폼에서 Ingress 컨트롤러를 생성할 때 Ingress 컨트롤러는 기본적으로 퍼블릭 클라우드 로드 밸런서에 의해 게시됩니다. 관리자는 내부 클라우드 로드 밸런서를 사용하는 Ingress 컨트롤러를 생성할 수 있습니다.

클라우드 공급자가 Microsoft Azure인 경우 노드를 가리키는 퍼블릭 로드 밸런서가 하나 이상 있어야 합니다. 그렇지 않으면 모든 노드의 인터넷 연결이 끊어집니다.

IngressController 의 범위를 변경하려면 CR(사용자 정의 리소스)을 생성한 후 .spec.endpointPublishingStrategy.loadBalancer.scope 매개변수를 변경할 수 있습니다.

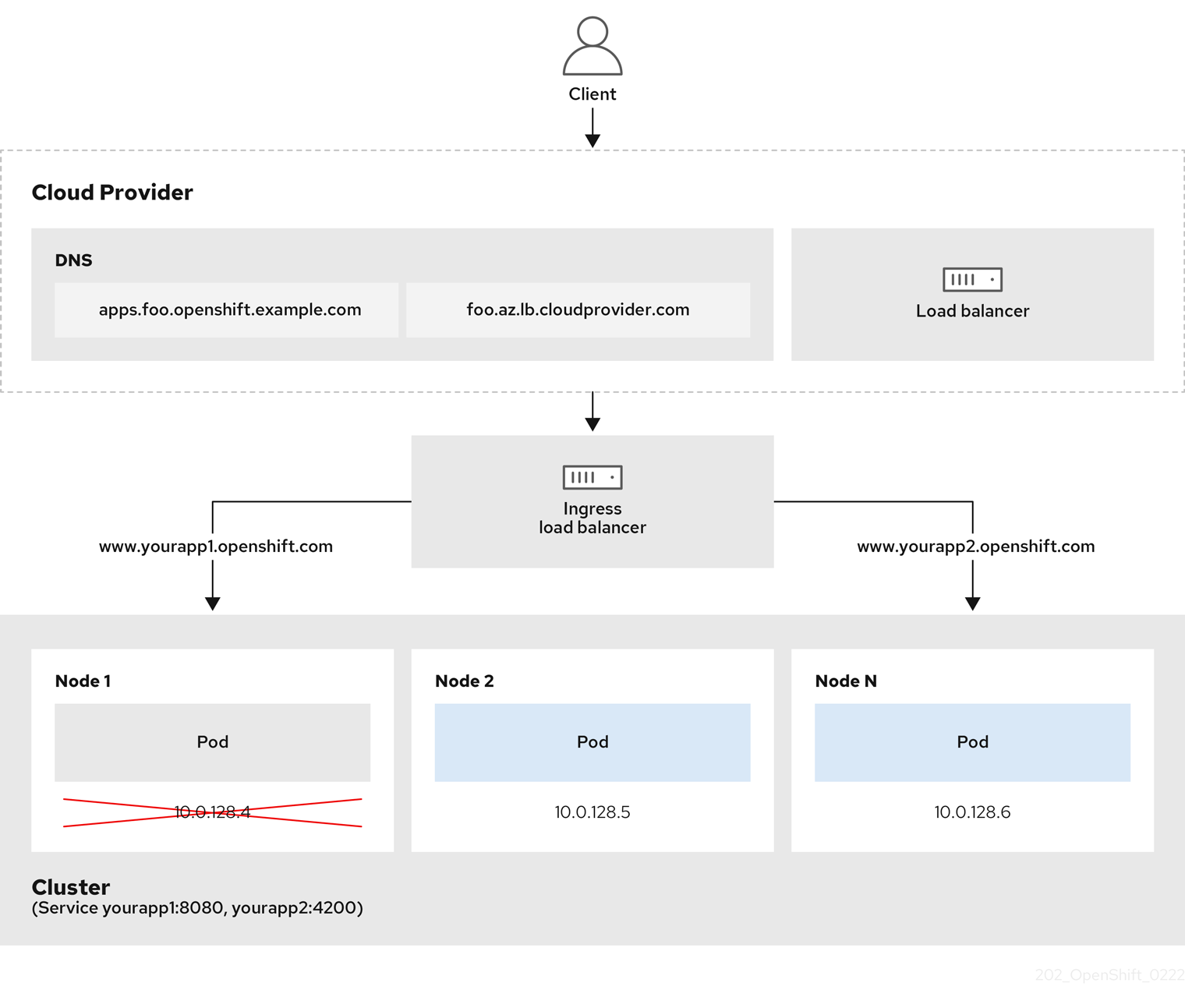

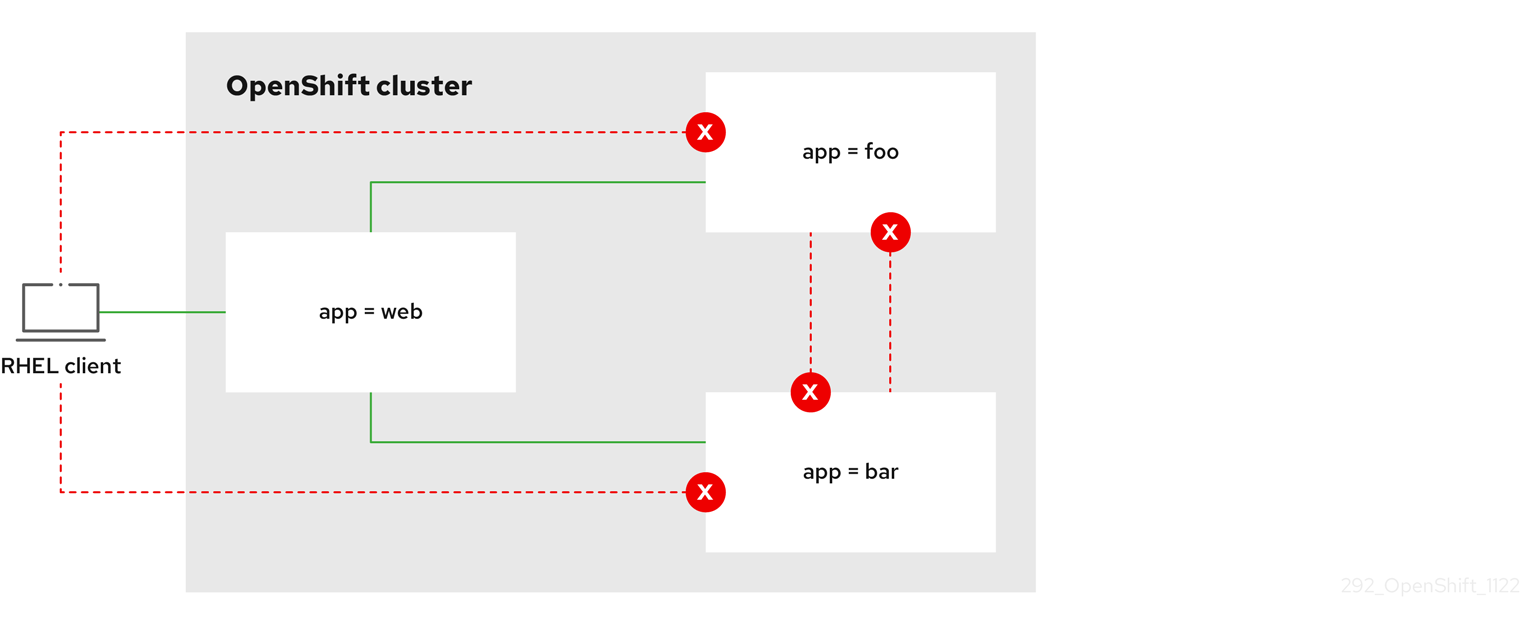

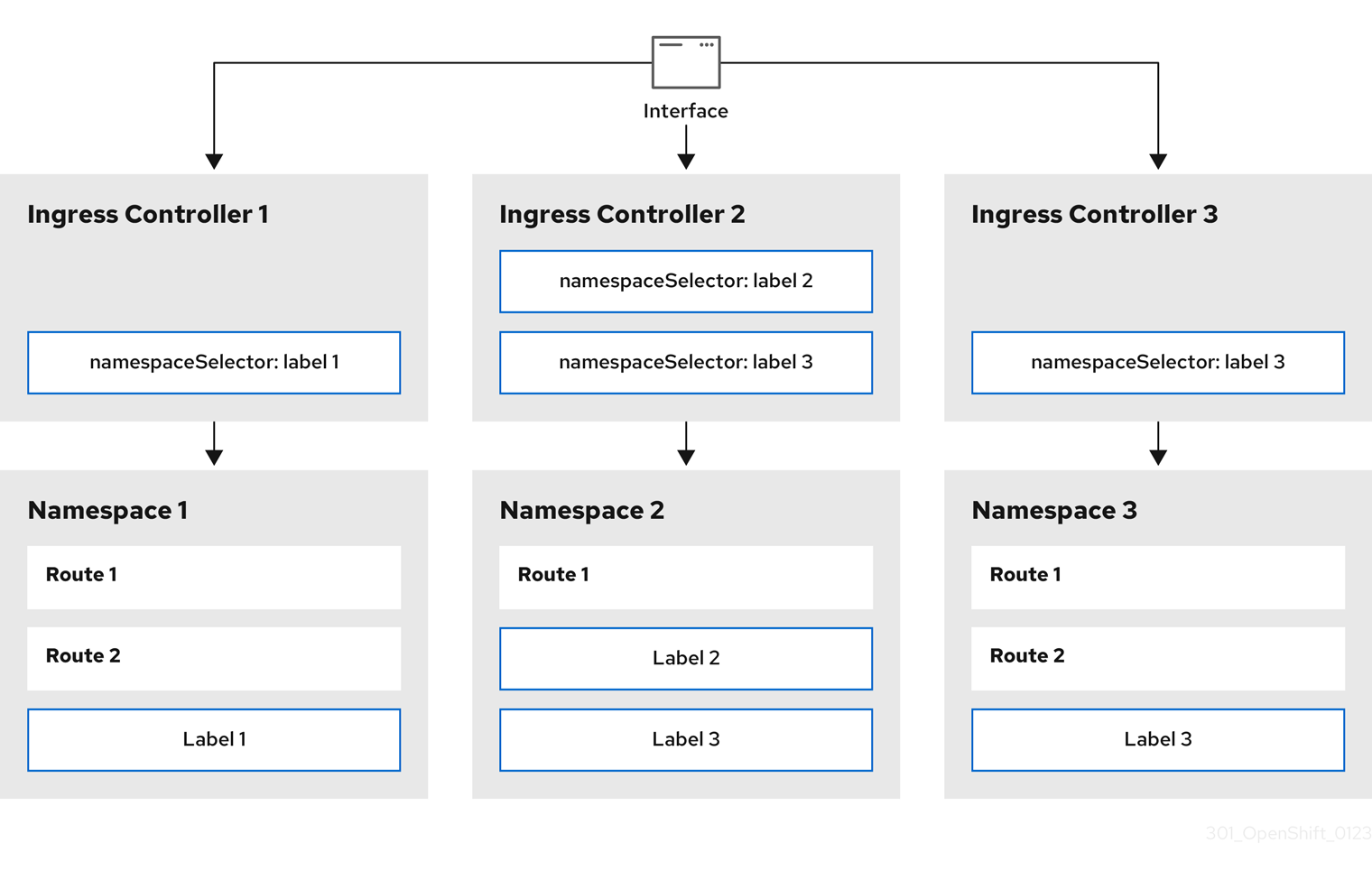

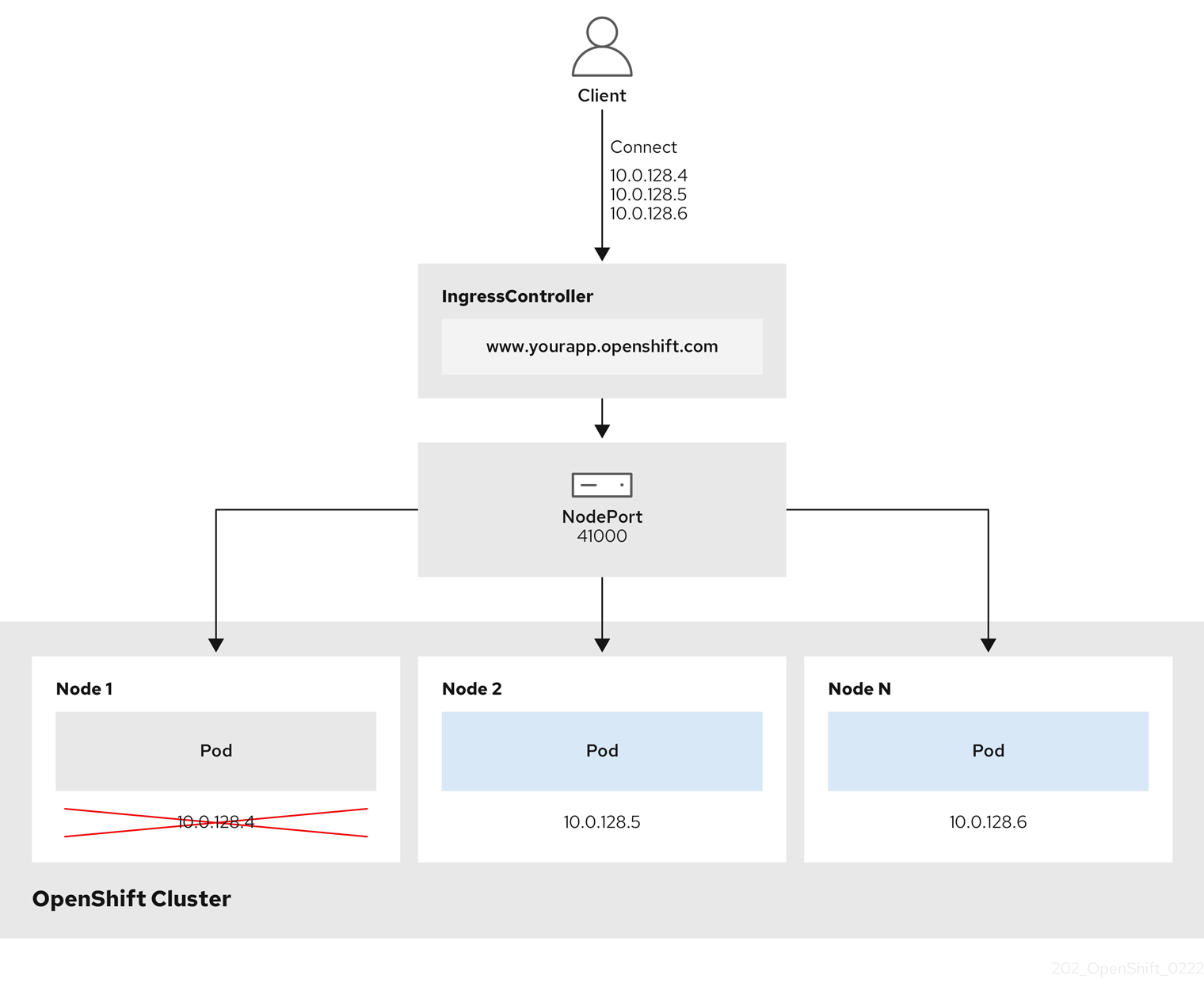

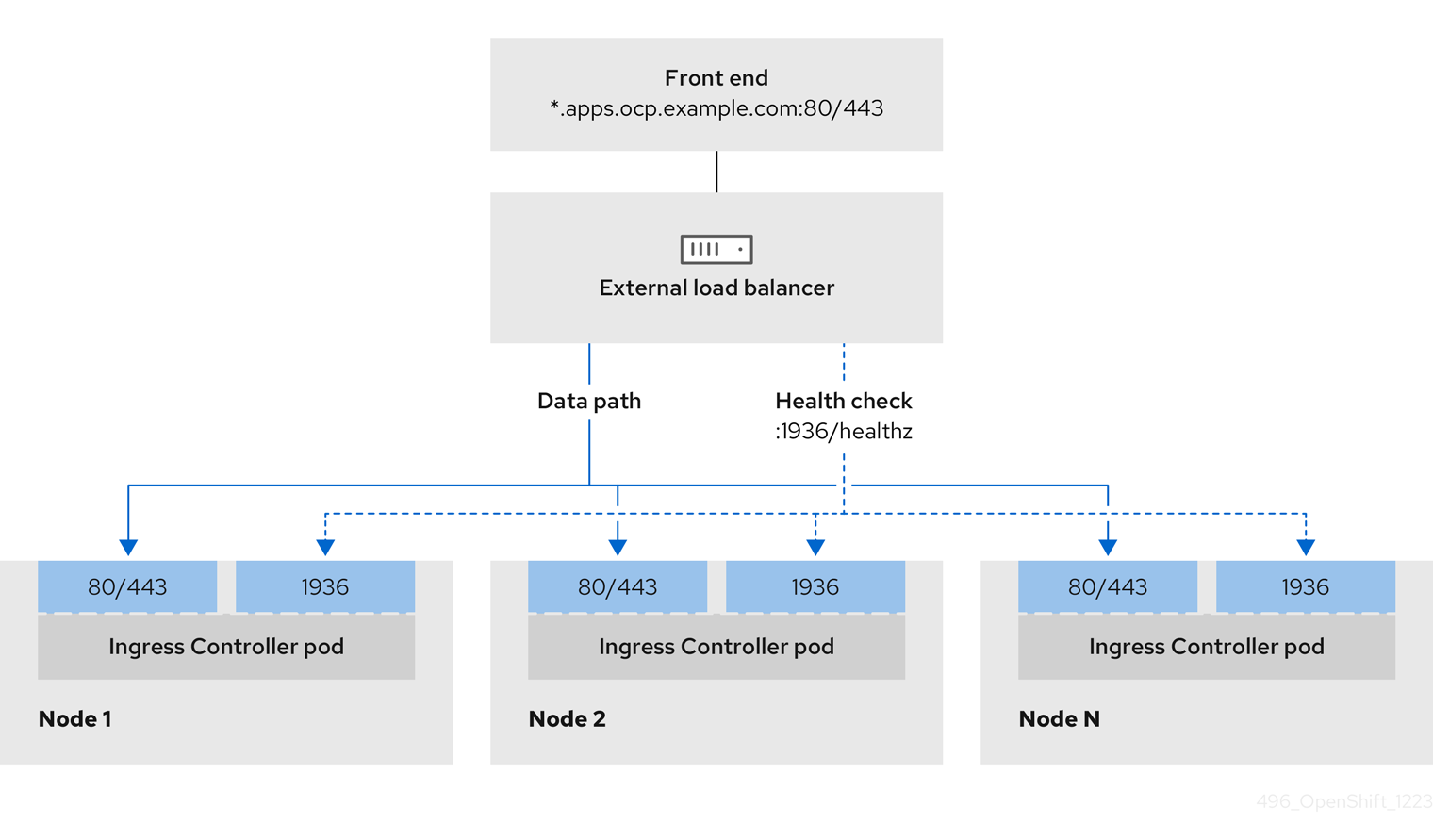

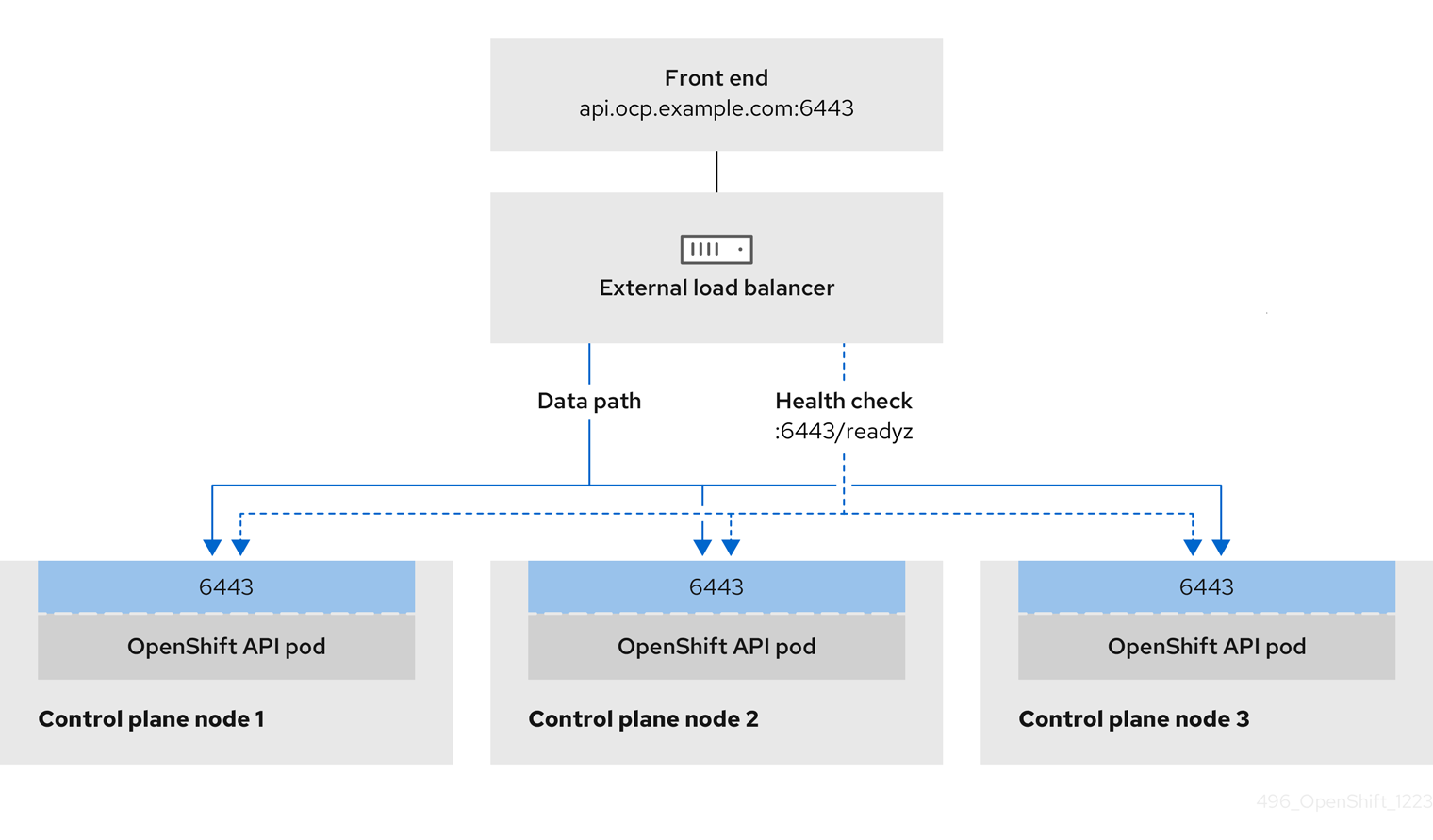

그림 9.1. LoadBalancer 다이어그램

이전 그림에서는 OpenShift Container Platform Ingress LoadBalancerService 끝점 게시 전략과 관련된 다음 개념을 보여줍니다.

- 클라우드 공급자 로드 밸런서를 사용하거나 내부적으로 OpenShift Ingress 컨트롤러 로드 밸런서를 사용하여 외부에서 부하를 분산할 수 있습니다.

- 그래픽에 표시된 클러스터에 표시된 대로 로드 밸런서의 단일 IP 주소와 8080 및 4200과 같은 더 친숙한 포트를 사용할 수 있습니다.

- 외부 로드 밸런서의 트래픽은 Pod에서 전달되고 다운 노드의 인스턴스에 표시된 대로 로드 밸런서에 의해 관리됩니다. 구현 세부 사항은 Kubernetes 서비스 설명서를 참조하십시오.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin권한이 있는 사용자로 로그인합니다.

프로세스

다음 예제와 같이

<name>-ingress-controller.yam파일에IngressControllerCR(사용자 정의 리소스)을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 이전 단계에서 정의된 Ingress 컨트롤러를 생성합니다.

oc create -f <name>-ingress-controller.yaml

$ oc create -f <name>-ingress-controller.yaml1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<name>을IngressController오브젝트의 이름으로 변경합니다.

선택 사항: Ingress 컨트롤러가 생성되었는지 확인하려면 다음 명령을 실행합니다.

oc --all-namespaces=true get ingresscontrollers

$ oc --all-namespaces=true get ingresscontrollersCopy to Clipboard Copied! Toggle word wrap Toggle overflow

9.9.8. GCP에서 Ingress 컨트롤러에 대한 글로벌 액세스 구성

내부 로드 밸런서가 있는 GCP에서 생성된 Ingress 컨트롤러는 서비스의 내부 IP 주소를 생성합니다. 클러스터 관리자는 로드 밸런서와 동일한 VPC 네트워크 및 컴퓨팅 리전 내의 모든 리전의 클라이언트가 클러스터에서 실행되는 워크로드에 도달할 수 있도록 하는 글로벌 액세스 옵션을 지정할 수 있습니다.

자세한 내용은 글로벌 액세스에 대한 GCP 설명서를 참조하십시오.

사전 요구 사항

- GCP 인프라에 OpenShift Container Platform 클러스터를 배포했습니다.

- 내부 로드 밸런서를 사용하도록 Ingress 컨트롤러 구성

-

OpenShift CLI(

oc)를 설치합니다.

프로세스

글로벌 액세스를 허용하도록 Ingress 컨트롤러 리소스를 구성합니다.

참고Ingress 컨트롤러를 생성하고 글로벌 액세스 옵션을 지정할 수도 있습니다.

Ingress 컨트롤러 리소스를 구성합니다.

oc -n openshift-ingress-operator edit ingresscontroller/default

$ oc -n openshift-ingress-operator edit ingresscontroller/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow YAML 파일을 편집합니다.

Global에 대한clientAccess구성 샘플Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

gcp.clientAccess를Global로 설정합니다.

- 파일을 저장하여 변경 사항을 적용합니다.

다음 명령을 실행하여 서비스가 글로벌 액세스를 허용하는지 확인합니다.

oc -n openshift-ingress edit svc/router-default -o yaml

$ oc -n openshift-ingress edit svc/router-default -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력에서 주석

networking.gke.io/internal-load-balancer-allow-global-access가 있는 GCP에 글로벌 액세스가 활성화되어 있음을 보여줍니다.

9.9.9. Ingress 컨트롤러 상태 점검 간격 설정

클러스터 관리자는 상태 점검 간격을 설정하여 라우터가 연속 상태 점검 사이에 대기하는 시간을 정의할 수 있습니다. 이 값은 모든 경로에 대해 전역적으로 적용됩니다. 기본값은 5초입니다.

사전 요구 사항

- 다음은 Ingress 컨트롤러를 이미 생성했다고 가정합니다.

프로세스

백엔드 상태 점검 간 간격을 변경하도록 Ingress 컨트롤러를 업데이트합니다.

oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"healthCheckInterval": "8s"}}}'$ oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"healthCheckInterval": "8s"}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고단일 경로의

healthCheckInterval을 재정의하려면 경로 주석router.openshift.io/haproxy.health.check.interval을 사용합니다.

9.9.10. 클러스터의 기본 Ingress 컨트롤러를 내부로 구성

클러스터를 삭제하고 다시 생성하여 클러스터의 default Ingress 컨트롤러를 내부용으로 구성할 수 있습니다.

클라우드 공급자가 Microsoft Azure인 경우 노드를 가리키는 퍼블릭 로드 밸런서가 하나 이상 있어야 합니다. 그렇지 않으면 모든 노드의 인터넷 연결이 끊어집니다.

IngressController 의 범위를 변경하려면 CR(사용자 정의 리소스)을 생성한 후 .spec.endpointPublishingStrategy.loadBalancer.scope 매개변수를 변경할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin권한이 있는 사용자로 로그인합니다.

프로세스

클러스터의

기본Ingress 컨트롤러를 삭제하고 다시 생성하여 내부용으로 구성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

9.9.11. 경로 허용 정책 구성

관리자 및 애플리케이션 개발자는 도메인 이름이 동일한 여러 네임스페이스에서 애플리케이션을 실행할 수 있습니다. 이는 여러 팀이 동일한 호스트 이름에 노출되는 마이크로 서비스를 개발하는 조직을 위한 것입니다.

네임스페이스 간 클레임은 네임스페이스 간 신뢰가 있는 클러스터에 대해서만 허용해야 합니다. 그렇지 않으면 악의적인 사용자가 호스트 이름을 인수할 수 있습니다. 따라서 기본 승인 정책에서는 네임스페이스 간에 호스트 이름 클레임을 허용하지 않습니다.

사전 요구 사항

- 클러스터 관리자 권한이 있어야 합니다.

프로세스

다음 명령을 사용하여

ingresscontroller리소스 변수의.spec.routeAdmission필드를 편집합니다.oc -n openshift-ingress-operator patch ingresscontroller/default --patch '{"spec":{"routeAdmission":{"namespaceOwnership":"InterNamespaceAllowed"}}}' --type=merge$ oc -n openshift-ingress-operator patch ingresscontroller/default --patch '{"spec":{"routeAdmission":{"namespaceOwnership":"InterNamespaceAllowed"}}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 샘플 Ingress 컨트롤러 구성

spec: routeAdmission: namespaceOwnership: InterNamespaceAllowed ...spec: routeAdmission: namespaceOwnership: InterNamespaceAllowed ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 작은 정보다음 YAML을 적용하여 경로 승인 정책을 구성할 수 있습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

9.9.12. 와일드카드 경로 사용

HAProxy Ingress 컨트롤러는 와일드카드 경로를 지원합니다. Ingress Operator는 wildcardPolicy를 사용하여 Ingress 컨트롤러의 ROUTER_ALLOW_WILDCARD_ROUTES 환경 변수를 구성합니다.

Ingress 컨트롤러의 기본 동작은 와일드카드 정책이 None인 경로를 허용하고, 이는 기존 IngressController 리소스의 이전 버전과 호환됩니다.

프로세스

와일드카드 정책을 구성합니다.

다음 명령을 사용하여

IngressController리소스를 편집합니다.oc edit IngressController

$ oc edit IngressControllerCopy to Clipboard Copied! Toggle word wrap Toggle overflow spec에서wildcardPolicy필드를WildcardsDisallowed또는WildcardsAllowed로 설정합니다.spec: routeAdmission: wildcardPolicy: WildcardsDisallowed # or WildcardsAllowedspec: routeAdmission: wildcardPolicy: WildcardsDisallowed # or WildcardsAllowedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

9.9.13. HTTP 헤더 구성

OpenShift Container Platform은 HTTP 헤더를 사용하는 다양한 방법을 제공합니다. 헤더를 설정하거나 삭제할 때 Ingress 컨트롤러의 특정 필드를 사용하거나 개별 경로를 사용하여 요청 및 응답 헤더를 수정할 수 있습니다. 경로 주석을 사용하여 특정 헤더를 설정할 수도 있습니다. 헤더를 구성하는 다양한 방법은 함께 작업할 때 문제가 발생할 수 있습니다.

IngressController 또는 Route CR 내에서 헤더만 설정하거나 삭제할 수 있으므로 추가할 수 없습니다. HTTP 헤더가 값으로 설정된 경우 해당 값은 완료되어야 하며 나중에 추가할 필요가 없습니다. X-Forwarded-For 헤더와 같은 헤더를 추가하는 것이 적합한 경우 spec.httpHeaders.actions 대신 spec.httpHeaders.forwardedHeaderPolicy 필드를 사용합니다.

9.9.13.1. 우선순위 순서

Ingress 컨트롤러와 경로에서 동일한 HTTP 헤더를 수정하는 경우 HAProxy는 요청 또는 응답 헤더인지 여부에 따라 특정 방식으로 작업에 우선순위를 부여합니다.

- HTTP 응답 헤더의 경우 경로에 지정된 작업 후에 Ingress 컨트롤러에 지정된 작업이 실행됩니다. 즉, Ingress 컨트롤러에 지정된 작업이 우선합니다.

- HTTP 요청 헤더의 경우 경로에 지정된 작업은 Ingress 컨트롤러에 지정된 작업 후에 실행됩니다. 즉, 경로에 지정된 작업이 우선합니다.

예를 들어 클러스터 관리자는 다음 구성을 사용하여 Ingress 컨트롤러에서 값이 DENY 인 X-Frame-Options 응답 헤더를 설정합니다.

IngressController 사양 예

경로 소유자는 클러스터 관리자가 Ingress 컨트롤러에 설정한 것과 동일한 응답 헤더를 설정하지만 다음 구성을 사용하여 SAMEORIGIN 값이 사용됩니다.

Route 사양의 예

IngressController 사양과 Route 사양 모두에서 X-Frame-Options 헤더를 구성하는 경우 특정 경로에서 프레임을 허용하는 경우에도 Ingress 컨트롤러의 글로벌 수준에서 이 헤더에 설정된 값이 우선합니다.

이 우선순위는 haproxy.config 파일에서 다음 논리를 사용하므로 Ingress 컨트롤러가 프런트 엔드로 간주되고 개별 경로가 백엔드로 간주되기 때문에 발생합니다. 프런트 엔드 구성에 적용된 헤더 값 DENY 는 백엔드에 설정된 SAMEORIGIN 값으로 동일한 헤더를 재정의합니다.

또한 Ingress 컨트롤러 또는 경로 주석을 사용하여 설정된 경로 덮어쓰기 값에 정의된 모든 작업입니다.

9.9.13.2. 특수 케이스 헤더

다음 헤더는 완전히 설정되거나 삭제되지 않거나 특정 상황에서 허용되지 않습니다.

| 헤더 이름 | IngressController 사양을 사용하여 구성 가능 | Route 사양을 사용하여 구성 가능 | 허용하지 않는 이유 | 다른 방법을 사용하여 구성 가능 |

|---|---|---|---|---|

|

| 없음 | 없음 |

| 없음 |

|

| 없음 | 제공됨 |

| 없음 |

|

| 없음 | 없음 |

|

제공됨: |

|

| 없음 | 없음 | HAProxy가 클라이언트 연결을 특정 백엔드 서버에 매핑하는 세션 추적에 사용되는 쿠키입니다. 이러한 헤더를 설정하도록 허용하면 HAProxy의 세션 선호도를 방해하고 HAProxy의 쿠키 소유권을 제한할 수 있습니다. | 예:

|

9.9.14. Ingress 컨트롤러에서 HTTP 요청 및 응답 헤더 설정 또는 삭제

규정 준수 목적 또는 기타 이유로 특정 HTTP 요청 및 응답 헤더를 설정하거나 삭제할 수 있습니다. Ingress 컨트롤러에서 제공하는 모든 경로 또는 특정 경로에 대해 이러한 헤더를 설정하거나 삭제할 수 있습니다.

예를 들어 상호 TLS를 사용하기 위해 클러스터에서 실행 중인 애플리케이션을 마이그레이션할 수 있습니다. 이 경우 애플리케이션에서 X-Forwarded-Client-Cert 요청 헤더를 확인해야 하지만 OpenShift Container Platform 기본 Ingress 컨트롤러는 X-SSL-Client-Der 요청 헤더를 제공합니다.

다음 절차에서는 X-Forwarded-Client-Cert 요청 헤더를 설정하도록 Ingress 컨트롤러를 수정하고 X-SSL-Client-Der 요청 헤더를 삭제합니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin역할의 사용자로 OpenShift Container Platform 클러스터에 액세스할 수 있습니다.

프로세스

Ingress 컨트롤러 리소스를 편집합니다.

oc -n openshift-ingress-operator edit ingresscontroller/default

$ oc -n openshift-ingress-operator edit ingresscontroller/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow X-SSL-Client-Der HTTP 요청 헤더를 X-Forwarded-Client-Cert HTTP 요청 헤더로 바꿉니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- HTTP 헤더에서 수행할 작업 목록입니다.

- 2

- 변경할 헤더 유형입니다. 이 경우 요청 헤더가 있습니다.

- 3

- 변경할 헤더의 이름입니다. 설정하거나 삭제할 수 있는 사용 가능한 헤더 목록은 HTTP 헤더 구성 을 참조하십시오.

- 4

- 헤더에서 수행되는 작업 유형입니다. 이 필드에는

Set또는Delete값이 있을 수 있습니다. - 5

- HTTP 헤더를 설정할 때

값을제공해야 합니다. 값은 해당 헤더에 사용 가능한 지시문 목록(예:DENY)의 문자열이거나 HAProxy의 동적 값 구문을 사용하여 해석되는 동적 값이 될 수 있습니다. 이 경우 동적 값이 추가됩니다.

참고HTTP 응답에 대한 동적 헤더 값을 설정하기 위해 허용되는 샘플 페이퍼는

res.hdr및ssl_c_der입니다. HTTP 요청에 대한 동적 헤더 값을 설정하는 경우 허용되는 샘플 페더는req.hdr및ssl_c_der입니다. request 및 response 동적 값은 모두lower및base64컨버터를 사용할 수 있습니다.- 파일을 저장하여 변경 사항을 적용합니다.

9.9.15. X-Forwarded 헤더 사용

HAProxy Ingress 컨트롤러를 구성하여 Forwarded 및 X-Forwarded-For를 포함한 HTTP 헤더 처리 방법에 대한 정책을 지정합니다. Ingress Operator는 HTTPHeaders 필드를 사용하여 Ingress 컨트롤러의 ROUTER_SET_FORWARDED_HEADERS 환경 변수를 구성합니다.

프로세스

Ingress 컨트롤러에 대한

HTTPHeaders필드를 구성합니다.다음 명령을 사용하여

IngressController리소스를 편집합니다.oc edit IngressController

$ oc edit IngressControllerCopy to Clipboard Copied! Toggle word wrap Toggle overflow spec에서HTTPHeaders정책 필드를Append,Replace,IfNone또는Never로 설정합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

사용 사례 예

클러스터 관리자는 다음을 수행할 수 있습니다.

Ingress 컨트롤러로 전달하기 전에

X-Forwarded-For헤더를 각 요청에 삽입하는 외부 프록시를 구성합니다.헤더를 수정하지 않은 상태로 전달하도록 Ingress 컨트롤러를 구성하려면

never정책을 지정합니다. 그러면 Ingress 컨트롤러에서 헤더를 설정하지 않으며 애플리케이션은 외부 프록시에서 제공하는 헤더만 수신합니다.외부 프록시에서 외부 클러스터 요청에 설정한

X-Forwarded-For헤더를 수정하지 않은 상태로 전달하도록 Ingress 컨트롤러를 구성합니다.외부 프록시를 통과하지 않는 내부 클러스터 요청에

X-Forwarded-For헤더를 설정하도록 Ingress 컨트롤러를 구성하려면if-none정책을 지정합니다. HTTP 요청에 이미 외부 프록시를 통해 설정된 헤더가 있는 경우 Ingress 컨트롤러에서 해당 헤더를 보존합니다. 요청이 프록시를 통해 제공되지 않아 헤더가 없는 경우에는 Ingress 컨트롤러에서 헤더를 추가합니다.

애플리케이션 개발자는 다음을 수행할 수 있습니다.

X-Forwarded-For헤더를 삽입하는 애플리케이션별 외부 프록시를 구성합니다.다른 경로에 대한 정책에 영향을 주지 않으면서 애플리케이션 경로에 대한 헤더를 수정하지 않은 상태로 전달하도록 Ingress 컨트롤러를 구성하려면 애플리케이션 경로에 주석

haproxy.router.openshift.io/set-forwarded-headers: if-none또는haproxy.router.openshift.io/set-forwarded-headers: never를 추가하십시오.참고Ingress 컨트롤러에 전역적으로 설정된 값과 관계없이 경로별로

haproxy.router.openshift.io/set-forwarded-headers주석을 설정할 수 있습니다.

9.9.16. HTTP/2 수신 연결 사용

이제 HAProxy에서 투명한 엔드 투 엔드 HTTP/2 연결을 활성화할 수 있습니다. 애플리케이션 소유자는 이를 통해 단일 연결, 헤더 압축, 바이너리 스트림 등 HTTP/2 프로토콜 기능을 활용할 수 있습니다.

개별 Ingress 컨트롤러 또는 전체 클러스터에 대해 HAProxy에서 HTTP/2 연결을 활성화할 수 있습니다.

클라이언트에서 HAProxy로의 연결에 HTTP/2 사용을 활성화하려면 경로에서 사용자 정의 인증서를 지정해야 합니다. 기본 인증서를 사용하는 경로에서는 HTTP/2를 사용할 수 없습니다. 이것은 동일한 인증서를 사용하는 다른 경로의 연결을 클라이언트가 재사용하는 등 동시 연결로 인한 문제를 방지하기 위한 제한입니다.

HAProxy에서 애플리케이션 pod로의 연결은 re-encrypt 라우팅에만 HTTP/2를 사용할 수 있으며 Edge termination 또는 비보안 라우팅에는 사용할 수 없습니다. 이 제한은 백엔드와 HTTP/2 사용을 협상할 때 HAProxy가 TLS의 확장인 ALPN(Application-Level Protocol Negotiation)을 사용하기 때문에 필요합니다. 이는 엔드 투 엔드 HTTP/2가 패스스루(passthrough) 및 re-encrypt 라우팅에는 적합하지만 비보안 또는 Edge termination 라우팅에는 적합하지 않음을 의미합니다.

패스스루(passthrough)가 아닌 경로의 경우 Ingress 컨트롤러는 클라이언트와의 연결과 관계없이 애플리케이션에 대한 연결을 협상합니다. 다시 말해 클라이언트가 Ingress 컨트롤러에 연결하여 HTTP/1.1을 협상하고, Ingress 컨트롤러가 애플리케이션에 연결하여 HTTP/2를 협상하고, 클라이언트 HTTP/1.1 연결에서 받은 요청을 HTTP/2 연결을 사용하여 애플리케이션에 전달할 수 있습니다. Ingress 컨트롤러는 WebSocket을 HTTP/2로 전달할 수 없고 HTTP/2 연결을 WebSocket으로 업그레이드할 수 없기 때문에 나중에 클라이언트가 HTTP/1.1 연결을 WebSocket 프로토콜로 업그레이드하려고 하면 문제가 발생하게 됩니다. 결과적으로, WebSocket 연결을 허용하는 애플리케이션이 있는 경우 HTTP/2 프로토콜 협상을 허용하지 않아야 합니다. 그러지 않으면 클라이언트가 WebSocket 프로토콜로 업그레이드할 수 없게 됩니다.

프로세스

단일 Ingress 컨트롤러에서 HTTP/2를 활성화합니다.

Ingress 컨트롤러에서 HTTP/2를 사용하려면 다음과 같이

oc annotate명령을 입력합니다.oc -n openshift-ingress-operator annotate ingresscontrollers/<ingresscontroller_name> ingress.operator.openshift.io/default-enable-http2=true

$ oc -n openshift-ingress-operator annotate ingresscontrollers/<ingresscontroller_name> ingress.operator.openshift.io/default-enable-http2=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow <ingresscontroller_name>을 주석 처리할 Ingress 컨트롤러의 이름으로 변경합니다.

전체 클러스터에서 HTTP/2를 활성화합니다.

전체 클러스터에 HTTP/2를 사용하려면

oc annotate명령을 입력합니다.oc annotate ingresses.config/cluster ingress.operator.openshift.io/default-enable-http2=true

$ oc annotate ingresses.config/cluster ingress.operator.openshift.io/default-enable-http2=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 작은 정보다음 YAML을 적용하여 주석을 추가할 수도 있습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

9.9.17. Ingress 컨트롤러에 대한 PROXY 프로토콜 구성

클러스터 관리자는 Ingress 컨트롤러에서 HostNetwork,NodePortService 또는 Private 엔드포인트 게시 전략 유형을 사용하는 경우 PROXY 프로토콜 을 구성할 수 있습니다. PROXY 프로토콜을 사용하면 로드 밸런서에서 Ingress 컨트롤러가 수신하는 연결에 대한 원래 클라이언트 주소를 유지할 수 있습니다. 원래 클라이언트 주소는 HTTP 헤더를 로깅, 필터링 및 삽입하는 데 유용합니다. 기본 구성에서 Ingress 컨트롤러가 수신하는 연결에는 로드 밸런서와 연결된 소스 주소만 포함됩니다.

Keepalived Ingress 가상 IP(VIP)를 사용하는 클라우드 플랫폼에 설치 관리자 프로비저닝 클러스터가 있는 기본 Ingress 컨트롤러는 PROXY 프로토콜을 지원하지 않습니다.

PROXY 프로토콜을 사용하면 로드 밸런서에서 Ingress 컨트롤러가 수신하는 연결에 대한 원래 클라이언트 주소를 유지할 수 있습니다. 원래 클라이언트 주소는 HTTP 헤더를 로깅, 필터링 및 삽입하는 데 유용합니다. 기본 구성에서 Ingress 컨트롤러에서 수신하는 연결에는 로드 밸런서와 연결된 소스 IP 주소만 포함됩니다.

패스스루 경로 구성의 경우 OpenShift Container Platform 클러스터의 서버는 원래 클라이언트 소스 IP 주소를 관찰할 수 없습니다. 원래 클라이언트 소스 IP 주소를 알아야 하는 경우 클라이언트 소스 IP 주소를 볼 수 있도록 Ingress 컨트롤러에 대한 Ingress 액세스 로깅을 구성합니다.

재암호화 및 에지 경로의 경우 OpenShift Container Platform 라우터는 애플리케이션 워크로드가 클라이언트 소스 IP 주소를 확인하도록 Forwarded 및 X-Forwarded-For 헤더를 설정합니다.

Ingress 액세스 로깅에 대한 자세한 내용은 " Ingress 액세스 로깅 구성"을 참조하십시오.

LoadBalancerService 끝점 게시 전략 유형을 사용하는 경우 Ingress 컨트롤러에 대한 PROXY 프로토콜 구성은 지원되지 않습니다. 이 제한은 OpenShift Container Platform이 클라우드 플랫폼에서 실행되고 Ingress 컨트롤러에서 서비스 로드 밸런서를 사용해야 함을 지정하기 때문에 Ingress Operator는 로드 밸런서 서비스를 구성하고 소스 주소를 유지하기 위한 플랫폼 요구 사항에 따라 PROXY 프로토콜을 활성화하기 때문입니다.

PROXY 프로토콜 또는 TCP를 사용하도록 OpenShift Container Platform과 외부 로드 밸런서를 모두 구성해야 합니다.

이 기능은 클라우드 배포에서 지원되지 않습니다. 이 제한은 OpenShift Container Platform이 클라우드 플랫폼에서 실행되고 Ingress 컨트롤러에서 서비스 로드 밸런서를 사용해야 함을 지정하기 때문에 Ingress Operator는 로드 밸런서 서비스를 구성하고 소스 주소를 유지하기 위한 플랫폼 요구 사항에 따라 PROXY 프로토콜을 활성화하기 때문입니다.

PROXY 프로토콜을 사용하거나 TCP(Transmission Control Protocol)를 사용하려면 OpenShift Container Platform과 외부 로드 밸런서를 모두 구성해야 합니다.

사전 요구 사항

- Ingress 컨트롤러가 생성되어 있습니다.

프로세스

CLI에 다음 명령을 입력하여 Ingress 컨트롤러 리소스를 편집합니다.

oc -n openshift-ingress-operator edit ingresscontroller/default

$ oc -n openshift-ingress-operator edit ingresscontroller/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow PROXY 구성을 설정합니다.

Ingress 컨트롤러에서

HostNetwork끝점 게시 전략 유형을 사용하는 경우spec.endpointPublishingStrategy.hostNetwork.protocol하위 필드를PROXY:로 설정합니다.PROXY에 대한hostNetwork구성 샘플Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress 컨트롤러에서

NodePortService끝점 게시 전략 유형을 사용하는 경우spec.endpointPublishingStrategy.nodePort.protocol하위 필드를PROXY로 설정합니다.PROXY에 대한nodePort구성 샘플Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress 컨트롤러에서