가상화

OpenShift Virtualization 설치, 사용법, 릴리스 정보

초록

1장. 정보

1.1. OpenShift Virtualization 정보

OpenShift Virtualization의 기능 및 지원 범위에 대해 알아보십시오.

1.1.1. OpenShift Virtualization으로 수행할 수 있는 작업

OpenShift Virtualization은 컨테이너 워크로드와 함께 가상 머신 워크로드를 실행하고 관리할 수 있는 OpenShift Container Platform의 애드온입니다.

OpenShift Virtualization은 Kubernetes 사용자 지정 리소스를 사용하여 가상화 작업을 활성화하여 OpenShift Container Platform 클러스터에 새 개체를 추가합니다. 다음과 같은 가상화 작업이 지원됩니다.

- Linux 및 Windows VM(가상 머신) 생성 및 관리

- 클러스터에서 서로 함께 Pod 및 VM 워크로드 실행

- 다양한 콘솔 및 CLI 툴을 통해 가상 머신에 연결

- 기존 가상 머신 가져오기 및 복제

- 가상 머신에 연결된 네트워크 인터페이스 컨트롤러 및 스토리지 디스크 관리

- 노드 간 실시간 가상 머신 마이그레이션

향상된 웹 콘솔에서 제공되는 그래픽 포털을 통해 OpenShift Container Platform 클러스터 컨테이너 및 인프라와 함께 가상화 리소스를 관리할 수 있습니다.

OpenShift Virtualization은 Red Hat OpenShift Data Foundation 기능과 원활하게 작동하도록 설계 및 테스트되었습니다.

OpenShift Data Foundation을 사용하여 OpenShift Virtualization을 배포할 때 Windows 가상 머신 디스크용 전용 스토리지 클래스를 생성해야 합니다. 자세한 내용은 Windows VM용 ODF PersistentVolume 최적화 를 참조하십시오.

OVN-Kubernetes,OpenShift SDN 또는 인증된 OpenShift CNI 플러그인에 나열된 다른 인증 네트워크 플러그인 중 하나와 함께 OpenShift Virtualization을 사용할 수 있습니다.

Compliance Operator 를 설치하고 ocp4-moderate 및 ocp4-moderate-node 프로필 을 사용하여 검사를 실행하여 OpenShift Virtualization 클러스터에서 규정 준수 문제를 확인할 수 있습니다. Compliance Operator는 NIST 인증 툴 인 OpenSCAP을 사용하여 보안 정책을 검사하고 적용합니다.

특수 스토리지, 네트워킹, 백업 및 추가 기능을 위한 ISV(독립 소프트웨어 벤더) 및 서비스 파트너와의 파트너 관계에 대한 자세한 내용은 Red Hat Ecosystem Catalog에서 참조하십시오.

1.1.1.1. OpenShift Virtualization 지원 클러스터 버전

OpenShift Virtualization 4.15의 안정적인 최신 릴리스는 4.15.10입니다.

OpenShift Container Platform 4.15 클러스터에서 사용할 수 있도록 OpenShift Virtualization 4.15가 지원됩니다. OpenShift Virtualization의 최신 z-stream 릴리스를 사용하려면 먼저 OpenShift Container Platform의 최신 버전으로 업그레이드해야 합니다.

1.1.2. 가상 머신 디스크의 볼륨 및 액세스 모드 정보

알려진 스토리지 공급자와 스토리지 API를 사용하는 경우 볼륨 및 액세스 모드가 자동으로 선택됩니다. 그러나 스토리지 프로필이 없는 스토리지 클래스를 사용하는 경우 볼륨 및 액세스 모드를 구성해야 합니다.

OpenShift Virtualization용 알려진 스토리지 공급자 목록은 Red Hat Ecosystem Catalog를 참조하십시오.

최상의 결과를 얻으려면 RWX( ReadWriteMany ) 액세스 모드와 Block 볼륨 모드를 사용합니다. 이는 다음과 같은 이유로 중요합니다.

-

실시간 마이그레이션에는 RWX(

ReadWriteMany) 액세스 모드가 필요합니다. 블록볼륨 모드는Filesystem볼륨 모드보다 훨씬 더 잘 작동합니다. 이는Filesystem볼륨 모드가 파일 시스템 계층 및 디스크 이미지 파일을 포함하여 더 많은 스토리지 계층을 사용하기 때문입니다. 이러한 계층은 VM 디스크 스토리지에 필요하지 않습니다.예를 들어 Red Hat OpenShift Data Foundation을 사용하는 경우 CephFS 볼륨에 Ceph RBD 볼륨을 사용하는 것이 좋습니다.

다음 구성으로 가상 머신을 실시간 마이그레이션할 수 없습니다.

-

RWO(

ReadWriteOnce) 액세스 모드가 있는 스토리지 볼륨 - GPU와 같은 패스스루 기능

이러한 가상 머신에 대해 evictionStrategy 필드를 None 으로 설정합니다. None 전략은 노드를 재부팅하는 동안 VM의 전원을 끕니다.

1.1.3. 단일 노드 OpenShift 차이점

단일 노드 OpenShift에 OpenShift Virtualization을 설치할 수 있습니다.

그러나 Single-node OpenShift는 다음 기능을 지원하지 않습니다.

- 고가용성

- Pod 중단

- 실시간 마이그레이션

- 제거 전략이 구성된 가상 머신 또는 템플릿

1.2. 지원되는 제한

OpenShift Virtualization에 대한 OpenShift Container Platform 환경을 계획할 때 테스트된 오브젝트 최대값을 참조할 수 있습니다. 그러나 최대값에 접근하면 성능을 줄이고 대기 시간을 높일 수 있습니다. 특정 사용 사례를 계획하고 클러스터 확장에 영향을 줄 수 있는 모든 요소를 고려해야 합니다.

성능에 영향을 미치는 클러스터 구성 및 옵션에 대한 자세한 내용은 Red Hat 지식 베이스의 OpenShift Virtualization - 튜닝 및 확장 가이드를 참조하십시오.

1.2.1. OpenShift Virtualization에서 테스트된 최대값

다음 제한은 대규모 OpenShift Virtualization 4.x 환경에 적용됩니다. 이는 가능한 가장 큰 크기의 단일 클러스터를 기반으로 합니다. 환경을 계획할 때는 여러 개의 작은 클러스터가 사용 사례에 가장 적합한 옵션이 될 수 있습니다.

1.2.1.1. 가상 머신 최대값

다음 최대값은 OpenShift Virtualization에서 실행되는 VM(가상 머신)에 적용됩니다. 이러한 값은 KVM을 사용하는 Red Hat Enterprise Linux의 가상화 제한에 지정된 제한의 적용을 받습니다.

| 목표(VM당) | 테스트된 제한 | 이론적 제한 |

|---|---|---|

| 가상 CPU | 216 vCPU | 255 vCPU |

| 메모리 | 6TB | 16TB |

| 단일 디스크 크기 | 20 TB | 100TB |

| 핫 플러그형 디스크 | 255 디스크 | 해당 없음 |

각 VM에는 최소 512MB 이상의 메모리가 있어야 합니다.

1.2.1.2. 호스트 최대값

다음 최대값은 OpenShift Virtualization에 사용되는 OpenShift Container Platform 호스트에 적용됩니다.

| 목표(호스트당) | 테스트된 제한 | 이론적 제한 |

|---|---|---|

| 논리 CPU 코어 또는 스레드 | Red Hat Enterprise Linux (RHEL)와 동일합니다. | 해당 없음 |

| RAM | RHEL과 동일합니다. | 해당 없음 |

| 동시 실시간 마이그레이션 | 기본값은 노드당 2개의 아웃바운드 마이그레이션 및 클러스터당 동시 마이그레이션 5개 | NIC 대역폭에 따라 다름 |

| 실시간 마이그레이션 대역폭 | 기본 제한 없음 | NIC 대역폭에 따라 다름 |

1.2.1.3. 클러스터 최대값

다음 최대값은 OpenShift Virtualization에 정의된 오브젝트에 적용됩니다.

| 목표(클러스터당) | 테스트된 제한 | 이론적 제한 |

|---|---|---|

| 노드당 연결된 PV 수 | 해당 없음 | CSI 스토리지 공급자 종속 |

| 최대 PV 크기 | 해당 없음 | CSI 스토리지 공급자 종속 |

| 호스트 | 500 호스트 (100개 이하 권장) [1] | OpenShift Container Platform과 동일합니다. |

| 정의된 VM | 10,000개의 VM [2] | OpenShift Container Platform과 동일합니다. |

100개 이상의 노드를 사용하는 경우 단일 컨트롤 플레인을 확장하는 대신 Red Hat Advanced Cluster Management(RHACM)를 사용하여 여러 클러스터를 관리하는 것이 좋습니다. 대규모 클러스터는 복잡성이 추가되고, 더 긴 업데이트가 필요하며, 노드 크기 및 총 오브젝트 밀도에 따라 컨트롤 플레인의 부담을 증가시킬 수 있습니다.

여러 클러스터를 사용하면 클러스터당 격리 및 고가용성과 같은 영역에서 유용할 수 있습니다.

노드당 최대 VM 수는 호스트 하드웨어 및 리소스 용량에 따라 다릅니다. 또한 다음 매개변수로 제한됩니다.

-

노드에 예약할 수 있는 Pod 수를 제한하는 설정입니다. 예:

maxPods. -

기본 KVM 장치 수입니다. 예:

devices.kubevirt.io/kvm: 1k.

-

노드에 예약할 수 있는 Pod 수를 제한하는 설정입니다. 예:

1.3. 보안 정책

OpenShift Virtualization 보안 및 권한 부여에 대해 알아보십시오.

키 포인트

-

OpenShift Virtualization은 Pod 보안을 위해 현재 모범 사례를 적용하는 것을 목표로

제한된Kubernetes Pod 보안 표준 프로필을 준수합니다. - VM(가상 머신) 워크로드는 권한이 없는 Pod로 실행됩니다.

-

SCC( 보안 컨텍스트 제약 조건 )는

kubevirt-controller서비스 계정에 대해 정의됩니다. - OpenShift Virtualization 구성 요소의 TLS 인증서는 자동으로 갱신되고 순환됩니다.

1.3.1. 워크로드 보안 정보

기본적으로 VM(가상 머신) 워크로드는 OpenShift Virtualization에서 root 권한으로 실행되지 않으며 루트 권한이 필요한 OpenShift Virtualization 기능이 없습니다.

각 VM에 대해 virt-launcher Pod는 세션 모드에서 libvirt 인스턴스를 실행하여 VM 프로세스를 관리합니다. 세션 모드에서 libvirt 데몬은 루트가 아닌 사용자 계정으로 실행되며 동일한 사용자 식별자(UID)에서 실행 중인 클라이언트의 연결만 허용합니다. 따라서 VM은 권한이 없는 포드로 실행되며 최소 권한의 보안 원칙을 따릅니다.

1.3.2. TLS 인증서

OpenShift Virtualization 구성 요소의 TLS 인증서는 자동으로 갱신되고 순환됩니다. 수동으로 새로 고치지 않아도 됩니다.

자동 갱신 일정

TLS 인증서는 다음 일정에 따라 자동으로 삭제되고 교체됩니다.

- KubeVirt 인증서는 매일 갱신됩니다.

- CDI(Containerized Data Importer) 컨트롤러 인증서는 15일마다 갱신됩니다.

- MAC 풀 인증서는 매년 갱신됩니다.

자동 TLS 인증서 순환이 수행되어도 작업이 중단되지 않습니다. 예를 들면 다음 작업이 중단되지 않고 계속 수행됩니다.

- 마이그레이션

- 이미지 업로드

- VNC 및 콘솔 연결

1.3.3. 권한 부여

OpenShift Virtualization에서는 역할 기반 액세스 제어 (RBAC)를 사용하여 사용자 및 서비스 계정에 대한 권한을 정의합니다. 서비스 계정에 정의된 권한은 OpenShift Virtualization 구성 요소가 수행할 수 있는 작업을 제어합니다.

RBAC 역할을 사용하여 가상화 기능에 대한 사용자 액세스를 관리할 수도 있습니다. 예를 들어 관리자는 가상 머신을 시작하는 데 필요한 권한을 제공하는 RBAC 역할을 생성할 수 있습니다. 그러면 관리자가 특정 사용자에게 역할을 바인딩하여 액세스를 제한할 수 있습니다.

1.3.3.1. OpenShift Virtualization의 기본 클러스터 역할

클러스터 역할 집계를 사용하면 OpenShift Virtualization에서 기본 OpenShift Container Platform 클러스터 역할을 확장하여 가상화 오브젝트에 대한 액세스 권한을 포함합니다.

| 기본 클러스터 역할 | OpenShift Virtualization 클러스터 역할 | OpenShift Virtualization 클러스터 역할 설명 |

|---|---|---|

|

|

| 클러스터의 모든 OpenShift Virtualization 리소스를 볼 수 있지만 생성, 삭제, 수정 또는 액세스할 수 없는 사용자입니다. 예를 들어 사용자는 VM(가상 머신)이 실행 중이지만 이를 종료하거나 콘솔에 액세스할 수 없음을 확인할 수 있습니다. |

|

|

| 클러스터의 모든 OpenShift Virtualization 리소스를 수정할 수 있는 사용자입니다. 예를 들어 사용자가 VM을 생성하고 VM 콘솔에 액세스한 후 VM을 삭제할 수 있습니다. |

|

|

|

리소스 컬렉션 삭제 기능을 포함하여 모든 OpenShift Virtualization 리소스에 대한 전체 권한이 있는 사용자입니다. 사용자는 |

1.3.3.2. OpenShift Virtualization의 스토리지 기능에 대한 RBAC 역할

cdi-operator 및 cdi-controller 서비스 계정을 포함하여 CDI(Containerized Data Importer)에 다음 권한이 부여됩니다.

1.3.3.2.1. 클러스터 전체 RBAC 역할

| CDI 클러스터 역할 | Resources | verbs |

|---|---|---|

|

|

|

|

|

|

| |

|

|

|

|

|

|

| |

|

|

|

|

|

|

| |

|

|

|

|

| API 그룹 | Resources | verbs |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

허용 목록: |

|

|

|

허용 목록: |

|

|

|

|

|

| API 그룹 | Resources | verbs |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1.3.3.2.2. 네임스페이스가 지정된 RBAC 역할

| API 그룹 | Resources | verbs |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| API 그룹 | Resources | verbs |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1.3.3.3. kubevirt-controller 서비스 계정에 대한 추가 SCC 및 권한

SCC(보안 컨텍스트 제약 조건)는 Pod에 대한 권한을 제어합니다. 이러한 권한에는 컨테이너 모음인 Pod에서 수행할 수 있는 작업과 액세스할 수 있는 리소스가 포함됩니다. Pod가 시스템에 수용되려면 일련의 조건을 함께 실행해야 하는데, SCC를 사용하여 이러한 조건을 정의할 수 있습니다.

virt-controller 는 클러스터의 가상 머신에 대해 virt-launcher Pod를 생성하는 클러스터 컨트롤러입니다. 이러한 Pod에는 kubevirt-controller 서비스 계정에서 권한을 부여합니다.

kubevirt-controller 서비스 계정에는 적절한 권한으로 virt-launcher Pod를 생성할 수 있도록 추가 SCC 및 Linux 기능이 부여됩니다. 이러한 확장된 권한을 통해 가상 머신은 일반적인 Pod 범위를 벗어나는 OpenShift Virtualization 기능을 사용할 수 있습니다.

kubevirt-controller 서비스 계정에는 다음 SCC가 부여됩니다.

-

scc.AllowHostDirVolumePlugin = true

가상 머신에서 hostpath 볼륨 플러그인을 사용할 수 있습니다. -

scc.AllowPrivilegedContainer = false

virt-launcher Pod가 권한 있는 컨테이너로 실행되지 않습니다. scc.AllowedCapabilities = []corev1.Capability{"SYS_NICE", "NET_BIND_SERVICE"}-

SYS_NICE를 사용하면 CPU 선호도를 설정할 수 있습니다. -

NET_BIND_SERVICE는 DHCP 및 Slirp 작업을 허용합니다.

-

kubevirt-controller에 대한 SCC 및 RBAC 정의 보기

oc 툴을 사용하여 kubevirt-controller에 대한 SecurityContextConstraints 정의를 볼 수 있습니다.

oc get scc kubevirt-controller -o yaml

$ oc get scc kubevirt-controller -o yaml

oc 툴을 사용하여 kubevirt-controller clusterrole에 대한 RBAC 정의를 볼 수 있습니다.

oc get clusterrole kubevirt-controller -o yaml

$ oc get clusterrole kubevirt-controller -o yaml1.4. OpenShift Virtualization Architecture

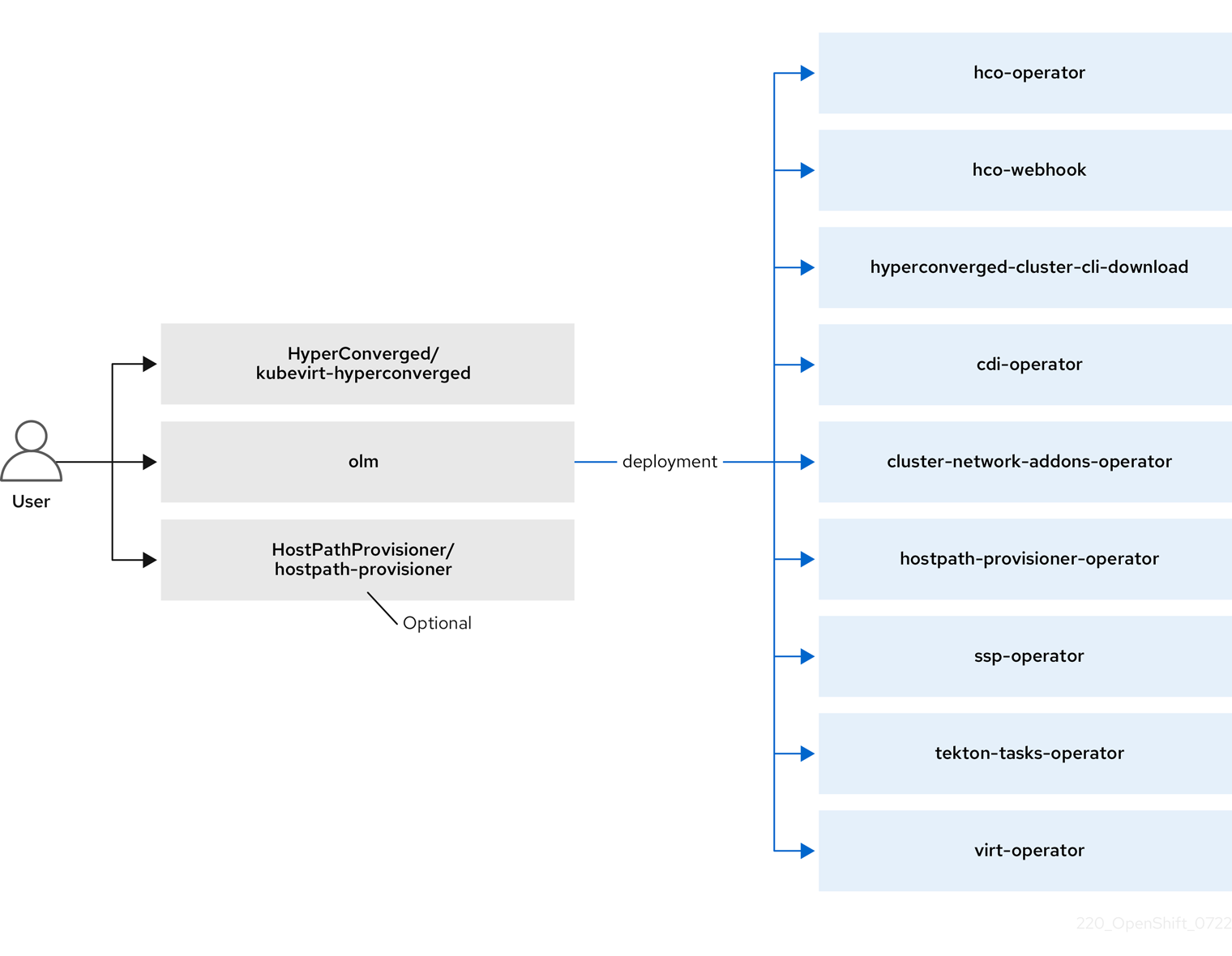

OLM(Operator Lifecycle Manager)은 OpenShift Virtualization의 각 구성 요소에 대해 Operator Pod를 배포합니다.

-

Compute:

virt-operator -

스토리지:

cdi-operator -

Network:

cluster-network-addons-operator -

스케일링:

ssp-operator -

템플릿:

tekton-tasks-operator

또한 OLM은 다른 구성 요소의 배포, 구성 및 라이프 사이클과 hco-webhook 및 하이퍼 컨버지드-cluster- cli-download 라는 여러 도우미 Pod를 담당하는 Pod를 배포합니다.

hyperconverged-cluster- operator

모든 Operator Pod가 성공적으로 배포된 후 HyperConverged CR(사용자 정의 리소스)을 생성해야 합니다. HyperConverged CR에 설정된 구성은 단일 정보 소스 및 OpenShift Virtualization의 진입점 역할을 하며 CR의 동작을 안내합니다.

HyperConverged CR은 조정 루프 내에서 다른 모든 구성 요소의 Operator에 대한 해당 CR을 생성합니다. 각 Operator는 OpenShift Virtualization 컨트롤 플레인에 대한 데몬 세트, 구성 맵 및 추가 구성 요소와 같은 리소스를 생성합니다. 예를 들어 HyperConverged Operator(HCO)가 KubeVirt CR을 생성하면 OpenShift Virtualization Operator가 이를 조정하고 virt-controller,virt-handler, virt-api 와 같은 추가 리소스를 생성합니다.

OLM은 HPP(Hostpath Provisioner) Operator를 배포하지만 hostpath-provisioner CR을 생성할 때까지 작동하지 않습니다.

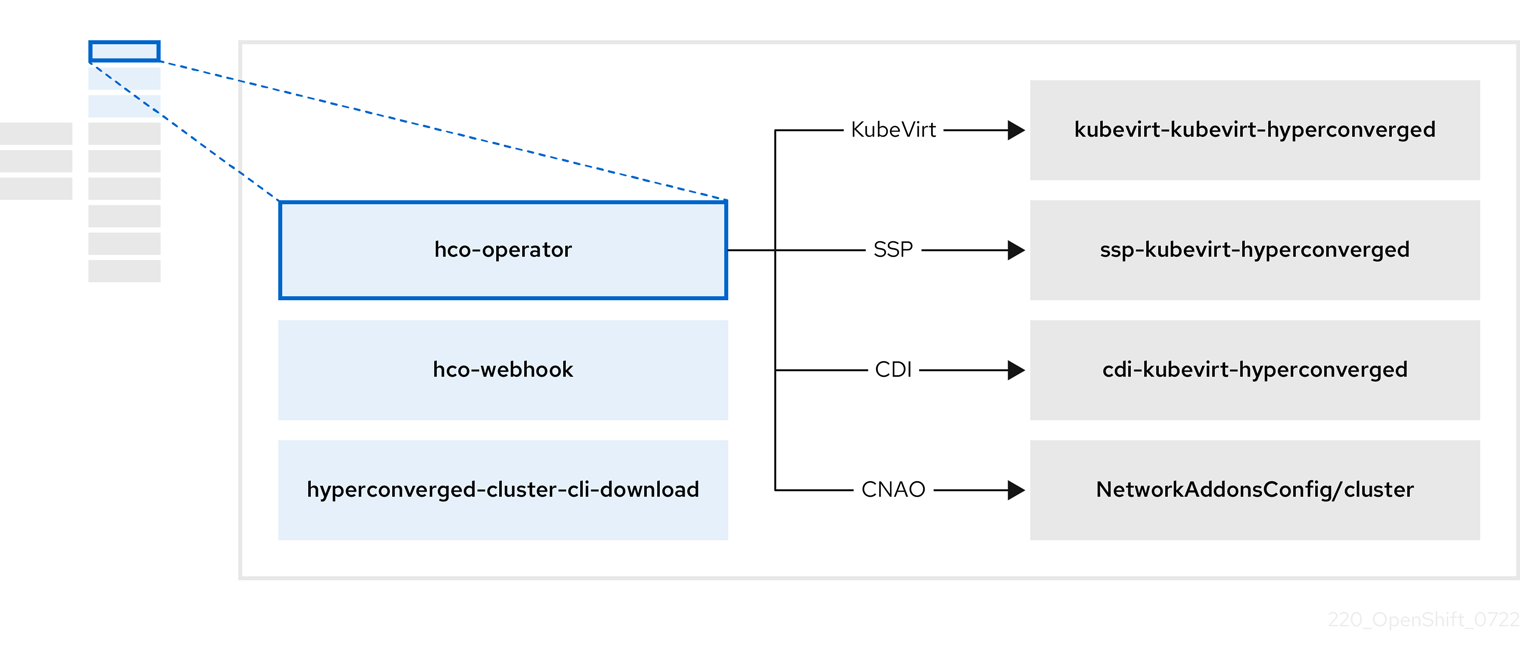

1.4.1. HyperConverged Operator(HCO) 정보

HCO인 hco-operator 는 OpenShift Virtualization과 의견이 지정된 기본값을 사용하여 여러 도우미 운영자를 배포 및 관리하기 위한 단일 진입점을 제공합니다. 또한 해당 Operator에 대한 CR(사용자 정의 리소스)을 생성합니다.

| Component | 설명 |

|---|---|

|

|

|

|

|

클러스터에서 직접 다운로드할 수 있도록 |

|

| OpenShift Virtualization에 필요한 모든 Operator, CR 및 개체를 포함합니다. |

|

| 스케줄링, 스케일 및 성능(SSP) CR. 이는 HCO에 의해 자동으로 생성됩니다. |

|

| CDI(Containerized Data Importer) CR. 이는 HCO에 의해 자동으로 생성됩니다. |

|

|

|

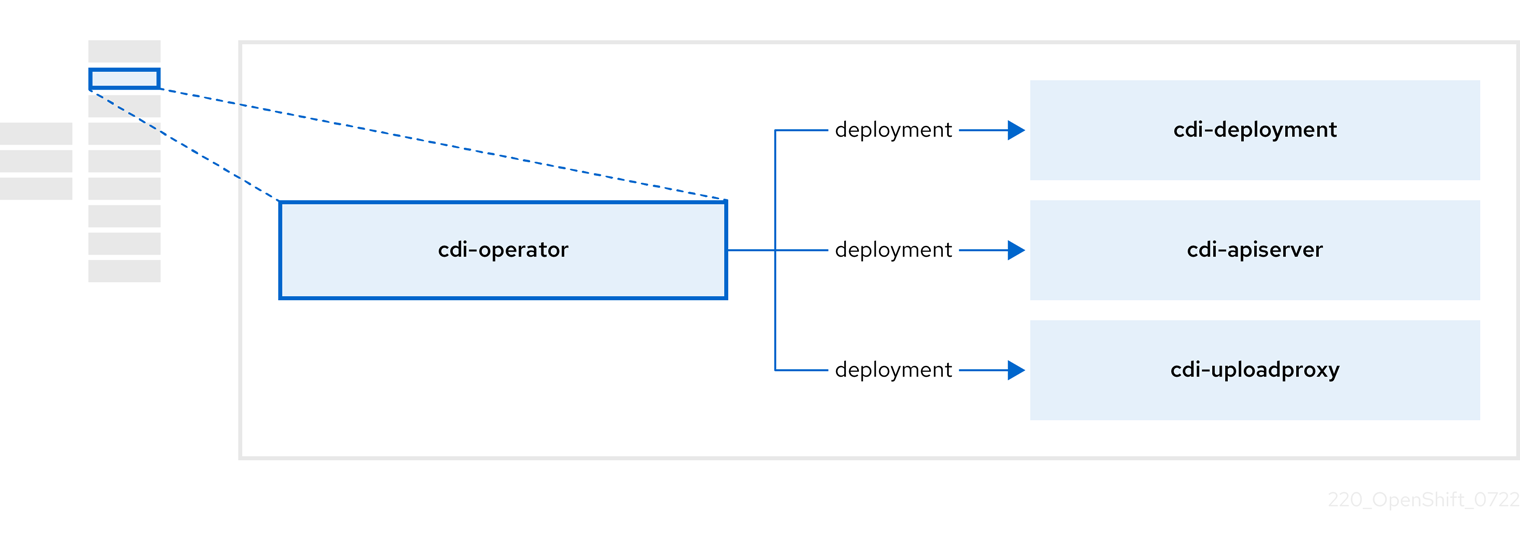

1.4.2. CDI(Containerized Data Importer) Operator 정보

CDI Operator인 cdi-operator 는 데이터 볼륨을 사용하여 CDI 및 해당 관련 리소스를 관리하여 VM(가상 머신) 이미지를 PVC(영구 볼륨 클레임)로 가져옵니다.

| Component | 설명 |

|---|---|

|

| 보안 업로드 토큰을 발행하여 VM 디스크를 PVC에 업로드하는 권한을 관리합니다. |

|

| 올바른 PVC에 쓸 수 있도록 외부 디스크 업로드 트래픽을 적절한 업로드 서버 pod로 전달합니다. 유효한 업로드 토큰이 필요합니다. |

|

| 데이터 볼륨을 생성할 때 가상 머신 이미지를 PVC로 가져오는 도우미 Pod입니다. |

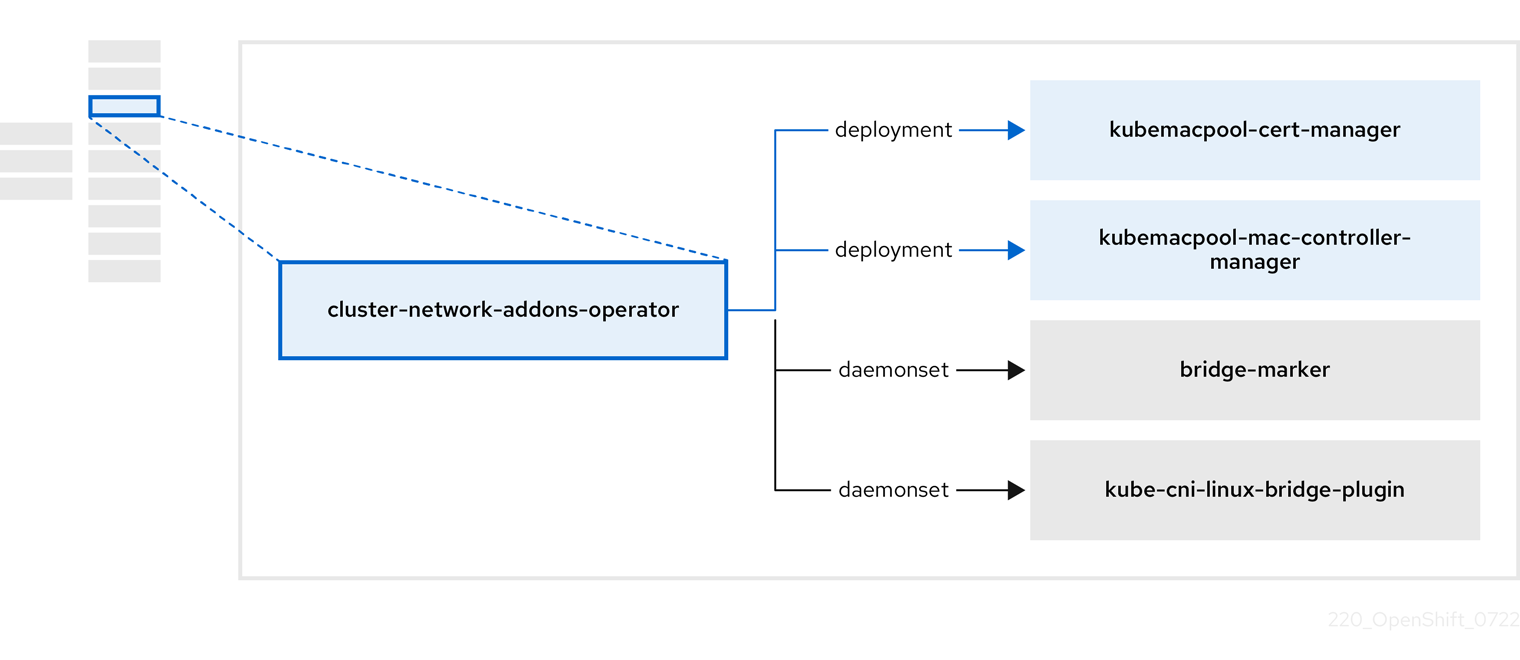

1.4.3. CNO(Cluster Network Addons) Operator 정보

Cluster Network Addons Operator인 cluster-network-addons-operator 는 클러스터에 네트워킹 구성 요소를 배포하고 확장된 네트워크 기능에 대한 관련 리소스를 관리합니다.

| Component | 설명 |

|---|---|

|

| Kubemacpool의 Webhook TLS 인증서를 관리합니다. |

|

| VM(가상 머신) 네트워크 인터페이스 카드(NIC)에 대한 MAC 주소 풀링 서비스를 제공합니다. |

|

| 노드에서 사용 가능한 네트워크 브릿지를 노드 리소스로 표시합니다. |

|

| 클러스터 노드에 CNI(Container Network Interface) 플러그인을 설치하여 네트워크 연결 정의를 통해 Linux 브리지에 VM을 연결할 수 있습니다. |

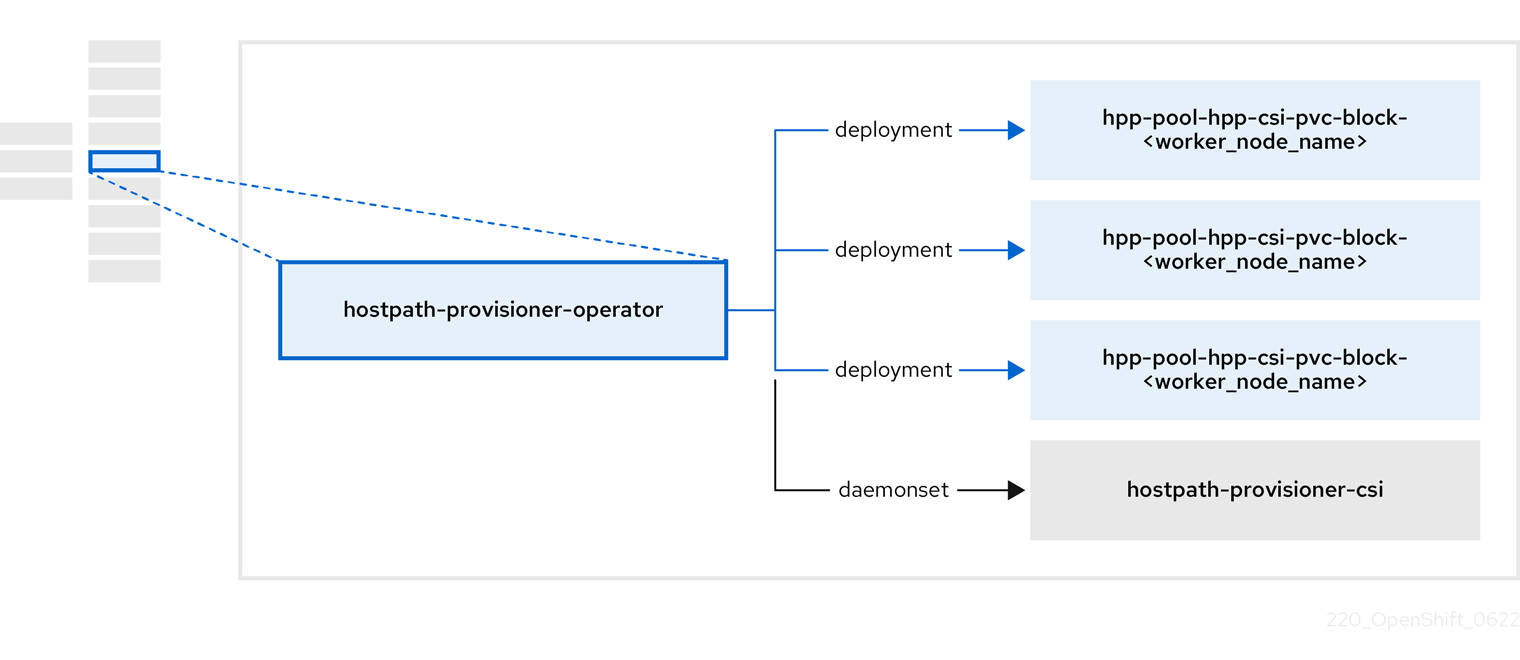

1.4.4. HPP(Hostpath Provisioner) Operator 정보

HPP Operator인 hostpath-provisioner-operator 는 다중 노드 HPP 및 관련 리소스를 배포 및 관리합니다.

| Component | 설명 |

|---|---|

|

| HPP가 실행되도록 지정된 각 노드에 대해 작업자를 제공합니다. Pod는 지정된 백업 스토리지를 노드에 마운트합니다. |

|

| HPP의 CSI(Container Storage Interface) 드라이버 인터페이스를 구현합니다. |

|

| HPP의 레거시 드라이버 인터페이스를 구현합니다. |

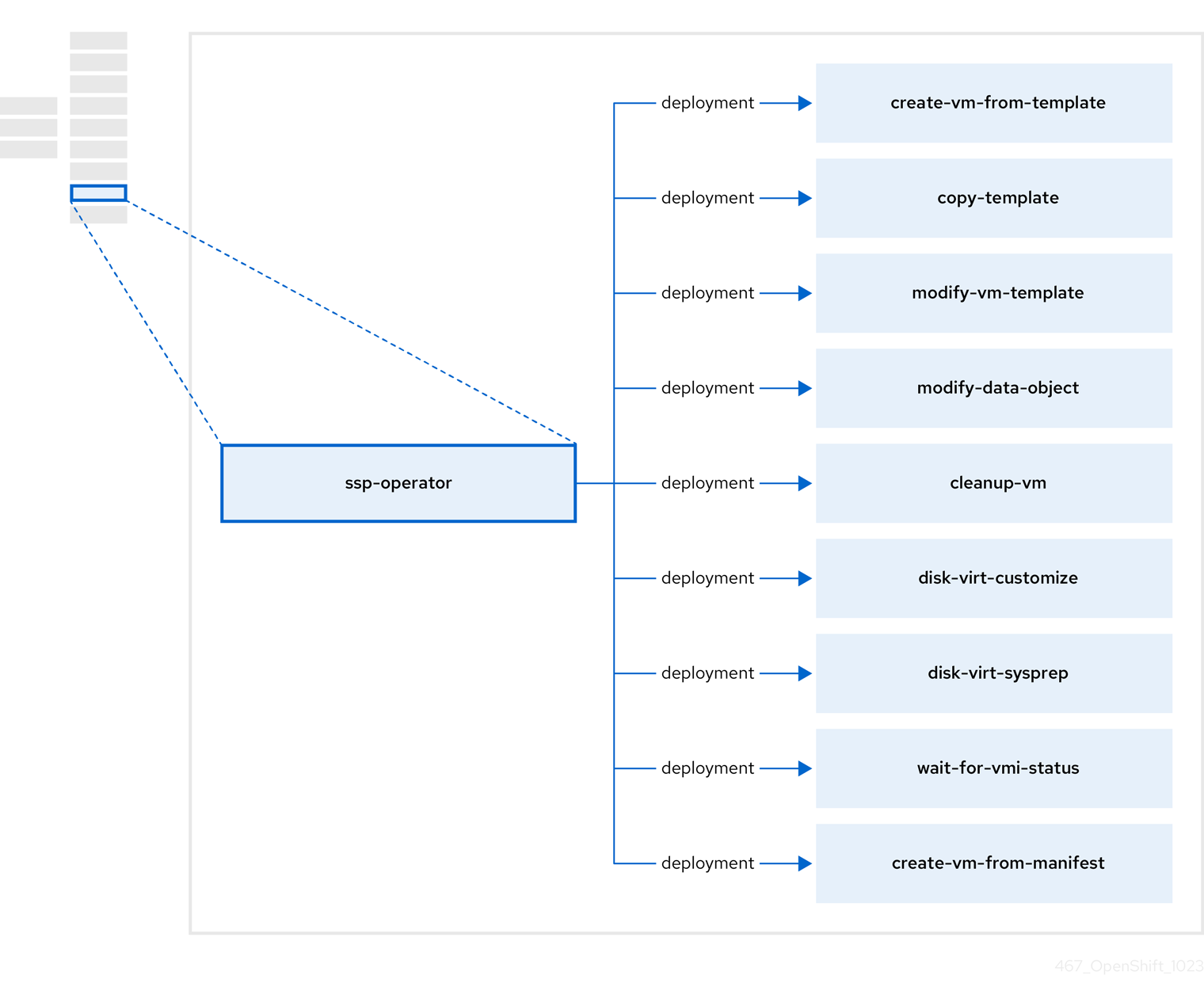

1.4.5. SSP(Scheduling, Scale, Performance) Operator 정보

SSP Operator, ssp-operator 는 공통 템플릿, 관련 기본 부팅 소스, 파이프라인 작업, 템플릿 검증기를 배포합니다.

| Component | 설명 |

|---|---|

|

| 템플릿에서 VM을 생성합니다. |

|

| VM 템플릿을 복사합니다. |

|

| VM 템플릿을 생성하거나 제거합니다. |

|

| 데이터 볼륨 또는 데이터 소스를 생성하거나 제거합니다. |

|

| VM에서 스크립트 또는 명령을 실행한 다음 VM을 중지하거나 삭제합니다. |

|

|

|

|

|

|

|

| 특정 VMI(가상 머신 인스턴스) 상태를 기다린 다음 해당 상태에 따라 실패하거나 성공합니다. |

|

| 매니페스트에서 VM을 생성합니다. |

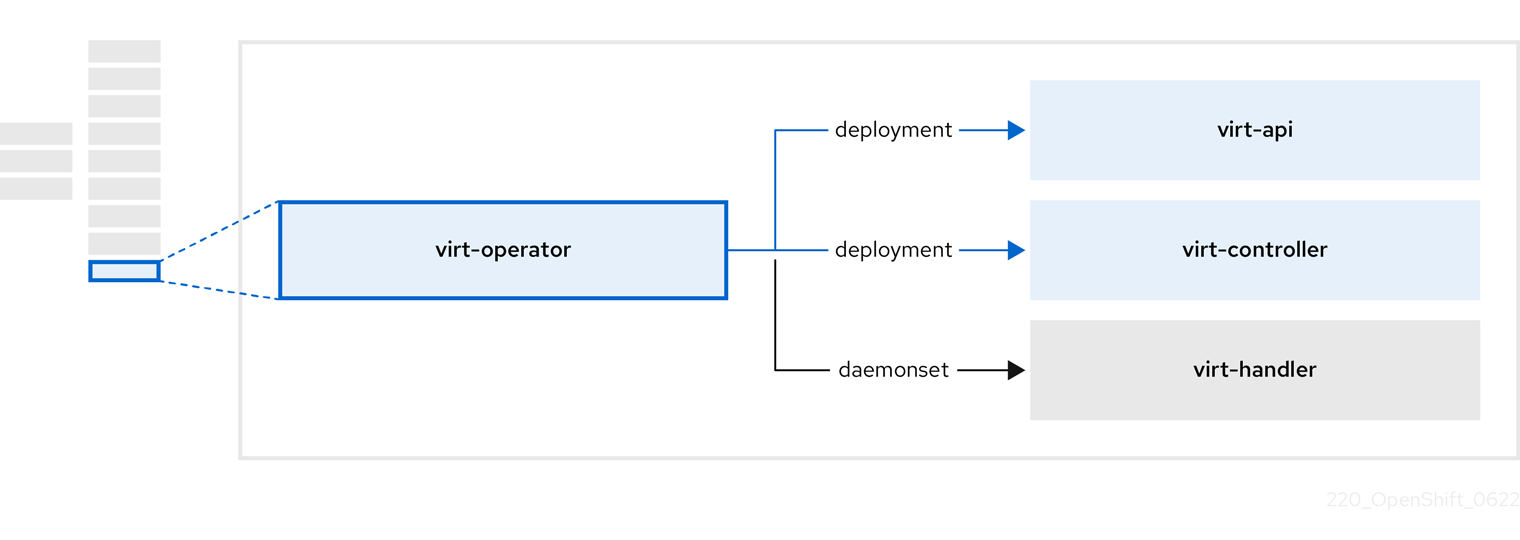

1.4.6. OpenShift Virtualization Operator 정보

virt-operator OpenShift Virtualization Operator는 현재 VM(가상 머신) 워크로드를 중단하지 않고 OpenShift Virtualization을 배포, 업그레이드 및 관리합니다.

| Component | 설명 |

|---|---|

|

| 모든 가상화 관련 흐름의 진입점 역할을 하는 HTTP API 서버입니다. |

|

|

새 VM 인스턴스 오브젝트 생성을 관찰하고 해당 Pod를 생성합니다. 노드에 Pod가 예약되면 |

|

|

VM에 대한 모든 변경 사항을 모니터링하고 |

|

|

|

2장. 릴리스 노트

2.1. OpenShift Virtualization 릴리스 정보

2.1.1. 문서 피드백 제공

오류를 보고하거나 문서를 개선하기 위해 Red Hat Jira 계정에 로그인하여 Jira 문제를 제출하십시오.

2.1.2. Red Hat OpenShift Virtualization 정보

Red Hat OpenShift Virtualization을 사용하면 기존 VM(가상 머신)을 OpenShift Container Platform에 가져와서 컨테이너와 함께 실행할 수 있습니다. OpenShift Virtualization에서 VM은 OpenShift Container Platform 웹 콘솔 또는 명령줄을 사용하여 관리할 수 있는 기본 Kubernetes 오브젝트입니다.

OpenShift Virtualization은

![]() 아이콘으로 표시됩니다.

아이콘으로 표시됩니다.

OVN-Kubernetes 또는 OpenShiftSDN 기본 CNI(Container Network Interface) 네트워크 공급자와 함께 OpenShift Virtualization을 사용할 수 있습니다.

OpenShift Virtualization으로 수행할 수 있는 작업에 대해 자세히 알아보십시오.

OpenShift Virtualization 아키텍처 및 배포에 대해 자세히 알아보십시오.

OpenShift Virtualization을 위한 클러스터를 준비합니다.

2.1.2.1. OpenShift Virtualization 지원 클러스터 버전

OpenShift Virtualization 4.15의 안정적인 최신 릴리스는 4.15.10입니다.

OpenShift Container Platform 4.15 클러스터에서 사용할 수 있도록 OpenShift Virtualization 4.15가 지원됩니다. OpenShift Virtualization의 최신 z-stream 릴리스를 사용하려면 먼저 OpenShift Container Platform의 최신 버전으로 업그레이드해야 합니다.

2.1.2.2. 지원되는 게스트 운영 체제

OpenShift Virtualization에서 지원되는 게스트 운영 체제를 보려면 Certified Guest Operating Systems in Red Hat OpenStack Platform, Red Hat Virtualization, OpenShift Virtualization 및 Red Hat Enterprise Linux with KVM 을 참조하십시오.

2.1.2.3. Microsoft Windows SVVP 인증

OpenShift Virtualization은 Microsoft의 Windows SVVP(서버 가상화 유효성 검사 프로그램)에서 Windows Server 워크로드를 실행하도록 인증되었습니다.

SVVP 인증은 다음에 적용됩니다.

- Red Hat Enterprise Linux CoreOS 작업자. SVVP 카탈로그에서는 RHEL CoreOS 9의 Red Hat OpenShift Container Platform 4로 이름이 지정됩니다.

- Intel 및 AMD CPU

2.1.3. 퀵스타트

여러 OpenShift Virtualization 기능에 대한 퀵스타트 둘러보기를 사용할 수 있습니다. 둘러보기를 보려면 OpenShift Container Platform 웹 콘솔의 헤더에 있는 메뉴 표시줄에서 도움말 아이콘 ? 을 클릭한 다음 빠른 시작을 선택합니다. 필터 필드에 키워드 가상화를 입력하여 사용 가능한 둘러보기를 필터링 할 수 있습니다.

2.1.4. 새로운 기능 및 변경된 기능

이 릴리스에는 다음 구성 요소 및 개념과 관련된 새로운 기능 및 개선 사항이 추가되었습니다.

2.1.4.1. 설치 및 업데이트

-

kubevirt_vm_created_total메트릭을 사용하여 지정된 네임스페이스에 생성된 VM 수를 쿼리할 수 있습니다.

2.1.4.2. 인프라

-

이제

instanceTypeAPI에서 더 안정적인v1beta1버전을 사용합니다.

2.1.4.3. 가상화

- 이제 VM 게스트의 직렬 콘솔 로그에 대한 액세스를 활성화하여 문제 해결을 원활하게 수행할 수 있습니다. 이 기능은 기본적으로 비활성화되어 있습니다. 클러스터 관리자는 웹 콘솔 또는 CLI를 사용하여 VM의 기본 설정을 변경할 수 있습니다. 사용자는 클러스터 전체 기본 설정과 관계없이 개별 VM에서 게스트 로그 액세스를 전환할 수 있습니다.

- 무료 페이지 보고는 기본적으로 활성화되어 있습니다.

- 노드가 과부하될 때 커널 동일 페이지 병합(KSM)을 활성화 하도록 OpenShift Virtualization을 구성할 수 있습니다.

2.1.4.4. 네트워킹

- 보조 네트워크 인터페이스를 실행 중인 VM(가상 머신)에 핫플러그 할 수 있습니다. 핫플러그 및 핫 플러그는 OpenShift Virtualization 4.14 이상에서 생성된 VM에서만 지원됩니다. SR-IOV(Single Root I/O Virtualization) 인터페이스에 핫 연결 해제는 지원되지 않습니다.

- OpenShift Virtualization은 이제 OVN-Kubernetes 보조 네트워크의 localnet 토폴로지를 지원합니다. localnet 토폴로지는 보조 네트워크를 물리적 오버레이에 연결합니다. 이렇게 하면 east-west 클러스터 트래픽과 클러스터 외부에서 실행되는 서비스에 대한 액세스를 모두 사용할 수 있지만 클러스터 노드에서 기본 OVS(Open vSwitch) 시스템에 대한 추가 구성이 필요합니다.

-

OVN-Kubernetes 보조 네트워크는 VM로의 트래픽 흐름을 제어하기 위해

MultiNetworkPolicyCRD(사용자 정의 리소스 정의)를 제공하는 다중 네트워크 정책 API 와 호환됩니다.ipBlock속성을 사용하여 특정 CIDR 블록에 대한 네트워크 정책 수신 및 송신 규칙을 정의할 수 있습니다.

- SR-IOV에서 DPDK 워크로드에 대한 클러스터를 구성하는 것은 이전에는 기술 프리뷰였으며 이제 일반적으로 사용할 수 있습니다.

2.1.4.5. 스토리지

-

데이터 볼륨을 복제할 때 CDI(Containerized Data Importer)는 특정 사전 요구 사항이 충족되면 효율적인 CSI(Container Storage Interface) 복제를 선택합니다. 더 효율적인 방법인 호스트 지원 복제가 폴백으로 사용됩니다. 호스트 지원 복제가 사용된 이유를 이해하려면 복제된 PVC(영구 볼륨 클레임)에서

cdi.kubevirt.io/cloneFallbackReason주석을 확인할 수 있습니다.

2.1.4.6. 웹 콘솔

- 볼륨 또는 PVC(영구 볼륨 클레임)에서 VM(가상 머신)을 생성하기 위해 사용자 지정 인스턴스 유형 및 기본 설정을 설치하고 편집하는 것은 이전에는 이전에는 기술 프리뷰였으며 일반적으로 사용할 수 있습니다.

- 이제 프리뷰 기능 탭은 가상화 → 개요 → 설정에서 확인할 수 있습니다.

여러 VM이 동일한 기본 스토리지를 공유할 수 있도록 일반 VM(가상 머신) 또는 LUN 지원 VM 디스크에 대한 디스크 공유를 구성할 수 있습니다. 공유할 모든 디스크는 블록 모드여야 합니다.

LUN 지원 블록 모드 VM 디스크를 여러 VM에서 공유할 수 있도록 하려면 클러스터 관리자가 SCSI

persistentReservation기능 게이트를 활성화해야 합니다.자세한 내용은 가상 머신의 공유 볼륨 구성 을 참조하십시오.

- VirtualMachine 세부 정보 페이지의 구성 탭에서 VM 구성 설정을 검색할 수 있습니다.

- 이제 가상화 → 개요 → 설정 → 클러스터 → 일반 설정 → SSH 구성에서 NodePort 서비스를 통해 SSH 를 구성할 수 있습니다.

- 인스턴스 유형에서 VM을 생성할 때 OpenShift Container Platform 웹 콘솔의 볼륨 목록에 켜지어 선호하는 부팅 가능한 볼륨을 지정할 수 있습니다.

- 웹 콘솔을 사용하여 VM 대기 시간 점검을 실행할 수 있습니다. 사이드 메뉴에서 가상화 → 검사 → 네트워크 대기 시간을 클릭합니다. 첫 번째 검사를 실행하려면 권한 설치를 클릭한 다음 점검 실행을 클릭합니다.

- 웹 콘솔을 사용하여 스토리지 검증 점검을 실행할 수 있습니다. 사이드 메뉴에서 가상화 → 점검 → 스토리지를 클릭합니다. 첫 번째 검사를 실행하려면 권한 설치를 클릭한 다음 점검 실행을 클릭합니다.

- 웹 콘솔 을 사용하여 모든 클러스터 노드에 대해 커널 동일 페이지 병합(KSM) 활성화 기능을 활성화 하거나 비활성화할 수 있습니다.

- 웹 콘솔을 사용하여 SR-IOV(Single Root I/O Virtualization) 인터페이스를 실행 중인 VM(가상 머신)에 핫플러그할 수 있습니다.

- 이제 VM 생성 중 공개 SSH 키를 추가하거나 기존 VM에 보안을 추가할 때 다른 프로젝트의 기존 시크릿을 사용할 수 있습니다.

- OpenShift Container Platform 웹 콘솔 을 사용하여 OVN-Kubernetes localnet 토폴로지에 대한 네트워크 연결 정의(NAD)를 생성할 수 있습니다.

2.1.5. 사용되지 않거나 삭제된 기능

2.1.5.1. 더 이상 사용되지 않는 기능

더 이상 사용되지 않는 기능은 현재 릴리스에 포함되어 있으며 지원됩니다. 그러나 향후 릴리스에서 제거될 예정이므로 새로운 배포에는 사용하지 않는 것이 좋습니다.

-

tekton-tasks-operator는 더 이상 사용되지 않으며 Tekton 작업과 예제 파이프라인은 이제ssp-operator에서 배포합니다.

-

copy-template,modify-vm-template및create-vm-from-template작업은 더 이상 사용되지 않습니다.

- Windows Server 2012 R2 템플릿에 대한 지원은 더 이상 사용되지 않습니다.

2.1.5.2. 삭제된 기능

제거된 기능은 현재 릴리스에서 지원되지 않습니다.

- 기존 HPP 사용자 정의 리소스 및 관련 스토리지 클래스에 대한 지원이 모든 새 배포에 대해 제거되었습니다. OpenShift Virtualization 4.15에서 HPP Operator는 Kubernetes CSI(Container Storage Interface) 드라이버를 사용하여 로컬 스토리지를 구성합니다. 레거시 HPP 사용자 지정 리소스는 이전 버전의 OpenShift Virtualization에 설치된 경우에만 지원됩니다.

- CentOS 7 및 CentOS 스트림 8은 이제 지원 종료 단계에 있습니다. 그 결과 이러한 운영 체제의 컨테이너 이미지가 OpenShift Virtualization에서 제거되었으며 더 이상 커뮤니티가 지원되지 않습니다.

2.1.6. 기술 프리뷰 기능

이 릴리스의 일부 기능은 현재 기술 프리뷰 단계에 있습니다. 이러한 실험적 기능은 프로덕션용이 아닙니다. 해당 기능은 Red Hat Customer Portal의 지원 범위를 참조하십시오.

- 이제 OpenShift Virtualization 호스트에서 중첩된 가상화를 활성화할 수 있습니다.

- 클러스터 관리자는 이제 개요 → 설정 → 클러스터 → 프리뷰 기능에 있는 OpenShift Container Platform 웹 콘솔의 네임스페이스에서 CPU 리소스 제한을 활성화할 수 있습니다.

2.1.7. 버그 수정

-

이전에는

volumeBindingMode가WaitForFirstConsumer로 설정된 스토리지 클래스로 시작할 때windows-efi-installer파이프라인이 실패했습니다. 이번 수정에서는 파이프라인이 실패하는StorageClass오브젝트의 주석을 제거합니다. (CNV-32287) -

이전 버전에서는

openshift-virtualization-os-images네임스페이스에 제공된 데이터 소스를 사용하여 약 1000개의 VM(가상 머신)을 동시에 복제한 경우 일부 VM이 실행 중 상태로 이동되지 않았습니다. 이번 수정을 통해 다수의 VM을 동시에 복제할 수 있습니다. (CNV-30083) -

이전에는

install-config.yaml파일에서networkType: OVNKubernetes를 사용할 때 웹 콘솔에 표시되는NodePort서비스 및 정규화된 도메인 이름(FQDN)을 사용하여 VM에 SSH를 수행할 수 없었습니다. 이번 업데이트를 통해 SSHNodePort서비스에 대해 액세스 가능한 유효한 엔드포인트가 표시되도록 웹 콘솔을 구성할 수 있습니다. (CNV-24889) - 이번 업데이트를 통해 가상 디스크를 핫플러그한 후 VMI(가상 머신 인스턴스)에 대한 실시간 마이그레이션이 더 이상 실패하지 않습니다. (CNV-34761)

2.1.8. 확인된 문제

모니터링

네트워킹

OpenShift Container Platform 4.12에서 최신 마이너 버전으로 업데이트하면

cnv-bridgeCNI(Container Network Interface)를 사용하는 VM이 실시간 마이그레이션에 실패합니다. (https://access.redhat.com/solutions/7069807)-

이 문제를 해결하려면 업데이트를 수행하기 전에

NetworkAttachmentDefinition매니페스트의spec.config.type필드를cnv-에서 bridge로 변경합니다.bridge

-

이 문제를 해결하려면 업데이트를 수행하기 전에

노드

-

OpenShift Virtualization을 설치 제거해도 OpenShift Virtualization에서 생성한

feature.node.kubevirt.io노드 레이블이 제거되지 않습니다. 레이블을 수동으로 제거해야 합니다. (CNV-38543)

- 컴퓨팅 노드가 다른 이기종 클러스터에서 HyperV 재조화가 활성화된 가상 머신은 TSC( timestamp-counter scaling)를 지원하지 않거나 적절한 TSC 빈도를 가진 노드에서 예약할 수 없습니다. (BZ#2151169)

스토리지

AWS에서 Portworx를 스토리지 솔루션으로 사용하고 VM 디스크 이미지를 생성하는 경우 두 번 고려되는 파일 시스템 오버헤드로 인해 생성된 이미지가 예상보다 작을 수 있습니다. (CNV-32695)

- 이 문제를 해결하려면 초기 프로비저닝 프로세스가 완료된 후 PVC(영구 볼륨 클레임)를 수동으로 확장하여 사용 가능한 공간을 늘릴 수 있습니다.

경우에 따라 여러 가상 머신이 읽기-쓰기 모드로 동일한 PVC를 마운트할 수 있으므로 데이터가 손상될 수 있습니다. (CNV-13500)

- 이 문제를 해결하려면 여러 VM이 있는 읽기-쓰기 모드에서 단일 PVC를 사용하지 마십시오.

csi-clone복제 전략을 사용하여 100개 이상의 VM을 복제하면 Ceph CSI에서 복제본을 제거하지 못할 수 있습니다. 복제를 수동으로 삭제하는 경우에도 실패할 수 있습니다. (CNV-23501)-

이 문제를 해결하려면

ceph-mgr을 다시 시작하여 VM 복제를 제거할 수 있습니다.

-

이 문제를 해결하려면

가상화

-

일부 OpenShift Virtualization 4.15 버전은 누락된 CRD(사용자 정의 리소스 정의)로 인해 Red Hat OpenShift Pipelines 1.19와 호환되지 않습니다. 문제를 방지하려면 OpenShift Pipelines 1.18을 사용하십시오. 또는 OpenShift Pipelines 1.19로 업데이트하기 전에

deployTektonTaskResources기능 게이트를false로 설정합니다. (CNV-66487)

qemu-kvm의 중요한 버그로 인해 디스크 핫플러그 작업 후 VM이 중단되고 I/O 오류가 발생했습니다. 이 문제는 핫 플러그 작업과 관련이 없는 운영 체제 디스크 및 기타 디스크에도 영향을 미칠 수 있습니다. 운영 체제 디스크가 작동을 중지하면 루트 파일 시스템이 종료됩니다. 자세한 내용은 Red Hat 지식 베이스에서 일부 추가 디스크를 핫플러그한 후 가상 머신의 디스크 액세스 권한 손실을 참조하십시오.중요패키지 버전 관리로 인해 OpenShift Virtualization을 4.13.z 또는 4.14.z에서 4.15.0으로 업데이트한 후 이 버그가 다시 표시될 수 있습니다.

-

Windows VM에 vTPM(가상 신뢰할 수 있는 플랫폼 모듈) 장치를 추가하면 vTPM 장치가 영구적이지 않은 경우에도 BitLocker 드라이브 암호화 시스템 검사가 통과됩니다. 이는 영구 저장소가 아닌 vTPM 장치는

virt-launcherPod의 수명 동안 임시 스토리지를 사용하여 암호화 키를 복구하기 때문입니다. VM이 마이그레이션되거나 종료되면 vTPM 데이터가 손실됩니다. (CNV-36448)

OpenShift Virtualization은 Pod에서 사용하는 서비스 계정 토큰을 해당 특정 Pod에 연결합니다. OpenShift Virtualization은 토큰이 포함된 디스크 이미지를 생성하여 서비스 계정 볼륨을 구현합니다. VM을 마이그레이션하면 서비스 계정 볼륨이 유효하지 않습니다. (CNV-33835)

- 이 문제를 해결하려면 사용자 계정 토큰이 특정 Pod에 바인딩되지 않으므로 서비스 계정 대신 사용자 계정을 사용합니다.

RHSA-2023:3722 권고가 릴리스되면서 TLS

확장 마스터 시크릿(ECDSA) 확장(RFC 7627)은 FIPS 지원 Red Hat Enterprise Linux (RHEL) 9 시스템에서 TLS 1.2 연결에 필요합니다. 이는 FIPS-140-3 요구 사항에 따라 수행됩니다. TLS 1.3은 영향을 받지 않습니다.ECDSA 또는 TLS 1.3을 지원하지 않는 기존 OpenSSL 클라이언트는 이제 RHEL 9에서 실행되는 FIPS 서버에 연결할 수 없습니다. 마찬가지로 FIPS 모드의 RHEL 9 클라이언트는 ECDSA 없이 TLS 1.2만 지원하는 서버에 연결할 수 없습니다. 실제로 이러한 클라이언트는 RHEL 6, RHEL 7 및 비 RHEL 레거시 운영 체제의 서버에 연결할 수 없습니다. 이는 OpenSSL의 기존 1.0.x 버전이 ECDSA 또는 TLS 1.3을 지원하지 않기 때문입니다. 자세한 내용은 Red Hat Enterprise Linux 9.2에서 적용된 TLS 확장 "확장 마스터 시크릿" 을 참조하십시오.

-

이 문제를 해결하려면 기존 OpenSSL 클라이언트를 TLS 1.3을 지원하는 버전으로 업데이트하고 FIPS 모드의 경우

ModernTLS 보안 프로필 유형으로 TLS 1.3을 사용하도록 OpenShift Virtualization을 구성합니다.

-

이 문제를 해결하려면 기존 OpenSSL 클라이언트를 TLS 1.3을 지원하는 버전으로 업데이트하고 FIPS 모드의 경우

웹 콘솔

OpenShift Container Platform 클러스터를 처음 배포할 때 웹 콘솔을 사용하여 템플릿 또는 인스턴스 유형에서 VM을 생성하면

cluster-admin권한이 없는 경우 실패합니다.- 이 문제를 해결하려면 클러스터 관리자가 먼저 다른 사용자가 템플릿과 인스턴스 유형을 사용하여 VM을 생성할 수 있도록 구성 맵 을 생성해야 합니다. (링크: CNV-38284)

웹 콘솔을 사용하여 OVN-Kubernetes localnet 토폴로지에 대한 네트워크 연결 정의(NAD)를 생성하면 유효하지 않은 주석

k8s.v1.cni.cncf.io/resourceName: openshift.io/가 표시됩니다. 이 주석은 VM을 시작할 수 없습니다.- 이 문제를 해결하려면 주석을 제거합니다.

3장. 시작하기

3.1. OpenShift Virtualization 시작하기

기본 환경을 설치하고 구성하여 OpenShift Virtualization의 기능 및 기능을 탐색할 수 있습니다.

클러스터 구성 절차에는 cluster-admin 권한이 필요합니다.

3.1.1. OpenShift Virtualization 계획 및 설치

OpenShift Container Platform 클러스터에 OpenShift Virtualization을 계획하고 설치합니다.

계획 및 설치 리소스

3.1.2. 가상 머신 생성 및 관리

VM(가상 머신)을 생성합니다.

Red Hat 템플릿 또는 인스턴스 유형을 사용하여 VM을 생성할 수 있습니다.

컨테이너 레지스트리 또는 웹 페이지에서 사용자 정의 이미지를 가져오거나, 로컬 머신에서 이미지를 업로드하거나 PVC(영구 볼륨 클레임)를 복제하여 VM을 생성할 수 있습니다.

VM을 보조 네트워크에 연결합니다.

- Linux 브리지 네트워크.

- OVN(가상 네트워크)-Kubernetes 보조 네트워크.

SR-IOV(Single Root I/O Virtualization) 네트워크.

참고VM은 기본적으로 Pod 네트워크에 연결됩니다.

VM에 연결합니다.

- VM의 직렬 콘솔 또는 VNC 콘솔에 연결합니다.

- SSH를 사용하여 VM에 연결합니다.

- Windows VM의 데스크탑 뷰어에 연결합니다.

VM을 관리합니다.

3.1.3. 다음 단계

3.2. virtctl 및 libguestfs CLI 툴 사용

virtctl 명령줄 툴을 사용하여 OpenShift Virtualization 리소스를 관리할 수 있습니다.

libguestfs 명령줄 툴을 사용하여 VM(가상 머신) 디스크 이미지에 액세스하고 수정할 수 있습니다. virtctl libguestfs 명령을 사용하여 libguestfs를 배포합니다.

3.2.1. virtctl 설치

RHEL(Red Hat Enterprise Linux) 9, Linux, Windows 및 MacOS 운영 체제에 virtctl 을 설치하려면 virtctl 바이너리 파일을 다운로드하여 설치합니다.

RHEL 8에 virtctl 을 설치하려면 OpenShift Virtualization 리포지토리를 활성화한 다음 kubevirt-virtctl 패키지를 설치합니다.

3.2.1.1. RHEL 9, Linux, Windows 또는 macOS에 virtctl 바이너리 설치

OpenShift Container Platform 웹 콘솔에서 운영 체제의 virtctl 바이너리를 다운로드한 다음 설치할 수 있습니다.

프로세스

- 웹 콘솔의 가상화 → 개요 페이지로 이동합니다.

-

Download virtctl 링크를 클릭하여 운영 체제의

virtctl바이너리를 다운로드합니다. install

virtctl:RHEL 9 및 기타 Linux 운영 체제의 경우:

아카이브 파일의 압축을 풉니다.

tar -xvf <virtctl-version-distribution.arch>.tar.gz

$ tar -xvf <virtctl-version-distribution.arch>.tar.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

virtctl바이너리를 실행할 수 있도록 합니다.chmod +x <path/virtctl-file-name>

$ chmod +x <path/virtctl-file-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow virtctl바이너리를PATH환경 변수의 디렉터리로 이동합니다.다음 명령을 실행하여 경로를 확인할 수 있습니다.

echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow KUBECONFIG환경 변수를 설정합니다.export KUBECONFIG=/home/<user>/clusters/current/auth/kubeconfig

$ export KUBECONFIG=/home/<user>/clusters/current/auth/kubeconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Windows의 경우:

- 아카이브 파일의 압축을 풉니다.

-

추출된 폴더 계층 구조로 이동하고

virtctl실행 파일을 두 번 클릭하여 클라이언트를 설치합니다. virtctl바이너리를PATH환경 변수의 디렉터리로 이동합니다.다음 명령을 실행하여 경로를 확인할 수 있습니다.

path

C:\> pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow

macOS의 경우:

- 아카이브 파일의 압축을 풉니다.

virtctl바이너리를PATH환경 변수의 디렉터리로 이동합니다.다음 명령을 실행하여 경로를 확인할 수 있습니다.

echo $PATH

echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.2.1.2. RHEL 8에 virtctl RPM 설치

OpenShift Virtualization 리포지토리를 활성화하고 kubevirt-virtctl 패키지를 설치하여 RHEL(Red Hat Enterprise Linux) 8에 virtctl RPM 패키지를 설치할 수 있습니다.

사전 요구 사항

- 클러스터의 각 호스트는 RHSM(Red Hat Subscription Manager)에 등록되어 있어야 하며 유효한 OpenShift Container Platform 서브스크립션이 있어야 합니다.

프로세스

subscription-managerCLI 툴을 사용하여 다음 명령을 실행하여 OpenShift Virtualization 리포지토리를 활성화합니다.subscription-manager repos --enable cnv-4.15-for-rhel-8-x86_64-rpms

# subscription-manager repos --enable cnv-4.15-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

kubevirt-virtctl패키지를 설치합니다.yum install kubevirt-virtctl

# yum install kubevirt-virtctlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.2.2. virtctl 명령

virtctl 클라이언트는 OpenShift Virtualization 리소스를 관리하는 명령줄 유틸리티입니다.

VM(가상 머신) 명령은 별도로 지정하지 않는 한 VMI(가상 머신 인스턴스)에도 적용됩니다.

3.2.2.1. virtctl information 명령

virtctl information 명령을 사용하여 virtctl 클라이언트에 대한 정보를 봅니다.

| 명령 | 설명 |

|---|---|

|

|

|

|

|

|

|

| 특정 명령의 옵션 목록을 확인합니다. |

|

|

|

3.2.2.2. VM 정보 명령

virtctl 을 사용하여 VM(가상 머신) 및 VMI(가상 머신 인스턴스)에 대한 정보를 볼 수 있습니다.

| 명령 | 설명 |

|---|---|

|

| 게스트 머신에서 사용 가능한 파일 시스템을 확인합니다. |

|

| 게스트 머신의 운영 체제에 대한 정보를 봅니다. |

|

| 게스트 머신에서 로그인한 사용자를 확인합니다. |

3.2.2.3. VM 매니페스트 생성 명령

virtctl create 명령을 사용하여 가상 머신, 인스턴스 유형 및 기본 설정에 대한 매니페스트를 생성할 수 있습니다.

| 명령 | 설명 |

|---|---|

|

|

|

| VM 매니페스트를 생성하여 VM의 이름을 지정합니다. |

|

| 기존 클러스터 전체 인스턴스 유형을 사용하는 VM 매니페스트를 생성합니다. |

|

| 기존 네임스페이스 인스턴스 유형을 사용하는 VM 매니페스트를 생성합니다. |

|

| 클러스터 전체 인스턴스 유형에 대한 매니페스트를 생성합니다. |

|

| 네임스페이스가 지정된 인스턴스 유형에 대한 매니페스트를 생성합니다. |

|

| 클러스터 전체 VM 기본 설정에 대한 매니페스트를 생성하여 기본 설정 이름을 지정합니다. |

|

| 네임스페이스가 지정된 VM 기본 설정에 대한 매니페스트를 생성합니다. |

3.2.2.4. VM 관리 명령

virtctl VM(가상 머신) 관리 명령을 사용하여 VM(가상 머신) 및 VMI(가상 머신 인스턴스)를 관리하고 마이그레이션합니다.

| 명령 | 설명 |

|---|---|

|

| VM을 시작합니다. |

|

| 일시 중지된 상태에서 VM을 시작합니다. 이 옵션을 사용하면 VNC 콘솔에서 부팅 프로세스를 중단할 수 있습니다. |

|

| VM을 중지합니다. |

|

| VM을 강제로 중지합니다. 이 옵션을 사용하면 데이터 불일치 또는 데이터 손실이 발생할 수 있습니다. |

|

| VM 일시 중지. 머신 상태는 메모리에 유지됩니다. |

|

| VM 일시 중지를 해제합니다. |

|

| VM 마이그레이션. |

|

| VM 마이그레이션을 취소합니다. |

|

| VM을 다시 시작합니다. |

3.2.2.5. VM 연결 명령

virtctl 연결 명령을 사용하여 포트를 노출하고 VM(가상 머신) 및 VMI(가상 머신 인스턴스)에 연결합니다.

| 명령 | 설명 |

|---|---|

|

| VM의 직렬 콘솔에 연결합니다. |

|

| VM의 지정된 포트를 전달하고 서비스를 노드의 지정된 포트에 노출하는 서비스를 생성합니다.

예: |

|

| 시스템에서 VM으로 파일을 복사합니다. 이 명령은 SSH 키 쌍의 개인 키를 사용합니다. VM은 공개 키를 사용하여 구성해야 합니다. |

|

| VM에서 시스템으로 파일을 복사합니다. 이 명령은 SSH 키 쌍의 개인 키를 사용합니다. VM은 공개 키를 사용하여 구성해야 합니다. |

|

| VM을 사용하여 SSH 연결을 엽니다. 이 명령은 SSH 키 쌍의 개인 키를 사용합니다. VM은 공개 키를 사용하여 구성해야 합니다. |

|

| VM의 VNC 콘솔에 연결합니다.

|

|

| 포트 번호를 표시하고 VNC 연결을 통해 뷰어를 사용하여 VM에 수동으로 연결합니다. |

|

| 해당 포트를 사용할 수 있는 경우 지정된 포트에서 프록시를 실행할 포트 번호를 지정합니다. 포트 번호를 지정하지 않으면 프록시는 임의의 포트에서 실행됩니다. |

3.2.2.6. VM 내보내기 명령

virtctl vmexport 명령을 사용하여 VM, VM 스냅샷 또는 PVC(영구 볼륨 클레임)에서 내보낸 볼륨을 생성, 다운로드 또는 삭제합니다. 특정 매니페스트에는 OpenShift Virtualization에서 사용할 수 있는 형식으로 디스크 이미지를 가져오기 위해 엔드포인트에 대한 액세스 권한을 부여하는 헤더 시크릿도 포함되어 있습니다.

| 명령 | 설명 |

|---|---|

|

|

|

|

|

|

|

|

선택 사항:

|

|

|

|

|

| 기존 내보내기에 대한 매니페스트를 검색합니다. 매니페스트에는 헤더 보안이 포함되지 않습니다. |

|

| VM 예제에 대한 VM 내보내기를 생성하고 매니페스트를 검색합니다. 매니페스트에는 헤더 보안이 포함되지 않습니다. |

|

| VM 스냅샷 예에 대한 VM 내보내기를 생성하고 매니페스트를 검색합니다. 매니페스트에는 헤더 보안이 포함되지 않습니다. |

|

| 기존 내보내기에 대한 매니페스트를 검색합니다. 매니페스트에는 헤더 보안이 포함됩니다. |

|

| 기존 내보내기에 대한 매니페스트를 json 형식으로 검색합니다. 매니페스트에는 헤더 보안이 포함되지 않습니다. |

|

| 기존 내보내기에 대한 매니페스트를 검색합니다. 매니페스트에는 헤더 보안이 포함되어 있으며 지정된 파일에 씁니다. |

3.2.2.7. VM 메모리 덤프 명령

virtctl memory-dump 명령을 사용하여 PVC에 VM 메모리 덤프를 출력할 수 있습니다. 기존 PVC를 지정하거나 --create-claim 플래그를 사용하여 새 PVC를 생성할 수 있습니다.

사전 요구 사항

-

PVC 볼륨 모드는

FileSystem이어야 합니다. PVC는 메모리 덤프를 포함할 수 있을 만큼 커야 합니다.

PVC 크기를 계산하는 공식은

(VMMemorySize + 100Mi) * FileSystemOverhead입니다. 여기서100Mi는 메모리 덤프 오버헤드입니다.다음 명령을 실행하여

HyperConverged사용자 정의 리소스에서 핫 플러그 기능 게이트를 활성화해야 합니다.oc patch hyperconverged kubevirt-hyperconverged -n openshift-cnv \ --type json -p '[{"op": "add", "path": "/spec/featureGates", \ "value": "HotplugVolumes"}]'$ oc patch hyperconverged kubevirt-hyperconverged -n openshift-cnv \ --type json -p '[{"op": "add", "path": "/spec/featureGates", \ "value": "HotplugVolumes"}]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

메모리 덤프 다운로드

virtctl vmexport download 명령을 사용하여 메모리 덤프를 다운로드해야 합니다.

virtctl vmexport download <vmexport_name> --vm|pvc=<object_name> \ --volume=<volume_name> --output=<output_file>

$ virtctl vmexport download <vmexport_name> --vm|pvc=<object_name> \

--volume=<volume_name> --output=<output_file>| 명령 | 설명 |

|---|---|

|

|

VM의 메모리 덤프를 PVC에 저장합니다. 메모리 덤프 상태가 선택 사항:

|

|

|

동일한 PVC를 사용하여 이 명령은 이전 메모리 덤프를 덮어씁니다. |

|

| 메모리 덤프 제거. 대상 PVC를 변경하려면 메모리 덤프를 수동으로 제거해야 합니다.

이 명령은 VM과 PVC 간의 연결을 제거하여 메모리 덤프가 |

3.2.2.8. 핫플러그 및 핫 플러그 해제 명령

virtctl 을 사용하여 실행 중인 VM(가상 머신) 및 VMI(가상 머신 인스턴스)에서 리소스를 추가하거나 제거합니다.

| 명령 | 설명 |

|---|---|

|

| 데이터 볼륨 또는 PVC(영구 볼륨 클레임)를 핫플러그합니다. 선택 사항:

|

|

| 가상 디스크 핫 플러그를 해제합니다. |

|

| Linux 브리지 네트워크 인터페이스를 핫 플러그로 연결합니다. |

|

| Linux 브리지 네트워크 인터페이스를 핫 플러그 해제합니다. |

3.2.2.9. 이미지 업로드 명령

virtctl image-upload 명령을 사용하여 VM 이미지를 데이터 볼륨에 업로드합니다.

| 명령 | 설명 |

|---|---|

|

| VM 이미지를 이미 존재하는 데이터 볼륨에 업로드합니다. |

|

| 요청된 크기의 새 데이터 볼륨에 VM 이미지를 업로드합니다. |

3.2.3. virtctl을 사용하여 libguestfs 배포

virtctl guestfs 명령을 사용하여 libguestfs-tools 및 연결된 PVC(영구 볼륨 클레임)를 사용하여 대화형 컨테이너를 배포할 수 있습니다.

절차

libguestfs-tools를 사용하여 컨테이너를 배포하려면 PVC를 마운트하고 쉘을 연결하려면 다음 명령을 실행합니다.virtctl guestfs -n <namespace> <pvc_name>

$ virtctl guestfs -n <namespace> <pvc_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- PVC 이름은 필수 인수입니다. 이를 포함하지 않으면 오류 메시지가 표시됩니다.

3.2.3.1. libguestfs 및 virtctl guestfs 명령

Libguestfs 툴을 사용하면 VM(가상 머신) 디스크 이미지에 액세스하고 수정할 수 있습니다. libguestfs 툴을 사용하여 게스트의 파일을 보고 편집하고, 가상 시스템을 복제 및 빌드하며, 디스크를 포맷하고 크기를 조정할 수 있습니다.

virtctl guestfs 명령과 해당 하위 명령을 사용하여 PVC에서 VM 디스크를 수정, 검사 및 디버깅할 수도 있습니다. 가능한 하위 명령의 전체 목록을 보려면 명령줄에 virt- 을 입력하고 Tab 키를 누릅니다. 예를 들면 다음과 같습니다.

| 명령 | 설명 |

|---|---|

|

| 터미널에서 파일을 대화식으로 편집합니다. |

|

| ssh 키를 게스트에 삽입하고 로그인을 만듭니다. |

|

| VM에서 사용하는 디스크 공간 크기를 확인하십시오. |

|

| 전체 목록이 포함된 출력 파일을 생성하여 게스트에 설치된 모든 RPM의 전체 목록을 확인하십시오. |

|

|

터미널에서 |

|

| 템플릿으로 사용할 가상 시스템 디스크 이미지를 봉인합니다. |

기본적으로 virtctl guestfs 는 VM 디스크를 관리하는 데 필요한 모든 내용으로 세션을 생성합니다. 그러나 이 명령은 동작을 사용자 지정하려는 경우 여러 플래그 옵션도 지원합니다.

| 플래그 옵션 | 설명 |

|---|---|

|

|

|

|

| 특정 네임스페이스에서 PVC를 사용하려면 다음을 수행합니다.

|

|

|

|

|

|

기본적으로

클러스터에

설정되지 않은 경우 |

|

|

|

또한 명령은 다른 pod에서 PVC를 사용 중인지 확인합니다. 이 경우 오류 메시지가 표시됩니다. 그러나 libguestfs-tools 프로세스가 시작되면 동일한 PVC를 사용하는 새 Pod를 방지할 수 없습니다. 동일한 PVC에 액세스하는 VM을 시작하기 전에 활성 virtctl guestfs Pod가 없는지 확인해야 합니다.

virtctl guestfs 명령은 대화형 Pod에 연결된 단일 PVC만 허용합니다.

3.3. 웹 콘솔 개요

OpenShift Container Platform 웹 콘솔의 가상화 섹션에는 OpenShift Virtualization 환경을 관리하고 모니터링하기 위한 다음 페이지가 포함되어 있습니다.

| 페이지 | 설명 |

|---|---|

| OpenShift Virtualization 환경을 관리하고 모니터링합니다. | |

| 템플릿 카탈로그에서 가상 머신을 생성합니다. | |

| 가상 머신 생성 및 관리. | |

| 템플릿 생성 및 관리. | |

| 가상 머신 인스턴스 유형을 생성하고 관리합니다. | |

| 가상 머신 기본 설정 생성 및 관리. | |

| 부팅 가능한 볼륨에 대한 DataSources를 생성하고 관리합니다. | |

| 워크로드에 대한 마이그레이션 정책을 생성하고 관리합니다. | |

| 가상 머신에 대한 네트워크 대기 시간 및 스토리지 검사를 실행합니다. |

| icon | 설명 |

|---|---|

|

| 아이콘 편집 |

|

| 링크 아이콘 |

|

| VM 아이콘 시작 |

|

| VM 아이콘 중지 |

|

| VM 아이콘 재시작 |

|

| VM 아이콘 일시 중지 |

|

| VM 일시 중지 해제 아이콘 |

3.3.1. 개요 페이지

개요 페이지에는 리소스, 지표, 마이그레이션 진행 상황 및 클러스터 수준 설정이 표시됩니다.

예 3.1. 개요 페이지

| element | 설명 |

|---|---|

|

virtctl 다운로드 |

|

| 리소스, 사용량, 경고 및 상태. | |

| CPU, 메모리 및 스토리지 리소스의 상위 소비자입니다. | |

| 실시간 마이그레이션 상태. | |

| Settings 탭에는 Cluster 탭, 사용자 탭 및 프리뷰 기능 탭이 포함되어 있습니다. | |

| 설정 → 클러스터 탭 | OpenShift Virtualization 버전, 업데이트 상태, 실시간 마이그레이션, 템플릿 프로젝트, 로드 밸런서 서비스, 게스트 관리, 리소스 관리 및 SCSI 영구 예약 설정 |

| 설정 → 사용자 탭 | 공개 SSH 키, 사용자 권한 및 시작 정보 설정 |

| 설정 → 프리뷰 기능 | 웹 콘솔에서 선택 프리뷰 기능을 활성화합니다. 이 탭의 기능은 자주 변경됩니다. 프리뷰 기능은 기본적으로 비활성화되어 있으며 프로덕션 환경에서 활성화해서는 안 됩니다. |

3.3.1.1. 개요 탭

개요 탭에는 리소스, 사용량, 경고 및 상태가 표시됩니다.

예 3.2. 개요 탭

| element | 설명 |

|---|---|

| 시작하기 리소스 카드 |

|

| 메모리 타일 | 메모리 사용량은 지난 1일의 추세를 보여주는 차트와 함께 사용됩니다. |

| 스토리지 타일 | 스토리지 사용량은 지난 1일의 추세를 보여주는 차트와 함께 사용됩니다. |

| vCPU 사용 타일 | vCPU 사용량은 지난 1일 동안의 추세를 보여주는 차트를 사용합니다. |

| VirtualMachines 타일 | 마지막 1일의 추세를 보여주는 차트가 포함된 가상 머신 수입니다. |

| 경고 타일 | 심각도별로 그룹화된 OpenShift Virtualization 경고. |

| VirtualMachine 상태 타일 | 상태로 그룹화된 가상 머신 수입니다. |

| 리소스 차트당 VirtualMachines | 템플릿 및 인스턴스 유형에서 생성된 가상 머신 수입니다. |

3.3.1.2. 상위 소비자 탭

Top consumers (상위 소비자) 탭에는 CPU, 메모리 및 스토리지의 상위 소비자가 표시됩니다.

예 3.3. 상위 소비자 탭

| element | 설명 |

|---|---|

|

가상화 대시보드 보기 | OpenShift Virtualization의 상위 소비자를 표시하는 Observe → Dashboards 에 연결됩니다. |

| 시간 기간 목록 | 결과를 필터링할 기간을 선택합니다. |

| 상위 소비자 목록 | 결과를 필터링할 상위 소비자 수를 선택합니다. |

| CPU 차트 | CPU 사용량이 가장 많은 가상 머신입니다. |

| 메모리 차트 | 메모리 사용량이 가장 많은 가상 머신입니다. |

| 메모리 스왑 트래픽 차트 | 메모리 스왑 트래픽이 가장 많은 가상 머신입니다. |

| vCPU 대기 차트 | vCPU 대기 기간이 가장 많은 가상 머신입니다. |

| 스토리지 처리량 차트 | 스토리지 처리량이 가장 많은 가상 머신입니다. |

| 스토리지 IOPS 차트 | 초당 스토리지 입력/출력 작업이 가장 많은 가상 머신입니다. |

3.3.1.3. 마이그레이션 탭

마이그레이션 탭에는 가상 머신 마이그레이션의 상태가 표시됩니다.

예 3.4. 마이그레이션 탭

| element | 설명 |

|---|---|

| 시간 기간 목록 | 가상 머신 마이그레이션을 필터링할 기간을 선택합니다. |

| VirtualMachineInstanceMigrations 정보 테이블 | 가상 머신 마이그레이션 목록입니다. |

3.3.1.4. 설정 탭

설정 탭에는 클러스터 전체 설정이 표시됩니다.

예 3.5. 설정 탭의 탭

3.3.1.4.1. 클러스터 탭

Cluster (클러스터) 탭에는 OpenShift Virtualization 버전 및 업데이트 상태가 표시됩니다. 클러스터 탭에서 실시간 마이그레이션 및 기타 설정을 구성합니다.

예 3.6. 클러스터 탭

| element | 설명 |

|---|---|

| 설치된 버전 | OpenShift Virtualization 버전. |

| 업데이트 상태 | OpenShift Virtualization 업데이트 상태. |

| 채널 | OpenShift Virtualization 업데이트 채널. |

| 일반 설정 섹션 | 이 섹션을 확장하여 실시간 마이그레이션 설정, SSH 구성 설정 및 템플릿 프로젝트 설정을 구성합니다. |

| 일반 설정 → 실시간 마이그레이션 섹션 | 이 섹션을 확장하여 실시간 마이그레이션 설정을 구성합니다. |

| 일반 설정 → 실시간 마이그레이션 → 클러스터당 최대 마이그레이션 필드 | 클러스터당 최대 실시간 마이그레이션 수를 선택합니다. |

| 일반 설정 → 실시간 마이그레이션 → 최대. 노드 필드당 마이그레이션 | 노드당 최대 실시간 마이그레이션 수를 선택합니다. |

| 일반 설정 → 실시간 마이그레이션 → 실시간 마이그레이션 네트워크 목록 | 실시간 마이그레이션을 위한 전용 보조 네트워크를 선택합니다. |

| 일반 설정 → SSH 구성 → LoadBalancer 서비스 스위치를 통한 SSH | VM에 대한 SSH 연결에 사용할 LoadBalancer 서비스 생성을 활성화합니다. 로드 밸런서를 구성해야 합니다. |

| 일반 설정 → SSH 구성 → NodePort 서비스 스위치를 통한 SSH | 가상 머신에 SSH 연결을 위한 노드 포트 서비스를 생성할 수 있습니다. |

| 일반 설정 → 템플릿 프로젝트 섹션 |

이 섹션을 확장하여 Red Hat 템플릿의 프로젝트를 선택합니다. 기본 프로젝트는 Red Hat 템플릿을 여러 프로젝트에 저장하려면 템플릿을 복제 한 다음 복제된 템플릿에 사용할 프로젝트를 선택합니다. |

| 게스트 관리 | 새 RHEL VirtualMachines 설정 및 게스트 시스템 로그 액세스 스위치 활성화 의 자동 서브스크립션 을 구성하려면 이 섹션을 확장합니다. |

| 게스트 관리 → 새로운 RHEL VirtualMachine의 자동 서브스크립션 | 이 섹션을 확장하여 RHEL(Red Hat Enterprise Linux) 가상 머신 및 게스트 시스템 로그 액세스에 대한 자동 서브스크립션을 활성화합니다. 이 기능을 활성화하려면 클러스터 관리자 권한, 조직 ID 및 활성화 키가 필요합니다. |

| 게스트 관리 → 새로운 RHEL VirtualMachines → 활성화 키 필드의 자동 서브스크립션 | 활성화 키를 입력합니다. |

| 게스트 관리 → 새로운 RHEL VirtualMachines → 조직 ID 필드의 자동 서브스크립션 | 조직 ID를 입력합니다. |

| 게스트 관리 → 새로운 RHEL VirtualMachines 자동 서브스크립션 → RHEL VirtualMachines 스위치 자동 업데이트 활성화 | RHEL 리포지토리에서 자동 업데이트 가져오기를 활성화합니다. 이 기능을 활성화하려면 활성화 키와 조직 ID가 필요합니다. |

| 게스트 관리 → 게스트 시스템 로그 액세스 스위치 활성화 | 가상 머신의 게스트 시스템 로그에 대한 액세스를 활성화합니다. |

| 리소스 관리 | 이 섹션을 확장하여 Auto-compute CPU 제한 설정 및 KSM(커널 동일 페이지 병합) 스위치를 구성합니다. |

| 리소스 관리 → 자동 계산 CPU 제한 | 라벨이 포함된 프로젝트에서 자동 컴퓨팅 CPU 제한을 활성화합니다. |

| 리소스 관리 → KSM(커널 동일 페이지 병합) | 클러스터의 모든 노드에 대해 KSM을 활성화합니다. |

| SCSI 영구 예약 | 이 섹션을 확장하여 영구 예약 스위치 활성화를 구성합니다. |

| SCSI 영구 예약 → 영구 예약 활성화 | 디스크에 대해 SCSI 예약을 활성화합니다. 이 옵션은 클러스터 인식 애플리케이션에만 사용해야 합니다. |

3.3.1.4.2. 사용자 탭

사용자 권한을 보고 공개 SSH 키 및 사용자 탭에 대한 시작 정보를 관리합니다.

예 3.7. 사용자 탭

| element | 설명 |

|---|---|

| SSH 키 섹션 관리 | 프로젝트에 공용 SSH 키를 추가하려면 이 섹션을 확장합니다. 키는 나중에 선택한 프로젝트에서 생성하는 모든 가상 머신에 자동으로 추가됩니다. |

| 권한 섹션 | 클러스터 전체 사용자 권한을 보려면 이 섹션을 확장합니다. |

| 시작 정보 섹션 | welcome 정보 대화 상자를 표시하거나 숨기려면 이 섹션을 확장합니다. |

3.3.1.4.3. 프리뷰 기능 탭

웹 콘솔에서 선택 프리뷰 기능을 활성화합니다. 이 탭의 기능은 자주 변경됩니다.

3.3.2. 카탈로그 페이지

카탈로그 페이지의 템플릿 또는 인스턴스 유형에서 가상 머신을 생성합니다.

예 3.8. 카탈로그 페이지

| element | 설명 |

|---|---|

| 가상 머신을 생성하기 위한 부팅 가능한 볼륨 및 인스턴스 유형을 표시합니다. | |

| 가상 머신을 생성하기 위한 템플릿 카탈로그를 표시합니다. |

3.3.2.1. InstanceTypes tab

InstanceTypes 탭의 인스턴스 유형에서 가상 머신을 생성합니다.

| element | 설명 |

|---|---|

| 볼륨 버튼 추가 | 볼륨을 업로드하거나 기존 영구 볼륨 클레임, 볼륨 스냅샷 또는 데이터 소스를 사용하려면 클릭합니다. |

| volumes 프로젝트 필드 |

부팅 가능한 볼륨이 저장되는 프로젝트입니다. 기본값은 |

| 필터 필드 | 운영 체제 또는 리소스에 따라 부팅 소스를 필터링합니다. |

| 검색 필드 | 이름으로 부팅 소스를 검색합니다. |

| 열 아이콘 관리 | 테이블에 표시할 최대 9개의 열을 선택합니다. |

| 볼륨 테이블 | 가상 머신의 부팅 가능한 볼륨을 선택합니다. |

| Red Hat 제공 탭 | Red Hat에서 제공하는 인스턴스 유형을 선택합니다. |

| 사용자가 제공한 탭 | InstanceType 페이지에서 생성한 인스턴스 유형을 선택합니다. |

| VirtualMachine 세부 정보 창 | 가상 머신 설정을 표시합니다. |

| 이름 필드 | 선택 사항: 가상 머신 이름을 입력합니다. |

| 스토리지 클래스 필드 | 스토리지 클래스를 선택합니다. |

| 공개 SSH 키 | 편집 아이콘을 클릭하여 신규 또는 기존 공개 SSH 키를 추가합니다. |

| 동적 SSH 키 삽입 스위치 | 동적 SSH 키 삽입을 활성화합니다. RHEL만 동적 SSH 키 삽입을 지원합니다. |

| 생성 후 이 VirtualMachine 시작 확인란 | 가상 머신이 자동으로 시작되지 않도록 하려면 이 확인란을 지웁니다. |

| VirtualMachine 버튼 생성 | 가상 머신을 생성합니다. |

| YAML 및 CLI 버튼 보기 |

명령줄에서 가상 머신을 생성하기 위해 YAML 구성 파일과 |

3.3.2.2. 템플릿 카탈로그 탭

템플릿 카탈로그 탭에서 템플릿을 선택하여 가상 머신을 생성합니다.

예 3.9. 템플릿 카탈로그 탭

| element | 설명 |

|---|---|

| 템플릿 프로젝트 목록 | Red Hat 템플릿이 있는 프로젝트를 선택합니다.

기본적으로 Red Hat 템플릿은 |

| 모든 항목 | 기본 템플릿 | 사용자 템플릿 | 모든 항목을 클릭하여 사용 가능한 모든 템플릿, 기본 템플릿을 표시하도록 기본 템플릿 및 사용자 템플릿을 표시하여 사용자가 생성한 템플릿을 표시합니다. |

| 부팅 소스 사용 가능 확인란 | 사용 가능한 부팅 소스가 있는 템플릿을 표시하려면 확인란을 선택합니다. |

| 운영 체제 확인란 | 선택한 운영 체제가 있는 템플릿을 표시하려면 확인란을 선택합니다. |

| 워크로드 확인란 | 선택한 워크로드가 포함된 템플릿을 표시하려면 확인란을 선택합니다. |

|

|

|

|

|

|

3.3.3.

예 3.10.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.3.1.

VirtualMachine 세부 정보 페이지의 구성 탭에서 가상 머신을 구성합니다.

예 3.11. VirtualMachine 세부 정보 페이지

| element | 설명 |

|---|---|

| 작업 메뉴 | 작업 메뉴를 클릭하여 중지,다시 시작,일시 중지,복제,마이그레이션,SSH 명령 복사,레이블 편집,주석 편집 또는 삭제를 선택합니다. 중지 를 선택하면 작업 메뉴에서Force stop 이 Stop 을 대체합니다. 운영 체제가 응답하지 않는 경우 강제 중지 를 사용하여 즉각적인 종료를 시작합니다. |

| 리소스 사용량, 경고, 디스크 및 장치. | |

| 메모리, CPU, 스토리지, 네트워크 및 마이그레이션 메트릭. | |

| 가상 머신 YAML 구성 파일. | |

| 세부 정보,스토리지,네트워크,스케줄링,SSH,초기 실행 및 메타데이터 탭이 포함되어 있습니다. | |

| VM의 VirtualMachine 세부 정보를 구성합니다. | |

| VM의 스토리지를 구성합니다. | |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.3.1.1.

예 3.12.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.3.1.2.

예 3.13.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.3.1.3.

예 3.14.

|

|

|

|

|

|

|

|

|

|

|

|

3.3.3.1.4.

예 3.15.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.3.1.4.1.

예 3.16.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.3.1.4.2.

예 3.17.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.3.1.4.3.

예 3.18.

|

|

|

|

|

|

|

|

|

|

|

|

3.3.3.1.4.4.

예 3.19.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.3.1.4.5.

예 3.20.

|

|

|

|

|

|

3.3.3.1.4.6.

예 3.21.

|

|

|

|

|

|

3.3.3.1.4.7.

예 3.22.

|

|

|

|

|

|

3.3.3.1.5.

3.3.3.1.6.

예 3.23.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.3.1.7.

예 3.24.

|

|

|

|

|

|

|

|

|

|

|

|

3.3.3.1.8.

예 3.25.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.4.

예 3.26.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.4.1.

예 3.27.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.4.1.1.

예 3.28.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.4.1.2.

예 3.29.

|

|

|

|

|

|

|

|

|

|

|

|

3.3.4.1.3.

예 3.30.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.4.1.4.

예 3.31.

|

|

|

|

|

|

|

|

|

|

|

|

3.3.4.1.5.

예 3.32.

|

|

|

|

|

|

|

|

|

|

|

|

3.3.4.1.6.

예 3.33.

|

|

|

|

|

|

|

|

|

3.3.4.1.7.

예 3.34.

|

|

|

|

|

|

3.3.5.

예 3.35.

|

|

|

|

|

|

|

|

|

|

|

|

3.3.5.1.

예 3.36.

|

|

|

|

|

|

|

|

|

3.3.5.1.1.

예 3.37.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.5.1.2.

예 3.38.

|

|

|

|

|

|

|

|

|

|

|

|

3.3.6.

예 3.39.

|

|

|

|

|

|

|

|

|

|

|

|

3.3.6.1.

예 3.40.

|

|

|

|

|

|

|

|

|

3.3.6.1.1.

예 3.41.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.6.1.2.

예 3.42.

|

|

|

|

|

|

|

|

|

|

|

|

3.3.7.

예 3.43.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.7.1.

예 3.44.

|

|

|

|

|

|

3.3.7.1.1.

예 3.45.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.7.1.2.

예 3.46.

|

|

|

|

|

|

|

|

|

|

|

|

3.3.8.

예 3.47.

|

|

|

|

|

|

|

|

|

|

|

|

3.3.8.1.

예 3.48.

|

|

|

|

|

|

|

|

|

3.3.8.1.1.

예 3.49.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

3.3.8.1.2.

예 3.50.

|

|

|

|

|

|

|

|

|

|

|

|

3.3.9.

예 3.51.

|

|

|

|

|

|

4장.

4.1.

4.1.1.

- 중요

4.1.1.1.

- 중요

4.1.2.

4.1.2.1.

- 참고

4.1.2.2.

- 참고

4.1.2.3.

4.1.2.3.1.

4.1.3.

- 참고

Product of (Maximum number of nodes that can drain in parallel) and (Highest total VM memory request allocations across nodes)

Product of (Maximum number of nodes that can drain in parallel) and (Highest total VM memory request allocations across nodes)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.4.

Memory overhead per infrastructure node ≈ 150 MiB

Memory overhead per infrastructure node ≈ 150 MiBMemory overhead per worker node ≈ 360 MiB

Memory overhead per worker node ≈ 360 MiB

Memory overhead per virtual machine ≈ (1.002 × requested memory) \

+ 218 MiB \

+ 8 MiB × (number of vCPUs) \

+ 16 MiB × (number of graphics devices) \

+ (additional memory overhead)

Memory overhead per virtual machine ≈ (1.002 × requested memory) \

+ 218 MiB \

+ 8 MiB × (number of vCPUs) \

+ 16 MiB × (number of graphics devices) \

+ (additional memory overhead)

CPU overhead for infrastructure nodes ≈ 4 cores

CPU overhead for infrastructure nodes ≈ 4 cores

CPU overhead for worker nodes ≈ 2 cores + CPU overhead per virtual machine

CPU overhead for worker nodes ≈ 2 cores + CPU overhead per virtual machine

Aggregated storage overhead per node ≈ 10 GiB

Aggregated storage overhead per node ≈ 10 GiB

4.1.5.

4.1.6.

4.1.7.

- 참고

- 참고

4.2.

4.2.1.

4.2.1.1.

- 주의

- 주의

4.2.1.2.

4.2.1.2.1.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc apply -f <file name>.yaml

$ oc apply -f <file name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.1.2.2.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc apply -f <file_name>.yaml

$ oc apply -f <file_name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

watch oc get csv -n openshift-cnv

$ watch oc get csv -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow NAME DISPLAY VERSION REPLACES PHASE kubevirt-hyperconverged-operator.v4.15.10 OpenShift Virtualization 4.15.10 Succeeded

NAME DISPLAY VERSION REPLACES PHASE kubevirt-hyperconverged-operator.v4.15.10 OpenShift Virtualization 4.15.10 SucceededCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.2.

4.3.

4.3.1.

4.3.1.1.

4.3.1.2.

- 참고

4.3.1.3.

4.3.1.4.

4.3.2.

oc delete HyperConverged kubevirt-hyperconverged -n openshift-cnv

$ oc delete HyperConverged kubevirt-hyperconverged -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete subscription kubevirt-hyperconverged -n openshift-cnv

$ oc delete subscription kubevirt-hyperconverged -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete csv -n openshift-cnv -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnv

$ oc delete csv -n openshift-cnv -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete namespace openshift-cnv

$ oc delete namespace openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete crd --dry-run=client -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnv

$ oc delete crd --dry-run=client -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete crd -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnv

$ oc delete crd -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5장.

5.1.

5.2.

5.2.1.

5.2.2.

oc edit <resource_type> <resource_name> -n openshift-cnv

$ oc edit <resource_type> <resource_name> -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2.3.

5.2.3.1.

5.2.3.2.

5.2.3.3.

5.3.

5.3.1.

5.3.2.

5.3.2.1.

5.3.2.2.

- 참고

5.3.3.

5.3.3.1.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc edit hyperconverged kubevirt-hyperconverged -n openshift-cnv

$ oc edit hyperconverged kubevirt-hyperconverged -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

oc get vmi <vmi_name> -o jsonpath='{.status.migrationState.targetNodeAddress}'$ oc get vmi <vmi_name> -o jsonpath='{.status.migrationState.targetNodeAddress}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3.3.2.

5.3.4.

5.3.4.1.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고oc create -f <name>-sriov-node-network.yaml

$ oc create -f <name>-sriov-node-network.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get sriovnetworknodestates -n openshift-sriov-network-operator <node_name> -o jsonpath='{.status.syncStatus}'$ oc get sriovnetworknodestates -n openshift-sriov-network-operator <node_name> -o jsonpath='{.status.syncStatus}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3.5.

5.4.

5.4.1.

5.4.1.1.

6장.

6.1.

6.1.1.

6.1.1.1.

6.1.1.2.

6.1.1.3.

6.1.1.4.

6.1.1.4.1.

6.1.2.

oc get csv -n openshift-cnv

$ oc get csv -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow VERSION REPLACES PHASE 4.9.0 kubevirt-hyperconverged-operator.v4.8.2 Installing 4.9.0 kubevirt-hyperconverged-operator.v4.9.0 Replacing

VERSION REPLACES PHASE 4.9.0 kubevirt-hyperconverged-operator.v4.8.2 Installing 4.9.0 kubevirt-hyperconverged-operator.v4.9.0 ReplacingCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get hyperconverged kubevirt-hyperconverged -n openshift-cnv \ -o=jsonpath='{range .status.conditions[*]}{.type}{"\t"}{.status}{"\t"}{.message}{"\n"}{end}'$ oc get hyperconverged kubevirt-hyperconverged -n openshift-cnv \ -o=jsonpath='{range .status.conditions[*]}{.type}{"\t"}{.status}{"\t"}{.message}{"\n"}{end}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow ReconcileComplete True Reconcile completed successfully Available True Reconcile completed successfully Progressing False Reconcile completed successfully Degraded False Reconcile completed successfully Upgradeable True Reconcile completed successfully

ReconcileComplete True Reconcile completed successfully Available True Reconcile completed successfully Progressing False Reconcile completed successfully Degraded False Reconcile completed successfully Upgradeable True Reconcile completed successfullyCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.1.3.

6.1.3.1.

- 참고

6.1.3.2.

oc get vmi -l kubevirt.io/outdatedLauncherImage --all-namespaces

$ oc get vmi -l kubevirt.io/outdatedLauncherImage --all-namespacesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.1.4.

6.1.4.1.

6.1.4.2.

oc get kv kubevirt-kubevirt-hyperconverged \ -n openshift-cnv -o jsonpath='{.spec.workloadUpdateStrategy.workloadUpdateMethods}'$ oc get kv kubevirt-kubevirt-hyperconverged \ -n openshift-cnv -o jsonpath='{.spec.workloadUpdateStrategy.workloadUpdateMethods}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc patch hyperconverged kubevirt-hyperconverged -n openshift-cnv \ --type json -p '[{"op":"replace","path":"/spec/workloadUpdateStrategy/workloadUpdateMethods", "value":[]}]'$ oc patch hyperconverged kubevirt-hyperconverged -n openshift-cnv \ --type json -p '[{"op":"replace","path":"/spec/workloadUpdateStrategy/workloadUpdateMethods", "value":[]}]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow hyperconverged.hco.kubevirt.io/kubevirt-hyperconverged patched

hyperconverged.hco.kubevirt.io/kubevirt-hyperconverged patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get hyperconverged kubevirt-hyperconverged -n openshift-cnv -o json | jq ".status.conditions"

$ oc get hyperconverged kubevirt-hyperconverged -n openshift-cnv -o json | jq ".status.conditions"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예 6.1.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc adm upgrade

$ oc adm upgradeCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get clusterversion

$ oc get clusterversionCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고

oc get csv -n openshift-cnv

$ oc get csv -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get hyperconverged kubevirt-hyperconverged -n openshift-cnv -o json | jq ".status.versions"

$ oc get hyperconverged kubevirt-hyperconverged -n openshift-cnv -o json | jq ".status.versions"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc get hyperconverged kubevirt-hyperconverged -n openshift-cnv -o json | jq ".status.conditions"

$ oc get hyperconverged kubevirt-hyperconverged -n openshift-cnv -o json | jq ".status.conditions"Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc get clusterversion

$ oc get clusterversionCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get csv -n openshift-cnv

$ oc get csv -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc patch hyperconverged kubevirt-hyperconverged -n openshift-cnv --type json -p \ "[{\"op\":\"add\",\"path\":\"/spec/workloadUpdateStrategy/workloadUpdateMethods\", \"value\":{WorkloadUpdateMethodConfig}}]"$ oc patch hyperconverged kubevirt-hyperconverged -n openshift-cnv --type json -p \ "[{\"op\":\"add\",\"path\":\"/spec/workloadUpdateStrategy/workloadUpdateMethods\", \"value\":{WorkloadUpdateMethodConfig}}]"Copy to Clipboard Copied! Toggle word wrap Toggle overflow hyperconverged.hco.kubevirt.io/kubevirt-hyperconverged patched

hyperconverged.hco.kubevirt.io/kubevirt-hyperconverged patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get vmim -A

$ oc get vmim -ACopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.1.5.

6.1.5.1.

6.1.5.2.

6.1.5.3.

7장.

7.1.

7.1.1.

7.1.1.1.

7.1.1.1.1.

7.1.1.1.2.

7.1.1.2.

7.1.2.

7.1.2.1.

7.1.2.1.1.

virtctl create instancetype --cpu 2 --memory 256Mi

$ virtctl create instancetype --cpu 2 --memory 256Mi

virtctl create instancetype --cpu 2 --memory 256Mi | oc apply -f -

$ virtctl create instancetype --cpu 2 --memory 256Mi | oc apply -f -7.1.2.1.2.

7.1.2.2.

|

|

| |

| |

|

|

| |

| |

|

|

| |

| |

|

|

| |

| |

|

|

| |

| |

|

|

| |

| |

7.1.2.3.

7.1.2.4.

- 참고

7.1.3.

7.1.3.1.

7.1.3.2.

7.1.3.2.1.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

참고

|

|

|

|

7.1.3.2.2.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| |

|

|

|

|

|

|

참고

|

7.1.3.2.3.

7.1.3.2.4.

7.1.4.

7.1.4.1.

7.1.4.2.

- 참고

Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc create -f <vm_manifest_file>.yaml

$ oc create -f <vm_manifest_file>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow virtctl start <vm_name> -n <namespace>

$ virtctl start <vm_name> -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.

7.2.1.

7.2.2.

7.2.2.1.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow podman build -t <registry>/<container_disk_name>:latest .

$ podman build -t <registry>/<container_disk_name>:latest .Copy to Clipboard Copied! Toggle word wrap Toggle overflow podman push <registry>/<container_disk_name>:latest

$ podman push <registry>/<container_disk_name>:latestCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.2.2.

oc edit hyperconverged kubevirt-hyperconverged -n openshift-cnv

$ oc edit hyperconverged kubevirt-hyperconverged -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.2.3.

7.2.2.4.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc apply -f data-source-secret.yaml

$ oc apply -f data-source-secret.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc create configmap tls-certs --from-file=</path/to/file/ca.pem>

$ oc create configmap tls-certs1 --from-file=</path/to/file/ca.pem>2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc create -f vm-fedora-datavolume.yaml

$ oc create -f vm-fedora-datavolume.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc describe dv fedora-dv

$ oc describe dv fedora-dv1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow virtctl console vm-fedora-datavolume

$ virtctl console vm-fedora-datavolumeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.3.

7.2.3.1.

7.2.3.2.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc apply -f data-source-secret.yaml

$ oc apply -f data-source-secret.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc create configmap tls-certs --from-file=</path/to/file/ca.pem>

$ oc create configmap tls-certs1 --from-file=</path/to/file/ca.pem>2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc create -f vm-fedora-datavolume.yaml

$ oc create -f vm-fedora-datavolume.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc describe dv fedora-dv

$ oc describe dv fedora-dv1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow virtctl console vm-fedora-datavolume

$ virtctl console vm-fedora-datavolumeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.4.

7.2.4.1.

7.2.4.2.

7.2.4.2.1.

%WINDIR%\System32\Sysprep\sysprep.exe /generalize /shutdown /oobe /mode:vm

%WINDIR%\System32\Sysprep\sysprep.exe /generalize /shutdown /oobe /mode:vmCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.4.2.2.

7.2.4.3.

virtctl image-upload dv <datavolume_name> \ --size=<datavolume_size> \ --image-path=</path/to/image> \

$ virtctl image-upload dv <datavolume_name> \1 --size=<datavolume_size> \2 --image-path=</path/to/image> \3 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고oc get dvs

$ oc get dvsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.5.

7.2.5.1.

7.2.5.1.1.

yum install -y qemu-guest-agent

$ yum install -y qemu-guest-agentCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl enable --now qemu-guest-agent

$ systemctl enable --now qemu-guest-agentCopy to Clipboard Copied! Toggle word wrap Toggle overflow

oc get vm <vm_name>

$ oc get vm <vm_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.5.1.2.

net start

$ net startCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.5.2.

|

|

|

|

|

|

|

|

|

|

|

|

7.2.5.2.1.

7.2.5.2.2.

7.2.5.2.3.

7.2.5.2.4.

7.2.5.2.5.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow virtctl start <vm> -n <namespace>

$ virtctl start <vm> -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc apply -f <vm.yaml>

$ oc apply -f <vm.yaml>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.5.3.

7.2.5.3.1.

7.2.6.

7.2.6.1.

7.2.6.2.

7.2.7.

7.2.7.1.

7.2.7.1.1.

7.2.7.1.2.

7.2.7.1.3.

NAMESPACE LAST SEEN TYPE REASON OBJECT MESSAGE test-ns 0s Warning IncompatibleVolumeModes persistentvolumeclaim/test-target The volume modes of source and target are incompatible

NAMESPACE LAST SEEN TYPE REASON OBJECT MESSAGE

test-ns 0s Warning IncompatibleVolumeModes persistentvolumeclaim/test-target The volume modes of source and target are incompatible7.2.7.2.

7.2.7.3.

7.2.7.3.1.

spec:

source:

snapshot:

namespace: golden-ns

name: golden-volumesnapshot

spec:

source:

snapshot:

namespace: golden-ns

name: golden-volumesnapshot7.2.7.3.2.

kind: VolumeSnapshotClass apiVersion: snapshot.storage.k8s.io/v1 driver: openshift-storage.rbd.csi.ceph.com # ...

kind: VolumeSnapshotClass apiVersion: snapshot.storage.k8s.io/v1 driver: openshift-storage.rbd.csi.ceph.com # ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow kind: StorageClass apiVersion: storage.k8s.io/v1 # ... provisioner: openshift-storage.rbd.csi.ceph.com

kind: StorageClass apiVersion: storage.k8s.io/v1 # ... provisioner: openshift-storage.rbd.csi.ceph.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.7.3.3.

7.3.

7.3.1.

7.3.1.1.

7.3.1.2.

virtctl vnc <vm_name>

$ virtctl vnc <vm_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow virtctl vnc <vm_name> -v 4

$ virtctl vnc <vm_name> -v 4Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3.1.3.

oc patch hyperconverged kubevirt-hyperconverged -n openshift-cnv --type json -p '[{"op": "replace", "path": "/spec/featureGates/deployVmConsoleProxy", "value": true}]'$ oc patch hyperconverged kubevirt-hyperconverged -n openshift-cnv --type json -p '[{"op": "replace", "path": "/spec/featureGates/deployVmConsoleProxy", "value": true}]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow curl --header "Authorization: Bearer ${TOKEN}" \ "https://api.<cluster_fqdn>/apis/token.kubevirt.io/v1alpha1/namespaces/<namespace>/virtualmachines/<vm_name>/vnc?duration=<duration>"$ curl --header "Authorization: Bearer ${TOKEN}" \ "https://api.<cluster_fqdn>/apis/token.kubevirt.io/v1alpha1/namespaces/<namespace>/virtualmachines/<vm_name>/vnc?duration=<duration>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow { "token": "eyJhb..." }{ "token": "eyJhb..." }Copy to Clipboard Copied! Toggle word wrap Toggle overflow export VNC_TOKEN="<token>"

$ export VNC_TOKEN="<token>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

oc login --token ${VNC_TOKEN}$ oc login --token ${VNC_TOKEN}Copy to Clipboard Copied! Toggle word wrap Toggle overflow virtctl vnc <vm_name> -n <namespace>

$ virtctl vnc <vm_name> -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

virtctl delete serviceaccount --namespace "<namespace>" "<vm_name>-vnc-access"

$ virtctl delete serviceaccount --namespace "<namespace>" "<vm_name>-vnc-access"7.3.2.

7.3.2.1.

7.3.2.2.

virtctl console <vm_name>

$ virtctl console <vm_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow virtctl vnc <vm_name>

$ virtctl vnc <vm_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow virtctl vnc <vm_name> -v 4

$ virtctl vnc <vm_name> -v 4Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3.3.

7.3.3.1.

7.4.

7.4.1.

7.4.2.

7.4.2.1.

7.4.2.2.

7.4.2.2.1.

7.4.2.2.2.

- 참고

7.4.2.2.3.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc create -f <manifest_file>.yaml

$ oc create -f <manifest_file>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow virtctl start vm example-vm -n example-namespace

$ virtctl start vm example-vm -n example-namespaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

oc describe vm example-vm -n example-namespace

$ oc describe vm example-vm -n example-namespaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4.2.3.

7.4.2.3.1.

7.4.2.3.2.

- 참고

7.4.2.3.3.

7.4.2.3.4.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc create -f <manifest_file>.yaml

$ oc create -f <manifest_file>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow virtctl start vm example-vm -n example-namespace

$ virtctl start vm example-vm -n example-namespaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

oc describe vm example-vm -n example-namespace

$ oc describe vm example-vm -n example-namespaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4.2.4.

virtctl -n <namespace> ssh <username>@example-vm -i <ssh_key>

$ virtctl -n <namespace> ssh <username>@example-vm -i <ssh_key>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow virtctl -n my-namespace ssh cloud-user@example-vm -i my-key

$ virtctl -n my-namespace ssh cloud-user@example-vm -i my-keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4.3.

Host vm/* ProxyCommand virtctl port-forward --stdio=true %h %p

Host vm/* ProxyCommand virtctl port-forward --stdio=true %h %pCopy to Clipboard Copied! Toggle word wrap Toggle overflow ssh <user>@vm/<vm_name>.<namespace>

$ ssh <user>@vm/<vm_name>.<namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4.4.

7.4.4.1.

7.4.4.2.

7.4.4.2.1.

7.4.4.2.2.

7.4.4.2.3.

virtctl expose vm <vm_name> --name <service_name> --type <service_type> --port <port>

$ virtctl expose vm <vm_name> --name <service_name> --type <service_type> --port <port>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow virtctl expose vm example-vm --name example-service --type NodePort --port 22

$ virtctl expose vm example-vm --name example-service --type NodePort --port 22Copy to Clipboard Copied! Toggle word wrap Toggle overflow

oc get service

$ oc get serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4.4.2.4.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc create -f example-service.yaml

$ oc create -f example-service.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

oc get service -n example-namespace

$ oc get service -n example-namespaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4.4.3.

ssh <user_name>@<ip_address> -p <port>

$ ssh <user_name>@<ip_address> -p <port>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.4.5.

7.4.5.1.

7.4.5.2.

oc describe vm <vm_name> -n <namespace>

$ oc describe vm <vm_name> -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow ssh <user_name>@<ip_address> -i <ssh_key>

$ ssh <user_name>@<ip_address> -i <ssh_key>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ssh cloud-user@10.244.0.37 -i ~/.ssh/id_rsa_cloud-user

$ ssh cloud-user@10.244.0.37 -i ~/.ssh/id_rsa_cloud-userCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.5.

7.5.1.

oc edit vm <vm_name>

$ oc edit vm <vm_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc apply vm <vm_name> -n <namespace>

$ oc apply vm <vm_name> -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.5.2.

7.5.2.1.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| |

|

|

|

|

|

|

참고

|

7.5.3.

7.6.

7.6.1.

7.6.2.

7.6.3.

7.6.4.

7.7.

7.7.1.

7.7.2.

oc delete vm <vm_name>

$ oc delete vm <vm_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고

7.8.

7.8.1.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc create -f example-export.yaml

$ oc create -f example-export.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get vmexport example-export -o yaml

$ oc get vmexport example-export -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8.2.

- 참고

oc get vmexport <export_name> -o jsonpath={.status.links.external.cert} > cacert.crt$ oc get vmexport <export_name> -o jsonpath={.status.links.external.cert} > cacert.crt1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow

oc get secret export-token-<export_name> -o jsonpath={.data.token} | base64 --decode > token_decode$ oc get secret export-token-<export_name> -o jsonpath={.data.token} | base64 --decode > token_decode1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc get vmexport <export_name> -o yaml

$ oc get vmexport <export_name> -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow curl --cacert cacert.crt <secret_manifest_url> -H \ "x-kubevirt-export-token:token_decode" -H \ "Accept:application/yaml"

$ curl --cacert cacert.crt <secret_manifest_url> -H \1 "x-kubevirt-export-token:token_decode" -H \2 "Accept:application/yaml"Copy to Clipboard Copied! Toggle word wrap Toggle overflow curl --cacert cacert.crt https://vmexport-proxy.test.net/api/export.kubevirt.io/v1alpha1/namespaces/example/virtualmachineexports/example-export/external/manifests/secret -H "x-kubevirt-export-token:token_decode" -H "Accept:application/yaml"

$ curl --cacert cacert.crt https://vmexport-proxy.test.net/api/export.kubevirt.io/v1alpha1/namespaces/example/virtualmachineexports/example-export/external/manifests/secret -H "x-kubevirt-export-token:token_decode" -H "Accept:application/yaml"Copy to Clipboard Copied! Toggle word wrap Toggle overflow curl --cacert cacert.crt <all_manifest_url> -H \ "x-kubevirt-export-token:token_decode" -H \ "Accept:application/yaml"

$ curl --cacert cacert.crt <all_manifest_url> -H \1 "x-kubevirt-export-token:token_decode" -H \2 "Accept:application/yaml"Copy to Clipboard Copied! Toggle word wrap Toggle overflow curl --cacert cacert.crt https://vmexport-proxy.test.net/api/export.kubevirt.io/v1alpha1/namespaces/example/virtualmachineexports/example-export/external/manifests/all -H "x-kubevirt-export-token:token_decode" -H "Accept:application/yaml"

$ curl --cacert cacert.crt https://vmexport-proxy.test.net/api/export.kubevirt.io/v1alpha1/namespaces/example/virtualmachineexports/example-export/external/manifests/all -H "x-kubevirt-export-token:token_decode" -H "Accept:application/yaml"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.9.

7.9.1.

7.9.2.

oc get vmis -A

$ oc get vmis -ACopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.9.3.

7.9.4.

7.9.5.

oc delete vmi <vmi_name>

$ oc delete vmi <vmi_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.9.6.

7.10.

7.10.1.

7.10.2.

7.10.3.

7.10.4.

7.10.5.

7.11.

7.11.1.

7.11.2.

7.12.

7.12.1.

7.12.2.

7.12.3.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

7.12.4.

7.12.4.1.