Ingress 및 로드 밸런싱

OpenShift Container Platform에서 서비스 노출 및 외부 트래픽 관리

초록

1장. 라우트

1.1. 기본 경로 생성

암호화되지 않은 HTTP가 있는 경우 경로 오브젝트를 사용하여 기본 경로를 만들 수 있습니다.

1.1.1. HTTP 기반 경로 생성

다음 절차에 따라 hello-openshift 애플리케이션을 예제로 사용하여 웹 애플리케이션에 대한 간단한 HTTP 기반 경로를 생성할 수 있습니다.

공용 URL에서 애플리케이션을 호스팅할 경로를 생성할 수 있습니다. 경로는 애플리케이션의 네트워크 보안 구성에 따라 보안 또는 비보안일 수 있습니다. HTTP 기반 경로는 기본 HTTP 라우팅 프로토콜을 사용하고 안전하지 않은 애플리케이션 포트에 서비스를 노출하는 비보안 경로입니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. - 관리자로 로그인했습니다.

- 포트에서 트래픽을 수신하는 포트와 TCP 끝점을 노출하는 웹 애플리케이션이 있습니다.

프로세스

다음 명령을 실행하여

hello-openshift라는 프로젝트를 생성합니다.oc new-project hello-openshift

$ oc new-project hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 프로젝트에 Pod를 생성합니다.

oc create -f https://raw.githubusercontent.com/openshift/origin/master/examples/hello-openshift/hello-pod.json

$ oc create -f https://raw.githubusercontent.com/openshift/origin/master/examples/hello-openshift/hello-pod.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

hello-openshift라는 서비스를 생성합니다.oc expose pod/hello-openshift

$ oc expose pod/hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

hello-openshift애플리케이션에 대한 비보안 경로를 생성합니다.oc expose svc hello-openshift

$ oc expose svc hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

생성한

경로리소스가 있는지 확인하려면 다음 명령을 실행합니다.oc get routes -o yaml hello-openshift

$ oc get routes -o yaml hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow 생성된 비보안 경로에 대한 YAML 정의의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

host-

서비스를 가리키는 별칭 DNS 레코드를 지정합니다. 이 필드는 유효한 DNS 이름(예:

www.example.com)일 수 있습니다. DNS 이름은 DNS952 하위 도메인 규칙을 따라야 합니다. 지정하지 않으면 경로 이름이 자동으로 생성됩니다. targetPort이 경로가 가리키는 서비스에서 선택한 Pod의 대상 포트를 지정합니다.

참고기본 수신 도메인을 표시하려면 다음 명령을 실행합니다.

oc get ingresses.config/cluster -o jsonpath={.spec.domain}$ oc get ingresses.config/cluster -o jsonpath={.spec.domain}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.1.2. 경로 기반 라우터

경로 기반 라우터는 URL과 비교할 수 있는 경로 구성 요소를 지정하며 이를 위해 라우트의 트래픽이 HTTP 기반이어야 합니다. 따라서 동일한 호스트 이름을 사용하여 여러 경로를 제공할 수 있으며 각각 다른 경로가 있습니다. 라우터는 가장 구체적인 경로를 기반으로 하는 라우터와 일치해야 합니다.

다음 표에서는 경로 및 액세스 가능성을 보여줍니다.

| 경로 | 비교 대상 | 액세스 가능 |

|---|---|---|

| www.example.com/test | www.example.com/test | 제공됨 |

| www.example.com | 없음 | |

| www.example.com/test 및 www.example.com | www.example.com/test | 제공됨 |

| www.example.com | 제공됨 | |

| www.example.com | www.example.com/text | 예 (경로가 아닌 호스트에 의해 결정됨) |

| www.example.com | 제공됨 |

경로가 있는 보안되지 않은 라우터

- 1

- 경로는 경로 기반 라우터에 대해 추가된 유일한 속성입니다.

라우터가 해당 경우 TLS를 종료하지 않고 요청 콘텐츠를 읽을 수 없기 때문에 패스스루 TLS를 사용할 때 경로 기반 라우팅을 사용할 수 없습니다.

1.1.3. Ingress 컨트롤러 샤딩의 경로 생성

경로를 사용하면 URL에서 애플리케이션을 호스팅할 수 있습니다. Ingress 컨트롤러 분할은 들어오는 트래픽 부하를 일련의 Ingress 컨트롤러 간에 균형을 유지하는 데 도움이 됩니다. 특정 Ingress 컨트롤러로 트래픽을 분리할 수도 있습니다. 예를 들어, 회사 A는 하나의 Ingress 컨트롤러로, 회사 B는 다른 Ingress 컨트롤러로 이동합니다.

다음 절차에서는 hello-openshift 애플리케이션을 예로 사용하여 Ingress 컨트롤러 샤딩에 대한 경로를 생성하는 방법을 설명합니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. - 프로젝트 관리자로 로그인했습니다.

- 포트에서 트래픽을 수신하는 포트와 HTTP 또는 TLS 끝점을 노출하는 웹 애플리케이션이 있습니다.

- 분할을 위해 Ingress 컨트롤러를 구성했습니다.

프로세스

다음 명령을 실행하여

hello-openshift라는 프로젝트를 생성합니다.oc new-project hello-openshift

$ oc new-project hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 프로젝트에 Pod를 생성합니다.

oc create -f https://raw.githubusercontent.com/openshift/origin/master/examples/hello-openshift/hello-pod.json

$ oc create -f https://raw.githubusercontent.com/openshift/origin/master/examples/hello-openshift/hello-pod.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

hello-openshift라는 서비스를 생성합니다.oc expose pod/hello-openshift

$ oc expose pod/hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow hello-openshift-route.yaml이라는 경로 정의를 생성합니다.샤딩을 위해 생성된 경로의 YAML 정의

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

hello-openshift-route.yaml을 사용하여hello-openshift애플리케이션에 대한 경로를 생성합니다.oc -n hello-openshift create -f hello-openshift-route.yaml

$ oc -n hello-openshift create -f hello-openshift-route.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

다음 명령을 사용하여 경로 상태를 가져옵니다.

oc -n hello-openshift get routes/hello-openshift-edge -o yaml

$ oc -n hello-openshift get routes/hello-openshift-edge -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 생성된

Route리소스는 다음과 유사해야 합니다.출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Ingress 컨트롤러 또는 라우터의 호스트 이름은 을 사용하여 경로를 노출합니다.

host필드의 값은 Ingress 컨트롤러에서 자동으로 결정하고 해당 도메인을 사용합니다. 이 예에서 Ingress 컨트롤러의 도메인은 <apps-sharded.basedomain.example.net>입니다. - 2

- Ingress 컨트롤러의 호스트 이름입니다. 호스트 이름이 설정되지 않은 경우 경로는 하위 도메인을 대신 사용할 수 있습니다. 하위 도메인을 지정하면 경로를 노출하는 Ingress 컨트롤러의 도메인을 자동으로 사용합니다. 여러 Ingress 컨트롤러에서 경로를 노출하면 경로가 여러 URL에서 호스팅됩니다.

- 3

- Ingress 컨트롤러의 이름입니다. 이 예에서 Ingress 컨트롤러에는

shard된이름이 있습니다.

1.1.4. Ingress 오브젝트를 통해 경로 생성

일부 에코시스템 구성 요소는 Ingress 리소스와 통합되지만 경로 리소스와는 통합되지 않습니다. 이러한 경우를 처리하기 위해 OpenShift Container Platform에서는 Ingress 오브젝트가 생성될 때 관리형 경로 오브젝트를 자동으로 생성합니다. 이러한 경로 오브젝트는 해당 Ingress 오브젝트가 삭제될 때 삭제됩니다.

프로세스

OpenShift Container Platform 콘솔에서 또는

oc create명령을 입력하여 Ingress 오브젝트를 정의합니다.Ingress의 YAML 정의

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

Ingress에는Route에 대한 필드가 없으므로route.openshift.io/termination주석을 사용하여spec.tls.termination필드를 구성할 수 있습니다. 허용되는 값은edge,passthrough,reencrypt입니다. 다른 모든 값은 자동으로 무시됩니다. 주석 값이 설정되지 않으면edge가 기본 경로입니다. 기본 엣지 경로를 구현하려면 TLS 인증서 세부 정보를 템플릿 파일에 정의해야 합니다.- 3

Ingress오브젝트로 작업할 때는 경로를 사용할 때와 달리 명시적 호스트 이름을 지정해야 합니다. <host_name>.<cluster_ingress_domain> 구문(예:apps.openshiftdemos.com)을 사용하여*.<cluster_ingress_domain> 와일드카드 DNS 레코드 및 클러스터에 대한 인증서를 제공할 수 있습니다. 그렇지 않으면 선택한 호스트 이름에 대한 DNS 레코드가 있는지 확인해야 합니다.route.openshift.io/termination주석에passthrough값을 지정하는 경우path를''로 설정하고 spec에서pathType을ImplementationSpecific으로 설정합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc apply -f ingress.yaml

$ oc apply -f ingress.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- 2

- Ingress 오브젝트에서

route.openshift.io/destination-ca-certificate-secret을 사용하여 사용자 정의 대상 인증서(CA)로 경로를 정의할 수 있습니다. 이 주석은 생성된 경로에 삽입될 kubernetes 시크릿 secretsecret-ca-cert를 참조합니다.-

Ingress 오브젝트에서 대상 CA를 사용하여 경로 오브젝트를 지정하려면 시크릿의

data.tls.crt지정자에 PEM 인코딩 형식으로 인증서를 사용하여kubernetes.io/tls또는Opaque유형 시크릿을 생성해야 합니다.

-

Ingress 오브젝트에서 대상 CA를 사용하여 경로 오브젝트를 지정하려면 시크릿의

노드를 나열합니다.

oc get routes

$ oc get routesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 결과에는 이름이

frontend-로 시작하는 자동 생성 경로가 포함됩니다.NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD frontend-gnztq www.example.com frontend 443 reencrypt/Redirect None

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD frontend-gnztq www.example.com frontend 443 reencrypt/Redirect NoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 경로를 살펴보면 다음과 같습니다.

자동 생성 경로의 YAML 정의

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.2. 경로 보안

HSTS(HTTP Strict Transport Security)로 경로를 보호할 수 있습니다.

1.2.1. HSTS(HTTP Strict Transport Security)

HSTS(HTTP Strict Transport Security) 정책은 라우트 호스트에서 HTTPS 트래픽만 허용됨을 브라우저 클라이언트에 알리는 보안 강화 정책입니다. 또한 HSTS는 HTTP 리디렉션을 사용하지 않고 HTTPS 전송 신호를 통해 웹 트래픽을 최적화합니다. HSTS는 웹사이트와의 상호 작용을 가속화하는 데 유용합니다.

HSTS 정책이 적용되면 HSTS는 사이트의 HTTP 및 HTTPS 응답에 Strict Transport Security 헤더를 추가합니다. 경로에서 insecureEdgeTerminationPolicy 값을 사용하여 HTTP를 HTTPS로 리디렉션할 수 있습니다. HSTS를 적용하면 클라이언트는 요청을 전송하기 전에 HTTP URL의 모든 요청을 HTTPS로 변경하여 리디렉션이 필요하지 않습니다.

클러스터 관리자는 다음을 수행하도록 HSTS를 구성할 수 있습니다.

- 경로당 HSTS 활성화

- 라우팅당 HSTS 비활성화

- 도메인당 HSTS 시행, 도메인 집합 또는 도메인과 함께 네임스페이스 라벨 사용

HSTS는 보안 경로(엣지 종료 또는 재암호화)에서만 작동합니다. HTTP 또는 패스스루(passthrough) 경로에서는 구성이 유효하지 않습니다.

1.2.1.1. 라우팅당 HSTS(HTTP Strict Transport Security) 활성화

HSTS(HTTP Strict Transport Security)는 HAProxy 템플릿에 구현되고 haproxy.router.openshift.io/hsts_header 주석이 있는 에지 및 재암호화 경로에 적용됩니다.

사전 요구 사항

- 프로젝트에 대한 관리자 권한이 있는 사용자로 클러스터에 로그인했습니다.

-

OpenShift CLI(

oc)를 설치합니다.

프로세스

경로에서 HSTS를 활성화하려면

haproxy.router.openshift.io/hsts_header값을 에지 종료 또는 재암호화 경로에 추가합니다.oc annotatetool을 사용하여 다음 명령을 실행하여 이 작업을 수행할 수 있습니다.oc annotate route <route_name> -n <namespace> --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=31536000;\ includeSubDomains;preload"

$ oc annotate route <route_name> -n <namespace> --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=31536000;\1 includeSubDomains;preload"Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 이 예에서 최대 나이는

31536000ms로 설정되며 이는 약 8.5시간입니다.

참고이 예에서 등호(

=)는 따옴표로 되어 있습니다. 이 작업은 annotate 명령을 올바르게 실행하는 데 필요합니다.주석으로 구성된 경로 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 필수 항목입니다.

Max-age는 HSTS 정책이 적용되는 시간(초)을 측정합니다.0으로 설정하면 정책이 무효화됩니다. - 2

- 선택 사항: 포함되는 경우

includeSubDomains는 호스트의 모든 하위 도메인에 호스트와 동일한 HSTS 정책이 있어야 함을 알려줍니다. - 3

- 선택 사항:

max-age가 0보다 크면haproxy.router.openshift.io/hsts_header에preload를 추가하여 외부 서비스에서 이 사이트를 HSTS 사전 로드 목록에 포함할 수 있습니다. 예를 들어 Google과 같은 사이트는preload가 설정된 사이트 목록을 구성할 수 있습니다. 그런 다음 브라우저는 이 목록을 사용하여 사이트와 상호 작용하기 전에 HTTPS를 통해 통신할 수 있는 사이트를 결정할 수 있습니다.preload를 설정하지 않으면 브라우저가 HTTPS를 통해 사이트와 상호 작용하여 헤더를 가져와야 합니다.

1.2.1.2. 라우팅당 HSTS(HTTP Strict Transport Security) 비활성화

경로당 HSTS(HTTP Strict Transport Security)를 비활성화하려면 경로 주석에서 max-age 값을 0으로 설정할 수 있습니다.

사전 요구 사항

- 프로젝트에 대한 관리자 권한이 있는 사용자로 클러스터에 로그인했습니다.

-

OpenShift CLI(

oc)를 설치합니다.

프로세스

HSTS를 비활성화하려면 다음 명령을 입력하여 경로 주석의

max-age값을0으로 설정합니다.oc annotate route <route_name> -n <namespace> --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=0"

$ oc annotate route <route_name> -n <namespace> --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=0"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 작은 정보다음 YAML을 적용하여 구성 맵을 만들 수 있습니다.

경로당 HSTS 비활성화 예

metadata: annotations: haproxy.router.openshift.io/hsts_header: max-age=0metadata: annotations: haproxy.router.openshift.io/hsts_header: max-age=0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 네임스페이스의 모든 경로에 대해 HSTS를 비활성화하려면 다음 명령을 입력합니다.

oc annotate route --all -n <namespace> --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=0"

$ oc annotate route --all -n <namespace> --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=0"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

모든 경로에 대한 주석을 쿼리하려면 다음 명령을 입력합니다.

oc get route --all-namespaces -o go-template='{{range .items}}{{if .metadata.annotations}}{{$a := index .metadata.annotations "haproxy.router.openshift.io/hsts_header"}}{{$n := .metadata.name}}{{with $a}}Name: {{$n}} HSTS: {{$a}}{{"\n"}}{{else}}{{""}}{{end}}{{end}}{{end}}'$ oc get route --all-namespaces -o go-template='{{range .items}}{{if .metadata.annotations}}{{$a := index .metadata.annotations "haproxy.router.openshift.io/hsts_header"}}{{$n := .metadata.name}}{{with $a}}Name: {{$n}} HSTS: {{$a}}{{"\n"}}{{else}}{{""}}{{end}}{{end}}{{end}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Name: routename HSTS: max-age=0

Name: routename HSTS: max-age=0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.2.1.3. 도메인별 HSTS(HTTP Strict Transport Security) 적용

도메인당 HSTS(HTTP Strict Transport Security)를 적용하여 보안 경로에 requiredHSTSPolicies 레코드를 Ingress 사양에 추가하여 HSTS 정책 구성을 캡처합니다.

HSTS를 적용하도록 requiredHSTSPolicy를 구성하는 경우 규정 준수 HSTS 정책 주석을 사용하여 새로 생성된 경로를 구성해야 합니다.

준수하지 않는 HSTS 경로를 사용하여 업그레이드된 클러스터를 처리하려면 소스에서 매니페스트를 업데이트하고 업데이트를 적용할 수 있습니다.

oc expose route 또는 oc create route 명령을 사용하여 이러한 명령의 API에서 주석을 수락하지 않기 때문에 HSTS를 적용하는 도메인에 경로를 추가할 수 없습니다.

HSTS는 전역적으로 모든 경로에 HSTS를 요청하더라도 비보안 또는 비 TLS 경로에 적용할 수 없습니다.

사전 요구 사항

- 프로젝트에 대한 관리자 권한이 있는 사용자로 클러스터에 로그인했습니다.

-

OpenShift CLI(

oc)를 설치합니다.

프로세스

필요에 따라 다음 명령을 실행하고 필드를 업데이트하여 Ingress 구성 YAML을 편집합니다.

oc edit ingresses.config.openshift.io/cluster

$ oc edit ingresses.config.openshift.io/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow HSTS 정책 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 필수 항목입니다.

requiredHSTSPolicies는 순서대로 검증되고 일치하는 첫 번째domainPatterns가 적용됩니다. - 2

- 필수 항목입니다. 하나 이상의

domainPatterns호스트 이름을 지정해야 합니다. 도메인 수를 나열할 수 있습니다. 다른domainPatterns에 대한 적용 옵션의 여러 섹션을 포함할 수 있습니다. - 3

- 선택 사항:

namespaceSelector를 포함하는 경우 경로가 있는 프로젝트의 레이블과 일치하여 경로에 설정된 HSTS 정책을 적용해야 합니다.namespaceSelector만 일치하고domainPatterns와 일치하지 않는 경로는 검증되지 않습니다. - 4

- 필수 항목입니다.

Max-age는 HSTS 정책이 적용되는 시간(초)을 측정합니다. 이 정책 설정을 사용하면 최소 및 최대max-age를 적용할 수 있습니다.-

largestMaxAge값은0에서2147483647사이여야 합니다. 지정되지 않은 상태로 둘 수 있습니다. 즉, 상한이 적용되지 않습니다. -

smallestMaxAge값은0에서2147483647사이여야 합니다. 문제 해결을 위해 HSTS를 비활성화하려면0을 입력합니다. HSTS를 비활성화하지 않으려면1을 입력합니다. 지정되지 않은 상태로 둘 수 있습니다. 즉, 더 낮은 제한이 적용되지 않습니다.

-

- 5

- 선택 사항:

haproxy.router.openshift.io/hsts_header에preload를 포함하면 외부 서비스에서 이 사이트를 HSTS 사전 로드 목록에 포함할 수 있습니다. 그런 다음 브라우저는 이 목록을 사용하여 사이트와 상호 작용하기 전에 HTTPS를 통해 통신할 수 있는 사이트를 결정할 수 있습니다.preload를 설정하지 않으면 브라우저가 헤더를 얻기 위해 사이트와 한 번 이상 상호 작용해야 합니다. 다음 중 하나로preload를 설정할 수 있습니다.-

RequirePreload:RequiredHSTSPolicy에preload가 필요합니다. -

RequireNoPreload:RequiredHSTSPolicy에서preload를 금지합니다. -

NoOpinion:preload는RequiredHSTSPolicy에 중요하지 않습니다.

-

- 6

- 선택 사항:

includeSubDomainsPolicy는 다음 중 하나를 사용하여 설정할 수 있습니다.-

RequireIncludeSubDomains:includeSubDomains는RequiredHSTSPolicy에 필요합니다. -

RequireNoIncludeSubDomains:includeSubDomains는RequiredHSTSPolicy에서 금지합니다. -

NoOpinion:includeSubDomains는RequiredHSTSPolicy와 관련이 없습니다.

-

oc annotate command를 입력하여 클러스터 또는 특정 네임스페이스에 HSTS를 적용할 수 있습니다.클러스터의 모든 경로에 HSTS를 적용하려면

oc annotate command를 입력합니다. 예를 들면 다음과 같습니다.oc annotate route --all --all-namespaces --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=31536000"

$ oc annotate route --all --all-namespaces --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=31536000"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 특정 네임스페이스의 모든 경로에 HSTS를 적용하려면

oc annotate command를 입력합니다. 예를 들면 다음과 같습니다.oc annotate route --all -n my-namespace --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=31536000"

$ oc annotate route --all -n my-namespace --overwrite=true "haproxy.router.openshift.io/hsts_header"="max-age=31536000"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

구성한 HSTS 정책을 검토할 수 있습니다. 예를 들면 다음과 같습니다.

필요한 HSTS 정책에 대한

maxAge세트를 검토하려면 다음 명령을 입력합니다.oc get clusteroperator/ingress -n openshift-ingress-operator -o jsonpath='{range .spec.requiredHSTSPolicies[*]}{.spec.requiredHSTSPolicies.maxAgePolicy.largestMaxAge}{"\n"}{end}'$ oc get clusteroperator/ingress -n openshift-ingress-operator -o jsonpath='{range .spec.requiredHSTSPolicies[*]}{.spec.requiredHSTSPolicies.maxAgePolicy.largestMaxAge}{"\n"}{end}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 모든 경로에서 HSTS 주석을 검토하려면 다음 명령을 입력합니다.

oc get route --all-namespaces -o go-template='{{range .items}}{{if .metadata.annotations}}{{$a := index .metadata.annotations "haproxy.router.openshift.io/hsts_header"}}{{$n := .metadata.name}}{{with $a}}Name: {{$n}} HSTS: {{$a}}{{"\n"}}{{else}}{{""}}{{end}}{{end}}{{end}}'$ oc get route --all-namespaces -o go-template='{{range .items}}{{if .metadata.annotations}}{{$a := index .metadata.annotations "haproxy.router.openshift.io/hsts_header"}}{{$n := .metadata.name}}{{with $a}}Name: {{$n}} HSTS: {{$a}}{{"\n"}}{{else}}{{""}}{{end}}{{end}}{{end}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Name: <_routename_> HSTS: max-age=31536000;preload;includeSubDomains

Name: <_routename_> HSTS: max-age=31536000;preload;includeSubDomainsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.3. 경로 구성

주석, 헤더, 쿠키 등을 사용하여 경로 구성을 사용자 지정할 수 있습니다.

1.3.1. 경로 시간 초과 구성

SLA(Service Level Availability) 목적에 필요한 낮은 시간 초과 또는 백엔드가 느린 경우 높은 시간 초과가 필요한 서비스가 있는 경우 기존 경로에 대한 기본 시간 초과를 구성할 수 있습니다.

OpenShift Container Platform 클러스터 앞에 사용자 관리 외부 로드 밸런서를 구성한 경우 사용자 관리 외부 로드 밸런서의 시간 초과 값이 경로의 시간 초과 값보다 높습니다. 이 구성으로 인해 클러스터가 사용하는 네트워크를 통한 네트워크 정체 문제가 발생하지 않습니다.

사전 요구 사항

- 실행 중인 클러스터에 배포된 Ingress 컨트롤러가 필요합니다.

프로세스

oc annotate명령을 사용하여 경로에 시간 초과를 추가합니다.oc annotate route <route_name> \ --overwrite haproxy.router.openshift.io/timeout=<timeout><time_unit>$ oc annotate route <route_name> \ --overwrite haproxy.router.openshift.io/timeout=<timeout><time_unit>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 지원되는 시간 단위는 마이크로초(us), 밀리초(ms), 초(s), 분(m), 시간(h) 또는 일(d)입니다.

다음 예제는 이름이

myroute인 경로에서 2초의 시간 초과를 설정합니다.oc annotate route myroute --overwrite haproxy.router.openshift.io/timeout=2s

$ oc annotate route myroute --overwrite haproxy.router.openshift.io/timeout=2sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.3.2. HTTP 헤더 구성

OpenShift Container Platform은 HTTP 헤더를 사용하는 다양한 방법을 제공합니다. 헤더를 설정하거나 삭제할 때 Ingress 컨트롤러의 특정 필드를 사용하거나 개별 경로를 사용하여 요청 및 응답 헤더를 수정할 수 있습니다. 경로 주석을 사용하여 특정 헤더를 설정할 수도 있습니다. 헤더를 구성하는 다양한 방법은 함께 작업할 때 문제가 발생할 수 있습니다.

IngressController 또는 Route CR 내에서 헤더만 설정하거나 삭제할 수 있으므로 추가할 수 없습니다. HTTP 헤더가 값으로 설정된 경우 해당 값은 완료되어야 하며 나중에 추가할 필요가 없습니다. X-Forwarded-For 헤더와 같은 헤더를 추가하는 것이 적합한 경우 spec.httpHeaders.actions 대신 spec.httpHeaders.forwardedHeaderPolicy 필드를 사용합니다.

1.3.2.1. 우선순위 순서

Ingress 컨트롤러와 경로에서 동일한 HTTP 헤더를 수정하는 경우 HAProxy는 요청 또는 응답 헤더인지 여부에 따라 특정 방식으로 작업에 우선순위를 부여합니다.

- HTTP 응답 헤더의 경우 경로에 지정된 작업 후에 Ingress 컨트롤러에 지정된 작업이 실행됩니다. 즉, Ingress 컨트롤러에 지정된 작업이 우선합니다.

- HTTP 요청 헤더의 경우 경로에 지정된 작업은 Ingress 컨트롤러에 지정된 작업 후에 실행됩니다. 즉, 경로에 지정된 작업이 우선합니다.

예를 들어 클러스터 관리자는 다음 구성을 사용하여 Ingress 컨트롤러에서 값이 DENY 인 X-Frame-Options 응답 헤더를 설정합니다.

IngressController 사양 예

경로 소유자는 클러스터 관리자가 Ingress 컨트롤러에 설정한 것과 동일한 응답 헤더를 설정하지만 다음 구성을 사용하여 SAMEORIGIN 값이 사용됩니다.

Route 사양의 예

IngressController 사양과 Route 사양 모두에서 X-Frame-Options 응답 헤더를 구성하는 경우 특정 경로에서 프레임을 허용하는 경우에도 Ingress 컨트롤러의 글로벌 수준에서 이 헤더에 설정된 값이 우선합니다. 요청 헤더의 경우 Route spec 값은 IngressController 사양 값을 재정의합니다.

이 우선순위는 haproxy.config 파일에서 다음 논리를 사용하므로 Ingress 컨트롤러가 프런트 엔드로 간주되고 개별 경로가 백엔드로 간주되기 때문입니다. 프런트 엔드 구성에 적용된 헤더 값 DENY 는 백엔드에 설정된 SAMEORIGIN 값으로 동일한 헤더를 재정의합니다.

또한 Ingress 컨트롤러 또는 경로 주석을 사용하여 설정된 경로 덮어쓰기 값에 정의된 모든 작업입니다.

1.3.2.2. 특수 케이스 헤더

다음 헤더는 완전히 설정되거나 삭제되지 않거나 특정 상황에서 허용되지 않습니다.

| 헤더 이름 | IngressController 사양을 사용하여 구성 가능 | Route 사양을 사용하여 구성 가능 | 허용하지 않는 이유 | 다른 방법을 사용하여 구성 가능 |

|---|---|---|---|---|

|

| 없음 | 없음 |

| 없음 |

|

| 없음 | 제공됨 |

| 없음 |

|

| 없음 | 없음 |

|

제공됨: |

|

| 없음 | 없음 | HAProxy가 클라이언트 연결을 특정 백엔드 서버에 매핑하는 세션 추적에 사용되는 쿠키입니다. 이러한 헤더를 설정하도록 허용하면 HAProxy의 세션 선호도를 방해하고 HAProxy의 쿠키 소유권을 제한할 수 있습니다. | 예:

|

1.3.3. 경로에서 HTTP 요청 및 응답 헤더 설정 또는 삭제

규정 준수 목적 또는 기타 이유로 특정 HTTP 요청 및 응답 헤더를 설정하거나 삭제할 수 있습니다. Ingress 컨트롤러에서 제공하는 모든 경로 또는 특정 경로에 대해 이러한 헤더를 설정하거나 삭제할 수 있습니다.

예를 들어 경로를 제공하는 Ingress 컨트롤러에서 지정하는 기본 글로벌 위치가 있더라도 해당 콘텐츠가 여러 언어로 작성된 경우 웹 애플리케이션에서 특정 경로에 대한 콘텐츠를 제공할 수 있도록 할 수 있습니다.

다음 절차에서는 애플리케이션 https://app.example.com 과 연결된 URL이 위치 https://app.example.com/lang/en-us 로 전달되도록 Content-Location HTTP 요청 헤더를 설정하는 경로를 생성합니다. 애플리케이션 트래픽을 이 위치로 전달한다는 것은 특정 경로를 사용하는 사람이 미국 영어로 작성된 웹 콘텐츠에 액세스하는 것을 의미합니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. - OpenShift Container Platform 클러스터에 프로젝트 관리자로 로그인되어 있습니다.

- 포트에서 트래픽을 수신하는 포트와 HTTP 또는 TLS 끝점을 노출하는 웹 애플리케이션이 있습니다.

프로세스

경로 정의를 생성하고

app-example-route.yaml이라는 파일에 저장합니다.HTTP 헤더 지시문을 사용하여 생성된 경로의 YAML 정의

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- HTTP 헤더에서 수행할 작업 목록입니다.

- 2

- 변경할 헤더 유형입니다. 이 경우 응답 헤더입니다.

- 3

- 변경할 헤더의 이름입니다. 설정하거나 삭제할 수 있는 사용 가능한 헤더 목록은 HTTP 헤더 구성 을 참조하십시오.

- 4

- 헤더에서 수행되는 작업 유형입니다. 이 필드에는

Set또는Delete값이 있을 수 있습니다. - 5

- HTTP 헤더를 설정할 때

값을제공해야 합니다. 값은 해당 헤더에 사용 가능한 지시문 목록(예:DENY)의 문자열이거나 HAProxy의 동적 값 구문을 사용하여 해석되는 동적 값이 될 수 있습니다. 이 경우 값은 콘텐츠의 상대 위치로 설정됩니다.

새로 생성된 경로 정의를 사용하여 기존 웹 애플리케이션에 대한 경로를 생성합니다.

oc -n app-example create -f app-example-route.yaml

$ oc -n app-example create -f app-example-route.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

HTTP 요청 헤더의 경우 경로 정의에 지정된 작업이 Ingress 컨트롤러의 HTTP 요청 헤더에 실행된 후 실행됩니다. 즉, 경로의 해당 요청 헤더에 설정된 모든 값이 Ingress 컨트롤러에 설정된 값보다 우선합니다. HTTP 헤더 처리 순서에 대한 자세한 내용은 HTTP 헤더 구성 을 참조하십시오.

1.3.4. 쿠키를 사용하여 경로 상태 유지

OpenShift Container Platform은 모든 트래픽이 동일한 끝점에 도달하도록 하여 스테이트풀(stateful) 애플리케이션 트래픽을 사용할 수 있는 고정 세션을 제공합니다. 그러나 재시작, 스케일링 또는 구성 변경 등으로 인해 끝점 pod가 종료되면 이러한 상태 저장 특성이 사라질 수 있습니다.

OpenShift Container Platform에서는 쿠키를 사용하여 세션 지속성을 구성할 수 있습니다. 수신 컨트롤러는 사용자 요청을 처리할 끝점을 선택하고 세션에 대한 쿠키를 생성합니다. 쿠키는 요청에 대한 응답으로 다시 전달되고 사용자는 세션의 다음 요청과 함께 쿠키를 다시 보냅니다. 쿠키는 세션을 처리하는 끝점을 Ingress 컨트롤러에 알려 클라이언트 요청이 쿠키를 사용하여 동일한 pod로 라우팅되도록 합니다.

HTTP 트래픽을 볼 수 없기 때문에 패스스루 경로에 쿠키를 설정할 수 없습니다. 대신 백엔드를 결정하는 소스 IP 주소를 기반으로 번호가 계산됩니다.

백엔드가 변경되면 트래픽이 잘못된 서버로 전달되어 덜 고정될 수 있습니다. 소스 IP를 숨기는 로드 밸런서를 사용하는 경우 모든 연결에 대해 동일한 번호가 설정되고 트래픽이 동일한 Pod로 전송됩니다.

1.3.4.1. 쿠키를 사용하여 경로에 주석 달기

쿠키 이름을 설정하여 경로에 자동 생성되는 기본 쿠키 이름을 덮어쓸 수 있습니다. 그러면 경로 트래픽을 수신하는 애플리케이션에서 쿠키 이름을 확인할 수 있게 됩니다. 쿠키를 삭제하면 다음 요청이 끝점을 다시 선택하도록 강제할 수 있습니다. 결과적으로 서버가 과부하된 경우 해당 서버에서 클라이언트의 요청을 제거하고 재배포하려고 합니다.

프로세스

지정된 쿠키 이름으로 경로에 주석을 답니다.

oc annotate route <route_name> router.openshift.io/cookie_name="<cookie_name>"

$ oc annotate route <route_name> router.openshift.io/cookie_name="<cookie_name>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

<route_name>- 경로 이름을 지정합니다.

<cookie_name>- 쿠키 이름을 지정합니다.

예를 들어 쿠키 이름

my_cookie로my_route경로에 주석을 달 수 있습니다.oc annotate route my_route router.openshift.io/cookie_name="my_cookie"

$ oc annotate route my_route router.openshift.io/cookie_name="my_cookie"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 경로 호스트 이름을 변수에 캡처합니다.

ROUTE_NAME=$(oc get route <route_name> -o jsonpath='{.spec.host}')$ ROUTE_NAME=$(oc get route <route_name> -o jsonpath='{.spec.host}')Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

<route_name>- 경로 이름을 지정합니다.

쿠키를 저장한 다음 경로에 액세스합니다.

curl $ROUTE_NAME -k -c /tmp/cookie_jar

$ curl $ROUTE_NAME -k -c /tmp/cookie_jarCopy to Clipboard Copied! Toggle word wrap Toggle overflow 경로에 연결할 때 이전 명령으로 저장된 쿠키를 사용합니다.

curl $ROUTE_NAME -k -b /tmp/cookie_jar

$ curl $ROUTE_NAME -k -b /tmp/cookie_jarCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.3.5. 경로별 주석

Ingress 컨트롤러는 노출하는 모든 경로에 기본 옵션을 설정할 수 있습니다. 개별 경로는 주석에 특정 구성을 제공하는 방식으로 이러한 기본값 중 일부를 덮어쓸 수 있습니다. Red Hat은 operator 관리 경로에 경로 주석 추가를 지원하지 않습니다.

여러 소스 IP 또는 서브넷이 있는 화이트리스트를 생성하려면 공백으로 구분된 목록을 사용합니다. 다른 구분 기호 유형으로 인해 경고 또는 오류 메시지 없이 목록이 무시됩니다.

| 변수 | 설명 | 기본값으로 사용되는 환경 변수 |

|---|---|---|

|

|

로드 밸런싱 알고리즘을 설정합니다. 사용 가능한 옵션은 |

경유 경로의 경우 |

|

|

쿠키를 사용하여 관련 연결을 추적하지 않도록 설정합니다. | |

|

| 이 경로에 사용할 선택적 쿠키를 지정합니다. 이름은 대문자와 소문자, 숫자, ‘_’, ‘-’의 조합으로 구성해야 합니다. 기본값은 경로의 해시된 내부 키 이름입니다. | |

|

|

라우터에서 백업 pod로 허용되는 최대 연결 수를 설정합니다. | |

|

|

| |

|

|

동일한 소스 IP 주소를 통해 만든 동시 TCP 연결 수를 제한합니다. 숫자 값을 허용합니다. | |

|

|

동일한 소스 IP 주소가 있는 클라이언트에서 HTTP 요청을 수행할 수 있는 속도를 제한합니다. 숫자 값을 허용합니다. | |

|

|

동일한 소스 IP 주소가 있는 클라이언트에서 TCP 연결을 수행할 수 있는 속도를 제한합니다. 숫자 값을 허용합니다. | |

|

| 경로에 대한 서버 쪽 타임아웃을 설정합니다. (TimeUnits) |

|

|

| 이 제한 시간은 터널 연결(예: 일반 텍스트, 에지, 재암호화 또는 패스스루)을 통한 WebSocket에 적용됩니다. 일반 텍스트, 에지 또는 재암호화 경로 유형을 사용하면 이 주석이 기존 시간 초과 값을 사용하여 시간 초과 터널로 적용됩니다. passthrough 경로 유형의 경우 주석이 설정된 기존 시간 초과 값보다 우선합니다. |

|

|

|

IngressController 또는 Ingress 구성을 설정할 수 있습니다. 이 주석은 라우터를 재배포하고, 정리 소프트 |

|

|

| 백엔드 상태 점검 간격을 설정합니다. (TimeUnits) |

|

|

| 경로에 대한 허용 목록을 설정합니다. 허용 목록은 승인된 소스 주소에 대한 IP 주소 및 CIDR 범위로 이루어진 공백으로 구분된 목록입니다. 허용 목록에 없는 IP 주소의 요청은 삭제됩니다.

| |

|

| 엣지 종단 경로 또는 재암호화 경로에 Strict-Transport-Security 헤더를 설정합니다. | |

|

| 백엔드의 요청 재작성 경로를 설정합니다. | |

|

| 쿠키를 제한하는 값을 설정합니다. 값은 다음과 같습니다.

이 값은 재암호화 및 엣지 경로에만 적용됩니다. 자세한 내용은 SameSite 쿠키 설명서를 참조하십시오. | |

|

|

라우터당

|

|

-

기본적으로 라우터는 5s마다 다시 로드되어 처음부터 포드 간에 분산 연결을 재설정합니다. 결과적으로

roundrobin상태는 다시 로드해도 유지되지 않습니다. 이 알고리즘은 Pod에 거의 동일한 컴퓨팅 용량 및 스토리지 용량이 있는 경우 가장 잘 작동합니다. 예를 들어 CI/CD 파이프라인을 사용하므로 애플리케이션 또는 서비스에서 끝점을 지속적으로 변경한 경우 분산이 일관되지 않을 수 있습니다. 이 경우 다른 알고리즘을 사용하십시오. 허용 목록의 IP 주소 및 CIDR 범위가 61를 초과하면

haproxy.config파일에서 참조되는 별도의 파일에 작성됩니다. 이 파일은/var/lib/haproxy/router/allowlists폴더에 저장됩니다.참고주소가 허용 목록에 작성되도록 하려면 전체 CIDR 범위가 Ingress 컨트롤러 구성 파일에 나열되어 있는지 확인합니다. etcd 오브젝트 크기 제한은 경로 주석의 크기를 제한합니다. 이로 인해 허용 목록에 포함할 수 있는 최대 IP 주소 및 CIDR 범위에 대한 임계값이 생성됩니다.

환경 변수는 편집할 수 없습니다.

라우터 시간 제한 변수

TimeUnits는 다음과 같이 표시됩니다. us *(마이크로초), ms (밀리초, 기본값), s (초), m (분), h *(시간), d (일).

정규 표현식은 [1-9][0-9]*(us\|ms\|s\|m\|h\|d)입니다.

| Variable | Default | 설명 |

|---|---|---|

|

|

| 백엔드에서 후속 활성 검사 사이의 시간입니다. |

|

|

| 경로에 연결된 클라이언트의 TCP FIN 시간 제한 기간을 제어합니다. FIN이 연결을 닫도록 전송한 경우 지정된 시간 내에 응답하지 않으면 HAProxy가 연결을 종료합니다. 낮은 값으로 설정하면 문제가 없으며 라우터에서 더 적은 리소스를 사용합니다. |

|

|

| 클라이언트가 데이터를 승인하거나 보내야 하는 시간입니다. |

|

|

| 최대 연결 시간입니다. |

|

|

| 라우터에서 경로를 지원하는 pod로의 TCP FIN 시간 초과를 제어합니다. |

|

|

| 서버에서 데이터를 승인하거나 보내야 하는 시간입니다. |

|

|

| TCP 또는 WebSocket 연결이 열린 상태로 유지되는 동안의 시간입니다. 이 시간 제한 기간은 HAProxy를 다시 로드할 때마다 재설정됩니다. |

|

|

|

새 HTTP 요청이 표시될 때까지 대기할 최대 시간을 설정합니다. 이 값을 너무 낮게 설정하면 작은

일부 유효한 시간 제한 값은 예상되는 특정 시간 초과가 아니라 특정 변수의 합계일 수 있습니다. 예를 들어 |

|

|

| HTTP 요청 전송에 걸리는 시간입니다. |

|

|

| 라우터의 최소 빈도가 새 변경 사항을 다시 로드하고 승인하도록 허용합니다. |

|

|

| HAProxy 메트릭 수집에 대한 시간 제한입니다. |

경로 설정 사용자 정의 타임아웃

- 1

- HAProxy 지원 단위(

us,ms,s,m,h,d)를 사용하여 새 타임아웃을 지정합니다. 단위가 제공되지 않는 경우ms가 기본값입니다.

패스스루(passthrough) 경로에 대한 서버 쪽 타임아웃 값을 너무 낮게 설정하면 해당 경로에서 WebSocket 연결이 자주 시간 초과될 수 있습니다.

하나의 특정 IP 주소만 허용하는 경로

metadata:

annotations:

haproxy.router.openshift.io/ip_whitelist: 192.168.1.10

metadata:

annotations:

haproxy.router.openshift.io/ip_whitelist: 192.168.1.10여러 IP 주소를 허용하는 경로

metadata:

annotations:

haproxy.router.openshift.io/ip_whitelist: 192.168.1.10 192.168.1.11 192.168.1.12

metadata:

annotations:

haproxy.router.openshift.io/ip_whitelist: 192.168.1.10 192.168.1.11 192.168.1.12IP 주소 CIDR 네트워크를 허용하는 경로

metadata:

annotations:

haproxy.router.openshift.io/ip_whitelist: 192.168.1.0/24

metadata:

annotations:

haproxy.router.openshift.io/ip_whitelist: 192.168.1.0/24IP 주소 및 IP 주소 CIDR 네트워크를 둘 다 허용하는 경로

metadata:

annotations:

haproxy.router.openshift.io/ip_whitelist: 180.5.61.153 192.168.1.0/24 10.0.0.0/8

metadata:

annotations:

haproxy.router.openshift.io/ip_whitelist: 180.5.61.153 192.168.1.0/24 10.0.0.0/8재작성 대상을 지정하는 경로

- 1

/를 백엔드의 요청 재작성 경로로 설정합니다.

경로에 haproxy.router.openshift.io/rewrite-target 주석을 설정하면 Ingress Controller에서 요청을 백엔드 애플리케이션으로 전달하기 전에 이 경로를 사용하여 HTTP 요청의 경로를 재작성해야 합니다. spec.path에 지정된 경로와 일치하는 요청 경로 부분은 주석에 지정된 재작성 대상으로 교체됩니다.

다음 표에 spec.path, 요청 경로, 재작성 대상의 다양한 조합에 따른 경로 재작성 동작의 예가 있습니다.

| Route.spec.path | 요청 경로 | 재작성 대상 | 전달된 요청 경로 |

|---|---|---|---|

| /foo | /foo | / | / |

| /foo | /foo/ | / | / |

| /foo | /foo/bar | / | /bar |

| /foo | /foo/bar/ | / | /bar/ |

| /foo | /foo | /bar | /bar |

| /foo | /foo/ | /bar | /bar/ |

| /foo | /foo/bar | /baz | /baz/bar |

| /foo | /foo/bar/ | /baz | /baz/bar/ |

| /foo/ | /foo | / | N/A(요청 경로가 라우팅 경로와 일치하지 않음) |

| /foo/ | /foo/ | / | / |

| /foo/ | /foo/bar | / | /bar |

haproxy.router.openshift.io/rewrite-target 의 특정 특수 문자는 올바르게 이스케이프해야 하므로 특수 처리가 필요합니다. 이러한 문자를 처리하는 방법을 알아보려면 다음 표를 참조하십시오.

| 문자의 경우 | 문자 사용 | 참고 |

|---|---|---|

| # | \# | #을 사용하지 마십시오. 재작성 표현식이 종료되기 때문입니다. |

| % | % 또는 %% | %%와 같은 홀수 시퀀스를 사용하지 마십시오. |

| ‘ | \’ | 무시될 수 있기 때문에 방지 |

다른 모든 유효한 URL 문자는 이스케이프 없이 사용할 수 있습니다.

1.3.6. 처리량 문제 문제 해결 방법

OpenShift Container Platform을 사용하여 애플리케이션을 배포하면 특정 서비스 간의 대기 시간이 비정상적으로 길어지는 등 네트워크 처리량 문제가 발생할 수 있습니다.

Pod 로그에 문제의 원인이 표시되지 않는 경우 다음 방법을 사용하여 성능 문제를 분석하십시오.

ping또는tcpdump와 같은 패킷 Analyzer를 사용하여 Pod와 해당 노드 간의 트래픽을 분석합니다.예를 들어 각 Pod에서

tcpdump도구를 실행하여 문제의 원인이 되는 동작을 재현합니다. Pod에서 나가거나 Pod로 들어오는 트래픽의 대기 시간을 분석하기 위해 전송 및 수신 타임 스탬프를 비교하려면 전송 캡처와 수신 캡처를 둘 다 검토하십시오. 다른 Pod, 스토리지 장치 또는 데이터 플레인의 트래픽으로 노드 인터페이스가 과부하된 경우 OpenShift Container Platform에서 대기 시간이 발생할 수 있습니다.tcpdump -s 0 -i any -w /tmp/dump.pcap host <podip 1> && host <podip 2>

$ tcpdump -s 0 -i any -w /tmp/dump.pcap host <podip 1> && host <podip 2>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

podip은 Pod의 IP 주소입니다.oc get pod <pod_name> -o wide명령을 실행하여 Pod의 IP 주소를 가져옵니다.

tcpdump명령은 두 Pod 간 모든 트래픽을 포함하는/tmp/dump.pcap에 파일을 생성합니다. 문제가 재현되기 직전에 Analyzer를 실행하고 문제 재현이 완료된 직후 Analyzer를 중지하여 파일 크기를 최소화할 수 있습니다. 다음을 사용하여 노드 간에 패킷 Analyzer를 실행할 수도 있습니다.tcpdump -s 0 -i any -w /tmp/dump.pcap port 4789

$ tcpdump -s 0 -i any -w /tmp/dump.pcap port 4789Copy to Clipboard Copied! Toggle word wrap Toggle overflow 스트리밍 처리량 및 UDP 처리량을 측정하려면

iperf와 같은 대역폭 측정 툴을 사용합니다. 먼저 Pod에서 툴을 실행한 다음 노드에서 실행하여 병목 현상이 발생하는지 확인합니다.-

iperf설치 및 사용에 대한 자세한 내용은 Red Hat 솔루션을 참조하십시오.

-

- 경우에 따라 대기 시간 문제로 인해 클러스터에서 라우터 Pod를 사용하여 노드를 비정상으로 표시할 수 있습니다. 작업자 대기 시간 프로필을 사용하여 조치를 수행하기 전에 클러스터에서 노드 상태 업데이트를 기다리는 빈도를 조정합니다.

-

클러스터에 대기 시간이 짧고 대기 시간이 많은 노드가 지정된 경우 Ingress 컨트롤러에서

spec.nodePlacement필드를 구성하여 라우터 Pod 배치를 제어합니다.

1.3.7. 경로 허용 정책 구성

관리자 및 애플리케이션 개발자는 도메인 이름이 동일한 여러 네임스페이스에서 애플리케이션을 실행할 수 있습니다. 이는 여러 팀이 동일한 호스트 이름에 노출되는 마이크로 서비스를 개발하는 조직을 위한 것입니다.

네임스페이스 간 클레임은 네임스페이스 간 신뢰가 있는 클러스터에 대해서만 허용해야 합니다. 그렇지 않으면 악의적인 사용자가 호스트 이름을 인수할 수 있습니다. 따라서 기본 승인 정책에서는 네임스페이스 간에 호스트 이름 클레임을 허용하지 않습니다.

사전 요구 사항

- 클러스터 관리자 권한이 있어야 합니다.

프로세스

다음 명령을 사용하여

ingresscontroller리소스 변수의.spec.routeAdmission필드를 편집합니다.oc -n openshift-ingress-operator patch ingresscontroller/default --patch '{"spec":{"routeAdmission":{"namespaceOwnership":"InterNamespaceAllowed"}}}' --type=merge$ oc -n openshift-ingress-operator patch ingresscontroller/default --patch '{"spec":{"routeAdmission":{"namespaceOwnership":"InterNamespaceAllowed"}}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 샘플 Ingress 컨트롤러 구성

spec: routeAdmission: namespaceOwnership: InterNamespaceAllowed ...spec: routeAdmission: namespaceOwnership: InterNamespaceAllowed ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 작은 정보다음 YAML을 적용하여 경로 승인 정책을 구성할 수 있습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.3.8. 듀얼 스택 네트워킹을 위한 OpenShift Container Platform Ingress 컨트롤러 구성

OpenShift Container Platform 클러스터가 IPv4 및 IPv6 이중 스택 네트워킹에 맞게 구성된 경우 OpenShift Container Platform 경로에서 외부에서 클러스터에 연결할 수 있습니다.

Ingress 컨트롤러는 IPv4 및 IPv6 엔드 포인트가 모두 있는 서비스를 자동으로 제공하지만 단일 스택 또는 듀얼 스택 서비스에 대해 Ingress 컨트롤러를 구성할 수 있습니다.

사전 요구 사항

- 베어메탈에 OpenShift Container Platform 클러스터를 배포했습니다.

-

OpenShift CLI(

oc)를 설치합니다.

프로세스

Ingress 컨트롤러가 워크로드로 IPv4/IPv6을 통해 트래픽을 제공하도록 하려면

ipFamilies및ipFamilyPolicy필드를 설정하여 서비스 YAML 파일을 생성하거나 기존 서비스 YAML 파일을 수정할 수 있습니다. 예를 들면 다음과 같습니다.샘플 서비스 YAML 파일

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이러한 리소스는 해당

endpoints를 생성합니다. Ingress 컨트롤러는 이제endpointslices를 감시합니다.endpoints를 확인하려면 다음 명령을 입력합니다:oc get endpoints

$ oc get endpointsCopy to Clipboard Copied! Toggle word wrap Toggle overflow endpointslices를 확인하려면 다음 명령을 입력합니다.oc get endpointslices

$ oc get endpointslicesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.4. 고급 경로 생성

여러 유형의 TLS 종료를 사용하여 클라이언트에 인증서를 제공하는 기능으로 보안 경로를 생성할 수 있습니다. 다음 섹션에서는 사용자 정의 인증서를 사용하여 재암호화 에지 및 패스스루 경로를 생성하는 방법을 설명합니다.

1.4.1. 사용자 정의 인증서를 사용하여 엣지 경로 생성

oc create route 명령을 사용하면 엣지 TLS 종료와 사용자 정의 인증서로 보안 경로를 구성할 수 있습니다. 엣지 경로를 사용하면 Ingress 컨트롤러에서 트래픽을 대상 Pod로 전달하기 전에 TLS 암호화를 종료합니다. 이 경로는 Ingress 컨트롤러가 경로에 사용하는 TLS 인증서 및 키를 지정합니다.

사전 요구 사항

- PEM 인코딩 파일에 인증서/키 쌍이 있고 해당 인증서가 경로 호스트에 유효해야 합니다.

- 인증서 체인을 완성하는 PEM 인코딩 파일에 별도의 CA 인증서가 있을 수 있습니다.

- 노출하려는 서비스가 있어야 합니다.

암호로 보호되는 키 파일은 지원되지 않습니다. 키 파일에서 암호를 제거하려면 다음 명령을 사용하십시오.

openssl rsa -in password_protected_tls.key -out tls.key

$ openssl rsa -in password_protected_tls.key -out tls.key프로세스

이 절차에서는 사용자 정의 인증서 및 엣지 TLS 종료를 사용하여 Route 리소스를 생성합니다. 다음 예에서는 인증서/키 쌍이 현재 작업 디렉터리의 tls.crt 및 tls.key 파일에 있다고 가정합니다. 인증서 체인을 완료하는 데 필요한 경우 CA 인증서를 지정할 수도 있습니다. tls.crt, tls.key, ca.crt(옵션)에 실제 경로 이름을 사용하십시오. frontend에는 노출하려는 서비스 이름을 사용합니다. www.example.com을 적절한 호스트 이름으로 바꿉니다.

엣지 TLS 종료 및 사용자 정의 인증서를 사용하여 보안

Route리소스를 생성합니다.oc create route edge --service=frontend --cert=tls.crt --key=tls.key --ca-cert=ca.crt --hostname=www.example.com

$ oc create route edge --service=frontend --cert=tls.crt --key=tls.key --ca-cert=ca.crt --hostname=www.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 생성된

Route리소스는 다음과 유사합니다.보안 경로의 YAML 정의

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 추가 옵션은

oc create route edge --help를 참조하십시오.

1.4.2. 사용자 정의 인증서를 사용하여 재암호화 경로 생성

oc create route 명령을 사용하면 재암호화 TLS 종료와 사용자 정의 인증서로 보안 경로를 구성할 수 있습니다.

사전 요구 사항

- PEM 인코딩 파일에 인증서/키 쌍이 있고 해당 인증서가 경로 호스트에 유효해야 합니다.

- 인증서 체인을 완성하는 PEM 인코딩 파일에 별도의 CA 인증서가 있을 수 있습니다.

- PEM 인코딩 파일에 별도의 대상 CA 인증서가 있어야 합니다.

- 노출하려는 서비스가 있어야 합니다.

암호로 보호되는 키 파일은 지원되지 않습니다. 키 파일에서 암호를 제거하려면 다음 명령을 사용하십시오.

openssl rsa -in password_protected_tls.key -out tls.key

$ openssl rsa -in password_protected_tls.key -out tls.key프로세스

이 절차에서는 사용자 정의 인증서를 사용하여 Route 리소스를 생성하고 TLS 종료를 재암호화합니다. 다음 예에서는 인증서/키 쌍이 현재 작업 디렉터리의 tls.crt 및 tls.key 파일에 있다고 가정합니다. Ingress 컨트롤러에서 서비스의 인증서를 신뢰하도록 하려면 대상 CA 인증서도 지정해야 합니다. 인증서 체인을 완료하는 데 필요한 경우 CA 인증서를 지정할 수도 있습니다. tls.crt, tls.key, cacert.crt, ca.crt(옵션)에 실제 경로 이름을 사용하십시오. frontend에는 노출하려는 서비스 리소스 이름을 사용합니다. www.example.com을 적절한 호스트 이름으로 바꿉니다.

재암호화 TLS 종료 및 사용자 정의 인증서를 사용하여 보안

Route리소스를 생성합니다.oc create route reencrypt --service=frontend --cert=tls.crt --key=tls.key --dest-ca-cert=destca.crt --ca-cert=ca.crt --hostname=www.example.com

$ oc create route reencrypt --service=frontend --cert=tls.crt --key=tls.key --dest-ca-cert=destca.crt --ca-cert=ca.crt --hostname=www.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 생성된

Route리소스는 다음과 유사합니다.보안 경로의 YAML 정의

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 자세한 옵션은

oc create route reencrypt --help를 참조하십시오.

1.4.3. 패스스루 라우팅 생성

oc create route 명령을 사용하면 패스스루 종료와 사용자 정의 인증서로 보안 경로를 구성할 수 있습니다. 패스스루 종료를 사용하면 암호화된 트래픽이 라우터에서 TLS 종료를 제공하지 않고 바로 대상으로 전송됩니다. 따라서 라우터에 키 또는 인증서가 필요하지 않습니다.

사전 요구 사항

- 노출하려는 서비스가 있어야 합니다.

프로세스

Route리소스를 생성합니다.oc create route passthrough route-passthrough-secured --service=frontend --port=8080

$ oc create route passthrough route-passthrough-secured --service=frontend --port=8080Copy to Clipboard Copied! Toggle word wrap Toggle overflow 생성된

Route리소스는 다음과 유사합니다.패스스루 종료를 사용하는 보안 경로

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 대상 Pod는 끝점의 트래픽에 대한 인증서를 제공해야 합니다. 현재 이 방법은 양방향 인증이라고도 하는 클라이언트 인증서도 지원할 수 있는 유일한 방법입니다.

1.4.4. Ingress 주석에서 대상 CA 인증서를 사용하여 경로 생성

Ingress 오브젝트에 route.openshift.io/destination-ca-certificate-secret 주석을 사용하여 사용자 정의 대상 CA 인증서로 경로를 정의할 수 있습니다.

사전 요구 사항

- PEM 인코딩 파일에 인증서/키 쌍이 있을 수 있습니다. 여기서 인증서가 경로 호스트에 유효합니다.

- 인증서 체인을 완성하는 PEM 인코딩 파일에 별도의 CA 인증서가 있을 수 있습니다.

- PEM 인코딩 파일에 별도의 대상 CA 인증서가 있어야 합니다.

- 노출하려는 서비스가 있어야 합니다.

프로세스

다음 명령을 입력하여 대상 CA 인증서에 대한 보안을 생성합니다.

oc create secret generic dest-ca-cert --from-file=tls.crt=<file_path>

$ oc create secret generic dest-ca-cert --from-file=tls.crt=<file_path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들면 다음과 같습니다.

oc -n test-ns create secret generic dest-ca-cert --from-file=tls.crt=tls.crt

$ oc -n test-ns create secret generic dest-ca-cert --from-file=tls.crt=tls.crtCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

secret/dest-ca-cert created

secret/dest-ca-cert createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress 주석에

route.openshift.io/destination-ca-certificate-secret을 추가합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 이 주석은 kubernetes 시크릿을 참조합니다.

이 주석에서 참조된 시크릿은 생성된 경로에 삽입됩니다.

출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.4.5. 외부 관리 인증서를 사용하여 경로 생성

TLS 시크릿에서 외부 인증서로 경로를 보호하는 것은 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 다음 링크를 참조하십시오.

경로 API의 .spec.tls.externalCertificate 필드를 사용하여 타사 인증서 관리 솔루션으로 OpenShift Container Platform 경로를 구성할 수 있습니다. 시크릿을 통해 외부 관리형 TLS 인증서를 참조할 수 있으므로 수동 인증서 관리가 필요하지 않습니다.

외부 관리형 인증서를 사용하면 오류를 줄여 인증서 업데이트를 원활하게 롤아웃하고 OpenShift 라우터에서 갱신된 인증서를 즉시 제공할 수 있습니다. 에지 경로 및 재암호화 경로 둘 다와 함께 외부 관리형 인증서를 사용할 수 있습니다.

이 기능은 에지 경로와 재암호화 경로에 모두 적용됩니다.

사전 요구 사항

-

RouteExternalCertificate기능 게이트를 활성화해야 합니다. -

경로

생성및 업데이트 모두에 사용되는routes/custom-host하위 리소스에 대한 생성 권한이 있습니다. -

tls.key및tls.crt키가 모두 포함된kubernetes.io/tls유형의 PEM 인코딩 형식으로 유효한 인증서 또는 키 쌍을 포함하는 시크릿이 있어야 합니다. 예:$ oc create secret tls myapp-tls --cert=server.crt --key=server.key.

프로세스

다음 명령을 실행하여 라우터 서비스 계정 읽기 권한을 허용하기 위해 시크릿과 동일한 네임스페이스에

역할오브젝트를 생성합니다.oc create role secret-reader --verb=get,list,watch --resource=secrets --resource-name=<secret-name> \ --namespace=<current-namespace>

$ oc create role secret-reader --verb=get,list,watch --resource=secrets --resource-name=<secret-name> \ --namespace=<current-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

<secret-name> : 시크릿의 실제 이름을 지정합니다. -

<current-namespace>: 시크릿과 경로가 모두 있는 네임스페이스를 지정합니다.

-

보안과 동일한 네임스페이스에

rolebinding오브젝트를 생성하고 다음 명령을 실행하여 라우터 서비스 계정을 새로 생성된 역할에 바인딩합니다.oc create rolebinding secret-reader-binding --role=secret-reader --serviceaccount=openshift-ingress:router --namespace=<current-namespace>

$ oc create rolebinding secret-reader-binding --role=secret-reader --serviceaccount=openshift-ingress:router --namespace=<current-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

<current-namespace>: 시크릿과 경로가 모두 있는 네임스페이스를 지정합니다.

-

경로를정의하는 YAML 파일을 생성하고 다음 예제를 사용하여 인증서가 포함된 보안을 지정합니다.보안 경로에 대한 YAML 정의

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

<secret-name> : 시크릿의 실제 이름을 지정합니다.

-

다음 명령을 실행하여

경로리소스를 생성합니다. 보안이 존재하고 인증서/키 쌍이 있는 경우 라우터는 모든 사전 요구 사항을 충족하는 경우 생성된 인증서를 제공합니다.oc apply -f <route.yaml>

$ oc apply -f <route.yaml>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

<route.yaml> : 생성된 YAML 파일 이름을 지정합니다.

-

.spec.tls.externalCertificate 가 제공되지 않으면 라우터에서 기본 생성된 인증서를 사용합니다.

.spec.tls.externalCertificate 필드를 사용하는 경우 .spec.tls.certificate 필드 또는 .spec.tls.key 필드를 지정할 수 없습니다.

1.4.6. Ingress 오브젝트를 통해 기본 인증서를 사용하여 경로 생성

TLS 구성을 지정하지 않고 Ingress 오브젝트를 생성하면 OpenShift Container Platform에서 비보안 경로를 생성합니다. 기본 Ingress 인증서를 사용하여 보안 에지 종료 경로를 생성하는 Ingress 오브젝트를 생성하려면 다음과 같이 빈 TLS 구성을 지정할 수 있습니다.

사전 요구 사항

- 노출하려는 서비스가 있습니다.

-

OpenShift CLI(

oc)에 액세스할 수 있습니다.

프로세스

Ingress 오브젝트에 대한 YAML 파일을 생성합니다. 이 예제에서는 파일을

example-ingress.yaml이라고 합니다.Ingress 오브젝트의 YAML 정의

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 Ingress 오브젝트를 생성합니다.

oc create -f example-ingress.yaml

$ oc create -f example-ingress.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

다음 명령을 실행하여 OpenShift Container Platform에서 Ingress 오브젝트에 대한 예상 경로를 생성했는지 확인합니다.

oc get routes -o yaml

$ oc get routes -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2장. 수신 클러스터 트래픽 구성

2.1. 수신 클러스터 트래픽 구성 개요

OpenShift Container Platform에서는 다음 방법을 통해 클러스터에서 실행되는 서비스와 클러스터 외부에서 통신할 수 있습니다.

순서 또는 기본 설정에 따라 권장되는 방법입니다.

- HTTP/HTTPS가 있는 경우 Ingress 컨트롤러를 사용합니다.

- HTTPS 이외의 TLS 암호화 프로토콜이 있는 경우(예: SNI 헤더가 있는 TLS), Ingress 컨트롤러를 사용합니다.

-

그 외에는 로드 밸런서, 외부 IP 또는

NodePort를 사용합니다.

| 방법 | 목적 |

|---|---|

| HTTPS 이외의 HTTP/HTTPS 트래픽 및 TLS 암호화 프로토콜(예: SNI 헤더가 있는 TLS)에 액세스할 수 있습니다. | |

| 풀에서 할당된 IP 주소를 통해 비표준 포트로의 트래픽을 허용합니다. 대부분의 클라우드 플랫폼은 로드 밸런서 IP 주소로 서비스를 시작하는 방법을 제공합니다. | |

| 시스템 네트워크의 풀에서 특정 IP 주소 또는 주소로의 트래픽을 허용합니다. 베어 메탈과 같은 베어 메탈 설치 또는 플랫폼의 경우 MetalLB는 로드 밸런서 IP 주소로 서비스를 시작하는 방법을 제공합니다. | |

| 특정 IP 주소를 통해 비표준 포트로의 트래픽을 허용합니다. | |

| 클러스터의 모든 노드에 서비스를 공개합니다. |

2.1.1. 비교: 외부 IP 주소에 대한 내결함성 액세스

외부 IP 주소에 대한 액세스를 제공하는 통신 방법의 경우 IP 주소에 대한 내결함성 액세스를 고려해야 합니다. 다음 기능은 외부 IP 주소에 대한 내결함성 액세스를 제공합니다.

- IP 페일오버

- IP 페일오버는 노드 집합의 가상 IP 주소 풀을 관리합니다. Keepalived 및 VRRP(Virtual Router Redundancy Protocol)로 구현됩니다. IP 페일오버는 계층 2 메커니즘일 뿐이며 멀티캐스트를 사용합니다. 멀티캐스트에는 일부 네트워크에 대한 단점이 있을 수 있습니다.

- MetalLB

- MetalLB에는 계층 2 모드가 있지만 멀티캐스트를 사용하지 않습니다. 계층 2 모드에는 하나의 노드를 통해 외부 IP 주소에 대한 모든 트래픽을 전송하는 단점이 있습니다.

- 수동으로 외부 IP 주소 할당

- 외부 IP 주소를 서비스에 할당하는 데 사용되는 IP 주소 블록을 사용하여 클러스터를 구성할 수 있습니다. 이 기능은 기본적으로 비활성화되어 있습니다. 이 기능은 유연하지만 클러스터 또는 네트워크 관리자에게 가장 큰 부담이 됩니다. 클러스터는 외부 IP로 향하는 트래픽을 수신할 준비가 되지만 각 고객은 트래픽을 노드로 라우팅하는 방법을 결정해야 합니다.

2.2. 서비스의 ExternalIP 구성

클러스터 관리자는 클러스터의 서비스로 트래픽을 보낼 수 있는 클러스터 외부의 IP 주소 블록을 선택할 수 있습니다.

이 기능은 일반적으로 베어 메탈 하드웨어에 설치된 클러스터에 가장 유용합니다.

2.2.1. 사전 요구 사항

- 네트워크 인프라는 외부 IP 주소에 대한 트래픽을 클러스터로 라우팅해야 합니다.

2.2.2. ExternalIP 정보

클라우드 환경이 아닌 경우 OpenShift Container Platform은 ExternalIP 기능을 사용하여 Service 오브젝트의 spec.externalIPs[] 매개변수에 외부 IP 주소를 지정할 수 있습니다. ExternalIP로 구성된 서비스는 type=NodePort 인 서비스와 유사하게 작동합니다. 여기서 트래픽이 로드 밸런싱을 위해 로컬 노드로 전달합니다.

클라우드 환경의 경우 클라우드 로드 밸런서 자동 배포를 위해 로드 밸런서 서비스를 사용하여 서비스 끝점을 대상으로 합니다.

매개변수 값을 지정하면 OpenShift Container Platform에서 추가 가상 IP 주소를 서비스에 할당합니다. IP 주소는 클러스터에 대해 정의한 서비스 네트워크 외부에 있을 수 있습니다.

ExternalIP는 기본적으로 비활성화되어 있으므로 ExternalIP 기능을 활성화하면 외부 IP 주소에 대한 클러스터 내 트래픽이 해당 서비스로 전달되므로 서비스에 보안 위험이 발생할 수 있습니다. 이 구성을 사용하면 클러스터 사용자가 외부 리소스로 향하는 민감한 트래픽을 가로챌 수 있습니다.

MetalLB 구현 또는 IP 페일오버 배포를 사용하여 다음과 같은 방법으로 ExternalIP 리소스를 서비스에 연결할 수 있습니다.

- 외부 IP 자동 할당

-

OpenShift Container Platform에서는

spec.type=LoadBalancer가 설정된Service오브젝트를 생성할 때autoAssignCIDRsCIDR 블록의 IP 주소를spec.externalIPs[]배열에 자동으로 할당합니다. 이 구성을 위해 OpenShift Container Platform은 로드 밸런서 서비스 유형의 클라우드 버전을 구현하고 서비스에 IP 주소를 할당합니다. 자동 할당은 기본적으로 비활성화되어 있으며 " ExternalIP용 구성" 섹션에 설명된 대로 클러스터 관리자가 구성해야 합니다. - 외부 IP 수동 할당

-

OpenShift Container Platform에서는

Service오브젝트를 생성할 때spec.externalIPs[]배열에 할당된 IP 주소를 사용합니다. 다른 서비스에서 이미 사용 중인 IP 주소는 지정할 수 없습니다.

MetalLB 구현 또는 IP 페일오버 배포를 사용하여 외부 IP 주소 블록을 호스팅한 후 외부 IP 주소 블록이 클러스터로 라우팅되도록 네트워킹 인프라를 구성해야 합니다. 이 구성은 IP 주소가 노드의 네트워크 인터페이스에 구성되지 않았음을 의미합니다. 트래픽을 처리하려면 ARM(Static Address Resolution Protocol) 항목과 같은 방법을 사용하여 라우팅 및 외부 IP에 대한 액세스를 구성해야 합니다.

OpenShift Container Platform은 다음 기능을 추가하여 Kubernetes의 ExternalIP 기능을 확장합니다.

- 구성 가능한 정책을 통해 사용자가 외부 IP 주소 사용 제한

- 요청 시 서비스에 자동으로 외부 IP 주소 할당

2.2.3. ExternalIP 구성

Network.config.openshift.io CR(사용자 정의 리소스)의 다음 매개변수는 OpenShift Container Platform의 외부 IP 주소 사용을 제어합니다.

-

spec.externalIP.autoAssignCIDRs는 서비스에 대한 외부 IP 주소를 선택할 때 로드 밸런서에서 사용하는 IP 주소 블록을 정의합니다. OpenShift Container Platform에서는 자동 할당에 대해 하나의 IP 주소 블록만 지원합니다. 이 구성에는 서비스에 ExternalIP를 수동으로 할당하는 것보다 적은 단계가 필요하므로 제한된 수의 공유 IP 주소의 포트 공간을 관리해야 합니다. 자동 할당을 활성화하면 Cloud Controller Manager Operator는 구성에서spec.type=LoadBalancerdefind를 사용하여서비스오브젝트에 외부 IP 주소를 할당합니다. -

spec.externalIP.policy는 IP 주소를 수동으로 지정할 때 허용되는 IP 주소 블록을 정의합니다. OpenShift Container Platform은spec.externalIP.autoAssignCIDRs매개변수에 정의된 IP 주소 블록에 정책 규칙을 적용하지 않습니다.

올바르게 라우팅되면 구성된 외부 IP 주소 블록의 외부 트래픽이 서비스에서 노출하는 TCP 또는 UDP 포트를 통해 서비스 끝점에 도달할 수 있습니다.

클러스터 관리자는 externalIP로 라우팅을 구성해야 합니다. 또한 할당하는 IP 주소 블록이 클러스터의 하나 이상의 노드에서 종료되는지 확인해야 합니다. 자세한 내용은 Kubernetes 외부 IP를 참조하십시오.

OpenShift Container Platform은 자동 및 수동 IP 주소 할당을 모두 지원합니다. 이 지원을 통해 각 주소가 최대 하나의 서비스에 할당되고 각 서비스가 다른 서비스에서 노출하는 포트와 관계없이 선택한 포트를 노출할 수 있습니다.

OpenShift Container Platform에서 autoAssignCIDR로 정의된 IP 주소 블록을 사용하려면 호스트 네트워크에 필요한 IP 주소 할당 및 라우팅을 구성해야 합니다.

다음 YAML에서는 외부 IP 주소가 구성된 서비스를 설명합니다.

spec.externalIPs[]가 설정된 Service 오브젝트의 예

클라우드 공급자 플랫폼에서 프라이빗 클러스터를 실행하는 경우 다음 패치 명령을 실행하여 Ingress 컨트롤러의 로드 밸런서에 대한 게시 범위를 internal 로 변경할 수 있습니다.

oc -n openshift-ingress-operator patch ingresscontrollers/ingress-controller-with-nlb --type=merge --patch='{"spec":{"endpointPublishingStrategy":{"loadBalancer":{"scope":"Internal"}}}}'

$ oc -n openshift-ingress-operator patch ingresscontrollers/ingress-controller-with-nlb --type=merge --patch='{"spec":{"endpointPublishingStrategy":{"loadBalancer":{"scope":"Internal"}}}}'이 명령을 실행하면 Ingress 컨트롤러는 OpenShift Container Platform 애플리케이션의 경로에 대한 액세스를 내부 네트워크로만 제한합니다.

2.2.4. 외부 IP 주소 할당 제한 사항

클러스터 관리자는 IP 주소 블록을 지정하여 서비스의 IP 주소를 허용할 수 있습니다. 제한 사항은 cluster-admin 권한이 없는 사용자에게만 적용됩니다. 클러스터 관리자는 서비스 spec.externalIPs[] 필드를 IP 주소로 항상 설정할 수 있습니다.

정책 오브젝트에서 spec.ExternalIP.policy 매개변수에 대해 CIDR(Classless Inter-Domain Routing) 주소 블록을 지정하여 IP 주소 정책을 구성합니다.

정책 오브젝트의 JSON 형식 및 CIDR 매개변수의 예

정책 제한을 구성할 때는 다음 규칙이 적용됩니다.

-

policy가{}로 설정된 경우spec.ExternalIPs[]를 사용하여Service를 생성하면 실패한 서비스가 생성됩니다. 이 설정은 OpenShift Container Platform의 기본값입니다.정책에도 동일한 동작이 있습니다. null. policy가 설정되고policy.allowedCIDRs[]또는policy.rejectedCIDRs[]가 설정된 경우 다음 규칙이 적용됩니다.-

allowedCIDRs[]및rejectedCIDRs[]가 둘 다 설정된 경우rejectedCIDRs[]가allowedCIDRs[]보다 우선합니다. -

allowedCIDRs[]가 설정된 경우 지정된 IP 주소가 허용되는 경우에만spec.ExternalIPs[]를 사용하여Service오브젝트를 생성합니다. -

rejectedCIDRs[]가 설정된 경우 지정된 IP 주소가 거부되지 않는 경우에만spec.ExternalIPs[]를 사용하여Service오브젝트를 생성할 수 있습니다.

-

2.2.5. 정책 오브젝트의 예

이 섹션의 예제에서는 다른 spec.externalIP.policy 구성을 보여줍니다.

다음 예에서 정책은 OpenShift Container Platform에서 지정된 외부 IP 주소로 서비스를 생성하지 못하도록 합니다.

Service오브젝트spec.externalIPs[]에 지정된 값을 거부하는 정책의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 예에서는

allowedCIDRs및rejectedCIDRs필드가 모두 설정되어 있습니다.허용되거나 거부된 CIDR 블록을 모두 포함하는 정책의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 예에서

policy는{}로 설정됩니다. 이 구성으로oc get networks.config.openshift.io -o yaml명령을 사용하여 configuration meanspolicy매개변수가 명령 출력에 표시되지 않습니다.정책에도 동일한 동작이 있습니다. null.Service오브젝트spec.externalIPs[]에 지정된 값을 허용하는 정책의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.6. ExternalIP 주소 블록 구성

ExternalIP 주소 블록에 대한 구성은 cluster라는 네트워크 CR(사용자 정의 리소스)에 의해 정의됩니다. 네트워크 CR은 config.openshift.io API 그룹의 일부입니다.

CVO(Cluster Version Operator)는 클러스터를 설치하는 동안 cluster라는 네트워크 CR을 자동으로 생성합니다. 이 유형의 다른 CR 오브젝트는 생성할 수 없습니다.

다음 YAML에서는 ExternalIP 구성을 설명합니다.

cluster라는 Network.config.openshift.io CR

다음 YAML에서는 policy 스탠자의 필드를 설명합니다.

Network.config.openshift.io policy 스탠자

policy: allowedCIDRs: [] rejectedCIDRs: []

policy:

allowedCIDRs: []

rejectedCIDRs: [] 2.2.6.1. 외부 IP 구성의 예

외부 IP 주소 풀에 사용 가능한 몇 가지 구성이 다음 예에 표시되어 있습니다.

다음 YAML에서는 자동으로 할당된 외부 IP 주소를 사용하는 구성을 설명합니다.

spec.externalIP.autoAssignCIDRs가 설정된 구성의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 YAML에서는 허용되거나 거부된 CIDR 범위에 대한 정책 규칙을 구성합니다.

spec.externalIP.policy가 설정된 구성의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.7. 클러스터에 대한 외부 IP 주소 블록 구성

클러스터 관리자는 다음 ExternalIP 설정을 구성할 수 있습니다.

-

Service오브젝트의spec.clusterIP필드를 자동으로 채우도록 OpenShift Container Platform에서 사용하는 ExternalIP 주소 블록입니다. -

Service오브젝트의spec.clusterIP배열에 수동으로 할당할 수 있는 IP 주소를 제한하는 정책 오브젝트입니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

프로세스

선택 사항: 현재 외부 IP 구성을 표시하려면 다음 명령을 입력합니다.

oc describe networks.config cluster

$ oc describe networks.config clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 구성을 편집하려면 다음 명령을 입력합니다.

oc edit networks.config cluster

$ oc edit networks.config clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 예와 같이 ExternalIP 구성을 수정합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

externalIP스탠자에 대한 구성을 지정합니다.

업데이트된 ExternalIP 구성을 확인하려면 다음 명령을 입력합니다.

oc get networks.config cluster -o go-template='{{.spec.externalIP}}{{"\n"}}'$ oc get networks.config cluster -o go-template='{{.spec.externalIP}}{{"\n"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.9. 다음 단계

2.3. Ingress 컨트롤러를 사용한 수신 클러스터 트래픽 구성

OpenShift Container Platform에서는 클러스터에서 실행되는 서비스와 클러스터 외부에서 통신할 수 있습니다. 이 방법에서는 Ingress 컨트롤러를 사용합니다.

2.3.1. Ingress 컨트롤러 및 경로 사용

Ingress Operator에서는 Ingress 컨트롤러 및 와일드카드 DNS를 관리합니다.

OpenShift Container Platform 클러스터에 대한 외부 액세스를 허용하는 가장 일반적인 방법은 Ingress 컨트롤러를 사용하는 것입니다.

Ingress 컨트롤러는 외부 요청을 수락하고 구성된 경로를 기반으로 이러한 요청을 프록시하도록 구성되어 있습니다. 이는 HTTP, SNI를 사용하는 HTTPS, SNI를 사용하는 TLS로 제한되며, SNI를 사용하는 TLS를 통해 작동하는 웹 애플리케이션 및 서비스에 충분합니다.

관리자와 협력하여 구성된 경로를 기반으로 외부 요청을 수락하고 프록시하도록 Ingress 컨트롤러를 구성하십시오.

관리자는 와일드카드 DNS 항목을 생성한 다음 Ingress 컨트롤러를 설정할 수 있습니다. 그러면 관리자에게 문의하지 않고도 엣지 Ingress 컨트롤러로 작업할 수 있습니다.

기본적으로 클러스터의 모든 Ingress 컨트롤러는 클러스터의 모든 프로젝트에서 생성된 모든 경로를 허용할 수 있습니다.

Ingress 컨트롤러의 경우

- 기본적으로 두 개의 복제본이 있으므로 두 개의 작업자 노드에서 실행되어야 합니다.

- 더 많은 노드에 더 많은 복제본을 갖도록 확장할 수 있습니다.

이 섹션의 절차에는 클러스터 관리자가 수행해야 하는 사전 요구 사항이 필요합니다.

2.3.2. 사전 요구 사항

다음 절차를 시작하기 전에 관리자는 다음을 수행해야 합니다.

- 요청이 클러스터에 도달할 수 있도록 외부 포트를 클러스터 네트워킹 환경으로 설정합니다.

클러스터 관리자 역할의 사용자가 한 명 이상 있는지 확인합니다. 이 역할을 사용자에게 추가하려면 다음 명령을 실행합니다.

oc adm policy add-cluster-role-to-user cluster-admin username

$ oc adm policy add-cluster-role-to-user cluster-admin usernameCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 클러스터에 대한 네트워크 액세스 권한이 있는 마스터와 노드가 하나 이상 있고 클러스터 외부의 시스템이 있는 OpenShift Container Platform 클러스터가 있어야 합니다. 이 절차에서는 외부 시스템이 클러스터와 동일한 서브넷에 있다고 가정합니다. 다른 서브넷에 있는 외부 시스템에 필요한 추가 네트워킹은 이 주제에서 다루지 않습니다.

2.3.3. 프로젝트 및 서비스 생성

노출하려는 프로젝트 및 서비스가 존재하지 않는 경우 프로젝트를 생성한 다음 서비스를 생성합니다.

프로젝트 및 서비스가 이미 존재하는 경우 서비스 노출 절차로 건너뛰어 경로를 생성합니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치하고 클러스터 관리자로 로그인합니다.

프로세스

oc new-project명령을 실행하여 서비스에 대한 새 프로젝트를 생성합니다.oc new-project <project_name>

$ oc new-project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc new-app명령을 사용하여 서비스를 생성합니다.oc new-app nodejs:12~https://github.com/sclorg/nodejs-ex.git

$ oc new-app nodejs:12~https://github.com/sclorg/nodejs-ex.gitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 서비스가 생성되었는지 확인하려면 다음 명령을 실행합니다.

oc get svc -n <project_name>

$ oc get svc -n <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE nodejs-ex ClusterIP 172.30.197.157 <none> 8080/TCP 70s

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE nodejs-ex ClusterIP 172.30.197.157 <none> 8080/TCP 70sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고기본적으로 새 서비스에는 외부 IP 주소가 없습니다.

2.3.4. 경로를 생성하여 서비스 노출

oc expose 명령을 사용하여 서비스를 경로로 노출할 수 있습니다.

사전 요구 사항

- OpenShift Container Platform에 로그인되어 있습니다.

프로세스

노출하려는 서비스가 있는 프로젝트에 로그인합니다.

oc project <project_name>

$ oc project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc expose service명령을 실행하여 경로를 노출합니다.oc expose service nodejs-ex

$ oc expose service nodejs-exCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

route.route.openshift.io/nodejs-ex exposed

route.route.openshift.io/nodejs-ex exposedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 서비스가 노출되었는지 확인하려면

curl과 같은 툴을 사용하여 클러스터 외부에서 서비스에 액세스할 수 있는지 확인할 수 있습니다.경로의 호스트 이름을 찾으려면 다음 명령을 입력합니다.

oc get route

$ oc get routeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD nodejs-ex nodejs-ex-myproject.example.com nodejs-ex 8080-tcp None

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD nodejs-ex nodejs-ex-myproject.example.com nodejs-ex 8080-tcp NoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 호스트가 GET 요청에 응답하는지 확인하려면 다음 명령을 입력합니다.

curl명령 예curl --head nodejs-ex-myproject.example.com

$ curl --head nodejs-ex-myproject.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

HTTP/1.1 200 OK ...

HTTP/1.1 200 OK ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.5. OpenShift Container Platform의 Ingress 분할

OpenShift Container Platform에서 Ingress 컨트롤러는 모든 경로를 제공하거나 경로 서브 세트를 제공할 수 있습니다. 기본적으로 Ingress 컨트롤러는 클러스터의 모든 네임스페이스에서 생성된 모든 경로를 제공합니다. 선택한 특성을 기반으로 하는 경로의 하위 집합인 shard 를 생성하여 라우팅을 최적화하기 위해 클러스터에 Ingress 컨트롤러를 추가할 수 있습니다. 경로를 shard의 멤버로 표시하려면 경로 또는 네임스페이스 메타데이터 필드의 라벨을 사용합니다. Ingress 컨트롤러는 선택 표현식 이라고도 하는 선택기 를 사용하여 제공할 전체 경로 풀에서 경로 서브 세트를 선택합니다.

Ingress 분할은 여러 Ingress 컨트롤러에서 들어오는 트래픽을 로드 밸런싱하거나, 트래픽을 특정 Ingress 컨트롤러로 라우팅하려는 경우 또는 다음 섹션에 설명된 다양한 다른 이유로 유용합니다.

기본적으로 각 경로는 클러스터의 기본 도메인을 사용합니다. 그러나 라우터의 도메인을 사용하도록 경로를 구성할 수 있습니다.

2.3.6. Ingress 컨트롤러 분할

라우터 샤딩이라고도 하는 Ingress 분할을 사용하여 경로, 네임스페이스 또는 둘 다에 라벨을 추가하여 여러 라우터에 경로 세트를 배포할 수 있습니다. Ingress 컨트롤러는 해당 선택기 세트를 사용하여 라벨이 지정된 경로만 허용합니다. 각 Ingress shard는 지정된 선택 표현식을 사용하여 필터링된 경로로 구성됩니다.

클러스터로 들어오는 트래픽의 기본 메커니즘으로 Ingress 컨트롤러의 요구 사항이 중요할 수 있습니다. 클러스터 관리자는 다음을 위해 경로를 분할할 수 있습니다.

- 변경 사항에 대한 응답을 가속화하기 위해 여러 경로를 사용하여 Ingress 컨트롤러 또는 라우터의 균형을 조정합니다.

- 특정 경로를 할당하여 다른 경로와 안정성을 보장합니다.

- 특정 Ingress 컨트롤러에 다른 정책을 정의할 수 있도록 허용

- 특정 경로만 추가 기능을 사용하도록 허용

- 예를 들어, 내부 및 외부 사용자가 다른 경로를 볼 수 있도록 다른 주소에 다른 경로를 노출

- Blue-Green 배포 중에 한 버전의 애플리케이션에서 다른 애플리케이션으로 트래픽을 전송합니다.

Ingress 컨트롤러가 분할되면 지정된 경로가 그룹의 Ingress 컨트롤러가 0개 이상 허용됩니다. 경로 상태는 Ingress 컨트롤러가 경로를 수락했는지 여부를 나타냅니다. Ingress 컨트롤러는 경로가 shard에 고유한 경우에만 경로를 허용합니다.

분할을 사용하면 여러 Ingress 컨트롤러를 통해 경로 서브 세트를 배포할 수 있습니다. 이러한 하위 집합은 겹치지 않거나 기존 샤딩이라고도 하거나 겹치는 분할이라고 할 수 있습니다. 그렇지 않으면 중복 분할이라고 합니다.

다음 표에서는 다음 세 가지 분할 방법을 간략하게 설명합니다.

| 샤딩 방법 | 설명 |

|---|---|

| 네임스페이스 선택기 | Ingress 컨트롤러에 네임스페이스 선택기를 추가하면 네임스페이스 선택기에 일치하는 라벨이 있는 네임스페이스의 모든 경로가 Ingress shard에 포함됩니다. Ingress 컨트롤러가 네임스페이스에서 생성된 모든 경로를 제공할 때 이 방법을 고려하십시오. |

| 경로 선택기 | Ingress 컨트롤러에 경로 선택기를 추가하면 경로 선택기와 일치하는 라벨이 있는 모든 경로가 Ingress shard에 포함됩니다. Ingress 컨트롤러에서 경로의 하위 집합 또는 네임스페이스의 특정 경로만 제공하려는 경우 이 방법을 고려하십시오. |

| 네임스페이스 및 경로 선택기 | 네임스페이스 선택기 및 경로 선택기 방법 모두에 대한 Ingress 컨트롤러 범위를 제공합니다. 네임스페이스 선택기와 경로 선택기 방법의 유연성을 원할 때 이 방법을 고려하십시오. |

2.3.6.1. 기존 분할 예

레이블 선택기 spec.namespaceSelector.matchExpressions 가 있는 구성된 Ingress 컨트롤러 finops-router 의 예로, key 값이 financial 및 ops 로 설정되어 있습니다.

finops-router의 YAML 정의 예

선택기 spec.namespaceSelector.matchLabels.name 레이블이 dev 로 설정된 구성된 Ingress 컨트롤러 dev-router 의 예입니다.

dev-router의 YAML 정의 예

name:finance,name:ops, name:dev 로 레이블이 지정된 각 네임스페이스와 같은 모든 애플리케이션 경로가 별도의 네임스페이스에 있는 경우 구성은 두 Ingress 컨트롤러 간에 경로를 효과적으로 배포합니다. 콘솔, 인증 및 기타 용도로 사용되는 OpenShift Container Platform 경로를 처리해서는 안 됩니다.

이전 시나리오에서는 분할의 특수한 경우가 되며 하위 집합이 겹치지 않습니다. 경로는 라우터 shard로 나뉩니다.

기본 Ingress 컨트롤러는 namespaceSelector 또는 routeSelector 필드에 제외를 위한 경로가 포함되지 않는 한 모든 경로를 계속 제공합니다. 기본 Ingress 컨트롤러에서 경로를 제외하는 방법에 대한 자세한 내용은 이 Red Hat Knowledgebase 솔루션 및 "기본 Ingress 컨트롤러 공유" 섹션을 참조하십시오.

2.3.6.2. 중복된 분할 예

선택기 spec.namespaceSelector.matchExpressions에 dev 및 ops 로 설정된 라벨 선택기 spec.namespaceSelector.matchExpressions 가 있는 구성된 Ingress 컨트롤러 Cryostat -router 의 예

Cryostat -router의 YAML정의 예

name:dev 및 name:ops 레이블이 지정된 네임스페이스의 경로는 이제 두 개의 다른 Ingress 컨트롤러에서 서비스를 제공합니다. 이 구성을 사용하면 경로의 하위 집합이 겹치게 됩니다.

경로의 하위 집합을 겹치는 상태에서 더 복잡한 라우팅 규칙을 생성할 수 있습니다. 예를 들어 우선순위가 더 높은 트래픽을 전용 finops-router 로 분산하는 동안 우선순위가 낮은 트래픽을 Cryostat -router 로 보낼 수 있습니다.

2.3.6.3. 기본 Ingress 컨트롤러 분할

새 Ingress shard를 생성한 후 기본 Ingress 컨트롤러에서 승인한 새 Ingress shard에 허용되는 경로가 있을 수 있습니다. 이는 기본 Ingress 컨트롤러에 선택기가 없으며 기본적으로 모든 경로를 허용하기 때문입니다.

네임스페이스 선택기 또는 경로 선택기를 사용하여 특정 라벨이 있는 라우팅에서 Ingress 컨트롤러를 제한할 수 있습니다. 다음 절차에서는 네임스페이스 선택기를 사용하여 기본 Ingress 컨트롤러가 새로 shard된 financial ,ops, dev 경로를 서비스하지 못하도록 제한합니다. 이렇게 하면 Ingress shard에 추가 격리가 추가됩니다.

동일한 Ingress 컨트롤러에 모든 OpenShift Container Platform 관리 경로를 유지해야 합니다. 따라서 이러한 필수 경로를 제외하는 기본 Ingress 컨트롤러에 선택기를 추가하지 마십시오.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. - 프로젝트 관리자로 로그인했습니다.

프로세스

다음 명령을 실행하여 기본 Ingress 컨트롤러를 수정합니다.

oc edit ingresscontroller -n openshift-ingress-operator default

$ oc edit ingresscontroller -n openshift-ingress-operator defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow financial ,

ops,dev라벨이 있는 경로를 제외하는namespaceSelector를포함하도록 Ingress 컨트롤러를 편집합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

기본 Ingress 컨트롤러는 더 이상 name:finance,name:ops, name:dev 이라는 네임스페이스를 제공하지 않습니다.

2.3.6.4. Ingress 샤딩 및 DNS

클러스터 관리자는 프로젝트의 각 라우터에 대해 별도의 DNS 항목을 만듭니다. 라우터는 알 수 없는 경로를 다른 라우터로 전달하지 않습니다.

다음 예제를 고려하십시오.

-

라우터 A는 호스트 192.168.0.5에 있으며

*.foo.com이 있는 경로가 있습니다. -

라우터 B는 호스트 192.168.1.9에 있으며

*.example.com이 있는 경로가 있습니다.

별도의 DNS 항목은 라우터 B를 호스팅하는 노드와 *.example.com 을 호스팅하는 노드로 *.foo.com 을 확인해야 합니다.

-

*.foo.com A IN 192.168.0.5 -

*.example.com A IN 192.168.1.9

2.3.6.5. 경로 라벨을 사용하여 Ingress 컨트롤러 분할 구성

경로 라벨을 사용한 Ingress 컨트롤러 분할이란 Ingress 컨트롤러가 경로 선택기에서 선택한 모든 네임스페이스의 모든 경로를 제공한다는 뜻입니다.

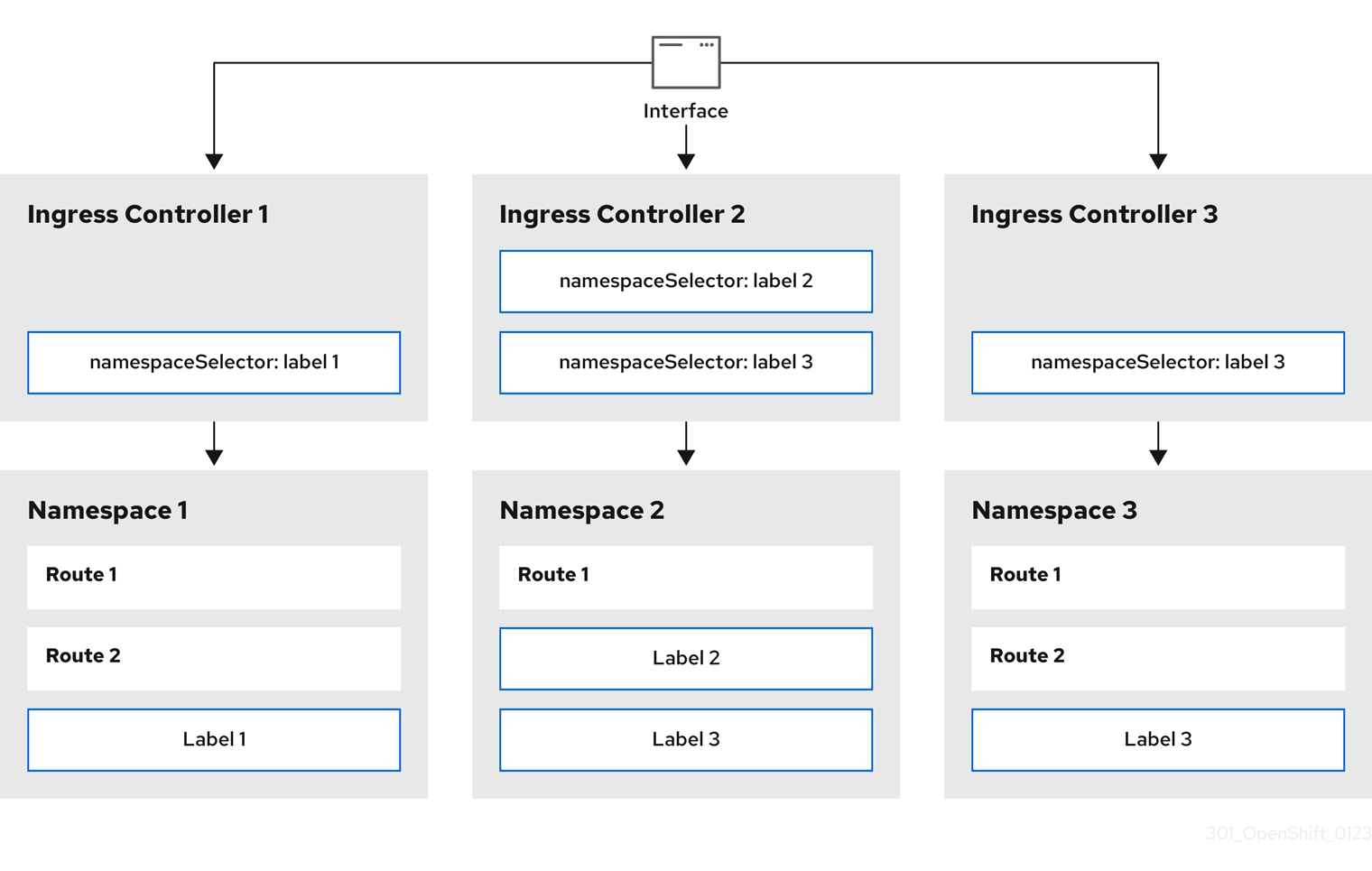

그림 2.1. 경로 라벨을 사용한 Ingress 분할

Ingress 컨트롤러 분할은 들어오는 트래픽 부하를 일련의 Ingress 컨트롤러에 균형 있게 분배하고 트래픽을 특정 Ingress 컨트롤러에 격리할 때 유용합니다. 예를 들어, 회사 A는 하나의 Ingress 컨트롤러로, 회사 B는 다른 Ingress 컨트롤러로 이동합니다.

프로세스

router-internal.yaml파일을 다음과 같이 편집합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Ingress 컨트롤러에서 사용할 도메인을 지정합니다. 이 도메인은 기본 Ingress 컨트롤러 도메인과 달라야 합니다.

Ingress 컨트롤러

router-internal.yaml파일을 적용합니다.oc apply -f router-internal.yaml

# oc apply -f router-internal.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress 컨트롤러는

type: sharded라벨이 있는 네임스페이스에서 경로를 선택합니다.router-internal.yaml에 구성된 도메인을 사용하여 새 경로를 생성합니다.oc expose svc <service-name> --hostname <route-name>.apps-sharded.basedomain.example.net

$ oc expose svc <service-name> --hostname <route-name>.apps-sharded.basedomain.example.netCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.6.6. 네임스페이스 라벨을 사용하여 Ingress 컨트롤러 분할 구성

네임스페이스 라벨을 사용한 Ingress 컨트롤러 분할이란 Ingress 컨트롤러가 네임스페이스 선택기에서 선택한 모든 네임스페이스의 모든 경로를 제공한다는 뜻입니다.

그림 2.2. 네임스페이스 라벨을 사용한 Ingress 분할

Ingress 컨트롤러 분할은 들어오는 트래픽 부하를 일련의 Ingress 컨트롤러에 균형 있게 분배하고 트래픽을 특정 Ingress 컨트롤러에 격리할 때 유용합니다. 예를 들어, 회사 A는 하나의 Ingress 컨트롤러로, 회사 B는 다른 Ingress 컨트롤러로 이동합니다.

프로세스

router-internal.yaml파일을 다음과 같이 편집합니다.cat router-internal.yaml

$ cat router-internal.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Ingress 컨트롤러에서 사용할 도메인을 지정합니다. 이 도메인은 기본 Ingress 컨트롤러 도메인과 달라야 합니다.

Ingress 컨트롤러

router-internal.yaml파일을 적용합니다.oc apply -f router-internal.yaml

$ oc apply -f router-internal.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress 컨트롤러는 네임스페이스 선택기에서 선택한

type: sharded라벨이 있는 네임스페이스에서 경로를 선택합니다.router-internal.yaml에 구성된 도메인을 사용하여 새 경로를 생성합니다.oc expose svc <service-name> --hostname <route-name>.apps-sharded.basedomain.example.net

$ oc expose svc <service-name> --hostname <route-name>.apps-sharded.basedomain.example.netCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.6.7. Ingress 컨트롤러 샤딩의 경로 생성

경로를 사용하면 URL에서 애플리케이션을 호스팅할 수 있습니다. Ingress 컨트롤러 분할은 들어오는 트래픽 부하를 일련의 Ingress 컨트롤러 간에 균형을 유지하는 데 도움이 됩니다. 특정 Ingress 컨트롤러로 트래픽을 분리할 수도 있습니다. 예를 들어, 회사 A는 하나의 Ingress 컨트롤러로, 회사 B는 다른 Ingress 컨트롤러로 이동합니다.

다음 절차에서는 hello-openshift 애플리케이션을 예로 사용하여 Ingress 컨트롤러 샤딩에 대한 경로를 생성하는 방법을 설명합니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. - 프로젝트 관리자로 로그인했습니다.

- 포트에서 트래픽을 수신하는 포트와 HTTP 또는 TLS 끝점을 노출하는 웹 애플리케이션이 있습니다.

- 분할을 위해 Ingress 컨트롤러를 구성했습니다.

프로세스

다음 명령을 실행하여

hello-openshift라는 프로젝트를 생성합니다.oc new-project hello-openshift

$ oc new-project hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 프로젝트에 Pod를 생성합니다.

oc create -f https://raw.githubusercontent.com/openshift/origin/master/examples/hello-openshift/hello-pod.json

$ oc create -f https://raw.githubusercontent.com/openshift/origin/master/examples/hello-openshift/hello-pod.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

hello-openshift라는 서비스를 생성합니다.oc expose pod/hello-openshift

$ oc expose pod/hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow hello-openshift-route.yaml이라는 경로 정의를 생성합니다.샤딩을 위해 생성된 경로의 YAML 정의

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

hello-openshift-route.yaml을 사용하여hello-openshift애플리케이션에 대한 경로를 생성합니다.oc -n hello-openshift create -f hello-openshift-route.yaml

$ oc -n hello-openshift create -f hello-openshift-route.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

다음 명령을 사용하여 경로 상태를 가져옵니다.

oc -n hello-openshift get routes/hello-openshift-edge -o yaml

$ oc -n hello-openshift get routes/hello-openshift-edge -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 생성된

Route리소스는 다음과 유사해야 합니다.출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Ingress 컨트롤러 또는 라우터의 호스트 이름은 을 사용하여 경로를 노출합니다.

host필드의 값은 Ingress 컨트롤러에서 자동으로 결정하고 해당 도메인을 사용합니다. 이 예에서 Ingress 컨트롤러의 도메인은 <apps-sharded.basedomain.example.net>입니다. - 2

- Ingress 컨트롤러의 호스트 이름입니다. 호스트 이름이 설정되지 않은 경우 경로는 하위 도메인을 대신 사용할 수 있습니다. 하위 도메인을 지정하면 경로를 노출하는 Ingress 컨트롤러의 도메인을 자동으로 사용합니다. 여러 Ingress 컨트롤러에서 경로를 노출하면 경로가 여러 URL에서 호스팅됩니다.

- 3

- Ingress 컨트롤러의 이름입니다. 이 예에서 Ingress 컨트롤러에는

shard된이름이 있습니다.

2.3.6.8. 추가 리소스

2.4. Ingress 컨트롤러 끝점 게시 전략 구성

endpointPublishingStrategy 는 Ingress 컨트롤러 끝점을 다른 네트워크에 게시하고 로드 밸런서 통합을 활성화하며 다른 시스템에 대한 액세스를 제공하는 데 사용됩니다.

RHOSP(Red Hat OpenStack Platform)에서 LoadBalancerService 끝점 게시 전략은 클라우드 공급자가 상태 모니터를 생성하도록 구성된 경우에만 지원됩니다. RHOSP 16.2의 경우 이 전략은 Amphora Octavia 공급자를 사용하는 경우에만 가능합니다.

자세한 내용은 RHOSP 설치 설명서의 "RHOSP Cloud Controller Manager 옵션 설정" 섹션을 참조하십시오.

2.4.1. Ingress 컨트롤러 끝점 게시 전략

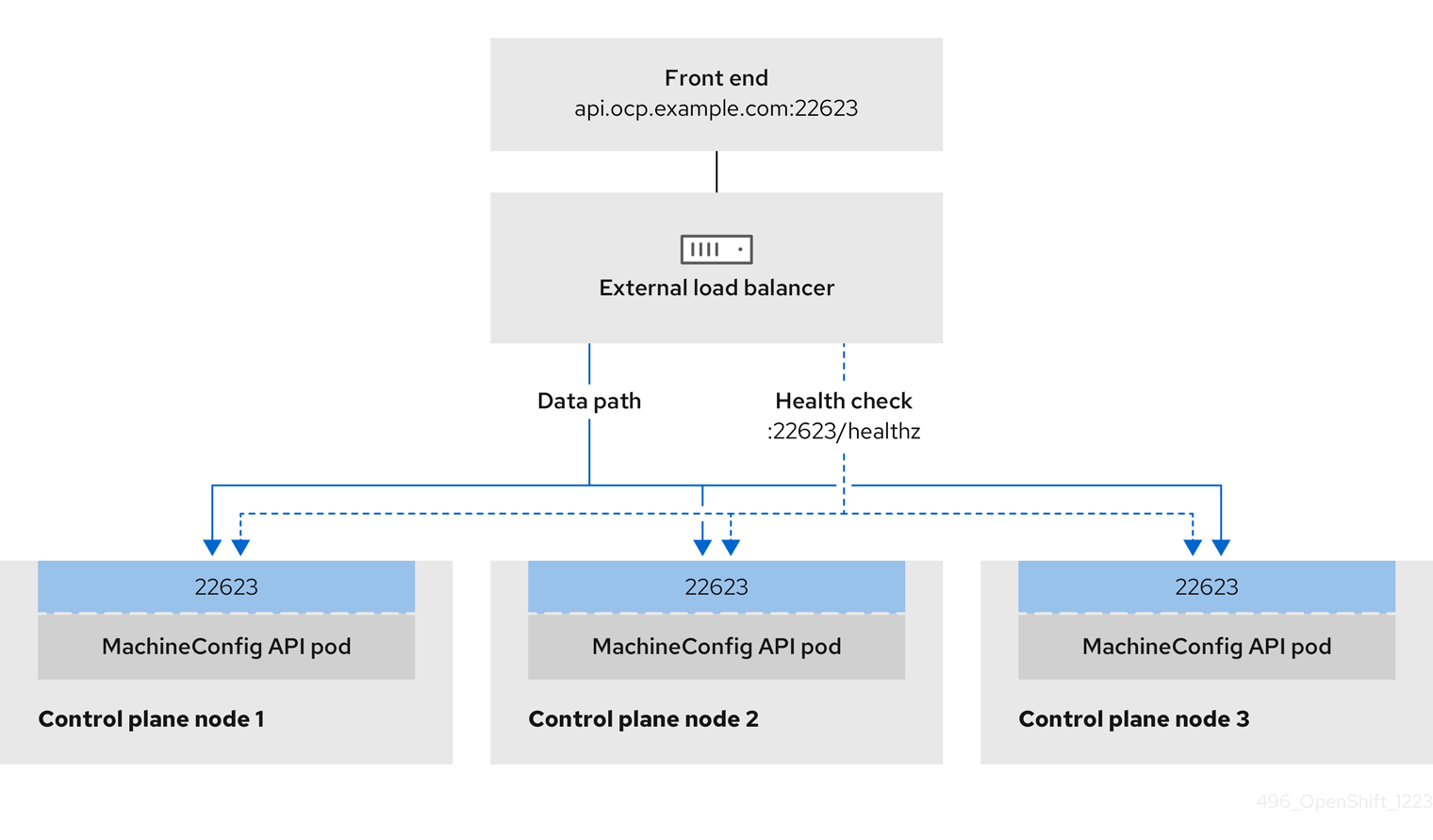

NodePortService 끝점 게시 전략

NodePortService 끝점 게시 전략에서는 Kubernetes NodePort 서비스를 사용하여 Ingress 컨트롤러를 게시합니다.

이 구성에서는 Ingress 컨트롤러를 배포하기 위해 컨테이너 네트워킹을 사용합니다. 배포를 게시하기 위해 NodePortService가 생성됩니다. 특정 노드 포트는 OpenShift Container Platform에 의해 동적으로 할당됩니다. 그러나 정적 포트 할당을 지원하기 위해 관리형 NodePortService의 노드 포트 필드에 대한 변경 사항은 유지됩니다.

그림 2.3. NodePortService 다이어그램

이전 그림에서는 OpenShift Container Platform Ingress NodePort 끝점 게시 전략과 관련된 다음 개념을 보여줍니다.

- 클러스터에서 사용 가능한 모든 노드에는 외부에서 액세스할 수 있는 자체 IP 주소가 있습니다. 클러스터에서 실행 중인 서비스는 모든 노드의 고유한 NodePort에 바인딩됩니다.

-

예를 들어 그래픽에서

10.0.128.4IP 주소를 연결하여 클라이언트가 다운된 노드에 연결하면 노드 포트는 클라이언트를 서비스를 실행하는 사용 가능한 노드에 직접 연결합니다. 이 시나리오에서는 로드 밸런싱이 필요하지 않습니다. 이미지가 표시된 대로10.0.128.4주소가 다운되었으며 다른 IP 주소를 대신 사용해야 합니다.

Ingress Operator는 서비스의 .spec.ports[].nodePort 필드에 대한 업데이트를 무시합니다.

기본적으로 포트는 자동으로 할당되며 통합을 위해 포트 할당에 액세스할 수 있습니다. 그러나 동적 포트에 대한 응답으로 쉽게 재구성할 수 없는 기존 인프라와 통합하기 위해 정적 포트 할당이 필요한 경우가 있습니다. 정적 노드 포트와 통합하기 위해 관리 서비스 리소스를 직접 업데이트할 수 있습니다.

자세한 내용은 NodePort에 대한 Kubernetes 서비스 설명서를 참조하십시오.

HostNetwork 끝점 게시 전략

HostNetwork 끝점 게시 전략에서는 Ingress 컨트롤러가 배포된 노드 포트에 Ingress 컨트롤러를 게시합니다.

HostNetwork 끝점 게시 전략이 있는 Ingress 컨트롤러는 노드당 하나의 Pod 복제본만 가질 수 있습니다. n개의 복제본이 필요한 경우에는 해당 복제본을 예약할 수 있는 n개 이상의 노드를 사용해야 합니다. 각 pod 복제본은 예약된 노드 호스트에서 포트 80 및 443을 요청하므로 동일한 노드의 다른 pod가 해당 포트를 사용하는 경우 복제본을 노드에 예약할 수 없습니다.

HostNetwork 오브젝트에는 httpPort: 80,httpsPort: 443, statsPort: 1936 이라는 선택적 바인딩 포트에 대해 다음과 같은 기본값이 있는 hostNetwork 필드가 있습니다. 네트워크에 다른 바인딩 포트를 지정하면 HostNetwork 전략에 대해 동일한 노드에 여러 Ingress 컨트롤러를 배포할 수 있습니다.

예

2.4.1.1. Ingress 컨트롤러 끝점에서 내부로 게시 범위 구성

클러스터 관리자가 클러스터가 프라이빗임을 지정하지 않고 새 클러스터를 설치하면 범위를 External 로 설정하여 기본 Ingress 컨트롤러가 생성됩니다. 클러스터 관리자는 외부 범위가 지정된 Ingress 컨트롤러를 Internal 로 변경할 수 있습니다.

사전 요구 사항

-

ocCLI를 설치했습니다.

프로세스

외부범위가 지정된 Ingress 컨트롤러를Internal로 변경하려면 다음 명령을 입력합니다.oc -n openshift-ingress-operator patch ingresscontrollers/default --type=merge --patch='{"spec":{"endpointPublishingStrategy":{"type":"LoadBalancerService","loadBalancer":{"scope":"Internal"}}}}'$ oc -n openshift-ingress-operator patch ingresscontrollers/default --type=merge --patch='{"spec":{"endpointPublishingStrategy":{"type":"LoadBalancerService","loadBalancer":{"scope":"Internal"}}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress 컨트롤러의 상태를 확인하려면 다음 명령을 입력합니다.

oc -n openshift-ingress-operator get ingresscontrollers/default -o yaml

$ oc -n openshift-ingress-operator get ingresscontrollers/default -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Progressing상태 조건은 추가 작업을 수행해야 하는지 여부를 나타냅니다. 예를 들어 상태 조건은 다음 명령을 입력하여 서비스를 삭제해야 함을 나타낼 수 있습니다.oc -n openshift-ingress delete services/router-default

$ oc -n openshift-ingress delete services/router-defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 서비스를 삭제하면 Ingress Operator에서 해당 서비스를

Internal로 다시 생성합니다.

2.4.1.2. 외부로 범위를 게시하는 Ingress 컨트롤러 끝점 구성

클러스터 관리자가 클러스터가 프라이빗임을 지정하지 않고 새 클러스터를 설치하면 범위를 External 로 설정하여 기본 Ingress 컨트롤러가 생성됩니다.

Ingress 컨트롤러의 범위는 설치 중 또는 이후에 내부로 구성할 수 있으며 클러스터 관리자는 내부 Ingress 컨트롤러를 외부로 변경할 수 있습니다.

일부 플랫폼에서는 서비스를 삭제하고 다시 생성해야 합니다.

범위를 변경하면 Ingress 트래픽으로 인해 몇 분 동안 중단될 수 있습니다. 이 절차는 OpenShift Container Platform에서 기존 서비스 로드 밸런서를 프로비저닝 해제하고 새 서비스 로드 밸런서를 프로비저닝하고 DNS를 업데이트할 수 있으므로 서비스를 삭제하고 다시 생성해야 하는 플랫폼에 적용됩니다.

사전 요구 사항

-

ocCLI를 설치했습니다.

프로세스

내부범위가 지정된 Ingress 컨트롤러를외부로변경하려면 다음 명령을 입력합니다.oc -n openshift-ingress-operator patch ingresscontrollers/private --type=merge --patch='{"spec":{"endpointPublishingStrategy":{"type":"LoadBalancerService","loadBalancer":{"scope":"External"}}}}'$ oc -n openshift-ingress-operator patch ingresscontrollers/private --type=merge --patch='{"spec":{"endpointPublishingStrategy":{"type":"LoadBalancerService","loadBalancer":{"scope":"External"}}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress 컨트롤러의 상태를 확인하려면 다음 명령을 입력합니다.

oc -n openshift-ingress-operator get ingresscontrollers/default -o yaml

$ oc -n openshift-ingress-operator get ingresscontrollers/default -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Progressing상태 조건은 추가 작업을 수행해야 하는지 여부를 나타냅니다. 예를 들어 상태 조건은 다음 명령을 입력하여 서비스를 삭제해야 함을 나타낼 수 있습니다.oc -n openshift-ingress delete services/router-default

$ oc -n openshift-ingress delete services/router-defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 서비스를 삭제하면 Ingress Operator에서

외부로 다시 생성합니다.

2.4.1.3. Ingress 컨트롤러에 단일 NodePort 서비스 추가

각 프로젝트에 NodePort-type Service 를 생성하는 대신 사용자 정의 Ingress 컨트롤러를 생성하여 NodePortService 끝점 게시 전략을 사용할 수 있습니다. 포트 충돌을 방지하려면 Ingress 샤딩을 통해 HostNetwork Ingress 컨트롤러가 있을 수 있는 노드에 경로 세트를 적용하려면 Ingress 컨트롤러에 대해 이 구성을 고려하십시오.

각 프로젝트에 NodePort-type 서비스를 설정하기 전에 다음 고려 사항을 읽으십시오.

- Nodeport Ingress 컨트롤러 도메인에 대한 와일드카드 DNS 레코드를 생성해야 합니다. Nodeport Ingress 컨트롤러 경로는 작업자 노드의 주소에서 연결할 수 있습니다. 경로에 필요한 DNS 레코드에 대한 자세한 내용은 "사용자 프로비저닝 DNS 요구 사항"을 참조하십시오.

-

서비스의 경로를 노출하고 사용자 정의 Ingress 컨트롤러 도메인의

--hostname인수를 지정해야 합니다. -

애플리케이션 Pod에 액세스할 수 있도록 경로의

NodePort-type서비스에할당된 포트를 추가해야 합니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin권한이 있는 사용자로 로그인합니다. - 와일드카드 DNS 레코드를 생성했습니다.

프로세스

Ingress 컨트롤러에 대한 CR(사용자 정의 리소스) 파일을 생성합니다.

IngressController오브젝트에 대한 정보를 정의하는 CR 파일의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

IngressControllerCR의 사용자 정의이름을지정합니다.- 2

- Ingress 컨트롤러 서비스의 DNS 이름입니다. 예를 들어 기본 ingresscontroller 도메인은

apps.ipi-cluster.example.com이므로 <custom_ic_domain_name>을nodeportsvc.ipi-cluster.example.com으로 지정합니다. - 3

- 사용자 정의 Ingress 컨트롤러를 포함하는 노드의 라벨을 지정합니다.

- 4

- 네임스페이스 집합의 라벨을 지정합니다. <

key>:<value>를 <key>가 새 레이블의 고유 이름이며 <value>가 값인키-값 쌍의 맵으로 바꿉니다. 예:ingresscontroller: custom-ic.

oc label node명령을 사용하여 노드에 라벨을 추가합니다.oc label node <node_name> <key>=<value>

$ oc label node <node_name> <key>=<value>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 여기서

<value>는IngressControllerCR의nodePlacement섹션에 지정된 키-값 쌍과 일치해야 합니다.

IngressController오브젝트를 생성합니다.oc create -f <ingress_controller_cr>.yaml

$ oc create -f <ingress_controller_cr>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow IngressControllerCR에 대해 생성된 서비스의 포트를 찾습니다.oc get svc -n openshift-ingress

$ oc get svc -n openshift-ingressCopy to Clipboard Copied! Toggle word wrap Toggle overflow router-nodeport-custom-ic3서비스의 포트80:32432/TCP를 표시하는 출력 예NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE router-internal-default ClusterIP 172.30.195.74 <none> 80/TCP,443/TCP,1936/TCP 223d router-nodeport-custom-ic3 NodePort 172.30.109.219 <none> 80:32432/TCP,443:31366/TCP,1936:30499/TCP 155m

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE router-internal-default ClusterIP 172.30.195.74 <none> 80/TCP,443/TCP,1936/TCP 223d router-nodeport-custom-ic3 NodePort 172.30.109.219 <none> 80:32432/TCP,443:31366/TCP,1936:30499/TCP 155mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 새 프로젝트를 생성하려면 다음 명령을 입력합니다.

oc new-project <project_name>

$ oc new-project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 새 네임스페이스에 레이블을 지정하려면 다음 명령을 입력합니다.

oc label namespace <project_name> <key>=<value>

$ oc label namespace <project_name> <key>=<value>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 여기서 &

lt;key>=<value>는 Ingress 컨트롤러 CR의namespaceSelector섹션에 있는 값과 일치해야 합니다.

클러스터에 새 애플리케이션을 생성합니다.

oc new-app --image=<image_name>

$ oc new-app --image=<image_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- <

image_name>의 예는quay.io/openshifttest/hello-openshift:multiarch입니다.

Pod에서 서비스를 사용하여 클러스터 외부에 애플리케이션을 노출할 수 있도록 서비스의

Route오브젝트를 생성합니다.oc expose svc/<service_name> --hostname=<svc_name>-<project_name>.<custom_ic_domain_name>

$ oc expose svc/<service_name> --hostname=<svc_name>-<project_name>.<custom_ic_domain_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고--hostname인수에서 사용자 정의 Ingress 컨트롤러의 도메인 이름을 지정해야 합니다. 이 작업을 수행하지 않으면 Ingress Operator는 기본 Ingress 컨트롤러를 사용하여 클러스터의 모든 경로를 제공합니다.경로에

Admitted상태가 있고 사용자 정의 Ingress 컨트롤러에 대한 메타데이터가 포함되어 있는지 확인합니다.oc get route/hello-openshift -o json | jq '.status.ingress'

$ oc get route/hello-openshift -o json | jq '.status.ingress'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 기본 Ingress 컨트롤러에서

NodePort-type서비스를관리하지 못하도록 기본IngressControllerCR을 업데이트합니다. 기본 Ingress 컨트롤러는 다른 모든 클러스터 트래픽을 계속 모니터링합니다.oc patch --type=merge -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"namespaceSelector":{"matchExpressions":[{"key":"<key>","operator":"NotIn","values":["<value>]}]}}}'$ oc patch --type=merge -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"namespaceSelector":{"matchExpressions":[{"key":"<key>","operator":"NotIn","values":["<value>]}]}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

다음 명령을 입력하여 DNS 항목이 클러스터 내부 및 외부에서 라우팅될 수 있는지 확인합니다. 이 명령은 절차의 앞부분에서

oc label node명령을 실행하여 레이블을 수신한 노드의 IP 주소를 출력합니다.dig +short <svc_name>-<project_name>.<custom_ic_domain_name>

$ dig +short <svc_name>-<project_name>.<custom_ic_domain_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 클러스터가 DNS 확인을 위해 외부 DNS 서버의 IP 주소를 사용하는지 확인하려면 다음 명령을 입력하여 클러스터 연결을 확인합니다.

curl <svc_name>-<project_name>.<custom_ic_domain_name>:<port>

$ curl <svc_name>-<project_name>.<custom_ic_domain_name>:<port>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Hello OpenShift!

Hello OpenShift!Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5. 로드 밸런서를 사용하여 수신 클러스터 트래픽 구성

OpenShift Container Platform에서는 클러스터에서 실행되는 서비스와 클러스터 외부에서 통신할 수 있습니다. 이 방법에서는 로드 밸런서를 사용합니다.

2.5.1. 로드 밸런서를 사용하여 클러스터로 트래픽 가져오기

특정 외부 IP 주소가 필요하지 않은 경우 OpenShift Container Platform 클러스터에 대한 외부 액세스를 허용하도록 로드 밸런서 서비스를 구성할 수 있습니다.

로드 밸런서 서비스에서는 고유 IP를 할당합니다. 로드 밸런서에는 VIP(가상 IP)일 수 있는 단일 엣지 라우터 IP가 있지만 이는 초기 로드 밸런싱을 위한 단일 머신에 불과합니다.

풀이 구성된 경우 클러스터 관리자가 아닌 인프라 수준에서 수행됩니다.

이 섹션의 절차에는 클러스터 관리자가 수행해야 하는 사전 요구 사항이 필요합니다.

2.5.2. 사전 요구 사항

다음 절차를 시작하기 전에 관리자는 다음을 수행해야 합니다.

- 요청이 클러스터에 도달할 수 있도록 외부 포트를 클러스터 네트워킹 환경으로 설정합니다.

클러스터 관리자 역할의 사용자가 한 명 이상 있는지 확인합니다. 이 역할을 사용자에게 추가하려면 다음 명령을 실행합니다.

oc adm policy add-cluster-role-to-user cluster-admin username

$ oc adm policy add-cluster-role-to-user cluster-admin usernameCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 클러스터에 대한 네트워크 액세스 권한이 있는 마스터와 노드가 클러스터 외부에 각각 1개 이상씩 있는 OpenShift Container Platform 클러스터가 있어야 합니다. 이 절차에서는 외부 시스템이 클러스터와 동일한 서브넷에 있다고 가정합니다. 다른 서브넷에 있는 외부 시스템에 필요한 추가 네트워킹은 이 주제에서 다루지 않습니다.

2.5.3. 프로젝트 및 서비스 생성

노출하려는 프로젝트 및 서비스가 존재하지 않는 경우 프로젝트를 생성한 다음 서비스를 생성합니다.

프로젝트 및 서비스가 이미 존재하는 경우 서비스 노출 절차로 건너뛰어 경로를 생성합니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치하고 클러스터 관리자로 로그인합니다.

프로세스

oc new-project명령을 실행하여 서비스에 대한 새 프로젝트를 생성합니다.oc new-project <project_name>

$ oc new-project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc new-app명령을 사용하여 서비스를 생성합니다.oc new-app nodejs:12~https://github.com/sclorg/nodejs-ex.git

$ oc new-app nodejs:12~https://github.com/sclorg/nodejs-ex.gitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 서비스가 생성되었는지 확인하려면 다음 명령을 실행합니다.

oc get svc -n <project_name>

$ oc get svc -n <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE nodejs-ex ClusterIP 172.30.197.157 <none> 8080/TCP 70s

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE nodejs-ex ClusterIP 172.30.197.157 <none> 8080/TCP 70sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고기본적으로 새 서비스에는 외부 IP 주소가 없습니다.

2.5.4. 경로를 생성하여 서비스 노출

oc expose 명령을 사용하여 서비스를 경로로 노출할 수 있습니다.

사전 요구 사항

- OpenShift Container Platform에 로그인되어 있습니다.

프로세스

노출하려는 서비스가 있는 프로젝트에 로그인합니다.

oc project <project_name>

$ oc project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc expose service명령을 실행하여 경로를 노출합니다.oc expose service nodejs-ex

$ oc expose service nodejs-exCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

route.route.openshift.io/nodejs-ex exposed

route.route.openshift.io/nodejs-ex exposedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 서비스가 노출되었는지 확인하려면

curl과 같은 툴을 사용하여 클러스터 외부에서 서비스에 액세스할 수 있는지 확인할 수 있습니다.경로의 호스트 이름을 찾으려면 다음 명령을 입력합니다.

oc get route

$ oc get routeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD nodejs-ex nodejs-ex-myproject.example.com nodejs-ex 8080-tcp None

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD nodejs-ex nodejs-ex-myproject.example.com nodejs-ex 8080-tcp NoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 호스트가 GET 요청에 응답하는지 확인하려면 다음 명령을 입력합니다.

curl명령 예curl --head nodejs-ex-myproject.example.com

$ curl --head nodejs-ex-myproject.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

HTTP/1.1 200 OK ...

HTTP/1.1 200 OK ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.5. 로드 밸런서 서비스 생성

다음 절차에 따라 로드 밸런서 서비스를 생성합니다.

사전 요구 사항

- 노출하려는 프로젝트와 서비스가 존재하는지 확인합니다.

- 클라우드 공급자는 로드 밸런서를 지원합니다.

프로세스

로드 밸런서 서비스를 생성하려면 다음을 수행합니다.

- OpenShift Container Platform 4에 로그인합니다.

노출하려는 서비스가 있는 프로젝트를 로드합니다.

oc project project1

$ oc project project1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 필요에 따라 컨트롤 플레인 노드에서 텍스트 파일을 열고 다음 텍스트를 붙여넣고 파일을 편집합니다.

로드 밸런서 구성 파일 샘플

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고로드 밸런서를 통한 트래픽을 특정 IP 주소로 제한하려면 Ingress 컨트롤러 필드

spec.endpointPublishingStrategy.loadBalancer.allowedSourceRanges를 사용하는 것이 좋습니다.loadBalancerSourceRanges필드를 설정하지 마십시오.- 파일을 저장하고 종료합니다.

다음 명령을 실행하여 서비스를 생성합니다.

oc create -f <file-name>

$ oc create -f <file-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들면 다음과 같습니다.

oc create -f mysql-lb.yaml

$ oc create -f mysql-lb.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 새 서비스를 보려면 다음 명령을 실행합니다.

oc get svc

$ oc get svcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE egress-2 LoadBalancer 172.30.22.226 ad42f5d8b303045-487804948.example.com 3306:30357/TCP 15m

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE egress-2 LoadBalancer 172.30.22.226 ad42f5d8b303045-487804948.example.com 3306:30357/TCP 15mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 활성화된 클라우드 공급자가 있는 경우 서비스에 외부 IP 주소가 자동으로 할당됩니다.

마스터에서 cURL과 같은 도구를 사용하여 공개 IP 주소로 서비스에 도달할 수 있는지 확인합니다.

curl <public-ip>:<port>

$ curl <public-ip>:<port>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들면 다음과 같습니다.

curl 172.29.121.74:3306