This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.애플리케이션 빌드

OpenShift Container Platform에서 애플리케이션 생성 및 관리

초록

1장. 애플리케이션 빌드 개요

OpenShift Container Platform을 사용하면 웹 콘솔 또는 CLI(명령줄 인터페이스)를 사용하여 애플리케이션을 생성, 편집, 삭제 및 관리할 수 있습니다.

1.1. 프로젝트 작업

프로젝트를 사용하면 별도로 애플리케이션을 구성하고 관리할 수 있습니다. OpenShift Container Platform에서 프로젝트를 생성, 보기, 삭제하는 등 전체 프로젝트 라이프사이클을 관리할 수 있습니다.

프로젝트를 생성한 후 개발자 화면을 사용하여 프로젝트에 대한 액세스 권한을 부여하거나 취소하고 사용자의 클러스터 역할을 관리할 수 있습니다. 새 프로젝트의 자동 프로비저닝에 사용되는 프로젝트 템플릿을 생성하는 동안 프로젝트 구성 리소스를 편집할 수도 있습니다.

CLI를 사용하면 OpenShift Container Platform API에 요청을 가장하여 다른 사용자로 프로젝트를 생성할 수 있습니다. 새 프로젝트를 생성하도록 요청할 때 OpenShift Container Platform은 끝점을 사용하여 사용자 지정 템플릿에 따라 프로젝트를 프로비저닝합니다. 클러스터 관리자는 인증된 사용자 그룹이 새 프로젝트를 자체 프로비저닝하지 못하도록 할 수 있습니다.

1.2. 애플리케이션 작업

1.2.1. 애플리케이션 생성

애플리케이션을 생성하려면 프로젝트를 생성하거나 적절한 역할 및 권한이 있는 프로젝트에 액세스할 수 있어야 합니다. 웹 콘솔의 개발자 화면,설치된 Operator 또는 OpenShift Container Platform CLI 를 사용하여 애플리케이션을 생성할 수 있습니다. Git, JAR 파일, devfile 또는 개발자 카탈로그에서 프로젝트에 추가할 애플리케이션을 소싱할 수 있습니다.

OpenShift Container Platform CLI를 사용하여 애플리케이션을 생성하는 소스 또는 바이너리 코드, 이미지 및 템플릿이 포함된 구성 요소를 사용할 수도 있습니다. OpenShift Container Platform 웹 콘솔을 사용하면 클러스터 관리자가 설치한 Operator에서 애플리케이션을 생성할 수 있습니다.

1.2.2. 애플리케이션 유지 관리

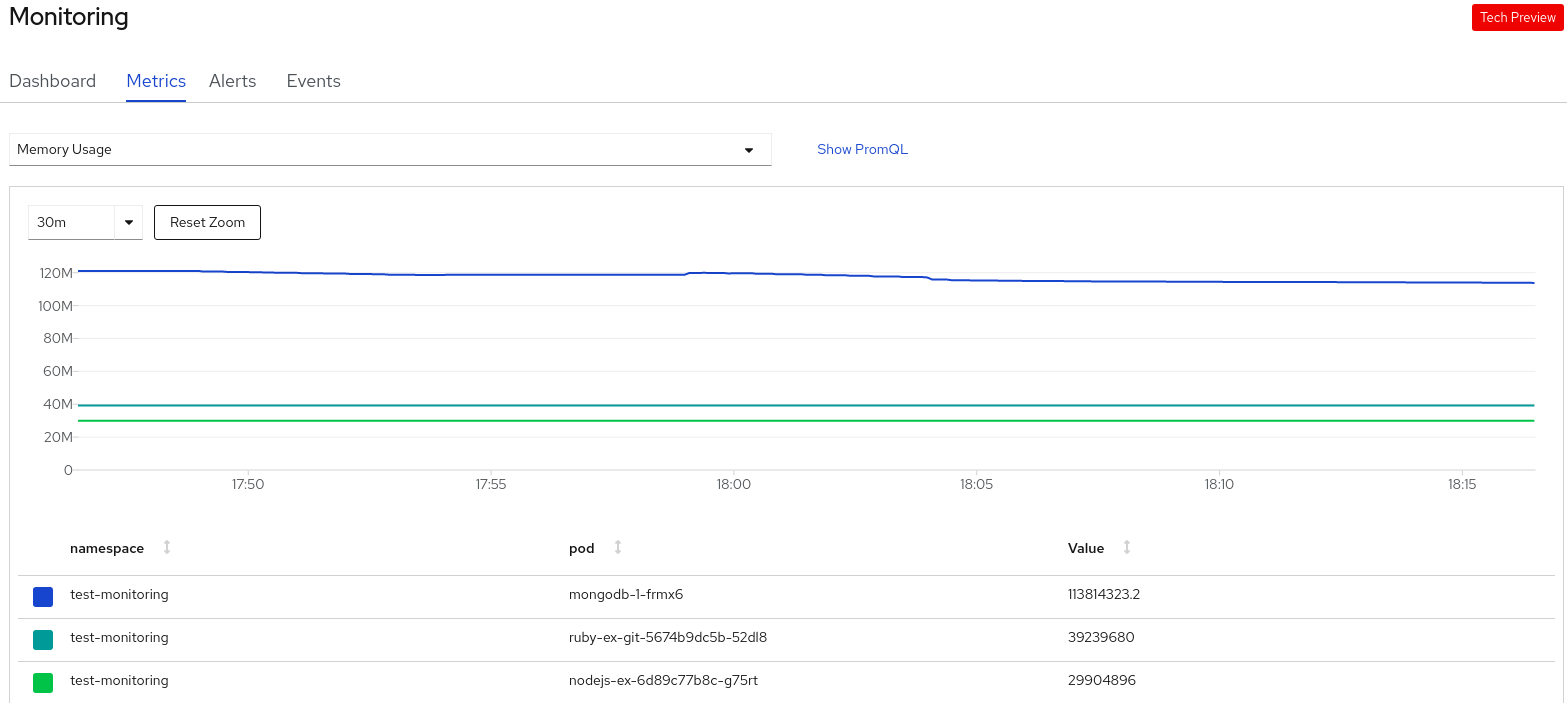

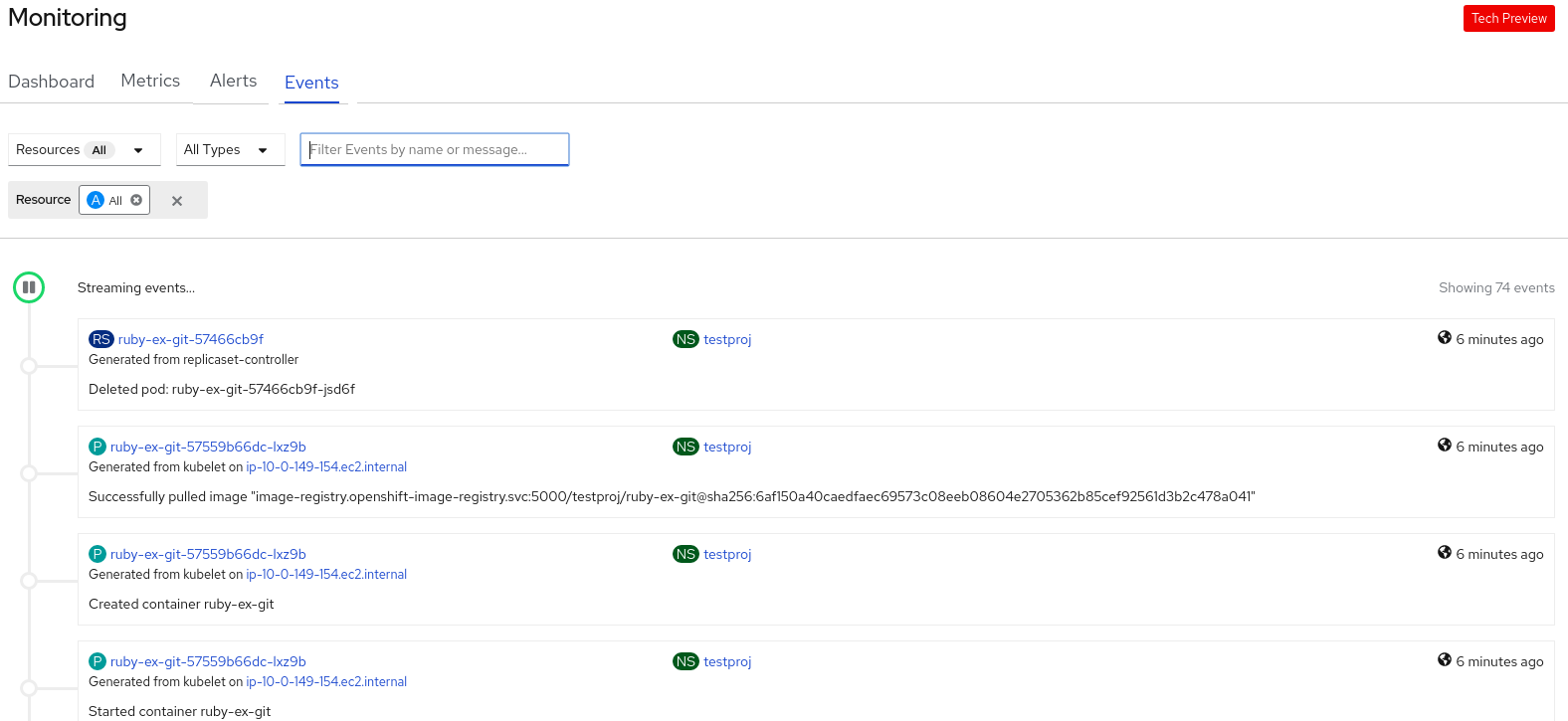

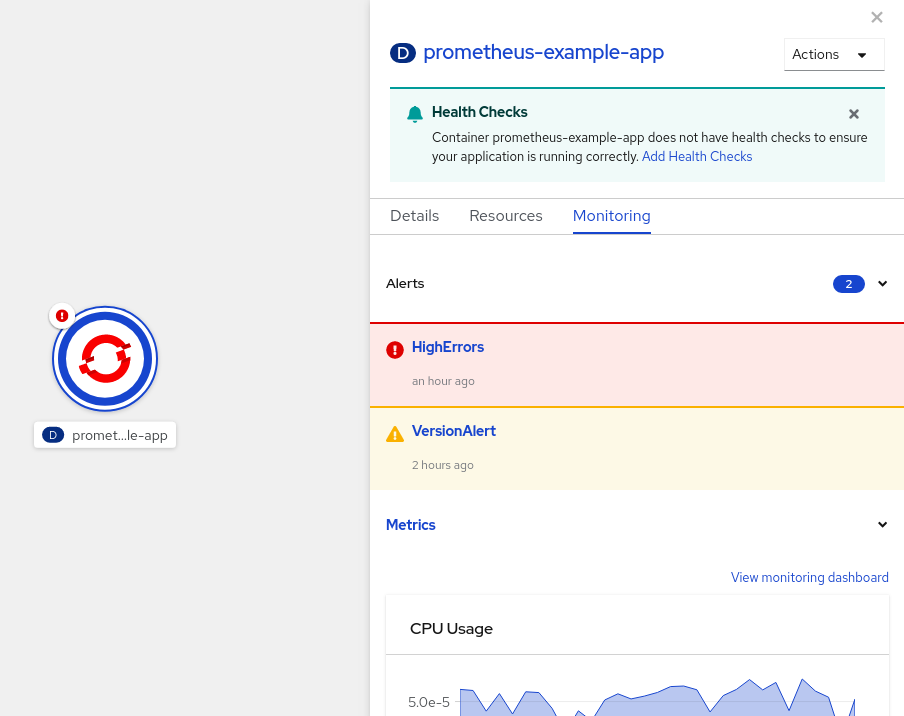

애플리케이션을 생성한 후 웹 콘솔을 사용하여 프로젝트 또는 애플리케이션 지표를 모니터링할 수 있습니다. 웹 콘솔을 사용하여 애플리케이션을 편집하거나 삭제할 수도 있습니다. 애플리케이션이 실행 중이면 모든 애플리케이션 리소스가 사용되지 않습니다. 클러스터 관리자는 이러한 확장 가능한 리소스를 유휴 상태로 설정하여 리소스 사용을 줄일 수 있습니다.

1.2.3. 애플리케이션 배포

Deployment 또는 DeploymentConfig오브젝트 를 사용하여 애플리케이션을 배포하고 웹 콘솔에서 관리할 수 있습니다. 변경 중 또는 애플리케이션을 업그레이드하는 동안 다운타임을 줄이는 데 도움이 되는 배포 전략을 생성할 수 있습니다.

OpenShift Container Platform 클러스터에 애플리케이션 및 서비스 배포를 간소화하는 소프트웨어 패키지 관리자인 Helm 을 사용할 수도 있습니다.

1.3. Red Hat Marketplace 사용

Red Hat Marketplace 는 퍼블릭 클라우드 및 온프레미스에서 실행되는 컨테이너 기반 환경에 대해 인증된 소프트웨어를 검색하고 액세스할 수 있는 오픈 클라우드 마켓플레이스입니다.

2장. 프로젝트

2.1. 노드 작업

사용자 커뮤니티는 프로젝트를 통해 다른 커뮤니티와 별도로 콘텐츠를 구성하고 관리할 수 있습니다.

openshift- 및 kube-로 시작하는 프로젝트는 기본 프로젝트입니다. 이러한 프로젝트는 Pod 및 기타 인프라 구성 요소로 실행되는 클러스터 구성 요소를 호스팅합니다. 따라서 OpenShift Container Platform에서는 oc new-project 명령을 사용하여 openshift- 또는 kube-로 시작하는 프로젝트를 생성할 수 없습니다. 클러스터 관리자는 oc adm new-project 명령을 사용하여 이러한 프로젝트를 생성할 수 있습니다.

기본 네임스페이스(default, kube-system, kube-public, openshift-node, openshift-infra, openshift) 중 하나에서 생성된 Pod에는 SCC를 할당할 수 없습니다. 이러한 네임스페이스는 Pod 또는 서비스를 실행하는 데 사용할 수 없습니다.

2.1.1. 웹 콘솔을 사용하여 프로젝트 생성

클러스터 관리자가 허용한 경우 새 프로젝트를 생성할 수 있습니다.

openshift- 및 kube-로 시작하는 프로젝트는 OpenShift Container Platform에서 중요한 것으로 간주합니다. 따라서 OpenShift Container Platform에서는 웹 콘솔을 사용하여 openshift-로 시작하는 프로젝트를 생성할 수 없습니다.

기본 네임스페이스(default, kube-system, kube-public, openshift-node, openshift-infra, openshift) 중 하나에서 생성된 Pod에는 SCC를 할당할 수 없습니다. 이러한 네임스페이스는 Pod 또는 서비스를 실행하는 데 사용할 수 없습니다.

프로세스

- 홈 → 프로젝트로 이동합니다.

- Create Project를 클릭합니다.

- 프로젝트 세부 정보를 입력합니다.

- Create를 클릭합니다.

2.1.2. 웹 콘솔의 개발자 화면을 사용하여 프로젝트 만들기

OpenShift Container Platform 웹 콘솔의 개발자 화면을 사용하여 클러스터에 프로젝트를 생성할 수 있습니다.

openshift- 및 kube-로 시작하는 프로젝트는 OpenShift Container Platform에서 중요한 것으로 간주합니다. 따라서 OpenShift Container Platform에서는 개발자 화면을 사용하여 openshift- 또는 kube-로 시작하는 프로젝트를 생성할 수 없습니다. 클러스터 관리자는 oc adm new-project 명령을 사용하여 이러한 프로젝트를 생성할 수 있습니다.

기본 네임스페이스(default, kube-system, kube-public, openshift-node, openshift-infra, openshift) 중 하나에서 생성된 Pod에는 SCC를 할당할 수 없습니다. 이러한 네임스페이스는 Pod 또는 서비스를 실행하는 데 사용할 수 없습니다.

사전 요구 사항

- OpenShift Container Platform에서 프로젝트, 애플리케이션 및 기타 워크로드를 생성할 적절한 역할과 권한이 있는지 확인합니다.

프로세스

다음과 같이 개발자 화면을 사용하여 프로젝트를 생성할 수 있습니다.

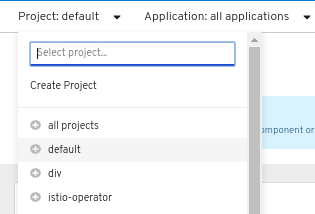

프로젝트 드롭다운 메뉴를 클릭하여 사용 가능한 전체 프로젝트 목록을 확인합니다. 프로젝트 생성을 선택합니다.

그림 2.1. 프로젝트 생성

-

프로젝트 생성 대화 상자에서 이름 필드에

myproject와 같은 고유한 이름을 입력합니다. - 선택 사항: 프로젝트의 Display Name (표시 이름) 및 Description (설명) 세부 정보를 추가합니다.

- 생성을 클릭합니다.

- 왼쪽 탐색 패널을 사용하여 프로젝트 보기로 이동하여 프로젝트 대시보드를 확인합니다.

선택 사항:

- 클러스터의 프로젝트를 모두 나열하려면 화면 위쪽에 있는 프로젝트 드롭다운 메뉴를 사용하여 모든 프로젝트를 선택합니다.

- 프로젝트 세부 정보를 확인하려면 세부 정보 탭을 사용합니다.

- 프로젝트에 대한 적절한 권한이 있는 경우 프로젝트 액세스 탭을 사용하여 관리자를 제공하거나 취소하고 프로젝트에 대한 권한을 편집 및 확인할 수 있습니다.

2.1.3. CLI를 사용하여 프로젝트 생성

클러스터 관리자가 허용한 경우 새 프로젝트를 생성할 수 있습니다.

openshift- 및 kube-로 시작하는 프로젝트는 OpenShift Container Platform에서 중요한 것으로 간주합니다. 따라서 OpenShift Container Platform에서는 oc new-project 명령을 사용하여 openshift- 또는 kube-로 시작하는 프로젝트를 생성할 수 없습니다. 클러스터 관리자는 oc adm new-project 명령을 사용하여 이러한 프로젝트를 생성할 수 있습니다.

기본 네임스페이스(default, kube-system, kube-public, openshift-node, openshift-infra, openshift) 중 하나에서 생성된 Pod에는 SCC를 할당할 수 없습니다. 이러한 네임스페이스는 Pod 또는 서비스를 실행하는 데 사용할 수 없습니다.

프로세스

다음을 실행합니다.

oc new-project <project_name> \ --description="<description>" --display-name="<display_name>"$ oc new-project <project_name> \ --description="<description>" --display-name="<display_name>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들면 다음과 같습니다.

oc new-project hello-openshift \ --description="This is an example project" \ --display-name="Hello OpenShift"$ oc new-project hello-openshift \ --description="This is an example project" \ --display-name="Hello OpenShift"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

생성할 수 있는 프로젝트 수는 시스템 관리자가 제한할 수 있습니다. 제한에 도달한 후 새 프로젝트를 생성하려면 기존 프로젝트를 삭제해야 할 수 있습니다.

2.1.4. 웹 콘솔을 사용하여 프로젝트 보기

프로세스

- 홈 → 프로젝트로 이동합니다.

확인할 프로젝트를 선택합니다.

이 페이지에서 Workloads(워크로드 )를 클릭하여 프로젝트의 워크로드를 확인합니다.

2.1.5. CLI를 사용하여 프로젝트 보기

프로젝트를 볼 때는 권한 부여 정책에 따라 볼 수 있는 액세스 권한이 있는 프로젝트만 볼 수 있습니다.

프로세스

프로젝트 목록을 보려면 다음을 실행합니다.

oc get projects

$ oc get projectsCopy to Clipboard Copied! Toggle word wrap Toggle overflow CLI 작업을 위해 현재 프로젝트에서 다른 프로젝트로 변경할 수 있습니다. 그러면 지정된 프로젝트가 프로젝트 범위의 콘텐츠를 조작하는 모든 후속 작업에서 사용됩니다.

oc project <project_name>

$ oc project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.6. 개발자 화면을 사용하여 프로젝트에 액세스 권한 제공

개발자 화면의 프로젝트 보기를 사용하여 프로젝트에 대한 액세스 권한을 부여하거나 취소할 수 있습니다.

프로세스

프로젝트에 사용자를 추가하고 관리자, 편집 또는 보기 액세스 권한을 제공하려면 다음을 수행합니다.

- 개발자 화면에서 프로젝트 보기로 이동합니다.

- 프로젝트 페이지에서 프로젝트 액세스 탭을 선택합니다.

액세스 추가를 클릭하여 기본 권한에 새 권한 행을 추가합니다.

그림 2.2. 프로젝트 권한

- 사용자 이름을 입력하고 역할 선택 드롭다운 목록을 클릭하고 적절한 역할을 선택합니다.

- 저장을 클릭하여 새 권한을 추가합니다.

또는 다음을 수행할 수도 있습니다.

- 역할 선택 드롭다운 목록을 사용하여 기존 사용자의 액세스 권한을 수정합니다.

- 액세스 제거 아이콘을 사용하여 프로젝트에 대한 기존 사용자의 액세스 권한을 완전히 제거합니다.

고급 역할 기반 액세스 제어는 관리자 화면의 역할 및 역할 바인딩 보기에서 관리됩니다.

2.1.7. 개발자 화면을 사용하여 사용 가능한 클러스터 역할 사용자 정의

프로젝트 사용자는 액세스 제어를 기반으로 클러스터 역할에 할당됩니다. 프로젝트 → 프로젝트 액세스 → 역할로 이동하여 이러한 클러스터 역할에 액세스할 수 있습니다. 기본적으로 이러한 역할은 Admin,Edit, View 입니다.

프로젝트의 클러스터 역할을 추가하거나 편집하려면 클러스터의 YAML 코드를 사용자 지정할 수 있습니다.

프로세스

프로젝트의 다양한 클러스터 역할을 사용자 지정하려면 다음을 수행합니다.

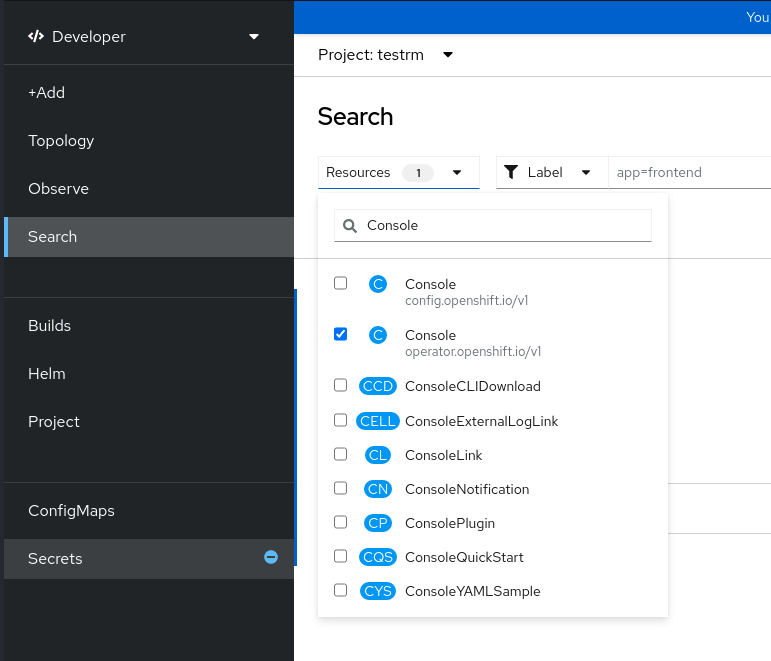

-

검색 보기에서 리소스 드롭다운 목록을 사용하여 콘솔을

검색합니다. 사용 가능한 옵션에서 Console

operator.openshift.io/v1을 선택합니다.그림 2.3. 콘솔 리소스 검색

- 이름 목록에서 클러스터를 선택합니다.

- YAML 탭으로 이동하여 YAML 코드를 보고 편집합니다.

spec아래의 YAML 코드에서availableClusterRoles목록을 추가하거나 편집하고 변경 사항을 저장합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.8. 프로젝트에 추가

프로세스

- 웹 콘솔 탐색 메뉴 위쪽의 컨텍스트 선택기에서 개발자를 선택합니다.

- +추가를 클릭합니다.

- 페이지 위쪽에서 추가할 프로젝트 이름을 선택합니다.

- 프로젝트에 추가하는 방법을 클릭한 다음 워크플로를 따릅니다.

빠른 검색을 사용하여 토폴로지에 구성 요소를 추가할 수도 있습니다.

2.1.9. 웹 콘솔을 사용하여 프로젝트 상태 확인

프로세스

- 홈 → 프로젝트로 이동합니다.

- 상태를 확인할 프로젝트를 선택합니다.

2.1.10. CLI를 사용하여 프로젝트 상태 확인

프로세스

다음을 실행합니다.

oc status

$ oc statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 명령은 현재 프로젝트에 대한 고급 개요에 해당 구성 요소와 그 관계를 제공합니다.

2.1.11. 웹 콘솔을 사용하여 프로젝트 삭제

OpenShift Container Platform 웹 콘솔을 사용하여 프로젝트를 삭제할 수 있습니다.

프로젝트를 삭제할 수 있는 권한이 없는 경우 프로젝트 삭제 옵션이 제공되지 않습니다.

프로세스

- 홈 → 프로젝트로 이동합니다.

- 프로젝트 목록에서 삭제할 프로젝트를 찾습니다.

-

프로젝트 목록 맨 오른쪽에 있는 옵션 메뉴

에서 프로젝트 삭제 를 선택합니다.

에서 프로젝트 삭제 를 선택합니다.

- 프로젝트 삭제 창이 열리면 삭제할 프로젝트 이름을 필드에 입력합니다.

- 삭제를 클릭합니다.

2.1.12. CLI를 사용하여 프로젝트 삭제

프로젝트를 삭제하면 서버에서 프로젝트 상태를 활성에서 종료로 업데이트합니다. 그런 다음 서버는 프로젝트를 완전히 제거하기 전에 상태가 종료인 프로젝트의 모든 콘텐츠를 지웁니다. 프로젝트 상태가 종료인 동안에는 프로젝트에 새 콘텐츠를 추가할 수 없습니다. CLI 또는 웹 콘솔에서 프로젝트를 삭제할 수 있습니다.

프로세스

다음을 실행합니다.

oc delete project <project_name>

$ oc delete project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2. 다른 사용자로 프로젝트 생성

가장 기능을 사용하면 다른 사용자로 프로젝트를 생성할 수 있습니다.

2.2.1. API 가장

OpenShift Container Platform API에 대한 요청을 다른 사용자가 보낸 것처럼 작동하도록 구성할 수 있습니다. 자세한 내용은 Kubernetes 설명서의 사용자 가장을 참조하십시오.

2.2.2. 프로젝트를 만들 때 사용자 가장

프로젝트 요청을 생성할 때 다른 사용자로 가장할 수 있습니다. system:authenticated:oauth는 프로젝트 요청을 생성할 수 있는 유일한 부트스트랩 그룹이므로 이 그룹을 가장해야 합니다.

프로세스

다른 사용자를 대신하여 프로젝트 요청을 생성하려면 다음을 실행합니다.

oc new-project <project> --as=<user> \ --as-group=system:authenticated --as-group=system:authenticated:oauth$ oc new-project <project> --as=<user> \ --as-group=system:authenticated --as-group=system:authenticated:oauthCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. 프로젝트 생성 구성

OpenShift Container Platform에서 프로젝트는 관련 오브젝트를 그룹화하고 격리하는 데 사용됩니다. 웹 콘솔 또는 oc new-project 명령을 사용하여 새 프로젝트를 생성하라는 요청이 생성되면 OpenShift Container Platform의 끝점을 사용하여 사용자 지정할 수 있는 템플릿에 따라 프로젝트를 프로비저닝합니다.

클러스터 관리자는 개발자 및 서비스 계정이 자체 프로젝트를 생성하거나 자체 프로비저닝하는 방법을 허용하고 구성할 수 있습니다.

2.3.1. 프로젝트 생성 정보

OpenShift Container Platform API 서버는 클러스터의 프로젝트 구성 리소스에서 projectRequestTemplate 매개변수로 식별하는 프로젝트 템플릿을 기반으로 새 프로젝트를 자동으로 프로비저닝합니다. 매개변수가 정의되지 않은 경우 API 서버는 요청된 이름으로 프로젝트를 생성하는 기본 템플릿을 생성하고 요청하는 사용자에게 해당 프로젝트의 admin 역할을 할당합니다.

프로젝트 요청을 제출하면 API에서 다음 매개변수를 템플릿으로 대체합니다.

| 매개변수 | 설명 |

|---|---|

|

| 프로젝트 이름입니다. 필수 항목입니다. |

|

| 프로젝트의 표시 이름입니다. 비어 있을 수 있습니다. |

|

| 프로젝트에 대한 설명입니다. 비어 있을 수 있습니다. |

|

| 관리 사용자의 사용자 이름입니다. |

|

| 요청하는 사용자의 사용자 이름입니다. |

API에 대한 액세스 권한은 self-provisioner 역할 및 self-provisioner 클러스터 역할 바인딩을 가진 개발자에게 부여됩니다. 이 역할은 기본적으로 인증된 모든 개발자에게 제공됩니다.

2.3.2. 새 프로젝트의 템플릿 수정

클러스터 관리자는 사용자 정의 요구 사항을 사용하여 새 프로젝트를 생성하도록 기본 프로젝트 템플릿을 수정할 수 있습니다.

사용자 정의 프로젝트 템플릿을 만들려면:

프로세스

-

cluster-admin권한이 있는 사용자로 로그인합니다. 기본 프로젝트 템플릿을 생성합니다.

oc adm create-bootstrap-project-template -o yaml > template.yaml

$ oc adm create-bootstrap-project-template -o yaml > template.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

텍스트 편집기를 사용하여 오브젝트를 추가하거나 기존 오브젝트를 수정하여 생성된

template.yaml파일을 수정합니다. 프로젝트 템플릿은

openshift-config네임스페이스에서 생성해야 합니다. 수정된 템플릿을 불러옵니다.oc create -f template.yaml -n openshift-config

$ oc create -f template.yaml -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 웹 콘솔 또는 CLI를 사용하여 프로젝트 구성 리소스를 편집합니다.

웹 콘솔에 액세스:

- 관리 → 클러스터 설정으로 이동합니다.

- 전역 구성을 클릭하여 모든 구성 리소스를 확인합니다.

- 프로젝트 항목을 찾아 YAML 편집을 클릭합니다.

CLI 사용:

다음과 같이

project.config.openshift.io/cluster리소스를 편집합니다.oc edit project.config.openshift.io/cluster

$ oc edit project.config.openshift.io/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow

projectRequestTemplate및name매개변수를 포함하도록spec섹션을 업데이트하고 업로드된 프로젝트 템플릿의 이름을 설정합니다. 기본 이름은project-request입니다.사용자 정의 프로젝트 템플릿이 포함된 프로젝트 구성 리소스

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 변경 사항을 저장한 후 새 프로젝트를 생성하여 변경 사항이 성공적으로 적용되었는지 확인합니다.

2.3.3. 프로젝트 자체 프로비저닝 비활성화

인증된 사용자 그룹이 새 프로젝트를 자체 프로비저닝하지 못하도록 할 수 있습니다.

프로세스

-

cluster-admin권한이 있는 사용자로 로그인합니다. 다음 명령을 실행하여

self-provisioners클러스터 역할 바인딩 사용을 확인합니다.oc describe clusterrolebinding.rbac self-provisioners

$ oc describe clusterrolebinding.rbac self-provisionersCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow self-provisioners섹션의 제목을 검토합니다.그룹

system:authenticated:oauth에서self-provisioner클러스터 역할을 제거합니다.self-provisioners클러스터 역할 바인딩에서self-provisioner역할을system:authenticated:oauth그룹에만 바인딩하는 경우 다음 명령을 실행합니다.oc patch clusterrolebinding.rbac self-provisioners -p '{"subjects": null}'$ oc patch clusterrolebinding.rbac self-provisioners -p '{"subjects": null}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow self-provisioners클러스터 역할 바인딩에서self-provisioner역할을system:authenticated:oauth그룹 이외에도 추가 사용자, 그룹 또는 서비스 계정에 바인딩하는 경우 다음 명령을 실행합니다.oc adm policy \ remove-cluster-role-from-group self-provisioner \ system:authenticated:oauth$ oc adm policy \ remove-cluster-role-from-group self-provisioner \ system:authenticated:oauthCopy to Clipboard Copied! Toggle word wrap Toggle overflow

역할이 자동으로 업데이트되지 않도록

self-provisioners클러스터 역할 바인딩을 편집합니다. 역할이 자동으로 업데이트되면 클러스터 역할이 기본 상태로 재설정됩니다.CLI를 사용하여 역할 바인딩을 업데이트하려면 다음을 수행합니다.

다음 명령을 실행합니다.

oc edit clusterrolebinding.rbac self-provisioners

$ oc edit clusterrolebinding.rbac self-provisionersCopy to Clipboard Copied! Toggle word wrap Toggle overflow 표시된 역할 바인딩에서 다음 예와 같이

rbac.authorization.kubernetes.io/autoupdate매개변수 값을false로 설정합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

단일 명령을 사용하여 역할 바인딩을 업데이트하려면 다음을 실행합니다.

oc patch clusterrolebinding.rbac self-provisioners -p '{ "metadata": { "annotations": { "rbac.authorization.kubernetes.io/autoupdate": "false" } } }'$ oc patch clusterrolebinding.rbac self-provisioners -p '{ "metadata": { "annotations": { "rbac.authorization.kubernetes.io/autoupdate": "false" } } }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

인증된 사용자로 로그인하여 프로젝트를 더 이상 자체 프로비저닝할 수 없는지 확인합니다.

oc new-project test

$ oc new-project testCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Error from server (Forbidden): You may not request a new project via this API.

Error from server (Forbidden): You may not request a new project via this API.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 조직과 관련된 더 유용한 지침을 제공하도록 이 프로젝트 요청 메시지를 사용자 정의하는 것이 좋습니다.

2.3.4. 프로젝트 요청 메시지 사용자 정의

프로젝트를 자체 프로비저닝할 수 없는 개발자 또는 서비스 계정이 웹 콘솔 또는 CLI를 사용하여 프로젝트 생성을 요청하면 기본적으로 다음과 같은 오류 메시지가 반환됩니다.

You may not request a new project via this API.

You may not request a new project via this API.클러스터 관리자는 이 메시지를 사용자 지정할 수 있습니다. 조직과 관련된 새 프로젝트를 요청하는 방법에 대한 추가 지침을 제공하려면 업데이트하는 것이 좋습니다. 예를 들면 다음과 같습니다.

-

프로젝트를 요청하려면

projectname@example.com을 통해 시스템 관리자에게 문의하십시오. -

새 프로젝트를 요청하려면

https://internal.example.com/openshift-project-request에 있는 프로젝트 요청 양식을 작성합니다.

프로젝트 요청 메시지를 사용자 지정하려면 다음을 수행합니다.

프로세스

웹 콘솔 또는 CLI를 사용하여 프로젝트 구성 리소스를 편집합니다.

웹 콘솔에 액세스:

- 관리 → 클러스터 설정으로 이동합니다.

- 전역 구성을 클릭하여 모든 구성 리소스를 확인합니다.

- 프로젝트 항목을 찾아 YAML 편집을 클릭합니다.

CLI 사용:

-

cluster-admin권한이 있는 사용자로 로그인합니다. 다음과 같이

project.config.openshift.io/cluster리소스를 편집합니다.oc edit project.config.openshift.io/cluster

$ oc edit project.config.openshift.io/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

projectRequestMessage매개변수를 포함하도록spec섹션을 업데이트하고 해당 값을 사용자 정의 메시지로 설정합니다.사용자 정의 프로젝트 요청 메시지가 포함된 프로젝트 구성 리소스

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들면 다음과 같습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 변경 사항을 저장한 후 프로젝트를 자체 프로비저닝하여 변경 사항이 성공적으로 적용되었는지 확인할 수 없는 개발자 또는 서비스 계정으로 새 프로젝트를 생성합니다.

3장. 애플리케이션 생성

3.1. 개발자 화면을 사용하여 애플리케이션 생성

웹 콘솔의 개발자 화면은 +추가 보기에서 애플리케이션 및 관련 서비스를 생성하고 OpenShift Container Platform에 배포할 수 있는 다음 옵션을 제공합니다.

시작하기 리소스: 이러한 리소스를 사용하여 개발자 콘솔을 시작하는 데 도움이 됩니다. 옵션 메뉴

를 사용하여 헤더를 숨기도록 선택할 수 있습니다.

를 사용하여 헤더를 숨기도록 선택할 수 있습니다.

- 샘플을 사용하여 애플리케이션 생성: 기존 코드 샘플을 사용하여 OpenShift Container Platform에서 애플리케이션 생성을 시작합니다.

- 안내 문서를 사용하여 빌드: 안내 문서에 따라 애플리케이션을 빌드하고 주요 개념과 용어를 숙지하십시오.

- 새로운 개발자 기능 살펴보기: 개발자 화면에서 새로운 기능과 리소스를 살펴봅니다.

개발자 카탈로그: 개발자 카탈로그를 살펴보고 이미지 빌더에 필요한 애플리케이션, 서비스 또는 소스를 선택한 다음 프로젝트에 추가합니다.

- 모든 서비스: 카탈로그를 참조하여 OpenShift Container Platform에서 서비스를 검색합니다.

- 데이터베이스: 필요한 데이터베이스 서비스를 선택하여 애플리케이션에 추가합니다.

- Operator 지원: 필요한 Operator 관리 서비스를 선택하고 배포합니다.

- Helm 차트: 필요한 Helm 차트를 선택하여 애플리케이션 및 서비스 배포를 간소화합니다.

이벤트 소스: 이벤트 소스를 선택하여 특정 시스템에서 관심있는 이벤트 클래스에 등록합니다.

참고RHOAS Operator가 설치된 경우에도 Managed 서비스 옵션을 사용할 수 있습니다.

- Git 리포지토리: 각각 From Git, From Devfile 또는 From Dockerfile 옵션을 사용하여 Git 리포지토리에서 기존 코드베이스,Devfile 또는 Dockerfile 을 가져와 OpenShift Container Platform에서 애플리케이션을 빌드하고 배포합니다.

- 컨테이너 이미지: 이미지 스트림 또는 레지스트리의 기존 이미지를 사용하여 OpenShift Container Platform에 배포합니다.

- 파이프 라인: Tekton 파이프라인을 사용하여 OpenShift Container Platform의 소프트웨어 제공 프로세스에 사용할 CI/CD 파이프라인을 생성합니다.

서버리스: OpenShift Container Platform에서 상태 비저장 및 서버리스 애플리케이션을 생성, 빌드 및 배포하는 Serverless 옵션을 살펴봅니다.

- 채널: Knative 채널을 생성하여 인메모리 및 안정적인 구현으로 이벤트 전달 및 지속성 계층을 생성합니다.

- 샘플: 사용 가능한 샘플 애플리케이션을 살펴보고 애플리케이션을 빠르게 생성, 빌드 및 배포합니다.

- 빠른 시작: 빠른 시작 옵션을 살펴보고 단계별 지침 및 작업을 사용하여 애플리케이션을 생성, 가져오기 및 실행합니다.

로컬 머신에서: 애플리케이션을 쉽게 빌드 및 배포하기 위해 로컬 머신에서 파일을 가져오거나 업로드하려면 From Local Machine 타일을 탐색합니다.

- YAML 가져 오기: YAML 파일을 업로드하여 애플리케이션을 빌드하고 배포하기 위한 리소스를 생성하고 정의합니다.

- JAR 파일 업로드: JAR 파일을 업로드하여 Java 애플리케이션을 빌드 및 배포합니다.

Pipeline,Event Source, Import Virtual Machines 와 같은 특정 옵션은 각각 OpenShift Pipelines Operator, OpenShiftServerless Operator 및 OpenShift Virtualization Operator 가 설치된 경우에만 표시됩니다.

3.1.1. 사전 요구 사항

개발자 화면을 사용하여 애플리케이션을 생성하려면 다음 조건을 충족해야 합니다.

서버리스 애플리케이션을 생성하려면 위 사전 요구 사항에 다음 조건이 추가됩니다.

3.1.2. 샘플 애플리케이션 생성

개발자 화면의 +추가 흐름에서 샘플 애플리케이션을 사용하여 애플리케이션을 빠르게 생성, 빌드 및 배포할 수 있습니다.

사전 요구 사항

- OpenShift Container Platform 웹 콘솔에 로그인하여 개발자 화면에 있습니다.

절차

- +추가 보기에서 샘플 타일을 클릭하여 샘플 페이지를 확인합니다.

- 샘플 페이지에서 사용 가능한 샘플 애플리케이션 중 하나를 선택하여 샘플 애플리케이션 생성 양식을 확인합니다.

샘플 애플리케이션 생성 양식에서 다음을 수행합니다.

- 이름 필드에는 기본적으로 배포 이름이 표시됩니다. 필요에 따라 이 이름을 수정할 수 있습니다.

- 빌더 이미지 버전에는 빌더 이미지가 기본적으로 선택되어 있습니다. 빌더 이미지 버전 드롭다운 목록을 사용하여 이 이미지 버전을 수정할 수 있습니다.

- 샘플 Git 리포지토리 URL이 기본적으로 추가됩니다.

- 생성을 클릭하여 샘플 애플리케이션을 생성합니다. 샘플 애플리케이션의 빌드 상태가 토폴로지 보기에 표시됩니다. 샘플 애플리케이션이 생성되면 애플리케이션에 추가된 배포를 볼 수 있습니다.

3.1.3. 빠른 시작을 사용하여 애플리케이션 생성

빠른 시작 페이지에는 단계별 지침 및 작업을 사용하여 OpenShift Container Platform에서 애플리케이션을 생성, 가져오기 및 실행하는 방법을 보여줍니다.

사전 요구 사항

- OpenShift Container Platform 웹 콘솔에 로그인하여 개발자 화면에 있습니다.

절차

- +추가 보기에서 모든 퀵 스타트 보기 링크를 클릭하여 빠른 시작 페이지를 확인합니다.

- 빠른 시작 페이지에서 사용하려는 퀵 스타트의 타일을 클릭합니다.

- 시작을 클릭하여 퀵 스타트 를 시작합니다.

3.1.4. Git에서 코드베이스를 가져와 애플리케이션 생성

개발자 화면에서는 GitHub의 기존 코드베이스를 사용하여 OpenShift Container Platform에 애플리케이션을 생성, 빌드, 배포할 수 있습니다.

다음 절차에서는 개발자 화면의 Git에서 옵션을 통해 애플리케이션을 생성합니다.

절차

- +추가 보기의 Git 리포지토리 타일에서 Git 에서 클릭하여 Git 에서 가져오기 양식을 확인합니다.

-

Git 섹션에서 애플리케이션을 생성하는 데 사용할 코드베이스의 Git 리포지토리 URL을 입력합니다. 예를 들어 이 샘플 Node.js 애플리케이션의 URL

https://github.com/sclorg/nodejs-ex를 입력합니다. 그런 다음 URL을 검증합니다. 선택 사항: Show Advanced Git Options(고급 Git 옵션 표시)를 클릭하여 다음과 같은 세부 정보를 추가할 수 있습니다.

- Git 참조: 애플리케이션을 빌드하는 데 사용할 특정 분기의 코드, 태그 또는 커밋을 가리킵니다.

- 컨텍스트 디렉터리: 애플리케이션을 빌드하는 데 사용할 애플리케이션 소스 코드의 하위 디렉터리를 지정합니다.

- 소스 시크릿: 프라이빗 리포지토리에서 소스 코드를 가져올 수 있는 자격 증명이 포함된 시크릿 이름을 생성합니다.

선택 사항: 배포를 추가로 사용자 지정하기 위해 Git 리포지토리를 통해 devfile, Dockerfile 또는 빌더 이미지를 가져올 수 있습니다.

- Git 리포지토리에 devfile, Dockerfile 또는 빌더 이미지가 포함된 경우 해당 경로 필드에서 자동으로 탐지되어 채워집니다. 동일한 리포지토리에서 devfile, Dockerfile, 빌더 이미지가 탐지되면 기본적으로 devfile이 선택됩니다.

- 파일 가져오기 유형을 편집하고 다른 전략을 선택하려면 Edit import strategy (가져오기 전략 편집) 옵션을 클릭합니다.

- 여러 devfile, Dockerfile 또는 빌더 이미지가 감지되어 특정 devfile, Dockerfile 또는 빌더 이미지를 가져오려면 컨텍스트 디렉터리를 기준으로 해당 경로를 지정합니다.

Git URL의 유효성을 검사하고 나면 권장 빌더 이미지가 선택되어 별표로 표시됩니다. 빌더 이미지가 자동으로 탐지되지 않으면 빌더 이미지를 선택합니다.

https://github.com/sclorg/nodejs-exGit URL의 경우 기본적으로 Node.js 빌더 이미지가 선택됩니다.- 선택 사항: 빌더 이미지 버전 드롭다운을 사용하여 버전을 지정합니다.

- 선택 사항: Edit import(가져오기 편집) 전략을 사용하여 다른 전략을 선택합니다.

일반 섹션에서 다음을 수행합니다.

-

애플리케이션 필드에서 애플리케이션 그룹화에 대한 고유 이름을 입력합니다(예:

myapp). 애플리케이션 이름이 네임스페이스에서 고유해야 합니다. 기존 애플리케이션이 없는 경우 이 애플리케이션에 대해 생성된 리소스를 확인하는 이름 필드는 Git 리포지토리 URL에 따라 자동으로 채워집니다. 기존 애플리케이션이 있는 경우에는 기존 애플리케이션 내에 구성 요소를 배포하거나 새 애플리케이션을 생성하거나 구성 요소를 할당하지 않은 상태로 유지하도록 선택할 수 있습니다.

참고리소스 이름은 네임스페이스에서 고유해야 합니다. 오류가 발생하면 리소스 이름을 수정합니다.

-

애플리케이션 필드에서 애플리케이션 그룹화에 대한 고유 이름을 입력합니다(예:

리소스 섹션에서 다음 옵션을 선택합니다.

- 배포: 일반 Kubernetes 형식으로 애플리케이션을 생성합니다.

- 배포 구성: OpenShift Container Platform 스타일 애플리케이션을 생성합니다.

- Knative 서비스: 마이크로 서비스를 생성합니다.

참고Knative 서비스 옵션은 Serverless Operator가 클러스터에 설치된 경우에만 Git에서 가져오기 양식에 표시됩니다. 자세한 내용은 OpenShift Serverless 설치 설명서를 참조하십시오.

- 파이프라인 섹션에서 파이프라인 추가를 선택한 다음 파이프라인 시각화 표시를 클릭하여 애플리케이션의 파이프라인을 확인합니다.

- 공개적으로 제공되는 URL을 사용하여 애플리케이션에 액세스할 수 있도록 고급 옵션 섹션의 애플리케이션의 경로 만들기가 기본적으로 선택되어 있어 습니다. 공개 경로에 애플리케이션을 노출하지 않으려면 확인란을 지우면 됩니다.

- 선택 사항: 다음 고급 옵션을 사용하여 애플리케이션을 추가로 사용자 지정할 수 있습니다.

- 라우팅

라우팅 링크를 클릭하면 다음 작업을 수행할 수 있습니다.

- 경로의 호스트 이름을 사용자 지정합니다.

- 라우터에서 감시하는 경로를 지정합니다.

- 드롭다운 목록에서 트래픽의 대상 포트를 선택합니다.

Secure Route 확인란을 선택하여 경로를 보호합니다. 필요한 TLS 종료 유형을 선택하고 해당 드롭다운 목록에서 안전하지 않은 트래픽에 대한 정책을 설정합니다.

참고서버리스 애플리케이션의 경우 Knative 서비스는 위의 모든 라우팅 옵션을 관리합니다. 그러나 필요한 경우 트래픽에 대한 대상 포트를 사용자 지정할 수 있습니다. 대상 포트를 지정하지 않으면 기본 포트

8080이 사용됩니다.

- 상태 점검

애플리케이션에 준비 상태, 활성 상태, 시작 프로브를 추가하려면 상태 점검 링크를 클릭합니다. 모든 프로브에는 기본 데이터가 미리 채워져 있습니다. 기본 데이터가 포함된 프로브를 추가하거나 필요에 따라 사용자 지정할 수 있습니다.

상태 프로브를 사용자 지정하려면 다음을 수행합니다.

- 필요한 경우 준비 상태 프로브 추가를 클릭하여 컨테이너에서 요청을 처리할 준비가 되었는지 확인하도록 매개변수를 수정하고 확인 표시를 선택하여 프로브를 추가합니다.

- 필요한 경우 활성 상태 프로브 추가를 클릭하여 컨테이너가 아직 실행되고 있는지 확인하도록 매개변수를 수정하고 확인 표시를 선택하여 프로브를 추가합니다.

필요한 경우 시작 프로브 추가를 클릭하여 컨테이너 내 애플리케이션이 시작되었는지 확인하도록 매개변수를 수정하고 확인 표시를 선택하여 프로브를 추가합니다.

각 프로브의 드롭다운 목록에서 요청 유형을 HTTP GET, 컨테이너 명령 또는 TCP 소켓으로 지정할 수 있습니다. 선택한 요청 유형에 따라 양식이 변경됩니다. 그런 다음 기타 매개변수(예: 프로브의 성공 및 실패 임계값, 컨테이너를 시작한 후 첫 번째 프로브를 수행할 때까지의 시간(초), 프로브 빈도, 시간 제한 값)에 대한 기본값을 수정할 수 있습니다.

- 빌드 구성 및 배포

빌드 구성 및 배포 링크를 클릭하여 해당 구성 옵션을 확인합니다. 일부 옵션은 기본적으로 선택되어 있습니다. 필요한 트리거 및 환경 변수를 추가하여 추가로 사용자 지정할 수 있습니다.

서버리스 애플리케이션의 경우 Knative 구성 리소스가

DeploymentConfig리소스 대신 배포에 필요한 상태를 유지 관리하므로 배포 옵션이 표시되지 않습니다.

- 스케일링

처음에 배포할 애플리케이션의 Pod 수 또는 인스턴스 수를 정의하려면 스케일링 링크를 클릭합니다.

서버리스 배포를 생성하는 경우 다음 설정을 구성할 수도 있습니다.

-

min Pod 는 Knative 서비스에 대해 언제든지 실행해야 하는 Pod 수에 대한 낮은 제한을 결정합니다.

minScale설정라고도 합니다. -

Max Pod 는 Knative 서비스에 대해 언제든지 실행할 수 있는 Pod 수의 상한값을 결정합니다. 이를

maxScale설정이라고도 합니다. - 동시성 대상은 지정된 시간에 애플리케이션의 각 인스턴스에 필요한 동시 요청 수를 결정합니다.

- 동시성 제한은 지정된 시간에 애플리케이션의 각 인스턴스에 허용되는 동시 요청 수에 대한 제한을 결정합니다.

- 동시성 사용률 은 Knative에서 추가 트래픽을 처리하기 위해 추가 Pod를 확장하기 전에 충족해야 하는 동시 요청 제한의 백분율을 결정합니다.

-

자동 스케일링 창 은 자동 스케일러가 패닉 모드가 아닌 경우 스케일링 결정에 대한 입력을 제공하기 위해 평균인 시간 창을 정의합니다. 이 기간 동안 요청이 수신되지 않으면 서비스가 스케일링-to-zero입니다. autoscale 창의 기본 기간은

60s입니다. 이 창은 stable 창이라고도 합니다.

-

min Pod 는 Knative 서비스에 대해 언제든지 실행해야 하는 Pod 수에 대한 낮은 제한을 결정합니다.

- 리소스 제한

- 컨테이너 실행 시 컨테이너에서 사용하도록 보장하거나 허용하는 CPU 및 메모리 리소스의 양을 설정하려면 리소스 제한 링크를 클릭합니다.

- 라벨

라벨 링크를 클릭하여 애플리케이션에 사용자 정의 라벨을 추가합니다.

- 생성을 클릭하여 애플리케이션을 생성하고 토폴로지 보기에서 빌드 상태를 확인합니다.

3.1.5. Java 애플리케이션을 쉽게 배포하기 위해 JAR 파일 업로드

개발자 화면에서 토폴로지 보기에서 JAR 파일을 사용하여 Java 애플리케이션을 배포할 수 있습니다. 다음 옵션을 사용하여 JAR 파일을 업로드할 수 있습니다.

- 개발자 화면의 +추가 보기로 이동하고 From Local Machine 타일에서 JAR 파일 업로드 를 클릭합니다. JAR 파일을 찾아서 선택하거나 JAR 파일을 드래그 앤 드롭하여 애플리케이션을 배포합니다.

- 토폴로지 보기로 이동하고 JAR 파일 업로드 옵션을 사용하거나 JAR 파일을 드래그 앤 드롭하여 애플리케이션을 배포합니다.

- 토폴로지 보기에서 컨텍스트 내부 메뉴를 사용한 다음 JAR 파일 업로드 옵션을 사용하여 JAR 파일을 업로드하여 애플리케이션을 배포합니다.

다음 지침을 사용하여 토폴로지 보기에 JAR 파일을 업로드하여 Java 애플리케이션을 배포합니다.

프로세스

- 토폴로지 보기에서 토폴로지 보기의 아무 곳이나 마우스 오른쪽 버튼으로 클릭하여 프로젝트에 추가 메뉴를 확인합니다.

- 프로젝트에 추가 메뉴를 커서를 올려 놓으면 나타나는 메뉴 옵션을 확인한 다음 JAR 파일 업로드 옵션을 선택하여 JAR 파일 업로드양식을 확인합니다. 또는 토폴로지 보기에서 JAR 파일을 끌어다 놓을 수 있습니다.

- JAR 파일 필드에서 로컬 시스템에 필요한 JAR 파일을 찾아 업로드합니다. 또는 필드에 JAR 파일을 드래그 앤 드롭할 수 있습니다. 호환되지 않는 파일 유형이 토폴로지 보기에 삭제되면 오른쪽 상단에 경고가 표시됩니다. 호환되지 않는 파일 유형이 업로드 양식의 필드에 삭제되면 필드 오류가 표시됩니다.

- 배포된 애플리케이션을 사용자 지정하기 위해 선택적 Java 명령을 추가로 지정할 수 있습니다. 런타임 아이콘 및 빌더 이미지는 기본적으로 선택됩니다. 빌더 이미지가 자동으로 탐지되지 않으면 빌더 이미지를 선택합니다. 필요한 경우 빌더 이미지 버전 드롭다운 목록을 사용하여 버전을 변경할 수 있습니다.

- 선택 사항인 애플리케이션 이름 필드에 리소스 레이블링에 대한 애플리케이션의 고유 이름을 입력합니다.

- 이름 필드에 고유한 구성 요소 이름을 입력하여 관련 리소스의 이름을 지정합니다.

- 리소스 필드에서 애플리케이션의 리소스 유형을 선택합니다.

- 고급 옵션에서 애플리케이션에 대한 경로 만들기를 클릭하여 배포된 애플리케이션에 대한 공용 URL을 구성합니다.

생성을 클릭하여 애플리케이션을 배포합니다. 사용자는 JAR 파일이 업로드되고 있음을 알리는 알림을 받습니다. 알림에는 빌드 로그를 볼 수 있는 링크도 포함됩니다.

참고사용자가 빌드가 실행 중인 동안 브라우저 탭을 종료하려고 하면 웹 경고가 나타나 사용자에게 페이지를 종료할지 묻는 메시지가 표시됩니다.

JAR 파일이 업로드되고 애플리케이션이 배포되면 토폴로지 보기에 배포가 표시됩니다.

3.1.6. 개발자 카탈로그를 사용하여 애플리케이션에 서비스 또는 구성 요소 추가

개발자 카탈로그를 사용하여 Operator 지원 서비스를 기반으로 애플리케이션 및 서비스(예: 데이터베이스, 빌더 이미지, Helm 차트)를 배포합니다. 개발자 카탈로그에는 프로젝트에 추가할 수 있는 애플리케이션 구성 요소, 서비스, 이벤트 소스 또는 source-to-image 빌더 컬렉션이 포함되어 있습니다. 클러스터 관리자는 카탈로그에서 사용 가능한 내용을 사용자 지정할 수 있습니다.

절차

- 개발자 화면에서 +추가 보기로 이동하고 개발자 카탈로그 타일에서 All Services (모든 서비스)를 클릭하여 개발자 카탈로그에서 사용 가능한 모든 서비스를 확인합니다.

- All Services (모든 서비스)에서 프로젝트에 추가해야 하는 서비스 종류 또는 구성 요소를 선택합니다. 이 예제에서는 데이터베이스를 선택하여 모든 데이터베이스 서비스를 나열하고 MariaDB를 클릭하여 서비스 세부 정보를 확인합니다.

템플릿 인스턴스화를 클릭하여 MariaDB 서비스 세부 정보가 자동으로 채워진 템플릿을 확인한 다음 생성을 클릭하여 토폴로지 보기에서 MariaDB 서비스를 생성하고 확인합니다.

그림 3.1. 토폴로지의 MariaDB

3.2. 설치된 Operator에서 애플리케이션 생성

Operator는 Kubernetes 애플리케이션을 패키징, 배포 및 관리하는 방법입니다. 클러스터 관리자가 설치한 Operator를 사용하여 OpenShift Container Platform에서 애플리케이션을 생성할 수 있습니다.

이 가이드에서는 개발자에게 OpenShift Container Platform 웹 콘솔을 사용하여 설치된 Operator에서 애플리케이션을 생성하는 예제를 보여줍니다.

3.2.1. Operator를 사용하여 etcd 클러스터 생성

이 절차에서는 OLM(Operator Lifecycle Manager)에서 관리하는 etcd Operator를 사용하여 새 etcd 클러스터를 생성하는 과정을 안내합니다.

사전 요구 사항

- OpenShift Container Platform 4.8 클러스터에 액세스할 수 있습니다.

- 관리자가 클러스터 수준에 etcd Operator를 이미 설치했습니다.

프로세스

-

이 절차를 위해 OpenShift Container Platform 웹 콘솔에 새 프로젝트를 생성합니다. 이 예제에서는

my-etcd라는 프로젝트를 사용합니다. Operator → 설치된 Operator 페이지로 이동합니다. 이 페이지에는 클러스터 관리자가 클러스터에 설치하여 사용할 수 있는 Operator가 CSV(클러스터 서비스 버전) 목록으로 표시됩니다. CSV는 Operator에서 제공하는 소프트웨어를 시작하고 관리하는 데 사용됩니다.

작은 정보다음을 사용하여 CLI에서 이 목록을 가져올 수 있습니다.

oc get csv

$ oc get csvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 자세한 내용과 사용 가능한 작업을 확인하려면 설치된 Operator 페이지에서 etcd Operator를 클릭합니다.

이 Operator에서는 제공된 API 아래에 표시된 것과 같이 etcd 클러스터(

EtcdCluster리소스)용 하나를 포함하여 새로운 리소스 유형 세 가지를 사용할 수 있습니다. 이러한 오브젝트는 내장된 네이티브 Kubernetes 오브젝트(예:Deployment또는ReplicaSet)와 비슷하게 작동하지만 etcd 관리와 관련된 논리가 포함됩니다.새 etcd 클러스터를 생성합니다.

- etcd 클러스터 API 상자에서 인스턴스 생성을 클릭합니다.

-

다음 화면을 사용하면 클러스터 크기와 같은

EtcdCluster오브젝트의 최소 시작 템플릿을 수정할 수 있습니다. 지금은 생성을 클릭하여 종료하십시오. 그러면 Operator에서 새 etcd 클러스터의 Pod, 서비스 및 기타 구성 요소를 가동합니다.

예제 etcd 클러스터를 클릭한 다음 리소스 탭을 클릭하여 Operator에서 자동으로 생성 및 구성한 리소스 수가 프로젝트에 포함되는지 확인합니다.

프로젝트의 다른 Pod에서 데이터베이스에 액세스할 수 있도록 Kubernetes 서비스가 생성되었는지 확인합니다.

지정된 프로젝트에서

edit역할을 가진 모든 사용자는 클라우드 서비스와 마찬가지로 셀프 서비스 방식으로 프로젝트에 이미 생성된 Operator에서 관리하는 애플리케이션 인스턴스(이 예제의 etcd 클러스터)를 생성, 관리, 삭제할 수 있습니다. 이 기능을 사용하여 추가 사용자를 활성화하려면 프로젝트 관리자가 다음 명령을 사용하여 역할을 추가하면 됩니다.oc policy add-role-to-user edit <user> -n <target_project>

$ oc policy add-role-to-user edit <user> -n <target_project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

이제 Pod가 비정상적인 상태가 되거나 클러스터의 다른 노드로 마이그레이션되면 오류에 반응하고 데이터를 재조정할 etcd 클러스터가 생성되었습니다. 가장 중요한 점은 적절한 액세스 권한이 있는 클러스터 관리자 또는 개발자가 애플리케이션과 함께 데이터베이스를 쉽게 사용할 수 있다는 점입니다.

3.3. CLI를 사용하여 애플리케이션 생성

OpenShift Container Platform CLI를 사용하여 소스 또는 바이너리 코드, 이미지, 템플릿이 포함된 구성 요소에서 OpenShift Container Platform 애플리케이션을 생성할 수 있습니다.

new-app으로 생성되는 오브젝트 세트는 입력을 통해 전달되는 아티팩트(소스 리포지토리, 이미지 또는 템플릿)에 따라 다릅니다.

3.3.1. 소스 코드에서 애플리케이션 생성

new-app 명령을 사용하면 로컬 또는 원격 Git 리포지토리의 소스 코드에서 애플리케이션을 생성할 수 있습니다.

new-app 명령은 소스 코드에서 자체적으로 새 애플리케이션 이미지를 생성하는 빌드 구성을 생성합니다. 또한 new-app 명령은 새 이미지를 배포하는 Deployment 오브젝트와 이미지를 실행하는 배포에 부하 분산된 액세스를 제공하는 서비스를 생성합니다.

OpenShift Container Platform에서는 파이프라인 또는 소스 빌드 전략 사용 여부를 자동으로 탐지하고, 소스 빌드의 경우 적절한 언어 빌더 이미지를 탐지합니다.

3.3.1.1. 로컬

로컬 디렉터리의 Git 리포지토리에서 애플리케이션을 생성하려면 다음을 실행합니다.

oc new-app /<path to source code>

$ oc new-app /<path to source code>

로컬 Git 리포지토리를 사용하는 경우 리포지토리에 OpenShift Container Platform 클러스터에서 액세스할 수 있는 URL을 가리키는 origin이라는 원격이 있어야 합니다. 확인되는 원격이 없는 경우 new-app 명령을 실행하면 바이너리 빌드가 생성됩니다.

3.3.1.2. 원격

원격 Git 리포지토리에서 애플리케이션을 생성하려면 다음을 실행합니다.

oc new-app https://github.com/sclorg/cakephp-ex

$ oc new-app https://github.com/sclorg/cakephp-ex프라이빗 원격 Git 리포지토리에서 애플리케이션을 생성하려면 다음을 실행합니다.

oc new-app https://github.com/youruser/yourprivaterepo --source-secret=yoursecret

$ oc new-app https://github.com/youruser/yourprivaterepo --source-secret=yoursecret

프라이빗 원격 Git 리포지토리를 사용하는 경우 --source-secret 플래그를 사용하면 빌드 구성에 삽입할 기존 소스 복제 시크릿을 지정하여 리포지토리에 액세스할 수 있습니다.

--context-dir 플래그를 지정하여 소스 코드 리포지토리의 하위 디렉터리를 사용할 수 있습니다. 원격 Git 리포지토리 및 컨텍스트 하위 디렉터리에서 애플리케이션을 생성하려면 다음을 실행합니다.

oc new-app https://github.com/sclorg/s2i-ruby-container.git \

--context-dir=2.0/test/puma-test-app

$ oc new-app https://github.com/sclorg/s2i-ruby-container.git \

--context-dir=2.0/test/puma-test-app

또한 원격 URL을 지정하면 URL 끝에 #<branch_name>을 추가하여 사용할 Git 분기를 지정할 수 있습니다.

oc new-app https://github.com/openshift/ruby-hello-world.git#beta4

$ oc new-app https://github.com/openshift/ruby-hello-world.git#beta43.3.1.3. 빌드 전략 탐지

새 애플리케이션을 생성할 때 Jenkins 파일이 소스 리포지토리의 루트 또는 지정된 컨텍스트 디렉터리에 있는 경우 OpenShift Container Platform에서는 파이프라인 빌드 전략을 생성합니다. 그렇지 않으면 소스 빌드 전략을 생성합니다.

--strategy 플래그를 pipeline 또는 source에 설정하여 빌드 전략을 재정의합니다.

oc new-app /home/user/code/myapp --strategy=docker

$ oc new-app /home/user/code/myapp --strategy=docker

oc 명령을 실행하려면 빌드 소스가 포함된 파일이 원격 Git 리포지토리에 제공되어야 합니다. 모든 소스 빌드에 git remote -v를 사용해야 합니다.

3.3.1.4. 언어 탐지

소스 빌드 전략을 사용하는 경우 new-app은 리포지토리의 루트 또는 지정된 컨텍스트 디렉터리에 특정 파일이 있는지에 따라 사용할 언어 빌더를 결정합니다.

| 언어 | 파일 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

언어를 탐지한 후 new-app은 OpenShift Container Platform 서버에서 탐지한 언어와 일치하는 supports 주석이 있는 이미지 스트림 태그 또는 탐지된 언어의 이름과 일치하는 이미지 스트림을 검색합니다. 일치 항목이 없는 경우 new-app은 Docker Hub 레지스트리에서 이름을 기반으로 탐지된 언어와 일치하는 이미지를 검색합니다.

이미지, 이미지 스트림 또는 컨테이너 사양 중 하나, 리포지토리를 구분자 ~를 사용하여 지정하면 빌더에서 특정 소스 리포지토리에 사용하는 이미지를 재정의할 수 있습니다. 이 작업이 완료되면 빌드 전략 탐지 및 언어 탐지가 수행되지 않습니다.

예를 들어 원격 리포지토리의 소스에 myproject/my-ruby 이미지 스트림을 사용하려면 다음을 실행합니다.

oc new-app myproject/my-ruby~https://github.com/openshift/ruby-hello-world.git

$ oc new-app myproject/my-ruby~https://github.com/openshift/ruby-hello-world.git

로컬 리포지토리의 소스에 openshift/ruby-20-centos7:latest 컨테이너 이미지 스트림을 사용하려면 다음을 실행합니다.

oc new-app openshift/ruby-20-centos7:latest~/home/user/code/my-ruby-app

$ oc new-app openshift/ruby-20-centos7:latest~/home/user/code/my-ruby-app

언어 탐지 기능에는 리포지토리를 복제하고 검사할 수 있도록 Git 클라이언트를 로컬에 설치해야 합니다. Git을 사용할 수 없는 경우 <image>~<repository> 구문으로 리포지토리에 사용할 빌더 이미지를 지정하여 언어 탐지 단계가 수행되지 않도록 수 있습니다.

-i <image> <repository> 호출을 실행하려면 new-app에서 아티팩트 유형이 무엇인지 확인하기 위해 repository를 복제해야 하므로 Git을 사용할 수 없는 경우 이 명령이 실패합니다.

-i <image> --code <repository> 호출을 실행하려면 image를 소스 코드의 빌더로 사용해야 하는지 아니면 데이터베이스 이미지의 경우와 같이 별도로 배포해야 하는지 확인하기 위해 new-app에서 repository를 복제해야 합니다.

3.3.2. 이미지에서 애플리케이션 생성

기존 이미지에서 애플리케이션을 배포할 수 있습니다. 이미지는 OpenShift Container Platform 서버의 이미지 스트림, 특정 레지스트리의 이미지 또는 로컬 Docker 서버의 이미지에서 가져올 수 있습니다.

new-app 명령은 전달된 인수에 지정된 이미지 유형을 확인합니다. 그러나 컨테이너 이미지에는 --docker-image 인수를, 이미지 스트림에는 -i|--image-stream 인수를 사용하여 new-app에 이미지 유형을 명시적으로 표시할 수 있습니다.

로컬 Docker 리포지토리에서 이미지를 지정하는 경우 OpenShift Container Platform 클러스터 노드에서 동일한 이미지를 사용할 수 있는지 확인해야 합니다.

3.3.2.1. Docker Hub MySQL 이미지

Docker Hub MySQL 이미지에서 애플리케이션을 생성합니다. 예를 들면 다음과 같습니다.

oc new-app mysql

$ oc new-app mysql3.3.2.2. 프라이빗 레지스트리의 이미지

프라이빗 레지스트리의 이미지를 사용하여 애플리케이션을 생성하고 전체 컨테이너 이미지 사양을 지정합니다.

oc new-app myregistry:5000/example/myimage

$ oc new-app myregistry:5000/example/myimage3.3.2.3. 기존 이미지 스트림 및 선택적 이미지 스트림 태그

기존 이미지 스트림 및 선택적 이미지 스트림 태그에서 애플리케이션을 생성합니다.

oc new-app my-stream:v1

$ oc new-app my-stream:v13.3.3. 템플릿에서 애플리케이션 생성

템플릿 이름을 인수로 지정하여 이전에 저장된 템플릿 또는 템플릿 파일에서 애플리케이션을 생성할 수 있습니다. 예를 들어 샘플 애플리케이션 템플릿을 저장하고 이 템플릿을 사용하여 애플리케이션을 생성할 수 있습니다.

현재 프로젝트의 템플릿 라이브러리에 애플리케이션 템플릿을 업로드합니다. 다음 예제에서는 examples/sample-app/application-template-stibuild.json이라는 파일에서 애플리케이션 템플릿을 업로드합니다.

oc create -f examples/sample-app/application-template-stibuild.json

$ oc create -f examples/sample-app/application-template-stibuild.json

그런 다음 애플리케이션 템플릿을 참조하여 새 애플리케이션을 생성합니다. 이 예에서 템플릿 이름은 ruby-helloworld-sample입니다.

oc new-app ruby-helloworld-sample

$ oc new-app ruby-helloworld-sample

OpenShift Container Platform에 먼저 저장하지 않고 로컬 파일 시스템에서 템플릿 파일을 참조하여 새 애플리케이션을 생성하려면 -f|--file 인수를 사용하십시오. 예를 들면 다음과 같습니다.

oc new-app -f examples/sample-app/application-template-stibuild.json

$ oc new-app -f examples/sample-app/application-template-stibuild.json3.3.3.1. 템플릿 매개변수

템플릿을 기반으로 애플리케이션을 생성할 때 -p|--param 인수를 사용하여 템플릿에 정의된 매개변수 값을 설정합니다.

oc new-app ruby-helloworld-sample \

-p ADMIN_USERNAME=admin -p ADMIN_PASSWORD=mypassword

$ oc new-app ruby-helloworld-sample \

-p ADMIN_USERNAME=admin -p ADMIN_PASSWORD=mypassword

템플릿을 인스턴스화할 때 해당 매개변수를 파일에 저장한 다음 해당 파일을 --param-file과 함께 사용할 수 있습니다. 표준 입력에서 매개변수를 읽으려면 --param-file=-을 사용합니다. 다음은 helloworld.params라는 예제 파일입니다.

ADMIN_USERNAME=admin ADMIN_PASSWORD=mypassword

ADMIN_USERNAME=admin

ADMIN_PASSWORD=mypassword템플릿을 인스턴스화할 때 파일에서 매개변수를 참조합니다.

oc new-app ruby-helloworld-sample --param-file=helloworld.params

$ oc new-app ruby-helloworld-sample --param-file=helloworld.params3.3.4. 애플리케이션 생성 수정

new-app 명령은 생성된 애플리케이션을 빌드, 배포, 실행하는 OpenShift Container Platform 오브젝트를 생성합니다. 일반적으로 이러한 오브젝트는 현재 프로젝트에서 생성되고 입력 소스 리포지토리 또는 입력 이미지에서 파생된 이름이 할당됩니다. 그러나 new-app을 사용하면 이 동작을 수정할 수 있습니다.

| 개체 | 설명 |

|---|---|

|

|

명령줄에 지정된 각 소스 리포지토리에 대해 |

|

|

|

|

|

|

|

|

|

| 기타 | 다른 오브젝트는 템플릿을 인스턴스화할 때 템플릿에 따라 생성할 수 있습니다. |

3.3.4.1. 환경 변수 지정

템플릿, 소스 또는 이미지에서 애플리케이션을 생성할 때 -e|--env 인수를 사용하여 런타임 시 환경 변수를 애플리케이션 컨테이너에 전달할 수 있습니다.

oc new-app openshift/postgresql-92-centos7 \

-e POSTGRESQL_USER=user \

-e POSTGRESQL_DATABASE=db \

-e POSTGRESQL_PASSWORD=password

$ oc new-app openshift/postgresql-92-centos7 \

-e POSTGRESQL_USER=user \

-e POSTGRESQL_DATABASE=db \

-e POSTGRESQL_PASSWORD=password

이 변수는 --env-file 인수를 사용하여 파일에서 읽을 수도 있습니다. 다음은 postgresql.env라는 예제 파일입니다.

POSTGRESQL_USER=user POSTGRESQL_DATABASE=db POSTGRESQL_PASSWORD=password

POSTGRESQL_USER=user

POSTGRESQL_DATABASE=db

POSTGRESQL_PASSWORD=password파일에서 변수를 읽습니다.

oc new-app openshift/postgresql-92-centos7 --env-file=postgresql.env

$ oc new-app openshift/postgresql-92-centos7 --env-file=postgresql.env

또한 --env-file=-을 사용하여 환경 변수를 표준 입력에 제공할 수 있습니다.

cat postgresql.env | oc new-app openshift/postgresql-92-centos7 --env-file=-

$ cat postgresql.env | oc new-app openshift/postgresql-92-centos7 --env-file=-

new-app 처리의 일부로 생성된 모든 BuildConfig 오브젝트는 -e|--env 또는 --env-file 인수로 전달되는 환경 변수를 통해 업데이트되지 않습니다.

3.3.4.2. 빌드 환경 변수 지정

템플릿, 소스 또는 이미지에서 애플리케이션을 생성할 때 --build-env 인수를 사용하여 런타임 시 환경 변수를 빌드 컨테이너에 전달할 수 있습니다.

oc new-app openshift/ruby-23-centos7 \

--build-env HTTP_PROXY=http://myproxy.net:1337/ \

--build-env GEM_HOME=~/.gem

$ oc new-app openshift/ruby-23-centos7 \

--build-env HTTP_PROXY=http://myproxy.net:1337/ \

--build-env GEM_HOME=~/.gem

이 변수는 --build-env-file 인수를 사용하여 파일에서 읽을 수도 있습니다. 다음은 ruby.env라는 예제 파일입니다.

HTTP_PROXY=http://myproxy.net:1337/ GEM_HOME=~/.gem

HTTP_PROXY=http://myproxy.net:1337/

GEM_HOME=~/.gem파일에서 변수를 읽습니다.

oc new-app openshift/ruby-23-centos7 --build-env-file=ruby.env

$ oc new-app openshift/ruby-23-centos7 --build-env-file=ruby.env

또한 --build-env-file=-을 사용하여 환경 변수를 표준 입력에 제공할 수 있습니다.

cat ruby.env | oc new-app openshift/ruby-23-centos7 --build-env-file=-

$ cat ruby.env | oc new-app openshift/ruby-23-centos7 --build-env-file=-3.3.4.3. 라벨 지정

소스, 이미지 또는 템플릿에서 애플리케이션을 생성할 때는 -l|--label 인수를 사용하여 생성된 오브젝트에 라벨을 추가할 수 있습니다. 라벨을 사용하면 애플리케이션과 관련된 오브젝트를 전체적으로 선택, 구성, 삭제할 수 있습니다.

oc new-app https://github.com/openshift/ruby-hello-world -l name=hello-world

$ oc new-app https://github.com/openshift/ruby-hello-world -l name=hello-world3.3.4.4. 생성하지 않고 출력 보기

new-app 명령 실행의 시험 실행을 보려면 -o|--output 인수를 yaml 또는 json 값과 함께 사용하면 됩니다. 그런 다음 출력을 사용하여 생성된 오브젝트를 미리 보거나 편집할 수 있는 파일로 리디렉션할 수 있습니다. 만족하는 경우 oc create를 사용하여 OpenShift Container Platform 오브젝트를 생성할 수 있습니다.

new-app 아티팩트를 파일에 출력하려면 다음을 실행합니다.

oc new-app https://github.com/openshift/ruby-hello-world \

-o yaml > myapp.yaml

$ oc new-app https://github.com/openshift/ruby-hello-world \

-o yaml > myapp.yaml파일을 편집합니다.

vi myapp.yaml

$ vi myapp.yaml파일을 참조하여 새 애플리케이션을 생성합니다.

oc create -f myapp.yaml

$ oc create -f myapp.yaml3.3.4.5. 다양한 이름으로 오브젝트 생성

new-app으로 생성한 오브젝트는 일반적으로 소스 리포지토리 또는 해당 오브젝트를 생성하는 데 사용된 이미지의 이름을 따서 이름이 지정됩니다. 명령에 --name 플래그를 추가하여 생성한 오브젝트의 이름을 설정할 수 있습니다.

oc new-app https://github.com/openshift/ruby-hello-world --name=myapp

$ oc new-app https://github.com/openshift/ruby-hello-world --name=myapp3.3.4.6. 다른 프로젝트에서 오브젝트 생성

일반적으로 new-app은 현재 프로젝트에서 오브젝트를 생성합니다. 그러나 -n|--namespace 인수를 사용하면 다른 프로젝트에서 오브젝트를 생성할 수 있습니다.

oc new-app https://github.com/openshift/ruby-hello-world -n myproject

$ oc new-app https://github.com/openshift/ruby-hello-world -n myproject3.3.4.7. 여러 오브젝트 생성

new-app 명령을 사용하면 new-app에 다양한 매개변수를 지정하는 애플리케이션을 여러 개 생성할 수 있습니다. 명령 줄에서 지정된 라벨은 단일 명령으로 생성된 모든 개체에 적용됩니다. 환경 변수는 소스 또는 이미지에서 생성한 모든 구성 요소에 적용됩니다.

소스 리포지토리 및 Docker Hub 이미지에서 애플리케이션을 생성하려면 다음을 실행합니다.

oc new-app https://github.com/openshift/ruby-hello-world mysql

$ oc new-app https://github.com/openshift/ruby-hello-world mysql

소스 코드 리포지토리와 빌더 이미지가 별도의 인수로 지정되면 new-app에서 빌더 이미지를 소스 코드 저장소의 빌더로 사용합니다. 이를 원하지 않는 경우 ~ 구분자를 사용하여 소스에 필요한 빌더 이미지를 지정합니다.

3.3.4.8. 단일 Pod에서 이미지 및 소스 그룹화

new-app 명령을 사용하면 단일 Pod에 여러 이미지를 함께 배포할 수 있습니다. 함께 그룹화할 이미지를 지정하려면 + 구분자를 사용합니다. --group 명령줄 인수를 사용하여 함께 그룹화해야 하는 이미지를 지정할 수도 있습니다. 소스 리포지토리에서 빌드한 이미지를 기타 이미지와 함께 그룹화하려면 그룹에 해당 빌더 이미지를 지정합니다.

oc new-app ruby+mysql

$ oc new-app ruby+mysql소스에서 빌드한 이미지를 외부 이미지와 함께 배포하려면 다음을 실행합니다.

oc new-app \

ruby~https://github.com/openshift/ruby-hello-world \

mysql \

--group=ruby+mysql

$ oc new-app \

ruby~https://github.com/openshift/ruby-hello-world \

mysql \

--group=ruby+mysql3.3.4.9. 이미지, 템플릿 및 기타 입력 검색

oc new-app 명령에 대한 이미지, 템플릿 및 기타 입력을 검색하려면 --search 및 --list플래그를 추가합니다. 예를 들어 PHP를 포함하는 모든 이미지 또는 템플릿을 찾으려면 다음을 실행합니다.

oc new-app --search php

$ oc new-app --search php4장. 토폴로지 보기를 사용하여 애플리케이션 구성 보기

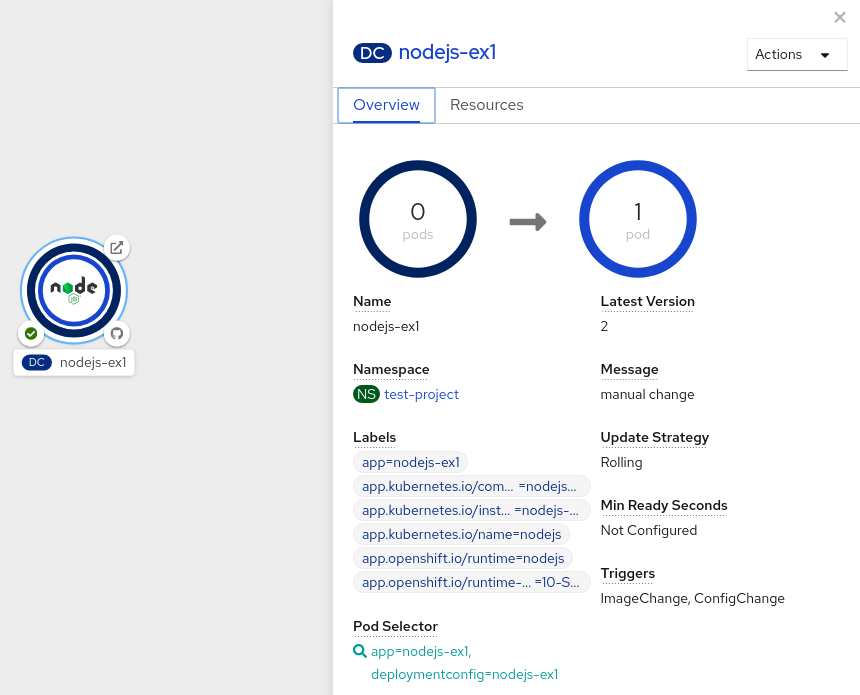

웹 콘솔의 개발자 화면에 있는 토폴로지 보기에는 프로젝트 내의 모든 애플리케이션과 해당 빌드 상태, 애플리케이션에 연결된 구성 요소 및 서비스가 그래픽으로 표시되어 있습니다.

4.1. 사전 요구 사항

토폴로지 보기에서 애플리케이션을 확인하고 애플리케이션과 상호 작용하려면 다음을 수행합니다.

4.2. 애플리케이션의 토폴로지 보기

개발자 화면의 왼쪽 탐색 패널을 사용하여 토폴로지 보기로 이동할 수 있습니다. 애플리케이션을 배포하면 그래프 보기가 자동으로 표시됩니다. 여기에서 애플리케이션 Pod의 상태를 확인하고 공개 URL에서 애플리케이션에 빠르게 액세스한 후 소스 코드에 액세스하여 수정하고 마지막 빌드의 상태를 확인할 수 있습니다. 확대 및 축소하여 특정 애플리케이션에 대한 세부 정보를 확인할 수 있습니다.

토폴로지 보기는 목록 보기를 사용하여 애플리케이션을 모니터링할 수 있는 옵션도 제공합니다. 목록 보기 아이콘(

![]() )을 사용하여 모든 애플리케이션 목록을 확인하고 그래프 보기 아이콘(

)을 사용하여 모든 애플리케이션 목록을 확인하고 그래프 보기 아이콘(

![]() )을 사용하여 그래프 보기로 다시 전환합니다.

)을 사용하여 그래프 보기로 다시 전환합니다.

다음을 사용하여 필요에 따라 보기를 사용자 지정할 수 있습니다.

- 필요한 구성 요소를 찾으려면 이름으로 찾기 필드를 사용합니다. 검색 결과가 표시 영역 외부에 표시될 수 있습니다. 왼쪽 아래에 있는 툴바에서 화면에 맞추기를 클릭하여 모든 구성 요소를 표시하도록 토폴로지 보기의 크기를 조정합니다.

다양한 애플리케이션 그룹화에 대한 토폴로지 보기를 구성하려면 표시 옵션 드롭다운 목록을 사용합니다. 해당 옵션은 프로젝트에 배포된 구성 요소 유형에 따라 제공됩니다.

모드(연결 또는 사용량)

- 연결: 토폴로지의 여러 노드 간 연결을 모두 표시하려면 선택합니다.

- 소비: 토폴로지의 모든 노드에 대한 리소스 사용량을 표시하려면 선택합니다.

그룹 확장

- 가상 머신: 토글을 선택하여 가상 시스템을 표시하거나 숨길 수 있습니다.

- 애플리케이션 그룹화 : 애플리케이션 그룹을 애플리케이션 그룹 개요와 연결된 경고가 포함된 카드로 축소하려면 지웁니다.

- Helm 릴리스: Helm 릴리스로 배포된 구성 요소를 지정된 릴리스의 개요가 포함된 카드로 축소하려면 지웁니다.

- Knative 서비스: Knative 서비스 구성 요소를 지정된 구성 요소의 개요가 포함된 카드로 축소하려면 지웁니다.

- Operator 그룹화: Operator와 함께 배포된 구성 요소를 지정된 그룹의 개요가 포함된 카드로 축소하려면 지웁니다.

Pod 수 또는 라벨에 따라 표시

- Pod 개수: 구성 요소 아이콘에 구성 요소의 포드 수를 표시하려면 선택합니다.

- 레이블: 구성 요소 레이블을 표시하거나 숨기려면 전환합니다.

4.3. 애플리케이션 및 구성 요소와 상호 작용

웹 콘솔의 개발자 화면에 있는 토폴로지 보기에서는 애플리케이션 및 구성 요소와 상호 작용할 수 있는 다음과 같은 옵션을 제공합니다.

-

공개 URL의 경로에 의해 노출되는 애플리케이션을 확인하려면 URL 열기 (

)를 클릭합니다.

)를 클릭합니다.

소스 코드에 액세스하여 수정하려면 소스 코드 편집을 클릭합니다.

참고이 기능은 Git에서, 카탈로그에서, Dockerfile에서 옵션을 사용하여 애플리케이션을 생성할 때만 사용할 수 있습니다.

-

최신 빌드의 이름과 해당 상태를 확인하려면 Pod의 왼쪽 아래 아이콘 위에 커서를 올려 놓습니다. 애플리케이션 빌드 상태는 신규 (

), 보류 중(

), 보류 중(

), 실행 중 (

), 실행 중 (

), 완료됨 (

), 완료됨 (

), 실패 (

), 실패 (

), 취소됨 ()으로 표시됩니다.

), 취소됨 ()으로 표시됩니다.

Pod의 상태 또는 단계는 다음과 같이 다양한 색상 및 툴팁으로 표시됩니다.

-

실행 중 (

): 포드는 노드에 바인딩되고 모든 컨테이너가 생성됩니다. 하나 이상의 컨테이너가 계속 실행 중이거나 시작 또는 다시 시작하는 중입니다.

): 포드는 노드에 바인딩되고 모든 컨테이너가 생성됩니다. 하나 이상의 컨테이너가 계속 실행 중이거나 시작 또는 다시 시작하는 중입니다.

-

준비되지 않음 (

): 컨테이너가 여러 개 실행되고 있지만 일부 컨테이너가 준비되지 않은 포드.

): 컨테이너가 여러 개 실행되고 있지만 일부 컨테이너가 준비되지 않은 포드.

-

경고(

): 포드의 컨테이너가 종료되고 있지만 종료에 성공하지 못했습니다. 일부 컨테이너는 다른 상태일 수 있습니다.

): 포드의 컨테이너가 종료되고 있지만 종료에 성공하지 못했습니다. 일부 컨테이너는 다른 상태일 수 있습니다.

-

실패(

): 포드의 모든 컨테이너가 종료되었지만 하나 이상의 컨테이너가 실패로 종료되었습니다. 즉 컨테이너는 0이 아닌 상태로 종료되었거나 시스템에 의해 종료되었습니다.

): 포드의 모든 컨테이너가 종료되었지만 하나 이상의 컨테이너가 실패로 종료되었습니다. 즉 컨테이너는 0이 아닌 상태로 종료되었거나 시스템에 의해 종료되었습니다.

-

보류 중(

): Pod는 Kubernetes 클러스터에서 허용되지만 하나 이상의 컨테이너가 설정되어 실행할 준비가 되어 있지 않습니다. 여기에는 Pod가 네트워크를 통해 컨테이너 이미지를 다운로드하는 데 소요되는 시간뿐만 아니라 Pod를 예약 대기하는 시간이 포함됩니다.

): Pod는 Kubernetes 클러스터에서 허용되지만 하나 이상의 컨테이너가 설정되어 실행할 준비가 되어 있지 않습니다. 여기에는 Pod가 네트워크를 통해 컨테이너 이미지를 다운로드하는 데 소요되는 시간뿐만 아니라 Pod를 예약 대기하는 시간이 포함됩니다.

-

성공(

): 포드의 모든 컨테이너가 성공적으로 종료되고 다시 시작되지 않습니다.

): 포드의 모든 컨테이너가 성공적으로 종료되고 다시 시작되지 않습니다.

-

종료(

): Pod가 삭제되면 일부 kubectl 명령에서 종료하는 것으로 표시됩니다. 종료 중 상태는 Pod 단계 중 하나가 아닙니다. Pod에는 정상 종료 기간이 부여되며 기본값은 30초입니다.

): Pod가 삭제되면 일부 kubectl 명령에서 종료하는 것으로 표시됩니다. 종료 중 상태는 Pod 단계 중 하나가 아닙니다. Pod에는 정상 종료 기간이 부여되며 기본값은 30초입니다.

-

알 수 없음(

): 포드의 상태를 가져올 수 없습니다. 일반적으로 이 단계는 Pod가 실행되어야 하는 노드와 통신하는 동안 오류로 인해 발생합니다.

): 포드의 상태를 가져올 수 없습니다. 일반적으로 이 단계는 Pod가 실행되어야 하는 노드와 통신하는 동안 오류로 인해 발생합니다.

-

실행 중 (

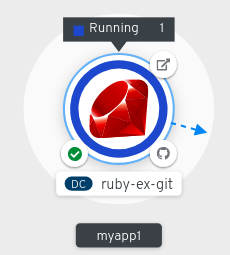

애플리케이션을 생성하고 이미지를 배포하면 해당 상태가 보류 중으로 표시됩니다. 애플리케이션을 빌드한 후에는 실행 중으로 표시됩니다.

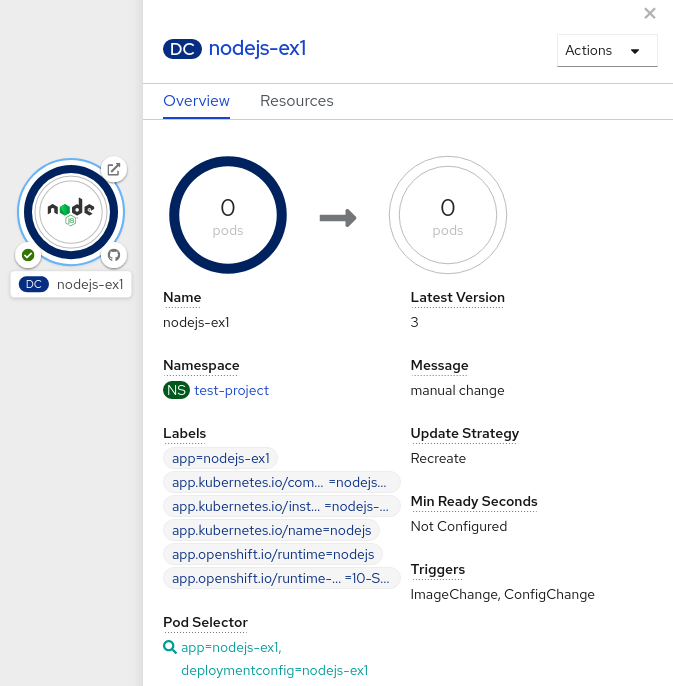

그림 4.1. 애플리케이션 토폴로지

애플리케이션 리소스 이름에는 다음과 같이 다양한 유형의 리소스 오브젝트에 대한 표시가 추가됩니다.

-

CJ:

CronJob -

D:

Deployment -

DC:

DeploymentConfig -

DS:

DaemonSet -

J:

Job -

P:

Pod -

SS:

StatefulSet  (Knative): 서버리스 애플리케이션

참고

(Knative): 서버리스 애플리케이션

참고서버리스 애플리케이션은 그래프 보기에 로드 및 표시되는 데 시간이 걸립니다. 서버리스 애플리케이션을 배포할 때는 먼저 서비스 리소스를 생성한 다음 리버전을 생성합니다. 그런 다음 개정 버전이 배포되고 그래프 보기에 표시됩니다. 이 작업이 유일한 워크로드인 경우 추가 페이지로 리디렉션될 수 있습니다. 리버전이 배포되면 그래프 보기에 서버리스 애플리케이션이 표시됩니다.

-

CJ:

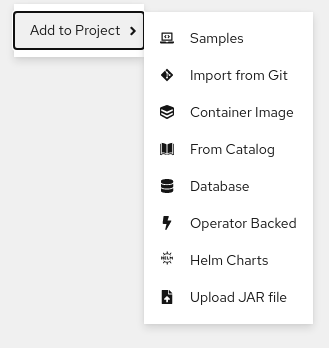

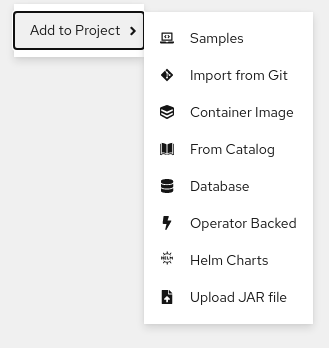

토폴로지 그래프 보기에서 마우스 오른쪽 버튼으로 클릭하여 Git에서 가져오기,컨테이너 이미지,데이터베이스,카탈로그에서,Operator 지원,Helm 차트,샘플 또는 JAR 파일 업로드 와 같은 서비스를 프로젝트에 추가하여 컨텍스트 메뉴를 사용할 수도 있습니다.

그림 4.2. 서비스 추가를 위한 컨텍스트 메뉴

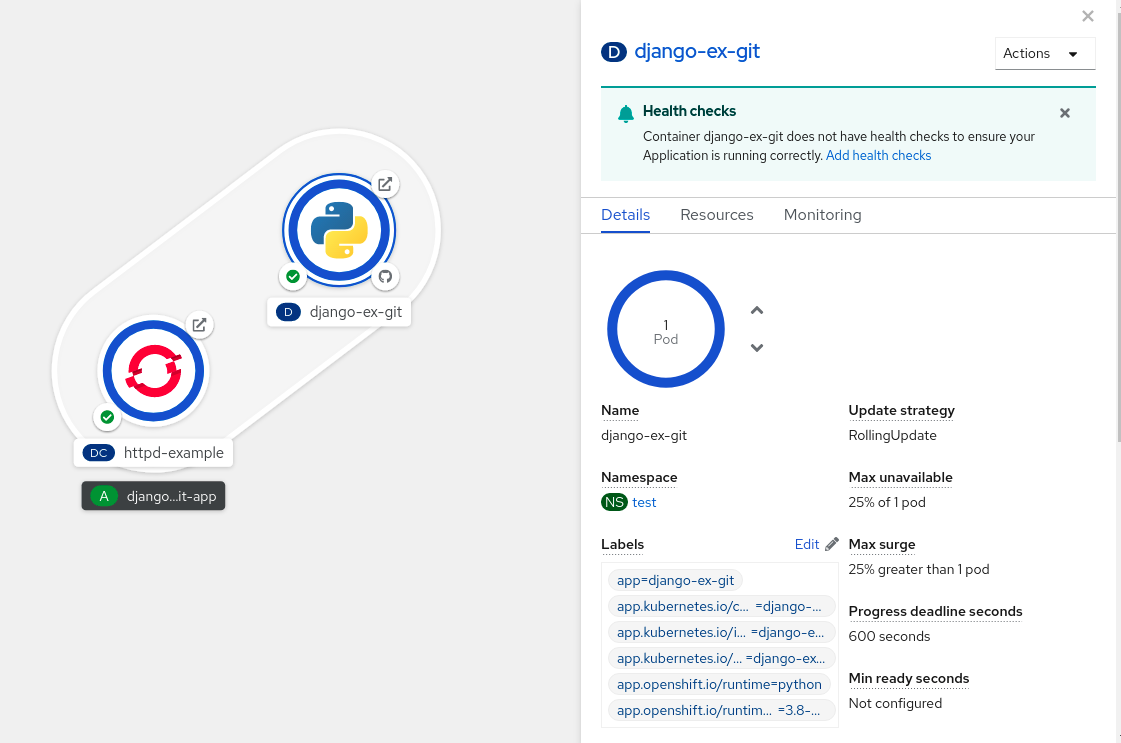

4.4. 애플리케이션 Pod 스케일링 및 빌드와 경로 확인

토폴로지 보기에는 개요 패널에 배포된 구성 요소의 세부 정보가 있습니다. 다음과 같이 개요 및 리소스 탭을 사용하여 애플리케이션 Pod를 스케일링하고 빌드 상태, 서비스, 경로를 확인할 수 있습니다.

구성 요소 노드를 클릭하면 오른쪽에 개요 패널이 표시됩니다. 개요 탭에서는 다음을 수행할 수 있습니다.

- 위쪽 및 아래쪽 화살표를 사용하여 Pod 수를 스케일링하여 애플리케이션 인스턴스 수를 수동으로 늘리거나 줄입니다. 서버리스 애플리케이션의 경우 유휴 상태에서는 Pod가 자동으로 0으로 축소되고 채널 트래픽에 따라 확장됩니다.

- 애플리케이션의 라벨, 주석, 상태를 확인합니다.

다음을 수행하려면 리소스 탭을 클릭합니다.

- 모든 Pod 목록을 확인하고 해당 상태 및 액세스 로그를 본 후 Pod 세부 정보를 확인할 Pod를 클릭합니다.

- 빌드, 해당 상태, 액세스 로그를 확인하고 필요한 경우 새 빌드를 시작합니다.

- 구성 요소에서 사용하는 서비스 및 경로를 참조하십시오.

서버리스 애플리케이션의 경우 리소스 탭에는 해당 구성 요소에 사용된 리버전, 경로, 구성 정보가 있습니다.

4.5. 기존 프로젝트에 구성 요소 추가

절차

-

왼쪽 탐색 창 옆에 있는 프로젝트 (

)에 추가하거나 Ctrl+공간을누릅니다.

)에 추가하거나 Ctrl+공간을누릅니다.

- 구성 요소를 검색하고 Create(생성 ) 또는 Enter( 종료)를 선택하여 프로젝트에 구성 요소를 추가하고 토폴로지 그래프 보기에서 확인합니다.

그림 4.3. 빠른 검색을 통해 구성 요소 추가

또는 토폴로지 그래프 보기에서 마우스 오른쪽 버튼으로 클릭하여 프로젝트에 구성 요소를 추가하여 Git,컨테이너 이미지,데이터베이스,카탈로그,Operator 백업,Helm 차트,샘플 또는 업로드 JAR 파일 옵션에서 가져오기 를 사용할 수도 있습니다.

그림 4.4. 서비스 추가를 위한 컨텍스트 메뉴

4.6. 애플리케이션 내의 여러 구성 요소 그룹화

+추가 보기를 사용하여 프로젝트에 여러 구성 요소 또는 서비스를 추가하고 토폴로지 그래프 보기를 사용하여 애플리케이션 그룹 내에서 애플리케이션 및 리소스를 그룹화할 수 있습니다.

사전 요구 사항

- 개발자 화면을 사용하여 OpenShift Container Platform에서 최소 두 개 이상의 구성 요소를 생성하고 배포했습니다.

절차

서비스를 기존 애플리케이션 그룹에 추가하려면 Shift키를 누르고 기존 애플리케이션 그룹으로 끌어 옵니다. 구성 요소를 끌어서 애플리케이션 그룹에 추가하면 구성 요소에 필요한 레이블이 추가됩니다.

그림 4.5. 애플리케이션 그룹화

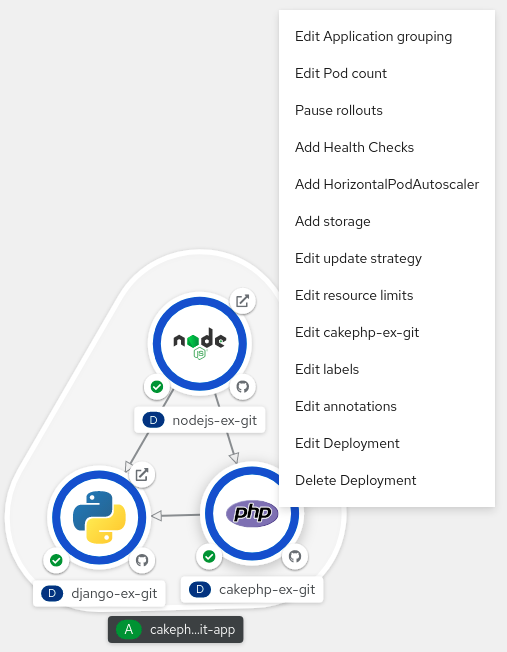

또는 다음과 같이 애플리케이션에 구성 요소를 추가할 수도 있습니다.

- 서비스 포드를 클릭하여 오른쪽에 있는 개요 패널을 확인합니다.

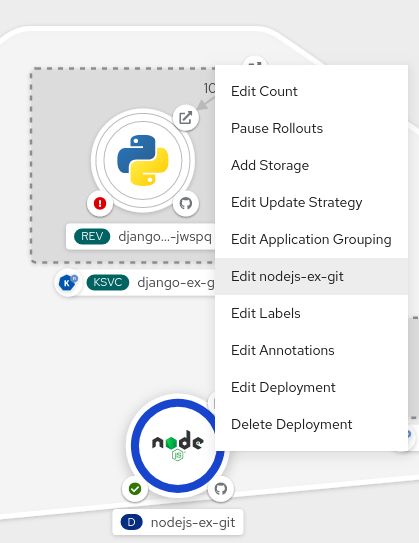

- 작업 드롭다운 메뉴를 클릭하고 Edit Application Grouping (애플리케이션 그룹화 편집)을 선택합니다.

- Edit Application Grouping (애플리케이션 그룹화 편집) 대화 상자에서 Application (애플리케이션) 드롭 다운 목록을 클릭하고 적절한 애플리케이션 그룹을 선택합니다.

- Save(저장 )를 클릭하여 서비스를 애플리케이션 그룹에 추가합니다.

구성 요소를 선택하고 Shift 키를 누른 상태로 애플리케이션 그룹 밖으로 드래그하면 애플리케이션 그룹에서 구성 요소를 제거할 수 있습니다.

4.7. 애플리케이션에 서비스 추가

애플리케이션에 서비스를 추가하려면 토폴로지 그래프 보기 의 컨텍스트 메뉴를 사용하여 +추가 작업을 사용합니다.

컨텍스트 메뉴 외에도 사이드바를 사용하거나 애플리케이션 그룹에서 출발하는 화살표를 드래그하여 서비스를 추가할 수 있습니다.

절차

토폴로지 Graph 보기에서 애플리케이션 그룹을 마우스 오른쪽 버튼으로 클릭하여 컨텍스트 메뉴를 표시합니다.

그림 4.6. 리소스 컨텍스트 메뉴 추가

- Add to Application (애플리케이션에 추가)을 사용하여 애플리케이션 그룹에 서비스를 추가하는 방법을 선택합니다(예 : Git,컨테이너 이미지,Dockerfile에서,Devfile에서,JAR 파일 업로드,이벤트 소스,채널 또는 브로커 ).

- 선택한 방법에 대한 양식을 작성하고 Create(생성 )를 클릭합니다. 예를 들어 Git 리포지토리의 소스 코드를 기반으로 서비스를 추가하려면 From Git 메서드를 선택하고 Import from Git 양식을 입력한 다음 Create(만들기 )를 클릭합니다.

4.8. 애플리케이션에서 서비스 제거

토폴로지 Graph 보기에서 컨텍스트 메뉴를 사용하여 애플리케이션에서 서비스를 제거합니다.

절차

- 토폴로지 Graph 보기 의 애플리케이션 그룹에서 서비스를 마우스 오른쪽 버튼으로 클릭하여 컨텍스트 메뉴를 표시합니다.

Delete Deployment(배포 삭제) 를 선택하여 서비스를 삭제합니다.

그림 4.7. 배포 옵션 삭제

4.9. 애플리케이션 내 및 애플리케이션 간 구성 요소 연결

애플리케이션 내에서 여러 구성 요소를 그룹화하는 것 외에도 토폴로지 보기를 사용하여 구성 요소를 서로 연결할 수 있습니다. 바인딩 커넥터 또는 시각적 커넥터를 사용하여 구성 요소를 연결할 수 있습니다.

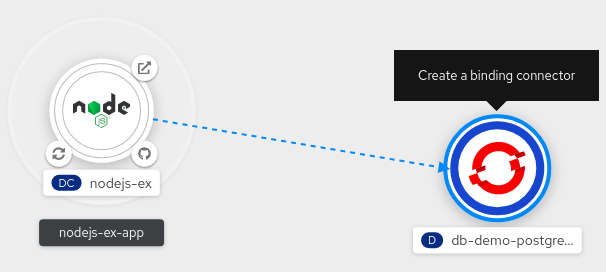

대상 노드가 Operator 지원 서비스인 경우에만 구성 요소 간 바인딩 연결을 설정할 수 있습니다. 이러한 연결은 해당 대상 노드로 화살표를 드래그할 때 표시되는 바인딩 커넥터 생성 툴팁으로 표시됩니다. 바인딩 커넥터를 사용하여 애플리케이션을 서비스에 연결하면 서비스 바인딩 요청이 생성됩니다. 그러면 Service Binding Operator 컨트롤러에서 중간 시크릿을 사용하여 필요한 바인딩 데이터를 애플리케이션 배포에 환경 변수로 삽입합니다. 요청이 성공하면 애플리케이션이 재배포되어 연결된 구성 요소 간 상호 작용을 설정합니다.

시각적 커넥터는 구성 요소 간 시각적 연결만 설정하고 연결하려는 의도를 표시합니다. 구성 요소 간 상호 작용은 설정되지 않습니다. 대상 노드가 Operator에서 지원하는 서비스가 아닌 경우 대상 노드로 화살표를 드래그하면 시각적 커넥터 생성 툴팁이 표시됩니다.

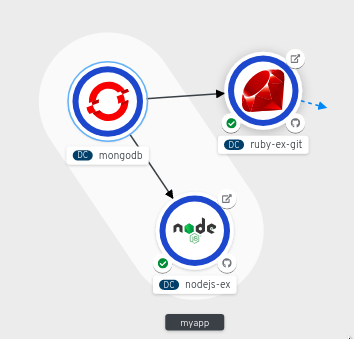

4.9.1. 구성 요소 간 시각적 연결 생성

시각적 커넥터를 사용하여 애플리케이션 구성 요소를 연결하려는 의도를 나타낼 수 있습니다.

이 절차에서는 MongoDB 서비스와 Node.js 애플리케이션 간 시각적 연결을 생성하는 예제를 보여줍니다.

사전 요구 사항

- 개발자 화면을 사용하여 Node.js 애플리케이션을 생성하고 배포했는지 확인합니다.

- 개발자 화면을 사용하여 MongoDB 서비스를 생성하고 배포했는지 확인합니다.

프로세스

MongoDB 서비스 위에 커서를 올리면 노드에서 출발하는 화살표가 표시됩니다.

그림 4.8. 커넥터

- 화살표를 클릭하고 Node.js 구성 요소 쪽으로 드래그하여 MongoDB 서비스와 연결합니다.

-

MongoDB 서비스를 클릭하여 개요 패널을 확인합니다. 서비스에 추가된 Key =

app.openshift.io/connects-to및 Value =[{"apiVersion":"apps.openshift.io/v1","kind":"DeploymentConfig","name":"nodejs-ex"}]주석을 확인하려면 주석 섹션에서 편집 아이콘을 클릭합니다.

마찬가지로 기타 애플리케이션 및 구성 요소를 생성하고 이들 간의 연결을 설정할 수 있습니다.

그림 4.9. 여러 애플리케이션 연결

4.9.2. 구성 요소 간 바인딩 연결 생성

서비스 바인딩은 기술 프리뷰 기능 전용입니다. Technology Preview 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 https://access.redhat.com/support/offerings/techpreview/를 참조하십시오.

현재 etcd 및 PostgresSQL Database Operator의 서비스 인스턴스와 같은 몇 가지 특정 Operator를 바인딩할 수 있습니다.

Operator 지원 구성 요소를 사용하여 바인딩 연결을 설정할 수 있습니다.

이 절차에서는 PostgreSQL 데이터베이스 서비스와 Node.js 애플리케이션 간 바인딩 연결을 생성하는 예를 보여줍니다. PostgreSQL Database Operator에서 지원하는 서비스로 바인딩 연결을 생성하려면 먼저 CatalogSource 리소스를 사용하여 OperatorHub에 Red Hat 제공 PostgreSQL Database Operator를 추가한 후에 Operator를 설치해야 합니다. 그러면 PostreSQL Database Operator에서 시크릿, 구성 맵, 상태, 사양 속성에 바인딩 정보를 노출하는 데이터베이스 리소스를 생성하고 관리합니다.

사전 요구 사항

- 개발자 화면을 사용하여 Node.js 애플리케이션을 생성하고 배포했는지 확인합니다.

- OperatorHub에서 Service Binding Operator를 설치했는지 확인합니다.

프로세스

Red Hat에서 제공하는 PostgresSQL Database Operator를 OperatorHub에 추가하는

CatalogSource리소스를 생성합니다.- +추가 보기에서 YAML 옵션을 클릭하여 YAML 가져오기 화면을 확인합니다.

다음 YAML 파일을 추가하여

CatalogSource리소스를 적용합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

생성을 클릭하여 클러스터에서

CatalogSource리소스를 생성합니다.

Red Hat에서 제공하는 PostgreSQL Database Operator를 설치합니다.

- 콘솔의 관리자 화면에서 Operator → OperatorHub로 이동합니다.

- 데이터베이스 카테고리에서 PostgreSQL Database Operator를 선택하고 설치합니다.

애플리케이션에 대한 DB(데이터베이스) 인스턴스를 생성합니다.

-

개발자 화면으로 전환하고 적절한 프로젝트(예:

test-project)에 있는지 확인합니다. - +추가 보기에서 YAML 옵션을 클릭하여 YAML 가져오기 화면을 확인합니다.

편집기에 서비스 인스턴스 YAML을 추가하고 생성을 클릭하여 서비스를 배포합니다. 다음은 서비스 YAML의 예입니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow DB 인스턴스가 토폴로지 보기에 배포됩니다.

-

개발자 화면으로 전환하고 적절한 프로젝트(예:

- 토폴로지 보기에서 Node.js 구성 요소 위에 커서를 올리면 노드에서 출발하는 화살표가 표시됩니다.

이 화살표를 클릭하고 db-demo-postgresql 서비스를 향해 끌어와서 Node.js 애플리케이션과 바인딩 연결합니다. 서비스 바인딩 요청이 생성되고 Service Binding Operator 컨트롤러에서 DB 연결 정보를 애플리케이션 배포에 환경 변수로 삽입합니다. 요청이 성공하면 애플리케이션이 재배포되고 연결이 설정됩니다.

그림 4.10. 바인딩 커넥터

dangling 화살표를 끌어서 운영자가 지원하는 서비스에 바인딩 연결을 추가하고 만들면 컨텍스트 메뉴를 사용할 수도 있습니다.

그림 4.11. 바인딩 연결을 생성하는 컨텍스트 메뉴

4.10. 토폴로지 보기에 사용되는 라벨 및 주석

토폴로지 보기에서는 다음 라벨 및 주석을 사용합니다.

- 노드에 표시되는 아이콘

-

노드의 아이콘은

app.openshift.io/runtime라벨과 다음으로app.kubernetes.io/name라벨을 사용하여 일치하는 아이콘을 찾아 정의됩니다. 이러한 일치는 사전 정의된 아이콘 세트를 사용하여 수행됩니다. - 소스 코드 편집기 또는 소스에 대한 링크

-

app.openshift.io/vcs-uri주석은 소스 코드 편집기에 대한 링크를 생성하는 데 사용됩니다. - 노드 커넥터

-

app.openshift.io/connects-to주석은 노드를 연결하는 데 사용됩니다. - 앱 그룹화

-

app.kubernetes.io/part-of=<appname>라벨은 애플리케이션, 서비스, 구성 요소를 그룹화하는 데 사용됩니다.

OpenShift Container Platform 애플리케이션에서 사용해야 하는 라벨 및 주석에 대한 자세한 내용은 OpenShift 애플리케이션의 라벨 및 주석에 대한 지침을 참조하십시오.

5장. Helm 차트 작업

5.1. Helm 이해

Helm은 OpenShift Container Platform 클러스터에 대한 애플리케이션 및 서비스 배포를 간소화하는 소프트웨어 패키지 관리자입니다.

Helm은 차트라는 패키징 형식을 사용합니다. Helm 차트는 OpenShift Container Platform 리소스에 대해 설명하는 파일 컬렉션입니다.

클러스터에 있는 차트의 실행 중인 인스턴스를 릴리스라고 합니다. 클러스터에 차트가 설치될 때마다 새 릴리스가 생성됩니다.

차트를 설치하거나 릴리스를 업그레이드하거나 롤백할 때마다 번호가 증가한 리버전이 생성됩니다.

5.1.1. 주요 기능

Helm은 다음을 수행할 수 있는 기능을 제공합니다.

- 차트 리포지토리에 저장된 대규모 차트 컬렉션에서 검색합니다.

- 기존 차트를 수정합니다.

- OpenShift Container Platform 또는 Kubernetes 리소스를 사용하여 자체 차트를 생성합니다.

- 애플리케이션을 차트로 패키징하고 공유합니다.

5.1.2. OpenShift에 대한 Red Hat 인증 Helm 차트

Red Hat OpenShift Container Platform에 배포할 모든 구성 요소에 대해 Red Hat에서 Helm 차트를 확인하고 인증하도록 선택할 수 있습니다. 차트는 보안 준수는 물론 플랫폼과의 최상의 통합 및 경험을 보장하는 자동화된 Red Hat OpenShift 인증 워크플로를 거칩니다. 인증은 차트의 무결성을 보장하고 Helm 차트가 Red Hat OpenShift 클러스터에서 원활하게 작동하는지 확인합니다.

5.2. Helm 설치

다음 섹션에서는 CLI를 사용하여 다양한 플랫폼에 Helm을 설치하는 방법을 설명합니다.

오른쪽 상단에 있는 ? 아이콘을 클릭하고 명령줄 툴을 선택하여 OpenShift Container Platform 웹 콘솔의 최신 바이너리 URL을 찾을 수도 있습니다.

사전 요구 사항

- Go 버전 1.13 이상이 설치되어 있어야 합니다.

5.2.1. On Linux

Helm 바이너리를 다운로드하여 경로에 추가합니다.

curl -L https://mirror.openshift.com/pub/openshift-v4/clients/helm/latest/helm-linux-amd64 -o /usr/local/bin/helm

# curl -L https://mirror.openshift.com/pub/openshift-v4/clients/helm/latest/helm-linux-amd64 -o /usr/local/bin/helmCopy to Clipboard Copied! Toggle word wrap Toggle overflow 바이너리 파일을 실행 가능하게 합니다.

chmod +x /usr/local/bin/helm

# chmod +x /usr/local/bin/helmCopy to Clipboard Copied! Toggle word wrap Toggle overflow 설치된 버전을 확인합니다.

helm version

$ helm versionCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

version.BuildInfo{Version:"v3.0", GitCommit:"b31719aab7963acf4887a1c1e6d5e53378e34d93", GitTreeState:"clean", GoVersion:"go1.13.4"}version.BuildInfo{Version:"v3.0", GitCommit:"b31719aab7963acf4887a1c1e6d5e53378e34d93", GitTreeState:"clean", GoVersion:"go1.13.4"}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2.2. Windows 7/8

-

최신

.exe파일을 다운로드하여 기본 설정 디렉터리에 배치합니다. - 시작을 마우스 오른쪽 버튼으로 클릭하고 제어판을 클릭합니다.

- 시스템 및 보안을 선택하고 시스템을 클릭합니다.

- 왼쪽 메뉴에서 고급 시스템 설정을 선택하고 아래에 있는 환경 변수를 클릭합니다.

- 변수 섹션에서 경로를 선택하고 편집을 클릭합니다.

-

새로 생성을 클릭하고 필드에

.exe파일이 있는 폴더의 경로를 입력하거나 검색을 클릭하고 디렉터리를 선택한 후 확인을 클릭합니다.

5.2.3. Windows 10

-

최신

.exe파일을 다운로드하여 기본 설정 디렉터리에 배치합니다. -

검색을 클릭하고

env또는environment를 입력합니다. - 계정의 환경 변수 편집을 선택합니다.

- 변수 섹션에서 경로를 선택하고 편집을 클릭합니다.

- 새로 생성을 클릭하고 필드에 exe 파일이 있는 디렉터리의 경로를 입력하거나 검색을 클릭하고 디렉터리를 선택한 후 확인을 클릭합니다.

5.2.4. MacOS

Helm 바이너리를 다운로드하여 경로에 추가합니다.

curl -L https://mirror.openshift.com/pub/openshift-v4/clients/helm/latest/helm-darwin-amd64 -o /usr/local/bin/helm

# curl -L https://mirror.openshift.com/pub/openshift-v4/clients/helm/latest/helm-darwin-amd64 -o /usr/local/bin/helmCopy to Clipboard Copied! Toggle word wrap Toggle overflow 바이너리 파일을 실행 가능하게 합니다.

chmod +x /usr/local/bin/helm

# chmod +x /usr/local/bin/helmCopy to Clipboard Copied! Toggle word wrap Toggle overflow 설치된 버전을 확인합니다.

helm version

$ helm versionCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

version.BuildInfo{Version:"v3.0", GitCommit:"b31719aab7963acf4887a1c1e6d5e53378e34d93", GitTreeState:"clean", GoVersion:"go1.13.4"}version.BuildInfo{Version:"v3.0", GitCommit:"b31719aab7963acf4887a1c1e6d5e53378e34d93", GitTreeState:"clean", GoVersion:"go1.13.4"}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3. 사용자 정의 Helm 차트 리포지터리 구성

다음 방법을 사용하여 OpenShift Container Platform 클러스터에 Helm 차트를 설치할 수 있습니다.

- CLI.

- 웹 콘솔의 개발자 화면.

개발자 카탈로그는 웹 콘솔의 개발자 관점으로 클러스터에서 사용할 수 있는 Helm 차트를 표시합니다. 기본적으로 Red Hat OpenShift Helm 차트 리포지터리의 Helm 차트를 나열합니다. 차트 목록은 Red Hat Helm 인덱스 파일을 참조하십시오.

클러스터 관리자는 기본 리포지터리 외에도 여러 Helm 차트 리포지터리를 추가하여 해당 리포지터리의 Helm 차트를 개발자 카탈로그에 표시할 수 있습니다.

5.3.1. OpenShift Container Platform 클러스터에 Helm 차트 설치

사전 요구 사항

- 실행 중인 OpenShift Container Platform 클러스터가 있고 로그인되어 있어야 합니다.

- Helm이 설치되어 있어야 합니다.

절차

새 프로젝트를 생성합니다.

oc new-project mysql

$ oc new-project mysqlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 로컬 Helm 클라이언트에 Helm 차트 리포지터리를 추가합니다.

helm repo add stable https://kubernetes-charts.storage.googleapis.com/

$ helm repo add stable https://kubernetes-charts.storage.googleapis.com/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

"stable" has been added to your repositories

"stable" has been added to your repositoriesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 리포지터리를 업데이트합니다.

helm repo update

$ helm repo updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow MySQL 차트 예를 설치합니다.

helm install example-mysql stable/mysql

$ helm install example-mysql stable/mysqlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 차트가 성공적으로 설치되었는지 확인합니다.

helm list

$ helm listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME NAMESPACE REVISION UPDATED STATUS CHART APP VERSION example-mysql mysql 1 2019-12-05 15:06:51.379134163 -0500 EST deployed mysql-1.5.0 5.7.27

NAME NAMESPACE REVISION UPDATED STATUS CHART APP VERSION example-mysql mysql 1 2019-12-05 15:06:51.379134163 -0500 EST deployed mysql-1.5.0 5.7.27Copy to Clipboard Copied! Toggle word wrap Toggle overflow

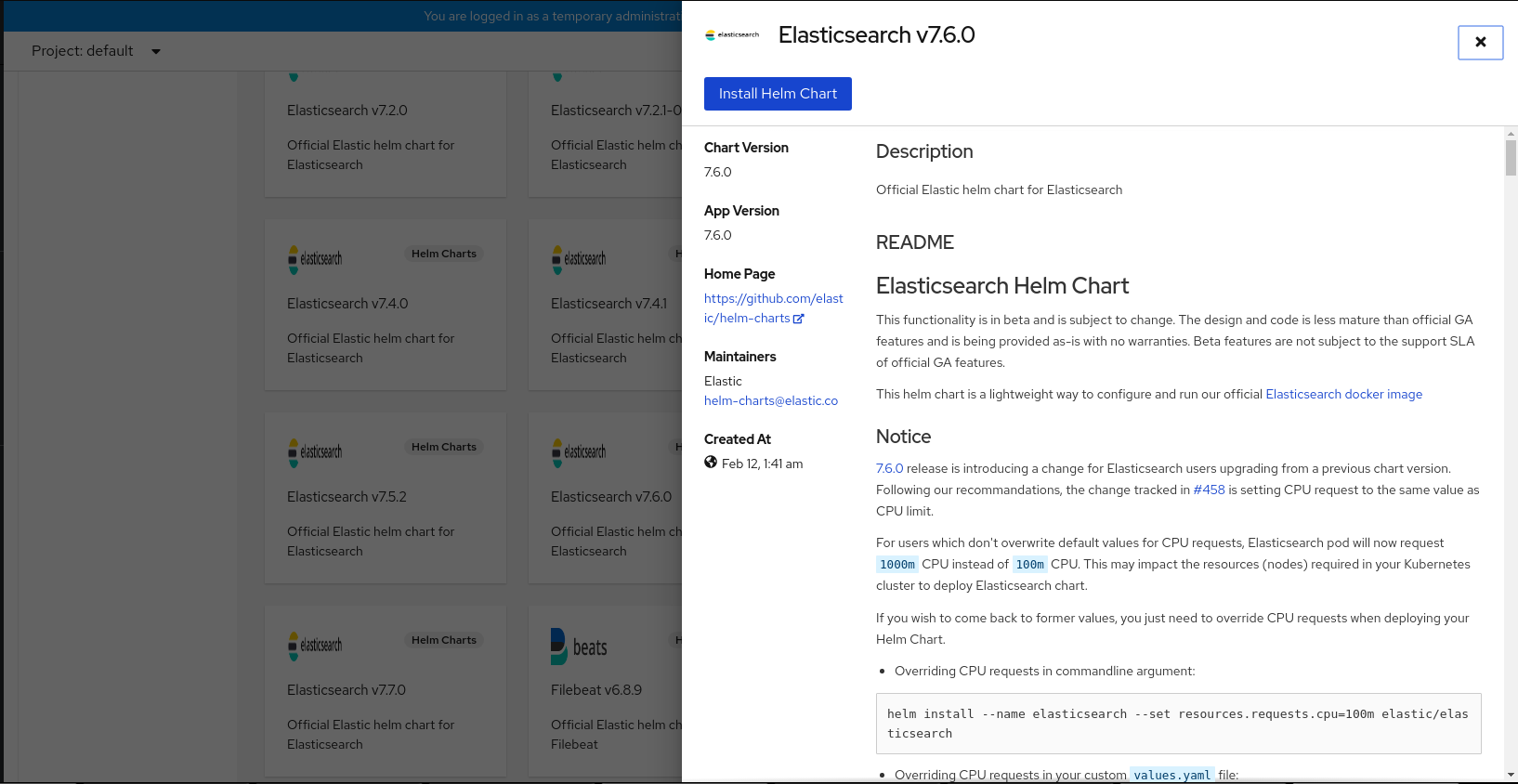

5.3.2. 개발자 화면을 사용하여 Helm 차트 설치

웹 콘솔 또는 CLI의 개발자 화면을 사용하여 개발자 카탈로그에 나열된 Helm 차트에서 차트를 선택하고 설치할 수 있습니다. Helm 차트를 설치하여 Helm 릴리스를 생성하고 웹 콘솔의 개발자 화면에서 볼 수 있습니다.

사전 요구 사항

- 웹 콘솔에 로그인하여 개발자 화면으로 전환했습니다.

절차

개발자 카탈로그에 제공된 Helm 차트에서 Helm 릴리스를 생성하려면 다음을 수행합니다.

- 개발자 화면에서 +추가 보기로 이동하여 프로젝트를 선택합니다. 그런 다음 Helm 차트 옵션을 클릭하여 개발자 카탈로그의 모든 Helm 차트를 확인합니다.

- 차트를 선택하고 해당 차트에 대한 설명, README 및 기타 세부 정보를 읽습니다.

Helm 차트 설치를 클릭합니다.

그림 5.1. 개발자 카탈로그의 Helm 차트

Helm 차트 설치 페이지에서 다음을 수행합니다.

- 릴리스 이름 필드에 고유한 릴리스 이름을 입력합니다.

- 차트 버전 드롭다운 목록에서 필요한 차트 버전을 선택합니다.

보기에서 또는 YAML 보기를 사용하여 Helm 차트를 구성합니다.

참고가능한 경우 YAML 보기 및 양식 보기를 전환할 수 있습니다. 다른 보기로 전환해도 데이터는 유지됩니다.

- 설치를 클릭하여 Helm 릴리스를 생성합니다. 릴리스가 표시되는 토폴로지 보기로 리디렉션됩니다. Helm 차트에 릴리스 노트가 있는 경우 이 차트가 사전에 선택되고 오른쪽 패널에 해당 릴리스의 릴리스 노트가 표시됩니다.

측면 패널의 작업 버튼을 사용하거나 Helm 릴리스를 마우스 오른쪽 버튼으로 클릭하여 Helm 릴리스를 업그레이드, 롤백 또는 설치 제거할 수 있습니다.

5.3.3. 웹 터미널에서 Helm 사용

웹 콘솔의 개발자 화면에서 웹 터미널을 초기화하여 Helm을 사용할 수 있습니다. 자세한 내용은 웹 터미널 사용을 참조하십시오.

5.3.4. OpenShift Container Platform에서 사용자 정의 Helm 차트 생성

절차

새 프로젝트를 생성합니다.

oc new-project nodejs-ex-k

$ oc new-project nodejs-ex-kCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform 오브젝트가 포함된 Node.js 차트 예를 다운로드합니다.

git clone https://github.com/redhat-developer/redhat-helm-charts

$ git clone https://github.com/redhat-developer/redhat-helm-chartsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 샘플 차트가 있는 디렉터리로 이동합니다.

cd redhat-helm-charts/alpha/nodejs-ex-k/

$ cd redhat-helm-charts/alpha/nodejs-ex-k/Copy to Clipboard Copied! Toggle word wrap Toggle overflow Chart.yaml파일을 편집하고 차트에 대한 설명을 추가합니다.apiVersion: v2 name: nodejs-ex-k description: A Helm chart for OpenShift icon: https://static.redhat.com/libs/redhat/brand-assets/latest/corp/logo.svg

apiVersion: v21 name: nodejs-ex-k2 description: A Helm chart for OpenShift3 icon: https://static.redhat.com/libs/redhat/brand-assets/latest/corp/logo.svg4 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 차트 형식이 올바르게 지정되었는지 확인합니다.

helm lint

$ helm lintCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

[INFO] Chart.yaml: icon is recommended 1 chart(s) linted, 0 chart(s) failed

[INFO] Chart.yaml: icon is recommended 1 chart(s) linted, 0 chart(s) failedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이전 디렉터리 수준으로 이동합니다.

cd ..

$ cd ..Copy to Clipboard Copied! Toggle word wrap Toggle overflow 차트를 설치합니다.

helm install nodejs-chart nodejs-ex-k

$ helm install nodejs-chart nodejs-ex-kCopy to Clipboard Copied! Toggle word wrap Toggle overflow 차트가 성공적으로 설치되었는지 확인합니다.

helm list

$ helm listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME NAMESPACE REVISION UPDATED STATUS CHART APP VERSION nodejs-chart nodejs-ex-k 1 2019-12-05 15:06:51.379134163 -0500 EST deployed nodejs-0.1.0 1.16.0

NAME NAMESPACE REVISION UPDATED STATUS CHART APP VERSION nodejs-chart nodejs-ex-k 1 2019-12-05 15:06:51.379134163 -0500 EST deployed nodejs-0.1.0 1.16.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3.5. 사용자 정의 Helm 차트 리포지터리 추가

클러스터 관리자는 사용자 정의 Helm 차트 리포지터리를 클러스터에 추가하여 개발자 카탈로그에서 해당 리포지터리의 Helm 차트에 대한 액세스를 활성화할 수 있습니다.

절차

새 Helm 차트 리포지터리를 추가하려면 클러스터에 Helm 차트 리포지터리 CR(사용자 정의 리소스)을 추가해야 합니다.

샘플 Helm 차트 리포지터리 CR

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들어 Azure 샘플 차트 리포지터리를 추가하려면 다음을 실행합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 웹 콘솔에서 개발자 카탈로그로 이동하여 차트 리포지터리의 Helm 차트가 표시되는지 확인합니다.

예를 들어 차트 리포지터리 필터를 사용하여 리포지터리의 Helm 차트를 검색합니다.

그림 5.2. 차트 리포지터리 필터

참고

참고클러스터 관리자가 모든 차트 리포지터리를 제거하는 경우 +추가 보기, 개발자 카탈로그 및 왼쪽 탐색 패널에서 Helm 옵션을 볼 수 없습니다.

5.3.6. 인증 정보 및 CA 인증서를 생성하여 Helm 차트 리포지터리 추가

일부 Helm 차트 리포지터리는 연결하려면 인증 정보 및 사용자 정의 CA(인증 기관) 인증서가 필요합니다. 웹 콘솔 및 CLI를 사용하여 인증 정보 및 인증서를 추가할 수 있습니다.

절차

CLI를 사용하여 인증 정보 및 인증서를 구성한 후 Helm 차트 리포지터리를 추가하려면 다음을 실행합니다.

openshift-config네임스페이스에서 PEM 인코딩 형식의 사용자 정의 CA 인증서로ConfigMap오브젝트를 생성한 후 구성 맵 내의ca-bundle.crt키에 저장합니다.oc create configmap helm-ca-cert \ --from-file=ca-bundle.crt=/path/to/certs/ca.crt \ -n openshift-config

$ oc create configmap helm-ca-cert \ --from-file=ca-bundle.crt=/path/to/certs/ca.crt \ -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow openshift-config네임스페이스에서Secret오브젝트를 생성하여 클라이언트 TLS 구성을 추가합니다.oc create secret tls helm-tls-configs \ --cert=/path/to/certs/client.crt \ --key=/path/to/certs/client.key \ -n openshift-config

$ oc create secret tls helm-tls-configs \ --cert=/path/to/certs/client.crt \ --key=/path/to/certs/client.key \ -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 클라이언트 인증서 및 키는 PEM 인코딩 형식이어야 하며 각각

tls.crt및tls.key키에 저장되어야 합니다.다음과 같이 Helm 리포지터리를 추가합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ConfigMap및Secret은tlsConfig및ca필드를 사용하는 HelmChartRepository CR에서 사용됩니다. 이러한 인증서는 Helm 리포지터리 URL에 연결하는 데 사용됩니다.기본적으로 모든 인증된 사용자는 모든 구성된 차트에 액세스할 수 있습니다. 하지만 인증서가 필요한 차트 리포지터리의 경우 다음과 같이 사용자에게

openshift-config네임스페이스의helm-ca-cert구성 맵과helm-tls-configs시크릿에 대한 읽기 액세스 권한을 제공해야 합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3.7. 인증 수준에 따라 Helm 차트 필터링

개발자 카탈로그의 인증 수준에 따라 Helm 차트를 필터링할 수 있습니다.

절차

- 개발자 화면에서 +추가 보기로 이동하여 프로젝트를 선택합니다.

- 개발자 카탈로그 타일에서 Helm 차트 옵션을 선택하여 개발자 카탈로그의 모든 Helm 차트를 확인합니다.

필요한 차트를 필터링하려면 Helm 차트 목록 왼쪽에 있는 필터를 사용합니다.

- 차트 리포지토리 필터를 사용하여 Red Hat 인증 차트 또는 OpenShift Helm 차트에서 제공하는 차트를 필터링합니다.

-

소스 필터를 사용하여 파트너,커뮤니티 또는 Red Hat에서 제공한 차트를 필터링합니다. 인증 차트는 (

) 아이콘으로 표시됩니다.

) 아이콘으로 표시됩니다.

공급업체 유형이 하나뿐이면 소스 필터가 표시되지 않습니다.

이제 필요한 차트를 선택하고 설치할 수 있습니다.

5.3.8. Helm 차트 리포지터리 비활성화

Helm ChartRepository 사용자 정의 리소스의 차트 리포지터리를 비활성화할 수 있습니다.

disabled 속성을 true 로 설정하여 카탈로그의 특정 Helm 차트 리포지터리에서 Helm

절차

CLI를 사용하여 Helm 차트 리포지터리를 비활성화하려면

disabled: true플래그를 사용자 정의 리소스에 추가합니다. 예를 들어 Azure 샘플 차트 리포지터리를 제거하려면 다음을 실행합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 웹 콘솔을 사용하여 최근에 추가된 Helm 차트 리포지터리를 비활성화하려면 다음을 수행합니다.

-

사용자 정의 리소스 정의로 이동하여

HelmChartRepository사용자 정의 리소스를 검색합니다. - 인스턴스로 이동하여 비활성화할 저장소를 찾아 이름을 클릭합니다.

YAML 탭으로 이동하여

spec섹션에disabled: true플래그를 추가하고저장을 클릭합니다.예제

spec: connectionConfig: url: <url-of-the-repositoru-to-be-disabled> disabled: truespec: connectionConfig: url: <url-of-the-repositoru-to-be-disabled> disabled: trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이제 리포지터리가 비활성화되어 카탈로그에 표시되지 않습니다.

-

사용자 정의 리소스 정의로 이동하여

5.4. Helm 릴리스 작업

웹 콘솔에서 개발자 화면을 사용하여 Helm 릴리스를 업데이트, 롤백 또는 설치 제거할 수 있습니다.

5.4.1. 사전 요구 사항

- 웹 콘솔에 로그인하여 개발자 화면으로 전환했습니다.

5.4.2. Helm 릴리스 업그레이드

Helm 릴리스를 업그레이드하여 새 차트 버전으로 업그레이드하거나 릴리스 구성을 업데이트할 수 있습니다.

프로세스

- 토폴로지 보기에서 Helm 릴리스를 선택하여 측면 패널을 확인합니다.

- 작업 → Helm 릴리스 업그레이드를 클릭합니다.

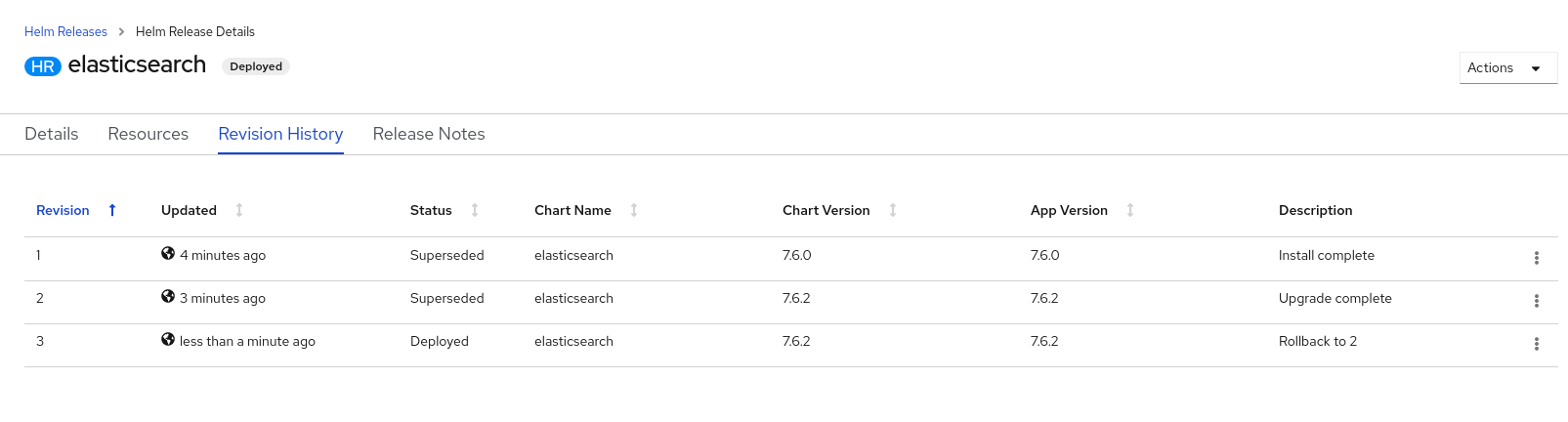

- Helm 릴리스 업그레이드 페이지에서 업그레이드할 차트 버전을 선택한 다음 업그레이드를 클릭하면 또 하나의 Helm 릴리스가 생성됩니다. Helm 릴리스 페이지에 두 가지 리버전이 표시됩니다.

5.4.3. Helm 릴리스 롤백

릴리스가 실패하면 Helm 릴리스를 이전 버전으로 롤백할 수 있습니다.

프로세스

Helm 보기를 사용하여 릴리스를 롤백하려면 다음을 수행합니다.

- 개발자 화면에서 Helm 보기로 이동하여 네임스페이스에서 Helm 릴리스를 확인합니다.

-

나열된 릴리스 옆에 있는 옵션 메뉴

를 클릭하고 롤백을 선택합니다.

를 클릭하고 롤백을 선택합니다.

- 롤백 Helm 릴리스 페이지에서 롤백할 리버전을 선택하고 롤백을 클릭합니다.

- Helm 릴리스 페이지에서 차트를 클릭하여 해당 릴리스의 세부 정보 및 리소스를 확인합니다.

리버전 내역 탭으로 이동하여 차트의 리버전을 모두 확인합니다.

그림 5.3. Helm 리버전 내역

-

필요한 경우 특정 리버전 옆에 있는 옵션 메뉴

를 사용하여 롤백할 리버전을 선택할 수 있습니다.

를 사용하여 롤백할 리버전을 선택할 수 있습니다.

5.4.4. Helm 릴리스 설치 제거

프로세스

- 토폴로지 보기에서 Helm 릴리스를 마우스 오른쪽 버튼으로 클릭하고 Helm 릴리스 설치 제거를 선택합니다.

- 확인 프롬프트에서 차트 이름을 입력하고 설치 제거를 클릭합니다.

6장. 배포

6.1. Deployment 및 DeploymentConfig 오브젝트 이해

OpenShift Container Platform의 Deployment 및 DeploymentConfig API 오브젝트에서는 일반적인 사용자 애플리케이션을 세밀하게 관리할 수 있도록 유사하지만 서로 다른 두 가지 방법을 제공합니다. 이러한 오브젝트는 다음과 같이 별도의 API 오브젝트로 구성됩니다.

-

DeploymentConfig또는Deployment오브젝트: 특정 애플리케이션 구성 요소에 대해 원하는 상태를 Pod 템플릿으로 설명합니다. -

DeploymentConfig오브젝트: 특정 시점의 배포 상태 레코드가 Pod 템플릿으로 포함되는 복제 컨트롤러가 한 개 이상 포함됩니다. 마찬가지로배포오브젝트에는 복제 컨트롤러를 대체하는 복제본 세트가 한 개 이상 포함됩니다. - 하나 이상의 Pod: 특정 버전의 애플리케이션 인스턴스를 나타냅니다.

6.1.1. 배포 블록 빌드

배포 및 배포 구성은 각각 기본 Kubernetes API 오브젝트인 ReplicaSet 및 ReplicationController를 빌딩 블록으로 사용하여 활성화됩니다.

사용자가 DeploymentConfig 오브젝트 또는 배포에서 다루는 복제 컨트롤러, 복제본 세트 또는 Pod를 조작할 필요가 없습니다. 배포 시스템을 통해 변경 사항이 적절하게 전파됩니다.

기존 배포 전략이 사용 사례에 적합하지 않고 배포 라이프사이클 중 수동 단계를 실행해야 하는 경우에는 사용자 정의 배포 전략을 생성해야 합니다.

다음 섹션에서는 이러한 오브젝트에 대해 자세히 설명합니다.

6.1.1.1. 복제 컨트롤러

복제 컨트롤러를 사용하면 항상 지정된 수의 Pod 복제본이 실행됩니다. Pod가 종료되거나 삭제되면 복제 컨트롤러가 작동하여 정의된 수까지 추가로 인스턴스화합니다. 마찬가지로 필요한 것보다 많은 Pod가 실행되고 있는 경우에는 정의된 수에 맞게 필요한 개수의 Pod를 삭제합니다.

복제 컨트롤러 구성은 다음과 같이 구성됩니다.

- 런타임에 조정할 수 있는 원하는 복제본 수

-

복제된 Pod를 생성할 때 사용할

Pod정의 - 관리형 Pod를 확인하는 선택기

선택기는 복제 컨트롤러에서 관리하는 Pod에 할당한 라벨 세트입니다. 이러한 라벨은 복제 컨트롤러에서 인스턴스화하는 Pod 정의에 포함됩니다. 복제 컨트롤러에서는 필요에 따라 조정할 수 있도록 선택기를 사용하여 이미 실행 중인 Pod의 인스턴스 수를 결정합니다.

복제 컨트롤러에서 로드나 트래픽을 추적하지 않으므로 로드 또는 트래픽을 기반으로 자동 스케일링하지 않습니다. 대신 외부 Autoscaler에서 복제본 수를 조정해야 합니다.

다음은 복제 컨트롤러 정의의 예입니다.

6.1.1.2. 복제본 세트

복제 컨트롤러와 유사하게 ReplicaSet은 지정된 수의 Pod 복제본을 언제든지 실행할 수 있는 기본 Kubernetes API 오브젝트입니다. 복제본 세트와 복제 컨트롤러의 차이점은 복제본 세트는 세트 기반 선택기 요구 사항을 지원하는 반면 복제 컨트롤러는 일치 기반 선택기 요구 사항만 지원한다는 점입니다.

사용자 정의 업데이트 오케스트레이션이 필요한 경우에만 복제본 세트를 사용하거나 업데이트가 필요하지 않습니다. 그러지 않으면 배포를 사용하십시오. 복제본 세트는 독립적으로 사용할 수 있지만 배포에서 Pod 생성, 삭제, 업데이트를 오케스트레이션하는 데 사용합니다. 배포는 복제본 세트를 자동으로 관리하고 Pod에 선언적 업데이트를 제공하며 생성한 복제본 세트를 수동으로 관리할 필요가 없습니다.

다음은 ReplicaSet 정의의 예입니다.

6.1.2. DeploymentConfig 오브젝트

OpenShift Container Platform은 복제 컨트롤러를 기반으로 소프트웨어 개발 및 배포 라이프사이클에 대한 지원을 DeploymentConfig 오브젝트의 개념으로 확장합니다. 가장 간단한 경우 DeploymentConfig 오브젝트는 새 복제 컨트롤러를 생성하고 이 컨트롤러에서 Pod를 시작할 수 있도록 설정합니다.

그러나 DeploymentConfig 오브젝트의 OpenShift Container Platform 배포에서는 이미지의 기존 배포에서 새 버전으로 전환하는 기능도 제공하고 복제 컨트롤러를 생성하기 전이나 후에 실행할 후크도 정의합니다.

DeploymentConfig 배포 시스템에서는 다음 기능을 제공합니다.

-

실행 중인 애플리케이션에 대한 템플릿인

DeploymentConfig오브젝트 - 이벤트에 대한 응답으로 자동 배포를 실행하는 트리거

- 이전 버전에서 새 버전으로의 전환을 위한 사용자 정의 가능 배포 전략. 전략은 일반적으로 배포 프로세스라는 Pod 내에서 실행됩니다.

- 배포 라이프사이클 중 다른 시점에서 사용자 정의 동작을 실행하는 일련의 후크(라이프사이클 후크)

- 배포가 실패하는 경우 롤백을 수동 또는 자동으로 지원하기 위한 애플리케이션 버전 관리

- 복제본 수동 스케일링 및 자동 스케일링

DeploymentConfig 오브젝트를 생성하면 DeploymentConfig 오브젝트의 Pod 템플릿을 나타내는 복제 컨트롤러가 생성됩니다. 배포가 변경되면 최신 Pod 템플릿을 사용하여 새 복제 컨트롤러가 생성되고 배포 프로세스가 실행되어 이전 복제 컨트롤러가 축소되고 새 복제 컨트롤러가 확장됩니다.

애플리케이션 인스턴스는 생성 시 서비스 로드 밸런서와 라우터 모두에서 자동으로 추가 및 제거됩니다. 애플리케이션에서 TERM 신호를 수신할 때 정상 종료를 지원하는 경우 실행 중인 사용자 연결을 정상적으로 완료할 수 있는 기회를 제공할 수 있습니다.

OpenShift Container Platform DeploymentConfig 오브젝트는 다음과 같은 세부 정보를 정의합니다.

-

ReplicationController정의의 요소 - 새 배포를 자동으로 생성하는 트리거

- 배포 간 전환을 위한 전략

- 라이프사이클 후크

배포가 수동 또는 자동으로 트리거될 때마다 배포자 Pod에서 배포를 관리합니다(이전 복제 컨트롤러 축소, 새 복제 컨트롤러 확장, 후크 실행 포함). 배포 Pod는 배포 로그를 유지하기 위해 배포 완료 후 무기한으로 유지됩니다. 배포가 다른 배포로 대체되면 필요한 경우 쉽게 롤백할 수 있도록 이전 복제 컨트롤러가 유지됩니다.

DeploymentConfig 정의의 예

6.1.3. 배포

Kubernetes는 OpenShift Container Platform에서 Deployment라는 최상위 기본 API 오브젝트 유형을 제공합니다. Deployment 오브젝트는 OpenShift Container Platform 관련 DeploymentConfig 오브젝트의 하위 항목 역할을 합니다.

Deployment 오브젝트는 DeploymentConfig 오브젝트와 같이 특정 애플리케이션 구성 요소의 원하는 상태를 Pod 템플릿으로 설명합니다. 배포에서는 Pod 라이프사이클을 오케스트레이션하는 복제본 세트를 생성합니다.

예를 들어 다음 배포 정의에서는 하나의 hello-openshift Pod를 가져오는 복제본 세트를 생성합니다.

배포 정의

6.1.4. Deployment 및 DeploymentConfig 오브젝트 비교

OpenShift Container Platform에서는 Kubernetes Deployment 오브젝트와 OpenShift Container Platform 제공 DeploymentConfig 오브젝트가 모두 지원되지만 DeploymentConfig 오브젝트에서 제공하는 특정 기능 또는 동작이 필요하지 않는 한 Deployment 오브젝트를 사용하는 것이 좋습니다.

다음 섹션은 두 오브젝트 유형의 차이점에 대해 더 자세히 설명하여 사용할 유형을 결정하는 데 도움이 됩니다.

6.1.4.1. 설계

Deployment 및 DeploymentConfig 오브젝트의 중요한 차이점은 각 설계에서 롤아웃 프로세스에 대해 선택한 CAP theorem의 속성입니다. DeploymentConfig 오브젝트는 일관성을 선호하는 반면 Deployments 오브젝트는 일관성보다 가용성을 우선합니다.

DeploymentConfig 오브젝트의 경우 배포자 Pod를 실행하는 노드가 종료되면 대체되지 않습니다. 이 프로세스는 노드가 다시 온라인 상태가 될 때까지 기다리거나 수동으로 삭제됩니다. 노드를 수동으로 삭제하면 해당 Pod도 삭제됩니다. 즉 kubelet에서 연결된 Pod를 삭제해야 하므로 롤아웃을 해제하기 위해 Pod를 삭제할 수 없습니다.

그러나 배포 롤아웃은 컨트롤러 관리자에서 구동됩니다. 컨트롤러 관리자는 마스터에서 고가용성 모드로 실행되고 리더 선택 알고리즘을 사용하여 일관성보다 가용성을 중시합니다. 오류가 발생하는 동안 기타 마스터가 동일한 배포에서 동시에 작업할 수 있지만 이러한 문제는 오류 발생 직후 조정됩니다.

6.1.4.2. DeploymentConfig 오브젝트별 기능

자동 롤백

현재 배포에서는 배포에 실패하는 경우 성공적으로 배포된 마지막 복제본 세트로 자동 롤백되지 않습니다.

Trigger

배포의 Pod 템플릿이 변경될 때마다 새 롤아웃이 자동으로 트리거된다는 점에서 배포에는 암시적 구성 변경 트리거가 포함되어 있습니다. Pod 템플릿 변경 시 새 롤아웃을 수행하지 않으려면 배포를 정지하십시오.

oc rollout pause deployments/<name>

$ oc rollout pause deployments/<name>라이프사이클 후크

배포에서는 아직 라이프사이클 후크를 지원하지 않습니다.

사용자 정의 전략

배포에서는 사용자가 지정하는 사용자 정의 배포 전략을 아직 지원하지 않습니다.

6.1.4.3. 배포별 기능

롤오버

Deployment 오브젝트에 대한 배포 프로세스는 모든 새 롤아웃에 대해 배포자 Pod를 사용하는 DeploymentConfig 오브젝트와 달리 컨트롤러 반복문에 의해 실행됩니다. 즉 Deployment 오브젝트에는 활성 상태의 복제본 세트가 가능한 한 많이 있을 수 있습니다. 결국 배포 컨트롤러에서 이전 복제본 세트를 축소하고 최신 복제본 세트를 확장합니다.

DeploymentConfig 오브젝트에서는 최대 1개의 배포자 Pod를 실행할 수 있습니다. 그러지 않으면 여러 배포자가 최신이라고 생각하는 복제 컨트롤러를 확장하면서 충돌하게 됩니다. 이로 인해 어느 시점에 두 개의 복제 컨트롤러만 활성화할 수 있습니다. 결국 Deployment 오브젝트에 대한 신속한 롤아웃이 더 빨라집니다.

비례 스케일링

배포 컨트롤러는 Deployment 오브젝트가 소유한 새 복제본 세트 및 이전 복제본 세트의 크기에 대한 유일한 정보 소스이므로 지속적인 롤아웃을 확장할 수 있습니다. 추가 복제본은 각 복제본 세트의 크기에 비례하여 배포됩니다.

롤아웃이 진행 중이면 컨트롤러에서 새 복제 컨트롤러 크기에 대한 배포자 프로세스에 문제가 발생하므로 DeploymentConfig 오브젝트를 확장할 수 없습니다.

롤아웃 중 정지

배포는 언제든지 정지할 수 있습니다. 따라서 지속적인 롤아웃도 정지할 수 있습니다. 반면 현재 배포자 Pod는 정지할 수 없으므로 롤아웃 중 배포를 정지하려고 해도 배포자 프로세스는 영향을 받지 않고 완료될 때까지 계속 수행됩니다.

6.2. 배포 프로세스 관리

6.2.1. DeploymentConfig 오브젝트 관리

DeploymentConfig 오브젝트는 OpenShift Container Platform 웹 콘솔의 워크로드 페이지 또는 oc CLI에서 관리할 수 있습니다. 다음 절차에서는 달리 명시하지 않는 한 CLI 사용법을 보여줍니다.

6.2.1.1. 배포 시작

롤아웃을 시작하여 애플리케이션 배포 프로세스를 시작할 수 있습니다.

프로세스

기존

DeploymentConfig오브젝트에서 새 배포 프로세스를 시작하려면 다음 명령을 실행합니다.oc rollout latest dc/<name>

$ oc rollout latest dc/<name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고배포 프로세스가 이미 진행 중인 경우 명령에서 메세지를 표시하고 새 복제 컨트롤러가 배포되지 않습니다.

6.2.1.2. 배포 보기

배포를 보고 애플리케이션의 모든 사용 가능한 리버전에 대한 기본 정보를 얻을 수 있습니다.

프로세스

현재 실행 중인 배포 프로세스를 포함하여 제공된

DeploymentConfig오브젝트에 대해 최근 생성된 모든 복제 컨트롤러에 대한 세부 정보를 보려면 다음 명령을 실행합니다.oc rollout history dc/<name>

$ oc rollout history dc/<name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 버전과 관련된 세부 정보를 보려면

--revision플래그를 추가합니다.oc rollout history dc/<name> --revision=1

$ oc rollout history dc/<name> --revision=1Copy to Clipboard Copied! Toggle word wrap Toggle overflow DeploymentConfig오브젝트 및 이 오브젝트의 최신 버전에 대한 자세한 내용을 보려면oc describe명령을 사용합니다.oc describe dc <name>

$ oc describe dc <name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.1.3. 배포 재시도

DeploymentConfig 오브젝트의 현재 리버전을 배포하지 못한 경우 배포 프로세스를 재시작할 수 있습니다.

프로세스

실패한 배포 프로세스를 재시작하려면 다음을 수행합니다.

oc rollout retry dc/<name>

$ oc rollout retry dc/<name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 최신 버전이 성공적으로 배포된 경우 명령에서 메시지를 표시하고 배포 프로세스가 다시 수행되지 않습니다.

참고배포를 다시 시도하면 배포 프로세스가 다시 시작되고 새 배포 리버전이 생성되지 않습니다. 재시작한 복제 컨트롤러의 구성은 실패한 경우의 구성과 동일합니다.

6.2.1.4. 배포 롤백

롤백은 애플리케이션을 이전 리버전으로 되돌리고 REST API, CLI 또는 웹 콘솔을 사용하여 수행할 수 있습니다.

프로세스

마지막으로 성공적으로 배포된 구성 리버전으로 롤백하려면 다음을 수행합니다.

oc rollout undo dc/<name>

$ oc rollout undo dc/<name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow DeploymentConfig오브젝트의 템플릿이 undo 명령에 지정된 배포 리버전과 일치하도록 되돌아가고 새 복제 컨트롤러가 시작됩니다. 리버전이--to-revision을 사용하여 지정되지 않은 경우 마지막으로 성공적으로 배포된 리버전이 사용됩니다.롤백이 완료되면 실수로 새 배포 프로세스가 시작되지 않도록

DeploymentConfig오브젝트에서 이미지 변경 트리거가 비활성화됩니다.이미지 변경 트리거를 다시 활성화하려면 다음을 수행합니다.

oc set triggers dc/<name> --auto

$ oc set triggers dc/<name> --autoCopy to Clipboard Copied! Toggle word wrap Toggle overflow

배포 구성에서는 최신 배포 프로세스가 실패하는 경우 마지막으로 성공한 구성 리버전으로의 자동 롤백도 지원합니다. 이 경우 배포되지 않은 최신 템플릿은 시스템에서 그대로 유지되며 사용자가 해당 구성을 수정할 수 있습니다.

6.2.1.5. 컨테이너 내에서 명령 실행

이미지의 ENTRYPOINT 를 오버레이하여 컨테이너의 시작 동작을 수정하는 명령을 컨테이너에 추가할 수 있습니다. 이 명령은 지정된 시점에 배포당 한 번만 실행할 수 있는 라이프사이클 후크와는 다릅니다.

프로세스

DeploymentConfig오브젝트의spec필드에command매개변수를 추가합니다. 또한command(command가 존재하지 않는 경우ENTRYPOINT)를 수정하는args필드를 추가할 수 있습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들어

-jar및/opt/app-root/springboots2idemo.jar인수를 사용하여java명령을 실행하려면 다음을 수행합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.1.6. 배포 로그 보기

프로세스

지정된

DeploymentConfig오브젝트의 최신 리버전 로그를 스트리밍하려면 다음을 수행합니다.oc logs -f dc/<name>

$ oc logs -f dc/<name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 최신 리버전이 실행 중이거나 실패한 경우 명령에서 Pod 배포를 담당하는 프로세스의 로그를 반환합니다. 성공하는 경우 애플리케이션 Pod의 로그를 반환합니다.

또한 실패한 이전 배포 프로세스(복제 컨트롤러 및 배포 Pod)가 존재하고 이를 수동으로 정리하거나 삭제하지 않은 경우에만 이러한 프로세스의 로그를 볼 수 있습니다.

oc logs --version=1 dc/<name>

$ oc logs --version=1 dc/<name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.1.7. 배포 트리거

DeploymentConfig 오브젝트에는 클러스터 내부 이벤트에 대한 응답으로 새 배포 프로세스 생성을 유도하는 트리거가 포함될 수 있습니다.

DeploymentConfig 오브젝트에 트리거가 정의되어 있지 않은 경우 기본적으로 구성 변경 트리거가 추가됩니다. Trigger가 빈 필드로 정의되면 배포를 수동으로 시작해야 합니다.

구성 변경 배포 트리거

구성 변경 트리거를 사용하면 DeploymentConfig 오브젝트의 Pod 템플릿에서 구성 변경이 탐지될 때마다 새 복제 컨트롤러가 생성됩니다.

DeploymentConfig 오브젝트에 구성 변경 트리거를 정의하면 DeploymentConfig 오브젝트 자체를 생성한 직후 첫 번째 복제 컨트롤러가 자동으로 생성되고 정지되지 않습니다.

구성 변경 배포 트리거

triggers: - type: "ConfigChange"

triggers:

- type: "ConfigChange"이미지 변경 배포 트리거

이미지 변경 트리거를 사용하면 이미지 스트림 태그 내용이 변경될 때마다(새 버전의 이미지를 내보낼 때) 새 복제 컨트롤러가 생성됩니다.

이미지 변경 배포 트리거

- 1

imageChangeParams.automatic필드를false로 설정하면 트리거가 비활성화됩니다.

위 예제에서 origin-ruby-sample 이미지 스트림의 latest 태그 값이 변경되고 새 이미지 값이 DeploymentConfig 오브젝트의 helloworld 컨테이너에 지정된 현재 이미지와 다른 경우 helloworld 컨테이너의 새 이미지를 사용하여 새 복제 컨트롤러가 생성됩니다.

DeploymentConfig 오브젝트에 이미지 변경 트리거가 정의되고(구성 변경 트리거와 automatic=false 또는 automatic=true 사용) 이미지 변경 트리거가 가리키는 이미지 스트림 태그가 아직 존재하지 않는 경우 빌드에서 이미지를 가져오거나 이미지 스트림 태그로 내보내는 즉시 초기 배포 프로세스가 자동으로 시작됩니다.

6.2.1.7.1. 배포 트리거 설정

프로세스

oc set triggers명령을 사용하여DeploymentConfig오브젝트에 대한 배포 트리거를 설정할 수 있습니다. 예를 들어 이미지 변경 트리거를 설정하려면 다음 명령을 사용하십시오.oc set triggers dc/<dc_name> \ --from-image=<project>/<image>:<tag> -c <container_name>$ oc set triggers dc/<dc_name> \ --from-image=<project>/<image>:<tag> -c <container_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.1.8. 배포 리소스 설정

배포는 노드에서 리소스(메모리, CPU, 임시 스토리지)를 사용하는 Pod에 의해 완료됩니다. 기본적으로 Pod는 바인딩되지 않은 노드 리소스를 사용합니다. 그러나 프로젝트에서 기본 컨테이너 제한을 지정하는 경우 Pod는 해당 제한까지 리소스를 사용합니다.

배포를 위한 최소 메모리 제한은 12MB입니다. 메모리를 할당할 수 없음 Pod 이벤트로 인해 컨테이너가 시작되지 않으면 메모리 제한이 너무 낮은 것입니다. 메모리 제한을 늘리거나 제거합니다. 제한을 제거하면 Pod에서 바인딩되지 않은 노드 리소스를 사용할 수 있습니다.

리소스 제한을 배포 전략의 일부로 지정하여 리소스 사용을 제한할 수도 있습니다. 배포 리소스는 재현, 롤링 또는 사용자 정의 배포 전략과 함께 사용할 수 있습니다.

프로세스

다음 예에서 각

resources,cpu,memory,ephemeral-storage는 선택 사항입니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 그러나 프로젝트에 할당량을 정의한 경우 다음 두 항목 중 하나가 필요합니다.

requests가 명시적으로 설정된resources섹션:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

requests오브젝트에 할당량의 리소스 목록에 해당하는 리소스 목록이 포함되어 있습니다.

-

프로젝트에 정의된 제한 범위:

LimitRange오브젝트의 기본값은 배포 프로세스 중 생성된 Pod에 적용됩니다.

배포 리소스를 설정하려면 위 옵션 중 하나를 선택하십시오. 그러지 않으면 할당량을 충족하지 못하여 배포 Pod가 생성되지 않습니다.

6.2.1.9. 수동 스케일링

롤백 외에도 수동으로 스케일링하여 복제본 수를 세부적으로 제어할 수 있습니다.

autoscale 명령을 사용하여 Pod를 자동 스케일링할 수도 있습니다.

프로세스

DeploymentConfig오브젝트를 수동으로 스케일링하려면oc scale명령을 사용합니다. 예를 들어 다음 명령은frontendDeploymentConfig오브젝트의 복제본 수를3으로 설정합니다.oc scale dc frontend --replicas=3

$ oc scale dc frontend --replicas=3Copy to Clipboard Copied! Toggle word wrap Toggle overflow 결국 복제본 수는

DeploymentConfig오브젝트의frontend에서 구성한 배포의 원하는 현재 상태로 전달됩니다.

6.2.1.10. DeploymentConfig 오브젝트에서 프라이빗 리포지토리에 액세스

프라이빗 리포지토리에서 이미지에 액세스할 수 있도록 DeploymentConfig 오브젝트에 시크릿을 추가할 수 있습니다. 이 절차에서는 OpenShift Container Platform 웹 콘솔 방법을 보여줍니다.

프로세스

- 새 프로젝트를 생성합니다.

- 워크로드 페이지에서 프라이빗 이미지 리포지토리에 액세스하는 데 필요한 인증 정보가 포함된 시크릿을 생성합니다.

-

DeploymentConfig오브젝트를 생성합니다. -

DeploymentConfig오브젝트 편집기 페이지에서 시크릿 가져오기를 설정하고 변경 사항을 저장합니다.

6.2.1.11. 특정 노드에 Pod 할당

라벨이 지정된 노드와 함께 노드 선택기를 사용하여 Pod 배치를 제어할 수 있습니다.

클러스터 관리자는 Pod 배치를 특정 노드로 제한하기 위해 프로젝트의 기본 노드 선택기를 설정할 수 있습니다. 개발자는 Pod 구성에 노드 선택기를 설정하여 노드를 추가로 제한할 수 있습니다.

프로세스

Pod를 생성할 때 노드 선택기를 추가하려면

Pod구성을 편집하고nodeSelector값을 추가합니다. 이 값은 단일Pod구성 또는Pod템플릿에 추가할 수 있습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 노드 선택기가 제 위치에 있으면 생성된 Pod가 라벨이 지정된 노드에 할당됩니다. 여기 지정된 라벨은 클러스터 관리자가 추가한 라벨과 함께 사용됩니다.

예를 들어 클러스터 관리자가 프로젝트에

type=user-node및region=east라벨을 추가하고 위의disktype: ssd라벨을 Pod에 추가하는 경우 Pod는 세 라벨이 모두 있는 노드에서만 예약됩니다.참고라벨은 하나의 값으로만 설정할 수 있으므로 관리자가 설정한 기본값이

region=east인Pod구성에region=west인 노드 선택기를 설정하면 예약되지 않는 Pod가 생성됩니다.

6.2.1.12. 다른 서비스 계정으로 Pod 실행

기본 계정 이외의 서비스 계정으로 Pod를 실행할 수 있습니다.

프로세스

DeploymentConfig오브젝트를 편집합니다.oc edit dc/<deployment_config>

$ oc edit dc/<deployment_config>Copy to Clipboard Copied! Toggle word wrap Toggle overflow serviceAccount및serviceAccountName매개변수를spec필드에 추가하고 사용할 서비스 계정을 지정합니다.spec: securityContext: {} serviceAccount: <service_account> serviceAccountName: <service_account>spec: securityContext: {} serviceAccount: <service_account> serviceAccountName: <service_account>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.3. 배포 전략 사용

배포 전략은 애플리케이션을 변경하거나 업그레이드하는 방법입니다. 사용자가 개선 작업을 거의 알아채지 못하도록 다운타임 없이 변경하는 것이 목표입니다.

최종 사용자는 일반적으로 라우터에서 처리한 경로를 통해 애플리케이션에 액세스하므로 배포 전략에서는 DeploymentConfig 오브젝트 기능 또는 라우팅 기능에 중점을 둘 수 있습니다. 배포에 중점을 둔 전략은 애플리케이션을 사용하는 모든 경로에 영향을 미칩니다. 라우터 기능을 사용하는 전략은 개별 경로를 대상으로 합니다.

대다수의 배포 전략은 DeploymentConfig 오브젝트를 통해 지원되며 일부 추가 전략은 라우터 기능을 통해 지원됩니다. 이 섹션에서는 배포 전략에 대해 설명합니다.

배포 전략 선택

배포 전략을 선택할 때는 다음을 고려하십시오.

- 장기 실행 연결은 정상적으로 처리해야 합니다.

- 데이터베이스 변환은 복잡할 수 있으며 애플리케이션과 함께 수행하고 롤백해야 합니다.

- 애플리케이션이 마이크로 서비스와 기존 구성 요소의 하이브리드인 경우 전환을 완료하기 위해 다운타임이 필요할 수 있습니다.

- 이 작업을 수행하려면 인프라가 있어야 합니다.

- 격리되지 않은 테스트 환경이 있는 경우 새 버전과 이전 버전을 모두 중단할 수 있습니다.

배포 전략에서는 준비 상태 점검을 통해 새 Pod를 사용할 준비가 되었는지 확인합니다. 준비 상태 점검이 실패하면 DeploymentConfig 오브젝트에서 타임아웃될 때까지 Pod를 다시 실행하려고 합니다. 기본 타임아웃은 dc.spec.strategy.*params의 TimeoutSeconds에 설정된 값인 10m입니다.

6.3.1. 롤링 전략

롤링 배포를 통해 이전 버전의 애플리케이션 인스턴스를 새 버전의 애플리케이션 인스턴스로 대체합니다. 롤링 전략은 DeploymentConfig 오브젝트에 전략이 지정되지 않은 경우 사용되는 기본 배포 전략입니다.

롤링 배포는 일반적으로 새 Pod가 준비 상태 점검을 통해 준비 상태가 될 때까지 기다린 후 이전 구성 요소를 축소합니다. 심각한 문제가 발생하는 경우 롤링 배포가 중단될 수 있습니다.

롤링 배포를 사용하는 경우는 다음과 같습니다.

- 애플리케이션을 업데이트하는 동안 다운타임이 발생하지 않도록 하려는 경우

- 애플리케이션에서 이전 코드 및 새 코드가 동시에 실행되도록 지원하는 경우