边缘计算

在网络边缘配置和部署 OpenShift Container Platform 集群

摘要

第 1 章 网络边缘的挑战

在地理位置管理多个站点时,边缘计算带来了复杂的挑战。使用 GitOps Zero Touch Provisioning (ZTP) 在网络边缘置备和管理站点。

1.1. 克服网络边缘的挑战

今天,服务提供商希望在网络边缘部署其基础架构。这带来了显著的挑战:

- 您怎样处理并行部署多个边缘站点的部署?

- 当您需要在断开连接的环境中部署站点时,会出现什么情况?

- 如何管理集群的生命周期?

GitOps Zero Touch Provisioning (ZTP) 和 GitOps 通过允许您为裸机设备使用声明站点定义和配置大规模置备远程边缘站点。模板或覆盖配置安装 CNF 工作负载所需的 OpenShift Container Platform 功能。安装和升级的完整生命周期通过 GitOps ZTP 管道处理。

GitOps ZTP 使用 GitOps 进行基础架构部署。使用 GitOps,您可以使用声明 YAML 文件和其他存储在 Git 存储库中的其他定义模式。Red Hat Advanced Cluster Management (RHACM)使用 Git 存储库来驱动基础架构部署。

GitOps 提供可追溯性、基于角色的访问控制 (RBAC),以及每个站点的所需状态的单一数据源。Git 方法可通过 webhook 解决可扩展性问题,以及事件驱动的操作。

您可以通过创建 GitOps ZTP 管道提供给边缘节点的声明站点定义和配置自定义资源 (CR) 来启动 GitOps ZTP 工作流。

下图显示了 GitOps ZTP 如何在最边缘框架内工作。

1.2. 使用 GitOps ZTP 在网络边缘置备集群

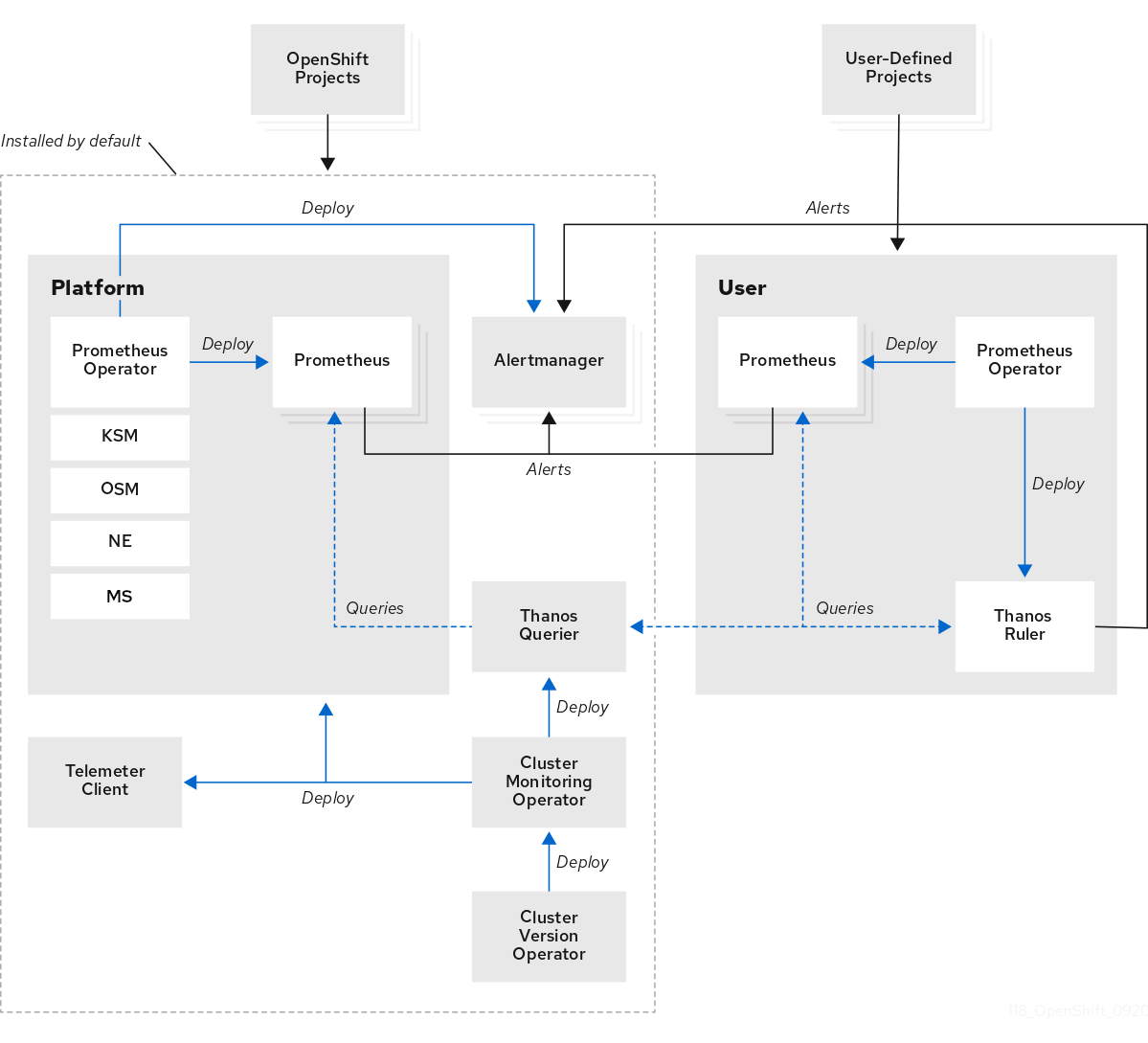

Red Hat Advanced Cluster Management (RHACM)在 hub 和 spoke 架构中管理集群,其中单个 hub 集群管理多个 spoke 集群。运行 RHACM 的 hub 集群使用 GitOps Zero Touch Provisioning (ZTP) 和安装 RHACM 时部署的辅助服务来置备和部署受管集群。

协助的服务处理在单一节点集群、三节点集群或裸机上运行的标准集群上 OpenShift Container Platform 置备。

使用 GitOps ZTP 的高级别概述来置备和维护使用 OpenShift Container Platform 的裸机主机,如下所示:

- 运行 RHACM 的 hub 集群管理一个 OpenShift 镜像 registry,用于镜像 OpenShift Container Platform 发行镜像。RHACM 使用 OpenShift 镜像 registry 来置备受管集群。

- 您以 YAML 格式清单文件管理裸机主机,并在 Git 存储库中版本。

- 您可以使主机准备好作为受管集群置备,并使用 RHACM 和辅助服务在站点上安装裸机主机。

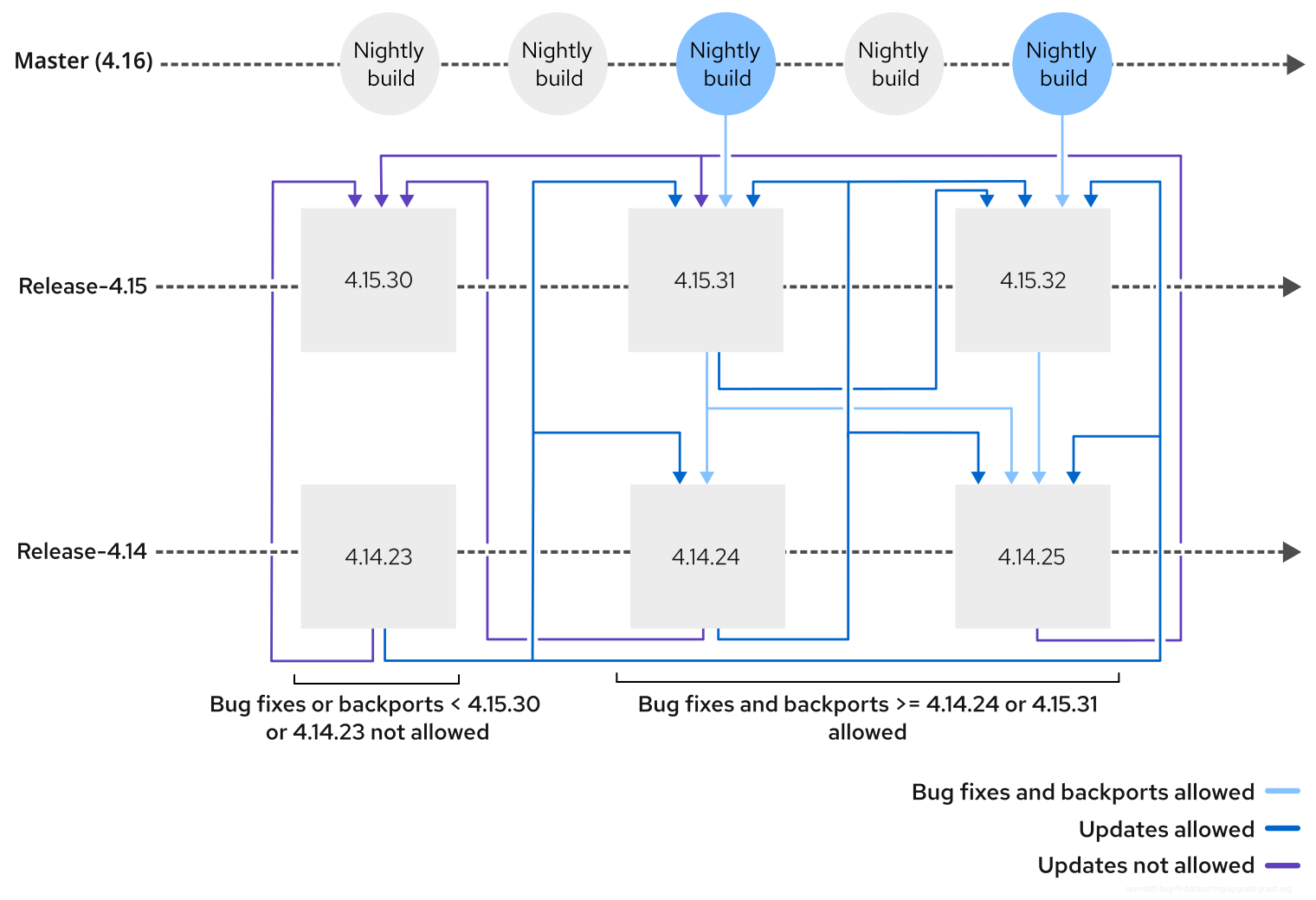

安装和部署集群分为两个阶段,涉及初始安装阶段,以及后续配置和部署阶段。下图演示了这个工作流:

1.3. 使用 SiteConfig 资源和 RHACM 安装受管集群

GitOps Zero Touch Provisioning (ZTP) 使用 Git 存储库中的 SiteConfig 自定义资源 (CR) 来管理安装 OpenShift Container Platform 集群的进程。SiteConfig CR 包含安装所需的特定于集群的参数。它有在安装过程中应用所选配置 CR 的选项,包括用户定义的额外清单。

GitOps ZTP 插件处理 SiteConfig CR,以便在 hub 集群上生成 CR 集合。这会在 Red Hat Advanced Cluster Management (RHACM) 中触发辅助服务,以便在裸机主机上安装 OpenShift Container Platform。您可以在 hub 集群上的这些 CR 中找到安装状态和错误消息。

您可以手动置备单个集群,或使用 GitOps ZTP 批量置备单个集群:

- 置备单个集群

-

为集群创建单一

SiteConfigCR 及相关的安装和配置 CR,并在 hub 集群中应用它们以开始集群置备。这是在大规模部署前测试 CR 的好方法。 - 置备多个集群

-

通过在 Git 仓库中定义

SiteConfig和相关 CR,以最多 400 的批处理中安装受管集群。ArgoCD 使用SiteConfigCR 来部署站点。RHACM 策略生成器创建清单,并将其应用到 hub 集群。这将启动集群置备过程。

1.4. 使用策略和 PolicyGenTemplate 资源配置受管集群

GitOps Zero Touch Provisioning (ZTP) 使用 Red Hat Advanced Cluster Management (RHACM) 使用基于策略的监管方法应用配置配置。

策略生成器或 PolicyGen 是 GitOps 操作器的一个插件,它允许从简洁的模板创建 RHACM 策略。该工具可将多个 CR 合并为一个策略,您可以生成多个策略应用到团队中集群的不同子集的策略。

为了扩展并降低跨集群管理配置的复杂性,请尽可能使用配置 CR。

- 在可能的情况下,使用机范围的通用策略应用配置 CR。

- 下一个首选项是创建集群的逻辑分组,以在组策略下尽可能管理剩余的配置。

- 当配置对单个站点是唯一的时,请使用 hub 集群上的 RHACM 模板将特定于站点的数据注入通用或组策略。或者,为站点应用单个站点策略。

下图显示了在集群部署配置阶段策略生成器如何与 GitOps 和 RHACM 交互。

对于大型集群群,在配置这些集群时通常具有高级别的一致性。

以下推荐的策略结构组合了配置 CR,以满足几个目标:

- 描述一次通用配置,并应用到所有系统。

- 最小化维护和管理策略的数量。

- 支持集群变体的通用配置的灵活性。

| 策略类别 | 描述 |

|---|---|

| Common |

一个存在于 common 类别中的策略被应用到该团队中的所有集群。使用通用 |

| 组 |

组类别中存在的策略应用到一组集群。使用组 |

| Sites | 站点类别中存在的策略应用到特定的集群站点。任何集群都可以维护自己的特定策略。 |

使用 PolicyGenTemplate CR 管理和监控对受管集群的策略将在即将发布的 OpenShift Container Platform 发行版本中弃用。使用 Red Hat Advanced Cluster Management (RHACM) 和 PolicyGenerator CR 提供了等效的和改进的功能。

有关 PolicyGenerator 资源的更多信息,请参阅 RHACM 策略生成器 文档。

第 2 章 为 GitOps ZTP 准备 hub 集群

要在断开连接的环境中使用 RHACM,请创建一个镜像 registry,镜像 OpenShift Container Platform 发行镜像和包含所需 Operator 镜像的 Operator Lifecycle Manager (OLM) 目录。OLM 在集群中管理、安装和升级 Operator 及其依赖项。您还可以使用断开连接的镜像主机来提供用于置备裸机主机的 RHCOS ISO 和 RootFS 磁盘镜像。

2.1. Telco RAN DU 4.16 验证软件组件

Red Hat Telco RAN DU 4.16 解决方案已在为 OpenShift Container Platform 受管集群和 hub 集群使用以下红帽产品进行验证。

| 组件 | 软件版本 |

|---|---|

| 受管集群版本 | 4.16 |

| Cluster Logging Operator | 5.9 |

| Local Storage Operator | 4.16 |

| PTP Operator | 4.16 |

| SRIOV Operator | 4.16 |

| Node Tuning Operator | 4.16 |

| Logging Operator | 4.16 |

| SRIOV-FEC Operator | 2.9 |

| 组件 | 软件版本 |

|---|---|

| hub 集群版本 | 4.16 |

| GitOps ZTP 插件 | 4.16 |

| Red Hat Advanced Cluster Management (RHACM) | 2.10, 2.11 |

| Red Hat OpenShift GitOps | 1.12 |

| Topology Aware Lifecycle Manager (TALM) | 4.16 |

2.2. GitOps ZTP 推荐的 hub 集群规格和受管集群限制

使用 GitOps Zero Touch Provisioning (ZTP),您可以在地理分散的区域和网络中管理数千个集群。在实验室环境中,Red Hat Performance and Scale 实验室成功创建和管理了 3500 个虚拟单节点 OpenShift 集群,该集群减少了 DU 配置集。

在实际情况下,您可以管理的集群数量扩展限制将因影响 hub 集群的不同因素而有所不同。例如:

- hub 集群资源

- 可用的 hub 集群主机资源(CPU、内存、存储)是决定 hub 集群可以管理的集群的一个重要因素。分配给 hub 集群的更多资源,它可以容纳更多受管集群。

- hub 集群存储

- hub 集群主机存储 IOPS 评级以及 hub 集群主机是否使用 NVMe 存储可能会影响 hub 集群性能及其可以管理的集群数量。

- 网络带宽和延迟

- hub 集群和受管集群之间的延迟或高延迟网络连接可能会影响 hub 集群管理多个集群的方式。

- 受管集群大小和复杂性

- 受管集群的大小和复杂性也会影响 hub 集群的容量。具有更多节点、命名空间和资源的大型受管集群需要额外的处理和管理资源。同样,具有复杂配置(如 RAN DU 配置集或不同工作负载)的集群可以从 hub 集群中需要更多资源。

- 受管策略数量

- 由 hub 集群管理的策略数量通过绑定到这些策略的受管集群数量进行扩展,是一个重要的因素,决定了可以管理多少个集群。

- 监控和管理工作负载

- RHACM 持续监控和管理受管集群。在 hub 集群中运行的监控和管理工作负载的数量和复杂性可能会影响其容量。密集型监控或频繁协调操作可能需要其他资源,从而可能会限制可管理的集群数量。

- RHACM 版本和配置

- RHACM 的不同版本可能具有不同的性能特性和资源要求。另外,RHACM 的配置设置(如并发协调的数量或健康检查的频率)可能会影响 hub 集群的受管集群容量。

使用以下代表配置和网络规格来开发您自己的 Hub 集群和网络规格。

以下准则仅基于内部实验室基准测试,并不代表完整的实际主机规格。

| 要求 | 描述 |

|---|---|

| 服务器硬件 | 3 x Dell PowerEdge R650 机架服务器 |

| NVMe 硬盘 |

|

| SSD 硬盘 |

|

| 应用的 DU 配置集策略数量 | 5 |

以下网络规格是典型的实际 RAN 网络的代表,并在测试过程中应用于扩展实验室环境。

| 规格 | 描述 |

|---|---|

| 往返时间(RTT)延迟 | 50 ms |

| 数据包丢失 | 0.02% 数据包丢失 |

| 网络带宽限制 | 20 Mbps |

2.3. 在断开连接的环境中安装 GitOps ZTP

在断开连接的环境中,使用 Red Hat Advanced Cluster Management (RHACM)、Red Hat OpenShift GitOps 和 Topology Aware Lifecycle Manager (TALM) 来管理多个受管集群的部署。

先决条件

-

已安装 OpenShift Container Platform CLI (

oc)。 -

您已以具有

cluster-admin权限的用户身份登录。 您已配置了断开连接的镜像 registry 以在集群中使用。

注意您创建的断开连接的镜像 registry 必须包含 TALM backup 和 pre-cache 镜像的版本,该镜像与 hub 集群中运行的 TALM 版本匹配。spoke 集群必须能够在断开连接的镜像 registry 中解析这些镜像。

流程

- 在 hub 集群上安装 RHACM。请参阅在断开连接的环境中安装 RHACM。

- 在 hub 集群中安装 GitOps 和 TALM。

2.4. 在断开连接的镜像主机中添加 RHCOS ISO 和 RootFS 镜像

在使用 Red Hat Advanced Cluster Management (RHACM) 在断开连接的环境中安装集群前,您必须首先托管 Red Hat Enterprise Linux CoreOS (RHCOS) 镜像供其使用。使用断开连接的镜像来托管 RHCOS 镜像。

先决条件

- 部署和配置 HTTP 服务器以托管网络上的 RHCOS 镜像资源。您必须能够从计算机以及您创建的机器访问 HTTP 服务器。

RHCOS 镜像可能不会随着 OpenShift Container Platform 的每个发行版本而改变。您必须下载最高版本的镜像,其版本号应小于或等于您安装的版本。如果可用,请使用与 OpenShift Container Platform 版本匹配的镜像版本。您需要 ISO 和 RootFS 镜像在主机上安装 RHCOS。此安装类型不支持 RHCOS QCOW2 镜像。

流程

- 登录到镜像主机。

从 mirror.openshift.com 获取 RHCOS ISO 和 RootFS 镜像,例如:

将所需的镜像名称和 OpenShift Container Platform 版本导出为环境变量:

export ISO_IMAGE_NAME=<iso_image_name>

$ export ISO_IMAGE_NAME=<iso_image_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow export ROOTFS_IMAGE_NAME=<rootfs_image_name>

$ export ROOTFS_IMAGE_NAME=<rootfs_image_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow export OCP_VERSION=<ocp_version>

$ export OCP_VERSION=<ocp_version>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 下载所需的镜像:

sudo wget https://mirror.openshift.com/pub/openshift-v4/dependencies/rhcos/4.16/${OCP_VERSION}/${ISO_IMAGE_NAME} -O /var/www/html/${ISO_IMAGE_NAME}$ sudo wget https://mirror.openshift.com/pub/openshift-v4/dependencies/rhcos/4.16/${OCP_VERSION}/${ISO_IMAGE_NAME} -O /var/www/html/${ISO_IMAGE_NAME}Copy to Clipboard Copied! Toggle word wrap Toggle overflow sudo wget https://mirror.openshift.com/pub/openshift-v4/dependencies/rhcos/4.16/${OCP_VERSION}/${ROOTFS_IMAGE_NAME} -O /var/www/html/${ROOTFS_IMAGE_NAME}$ sudo wget https://mirror.openshift.com/pub/openshift-v4/dependencies/rhcos/4.16/${OCP_VERSION}/${ROOTFS_IMAGE_NAME} -O /var/www/html/${ROOTFS_IMAGE_NAME}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

验证步骤

验证下载的镜像是否成功,并在断开连接的镜像主机上提供,例如:

wget http://$(hostname)/${ISO_IMAGE_NAME}$ wget http://$(hostname)/${ISO_IMAGE_NAME}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Saving to: rhcos-4.16.1-x86_64-live.x86_64.iso rhcos-4.16.1-x86_64-live.x86_64.iso- 11%[====> ] 10.01M 4.71MB/s

Saving to: rhcos-4.16.1-x86_64-live.x86_64.iso rhcos-4.16.1-x86_64-live.x86_64.iso- 11%[====> ] 10.01M 4.71MB/sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5. 启用辅助服务

Red Hat Advanced Cluster Management (RHACM)使用辅助服务来部署 OpenShift Container Platform 集群。当您在 Red Hat Advanced Cluster Management (RHACM)上启用 MultiClusterHub Operator 时,辅助服务会自动部署。之后,您需要配置 Provisioning 资源以监视所有命名空间,并更新 AgentServiceConfig 自定义资源(CR)以引用托管在镜像 registry HTTP 服务器上的 ISO 和 RootFS 镜像。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

已以具有

cluster-admin权限的用户身份登录到 hub 集群。 - 启用了 MultiClusterHub 的 RHACM。

流程

-

启用

Provisioning资源,以监视所有命名空间并为断开连接的环境配置镜像。如需更多信息,请参阅启用中央基础架构管理服务。 运行以下命令来更新

AgentServiceConfigCR:oc edit AgentServiceConfig

$ oc edit AgentServiceConfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在 CR 的

items.spec.osImages字段中添加以下条目:- cpuArchitecture: x86_64 openshiftVersion: "4.16" rootFSUrl: https://<host>/<path>/rhcos-live-rootfs.x86_64.img url: https://<host>/<path>/rhcos-live.x86_64.iso- cpuArchitecture: x86_64 openshiftVersion: "4.16" rootFSUrl: https://<host>/<path>/rhcos-live-rootfs.x86_64.img url: https://<host>/<path>/rhcos-live.x86_64.isoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 其中:

- <host>

- 是目标镜像 registry HTTP 服务器的完全限定域名 (FQDN)。

- <path>

- 是目标镜像 registry 上镜像的路径。

保存并退出编辑器以应用更改。

2.6. 将 hub 集群配置为使用断开连接的镜像 registry

您可以将 hub 集群配置为使用断开连接的镜像 registry 作为断开连接的环境。

先决条件

- 已安装 Red Hat Advanced Cluster Management (RHACM) 2.11 的断开连接的 hub 集群安装。

-

您已在 HTTP 服务器中托管

rootfs和iso镜像。有关 Mirroring the OpenShift Container Platform image repository 的信息,请参阅附加资源部分。

如果为 HTTP 服务器启用 TLS,您必须确认 root 证书由客户端信任的颁发机构签名,并验证 OpenShift Container Platform hub 和受管集群和 HTTP 服务器之间的可信证书链。使用配置了不受信任的证书的服务器可防止将镜像下载到创建镜像中。不支持使用不受信任的 HTTPS 服务器。

流程

创建包含镜像 registry 配置的

ConfigMap:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

ConfigMap命名空间必须设置为multicluster-engine。- 2

- 创建镜像 registry 时使用的镜像 registry 证书。

- 3

- 镜像 registry 的配置文件。镜像 registry 配置将镜像信息添加到发现镜像的

/etc/containers/registries.conf文件中。当信息传递给安装程序时,镜像信息会存储在install-config.yaml文件的imageContentSources部分中。在 hub 集群上运行的 Assisted Service pod 从配置的镜像 registry 获取容器镜像。 - 4

- 镜像 registry 的 URL。在配置镜像 registry 时,您必须运行

oc adm release mirror命令使用imageContentSources部分中的 URL。如需更多信息,请参阅 Mirroring the OpenShift Container Platform image repository 部分。 - 5

registries.conf文件中定义的 registry 必须由存储库范围,而不是由 registry 范围。在本例中,quay.io/example-repository和mirror1.registry.corp.com:5000/example-repository存储库都限定了example-repository存储库。

这会更新

AgentServiceConfig自定义资源中的mirrorRegistryRef,如下所示:输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

集群安装过程中需要一个有效的 NTP 服务器。确保有合适的 NTP 服务器可用,并可通过断开连接的网络从安装的系统访问。

2.7. 将 hub 集群配置为使用未经身份验证的 registry

您可以将 hub 集群配置为使用未经身份验证的 registry。未经身份验证的 registry 不需要进行身份验证才能访问和下载镜像。

先决条件

- 您已在 hub 集群上安装并配置了 hub 集群,并安装了 Red Hat Advanced Cluster Management (RHACM)。

- 已安装 OpenShift Container Platform CLI (oc)。

-

您已以具有

cluster-admin权限的用户身份登录。 - 已配置了一个未经身份验证的 registry 以用于 hub 集群。

流程

运行以下命令来更新

AgentServiceConfig自定义资源 (CR):oc edit AgentServiceConfig agent

$ oc edit AgentServiceConfig agentCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在 CR 中添加

unauthenticatedRegistries字段:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 未经身份验证的 registry 在

AgentServiceConfig资源的spec.unauthenticatedRegistries下列出。任何此列表中的 registry 都不需要在用于 spoke 集群安装的 pull secret 中有一个条目。assisted-service通过确保包含用于安装的每个镜像 registry 的身份验证信息来验证 pull secret。

镜像 registry 会自动添加到 ignore 列表中,不需要在 spec.unauthenticatedRegistries 下添加。在 ConfigMap 中指定 PUBLIC_CONTAINER_REGISTRIES 环境变量会用指定的值覆盖默认值。PUBLIC_CONTAINER_REGISTRIES 默认值是 quay.io 和 registry.svc.ci.openshift.org。

验证

运行以下命令,验证您可以从 hub 集群访问新添加的 registry:

在 hub 集群中打开一个 debug shell 提示符:

oc debug node/<node_name>

$ oc debug node/<node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令测试对未经身份验证的 registry 的访问:

podman login -u kubeadmin -p $(oc whoami -t) <unauthenticated_registry>

sh-4.4# podman login -u kubeadmin -p $(oc whoami -t) <unauthenticated_registry>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 其中:

- <unauthenticated_registry>

-

新的 registry,如

unauthenticated-image-registry.openshift-image-registry.svc:5000。

输出示例

Login Succeeded!

Login Succeeded!Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.8. 使用 ArgoCD 配置 hub 集群

您可以使用一组 ArgoCD 应用程序来配置 hub 集群,每个站点使用 GitOps 零接触置备 (ZTP) 生成所需的安装和策略自定义资源(CR)。

Red Hat Advanced Cluster Management (RHACM) 使用 SiteConfig CR 为 ArgoCD 生成第 1 天受管集群安装 CR。每个 ArgoCD 应用程序都可以管理最多 300 个 SiteConfig CR。

先决条件

- 已安装 Red Hat Advanced Cluster Management (RHACM) 和 Red Hat OpenShift GitOps 的 OpenShift Container Platform hub 集群。

-

您已从 GitOps ZTP 插件容器中提取了引用部署,如 "Preparing the GitOps ZTP site configuration repository" 部分所述。提取引用部署会创建以下流程中引用的

out/argocd/deployment目录。

流程

准备 ArgoCD 管道配置:

- 创建 Git 存储库,其目录结构类似于 example 目录。如需更多信息,请参阅"准备 GitOps ZTP 站点配置存储库"。

使用 ArgoCD UI 配置对存储库的访问。在 Settings 下配置以下内容:

-

Repositories - 添加连接信息。URL 必须以

.git结尾,例如https://repo.example.com/repo.git和凭证。 - 证书 - 如果需要,为存储库添加公共证书。

-

Repositories - 添加连接信息。URL 必须以

根据您的 Git 仓库修改两个 ArgoCD 应用程序,

out/argocd/deployment/clusters-app.yaml和out/argocd/deployment/policies-app.yaml:-

更新 URL 以指向 Git 存储库。URL 以

.git结尾,例如https://repo.example.com/repo.git。 -

targetRevision表示要监控的 Git 存储库分支。 -

path用于指定到SiteConfig和PolicyGenerator或PolicyGentemplateCR 的路径。

-

更新 URL 以指向 Git 存储库。URL 以

要安装 GitOps ZTP 插件,使用相关多集群引擎 (MCE) 订阅镜像对 hub 集群中的 ArgoCD 实例进行补丁。自定义您解压到环境的

out/argocd/deployment/目录中的补丁文件。选择与您的 RHACM 版本匹配的

multicluster-operators-subscription镜像。-

对于 RHACM 2.8 和 2.9,请使用

registry.redhat.io/rhacm2/multicluster-operators-subscription-rhel8:v<rhacm_version>镜像。 -

对于 RHACM 2.10 及更高版本,请使用

registry.redhat.io/rhacm2/multicluster-operators-subscription-rhel9:v<rhacm_version>镜像。

重要multicluster-operators-subscription镜像的版本必须与 RHACM 版本匹配。从 MCE 2.10 发行版本开始,RHEL 9 是multicluster-operators-subscription镜像的基础镜像。在 OpenShift Operator 生命周期中的"Platform Aligned Operators"表中点

[Expand for Operatorlist] 查看 OpenShift Container Platform 的完整支持的 Operator 列表。-

对于 RHACM 2.8 和 2.9,请使用

使用与您的 RHACM 版本匹配的

multicluster-operators-subscription镜像来修改out/argocd/deployment/argocd-openshift-gitops-patch.json文件:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 对 ArgoCD 实例进行补丁。运行以下命令:

oc patch argocd openshift-gitops \ -n openshift-gitops --type=merge \ --patch-file out/argocd/deployment/argocd-openshift-gitops-patch.json

$ oc patch argocd openshift-gitops \ -n openshift-gitops --type=merge \ --patch-file out/argocd/deployment/argocd-openshift-gitops-patch.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow

在 RHACM 2.7 及更高版本中,多集群引擎默认启用

cluster-proxy-addon功能。应用以下补丁来禁用cluster-proxy-addon功能,并删除负责此附加组件的相关 hub 集群和受管 pod。运行以下命令:oc patch multiclusterengines.multicluster.openshift.io multiclusterengine --type=merge --patch-file out/argocd/deployment/disable-cluster-proxy-addon.json

$ oc patch multiclusterengines.multicluster.openshift.io multiclusterengine --type=merge --patch-file out/argocd/deployment/disable-cluster-proxy-addon.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,将管道配置应用到 hub 集群:

oc apply -k out/argocd/deployment

$ oc apply -k out/argocd/deploymentCopy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:如果您已有 ArgoCD 应用程序,请运行以下命令验证在

应用程序资源中设置PrunePropagationPolicy=background策略:oc -n openshift-gitops get applications.argoproj.io \ clusters -o jsonpath='{.spec.syncPolicy.syncOptions}' |jq$ oc -n openshift-gitops get applications.argoproj.io \ clusters -o jsonpath='{.spec.syncPolicy.syncOptions}' |jqCopy to Clipboard Copied! Toggle word wrap Toggle overflow 现有策略的输出示例

[ "CreateNamespace=true", "PrunePropagationPolicy=background", "RespectIgnoreDifferences=true" ]

[ "CreateNamespace=true", "PrunePropagationPolicy=background", "RespectIgnoreDifferences=true" ]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果

spec.syncPolicy.syncOption字段不包含PrunePropagationPolicy参数,或PrunePropagationPolicy设置为foreground值,请在Application资源中将策略设置为后台。请参见以下示例:kind: Application spec: syncPolicy: syncOptions: - PrunePropagationPolicy=backgroundkind: Application spec: syncPolicy: syncOptions: - PrunePropagationPolicy=backgroundCopy to Clipboard Copied! Toggle word wrap Toggle overflow

设置

后台删除策略可确保ManagedClusterCR 及其所有相关资源都被删除。

2.9. 准备 GitOps ZTP 站点配置存储库

在使用 GitOps Zero Touch Provisioning (ZTP) 管道前,您需要准备 Git 存储库来托管站点配置数据。

先决条件

- 已配置了 hub 集群 GitOps 应用程序来生成所需的安装和策略自定义资源 (CR)。

- 已使用 GitOps ZTP 部署受管集群。

流程

使用

SiteConfig和PolicyGenerator,或PolicyGentemplateCR 的单独路径创建一个目录结构。注意将

SiteConfig和PolicyGenerator,或PolicyGentemplateCR 保留在单独的目录中。SiteConfig和PolicyGenerator,或PolicyGentemplate目录必须包含一个kustomization.yaml文件,该文件明确包含该目录中的文件。使用以下命令,从

ztp-site-generate容器镜像导出argocd目录:podman pull registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.16

$ podman pull registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.16Copy to Clipboard Copied! Toggle word wrap Toggle overflow mkdir -p ./out

$ mkdir -p ./outCopy to Clipboard Copied! Toggle word wrap Toggle overflow podman run --log-driver=none --rm registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.16 extract /home/ztp --tar | tar x -C ./out

$ podman run --log-driver=none --rm registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.16 extract /home/ztp --tar | tar x -C ./outCopy to Clipboard Copied! Toggle word wrap Toggle overflow 检查

out目录是否包含以下子目录:-

out/extra-manifest包含SiteConfig用来生成额外清单configMap的源 CR 文件。 -

out/source-crs包含PolicyGenerator用来生成 Red Hat Advanced Cluster Management (RHACM) 策略的源 CR 文件。 -

out/argocd/deployment包含补丁和 YAML 文件,可在 hub 集群中应用,以便在此过程的下一步中使用。 -

out/argocd/example包含代表推荐的配置的SiteConfig和PolicyGenerator,或PolicyGentemplate文件的示例。

-

-

将

out/source-crs文件夹和内容复制到PolicyGenerator或PolicyGentemplate目录。 out/extra-manifests 目录包含 RAN DU 集群的参考清单。将

out/extra-manifests目录复制到SiteConfig文件夹。此目录应包含来自ztp-site-generate容器的 CR。不要在此处添加用户提供的 CR。如果要使用用户提供的 CR,您必须为其内容创建另一个目录。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 使用

PolicyGenTemplateCR 管理和部署策略来管理集群将在以后的 OpenShift Container Platform 发行版本中弃用。使用 Red Hat Advanced Cluster Management (RHACM) 和PolicyGeneratorCR 提供了等效和改进的功能。

-

提交目录结构和

kustomization.yaml文件并推送到 Git 存储库。初始推送到 Git 的推送应包含kustomization.yaml文件。

您可以使用 out/argocd/example 下的目录结构作为 Git 存储库结构和内容的参考。该结构包括用于单节点、三节点和标准集群的 SiteConfig 和 PolicyGenerator,或 PolicyGentemplate 引用 CR。删除您对未使用集群类型的引用。

对于所有集群类型,您必须:

-

将

source-crs子目录添加到acmpolicygenerator或policygentemplates目录中。 -

将

extra-manifests目录添加到siteconfig目录中。

以下示例描述了单节点集群网络的一组 CR:

使用 PolicyGenTemplate CR 管理和监控对受管集群的策略将在即将发布的 OpenShift Container Platform 发行版本中弃用。使用 Red Hat Advanced Cluster Management (RHACM) 和 PolicyGenerator CR 提供了等效的和改进的功能。

有关 PolicyGenerator 资源的更多信息,请参阅 RHACM 策略生成器 文档。

2.10. 为独立版本准备 GitOps ZTP 站点配置存储库

您可以使用 GitOps ZTP 管理运行不同版本的 OpenShift Container Platform 的受管集群的源自定义资源(CR)。这意味着,在 hub 集群中运行的 OpenShift Container Platform 版本可以独立于受管集群上运行的版本。

以下流程假设您使用 PolicyGenerator 资源而不是 PolicyGentemplate 资源进行集群策略管理。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

您已以具有

cluster-admin权限的用户身份登录。

流程

-

使用

SiteConfig和PolicyGeneratorCR 的单独路径创建一个目录结构。 在

PolicyGenerator目录中,为您要提供的每个 OpenShift Container Platform 版本创建一个目录。对于每个版本,创建以下资源:-

明确包含该目录中文件的

kustomization.yaml文件 source-crs目录,其中包含ztp-site-generate容器中的引用 CR 配置文件如果要使用用户提供的 CR,必须为它们创建一个单独的目录。

-

明确包含该目录中文件的

在

/siteconfig目录中,为您要提供的每个 OpenShift Container Platform 版本创建一个子目录。对于每个版本,至少创建一个目录,用于从容器中复制引用 CR。对目录命名或引用目录数量没有限制。如果要使用自定义清单,必须为它们创建单独的目录。以下示例描述了对不同 OpenShift Container Platform 版本使用用户提供的清单和 CR 的结构:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 创建顶级

kustomizationYAML 文件。 - 2 7

- 在自定义

/acmpolicygenerator目录中创建特定于版本的目录。 - 3 8

- 为每个版本创建一个

kustomization.yaml文件。 - 4 9

- 为每个版本创建一个

source-crs目录,使其包含ztp-site-generate容器中的引用 CR。 - 5 10

- 为从 ZTP 容器中提取的策略 CR 创建

reference-crs目录。 - 6 11

- 可选:为用户提供的 CR 创建一个

custom-crs目录。 - 12 14

- 在自定义

/siteconfig目录中创建一个目录,使其包含ztp-site-generate容器的额外清单。 - 13 15

- 创建用于存放用户提供的清单的文件夹。

注意在上例中,自定义

/siteconfig目录中的每个版本子目录包含两个进一步的子目录,一个子目录包含从容器中复制的引用清单,另一个用于您提供的自定义清单。分配给这些目录的名称是示例。如果使用用户提供的 CR,则SiteConfigCR 中的extraManifests.searchPaths下列出的最后一个目录必须是包含用户提供的 CR 的目录。编辑

SiteConfigCR,使其包含您创建的任何目录的搜索路径。extraManifests.searchPaths下列出的第一个目录必须是包含引用清单的目录。考虑列出目录的顺序。如果目录包含相同名称的文件,则最终目录中的文件将具有优先权。SiteConfig CR 示例

extraManifests: searchPaths: - extra-manifest/ - custom-manifest/extraManifests: searchPaths: - extra-manifest/1 - custom-manifest/2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 编辑顶级

kustomization.yaml文件,以控制哪些 OpenShift Container Platform 版本处于活跃状态。以下是顶层的kustomization.yaml文件示例:resources: - version_4.13 #- version_4.14

resources: - version_4.131 #- version_4.142 Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 3 章 更新 GitOps ZTP

您可以独立于 hub 集群、Red Hat Advanced Cluster Management (RHACM) 和受管 OpenShift Container Platform 集群更新 Gitops Zero Touch Provisioning (ZTP) 基础架构。

当新版本可用时,您可以更新 Red Hat OpenShift GitOps Operator。更新 GitOps ZTP 插件时,请查看参考配置中的更新文件,并确保更改满足您的要求。

使用 PolicyGenTemplate CR 管理和监控对受管集群的策略将在即将发布的 OpenShift Container Platform 发行版本中弃用。使用 Red Hat Advanced Cluster Management (RHACM) 和 PolicyGenerator CR 提供了等效的和改进的功能。

有关 PolicyGenerator 资源的更多信息,请参阅 RHACM 策略生成器 文档。

3.1. GitOps ZTP 更新过程概述

您可以为运行较早版本的 GitOps ZTP 集群更新 GitOps Zero Touch Provisioning (ZTP)。更新过程可避免对受管集群的影响。

对策略设置的任何更改(包括添加推荐内容)都会生成要应用到受管集群并协调的更新策略。

在高级别上,更新 GitOps ZTP 基础架构的策略如下:

-

使用

ztp-done标签标记所有现有集群。 - 停止 ArgoCD 应用程序。

- 安装新的 GitOps ZTP 工具。

- 更新 Git 存储库中的所需内容和可选更改。

- 更新并重启应用程序配置。

3.2. 准备升级

使用以下步骤为 GitOps Zero Touch Provisioning (ZTP)升级准备您的站点。

流程

- 获取具有用于配置 Red Hat OpenShift GitOps 的自定义资源 (CR) 的 GitOps ZTP 容器的最新版本,以用于 GitOps ZTP。

使用以下命令提取

argocd/deployment目录:mkdir -p ./update

$ mkdir -p ./updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow podman run --log-driver=none --rm registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.16 extract /home/ztp --tar | tar x -C ./update

$ podman run --log-driver=none --rm registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.16 extract /home/ztp --tar | tar x -C ./updateCopy to Clipboard Copied! Toggle word wrap Toggle overflow /update目录包含以下子目录:-

update/extra-manifest: 包含SiteConfigCR 用来生成额外清单configMap的源 CR 文件。 -

update/source-crs:包含PolicyGenerator或PolicyGentemplateCR 用于生成 Red Hat Advanced Cluster Management (RHACM) 策略的源 CR 文件。 -

update/argocd/deployment: 包含要在 hub 集群上应用的补丁和 YAML 文件,以便在此过程的下一步中使用。 -

update/argocd/example: 包含代表推荐的配置的SiteConfig和PolicyGenerator,或PolicyGentemplate文件示例。

-

更新

cluster-app.yaml和policies-app.yaml文件,以反映应用程序的名称以及 Git 仓库的 URL、分支和路径。如果升级包含导致过时的策略的更改,则应该在执行升级前删除过时的策略。

在

/update文件夹和 Git 仓库(您管理团队站点 CR)中的配置和部署源 CR 之间的更改进行 diff 操作。应用所需的更改并将其推送到您的站点存储库。重要当您将 GitOps ZTP 更新至最新版本时,您必须将

update/argocd/deployment目录中的更改应用到您的站点存储库。不要使用旧版本的argocd/deployment/文件。

3.3. 标记现有集群

为确保现有集群由工具更新保持不变,请使用 ztp-done 标签标记所有现有的受管集群。

此流程仅在更新没有使用 Topology Aware Lifecycle Manager (TALM) 置备的集群时应用。使用 TALM 置备的集群会使用 ztp-done 自动标记。

流程

找到列出使用 GitOps Zero Touch Provisioning (ZTP) 部署的受管集群的标签选择器,如

local-cluster!=true:oc get managedcluster -l 'local-cluster!=true'

$ oc get managedcluster -l 'local-cluster!=true'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 确保生成的列表中包含使用 GitOps ZTP 部署的所有受管集群,然后使用该选择器添加

ztp-done标签:oc label managedcluster -l 'local-cluster!=true' ztp-done=

$ oc label managedcluster -l 'local-cluster!=true' ztp-done=Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. 停止现有的 GitOps ZTP 应用程序

删除现有的应用程序可确保在有新版本工具可用前,不会推出对 Git 存储库中现有内容的任何更改。

使用 deployment 目录中的应用文件。如果您为应用程序使用自定义名称,则首先更新这些文件中的名称。

流程

在

clusters应用程序上执行非级联删除以保留所有生成的资源:oc delete -f update/argocd/deployment/clusters-app.yaml

$ oc delete -f update/argocd/deployment/clusters-app.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

policies应用程序上执行级联删除以删除所有之前的策略:oc patch -f policies-app.yaml -p '{"metadata": {"finalizers": ["resources-finalizer.argocd.argoproj.io"]}}' --type merge$ oc patch -f policies-app.yaml -p '{"metadata": {"finalizers": ["resources-finalizer.argocd.argoproj.io"]}}' --type mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete -f update/argocd/deployment/policies-app.yaml

$ oc delete -f update/argocd/deployment/policies-app.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5. 对 Git 存储库进行所需的更改

当将 ztp-site-generate 容器从较早版本的 GitOps Zero Touch Provisioning (ZTP) 升级到 v4.10 或更高版本时,Git 仓库的内容需要额外的要求。存储库中的现有内容必须更新,以反映这些更改。

以下流程假设您使用 PolicyGenerator 资源而不是 PolicyGentemplate 资源进行集群策略管理。

对

PolicyGenerator文件进行必要的更改:所有

PolicyGenerator文件都必须在带有ztp前缀的命名空间中创建。这样可确保 GitOps ZTP 应用程序能够管理由 GitOps ZTP 生成的策略 CR,而无需与 Red Hat Advanced Cluster Management (RHACM) 在内部管理策略冲突。将

kustomization.yaml文件添加到存储库中:所有

SiteConfig和PolicyGeneratorCR 必须包含在其各自目录树下的kustomization.yaml文件中。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意generator部分中列出的文件只能包含SiteConfig或{policy-gen-cr}CR。如果现有 YAML 文件包含其他 CR,如Namespace,则这些其他 CR 必须拉取到单独的文件中,并在resources部分列出。PolicyGeneratorkustomization 文件需要包括在generator部分中的所有PolicyGeneratorYAML 文件,以及resources部分中的NamespaceCR。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow SiteConfigkustomization 文件必须包括generator部分中的所有SiteConfigYAML 文件,以及资源中的任何其他 CR:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 删除

pre-sync.yaml和post-sync.yaml文件。在 OpenShift Container Platform 4.10 及更新的版本中,不再需要

pre-sync.yaml和post-sync.yaml文件。update/deployment/kustomization.yamlCR 管理 hub 集群上的策略部署。注意在

SiteConfig和{policy-gen-cr}树下都有一组pre-sync.yaml和post-sync.yaml文件。检查并纳入推荐的更改

每个发行版本可能会包括对应用到已部署集群的配置进行额外的推荐更改。通常,这些更改由 OpenShift 平台、额外功能或改进对平台的调整带来较低的 CPU 使用。

查看适用于您网络中的集群类型的参考

SiteConfig和PolicyGeneratorCR。这些示例可在从 GitOps ZTP 容器中提取的argocd/example目录中找到。

3.6. 安装新的 GitOps ZTP 应用程序

使用提取的 argocd/deployment 目录,并在确保应用程序指向 Git 存储库后应用部署目录的所有内容。应用目录的内容可确保正确配置应用程序的所有必要资源。

流程

要安装 GitOps ZTP 插件,使用相关多集群引擎 (MCE) 订阅镜像对 hub 集群中的 ArgoCD 实例进行补丁。自定义您解压到环境的

out/argocd/deployment/目录中的补丁文件。选择与您的 RHACM 版本匹配的

multicluster-operators-subscription镜像。-

对于 RHACM 2.8 和 2.9,请使用

registry.redhat.io/rhacm2/multicluster-operators-subscription-rhel8:v<rhacm_version>镜像。 -

对于 RHACM 2.10 及更高版本,请使用

registry.redhat.io/rhacm2/multicluster-operators-subscription-rhel9:v<rhacm_version>镜像。

重要multicluster-operators-subscription镜像的版本必须与 RHACM 版本匹配。从 MCE 2.10 发行版本开始,RHEL 9 是multicluster-operators-subscription镜像的基础镜像。在 OpenShift Operator 生命周期中的"Platform Aligned Operators"表中点

[Expand for Operatorlist] 查看 OpenShift Container Platform 的完整支持的 Operator 列表。-

对于 RHACM 2.8 和 2.9,请使用

使用与您的 RHACM 版本匹配的

multicluster-operators-subscription镜像来修改out/argocd/deployment/argocd-openshift-gitops-patch.json文件:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 对 ArgoCD 实例进行补丁。运行以下命令:

oc patch argocd openshift-gitops \ -n openshift-gitops --type=merge \ --patch-file out/argocd/deployment/argocd-openshift-gitops-patch.json

$ oc patch argocd openshift-gitops \ -n openshift-gitops --type=merge \ --patch-file out/argocd/deployment/argocd-openshift-gitops-patch.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow

在 RHACM 2.7 及更高版本中,多集群引擎默认启用

cluster-proxy-addon功能。应用以下补丁来禁用cluster-proxy-addon功能,并删除负责此附加组件的相关 hub 集群和受管 pod。运行以下命令:oc patch multiclusterengines.multicluster.openshift.io multiclusterengine --type=merge --patch-file out/argocd/deployment/disable-cluster-proxy-addon.json

$ oc patch multiclusterengines.multicluster.openshift.io multiclusterengine --type=merge --patch-file out/argocd/deployment/disable-cluster-proxy-addon.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,将管道配置应用到 hub 集群:

oc apply -k out/argocd/deployment

$ oc apply -k out/argocd/deploymentCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.7. 推出 GitOps ZTP 配置更改

如果因为实现推荐的更改而在升级过程中包括任何配置更改,升级过程会在 hub 集群上生成 Non-Compliant 状态的一组策略 CR。使用 GitOps Zero Touch Provisioning (ZTP) 版本 4.10 及更新的版本 ztp-site-generate 容器,这些策略被设置为 inform 模式,且不会由用户在没有额外步骤的情况下推送到受管集群。这样可保证在进行更改时可以管理对集群的破坏性更改,例如在维护窗口期间以及同时更新多少个集群。

要推出更改,请创建一个或多个 ClusterGroupUpgrade CR,如 TALM 文档所述。CR 必须包含您要推送到受管集群的 Non-Compliant 策略列表,以及应包含在更新中的集群的列表或选择器。

第 4 章 使用 RHACM 和 SiteConfig 资源安装受管集群

您可以使用辅助服务以及启用了 core-reduction 技术的 GitOps 插件策略生成器,以扩展 Red Hat Advanced Cluster Management (RHACM) 来大规模置备 OpenShift Container Platform 集群。GitOps Zero Touch Provisioning (ZTP) 管道执行集群安装。GitOps ZTP 可以在断开连接的环境中使用。

使用 PolicyGenTemplate CR 管理和监控对受管集群的策略将在即将发布的 OpenShift Container Platform 发行版本中弃用。使用 Red Hat Advanced Cluster Management (RHACM) 和 PolicyGenerator CR 提供了等效的和改进的功能。

有关 PolicyGenerator 资源的更多信息,请参阅 RHACM 策略生成器 文档。

4.1. GitOps ZTP 和 Topology Aware Lifecycle Manager

GitOps Zero Touch Provisioning (ZTP) 从 Git 中存储的清单生成安装和配置 CR。这些工件应用到一个中央化的 hub 集群,其中 Red Hat Advanced Cluster Management (RHACM)、辅助服务和 Topology Aware Lifecycle Manager (TALM) 使用 CR 来安装和配置受管集群。GitOps ZTP 管道的配置阶段使用 TALM 将配置 CR 的应用程序编排到集群。GitOps ZTP 和 TALM 之间有几个关键集成点。

- 通知策略

-

默认情况下,GitOps ZTP 创建所有带有

inform的补救操作的策略。这些策略会导致 RHACM 报告与策略相关的集群合规性状态,但不会应用所需的配置。在 GitOps ZTP 过程中,在 OpenShift 安装后,TALM 步骤通过创建的inform策略,并在目标受管集群中强制实施它们。这会将配置应用到受管集群。在集群生命周期的 GitOps ZTP 阶段之外,这允许您在不立即将这些更改部署到受影响的受管集群的情况下更改策略。您可以使用 TALM 控制时间和修复的集群集合。 - 自动创建 ClusterGroupUpgrade CR

要自动执行新部署的集群的初始配置,TALM 会监控 hub 集群上所有

ManagedClusterCR 的状态。任何未应用ztp-done标签的ManagedClusterCR,包括新创建的ManagedClusterCR,会导致 TALM 自动创建一个具有以下特征的ClusterGroupUpgradeCR:-

在

ztp-install命名空间中创建并启用ClusterGroupUpgradeCR。 -

ClusterGroupUpgradeCR 的名称与ManagedClusterCR 的名称相同。 -

集群选择器仅包括与该

ManagedClusterCR 关联的集群。 -

受管策略集合包含 RHACM 在

ClusterGroupUpgrade创建时绑定到集群的所有策略。 - 禁用预缓存。

- 超时设置为 4 小时(240 分钟)。

启用的

ClusterGroupUpgrade的自动创建可确保初始零接触集群部署继续进行,而无需用户干预。另外,为任何没有ztp-done标签的ManagedCluster自动创建一个ClusterGroupUpgradeCR,可以通过删除集群的ClusterGroupUpgradeCR 来重启失败的 GitOps ZTP 安装。-

在

- Waves

从

PolicyGenerator或PolicyGentemplateCR 生成的每个策略都包含一个ztp-deploy-wave注解。此注解基于来自每个 CR 的同一注解,该注解包含在该策略中。wave 注解用于对自动生成的ClusterGroupUpgradeCR 中的策略进行排序。wave 注解没有用于自动生成的ClusterGroupUpgradeCR。注意同一策略中的所有 CR 都必须具有

ztp-deploy-wave注解的设置。可以在PolicyGenerator或PolicyGentemplate中覆盖每个 CR 的此注解的默认值。源 CR 中的 wave 注解用来决定和设置策略 wave 注解。此注解已从每个构建 CR 中删除,该 CR 在运行时包含在生成的策略中。TALM 按照 wave 注解指定的顺序应用配置策略。在移至下一个策略前,TALM 会等待每个策略兼容。确保每个 CR 的 wave 注解考虑要应用到集群的任何 CR 的先决条件。例如,必须在 Operator 配置之前或同时安装 Operator。同样,Operator 的

CatalogSource必须在 Operator Subscription 之前或同时安装 wave。每个 CR 的默认 wave 值会考虑这些先决条件。多个 CR 和策略可以共享相同的 wave 编号。拥有较少的策略可缩短部署速度并降低 CPU 用量。将多个 CR 分组到相对较少的waves 是最佳实践方案。

要检查每个源 CR 中的默认 wave 值,请针对从 ztp-site-generate 容器镜像中提取的 out/source-crs 目录运行以下命令:

grep -r "ztp-deploy-wave" out/source-crs

$ grep -r "ztp-deploy-wave" out/source-crs- 阶段标签

ClusterGroupUpgradeCR 会被自动创建,并包含在 GitOps ZTP 进程开始和结尾使用标签为ManagedClusterCR 的说明。当 GitOps ZTP 配置安装后启动时,

ManagedCluster会应用ztp-running标签。当所有策略都修复至集群并完全合规时,这些指令会导致 TALM 删除ztp-running标签并应用ztp-done标签。对于使用

informDuValidator策略的部署,当集群完全准备好部署应用程序时,会应用ztp-done标签。这包括 GitOps ZTP 应用的配置 CR 的所有协调并产生影响。ztp-done标签会影响 TALM 创建自动ClusterGroupUpgradeCR。不要在集群初始 GitOps ZTP 安装后操作此标签。- 链接的 CR

-

自动创建的

ClusterGroupUpgradeCR 将所有者引用设置为派生于ManagedCluster的 ManagedCluster。此引用可确保删除ManagedClusterCR 会导致ClusterGroupUpgrade的实例以及任何支持的资源被删除。

4.2. 使用 GitOps ZTP 部署受管集群概述

Red Hat Advanced Cluster Management (RHACM) 使用 GitOps Zero Touch Provisioning (ZTP) 来部署单节点 OpenShift Container Platform 集群、三节点集群和标准集群。您可以在 Git 存储库中将站点配置数据作为 OpenShift Container Platform 自定义资源 (CR) 进行管理。GitOps ZTP 使用声明性 GitOps 方法进行开发一次,部署任意位置模型来部署受管集群。

集群部署包括:

- 在空白服务器上安装主机操作系统 (RHCOS)

- 部署 OpenShift Container Platform

- 创建集群策略和站点订阅

- 为服务器操作系统进行必要的网络配置

- 部署配置集 Operator 并执行任何所需的软件相关配置,如性能配置集、PTP 和 SR-IOV

受管站点安装过程概述

在 hub 集群中应用受管站点自定义资源 (CR) 后,会自动执行以下操作:

- 在目标主机上生成并启动发现镜像 ISO 文件。

- 当 ISO 文件成功在目标主机上引导时,它会将主机硬件信息报告给 RHACM。

- 在所有主机被发现后,会安装 OpenShift Container Platform。

-

当 OpenShift Container Platform 完成安装后,hub 在目标集群上安装

klusterlet服务。 - 请求的附加组件服务安装在目标集群中。

当在 hub 集群上创建受管集群的 Agent CR 时,发现镜像 ISO 过程已完成。

目标裸机主机必须满足 vDU 应用程序工作负载的推荐单节点 OpenShift 集群配置中列出的网络、固件和硬件要求。

4.3. 创建受管裸机主机 secret

将受管裸机主机所需的 Secret 自定义资源 (CR) 添加到 hub 集群。您需要 GitOps Zero Touch Provisioning (ZTP) 管道的 secret 来访问 Baseboard Management Controller (BMC) 和支持的安装程序服务的 secret,以便从 registry 中拉取集群安装镜像。

secret 按名称从 SiteConfig CR 引用。命名空间必须与 SiteConfig 命名空间匹配。

流程

创建一个 YAML secret 文件,其中包含主机 Baseboard Management Controller (BMC) 和安装 OpenShift 和所有附加组件集群 Operator 所需的凭证:

-

将到

example-sno-secret.yaml的相对路径添加用于安装集群的kustomization.yaml文件中。

4.4. 使用 GitOps ZTP 为安装配置 Discovery ISO 内核参数

GitOps Zero Touch Provisioning (ZTP) 工作流使用 Discovery ISO 作为托管裸机主机的 OpenShift Container Platform 安装过程的一部分。您可以编辑 InfraEnv 资源来为 Discovery ISO 指定内核参数。这对具有特定环境要求的集群安装非常有用。例如,为发现 ISO 配置 rd.net.timeout.carrier 内核参数以促进集群的静态网络,或者在在安装过程中下载根文件系统前接收 DHCP 地址。

在 OpenShift Container Platform 4.16 中,您只能添加内核参数。您不能替换或删除内核参数。

先决条件

- 已安装 OpenShift CLI(oc)。

- 已以具有 cluster-admin 权限的用户身份登录到 hub 集群。

流程

创建

InfraEnvCR,并编辑spec.kernelArguments规格以配置内核参数。将

InfraEnv-example.yamlCR 提交到 Git 存储库中具有SiteConfigCR 并推送您的更改的相同位置。以下示例显示了 Git 存储库结构示例:~/example-ztp/install └── site-install ├── siteconfig-example.yaml ├── InfraEnv-example.yaml ...~/example-ztp/install └── site-install ├── siteconfig-example.yaml ├── InfraEnv-example.yaml ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 编辑

SiteConfigCR 中的spec.clusters.crTemplates规格来引用 Git 存储库中的InfraEnv-example.yamlCR:clusters: crTemplates: InfraEnv: "InfraEnv-example.yaml"clusters: crTemplates: InfraEnv: "InfraEnv-example.yaml"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 当您准备好通过提交和推送

SiteConfigCR 来部署集群时,构建管道会使用 Git 存储库中的自定义InfraEnv-exampleCR 来配置基础架构环境,包括自定义内核参数。

验证

要验证是否应用了内核参数,在 Discovery 镜像验证 OpenShift Container Platform 是否准备好安装后,您可以在安装过程开始前通过 SSH 连接到目标主机。此时,您可以在 /proc/cmdline 文件中查看发现 ISO 的内核参数。

使用目标主机开始 SSH 会话:

ssh -i /path/to/privatekey core@<host_name>

$ ssh -i /path/to/privatekey core@<host_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用以下命令查看系统的内核参数:

cat /proc/cmdline

$ cat /proc/cmdlineCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5. 使用 SiteConfig 和 GitOps ZTP 部署受管集群

使用以下步骤创建 SiteConfig 自定义资源(CR) 和相关文件,并启动 GitOps Zero Touch Provisioning (ZTP) 集群部署。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

已以具有

cluster-admin权限的用户身份登录到 hub 集群。 - 配置了 hub 集群来生成所需的安装和策略 CR。

您创建了 Git 存储库,用于管理自定义站点配置数据。存储库必须可从 hub 集群访问,且必须将其配置为 ArgoCD 应用程序的源存储库。如需更多信息,请参阅"准备 GitOps ZTP 站点配置存储库"。

注意在创建源存储库时,请确保使用从

ztp-site-generate容器中提取的argocd/deployment/argocd-openshift-gitops-patch.jsonpatch-file 来修补 ArgoCD 应用程序。请参阅"使用 ArgoCD 配置 hub 集群"。要准备好置备受管集群,每个裸机主机都需要以下内容:

- 网络连接

- 您的网络需要 DNS。受管集群主机应该可从 hub 集群访问。确保 hub 集群和受管集群主机之间存在第 3 层连接。

- Baseboard Management Controller (BMC) 详情

-

GitOps ZTP 使用 BMC 用户名和密码详情来在集群安装过程中连接到 BMC。GitOps ZTP 插件根据站点 Git 仓库中的

SiteConfigCR 管理 hub 集群上的ManagedClusterCR。您可以手动为每个主机创建单独的BMCSecretCR。

流程

在 hub 集群中创建所需的受管集群 secret。这些资源必须位于名称与集群名称匹配的命名空间中。例如,在

out/argocd/example/siteconfig/example-sno.yaml中,集群名称和命名空间是example-sno。运行以下命令来导出集群命名空间:

export CLUSTERNS=example-sno

$ export CLUSTERNS=example-snoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建命名空间:

oc create namespace $CLUSTERNS

$ oc create namespace $CLUSTERNSCopy to Clipboard Copied! Toggle word wrap Toggle overflow

为受管集群创建 pull secret 和 BMC

SecretCR。pull secret 必须包含安装 OpenShift Container Platform 和其他需要安装的 Operator 所需的所有凭证。如需更多信息,请参阅"创建受管裸机主机 secret"。注意secret 根据名称从

SiteConfig自定义资源 (CR) 引用。命名空间必须与SiteConfig命名空间匹配。在 Git 存储库本地克隆中为集群创建一个

SiteConfigCR:从

out/argocd/example/siteconfig/文件夹中选择适合您的 CR 示例。文件夹中包含单一节点、三节点和标准集群的示例文件:-

example-sno.yaml -

example-3node.yaml -

example-standard.yaml

-

更改示例文件中的集群和主机详情,以匹配您想要的集群类型。例如:

单节点 OpenShift SiteConfig CR 示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意有关 BMC 寻址的更多信息,请参阅"添加资源"部分。

installConfigOverrides和ignitionConfigOverride字段在示例中扩展,以简化可读性。-

您可以在

out/argocd/extra-manifest中检查默认的 extra-manifestMachineConfigCR。它在安装时会自动应用到集群。 可选: 要在置备的集群中置备额外的安装清单,请在 Git 存储库中创建一个目录,如

sno-extra-manifest/,并将自定义清单 CR 添加到这个目录中。如果您的SiteConfig.yaml在extraManifestPath字段中引用这个目录,则这个引用目录中的所有 CR 都会被附加到默认的额外的清单集合中。启用 crun OCI 容器运行时为获得最佳的集群性能,请在单节点 OpenShift 中为 master 和 worker 节点启用 crun,使用额外的 worker 节点、三节点 OpenShift 和标准集群中启用单节点 OpenShift。

在

ContainerRuntimeConfigCR 中启用 crun,作为额外的第-0 天安装时间清单,以避免集群需要重启。enable-crun-master.yaml和enable-crun-worker.yamlCR 文件位于您可以从ztp-site-generate容器中提取的out/source-crs/optional-extra-manifest/文件夹中。如需更多信息,请参阅"在 GitOps ZTP 管道中自定义额外安装清单"。

-

在

kustomization.yaml文件中将SiteConfigCR 添加到generators部分中 ,类似于out/argocd/example/siteconfig/kustomization.yaml中显示的示例。 在 Git 存储库中提交

SiteConfigCR 及关联的kustomization.yaml更改并推送更改。ArgoCD 管道检测到更改并开始受管集群部署。

验证

验证在部署节点后是否应用了自定义角色和标签:

oc describe node example-node.example.com

$ oc describe node example-node.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow

输出示例

- 1

- 自定义标签应用到节点。

4.5.1. 加速置备 GitOps ZTP

GitOps ZTP 的加速置备只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

您可以通过为单节点 OpenShift 使用 GitOps ZTP 的加速置备来减少集群安装所需的时间。加速 ZTP 通过在早期阶段应用从策略派生的第 2 天清单来加快安装速度。

只有在使用 Assisted Installer 安装单节点 OpenShift 时,才支持加速 GitOps ZTP 置备。否则,这个安装方法将失败。

4.5.1.1. 激活加速 ZTP

您可以使用 spec.clusters.clusterLabels.accelerated-ztp 标签激活加速 ZTP,如下例所示:

加速 ZTP SiteConfig CR 示例。

您可以使用 accelerated-ztp: full 来完全自动化加速过程。GitOps ZTP 使用对加速 GitOps ZTP ConfigMap 的引用来更新 AgentClusterInstall 资源,并包括 TALM 从策略提取的资源,以及加速 ZTP 作业清单。

如果您使用 accelerated-ztp: partial,GitOps ZTP 不包括加速的作业清单,但会包括以下 kind 类型的集群安装过程中创建的 policy-derived 对象:

-

PerformanceProfile.performance.openshift.io -

Tuned.tuned.openshift.io -

Namespace -

CatalogSource.operators.coreos.com -

ContainerRuntimeConfig.machineconfiguration.openshift.io

在应用 Performance Profile、Tuned 和 ContainerRuntimeConfig 资源时,这个部分加速可以减少节点完成的重启数量。TALM 在 RHACM 完成导入集群后安装从策略派生的 Operator 订阅,遵循与标准 GitOps ZTP 相同的流程。

加速 ZTP 的好处会随着部署的规模而增加。对于带有大量集群的环境,使用 accelerated-ztp: full 会有更多好处。如果集群数量较少,则对减少安装时间的效果会显著减少。全加速 ZTP 会在 spoke 上保留一个命名空间和完成的作业,它们需要被手工删除。

使用 accelerated-ztp: partial 的好处之一是,如果 stock 实施出现问题,或者需要自定义功能,您可以覆盖 on-spoke 任务的功能。

4.5.1.2. 加速 ZTP 进程

加速 ZTP 使用额外的 ConfigMap 来创建从 spoke 集群上的策略派生的资源。标准 ConfigMap 包含 GitOps ZTP 工作流用来自定义集群安装的清单。

TALM 检测到设置了 accelerated-ztp 标签,然后创建了第二个 ConfigMap。作为加速 ZTP 的一部分,SiteConfig 生成器会添加到第二个 ConfigMap 的引用,其名称的格式是 <spoke-cluster-name>-aztp。

在 TALM 创建了第二个 ConfigMap 后,它会找到与受管集群绑定的所有策略,并会提取 GitOps ZTP 配置集信息。TALM 将 GitOps ZTP 配置集信息添加到 <spoke-cluster-name>-aztp ConfigMap 自定义资源 (CR) 中,并将 CR 应用到 hub 集群 API。

您可以使用 GitOps ZTP 和 Red Hat Advanced Cluster Management (RHACM) 在受管单节点 OpenShift 集群中启用 IPsec 加密。您可以加密受管集群外部 pod 和 IPsec 端点之间的外部流量。OVN-Kubernetes 集群网络上的节点之间的所有 pod 到 pod 网络流量都使用 IPsec 传输模式加密。

在 OpenShift Container Platform 4.16 中,使用 GitOps ZTP 和 RHACM 部署 IPsec 加密,只针对单节点 OpenShift 集群验证。

GitOps ZTP IPsec 实现假设您部署到资源受限平台。因此,您只能使用单个 MachineConfig CR 安装该功能,您不需要在单节点 OpenShift 集群上安装 NMState Operator。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

已以具有

cluster-admin权限的用户身份登录到 hub 集群。 - 您已配置了 RHACM 和 hub 集群,为受管集群生成所需的安装和策略自定义资源 (CR)。

- 您已创建了管理自定义站点配置数据的 Git 存储库。该存储库必须可从 hub 集群访问,并定义为 Argo CD 应用程序的源仓库。

-

已安装

butane工具,版本为 0.20.0 或更高版本。 - 您有一个 IPsec 端点的 PKCS#12 证书,以及一个 PEM 格式的 CA 证书。

流程

-

提取

ztp-site-generate容器源的最新版本,并将其与您管理自定义站点配置数据的存储库合并。 使用在集群中配置 IPsec 所需的值来配置

optional-extra-manifest/ipsec/ipsec-endpoint-config.yaml。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将您的

ca.pem和left_server.p12证书添加到optional-extra-manifest/ipsec文件夹中。每个主机上的网络安全服务 (NSS) 数据库都需要证书文件。这些文件在后续步骤中作为 Butane 配置的一部分导入。-

left_server.p12:IPsec 端点的证书捆绑包 -

ca.pem:您使用签名证书的证书颁发机构

-

-

在您维护自定义站点配置数据的 Git 存储库的

optional-extra-manifest/ipsec文件夹下打开 shell 提示符。 运行

optional-extra-manifest/ipsec/build.sh脚本来生成所需的 Butane 和MachineConfigCR 文件。输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在您管理自定义站点配置数据的存储库中创建

custom-manifest/文件夹。将enable-ipsec.yaml和99-ipsec-*YAML 文件添加到目录中。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在

SiteConfigCR 中,将custom-manifest/目录添加到extraManifests.searchPaths字段中。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 提交

SiteConfigCR 更改和更新的文件,并推送更改以置备受管集群并配置 IPsec 加密。ArgoCD 管道检测到更改并开始受管集群部署。

在集群置备过程中,GitOps ZTP 管道会将

/custom-manifest目录中的 CR 附加到存储在extra-manifest/中的默认额外清单集合中。

验证

要验证 IPsec 加密是否在受管单节点 OpenShift 集群中成功应用,请执行以下步骤:

运行以下命令为受管集群启动 debug pod:

oc debug node/<node_name>

$ oc debug node/<node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查 IPsec 策略是否在集群节点中应用:

ip xfrm policy

sh-5.1# ip xfrm policyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查 IPsec 隧道是否已启动并连接:

ip xfrm state

sh-5.1# ip xfrm stateCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在外部主机子网中 ping 已知 IP。例如,ping 您在

ipsec/ipsec-endpoint-config.yaml中设置的rightsubnet范围内的 IP:ping 172.16.110.8

sh-5.1# ping 172.16.110.8Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

ping 172.16.110.8 PING 172.16.110.8 (172.16.110.8) 56(84) bytes of data. 64 bytes from 172.16.110.8: icmp_seq=1 ttl=64 time=153 ms 64 bytes from 172.16.110.8: icmp_seq=2 ttl=64 time=155 ms

sh-5.1# ping 172.16.110.8 PING 172.16.110.8 (172.16.110.8) 56(84) bytes of data. 64 bytes from 172.16.110.8: icmp_seq=1 ttl=64 time=153 ms 64 bytes from 172.16.110.8: icmp_seq=2 ttl=64 time=155 msCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5.3. 单节点 OpenShift SiteConfig CR 安装参考

| SiteConfig CR 字段 | 描述 |

|---|---|

|

|

通过将 注意

使用 |

|

|

将 |

|

|

为站点中的所有集群配置 hub 集群上可用的镜像集。要查看 hub 集群上支持的版本列表,请运行 |

|

|

将 重要

使用示例 |

|

|

指定用于部署单个集群的集群镜像集。如果定义,它会在站点级别覆盖 |

|

|

配置集群标签,以对应于您定义的

例如, |

|

|

可选。将 |

|

|

对于单节点部署,请定义一个主机。对于三节点部署,请定义三个主机。对于标准部署,使用 |

|

| 为受管集群中的节点指定自定义角色。这些是其他角色,不供任何 OpenShift Container Platform 组件使用,仅限用户使用。添加自定义角色时,它可以与引用该角色的特定配置的自定义机器配置池相关联。在安装过程中添加自定义标签或角色可使部署过程更高效,并防止在安装完成后进行额外的重启。 |

|

|

可选。取消注释并将值设置为 |

|

| 用于访问主机的 BMC 地址。适用于所有集群类型。GitOps ZTP 支持使用 Redfish 或 IPMI 协议进行 iPXE 和虚拟介质引导。要使用 iPXE 启动,您必须使用 RHACM 2.8 或更高版本。有关 BMC 寻址的更多信息,请参阅"添加资源"部分。 |

|

| 用于访问主机的 BMC 地址。适用于所有集群类型。GitOps ZTP 支持使用 Redfish 或 IPMI 协议进行 iPXE 和虚拟介质引导。要使用 iPXE 启动,您必须使用 RHACM 2.8 或更高版本。有关 BMC 寻址的更多信息,请参阅"添加资源"部分。 注意 在边缘 Telco 用例中,只有虚拟介质可用于 GitOps ZTP。 |

|

|

配置使用主机 BMC 凭证单独创建的 |

|

|

将主机的引导模式设置为 |

|

|

指定用于部署的设备。建议在重启后保持标识符稳定。例如, |

|

| 可选。使用此字段为持久性存储分配分区。将磁盘 ID 和大小调整为特定的硬件。 |

|

| 配置节点的网络设置。 |

|

| 为主机配置 IPv6 地址。对于带有静态 IP 地址的单节点 OpenShift 集群,特定于节点的 API 和 Ingress IP 应该相同。 |

4.6. 监控受管集群安装进度

ArgoCD 管道使用 SiteConfig CR 生成集群配置 CR,并将其与 hub 集群同步。您可以在 ArgoCD 仪表板中监控此同步的进度。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

已以具有

cluster-admin权限的用户身份登录到 hub 集群。

流程

同步完成后,安装通常会按如下方式进行:

Assisted Service Operator 会在集群中安装 OpenShift Container Platform。您可以运行以下命令来从 RHACM 仪表板或命令行监控集群安装进度:

导出集群名称:

export CLUSTER=<clusterName>

$ export CLUSTER=<clusterName>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 查询受管集群的

AgentClusterInstallCR:oc get agentclusterinstall -n $CLUSTER $CLUSTER -o jsonpath='{.status.conditions[?(@.type=="Completed")]}' | jq$ oc get agentclusterinstall -n $CLUSTER $CLUSTER -o jsonpath='{.status.conditions[?(@.type=="Completed")]}' | jqCopy to Clipboard Copied! Toggle word wrap Toggle overflow 获取集群的安装事件:

curl -sk $(oc get agentclusterinstall -n $CLUSTER $CLUSTER -o jsonpath='{.status.debugInfo.eventsURL}') | jq '.[-2,-1]'$ curl -sk $(oc get agentclusterinstall -n $CLUSTER $CLUSTER -o jsonpath='{.status.debugInfo.eventsURL}') | jq '.[-2,-1]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7. 通过验证安装 CR 对 GitOps ZTP 进行故障排除

ArgoCD 管道使用 SiteConfig 和 PolicyGenerator 或 PolicyGentemplate 自定义资源(CR) 生成集群配置 CR 和 Red Hat Advanced Cluster Management (RHACM) 策略。使用以下步骤对此过程中可能出现的问题进行故障排除。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

已以具有

cluster-admin权限的用户身份登录到 hub 集群。

流程

您可以使用以下命令检查安装 CR 是否已创建:

oc get AgentClusterInstall -n <cluster_name>

$ oc get AgentClusterInstall -n <cluster_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果没有返回对象,请使用以下步骤对从

SiteConfig文件到安装 CR 的 ArgoCD 管道流进行故障排除。验证

ManagedClusterCR 是否使用 hub 集群上的SiteConfigCR 生成:oc get managedcluster

$ oc get managedclusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果缺少

ManagedCluster,请检查clusters应用程序是否将 Git 存储库中的文件与 hub 集群同步:oc get applications.argoproj.io -n openshift-gitops clusters -o yaml

$ oc get applications.argoproj.io -n openshift-gitops clusters -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要识别受管集群的错误日志,请检查

status.operationState.syncResult.resources字段。例如,如果为SiteConfigCR 中的extraManifestPath分配了一个无效的值,则会生成类似如下的错误:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要查看更详细的

SiteConfig错误,请完成以下步骤:- 在 Argo CD 仪表板中,点 Argo CD 试图同步的 SiteConfig 资源。

选中 DESIRED MANIFEST 选项卡,以查找

siteConfigError字段。siteConfigError: >- Error: could not build the entire SiteConfig defined by /tmp/kust-plugin-config-1081291903: stat sno-extra-manifest: no such file or directory

siteConfigError: >- Error: could not build the entire SiteConfig defined by /tmp/kust-plugin-config-1081291903: stat sno-extra-manifest: no such file or directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow

检查

Status.Sync字段。如果有日志错误,Status.Sync字段可能会指示Unknown错误:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.8. 在 SuperMicro 服务器中对 GitOps ZTP 虚拟介质引导进行故障排除

在使用 https 协议提供镜像时,Supermicro X11 服务器不支持虚拟介质安装。因此,此环境的单节点 OpenShift 部署无法在目标节点上引导。要避免这个问题,请登录到 hub 集群并禁用 Provisioning 资源中的传输层安全 (TLS)。这样可确保镜像不通过 TLS 提供,即使镜像地址使用 https 方案。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

已以具有

cluster-admin权限的用户身份登录到 hub 集群。

流程

运行以下命令,在

Provisioning资源中禁用 TLS:oc patch provisioning provisioning-configuration --type merge -p '{"spec":{"disableVirtualMediaTLS": true}}'$ oc patch provisioning provisioning-configuration --type merge -p '{"spec":{"disableVirtualMediaTLS": true}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 继续部署单节点 OpenShift 集群的步骤。

4.9. 从 GitOps ZTP 管道中删除受管集群站点

您可以从 GitOps Zero Touch Provisioning (ZTP) 管道中删除受管站点以及关联的安装和配置策略 CR。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

已以具有

cluster-admin权限的用户身份登录到 hub 集群。

流程

-

通过从

kustomization.yaml文件中删除关联的SiteConfig和PolicyGenTemplate或PolicyGentemplate文件来删除站点和相关的 CR。 在您的

SiteConfig应用程序中添加以下syncOptions字段。kind: Application spec: syncPolicy: syncOptions: - PrunePropagationPolicy=backgroundkind: Application spec: syncPolicy: syncOptions: - PrunePropagationPolicy=backgroundCopy to Clipboard Copied! Toggle word wrap Toggle overflow 当您再次运行 GitOps ZTP 管道时,生成的 CR 会被删除。

-

可选: 如果要永久删除站点,您还应从 Git 仓库中删除

SiteConfig和特定站点的PolicyGenerator或PolicyGentemplate文件。 -

可选:如果要临时删除站点,例如在重新部署站点时,可以保留 Git 存储库中的

SiteConfig和特定站点的PolicyGenerator或PolicyGentemplateCR。

4.10. 从 GitOps ZTP 管道中删除过时的内容

如果对 PolicyGenerator 或 PolicyGentemplate 配置的更改会导致过时的策略,例如,如果您重命名策略,请使用以下步骤删除过时的策略。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

已以具有

cluster-admin权限的用户身份登录到 hub 集群。

流程

-

从 Git 存储库中删除受影响的

PolicyGenerator或PolicyGentemplate文件,提交并推送到远程存储库。 - 等待更改通过应用程序同步,并将受影响的策略从 hub 集群中删除。

将更新的

PolicyGenerator或PolicyGentemplate文件重新添加到 Git 存储库,然后提交并推送到远程存储库。注意从 Git 仓库中删除 GitOps Zero Touch Provisioning (ZTP) 策略,因此也会从 hub 集群中删除它们,不会影响受管集群的配置。由该策略管理的策略和 CR 保留在受管集群上。

可选:作为替代方案,在更改生成过时策略的

PolicyGenerator或PolicyGentemplateCR 后,您可以手动从 hub 集群中删除这些策略。您可以使用 Governance 选项卡或运行以下命令来从 RHACM 控制台删除策略:oc delete policy -n <namespace> <policy_name>

$ oc delete policy -n <namespace> <policy_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.11. 弃用 GitOps ZTP 管道

您可以删除 ArgoCD 管道和所有生成的 GitOps Zero Touch Provisioning (ZTP) 工件。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

已以具有

cluster-admin权限的用户身份登录到 hub 集群。

流程

- 从 hub 集群上的 Red Hat Advanced Cluster Management (RHACM)分离所有集群。

使用以下命令,删除

deployment目录中的kustomization.yaml文件:oc delete -k out/argocd/deployment

$ oc delete -k out/argocd/deploymentCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 提交您的更改并推送到站点存储库。

第 5 章 使用 GitOps ZTP 手动安装单节点 OpenShift 集群

您可以使用 Red Hat Advanced Cluster Management (RHACM) 和支持的服务部署受管单节点 OpenShift 集群。

如果要创建多个受管集群,请参阅使用 ZTP 部署边缘站点中描述的 SiteConfig 方法。

目标裸机主机必须满足 vDU 应用程序工作负载的推荐集群配置中列出的网络、固件和硬件要求。

5.1. 手动生成 GitOps ZTP 安装和配置 CR

使用 ztp-site-generate 容器的 generator 入口点,根据 SiteConfig 和 PolicyGenerator CR 为集群生成站点安装和配置自定义资源 (CR)。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

已以具有

cluster-admin权限的用户身份登录到 hub 集群。

流程

运行以下命令来创建输出文件夹:

mkdir -p ./out

$ mkdir -p ./outCopy to Clipboard Copied! Toggle word wrap Toggle overflow 从

ztp-site-generate容器镜像导出argocd目录:podman run --log-driver=none --rm registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.16 extract /home/ztp --tar | tar x -C ./out

$ podman run --log-driver=none --rm registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.16 extract /home/ztp --tar | tar x -C ./outCopy to Clipboard Copied! Toggle word wrap Toggle overflow ./out目录包含out/argocd/example/文件夹中的参考PolicyGenerator和SiteConfigCR。输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 为站点安装 CR 创建输出文件夹:

mkdir -p ./site-install

$ mkdir -p ./site-installCopy to Clipboard Copied! Toggle word wrap Toggle overflow 为您要安装的集群类型修改示例

SiteConfigCR。将example-sno.yaml复制到site-1-sno.yaml,并修改 CR 以匹配您要安装的站点和裸机主机的详情,例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意从

ztp-site-generate容器的out/extra-manifest目录中提取引用 CR 配置文件后,您可以使用extraManifests.searchPaths来包含包含这些文件的 git 目录的路径。这允许 GitOps ZTP 管道在集群安装过程中应用这些 CR 文件。如果您配置searchPaths目录,GitOps ZTP 管道不会在站点安装过程中从ztp-site-generate容器获取清单。运行以下命令,通过处理修改后的

SiteConfigCRsite-1-sno.yaml来生成第 0 天安装 CR:podman run -it --rm -v `pwd`/out/argocd/example/siteconfig:/resources:Z -v `pwd`/site-install:/output:Z,U registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.16 generator install site-1-sno.yaml /output

$ podman run -it --rm -v `pwd`/out/argocd/example/siteconfig:/resources:Z -v `pwd`/site-install:/output:Z,U registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.16 generator install site-1-sno.yaml /outputCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:使用

-E选项处理参考SiteConfigCR,只为特定集群类型生成 day-0MachineConfig安装 CR。例如,运行以下命令:为

MachineConfigCR 创建输出文件夹:mkdir -p ./site-machineconfig

$ mkdir -p ./site-machineconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow 生成

MachineConfig安装 CR:podman run -it --rm -v `pwd`/out/argocd/example/siteconfig:/resources:Z -v `pwd`/site-machineconfig:/output:Z,U registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.16 generator install -E site-1-sno.yaml /output

$ podman run -it --rm -v `pwd`/out/argocd/example/siteconfig:/resources:Z -v `pwd`/site-machineconfig:/output:Z,U registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.16 generator install -E site-1-sno.yaml /outputCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

site-machineconfig └── site-1-sno ├── site-1-sno_machineconfig_02-master-workload-partitioning.yaml ├── site-1-sno_machineconfig_predefined-extra-manifests-master.yaml └── site-1-sno_machineconfig_predefined-extra-manifests-worker.yamlsite-machineconfig └── site-1-sno ├── site-1-sno_machineconfig_02-master-workload-partitioning.yaml ├── site-1-sno_machineconfig_predefined-extra-manifests-master.yaml └── site-1-sno_machineconfig_predefined-extra-manifests-worker.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

使用上一步中的参考

PolicyGeneratorCR 生成并导出 day-2 配置 CR。运行以下命令:为 day-2 CR 创建输出文件夹:

mkdir -p ./ref

$ mkdir -p ./refCopy to Clipboard Copied! Toggle word wrap Toggle overflow 生成并导出第 2 天配置 CR:

podman run -it --rm -v `pwd`/out/argocd/example/acmpolicygenerator:/resources:Z -v `pwd`/ref:/output:Z,U registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.16 generator config -N . /output

$ podman run -it --rm -v `pwd`/out/argocd/example/acmpolicygenerator:/resources:Z -v `pwd`/ref:/output:Z,U registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.16 generator config -N . /outputCopy to Clipboard Copied! Toggle word wrap Toggle overflow 该命令在

./ref文件夹中为单节点 OpenShift、三节点集群和标准集群生成示例组和特定于站点的PolicyGeneratorCR。输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- 使用生成的 CR 作为安装集群的 CR 的基础。您可以将安装 CR 应用到 hub 集群,如 "Installing a single managed cluster" 所述。配置 CR 可以在集群安装后应用到集群。

验证

验证在部署节点后是否应用了自定义角色和标签:

oc describe node example-node.example.com

$ oc describe node example-node.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow

输出示例

- 1

- 自定义标签应用到节点。

5.2. 创建受管裸机主机 secret

将受管裸机主机所需的 Secret 自定义资源 (CR) 添加到 hub 集群。您需要 GitOps Zero Touch Provisioning (ZTP) 管道的 secret 来访问 Baseboard Management Controller (BMC) 和支持的安装程序服务的 secret,以便从 registry 中拉取集群安装镜像。

secret 按名称从 SiteConfig CR 引用。命名空间必须与 SiteConfig 命名空间匹配。

流程

创建一个 YAML secret 文件,其中包含主机 Baseboard Management Controller (BMC) 和安装 OpenShift 和所有附加组件集群 Operator 所需的凭证:

-

将到

example-sno-secret.yaml的相对路径添加用于安装集群的kustomization.yaml文件中。

5.3. 使用 GitOps ZTP 为手动安装配置 Discovery ISO 内核参数

GitOps Zero Touch Provisioning (ZTP) 工作流使用 Discovery ISO 作为托管裸机主机的 OpenShift Container Platform 安装过程的一部分。您可以编辑 InfraEnv 资源来为 Discovery ISO 指定内核参数。这对具有特定环境要求的集群安装非常有用。例如,为发现 ISO 配置 rd.net.timeout.carrier 内核参数以促进集群的静态网络,或者在在安装过程中下载根文件系统前接收 DHCP 地址。

在 OpenShift Container Platform 4.16 中,您只能添加内核参数。您不能替换或删除内核参数。

先决条件

- 已安装 OpenShift CLI(oc)。

- 已以具有 cluster-admin 权限的用户身份登录到 hub 集群。

- 您已手动生成安装和配置自定义资源(CR)。

流程

-

编辑

InfraEnvCR 中的spec.kernelArguments规格以配置内核参数:

SiteConfig CR 生成 InfraEnv 资源,作为 day-0 安装 CR 的一部分。

验证

要验证是否应用了内核参数,在 Discovery 镜像验证 OpenShift Container Platform 是否准备好安装后,您可以在安装过程开始前通过 SSH 连接到目标主机。此时,您可以在 /proc/cmdline 文件中查看发现 ISO 的内核参数。

使用目标主机开始 SSH 会话:

ssh -i /path/to/privatekey core@<host_name>

$ ssh -i /path/to/privatekey core@<host_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用以下命令查看系统的内核参数:

cat /proc/cmdline

$ cat /proc/cmdlineCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4. 安装单个受管集群

您可以使用辅助服务和 Red Hat Advanced Cluster Management (RHACM) 手动部署单个受管集群。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

已以具有

cluster-admin权限的用户身份登录到 hub 集群。 -

您已创建了基板管理控制器(BMC)

Secret和镜像 pull-secretSecret自定义资源 (CR)。详情请参阅"创建受管裸机主机 secret"。 - 您的目标裸机主机满足受管集群的网络和硬件要求。

流程

为要部署的每个特定集群版本创建一个

ClusterImageSet,如clusterImageSet-4.16.yaml。ClusterImageSet具有以下格式:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 应用

clusterImageSetCR:oc apply -f clusterImageSet-4.16.yaml

$ oc apply -f clusterImageSet-4.16.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

cluster-namespace.yaml文件中创建NamespaceCR:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来应用

NamespaceCR:oc apply -f cluster-namespace.yaml

$ oc apply -f cluster-namespace.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 应用从

ztp-site-generate容器中提取的生成的 day-0 CR,并自定义以满足您的要求:oc apply -R ./site-install/site-sno-1

$ oc apply -R ./site-install/site-sno-1Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.5. 监控受管集群安装状态

通过检查集群状态,确保集群置备成功。

先决条件

-

所有自定义资源都已配置并置备,在受管集群的 hub 上创建

Agent自定义资源。

流程

检查受管集群的状态:

oc get managedcluster

$ oc get managedclusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow True表示受管集群已就绪。检查代理状态:

oc get agent -n <cluster_name>

$ oc get agent -n <cluster_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

describe命令,提供代理条件的深入描述。支持的状态包括BackendError、InputError、ValidationsFailing、InFailed和AgentIsConnected。这些状态与Agent和AgentClusterInstall自定义资源相关。oc describe agent -n <cluster_name>

$ oc describe agent -n <cluster_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查集群置备状态:

oc get agentclusterinstall -n <cluster_name>

$ oc get agentclusterinstall -n <cluster_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

describe命令提供集群置备状态的深入描述:oc describe agentclusterinstall -n <cluster_name>

$ oc describe agentclusterinstall -n <cluster_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查受管集群的附加服务的状态:

oc get managedclusteraddon -n <cluster_name>

$ oc get managedclusteraddon -n <cluster_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检索受管集群的

kubeconfig文件的身份验证信息:oc get secret -n <cluster_name> <cluster_name>-admin-kubeconfig -o jsonpath={.data.kubeconfig} | base64 -d > <directory>/<cluster_name>-kubeconfig$ oc get secret -n <cluster_name> <cluster_name>-admin-kubeconfig -o jsonpath={.data.kubeconfig} | base64 -d > <directory>/<cluster_name>-kubeconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.6. 受管集群故障排除

使用这个流程诊断受管集群中可能出现的任何安装问题。

流程

检查受管集群的状态:

oc get managedcluster

$ oc get managedclusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME HUB ACCEPTED MANAGED CLUSTER URLS JOINED AVAILABLE AGE SNO-cluster true True True 2d19h

NAME HUB ACCEPTED MANAGED CLUSTER URLS JOINED AVAILABLE AGE SNO-cluster true True True 2d19hCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果

AVAILABLE列中的状态为True,受管集群由 hub 管理。如果

AVAILABLE列中的状态为Unknown,则受管集群不会由 hub 管理。使用以下步骤继续检查 以了解更多信息。检查

AgentClusterInstall安装状态:oc get clusterdeployment -n <cluster_name>

$ oc get clusterdeployment -n <cluster_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME PLATFORM REGION CLUSTERTYPE INSTALLED INFRAID VERSION POWERSTATE AGE Sno0026 agent-baremetal false Initialized 2d14h

NAME PLATFORM REGION CLUSTERTYPE INSTALLED INFRAID VERSION POWERSTATE AGE Sno0026 agent-baremetal false Initialized 2d14hCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果

INSTALLED列中的状态为false,则安装会失败。如果安装失败,请输入以下命令查看

AgentClusterInstall资源的状态:oc describe agentclusterinstall -n <cluster_name> <cluster_name>

$ oc describe agentclusterinstall -n <cluster_name> <cluster_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 解决错误并重置集群:

删除集群的受管集群资源:

oc delete managedcluster <cluster_name>

$ oc delete managedcluster <cluster_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 删除集群的命名空间:

oc delete namespace <cluster_name>

$ oc delete namespace <cluster_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 这会删除为此集群创建的所有命名空间范围自定义资源。您必须等待

ManagedClusterCR 删除完成,然后才能继续。- 为受管集群重新创建自定义资源。

5.7. RHACM 生成的集群安装 CR 参考

Red Hat Advanced Cluster Management (RHACM)支持在每个站点的 SiteConfig CR 上部署 OpenShift Container Platform,以及带有特定安装自定义资源 (CR) 的 OpenShift Container Platform。

每个受管集群都有自己的命名空间,除 ManagedCluster 和 ClusterImageSet 以外的所有安装 CR 都位于该命名空间中。ManagedCluster 和 ClusterImageSet 是集群范围的,而不是命名空间范围的。命名空间和 CR 名称与集群名称匹配。

下表列出了在使用您配置的 SiteConfig CR 安装集群时 RHACM 辅助服务自动应用的安装 CR。

| CR | 描述 | 使用方法 |

|---|---|---|

|

| 包含目标裸机主机 Baseboard Management Controller(BMC)的连接信息。 | 提供对 BMC 的访问,以使用 Redfish 协议在目标服务器上加载和启动发现镜像。 |

|

| 包含在目标裸机主机上安装 OpenShift Container Platform 的信息。 |

与 |

|

|

指定管理集群配置的详情,如网络和 control plane 节点的数量。安装完成后,显示集群 | 指定受管集群配置信息,并在安装集群期间提供状态。 |

|

|

引用要使用的 |

与 |

|

|

提供网络配置信息,如 | 为受管集群的 Kube API 服务器设置静态 IP 地址。 |

|

| 包含有关目标裸机主机的硬件信息。 | 当目标机器的发现镜像引导时,在 hub 上自动创建。 |

|

| 当集群由 hub 管理时,必须导入并已知的集群。此 Kubernetes 对象提供该接口。 | hub 使用这个资源来管理和显示受管集群的状态。 |

|

|

包含要部署到 |

告知 hub 部署到 |

|

|

hub 上已存在的 |

将资源传播到 |

|

|

创建两个 CR: |

|

|

| 包含 OpenShift Container Platform 镜像信息,如存储库和镜像名称。 | 传递给资源以提供 OpenShift Container Platform 镜像。 |

第 6 章 推荐的 vDU 应用程序工作负载的单节点 OpenShift 集群配置

使用以下引用信息,了解在集群中部署虚拟分布式单元 (vDU) 应用程序所需的单节点 OpenShift 配置。配置包括用于高性能工作负载的集群优化、启用工作负载分区以及最大程度减少安装后所需的重启数量。

6.1. 在 OpenShift Container Platform 上运行低延迟应用程序

OpenShift Container Platform 通过使用几个技术和专用硬件设备,为在商业现成 (COTS) 硬件上运行的应用程序启用低延迟处理:

- RHCOS 的实时内核

- 确保以高度的进程确定性处理工作负载。

- CPU 隔离

- 避免 CPU 调度延迟并确保 CPU 容量一致可用。

- NUMA 感知拓扑管理

- 将内存和巨页与 CPU 和 PCI 设备对齐,以将容器内存和巨页固定到非统一内存访问(NUMA)节点。所有服务质量 (QoS) 类的 Pod 资源保留在同一个 NUMA 节点上。这可降低延迟并提高节点的性能。

- 巨页内存管理

- 使用巨页大小可减少访问页表所需的系统资源量,从而提高系统性能。

- 使用 PTP 进行精确计时同步

- 允许以子微秒的准确性在网络中的节点之间进行同步。

6.2. vDU 应用程序工作负载的推荐集群主机要求

运行 vDU 应用程序工作负载需要一个具有足够资源的裸机主机来运行 OpenShift Container Platform 服务和生产工作负载。

| profile | vCPU | memory | Storage |

|---|---|---|---|

| 最小值 | 4 到 8 个 vCPU | 32GB RAM | 120GB |

一个 vCPU 等于一个物理内核。但是,如果您启用并发多线程(SMT)或超线程,请使用以下公式来计算代表一个物理内核的 vCPU 数量:

- (每个内核的线程数 x 内核数)x 插槽数 = vCPU

使用虚拟介质引导时,服务器必须具有基板管理控制器(BMC)。

6.3. 为低延迟和高性能配置主机固件

裸机主机需要在置备主机前配置固件。固件配置取决于您的特定硬件和安装的具体要求。

流程

-

将 UEFI/BIOS Boot Mode 设置为

UEFI。 - 在主机引导顺序中,设置 Hard drive first。

为您的硬件应用特定的固件配置。下表描述了 Intel Xeon Skylake 服务器和更新的硬件生成的代表固件配置,具体取决于 Intel FlexRAN 4G 和 5G 基带 PHY 参考设计。

重要确切的固件配置取决于您的特定硬件和网络要求。以下示例配置仅用于说明目的。

Expand 表 6.2. 固件配置示例 固件设置 配置 CPU Power 和性能策略

性能

非核心频率扩展

Disabled

性能限制

Disabled

增强的 Intel SpeedStep ® Tech

Enabled

Intel 配置的 TDP

Enabled

可配置 TDP 级别

2 级

Intel® Turbo Boost Technology

Enabled

节能 Turbo

Disabled

硬件 P-State

Disabled

软件包 C-State

C0/C1 状态

C1E

Disabled

处理器 C6

Disabled

在主机的固件中启用全局 SR-IOV 和 VT-d 设置。这些设置与裸机环境相关。

6.4. 受管集群网络的连接先决条件

在安装并置备带有 GitOps Zero Touch Provisioning (ZTP) 管道的受管集群前,受管集群主机必须满足以下网络先决条件:

- hub 集群中的 GitOps ZTP 容器和目标裸机主机的 Baseboard Management Controller (BMC) 之间必须有双向连接。

受管集群必须能够解析和访问 hub 主机名和

*.apps主机名的 API 主机名。以下是 hub 和*.apps主机名的 API 主机名示例:-

api.hub-cluster.internal.domain.com -

console-openshift-console.apps.hub-cluster.internal.domain.com

-

hub 集群必须能够解析并访问受管集群的 API 和

*.app主机名。以下是受管集群的 API 主机名和*.apps主机名示例:-

api.sno-managed-cluster-1.internal.domain.com -

console-openshift-console.apps.sno-managed-cluster-1.internal.domain.com

-

6.5. 使用 GitOps ZTP 在单节点 OpenShift 中的工作负载分区

工作负载分区配置 OpenShift Container Platform 服务、集群管理工作负载和基础架构 pod,以便在保留数量的主机 CPU 上运行。

要使用 GitOps Zero Touch Provisioning (ZTP)配置工作负载分区,您可以在用于安装集群的 SiteConfig 自定义资源(CR)中配置 cpuPartitioningMode 字段,并应用在主机上配置 isolated 和 reserved CPU 的 PerformanceProfile CR。

配置 SiteConfig CR 在集群安装过程中启用工作负载分区,并应用 PerformanceProfile CR 将 CPU 的特定分配配置为保留和隔离的集合。这两个步骤在集群置备过程中的不同点发生。

使用 SiteConfig CR 中的 cpuPartitioningMode 字段配置工作负载分区是 OpenShift Container Platform 4.13 中的技术预览功能。

另外,您可以使用 SiteConfig 自定义资源(CR)的 cpuset 字段指定集群管理 CPU 资源,以及组 PolicyGenerator 或 PolicyGentemplate CR 的 reserved 字段。GitOps ZTP 管道使用这些值来填充工作负载分区 MachineConfig CR (cpuset) 和配置单节点 OpenShift 集群的 PerformanceProfile CR (reserved)中的所需字段。这个方法是 OpenShift Container Platform 4.14 中的正式发行(GA)。

工作负载分区配置将 OpenShift Container Platform 基础架构 pod 固定到 reserved CPU 集。systemd、CRI-O 和 kubelet 等平台服务在 reserved CPU 集中运行。isolated CPU 集只分配给容器工作负载。隔离 CPU 可确保工作负载保证对指定 CPU 的访问,而不会与同一节点上运行的其他应用程序竞争。所有不是隔离的 CPU 都应保留。

确保 reserved 和 isolated CPU 集不会相互重叠。

6.6. 推荐的集群安装清单

ZTP 管道在集群安装过程中应用以下自定义资源 (CR)。这些配置 CR 确保集群满足运行 vDU 应用程序所需的功能和性能要求。

当将 GitOps ZTP 插件和 SiteConfig CR 用于集群部署时,默认包含以下 MachineConfig CR。

使用 SiteConfig extraManifests 过滤器更改默认包括的 CR。如需更多信息,请参阅使用 SiteConfig CR 的高级受管集群配置。

6.6.1. 工作负载分区

运行 DU 工作负载的单节点 OpenShift 集群需要工作负载分区。这限制了运行平台服务的内核数,从而最大程度提高应用程序有效负载的 CPU 内核。

工作负载分区只能在集群安装过程中启用。您不能在安装后禁用工作负载分区。但是,您可以通过 PerformanceProfile CR 更改分配给隔离和保留集的 CPU 集合。更改 CPU 设置会导致节点重新引导。

当使用 cpuPartitioningMode 启用工作负载分区时,从用来置备集群的 /extra-manifest 文件夹中删除工作负载分区 MachineConfig CR。

工作负载分区的建议 SiteConfig CR 配置

- 1

- 将

cpuPartitioningMode字段设置为AllNodes,为集群中的所有节点配置工作负载分区。

验证

检查应用程序和集群系统 CPU 固定是否正确。运行以下命令:

为受管集群打开远程 shell 提示符:

oc debug node/example-sno-1

$ oc debug node/example-sno-1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查 OpenShift 基础架构应用程序 CPU 固定是否正确:

pgrep ovn | while read i; do taskset -cp $i; done

sh-4.4# pgrep ovn | while read i; do taskset -cp $i; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查系统应用程序 CPU 固定是否正确:

pgrep systemd | while read i; do taskset -cp $i; done

sh-4.4# pgrep systemd | while read i; do taskset -cp $i; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

pid 1's current affinity list: 0-1,52-53 pid 938's current affinity list: 0-1,52-53 pid 962's current affinity list: 0-1,52-53 pid 1197's current affinity list: 0-1,52-53

pid 1's current affinity list: 0-1,52-53 pid 938's current affinity list: 0-1,52-53 pid 962's current affinity list: 0-1,52-53 pid 1197's current affinity list: 0-1,52-53Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.6.2. 减少平台管理占用空间

要减少平台的整体管理空间,需要一个 MachineConfig 自定义资源 (CR),它将所有特定于 Kubernetes 的挂载点放在独立于主机操作系统的新命名空间中。以下 base64 编码的示例 MachineConfig CR 演示了此配置。

推荐的容器挂载命名空间配置 (01-container-mount-ns-and-kubelet-conf-master.yaml)

6.6.3. SCTP

流控制传输协议 (SCTP) 是在 RAN 应用程序中使用的密钥协议。此 MachineConfig 对象向节点添加 SCTP 内核模块以启用此协议。

推荐的 control plane 节点 SCTP 配置 (03-sctp-machine-config-master.yaml)

推荐的 worker 节点 SCTP 配置 (03-sctp-machine-config-worker.yaml)

6.6.4. 设置 rcu_normal

以下 MachineConfig CR 将系统配置为在系统完成启动后将 rcu_normal 设置为 1。这提高了 vDU 应用程序的内核延迟。

在节点启动后禁用 rcu_expedited 的推荐配置 (08-set-rcu-normal-master.yaml)

6.6.5. 使用 kdump 自动内核崩溃转储

kdump 是一个 Linux 内核功能,可在内核崩溃时创建内核崩溃转储。kdump 使用以下 MachineConfig CR 启用。

推荐的 MachineConfig CR 从 control plane kdump 日志中删除 ice 驱动程序 (05-kdump-config-master.yaml)

推荐的 control plane 节点 kdump 配置 (06-kdump-master.yaml)

推荐的 MachineConfig CR 从 worker 节点 kdump 日志中删除 ice 驱动程序 (05-kdump-config-worker.yaml)

推荐的 kdump worker 节点配置 (06-kdump-worker.yaml)

6.6.6. 禁用自动 CRI-O 缓存擦除

在不受控制的主机关闭或集群重启后,CRI-O 会自动删除整个 CRI-O 缓存,从而导致在节点重启时从 registry 中拉取所有镜像。这可能导致不可接受的恢复时间或者恢复失败。要防止这会在使用 GitOps ZTP 安装的单节点 OpenShift 集群中发生,请在集群安装过程中禁用 CRI-O 删除缓存功能。

推荐的 MachineConfig CR 在 control plane 节点上禁用 CRI-O 缓存擦除 (99-crio-disable-wipe-master.yaml)

推荐的 MachineConfig CR 在 worker 节点上禁用 CRI-O 缓存擦除 (99-crio-disable-wipe-worker.yaml)

6.6.7. 将 crun 配置为默认容器运行时

以下 ContainerRuntimeConfig 自定义资源 (CR) 将 crun 配置为 control plane 和 worker 节点的默认 OCI 容器运行时。crun 容器运行时快速且轻量级,内存占用较低。

为获得最佳性能,请在单节点 OpenShift、三节点 OpenShift 和标准集群中为 control plane 和 worker 节点启用 crun。要避免在应用 CR 时重启集群,请将更改作为 GitOps ZTP 额外日期 0 安装清单应用。

control plane 节点推荐的 ContainerRuntimeConfig CR (enable-crun-master.yaml)

worker 节点的推荐 ContainerRuntimeConfig CR (enable-crun-worker.yaml)

6.7. 推荐的安装后集群配置

当集群安装完成后,ZTP 管道会应用运行 DU 工作负载所需的以下自定义资源 (CR)。

在 GitOps ZTP v4.10 及更早版本中,您可以使用 MachineConfig CR 配置 UEFI 安全引导。GitOps ZTP v4.11 及更新的版本中不再需要。在 v4.11 中,您可以通过更新用于安装集群的 SiteConfig CR 中的 spec.clusters.nodes.bootMode 字段来为单节点 OpenShift 集群配置 UEFI 安全引导。如需更多信息,请参阅使用 SiteConfig 和 GitOps ZTP 部署受管集群。

6.7.1. Operator

运行 DU 工作负载的单节点 OpenShift 集群需要安装以下 Operator:

- Local Storage Operator

- Logging Operator

- PTP Operator

- Cluster Network Operator

您还需要配置自定义 CatalogSource CR,禁用默认的 OperatorHub 配置,并配置可从您安装的集群访问的 ImageContentSourcePolicy 镜像 registry。

推荐的 Storage Operator 命名空间和 Operator 组配置 (StorageNS.yaml,StorageOperGroup.yaml)

推荐的 Cluster Logging Operator 命名空间和 Operator 组配置 (ClusterLogNS.yaml,ClusterLogOperGroup.yaml)

推荐的 PTP Operator 命名空间和 Operator 组配置 (PtpSubscriptionNS.yaml,PtpSubscriptionOperGroup.yaml)

推荐的 SR-IOV Operator 命名空间和 Operator 组配置 (SriovSubscriptionNS.yaml,SriovSubscriptionOperGroup.yaml)

推荐的 CatalogSource 配置 (DefaultCatsrc.yaml)

推荐的 ImageContentSourcePolicy 配置 (DisconnectedICSP.yaml)

推荐的 OperatorHub 配置 (OperatorHub.yaml)

6.7.2. Operator 订阅

运行 DU 工作负载的单节点 OpenShift 集群需要以下 Subscription CR。订阅提供下载以下 Operator 的位置:

- Local Storage Operator

- Logging Operator

- PTP Operator

- Cluster Network Operator

- SRIOV-FEC Operator

对于每个 Operator 订阅,指定要从中获取 Operator 的频道。推荐的频道是 stable。

您可以指定 Manual 或 Automatic 更新。在 Automatic 模式中,Operator 会在 registry 中可用时自动更新到频道中最新版本。在 Manual 模式中,只有在被明确批准时才会安装新的 Operator 版本。

对订阅使用 Manual 模式。这可让您控制 Operator 更新在调度的维护窗口中适合的时间。

推荐的 Local Storage Operator 订阅 (StorageSubscription.yaml)

推荐的 SR-IOV Operator 订阅 (SriovSubscription.yaml)

推荐的 PTP Operator 订阅 (PtpSubscription.yaml)

推荐的 Cluster Logging Operator 订阅 (ClusterLogSubscription.yaml)

6.7.3. 集群日志记录和日志转发

运行 DU 工作负载的单节点 OpenShift 集群需要日志记录和日志转发以进行调试。需要以下 ClusterLogging 和 ClusterLogForwarder 自定义资源 (CR)。

推荐的集群日志记录配置 (ClusterLogging.yaml)

推荐的日志转发配置 (ClusterLogForwarder.yaml)

将 spec.outputs.url 字段设置为日志转发到的 Kafka 服务器的 URL。

6.7.4. 性能配置集

运行 DU 工作负载的单节点 OpenShift 集群需要 Node Tuning Operator 性能配置集才能使用实时主机功能和服务。

在早期版本的 OpenShift Container Platform 中,Performance Addon Operator 用来实现自动性能优化,以便为 OpenShift 应用程序实现低延迟性能。在 OpenShift Container Platform 4.11 及更新的版本中,这个功能是 Node Tuning Operator 的一部分。

以下示例 PerformanceProfile CR 演示了所需的单节点 OpenShift 集群配置。

推荐的性能配置集配置 (PerformanceProfile.yaml)

| PerformanceProfile CR 字段 | 描述 |

|---|---|

|

|

确保

|

|

|

|

|

| 设置隔离的 CPU。确保所有 Hyper-Threading 对都匹配。 重要 保留和隔离的 CPU 池不得重叠,并且必须一起跨越所有可用的内核。未考虑导致系统中未定义的 CPU 内核。 |

|

| 设置保留的 CPU。启用工作负载分区时,系统进程、内核线程和系统容器线程仅限于这些 CPU。所有不是隔离的 CPU 都应保留。 |

|

|

|

|

|

将 |

|

|

使用 |

6.7.5. 配置集群时间同步

为 control plane 或 worker 节点运行一次性系统时间同步作业。

推荐的 control plane 节点一次同步 (99-sync-time-once-master.yaml)

推荐的 worker 节点一次同步时间 (99-sync-time-once-worker.yaml)

6.7.6. PTP

单节点 OpenShift 集群使用 Precision Time Protocol (PTP) 进行网络时间同步。以下示例 PtpConfig CR 演示了普通时钟、边界时钟和 grandmaster 时钟所需的 PTP 配置。您应用的确切配置将取决于节点硬件和特定用例。

推荐的 PTP 普通时钟配置 (PtpConfigSlave.yaml)

推荐的边界时钟配置 (PtpConfigBoundary.yaml)

推荐的 PTP Westport Channel e810 grandmaster 时钟配置 (PtpConfigGmWpc.yaml)

以下可选 PtpOperatorConfig CR 为节点配置 PTP 事件报告。

推荐的 PTP 事件配置 (PtpOperatorConfigForEvent.yaml)

6.7.7. 扩展的 Tuned 配置集

运行 DU 工作负载的单节点 OpenShift 集群需要额外的高性能工作负载所需的性能调优配置。以下 Tuned CR 示例扩展了 Tuned 配置集:

推荐的扩展 Tuned 配置集配置 (Tuned PerformancePatch.yaml)

| TuneD CR 字段 | 描述 |

|---|---|

|

|

|

6.7.8. SR-IOV

单根 I/O 虚拟化(SR-IOV)通常用于启用前端和中间网络。以下 YAML 示例为单节点 OpenShift 集群配置 SR-IOV。

SriovNetwork CR 的配置会根据您的特定网络和基础架构要求而有所不同。

推荐的 SriovOperatorConfig CR 配置 (SriovOperatorConfig.yaml)

| SriovOperatorConfig CR 字段 | 描述 |

|---|---|

|

|

禁用 例如: |

|

|

禁用 |

推荐的 SriovNetwork 配置 (SriovNetwork.yaml)

| SriovNetwork CR 字段 | 描述 |

|---|---|

|

|

为 midhaul 网络配置 VLAN 的 |

推荐的 SriovNetworkNodePolicy CR 配置 (SriovNetworkNodePolicy.yaml)

| SriovNetworkNodePolicy CR 字段 | 描述 |

|---|---|

|

|

将 |

|

| 指定连接到前端网络的接口。 |

|

| 指定前端网络的 VF 数量。 |

|

| 物理功能的确切名称必须与硬件匹配。 |

推荐的 SR-IOV 内核配置 (07-sriov-related-kernel-args-master.yaml)

6.7.9. Console Operator

使用集群功能来防止安装 Console Operator。当节点被集中管理时,不需要它。删除 Operator 为应用程序工作负载提供额外的空间和容量。

要在安装过程中禁用 Console Operator,请在 SiteConfig 自定义资源(CR)的 spec.clusters.0.installConfigOverrides 字段中设置以下内容:

installConfigOverrides: "{\"capabilities\":{\"baselineCapabilitySet\": \"None\" }}"

installConfigOverrides: "{\"capabilities\":{\"baselineCapabilitySet\": \"None\" }}"6.7.10. Alertmanager

运行 DU 工作负载的单节点 OpenShift 集群需要减少 OpenShift Container Platform 监控组件所消耗的 CPU 资源。以下 ConfigMap 自定义资源(CR)禁用 Alertmanager。

推荐的集群监控配置 (ReduceMonitoringFootprint.yaml)

6.7.11. Operator Lifecycle Manager

运行分布式单元工作负载的单节点 OpenShift 集群需要对 CPU 资源进行一致的访问。Operator Lifecycle Manager (OLM) 会定期从 Operator 收集性能数据,从而增加 CPU 利用率。以下 ConfigMap 自定义资源 (CR) 禁用 OLM 的 Operator 性能数据收集。

推荐的集群 OLM 配置 (ReduceOLMFootprint.yaml)

6.7.12. LVM 存储

您可以使用逻辑卷管理器(LVM)存储在单节点 OpenShift 集群上动态置备本地存储。

推荐的单节点 OpenShift 存储解决方案是 Local Storage Operator。另外,您可以使用 LVM Storage,但需要额外的 CPU 资源。

以下 YAML 示例将节点的存储配置为可供 OpenShift Container Platform 应用程序使用。

推荐的 LVMCluster 配置 (StorageLVMCluster.yaml)

| LVMCluster CR 字段 | 描述 |

|---|---|

|

| 配置用于 LVM 存储的磁盘。如果没有指定磁盘,LVM 存储将使用指定精简池中所有未使用的磁盘。 |

6.7.13. 网络诊断

运行 DU 工作负载的单节点 OpenShift 集群需要较少的 pod 网络连接检查,以减少这些 pod 创建的额外负载。以下自定义资源 (CR) 禁用这些检查。

推荐的网络诊断配置 (DisableSnoNetworkDiag.yaml)

第 7 章 为 vDU 应用程序工作负载验证单节点 OpenShift 集群调整

在部署虚拟分布式单元 (vDU) 应用程序前,您需要调整并配置集群主机固件和各种其他集群配置设置。使用以下信息来验证集群配置以支持 vDU 工作负载。

7.1. vDU 集群主机的建议固件配置

使用下表为在 OpenShift Container Platform 4.16 上运行的 vDU 应用程序配置集群主机固件的基础。

下表是 vDU 集群主机固件配置的一般建议。具体固件设置将取决于您的要求和特定的硬件平台。固件的自动设置不会被零接触置备管道处理。

| 固件设置 | 配置 | 描述 |

|---|---|---|

| HyperTransport (HT) | Enabled | HyperTransport (HT) 总线是由 AMD 开发的总线技术。HT 提供主机内存中组件与其他系统外围之间的高速链接。 |

| UEFI | Enabled | 为 vDU 主机启用从 UEFI 引导。 |

| CPU Power 和性能策略 | 性能 | 设置 CPU 电源和性能策略,以优化系统以提高能源效率。 |

| 非核心频率扩展 | Disabled | 禁用 Uncore Frequency 扩展,以防止单独设置 CPU 的非内核部分和频率。 |

| Uncore Frequency | 最大值 | 将 CPU 的非内核部分(如缓存和内存控制器)设置为操作最多可能的频率。 |

| 性能限制 | Disabled | 禁用性能 P-limit 以防止处理器的 Uncore 频率协调。 |

| 增强的 Intel® SpeedStep Tech | Enabled | 启用增强的 Intel SpeedStep,以便系统动态调整处理器消耗和降低主机中功耗和 heat 生产的核心频率。 |

| Intel® Turbo Boost Technology | Enabled | 为基于 Intel 的 CPU 启用 Turbo Boost Technology,允许处理器内核比底层操作频率更快运行(如果它们低于 power、current 和 temperature 规格限制)。 |

| Intel 配置的 TDP | Enabled | 为 CPU 启用 Thermal Design Power (TDP) |

| 可配置 TDP 级别 | 2 级 | TDP 级别设置特定性能评级所需的 CPU 功耗。TDP 级别 2 以功耗为代价以实现最稳定的性能水平。 |

| 节能 Turbo | Disabled | 禁用 Energy Efficient Turbo,以防止处理器使用基于能源效率的策略。 |

| 硬件 P-State | Enabled 或 Disabled |

启用 OS 控制的 P-States 以允许节能配置。禁用 |

| 软件包 C-State | C0/C1 状态 | 使用 C0 或 C1 状态将处理器设置为完全活动状态 (C0) 或停止在软件中运行的 CPU 内部时钟 (C1)。 |

| C1E | Disabled | CPU Enhanced Halt (C1E) 是 Intel 芯片中的节能功能。禁用 C1E 可防止操作系统在不活跃时向 CPU 发送 halt 命令。 |

| 处理器 C6 | Disabled | C6 节能程序是 CPU 功能,可自动禁用空闲 CPU 内核和缓存。禁用 C6 可提高系统性能。 |

| 子 NUMA 集群 | Disabled | 子 NUMA 集群将处理器内核、缓存和内存划分为多个 NUMA 域。禁用这个选项可以提高对延迟敏感工作负载的性能。 |

在主机的固件中启用全局 SR-IOV 和 VT-d 设置。这些设置与裸机环境相关。

启用 C-states 和 OS 控制的 P-States 来允许每个 pod 电源管理。

7.2. 推荐的集群配置来运行 vDU 应用程序

运行虚拟化分布式单元 (vDU) 应用程序的集群需要高度调整和优化的配置。以下信息描述了在 OpenShift Container Platform 4.16 集群中支持 vDU 工作负载时所需的各种元素。

7.2.1. 为单节点 OpenShift 集群推荐的集群 MachineConfig CR

检查您从 ztp-site-generate 容器中提取的 MachineConfig 自定义资源 (CR) 是否已在集群中应用。CR 可以在提取的 out/source-crs/extra-manifest/ 文件夹中找到。

ztp-site-generate 容器中的以下 MachineConfig CR 配置集群主机:

| MachineConfig CR | 描述 |

|---|---|

|

| 配置容器挂载命名空间和 kubelet 配置。 |

|

|

加载 SCTP 内核模块。这些 |

|

| 为集群配置 kdump 崩溃报告。 |

|

| 在集群中配置 SR-IOV 内核参数。 |

|

|

在集群重启后禁用 |

|

| 在集群重启后禁用自动 CRI-O 缓存擦除。 |

|

| 通过 Chrony 服务配置一次性检查并调整系统时钟。 |

|

|

启用 |

|

| 在集群安装过程中和生成 RHACM 集群策略时启用 cgroup v1。 |

在 OpenShift Container Platform 4.14 及更高版本中,您可以使用 SiteConfig CR 中的 cpuPartitioningMode 字段配置工作负载分区。

7.2.2. 推荐的集群 Operator

运行虚拟化分布式单元 (vDU) 应用程序的集群需要以下 Operator,它是基准参考配置的一部分:

- Node Tuning Operator (NTO).与 Performance Addon Operator 一起提供的 NTO 软件包功能,现在是 NTO 的一部分。

- PTP Operator

- Cluster Network Operator

- Red Hat OpenShift Logging Operator

- Local Storage Operator

7.2.3. 推荐的集群内核配置

始终使用集群中最新支持的实时内核版本。确保在集群中应用以下配置:

确保在集群性能配置集中设置以下

additionalKernelArgs:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:在

hardwareTuning字段中设置 CPU 频率:您可以使用硬件调优来为保留和隔离的内核 CPU 调优 CPU 频率。对于像应用程序一样的 FlexRAN,硬件厂商建议您在默认 CPU 上运行 CPU 频率。强烈建议您在设置任何频率之前,请参阅硬件厂商的准则,以获得处理器生成的最大频率设置。本例显示了为 Sapphire 快速硬件保留和隔离的 CPU 频率:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 确保

TunedCR 中的performance-patch配置集配置与相关PerformanceProfileCR 中设置的隔离CPU 的正确 CPU 隔离集,例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2.4. 检查实时内核版本