在裸机上安装

在裸机上安装 OpenShift Container Platform

摘要

第 1 章 准备裸机集群安装

1.1. 先决条件

- 您可以参阅有关 OpenShift Container Platform 安装和更新 流程的详细信息。

- 您已阅读了有关 选择集群安装方法并为用户准备它 的文档。

1.2. OpenShift Virtualization 的裸机集群安装要求

如果您计划在裸机集群中使用 OpenShift Virtualization,您必须确保在安装过程中正确配置集群。这是因为,OpenShift Virtualization 需要一些在安装集群后无法更改的某些设置。

1.2.1. OpenShift Virtualization 的高可用性要求

在 OpenShift Virtualization 上下文中讨论高可用性(HA)功能时,这只指的是核心集群组件的复制模型,由 Infrastructure 自定义资源(CR)中的 controlPlaneTopology 和 infrastructureTopology 字段决定。将这些字段设置为 HighlyAvailable 提供了组件冗余功能,它与常规集群范围的应用程序 HA 不同。将这些字段设置为 SingleReplica 可禁用组件冗余,因此禁用 OpenShift Virtualization HA 功能。

如果您计划使用 OpenShift Virtualization HA 功能,则集群安装时必须有三个 control plane 节点。集群的 Infrastructure CR 中的 controlPlaneTopology 状态必须是 HighlyAvailable。

您可以在单节点集群中安装 OpenShift Virtualization,但单节点 OpenShift 不支持高可用性。

1.2.2. OpenShift Virtualization 的实时迁移要求

如果计划使用实时迁移,则必须有多个 worker 节点。集群的

InfrastructureCR 中的infrastructureTopology状态必须是HighlyAvailable,且至少有三个 worker 节点。注意您可以在单节点集群中安装 OpenShift Virtualization,但单节点 OpenShift 不支持实时迁移。

- 实时迁移需要共享存储。OpenShift Virtualization 的存储必须支持并使用 ReadWriteMany (RWX) 访问模式。

1.2.3. OpenShift Virtualization 的 SR-IOV 要求

如果您计划使用单根 I/O 虚拟化 (SR-IOV),请确保 OpenShift Container Platform 支持网络接口控制器 (NIC)。

1.3. SR-IOV 设备的 NIC 分区

OpenShift Container Platform 可以部署到具有双端口网络接口卡(NIC)的服务器上。您可以将单个、高速的双端口 NIC 分区到多个虚拟功能 (VF) 并启用 SR-IOV。

此功能支持使用绑定来实现链路聚合控制协议 (LACP) 的高可用性。

物理 NIC 只能声明一个 LACP。

OpenShift Container Platform 集群可以使用以下方法之一部署到 2 个物理功能 (PF)上带有 2 个 VF 的绑定接口中:

基于代理的安装程序

注意nmstate的最低所需版本是:-

1.4.2-4对于 RHEL 8 版本 -

2.2.7对于 RHEL 9 版本

-

- 安装程序置备的基础架构安装

- 用户置备的基础架构安装

1.4. 选择在裸机上安装 OpenShift Container Platform 的方法

OpenShift Container Platform 安装程序提供四个部署集群的方法:

- 交互式 :您可以使用基于 Web 的 辅助安装程序(Assisted Installer)部署集群。这是使用连接到互联网的网络的集群推荐的方法。Assisted Installer 是安装 OpenShift Container Platform 的最简单方法,它提供智能默认值,并在安装集群前执行预动态验证。它还提供了一个 RESTful API 用于自动化和高级配置场景。

- 本地基于代理的: 您可以使用 基于代理的安装程序为 air- gapped 或受限网络在本地部署集群。它提供了 Assisted Installer 的许多优点,但您必须首先下载并配置基于代理的安装程序。使用命令行界面完成配置。这个方法对于 air-gapped 或受限网络是一个理想的方法。

- 自动 :您可以在安装程序置备的基础架构中部署集群及其维护的集群。安装程序使用每个集群主机的基板管理控制器 (BMC) 进行置备。您可以使用连接的网络或 air-gapped 网络或受限网络部署集群。

- 完全控制:您可以在自己准备和维护的基础架构上部署集群,这种方法提供了最大的定制性。您可以使用连接的网络或 air-gapped 网络或受限网络部署集群。

集群有以下特征:

- 默认提供无单点故障的高可用性基础架构。

- 管理员可以控制要应用的更新内容和时间。

如需有关安装程序置备和用户置备的安装过程的更多信息,请参阅 安装过程。

1.4.1. 在安装程序置备的基础架构上安装集群

您可以使用以下方法在 OpenShift Container Platform 安装程序置备的裸机基础架构上安装集群:

- 在裸机上安装由安装程序置备的集群

- 您可以在裸机上使用安装程序置备安装 OpenShift Container Platform。

1.4.2. 在用户置备的基础架构上安装集群

您可以使用以下方法之一在您置备的裸机基础架构上安装集群:

- 在裸机上安装用户置备的集群

- 您可以在您置备的裸机基础架构上安装 OpenShift Container Platform。对于包含用户置备的基础架构的集群,您必须部署所有所需的机器。

- 使用自定义网络安装用户置备的裸机集群

- 您可以使用网络自定义在用户置备的基础架构上安装裸机集群。通过自定义网络配置,您的集群可以与环境中现有的 IP 地址分配共存,并与现有的 MTU 和 VXLAN 配置集成。大多数网络自定义必须在安装阶段应用。

- 在受限网络中安装用户置备的裸机集群

- 您可以使用镜像(mirror)registry 在受限或断开连接的网络中安装用户置备的裸机集群。您还可以使用此安装方法来确保集群只使用满足您组织对外部内容控制的容器镜像。

第 2 章 用户置备的基础架构

2.1. 在裸机上安装用户置备的集群

在 OpenShift Container Platform 4.19 中,您可以在您置备的裸机基础架构上安装集群。

虽然您可能能够按照以下步骤在虚拟化或云环境中部署集群,但您必须了解非裸机平台的其他注意事项。在尝试在此类环境中安装 OpenShift Container Platform 集群前,请参阅有关在未经测试的平台上部署 OpenShift Container Platform 的指南 中的信息。

2.1.1. 先决条件

- 您可以参阅有关 OpenShift Container Platform 安装和更新 流程的详细信息。

- 您可以阅读有关 选择集群安装方法的文档,并为用户准备它。

如果使用防火墙,则会 将其配置为允许集群需要访问的站点。

注意如果要配置代理,请务必查看此站点列表。

2.1.2. OpenShift Container Platform 互联网访问

在 OpenShift Container Platform 4.19 中,您需要访问互联网来安装集群。

您需要连接到互联网才能执行以下操作:

- 访问 OpenShift Cluster Manager 以下载安装程序并执行订阅管理。如果集群可以访问互联网,并且没有禁用 Telemetry,该服务会自动授权您的集群。

- 访问 Quay.io,以获取安装集群所需的软件包。

- 获取执行集群更新所需的软件包。

如果您的集群无法直接访问互联网,则可以在置备的某些类型的基础架构上执行受限网络安装。在此过程中,您可以下载所需的内容,并使用它为镜像 registry 填充安装软件包。对于某些安装类型,集群要安装到的环境不需要访问互联网。在更新集群前,您要更新镜像 registry 的内容。

2.1.3. 具有用户置备基础架构的集群的要求

对于包含用户置备的基础架构的集群,您必须部署所有所需的机器。

本节论述了在用户置备的基础架构上部署 OpenShift Container Platform 的要求。

2.1.3.1. 集群安装所需的机器

最小的 OpenShift Container Platform 集群需要以下主机:

| 主机 | 描述 |

|---|---|

| 一个临时 bootstrap 机器 | 集群需要 bootstrap 机器在三台 control plane 机器上部署 OpenShift Container Platform 集群。您可在安装集群后删除 bootstrap 机器。 |

| 三台 control plane 机器 | control plane 机器运行组成 control plane 的 Kubernetes 和 OpenShift Container Platform 服务。 |

| 至少两台计算机器,也称为 worker 机器。 | OpenShift Container Platform 用户请求的工作负载在计算机器上运行。 |

作为例外,您可以在裸机集群中运行零台计算机器,它们仅由三台 control plane 机器组成。这为集群管理员和开发人员提供了更小、效率更高的集群,用于测试、开发和生产。不支持运行一台计算机器。

要保持集群的高可用性,请将独立的物理主机用于这些集群机器。

bootstrap 和 control plane 机器必须使用 Red Hat Enterprise Linux CoreOS(RHCOS)作为操作系统。但是,计算机器可以在 Red Hat Enterprise Linux CoreOS(RHCOS)、Red Hat Enterprise Linux(RHEL) 8.6 和更高的版本。

请注意,RHCOS 基于 Red Hat Enterprise Linux(RHEL) 9.2,并继承其所有硬件认证和要求。查看 红帽企业 Linux 技术功能和限制。

2.1.3.2. 集群安装的最低资源要求

每台集群机器都必须满足以下最低要求:

| 机器 | 操作系统 | CPU [1] | RAM | Storage | 每秒输入/输出 (IOPS) [2] |

|---|---|---|---|---|---|

| bootstrap | RHCOS | 4 | 16 GB | 100 GB | 300 |

| Control plane(控制平面) | RHCOS | 4 | 16 GB | 100 GB | 300 |

| Compute | RHCOS、RHEL 8.6 及更新版本 [3] | 2 | 8 GB | 100 GB | 300 |

- 当未启用并发多线程 (SMT) 或超线程时,一个 CPU 相当于一个物理内核。启用后,使用以下公式来计算对应的比例:(每个内核数的线程)× sockets = CPU。

- OpenShift Container Platform 和 Kubernetes 对磁盘性能非常敏感,建议使用更快的存储速度,特别是 control plane 节点上需要 10 ms p99 fsync 持续时间的 etcd。请注意,在许多云平台上,存储大小和 IOPS 可一起扩展,因此您可能需要过度分配存储卷来获取足够的性能。

- 与所有用户置备的安装一样,如果您选择在集群中使用 RHEL 计算机器,则负责所有操作系统生命周期管理和维护,包括执行系统更新、应用补丁和完成所有其他必要的任务。RHEL 7 计算机器的使用已弃用,并已在 OpenShift Container Platform 4.10 及更新的版本中删除。

对于 OpenShift Container Platform 版本 4.19,RHCOS 基于 RHEL 版本 9.6,它会更新微架构要求。以下列表包含每个架构需要的最小指令集架构 (ISA):

- x86-64 体系结构需要 x86-64-v2 ISA

- ARM64 架构需要 ARMv8.0-A ISA

- IBM Power 架构需要 Power 9 ISA

- s390x 架构需要 z14 ISA

如需更多信息,请参阅 架构 (RHEL 文档)。

如果平台的实例类型满足集群机器的最低要求,则 OpenShift Container Platform 支持使用它。

2.1.3.3. 证书签名请求管理

在使用您置备的基础架构时,集群只能有限地访问自动机器管理,因此您必须提供一种在安装后批准集群证书签名请求 (CSR) 的机制。kube-controller-manager 只能批准 kubelet 客户端 CSR。machine-approver 无法保证使用 kubelet 凭证请求的提供证书的有效性,因为它不能确认是正确的机器发出了该请求。您必须决定并实施一种方法,以验证 kubelet 提供证书请求的有效性并进行批准。

2.1.3.4. vSphere 上裸机集群的要求

确保在集群中的所有虚拟机上启用 disk.EnableUUID 参数。

2.1.3.5. 用户置备的基础架构对网络的要求

所有 Red Hat Enterprise Linux CoreOS(RHCOS)机器都需要在启动时在 initramfs 中配置联网,以获取它们的 Ignition 配置文件。

在初次启动过程中,机器需要 IP 地址配置,该配置通过 DHCP 服务器或静态设置,提供所需的引导选项。建立网络连接后,机器会从 HTTP 或 HTTPS 服务器下载 Ignition 配置文件。然后,Ignition 配置文件用于设置每台机器的确切状态。Machine Config Operator 在安装后完成对机器的更多更改,如应用新证书或密钥。

- 建议使用 DHCP 服务器对集群机器进行长期管理。确保 DHCP 服务器已配置为向集群机器提供持久的 IP 地址、DNS 服务器信息和主机名。

- 如果用户置备的基础架构没有 DHCP 服务,您可以在 RHCOS 安装时向节点提供 IP 网络配置和 DNS 服务器地址。如果要从 ISO 镜像安装,这些参数可作为引导参数传递。如需有关静态 IP 置备和高级网络选项的更多信息,请参阅 安装 RHCOS 并启动 OpenShift Container Platform bootstrap 过程 部分。

Kubernetes API 服务器必须能够解析集群机器的节点名称。如果 API 服务器和 worker 节点位于不同的区域中,您可以配置默认 DNS 搜索区域,以允许 API 服务器解析节点名称。另一种支持的方法是始终通过节点对象和所有 DNS 请求中的完全限定域名引用主机。

2.1.3.5.1. 通过 DHCP 设置集群节点主机名

在 Red Hat Enterprise Linux CoreOS(RHCOS)机器上,主机名是通过 NetworkManager 设置的。默认情况下,机器通过 DHCP 获取其主机名。如果主机名不是由 DHCP 提供,请通过内核参数或者其它方法进行静态设置,请通过反向 DNS 查找获取。反向 DNS 查找在网络初始化后进行,可能需要一些时间来解决。其他系统服务可以在此之前启动,并将主机名检测为 localhost 或类似的内容。您可以使用 DHCP 为每个集群节点提供主机名来避免这种情况。

另外,通过 DHCP 设置主机名可以绕过实施 DNS split-horizon 的环境中的手动 DNS 记录名称配置错误。

2.1.3.5.2. 网络连接要求

您必须配置机器之间的网络连接,以允许 OpenShift Container Platform 集群组件进行通信。每台机器都必须能够解析集群中所有其他机器的主机名。

本节详细介绍了所需的端口。

在连接的 OpenShift Container Platform 环境中,所有节点都需要访问互联网才能为平台容器拉取镜像,并向红帽提供遥测数据。

| 协议 | port | 描述 |

|---|---|---|

| ICMP | N/A | 网络可访问性测试 |

| TCP |

| 指标 |

|

|

主机级别的服务,包括端口 9 | |

|

| Kubernetes 保留的默认端口 | |

|

| 端口处理来自 Machine Config 服务器的流量,并将流量定向到 control plane 机器。 | |

| UDP |

| Geneve |

|

|

主机级别的服务,包括端口 | |

|

| IPsec IKE 数据包 | |

|

| IPsec NAT-T 数据包 | |

|

|

UDP 端口 | |

| TCP/UDP |

| |

| Kubernetes 节点端口 | ESP | N/A |

| 协议 | port | 描述 |

|---|---|---|

| TCP |

| Kubernetes API |

| 协议 | port | 描述 |

|---|---|---|

| TCP |

| etcd 服务器和对等端口 |

2.1.3.5.3. 用户置备的基础架构的 NTP 配置

OpenShift Container Platform 集群被配置为默认使用公共网络时间协议(NTP)服务器。如果要使用本地企业 NTP 服务器,或者集群部署在断开连接的网络中,您可以将集群配置为使用特定的时间服务器。如需更多信息,请参阅配置 chrony 时间服务 的文档。

如果 DHCP 服务器提供 NTP 服务器信息,Red Hat Enterprise Linux CoreOS(RHCOS)机器上的 chrony 时间服务会读取信息,并可以把时钟与 NTP 服务器同步。

2.1.3.6. 用户置备的 DNS 要求

在 OpenShift Container Platform 部署中,以下组件需要 DNS 名称解析:

- The Kubernetes API

- OpenShift Container Platform 应用程序通配符

- bootstrap、control plane 和计算机器

Kubernetes API、bootstrap 机器、control plane 机器和计算机器也需要反向 DNS 解析。

DNS A/AAAA 或 CNAME 记录用于名称解析,PTR 记录用于反向名称解析。反向记录很重要,因为 Red Hat Enterprise Linux CoreOS(RHCOS)使用反向记录为所有节点设置主机名,除非 DHCP 提供主机名。另外,反向记录用于生成 OpenShift Container Platform 需要操作的证书签名请求(CSR)。

建议使用 DHCP 服务器为每个群集节点提供主机名。如需更多信息,请参阅用户置备的基础架构部分的 DHCP 建议。

用户置备的 OpenShift Container Platform 集群需要以下 DNS 记录,这些记录必须在安装前就位。在每个记录中,<cluster_name> 是集群名称,<base_domain> 是您在 install-config.yaml 文件中指定的基域。完整的 DNS 记录采用以下形式: <component>.<cluster_name>.<base_domain>.。

| 组件 | 记录 | 描述 |

|---|---|---|

| Kubernetes API |

| DNS A/AAAA 或 CNAME 记录,以及用于标识 API 负载均衡器的 DNS PTR 记录。这些记录必须由集群外的客户端和集群中的所有节点解析。 |

|

| DNS A/AAAA 或 CNAME 记录,以及用于内部标识 API 负载均衡器的 DNS PTR 记录。这些记录必须可以从集群中的所有节点解析。 重要 API 服务器必须能够根据 Kubernetes 中记录的主机名解析 worker 节点。如果 API 服务器无法解析节点名称,则代理的 API 调用会失败,且您无法从 pod 检索日志。 | |

| Routes |

| 通配符 DNS A/AAAA 或 CNAME 记录,指向应用程序入口负载均衡器。应用程序入口负载均衡器以运行 Ingress Controller Pod 的机器为目标。默认情况下,Ingress Controller Pod 在计算机器上运行。这些记录必须由集群外的客户端和集群中的所有节点解析。

例如,console |

| bootstrap 机器 |

| DNS A/AAAA 或 CNAME 记录,以及用于标识 bootstrap 机器的 DNS PTR 记录。这些记录必须由集群中的节点解析。 |

| control plane 机器 |

| DNS A/AAAA 或 CNAME 记录,以识别 control plane 节点的每台机器。这些记录必须由集群中的节点解析。 |

| 计算机器 |

| DNS A/AAAA 或 CNAME 记录,用于识别 worker 节点的每台机器。这些记录必须由集群中的节点解析。 |

在 OpenShift Container Platform 4.4 及更新的版本中,您不需要在 DNS 配置中指定 etcd 主机和 SRV 记录。

您可以使用 dig 命令验证名称和反向名称解析。如需了解详细的 验证步骤,请参阅为用户置备的基础架构验证 DNS 解析 一节。

2.1.3.6.1. 用户置备的集群的 DNS 配置示例

本节提供 A 和 PTR 记录配置示例,它们满足了在用户置备的基础架构上部署 OpenShift Container Platform 的 DNS 要求。样本不是为选择一个 DNS 解决方案提供建议。

在这个示例中,集群名称为 ocp4,基域是 example.com。

用户置备的集群的 DNS A 记录配置示例

以下示例是 BIND 区域文件,其中显示了用户置备的集群中名称解析的 A 记录示例。

例 2.1. DNS 区数据库示例

- 1

- 为 Kubernetes API 提供名称解析。记录引用 API 负载均衡器的 IP 地址。

- 2

- 为 Kubernetes API 提供名称解析。记录引用 API 负载均衡器的 IP 地址,用于内部集群通信。

- 3

- 为通配符路由提供名称解析。记录引用应用程序入口负载均衡器的 IP 地址。应用程序入口负载均衡器以运行 Ingress Controller Pod 的机器为目标。默认情况下,Ingress Controller Pod 在计算机器上运行。注意

在这个示例中,将相同的负载均衡器用于 Kubernetes API 和应用入口流量。在生产环境中,您可以单独部署 API 和应用程序入口负载均衡器,以便可以隔离扩展每个负载均衡器基础架构。

- 4

- 为 bootstrap 机器提供名称解析。

- 5 6 7

- 为 control plane 机器提供名称解析。

- 8 9

- 为计算机器提供名称解析。

用户置备的集群的 DNS PTR 记录配置示例

以下示例 BIND 区域文件显示了用户置备的集群中反向名称解析的 PTR 记录示例。

例 2.2. 反向记录的 DNS 区数据库示例

OpenShift Container Platform 应用程序通配符不需要 PTR 记录。

2.1.3.7. 用户置备的基础架构的负载均衡要求

在安装 OpenShift Container Platform 前,您必须置备 API 和应用程序入口负载均衡基础架构。在生产环境中,您可以单独部署 API 和应用程序入口负载均衡器,以便可以隔离扩展每个负载均衡器基础架构。

如果要使用 Red Hat Enterprise Linux (RHEL) 实例部署 API 和应用程序入口负载均衡器,您必须单独购买 RHEL 订阅。

负载平衡基础架构必须满足以下要求:

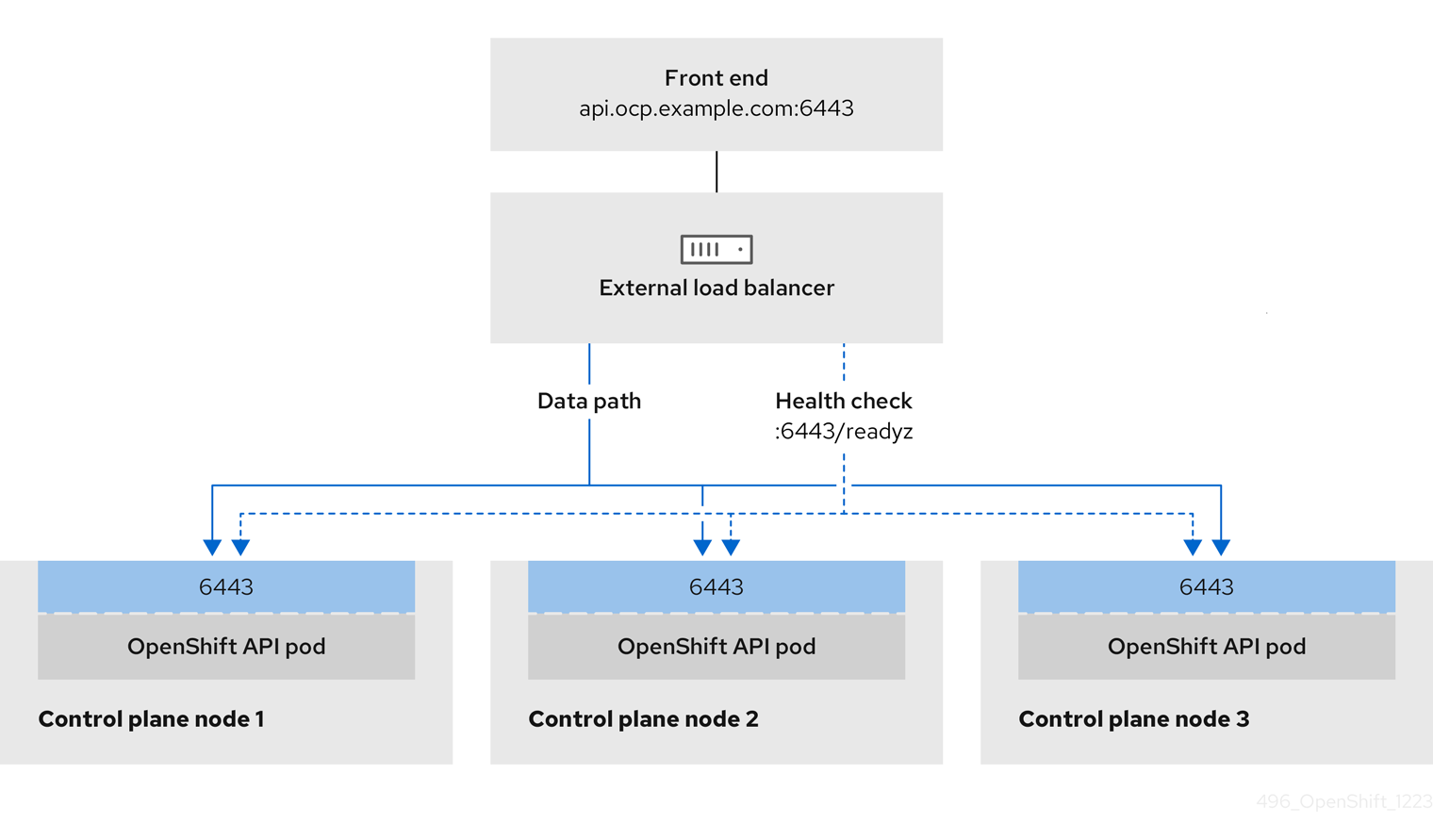

API 负载均衡器 :提供一个通用端点,供用户(包括人工和机器)与平台交互和配置。配置以下条件:

- 仅第 4 层负载均衡.这可被称为 Raw TCP 或 SSL Passthrough 模式。

- 无状态负载平衡算法。这些选项根据负载均衡器的实施而有所不同。

重要不要为 API 负载均衡器配置会话持久性。为 Kubernetes API 服务器配置会话持久性可能会导致出现过量 OpenShift Container Platform 集群应用程序流量,以及过量的在集群中运行的 Kubernetes API。

在负载均衡器的前端和后端配置以下端口:

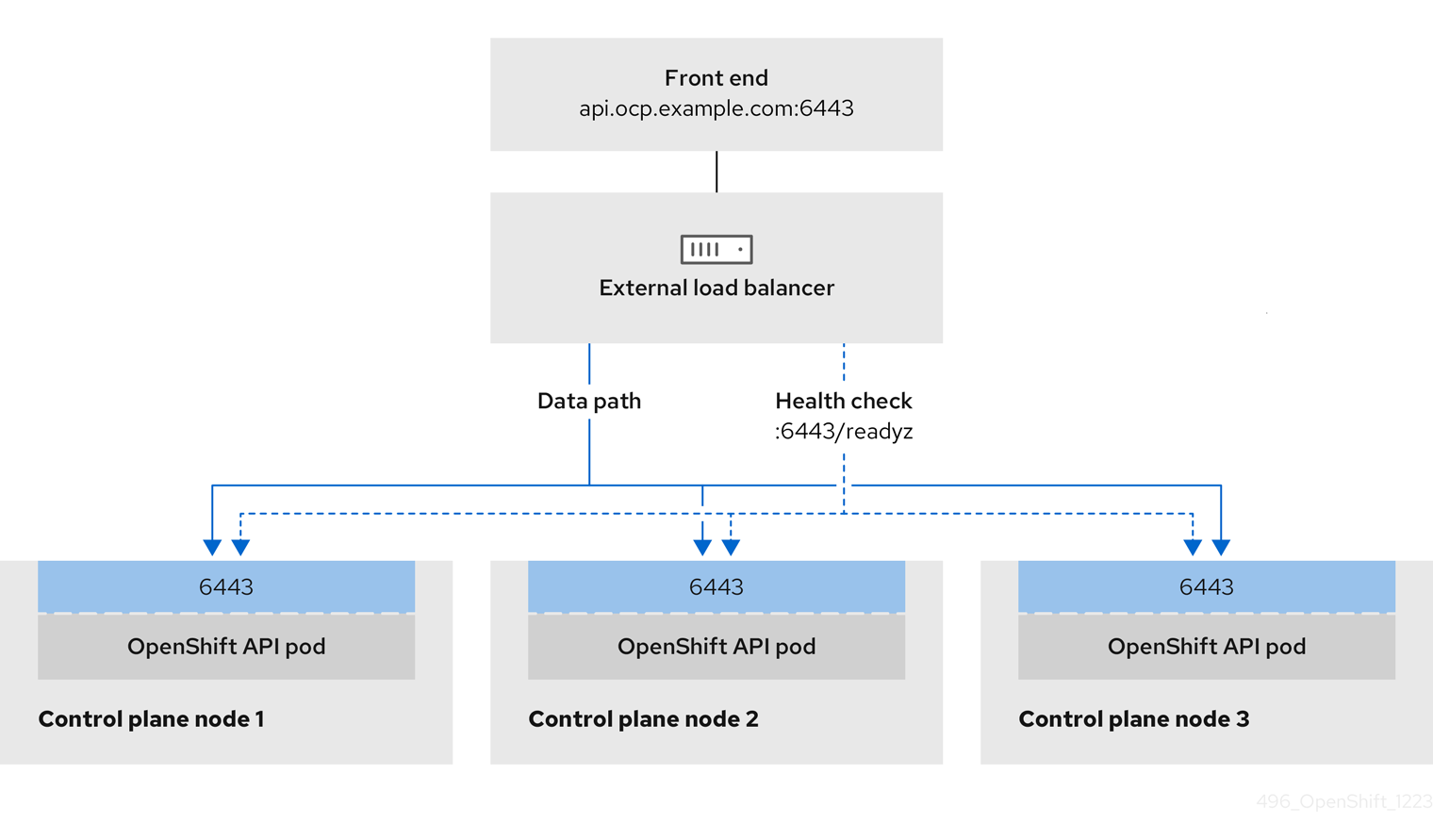

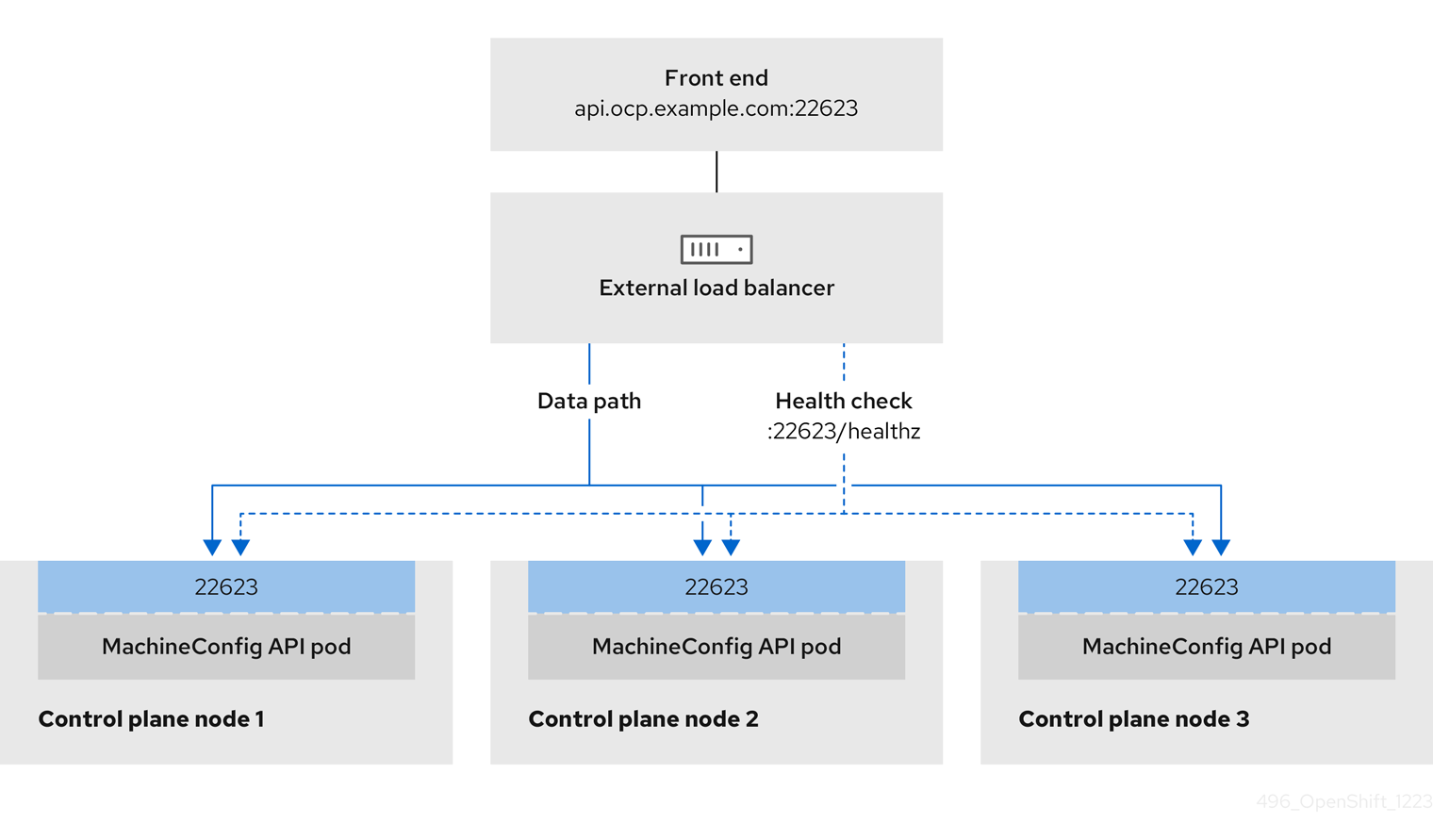

Expand 表 2.7. API 负载均衡器 port 后端机器(池成员) internal 外部 描述 6443Bootstrap 和 control plane.bootstrap 机器初始化集群 control plane 后,您要从负载均衡器中删除 bootstrap 机器。您必须为 API 服务器健康检查探测配置

/readyz端点。X

X

Kubernetes API 服务器

22623Bootstrap 和 control plane.bootstrap 机器初始化集群 control plane 后,您要从负载均衡器中删除 bootstrap 机器。

X

机器配置服务器

注意负载均衡器必须配置为,从 API 服务器关闭

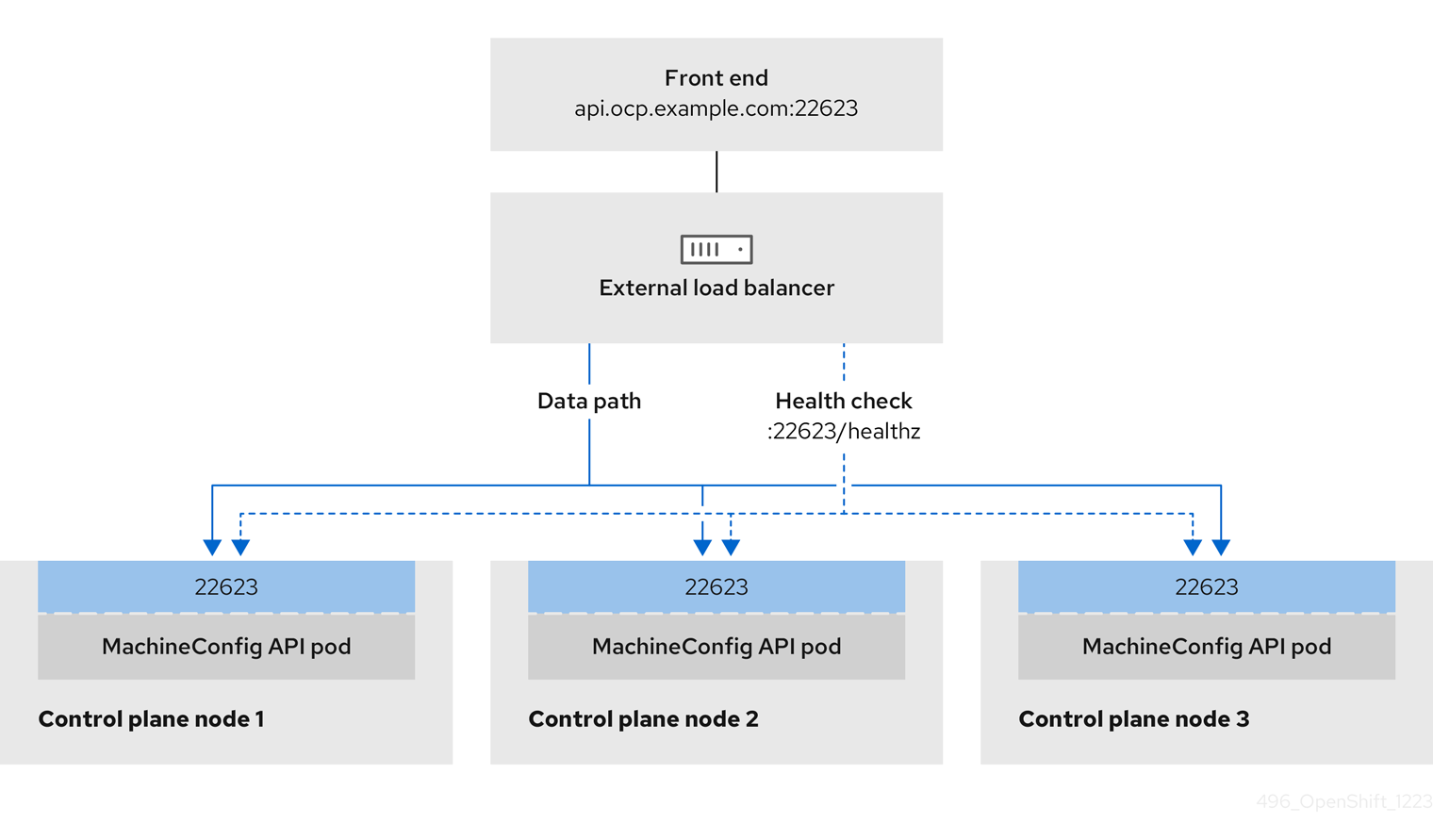

/readyz端点到从池中移除 API 服务器实例时最多需要 30 秒。在/readyz返回错误或健康后的时间范围内,端点必须被删除或添加。每 5 秒或 10 秒探测一次,有两个成功请求处于健康状态,三个成为不健康的请求是经过良好测试的值。应用程序入口负载均衡器 :为应用程序流量从集群外部流提供入口点。OpenShift Container Platform 集群需要正确配置入口路由器。

配置以下条件:

- 仅第 4 层负载均衡.这可被称为 Raw TCP 或 SSL Passthrough 模式。

- 建议根据可用选项以及平台上托管的应用程序类型,使用基于连接的或基于会话的持久性。

提示如果应用程序入口负载均衡器可以看到客户端的真实 IP 地址,启用基于 IP 的会话持久性可以提高使用端到端 TLS 加密的应用程序的性能。

在负载均衡器的前端和后端配置以下端口:

Expand 表 2.8. 应用程序入口负载均衡器 port 后端机器(池成员) internal 外部 描述 443默认情况下,运行 Ingress Controller Pod、计算或 worker 的机器。

X

X

HTTPS 流量

80默认情况下,运行 Ingress Controller Pod、计算或 worker 的机器。

X

X

HTTP 流量

注意如果要部署一个带有零计算节点的三节点集群,Ingress Controller Pod 在 control plane 节点上运行。在三节点集群部署中,您必须配置应用程序入口负载均衡器,将 HTTP 和 HTTPS 流量路由到 control plane 节点。

2.1.3.7.1. 用户置备的集群的负载均衡器配置示例

本节提供了一个满足用户置备集群的负载均衡要求的 API 和应用程序入口负载均衡器配置示例。示例是 HAProxy 负载均衡器的 /etc/haproxy/haproxy.cfg 配置。这个示例不是为选择一个负载平衡解决方案提供建议。

在这个示例中,将相同的负载均衡器用于 Kubernetes API 和应用入口流量。在生产环境中,您可以单独部署 API 和应用程序入口负载均衡器,以便可以隔离扩展每个负载均衡器基础架构。

如果您使用 HAProxy 作为负载均衡器,并且 SELinux 设置为 enforcing,您必须通过运行 setsebool -P haproxy_connect_any=1 来确保 HAProxy 服务可以绑定到配置的 TCP 端口。

例 2.3. API 和应用程序入口负载均衡器配置示例

- 1

- 端口

6443处理 Kubernetes API 流量并指向 control plane 机器。 - 2 4

- bootstrap 条目必须在 OpenShift Container Platform 集群安装前就位,且必须在 bootstrap 过程完成后删除它们。

- 3

- 端口

22623处理机器配置服务器流量并指向 control plane 机器。 - 5

- 端口

443处理 HTTPS 流量,并指向运行 Ingress Controller pod 的机器。默认情况下,Ingress Controller Pod 在计算机器上运行。 - 6

- 端口

80处理 HTTP 流量,并指向运行 Ingress Controller pod 的机器。默认情况下,Ingress Controller Pod 在计算机器上运行。注意如果要部署一个带有零计算节点的三节点集群,Ingress Controller Pod 在 control plane 节点上运行。在三节点集群部署中,您必须配置应用程序入口负载均衡器,将 HTTP 和 HTTPS 流量路由到 control plane 节点。

如果您使用 HAProxy 作为负载均衡器,您可以通过在 HAProxy 节点上运行 netstat -nltupe 来检查 haproxy 进程是否在侦听端口 6443、22623、443 和 80。

2.1.4. 创建包含一个自定义 br-ex 网桥的清单对象

除了使用 configure-ovs.sh shell 脚本在裸机平台上设置 br-ex 网桥的替代选择,您可以创建一个包括 NMState 配置文件的 MachineConfig 对象。主机 nmstate-configuration.service 和 nmstate.service 将 NMState 配置文件应用到集群中运行的每个节点。

请考虑以下用例:创建包含自定义 br-ex 网桥的清单对象:

-

您需要对网桥进行安装后更改,如更改 Open vSwitch (OVS) 或 OVN-Kubernetes

br-ex网桥网络。configure-ovs.shshell 脚本不支持对网桥进行安装后更改。 - 您希望将网桥部署到与主机或服务器 IP 地址上可用的接口不同的接口上。

-

您希望通过

configure-ovs.shshell 脚本对网桥进行高级配置。对这些配置使用脚本可能会导致网桥无法连接多个网络接口,并无法正确处理接口之间的数据转发。

如果您需要一个只带有单一网络接口控制器 (NIC) 和默认网络设置的环境,请使用 configure-ovs.sh shell 脚本。

在安装 Red Hat Enterprise Linux CoreOS (RHCOS) 并重启系统后,Machine Config Operator 会将 Ignition 配置文件注入集群中的每个节点,以便每个节点收到 br-ex 网桥网络配置。为防止配置冲突,configure-ovs.sh shell 脚本会收到一个不要配置 br-ex 网桥的信号。

以下接口名称列表被保留,您不能使用带有 NMstate 配置的名称:

-

br-ext -

br-int -

br-local -

br-nexthop -

br0 -

ext-vxlan -

ext -

genev_sys_* -

int -

k8s-* -

ovn-k8s-* -

patch-br-* -

tun0 -

vxlan_sys_*

先决条件

-

可选: 已安装

nmstateAPI,以便您可以验证 NMState 配置。

流程

为您的自定义

br-ex网桥网络创建一个使用 base64 信息的 NMState 配置文件:自定义

br-ex网桥网络的 NMState 配置示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 其中:

interfaces.name- 接口的名称。

interfaces.type- 以太网的类型。

interfaces.state- 创建后接口的请求状态。

ipv4.enabled- 在这个示例中禁用 IPv4 和 IPv6。

port.name- 网桥附加到的节点 NIC。

auto-route-metric-

将参数设置为

48,以确保br-ex默认路由始终具有最高的优先级(最低指标)。此配置可防止与NetworkManager服务自动配置的任何其他接口冲突。

使用

cat命令对 NMState 配置的内容进行 base64 编码:cat <nmstate_configuration>.yml | base64

$ cat <nmstate_configuration>.yml | base64Copy to Clipboard Copied! Toggle word wrap Toggle overflow 其中:

<nmstate_configuration>-

将

<nmstate_configuration>替换为 NMState 资源 YAML 文件的名称。

创建

MachineConfig清单文件,并定义一个自定义br-ex网桥网络配置,如下例所示:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 其中:

metadata.name- 策略的名称。

contents.source- 将编码的 base64 信息写入指定路径。

path对于集群中的每个节点,指定节点的主机名路径以及机器类型的 base-64 编码 Ignition 配置文件数据。

worker角色是集群中节点的默认角色。在为配置文件指定短主机名路径或MachineConfig清单文件中的所有节点时,您必须使用.yml扩展作为配置文件,如$(hostname -s).yml。如果您有一个在

/etc/nmstate/openshift/cluster.yml配置文件中定义的单一全局配置,您需要将它应用到集群中的所有节点,则不需要为每个节点指定短主机名路径,如/etc/nmstate/openshift/<node_hostname>.yml。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

后续步骤

-

扩展计算节点,以将包含自定义

br-ex网桥的 manifest 对象应用到集群中存在的每个计算节点。如需更多信息,请参阅附加资源部分中的"扩展集群"。

2.1.4.1. 将每个机器集扩展到计算节点

要将自定义 br-ex 网桥配置应用到 OpenShift Container Platform 集群中的所有计算节点,您必须编辑 MachineConfig 自定义资源 (CR) 并修改其角色。另外,您必须创建一个 BareMetalHost CR,用于定义裸机机器的信息,如主机名、凭证等。

配置这些资源后,您必须扩展机器集,以便机器集可以将资源配置应用到每个计算节点并重新引导节点。

先决条件

-

您创建了包含自定义

br-ex网桥配置的MachineConfig清单对象。

流程

输入以下命令编辑

MachineConfigCR:oc edit mc <machineconfig_custom_resource_name>

$ oc edit mc <machineconfig_custom_resource_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 将每个计算节点配置添加到 CR,以便 CR 可以管理集群中每个定义的计算节点的角色。

-

创建名为

extraworker-secret的Secret对象,该对象具有最小的静态 IP 配置。 输入以下命令将

extraworker-secretsecret 应用到集群中的每个节点。此步骤提供每个计算节点对 Ignition 配置文件的访问权限。oc apply -f ./extraworker-secret.yaml

$ oc apply -f ./extraworker-secret.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建

BareMetalHost资源并在preprovisioningNetworkDataName参数中指定网络 secret:带有附加网络 secret 的

BareMetalHost资源示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要在集群的

openshift-machine-api命名空间中管理BareMetalHost对象,请输入以下命令来更改命名空间:oc project openshift-machine-api

$ oc project openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 获取机器集:

oc get machinesets

$ oc get machinesetsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令扩展每个机器集。您必须为每个机器集运行这个命令。

oc scale machineset <machineset_name> --replicas=<n>

$ oc scale machineset <machineset_name> --replicas=<n>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 其中

<machineset_name>是机器集的名称,<n>是计算节点的数量。

2.1.5. 为集群启用 OVS balance-slb 模式

您可以启用 Open vSwitch (OVS) balance-slb 模式,以便两个或多个物理接口共享其网络流量。balance-slb 模式接口可以为运行虚拟化工作负载的集群提供源负载均衡(SLB)功能,而无需与网络交换机协商。

目前,源负载均衡在绑定接口上运行,该接口连接到辅助网桥,如 br-phy。源负载均衡仅在不同的 Media Access Control (MAC)地址和虚拟局域网(VLAN)组合之间平衡。请注意,所有 OVN-Kubernetes pod 流量都使用相同的 MAC 地址和 VLAN,因此此流量无法在多个物理接口负载平衡。

下图显示了简单集群基础架构布局上的 balance-slb 模式。虚拟机(VM)连接到特定的 localnet NetworkAttachmentDefinition (NAD)自定义资源定义(CRD)、NAD 0 或 NAD 1。每个 NAD 为虚拟机提供对底层物理网络的访问,支持 VLAN 标记或未标记的流量。br-ex OVS 网桥从虚拟机接收流量,并将流量传递到下一个 OVS 网桥 br-phy。br-phy 网桥作为 SLB 绑定的控制器。SLB 绑定通过物理接口链接(如 eno0 和 eno1)平衡来自不同虚拟机端口的流量。此外,来自一个物理接口的入口流量可以通过一组 OVS 网桥来访问虚拟机。

图 2.1. OVS balance-slb 模式在带有两个 NAD 的 localnet 上运行

您可以使用 OVS 绑定将 balance-slb 模式接口集成到主或二级网络类型中。注意关于 OVS 绑定的以下点:

- 支持 OVN-Kubernetes CNI 插件,并轻松与插件集成。

-

原生支持

balance-slb模式。

先决条件

-

将多个物理接口附加到主网络,并在

MachineConfig文件中定义接口。 -

您创建了清单对象,并在对象配置文件中定义了自定义

br-ex网桥。 - 您附加了多个物理接口到您的主网络,并在 NAD CRD 文件中定义接口。

流程

对于集群中的每个裸机主机,在

install-config.yaml文件中为集群定义一个networkConfig部分,如下例所示:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在 NMState 配置文件中定义每个网络接口:

定义许多网络接口的 NMState 配置文件示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 在绑定端口上手动设置

br-exMTU。

使用

base64命令对 NMState 配置文件的接口内容进行编码:base64 -w0 <nmstate_configuration>.yml

$ base64 -w0 <nmstate_configuration>.yml1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 其中

-w0选项可防止在 base64 编码操作中换行。

为

master角色和worker角色创建MachineConfig清单文件。确保将之前命令中的 base64 编码的字符串嵌入到每个MachineConfig清单文件中。以下示例清单文件为集群中存在的所有节点配置master角色。您还可以为特定于节点的master和worker角色创建清单文件。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将每个

MachineConfig清单文件保存到./<installation_directory>/manifests目录,其中<installation_directory>是安装程序在其中创建文件的目录。Machine Config Operator (MCO) 从每个清单文件中获取内容,并在滚动更新期间持续将内容应用到所有所选节点。

2.1.6. 准备用户置备的基础架构

在用户置备的基础架构上安装 OpenShift Container Platform 之前,您必须准备底层基础架构。

本节详细介绍了设置集群基础架构以准备 OpenShift Container Platform 安装所需的高级别步骤。这包括为您的集群节点配置 IP 网络和网络连接,通过防火墙启用所需的端口,以及设置所需的 DNS 和负载均衡基础架构。

准备后,集群基础架构必须满足 带有用户置备的基础架构部分的集群要求。

先决条件

- 您已参阅 OpenShift Container Platform 4.x Tested Integrations 页面。

- 您已查看了 具有用户置备基础架构的集群要求部分中详述的基础架构 要求。

流程

如果您使用 DHCP 向集群节点提供 IP 网络配置,请配置 DHCP 服务。

- 将节点的持久 IP 地址添加到您的 DHCP 服务器配置。在您的配置中,将相关网络接口的 MAC 地址与每个节点的预期 IP 地址匹配。

当您使用 DHCP 为集群机器配置 IP 寻址时,机器还通过 DHCP 获取 DNS 服务器信息。定义集群节点通过 DHCP 服务器配置使用的持久性 DNS 服务器地址。

注意如果没有使用 DHCP 服务,则必须在 RHCOS 安装时为节点提供 IP 网络配置和 DNS 服务器地址。如果要从 ISO 镜像安装,这些参数可作为引导参数传递。如需有关静态 IP 置备和高级网络选项的更多信息,请参阅 安装 RHCOS 并启动 OpenShift Container Platform bootstrap 过程 部分。

在 DHCP 服务器配置中定义集群节点的主机名。有关 主机名注意事项的详情,请参阅通过 DHCP 设置集群节点 主机名部分。

注意如果没有使用 DHCP 服务,集群节点可以通过反向 DNS 查找来获取其主机名。

- 确保您的网络基础架构提供集群组件之间所需的网络连接。有关 要求的详情,请参阅用户置备的基础架构 的网络要求部分。

将防火墙配置为启用 OpenShift Container Platform 集群组件进行通信所需的端口。如需有关所需端口的详细信息,请参阅用户置备的基础架构 部分的网络要求。

重要默认情况下,OpenShift Container Platform 集群可以访问端口

1936,因为每个 control plane 节点都需要访问此端口。避免使用 Ingress 负载均衡器公开此端口,因为这样做可能会导致公开敏感信息,如统计信息和指标(与 Ingress Controller 相关的统计信息和指标)。

为集群设置所需的 DNS 基础架构。

- 为 Kubernetes API、应用程序通配符、bootstrap 机器、control plane 机器和计算机器配置 DNS 名称解析。

为 Kubernetes API、bootstrap 机器、control plane 机器和计算机器配置反向 DNS 解析。

如需有关 OpenShift Container Platform DNS 要求的更多信息,请参阅用户置备 DNS 要求部分。

验证您的 DNS 配置。

- 从安装节点,针对 Kubernetes API 的记录名称、通配符路由和集群节点运行 DNS 查找。验证响应中的 IP 地址是否与正确的组件对应。

从安装节点,针对负载均衡器和集群节点的 IP 地址运行反向 DNS 查找。验证响应中的记录名称是否与正确的组件对应。

有关详细的 DNS 验证步骤,请参阅用户置备的基础架构 验证 DNS 解析部分。

- 置备所需的 API 和应用程序入口负载平衡基础架构。有关 要求的更多信息,请参阅用户置备的基础架构的负载平衡 要求部分。

某些负载平衡解决方案要求在初始化负载平衡之前,对群集节点进行 DNS 名称解析。

2.1.7. 验证用户置备的基础架构的 DNS 解析

您可以在在用户置备的基础架构上安装 OpenShift Container Platform 前验证 DNS 配置。

本节中详述的验证步骤必须在安装集群前成功。

先决条件

- 已为您的用户置备的基础架构配置了所需的 DNS 记录。

流程

从安装节点,针对 Kubernetes API 的记录名称、通配符路由和集群节点运行 DNS 查找。验证响应中包含的 IP 地址是否与正确的组件对应。

对 Kubernetes API 记录名称执行查询。检查结果是否指向 API 负载均衡器的 IP 地址:

dig +noall +answer @<nameserver_ip> api.<cluster_name>.<base_domain>

$ dig +noall +answer @<nameserver_ip> api.<cluster_name>.<base_domain>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

<nameserver_ip>替换为 nameserver 的 IP 地址,<cluster_name>替换为您的集群名称,<base_domain>替换为您的基本域名。

输出示例

api.ocp4.example.com. 604800 IN A 192.168.1.5

api.ocp4.example.com. 604800 IN A 192.168.1.5Copy to Clipboard Copied! Toggle word wrap Toggle overflow 对 Kubernetes 内部 API 记录名称执行查询。检查结果是否指向 API 负载均衡器的 IP 地址:

dig +noall +answer @<nameserver_ip> api-int.<cluster_name>.<base_domain>

$ dig +noall +answer @<nameserver_ip> api-int.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

api-int.ocp4.example.com. 604800 IN A 192.168.1.5

api-int.ocp4.example.com. 604800 IN A 192.168.1.5Copy to Clipboard Copied! Toggle word wrap Toggle overflow 测试

*.apps.<cluster_name>.<base_domain> DNS通配符查找示例。所有应用程序通配符查询都必须解析为应用程序入口负载均衡器的 IP 地址:dig +noall +answer @<nameserver_ip> random.apps.<cluster_name>.<base_domain>

$ dig +noall +answer @<nameserver_ip> random.apps.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

random.apps.ocp4.example.com. 604800 IN A 192.168.1.5

random.apps.ocp4.example.com. 604800 IN A 192.168.1.5Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意在示例中,将相同的负载均衡器用于 Kubernetes API 和应用程序入口流量。在生产环境中,您可以单独部署 API 和应用程序入口负载均衡器,以便可以隔离扩展每个负载均衡器基础架构。

您可以使用另一个通配符值替换

random。例如,您可以查询到 OpenShift Container Platform 控制台的路由:dig +noall +answer @<nameserver_ip> console-openshift-console.apps.<cluster_name>.<base_domain>

$ dig +noall +answer @<nameserver_ip> console-openshift-console.apps.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

console-openshift-console.apps.ocp4.example.com. 604800 IN A 192.168.1.5

console-openshift-console.apps.ocp4.example.com. 604800 IN A 192.168.1.5Copy to Clipboard Copied! Toggle word wrap Toggle overflow 针对 bootstrap DNS 记录名称运行查询。检查结果是否指向 bootstrap 节点的 IP 地址:

dig +noall +answer @<nameserver_ip> bootstrap.<cluster_name>.<base_domain>

$ dig +noall +answer @<nameserver_ip> bootstrap.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

bootstrap.ocp4.example.com. 604800 IN A 192.168.1.96

bootstrap.ocp4.example.com. 604800 IN A 192.168.1.96Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 使用此方法对 control plane 和计算节点的 DNS 记录名称执行查找。检查结果是否与每个节点的 IP 地址对应。

从安装节点,针对负载均衡器和集群节点的 IP 地址运行反向 DNS 查找。验证响应中包含的记录名称是否与正确的组件对应。

对 API 负载均衡器的 IP 地址执行反向查找。检查响应是否包含 Kubernetes API 和 Kubernetes 内部 API 的记录名称:

dig +noall +answer @<nameserver_ip> -x 192.168.1.5

$ dig +noall +answer @<nameserver_ip> -x 192.168.1.5Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

5.1.168.192.in-addr.arpa. 604800 IN PTR api-int.ocp4.example.com. 5.1.168.192.in-addr.arpa. 604800 IN PTR api.ocp4.example.com.

5.1.168.192.in-addr.arpa. 604800 IN PTR api-int.ocp4.example.com.1 5.1.168.192.in-addr.arpa. 604800 IN PTR api.ocp4.example.com.2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意OpenShift Container Platform 应用程序通配符不需要 PTR 记录。针对应用程序入口负载均衡器的 IP 地址解析反向 DNS 解析不需要验证步骤。

对 bootstrap 节点的 IP 地址执行反向查找。检查结果是否指向 bootstrap 节点的 DNS 记录名称:

dig +noall +answer @<nameserver_ip> -x 192.168.1.96

$ dig +noall +answer @<nameserver_ip> -x 192.168.1.96Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

96.1.168.192.in-addr.arpa. 604800 IN PTR bootstrap.ocp4.example.com.

96.1.168.192.in-addr.arpa. 604800 IN PTR bootstrap.ocp4.example.com.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 使用此方法对 control plane 和计算节点的 IP 地址执行反向查找。检查结果是否与每个节点的 DNS 记录名称对应。

2.1.8. 为集群节点 SSH 访问生成密钥对

在 OpenShift Container Platform 安装过程中,您可以为安装程序提供 SSH 公钥。密钥通过 Ignition 配置文件传递给 Red Hat Enterprise Linux CoreOS (RHCOS)节点,用于验证对节点的 SSH 访问。密钥添加到每个节点上 core 用户的 ~/.ssh/authorized_keys 列表中,这将启用免密码身份验证。

将密钥传递给节点后,您可以使用密钥对作为用户 核心 通过 SSH 连接到 RHCOS 节点。若要通过 SSH 访问节点,必须由 SSH 为您的本地用户管理私钥身份。

如果要通过 SSH 连接到集群节点来执行安装调试或灾难恢复,则必须在安装过程中提供 SSH 公钥。./openshift-install gather 命令还需要在集群节点上设置 SSH 公钥。

不要在生产环境中跳过这个过程,在生产环境中需要灾难恢复和调试。

您必须使用本地密钥,而不是使用特定平台方法配置的密钥。

流程

如果您在本地计算机上没有可用于在集群节点上进行身份验证的现有 SSH 密钥对,请创建一个。例如,在使用 Linux 操作系统的计算机上运行以下命令:

ssh-keygen -t ed25519 -N '' -f <path>/<file_name>

$ ssh-keygen -t ed25519 -N '' -f <path>/<file_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定新 SSH 密钥的路径和文件名,如

~/.ssh/id_ed25519。如果您已有密钥对,请确保您的公钥位于~/.ssh目录中。

注意如果您计划在

x86_64、ppc64le和s390x架构上安装使用 RHEL 加密库(这些加密库已提交给 NIST 用于 FIPS 140-2/140-3 验证)的 OpenShift Container Platform 集群,则不要创建使用ed25519算法的密钥。相反,创建一个使用rsa或ecdsa算法的密钥。查看公共 SSH 密钥:

cat <path>/<file_name>.pub

$ cat <path>/<file_name>.pubCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例如,运行以下命令来查看

~/.ssh/id_ed25519.pub公钥:cat ~/.ssh/id_ed25519.pub

$ cat ~/.ssh/id_ed25519.pubCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将 SSH 私钥身份添加到本地用户的 SSH 代理(如果尚未添加)。在集群节点上,或者要使用

./openshift-install gather命令,需要对该密钥进行 SSH 代理管理,才能在集群节点上进行免密码 SSH 身份验证。注意在某些发行版中,自动管理默认 SSH 私钥身份,如

~/.ssh/id_rsa和~/.ssh/id_dsa。如果

ssh-agent进程尚未为您的本地用户运行,请将其作为后台任务启动:eval "$(ssh-agent -s)"

$ eval "$(ssh-agent -s)"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Agent pid 31874

Agent pid 31874Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意如果集群处于 FIPS 模式,则只使用 FIPS 兼容算法来生成 SSH 密钥。密钥必须是 RSA 或 ECDSA。

将 SSH 私钥添加到

ssh-agent:ssh-add <path>/<file_name>

$ ssh-add <path>/<file_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定 SSH 私钥的路径和文件名,如

~/.ssh/id_ed25519.pub

输出示例

Identity added: /home/<you>/<path>/<file_name> (<computer_name>)

Identity added: /home/<you>/<path>/<file_name> (<computer_name>)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

后续步骤

- 安装 OpenShift Container Platform 时,为安装程序提供 SSH 公钥。如果在您置备的基础架构上安装集群,则必须为安装程序提供密钥。

2.1.9. 获取安装程序

在安装 OpenShift Container Platform 前,将安装文件下载到您用于安装的主机上。

先决条件

- 您有一台运行 Linux 或 macOS 的计算机,本地磁盘空间为 500 MB。

流程

进入 Red Hat Hybrid Cloud Console 上的 Cluster Type 页。如果您有红帽帐户,请使用您的凭证登录。如果没有,请创建一个帐户。

提示- 在页的 Run it yourself 部分中选择您的基础架构供应商。

- 从 OpenShift 安装程序下的下拉菜单中选择您的主机操作系统和架构,然后点下载安装程序。

将下载的文件保存在要存储安装配置文件的目录中。

重要- 安装程序会在用来安装集群的计算机上创建几个文件。在完成集群安装后,您必须保留安装程序和安装程序所创建的文件。删除集群需要这两个文件。

- 删除安装程序创建的文件不会删除您的集群,即使集群在安装过程中失败也是如此。要删除集群,请为特定云供应商完成 OpenShift Container Platform 卸载流程。

提取安装程序。例如,在使用 Linux 操作系统的计算机上运行以下命令:

tar -xvf openshift-install-linux.tar.gz

$ tar -xvf openshift-install-linux.tar.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 从 Red Hat OpenShift Cluster Manager 下载安装 pull secret。此 pull secret 允许您与所含授权机构提供的服务进行身份验证,这些服务包括为 OpenShift Container Platform 组件提供容器镜像的 Quay.io。

另外,您还可以从红帽客户门户网站检索安装程序,您可以在其中指定要下载的安装程序版本。但是,您需要有一个有效的订阅才能访问此页。

2.1.10. 安装 OpenShift CLI

您可以安装 OpenShift CLI(oc)来使用命令行界面与 OpenShift Container Platform 进行交互。您可以在 Linux、Windows 或 macOS 上安装 oc。

如果安装了旧版本的 oc,则可能无法使用 OpenShift Container Platform 中的所有命令。

下载并安装新版本的 oc。

2.1.10.1. 在 Linux 上安装 OpenShift CLI

您可以按照以下流程在 Linux 上安装 OpenShift CLI(oc)二进制文件。

流程

- 进入到红帽客户门户网站上的 Download OpenShift Container Platform 页。

- 从 Product Variant 列表中选择构架。

- 从 Version 列表中选择适当的版本。

- 点 OpenShift v4.19 Linux Clients 条目旁的 Download Now 来保存文件。

解包存档:

tar xvf <file>

$ tar xvf <file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将

oc二进制文件放到PATH 中的目录中。要查看您的

PATH,请执行以下命令:echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

安装 OpenShift CLI 后,可以使用

oc命令:oc <command>

$ oc <command>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.10.2. 在 Windows 上安装 OpenShift CLI

您可以按照以下流程在 Windows 上安装 OpenShift CLI(oc)二进制文件。

流程

- 进入到红帽客户门户网站上的 Download OpenShift Container Platform 页。

- 从 Version 列表中选择适当的版本。

- 点 OpenShift v4.19 Windows Client 条目旁的 Download Now 来保存文件。

- 使用 ZIP 程序解压存档。

将

oc二进制文件移到PATH 中的目录中。要查看您的

PATH,请打开命令提示并执行以下命令:path

C:\> pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

安装 OpenShift CLI 后,可以使用

oc命令:oc <command>

C:\> oc <command>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.10.3. 在 macOS 上安装 OpenShift CLI

您可以按照以下流程在 macOS 上安装 OpenShift CLI(oc)二进制文件。

流程

- 进入到红帽客户门户网站上的 Download OpenShift Container Platform 页。

- 从 版本 下拉列表中选择适当的版本。

点 OpenShift v4.19 macOS Clients 条目旁的 Download Now 来保存文件。

注意对于 macOS arm64,请选择 OpenShift v4.19 macOS arm64 Client 条目。

- 解包和解压存档。

将

oc二进制文件移到 PATH 的目录中。要查看您的

PATH,请打开终端并执行以下命令:echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

使用

oc命令验证安装:oc <command>

$ oc <command>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.11. 手动创建安装配置文件

安装集群要求您手动创建安装配置文件。

先决条件

- 在本地机器上有一个 SSH 公钥用于安装程序。您可以使用密钥在集群节点上进行 SSH 身份验证,以进行调试和灾难恢复。

- 已获取 OpenShift Container Platform 安装程序和集群的 pull secret。

流程

创建一个安装目录来存储所需的安装资产:

mkdir <installation_directory>

$ mkdir <installation_directory>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要您必须创建一个目录。有些安装资产,如 bootstrap X.509 证书的过期间隔较短,因此不得重复使用安装目录。如果要重复使用另一个集群安装中的单个文件,您可以将它们复制到您的目录中。但是,安装资产的文件名可能会在发行版本间有所变化。从以前的 OpenShift Container Platform 版本中复制安装文件时请小心。

对提供的

install-config.yaml文件模板示例进行自定义,并将文件保存到<installation_directory>中。注意此配置文件必须命名为

install-config.yaml。备份

install-config.yaml文件,以便使用它来安装多个集群。重要现在备份

install-config.yaml文件,因为安装过程会在下一步中消耗该文件。

2.1.11.1. 裸机 install-config.yaml 文件示例

您可以自定义 install-config.yaml 文件,以指定有关 OpenShift Container Platform 集群平台的更多详情,或修改所需参数的值。

- 1

- 集群的基域。所有 DNS 记录都必须是这个基域的子域,并包含集群名称。

- 2 5

controlPlane部分是一个单个映射,但compute部分是一系列映射。为满足不同数据结构的要求,compute部分的第一行必须以连字符-开头,controlPlane部分的第一行则不以连字符开头。仅使用一个 control plane 池。- 3 6

- 指定要启用或禁用并发多线程(SMT)还是超线程。默认情况下,启用 SMT 可提高机器中内核的性能。您可以通过将 参数值设置为

Disabled来禁用它。如果禁用 SMT,则必须在所有集群机器中禁用它;这包括 control plane 和计算机器。注意默认启用并发多线程(SMT)。如果您的 BIOS 设置中没有启用 SMT,

超线程参数无效。重要如果您禁用

超线程,无论是在 BIOS 中,还是在install-config.yaml文件中,请确保您的容量规划考虑机器性能显著降低的情况。 - 4

- 在用户置备的基础架构上安装 OpenShift Container Platform 时,必须将这个值设置为

0。在安装程序置备的安装中,参数控制集群为您创建和管理的计算机器数量。在用户置备的安装中,您必须在完成集群安装前手动部署计算机器。注意如果要安装一个三节点集群,在安装 Red Hat Enterprise Linux CoreOS(RHCOS)机器时不要部署任何计算机器。

- 7

- 您添加到集群的 control plane 机器数量。由于集群使用这些值作为集群中的 etcd 端点数量,所以该值必须与您部署的 control plane 机器数量匹配。

- 8

- 您在 DNS 记录中指定的集群名称。

- 9

- 从中分配 Pod IP 地址的 IP 地址块。此块不得与现有物理网络重叠。这些 IP 地址用于 pod 网络。如果需要从外部网络访问 pod,您必须配置负载均衡器和路由器来管理流量。注意

类 E CIDR 范围被保留以供以后使用。要使用 Class E CIDR 范围,您必须确保您的网络环境接受 Class E CIDR 范围内的 IP 地址。

- 10

- 分配给每个节点的子网前缀长度。例如,如果

hostPrefix 设为23,则每个节点从 givencidr中分配 a/23子网,这样就能有 510(2^(32 - 23)- 2)个 pod IP 地址。如果需要从外部网络访问节点,请配置负载均衡器和路由器来管理流量。 - 11

- 要安装的集群网络插件。默认值

OVNKubernetes是唯一支持的值。 - 12

- 用于服务 IP 地址的 IP 地址池。您只能输入一个 IP 地址池。此块不得与现有物理网络重叠。如果您需要从外部网络访问服务,请配置负载均衡器和路由器来管理流量。

- 13

- 您必须将平台设置为

none。您无法为您的平台提供额外的平台配置变量。重要使用平台类型

none安装的集群无法使用一些功能,如使用 Machine API 管理计算机器。即使附加到集群的计算机器安装在通常支持该功能的平台上,也会应用这个限制。在安装后无法更改此参数。 - 14

- 是否启用或禁用 FIPS 模式。默认情况下不启用 FIPS 模式。如果启用了 FIPS 模式,运行 OpenShift Container Platform 的 Red Hat Enterprise Linux CoreOS(RHCOS)机器会绕过默认的 Kubernetes 加密套件,并使用由 RHCOS 提供的加密模块。重要

要为集群启用 FIPS 模式,您必须从配置为以 FIPS 模式操作的 Red Hat Enterprise Linux (RHEL) 计算机运行安装程序。有关在 RHEL 中配置 FIPS 模式的更多信息,请参阅将 RHEL 切换到 FIPS 模式。

当以 FIPS 模式运行 Red Hat Enterprise Linux (RHEL) 或 Red Hat Enterprise Linux CoreOS (RHCOS) 时,OpenShift Container Platform 核心组件使用 RHEL 加密库,只有在 x86_64, ppc64le, 和 s390x 架构上的库被提交到 NIST 进行 FIPS 140-2/140-3 Validation。

- 15

- Red Hat OpenShift Cluster Manager 的 pull secret。此 pull secret 允许您与所含授权机构提供的服务进行身份验证,这些服务包括为 OpenShift Container Platform 组件提供容器镜像的 Quay.io。

- 16

- Red Hat Enterprise Linux CoreOS(RHCOS)中

core用户的 SSH 公钥。注意对于您要在其上执行安装调试或灾难恢复的生产环境 OpenShift Container Platform 集群,请指定

ssh-agent进程使用的 SSH 密钥。

2.1.11.2. 在安装过程中配置集群范围的代理

生产环境可能会拒绝直接访问互联网,而是提供 HTTP 或 HTTPS 代理。您可以通过在 install-config.yaml 文件中配置代理设置,将新的 OpenShift Container Platform 集群配置为使用代理。

对于裸机安装,如果您没有从 install-config.yaml 文件中的 networking.machineNetwork[].cidr 字段指定的范围分配节点 IP 地址,您必须将其包括在 proxy.noProxy 字段中。

先决条件

-

您有一个现有的

install-config.yaml文件。 您检查了集群需要访问的站点,并确定它们中的任何站点是否需要绕过代理。默认情况下,所有集群出口流量都经过代理,包括对托管云供应商 API 的调用。如果需要,您将在

Proxy 对象的spec.noProxy字段中添加站点来绕过代理。注意Proxy对象status.noProxy字段使用安装配置中的networking.machineNetwork[].cidr、networking.clusterNetwork[].cidr和networking.serviceNetwork[]字段的值填充。对于在 Amazon Web Services(AWS)、Google Cloud、Microsoft Azure 和 Red Hat OpenStack Platform(RHOSP)上安装,

Proxy对象status.noProxy字段也会使用实例元数据端点填充(169.254.169.254)。

流程

编辑

install-config.yaml文件并添加代理设置。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 用于创建集群外 HTTP 连接的代理 URL。URL 方案必须是

http。 - 2

- 用于创建集群外 HTTPS 连接的代理 URL。

- 3

- 要从代理中排除的目标域名、IP 地址或其他网络 CIDR 的逗号分隔列表。在域前面加上

.以仅匹配子域。例如,.y.com匹配x.y.com,但不匹配y.com。使用*绕过所有目的地的代理。 - 4

- 如果提供,安装程序会在

openshift-config命名空间中生成名为user-ca-bundle的配置映射,其包含代理 HTTPS 连接所需的一个或多个额外 CA 证书。然后,Cluster Network Operator 会创建一个trusted-ca-bundle配置映射,将这些内容与 Red Hat Enterprise Linux CoreOS (RHCOS)信任捆绑包合并,Proxy对象的trustedCA字段中也会引用此配置映射。additionalTrustBundle字段是必需的,除非代理的身份证书由来自 RHCOS 信任捆绑包的颁发机构签名。 - 5

- 可选:决定

Proxy对象的配置以引用trustedCA字段中user-ca-bundle配置映射的策略。允许的值是Proxyonly和Always。仅在配置了http/https代理时,使用Proxyonly引用user-ca-bundle配置映射。使用Always始终引用user-ca-bundle配置映射。默认值为Proxyonly。

注意安装程序不支持代理的

readinessEndpoints字段。注意如果安装程序超时,重启并使用安装程序的

wait-for命令完成部署。例如:./openshift-install wait-for install-complete --log-level debug

$ ./openshift-install wait-for install-complete --log-level debugCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存该文件并在安装 OpenShift Container Platform 时引用。

安装程序会创建一个名为 cluster 的集群范围代理,该代理 使用 提供的 install-config.yaml 文件中的代理设置。如果没有提供代理设置,仍然会创建一个 cluster Proxy 对象,但它会有一个空 spec。

只支持名为 cluster 的 Proxy 对象,且无法创建额外的代理。

2.1.11.3. 配置三节点集群

另外,您可以在只由三台 control plane 机器组成的裸机集群中部署零台计算机器。这为集群管理员和开发人员提供了更小、效率更高的集群,用于测试、开发和生产。

在三节点 OpenShift Container Platform 环境中,三台 control plane 机器可以调度,这意味着应用程序工作负载被调度到它们上运行。

先决条件

-

您有一个现有的

install-config.yaml文件。

流程

确保

install-config.yaml文件中的计算副本数量设置为0,如以下计算小节所示:compute: - name: worker platform: {} replicas: 0compute: - name: worker platform: {} replicas: 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意在用户置备的基础架构上安装 OpenShift Container Platform 时,无论您要部署的计算机器数量有多少,您必须将计算机器的

replicas参数值设置为0。在安装程序置备的安装中,参数控制集群为您创建和管理的计算机器数量。这不适用于手动部署计算机器的用户置备安装。

对于三节点集群安装,请按照以下步骤执行:

- 如果要部署一个带有零计算节点的三节点集群,Ingress Controller Pod 在 control plane 节点上运行。在三节点集群部署中,您必须配置应用程序入口负载均衡器,将 HTTP 和 HTTPS 流量路由到 control plane 节点。如需更多信息,请参阅用户置备的基础架构的负载平衡要求 部分。

-

在以下步骤中创建 Kubernetes 清单文件时,请确保

<installation_directory>/manifests/cluster-scheduler-02-config.yml文件中的mastersSchedulable参数被设置为true。这可让应用程序工作负载在 control plane 节点上运行。 - 在创建 Red Hat Enterprise Linux CoreOS(RHCOS)机器时,不要部署任何计算节点。

2.1.12. 创建 Kubernetes 清单和 Ignition 配置文件

由于您必须修改一些集群定义文件并手动启动集群机器,因此您必须生成 Kubernetes 清单和 Ignition 配置文件来配置机器。

安装配置文件转换为 Kubernetes 清单。清单嵌套到 Ignition 配置文件中,稍后用于配置集群机器。

-

OpenShift Container Platform 安装程序生成的 Ignition 配置文件包含 24 小时后过期的证书,然后在该时进行续订。如果在更新证书前关闭集群,且集群在 24 小时后重启,集群会自动恢复过期的证书。一个例外是,您必须手动批准待处理的

node-bootstrapper证书签名请求(CSR)来恢复 kubelet 证书。如需更多信息,请参阅从过期的 control plane 证书 中恢复的文档。 - 建议您在 Ignition 配置文件生成后的 12 小时内使用它们,因为 24 小时的证书会在集群安装后的 16 小时到 22 小时间进行轮转。通过在 12 小时内使用 Ignition 配置文件,您可以避免在安装过程中因为执行了证书更新而导致安装失败的问题。

先决条件

- 已获得 OpenShift Container Platform 安装程序。

-

已创建

install-config.yaml安装配置文件。

流程

进入包含 OpenShift Container Platform 安装程序的目录,并为集群生成 Kubernetes 清单:

./openshift-install create manifests --dir <installation_directory>

$ ./openshift-install create manifests --dir <installation_directory>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 对于

<installation_directory>,请指定包含您创建的install-config.yaml文件的安装目录。

警告如果您要安装一个三节点集群,请跳过以下步骤,以便可以调度 control plane 节点。

重要当您将 control plane 节点从默认的不可调度配置为可以调度时,需要额外的订阅。这是因为 control plane 节点变为计算节点。

检查

<installation_directory>/manifests/cluster-scheduler-02-config.yml Kubernetes 清单文件中的mastersSchedulable参数是否已设置为false。此设置可防止在 control plane 机器上调度 pod:-

打开

<installation_directory>/manifests/cluster-scheduler-02-config.yml文件。 -

找到

mastersSchedulable参数,并确保它被设置为false。 - 保存并退出 文件。

-

打开

要创建 Ignition 配置文件,请从包含安装程序的目录运行以下命令:

./openshift-install create ignition-configs --dir <installation_directory>

$ ./openshift-install create ignition-configs --dir <installation_directory>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 对于

<installation_directory>,请指定相同的安装目录。

为安装目录中的 bootstrap、control plane 和计算节点创建 Ignition 配置文件。

kubeadmin-password和kubeconfig文件在./<installation_directory>/auth目录中创建:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

要在您置备的裸机基础架构上安装 OpenShift Container Platform,您必须在机器上安装 Red Hat Enterprise Linux CoreOS(RHCOS)。安装 RHCOS 时,您必须为您要安装的机器类型提供 OpenShift Container Platform 安装程序生成的 Ignition 配置文件。如果您配置了适当的网络、DNS 和负载均衡基础架构,OpenShift Container Platform bootstrap 过程会在 RHCOS 机器重启后自动启动。

要在机器上安装 RHCOS,请按照以下步骤使用 ISO 镜像或网络 PXE 引导。

本安装文档中包括的计算节点部署步骤特定于 RHCOS。如果您选择部署基于 RHEL 的计算节点,您需要负责所有操作系统生命周期管理和维护,包括执行系统更新、应用补丁和完成所有其他必要的任务。仅支持 RHEL 8 计算机器。

您可以使用以下方法在 ISO 和 PXE 安装过程中配置 RHCOS:

-

内核参数: 您可以使用内核参数来提供特定于安装的信息。例如,您可以指定上传到 HTTP 服务器的 RHCOS 安装文件的位置以及您要安装的节点类型的 Ignition 配置文件的位置。对于 PXE 安装,您可以使用

APPEND参数将参数传递给 live 安装程序的内核。对于 ISO 安装,您可以中断实时安装引导过程来添加内核参数。在这两个安装情形中,您可以使用特殊的coreos.inst.*参数来指示实时安装程序,以及标准安装引导参数来打开或关闭标准内核服务。 -

Ignition 配置:OpenShift Container Platform Ignition 配置文件(

*.ign)特定于您要安装的节点类型。您可以在 RHCOS 安装过程中传递 bootstrap、control plane 或计算节点 Ignition 配置文件的位置,以便在首次启动时生效。特殊情况下,您可以创建单独的、有限的 Ignition 配置以传递给 live 系统。该 Ignition 配置可以执行特定的任务,如在安装完成后向置备系统报告成功。此特殊的 Ignition 配置由coreos-installer使用,以便在首次引导安装的系统时应用。不要直接为实时 ISO 提供标准 control plane 和计算节点 Ignition 配置。 coreos-installer:您可以将 live ISO 安装程序引导到 shell 提示符,这可让您在第一次引导前以多种方式准备持久性系统。特别是,您可以运行coreos-installer命令来识别要包含的各种工件、使用磁盘分区和设置网络。在某些情况下,您可以配置 live 系统上的功能并将其复制到安装的系统中。注意自

0.17.0-3起,coreos-installer需要 RHEL 9 或更高版本来运行该程序。您仍然可以使用旧版本的coreos-installer自定义较新的 OpenShift Container Platform 版本的 RHCOS 工件,并将构建器镜像安装到磁盘。您可以从coreos-installerimage mirror 页下载旧版本的coreos-installer二进制文件。

使用 ISO 安装还是 PXE 安装取决于您的情况。PXE 安装需要可用的 DHCP 服务并进行更多准备,但可以使安装过程更加自动化。ISO 安装是一个更手动的过程,如果您设置的机器数超过几台,则可能不方便。

2.1.13.1. 使用 ISO 镜像安装 RHCOS

您可以使用 ISO 镜像在机器上安装 RHCOS。

先决条件

- 已为集群创建 Ignition 配置文件。

- 您已配置了适当的网络、DNS 和负载平衡基础架构。

- 您有一个可以从计算机以及您创建的机器访问的 HTTP 服务器。

- 您已参阅 Advanced RHCOS 安装配置 部分来了解配置功能的不同方法,如网络和磁盘分区。

流程

获取每个 Ignition 配置文件的 SHA512 摘要。例如,您可以在运行 Linux 的系统上使用以下内容来获取

bootstrap.ignIgnition 配置文件的 SHA512 摘要:sha512sum <installation_directory>/bootstrap.ign

$ sha512sum <installation_directory>/bootstrap.ignCopy to Clipboard Copied! Toggle word wrap Toggle overflow 后续步骤中会向

coreos-installer提供摘要,以验证集群节点上 Ignition 配置文件的真实性。将安装程序创建的 bootstrap、control plane 和计算节点 Ignition 配置文件上传到 HTTP 服务器。注意这些文件的 URL。

重要您可以在 Ignition 配置中添加或更改配置设置,然后将其保存到 HTTP 服务器。如果您计划在安装完成后在集群中添加更多计算机器,请不要删除这些文件。

从安装主机上,验证 Ignition 配置文件是否在 URL 上可用。以下示例获取 bootstrap 节点的 Ignition 配置文件:

curl -k http://<HTTP_server>/bootstrap.ign

$ curl -k http://<HTTP_server>/bootstrap.ign1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

% Total % Received % Xferd Average Speed Time Time Time Current Dload Upload Total Spent Left Speed 0 0 0 0 0 0 0 0 --:--:-- --:--:-- --:--:-- 0{"ignition":{"version":"3.2.0"},"passwd":{"users":[{"name":"core","sshAuthorizedKeys":["ssh-rsa...% Total % Received % Xferd Average Speed Time Time Time Current Dload Upload Total Spent Left Speed 0 0 0 0 0 0 0 0 --:--:-- --:--:-- --:--:-- 0{"ignition":{"version":"3.2.0"},"passwd":{"users":[{"name":"core","sshAuthorizedKeys":["ssh-rsa...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在命令中将

bootstrap.ign替换为master.ign或worker.ign,以验证 control plane 和计算节点的 Ignition 配置文件是否可用。虽然可以从 RHCOS 镜像镜像页面获取您选择的操作系统实例安装方法所需的 RHCOS 镜像,但推荐的方法是从

openshift-install命令的输出获取 RHCOS 镜像的正确版本:openshift-install coreos print-stream-json | grep '\.iso[^.]'

$ openshift-install coreos print-stream-json | grep '\.iso[^.]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

"location": "<url>/art/storage/releases/rhcos-4.19-aarch64/<release>/aarch64/rhcos-<release>-live.aarch64.iso", "location": "<url>/art/storage/releases/rhcos-4.19-ppc64le/<release>/ppc64le/rhcos-<release>-live.ppc64le.iso", "location": "<url>/art/storage/releases/rhcos-4.19-s390x/<release>/s390x/rhcos-<release>-live.s390x.iso", "location": "<url>/art/storage/releases/rhcos-4.19/<release>/x86_64/rhcos-<release>-live.x86_64.iso",

"location": "<url>/art/storage/releases/rhcos-4.19-aarch64/<release>/aarch64/rhcos-<release>-live.aarch64.iso", "location": "<url>/art/storage/releases/rhcos-4.19-ppc64le/<release>/ppc64le/rhcos-<release>-live.ppc64le.iso", "location": "<url>/art/storage/releases/rhcos-4.19-s390x/<release>/s390x/rhcos-<release>-live.s390x.iso", "location": "<url>/art/storage/releases/rhcos-4.19/<release>/x86_64/rhcos-<release>-live.x86_64.iso",Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要RHCOS 镜像可能不会随着 OpenShift Container Platform 的每个发行版本而改变。您必须下载最高版本的镜像,其版本号应小于或等于您安装的 OpenShift Container Platform 版本。如果可用,请使用与 OpenShift Container Platform 版本匹配的镜像版本。这个过程只使用 ISO 镜像。此安装类型不支持 RHCOS qcow2 镜像。

ISO 文件名类似以下示例:

rhcos-<version>-live.<architecture>.iso使用 ISO 启动 RHCOS 安装。使用以下安装选项之一:

- 将 ISO 映像刻录到磁盘并直接启动。

- 使用 light-out 管理(LOM)接口使用 ISO 重定向。

在不指定任何选项或中断实时引导序列的情况下引导 RHCOS ISO 镜像。等待安装程序在 RHCOS live 环境中引导进入 shell 提示符。

注意可以中断 RHCOS 安装引导过程来添加内核参数。但是,在这个 ISO 过程中,您应该使用以下步骤中所述的

coreos-installer命令,而不是添加内核参数。运行

coreos-installer命令并指定满足您的安装要求的选项。您至少必须指定指向节点类型的 Ignition 配置文件的 URL,以及您要安装到的设备:sudo coreos-installer install --ignition-url=http://<HTTP_server>/<node_type>.ign <device> \ --ignition-hash=sha512-<digest>

$ sudo coreos-installer install --ignition-url=http://<HTTP_server>/<node_type>.ign <device> \1 --ignition-hash=sha512-<digest>2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意如果要通过使用 TLS 的 HTTPS 服务器提供 Ignition 配置文件,您可以在运行

coreos-installer前将内部证书颁发机构(CA)添加到系统信任存储中。以下示例将引导节点安装初始化到

/dev/sda设备。bootstrap 节点的 Ignition 配置文件从 IP 地址 192.168.1.2 的 HTTP Web 服务器获取:+

sudo coreos-installer install --ignition-url=http://192.168.1.2:80/installation_directory/bootstrap.ign /dev/sda \ --ignition-hash=sha512-a5a2d43879223273c9b60af66b44202a1d1248fc01cf156c46d4a79f552b6bad47bc8cc78ddf0116e80c59d2ea9e32ba53bc807afbca581aa059311def2c3e3b

$ sudo coreos-installer install --ignition-url=http://192.168.1.2:80/installation_directory/bootstrap.ign /dev/sda \

--ignition-hash=sha512-a5a2d43879223273c9b60af66b44202a1d1248fc01cf156c46d4a79f552b6bad47bc8cc78ddf0116e80c59d2ea9e32ba53bc807afbca581aa059311def2c3e3b在机器的控制台上监控 RHCOS 安装的进度。

重要在开始安装 OpenShift Container Platform 之前,确保每个节点中安装成功。观察安装过程可以帮助确定可能会出现 RHCOS 安装问题的原因。

- 安装 RHCOS 后,您必须重启系统。系统重启过程中,它会应用您指定的 Ignition 配置文件。

检查控制台输出,以验证 Ignition 是否运行。

示例命令

Ignition: ran on 2022/03/14 14:48:33 UTC (this boot) Ignition: user-provided config was applied

Ignition: ran on 2022/03/14 14:48:33 UTC (this boot) Ignition: user-provided config was appliedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 继续为集群创建其他机器。

重要此时您必须创建 bootstrap 和 control plane 机器。如果 control plane 机器不可调度,请在安装 OpenShift Container Platform 前至少创建两台计算机器。

如果存在所需的网络、DNS 和负载均衡器基础架构,OpenShift Container Platform bootstrap 过程会在 RHCOS 节点重启后自动启动。

注意RHCOS 节点不包含

core用户的默认密码。您可以使用可访问 SSH 私钥的用户的身份运行ssh core@<node>.<cluster_name>.<base_domain> 来访问节点,该私钥与您在install_config.yaml文件中指定的公钥配对。运行 RHCOS 的 OpenShift Container Platform 4 集群节点不可变,它依赖于 Operator 来应用集群更改。不建议使用 SSH 访问集群节点。但是,当调查安装问题时,如果 OpenShift Container Platform API 不可用,或者 kubelet 在目标节点上无法正常工作,则调试或灾难恢复可能需要 SSH 访问。

2.1.13.2. 使用 PXE 或 iPXE 启动安装 RHCOS

您可以使用 PXE 或 iPXE 启动在机器上安装 RHCOS。

先决条件

- 已为集群创建 Ignition 配置文件。

- 您已配置了适当的网络、DNS 和负载平衡基础架构。

- 您已配置了合适的 PXE 或 iPXE 基础架构。

- 您有一个可以从计算机以及您创建的机器访问的 HTTP 服务器。

- 您已参阅 Advanced RHCOS 安装配置 部分来了解配置功能的不同方法,如网络和磁盘分区。

流程

将安装程序创建的 bootstrap、control plane 和计算节点 Ignition 配置文件上传到 HTTP 服务器。注意这些文件的 URL。

重要您可以在 Ignition 配置中添加或更改配置设置,然后将其保存到 HTTP 服务器。如果您计划在安装完成后在集群中添加更多计算机器,请不要删除这些文件。

从安装主机上,验证 Ignition 配置文件是否在 URL 上可用。以下示例获取 bootstrap 节点的 Ignition 配置文件:

curl -k http://<HTTP_server>/bootstrap.ign

$ curl -k http://<HTTP_server>/bootstrap.ign1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

% Total % Received % Xferd Average Speed Time Time Time Current Dload Upload Total Spent Left Speed 0 0 0 0 0 0 0 0 --:--:-- --:--:-- --:--:-- 0{"ignition":{"version":"3.2.0"},"passwd":{"users":[{"name":"core","sshAuthorizedKeys":["ssh-rsa...% Total % Received % Xferd Average Speed Time Time Time Current Dload Upload Total Spent Left Speed 0 0 0 0 0 0 0 0 --:--:-- --:--:-- --:--:-- 0{"ignition":{"version":"3.2.0"},"passwd":{"users":[{"name":"core","sshAuthorizedKeys":["ssh-rsa...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在命令中将

bootstrap.ign替换为master.ign或worker.ign,以验证 control plane 和计算节点的 Ignition 配置文件是否可用。虽然可以从 RHCOS image mirror 页面获取您选择的操作系统实例所需的 RHCOS

kernel、initramfs和rootfs文件,但推荐的方法是从openshift-install命令的输出中获取 RHCOS 文件的正确版本:openshift-install coreos print-stream-json | grep -Eo '"https.*(kernel-|initramfs.|rootfs.)\w+(\.img)?"'

$ openshift-install coreos print-stream-json | grep -Eo '"https.*(kernel-|initramfs.|rootfs.)\w+(\.img)?"'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要RHCOS 工件可能不会随着 OpenShift Container Platform 的每个发行版本而改变。您必须下载最高版本的镜像,其版本号应小于或等于您安装的 OpenShift Container Platform 版本。这个过程只使用下面描述的适当

kernel、initramfs 和 rootfs工件。此安装类型不支持 RHCOS QCOW2 镜像。文件名包含 OpenShift Container Platform 版本号。它们类似以下示例:

-

kernel:rhcos-<version>-live-kernel-<architecture> -

initramfs:rhcos-<version>-live-initramfs.<architecture>.img -

rootfs:rhcos-<version>-live-rootfs.<architecture>.img

-

将

rootfs、kernel和initramfs文件上传到 HTTP 服务器。重要如果您计划在安装完成后在集群中添加更多计算机器,请不要删除这些文件。

- 配置网络引导基础架构,以便在安装 RHCOS 后机器从本地磁盘启动。

为 RHCOS 镜像配置 PXE 或 iPXE 安装并开始安装。

为环境修改以下示例菜单条目之一,并验证能否正确访问镜像和 Ignition 文件:

对于 PXE(

x86_64):Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1 1

- 指定上传到 HTTP 服务器的 live

kernel文件位置。URL 必须是 HTTP、TFTP 或 FTP;不支持 HTTPS 和 NFS。 - 2

- 如果您使用多个 NIC,请在

ip选项中指定一个接口。例如,要在名为eno1的 NIC 上使用 DHCP,请设置ip=eno1:dhcp。 - 3

- 指定上传到 HTTP 服务器的 RHCOS 文件的位置。

initrd参数值是initramfs文件的位置,coreos.live.rootfs_url参数值是rootfs文件的位置,coreos.inst.ignition_url参数值则是 bootstrap Ignition 配置文件的位置。您还可以在APPEND行中添加更多内核参数来配置联网或其他引导选项。

注意此配置不会在图形控制台的机器上启用串行控制台访问。要配置不同的控制台,请在

APPEND行中添加一个或多个console=参数。例如,添加console=tty0 console=ttyS0以将第一个 PC 串口设置为主控制台,并将图形控制台设置为二级控制台。如需更多信息,请参阅如何在 Red Hat Enterprise Linux 中设置串行终端和/或控制台? 和"启用 PXE 和 ISO 安装的串行控制台"部分。对于 iPXE (

x86_64+aarch64):kernel http://<HTTP_server>/rhcos-<version>-live-kernel-<architecture> initrd=main coreos.live.rootfs_url=http://<HTTP_server>/rhcos-<version>-live-rootfs.<architecture>.img coreos.inst.install_dev=/dev/sda coreos.inst.ignition_url=http://<HTTP_server>/bootstrap.ign initrd --name main http://<HTTP_server>/rhcos-<version>-live-initramfs.<architecture>.img boot

kernel http://<HTTP_server>/rhcos-<version>-live-kernel-<architecture> initrd=main coreos.live.rootfs_url=http://<HTTP_server>/rhcos-<version>-live-rootfs.<architecture>.img coreos.inst.install_dev=/dev/sda coreos.inst.ignition_url=http://<HTTP_server>/bootstrap.ign1 2 initrd --name main http://<HTTP_server>/rhcos-<version>-live-initramfs.<architecture>.img3 bootCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意此配置不会在图形控制台的机器上启用串行控制台访问。要配置不同的控制台,请在

内核参数中添加一个或多个console=参数。例如,添加console=tty0 console=ttyS0以将第一个 PC 串口设置为主控制台,并将图形控制台设置为二级控制台。如需更多信息,请参阅如何在 Red Hat Enterprise Linux 中设置串行终端和/或控制台? 和"启用 PXE 和 ISO 安装的串行控制台"部分。注意要在

aarch64架构中网络引导 CoreOS内核,您需要使用启用了IMAGE_GZIP选项的 iPXE 构建版本。请参阅 iPXE 中的IMAGE_GZIP选项。对于

aarch64中的 PXE(使用 UEFI 和 Grub 作为第二阶段):menuentry 'Install CoreOS' { linux rhcos-<version>-live-kernel-<architecture> coreos.live.rootfs_url=http://<HTTP_server>/rhcos-<version>-live-rootfs.<architecture>.img coreos.inst.install_dev=/dev/sda coreos.inst.ignition_url=http://<HTTP_server>/bootstrap.ign initrd rhcos-<version>-live-initramfs.<architecture>.img }menuentry 'Install CoreOS' { linux rhcos-<version>-live-kernel-<architecture> coreos.live.rootfs_url=http://<HTTP_server>/rhcos-<version>-live-rootfs.<architecture>.img coreos.inst.install_dev=/dev/sda coreos.inst.ignition_url=http://<HTTP_server>/bootstrap.ign1 2 initrd rhcos-<version>-live-initramfs.<architecture>.img3 }Copy to Clipboard Copied! Toggle word wrap Toggle overflow

在机器的控制台上监控 RHCOS 安装的进度。

重要在开始安装 OpenShift Container Platform 之前,确保每个节点中安装成功。观察安装过程可以帮助确定可能会出现 RHCOS 安装问题的原因。

- 安装 RHCOS 后,系统会重启。在重启过程中,系统会应用您指定的 Ignition 配置文件。

检查控制台输出,以验证 Ignition 是否运行。

示例命令

Ignition: ran on 2022/03/14 14:48:33 UTC (this boot) Ignition: user-provided config was applied

Ignition: ran on 2022/03/14 14:48:33 UTC (this boot) Ignition: user-provided config was appliedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 继续为集群创建机器。

重要此时您必须创建 bootstrap 和 control plane 机器。如果 control plane 机器不可调度,请在安装集群前至少创建两台计算机器。

如果存在所需的网络、DNS 和负载均衡器基础架构,OpenShift Container Platform bootstrap 过程会在 RHCOS 节点重启后自动启动。

注意RHCOS 节点不包含

core用户的默认密码。您可以使用可访问 SSH 私钥的用户的身份运行ssh core@<node>.<cluster_name>.<base_domain> 来访问节点,该私钥与您在install_config.yaml文件中指定的公钥配对。运行 RHCOS 的 OpenShift Container Platform 4 集群节点不可变,它依赖于 Operator 来应用集群更改。不建议使用 SSH 访问集群节点。但是,当调查安装问题时,如果 OpenShift Container Platform API 不可用,或者 kubelet 在目标节点上无法正常工作,则调试或灾难恢复可能需要 SSH 访问。

2.1.13.3. 高级 RHCOS 安装配置

为 OpenShift Container Platform 手动置备 Red Hat Enterprise Linux CoreOS(RHCOS)节点的一个关键优点是能够进行通过默认的 OpenShift Container Platform 安装方法无法进行的配置。本节介绍了您可以使用的一些技术进行配置,其中包括:

- 将内核参数传递给实时安装程序

-

从 live 系统手动运行

coreos-installer - 自定义实时 ISO 或 PXE 引导镜像

本节详述了与 Red Hat Enterprise Linux CoreOS(RHCOS)手动安装的高级配置相关的内容,如磁盘分区、网络以及使用 Ignition 配置的不同方式相关。

2.1.13.3.1. 使用高级网络选项进行 PXE 和 ISO 安装

OpenShift Container Platform 节点的网络默认使用 DHCP 来收集所有必要的配置设置。要设置静态 IP 地址或配置特殊设置,如绑定,您可以执行以下操作之一:

- 引导 live 安装程序时传递特殊内核参数。

- 使用机器配置将网络文件复制到安装的系统中。

- 从 live 安装程序 shell 提示符配置网络,然后将这些设置复制到安装的系统上,以便在安装的系统第一次引导时生效。

要配置 PXE 或 iPXE 安装,请使用以下选项之一:

- 请参阅"高级 RHCOS 安装参考"表。

- 使用机器配置将网络文件复制到安装的系统中。

要配置 ISO 安装,请使用以下步骤:

流程

- 引导 ISO 安装程序.

-

在 live 系统 shell 提示符下,使用可用的 RHEL 工具(如

nmcli或nmtui)为 live 系统配置网络。 运行

coreos-installer命令以安装系统,添加--copy-network选项来复制网络配置。例如:sudo coreos-installer install --copy-network \ --ignition-url=http://host/worker.ign /dev/disk/by-id/scsi-<serial_number>$ sudo coreos-installer install --copy-network \ --ignition-url=http://host/worker.ign /dev/disk/by-id/scsi-<serial_number>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要copy-network选项仅复制在/etc/NetworkManager/system-connections下找到的网络配置。特别是,它不会复制系统主机名。- 重启安装的系统。

2.1.13.3.2. 磁盘分区

磁盘分区是在 Red Hat Enterprise Linux CoreOS(RHCOS)安装过程中在 OpenShift Container Platform 集群节点上创建的。特定架构的每个 RHCOS 节点使用相同的分区布局,除非覆盖默认的分区配置。在 RHCOS 安装过程中,根文件系统的大小会增加,以使用目标设备中剩余的可用空间。

在节点上使用自定义分区方案可能会导致 OpenShift Container Platform 在某些节点分区上监控或警报。如果要覆盖默认分区,请参阅 了解 OpenShift 文件系统监控(驱除条件) 以了解有关 OpenShift Container Platform 如何监控主机文件系统的更多信息。

OpenShift Container Platform 监控以下两个文件系统标识符:

-

nodefs,这是包含/var/lib/kubelet的文件系统 -

imagefs,这是包含/var/lib/containers的文件系统

对于默认分区方案,nodefs 和 imagefs 监控相同的根文件系统 /。

要在 OpenShift Container Platform 集群节点上安装 RHCOS 时覆盖默认分区,您必须创建单独的分区。您可能想要为容器和容器镜像添加单独的存储分区。例如,通过在独立分区中挂载 /var/lib/containers,kubelet 会单独监控 /var/lib/containers 作为 imagefs 目录,以及 root 文件系统作为 nodefs 目录。

如果您已将磁盘大小调整为托管更大的文件系统,请考虑创建单独的 /var/lib/containers 分区。考虑重新定义具有 xfs 格式的磁盘大小,以减少大量分配组导致的 CPU 时间问题。

2.1.13.3.2.1. 创建独立 /var 分区

通常,您应该使用在 RHCOS 安装过程中创建的默认磁盘分区。然而,在有些情况下您可能需要为预期增长的目录创建独立分区。

OpenShift Container Platform 支持添加单个分区将存储附加到 /var 目录或 /var 的子目录中。例如:

-

/var/lib/containers:保存随着系统中添加更多镜像和容器而增长的容器相关内容。 -

/var/lib/etcd:保存您可能希望独立保留的数据,比如 etcd 存储的性能优化。 /var:保存您可能希望独立保留的数据,以满足审计等目的。重要对于大于 100GB 的磁盘大小,特别是磁盘大小大于 1TB,请创建一个独立的

/var分区。

通过单独存储 /var 目录的内容,可以更轻松地根据需要为区域扩展存储,并在以后重新安装 OpenShift Container Platform,并保持该数据的完整性。使用这个方法,您不必再次拉取所有容器,在更新系统时也不必复制大量日志文件。

将独立分区用于 /var 目录或 /var 的子目录也会防止分区目录中的数据增加填充根文件系统。

以下流程通过添加机器配置清单来设置独立的 /var 分区,该清单会在安装准备阶段封装到节点类型的 Ignition 配置文件中。

流程

在安装主机上,切换到包含 OpenShift Container Platform 安装程序的目录,并为集群生成 Kubernetes 清单:

openshift-install create manifests --dir <installation_directory>

$ openshift-install create manifests --dir <installation_directory>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建用于配置额外分区的 Butane 配置。例如,将文件命名为

$HOME/clusterconfig/98-var-partition.bu,将磁盘设备名称改为worker系统上存储设备的名称,并根据情况设置存储大小。这个示例将/var目录放在一个单独的分区中:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意在创建单独的

/var分区时,如果不同的实例类型没有相同的设备名称,则无法将不同的实例类型用于计算节点。从 Butane 配置创建一个清单,并将它保存到

clusterconfig/openshift目录中。例如,运行以下命令:butane $HOME/clusterconfig/98-var-partition.bu -o $HOME/clusterconfig/openshift/98-var-partition.yaml

$ butane $HOME/clusterconfig/98-var-partition.bu -o $HOME/clusterconfig/openshift/98-var-partition.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 Ignition 配置文件:

openshift-install create ignition-configs --dir <installation_directory>

$ openshift-install create ignition-configs --dir <installation_directory>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 对于

<installation_directory>,请指定相同的安装目录。

为安装目录中的 bootstrap、control plane 和计算节点创建 Ignition 配置文件:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow <installation_directory>/manifest和<installation_directory>/openshift目录中的文件被嵌套到 Ignition 配置文件中,包括包含98-var-partition自定义MachineConfig对象的文件。

后续步骤

- 您可以通过在 RHCOS 安装过程中引用 Ignition 配置文件来应用自定义磁盘分区。

2.1.13.3.2.2. 保留现有分区

对于 ISO 安装,您可以在 coreos-installer 命令中添加可让安装程序维护一个或多个现有分区的选项。对于 PXE 安装,您可以在 APPEND 参数中添加 coreos.inst.* 选项来保留分区。

保存的分区可能是来自现有 OpenShift Container Platform 系统的数据分区。您可以通过分区标签或编号识别您要保留的磁盘分区。

如果您保存了现有分区,且这些分区没有为 RHCOS 留下足够空间,则安装将失败,而不影响保存的分区。

在 ISO 安装过程中保留现有分区

这个示例保留分区标签以 数据开头的任何分区(data *):

coreos-installer install --ignition-url http://10.0.2.2:8080/user.ign \ --save-partlabel 'data*' \ /dev/disk/by-id/scsi-<serial_number>

# coreos-installer install --ignition-url http://10.0.2.2:8080/user.ign \

--save-partlabel 'data*' \

/dev/disk/by-id/scsi-<serial_number>

以下示例演示了在运行 coreos-installer 时要保留磁盘上的第 6 个分区:

coreos-installer install --ignition-url http://10.0.2.2:8080/user.ign \ --save-partindex 6 /dev/disk/by-id/scsi-<serial_number>

# coreos-installer install --ignition-url http://10.0.2.2:8080/user.ign \

--save-partindex 6 /dev/disk/by-id/scsi-<serial_number>这个示例保留分区 5 及更高分区:

coreos-installer install --ignition-url http://10.0.2.2:8080/user.ign \ --save-partindex 5- /dev/disk/by-id/scsi-<serial_number>

# coreos-installer install --ignition-url http://10.0.2.2:8080/user.ign \

--save-partindex 5- /dev/disk/by-id/scsi-<serial_number>

在前面已保存分区的示例中,coreos-installer 会立即重新创建分区。

在 PXE 安装过程中保留现有分区

这个 APPEND 选项保留分区标签以 'data'('data*')开头的任何分区:

coreos.inst.save_partlabel=data*

coreos.inst.save_partlabel=data*

这个 APPEND 选项保留分区 5 及更高分区:

coreos.inst.save_partindex=5-

coreos.inst.save_partindex=5-

这个 APPEND 选项保留分区 6:

coreos.inst.save_partindex=6

coreos.inst.save_partindex=62.1.13.3.3. 识别 Ignition 配置

在进行 RHCOS 手动安装时,您可以提供两种 Ignition 配置类型,它们有不同的原因:

-

永久安装 Ignition 配置 :每个手动 RHCOS 安装都需要传递

openshift-installer生成的 Ignition 配置文件之一,如bootstrap.ign、master.ign和worker.ign,才能进行安装。

不建议直接修改这些 Ignition 配置文件。您可以更新嵌套到 Ignition 配置文件中的清单文件,如上一节示例中所述。

对于 PXE 安装,您可以使用 coreos.inst.ignition_url= 选项在 APPEND 行上传递 Ignition 配置。对于 ISO 安装,在 ISO 引导至 shell 提示符后,您可以使用带有 --ignition-url= 选项的 coreos-installer 命令行。在这两种情况下,只支持 HTTP 和 HTTPS 协议。

-

实时安装 Ignition 配置 :可使用

coreos-installercustomize子命令及其各种选项来创建此类型。使用此方法,Ignition 配置会传递到 live 安装介质,在引导时立即运行,并在 RHCOS 系统安装到磁盘之前或之后执行设置任务。这个方法只用于必须执行一次且之后不能再次应用的任务,比如不能使用机器配置进行的高级分区。

对于 PXE 或 ISO 引导,您可以创建 Ignition 配置,APP END ignition.config.url= 选项来标识 Ignition 配置的位置。您还需要附加 ignition.firstboot ignition.platform.id=metal 或 ignition.config.url 选项。

2.1.13.3.4. 默认控制台配置

从 OpenShift Container Platform 4.19 引导镜像安装的 Red Hat Enterprise Linux CoreOS (RHCOS) 节点使用默认控制台,旨在识别大多数虚拟化和裸机设置。不同的云和虚拟化平台可能会根据所选的架构使用不同的默认设置。裸机安装使用内核默认设置,这通常意味着图形控制台是主控制台,并且禁用串行控制台。

默认控制台可能与特定的硬件配置不匹配,或者您可能具有需要调整默认控制台的特定需求。例如:

- 您希望访问控制台上的紧急 shell 进行调试。

- 您的云平台没有提供到图形控制台的互动访问,但提供了一个串行控制台。

- 您需要启用多个控制台。

控制台配置继承自引导镜像。这意味着现有集群中的新节点不受默认控制台的影响。

您可以使用以下方法为裸机安装配置控制台:

-

在命令行中手动使用

coreos-installer。 -

使用带有

--dest-console选项的coreos-installer iso customize或coreos-installer pxe customize子命令,以创建可自动执行进程的自定义镜像。

对于高级自定义,请使用 coreos-installer iso 或 coreos-installer pxe 子命令而不是内核参数来执行控制台配置。

2.1.13.3.5. 为 PXE 和 ISO 安装启用串行控制台

默认情况下,Red Hat Enterprise Linux CoreOS (RHCOS) 串行控制台被禁用,所有输出都会写入图形控制台。您可以为 ISO 安装启用串行控制台并重新配置引导装载程序,以便输出同时发送到串行控制台和图形控制台。

流程

- 引导 ISO 安装程序.

运行

coreos-installer命令来安装系统,添加--console选项一次来指定图形控制台,然后第二次指定串行控制台:coreos-installer install \ --console=tty0 \ --console=ttyS0,<options> \ --ignition-url=http://host/worker.ign /dev/disk/by-id/scsi-<serial_number>

$ coreos-installer install \ --console=tty0 \1 --console=ttyS0,<options> \2 --ignition-url=http://host/worker.ign /dev/disk/by-id/scsi-<serial_number>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 所需的二级控制台。在这种情况下,是图形控制台。省略这个选项将禁用图形控制台。

- 2

- 所需的主控制台。在这种情况下,是串行控制台。

options字段定义 baud 速率和其他设置。此字段的一个常见值为115200n8。如果没有提供选项,则使用默认内核值9600n8。有关这个选项格式的更多信息,请参阅 Linux 内核串口控制台 文档。

重启安装的系统。

注意可以使用

coreos-installer install --append-karg选项来获取类似的结果,并使用console=指定控制台。但是,这只会为内核设置控制台,而不为引导装载程序设置控制台。

要配置 PXE 安装,请确保省略 coreos.inst.install_dev 内核命令行选项,并使用 shell 提示符使用上述 ISO 安装过程手动运行 coreos-installer。

2.1.13.3.6. 自定义 live RHCOS ISO 或 PXE 安装

您可以通过将 Ignition 配置文件直接注入镜像中来使用 live ISO 镜像或 PXE 环境来安装 RHCOS。这会创建一个自定义镜像,供您用来置备系统。

对于 ISO 镜像,此操作的机制是 coreos-installer iso custom 子命令,它使用您的配置修改 .iso 文件。同样,PXE 环境的机制是 coreos-installer pxe customize 子命令,它会创建一个包含自定义的新 initramfs 文件。

custom 子命令是一个通用工具,也可以嵌入其他类型的自定义。以下任务是一些更常见的自定义示例:

- 当公司安全策略需要使用时,注入自定义的 CA 证书。

- 在不需要内核参数的情况下配置网络设置。

- 嵌入任意预安装和安装后脚本或二进制文件。

2.1.13.3.7. 自定义 live RHCOS ISO 镜像

您可以使用 coreos-installer iso custom 子命令直接自定义 live RHCOS ISO 镜像。当您引导 ISO 镜像时,会自动应用自定义。

您可以使用此功能配置 ISO 镜像来自动安装 RHCOS。

流程

-

从

coreos-installer镜像镜像页面下载coreos-installer二进制文件。 从 RHCOS 镜像镜像页面和 Ignition 配置文件检索 RHCOS ISO 镜像,然后运行以下命令来直接将 Ignition 配置注入 ISO 镜像:

coreos-installer iso customize rhcos-<version>-live.x86_64.iso \ --dest-ignition bootstrap.ign \ --dest-device /dev/disk/by-id/scsi-<serial_number>$ coreos-installer iso customize rhcos-<version>-live.x86_64.iso \ --dest-ignition bootstrap.ign \1 --dest-device /dev/disk/by-id/scsi-<serial_number>2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选: 要删除 ISO 镜像自定义并将镜像返回到其 pristine 状态,请运行:

coreos-installer iso reset rhcos-<version>-live.x86_64.iso

$ coreos-installer iso reset rhcos-<version>-live.x86_64.isoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 现在,您可以重新自定义 live ISO 镜像,或者在其 pristine 状态中使用它。

应用您的自定义会影响每个后续 RHCOS 引导。

2.1.13.3.7.1. 修改实时安装 ISO 镜像以启用串行控制台

在使用 OpenShift Container Platform 4.12 及更高版本安装的集群中,串行控制台默认被禁用,所有输出都会写入图形控制台。您可以按照以下流程启用串行控制台。

流程

-

从

coreos-installer镜像镜像页面下载coreos-installer二进制文件。 从 RHCOS image mirror 页中获取 RHCOS ISO 镜像,并运行以下命令来自定义 ISO 镜像,使串行控制台能够接收输出:

coreos-installer iso customize rhcos-<version>-live.x86_64.iso \ --dest-ignition <path> \ --dest-console tty0 \ --dest-console ttyS0,<options> \ --dest-device /dev/disk/by-id/scsi-<serial_number>

$ coreos-installer iso customize rhcos-<version>-live.x86_64.iso \ --dest-ignition <path> \1 --dest-console tty0 \2 --dest-console ttyS0,<options> \3 --dest-device /dev/disk/by-id/scsi-<serial_number>4 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 要安装 Ignition 配置的位置。

- 2

- 所需的二级控制台。在这种情况下,是图形控制台。省略这个选项将禁用图形控制台。

- 3

- 所需的主控制台。在这种情况下,是串行控制台。

options字段定义 baud 速率和其他设置。此字段的一个常见值为115200n8。如果没有提供选项,则使用默认内核值9600n8。有关这个选项格式的更多信息,请参阅 Linux 内核串口控制台文档。 - 4

- 要安装到的指定磁盘。如果省略这个选项,ISO 镜像会自动运行安装程序,除非还指定了

coreos.inst.install_dev内核参数。

注意--dest-console选项会影响安装的系统,而不是实时 ISO 系统。要修改 live ISO 系统的控制台,请使用--live-karg-append选项并使用console=指定控制台。自定义会被应用,并影响每个后续 ISO 镜像引导。

可选: 要删除 ISO 镜像自定义并将镜像返回到其原始状态,请运行以下命令:

coreos-installer iso reset rhcos-<version>-live.x86_64.iso

$ coreos-installer iso reset rhcos-<version>-live.x86_64.isoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 现在,您可以重新自定义 live ISO 镜像,或者在其原始状态中使用它。

2.1.13.3.7.2. 修改实时安装 ISO 镜像以使用自定义证书颁发机构

您可以使用 custom 子命令的 --ignition-ca 标志向 Ignition 提供证书颁发机构(CA)证书。您可以在安装过程中使用 CA 证书,并在置备安装的系统时使用 CA 证书。

自定义 CA 证书会影响 Ignition 获取远程资源的方式,但它们不会影响安装到系统中的证书。

流程

-

从

coreos-installer镜像镜像页面下载coreos-installer二进制文件。 从 RHCOS 镜像镜像页面检索 RHCOS ISO 镜像,并运行以下命令来自定义 ISO 镜像以用于自定义 CA:

coreos-installer iso customize rhcos-<version>-live.x86_64.iso --ignition-ca cert.pem

$ coreos-installer iso customize rhcos-<version>-live.x86_64.iso --ignition-ca cert.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow

coreos.inst.ignition_url 内核参数无法使用 --ignition-ca 标志。您必须使用 --dest-ignition 标志为每个集群创建自定义镜像。

应用自定义 CA 证书会影响每个后续 RHCOS 引导。

2.1.13.3.7.3. 使用自定义网络设置修改实时安装 ISO 镜像

您可以将 NetworkManager 密钥文件嵌入到 live ISO 镜像中,并使用 customize 子命令的 --network-keyfile 标志将其传递给安装的系统。

在创建连接配置文件时,您必须在连接配置文件的文件名中使用 .nmconnection 文件名扩展名。如果不使用 .nmconnection 文件名扩展,集群会将连接配置集应用到 live 环境,但它不会在集群首次启动节点时应用配置,从而导致无法正常工作的设置。

流程

-

从

coreos-installer镜像镜像页面下载coreos-installer二进制文件。 为绑定接口创建连接配置集。例如,在本地目录中创建

bond0.nmconnection文件,其内容如下:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 为二级接口创建连接配置集,以添加到绑定中。例如,在本地目录中创建

bond0-proxy-em1.nmconnection文件,其内容如下:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 为二级接口创建连接配置集,以添加到绑定中。例如,在本地目录中创建

bond0-proxy-em2.nmconnection文件,其内容如下:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 从 RHCOS 镜像镜像页面检索 RHCOS ISO 镜像,并运行以下命令来使用您配置网络自定义 ISO 镜像:

coreos-installer iso customize rhcos-<version>-live.x86_64.iso \ --network-keyfile bond0.nmconnection \ --network-keyfile bond0-proxy-em1.nmconnection \ --network-keyfile bond0-proxy-em2.nmconnection$ coreos-installer iso customize rhcos-<version>-live.x86_64.iso \ --network-keyfile bond0.nmconnection \ --network-keyfile bond0-proxy-em1.nmconnection \ --network-keyfile bond0-proxy-em2.nmconnectionCopy to Clipboard Copied! Toggle word wrap Toggle overflow 网络设置应用于实时系统,并传输到目标系统。

2.1.13.3.7.4. 为 iSCSI 引导设备自定义实时安装 ISO 镜像

您可以设置 iSCSI 目标和 initiator 值,以便使用自定义的 live RHCOS 镜像版本自动挂载、引导和配置。

先决条件

- 您有一个 iSCSI 目标,您要在其中安装 RHCOS。

流程

-

从

coreos-installer镜像镜像页面下载coreos-installer二进制文件。 从 RHCOS 镜像镜像页面检索 RHCOS ISO 镜像,并运行以下命令使用以下信息自定义 ISO 镜像:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 有关

dracut支持的 iSCSI 选项的更多信息,请参阅dracut.cmdline手册页。

2.1.13.3.7.5. 使用 iBFT 为 iSCSI 引导设备自定义实时安装 ISO 镜像

您可以设置 iSCSI 目标和 initiator 值,以便使用自定义的 live RHCOS 镜像版本自动挂载、引导和配置。

先决条件

- 您有一个 iSCSI 目标,您要在其中安装 RHCOS。

- 可选:有多路径 iSCSI 目标。

流程

-

从

coreos-installer镜像镜像页面下载coreos-installer二进制文件。 从 RHCOS 镜像镜像页面检索 RHCOS ISO 镜像,并运行以下命令使用以下信息自定义 ISO 镜像:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 有关

dracut支持的 iSCSI 选项的更多信息,请参阅dracut.cmdline手册页。

2.1.13.3.8. 自定义 live RHCOS PXE 环境

您可以使用 coreos-installer pxe customize 子命令直接自定义 live RHCOS PXE 环境。当您引导 PXE 环境时,会自动应用自定义。

您可以使用此功能配置 PXE 环境来自动安装 RHCOS。

流程

-

从

coreos-installer镜像镜像页面下载coreos-installer二进制文件。 从 RHCOS 镜像镜像页面和 Ignition 配置文件获取 RHCOS

kernel,initramfs和rootfs文件,然后运行以下命令创建一个包含 Ignition 配置中的自定义的新initramfs文件:coreos-installer pxe customize rhcos-<version>-live-initramfs.x86_64.img \ --dest-ignition bootstrap.ign \ --dest-device /dev/disk/by-id/scsi-<serial_number> \ -o rhcos-<version>-custom-initramfs.x86_64.img$ coreos-installer pxe customize rhcos-<version>-live-initramfs.x86_64.img \ --dest-ignition bootstrap.ign \1 --dest-device /dev/disk/by-id/scsi-<serial_number> \2 -o rhcos-<version>-custom-initramfs.x86_64.img3 Copy to Clipboard Copied! Toggle word wrap Toggle overflow

应用您的自定义会影响每个后续 RHCOS 引导。

2.1.13.3.8.1. 修改实时安装 PXE 环境以启用串行控制台。

在使用 OpenShift Container Platform 4.12 及更高版本安装的集群中,串行控制台默认被禁用,所有输出都会写入图形控制台。您可以按照以下流程启用串行控制台。

流程

-

从

coreos-installer镜像镜像页面下载coreos-installer二进制文件。 从 RHCOS image mirror 页面获取

kernel,initramfs和rootfs文件,然后运行以下命令来创建新的自定义initramfs文件,以便串行控制台接收输出:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 要安装 Ignition 配置的位置。

- 2

- 所需的二级控制台。在这种情况下,是图形控制台。省略这个选项将禁用图形控制台。

- 3

- 所需的主控制台。在这种情况下,是串行控制台。

options字段定义 baud 速率和其他设置。此字段的一个常见值为115200n8。如果没有提供选项,则使用默认内核值9600n8。有关这个选项格式的更多信息,请参阅 Linux 内核串口控制台文档。 - 4

- 要安装到的指定磁盘。如果省略这个选项,PXE 环境会自动运行安装程序,除非还指定了

coreos.inst.install_dev内核参数。 - 5

- 在 PXE 配置中使用自定义

initramfs文件。添加ignition.firstboot和ignition.platform.id=metal内核参数(如果它们尚不存在)。

自定义会被应用,并影响 PXE 环境的每个后续引导。

2.1.13.3.8.2. 修改实时安装 PXE 环境以使用自定义证书颁发机构

您可以使用 custom 子命令的 --ignition-ca 标志向 Ignition 提供证书颁发机构(CA)证书。您可以在安装过程中使用 CA 证书,并在置备安装的系统时使用 CA 证书。

自定义 CA 证书会影响 Ignition 获取远程资源的方式,但它们不会影响安装到系统中的证书。

流程

-

从

coreos-installer镜像镜像页面下载coreos-installer二进制文件。 从 RHCOS 镜像镜像页面获取 RHCOS

kernel、initramfs和rootfs文件,并运行以下命令来创建一个新的自定义initramfs文件以用于自定义 CA:coreos-installer pxe customize rhcos-<version>-live-initramfs.x86_64.img \ --ignition-ca cert.pem \ -o rhcos-<version>-custom-initramfs.x86_64.img$ coreos-installer pxe customize rhcos-<version>-live-initramfs.x86_64.img \ --ignition-ca cert.pem \ -o rhcos-<version>-custom-initramfs.x86_64.imgCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

在 PXE 配置中使用自定义

initramfs文件。添加ignition.firstboot和ignition.platform.id=metal内核参数(如果它们尚不存在)。

coreos.inst.ignition_url 内核参数无法使用 --ignition-ca 标志。您必须使用 --dest-ignition 标志为每个集群创建自定义镜像。

应用自定义 CA 证书会影响每个后续 RHCOS 引导。

2.1.13.3.8.3. 使用自定义网络设置修改实时安装 PXE 环境

您可以将 NetworkManager 密钥文件嵌入到 live PXE 环境中,并使用 customize 子命令的 --network-keyfile 标志将其传递给安装的系统。

在创建连接配置文件时,您必须在连接配置文件的文件名中使用 .nmconnection 文件名扩展名。如果不使用 .nmconnection 文件名扩展,集群会将连接配置集应用到 live 环境,但它不会在集群首次启动节点时应用配置,从而导致无法正常工作的设置。

流程

-

从

coreos-installer镜像镜像页面下载coreos-installer二进制文件。 为绑定接口创建连接配置集。例如,在本地目录中创建

bond0.nmconnection文件,其内容如下:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 为二级接口创建连接配置集,以添加到绑定中。例如,在本地目录中创建

bond0-proxy-em1.nmconnection文件,其内容如下:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 为二级接口创建连接配置集,以添加到绑定中。例如,在本地目录中创建

bond0-proxy-em2.nmconnection文件,其内容如下:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 从 RHCOS 镜像镜像页面获取 RHCOS

kernel、initramfs和rootfs文件,并运行以下命令来创建一个新的自定义initramfs文件,它包括您的配置网络:coreos-installer pxe customize rhcos-<version>-live-initramfs.x86_64.img \ --network-keyfile bond0.nmconnection \ --network-keyfile bond0-proxy-em1.nmconnection \ --network-keyfile bond0-proxy-em2.nmconnection \ -o rhcos-<version>-custom-initramfs.x86_64.img$ coreos-installer pxe customize rhcos-<version>-live-initramfs.x86_64.img \ --network-keyfile bond0.nmconnection \ --network-keyfile bond0-proxy-em1.nmconnection \ --network-keyfile bond0-proxy-em2.nmconnection \ -o rhcos-<version>-custom-initramfs.x86_64.imgCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在 PXE 配置中使用自定义

initramfs文件。添加ignition.firstboot和ignition.platform.id=metal内核参数(如果它们尚不存在)。网络设置应用于实时系统,并传输到目标系统。

2.1.13.3.8.4. 为 iSCSI 引导设备自定义实时安装 PXE 环境

您可以设置 iSCSI 目标和 initiator 值,以便使用自定义的 live RHCOS 镜像版本自动挂载、引导和配置。

先决条件

- 您有一个 iSCSI 目标,您要在其中安装 RHCOS。

流程

-

从

coreos-installer镜像镜像页面下载coreos-installer二进制文件。 从 RHCOS image mirror 页获取 RHCOS

kernel、initramfs和rootfs文件,并运行以下命令来使用以下信息创建新的自定义initramfs文件:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 有关

dracut支持的 iSCSI 选项的更多信息,请参阅dracut.cmdline手册页。

2.1.13.3.8.5. 使用 iBFT 为 iSCSI 引导设备自定义实时安装 PXE 环境

您可以设置 iSCSI 目标和 initiator 值,以便使用自定义的 live RHCOS 镜像版本自动挂载、引导和配置。

先决条件

- 您有一个 iSCSI 目标,您要在其中安装 RHCOS。

- 可选:有多路径 iSCSI 目标。

流程

-

从

coreos-installer镜像镜像页面下载coreos-installer二进制文件。 从 RHCOS image mirror 页获取 RHCOS

kernel、initramfs和rootfs文件,并运行以下命令来使用以下信息创建新的自定义initramfs文件:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 有关

dracut支持的 iSCSI 选项的更多信息,请参阅dracut.cmdline手册页。

2.1.13.3.9. 高级 RHCOS 安装参考

本节演示了网络配置和其他高级选项,允许您修改 Red Hat Enterprise Linux CoreOS(RHCOS)手动安装过程。下表描述了您可以用于 RHCOS live 安装程序和 coreos-installer 命令的内核参数和命令行选项。

2.1.13.3.9.1. ISO 安装的网络和绑定选项

如果从 ISO 镜像安装 RHCOS,您可以在引导镜像时手动添加内核参数,以便为节点配置网络。如果没有指定网络参数,当 RHCOS 检测到需要网络来获取 Ignition 配置文件时,在 initramfs 中激活 DHCP。

在手动添加网络参数时,还必须添加 rd.neednet=1 内核参数,以便在 initramfs 中启动网络。

以下信息提供了在 RHCOS 节点上为 ISO 安装配置网络和绑定的示例。示例描述了如何使用 ip=、name server = 和 bond= 内核参数。

添加内核参数时顺序非常重要: ip=、name server=,然后 bond=。

网络选项在系统引导过程中传递给 dracut 工具。有关 dracut 支持的网络选项的更多信息,请参阅 dracut.cmdline 手册页。

以下示例是 ISO 安装的网络选项。

2.1.13.3.9.1.1. 配置 DHCP 或静态 IP 地址

要配置 IP 地址,可使用 DHCP(ip=dhcp)或设置单独的静态 IP 地址(ip=<host_ip>)。如果设置静态 IP,则必须在每个节点上识别 DNS 服务器 IP 地址(名称服务器=<dns_ip>)。以下示例集:

-

节点的 IP 地址为

10.10.10.2 -

网关地址为

10.10.10.254 -

子网掩码为

255.255.255.0 -

到

core0.example.com的主机名 -

DNS 服务器地址为

4.4.4.41 -

自动配置值为

none。当以静态方式配置 IP 网络时,不需要自动配置。

ip=10.10.10.2::10.10.10.254:255.255.255.0:core0.example.com:enp1s0:none nameserver=4.4.4.41

ip=10.10.10.2::10.10.10.254:255.255.255.0:core0.example.com:enp1s0:none

nameserver=4.4.4.41当您使用 DHCP 为 RHCOS 机器配置 IP 寻址时,机器还通过 DHCP 获取 DNS 服务器信息。对于基于 DHCP 的部署,您可以通过 DHCP 服务器配置定义 RHCOS 节点使用的 DNS 服务器地址。

2.1.13.3.9.1.2. 配置没有静态主机名的 IP 地址

您可以在不分配静态主机名的情况下配置 IP 地址。如果用户没有设置静态主机名,则会提取并通过反向 DNS 查找自动设置。要在没有静态主机名的情况下配置 IP 地址,请参考以下示例:

-

节点的 IP 地址为

10.10.10.2 -

网关地址为

10.10.10.254 -

子网掩码为

255.255.255.0 -

DNS 服务器地址为

4.4.4.41 -

自动配置值为

none。当以静态方式配置 IP 网络时,不需要自动配置。

ip=10.10.10.2::10.10.10.254:255.255.255.0::enp1s0:none nameserver=4.4.4.41

ip=10.10.10.2::10.10.10.254:255.255.255.0::enp1s0:none

nameserver=4.4.4.412.1.13.3.9.1.3. 指定多个网络接口

您可以通过设置多个 ip= 条目来指定多个网络接口。

ip=10.10.10.2::10.10.10.254:255.255.255.0:core0.example.com:enp1s0:none ip=10.10.10.3::10.10.10.254:255.255.255.0:core0.example.com:enp2s0:none

ip=10.10.10.2::10.10.10.254:255.255.255.0:core0.example.com:enp1s0:none

ip=10.10.10.3::10.10.10.254:255.255.255.0:core0.example.com:enp2s0:none2.1.13.3.9.1.4. 配置默认网关和路由

可选:您可以通过设置 a rd.route= 值来配置到额外网络的路由。

当您配置一个或多个网络时,需要一个默认网关。如果额外网络网关与主要网络网关不同,则默认网关必须是主要网络网关。

运行以下命令来配置默认网关:

ip=::10.10.10.254::::

ip=::10.10.10.254::::Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令为额外网络配置路由:

rd.route=20.20.20.0/24:20.20.20.254:enp2s0

rd.route=20.20.20.0/24:20.20.20.254:enp2s0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.13.3.9.1.5. 在单个接口中禁用 DHCP

您可以在单一接口中禁用 DHCP,例如当有两个或者多个网络接口时,且只有一个接口被使用。在示例中,enp1s0 接口具有一个静态网络配置,而 enp2s0 禁用了 DHCP,不使用它:

ip=10.10.10.2::10.10.10.254:255.255.255.0:core0.example.com:enp1s0:none ip=::::core0.example.com:enp2s0:none

ip=10.10.10.2::10.10.10.254:255.255.255.0:core0.example.com:enp1s0:none

ip=::::core0.example.com:enp2s0:none2.1.13.3.9.1.6. 合并 DHCP 和静态 IP 配置

您可以将系统上的 DHCP 和静态 IP 配置与多个网络接口合并,例如:

ip=enp1s0:dhcp ip=10.10.10.2::10.10.10.254:255.255.255.0:core0.example.com:enp2s0:none

ip=enp1s0:dhcp

ip=10.10.10.2::10.10.10.254:255.255.255.0:core0.example.com:enp2s0:none2.1.13.3.9.1.7. 在独立接口上配置 VLAN

可选: 您可以使用 vlan= 参数在单个接口上配置 VLAN。

要在网络接口中配置 VLAN 并使用静态 IP 地址,请运行以下命令:

ip=10.10.10.2::10.10.10.254:255.255.255.0:core0.example.com:enp2s0.100:none vlan=enp2s0.100:enp2s0

ip=10.10.10.2::10.10.10.254:255.255.255.0:core0.example.com:enp2s0.100:none vlan=enp2s0.100:enp2s0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要在网络接口中配置 VLAN 并使用 DHCP,请运行以下命令:

ip=enp2s0.100:dhcp vlan=enp2s0.100:enp2s0

ip=enp2s0.100:dhcp vlan=enp2s0.100:enp2s0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.13.3.9.1.8. 提供多个 DNS 服务器

您可以通过为每个服务器添加一个 nameserver= 条目来提供多个 DNS 服务器,例如

nameserver=1.1.1.1 nameserver=8.8.8.8

nameserver=1.1.1.1

nameserver=8.8.8.82.1.13.3.9.1.9. 将多个网络接口绑定到一个接口

可选: 您可以使用 bond= 选项将多个网络接口绑定到一个接口。请参见以下示例:

配置绑定接口的语法为:

bond=<name>[:<network_interfaces>][:options]<name>是绑定设备名称 (bond0)、<network_interfaces>代表以逗号分隔的物理(以太网)接口列表(em1,em2),options 是用逗号分开的绑定选项列表。输入modinfo bonding查看可用选项。当使用

bond=创建绑定接口时,您必须指定如何分配 IP 地址以及绑定接口的其他信息。要将绑定接口配置为使用 DHCP,请将绑定的 IP 地址设置为

dhcp。例如:bond=bond0:em1,em2:mode=active-backup ip=bond0:dhcp

bond=bond0:em1,em2:mode=active-backup ip=bond0:dhcpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要将绑定接口配置为使用静态 IP 地址,请输入您需要的特定 IP 地址和相关信息。例如:

bond=bond0:em1,em2:mode=active-backup ip=10.10.10.2::10.10.10.254:255.255.255.0:core0.example.com:bond0:none

bond=bond0:em1,em2:mode=active-backup ip=10.10.10.2::10.10.10.254:255.255.255.0:core0.example.com:bond0:noneCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.13.3.9.1.10. 将多个 SR-IOV 网络接口绑定到双端口 NIC 接口

可选: 您可以使用 bond= 选项将多个 SR-IOV 网络接口绑定到双端口 NIC 接口。

在每个节点上,您必须执行以下任务:

- 按照管理 SR-IOV 设备中的指导创建 SR-IOV 虚拟功能(VF)。按照"将 SR-IOV 网络设备附加到虚拟机"部分中的步骤操作。

- 创建绑定,将所需的 VF 附加到绑定,并根据配置网络绑定的指导设置绑定链接状态。按照任何描述的步骤创建绑定。

以下示例演示了您必须使用的语法:

配置绑定接口的语法为:

bond=<name>[:<network_interfaces>][:options]<name>是绑定设备名称 (bond0)、<network_interfaces>由内核中已知的名称来代表虚拟功能(VF),并显示在ip link命令的输出中 (eno1f0,eno2f0),options 是以逗号分隔的绑定选项列表。输入modinfo bonding查看可用选项。当使用

bond=创建绑定接口时,您必须指定如何分配 IP 地址以及绑定接口的其他信息。要将绑定接口配置为使用 DHCP,请将绑定的 IP 地址设置为

dhcp。例如:bond=bond0:eno1f0,eno2f0:mode=active-backup ip=bond0:dhcp

bond=bond0:eno1f0,eno2f0:mode=active-backup ip=bond0:dhcpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要将绑定接口配置为使用静态 IP 地址,请输入您需要的特定 IP 地址和相关信息。例如:

bond=bond0:eno1f0,eno2f0:mode=active-backup ip=10.10.10.2::10.10.10.254:255.255.255.0:core0.example.com:bond0:none

bond=bond0:eno1f0,eno2f0:mode=active-backup ip=10.10.10.2::10.10.10.254:255.255.255.0:core0.example.com:bond0:noneCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.13.3.9.1.11. 使用网络团队

可选: 您可以使用 team= 参数来将网络团队用作绑定的替代选择:

配置组接口的语法为:

team=name[:network_interfaces]name 是组设备名称(

team0),network_interfaces 代表以逗号分隔的物理(以太网)接口(em1、em2)列表。

当 RHCOS 切换到即将推出的 RHEL 版本时,团队(team)功能被计划弃用。如需更多信息,请参阅红帽知识库文章。

使用以下示例配置网络团队:

team=team0:em1,em2 ip=team0:dhcp

team=team0:em1,em2

ip=team0:dhcp2.1.13.3.9.2. ISO 和 PXE 安装的 coreos-installer 选项

从 ISO 镜像引导 RHCOS live 环境后,您可以通过 在命令提示符下运行 coreos-installer install <options> <device > 来安装 RHCOS。

下表显示了您可以传递给 coreos-installer 命令的子命令、选项和参数。

| coreos-installer install 子命令 | |

| 子命令 | 描述 |

|

| 在 ISO 镜像中嵌入 Ignition 配置。 |

| coreos-installer install 子命令选项 | |

| 选项 | 描述 |

|

| 手动指定镜像 URL。 |

|

| 手动指定本地镜像文件。用于调试。 |

|

| 从文件中嵌入 Ignition 配置。 |

|

| 从 URL 嵌入 Ignition 配置。 |

|

|

Ignition 配置 |

|

| 覆盖已安装系统的 Ignition 平台 ID。 |

|

|

为安装的系统设置内核和引导装载程序控制台。有关 |

|