This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.可伸缩性和性能

扩展 OpenShift Container Platform 集群并调整产品环境的性能

摘要

第 1 章 推荐的主机实践

本节为 OpenShift Container Platform 提供推荐的主机实践。

这些指南适用于带有软件定义网络(SDN)而不是开放虚拟网络(OVN)的 OpenShift Container Platform。

1.1. 推荐的节点主机实践

OpenShift Container Platform 节点配置文件包含重要的选项。例如,控制可以为节点调度的最大 pod 数量的两个参数: podsPerCore 和 maxPods。

当两个参数都被设置时,其中较小的值限制了节点上的 pod 数量。超过这些值可导致:

- CPU 使用率增加。

- 减慢 pod 调度的速度。

- 根据节点中的内存数量,可能出现内存耗尽的问题。

- 耗尽 IP 地址池。

- 资源过量使用,导致用户应用程序性能变差。

在 Kubernetes 中,包含单个容器的 pod 实际使用两个容器。第二个容器用来在实际容器启动前设置联网。因此,运行 10 个 pod 的系统实际上会运行 20 个容器。

云供应商的磁盘 IOPS 节流可能会对 CRI-O 和 kubelet 产生影响。当节点上运行大量 I/O 高负载的 pod 时,可能会出现超载的问题。建议您监控节点上的磁盘 I/O,并使用有足够吞吐量的卷。

podsPerCore 根据节点中的处理器内核数来设置节点可运行的 pod 数量。例如:在一个有 4 个处理器内核的节点上将 podsPerCore 设为 10 ,则该节点上允许的最大 pod 数量为 40。

kubeletConfig: podsPerCore: 10

kubeletConfig:

podsPerCore: 10

将 podsPerCore 设置为 0 可禁用这个限制。默认为 0。podsPerCore 不能超过 maxPods。

maxPods 把节点可以运行的 pod 数量设置为一个固定值,而不需要考虑节点的属性。

kubeletConfig:

maxPods: 250

kubeletConfig:

maxPods: 2501.2. 创建 KubeletConfig CRD 来编辑 kubelet 参数

kubelet 配置目前被序列化为 Ignition 配置,因此可以直接编辑。但是,在 Machine Config Controller (MCC) 中同时添加了新的 kubelet-config-controller 。这可让您使用 KubeletConfig 自定义资源 (CR) 来编辑 kubelet 参数。

因为 kubeletConfig 对象中的字段直接从上游 Kubernetes 传递给 kubelet,kubelet 会直接验证这些值。kubeletConfig 对象中的无效值可能会导致集群节点不可用。有关有效值,请参阅 Kubernetes 文档。

请考虑以下指导:

-

为每个机器配置池创建一个

KubeletConfigCR,带有该池需要更改的所有配置。如果要将相同的内容应用到所有池,则所有池仅需要一个KubeletConfigCR。 -

编辑现有的

KubeletConfigCR 以修改现有设置或添加新设置,而不是为每个更改创建一个 CR。建议您仅创建一个 CR 来修改不同的机器配置池,或用于临时更改,以便您可以恢复更改。 -

根据需要,创建多个

KubeletConfigCR,每个集群限制为 10。对于第一个KubeletConfigCR,Machine Config Operator (MCO) 会创建一个机器配置,并附带kubelet。对于每个后续 CR,控制器会创建另一个带有数字后缀的kubelet机器配置。例如,如果您有一个带有-2后缀的kubelet机器配置,则下一个kubelet机器配置会附加-3。

如果要删除机器配置,以相反的顺序删除它们,以避免超过限制。例如,在删除 kubelet-2 机器配置前删除 kubelet-3 机器配置。

如果您有一个带有 kubelet-9 后缀的机器配置,并且创建了另一个 KubeletConfig CR,则不会创建新的机器配置,即使少于 10 个 kubelet 机器配置。

KubeletConfig CR 示例

oc get kubeletconfig

$ oc get kubeletconfigNAME AGE set-max-pods 15m

NAME AGE

set-max-pods 15m显示 KubeletConfig 机器配置示例

oc get mc | grep kubelet

$ oc get mc | grep kubelet... 99-worker-generated-kubelet-1 b5c5119de007945b6fe6fb215db3b8e2ceb12511 3.2.0 26m ...

...

99-worker-generated-kubelet-1 b5c5119de007945b6fe6fb215db3b8e2ceb12511 3.2.0 26m

...以下流程演示了如何配置 worker 节点上的每个节点的最大 pod 数量。

先决条件

为您要配置的节点类型获取与静态

MachineConfigPoolCR 关联的标签。执行以下步骤之一:查看机器配置池:

oc describe machineconfigpool <name>

$ oc describe machineconfigpool <name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

oc describe machineconfigpool worker

$ oc describe machineconfigpool workerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 如果添加了标签,它会出现在

labels下。

如果标签不存在,则添加一个键/值对:

oc label machineconfigpool worker custom-kubelet=set-max-pods

$ oc label machineconfigpool worker custom-kubelet=set-max-podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

流程

查看您可以选择的可用机器配置对象:

oc get machineconfig

$ oc get machineconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow 默认情况下,与 kubelet 相关的配置为

01-master-kubelet和01-worker-kubelet。检查每个节点的最大 pod 的当前值:

oc describe node <node_name>

$ oc describe node <node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例如:

oc describe node ci-ln-5grqprb-f76d1-ncnqq-worker-a-mdv94

$ oc describe node ci-ln-5grqprb-f76d1-ncnqq-worker-a-mdv94Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在

Allocatable小节中找到value: pods: <value>:输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 通过创建一个包含 kubelet 配置的自定义资源文件,设置 worker 节点上的每个节点的最大 pod:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意kubelet 与 API 服务器进行交互的频率取决于每秒的查询数量 (QPS) 和 burst 值。如果每个节点上运行的 pod 数量有限,使用默认值(

kubeAPIQPS为50,kubeAPIBurst为100)就可以。如果节点上有足够 CPU 和内存资源,则建议更新 kubelet QPS 和 burst 速率。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 为带有标签的 worker 更新机器配置池:

oc label machineconfigpool worker custom-kubelet=large-pods

$ oc label machineconfigpool worker custom-kubelet=large-podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建

KubeletConfig对象:oc create -f change-maxPods-cr.yaml

$ oc create -f change-maxPods-cr.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证

KubeletConfig对象是否已创建:oc get kubeletconfig

$ oc get kubeletconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME AGE set-max-pods 15m

NAME AGE set-max-pods 15mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 根据集群中的 worker 节点数量,等待每个 worker 节点被逐个重启。对于有 3 个 worker 节点的集群,这个过程可能需要大约 10 到 15 分钟。

验证更改是否已应用到节点:

在 worker 节点上检查

maxPods值已更改:oc describe node <node_name>

$ oc describe node <node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 找到

Allocatable小节:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 在本例中,

pods参数应报告您在KubeletConfig对象中设置的值。

验证

KubeletConfig对象中的更改:oc get kubeletconfigs set-max-pods -o yaml

$ oc get kubeletconfigs set-max-pods -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 这应该会显示

status: "True"和type:Success:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.4. Control plane 节点大小

control plane 节点对资源的要求取决于集群中的节点数量。以下推荐的 control plane 节点大小是基于 control plane 密度测试的结果。control plane 测试会根据节点数在每个命名空间中在集群中创建以下对象:

- 12 个镜像流

- 3 个构建配置

- 6 个构建

- 1 个部署,带有 2 个 pod 副本,每个都挂载两个 secret

- 2 个部署,带有 1 个 pod 副本,挂载了两个 secret

- 3 个指向以前部署的服务

- 3 个指向之前部署的路由

- 10 个 secret,其中 2 个由以前的部署挂载

- 10 个配置映射,其中 2 个由以前的部署挂载

| worker 节点数量 | 集群负载(命名空间) | CPU 内核 | 内存 (GB) |

|---|---|---|---|

| 25 | 500 | 4 | 16 |

| 100 | 1000 | 8 | 32 |

| 250 | 4000 | 16 | 96 |

在具有三个 master 或 control plane 节点的大型高密度集群中,当其中一个节点停止、重启或失败时,CPU 和内存用量将会激增。故障可能是因为电源、网络或底层基础架构出现意外问题,除了在关闭集群后重启集群以节约成本的情况下。其余两个 control plane 节点必须处理负载才能高度可用,从而增加资源使用量。另外,在升级过程中还会有这个预期,因为 master 被封锁、排空并按顺序重新引导,以应用操作系统更新以及 control plane Operator 更新。为了避免级联失败,请将 control plane 节点上的总体 CPU 和内存资源使用量保留为最多 60% 的所有可用容量,以处理资源使用量激增。相应地增加 control plane 节点上的 CPU 和内存,以避免因为缺少资源而造成潜在的停机。

节点大小取决于集群中的节点和对象数量。它还取决于集群上是否正在主动创建这些对象。在创建对象时,control plane 在资源使用量方面与对象处于运行(running)阶段的时间相比更活跃。

Operator Lifecycle Manager(OLM)在 control plane 节点上运行,其内存占用量取决于 OLM 在集群中管理的命名空间和用户安装的 operator 的数量。Control plane 节点需要相应地调整大小,以避免 OOM 终止。以下数据基于集群最大测试的结果。

| 命名空间数量 | 处于空闲状态的 OLM 内存(GB) | 安装了 5 个用户 operator 的 OLM 内存(GB) |

|---|---|---|

| 500 | 0.823 | 1.7 |

| 1000 | 1.2 | 2.5 |

| 1500 | 1.7 | 3.2 |

| 2000 | 2 | 4.4 |

| 3000 | 2.7 | 5.6 |

| 4000 | 3.8 | 7.6 |

| 5000 | 4.2 | 9.02 |

| 6000 | 5.8 | 11.3 |

| 7000 | 6.6 | 12.9 |

| 8000 | 6.9 | 14.8 |

| 9000 | 8 | 17.7 |

| 10,000 | 9.9 | 21.6 |

如果使用安装程序置备的基础架构安装方法,则无法修改正在运行的 OpenShift Container Platform 4.8 集群中的 control plane 节点大小。反之,您必须估计节点总数并在安装过程中使用推荐的 control plane 节点大小。

建议基于在带有 OpenShiftSDN 作为网络插件的 OpenShift Container Platform 集群上捕获的数据点。

在 OpenShift Container Platform 4.8 中,与 OpenShift Container Platform 3.11 及之前的版本相比,系统现在默认保留半个 CPU 内核(500 millicore)。确定大小时应该考虑这一点。

1.4.1. 增加 Amazon Web Services(AWS)master 实例的类别大小

当您在集群中过载 AWS master 节点并且 master 节点需要更多资源时,您可以增加 master 实例的类别文件大小。

建议您在增大 AWS master 实例的类别大小前备份 etcd。

先决条件

- AWS 上有一个 IPI(安装程序置备的基础架构)或 UPI(用户置备的基础架构)集群。

流程

- 打开 AWS 控制台,获取 master 实例。

- 停止一个 master 实例。

- 选择已停止的实例,然后点 Actions → Instance Settings → Change instance type。

-

将实例更改为较大的类型,确保类型与之前选择相同,并应用更改。例如,您可以将

m5.xlarge更改为m5.2xlarge或m5.4xlarge。 - 备份实例,再对下一个 master 实例重复上述步骤。

1.5. 推荐的 etcd 实践

因为 etcd 将数据写入磁盘并在磁盘上持久化,所以其性能取决于磁盘性能。虽然 etcd 并不是有非常高的 I/O 负载,但它需要使用一个具有低延迟的块设备才能获得最佳性能和稳定性。因为 etcd 的共识协议依赖于将元数据永久存储到一个日志 (WAL),所以 etcd 对磁盘的写延迟非常敏感。减慢来自其他进程的磁盘活动和磁盘活动可能会导致长时间的 fsync 延迟。

这些延迟可能会导致 etcd 丢失心跳,不会及时向磁盘提交新的建议,并最终遇到请求超时和临时丢失问题。高写入延迟也会导致 OpenShift API 较慢,这会影响集群性能。因此,需要避免在 control-plane 节点运行其他工作负载。

就延迟而言,应该在一个可最少以 50 IOPS 按顺序写入 8000 字节的块设备上运行。也就是说,当有一个 20ms 的延迟时,使用 fdatasync 来同步 WAL 中的写入操作。对于高负载的集群,建议使用 8000 字节的连续 500 IOPS (2 毫秒)。要测量这些数字,您可以使用基准测试工具,如 fio。

要实现这样的性能,在由低延迟和高吞吐量的 SSD 或 NVMe 磁盘支持的机器上运行 etcd。考虑使用单层单元(SLC)固态驱动器(SSD)(它为每个内存单元提供 1 位),这是可靠的,非常适合于写密集型工作负载。

以下硬盘功能提供最佳的 etcd 性能:

- 支持快速读取操作的低延迟。

- 高带宽写入,实现更快速的压缩和碎片处理。

- 高带宽读取,加快从故障恢复。

- 固态硬盘是最小的选择,NVMe 驱动器是首选的。

- 来自不同制造商的服务器级硬件可以提高可靠性。

- RAID 0 技术以提高性能。

- 专用 etcd 驱动器。不要将日志文件或其他重重工作负载放在 etcd 驱动器中。

避免 NAS 或 SAN 设置,以及旋转驱动器。始终使用相关工具(如 fio)进行基准测试。在增加时,持续监控集群性能。

避免使用网络文件系统 (NFS) 协议或其他基于网络的文件系统。

需要在部署的 OpenShift Container Platform 集群上监控的一些关键指标包括,日志持续时间之前的 etcd 磁盘写入的 p99 值,以及 etcd leader 更改的数量。使用 Prometheus 跟踪这些指标。

要在创建 OpenShift Container Platform 集群之前或之后验证 etcd 的硬件,您可以使用 fio。

先决条件

- 您正在测试的机器上安装了 Podman 或 Docker 等容器运行时。

-

数据被写入

/var/lib/etcd路径。

流程

运行 fio 并分析结果:

如果使用 Podman,请运行以下命令:

sudo podman run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/openshift-scale/etcd-perf

$ sudo podman run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/openshift-scale/etcd-perfCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果使用 Docker,请运行以下命令:

sudo docker run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/openshift-scale/etcd-perf

$ sudo docker run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/openshift-scale/etcd-perfCopy to Clipboard Copied! Toggle word wrap Toggle overflow

输出会报告磁盘是否足够快以运行 etcd,它会检查测试运行中获得的 fsync 指标的 p99 值是否小于 20ms。一些最重要的 etcd 指标可能受到 I/O 性能的影响,如下所示:

-

etcd_disk_wal_fsync_duration_seconds_bucket指标报告了 etcd 的 WAL fsync 持续时间。 -

etcd_disk_backend_commit_duration_seconds_bucket指标报告 etcd 后端提交延迟持续时间 -

etcd_server_leader_changes_seen_total指标报告领导更改

etcd 在所有成员间复制请求,因此其性能会严重依赖于网络输入/输出(I/O)的延迟。大量网络延迟会导致 etcd heartbeat 的时间比选举超时时间更长,这会导致一个可能会对集群造成破坏的领导选举。在部署的 OpenShift Container Platform 集群上监控的一个关键指标是每个 etcd 集群成员上的 etcd 网络对延迟的 p99 百分比。使用 Prometheus 跟踪指标数据。

histogram_quantile(0.99, rate(etcd_network_peer_round_trip_time_seconds_bucket[2m]) 指标报告 etcd 在成员间复制客户端请求的时间。确保它小于 50 ms。

1.6. 分离 etcd 数据

对于大型、高密度的集群,如果键空间增长过大并超过空间配额,etcd 的性能将会受到影响。定期维护并处理碎片化的 etcd,以释放数据存储中的空间。监控 Prometheus 以了解 etcd 指标数据,并在需要时对其进行碎片处理;否则,etcd 可能会引发一个集群范围的警报,使集群进入维护模式,仅能接受对键的读和删除操作。

监控这些关键指标:

-

etcd_server_quota_backend_bytes,这是当前配额限制 -

etcd_mvcc_db_total_size_in_use_in_bytes,表示历史压缩后实际数据库使用量 -

etcd_debugging_mvcc_db_total_size_in_bytes会显示数据库大小,包括等待碎片整理的空闲空间

在导致磁盘碎片的事件后(如 etcd 历史记录紧凑)对 etcd 数据进行清理以回收磁盘空间。

历史压缩将自动每五分钟执行一次,并在后端数据库中造成混乱。此碎片空间可供 etcd 使用,但主机文件系统不可用。您必须对碎片 etcd 进行碎片清除,才能使这个空间可供主机文件系统使用。

因为 etcd 将数据写入磁盘,所以其性能主要取决于磁盘性能。根据您的集群的具体情况,考虑每个月清理一次 etcd 碎片,或每个月清理两次。您还可以监控 etcd_db_total_size_in_bytes 指标,以确定是否需要进行碎片操作。

您还可以通过检查 etcd 数据库大小(MB)来决定是否需要进行碎片整理。通过 PromQL 表达 (etcd_mvcc_db_total_size_in_bytes - etcd_mvcc_db_total_size_in_use_in_bytes)/1024/1024 来释放空间。

分离 etcd 是一个阻止性操作。在进行碎片处理完成前,etcd 成员不会响应。因此,在每个下一个 pod 要进行碎片清理前,至少等待一分钟,以便集群可以恢复正常工作。

按照以下步骤对每个 etcd 成员上的 etcd 数据进行碎片处理。

先决条件

-

您可以使用具有

cluster-admin角色的用户访问集群。

流程

确定哪个 etcd 成员是领导成员,因为领导会进行最后的碎片处理。

获取 etcd pod 列表:

oc get pods -n openshift-etcd -o wide | grep -v quorum-guard | grep etcd

$ oc get pods -n openshift-etcd -o wide | grep -v quorum-guard | grep etcdCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

etcd-ip-10-0-159-225.example.redhat.com 3/3 Running 0 175m 10.0.159.225 ip-10-0-159-225.example.redhat.com <none> <none> etcd-ip-10-0-191-37.example.redhat.com 3/3 Running 0 173m 10.0.191.37 ip-10-0-191-37.example.redhat.com <none> <none> etcd-ip-10-0-199-170.example.redhat.com 3/3 Running 0 176m 10.0.199.170 ip-10-0-199-170.example.redhat.com <none> <none>

etcd-ip-10-0-159-225.example.redhat.com 3/3 Running 0 175m 10.0.159.225 ip-10-0-159-225.example.redhat.com <none> <none> etcd-ip-10-0-191-37.example.redhat.com 3/3 Running 0 173m 10.0.191.37 ip-10-0-191-37.example.redhat.com <none> <none> etcd-ip-10-0-199-170.example.redhat.com 3/3 Running 0 176m 10.0.199.170 ip-10-0-199-170.example.redhat.com <none> <none>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 选择 pod 并运行以下命令来确定哪个 etcd 成员是领导:

oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.com etcdctl endpoint status --cluster -w table

$ oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.com etcdctl endpoint status --cluster -w tableCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 基于此输出的

IS LEADER列,https://10.0.199.170:2379端点是领导。与上一步输出匹配此端点,领导的 pod 名称为etcd-ip-10-0-199-170.example.redhat.com。

清理 etcd 成员。

连接到正在运行的 etcd 容器,传递 不是 领导的 pod 的名称:

oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.com

$ oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 取消设置

ETCDCTL_ENDPOINTS环境变量:unset ETCDCTL_ENDPOINTS

sh-4.4# unset ETCDCTL_ENDPOINTSCopy to Clipboard Copied! Toggle word wrap Toggle overflow 清理 etcd 成员:

etcdctl --command-timeout=30s --endpoints=https://localhost:2379 defrag

sh-4.4# etcdctl --command-timeout=30s --endpoints=https://localhost:2379 defragCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Finished defragmenting etcd member[https://localhost:2379]

Finished defragmenting etcd member[https://localhost:2379]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果发生超时错误,增加

--command-timeout的值,直到命令成功为止。验证数据库大小是否已缩小:

etcdctl endpoint status -w table --cluster

sh-4.4# etcdctl endpoint status -w table --clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 本例显示这个 etcd 成员的数据库大小现在为 41 MB,而起始大小为 104 MB。

重复这些步骤以连接到其他 etcd 成员并进行碎片处理。最后才对领导进行碎片清除。

至少要在碎片处理操作之间等待一分钟,以便 etcd pod 可以恢复。在 etcd pod 恢复前,etcd 成员不会响应。

如果因为超过空间配额而触发任何

NOSPACE警告,请清除它们。检查是否有

NOSPACE警告:etcdctl alarm list

sh-4.4# etcdctl alarm listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

memberID:12345678912345678912 alarm:NOSPACE

memberID:12345678912345678912 alarm:NOSPACECopy to Clipboard Copied! Toggle word wrap Toggle overflow 清除警告:

etcdctl alarm disarm

sh-4.4# etcdctl alarm disarmCopy to Clipboard Copied! Toggle word wrap Toggle overflow

1.7. OpenShift Container Platform 基础架构组件

以下基础架构工作负载不会导致 OpenShift Container Platform worker 订阅:

- 在主控机上运行的 Kubernetes 和 OpenShift Container Platform control plane 服务

- 默认路由器

- 集成的容器镜像 registry

- 基于 HAProxy 的 Ingress Controller

- 集群指标集合或监控服务,包括监控用户定义的项目的组件

- 集群聚合日志

- 服务代理

- Red Hat Quay

- Red Hat OpenShift Container Storage

- Red Hat Advanced Cluster Manager

- Red Hat Advanced Cluster Security for Kubernetes

- Red Hat OpenShift GitOps

- Red Hat OpenShift Pipelines

运行任何其他容器、Pod 或组件的所有节点都需要是您的订阅可涵盖的 worker 节点。

1.8. 移动监控解决方案

监控堆栈包含多个组件,包括 Prometheus、Grafana 和 Alertmanager。Cluster Monitoring Operator 管理此堆栈。要将监控堆栈重新部署到基础架构节点,您可以创建并应用自定义配置映射。

流程

编辑

cluster-monitoring-config配置映射,并更改nodeSelector以使用infra标签:oc edit configmap cluster-monitoring-config -n openshift-monitoring

$ oc edit configmap cluster-monitoring-config -n openshift-monitoringCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow 观察监控 pod 移至新机器:

watch 'oc get pod -n openshift-monitoring -o wide'

$ watch 'oc get pod -n openshift-monitoring -o wide'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果组件没有移到

infra节点,请删除带有这个组件的 pod:oc delete pod -n openshift-monitoring <pod>

$ oc delete pod -n openshift-monitoring <pod>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 已删除 pod 的组件在

infra节点上重新创建。

1.9. 移动默认 registry

您需要配置 registry Operator,以便将其 Pod 部署到其他节点。

先决条件

- 在 OpenShift Container Platform 集群中配置额外的机器集。

流程

查看

config/instance对象:oc get configs.imageregistry.operator.openshift.io/cluster -o yaml

$ oc get configs.imageregistry.operator.openshift.io/cluster -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 编辑

config/instance对象:oc edit configs.imageregistry.operator.openshift.io/cluster

$ oc edit configs.imageregistry.operator.openshift.io/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 添加

nodeSelector参数,并设为适用于您想要移动的组件的值。您可以根据为节点指定的值,按所示格式使用nodeSelector或使用<key>: <value>对。如果您在 infrasructure 节点中添加了污点,还要添加匹配的容限。

验证 registry pod 已移至基础架构节点。

运行以下命令,以识别 registry pod 所在的节点:

oc get pods -o wide -n openshift-image-registry

$ oc get pods -o wide -n openshift-image-registryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 确认节点具有您指定的标签:

oc describe node <node_name>

$ oc describe node <node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 查看命令输出,并确认

node-role.kubernetes.io/infra列在LABELS列表中。

1.10. 移动路由器

您可以将路由器 pod 部署到不同的机器集中。默认情况下,pod 部署到 worker 节点。

先决条件

- 在 OpenShift Container Platform 集群中配置额外的机器集。

流程

查看路由器 Operator 的

IngressController自定义资源:oc get ingresscontroller default -n openshift-ingress-operator -o yaml

$ oc get ingresscontroller default -n openshift-ingress-operator -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 命令输出类似于以下文本:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 编辑

ingresscontroller资源,并更改nodeSelector以使用infra标签:oc edit ingresscontroller default -n openshift-ingress-operator

$ oc edit ingresscontroller default -n openshift-ingress-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 添加

nodeSelector参数,并设为适用于您想要移动的组件的值。您可以根据为节点指定的值,按所示格式使用nodeSelector或使用<key>: <value>对。如果您在 infrasructure 节点中添加了污点,还要添加匹配的容限。

确认路由器 Pod 在

infra节点上运行。查看路由器 Pod 列表,并记下正在运行的 Pod 的节点名称:

oc get pod -n openshift-ingress -o wide

$ oc get pod -n openshift-ingress -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES router-default-86798b4b5d-bdlvd 1/1 Running 0 28s 10.130.2.4 ip-10-0-217-226.ec2.internal <none> <none> router-default-955d875f4-255g8 0/1 Terminating 0 19h 10.129.2.4 ip-10-0-148-172.ec2.internal <none> <none>

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES router-default-86798b4b5d-bdlvd 1/1 Running 0 28s 10.130.2.4 ip-10-0-217-226.ec2.internal <none> <none> router-default-955d875f4-255g8 0/1 Terminating 0 19h 10.129.2.4 ip-10-0-148-172.ec2.internal <none> <none>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在本例中,正在运行的 Pod 位于

ip-10-0-217-226.ec2.internal节点上。查看正在运行的 Pod 的节点状态:

oc get node <node_name>

$ oc get node <node_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定从 Pod 列表获得的

<node_name>。

输出示例

NAME STATUS ROLES AGE VERSION ip-10-0-217-226.ec2.internal Ready infra,worker 17h v1.21.0

NAME STATUS ROLES AGE VERSION ip-10-0-217-226.ec2.internal Ready infra,worker 17h v1.21.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 由于角色列表包含

infra,因此 Pod 在正确的节点上运行。

1.11. 基础架构节点大小

基础架构节点是标记为运行 OpenShift Container Platform 环境组成部分的节点。基础架构节点的资源要求取决于集群中的集群年龄、节点和对象,因为这些因素可能会导致 Prometheus 的指标或时间序列增加。以下推荐的基础架构节点大小是基于集群最大值和 control plane 密度测试的结果。

| worker 节点数量 | CPU 内核 | 内存 (GB) |

|---|---|---|

| 25 | 4 | 16 |

| 100 | 8 | 32 |

| 250 | 16 | 128 |

| 500 | 32 | 128 |

通常,建议每个集群有三个基础架构节点。

这些大小建议基于缩放测试,该测试可在整个集群中创建大量对象。这些测试包括达到一些集群最大值。在 OpenShift Container Platform 4.8 集群中有 250 个和 500 个节点时,这些最大值为 10000 个命名空间,包含 61000 个 pod、10000 个 部署、181000 个 secret、400 个配置映射等。Prometheus 是一个高内存密集型应用程序,资源使用量取决于各种因素,包括节点、对象、Prometheus 指标提取间隔、指标或时间序列以及集群的年龄。磁盘大小还取决于保留周期。您必须考虑以上因素并相应地调整它们的大小。

建议的大小只适用于在集群安装过程中安装的 Prometheus、Router 和 Registry 基础架构组件。日志记录(Logging)是第二天操作,因此没有包含在这些建议中。

在 OpenShift Container Platform 4.8 中,与 OpenShift Container Platform 3.11 及之前的版本相比,系统现在默认保留半个 CPU 内核(500 millicore)。这会影响缩放建议。

第 2 章 IBM Z 和 LinuxONE 环境的推荐主机实践

本节为 IBM Z 和 LinuxONE 上的 OpenShift Container Platform 提供推荐的主机实践。

s390x 架构在很多方面都是唯一的。因此,此处提出的一些建议可能不适用于其他平台。

除非另有说明,否则这些实践适用于 IBM Z 和 LinuxONE 上的 z/VM 和 Red Hat Enterprise Linux (RHEL) KVM 安装。

2.1. 管理 CPU 过量使用

在高度虚拟化的 IBM Z 环境中,您必须仔细规划基础架构的设置和大小。虚拟化最重要的功能之一是能够进行资源过量使用,从而将更多资源分配给虚拟机,而不是在管理程序级别实际可用。这主要依赖于具体的工作负载,并没有适用于所有环境的“黄金法则”。

根据您的设置,在设计 CPU 过量使用 时请考虑这些最佳实践:

- 在 LPAR 级别 (PR/SM hypervisor),避免将所有可用物理内核 (IFL) 分配给每个 LPAR。例如,当有四个物理 IFL 可用时,您不应该定义三个 LPAR,每个都带有四个逻辑 IFL。

- 检查并了解 LPAR 共享和权重.

- 过多的虚拟 CPU 会对性能造成负面影响。不要将比逻辑处理器定义为 LPAR 更多的虚拟处理器。

- 为峰值工作负载配置每个客户机的虚拟处理器数量,而不是配置更多.

- 从一个小的数量开始,并监控工作负载。如有必要,逐步增加 vCPU 数量。

- 并非所有工作负载都适合适用高过量使用比率。如果工作负载是 CPU 密集型的,那么您可能无法在不对性能造成影响的情况下使用高的比率。对于高 I/O 密集型工作负载,即便具有较高的过量使用比率,也能保持一致的性能。

2.2. 禁用透明巨页

Transparent Huge Pages (THP) 会试图自动执行创建、管理和使用巨页的大部分方面。由于 THP 自动管理巨页,因此并不始终对所有类型的工作负载进行最佳处理。THP 可能会导致性能下降,因为许多应用程序都自行处理巨页。因此,请考虑禁用 THP。

2.3. 使用 Receive Flow Steering(RFS)提高网络性能

通过进一步减少网络延迟,Receive Flow Steering (RFS) 进一步扩展了 Receive Packet Steering (RPS)。RFS 在技术上基于 RPS,通过增加 CPU 缓存命中率来提高数据包处理的效率。RFS 通过确定计算最方便的 CPU,以便缓存命中更有可能在 CPU 中发生,增加了对队列长度的考虑。因此,会减少 CPU 缓存无效的频率,从而只需要较少的循环来重建缓存。这有助于缩短数据包处理运行时间。

2.3.1. 使用 Machine Config Operator (MCO) 激活 RFS

流程

将以下 MCO 示例配置集复制到 YAML 文件中。例如,

enable-rfs.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 MCO 配置集:

oc create -f enable-rfs.yaml

$ oc create -f enable-rfs.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证是否列出了名为

50-enable-rfs的条目:oc get mc

$ oc get mcCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要取消激活,请输入:

oc delete mc 50-enable-rfs

$ oc delete mc 50-enable-rfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4. 选择您的网络设置

网络堆栈是 OpenShift Container Platform 等基于 Kubernetes 的产品最重要的组件之一。对于 IBM Z 设置,网络设置取决于您选择的虚拟机监控程序。取决于具体的工作负载和应用,最佳实践通常需要根据用例和流量模式进行更改。

根据您的设置,考虑以下最佳实践:

- 考虑有关网络设备的所有选项,以优化您的流量模式。探索 OSA-Express、RoCE Express、HiperSockets、z/VM VSwitch、Linux 网桥 (KVM) 的优势,以确定哪个选项为您的设置带来最大好处。

- 始终使用最新可用的 NIC 版本。例如,OSA Express 7S 10 GbE 与带有事务工作负载类型的 OSA Express 6S 10 GbE 相比有显著改进,尽管两者都是 10 GbE 适配器。

- 每个虚拟交换机都添加了额外的延迟层。

- 负载平衡器在集群外的网络通信中扮演重要角色。如果这对应用程序至关重要,请考虑使用生产环境级的硬件负载平衡器。

- OpenShift Container Platform SDN 引入了影响网络性能的流程和规则。确保对 pod 关联性和放置进行考虑,以便至关重要的服务会受益于本地通信的优势。

- 平衡性能和功能之间的权衡.

2.5. 确保 z/VM 上使用 HyperPAV 的高磁盘性能

DASD 和 ECKD 设备在 IBM Z 环境中通常使用磁盘类型。在 z/VM 环境中的典型 OpenShift Container Platform 设置中,DASD 磁盘通常用于支持节点的本地存储。您可以设置 HyperPAV 别名设备,以便为支持 z/VM 客户机的 DASD 磁盘提供更多吞吐量和总体更好的 I/O 性能。

将 HyperPAV 用于本地存储设备可带来显著的性能优势。但是,您必须考虑吞吐量和 CPU 成本之间有一个权衡。

对于使用 full-pack minidisk 的基于 z/VM 的 OpenShift Container Platform 设置,您可以通过在所有节点中激活 HyperPAV 别名来利用 MCO 配置集的优势。您必须为 control plane 和计算节点添加 YAML 配置。

流程

将以下 MCO 示例配置集复制到 control plane 节点的 YAML 文件中。例如,

05-master-kernelarg-hpav.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将以下 MCO 示例配置集复制到计算节点的 YAML 文件中。例如,

05-worker-kernelarg-hpav.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意您必须修改

rd.dasd参数以适合设备 ID。创建 MCO 配置集:

oc create -f 05-master-kernelarg-hpav.yaml

$ oc create -f 05-master-kernelarg-hpav.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc create -f 05-worker-kernelarg-hpav.yaml

$ oc create -f 05-worker-kernelarg-hpav.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要取消激活,请输入:

oc delete -f 05-master-kernelarg-hpav.yaml

$ oc delete -f 05-master-kernelarg-hpav.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete -f 05-worker-kernelarg-hpav.yaml

$ oc delete -f 05-worker-kernelarg-hpav.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6. IBM Z 主机上的 RHEL KVM 建议

优化 KVM 虚拟服务器环境很大程度上取决于虚拟服务器的工作负载和可用资源。增强一个环境中性能的相同操作可能会对另一种环境产生负面影响。为特定设置找到最佳平衡可能是一项挑战,通常需要进行各种试验。

下面的部分论述了在 IBM Z 和 LinuxONE 环境中将 OpenShift Container Platform 与 RHEL KVM 搭配使用时的一些最佳实践。

2.6.1. 将多个队列用于您的 VirtIO 网络接口

使用多个虚拟 CPU 时,如果您为传入和传出数据包提供多个队列,则可以并行传输软件包。使用 driver 元素的 queues 属性来配置多个队列。指定一个最小为 2 的整数,该整数不超过虚拟服务器的虚拟 CPU 数量。

以下示例规格为网络接口配置两个输入和输出队列:

<interface type="direct">

<source network="net01"/>

<model type="virtio"/>

<driver ... queues="2"/>

</interface>

<interface type="direct">

<source network="net01"/>

<model type="virtio"/>

<driver ... queues="2"/>

</interface>多个队列旨在为网络接口提供增强的性能,但也使用内存和 CPU 资源。首先为繁忙的接口定义两个队列。接下来,尝试为不太繁忙的接口定义两个队列,为繁忙的接口设置两个以上的队列。

2.6.2. 对虚拟块设备使用 I/O 线程

要使虚拟块设备使用 I/O 线程,您必须为虚拟服务器和每个虚拟块设备配置一个或多个 I/O 线程,以使用其中一个 I/O 线程。

以下示例指定了 <iothreads>3</iothreads> 来配置三个 I/O 线程,带有连续十进制线程 ID 1、2 和 3。iothread="2" 参数指定要使用 ID 为 2 的 I/O 线程的磁盘设备的驱动程序元素。

I/O 线程规格示例

线程可以提高磁盘设备的 I/O 操作性能,但也可使用内存和 CPU 资源。您可以将多个设备配置为使用同一线程。线程到设备的最佳映射取决于可用资源和工作负载。

从少量 I/O 线程开始。通常,为所有磁盘设备使用单个 I/O 线程就足够了。不要配置超过虚拟 CPU 数量的线程,也不要配置空闲线程。

您可以使用 virsh iothreadadd 命令将具有特定线程 ID 的 I/O 线程添加到正在运行的虚拟服务器。

2.6.3. 避免虚拟 SCSI 设备

仅在需要通过 SCSI 特定的接口解决设备时配置虚拟 SCSI 设备。将磁盘空间配置为虚拟块设备,而非虚拟 SCSI 设备,无论主机上的支持是什么。

但是,您可能需要以下特定于 SCSI 的接口:

- 主机上 SCSI 附加磁带驱动器的 LUN。

- 在主机文件系统中挂载在虚拟 DVD 驱动器中的 DVD ISO 文件。

2.6.4. 为磁盘配置客户机缓存

将磁盘设备配置为由客户机而不是主机执行缓存。

确保磁盘设备的 driver 元素包含 cache="none" 和 io="native" 参数。

<disk type="block" device="disk">

<driver name="qemu" type="raw" cache="none" io="native" iothread="1"/>

...

</disk>

<disk type="block" device="disk">

<driver name="qemu" type="raw" cache="none" io="native" iothread="1"/>

...

</disk>2.6.5. 排除内存气球(Balloon)设备

除非您需要动态内存大小,否则请不要定义内存气球设备,并确保 libvirt 不会为您创建。将 memballoon 参数作为设备元素的子项包含在您的域配置 XML 文件中。

检查活跃配置集列表:

<memballoon model="none"/>

<memballoon model="none"/>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6.6. 调整主机调度程序的 CPU 迁移算法

除非您非常了解相关的影响,请不要更改调度程序设置。在进行完整的测试并确定相关的影响前,不要对生产系统应用更改。

kernel.sched_migration_cost_ns 参数指定以纳秒为单位的时间间隔。任务最后一次执行后,CPU 缓存被视为具有有用内容,直到此间隔过期为止。增加这个间隔会导致任务迁移减少。默认值为 500000 ns。

如果存在可运行的进程时 CPU 空闲时间高于预期的间隔,请尝试缩短这个间隔。如果任务非常频繁地在 CPU 或节点之间进行转换,请尝试增加它。

要动态将间隔设置为 60000 ns,请输入以下命令:

sysctl kernel.sched_migration_cost_ns=60000

# sysctl kernel.sched_migration_cost_ns=60000

要将值永久更改为 60000 ns,在 /etc/sysctl.conf 中添加以下条目:

kernel.sched_migration_cost_ns=60000

kernel.sched_migration_cost_ns=600002.6.7. 禁用 cpuset cgroup 控制器

此设置仅适用于使用 cgroups 版本 1 的 KVM 主机。要在主机上启用 CPU 热插拔,请禁用 cgroup 控制器。

流程

-

使用您选择的编辑器打开

/etc/libvirt/qemu.conf。 -

转至

cgroup_controllers行。 - 复制整行并从副本中删除前导编号符号(#)。

删除

cpuset条目,如下所示:cgroup_controllers = [ "cpu", "devices", "memory", "blkio", "cpuacct" ]

cgroup_controllers = [ "cpu", "devices", "memory", "blkio", "cpuacct" ]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要使新设置生效,您必须重启 libvirtd 守护进程:

- 停止所有虚拟机。

运行以下命令:

systemctl restart libvirtd

# systemctl restart libvirtdCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 重新启动虚拟机。

此设置在主机重新引导后保留。

2.6.8. 为空闲的虚拟 CPU 调整轮询周期

当虚拟 CPU 空闲时,KVM 会轮询虚拟 CPU 的唤醒条件,然后再分配主机资源。您可以指定时间间隔,在间隔期间在 /sys/module/kvm/parameters/halt_poll_ns 的 sysfs 中进行轮询。在指定时间内,轮询可减少虚拟 CPU 的唤醒延迟,但会牺牲资源使用量。根据工作负载,更长或更短的轮询时间可能很有用。时间间隔以纳秒为单位指定。默认值为 50000 ns。

要针对低 CPU 消耗进行优化,请输入一个小的值或写入 0 来禁用轮询:

echo 0 > /sys/module/kvm/parameters/halt_poll_ns

# echo 0 > /sys/module/kvm/parameters/halt_poll_nsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要针对低延迟进行优化(例如,用于事务的工作负载),请输入一个大的值:

echo 80000 > /sys/module/kvm/parameters/halt_poll_ns

# echo 80000 > /sys/module/kvm/parameters/halt_poll_nsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 3 章 推荐的集群扩展实践

本节中的指导信息仅与使用云供应商集成的安装相关。

这些指南适用于带有软件定义网络(SDN)而不是开放虚拟网络(OVN)的 OpenShift Container Platform。

应用以下最佳实践来扩展 OpenShift Container Platform 集群中的 worker 机器数量。您可以通过增加或减少 worker MachineSet 中定义的副本数量来扩展 worker 机器集。

3.1. 扩展集群的建议实践

将集群扩展到具有更多节点时:

- 将节点分散到所有可用区以获得更高的可用性。

- 同时扩展的机器数量不要超过 25 到 50 个。

- 考虑在每个可用区创建一个具有类似大小的替代实例类型的新机器集,以帮助缓解周期性供应商容量限制。例如,在 AWS 上,使用 m5.large 和 m5d.large。

云供应商可能会为 API 服务实施配额。因此,需要对集群逐渐进行扩展。

如果同时将机器集中的副本设置为更高数量,则控制器可能无法创建机器。部署 OpenShift Container Platform 的云平台可以处理的请求数量将会影响该进程。当尝试创建、检查和更新有状态的机器时,控制器会开始进行更多的查询。部署 OpenShift Container Platform 的云平台具有 API 请求限制,如果出现过量查询,则可能会因为云平台的限制而导致机器创建失败。

当扩展到具有大量节点时,启用机器健康检查。如果出现故障,健康检查会监控状况并自动修复不健康的机器。

当对大型且高密度的集群减少节点数时,可能需要大量时间,因为这个过程涉及排空或驱除在同时终止的节点上运行的对象。另外,如果要驱除的对象太多,对客户端的请求处理会出现瓶颈。目前将默认的客户端 QPS 和 burst 率分别设定为 5 和 10,且无法在 OpenShift Container Platform 中进行修改。

3.2. 修改机器集

要更改机器集,编辑 MachineSet YAML。然后,通过删除每台机器或将机器设置为 0 个副本来删除与机器设置关联的所有机器。然后,将副本数量调回所需的数量。您对机器集所做的更改不会影响现有的机器。

如果您需要在不进行其他更改的情况下扩展机器集,则不需要删除机器。

默认情况下,OpenShift Container Platform 路由器 Pod 部署在 worker 上。由于路由器需要访问某些集群资源(包括 Web 控制台),除非先重新放置了路由器 Pod,否则请不要将 worker 机器集扩展为 0。

先决条件

-

安装 OpenShift Container Platform 集群和

oc命令行。 -

以具有

cluster-admin权限的用户身份登录oc。

流程

编辑机器集:

oc edit machineset <machineset> -n openshift-machine-api

$ oc edit machineset <machineset> -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将机器缩减为

0:oc scale --replicas=0 machineset <machineset> -n openshift-machine-api

$ oc scale --replicas=0 machineset <machineset> -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 或者:

oc edit machineset <machineset> -n openshift-machine-api

$ oc edit machineset <machineset> -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 提示您还可以应用以下 YAML 来扩展机器集:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 等待机器被删除。

根据需要扩展机器设置:

oc scale --replicas=2 machineset <machineset> -n openshift-machine-api

$ oc scale --replicas=2 machineset <machineset> -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 或者:

oc edit machineset <machineset> -n openshift-machine-api

$ oc edit machineset <machineset> -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 提示您还可以应用以下 YAML 来扩展机器集:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 等待机器启动。新机器包含您对机器集所做的更改。

3.3. 关于机器健康检查

机器健康检查自动修复特定机器池中不健康的机器。

要监控机器的健康状况,创建资源来定义控制器的配置。设置要检查的条件(例如,处于 NotReady 状态达到五分钟或 node-problem-detector 中显示了持久性状况),以及用于要监控的机器集合的标签。

您不能对具有 master 角色的机器进行机器健康检查。

监控 MachineHealthCheck 资源的控制器会检查定义的条件。如果机器无法进行健康检查,则会自动删除机器并创建一个机器来代替它。删除机器之后,您会看到机器被删除事件。

为限制删除机器造成的破坏性影响,控制器一次仅清空并删除一个节点。如果目标机器池中不健康的机器池中不健康的机器数量大于 maxUnhealthy 的值,则补救会停止,需要启用手动干预。

请根据工作负载和要求仔细考虑超时。

- 超时时间较长可能会导致不健康的机器上的工作负载长时间停机。

-

超时时间太短可能会导致补救循环。例如,检查

NotReady状态的超时时间必须足够长,以便机器能够完成启动过程。

要停止检查,请删除资源。

例如,您应该在升级过程中停止检查,因为集群中的节点可能会临时不可用。MachineHealthCheck 可能会识别不健康的节点,并重新引导它们。为避免重新引导这样的节点,请在更新集群前删除您部署的任何 MachineHealthCheck 资源。但是,默认部署的 MachineHealthCheck 资源(如 machine-api-termination-handler)不能被删除并重新创建。

3.3.1. 部署机器健康检查时的限制

部署机器健康检查前需要考虑以下限制:

- 只有机器集拥有的机器才可以由机器健康检查修复。

- 目前不支持 control plane 机器,如果不健康,则不会被修复。

- 如果机器的节点从集群中移除,机器健康检查会认为机器不健康,并立即修复机器。

-

如果机器对应的节点在

nodeStartupTimeout之后没有加入集群,则会修复机器。 -

如果

Machine资源阶段为Failed,则会立即修复机器。

3.4. MachineHealthCheck 资源示例

所有基于云的安装类型的 MachineHealthCheck 资源,以及裸机以外的资源,类似以下 YAML 文件:

matchLabels 只是示例; 您必须根据具体需要映射您的机器组。

3.4.1. 短路机器健康检查补救

短路可确保仅在集群健康时机器健康检查修复机器。通过 MachineHealthCheck 资源中的 maxUnhealthy 字段配置短路。

如果用户在修复任何机器前为 maxUnhealthy 字段定义了一个值,MachineHealthCheck 会将 maxUnhealthy 的值与它决定不健康的目标池中的机器数量进行比较。如果不健康的机器数量超过 maxUnhealthy 限制,则不会执行补救。

如果没有设置 maxUnhealthy,则默认值为 100%,无论集群状态如何,机器都会被修复。

适当的 maxUnhealthy 值取决于您部署的集群规模以及 MachineHealthCheck 覆盖的机器数量。例如,您可以使用 maxUnhealthy 值覆盖多个可用区间的多个机器集,以便在丢失整个区时,maxUnhealthy 设置可以在集群中阻止进一步补救。

maxUnhealthy 字段可以设置为整数或百分比。根据 maxUnhealthy 值,有不同的补救实现。

3.4.1.1. 使用绝对值设置 maxUnhealthy

如果将 maxUnhealthy 设为 2:

- 如果 2 个或更少节点不健康,则可执行补救

- 如果 3 个或更多节点不健康,则不会执行补救

这些值与机器健康检查要检查的机器数量无关。

3.4.1.2. 使用百分比设置 maxUnhealthy

如果 maxUnhealthy 被设置为 40%,有 25 个机器被检查:

- 如果有 10 个或更少节点处于不健康状态,则可执行补救

- 如果 11 个或多个节点不健康,则不会执行补救

如果 maxUnhealthy 被设置为 40%,有 6 个机器被检查:

- 如果 2 个或更少节点不健康,则可执行补救

- 如果 3 个或更多节点不健康,则不会执行补救

当被检查的 maxUnhealthy 机器的百分比不是一个整数时,允许的机器数量会被舍入到一个小的整数。

3.5. 创建 MachineHealthCheck 资源

您可以为集群中的所有 MachineSet 创建 MachineHealthCheck 资源。您不应该创建针对 control plane 机器的 MachineHealthCheck 资源。

先决条件

-

安装

oc命令行界面。

流程

-

创建一个

healthcheck.yml文件,其中包含您的机器健康检查的定义。 将

healthcheck.yml文件应用到您的集群:oc apply -f healthcheck.yml

$ oc apply -f healthcheck.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 4 章 使用 Node Tuning Operator

了解 Node Tuning Operator,以及如何使用它通过编排 tuned 守护进程以管理节点级别的性能优化。

4.1. 关于 Node Tuning Operator

Node Tuning Operator 可以帮助您通过编排 TuneD 守护进程来管理节点级别的性能优化。大多数高性能应用程序都需要一定程度的内核级性能优化。Node Tuning Operator 为用户提供了一个统一的、节点一级的 sysctl 管理接口,并可以根据具体用户的需要灵活地添加自定义性能优化设置。

Operator 将为 OpenShift Container Platform 容器化 TuneD 守护进程作为一个 Kubernetes 守护进程集进行管理。它保证了自定义性能优化设置以可被守护进程支持的格式传递到在集群中运行的所有容器化的 TuneD 守护进程中。相应的守护进程会在集群的所有节点上运行,每个节点上运行一个。

在发生触发配置集更改的事件时,或通过接收和处理终止信号安全终止容器化 TuneD 守护进程时,容器化 TuneD 守护进程所应用的节点级设置将被回滚。

在版本 4.1 及更高版本中,OpenShift Container Platform 标准安装中包含了 Node Tuning Operator。

4.2. 访问 Node Tuning Operator 示例规格

使用此流程来访问 Node Tuning Operator 的示例规格。

流程

运行:

oc get Tuned/default -o yaml -n openshift-cluster-node-tuning-operator

$ oc get Tuned/default -o yaml -n openshift-cluster-node-tuning-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow

默认 CR 旨在为 OpenShift Container Platform 平台提供标准的节点级性能优化,它只能被修改来设置 Operator Management 状态。Operator 将覆盖对默认 CR 的任何其他自定义更改。若进行自定义性能优化,请创建自己的 Tuned CR。新创建的 CR 将与默认的 CR 合并,并基于节点或 pod 标识和配置文件优先级对节点应用自定义调整。

虽然在某些情况下,对 pod 标识的支持可以作为自动交付所需调整的一个便捷方式,但我们不鼓励使用这种方法,特别是在大型集群中。默认 Tuned CR 并不带有 pod 标识匹配。如果创建了带有 pod 标识匹配的自定义配置集,则该功能将在此时启用。在以后的 Node Tuning Operator 版本中可能会弃用 pod 标识功能。

4.3. 在集群中设置默认配置集

以下是在集群中设置的默认配置集。

4.4. 验证是否应用了 TuneD 配置集

验证应用到集群节点的 TuneD 配置集。

oc get profile -n openshift-cluster-node-tuning-operator

$ oc get profile -n openshift-cluster-node-tuning-operator输出示例

-

NAME:配置集(Profile)对象的名称。每个节点有一个 Profile 对象,其名称相互匹配。 -

TUNED:要应用的 TuneD 配置集的名称。 -

APPLIED:如果 TuneD 守护进程应用了所需的配置集,则为True。(True/False/Unknown)。 -

DEGRADED:如果在应用 TuneD 配置集时报告了任何错误则为True(True/False/Unknown)。 -

AGE:创建 Profile 对象后经过的时间。

4.5. 自定义调整规格

Operator 的自定义资源 (CR) 包含两个主要部分。第一部分是 profile:,这是 TuneD 配置集及其名称的列表。第二部分是 recommend:,用来定义配置集选择逻辑。

多个自定义调优规格可以共存,作为 Operator 命名空间中的多个 CR。Operator 会检测到是否存在新 CR 或删除了旧 CR。所有现有的自定义性能优化设置都会合并,同时更新容器化 TuneD 守护进程的适当对象。

管理状态

通过调整默认的 Tuned CR 来设置 Operator Management 状态。默认情况下,Operator 处于 Managed 状态,默认的 Tuned CR 中没有 spec.managementState 字段。Operator Management 状态的有效值如下:

- Managed: Operator 会在配置资源更新时更新其操作对象

- Unmanaged: Operator 将忽略配置资源的更改

- Removed: Operator 将移除 Operator 置备的操作对象和资源

配置集数据

profile: 部分列出了 TuneD 配置集及其名称。

建议的配置集

profile: 选择逻辑通过 CR 的 recommend: 部分来定义。recommend: 部分是根据选择标准推荐配置集的项目列表。

recommend: <recommend-item-1> # ... <recommend-item-n>

recommend:

<recommend-item-1>

# ...

<recommend-item-n>列表中的独立项:

<match> 是一个递归定义的可选数组,如下所示:

- label: <label_name>

value: <label_value>

type: <label_type>

<match>

- label: <label_name>

value: <label_value>

type: <label_type>

<match>

如果不省略 <match>,则所有嵌套的 <match> 部分也必须评估为 true。否则会假定 false,并且不会应用或建议具有对应 <match> 部分的配置集。因此,嵌套(子级 <match> 部分)会以逻辑 AND 运算来运作。反之,如果匹配 <match> 列表中任何一项,整个 <match> 列表评估为 true。因此,该列表以逻辑 OR 运算来运作。

如果定义 了 machineConfigLabels,基于机器配置池的匹配会对给定的 recommend: 列表项打开。<mcLabels> 指定机器配置标签。机器配置会自动创建,以在配置集 <tuned_profile_name> 中应用主机设置,如内核引导参数。这包括使用与 <mcLabels> 匹配的机器配置选择器查找所有机器配置池,并在分配了找到的机器配置池的所有节点上设置配置集 <tuned_profile_name>。要针对同时具有 master 和 worker 角色的节点,您必须使用 master 角色。

列表项 match 和 machineConfigLabels 由逻辑 OR 操作符连接。match 项首先以短电路方式评估。因此,如果它被评估为 true,则不考虑 MachineConfigLabels 项。

当使用基于机器配置池的匹配时,建议将具有相同硬件配置的节点分组到同一机器配置池中。不遵循这个原则可能会导致在共享同一机器配置池的两个或者多个节点中 TuneD 操作对象导致内核参数冲突。

示例:基于节点或 pod 标签的匹配

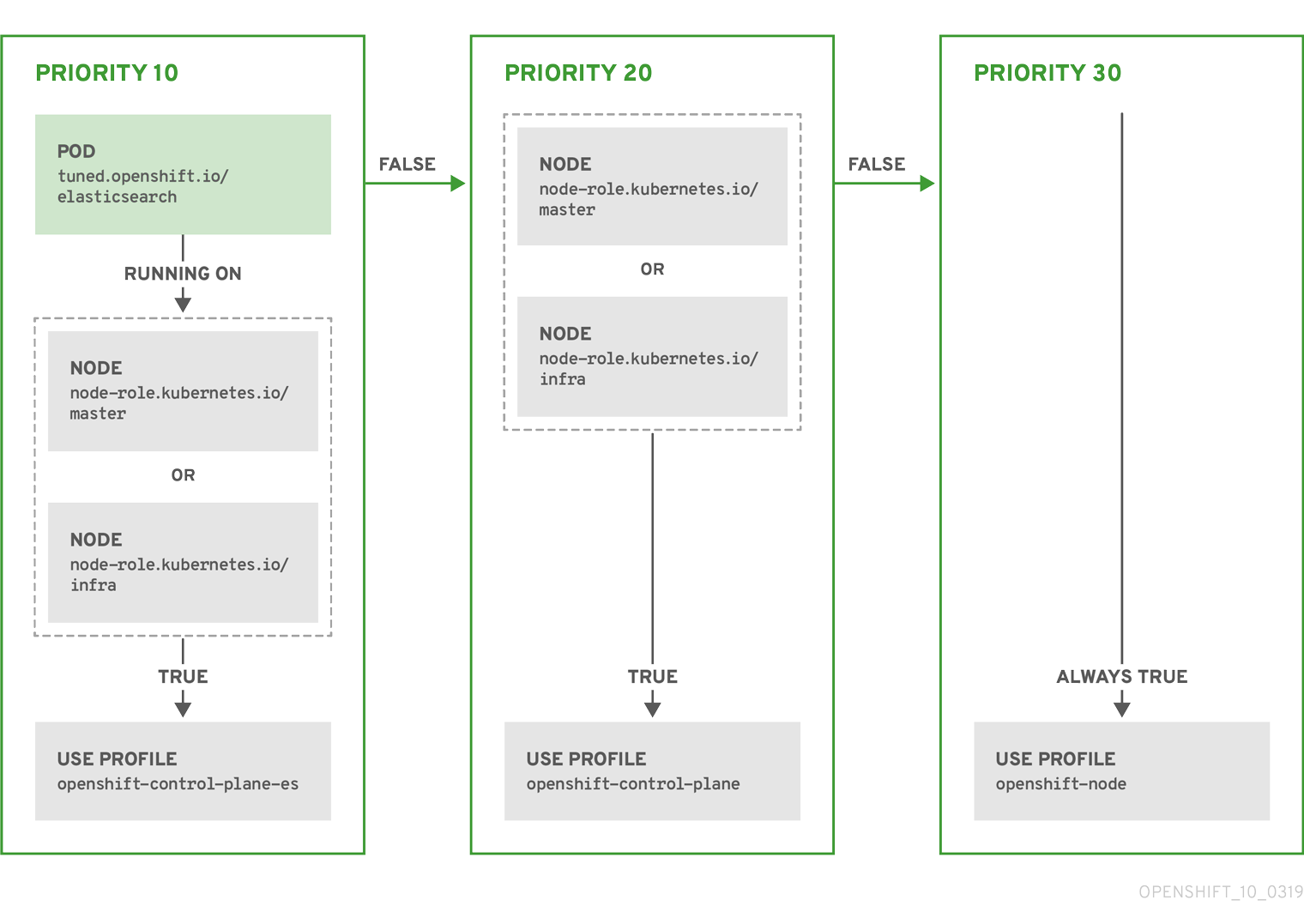

根据配置集优先级,以上 CR 针对容器化 TuneD 守护进程转换为 recommend.conf 文件。优先级最高 (10) 的配置集是 openshift-control-plane-es,因此会首先考虑它。在给定节点上运行的容器化 TuneD 守护进程会查看同一节点上是否在运行设有 tuned.openshift.io/elasticsearch 标签的 pod。如果没有,则整个 <match> 部分评估为 false。如果存在具有该标签的 pod,为了让 <match> 部分评估为 true,节点标签也需要是 node-role.kubernetes.io/master 或 node-role.kubernetes.io/infra。

如果这些标签对优先级为 10 的配置集而言匹配,则应用 openshift-control-plane-es 配置集,并且不考虑其他配置集。如果节点/pod 标签组合不匹配,则考虑优先级第二高的配置集 (openshift-control-plane)。如果容器化 TuneD Pod 在具有标签 node-role.kubernetes.io/master 或 node-role.kubernetes.io/infra 的节点上运行,则应用此配置集。

最后,配置集 openshift-node 的优先级最低 (30)。它没有 <match> 部分,因此始终匹配。如果给定节点上不匹配任何优先级更高的配置集,它会作为一个适用于所有节点的配置集来设置 openshift-node 配置集。

示例:基于机器配置池的匹配

为尽量减少节点的重新引导情况,为目标节点添加机器配置池将匹配的节点选择器标签,然后创建上述 Tuned CR,最后创建自定义机器配置池。

4.6. 自定义调整示例

从默认 CR 中使用 TuneD 配置集

以下 CR 对带有标签 tuned.openshift.io/ingress-node-label 的 OpenShift Container Platform 节点应用节点一级的自定义调整。

示例:使用 openshift-control-plane TuneD 配置集进行自定义性能优化

对于开发自定义配置集的人员。我们强烈建议包括在默认 Tuned CR 中提供的默认 TuneD 守护进程配置集。上面的示例使用默认 openshift-control-plane 配置集。

使用内置 TuneD 配置集

由于 NTO 管理的守护进程集已被成功推出,TuneD 操作对象会管理 TuneD 守护进程的同一版本。要列出守护进程支持的内置 TuneD 配置集,请以以下方式查询任何 TuneD pod:

oc exec $tuned_pod -n openshift-cluster-node-tuning-operator -- find /usr/lib/tuned/ -name tuned.conf -printf '%h\n' | sed 's|^.*/||'

$ oc exec $tuned_pod -n openshift-cluster-node-tuning-operator -- find /usr/lib/tuned/ -name tuned.conf -printf '%h\n' | sed 's|^.*/||'您可以使用自定义调优规格中检索的配置集名称。

示例:使用内置 hpc-compute TuneD 配置集

除了内置的 hpc-compute 配置集外,上面的示例还包括默认 Tuned CR 中提供的 openshift-node TuneD 守护进程配置集,以对计算节点使用特定于 OpenShift 的调优。

4.7. 支持的 TuneD 守护进程插件

在使用 Tuned CR 的 profile: 部分中定义的自定义配置集时,以下 TuneD 插件都受到支持,但 [main] 部分除外:

- audio

- cpu

- disk

- eeepc_she

- modules

- mounts

- net

- scheduler

- scsi_host

- selinux

- sysctl

- sysfs

- usb

- video

- vm

其中一些插件提供了不受支持的动态性能优化功能。目前不支持以下 TuneD 插件:

- bootloader

- script

- systemd

如需更多信息,请参阅 Available TuneD Plug-ins 和 Getting Started with TuneD 。

第 5 章 使用 Cluster Loader

Cluster Loader 是一个将大量对象部署到集群的工具程序,它可创建用户定义的集群对象。构建、配置并运行 Cluster Loader 以测量处于各种集群状态的 OpenShift Container Platform 部署的性能指标。

Cluster Loader 现已弃用,并将在以后的发行版本中删除。

5.1. 安装 Cluster Loader

流程

要拉取容器镜像,请运行:

podman pull quay.io/openshift/origin-tests:4.8

$ podman pull quay.io/openshift/origin-tests:4.8Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2. 运行 Cluster Loader

先决条件

- 软件仓库会提示您进行验证。registry 凭证允许您访问没有公开的镜像。使用您在安装时产生的现有身份验证凭证。

流程

使用内置的测试配置执行 Cluster Loader,它会部署五个模板构建并等待它们完成:

podman run -v ${LOCAL_KUBECONFIG}:/root/.kube/config:z -i \ quay.io/openshift/origin-tests:4.8 /bin/bash -c 'export KUBECONFIG=/root/.kube/config && \ openshift-tests run-test "[sig-scalability][Feature:Performance] Load cluster \ should populate the cluster [Slow][Serial] [Suite:openshift]"'$ podman run -v ${LOCAL_KUBECONFIG}:/root/.kube/config:z -i \ quay.io/openshift/origin-tests:4.8 /bin/bash -c 'export KUBECONFIG=/root/.kube/config && \ openshift-tests run-test "[sig-scalability][Feature:Performance] Load cluster \ should populate the cluster [Slow][Serial] [Suite:openshift]"'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 或者,通过设置

VIPERCONFIG环境变量来执行带有用户定义的配置的 Cluster Loader:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在这个示例中,

${LOCAL_KUBECONFIG}代表kubeconfig在本地文件系统中的路径。另外,还有一个名为${LOCAL_CONFIG_FILE_PATH}的目录,它被挂载到包含名为test.yaml的配置文件的容器中。另外,如果test.yaml引用了任何外部模板文件或 podspec 文件,则也应该被挂载到容器中。

5.3. 配置 Cluster Loader

该工具创建多个命名空间(项目),其中包含多个模板或 pod。

5.3.1. Cluster Loader 配置文件示例

Cluster Loader 的配置文件是一个基本的 YAML 文件:

本例假定对任何外部模板文件或 pod spec 文件的引用也会挂载到容器中。

如果您在 Microsoft Azure 上运行 Cluster Loader,则必须将 AZURE_AUTH_LOCATION 变量设置为包含 terraform.azure.auto.tfvars.json 输出结果的文件,该文件存在于安装程序目录中。

5.3.2. 配置字段

| 字段 | 描述 |

|---|---|

|

|

可设置为 |

|

|

包含一个或多个定义的子对象。在 |

|

|

每个配置都有一个定义的子对象。 |

|

| 每个配置都有一个定义的可选子对象。在创建对象的过程中添加同步的可能性。 |

| 字段 | 描述 |

|---|---|

|

| 整数。定义要创建项目的数量。 |

|

|

字符串项目基本名称的一个定义。在 |

|

| 字符串需要应用到在这个命名空间里部署的项目的 tuning 设置。 |

|

|

包含 |

|

| 键值对列表。键是配置映射名称,值是指向创建配置映射的文件的路径。 |

|

| 键值对列表。key 是 secret 名称,值是一个指向用来创建 secret 的文件的路径。 |

|

| 要部署的 pod 的一个或者多个定义的子对象。 |

|

| 要部署模板的一个或者多个定义的子对象。 |

| 字段 | 描述 |

|---|---|

|

| 整数。要部署的 pod 或模板数量。 |

|

| 字符串到可以拉取镜像的软件仓库的 docker 镜像 URL。 |

|

| 字符串要创建的模板(或 pod)的基本名称的一个定义。 |

|

| 字符串到要创建的 pod 规格或模板的本地文件的路径。 |

|

|

健值对。在 |

| 字段 | 描述 |

|---|---|

|

| 字符串tuning 集的名称,该名称将与在一个项目中定义 turning 时指定的名称匹配。 |

|

|

指定应用于 pod 的 |

|

|

指定应用于模板的 |

| 字段 | 描述 |

|---|---|

|

| 子对象。如果要在步骤创建模式中创建对象,需要使用的步骤配置。 |

|

| 子对象。用来限制对象创建率的频率限制 turning 集。 |

| 字段 | 描述 |

|---|---|

|

| 整数。在暂停对象创建前要创建的对象数量。 |

|

|

整数。在创建了由 |

|

| 整数。如果对象创建失败,在失败前要等待的秒数。 |

|

| 整数。在创建请求间等待多少毫秒 (ms) |

| 字段 | 描述 |

|---|---|

|

|

带有 |

|

|

布尔值等待带有与 |

|

|

布尔值等待带有与 |

|

|

匹配处于 |

|

|

字符串等待处于 |

5.4. 已知问题

- 当在没有配置的情况下调用 Cluster Loader 会失败。(BZ#1761925)

如果用户模板中没有定义

IDENTIFIER参数,则模板创建失败,错误信息为:error: unknown parameter name "IDENTIFIER"。如果部署模板,在模板中添加这个参数以避免出现这个错误:{ "name": "IDENTIFIER", "description": "Number to append to the name of resources", "value": "1" }{ "name": "IDENTIFIER", "description": "Number to append to the name of resources", "value": "1" }Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果部署 pod,则不需要添加该参数。

第 6 章 使用 CPU Manager

CPU Manager 管理 CPU 组并限制特定 CPU 的负载。

CPU Manager 对于有以下属性的负载有用:

- 需要尽可能多的 CPU 时间。

- 对处理器缓存丢失非常敏感。

- 低延迟网络应用程序。

- 需要与其他进程协调,并从共享一个处理器缓存中受益。

6.1. 设置 CPU Manager

流程

可选:标记节点:

oc label node perf-node.example.com cpumanager=true

# oc label node perf-node.example.com cpumanager=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 编辑启用 CPU Manager 的节点的

MachineConfigPool。在这个示例中,所有 worker 都启用了 CPU Manager:oc edit machineconfigpool worker

# oc edit machineconfigpool workerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 为 worker 机器配置池添加标签:

metadata: creationTimestamp: 2020-xx-xxx generation: 3 labels: custom-kubelet: cpumanager-enabledmetadata: creationTimestamp: 2020-xx-xxx generation: 3 labels: custom-kubelet: cpumanager-enabledCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建

KubeletConfig,cpumanager-kubeletconfig.yaml,自定义资源 (CR) 。请参阅上一步中创建的标签,以便使用新的 kubelet 配置更新正确的节点。请参见MachineConfigPoolSelector部分:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建动态 kubelet 配置:

oc create -f cpumanager-kubeletconfig.yaml

# oc create -f cpumanager-kubeletconfig.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 这会在 kubelet 配置中添加 CPU Manager 功能,如果需要,Machine Config Operator(MCO)将重启节点。要启用 CPU Manager,则不需要重启。

检查合并的 kubelet 配置:

oc get machineconfig 99-worker-XXXXXX-XXXXX-XXXX-XXXXX-kubelet -o json | grep ownerReference -A7

# oc get machineconfig 99-worker-XXXXXX-XXXXX-XXXX-XXXXX-kubelet -o json | grep ownerReference -A7Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查 worker 是否有更新的

kubelet.conf:oc debug node/perf-node.example.com sh-4.2# cat /host/etc/kubernetes/kubelet.conf | grep cpuManager

# oc debug node/perf-node.example.com sh-4.2# cat /host/etc/kubernetes/kubelet.conf | grep cpuManagerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

cpuManagerPolicy: static cpuManagerReconcilePeriod: 5s

cpuManagerPolicy: static1 cpuManagerReconcilePeriod: 5s2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建请求一个或多个内核的 pod。限制和请求都必须将其 CPU 值设置为一个整数。这是专用于此 pod 的内核数:

cat cpumanager-pod.yaml

# cat cpumanager-pod.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 pod:

oc create -f cpumanager-pod.yaml

# oc create -f cpumanager-pod.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 确定为您标记的节点调度了 pod:

oc describe pod cpumanager

# oc describe pod cpumanagerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 确认正确配置了

cgroups。获取pause进程的进程 ID(PID):Copy to Clipboard Copied! Toggle word wrap Toggle overflow 服务质量(QoS)等级为

Guaranteed的 pod 被放置到kubepods.slice中。其它 QoS 等级的 pod 会位于kubepods的子cgroups中:cd /sys/fs/cgroup/cpuset/kubepods.slice/kubepods-pod69c01f8e_6b74_11e9_ac0f_0a2b62178a22.slice/crio-b5437308f1ad1a7db0574c542bdf08563b865c0345c86e9585f8c0b0a655612c.scope for i in `ls cpuset.cpus tasks` ; do echo -n "$i "; cat $i ; done

# cd /sys/fs/cgroup/cpuset/kubepods.slice/kubepods-pod69c01f8e_6b74_11e9_ac0f_0a2b62178a22.slice/crio-b5437308f1ad1a7db0574c542bdf08563b865c0345c86e9585f8c0b0a655612c.scope # for i in `ls cpuset.cpus tasks` ; do echo -n "$i "; cat $i ; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

cpuset.cpus 1 tasks 32706

cpuset.cpus 1 tasks 32706Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查任务允许的 CPU 列表:

grep ^Cpus_allowed_list /proc/32706/status

# grep ^Cpus_allowed_list /proc/32706/statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Cpus_allowed_list: 1

Cpus_allowed_list: 1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 确认系统中的另一个 pod(在这个示例中,QoS 等级为

burstable的 pod)不能在为等级为Guaranteed的 pod 分配的内核中运行:cat /sys/fs/cgroup/cpuset/kubepods.slice/kubepods-besteffort.slice/kubepods-besteffort-podc494a073_6b77_11e9_98c0_06bba5c387ea.slice/crio-c56982f57b75a2420947f0afc6cafe7534c5734efc34157525fa9abbf99e3849.scope/cpuset.cpus 0 oc describe node perf-node.example.com

# cat /sys/fs/cgroup/cpuset/kubepods.slice/kubepods-besteffort.slice/kubepods-besteffort-podc494a073_6b77_11e9_98c0_06bba5c387ea.slice/crio-c56982f57b75a2420947f0afc6cafe7534c5734efc34157525fa9abbf99e3849.scope/cpuset.cpus 0 # oc describe node perf-node.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 这个 VM 有两个 CPU 内核。

system-reserved设置保留 500 millicores,这代表一个内核中的一半被从节点的总容量中减小,以达到Node Allocatable的数量。您可以看到Allocatable CPU是 1500 毫秒。这意味着您可以运行一个 CPU Manager pod,因为每个 pod 需要一个完整的内核。一个完整的内核等于 1000 毫秒。如果您尝试调度第二个 pod,系统将接受该 pod,但不会调度它:NAME READY STATUS RESTARTS AGE cpumanager-6cqz7 1/1 Running 0 33m cpumanager-7qc2t 0/1 Pending 0 11s

NAME READY STATUS RESTARTS AGE cpumanager-6cqz7 1/1 Running 0 33m cpumanager-7qc2t 0/1 Pending 0 11sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 7 章 使用拓扑管理器

拓扑管理器(Topology Manager)从 CPU Manager、设备管理器和其他 Hint 提供者收集提示信息,以匹配相同非统一 内存访问(NUMA)节点上的所有 QoS 类的 pod 资源(如 CPU、SR-IOV VF 和其他设备资源)。

拓扑管理器使用收集来的提示信息中获得的拓扑信息,根据配置的 Topology Manager 策略以及请求的 Pod 资源,决定节点是否被节点接受或拒绝。

拓扑管理器对希望使用硬件加速器来支持对工作延迟有极高要求的操作及高吞吐并发计算的负载很有用。

要使用拓扑管理器,必须使用 static 策略的 CPU Manager。有关 CPU Manager 的详情请参考使用 CPU Manager。

7.1. 拓扑管理器策略

拓扑管理器通过从 Hint 提供者(如 CPU Manager 和设备管理器)收集拓扑提示来调整所有级别服务质量(QoS)的 Pod 资源,并使用收集的提示来匹配 Pod 资源。

要将 CPU 资源与 Pod 规格中的其他请求资源匹配,必须使用 static CPU Manager 策略启用 CPU Manager。

拓扑管理器支持四个分配策略,这些策略在 cpumanager-enabled 自定义资源(CR)中定义:

none策略- 这是默认策略,不执行任何拓扑对齐调整。

best-effort策略-

对于带有

best-effort拓扑管理策略的 pod 中的每个容器,kubelet 会调用每个 Hint 提供者来发现其资源的可用性。使用这些信息,拓扑管理器会保存那个容器的首选 NUMA 节点关联性设置。如果关联性没有被首选设置,则拓扑管理器会保存这个设置,并把 pod 分配给节点。 restricted策略-

对于带有

restricted拓扑管理策略的 pod 中的每个容器,kubelet 会调用每个 Hint 提供者来发现其资源的可用性。使用这些信息,拓扑管理器会保存那个容器的首选 NUMA 节点关联性设置。如果关联性没有被首选,则拓扑管理器会从节点拒绝这个 pod,从而导致 pod 处于Terminated状态,且 pod 准入失败。 single-numa-node策略-

对于带有

single-numa-node拓扑管理策略的 pod 中的每个容器,kubelet 会调用每个 Hint 提供者来发现其资源的可用性。使用这个信息,拓扑管理器会决定单个 NUMA 节点关联性是否可能。如果是,pod 将会分配给该节点。如果无法使用单一 NUMA 节点关联性,则拓扑管理器会拒绝来自节点的 pod。这会导致 pod 处于 Terminated 状态,且 pod 准入失败。

7.2. 设置拓扑管理器

要使用拓扑管理器,您必须在 cpumanager-enabled 自定义资源(CR)中配置分配策略。如果您设置了 CPU Manager,则该文件可能会存在。如果这个文件不存在,您可以创建该文件。

先决条件

-

将 CPU Manager 策略配置为

static。请参考扩展和性能文档中的使用 CPU Manager 部分 。

流程

激活 Topolgy Manager:

在

cpumanager-enabled自定义资源(CR)中配置拓扑管理器分配策略。oc edit KubeletConfig cpumanager-enabled

$ oc edit KubeletConfig cpumanager-enabledCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3. Pod 与拓扑管理器策略的交互

以下的 Pod specs 示例演示了 Pod 与 Topology Manager 的交互。

因为没有指定资源请求或限制,以下 pod 以 BestEffort QoS 类运行。

spec:

containers:

- name: nginx

image: nginx

spec:

containers:

- name: nginx

image: nginx

因为请求小于限制,下一个 pod 以 Burstable QoS 类运行。

如果所选策略不是 none,则拓扑管理器将不考虑其中任何一个 Pod 规格。

因为请求等于限制,最后一个 pod 以 Guaranteed QoS 类运行。

拓扑管理器将考虑这个 pod。拓扑管理器会参考 CPU Manager 的静态策略,该策略可返回可用 CPU 的拓扑结构。拓扑管理器还参考设备管理器来发现可用设备的拓扑结构,如 example.com/device。

拓扑管理器将使用此信息存储该容器的最佳拓扑。在本 pod 中,CPU Manager 和设备管理器将在资源分配阶段使用此存储的信息。

第 8 章 扩展 Cluster Monitoring Operator

OpenShift Container Platform 会提供 Cluster Monitoring Operator 在基于 Prometheus 的监控堆栈中收集并存储的数据。作为管理员,您可以在一个 dashboard 接口(Grafana)中查看系统资源、容器和组件指标。

8.1. Prometheus 数据库存储要求

红帽对不同的扩展大小进行了各种测试。

以下 Prometheus 存储要求并不具有规定性。取决于工作负载活动和资源使用情况,集群中可能会观察到更高资源消耗。

| 节点数量 | pod 数量 | 每天增加的 Prometheus 存储 | 每 15 天增加的 Prometheus 存储 | RAM 空间(每个缩放大小) | 网络(每个 tsdb 块) |

|---|---|---|---|---|---|

| 50 | 1800 | 6.3 GB | 94 GB | 6 GB | 16 MB |

| 100 | 3600 | 13 GB | 195 GB | 10 GB | 26 MB |

| 150 | 5400 | 19 GB | 283 GB | 12 GB | 36 MB |

| 200 | 7200 | 25 GB | 375 GB | 14 GB | 46 MB |

大约 20%的预期大小被添加为开销,以保证存储要求不会超过计算的值。

上面的计算用于默认的 OpenShift Container Platform Cluster Monitoring Operator。

CPU 利用率会有轻微影响。这个比例为在每 50 个节点和 1800 个 pod 的 40 个内核中大约有 1 个。

针对 OpenShift Container Platform 的建议

- 至少使用三个基础架构(infra)节点。

- 至少使用三个带有 NVMe(non-volatile memory express)驱动的 openshift-container-storage 节点。

8.2. 配置集群监控

您可以为集群监控堆栈中的 Prometheus 组件增加存储容量。

流程

为 Prometheus 增加存储容量:

创建 YAML 配置文件

cluster-monitoring-config.yaml。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 一个典型的值是

PROMETHEUS_retention_PERIOD=15d。时间单位使用以下后缀之一 : s 、m 、h 、d。 - 2 4

- 集群的存储类。

- 3

- 一个典型的值是

PROMETHEUS_STORAGE_SIZE=2000Gi。存储值可以是一个纯整数,也可以是带有以下后缀之一的整数: E 、P 、T 、G 、M 、K。您也可以使用以下效果相同的后缀:Ei 、Pi 、Ti 、Gi 、Mi 、Ki。 - 5

- 一个典型的值

是 alertmanager_STORAGE_SIZE=20Gi。存储值可以是一个纯整数,也可以是带有以下后缀之一的整数: E 、P 、T 、G 、M 、K。您也可以使用以下效果相同的后缀:Ei 、Pi 、Ti 、Gi 、Mi 、Ki。

- 为保留周期、存储类和存储大小添加值。

- 保存这个文件。

运行以下命令应用这些更改:

oc create -f cluster-monitoring-config.yaml

$ oc create -f cluster-monitoring-config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 9 章 Node Feature Discovery Operator

了解 Node Feature Discovery(NFD)Operator 以及如何使用它通过编排节点功能发现(用于检测硬件功能和系统配置的 Kubernetes 附加组件)来公开节点级信息。

9.1. 关于 Node Feature Discovery Operator

Node Feature Discovery Operator(NFD)通过将节点标记为硬件特定信息来管理 OpenShift Container Platform 集群中硬件功能和配置的检测。NFD 使用特定于节点的属性标记主机,如 PCI 卡、内核、操作系统版本等。

NFD Operator 可以通过搜索 "Node Feature Discovery" 在 Operator Hub 上找到。

9.2. 安装 Node Feature Discovery Operator

Node Feature Discovery(NFD)Operator 编排运行 NFD 守护进程集需要的所有资源。作为集群管理员,您可以使用 OpenShift Container Platform CLI 或 Web 控制台安装 NFD Operator。

9.2.1. 使用 CLI 安装 NFD Operator

作为集群管理员,您可以使用 CLI 安装 NFD Operator。

先决条件

- OpenShift Container Platform 集群

-

安装 OpenShift CLI (

oc) 。 -

以具有

cluster-admin特权的用户身份登录。

流程

为 NFD Operator 创建命名空间。

创建定义

openshift-nfd命名空间的以下Namespace自定义资源(CR),然后在nfd-namespace.yaml文件中保存 YAML:apiVersion: v1 kind: Namespace metadata: name: openshift-nfd

apiVersion: v1 kind: Namespace metadata: name: openshift-nfdCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令创建命名空间:

oc create -f nfd-namespace.yaml

$ oc create -f nfd-namespace.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

通过创建以下对象,在您上一步中创建的命名空间中安装 NFD Operator:

创建以下

OperatorGroupCR,并在 nfd-operatorgroup.yaml文件中保存 YAML:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建

OperatorGroupCR:oc create -f nfd-operatorgroup.yaml

$ oc create -f nfd-operatorgroup.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令获取下一步所需的

channel值。oc get packagemanifest nfd -n openshift-marketplace -o jsonpath='{.status.defaultChannel}'$ oc get packagemanifest nfd -n openshift-marketplace -o jsonpath='{.status.defaultChannel}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

4.8

4.8Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建以下

SubscriptionCR,并将 YAML 保存到nfd-sub.yaml文件中:订阅示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建订阅对象:

oc create -f nfd-sub.yaml

$ oc create -f nfd-sub.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 进入

openshift-nfd项目:oc project openshift-nfd

$ oc project openshift-nfdCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

要验证 Operator 部署是否成功,请运行:

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY STATUS RESTARTS AGE nfd-controller-manager-7f86ccfb58-vgr4x 2/2 Running 0 10m

NAME READY STATUS RESTARTS AGE nfd-controller-manager-7f86ccfb58-vgr4x 2/2 Running 0 10mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 一个成功的部署会显示

Running状态。

9.2.2. 使用 Web 控制台安装 NFD Operator

作为集群管理员,您可以使用 Web 控制台安装 NFD Operator。

建议按照上一节所述创建命名空间。

流程

- 在 OpenShift Container Platform Web 控制台中,点击 Operators → OperatorHub。

- 从可用的 Operator 列表中选择 Node Feature Discovery,然后点 Install。

- 在 Install Operator 页面中,选择集群上的一个特定命名空间,选择上一节中创建的命名空间,然后点 Install。

验证

验证 NFD Operator 是否已成功安装:

- 进入到 Operators → Installed Operators 页面。

确保 openshift-nfd 项目中列出了 Node Feature Discovery,Status 为 InstallSucceeded。

注意在安装过程中,Operator 可能会显示 Failed 状态。如果安装过程结束后有 InstallSucceeded 信息,您可以忽略这个 Failed 信息。

故障排除

如果 Operator 没有被安装,请按照以下步骤进行故障排除:

- 导航到 Operators → Installed Operators 页面,检查 Operator Subscriptions 和 Install Plans 选项卡中的 Status 项中是否有任何错误。

-

导航到 Workloads → Pods 页面,在

openshift-nfd项目中检查 pod 的日志。

9.3. 使用 Node Feature Discovery Operator

Node Feature Discovery(NFD)Operator 通过监视 NodeFeatureDiscovery CR 来编排运行 Node-Feature-Discovery 守护进程所需的所有资源。根据 NodeFeatureDiscovery CR,Operator 将在所需命名空间中创建操作对象(NFD)组件。您可以编辑 CR 来选择另一个 命名空间、镜像、imagePullPolicy 和 nfd-worker-conf,以及其他选项。

作为集群管理员,您可以使用 OpenShift Container Platform CLI 或 Web 控制台创建 NodeFeatureDiscovery 实例。

9.3.1. 使用 CLI 创建 NodeFeatureDiscovery 实例

作为集群管理员,您可以使用 CLI 创建 NodeFeatureDiscovery CR 实例。

先决条件

- OpenShift Container Platform 集群

-

安装 OpenShift CLI (

oc) 。 -

以具有

cluster-admin权限的用户身份登录。 - 安装 NFD Operator。

流程

创建以下

NodeFeatureDiscovery自定义资源(CR),然后在NodeFeatureDiscovery.yaml文件中保存 YAML:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建

NodeFeatureDiscoveryCR 实例:oc create -f NodeFeatureDiscovery.yaml

$ oc create -f NodeFeatureDiscovery.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

要验证是否已创建实例,请运行:

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 一个成功的部署会显示

Running状态。

9.3.2. 使用 Web 控制台创建 NodeFeatureDiscovery CR

流程

- 进入到 Operators → Installed Operators 页面。

- 查找 Node Feature Discovery,并在 Provided APIs 下看到一个方框。

- 单击 Create instance。

-

编辑

NodeFeatureDiscoveryCR 的值。 - 点 Create。

9.4. 配置 Node Feature Discovery Operator

9.4.1. core

core 部分包含不特定于任何特定功能源的常见配置设置。

core.sleepInterval

core.sleepInterval 指定连续通过功能检测或重新检测之间的间隔,还可指定节点重新标记之间的间隔。非正数值意味着睡眠间隔无限 ; 不进行重新检测或重新标记。

如果指定,这个值会被弃用的 --sleep-interval 命令行标志覆盖。

用法示例

core: sleepInterval: 60s

core:

sleepInterval: 60s

默认值为 60s。

core.sources

core.sources 指定启用的功能源列表。特殊值 all 可启用所有功能源。

如果指定,这个值会被弃用的 --sources 命令行标志覆盖。

默认:[all]

用法示例

core:

sources:

- system

- custom

core:

sources:

- system

- customcore.labelWhiteList

core.labelWhiteList 根据标签名称指定用于过滤功能标签的正则表达式。不匹配的标签将不会被发布。

正则表达式仅与标签的 basename 部分("/"后的名称部分)进行匹配。标签前缀或命名空间会被省略。

如果指定,这个值会被弃用的 --label-whitelist 命令行标志覆盖。

默认: null

用法示例

core: labelWhiteList: '^cpu-cpuid'

core:

labelWhiteList: '^cpu-cpuid'core.noPublish

将 core.noPublish 设置为 true 可禁用与 nfd-master 的所有通信。它实际上是一个空运行标记; nfd-worker 会正常运行功能检测,但不会向 nfd-master 发送实际的标记请求。

如果指定,--no-publish 命令行标志会覆盖这个值。

例如:

用法示例

core: noPublish: true

core:

noPublish: true

默认值为 false。

core.klog

以下选项指定日志记录器配置,其中大多数可以在运行时动态调整。

日志记录器选项也可以使用命令行标志来指定,其优先级高于任何对应的配置文件选项。

core.klog.addDirHeader

如果设置为 true,core.klog.addDirHeader 将文件目录添加到日志消息的标头中。

默认:false

运行时可配置:是

core.klog.alsologtostderr

将日志信息输出到标准错误以及文件。

默认:false

运行时可配置:是

core.klog.logBacktraceAt

当日志记录达到行 file:N 时,触发堆栈跟踪功能。

默认: 空

运行时可配置:是

core.klog.logDir

如果非空,在此目录中写入日志文件。

默认: 空

运行是时配置:否

core.klog.logFile

如果不为空,则使用此日志文件。

默认: 空

运行是时配置:否

core.klog.logFileMaxSize

core.klog.logFileMaxSize 定义日志文件可增大的最大大小。单位是 MB。如果值为 0,则最大文件大小没有限制。

默认: 1800

运行是时配置:否

core.klog.logtostderr

将日志信息输出到标准错误而不是文件

默认: true

运行时可配置:是

core.klog.skipHeaders

如果 core.klog.skipHeaders 设为 true,忽略日志消息中的标头前缀。

默认:false

运行时可配置:是

core.klog.skipLogHeaders

如果 core.klog.skipLogHeaders 设为 true,在打开日志文件时忽略标头。

默认:false

运行是时配置:否

core.klog.stderrthreshold

处于或超过此阈值的日志输出到 stderr。

默认: 2

运行时可配置:是

core.klog.v

core.klog.v 是日志级别详细程度的值。

默认: 0

运行时可配置:是

core.klog.vmodule

core.klog.vmodule 是文件过滤日志的、以逗号分隔的 pattern=N 设置列表。

默认: 空

运行时可配置:是

9.4.2. sources

sources 部分包含特定于功能源的配置参数。

sources.cpu.cpuid.attributeBlacklist

防止发布此选项中列出的 cpuid 功能。

如果指定,则 source.cpu.cpuid.attributeWhitelist 将覆盖这个值。

默认:[BMI1, BMI2, CLMUL, CMOV, CX16, ERMS, F16C, HTT, LZCNT, MMX, MMXEXT, NX, POPCNT, RDRAND, RDSEED, RDTSCP, SGX, SGXLC, SSE, SSE2, SSE3, SSE4.1, SSE4.2, SSSE3]

用法示例

sources:

cpu:

cpuid:

attributeBlacklist: [MMX, MMXEXT]

sources:

cpu:

cpuid:

attributeBlacklist: [MMX, MMXEXT]sources.cpu.cpuid.attributeWhitelist

仅发布在此选项中列出的 cpuid 功能。

source.cpu.cpuid.attributeWhitelist 优先于 source.cpu.cpuid.attributeBlacklist。

默认: 空

用法示例

sources:

cpu:

cpuid:

attributeWhitelist: [AVX512BW, AVX512CD, AVX512DQ, AVX512F, AVX512VL]

sources:

cpu:

cpuid:

attributeWhitelist: [AVX512BW, AVX512CD, AVX512DQ, AVX512F, AVX512VL]sources.kernel.kconfigFile

source.kernel.kconfigFile 是内核配置文件的路径。如果为空,NFD 会在已知的标准位置运行搜索。

默认: 空

用法示例

sources:

kernel:

kconfigFile: "/path/to/kconfig"

sources:

kernel:

kconfigFile: "/path/to/kconfig"sources.kernel.configOpts

sources.kernel.configOpts 代表内核配置选项,作为功能标签发布。

默认:[NO_HZ, NO_HZ_IDLE, NO_HZ_FULL, PREEMPT]

用法示例

sources:

kernel:

configOpts: [NO_HZ, X86, DMI]

sources:

kernel:

configOpts: [NO_HZ, X86, DMI]sources.pci.deviceClassWhitelist

sources.pci.deviceClassWhitelist 是用来发布标签的 PCI 设备类 ID 列表。它只能指定为主类(例如 03)或全类子类组合(例如 0300)。前者表示接受所有子类。可以使用 deviceLabelFields 进一步配置标签格式。

默认: ["03", "0b40", "12"]

用法示例

sources:

pci:

deviceClassWhitelist: ["0200", "03"]

sources:

pci:

deviceClassWhitelist: ["0200", "03"]sources.pci.deviceLabelFields

sources.pci.deviceLabelFields 是构建功能标签名称时要使用的 PCI ID 字段集合。有效字段包括 class、vendor、device、subsystem_vendor 和 subsystem_device。

默认: [class, vendor]

用法示例

sources:

pci:

deviceLabelFields: [class, vendor, device]

sources:

pci:

deviceLabelFields: [class, vendor, device]

在上例配置中,NFD 会发布标签,如 feature.node.kubernetes.io/pci-<class-id>_<vendor-id>_<device-id>.present=true

sources.usb.deviceClassWhitelist

sources.usb.deviceClassWhitelist 是一个 USB 设备类 ID 列表,用于发布功能标签。可以使用 deviceLabelFields 进一步配置标签格式。

默认: ["0e", "ef", "fe", "ff"]

用法示例

sources:

usb:

deviceClassWhitelist: ["ef", "ff"]

sources:

usb:

deviceClassWhitelist: ["ef", "ff"]sources.usb.deviceLabelFields

sources.usb.deviceLabelFields 是一组 USB ID 字段,用于编写功能标签的名称。有效字段包括 class、vendor 和 device。

默认: [class、vendor、device]

用法示例

sources:

pci:

deviceLabelFields: [class, vendor]

sources:

pci:

deviceLabelFields: [class, vendor]

使用上面的示例配置,NFD 会发布类似如下标签: feature.node.kubernetes.io/usb-<class-id>_<vendor-id>.present=true。

sources.custom

sources.custom 是在自定义功能源中处理的规则列表,用于创建特定于用户的标签。

默认: 空

用法示例

第 10 章 驱动程序工具包(Driver Toolkit)

了解驱动程序工具包以及如何将其用作驱动程序容器的基础镜像,以便在 Kubernetes 上启用特殊软件和硬件设备。

Driver Toolkit 只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的详情,请参考 https://access.redhat.com/support/offerings/techpreview/。

10.1. 关于驱动程序工具包

背景信息

Driver Toolkit 是 OpenShift Container Platform 有效负载中的一个容器镜像,用作可构建驱动程序容器的基础镜像。Driver Toolkit 镜像包含通常作为构建或安装内核模块的依赖项所需的内核软件包,以及驱动程序容器所需的一些工具。这些软件包的版本将与相应 OpenShift Container Platform 发行版本中的 Red Hat Enterprise Linux CoreOS(RHCOS)节点上运行的内核版本匹配。

驱动程序容器是容器镜像,用于在容器操作系统(如 RHCOS)上构建和部署树外内核模块和驱动程序。内核模块和驱动程序是在操作系统内核中具有高级别权限运行的软件库。它们扩展了内核功能,或者提供控制新设备所需的硬件特定代码。示例包括 Field Programmable Gate Arrays(FPGA)或 GPU 等硬件设备,以及软件定义型存储(SDS)解决方案(如 Lustre parallel 文件系统,它在客户端机器上需要内核模块)。驱动程序容器是用于在 Kubernetes 上启用这些技术的软件堆栈的第一层。

Driver Toolkit 中的内核软件包列表包括以下内容及其依赖项:

-

kernel-core -

kernel-devel -

kernel-headers -

kernel-modules -

kernel-modules-extra

另外,Driver Toolkit 还包含相应的实时内核软件包:

-

kernel-rt-core -

kernel-rt-devel -

kernel-rt-modules -

kernel-rt-modules-extra

Driver Toolkit 还有几个通常需要的工具来构建和安装内核模块,其中包括:

-

elfutils-libelf-devel -

kmod -

binutilskabi-dw -

kernel-abi-whitelists - 以上的依赖项

目的

在出现 Driver Toolkit 之前,您可以在 OpenShift Container Platform 中的一个 pod 中安装内核软件包,或在构建配置中使用 entitled builds,或从主机 machine-os-content 的内核 RPM 进行安装。Driver Toolkit 通过删除授权步骤简化了流程,并避免了访问 pod 中的 machine-os-content 特权操作。Driver Toolkit 也可以由有权访问预发布的 OpenShift Container Platform 版本的合作伙伴使用,用于未来的 OpenShift Container Platform 版本的硬件设备的预构建 driver-containers。

特殊资源 Operator(SRO)也使用 Driver Toolkit,目前作为 OperatorHub 上的社区 Operator 提供。SRO 支持树外和第三方内核驱动程序以及底层操作系统的支持软件。用户可以为 SRO 创建配方(recipes)来构建和部署驱动程序容器,以及支持诸如设备插件或指标的软件。配方可以包含构建配置,以基于 Driver Toolkit 构建驱动程序容器,或者 SRO 可以部署预构建驱动程序容器。

10.2. 拉取 Driver Toolkit 容器镜像

driver-toolkit 镜像包括在 Red Hat Ecosystem Catalog 的容器镜像部分和 OpenShift Container Platform 发行版本有效负载中。与 OpenShift Container Platform 最新次要版本对应的镜像将标记为目录中的版本号。具体版本的镜像 URL 可使用 oc adm CLI 命令找到。

10.2.1. 从 registry.redhat.io 中拉取 Driver Toolkit 容器镜像

Red Hat Ecosystem Catalog 包括了使用 podman 或 OpenShift Container Platform 从 registry.redhat.io 中拉取 driver-toolkit 镜像的说明。最新次版本的 driver-toolkit 镜像将标记为 registry.redhat.io 中的次版本,如 registry.redhat.io/openshift4/driver-toolkit-rhel8:v4.8。

10.2.2. 在有效负载中查找驱动程序工具包镜像 URL

先决条件

- 您已从 Red Hat OpenShift Cluster Manager 获取了镜像 pull secret。

-

已安装 OpenShift CLI(

oc)。

流程

可以使用

oc adm命令从发行镜像中提取与特定发行版本对应的driver-toolkit镜像 URL:oc adm release info 4.8.0 --image-for=driver-toolkit

$ oc adm release info 4.8.0 --image-for=driver-toolkitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

quay.io/openshift-release-dev/ocp-v4.0-art-dev@sha256:0fd84aee79606178b6561ac71f8540f404d518ae5deff45f6d6ac8f02636c7f4

quay.io/openshift-release-dev/ocp-v4.0-art-dev@sha256:0fd84aee79606178b6561ac71f8540f404d518ae5deff45f6d6ac8f02636c7f4Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 可以使用有效的 pull secret 拉取此镜像,如安装 OpenShift Container Platform 所需的 pull secret。

podman pull --authfile=path/to/pullsecret.json quay.io/openshift-release-dev/ocp-v4.0-art-dev@sha256:<SHA>

$ podman pull --authfile=path/to/pullsecret.json quay.io/openshift-release-dev/ocp-v4.0-art-dev@sha256:<SHA>10.3. 使用 Driver Toolkit

例如,Driver Toolkit 可用作基础镜像来构建非常简单的内核模块,名为 simple-kmod。

10.3.1. 在集群中构建并运行 simple-kmod 驱动程序容器

先决条件

- OpenShift Container Platform 集群

-

安装 OpenShift CLI (

oc) 。 -

以具有

cluster-admin特权的用户身份登录。

流程

创建命名空间。例如:

oc new-project simple-kmod-demo

$ oc new-project simple-kmod-demoYAML 定义了

ImageStream,用于存储simple-kmod驱动程序容器镜像,以及用于构建容器的BuildConfig。将此 YAML 保存为0000-buildconfig.yaml.template。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在以下命令中,使用您运行的 OpenShift Container Platform 版本的相关的正确 driver toolki 镜像替换 "DRIVER_TOOLKIT_IMAGE" 部分。

OCP_VERSION=$(oc get clusterversion/version -ojsonpath={.status.desired.version})$ OCP_VERSION=$(oc get clusterversion/version -ojsonpath={.status.desired.version})Copy to Clipboard Copied! Toggle word wrap Toggle overflow DRIVER_TOOLKIT_IMAGE=$(oc adm release info $OCP_VERSION --image-for=driver-toolkit)

$ DRIVER_TOOLKIT_IMAGE=$(oc adm release info $OCP_VERSION --image-for=driver-toolkit)Copy to Clipboard Copied! Toggle word wrap Toggle overflow sed "s#DRIVER_TOOLKIT_IMAGE#${DRIVER_TOOLKIT_IMAGE}#" 0000-buildconfig.yaml.template > 0000-buildconfig.yaml$ sed "s#DRIVER_TOOLKIT_IMAGE#${DRIVER_TOOLKIT_IMAGE}#" 0000-buildconfig.yaml.template > 0000-buildconfig.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意OpenShift Container Platform 4.6 中引入了驱动程序工具包,其版本为 4.6.30,在 4.7 和 4.8 中的版本为 4.7.11。

使用创建镜像流和构建配置

oc create -f 0000-buildconfig.yaml

$ oc create -f 0000-buildconfig.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 构建器 Pod 成功完成后,将驱动程序容器镜像部署为

DaemonSet。驱动程序容器必须使用特权安全上下文运行,才能在主机上加载内核模块。以下 YAML 文件包含用于运行驱动程序容器的 RBAC 规则和

DaemonSet。将此 YAML 保存为1000-drivercontainer.yaml。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 RBAC 规则和守护进程集:

oc create -f 1000-drivercontainer.yaml

$ oc create -f 1000-drivercontainer.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

当 pod 在 worker 节点上运行后,使用

lsmod验证在主机机器上是否成功载入了simple_kmod内核模块。验证 pod 是否正在运行:

oc get pod -n simple-kmod-demo

$ oc get pod -n simple-kmod-demoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY STATUS RESTARTS AGE simple-kmod-driver-build-1-build 0/1 Completed 0 6m simple-kmod-driver-container-b22fd 1/1 Running 0 40s simple-kmod-driver-container-jz9vn 1/1 Running 0 40s simple-kmod-driver-container-p45cc 1/1 Running 0 40s

NAME READY STATUS RESTARTS AGE simple-kmod-driver-build-1-build 0/1 Completed 0 6m simple-kmod-driver-container-b22fd 1/1 Running 0 40s simple-kmod-driver-container-jz9vn 1/1 Running 0 40s simple-kmod-driver-container-p45cc 1/1 Running 0 40sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在驱动程序容器 pod 中执行

lsmod命令:oc exec -it pod/simple-kmod-driver-container-p45cc -- lsmod | grep simple

$ oc exec -it pod/simple-kmod-driver-container-p45cc -- lsmod | grep simpleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

simple_procfs_kmod 16384 0 simple_kmod 16384 0

simple_procfs_kmod 16384 0 simple_kmod 16384 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 11 章 根据对象限制规划您的环境

在规划 OpenShift Container Platform 集群时,请考虑以下对象限制。

这些限制基于最大可能的集群。对于较小的集群,最大值限制会较低。很多因素会影响指定的阈值,包括 etcd 版本或者存储数据格式。

这些指南适用于带有软件定义网络(SDN)而不是开放虚拟网络(OVN)的 OpenShift Container Platform。

在大多数情况下,超过这些限制会降低整体性能。它不一定意味着集群会出现错误。

11.1. OpenShift Container Platform 为主发行版本测试了集群最大值

为 OpenShift Container Platform 3.x 测试的云平台: Red Hat OpenStack Platform(RHOSP)、Amazon Web Services 和 Microsoft Azure。为 OpenShift Container Platform 4.x 测试的云平台: Amazon Web Services、Microsoft Azure 和 Google Cloud Platform。

| 最大类型 | 3.x 测试的最大值 | 4.x 测试的最大值 |

|---|---|---|

| 节点数 | 2,000 | 2,000 |

| pod 数量 [1] | 150,000 | 150,000 |

| 每个节点的 pod 数量 | 250 | 500 [2] |

| 每个内核的 pod 数量 | 没有默认值。 | 没有默认值。 |

| 命名空间数量 [3] | 10,000 | 10,000 |

| 构建(build)数 | 10,000(默认 pod RAM 512 Mi)- 管道 (Pipeline) 策略 | 10,000(默认 pod RAM 512 Mi)- Source-to-Image (S2I) 构建策略 |

| 每个命名空间的 pod 数量 [4] | 25,000 | 25,000 |

| 每个 Ingress Controller 的路由和后端数量 | 每个路由器 2,000 个 | 每个路由器 2,000 个 |

| secret 的数量 | 80,000 | 80,000 |

| 配置映射数量 | 90,000 | 90,000 |

| 服务数量 [5] | 10,000 | 10,000 |

| 每个命名空间的服务数 | 5,000 | 5,000 |

| 每个服务中的后端数 | 5,000 | 5,000 |

| 每个命名空间的部署数量 [4] | 2,000 | 2,000 |

| 构建配置数 | 12,000 | 12,000 |

| 自定义资源定义 (CRD) 的数量 | 没有默认值。 | 512 [6] |

- 这里的 pod 数量是 test pod 的数量。实际的 pod 数量取决于应用程序的内存、CPU 和存储要求。

-

这在一个有 100 个 work 节点,每个 worker 节点有 500 个 pod 的集群中测试。默认

maxPods仍为 250。要获得 500maxPods,则必须使用自定义 kubelet 配置将maxPods设置为500来创建集群。如果需要 500 个用户 Pod,则需要hostPrefix为22,因为节点上已经运行了 10-15 个系统 pod。带有 Persistent VolumeClaim (PVC) 的最大 pod 数量取决于分配 PVC 的后端存储。在我们的测试中,只有 OpenShift Container Storage (OCS v4) 能够满足本文档中提到的每个节点的 pod 数量。 - 当有大量活跃的项目时,如果键空间增长过大并超过空间配额,etcd 的性能将会受到影响。强烈建议您定期维护 etcd 存储(包括整理碎片)来释放 etcd 存储。

- 系统中有一些控制循环,它们必须对给定命名空间中的所有对象进行迭代,以作为对一些状态更改的响应。在单一命名空间中有大量给定类型的对象可使这些循环的运行成本变高,并降低对给定状态变化的处理速度。限制假设系统有足够的 CPU 、内存和磁盘来满足应用程序的要求。

- 每个服务端口和每个服务后端在 iptables 中都有对应条目。给定服务的后端数量会影响端点对象的大小,这会影响到整个系统发送的数据大小。

-

OpenShift Container Platform 的限制是 512 个总自定义资源定义(CRD),其中包括由 OpenShift Container Platform 安装的产品、与 OpenShift Container Platform 集成并创建了 CRD 的产品。如果创建超过 512 CRD,则

oc命令请求可能会节流。

红帽不提供针对 OpenShift Container Platform 集群大小调整的直接指导。这是因为,判断集群是否在 OpenShift Container Platform 支持的边界内,需要仔细考虑限制集群扩展的所有多维因素。

11.2. 测试集群最大值的 OpenShift Container Platform 环境和配置

AWS 云平台:

| 节点 | Flavor | vCPU | RAM(GiB) | 磁盘类型 | 磁盘大小(GiB)/IOS | 数量 | 区域 |

|---|---|---|---|---|---|---|---|

| Master/etcd [1] | r5.4xlarge | 16 | 128 | gp3 | 220 | 3 | us-west-2 |

| Infra [2] | m5.12xlarge | 48 | 192 | gp3 | 100 | 3 | us-west-2 |

| Workload [3] | m5.4xlarge | 16 | 64 | gp3 | 500 [4] | 1 | us-west-2 |

| Worker | m5.2xlarge | 8 | 32 | gp3 | 100 | 3/25/250/500 [5] | us-west-2 |

- 带有基准性能为 3000 IOPS 和 125 MiB 每秒的 gp3 磁盘用于 control plane/etcd 节点,因为 etcd 对延迟敏感。gp3 卷不使用突发性能。

- Infra 节点用于托管 Monitoring、Ingress 和 Registry 组件,以确保它们有足够资源可大规模运行。

- 工作负载节点专用于运行性能和可扩展工作负载生成器。

- 使用更大的磁盘,以便有足够的空间存储在运行性能和可扩展性测试期间收集的大量数据。

- 在迭代中扩展了集群,且性能和可扩展性测试是在指定节点数中执行的。

IBM Power 系统平台:

| 节点 | vCPU | RAM(GiB) | 磁盘类型 | 磁盘大小(GiB)/IOS | 数量 |

|---|---|---|---|---|---|

| Master/etcd [1] | 16 | 32 | io1 | 每个 GiB 120 / 10 IOPS | 3 |

| Infra [2] | 16 | 64 | gp2 | 120 | 2 |

| Workload [3] | 16 | 256 | gp2 | 120 [4] | 1 |

| Worker | 16 | 64 | gp2 | 120 | 3/25/250/500 [5] |

- 带有 120 / 3 IOPS 的 io1 磁盘用于 master/etcd 节点,因为 etcd 非常大,且敏感延迟。

- Infra 节点用于托管 Monitoring、Ingress 和 Registry 组件,以确保它们有足够资源可大规模运行。

- 工作负载节点专用于运行性能和可扩展工作负载生成器。

- 使用更大的磁盘,以便有足够的空间存储在运行性能和可扩展性测试期间收集的大量数据。

- 在迭代中扩展了集群,且性能和可扩展性测试是在指定节点数中执行的。

11.2.1. IBM Z 平台

| 节点 | vCPU [4] | RAM(GiB)[5] | 磁盘类型 | 磁盘大小(GiB)/IOS | 数量 |

|---|---|---|---|---|---|

| Control plane/etcd [1,2] | 8 | 32 | ds8k | 300 / LCU 1 | 3 |

| Compute [1,3] | 8 | 32 | ds8k | 150 / LCU 2 | 4 节点(每个节点扩展到 100/250/500 pod) |

- 节点在两个逻辑控制单元 (LCU) 之间分发,以优化 control plane/etcd 节点的磁盘 I/O 负载,因为 etcd 非常大,且对延迟敏感。etcd I/O 需求不应干扰其他工作负载。

- 四个计算节点用于运行同时具有 100/250/500 pod 的多个迭代的测试。首先,使用闲置 pod 来评估 pod 是否可以实例。接下来,使用网络和 CPU 要求客户端/服务器工作负载来评估系统在压力下的稳定性。客户端和服务器 pod 是部署范围,每个对分布在两个计算节点上。

- 没有单独的工作负载节点。工作负载在两个计算节点之间模拟微服务工作负载。

- 使用的物理处理器数量是 6 个用于 Linux (IFL)的集成设施。

- 使用的总物理内存为 512 GiB。

11.3. 如何根据经过测试的集群限制规划您的环境

在节点中过度订阅物理资源会影响在 pod 放置过程中对 Kubernetes 调度程序的资源保证。了解可以采取什么措施避免内存交换。

某些限制只在单一维度中扩展。当很多对象在集群中运行时,它们会有所不同。

本文档中给出的数字基于红帽的测试方法、设置、配置和调整。这些数字会根据您自己的设置和环境而有所不同。

在规划您的环境时,请确定每个节点会运行多少 个 pod :

required pods per cluster / pods per node = total number of nodes needed

required pods per cluster / pods per node = total number of nodes needed每个节点上的 Pod 数量做多为 250。而在某个节点中运行的 pod 的具体数量取决于应用程序本身。请参阅 如何根据应用程序要求规划您的环境 中的内容来计划应用程序的内存、CPU 和存储要求。

示例情境

如果您计划把集群的规模限制在有 2200 个 pod,则需要至少有五个节点,假设每个节点最多有 500 个 pod:

2200 / 500 = 4.4

2200 / 500 = 4.4如果将节点数量增加到 20,那么 pod 的分布情况将变为每个节点有 110 个 pod:

2200 / 20 = 110

2200 / 20 = 110其中:

required pods per cluster / total number of nodes = expected pods per node

required pods per cluster / total number of nodes = expected pods per node11.4. 如何根据应用程序要求规划您的环境

考虑应用程序环境示例:

| pod 类型 | pod 数量 | 最大内存 | CPU 内核 | 持久性存储 |

|---|---|---|---|---|

| Apache | 100 | 500 MB | 0.5 | 1 GB |

| node.js | 200 | 1 GB | 1 | 1 GB |

| postgresql | 100 | 1 GB | 2 | 10 GB |

| JBoss EAP | 100 | 1 GB | 1 | 1 GB |

推断的要求: 550 个 CPU 内核、450GB RAM 和 1.4TB 存储。

根据您的具体情况,节点的实例大小可以被增大或降低。在节点上通常会使用资源过度分配。在这个部署场景中,您可以选择运行多个额外的较小节点,或数量更少的较大节点来提供同样数量的资源。在做出决定前应考虑一些因素,如操作的灵活性以及每个实例的成本。

| 节点类型 | 数量 | CPU | RAM (GB) |

|---|---|---|---|

| 节点(选择 1) | 100 | 4 | 16 |

| 节点(选择 2) | 50 | 8 | 32 |

| 节点(选择 3) | 25 | 16 | 64 |

有些应用程序很适合于过度分配的环境,有些则不适合。大多数 Java 应用程序以及使用巨页的应用程序都不允许使用过度分配功能。它们的内存不能用于其他应用程序。在上面的例子中,环境大约会出现 30% 过度分配的情况,这是一个常见的比例。

应用程序 pod 可以使用环境变量或 DNS 访问服务。如果使用环境变量,当 pod 在节点上运行时,对于每个活跃服务,则 kubelet 的变量都会注入。集群感知 DNS 服务器监视 Kubernetes API 提供了新服务,并为每个服务创建一组 DNS 记录。如果整个集群中启用了 DNS,则所有 pod 都应自动根据其 DNS 名称解析服务。如果您必须超过 5000 服务,可以使用 DNS 进行服务发现。当使用环境变量进行服务发现时,参数列表超过了命名空间中 5000 服务后允许的长度,则 pod 和部署将失败。要解决这个问题,请禁用部署的服务规格文件中的服务链接:

可在命名空间中运行的应用程序 pod 数量取决于服务数量以及环境变量用于服务发现时的服务名称长度。系统中的ARG_MAX 为新进程定义最大参数长度,默认设置为 2097152 KiB。Kubelet 将环境变量注入到要在命名空间中运行的每个 pod 中,包括:

-

<SERVICE_NAME>_SERVICE_HOST=<IP> -

<SERVICE_NAME>_SERVICE_PORT=<PORT> -

<SERVICE_NAME>_PORT=tcp://<IP>:<PORT> -

<SERVICE_NAME>_PORT_<PORT>_TCP=tcp://<IP>:<PORT> -

<SERVICE_NAME>_PORT_<PORT>_TCP_PROTO=tcp -

<SERVICE_NAME>_PORT_<PORT>_TCP_PORT=<PORT> -

<SERVICE_NAME>_PORT_<PORT>_TCP_ADDR=<ADDR>

如果参数长度超过允许的值,服务名称中的字符数会受到影响,命名空间中的 pod 将开始失败。例如,在一个带有 5000 服务的命名空间中,服务名称的限制为 33 个字符,它可让您在命名空间中运行 5000 个 Pod。

第 12 章 优化存储

优化存储有助于最小化所有资源中的存储使用。通过优化存储,管理员可帮助确保现有存储资源以高效的方式工作。

12.1. 可用的持久性存储选项

了解持久性存储选项,以便可以优化 OpenShift Container Platform 环境。

| 存储类型 | 描述 | 例子 |

|---|---|---|

| Block |

| AWS EBS 和 VMware vSphere 支持在 OpenShift Container Platform 中的原生动态持久性卷 (PV)置备 。 |

| File |

| RHEL NFS、NetApp NFS [1] 和供应商 NFS |

| 对象 |

| AWS S3 |

- NetApp NFS 在使用 Trident 插件时支持动态 PV 置备。

目前,OpenShift Container Platform 4.8 不支持 CNS。

12.2. 推荐的可配置存储技术

下表总结了为给定的 OpenShift Container Platform 集群应用程序推荐的可配置存储技术。

| 存储类型 | ROX1 | RWX2 | Registry | 扩展的 registry | Metrics3 | 日志记录 | Apps |

|---|---|---|---|---|---|---|---|

|

1

2 3 Prometheus 是用于指标数据的底层技术。 4 这不适用于物理磁盘、虚拟机物理磁盘、VMDK 、NFS 回送、AWS EBS 和 Azure 磁盘。

5 对于指标数据,使用 6 用于日志记录,使用任何共享存储都将是一个反模式。每个 elasticsearch 都需要一个卷。 7 对象存储不会通过 OpenShift Container Platform 的 PV 或 PVC 使用。应用程序必须与对象存储 REST API 集成。 | |||||||

| Block | Yes4 | 否 | 可配置 | 无法配置 | 推荐的 | 推荐的 | 推荐的 |

| File | Yes4 | 是 | 可配置 | 可配置 | Configurable5 | Configurable6 | 推荐的 |

| 对象 | 是 | 是 | 推荐的 | 推荐的 | 无法配置 | 无法配置 | Not configurable7 |

扩展的容器镜像仓库(registry)是一个 OpenShift Container Platform 容器镜像仓库,它有两个或更多个 pod 运行副本。

12.2.1. 特定应用程序存储建议

测试显示在 Red Hat Enterprise Linux(RHEL)中使用 NFS 服务器作为核心服务的存储后端的问题。这包括 OpenShift Container Registry 和 Quay,Prometheus 用于监控存储,以及 Elasticsearch 用于日志存储。因此,不建议使用 RHEL NFS 作为 PV 后端用于核心服务。

市场上的其他 NFS 实现可能没有这些问题。如需了解更多与此问题相关的信息,请联络相关的 NFS 厂商。

12.2.1.1. Registry

在一个非扩展的/高可用性 (HA) OpenShift Container Platform registry 集群部署中:

- 存储技术不需要支持 RWX 访问模式。

- 存储技术必须保证读写一致性。

- 首选存储技术是对象存储,然后是块存储。

- 对于应用于生产环境工作负载的 OpenShift Container Platform Registry 集群部署,我们不推荐使用文件存储。

12.2.1.2. 扩展的 registry

在扩展的/HA OpenShift Container Platform registry 集群部署中:

- 存储技术必须支持 RWX 访问模式。

- 存储技术必须保证读写一致性。

- 首选存储技术是对象存储。

- 支持 Amazon Simple Storage Service(Amazon S3)、Google Cloud Storage(GCS)、Microsoft Azure Blob Storage 和 OpenStack Swift。

- 对象存储应该兼容 S3 或 Swift。

- 对于非云平台,如 vSphere 和裸机安装,唯一可配置的技术是文件存储。

- 块存储是不可配置的。

12.2.1.3. 指标

在 OpenShift Container Platform 托管的 metrics 集群部署中:

- 首选存储技术是块存储。

- 对象存储是不可配置的。

在带有生产环境负载的托管 metrics 集群部署中不推荐使用文件存储。

12.2.1.4. 日志记录

在 OpenShift Container Platform 托管的日志集群部署中:

- 首选存储技术是块存储。

- 对象存储是不可配置的。

12.2.1.5. 应用程序

应用程序的用例会根据不同应用程序而不同,如下例所示: