This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.Serverless

OpenShift Serverless 的安装、使用与发行注记

摘要

第 1 章 发行注记

如需有关 OpenShift Serverless 生命周期和支持的平台的更多信息,请参阅 平台生命周期政策。

发行注记包含有关新的和已弃用的功能、破坏更改以及已知问题的信息。以下发行注记适用于 OpenShift Container Platform 的最新 OpenShift Serverless 版本。

如需了解 OpenShift Serverless 功能概述,请参阅 关于 OpenShift Serverless。

OpenShift Serverless 基于开源的 Knative 项目。

有关最新 Knative 组件发行版本的详情,请参阅 Knative 博客。

1.1. 关于 API 版本

API 版本是 OpenShift Serverless 中特定函数和自定义资源的开发状态的重要因素。在没有使用正确 API 版本的集群中创建资源可能会导致部署出现问题。

OpenShift Serverless Operator 会自动升级使用已弃用 API 版本的旧资源以使用最新版本。例如,如果您在集群中创建了使用旧版本的 ApiServerSource API(如 v1beta1 )的资源,OpenShift Serverless Operator 会在可用时自动更新这些资源以使用 API 的 v1 版本,并弃用 v1beta1 版本。

弃用后,可能会在任何即将发布的发行版本中删除旧版本的 API。使用已弃用的 API 版本不会导致资源失败。但是,如果您尝试使用已删除的 API 版本,则会导致资源失败。确保您的清单已更新为使用最新版本以避免出现问题。

1.2. 正式发布(GA)和技术预览(TP)功能

正式发布(GA)的功能被完全支持,并适用于生产环境。技术预览功能为实验性功能,不适用于生产环境。有关 TP 功能的更多信息,请参阅红帽客户门户网站中的技术支持范围。

下表提供了有关哪些 OpenShift Serverless 功能是 GA 以及 TP 的信息:

| 功能 | 1.26 | 1.27 | 1.28 |

|---|---|---|---|

|

| GA | GA | GA |

| Quarkus 功能 | GA | GA | GA |

| Node.js 功能 | TP | TP | GA |

| TypeScript 功能 | TP | TP | GA |

| Python 功能 | - | - | TP |

| Service Mesh mTLS | GA | GA | GA |

|

| GA | GA | GA |

| HTTPS 重定向 | GA | GA | GA |

| Kafka 代理 | GA | GA | GA |

| Kafka 接收器 | GA | GA | GA |

| init 容器支持 Knative 服务 | GA | GA | GA |

| Knative 服务的 PVC 支持 | GA | GA | GA |

| TLS 用于内部流量 | TP | TP | TP |

| 命名空间范围的代理 | - | TP | TP |

|

| - | - | TP |

1.3. 弃用和删除的功能

一些在以前发行本中正式发布 (GA) 或技术预览 (TP) 的功能已被弃用或删除。弃用的功能仍然包含在 OpenShift Serverless 中,并且仍然被支持。但是,弃用的功能可能会在以后的发行版本中被删除,且不建议在新的部署中使用。

有关 OpenShift Serverless 中已弃用并删除的主要功能的最新列表,请参考下表:

| 功能 | 1.20 | 1.21 | 1.22 到 1.26 | 1.27 | 1.28 |

|---|---|---|---|---|---|

|

| 已弃用 | 已弃用 | 删除 | 删除 | 删除 |

|

| 已弃用 | 删除 | 删除 | 删除 | 删除 |

|

Serving 和 Eventing | - | - | - | 已弃用 | 已弃用 |

|

| - | - | - | - | 已弃用 |

1.4. Red Hat OpenShift Serverless 1.28 发行注记

OpenShift Serverless 1.28 现已正式发布。OpenShift Container Platform 上的 OpenShift Serverless 的新功能、改变以及已知的问题包括在此文档中。

1.4.1. 新功能

- OpenShift Serverless 现在使用 Knative Serving 1.7。

- OpenShift Serverless 现在使用 Knative Eventing 1.7。

- OpenShift Serverless 现在使用 Kourier 1.7。

-

OpenShift Serverless 现在使用 Knative (

kn) CLI 1.7。 - OpenShift Serverless 现在使用 Knative Kafka 1.7。

-

kn funcCLI 插件现在使用func1.9.1 版本。 - Node.js 和 TypeScript 运行时现在正式发布 (GA)。

- OpenShift Serverless 功能的 Python 运行时现在作为技术预览提供。

- Knative Serving 的多容器支持现在作为技术预览提供。此功能允许您使用单个 Knative 服务来部署多容器 pod。

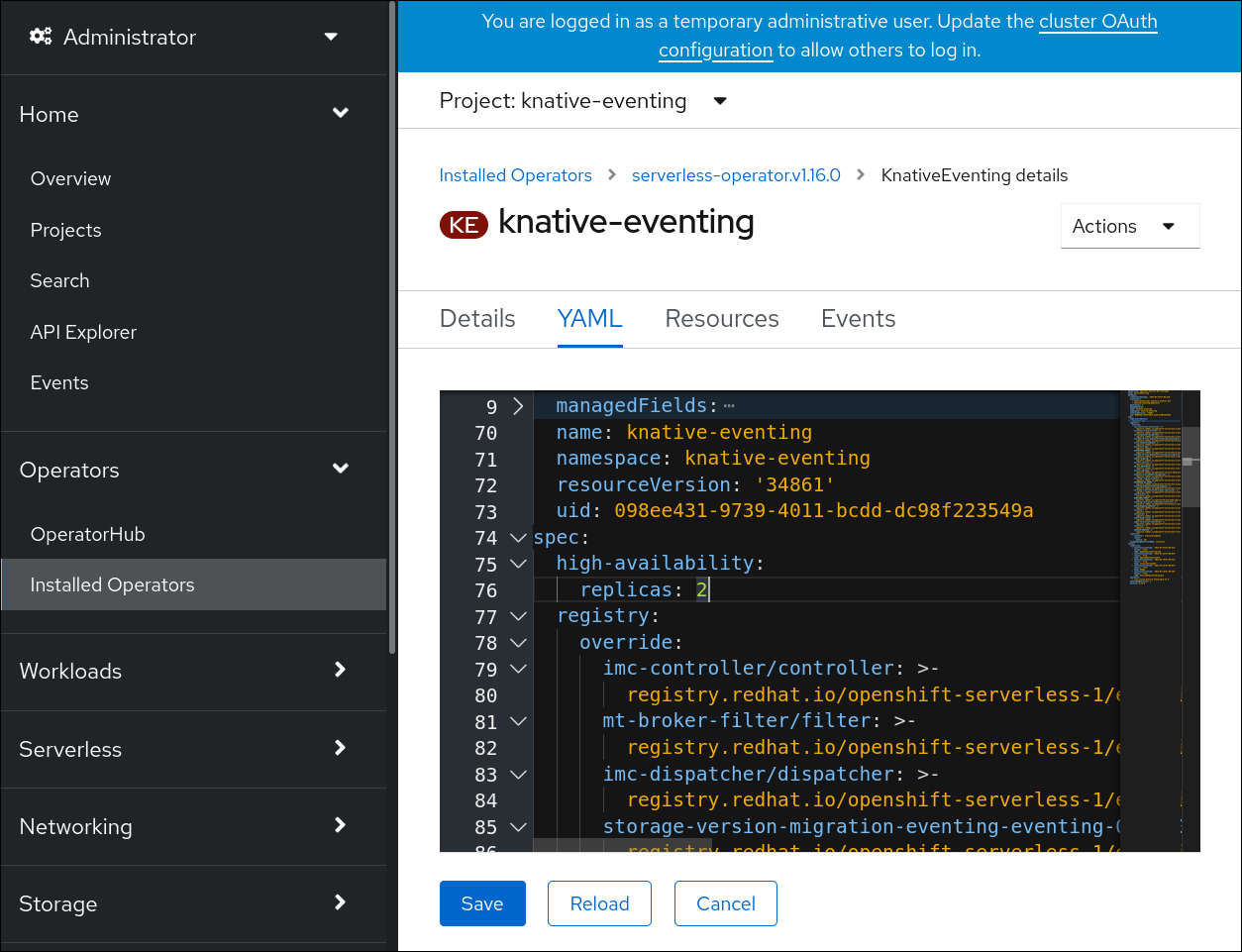

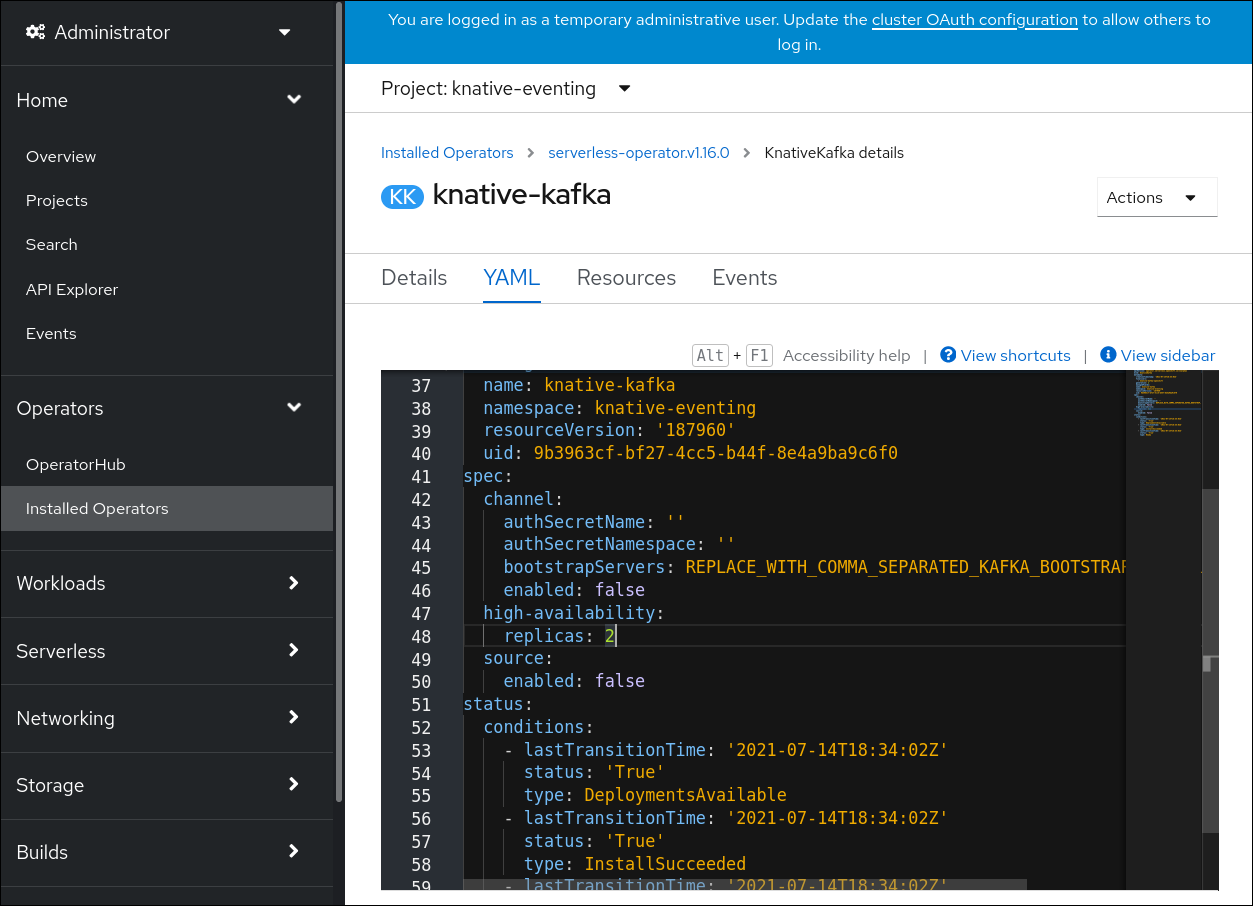

在 OpenShift Serverless 1.29 或更高版本中,Knative Eventing 的以下组件将从两个 pod 缩减为一个:

-

imc-controller -

imc-dispatcher -

mt-broker-controller -

mt-broker-filter -

mt-broker-ingress

-

Serving CR 的

serverless.openshift.io/enable-secret-informer-filtering注解现已弃用。该注解仅适用于 Istio,不适用于 Kourier。在 OpenShift Serverless 1.28 中,OpenShift Serverless Operator 允许注入

net-istio和net-kourier的环境变量ENABLE_SECRET_INFORMER_FILTERING_BY_CERT_UID。要防止从 OpenShift Serverless 1.28 升级到一些将来的版本时出现问题,用户必须使用

networking.internal.knative.dev/certificate-uid:some_cuid注解其 secret。

1.4.2. 已知问题

目前,IBM Power、IBM zSystems 和 IBM® LinuxONE 上的 OpenShift Serverless 功能不支持 Python 的运行时。

Node.js、typetype 和 Quarkus 功能在这些架构中被支持。

在 Windows 平台上,因为

app.sh文件权限,无法使用 Source-to-Image 构建器在本地构建、运行或部署 Python 功能。要临时解决这个问题,对 Linux 使用 Windows 子系统。

1.5. Red Hat OpenShift Serverless 1.27 发行注记

OpenShift Serverless 1.27 现已正式发布。OpenShift Container Platform 上的 OpenShift Serverless 的新功能、改变以及已知的问题包括在此文档中。

OpenShift Serverless 1.26 是 OpenShift Container Platform 4.12 完全支持的最早版本。OpenShift Serverless 1.25 和更早的版本不会在 OpenShift Container Platform 4.12 上部署。

因此,在将 OpenShift Container Platform 升级到 4.12 之前,首先将 OpenShift Serverless 升级到 1.26 或 1.27。

1.5.1. 新功能

- OpenShift Serverless 现在使用 Knative Serving 1.6。

- OpenShift Serverless 现在使用 Knative Eventing 1.6。

- OpenShift Serverless 现在使用 Kourier 1.6。

-

OpenShift Serverless 现在使用 Knative (

kn) CLI 1.6。 - OpenShift Serverless 现在使用 Knative Kafka 1.6。

-

kn funcCLI 插件现在使用func1.8.1。 - 命名空间范围的代理现在作为技术预览提供。例如,此类代理可用于实施基于角色的访问控制 (RBAC) 策略。

-

KafkaSink现在使用CloudEvent二进制内容模式。二进制内容模式比结构化模式更高效,因为它使用其正文中的标头而不是CloudEvent。例如,对于 HTTP 协议,它使用 HTTP 标头。 - 现在,您可以使用 OpenShift Container Platform 4.10 及更新的版本中的 OpenShift Route 通过 HTTP/2 协议使用 gRPC 框架。这提高了客户端和服务器间的通信效率和速度。

-

Knative Operator Serving 和 Eventings CRD 的 API 版本

v1alpha1在 1.27 中弃用。它将在以后的版本中删除。红帽强烈建议使用v1beta1版本。这不会影响现有安装,因为在升级 Serverless Operator 时 CRD 会被自动更新。 - 现在默认启用交付超时功能。它允许您指定每个发送的 HTTP 请求的超时时间。这个功能仍是一个技术预览。

1.5.2. 修复的问题

-

在以前的版本中,Knative 服务有时没有处于

Ready状态,报告等待负载均衡器就绪。这个问题已被解决。

1.5.3. 已知问题

-

当集群中存在太多 secret 时,将 OpenShift Serverless 与 Red Hat OpenShift Service Mesh 集成会导致

net-kourierpod 在启动时耗尽内存。 命名空间范围的代理可能会在用户命名空间中保留

ClusterRoleBindings,即使删除了命名空间范围的代理。如果发生这种情况,删除用户命名空间中名为

rbac-proxy-reviews-prom-rb-knative-kafka-broker-data-plane-{{.Namespace}}的ClusterRoleBinding。如果您将

net-istio用于 Ingress,并使用security.dataPlane.mtls: true通过 SMCP 启用 mTLS,Service Mesh 为*.local主机部署DestinationRule,这代表不允许对 OpenShift Serverless 使用DomainMapping。要临时解决这个问题,部署

PeerAuthentication来启用 mTLS,而不是使用security.dataPlane.mtls: true。

1.6. Red Hat OpenShift Serverless 1.26 发行注记

OpenShift Serverless 1.26 现已正式发布。OpenShift Container Platform 上的 OpenShift Serverless 的新功能、改变以及已知的问题包括在此文档中。

1.6.1. 新功能

- 带有 Quarkus 的 OpenShift Serverless 功能现在是 GA。

- OpenShift Serverless 现在使用 Knative Serving 1.5。

- OpenShift Serverless 现在使用 Knative Eventing 1.5。

- OpenShift Serverless 现在使用 Kourier 1.5。

-

OpenShift Serverless 现在使用 Knative (

kn) CLI 1.5。 - OpenShift Serverless 现在使用 Knative Kafka 1.5。

- OpenShift Serverless 现在使用 Knative Operator 1.3。

-

kn funcCLI 插件现在使用func1.8.1。 - 持久性卷声明 (PVC) 现在为 GA。PVC 为 Knative 服务提供持久性数据存储。

新的触发器过滤器功能现在作为技术预览提供。它允许用户指定一组过滤器表达式,其中每个表达式都会为每个事件评估为 true 或 false。

要启用新的触发器过滤器,请在 operator 配置映射中

KnativeEventing类型的部分中添加new-trigger-filters: enabled条目:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Knative Operator 1.3 为

operator.knative.dev添加了 API 的更新v1beta1版本。要从

KnativeServing和KnativeEventing自定义资源配置映射中的v1alpha1更新至v1beta1,请编辑apiVersion键:KnativeServing自定义资源配置映射示例apiVersion: operator.knative.dev/v1beta1 kind: KnativeServing ...

apiVersion: operator.knative.dev/v1beta1 kind: KnativeServing ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow KnativeEventing自定义资源配置映射示例apiVersion: operator.knative.dev/v1beta1 kind: KnativeEventing ...

apiVersion: operator.knative.dev/v1beta1 kind: KnativeEventing ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.6.2. 修复的问题

- 在以前的版本中,Kafka 代理、Kafka 源和 Kafka sink 禁用联邦信息处理标准 (FIPS) 模式。这个问题已被解决,现在 FIPS 模式可用。

1.6.3. 已知问题

如果您将

net-istio用于 Ingress,并使用security.dataPlane.mtls: true通过 SMCP 启用 mTLS,Service Mesh 为*.local主机部署DestinationRule,这代表不允许对 OpenShift Serverless 使用DomainMapping。要临时解决这个问题,部署

PeerAuthentication来启用 mTLS,而不是使用security.dataPlane.mtls: true。

1.7. Red Hat OpenShift Serverless 1.25.0 发行注记

OpenShift Serverless 1.25.0 现已正式发布。OpenShift Container Platform 上的 OpenShift Serverless 的新功能、改变以及已知的问题包括在此文档中。

1.7.1. 新功能

- OpenShift Serverless 现在使用 Knative Serving 1.4。

- OpenShift Serverless 现在使用 Knative Eventing 1.4。

- OpenShift Serverless 现在使用 Kourier 1.4。

-

OpenShift Serverless 现在使用 Knative (

kn) CLI 1.4。 - OpenShift Serverless 现在使用 Knative Kafka 1.4。

-

kn funcCLI 插件现在使用func1.7.0。 - 用于创建和部署功能的集成开发环境(IDE)插件现在可用于 Visual Studio Code 和 IntelliJ。

Knative Kafka 代理现在是 GA。Knative Kafka 代理是 Knative 代理 API 的高性能实现,直接以 Apache Kafka 为目标。

建议您不要使用 MT-Channel-Broker,而是使用 Knative Kafka 代理。

-

Knative Kafka sink 现在为 GA。

KafkaSink使用CloudEvent,并将其发送到 Apache Kafka 主题。事件可以在结构化或二进制内容模式中指定。 - 为内部流量启用 TLS 现在作为技术预览提供。

1.7.2. 修复的问题

- 在以前的版本中,如果在存活度探测失败后重启容器,Knative Serving 会出现一个就绪度探测失败。这个问题已被解决。

1.7.3. 已知问题

- Kafka 代理、Kafka 源和 Kafka sink 禁用 Federal Information Processing Standards (FIPS) 模式。

-

SinkBinding对象不支持服务的自定义修订名称。 Knative Serving Controller pod 添加了一个新的 informer 来监视集群中的 secret。informer 在缓存中包含 secret,这会增加控制器 pod 的内存消耗。

如果 pod 内存不足,您可以通过增加部署的内存限值来解决此问题。

如果您将

net-istio用于 Ingress,并使用security.dataPlane.mtls: true通过 SMCP 启用 mTLS,Service Mesh 为*.local主机部署DestinationRule,这代表不允许对 OpenShift Serverless 使用DomainMapping。要临时解决这个问题,部署

PeerAuthentication来启用 mTLS,而不是使用security.dataPlane.mtls: true。

1.8. Red Hat OpenShift Serverless 1.24.0 发行注记

OpenShift Serverless 1.24.0 现已正式发布。OpenShift Container Platform 上的 OpenShift Serverless 的新功能、改变以及已知的问题包括在此文档中。

1.8.1. 新功能

- OpenShift Serverless 现在使用 Knative Serving 1.3。

- OpenShift Serverless 现在使用 Knative Eventing 1.3。

- OpenShift Serverless 现在使用 Kourier 1.3。

-

OpenShift Serverless 现在使用 Knative

knCLI 1.3。 - OpenShift Serverless 现在使用 Knative Kafka 1.3。

-

kn funcCLI 插件现在使用func0.24。 - 现在,提供了对 Knative 服务的 init 容器支持 (GA)。

- OpenShift Serverless 逻辑现在作为技术预览提供。它启用了定义声明工作流模型来管理无服务器应用程序。

- 现在,您可以在 OpenShift Serverless 中使用成本管理服务。

1.8.2. 修复的问题

当集群中存在太多 secret 时,将 OpenShift Serverless 与 Red Hat OpenShift Service Mesh 集成会导致

net-istio-controllerpod 在启动时耗尽内存。现在,可以启用 secret 过滤,这会导致

net-istio-controller只考虑带有networking.internal.knative.dev/certificate-uid标签的 secret,从而减少所需的内存量。- OpenShift Serverless 功能技术预览现在默认使用 Cloud Native Buildpacks 构建容器镜像。

1.8.3. 已知问题

- Kafka 代理、Kafka 源和 Kafka sink 禁用 Federal Information Processing Standards (FIPS) 模式。

在 OpenShift Serverless 1.23 中,删除了 KafkaBindings 和

kafka-bindingWebhook 的支持。但是,现有kafkabindings.webhook.sources.knative.dev MutatingWebhookConfiguration可能保留,指向kafka-source-webhook服务,该服务不再存在。对于集群上 KafkaBindings 的某些规格,

kafkabindings.webhook.kafka.sources.knative.dev MutatingWebhookConfiguration可能会被配置,将任何创建和更新事件传递给各种资源,如 Deployment、Knative Services 或 Jobs,然后 Webhook 会失败。要临时解决这个问题,请在升级到 OpenShift Serverless 1.23 后从集群中删除

kafkabindings.webhook.sources.knative.dev MutatingWebhookConfiguration:oc delete mutatingwebhookconfiguration kafkabindings.webhook.kafka.sources.knative.dev

$ oc delete mutatingwebhookconfiguration kafkabindings.webhook.kafka.sources.knative.devCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果您将

net-istio用于 Ingress,并使用security.dataPlane.mtls: true通过 SMCP 启用 mTLS,Service Mesh 为*.local主机部署DestinationRule,这代表不允许对 OpenShift Serverless 使用DomainMapping。要临时解决这个问题,部署

PeerAuthentication来启用 mTLS,而不是使用security.dataPlane.mtls: true。

1.9. Red Hat OpenShift Serverless 1.23.0 发行注记

OpenShift Serverless 1.23.0 现已发布。OpenShift Container Platform 上的 OpenShift Serverless 的新功能、改变以及已知的问题包括在此文档中。

1.9.1. 新功能

- OpenShift Serverless 现在使用 Knative Serving 1.2。

- OpenShift Serverless 现在使用 Knative Eventing 1.2。

- OpenShift Serverless 现在使用 Kourier 1.2。

-

OpenShift Serverless 现在使用 Knative (

kn) CLI 1.2。 - OpenShift Serverless 现在使用 Knative Kafka 1.2。

-

kn funcCLI 插件现在使用func0.24。 -

现在,可以在 Kafka 代理中使用

kafka.eventing.knative.dev/external.topic注解。此注解可以使用现有的外部管理主题,而不是代理自行创建内部主题。 -

kafka-ch-controller和kafka-webhookKafka 组件不再存在。这些组件已被kafka-webhook-eventing组件替代。 - OpenShift Serverless 功能技术预览现在默认使用 Source-to-Image (S2I) 来构建容器镜像。

1.9.2. 已知问题

- Kafka 代理、Kafka 源和 Kafka sink 禁用 Federal Information Processing Standards (FIPS) 模式。

-

如果您要删除包括 Kafka 代理的命名空间,当

auth.secret.ref.namesecret 在代理被删除之前被删除,则命名空间终结器(finalizer)可能无法删除。 使用大量 Knative 服务运行 OpenShift Serverless 时,可能会导致运行的 Knativeivator pod 接近其默认的内存限值 600MB。如果使用的内存达到这个限值,则这些 pod 可能会重启。通过修改

KnativeServing自定义资源,可以配置激活器部署的请求和限值:Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

如果您使用 Cloud Native Buildpacks 作为一个函数的本地构建策略,

kn func将无法自动启动 podman,或使用 SSH 隧道到远程守护进程。这些问题的解决方法是,在部署函数前,在本地开发计算机上已在运行 Docker 或 podman 守护进程。 - On-cluster 函数构建当前针对 Quarkus 和 Golang 运行时会失败。它们适用于 Node、Typescript、Python 和 Springboot 运行时。

如果您将

net-istio用于 Ingress,并使用security.dataPlane.mtls: true通过 SMCP 启用 mTLS,Service Mesh 为*.local主机部署DestinationRule,这代表不允许对 OpenShift Serverless 使用DomainMapping。要临时解决这个问题,部署

PeerAuthentication来启用 mTLS,而不是使用security.dataPlane.mtls: true。

1.10. Red Hat OpenShift Serverless 1.22.0 发行注记

OpenShift Serverless 1.22.0 现已正式发布。OpenShift Container Platform 上的 OpenShift Serverless 的新功能、改变以及已知的问题包括在此文档中。

1.10.1. 新功能

- OpenShift Serverless 现在使用 Knative Serving 1.1。

- OpenShift Serverless 现在使用 Knative Eventing 1.1。

- OpenShift Serverless 现在使用 Kourier 1.1。

-

OpenShift Serverless 现在使用 Knative (

kn) CLI 1.1。 - OpenShift Serverless 现在使用 Knative Kafka 1.1。

-

kn funcCLI 插件现在使用func0.23。 - init 容器支持 Knative 服务现在作为技术预览提供。

- 持久性卷声明 (PVC) 对 Knative 服务的支持现在作为技术预览提供。

-

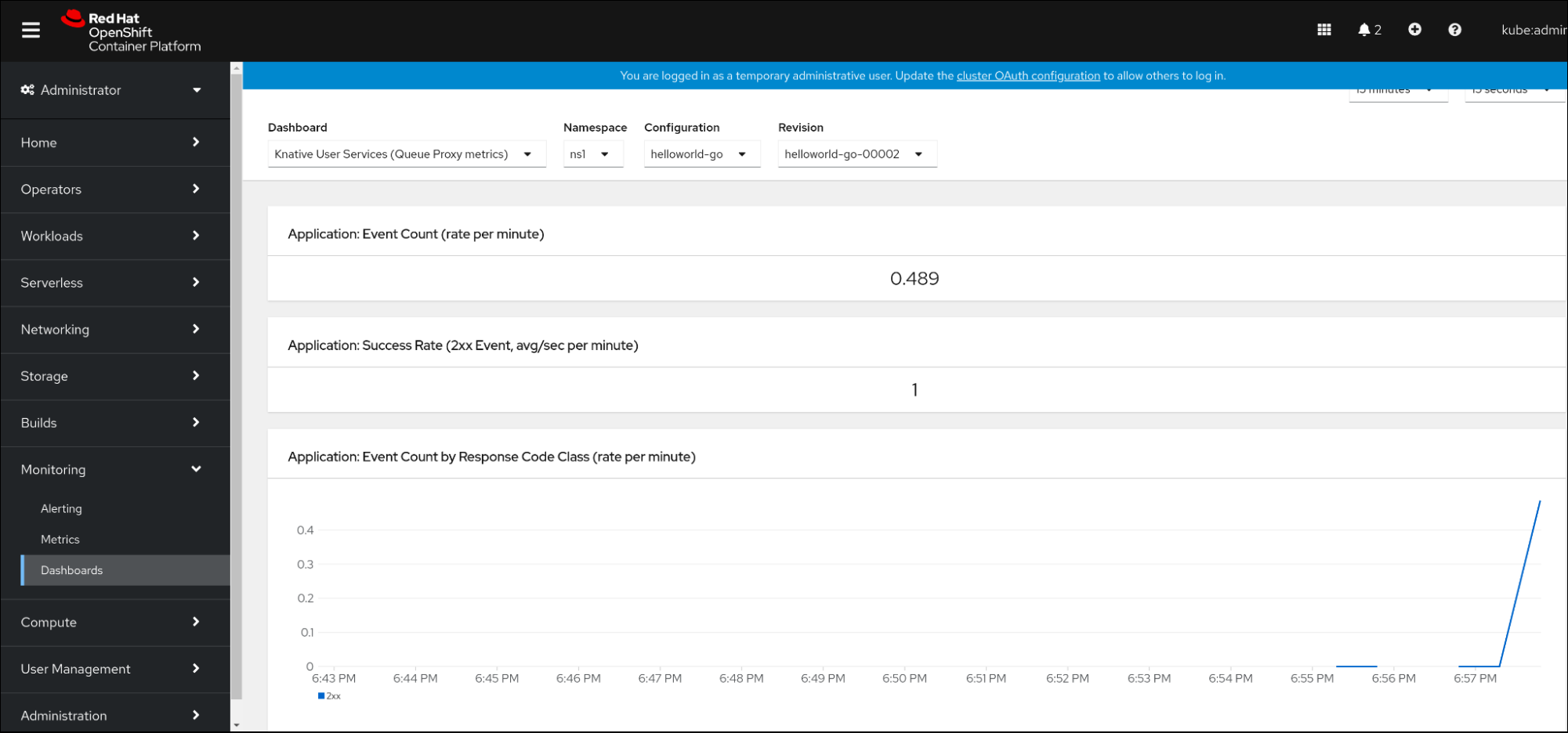

knative-serving、knative-serving-ingress、knative-eventing和knative-kafka系统命名空间现在默认具有knative.openshift.io/part-of: "openshift-serverless"标签。 - 添加了 Knative Eventing - Kafka Broker/Trigger 仪表板,它允许在 web 控制台中视觉化 Kafka 代理并触发指标。

- 添加了 Knative Eventing - KafkaSink 仪表板,它允许在 web 控制台中视觉化 KafkaSink 指标。

- Knative Eventing - Broker/Trigger 仪表板现在被称为 Knative Eventing - 基于频道的代理/触发器。

-

knative.openshift.io/part-of: "openshift-serverless"标签已替换knative.openshift.io/system-namespace标签。 -

Knative Serving YAML 配置文件中的命名样式从 camel 格式(

ExampleName)改为连字符格式 (example-name) 。从这个版本开始,在创建或编辑 Knative Serving YAML 配置文件时使用连字符格式表示法。

1.10.2. 已知问题

- Kafka 代理、Kafka 源和 Kafka sink 禁用 Federal Information Processing Standards (FIPS) 模式。

1.11. Red Hat OpenShift Serverless 1.21.0 发行注记

OpenShift Serverless 1.21.0 现已正式发布。OpenShift Container Platform 上的 OpenShift Serverless 的新功能、改变以及已知的问题包括在此文档中。

1.11.1. 新功能

- OpenShift Serverless 现在使用 Knative Serving 1.0

- OpenShift Serverless 现在使用 Knative Eventing 1.0。

- OpenShift Serverless 现在使用 Kourier 1.0.

-

OpenShift Serverless 现在使用 Knative (

kn) CLI 1.0。 - OpenShift Serverless 现在使用 Knative Kafka 1.0。

-

kn funcCLI 插件现在使用func0.21。 - Kafka sink 现在作为技术预览提供。

-

Knative 开源项目已开始弃用发现配置密钥,而是统一使用 kebab-cased 键。因此,OpenShift Serverless 1.18.0 发行注记中提到的

defaultExternalScheme键现已弃用,并被default-external-scheme键替代。键的使用说明保持不变。

1.11.2. 修复的问题

-

在 OpenShift Serverless 1.20.0 中,存在一个与发送事件相关的问题,会影响使用

kn event send向服务发送事件。这个问题现已解决。 -

在 OpenShift Serverless 1.20.0 (

func0.20) 中,使用http模板创建的 TypeScript 功能无法在集群中部署。这个问题现已解决。 -

在 OpenShift Serverless 1.20.0 (

func0.20) 中,使用gcr.ioregistry 部署功能会失败,并出现错误。这个问题现已解决。 -

在 OpenShift Serverless 1.20.0 (

func0.20) 中,使用kn func create命令创建 Springboot 功能项目目录,然后运行kn func build命令失败并显示错误消息。这个问题现已解决。 -

在 OpenShift Serverless 1.19.0 (

func0.19) 中,一些运行时无法使用 podman 来构建功能。这个问题现已解决。

1.11.3. 已知问题

目前,域映射控制器无法处理包含当前不支持的路径的代理 URI。

这意味着,如果要使用

DomainMapping自定义资源 (CR) 将自定义域映射到代理,则必须使用代理的 ingress 服务配置DomainMappingCR,并将代理的确切路径附加到自定义域:DomainMappingCR 示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 代理的 URI 为

<domain-name>/<broker-namespace>/<broker-name>。

1.12. Red Hat OpenShift Serverless 1.20.0 发行注记

OpenShift Serverless 1.20.0 现已正式发布。OpenShift Container Platform 上的 OpenShift Serverless 的新功能、改变以及已知的问题包括在此文档中。

1.12.1. 新功能

- OpenShift Serverless 现在使用 Knative Serving 0.26。

- OpenShift Serverless 现在使用 Knative Eventing 0.26。

- OpenShift Serverless 现在使用 Kourier 0.26。

-

OpenShift Serverless 现在使用 Knative (

kn) CLI 0.26。 - OpenShift Serverless 现在使用 Knative Kafka 0.26。

-

kn funcCLI 插件现在使用func0.20。 Kafka 代理现在作为技术预览提供。

重要FIPS 不支持 Kafka 代理(当前为技术预览)。

-

kn event插件现在作为技术预览提供。 -

kn service create命令的--min-scale和--max-scale标志已弃用。使用--scale-min和--scale-max标志。

1.12.2. 已知问题

OpenShift Serverless 使用 HTTPS 的默认地址部署 Knative 服务。将事件发送到集群中的资源时,发件人不会配置集群证书颁发机构 (CA) 。这会导致事件交付失败,除非集群使用全局接受的证书。

例如,向公开访问的地址发送事件可正常工作:

kn event send --to-url https://ce-api.foo.example.com/

$ kn event send --to-url https://ce-api.foo.example.com/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 另一方面,如果服务使用由自定义 CA 发布的 HTTPS 证书的公共地址,则此交付会失败:

kn event send --to Service:serving.knative.dev/v1:event-display

$ kn event send --to Service:serving.knative.dev/v1:event-displayCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将事件发送到其他可寻址的对象(如代理或频道)不受此问题的影响,并可以正常工作。

- Kafka 代理目前无法在启用了联邦信息处理标准 (FIPS) 模式的集群中工作。

如果您使用

kn func create命令创建 Springboot 功能项目目录,后续的kn func build命令运行会失败并显示以下错误消息:[analyzer] no stack metadata found at path '' [analyzer] ERROR: failed to : set API for buildpack 'paketo-buildpacks/ca-certificates@3.0.2': buildpack API version '0.7' is incompatible with the lifecycle

[analyzer] no stack metadata found at path '' [analyzer] ERROR: failed to : set API for buildpack 'paketo-buildpacks/ca-certificates@3.0.2': buildpack API version '0.7' is incompatible with the lifecycleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 作为临时解决方案,您可以在函数配置文件

func.yaml中将builder属性更改为gcr.io/paketo-buildpacks/builder:base。使用

gcr.ioregistry 部署函数会失败并显示以下错误消息:Error: failed to get credentials: failed to verify credentials: status code: 404

Error: failed to get credentials: failed to verify credentials: status code: 404Copy to Clipboard Copied! Toggle word wrap Toggle overflow 作为临时解决方案,请使用与

gcr.io不同的 registry,如quay.io或docker.io。使用

http模板创建的 TypeScript 函数无法在集群中部署。作为临时解决方案,在

func.yaml文件中替换以下部分:buildEnvs: []

buildEnvs: []Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用这个:

buildEnvs: - name: BP_NODE_RUN_SCRIPTS value: build

buildEnvs: - name: BP_NODE_RUN_SCRIPTS value: buildCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

func版本 0.20 中,一些运行时可能无法使用 podman 构建函数。您可能会看到类似如下的错误消息:ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOF

ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOFCopy to Clipboard Copied! Toggle word wrap Toggle overflow 这个问题存在以下临时解决方案:

通过在 service

ExecStart定义中添加--time=0来更新 podman 服务:服务配置示例

ExecStart=/usr/bin/podman $LOGGING system service --time=0

ExecStart=/usr/bin/podman $LOGGING system service --time=0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来重启 podman 服务:

systemctl --user daemon-reload

$ systemctl --user daemon-reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl restart --user podman.socket

$ systemctl restart --user podman.socketCopy to Clipboard Copied! Toggle word wrap Toggle overflow

或者,您可以使用 TCP 公开 podman API:

podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534

$ podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.13. Red Hat OpenShift Serverless 1.19.0 发行注记

OpenShift Serverless 1.19.0 现已正式发布。OpenShift Container Platform 上的 OpenShift Serverless 的新功能、改变以及已知的问题包括在此文档中。

1.13.1. 新功能

- OpenShift Serverless 现在使用 Knative Serving 0.25。

- OpenShift Serverless 现在使用 Knative Eventing 0.25。

- OpenShift Serverless 现在使用 Kourier 0.25。

-

OpenShift Serverless 现在使用 Knative (

kn) CLI 0.25。 - OpenShift Serverless 现在使用 Knative Kafka 0.25。

-

kn funcCLI 插件现在使用func0.19。 -

KafkaBindingAPI 在 OpenShift Serverless 1.19.0 中已弃用,并将在以后的发行版本中删除。 - HTTPS 重定向现在被支持,并可以为集群或每个 Knative 服务配置。

1.13.2. 修复的问题

- 在以前的版本中,Kafka 频道分配程序仅在响应前等待本地提交成功,这可能会在 Apache Kafka 节点失败时导致事件丢失。Kafka 频道分配程序现在会在响应前等待所有同步副本提交。

1.13.3. 已知问题

在

func版本 0.19 中,一些运行时可能无法使用 podman 构建函数。您可能会看到类似如下的错误消息:ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOF

ERROR: failed to image: error during connect: Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.40/info": EOFCopy to Clipboard Copied! Toggle word wrap Toggle overflow 这个问题存在以下临时解决方案:

通过在 service

ExecStart定义中添加--time=0来更新 podman 服务:服务配置示例

ExecStart=/usr/bin/podman $LOGGING system service --time=0

ExecStart=/usr/bin/podman $LOGGING system service --time=0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来重启 podman 服务:

systemctl --user daemon-reload

$ systemctl --user daemon-reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow systemctl restart --user podman.socket

$ systemctl restart --user podman.socketCopy to Clipboard Copied! Toggle word wrap Toggle overflow

或者,您可以使用 TCP 公开 podman API:

podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534

$ podman system service --time=0 tcp:127.0.0.1:5534 & export DOCKER_HOST=tcp://127.0.0.1:5534Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.14. Red Hat OpenShift Serverless 1.18.0 发行注记

OpenShift Serverless 1.18.0 现已正式发布。OpenShift Container Platform 上的 OpenShift Serverless 的新功能、改变以及已知的问题包括在此文档中。

1.14.1. 新功能

- OpenShift Serverless 现在使用 Knative Serving 0.24.0。

- OpenShift Serverless 现在使用 Knative Eventing 0.24.0。

- OpenShift Serverless 现在使用 Kourier 0.24.0。

-

OpenShift Serverless 现在使用 Knative (

kn) CLI 0.24.0。 - OpenShift Serverless 现在使用 Knative Kafka 0.24.7。

-

kn funcCLI 插件现在使用func0.18.0。 在即将发布的 OpenShift Serverless 1.19.0 发行版本中,外部路由的 URL 方案将默认为 HTTPS 以增强安全性。

如果您不希望此更改应用到工作负载,您可以在升级到 1.19.0 前覆盖默认设置,方法是将以下 YAML 添加到

KnativeServing自定义资源 (CR) :Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果您想在 1.18.0 中应用更改,请添加以下 YAML:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在接下来的 OpenShift Serverless 1.19.0 发行版本中,公开 Kourier 网关的默认服务类型将是

ClusterIP,而不是LoadBalancer。如果您不希望此更改应用到工作负载,您可以在升级到 1.19.0 前覆盖默认设置,方法是将以下 YAML 添加到

KnativeServing自定义资源 (CR) :Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

现在,您可以在 OpenShift Serverless 中使用

emptyDir卷。详情请参阅 OpenShift Serverless 文档中的 Knative Serving 文档。 -

现在,当您使用

kn func创建函数时,可以使用 Rust 模板。

1.14.2. 修复的问题

- 1.4 之前的 Camel-K 版本与 OpenShift Serverless 1.17.0 不兼容。Camel-K 中的问题已被解决,Camel-K 版本 1.4.1 可以用于 OpenShift Serverless 1.17.0。

在以前的版本中,如果您为 Kafka 频道或新 Kafka 源创建新订阅,则 Kafka 数据平面可能会在新创建的订阅或 sink 报告就绪状态后准备好发送信息。

因此,数据平面没有报告就绪状态时发送的信息可能没有传送到订阅者或 sink。

在 OpenShift Serverless 1.18.0 中,这个问题已被解决,初始消息不再丢失。有关此问题的更多信息,请参阅 知识库文章 #6343981。

1.14.3. 已知问题

较旧版本的 Knative

knCLI 可能会使用较旧版本的 Knative Serving 和 Knative Eventing API。例如,knCLI 版本 0.23.2 使用v1alpha1API 版本。另一方面,较新的 OpenShift Serverless 发行版本可能不再支持旧的 API 版本。例如,OpenShift Serverless 1.18.0 不再支持

kafkasources.sources.knative.dev API的版本v1alpha1。因此,使用带有较新的 OpenShift Serverless 的 Knative

knCLI 的旧版本可能会产生错误,因为kn无法找到过时的 API。例如,knCLI的 0.23.2 版本无法用于 OpenShift Serverless 1.18.0。为避免出现问题,请使用适用于 OpenShift Serverless 发行版本的最新

knCLI 版本。对于 OpenShift Serverless 1.18.0,使用 KnativeknCLI 0.24.0。

1.15. Red Hat OpenShift Serverless 1.17.0 发行注记

OpenShift Serverless 1.17.0 现已正式发布。OpenShift Container Platform 上的 OpenShift Serverless 的新功能、改变以及已知的问题包括在此文档中。

1.15.1. 新功能

- OpenShift Serverless 现在使用 Knative Serving 0.23.0。

- OpenShift Serverless 现在使用 Knative Eventing 0.23.0。

- OpenShift Serverless 现在使用 Kourier 0.23.0。

-

OpenShift Serverless 现在使用 Knative

knCLI 0.23.0。 - OpenShift Serverless 现在使用 Knative Kafka 0.23.0。

-

kn funcCLI 插件现在使用func0.17.0. 在即将发布的 OpenShift Serverless 1.19.0 发行版本中,外部路由的 URL 方案将默认为 HTTPS 以增强安全性。

如果您不希望此更改应用到工作负载,您可以在升级到 1.19.0 前覆盖默认设置,方法是将以下 YAML 添加到

KnativeServing自定义资源(CR):Copy to Clipboard Copied! Toggle word wrap Toggle overflow - mTLS 功能现在正式发布 (GA)。

-

现在,在使用

kn func创建函数时,typeScript 模板可用。 Knative Eventing 0.23.0 中的 API 版本更改:

-

KafkaChannelAPI 的v1alpha1版本已在 OpenShift Serverless 版本 1.14.0 中弃用,它已被删除。如果配置映射的ChannelTemplateSpec参数包含对此旧版本的引用,您必须更新 spec 的这一部分以使用正确的 API 版本。

-

1.15.2. 已知问题

如果您试图将较旧版本的 Knative

knCLI 与较新的 OpenShift Serverless 发行版本搭配使用,则不会找到 API,并出现错误。例如,如果您使用

knCLI 的 1.16.0 发行版本,它使用版本 0.22.0,其 1.17.0 OpenShift Serverless 发行版本使用 Knative Serving 和 Knative Eventing API 的 0.23.0 版本,则 CLI 无法正常工作,因为它仍然会查找过时的 0.22.0 API 版本。确保您使用 OpenShift Serverless 发行版本的最新

knCLI 版本来避免问题。- 此发行版本中的相应 web 控制台仪表板中不会监控或显示 Kafka 频道指标。这是因为 Kafka 分配程序协调过程中的中断更改。

如果您为 Kafka 频道或新 Kafka 源创建新订阅,在新创建的订阅或 sink 报告就绪状态后 Kafka 数据平面可能会延迟分配信息。

因此,在 data plane 没有报告就绪状态时发送的信息可能无法传送到订阅者或 sink。

有关此问题和可能的解决方案的更多信息,请参阅知识库文章 #6343981。

Camel-K 1.4 发行版本与 OpenShift Serverless 版本 1.17.0 不兼容。这是因为 Camel-K 1.4 使用 Knative 版本 0.23.0 中删除的 API。目前,这个问题还没有可用的临时解决方案。如果您需要在 OpenShift Serverless 中使用 Camel-K 1.4,请不要升级到 OpenShift Serverless 版本 1.17.0。

注意这个问题已被解决,Camel-K 版本 1.4.1 与 OpenShift Serverless 1.17.0 兼容。

1.16. Red Hat OpenShift Serverless 1.16.0 发行注记

OpenShift Serverless 1.16.0 现已正式发布。OpenShift Container Platform 上的 OpenShift Serverless 的新功能、改变以及已知的问题包括在此文档中。

1.16.1. 新功能

- OpenShift Serverless 现在使用 Knative Serving 0.22.0。

- OpenShift Serverless 现在使用 Knative Eventing 0.22.0。

- OpenShift Serverless 现在使用 Kourier 0.22.0。

-

OpenShift Serverless 现在使用 Knative

knCLI 0.22.0。 - OpenShift Serverless 现在使用 Knative Kafka 0.22.0。

-

kn funcCLI 插件现在使用func0.16.0。 -

kn func emit命令已添加到功能kn插件中。您可以使用此命令发送事件来测试本地部署的功能。

1.16.2. 已知问题

- 在升级到 OpenShift Serverless 1.16.0 前,您必须将 OpenShift Container Platform 升级到 4.6.30、4.7.11 或更高版本。

AMQ Streams Operator 可能会阻止安装或升级 OpenShift Serverless Operator。如果发生这种情况,Operator Lifecycle Manager (OLM) 会抛出以下错误:

WARNING: found multiple channel heads: [amqstreams.v1.7.2 amqstreams.v1.6.2], please check the `replaces`/`skipRange` fields of the operator bundles.

WARNING: found multiple channel heads: [amqstreams.v1.7.2 amqstreams.v1.6.2], please check the `replaces`/`skipRange` fields of the operator bundles.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您可以在安装或升级 OpenShift Serverless Operator 前卸载 AMQ Streams Operator,从而解决这个问题。然后您可以重新安装 AMQ Streams Operator。

- 如果使用 mTLS 启用 Service Mesh,则 Knative Serving 的指标会被默认禁用,因为 Service Mesh 会防止 Prometheus 提取指标。有关启用 Knative Serving 指标以用于 Service Mesh 和 mTLS 的说明,请参阅 Serverless 文档中的"集成 Service Mesh with OpenShift Serverless"部分。

如果您部署启用了 Istio ingress 的 Service Mesh CR,您可能会在

istio-ingressgatewaypod 中看到以下警告:2021-05-02T12:56:17.700398Z warning envoy config [external/envoy/source/common/config/grpc_subscription_impl.cc:101] gRPC config for type.googleapis.com/envoy.api.v2.Listener rejected: Error adding/updating listener(s) 0.0.0.0_8081: duplicate listener 0.0.0.0_8081 found

2021-05-02T12:56:17.700398Z warning envoy config [external/envoy/source/common/config/grpc_subscription_impl.cc:101] gRPC config for type.googleapis.com/envoy.api.v2.Listener rejected: Error adding/updating listener(s) 0.0.0.0_8081: duplicate listener 0.0.0.0_8081 foundCopy to Clipboard Copied! Toggle word wrap Toggle overflow 您的 Knative 服务也可能无法访问。

您可以按照以下的临时解决方案,通过重新创建

knative-local-gateway服务来解决这个问题:删除

istio-system命名空间中现有的knative-local-gateway服务:oc delete services -n istio-system knative-local-gateway

$ oc delete services -n istio-system knative-local-gatewayCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建并应用包含以下 YAML 的

knative-local-gateway服务:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

如果您在集群中有 1000 个 Knative 服务,然后执行 Knative Serving 的重新安装或升级,则在

KnativeServing自定义资源(CR)变为Ready后创建第一个新服务会有一个延迟。3scale-kourier-control服务会在创建新服务前协调所有以前存在的 Knative 服务。因此,新服务在状态被更新为Ready前,大约会有 800 秒的时间处于IngressNotConfigured或Unknown状态。如果您为 Kafka 频道或新 Kafka 源创建新订阅,在新创建的订阅或 sink 报告就绪状态后 Kafka 数据平面可能会延迟分配信息。

因此,在 data plane 没有报告就绪状态时发送的信息可能无法传送到订阅者或 sink。

有关此问题和可能的解决方案的更多信息,请参阅知识库文章 #6343981。

第 2 章 发现

2.1. 关于 OpenShift Serverless

OpenShift Serverless 提供 Kubernetes 原生构建块,供开发人员在 OpenShift Container Platform 中创建和部署无服务器、事件驱动的应用程序。OpenShift Serverless 基于开源 Knative 项目,通过启用企业级无服务器平台为混合和多云环境提供可移植性和一致性。

因为 OpenShift Serverless 的发行节奏与 OpenShift Container Platform 不同,所以 OpenShift Serverless 文档不会为产品的次版本维护单独的文档。当前文档集适用于所有当前支持的 OpenShift Serverless 版本,除非在特定主题或特定功能中明确指定了特定版本。

如需有关 OpenShift Serverless 生命周期和支持的平台的更多信息,请参阅 平台生命周期政策。

2.1.1. Knative Serving

Knative Serving 可以帮助需要创建、部署和管理云原生应用程序的开发人员。它以 Kubernetes 自定义资源定义 (CRD) 的形式提供一组对象,用于定义和控制 OpenShift Container Platform 集群上无服务器工作负载的行为。

开发人员使用这些 CRD 创建自定义资源(CR)实例,这些实例可作为构建块用于处理复杂用例。例如:

- 快速部署无服务器容器。

- 自动缩放 pod。

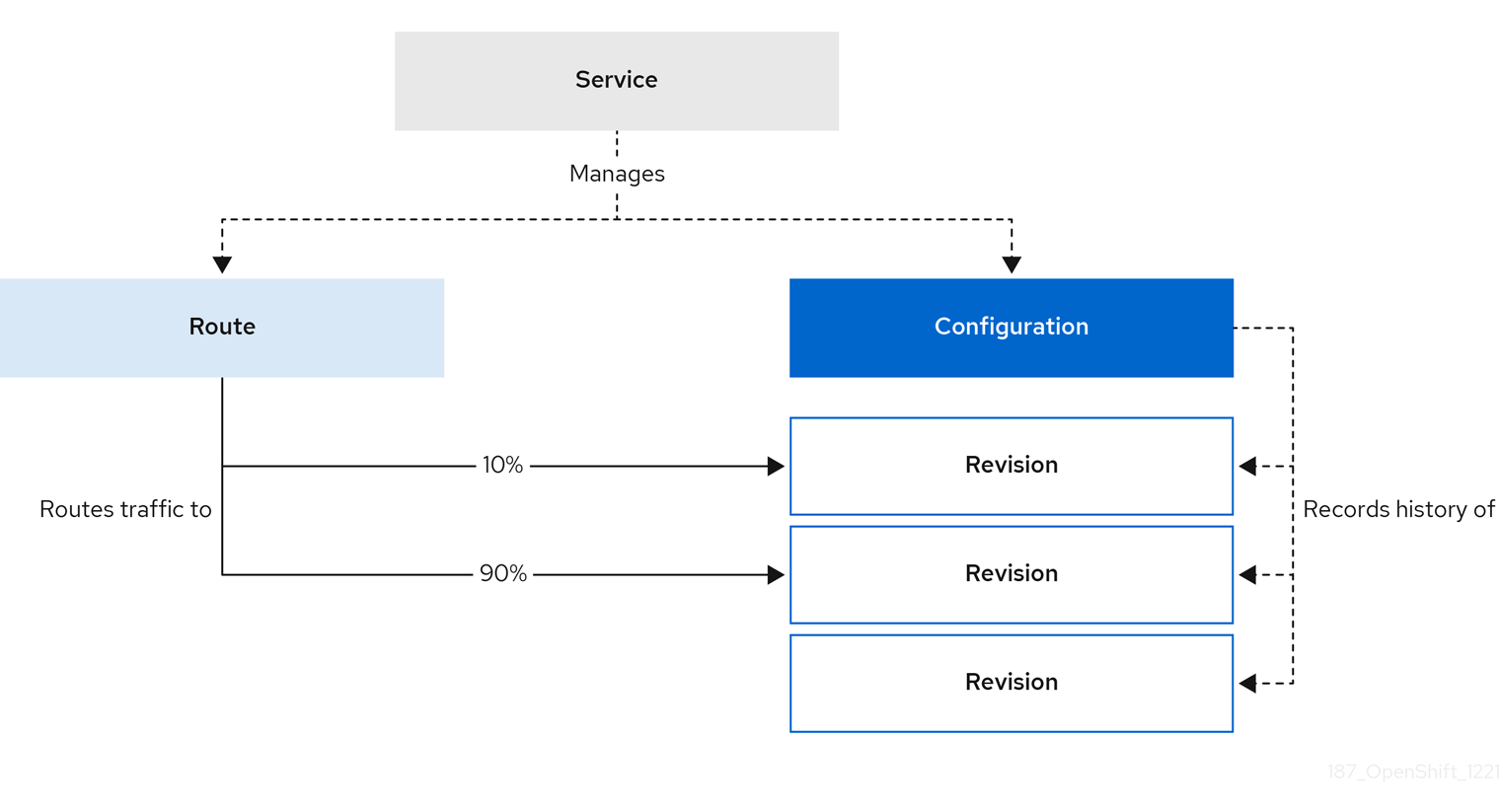

2.1.1.1. Knative Serving 资源

- 服务

-

service.serving.knative.devCRD 会自动管理工作负载的生命周期,以确保应用程序通过网络部署并可访问。每次用户创建的服务或自定义资源发生变化时,它都会创建一个路由、配置和新修订。Knative 中进行的大多数开发人员交互都是通过修改服务进行的。 - Revision(修订)

-

revision.serving.knative.devCRD 是每次对工作负载进行修改所涉及代码和配置的时间点快照。所有修订均为不可变对象,可以根据需要保留。 - Route(路由)

-

route.serving.knative.devCRD 可将网络端点映射到一个或多个修订。您可通过多种方式管理流量,包括部分流量和指定路由。 - Configuration(配置)

-

configuration.serving.knative.devCRD 可保持部署所需状态。它可在使编程过程和配置配置过程相互分离。修改配置则会创建一个新修订。

2.1.2. Knative Eventing

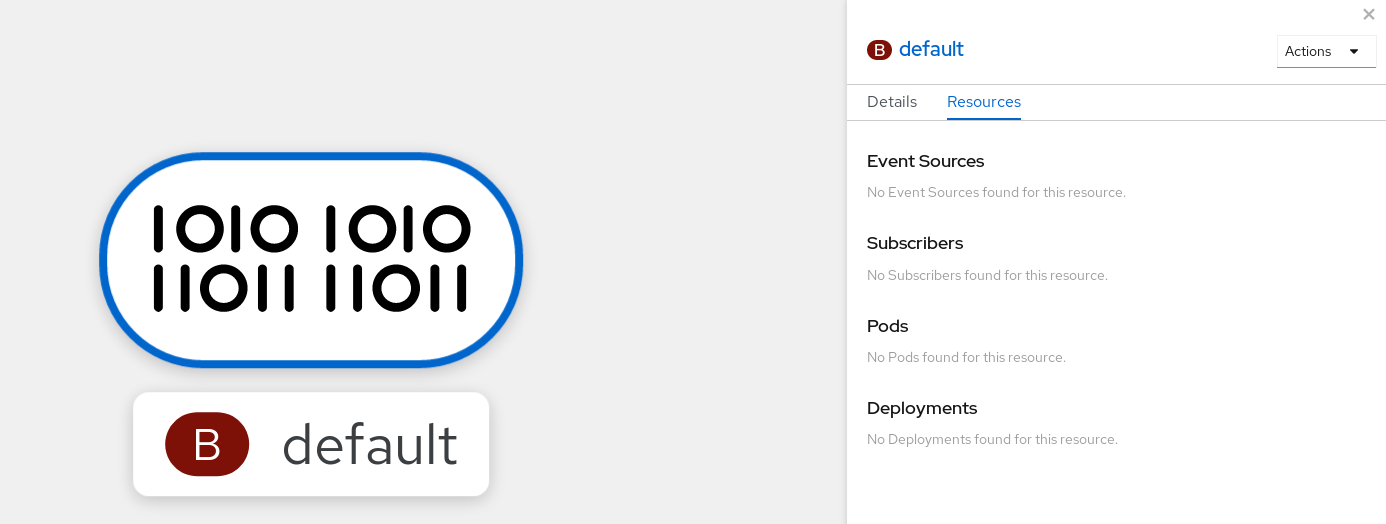

OpenShift Container Platform 上的 Knative Eventing 可让开发人员使用 事件驱动的架构和无服务器应用程序。事件驱动的体系结构是基于事件和事件用户间分离关系的概念。

事件生成者创建事件,事件 sink、或消费者接收事件。Knative Eventing 使用标准 HTTP POST 请求来发送和接收事件制作者和 sink 之间的事件。这些事件符合 CloudEvents 规范,它允许在任何编程语言中创建、解析、发送和接收事件。

Knative Eventing 支持以下用例:

- 在不创建消费者的情况下发布事件

- 您可以将事件作为 HTTP POST 发送到代理,并使用绑定分离生成事件的应用程序的目标配置。

- 在不创建发布程序的情况下消费事件

- 您可以使用 Trigger 来根据事件属性消费来自代理的事件。应用程序以 HTTP POST 的形式接收事件。

要启用多种 sink 类型的交付,Knative Eventing 会定义以下通用接口,这些接口可由多个 Kubernetes 资源实现:

- 可寻址的资源

-

能够接收和确认通过 HTTP 发送的事件到 Event 的

status.address.url字段中定义的地址。KubernetesService资源也满足可寻址的接口。 - 可调用的资源

-

能够通过 HTTP 接收事件并转换它,并在 HTTP 响应有效负载中返回

0或1新事件。这些返回的事件可能会象处理外部事件源中的事件一样进一步处理。

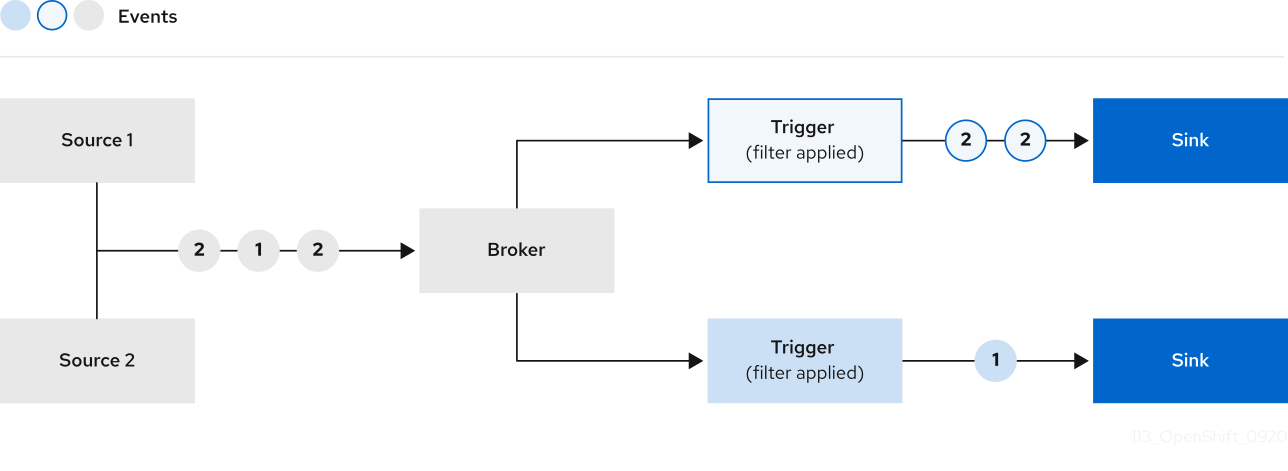

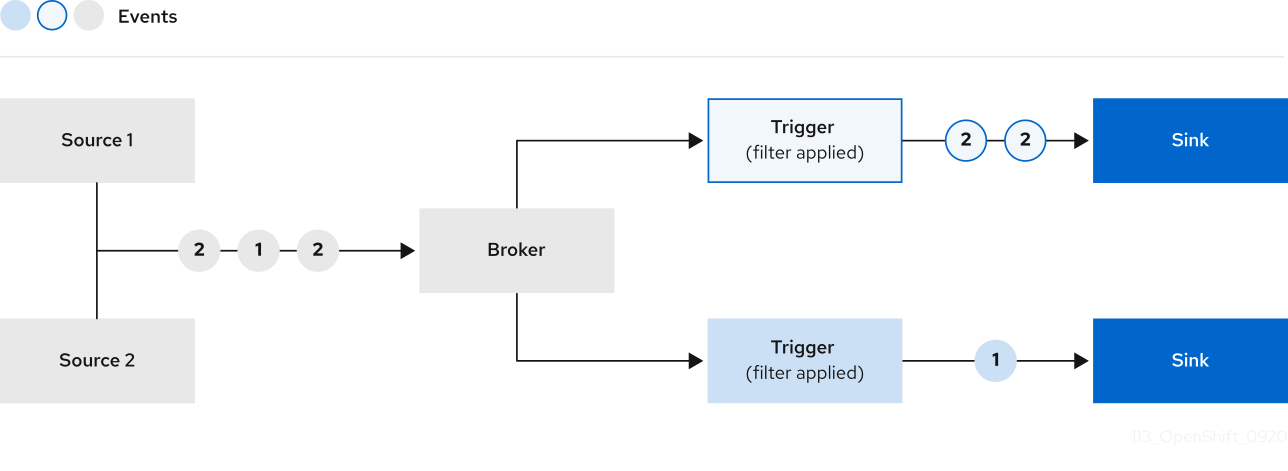

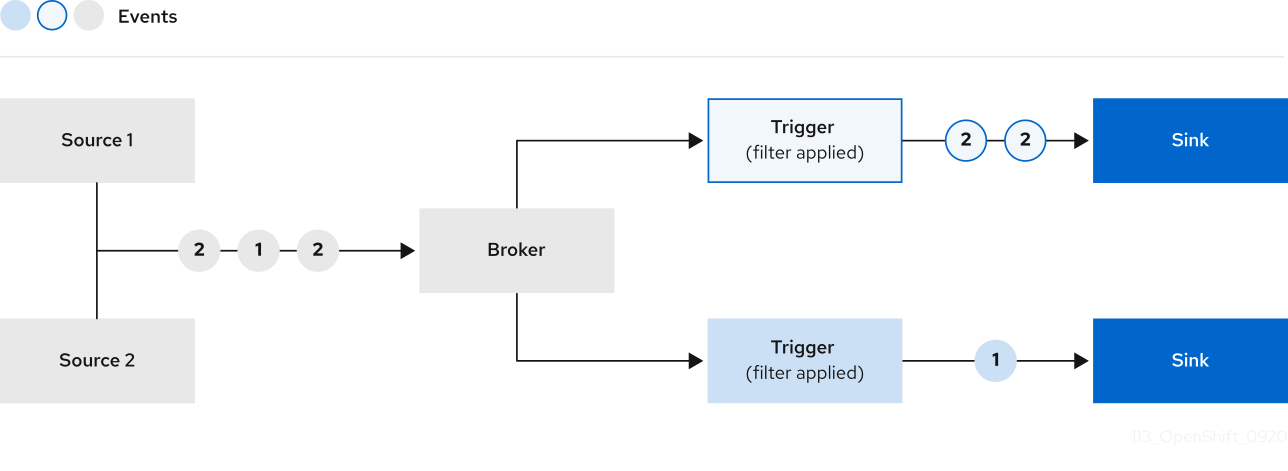

您可以使用以下方法将事件从事件源传播到多个事件接收器:

2.1.3. 支持的配置

OpenShift Serverless 支持的功能、配置和集成(当前和过去的版本)包括在 支持的配置页面中。

2.1.4. 可伸缩性和性能

OpenShift Serverless 已使用配置为 3 个主要节点和 3 个 worker 节点进行测试,每个节点都有 64 个 CPU、457 GB 内存和 394 GB 存储。

使用此配置创建的最大 Knative 服务数为 3,000。这与 OpenShift Container Platform Kubernetes 服务限制 10,000 对应,因为 1 个 Knative 服务创建 3 个 Kubernetes 服务。

零响应时间的平均缩放约为 3.4 秒,最大响应时间为 8 秒,而一个简单 Quarkus 应用程序使用 99.9thile 的 4.5 秒。这些时间可能因应用程序和应用程序的运行时的不同而有所不同。

2.2. 关于 OpenShift Serverless Functions

OpenShift Serverless Functions 帮助开发人员在 OpenShift Container Platform 上创建和部署无状态、事件驱动的函数,作为 Knative 服务。kn func CLI 作为 Knative kn CLI 的插件提供。您可以使用 kn func CLI 在集群中创建、构建和部署容器镜像作为 Knative 服务。

2.2.1. 包括的运行时

OpenShift Serverless Functions 提供了一组模板,可用于为以下运行时创建基本函数:

2.2.2. 后续步骤

- 函数入门。

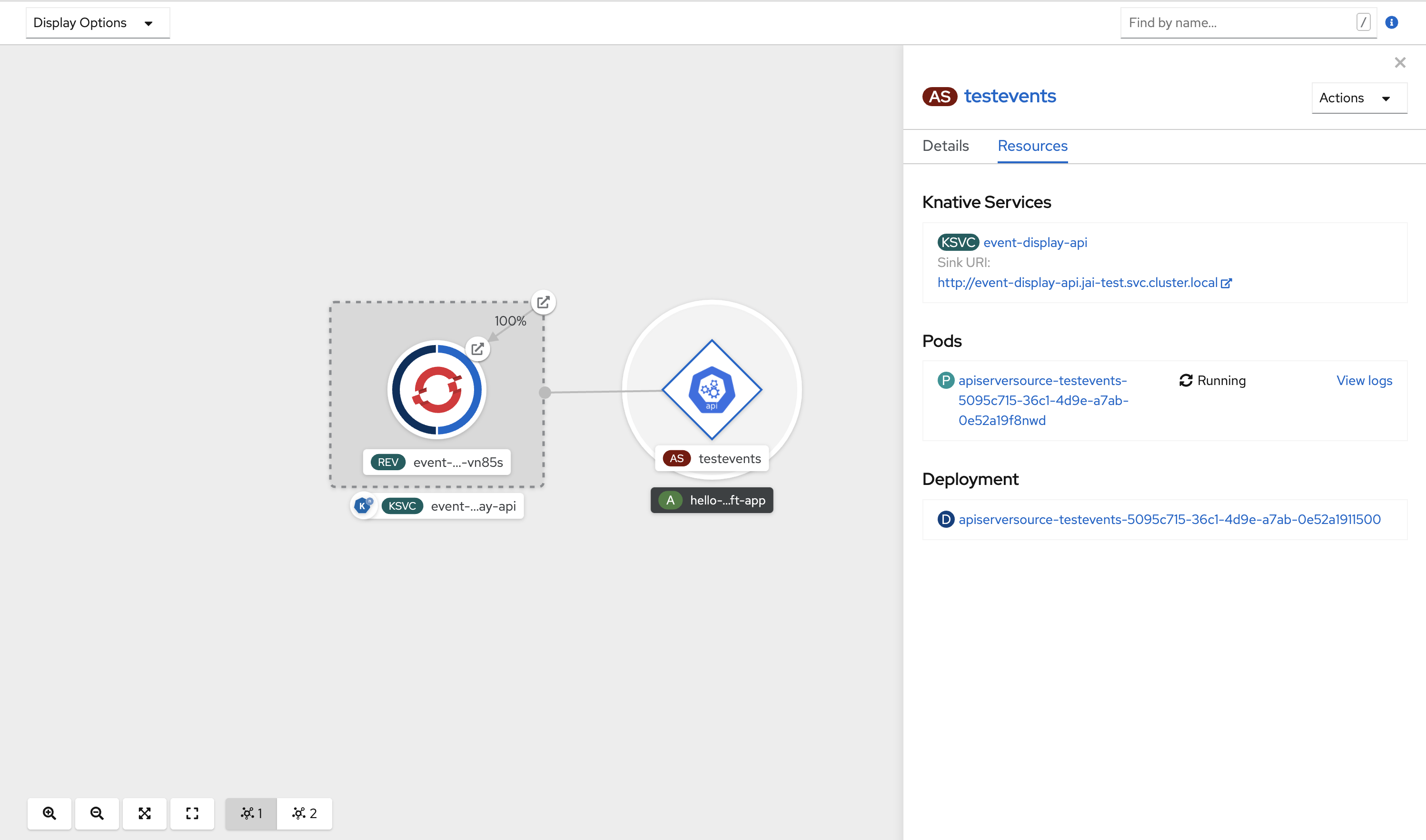

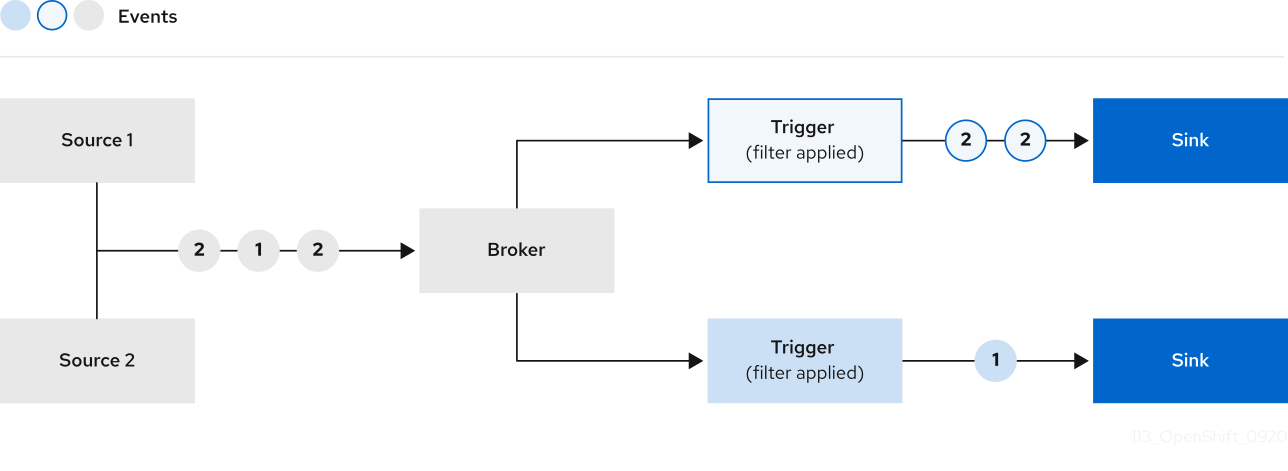

2.3. 事件源

Knative 事件源可以是生成或导入云事件的任何 Kubernetes 对象,并将这些事件转发到另一个端点,称为接收器(sink)。事件源对于开发对事件做出反应的分布式系统至关重要。

您可以使用 OpenShift Container Platform Web 控制台、Knative (kn) CLI 或应用 YAML 文件的 Developer 视角创建和管理 Knative 事件源。

目前,OpenShift Serverless 支持以下事件源类型:

您还可以创建自定义事件源。

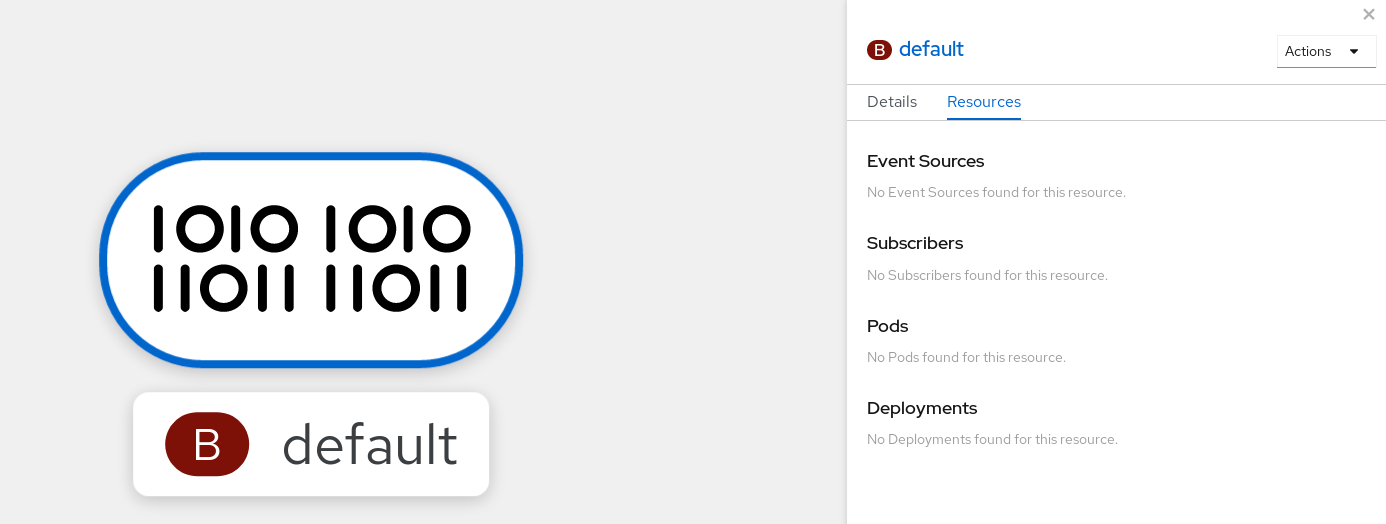

2.4. 代理(Broker)

代理可与触发器结合使用,用于将事件源发送到事件 sink。事件从事件源发送到代理,作为 HTTP POST 请求。事件进入代理后,可使用触发器根据 CloudEvent 属性 进行过滤,并作为 HTTP POST 请求发送到事件 sink。

2.4.1. 代理类型

集群管理员可为集群设置 default 代理实施。创建代理时,会使用默认代理实现,除非在 Broker 对象中提供配置。

2.4.1.1. 用于开发的默认代理实现

Knative 提供基于频道的默认代理实现。这个基于频道的代理可用于开发和测试目的,但不为生产环境提供适当的事件交付保证。默认代理由 InMemoryChannel 频道实现支持。

如果要使用 Kafka 降低网络跃点,请使用 Kafka 代理实现。不要将基于频道的代理配置为由 KafkaChannel 频道实现支持。

2.4.1.2. 生产环境就绪的 Kafka 代理实现

对于生产环境就绪的 Knative Eventing 部署,红帽建议您使用 Knative Kafka 代理实现。Kafka 代理是 Knative 代理的 Apache Kafka 原生实现,它将 CloudEvents 直接发送到 Kafka 实例。

Kafka 代理禁用联邦信息处理标准 (FIPS) 模式。

Kafka 代理具有与 Kafka 的原生集成,用于存储和路由事件。它可以更好地与 Kafka 集成用于代理,并在其他代理类型中触发模型,并减少网络跃点。Kafka 代理实现的其他优点包括:

- 最少一次的交付保证

- 根据 CloudEvents 分区扩展排序事件交付

- 数据平面的高可用性

- 水平扩展数据平面

Knative Kafka 代理使用二进制内容模式将传入的 CloudEvents 存储为 Kafka 记录。这意味着,所有 CloudEvent 属性和扩展都会在 Kafka 记录上映射,而 CloudEvent 的 data 规格与 Kafka 记录的值对应。

2.4.2. 后续步骤

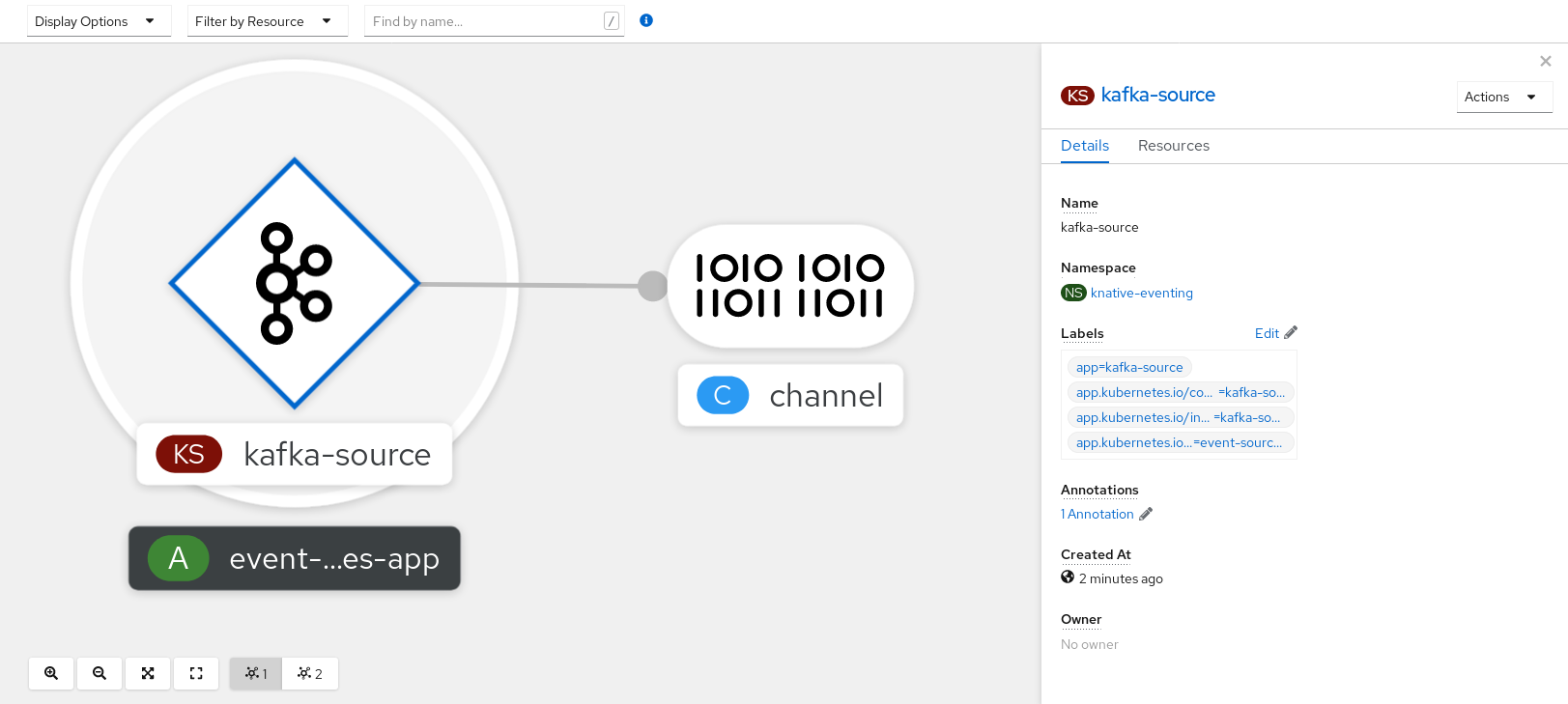

2.5. 频道和订阅

频道是定义单一事件转发和持久层的自定义资源。事件源或生成程序在将事件发送到频道后,可使用订阅将这些事件发送到多个 Knative 服务或其他 sink。

您可以通过实例化受支持的 Channel 对象来创建频道,并通过修改 Subscription 对象中的 delivery 规格来配置重新发送尝试。

创建 Channel 对象后,根据默认频道实现,一个经过更改的准入 Webhook 会为 Channel 对象添加一组 spec.channelTemplate 属性。例如,对于 InMemoryChannel 默认实现,Channel 对象如下所示:

然后,频道控制器将根据这个 spec.channelTemplate 配置创建后备频道实例。

创建后,spec.channelTemplate 属性将无法更改,因为它们由默认频道机制设置,而不是由用户设置。

当此机制与上例搭配使用时,会创建两个对象:一个通用的后备频道和一个 InMemoryChannel 频道。如果您使用不同的默认频道实现,使用特定于您的实现的频道替换 InMemoryChannel。例如,在 Knative Kafka 中,创建 KafkaChannel 频道。

后备频道充当将订阅复制到用户创建的频道对象的代理,并设置用户创建的频道对象状态来反映后备频道的状态。

2.5.1. 频道实现类型

InMemoryChannel 和 KafkaChannel 频道实现可用于 OpenShift Serverless 进行开发。

以下是 InMemoryChannel 类型频道的限制:

- 事件没有持久性。如果 Pod 停机,则 Pod 上的事件将会丢失。

-

InMemoryChannel频道没有实现事件排序,因此同时接收到的两个事件可能会以任何顺序传送给订阅者。 -

如果订阅者拒绝某个事件,则不会默认重新发送尝试。您可以通过修改

Subscription对象中的delivery规格来配置重新发送尝试。

有关 Kafka 频道的更多信息,请参阅 Knative Kafka 文档。

2.5.2. 后续步骤

第 3 章 安装

3.1. 安装 OpenShift Serverless Operator

安装 OpenShift Serverless Operator 后,您就可以在 OpenShift Container Platform 集群中安装和使用 Knative Serving、Knative Eventing 和 Knative Kafka。OpenShift Serverless Operator 管理集群的 Knative 自定义资源定义 (CRD) ,并可让您在不直接为每个组件修改单个配置映射的情况下配置它们。

3.1.1. 开始前

在安装 OpenShift Serverless 前,请阅读以下有关支持的配置和先决条件的信息。

- OpenShift Serverless 支持在受限网络环境中安装。

- OpenShift Serverless 目前无法在单个集群的多租户配置中使用。

3.1.1.1. 定义集群大小要求

要安装和使用 OpenShift Serverless,OpenShift Container Platform 集群必须正确定义大小。

以下要求仅与 OpenShift Container Platform 集群的 worker 机器池相关。control plane 节点不用于常规调度,它不在要求中。

使用 OpenShift Serverless 的最低要求是集群有 10 个 CPU 和 40GB 内存。默认情况下,每个 Pod 需要大约 400m 的 CPU,最下的要求基于此值。

运行 OpenShift Serverless 的总大小要求取决于安装的组件以及部署的应用程序,并因部署的不同而有所不同。

3.1.1.2. 使用机器集扩展集群

您可以使用 OpenShift Container Platform MachineSet API 手动将集群扩展至所需大小。最低要求通常意味着,您需要将一个默认机器集进行扩展,增加两个额外的机器。请参阅手动扩展机器集。

3.1.2. 通过 Web 控制台安装 OpenShift Serverless Operator

您可以使用 OpenShift Container Platform Web 控制台从 OperatorHub 安装 OpenShift Serverless Operator。安装此 Operator 可让您安装和使用 Knative 组件。

先决条件

- 您可以访问具有集群管理员权限的 OpenShift Container Platform 帐户。

- 已登陆到 OpenShift Container Platform Web 控制台。

流程

- 在 OpenShift Container Platform web 控制台中进入到 Operators → OperatorHub 页。

- 滚动页面,或在 Filter by keyword 框中输入关键字 Serverless 来查找 OpenShift Serverless Operator。

- 查看 Operator 信息并单击 Install。

在 Install Operator 页面中:

-

Installation Mode 是 All namespaces on the cluster (default) 。此模式将 Operator 安装至默认

openshift-serverless命名空间,以便供集群中的所有命名空间监视和使用。 -

安装的命名空间 是

openshift-serverless。 - 选择 stable 频道作为 更新频道。stable 频道将启用 OpenShift Serverless Operator 最新稳定版本的安装。

- 选择 Automatic 或 Manual 批准策略。

-

Installation Mode 是 All namespaces on the cluster (default) 。此模式将 Operator 安装至默认

- 点 Install 使 Operator 可供 OpenShift Container Platform 集群上的所选命名空间使用。

在 Catalog → Operator Management 页面中,您可以监控 OpenShift Serverless Operator 订阅的安装和升级进度。

- 如果选择了 Manual 批准策略,订阅的升级状态将会一直保持在 Upgrading,直到您审阅并批准了它的安装计划。在 Install Plan 页面批准后,订阅的升级状态将变为 Up to date。

- 如果选择了 Automatic 批准策略,升级状态会在不用人工参与的情况下变为 Up to date。

验证

当订阅的升级状态变为Up to date 后,选择 Catalog → Installed Operators 来验证 OpenShift Serverless Operator 最终出现,它的 Status 在相关的命名空间中最终会变为 InstallSucceeded。

如果没有:

- 切换到 Catalog → Operator Management 页,检查 Operator Subscriptions 和 Install Plans 页中的 Status 是否有错误。

-

检查 Workloads → Pods 页中提供的关于

openshift-serverless项目中的 pod 的日志信息,以便进一步排除故障。

如果要在 OpenShift Serverless 中使用 Red Hat OpenShift distributed tracing,则必须在安装 Knative Serving 或 Knative Eventing 前安装和配置 Red Hat OpenShift distributed tracing。

3.1.3. 通过 CLI 安装 OpenShift Serverless Operator

您可以使用 CLI 从 OperatorHub 安装 OpenShift Serverless Operator。安装此 Operator 可让您安装和使用 Knative 组件。

先决条件

- 您可以访问具有集群管理员权限的 OpenShift Container Platform 帐户。

- 您的集群启用了 Marketplace 功能,或者手动配置 Red Hat Operator 目录源。

- 已登陆到 OpenShift Container Platform 集群。

流程

创建包含

Namespace、OperatorGroup和Subscription对象的 YAML 文件,以便为 OpenShift Serverless Operator 订阅命名空间。例如,使用以下内容创建文件serverless-subscription.yaml:订阅示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建

Subscription对象:oc apply -f serverless-subscription.yaml

$ oc apply -f serverless-subscription.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

检查集群服务版本 (CSV) 是否已进入 Succeeded 阶段:

示例命令

$ oc get csv

$ oc get csv输出示例

NAME DISPLAY VERSION REPLACES PHASE serverless-operator.v1.25.0 Red Hat OpenShift Serverless 1.25.0 serverless-operator.v1.24.0 Succeeded

NAME DISPLAY VERSION REPLACES PHASE

serverless-operator.v1.25.0 Red Hat OpenShift Serverless 1.25.0 serverless-operator.v1.24.0 Succeeded如果要在 OpenShift Serverless 中使用 Red Hat OpenShift distributed tracing,则必须在安装 Knative Serving 或 Knative Eventing 前安装和配置 Red Hat OpenShift distributed tracing。

3.1.5. 后续步骤

- 安装 OpenShift Serverless Operator 后,您可以安装 Knative Serving 或 安装 Knative Eventing。

3.2. 安装 Knative Serving

安装 Knative Serving 可让您在集群中创建 Knative 服务和功能。它还允许您为应用程序使用自动扩展和网络选项等其他功能。

安装 OpenShift Serverless Operator 后,您可以使用默认设置安装 Knative Serving,或者在 KnativeServing 自定义资源 (CR) 中配置更高级的设置。如需有关 KnativeServing CR 的配置选项的更多信息,请参阅全局配置。

如果要在 OpenShift Serverless 中使用 Red Hat OpenShift distributed tracing,则必须在安装 Knative Serving 前安装和配置 Red Hat OpenShift distributed tracing。

3.2.1. 使用 Web 控制台安装 Knative Serving

安装 OpenShift Serverless Operator 后,使用 OpenShift Container Platform Web 控制台安装 Knative Serving。您可以使用默认设置安装 Knative Serving,或者在 KnativeServing 自定义资源 (CR) 中配置更高级的设置。

先决条件

- 您可以访问具有集群管理员权限的 OpenShift Container Platform 帐户。

- 已登陆到 OpenShift Container Platform Web 控制台。

- 已安装 OpenShift Serverless Operator。

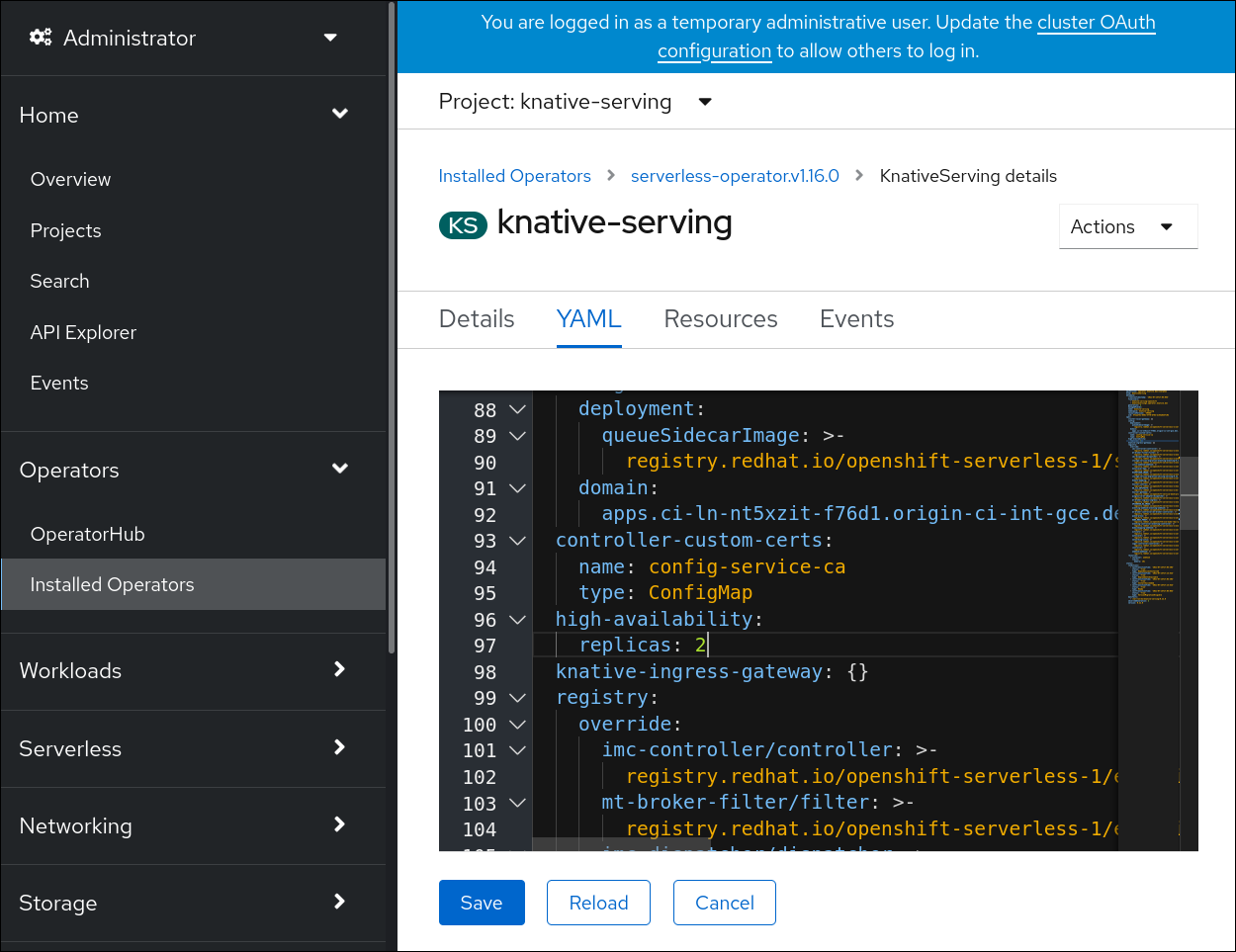

流程

- 在 OpenShift Container Platform web 控制台的 Administrator 视角中,进入 Operators → Installed Operators。

- 检查页面顶部的 Project 下拉菜单是否已设置为 Project: knative-serving。

- 点 OpenShift Serverless Operator 的 Provided APIs 列表中的 Knative Serving 来进入 Knative Serving 选项卡。

- 点 Create Knative Serving。

在 Create Knative Serving 页中,您可以使用默认设置安装 Knative Serving。点 Create。

您还可以使用提供的表单或编辑 YAML 来修改

KnativeServing对象来修改 Knative Serving 安装的设置。-

建议您在不需要完全控制

KnativeServing对象创建的简单配置中使用该表单。 对于更复杂的配置,建议编辑 YAML,这可以完全控制

KnativeServing对象的创建。您可以通过点 Create Knative Serving 页右上角的 edit YAML 链接来访问 YAML。完成表单后,或者完成对 YAML 的修改后,点 Create。

注意如需有关 KnativeServing 自定义资源定义的配置选项的更多信息,请参阅高级安装配置选项。

-

建议您在不需要完全控制

-

安装 Knative Serving 后,会创建

KnativeServing对象,并自动定向到 Knative Serving 选项卡。您可以在资源列表中看到knative-serving自定义资源。

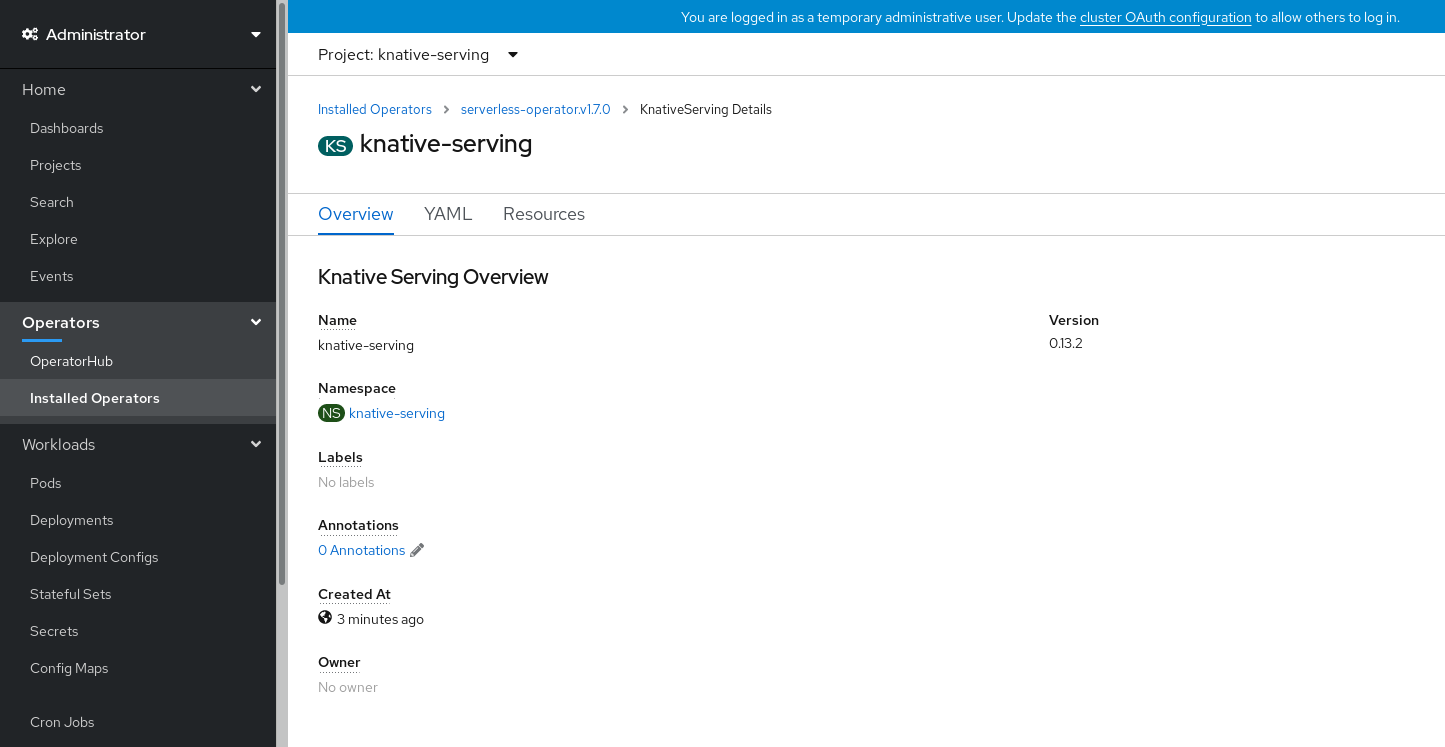

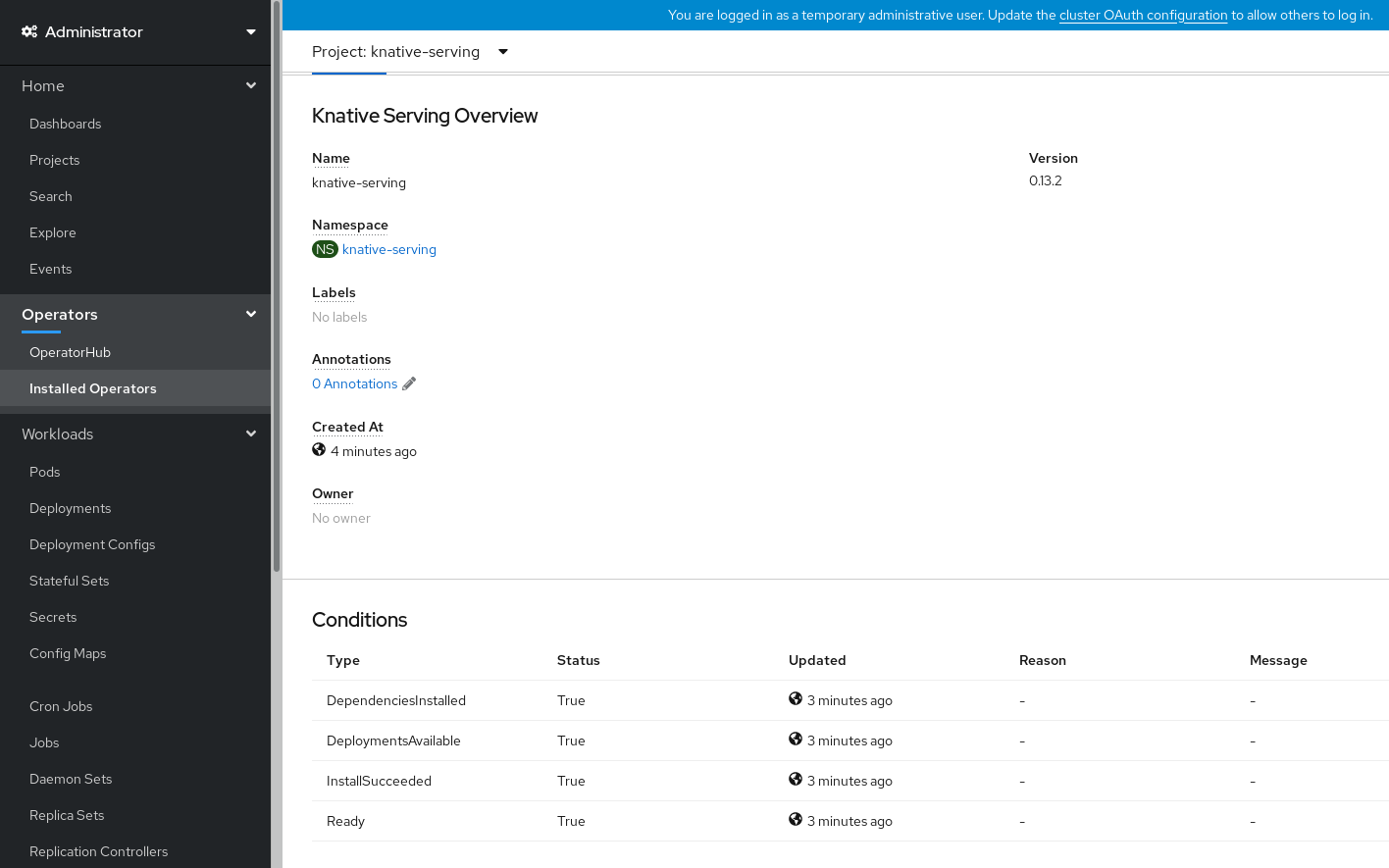

验证

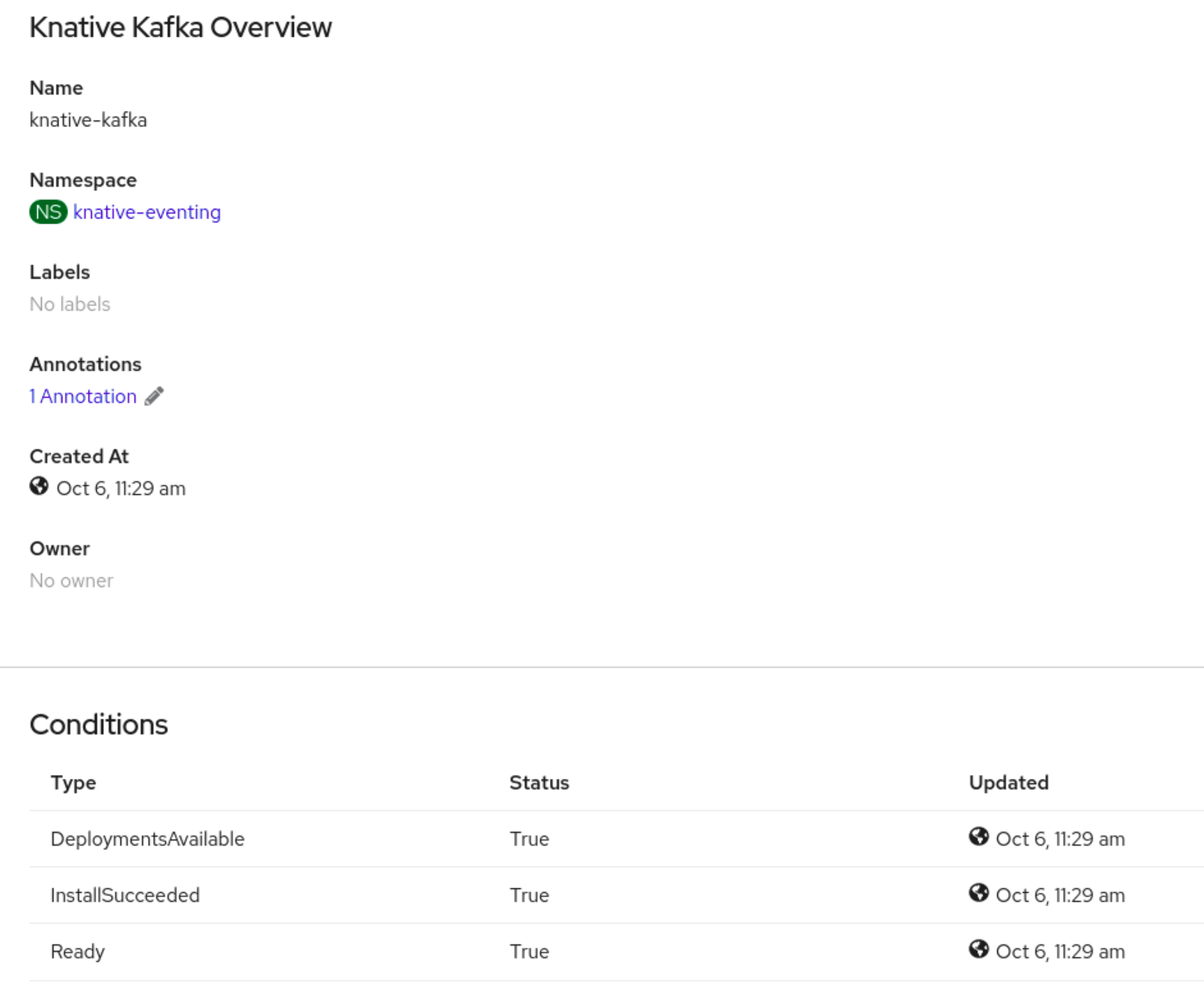

-

在 Knative Serving 选项卡中点

knative-serving自定义资源。 您将被自动定向到 Knative Serving Overview 页面。

- 向下滚动查看条件列表。

您应该看到一个状况为 True 的条件列表,如示例镜像所示。

注意

注意创建 Knative Serving 资源可能需要几秒钟时间。您可以在 Resources 选项卡中查看其状态。

- 如果条件状态为 Unknown 或 False,请等待几分钟,然后在确认已创建资源后再重新检查。

3.2.2. 使用 YAML 安装 Knative Serving

安装 OpenShift Serverless Operator 后,您可以使用默认设置安装 Knative Serving,或者在 KnativeServing 自定义资源 (CR) 中配置更高级的设置。您可以使用 YAML 文件和 oc CLI 安装 Knative Serving。

先决条件

- 您可以访问具有集群管理员权限的 OpenShift Container Platform 帐户。

- 已安装 OpenShift Serverless Operator。

-

安装 OpenShift CLI (

oc) 。

流程

创建名为

serving.yaml的文件并将以下示例 YAML 复制到其中:apiVersion: operator.knative.dev/v1beta1 kind: KnativeServing metadata: name: knative-serving namespace: knative-servingapiVersion: operator.knative.dev/v1beta1 kind: KnativeServing metadata: name: knative-serving namespace: knative-servingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 应用

service.yaml文件:oc apply -f serving.yaml

$ oc apply -f serving.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

使用以下命令校验安装是否完成:

oc get knativeserving.operator.knative.dev/knative-serving -n knative-serving --template='{{range .status.conditions}}{{printf "%s=%s\n" .type .status}}{{end}}'$ oc get knativeserving.operator.knative.dev/knative-serving -n knative-serving --template='{{range .status.conditions}}{{printf "%s=%s\n" .type .status}}{{end}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

DependenciesInstalled=True DeploymentsAvailable=True InstallSucceeded=True Ready=True

DependenciesInstalled=True DeploymentsAvailable=True InstallSucceeded=True Ready=TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意创建 Knative Serving 资源可能需要几秒钟时间。

如果条件状态为

Unknown或False,请等待几分钟,然后在确认已创建资源后再重新检查。检查是否已创建 Knative Serving 资源:

oc get pods -n knative-serving

$ oc get pods -n knative-servingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 检查所需的网络组件是否已安装到自动创建的

knative-serving-ingress命名空间:oc get pods -n knative-serving-ingress

$ oc get pods -n knative-serving-ingressCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY STATUS RESTARTS AGE net-kourier-controller-7d4b6c5d95-62mkf 1/1 Running 0 76s net-kourier-controller-7d4b6c5d95-qmgm2 1/1 Running 0 76s 3scale-kourier-gateway-6688b49568-987qz 1/1 Running 0 75s 3scale-kourier-gateway-6688b49568-b5tnp 1/1 Running 0 75s

NAME READY STATUS RESTARTS AGE net-kourier-controller-7d4b6c5d95-62mkf 1/1 Running 0 76s net-kourier-controller-7d4b6c5d95-qmgm2 1/1 Running 0 76s 3scale-kourier-gateway-6688b49568-987qz 1/1 Running 0 75s 3scale-kourier-gateway-6688b49568-b5tnp 1/1 Running 0 75sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.2.3. 后续步骤

- 如果要使用 Knative 事件驱动的架构,您可以安装 Knative Eventing。

3.3. 安装 Knative Eventing

要在集群上使用事件驱动的构架,请安装 Knative Eventing。您可以创建 Knative 组件,如事件源、代理和频道,然后使用它们向应用程序或外部系统发送事件。

安装 OpenShift Serverless Operator 后,您可以使用默认设置安装 Knative Eventing,或者在 KnativeEventing 自定义资源 (CR) 中配置更高级的设置。有关 KnativeEventing CR 的配置选项的更多信息,请参阅全局配置。

如果要在 OpenShift Serverless 中使用 Red Hat OpenShift distributed tracing,则必须在安装 Knative Eventing 前安装和配置 Red Hat OpenShift distributed tracing。

3.3.1. 使用 Web 控制台安装 Knative Eventing

安装 OpenShift Serverless Operator 后,使用 OpenShift Container Platform Web 控制台安装 Knative Eventing。您可以使用默认设置安装 Knative Eventing,或者在 KnativeEventing 自定义资源 (CR) 中配置更高级的设置。

先决条件

- 您可以访问具有集群管理员权限的 OpenShift Container Platform 帐户。

- 已登陆到 OpenShift Container Platform Web 控制台。

- 已安装 OpenShift Serverless Operator。

流程

- 在 OpenShift Container Platform web 控制台的 Administrator 视角中,进入 Operators → Installed Operators。

- 检查页面顶部的 Project 下拉菜单是否已设置为 Project: knative-eventing。

- 点 OpenShift Serverless Operator 的 Provided APIs 列表中的 Knative Eventing 来进入 Knative Eventing 选项卡。

- 点 Create Knative Eventing。

在 Create Knative Eventing 页面中,您可以选择使用提供的默认表单或编辑 YAML 来配置

KnativeEventing对象。建议您在不需要完全控制

KnativeEventing对象创建的简单配置中使用该表单。可选。如果您要使用表单配置

KnativeEventing对象,请为您的 Knative Eventing 部署进行任何要实现的更改。

点 Create。

对于更复杂的配置,建议编辑 YAML,这可以完全控制

KnativeEventing对象的创建。您可以通过点 Create Knative Eventing 页右上角的 edit YAML 链接来访问 YAML。可选。如果您要通过编辑 YAML 配置

KnativeEventing对象,请对您希望用于 Knative Eventing 部署的 YAML 进行更改。

- 点 Create。

-

安装 Knative Eventing 后,会创建

KnativeEventing对象,并自动定向到 Knative Eventing 选项卡。您可以在资源列表中看到knative-eventing自定义资源。

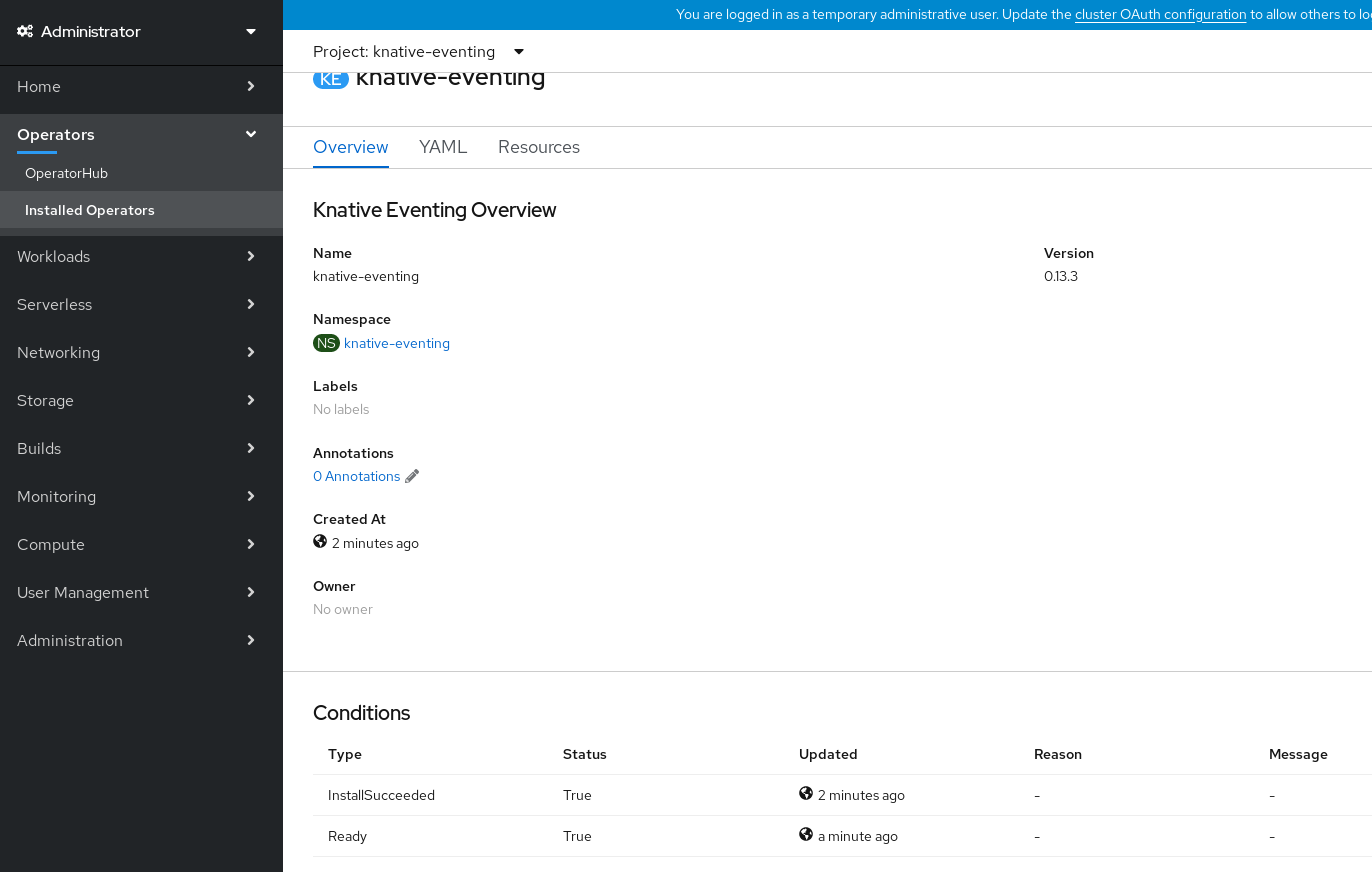

验证

-

点 Knative Eventing 选项卡中的

knative-eventing自定义资源。 您会自动定向到 Knative Eventing Overview 页面。

- 向下滚动查看条件列表。

您应该看到一个状况为 True 的条件列表,如示例镜像所示。

注意

注意创建 Knative Eventing 资源可能需要几秒钟时间。您可以在 Resources 选项卡中查看其状态。

- 如果条件状态为 Unknown 或 False,请等待几分钟,然后在确认已创建资源后再重新检查。

3.3.2. 使用 YAML 安装 Knative Eventing

安装 OpenShift Serverless Operator 后,您可以使用默认设置安装 Knative Eventing,或者在 KnativeEventing 自定义资源 (CR) 中配置更高级的设置。您可以使用 YAML 文件和 oc CLI 安装 Knative Eventing。

先决条件

- 您可以访问具有集群管理员权限的 OpenShift Container Platform 帐户。

- 已安装 OpenShift Serverless Operator。

-

安装 OpenShift CLI (

oc) 。

流程

-

创建名为

eventing.yaml的文件。 将以下示例 YAML 复制到

eventing.yaml中:apiVersion: operator.knative.dev/v1beta1 kind: KnativeEventing metadata: name: knative-eventing namespace: knative-eventingapiVersion: operator.knative.dev/v1beta1 kind: KnativeEventing metadata: name: knative-eventing namespace: knative-eventingCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 可选。根据您的 Knative Eventing 部署,对 YAML 进行相应的更改。

输入以下内容来应用

eventing.yaml文件:oc apply -f eventing.yaml

$ oc apply -f eventing.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

输入以下命令验证安装是否完成,并观察输出结果:

oc get knativeeventing.operator.knative.dev/knative-eventing \ -n knative-eventing \ --template='{{range .status.conditions}}{{printf "%s=%s\n" .type .status}}{{end}}'$ oc get knativeeventing.operator.knative.dev/knative-eventing \ -n knative-eventing \ --template='{{range .status.conditions}}{{printf "%s=%s\n" .type .status}}{{end}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

InstallSucceeded=True Ready=True

InstallSucceeded=True Ready=TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意创建 Knative Eventing 资源可能需要几秒钟时间。

-

如果条件状态为

Unknown或False,请等待几分钟,然后在确认已创建资源后再重新检查。 使用以下命令检查是否已创建 Knative Eventing 资源:

oc get pods -n knative-eventing

$ oc get pods -n knative-eventingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.3. 后续步骤

- 如果要使用 Knative 服务,可以安装 Knative Serving。

3.4. 删除 OpenShift Serverless

如果需要从集群中删除 OpenShift Serverless,您可以手动删除 OpenShift Serverless Operator 和其他 OpenShift Serverless 组件。在删除 OpenShift Serverless Operator 之前,您必须删除 Knative Serving 和 Knative Eventing。

3.4.1. 卸载 Knative Serving

在删除 OpenShift Serverless Operator 之前,您必须删除 Knative Serving。要卸载 Knative Serving,您必须删除 KnativeServing 自定义资源 (CR) 并删除 knative-serving 命名空间。

先决条件

- 您可以访问具有集群管理员权限的 OpenShift Container Platform 帐户。

-

安装 OpenShift CLI (

oc) 。

流程

删除

KnativeServingCR:oc delete knativeservings.operator.knative.dev knative-serving -n knative-serving

$ oc delete knativeservings.operator.knative.dev knative-serving -n knative-servingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在该命令运行完成且已从

knative-serving命名空间中移除所有 Pod 后,删除命名空间:oc delete namespace knative-serving

$ oc delete namespace knative-servingCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.2. 卸载 Knative Eventing

在删除 OpenShift Serverless Operator 之前,您必须删除 Knative Eventing。要卸载 Knative Eventing,您必须删除 KnativeEventing 自定义资源 (CR) 并删除 knative-eventing 命名空间。

先决条件

- 您可以访问具有集群管理员权限的 OpenShift Container Platform 帐户。

-

安装 OpenShift CLI (

oc) 。

流程

删除

KnativeEventingCR:oc delete knativeeventings.operator.knative.dev knative-eventing -n knative-eventing

$ oc delete knativeeventings.operator.knative.dev knative-eventing -n knative-eventingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在该命令运行完成且已从

knative-eventing命名空间中移除所有 Pod 后,删除命名空间:oc delete namespace knative-eventing

$ oc delete namespace knative-eventingCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3. 删除 OpenShift Serverless Operator

删除 Knative Serving 和 Knative Eventing 后,您可以删除 OpenShift Serverless Operator。您可以使用 OpenShift Container Platform Web 控制台或 oc CLI 完成此操作。

3.4.3.1. 使用 Web 控制台从集群中删除 Operator

集群管理员可以使用 Web 控制台从所选命名空间中删除已安装的 Operator。

先决条件

-

使用具有

cluster-admin权限的账户访问 OpenShift Container Platform 集群 Web 控制台。

流程

- 进入 Operators → Installed Operators 页面,在 Filter by name 字段滚动鼠标或键入关键词,以查找您想要的 Operator。然后点它。

在 Operator Details 页面右侧,从 Actions 列表中选择 Uninstall Operator。

此时会显示 Uninstall Operator? 对话框,提醒您:

删除 Operator 不会移除任何自定义资源定义或受管资源。如果 Operator 在集群中部署了应用程序,或者配置了非集群资源,则这些应用程序将继续运行,需要手动清理。

此操作将删除 Operator 以及 Operator 部署和 pod(若有)。任何 Operands 和由 Operator 管理的资源(包括 CRD 和 CR)都不会被删除。Web 控制台为一些 Operator 启用仪表板和导航项。要在卸载 Operator 后删除这些,您可能需要手动删除 Operator CRD。

- 选择 Uninstall。此 Operator 将停止运行,并且不再接收更新。

3.4.3.2. 使用 CLI 从集群中删除 Operator

集群管理员可以使用 CLI 从所选命名空间中删除已安装的 Operator。

先决条件

-

使用具有

cluster-admin权限的账户访问 OpenShift Container Platform 集群。 -

已在工作站上安装

oc命令。

流程

通过

currentCSV字段检查已订阅 Operator 的当前版本(如jaeger):oc get subscription jaeger -n openshift-operators -o yaml | grep currentCSV

$ oc get subscription jaeger -n openshift-operators -o yaml | grep currentCSVCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

currentCSV: jaeger-operator.v1.8.2

currentCSV: jaeger-operator.v1.8.2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 删除订阅(如

jaeger):oc delete subscription jaeger -n openshift-operators

$ oc delete subscription jaeger -n openshift-operatorsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

subscription.operators.coreos.com "jaeger" deleted

subscription.operators.coreos.com "jaeger" deletedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用上一步中的

currentCSV值来删除目标命名空间中相应 Operator 的 CSV:oc delete clusterserviceversion jaeger-operator.v1.8.2 -n openshift-operators

$ oc delete clusterserviceversion jaeger-operator.v1.8.2 -n openshift-operatorsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

clusterserviceversion.operators.coreos.com "jaeger-operator.v1.8.2" deleted

clusterserviceversion.operators.coreos.com "jaeger-operator.v1.8.2" deletedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.3.3. 刷新失败的订阅

在 Operator Lifecycle Manager(OLM)中,如果您订阅的是引用网络中无法访问的镜像的 Operator,您可以在 openshift-marketplace 命名空间中找到带有以下错误的作业:

输出示例

ImagePullBackOff for Back-off pulling image "example.com/openshift4/ose-elasticsearch-operator-bundle@sha256:6d2587129c846ec28d384540322b40b05833e7e00b25cca584e004af9a1d292e"

ImagePullBackOff for

Back-off pulling image "example.com/openshift4/ose-elasticsearch-operator-bundle@sha256:6d2587129c846ec28d384540322b40b05833e7e00b25cca584e004af9a1d292e"输出示例

rpc error: code = Unknown desc = error pinging docker registry example.com: Get "https://example.com/v2/": dial tcp: lookup example.com on 10.0.0.1:53: no such host

rpc error: code = Unknown desc = error pinging docker registry example.com: Get "https://example.com/v2/": dial tcp: lookup example.com on 10.0.0.1:53: no such host因此,订阅会处于这个失败状态,Operator 无法安装或升级。

您可以通过删除订阅、集群服务版本(CSV)及其他相关对象来刷新失败的订阅。重新创建订阅后,OLM 会重新安装 Operator 的正确版本。

先决条件

- 您有一个失败的订阅,无法拉取不能访问的捆绑包镜像。

- 已确认可以访问正确的捆绑包镜像。

流程

从安装 Operator 的命名空间中获取

Subscription和ClusterServiceVersion对象的名称:oc get sub,csv -n <namespace>

$ oc get sub,csv -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME PACKAGE SOURCE CHANNEL subscription.operators.coreos.com/elasticsearch-operator elasticsearch-operator redhat-operators 5.0 NAME DISPLAY VERSION REPLACES PHASE clusterserviceversion.operators.coreos.com/elasticsearch-operator.5.0.0-65 OpenShift Elasticsearch Operator 5.0.0-65 Succeeded

NAME PACKAGE SOURCE CHANNEL subscription.operators.coreos.com/elasticsearch-operator elasticsearch-operator redhat-operators 5.0 NAME DISPLAY VERSION REPLACES PHASE clusterserviceversion.operators.coreos.com/elasticsearch-operator.5.0.0-65 OpenShift Elasticsearch Operator 5.0.0-65 SucceededCopy to Clipboard Copied! Toggle word wrap Toggle overflow 删除订阅:

oc delete subscription <subscription_name> -n <namespace>

$ oc delete subscription <subscription_name> -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 删除集群服务版本:

oc delete csv <csv_name> -n <namespace>

$ oc delete csv <csv_name> -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在

openshift-marketplace命名空间中获取所有失败的作业的名称和相关配置映射:oc get job,configmap -n openshift-marketplace

$ oc get job,configmap -n openshift-marketplaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME COMPLETIONS DURATION AGE job.batch/1de9443b6324e629ddf31fed0a853a121275806170e34c926d69e53a7fcbccb 1/1 26s 9m30s NAME DATA AGE configmap/1de9443b6324e629ddf31fed0a853a121275806170e34c926d69e53a7fcbccb 3 9m30s

NAME COMPLETIONS DURATION AGE job.batch/1de9443b6324e629ddf31fed0a853a121275806170e34c926d69e53a7fcbccb 1/1 26s 9m30s NAME DATA AGE configmap/1de9443b6324e629ddf31fed0a853a121275806170e34c926d69e53a7fcbccb 3 9m30sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 删除作业:

oc delete job <job_name> -n openshift-marketplace

$ oc delete job <job_name> -n openshift-marketplaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 这样可确保尝试拉取无法访问的镜像的 Pod 不会被重新创建。

删除配置映射:

oc delete configmap <configmap_name> -n openshift-marketplace

$ oc delete configmap <configmap_name> -n openshift-marketplaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 在 Web 控制台中使用 OperatorHub 重新安装 Operator。

验证

检查是否已成功重新安装 Operator:

oc get sub,csv,installplan -n <namespace>

$ oc get sub,csv,installplan -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4.4. 删除 OpenShift Serverless 自定义资源定义

卸载 OpenShift Serverless 后,Operator 和 API 自定义资源定义(CRD)会保留在集群中。您可以使用以下步骤删除剩余的 CRD。

移除 Operator 和 API CRD 也会移除所有使用它们定义的资源,包括 Knative 服务。

先决条件

- 您可以访问具有集群管理员权限的 OpenShift Container Platform 帐户。

- 您已卸载了 Knative Serving 并移除了 OpenShift Serverless Operator。

-

安装 OpenShift CLI (

oc) 。

流程

运行以下命令删除 OpenShift Serverless CRD:

oc get crd -oname | grep 'knative.dev' | xargs oc delete

$ oc get crd -oname | grep 'knative.dev' | xargs oc deleteCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 4 章 Knative CLI

4.1. 安装 Knative CLI

Knative (kn) CLI 本身没有登录机制。要登录到集群,您必须安装 OpenShift CLI (oc),并使用 oc login 命令。CLI 的安装选项可能会因您的操作系统而异。

有关为您的操作系统安装 oc CLI 并使用 oc 登录的更多信息,请参阅 OpenShift CLI 启动文档。

OpenShift Serverless 不能使用 Knative(kn)CLI 安装。集群管理员必须安装 OpenShift Serverless Operator 并设置 Knative 组件,如 安装 OpenShift Serverless Operator 文档所述。

如果您试图将较旧版本的 Knative kn CLI 与较新的 OpenShift Serverless 发行版本搭配使用,则不会找到 API,并出现错误。

例如,您使用 1.23.0 版本的 Knative (kn) CLI(使用版本 1.2),以及 1.24.0 版本的 OpenShift Serverless(使用版本 1.3 的 Knative Serving 和 Knative Eventing API),则 CLI 将无法正常工作,因为它会一直寻找已过时的 1.2 版本的 API。

确保为 OpenShift Serverless 版本使用最新的 Knative (kn) CLI 版本以避免出现问题。

使用 OpenShift Container Platform Web 控制台提供了一个简洁、直观的用户界面来安装 Knative (kn) CLI。安装 OpenShift Serverless Operator 后,您会看到从 OpenShift Container Platform Web 控制台的 Command Line Tools 页面中下载适用于 Linux 的 Knative (kn) CLI 的链接(amd64、s390x、ppc64le)、macOS 或 Windows。

先决条件

- 已登陆到 OpenShift Container Platform Web 控制台。

OpenShift Serverless Operator 和 Knative Serving 已安装在 OpenShift Container Platform 集群中。

重要如果 libc 不可用,您在运行 CLI 命令时可能会看到以下错误:

kn: No such file or directory

$ kn: No such file or directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

如果要使用验证步骤,您必须安装 OpenShift (

oc) CLI。

流程

-

从 Command Line Tools 页面下载 Knative (

kn) CLI。您可以点 web 控制台右上角的 图标进入 Command Line Tools 页,并在列表中选择 Command Line Tools。

图标进入 Command Line Tools 页,并在列表中选择 Command Line Tools。

解包存档:

tar -xf <file>

$ tar -xf <file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

将

kn二进制文件移到PATH中的目录中。 运行以下命令可以查看

PATH的值:echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

运行以下命令检查是否已创建了正确的 Knative CLI 资源和路由:

oc get ConsoleCLIDownload

$ oc get ConsoleCLIDownloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME DISPLAY NAME AGE kn kn - OpenShift Serverless Command Line Interface (CLI) 2022-09-20T08:41:18Z oc-cli-downloads oc - OpenShift Command Line Interface (CLI) 2022-09-20T08:00:20Z

NAME DISPLAY NAME AGE kn kn - OpenShift Serverless Command Line Interface (CLI) 2022-09-20T08:41:18Z oc-cli-downloads oc - OpenShift Command Line Interface (CLI) 2022-09-20T08:00:20ZCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get route -n openshift-serverless

$ oc get route -n openshift-serverlessCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD kn kn-openshift-serverless.apps.example.com knative-openshift-metrics-3 http-cli edge/Redirect None

NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD kn kn-openshift-serverless.apps.example.com knative-openshift-metrics-3 http-cli edge/Redirect NoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.2. 使用 RPM 软件包管理器为 Linux 安装 Knative CLI

对于 Red Hat Enterprise Linux (RHEL) ,您可以使用软件包管理器(如 yum 或 dnf )将 Knative (kn) CLI 作为 RPM 安装。这允许系统自动管理 Knative CLI 版本。例如,如果有新版本可用,使用 dnf upgrade 一样的命令升级所有软件包,包括 kn。

先决条件

- 您的红帽帐户必须具有有效的 OpenShift Container Platform 订阅。

流程

使用 Red Hat Subscription Manager 注册:

subscription-manager register

# subscription-manager registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 获取最新的订阅数据:

subscription-manager refresh

# subscription-manager refreshCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将订阅附加到注册的系统:

subscription-manager attach --pool=<pool_id>

# subscription-manager attach --pool=<pool_id>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 活跃的 OpenShift Container Platform 订阅的池 ID

启用 Knative (

kn) CLI 所需的仓库:Linux (x86_64, amd64)

subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-x86_64-rpms"

# subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-x86_64-rpms"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Linux on IBM Z and LinuxONE (s390x)

subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-s390x-rpms"

# subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-s390x-rpms"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Linux on IBM Power (ppc64le)

subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-ppc64le-rpms"

# subscription-manager repos --enable="openshift-serverless-1-for-rhel-8-ppc64le-rpms"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

使用软件包管理器将 Knative (

kn) CLI 作为 RPM 安装:yum命令示例yum install openshift-serverless-clients

# yum install openshift-serverless-clientsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.3. 为 Linux 安装 Knative CLI

如果您使用没有 RPM 或者另一个软件包管理器的 Linux 发行版本,您可以将 Knative (kn) CLI 安装为二进制文件。要做到这一点,您必须下载并解包一个 tar.gz 存档,并将二进制文件添加到 PATH 的目录中。

先决条件

如果您不使用 RHEL 或 Fedora,请确保将 libc 安装在库路径的目录中。

重要如果 libc 不可用,您在运行 CLI 命令时可能会看到以下错误:

kn: No such file or directory

$ kn: No such file or directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow

流程

下载相关的 Knative (

kn) CLItar.gz存档:您还可以通过进入到 Serverless 客户端下载镜像 中的相应目录来下载任何

kn版本。解包存档:

tar -xf <filename>

$ tar -xf <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

将

kn二进制文件移到PATH中的目录中。 运行以下命令可以查看

PATH的值:echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.4. 为 macOS 安装 Knative CLI

如果使用 macOS,您可以将 Knative (kn) CLI 安装为二进制文件。要做到这一点,您必须下载并解包一个 tar.gz 存档,并将二进制文件添加到 PATH 的目录中。

流程

下载 Knative (

kn) CLItar.gz存档。您还可以通过进入到 Serverless 客户端下载镜像 中的相应目录来下载任何

kn版本。- 解包并提取存档。

-

将

kn二进制文件移到PATH中的目录中。 要查看

PATH,打开终端窗口并运行:echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.1.5. 为 Windows 安装 Knative CLI

如果使用 Windows,您可以将 Knative (kn) CLI 安装为二进制文件。要做到这一点,您必须下载并解包 ZIP 存档,并将二进制文件添加到 PATH 的目录中。

流程

您还可以通过进入到 Serverless 客户端下载镜像 中的相应目录来下载任何

kn版本。- 使用 ZIP 程序解压存档。

-

将

kn二进制文件移到PATH中的目录中。 要查看您的

PATH,请打开命令窗口并运行以下命令:path

C:\> pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2. 配置 Knative CLI

您可以通过创建 config.yaml 配置文件来自定义 Knative (kn) CLI 设置。您可以使用 --config 标志来提供此配置,否则会从默认位置提取配置。默认配置位置符合 XDG Base Directory 规格,对于 UNIX 系统和 Windows 系统有所不同。

对于 UNIX 系统:

-

如果设置了

XDG_CONFIG_HOME环境变量,Knative (kn) CLI 查找的默认配置位置为$XDG_CONFIG_HOME/kn。 -

如果没有设置

XDG_CONFIG_HOME环境变量,Knative (kn) CLI 会在$HOME/.config/kn/config.yaml的用户主目录中查找配置。

对于 Windows 系统,默认的 Knative (kn) CLI 配置位置为 %APPDATA%\kn。

配置文件示例

- 1

- 指定 Knative (

kn) CLI 是否应该在PATH环境变量中查找插件。这是一个布尔值配置选项。默认值为false。 - 2

- 指定 Knative (

kn) CLI 查找插件的目录。默认路径取决于操作系统,如前面所述。这可以是用户可见的任何目录。 - 3

sink-mappingsspec 定义了在 Knative (kn) CLI 命令中使用--sink标志时使用的 Kubernetes 可寻址资源。- 4

- 您用来描述接收器(sink)的前缀。

svc(用于服务)、channel和broker是 Knative (kn) CLI 中预定义的前缀。 - 5

- Kubernetes 资源的 API 组。

- 6

- Kubernetes 资源的版本。

- 7

- Kubernetes 资源类型的复数名称。例如,

services或brokers。

4.3. Knative CLI 插件

Knative (kn) CLI 支持使用插件,这允许您通过添加不是核心发行版本一部分的自定义命令和其他共享命令来扩展 kn 安装的功能。Knative (kn) CLI 插件的使用方式与主 kn 功能相同。

目前,红帽支持 kn-source-kafka 插件和 kn-event 插件。

kn-event 插件只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的详情,请参考 https://access.redhat.com/support/offerings/techpreview/。

4.3.1. 使用 kn-event 插件构建事件

您可以使用 kn event build 命令的 builder 接口来构建事件。然后,您可以稍后发送该事件或在另一个上下文中使用它。

先决条件

-

已安装 Knative (

kn) CLI。

流程

构建事件:

kn event build --field <field-name>=<value> --type <type-name> --id <id> --output <format>

$ kn event build --field <field-name>=<value> --type <type-name> --id <id> --output <format>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 其中:

-

--field标志将数据作为字段值对添加到事件中。您可以多次使用它。 -

--type标志允许您指定指定事件类型的字符串。 -

--id标志指定事件的 ID。 您可以将

json或yaml参数与--output标志一起使用,以更改事件的输出格式。所有这些标记都是可选的。

构建简单的事件

kn event build -o yaml

$ kn event build -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 结果为 YAML 格式

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 构建示例事务事件

Copy to Clipboard Copied! Toggle word wrap Toggle overflow JSON 格式的结果事件

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

4.3.2. 使用 kn-event 插件发送事件

您可以使用 kn event send 命令来发送事件。事件可以发送到公开的地址,或发送到集群中的可寻址资源,如 Kubernetes 服务,以及 Knative 服务、代理和频道。命令使用与 kn event build 命令相同的 builder 接口。

先决条件

-

已安装 Knative (

kn) CLI。

流程

发送事件:

kn event send --field <field-name>=<value> --type <type-name> --id <id> --to-url <url> --to <cluster-resource> --namespace <namespace>

$ kn event send --field <field-name>=<value> --type <type-name> --id <id> --to-url <url> --to <cluster-resource> --namespace <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 其中:

-

--field标志将数据作为字段值对添加到事件中。您可以多次使用它。 -

--type标志允许您指定指定事件类型的字符串。 -

--id标志指定事件的 ID。 -

如果您要将事件发送到公开的目的地,请使用

--to-url标志指定 URL。 如果要将事件发送到集群内 Kubernetes 资源,请使用

--to标志指定目的地。-

使用

<Kind>:<ApiVersion>:<name>格式指定 Kubernetes 资源。

-

使用

--namespace标志指定命名空间。如果省略,则会从当前上下文中获取命名空间。所有这些标志都是可选的,除了目的地规格外,您需要使用

--to-url或--to。以下示例显示向 URL 发送事件:

示例命令

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下示例显示了将事件发送到 in-cluster 资源:

示例命令

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

4.4. Knative Serving CLI 命令

您可以使用以下 Knative (kn) CLI 命令,在集群中完成 Knative Serving 任务。

4.4.1. kn service 命令

您可以使用以下命令创建和管理 Knative 服务。

4.4.1.1. 使用 Knative CLI 创建无服务器应用程序

通过使用 Knative (kn) CLI 创建无服务器应用程序,通过直接修改 YAML 文件来提供更精简且直观的用户界面。您可以使用 kn service create 命令创建基本无服务器应用程序。

先决条件

- 在集群中安装了 OpenShift Serverless Operator 和 Knative Serving。

-

已安装 Knative (

kn) CLI。 - 您已创建了一个项目,或者具有适当的角色和权限访问项目,以便在 OpenShift Container Platform 中创建应用程序和其他工作负载。

流程

创建 Knative 服务:

kn service create <service-name> --image <image> --tag <tag-value>

$ kn service create <service-name> --image <image> --tag <tag-value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 其中:

-

--image是应用的镜像的 URI。 --tag是一个可选标志,可用于向利用服务创建的初始修订版本添加标签。示例命令

kn service create event-display \ --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest$ kn service create event-display \ --image quay.io/openshift-knative/knative-eventing-sources-event-display:latestCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

4.4.1.2. 使用 Knative CLI 更新无服务器应用程序

在以递增方式构建服务时,您可以使用 kn service update 命令进行命令行上的互动会话。与 kn service apply 命令不同,在使用 kn service update 命令时,只需要指定您要更新的更改,而不是指定 Knative 服务的完整配置。

示例命令

通过添加新环境变量来更新服务:

kn service update <service_name> --env <key>=<value>

$ kn service update <service_name> --env <key>=<value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 通过添加新端口来更新服务:

kn service update <service_name> --port 80

$ kn service update <service_name> --port 80Copy to Clipboard Copied! Toggle word wrap Toggle overflow 通过添加新的请求和限制参数来更新服务:

kn service update <service_name> --request cpu=500m --limit memory=1024Mi --limit cpu=1000m

$ kn service update <service_name> --request cpu=500m --limit memory=1024Mi --limit cpu=1000mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 为修订分配

latest标签:kn service update <service_name> --tag <revision_name>=latest

$ kn service update <service_name> --tag <revision_name>=latestCopy to Clipboard Copied! Toggle word wrap Toggle overflow 为服务的最新

READY修订将标签从testing更新为staging:kn service update <service_name> --untag testing --tag @latest=staging

$ kn service update <service_name> --untag testing --tag @latest=stagingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将

test标签添加到接收 10% 流量的修订,并将其它流量发送到服务的最新READY修订:kn service update <service_name> --tag <revision_name>=test --traffic test=10,@latest=90

$ kn service update <service_name> --tag <revision_name>=test --traffic test=10,@latest=90Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4.1.3. 应用服务声明

您可以使用 kn service apply 命令声明性配置 Knative 服务。如果服务不存在,则使用已更改的选项更新现有服务。

kn service apply 命令对 shell 脚本或持续集成管道特别有用,因为用户通常希望在单个命令中完全指定服务的状态来声明目标状态。

使用 kn service apply 时,必须为 Knative 服务提供完整的配置。这与 kn service update 命令不同,它只在命令中指定您要更新的选项。

示例命令

创建服务:

kn service apply <service_name> --image <image>

$ kn service apply <service_name> --image <image>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将环境变量添加到服务:

kn service apply <service_name> --image <image> --env <key>=<value>

$ kn service apply <service_name> --image <image> --env <key>=<value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 从 JSON 或 YAML 文件中读取服务声明:

kn service apply <service_name> -f <filename>

$ kn service apply <service_name> -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4.1.4. 使用 Knative CLI 描述无服务器应用程序

您可以使用 kn service describe 命令来描述 Knative 服务。

示例命令

描述服务:

kn service describe --verbose <service_name>

$ kn service describe --verbose <service_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow --verbose标志是可选的,但可以包含它以提供更详细的描述。常规输出和详细输出之间的区别在以下示例中显示:没有

--verbose标记的输出示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 带有

--verbose标记的输出示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以 YAML 格式描述服务:

kn service describe <service_name> -o yaml

$ kn service describe <service_name> -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以 JSON 格式描述服务:

kn service describe <service_name> -o json

$ kn service describe <service_name> -o jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 仅输出服务 URL:

kn service describe <service_name> -o url

$ kn service describe <service_name> -o urlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4.2. 关于 Knative CLI 离线模式

执行 kn service 命令时,更改会立即传播到集群。但是,作为替代方案,您可以在离线模式下执行 kn service 命令。当您以离线模式创建服务时,集群不会发生任何更改,而是在本地计算机上创建服务描述符文件。

Knative CLI 的离线模式只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的详情,请参考 https://access.redhat.com/support/offerings/techpreview/。

创建描述符文件后,您可以手动修改并在版本控制系统中跟踪该文件。您还可以使用 kn service create -f、kn service apply -f 或 oc apply -f 命令将更改传播到集群。

离线模式有几种用途:

- 在使用描述符文件对集群进行更改之前,您可以手动修改该文件。

- 您可以在本地跟踪版本控制系统中服务的描述符文件。这可让您在目标集群以外的位置重复使用描述符文件,例如在持续集成(CI)管道、开发环境或演示中。

-

您可以检查创建的描述符文件,以了解 Knative 服务的信息。特别是,您可以看到生成的服务如何受到传递给

kn命令的不同参数的影响。

离线模式有其优点:速度非常快,不需要连接到集群。但是,离线模式缺少服务器端验证。因此,您无法验证服务名称是否唯一,或者是否可以拉取指定镜像。

4.4.2.1. 使用离线模式创建服务

您可以在离线模式下执行 kn service 命令,以便集群中不会发生任何更改,而是在本地机器上创建服务描述符文件。创建描述符文件后,您可以在向集群传播更改前修改该文件。

Knative CLI 的离线模式只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的详情,请参考 https://access.redhat.com/support/offerings/techpreview/。

先决条件

- 在集群中安装了 OpenShift Serverless Operator 和 Knative Serving。

-

已安装 Knative (

kn) CLI。

流程

在离线模式下,创建一个本地 Knative 服务描述符文件:

kn service create event-display \ --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest \ --target ./ \ --namespace test$ kn service create event-display \ --image quay.io/openshift-knative/knative-eventing-sources-event-display:latest \ --target ./ \ --namespace testCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Service 'event-display' created in namespace 'test'.

Service 'event-display' created in namespace 'test'.Copy to Clipboard Copied! Toggle word wrap Toggle overflow --target ./标志启用脱机模式,并将./指定为用于存储新目录树的目录。如果您没有指定现有目录,但使用文件名,如

--target my-service.yaml,则不会创建目录树。相反,当前目录中只创建服务描述符my-service.yaml文件。文件名可以具有

.yaml、.yml或.json扩展名。选择.json以 JSON 格式创建服务描述符文件。namespace test选项将新服务放在test命名空间中。如果不使用

--namespace,且您登录到 OpenShift Container Platform 集群,则会在当前命名空间中创建描述符文件。否则,描述符文件会在default命名空间中创建。

检查创建的目录结构:

tree ./

$ tree ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

使用

--target指定的当前./目录包含新的test/目录,它在指定的命名空间后命名。 -

test/目录包含ksvc,它在资源类型后命名。 -

ksvc目录包含描述符文件event-display.yaml,它根据指定的服务名称命名。

-

使用

检查生成的服务描述符文件:

cat test/ksvc/event-display.yaml

$ cat test/ksvc/event-display.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 列出新服务的信息:

kn service describe event-display --target ./ --namespace test

$ kn service describe event-display --target ./ --namespace testCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow --target ./选项指定包含命名空间子目录的目录结构的根目录。另外,您可以使用

--target选项直接指定 YAML 或 JSON 文件名。可接受的文件扩展包括.yaml、.yml和.json。--namespace选项指定命名空间,与kn通信包含所需服务描述符文件的子目录。如果不使用

--namespace,并且您登录到 OpenShift Container Platform 集群,kn会在以当前命名空间命名的子目录中搜索该服务。否则,kn在default/子目录中搜索。

使用服务描述符文件在集群中创建服务:

kn service create -f test/ksvc/event-display.yaml

$ kn service create -f test/ksvc/event-display.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4.3. kn 容器命令

您可以使用以下命令在 Knative 服务规格中创建和管理多个容器。

4.4.3.1. Knative 客户端多容器支持

您可以使用 kn container add 命令将 YAML 容器 spec 打印到标准输出。此命令对多容器用例很有用,因为它可以与其他标准 kn 标志一起使用来创建定义。

kn container add 命令接受与容器相关的所有标志,它们都支持与 kn service create 命令搭配使用。kn container add 命令也可以使用 UNIX 管道 (|) 一次创建多个容器定义来串联。

示例命令

从镜像添加容器并将其打印到标准输出中:

kn container add <container_name> --image <image_uri>

$ kn container add <container_name> --image <image_uri>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例命令

kn container add sidecar --image docker.io/example/sidecar

$ kn container add sidecar --image docker.io/example/sidecarCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

containers: - image: docker.io/example/sidecar name: sidecar resources: {}containers: - image: docker.io/example/sidecar name: sidecar resources: {}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将两个

kn container add命令链接在一起,然后将它们传递给kn service create命令创建带有两个容器的 Knative 服务:kn container add <first_container_name> --image <image_uri> | \ kn container add <second_container_name> --image <image_uri> | \ kn service create <service_name> --image <image_uri> --extra-containers -

$ kn container add <first_container_name> --image <image_uri> | \ kn container add <second_container_name> --image <image_uri> | \ kn service create <service_name> --image <image_uri> --extra-containers -Copy to Clipboard Copied! Toggle word wrap Toggle overflow --extra-containers -指定一个特殊情况,kn读取管道输入,而不是 YAML 文件。示例命令

kn container add sidecar --image docker.io/example/sidecar:first | \ kn container add second --image docker.io/example/sidecar:second | \ kn service create my-service --image docker.io/example/my-app:latest --extra-containers -

$ kn container add sidecar --image docker.io/example/sidecar:first | \ kn container add second --image docker.io/example/sidecar:second | \ kn service create my-service --image docker.io/example/my-app:latest --extra-containers -Copy to Clipboard Copied! Toggle word wrap Toggle overflow --extra-containers标志也可以接受到 YAML 文件的路径:kn service create <service_name> --image <image_uri> --extra-containers <filename>

$ kn service create <service_name> --image <image_uri> --extra-containers <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例命令

kn service create my-service --image docker.io/example/my-app:latest --extra-containers my-extra-containers.yaml

$ kn service create my-service --image docker.io/example/my-app:latest --extra-containers my-extra-containers.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4.4. kn 域命令

您可以使用下列命令创建和管理域映射。

4.4.4.1. 使用 Knative CLI 创建自定义域映射

您可以通过将您自己的自定义域名映射到 Knative 服务来自定义 Knative 服务域。您可以使用 Knative (kn) CLI 创建映射到可寻址目标 CR 的 DomainMapping 自定义资源 (CR) ,如 Knative 服务或 Knative 路由。

先决条件

- 在集群中安装了 OpenShift Serverless Operator 和 Knative Serving。

您已创建了 Knative 服务或路由,并控制要映射到该 CR 的自定义域。

注意您的自定义域必须指向 OpenShift Container Platform 集群的 DNS。

-

已安装 Knative (

kn) CLI。 - 您已创建了一个项目,或者具有适当的角色和权限访问项目,以便在 OpenShift Container Platform 中创建应用程序和其他工作负载。

流程

将域映射到当前命名空间中的 CR:

kn domain create <domain_mapping_name> --ref <target_name>

$ kn domain create <domain_mapping_name> --ref <target_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例命令

kn domain create example.com --ref example-service

$ kn domain create example.com --ref example-serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow --ref标志为域映射指定一个可寻址的目标 CR。如果使用

--ref标志时没有提供前缀,则会假定目标为当前命名空间中的 Knative 服务。将域映射到指定命名空间中的 Knative 服务:

kn domain create <domain_mapping_name> --ref <ksvc:service_name:service_namespace>

$ kn domain create <domain_mapping_name> --ref <ksvc:service_name:service_namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例命令

kn domain create example.com --ref ksvc:example-service:example-namespace

$ kn domain create example.com --ref ksvc:example-service:example-namespaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将域映射到 Knative 路由:

kn domain create <domain_mapping_name> --ref <kroute:route_name>

$ kn domain create <domain_mapping_name> --ref <kroute:route_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 示例命令

kn domain create example.com --ref kroute:example-route

$ kn domain create example.com --ref kroute:example-routeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4.4.2. 使用 Knative CLI 管理自定义域映射

创建 DomainMapping 自定义资源 (CR) 后,您可以使用 Knative (kn) CLI 列出现有 CR、查看现有 CR 的信息、更新 CR 或删除 CR。

先决条件

- 在集群中安装了 OpenShift Serverless Operator 和 Knative Serving。

-

您至少已创建了一个

DomainMappingCR。 -

已安装 Knative (

kn) CLI 工具。 - 您已创建了一个项目,或者具有适当的角色和权限访问项目,以便在 OpenShift Container Platform 中创建应用程序和其他工作负载。

流程

列出现有的

DomainMappingCR:kn domain list -n <domain_mapping_namespace>

$ kn domain list -n <domain_mapping_namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 查看现有

DomainMappingCR 的详情:kn domain describe <domain_mapping_name>

$ kn domain describe <domain_mapping_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 更新

DomainMappingCR 以指向新目标:kn domain update --ref <target>

$ kn domain update --ref <target>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 删除

DomainMappingCR:kn domain delete <domain_mapping_name>

$ kn domain delete <domain_mapping_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5. Knative Eventing CLI 命令

您可以使用以下 Knative (kn) CLI 命令在集群中完成 Knative Eventing 任务。

4.5.1. kn source 命令

您可以使用以下命令列出、创建和管理 Knative 事件源。

4.5.1.1. 使用 Knative CLI 列出可用事件源类型

使用 Knative (kn) CLI 提供了简化和直观的用户界面,用来在集群中查看可用事件源类型。您可以使用 kn source list-types CLI 命令列出集群中创建和使用的事件源类型。

先决条件

- 在集群中安装了 OpenShift Serverless Operator 和 Knative Eventing。

-

已安装 Knative (

kn) CLI。

流程

列出终端中的可用事件源类型:

kn source list-types

$ kn source list-typesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

TYPE NAME DESCRIPTION ApiServerSource apiserversources.sources.knative.dev Watch and send Kubernetes API events to a sink PingSource pingsources.sources.knative.dev Periodically send ping events to a sink SinkBinding sinkbindings.sources.knative.dev Binding for connecting a PodSpecable to a sink

TYPE NAME DESCRIPTION ApiServerSource apiserversources.sources.knative.dev Watch and send Kubernetes API events to a sink PingSource pingsources.sources.knative.dev Periodically send ping events to a sink SinkBinding sinkbindings.sources.knative.dev Binding for connecting a PodSpecable to a sinkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:您也可以以 YAML 格式列出可用事件源类型:

kn source list-types -o yaml