Service Mesh

Service Mesh 的安装、使用和发行注记信息

摘要

第 1 章 Service Mesh 2.x

1.1. 关于 OpenShift Service Mesh

因为 Red Hat OpenShift Service Mesh 的发行节奏与 Red Hat OpenShift Service on AWS 不同,且 Red Hat OpenShift Service Mesh Operator 支持部署多个版本的 ServiceMeshControlPlane,所以 Service Mesh 没有为产品的次版本维护单独的文档。当前文档集适用于 Service Mesh 的最新版本,除非在特定主题或特定功能中明确指定了特定于版本的限制。

如需有关 Red Hat OpenShift Service Mesh 生命周期和支持的平台的更多信息,请参阅平台生命周期政策。

1.1.1. Red Hat OpenShift Service Mesh 简介

Red Hat OpenShift Service Mesh 通过在应用程序中创建集中控制点来解决微服务架构中的各种问题。它在现有分布式应用上添加一个透明层,而无需对应用代码进行任何更改。

微服务架构将企业应用的工作分成模块化服务,从而简化扩展和维护。但是,随着微服务架构上构建的企业应用的规模和复杂性不断增长,理解和管理变得困难。Service Mesh 可以通过捕获或截获服务间的流量来解决这些架构问题,并可修改、重定向或创建新请求到其他服务。

Service Mesh 基于开源 Istio 项目,为创建部署的服务提供发现、负载均衡、服务对服务身份验证、故障恢复、指标和监控的服务网络提供了便捷的方法。服务网格还提供更复杂的操作功能,其中包括 A/B 测试、canary 发行版本、访问控制以及端到端验证。

Red Hat OpenShift Service Mesh 3 已正式发布。如需更多信息,请参阅 Red Hat OpenShift Service Mesh 3.0。

1.1.2. 核心功能

Red Hat OpenShift Service Mesh 在服务网络间提供了实现关键功能的统一方式:

- 流量管理 - 控制服务间的流量和 API 调用,提高调用的可靠性,并使网络在条件不好的情况保持稳定。

- 服务标识和安全性 - 在网格中提供可验证身份的服务,并提供保护服务流量的能力,以便可以通过信任度不同的网络进行传输。

- 策略强制 - 对服务间的交互应用机构策略,确保实施访问策略,并在用户间分配资源。通过配置网格就可以对策略进行更改,而不需要修改应用程序代码。

- 遥测 - 了解服务间的依赖关系以及服务间的网络数据流,从而可以快速发现问题。

1.2. Service Mesh 发行注记

1.2.1. Red Hat OpenShift Service Mesh 版本 2.6.7

此 Red Hat OpenShift Service Mesh 发行版本将 Red Hat OpenShift Service Mesh Operator 版本更新至 2.6.7,并包括以下 ServiceMeshControlPlane 资源版本更新: 2.6.7 和 2.5.10。

此发行版本解决了 CVE 报告的安全漏洞问题,并在 Red Hat OpenShift Service on AWS 4.14 及更新的版本中被支持。

Red Hat OpenShift Service Mesh Operator 的最新版本可与所有支持的 Service Mesh 版本一起使用。Service Mesh 的版本使用 ServiceMeshControlPlane 指定。

您可以使用红帽提供的 Kiali Operator 的最新版本以及所有支持的 Red Hat OpenShift Service Mesh 版本。Service Mesh 的版本使用 ServiceMeshControlPlane 资源指定。Service Mesh 的版本会自动确保 Kiali 的兼容版本。

1.2.1.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.20.8 |

| Envoy Proxy | 1.28.7 |

| Kiali Server | 1.73.20 |

1.2.2. Red Hat OpenShift Service Mesh 版本 2.5.10

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.6.7 中,并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。此发行版本解决了 CVE 报告的安全漏洞问题。

1.2.2.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.18.7 |

| Envoy Proxy | 1.26.8 |

| Kiali Server | 1.73.20 |

1.2.3. Red Hat OpenShift Service Mesh 版本 2.6.6

此 Red Hat OpenShift Service Mesh 发行版本将 Red Hat OpenShift Service Mesh Operator 版本更新至 2.6.6,并包括以下 ServiceMeshControlPlane 资源版本更新: 2.6.6, 2.5.9 和 2.4.15。

此发行版本解决了 CVE 报告的安全漏洞问题,并在 Red Hat OpenShift Service on AWS 4.14 及更新的版本中被支持。

您可以使用红帽提供的 Kiali Operator 的最新版本以及所有支持的 Red Hat OpenShift Service Mesh 版本。Service Mesh 的版本使用 ServiceMeshControlPlane 资源指定。Service Mesh 的版本会自动确保 Kiali 的兼容版本。

1.2.3.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.20.8 |

| Envoy Proxy | 1.28.7 |

| Kiali Server | 1.73.19 |

1.2.3.2. 新功能

- 在这个版本中,Red Hat OpenShift Service Mesh 2.6 的 Operator 被重命名为 Red Hat OpenShift Service Mesh 2,以便与 Red Hat OpenShift Service Mesh 3.0 发行版本保持一致并改进清晰性。

1.2.4. Red Hat OpenShift Service Mesh 版本 2.5.9

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.6.6 中,并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。此发行版本解决了 CVE 报告的安全漏洞问题。

1.2.4.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.18.7 |

| Envoy Proxy | 1.26.8 |

| Kiali Server | 1.73.19 |

1.2.5. Red Hat OpenShift Service Mesh 版本 2.4.15

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.6.6 中,并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。

1.2.5.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.16.7 |

| Envoy Proxy | 1.24.12 |

| Kiali Server | 1.65.20 |

1.2.6. Red Hat OpenShift Service Mesh 版本 2.6.5

此 Red Hat OpenShift Service Mesh 发行版本将 Red Hat OpenShift Service Mesh Operator 版本更新至 2.6.5,并包括以下 ServiceMeshControlPlane 资源版本更新: 2.6.5, 2.5.8 和 2.4.14。

此发行版本解决了 CVE 报告的安全漏洞问题,并在 Red Hat OpenShift Service on AWS 4.14 及更新的版本中被支持。

您可以使用红帽提供的 Kiali Operator 的最新版本以及所有支持的 Red Hat OpenShift Service Mesh 版本。Service Mesh 的版本使用 ServiceMeshControlPlane 资源指定。Service Mesh 的版本会自动确保 Kiali 的兼容版本。

1.2.6.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.20.8 |

| Envoy Proxy | 1.28.7 |

| Kiali Server | 1.73.18 |

1.2.6.2. 新功能

- IBM Z 现在支持 Red Hat OpenShift distributed Tracing Platform Stack。

1.2.6.3. 修复的问题

- OSSM-8608 以前,在安装过程中终止 Container Network Interface (CNI) pod,同时复制二进制文件可能会在节点文件系统中保留 Istio-CNI 临时文件。重复发生可能会最终填满节点磁盘空间。现在,当在安装过程中终止 CNI pod 时,在复制 CNI 二进制文件前会删除现有临时文件,确保节点文件系统中只有一个临时文件。

1.2.7. Red Hat OpenShift Service Mesh 版本 2.5.8

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.6.5 中,并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。此发行版本解决了 CVE 报告的安全漏洞问题。

1.2.7.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.18.7 |

| Envoy Proxy | 1.26.8 |

| Kiali Server | 1.73.18 |

1.2.7.2. 修复的问题

- OSSM-8608 以前,在安装过程中终止 Container Network Interface (CNI) pod,同时复制二进制文件可能会在节点文件系统中保留 Istio-CNI 临时文件。重复发生可能会最终填满节点磁盘空间。现在,当在安装过程中终止 CNI pod 时,在复制 CNI 二进制文件前会删除现有临时文件,确保节点文件系统中只有一个临时文件。

1.2.8. Red Hat OpenShift Service Mesh 版本 2.4.14

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.6.5 中,并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。此发行版本解决了 CVE 报告的安全漏洞问题。

1.2.8.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.16.7 |

| Envoy Proxy | 1.24.12 |

| Kiali Server | 1.65.19 |

1.2.8.2. 修复的问题

- OSSM-8608 以前,在安装过程中终止 Container Network Interface (CNI) pod,同时复制二进制文件可能会在节点文件系统中保留 Istio-CNI 临时文件。重复发生可能会最终填满节点磁盘空间。现在,当在安装过程中终止 CNI pod 时,在复制 CNI 二进制文件前会删除现有临时文件,确保节点文件系统中只有一个临时文件。

1.2.9. Red Hat OpenShift Service Mesh 版本 2.6.4

此 Red Hat OpenShift Service Mesh 发行版本将 Red Hat OpenShift Service Mesh Operator 版本更新至 2.6.4,并包括以下 ServiceMeshControlPlane 资源版本更新: 2.6.4、2.5.7 和 2.4.13。

此发行版本解决了 CVE 报告的安全漏洞问题,并在 Red Hat OpenShift Service on AWS 4.14 及更新的版本中被支持。

红帽提供的 Kiali Operator 的最新版本可与所有支持的 Red Hat OpenShift Service Mesh 版本一起使用。Service Mesh 的版本使用 ServiceMeshControlPlane 资源指定。Service Mesh 的版本会自动确保 Kiali 的兼容版本。

1.2.9.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.20.8 |

| Envoy Proxy | 1.28.7 |

| Kiali Server | 1.73.17 |

1.2.10. Red Hat OpenShift Service Mesh 版本 2.5.7

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.6.4 中,并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。此发行版本解决了 CVE 报告的安全漏洞问题。

1.2.10.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.18.7 |

| Envoy Proxy | 1.26.8 |

| Kiali Server | 1.73.17 |

1.2.11. Red Hat OpenShift Service Mesh version 2.4.13

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.6.4 中,并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。此发行版本解决了 CVE 报告的安全漏洞问题。

1.2.11.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.16.7 |

| Envoy Proxy | 1.24.12 |

| Kiali Server | 1.65.18 |

1.2.12. Red Hat OpenShift Service Mesh version 2.6.3

此 Red Hat OpenShift Service Mesh 发行版本将 Red Hat OpenShift Service Mesh Operator 版本更新至 2.6.3,并包括以下 ServiceMeshControlPlane 资源版本更新: 2.6.3, 2.5.6 和 2.4.12。

此发行版本解决了 CVE 报告的安全漏洞问题,并在 Red Hat OpenShift Service on AWS 4.14 及更新的版本中被支持。

红帽提供的 Kiali Operator 的最新版本可与所有支持的 Red Hat OpenShift Service Mesh 版本一起使用。Service Mesh 的版本使用 ServiceMeshControlPlane 资源指定。Service Mesh 的版本会自动确保 Kiali 的兼容版本。

1.2.12.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.20.8 |

| Envoy Proxy | 1.28.7 |

| Kiali Server | 1.73.16 |

1.2.13. Red Hat OpenShift Service Mesh 版本 2.5.6

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.6.3 中,解决了 CVE 报告的安全漏洞问题,并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。

1.2.13.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.18.7 |

| Envoy Proxy | 1.26.8 |

| Kiali Server | 1.73.16 |

1.2.14. Red Hat OpenShift Service Mesh version 2.4.12

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.6.3 中,解决了 CVE 报告的安全漏洞问题,并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。

1.2.14.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.16.7 |

| Envoy Proxy | 1.24.12 |

| Kiali Server | 1.65.17 |

1.2.15. Red Hat OpenShift Service Mesh version 2.6.2

此 Red Hat OpenShift Service Mesh 发行版本将 Red Hat OpenShift Service Mesh Operator 版本更新至 2.6.2,并包括以下 ServiceMeshControlPlane 资源版本更新: 2.6.2, 2.5.5 和 2.4.11。

此发行版本解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。

红帽提供的 Kiali Operator 的最新版本可与所有支持的 Red Hat OpenShift Service Mesh 版本一起使用。Service Mesh 的版本使用 ServiceMeshControlPlane 资源指定。Service Mesh 的版本会自动确保 Kiali 的兼容版本。

1.2.15.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.20.8 |

| Envoy Proxy | 1.28.7 |

| Kiali Server | 1.73.15 |

1.2.15.2. 新功能

- IBM Power、IBM Z 和 IBM® LinuxONE 支持 Red Hat OpenShift 的 cert-manager Operator。

1.2.15.3. 修复的问题

- OSSM-8099 以前,当端点处于 draining 阶段时,支持持久性会话标签存在问题。现在,有处理有状态标头会话的排空端点的方法。

-

OSSM-8001 以前,当

runAsUser和runAsGroup在 pod 中被设置为相同的值时,代理 GID 会错误地设置为与容器的 GID 匹配,从而导致 Istio CNI 应用 iptables 规则的流量截获问题。现在,容器可以具有与 runAsUser 和 runAsGroup 的值相同,iptables 规则会正确应用。 -

OSSM-8074 在以前的版本中,当 Service Mesh 有一个仅限数字的命名空间(如

12345)时,Kiali Operator 无法安装 Kiali 服务器。现在,只有 numerals 的命名空间可以正常工作。

1.2.16. Red Hat OpenShift Service Mesh version 2.5.5

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.6.2 中,解决了 CVE 报告的安全漏洞问题,并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。

1.2.16.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.18.7 |

| Envoy Proxy | 1.26.8 |

| Kiali Server | 1.73.15 |

1.2.16.2. 修复的问题

1.2.17. Red Hat OpenShift Service Mesh version 2.4.11

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.6.2 中,解决了 CVE 报告的安全漏洞问题,并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。

1.2.17.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.16.7 |

| Envoy Proxy | 1.24.12 |

| Kiali Server | 1.65.16 |

1.2.17.2. 修复的问题

1.2.18. Red Hat OpenShift Service Mesh version 2.6.1

此 Red Hat OpenShift Service Mesh 发行版本将 Red Hat OpenShift Service Mesh Operator 版本更新至 2.6.1,并包括以下 ServiceMeshControlPlane 资源版本更新: 2.6.1, 2.5.4 和 2.4.10。此发行版本解决了 CVE 报告的安全漏洞问题(CVE),它包含一个程序错误修复,并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。

红帽提供的 Kiali Operator 的最新版本可与所有支持的 Red Hat OpenShift Service Mesh 版本一起使用。Service Mesh 的版本使用 ServiceMeshControlPlane 资源指定。Service Mesh 的版本会自动确保 Kiali 的兼容版本。

1.2.18.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.20.8 |

| Envoy Proxy | 1.28.5 |

| Kiali Server | 1.73.14 |

1.2.18.2. 修复的问题

- OSSM-6766 以前,如果用户想更新命名空间(如启用或禁用注入)或创建任何 Istio 对象(例如,创建流量策略),则 OpenShift Service Mesh Console (OSSMC)插件会失败。现在,如果用户更新命名空间或创建任何 Istio 对象,OpenShift Service Mesh Console (OSSMC)插件不会失败。

1.2.19. Red Hat OpenShift Service Mesh 版本 2.5.4

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.6.1 中,解决了 CVE 报告的安全漏洞问题,并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。

1.2.19.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.18.7 |

| Envoy Proxy | 1.26.8 |

| Kiali Server | 1.73.14 |

1.2.20. Red Hat OpenShift Service Mesh version 2.4.10

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.6.1 中,解决了 CVE 报告的安全漏洞问题,并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。

1.2.20.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.16.7 |

| Envoy Proxy | 1.24.12 |

| Kiali Server | 1.65.15 |

1.2.21. Red Hat OpenShift Service Mesh version 2.6.0

此 Red Hat OpenShift Service Mesh 发行版本将 Red Hat OpenShift Service Mesh Operator 版本更新至 2.6.0,并包括以下 ServiceMeshControlPlane 资源版本更新: 2.6.0, 2.5.3 和 2.4.9。此发行版本添加了新功能,解决了 CVE 报告的安全漏洞问题(CVE),并受 Red Hat OpenShift Service on AWS 4.14 及更新版本的支持。

此发行版本结束了对 Red Hat OpenShift Service Mesh 版本 2.3 的维护支持。如果使用 Service Mesh 版本 2.3,您应该更新到一个受支持的版本。

Red Hat OpenShift Service Mesh 为 FIPS 设计。Service Mesh 使用已提交到 NIST for FIPS 140-2/140-3 Validation 的 RHEL 加密库,用于 x86_64、ppc64le 和 s390x 架构。有关 NIST 验证程序的更多信息,请参阅加密模块验证程序。有关已提交用于验证的 RHEL 加密库的最新 NIST 状态,请参阅 Compliance Activities 和 Government Standards。

1.2.21.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.20.8 |

| Envoy Proxy | 1.28.5 |

| Kiali | 1.73.9 |

1.2.21.2. Istio 1.20 支持

Service Mesh 2.6 基于 Istio 1.20,它提供新功能和产品改进,其中包括:

Red Hat OpenShift Service on AWS 4.16 或更高版本支持原生 sidecar。

ServiceMeshControlPlane资源示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Istio 1.20 中的流量镜像现在支持多个目的地。此功能支持将流量镜像到不同的端点,允许在不同服务版本或配置间同时观察。

虽然 Red Hat OpenShift Service Mesh 支持许多 Istio 1.20 功能,但请注意以下例外:

- 不支持 ambient mesh

- 不支持 Istio 中的 QuickAssist Technology (QAT) PrivateKeyProvider

1.2.21.3. Istio 和 Kiali 捆绑包镜像名称更改

此发行版本更新了 Istio 捆绑包镜像名称和 Kiali 捆绑包镜像名称,以更好地与红帽命名约定保持一致。

-

Istio 捆绑包镜像名称:

openshift-service-mesh/istio-operator-bundle -

Kiali bundle image name:

openshift-service-mesh/kiali-operator-bundle

此发行版本引入了对追踪扩展供应商的通用集成,Red Hat OpenShift distributed Tracing Platform 和 Red Hat build of OpenTelemetry。

您可以通过将指定元素和 opentelemetry 供应商附加到 ServiceMehControlPlane 资源中的 spec.meshConfig.extensionProviders 规格中,向 Red Hat OpenShift distributed Tracing Platform 公开追踪数据。然后,遥测自定义资源将 Istio 代理配置为收集 trace span,并将其发送到 OpenTelemetry Collector 端点。

您可以在网格命名空间中创建红帽构建的 OpenTelemetry 实例,并将其配置为将追踪数据发送到追踪平台后端服务。

此发行版本默认为 ServiceMeshControlPlane 资源的新实例禁用 Red Hat OpenShift Distributed Tracing Platform (Jaeger)。

将 ServiceMeshControlPlane 资源的现有实例更新至 Red Hat OpenShift Service Mesh 版本 2.6 时,分布式 Tracing Platform (Jaeger)会被默认启用。

Red Hat OpenShift Service Mesh 2.6 是最后一个发行版本,包括对 Red Hat OpenShift distributed Tracing Platform (Jaeger)和 OpenShift Elasticsearch Operator 的支持。分布式追踪平台(Jaeger)和 OpenShift Elasticsearch Operator 将在以后的版本中删除。目前使用分布式跟踪平台(Jaeger)和 OpenShift Elasticsearch Operator,则需要切换到 Red Hat OpenShift distributed Tracing Platform 和 Red Hat build of OpenTelemetry。

此发行版本引入了在 Red Hat OpenShift Service Mesh 2.6 中使用 Kubernetes 网关 API 版本 1.0.0 的 General Availability。此 API 使用仅限于 Red Hat OpenShift Service Mesh。不支持 Gateway API 自定义资源定义(CRD)。

如果启用了集群范围的模式,网关 API 现在会被默认启用(spec.mode: ClusterWide)。即使集群中没有安装自定义资源定义(CRD),也可以启用它。

用于多租户网格部署的网关 API 仍只是一个技术预览。

请参阅下表来确定应使用的 OpenShift Service Mesh 版本安装哪个网关 API 版本:

| Service Mesh 版本 | Istio 版本 | 网关 API 版本 | 备注 |

|---|---|---|---|

| 2.6 | 1.20.x | 1.0.0 | N/A |

| 2.5.x | 1.18.x | 0.6.2 |

使用实验性分支,因为 v0.6.2 中缺少 |

| 2.4.x | 1.16.x | 0.5.1 | 对于多租户网格部署,所有网关 API CRD 都必须存在。使用实验性分支。 |

您可以通过将 PILOT_ENABLE_GATEWAY_API 设置为 false 来禁用此功能:

1.2.21.7. 修复的问题

- OSSM-6754 在以前的版本中,在 Red Hat OpenShift Service on AWS 4.15 中,当用户进入到 Service 详情页面 时,点 Service Mesh 选项卡并刷新页面,Service Mesh 详情页面 仍然处于 Service Mesh 内容信息,即使 active 选项卡是默认的 Details 选项卡。现在,在刷新后,用户可以浏览服务详情页面的不同标签页,而无需问题。

-

OSSM-2101 在以前的版本中,Istio Operator 在不再需要时不会删除

istio-cni-nodeDaemonSet 和其他 CNI 资源。现在,在升级 Operator 后,如果集群中至少安装了一个 SMCP,Operator 会协调这个 SMCP,然后删除所有未使用的 CNI 安装(甚至非常旧的 CNI 版本为 v2.0)。

1.2.21.8. Kiali 已知问题

OSSM-6099 在 IPv6 集群上安装 OpenShift Service Mesh 控制台 (OSSMC) 插件失败。

临时解决方案:在 IPv4 集群上安装 OSSMC 插件。

1.2.22. Red Hat OpenShift Service Mesh 版本 2.5.3

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.6.0 中,解决了 CVE 报告的安全漏洞问题,并受 Red Hat OpenShift Service on AWS 4.12 及更新的版本的支持。

1.2.22.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.18.7 |

| Envoy Proxy | 1.26.8 |

| Kiali | 1.73.9 |

1.2.23. Red Hat OpenShift Service Mesh version 2.4.9

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.6.0 中,解决了 CVE 报告的安全漏洞问题,并受 Red Hat OpenShift Service on AWS 4.12 及更新的版本的支持。

1.2.23.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.16.7 |

| Envoy Proxy | 1.24.12 |

| Kiali | 1.65.11 |

1.2.24. Red Hat OpenShift Service Mesh version 2.5.2

此 Red Hat OpenShift Service Mesh 发行版本将 Red Hat OpenShift Service Mesh Operator 版本更新至 2.5.2,并包括以下 ServiceMeshControlPlane 资源版本更新: 2.5.2、2.4.8 和 2.3.12。此发行版本解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.12 及更新的版本的支持。

1.2.24.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.18.7 |

| Envoy Proxy | 1.26.8 |

| Kiali | 1.73.8 |

1.2.24.2. 修复的问题

-

OSSM-6331 以前,

smcp.general.logging.componentLevelsspec 接受无效的LogLevel值,ServiceMeshControlPlane资源仍然被创建。现在,当使用无效的值且没有创建 control plane 时,终端会显示一个错误消息。 -

OSSM-6290 以前,Istio Config 列表页面的 Project 过滤器下拉列表无法正常工作。所有

istio config项都会从所有命名空间中显示,即使您从下拉菜单中选择一个特定的项目。现在,只会显示属于过滤器下拉菜单中所选项目的istio配置项。 - OSSM-6298 以前,当您点击 OpenShift Service Mesh 控制台(OSSMC)插件中的项目引用时,控制台有时会在打开所需页面前执行多个重定向。因此,导航到在控制台中打开的上一页会导致您的 Web 浏览器打开错误页面。现在,这些重定向不会发生,在网页浏览器中点 Back 会打开正确的页面。

- OSSM-6299 以前,在 Red Hat OpenShift Service on AWS 4.15 中,当您点击流量图中任何节点菜单的 Node 图形 菜单选项时,不会显示节点图。相反,页面使用相同的流量图刷新。现在,点 Node 图形 菜单选项可以正确地显示节点图。

- OSSM-6267 以前,在 Red Hat OpenShift Service Mesh 2.5 Grafana 中配置数据源会导致数据查询身份验证错误,用户无法在 Istio 服务和工作负载仪表板中查看数据。现在,将现有 2.5 SMCP 升级到 2.5.2 或更高版本可解决 Grafana 错误。

1.2.25. Red Hat OpenShift Service Mesh 版本 2.4.8

此 Red Hat OpenShift Service Mesh 发行版本包含在 Red Hat OpenShift Service Mesh Operator 2.5.2 中,解决了 CVE 报告的安全漏洞问题,包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.12 及更新的版本的支持。

Red Hat OpenShift Service Mesh Operator 的最新版本可与所有支持的 Service Mesh 版本一起使用。Service Mesh 的版本使用 ServiceMeshControlPlane 指定。

1.2.25.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.16.7 |

| Envoy Proxy | 1.24.12 |

| Kiali | 1.65.11 |

1.2.26. Red Hat OpenShift Service Mesh version 2.3.12

此 Red Hat OpenShift Service Mesh 发行版本包含在 Red Hat OpenShift Service Mesh Operator 2.5.2 中,解决了 CVE 报告的安全漏洞问题,包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.12 及更新的版本的支持。

Red Hat OpenShift Service Mesh Operator 的最新版本可与所有支持的 Service Mesh 版本一起使用。Service Mesh 的版本使用 ServiceMeshControlPlane 资源指定。

1.2.26.1. 组件更新

| 组件 | 版本 |

|---|---|

| Istio | 1.14.5 |

| Envoy Proxy | 1.22.11 |

| Kiali | 1.57.14 |

1.2.27. 之前的版本

之前的版本添加了功能和改进。

1.2.27.1. Red Hat OpenShift Service Mesh 版本 2.5.1 的新功能

此 Red Hat OpenShift Service Mesh 发行版本将 Red Hat OpenShift Service Mesh Operator 版本更新至 2.5.1,并包括以下 ServiceMeshControlPlane 资源版本更新: 2.5.1、2.4.7 和 2.3.11。

此发行版本解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.12 及更新的版本的支持。

1.2.27.1.1. Red Hat OpenShift Service Mesh 2.5.1 的组件版本

| 组件 | 版本 |

|---|---|

| Istio | 1.18.7 |

| Envoy Proxy | 1.26.8 |

| Kiali | 1.73.7 |

1.2.27.2. Red Hat OpenShift Service Mesh 版本 2.5 的新功能

此 Red Hat OpenShift Service Mesh 发行版本将 Red Hat OpenShift Service Mesh Operator 版本更新至 2.5.0,并包括以下 ServiceMeshControlPlane 资源版本更新: 2.5.0, 2.4.6 和 2.3.10。

此发行版本添加了新功能,解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.12 及之后的版本的支持。

此发行版本结束了对 OpenShift Service Mesh 版本 2.2 的维护支持。如果使用 OpenShift Service Mesh 版本 2.2,您应该升级到受支持的版本。

1.2.27.2.1. Red Hat OpenShift Service Mesh 2.5 的组件版本

| 组件 | 版本 |

|---|---|

| Istio | 1.18.7 |

| Envoy Proxy | 1.26.8 |

| Kiali | 1.73.4 |

1.2.27.2.2. Istio 1.18 支持

Service Mesh 2.5 基于 Istio 1.18,它引入了新功能和产品改进。虽然 Red Hat OpenShift Service Mesh 支持许多 Istio 1.18 功能,但请注意以下例外:

- 不支持 ambient mesh

- 不支持 Istio 中的 QuickAssist Technology (QAT) PrivateKeyProvider

1.2.27.2.3. Cluster-Wide 网格迁移

此发行版本添加了从多租户网格迁移到集群范围代理的文档。如需更多信息,请参阅以下文档:

- "关于迁移到集群范围的网格"

- "从集群范围的网格中排除命名空间"

- "定义哪些命名空间在集群范围的网格中接收 sidecar 注入"

- "不包括集群范围的网格中的单个 pod"

此发行版本在基于 ARM 的集群上提供了 Red Hat OpenShift Service Mesh Operator,作为正式发布的功能。

此发行版本引入了对追踪扩展供应商的通用集成。您可以通过将命名元素和 zipkin 供应商附加到 spec.meshConfig.extensionProviders 规格中,将追踪数据公开给 Red Hat OpenShift distributed Tracing Platform (Tempo)堆栈。然后,遥测自定义资源将 Istio 代理配置为收集 trace 并将其发送到 Tempo 经销商服务端点。

IBM Z 不支持 Red Hat OpenShift distributed Tracing Platform (Tempo) Stack。

1.2.27.2.6. OpenShift Service Mesh 控制台插件

此发行版本引入了 OpenShift Service Mesh 控制台(OSSMC)插件的通用版本。

OSSMC 插件是 OpenShift 控制台的扩展,可为您的 Service Mesh 提供可见性。安装 OSSMC 插件后,web 控制台的导航窗格中提供了一个新的 Service Mesh 菜单选项,以及增强现有 Workloads 和 Service 控制台页面的新 Service Mesh 标签页。

OSSMC 插件的功能与独立 Kiali 控制台的功能非常相似。OSSMC 插件不会替换 Kiali 控制台,在安装 OSSMC 插件后,您仍可以访问独立 Kiali 控制台。

1.2.27.2.7. Istio OpenShift 路由(IOR)默认设置更改

Istio OpenShift 路由(IOR)的默认设置已更改。从这个版本开始,对于 ServiceMeshControlPlane 资源的新实例,默认禁用自动路由。

对于 ServiceMeshControlPlane 资源的新实例,您可以通过在 ServiceMeshControlPlane 资源的 gateway .openshiftRoute 规格中将 enabled 字段设置为 true 来使用自动路由。

ServiceMeshControlPlane 资源示例

将 ServiceMeshControlPlane 资源的现有实例更新至 Red Hat OpenShift Service Mesh 版本 2.5 时,自动路由会默认启用。

1.2.27.2.8. Istio 代理并发配置增强

networking.istio API 中的 concurrency 参数配置 Istio 代理运行的 worker 线程数量。

为了在部署间一致性,Istio 现在根据分配给代理容器的 CPU 限制配置 concurrency 参数。例如,限制 2500m 会将 concurrency 参数设置为 3。如果将 concurrency 参数设置为不同的值,则 Istio 会使用该值来配置代理运行的线程数量,而不是使用 CPU 限制。

在以前的版本中,参数的默认设置是 2。

1.2.27.2.9. 网关 API CRD 版本

Red Hat OpenShift Service on AWS Gateway API 支持只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

现在提供了网关 API 自定义资源定义(CRD)的新版本。请参阅下表来确定应使用的 OpenShift Service Mesh 版本安装哪个网关 API 版本:

| Service Mesh 版本 | Istio 版本 | 网关 API 版本 | 备注 |

|---|---|---|---|

| 2.5.x | 1.18.x | 0.6.2 |

使用实验性分支,因为 v0.6.2 缺少 |

| 2.4.x | 1.16.x | 0.5.1 | 对于多租户网格部署,所有网关 API CRD 都必须存在。使用实验性分支。 |

1.2.27.3. Red Hat OpenShift Service Mesh 版本 2.4.7 的新功能

此 Red Hat OpenShift Service Mesh 发行版本包含在 Red Hat OpenShift Service Mesh Operator 2.5.1 中,解决了 CVE 报告的安全漏洞问题,包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.12 及更新的版本的支持。

1.2.27.3.1. Red Hat OpenShift Service Mesh 2.4.7 的组件版本

| 组件 | 版本 |

|---|---|

| Istio | 1.16.7 |

| Envoy Proxy | 1.24.12 |

| Kiali | 1.65.11 |

1.2.27.4. Red Hat OpenShift Service Mesh 版本 2.4.6 的新功能

此 Red Hat OpenShift Service Mesh 发行版本包含在 Red Hat OpenShift Service Mesh Operator 2.5.0 中,解决了 CVE 报告的安全漏洞问题,包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.12 及更新的版本的支持。

1.2.27.4.1. Red Hat OpenShift Service Mesh 2.4.6 的组件版本

| 组件 | 版本 |

|---|---|

| Istio | 1.16.7 |

| Envoy Proxy | 1.24.12 |

| Kiali | 1.65.11 |

1.2.27.5. Red Hat OpenShift Service Mesh 版本 2.4.5 的新功能

此 Red Hat OpenShift Service Mesh 发行版本将 Red Hat OpenShift Service Mesh Operator 版本更新至 2.4.5,并包括以下 ServiceMeshControlPlane 资源版本更新: 2.4.5、2.3.9 和 2.2.12。

此发行版本解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.11 及之后的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.16.7 |

| Envoy Proxy | 1.24.12 |

| Kiali | 1.65.11 |

1.2.27.6. Red Hat OpenShift Service Mesh 版本 2.4.4 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.11 及更新的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.16.7 |

| Envoy Proxy | 1.24.12 |

| Jaeger | 1.47.0 |

| Kiali | 1.65.10 |

1.2.27.7. Red Hat OpenShift Service Mesh 版本 2.4.3 的新功能

-

添加了

envoyExtAuthzGrpc字段,该字段用于使用 gRPC API 配置外部授权提供程序。 - 解决了常见的漏洞和风险(CVE)。

- 此发行版本在 Red Hat OpenShift Service on AWS 4.10 及更新的版本中被支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.16.7 |

| Envoy Proxy | 1.24.10 |

| Jaeger | 1.42.0 |

| Kiali | 1.65.8 |

1.2.27.7.2. 远程过程调用(gRPC) API 支持外部授权配置

此功能增强添加了 envoyExtAuthzGrpc 字段,以使用 gRPC API 配置外部授权供应商。

1.2.27.8. Red Hat OpenShift Service Mesh 版本 2.4.2 的新功能

此 Red Hat OpenShift Service Mesh 发行版本引入了新功能,解决了 CVE 报告的安全漏洞问题 (CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.10 和更高版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.16.7 |

| Envoy Proxy | 1.24.10 |

| Jaeger | 1.42.0 |

| Kiali | 1.65.7 |

1.2.27.9. Red Hat OpenShift Service Mesh 版本 2.4.1 的新功能

此 Red Hat OpenShift Service Mesh 发行版本引入了新功能,解决了 CVE 报告的安全漏洞问题 (CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.10 和更高版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.16.5 |

| Envoy Proxy | 1.24.8 |

| Jaeger | 1.42.0 |

| Kiali | 1.65.7 |

1.2.27.10. Red Hat OpenShift Service Mesh 版本 2.4 的新功能

此 Red Hat OpenShift Service Mesh 发行版本引入了新功能,解决了 CVE 报告的安全漏洞问题 (CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.10 和更高版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.16.5 |

| Envoy Proxy | 1.24.8 |

| Jaeger | 1.42.0 |

| Kiali | 1.65.6 |

1.2.27.10.2. 集群范围的部署

此功能增强引入了集群范围的部署的通用版本。集群范围的部署包含一个服务网格 control plane,用于监控整个集群的资源。control plane 在所有命名空间中使用单个查询来监控影响网格配置的每个 Istio 或 Kubernetes 资源。减少集群范围的部署中 control plane 执行的查询数量可提高性能。

1.2.27.10.3. 支持发现选择器

此功能增强引入了一个通用的 meshConfig.discoverySelectors 字段版本,该字段可用于集群范围的部署来限制服务网格 control plane 可以发现的服务。

1.2.27.10.4. 与 cert-manager istio-csr 集成

在这个版本中,Red Hat OpenShift Service Mesh 与 cert-manager 控制器和 istio-csr 代理集成。cert-manager 在 Kubernetes 集群中将证书和证书签发者添加为资源类型,并简化了获取、续订和使用这些证书的过程。cert-manager 为 Istio 提供并轮转中间 CA 证书。与 istio-csr 集成可让用户将 Istio 代理的签名证书请求委派给 cert-manager。ServiceMeshControlPlane v2.4 接受 cert-manager 提供的 CA 证书作为 cacerts secret。

IBM Power®、IBM Z® 和 IBM® LinuxONE 不支持与 cert-manager 和 istio-csr 集成。

1.2.27.10.5. 与外部授权系统集成

此功能增强引入了一种通用可用的方法,使用 AuthorizationPolicy 资源的 action: CUSTOM 字段将 Red Hat OpenShift Service Mesh 与外部授权系统集成。使用 envoyExtAuthzHttp 字段将访问控制委派给外部授权系统。

1.2.27.10.6. 与外部 Prometheus 安装集成

此功能增强引入了 Prometheus 扩展供应商的通用版本。您可以通过在 spec.meshConfig 规格中将 extensionProviders 字段的值设置为 prometheus,将指标公开给 Red Hat OpenShift Service on AWS 监控堆栈或自定义 Prometheus 安装。Telemetry 对象配置 Istio 代理来收集流量指标。Service Mesh 只支持 Prometheus 指标的 Telemetry API。

1.2.27.10.7. 单堆栈 IPv6 支持

此功能增强引进了对单堆栈 IPv6 集群的常用支持,提供对更广泛的 IP 地址的访问。不支持双堆栈 IPv4 或 IPv6 集群。

IBM Power®、IBM Z® 和 IBM® LinuxONE 不提供单一堆栈 IPv6 支持。

要在 AWS 网关 API 上启用 Red Hat OpenShift Service,在 ServiceMeshControlPlane 资源的 techPreview.gatewayAPI 规格中将 enabled 字段的值设置为 true。

spec:

techPreview:

gatewayAPI:

enabled: true

spec:

techPreview:

gatewayAPI:

enabled: true在以前的版本中,环境变量用于启用网关 API。

1.2.27.10.8. Istio 1.16 支持

Service Mesh 2.4 基于 Istio 1.16,它引入了新功能和产品改进。虽然很多 Istio 1.16 功能被支持,但请注意以下例外:

- 对于 sidecar 的 HBONE 协议是一个实验性功能,它不被支持。

- 不支持 ARM64 架构上的 Service Mesh。

1.2.27.11. Red Hat OpenShift Service Mesh 版本 2.3.11 的新功能

此 Red Hat OpenShift Service Mesh 发行版本包含在 Red Hat OpenShift Service Mesh Operator 2.5.1 中,解决了 CVE 报告的安全漏洞问题,包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.12 及更新的版本的支持。

1.2.27.11.1. Red Hat OpenShift Service Mesh 2.3.11 的组件版本

| 组件 | 版本 |

|---|---|

| Istio | 1.14.5 |

| Envoy Proxy | 1.22.11 |

| Kiali | 1.57.14 |

1.2.27.12. Red Hat OpenShift Service Mesh 版本 2.3.10 的新功能

此 Red Hat OpenShift Service Mesh 发行版本包含在 Red Hat OpenShift Service Mesh Operator 2.5.0 中,解决了 CVE 报告的安全漏洞问题,包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.12 及更新的版本的支持。

1.2.27.12.1. Red Hat OpenShift Service Mesh 2.3.10 的组件版本

| 组件 | 版本 |

|---|---|

| Istio | 1.14.5 |

| Envoy Proxy | 1.22.11 |

| Kiali | 1.57.14 |

1.2.27.13. Red Hat OpenShift Service Mesh 2.3.9 的新功能

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.4.5 中,解决了 CVE 报告的安全漏洞问题,包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.11 及之后的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.14.5 |

| Envoy Proxy | 1.22.11 |

| Jaeger | 1.47.0 |

| Kiali | 1.57.14 |

1.2.27.14. Red Hat OpenShift Service Mesh 版本 2.3.8 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.11 及更新的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.14.5 |

| Envoy Proxy | 1.22.11 |

| Jaeger | 1.47.0 |

| Kiali | 1.57.13 |

1.2.27.15. Red Hat OpenShift Service Mesh 版本 2.3.7 的新功能

此 Red Hat OpenShift Service Mesh 发行版本引入了新功能,解决了 CVE 报告的安全漏洞问题 (CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.10 和更高版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.14.6 |

| Envoy Proxy | 1.22.11 |

| Jaeger | 1.42.0 |

| Kiali | 1.57.11 |

1.2.27.16. Red Hat OpenShift Service Mesh 版本 2.3.6 的新功能

此 Red Hat OpenShift Service Mesh 发行版本引入了新功能,解决了 CVE 报告的安全漏洞问题 (CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.10 和更高版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.14.5 |

| Envoy Proxy | 1.22.11 |

| Jaeger | 1.42.0 |

| Kiali | 1.57.10 |

1.2.27.17. Red Hat OpenShift Service Mesh 2.3.5 的新功能

此 Red Hat OpenShift Service Mesh 发行版本引入了新功能,解决了 CVE 报告的安全漏洞问题 (CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.10 和更高版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.14.5 |

| Envoy Proxy | 1.22.9 |

| Jaeger | 1.42.0 |

| Kiali | 1.57.10 |

1.2.27.18. Red Hat OpenShift Service Mesh 版本 2.3.4 的新功能

此 Red Hat OpenShift Service Mesh 发行版本引入了新功能,解决了 CVE 报告的安全漏洞问题 (CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.10 和更高版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.14.6 |

| Envoy Proxy | 1.22.9 |

| Jaeger | 1.42.0 |

| Kiali | 1.57.9 |

1.2.27.19. Red Hat OpenShift Service Mesh 版本 2.3.3 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.9 及更新的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.14.5 |

| Envoy Proxy | 1.22.9 |

| Jaeger | 1.42.0 |

| Kiali | 1.57.7 |

1.2.27.20. Red Hat OpenShift Service Mesh 版本 2.3.2 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.9 及更新的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.14.5 |

| Envoy Proxy | 1.22.7 |

| Jaeger | 1.39 |

| Kiali | 1.57.6 |

1.2.27.21. Red Hat OpenShift Service Mesh 版本 2.3.1 的新功能

此 Red Hat OpenShift Service Mesh 发行版本引入了新功能,解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.9 及更新的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.14.5 |

| Envoy Proxy | 1.22.4 |

| Jaeger | 1.39 |

| Kiali | 1.57.5 |

此 Red Hat OpenShift Service Mesh 发行版本引入了新功能,解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.9 及更新的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.14.3 |

| Envoy Proxy | 1.22.4 |

| Jaeger | 1.38 |

| Kiali | 1.57.3 |

openshift-operators 命名空间包括一个新的 istio CNI DaemonSet istio-cni-node-v2-3 和一个新的 ConfigMap 资源 istio-cni-config-v2-3。

当升级到 Service Mesh Control Plane 2.3 时,现有的 istio-cni-node DaemonSet 不会被更改,并创建一个新的 istio-cni-node-v2-3 DaemonSet。

这个名称更改不会影响以前版本,或与之前版本部署的 Service Mesh Control Plane 关联的 istio-cni-node CNI DaemonSet。

1.2.27.22.3. 网关注入支持

此发行版本引进了对网关注入的正式支持。网关配置应用到在网格边缘运行的独立 Envoy 代理,而不是与您的服务工作负载一同运行的 sidecar Envoy 代理。这可让自定义网关选项。使用网关注入时,您必须在要运行网关代理的命名空间中创建以下资源: Service、Deployment、Role 和 RoleBinding。

1.2.27.22.4. Istio 1.14 支持

Service Mesh 2.3 基于 Istio 1.14,这会带来新功能和产品改进。虽然支持很多 Istio 1.14 功能,但需要注意以下例外:

- ProxyConfig API 支持在 image 字段外。

- SPIRE 运行时不是受支持的功能。

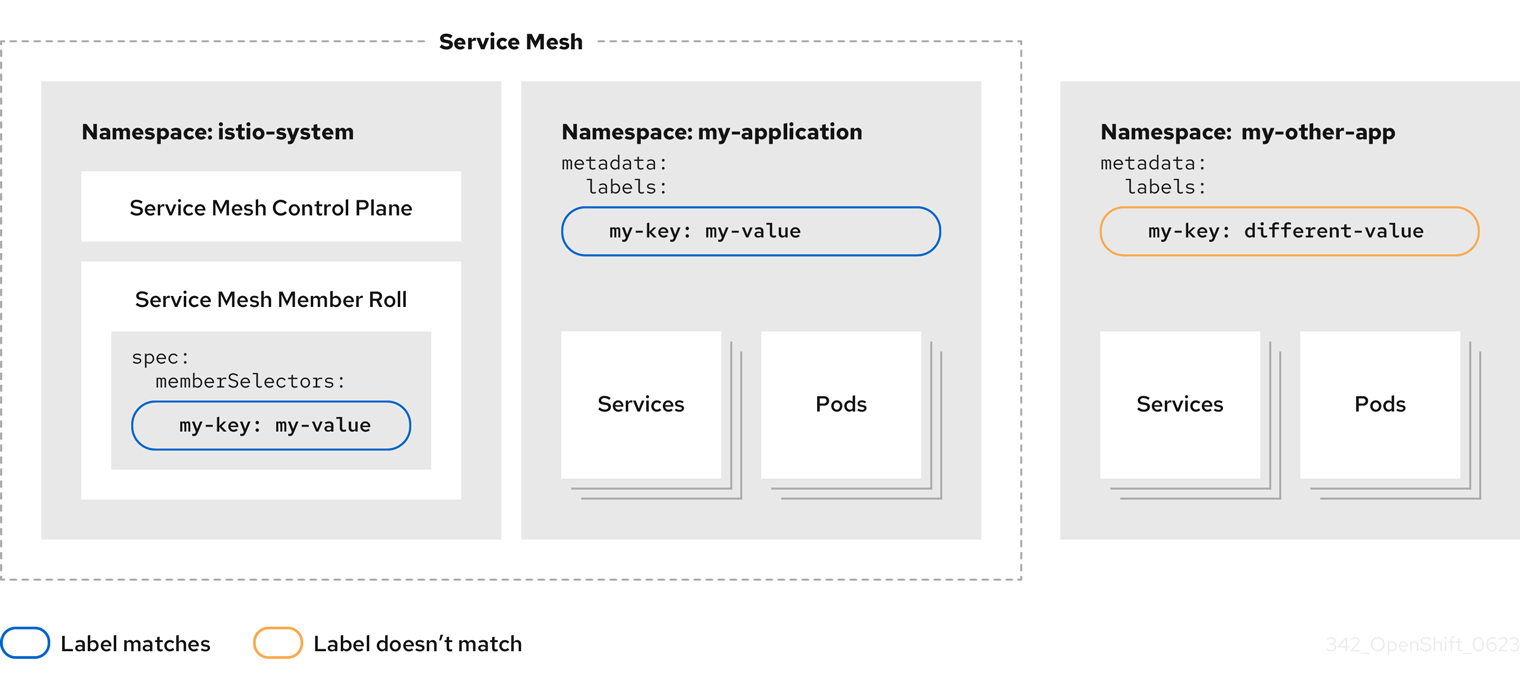

1.2.27.22.4.1. 配置集群范围部署

以下示例 ServiceMeshControlPlane 对象配置集群范围的部署。

要为集群范围的部署创建 SMCP,用户必须属于 cluster-admin ClusterRole。如果为集群范围的部署配置了 SMCP,则它必须是集群中唯一的 SMCP。您无法将 control plane 模式从多租户改为集群范围的(或从集群范围改为多租户)。如果多租户 control plane 已存在,请删除它并创建一个新 control plane。

这个示例为集群范围的部署配置 SMCP。

- 1

- 启用 Istiod 来监控集群一级的资源,而不是监控每个命名空间。

另外,还必须为集群范围的部署配置 SMMR。这个示例为集群范围的部署配置了 SMMR。

- 1

- 在网格中添加所有命名空间,包括您随后创建的任何命名空间。以下命名空间不是网格的一部分:kube、openshift、kube-* 和 openshift-*。

1.2.27.23. Red Hat OpenShift Service Mesh 版本 2.2.12 的新功能

此 Red Hat OpenShift Service Mesh 发行版本包括在 Red Hat OpenShift Service Mesh Operator 2.4.5 中,解决了 CVE 报告的安全漏洞问题,包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.11 及之后的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.12.9 |

| Envoy Proxy | 1.20.8 |

| Jaeger | 1.47.0 |

| Kiali | 1.48.11 |

1.2.27.24. Red Hat OpenShift Service Mesh 版本 2.2.11 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.11 及更新的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.12.9 |

| Envoy Proxy | 1.20.8 |

| Jaeger | 1.47.0 |

| Kiali | 1.48.10 |

1.2.27.25. Red Hat OpenShift Service Mesh 版本 2.2.10 的新功能

此 Red Hat OpenShift Service Mesh 发行版本引入了新功能,解决了 CVE 报告的安全漏洞问题 (CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.10 和更高版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.12.9 |

| Envoy Proxy | 1.20.8 |

| Jaeger | 1.42.0 |

| Kiali | 1.48.8 |

1.2.27.26. Red Hat OpenShift Service Mesh 版本 2.2.9 的新功能

此 Red Hat OpenShift Service Mesh 发行版本引入了新功能,解决了 CVE 报告的安全漏洞问题 (CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.10 和更高版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.12.9 |

| Envoy Proxy | 1.20.8 |

| Jaeger | 1.42.0 |

| Kiali | 1.48.7 |

1.2.27.27. Red Hat OpenShift Service Mesh 版本 2.2.8 的新功能

此 Red Hat OpenShift Service Mesh 发行版本引入了新功能,解决了 CVE 报告的安全漏洞问题 (CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.10 和更高版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.12.9 |

| Envoy Proxy | 1.20.8 |

| Jaeger | 1.42.0 |

| Kiali | 1.48.7 |

1.2.27.28. Red Hat OpenShift Service Mesh 版本 2.2.7 的新功能

此 Red Hat OpenShift Service Mesh 发行版本引入了新功能,解决了 CVE 报告的安全漏洞问题 (CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.10 和更高版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.12.9 |

| Envoy Proxy | 1.20.8 |

| Jaeger | 1.42.0 |

| Kiali | 1.48.6 |

1.2.27.29. Red Hat OpenShift Service Mesh 版本 2.2.6 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.9 及更新的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.12.9 |

| Envoy Proxy | 1.20.8 |

| Jaeger | 1.39 |

| Kiali | 1.48.5 |

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.9 及更新的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.12.9 |

| Envoy Proxy | 1.20.8 |

| Jaeger | 1.39 |

| Kiali | 1.48.3 |

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.9 及更新的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.12.9 |

| Envoy Proxy | 1.20.8 |

| Jaeger | 1.36.14 |

| Kiali | 1.48.3 |

1.2.27.32. Red Hat OpenShift Service Mesh 版本 2.2.3 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE)、程序错误修正,并受 Red Hat OpenShift Service on AWS 4.9 及更新版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.12.9 |

| Envoy Proxy | 1.20.8 |

| Jaeger | 1.36 |

| Kiali | 1.48.3 |

1.2.27.33. Red Hat OpenShift Service Mesh 版本 2.2.2 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE)、程序错误修正,并受 Red Hat OpenShift Service on AWS 4.9 及更新版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.12.7 |

| Envoy Proxy | 1.20.6 |

| Jaeger | 1.36 |

| Kiali | 1.48.2-1 |

1.2.27.33.2. 复制路由标签

在这个版本中,除了复制注解外,您还可以为 OpenShift 路由复制特定的标签。Red Hat OpenShift Service Mesh 将 Istio 网关资源中存在的所有标签和注解(从 kubectl.kubernetes.io 开始的注解除外)复制到受管 OpenShift Route 资源中。

1.2.27.34. Red Hat OpenShift Service Mesh 版本 2.2.1 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE)、程序错误修正,并受 Red Hat OpenShift Service on AWS 4.9 及更新版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.12.7 |

| Envoy Proxy | 1.20.6 |

| Jaeger | 1.34.1 |

| Kiali | 1.48.2-1 |

1.2.27.35. Red Hat OpenShift Service Mesh 2.2 的新功能

此 Red Hat OpenShift Service Mesh 发行版本添加了新的功能和增强,并受 Red Hat OpenShift Service on AWS 4.9 及更新的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.12.7 |

| Envoy Proxy | 1.20.4 |

| Jaeger | 1.34.1 |

| Kiali | 1.48.0.16 |

1.2.27.35.2. WasmPlugin API

此发行版本添加了对 WasmPlugin API 的支持,并弃用 ServiceMeshExtension API。

1.2.27.35.3. ROSA 支持

此发行版本引进了对 AWS(ROSA)上的 Red Hat OpenShift 的服务网格支持,包括多集群联邦。

1.2.27.35.4. istio-node DaemonSet 重命名

在此发行版本中,istio-node DaemonSet 被重命名为 istio-cni-node,以匹配上游 Istio 中的名称。

1.2.27.35.5. Envoy sidecar 网络更改

Istio 1.10 更新了 Envoy,默认使用 eth0 而不是 lo 将流量发送到应用程序容器。

1.2.27.35.6. Service Mesh Control Plane 1.1

对于所有平台,此发行版本结束了对基于 Service Mesh 1.1 的 Service Mesh Control Planes 的支持。

1.2.27.35.7. Istio 1.12 支持

Service Mesh 2.2 基于 Istio 1.12,它带来新功能和产品改进。虽然仍然会支持许多 Istio 1.12 功能,但请注意以下不被支持的功能:

- AuthPolicy Dry Run 是一个技术预览功能。

- gRPC Proxyless Service Mesh 是一个技术预览功能。

- Telemetry API 是一个技术预览功能。

- 发现选择器功能不受支持。

- 外部 control plane 不受支持。

- 网关注入不受支持。

1.2.27.35.7.1. 安装网关 API CRD

默认情况下,网关 API CRD 不会在 OpenShift 集群中预安装。在 SMCP 中启用网关 API 支持前安装 CRD。

kubectl get crd gateways.gateway.networking.k8s.io || { kubectl kustomize "github.com/kubernetes-sigs/gateway-api/config/crd?ref=v0.4.0" | kubectl apply -f -; }

$ kubectl get crd gateways.gateway.networking.k8s.io || { kubectl kustomize "github.com/kubernetes-sigs/gateway-api/config/crd?ref=v0.4.0" | kubectl apply -f -; }1.2.27.35.7.2. 启用 Kubernetes 网关 API

要启用这个功能,请在 ServiceMeshControlPlane 中为 Istiod 容器设置以下环境变量:

使用 SameNamespace 或 All 设置在 Gateway API 监听器上限制路由附加功能可能。Istio 会忽略 listeners.allowedRoutes.namespaces 中标签选择器的使用,并恢复到默认行为 (SameNamespace)。

1.2.27.35.7.3. 手动将现有网关链接到网关资源

如果禁用 Kubernetes API 部署控制器,您必须手动部署,然后将入口网关链接到创建的网关资源。

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.9 及更新的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.9.9 |

| Envoy Proxy | 1.17.5 |

| Jaeger | 1.36 |

| Kiali | 1.36.16 |

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE),包含程序错误修复,并受 Red Hat OpenShift Service on AWS 4.9 及更新的版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.9.9 |

| Envoy Proxy | 1.17.5 |

| Jaeger | 1.36 |

| Kiali | 1.24.17 |

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE)、程序错误修正,并受 Red Hat OpenShift Service on AWS 4.9 及更新版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.9.9 |

| Envoy Proxy | 1.17.5 |

| Jaeger | 1.36 |

| Kiali | 1.36.13 |

1.2.27.39. Red Hat OpenShift Service Mesh 2.1.5 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE)、程序错误修正,并受 Red Hat OpenShift Service on AWS 4.9 及更新版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.9.9 |

| Envoy Proxy | 1.17.1 |

| Jaeger | 1.36 |

| Kiali | 1.36.12-1 |

1.2.27.40. Red Hat OpenShift Service Mesh 2.1.4 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题以及程序错误。

| 组件 | 版本 |

|---|---|

| Istio | 1.9.9 |

| Envoy Proxy | 1.17.1 |

| Jaeger | 1.30.2 |

| Kiali | 1.36.12-1 |

1.2.27.41. Red Hat OpenShift Service Mesh 2.1.3 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题以及程序错误。

| 组件 | 版本 |

|---|---|

| Istio | 1.9.9 |

| Envoy Proxy | 1.17.1 |

| Jaeger | 1.30.2 |

| Kiali | 1.36.10-2 |

1.2.27.42. Red Hat OpenShift Service Mesh 2.1.2.1 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题以及程序错误。

| 组件 | 版本 |

|---|---|

| Istio | 1.9.9 |

| Envoy Proxy | 1.17.1 |

| Jaeger | 1.30.2 |

| Kiali | 1.36.9 |

1.2.27.43. Red Hat OpenShift Service Mesh 2.1.2 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题以及程序错误。

在这个版本中,Red Hat OpenShift distributed Tracing Platform (Jaeger) Operator 被默认安装到 openshift-distributed-tracing 命名空间。在以前的版本中,默认安装已在 openshift-operator 命名空间中。

| 组件 | 版本 |

|---|---|

| Istio | 1.9.9 |

| Envoy Proxy | 1.17.1 |

| Jaeger | 1.30.1 |

| Kiali | 1.36.8 |

1.2.27.44. Red Hat OpenShift Service Mesh 2.1.1 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题以及程序错误。

此发行版本还添加了禁用自动创建网络策略的功能。

| 组件 | 版本 |

|---|---|

| Istio | 1.9.9 |

| Envoy Proxy | 1.17.1 |

| Jaeger | 1.24.1 |

| Kiali | 1.36.7 |

1.2.27.44.2. 禁用网络策略

Red Hat OpenShift Service Mesh 自动在 Service Mesh control plane 和应用程序命名空间中创建和管理多个 NetworkPolicies 资源。这是为了确保应用程序和 control plane 可以相互通信。

如果要禁用自动创建和管理 NetworkPolicies 资源,例如为了强制执行公司安全策略,您可以编辑 ServiceMeshControlPlane,将 spec.security.manageNetworkPolicy 设置设置为 false

当您禁用了 spec.security.manageNetworkPolicy,Red Hat OpenShift Service Mesh 不会创建 任何 NetworkPolicy 对象。系统管理员负责管理网络并修复可能导致的任何问题。

流程

- 在 Red Hat OpenShift Service on AWS web 控制台中,点 Operators → Installed Operators。

-

从 Project 菜单中选择安装 Service Mesh control plane 的项目,如

istio-system。 -

点 Red Hat OpenShift Service Mesh Operator。在 Istio Service Mesh Control Plane 栏中,点

ServiceMeshControlPlane的名称,如basic-install。 -

在 Create ServiceMeshControlPlane Details 页中,点

YAML修改您的配置。 将

ServiceMeshControlPlane字段spec.security.manageNetworkPolicy设置为false,如下例所示。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 点 Save。

1.2.27.45. Red Hat OpenShift Service Mesh 2.1 的新功能和增强

这个版本的 Red Hat OpenShift Service Mesh 增加了在 Red Hat OpenShift Service on AWS 4.6 EUS, 4.7, 4.8, 4.9 上对 Istio 1.9.8, Envoy Proxy 1.17.1, Jaeger 1.24.1, 和 Kiali 1.36.5 的支持,以及新的功能和增强。

| 组件 | 版本 |

|---|---|

| Istio | 1.9.6 |

| Envoy Proxy | 1.17.1 |

| Jaeger | 1.24.1 |

| Kiali | 1.36.5 |

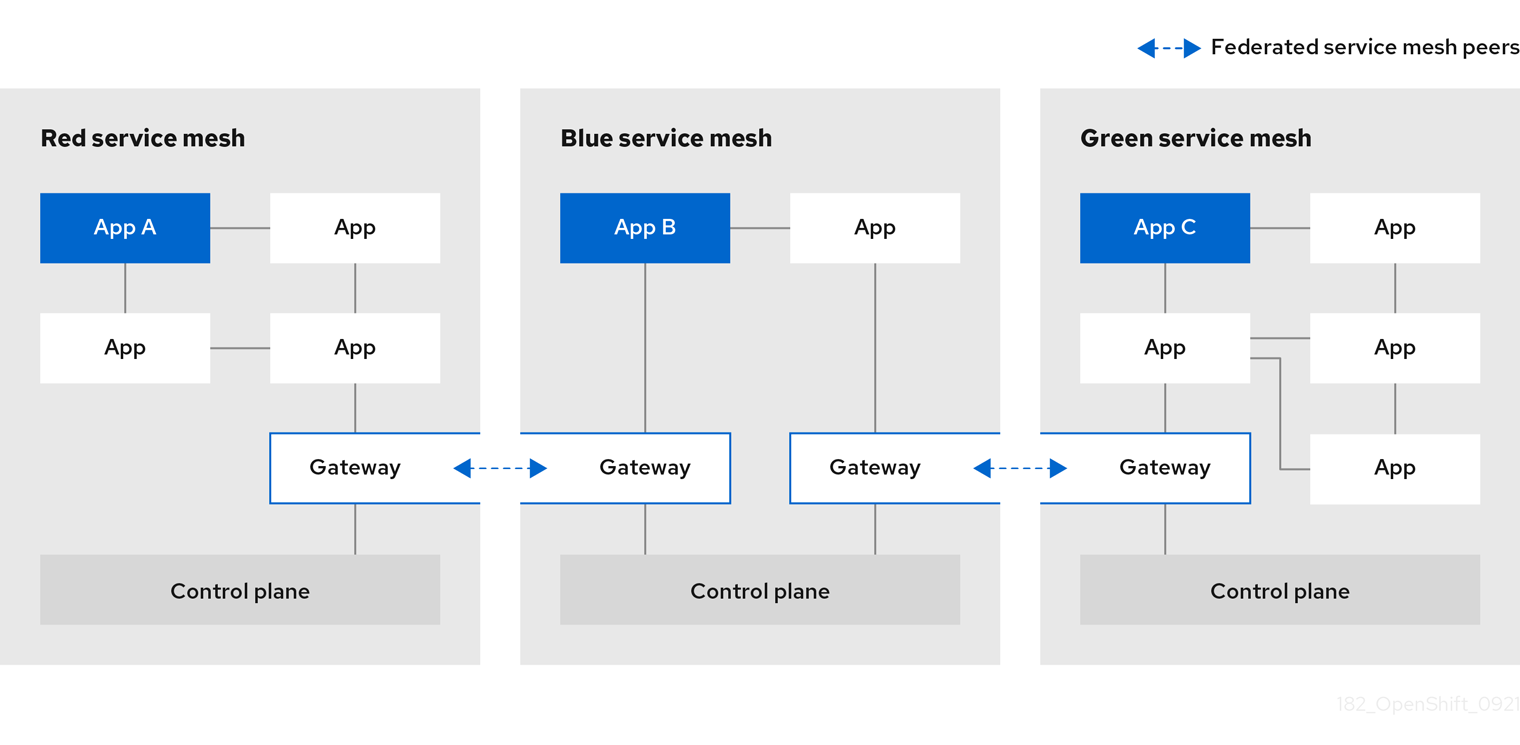

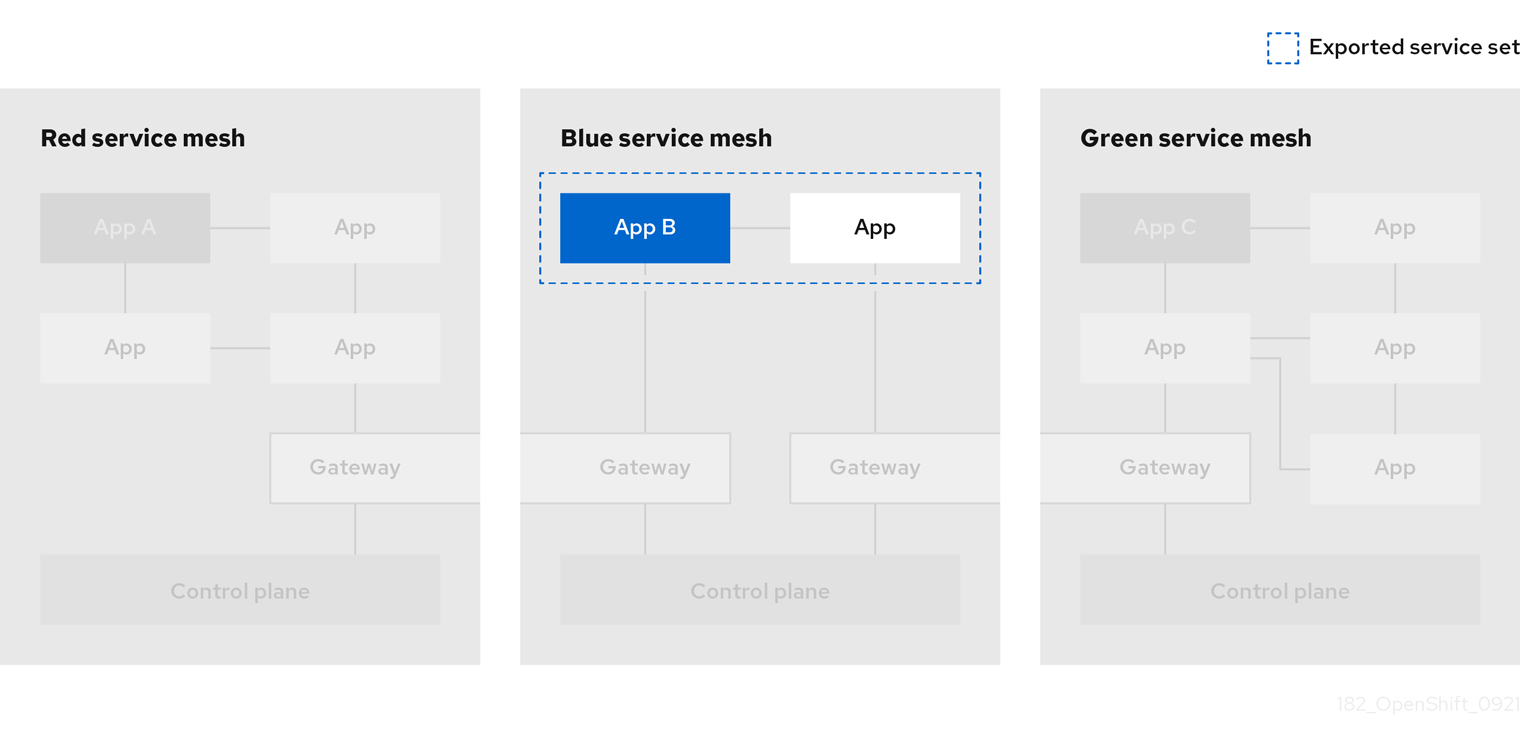

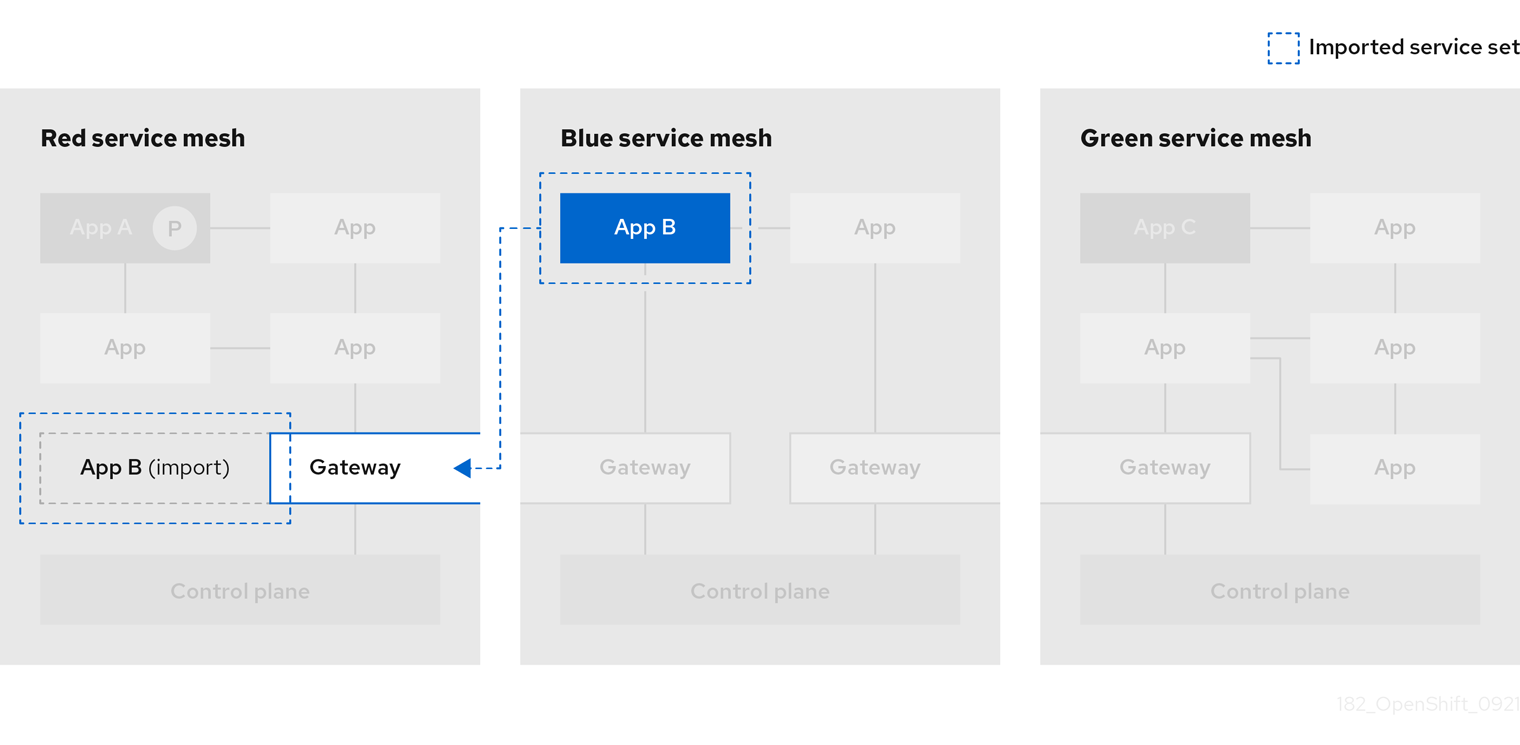

1.2.27.45.2. Service Mesh Federation

添加了新的自定义资源定义(CRD)以支持联邦服务网格(federating service mesh)。服务网格可以整合到同一集群中或跨不同的 OpenShift 集群。这些新资源包括:

-

ServiceMeshPeer- 使用单独的服务网格定义联邦,包括网关配置、root 信任证书配置和状态字段。在一对联邦网格中,每个网格将定义自己的独立ServiceMeshPeer资源。 -

ExportedServiceMeshSet- 定义给定ServiceMeshPeshPeer的服务可用于导入的对等网格。 -

ImportedServiceSet- 定义给定ServiceMeshPeer的服务是从 peer 网格中导入的。这些服务还必须由 peer 的ExportedServiceMeshSet资源提供。

在 AWS (ROSA)或 OpenShift Dedicated (OSD)上的 Red Hat OpenShift Service 上的集群间不支持 Service Mesh Federation。

OVN-Kubernetes Container Network Interface(CNI)以前在 Red Hat OpenShift Service Mesh 2.0.1 中作为技术预览功能引进,现在包括在 Red Hat OpenShift Service Mesh 2.1 和 2.0.x 中,用于 Red Hat OpenShift Service on AWS 4.7.32、OpenShift Container Platform 4.8.12 和 OpenShift Container Platform 4.9。

1.2.27.45.4. Service Mesh WebAssembly(WASM)扩展

ServiceMeshExtensions 自定义资源定义(CRD)现已正式发布,它首次作为技术预览功能在版本 2.0 中推出。您可以使用 CRD 构建自己的插件,但红帽并不支持您创建的插件。

在 Service Mesh 2.1 中已完全删除 Mixer。如果启用了 Mixer,则会阻止从 Service Mesh 2.0.x 升级到 2.1。混合器插件需要移植到 WebAssembly 扩展。

1.2.27.45.5. 3scale WebAssembly Adapter(WASM)

Mixer 现已正式删除,OpenShift Service Mesh 2.1 不支持 3scale 混合器适配器。在升级到 Service Mesh 2.1 之前,删除基于 Mixer 的 3scale 适配器和任何其他 Mixer 插件。然后,使用 Service MeshExtension 资源手动安装和配置使用 Service Mesh 2.1+ 的新 3scale WebAssembly 适配器。

3scale 2.11 引入了基于 WebAssembly 的更新 Service Mesh 集成。

1.2.27.45.6. Istio 1.9 支持

Service Mesh 2.1 基于 Istio 1.9,它带来了大量新功能和产品增强。虽然大多数 Istio 1.9 功能被支持,但请注意以下例外:

- 虚拟机集成尚不受支持

- 尚不支持 Kubernetes 网关 API

- 尚不支持远程获取和加载 WebAssembly HTTP 过滤器

- 尚不支持使用 Kubernetes CSR API 的自定义 CA 集成

- 监控流量的请求分类是一个技术预览功能

- 通过授权策略的 CUSTOM 操作与外部授权系统集成是一项技术预览功能

1.2.27.45.7. 改进了 Service Mesh operator 性能

Red Hat OpenShift Service Mesh 在每个 ServiceMeshControlPlane 协调结束时用于修剪旧资源的时间已经减少。这会更快地进行 ServiceMeshControlPlane 部署,并允许应用到现有 SMCP 的更改更快地生效。

1.2.27.45.8. Kiali 更新

Kiali 1.36 包括以下功能和增强:

Service Mesh 故障排除功能

- control plane 和网关监控

- 代理同步状态

- Envoy 配置视图

- 显示 Envoy 代理和应用程序日志处于交集的统一视图

- 支持联邦服务网格视图的命名空间和集群选择

- 新的验证、向导和分布式追踪增强

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE)、程序错误修正,并受 Red Hat OpenShift Service on AWS 4.9 或更高版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.6.14 |

| Envoy Proxy | 1.14.5 |

| Jaeger | 1.36 |

| Kiali | 1.24.17 |

1.2.27.47. Red Hat OpenShift Service Mesh 2.0.11 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题(CVE)、程序错误修正,并受 Red Hat OpenShift Service on AWS 4.9 或更高版本的支持。

| 组件 | 版本 |

|---|---|

| Istio | 1.6.14 |

| Envoy Proxy | 1.14.5 |

| Jaeger | 1.36 |

| Kiali | 1.24.16-1 |

1.2.27.48. Red Hat OpenShift Service Mesh 2.0.10 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题以及程序错误。

| 组件 | 版本 |

|---|---|

| Istio | 1.6.14 |

| Envoy Proxy | 1.14.5 |

| Jaeger | 1.28.0 |

| Kiali | 1.24.16-1 |

1.2.27.49. Red Hat OpenShift Service Mesh 2.0.9 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题以及程序错误。

| 组件 | 版本 |

|---|---|

| Istio | 1.6.14 |

| Envoy Proxy | 1.14.5 |

| Jaeger | 1.24.1 |

| Kiali | 1.24.11 |

1.2.27.50. Red Hat OpenShift Service Mesh 2.0.8 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了程序错误修正。

1.2.27.51. Red Hat OpenShift Service Mesh 2.0.7.1 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题。

Red Hat OpenShift Service Mesh 包含一个可远程利用的漏洞 CVE-2021-39156,其中 HTTP 请求带有片段(以 # 字符开头的 URI 末尾的一个部分),您可以绕过 Istio URI 基于路径的授权策略。例如,Istio 授权策略拒绝发送到 URI 路径 /user/profile 的请求。在存在安全漏洞的版本中,带有 URI 路径 /user/profile#section1 的请求绕过拒绝策略并路由到后端(通过规范的 URI path /user/profile%23section1),可能会导致安全事件。

如果您使用带有 DENY 操作和 operation.paths 的授权策略,或者 ALLOW 操作和 operation.notPaths,则会受到此漏洞的影响。

在这个版本中,在授权和路由前会删除请求的 URI 片段部分。这可以防止其 URI 中带有片段的请求绕过基于 URI 且没有片段部分的授权策略。

要从缓解措施中的新行为中选择,将保留 URI 的片段部分。您可以将 ServiceMeshControlPlane 配置为保留 URI 片段。

如前文所述,禁用新行为将对路径进行规范化,并被视为不安全。在选择保留 URI 片段之前,确保您已将这些内容放入任何安全策略中。

ServiceMeshControlPlane 修改示例

1.2.27.51.2. 授权策略所需的更新

Istio 为主机名本身和所有匹配端口生成主机名。例如,用于 "httpbin.foo" 主机的虚拟服务或网关会生成匹配 "httpbin.foo 和 httpbin.foo:*" 的配置。但是,完全匹配授权策略仅与为 hosts 或 notHosts 字段给出的确切字符串匹配。

如果您使用精确字符串比较的 AuthorizationPolicy 来确定 主机或非主机,则会影响您的集群。

您必须更新授权策略 规则,以使用前缀匹配而不是完全匹配。例如,在第一个 AuthorizationPolicy 示例中,将 hosts: ["httpbin.com"] 替换为 hosts: ["httpbin.com:*"]。

第一个 AuthorizationPolicy 示例使用前缀匹配

第二个 AuthorizationPolicy 示例使用前缀匹配

1.2.27.52. Red Hat OpenShift Service Mesh 2.0.7 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题以及程序错误。

Red Hat OpenShift Service Mesh 现在通过 Red Hat OpenShift Dedicated 支持。

1.2.27.54. Red Hat OpenShift Service Mesh 2.0.6 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题以及程序错误。

1.2.27.55. Red Hat OpenShift Service Mesh 2.0.5 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题以及程序错误。

1.2.27.56. Red Hat OpenShift Service Mesh 2.0.4 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题以及程序错误。

要解决 CVE-2021-29492 和 CVE-2021-31920 的问题,则必须完成手动步骤。

1.2.27.56.1. CVE-2021-29492 和 CVE-2021-31920 所需的手动更新

Istio 包含一个可被远程利用的漏洞,当使用基于路径的授权规则时,带有多个斜杠或转义的斜杠字符(%2F 或 %5C)的 HTTP 请求路径可能会绕过 Istio 授权策略。

例如,假设 Istio 集群管理员定义了一个授权 DENY 策略,以便在路径 /admin 上拒绝请求。发送到 URL 路径 //admin 的请求不会被授权策略拒绝。

根据 RFC 3986,带有多个斜杠的路径 //admin 在技术上应被视为与 /admin 不同的路径。但是,一些后端服务选择通过将多个斜杠合并成单斜杠来规范 URL 路径。这可能导致绕过授权策略(//admin 不匹配 /admin),用户可以在后端的路径 /admin 上访问资源,这可能会产生安全问题。

如果您使用 ALLOW action + notPaths 字段或者 DENY action + paths 字段特征,您的集群会受到这个漏洞的影响。这些模式可能会被意外的策略绕过。

在以下情况下,集群不会受到此漏洞的影响:

- 您没有授权策略。

-

您的授权策略没有定义

paths或notPaths字段。 -

您的授权策略使用

ALLOW action + paths字段或DENY action + notPaths字段特征。这些模式只会导致意外的拒绝,而不是绕过策略。对于以上情况,升级是可选的。

路径规范化的 Red Hat OpenShift Service Mesh 配置位置与 Istio 配置不同。

1.2.27.56.2. 更新路径规范化配置

Istio 授权策略可能基于 HTTP 请求中的 URL 路径。路径规范化 (也称为 URI 规范化)、修改和标准化传入请求的路径,以便能够以标准的方式处理规范化路径。在路径规范化后,同步不同路径可能是等同的。

Istio 在根据授权策略和路由请求前,支持请求路径中的以下规范化方案:

| Option | Description | Example | 备注 |

|---|---|---|---|

|

| 没有进行规范化。Envoy 接收的任何内容都会完全按原样转发到任何后端服务。 |

| 此设置会受到 CVE-2021-31920 的影响。 |

|

|

这是目前 Istio 默认安装中使用的选项。这在 Envoy 代理上应用 |

| 此设置会受到 CVE-2021-31920 的影响。 |

|

| 斜杠会在 BASE 规范化后合并。 |

| 更新此设置以缓解 CVE-2021-31920 的问题。 |

|

|

默认允许所有流量时的最严格设置。建议使用此设置,请注意您必须对您的授权策略路由进行彻底测试。Percent 编码的 斜杠和反斜杠字符( |

| 更新此设置以缓解 CVE-2021-31920 的问题。这个设置更为安全,但可能会破坏应用程序。在部署到生产环境中前测试您的应用程序。 |

规范化算法按以下顺序进行:

-

解码百分比

%2F、%2f、%5C和%5c。 -

RFC 3986 和其他在 Envoy 中的

normalize_path选项实现的规范化。 - 合并斜杠。

虽然这些规范化选项代表来自 HTTP 标准和常见行业实践的建议,但应用程序可能会以它选择的任何方式解释 URL。在使用拒绝策略时,请确保您了解应用程序的行为方式。

1.2.27.56.3. 路径规范配置示例

确保 Envoy 规范化请求路径以匹配后端服务的预期,对您的系统安全至关重要。以下示例可用作配置系统的参考。规范化 URL 路径,如果选择 NONE,则原始 URL 路径为:

- 用于检查授权策略。

- 转发到后端应用程序。

1.2.27.56.4. 为路径规范化配置 SMCP

要为 Red Hat OpenShift Service Mesh 配置路径规范化,请在 ServiceMeshControlPlane 中指定以下内容。使用配置示例来帮助确定您的系统设置。

SMCP v2 路径规范化

spec:

techPreview:

global:

pathNormalization: <option>

spec:

techPreview:

global:

pathNormalization: <option>1.2.27.56.5. 配置大小写规范化

在某些环境中,在授权策略中对路径进行比较时不区分大小写可能很有用。例如,把 https://myurl/get 视为与 https://myurl/GeT 一样。在这些情况下,您可以使用如下所示的 EnvoyFilter。此过滤器将更改用于比较的路径以及应用程序显示的路径。在本例中,istio-system 是 Service Mesh control plane 项目的名称。

将 EnvoyFilter 保存到文件中并运行以下命令:

oc create -f <myEnvoyFilterFile>

$ oc create -f <myEnvoyFilterFile>1.2.27.57. Red Hat OpenShift Service Mesh 2.0.3 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题以及程序错误。

另外,这个版本有以下新特性:

-

在

must-gather数据收集工具中添加了一个选项,用于从指定的 Service Mesh control plane 命名空间中收集信息。如需更多信息,请参阅 OSSM-351。 - 提高了带有数百个命名空间的 Service Mesh control plane 的性能

1.2.27.58. Red Hat OpenShift Service Mesh 2.0.2 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题以及程序错误。

1.2.27.59. Red Hat OpenShift Service Mesh 2.0.1 的新功能

此 Red Hat OpenShift Service Mesh 发行版本解决了 CVE 报告的安全漏洞问题以及程序错误。

1.2.27.60. Red Hat OpenShift Service Mesh 2.0 的新功能

此 Red Hat OpenShift Service Mesh 发行版本添加了对 Istio 1.6.5、Jaeger 1.20.0、Kiali 1.24.2、3scale Istio Adapter 2.0 和 Red Hat OpenShift Service on AWS 4.6 的支持。

另外,这个版本有以下新特性:

- 简化了 Service Mesh control plane 的安装、升级和管理。

- 减少 Service Mesh control plane 的资源使用情况和启动时间。

通过降低网络间 control plane 通讯来提高性能。

- 添加对 Envoy 的 Secret Discovery Service(SDS)的支持。SDS 是一个更加安全有效地向 Envoy side car proxies 发送 secret 的机制。

- 不再需要使用具有已知安全风险的 Kubernetes Secret。

在轮转证书的过程中提高了性能,因为代理不再需要重启来识别新证书。

- 添加了对 Istio Telemetry v2 架构的支持,该架构是由 WebAssembly 扩展构建的。这个新架构带来了显著的性能改进。

- 使用简化的配置将 ServiceMeshControlPlane 资源更新至 v2,以便更轻松地管理 Service Mesh Control Plane。

1.2.28. 弃用和删除的功能

之前版本中的一些功能已被弃用或删除。

弃用的功能仍然包含在 Red Hat OpenShift Service on AWS 中,并且仍然被支持。但是,弃用的功能可能会在以后的发行版本中被删除,且不建议在新的部署中使用。

删除的功能不再存在于产品中。

1.2.28.1. Red Hat OpenShift Service Mesh 2.5 中已弃用和删除的功能

v2.2 ServiceMeshControlPlane 资源不再被支持。客户应该更新其网格部署,以使用更新的 ServiceMeshControlPlane 资源版本。

对 Red Hat OpenShift distributed Tracing Platform (Jaeger) Operator 的支持已弃用。要收集追踪范围,请使用 Red Hat OpenShift distributed Tracing Platform (Tempo) Stack。

对 OpenShift Elasticsearch Operator 的支持已弃用。

Istio 将删除对第三方 JSON Web 令牌(JWT)的支持。Istio 仍然支持第三方 JWT。

1.2.28.2. Red Hat OpenShift Service Mesh 2.4 中已弃用和删除的功能

v2.1 ServiceMeshControlPlane 资源不再被支持。客户应升级其网格部署,以使用更新的 ServiceMeshControlPlane 资源版本。

对 Istio OpenShift 路由(IOR)的支持已弃用,并将在以后的发行版本中删除。

对 Grafana 的支持已弃用,并将在以后的发行版本中删除。

对 Red Hat OpenShift Service Mesh 2.3 中已弃用的以下密码套件的支持已从客户端和服务器端的 TLS 协商中使用的默认密码列表中删除。当从代理发起 TLS 连接时,需要访问需要这些密码套件之一的服务的应用程序将无法连接。

- ECDHE-ECDSA-AES128-SHA

- ECDHE-RSA-AES128-SHA

- AES128-GCM-SHA256

- AES128-SHA

- ECDHE-ECDSA-AES256-SHA

- ECDHE-RSA-AES256-SHA

- AES256-GCM-SHA384

- AES256-SHA

1.2.28.3. Red Hat OpenShift Service Mesh 2.3 中已弃用和删除的功能

对以下密码套件的支持已弃用。在以后的发行版本中,它们将从客户端和服务器端使用 TLS 协商的默认密码列表中删除。

- ECDHE-ECDSA-AES128-SHA

- ECDHE-RSA-AES128-SHA

- AES128-GCM-SHA256

- AES128-SHA

- ECDHE-ECDSA-AES256-SHA

- ECDHE-RSA-AES256-SHA

- AES256-GCM-SHA384

- AES256-SHA

Red Hat OpenShift Service Mesh 2.2 中已弃用的 ServiceMeshExtension API 已在 Red Hat OpenShift Service Mesh 2.3 中删除。如果使用 ServiceMeshExtension API,则必须迁移到 WasmPlugin API 来继续使用 WebAssembly 扩展。

1.2.28.4. Red Hat OpenShift Service Mesh 2.2 中已弃用的功能

ServiceMeshExtension API 从版本 2.2 开始已弃用,并将在以后的版本中删除。虽然 ServiceMeshExtension API 仍然在 2.2 版本中被支持,但客户应该开始使用新的 WasmPlugin API。

1.2.28.5. 删除了 Red Hat OpenShift Service Mesh 2.2 中的功能

对于所有平台,此发行版本结束了对基于 Service Mesh 1.1 的 Service Mesh Control Planes 的支持。

1.2.28.6. 删除了 Red Hat OpenShift Service Mesh 2.1 中的功能

在 Service Mesh 2.1 中,Mixer 组件被删除。程序错误修正和支持会在 Service Mesh 2.0 生命周期结束时提供。

如果启用了 Mixer 插件,则不会从 Service Mesh 2.0.x 升级到 2.1。Mixer 插件必须移植到 WebAssembly 扩展。

1.2.28.7. Red Hat OpenShift Service Mesh 2.0 中已弃用的功能

Mixer 组件在版本 2.0 中已弃用,并将在版本 2.1 中删除。虽然在版本 2.0 中仍支持使用 Mixer 来实现扩展,但扩展应该已迁移到新的 WebAsembly 机制。

Red Hat OpenShift Service Mesh 2.0 不再支持以下资源类型:

Policy(策略)(authentication.istio.io/v1alpha1)不再被支持。根据策略资源中的具体配置,您可能需要配置多个资源来达到同样效果。-

使用

RequestAuthentication(security.istio.io/v1beta1) -

使用

PeerAuthentication(security.istio.io/v1beta1)

-

使用

ServiceMeshPolicy(maistra.io/v1)不再被支持。-

使用上述

RequestAuthentication或PeerAuthentication,但放置在 Service Mesh control plane 命名空间中。

-

使用上述

RbacConfig(rbac.istio.io/v1alpha1)不再被支持。-

由

AuthorizationPolicy(security.istio.io/v1beta1)替代,其中包含RbacConfig、ServiceRole和ServiceRoleBinding的行为。

-

由

ServiceMeshRbacConfig( maistra.io/v1)不再被支持。-

使用上述

AuthorizationPolicy,但保留在 Service Mesh control plane 命名空间中。

-

使用上述

-

ServiceRole(rbac.istio.io/v1alpha1)不再被支持。 -

ServiceRoleBinding(rbac.istio.io/v1alpha1)不再被支持。 -

在 Kiali 中,

login和LDAP策略已被弃用。将来的版本将引入使用 OpenID 供应商的身份验证。

1.2.29. 已知问题

Red Hat OpenShift Service Mesh 中存在以下限制:

- Red Hat OpenShift Service Mesh 还没有完全支持 IPv6。因此,Red Hat OpenShift Service Mesh 不支持双栈集群。

- 图形布局 - Kiali 图形的布局会根据应用程序构架和要显示的数据(图形节点数目及其交互)的不同而有所变化。因为创建一个统一布局的难度较大,所以 Kiali 提供了几种不同布局的选择。要选择不同的布局,可从 Graph Settings 菜单中选择一个不同的 Layout Schema。

- 您第一次从 Kiali 控制台访问相关服务,如分布式 Tracing Platform (Jaeger)和 Grafana,您必须接受证书并使用您的 Red Hat OpenShift Service on AWS 登录凭证重新进行身份验证。这是因为框架如何显示控制台中的内置页面中存在问题。

1.2.29.1. Service Mesh 已知问题

当 istio-system 标签与发现选择器不匹配时,会跳过这些 Red Hat OpenShift Service Mesh 中已知的问题:* OSSM-5556 Gateways 会被跳过。

+ 临时解决方案 :标记 control plane 命名空间以匹配发现选择器,以避免跳过网关配置。

+ .example ServiceMeshControlPlane 资源

+ 然后在命令行中运行以下命令:

+

oc label namespace istio-system istio-discovery=enabled

oc label namespace istio-system istio-discovery=enabledOSSM-3890 尝试在多租户网格部署中使用网关 API 会生成类似如下的错误消息:

2023-05-02T15:20:42.541034Z error watch error in cluster Kubernetes: failed to list *v1alpha2.TLSRoute: the server could not find the requested resource (get tlsroutes.gateway.networking.k8s.io) 2023-05-02T15:20:42.616450Z info kube controller "gateway.networking.k8s.io/v1alpha2/TCPRoute" is syncing...

2023-05-02T15:20:42.541034Z error watch error in cluster Kubernetes: failed to list *v1alpha2.TLSRoute: the server could not find the requested resource (get tlsroutes.gateway.networking.k8s.io) 2023-05-02T15:20:42.616450Z info kube controller "gateway.networking.k8s.io/v1alpha2/TCPRoute" is syncing...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要在多租户网格部署中支持网关 API,集群中必须存在所有网关 API 自定义资源定义(CRD)文件。

在多租户网格部署中,禁用了 CRD 扫描,Istio 无法发现集群中存在哪些 CRD。因此,Istio 会尝试监视所有支持的网关 API CRD,但如果这些 CRD 不存在,则会生成错误。

Service Mesh 2.3.1 及更新的版本支持

v1alpha2和v1beta1CRD。因此,两个 CRD 版本都必须存在才能多租户网格部署来支持网关 API。临时解决方案: 在以下示例中,

kubectl get操作会安装v1alpha2和v1beta1CRD。请注意,URL 包含额外的实验性片段,并相应地更新任何现有脚本:kubectl get crd gateways.gateway.networking.k8s.io || { kubectl kustomize "github.com/kubernetes-sigs/gateway-api/config/crd/experimental?ref=v0.5.1" | kubectl apply -f -; }$ kubectl get crd gateways.gateway.networking.k8s.io || { kubectl kustomize "github.com/kubernetes-sigs/gateway-api/config/crd/experimental?ref=v0.5.1" | kubectl apply -f -; }Copy to Clipboard Copied! Toggle word wrap Toggle overflow OSSM-2042 Deployment of SMCP named

default会失败。如果您要创建 SMCP 对象,并将其 version 字段设置为 v2.3,则对象的名称不能是默认的。如果名称是默认,则 control plane 无法部署,OpenShift 会生成一个带有以下信息的Warning事件:error processing component mesh-config: error: [mesh-config/templates/telemetryv2_1.6.yaml: 发生内部错误: 调用 Webhook "rev.validation.istio.io": post "https://istiod-default.istio-system.svc:443/validate?timeout=10s": x509: 证书对 istiod.istio-system.svc、istiod-remote.istio-system.svc, istio-pilot.istio-system.svc 有效,而不是 istiod-default.istio-system.svc, mesh-config/templates/enable-mesh-permissive.yaml

OSSM-1655 Kiali 仪表板在

SMCP中启用 mTLS 后显示错误。在 SMCP 中启用

spec.security.controlPlane.mtls设置后,Kiali 控制台会显示以下错误消息No subsets defined。OSSM-1505 只有在 OpenShift Container Platform 4.11 中使用

ServiceMeshExtension资源时才会发生。当在 OpenShift Container Platform 4.11 上使用ServiceMeshExtension时,资源永不会变为就绪。如果使用oc describe ServiceMeshExtension检查问题,您会看到以下错误:stderr: Error create mount namespace before pivot: function not implemented。临时解决方案:

ServiceMeshExtension在 Service Mesh 2.2 中已弃用。从ServiceMeshExtension迁移到WasmPlugin资源。如需更多信息,请参阅从 ServiceMeshExtension迁移到WasmPlugin资源。-

OSSM-1396 如果一个网关资源包含

spec.externalIPs设置,而不是在ServiceMeshControlPlane更新时重新创建,则该网关会被删除且永远不会重新创建。 - OSSM-1168 当以单个 YAML 文件形式创建服务网格资源时,Envoy proxy sidecar 不会可靠地注入 pod。当单独创建 SMCP、SMMR 和 Deployment 资源时,部署可以正常工作。

OSSM-1115

spec.proxyAPI的并发字段没有传播到 istio-proxy。当使用ProxyConfig设置时,并发字段可以正常工作。concurrency字段指定要运行的 worker 线程数量。如果字段设为0,则可用的 worker 线程数量等于 CPU 内核数。如果没有设置该字段,则可使用的 worker 线程数量默认为2。在以下示例中,

concurrency字段设置为0。Copy to Clipboard Copied! Toggle word wrap Toggle overflow OSSM-1052 在为服务网格 control plane 中为 ingressgateway 配置 Service

ExternalIP时,不会创建该服务。SMCP 的 schema 缺少该服务的参数。临时解决方案:禁用 SMCP spec 中的网关创建,手动管理网关部署(包括 Service、Role 和 RoleBinding)。

OSSM-882 适用于 Service Mesh 2.1 及更早版本。命名空间位于 accessible_namespace 列表中,但不出现在 Kiali UI 中。默认情况下,Kiali 不会显示任何以"kube"开头的命名空间,因为这些命名空间通常仅供内部使用,而不是网格的一部分。

例如,如果您创建一个名为 'akube-a' 的命名空间并将其添加到 Service Mesh member roll 中,Kiali UI 不会显示这个命名空间。这是因为对于定义的排除特征,软件会排除以定义特征开始或包括定义特征的命名空间。

临时解决方案:更改 Kiali 自定义资源设置,以便使用尖号 (^) 前缀设置。例如:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

MAISTRA-2692 删除了 Mixer,在 Service Mesh 2.0.x 中定义的自定义指标无法在 2.1 中使用。可以使用

EnvoyFilter配置自定义指标。除非有明确记录,红帽不支持EnvoyFilter配置。这是因为与底层 Envoy API 耦合紧密,这意味着无法维护向后兼容性。 MAISTRA-1959 迁移到 2.0 Prometheus 提取(

spec.addons.prometheus.scrape设置为true)在启用 mTLS 时无法正常工作。另外,当禁用 mTLS 时,Kiali 会显示无关的图形数据。可通过将端口 15020 从代理配置中排除来解决这个问题,例如:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

MAISTRA-453 如果创建新项目并立即部署 pod,则不会进行 sidecar 注入。在创建 pod 前,operator 无法添加

maistra.io/member-of,因此必须删除 pod 并重新创建它以执行 sidecar 注入操作。 - MAISTRA-158 应用指向同一主机名的多个网关时,会导致所有网关停止工作。

1.2.29.2. Kiali 已知问题

Kiali 的新问题应该在 OpenShift Service Mesh 项目中创建,Component 设为 Kiali。

Kiali 中已知的问题:

- OSSM-6299 在 Red Hat OpenShift Service on AWS 4.15 中,当您点击流量图中任何节点菜单选项时,不会显示节点图形。相反,页面会使用相同的流量图刷新。目前,这个问题还没有临时解决方案。

- OSSM-6298 当您点 OpenShift Service Mesh Console (OSSMC)插件中的项目引用时,如与特定服务相关的工作负载链接,控制台有时会在打开所需页面前执行多个重定向。如果您在网页浏览器中点 Back,则会打开控制台的不同页面,而不是上一页。作为临时解决方案,点 Back 两次来进入上一页。

-

OSSM-6290 for Red Hat OpenShift Service on AWS 4.15,Istio Config 列表页面的 Project 过滤器无法正常工作。即使从下拉菜单选择一个特定的项目,也会显示所有

istio项。目前,这个问题还没有临时解决方案。

- KIALI-2206 当您第一次访问 Kiali 控制台时,浏览器中没有 Kiali 的缓存数据,Kiali 服务详情页面的 Metrics 标签页中的 “View in grafana” 链接会重定向到错误的位置。只有在第一次访问 Kiali 才会出现这个问题。

- KIALI-507 Kiali 不支持 Internet Explorer 11。这是因为底层框架不支持 Internet Explorer。要访问 Kiali 控制台,请使用 Chrome 、Edge 、Firefox 或 Safari 浏览器的两个最新版本之一。

1.2.30. 修复的问题

在之前的版本中解决了以下问题:

1.2.30.1. Service Mesh 修复的问题

-

OSSM-6177 以前,当在

ServiceMeshControlPlane(SMCP)中启用验证信息时,istiod 会持续崩溃,除非启用了GatewayAPI支持。现在,当启用验证信息但没有支持GatewayAPI时,istiod不会持续崩溃。 OSSM-6163 解决了以下问题:

- 在以前的版本中,Service Mesh control plane (SMCP) v2.5 中包含了一个不稳定的 Prometheus 镜像,用户无法访问 Prometheus 仪表板。现在,在 Service Mesh operator 2.5.1 中,Prometheus 镜像已被更新。

-

在以前的版本中,在 Service Mesh control plane (SMCP)中,Grafana 数据源无法自动设置基本身份验证密码,用户可以在 Grafana mesh 仪表板中查看 Prometheus 的指标。现在,Grafana 数据源密码配置在

secureJsonData字段下。指标数据会在仪表板中正确显示。

- OSSM-6148 以前,当用户点击 Traffic Graph 页面上任何节点菜单中的任何选项时,OpenShift Service Mesh Console (OSSMC)插件没有响应。现在,插件通过重定向到对应的详情页面来响应菜单中的所选选项。

- OSSM-6099 以前,OpenShift Service Mesh 控制台(OSSMC)插件无法在 IPv6 集群中正确加载。现在,OSSMC 插件配置已被修改,以确保在 IPv6 集群中正确载入。

- OSSM-5960 以前,OpenShift Service Mesh Console (OSSMC)插件没有显示通知信息,如后端错误或 Istio 验证。现在,这些通知会在插件页面的顶部正确显示。

- OSSM-5959 以前,OpenShift Service Mesh Console (OSSMC)插件没有在 Overview 页面中显示 TLS 和 Istio 认证信息。现在,这些信息会被正确显示。

- OSSM-5902 以前,当用户在 Overview 页面中点 Istio 配置健康符号时,OpenShift Service Mesh Console (OSSMC)插件会重定向到 "Not Found Page" 错误。现在,插件会重定向到正确的 Istio 配置 详情页面。

- OSSM-5541 以前,Istio operator pod 在一些重启条件中可能会等待领导租期。现在,领导选举实施已被改进,以避免出现这个问题。

OSSM-1397 以前,如果您从命名空间中删除了

maistra.io/member-of标签,Service Mesh Operator 不会自动将标签应用到命名空间。因此,sidecar 注入无法在命名空间中工作。当您更改

ServiceMeshMember对象时,Operator 会将标签应用到命名空间,这会触发此 member 对象的协调。现在,对命名空间的任何更改也会触发 member 对象协调。

OSSM-3647 以前,在 Service Mesh control plane (SMCP) v2.2 (Istio 1.12)中,WasmPlugins 仅适用于入站监听程序。从 SMCP v2.3 (Istio 1.14)开始,WasmPlugins 默认应用于入站和出站监听程序,这为 3scale WasmPlugin 的用户引入了回归。现在,添加了环境变量

APPLY_WASM_PLUGINS_TO_INBOUND_ONLY,它允许从 SMCP v2.2 安全地迁移到 v2.3 和 v2.4。以下设置应添加到 SMCP 配置中:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要确保安全迁移,请执行以下步骤:

-

在 SMCP v2.2 中设置

APPLY_WASM_PLUGINS_TO_INBOUND_ONLY。 - 升级到 2.4。

-

在 WasmPlugins 中设置

spec.match[].mode: SERVER。 - 删除之前添加的环境变量。

-

在 SMCP v2.2 中设置

-

OSSM-4851 以前,当

runAsGroup、runAsUser或fsGroup参数为nil时,Operator 在网格内部署新 pod 时出错。现在,添加了 yaml 验证以避免nil值。 -

OSSM-3771 以前,对于 Service Mesh Control Plane (SMCP)中定义的额外入口网关无法禁用 OpenShift 路由。现在,可以将

routeConfig块添加到每个额外的Ingress网关中,以便为每个网关启用或禁用 OpenShift 路由。 OSSM-4197 以前,如果您部署了 'ServiceMeshControlPlane' 资源的 v2.2 或 v2.1,则不会创建

/etc/cni/multus/net.d/目录。因此,istio-cnipod 无法就绪,istio-cnipod 日志包含以下消息:error Installer exits with open /host/etc/cni/multus/net.d/v2-2-istio-cni.kubeconfig.tmp.841118073: no such file or directory

$ error Installer exits with open /host/etc/cni/multus/net.d/v2-2-istio-cni.kubeconfig.tmp.841118073: no such file or directoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 现在,如果您部署 'ServiceMeshControlPlane' 资源的 v2.2 或 v2.1,则

/etc/cni/multus/net.d/目录已创建,并且istio-cnipod 变为 ready。-

OSSM-3993 之前,Kiali 只通过标准 HTTPS 端口

443上的代理支持 OpenShift OAuth。现在,Kiali 通过非标准 HTTPS 端口支持 OpenShift OAuth。要启用端口,您必须将spec.server.web_port字段设置为 Kiali CR 中的代理的非标准 HTTPS 端口。 -

OSSM-3936 之前,

injection_label_rev和injection_label_name属性的值被硬编码。这导致自定义配置无法在 Kiali 自定义资源定义(CRD)中生效。现在,属性值不会被硬编码。您可以在spec.istio_labels规格中自定义injection_label_rev和injection_label_name属性的值。 - OSSM-3644 以前,联邦 egress-gateway 收到网络网关端点的错误更新,从而导致额外的端点条目。现在,在服务器端更新了 federation-egress 网关,以便它接收正确的网络网关端点。

-

OSSM-3595 以前,

istio-cni插件有时会在 RHEL 上失败,因为 SELinux 不允许工具iptables-restore打开/tmp目录中的文件。现在,SELinux 通过stdin输入流而不是通过一个文件传递iptables-restore。 - OSSM-3586 之前,当 Google Cloud Platform (GCP)元数据服务器不可用时,Istio 代理会较慢。当您升级到 Istio 1.14.6 时,Istio 代理会在 GCP 上按预期启动,即使元数据服务器不可用。

- OSSM-3025 Istiod 有时无法就绪。有时,当网格包含很多成员命名空间时,Istiod pod 未就绪,因为 Istiod 中的死锁。现在,死锁已被解决,pod 现在会如预期启动。

-

OSSM-2493 默认

nodeSelector和tolerations不在 SMCP 中传递给 Kiali。您添加到SMCP.spec.runtime.defaults的nodeSelector和tolerations现在被传递给 Kiali 资源。 -

OSSM-2492 默认容限没有传递给 Jaeger。您添加到

SMCP.spec.runtime.defaults的nodeSelector和tolerations现在被传递给 Jaeger 资源。 -

OSSM-2374 如果您删除了其中一个

ServiceMeshMember资源,则 Service Mesh operator 会删除ServiceMeshMemberRoll。虽然当您删除最后一个ServiceMeshMember时这是预期的行为,但如果它还包含任何成员,Operator 不应该删除ServiceMeshMemberRoll。这个问题现已解决,Operator 仅在最后一个ServiceMeshMember资源被删除时删除 ServiceMeshMemberRoll。 OSSM-2373 登录时尝试获取 OAuth 元数据的错误。要获取集群版本,请使用

system:anonymous帐户。使用集群的默认捆绑的 ClusterRole 和 ClusterRoleBinding,匿名帐户可以正确地获取版本。如果system:anonymous帐户丢失了获取集群版本的权限,OpenShift 身份验证将不可用。这个问题已通过使用 Kiali SA 获取集群版本来解决。这也允许提高集群上的安全性。

- OSSM-2371 虽然 Kiali 配置为 "view-only",但用户可以通过 Workload details 的 kebab 菜单更改代理日志级别。这个问题已被解决,当 Kiali 配置为 "view-only" 时,"Set Proxy Log Level" 下的选项被禁用。

- OSSM-2344 Restarting Istiod 会导致 Kiali 使用 port-forward 请求大量 CRI-O。当 Kiali 无法连接到 Istiod,Kiali 同时向 istiod 发出大量请求时会出现这种情况。Kiali 现在限制它发送到 istiod 的请求数。

- OSSM-2335 将鼠标指针拖放到 Traces scatterchart 图表上,有时会导致 Kiali 控制台因为并发后端请求停止响应。

OSSM-2221 以前,

ServiceMeshControlPlane命名空间中的网关注入无法进行,因为ignore-namespace标签默认应用到命名空间。在创建 v2.4 control plane 时,命名空间不再应用

ignore-namespace标签,并可进行网关注入。在以下示例中,

oc label命令从现有部署中的命名空间中删除ignore-namespace标签:oc label namespace istio-system maistra.io/ignore-namespace-

$ oc label namespace istio-system maistra.io/ignore-namespace-Copy to Clipboard Copied! Toggle word wrap Toggle overflow 其中:

- istio_system

-

指定

ServiceMeshControlPlane命名空间的名称。

OSSM-2053 使用 Red Hat OpenShift Service Mesh Operator 2.2 或 2.3,在 SMCP 协调过程中,SMMR 控制器会从

SMMR.status.configuredMembers中删除成员命名空间。这会导致成员命名空间中的服务在一些时间不可用。使用 Red Hat OpenShift Service Mesh Operator 2.2 或 2.3,SMMR 控制器不再从

SMMR.status.configuredMembers中删除命名空间。相反,控制器会将命名空间添加到SMMR.status.pendingMembers中,以指示它们不是最新的。在协调过程中,因为每个命名空间与 SMCP 同步,命名空间会自动从SMMR.status.pendingMembers中删除。-

OSSM-1962 使用

EndpointSlices联合控制器。联合控制器现在使用EndpointSlices,这提高了大型部署的可扩展性和性能。默认情况下启用 PILOT_USE_ENDPOINT_SLICE 标志。禁用该标志可防止使用联合部署。 -

OSSM-1668 一个新的字段

spec.security.jwksResolverCA已添加到版本 2.1SMCP中,但没有存在于 2.2.0 和 2.2.1 版本中。当从存在此字段的 Operator 版本升级到缺少此字段的 Operator 版本时,则SMCP中没有.spec.security.jwksResolverCA字段。 -

OSSM-1325 istiod pod 崩溃并显示以下出错信息:

fatal error: concurrent map iteration and map write。 OSSM-1211 为故障转移配置联邦服务网格无法正常工作。

Istiod pilot 日志显示以下错误:

envoy connection [C289] TLS error: 337047686:SSL routines:tls_process_server_certificate:certificate verify failed-

OSSM-1099 Kiali 控制台显示消息

Sorry, there was a problem.Try a refresh or navigate to a different page. - OSSM-1074 Pod 注解没有在 pod 中注入。

- OSSM-999 Kiali retention 无法按预期工作。仪表板图中的日历时间会被问候。

-

OSSM-797 Kiali Operator pod 在安装或更新 Operator 时生成

CreateContainerConfigError。 -

从

kube开始的 OSSM-722 命名空间从 Kiali 中隐藏。 -

OSSM-569 Prometheus

istio-proxy容器没有 CPU 内存限值。Prometheusistio-proxysidecar 现在使用spec.proxy.runtime.container中定义的资源限值。 -

OSSM-535 支持 SMCP 中的验证消息。Service Mesh Control Plane 中的

ValidationMessages字段现在可以设置为True。这会写入资源状态的日志,这在进行故障排除时很有用。 - OSSM-449 VirtualService 和 Service 会导致一个错误 - "Only unique values for domains are permitted.Duplicate entry of domain."

- 具有类似名称的 OSSM-419 命名空间都显示在 Kiali 命名空间列表中,即使命名空间可能无法在 Service Mesh Member Role 中定义。

- OSSM-296 当在 Kiali 自定义资源(CR)中添加健康配置时,不会将其复制到 Kiali configmap 中。

- OSSM-291 在 Kiali 控制台中,在 Applications、Services 和 Workloads 页面中,"Remove Label from Filters"功能无法正常工作。

- OSSM-289 在 Kiali 控制台中,'istio-ingressgateway' 和 'jaeger-query' 服务的服务详情页面中没有显示 Traces。Jaeger 中存在 trace。

- OSSM-287 在 Kiali 控制台中没有显示 Graph 服务中的 trace。

OSSM-285 试图访问 Kiali 控制台时会收到以下错误消息:"Error trying to get OAuth Metadata"。

临时解决方案:重启 Kiali pod。

MAISTRA-2735 当 Red Hat OpenShift Service Mesh 2.1 中协调 SMCP 更改时,Service Mesh Operator 会删除的资源。在以前的版本中,Operator 删除了带有以下标签的资源:

-

maistra.io/owner -

app.kubernetes.io/version

现在,Operator 会忽略没有包括

app.kubernetes.io/managed-by=maistra-istio-operator标签的资源。如果创建自己的资源,则不应将app.kubernetes.io/managed-by=maistra-istio-operator标签添加到其中。-

-

MAISTRA-2687 Red Hat OpenShift Service Mesh 2.1 联邦网关在使用外部证书时不会发送完整的证书链。Service Mesh 联邦出口网关仅发送客户端证书。因为联邦入口网关只知道 root 证书,所以它无法验证客户端证书,除非您将 root 证书添加到联合导入

ConfigMap中。 -

MAISTRA-2635 替换已弃用的 Kubernetes API。为了保持与 Red Hat OpenShift Service on AWS 4.8 兼容,

apiextensions.k8s.io/v1beta1API 从 Red Hat OpenShift Service Mesh 2.0.8 开始已弃用。 -

MAISTRA-2631 WASM 功能不起作用,因为 podman 因 nsenter 二进制不存在而失败。Red Hat OpenShift Service Mesh 生成以下出错信息:

Error: error configuring CNI network plugin exec: "nsenter": executable file not found in $PATH。容器镜像现在包含 nsenter,WASM 可以正常工作。 - MAISTRA-2534 当 istiod 试图为 JWT 规则中指定的签发者获取 JWKS 时,签发者服务会使用 502 响应。这导致代理容器就绪,并导致部署挂起。Service Mesh 2.0.7 版本中包括了对社区程序漏洞的修复。

MAISTRA-2411 当 Operator 使用

ServiceMeshControlPlane中的spec.gateways.additionaIngress创建新的入口网关时,Operator 不会为额外的入口网关创建一个NetworkPolicy,如默认的 istio-ingressgateway。这导致了来自新网关路由的 503 响应。临时解决方案:在

istio-system命名空间中手动创建NetworkPolicy。MAISTRA-2401 CVE-2021-3586 servicemesh-operator:NetworkPolicy 资源为 ingress 资源指定错误的端口。为 Red Hat OpenShift Service Mesh 安装的 NetworkPolicy 资源没有正确指定可访问哪些端口。这允许从任何 pod 访问这些资源上的所有端口。应用到以下资源的网络策略会受到影响:

- Galley

- Grafana

- Istiod

- Jaeger

- Kiali

- Prometheus

- Sidecar injector

-

MAISTRA-2378 当集群被配置为使用带有

ovs-multitenant的 OpenShift SDN,且网格包含大量命名空间(200+),Red Hat OpenShift Service on AWS 网络插件无法快速配置命名空间。Service Mesh 超时会导致从服务网格中持续丢弃命名空间,然后重新加入。 - MAISTRA-2370 Handle tombstones in listerInformer。在将事件从命名空间缓存转换为聚合缓存时,更新的缓存代码库没有处理 tombstones,从而导致在 go 中出现 panic 的问题。

MAISTRA-2117 向 operator 添加可选的

ConfigMap挂载。CSV 现在包含一个可选的ConfigMap卷挂载,它会挂载smcp-templatesConfigMap(如果存在)。如果smcp-templatesConfigMap不存在,则挂载的目录为空。创建ConfigMap时,目录会填充ConfigMap中的条目,并可在SMCP.spec.profiles中引用。不需要重启 Service Mesh operator。使用带有修改 CSV 的 2.0 operator 挂载 smcp-templates ConfigMap 的用户可升级到 Red Hat OpenShift Service Mesh 2.1。升级后,您可以继续使用现有的 ConfigMap 及其包含的配置集,而无需编辑 CSV。以前使用不同名称的 ConfigMap 的客户需要重命名 ConfigMap 或升级后更新 CSV。

-

MAISTRA-2010 AuthorizationPolicy 不支持

request.regex.headers字段。validatingwebhook会拒绝任何带有字段的 AuthorizationPolicy,即使您禁用该字段,Pilot 也会尝试使用相同的代码验证它,且它无法正常工作。 MAISTRA-1979 迁移至 2.0 在将

SMCP.status从 v2 转换为 v1 时,转换 Webhook 会丢弃以下重要字段:- conditions

- components

- observedGeneration

annotations

将 operator 升级到 2.0 可能会破坏使用 maistra.io/v1 版本读取 SMCP 状态的客户端工具。

这还会导致在运行

oc get servicemeshcontrolplanes.v1.maistra.io时 READY 和 STATUS 列为空。

-

MAISTRA-1983 迁移到 2.0 把带有存在无效

ServiceMeshControlPlane的系统升级到 2.0.0 的问题无法被简单修复。ServiceMeshControlPlane资源中的无效项会导致无法恢复的错误。在这个版本中,这个错误可以被恢复。您可以删除无效的资源,并将其替换为新资源或编辑资源来修复错误。有关编辑资源的更多信息,请参阅 [配置 Red Hat OpenShift Service Mesh 安装]。 - MAISTRA-1502 由于在版本 1.0.10 中修复了 CVE,Istio 仪表板将不会出现在 Grafana 的 Home Dashboard 菜单中。要访问 Istio 仪表板,点导航面板中的 Dashboard 菜单,然后选择 Manage 选项卡。

- MAISTRA-1399 Red Hat OpenShift Service Mesh 不再阻止您安装不支持的 CNI 协议。支持的网络配置没有改变。

- MAISTRA-1089 迁移到在非 control plane 命名空间中创建的 2.0 网关将自动删除。从 SMCP spec 中删除网关定义后,您需要手动删除这些资源。

MAISTRA-858 Envoy 日志中以下与 与 Istio 1.1.x 相关的弃用选项和配置相关的信息是正常的:

- [2019-06-03 07:03:28.943][19][warning][misc] [external/envoy/source/common/protobuf/utility.cc:129] Using deprecated option 'envoy.api.v2.listener.Filter.config'。This configuration will be removed from Envoy soon.

- [2019-08-12 22:12:59.001][13][warning][misc] [external/envoy/source/common/protobuf/utility.cc:174] Using deprecated option 'envoy.api.v2.Listener.use_original_dst' from file LDS.proto。This configuration will be removed from Envoy soon.

MAISTRA-806 被逐出的 Istio Operator Pod 会导致 mesh 和 CNI 不能被部署。

临时解决方案:如果在部署 control pane 时

istio-operatorpod 被逐出,删除被逐出的istio-operatorpod。- MAISTRA-681 当 Service Mesh control plane 有多个命名空间时,可能会导致出现性能问题。

- MAISTRA-193 当为 citadel 启用了健康检查功能时,会出现预期外的控制台信息。

- Bugzilla 1821432 Red Hat OpenShift Service on AWS 自定义资源详情页面中的切换控件无法正确更新 CR。Red Hat OpenShift Service on AWS Web 控制台中的 Service Mesh Control Plane (smcp) Overview 页面中的 UI 切换控制有时会更新资源中的错误字段。要更新 SMCP,直接编辑 YAML 内容,或者从命令行更新资源,而不是点击 toggle 控件。

1.3. 了解 Service Mesh

Red Hat OpenShift Service Mesh 提供了一个平台,用于对服务网格(service mesh)中联网的微服务进行行为了解和操作控制。通过使用 Red Hat OpenShift Service Mesh,可以连接、控制并监控 Red Hat OpenShift Service on AWS 环境中的微服务。

1.3.1. 什么是 Red Hat OpenShift Service Mesh?

服务网格(service mesh)是一个微服务网络,它用于在一个分布式的微服务架构中构成应用程序,并提供不同微服务间的交互功能。当服务网格的规模和复杂性增大时,了解和管理它就会变得非常困难。

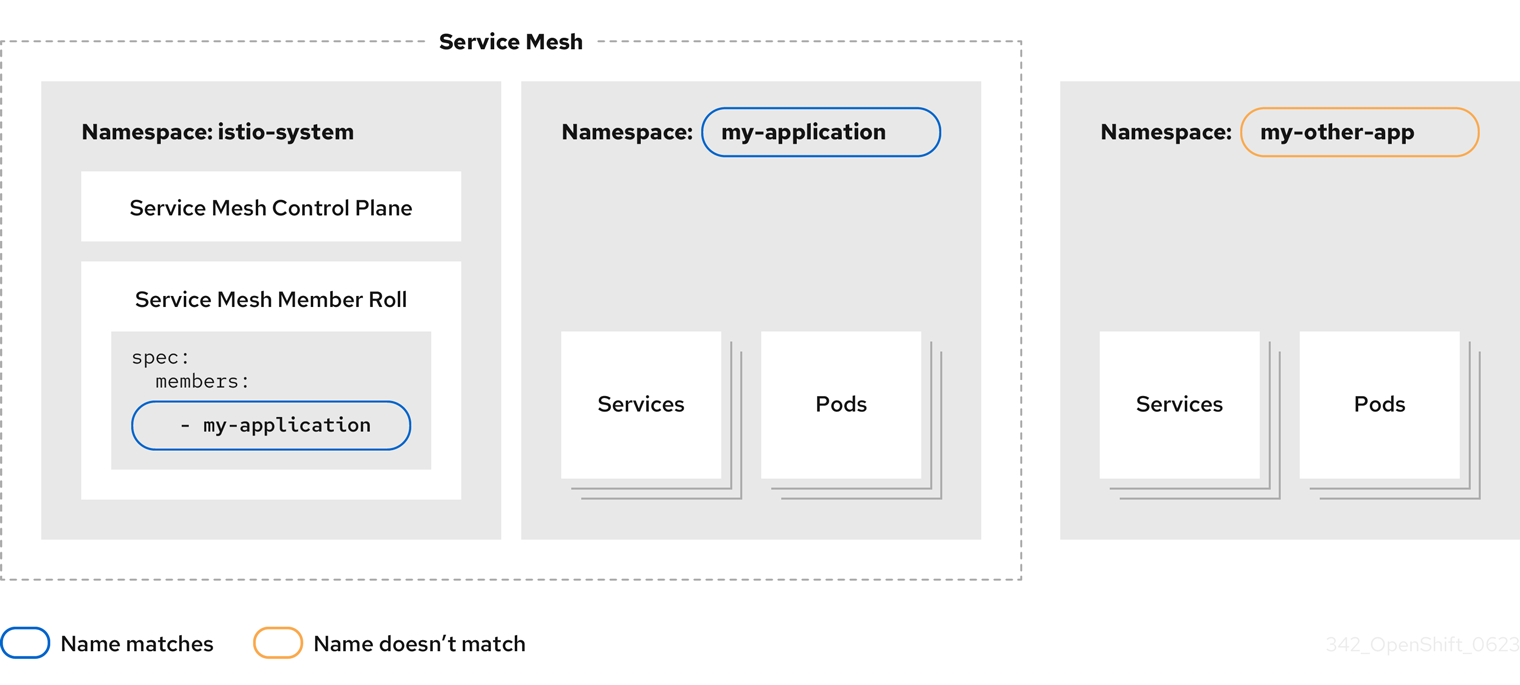

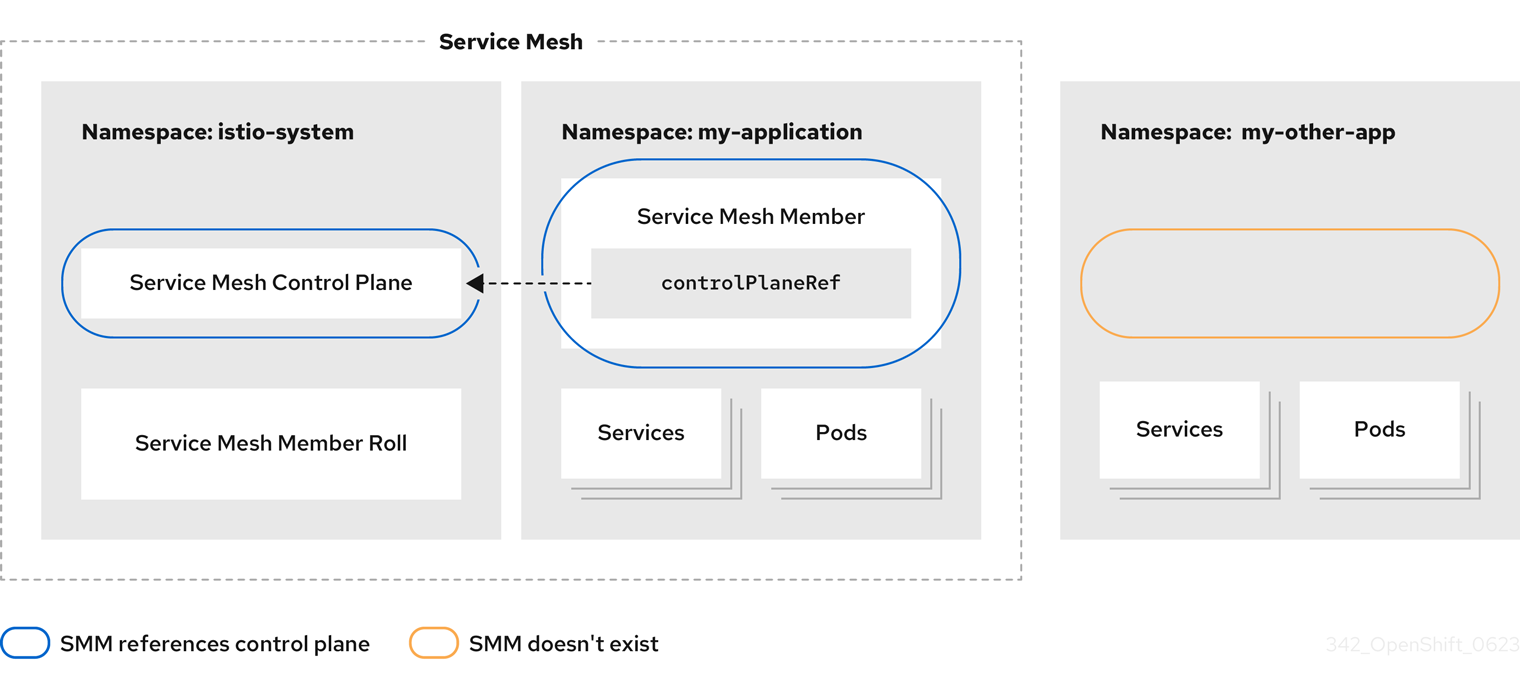

Red Hat OpenShift Service Mesh 基于开源 Istio 项目,它在不需要修改服务代码的情况下,为现有的分布式应用程序添加了一个透明的层。您可以在服务中添加对 Red Hat OpenShift Service Mesh 的支持,方法是将一个特殊的 sidecar 代理服务器部署到用于处理不同微服务之间的所有网络通讯的服务网格中。您可以使用 Service Mesh control plane 功能配置和管理 Service Mesh。

Red Hat OpenShift Service Mesh 可让您轻松创建部署的服务网络,该网络提供:

- 发现

- 负载平衡

- 服务到服务的验证

- 故障恢复

- 指标

- 监控

Red Hat OpenShift Service Mesh 还提供更复杂的操作功能,其中包括:

- A/B 测试

- Canary 发行版本

- Access control

- 端到端的验证

1.3.2. Service Mesh 架构

服务网格技术在网络通信级别运作。也就是说,服务网格组件捕获或截获进出微服务的流量,或修改请求、重定向请求或创建新请求到其他服务。

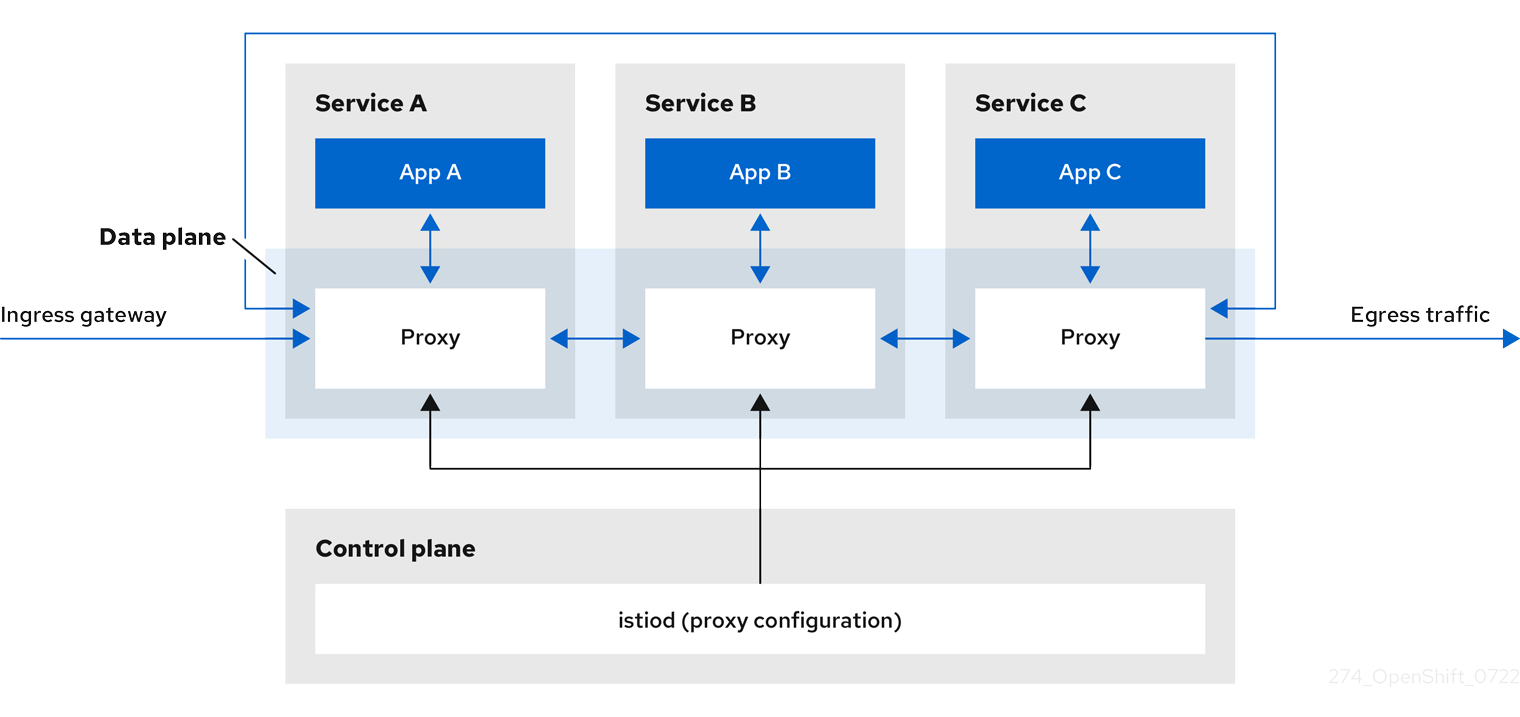

在高级别上,Red Hat OpenShift Service Mesh 由 data plane 和一个 control plane 组成

数据平面是一组智能代理,与 pod 中的应用容器一起运行,用于拦截和控制服务网格中微服务之间的所有入站和出站网络通信。数据平面的实现方式是它会截获所有入站(ingress)和出站(egress)网络流量。Istio 数据平面由与 pod 中侧应用程序容器一起运行的 Envoy 容器组成。Envoy 容器充当代理,控制与 pod 往来的所有网络通信。

Envoy 代理 是与 data plane 流量交互的唯一 Istio 组件。服务之间的所有传入(ingress)和传出(egress)网络流量通过代理流。Envoy 代理还会收集与网格内服务流量相关的所有指标。Envoy 代理部署为 sidecar,与服务在同一个 pod 中运行。Envoy 代理也用于实现网格网关。

- sidecar 代理 为其工作负载实例管理入站和出站通信。

网关是作为接收传入或传出 HTTP/TCP 连接的负载平衡器运行的代理。网关配置适用于在网格边缘运行的独立的 Envoy 代理,而不是与您的服务负载一同运行的 sidecar Envoy 代理。您可以使用网关来管理入站和出站流量,允许您指定您要进入或离开网格的流量。

- Ingress-gateway - 也称为入口控制器,Ingress 网关是一个专用的 Envoy 代理,用于接收和控制进入服务网格的流量。Ingress 网关允许将监控和路由规则等功能应用到进入集群的流量。

- Egress-gateway - 另外称为出口控制器(Egress Gateway),Egress 网关是一个专用的 Envoy 代理,用于管理离开服务网格的流量。Egress 网关允许对流量退出网格应用监控和路由规则等功能。

control plane 管理并配置组成数据平面的代理。它是配置的权威源,管理访问控制和使用策略,并从服务网格中的代理收集指标。

Istio control plane 由 Istiod 组成,它会将几个之前的 control plane 组件(Citadel、Galley 和 Pilot)整合为一个二进制。Istiod 提供服务发现、配置和证书管理。它将高级别路由规则转换为 Envoy 配置,并在运行时将其传播到 sidecar。

- Istiod 可以充当证书颁发机构 (CA),在 data plane 中生成支持安全 mTLS 通信的证书。您还可以使用外部 CA 来实现这一目的。

- Istiod 负责将 sidecar 代理容器注入到部署到 OpenShift 集群的工作负载中。

Red Hat OpenShift Service Mesh 使用 istio-operator 来管理 control plane 的安装。Operator 是一个软件,它可让您实现和自动化 OpenShift 集群中的常见操作。它充当控制器,允许您设置或更改集群中对象的所需状态,本例中为 Red Hat OpenShift Service Mesh 安装。

Red Hat OpenShift Service Mesh 还捆绑以下 Istio 附加组件作为该产品的一部分:

- Kiali - Kiali 是 Red Hat OpenShift Service Mesh 的管理控制台。它提供了仪表板、可观察性以及强大的配置和验证功能。它通过推断流量拓扑显示服务网格的结构,并显示网格的健康状况。Kiali 提供详细的指标、强大的验证、访问 Grafana 以及与分布式 Tracing Platform (Jaeger)的强大集成。

- Prometheus - Red Hat OpenShift Service Mesh 使用 Prometheus 来存储来自服务的遥测信息。Kiali 依靠 Prometheus 获取指标数据、健康状况和网格拓扑。

- Jaeger - Red Hat OpenShift Service Mesh 支持分布式 Tracing Platform (Jaeger)。Jaeger 是一个开源可追踪性服务器,可以集中并显示与多个服务间单一请求关联的 trace。利用分布式跟踪平台(Jaeger),您可以监控基于微服务的分布式系统并进行故障排除。

- Elasticsearch - Elasticsearch 是一个开源、分布式、基于 JSON 的搜索和分析引擎。分布式跟踪平台(Jaeger)使用 Elasticsearch 进行持久性存储。

- Grafana - Grafana 为网格管理员提供用于 Istio 数据的高级查询和指标分析和仪表板。另外,Grafana 可以用来分析服务网格指标。

以下 Istio 集成与 Red Hat OpenShift Service Mesh 支持:

- 3scale - Istio 提供与红帽 3scale API 管理解决方案的可选集成。对于 2.1 之前的版本,这个集成是通过 3scale Istio 适配器实现的。对于 2.1 版本,3scale 集成通过 WebAssembly 模块实现。

有关如何安装 3scale 适配器的详情,请参考 3scale Istio 适配器文档

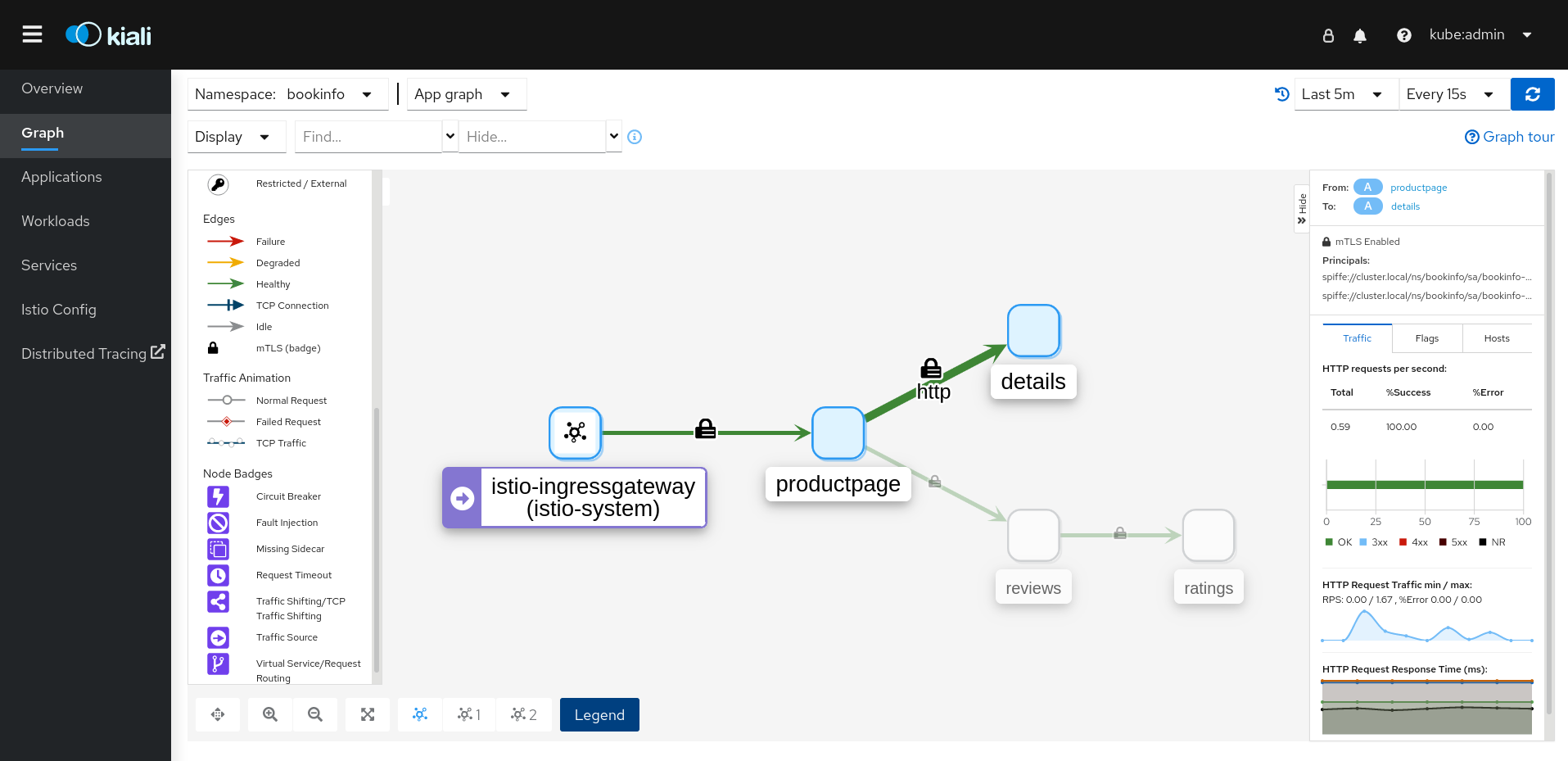

1.3.3. 了解 Kiali

Kiali 通过显示服务网格中的微服务服务以及连接方式,为您提供了一个可视性的服务网格概述。

1.3.3.1. Kiali 概述

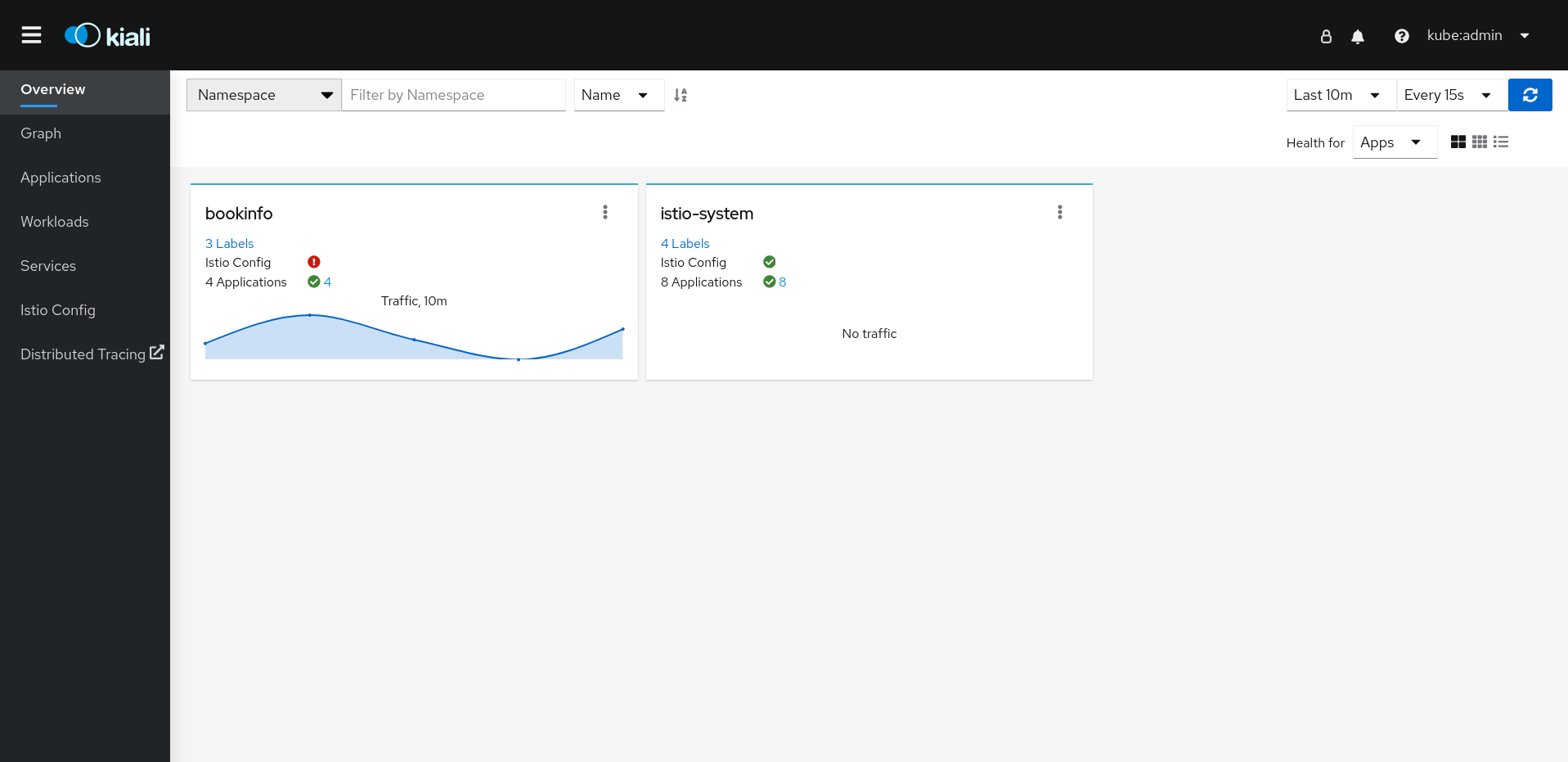

Kiali 为在 Red Hat OpenShift Service on AWS 上运行的 Service Mesh 提供了一个观察平台。Kiali 可以帮助您定义、验证并观察 Istio 服务网格。它所提供的拓扑结构可以帮助您了解服务网格的结构,并提供服务网格的健康状况信息。

Kiali 实时提供命名空间的交互式图形视图,可让您了解诸如电路断路器、请求率、延迟甚至流量图等功能。Kiali 提供了从应用程序到服务以及负载等不同级别的组件的了解,并可显示与所选图形节点或边缘的上下文信息和图表的交互。Kiali 还提供了验证 Istio 配置(如网关、目的规则、虚拟服务、网格策略等等)的功能。Kiali 提供了详细的指标数据,并可使用基本的 Grafana 集成来进行高级查询。通过将 Jaeger 集成到 Kiali 控制台来提供分布式追踪。

默认情况下,Kiali 作为 Red Hat OpenShift Service Mesh 的一部分被安装。

1.3.3.2. Kiali 架构

Kiali 基于开源 Kiali 项目。Kiali 由两个组件组成: Kiali 应用程序和 Kiali 控制台。

- Kiali 应用程序 (后端)- 该组件运行在容器应用程序平台中,并与服务网格组件进行通讯,检索和处理数据,并将这些数据提供给控制台。Kiali 应用程序不需要存储。当在集群中部署应用程序时,配置在 ConfigMaps 和 secret 中设置。

- Kiali 控制台 (前端) – Kiali 控制台是一个 Web 应用程序。Kiali 应用程序为 Kiali 控制台提供服务,控制台会查询后端数据并把数据提供给用户。

另外,Kiali 依赖于由容器应用程序平台和 Istio 提供的外部服务和组件。

- Red Hat Service Mesh (Istio) - Kiali 需要 Istio。Istio 是提供和控制服务网格的组件。虽然 Kiali 和 Istio 可以单独安装,但是 Kiali 需要 Istio。如果没有安装 Istio,则无法工作。Kiali 需要检索 Istio 数据和配置,这些数据和配置可以通过 Prometheus 和集群 API 获得。

- Prometheus - 一个专用的 Prometheus 实例作为 Red Hat OpenShift Service Mesh 安装的一部分被包括。启用 Istio 遥测时,指标数据存储在 Prometheus 中。Kiali 使用这个 Prometheus 数据来决定网状拓扑结构、显示指标数据、计算健康状况、显示可能的问题等等。Kiali 与 Prometheus 直接沟通,并假设 Istio Telemetry 使用的数据 schema。Istio 依赖于 Prometheus,Kiali 也依赖于 Prometheus。许多 Kiali 的功能在没有 Prometheus 的情况下将无法工作。

- Cluster API - Kiali 使用 Red Hat OpenShift Service on AWS (cluster API) API 来获取和解析服务网格配置。Kiali 通过查询集群 API 获取信息,如获取命名空间、服务、部署、pod 和其他实体的定义。Kiali 还提供查询来解析不同集群实体之间的关系。另外,还可以通过查询集群 API 以获取 Istio 配置,比如虚拟服务、目的规则、路由规则、网关、配额等等。

- Jaeger - Jaeger 是可选的,但会作为 Red Hat OpenShift Service Mesh 安装的一部分被默认安装。当您作为默认 Red Hat OpenShift Service Mesh 安装的一部分安装 Distributed Tracing Platform (Jaeger)时,Kiali 控制台会包括一个显示分布式追踪数据的标签页。请注意:如果禁用 Istio 的分布式追踪功能,则不会提供追踪数据。另请注意,用户必须可以访问安装 Service Mesh control plane 的命名空间,才能查看追踪数据。

- Grafana - Grafana 是可选的,但作为 Red Hat OpenShift Service Mesh 安装的一部分被默认安装。如果使用了 Grafana,Kiali 的 metrics 页会包括一个链接,用户可以使用它访问 Grafana 中相同的指标数据。请注意,用户必须可以访问安装 Service Mesh control plane 的命名空间,以便查看到 Grafana 仪表板的链接并查看 Grafana 数据。

1.3.3.3. Kiali 的功能

Kiali 控制台与 Red Hat Service Mesh 集成,提供以下功能:

- 健康 – 快速识别应用程序、服务或者工作负载的问题。

- 拓扑 – 以图形的形式显示应用程序、服务或工作负载如何通过 Kiali 进行通信。

- 指标 – 预定义的 metrics dashboard 可为您生成 Go、Node.js、Quarkus 、Spring Boot 、Thonttail 和 Vert.x 的服务网格和应用程序性能图表。。您还可以创建您自己的自定义仪表板。

- 追踪 – 通过与 Jaeger 集成,可以在组成一个应用程序的多个微服务间追踪请求的路径。

- 验证 – 对最常见 Istio 对象(Destination Rules 、Service Entries 、Virtual Services 等等)进行高级验证。

- 配置 – 使用向导创建、更新和删除 Istio 路由配置的可选功能,或者直接在 Kiali Console 的 YAML 编辑器中创建、更新和删除 Istio 路由配置。

1.3.4. 了解分布式追踪

每次用户在某个应用程序中执行一项操作时,一个请求都会在所在的系统上执行,而这个系统可能需要几十个不同服务的共同参与才可以做出相应的响应。这个请求的路径是一个分布式的事务。分布式跟踪平台(Jaeger)可让您执行分布式追踪,它会在组成一个应用程序的多个微服务间追踪请求的路径。

分布式追踪是用来将不同工作单元的信息关联起来的技术,通常是在不同进程或主机中执行的,以便理解分布式事务中的整个事件链。分布式追踪可让开发人员在大型服务架构中视觉化调用流程。它对理解序列化、平行和延迟来源会很有价值。

分布式追踪平台(Jaeger)记录了在微服务的整个堆栈间执行单个请求,并将其显示为 trace。trace是系统的数据/执行路径。端到端追踪包含一个或多个范围。

span 代表具有操作名称、操作的开始时间和持续时间的逻辑工作单元。span 可能会被嵌套并排序以模拟因果关系。

1.3.4.1. 分布式追踪概述

作为服务所有者,您可以使用分布式追踪来检测您的服务,以收集与服务架构相关的信息。您可以使用 Red Hat OpenShift distributed Tracing Platform 来监控、网络性能分析,并对现代、云原生的基于微服务的应用程序中组件之间的交互进行故障排除。

使用分布式跟踪平台,您可以执行以下功能:

- 监控分布式事务

- 优化性能和延迟时间

- 执行根原因分析

Red Hat OpenShift distributed Tracing Platform 由几个组件组成,它们一起收集、存储和显示追踪数据。

Red Hat OpenShift distributed Tracing Platform - 此组件基于开源 Grafana Tempo 项目。