第 6 章 容器化 Ceph 守护进程的共存

本节描述:

6.1. colocation 如何工作及其优点

您可以在同一个节点上并置容器化 Ceph 守护进程。以下是合并某些 Ceph 服务的优点:

- 规模小,产品总购置成本(TCO)显著改进。

- 对于最低配置,从六个节点减少到三。

- 简化升级.

- 更好的资源隔离。

请参阅知识库文章 Red Hat Ceph Storage: 支持的配置 以了解更多有关在 Red Hat Ceph Storage 集群中并置守护进程的信息。

Colocation 工作方式

您可以将以下列表中的一个守护进程与 OSD 守护进程 (ceph-osd) 并置,方法是将同一节点添加到 Ansible 清单文件中的相应部分中。

-

Ceph 元数据服务器 (

ceph-mds) -

Ceph monitor (

ceph-mon) 和 Ceph 管理器 (ceph-mgr) 守护进程 -

NFS Ganesha (

nfs-ganesha) -

RBD 镜像(

rbd-mirror) -

iSCSI 网关(

iscsigw)

从红帽 Ceph 存储 4.2 开始,元数据服务器(MDS)可以和一个额外的扩展守护进程在一起。

此外,对于 Ceph 对象网关(comma)或 Grafana,您可以将 OSD 守护进程与上述列表中的守护进程共存,不包括 RBD mirror.z,例如,以下是有效的五个节点共存配置:

| 节点 | Daemon | Daemon | Daemon |

|---|---|---|---|

| node1 | OSD | Monitor | Grafana |

| node2 | OSD | Monitor | RADOS Gateway |

| node3 | OSD | Monitor | RADOS Gateway |

| node4 | OSD | Metadata Server | |

| node5 | OSD | Metadata Server |

如上述设置一样部署一个五个节点集群,请配置 Ansible 清单文件,如下所示:

带有并置守护进程的 Ansible 清单文件

[grafana-server] node1 [mons] node[1:3] [mgrs] node[1:3] [osds] node[1:5] [rgws] node[2:3] [mdss] node[4:5]

因为 ceph-mon 和 ceph-mgr 可以一起工作,所以不能把两个独立的守护进程计数为两个独立的守护进程。

基于 Cockpit 的安装不支持 Colocating Grafana。使用 ceph-ansible 配置存储集群。

红帽建议将 Ceph 对象网关与 OSD 容器共存以提高性能。要在不增加成本的情况下获得最高性能,请在 group_vars/all.yml 中设置 radosgw_num_instances: 2 来使用两个网关。如需更多信息,请参阅 Red Hat Ceph Storage RGW 部署策略和大小调整指导。

需要适当的 CPU 和网络资源才能将 Grafana 与另外两个容器并置在一起。如果发生资源耗尽,只将 Grafana 与 monitor 共存,如果仍然发生资源耗尽,请在专用节点上运行 Grafana。

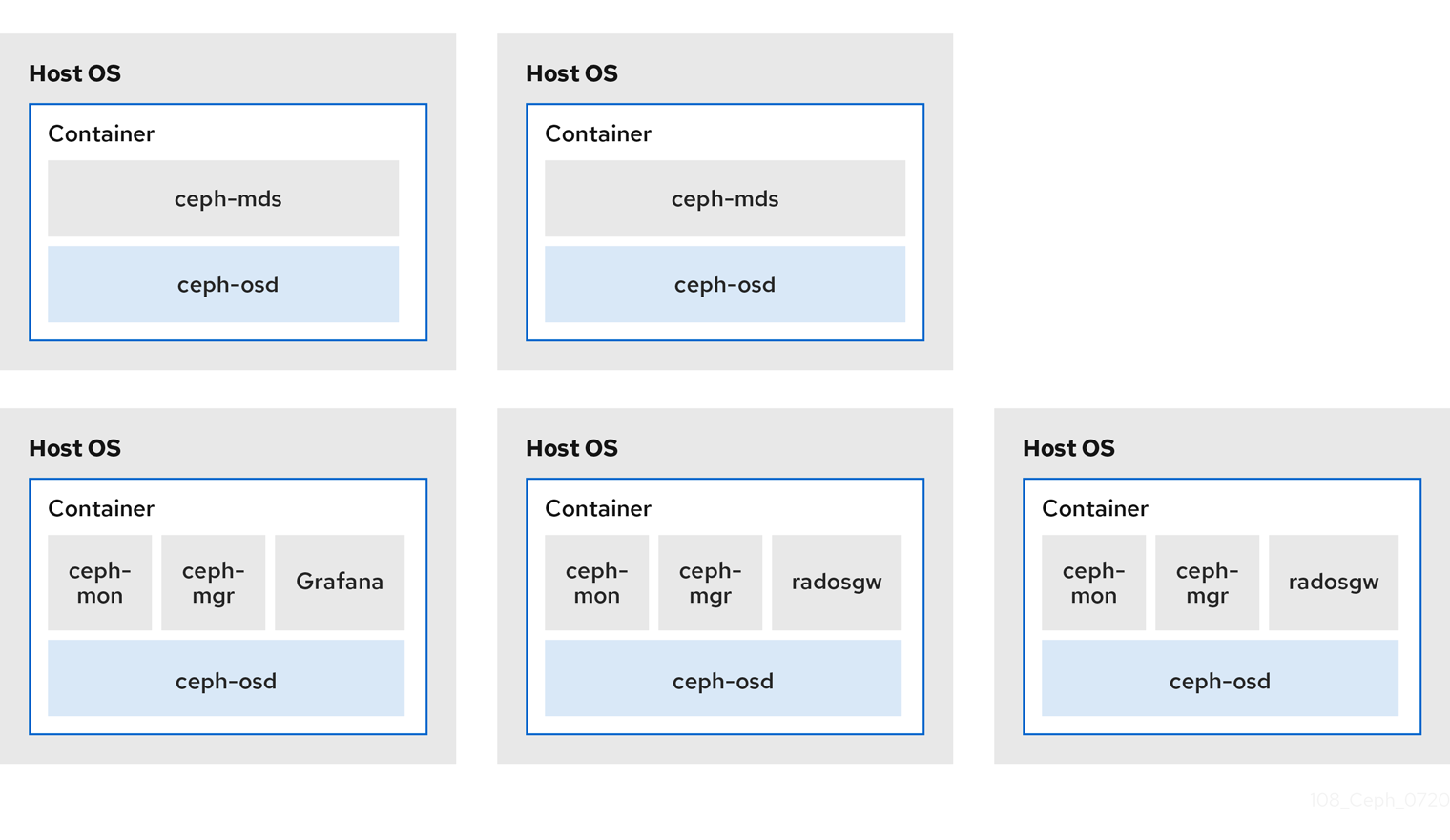

图 6.1 “colocated Daemons” 和 图 6.2 “非并置守护进程” 镜像显示具有 colocated 和非并置守护进程的集群之间的区别。

图 6.1. colocated Daemons

图 6.2. 非并置守护进程

当您在同一节点上并置多个容器化 Ceph 守护进程时,ceph-ansible playbook 会为每个节点保留专用的 CPU 和 RAM 资源。默认情况下,ceph-ansible 使用 Red Hat Ceph Storage 硬件指南中推荐的最小硬件章节中列出的值。要了解如何更改默认值,请参阅 Colocated Daemons 的 Setting Dedicated Resources 部分。