이 콘텐츠는 선택한 언어로 제공되지 않습니다.

Monitoring

Monitoring projects in OpenShift Dedicated

Abstract

Chapter 1. About monitoring

1.1. About OpenShift Dedicated monitoring

In OpenShift Dedicated, you can monitor your own projects in isolation from Red Hat Site Reliability Engineering (SRE) platform metrics. You can monitor your own projects without the need for an additional monitoring solution.

The OpenShift Dedicated monitoring stack is based on the Prometheus open source project and its wider ecosystem.

1.2. Monitoring stack architecture

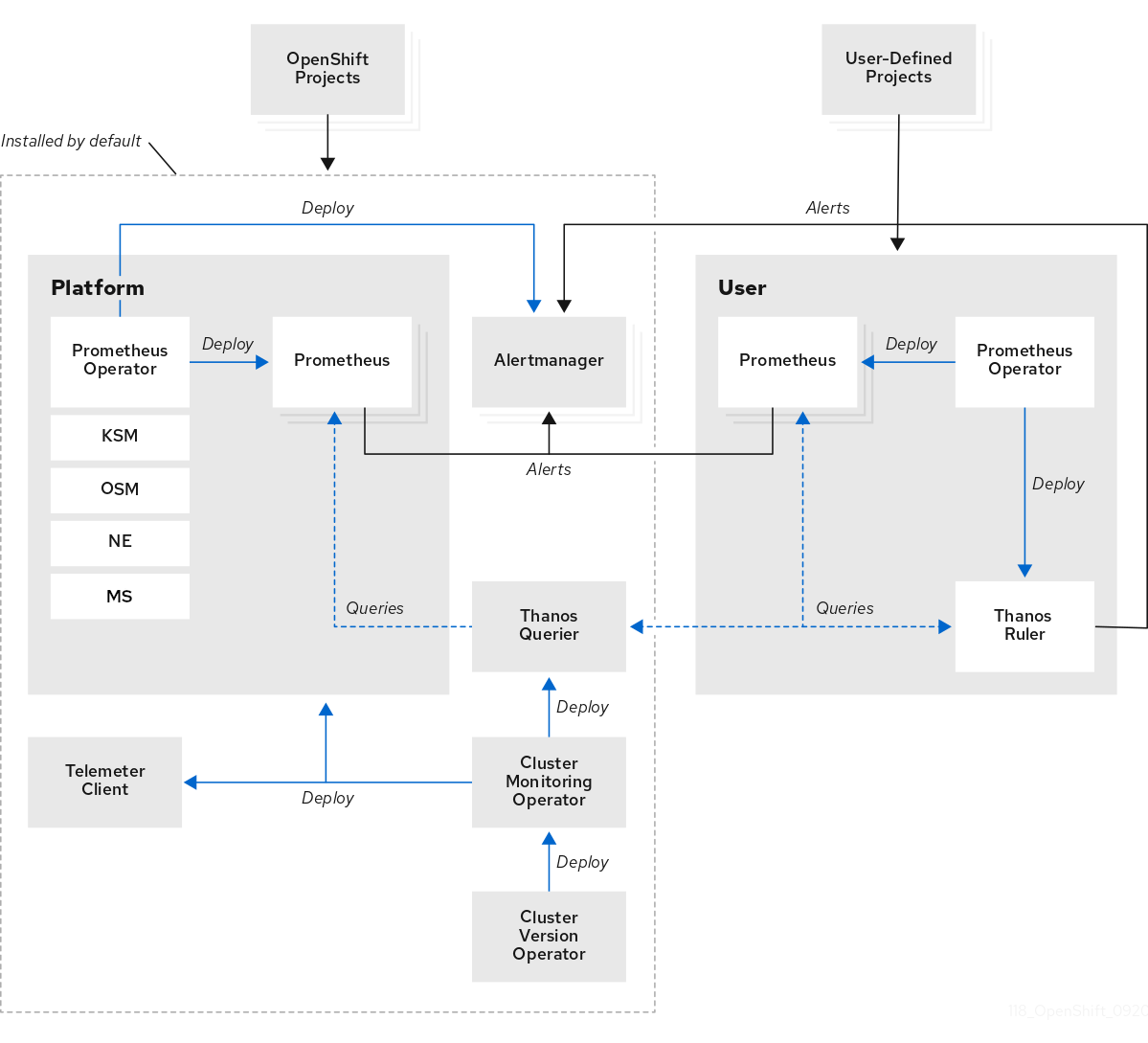

You can learn about the monitoring stack architecture, which includes default monitoring components and components for monitoring user-defined projects.

1.2.1. Understanding the monitoring stack

The monitoring stack includes the following components:

- Default platform monitoring components

A set of platform monitoring components are installed in the

openshift-monitoringproject by default during a OpenShift Dedicated installation. Red Hat Site Reliability Engineers (SRE) use these components to monitor core cluster components including Kubernetes services. This includes critical metrics, such as CPU and memory, collected from all of the workloads in every namespace.You can see these components in the Installed by default section in the following diagram.

- Components for monitoring user-defined projects

A set of user-defined project monitoring components are installed in the

openshift-user-workload-monitoringproject by default during a OpenShift Dedicated installation. You can use these components to monitor services and pods in user-defined projects.You can see these components in the User section in the following diagram.

1.2.1.1. Default monitoring targets

The following are examples of targets monitored by Red Hat Site Reliability Engineers (SRE) in your OpenShift Dedicated cluster:

- CoreDNS

- etcd

- HAProxy

- Image registry

- Kubelets

- Kubernetes API server

- Kubernetes controller manager

- Kubernetes scheduler

- OpenShift API server

- OpenShift Controller Manager

- Operator Lifecycle Manager (OLM)

The exact list of targets can vary depending on your cluster capabilities and installed components.

1.2.2. Components for monitoring user-defined projects

OpenShift Dedicated includes an optional enhancement to the monitoring stack that helps you monitor services and pods in user-defined projects. This feature includes the following components:

| Component | Description |

|---|---|

| Prometheus Operator |

The Prometheus Operator in the |

| Prometheus | Prometheus is the monitoring system that provides monitoring for user-defined projects. Prometheus sends alerts to Alertmanager for processing. |

| Thanos Ruler | The Thanos Ruler is a rule evaluation engine for Prometheus that is deployed as a separate process. In OpenShift Dedicated , Thanos Ruler provides rule and alerting evaluation for the monitoring of user-defined projects. |

| Alertmanager | The Alertmanager service handles alerts received from Prometheus and Thanos Ruler. Alertmanager is also responsible for sending user-defined alerts to external notification systems. Deploying this service is optional. |

The monitoring stack monitors all components for user-defined projects. The components are automatically updated when OpenShift Dedicated is updated.

1.2.2.1. Monitoring targets for user-defined projects

Monitoring is enabled by default for OpenShift Dedicated user-defined projects. You can monitor:

- Metrics provided through service endpoints in user-defined projects.

- Pods running in user-defined projects.

1.2.3. The monitoring stack in high-availability clusters

By default, in multi-node clusters, the following components run in high-availability (HA) mode to prevent data loss and service interruption:

- Prometheus

- Alertmanager

- Thanos Ruler

The component is replicated across two pods, each running on a separate node. This means that the monitoring stack can tolerate the loss of one pod.

- Prometheus in HA mode

- Both replicas independently scrape the same targets and evaluate the same rules.

- The replicas do not communicate with each other. Therefore, data might differ between the pods.

- Alertmanager in HA mode

- The two replicas synchronize notification and silence states with each other. This ensures that each notification is sent at least once.

- If the replicas fail to communicate or if there is an issue on the receiving side, notifications are still sent, but they might be duplicated.

Prometheus, Alertmanager, and Thanos Ruler are stateful components. To ensure high availability, you must configure them with persistent storage.

1.2.4. TLS security and rotation in the monitoring stack

Learn how TLS profiles and certificate rotation work in the OpenShift Dedicated monitoring stack to keep communication secure.

- TLS security profiles for monitoring components

-

All components of the monitoring stack use the TLS security profile settings that are centrally configured by a cluster administrator. The monitoring stack component uses the TLS security profile settings that already exist in the

tlsSecurityProfilefield in the global OpenShift Dedicatedapiservers.config.openshift.io/clusterresource. - TLS certificate rotation and automatic restarts

The Cluster Monitoring Operator manages the internal TLS certificate lifecycle for the monitoring components. These certificates secure the internal communication between the monitoring components.

During certificate rotation, the CMO updates secrets and config maps, which triggers automatic restarts of affected pods. This is an expected behavior, and the pods recover automatically.

The following example shows events that occur during certificate rotation:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.2.5. Glossary of common terms for OpenShift Dedicated monitoring

This glossary defines common terms that are used in OpenShift Dedicated architecture.

- Alertmanager

- Alertmanager handles alerts received from Prometheus. Alertmanager is also responsible for sending the alerts to external notification systems.

- Alerting rules

- Alerting rules contain a set of conditions that outline a particular state within a cluster. Alerts are triggered when those conditions are true. An alerting rule can be assigned a severity that defines how the alerts are routed.

- Cluster Monitoring Operator

- The Cluster Monitoring Operator (CMO) is a central component of the monitoring stack. It deploys and manages Prometheus instances such as, the Thanos Querier, the Telemeter Client, and metrics targets to ensure that they are up to date. The CMO is deployed by the Cluster Version Operator (CVO).

- Cluster Version Operator

- The Cluster Version Operator (CVO) manages the lifecycle of cluster Operators, many of which are installed in OpenShift Dedicated by default.

- config map

-

A config map provides a way to inject configuration data into pods. You can reference the data stored in a config map in a volume of type

ConfigMap. Applications running in a pod can use this data. - Container

- A container is a lightweight and executable image that includes software and all its dependencies. Containers virtualize the operating system. As a result, you can run containers anywhere from a data center to a public or private cloud as well as a developer’s laptop.

- custom resource (CR)

- A CR is an extension of the Kubernetes API. You can create custom resources.

- etcd

- etcd is the key-value store for OpenShift Dedicated, which stores the state of all resource objects.

- Kubelets

- Runs on nodes and reads the container manifests. Ensures that the defined containers have started and are running.

- Kubernetes API server

- Kubernetes API server validates and configures data for the API objects.

- Kubernetes controller manager

- Kubernetes controller manager governs the state of the cluster.

- Kubernetes scheduler

- Kubernetes scheduler allocates pods to nodes.

- labels

- Labels are key-value pairs that you can use to organize and select subsets of objects such as a pod.

- Metrics Server

-

The Metrics Server monitoring component collects resource metrics and exposes them in the

metrics.k8s.ioMetrics API service for use by other tools and APIs, which frees the core platform Prometheus stack from handling this functionality. - node

- A compute machine in the OpenShift Dedicated cluster. A node is either a virtual machine (VM) or a physical machine.

- Operator

- The preferred method of packaging, deploying, and managing a Kubernetes application in your OpenShift Dedicated cluster. An Operator takes human operational knowledge and encodes it into software that is packaged and shared with customers.

- Operator Lifecycle Manager (OLM)

- OLM helps you install, update, and manage the lifecycle of Kubernetes native applications. OLM is an open source toolkit designed to manage Operators in an effective, automated, and scalable way.

- Persistent storage

- Stores the data even after the device is shut down. Kubernetes uses persistent volumes to store the application data.

- Persistent volume claim (PVC)

- You can use a PVC to mount a PersistentVolume into a Pod. You can access the storage without knowing the details of the cloud environment.

- pod

- The pod is the smallest logical unit in Kubernetes. A pod is comprised of one or more containers to run in a worker node.

- Prometheus

- Prometheus is the monitoring system on which the OpenShift Dedicated monitoring stack is based. Prometheus is a time-series database and a rule evaluation engine for metrics. Prometheus sends alerts to Alertmanager for processing.

- Prometheus Operator

-

The Prometheus Operator in the

openshift-monitoringproject creates, configures, and manages platform Prometheus and Alertmanager instances. It also automatically generates monitoring target configurations based on Kubernetes label queries. - Silences

- A silence can be applied to an alert to prevent notifications from being sent when the conditions for an alert are true. You can mute an alert after the initial notification, while you work on resolving the underlying issue.

- storage

- OpenShift Dedicated supports many types of storage on AWS and Google Cloud. You can manage container storage for persistent and non-persistent data in your OpenShift Dedicated cluster.

- Thanos Ruler

- The Thanos Ruler is a rule evaluation engine for Prometheus that is deployed as a separate process. In OpenShift Dedicated, Thanos Ruler provides rule and alerting evaluation for the monitoring of user-defined projects.

- Vector

- Vector is a log collector that deploys to each OpenShift Dedicated node. It collects log data from each node, transforms the data, and forwards it to configured outputs.

- web console

- A user interface (UI) to manage OpenShift Dedicated.

1.3. Understanding the monitoring stack - key concepts

Get familiar with the OpenShift Dedicated monitoring concepts and terms. Learn about how you can improve performance and scale of your cluster, store and record data, manage metrics and alerts, and more.

1.3.1. About performance and scalability

You can optimize the performance and scale of your clusters. You can configure the monitoring stack by performing any of the following actions:

Control the placement and distribution of monitoring components:

- Use node selectors to move components to specific nodes.

- Assign tolerations to enable moving components to tainted nodes.

- Use pod topology spread constraints.

- Manage CPU and memory resources.

1.3.1.1. Using node selectors to move monitoring components

By using the nodeSelector constraint with labeled nodes, you can move any of the monitoring stack components to specific nodes. By doing so, you can control the placement and distribution of the monitoring components across a cluster.

By controlling placement and distribution of monitoring components, you can optimize system resource use, improve performance, and separate workloads based on specific requirements or policies.

How node selectors work with other constraints

If you move monitoring components by using node selector constraints, be aware that other constraints to control pod scheduling might exist for a cluster:

- Topology spread constraints might be in place to control pod placement.

- Hard anti-affinity rules are in place for Prometheus, Alertmanager, and other monitoring components to ensure that multiple pods for these components are always spread across different nodes and are therefore always highly available.

When scheduling pods onto nodes, the pod scheduler tries to satisfy all existing constraints when determining pod placement. That is, all constraints compound when the pod scheduler determines which pods will be placed on which nodes.

Therefore, if you configure a node selector constraint but existing constraints cannot all be satisfied, the pod scheduler cannot match all constraints and will not schedule a pod for placement onto a node.

To maintain resilience and high availability for monitoring components, ensure that enough nodes are available and match all constraints when you configure a node selector constraint to move a component.

1.3.1.2. About pod topology spread constraints for monitoring

You can use pod topology spread constraints to control how the monitoring pods are spread across a network topology when OpenShift Dedicated pods are deployed in multiple availability zones.

Pod topology spread constraints are suitable for controlling pod scheduling within hierarchical topologies in which nodes are spread across different infrastructure levels, such as regions and zones within those regions. Additionally, by being able to schedule pods in different zones, you can improve network latency in certain scenarios.

You can configure pod topology spread constraints for all the pods deployed by the Cluster Monitoring Operator to control how pod replicas are scheduled to nodes across zones. This ensures that the pods are highly available and run more efficiently, because workloads are spread across nodes in different data centers or hierarchical infrastructure zones.

1.3.1.3. About specifying limits and requests for monitoring components

You can configure resource limits and requests for the following components that monitor user-defined projects:

- Alertmanager

- Prometheus

- Thanos Ruler

By defining the resource limits, you limit a container’s resource usage, which prevents the container from exceeding the specified maximum values for CPU and memory resources.

By defining the resource requests, you specify that a container can be scheduled only on a node that has enough CPU and memory resources available to match the requested resources.

1.3.2. About storing and recording data

You can store and record data to help you protect the data and use them for troubleshooting. You can configure the monitoring stack by performing any of the following actions:

Configure persistent storage:

- Protect your metrics and alerting data from data loss by storing them in a persistent volume (PV). As a result, they can survive pods being restarted or recreated.

- Avoid getting duplicate notifications and losing silences for alerts when the Alertmanager pods are restarted.

- Modify the retention time and size for Prometheus and Thanos Ruler metrics data.

Configure logging to help you troubleshoot issues with your cluster:

- Set log levels for monitoring.

- Enable the query logging for Prometheus and Thanos Querier.

1.3.2.1. Retention time and size for Prometheus metrics

By default, Prometheus retains metrics data for the following durations:

- Core platform monitoring: 15 days

- Monitoring for user-defined projects: 24 hours

You can modify the retention time for the Prometheus instance to change how soon the data is deleted. You can also set the maximum amount of disk space the retained metrics data uses. If the data reaches this size limit, Prometheus deletes the oldest data first until the disk space used is again below the limit.

Note the following behaviors of these data retention settings:

-

The size-based retention policy applies to all data block directories in the

/prometheusdirectory, including persistent blocks, write-ahead log (WAL) data, and m-mapped chunks. -

Data in the

/waland/head_chunksdirectories counts toward the retention size limit, but Prometheus never purges data from these directories based on size- or time-based retention policies. Thus, if you set a retention size limit lower than the maximum size set for the/waland/head_chunksdirectories, you have configured the system not to retain any data blocks in the/prometheusdata directories. - The size-based retention policy is applied only when Prometheus cuts a new data block, which occurs every two hours after the WAL contains at least three hours of data.

-

If you do not explicitly define values for either

retentionorretentionSize, retention time defaults to 15 days for core platform monitoring and 24 hours for user-defined project monitoring. Retention size is not set. -

If you define values for both

retentionandretentionSize, both values apply. If any data blocks exceed the defined retention time or the defined size limit, Prometheus purges these data blocks. -

If you define a value for

retentionSizeand do not defineretention, only theretentionSizevalue applies. -

If you do not define a value for

retentionSizeand only define a value forretention, only theretentionvalue applies. -

If you set the

retentionSizeorretentionvalue to0, the default settings apply. The default settings set retention time to 15 days for core platform monitoring and 24 hours for user-defined project monitoring. By default, retention size is not set.

Data compaction occurs every two hours. Therefore, a persistent volume (PV) might fill up before compaction, potentially exceeding the retentionSize limit. In such cases, the KubePersistentVolumeFillingUp alert fires until the space on a PV is lower than the retentionSize limit.

1.3.3. Understanding metrics

In OpenShift Dedicated, cluster components are monitored by scraping metrics exposed through service endpoints. You can also configure metrics collection for user-defined projects. Metrics enable you to monitor how cluster components and your own workloads are performing.

You can define the metrics that you want to provide for your own workloads by using Prometheus client libraries at the application level.

In OpenShift Dedicated, metrics are exposed through an HTTP service endpoint under the /metrics canonical name. You can list all available metrics for a service by running a curl query against http://<endpoint>/metrics. For instance, you can expose a route to the prometheus-example-app example application and then run the following to view all of its available metrics:

curl http://<example_app_endpoint>/metrics

$ curl http://<example_app_endpoint>/metricsExample output

1.3.3.1. Controlling the impact of unbound metrics attributes in user-defined projects

Developers can create labels to define attributes for metrics in the form of key-value pairs. The number of potential key-value pairs corresponds to the number of possible values for an attribute. An attribute that has an unlimited number of potential values is called an unbound attribute. For example, a customer_id attribute is unbound because it has an infinite number of possible values.

Every assigned key-value pair has a unique time series. The use of many unbound attributes in labels can result in an exponential increase in the number of time series created. This can impact Prometheus performance and can consume a lot of disk space.

A dedicated-admin can use the following measures to control the impact of unbound metrics attributes in user-defined projects:

- Limit the number of samples that can be accepted per target scrape in user-defined projects

- Limit the number of scraped labels, the length of label names, and the length of label values

- Configure the intervals between consecutive scrapes and between Prometheus rule evaluations

- Create alerts that fire when a scrape sample threshold is reached or when the target cannot be scraped

Limiting scrape samples can help prevent the issues caused by adding many unbound attributes to labels. Developers can also prevent the underlying cause by limiting the number of unbound attributes that they define for metrics. Using attributes that are bound to a limited set of possible values reduces the number of potential key-value pair combinations.

1.3.3.2. Adding cluster ID labels to metrics

If you manage multiple OpenShift Dedicated clusters and use the remote write feature to send metrics data from these clusters to an external storage location, you can add cluster ID labels to identify the metrics data coming from different clusters. You can then query these labels to identify the source cluster for a metric and distinguish that data from similar metrics data sent by other clusters.

This way, if you manage many clusters for multiple customers and send metrics data to a single centralized storage system, you can use cluster ID labels to query metrics for a particular cluster or customer.

Creating and using cluster ID labels involves three general steps:

- Configuring the write relabel settings for remote write storage.

- Adding cluster ID labels to the metrics.

- Querying these labels to identify the source cluster or customer for a metric.

1.3.4. About monitoring dashboards

OpenShift Dedicated provides a set of monitoring dashboards that help you understand the state of cluster components and user-defined workloads.

Starting with OpenShift Dedicated 4.19, the perspectives in the web console have unified. The Developer perspective is no longer enabled by default.

All users can interact with all OpenShift Dedicated web console features. However, if you are not the cluster owner, you might need to request permission to access certain features from the cluster owner.

You can still enable the Developer perspective. On the Getting Started pane in the web console, you can take a tour of the console, find information on setting up your cluster, view a quick start for enabling the Developer perspective, and follow links to explore new features and capabilities.

As an administrator, you can access dashboards for the core OpenShift Dedicated components, including the following items:

- API performance

- etcd

- Kubernetes compute resources

- Kubernetes network resources

- Prometheus

- USE method dashboards relating to cluster and node performance

- Node performance metrics

1.3.5. Managing alerts

In the OpenShift Dedicated, the Alerting UI enables you to manage alerts, silences, and alerting rules.

- Alerting rules. Alerting rules contain a set of conditions that outline a particular state within a cluster. Alerts are triggered when those conditions are true. An alerting rule can be assigned a severity that defines how the alerts are routed.

- Alerts. An alert is fired when the conditions defined in an alerting rule are true. Alerts provide a notification that a set of circumstances are apparent within your OpenShift Dedicated cluster.

- Silences. A silence can be applied to an alert to prevent notifications from being sent when the conditions for an alert are true. You can mute an alert after the initial notification, while you work on resolving the issue.

The alerts, silences, and alerting rules that are available in the Alerting UI relate to the projects that you have access to. For example, if you are logged in as a user with the cluster-admin role, you can access all alerts, silences, and alerting rules.

1.3.5.1. Managing silences

You can create a silence for an alert in the OpenShift Dedicated web console. After you create a silence, you will not receive notifications about an alert when the alert fires.

Creating silences is useful in scenarios where you have received an initial alert notification, and you do not want to receive further notifications during the time in which you resolve the underlying issue causing the alert to fire.

When creating a silence, you must specify whether it becomes active immediately or at a later time. You must also set a duration period after which the silence expires.

After you create silences, you can view, edit, and expire them.

When you create silences, they are replicated across Alertmanager pods. However, if you do not configure persistent storage for Alertmanager, silences might be lost. This can happen, for example, if all Alertmanager pods restart at the same time.

1.3.5.2. Creating alerting rules for user-defined projects

In OpenShift Dedicated, you can create alerting rules for user-defined projects. Those alerting rules will trigger alerts based on the values of the chosen metrics.

If you create alerting rules for a user-defined project, consider the following key behaviors and important limitations when you define the new rules:

A user-defined alerting rule can include metrics exposed by its own project in addition to the default metrics from core platform monitoring. You cannot include metrics from another user-defined project.

For example, an alerting rule for the

ns1user-defined project can use metrics exposed by thens1project in addition to core platform metrics, such as CPU and memory metrics. However, the rule cannot include metrics from a differentns2user-defined project.-

By default, when you create an alerting rule, the

namespacelabel is enforced on it even if a rule with the same name exists in another project. To create alerting rules that are not bound to their project of origin, see "Creating cross-project alerting rules for user-defined projects". To reduce latency and to minimize the load on core platform monitoring components, you can add the

openshift.io/prometheus-rule-evaluation-scope: leaf-prometheuslabel to a rule. This label forces only the Prometheus instance deployed in theopenshift-user-workload-monitoringproject to evaluate the alerting rule and prevents the Thanos Ruler instance from doing so.ImportantIf an alerting rule has this label, your alerting rule can use only those metrics exposed by your user-defined project. Alerting rules you create based on default platform metrics might not trigger alerts.

1.3.5.3. Managing alerting rules for user-defined projects

In OpenShift Dedicated, you can view, edit, and remove alerting rules in user-defined projects.

Managing alerting rules for user-defined projects is only available in OpenShift Dedicated version 4.11 and later.

Alerting rule considerations

- The default alerting rules are used specifically for the OpenShift Dedicated cluster.

- Some alerting rules intentionally have identical names. They send alerts about the same event with different thresholds, different severity, or both.

- Inhibition rules prevent notifications for lower severity alerts that are firing when a higher severity alert is also firing.

1.3.5.4. Optimizing alerting for user-defined projects

You can optimize alerting for your own projects by considering the following recommendations when creating alerting rules:

- Minimize the number of alerting rules that you create for your project. Create alerting rules that notify you of conditions that impact you. It is more difficult to notice relevant alerts if you generate many alerts for conditions that do not impact you.

- Create alerting rules for symptoms instead of causes. Create alerting rules that notify you of conditions regardless of the underlying cause. The cause can then be investigated. You will need many more alerting rules if each relates only to a specific cause. Some causes are then likely to be missed.

- Plan before you write your alerting rules. Determine what symptoms are important to you and what actions you want to take if they occur. Then build an alerting rule for each symptom.

- Provide clear alert messaging. State the symptom and recommended actions in the alert message.

- Include severity levels in your alerting rules. The severity of an alert depends on how you need to react if the reported symptom occurs. For example, a critical alert should be triggered if a symptom requires immediate attention by an individual or a critical response team.

1.3.5.5. Searching and filtering alerts, silences, and alerting rules

You can filter the alerts, silences, and alerting rules that are displayed in the Alerting UI. This section provides a description of each of the available filtering options.

1.3.5.5.1. Understanding alert filters

The Alerts page in the Alerting UI provides details about alerts relating to default OpenShift Dedicated and user-defined projects. The page includes a summary of severity, state, and source for each alert. The time at which an alert went into its current state is also shown.

You can filter by alert state, severity, and source. By default, only Platform alerts that are Firing are displayed. The following describes each alert filtering option:

State filters:

-

Firing. The alert is firing because the alert condition is true and the optional

forduration has passed. The alert continues to fire while the condition remains true. - Pending. The alert is active but is waiting for the duration that is specified in the alerting rule before it fires.

- Silenced. The alert is now silenced for a defined time period. Silences temporarily mute alerts based on a set of label selectors that you define. Notifications are not sent for alerts that match all the listed values or regular expressions.

-

Firing. The alert is firing because the alert condition is true and the optional

Severity filters:

- Critical. The condition that triggered the alert could have a critical impact. The alert requires immediate attention when fired and is typically paged to an individual or to a critical response team.

- Warning. The alert provides a warning notification about something that might require attention to prevent a problem from occurring. Warnings are typically routed to a ticketing system for non-immediate review.

- Info. The alert is provided for informational purposes only.

- None. The alert has no defined severity.

- You can also create custom severity definitions for alerts relating to user-defined projects.

Source filters:

- Platform. Platform-level alerts relate only to default OpenShift Dedicated projects. These projects provide core OpenShift Dedicated functionality.

- User. User alerts relate to user-defined projects. These alerts are user-created and are customizable. User-defined workload monitoring can be enabled postinstallation to provide observability into your own workloads.

1.3.5.5.2. Understanding silence filters

The Silences page in the Alerting UI provides details about silences applied to alerts in default OpenShift Dedicated and user-defined projects. The page includes a summary of the state of each silence and the time at which a silence ends.

You can filter by silence state. By default, only Active and Pending silences are displayed. The following describes each silence state filter option:

State filters:

- Active. The silence is active and the alert will be muted until the silence is expired.

- Pending. The silence has been scheduled and it is not yet active.

- Expired. The silence has expired and notifications will be sent if the conditions for an alert are true.

1.3.5.5.3. Understanding alerting rule filters

The Alerting rules page in the Alerting UI provides details about alerting rules relating to default OpenShift Dedicated and user-defined projects. The page includes a summary of the state, severity, and source for each alerting rule.

You can filter alerting rules by alert state, severity, and source. By default, only Platform alerting rules are displayed. The following describes each alerting rule filtering option:

Alert state filters:

-

Firing. The alert is firing because the alert condition is true and the optional

forduration has passed. The alert continues to fire while the condition remains true. - Pending. The alert is active but is waiting for the duration that is specified in the alerting rule before it fires.

- Silenced. The alert is now silenced for a defined time period. Silences temporarily mute alerts based on a set of label selectors that you define. Notifications are not sent for alerts that match all the listed values or regular expressions.

- Not Firing. The alert is not firing.

-

Firing. The alert is firing because the alert condition is true and the optional

Severity filters:

- Critical. The conditions defined in the alerting rule could have a critical impact. When true, these conditions require immediate attention. Alerts relating to the rule are typically paged to an individual or to a critical response team.

- Warning. The conditions defined in the alerting rule might require attention to prevent a problem from occurring. Alerts relating to the rule are typically routed to a ticketing system for non-immediate review.

- Info. The alerting rule provides informational alerts only.

- None. The alerting rule has no defined severity.

- You can also create custom severity definitions for alerting rules relating to user-defined projects.

Source filters:

- Platform. Platform-level alerting rules relate only to default OpenShift Dedicated projects. These projects provide core OpenShift Dedicated functionality.

- User. User-defined workload alerting rules relate to user-defined projects. These alerting rules are user-created and are customizable. User-defined workload monitoring can be enabled postinstallation to provide observability into your own workloads.

1.3.6. Understanding alert routing for user-defined projects

As a dedicated-admin, you can enable alert routing for user-defined projects. With this feature, you can allow users with the alert-routing-edit cluster role to configure alert notification routing and receivers for user-defined projects. These notifications are routed by an Alertmanager instance dedicated to user-defined monitoring.

Users can then create and configure user-defined alert routing by creating or editing the AlertmanagerConfig objects for their user-defined projects without the help of an administrator.

After a user has defined alert routing for a user-defined project, user-defined alert notifications are routed to the alertmanager-user-workload pods in the openshift-user-workload-monitoring namespace.

Review the following limitations of alert routing for user-defined projects:

-

For user-defined alerting rules, user-defined routing is scoped to the namespace in which the resource is defined. For example, a routing configuration in namespace

ns1only applies toPrometheusRulesresources in the same namespace. -

When a namespace is excluded from user-defined monitoring,

AlertmanagerConfigresources in the namespace cease to be part of the Alertmanager configuration.

1.3.7. Sending notifications to external systems

In OpenShift Dedicated , firing alerts can be viewed in the Alerting UI. Alerts are not configured by default to be sent to any notification systems. You can configure OpenShift Dedicated to send alerts to the following receiver types:

- PagerDuty

- Webhook

- Slack

- Microsoft Teams

Routing alerts to receivers enables you to send timely notifications to the appropriate teams when failures occur. For example, critical alerts require immediate attention and are typically paged to an individual or a critical response team. Alerts that provide non-critical warning notifications might instead be routed to a ticketing system for non-immediate review.

Checking that alerting is operational by using the watchdog alert

OpenShift Dedicated monitoring includes a watchdog alert that fires continuously. Alertmanager repeatedly sends watchdog alert notifications to configured notification providers. The provider is usually configured to notify an administrator when it stops receiving the watchdog alert. This mechanism helps you quickly identify any communication issues between Alertmanager and the notification provider.

Chapter 2. Getting started

2.1. Maintenance and support for monitoring

Not all configuration options for the monitoring stack are exposed. The only supported way of configuring OpenShift Dedicated monitoring is by configuring the Cluster Monitoring Operator (CMO) using the options described in the Config map reference for the Cluster Monitoring Operator. Do not use other configurations, as they are unsupported.

Configuration paradigms might change across Prometheus releases, and such cases can only be handled gracefully if all configuration possibilities are controlled. If you use configurations other than those described in the Config map reference for the Cluster Monitoring Operator, your changes will disappear because the CMO automatically reconciles any differences and resets any unsupported changes back to the originally defined state by default and by design.

Installing another Prometheus instance is not supported by the Red Hat Site Reliability Engineers (SRE).

2.1.1. Support considerations for monitoring

Backward compatibility for metrics, recording rules, or alerting rules is not guaranteed.

The following modifications are explicitly not supported:

- Installing custom Prometheus instances on OpenShift Dedicated. A custom instance is a Prometheus custom resource (CR) managed by the Prometheus Operator.

-

Modifying the default platform monitoring components. You should not modify any of the components defined in the

cluster-monitoring-configconfig map. Red Hat SRE uses these components to monitor the core cluster components and Kubernetes services.

2.1.2. Support version matrix for monitoring components

The following matrix contains information about versions of monitoring components for OpenShift Dedicated 4.12 and later releases:

| OpenShift Dedicated | Prometheus Operator | Prometheus | Metrics Server | Alertmanager | kube-state-metrics agent | monitoring-plugin | node-exporter agent | Thanos |

|---|---|---|---|---|---|---|---|---|

| 4.20 | 0.85.0 | 3.5.0 | 0.8.0 | 0.28.1 | 2.16.0 | 1.0.0 | 1.9.1 | 0.39.2 |

| 4.19 | 0.81.0 | 3.2.1 | 0.7.2 | 0.28.1 | 2.15.0 | 1.0.0 | 1.9.1 | 0.37.2 |

| 4.18 | 0.78.1 | 2.55.1 | 0.7.2 | 0.27.0 | 2.13.0 | 1.0.0 | 1.8.2 | 0.36.1 |

| 4.17 | 0.75.2 | 2.53.1 | 0.7.1 | 0.27.0 | 2.13.0 | 1.0.0 | 1.8.2 | 0.35.1 |

| 4.16 | 0.73.2 | 2.52.0 | 0.7.1 | 0.26.0 | 2.12.0 | 1.0.0 | 1.8.0 | 0.35.0 |

| 4.15 | 0.70.0 | 2.48.0 | 0.6.4 | 0.26.0 | 2.10.1 | 1.0.0 | 1.7.0 | 0.32.5 |

| 4.14 | 0.67.1 | 2.46.0 | N/A | 0.25.0 | 2.9.2 | 1.0.0 | 1.6.1 | 0.30.2 |

| 4.13 | 0.63.0 | 2.42.0 | N/A | 0.25.0 | 2.8.1 | N/A | 1.5.0 | 0.30.2 |

| 4.12 | 0.60.1 | 2.39.1 | N/A | 0.24.0 | 2.6.0 | N/A | 1.4.0 | 0.28.1 |

The openshift-state-metrics agent and Telemeter Client are OpenShift-specific components. Therefore, their versions correspond with the versions of OpenShift Dedicated.

2.2. Accessing monitoring for user-defined projects

When you install a OpenShift Dedicated cluster, monitoring for user-defined projects is enabled by default. With monitoring for user-defined projects enabled, you can monitor your own OpenShift Dedicated projects without the need for an additional monitoring solution.

The dedicated-admin user has default permissions to configure and access monitoring for user-defined projects.

Custom Prometheus instances and the Prometheus Operator installed through Operator Lifecycle Manager (OLM) can cause issues with user-defined project monitoring if it is enabled. Custom Prometheus instances are not supported.

Optionally, you can disable monitoring for user-defined projects during or after a cluster installation.

2.3. Disabling monitoring for user-defined projects

As a dedicated-admin, you can disable monitoring for user-defined projects. You can also exclude individual projects from user workload monitoring.

2.3.1. Disabling monitoring for user-defined projects

By default, monitoring for user-defined projects is enabled. If you do not want to use the built-in monitoring stack to monitor user-defined projects, you can disable it.

Prerequisites

- You logged in to OpenShift Cluster Manager.

Procedure

- From the OpenShift Cluster Manager Hybrid Cloud Console, select a cluster.

- Click the Settings tab.

Click the Enable user workload monitoring check box to unselect the option, and then click Save.

User workload monitoring is disabled. The Prometheus, Prometheus Operator, and Thanos Ruler components are stopped in the

openshift-user-workload-monitoringproject.

2.3.2. Excluding a user-defined project from monitoring

Individual user-defined projects can be excluded from user workload monitoring. To do so, add the openshift.io/user-monitoring label to the project’s namespace with a value of false.

Procedure

Add the label to the project namespace:

oc label namespace my-project 'openshift.io/user-monitoring=false'

$ oc label namespace my-project 'openshift.io/user-monitoring=false'Copy to Clipboard Copied! Toggle word wrap Toggle overflow To re-enable monitoring, remove the label from the namespace:

oc label namespace my-project 'openshift.io/user-monitoring-'

$ oc label namespace my-project 'openshift.io/user-monitoring-'Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteIf there were any active monitoring targets for the project, it may take a few minutes for Prometheus to stop scraping them after adding the label.

Chapter 3. Configuring user workload monitoring

3.1. Preparing to configure the user workload monitoring stack

This section explains which user-defined monitoring components can be configured and how to prepare for configuring the user workload monitoring stack.

- Not all configuration parameters for the monitoring stack are exposed. Only the parameters and fields listed in the Config map reference for the Cluster Monitoring Operator are supported for configuration.

3.1.1. Configurable monitoring components

This table shows the monitoring components you can configure and the keys used to specify the components in the user-workload-monitoring-config config map.

Do not modify the monitoring components in the cluster-monitoring-config ConfigMap object. Red Hat Site Reliability Engineers (SRE) use these components to monitor the core cluster components and Kubernetes services.

| Component | user-workload-monitoring-config config map key |

|---|---|

| Prometheus Operator |

|

| Prometheus |

|

| Alertmanager |

|

| Thanos Ruler |

|

3.1.2. Enabling alert routing for user-defined projects

In OpenShift Dedicated, an administrator can enable alert routing for user-defined projects. This process consists of the following steps:

- Enable alert routing for user-defined projects to use a separate Alertmanager instance.

- Grant users permission to configure alert routing for user-defined projects.

After you complete these steps, developers and other users can configure custom alerts and alert routing for their user-defined projects.

3.1.2.1. Enabling a separate Alertmanager instance for user-defined alert routing

In OpenShift Dedicated, you may want to deploy a dedicated Alertmanager instance for user-defined projects, which provides user-defined alerts separate from default platform alerts. In these cases, you can optionally enable a separate instance of Alertmanager to send alerts for user-defined projects only.

Prerequisites

-

You have access to the cluster as a user with the

dedicated-adminrole. -

The

user-workload-monitoring-configConfigMapobject exists. This object is created by default when the cluster is created. -

You have installed the OpenShift CLI (

oc).

Procedure

Edit the

user-workload-monitoring-configConfigMapobject:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Add

enabled: trueandenableAlertmanagerConfig: truein thealertmanagersection underdata/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Set the

enabledvalue totrueto enable a dedicated instance of the Alertmanager for user-defined projects in a cluster. Set the value tofalseor omit the key entirely to disable the Alertmanager for user-defined projects. If you set this value tofalseor if the key is omitted, user-defined alerts are routed to the default platform Alertmanager instance. - 2

- Set the

enableAlertmanagerConfigvalue totrueto enable users to define their own alert routing configurations withAlertmanagerConfigobjects.

- Save the file to apply the changes. The dedicated instance of Alertmanager for user-defined projects starts automatically.

Verification

Verify that the

alert-manager-user-workloadpods are running:oc -n openshift-user-workload-monitoring get pods

$ oc -n openshift-user-workload-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Example output

NAME READY STATUS RESTARTS AGE alertmanager-user-workload-0 6/6 Running 0 38s alertmanager-user-workload-1 6/6 Running 0 38s ...

NAME READY STATUS RESTARTS AGE alertmanager-user-workload-0 6/6 Running 0 38s alertmanager-user-workload-1 6/6 Running 0 38s ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.1.2.2. Granting users permission to configure alert routing for user-defined projects

You can grant users permission to configure alert routing for user-defined projects.

Prerequisites

-

You have access to the cluster as a user with the

dedicated-adminrole. -

The

user-workload-monitoring-configConfigMapobject exists. This object is created by default when the cluster is created. - The user account that you are assigning the role to already exists.

-

You have installed the OpenShift CLI (

oc).

Procedure

Assign the

alert-routing-editcluster role to a user in the user-defined project:oc -n <namespace> adm policy add-role-to-user alert-routing-edit <user>

$ oc -n <namespace> adm policy add-role-to-user alert-routing-edit <user>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- For

<namespace>, substitute the namespace for the user-defined project, such asns1. For<user>, substitute the username for the account to which you want to assign the role.

3.2. Configuring performance and scalability for user workload monitoring

You can configure the monitoring stack to optimize the performance and scale of your clusters. The following documentation provides information about how to distribute the monitoring components and control the impact of the monitoring stack on CPU and memory resources.

3.2.1. Controlling the placement and distribution of monitoring components

You can move the monitoring stack components to specific nodes:

-

Use the

nodeSelectorconstraint with labeled nodes to move any of the monitoring stack components to specific nodes. - Assign tolerations to enable moving components to tainted nodes.

By doing so, you control the placement and distribution of the monitoring components across a cluster.

By controlling placement and distribution of monitoring components, you can optimize system resource use, improve performance, and separate workloads based on specific requirements or policies.

3.2.1.1. Moving monitoring components to different nodes

You can move any of the components that monitor workloads for user-defined projects to specific worker nodes.

It is not permitted to move components to control plane or infrastructure nodes.

Prerequisites

-

You have access to the cluster as a user with the

dedicated-adminrole. -

The

user-workload-monitoring-configConfigMapobject exists. This object is created by default when the cluster is created. -

You have installed the OpenShift CLI (

oc).

Procedure

If you have not done so yet, add a label to the nodes on which you want to run the monitoring components:

oc label nodes <node_name> <node_label>

$ oc label nodes <node_name> <node_label>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Replace

<node_name>with the name of the node where you want to add the label. Replace<node_label>with the name of the wanted label.

Edit the

user-workload-monitoring-configConfigMapobject in theopenshift-user-workload-monitoringproject:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Specify the node labels for the

nodeSelectorconstraint for the component underdata/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Substitute

<component>with the appropriate monitoring stack component name. - 2

- Substitute

<node_label_1>with the label you added to the node. - 3

- Optional: Specify additional labels. If you specify additional labels, the pods for the component are only scheduled on the nodes that contain all of the specified labels.

NoteIf monitoring components remain in a

Pendingstate after configuring thenodeSelectorconstraint, check the pod events for errors relating to taints and tolerations.- Save the file to apply the changes. The components specified in the new configuration are automatically moved to the new nodes, and the pods affected by the new configuration are redeployed.

3.2.1.2. Assigning tolerations to monitoring components

You can assign tolerations to the components that monitor user-defined projects, to enable moving them to tainted worker nodes. Scheduling is not permitted on control plane or infrastructure nodes.

Prerequisites

-

You have access to the cluster as a user with the

dedicated-adminrole. -

The

user-workload-monitoring-configConfigMapobject exists in theopenshift-user-workload-monitoringnamespace. This object is created by default when the cluster is created. -

You have installed the OpenShift CLI (

oc).

Procedure

Edit the

user-workload-monitoring-configconfig map in theopenshift-user-workload-monitoringproject:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Specify

tolerationsfor the component:Copy to Clipboard Copied! Toggle word wrap Toggle overflow Substitute

<component>and<toleration_specification>accordingly.For example,

oc adm taint nodes node1 key1=value1:NoScheduleadds a taint tonode1with the keykey1and the valuevalue1. This prevents monitoring components from deploying pods onnode1unless a toleration is configured for that taint. The following example configures thethanosRulercomponent to tolerate the example taint:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Save the file to apply the changes. The pods affected by the new configuration are automatically redeployed.

3.2.2. Managing CPU and memory resources for monitoring components

You can ensure that the containers that run monitoring components have enough CPU and memory resources by specifying values for resource limits and requests for those components.

You can configure these limits and requests for monitoring components that monitor user-defined projects in the openshift-user-workload-monitoring namespace.

3.2.2.1. Specifying limits and requests

To configure CPU and memory resources, specify values for resource limits and requests in the user-workload-monitoring-config ConfigMap object in the openshift-user-workload-monitoring namespace.

Prerequisites

-

You have access to the cluster as a user with the

cluster-admincluster role, or as a user with theuser-workload-monitoring-config-editrole in theopenshift-user-workload-monitoringproject. -

You have installed the OpenShift CLI (

oc).

Procedure

Edit the

user-workload-monitoring-configconfig map in theopenshift-user-workload-monitoringproject:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Add values to define resource limits and requests for each component you want to configure.

ImportantEnsure that the value set for a limit is always higher than the value set for a request. Otherwise, an error will occur, and the container will not run.

Example of setting resource limits and requests

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Save the file to apply the changes. The pods affected by the new configuration are automatically redeployed.

3.2.3. Controlling the impact of unbound metrics attributes in user-defined projects

A dedicated-admin can use the following measures to control the impact of unbound metrics attributes in user-defined projects:

- Limit the number of samples that can be accepted per target scrape in user-defined projects

- Limit the number of scraped labels, the length of label names, and the length of label values

- Configure the intervals between consecutive scrapes and between Prometheus rule evaluations

Limiting scrape samples can help prevent the issues caused by adding many unbound attributes to labels. Developers can also prevent the underlying cause by limiting the number of unbound attributes that they define for metrics. Using attributes that are bound to a limited set of possible values reduces the number of potential key-value pair combinations.

You can set the following scrape and label limits for user-defined projects:

- Limit the number of samples that can be accepted per target scrape

- Limit the number of scraped labels

- Limit the length of label names and label values

You can also set an interval between consecutive scrapes and between Prometheus rule evaluations.

If you set sample or label limits, no further sample data is ingested for that target scrape after the limit is reached.

Prerequisites

-

You have access to the cluster as a user with the

dedicated-adminrole. -

The

user-workload-monitoring-configConfigMapobject exists. This object is created by default when the cluster is created. -

You have installed the OpenShift CLI (

oc).

Procedure

Edit the

user-workload-monitoring-configConfigMapobject in theopenshift-user-workload-monitoringproject:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Add the enforced limit and time interval configurations to

data/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- A value is required if this parameter is specified. This

enforcedSampleLimitexample limits the number of samples that can be accepted per target scrape in user-defined projects to 50,000. - 2

- Specifies the maximum number of labels per scrape. The default value is

0, which specifies no limit. - 3

- Specifies the maximum character length for a label name. The default value is

0, which specifies no limit. - 4

- Specifies the maximum character length for a label value. The default value is

0, which specifies no limit. - 5

- Specifies the interval between consecutive scrapes. The interval must be set between 5 seconds and 5 minutes. The default value is

30s. - 6

- Specifies the interval between Prometheus rule evaluations. The interval must be set between 5 seconds and 5 minutes. The default value for Prometheus is

30s.

NoteYou can also configure the

evaluationIntervalproperty for Thanos Ruler through thedata/config.yaml/thanosRulerfield. The default value for Thanos Ruler is15s.- Save the file to apply the changes. The limits are applied automatically.

3.2.4. Configuring pod topology spread constraints

You can configure pod topology spread constraints for all the pods for user-defined monitoring to control how pod replicas are scheduled to nodes across zones. This ensures that the pods are highly available and run more efficiently, because workloads are spread across nodes in different data centers or hierarchical infrastructure zones.

You can configure pod topology spread constraints for monitoring pods by using the user-workload-monitoring-config config map.

Prerequisites

-

You have access to the cluster as a user with the

dedicated-adminrole. -

The

user-workload-monitoring-configConfigMapobject exists. This object is created by default when the cluster is created. -

You have installed the OpenShift CLI (

oc).

Procedure

Edit the

user-workload-monitoring-configconfig map in theopenshift-user-workload-monitoringproject:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Add the following settings under the

data/config.yamlfield to configure pod topology spread constraints:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Specify a name of the component for which you want to set up pod topology spread constraints.

- 2

- Specify a numeric value for

maxSkew, which defines the degree to which pods are allowed to be unevenly distributed. - 3

- Specify a key of node labels for

topologyKey. Nodes that have a label with this key and identical values are considered to be in the same topology. The scheduler tries to put a balanced number of pods into each domain. - 4

- Specify a value for

whenUnsatisfiable. Available options areDoNotScheduleandScheduleAnyway. SpecifyDoNotScheduleif you want themaxSkewvalue to define the maximum difference allowed between the number of matching pods in the target topology and the global minimum. SpecifyScheduleAnywayif you want the scheduler to still schedule the pod but to give higher priority to nodes that might reduce the skew. - 5

- Specify

labelSelectorto find matching pods. Pods that match this label selector are counted to determine the number of pods in their corresponding topology domain.

Example configuration for Thanos Ruler

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Save the file to apply the changes. The pods affected by the new configuration are automatically redeployed.

3.3. Storing and recording data for user workload monitoring

Store and record your metrics and alerting data, configure logs to specify which activities are recorded, control how long Prometheus retains stored data, and set the maximum amount of disk space for the data. These actions help you protect your data and use them for troubleshooting.

3.3.1. Configuring persistent storage

Run cluster monitoring with persistent storage to gain the following benefits:

- Protect your metrics and alerting data from data loss by storing them in a persistent volume (PV). As a result, they can survive pods being restarted or recreated.

- Avoid getting duplicate notifications and losing silences for alerts when the Alertmanager pods are restarted.

In multi-node clusters, you must configure persistent storage for Prometheus, Alertmanager, and Thanos Ruler to ensure high availability.

For production environments, it is highly recommended to configure persistent storage.

3.3.1.1. Persistent storage prerequisites

- Use the block type of storage.

3.3.1.2. Configuring a persistent volume claim

To use a persistent volume (PV) for monitoring components, you must configure a persistent volume claim (PVC).

Prerequisites

-

You have access to the cluster as a user with the

dedicated-adminrole. -

The

user-workload-monitoring-configConfigMapobject exists. This object is created by default when the cluster is created. -

You have installed the OpenShift CLI (

oc).

Procedure

Edit the

user-workload-monitoring-configconfig map in theopenshift-user-workload-monitoringproject:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Add your PVC configuration for the component under

data/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow The following example configures a PVC that claims persistent storage for Thanos Ruler:

Example PVC configuration

Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteStorage requirements for the

thanosRulercomponent depend on the number of rules that are evaluated and how many samples each rule generates.Save the file to apply the changes. The pods affected by the new configuration are automatically redeployed and the new storage configuration is applied.

WarningWhen you update the config map with a PVC configuration, the affected

StatefulSetobject is recreated, resulting in a temporary service outage.

3.3.2. Modifying retention time and size for Prometheus metrics data

By default, Prometheus retains metrics data for 24 hours for monitoring for user-defined projects. You can modify the retention time for the Prometheus instance to change when the data is deleted. You can also set the maximum amount of disk space the retained metrics data uses.

Data compaction occurs every two hours. Therefore, a persistent volume (PV) might fill up before compaction, potentially exceeding the retentionSize limit. In such cases, the KubePersistentVolumeFillingUp alert fires until the space on a PV is lower than the retentionSize limit.

Prerequisites

-

You have access to the cluster as a user with the

dedicated-adminrole. -

The

user-workload-monitoring-configConfigMapobject exists. This object is created by default when the cluster is created. -

You have installed the OpenShift CLI (

oc).

Procedure

Edit the

user-workload-monitoring-configconfig map in theopenshift-user-workload-monitoringproject:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Add the retention time and size configuration under

data/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- The retention time: a number directly followed by

ms(milliseconds),s(seconds),m(minutes),h(hours),d(days),w(weeks), ory(years). You can also combine time values for specific times, such as1h30m15s. - 2

- The retention size: a number directly followed by

B(bytes),KB(kilobytes),MB(megabytes),GB(gigabytes),TB(terabytes),PB(petabytes), andEB(exabytes).

The following example sets the retention time to 24 hours and the retention size to 10 gigabytes for the Prometheus instance:

Example of setting retention time for Prometheus

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Save the file to apply the changes. The pods affected by the new configuration are automatically redeployed.

3.3.2.1. Modifying the retention time for Thanos Ruler metrics data

By default, for user-defined projects, Thanos Ruler automatically retains metrics data for 24 hours. You can modify the retention time to change how long this data is retained by specifying a time value in the user-workload-monitoring-config config map in the openshift-user-workload-monitoring namespace.

If you configure retention for user-workload Prometheus, Thanos Ruler automatically inherits the same retention time, unless explicitly configured otherwise.

Prerequisites

-

You have access to the cluster as a user with the

dedicated-adminrole. -

The

user-workload-monitoring-configConfigMapobject exists. This object is created by default when the cluster is created. -

You have installed the OpenShift CLI (

oc).

Procedure

Edit the

user-workload-monitoring-configConfigMapobject in theopenshift-user-workload-monitoringproject:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Add the retention time configuration under

data/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Specify the retention time in the following format: a number directly followed by

ms(milliseconds),s(seconds),m(minutes),h(hours),d(days),w(weeks), ory(years). You can also combine time values for specific times, such as1h30m15s. The default is24h.

The following example sets the retention time to 10 days for Thanos Ruler data:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Save the file to apply the changes. The pods affected by the new configuration are automatically redeployed.

3.3.3. Setting log levels for monitoring components

You can configure the log level for Alertmanager, Prometheus Operator, Prometheus, and Thanos Ruler. You can use these settings for troubleshooting and to gain better insight into how the components are functioning.

The following log levels can be applied to the relevant component in the user-workload-monitoring-config ConfigMap object:

-

debug. Log debug, informational, warning, and error messages. -

info(default). Log informational, warning, and error messages. -

warn. Log warning and error messages only. -

error. Log error messages only.

Prerequisites

-

You have access to the cluster as a user with the

dedicated-adminrole. -

The

user-workload-monitoring-configConfigMapobject exists. This object is created by default when the cluster is created. -

You have installed the OpenShift CLI (

oc).

Procedure

Edit the

user-workload-monitoring-configconfig map in theopenshift-user-workload-monitoringproject:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Add log configuration for a component under

data/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Save the file to apply the changes. The pods affected by the new configuration are automatically redeployed.

Verify that the log configuration is applied by reviewing the deployment or pod configuration in the related project.

The following example checks the log level for the

prometheus-operatordeployment:oc -n openshift-user-workload-monitoring get deploy prometheus-operator -o yaml | grep "log-level"

$ oc -n openshift-user-workload-monitoring get deploy prometheus-operator -o yaml | grep "log-level"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Example output

- --log-level=debug

- --log-level=debugCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Verify that the pods for the component are running:

oc -n openshift-user-workload-monitoring get pods

$ oc -n openshift-user-workload-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow NoteIf an unrecognized

logLevelvalue is included in theConfigMapobject, the pods for the component might not restart successfully.

3.3.4. Enabling the query log file for Prometheus

You can configure Prometheus to write all queries that have been run by the engine to a log file.

Because log rotation is not supported, only enable this feature temporarily when you need to troubleshoot an issue. After you finish troubleshooting, disable query logging by reverting the changes you made to the ConfigMap object to enable the feature.

Prerequisites

-

You have access to the cluster as a user with the

dedicated-adminrole. -

The

user-workload-monitoring-configConfigMapobject exists. This object is created by default when the cluster is created. -

You have installed the OpenShift CLI (

oc).

Procedure

Edit the

user-workload-monitoring-configconfig map in theopenshift-user-workload-monitoringproject:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Add the

queryLogFileparameter for Prometheus underdata/config.yaml:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Add the full path to the file in which queries will be logged.

- Save the file to apply the changes. The pods affected by the new configuration are automatically redeployed.

Verify that the pods for the component are running. The following sample command lists the status of pods:

oc -n openshift-user-workload-monitoring get pods

$ oc -n openshift-user-workload-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Example output

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Read the query log:

oc -n openshift-user-workload-monitoring exec prometheus-user-workload-0 -- cat <path>

$ oc -n openshift-user-workload-monitoring exec prometheus-user-workload-0 -- cat <path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ImportantRevert the setting in the config map after you have examined the logged query information.

3.4. Configuring metrics for user workload monitoring

Configure the collection of metrics to monitor how cluster components and your own workloads are performing.

You can send ingested metrics to remote systems for long-term storage and add cluster ID labels to the metrics to identify the data coming from different clusters.

3.4.1. Configuring remote write storage

You can configure remote write storage to enable Prometheus to send ingested metrics to remote systems for long-term storage. Doing so has no impact on how or for how long Prometheus stores metrics.

Prerequisites

-

You have access to the cluster as a user with the

dedicated-adminrole. -

The

user-workload-monitoring-configConfigMapobject exists. This object is created by default when the cluster is created. -

You have installed the OpenShift CLI (

oc). You have set up a remote write compatible endpoint (such as Thanos) and know the endpoint URL. See the Prometheus remote endpoints and storage documentation for information about endpoints that are compatible with the remote write feature.

ImportantRed Hat only provides information for configuring remote write senders and does not offer guidance on configuring receiver endpoints. Customers are responsible for setting up their own endpoints that are remote-write compatible. Issues with endpoint receiver configurations are not included in Red Hat production support.

You have set up authentication credentials in a

Secretobject for the remote write endpoint. You must create the secret in theopenshift-user-workload-monitoringnamespace.WarningTo reduce security risks, use HTTPS and authentication to send metrics to an endpoint.

Procedure

Edit the

user-workload-monitoring-configconfig map in theopenshift-user-workload-monitoringproject:oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Add a

remoteWrite:section underdata/config.yaml/prometheus, as shown in the following example:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- The URL of the remote write endpoint.

- 2

- The authentication method and credentials for the endpoint. Currently supported authentication methods are AWS Signature Version 4, authentication using HTTP in an

Authorizationrequest header, Basic authentication, OAuth 2.0, and TLS client. See Supported remote write authentication settings for sample configurations of supported authentication methods.

Add write relabel configuration values after the authentication credentials:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Add configuration for metrics that you want to send to the remote endpoint.

Example of forwarding a single metric called

my_metricCopy to Clipboard Copied! Toggle word wrap Toggle overflow Example of forwarding metrics called

my_metric_1andmy_metric_2inmy_namespacenamespaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Save the file to apply the changes. The new configuration is applied automatically.

3.4.1.1. Supported remote write authentication settings

You can use different methods to authenticate with a remote write endpoint. Currently supported authentication methods are AWS Signature Version 4, basic authentication, authorization, OAuth 2.0, and TLS client. The following table provides details about supported authentication methods for use with remote write.

| Authentication method | Config map field | Description |

|---|---|---|

| AWS Signature Version 4 |

| This method uses AWS Signature Version 4 authentication to sign requests. You cannot use this method simultaneously with authorization, OAuth 2.0, or Basic authentication. |

| Basic authentication |

| Basic authentication sets the authorization header on every remote write request with the configured username and password. |

| authorization |

|

Authorization sets the |

| OAuth 2.0 |

|

An OAuth 2.0 configuration uses the client credentials grant type. Prometheus fetches an access token from |

| TLS client |

| A TLS client configuration specifies the CA certificate, the client certificate, and the client key file information used to authenticate with the remote write endpoint server using TLS. The sample configuration assumes that you have already created a CA certificate file, a client certificate file, and a client key file. |

3.4.1.2. Example remote write authentication settings

The following samples show different authentication settings you can use to connect to a remote write endpoint. Each sample also shows how to configure a corresponding Secret object that contains authentication credentials and other relevant settings. Each sample configures authentication for use with monitoring for user-defined projects in the openshift-user-workload-monitoring namespace.

3.4.1.2.1. Sample YAML for AWS Signature Version 4 authentication

The following shows the settings for a sigv4 secret named sigv4-credentials in the openshift-user-workload-monitoring namespace.

The following shows sample AWS Signature Version 4 remote write authentication settings that use a Secret object named sigv4-credentials in the openshift-user-workload-monitoring namespace:

- 1

- The AWS region.

- 2 4

- The name of the

Secretobject containing the AWS API access credentials. - 3

- The key that contains the AWS API access key in the specified

Secretobject. - 5

- The key that contains the AWS API secret key in the specified

Secretobject. - 6

- The name of the AWS profile that is being used to authenticate.

- 7

- The unique identifier for the Amazon Resource Name (ARN) assigned to your role.

3.4.1.2.2. Sample YAML for Basic authentication

The following shows sample Basic authentication settings for a Secret object named rw-basic-auth in the openshift-user-workload-monitoring namespace:

The following sample shows a basicAuth remote write configuration that uses a Secret object named rw-basic-auth in the openshift-user-workload-monitoring namespace. It assumes that you have already set up authentication credentials for the endpoint.

3.4.1.2.3. Sample YAML for authentication with a bearer token using a Secret Object

The following shows bearer token settings for a Secret object named rw-bearer-auth in the openshift-user-workload-monitoring namespace:

- 1

- The authentication token.

The following shows sample bearer token config map settings that use a Secret object named rw-bearer-auth in the openshift-user-workload-monitoring namespace:

3.4.1.2.4. Sample YAML for OAuth 2.0 authentication