노드

OpenShift Dedicated 노드

초록

1장. 노드 개요

1.1. 노드 정보

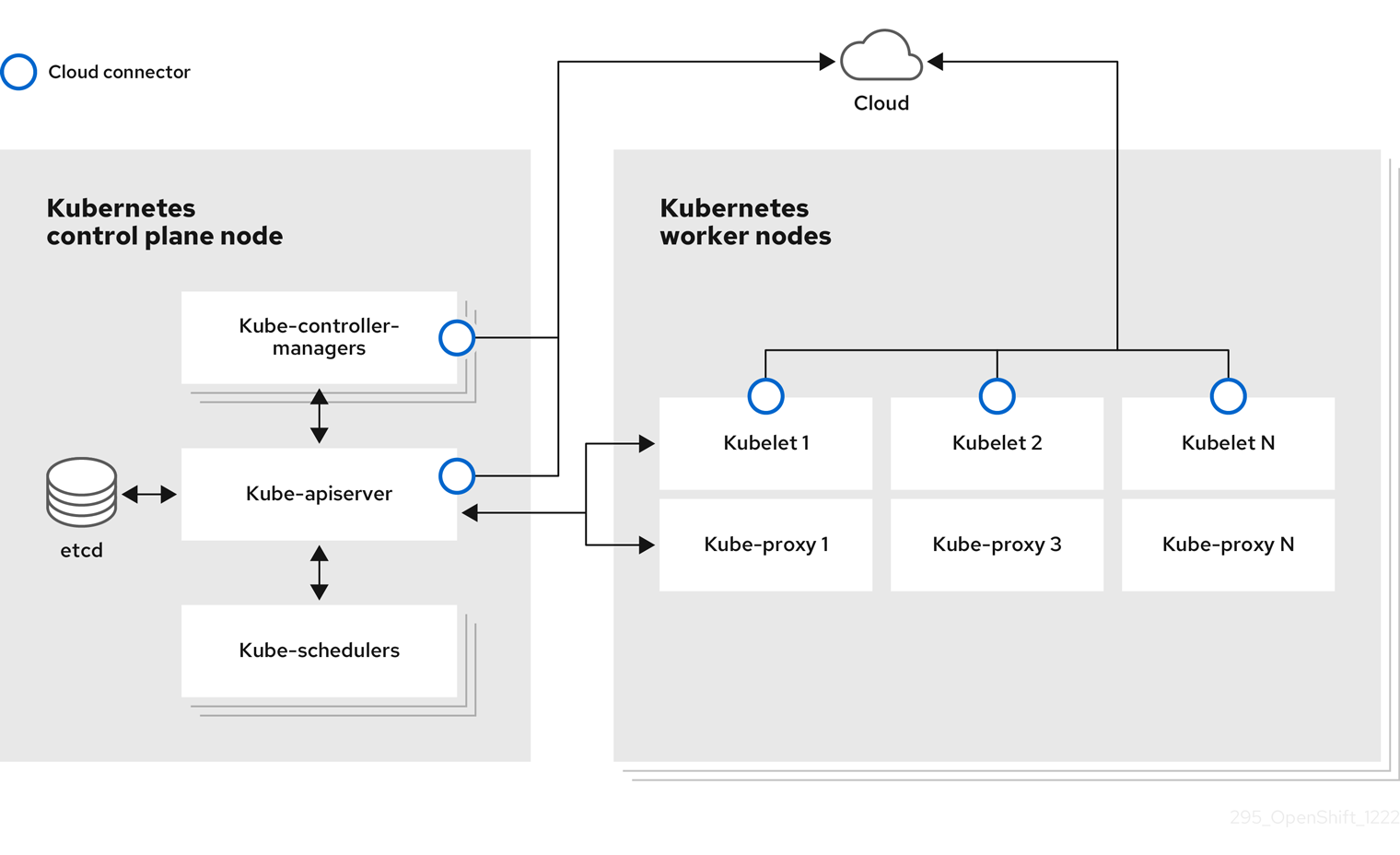

노드는 Kubernetes 클러스터의 가상 또는 베어 메탈 머신입니다. 작업자 노드는 포드로 그룹화된 애플리케이션 컨테이너를 호스팅합니다. 컨트롤 플레인 노드는 Kubernetes 클러스터를 제어하는 데 필요한 서비스를 실행합니다. OpenShift Dedicated에서 컨트롤 플레인 노드에는 OpenShift Dedicated 클러스터를 관리하기 위한 Kubernetes 서비스 이상의 것이 포함되어 있습니다.

클러스터에서 안정적이고 정상적인 노드를 보유하는 것은 호스팅된 애플리케이션의 원활한 작동을 위한 필수 요소입니다. OpenShift Dedicated에서는 노드를 나타내는 Node 오브젝트를 통해 노드에 액세스, 관리 및 모니터링할 수 있습니다. OpenShift CLI(oc) 또는 웹 콘솔을 사용하여 노드에서 다음 작업을 수행할 수 있습니다.

노드의 다음 구성 요소는 Pod의 실행을 유지 관리하고 Kubernetes 런타임 환경을 제공합니다.

- 컨테이너 런타임

- 컨테이너 런타임은 컨테이너 실행을 담당합니다. OpenShift Dedicated는 클러스터의 각 RHCOS(Red Hat Enterprise Linux CoreOS) 노드에 CRI-O 컨테이너 런타임을 배포합니다. WMCO(Windows Machine Config Operator)는 Windows 노드에 컨테이너된 런타임을 배포합니다.

- kubelet

- kubelet은 노드에서 실행되며 컨테이너 매니페스트를 읽습니다. 이렇게 하면 정의된 컨테이너가 시작되어 실행 중인지 확인합니다. kubelet 프로세스는 작업 상태와 노드 서버를 유지 관리합니다. kubelet은 네트워크 규칙 및 포트 전달을 관리합니다. kubelet은 Kubernetes에서만 생성된 컨테이너를 관리합니다.

- DNS

- 클러스터 DNS는 Kubernetes 서비스에 대한 DNS 레코드를 제공하는 DNS 서버입니다. Kubernetes로 시작한 컨테이너는 DNS 검색에 이 DNS 서버를 자동으로 포함합니다.

1.1.1. 읽기 작업

읽기 작업을 사용하면 관리자 또는 개발자가 OpenShift Dedicated 클러스터의 노드에 대한 정보를 가져올 수 있습니다.

- 클러스터의 모든 노드를 나열합니다.

- 메모리 및 CPU 사용량, 상태, 기간과 같은 노드에 대한 정보를 가져옵니다.

- 노드에서 실행 중인 Pod를 나열합니다.

1.1.2. 기능 개선 작업

OpenShift Dedicated를 사용하면 노드 액세스 및 관리 이상의 작업을 수행할 수 있습니다. 관리자는 노드에서 다음 작업을 수행하여 클러스터를 보다 효율적이고 애플리케이션 친화적인 상태로 만들고 개발자에게 더 나은 환경을 제공할 수 있습니다.

- Node Tuning Operator를 사용하여 일정 수준의 커널 튜닝이 필요한 고성능 애플리케이션에 대한 노드 수준 튜닝을 관리합니다.

- 데몬 세트를 사용하여 노드에서 백그라운드 작업을 자동으로 실행합니다. 데몬 세트를 생성하고 사용하여 공유 스토리지를 생성하거나, 모든 노드에서 로깅 Pod를 실행하거나, 모든 노드에 모니터링 에이전트를 배포할 수 있습니다.

1.2. Pod 정보

Pod는 노드에 함께 배포되는 하나 이상의 컨테이너입니다. 클러스터 관리자는 Pod를 정의하고 예약할 준비가 된 정상 노드에서 실행하도록 할당할 수 있습니다. Pod는 컨테이너가 실행되는 동안 실행됩니다. Pod가 정의되고 실행되면 변경할 수 없습니다. Pod로 작업할 때 수행할 수 있는 일부 작업은 다음과 같습니다.

1.2.1. 읽기 작업

관리자는 다음 작업을 통해 프로젝트의 Pod에 대한 정보를 가져올 수 있습니다.

- 복제본 수 및 재시작, 현재 상태 및 경과와 같은 정보를 포함하여 프로젝트와 연결된 Pod를 나열합니다.

- CPU, 메모리, 스토리지 소비와 같은 Pod 사용량 통계를 확인합니다.

1.2.2. 관리 작업

다음 작업 목록은 관리자가 OpenShift Dedicated 클러스터에서 Pod를 관리하는 방법에 대한 개요를 제공합니다.

OpenShift Dedicated에서 사용할 수 있는 고급 스케줄링 기능을 사용하여 Pod 예약을 제어합니다.

- pod affinity, node affinity,anti-affinity Node-to-pod 바인딩 규칙입니다.

- 노드 레이블 및 선택기.

- Pod 토폴로지 분배 제약 조건.

- Pod 컨트롤러를 사용하여 재시작하고 정책을 다시 시작한 후 Pod가 작동하는 방식을 구성합니다.

- Pod에서 송신 및 수신 트래픽을 모두 제한합니다.

- Pod 템플릿이 있는 모든 오브젝트에 볼륨을 추가하고 제거합니다. 볼륨은 Pod의 모든 컨테이너에서 사용할 수 있는 마운트된 파일 시스템입니다. 컨테이너 스토리지는 임시 스토리지입니다. 볼륨을 사용하여 컨테이너 데이터를 유지할 수 있습니다.

1.2.3. 기능 개선 작업

OpenShift Dedicated에서 사용할 수 있는 다양한 툴 및 기능의 도움을 통해 Pod를 보다 쉽고 효율적으로 사용할 수 있습니다. 다음 작업에는 Pod를 더 잘 관리하기 위해 해당 툴과 기능을 사용하는 작업이 포함됩니다.

-

보안: 일부 애플리케이션에는 암호 및 사용자 이름과 같은 민감한 정보가 필요합니다. 관리자는

Secret오브젝트를 사용하여Secret오브젝트 를 사용하여 Pod에 중요한 데이터를 제공할 수 있습니다.

1.3. 컨테이너 정보

컨테이너는 OpenShift Dedicated 애플리케이션의 기본 단위이며, 종속 항목, 라이브러리 및 바이너리와 함께 패키지된 애플리케이션 코드로 구성됩니다. 컨테이너에서는 물리 서버, 가상 머신(VM) 및 프라이빗 또는 퍼블릭 클라우드와 같은 환경 및 여러 배치 대상 사이에 일관성을 제공합니다.

Linux 컨테이너 기술은 실행 중인 프로세스를 격리하고 지정된 리소스로만 액세스를 제한하는 간단한 메커니즘입니다. 관리자는 다음과 같은 Linux 컨테이너에서 다양한 작업을 수행할 수 있습니다.

OpenShift Dedicated는 Init 컨테이너라는 특수 컨테이너를 제공합니다. Init 컨테이너는 애플리케이션 컨테이너보다 먼저 실행되며 애플리케이션 이미지에 없는 유틸리티 또는 설정 스크립트를 포함할 수 있습니다. Init 컨테이너를 사용하여 나머지 Pod를 배포하기 전에 작업을 수행할 수 있습니다.

노드, Pod 및 컨테이너에서 특정 작업을 수행하는 것 외에도 전체 OpenShift Dedicated 클러스터에서 작업하여 클러스터 효율성과 애플리케이션 pod의 가용성을 유지할 수 있습니다.

1.4. OpenShift Dedicated 노드의 일반 용어집

이 용어집은 노드 콘텐츠에 사용되는 일반적인 용어를 정의합니다.

- 컨테이너

- 이는 소프트웨어와 모든 종속 항목을 포함하는 가볍고 실행 가능한 이미지입니다. 따라서 컨테이너는 운영 체제를 가상화하므로 데이터 센터에서 퍼블릭 또는 프라이빗 클라우드, 개발자의 노트북까지 컨테이너를 실행할 수 있습니다.

- 데몬 세트

- Pod 복제본이 OpenShift Dedicated 클러스터의 적격 노드에서 실행되는지 확인합니다.

- egress

- Pod의 네트워크 아웃 바운드 트래픽을 통해 외부적으로 데이터 공유 프로세스.

- 가비지 컬렉션

- 실행 중인 Pod에서 참조하지 않는 종료된 컨테이너 및 이미지와 같은 클러스터 리소스를 정리하는 프로세스입니다.

- Ingress

- Pod로 들어오는 트래픽입니다.

- 작업

- 완료까지 실행되는 프로세스입니다. 작업은 하나 이상의 Pod 오브젝트를 생성하고 지정된 Pod가 성공적으로 완료되었는지 확인합니다.

- 라벨

- 키-값 쌍인 레이블을 사용하여 Pod와 같은 오브젝트 하위 집합을 구성하고 선택할 수 있습니다.

- 노드

- OpenShift Dedicated 클러스터의 작업자 시스템입니다. 노드는 VM(가상 머신) 또는 물리적 머신일 수 있습니다.

- Node Tuning Operator

- Node Tuning Operator를 사용하여 TuneD 데몬을 사용하여 노드 수준 튜닝을 관리할 수 있습니다. 이렇게 하면 데몬이 이해할 수 있는 형식으로 클러스터에서 실행되는 모든 컨테이너화된 TuneD 데몬에 사용자 정의 튜닝 사양이 전달됩니다. 데몬은 클러스터의 모든 노드에서 노드당 하나씩 실행됩니다.

- Self Node Remediation Operator

- Operator는 클러스터 노드에서 실행되며 비정상인 노드를 식별하고 재부팅합니다.

- Pod

- OpenShift Dedicated 클러스터에서 실행되는 볼륨 및 IP 주소와 같은 공유 리소스가 있는 하나 이상의 컨테이너입니다. Pod는 정의, 배포 및 관리되는 최소 컴퓨팅 단위입니다.

- 톨러레이션

- 일치하는 테인트가 있는 노드 또는 노드 그룹에 Pod를 예약할 수 있지만 필요하지는 않음을 나타냅니다. 허용 오차를 사용하여 스케줄러에서 일치하는 테인트로 Pod를 예약할 수 있습니다.

- taint

- 키, 값 및 효과를 포함하는 코어 오브젝트입니다. 테인트 및 허용 오차가 함께 작동하여 관련 노드에서 Pod를 예약하지 않도록 합니다.

2장. 노드 작업

2.1. Pod 사용

Pod는 하나의 호스트에 함께 배포되는 하나 이상의 컨테이너이자 정의, 배포, 관리할 수 있는 최소 컴퓨팅 단위입니다.

2.1.1. Pod 이해

Pod는 컨테이너에 대한 머신 인스턴스(실제 또는 가상)와 대략적으로 동일합니다. 각 Pod에는 자체 내부 IP 주소가 할당되므로 해당 Pod가 전체 포트 공간을 소유하고 Pod 내의 컨테이너는 로컬 스토리지와 네트워킹을 공유할 수 있습니다.

Pod에는 라이프사이클이 정의되어 있으며 노드에서 실행되도록 할당된 다음 컨테이너가 종료되거나 기타 이유로 제거될 때까지 실행됩니다. Pod는 정책 및 종료 코드에 따라 종료 후 제거되거나 컨테이너 로그에 대한 액세스를 활성화하기 위해 유지될 수 있습니다.

OpenShift Dedicated는 포드를 대체로 변경할 수 없는 것으로 취급합니다. 실행 중에 포드 정의를 변경할 수 없습니다. OpenShift Dedicated는 기존 pod를 종료하고 수정된 구성, 기본 이미지 또는 둘 다로 다시 생성하여 변경 사항을 구현합니다. Pod를 다시 생성하면 확장 가능한 것으로 취급되고 상태가 유지되지 않습니다. 따라서 일반적으로 Pod는 사용자가 직접 관리하는 대신 상위 수준의 컨트롤러에서 관리해야 합니다.

복제 컨트롤러에서 관리하지 않는 베어 Pod는 노드 중단 시 다시 예약되지 않습니다.

2.1.2. Pod 구성의 예

OpenShift Dedicated는 하나의 호스트에 함께 배포되는 하나 이상의 컨테이너이자 정의, 배포 및 관리할 수 있는 최소 컴퓨팅 단위인 Pod 의 Kubernetes 개념을 활용합니다.

다음은 Pod 정의의 예입니다. 이 예제에서는 Pod의 다양한 기능을 보여줍니다. 대부분 다른 주제에서 설명하므로 여기에서는 간단히 언급합니다.

Pod 오브젝트 정의(YAML)

- 1

- Pod는 단일 작업에서 Pod 그룹을 선택하고 관리하는 데 사용할 수 있는 라벨을 하나 이상 사용하여 "태그를 지정"할 수 있습니다. 라벨은

metadata해시의 키/값 형식으로 저장됩니다. - 2

- Pod는 가능한 값

Always,OnFailure,Never를 사용하여 정책을 재시작합니다. 기본값은Always입니다. - 3

- OpenShift Dedicated는 컨테이너에 대한 보안 컨텍스트를 정의하여 권한이 있는 컨테이너로 실행할 수 있는지, 선택한 사용자로 실행할 수 있는지 등을 지정합니다. 기본 컨텍스트는 매우 제한적이지만 필요에 따라 관리자가 수정할 수 있습니다.

- 4

containers는 하나 이상의 컨테이너 정의로 이루어진 배열을 지정합니다.- 5

- 이 컨테이너는 컨테이너 내에서 외부 스토리지 볼륨이 마운트되는 위치를 지정합니다.

- 6

- Pod에 제공할 볼륨을 지정합니다. 지정된 경로에 볼륨을 마운트합니다. 컨테이너 루트,

/또는 호스트와 컨테이너에서 동일한 경로에 마운트하지 마십시오. 컨테이너가 호스트/dev/pts파일과 같이 충분한 권한이 있는 경우 호스트 시스템이 손상될 수 있습니다./host를 사용하여 호스트를 마운트하는 것이 안전합니다. - 7

- Pod의 각 컨테이너는 자체 컨테이너 이미지에서 인스턴스화됩니다.

- 8

- Pod는 사용할 컨테이너에서 사용할 수 있는 스토리지 볼륨을 정의합니다.

파일 수가 많은 영구 볼륨을 Pod에 연결하면 해당 Pod가 실패하거나 시작하는 데 시간이 오래 걸릴 수 있습니다. 자세한 내용은 OpenShift에서 파일 수가 많은 영구 볼륨을 사용하는 경우 Pod를 시작하지 못하거나 "Ready" 상태를 달성하는 데 과도한 시간이 걸리는 이유를 참조하십시오.

이 pod 정의에는 Pod가 생성되고 라이프사이클이 시작된 후 OpenShift Dedicated에 의해 자동으로 채워지는 특성이 포함되지 않습니다. Kubernetes Pod 설명서에는 Pod의 기능 및 용도에 대한 세부 정보가 있습니다.

2.1.3. 리소스 요청 및 제한 이해

"Pod 구성 예"와 같이 Pod 사양을 사용하거나 Pod 제어 오브젝트에 대한 사양을 사용하여 Pod에 대한 CPU 및 메모리 요청 및 제한을 지정할 수 있습니다.

CPU 및 메모리 요청 은 Pod를 실행해야 하는 최소한의 리소스를 지정하여 OpenShift Dedicated에서 충분한 리소스가 있는 노드에서 Pod를 예약할 수 있도록 지원합니다.

CPU 및 메모리 제한은 Pod에서 사용할 수 있는 최대 리소스 양을 정의하여 Pod에서 과도한 리소스를 소비하지 않고 동일한 노드의 다른 Pod에 영향을 미칠 수 있습니다.

CPU 및 메모리 요청 및 제한은 다음 원칙을 사용하여 처리됩니다.

CPU 제한은 CPU 제한을 사용하여 적용됩니다. 컨테이너가 CPU 제한에 도달하면 커널은 컨테이너 제한으로 지정된 CPU에 대한 액세스를 제한합니다. 따라서 CPU 제한은 커널이 적용하는 하드 제한입니다. OpenShift Dedicated를 사용하면 컨테이너가 연장된 기간 동안 CPU 제한을 초과할 수 있습니다. 그러나 컨테이너 런타임은 과도한 CPU 사용을 위해 Pod 또는 컨테이너를 종료하지 않습니다.

CPU 제한 및 요청은 CPU 단위로 측정됩니다. 하나의 CPU 단위는 노드가 물리적 호스트인지 아니면 물리적 시스템 내에서 실행되는 가상 시스템인지에 따라 하나의 물리적 CPU 코어 또는 1개의 가상 코어와 동일합니다. 소수 요청은 허용됩니다. 예를 들어 CPU 요청이

0.5인 컨테이너를 정의할 때1.0CPU를 요청한 경우보다 절반의 CPU 시간을 요청합니다. CPU 단위의 경우0.1은100m에 해당하며 100밀리코어 또는 100밀리코어로 읽을 수 있습니다. CPU 리소스는 항상 절대 리소스이며 상대 양이 아닙니다.참고기본적으로 Pod에 할당할 수 있는 최소 CPU 양은 10 mCPU입니다. Pod 사양에서 10mCPU 미만의 리소스 제한을 요청할 수 있습니다. 그러나 Pod에는 여전히 10 mCPU가 할당됩니다.

메모리 제한은 OOM(메모리 부족) 종료를 사용하여 커널에 의해 적용됩니다. 컨테이너에서 메모리 제한을 초과하는 경우 커널은 해당 컨테이너를 종료할 수 있습니다. 그러나 종료는 커널이 메모리 부족을 감지할 때만 발생합니다. 따라서 메모리를 과도하게 할당하는 컨테이너는 즉시 종료되지 않을 수 있습니다. 즉, 메모리 제한이 반응적으로 적용됩니다. 컨테이너는 메모리 제한보다 많은 메모리를 사용할 수 있습니다. 이 경우 컨테이너가 종료될 수 있습니다.

메모리를 일반 정수로 표현하거나 이러한 수량 접미사 중 하나를 사용하여 고정 소수점 숫자로 표현할 수 있습니다.

E,P,T,G,M또는k.Ei,Pi,Ti,Gi,Mi또는Ki와 같은 2 개의 전원을 사용할 수도 있습니다.

Pod가 실행 중인 노드에 사용 가능한 리소스가 충분한 경우 컨테이너에서 요청한 것보다 더 많은 CPU 또는 메모리 리소스를 사용할 수 있습니다. 그러나 컨테이너는 해당 제한을 초과할 수 없습니다. 예를 들어 컨테이너 메모리 요청을 256MiB 로 설정하고 해당 컨테이너가 8GiB 메모리가 있는 노드에 예약되고 다른 Pod가 없는 Pod에 있는 경우 컨테이너에서 요청된 256MiB 보다 많은 메모리를 사용하려고 시도할 수 있습니다.

이 동작은 CPU 및 메모리 제한에는 적용되지 않습니다. 이러한 제한은 kubelet 및 컨테이너 런타임에 의해 적용되며 커널에 의해 적용됩니다. Linux 노드에서 커널은 cgroup을 사용하여 제한을 적용합니다.

2.2. Pod 보기

관리자는 클러스터 Pod를 보고 상태를 확인하고 클러스터의 전반적인 상태를 평가할 수 있습니다. 특정 프로젝트와 연결된 Pod 목록을 보거나 Pod에 대한 사용량 통계를 볼 수도 있습니다. Pod를 정기적으로 보면 문제를 조기에 감지하고 리소스 사용량을 추적하며 클러스터의 안정성을 확인하는 데 도움이 될 수 있습니다.

2.2.1. 프로젝트의 Pod 보기

CPU, 메모리, 스토리지 사용량과 같은 Pod 사용량 통계를 표시하여 컨테이너 런타임 환경을 모니터링하고 리소스 효율적인 사용을 보장할 수 있습니다.

프로세스

다음 명령을 입력하여 프로젝트로 변경합니다.

oc project <project_name>

$ oc project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 입력하여 Pod 목록을 가져옵니다.

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME READY STATUS RESTARTS AGE console-698d866b78-bnshf 1/1 Running 2 165m console-698d866b78-m87pm 1/1 Running 2 165m

NAME READY STATUS RESTARTS AGE console-698d866b78-bnshf 1/1 Running 2 165m console-698d866b78-m87pm 1/1 Running 2 165mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 선택 사항:

-o wide플래그를 추가하여 Pod IP 주소와 Pod가 있는 노드를 확인합니다. 예를 들면 다음과 같습니다.oc get pods -o wide

$ oc get pods -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE console-698d866b78-bnshf 1/1 Running 2 166m 10.128.0.24 ip-10-0-152-71.ec2.internal <none> console-698d866b78-m87pm 1/1 Running 2 166m 10.129.0.23 ip-10-0-173-237.ec2.internal <none>

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE console-698d866b78-bnshf 1/1 Running 2 166m 10.128.0.24 ip-10-0-152-71.ec2.internal <none> console-698d866b78-m87pm 1/1 Running 2 166m 10.129.0.23 ip-10-0-173-237.ec2.internal <none>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.2. Pod 사용량 통계 보기

컨테이너의 런타임 환경을 제공하는 Pod에 대한 사용량 통계를 표시할 수 있습니다. 이러한 사용량 통계에는 CPU, 메모리, 스토리지 사용량이 포함됩니다.

사전 요구 사항

-

사용량 통계를 보려면

cluster-reader권한이 있어야 합니다. - 사용량 통계를 보려면 메트릭이 설치되어 있어야 합니다.

프로세스

다음 명령을 입력하여 사용량 통계를 확인합니다.

oc adm top pods -n <namespace>

$ oc adm top pods -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME CPU(cores) MEMORY(bytes) console-7f58c69899-q8c8k 0m 22Mi console-7f58c69899-xhbgg 0m 25Mi downloads-594fcccf94-bcxk8 3m 18Mi downloads-594fcccf94-kv4p6 2m 15Mi

NAME CPU(cores) MEMORY(bytes) console-7f58c69899-q8c8k 0m 22Mi console-7f58c69899-xhbgg 0m 25Mi downloads-594fcccf94-bcxk8 3m 18Mi downloads-594fcccf94-kv4p6 2m 15MiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 선택 사항:

--selector='레이블을 추가하여 라벨이 있는 Pod의 사용량 통계를 확인합니다. 필터링할 레이블 쿼리를 선택해야 합니다(예:=,==, 또는!=). 예를 들면 다음과 같습니다.oc adm top pod --selector='<pod_name>'

$ oc adm top pod --selector='<pod_name>'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.3. 리소스 로그 보기

OpenShift CLI(oc) 또는 웹 콘솔에서 리소스의 로그를 볼 수 있습니다. 로그는 기본적으로 끝(또는 tail)에서 표시됩니다. 리소스의 로그를 보면 문제를 해결하고 리소스 동작을 모니터링하는 데 도움이 될 수 있습니다.

2.2.3.1. 웹 콘솔을 사용하여 리소스 로그 보기

OpenShift Dedicated 웹 콘솔을 사용하여 리소스 로그를 보려면 다음 절차를 사용하십시오.

프로세스

OpenShift Dedicated 콘솔에서 워크로드 → Pod 로 이동하거나 조사할 리소스를 통해 Pod로 이동합니다.

참고빌드와 같은 일부 리소스에는 직접 쿼리할 Pod가 없습니다. 이러한 인스턴스에서 리소스의 세부 정보 페이지에서 로그 링크를 찾을 수 있습니다.

- 드롭다운 메뉴에서 프로젝트를 선택합니다.

- 조사할 Pod 이름을 클릭합니다.

- 로그를 클릭합니다.

2.2.3.2. CLI를 사용하여 리소스 로그 보기

CLI(명령줄 인터페이스)를 사용하여 리소스 로그를 보려면 다음 절차를 사용하십시오.

사전 요구 사항

-

OpenShift CLI(

oc)에 액세스합니다.

프로세스

다음 명령을 입력하여 특정 Pod의 로그를 확인합니다.

oc logs -f <pod_name> -c <container_name>

$ oc logs -f <pod_name> -c <container_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

-f- 선택 사항: 출력에서 로그에 기록되는 내용을 따르도록 지정합니다.

<pod_name>- pod 이름을 지정합니다.

<container_name>- 선택 사항: 컨테이너의 이름을 지정합니다. Pod에 여러 컨테이너가 있는 경우 컨테이너 이름을 지정해야 합니다.

예를 들면 다음과 같습니다.

oc logs -f ruby-57f7f4855b-znl92 -c ruby

$ oc logs -f ruby-57f7f4855b-znl92 -c rubyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 입력하여 특정 리소스의 로그를 확인합니다.

oc logs <object_type>/<resource_name>

$ oc logs <object_type>/<resource_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들면 다음과 같습니다.

oc logs deployment/ruby

$ oc logs deployment/rubyCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. Pod에 대한 OpenShift Dedicated 클러스터 구성

관리자는 Pod에 효율적인 클러스터를 생성하고 유지 관리할 수 있습니다.

클러스터를 효율적으로 유지하면 Pod가 종료될 때 수행하는 작업과 같은 툴을 사용하여 개발자에게 더 나은 환경을 제공할 수 있습니다. 즉 필요한 수의 Pod가 항상 실행되고 있는지 확인하여 한 번만 실행되도록 설계된 Pod를 재시작하는 경우 Pod에 사용할 수 있는 대역폭을 제한하고, 중단 중 Pod를 계속 실행하는 방법을 제공합니다.

2.3.1. 재시작 후 Pod 작동 방식 구성

Pod 재시작 정책에 따라 해당 Pod의 컨테이너가 종료될 때 OpenShift Dedicated가 응답하는 방식이 결정됩니다. 정책은 해당 Pod의 모든 컨테이너에 적용됩니다.

가능한 값은 다음과 같습니다.

-

Always- 기하급수적 백오프 지연(10s, 20s, 40s)이 5분으로 제한되어 Pod에서 성공적으로 종료된 컨테이너를 지속적으로 재시작합니다. 기본값은Always입니다. -

OnFailure- 급격한 백오프 지연(10초, 20초, 40초)을 5분으로 제한하여 Pod에서 실패한 컨테이너를 재시작합니다. -

Never- Pod에서 종료되거나 실패한 컨테이너를 재시작하지 않습니다. Pod가 즉시 실패하고 종료됩니다.

Pod가 특정 노드에 바인딩된 후에는 다른 노드에 바인딩되지 않습니다. 따라서 노드 장애 시 Pod가 작동하려면 컨트롤러가 필요합니다.

| 상태 | 컨트롤러 유형 | 재시작 정책 |

|---|---|---|

| 종료할 것으로 예상되는 Pod(예: 일괄 계산) | Job |

|

| 종료되지 않을 것으로 예상되는 Pod(예: 웹 서버) | 복제 컨트롤러 |

|

| 머신당 하나씩 실행해야 하는 Pod | 데몬 세트 | Any |

Pod의 컨테이너가 실패하고 재시작 정책이 OnFailure로 설정된 경우 Pod가 노드에 남아 있고 컨테이너가 재시작됩니다. 컨테이너를 재시작하지 않으려면 재시작 정책 Never를 사용하십시오.

전체 Pod가 실패하면 OpenShift Dedicated에서 새 Pod를 시작합니다. 개발자는 애플리케이션이 새 Pod에서 재시작될 수 있는 가능성을 고려해야 합니다. 특히 애플리케이션에서는 이전 실행으로 발생한 임시 파일, 잠금, 불완전한 출력 등을 처리해야 합니다.

Kubernetes 아키텍처에서는 클라우드 공급자의 끝점이 안정적인 것으로 예상합니다. 클라우드 공급자가 다운되면 kubelet에서 OpenShift Dedicated가 다시 시작되지 않습니다.

기본 클라우드 공급자 끝점이 안정적이지 않은 경우 클라우드 공급자 통합을 사용하여 클러스터를 설치하지 마십시오. 클라우드가 아닌 환경에서처럼 클러스터를 설치합니다. 설치된 클러스터에서 클라우드 공급자 통합을 설정하거나 해제하는 것은 권장되지 않습니다.

OpenShift Dedicated에서 실패한 컨테이너와 함께 재시작 정책을 사용하는 방법에 대한 자세한 내용은 Kubernetes 문서의 예제 상태를 참조하십시오.

2.3.2. Pod에서 사용할 수 있는 대역폭 제한

Pod에 서비스 품질 트래픽 조절 기능을 적용하고 사용 가능한 대역폭을 효과적으로 제한할 수 있습니다. Pod에서 송신하는 트래픽은 구성된 속도를 초과하는 패킷을 간단히 삭제하는 정책에 따라 처리합니다. Pod에 수신되는 트래픽은 데이터를 효과적으로 처리하기 위해 대기 중인 패킷을 구성하여 처리합니다. 특정 Pod에 대한 제한 사항은 다른 Pod의 대역폭에 영향을 미치지 않습니다.

프로세스

Pod의 대역폭을 제한하려면 다음을 수행합니다.

오브젝트 정의 JSON 파일을 작성하고

kubernetes.io/ingress-bandwidth및kubernetes.io/egress-bandwidth주석을 사용하여 데이터 트래픽 속도를 지정합니다. 예를 들어 Pod 송신 및 수신 대역폭을 둘 다 10M/s로 제한하려면 다음을 수행합니다.제한된

Pod오브젝트 정의Copy to Clipboard Copied! Toggle word wrap Toggle overflow 오브젝트 정의를 사용하여 Pod를 생성합니다.

oc create -f <file_or_dir_path>

$ oc create -f <file_or_dir_path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.3. Pod 중단 예산을 사용하여 실행 중인 pod 수를 지정하는 방법

Pod 중단 예산을 사용하면 유지보수를 위해 노드를 드레이닝하는 등 작업 중에 Pod에 대한 보안 제약 조건을 지정할 수 있습니다.

PodDisruptionBudget은 동시에 작동해야 하는 최소 복제본 수 또는 백분율을 지정하는 API 오브젝트입니다. 프로젝트에서 이러한 설정은 노드 유지 관리 (예: 클러스터 축소 또는 클러스터 업그레이드) 중에 유용할 수 있으며 (노드 장애 시가 아니라) 자발적으로 제거된 경우에만 적용됩니다.

PodDisruptionBudget 오브젝트의 구성은 다음과 같은 주요 부분으로 구성되어 있습니다.

- 일련의 pod에 대한 라벨 쿼리 기능인 라벨 선택기입니다.

동시에 사용할 수 있어야 하는 최소 pod 수를 지정하는 가용성 수준입니다.

-

minAvailable은 중단 중에도 항상 사용할 수 있어야하는 pod 수입니다. -

maxUnavailable은 중단 중에 사용할 수없는 pod 수입니다.

-

available 은 조건이 Ready=True 인 Pod 수를 나타냅니다. ready=True 는 요청을 제공할 수 있는 Pod를 나타내며 일치하는 모든 서비스의 로드 밸런싱 풀에 추가해야 합니다.

maxUnavailable 0 % 또는 0이나 minAvailable의 100 % 혹은 복제본 수와 동일한 값은 허용되지만 이로 인해 노드가 드레인되지 않도록 차단할 수 있습니다.

maxUnavailable 의 기본 설정은 OpenShift Dedicated의 모든 머신 구성 풀에 대해 1 입니다. 이 값을 변경하지 않고 한 번에 하나의 컨트롤 플레인 노드를 업데이트하는 것이 좋습니다. 컨트롤 플레인 풀의 경우 이 값을 3 으로 변경하지 마십시오.

다음을 사용하여 모든 프로젝트에서 pod 중단 예산을 확인할 수 있습니다.

oc get poddisruptionbudget --all-namespaces

$ oc get poddisruptionbudget --all-namespaces다음 예제에는 AWS의 OpenShift Dedicated와 관련된 몇 가지 값이 포함되어 있습니다.

출력 예

PodDisruptionBudget은 시스템에서 최소 minAvailable pod가 실행중인 경우 정상으로 간주됩니다. 이 제한을 초과하는 모든 pod는 제거할 수 있습니다.

Pod 우선 순위 및 선점 설정에 따라 우선 순위가 낮은 pod는 pod 중단 예산 요구 사항을 무시하고 제거될 수 있습니다.

2.3.3.1. Pod 중단 예산을 사용하여 실행해야 할 pod 수 지정

PodDisruptionBudget 오브젝트를 사용하여 동시에 가동되어야 하는 최소 복제본 수 또는 백분율을 지정할 수 있습니다.

프로세스

pod 중단 예산을 구성하려면 다음을 수행합니다.

다음과 같은 오브젝트 정의를 사용하여 YAML 파일을 만듭니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 또는 다음을 수행합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 오브젝트를 프로젝트에 추가합니다.

oc create -f </path/to/file> -n <project_name>

$ oc create -f </path/to/file> -n <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5. 구성 맵 생성 및 사용

다음 섹션에서는 구성 맵과 이를 생성하고 사용하는 방법을 정의합니다.

2.5.1. 구성 맵 이해

많은 애플리케이션에는 구성 파일, 명령줄 인수 및 환경 변수의 조합을 사용하여 구성이 필요합니다. OpenShift Dedicated에서 컨테이너화된 애플리케이션을 이식하기 위해 이러한 구성 아티팩트는 이미지 콘텐츠와 분리됩니다.

ConfigMap 오브젝트는 컨테이너를 OpenShift Dedicated와 무관하게 유지하면서 구성 데이터를 사용하여 컨테이너를 삽입하는 메커니즘을 제공합니다. 구성 맵은 개별 속성 또는 전체 구성 파일 또는 JSON Blob과 같은 세분화된 정보를 저장하는 데 사용할 수 있습니다.

ConfigMap 오브젝트에는 Pod에서 사용하거나 컨트롤러와 같은 시스템 구성 요소의 구성 데이터를 저장하는 데 사용할 수 있는 구성 데이터의 키-값 쌍이 있습니다. 예를 들면 다음과 같습니다.

ConfigMap 오브젝트 정의

이미지와 같은 바이너리 파일에서 구성 맵을 생성할 때 binaryData 필드를 사용할 수 있습니다.

다양한 방법으로 Pod에서 구성 데이터를 사용할 수 있습니다. 구성 맵을 다음과 같이 사용할 수 있습니다.

- 컨테이너에서 환경 변수 값 채우기

- 컨테이너에서 명령줄 인수 설정

- 볼륨에 구성 파일 채우기

사용자 및 시스템 구성 요소는 구성 데이터를 구성 맵에 저장할 수 있습니다.

구성 맵은 보안과 유사하지만 민감한 정보가 포함되지 않은 문자열 작업을 더 편리하게 지원하도록 설계되었습니다.

2.5.1.1. 구성 맵 제한 사항

Pod에서 콘텐츠를 사용하기 전에 구성 맵을 생성해야 합니다.

컨트롤러는 누락된 구성 데이터를 허용하도록 작성할 수 있습니다. 상황에 따라 구성 맵을 사용하여 구성된 개별 구성 요소를 참조하십시오.

ConfigMap 오브젝트는 프로젝트에 있습니다.

동일한 프로젝트의 Pod에서만 참조할 수 있습니다.

Kubelet은 API 서버에서 가져오는 Pod에 대한 구성 맵만 지원합니다.

여기에는 CLI를 사용하거나 복제 컨트롤러에서 간접적으로 생성되는 모든 Pod가 포함됩니다. OpenShift Dedicated 노드의 --manifest-url 플래그, --config 플래그 또는 해당 REST API를 사용하여 생성된 Pod는 Pod를 생성하는 일반적인 방법이 아니므로 포함하지 않습니다.

2.5.2. OpenShift Dedicated 웹 콘솔에서 구성 맵 생성

OpenShift Dedicated 웹 콘솔에서 구성 맵을 생성할 수 있습니다.

프로세스

클러스터 관리자로 구성 맵을 생성하려면 다음을 수행합니다.

-

관리자 관점에서

Workloads→Config Maps을 선택합니다. - 페이지 오른쪽 상단에서 구성 맵 생성을 선택합니다.

- 구성 맵의 콘텐츠를 입력합니다.

- 생성을 선택합니다.

-

관리자 관점에서

개발자로 구성 맵을 생성하려면 다음을 수행합니다.

-

개발자 관점에서

Config Maps을 선택합니다. - 페이지 오른쪽 상단에서 구성 맵 생성을 선택합니다.

- 구성 맵의 콘텐츠를 입력합니다.

- 생성을 선택합니다.

-

개발자 관점에서

2.5.3. CLI를 사용하여 구성 맵 생성

다음 명령을 사용하여 디렉토리, 특정 파일 또는 리터럴 값에서 구성 맵을 생성할 수 있습니다.

절차

구성 맵 생성:

oc create configmap <configmap_name> [options]

$ oc create configmap <configmap_name> [options]Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.3.1. 디렉토리에서 구성 맵 생성

--from-file 플래그를 사용하여 디렉터리에서 구성 맵을 생성할 수 있습니다. 이 방법을 사용하면 디렉토리 내 여러 파일을 사용하여 구성 맵을 생성할 수 있습니다.

디렉터리의 각 파일은 구성 맵에서 키를 채우는 데 사용됩니다. 여기서 키 이름은 파일 이름이며 키 값은 파일의 내용입니다.

예를 들어 다음 명령은 example-files 디렉터리의 콘텐츠를 사용하여 구성 맵을 생성합니다.

oc create configmap game-config --from-file=example-files/

$ oc create configmap game-config --from-file=example-files/구성 맵에서 키를 표시합니다.

oc describe configmaps game-config

$ oc describe configmaps game-config출력 예

맵의 두 키가 명령에 지정된 디렉토리의 파일 이름에서 생성되는 것을 확인할 수 있습니다. 해당 키의 내용은 커질 수 있으므로 oc describe 의 출력은 키와 크기의 이름만 표시합니다.

사전 요구 사항

구성 맵을 채우려는 데이터가 포함된 파일이 있는 디렉터리가 있어야 합니다.

다음 절차에서는 다음 예제 파일을 사용합니다.

game.properties및ui.properties:cat example-files/game.properties

$ cat example-files/game.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow cat example-files/ui.properties

$ cat example-files/ui.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

color.good=purple color.bad=yellow allow.textmode=true how.nice.to.look=fairlyNice

color.good=purple color.bad=yellow allow.textmode=true how.nice.to.look=fairlyNiceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

프로세스

다음 명령을 입력하여 이 디렉터리에 있는 각 파일의 콘텐츠를 포함하는 구성 맵을 생성합니다.

oc create configmap game-config \ --from-file=example-files/$ oc create configmap game-config \ --from-file=example-files/Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

키 값을 보려면

-o옵션을 사용하여 오브젝트에 대한oc get명령을 입력합니다.oc get configmaps game-config -o yaml

$ oc get configmaps game-config -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.3.2. 파일에서 구성 맵 생성

--from-file 플래그를 사용하여 파일에서 구성 맵을 생성할 수 있습니다. --from-file 옵션을 CLI에 여러 번 전달할 수 있습니다.

key=value 표현식을 --from-file 옵션에 전달하여 파일에서 가져온 콘텐츠의 구성 맵에 설정할 키를 지정할 수도 있습니다. 예를 들면 다음과 같습니다.

oc create configmap game-config-3 --from-file=game-special-key=example-files/game.properties

$ oc create configmap game-config-3 --from-file=game-special-key=example-files/game.properties

파일에서 구성 맵을 생성하는 경우 UTF8이 아닌 데이터를 손상시키지 않고 이 필드에 배치된 UTF8이 아닌 데이터가 포함된 파일을 포함할 수 있습니다. OpenShift Dedicated는 바이너리 파일을 감지하고 파일을 MIME 로 투명하게 인코딩합니다. 서버에서 MIME 페이로드는 데이터 손상 없이 디코딩되어 저장됩니다.

사전 요구 사항

구성 맵을 채우려는 데이터가 포함된 파일이 있는 디렉터리가 있어야 합니다.

다음 절차에서는 다음 예제 파일을 사용합니다.

game.properties및ui.properties:cat example-files/game.properties

$ cat example-files/game.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow cat example-files/ui.properties

$ cat example-files/ui.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

color.good=purple color.bad=yellow allow.textmode=true how.nice.to.look=fairlyNice

color.good=purple color.bad=yellow allow.textmode=true how.nice.to.look=fairlyNiceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

프로세스

특정 파일을 지정하여 구성 맵을 생성합니다.

oc create configmap game-config-2 \ --from-file=example-files/game.properties \ --from-file=example-files/ui.properties$ oc create configmap game-config-2 \ --from-file=example-files/game.properties \ --from-file=example-files/ui.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 키-값 쌍을 지정하여 구성 맵을 생성합니다.

oc create configmap game-config-3 \ --from-file=game-special-key=example-files/game.properties$ oc create configmap game-config-3 \ --from-file=game-special-key=example-files/game.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

파일에서 키 값을 확인하려면

-o옵션을 사용하여 오브젝트에 대한oc get명령을 입력합니다.oc get configmaps game-config-2 -o yaml

$ oc get configmaps game-config-2 -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 키-값 쌍의 키 값을 확인하려면

-o옵션을 사용하여 오브젝트에 대한oc get명령을 입력합니다.oc get configmaps game-config-3 -o yaml

$ oc get configmaps game-config-3 -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 이전 단계에서 설정한 키입니다.

2.5.3.3. 리터럴 값에서 구성 맵 생성

구성 맵에 리터럴 값을 제공할 수 있습니다.

--from-literal 옵션은 key=value 구문을 사용하므로 명령줄에서 직접 리터럴 값을 제공할 수 있습니다.

프로세스

리터럴 값을 지정하여 구성 맵을 생성합니다.

oc create configmap special-config \ --from-literal=special.how=very \ --from-literal=special.type=charm$ oc create configmap special-config \ --from-literal=special.how=very \ --from-literal=special.type=charmCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

키 값을 보려면

-o옵션을 사용하여 오브젝트에 대한oc get명령을 입력합니다.oc get configmaps special-config -o yaml

$ oc get configmaps special-config -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.4. 사용 사례: Pod에서 구성 맵 사용

다음 섹션에서는 Pod에서 ConfigMap 오브젝트를 사용할 때 몇 가지 사용 사례에 대해 설명합니다.

2.5.4.1. 구성 맵을 사용하여 컨테이너에서 환경 변수 채우기

구성 맵을 사용하여 컨테이너에서 개별 환경 변수를 채우거나 유효한 환경 변수 이름을 형성하는 모든 키에서 컨테이너의 환경 변수를 채울 수 있습니다.

예를 들어 다음 구성 맵을 고려하십시오.

두 개의 환경 변수가 있는 ConfigMap

하나의 환경 변수가 있는 ConfigMap

절차

configMapKeyRef섹션을 사용하여 Pod에서 이ConfigMap의 키를 사용할 수 있습니다.특정 환경 변수를 삽입하도록 구성된 샘플

Pod사양Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 Pod가 실행되면 Pod 로그에 다음 출력이 포함됩니다.

SPECIAL_LEVEL_KEY=very log_level=INFO

SPECIAL_LEVEL_KEY=very log_level=INFOCopy to Clipboard Copied! Toggle word wrap Toggle overflow

SPECIAL_TYPE_KEY=charm은 예제 출력에 나열되지 않습니다. optional: true가 설정되어 있기 때문입니다.

2.5.4.2. 구성 맵을 사용하여 컨테이너 명령의 명령줄 인수 설정

구성 맵을 사용하여 Kubernetes 대체 구문 $(VAR_NAME) 을 사용하여 컨테이너에서 명령 또는 인수 값을 설정할 수 있습니다.

예를 들어 다음 구성 맵을 고려하십시오.

프로세스

컨테이너의 명령에 값을 삽입하려면 환경 변수로 사용할 키를 사용해야 합니다. 그런 다음

$(VAR_NAME)구문을 사용하여 컨테이너의 명령에서 참조할 수 있습니다.특정 환경 변수를 삽입하도록 구성된 샘플 Pod 사양

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 환경 변수로 사용할 키를 사용하여 컨테이너의 명령에 값을 삽입합니다.

이 Pod가 실행되면 test-container 컨테이너에서 실행되는 echo 명령의 출력은 다음과 같습니다.

very charm

very charmCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.4.3. 구성 맵을 사용하여 볼륨에 콘텐츠 삽입

구성 맵을 사용하여 볼륨에 콘텐츠를 삽입할 수 있습니다.

ConfigMap CR(사용자 정의 리소스)의 예

프로세스

구성 맵을 사용하여 볼륨에 콘텐츠를 삽입하는 몇 가지 다른 옵션이 있습니다.

구성 맵을 사용하여 콘텐츠를 볼륨에 삽입하는 가장 기본적인 방법은 키가 파일 이름이고 파일의 콘텐츠가 키의 값인 파일로 볼륨을 채우는 것입니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 키가 포함된 파일입니다.

이 Pod가 실행되면 cat 명령의 출력은 다음과 같습니다.

very

veryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 구성 맵 키가 프로젝션된 볼륨 내의 경로를 제어할 수도 있습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 구성 맵 키 경로입니다.

이 Pod가 실행되면 cat 명령의 출력은 다음과 같습니다.

very

veryCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6. Pod 예약 결정에 Pod 우선순위 포함

클러스터에서 Pod 우선순위 및 선점을 활성화할 수 있습니다. Pod 우선순위는 다른 Pod와 관련된 Pod의 중요도를 나타내며 해당 우선 순위에 따라 Pod를 대기열에 넣습니다. Pod 선점을 사용하면 적절한 노드 Pod 우선순위에 사용 가능한 공간이 없는 경우 우선 순위가 낮은 Pod를 제거하거나 우선순위가 낮은 Pod를 예약할 수 있습니다. 노드의 예약 순서 및 리소스 부족 제거 순서에도 영향을 미칩니다.

우선순위 및 선점 기능을 사용하려면 Pod 사양의 우선순위 클래스를 참조하여 스케줄링에 해당 가중치를 적용합니다.

2.6.1. Pod 우선순위 이해

Pod 우선순위 및 선점 기능을 사용하면 스케줄러에서 보류 중인 Pod를 우선순위에 따라 정렬하고, 보류 중인 Pod는 예약 큐에서 우선순위가 더 낮은 다른 대기 중인 Pod보다 앞에 배치됩니다. 그 결과 예약 요구 사항이 충족되는 경우 우선순위가 높은 Pod가 우선순위가 낮은 Pod보다 더 빨리 예약될 수 있습니다. Pod를 예약할 수 없는 경우에는 스케줄러에서 우선순위가 낮은 다른 Pod를 계속 예약합니다.

2.6.1.1. Pod 우선순위 클래스

네임스페이스가 지정되지 않은 오브젝트로서 이름에서 우선순위 정수 값으로의 매핑을 정의하는 우선순위 클래스를 Pod에 할당할 수 있습니다. 값이 클수록 우선순위가 높습니다.

우선순위 클래스 오브젝트에는 1000000000(10억)보다 작거나 같은 32비트 정수 값을 사용할 수 있습니다. 선점 또는 제거해서는 안 되는 중요한 Pod의 경우 10억보다 크거나 같은 수를 예약합니다. 기본적으로 OpenShift Dedicated에는 중요한 시스템 Pod의 스케줄링을 보장하기 위해 두 가지 우선순위 클래스가 예약되어 있습니다.

oc get priorityclasses

$ oc get priorityclasses출력 예

NAME VALUE GLOBAL-DEFAULT AGE system-node-critical 2000001000 false 72m system-cluster-critical 2000000000 false 72m openshift-user-critical 1000000000 false 3d13h cluster-logging 1000000 false 29s

NAME VALUE GLOBAL-DEFAULT AGE

system-node-critical 2000001000 false 72m

system-cluster-critical 2000000000 false 72m

openshift-user-critical 1000000000 false 3d13h

cluster-logging 1000000 false 29ssystem-node-critical - 이 우선순위 클래스의 값은 2000001000이며 노드에서 제거해서는 안 되는 모든 Pod에 사용합니다. 이 우선순위 클래스가 있는 Pod의 예는

ovnkube-node등입니다. 대다수의 중요한 구성 요소에는 기본적으로system-node-critical우선순위 클래스가 포함됩니다. 예를 들면 다음과 같습니다.- master-api

- master-controller

- master-etcd

- OVN-kubernetes

- sync

system-cluster-critical - 이 우선순위 클래스의 값은 2000000000(10억)이며 클러스터에 중요한 Pod에 사용합니다. 이 우선순위 클래스가 있는 Pod는 특정 상황에서 노드에서 제거할 수 있습니다. 예를 들어

system-node-critical우선순위 클래스를 사용하여 구성한 Pod가 우선할 수 있습니다. 그러나 이 우선순위 클래스는 예약을 보장합니다. 이 우선순위 클래스를 사용할 수 있는 Pod의 예로는 fluentd, Descheduler와 같은 추가 기능 구성 요소 등이 있습니다. 대다수의 중요한 구성 요소에는 기본적으로system-cluster-critical우선순위 클래스가 포함됩니다. 예를 들면 다음과 같습니다.- fluentd

- metrics-server

- Descheduler

-

OpenShift-user-critical -

priorityClassName필드를 리소스 사용을 바인딩할 수 없고 예측 가능한 리소스 사용량 동작이 없는 중요한 Pod와 함께 사용할 수 있습니다.openshift-monitoring및openshift-user-workload-monitoring네임스페이스 아래의 Prometheus Pod는openshift-user-criticalpriorityClassName을 사용합니다. 모니터링 워크로드는 첫 번째priorityClass로시스템 중요를 사용하지만 모니터링에서 과도한 메모리를 사용하고 노드를 제거할 수 없는 경우 문제가 발생합니다. 결과적으로 모니터링은 중요한 노드 작동을 유지하기 위해 스케줄러의 유연성을 제공하기 위해 우선 순위가 떨어지고 많은 워크로드를 이동합니다. - cluster-logging - 이 우선순위는 Fluentd에서 Fluentd Pod가 다른 앱보다 먼저 노드에 예약되도록 하는 데 사용합니다.

2.6.1.2. Pod 우선순위 이름

우선순위 클래스가 한 개 이상 있으면 Pod 사양에서 우선순위 클래스 이름을 지정하는 Pod를 생성할 수 있습니다. 우선순위 승인 컨트롤러는 우선순위 클래스 이름 필드를 사용하여 정수 값으로 된 우선순위를 채웁니다. 이름이 지정된 우선순위 클래스가 없는 경우 Pod가 거부됩니다.

2.6.2. Pod 선점 이해

개발자가 Pod를 생성하면 Pod가 큐로 들어갑니다. 개발자가 Pod에 Pod 우선순위 또는 선점을 구성한 경우 스케줄러는 큐에서 Pod를 선택하고 해당 Pod를 노드에 예약하려고 합니다. 스케줄러가 노드에서 Pod의 지정된 요구 사항을 모두 충족하는 적절한 공간을 찾을 수 없는 경우 보류 중인 Pod에 대한 선점 논리가 트리거됩니다.

스케줄러가 노드에서 Pod를 하나 이상 선점하면 우선순위가 높은 Pod 사양의 nominatedNodeName 필드가 nodename 필드와 함께 노드의 이름으로 설정됩니다. 스케줄러는 nominatedNodeName 필드를 사용하여 Pod용으로 예약된 리소스를 계속 추적하고 클러스터의 선점에 대한 정보도 사용자에게 제공합니다.

스케줄러에서 우선순위가 낮은 Pod를 선점한 후에는 Pod의 정상 종료 기간을 따릅니다. 스케줄러에서 우선순위가 낮은 Pod가 종료되기를 기다리는 동안 다른 노드를 사용할 수 있게 되는 경우 스케줄러는 해당 노드에서 우선순위가 더 높은 Pod를 예약할 수 있습니다. 따라서 Pod 사양의 nominatedNodeName 필드 및 nodeName 필드가 다를 수 있습니다.

또한 스케줄러가 노드의 Pod를 선점하고 종료되기를 기다리고 있는 상태에서 보류 중인 Pod보다 우선순위가 높은 Pod를 예약해야 하는 경우, 스케줄러는 우선순위가 더 높은 Pod를 대신 예약할 수 있습니다. 이러한 경우 스케줄러는 보류 중인 Pod의 nominatedNodeName을 지워 해당 Pod를 다른 노드에 사용할 수 있도록 합니다.

선점을 수행해도 우선순위가 낮은 Pod가 노드에서 모두 제거되는 것은 아닙니다. 스케줄러는 우선순위가 낮은 Pod의 일부를 제거하여 보류 중인 Pod를 예약할 수 있습니다.

스케줄러는 노드에서 보류 중인 Pod를 예약할 수 있는 경우에만 해당 노드에서 Pod 선점을 고려합니다.

2.6.2.1. 선점되지 않은 우선 순위 클래스

선점 정책이 Never로 설정된 Pod는 예약 큐에서 우선순위가 낮은 Pod보다 앞에 배치되지만 다른 Pod는 선점할 수 없습니다. 예약 대기 중인 비 선점 Pod는 사용 가능한 리소스가 충분하고 해당 Pod를 예약할 수 있을 때까지 예약 큐에 남아 있습니다. 비 선점 Pod는 다른 Pod와 마찬가지로 스케줄러 백오프의 영향을 받습니다. 즉 스케줄러에서 이러한 Pod를 예약하지 못하면 더 낮은 빈도로 다시 예약을 시도하여 우선순위가 더 낮은 기타 Pod를 먼저 예약할 수 있습니다.

비 선점 Pod는 우선순위가 높은 다른 Pod에서 계속 선점할 수 있습니다.

2.6.2.2. Pod 선점 및 기타 스케줄러 설정

Pod 우선순위 및 선점 기능을 활성화하는 경우 다른 스케줄러 설정을 고려하십시오.

- Pod 우선순위 및 Pod 중단 예산

- Pod 중단 예산은 동시에 작동해야 하는 최소 복제본 수 또는 백분율을 지정합니다. Pod 중단 예산을 지정하면 Pod를 최상의 노력 수준에서 선점할 때 OpenShift Dedicated에서 해당 예산을 준수합니다. 스케줄러는 Pod 중단 예산을 위반하지 않고 Pod를 선점하려고 합니다. 이러한 Pod를 찾을 수 없는 경우 Pod 중단 예산 요구 사항과 관계없이 우선순위가 낮은 Pod를 선점할 수 있습니다.

- Pod 우선순위 및 Pod 유사성

- Pod 유사성을 위해서는 동일한 라벨이 있는 다른 Pod와 같은 노드에서 새 Pod를 예약해야 합니다.

노드에서 우선순위가 낮은 하나 이상의 Pod와 보류 중인 Pod에 Pod 간 유사성이 있는 경우 스케줄러는 선호도 요구 사항을 위반하지 않고 우선순위가 낮은 Pod를 선점할 수 없습니다. 이 경우 스케줄러는 보류 중인 Pod를 예약할 다른 노드를 찾습니다. 그러나 스케줄러에서 적절한 노드를 찾을 수 있다는 보장이 없고 보류 중인 Pod가 예약되지 않을 수 있습니다.

이러한 상황을 방지하려면 우선순위가 같은 Pod를 사용하여 Pod 유사성을 신중하게 구성합니다.

2.6.2.3. 선점된 Pod의 정상 종료

Pod를 선점할 때 스케줄러는 Pod의 정상 종료 기간이 만료될 때까지 대기하여 Pod가 작동을 완료하고 종료할 수 있도록 합니다. 기간이 지난 후에도 Pod가 종료되지 않으면 스케줄러에서 Pod를 종료합니다. 이러한 정상 종료 기간으로 인해 스케줄러에서 Pod를 선점하는 시점과 노드에서 보류 중인 Pod를 예약할 수 있는 시간 사이에 시차가 발생합니다.

이 간격을 최소화하려면 우선순위가 낮은 Pod의 정상 종료 기간을 짧게 구성하십시오.

2.6.3. 우선순위 및 선점 구성

Pod 사양에 priorityClassName 을 사용하여 우선순위 클래스 오브젝트를 생성하고 Pod를 우선순위에 연결하여 우선순위 및 선점을 적용합니다.

예약된 기존 Pod에 우선순위 클래스를 직접 추가할 수 없습니다.

프로세스

우선순위 및 선점을 사용하도록 클러스터를 구성하려면 다음을 수행합니다.

다음과 유사한 YAML 파일을 생성하여 우선순위 클래스의 이름을 포함하도록 Pod 사양을 정의합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 이 Pod에 사용할 우선순위 클래스를 지정합니다.

Pod를 생성합니다.

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod 구성 또는 Pod 템플릿에 우선순위 이름을 직접 추가할 수 있습니다.

2.7. 노드 선택기를 사용하여 특정 노드에 Pod 배치

노드 선택기는 키-값 쌍으로 구성된 맵을 지정합니다. 규칙은 노드의 사용자 정의 라벨과 Pod에 지정된 선택기를 사용하여 정의합니다.

Pod를 노드에서 실행하려면 Pod에 노드의 라벨로 표시된 키-값 쌍이 있어야 합니다.

동일한 Pod 구성에서 노드 유사성 및 노드 선택기를 사용하는 경우 아래의 중요 고려 사항을 참조하십시오.

2.7.1. 노드 선택기를 사용하여 Pod 배치 제어

Pod의 노드 선택기와 노드의 라벨을 사용하여 Pod가 예약되는 위치를 제어할 수 있습니다. 노드 선택기를 사용하면 OpenShift Dedicated에서 일치하는 라벨이 포함된 노드에 Pod를 예약합니다.

노드, 컴퓨팅 머신 세트 또는 머신 구성에 라벨을 추가합니다. 컴퓨팅 시스템 세트에 레이블을 추가하면 노드 또는 머신이 중단되면 새 노드에 라벨이 지정됩니다. 노드 또는 머신이 중단된 경우 노드 또는 머신 구성에 추가된 라벨이 유지되지 않습니다.

기존 Pod에 노드 선택기를 추가하려면 ReplicaSet 오브젝트, DaemonSet 오브젝트, StatefulSet 오브젝트, Deployment 오브젝트 또는 DeploymentConfig 오브젝트와 같이 해당 Pod의 제어 오브젝트에 노드 선택기를 추가합니다. 이 제어 오브젝트 아래의 기존 Pod는 라벨이 일치하는 노드에서 재생성됩니다. 새 Pod를 생성하는 경우 Pod 사양에 노드 선택기를 직접 추가할 수 있습니다. Pod에 제어 오브젝트가 없는 경우 Pod를 삭제하고 Pod 사양을 편집하고 Pod를 다시 생성해야 합니다.

예약된 기존 Pod에 노드 선택기를 직접 추가할 수 없습니다.

사전 요구 사항

기존 Pod에 노드 선택기를 추가하려면 해당 Pod의 제어 오브젝트를 결정하십시오. 예를 들어 router-default-66d5cf9464-m2g75 Pod는 router-default-66d5cf9464 복제본 세트에서 제어합니다.

oc describe pod router-default-66d5cf9464-7pwkc

$ oc describe pod router-default-66d5cf9464-7pwkc출력 예

웹 콘솔에서 Pod YAML의 ownerReferences 아래에 제어 오브젝트가 나열됩니다.

프로세스

Pod에 일치하는 노드 선택기를 추가합니다.

기존 및 향후 Pod에 노드 선택기를 추가하려면 Pod의 제어 오브젝트에 노드 선택기를 추가합니다.

라벨이 있는

ReplicaSet오브젝트의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 노드 선택기를 추가합니다.

특정 새 Pod에 노드 선택기를 추가하려면 선택기를

Pod오브젝트에 직접 추가합니다.노드 선택기가 있는

Pod오브젝트의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고예약된 기존 Pod에 노드 선택기를 직접 추가할 수 없습니다.

3장. Custom Metrics Autoscaler Operator를 사용하여 Pod 자동 스케일링

3.1. 릴리스 노트

3.1.1. 사용자 정의 Metrics Autoscaler Operator 릴리스 노트

Custom Metrics Autoscaler Operator for Red Hat OpenShift의 릴리스 노트는 새로운 기능 및 개선 사항, 더 이상 사용되지 않는 기능 및 알려진 문제에 대해 설명합니다.

Custom Metrics Autoscaler Operator는 Kubernetes 기반 이벤트 기반 자동 스케일러(KEDA)를 사용하며 OpenShift Dedicated HPA(Horizontal Pod Autoscaler) 상단에 빌드됩니다.

Custom Metrics Autoscaler Operator for Red Hat OpenShift는 코어 OpenShift Dedicated와 별도의 릴리스 사이클과 함께 설치 가능한 구성 요소로 제공됩니다. Red Hat OpenShift Container Platform 라이프 사이클 정책은 릴리스 호환성에 대해 간단히 설명합니다.

3.1.1.1. 지원되는 버전

다음 표는 각 OpenShift Dedicated 버전에 대한 Custom Metrics Autoscaler Operator 버전을 정의합니다.

| 버전 | OpenShift Dedicated 버전 | 정식 출시일 (GA) |

|---|---|---|

| 2.17.2-2 | 4.20 | 정식 출시일 (GA) |

| 2.17.2-2 | 4.19 | 정식 출시일 (GA) |

| 2.17.2-2 | 4.18 | 정식 출시일 (GA) |

| 2.17.2-2 | 4.17 | 정식 출시일 (GA) |

| 2.17.2-2 | 4.16 | 정식 출시일 (GA) |

| 2.17.2-2 | 4.15 | 정식 출시일 (GA) |

| 2.17.2-2 | 4.14 | 정식 출시일 (GA) |

| 2.17.2-2 | 4.13 | 정식 출시일 (GA) |

| 2.17.2-2 | 4.12 | 정식 출시일 (GA) |

3.1.1.2. 사용자 정의 지표 Autoscaler Operator 2.17.2-2 릴리스 노트

출시 날짜: 2025년 10월 21일

이번 Custom Metrics Autoscaler Operator 2.17.2-2 릴리스는 최신 기본 이미지 및 Go 컴파일러를 사용하여 Custom Metrics Autoscaler Operator의 2.17.2 버전의 재빌드입니다. Custom Metrics Autoscaler Operator에 대한 코드 변경 사항은 없습니다. Custom Metrics Autoscaler Operator에 대한 다음 권고를 사용할 수 있습니다.

이 버전의 Custom Metrics Autoscaler Operator를 설치하기 전에 이전에 설치한 기술 프리뷰 버전 또는 Kubernetes 기반 이벤트 기반 자동 스케일러(KEDA)의 커뮤니티 지원 버전을 제거합니다.

3.1.2. Custom Metrics Autoscaler Operator의 이전 릴리스 릴리스 노트

다음 릴리스 노트는 이전 버전의 Custom Metrics Autoscaler Operator에 대한 것입니다.

현재 버전의 경우 Custom Metrics Autoscaler Operator 릴리스 노트를 참조하십시오.

3.1.2.1. 사용자 정의 지표 Autoscaler Operator 2.17.2 릴리스 노트

출시 날짜: 2025년 9월 25일

이번 Custom Metrics Autoscaler Operator 2.17.2 릴리스는 CVE(Common Vulnerabilities and Exposures)를 처리합니다. Custom Metrics Autoscaler Operator에 대한 다음 권고를 사용할 수 있습니다.

이 버전의 Custom Metrics Autoscaler Operator를 설치하기 전에 이전에 설치한 기술 프리뷰 버전 또는 Kubernetes 기반 이벤트 기반 자동 스케일러(KEDA)의 커뮤니티 지원 버전을 제거합니다.

3.1.2.1.1. 새로운 기능 및 개선 사항

3.1.2.1.1.1. 설치 중에 KEDA 컨트롤러가 자동으로 생성됩니다.

Custom Metrics Autoscaler Operator를 설치할 때 KEDA 컨트롤러가 자동으로 생성됩니다. 이전에는 KEDA 컨트롤러를 수동으로 생성해야 했습니다. 필요에 따라 자동으로 생성된 KEDA 컨트롤러를 편집할 수 있습니다.

3.1.2.1.1.2. Kubernetes 워크로드 트리거 지원

Cluster Metrics Autoscaler Operator는 이제 Kubernetes 워크로드 트리거 사용을 지원하여 특정 라벨 선택기와 일치하는 Pod 수에 따라 Pod를 스케일링할 수 있습니다.

3.1.2.1.1.3. 서비스 계정 토큰 바인딩 지원

Cluster Metrics Autoscaler Operator에서 바인딩된 서비스 계정 토큰을 지원합니다. 이전에는 Operator에서 보안상의 이유로 바인딩된 서비스 계정 토큰을 사용하도록 단계적으로 제공되는 레거시 서비스 계정 토큰만 지원했습니다.

3.1.2.1.2. 버그 수정

- 이전에는 KEDA 컨트롤러에서 볼륨 마운트를 지원하지 않았습니다. 결과적으로 Kafka scaler에서 Kerberos를 사용할 수 없었습니다. 이번 수정으로 KEDA 컨트롤러에서 볼륨 마운트를 지원합니다. (OCPBUGS-42559)

-

이전에는

keda-operator배포 오브젝트 로그의 KEDA 버전에서 Custom Metrics Autoscaler Operator가 잘못된 KEDA 버전을 기반으로 했습니다. 이번 수정으로 올바른 KEDA 버전이 로그에 보고됩니다. (OCPBUGS-58129)

3.1.2.2. 사용자 정의 메트릭 자동 스케일러 Operator 2.15.1-4 릴리스 노트

출시 날짜: 2025년 3월 31일

이번 Custom Metrics Autoscaler Operator 2.15.1-4 릴리스는 CVE(Common Vulnerabilities and Exposures)를 제공합니다. Custom Metrics Autoscaler Operator에 대한 다음 권고를 사용할 수 있습니다.

이 버전의 Custom Metrics Autoscaler Operator를 설치하기 전에 이전에 설치한 기술 프리뷰 버전 또는 Kubernetes 기반 이벤트 기반 자동 스케일러(KEDA)의 커뮤니티 지원 버전을 제거합니다.

3.1.2.2.1. 새로운 기능 및 개선 사항

3.1.2.2.1.1. CMA 다중 아키텍처 빌드

이 버전의 Custom Metrics Autoscaler Operator를 사용하면 ARM64 OpenShift Dedicated 클러스터에서 Operator를 설치하고 실행할 수 있습니다.

3.1.2.3. 사용자 정의 지표 Autoscaler Operator 2.14.1-467 릴리스 노트

이번 Custom Metrics Autoscaler Operator 2.14.1-467 릴리스는 OpenShift Dedicated 클러스터에서 Operator를 실행하기 위한 CVE 및 버그 수정을 제공합니다. RHSA-2024:7348 에 대해 다음 권고를 사용할 수 있습니다.

이 버전의 Custom Metrics Autoscaler Operator를 설치하기 전에 이전에 설치한 기술 프리뷰 버전 또는 Kubernetes 기반 이벤트 기반 자동 스케일러(KEDA)의 커뮤니티 지원 버전을 제거합니다.

3.1.2.3.1. 버그 수정

- 이전에는 Custom Metrics Autoscaler Operator Pod의 루트 파일 시스템에 쓸 수 있었기 때문에 필요하지 않으며 보안 문제가 발생할 수 있었습니다. 이번 업데이트에서는 Pod 루트 파일 시스템을 읽기 전용으로 설정하여 잠재적인 보안 문제를 해결합니다. (OCPBUGS-37989)

3.1.2.4. 사용자 정의 메트릭 자동 스케일러 Operator 2.14.1-454 릴리스 노트

이번 Custom Metrics Autoscaler Operator 2.14.1-454 릴리스는 OpenShift Dedicated 클러스터에서 Operator를 실행하기 위한 CVE, 새로운 기능 및 버그 수정을 제공합니다. RHBA-2024:5865 에 대해 다음 권고를 사용할 수 있습니다.

이 버전의 Custom Metrics Autoscaler Operator를 설치하기 전에 이전에 설치한 기술 프리뷰 버전 또는 Kubernetes 기반 이벤트 기반 자동 스케일러(KEDA)의 커뮤니티 지원 버전을 제거합니다.

3.1.2.4.1. 새로운 기능 및 개선 사항

3.1.2.4.1.1. Custom Metrics Autoscaler Operator를 사용하여 Cron 트리거 지원

Custom Metrics Autoscaler Operator는 Cron 트리거를 사용하여 시간별 스케줄에 따라 Pod를 스케일링할 수 있습니다. 지정된 시간 프레임이 시작되면 Custom Metrics Autoscaler Operator는 Pod를 원하는 양으로 스케일링합니다. 시간 프레임이 종료되면 Operator는 이전 수준으로 다시 축소됩니다.

자세한 내용은 Cron 트리거 이해를 참조하십시오.

3.1.2.4.2. 버그 수정

-

이전에는

KedaController사용자 정의 리소스에서 구성 매개변수를 감사하는 경우keda-metrics-server-audit-policy구성 맵이 업데이트되지 않았습니다. 결과적으로 Custom Metrics Autoscaler의 초기 배포 후 감사 구성 매개변수를 변경할 수 없었습니다. 이번 수정을 통해 구성 맵에서 감사 구성을 올바르게 렌더링하여 설치 후 언제든지 감사 구성을 변경할 수 있습니다. (OCPBUGS-32521)

3.1.2.5. 사용자 정의 지표 Autoscaler Operator 2.13.1 릴리스 노트

이번 Custom Metrics Autoscaler Operator 2.13.1-421 릴리스는 OpenShift Dedicated 클러스터에서 Operator를 실행하기 위한 새로운 기능 및 버그 수정을 제공합니다. RHBA-2024:4837 에 대해 다음 권고를 사용할 수 있습니다.

이 버전의 Custom Metrics Autoscaler Operator를 설치하기 전에 이전에 설치한 기술 프리뷰 버전 또는 Kubernetes 기반 이벤트 기반 자동 스케일러(KEDA)의 커뮤니티 지원 버전을 제거합니다.

3.1.2.5.1. 새로운 기능 및 개선 사항

3.1.2.5.1.1. Custom Metrics Autoscaler Operator를 사용하여 사용자 정의 인증서 지원

Custom Metrics Autoscaler Operator는 사용자 정의 서비스 CA 인증서를 사용하여 외부 Kafka 클러스터 또는 외부 Prometheus 서비스와 같은 TLS 사용 지표 소스에 안전하게 연결할 수 있습니다. 기본적으로 Operator는 자동으로 생성된 서비스 인증서를 사용하여 클러스터 내 서비스에만 연결합니다. KedaController 오브젝트에는 구성 맵을 사용하여 외부 서비스에 연결하기 위한 사용자 정의 서버 CA 인증서를 로드할 수 있는 새 필드가 있습니다.

3.1.2.5.2. 버그 수정

-

이전에는

custom-metrics-autoscaler및custom-metrics-autoscaler-adapter이미지에 시간대 정보가 누락되었습니다. 결과적으로 컨트롤러가 시간대 정보를 찾을 수 없기 때문에cron트리거를 사용하여 확장 개체가 작동하지 않았습니다. 이번 수정을 통해 시간대 정보를 포함하도록 이미지 빌드가 업데이트됩니다. 결과적으로cron트리거를 포함하는 확장 오브젝트가 올바르게 작동합니다. 현재cron트리거를 포함하는 확장 오브젝트는 사용자 정의 메트릭 자동 스케일러에서 지원되지 않습니다. (OCPBUGS-34018)

3.1.2.6. 사용자 정의 지표 Autoscaler Operator 2.12.1-394 릴리스 노트

이번 Custom Metrics Autoscaler Operator 2.12.1-394 릴리스는 OpenShift Dedicated 클러스터에서 Operator를 실행하기 위한 버그 수정을 제공합니다. RHSA-2024:2901 에 대해 다음 권고를 사용할 수 있습니다.

이 버전의 Custom Metrics Autoscaler Operator를 설치하기 전에 이전에 설치한 기술 프리뷰 버전 또는 Kubernetes 기반 이벤트 기반 자동 스케일러(KEDA)의 커뮤니티 지원 버전을 제거합니다.

3.1.2.6.1. 버그 수정

-

이전에는

protojson.Unmarshal함수가 특정 양식의 잘못된 JSON 형식을 해제 할 때 무한 루프에 입력되었습니다. 이 조건은Google.protobuf.Any 값이 포함된 메시지 또는옵션이 설정된 경우 발생할 수 있습니다. 이 릴리스에서는 이 문제가 해결되었습니다. (OCPBUGS-30305)UnmarshalOptions.DiscardUnknown -

이전 버전에서는 multipart 양식을 구문 분석할 때

Request.ParseMultipartForm메서드를 사용하여 명시적으로 또는Request.FormValue,Request.PostFormValue또는Request.FormFile메서드를 사용하여 암시적으로 해석될 때 구문 분석된 양식의 총 크기에 대한 제한이 사용된 메모리에 적용되지 않았습니다. 이로 인해 메모리 소진이 발생할 수 있습니다. 이번 수정을 통해 이제 구문 분석 프로세스가 단일 양식 줄을 읽는 동안 양식 행의 최대 크기를 올바르게 제한합니다. (OCPBUGS-30360) -

이전 버전에서는 HTTP 리디렉션을 따르는 경우 일치하는 하위 도메인에 없거나 초기 도메인의 정확한 일치에 따라 HTTP 클라이언트가

Authorization또는 Cryostat와 같은 중요한 헤더를 전달하지않았습니다. 예를 들어example.com에서www.example.com로의 리디렉션은Authorization헤더를 전달하지만www.example.org로 리디렉션은 헤더를 전달하지 않습니다. 이 릴리스에서는 이 문제가 해결되었습니다. (OCPBUGS-30365) -

이전에는 알 수 없는 공개 키 알고리즘이 포함된 인증서 체인을 확인하면 인증서 확인 프로세스가 패닉 상태가 되었습니다. 이 조건은

Config.ClientAuth매개변수를VerifyClientCertIfGiven또는RequireAndVerifyClientCert값으로 설정하는 모든 TLS(Transport Layer Security) 클라이언트 및 서버에 영향을 미쳤습니다. 기본 동작은 TLS 서버가 클라이언트 인증서를 확인하지 않는 것입니다. 이 릴리스에서는 이 문제가 해결되었습니다. (OCPBUGS-30370) -

이전 버전에서는

MarshalJSON메서드에서 반환된 오류가 사용자 제어 데이터가 포함된 경우 공격자는 데이터를 사용하여 HTML 템플릿 패키지의 컨텍스트 자동 이스케이프 동작을 중단할 수 있었습니다. 이 조건을 사용하면 후속 작업에서 예기치 않은 콘텐츠를 템플릿에 삽입할 수 있습니다. 이 릴리스에서는 이 문제가 해결되었습니다. (OCPBUGS-30397) -

이전에는

net/http및golang.org/x/net/http2Go 패키지에서 HTTP/2 요청의CONTINUATION프레임 수를 제한하지 않았습니다. 이 조건으로 인해 CPU 사용량이 과도해질 수 있습니다. 이 릴리스에서는 이 문제가 해결되었습니다. (OCPBUGS-30894)

3.1.2.7. 사용자 정의 Metrics Autoscaler Operator 2.12.1-384 릴리스 노트

이번 Custom Metrics Autoscaler Operator 2.12.1-384 릴리스는 OpenShift Dedicated 클러스터에서 Operator를 실행하기 위한 버그 수정을 제공합니다. RHBA-2024:2043 에 대해 다음 권고를 사용할 수 있습니다.

이 버전의 Custom Metrics Autoscaler Operator를 설치하기 전에 이전에 설치한 기술 프리뷰 버전 또는 커뮤니티 지원 KEDA 버전을 제거합니다.

3.1.2.7.1. 버그 수정

-

이전에는

custom-metrics-autoscaler및custom-metrics-autoscaler-adapter이미지에 시간대 정보가 누락되었습니다. 결과적으로 컨트롤러가 시간대 정보를 찾을 수 없기 때문에cron트리거를 사용하여 확장 개체가 작동하지 않았습니다. 이번 수정을 통해 시간대 정보를 포함하도록 이미지 빌드가 업데이트됩니다. 결과적으로cron트리거를 포함하는 확장 오브젝트가 올바르게 작동합니다. (OCPBUGS-32395)

3.1.2.8. 사용자 정의 지표 Autoscaler Operator 2.12.1-376 릴리스 노트

이번 Custom Metrics Autoscaler Operator 2.12.1-376 릴리스는 OpenShift Dedicated 클러스터에서 Operator를 실행하기 위한 보안 업데이트 및 버그 수정을 제공합니다. RHSA-2024:1812 에 대해 다음 권고를 사용할 수 있습니다.

이 버전의 Custom Metrics Autoscaler Operator를 설치하기 전에 이전에 설치한 기술 프리뷰 버전 또는 커뮤니티 지원 KEDA 버전을 제거합니다.

3.1.2.8.1. 버그 수정

- 이전 버전에서는 존재하지 않는 네임스페이스와 같은 잘못된 값이 확장 오브젝트 메타데이터에 지정된 경우 기본 확장기 클라이언트가 해제되거나 닫지 않아 클라이언트 설명자가 느려졌습니다. 이번 수정을 통해 오류가 있을 때 기본 클라이언트 설명자가 올바르게 닫히고 메모리가 유출되지 않습니다. (OCPBUGS-30145)

-

이전 버전에서는 CR에서

http의 메트릭 포트 이름을 참조했기 때문에keda-metrics-apiserverPod의ServiceMonitorCR(사용자 정의 리소스)이 작동하지 않았습니다. 이번 수정에서는메트릭의 적절한 포트 이름을 참조하도록. 결과적으로 서비스 모니터가 제대로 작동합니다. (OCPBUGS-25806)ServiceMonitorCR이 수정되었습니다

3.1.2.9. 사용자 정의 지표 Autoscaler Operator 2.11.2-322 릴리스 노트

이번 Custom Metrics Autoscaler Operator 2.11.2-322 릴리스는 OpenShift Dedicated 클러스터에서 Operator를 실행하기 위한 보안 업데이트 및 버그 수정을 제공합니다. RHSA-2023:6144 에 대해 다음 권고를 사용할 수 있습니다.

이 버전의 Custom Metrics Autoscaler Operator를 설치하기 전에 이전에 설치한 기술 프리뷰 버전 또는 커뮤니티 지원 KEDA 버전을 제거합니다.

3.1.2.9.1. 버그 수정

- Custom Metrics Autoscaler Operator 버전 3.11.2-311이 Operator 배포에 필요한 볼륨 마운트 없이 릴리스되었으므로 Custom Metrics Autoscaler Operator Pod가 15분마다 다시 시작됩니다. 이번 수정에서는 Operator 배포에 필요한 볼륨 마운트가 추가되었습니다. 결과적으로 Operator가 15분마다 더 이상 재시작되지 않습니다. (OCPBUGS-22361)

3.1.2.10. 사용자 정의 지표 Autoscaler Operator 2.11.2-311 릴리스 노트

이번 Custom Metrics Autoscaler Operator 2.11.2-311 릴리스는 OpenShift Dedicated 클러스터에서 Operator를 실행하기 위한 새로운 기능 및 버그 수정을 제공합니다. Custom Metrics Autoscaler Operator 2.11.2-311의 구성 요소는 RHBA-2023:5981 에서 릴리스되었습니다.

이 버전의 Custom Metrics Autoscaler Operator를 설치하기 전에 이전에 설치한 기술 프리뷰 버전 또는 커뮤니티 지원 KEDA 버전을 제거합니다.

3.1.2.10.1. 새로운 기능 및 개선 사항

3.1.2.10.1.1. AWS 및 OpenShift Dedicated에서 Red Hat OpenShift Service 지원

Custom Metrics Autoscaler Operator 2.11.2-311은 AWS 및 OpenShift Dedicated 관리 클러스터의 Red Hat OpenShift Service에 설치할 수 있습니다. 이전 버전의 Custom Metrics Autoscaler Operator는 openshift-keda 네임스페이스에만 설치할 수 있었습니다. 이로 인해 AWS 및 OpenShift Dedicated 클러스터의 Red Hat OpenShift Service에 Operator가 설치되지 않았습니다. 이 Custom Metrics Autoscaler 버전을 사용하면 openshift-operators 또는 keda 와 같은 다른 네임스페이스에 설치할 수 있으므로 AWS 및 OpenShift Dedicated 클러스터에서 Red Hat OpenShift Service에 설치할 수 있습니다.

3.1.2.10.2. 버그 수정

-

이전 버전에서는 Custom Metrics Autoscaler Operator를 설치 및 구성했지만 사용하지 않은 경우 OpenShift CLI에서

oc명령을 입력한 후external.metrics.k8s.io/v1beta1에 대한 Got 빈 응답: external.metrics.k8s.io/v1beta1 오류에 대한 리소스 목록을 가져올 수 없었습니다. 메시지가 무해하지만 혼동을 일으킬 수 있었습니다. 이번 수정으로external.metrics… 오류에 대한 Got 빈 응답이더 이상 부적절하게 표시되지 않습니다. (OCPBUGS-15779) - 이전에는 Custom Metrics Autoscaler에서 관리하는 오브젝트에 대한 주석 또는 레이블 변경이 Keda Controller를 수정할 때마다 Custom Metrics Autoscaler Operator에 의해 취소되었습니다(예: 구성 변경 후). 이로 인해 오브젝트에서 라벨이 지속적으로 변경되었습니다. Custom Metrics Autoscaler는 이제 자체 주석을 사용하여 레이블 및 주석을 관리하고 주석 또는 레이블을 더 이상 잘못 되돌리지 않습니다. (OCPBUGS-15590)

3.1.2.11. 사용자 정의 지표 Autoscaler Operator 2.10.1-267 릴리스 노트

이번 Custom Metrics Autoscaler Operator 2.10.1-267 릴리스는 OpenShift Dedicated 클러스터에서 Operator를 실행하기 위한 새로운 기능 및 버그 수정을 제공합니다. Custom Metrics Autoscaler Operator 2.10.1-267의 구성 요소는 RHBA-2023:4089 에서 릴리스되었습니다.

이 버전의 Custom Metrics Autoscaler Operator를 설치하기 전에 이전에 설치한 기술 프리뷰 버전 또는 커뮤니티 지원 KEDA 버전을 제거합니다.

3.1.2.11.1. 버그 수정

-

이전에는

custom-metrics-autoscaler및custom-metrics-autoscaler-adapter이미지에 시간대 정보가 포함되지 않았습니다. 이로 인해 컨트롤러가 시간대 정보를 찾을 수 없기 때문에 cron 트리거를 사용하여 확장 개체가 작동하지 않았습니다. 이번 수정으로 이미지 빌드에 시간대 정보가 포함됩니다. 결과적으로 cron 트리거를 포함하는 확장 오브젝트가 올바르게 작동합니다. (OCPBUGS-15264) -

이전에는 Custom Metrics Autoscaler Operator에서 다른 네임스페이스 및 클러스터 범위 오브젝트의 오브젝트를 포함하여 모든 관리 오브젝트의 소유권을 시도했습니다. 이로 인해 Custom Metrics Autoscaler Operator에서 API 서버가 되는 데 필요한 인증 정보를 읽기 위해 역할 바인딩을 생성할 수 없었습니다. 이로 인해

kube-system네임 스페이스에 오류가 발생했습니다. 이번 수정을 통해 Custom Metrics Autoscaler Operator는ownerReference필드를 다른 네임스페이스 또는 클러스터 범위 오브젝트의 오브젝트에 추가하는 것을 건너뜁니다. 결과적으로 이제 오류 없이 역할 바인딩이 생성됩니다. (OCPBUGS-15038) -

이전에는 Custom Metrics Autoscaler Operator에서

ownerReferences필드를openshift-keda네임스페이스에 추가했습니다. 이로 인해 기능 문제가 발생하지 않았지만 이 필드가 있으면 클러스터 관리자에게 혼동이 발생할 수 있었습니다. 이번 수정으로 Custom Metrics Autoscaler Operator는ownerReference필드를openshift-keda네임스페이스에 추가하지 않습니다. 결과적으로openshift-keda네임스페이스에 더 이상 불필요한ownerReference필드가 없습니다. (OCPBUGS-15293) -

이전 버전에서는 Pod ID 이외의 인증 방법으로 구성된 Prometheus 트리거를 사용한 후

podIdentity매개변수가none으로 설정된 경우 트리거를 스케일링하지 못했습니다. 이번 수정으로 OpenShift의 Custom Metrics Autoscaler에서 이제nonePod ID 공급자 유형을 올바르게 처리합니다. 결과적으로 Prometheus 트리거는 Pod ID 이외의 인증 방법으로 구성되고podIdentity매개변수 sset을none으로 올바르게 스케일링합니다. (OCPBUGS-15274)

3.1.2.12. 사용자 정의 Metrics Autoscaler Operator 2.10.1 릴리스 노트

이번 Custom Metrics Autoscaler Operator 2.10.1 릴리스는 OpenShift Dedicated 클러스터에서 Operator를 실행하기 위한 새로운 기능 및 버그 수정을 제공합니다. Custom Metrics Autoscaler Operator 2.10.1의 구성 요소는 RHEA-2023:3199 에서 릴리스되었습니다.

이 버전의 Custom Metrics Autoscaler Operator를 설치하기 전에 이전에 설치한 기술 프리뷰 버전 또는 커뮤니티 지원 KEDA 버전을 제거합니다.

3.1.2.12.1. 새로운 기능 및 개선 사항

3.1.2.12.1.1. 사용자 정의 지표 Autoscaler Operator 일반 가용성

Custom Metrics Autoscaler Operator는 이제 일반적으로 Custom Metrics Autoscaler Operator 버전 2.10.1에서 사용할 수 있습니다.

확장된 작업을 사용하여 스케일링하는 것은 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 기술 프리뷰 기능 지원 범위를 참조하십시오.

3.1.2.12.1.2. 성능 지표

이제 PromQL(Prometheus Query Language)을 사용하여 Custom Metrics Autoscaler Operator에서 지표를 쿼리할 수 있습니다.

3.1.2.12.1.3. 확장된 오브젝트에 대한 사용자 정의 지표 자동 스케일링 일시 중지

이제 필요에 따라 확장 오브젝트의 자동 스케일링을 일시 중지하고 준비가 되면 자동 스케일링을 재개할 수 있습니다.

3.1.2.12.1.4. 확장 오브젝트의 복제본 대체

이제 스케일링된 오브젝트가 소스에서 메트릭을 가져오지 못하는 경우 다시 대체할 복제본 수를 지정할 수 있습니다.

3.1.2.12.1.5. 확장된 오브젝트에 대해 사용자 정의 가능한 HPA 이름 지정

확장된 오브젝트에서 수평 Pod 자동 스케일러의 사용자 정의 이름을 지정할 수 있습니다.

3.1.2.12.1.6. 활성화 및 스케일링 임계값

HPA(수평 Pod 자동 스케일러)는 복제본 0개로 스케일링할 수 없으므로 Custom Metrics Autoscaler Operator는 해당 스케일링을 수행하여 HPA에서 스케일링을 수행합니다. 이제 HPA에서 복제본 수에 따라 자동 스케일링을 인수하는 시기를 지정할 수 있습니다. 이를 통해 확장 정책을 통해 유연성을 높일 수 있습니다.

3.1.2.13. 사용자 정의 메트릭 자동 스케일러 Operator 2.8.2-174 릴리스 노트

이번 Custom Metrics Autoscaler Operator 2.8.2-174 릴리스는 OpenShift Dedicated 클러스터에서 Operator를 실행하기 위한 새로운 기능 및 버그 수정을 제공합니다. Custom Metrics Autoscaler Operator 2.8.2-174의 구성 요소는 RHEA-2023:1683 에서 릴리스되었습니다.

Custom Metrics Autoscaler Operator 버전 2.8.2-174는 기술 프리뷰 기능입니다.

3.1.2.13.1. 새로운 기능 및 개선 사항

3.1.2.13.1.1. Operator 업그레이드 지원

이제 이전 버전의 Custom Metrics Autoscaler Operator에서 업그레이드할 수 있습니다. Operator 업그레이드에 대한 자세한 내용은 "Operator의 업데이트 채널 변경"에서 "추가 리소스"를 참조하십시오.

3.1.2.13.1.2. must-gather 지원

OpenShift Dedicated must-gather 툴을 사용하여 Custom Metrics Autoscaler Operator 및 해당 구성 요소에 대한 데이터를 수집할 수 있습니다. 현재 사용자 정의 메트릭 자동 스케일러와 함께 must-gather 툴을 사용하는 프로세스는 다른 Operator의 경우와 다릅니다. 자세한 내용은 "추가 리소스"에서 "추가 리소스"의 디버깅 데이터를 참조하십시오.

3.1.2.14. 사용자 정의 지표 Autoscaler Operator 2.8.2 릴리스 노트

이번 Custom Metrics Autoscaler Operator 2.8.2 릴리스는 OpenShift Dedicated 클러스터에서 Operator를 실행하기 위한 새로운 기능 및 버그 수정을 제공합니다. Custom Metrics Autoscaler Operator 2.8.2의 구성 요소는 RHSA-2023:1042 에서 릴리스되었습니다.

Custom Metrics Autoscaler Operator 버전 2.8.2는 기술 프리뷰 기능입니다.

3.1.2.14.1. 새로운 기능 및 개선 사항

3.1.2.14.1.1. 감사 로깅

Custom Metrics Autoscaler Operator 및 관련 구성 요소에 대한 감사 로그를 수집하고 볼 수 있습니다. 감사 로그는 개별 사용자, 관리자 또는 시스템의 기타 구성 요소가 시스템에 영향을 준 활동 순서를 문서화하는 보안 관련 레코드 집합입니다.

3.1.2.14.1.2. Apache Kafka 메트릭을 기반으로 애플리케이션 스케일링

이제 KEDA Apache kafka 트리거/scaler를 사용하여 Apache Kafka 주제를 기반으로 배포를 확장할 수 있습니다.

3.1.2.14.1.3. CPU 메트릭을 기반으로 애플리케이션 스케일링

이제 KEDA CPU 트리거/scaler를 사용하여 CPU 메트릭을 기반으로 배포를 확장할 수 있습니다.

3.1.2.14.1.4. 메모리 메트릭을 기반으로 애플리케이션 확장

이제 KEDA 메모리 트리거/scaler를 사용하여 메모리 메트릭을 기반으로 배포를 확장할 수 있습니다.

3.2. 사용자 정의 Metrics Autoscaler Operator 개요

개발자는 Red Hat OpenShift용 Custom Metrics Autoscaler Operator를 사용하여 CPU 또는 메모리를 기반으로 하지 않는 사용자 정의 메트릭을 기반으로 OpenShift Dedicated에서 배포, 상태 저장 세트, 사용자 정의 리소스 또는 작업의 Pod 수를 자동으로 늘리거나 줄이는 방법을 지정할 수 있습니다.

Custom Metrics Autoscaler Operator는 쿠버네티스 이벤트 기반 자동 스케일러(KEDA)를 기반으로 하는 선택적 Operator로, Pod 메트릭 이외의 추가 메트릭 소스를 사용하여 워크로드를 확장할 수 있습니다.

사용자 정의 지표 자동 스케일러는 현재 Prometheus, CPU, 메모리 및 Apache Kafka 지표만 지원합니다.

Custom Metrics Autoscaler Operator는 특정 애플리케이션의 사용자 지정 외부 메트릭을 기반으로 Pod를 확장 및 축소합니다. 다른 애플리케이션에서는 다른 확장 방법을 계속 사용합니다. 사용자 정의 메트릭 자동 스케일러가 확장 방법을 결정하는 데 사용하는 이벤트 및 메트릭의 소스인 스케일러라고도 하는 트리거 를 구성합니다. 사용자 정의 메트릭 자동 스케일러는 메트릭 API를 사용하여 OpenShift Dedicated에서 사용할 수 있는 양식으로 외부 메트릭을 변환합니다. 사용자 정의 지표 자동 스케일러는 실제 스케일링을 수행하는 HPA(수평 Pod 자동 스케일러)를 생성합니다.

사용자 정의 지표 자동 스케일러를 사용하려면 스케일링 메타데이터를 정의하는 CR(사용자 정의 리소스)인 워크로드에 대해 scaled Object 또는 scaled Job 오브젝트를 만듭니다. 스케일링할 배포 또는 작업, 스케일링할 메트릭의 소스(trigger), 허용된 최소 및 최대 복제본 수와 같은 기타 매개변수를 지정합니다.

스케일링할 각 워크로드에 대해 하나의 확장 오브젝트 또는 스케일링된 작업만 생성할 수 있습니다. 또한 확장 오브젝트 또는 확장 작업 및 동일한 워크로드에서 HPA(수평 Pod 자동 스케일러)를 사용할 수 없습니다.

HPA와 달리 사용자 정의 지표 자동 스케일러는 0으로 확장할 수 있습니다. 사용자 정의 지표 자동 스케일러 CR에서 minReplicaCount 값을 0 으로 설정하면 사용자 정의 메트릭 자동 스케일러가 1에서 복제본 0 또는 0 복제본으로 또는 최대 0개의 복제본으로 워크로드를 축소합니다. 이를 활성화 단계 라고 합니다. 최대 1개의 복제본을 확장한 후 HPA는 스케일링을 제어합니다. 이를 스케일링 단계 라고 합니다.

일부 트리거를 사용하면 클러스터 지표 자동 스케일러에서 스케일링하는 복제본 수를 변경할 수 있습니다. 모든 경우에 활성화 단계를 구성하는 매개 변수는 항상 동일한 문구를 사용하며 활성화 접두사가 붙습니다. 예를 들어 threshold 매개변수가 스케일링을 구성하는 경우 activationThreshold 는 활성화를 구성합니다. 활성화 및 스케일링 단계를 구성하면 확장 정책에 대한 유연성을 높일 수 있습니다. 예를 들어 메트릭이 특히 낮은 경우 확장 또는 축소되지 않도록 더 높은 활성화 단계를 구성할 수 있습니다.

활성화 값은 각각에 대해 서로 다른 의사 결정의 경우 스케일링 값보다 우선 순위가 높습니다. 예를 들어 임계값 이 10 으로 설정되고 activationThreshold 가 50 개인 경우 지표에서 40 을 보고하는 경우 scaler는 활성 상태가 아니며 HPA에 4개의 인스턴스가 필요한 경우에도 Pod는 0으로 확장됩니다.

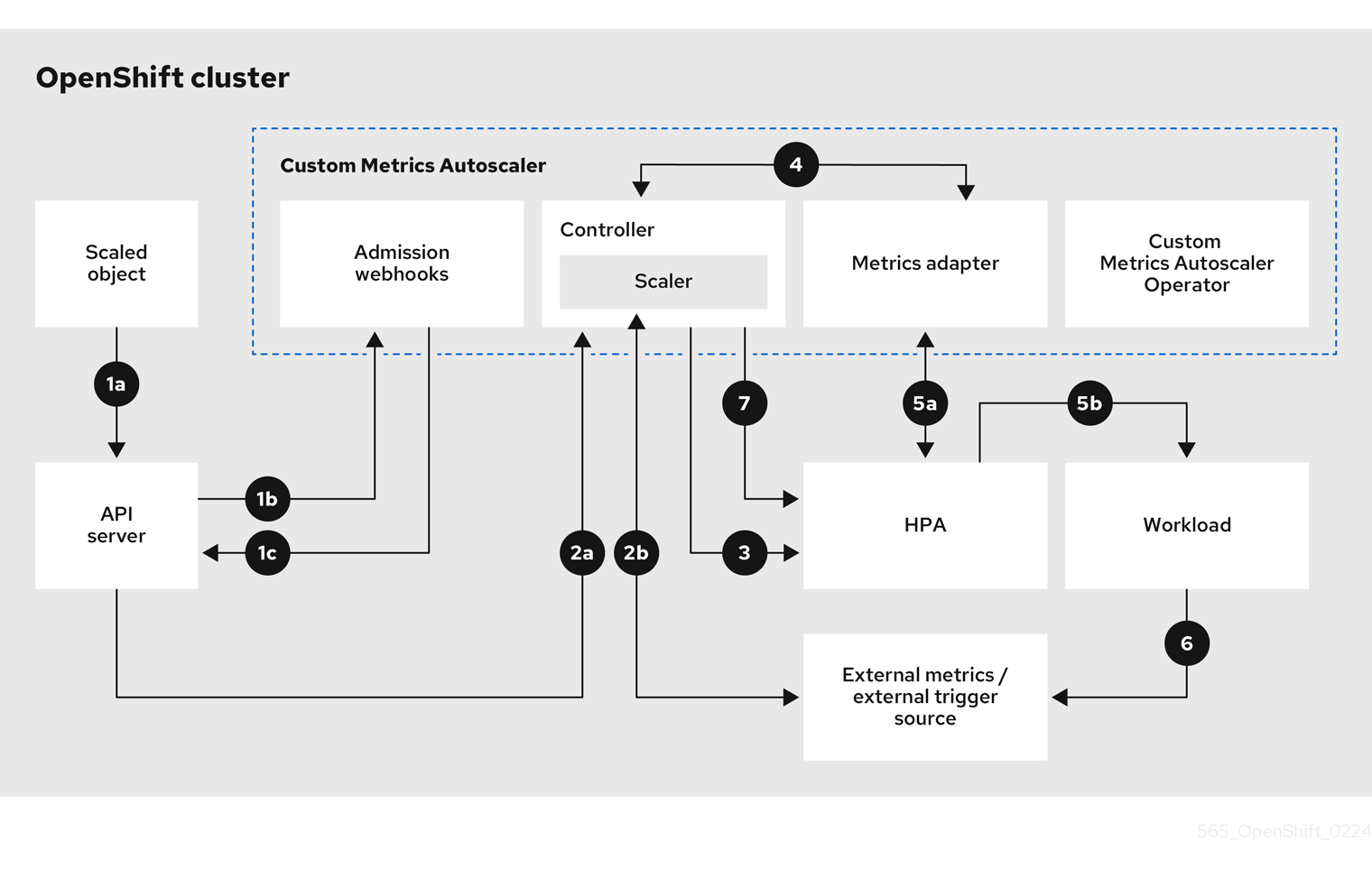

그림 3.1. 사용자 정의 메트릭 자동 스케일러 워크플로

- 클러스터의 워크로드에 대해 확장된 오브젝트 사용자 정의 리소스를 생성하거나 수정합니다. 오브젝트에는 해당 워크로드에 대한 스케일링 구성이 포함되어 있습니다. 새 오브젝트를 수락하기 전에 OpenShift API 서버에서 사용자 정의 지표 자동 스케일러 승인 Webhook 프로세스로 전송하여 오브젝트가 유효한지 확인합니다. 유효성 검사가 성공하면 API 서버는 오브젝트를 유지합니다.

- 사용자 정의 메트릭 자동 스케일러 컨트롤러는 새 확장 오브젝트 또는 수정된 오브젝트를 감시합니다. OpenShift API 서버가 컨트롤러에게 변경 사항을 알릴 때 컨트롤러는 지표 데이터 변경을 위해 오브젝트에 지정된 데이터 소스라고도 하는 외부 트리거 소스를 모니터링합니다. 하나 이상의 스케일러는 외부 트리거 소스에서 스케일링 데이터를 요청합니다. 예를 들어 Kafka 트리거 유형의 경우 컨트롤러는 Kafka 스케일러를 사용하여 Kafka 인스턴스와 통신하여 트리거에서 요청한 데이터를 가져옵니다.

- 컨트롤러는 확장된 오브젝트에 대한 수평 Pod 자동 스케일러 오브젝트를 생성합니다. 결과적으로 Horizontal Pod Autoscaler (HPA) Operator가 트리거와 연결된 스케일링 데이터 모니터링을 시작합니다. HPA는 클러스터 OpenShift API 서버 끝점에서 데이터 스케일링을 요청합니다.

- OpenShift API 서버 끝점은 사용자 정의 지표 자동 스케일러 지표 어댑터에서 제공합니다. 메트릭 어댑터가 사용자 지정 메트릭에 대한 요청을 수신하면 컨트롤러에 GRPC 연결을 사용하여 scaler에서 수신한 최신 트리거 데이터에 대해 요청합니다.

- HPA는 지표 어댑터에서 수신된 데이터를 기반으로 스케일링 결정을 내리고 복제본을 늘리거나 줄여 워크로드를 확장 또는 축소합니다.

- 워크로드가 작동하면 스케일링 메트릭에 영향을 미칠 수 있습니다. 예를 들어 Kafka 큐에서 작업을 처리하도록 워크로드가 확장되면 워크로드 프로세스가 모든 작업 후에 큐 크기가 감소합니다. 결과적으로 워크로드가 축소됩니다.

-

지표가

minReplicaCount값으로 지정된 범위에 있는 경우 사용자 정의 지표 자동 스케일러 컨트롤러는 모든 스케일링을 비활성화하고 복제본 수를 고정된 수준으로 유지합니다. 메트릭이 해당 범위를 초과하면 사용자 정의 지표 자동 스케일러 컨트롤러에서 스케일링을 활성화하고 HPA에서 워크로드를 확장할 수 있습니다. 스케일링은 비활성화되어 있지만 HPA는 작업을 수행하지 않습니다.

3.2.1. 사용자 정의 지표 자동 스케일러의 사용자 정의 CA 인증서

기본적으로 Custom Metrics Autoscaler Operator는 자동으로 생성된 서비스 CA 인증서를 사용하여 클러스터 내 서비스에 연결합니다.

사용자 정의 CA 인증서가 필요한 클러스터 외부 서비스를 사용하려면 구성 맵에 필요한 인증서를 추가할 수 있습니다. 그런 다음 사용자 정의 지표 자동 스케일러 설치에 설명된 대로 구성 맵을 KedaController 사용자 정의 리소스에 추가합니다. Operator는 시작 시 해당 인증서를 로드하고 Operator에서 신뢰할 수 있는 인증서로 등록합니다.

구성 맵에는 하나 이상의 PEM 인코딩 CA 인증서가 포함된 인증서 파일이 하나 이상 포함될 수 있습니다. 또는 각 인증서 파일에 대해 별도의 구성 맵을 사용할 수 있습니다.

나중에 구성 맵을 업데이트하여 인증서를 추가하는 경우 변경 사항을 적용하려면 keda-operator-* Pod를 다시 시작해야 합니다.

3.3. 사용자 정의 메트릭 자동 스케일러 설치

OpenShift Dedicated 웹 콘솔을 사용하여 Custom Metrics Autoscaler Operator를 설치할 수 있습니다.

설치 시 다음 5개의 CRD가 생성됩니다.

-

ClusterTriggerAuthentication -

KedaController -

ScaledJob -

ScaledObject -

TriggerAuthentication

설치 프로세스에서는 KedaController CR(사용자 정의 리소스)도 생성합니다. 필요한 경우 기본 KedaController CR을 수정할 수 있습니다. 자세한 내용은 "Keda Controller CR 편집"을 참조하십시오.

2.17.2 미만의 Custom Metrics Autoscaler Operator 버전을 설치하는 경우 Keda Controller CR을 수동으로 생성해야 합니다. "Keda Controller CR 편집"에 설명된 절차를 사용하여 CR을 생성할 수 있습니다.

3.3.1. 사용자 정의 메트릭 자동 스케일러 설치

다음 절차를 사용하여 Custom Metrics Autoscaler Operator를 설치할 수 있습니다.

사전 요구 사항

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.OpenShift Dedicated 클러스터가 Red Hat(CCS 외)이 소유한 클라우드 계정에 있는 경우

cluster-admin권한을 요청해야 합니다.- Cluster Metrics Autoscaler Operator의 이전에 설치한 기술 프리뷰 버전을 제거합니다.

커뮤니티 기반 KEDA 버전을 제거합니다.

또한 다음 명령을 실행하여 KEDA 1.x 사용자 지정 리소스 정의를 제거합니다.

oc delete crd scaledobjects.keda.k8s.io

$ oc delete crd scaledobjects.keda.k8s.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete crd triggerauthentications.keda.k8s.io

$ oc delete crd triggerauthentications.keda.k8s.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

keda네임스페이스가 있는지 확인합니다. 그렇지 않은 경우keda네임스페이스를 생성해야 합니다. 선택 사항: 외부 Kafka 클러스터 또는 외부 Prometheus 서비스와 같은 클러스터 외부 서비스에 연결하는 데 Custom Metrics Autoscaler Operator가 필요한 경우 필요한 서비스 CA 인증서를 구성 맵에 배치합니다. 구성 맵은 Operator가 설치된 동일한 네임스페이스에 있어야 합니다. 예를 들면 다음과 같습니다.

oc create configmap -n openshift-keda thanos-cert --from-file=ca-cert.pem

$ oc create configmap -n openshift-keda thanos-cert --from-file=ca-cert.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow

프로세스

- OpenShift Dedicated 웹 콘솔에서 에코시스템 → 소프트웨어 카탈로그 를 클릭합니다.

- 사용 가능한 Operator 목록에서 사용자 정의 지표 자동 스케일러를 선택하고 설치를 클릭합니다.

- Operator 설치 페이지에서 설치 모드에 대해 클러스터 옵션의 특정 네임스페이스 가 선택되어 있는지 확인합니다.

- 설치된 네임스페이스 의 경우 네임스페이스 선택을 클릭합니다.

프로젝트 선택을 클릭합니다.

-

keda네임스페이스가 있는 경우 목록에서 keda 를 선택합니다. keda네임스페이스가 없는 경우:- Create Project 를 선택하여 Create Project 창을 엽니다.

-

이름 필드에

keda를 입력합니다. -

표시 이름 필드에

keda와 같은 설명이 포함된 이름을 입력합니다. - 선택 사항: 표시 이름 필드에 네임스페이스에 대한 설명을 추가합니다.

- 생성을 클릭합니다.

-

- 설치를 클릭합니다.

Custom Metrics Autoscaler Operator 구성 요소를 나열하여 설치를 확인합니다.

- 워크로드 → Pod로 이동합니다.

-

드롭다운 메뉴에서

keda프로젝트를 선택하고custom-metrics-autoscaler-operator-*Pod가 실행 중인지 확인합니다. -

워크로드 → 배포로 이동하여

custom-metrics-autoscaler-operator배포가 실행 중인지 확인합니다.

선택 사항: 다음 명령을 사용하여 OpenShift CLI에서 설치를 확인합니다.

oc get all -n keda

$ oc get all -n kedaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력은 다음과 유사합니다.

출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.2. Keda Controller CR 편집

다음 절차에 따라 Custom Metrics Autoscaler Operator를 설치하는 동안 자동으로 설치된 KedaController CR(사용자 정의 리소스)을 수정할 수 있습니다.

프로세스

- OpenShift Dedicated 웹 콘솔에서 에코시스템 → 설치된 Operator 를 클릭합니다.

- Custom Metrics Autoscaler 를 클릭합니다.

- Operator 세부 정보 페이지에서 KedaController 탭을 클릭합니다.

KedaController 탭에서 KedaController 만들기 를 클릭하고 파일을 편집합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Custom Metrics Autoscaler Operator가 애플리케이션을 스케일링하는 단일 네임스페이스를 지정합니다. 비워 두거나 모든 네임스페이스의 애플리케이션을 확장하려면 비워 둡니다. 이 필드에는 네임스페이스가 있거나 비어 있어야 합니다. 기본값은 비어 있습니다.

- 2

- Custom Metrics Autoscaler Operator 로그 메시지의 상세 정보 수준을 지정합니다. 허용되는 값은

debug,info,error입니다. 기본값은info입니다. - 3

- Custom Metrics Autoscaler Operator 로그 메시지의 로깅 형식을 지정합니다. 허용되는 값은

console또는json입니다. 기본값은console입니다. - 4

- 선택 사항: Custom Metrics Autoscaler Operator에서 TLS 사용 메트릭 소스에 안전하게 연결하는 데 사용할 수 있는 CA 인증서로 하나 이상의 구성 맵을 지정합니다.

- 5

- 선택 사항: 컨테이너 마운트 경로를 추가합니다.

- 6

- 선택 사항:

volumes블록을 추가하여 각 예상 볼륨 소스를 나열합니다. - 7

- Custom Metrics Autoscaler Metrics Server의 로깅 수준을 지정합니다. 허용되는 값은

info의 경우0이고디버그의 경우4입니다. 기본값은0입니다. - 8

- Custom Metrics Autoscaler Operator에 대한 감사 로깅을 활성화하고 "감사 로깅 구성" 섹션에 설명된 대로 사용할 감사 정책을 지정합니다.

- 저장을 클릭하여 변경 사항을 저장합니다.

3.4. 사용자 정의 메트릭 자동 스케일러 트리거 이해

스케일러라고도 하는 트리거는 Custom Metrics Autoscaler Operator에서 Pod를 확장하는 데 사용하는 메트릭을 제공합니다.

사용자 정의 지표 자동 스케일러는 현재 Prometheus, CPU, 메모리, Apache Kafka 및 cron 트리거를 지원합니다.

scaled Object 또는 scaled Job 사용자 정의 리소스를 사용하여 다음 섹션에 설명된 대로 특정 오브젝트에 대한 트리거를 구성합니다.

확장된 오브젝트 또는 클러스터의 모든 확장기와 함께 사용할 인증 기관을 구성할 수 있습니다.

3.4.1. Prometheus 트리거 이해

설치된 OpenShift Dedicated 모니터링 또는 외부 Prometheus 서버를 메트릭 소스로 사용할 수 있는 Prometheus 메트릭을 기반으로 Pod를 확장할 수 있습니다. OpenShift Dedicated 모니터링을 메트릭 소스로 사용하는 데 필요한 구성에 대한 정보는 "사용자 정의 메트릭 자동 스케일러가 OpenShift Dedicated 모니터링을 사용하도록 구성"을 참조하십시오.

Prometheus가 사용자 정의 지표 자동 스케일러가 스케일링하는 애플리케이션에서 지표를 수집하는 경우 사용자 정의 리소스에서 최소 복제본을 0 으로 설정하지 마십시오. 애플리케이션 Pod가 없는 경우 사용자 정의 메트릭 자동 스케일러에는 확장할 메트릭이 없습니다.

Prometheus 대상이 있는 확장 오브젝트의 예

- 1

- Prometheus를 트리거 유형으로 지정합니다.

- 2

- Prometheus 서버의 주소를 지정합니다. 이 예에서는 OpenShift Dedicated 모니터링을 사용합니다.

- 3

- 선택 사항: 스케일링할 오브젝트의 네임스페이스를 지정합니다. 이 매개변수는 OpenShift Dedicated 모니터링을 메트릭 소스로 사용하는 경우 필수입니다.

- 4

external.metrics.k8s.ioAPI에서 메트릭을 식별하는 이름을 지정합니다. 둘 이상의 트리거를 사용하는 경우 모든 메트릭 이름은 고유해야 합니다.- 5

- 스케일링을 트리거하는 값을 지정합니다. 따옴표로 묶은 문자열 값으로 지정해야 합니다.

- 6

- 사용할 Prometheus 쿼리를 지정합니다.

- 7

- 사용할 인증 방법을 지정합니다. Prometheus 스케일러는 전달자 인증( 베어러

), 기본 인증(기본) 또는 TLS 인증(TLS )을 지원합니다.다음 섹션에 설명된 대로 트리거 인증에 특정 인증 매개 변수를 구성합니다. 필요에 따라 시크릿을 사용할 수도 있습니다. - 8

- 9

- 선택 사항: Prometheus 대상이 손실된 경우 트리거를 진행하는 방법을 지정합니다.

-

true인 경우 Prometheus 대상이 손실되면 트리거가 계속 작동합니다. 이는 기본 동작입니다. -

false인 경우 Prometheus 대상이 손실되면 트리거에서 오류를 반환합니다.

-

- 10

- 선택 사항: 인증서 검사를 건너뛸지 여부를 지정합니다. 예를 들어 테스트 환경에서 실행 중이고 Prometheus 끝점에서 자체 서명된 인증서를 사용하는 경우 검사를 건너뛸 수 있습니다.

-

false인 경우 인증서 검사가 수행됩니다. 이는 기본 동작입니다. true인 경우 인증서 검사가 수행되지 않습니다.중요검사를 건너뛰는 것은 권장되지 않습니다.

-

- 11

- 선택 사항: 이 Prometheus 트리거에서 사용하는 HTTP 클라이언트에 대해 HTTP 요청 시간(밀리초)을 지정합니다. 이 값은 글로벌 시간 초과 설정을 덮어씁니다.

3.4.1.1. Prometheus 및 DCGM 메트릭을 사용하여 GPU 기반 자동 스케일링 구성

DCGM( NVIDIA Data Center GPU Manager) 메트릭과 함께 사용자 정의 지표 자동 스케일러를 사용하여 GPU 사용률에 따라 워크로드를 확장할 수 있습니다. 이는 GPU 리소스가 필요한 AI 및 머신러닝 워크로드에 특히 유용합니다.

GPU 기반 자동 스케일링을 위한 Prometheus 대상이 있는 확장 오브젝트의 예

- 1

- 유지할 최소 복제본 수를 지정합니다. GPU 워크로드의 경우 메트릭을 계속 수집하려면 이 값을

0으로 설정하지 않아야 합니다. - 2

- 확장 작업 중에 허용되는 최대 복제본 수를 지정합니다.

- 3

- 스케일링을 트리거하는 GPU 사용률 백분율 임계값을 지정합니다. 평균 GPU 사용률이 90%를 초과하면 자동 스케일러가 배포를 확장합니다.

- 4

- NVIDIA DCGM 메트릭을 사용하여 모든 GPU 장치에서 GPU 사용률을 모니터링하는 Prometheus 쿼리를 지정합니다.

DCGM_FI_DEV_GPU_UTIL메트릭은 GPU 사용률 비율을 제공합니다.

3.4.1.2. OpenShift Dedicated 모니터링을 사용하도록 사용자 정의 메트릭 자동 스케일러 구성

설치된 OpenShift Dedicated Prometheus 모니터링을 사용자 정의 메트릭 자동 스케일러에서 사용하는 지표의 소스로 사용할 수 있습니다. 그러나 수행해야 하는 몇 가지 추가 구성이 있습니다.

확장된 오브젝트에서 OpenShift Dedicated Prometheus 지표를 읽을 수 있으려면 필요한 인증 정보를 제공하기 위해 트리거 인증 또는 클러스터 트리거 인증을 사용해야 합니다. 다음 절차는 사용하는 트리거 인증 방법에 따라 다릅니다. 트리거 인증에 대한 자세한 내용은 "사용자 정의 메트릭 자동 스케일러 트리거 인증 정보"를 참조하십시오.

다음 단계는 외부 Prometheus 소스에 필요하지 않습니다.

이 섹션에 설명된 대로 다음 작업을 수행해야 합니다.

- 서비스 계정을 생성합니다.

- 트리거 인증을 생성합니다.

- 역할을 생성합니다.

- 서비스 계정에 해당 역할을 추가합니다.

- Prometheus에서 사용하는 트리거 인증 오브젝트에서 토큰을 참조합니다.

사전 요구 사항

- OpenShift Dedicated 모니터링이 설치되어 있어야 합니다.

- 사용자 정의 워크로드 모니터링 섹션에 설명된 대로 사용자 정의 워크로드 모니터링은 OpenShift Dedicated 모니터링 에서 활성화되어야 합니다.

- Custom Metrics Autoscaler Operator가 설치되어 있어야 합니다.

프로세스

적절한 프로젝트로 변경합니다.

oc project <project_name>

$ oc project <project_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 다음 프로젝트 중 하나를 지정합니다.

- 트리거 인증을 사용하는 경우 스케일링할 오브젝트로 프로젝트를 지정합니다.

-

클러스터 트리거 인증을 사용하는 경우

openshift-keda프로젝트를 지정합니다.

클러스터에 없는 경우 서비스 계정을 생성합니다.

다음 명령을 사용하여

서비스 계정오브젝트를 생성합니다.oc create serviceaccount thanos

$ oc create serviceaccount thanos1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 서비스 계정의 이름을 지정합니다.

서비스 계정 토큰을 사용하여 트리거 인증을 생성합니다.

다음과 유사한 YAML 파일을 생성합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow CR 오브젝트를 생성합니다.

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Thanos 지표를 읽는 역할을 생성합니다.

다음 매개변수를 사용하여 YAML 파일을 생성합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow CR 오브젝트를 생성합니다.

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Thanos 메트릭을 읽기 위한 역할 바인딩을 생성합니다.

다음과 유사한 YAML 파일을 생성합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 다음 오브젝트 유형 중 하나를 지정합니다.

-

트리거 인증을 사용하는 경우

RoleBinding을 지정합니다. -

클러스터 트리거 인증을 사용하는 경우

ClusterRoleBinding을 지정합니다.

-

트리거 인증을 사용하는 경우

- 2

- 생성한 역할의 이름을 지정합니다.

- 3

- 다음 프로젝트 중 하나를 지정합니다.

- 트리거 인증을 사용하는 경우 스케일링할 오브젝트로 프로젝트를 지정합니다.

-

클러스터 트리거 인증을 사용하는 경우

openshift-keda프로젝트를 지정합니다.

- 4

- 역할에 바인딩할 서비스 계정의 이름을 지정합니다.

- 5

- 이전에 서비스 계정을 생성한 프로젝트를 지정합니다.

CR 오브젝트를 생성합니다.

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

"사용자 정의 메트릭 자동 스케일러를 추가하는 방법 이해"에 설명된 대로 확장 오브젝트 또는 확장 작업을 배포하여 애플리케이션에 대한 자동 스케일링을 활성화할 수 있습니다. OpenShift Dedicated 모니터링을 소스로 사용하려면 트리거 또는 scaler에서 다음 매개변수를 포함해야 합니다.

-

triggers.type은prometheus여야 합니다 -

triggers.metadata.serverAddress는https://thanos-querier.openshift-monitoring.svc.cluster.local:9092이어야 합니다 -

triggers.metadata.authModes는베어러여야 합니다. -

Trigger.metadata.namespace는 스케일링할 오브젝트의 네임스페이스로 설정해야 합니다. -

triggers.authenticationRef는 이전 단계에서 지정된 트리거 인증 리소스를 가리켜야 합니다.

3.4.2. CPU 트리거 이해

CPU 메트릭을 기반으로 Pod를 확장할 수 있습니다. 이 트리거는 클러스터 메트릭을 지표 소스로 사용합니다.

사용자 정의 메트릭 자동 스케일러는 오브젝트와 연결된 Pod를 스케일링하여 사용자가 지정하는 CPU 사용량을 유지합니다. 자동 스케일러는 최소 및 최대 수 간에 복제본 수를 늘리거나 줄여 모든 Pod에서 지정된 CPU 사용률을 유지합니다. 메모리 트리거는 전체 Pod의 메모리 사용률을 고려합니다. Pod에 컨테이너가 여러 개 있는 경우 메모리 트리거는 Pod에 있는 모든 컨테이너의 총 메모리 사용률을 고려합니다.

-

이 트리거는 scaled

Job 사용자 정의 리소스와 함께사용할 수 없습니다. -

메모리 트리거를 사용하여 오브젝트를 확장할 때 여러 트리거를 사용하는 경우에도 오브젝트는

0으로 스케일링되지 않습니다.

CPU 대상이 있는 확장 오브젝트의 예

- 1

- CPU를 트리거 유형으로 지정합니다.

- 2

- 사용할 메트릭 유형(사용 또는

AverageValue)을 지정합니다. - 3

- 스케일링을 트리거하는 값을 지정합니다. 따옴표로 묶은 문자열 값으로 지정해야 합니다.

-

Utilization을 사용하는 경우 대상 값은 Pod에 대해 요청된 리소스의 백분율로 표시되는 모든 관련 Pod의 리소스 지표의 평균 값입니다. -

AverageValue를 사용하는 경우 대상 값은 모든 관련 Pod의 지표의 평균입니다.

-

- 4

- 축소 시 최소 복제본 수를 지정합니다. CPU 트리거의 경우 CPU 지표만 사용하는 경우 HPA를 0으로 확장할 수 없기 때문에 CPU 트리거의 값을

1이상 입력합니다.

3.4.3. 메모리 트리거 이해

메모리 메트릭을 기반으로 Pod를 확장할 수 있습니다. 이 트리거는 클러스터 메트릭을 지표 소스로 사용합니다.

사용자 정의 메트릭 자동 스케일러는 오브젝트와 연결된 Pod를 스케일링하여 사용자가 지정하는 평균 메모리 사용량을 유지합니다. 자동 스케일러는 최소 및 최대 수 간에 복제본 수를 늘리거나 줄여 모든 Pod에서 지정된 메모리 사용률을 유지합니다. 메모리 트리거는 전체 Pod의 메모리 사용률을 고려합니다. Pod에 컨테이너가 여러 개 있는 경우 메모리 사용률은 모든 컨테이너의 합계입니다.

-

이 트리거는 scaled

Job 사용자 정의 리소스와 함께사용할 수 없습니다. -

메모리 트리거를 사용하여 오브젝트를 확장할 때 여러 트리거를 사용하는 경우에도 오브젝트는

0으로 스케일링되지 않습니다.

메모리 대상이 있는 확장 오브젝트의 예

- 1

- memory를 트리거 유형으로 지정합니다.

- 2

- 사용할 메트릭 유형(사용 또는

AverageValue)을 지정합니다. - 3

- 스케일링을 트리거하는 값을 지정합니다. 따옴표로 묶은 문자열 값으로 지정해야 합니다.

-

Utilization을 사용하는 경우 대상 값은 Pod에 대해 요청된 리소스의 백분율로 표시되는 모든 관련 Pod의 리소스 지표의 평균 값입니다. -

AverageValue를 사용하는 경우 대상 값은 모든 관련 Pod의 지표의 평균입니다.

-

- 4

- 선택 사항: 전체 Pod가 아닌 해당 컨테이너의 메모리 사용률에 따라 스케일링할 개별 컨테이너를 지정합니다. 이 예제에서는

api라는 컨테이너만 스케일링할 수 있습니다.

3.4.4. Kafka 트리거 이해

Apache Kafka 주제 또는 Kafka 프로토콜을 지원하는 기타 서비스를 기반으로 Pod를 확장할 수 있습니다. 확장된 오브젝트 또는 확장 작업에서 allowIdleConsumers 매개변수를 true 로 설정하지 않는 한 사용자 정의 지표 자동 스케일러는 Kafka 파티션 수보다 확장되지 않습니다.

소비자 그룹의 수가 주제의 파티션 수를 초과하면 추가 소비자 그룹은 유휴 상태로 유지됩니다. 이를 방지하려면 기본적으로 복제본 수를 초과하지 않습니다.

- 주제가 지정된 경우 주제의 파티션 수

- 주제가 지정되지 않은 경우 소비자 그룹에 있는 모든 항목의 파티션 수

-

확장 오브젝트 또는 확장 작업 CR에 지정된

maxReplicaCount

allowIdleConsumers 매개변수를 사용하여 이러한 기본 동작을 비활성화할 수 있습니다.

Kafka 대상이 있는 스케일링 오브젝트의 예

- 1

- Kafka를 트리거 유형으로 지정합니다.

- 2

- Kafka가 오프셋 지연을 처리하는 Kafka 주제의 이름을 지정합니다.

- 3

- 연결할 Kafka 브로커의 쉼표로 구분된 목록을 지정합니다.

- 4

- 주제의 오프셋을 확인하고 관련 지연을 처리하는 데 사용되는 Kafka 소비자 그룹의 이름을 지정합니다.

- 5

- 선택 사항: 스케일링을 트리거하는 평균 대상 값을 지정합니다. 따옴표로 묶은 문자열 값으로 지정해야 합니다. 기본값은

5입니다. - 6

- 선택 사항: 활성화 단계의 대상 값을 지정합니다. 따옴표로 묶은 문자열 값으로 지정해야 합니다.

- 7

- 선택 사항: Kafka 소비자에 대한 Kafka 오프셋 재설정 정책을 지정합니다. 사용 가능한 값은

latest및가장 빠른값입니다. 기본값은latest입니다. - 8

- 선택 사항: Kafka 복제본 수가 주제의 파티션 수를 초과할 수 있는지 여부를 지정합니다.

-

true인 경우 Kafka 복제본 수는 주제의 파티션 수를 초과할 수 있습니다. 이를 통해 Kafka 소비자를 유휴 상태로 설정할 수 있습니다. -

false인 경우 Kafka 복제본 수는 주제의 파티션 수를 초과할 수 없습니다. 이는 기본값입니다.

-

- 9

- Kafka 파티션에 유효한 오프셋이 없을 때 트리거가 작동하는 방식을 지정합니다.

-

true인 경우 소비자는 해당 파티션에 대해 0으로 확장됩니다. -

false인 경우 scaler는 해당 파티션에 대해 단일 소비자를 유지합니다. 이는 기본값입니다.

-

- 10

- 선택 사항: 트리거에서 현재 오프셋이 이전 폴링 주기의 현재 오프셋과 동일한 파티션의 파티션 지연을 포함하거나 제외하는지 여부를 지정합니다.

-

true인 경우 scaler는 이러한 파티션의 파티션 지연을 제외합니다. -

false인 경우 트리거에는 모든 파티션에 모든 소비자 지연이 포함됩니다. 이는 기본값입니다.

-

- 11

- 선택 사항: Kafka 브로커의 버전을 지정합니다. 따옴표로 묶은 문자열 값으로 지정해야 합니다. 기본값은

1.0.0입니다. - 12

- 선택 사항: 쉼표로 구분된 파티션 ID 목록을 지정하여 스케일링 범위를 지정합니다. 설정된 경우 지연을 계산할 때 나열된 ID만 고려됩니다. 따옴표로 묶은 문자열 값으로 지정해야 합니다. 기본값은 모든 파티션을 고려하는 것입니다.

- 13

- 선택 사항: Kafka에 TSL 클라이언트 인증을 사용할지 여부를 지정합니다. 기본값은

disable입니다. TLS 구성에 대한 자세한 내용은 "사용자 정의 메트릭 자동 스케일러 트리거 인증 이해"를 참조하십시오.

3.4.5. Cron 트리거 이해

시간 범위를 기반으로 Pod를 확장할 수 있습니다.

시간 범위가 시작되면 사용자 정의 지표 자동 스케일러는 구성된 최소 Pod 수에서 지정된 Pod 수로 오브젝트와 연결된 Pod를 스케일링합니다. 시간 범위가 끝나면 Pod가 구성된 최소로 다시 확장됩니다. 시간 기간은 cron 형식으로 구성해야 합니다.

다음 예제에서는 이 확장 오브젝트와 연결된 Pod를 오전 6시부터 오후 6 시 30분에서 오후 6시 30분으로 스케일링합니다.

Cron 트리거가 있는 확장 오브젝트의 예

3.4.6. Kubernetes 워크로드 트리거 이해

특정 라벨 선택기와 일치하는 Pod 수에 따라 Pod를 스케일링할 수 있습니다.

Custom Metrics Autoscaler Operator는 동일한 네임스페이스에 있는 특정 라벨이 있는 Pod 수를 추적한 다음 확장된 오브젝트의 Pod에 대해 레이블이 지정된 Pod 수를 기반으로 관계를 계산합니다. 이 관계를 사용하여 Custom Metrics Autoscaler Operator는 scaled Object 또는 scaled Job 사양의 스케일링 정책에 따라 오브젝트를 스케일링 합니다.

Pod 수에는 성공 또는 실패 단계가 있는 Pod가 포함됩니다.

예를 들어 프런트 엔드 배포 및 배포가 있는 경우입니다. 백엔드 kubernetes-workload 트리거를 사용하여 프런트 엔드 Pod 수에 따라 백엔드 배포를 스케일링할 수 있습니다. 프런트 엔드 Pod 수가 증가하면 Operator에서 백엔드 Pod를 확장하여 지정된 비율을 유지합니다. 이 예에서는 app=frontend Pod 선택기가 있는 10개의 Pod가 있는 경우 Operator는 확장된 오브젝트에 0.5 비율을 유지하기 위해 백엔드 Pod를 5로 스케일링합니다.

Kubernetes 워크로드 트리거가 있는 스케일링 오브젝트의 예

- 1

- Kubernetes 워크로드 트리거를 지정합니다.

- 2

- Pod 수를 가져오는 데 사용할 하나 이상의 Pod 선택기 및/또는 설정 기반 선택기를 쉼표로 구분하여 지정합니다.

- 3

- 스케일링된 워크로드와 선택기와 일치하는 Pod 수 간의 대상 관계를 지정합니다. 관계는 다음 공식에 따라 계산됩니다.

relation = (pods that match the selector) / (scaled workload pods)

relation = (pods that match the selector) / (scaled workload pods)Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 4

- 선택 사항: 스케일러 활성화 단계의 대상 값을 지정합니다. 기본값은

0입니다.

3.5. 사용자 정의 메트릭 자동 스케일러 트리거 인증 이해

트리거 인증을 사용하면 확장 오브젝트 또는 관련 컨테이너에서 사용할 수 있는 확장 작업에 인증 정보를 포함할 수 있습니다. 트리거 인증을 사용하여 OpenShift Dedicated 보안, 플랫폼 네이티브 Pod 인증 메커니즘, 환경 변수를 전달할 수 있습니다.

스케일링할 오브젝트와 동일한 네임스페이스에 TriggerAuthentication 오브젝트를 정의합니다. 해당 트리거 인증은 해당 네임스페이스의 오브젝트에서만 사용할 수 있습니다.

또는 여러 네임스페이스의 오브젝트 간에 인증 정보를 공유하려면 모든 네임스페이스에서 사용할 수 있는 ClusterTriggerAuthentication 오브젝트를 생성할 수 있습니다.

트리거 인증 및 클러스터 트리거 인증은 동일한 구성을 사용합니다. 그러나 클러스터 트리거 인증에는 확장된 오브젝트의 인증 참조에 추가 kind 매개변수가 필요합니다.

바인딩된 서비스 계정 토큰을 사용하는 트리거 인증의 예

바인딩된 서비스 계정 토큰을 사용하는 클러스터 트리거 인증의 예

기본 인증에 보안을 사용하는 트리거 인증의 예

기본 인증을 위한 시크릿 예

- 1

- 트리거 인증에 제공할 사용자 이름 및 암호입니다.

data스탠자의 값은 base-64로 인코딩되어야 합니다.

CA 세부 정보용으로 보안을 사용하는 트리거 인증의 예

CA(인증 기관) 세부 정보가 있는 보안 예

전달자 토큰을 사용하는 트리거 인증의 예

전달자 토큰의 시크릿 예

- 1

- 전달자 인증에 사용할 전달자 토큰을 지정합니다. 값은 base-64로 인코딩되어야 합니다.

환경 변수를 사용하는 트리거 인증의 예

Pod 인증 공급자를 사용하는 트리거 인증의 예

추가 리소스

3.5.1. 트리거 인증 사용

사용자 지정 리소스를 사용하여 인증을 생성한 다음 확장된 오브젝트 또는 확장 작업에 대한 참조를 추가하여 트리거 인증 및 클러스터 트리거 인증을 사용합니다.

사전 요구 사항

- Custom Metrics Autoscaler Operator가 설치되어 있어야 합니다.

- 바인딩된 서비스 계정 토큰을 사용하는 경우 서비스 계정이 있어야 합니다.

바인딩된 서비스 계정 토큰을 사용하는 경우 Custom Metrics Autoscaler Operator에서 서비스 계정 토큰을 요청할 수 있는 RBAC(역할 기반 액세스 제어) 오브젝트가 있어야 합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

보안을 사용하는 경우

Secret오브젝트가 있어야 합니다.

프로세스

TriggerAuthentication또는ClusterTriggerAuthentication오브젝트를 생성합니다.오브젝트를 정의하는 YAML 파일을 생성합니다.

바인딩된 서비스 계정 토큰을 사용한 트리거 인증의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow TriggerAuthentication오브젝트를 생성합니다.oc create -f <filename>.yaml

$ oc create -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

트리거 인증을 사용하는

scaledObjectYAML 파일을 생성하거나 편집합니다.다음 명령을 실행하여 오브젝트를 정의하는 YAML 파일을 생성합니다.

트리거 인증이 있는 확장된 오브젝트의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 클러스터 트리거 인증이 있는 확장 오브젝트의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 확장 오브젝트를 생성합니다.

oc apply -f <filename>

$ oc apply -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6. 사용자 정의 메트릭 자동 스케일러를 추가하는 방법

사용자 지정 지표 자동 스케일러를 추가하려면 배포, 상태 저장 세트 또는 사용자 정의 리소스에 대한 scaled Object 사용자 정의 리소스를 만듭니다. 작업에 대한 scaledJob 사용자 정의 리소스를 생성합니다.

스케일링할 각 워크로드에 대해 하나의 확장 오브젝트만 생성할 수 있습니다. 또한 동일한 워크로드에서 스케일링된 오브젝트와 HPA(수평 Pod 자동 스케일러)를 사용할 수 없습니다.

3.6.1. 워크로드에 사용자 정의 메트릭 자동 스케일러 추가

Deployment,StatefulSet 또는 사용자 정의 리소스 오브젝트에서 생성한 워크로드에 대한 사용자 정의 메트릭 자동 스케일러를 생성할 수 있습니다.

사전 요구 사항

- Custom Metrics Autoscaler Operator가 설치되어 있어야 합니다.

CPU 또는 메모리를 기반으로 스케일링에 사용자 정의 메트릭 자동 스케일러를 사용하는 경우:

클러스터 관리자가 클러스터 메트릭을 올바르게 구성해야 합니다.

oc describe PodMetrics <pod-name>명령을 사용하여 메트릭이 구성되어 있는지 확인할 수 있습니다. 메트릭이 구성된 경우 출력은 다음과 유사하게 표시되고 Usage에 CPU 및 메모리가 표시됩니다.oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internal

$ oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internalCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 스케일링할 오브젝트와 연결된 Pod에는 지정된 메모리 및 CPU 제한이 포함되어야 합니다. 예를 들면 다음과 같습니다.

Pod 사양의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

프로세스

다음과 유사한 YAML 파일을 생성합니다. 이름 <

;2> , 오브젝트 이름 <4> 및 오브젝트 종류 <5>만 필요합니다.확장된 오브젝트의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 선택 사항: Custom Metrics Autoscaler Operator가 "워크로드에 사용자 정의 메트릭 자동 스케일러 사용" 섹션에 설명된 대로 복제본을 지정된 값으로 확장하고 자동 스케일링을 중지하도록 지정합니다.

- 2

- 이 사용자 정의 메트릭 자동 스케일러의 이름을 지정합니다.

- 3

- 선택 사항: 대상 리소스의 API 버전을 지정합니다. 기본값은

apps/v1입니다. - 4

- 스케일링할 오브젝트의 이름을 지정합니다.

- 5

- type을

Deployment,StatefulSet또는CustomResource로 지정합니다. - 6

- 선택 사항: 사용자 지정 지표 자동 스케일러가 시크릿을 보유하는 환경 변수를 가져오는 대상 리소스의 컨테이너 이름을 지정합니다. 기본값은

.spec.template.spec.containers[0]입니다. - 7

- 선택 사항:

minReplicaCount가0으로 설정된 경우 배포를 다시0으로 스케일링하기 전에 마지막 트리거가 보고된 후 대기하는 기간(초)을 지정합니다. 기본값은300입니다. - 8

- 선택 사항: 확장 시 최대 복제본 수를 지정합니다. 기본값은

100입니다. - 9

- 선택 사항: 축소 시 최소 복제본 수를 지정합니다.

- 10

- 선택 사항: "감사 로깅 구성" 섹션에 설명된 대로 감사 로그의 매개변수를 지정합니다.

- 11

- 선택 사항: scaler가

failureThreshold매개변수로 정의된 횟수에 대한 소스에서 메트릭을 가져오지 못하는 경우 다시 대체할 복제본 수를 지정합니다. 대체 동작에 대한 자세한 내용은 KEDA 설명서 를 참조하십시오. - 12

- 선택 사항: 대체가 발생하는 경우 사용할 복제본 수를 지정합니다. 다음 옵션 중 하나를 입력하거나 매개변수를 생략합니다.

-

fallback.replicas매개변수로 지정된 복제본 수를 사용하려면static을 입력합니다. 이는 기본값입니다. -

currentReplicas를 입력하여 현재 복제본 수를 유지합니다. -

현재ReplicasIfHigher를 입력하여 현재 복제본 수(해당 수가fallback.replicas매개변수보다 큰 경우)를 입력합니다. 현재 복제본 수가fallback.replicas매개변수보다 작으면fallback.replicas값을 사용합니다. -

현재ReplicasIfLower를 입력하여 현재 복제본 수(해당 수가fallback.replicas매개변수보다 낮은 경우)를 입력합니다. 현재 복제본 수가fallback.replicas매개변수보다 크면fallback.replicas값을 사용합니다.

-

- 13

- 선택 사항: 각 트리거를 확인하는 간격을 초 단위로 지정합니다. 기본값은

30입니다. - 14

- 선택 사항: 확장된 개체를 삭제한 후 대상 리소스를 원래 복제본 수로 확장할지 여부를 지정합니다. 기본값은

false이며, 확장 오브젝트를 삭제할 때 복제본 수를 그대로 유지합니다. - 15

- 선택 사항: 수평 Pod 자동 스케일러의 이름을 지정합니다. 기본값은

keda-hpa-{scaled-object-name}입니다. - 16

- 선택 사항: "확장 정책" 섹션에 설명된 대로 Pod를 확장 또는 축소하는 데 사용할 스케일링 정책을 지정합니다.

- 17

- "사용자 정의 메트릭 자동 스케일러 트리거 이해" 섹션에 설명된 대로 스케일링의 기준으로 사용할 트리거를 지정합니다. 이 예에서는 OpenShift Dedicated 모니터링을 사용합니다.

- 18

- 선택 사항: 트리거 인증 또는 클러스터 트리거 인증을 지정합니다. 자세한 내용은 추가 리소스 섹션에서 사용자 정의 메트릭 자동 스케일러 트리거 인증 이해 를 참조하십시오.

-

트리거 인증을 사용하려면

TriggerAuthentication을 입력합니다. 이는 기본값입니다. -

클러스터 트리거 인증을 사용하려면

ClusterTriggerAuthentication을 입력합니다.

-

트리거 인증을 사용하려면

다음 명령을 실행하여 사용자 정의 메트릭 자동 스케일러를 생성합니다.

oc create -f <filename>.yaml

$ oc create -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

명령 출력을 보고 사용자 정의 메트릭 자동 스케일러가 생성되었는지 확인합니다.

oc get scaledobject <scaled_object_name>

$ oc get scaledobject <scaled_object_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME SCALETARGETKIND SCALETARGETNAME MIN MAX TRIGGERS AUTHENTICATION READY ACTIVE FALLBACK AGE scaledobject apps/v1.Deployment example-deployment 0 50 prometheus prom-triggerauthentication True True True 17s

NAME SCALETARGETKIND SCALETARGETNAME MIN MAX TRIGGERS AUTHENTICATION READY ACTIVE FALLBACK AGE scaledobject apps/v1.Deployment example-deployment 0 50 prometheus prom-triggerauthentication True True True 17sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력에서 다음 필드를 확인합니다.

-

TRIGGERS: 사용 중인 트리거 또는 스케일러를 나타냅니다. -

AUTHENTICATION: 사용 중인 트리거 인증의 이름을 나타냅니다. READY: 스케일링된 오브젝트가 스케일링을 시작할 준비가 되었는지 여부를 나타냅니다.-

True인 경우 확장 오브젝트가 준비됩니다. -

False인 경우 생성한 오브젝트 중 하나 이상의 오브젝트의 문제로 인해 확장 오브젝트가 준비되지 않은 것입니다.

-

ACTIVE: 스케일링이 수행되는지 여부를 나타냅니다.-

True인 경우 스케일링이 수행됩니다. -

False인 경우 메트릭이 없거나 생성한 오브젝트 중 하나 이상에 문제가 있기 때문에 스케일링이 수행되지 않습니다.

-

FALLBACK: 사용자 정의 메트릭 자동 스케일러가 소스에서 메트릭을 가져올 수 있는지 여부를 나타냅니다.-

False인 경우 사용자 정의 메트릭 자동 스케일러에 메트릭이 표시됩니다. -

True인 경우 메트릭이 없거나 생성한 오브젝트 중 하나 이상에 문제가 있기 때문에 사용자 정의 메트릭 자동 스케일러가 메트릭을 가져오고 있습니다.

-

-

3.7. 확장 오브젝트에 대한 사용자 정의 지표 자동 스케일러 일시 중지

필요에 따라 워크로드 자동 스케일링을 일시 중지하고 다시 시작할 수 있습니다.

예를 들어 클러스터 유지 관리를 수행하기 전에 자동 스케일링을 일시 중지하거나 해제 중요하지 않은 워크로드를 제거하여 리소스 부족을 방지할 수 있습니다.

3.7.1. 사용자 정의 메트릭 자동 스케일러 일시 중지

확장된 오브젝트의 사용자 정의 지표 자동 스케일러에 autoscaling.keda.sh/paused-replicas 주석을 추가하여 확장 오브젝트의 자동 스케일링을 일시 중지할 수 있습니다. 사용자 정의 지표 자동 스케일러는 해당 워크로드의 복제본을 지정된 값으로 스케일링하고 주석이 제거될 때까지 자동 스케일링을 일시 중지합니다.

프로세스

다음 명령을 사용하여 워크로드에 대한

scaledObjectCR을 편집합니다.oc edit ScaledObject scaledobject

$ oc edit ScaledObject scaledobjectCopy to Clipboard Copied! Toggle word wrap Toggle overflow 값이 있는

autoscaling.keda.sh/paused-replicas주석을 추가합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Custom Metrics Autoscaler Operator가 복제본을 지정된 값으로 확장하고 자동 스케일링을 중지하도록 지정합니다.

3.7.2. 확장 오브젝트의 사용자 정의 지표 자동 스케일러를 다시 시작

해당 scaled Object에 대한 시작할 수 있습니다.

autoscaling.keda.sh/paused-replicas 주석을 제거하여 일시 중지된 사용자 정의 지표 자동 스케일러를 다시

프로세스

다음 명령을 사용하여 워크로드에 대한

scaledObjectCR을 편집합니다.oc edit ScaledObject scaledobject

$ oc edit ScaledObject scaledobjectCopy to Clipboard Copied! Toggle word wrap Toggle overflow autoscaling.keda.sh/paused-replicas주석을 제거합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 일시 중지된 사용자 정의 메트릭 자동 스케일러를 다시 시작하려면 이 주석을 제거합니다.

3.8. 감사 로그 수집

개별 사용자, 관리자 또는 시스템의 기타 구성 요소가 시스템에 영향을 준 활동 순서를 문서화하는 보안 관련 레코드 세트인 감사 로그를 수집할 수 있습니다.

예를 들어 감사 로그는 자동 스케일링 요청이 들어오는 위치를 이해하는 데 도움이 될 수 있습니다. 이는 사용자 애플리케이션에서 만든 자동 확장 요청에 의해 백엔드가 과부하되는 경우 주요 정보입니다. 그러면 문제가 있는 애플리케이션인지 확인해야 합니다.

3.8.1. 감사 로깅 구성

KedaController 사용자 정의 리소스를 편집하여 Custom Metrics Autoscaler Operator에 대한 감사를 구성할 수 있습니다. 로그는 KedaController CR에서 영구 볼륨 클레임을 사용하여 보안되는 볼륨의 감사 로그 파일로 전송됩니다.

사전 요구 사항

- Custom Metrics Autoscaler Operator가 설치되어 있어야 합니다.

프로세스

KedaController사용자 정의 리소스를 편집하여auditConfig스탠자를 추가합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 감사 로그의 출력 형식을

legacy또는json으로 지정합니다. - 2

- 로그 데이터를 저장하기 위한 기존 영구 볼륨 클레임을 지정합니다. API 서버로 들어오는 모든 요청은 이 영구 볼륨 클레임에 기록됩니다. 이 필드를 비워 두면 로그 데이터가 stdout으로 전송됩니다.

- 3

- 기록해야 하는 이벤트와 포함해야 하는 데이터를 지정합니다.

-

None: 이벤트를 기록하지 마십시오. -

Metadata: 사용자, 타임스탬프 등과 같은 요청에 대한 메타데이터만 기록합니다. 요청 텍스트와 응답 텍스트를 기록하지 마십시오. 이는 기본값입니다. -

Request: 메타데이터와 요청 텍스트만 기록하지만 응답 텍스트는 기록하지 않습니다. 이 옵션은 리소스가 아닌 요청에는 적용되지 않습니다. -

RequestResponse: 이벤트 메타데이터, 요청 텍스트 및 응답 텍스트입니다. 이 옵션은 리소스가 아닌 요청에는 적용되지 않습니다.

-

- 4

- 이벤트가 생성되지 않는 단계를 지정합니다.

- 5

- 요청 및 응답 본문의 관리 필드가 API 감사 로그에 기록되지 않을지 여부를 생략할지 여부를