Applications de construction

Configurer Red Hat OpenShift Service sur AWS pour vos applications

Résumé

Chapitre 1. Aperçu des applications de construction

En utilisant Red Hat OpenShift Service sur AWS, vous pouvez créer, éditer, supprimer et gérer des applications à l’aide de la console Web ou de l’interface de ligne de commande (CLI).

1.1. Le travail sur un projet

En utilisant des projets, vous pouvez organiser et gérer des applications isolées. Il est possible de gérer l’ensemble du cycle de vie du projet, y compris la création, la visualisation et la suppression d’un projet dans Red Hat OpenShift Service sur AWS.

Après avoir créé le projet, vous pouvez accorder ou révoquer l’accès à un projet et gérer les rôles de cluster pour les utilisateurs en utilisant la perspective Développeur. En outre, vous pouvez modifier la ressource de configuration du projet tout en créant un modèle de projet qui est utilisé pour le provisionnement automatique de nouveaux projets.

En tant qu’utilisateur disposant d’autorisations d’administrateur dédiées, vous pouvez choisir d’empêcher un groupe d’utilisateurs authentifié de fournir automatiquement de nouveaux projets.

1.2. Le travail sur une application

1.2.1. Créer une application

Afin de créer des applications, vous devez avoir créé un projet ou avoir accès à un projet avec les rôles et autorisations appropriés. Il est possible de créer une application en utilisant soit la perspective Développeur dans la console Web, les Opérateurs installés, soit l’OpenShift CLI (oc). Les applications à ajouter au projet peuvent être obtenues à partir des fichiers Git, JAR, devfiles ou du catalogue de développeurs.

Il est également possible d’utiliser des composants qui incluent du code source ou binaire, des images et des modèles pour créer une application à l’aide de l’OpenShift CLI (oc). Avec le Red Hat OpenShift Service sur la console web AWS, vous pouvez créer une application à partir d’un opérateur installé par un administrateur de cluster.

1.2.2. Le maintien d’une application

Après avoir créé l’application, vous pouvez utiliser la console Web pour surveiller vos métriques de projet ou d’application. Il est également possible d’éditer ou de supprimer l’application à l’aide de la console Web.

Lorsque l’application est en cours d’exécution, toutes les ressources des applications ne sont pas utilisées. En tant qu’administrateur de cluster, vous pouvez choisir d’activer ces ressources évolutives pour réduire la consommation de ressources.

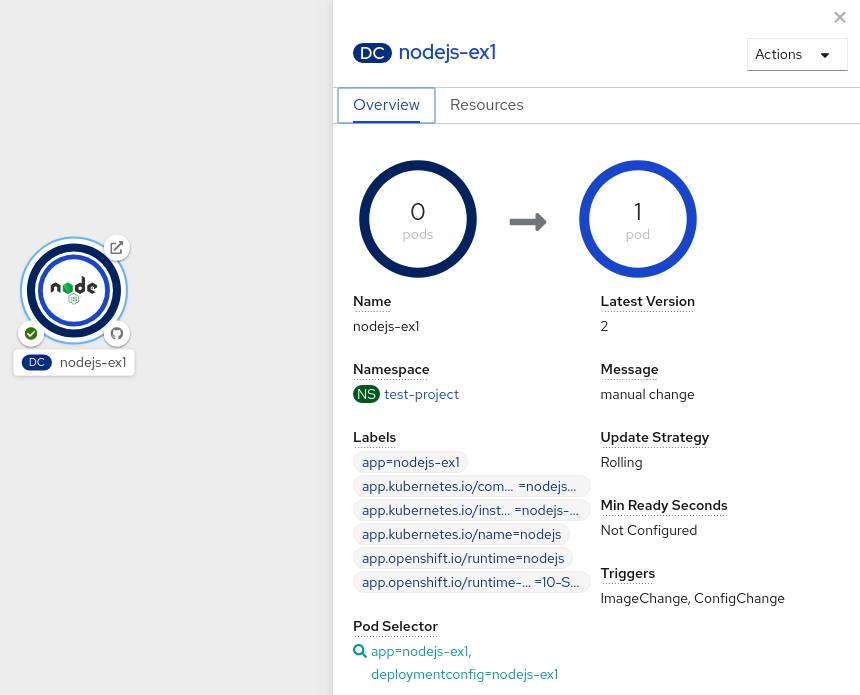

1.2.3. Déploiement d’une application

Il est possible de déployer votre application à l’aide d’objets Deployment ou DeploymentConfig et de les gérer à partir de la console Web. Il est possible de créer des stratégies de déploiement qui aident à réduire les temps d’arrêt lors d’un changement ou d’une mise à niveau vers l’application.

Il est également possible d’utiliser Helm, un gestionnaire de paquets logiciels qui simplifie le déploiement d’applications et de services à Red Hat OpenShift Service sur les clusters AWS.

1.3. En utilisant le Red Hat Marketplace

Le Red Hat Marketplace est un marché de cloud ouvert où vous pouvez découvrir et accéder à des logiciels certifiés pour les environnements basés sur des conteneurs qui fonctionnent sur les nuages publics et sur site.

Chapitre 2. Les projets

2.1. Collaborer avec des projets

Le projet permet à une communauté d’utilisateurs d’organiser et de gérer leur contenu indépendamment des autres communautés.

Les projets commençant par openshift- et kube- sont des projets par défaut. Ces projets hébergent des composants de cluster qui fonctionnent comme des pods et d’autres composants d’infrastructure. En tant que tel, Red Hat OpenShift Service sur AWS ne vous permet pas de créer des projets commençant par openshift- ou kube- à l’aide de la commande oc new-project. Les administrateurs de cluster peuvent créer ces projets à l’aide de la commande oc adm new-project.

Évitez d’exécuter des charges de travail ou de partager l’accès aux projets par défaut. Les projets par défaut sont réservés à l’exécution de composants de cluster de base.

Les projets par défaut suivants sont considérés comme hautement privilégiés: par défaut, kube-public, kube-system, openshift, openshift-infra, openshift-node, et d’autres projets créés par système qui ont l’étiquette openshift.io / run-level définie à 0 ou 1. La fonctionnalité qui repose sur des plugins d’admission, tels que l’admission de sécurité pod, les contraintes de contexte de sécurité, les quotas de ressources de cluster et la résolution de référence d’image, ne fonctionne pas dans des projets hautement privilégiés.

2.1.1. Créer un projet

Il est possible d’utiliser le service Red Hat OpenShift sur la console web AWS ou l’OpenShift CLI (oc) pour créer un projet dans votre cluster.

2.1.1.1. Créer un projet en utilisant la console web

Le Red Hat OpenShift Service vous permet de créer un projet dans votre cluster.

Les projets commençant par openshift- et kube- sont considérés comme critiques par Red Hat OpenShift Service sur AWS. En tant que tel, Red Hat OpenShift Service sur AWS ne vous permet pas de créer des projets commençant par openshift- à l’aide de la console Web.

Conditions préalables

- Assurez-vous d’avoir les rôles et autorisations appropriés pour créer des projets, des applications et d’autres charges de travail dans Red Hat OpenShift Service sur AWS.

Procédure

Lorsque vous utilisez la perspective de l’administrateur:

- Accédez à Home → Projets.

Cliquez sur Créer un projet:

- Dans la boîte de dialogue Créer un projet, entrez un nom unique, tel que myproject, dans le champ Nom.

- Facultatif: Ajoutez le nom de l’affichage et les détails de la description pour le projet.

Cliquez sur Create.

Le tableau de bord de votre projet est affiché.

- Facultatif: Sélectionnez l’onglet Détails pour afficher les détails du projet.

- Facultatif : Si vous disposez d’autorisations adéquates pour un projet, vous pouvez utiliser l’onglet Accès au projet pour fournir ou révoquer les privilèges d’administration, d’édition et de visualisation du projet.

Lorsque vous utilisez la perspective Développeur:

Cliquez sur le menu Projet et sélectionnez Créer un projet:

Figure 2.1. Créer un projet

- Dans la boîte de dialogue Créer un projet, entrez un nom unique, tel que myproject, dans le champ Nom.

- Facultatif: Ajoutez le nom de l’affichage et les détails de la description pour le projet.

- Cliquez sur Create.

- Facultatif : Utilisez le panneau de navigation de gauche pour accéder à la vue Projet et voir le tableau de bord de votre projet.

- Facultatif: Dans le tableau de bord du projet, sélectionnez l’onglet Détails pour afficher les détails du projet.

- Facultatif : Si vous disposez d’autorisations adéquates pour un projet, vous pouvez utiliser l’onglet Accès au projet du tableau de bord du projet pour fournir ou révoquer les privilèges d’administration, d’édition et d’affichage du projet.

Ressources supplémentaires

2.1.1.2. Créer un projet en utilisant le CLI

Lorsque votre administrateur de cluster l’autorise, vous pouvez créer un nouveau projet.

Les projets commençant par openshift- et kube- sont considérés comme critiques par Red Hat OpenShift Service sur AWS. En tant que tel, Red Hat OpenShift Service sur AWS ne vous permet pas de créer des projets commençant par openshift- ou kube- à l’aide de la commande oc new-project. Les administrateurs de cluster peuvent créer ces projets à l’aide de la commande oc adm new-project.

Procédure

Cours d’exécution:

oc new-project <project_name> \ --description="<description>" --display-name="<display_name>"$ oc new-project <project_name> \ --description="<description>" --display-name="<display_name>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow À titre d’exemple:

oc new-project hello-openshift \ --description="This is an example project" \ --display-name="Hello OpenShift"$ oc new-project hello-openshift \ --description="This is an example project" \ --display-name="Hello OpenShift"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Le nombre de projets que vous êtes autorisé à créer peut être limité par l’administrateur système. Après que votre limite est atteinte, vous devrez peut-être supprimer un projet existant afin d’en créer un nouveau.

2.1.2. Affichage d’un projet

Le service Red Hat OpenShift est disponible sur la console web AWS ou sur l’OpenShift CLI (oc) pour afficher un projet dans votre cluster.

2.1.2.1. Affichage d’un projet à l’aide de la console Web

Consultez les projets auxquels vous avez accès en utilisant le service Red Hat OpenShift sur la console web AWS.

Procédure

Lorsque vous utilisez la perspective de l’administrateur:

- Accédez à Home → Projets dans le menu de navigation.

- Choisissez un projet à afficher. L’onglet Aperçu comprend un tableau de bord pour votre projet.

- Choisissez l’onglet Détails pour afficher les détails du projet.

- Choisissez l’onglet YAML pour afficher et mettre à jour la configuration YAML pour la ressource du projet.

- Choisissez l’onglet Charges de travail pour afficher les charges de travail dans le projet.

- Choisissez l’onglet RoleBindings pour afficher et créer des liens de rôle pour votre projet.

Lorsque vous utilisez la perspective Développeur:

- Accédez à la page Projet dans le menu de navigation.

- Choisissez tous les projets dans le menu déroulant Projet en haut de l’écran pour énumérer tous les projets de votre cluster.

- Choisissez un projet à afficher. L’onglet Aperçu comprend un tableau de bord pour votre projet.

- Choisissez l’onglet Détails pour afficher les détails du projet.

- Lorsque vous disposez d’autorisations adéquates pour un projet, sélectionnez l’onglet d’accès au projet et mettez à jour les privilèges pour le projet.

2.1.2.2. Affichage d’un projet à l’aide du CLI

Lorsque vous visualisez des projets, vous êtes limité à voir uniquement les projets auxquels vous avez accès en fonction de la politique d’autorisation.

Procédure

Afin de consulter une liste de projets, exécutez:

oc get projects

$ oc get projectsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Il est possible de passer du projet actuel à un projet différent pour les opérations de CLI. Le projet spécifié est ensuite utilisé dans toutes les opérations ultérieures qui manipulent le contenu à portée de projet:

oc project <project_name>

$ oc project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.3. Fournir des autorisations d’accès à votre projet en utilisant la perspective Développeur

Dans la perspective Développeur, vous pouvez utiliser la vue Projet pour accorder ou révoquer les autorisations d’accès à votre projet.

Conditions préalables

- « vous avez créé un projet.

Procédure

Ajouter des utilisateurs à votre projet et leur fournir un accès Admin, Edit ou Affichage:

- Dans la perspective Développeur, accédez à la page Projet.

- Choisissez votre projet dans le menu Projet.

- Cliquez sur l’onglet Accès au projet.

Cliquez sur Ajouter un accès pour ajouter une nouvelle ligne d’autorisations aux autorisations par défaut.

Figure 2.2. Autorisations de projet

- Entrez le nom d’utilisateur, cliquez sur la liste déroulante Sélectionner un rôle et sélectionnez un rôle approprié.

- Cliquez sur Enregistrer pour ajouter les nouvelles autorisations.

Il est également possible d’utiliser:

- La liste déroulante Sélectionner un rôle, pour modifier les autorisations d’accès d’un utilisateur existant.

- L’icône Supprimer l’accès, pour supprimer complètement les autorisations d’accès d’un utilisateur existant au projet.

Le contrôle d’accès avancé basé sur les rôles est géré dans la perspective des rôles et des rôles dans la perspective de l’administrateur.

2.1.4. Personnalisation des rôles de cluster disponibles à l’aide de la console Web

Dans la perspective Développeur de la console web, la page d’accès Project → Project permet à un administrateur de projet d’accorder des rôles aux utilisateurs dans un projet. Les rôles de cluster disponibles qui peuvent être accordés aux utilisateurs d’un projet sont l’administration, l’édition et la visualisation.

En tant qu’administrateur de cluster, vous pouvez définir quels rôles de cluster sont disponibles dans la page d’accès au projet pour tous les projets à l’échelle du cluster. Il est possible de spécifier les rôles disponibles en personnalisant l’objet spec.customization.projectAccess.availableClusterRoles dans la ressource de configuration de la console.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle cluster-admin.

Procédure

- Dans la perspective de l’administrateur, accédez aux paramètres Administration → Cluster.

- Cliquez sur l’onglet Configuration.

- Dans la liste des ressources de configuration, sélectionnez Console operator.openshift.io.

- Accédez à l’onglet YAML pour afficher et modifier le code YAML.

Dans le code YAML sous Spéc, personnalisez la liste des rôles de cluster disponibles pour l’accès au projet. L’exemple suivant spécifie les rôles d’administrateur, d’édition et de visualisation par défaut:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Cliquez sur Enregistrer pour enregistrer les modifications apportées à la ressource de configuration de la console.

La vérification

- Dans la perspective Développeur, accédez à la page Projet.

- Choisissez un projet dans le menu Projet.

- Cliquez sur l’onglet Accès au projet.

- Cliquez sur le menu dans la colonne Rôle et vérifiez que les rôles disponibles correspondent à la configuration que vous avez appliquée à la configuration de ressource de la console.

2.1.5. Ajouter à un projet

Ajoutez des éléments à votre projet en utilisant la page +Ajouter dans la perspective Développeur.

Conditions préalables

- « vous avez créé un projet.

Procédure

- Dans la perspective Développeur, accédez à la page +Ajouter.

- Choisissez votre projet dans le menu Projet.

- Cliquez sur un élément de la page +Ajouter, puis suivez le flux de travail.

Il est également possible d’utiliser la fonction de recherche dans la page Add* pour trouver d’autres éléments à ajouter à votre projet. Cliquez * sous Ajouter en haut de la page et tapez le nom d’un composant dans le champ de recherche.

2.1.6. Contrôle de l’état du projet

Le service Red Hat OpenShift peut être utilisé sur la console web AWS ou sur l’OpenShift CLI (oc) pour visualiser l’état de votre projet.

2.1.6.1. Contrôle de l’état du projet à l’aide de la console Web

Il est possible d’examiner l’état de votre projet à l’aide de la console web.

Conditions préalables

- « vous avez créé un projet.

Procédure

Lorsque vous utilisez la perspective de l’administrateur:

- Accédez à Home → Projets.

- Choisissez un projet dans la liste.

- Examinez l’état du projet dans la page Aperçu.

Lorsque vous utilisez la perspective Développeur:

- Accédez à la page Projet.

- Choisissez un projet dans le menu Projet.

- Examinez l’état du projet dans la page Aperçu.

2.1.6.2. Contrôle de l’état du projet en utilisant le CLI

Consultez l’état d’avancement de votre projet à l’aide de l’OpenShift CLI (oc).

Conditions préalables

- L’OpenShift CLI (oc) a été installé.

- « vous avez créé un projet.

Procédure

Basculez vers votre projet:

oc project <project_name>

$ oc project <project_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- <project_name> par le nom de votre projet.

Avoir un aperçu de haut niveau du projet:

oc status

$ oc statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.7. La suppression d’un projet

Il est possible d’utiliser le service Red Hat OpenShift sur la console web AWS ou l’OpenShift CLI (oc) pour supprimer un projet.

Lorsque vous supprimez un projet, le serveur met à jour l’état du projet vers Terminating from Active. Ensuite, le serveur efface tout le contenu d’un projet qui est dans l’état de terminaison avant de finalement supprimer le projet. Bien qu’un projet soit en état de terminaison, vous ne pouvez pas ajouter de nouveau contenu au projet. Les projets peuvent être supprimés du CLI ou de la console web.

2.1.7.1. La suppression d’un projet en utilisant la console web

Il est possible de supprimer un projet en utilisant la console web.

Conditions préalables

- « vous avez créé un projet.

- Les autorisations requises pour supprimer le projet sont requises.

Procédure

Lorsque vous utilisez la perspective de l’administrateur:

- Accédez à Home → Projets.

- Choisissez un projet dans la liste.

Cliquez sur le menu déroulant Actions du projet et sélectionnez Supprimer le projet.

NoteL’option Supprimer le projet n’est pas disponible si vous n’avez pas les autorisations requises pour supprimer le projet.

- Dans le volet Supprimer le projet?, confirmez la suppression en saisissant le nom de votre projet.

- Cliquez sur Supprimer.

Lorsque vous utilisez la perspective Développeur:

- Accédez à la page Projet.

- Choisissez le projet que vous souhaitez supprimer dans le menu Projet.

Cliquez sur le menu déroulant Actions du projet et sélectionnez Supprimer le projet.

NoteDans le cas où vous n’avez pas les autorisations requises pour supprimer le projet, l’option Supprimer le projet n’est pas disponible.

- Dans le volet Supprimer le projet?, confirmez la suppression en saisissant le nom de votre projet.

- Cliquez sur Supprimer.

2.1.7.2. La suppression d’un projet en utilisant le CLI

Il est possible de supprimer un projet en utilisant l’OpenShift CLI (oc).

Conditions préalables

- L’OpenShift CLI (oc) a été installé.

- « vous avez créé un projet.

- Les autorisations requises pour supprimer le projet sont requises.

Procédure

Effacer votre projet:

oc delete project <project_name>

$ oc delete project <project_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- <project_name> par le nom du projet que vous souhaitez supprimer.

2.2. Configuration de la création de projet

Dans Red Hat OpenShift Service sur AWS, les projets sont utilisés pour regrouper et isoler des objets connexes. Lorsqu’une demande est faite pour créer un nouveau projet à l’aide de la console Web ou de la commande oc new-project, un point de terminaison dans Red Hat OpenShift Service sur AWS est utilisé pour fournir le projet en fonction d’un modèle, qui peut être personnalisé.

En tant qu’administrateur de cluster, vous pouvez autoriser et configurer la façon dont les développeurs et les comptes de services peuvent créer, ou auto-provisionner, leurs propres projets.

2.2.1. À propos de la création de projet

Le Red Hat OpenShift Service sur le serveur AWS API fournit automatiquement de nouveaux projets en fonction du modèle de projet identifié par le paramètre projectRequestTemplate dans la ressource de configuration de projet du cluster. Dans le cas où le paramètre n’est pas défini, le serveur API crée un modèle par défaut qui crée un projet avec le nom demandé et attribue l’utilisateur demandeur au rôle d’administrateur de ce projet.

Lorsqu’une demande de projet est soumise, l’API remplace les paramètres suivants dans le modèle:

| Le paramètre | Description |

|---|---|

|

| Le nom du projet. C’est nécessaire. |

|

| Le nom d’affichage du projet. C’est peut-être vide. |

|

| La description du projet. C’est peut-être vide. |

|

| Le nom d’utilisateur de l’utilisateur administrant. |

|

| Le nom d’utilisateur de l’utilisateur demandeur. |

L’accès à l’API est accordé aux développeurs ayant le rôle d’auto-proviseur et le rôle de cluster d’auto-fournisseurs. Ce rôle est disponible pour tous les développeurs authentifiés par défaut.

2.2.2. La modification du modèle pour les nouveaux projets

En tant qu’administrateur de cluster, vous pouvez modifier le modèle de projet par défaut afin que de nouveaux projets soient créés en utilisant vos exigences personnalisées.

Créer votre propre modèle de projet personnalisé:

Conditions préalables

- Grâce à un compte doté d’autorisations d’administration dédiées, vous avez accès à un service Red Hat OpenShift sur AWS.

Procédure

- Connectez-vous en tant qu’utilisateur avec des privilèges cluster-admin.

Générer le modèle de projet par défaut:

oc adm create-bootstrap-project-template -o yaml > template.yaml

$ oc adm create-bootstrap-project-template -o yaml > template.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Créez un éditeur de texte pour modifier le fichier template.yaml généré en ajoutant des objets ou en modifiant des objets existants.

Le modèle de projet doit être créé dans l’espace de noms openshift-config. Chargez votre modèle modifié:

oc create -f template.yaml -n openshift-config

$ oc create -f template.yaml -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Éditez la ressource de configuration du projet à l’aide de la console Web ou du CLI.

En utilisant la console web:

- Accédez à la page Administration → Paramètres du cluster.

- Cliquez sur Configuration pour afficher toutes les ressources de configuration.

- Cherchez l’entrée pour Projet et cliquez sur Modifier YAML.

En utilisant le CLI:

Editez la ressource project.config.openshift.io/cluster:

oc edit project.config.openshift.io/cluster

$ oc edit project.config.openshift.io/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Actualisez la section Spécifications pour inclure les paramètres projectRequestTemplate et nom, et définissez le nom de votre modèle de projet téléchargé. Le nom par défaut est project-request.

Configuration du projet ressource avec modèle de projet personnalisé

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Après avoir enregistré vos modifications, créez un nouveau projet pour vérifier que vos modifications ont été appliquées avec succès.

2.2.3. Désactivation de l’auto-provisionnement du projet

Il est possible d’empêcher un groupe d’utilisateurs authentifié d’auto-provisionner de nouveaux projets.

Procédure

- Connectez-vous en tant qu’utilisateur avec des privilèges cluster-admin.

Affichez l’utilisation de la liaison de rôle du cluster auto-fournisseur en exécutant la commande suivante:

oc describe clusterrolebinding.rbac self-provisioners

$ oc describe clusterrolebinding.rbac self-provisionersCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Examiner les sujets dans la section des autoprovisionnaires.

Enlevez le rôle de cluster d’auto-fournisseur du système de groupe:authenticated:oauth.

Lorsque la liaison de rôle du cluster auto-fournisseur lie uniquement le rôle d’auto-fournisseur au système:authenticated:oauth group, exécutez la commande suivante:

oc patch clusterrolebinding.rbac self-provisioners -p '{"subjects": null}'$ oc patch clusterrolebinding.rbac self-provisioners -p '{"subjects": null}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Lorsque la liaison de rôle de cluster auto-fournisseur lie le rôle d’auto-fournisseur à plus d’utilisateurs, de groupes ou de comptes de service que le groupe system:authenticated:oauth, exécutez la commande suivante:

oc adm policy \ remove-cluster-role-from-group self-provisioner \ system:authenticated:oauth$ oc adm policy \ remove-cluster-role-from-group self-provisioner \ system:authenticated:oauthCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Éditez la liaison du rôle de cluster d’auto-fournisseurs pour empêcher les mises à jour automatiques du rôle. Les mises à jour automatiques réinitialisent les rôles de cluster à l’état par défaut.

De mettre à jour la liaison de rôle à l’aide de l’ICC:

Exécutez la commande suivante:

oc edit clusterrolebinding.rbac self-provisioners

$ oc edit clusterrolebinding.rbac self-provisionersCopy to Clipboard Copied! Toggle word wrap Toggle overflow Dans la liaison de rôle affichée, définissez la valeur du paramètre rbac.authorization.kubernetes.io/autoupdate sur false, comme indiqué dans l’exemple suivant:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

De mettre à jour la liaison de rôle en utilisant une seule commande:

oc patch clusterrolebinding.rbac self-provisioners -p '{ "metadata": { "annotations": { "rbac.authorization.kubernetes.io/autoupdate": "false" } } }'$ oc patch clusterrolebinding.rbac self-provisioners -p '{ "metadata": { "annotations": { "rbac.authorization.kubernetes.io/autoupdate": "false" } } }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Connectez-vous en tant qu’utilisateur authentifié et vérifiez qu’il ne peut plus auto-provisionner un projet:

oc new-project test

$ oc new-project testCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Error from server (Forbidden): You may not request a new project via this API.

Error from server (Forbidden): You may not request a new project via this API.Copy to Clipboard Copied! Toggle word wrap Toggle overflow Envisagez de personnaliser ce message de demande de projet pour fournir des instructions plus utiles spécifiques à votre organisation.

2.2.4. Personnalisation du message de demande de projet

Lorsqu’un développeur ou un compte de service qui n’est pas en mesure d’auto-provisionner des projets fait une demande de création de projet à l’aide de la console Web ou du CLI, le message d’erreur suivant est retourné par défaut:

You may not request a new project via this API.

You may not request a new project via this API.Les administrateurs de clusters peuvent personnaliser ce message. Envisagez de le mettre à jour pour fournir d’autres instructions sur la façon de demander un nouveau projet spécifique à votre organisation. À titre d’exemple:

- Afin de demander un projet, communiquez avec votre administrateur système à projectname@example.com.

- Afin de demander un nouveau projet, remplissez le formulaire de demande de projet situé à https://internal.example.com/openshift-project-request.

Afin de personnaliser le message de demande de projet:

Procédure

Éditez la ressource de configuration du projet à l’aide de la console Web ou du CLI.

En utilisant la console web:

- Accédez à la page Administration → Paramètres du cluster.

- Cliquez sur Configuration pour afficher toutes les ressources de configuration.

- Cherchez l’entrée pour Projet et cliquez sur Modifier YAML.

En utilisant le CLI:

- Connectez-vous en tant qu’utilisateur avec des privilèges cluster-admin.

Editez la ressource project.config.openshift.io/cluster:

oc edit project.config.openshift.io/cluster

$ oc edit project.config.openshift.io/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Actualisez la section Spécifications pour inclure le paramètre projectRequestMessage et définissez la valeur à votre message personnalisé:

Configuration du projet ressource avec message personnalisé de demande de projet

Copy to Clipboard Copied! Toggle word wrap Toggle overflow À titre d’exemple:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Après avoir enregistré vos modifications, essayez de créer un nouveau projet en tant que développeur ou compte de service qui n’est pas en mesure d’auto-provisionner des projets pour vérifier que vos modifications ont été appliquées avec succès.

Chapitre 3. Création d’applications

3.1. En utilisant des modèles

Les sections suivantes fournissent un aperçu des modèles, ainsi que la façon de les utiliser et de les créer.

3.1.1. Comprendre les modèles

Le modèle décrit un ensemble d’objets qui peuvent être paramétrés et traités pour produire une liste d’objets à créer par Red Hat OpenShift Service sur AWS. Le modèle peut être traité pour créer tout ce que vous avez la permission de créer dans un projet, par exemple des services, des configurations de construction et des configurations de déploiement. Le modèle peut également définir un ensemble d’étiquettes à appliquer à chaque objet défini dans le modèle.

Il est possible de créer une liste d’objets à partir d’un modèle à l’aide du CLI ou, si un modèle a été téléchargé dans votre projet ou dans la bibliothèque globale de modèles, à l’aide de la console Web.

3.1.2. Chargement d’un modèle

Lorsque vous avez un fichier JSON ou YAML qui définit un modèle, vous pouvez télécharger le modèle vers des projets à l’aide du CLI. Cela permet d’enregistrer le modèle au projet pour une utilisation répétée par tout utilisateur ayant un accès approprié à ce projet. Des instructions sur la rédaction de vos propres modèles sont fournies plus tard dans ce sujet.

Procédure

Envoyez un modèle en utilisant l’une des méthodes suivantes:

Envoyez un modèle dans la bibliothèque de modèles de votre projet actuel, passez le fichier JSON ou YAML avec la commande suivante:

oc create -f <filename>

$ oc create -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Envoyez un modèle vers un autre projet en utilisant l’option -n avec le nom du projet:

oc create -f <filename> -n <project>

$ oc create -f <filename> -n <project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Le modèle est maintenant disponible pour la sélection à l’aide de la console Web ou du CLI.

3.1.3. Créer une application à l’aide de la console Web

Il est possible d’utiliser la console Web pour créer une application à partir d’un modèle.

Procédure

- Choisissez Développeur dans le sélecteur de contexte en haut du menu de navigation de la console Web.

- Dans le projet souhaité, cliquez sur +Ajouter

- Cliquez sur Tous les services dans la tuile du catalogue des développeurs.

Cliquez sur Builder Images sous Type pour voir les images du constructeur disponibles.

NoteLes balises de flux d’images qui ont la balise constructeur listée dans leurs annotations apparaissent dans cette liste, comme démontré ici:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Inclure le constructeur ici s’assure que cette balise de flux d’images apparaît dans la console Web en tant que constructeur.

- Modifiez les paramètres dans le nouvel écran de l’application pour configurer les objets pour prendre en charge votre application.

3.1.4. Création d’objets à partir de modèles en utilisant le CLI

Il est possible d’utiliser le CLI pour traiter les modèles et utiliser la configuration générée pour créer des objets.

3.1.4.1. Ajout d’étiquettes

Les étiquettes sont utilisées pour gérer et organiser des objets générés, tels que des pods. Les étiquettes spécifiées dans le modèle sont appliquées à chaque objet généré à partir du modèle.

Procédure

Ajouter des étiquettes dans le modèle à partir de la ligne de commande:

oc process -f <filename> -l name=otherLabel

$ oc process -f <filename> -l name=otherLabelCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.1.4.2. Liste des paramètres

La liste des paramètres que vous pouvez remplacer sont listées dans la section paramètres du modèle.

Procédure

Il est possible de répertorier les paramètres avec le CLI en utilisant la commande suivante et en spécifiant le fichier à utiliser:

oc process --parameters -f <filename>

$ oc process --parameters -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Alternativement, si le modèle est déjà téléchargé:

oc process --parameters -n <project> <template_name>

$ oc process --parameters -n <project> <template_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow À titre d’exemple, ce qui suit montre la sortie lors de la liste des paramètres de l’un des modèles de démarrage rapide dans le projet openshift par défaut:

oc process --parameters -n openshift rails-postgresql-example

$ oc process --parameters -n openshift rails-postgresql-exampleCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow La sortie identifie plusieurs paramètres qui sont générés avec un générateur d’expression régulier lorsque le modèle est traité.

3.1.4.3. Générer une liste d’objets

En utilisant le CLI, vous pouvez traiter un fichier définissant un modèle pour retourner la liste des objets à la sortie standard.

Procédure

Le processus d’un fichier définissant un modèle pour retourner la liste des objets à la sortie standard:

oc process -f <filename>

$ oc process -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Alternativement, si le modèle a déjà été téléchargé dans le projet actuel:

oc process <template_name>

$ oc process <template_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Créez des objets à partir d’un modèle en traitant le modèle et en comblant la sortie pour créer:

oc process -f <filename> | oc create -f -

$ oc process -f <filename> | oc create -f -Copy to Clipboard Copied! Toggle word wrap Toggle overflow Alternativement, si le modèle a déjà été téléchargé dans le projet actuel:

oc process <template> | oc create -f -

$ oc process <template> | oc create -f -Copy to Clipboard Copied! Toggle word wrap Toggle overflow Il est possible de remplacer les valeurs de paramètres définies dans le fichier en ajoutant l’option -p pour chaque paire <nom>=<valeur> que vous souhaitez remplacer. La référence de paramètre apparaît dans n’importe quel champ de texte à l’intérieur des éléments de modèle.

Dans les paramètres POSTGRESQL_USER et POSTGRESQL_DATABASE suivants, les paramètres POSTGRESQL_DATABASE d’un modèle sont dépassés pour produire une configuration avec des variables d’environnement personnalisées:

Création d’une liste d’objets à partir d’un modèle

oc process -f my-rails-postgresql \ -p POSTGRESQL_USER=bob \ -p POSTGRESQL_DATABASE=mydatabase$ oc process -f my-rails-postgresql \ -p POSTGRESQL_USER=bob \ -p POSTGRESQL_DATABASE=mydatabaseCopy to Clipboard Copied! Toggle word wrap Toggle overflow Le fichier JSON peut être redirigé vers un fichier ou appliqué directement sans télécharger le modèle en supprimant la sortie traitée vers la commande oc create:

oc process -f my-rails-postgresql \ -p POSTGRESQL_USER=bob \ -p POSTGRESQL_DATABASE=mydatabase \ | oc create -f -$ oc process -f my-rails-postgresql \ -p POSTGRESQL_USER=bob \ -p POSTGRESQL_DATABASE=mydatabase \ | oc create -f -Copy to Clipboard Copied! Toggle word wrap Toggle overflow Lorsque vous disposez d’un grand nombre de paramètres, vous pouvez les stocker dans un fichier, puis passer ce fichier au processus oc:

cat postgres.env POSTGRESQL_USER=bob POSTGRESQL_DATABASE=mydatabase

$ cat postgres.env POSTGRESQL_USER=bob POSTGRESQL_DATABASE=mydatabaseCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc process -f my-rails-postgresql --param-file=postgres.env

$ oc process -f my-rails-postgresql --param-file=postgres.envCopy to Clipboard Copied! Toggle word wrap Toggle overflow Il est également possible de lire l’environnement à partir de l’entrée standard en utilisant "-" comme argument pour --param-file:

sed s/bob/alice/ postgres.env | oc process -f my-rails-postgresql --param-file=-

$ sed s/bob/alice/ postgres.env | oc process -f my-rails-postgresql --param-file=-Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.1.5. La modification des modèles téléchargés

Il est possible d’éditer un modèle qui a déjà été téléchargé sur votre projet.

Procédure

De modifier un modèle qui a déjà été téléchargé:

oc edit template <template>

$ oc edit template <template>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.1.6. Écrire des modèles

Il est possible de définir de nouveaux modèles pour faciliter la recréation de tous les objets de votre application. Le modèle définit les objets qu’il crée ainsi que certaines métadonnées pour guider la création de ces objets.

Ce qui suit est un exemple d’une définition simple d’objet modèle (YAML):

3.1.6.1. Écrire la description du modèle

La description du modèle vous informe de ce que le modèle fait et vous aide à le trouver lors de la recherche dans la console Web. Des métadonnées supplémentaires au-delà du nom du modèle sont facultatives, mais utiles à avoir. En plus des informations descriptives générales, les métadonnées comprennent également un ensemble de balises. Les balises utiles incluent le nom du langage auquel le modèle est lié par exemple, Java, PHP, Ruby, etc.

Ce qui suit est un exemple de métadonnées de description de modèle:

- 1

- Le nom unique du modèle.

- 2

- Bref, nom convivial, qui peut être utilisé par les interfaces utilisateur.

- 3

- Description du modèle. Incluez suffisamment de détails pour que les utilisateurs comprennent ce qui est déployé et toutes les mises en garde qu’ils doivent savoir avant de le déployer. Il devrait également fournir des liens vers des informations supplémentaires, comme un fichier README. Les nouvelles lignes peuvent être incluses pour créer des paragraphes.

- 4

- Description de modèle supplémentaire. Cela peut être affiché par le catalogue de services, par exemple.

- 5

- Balises à associer au modèle pour la recherche et le regroupement. Ajoutez des tags qui l’incluent dans l’une des catégories de catalogue fournies. Consultez l’id et la catégorieAliases dans CATALOG_CATEGORIES dans le fichier constants de la console.

- 6

- Icône à afficher avec votre modèle dans la console Web.

Exemple 3.1. Icônes disponibles

-

icône-3scale -

icône-aerogear -

icône-amq -

icône-angularjs -

icône-ansible -

icône-apache -

icône-beaker -

icône-camel -

icône-capedwarf -

icône-cassandra -

icône-catalog-icon -

icône-clojure -

icône-codeigniter -

icône-cordova -

icône-datagrid -

icône-datavirt -

icône-debian -

icône-decisionserver -

icône-django -

icône-dotnet -

icône-drupal -

icône-eap -

icône-élastique -

icône-erlang -

icône-fedora -

icône-freebsd -

icône-git -

icône-github -

icône-gitlab -

icône-verre de poisson -

icône-go-gopher -

icône-golang -

icône-grails -

icône-hadoop -

icône-haproxy -

icône-helm -

icône-infinispan -

icône-jboss -

icône-jenkins -

icône-jetée -

icône-joomla -

icône-jruby -

icône-js -

icône-knative -

icône-kubevirt -

icône-laravel -

icône-charge-balanceur -

icône-mariadb -

icône-mediawiki -

icône-memcached -

icône-mongodb -

icône-mssql -

icône-mysql-base de données -

icône-nginx -

icône-nodejs -

icône-openjdk -

icône-openliberty -

icône-openshift -

icône-openstack -

icône-autre-linux -

icône-autre-inconnu -

icône-perl -

icône-phalcon -

icône-php -

jeu d’icônes -

icônepostgresql -

icône-processserver -

icône-python -

icône-quarkus -

icône-rabbitmq -

icône-rails -

icône-redhat -

icône-redis -

icône-rh-intégration -

icône-rh-spring-boot -

icône-rh-tomcat -

icône-ruby -

icône-scala -

icône-serverlessfx -

icône-shadowman -

icône-spring-boot -

icône-spring -

icône-sso -

icône-stackoverflow -

icône-suse -

icône-symfony -

icône-tomcat -

icône-ubuntu -

icône-vertx -

icône-wildfly -

icône-fenêtres -

icône-motpress -

icône-xamarin -

icône-zend

-

- 7

- Le nom de la personne ou de l’organisation fournissant le modèle.

- 8

- D’une URL faisant référence à d’autres documents pour le modèle.

- 9

- D’une URL où le support peut être obtenu pour le modèle.

- 10

- C’est un message d’instruction qui s’affiche lorsque ce modèle est instancié. Ce champ devrait indiquer à l’utilisateur comment utiliser les ressources nouvellement créées. La substitution de paramètres est effectuée sur le message avant d’être affichée de sorte que les informations d’identification générées et d’autres paramètres puissent être inclus dans la sortie. Inclure des liens vers toute documentation suivante que les utilisateurs devraient suivre.

3.1.6.2. Écrire des étiquettes de modèle

Les modèles peuvent inclure un ensemble d’étiquettes. Ces étiquettes sont ajoutées à chaque objet créé lorsque le modèle est instancié. Définir une étiquette de cette façon permet aux utilisateurs de trouver et de gérer facilement tous les objets créés à partir d’un modèle particulier.

Ce qui suit est un exemple d’étiquettes d’objets de modèle:

3.1.6.3. Écrire des paramètres de modèle

Les paramètres permettent qu’une valeur soit fournie par vous ou générée lorsque le modèle est instancié. Ensuite, cette valeur est remplacée partout où le paramètre est référencé. Les références peuvent être définies dans n’importe quel champ dans le champ de liste d’objets. Ceci est utile pour générer des mots de passe aléatoires ou vous permettre de fournir un nom d’hôte ou une autre valeur spécifique à l’utilisateur qui est nécessaire pour personnaliser le modèle. Les paramètres peuvent être référencés de deux manières:

- En tant que valeur de chaîne en plaçant des valeurs dans le formulaire ${PARAMETER_NAME} dans n’importe quel champ de chaîne du modèle.

- En tant que valeur JSON ou YAML en plaçant des valeurs dans la forme ${PARAMETER_NAME}} à la place de n’importe quel champ dans le modèle.

Lors de l’utilisation de la syntaxe ${PARAMETER_NAME}, plusieurs références de paramètres peuvent être combinées dans un seul champ et la référence peut être intégrée dans des données fixes, telles que "http://${PARAMETER_1}${PARAMETER_2}". Les deux valeurs de paramètres sont substituées et la valeur résultante est une chaîne citée.

Lors de l’utilisation de la syntaxe ${{PARAMETER_NAME}} seule une seule référence de paramètre est autorisée et les caractères menant et traînant ne sont pas autorisés. La valeur résultante n’est pas citée à moins que, après la substitution, le résultat n’est pas un objet JSON valide. Lorsque le résultat n’est pas une valeur JSON valide, la valeur résultante est citée et traitée comme une chaîne standard.

Il peut être référencé plusieurs fois dans un modèle et il peut être référencé à l’aide des deux syntaxes de substitution au sein d’un seul modèle.

La valeur par défaut peut être fournie, qui est utilisée si vous ne fournissez pas une valeur différente:

Ce qui suit est un exemple de définition d’une valeur explicite comme valeur par défaut:

parameters:

- name: USERNAME

description: "The user name for Joe"

value: joe

parameters:

- name: USERNAME

description: "The user name for Joe"

value: joeLes valeurs de paramètre peuvent également être générées en fonction des règles spécifiées dans la définition des paramètres, par exemple en générant une valeur de paramètre:

parameters:

- name: PASSWORD

description: "The random user password"

generate: expression

from: "[a-zA-Z0-9]{12}"

parameters:

- name: PASSWORD

description: "The random user password"

generate: expression

from: "[a-zA-Z0-9]{12}"Dans l’exemple précédent, le traitement génère un mot de passe aléatoire de 12 caractères, composé de toutes les lettres et chiffres de l’alphabet majuscule et minuscule.

La syntaxe disponible n’est pas une syntaxe d’expression régulière complète. Cependant, vous pouvez utiliser \w, \d, \a et \A modificateurs:

- [\W]{10} produit 10 caractères de l’alphabet, des nombres et des accents. Ceci suit la norme PCRE et est égal à [a-zA-Z0-9_]{10}.

- [\d]{10} produit 10 nombres. Ceci est égal à [0-9]{10}.

- [\a]{10} produit 10 caractères alphabétiques. Ceci est égal à [a-zA-Z]{10}.

- [\A]{10} produit 10 caractères de ponctuation ou de symbole. Ceci est égal à [~!@#$%\^&*()\-_+={}\\\\|<,>.?/"';:']{10}.

En fonction de si le modèle est écrit dans YAML ou JSON, et le type de chaîne dans laquelle le modificateur est intégré, vous devrez peut-être échapper au backslash avec un second backslash. Les exemples suivants sont équivalents:

Exemple de modèle YAML avec un modificateur

Exemple de modèle JSON avec un modificateur

En voici un exemple d’un modèle complet avec des définitions de paramètres et des références:

- 1

- Cette valeur est remplacée par la valeur du paramètre SOURCE_REPOSITORY_URL lorsque le modèle est instancié.

- 2

- Cette valeur est remplacée par la valeur non citée du paramètre REPLICA_COUNT lorsque le modèle est instancié.

- 3

- Le nom du paramètre. Cette valeur est utilisée pour référencer le paramètre dans le modèle.

- 4

- Le nom convivial du paramètre. Ceci est affiché pour les utilisateurs.

- 5

- Description du paramètre. Fournir des informations plus détaillées aux fins du paramètre, y compris toute contrainte sur la valeur attendue. Les descriptions doivent utiliser des phrases complètes pour suivre les normes de texte de la console. Il ne s’agit pas d’un duplicata du nom d’affichage.

- 6

- La valeur par défaut du paramètre qui est utilisé si vous ne remplacez pas la valeur lors de l’instanciation du modèle. Évitez d’utiliser des valeurs par défaut pour des choses comme les mots de passe, utilisez plutôt les paramètres générés en combinaison avec des secrets.

- 7

- Indique que ce paramètre est requis, ce qui signifie que vous ne pouvez pas le remplacer par une valeur vide. Dans le cas où le paramètre ne fournit pas de valeur par défaut ou générée, vous devez fournir une valeur.

- 8

- C’est un paramètre qui a sa valeur générée.

- 9

- L’entrée au générateur. Dans ce cas, le générateur produit une valeur alphanumérique de 40 caractères incluant des caractères majuscules et minuscules.

- 10

- Les paramètres peuvent être inclus dans le message de modèle. Cela vous informe des valeurs générées.

3.1.6.4. Écrire la liste d’objets du modèle

La partie principale du modèle est la liste des objets qui est créé lorsque le modèle est instancié. Cela peut être n’importe quel objet API valide, tel qu’une configuration de build, une configuration de déploiement ou un service. L’objet est créé exactement comme défini ici, avec des valeurs de paramètres substituées avant la création. La définition de ces objets peut référencer les paramètres définis précédemment.

Ce qui suit est un exemple d’une liste d’objets:

- 1

- La définition d’un service, qui est créé par ce modèle.

Lorsqu’une métadonnées de définition d’objet comprend une valeur de champ d’espace de noms fixe, le champ est retiré de la définition lors de l’instanciation du modèle. Lorsque le champ namespace contient une référence de paramètre, une substitution de paramètre normale est effectuée et l’objet est créé dans n’importe quel espace de noms auquel le paramètre a résolu la valeur, en supposant que l’utilisateur ait l’autorisation de créer des objets dans cet espace de noms.

3.1.6.5. Marquer un modèle comme liable

Le Template Service Broker annonce un service dans son catalogue pour chaque objet de modèle dont il est conscient. Chacun de ces services est annoncé par défaut comme étant liable, ce qui signifie qu’un utilisateur final est autorisé à se lier contre le service fourni.

Procédure

Les auteurs de modèles peuvent empêcher les utilisateurs finaux de se lier contre les services fournis à partir d’un modèle donné.

- Empêcher l’utilisateur final de se lier contre les services fournis à partir d’un modèle donné en ajoutant l’annotation template.openshift.io/bindable: "faux" au modèle.

3.1.6.6. Exposer les champs d’objets du modèle

Les auteurs de modèles peuvent indiquer que des champs d’objets particuliers dans un modèle doivent être exposés. Le Template Service Broker reconnaît les champs exposés sur les objets ConfigMap, Secret, Service et Route, et retourne les valeurs des champs exposés lorsqu’un utilisateur lie un service soutenu par le courtier.

Afin d’exposer un ou plusieurs champs d’un objet, ajoutez des annotations préfixées par template.openshift.io/expose- ou template.openshift.io/base64-expose- à l’objet dans le modèle.

Chaque clé d’annotation, avec son préfixe supprimé, est passée à travers pour devenir une clé dans une réponse de liaison.

Chaque valeur d’annotation est une expression Kubernetes JSONPath, qui est résolue au moment de la liaison pour indiquer le champ objet dont la valeur doit être retournée dans la réponse de liaison.

Les paires clé-valeur de réponse peuvent être utilisées dans d’autres parties du système comme variables d’environnement. Il est donc recommandé que chaque clé d’annotation avec son préfixe soit un nom de variable d’environnement valide - commençant par un caractère A-Z, a-z, ou _, et étant suivi de zéro ou plus caractères A-Z, a-z, 0-9, ou _.

À moins de s’échapper avec un backslash, l’implémentation JSONPath de Kubernetes interprète des caractères tels que ., @, et d’autres comme métacaractères, quelle que soit leur position dans l’expression. Donc, par exemple, pour se référer à un datum ConfigMap nommé my.key, l’expression JSONPath requise serait {.data['my\.key']}. En fonction de la façon dont l’expression JSONPath est alors écrite en YAML, un backslash supplémentaire peut être requis, par exemple "{.data['my\\\.key']}.

Ce qui suit est un exemple de champs d’objets différents exposés:

Exemple de réponse à une opération de liaison étant donné le modèle partiel ci-dessus:

Procédure

- L’annotation template.openshift.io/expose- renvoie la valeur du champ en tant que chaîne de caractères. C’est pratique, bien qu’il ne traite pas de données binaires arbitraires.

- Lorsque vous souhaitez retourner des données binaires, utilisez l’annotation template.openshift.io/base64-expose- pour coder les données avant qu’elles ne soient retournées.

3.1.6.7. En attente d’un modèle de préparation

Les auteurs de modèles peuvent indiquer que certains objets d’un modèle doivent être attendus avant qu’une instanciation de modèle par le catalogue de service, Template Service Broker ou l’API TemplateInstance soit considérée comme complète.

Afin d’utiliser cette fonctionnalité, marquez un ou plusieurs objets de type Build, BuildConfig, Deployment, DeploymentConfig, Job ou StatefulSet dans un modèle avec l’annotation suivante:

"template.alpha.openshift.io/wait-for-ready": "true"

"template.alpha.openshift.io/wait-for-ready": "true"L’instanciation du modèle n’est pas terminée tant que tous les objets marqués du rapport d’annotation ne sont pas prêts. De même, si l’un des rapports d’objets annotés a échoué, ou si le modèle ne parvient pas à devenir prêt dans un délai fixe d’une heure, l’instanciation du modèle échoue.

Aux fins de l’instanciation, la préparation et l’échec de chaque type d’objet sont définis comme suit:

| Je suis gentille. | L’état de préparation | Échec |

|---|---|---|

|

| La phase des rapports d’objets est terminée. | Les rapports d’objets ont été annulés, une erreur ou un échec. |

|

| Les derniers rapports d’objets associés sont terminés. | Les derniers rapports d’objets de construction associés ont été annulés, erreurs ou échoués. |

|

| L’objet signale un nouvel ensemble de répliques et un déploiement disponible. Cela honore les sondes de préparation définies sur l’objet. | L’état d’avancement des rapports d’objet est faux. |

|

| L’objet signale le nouveau contrôleur de réplication et le déploiement disponible. Cela honore les sondes de préparation définies sur l’objet. | L’état d’avancement des rapports d’objet est faux. |

|

| Les rapports d’objet sont terminés. | L’objet signale qu’un ou plusieurs échecs ont eu lieu. |

|

| L’objet signale toutes les répliques prêtes. Cela honore les sondes de préparation définies sur l’objet. | Ce n’est pas applicable. |

Ce qui suit est un exemple d’extrait de modèle, qui utilise l’annotation prête à attendre. D’autres exemples peuvent être trouvés dans le Red Hat OpenShift Service sur les modèles de démarrage rapide AWS.

Autres recommandations

- Définissez la mémoire, le CPU et les tailles par défaut de stockage pour vous assurer que votre application dispose de suffisamment de ressources pour fonctionner en douceur.

- Évitez de faire référence à la dernière balise à partir d’images si cette balise est utilisée dans les versions principales. Cela peut causer des applications en cours d’exécution à casser lorsque de nouvelles images sont poussées vers cette balise.

- Après le déploiement du modèle, un bon modèle construit et déploie proprement sans nécessiter de modifications.

3.1.6.8. Créer un modèle à partir d’objets existants

Au lieu d’écrire un modèle entier à partir de zéro, vous pouvez exporter des objets existants de votre projet dans le formulaire YAML, puis modifier le YAML à partir de là en ajoutant des paramètres et d’autres personnalisations en tant que formulaire de modèle.

Procédure

Exporter des objets dans un projet sous forme YAML:

oc get -o yaml all > <yaml_filename>

$ oc get -o yaml all > <yaml_filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Il est également possible de substituer un type de ressource particulier ou plusieurs ressources au lieu de toutes. Exécutez oc get -h pour plus d’exemples.

Les types d’objets inclus dans oc get -o yaml tous sont:

-

BuildConfig -

Construire -

DéploiementConfig -

ImageStream -

La pod -

Contrôleur de réplication -

Itinéraire -

Le service

-

L’utilisation de tous les alias n’est pas recommandée car le contenu peut varier selon différents clusters et versions. Au lieu de cela, spécifiez toutes les ressources requises.

3.2. Créer des applications en utilisant la perspective Développeur

La perspective Développeur dans la console Web vous fournit les options suivantes de la vue +Ajouter pour créer des applications et des services associés et les déployer sur Red Hat OpenShift Service sur AWS:

Démarrage des ressources: Utilisez ces ressources pour vous aider à démarrer avec la console de développement. Il est possible de cacher l’en-tête à l’aide du menu Options.

- Création d’applications à l’aide d’échantillons: Utilisez des échantillons de code existants pour commencer avec la création d’applications sur le service OpenShift Red Hat sur AWS.

- Construire avec la documentation guidée: Suivez la documentation guidée pour créer des applications et vous familiariser avec les concepts clés et les terminologies.

- Explorez les nouvelles fonctionnalités du développeur : explorez les nouvelles fonctionnalités et ressources dans la perspective du développeur.

Catalogue des développeurs: Découvrez le catalogue des développeurs pour sélectionner les applications, les services ou les sources nécessaires pour créer des images, puis l’ajouter à votre projet.

- All Services: Parcourez le catalogue pour découvrir les services de Red Hat OpenShift Service sur AWS.

- Base de données: Sélectionnez le service de base de données requis et ajoutez-le à votre application.

- L’opérateur Backed: Sélectionnez et déployez le service géré par l’opérateur requis.

- Graphique de helm: Sélectionnez le graphique Helm requis pour simplifier le déploiement des applications et des services.

- Devfile: Sélectionnez un devfile dans le registre Devfile pour définir de manière déclarative un environnement de développement.

Evénement Source: Sélectionnez une source d’événement pour enregistrer l’intérêt pour une classe d’événements à partir d’un système particulier.

NoteL’option Services gérés est également disponible si l’opérateur RHOAS est installé.

- Dépôt Git: Importez une base de code existante, Devfile ou Dockerfile à partir de votre dépôt Git en utilisant respectivement les options From Git, From Devfile ou From Dockerfile pour construire et déployer une application sur Red Hat OpenShift Service sur AWS.

- Images conteneur: Utilisez des images existantes à partir d’un flux d’images ou d’un registre pour les déployer sur le service Red Hat OpenShift sur AWS.

- Pipelines: Utilisez le pipeline Tekton pour créer des pipelines CI/CD pour votre processus de livraison de logiciels sur le service OpenShift Red Hat sur AWS.

Découvrez les options Serverless pour créer, construire et déployer des applications apatrides et sans serveur sur le service Red Hat OpenShift sur AWS.

- Canal: Créez un canal Knative pour créer une couche de transmission d’événements et de persistance avec des implémentations en mémoire et fiables.

- Échantillons : explorez les exemples d’applications disponibles pour créer, construire et déployer rapidement une application.

- Démarrage rapide : explorez les options de démarrage rapide pour créer, importer et exécuter des applications avec des instructions et des tâches étape par étape.

De la machine locale: explorez la tuile de la machine locale pour importer ou télécharger des fichiers sur votre machine locale pour créer et déployer facilement des applications.

- Importer YAML : Téléchargez un fichier YAML pour créer et définir des ressources pour la création et le déploiement d’applications.

- Envoyer un fichier JAR : Téléchargez un fichier JAR pour créer et déployer des applications Java.

- Le partage de mon projet : Utilisez cette option pour ajouter ou supprimer des utilisateurs à un projet et leur fournir des options d’accessibilité.

- Dépôts de graphiques helm: Utilisez cette option pour ajouter des référentiels Helm Chart dans un espace de noms.

- La ré-commandation des ressources : Utilisez ces ressources pour réorganiser les ressources épinglées ajoutées à votre volet de navigation. L’icône glisser-déposer s’affiche sur le côté gauche de la ressource épinglée lorsque vous le survolez dans le volet de navigation. La ressource traînée ne peut être supprimée que dans la section où elle réside.

Il est à noter que l’option Pipelines n’est affichée que lorsque l’opérateur de pipelines OpenShift est installé.

3.2.1. Conditions préalables

Créer des applications en utilisant la perspective Développeur s’assure que:

- Connectez-vous à la console web.

3.2.2. Créer des exemples d’applications

Les exemples d’applications peuvent être utilisés dans le flux +Ajouter de la perspective Développeur pour créer, construire et déployer rapidement des applications.

Conditions préalables

- Connectez-vous au service Red Hat OpenShift sur la console web AWS et vous êtes dans la perspective Développeur.

Procédure

- Dans la vue +Ajouter, cliquez sur la tuile Échantillons pour voir la page Échantillons.

- Dans la page Échantillons, sélectionnez l’une des applications types disponibles pour voir le formulaire Créer une demande d’échantillon.

Dans le formulaire de demande d’échantillon:

- Dans le champ Nom, le nom de déploiement est affiché par défaut. Il est possible de modifier ce nom au besoin.

- Dans la version d’image du constructeur, une image de constructeur est sélectionnée par défaut. Cette version d’image peut être modifiée à l’aide de la liste déroulante de la version déroulante de Builder Image.

- L’URL du référentiel Git est ajoutée par défaut.

- Cliquez sur Créer pour créer l’exemple d’application. L’état de construction de l’application de l’échantillon est affiché sur la vue Topology. Après la création de l’exemple d’application, vous pouvez voir le déploiement ajouté à l’application.

3.2.3. Création d’applications en utilisant Quick Starts

La page Démarrage rapide vous montre comment créer, importer et exécuter des applications sur Red Hat OpenShift Service sur AWS, avec des instructions et des tâches étape par étape.

Conditions préalables

- Connectez-vous au service Red Hat OpenShift sur la console web AWS et vous êtes dans la perspective Développeur.

Procédure

- Dans la vue +Ajouter, cliquez sur le lien Démarrer les ressources → Construire avec la documentation guidée → Voir tous les liens de démarrage rapide pour afficher la page Démarrage rapide.

- Dans la page Démarrage rapide, cliquez sur la tuile pour le démarrage rapide que vous souhaitez utiliser.

- Cliquez sur Démarrer pour commencer le démarrage rapide.

- Effectuez les étapes qui sont affichées.

3.2.4. Importer une base de code à partir de Git pour créer une application

La perspective Développeur peut être utilisée pour créer, construire et déployer une application sur Red Hat OpenShift Service sur AWS à l’aide d’une base de code existante dans GitHub.

La procédure suivante vous guide à travers l’option From Git dans la perspective Développeur pour créer une application.

Procédure

- Dans la vue +Ajouter, cliquez sur À partir de Git dans la tuile Git Repository pour voir le formulaire Importer à partir de git.

- Dans la section Git, entrez l’URL du référentiel Git pour la base de code que vous souhaitez utiliser pour créer une application. Entrez par exemple l’URL de cet exemple d’application Node.js https://github.com/sclorg/nodejs-ex. L’URL est ensuite validée.

Facultatif: Vous pouvez cliquer sur Afficher les options avancées de Git pour ajouter des détails tels que:

- Git Référence au point de code d’une branche, d’une balise ou d’un engagement spécifique pour être utilisé pour construire l’application.

- Context Dir pour spécifier le sous-répertoire du code source de l’application que vous souhaitez utiliser pour construire l’application.

- Créer un nom secret avec des informations d’identification pour tirer votre code source d’un référentiel privé.

Facultatif : Vous pouvez importer un fichier Devfile, un Dockerfile, une image Builder ou une fonction sans serveur via votre référentiel Git pour personnaliser davantage votre déploiement.

- Lorsque votre dépôt Git contient un Devfile, un Dockerfile, une image Builder ou un func.yaml, il est automatiquement détecté et peuplé sur les champs de chemin respectifs.

- Lorsqu’un Devfile, un Dockerfile ou une image Builder sont détectés dans le même référentiel, le Devfile est sélectionné par défaut.

- Lorsque func.yaml est détecté dans le référentiel Git, la stratégie d’importation change de fonction sans serveur.

- Alternativement, vous pouvez créer une fonction sans serveur en cliquant sur Créer la fonction Serverless dans la vue +Ajouter à l’aide de l’URL du référentiel Git.

- Afin d’éditer le type d’importation de fichier et de sélectionner une stratégie différente, cliquez sur Modifier la stratégie d’importation.

- Lorsque plusieurs Devfiles, Dockerfiles, ou un Builder Images sont détectés, pour importer une instance spécifique, spécifiez les chemins respectifs par rapport au répertoire contextuel.

Après la validation de l’URL Git, l’image de constructeur recommandée est sélectionnée et marquée d’une étoile. Lorsque l’image du constructeur n’est pas détectée automatiquement, sélectionnez une image de constructeur. Dans le cas de l’URL https://github.com/sclorg/nodejs-ex Git, l’image du constructeur Node.js est sélectionnée par défaut.

- Facultatif : Utilisez le déroulant de la version déroulante de Builder Image pour spécifier une version.

- Facultatif: Utilisez la stratégie Modifier l’importation pour sélectionner une stratégie différente.

- Facultatif: Pour l’image du constructeur Node.js, utilisez le champ de commande Exécuter pour remplacer la commande pour exécuter l’application.

Dans la section générale:

- Dans le champ Application, entrez un nom unique pour le groupement d’applications, par exemple myapp. Assurez-vous que le nom de l’application est unique dans un espace de noms.

Le champ Nom pour identifier les ressources créées pour cette application est automatiquement rempli en fonction de l’URL du référentiel Git s’il n’y a pas d’applications existantes. Dans le cas d’applications existantes, vous pouvez choisir de déployer le composant dans une application existante, de créer une nouvelle application ou de garder le composant non affecté.

NoteLe nom de la ressource doit être unique dans un espace de noms. Modifiez le nom de la ressource si vous obtenez une erreur.

Dans la section Ressources, sélectionnez:

- Déploiement, pour créer une application dans le style Kubernetes.

- Déploiement Config, pour créer un service Red Hat OpenShift sur l’application de style AWS.

Dans la section Pipelines, sélectionnez Ajouter un pipeline, puis cliquez sur Afficher la visualisation des pipelines pour voir le pipeline pour l’application. Le pipeline par défaut est sélectionné, mais vous pouvez choisir le pipeline que vous souhaitez dans la liste des pipelines disponibles pour l’application.

NoteLa case à cocher Ajouter un pipeline est cochée et Configure PAC est sélectionnée par défaut si les critères suivants sont remplis:

- L’opérateur de pipeline est installé

- les pipelines-as-code sont activés

- le répertoire .Tekton est détecté dans le référentiel Git

Ajoutez un webhook à votre référentiel. Lorsque Configurez PAC est vérifié et que l’application GitHub est configurée, vous pouvez voir les options Utiliser l’application GitHub et configurer un webhook. Dans le cas où l’application GitHub n’est pas configurée, vous ne pouvez voir que l’option Configuration d’un webhook:

- Allez dans Paramètres → Webhooks et cliquez sur Ajouter webhook.

- Définissez l’URL Charge utile sur les pipelines en tant qu’URL publique du contrôleur de code.

- Choisissez le type de contenu comme application/json.

- Ajoutez un secret de webhook et notez-le dans un autre endroit. Avec Opensl installé sur votre machine locale, générez un secret aléatoire.

- Cliquez sur Laissez-moi sélectionner des événements individuels et sélectionnez ces événements: Commiter les commentaires, émettre des commentaires, Pull request et Pushes.

- Cliquez sur Ajouter webhook.

Facultatif : Dans la section Options avancées, le port cible et l’itinéraire Créer un itinéraire vers l’application sont sélectionnés par défaut afin que vous puissiez accéder à votre application à l’aide d’une URL accessible au public.

Lorsque votre application n’expose pas ses données sur le port public par défaut, 80, effacer la case à cocher et définir le numéro de port cible que vous souhaitez exposer.

Facultatif: Vous pouvez utiliser les options avancées suivantes pour personnaliser davantage votre application:

- Le routage

En cliquant sur le lien de routage, vous pouvez effectuer les actions suivantes:

- Personnalisez le nom d’hôte pour l’itinéraire.

- Indiquez le chemin que le routeur montre.

- Choisissez le port cible pour le trafic dans la liste déroulante.

Assurez votre itinéraire en sélectionnant la case à cocher Route sécurisée. Choisissez le type de terminaison TLS requis et définissez une stratégie pour le trafic non sécurisé à partir des listes déroulantes respectives.

NoteDans le cas des applications sans serveur, le service Knative gère toutes les options de routage ci-dessus. Cependant, vous pouvez personnaliser le port cible pour le trafic, si nécessaire. Lorsque le port cible n’est pas spécifié, le port par défaut de 8080 est utilisé.

- Bilans de santé

Cliquez sur le lien Health Checks pour ajouter des sondes de préparation, de vie et de démarrage à votre application. L’ensemble des sondes ont des données par défaut prépopulées; vous pouvez ajouter les sondes avec les données par défaut ou les personnaliser au besoin.

Afin de personnaliser les sondes de santé:

- Cliquez sur Ajouter la sonde de préparation, si nécessaire, modifiez les paramètres pour vérifier si le conteneur est prêt à traiter les demandes et sélectionnez la marque de cocher pour ajouter la sonde.

- Cliquez sur Ajouter une sonde de vie, si nécessaire, modifiez les paramètres pour vérifier si un conteneur est toujours en cours d’exécution et sélectionnez la coche pour ajouter la sonde.

Cliquez sur Ajouter une sonde de démarrage, si nécessaire, modifiez les paramètres pour vérifier si l’application dans le conteneur a commencé et sélectionnez la coche pour ajouter la sonde.

Dans chacune des sondes, vous pouvez spécifier le type de requête - HTTP GET, Container Command ou TCP Socket, à partir de la liste déroulante. Le formulaire change selon le type de demande sélectionné. Ensuite, vous pouvez modifier les valeurs par défaut pour les autres paramètres, tels que les seuils de succès et de défaillance de la sonde, le nombre de secondes avant d’effectuer la première sonde après le démarrage du conteneur, la fréquence de la sonde et la valeur d’expiration.

- Construire la configuration et le déploiement

Cliquez sur les liens Configuration et déploiement pour voir les options de configuration respectives. Certaines options sont sélectionnées par défaut; vous pouvez les personnaliser davantage en ajoutant les déclencheurs et les variables d’environnement nécessaires.

Dans le cas des applications sans serveur, l’option Déploiement n’est pas affichée car la ressource de configuration Knative maintient l’état souhaité pour votre déploiement au lieu d’une ressource DeploymentConfig.

- La mise à l’échelle

Cliquez sur le lien Scaling pour définir le nombre de pods ou d’instances de l’application que vous souhaitez déployer initialement.

Lorsque vous créez un déploiement sans serveur, vous pouvez également configurer les paramètres suivants:

- Les Pods min déterminent la limite inférieure pour le nombre de gousses qui doivent fonctionner à tout moment pour un service Knative. Ceci est également connu sous le nom de paramètre minScale.

- Les Max Pods déterminent la limite supérieure pour le nombre de gousses pouvant fonctionner à tout moment pour un service Knative. Ceci est également connu sous le nom de réglage maxScale.

- La cible de concurrence détermine le nombre de demandes simultanées souhaitées pour chaque instance de la demande à un moment donné.

- La limite de concurrence détermine la limite pour le nombre de demandes simultanées autorisées pour chaque instance de la demande à un moment donné.

- L’utilisation de la concurrence détermine le pourcentage de la limite de demandes simultanées qui doit être respectée avant que Knative n’évolue de nouveaux pods pour gérer le trafic supplémentaire.

- La fenêtre Autoscale définit la fenêtre de temps sur laquelle les métriques sont moyennes pour fournir une entrée pour les décisions de mise à l’échelle lorsque l’autoscaler n’est pas en mode panique. Le service est réduit à zéro si aucune demande n’est reçue pendant cette fenêtre. La durée par défaut de la fenêtre autoscale est 60s. Ceci est également connu sous le nom de fenêtre stable.

- Limite de ressources

- Cliquez sur le lien Limite de ressources pour définir la quantité de ressources CPU et mémoire qu’un conteneur est garanti ou autorisé à utiliser lors de l’exécution.

- Étiquettes

- Cliquez sur le lien Labels pour ajouter des étiquettes personnalisées à votre application.

- Cliquez sur Créer pour créer l’application et une notification de succès est affichée. L’état de construction de l’application est affiché dans la vue Topology.

3.2.5. Créer des applications en déployant l’image de conteneur

Il est possible d’utiliser un registre d’images externe ou une balise de flux d’images à partir d’un registre interne pour déployer une application sur votre cluster.

Conditions préalables

- Connectez-vous au service Red Hat OpenShift sur la console web AWS et vous êtes dans la perspective Développeur.

Procédure

- Dans la vue +Ajouter, cliquez sur Container images pour afficher la page Deploy Images.

Dans la section Image:

- Choisissez le nom de l’image dans le registre externe pour déployer une image à partir d’un registre public ou privé, ou sélectionnez Image Stream tag dans le registre interne pour déployer une image à partir d’un registre interne.

- Choisissez une icône pour votre image dans l’onglet de l’icône Runtime.

Dans la section générale:

- Dans le champ Nom de l’application, entrez un nom unique pour le groupement d’applications.

- Dans le champ Nom, entrez un nom unique pour identifier les ressources créées pour ce composant.

Dans la section Type de ressource, sélectionnez le type de ressource à générer:

- Choisissez Déploiement pour activer les mises à jour déclaratives pour les objets Pod et ReplicaSet.

- Choisissez DéploymentConfig pour définir le modèle d’un objet Pod et gérer le déploiement de nouvelles images et sources de configuration.

- Cliquez sur Create. Il est possible d’afficher l’état de construction de l’application dans la vue Topology.

3.2.6. Déploiement d’une application Java en téléchargeant un fichier JAR

La perspective Développeur de la console Web vous permet de télécharger un fichier JAR en utilisant les options suivantes:

- Accédez à la vue +Ajouter de la perspective Développeur, puis cliquez sur Télécharger le fichier JAR dans la tuile From Local Machine. Recherchez et sélectionnez votre fichier JAR, ou faites glisser un fichier JAR pour déployer votre application.

- Accédez à la vue Topology et utilisez l’option Upload JAR, ou faites glisser un fichier JAR pour déployer votre application.

- Dans la vue Topology, utilisez le menu in-contexte, puis utilisez l’option Upload JAR pour télécharger votre fichier JAR pour déployer votre application.

Conditions préalables

- L’opérateur d’échantillons de cluster doit être installé par un utilisateur ayant le rôle d’administrateur dédié.

- Accès au service Red Hat OpenShift sur la console web AWS et vous êtes dans la perspective Développeur.

Procédure

- Dans la vue Topologie, faites un clic droit n’importe où pour afficher le menu Ajouter au projet.

- Survolez le menu Ajouter au projet pour voir les options de menu, puis sélectionnez l’option Télécharger le fichier JAR pour afficher le formulaire de fichier JAR. Alternativement, vous pouvez glisser le fichier JAR dans la vue Topology.

- Dans le champ fichier JAR, recherchez le fichier JAR requis sur votre machine locale et téléchargez-le. Alternativement, vous pouvez faire glisser le fichier JAR sur le champ. En haut à droite, une alerte toast est affichée si un type de fichier incompatible est glisser dans la vue Topology. L’erreur de champ s’affiche si un type de fichier incompatible est déposé sur le champ dans le formulaire de téléchargement.

- L’icône d’exécution et l’image du constructeur sont sélectionnées par défaut. Lorsqu’une image de constructeur n’est pas détectée automatiquement, sélectionnez une image de constructeur. Au besoin, vous pouvez modifier la version à l’aide de la liste déroulante de la version déroulante de Builder Image.

- Facultatif: Dans le champ Nom de l’application, entrez un nom unique pour votre application à utiliser pour l’étiquetage des ressources.

- Dans le champ Nom, entrez un nom de composant unique pour les ressources associées.

- Facultatif: Utilisez la liste déroulante type de ressource pour modifier le type de ressource.

- Dans le menu Options avancées, cliquez sur Créer un itinéraire vers l’application pour configurer une URL publique pour votre application déployée.

- Cliquez sur Créer pour déployer l’application. Il est indiqué qu’une notification de toast vous informe que le fichier JAR est en cours de téléchargement. La notification de toast comprend également un lien pour voir les journaux de construction.

Lorsque vous tentez de fermer l’onglet du navigateur pendant que la construction est en cours d’exécution, une alerte Web s’affiche.

Après le téléchargement du fichier JAR et le déploiement de l’application, vous pouvez afficher l’application dans la vue Topology.

3.2.7. En utilisant le registre Devfile pour accéder aux devfiles

Dans le flux +Add de la perspective Développeur, vous pouvez utiliser les devfiles pour créer une application. Le flux +Add fournit une intégration complète avec le registre communautaire devfile. Devfile est un fichier YAML portable qui décrit votre environnement de développement sans avoir besoin de le configurer à partir de zéro. En utilisant le registre Devfile, vous pouvez utiliser un devfile préconfiguré pour créer une application.

Procédure

- Accédez à Perspective des développeurs → +Ajouter → Catalogue des développeurs → Tous les services. La liste de tous les services disponibles dans le catalogue des développeurs est affichée.

- Dans Type, cliquez sur Devfiles pour parcourir les devfiles qui prennent en charge un langage ou un framework particulier. Alternativement, vous pouvez utiliser le filtre de mots clés pour rechercher un devfile particulier en utilisant leur nom, leur balise ou leur description.

- Cliquez sur le fichier devfile que vous souhaitez utiliser pour créer une application. La tuile devfile affiche les détails du devfile, y compris le nom, la description, le fournisseur et la documentation du devfile.

- Cliquez sur Créer pour créer une application et afficher l’application dans la vue Topology.

3.2.8. En utilisant le catalogue des développeurs pour ajouter des services ou des composants à votre application