Le suivi

Le suivi des projets sur Red Hat OpenShift Service sur AWS

Résumé

Chapitre 1. Aperçu du suivi

1.1. À propos de Red Hat OpenShift Service sur AWS monitoring

Dans Red Hat OpenShift Service sur AWS, vous pouvez surveiller vos propres projets indépendamment des métriques de la plate-forme Red Hat Site Reliability Engineering (SRE). Il est possible de surveiller vos propres projets sans avoir besoin d’une solution de surveillance supplémentaire.

La pile de surveillance Red Hat OpenShift Service sur AWS (ROSA) est basée sur le projet open source Prometheus et son écosystème plus large.

1.2. Comprendre la pile de surveillance

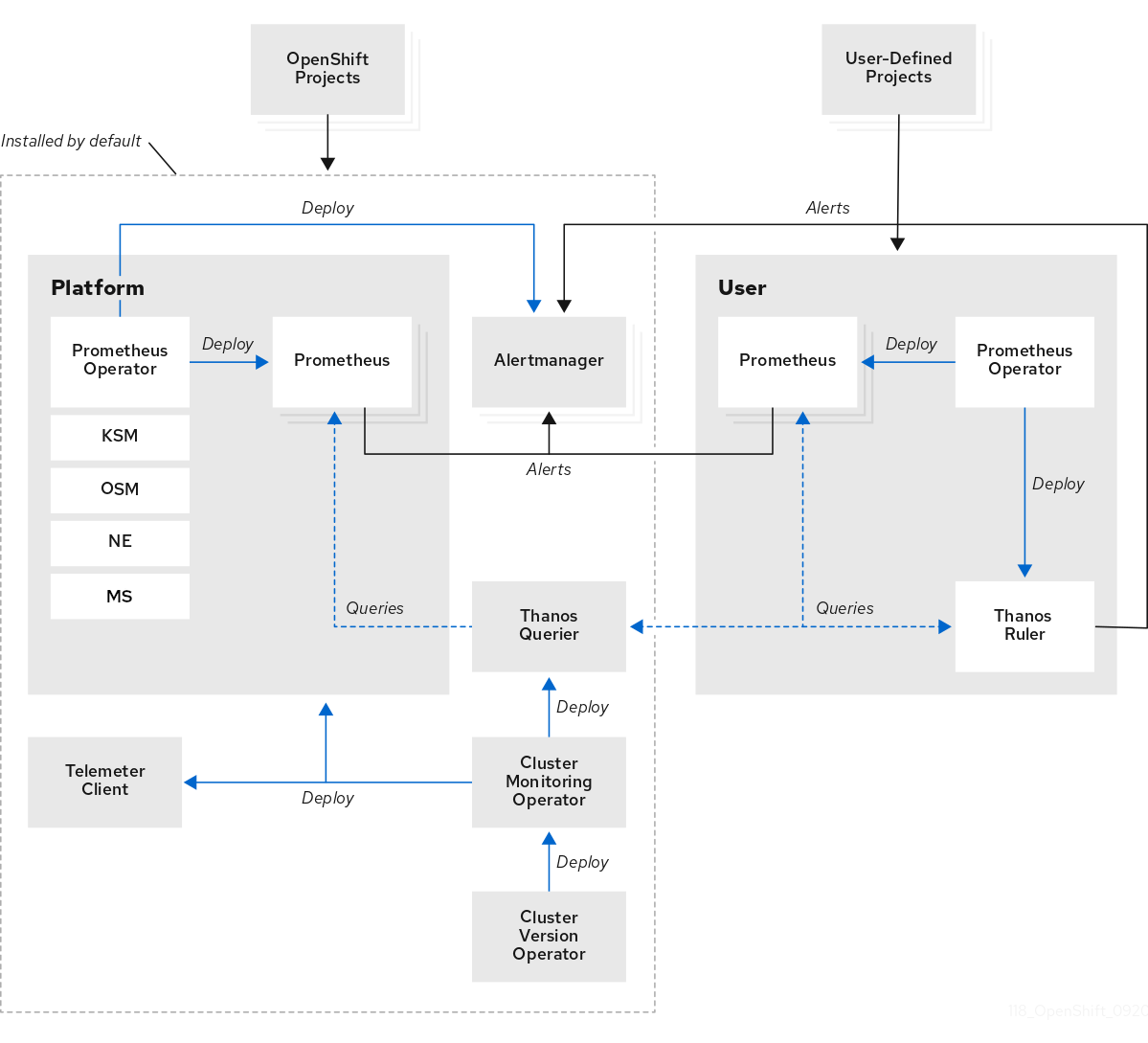

La pile de surveillance comprend les composants suivants:

Composants de surveillance de plate-forme par défaut. Des composants de surveillance de plate-forme sont installés dans le projet de surveillance openshift par défaut lors d’un Red Hat OpenShift Service sur l’installation AWS. Les ingénieurs de fiabilité du site Red Hat (SRE) utilisent ces composants pour surveiller les composants principaux des clusters, y compris les services Kubernetes. Cela inclut des métriques critiques, telles que CPU et mémoire, collectées à partir de toutes les charges de travail dans chaque espace de noms.

Ces composants sont illustrés dans la section Installé par défaut dans le diagramme suivant.

- Composants pour le suivi des projets définis par l’utilisateur. Dans l’installation AWS, un ensemble de composants de surveillance de projet définis par l’utilisateur sont installés par défaut dans le projet de surveillance de la charge de travail ouverte de l’utilisateur lors d’un service OpenShift Red Hat. Ces composants peuvent être utilisés pour surveiller les services et les pods dans les projets définis par l’utilisateur. Ces composants sont illustrés dans la section Utilisateur dans le diagramme suivant.

1.2.1. Cibles de surveillance par défaut

Ce qui suit sont des exemples de cibles surveillées par Red Hat Site Reliability Engineers (SRE) dans votre Red Hat OpenShift Service sur AWS cluster:

- CoreDNS

- etc.

- HAProxy

- Enregistrement d’images

- Kubelets

- Kubernetes serveur API

- Gestionnaire de contrôleur Kubernetes

- Kubernetes planificateur

La liste exacte des cibles peut varier en fonction des capacités de votre cluster et des composants installés.

1.2.2. Composants pour le suivi des projets définis par l’utilisateur

Le service OpenShift Red Hat sur AWS inclut une amélioration optionnelle de la pile de surveillance qui vous permet de surveiller les services et les pods dans les projets définis par l’utilisateur. Cette fonctionnalité comprend les composants suivants:

| Composante | Description |

|---|---|

| L’opérateur Prometheus | L’opérateur Prometheus (PO) dans le projet openshift-user-workload-monitoring crée, configure et gère les instances Prometheus et Thanos Ruler dans le même projet. |

| Le Prométhée | Le Prometheus est le système de surveillance par lequel la surveillance est assurée pour les projets définis par l’utilisateur. Le Prometheus envoie des alertes à Alertmanager pour le traitement. |

| Le chef de Thanos | Le Thanos Ruler est un moteur d’évaluation de règles pour Prometheus qui est déployé en tant que processus séparé. Dans Red Hat OpenShift Service sur AWS, Thanos Ruler fournit une évaluation des règles et des alertes pour le suivi des projets définis par l’utilisateur. |

| Alertmanager | Le service Alertmanager gère les alertes reçues de Prometheus et Thanos Ruler. Alertmanager est également responsable de l’envoi d’alertes définies par l’utilisateur aux systèmes de notification externes. Le déploiement de ce service est facultatif. |

L’ensemble de ces composants sont surveillés par la pile et sont automatiquement mis à jour lorsque Red Hat OpenShift Service sur AWS est mis à jour.

1.2.3. Cibles de suivi pour les projets définis par l’utilisateur

La surveillance est activée par défaut pour Red Hat OpenShift Service sur les projets définis par l’utilisateur AWS. Il est possible de surveiller:

- Les métriques fournies par l’intermédiaire de points de terminaison de service dans les projets définis par l’utilisateur.

- Des pods s’exécutant dans des projets définis par l’utilisateur.

1.2.4. La pile de surveillance dans les clusters à haute disponibilité

Dans les clusters multi-nœuds par défaut, les composants suivants s’exécutent en mode haute disponibilité (HA) pour éviter la perte de données et l’interruption de service:

- Le Prométhée

- Alertmanager

- Le chef de Thanos

Le composant est reproduit sur deux pods, chacun fonctionnant sur un nœud séparé. Cela signifie que la pile de surveillance peut tolérer la perte d’une gousse.

- Le Prométhée en mode HA

- Les deux répliques grattent indépendamment les mêmes cibles et évaluent les mêmes règles.

- Les répliques ne communiquent pas entre elles. Les données peuvent donc différer entre les pods.

- Alertmanager en mode HA

- Les deux répliques synchronisent les états de notification et de silence les uns avec les autres. Cela garantit que chaque notification est envoyée au moins une fois.

- Lorsque les répliques ne parviennent pas à communiquer ou s’il y a un problème du côté de la réception, des notifications sont toujours envoyées, mais elles peuvent être dupliquées.

Les Prometheus, Alertmanager et Thanos Ruler sont des composants d’état. Afin d’assurer une disponibilité élevée, vous devez les configurer avec un stockage persistant.

1.3. Glossaire des termes communs pour Red Hat OpenShift Service sur la surveillance AWS

Ce glossaire définit des termes communs qui sont utilisés dans Red Hat OpenShift Service sur l’architecture AWS.

- Alertmanager

- Alertmanager gère les alertes reçues de Prometheus. Alertmanager est également responsable de l’envoi des alertes aux systèmes de notification externes.

- Les règles d’alerte

- Les règles d’alerte contiennent un ensemble de conditions qui définissent un état particulier au sein d’un cluster. Les alertes sont déclenchées lorsque ces conditions sont vraies. Il est possible d’attribuer une règle d’alerte à une sévérité qui définit la manière dont les alertes sont acheminées.

- Opérateur de surveillance des clusters

- L’opérateur de surveillance des grappes (CMO) est un élément central de la pile de surveillance. Il déploie et gère des instances Prometheus telles que, le Thanos Querier, le Telemeter Client, et des cibles métriques pour s’assurer qu’elles sont à jour. Le CMO est déployé par l’opérateur de versions de cluster (CVO).

- L’opérateur de la version cluster

- Le CVO (Cluster Version Operator) gère le cycle de vie des opérateurs de clusters, dont beaucoup sont installés dans Red Hat OpenShift Service sur AWS par défaut.

- configuration de la carte

- La carte de configuration fournit un moyen d’injecter des données de configuration dans des pods. Les données stockées dans une carte de configuration peuvent être référencées dans un volume de type ConfigMap. Les applications qui s’exécutent dans un pod peuvent utiliser ces données.

- Conteneur

- Le conteneur est une image légère et exécutable qui comprend des logiciels et toutes ses dépendances. Les conteneurs virtualisent le système d’exploitation. En conséquence, vous pouvez exécuter des conteneurs n’importe où d’un centre de données vers un cloud public ou privé ainsi que l’ordinateur portable d’un développeur.

- les ressources personnalisées (CR)

- A CR est une extension de l’API Kubernetes. Créez des ressources personnalisées.

- etc.

- etcd est le magasin de valeur clé pour Red Hat OpenShift Service sur AWS, qui stocke l’état de tous les objets de ressource.

- Fluentd

Fluentd est un collectionneur de journaux qui réside sur chaque service Red Hat OpenShift sur le nœud AWS. Il rassemble les journaux d’applications, d’infrastructures et d’audits et les transmet à différents extrants.

NoteFluentd est déprécié et devrait être retiré dans une version ultérieure. Le Red Hat fournit des corrections de bogues et une prise en charge de cette fonctionnalité pendant le cycle de vie de la version actuelle, mais cette fonctionnalité ne reçoit plus d’améliorations. Comme alternative à Fluentd, vous pouvez utiliser Vector à la place.

- Kubelets

- Fonctionne sur les nœuds et lit le conteneur se manifeste. Assure que les conteneurs définis ont commencé et sont en cours d’exécution.

- Kubernetes serveur API

- Kubernetes API serveur valide et configure les données pour les objets API.

- Gestionnaire de contrôleur Kubernetes

- Le gestionnaire du contrôleur Kubernetes régit l’état du cluster.

- Kubernetes planificateur

- Kubernetes programmateur alloue des pods aux nœuds.

- étiquettes

- Les étiquettes sont des paires clé-valeur que vous pouvez utiliser pour organiser et sélectionner des sous-ensembles d’objets tels qu’un pod.

- Le serveur de métriques

- Le composant de surveillance Metrics Server recueille les métriques des ressources et les expose dans le service API Metrics.k8s.io pour une utilisation par d’autres outils et API, ce qui libère la pile de la plateforme principale Prometheus de gérer cette fonctionnalité.

- le nœud

- D’une machine ouvrier dans le Red Hat OpenShift Service sur le cluster AWS. Le nœud est soit une machine virtuelle (VM) soit une machine physique.

- Exploitant

- La méthode préférée d’emballage, de déploiement et de gestion d’une application Kubernetes dans un Red Hat OpenShift Service sur AWS cluster. L’opérateur utilise les connaissances opérationnelles humaines et l’encode dans un logiciel qui est emballé et partagé avec les clients.

- Gestionnaire du cycle de vie de l’opérateur (OLM)

- Il vous aide à installer, mettre à jour et gérer le cycle de vie des applications natives Kubernetes. L’OLM est une boîte à outils open source conçue pour gérer les opérateurs de manière efficace, automatisée et évolutive.

- Le stockage persistant

- Enregistre les données même après l’arrêt de l’appareil. Kubernetes utilise des volumes persistants pour stocker les données de l’application.

- Allégation de volume persistant (PVC)

- Il est possible d’utiliser un PVC pour monter un Volume Persistent dans un Pod. Il est possible d’accéder au stockage sans connaître les détails de l’environnement cloud.

- la pod

- Le pod est la plus petite unité logique de Kubernetes. La gousse est composée d’un ou de plusieurs contenants à utiliser dans un nœud ouvrier.

- Le Prométhée

- Le Prometheus est le système de surveillance sur lequel repose le Red Hat OpenShift Service sur la pile de surveillance AWS. Le Prometheus est une base de données de séries chronologiques et un moteur d’évaluation des règles pour les métriques. Le Prometheus envoie des alertes à Alertmanager pour le traitement.

- L’opérateur Prometheus

- L’opérateur Prometheus (PO) dans le projet de surveillance openshift crée, configure et gère les instances de la plateforme Prometheus et Alertmanager. Il génère également automatiquement des configurations cibles de surveillance basées sur les requêtes d’étiquettes Kubernetes.

- Les silences

- Le silence peut être appliqué à une alerte pour empêcher l’envoi de notifications lorsque les conditions d’une alerte sont vraies. Après la notification initiale, vous pouvez réduire une alerte pendant que vous travaillez à résoudre le problème sous-jacent.

- le stockage

- Le service Red Hat OpenShift sur AWS prend en charge de nombreux types de stockage sur AWS. Dans un cluster AWS, vous pouvez gérer le stockage de conteneurs pour des données persistantes et non persistantes dans un service Red Hat OpenShift.

- Le chef de Thanos

- Le Thanos Ruler est un moteur d’évaluation de règles pour Prometheus qui est déployé en tant que processus séparé. Dans Red Hat OpenShift Service sur AWS, Thanos Ruler fournit une évaluation des règles et des alertes pour le suivi des projets définis par l’utilisateur.

- Le vecteur

- Le vecteur est un collecteur de journaux qui se déploie sur chaque service Red Hat OpenShift sur le nœud AWS. Il collecte les données de log de chaque nœud, transforme les données et les transmet aux sorties configurées.

- console Web

- Interface utilisateur (UI) pour gérer Red Hat OpenShift Service sur AWS.

Chapitre 2. Accès au suivi pour les projets définis par l’utilisateur

Lorsque vous installez un Red Hat OpenShift Service sur AWS (ROSA), la surveillance des projets définis par l’utilisateur est activée par défaut. Avec la surveillance des projets définis par l’utilisateur activé, vous pouvez surveiller vos propres projets ROSA sans avoir besoin d’une solution de surveillance supplémentaire.

L’utilisateur admin dédié dispose d’autorisations par défaut pour configurer et accéder à la surveillance des projets définis par l’utilisateur.

Les instances Prometheus personnalisées et l’opérateur Prometheus installé via Operator Lifecycle Manager (OLM) peuvent causer des problèmes avec la surveillance de projet définie par l’utilisateur si elle est activée. Les instances Prometheus personnalisées ne sont pas prises en charge.

En option, vous pouvez désactiver la surveillance des projets définis par l’utilisateur pendant ou après l’installation d’un cluster.

Chapitre 3. Configuration de la pile de surveillance

Cette section explique quelle configuration est prise en charge, montre comment configurer la pile de surveillance pour les projets définis par l’utilisateur et présente plusieurs scénarios de configuration communs.

Les paramètres de configuration de la pile de surveillance ne sont pas tous exposés. Les paramètres et les champs listés dans la référence de la carte de configuration pour l’opérateur de surveillance du cluster sont pris en charge pour la configuration.

3.1. Entretien et prise en charge de la surveillance

Les options de configuration de la pile de surveillance ne sont pas toutes exposées. La seule façon prise en charge de configurer Red Hat OpenShift Service sur la surveillance AWS consiste à configurer l’opérateur de surveillance du cluster (CMO) en utilisant les options décrites dans la référence de la carte de configuration pour l’opérateur de surveillance du cluster. Il ne faut pas utiliser d’autres configurations, car elles ne sont pas prises en charge.

Les paradigmes de configuration peuvent changer entre les versions de Prometheus, et de tels cas ne peuvent être traités que si toutes les possibilités de configuration sont contrôlées. Lorsque vous utilisez des configurations autres que celles décrites dans la référence de la carte Config pour l’opérateur de surveillance du cluster, vos modifications disparaîtront parce que le CMO réconcilie automatiquement toutes les différences et réinitialise toute modification non prise en charge à l’état initialement défini par défaut et par conception.

L’installation d’une autre instance Prometheus n’est pas prise en charge par les ingénieurs de fiabilité du site Red Hat (SRE).

3.1.1. Considérations d’appui au suivi

La rétrocompatibilité pour les métriques, les règles d’enregistrement ou les règles d’alerte n’est pas garantie.

Les modifications suivantes ne sont explicitement pas prises en charge:

- Installation d’instances Prometheus personnalisées sur Red Hat OpenShift Service sur AWS. L’instance personnalisée est une ressource personnalisée (CR) de Prometheus gérée par l’opérateur Prometheus.

- La modification des composants de surveillance de la plate-forme par défaut. Il ne faut pas modifier aucun des composants définis dans la carte de configuration cluster-monitoring-config. Le Red Hat SRE utilise ces composants pour surveiller les composants principaux du cluster et les services Kubernetes.

3.1.2. La matrice de version de support pour les composants de surveillance

La matrice suivante contient des informations sur les versions des composants de surveillance pour Red Hat OpenShift Service sur AWS 4.12 et versions ultérieures:

| Le Red Hat OpenShift Service sur AWS | L’opérateur Prometheus | Le Prométhée | Le serveur de métriques | Alertmanager | Kube-state-metrics agent | la surveillance-plugin | agent d’exportation de nœuds | ♪ Thanos ♪ |

|---|---|---|---|---|---|---|---|---|

| 4.18 | 0,78.1 | 2.55.1 | 0,7.2 | 0,27,0 | 2.13.0 | 1.0.0. | 1.8.2 | 0.36.1 |

| 4.17 | 0,75.2 | 2.53.1 | 0,7.1 | 0,27,0 | 2.13.0 | 1.0.0. | 1.8.2 | 0.35.1 |

| 4.16 | 0,73.2 | 2.52.0 | 0,7.1 | 0,26.0 | 2.12.0 | 1.0.0. | 1.8.0 | 0.35.0 |

| 4.15 | 0,70,0 | 2.48.0 | 0.6.4 | 0,26.0 | 2.10.1 | 1.0.0. | 1.7.0 | 0.32.5 |

| 4.14 | 0.67.1 | 2.46.0 | C) N/A | 0,25,0 | 2.9.2 | 1.0.0. | 1.6.1 | 0.30.2 |

| 4.13 | 0.63.0 | 2.42.0 | C) N/A | 0,25,0 | 2.8.1 | C) N/A | 1.5.0 | 0.30.2 |

| 4.12 | 0.60.1 | 2.39.1 | C) N/A | 0.24.0 | 2.6.0 | C) N/A | 1.4.0 | 0,28.1 |

L’agent openshift-state-metrics et Telemeter Client sont des composants spécifiques à OpenShift. Leurs versions correspondent donc aux versions de Red Hat OpenShift Service sur AWS.

3.2. Configuration de la pile de surveillance

Dans Red Hat OpenShift Service sur AWS, vous pouvez configurer la pile qui surveille les charges de travail des projets définis par l’utilisateur en utilisant l’objet ConfigMap. Configurez les cartes configurer l’opérateur de surveillance des clusters (CMO), qui à son tour configure les composants de la pile.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle d’administrateur dédié.

- L’objet ConfigMap existe. Cet objet est créé par défaut lorsque le cluster est créé.

- L’OpenShift CLI (oc) a été installé.

Procédure

Éditez l’objet ConfigMap.

Éditer l’objet ConfigMap de l’utilisateur-workload-monitoring-config dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez votre configuration sous data/config.yaml en tant que paire de clés-valeur <component_name>: <component_configuration>:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow <composant> et <configuration_for_the_component> en conséquence.

L’exemple suivant de l’objet ConfigMap configure une période de conservation des données et des demandes minimales de ressources de conteneur pour Prometheus. Cela concerne l’instance Prometheus qui surveille uniquement les projets définis par l’utilisateur:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Définit le composant Prometheus et les lignes suivantes définissent sa configuration.

- 2

- Configure une période de conservation des données de vingt-quatre heures pour l’instance Prometheus qui surveille les projets définis par l’utilisateur.

- 3

- Définit une demande de ressources minimale de 200 millicores pour le conteneur Prometheus.

- 4

- Définit une demande minimale de ressources de Pod de 2 GiB de mémoire pour le conteneur Prometheus.

Enregistrez le fichier pour appliquer les modifications à l’objet ConfigMap.

AvertissementDifférentes modifications de configuration de l’objet ConfigMap donnent des résultats différents:

- Les pods ne sont pas redéployés. Il n’y a donc pas de panne de service.

Les gousses touchées sont redéployées:

- Dans le cas des clusters à nœud unique, il en résulte une panne de service temporaire.

- Dans le cas des grappes à nœuds multiples, en raison de leur disponibilité élevée, les gousses touchées sont progressivement déployées et la pile de surveillance reste disponible.

- La configuration et le redimensionnement d’un volume persistant entraînent toujours une panne de service, quelle que soit la disponibilité élevée.

Chaque procédure qui nécessite un changement dans la carte de configuration inclut le résultat attendu.

3.3. Composants de surveillance configurables

Ce tableau montre les composants de surveillance que vous pouvez configurer et les clés utilisées pour spécifier les composants de la carte de configuration de la configuration de la charge de travail-surveillance de l’utilisateur.

Il ne faut pas modifier les composants de surveillance de l’objet ConfigMap de cluster-monitoring-config. Les ingénieurs de fiabilité du site Red Hat (SRE) utilisent ces composants pour surveiller les composants principaux du cluster et les services Kubernetes.

| Composante | clé de configuration de configuration de la charge de travail-surveillance de l’utilisateur |

|---|---|

| L’opérateur Prometheus |

|

| Le Prométhée |

|

| Alertmanager |

|

| Le chef de Thanos |

|

3.4. En utilisant des sélecteurs de nœuds pour déplacer les composants de surveillance

En utilisant la contrainte nodeSelector avec des nœuds étiquetés, vous pouvez déplacer n’importe quel composant de la pile de surveillance vers des nœuds spécifiques. Ce faisant, vous pouvez contrôler le placement et la distribution des composants de surveillance sur un cluster.

En contrôlant le placement et la distribution des composants de surveillance, vous pouvez optimiser l’utilisation des ressources du système, améliorer les performances et séparer les charges de travail en fonction d’exigences ou de politiques spécifiques.

Comment les sélecteurs de nœuds fonctionnent avec d’autres contraintes

Lorsque vous déplacez les composants de surveillance en utilisant des contraintes de sélecteur de nœuds, sachez que d’autres contraintes pour contrôler la planification des pod peuvent exister pour un cluster:

- Des contraintes de propagation de la topologie pourraient être en place pour contrôler le placement des pods.

- Des règles anti-affinité dures sont en place pour Prometheus, Alertmanager et d’autres composants de surveillance pour s’assurer que plusieurs pods pour ces composants sont toujours répartis entre différents nœuds et sont donc toujours très disponibles.

Lors de la planification des pods sur les nœuds, le planificateur de pod tente de satisfaire toutes les contraintes existantes lors de la détermination du placement de la gousse. C’est-à-dire que toutes les contraintes se composent lorsque le planificateur de pod détermine quels pods seront placés sur quels nœuds.

Donc, si vous configurez une contrainte de sélecteur de nœuds mais que les contraintes existantes ne peuvent pas toutes être satisfaites, le programmeur de pod ne peut pas correspondre à toutes les contraintes et ne programmera pas un pod pour le placement sur un nœud.

Afin de maintenir la résilience et la disponibilité élevée pour les composants de surveillance, assurez-vous que suffisamment de nœuds sont disponibles et correspondent à toutes les contraintes lorsque vous configurez une contrainte de sélecteur de nœud pour déplacer un composant.

3.4.1. Déplacement des composants de surveillance vers différents nœuds

Il est possible de déplacer l’un des composants qui surveillent les charges de travail des projets définis par l’utilisateur vers des nœuds de travail spécifiques.

Il n’est pas permis de déplacer les composants vers des nœuds d’avion ou d’infrastructure de contrôle.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle d’administrateur dédié.

- L’objet ConfigMap existe. Cet objet est créé par défaut lorsque le cluster est créé.

- L’OpenShift CLI (oc) a été installé.

Procédure

Lorsque vous ne l’avez pas encore fait, ajoutez une étiquette aux nœuds sur lesquels vous souhaitez exécuter les composants de surveillance:

oc label nodes <node_name> <node_label>

$ oc label nodes <node_name> <node_label>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- <node_name> par le nom du nœud où vous souhaitez ajouter l’étiquette. <node_label> par le nom de l’étiquette recherchée.

Éditer l’objet ConfigMap de l’utilisateur-workload-monitoring-config dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Indiquez les étiquettes des nœuds pour la contrainte nodeSelector pour le composant sous data/config.yaml:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- <composant> par le nom approprié du composant de la pile de surveillance.

- 2

- Remplacez <node_label_1> par l’étiquette que vous avez ajoutée au nœud.

- 3

- Facultatif: Spécifiez des étiquettes supplémentaires. Lorsque vous spécifiez des étiquettes supplémentaires, les pods du composant ne sont programmés que sur les nœuds qui contiennent toutes les étiquettes spécifiées.

NoteLorsque les composants de surveillance restent dans un état en attente après avoir configuré la contrainte nodeSelector, vérifiez les événements de pod pour détecter les erreurs liées aux taintes et aux tolérances.

- Enregistrez le fichier pour appliquer les modifications. Les composants spécifiés dans la nouvelle configuration sont automatiquement déplacés vers les nouveaux nœuds, et les pods affectés par la nouvelle configuration sont redéployés.

3.5. Attribution des tolérances aux composants de surveillance

Il est possible d’attribuer des tolérances aux composants qui surveillent les projets définis par l’utilisateur, afin de les déplacer vers des nœuds de travail contaminés. La planification n’est pas autorisée sur les nœuds d’avion de contrôle ou d’infrastructure.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle d’administrateur dédié.

- L’objet ConfigMap existe dans l’espace de noms openshift-user-workload-monitoring. Cet objet est créé par défaut lorsque le cluster est créé.

- L’OpenShift CLI (oc) a été installé.

Procédure

Éditez la carte de configuration de la configuration de l’utilisateur-workload-monitoring dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Indiquez les tolérances pour le composant:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow <composant> et <tolérance_spécification> en conséquence.

À titre d’exemple, oc adm taint nodes node1 key1=value1:NoSchedule ajoute un taint à node1 avec la clé1 et la valeur1. Cela empêche les composants de surveillance de déployer des pods sur node1 à moins qu’une tolérance ne soit configurée pour cette tainte. L’exemple suivant configure le composant thanosRuler pour tolérer l’exemplaire:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Enregistrez le fichier pour appliquer les modifications. Les pods affectés par la nouvelle configuration sont automatiquement redéployés.

3.6. Gestion des ressources CPU et mémoire pour la surveillance des composants

Assurez-vous que les conteneurs qui exécutent des composants de surveillance disposent de suffisamment de ressources CPU et mémoire en spécifiant les valeurs pour les limites de ressources et les demandes pour ces composants.

Il est possible de configurer ces limites et demandes de composants principaux de surveillance de la plate-forme dans l’espace de noms openshift-monitoring et pour les composants qui surveillent les projets définis par l’utilisateur dans l’espace de noms openshift-Workload-monitoring.

3.6.1. À propos de spécifier les limites et les demandes de composants de surveillance

Configurez les limites de ressources et les demandes pour les composants de surveillance de la plate-forme de base suivants:

- Alertmanager

- Kube-state-metrics

- la surveillance-plugin

- exportateur de nœuds

- caractéristiques OpenShift-state-metrics

- Le Prométhée

- Le serveur de métriques

- L’opérateur Prometheus et son service webhook d’admission

- Client de télémètre

- À propos de Thanos Querier

Configurez les limites de ressources et les demandes pour les composants suivants qui surveillent les projets définis par l’utilisateur:

- Alertmanager

- Le Prométhée

- Le chef de Thanos

En définissant les limites de ressources, vous limitez l’utilisation des ressources d’un conteneur, ce qui empêche le conteneur de dépasser les valeurs maximales spécifiées pour les ressources CPU et mémoire.

En définissant les demandes de ressources, vous spécifiez qu’un conteneur ne peut être programmé que sur un nœud disposant de suffisamment de ressources CPU et mémoire disponibles pour correspondre aux ressources demandées.

3.6.2. Définir les limites et les demandes

Afin de configurer les ressources CPU et mémoire, spécifiez les valeurs des limites de ressources et des requêtes dans l’objet ConfigMap de l’utilisateur-workload-monitoring dans l’espace de noms openshift-user-workload-monitoring.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster en tant qu’utilisateur avec le rôle cluster-admin ou en tant qu’utilisateur avec le rôle utilisateur-téléchargement-surveillance-config-edit dans le projet openshift-user-workload-monitoring.

- L’OpenShift CLI (oc) a été installé.

Procédure

Éditez la carte de configuration de la configuration de l’utilisateur-workload-monitoring dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez des valeurs pour définir les limites de ressources et les demandes pour chaque composant que vous souhaitez configurer.

ImportantAssurez-vous que la valeur définie pour une limite est toujours supérieure à la valeur définie pour une demande. Dans le cas contraire, une erreur se produira et le conteneur ne fonctionnera pas.

Exemple de définition des limites de ressources et des demandes

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Enregistrez le fichier pour appliquer les modifications. Les pods affectés par la nouvelle configuration sont automatiquement redéployés.

3.7. Configuration du stockage persistant

Exécutez la surveillance des clusters avec un stockage persistant pour obtenir les avantages suivants:

- De protéger vos métriques et d’alerter les données contre la perte de données en les stockant dans un volume persistant (PV). En conséquence, ils peuvent survivre aux gousses redémarrées ou recréées.

- Évitez d’obtenir des notifications en double et de perdre des silences pour les alertes lorsque les pods Alertmanager sont redémarrés.

Dans les environnements de production, il est fortement recommandé de configurer le stockage persistant.

Dans les clusters multi-nœuds, vous devez configurer le stockage persistant pour Prometheus, Alertmanager et Thanos Ruler pour assurer une disponibilité élevée.

3.7.1. Conditions de stockage persistantes

- Employez le type de stockage de bloc.

3.7.2. Configuration d’une revendication de volume persistante

Afin d’utiliser un volume persistant (PV) pour la surveillance des composants, vous devez configurer une revendication de volume persistant (PVC).

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle d’administrateur dédié.

- L’objet ConfigMap existe. Cet objet est créé par défaut lorsque le cluster est créé.

- L’OpenShift CLI (oc) a été installé.

Procédure

Éditez la carte de configuration de la configuration de l’utilisateur-workload-monitoring dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez votre configuration PVC pour le composant sous data/config.yaml:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow L’exemple suivant configure un PVC qui revendique un stockage persistant pour Thanos Ruler:

Exemple de configuration PVC

Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteLes exigences de stockage pour le composant thanosRuler dépendent du nombre de règles évaluées et du nombre d’échantillons générés par chaque règle.

Enregistrez le fichier pour appliquer les modifications. Les pods affectés par la nouvelle configuration sont automatiquement redéployés et la nouvelle configuration de stockage est appliquée.

AvertissementLorsque vous mettez à jour la carte de configuration avec une configuration PVC, l’objet StatefulSet affecté est recréé, ce qui entraîne une panne de service temporaire.

3.7.3. Durée de conservation et taille pour les métriques Prometheus

Par défaut, Prometheus conserve les données métriques pour les durées suivantes:

- Base de surveillance de la plate-forme: 15 jours

- Contrôle des projets définis par l’utilisateur: 24 heures

Il est possible de modifier le délai de conservation de l’instance Prometheus afin de modifier la rapidité avec laquelle les données sont supprimées. De plus, vous pouvez définir la quantité maximale d’espace disque utilisée par les données métriques conservées. Lorsque les données atteignent cette limite de taille, Prometheus supprime d’abord les données les plus anciennes jusqu’à ce que l’espace disque utilisé soit de nouveau inférieur à la limite.

À noter les comportements suivants de ces paramètres de conservation des données:

- La stratégie de rétention basée sur la taille s’applique à tous les répertoires de blocs de données du répertoire /prometheus, y compris les blocs persistants, les données du journal d’écriture-ahead (WAL) et les morceaux m-mapped.

- Les données dans les répertoires /wal et /head_chunks comptent vers la limite de taille de rétention, mais Prometheus ne purge jamais les données de ces répertoires en fonction des politiques de conservation basées sur la taille ou le temps. Ainsi, si vous définissez une limite de taille de rétention inférieure à la taille maximale définie pour les répertoires /wal et /head_chunks, vous avez configuré le système pour ne pas conserver de blocs de données dans les répertoires de données /prometheus.

- La politique de conservation basée sur la taille n’est appliquée que lorsque Prometheus coupe un nouveau bloc de données, qui se produit toutes les deux heures après que le WAL contient au moins trois heures de données.

- Lorsque vous ne définissez pas explicitement des valeurs de rétention ou de rétention, le temps de rétention par défaut est de 15 jours pour la surveillance de la plate-forme de base et de 24 heures pour la surveillance de projet définie par l’utilisateur. La taille de rétention n’est pas définie.

- Lorsque vous définissez des valeurs pour la rétention et la taille de rétention, les deux valeurs s’appliquent. Lorsque des blocs de données dépassent le temps de conservation défini ou la limite de taille définie, Prometheus purge ces blocs de données.

- Lorsque vous définissez une valeur pour la taille de rétention et que vous ne définissez pas la rétention, seule la valeur de la taille de rétention s’applique.

- Dans le cas où vous ne définissez pas une valeur pour la taille de la rétention et que vous ne définissez qu’une valeur de rétention, seule la valeur de rétention s’applique.

- Lorsque vous définissez la valeur de rétention ou de rétention sur 0, les paramètres par défaut s’appliquent. Les paramètres par défaut fixent le temps de rétention à 15 jours pour la surveillance de la plate-forme de base et 24 heures pour la surveillance de projet définie par l’utilisateur. La taille de la rétention n’est pas définie par défaut.

Le compactage des données se produit toutes les deux heures. Ainsi, un volume persistant (PV) pourrait se remplir avant le compactage, dépassant potentiellement la limite de taille de rétention. Dans de tels cas, l’alerte KubePersistentVolumeFillingUp s’allume jusqu’à ce que l’espace sur un PV soit inférieur à la limite de taille de rétention.

3.7.4. La modification du temps de rétention et de la taille des données métriques de Prometheus

Par défaut, Prometheus conserve les données métriques pendant 24 heures pour la surveillance des projets définis par l’utilisateur. Lorsque les données sont supprimées, vous pouvez modifier le temps de conservation de l’instance Prometheus. De plus, vous pouvez définir la quantité maximale d’espace disque utilisée par les données métriques conservées.

Le compactage des données se produit toutes les deux heures. Ainsi, un volume persistant (PV) pourrait se remplir avant le compactage, dépassant potentiellement la limite de taille de rétention. Dans de tels cas, l’alerte KubePersistentVolumeFillingUp s’allume jusqu’à ce que l’espace sur un PV soit inférieur à la limite de taille de rétention.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle d’administrateur dédié.

- L’objet ConfigMap existe. Cet objet est créé par défaut lorsque le cluster est créé.

- L’OpenShift CLI (oc) a été installé.

Procédure

Éditez la carte de configuration de la configuration de l’utilisateur-workload-monitoring dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez la configuration du temps de rétention et de la taille sous data/config.yaml:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Le temps de rétention: un nombre directement suivi de ms (millisecondes), s (secondes), m (minutes), h (heures), d (jours), w (semaines) ou y (années). Il est également possible de combiner des valeurs de temps pour des temps spécifiques, tels que 1h30m15s.

- 2

- La taille de rétention: un nombre directement suivi de B (octets), KB (kilooctets), MB (mégaoctets), GB (gigaoctets), TB (teraoctets), PB (pétaoctets) et EB (exabytes).

L’exemple suivant définit le temps de rétention à 24 heures et la taille de rétention à 10 gigaoctets pour l’instance Prometheus:

Exemple de réglage du temps de rétention pour Prometheus

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Enregistrez le fichier pour appliquer les modifications. Les pods affectés par la nouvelle configuration sont automatiquement redéployés.

3.7.5. La modification du temps de conservation des données métriques Thanos Ruler

Dans le cas des projets définis par l’utilisateur, Thanos Ruler conserve automatiquement les données métriques pendant 24 heures. Il est possible de modifier le temps de conservation pour modifier la durée de conservation de ces données en spécifiant une valeur de temps dans la carte de configuration de configuration de la charge de travail de l’utilisateur dans l’espace de noms openshift-user-workload-monitoring.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle d’administrateur dédié.

- L’objet ConfigMap existe. Cet objet est créé par défaut lorsque le cluster est créé.

- L’OpenShift CLI (oc) a été installé.

Procédure

Éditer l’objet ConfigMap de l’utilisateur-workload-monitoring-config dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajouter la configuration du temps de rétention sous data/config.yaml:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Indiquez le temps de rétention dans le format suivant: un nombre directement suivi de ms (millisecondes), s (secondes), m (minutes), h (heures), d (jours), w (semaines) ou y (années). Il est également possible de combiner des valeurs de temps pour des temps spécifiques, tels que 1h30m15s. La valeur par défaut est 24h.

L’exemple suivant définit le temps de conservation à 10 jours pour les données Thanos Ruler:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Enregistrez le fichier pour appliquer les modifications. Les pods affectés par la nouvelle configuration sont automatiquement redéployés.

3.8. Configuration du stockage d’écriture à distance

Il est possible de configurer le stockage d’écriture à distance pour permettre à Prometheus d’envoyer des métriques ingérées à des systèmes distants pour un stockage à long terme. Cela n’a aucun impact sur la façon dont ou pendant combien de temps Prometheus stocke les métriques.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle d’administrateur dédié.

- L’objet ConfigMap existe. Cet objet est créé par défaut lorsque le cluster est créé.

- L’OpenShift CLI (oc) a été installé.

Il y a un point de terminaison compatible avec l’écriture à distance (tel que Thanos) et vous connaissez l’URL du point de terminaison. Consultez les points de terminaison distants Prometheus et la documentation de stockage pour obtenir des informations sur les points de terminaison compatibles avec la fonction d’écriture à distance.

ImportantLe Red Hat fournit uniquement des informations pour la configuration des expéditeurs d’écriture à distance et n’offre pas de conseils sur la configuration des points de terminaison du récepteur. Les clients sont responsables de la mise en place de leurs propres points de terminaison compatibles avec l’écriture à distance. Les problèmes avec les configurations des récepteurs de point de terminaison ne sont pas inclus dans le support de production de Red Hat.

Dans un objet Secret, vous avez configuré des identifiants d’authentification pour le point de terminaison de l’écriture à distance. Il faut créer le secret dans l’espace de noms openshift-user-workload-monitoring.

AvertissementAfin de réduire les risques de sécurité, utilisez HTTPS et l’authentification pour envoyer des métriques à un point de terminaison.

Procédure

Éditez la carte de configuration de la configuration de l’utilisateur-workload-monitoring dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajouter une section RemoteWrite: sous data/config.yaml/prometheus, comme indiqué dans l’exemple suivant:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- L’URL du point de terminaison de l’écriture distante.

- 2

- La méthode d’authentification et les informations d’identification pour le point de terminaison. Les méthodes d’authentification actuellement prises en charge sont AWS Signature Version 4, l’authentification à l’aide de HTTP dans un en-tête de demande d’autorisation, l’authentification de base, OAuth 2.0 et le client TLS. Consultez les paramètres d’authentification d’écriture à distance pris en charge pour les configurations d’échantillons de méthodes d’authentification prises en charge.

Ajouter des valeurs de configuration de relabel d’écriture après les identifiants d’authentification:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Ajoutez une configuration pour les métriques que vous souhaitez envoyer au point de terminaison distant.

Exemple de transfert d’une seule métrique appelée my_metric

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de mesures de transmission appelées my_metric_1 et my_metric_2 dans my_namespace namespace

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Enregistrez le fichier pour appliquer les modifications. La nouvelle configuration est appliquée automatiquement.

3.8.1. Paramètres d’authentification d’écriture à distance pris en charge

Il est possible d’utiliser différentes méthodes pour s’authentifier avec un point de terminaison d’écriture à distance. Les méthodes d’authentification actuellement prises en charge sont AWS Signature Version 4, l’authentification de base, l’autorisation, OAuth 2.0 et le client TLS. Le tableau suivant fournit des détails sur les méthodes d’authentification prises en charge pour une utilisation avec l’écriture à distance.

| La méthode d’authentification | Configurer le champ map | Description |

|---|---|---|

| AWS Signature Version 4 |

| Cette méthode utilise l’authentification AWS Signature Version 4 pour signer des requêtes. Cette méthode ne peut pas être utilisée simultanément avec l’autorisation, l’authentification OAuth 2.0 ou l’authentification Basic. |

| Authentification de base |

| L’authentification de base définit l’en-tête d’autorisation sur chaque demande d’écriture à distance avec le nom d’utilisateur et le mot de passe configurés. |

| autorisation |

| L’autorisation définit l’en-tête d’autorisation sur chaque demande d’écriture à distance à l’aide du jeton configuré. |

| À propos de OAuth 2.0 |

| La configuration OAuth 2.0 utilise le type de subvention d’identification client. Le Prometheus obtient un jeton d’accès à partir de tokenUrl avec l’ID client spécifié et le secret client pour accéder au point de terminaison d’écriture distante. Cette méthode ne peut pas être utilisée simultanément avec l’autorisation, l’authentification AWS Signature 4 ou l’authentification Basic. |

| Client TLS |

| La configuration du client TLS spécifie le certificat CA, le certificat client et les informations de fichier clé du client utilisées pour authentifier avec le serveur de point de terminaison d’écriture à distance à l’aide de TLS. La configuration de l’échantillon suppose que vous avez déjà créé un fichier de certificat CA, un fichier de certificat client et un fichier clé client. |

3.8.2. Exemple de paramètres d’authentification d’écriture à distance

Les échantillons suivants montrent différents paramètres d’authentification que vous pouvez utiliser pour vous connecter à un point de terminaison d’écriture à distance. Chaque échantillon montre également comment configurer un objet secret correspondant qui contient des informations d’authentification et d’autres paramètres pertinents. Chaque échantillon configure l’authentification pour une utilisation avec la surveillance des projets définis par l’utilisateur dans l’espace de noms openshift-user-workload-monitoring.

3.8.2.1. Exemple d’authentification YAML pour AWS Signature Version 4

Ce qui suit montre les paramètres d’un secret sigv4 nommé sigv4-credentials dans l’espace de noms openshift-user-workload-monitoring.

Ce qui suit montre les paramètres d’authentification d’écriture à distance AWS Signature Version 4 qui utilisent un objet secret nommé sigv4-credentials dans l’espace de noms openshift-user-workload-monitoring:

- 1

- La région AWS.

- 2 4

- Le nom de l’objet Secret contenant les identifiants d’accès AWS API.

- 3

- La clé qui contient la clé d’accès AWS API dans l’objet Secret spécifié.

- 5

- La clé qui contient la clé secrète AWS API dans l’objet secret spécifié.

- 6

- Le nom du profil AWS qui est utilisé pour authentifier.

- 7

- L’identifiant unique pour le nom de ressource Amazon (ARN) attribué à votre rôle.

3.8.2.2. Échantillon YAML pour l’authentification de base

Ce qui suit montre des paramètres d’authentification de base pour un objet secret nommé rw-basic-auth dans l’espace de noms openshift-user-workload-monitoring:

L’échantillon suivant montre une configuration d’écriture à distance de baseAuth qui utilise un objet secret nommé rw-basic-auth dans l’espace de noms openshift-user-workload-monitoring. Il suppose que vous avez déjà configuré des informations d’authentification pour le point de terminaison.

3.8.2.3. Échantillon YAML pour l’authentification avec un jeton porteur à l’aide d’un objet secret

Ce qui suit montre les paramètres de jeton porteur pour un objet secret nommé rw-porter-auth dans l’espace de noms openshift-user-workload-monitoring:

- 1

- Le jeton d’authentification.

Ce qui suit montre les paramètres de configuration de jeton de porteur d’échantillons qui utilisent un objet secret nommé rw-bearer-auth dans l’espace de noms openshift-user-workload-monitoring:

3.8.2.4. Échantillon YAML pour l’authentification OAuth 2.0

Ce qui suit montre les paramètres OAuth 2.0 pour un objet secret nommé oauth2-credentials dans l’espace de noms openshift-user-workload-monitoring:

Ce qui suit montre une configuration d’échantillon d’authentification d’écriture à distance oauth2 qui utilise un objet secret nommé oauth2-credentials dans l’espace de noms openshift-user-workload-monitoring:

- 1 3

- Le nom de l’objet secret correspondant. A noter que ClientId peut se référer alternativement à un objet ConfigMap, bien que clientSecret doive se référer à un objet secret.

- 2 4

- La clé qui contient les informations d’identification OAuth 2.0 dans l’objet secret spécifié.

- 5

- L’URL utilisée pour récupérer un jeton avec le clientId et clientSecret spécifiés.

- 6

- La portée OAuth 2.0 de la demande d’autorisation. Ces portées limitent les données auxquelles les jetons peuvent accéder.

- 7

- Les paramètres de demande d’autorisation OAuth 2.0 requis pour le serveur d’autorisation.

3.8.2.5. Échantillon YAML pour l’authentification client TLS

Ce qui suit montre les paramètres du client TLS pour un objet secret nommé mtls-grouple dans l’espace de noms openshift-user-workload-monitoring.

L’échantillon suivant montre une configuration d’authentification d’écriture à distance tlsConfig qui utilise un objet TLS Secret nommé mtls-bundle.

- 1 3 5

- Le nom de l’objet Secret correspondant qui contient les identifiants d’authentification TLS. A noter que ca et cert peuvent faire référence alternativement à un objet ConfigMap, bien que keySecret doive se référer à un objet secret.

- 2

- La clé dans l’objet secret spécifié qui contient le certificat CA pour le point de terminaison.

- 4

- La clé de l’objet Secret spécifié qui contient le certificat client pour le point de terminaison.

- 6

- La clé dans l’objet secret spécifié qui contient le secret de clé client.

3.8.3. Exemple de configuration de file d’attente d’écriture à distance

Il est possible d’utiliser l’objet queueConfig pour l’écriture à distance afin d’ajuster les paramètres de file d’écriture à distance. L’exemple suivant montre les paramètres de file d’attente avec leurs valeurs par défaut pour la surveillance des projets définis par l’utilisateur dans l’espace de noms openshift-user-workload-monitoring.

Exemple de configuration des paramètres d’écriture à distance avec des valeurs par défaut

- 1

- Le nombre d’échantillons à tampon par fragment avant qu’ils ne soient supprimés de la file d’attente.

- 2

- Le nombre minimum de fragments.

- 3

- Le nombre maximum de fragments.

- 4

- Le nombre maximal d’échantillons par envoi.

- 5

- Le temps maximum pour un échantillon d’attendre en tampon.

- 6

- L’heure initiale d’attendre avant de réessayer une demande échouée. Le temps est doublé pour chaque réessayer jusqu’au temps maxbackoff.

- 7

- Le temps maximum d’attendre avant de réessayer une demande échouée.

- 8

- Définissez ce paramètre sur true pour réessayer une requête après avoir reçu un code d’état 429 à partir du stockage d’écriture à distance.

- 9

- Les échantillons qui sont plus anciens que la limite de l’échantillonAgeLimit sont supprimés de la file d’attente. Lorsque la valeur n’est pas définie ou définie sur 0s, le paramètre est ignoré.

3.9. Ajout d’étiquettes de cluster ID aux métriques

Lorsque vous gérez plusieurs Red Hat OpenShift Service sur les clusters AWS et utilisez la fonction d’écriture à distance pour envoyer des données métriques de ces clusters à un emplacement de stockage externe, vous pouvez ajouter des étiquettes ID de cluster pour identifier les données métriques provenant de différents clusters. Ensuite, vous pouvez interroger ces étiquettes pour identifier le cluster source d’une métrique et distinguer ces données des données de mesures similaires envoyées par d’autres clusters.

De cette façon, si vous gérez de nombreux clusters pour plusieurs clients et envoyez des données métriques à un seul système de stockage centralisé, vous pouvez utiliser des étiquettes d’identification de cluster pour interroger des métriques pour un cluster ou un client particulier.

La création et l’utilisation d’étiquettes de cluster ID comporte trois étapes générales:

- Configuration des paramètres de relabel d’écriture pour le stockage d’écriture à distance.

- Ajout d’étiquettes de cluster ID aux métriques.

- Interroger ces étiquettes pour identifier le cluster source ou le client pour une métrique.

3.9.1. Création d’étiquettes d’ID de cluster pour les métriques

Il est possible de créer des étiquettes ID de cluster pour les métriques en ajoutant les paramètres write_relabel pour le stockage d’écriture à distance dans la carte de configuration de configuration de la charge de travail de l’utilisateur dans l’espace de noms openshift-user-workload-monitoring.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle d’administrateur dédié.

- L’objet ConfigMap existe. Cet objet est créé par défaut lorsque le cluster est créé.

- L’OpenShift CLI (oc) a été installé.

- Le stockage d’écriture à distance a été configuré.

Procédure

Éditez la carte de configuration de la configuration de l’utilisateur-workload-monitoring dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Dans la section writeRelabelConfigs: sous data/config.yaml/prometheus/remoteWrite, ajoutez les valeurs de configuration du cluster ID:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow L’échantillon suivant montre comment transférer une métrique avec le cluster ID cluster_id:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Le système applique initialement une étiquette source de cluster temporaire nommée __tmp_openshift_cluster_id__. Cette étiquette temporaire est remplacée par le nom de l’étiquette d’identification du cluster que vous spécifiez.

- 2

- Indiquez le nom de l’étiquette de cluster ID pour les métriques envoyées au stockage d’écriture à distance. Lorsque vous utilisez un nom d’étiquette qui existe déjà pour une métrique, cette valeur est écrasée avec le nom de cette étiquette ID de cluster. Dans le cas du nom de l’étiquette, n’utilisez pas __tmp_openshift_cluster_id__. La dernière étape de relabeling supprime les étiquettes qui utilisent ce nom.

- 3

- L’action de relabel d’écriture remplace l’étiquette temporaire par l’étiquette cible pour les mesures sortantes. Cette action est la valeur par défaut et est appliquée si aucune action n’est spécifiée.

- Enregistrez le fichier pour appliquer les modifications. La nouvelle configuration est appliquée automatiquement.

3.10. Contrôle de l’impact des attributs métriques non liés dans les projets définis par l’utilisateur

Les développeurs peuvent créer des étiquettes pour définir des attributs pour les métriques sous la forme de paires clé-valeur. Le nombre de paires de valeurs clés potentielles correspond au nombre de valeurs possibles pour un attribut. L’attribut qui a un nombre illimité de valeurs potentielles s’appelle un attribut non lié. A titre d’exemple, un attribut customer_id est non lié parce qu’il a un nombre infini de valeurs possibles.

Chaque paire clé-valeur assignée a une série chronologique unique. L’utilisation de nombreux attributs non liés dans les étiquettes peut entraîner une augmentation exponentielle du nombre de séries chronologiques créées. Cela peut avoir un impact sur les performances de Prometheus et peut consommer beaucoup d’espace disque.

L’administration dédiée peut utiliser les mesures suivantes pour contrôler l’impact des attributs métriques non liés dans les projets définis par l’utilisateur:

- Limiter le nombre d’échantillons pouvant être acceptés par raclette cible dans les projets définis par l’utilisateur

- Limiter le nombre d’étiquettes grattées, la longueur des noms d’étiquettes et la longueur des valeurs de l’étiquette

- Configurez les intervalles entre les éraflures consécutives et entre les évaluations des règles de Prometheus

- Créer des alertes indiquant que le feu lorsqu’un seuil d’échantillonnage de grattage est atteint ou lorsque la cible ne peut pas être grattée

Limiter les échantillons de raclette peut aider à prévenir les problèmes causés par l’ajout de nombreux attributs non liés aux étiquettes. Les développeurs peuvent également empêcher la cause sous-jacente en limitant le nombre d’attributs non liés qu’ils définissent pour les métriques. L’utilisation d’attributs liés à un ensemble limité de valeurs possibles réduit le nombre de combinaisons de paires clé-valeur potentielles.

3.10.1. Fixer des intervalles de raclette, des intervalles d’évaluation et des limites imposées pour les projets définis par l’utilisateur

Les limites de grattage et d’étiquette suivantes peuvent être définies pour les projets définis par l’utilisateur:

- Limiter le nombre d’échantillons qui peuvent être acceptés par raclette cible

- Limiter le nombre d’étiquettes grattées

- Limiter la longueur des noms d’étiquettes et des valeurs d’étiquettes

Il est également possible de définir un intervalle entre les éraflures consécutives et entre les évaluations des règles de Prometheus.

Lorsque vous définissez des limites d’échantillons ou d’étiquettes, aucune autre donnée d’échantillon n’est ingérée pour cette éraflure cible une fois la limite atteinte.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle d’administrateur dédié.

- L’objet ConfigMap existe. Cet objet est créé par défaut lorsque le cluster est créé.

- L’OpenShift CLI (oc) a été installé.

Procédure

Éditer l’objet ConfigMap de l’utilisateur-workload-monitoring-config dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajouter les configurations de limite et d’intervalle de temps appliquées à data/config.yaml:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- La valeur est requise si ce paramètre est spécifié. Cet exemple appliquéSampleLimit limite le nombre d’échantillons qui peuvent être acceptés par éraflure cible dans les projets définis par l’utilisateur à 50 000.

- 2

- Indique le nombre maximal d’étiquettes par raclette. La valeur par défaut est 0, ce qui ne spécifie aucune limite.

- 3

- Indique la longueur maximale du caractère d’un nom d’étiquette. La valeur par défaut est 0, ce qui ne spécifie aucune limite.

- 4

- Indique la longueur maximale du caractère pour une valeur d’étiquette. La valeur par défaut est 0, ce qui ne spécifie aucune limite.

- 5

- Indique l’intervalle entre les éraflures consécutives. L’intervalle doit être réglé entre 5 secondes et 5 minutes. La valeur par défaut est 30s.

- 6

- Indique l’intervalle entre les évaluations des règles de Prometheus. L’intervalle doit être réglé entre 5 secondes et 5 minutes. La valeur par défaut pour Prometheus est 30s.

NoteIl est également possible de configurer la propriété AssessmentInterval pour Thanos Ruler via le champ data/config.yaml/thanosRuler. La valeur par défaut pour Thanos Ruler est 15s.

- Enregistrez le fichier pour appliquer les modifications. Les limites sont appliquées automatiquement.

3.11. Configuration d’instances externes Alertmanager

Le Red Hat OpenShift Service sur la pile de surveillance AWS comprend une instance Alertmanager locale qui dirige les alertes de Prometheus.

Il est possible d’ajouter des instances Alertmanager externes pour acheminer les alertes pour les projets définis par l’utilisateur.

Lorsque vous ajoutez la même configuration externe Alertmanager pour plusieurs clusters et que vous désactivez l’instance locale pour chaque cluster, vous pouvez ensuite gérer le routage d’alerte pour plusieurs clusters en utilisant une instance Alertmanager externe unique.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle d’administrateur dédié.

- L’objet ConfigMap existe. Cet objet est créé par défaut lorsque le cluster est créé.

- L’OpenShift CLI (oc) a été installé.

Procédure

Éditez la carte de configuration de la configuration de l’utilisateur-workload-monitoring dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez une section supplémentaireAlertmanagerConfigs avec les détails de configuration sous data/config.yaml/<component>:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 2

- <alertmanager_spécification> par l’authentification et d’autres détails de configuration pour les instances Alertmanager supplémentaires. Les méthodes d’authentification actuellement prises en charge sont le jeton porteur (porteurToken) et le client TLS (tlsConfig).

- 1

- De substituer <composant> à l’un des deux composants de Alertmanager externes pris en charge: prometheus ou thanosRuler.

La carte de configuration de l’échantillon suivant configure un gestionnaire d’alerte supplémentaire pour Thanos Ruler en utilisant un jeton porteur avec l’authentification TLS client:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Enregistrez le fichier pour appliquer les modifications. Les pods affectés par la nouvelle configuration sont automatiquement redéployés.

3.12. Configuration des secrets pour Alertmanager

Le Red Hat OpenShift Service sur la pile de surveillance AWS inclut Alertmanager, qui dirige les alertes de Prometheus vers les récepteurs de point de terminaison. Lorsque vous avez besoin d’authentifier avec un récepteur afin que Alertmanager puisse lui envoyer des alertes, vous pouvez configurer Alertmanager pour utiliser un secret qui contient des informations d’authentification pour le récepteur.

À titre d’exemple, vous pouvez configurer Alertmanager pour utiliser un secret pour s’authentifier avec un récepteur de point de terminaison qui nécessite un certificat délivré par une autorité de certification privée (CA). Il est également possible de configurer Alertmanager pour utiliser un secret pour s’authentifier avec un récepteur qui nécessite un fichier mot de passe pour l’authentification HTTP Basic. Dans les deux cas, les détails d’authentification sont contenus dans l’objet Secret plutôt que dans l’objet ConfigMap.

3.12.1. Ajouter un secret à la configuration Alertmanager

Il est possible d’ajouter des secrets à la configuration Alertmanager en modifiant la carte de configuration de configuration utilisateur-workload-monitoring dans le projet openshift-user-workload-monitoring.

Après avoir ajouté un secret à la carte de configuration, le secret est monté en volume à /etc/alertmanager/secrets/<secret_name> dans le conteneur Alertmanager pour les pods Alertmanager.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle d’administrateur dédié.

- L’objet ConfigMap existe. Cet objet est créé par défaut lorsque le cluster est créé.

- « vous avez créé le secret à configurer dans Alertmanager dans le projet openshift-user-workload-monitoring.

- L’OpenShift CLI (oc) a été installé.

Procédure

Éditez la carte de configuration de la configuration de l’utilisateur-workload-monitoring dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajouter un secret: section sous data/config.yaml/alertmanager avec la configuration suivante:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Cette section contient les secrets à monter dans Alertmanager. Les secrets doivent être situés dans le même espace de noms que l’objet Alertmanager.

- 2

- Le nom de l’objet Secret qui contient des informations d’authentification pour le récepteur. En ajoutant plusieurs secrets, placez chacun sur une nouvelle ligne.

Les paramètres de carte de configuration de l’échantillon suivants configurent Alertmanager pour utiliser deux objets secrets nommés test-secret-basic-auth et test-secret-api-token:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Enregistrez le fichier pour appliquer les modifications. La nouvelle configuration est appliquée automatiquement.

3.13. Attacher des étiquettes supplémentaires à vos séries chronologiques et alertes

Il est possible d’attacher des étiquettes personnalisées à toutes les séries chronologiques et d’alerter Prometheus en utilisant la fonction d’étiquettes externes de Prometheus.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle d’administrateur dédié.

- L’objet ConfigMap existe. Cet objet est créé par défaut lorsque le cluster est créé.

- L’OpenShift CLI (oc) a été installé.

Procédure

Éditez la carte de configuration de la configuration de l’utilisateur-workload-monitoring dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Définissez les étiquettes que vous souhaitez ajouter pour chaque métrique sous data/config.yaml:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- <key>: <value> par des paires clé-valeur où <key> est un nom unique pour la nouvelle étiquette et <value> est sa valeur.

Avertissement- Il ne faut pas utiliser promitheus ou prometheus_replica comme noms clés, parce qu’ils sont réservés et seront écrasés.

- Il ne faut pas utiliser cluster ou Manag_cluster comme noms de clés. Les utiliser peut causer des problèmes où vous ne pouvez pas voir les données dans les tableaux de bord des développeurs.

NoteDans le projet openshift-user-workload-monitoring, Prometheus gère les métriques et Thanos Ruler gère les règles d’alerte et d’enregistrement. La configuration de l’objet ConfigMap pour la configuration de l’objet ConfigMap ne configurera que les étiquettes externes pour les métriques et non pour les règles.

À titre d’exemple, pour ajouter des métadonnées sur la région et l’environnement à toutes les séries chronologiques et aux alertes, utilisez l’exemple suivant:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Enregistrez le fichier pour appliquer les modifications. Les pods affectés par la nouvelle configuration sont automatiquement redéployés.

3.14. À propos des contraintes de propagation de la topologie des pod pour la surveillance

Lorsque Red Hat OpenShift Service sur les gousses AWS est déployé dans plusieurs zones de disponibilité, vous pouvez utiliser des contraintes de diffusion de la topologie de pod pour contrôler la façon dont les gousses de surveillance sont réparties sur une topologie réseau.

Les contraintes de propagation de la topologie des pod sont appropriées pour contrôler la planification des pods dans les topologies hiérarchiques dans lesquelles les nœuds sont répartis à différents niveaux d’infrastructure, tels que les régions et les zones à l’intérieur de ces régions. De plus, en étant capable de programmer des pods dans différentes zones, vous pouvez améliorer la latence du réseau dans certains scénarios.

Il est possible de configurer les contraintes de propagation de la topologie des pods pour toutes les gousses déployées par l’opérateur de surveillance du cluster afin de contrôler la façon dont les répliques des pod sont programmées en nœuds à travers les zones. Cela garantit que les pods sont très disponibles et fonctionnent plus efficacement, car les charges de travail sont réparties entre les nœuds dans différents centres de données ou zones d’infrastructure hiérarchiques.

3.14.1. Configuration des contraintes de propagation de la topologie des pod

Il est possible de configurer les contraintes de propagation de la topologie des pods pour toutes les gousses pour une surveillance définie par l’utilisateur afin de contrôler la façon dont les répliques des pod sont programmées pour les nœuds à travers les zones. Cela garantit que les pods sont très disponibles et fonctionnent plus efficacement, car les charges de travail sont réparties entre les nœuds dans différents centres de données ou zones d’infrastructure hiérarchiques.

Il est possible de configurer les contraintes de propagation de la topologie pod pour la surveillance des pods à l’aide de la carte de configuration de configuration de la charge de travail-surveillance de l’utilisateur.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle d’administrateur dédié.

- L’objet ConfigMap existe. Cet objet est créé par défaut lorsque le cluster est créé.

- L’OpenShift CLI (oc) a été installé.

Procédure

Éditez la carte de configuration de la configuration de l’utilisateur-workload-monitoring dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez les paramètres suivants dans le champ data/config.yaml pour configurer les contraintes de propagation de la topologie pod:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Indiquez un nom du composant pour lequel vous souhaitez configurer des contraintes de propagation de la topologie de pod.

- 2

- Indiquez une valeur numérique pour maxSkew, qui définit le degré auquel les pods sont autorisés à être distribués de manière inégale.

- 3

- Indiquez une clé des étiquettes des nœuds pour topologyKey. Les nœuds qui ont une étiquette avec cette clé et des valeurs identiques sont considérés comme étant dans la même topologie. Le planificateur essaie de mettre un nombre équilibré de pods dans chaque domaine.

- 4

- Indiquez une valeur pour quand Insatisfiable. Les options disponibles sont DoNotSchedule et ScheduleAnyway. Indiquez DoNotSchedule si vous voulez que la valeur maxSkew définisse la différence maximale autorisée entre le nombre de gousses correspondantes dans la topologie cible et le minimum global. Spécifiez ScheduleAnyway si vous voulez que le programmeur planifie toujours le pod, mais donne une priorité plus élevée aux nœuds qui pourraient réduire l’oscillation.

- 5

- Indiquez le labelSelector pour trouver les gousses correspondantes. Les pods qui correspondent à ce sélecteur d’étiquettes sont comptés pour déterminer le nombre de pods dans leur domaine de topologie correspondant.

Exemple de configuration pour Thanos Ruler

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Enregistrez le fichier pour appliquer les modifications. Les pods affectés par la nouvelle configuration sont automatiquement redéployés.

3.15. Définition des niveaux de log pour les composants de surveillance

Le niveau de journal peut être configuré pour Alertmanager, Prometheus Operator, Prometheus et Thanos Ruler.

Les niveaux de journal suivants peuvent être appliqués au composant pertinent de l’objet ConfigMap:

- déboguer. Débogue de journal, messages d’information, d’avertissement et d’erreur.

- info. Logez les messages d’information, d’avertissement et d’erreur.

- avertissez-vous. Enregistrez uniquement les messages d’avertissement et d’erreur.

- erreur. Journal des messages d’erreur seulement.

Le niveau de journal par défaut est info.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle d’administrateur dédié.

- L’objet ConfigMap existe. Cet objet est créé par défaut lorsque le cluster est créé.

- L’OpenShift CLI (oc) a été installé.

Procédure

Éditez la carte de configuration de la configuration de l’utilisateur-workload-monitoring dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajouter logLevel: <log_level> pour un composant sous data/config.yaml:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Le composant de la pile de surveillance pour lequel vous définissez un niveau de journal. Les valeurs des composants disponibles sont les promémorations, le gestionnaire d’alerte, le promériteOperator et le thanosRuler.

- 2

- Le niveau de journal à définir pour le composant. Les valeurs disponibles sont l’erreur, l’avertissement, l’information et le débogue. La valeur par défaut est info.

- Enregistrez le fichier pour appliquer les modifications. Les pods affectés par la nouvelle configuration sont automatiquement redéployés.

Confirmez que le niveau de journal a été appliqué en examinant la configuration de déploiement ou de pod dans le projet connexe. L’exemple suivant vérifie le niveau de journal pour le déploiement protéréheus-operator:

oc -n openshift-user-workload-monitoring get deploy prometheus-operator -o yaml | grep "log-level"

$ oc -n openshift-user-workload-monitoring get deploy prometheus-operator -o yaml | grep "log-level"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

- --log-level=debug

- --log-level=debugCopy to Clipboard Copied! Toggle word wrap Toggle overflow Assurez-vous que les pods du composant sont en cours d’exécution. L’exemple suivant répertorie l’état des pods:

oc -n openshift-user-workload-monitoring get pods

$ oc -n openshift-user-workload-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow NoteLorsqu’une valeur logLevel non reconnue est incluse dans l’objet ConfigMap, les pods du composant peuvent ne pas redémarrer avec succès.

3.16. Activer le fichier journal de requête pour Prometheus

Configurez Prometheus pour écrire toutes les requêtes qui ont été exécutées par le moteur dans un fichier journal.

Comme la rotation des journaux n’est pas prise en charge, activez cette fonctionnalité temporairement lorsque vous devez résoudre un problème. Après avoir terminé le dépannage, désactivez l’enregistrement des requêtes en retournant les modifications que vous avez apportées à l’objet ConfigMap pour activer la fonctionnalité.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle d’administrateur dédié.

- L’objet ConfigMap existe. Cet objet est créé par défaut lorsque le cluster est créé.

- L’OpenShift CLI (oc) a été installé.

Procédure

Éditez la carte de configuration de la configuration de l’utilisateur-workload-monitoring dans le projet openshift-user-workload-monitoring:

oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-config

$ oc -n openshift-user-workload-monitoring edit configmap user-workload-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ajouter le paramètre QueryLogFile pour Prometheus sous data/config.yaml:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Ajoutez le chemin complet au fichier dans lequel les requêtes seront enregistrées.

- Enregistrez le fichier pour appliquer les modifications. Les pods affectés par la nouvelle configuration sont automatiquement redéployés.

Assurez-vous que les pods pour le composant sont en cours d’exécution. La commande d’échantillon suivante répertorie l’état des pods:

oc -n openshift-user-workload-monitoring get pods

$ oc -n openshift-user-workload-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Lisez le journal des requêtes:

oc -n openshift-user-workload-monitoring exec prometheus-user-workload-0 -- cat <path>

$ oc -n openshift-user-workload-monitoring exec prometheus-user-workload-0 -- cat <path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ImportantInversez le paramètre dans la carte de configuration après avoir examiné les informations de requête enregistrée.

Chapitre 4. Désactivation du suivi des projets définis par l’utilisateur