Les tutoriels

Le Red Hat OpenShift Service sur AWS tutoriels

Résumé

Chapitre 1. Aperçu des tutoriels

Faites appel aux tutoriels étape par étape des experts Red Hat pour tirer le meilleur parti de votre cluster Managed OpenShift.

Ce contenu est rédigé par des experts de Red Hat mais n’a pas encore été testé sur toutes les configurations prises en charge.

Chapitre 2. Tutoriel: ROSA avec activation HCP et liaison de compte

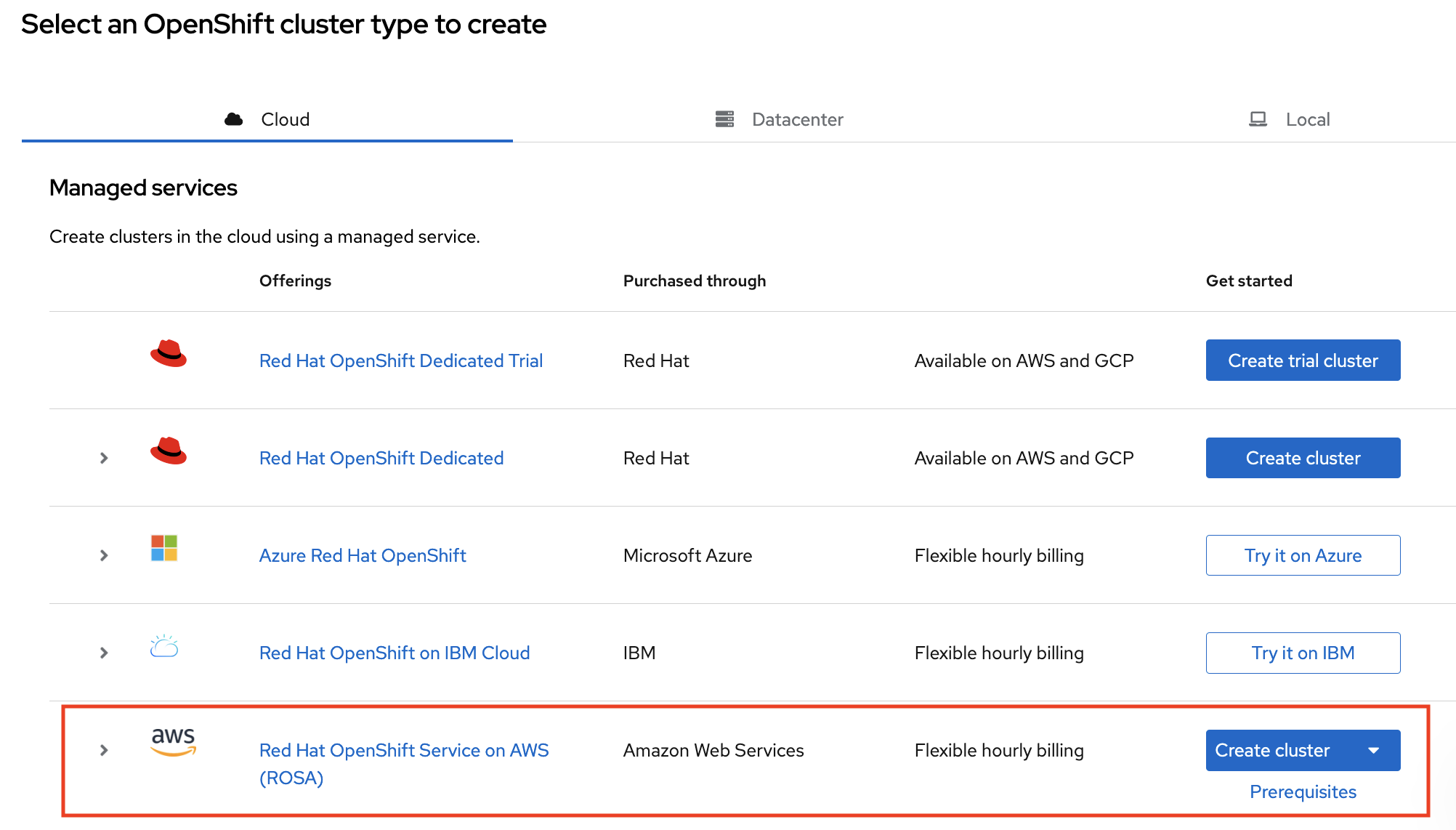

Ce tutoriel décrit le processus d’activation du service Red Hat OpenShift sur AWS (ROSA) avec des plans de contrôle hébergés (HCP) et la connexion à un compte AWS, avant de déployer le premier cluster.

Lorsque vous avez reçu une offre privée pour le produit, assurez-vous de procéder conformément aux instructions fournies avec l’offre privée avant de suivre ce tutoriel. L’offre privée est conçue soit pour un cas où le produit est déjà activé, qui remplace un abonnement actif, soit pour la première fois des activations.

2.1. Conditions préalables

- Assurez-vous de vous connecter au compte Red Hat que vous envisagez d’associer au compte AWS où vous avez activé ROSA avec HCP dans les étapes précédentes.

- Le compte AWS utilisé pour la facturation de service ne peut être associé qu’à un seul compte Red Hat. Généralement, un compte de payeur AWS est celui qui est utilisé pour s’abonner à ROSA et utilisé pour le lien de compte et la facturation.

- Les membres de l’équipe appartenant à la même organisation Red Hat peuvent utiliser le compte AWS lié pour la facturation de service tout en créant ROSA avec des clusters HCP.

2.2. Activation de l’abonnement et configuration du compte AWS

Activez le ROSA avec le produit HCP sur la page de la console AWS en cliquant sur le bouton Démarrer:

Figure 2.1. Démarrez-vous

Lorsque vous avez activé ROSA avant mais n’avez pas terminé le processus, vous pouvez cliquer sur le bouton et compléter le lien de compte comme décrit dans les étapes suivantes.

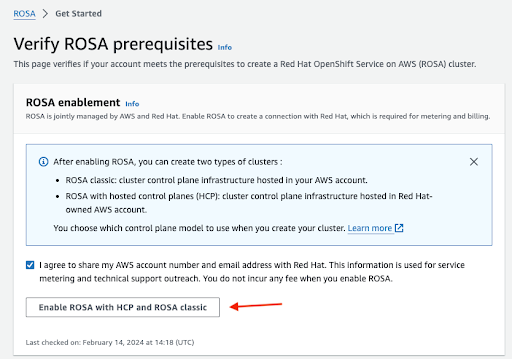

Confirmez que vous souhaitez que vos coordonnées soient partagées avec Red Hat et activez le service:

Figure 2.2. Activer ROSA

- Il ne vous sera pas facturé en activant le service dans cette étape. La connexion est faite pour la facturation et le comptage qui n’aura lieu qu’après le déploiement de votre premier cluster. Cela pourrait prendre quelques minutes.

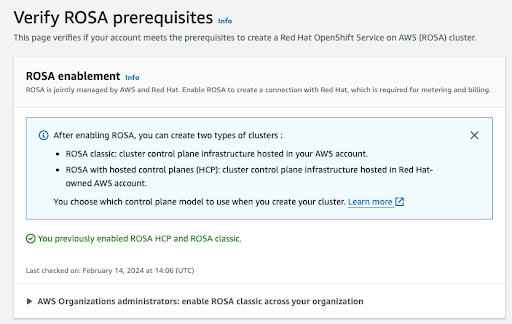

Après la fin du processus, vous verrez une confirmation:

Figure 2.3. Confirmation de l’activation ROSA

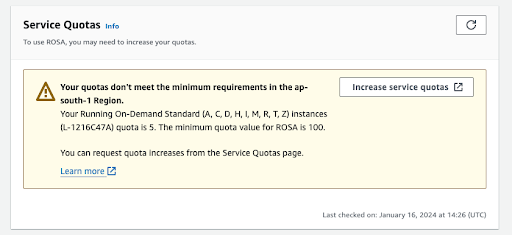

D’autres sections de cette page de vérification montrent l’état des conditions préalables supplémentaires. Dans le cas où l’une de ces conditions préalables ne serait pas remplie, un message correspondant est affiché. En voici un exemple d’insuffisance des quotas dans la région sélectionnée:

Figure 2.4. Quotas de service

- Cliquez sur le bouton Augmenter les quotas de service ou utilisez le lien En savoir plus pour obtenir plus d’informations sur la façon de gérer les quotas de service. Dans le cas d’un quota insuffisant, notez que les quotas sont spécifiques à la région. Dans le coin supérieur droit de la console Web, vous pouvez utiliser le commutateur de région pour redémarrer la vérification des quotas pour n’importe quelle région qui vous intéresse, puis soumettre des demandes d’augmentation de quota de service au besoin.

Lorsque toutes les conditions préalables sont remplies, la page ressemblera à ceci:

Figure 2.5. Vérifier les prérequis de ROSA

Le rôle ELB lié au service est créé automatiquement pour vous. Cliquez sur l’un des petits liens en bleu Info pour obtenir de l’aide et des ressources contextuelles.

2.3. Compte AWS et Red Hat et lien d’abonnement

Cliquez sur le bouton orange Continuer à Red Hat pour continuer avec le lien de compte:

Figure 2.6. Continuer à Red Hat

Dans le cas où vous n’êtes pas déjà connecté à votre compte Red Hat dans la session de votre navigateur actuel, il vous sera demandé de vous connecter à votre compte:

NoteLe compte AWS doit être lié à une seule organisation Red Hat.

Figure 2.7. Connectez-vous à votre compte Red Hat

- Il est également possible de vous inscrire à un nouveau compte Red Hat ou de réinitialiser votre mot de passe sur cette page.

- Assurez-vous de vous connecter au compte Red Hat que vous envisagez d’associer au compte AWS où vous avez activé ROSA avec HCP dans les étapes précédentes.

- Le compte AWS utilisé pour la facturation de service ne peut être associé qu’à un seul compte Red Hat. Généralement, un compte de payeur AWS est celui qui est utilisé pour s’abonner à ROSA et utilisé pour le lien de compte et la facturation.

- Les membres de l’équipe appartenant à la même organisation Red Hat peuvent utiliser le compte AWS lié pour la facturation de service tout en créant ROSA avec des clusters HCP.

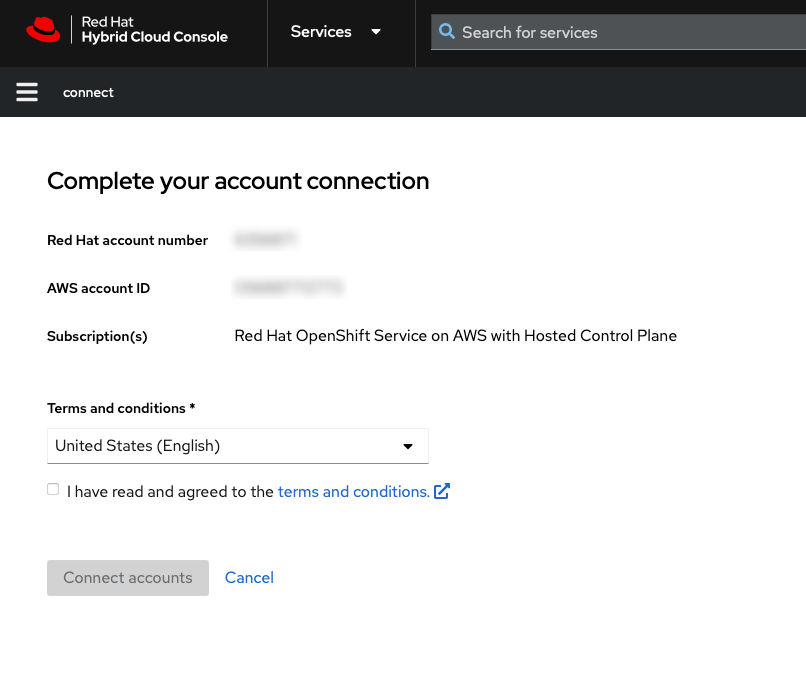

Complétez le lien du compte Red Hat après avoir examiné les termes et conditions:

NoteCette étape n’est disponible que si le compte AWS n’était pas lié à un compte Red Hat auparavant.

Cette étape est ignorée si le compte AWS est déjà lié au compte Red Hat connecté à l’utilisateur.

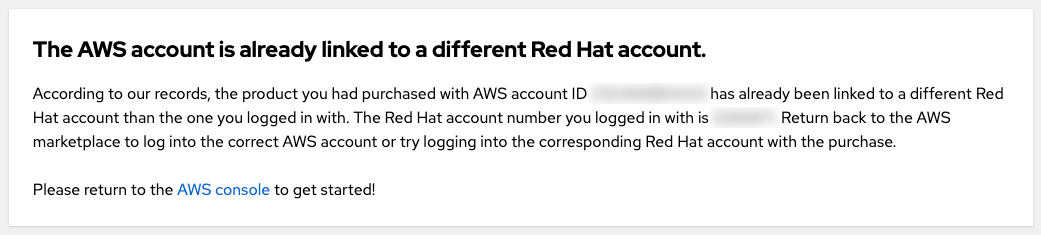

Lorsque le compte AWS est lié à un autre compte Red Hat, une erreur s’affiche. Consultez les informations sur le compte de facturation pour les clusters HCP pour le dépannage.

Figure 2.8. Complétez votre connexion de compte

Les numéros de compte Red Hat et AWS sont affichés sur cet écran.

Cliquez sur le bouton Connecter les comptes si vous êtes d’accord avec les conditions de service.

Lorsque c’est la première fois que vous utilisez la console Red Hat Hybrid Cloud, il vous sera demandé d’être d’accord avec les conditions générales des services gérés avant de pouvoir créer le premier cluster ROSA:

Figure 2.9. Conditions générales

D’autres termes qui doivent être examinés et acceptés sont affichés après avoir cliqué sur le bouton Afficher les conditions générales:

Figure 2.10. Conditions générales de Red Hat

Envoyez votre accord une fois que vous avez examiné des conditions supplémentaires lorsque vous l’invitez à ce moment-là.

La console hybride Cloud fournit une confirmation que la configuration du compte AWS a été terminée et répertorie les conditions préalables au déploiement de clusters:

Figure 2.11. Conditions préalables complètes de ROSA

La dernière section de cette page montre les options de déploiement de clusters, soit en utilisant le rosa CLI ou via la console web:

Figure 2.12. Déployez le cluster et configurez l’accès

2.4. Choisir le compte de facturation AWS pour ROSA avec HCP lors du déploiement du cluster à l’aide du CLI

Assurez-vous que vous avez installé l’interface de ligne de commande ROSA la plus récente (CLI) et AWS CLI et que vous ayez rempli les prérequis ROSA couverts dans la section précédente. Consultez Aide avec ROSA CLI configuration et Instructions pour installer l’AWS CLI pour plus d’informations.

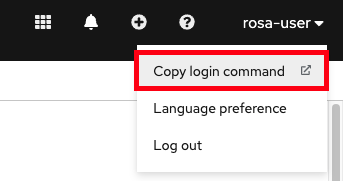

Lancez le déploiement de clusters à l’aide de la commande rosa create cluster. Cliquez sur le bouton copier sur la page de la console de Red Hat OpenShift sur la page de la console AWS (ROSA) et collez la commande dans votre terminal. Cela lance le processus de création de clusters en mode interactif:

Figure 2.13. Déployez le cluster et configurez l’accès

- Afin d’utiliser un profil AWS personnalisé, l’un des profils non par défaut spécifiés dans votre ~/.aws/credentials, vous pouvez ajouter le sélecteur -proffile <profile_name> à la commande rosa créer cluster afin que la commande ressemble à rosa créer cluster étape. Dans le cas où aucun profil AWS CLI n’est spécifié à l’aide de cette option, le profil AWS CLI par défaut déterminera le profil d’infrastructure AWS dans lequel le cluster est déployé. Le profil AWS de facturation est sélectionné dans l’une des étapes suivantes.

Lors du déploiement d’un ROSA avec le cluster HCP, le compte AWS de facturation doit être spécifié:

Figure 2.14. Indiquez le compte de facturation

- Les comptes AWS qui sont liés au compte Red Hat connecté à l’utilisateur sont affichés.

- Le compte AWS spécifié est facturé pour l’utilisation du service ROSA.

L’indicateur indique si le contrat ROSA est activé ou non pour un compte de facturation AWS donné.

- Lorsque vous sélectionnez un compte de facturation AWS qui affiche l’étiquette activée par le contrat, les taux de consommation à la demande ne sont facturés qu’après la consommation de la capacité de votre contrat prépayé.

- Les comptes AWS sans l’étiquette activée par le contrat sont facturés les taux de consommation applicables à la demande.

Ressources supplémentaires

- Les étapes détaillées de déploiement de clusters dépassent le cadre de ce tutoriel. Consultez Création de ROSA avec des clusters HCP en utilisant les options par défaut pour plus de détails sur la façon de compléter le ROSA avec le déploiement de cluster HCP à l’aide du CLI.

2.5. Choisir le compte de facturation AWS pour ROSA avec HCP lors du déploiement du cluster à l’aide de la console Web

Le cluster peut être créé à l’aide de la console web en sélectionnant la deuxième option dans la section inférieure de la page Introduction de ROSA:

Figure 2.15. Déploiement avec interface web

NoteComplétez les prérequis avant de démarrer le processus de déploiement de la console Web.

La rosa CLI est requise pour certaines tâches, telles que la création des rôles de compte. Lorsque vous déployez ROSA pour la première fois, suivez les étapes CLI jusqu’à l’exécution de la commande rosa whoami, avant de commencer les étapes de déploiement de la console Web.

La première étape lors de la création d’un cluster ROSA à l’aide de la console Web est la sélection du plan de contrôle. Assurez-vous que l’option Hosted est sélectionnée avant de cliquer sur le bouton suivant:

Figure 2.16. Choisissez l’option hébergée

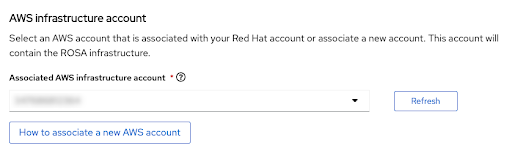

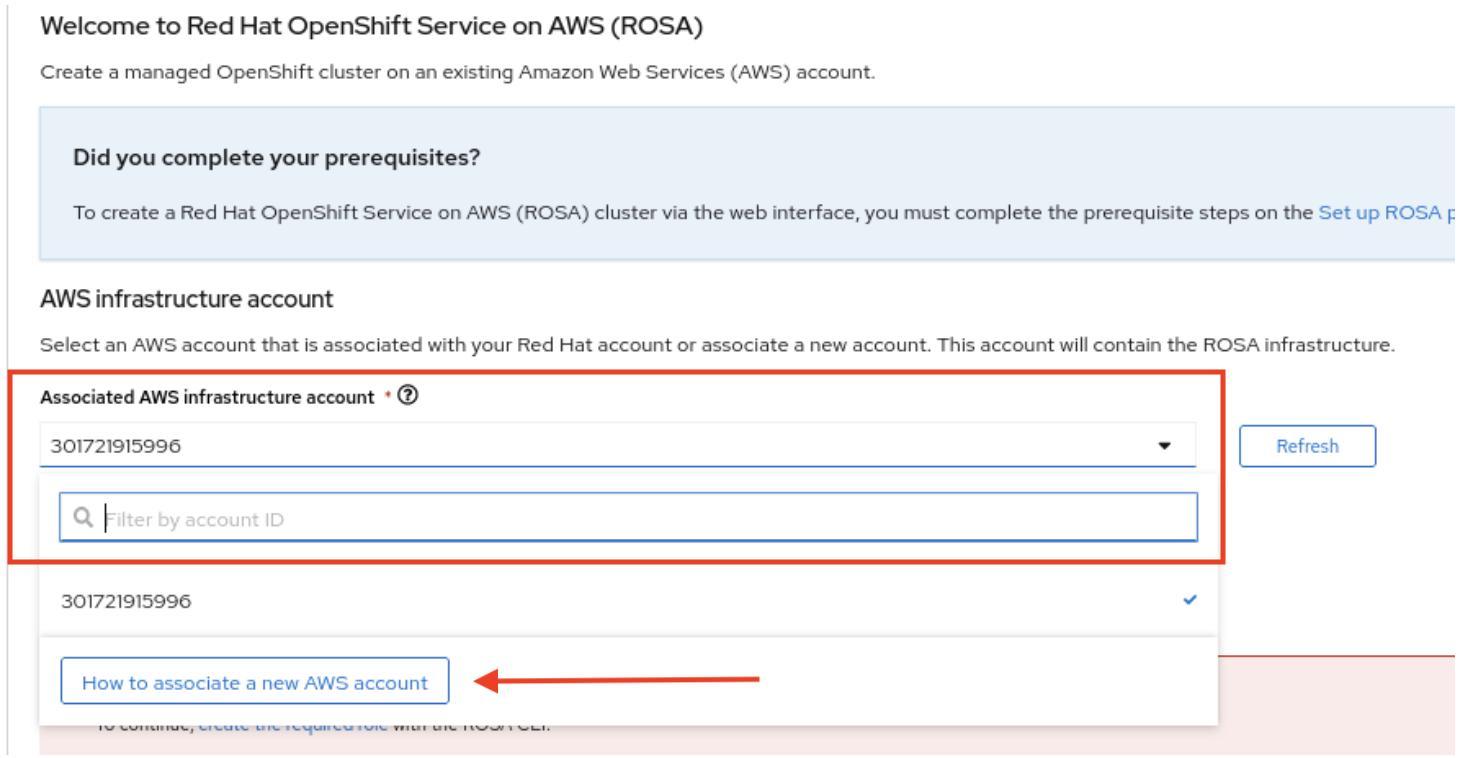

L’étape suivante Comptes et rôles vous permet de spécifier l’infrastructure du compte AWS, dans lequel le cluster ROSA est déployé et où les ressources sont consommées et gérées:

Figure 2.17. Compte infrastructure AWS

- Cliquez sur Comment associer un nouveau compte AWS, si vous ne voyez pas le compte dans lequel vous souhaitez déployer le cluster ROSA pour des informations détaillées sur la façon de créer ou de lier des rôles de compte pour cette association.

- La rosa CLI est utilisée pour cela.

- Lorsque vous utilisez plusieurs comptes AWS et que leurs profils sont configurés pour le CLI AWS, vous pouvez utiliser le sélecteur --profile pour spécifier le profil AWS lorsque vous travaillez avec les commandes rosa CLI.

Le compte AWS de facturation est sélectionné dans la section immédiatement suivante:

Figure 2.18. Compte de facturation AWS

- Les comptes AWS qui sont liés au compte Red Hat connecté à l’utilisateur sont affichés.

- Le compte AWS spécifié est facturé pour l’utilisation du service ROSA.

L’indicateur indique si le contrat ROSA est activé ou non pour un compte de facturation AWS donné.

- Lorsque vous sélectionnez un compte de facturation AWS qui affiche l’étiquette activée par le contrat, les taux de consommation à la demande ne sont facturés qu’après la consommation de la capacité de votre contrat prépayé.

- Les comptes AWS sans l’étiquette activée par le contrat sont facturés les taux de consommation applicables à la demande.

Les étapes suivantes après la sélection de compte AWS de facturation dépassent le cadre de ce tutoriel.

Ressources supplémentaires

- Afin d’obtenir de l’information sur l’utilisation du CLI pour créer un cluster, consultez Créer un ROSA avec le cluster HCP à l’aide du CLI.

- Consultez ce chemin d’apprentissage pour plus de détails sur la façon de compléter le déploiement de cluster ROSA à l’aide de la console Web.

Chapitre 3. Tutoriel: ROSA avec HCP offre privée acceptation et partage

Ce guide décrit comment accepter une offre privée pour Red Hat OpenShift Service sur AWS (ROSA) avec des avions de contrôle hébergés (HCP) et comment s’assurer que tous les membres de l’équipe peuvent utiliser l’offre privée pour les clusters qu’ils fournissent.

Les coûts de ROSA avec HCP sont composés des coûts d’infrastructure AWS et du ROSA avec les coûts de service HCP. Les coûts d’infrastructure AWS, tels que les instances EC2 qui exécutent les charges de travail nécessaires, sont imputés sur le compte AWS où l’infrastructure est déployée. Les coûts de service ROSA sont facturés au compte AWS spécifié comme le « compte de facturation AWS » lors du déploiement d’un cluster.

Les composants de coûts peuvent être facturés à différents comptes AWS. La description détaillée de la façon dont le coût du service ROSA et les coûts d’infrastructure AWS sont calculés peut être trouvée sur la page de tarification AWS de Red Hat OpenShift Service.

3.1. Accepter une offre privée

Lorsque vous obtenez une offre privée pour ROSA avec HCP, vous bénéficiez d’une URL unique accessible uniquement par un identifiant de compte AWS spécifique qui a été spécifié par le vendeur.

NoteAssurez-vous que vous êtes connecté à l’aide du compte AWS qui a été spécifié comme acheteur. Essayer d’accéder à l’offre à l’aide d’un autre compte AWS produit un message d’erreur « page non trouvée » comme le montre la figure 11 dans la section de dépannage ci-dessous.

Le menu déroulant de sélection d’offre avec une offre privée régulière présélectionnée dans la figure 1. Ce type d’offre ne peut être accepté que si la ROSA avec HCP n’a pas été activée avant d’utiliser l’offre publique ou une autre offre privée.

Figure 3.1. L’offre privée régulière

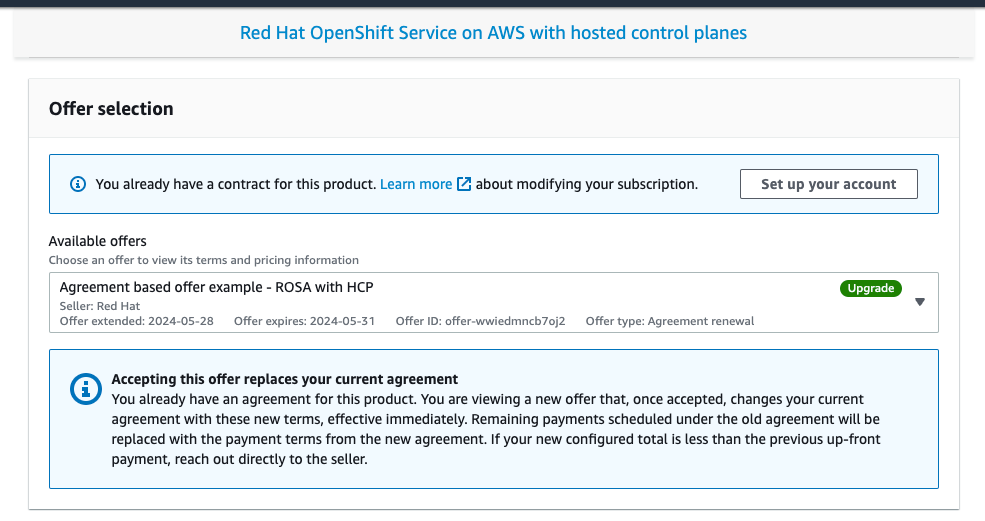

Il est possible de voir une offre privée qui a été créée pour un compte AWS qui a précédemment activé ROSA avec HCP en utilisant l’offre publique, montrant le nom du produit et l’offre privée sélectionnée étiquetée comme « Mise à niveau », qui remplace le contrat actuellement en cours d’exécution pour ROSA par HCP dans la figure 2.

Figure 3.2. Écran de sélection d’offre privée

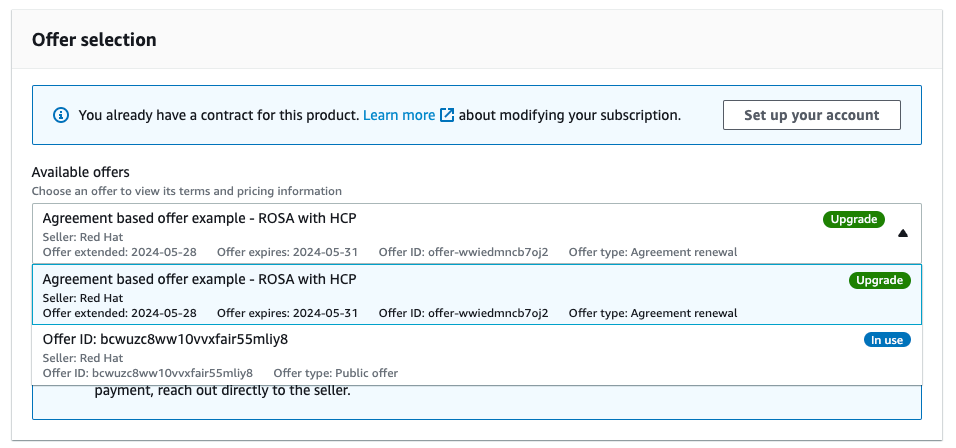

Le menu déroulant permet de sélectionner entre plusieurs offres, si elles sont disponibles. L’offre publique précédemment activée est présentée en même temps que l’offre nouvellement fournie basée sur l’accord qui est étiquetée comme « Mise à niveau » à la figure 3.

Figure 3.3. Liste déroulante de sélection d’offre privée

Assurez-vous que la configuration de votre offre est sélectionnée. La figure 4 montre la partie inférieure de la page de l’offre avec les détails de l’offre.

NoteLa date de fin du contrat, le nombre d’unités incluses dans l’offre et le calendrier de paiement. Dans cet exemple, 1 cluster et jusqu’à 3 nœuds utilisant 4 vCPU sont inclus.

Figure 3.4. Détails de l’offre privée

Facultatif: vous pouvez ajouter votre propre numéro de bon de commande (PO) à l’abonnement qui est acheté, de sorte qu’il est inclus sur vos factures AWS ultérieures. En outre, vérifiez les « frais d’utilisation supplémentaires » qui sont facturés pour toute utilisation au-dessus du champ d’application de la « Nouvelle offre de détails de configuration ».

NoteLes offres privées ont plusieurs configurations disponibles.

- Il est possible que l’offre privée que vous acceptez soit configurée avec une date de début future fixe.

- Lorsque vous n’avez pas une autre ROSA active avec abonnement HCP au moment de l’acceptation de l’offre privée, d’une offre publique ou d’une offre privée plus ancienne, acceptez l’offre privée elle-même et continuez avec les étapes de liaison de compte et de déploiement de clusters après la date de début du service spécifié.

Il faut avoir une ROSA active ayant le droit de remplir ces étapes. Les dates de début du service sont toujours indiquées dans le fuseau horaire UTC

Créez ou améliorez votre contrat.

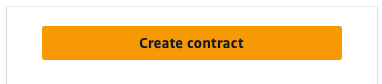

Dans le cas des offres privées acceptées par un compte AWS qui n’a pas encore ROSA avec HCP activée et qui crée le premier contrat pour ce service, cliquez sur le bouton Créer un contrat.

Figure 3.5. Créer un bouton de contrat

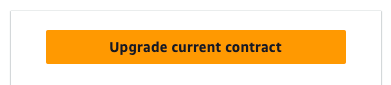

Dans le cas des offres fondées sur l’accord, cliquez sur le bouton Mise à niveau du contrat actuel affiché aux figures 4 et 6.

Figure 3.6. Bouton de mise à niveau du contrat

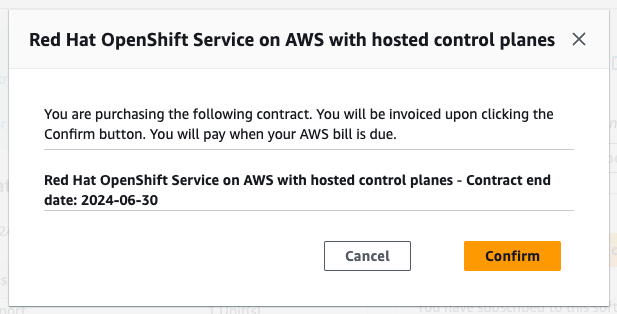

Cliquez sur Confirmer.

Figure 3.7. Fenêtre de confirmation d’acceptation de l’offre privée

Lorsque la date de début du service d’offre privée acceptée est définie pour être immédiatement après l’acceptation de l’offre, cliquez sur le bouton Configurer votre compte dans la fenêtre modale de confirmation.

Figure 3.8. Confirmation de l’abonnement

Lorsque l’offre privée acceptée a une date de début ultérieure spécifiée, retournez à la page de l’offre privée après la date de début du service, puis cliquez sur le bouton Configuration de votre compte pour procéder à la liaison du compte Red Hat et AWS.

NoteEn l’absence d’accord actif, le lien de compte décrit ci-dessous n’est pas déclenché, le processus de configuration du compte ne peut être effectué qu’après la date de début du service.

Ceux-ci sont toujours dans le fuseau horaire UTC.

3.2. Le partage d’une offre privée

En cliquant sur le bouton Configurer votre compte dans l’étape précédente, vous passez à l’étape de liaison du compte AWS et Red Hat. À ce moment-là, vous êtes déjà connecté avec le compte AWS qui a accepté l’offre. Lorsque vous n’êtes pas connecté avec un compte Red Hat, vous serez invité à le faire.

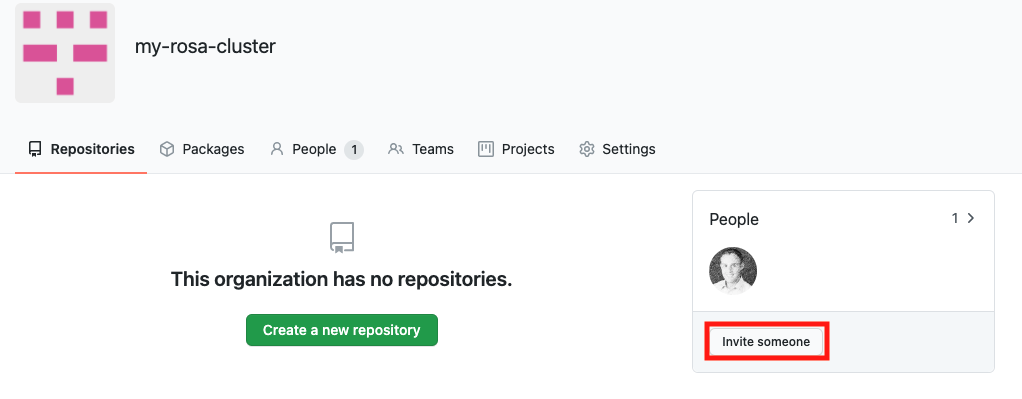

Le ROSA avec droit HCP est partagé avec d’autres membres de l’équipe via votre compte d’organisation Red Hat. Les utilisateurs existants d’une même organisation Red Hat peuvent sélectionner le compte AWS de facturation qui a accepté l’offre privée en suivant les étapes décrites ci-dessus. Lorsque vous êtes connecté en tant qu’administrateur de l’organisation Red Hat, vous pouvez gérer les utilisateurs de votre organisation Red Hat et inviter ou créer de nouveaux utilisateurs.

NoteLe ROSA avec l’offre privée HCP ne peut pas être partagé avec des comptes liés AWS via AWS License Manager.

- Ajoutez tous les utilisateurs que vous souhaitez déployer des clusters ROSA. Consultez cette FAQ de gestion de l’utilisateur pour plus de détails sur les tâches de gestion des utilisateurs du compte Red Hat.

- Assurez-vous que le compte Red Hat déjà connecté inclut tous les utilisateurs qui sont censés être des déployeurs de cluster ROSA bénéficiant de l’offre privée acceptée.

Assurez-vous que le numéro de compte Red Hat et l’ID de compte AWS sont les comptes souhaités qui doivent être liés. Ce lien est unique et un compte Red Hat ne peut être connecté qu’à un seul compte AWS (facturation).

Figure 3.9. Connexion aux comptes AWS et Red Hat

Lorsque vous souhaitez lier le compte AWS à un autre compte Red Hat que ce qui est affiché sur cette page dans la Figure 9, déconnectez-vous de la console de cloud hybride Red Hat avant de connecter les comptes et répétez l’étape de configuration du compte en retournant à l’URL de l’offre privée qui est déjà acceptée.

Le compte AWS ne peut être connecté qu’à un seul compte Red Hat. Lorsque les comptes Red Hat et AWS sont connectés, cela ne peut pas être modifié par l’utilisateur. En cas de changement, l’utilisateur doit créer un ticket d’assistance.

- Acceptez les termes et conditions, puis cliquez sur Connecter les comptes.

3.3. La sélection du compte de facturation AWS

- Lors du déploiement de ROSA avec des clusters HCP, vérifiez que les utilisateurs finaux sélectionnent le compte de facturation AWS qui a accepté l’offre privée.

Lors de l’utilisation de l’interface Web pour déployer ROSA avec HCP, le compte d’infrastructure AWS associé » est généralement défini sur l’ID de compte AWS utilisé par l’administrateur du cluster créé.

- Cela peut être le même compte AWS que le compte AWS de facturation.

Les ressources AWS sont déployées dans ce compte et toutes les facturations associées à ces ressources sont traitées en conséquence.

Figure 3.10. Infrastructure et facturation de la sélection de compte AWS pendant ROSA avec le déploiement de cluster HCP

- La liste déroulante du compte de facturation AWS sur la capture d’écran ci-dessus doit être définie sur le compte AWS qui a accepté l’offre privée, à condition que le quota acheté soit utilisé par le cluster créé. Lorsque différents comptes AWS sont sélectionnés dans l’infrastructure et les « rôles » de facturation, la note d’information bleue visible à la figure 10 est affichée.

3.4. Résolution de problèmes

Les problèmes les plus fréquents associés à l’acceptation d’une offre privée et à la liaison de compte Red Hat.

3.4.1. Accéder à une offre privée à l’aide d’un autre compte AWS

Lorsque vous essayez d’accéder à l’offre privée lorsque vous vous connectez sous l’ID de compte AWS qui n’est pas défini dans l’offre et que vous voyez le message affiché à la figure 11, vérifiez que vous êtes connecté comme compte de facturation AWS souhaité.

Figure 3.11. Erreur HTTP 404 lors de l’utilisation de l’URL de l’offre privée

- Contactez le vendeur si vous avez besoin que l’offre privée soit étendue à un autre compte AWS.

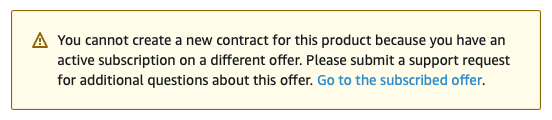

3.4.2. L’offre privée ne peut pas être acceptée en raison d’un abonnement actif

Lorsque vous essayez d’accéder à une offre privée créée pour la première fois ROSA avec activation HCP, alors que vous avez déjà ROSA avec HCP activé à l’aide d’une autre offre publique ou privée, et voir l’avis suivant, alors contactez le vendeur qui vous a fourni l’offre.

Le vendeur peut vous fournir une nouvelle offre qui remplacera de manière transparente votre accord actuel, sans avoir besoin d’annuler votre abonnement précédent.

Figure 3.12. Abonnement existant empêchant l’acceptation de l’offre privée

3.4.3. Le compte AWS est déjà lié à un autre compte Red Hat

Lorsque vous voyez le message d’erreur "AWS compte est déjà lié à un autre compte Red Hat" lorsque vous essayez de connecter le compte AWS qui a accepté l’offre privée avec un utilisateur Red Hat actuellement connecté, le compte AWS est déjà connecté à un autre utilisateur Red Hat.

Figure 3.13. Le compte AWS est déjà lié à un autre compte Red Hat

Connectez-vous à l’aide d’un autre compte Red Hat ou d’un autre compte AWS.

- Cependant, étant donné que ce guide concerne les offres privées, l’hypothèse est que vous êtes connecté au compte AWS qui a été spécifié comme acheteur et a déjà accepté l’offre privée, donc elle est destinée à être utilisée comme compte de facturation. La connexion comme un autre compte AWS n’est pas attendue après l’acceptation d’une offre privée.

- Il est toujours possible de vous connecter avec un autre utilisateur Red Hat qui est déjà connecté au compte AWS qui a accepté l’offre privée. D’autres utilisateurs de Red Hat appartenant à la même organisation Red Hat peuvent utiliser le compte AWS lié comme ROSA avec le compte de facturation AWS HCP lors de la création de clusters comme le montre la figure 10.

- Dans le cas où vous croyez que le lien de compte existant pourrait ne pas être correct, consultez la question « Les membres de mon équipe appartiennent à différentes organisations Red Hat » ci-dessous pour obtenir des conseils sur la façon dont vous pouvez procéder.

3.4.4. Les membres de mon équipe appartiennent à différentes organisations Red Hat

- Le compte AWS ne peut être connecté qu’à un seul compte Red Hat. Chaque utilisateur qui souhaite créer un cluster et bénéficier de l’offre privée accordée à ce compte AWS doit être dans le même compte Red Hat. Cela peut être réalisé en invitant l’utilisateur sur le même compte Red Hat et en créant un nouvel utilisateur Red Hat.

3.4.5. Compte de facturation AWS incorrect a été sélectionné lors de la création d’un cluster

- Lorsque l’utilisateur a sélectionné un compte de facturation AWS incorrect, le moyen le plus rapide de le corriger est de supprimer le cluster et d’en créer un nouveau, tout en sélectionnant le compte de facturation AWS correct.

- Dans le cas où il s’agit d’un cluster de production qui ne peut pas être facilement supprimé, veuillez contacter le support de Red Hat pour modifier le compte de facturation d’un cluster existant. Attendez-vous à un certain délai pour que cela soit résolu.

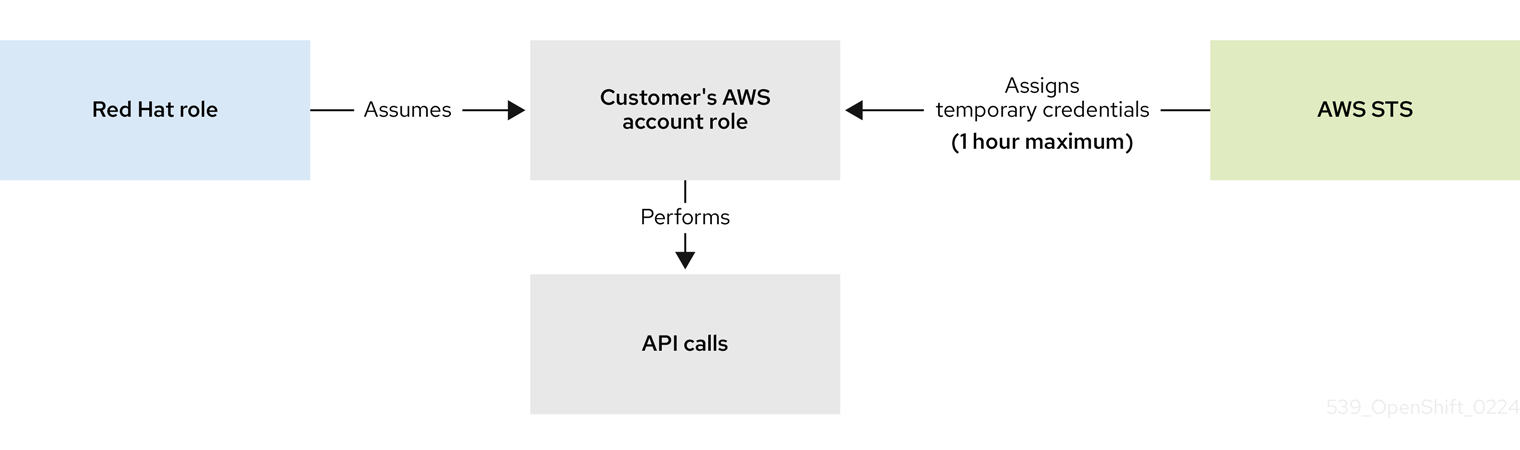

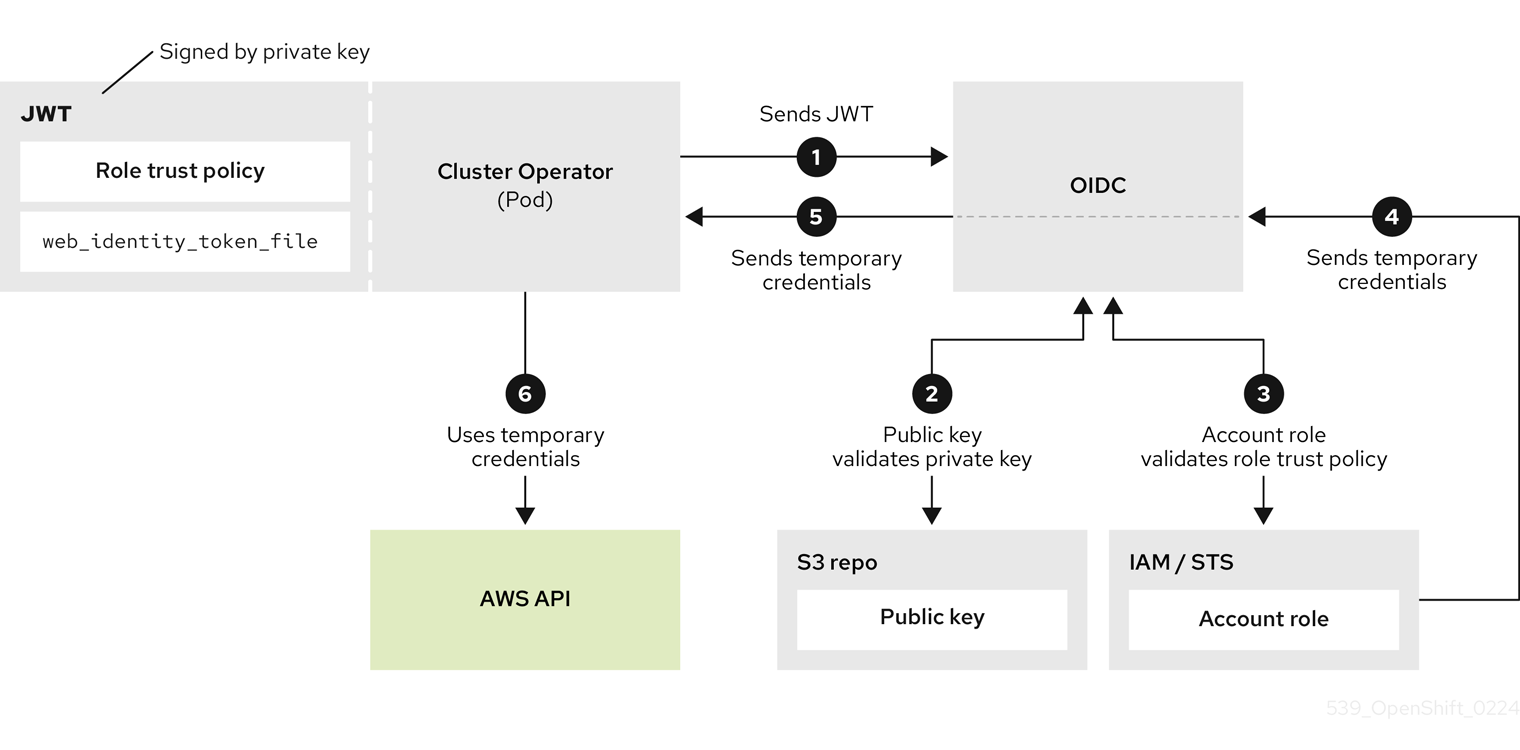

Chapitre 4. Tutoriel : Vérifier les autorisations pour un déploiement ROSA STS

Afin de procéder au déploiement d’un cluster ROSA, un compte doit prendre en charge les rôles et autorisations requis. Les stratégies de contrôle des services AWS (SCP) ne peuvent pas bloquer les appels API effectués par les rôles d’installateur ou d’opérateur.

Les détails sur les ressources IAM nécessaires pour une installation STS de ROSA peuvent être trouvés ici: À propos des ressources de l’IAM Les détails sur les ressources IAM nécessaires pour une installation STS de ROSA peuvent être trouvés ici: À propos des ressources de l’IAM pour les clusters ROSA qui utilisent STS

Ce guide est validé pour ROSA v4.11.X.

4.1. Conditions préalables

- AWS CLI

- CLI ROSA v1.2.6

- JQ CLI

- Le rôle AWS avec les autorisations requises

4.2. La vérification des autorisations ROSA

Afin de vérifier les autorisations requises pour ROSA, nous pouvons exécuter le script inclus dans la section suivante sans jamais créer de ressources AWS.

Le script utilise les commandes rosa, aws et jq CLI pour créer des fichiers dans le répertoire de travail qui seront utilisés pour vérifier les autorisations dans le compte connecté à la configuration AWS actuelle.

Le simulateur de stratégie AWS est utilisé pour vérifier les autorisations de chaque stratégie de rôle par rapport aux appels API extraits par jq; les résultats sont ensuite stockés dans un fichier texte joint avec .results.

Ce script est conçu pour vérifier les autorisations pour le compte courant et la région.

4.3. Instructions d’utilisation

Exécutez les commandes suivantes dans un terminal bash (l’option -p définit un préfixe pour les rôles):

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Après la fin du script, examinez chaque fichier de résultats pour s’assurer qu’aucun des appels API requis n’est bloqué:

for file in $(ls *.results); do echo $file; cat $file; done

$ for file in $(ls *.results); do echo $file; cat $file; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow La sortie ressemblera à ce qui suit:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteEn cas de blocage, examinez l’erreur fournie par AWS et consultez votre Administrateur pour déterminer si les SCP bloquent les appels API requis.

Chapitre 5. Tutoriel: Déploiement de ROSA avec un résolveur DNS personnalisé

Le jeu d’options DHCP personnalisé vous permet de personnaliser votre VPC avec votre propre serveur DNS, votre nom de domaine et plus encore. Les clusters Red Hat OpenShift Service sur AWS (ROSA) prennent en charge en utilisant des ensembles d’options DHCP personnalisés. Les clusters ROSA nécessitent par défaut de définir l’option "serveurs de noms de domaine" sur AmazonProvidedDNS pour assurer la création et l’exploitation réussies des clusters. Les clients qui souhaitent utiliser des serveurs DNS personnalisés pour la résolution DNS doivent faire une configuration supplémentaire pour assurer le succès de la création et du fonctionnement du cluster ROSA.

Dans ce tutoriel, nous configurerons notre serveur DNS pour transférer les recherches DNS pour des zones DNS spécifiques (détaillées plus loin ci-dessous) vers un Résolvateur entrant Amazon Route 53.

Ce tutoriel utilise le serveur DNS BIND open-source (nommé) pour démontrer la configuration nécessaire pour transférer les recherches DNS vers un Résolvateur entrant Amazon Route 53 situé dans le VPC dans lequel vous prévoyez de déployer un cluster ROSA. Consultez la documentation de votre serveur DNS préféré pour savoir comment configurer le transfert de zone.

5.1. Conditions préalables

- CLI ROSA (rosa)

- AWS CLI (aws)

- Création manuelle d’AWS VPC

- Configuration d’une option DHCP configurée pour pointer vers un serveur DNS personnalisé et définie par défaut pour votre VPC

5.2. Configuration de votre environnement

Configurez les variables d’environnement suivantes:

export VPC_ID=<vpc_ID> export REGION=<region> export VPC_CIDR=<vpc_CIDR>

$ export VPC_ID=<vpc_ID>1 $ export REGION=<region>2 $ export VPC_CIDR=<vpc_CIDR>3 Copy to Clipboard Copied! Toggle word wrap Toggle overflow Assurez-vous que tous les champs sortent correctement avant de passer à la section suivante:

echo "VPC ID: ${VPC_ID}, VPC CIDR Range: ${VPC_CIDR}, Region: ${REGION}"$ echo "VPC ID: ${VPC_ID}, VPC CIDR Range: ${VPC_CIDR}, Region: ${REGION}"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3. Créer une solution Amazon Route 53 Inbound Resolver

Dans le VPC, utilisez la procédure suivante pour déployer un Inbound Resolver Amazon Route 53 dans lequel nous prévoyons de déployer le cluster.

Dans cet exemple, nous déployons Amazon Route 53 Inbound Resolver dans le même VPC que le cluster utilisera. Lorsque vous souhaitez le déployer dans un VPC séparé, vous devez associer manuellement la zone(s) hébergée(s) privée(s) décrite ci-dessous une fois la création de cluster démarrée. Il est impossible d’associer la zone avant le début du processus de création de clusters. Le défaut d’associer la zone privée hébergée pendant le processus de création de clusters entraînera des échecs de création de clusters.

Créer un groupe de sécurité et permettre l’accès aux ports 53/tcp et 53/udp à partir du VPC:

SG_ID=$(aws ec2 create-security-group --group-name rosa-inbound-resolver --description "Security group for ROSA inbound resolver" --vpc-id ${VPC_ID} --region ${REGION} --output text) aws ec2 authorize-security-group-ingress --group-id ${SG_ID} --protocol tcp --port 53 --cidr ${VPC_CIDR} --region ${REGION} aws ec2 authorize-security-group-ingress --group-id ${SG_ID} --protocol udp --port 53 --cidr ${VPC_CIDR} --region ${REGION}$ SG_ID=$(aws ec2 create-security-group --group-name rosa-inbound-resolver --description "Security group for ROSA inbound resolver" --vpc-id ${VPC_ID} --region ${REGION} --output text) $ aws ec2 authorize-security-group-ingress --group-id ${SG_ID} --protocol tcp --port 53 --cidr ${VPC_CIDR} --region ${REGION} $ aws ec2 authorize-security-group-ingress --group-id ${SG_ID} --protocol udp --port 53 --cidr ${VPC_CIDR} --region ${REGION}Copy to Clipboard Copied! Toggle word wrap Toggle overflow Créez une solution Amazon Route 53 Inbound Resolver dans votre VPC:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteLa commande ci-dessus fixe les points de terminaison Amazon Route 53 Inbound Resolver à tous les sous-réseaux du VPC fourni à l’aide d’adresses IP allouées dynamiquement. Lorsque vous préférez spécifier manuellement les sous-réseaux et/ou les adresses IP, exécutez plutôt la commande suivante:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- <subnet_ID> par les ID de sous-réseau et <endpoint_IP> par les adresses IP statiques auxquelles vous souhaitez ajouter des points de terminaison de résolution entrant.

Accédez aux adresses IP de vos points de terminaison de résolution entrants à configurer dans la configuration de votre serveur DNS:

aws route53resolver list-resolver-endpoint-ip-addresses \ --resolver-endpoint-id ${RESOLVER_ID} \ --region=${REGION} \ --query 'IpAddresses[*].Ip'$ aws route53resolver list-resolver-endpoint-ip-addresses \ --resolver-endpoint-id ${RESOLVER_ID} \ --region=${REGION} \ --query 'IpAddresses[*].Ip'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

[ "10.0.45.253", "10.0.23.131", "10.0.148.159" ][ "10.0.45.253", "10.0.23.131", "10.0.148.159" ]Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4. Configurez votre serveur DNS

La procédure suivante permet de configurer votre serveur DNS afin de transférer les zones hébergées privées nécessaires à votre solution Amazon Route 53 Inbound Resolver.

Les clusters ROSA Classic vous obligent à configurer le transfert DNS pour une zone privée hébergée:

-

<domain-prefix>.<unique-ID>.p1.openshiftapps.com

Cette Amazon Route 53 zones hébergées privées est créée lors de la création de clusters. Le préfixe de domaine est une valeur spécifiée par le client, mais l’ID unique est généré au hasard lors de la création de clusters et ne peut pas être présélectionné. En tant que tel, vous devez attendre que le processus de création de cluster commence avant de configurer le transfert pour la zone hébergée privée p1.openshiftapps.com.

- Créez votre cluster.

Lorsque votre cluster a commencé le processus de création, localisez la zone hébergée privée nouvellement créée:

aws route53 list-hosted-zones-by-vpc \ --vpc-id ${VPC_ID} \ --vpc-region ${REGION} \ --query 'HostedZoneSummaries[*].Name' \ --output table$ aws route53 list-hosted-zones-by-vpc \ --vpc-id ${VPC_ID} \ --vpc-region ${REGION} \ --query 'HostedZoneSummaries[*].Name' \ --output tableCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

---------------------------------------------- | ListHostedZonesByVPC | +--------------------------------------------+ | domain-prefix.agls.p3.openshiftapps.com. | +--------------------------------------------+

---------------------------------------------- | ListHostedZonesByVPC | +--------------------------------------------+ | domain-prefix.agls.p3.openshiftapps.com. | +--------------------------------------------+Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteLe processus de création de clusters peut prendre quelques minutes pour créer les zones privées hébergées sur la Route 53. Lorsque vous ne voyez pas un domaine p1.openshiftapps.com, attendez quelques minutes et exécutez à nouveau la commande.

Lorsque vous connaissez l’identifiant unique du domaine du cluster, configurez votre serveur DNS pour transférer toutes les requêtes DNS pour <domain-prefix>.<unique-ID>.p1.openshiftapps.com vers vos points de terminaison Amazon Route 53 Inbound Resolver. Dans le cas des serveurs DNS BIND, modifiez votre fichier /etc/named.conf dans votre éditeur de texte préféré et ajoutez une nouvelle zone à l’aide de l’exemple ci-dessous:

Exemple :

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Chapitre 6. Tutoriel : Utilisation d’AWS WAF et d’Amazon CloudFront pour protéger les charges de travail ROSA

AWS WAF est un pare-feu d’application Web qui vous permet de surveiller les requêtes HTTP et HTTPS qui sont transmises à vos ressources d’application Web protégées.

Amazon CloudFront vous permet d’ajouter un pare-feu d’application Web (WAF) à vos charges de travail Red Hat OpenShift Service sur AWS (ROSA). L’utilisation d’une solution externe protège les ressources ROSA contre le déni de service dû à la gestion du WAF.

6.1. Conditions préalables

- A ROSA (HCP ou Classic) cluster.

- Accès à l’OpenShift CLI (oc).

- Accès à AWS CLI (aws).

6.1.1. Configuration de l’environnement

Élaborer les variables de l’environnement:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Le remplacement par le domaine personnalisé que vous souhaitez utiliser pour IngressController.

NoteLa sortie "Cluster" de la commande précédente peut être le nom de votre cluster, l’ID interne de votre cluster ou le préfixe de domaine du cluster. Lorsque vous préférez utiliser un autre identifiant, vous pouvez définir manuellement cette valeur en exécutant la commande suivante:

export CLUSTER=my-custom-value

$ export CLUSTER=my-custom-valueCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2. Configuration du contrôleur d’entrée secondaire

Il est nécessaire de configurer un contrôleur d’entrée secondaire pour segmenter votre trafic externe protégé par WAF de votre contrôleur d’entrée standard (et par défaut).

Conditions préalables

Certificat SAN ou wildcard de confiance pour votre domaine personnalisé, tel que CN=*.apps.example.com

ImportantAmazon CloudFront utilise HTTPS pour communiquer avec le contrôleur secondaire d’entrée de votre cluster. Comme expliqué dans la documentation Amazon CloudFront, vous ne pouvez pas utiliser un certificat autosigné pour la communication HTTPS entre CloudFront et votre cluster. Amazon CloudFront vérifie que le certificat a été délivré par une autorité de certification de confiance.

Procédure

Créez un nouveau secret TLS à partir d’une clé privée et d’un certificat public, où fullchain.pem est votre chaîne de certificats wildcard complète (y compris les intermédiaires) et privkey.pem est la clé privée de votre certificat wildcard.

Exemple :

oc -n openshift-ingress create secret tls waf-tls --cert=fullchain.pem --key=privkey.pem

$ oc -n openshift-ingress create secret tls waf-tls --cert=fullchain.pem --key=privkey.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow Créer une nouvelle ressource IngressController:

Exemple waf-ingress-controller.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Le remplacement par le domaine personnalisé que vous souhaitez utiliser pour IngressController.

- 2

- Filtre l’ensemble d’itinéraires desservis par le contrôleur Ingress. Dans ce tutoriel, nous utiliserons le sélecteur de route waf, mais si aucune valeur n’était fournie, aucun filtrage ne se produirait.

Appliquer le logiciel IngressController:

Exemple :

oc apply -f waf-ingress-controller.yaml

$ oc apply -f waf-ingress-controller.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Assurez-vous que votre IngressController a réussi à créer un équilibreur de charge externe:

oc -n openshift-ingress get service/router-cloudfront-waf

$ oc -n openshift-ingress get service/router-cloudfront-wafCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE router-cloudfront-waf LoadBalancer 172.30.16.141 a68a838a7f26440bf8647809b61c4bc8-4225395f488830bd.elb.us-east-1.amazonaws.com 80:30606/TCP,443:31065/TCP 2m19s

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE router-cloudfront-waf LoadBalancer 172.30.16.141 a68a838a7f26440bf8647809b61c4bc8-4225395f488830bd.elb.us-east-1.amazonaws.com 80:30606/TCP,443:31065/TCP 2m19sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.1. Configurer l’AWS WAF

Le service AWS WAF est un pare-feu d’application Web qui vous permet de surveiller, de protéger et de contrôler les requêtes HTTP et HTTPS qui sont transmises à vos ressources d’application Web protégées, comme ROSA.

Créer un fichier de règles AWS WAF pour s’appliquer à notre ACL web:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Cela activera les jeux de règles gérés Core (Common) et SQL AWS.

Créer un AWS WAF Web ACL en utilisant les règles que nous avons spécifiées ci-dessus:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.3. Configurer Amazon CloudFront

Le nom d’hôte NLB du contrôleur d’entrée personnalisé nouvellement créé:

NLB=$(oc -n openshift-ingress get service router-cloudfront-waf \ -o jsonpath='{.status.loadBalancer.ingress[0].hostname}')$ NLB=$(oc -n openshift-ingress get service router-cloudfront-waf \ -o jsonpath='{.status.loadBalancer.ingress[0].hostname}')Copy to Clipboard Copied! Toggle word wrap Toggle overflow Importez votre certificat dans Amazon Certificate Manager, où cert.pem est votre certificat wildcard, fullchain.pem est la chaîne de votre certificat wildcard et privkey.pem est la clé privée de votre certificat wildcard.

NoteIndépendamment de la région dans laquelle votre cluster est déployé, vous devez importer ce certificat pour nous-Est-1 car Amazon CloudFront est un service AWS mondial.

Exemple :

aws acm import-certificate --certificate file://cert.pem \ --certificate-chain file://fullchain.pem \ --private-key file://privkey.pem \ --region us-east-1

$ aws acm import-certificate --certificate file://cert.pem \ --certificate-chain file://fullchain.pem \ --private-key file://privkey.pem \ --region us-east-1Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Connectez-vous à la console AWS pour créer une distribution CloudFront.

Configurez la distribution CloudFront en utilisant les informations suivantes:

NoteDans le cas où une option n’est pas spécifiée dans le tableau ci-dessous, laissez-les par défaut (qui peut être vide).

Expand L’option La valeur Domaine d’origine

Sortie de la commande précédente [1]

Le nom

ingère Rosa-waf [2]

La politique du protocole d’affichage

Envoyer HTTP vers HTTPS

Les méthodes HTTP autorisées

GET, HEAD, OPTIONS, PUT, POSTER, PATCH, SUPPRIMER

Cache politique

CachingDisabled

Demande d’origine politique

AllViewer

Application Web Firewall (WAF)

Activer les protections de sécurité

Configuration WAF existante

C’est vrai

Choisissez un ACL web

CloudFront-wafAutre nom de domaine (CNAME)

*.apps.example.com [3]

Certificat SSL personnalisé

Choisissez le certificat que vous avez importé à partir de l’étape ci-dessus [4]

- Exécutez l’écho ${NLB} pour obtenir le domaine d’origine.

- Lorsque vous avez plusieurs clusters, assurez-vous que le nom d’origine est unique.

- Cela devrait correspondre au domaine wildcard que vous avez utilisé pour créer le contrôleur d’entrée personnalisé.

- Cela devrait correspondre au nom de domaine alternatif entré ci-dessus.

Découvrez le point de terminaison Amazon CloudFront Distribution:

aws cloudfront list-distributions --query "DistributionList.Items[?Origins.Items[?DomainName=='${NLB}']].DomainName" --output text$ aws cloudfront list-distributions --query "DistributionList.Items[?Origins.Items[?DomainName=='${NLB}']].DomainName" --output textCopy to Clipboard Copied! Toggle word wrap Toggle overflow Actualisez le DNS de votre domaine wildcard personnalisé avec un CNAME vers le point de terminaison Amazon CloudFront Distribution à partir de l’étape ci-dessus.

Exemple :

*.apps.example.com CNAME d1b2c3d4e5f6g7.cloudfront.net

*.apps.example.com CNAME d1b2c3d4e5f6g7.cloudfront.netCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.4. Déployer un exemple d’application

Créez un nouveau projet pour votre exemple d’application en exécutant la commande suivante:

oc new-project hello-world

$ oc new-project hello-worldCopy to Clipboard Copied! Toggle word wrap Toggle overflow Déployez une application hello world:

oc -n hello-world new-app --image=docker.io/openshift/hello-openshift

$ oc -n hello-world new-app --image=docker.io/openshift/hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow Créer un itinéraire pour l’application spécifiant votre nom de domaine personnalisé:

Exemple :

oc -n hello-world create route edge --service=hello-openshift hello-openshift-tls \ --hostname hello-openshift.${DOMAIN}$ oc -n hello-world create route edge --service=hello-openshift hello-openshift-tls \ --hostname hello-openshift.${DOMAIN}Copy to Clipboard Copied! Toggle word wrap Toggle overflow Étiqueter la route pour l’admettre à votre contrôleur d’entrée personnalisé:

oc -n hello-world label route.route.openshift.io/hello-openshift-tls route=waf

$ oc -n hello-world label route.route.openshift.io/hello-openshift-tls route=wafCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.5. Tester le WAF

Essayez que l’application est accessible derrière Amazon CloudFront:

Exemple :

curl "https://hello-openshift.${DOMAIN}"$ curl "https://hello-openshift.${DOMAIN}"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Hello OpenShift!

Hello OpenShift!Copy to Clipboard Copied! Toggle word wrap Toggle overflow Essayez que la WAF nie une mauvaise demande:

Exemple :

curl -X POST "https://hello-openshift.${DOMAIN}" \ -F "user='<script><alert>Hello></alert></script>'"$ curl -X POST "https://hello-openshift.${DOMAIN}" \ -F "user='<script><alert>Hello></alert></script>'"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Le résultat attendu est un 403 ERROR, ce qui signifie que l’AWS WAF protège votre application.

Chapitre 7. Tutoriel : Utilisation d’AWS WAF et d’AWS ALB pour protéger les charges de travail ROSA

AWS WAF est un pare-feu d’application Web qui vous permet de surveiller les requêtes HTTP et HTTPS qui sont transmises à vos ressources d’application Web protégées.

Il est possible d’utiliser un balanceur de charge d’application AWS (ALB) pour ajouter un pare-feu d’application Web (WAF) à votre Red Hat OpenShift Service sur AWS (ROSA). L’utilisation d’une solution externe protège les ressources ROSA contre le déni de service dû à la gestion du WAF.

Il est recommandé d’utiliser la méthode CloudFront plus flexible, sauf si vous devez absolument utiliser une solution basée sur ALB.

7.1. Conditions préalables

Cluster de zones de disponibilité multiples (AZ) ROSA (HCP ou Classic).

NoteLes ALB AWS nécessitent au moins deux sous-réseaux publics à travers les AZ, selon la documentation AWS. C’est pour cette raison que seuls plusieurs clusters AZ ROSA peuvent être utilisés avec des ALB.

- Accès à l’OpenShift CLI (oc).

- Accès à AWS CLI (aws).

7.1.1. Configuration de l’environnement

Élaborer les variables de l’environnement:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.1.2. AWS VPC et sous-réseaux

Cette section ne s’applique qu’aux clusters qui ont été déployés dans des VPC existants. Dans le cas où vous n’avez pas déployé votre cluster dans un VPC existant, sautez cette section et passez à la section d’installation ci-dessous.

Définissez les variables ci-dessous aux valeurs appropriées pour votre déploiement ROSA:

export VPC_ID=<vpc-id> export PUBLIC_SUBNET_IDS=(<space-separated-list-of-ids>) export PRIVATE_SUBNET_IDS=(<space-separated-list-of-ids>)

$ export VPC_ID=<vpc-id>1 $ export PUBLIC_SUBNET_IDS=(<space-separated-list-of-ids>)2 $ export PRIVATE_SUBNET_IDS=(<space-separated-list-of-ids>)3 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Le remplacement par l’ID VPC du cluster, par exemple: exporte VPC_ID=vpc-04c429b7dbc4680ba.

- 2

- Le remplacer par une liste séparée de l’espace des ID de sous-réseau privés du cluster, en veillant à préserver le (). Exportation PUBLIC_SUBNET_IDS=(subnet-056fd6861ad332ba2 sous-net-08ce3b4ec753fe74c sous-net-071aa2828664972f).

- 3

- Le remplacer par une liste séparée de l’espace des ID de sous-réseau privés du cluster, en veillant à préserver le (). Exportation PRIVATE_SUBNET_IDS=(subnet-0b933d72a8d72c36a sousnet-0817eb72070f1d3c2 sousnet-0806e64159b66665a).

Ajoutez une balise au VPC de votre cluster avec l’identifiant du cluster:

aws ec2 create-tags --resources ${VPC_ID} \ --tags Key=kubernetes.io/cluster/${CLUSTER},Value=shared --region ${REGION}$ aws ec2 create-tags --resources ${VPC_ID} \ --tags Key=kubernetes.io/cluster/${CLUSTER},Value=shared --region ${REGION}Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez une étiquette à vos sous-réseaux publics:

aws ec2 create-tags \ --resources ${PUBLIC_SUBNET_IDS} \ --tags Key=kubernetes.io/role/elb,Value='1' \ Key=kubernetes.io/cluster/${CLUSTER},Value=shared \ --region ${REGION}$ aws ec2 create-tags \ --resources ${PUBLIC_SUBNET_IDS} \ --tags Key=kubernetes.io/role/elb,Value='1' \ Key=kubernetes.io/cluster/${CLUSTER},Value=shared \ --region ${REGION}Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ajouter une balise à vos sous-réseaux privés:

aws ec2 create-tags \ --resources ${PRIVATE_SUBNET_IDS} \ --tags Key=kubernetes.io/role/internal-elb,Value='1' \ Key=kubernetes.io/cluster/${CLUSTER},Value=shared \ --region ${REGION}$ aws ec2 create-tags \ --resources ${PRIVATE_SUBNET_IDS} \ --tags Key=kubernetes.io/role/internal-elb,Value='1' \ Key=kubernetes.io/cluster/${CLUSTER},Value=shared \ --region ${REGION}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.2. Déployer l’opérateur AWS Load Balancer

L’opérateur AWS Load Balancer est utilisé pour installer, gérer et configurer une instance de contrôleur aws-charge-balancer dans un cluster ROSA. « pour déployer des ALB dans ROSA, nous devons d’abord déployer l’opérateur AWS Load Balancer.

Créez un nouveau projet pour déployer l’opérateur AWS Load Balancer en exécutant la commande suivante:

oc new-project aws-load-balancer-operator

$ oc new-project aws-load-balancer-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Créez une stratégie AWS IAM pour le contrôleur AWS Load Balancer si l’on n’existe pas déjà en exécutant la commande suivante:

NoteLa politique provient de la politique AWS Load Balancer Controller en amont. Ceci est requis par l’opérateur pour fonctionner.

POLICY_ARN=$(aws iam list-policies --query \ "Policies[?PolicyName=='aws-load-balancer-operator-policy'].{ARN:Arn}" \ --output text)$ POLICY_ARN=$(aws iam list-policies --query \ "Policies[?PolicyName=='aws-load-balancer-operator-policy'].{ARN:Arn}" \ --output text)Copy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow Créez une politique de confiance AWS IAM pour AWS Load Balancer Operator:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Créer un rôle AWS IAM pour l’opérateur AWS Load Balancer:

ROLE_ARN=$(aws iam create-role --role-name "${CLUSTER}-alb-operator" \ --assume-role-policy-document "file://${SCRATCH}/trust-policy.json" \ --query Role.Arn --output text)$ ROLE_ARN=$(aws iam create-role --role-name "${CLUSTER}-alb-operator" \ --assume-role-policy-document "file://${SCRATCH}/trust-policy.json" \ --query Role.Arn --output text)Copy to Clipboard Copied! Toggle word wrap Toggle overflow Joignez la politique AWS Load Balancer Operator au rôle IAM que nous avons créé précédemment en exécutant la commande suivante:

aws iam attach-role-policy --role-name "${CLUSTER}-alb-operator" \ --policy-arn ${POLICY_ARN}$ aws iam attach-role-policy --role-name "${CLUSTER}-alb-operator" \ --policy-arn ${POLICY_ARN}Copy to Clipboard Copied! Toggle word wrap Toggle overflow Créez un secret pour que l’opérateur AWS Load Balancer assume notre nouveau rôle AWS IAM:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Installez l’opérateur AWS Load Balancer:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Déployez une instance du contrôleur AWS Load Balancer à l’aide de l’opérateur:

NoteLorsque vous obtenez une erreur ici, attendez une minute et essayez à nouveau, cela signifie que l’opérateur n’a pas encore terminé l’installation.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Assurez-vous que les pods de l’opérateur et du contrôleur sont en cours d’exécution:

oc -n aws-load-balancer-operator get pods

$ oc -n aws-load-balancer-operator get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Il faut voir ce qui suit, sinon attendre un moment et réessayer:

NAME READY STATUS RESTARTS AGE aws-load-balancer-controller-cluster-6ddf658785-pdp5d 1/1 Running 0 99s aws-load-balancer-operator-controller-manager-577d9ffcb9-w6zqn 2/2 Running 0 2m4s

NAME READY STATUS RESTARTS AGE aws-load-balancer-controller-cluster-6ddf658785-pdp5d 1/1 Running 0 99s aws-load-balancer-operator-controller-manager-577d9ffcb9-w6zqn 2/2 Running 0 2m4sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3. Déployer un exemple d’application

Créez un nouveau projet pour notre exemple d’application:

oc new-project hello-world

$ oc new-project hello-worldCopy to Clipboard Copied! Toggle word wrap Toggle overflow Déployez une application hello world:

oc new-app -n hello-world --image=docker.io/openshift/hello-openshift

$ oc new-app -n hello-world --image=docker.io/openshift/hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow Convertissez la ressource de service pré-créée en un type de service NodePort:

oc -n hello-world patch service hello-openshift -p '{"spec":{"type":"NodePort"}}'$ oc -n hello-world patch service hello-openshift -p '{"spec":{"type":"NodePort"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow Déployer un AWS ALB à l’aide de l’opérateur AWS Load Balancer:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Curl le point de terminaison AWS ALB Ingress pour vérifier l’application hello world est accessible:

NoteAWS ALB provisioning prend quelques minutes. Lorsque vous recevez une erreur qui dit curl: (6) Ne peut pas résoudre l’hôte, s’il vous plaît attendre et essayer à nouveau.

INGRESS=$(oc -n hello-world get ingress hello-openshift-alb -o jsonpath='{.status.loadBalancer.ingress[0].hostname}') curl "http://${INGRESS}"$ INGRESS=$(oc -n hello-world get ingress hello-openshift-alb -o jsonpath='{.status.loadBalancer.ingress[0].hostname}') $ curl "http://${INGRESS}"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Hello OpenShift!

Hello OpenShift!Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3.1. Configurer l’AWS WAF

Le service AWS WAF est un pare-feu d’application Web qui vous permet de surveiller, de protéger et de contrôler les requêtes HTTP et HTTPS qui sont transmises à vos ressources d’application Web protégées, comme ROSA.

Créer un fichier de règles AWS WAF pour s’appliquer à notre ACL web:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Cela activera les jeux de règles gérés Core (Common) et SQL AWS.

Créer un AWS WAF Web ACL en utilisant les règles que nous avons spécifiées ci-dessus:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Annotez la ressource Ingress avec AWS WAF Web ACL ARN:

oc annotate -n hello-world ingress.networking.k8s.io/hello-openshift-alb \ alb.ingress.kubernetes.io/wafv2-acl-arn=${WAF_ARN}$ oc annotate -n hello-world ingress.networking.k8s.io/hello-openshift-alb \ alb.ingress.kubernetes.io/wafv2-acl-arn=${WAF_ARN}Copy to Clipboard Copied! Toggle word wrap Toggle overflow Attendez 10 secondes pour que les règles se propagent et testent que l’application fonctionne toujours:

curl "http://${INGRESS}"$ curl "http://${INGRESS}"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Hello OpenShift!

Hello OpenShift!Copy to Clipboard Copied! Toggle word wrap Toggle overflow Essayez que la WAF nie une mauvaise demande:

curl -X POST "http://${INGRESS}" \ -F "user='<script><alert>Hello></alert></script>'"$ curl -X POST "http://${INGRESS}" \ -F "user='<script><alert>Hello></alert></script>'"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteL’activation de l’intégration AWS WAF peut parfois prendre plusieurs minutes. Dans le cas où vous ne recevez pas une erreur 403 interdite, veuillez attendre quelques secondes et essayer à nouveau.

Le résultat attendu est une erreur 403 interdite, ce qui signifie que le WAF AWS protège votre application.

Chapitre 8. Déploiement de l’API OpenShift pour la protection des données sur un cluster ROSA

Ce contenu est rédigé par des experts de Red Hat, mais n’a pas encore été testé sur toutes les configurations prises en charge.

Conditions préalables

- Cluster classique ROSA

Environnement

Élaborer les variables de l’environnement:

NoteChangez le nom du cluster pour correspondre à votre cluster ROSA et assurez-vous d’être connecté au cluster en tant qu’administrateur. Assurez-vous que tous les champs sont affichés correctement avant de passer à autre chose.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

8.1. Créer un compte AWS

Créer une politique IAM pour permettre l’accès S3:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Créer une politique de confiance du rôle de l’IAM pour le cluster:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Joindre la politique de l’IAM au rôle de l’IAM:

aws iam attach-role-policy --role-name "${ROLE_NAME}" \ --policy-arn ${POLICY_ARN}$ aws iam attach-role-policy --role-name "${ROLE_NAME}" \ --policy-arn ${POLICY_ARN}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

8.2. Déployer OADP sur le cluster

Créer un espace de noms pour OADP:

oc create namespace openshift-adp

$ oc create namespace openshift-adpCopy to Clipboard Copied! Toggle word wrap Toggle overflow Créer un secret d’identification:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- <aws_region> par la région AWS à utiliser pour le point d’extrémité du service de jeton de sécurité (STS).

Déployer l’opérateur OADP:

NoteIl y a actuellement un problème avec la version 1.1 de l’opérateur avec des sauvegardes qui ont un statut PartiallyFailed. Cela ne semble pas affecter le processus de sauvegarde et de restauration, mais il convient de noter qu’il y a des problèmes avec lui.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Attendez que l’opérateur soit prêt:

watch oc -n openshift-adp get pods

$ watch oc -n openshift-adp get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME READY STATUS RESTARTS AGE openshift-adp-controller-manager-546684844f-qqjhn 1/1 Running 0 22s

NAME READY STATUS RESTARTS AGE openshift-adp-controller-manager-546684844f-qqjhn 1/1 Running 0 22sCopy to Clipboard Copied! Toggle word wrap Toggle overflow Créer le stockage en nuage:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Consultez la classe de stockage par défaut de votre application:

oc get pvc -n <namespace>

$ oc get pvc -n <namespace>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Entrez l’espace de noms de votre application.

Exemple de sortie

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE applog Bound pvc-351791ae-b6ab-4e8b-88a4-30f73caf5ef8 1Gi RWO gp3-csi 4d19h mysql Bound pvc-16b8e009-a20a-4379-accc-bc81fedd0621 1Gi RWO gp3-csi 4d19h

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE applog Bound pvc-351791ae-b6ab-4e8b-88a4-30f73caf5ef8 1Gi RWO gp3-csi 4d19h mysql Bound pvc-16b8e009-a20a-4379-accc-bc81fedd0621 1Gi RWO gp3-csi 4d19hCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc get storageclass

$ oc get storageclassCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME PROVISIONER RECLAIMPOLICY VOLUMEBINDINGMODE ALLOWVOLUMEEXPANSION AGE gp2 kubernetes.io/aws-ebs Delete WaitForFirstConsumer true 4d21h gp2-csi ebs.csi.aws.com Delete WaitForFirstConsumer true 4d21h gp3 ebs.csi.aws.com Delete WaitForFirstConsumer true 4d21h gp3-csi (default) ebs.csi.aws.com Delete WaitForFirstConsumer true 4d21h

NAME PROVISIONER RECLAIMPOLICY VOLUMEBINDINGMODE ALLOWVOLUMEEXPANSION AGE gp2 kubernetes.io/aws-ebs Delete WaitForFirstConsumer true 4d21h gp2-csi ebs.csi.aws.com Delete WaitForFirstConsumer true 4d21h gp3 ebs.csi.aws.com Delete WaitForFirstConsumer true 4d21h gp3-csi (default) ebs.csi.aws.com Delete WaitForFirstConsumer true 4d21hCopy to Clipboard Copied! Toggle word wrap Toggle overflow En utilisant gp3-csi, gp2-csi, gp3 ou gp2 fonctionneront. Dans le cas où les applications sauvegardées sont toutes utilisées par PV avec CSI, incluez le plugin CSI dans la configuration OADP DPA.

CSI seulement: Déployer une application de protection des données:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow NoteLorsque vous exécutez cette commande pour les volumes CSI, vous pouvez passer l’étape suivante.

Les volumes non CSI: Déployer une application de protection des données:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- Dans les environnements OADP 1.1.x ROSA STS, la valeur de sauvegarde et de restauration d’image de conteneur (spec.backupImages) doit être définie sur false car elle n’est pas prise en charge.

- La fonction Restic (restic.enable=false) est désactivée et n’est pas prise en charge dans les environnements ROSA STS.

- La fonction DataMover (dataMover.enable=false) est désactivée et n’est pas prise en charge dans les environnements ROSA STS.

8.3. Effectuer une sauvegarde

L’échantillon suivant d’application hello-world n’a pas de volumes persistants attachés. La configuration DPA fonctionnera.

Créer une charge de travail pour sauvegarder:

oc create namespace hello-world oc new-app -n hello-world --image=docker.io/openshift/hello-openshift

$ oc create namespace hello-world $ oc new-app -n hello-world --image=docker.io/openshift/hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exposer l’itinéraire:

oc expose service/hello-openshift -n hello-world

$ oc expose service/hello-openshift -n hello-worldCopy to Clipboard Copied! Toggle word wrap Toggle overflow Assurez-vous que l’application fonctionne:

curl `oc get route/hello-openshift -n hello-world -o jsonpath='{.spec.host}'`$ curl `oc get route/hello-openshift -n hello-world -o jsonpath='{.spec.host}'`Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Hello OpenShift!

Hello OpenShift!Copy to Clipboard Copied! Toggle word wrap Toggle overflow Sauvegardez la charge de travail:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Attendez que la sauvegarde soit faite:

watch "oc -n openshift-adp get backup hello-world -o json | jq .status"

$ watch "oc -n openshift-adp get backup hello-world -o json | jq .status"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow B) Supprimer la charge de travail de démonstration:

oc delete ns hello-world

$ oc delete ns hello-worldCopy to Clipboard Copied! Toggle word wrap Toggle overflow La restauration à partir de la sauvegarde:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Attendez que la restauration se termine:

watch "oc -n openshift-adp get restore hello-world -o json | jq .status"

$ watch "oc -n openshift-adp get restore hello-world -o json | jq .status"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Assurez-vous que la charge de travail est restaurée:

oc -n hello-world get pods

$ oc -n hello-world get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME READY STATUS RESTARTS AGE hello-openshift-9f885f7c6-kdjpj 1/1 Running 0 90s

NAME READY STATUS RESTARTS AGE hello-openshift-9f885f7c6-kdjpj 1/1 Running 0 90sCopy to Clipboard Copied! Toggle word wrap Toggle overflow curl `oc get route/hello-openshift -n hello-world -o jsonpath='{.spec.host}'`$ curl `oc get route/hello-openshift -n hello-world -o jsonpath='{.spec.host}'`Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Hello OpenShift!

Hello OpenShift!Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Conseils de dépannage s’il vous plaît consulter la documentation de dépannage de l’équipe OADP

- D’autres exemples d’applications peuvent être trouvés dans le répertoire des exemples d’applications de l’équipe OADP

8.4. Le nettoyage

B) Supprimer la charge de travail:

oc delete ns hello-world

$ oc delete ns hello-worldCopy to Clipboard Copied! Toggle word wrap Toggle overflow Enlevez les ressources de sauvegarde et de restauration du cluster si elles ne sont plus nécessaires:

oc delete backups.velero.io hello-world oc delete restores.velero.io hello-world

$ oc delete backups.velero.io hello-world $ oc delete restores.velero.io hello-worldCopy to Clipboard Copied! Toggle word wrap Toggle overflow De supprimer la sauvegarde/restauration et les objets distants dans s3:

velero backup delete hello-world velero restore delete hello-world

$ velero backup delete hello-world $ velero restore delete hello-worldCopy to Clipboard Copied! Toggle word wrap Toggle overflow Effacer l’application de protection des données:

oc -n openshift-adp delete dpa ${CLUSTER_NAME}-dpa$ oc -n openshift-adp delete dpa ${CLUSTER_NAME}-dpaCopy to Clipboard Copied! Toggle word wrap Toggle overflow Effacer le stockage en nuage:

oc -n openshift-adp delete cloudstorage ${CLUSTER_NAME}-oadp$ oc -n openshift-adp delete cloudstorage ${CLUSTER_NAME}-oadpCopy to Clipboard Copied! Toggle word wrap Toggle overflow AvertissementEn cas de suspension de cette commande, vous devrez peut-être supprimer le finalisateur:

oc -n openshift-adp patch cloudstorage ${CLUSTER_NAME}-oadp -p '{"metadata":{"finalizers":null}}' --type=merge$ oc -n openshift-adp patch cloudstorage ${CLUSTER_NAME}-oadp -p '{"metadata":{"finalizers":null}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow Enlevez l’opérateur s’il n’est plus nécessaire:

oc -n openshift-adp delete subscription oadp-operator

$ oc -n openshift-adp delete subscription oadp-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Enlever l’espace de noms de l’opérateur:

oc delete ns redhat-openshift-adp

$ oc delete ns redhat-openshift-adpCopy to Clipboard Copied! Toggle word wrap Toggle overflow Supprimez les Définitions de ressources personnalisées du cluster si vous ne souhaitez plus les avoir:

for CRD in `oc get crds | grep velero | awk '{print $1}'`; do oc delete crd $CRD; done $ for CRD in `oc get crds | grep -i oadp | awk '{print $1}'`; do oc delete crd $CRD; done$ for CRD in `oc get crds | grep velero | awk '{print $1}'`; do oc delete crd $CRD; done $ for CRD in `oc get crds | grep -i oadp | awk '{print $1}'`; do oc delete crd $CRD; doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow Effacer le seau AWS S3:

aws s3 rm s3://${CLUSTER_NAME}-oadp --recursive aws s3api delete-bucket --bucket ${CLUSTER_NAME}-oadp$ aws s3 rm s3://${CLUSTER_NAME}-oadp --recursive $ aws s3api delete-bucket --bucket ${CLUSTER_NAME}-oadpCopy to Clipboard Copied! Toggle word wrap Toggle overflow Détachez la politique du rôle:

aws iam detach-role-policy --role-name "${ROLE_NAME}" \ --policy-arn "${POLICY_ARN}"$ aws iam detach-role-policy --role-name "${ROLE_NAME}" \ --policy-arn "${POLICY_ARN}"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Effacer le rôle:

aws iam delete-role --role-name "${ROLE_NAME}"$ aws iam delete-role --role-name "${ROLE_NAME}"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Chapitre 9. Tutoriel: AWS Load Balancer Operator sur ROSA

Ce contenu est rédigé par des experts de Red Hat, mais n’a pas encore été testé sur toutes les configurations prises en charge.

Les balanceurs de charge créés par AWS Load Balancer Operator ne peuvent pas être utilisés pour les routes OpenShift, et ne doivent être utilisés que pour des services individuels ou des ressources d’entrée qui n’ont pas besoin des capacités de la couche 7 complète d’une route OpenShift.

Le contrôleur AWS Load Balancer gère AWS Elastic Load Balancers pour un cluster Red Hat OpenShift Service sur AWS (ROSA). Le contrôleur prévoit AWS Application Load Balancers (ALB) lorsque vous créez des ressources Kubernetes Ingress et AWS Network Load Balancers (NLB) lorsque vous implémentez des ressources Kubernetes Service avec un type de LoadBalancer.

Comparé au fournisseur d’équilibrage de charge AWS par défaut, ce contrôleur est développé avec des annotations avancées pour les ALB et les NLB. Certains cas d’utilisation avancés sont:

- En utilisant des objets natives Kubernetes Ingress avec ALBs

- Intégrez les ALB au service AWS Web Application Firewall (WAF)

- Spécifiez les plages IP de source NLB personnalisées

- Indiquez les adresses IP internes NLB personnalisées

L’opérateur AWS Load Balancer est utilisé pour installer, gérer et configurer une instance de contrôleur aws-charge-balancer dans un cluster ROSA.

9.1. Conditions préalables

Les ALB AWS nécessitent un cluster multi-AZ, ainsi que trois sous-réseaux publics répartis en trois AZ dans le même VPC que le cluster. Cela rend les ALB inadaptés à de nombreux clusters PrivateLink. Les NLB AWS n’ont pas cette restriction.

- Cluster classique ROSA multi-AZ

- BYO VPC cluster

- AWS CLI

- CLI D’OCC

9.1.1. Environnement

Élaborer les variables de l’environnement:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

9.1.2. AWS VPC et sous-réseaux

Cette section ne s’applique qu’aux clusters qui ont été déployés dans des VPC existants. Dans le cas où vous n’avez pas déployé votre cluster dans un VPC existant, sautez cette section et passez à la section d’installation ci-dessous.

Définissez les variables ci-dessous aux valeurs appropriées pour votre déploiement ROSA:

export VPC_ID=<vpc-id> export PUBLIC_SUBNET_IDS=<public-subnets> export PRIVATE_SUBNET_IDS=<private-subnets> export CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}")$ export VPC_ID=<vpc-id> $ export PUBLIC_SUBNET_IDS=<public-subnets> $ export PRIVATE_SUBNET_IDS=<private-subnets> $ export CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}")Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez une balise au VPC de votre cluster avec le nom du cluster:

aws ec2 create-tags --resources ${VPC_ID} --tags Key=kubernetes.io/cluster/${CLUSTER_NAME},Value=owned --region ${REGION}$ aws ec2 create-tags --resources ${VPC_ID} --tags Key=kubernetes.io/cluster/${CLUSTER_NAME},Value=owned --region ${REGION}Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ajoutez une étiquette à vos sous-réseaux publics:

aws ec2 create-tags \ --resources ${PUBLIC_SUBNET_IDS} \ --tags Key=kubernetes.io/role/elb,Value='' \ --region ${REGION}$ aws ec2 create-tags \ --resources ${PUBLIC_SUBNET_IDS} \ --tags Key=kubernetes.io/role/elb,Value='' \ --region ${REGION}Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ajouter une balise à vos sous-réseaux privés:

aws ec2 create-tags \ --resources "${PRIVATE_SUBNET_IDS}" \ --tags Key=kubernetes.io/role/internal-elb,Value='' \ --region ${REGION}$ aws ec2 create-tags \ --resources "${PRIVATE_SUBNET_IDS}" \ --tags Key=kubernetes.io/role/internal-elb,Value='' \ --region ${REGION}Copy to Clipboard Copied! Toggle word wrap Toggle overflow

9.2. Installation

Créez une stratégie AWS IAM pour le contrôleur AWS Load Balancer:

NoteLa stratégie provient de la stratégie AWS Load Balancer Controller en amont, plus l’autorisation de créer des balises sur les sous-réseaux. Ceci est requis par l’opérateur pour fonctionner.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Créez une politique de confiance AWS IAM pour AWS Load Balancer Operator:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Créer un rôle AWS IAM pour l’opérateur AWS Load Balancer:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Créez un secret pour que l’opérateur AWS Load Balancer assume notre nouveau rôle AWS IAM:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Installez l’opérateur AWS Load Balancer:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Déployez une instance du contrôleur AWS Load Balancer à l’aide de l’opérateur:

NoteLorsque vous obtenez une erreur ici, attendez une minute et essayez à nouveau, cela signifie que l’opérateur n’a pas encore terminé l’installation.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Assurez-vous que les pods de l’opérateur et du contrôleur sont en cours d’exécution:

oc -n aws-load-balancer-operator get pods

$ oc -n aws-load-balancer-operator get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Il faut voir ce qui suit, sinon attendre un moment et réessayer:

NAME READY STATUS RESTARTS AGE aws-load-balancer-controller-cluster-6ddf658785-pdp5d 1/1 Running 0 99s aws-load-balancer-operator-controller-manager-577d9ffcb9-w6zqn 2/2 Running 0 2m4s

NAME READY STATUS RESTARTS AGE aws-load-balancer-controller-cluster-6ddf658785-pdp5d 1/1 Running 0 99s aws-load-balancer-operator-controller-manager-577d9ffcb9-w6zqn 2/2 Running 0 2m4sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

9.3. La validation du déploiement

Créer un nouveau projet:

oc new-project hello-world

$ oc new-project hello-worldCopy to Clipboard Copied! Toggle word wrap Toggle overflow Déployez une application hello world:

oc new-app -n hello-world --image=docker.io/openshift/hello-openshift

$ oc new-app -n hello-world --image=docker.io/openshift/hello-openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow Configurez un service NodePort pour que AWS ALB se connecte à:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Déployer un AWS ALB à l’aide de l’opérateur AWS Load Balancer:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Curl le point de terminaison AWS ALB Ingress pour vérifier l’application hello world est accessible:

NoteAWS ALB provisioning prend quelques minutes. Lorsque vous recevez une erreur qui dit curl: (6) Ne peut pas résoudre l’hôte, s’il vous plaît attendre et essayer à nouveau.

INGRESS=$(oc -n hello-world get ingress hello-openshift-alb \ -o jsonpath='{.status.loadBalancer.ingress[0].hostname}') curl "http://${INGRESS}"$ INGRESS=$(oc -n hello-world get ingress hello-openshift-alb \ -o jsonpath='{.status.loadBalancer.ingress[0].hostname}') $ curl "http://${INGRESS}"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Hello OpenShift!

Hello OpenShift!Copy to Clipboard Copied! Toggle word wrap Toggle overflow Déployez une AWS NLB pour votre application hello world:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Essayez le point de terminaison AWS NLB:

NoteLe provisionnement de la NLB prend quelques minutes. Lorsque vous recevez une erreur qui dit curl: (6) Ne peut pas résoudre l’hôte, s’il vous plaît attendre et essayer à nouveau.

NLB=$(oc -n hello-world get service hello-openshift-nlb \ -o jsonpath='{.status.loadBalancer.ingress[0].hostname}') curl "http://${NLB}"$ NLB=$(oc -n hello-world get service hello-openshift-nlb \ -o jsonpath='{.status.loadBalancer.ingress[0].hostname}') $ curl "http://${NLB}"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Hello OpenShift!

Hello OpenShift!Copy to Clipboard Copied! Toggle word wrap Toggle overflow

9.4. Le nettoyage

Effacer l’espace de noms de l’application hello world (et toutes les ressources dans l’espace de noms):

oc delete project hello-world

$ oc delete project hello-worldCopy to Clipboard Copied! Toggle word wrap Toggle overflow Effacer l’opérateur AWS Load Balancer et les rôles AWS IAM:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Effacer la politique AWS IAM:

aws iam delete-policy --policy-arn $POLICY_ARN

$ aws iam delete-policy --policy-arn $POLICY_ARNCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Chapitre 10. Configuration de Microsoft Entra ID (anciennement Azure Active Directory) en tant que fournisseur d’identité

Il est possible de configurer Microsoft Entra ID (anciennement Azure Active Directory) en tant que fournisseur d’identité de cluster dans Red Hat OpenShift Service sur AWS (ROSA).

Ce tutoriel vous guide pour accomplir les tâches suivantes:

- Enregistrez une nouvelle application dans Entra ID pour l’authentification.

- Configurez l’enregistrement de l’application dans Entra ID pour inclure les revendications facultatives et de groupe dans les jetons.

- Configurez le Red Hat OpenShift Service sur AWS cluster pour utiliser Entra ID comme fournisseur d’identité.

- Accorder des autorisations supplémentaires à des groupes individuels.

10.1. Conditions préalables

- En suivant la documentation Microsoft, vous avez créé un ensemble de groupes de sécurité et d’utilisateurs assignés.

10.2. Enregistrement d’une nouvelle application dans Entra ID pour l’authentification

Afin d’enregistrer votre application dans Entra ID, créez d’abord l’URL de rappel OAuth, puis enregistrez votre application.

Procédure

Créez l’URL de rappel OAuth du cluster en modifiant les variables spécifiées et en exécutant la commande suivante:

NoteGardez à l’esprit d’enregistrer cette URL de rappel; elle sera nécessaire plus tard dans le processus.

domain=$(rosa describe cluster -c <cluster_name> | grep "DNS" | grep -oE '\S+.openshiftapps.com') echo "OAuth callback URL: https://oauth.${domain}/oauth2callback/AAD"$ domain=$(rosa describe cluster -c <cluster_name> | grep "DNS" | grep -oE '\S+.openshiftapps.com') echo "OAuth callback URL: https://oauth.${domain}/oauth2callback/AAD"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Le répertoire "AAD" à la fin de l’URL de rappel OAuth doit correspondre au nom du fournisseur d’identité OAuth que vous configurerez plus tard dans ce processus.

Créez l’application Entra ID en vous connectant au portail Azure et sélectionnez la lame d’enregistrement de l’application. Ensuite, sélectionnez Nouvelle inscription pour créer une nouvelle application.

- Indiquez l’application, par exemple openshift-auth.

- Choisissez Web dans la liste déroulante Redirect URI et entrez la valeur de l’URL de rappel OAuth que vous avez récupérée dans l’étape précédente.

Après avoir fourni les informations requises, cliquez sur S’inscrire pour créer l’application.

Choisissez la sous-lame Certificats & secrets et sélectionnez Nouveau secret client.

Complétez les détails demandés et stockez la valeur secrète du client générée. Ce secret est nécessaire plus tard dans ce processus.

ImportantAprès la configuration initiale, vous ne pouvez pas voir le secret client. « si vous n’avez pas enregistré le secret client, vous devez en générer un nouveau.

Choisissez la sous-lame Aperçu et notez l’ID de l’Application (client) et l’ID d’annuaire (locataire). Il vous faudra ces valeurs dans une étape future.

10.3. Configuration de l’enregistrement de l’application dans Entra ID pour inclure les revendications facultatives et de groupe