This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.第24章 永続ストレージの設定

24.1. 概要

Kubernetes の永続ボリュームフレームワークにより、お使いの環境で利用可能なネットワークストレージを使用して、OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これは、アプリケーションのニーズに応じて初回 OpenShift Container Platform インストールの完了後に行うことができ、ユーザーは基礎となるインフラストラクチャーの知識がなくてもこれらのリソースを要求できるようになります。

このトピックでは、以下のサポートされるボリュームプラグインを使って永続ボリュームを OpenShift Container Platform で設定する方法を説明します。

24.2. NFS を使用した永続ストレージ

24.2.1. 概要

OpenShift Container Platform クラスターは、NFS を使用している永続ストレージを使ってプロビジョニングすることが可能です。永続ボリューム (PV) および Persistent Volume Claim (永続ボリューム要求、PVC) は、プロジェクト全体でボリュームを共有するための便利な方法を提供します。PV 定義に含まれる NFS に固有の情報は、Pod 定義で直接定義することも可能ですが、この方法の場合にはボリュームが一意のクラスターリソースとして作成されされないため、ボリュームが競合の影響を受けやすくなります。

このトピックでは、NFS 永続ストレージタイプの具体的な使用方法について説明します。OpenShift Container Platform と NFS についてある程度理解していることを前提とします。OpenShift Container Platform 永続ボリューム (PV) の一般的なフレームワークの詳細は永続ストレージの概念に関するトピックを参照してください。

24.2.2. プロビジョニング

OpenShift Container Platform でストレージをボリュームとしてマウントするには、ストレージがあらかじめ基礎となるインフラストラクチャーに存在している必要があります。NFS ボリュームをプロビジョニングするには、NFS サーバーの一覧とエクスポートパスのみが必要です。

最初に、PV のオブジェクト定義を作成します。

例24.1 NFS を使用した PV オブジェクト定義

- 1

- ボリュームの名前。これは、各種の

oc <command> podコマンドの PV アイデンティティーです。 - 2

- このボリュームに割り当てられるストレージの量。

- 3

- これはボリュームへのアクセスの制御に関連するように見えますが、実際はラベルの場合と同様に、PVC を PV に一致させるために使用されます。現時点では、

accessModesに基づくアクセスルールは適用されていません。 - 4

- 使用されているボリュームタイプ。この場合は nfs プラグインです。

- 5

- NFS サーバーがエクスポートしているパス。

- 6

- NFS サーバーのホスト名または IP アドレス

- 7

- PV の回収ポリシー。ボリュームが要求から解放されるタイミングでボリュームで実行されることを定義します。有効な選択肢は Retain (デフォルト) と Recycle です。「リソースの回収」を参照してください。

各 NFS ボリュームは、クラスター内のスケジュール可能なすべてのノードによってマウント可能でなければなりません。

定義をファイル (nfs-pv.yaml など) に保存し、PV を作成します。

oc create -f nfs-pv.yaml persistentvolume "pv0001" created

$ oc create -f nfs-pv.yaml

persistentvolume "pv0001" createdPV が作成されたことを確認します。

oc get pv NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE pv0001 <none> 5368709120 RWO Available 31s

# oc get pv

NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE

pv0001 <none> 5368709120 RWO Available 31s以下の手順で PVC が作成されます。これは新規 PV にバインドされます。

例24.2 PVC オブジェクト定義

定義をファイル (nfs-claim.yaml など) に保存し、PVC を作成します。

oc create -f nfs-claim.yaml

# oc create -f nfs-claim.yaml24.2.3. ディスククォータの実施

ディスクパーティションを使用して、ディスククォータとサイズ制限を実施することができます。それぞれのパーティションを独自のエクスポートとすることができ、それぞれのエクスポートは 1 つの PV になります。OpenShift Container Platform は PV に固有の名前を適用しますが、NFS ボリュームのサーバーとパスの一意性については管理者に委ねられています。

この方法でクォータを有効にすると、開発者は永続ストレージを具体的な量 (10Gi など) を指定して要求し、この容量以上が設定されている対応のボリュームに適合できます。

24.2.4. NFS ボリュームのセキュリティー

このセクションでは、一致するパーミッションや SELinux の考慮点を含む、NFS ボリュームのセキュリティーについて説明します。ユーザーは、POSIX パーミッションやプロセス UID、補助グループおよび SELinux の基礎的な点を理解している必要があります。

NFS ボリュームを実装する前に 「ボリュームのセキュリティー」のトピックをすべてお読みください。

開発者は、Pod 定義の volumes セクションで、PVC を名前で参照するか、または NFS ボリュームのプラグインを直接参照して NFS ストレージを要求します。

NFS サーバーの /etc/exports ファイルにはアクセス可能な NFS ディレクトリーが含まれています。ターゲットの NFS ディレクトリーには、POSIX の所有者とグループ ID があります。OpenShift Container Platform NFS プラグインは、同じ POSIX の所有者とエクスポートされる NFS ディレクトリーにあるパーミッションを使って、コンテナーの NFS ディレクトリーをマウントします。ただし、コンテナーは NFS マウントの所有者と同等の実効 UID では実行されません。これは期待される動作です。

ターゲットの NFS ディレクトリーが NFS サーバーに表示される場合を例に取って見てみましょう。

ls -lZ /opt/nfs -d drwxrws---. nfsnobody 5555 unconfined_u:object_r:usr_t:s0 /opt/nfs id nfsnobody uid=65534(nfsnobody) gid=65534(nfsnobody) groups=65534(nfsnobody)

# ls -lZ /opt/nfs -d

drwxrws---. nfsnobody 5555 unconfined_u:object_r:usr_t:s0 /opt/nfs

# id nfsnobody

uid=65534(nfsnobody) gid=65534(nfsnobody) groups=65534(nfsnobody)コンテナーは SELinux ラベルと一致している必要があり、ディレクトリーにアクセスするために UID 65534 (nfsnobody 所有者) か、または補助グループの 5555 のいずれかを使って実行する必要があります。

ここで、所有者 ID 65534 は一例として使用されています。NFS の root_squash が root (0) を nfsnobody (65534) にマップしても、NFS エクスポートは任意の所有者 ID を持つことができます。所有者 65534 は NFS エクスポートには必要ありません。

24.2.4.1. グループ ID

NFS アクセスに対応する際の推奨される方法として、補助グループを使用することができます (NFS エクスポートのパーミッションを変更するオプションがないことを前提としています)。OpenShift Container Platform の補助グループは共有ストレージに使用されます (例: NFS)。これとは対照的に、Ceph RBD や iSCSI などのブロックストレージは、Pod の securityContext で fsGroup SCC ストラテジーと fsGroup の値を使用します。

一般的に、永続ストレージへのアクセスを取得する場合、ユーザー ID ではなく補助グループ ID を使用することが推奨されます。補助グループについては「ボリュームのセキュリティー」トピックで詳しく説明されています。

上記のターゲット NFS ディレクトリーの例で使用したグループ ID は 5555 なので、Pod は、supplementalGroups を使用してグループ ID を Pod レベルの securityContext 定義の下で定義することができます。以下は例になります。

Pod の要件を満たすカスタム SCC が存在しない場合、Pod は 制限付きの SCC に一致する可能性があります。この SCC では、supplementalGroups ストラテジーが RunAsAny に設定されています。これは、指定されるグループ ID は範囲のチェックなしに受け入れられることを意味します。

その結果、上記の Pod は受付をパスして起動します。しかし、グループ ID の範囲をチェックすることが望ましい場合は、「Pod のセキュリティーとカスタム SCC」で説明されているようにカスタム SCC の使用が推奨されます。カスタム SCC は、最小および最大のグループ ID が定義され、グループ ID の範囲チェックが実施され、グループ ID 5555 が許可されるように作成できます。

カスタム SCC を使用するには、最初にそこに適切なサービスアカウントを追加しておく必要があります。たとえば、所定のプロジェクトでは、Pod 仕様において別のサービスアカウントが指定されていない限り、default のサービスアカウントを使用してください。詳細は、「SCC のユーザー、グループまたはプロジェクトへの追加」を参照してください。

24.2.4.2. ユーザー ID

ユーザー ID は、コンテナーイメージまたは Pod 定義で定義できます。ユーザー ID に基づいてストレージアクセスを制御する方法については、「ボリュームのセキュリティー」のトピックで説明されています。NFS 永続ストレージをセットアップする前に、必ず読んでおいてください。

永続ストレージへのアクセスを取得する場合、通常はユーザー ID ではなく 補助グループ ID を使用することが推奨されます。

上記の ターゲット NFS ディレクトリーの例 では、コンテナーは UID を 65534 (ここではグループ ID を省略します) に設定する必要があります。したがって以下を Pod 定義に追加することができます。

デフォルトのプロジェクトと制限付き SCC を前提とする場合は、Pod が要求するユーザー ID 65534 は許可されず、Pod は失敗します。Pod が失敗する理由は以下の通りです。

- 65534 をユーザー ID として要求している。

- ユーザー ID 65534 を許可する SCC を確認するために Pod で利用できるすべての SCC が検査される (実際は SCC のすべてのポリシーがチェックされますが、ここでのフォーカスはユーザー ID になります)。

-

利用可能なすべての SCC は

runAsUserストラテジーに MustRunAsRange を使用するため、UID の範囲チェックが必要である。 - 65534 は SCC またはプロジェクトのユーザー ID 範囲に含まれていない。

一般に、事前定義された SCC は変更しないことが勧められています。ただし、この状況を改善するには、「ボリュームのセキュリティー」のトピックで説明されているようにカスタム SCC を作成することが推奨されます。カスタム SCC は、最小および最大のユーザー ID が定義され、UID 範囲のチェックの実施が設定されており、UID 65534 が許可されるように作成できます。

カスタム SCC を使用するには、最初にそこに適切なサービスアカウントを追加しておく必要があります。たとえば、所定のプロジェクトでは、Pod 仕様において別のサービスアカウントが指定されていない限り、default のサービスアカウントを使用してください。詳細は、「SCC のユーザー、グループまたはプロジェクトへの追加」を参照してください。

24.2.4.3. SELinux

SELinux を使用してストレージアクセスを制御する方法についての詳細は、「ボリュームのセキュリティー」を参照してください。

デフォルトでは、SELinux は Pod からリモートの NFS サーバーへの書き込みを許可していません。NFS ボリュームは正常にマウントされますが、読み取り専用です。

SELinux を各ノードで有効にした状態で NFS ボリュームへの書き込みを有効にするには、以下を実行します。

setsebool -P virt_use_nfs 1

# setsebool -P virt_use_nfs 1

上記の -P オプションは、ブール値をリブート間で継続させます。

virt_use_nfs ブール値は docker-selinux パッケージで定義されます。このブール値が定義されていないことを示すエラーが表示された場合は、このパッケージがインストールされていることを確認してください。

24.2.4.4. エクスポート設定

任意のコンテナーユーザーにボリュームの読み取りと書き出しを許可するには、NFS サーバーにエクスポートされる各ボリュームは以下の条件を満たしている必要があります。

各エクスポートを以下のように指定します。

/<example_fs> *(rw,root_squash)

/<example_fs> *(rw,root_squash)Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイアウォールは、マウントポイントへのトラフィックを許可するように設定する必要があります。

NFSv4 の場合、デフォルトのポート

2049(nfs) とポート111(portmapper) を設定します。NFSv4

iptables -I INPUT 1 -p tcp --dport 2049 -j ACCEPT iptables -I INPUT 1 -p tcp --dport 111 -j ACCEPT

# iptables -I INPUT 1 -p tcp --dport 2049 -j ACCEPT # iptables -I INPUT 1 -p tcp --dport 111 -j ACCEPTCopy to Clipboard Copied! Toggle word wrap Toggle overflow NFSv3 の場合、以下の 3 つのポートを設定します。

2049(nfs)、20048(mountd)、111(portmapper)。NFSv3

iptables -I INPUT 1 -p tcp --dport 2049 -j ACCEPT iptables -I INPUT 1 -p tcp --dport 20048 -j ACCEPT iptables -I INPUT 1 -p tcp --dport 111 -j ACCEPT

# iptables -I INPUT 1 -p tcp --dport 2049 -j ACCEPT # iptables -I INPUT 1 -p tcp --dport 20048 -j ACCEPT # iptables -I INPUT 1 -p tcp --dport 111 -j ACCEPTCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

NFS エクスポートとディレクトリーは、ターゲット Pod からアクセスできるようにセットアップされる必要があります。この場合、エクスポートをコンテナーのプライマリー UID で所有されるように設定するか、または上記の「グループ ID」で説明したように、

supplementalGroupsを使用して Pod にグループアクセスを付与します。Pod のセキュリティーに関する追加情報は、「ボリュームのセキュリティー」のトピックを参照してください。

24.2.5. リソースの回収

NFS は OpenShift Container Platform の 再利用可能な プラグインインターフェースを実装します。回収タスクは、それぞれの永続ボリュームに設定されるポリシーに基づいて自動プロセスによって処理されます。

デフォルトでは、PV は Retain に設定されます。Recycle に設定される NFS ボリュームは、要求からの解放後 (このボリュームにバインドされるユーザーの PersistentVolumeClaim の削除後) に除去されます ( rm -rf がこのボリュームで実行されます)。リサイクルされた NFS ボリュームは新規の要求にバインドさせることができます。

PV への要求が解除される (PVC が削除される) と、PV オブジェクトは再利用できません。代わりに、新規の PV が元のボリュームと同じ基本ボリューム情報を使って作成されます。

たとえば、管理者は nfs1 という名前の PV を作成するとします。

ユーザーは、nfs1 にバインドされる PVC1 を作成します。次にユーザーは PVC1 を削除し、nfs1 への要求を解除します。これにより、nfs1 は Released になります。管理者が同じ NFS 共有を利用可能にする必要がある場合には、同じ NFS サーバー情報を使って新規 PV を作成する必要があります。この場合、PV の名前は元の名前とは異なる名前にします。

元の PV を削除して、PV を同じ名前で再作成することは推奨されません。PV のステータスを Released から Available に手動で変更しようとすると、エラーが発生してデータが失われる可能性があります。

Recycle の保持ポリシーを持つ PV はデータを除去 (rm -rf を実行) し、要求について Available というマークを付けます。Recycle の保持ポリシーは、OpenShift Container Platform 3.6 以降で非推奨となっています。Recycler を利用しているユーザーは、代わりに動的プロビジョニングとボリュームの削除機能を使用してください。

24.2.6. 自動化

クラスターは、NFS を使用している永続ストレージを使って以下の方法でプロビジョニングすることができます。

- ディスクパーティションを使ってストレージクォータを実施する。

- 要求を持つプロジェクトにボリュームを制限してセキュリティーを実施する。

- 破棄されたリソースの回収を各 PV に設定する。

スクリプトを使って上記タスクを自動化する方法は多数あります。まずは Ansible Playbook のサンプルを使用して開始することができます。

24.2.7. その他の設定とトラブルシューティング

適切なエクスポートとセキュリティーマッピングを行うため、使用している NFS のバージョンおよびその設定方法に応じて追加の設定が必要になることがあります。以下は例になります。

|

NFSv4 のマウントにすべてのファイルの所有者が nobody:nobody と誤って表示される。 |

|

|

NFSv4 の ID マッピングが無効になっている |

|

24.3. Red Hat Gluster Storage を使用する永続ストレージ

24.3.1. 概要

Red Hat Gluster Storage は、OpenShift Container Platform の永続ストレージと動的プロビジョニングを提供するように設定でき、OpenShift Container Platform 内のコンテナー化ストレージ (コンバージドモード) としても、独自のノード上の非コンテナー化ストレージ (インデペンデントモード) としても使用できます。

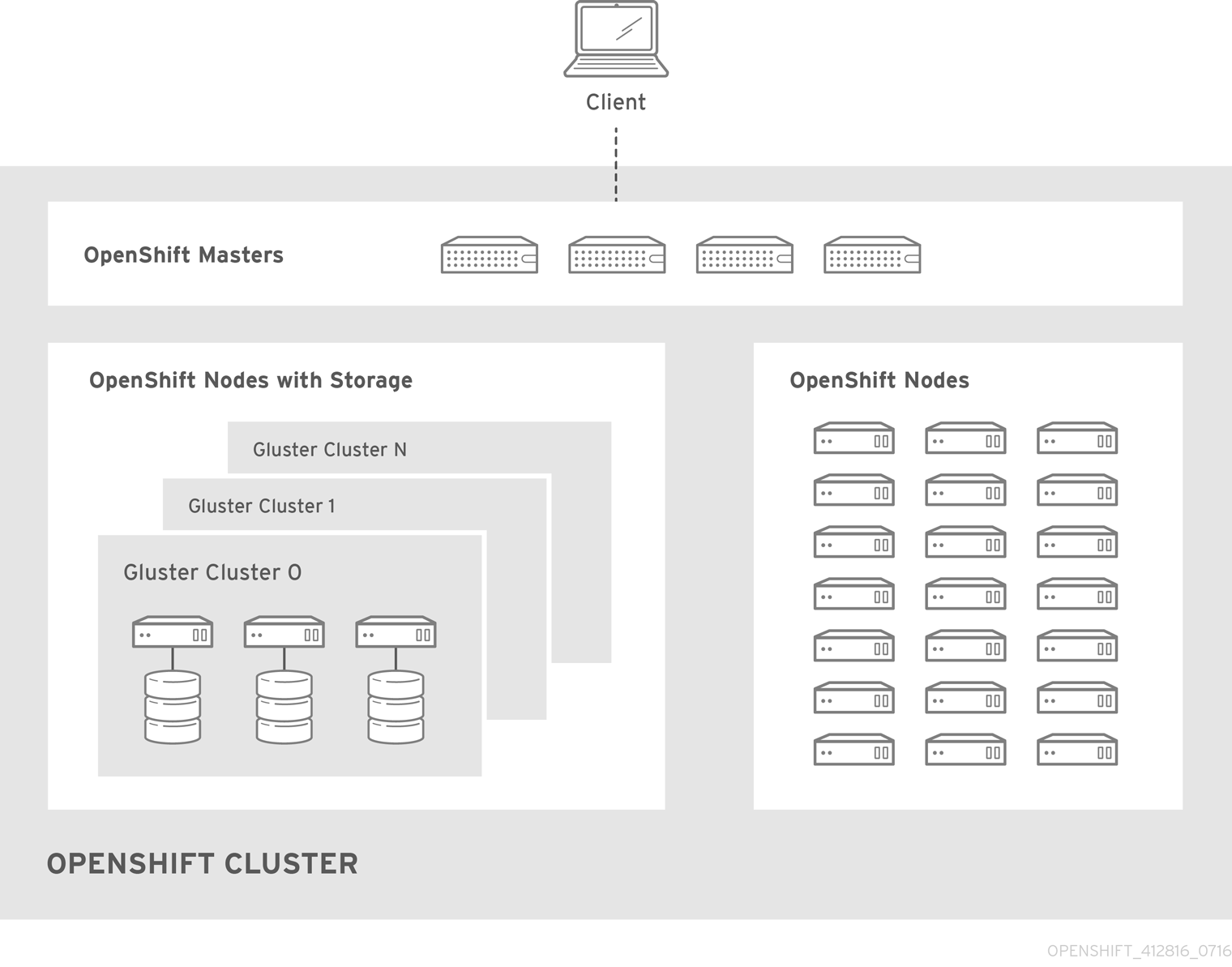

24.3.1.1. コンバージドモード

コンバージドモードの場合には、Red Hat Gluster Storage は、コンテナー化されたディレクトリーを OpenShift Container Platform ノードで直接実行します。それにより、コンピュートおよびストレージインスタンスをスケジュールでき、同じハードウェアのセットから実行することができます。

図24.1 アーキテクチャー - コンバージドモード

コンバージドモードは Red Hat Gluster Storage 3.1 update 3 より利用できます。詳細については、「converged mode for OpenShift Container Platform」を参照してください。

24.3.1.2. インデペンデントモード

インデペンデントモードの場合、Container-Ready Storage を使用することで、Red Hat Gluster Storage は独自の専用ノードで実行され、GlusterFS のボリューム管理 REST サービスの heketi のインスタンスによって管理されます。heketi サービスは、スタンドアロンまたはコンテナー化のいずれかで実行できます。コンテナー化の場合、簡単なメカニズムで高可用性をサービスに提供できます。ここでは、heketi をコンテナー化した場合の設定に焦点を当てます。

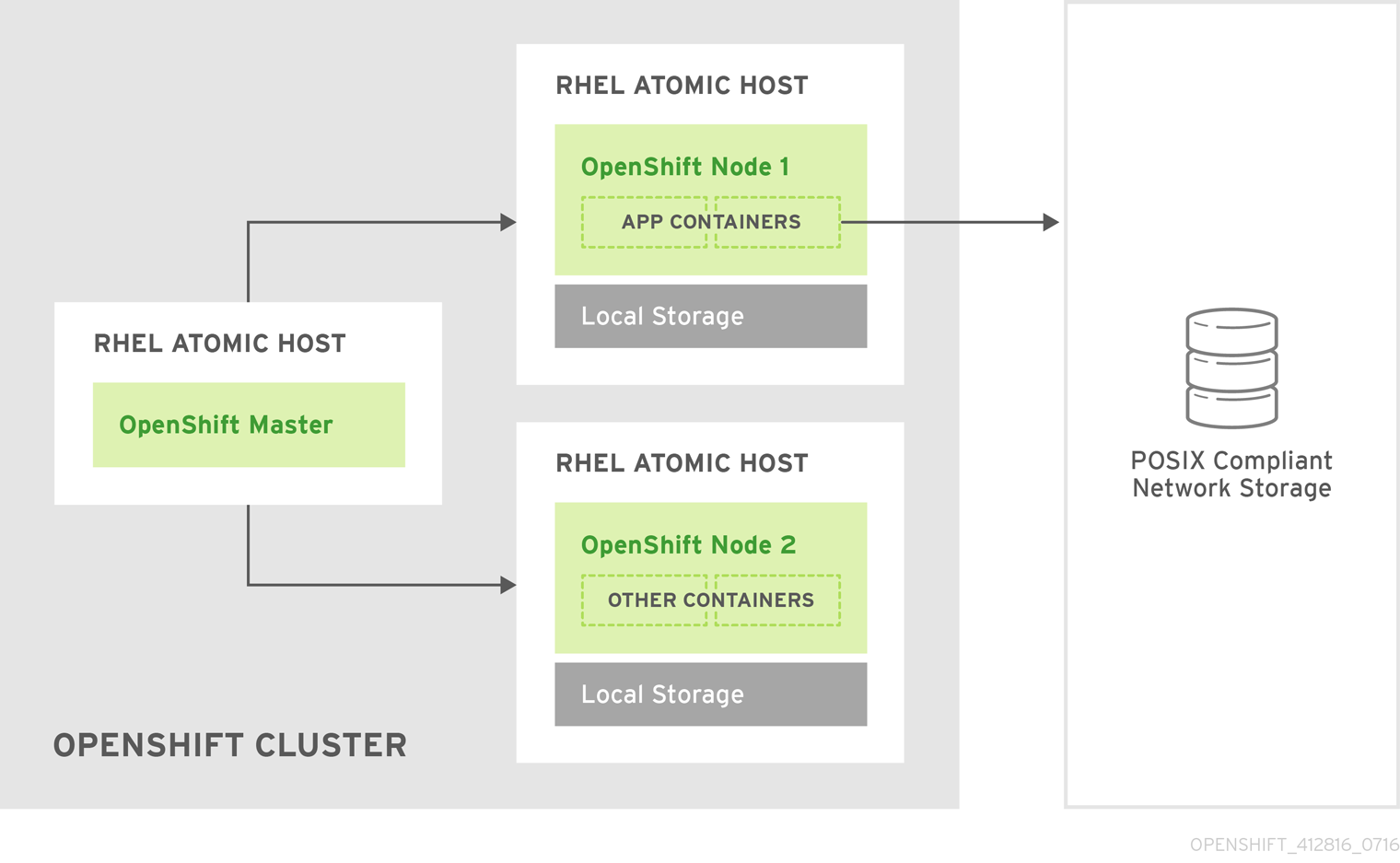

24.3.1.3. スタンドアロンの Red Hat Gluster Storage

スタンドアロンの Red Hat Gluster Storage クラスターが環境で使用できる場合、OpenShift Container Platform の GlusterFS ボリュームプラグインを使用してそのクラスター上でボリュームを使用することができます。この方法は、アプリケーションが専用のコンピュートノード、OpenShift Container Platform クラスターで実行され、ストレージはその専用ノードから提供される従来のデプロイメントです。

図24.2 アーキテクチャー - OpenShift Container Platform の GlusterFS ボリュームプラグインを使用したスタンドアロンの Red Hat Gluster Storage クラスター

Red Hat Gluster Storage の詳細については、『Red Hat Gluster Storage Installation Guide』および『Red Hat Gluster Storage Administration Guide』を参照してください。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

24.3.1.4. GlusterFS ボリューム

GlusterFS ボリュームは、POSIX に準拠したファイルシステムを提供し、クラスター上の 1 つ以上のノードにまたがる 1 つ以上の「ブリック」から構成されます。このブリックは所定のストレージノード上のディレクトリーであり、一般的にブロックストレージデバイスのマウントポイントになります。GlusterFS はボリュームの設定に応じて、所定のボリュームのブリック間でファイルの分散および複製を処理します。

heketi は、ボリューム管理において、作成、削除、サイズ変更といった一般的な操作に使用することが推奨されます。OpenShift Container Platform は、GlusterFS プロビジョナーを使用する際に heketi が存在していることを前提としています。heketi はデフォルトで、レプリカ数が 3 のボリュームを作成します。このボリュームの各ファイルには 3 つの異なるノードをまたがる 3 つのコピーがあります。したがって、heketi が使用する Red Hat Gluster Storage クラスターでは 3 つ以上のノードを利用可能にすることが推奨されます。

GlusterFS ボリュームに使用可能な機能は多数ありますが、これらについては本書では扱いません。

24.3.1.5. gluster-block ボリューム

gluster-block ボリュームは、iSCSI 上にマウントすることが可能なボリュームです。既存の GlusterFS ボリュームにファイルを作成し、そのファイルをブロックデバイスとして iSCSI ターゲットを介して提供することでマウントできます。このような GlusterFS ボリュームは、ブロックホスティングボリュームと呼ばれます。

gluster-block ボリュームにはトレードオフもあります。iSCSI ターゲットとして使用される場合、複数のノード/クライアントでマウントできる GlusterFS ボリュームとは対照的に、gluster-block ボリュームをマウントできるのは 1 回に 1 つのノード/クライアントのみです。ただし、バックエンドのファイルであるため、GlusterFS ボリュームでは一般にコストのかかる操作 (メタデータの参照など) を、GlusterFS ボリュームでの一般的により高速な操作 (読み取り、書き込みなど) に変換することが可能です。それにより、特定の負荷に対するパフォーマンスを大幅に改善できる可能性があります。

現時点では、gluster-block ボリュームは OpenShift ロギングと OpenShift メトリクスストレージにのみを使用することが推奨されます。

24.3.1.6. Gluster S3 ストレージ

Gluster S3 サービスは、ユーザーアプリケーションが S3 インターフェースを介して GlusterFS ストレージへアクセスすることを可能にします。このサービスは GlusterFS の、オブジェクトデータ用とオブジェクトメタデータ用の 2 つのボリュームにバインドされ、受信する S3 REST 要求をボリューム上のファイルシステム操作に変換します。このサービスは OpenShift Container Platform 内の Pod として実行することが推奨されます。

現時点では、Gluster S3 サービスの使用およびインストールはテクノロジープレビューの段階にあります。

24.3.2. 考慮事項

このセクションでは、Red Hat Gluster Storage を OpenShift Container Platform で使用する際に考慮すべきトピックについて取り上げます。

24.3.2.1. ソフトウェア要件

GlusterFS ボリュームにアクセスするには、すべてのスケジュール可能なノードで mount.glusterfs コマンドを利用できる必要があります。RPM ベースのシステムの場合は、glusterfs-fuse パッケージがインストールされている必要があります。

yum install glusterfs-fuse

# yum install glusterfs-fuseこのパッケージはすべての RHEL システムにインストールされています。ただし、サーバーが x86_64 アーキテクチャーを使用する場合は Red Hat Gluster Storage の最新バージョンに更新することを推奨します。そのためには、以下の RPM リポジトリーを有効にする必要があります。

subscription-manager repos --enable=rh-gluster-3-client-for-rhel-7-server-rpms

# subscription-manager repos --enable=rh-gluster-3-client-for-rhel-7-server-rpmsglusterfs-fuse がノードにすでにインストールされている場合、最新バージョンがインストールされていることを確認します。

yum update glusterfs-fuse

# yum update glusterfs-fuse24.3.2.2. ハードウェア要件

コンバージドモード (converged mode) またはインデペンデントモード (independent mode) のクラスターで使用されるノードはストレージノードとみなされます。単一ノードは複数のグループに分割できませんが、ストレージノードはそれぞれ別個のクラスターグループに分類できます。ストレージノードの各グループについては、以下が当てはまります。

- 1 グループあたり 3 つ以上のストレージノードが必要です。

各ストレージノードには 8 GB 以上の RAM が必要です。これにより、Red Hat Gluster Storage Pod、その他のアプリケーションおよび基礎となる OS を実行できます。

- 各 GlusterFS ボリュームはストレージクラスターにあるすべてのストレージノードのメモリー (約 30 MB) も消費します。RAM の合計量は、コンカレントボリュームがいくつ求められているか、またはいくつ予想されるかによって決める必要があります。

各ストレージノードには、現在のデータまたはメタデータを含まない 1 つ以上の raw ブロックデバイスが必要です。それらのブロックデバイス全体は GlusterFS ストレージで使用されます。以下が存在しないことを確認してください。

- パーティションテーブル (GPT または MSDOS)

- ファイルシステムまたは未処理のファイルシステムの署名

- 以前のボリュームグループの LVM2 署名および論理ボリューム

- LVM2 物理ボリュームの LVM2 メタデータ

不確かな場合には、

wipefs -a <device>で上記のすべてを消去する必要があります。

2 つのクラスター、つまりインフラストラクチャーアプリケーション (OpenShift Container レジストリーなど) のストレージ専用のクラスターと一般的なアプリケーションのストレージ専用のクラスターについて計画することをお勧めします。これには、合計で 6 つのストレージノードが必要となりますが、この設定は I/O およびボリューム作成のパフォーマンスへの潜在的な影響を回避するために推奨されます。

24.3.2.3. ストレージのサイジング

GlusterFS クラスターはすべて、そのストレージを利用するアプリケーションで想定される要件に基づいてサイズを決定する必要があります。たとえば、「OpenShift ロギング」と「OpenShift メトリクス」の両方に対して、サイジングガイドが提供されています。

その他考慮すべき事項:

コンバージドモードまたはインデペンデントモードのクラスターでは、デフォルトの動作により 3 通りのレプリケーションを持つ GlusterFS ボリュームが作成されます。そのため、合計のストレージの計画を立てる際には、必要な容量の 3 倍にする必要があります。

-

例として、各 heketi インスタンスは 2 GB の

heketidbstorageボリュームを作成する場合、ストレージクラスター内の 3 つのノードに合計で 6 GB の raw ストレージが必要になります。この容量は常に必要となり、これをサイジングの際に考慮する必要があります。 - 統合 OpenShift Container レジストリーなどのアプリケーションでは、GlusterFS の単一ボリュームがアプリケーションの複数インスタンスで共有されます。

-

例として、各 heketi インスタンスは 2 GB の

gluster-block ボリュームを使用する場合は、所定のブロックのボリューム容量をフルサイズで保持するための十分な容量を備えた GlusterFS ブロックホスティングボリュームがなければなりません。

- デフォルトでは、このようなブロックホスティングボリュームが存在しない場合、これが設定されたサイズで自動的に 1 つ作成されます。デフォルトのサイズは 100 GB です。クラスター内に新しいブロックホスティングボリュームを作成するための十分なスペースがない場合、ブロックボリュームの作成は失敗します。自動作成の動作、および自動作成されるボリュームのサイズはどちらも設定することが可能です。

- OpenShift ロギングや OpenShift メトリクスなどの gluster-block ボリュームを使用する複数のインスタンスを持つアプリケーションは、各インスタンスにつき 1 つのボリュームを使用します。

- Gluster S3 サービスは、2 つの GlusterFS ボリュームにバインドされます。デフォルトのクラスターインストールでは、ボリュームはそれぞれ 1 GB となり、合計 6 GB の raw ストレージを使用します。

24.3.2.4. ボリューム操作の動作

作成や削除などのボリューム操作は、さまざまな環境条件の影響を受けることもあれば、アプリケーションに影響を与えることもあります。

アプリケーション Pod が動的にプロビジョニングされた GlusterFS の Persistent Volume Claim (永続ボリューム要求、PVC) を要求する場合は、ボリュームの作成と対応する PVC へのバインドにかかる追加の時間を考慮する必要があります。これはアプリケーション Pod の起動時間に影響します。

注記GlusterFS ボリュームの作成時間は、ボリュームの数に応じて直線的に増加します。たとえば、クラスター内に推奨されるハードウェア仕様を使用する 100 のボリュームがある場合、各ボリュームの作成、割り当て、Pod へのバインドに約 6 秒の時間がかかりました。

PVC が削除されると、基礎となる GlusterFS ボリュームの削除がトリガーされます。PVC は

oc get pvcの出力からすぐに消えますが、ボリュームが完全に削除される訳ではありません。GlusterFS ボリュームは、heketi-cli volume listおよびgluster volume listのコマンドライン出力に表示されなくなったときにのみ削除されていると見なされます。注記GlusterFS ボリュームの削除とそのストレージのリサイクルの時間は、アクティブな GlusterFS ボリュームの数に応じて直線的に増加します。保留中のボリューム削除は実行中のアプリケーションに影響しませんが、ストレージ管理者は、特にリソース消費を大きな規模で調整している場合には、ボリュームの削除にかかる時間を認識し、それを見積もることができるようにしておく必要があります。

24.3.2.5. ボリュームのセキュリティー

このセクションでは、Portable Operating System Interface [Unix 向け] (POSIX) パーミッションや SELinux に関する考慮事項を含む、Red Hat Gluster Storage ボリュームのセキュリティーについて説明します。ボリュームのセキュリティー、POSIX パーミッションおよび SELinux に関する基本を理解していることを前提とします。

24.3.2.5.1. POSIX パーミッション

Red Hat Gluster Storage ボリュームは POSIX 準拠のファイルシステムを表します。そのため、chmod や chown などの標準コマンドラインツールを使用してアクセスパーミッションを管理できます。

コンバージドモードとインデペンデントモードでは、ボリュームの作成時に、ボリュームの Root を所有するグループ ID を指定することも可能です。静的なプロビジョニングでは、これは、heketi-cli ボリュームの作成コマンドの一部として指定します。

heketi-cli volume create --size=100 --gid=10001000

$ heketi-cli volume create --size=100 --gid=10001000このボリュームに関連付けられる PersistentVolume には、PersistentVolume を使用する Pod がファイルシステムにアクセスできるように、グループ ID をアノテーションとして付加する必要があります。このアノテーションは以下の形式で指定します。

pv.beta.kubernetes.io/gid: "<GID>" ---

動的プロビジョニングの場合は、プロビジョナーがグループ ID を自動的に生成し、これを適用します。gidMin および gidMax StorageClass パラメーターを使用してこのグループ ID の選択範囲を制御できます (「動的プロビジョニング」を参照してください)。プロビジョナーは、生成される PersistentVolume にグループ ID をアノテーションとして付ける処理も行います。

24.3.2.5.2. SELinux

デフォルトでは、SELinux は Pod からリモート Red Hat Gluster Storage サーバーへの書き込みを許可しません。SELinux が有効な状態で Red Hat Gluster Storage ボリュームへの書き込みを有効にするには、GlusterFS を実行する各ノードで以下のコマンドを実行します。

sudo setsebool -P virt_sandbox_use_fusefs on sudo setsebool -P virt_use_fusefs on

$ sudo setsebool -P virt_sandbox_use_fusefs on

$ sudo setsebool -P virt_use_fusefs on- 1

-Pオプションを使用すると、再起動した後もブール値が永続化されます。

virt_sandbox_use_fusefs ブール値は、docker-selinux パッケージによって定義されます。このブール値が定義されていないというエラーが表示される場合は、このパッケージがインストールされていることを確認してください。

Atomic Host を使用している場合に、Atomic Host をアップグレードすると、SELinux のブール値が消去されるので、Atomic Host をアップグレードする場合には、これらのブール値を設定し直す必要があります。

24.3.3. サポート要件

Red Hat Gluster Storage と OpenShift Container Platform のサポートされる統合を作成するには、以下の要件が満たされている必要があります。

インデペンデントモードまたは スタンドアロンの Red Hat Gluster Storage の場合:

- 最小バージョン: Red Hat Gluster Storage 3.1.3

- すべての Red Hat Gluster Storage ノードに Red Hat Network チャンネルとサブスクリプションマネージャーリポジトリーへの有効なサブスクリプションが必要です。

- Red Hat Gluster Storage ノードは、「Planning Red Hat Gluster Storage Installation」に記載されている要件に準拠している必要があります。

- Red Hat Gluster Storage ノードは、最新のパッチとアップグレードが適用された完全に最新の状態でなければなりません。最新バージョンへのアップグレードについては、『Red Hat Gluster Storage Installation Guide』を参照してください。

- 各 Red Hat Gluster Storage ノードには、完全修飾ドメイン名 (FQDN) が設定されている必要があります。適切な DNS レコードが存在すること、および FQDN が正引きと逆引きの両方の DNS ルックアップで解決できることを確認してください。

24.3.4. インストール

スタンドアロンの Red Hat Gluster Storage の場合、OpenShift Container Platform で使用するためにインストールする必要があるコンポーネントはありません。OpenShift Container Platform には組み込み GlusterFS ボリュームドライバーが付属しており、これを使用して既存のボリュームを既存のクラスターで活用できます。既存のボリュームの使用方法については、「プロビジョニング」を参照してください。

コンバージドモードおよびインデペンデントモードでは、「クラスターインストールプロセスを使用して、必要なコンポーネントをインストールすることを推奨します。

24.3.4.1. インデペンデントモード: Red Hat Gluster Storage ノードのインストール

インデペンデントモードの場合は、Red Hat Gluster Storage ノードに適切なシステム設定 (ファイアウォールポートやカーネルモジュールなど) が設定されており、Red Hat Gluster Storage サービスが実行されている必要があります。このサービスは追加で設定できず、Trusted Storage Pool を作成することはできません。

Red Hat Gluster Storage ノードのインストールは本書の対象外です。詳細については、「インデペンデントモードの設定」を参照してください。

24.3.4.2. インストーラーの使用

クラスターインストールプロセスを使用すると、2 つの GlusterFS ノードグループの 1 つまたは両方をインストールできます。

-

glusterfs: ユーザーアプリケーション用の汎用ストレージクラスター。 -

glusterfs-registry: 統合 OpenShift Container レジストリーなどのインフラストラクチャーアプリケーション用の専用ストレージクラスター。

I/O およびボリューム作成のパフォーマンスに対する潜在的影響を回避するため、両方のグループをデプロイすることを推奨します。これらはどちらもインベントリーホストファイルで定義されます。

クラスターを定義するには、[OSEv3:children] グループに該当する名前を追加し、類似した名前付きグループを作成して、グループにノード情報を設定します。その後、[OSEv3:vars] グループのさまざまな変数を使用してクラスターを定義できます。glusterfs 変数は openshift_storage_glusterfs_ から、glusterfs-registry 変数は openshift_storage_glusterfs_registry_ からそれぞれ始まります。openshift_hosted_registry_storage_kind などのその他のいくつかの変数は GlusterFS クラスターと対話します。

Red Hat Gluster Storage Pod が、サービス停止後に、異なるバージョンの Red Hat Gluster Storage が含まれるクラスターにアップグレードされないようにするには、すべてのコンテナー化コンポーネントに、イメージ名とバージョンタグを指定することを推奨します。関連のある変数は以下のとおりです。

-

openshift_storage_glusterfs_image -

openshift_storage_glusterfs_block_image -

openshift_storage_glusterfs_s3_image -

openshift_storage_glusterfs_heketi_image -

openshift_storage_glusterfs_registry_image -

openshift_storage_glusterfs_registry_block_image -

openshift_storage_glusterfs_registry_s3_image -

openshift_storage_glusterfs_registry_heketi_image

gluster-block および gluster-s3 のイメージ変数は、適切なデプロイメント変数 (末尾が _block_deploy および _s3_deploy の変数) が True の場合のみ必要です。

以下は、このバージョンの OpenShift Container Platform で推奨される値です。

-

openshift_storage_glusterfs_image=registry.access.redhat.com/rhgs3/rhgs-server-rhel7:v3.10 -

openshift_storage_glusterfs_block_image=registry.access.redhat.com/rhgs3/rhgs-gluster-block-prov-rhel7:v3.10 -

openshift_storage_glusterfs_s3_image=registry.access.redhat.com/rhgs3/rhgs-s3-server-rhel7:v3.10 -

openshift_storage_glusterfs_heketi_image=registry.access.redhat.com/rhgs3/rhgs-volmanager-rhel7:v3.10

これらの値は、対応する registry 変数と同じです。

変数の詳細な一覧については、GitHub の GlusterFS ロールに関する README を参照してください。

変数を設定したら、インストールの環境に応じていくつかの Playbook が利用可能になります。

クラスターインストールのメイン Playbook を使用すると、OpenShift Container Platform の初期インストールと並行して GlusterFS クラスターをデプロイできます。

- これには、GlusterFS ストレージを使用する統合 OpenShift Container レジストリーのデプロイが含まれます。

- OpenShift ロギングや OpenShift メトリクスは含まれません。現時点では、これは別の手順で扱われるためです。詳細については、「OpenShift ロギングおよびメトリクス用のコンバージドモード」を参照してください。

-

playbooks/openshift-glusterfs/config.ymlを使用して、クラスターを既存の OpenShift Container Platform インストールにデプロイできます。 playbooks/openshift-glusterfs/registry.ymlを使用して、クラスターを既存の OpenShift Container Platform インストールにデプロイできます。さらに、GlusterFS ストレージを使用する統合 OpenShift Container レジストリーもデプロイされます。重要OpenShift Container Platform クラスターに既存のレジストリーがない状態でなければなりません。

playbooks/openshift-glusterfs/uninstall.ymlを使用して、インベントリーホストファイルの設定に一致する既存のクラスターを削除できます。これは、設定エラーによってデプロイメントが失敗した場合に OpenShift Container Platform 環境をクリーンアップするのに便利です。注記GlusterFS Playbook では、必ず冪等性を確保できるわけではありません。

注記GlusterFS インストール全体 (ディスクデータを含む) を削除してインストールし直すことなく、特定のインストールに対して Playbook を複数回実行することは、現在はサポートされていません。

24.3.4.2.1. 例: 基本的なコンバージドモードのインストール

インベントリーファイルの

[OSEv3:vars]セクションに次の変数を追加し、設定に合わせてそれらを調整します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow [OSEv3:children]セクションにglusterfsを追加して、[glusterfs]グループを有効にします。[OSEv3:children] masters nodes glusterfs

[OSEv3:children] masters nodes glusterfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow GlusterFS ストレージをホストする各ストレージノードのエントリーを含む

[glusterfs]セクションを追加します。ノードごとに、glusterfs_devicesを GlusterFS クラスターの一部として完全に管理される raw ブロックデバイスの一覧に設定します。少なくとも 1 つのデバイスを一覧に含める必要があります。各デバイスは、パーティションや LVM PV がないベアでなければなりません。変数は以下の形式で指定します。<hostname_or_ip> glusterfs_devices='[ "</path/to/device1/>", "</path/to/device2>", ... ]'

<hostname_or_ip> glusterfs_devices='[ "</path/to/device1/>", "</path/to/device2>", ... ]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下は例を示しています。

[glusterfs] node11.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' node12.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' node13.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]'

[glusterfs] node11.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' node12.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' node13.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow [glusterfs]の下に一覧表示されているホストを[nodes]グループに追加します。[nodes] ... node11.example.com openshift_node_group_name="node-config-compute" node12.example.com openshift_node_group_name="node-config-compute" node13.example.com openshift_node_group_name="node-config-compute"

[nodes] ... node11.example.com openshift_node_group_name="node-config-compute" node12.example.com openshift_node_group_name="node-config-compute" node13.example.com openshift_node_group_name="node-config-compute"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記前述の手順では、インベントリーファイルに追加する必要のある一部のオプションのみを指定しています。Red Hat Gluster Storage をデプロイするには、完全なインベントリーファイルを使用します。

インストール Playbook を実行します。インベントリーファイルの相対パスをオプションとして指定します。

OpenShift Container Platform の新規インストール:

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/prerequisites.yml ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/deploy_cluster.yml

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/prerequisites.yml ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/deploy_cluster.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 既存の OpenShift Container Platform クラスターへのインストール:

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/config.yml

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/config.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

24.3.4.2.2. 例: 基本的なインデペンデントモードのインストール

インベントリーファイルの

[OSEv3:vars]セクションに次の変数を追加し、設定に合わせてそれらを調整します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow [OSEv3:children]セクションにglusterfsを追加して、[glusterfs]グループを有効にします。[OSEv3:children] masters nodes glusterfs

[OSEv3:children] masters nodes glusterfsCopy to Clipboard Copied! Toggle word wrap Toggle overflow GlusterFS ストレージをホストする各ストレージノードのエントリーを含む

[glusterfs]セクションを追加します。ノードごとに、glusterfs_devicesを GlusterFS クラスターの一部として完全に管理される raw ブロックデバイスの一覧に設定します。少なくと も 1 つのデバイスを一覧に含める必要があります。各デバイスはパーティションや LVM PV がないベアでなければなりません。また、glusterfs_ipをノードの IP アドレスに設定します。変数は以下の形式で指定します。<hostname_or_ip> glusterfs_ip=<ip_address> glusterfs_devices='[ "</path/to/device1/>", "</path/to/device2>", ... ]'

<hostname_or_ip> glusterfs_ip=<ip_address> glusterfs_devices='[ "</path/to/device1/>", "</path/to/device2>", ... ]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下は例を示しています。

[glusterfs] gluster1.example.com glusterfs_ip=192.168.10.11 glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' gluster2.example.com glusterfs_ip=192.168.10.12 glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' gluster3.example.com glusterfs_ip=192.168.10.13 glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]'

[glusterfs] gluster1.example.com glusterfs_ip=192.168.10.11 glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' gluster2.example.com glusterfs_ip=192.168.10.12 glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' gluster3.example.com glusterfs_ip=192.168.10.13 glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記前述の手順では、インベントリーファイルに追加する必要のある一部のオプションのみを指定しています。Red Hat Gluster Storage をデプロイするには、完全なインベントリーファイルを使用します。

インストール Playbook を実行します。インベントリーファイルの相対パスをオプションとして指定します。

OpenShift Container Platform の新規インストール:

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/prerequisites.yml ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/deploy_cluster.yml

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/prerequisites.yml ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/deploy_cluster.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 既存の OpenShift Container Platform クラスターへのインストール:

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/config.yml

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/config.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

24.3.4.2.3. 例: 統合 OpenShift Container レジストリーを使用するコンバージドモード

インベントリーファイルの

[OSEv3:vars]セクションに次の変数を追加し、設定に合わせてそれらを調整します。[OSEv3:vars] ... openshift_hosted_registry_storage_kind=glusterfs openshift_hosted_registry_storage_volume_size=5Gi openshift_hosted_registry_selector='node-role.kubernetes.io/infra=true'

[OSEv3:vars] ... openshift_hosted_registry_storage_kind=glusterfs1 openshift_hosted_registry_storage_volume_size=5Gi openshift_hosted_registry_selector='node-role.kubernetes.io/infra=true'Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 統合 OpenShift Container レジストリーをインフラストラクチャーノードで実行することが推奨されます。インフラストラクチャーノードは、OpenShift Container Platform クラスターのサービスを提供するために管理者がデプロイするアプリケーションを実行する専用ノードです。

[OSEv3:children]セクションにglusterfs_registryを追加して、[glusterfs_registry]グループを有効にします。[OSEv3:children] masters nodes glusterfs_registry

[OSEv3:children] masters nodes glusterfs_registryCopy to Clipboard Copied! Toggle word wrap Toggle overflow GlusterFS ストレージをホストする各ストレージノードのエントリーを含む

[glusterfs_registry]セクションを追加します。ノードごとに、glusterfs_devicesを GlusterFS クラスターの一部として完全に管理される raw ブロックデバイスの一覧に設定します。少なくとも 1 つのデバイスを一覧に含める必要があります。各デバイスはパーティションや LVM PV がないベアでなければなりません。変数は次の形式で指定します。<hostname_or_ip> glusterfs_devices='[ "</path/to/device1/>", "</path/to/device2>", ... ]'

<hostname_or_ip> glusterfs_devices='[ "</path/to/device1/>", "</path/to/device2>", ... ]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下は例を示しています。

[glusterfs_registry] node11.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' node12.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' node13.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]'

[glusterfs_registry] node11.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' node12.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' node13.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow [glusterfs_registry]の下に一覧表示されているホストを[nodes]グループに追加します。[nodes] ... node11.example.com openshift_node_group_name="node-config-infra" node12.example.com openshift_node_group_name="node-config-infra" node13.example.com openshift_node_group_name="node-config-infra"

[nodes] ... node11.example.com openshift_node_group_name="node-config-infra" node12.example.com openshift_node_group_name="node-config-infra" node13.example.com openshift_node_group_name="node-config-infra"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記前述の手順では、インベントリーファイルに追加する必要のある一部のオプションのみを指定しています。Red Hat Gluster Storage をデプロイするには、完全なインベントリーファイルを使用します。

インストール Playbook を実行します。インベントリーファイルの相対パスをオプションとして指定します。

OpenShift Container Platform の新規インストール:

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/prerequisites.yml ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/deploy_cluster.yml

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/prerequisites.yml ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/deploy_cluster.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 既存の OpenShift Container Platform クラスターへのインストール:

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/config.yml

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/config.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

24.3.4.2.4. 例: OpenShift ロギングおよびメトリクス用のコンバージドモード

インベントリーファイルの

[OSEv3:vars]セクションに次の変数を追加し、設定に合わせてそれらを調整します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1 2 3 5 6 7

- 統合 OpenShift Container レジストリー、ロギングおよびメトリクスは、管理者が OpenShift Container Platform クラスターにサービスを提供するためにデプロイしたアプリケーションである「インフラストラクチャー」アプリケーション専用のノードで実行することを推奨します。

- 4 9

- ロギングとメトリクスに使用する StorageClass を指定します。この名前は、ターゲットの GlusterFS クラスター (例:

glusterfs-<name>-block) 名から生成されます。この例ではregistryにデフォルト設定されています。 - 8

- OpenShift ロギングでは、PVC のサイズを指定する必要があります。ここで指定される値は単なる例であり、推奨される値ではありません。

注記これらの変数とその他の変数の詳細については、GlusterFS ロールに関する README を参照してください。

[OSEv3:children]セクションにglusterfs_registryを追加して、[glusterfs_registry]グループを有効にします。[OSEv3:children] masters nodes glusterfs_registry

[OSEv3:children] masters nodes glusterfs_registryCopy to Clipboard Copied! Toggle word wrap Toggle overflow GlusterFS ストレージをホストする各ストレージノードのエントリーを含む

[glusterfs_registry]セクションを追加します。ノードごとに、glusterfs_devicesを GlusterFS クラスターの一部として完全に管理される raw ブロックデバイスの一覧に設定します。少なくとも 1 つのデバイスを一覧に含める必要があります。各デバイスはパーティションや LVM PV がないベアでなければなりません。変数は次の形式で指定します。<hostname_or_ip> glusterfs_devices='[ "</path/to/device1/>", "</path/to/device2>", ... ]'

<hostname_or_ip> glusterfs_devices='[ "</path/to/device1/>", "</path/to/device2>", ... ]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下は例を示しています。

[glusterfs_registry] node11.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' node12.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' node13.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]'

[glusterfs_registry] node11.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' node12.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]' node13.example.com glusterfs_devices='[ "/dev/xvdc", "/dev/xvdd" ]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow [glusterfs_registry]の下に一覧表示されているホストを[nodes]グループに追加します。[nodes] ... node11.example.com openshift_node_group_name="node-config-infra" node12.example.com openshift_node_group_name="node-config-infra" node13.example.com openshift_node_group_name="node-config-infra"

[nodes] ... node11.example.com openshift_node_group_name="node-config-infra" node12.example.com openshift_node_group_name="node-config-infra" node13.example.com openshift_node_group_name="node-config-infra"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記前述の手順では、インベントリーファイルに追加する必要のある一部のオプションのみを指定しています。Red Hat Gluster Storage をデプロイするには、完全なインベントリーファイルを使用します。

インストール Playbook を実行します。インベントリーファイルの相対パスをオプションとして指定します。

OpenShift Container Platform の新規インストール:

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/prerequisites.yml ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/deploy_cluster.yml

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/prerequisites.yml ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/deploy_cluster.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 既存の OpenShift Container Platform クラスターへのインストール:

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/config.yml

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/config.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

24.3.4.2.5. 例: アプリケーション、レジストリー、ロギングおよびメトリクス用のコンバージドモード

インベントリーファイルの

[OSEv3:vars]セクションに次の変数を追加し、設定に合わせてそれらを調整します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1 2 3 4 6 7 8

- 統合 OpenShift Container レジストリー、ロギングおよびメトリクスをインフラストラクチャーノードで実行することが推奨されます。インフラストラクチャーノードは、OpenShift Container Platform クラスターのサービスを提供するために管理者がデプロイするアプリケーションを実行する専用ノードです。

- 5 10

- ロギングとメトリクスに使用する StorageClass を指定します。この名前は、ターゲットの GlusterFS クラスター (例:

glusterfs-<name>-block) 名から生成されます。この例では<name>はregistryにデフォルト設定されています。 - 9

- OpenShift ロギングでは、PVC サイズを指定する必要があります。ここで指定される値は単なる例であり、推奨される値ではありません。

[OSEv3:children]セクションにglusterfsとglusterfs_registryを追加し、[glusterfs]グループと[glusterfs_registry]グループを有効にします。[OSEv3:children] ... glusterfs glusterfs_registry

[OSEv3:children] ... glusterfs glusterfs_registryCopy to Clipboard Copied! Toggle word wrap Toggle overflow [glusterfs]セクションと[glusterfs_registry]セクションを追加し、両セクションに GlusterFS ストレージをホストするストレージノードを入力します。ノードごとにglusterfs_devicesを、GlusterFS クラスターの一部として完全に管理される raw ブロックデバイスの一覧に設定します。少なくとも 1 つのデバイスを一覧に含める必要があります。各デバイスは、パーティションや LVM PV がないベアでなければなりません。変数は以下の形式で指定します。<hostname_or_ip> glusterfs_devices='[ "</path/to/device1/>", "</path/to/device2>", ... ]'

<hostname_or_ip> glusterfs_devices='[ "</path/to/device1/>", "</path/to/device2>", ... ]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下は例を示しています。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow [glusterfs]と[glusterfs_registry]に一覧表示されているホストを[nodes]グループに追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記前述の手順では、インベントリーファイルに追加する必要のある一部のオプションのみを指定しています。Red Hat Gluster Storage をデプロイするには、完全なインベントリーファイルを使用します。

インストール Playbook を実行します。インベントリーファイルの相対パスをオプションとして指定します。

OpenShift Container Platform の新規インストール:

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/prerequisites.yml ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/deploy_cluster.yml

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/prerequisites.yml ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/deploy_cluster.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 既存の OpenShift Container Platform クラスターへのインストール:

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/config.yml

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/config.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

24.3.4.2.6. 例: アプリケーション、レジストリー、ロギングおよびメトリクス用のインデペンデントモード

インベントリーファイルの

[OSEv3:vars]セクションに次の変数を追加し、設定に合わせてそれらを調整します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1 2 3 4 6 7 8

- 統合 OpenShift Container レジストリーは、管理者が OpenShift Container Platform クラスターにサービスを提供するためにデプロイしたアプリケーションである「インフラストラクチャー」アプリケーション専用のノードで実行することが推奨されます。インフラストラクチャーアプリケーション用のノードは、管理者が選択し、それにラベルを付けます。

- 5 10

- ロギングとメトリクスに使用する StorageClass を指定します。この名前は、ターゲットの GlusterFS クラスター (例:

glusterfs-<name>-block) 名から生成されます。この例ではregistryにデフォルト設定されています。 - 9

- OpenShift ロギングでは、PVC のサイズを指定する必要があります。ここで指定される値は単なる例であり、推奨される値ではありません。

[OSEv3:children]セクションにglusterfsとglusterfs_registryを追加し、[glusterfs]グループと[glusterfs_registry]グループを有効にします。[OSEv3:children] ... glusterfs glusterfs_registry

[OSEv3:children] ... glusterfs glusterfs_registryCopy to Clipboard Copied! Toggle word wrap Toggle overflow [glusterfs]セクションと[glusterfs_registry]セクションを追加し、両セクションに GlusterFS ストレージをホストするストレージノードを入力します。ノードごとに、glusterfs_devicesを、GlusterFS クラスターの一部として完全に管理される raw ブロックデバイスの一覧に設定します。少なくと も 1 つのデバイスを一覧に含める必要があります。各デバイスは、パーティションや LVM PV がないベアでなければなりません。また、glusterfs_ipをノードの IP アドレスに設定します。変数は以下の形式で指定します。<hostname_or_ip> glusterfs_ip=<ip_address> glusterfs_devices='[ "</path/to/device1/>", "</path/to/device2>", ... ]'

<hostname_or_ip> glusterfs_ip=<ip_address> glusterfs_devices='[ "</path/to/device1/>", "</path/to/device2>", ... ]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下は例を示しています。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記前述の手順では、インベントリーファイルに追加する必要のある一部のオプションのみを指定しています。Red Hat Gluster Storage をデプロイするには、完全なインベントリーファイルを使用します。

インストール Playbook を実行します。インベントリーファイルの相対パスをオプションとして指定します。

OpenShift Container Platform の新規インストール:

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/prerequisites.yml ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/deploy_cluster.yml

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/prerequisites.yml ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/deploy_cluster.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 既存の OpenShift Container Platform クラスターへのインストール:

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/config.yml

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/config.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

24.3.5. コンバージドモードのアンイストール

コンバージドモードの場合、OpenShift Container Platform のインストールには、クラスターから全リソースおよびアーティファクトをアンイストールするための Playbook が同梱されています。この Playbook を使用するには、コンバージドモードのターゲットインスタンスをインストールするのに使用した元のインベントリーファイルを指定して、以下の Playbook を実行します。

ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/uninstall.yml

# ansible-playbook -i <path_to_inventory_file> /usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/uninstall.yml

さらに、Playbook は、openshift_storage_glusterfs_wipe と呼ばれる変数の使用をサポートします。これは、有効化されている場合には、Red Hat Gluster Storage バックエンドストレージに使用されていたブロックデバイス上のデータを破棄します。openshift_storage_glusterfs_wipe 変数を使用するには、以下を実行します。

ansible-playbook -i <path_to_inventory_file> -e "openshift_storage_glusterfs_wipe=true" /usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/uninstall.yml

# ansible-playbook -i <path_to_inventory_file> -e

"openshift_storage_glusterfs_wipe=true"

/usr/share/ansible/openshift-ansible/playbooks/openshift-glusterfs/uninstall.ymlこの手順ではデータが破棄されるので、注意して進めてください。

24.3.6. プロビジョニング

GlusterFS ボリュームは、静的または動的にプロビジョニングできます。静的プロビジョニングは、すべての設定で使用できます。動的プロビジョニングは、コンバージドモードおよびインデペンデントモードでサポートされます。

24.3.6.1. 静的プロビジョニング

-

静的プロビジョニングを有効にするには、最初に GlusterFS ボリュームを作成します。

glusterコマンドラインインターフェースを使用してこれを行う方法については、『Red Hat Gluster Storage Administration Guide』を参照してください。また、heketi-cliを使用してこれを行う方法については、heketi プロジェクトサイトを参照してください。この例では、ボリュームにmyVol1という名前を付けます。 gluster-endpoints.yamlで以下のサービスとエンドポイントを定義します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform マスターホストからサービスとエンドポイントを作成します。

oc create -f gluster-endpoints.yaml service "glusterfs-cluster" created endpoints "glusterfs-cluster" created

$ oc create -f gluster-endpoints.yaml service "glusterfs-cluster" created endpoints "glusterfs-cluster" createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow サービスとエンドポイントが作成されたことを確認します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記エンドポイントはプロジェクトごとに一意です。GlusterFS にアクセスする各プロジェクトには独自のエンドポイントが必要です。

ボリュームにアクセスするには、ボリューム上のファイルシステムにアクセスできるユーザー ID (UID) またはグループ ID (GID) でコンテナーを実行する必要があります。この情報は以下の方法で取得できます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow gluster-pv.yamlで以下の PersistentVolume (PV) を定義します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform マスターホストから PV を作成します。

oc create -f gluster-pv.yaml

$ oc create -f gluster-pv.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow PV が作成されたことを確認します。

oc get pv NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE gluster-default-volume <none> 2147483648 RWX Available 2s

$ oc get pv NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE gluster-default-volume <none> 2147483648 RWX Available 2sCopy to Clipboard Copied! Toggle word wrap Toggle overflow gluster-claim.yamlで、新規 PV にバインドする PersistentVolumeClaim (PVC) を作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform マスターホストから PVC を作成します。

oc create -f gluster-claim.yaml

$ oc create -f gluster-claim.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow PV と PVC がバインドされていることを確認します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

PVC はプロジェクトごとに一意です。GlusterFS ボリュームにアクセスする各プロジェクトには独自の PVC が必要です。PV は単一のプロジェクトにバインドされないため、複数のプロジェクトにまたがる PVC が同じ PV を参照する場合があります。

24.3.6.2. 動的プロビジョニング

動的プロビジョニングを有効にするには、最初に

StorageClassオブジェクト定義を作成します。以下の定義は、OpenShift Container Platform でこの例を使用するために必要な最小要件に基づいています。その他のパラメーターと仕様定義については、「動的プロビジョニングとストレージクラスの作成」を参照してください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform マスターホストから StorageClass を作成します。

oc create -f gluster-storage-class.yaml storageclass "glusterfs" created

# oc create -f gluster-storage-class.yaml storageclass "glusterfs" createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow 新たに作成される StorageClass を使用して PVC を作成します。以下は例になります。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform マスターホストから PVC を作成します。

oc create -f glusterfs-dyn-pvc.yaml persistentvolumeclaim "gluster1" created

# oc create -f glusterfs-dyn-pvc.yaml persistentvolumeclaim "gluster1" createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow PVC を表示し、ボリュームが動的に作成され、PVC にバインドされていることを確認します。

oc get pvc NAME STATUS VOLUME CAPACITY ACCESSMODES STORAGECLASS AGE gluster1 Bound pvc-78852230-d8e2-11e6-a3fa-0800279cf26f 30Gi RWX gluster-dyn 42s

# oc get pvc NAME STATUS VOLUME CAPACITY ACCESSMODES STORAGECLASS AGE gluster1 Bound pvc-78852230-d8e2-11e6-a3fa-0800279cf26f 30Gi RWX gluster-dyn 42sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

24.4. OpenStack Cinder を使用した永続ストレージ

24.4.1. 概要

OpenStack Cinder を使用して、OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これには、Kubernetes と OpenStack についてある程度の理解があることが前提となります。

Cinder を使用して永続ボリューム (PV) を作成する前に、OpenStack 向けに OpenShft Container Platform を設定してください。

Kubernetes の 永続ボリュームフレームワークは、管理者がクラスターに永続ストレージをプロビジョニングできるようにします。ユーザーが基礎となるインフラストラクチャーの知識がなくてもこれらのリソースを要求できるようにします。OpenStack Cinder ボリュームを動的にプロビジョニングできます。

永続ボリュームは、単一のプロジェクトまたは namespace にバインドされず、OpenShift Container Platform クラスター全体で共有できます。ただし、Persistent Volume Claim (永続ボリューム要求) は、プロジェクトまたは namespace に固有で、ユーザーが要求できます。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

24.4.2. Cinder PV のプロビジョニング

OpenShift Container Platform でストレージをボリュームとしてマウントするには、ストレージが基礎となるインフラストラクチャーに存在している必要があります。OpenShift Container Platform が OpenStack 用に設定されていることを確認した後、Cinder に必要なのは、Cinder ボリューム ID と PersistentVolume API のみになります。

24.4.2.1. 永続ボリュームの作成

Cinder では、「リサイクル」回収ポリシーはサポートされません。

OpenShift Container Platform に PV を作成する前に、PV をオブジェクト定義に定義する必要があります。

オブジェクト定義を cinder-pv.yaml などのファイルに保存します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要ボリュームをフォーマットしてプロビジョニングした後には、

fstypeパラメーターの値は変更しないでください。この値を変更すると、データの損失や、Pod の障害につながる可能性があります。永続ボリュームを作成します。

oc create -f cinder-pv.yaml persistentvolume "pv0001" created

# oc create -f cinder-pv.yaml persistentvolume "pv0001" createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow 永続ボリュームの存在を確認します。

oc get pv NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE pv0001 <none> 5Gi RWO Available 2s

# oc get pv NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE pv0001 <none> 5Gi RWO Available 2sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

次に、ユーザーは永続ボリューム要求 (Persistent Volume Claim) を使用してストレージを要求できるので、この新規の永続ボリュームを活用できます。

Persistent Volume Claim (永続ボリューム要求) は、ユーザーの namespace にのみ存在し、同じ namespace 内の Pod からしか参照できません。別の namespace から Persistent Volume Claim (永続ボリューム要求) にアクセスしようとすると、Pod にエラーが発生します。

24.4.2.2. Cinder の PV 形式

OpenShift Container Platform は、ボリュームをマウントしてコンテナーに渡す前に、永続ボリューム定義の fsType パラメーターで指定されたファイルシステムがボリュームにあるかどうか確認します。デバイスが指定されたファイルシステムでフォーマットされていない場合、デバイスのデータはすべて消去され、デバイスはそのファイルシステムで自動的にフォーマットされます。

これにより、OpenShift Container Platform がフォーマットされていない Cinder ボリュームを初回の使用前にフォーマットするため、それらを永続ボリュームとして使用することが可能になります。

24.4.2.3. Cinder ボリュームのセキュリティー

お使いのアプリケーションで Cinder PV を使用する場合に、そのデプロイメント設定にセキュリティーを追加します。

Cinder ボリュームを実装する前に、ボリュームのセキュリティーを確認します。

-

適切な

fsGroupストラテジーを使用するSCC を作成します。 サービスアカウントを作成して、そのアカウントを SCC に追加します。

[source,bash] $ oc create serviceaccount <service_account> $ oc adm policy add-scc-to-user <new_scc> -z <service_account> -n <project>

[source,bash] $ oc create serviceaccount <service_account> $ oc adm policy add-scc-to-user <new_scc> -z <service_account> -n <project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow アプリケーションのデプロイ設定で、サービスアカウント名と

securityContextを指定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

24.5. Ceph Rados ブロックデバイス (RBD) を使用した永続ストレージ

24.5.1. 概要

OpenShift Container Platform クラスターでは、Ceph RBD を使用して永続ストレージをプロビジョニングできます。

永続ボリューム (PV) と Persistent Volume Claim (永続ボリューム要求、PVC)は、単一プロジェクトでボリュームを共有できます。PV 定義に含まれている Ceph RBD 固有の情報は Pod 定義で直接定義することも可能ですが、この方法だとボリュームが一意のクラスターリソースとして作成されず、競合の影響を受けやすくなります。

このトピックでは、OpenShift Container Platform と Ceph RBD についてある程度理解していることを前提とします。OpenShift Container Platform 永続ボリューム (PV) の一般的なフレームワークについての詳細は、永続ストレージの概念に関するトピックを参照してください。

本書では、プロジェクトと namespace は区別せずに使用されています。両者の関係については、「プロジェクトおよびユーザー」を参照してください。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

24.5.2. プロビジョニング

Ceph ボリュームをプロビジョニングするには、以下が必要になります。

- 基礎となるインフラストラクチャーの既存ストレージデバイス。

- OpenShift Container Platform シークレットオブジェクトで使用される Ceph キー。

- Ceph イメージ名。

- ブロックストレージ上部のファイルシステムタイプ (ext4 など)。

クラスター内のスケジュール可能な各 OpenShift Container Platform ノードにインストールされた ceph-common。

yum install ceph-common

# yum install ceph-commonCopy to Clipboard Copied! Toggle word wrap Toggle overflow

24.5.2.1. Ceph シークレットの作成

承認キーをシークレット設定に定義します。これは後に OpenShift Container Platform で使用できるように base64 に変換されます。

Ceph ストレージを使用して永続ボリュームをサポートするには、シークレットを PVC や Pod と同じプロジェクトに作成する必要があります。シークレットは、単にデフォルトプロジェクトに置くことはできません。

Ceph MON ノードで

ceph auth get-keyを実行し、client.adminユーザーのキー値を表示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow シークレット定義を ceph-secret.yaml などのファイルに保存し、シークレットを作成します。

oc create -f ceph-secret.yaml

$ oc create -f ceph-secret.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットが作成されたことを確認します。

oc get secret ceph-secret NAME TYPE DATA AGE ceph-secret Opaque 1 23d

# oc get secret ceph-secret NAME TYPE DATA AGE ceph-secret Opaque 1 23dCopy to Clipboard Copied! Toggle word wrap Toggle overflow

24.5.2.2. 永続ボリュームの作成

Ceph RBD では、「リサイクル」回収ポリシーはサポートされません。

開発者は、PVC を参照するか、Pod 仕様の volumes セクションにある Gluster ボリュームプラグインを直接参照することによって Ceph RBD ストレージを要求します。PVC は、ユーザーの namespace にのみ存在し、同じ namespace 内の Pod からしか参照できません。別の namespace から PV にアクセスしようとすると、Pod エラーが発生します。

OpenShift Container Platform に PV を作成する前に、PV をオブジェクト定義に定義します。

例24.3 Ceph RBD を使用した永続ボリュームオブジェクトの定義

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Pod 定義で参照されるか、または各種の

ocボリュームコマンドで表示される PV の名前。 - 2

- このボリュームに割り当てられるストレージの量。

- 3

accessModesは、PV と PVC を一致させるためのラベルとして使用されます。現時点で、これらはいずれの形式のアクセス制御も定義しません。すべてのブロックストレージは単一ユーザーに対して定義されます (非共有ストレージ)。- 4

- 使用されるボリュームタイプ。この場合は、rbd プラグインです。

- 5

- Ceph モニターの IP アドレスとポートの配列。

- 6

- OpenShift Container Platform から Ceph サーバーへのセキュアな接続を作成するために使用される Ceph シークレット。

- 7

- Ceph RBD ブロックデバイスにマウントされるファイルシステムタイプ。

重要ボリュームをフォーマットしてプロビジョニングした後に

fstypeパラメーターの値を変更すると、データ損失や Pod エラーが発生する可能性があります。定義を ceph-pv.yaml などのファイルに保存し、PV を作成します。

oc create -f ceph-pv.yaml

# oc create -f ceph-pv.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 永続ボリュームが作成されたことを確認します。

oc get pv NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE ceph-pv <none> 2147483648 RWO Available 2s

# oc get pv NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE ceph-pv <none> 2147483648 RWO Available 2sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 新規 PV にバインドされる PVC を作成します。

定義をファイル (ceph-claim.yaml など) に保存し、PVC を作成します。

oc create -f ceph-claim.yaml

# oc create -f ceph-claim.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

24.5.3. Ceph ボリュームのセキュリティー

Ceph RBD ボリュームを実装する前に、「ボリュームのセキュリティー」トピックの詳細を参照してください。

共有ボリューム (NFS および GlusterFS) とブロックボリューム (Ceph RBD、iSCSI、およびほとんどのクラウドストレージ) の大きな違いは、Pod 定義またはコンテナーイメージで定義されたユーザー ID とグループ ID がターゲットの物理ストレージに適用されることです。これはブロックデバイスの所有権の管理と呼ばれます。たとえば、Ceph RBD マウントで所有者が 123 に、グループ ID が 567 に設定されていて、Pod で runAsUser が 222 に、fsGroup が 7777 に定義されている場合、Ceph RBD 物理マウントの所有権は 222:7777 に変更されます。

ユーザー ID とグループ ID が Pod 仕様で定義されていない場合でも、生成される Pod では、これらの ID のデフォルト値が一致する SCC またはプロジェクトに基づいて定義されることがあります。詳細については、「ボリュームのセキュリティー」トピックの詳細を参照してください。このトピックでは、SCC のストレージの側面とデフォルト値について説明しています。

Pod の securityContext 定義で fsGroup スタンザを使用して、Pod で Ceph RBD ボリュームのグループ所有権を定義します。

24.6. AWS Elastic Block Store を使用した永続ストレージ

24.6.1. 概要

OpenShift Container Platform では、AWS Elastic Block Store ボリューム (EBS) がサポートされます。AWS EC2 を使用して、OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これには、Kubernetes と AWS についてある程度の理解があることが前提となります。

AWS を使用して永続ボリュームを作成する前に、まず OpenShift Container Platform を AWS ElasticBlockStore 用に適切に設定する必要があります。

Kubernetes 永続ボリュームフレームワークは、管理者がクラスターに永続ストレージをプロビジョニングできるようにします。ユーザーが基礎となるインフラストラクチャーの知識がなくてもこれらのリソースを要求できるようになります。AWS Elastic Block Store ボリュームは、動的にプロビジョニングできます。永続ボリュームは、単一のプロジェクトまたは namespace にバインドされず、OpenShift Container Platform クラスター全体で共有できます。ただし、Persistent Volume Claim (永続ボリューム要求)は、プロジェクトまたは namespace に固有で、ユーザーが要求できます。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

24.6.2. プロビジョニング

OpenShift Container Platform でストレージをボリュームとしてマウントするには、基礎となるインフラストラクチャーにストレージが存在している必要があります。OpenShift Container Platform が AWS Elastic Block Store 用に設定されていることを確認した後、OpenShift と AWS に必要になるのは、AWS EBS ボリューム ID と PersistentVolume API のみです。

24.6.2.1. 永続ボリュームの作成

AWS では、「リサイクル」回収ポリシーはサポートされません。

OpenShift Container Platform に永続ボリュームを作成する前に、永続ボリュームをオブジェクト定義で定義する必要があります。

例24.5 AWS を使用した永続ボリュームオブジェクトの定義

ボリュームをフォーマットしてプロビジョニングした後に fstype パラメーターの値を変更すると、データ損失や Pod エラーが発生する可能性があります。

定義を aws-pv.yaml などのファイルに保存し、永続ボリュームを作成します。

oc create -f aws-pv.yaml persistentvolume "pv0001" created

# oc create -f aws-pv.yaml

persistentvolume "pv0001" created永続ボリュームが作成されたことを確認します。

oc get pv NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE pv0001 <none> 5Gi RWO Available 2s

# oc get pv

NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE

pv0001 <none> 5Gi RWO Available 2s次に、ユーザーは永続ボリューム要求 (Persistent Volume Claim) を使用してストレージを要求できるので、この新規の永続ボリュームを活用できます。

Persistent Volume Claim (永続ボリューム要求) は、ユーザーの namespace にのみ存在し、同じ namespace 内の Pod からしか参照できません。別の namespace から永続ボリュームにアクセスしようとすると、Pod にエラーが発生します。

24.6.2.2. ボリュームのフォーマット

OpenShift Container Platform は、ボリュームをマウントしてコンテナーに渡す前に、永続ボリューム定義の fsType パラメーターで指定されたファイルシステムがボリュームにあるかどうか確認します。デバイスが指定されたファイルシステムでフォーマットされていない場合、デバイスのデータはすべて消去され、デバイスはそのファイルシステムで自動的にフォーマットされます。

これにより、OpenShift Container Platform がフォーマットされていない AWS ボリュームを初回の使用前にフォーマットするため、それらを永続ボリュームとして使用することが可能になります。

24.6.2.3. ノード上の EBS ボリュームの最大数

OpenShift Container Platform では、デフォルトで 1 つのノードに最大 39 の EBS ボリュームを割り当てることができます。この制限は、AWS ボリュームの制限に合致します。

OpenShift Container Platform では、環境変数 KUBE_MAX_PD_VOLS を設定することで、より大きな制限値を設定できます。ただし、AWS では、割り当てられるデバイスに特定の命名スキーム (AWS デバイスの命名) を使用する必要があります。この命名スキームでは、最大で 52 のボリュームしかサポートされません。これにより、OpenShift Container Platform 経由でノードに割り当てることができるボリュームの数が 52 に制限されます。

24.7. GCE Persistent Disk を使用した永続ストレージ

24.7.1. 概要

OpenShift Container Platform では、GCE Persistent Disk ボリューム (gcePD) がサポートされます。GCE を使用して、OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これには、Kubernetes と GCE についてある程度の理解があることが前提となります。

GCE を使用して永続ボリュームを作成する前に、まず OpenShift Container Platform を GCE Persistent Disk 用に適切に設定する必要があります。

Kubernetes の 永続ボリュームフレームワークは、管理者がクラスターに永続ストレージをプロビジョニングできるようにします。また、ユーザーが基礎となるインフラストラクチャーの知識がなくてもこれらのリソースを要求できるようにします。GCE Persistent Disk ボリュームは、動的にプロビジョニングできます。永続ボリュームは、単一のプロジェクトまたは namespace にバインドされず、OpenShift Container Platform クラスター全体で共有できます。ただし、Persistent Volume Claim (永続ボリューム要求) は、プロジェクトまたは namespace に固有で、ユーザーが要求できます。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

24.7.2. プロビジョニング

OpenShift Container Platform でストレージをボリュームとしてマウントするには、基礎となるインフラストラクチャーにストレージが存在している必要があります。OpenShift Container Platform が GCE Persistent Disk 用に設定されていることを確認した後、OpenShift Container Platform と GCE に必要となるのは、GCE Persistent Disk ボリューム ID と PersistentVolume API のみです。

24.7.2.1. 永続ボリュームの作成

GCE では、「リサイクル」回収ポリシーはサポートされません。

OpenShift Container Platform に永続ボリュームを作成する前に、永続ボリュームをオブジェクト定義で定義する必要があります。

例24.6 GCE を使用した永続ボリュームオブジェクトの定義

ボリュームをフォーマットしてプロビジョニングした後に fstype パラメーターの値を変更すると、データ損失や Pod にエラーが発生する可能性があります。

定義を gce-pv.yaml などのファイルに保存し、永続ボリュームを作成します。

oc create -f gce-pv.yaml persistentvolume "pv0001" created

# oc create -f gce-pv.yaml

persistentvolume "pv0001" created永続ボリュームが作成されたことを確認します。

oc get pv NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE pv0001 <none> 5Gi RWO Available 2s

# oc get pv

NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE

pv0001 <none> 5Gi RWO Available 2s次に、ユーザーは永続ボリューム要求 (Persistent Volume Claim) を使用してストレージを要求できるので、この新規の永続ボリュームを活用できます。

Persistent Volume Claim (永続ボリューム要求) は、ユーザーの namespace にのみ存在し、同じ namespace 内の Pod からしか参照できません。別の namespace から永続ボリュームにアクセスしようとすると、Pod にエラーが発生します。

24.7.2.2. ボリュームのフォーマット

OpenShift Container Platform は、ボリュームをマウントしてコンテナーに渡す前に、永続ボリューム定義の fsType パラメーターで指定されたファイルシステムがボリュームにあるかどうか確認します。デバイスが指定されたファイルシステムでフォーマットされていない場合、デバイスのデータはすべて消去され、デバイスはそのファイルシステムで自動的にフォーマットされます。

これにより、OpenShift Container Platform がフォーマットされていない GCE ボリュームを初回の使用前にフォーマットするため、それらを永続ボリュームとして使用することが可能になります。

24.8. iSCSI を使用した永続ストレージ

24.8.1. 概要

iSCSI を使用して、OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これには、Kubernetes と iSCSI についてある程度の理解があることが前提となります。

Kubernetes の 永続ボリュームフレームワークは、管理者がクラスターに永続ストレージをプロビジョニングできるようにします。ユーザーが基礎となるインフラストラクチャーの知識がなくてもこれらのリソースを要求できるようにします。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

24.8.2. プロビジョニング

OpenShift Container Platform でストレージをボリュームとしてマウントする前に、基礎となるインフラストラクチャーにストレージが存在することを確認します。iSCSI に必要になるのは、iSCSI ターゲットポータル、有効な iSCSI 修飾名 (IQN)、有効な LUN 番号、ファイルシステムタイプ、および PersistentVolume API のみです。

オプションで、マルチパススポータルと CHAP (チャレンジハンドシェイク認証プロトコル) 設定を指定できます。

iSCSI では、「リサイクル」回収ポリシーはサポートされません。

例24.7 永続ボリュームオブジェクトの定義

24.8.2.1. ディスククォータの実施

LUN パーティションを使用してディスククォータとサイズ制限を実施します。それぞれの LUN には 1 つの永続ボリュームです。Kubernetes では、永続ボリュームに一意の名前を使用する必要があります。

上記の方法でクォータを実施すると、エンドユーザーは永続ストレージを具体的な量 (10Gi など) で要求することができ、これを同等またはそれ以上の容量の対応するボリュームに一致させることができます。

24.8.2.2. iSCSI ボリュームのセキュリティー

ユーザーは PersistentVolumeClaim でストレージを要求します。この要求はユーザーの namespace にのみ存在し、同じ namespace 内の Pod からのみ参照できます。namespace をまたいで永続ボリュームにアクセスしようとすると、Pod にエラーが発生します。

それぞれの iSCSI LUN は、クラスター内のすべてのノードからアクセスできる必要があります。

24.8.2.3. iSCSI のマルチパス化

iSCSI ベースのストレージの場合は、複数のターゲットポータルの IP アドレスに同じ IQN を使用することでマルチパスを設定できます。マルチパス化により、パス内の 1 つ以上のコンポーネントで障害が発生した場合でも、永続ボリュームにアクセスできることができます。

Pod 仕様でマルチパスを指定するには、portals フィールドを使用します。以下は例になります。

- 1

portalsフィールドを使用してターゲットポータルを追加します。

24.8.2.4. iSCSI のカスタムイニシエーター IQN

iSCSI ターゲットが特定に IQN に制限されている場合に、カスタムイニシエーターの iSCSI Qualified Name (IQN) を設定します。ただし、iSCSI PV が割り当てられているノードが必ず、これらの IQN を使用する保証はありません。

カスタムのイニシエーター IQN を指定するには、initiatorName フィールドを使用します。

- 1

- カスタムのイニシエーター IQN を追加するには、

initiatorNameフィールドを使用します。

24.9. ファイバーチャネルを使用した永続ストレージ

24.9.1. 概要

ファイバーチャネルを使用して、OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これには、Kubernetes と Fibre Channel についてある程度の理解があることが前提となります。

Kubernetes の 永続ボリュームフレームワークは、管理者がクラスターに永続ストレージをプロビジョニングできるようにします。ユーザーが基礎となるインフラストラクチャーの知識がなくてもこれらのリソースを要求できるようにします。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

24.9.2. プロビジョニング

OpenShift Container Platform でストレージをボリュームとしてマウントするには、基礎となるインフラストラクチャーにストレージが存在している必要があります。ファイバーチャネルの永続ストレージに必要になるのは、targetWWNs (ファイバーチャネルターゲットのワールドワイド名の配列)、有効な LUN 番号、ファイルシステムタイプ、および PersistentVolume API のみです。 永続ボリュームと LUN は 1 対 1 でマッピングされます。

ファイバーチャネルでは、「リサイクル」回収ポリシーはサポートされません。

永続ボリュームオブジェクトの定義

- 1

- ファイバーチャネルl WWN は、

/dev/disk/by-path/pci-<IDENTIFIER>-fc-0x<WWN>-lun-<LUN#>として識別されます。ただし、WWNまでのパス (0xを含む) と WWN の後の文字 (-(ハイフン) を含む) を入力する必要はありません。

ボリュームをフォーマットしてプロビジョニングした後に fstype パラメーターの値を変更すると、データ損失や Pod エラーが発生する可能性があります。

24.9.2.1. ディスククォータの実施

LUN パーティションを使用してディスククォータとサイズ制限を実施します。それぞれの LUN には 1 つの永続ボリュームです。Kubernetes では、永続ボリュームに一意の名前を使用する必要があります。

上記の方法でクォータを実施すると、エンドユーザーは永続ストレージを具体的な量 (10Gi など) で要求することができ、これを同等またはそれ以上の容量の対応するボリュームに一致させることができます。

24.9.2.2. ファイバーチャネルボリュームのセキュリティー

ユーザーは PersistentVolumeClaim でストレージを要求します。この要求はユーザーの namespace にのみ存在し、同じ namespace 内の Pod からのみ参照できます。namespace をまたいで永続ボリュームにアクセスしようとすると、Pod にエラーが発生します。

それぞれのファイバーチャネル LUN は、クラスター内のすべてのノードからアクセスできる必要があります。

24.10. Azure Disk を使用した永続ストレージ

24.10.1. 概要

OpenShift Container Platform では、Microsoft Azure Disk ボリュームがサポートされます。Azure を使用して、OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これには、Kubernetes と Azure についてある程度の理解があることが前提となります。

Kubernetes の 永続ボリュームフレームワークは、管理者がクラスターに永続ストレージをプロビジョニングできるようにします。ユーザーが基礎となるインフラストラクチャーの知識がなくてもこれらのリソースを要求できるようにします。

Azure Disk ボリュームは、動的にプロビジョニングできます。永続ボリュームは、単一のプロジェクトまたは namespace にバインドされず、OpenShift Container Platform クラスター全体で共有できます。ただし、Persistent Volume Claim (永続ボリューム要求) は、プロジェクトまたは namespace に固有で、ユーザーが要求できます。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

24.10.2. 前提条件

Azure を使用して永続ボリュームを作成する前に、OpenShift Container Platform クラスターが以下の要件を満たしていることを確認してください。

- まず、OpenShift Container Platform を Azure Disk 用に設定する必要があります。

- インフラストラクチャー内の各ノードは、Azure 仮想マシン名に一致している必要があります。

- それぞれのノードホストは、同じリソースグループに属している必要があります。

24.10.3. プロビジョニング

OpenShift Container Platform でストレージをボリュームとしてマウントするには、基礎となるインフラストラクチャーにストレージが存在している必要があります。OpenShift Container Platform が Azure Disk 用に設定されていることを確認した後、OpenShift Container Platform と Azure に必要になるのは、Azure Disk Name および Disk URI と PersistentVolume API のみです。

24.10.4. Azure Disk でのリージョンクラウドの設定

Azure には、インスタンスをデプロイする複数のリージョンがあります。必要なリージョンを指定するには、以下を azure.conf ファイルに追加します。

cloud: <region>

cloud: <region>リージョンは以下のいずれかになります。

-

ドイツクラウド:

AZUREGERMANCLOUD -

中国クラウド:

AZURECHINACLOUD -

パブリッククラウド:

AZUREPUBLICCLOUD -

米国クラウド:

AZUREUSGOVERNMENTCLOUD

24.10.4.1. 永続ボリュームの作成

Azure では、リサイクル回収ポリシーはサポートされません。

OpenShift Container Platform に永続ボリュームを作成する前に、永続ボリュームをオブジェクト定義で定義する必要があります。

例24.8 Azure を使用した永続ボリュームオブジェクトの定義

- 1

- ボリュームの名前です。これは Persistent Volume Claim (永続ボリューム要求)を使用して、または Pod からボリュームを識別するために使用されます。

- 2

- このボリュームに割り当てられるストレージの量。

- 3

- これは使用されるボリュームタイプを定義します (この例では、azureDisk プラグイン)。

- 4

- Blob ストレージのデータディスクの名前。

- 5

- Blob ストレージのデータディスクの URI

- 6

- ホストのキャッシングモード: None、ReadOnly、または ReadWrite。

- 7

- マウントするファイルシステムタイプ (

ext4、xfsなど)。 - 8

- デフォルトは

false(読み取り/書き込み) です。ここでReadOnlyを指定すると、VolumeMountsでReadOnly設定が強制的に実行されます。

ボリュームをフォーマットしてプロビジョニングした後に fsType パラメーターの値を変更すると、データ損失や Pod にエラーが発生する可能性があります。

定義を azure-pv.yaml などのファイルに保存し、永続ボリュームを作成します。

oc create -f azure-pv.yaml persistentvolume "pv0001" created

# oc create -f azure-pv.yaml persistentvolume "pv0001" createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow 永続ボリュームが作成されたことを確認します。

oc get pv NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE pv0001 <none> 5Gi RWO Available 2s

# oc get pv NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE pv0001 <none> 5Gi RWO Available 2sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

これで、Persistent Volume Claim (永続ボリューム要求) を使用してストレージを要求し、新規の永続ボリュームを活用できるようになります。

Azure Disk PVC を介してボリュームがマウントされている Pod の場合、新規ノードへの Pod のスケジューリングに数分の時間がかかります。ディスクの割り当て解除操作が完了するまで 2 ~ 3 分待ってから、新規デプロイメントを開始してください。ディスクの割り当て解除操作が完了する前に新規の Pod の作成要求が開始されると、Pod の作成によって開始されたディスクの割り当て操作が失敗し、結果として Pod の作成が失敗します。

Persistent Volume Claim (永続ボリューム要求) は、ユーザーの namespace にのみ存在し、同じ namespace 内の Pod からしか参照できません。別の namespace から永続ボリュームにアクセスしようとすると、Pod にエラーが発生します。

24.10.4.2. ボリュームのフォーマット

OpenShift Container Platform は、ボリュームをマウントしてコンテナーに渡す前に、永続ボリューム定義の fsType パラメーターで指定されたファイルシステムがボリュームにあるかどうか確認します。デバイスが指定されたファイルシステムでフォーマットされていない場合、デバイスのデータはすべて消去され、デバイスはそのファイルシステムで自動的にフォーマットされます。

これにより、OpenShift Container Platform がフォーマットされていない Azure ボリュームを初回の使用前にフォーマットするため、それらを永続ボリュームとして使用することが可能になります。

24.11. Azure File を使用した永続ストレージ

24.11.1. 概要

OpenShift Container Platform では、Microsoft Azure File ボリュームがサポートされます。Azure を使用して、OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これには、Kubernetes と Azure についてのある程度の理解があることが前提となります。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

24.11.2. 作業を開始する前の注意事項

すべてのノードに

samba-client、samba-common、およびcifs-utilsをインストールします。sudo yum install samba-client samba-common cifs-utils

$ sudo yum install samba-client samba-common cifs-utilsCopy to Clipboard Copied! Toggle word wrap Toggle overflow すべてのノードで SELinux ブール値を有効にします。

/usr/sbin/setsebool -P virt_use_samba on /usr/sbin/setsebool -P virt_sandbox_use_samba on

$ /usr/sbin/setsebool -P virt_use_samba on $ /usr/sbin/setsebool -P virt_sandbox_use_samba onCopy to Clipboard Copied! Toggle word wrap Toggle overflow mountコマンドを実行してdir_modeおよびfile_modeパーミッションなどを確認します。mount

$ mountCopy to Clipboard Copied! Toggle word wrap Toggle overflow

dir_mode および file_mode のパーミッションが 0755 に設定されている場合には、デフォルト値 0755 を 0777 または 0775 に変更します。OpenShift Container Platform 3.9 では、デフォルトの dir_mode および file_mode パーミッションが 0777 から 0755 に変更されるので、この手動の手順が必要です。以下の例では、変更された値が含まれる設定ファイルを紹介しています。

Azure File での MySQL および PostgresSQL を使用する場合の留意事項

- Azure File がマウントされるディレクトリーの所有者 UID は、コンテナーの UID とは異なります。

MySQL コンテナーは、マウントされたディレクトリーのファイルの所有者パーミッションを変更します。所有者 UID とコンテナープロセスの UID が一致しないので、この操作に失敗してしまいます。そのため、Azure File で MySQL を実行するには、以下を行うようにしてください。

PV 設定ファイルの

runAsUser変数に、Azure File のマウントされたディレクトリー UID を指定します。spec: containers: ... securityContext: runAsUser: <mounted_dir_uid>spec: containers: ... securityContext: runAsUser: <mounted_dir_uid>Copy to Clipboard Copied! Toggle word wrap Toggle overflow PV 設定ファイルの

mountOptionsでコンテナーのプロセス UID を指定します。mountOptions: - dir_mode=0700 - file_mode=0600 - uid=<conatiner_process_uid> - gid=0

mountOptions: - dir_mode=0700 - file_mode=0600 - uid=<conatiner_process_uid> - gid=0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- PostgreSQL は Azure File との併用はできません。これは、PostgreSQL に Azure File ディレクトリーのハードリンクが必要であるにもかかわらず、Azure File では ハードリンク をサポートしていないため、Pod の起動に失敗します。

PV 設定ファイル例

ストレージクラスの設定ファイル例

24.11.3. Azure File でのリージョンクラウドの設定

Azure Disk は複数のリージョンクラウドに対応していますが、Azure File は、エンドポイントがハードコードされているために Azure パブリッククラウドのみをサポートしています。

24.11.4. PV の作成

Azure File では、リサイクル回収ポリシーはサポートされません。

24.11.5. Azure Storage Account シークレットの作成

Azure Storage Account の名前とキーをシークレット設定に定義します。これは後に OpenShift Container Platform で使用できるように base64 に変換されます。

Azure Storage Account の名前とキーを取得し、base64 にエンコードします。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow シークレット定義を azure-secret.yaml などのファイルに保存し、シークレットを作成します。

oc create -f azure-secret.yaml

$ oc create -f azure-secret.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットが作成されたことを確認します。

oc get secret azure-secret NAME TYPE DATA AGE azure-secret Opaque 1 23d

$ oc get secret azure-secret NAME TYPE DATA AGE azure-secret Opaque 1 23dCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform に PV を作成する前に、PV をオブジェクト定義に定義します。

Azure File を使用した PV オブジェクト定義の例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 定義を azure-file-pv.yaml などのファイルに保存し、PV を作成します。

oc create -f azure-file-pv.yaml persistentvolume "pv0001" created

$ oc create -f azure-file-pv.yaml persistentvolume "pv0001" createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow PV が作成されたことを確認します。

oc get pv NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE pv0001 <none> 5Gi RWM Available 2s

$ oc get pv NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE pv0001 <none> 5Gi RWM Available 2sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

これで、PVC (永続ボリューム要求) を使用してストレージを要求し、新規の永続ボリュームを活用できるようになります。

PVC (永続ボリューム要求) は、ユーザーの namespace にのみ存在し、同じ namespace 内の Pod からしか参照できません。別の namespace から永続ボリュームにアクセスしようとすると、Pod にエラーが発生します。

24.12. FlexVolume プラグインを使用した永続ストレージ

24.12.1. 概要

OpenShift Container Platform には、各種のストレージテクノロジーを使用するためにボリュームプラグインが組み込まれています。組み込みプラグインがないバックエンドのストレージを使用する場合は、FlexVolume ドライバーを使用して OpenShift Container Platform を拡張し、アプリケーションに永続ストレージを提供できます。

24.12.2. FlexVolume ドライバー

FlexVolume ドライバーは、クラスター内のすべてのマシン (マスターとノードの両方) の明確に定義されたディレクトリーに格納されている実行可能ファイルです。OpenShift Container Platform は、flexVolume をソースとする PersistentVolume によって表されるボリュームの割り当て、割り当て解除、マウント、またはアンマウントが必要になるたびに FlexVolume ドライバーを呼び出します。

ドライバーの最初のコマンドライン引数は常に操作名です。その他のパラメーターは操作ごとに異なります。ほとんどの操作は、JSON (JavaScript Object Notation) 文字列をパラメーターとして取ります。このパラメーターは完全な JSON 文字列であり、JSON データを含むファイルの名前ではありません。

FlexVolume ドライバーには以下が含まれます。

-

すべての

flexVolume.options。 -

kubernetes.io/というプレフィックスが付いたflexVolumeのいくつかのオプション。たとえば、fsTypeやreadwriteなどです。 -

kubernetes.io/secret/というプレフィックスが付いた参照先シークレット (指定されている場合) の内容。

FlexVolume ドライバーの JSON 入力例

OpenShift Container Platform は、ドライバーの標準出力に JSON データが含まれていると想定します。指定されていない場合、出力には操作の結果が示されます。

FlexVolume ドライバーのデフォルトの出力

{

"status": "<Success/Failure/Not supported>",

"message": "<Reason for success/failure>"

}

{

"status": "<Success/Failure/Not supported>",

"message": "<Reason for success/failure>"

}

ドライバーの終了コードは、成功の場合は 0、エラーの場合は 1 です。

操作はべき等です。つまり、すでに割り当てられているボリュームの割り当て操作や、すでにマウントされているボリュームのマウント操作は成功します。

FlexVolume ドライバーは以下の 2 つのモードで動作します。

attach/detach 操作は、OpenShift Container Platform マスターにより、ノードにボリュームを割り当てるため、およびノードからボリュームの割り当てを解除するために使用されます。これは何らかの理由でノードが応答不能になった場合に役立ちます。その後、マスターはノード上のすべての Pod を強制終了し、ノードからすべてのボリュームの割り当てを解除して、ボリュームを他のノードに割り当てることで、元のノードがまだ到達不能な状態であってもアプリケーションを再開できます。

マスター実行の、別のマシンからのボリュームの割り当て解除は、すべてのストレージバックエンドでサポートされる訳ではありません。

24.12.2.1. マスター実行の割り当て/割り当て解除がある FlexVolume ドライバー

マスター制御の割り当て/割り当て解除をサポートする FlexVolume ドライバーは、以下の操作を実装する必要があります。

initドライバーを初期化します。マスターとノードの初期化中に呼び出されます。

- 引数: なし

- 実行場所: マスター、ノード

- 予期される出力: デフォルトの JSON

getvolumenameボリュームの一意の名前を返します。この名前は、後続の

detach呼び出しで<volume-name>として使用されるため、すべてのマスターとノード間で一致している必要があります。<volume-name>の/文字は自動的に~に置き換えられます。-

引数:

<json> - 実行場所: マスター、ノード

予期される出力: デフォルトの JSON +

volumeName:{ "status": "Success", "message": "", "volumeName": "foo-volume-bar" }{ "status": "Success", "message": "", "volumeName": "foo-volume-bar"1 }Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ストレージバックエンド

fooのボリュームの一意の名前。

-

引数:

attach指定されたノードに、JSON で表現したボリュームを割り当てます。この操作は、ノード上のデバイスが既知の場合 (つまり、そのデバイスが実行前にストレージバックエンドによって割り当て済みの場合)、そのデバイスの名前を返します。デバイスが既知でない場合は、後続の

waitforattach操作によってノード上のデバイスが検出される必要があります。-

引数:

<json><node-name> - 実行場所: マスター

予期される出力: デフォルトの JSON +

device(既知の場合)。{ "status": "Success", "message": "", "device": "/dev/xvda" }{ "status": "Success", "message": "", "device": "/dev/xvda"1 }Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ノード上のデバイスの名前 (既知の場合)。

-

引数:

waitforattachボリュームがノードに完全に割り当てられ、デバイスが出現するまで待機します。前の

attach操作から<device-name>が返された場合は、それが入力パラメーターとして渡されます。そうでない場合、<device-name>は空であり、この操作によってノード上のデバイスを検出する必要があります。-

引数:

<device-name><json> - 実行場所: ノード

予期される出力: デフォルトの JSON +

device{ "status": "Success", "message": "", "device": "/dev/xvda" }{ "status": "Success", "message": "", "device": "/dev/xvda"1 }Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ノード上のデバイスの名前。

-

引数:

detach指定されたボリュームをノードから割り当て解除します。

<volume-name>は、getvolumename操作から返されるデバイスの名前です。<volume-name>の/文字は、~に自動的に置き換えられます。-

引数:

<volume-name><node-name> - 実行場所: マスター

- 予期される出力: デフォルトの JSON

-

引数:

isattachedボリュームがノードに割り当てられていることを確認します。

-

引数:

<json><node-name> - 実行場所: マスター

予期される出力: デフォルトの JSON +

attached{ "status": "Success", "message": "", "attached": true }{ "status": "Success", "message": "", "attached": true1 }Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ノードへのボリュームの割り当てのステータス。

-

引数:

mountdeviceボリュームのデバイスをディレクトリーにマウントします。

<device-name>は、前のwaitforattach操作から返されるデバイスの名前です。-

引数:

<mount-dir><device-name><json> - 実行場所: ノード

- 予期される出力: デフォルトの JSON

-

引数:

unmountdeviceボリュームのデバイスをディレクトリーからアンマウントします。

-

引数:

<mount-dir> - 実行場所: ノード

-

引数:

その他のすべての操作は、{"status": "Not supported"} と終了コード 1 を出して JSON を返します。

OpenShift Container Platform 3.6 では、マスター実行の割り当て/割り当て解除操作はデフォルトで有効にされています。これらの操作は古いバージョンでも使用できる場合がありますが、その場合には明示的に有効にする必要があります。「コントローラー管理の割り当ておよび割り当て解除」を参照してください。有効にされていない場合、割り当て/割り当て解除操作は、ボリュームの割り当て/割り当て解除が実行される必要のあるノードで開始されます。FlexVolume ドライバー呼び出しの構文とすべてのパラメーターはどちらの場合も同じになります。

24.12.2.2. マスター実行の割り当て/割り当て解除がない FlexVolume ドライバー

マスター制御の割り当て/割り当て解除をサポートしない FlexVolume ドライバーは、ノードでのみ実行され、以下の操作を実装する必要があります。

initドライバーを初期化します。すべてのノードの初期化中に呼び出されます。

- 引数: なし

- 実行場所: ノード

- 予期される出力: デフォルトの JSON

mountボリュームをディレクトリーにマウントします。これには、ノードへのボリュームの割り当て、ノードのデバイスの検出、その後のデバイスのマウントを含む、ボリュームのマウントに必要なあらゆる操作が含まれます。

-

引数:

<mount-dir><json> - 実行場所: ノード

- 予期される出力: デフォルトの JSON

-

引数:

unmountボリュームをディレクトリーからアンマウントします。これには、ノードからのボリュームの割り当て解除など、アンマウント後のボリュームのクリーンアップに必要なあらゆる操作が含まれます。

-

引数:

<mount-dir> - 実行場所: ノード

- 予期される出力: デフォルトの JSON

-

引数:

その他のすべての操作は、{"status": "Not supported"} と終了コード 1 を出して JSON を返します。

24.12.3. FlexVolume ドライバーのインストール

FlexVolume ドライバーをインストールします。

- この実行可能ファイルがクラスター内のすべてのマスターとノードに存在することを確認します。

- この実行可能ファイルをボリュームプラグインのパス (/usr/libexec/kubernetes/kubelet-plugins/volume/exec/<vendor>~<driver>/<driver>) に配置します。

たとえば、ストレージ foo の FlexVolume ドライバーをインストールするには、実行可能ファイルを /usr/libexec/kubernetes/kubelet-plugins/volume/exec/openshift.com~foo/foo に配置します。

OpenShift Container Platform 3.10 では、controller-manager が静的 Pod として実行されるので、割り当ておよび割り当て解除の操作を行う FlexVolume バイナリーファイルは、外部の依存関係がなく、独立した実行可能ファイルでなければなりません。

Atomic ホストでは、FlexVolume プラグインディレクトリーのデフォルトの場所は /etc/origin/kubelet-plugins/ です。FlexVolume の実行可能ファイルを、クラスター内の全マスターとノードの /etc/origin/kubelet-plugins/volume/exec/<vendor>~<driver>/<driver> ディレクトリーに配置する必要があります。

24.12.4. FlexVolume ドライバーを使用したストレージの使用

インストールされているストレージを参照するには、PersistentVolume オブジェクトを使用します。OpenShift Container Platform の各 PersistentVolume オブジェクトは、ストレージバックエンドの 1 つのストレージアセット (通常はボリューム) を表します。

FlexVolume ドライバーを使用した永続ボリュームオブジェクト定義例

- 1

- ボリュームの名前。これはPersistent Volume Claim (永続ボリューム要求) を使用するか、または Pod からボリュームを識別するために使用されます。この名前は、バックエンドストレージのボリューム名とは異なるものにすることができます。

- 2

- このボリュームに割り当てられるストレージの量。

- 3

- ドライバーの名前。このフィールドは必須です。

- 4

- ボリュームに存在するオプションのファイルシステム。このフィールドはオプションです。

- 5

- シークレットへの参照。このシークレットのキーと値は、起動時に FlexVolume ドライバーに渡されます。このフィールドはオプションです。

- 6

- 読み取り専用のフラグ。このフィールドはオプションです。

- 7

- FlexVolume ドライバーの追加オプション。

optionsフィールドでユーザーが指定するフラグに加え、以下のフラグも実行可能ファイルに渡されます。

"fsType":"<FS type>", "readwrite":"<rw>", "secret/key1":"<secret1>" ... "secret/keyN":"<secretN>"

"fsType":"<FS type>",

"readwrite":"<rw>",

"secret/key1":"<secret1>"

...

"secret/keyN":"<secretN>"シークレットは、呼び出しのマウント/マウント解除のためにだけ渡されます。

24.13. 永続ストレージ用の VMware vSphere ボリューム

24.13.1. 概要

OpenShift Container Platform では、VMWare vSphere の仮想マシンディスク (VMDK: Virtual Machine Disk) ボリュームがサポートされます。VMWare vSphere を使用して、OpenShift Container Platform クラスターに永続ストレージをプロビジョニングできます。これには、Kubernetes と VMWare vSphere についてのある程度の理解があることが前提となります。

OpenShift Container Platform の永続ボリューム (PV) フレームワークを使用すると、管理者がクラスターに永続ストレージをプロビジョニングできるようになるだけでなく、ユーザーが、基盤となるインフラストラクチャーに精通していなくてもこれらのリソースを要求できるようになります。VMWare vSphere VMDK ボリュームは、動的にプロビジョニングできます。

永続ボリュームは、単一のプロジェクトまたは namespace にバインドされず、OpenShift Container Platform クラスター全体で共有できます。ただし、PVC (永続ボリューム要求) は、プロジェクトまたは namespace に固有で、ユーザーによる要求が可能です。

インフラストラクチャーにおけるストレージの高可用性は、基礎となるストレージのプロバイダーに委ねられています。

前提条件

vSphere を使用して永続ボリュームを作成する前に、OpenShift Container Platform クラスターが以下の要件を満たしていることを確認してください。

- 最初に OpenShift Container Platform を vSphere 用に設定する必要があります。

- インフラストラクチャー内の各ノードホストは、vSphere 仮想マシン名に一致する必要があります。

- それぞれのノードホストは、同じリソースグループに属している必要があります。

VMDK を使用する前に、以下のいずれかの方法を使用して VMDK を作成します。

vmkfstoolsを使用して作成する。セキュアシェル (SSH) を使用して ESX にアクセスし、以下のコマンドを使用して vmdk ボリュームを作成します。

vmkfstools -c 2G /vmfs/volumes/DatastoreName/volumes/myDisk.vmdk

vmkfstools -c 2G /vmfs/volumes/DatastoreName/volumes/myDisk.vmdkCopy to Clipboard Copied! Toggle word wrap Toggle overflow vmware-vdiskmanagerを使用して作成する。shell vmware-vdiskmanager -c -t 0 -s 40GB -a lsilogic myDisk.vmdk

shell vmware-vdiskmanager -c -t 0 -s 40GB -a lsilogic myDisk.vmdkCopy to Clipboard Copied! Toggle word wrap Toggle overflow

24.13.2. VMware vSphere ボリュームのプロビジョニング

OpenShift Container Platform でストレージをボリュームとしてマウントするには、ストレージが基礎となるインフラストラクチャーに存在している必要があります。OpenShift Container Platform が vSpehere 用に設定されていることを確認した後、OpenShift Container Platform と vSphere に必要になるのは、VM フォルダーパス、ファイルシステムタイプ、および PersistentVolume API のみです。

24.13.2.1. 永続ボリュームの作成

OpenShift Container Platform に PV を作成する前に、PV をオブジェクト定義に定義する必要があります。

VMware vSphere を使用した PV オブジェクト定義の例

- 1

- ボリュームの名前です。これを使用して、PVC (永続ボリューム要求) で、または Pod から、ボリュームを識別する必要があります。

- 2

- このボリュームに割り当てられるストレージの量。

- 3

- これは使用されるボリュームタイプを定義します (この例では、vsphereVolume プラグイン)。

vsphereVolumeラベルは、vSphere VMDK ボリュームを Pod にマウントするために使用されます。ボリュームがアンマウントされてもボリュームのコンテンツは保持されます。このボリュームタイプは、VMFS データストアと VSAN データストアの両方をサポートします。 - 4

- VMDK ボリュームが存在し、ボリューム定義内に括弧 ([]) を含める必要があります。

- 5

- マウントするファイルシステムタイプ (

ext4、xfs、その他のファイルシステムなど)。

ボリュームをフォーマットしてプロビジョニングした後に fsType パラメーターの値を変更すると、データ損失や Pod にエラーが発生する可能性があります。

永続ボリュームを作成します。

定義を vsphere-pv.yaml などのファイルに保存し、PV を作成します。

oc create -f vsphere-pv.yaml persistentvolume "pv0001" created

$ oc create -f vsphere-pv.yaml persistentvolume "pv0001" createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow PV が作成されたことを確認します。

oc get pv NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE pv0001 <none> 2Gi RWO Available 2s

$ oc get pv NAME LABELS CAPACITY ACCESSMODES STATUS CLAIM REASON AGE pv0001 <none> 2Gi RWO Available 2sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

これで、PVC (永続ボリューム要求) を使用してストレージを要求し、永続ボリュームを活用できるようになります。

PVC (永続ボリューム要求) は、ユーザーの namespace にのみ存在し、同じ namespace 内の Pod からしか参照できません。別の namespace から永続ボリュームにアクセスしようとすると、Pod にエラーが発生します。

24.13.2.2. VMware vSphere ボリュームのフォーマット