This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.MTC (Migration Toolkit for Containers)

OpenShift Container Platform 4 への移行

概要

第1章 MTC (Migration Toolkit for Containers)

MTC (Migration Toolkit for Containers) を使用すると、OpenShift Container Platform 4 クラスター間でステートフルなアプリケーションのワークロードを namespace のレベルで移行できます。

OpenShift Container Platform 3 から移行する場合は、OpenShift Container Platform 3 から 4 への移行 および OpenShift Container Platform 3 へのレガシー Migration Toolkit for Containers Operator のインストール を参照してください。

状態の移行を使用して、同じクラスター内またはクラスター間でアプリケーションを移行できます。

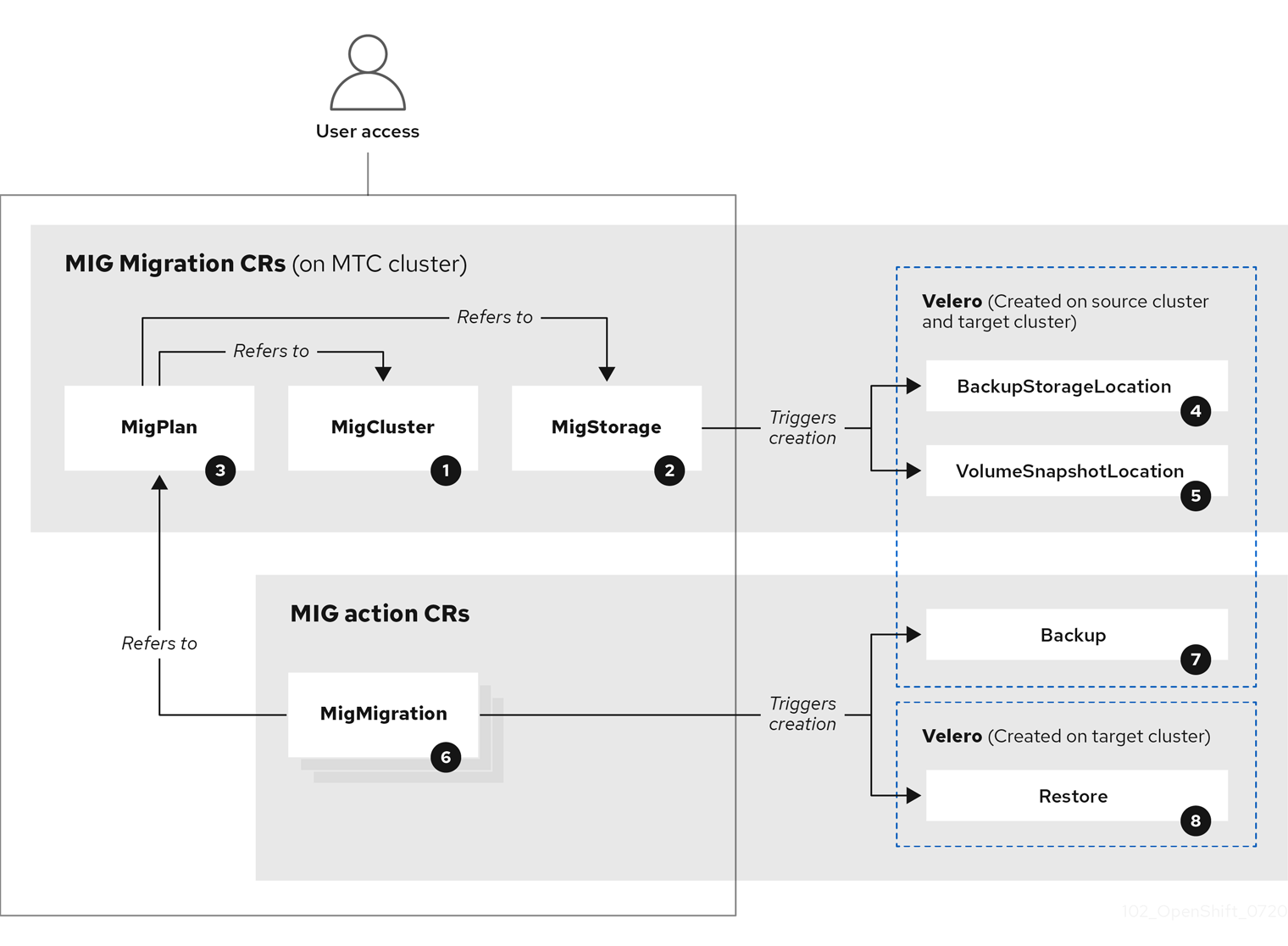

MTC には、Web コンソールおよび API が同梱されており、Kubernetes カスタムリソースに基づいて移行を制御してアプリケーションのダウンタイムを最小限に抑えることができます。

MTC コンソールはデフォルトでターゲットクラスターにインストールされます。Migration Toolkit for Containers Operator を、コンソールを リモートクラスター にインストールするように設定できます。

以下のトピックの詳細は、高度な移行オプション を参照してください。

- 移行フックおよび MTC API で移行を自動化する。

- リソースを除外して大規模な移行をサポートし、ボリュームを直接移行する場合の自動 PV サイズ調整を有効化にするように移行計画を設定する。

1.1. 用語

| 用語 | 定義 |

|---|---|

| ソースクラスター | アプリケーションの移行元となるクラスター。 |

| 宛先クラスター[1] | アプリケーションが移行されるクラスター。 |

| レプリケーションリポジトリー | ボリュームとイメージの直接的な移行時の Kubernetes オブジェクトに使用するオブジェクトストレージ、または間接的な移行時にイメージ、ボリューム、Kubernetes オブジェクトのコピーに使用するオブジェクトストレージ。 レプリケーションリポジトリーはすべてのクラスターからアクセスできる必要があります。 |

| ホストクラスター |

ホストクラスターには、イメージの直接移行にレジストリールートを公開する必要はありません。 |

| リモートクラスター | 通常、リモートクラスターはソースクラスターですが、これは必須ではありません。

リモートクラスターには、 リモートクラスターには、直接のイメージ移行用にセキュアなレジストリールートを公開する必要があります。 |

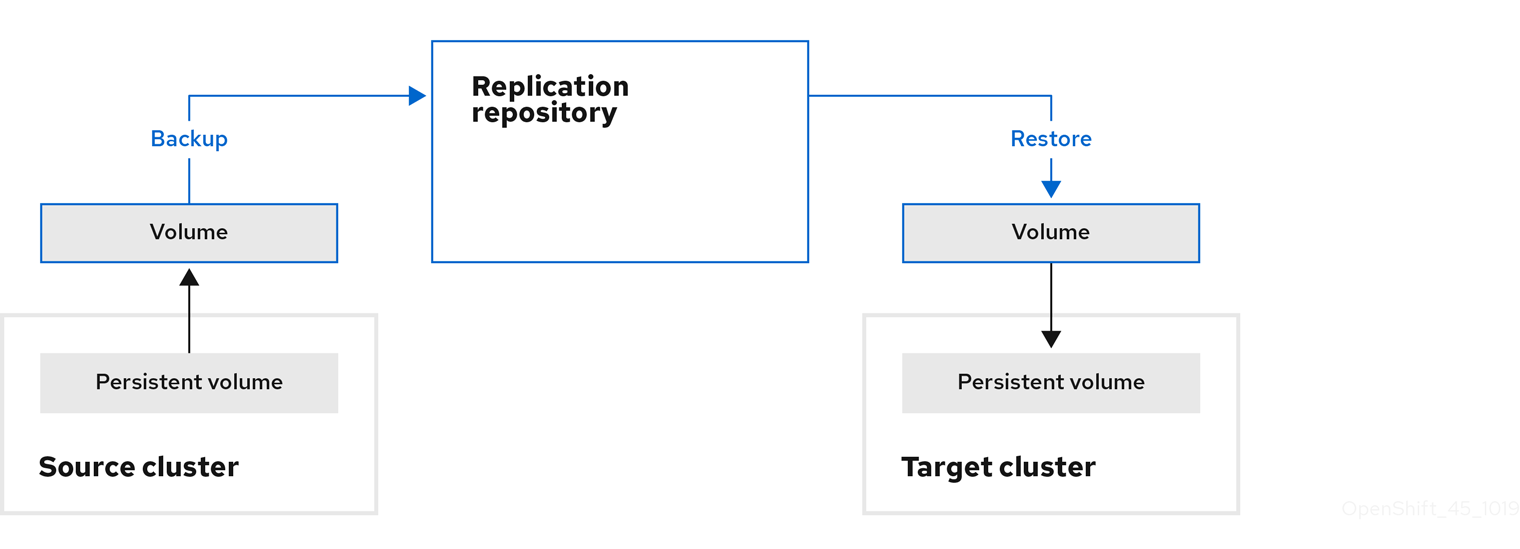

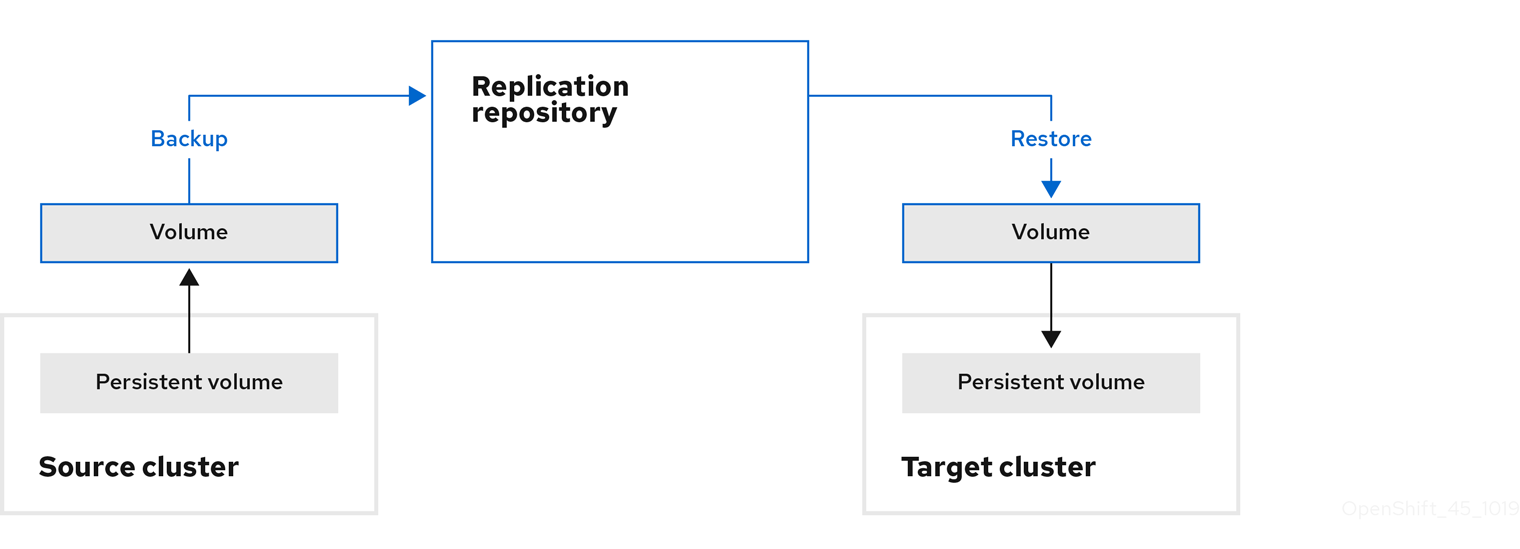

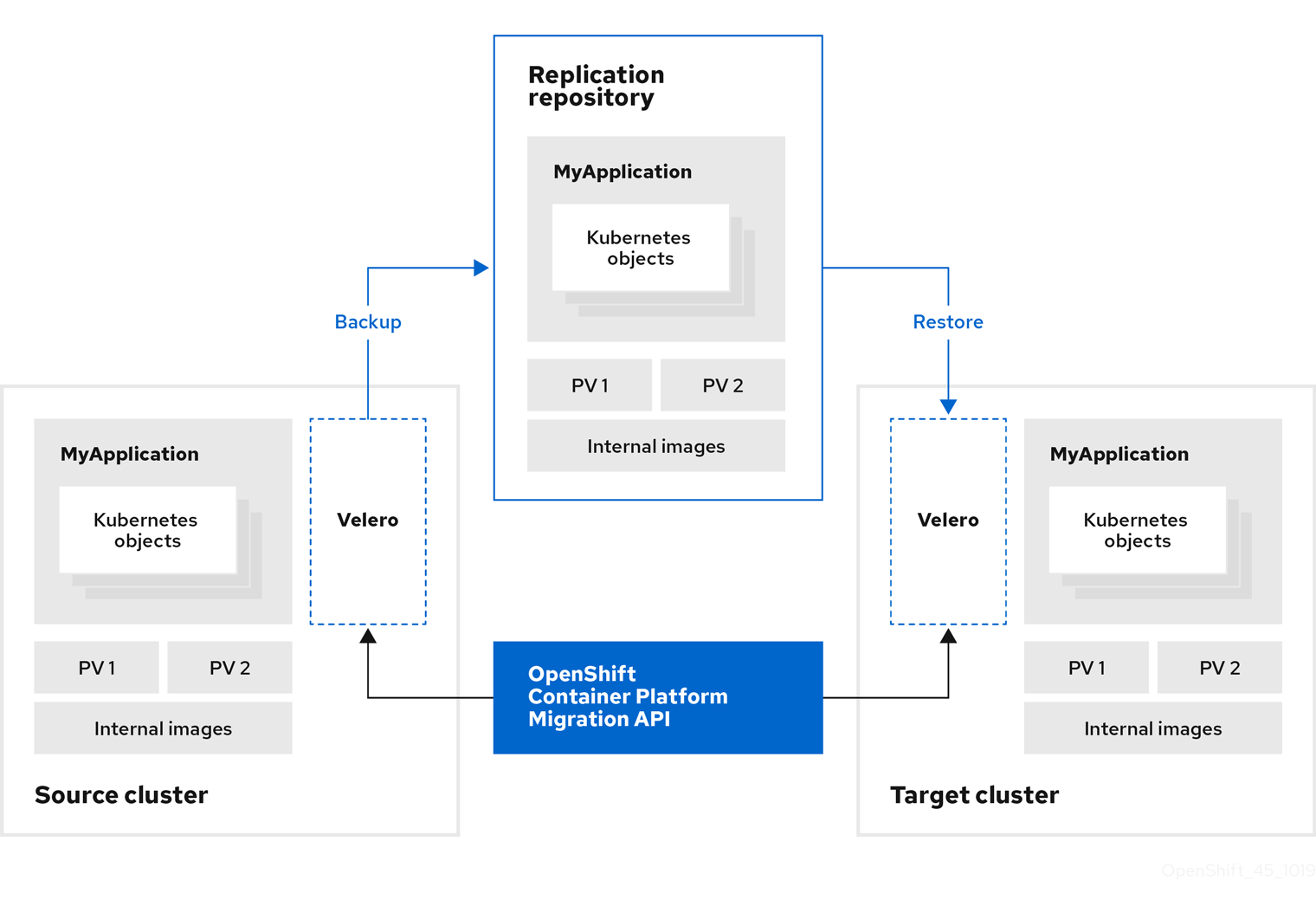

| 間接的な移行 | イメージ、ボリューム、および Kubernetes オブジェクトはソースクラスターからレプリケーションリポジトリーにコピーされ、その後にレプリケーションリポジトリーから宛先クラスターにコピーされます。 |

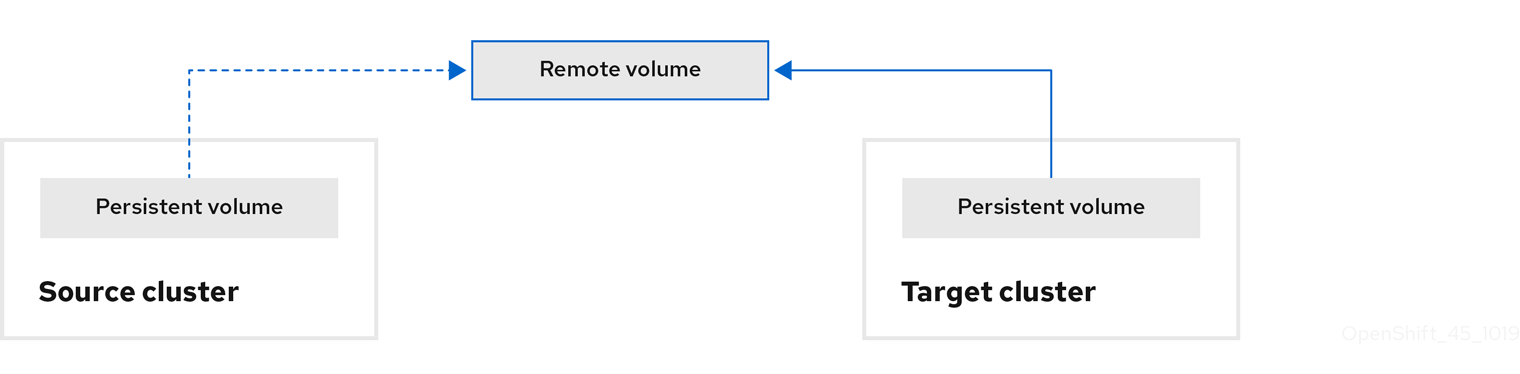

| ボリュームの直接移行 | 永続ボリュームはソースクラスターから宛先クラスターに直接コピーされます。 |

| イメージの直接移行 | イメージはソースクラスターから宛先クラスターに直接コピーされます。 |

| 段階移行 | データはアプリケーションを停止せずに、宛先クラスターにコピーされます。 段階移行を複数回実行すると、カットオーバー移行の時間が短縮されます。 |

| カットオーバー移行 | ソースクラスター上のアプリケーションが停止され、アプリケーションリソースが宛先クラスターに移行されます。 |

| 状態の移行 | アプリケーションの状態は、特定の永続ボリューム要求を宛先クラスターにコピーして移行されます。 |

| ロールバック移行 | ロールバック移行は完了した移行をロールバックします。 |

1 MTC の Web コンソールの ターゲットクラスターを指します。

1.2. MTC ワークフロー

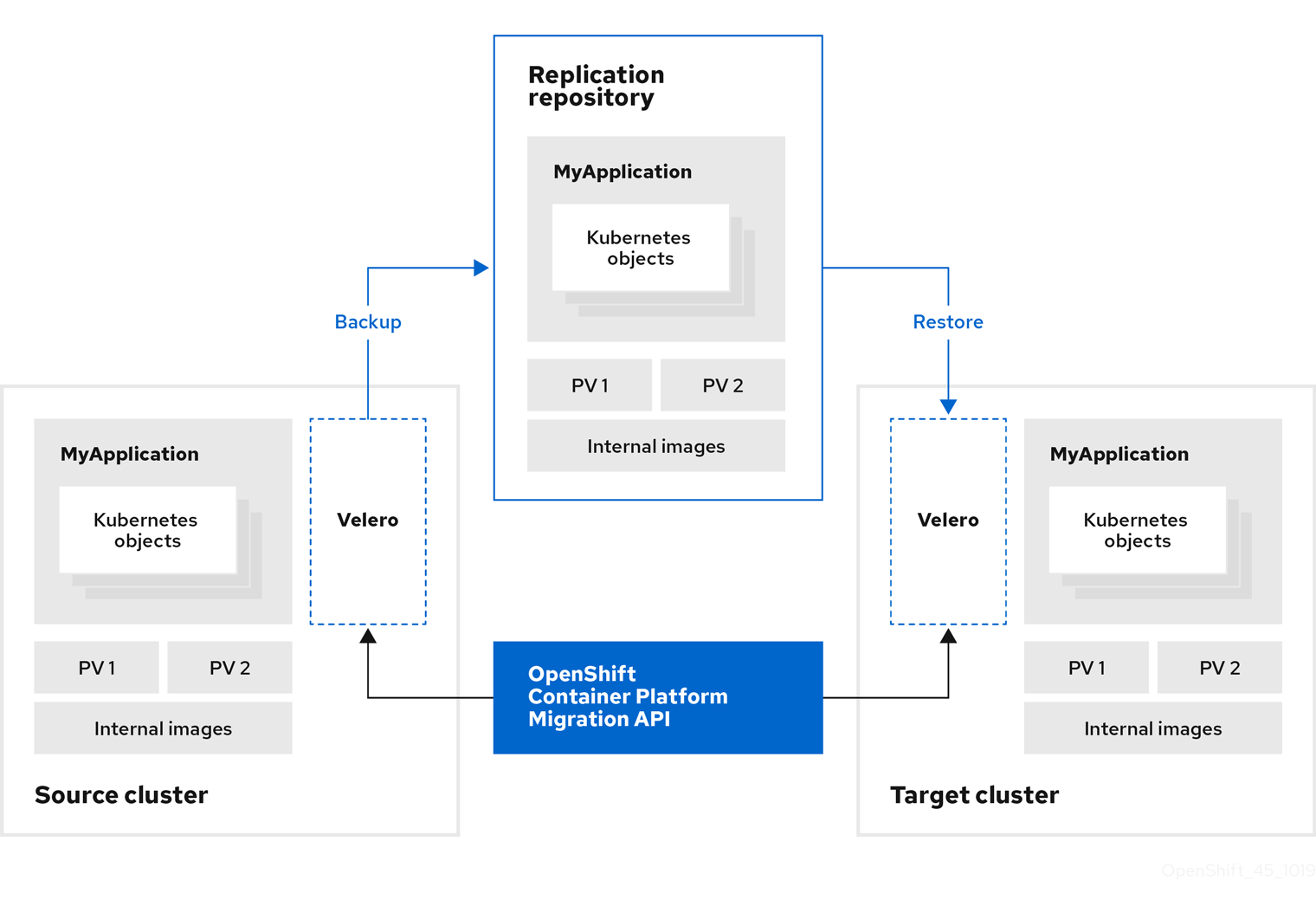

MTC (Migration Toolkit for Containers) の Web コンソールまたは Kubernetes API を使用して、Kubernetes リソース、永続ボリュームデータ、および内部コンテナーイメージを OpenShift Container Platform 4.11 に移行できます。

MTC は以下のリソースを移行します。

- 移行計画に指定される namespace。

namespace スコープのリソース: MTC が namespace を移行する場合、サービスや Pod などのその namespace に関連付けられるすべてのオブジェクトおよびリソースを移行します。さらに、namespace に存在するものの、クラスターレベルに存在しないリソースがクラスターレベルに存在するリソースに依存する場合、MTC は両方のリソースを移行します。

たとえば、SCC (Security Context Constraints) はクラスターレベルに存在するリソースであり、サービスアカウント (SA) は namespace レベルに存在するリソースです。SA が MTC が移行する namespace に存在する場合、MTC は SA にリンクされている SCC を自動的に識別し、それらの SCC も移行します。同様に、MTC は、namespace の永続ボリューム要求にリンクされている永続ボリュームを移行します。

注記クラスタースコープのリソースは、リソースによっては手動で移行する必要がある場合があります。

- カスタムリソース (CR) およびカスタムリソース定義 (CRD): MTC は、namespace レベルで CR および CRD を自動的に移行します。

MTC Web コンソールを使用してアプリケーションを移行するには、以下の手順が必要です。

すべてのクラスターに MTC (Migration Toolkit for Containers Operator) をインストールします。

インターネットアクセスが制限されているか、インターネットアクセスのない制限された環境で Migration Toolkit for Containers Operator をインストールできます。ソースおよびターゲットクラスターは、相互に対するネットワークアクセスおよびミラーレジストリーへのネットワークアクセスがなければなりません。

MTC がデータ移行に使用する中間オブジェクトストレージであるレプリケーションリポジトリーを設定します。

ソースおよびターゲットクラスターには、移行時にレプリケーションリポジトリーへのネットワークアクセスがなければなりません。プロキシーサーバーを使用している場合は、レプリケーションリポジトリーとクラスター間のネットワークトラフィックを許可するように設定する必要があります。

- ソースクラスターを MTC の Web コンソールに追加します。

- レプリケーションリポジトリーを MTC の Web コンソールに追加します。

以下のデータ移行オプションのいずれかを使用して、移行計画を作成します。

Copy: MTC は、データをソースクラスターからレプリケーションリポジトリーにコピーし、レプリケーションリポジトリーからターゲットクラスターにコピーします。

注記イメージの直接移行またはボリュームの直接移行を使用している場合、イメージまたはボリュームはソースクラスターからターゲットクラスターに直接コピーされます。

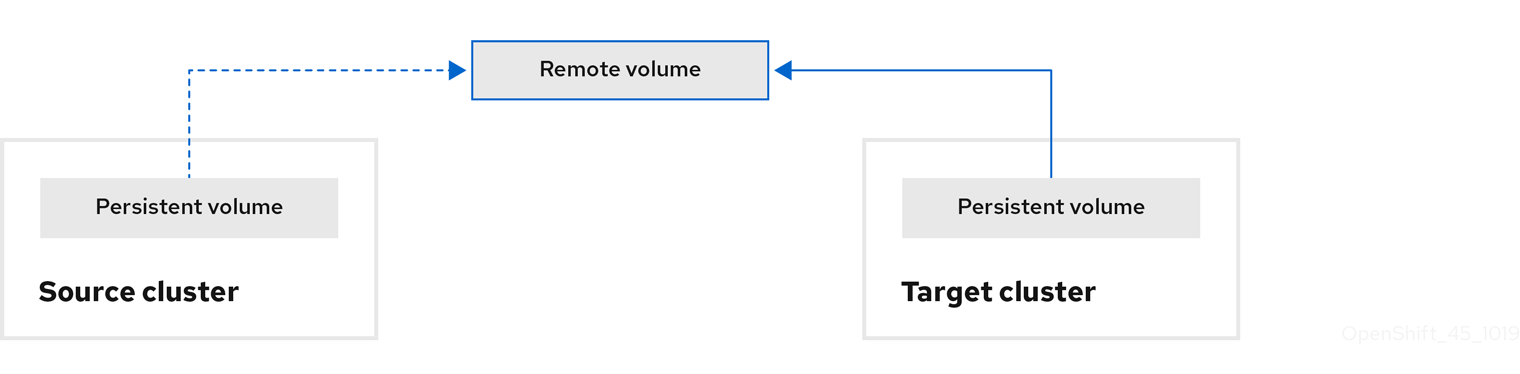

Move: MTC は、ソースクラスターからリモートボリューム (例: NFS) をアンマウントし、リモートボリュームをポイントするターゲットクラスターで PV リソースを作成し、その後にリモートボリュームをターゲットクラスターにマウントします。ターゲットクラスターで実行されているアプリケーションは、ソースクラスターが使用していたものと同じリモートボリュームを使用します。リモートボリュームは、ソースクラスターおよびターゲットクラスターからアクセスできる必要があります。

注記レプリケーションリポジトリーはこの図には表示されていませんが、これは移行に必要です。

以下のオプションのいずれかを使用して、移行計画を実行します。

段階 移行は、アプリケーションを停止せずにデータをターゲットクラスターにコピーします。

段階移行は複数回実行して、移行前にほとんどのデータがターゲットにコピーされるようにします。1 つ以上の段階移行を実行すると、カットオーバー移行の期間が短縮されます。

カットオーバー は、ソースクラスターでアプリケーションを停止し、リソースをターゲットクラスターに移動します。

オプション:Halt transactions on the source cluster during migrationのチェックボックスのチェックを解除できます。

1.3. データのコピー方法

MTC (Migration Toolkit for Containers) は、ソースクラスターからターゲットクラスターにデータを移行するために、ファイルシステムおよびスナップショットによるデータのコピー方法をサポートします。ご使用の環境に適した方法で、ストレージプロバイダーでサポートされる方法を選択できます。

1.3.1. ファイルシステムのコピー方法

MTC は、データファイルをソースクラスターからレプリケーションリポジトリーにコピーし、そこからターゲットクラスターにコピーします。

ファイルシステムのコピー方法では、間接移行に Restic を使用し、直接ボリューム移行に Rsync を使用します。

| 利点 | 制限 |

|---|---|

|

|

Restic および Rsync PV の移行では、サポートされている PV が volumeMode=filesystem のみであることを前提としています。ファイルシステムの移行に volumeMode=Block を使用することはサポートされて いません。

1.3.2. スナップショットのコピー方法

MTC は、ソースクラスターのデータのスナップショットを、クラウドプロバイダーのレプリケーションリポジトリーにコピーします。データはターゲットクラスターで復元されます。

スナップショットコピー方式は、Amazon Web Services、Google Cloud Provider、および Microsoft Azure で使用できます。

| 利点 | 制限 |

|---|---|

|

|

1.4. ボリュームの直接移行とイメージの直接移行

イメージの直接移行 (DIM) およびボリュームの直接移行 (DVM) を使用して、イメージおよびデータをソースクラスターからターゲットクラスターに直接移行できます。

異なるアベイラビリティーゾーンにあるノードで DVM を実行する場合に、移行した Pod は永続ボリューム要求にアクセスできないために移行が失敗する可能性があります。

DIM および DVM では、ソースクラスターからレプリケーションリポジトリーにファイルのバックアップを作成し、レプリケーションリポジトリーからターゲットクラスターにファイルを復元する中間ステップが省略されるため、大きなパフォーマンス上の利点があります。データは Rsync で転送されます。

DIM および DVM には追加の前提条件があります。

第2章 MTC (Migration Toolkit for Containers) リリースノート

MTC (Migration Toolkit for Containers) リリースノートでは、新機能および拡張機能、非推奨となった機能、および既知の問題について説明しています。

MTC を使用すると、namespace の粒度で OpenShift Container Platform クラスター間でアプリケーションワークロードを移行できます。

OpenShift Container Platform 3 から 4.11 および OpenShift Container Platform 4 クラスター間で移行できます。

MTC には、Web コンソールおよび API が同梱されており、Kubernetes カスタムリソースに基づいて移行を制御してアプリケーションのダウンタイムを最小限に抑えることができます。

MTC のサポートポリシーの詳細は、Red Hat OpenShift Container Platform ライフサイクルポリシー の一部である OpenShift Application and Cluster Migration Solutions を参照してください。

2.1. Migration Toolkit for Containers 1.8.2 リリースノート

2.1.1. 解決した問題

このリリースでは、次の主要な問題が解決されています。

カスタム CA レプリケーションリポジトリーの設定後にバックアップフェーズが失敗します

以前の Migration Toolkit for Containers (MTC) リリースでは、レプリケーションリポジトリーを編集し、カスタム CA 証明書を追加し、リポジトリーに正常に接続して移行をトリガーした後、バックアップフェーズ中にエラーが発生しました。

CVE-2023-26136: 4.1.3 より前の tough-cookie パッケージはプロトタイプ汚染に対して脆弱です

以前の (MTC) リリースでは、MTC で使用される tough-cookie パッケージの 4.1.3 より前のバージョンは、プロトタイプ汚染に対して脆弱でした。この脆弱性は、rejectPublicSuffixes の値が false に設定されている場合に CookieJar が cookie を適切に処理しないために発生しました。

詳細は、(CVE-2023-26136) を参照してください。

CVE-2022-25883 openshift-migration-ui-container: nodejs-semver: 正規表現によるサービス拒否

以前の (MTC) リリースでは、MTC で使用されている semver パッケージの 7.5.2 より前のバージョンは、信頼できないユーザーデータが範囲として指定された場合、関数 newRange からの Regular Expression Denial of Service (ReDoS) に対して脆弱でした。

詳細は、(CVE-2022-25883) を参照してください。

2.1.2. 既知の問題

このリリースには重大な既知の問題はありません。

2.2. Migration Toolkit for Containers 1.8.1 リリースノート

2.2.1. 解決した問題

このリリースでは、次の主要な問題が解決されています。

CVE-2023-39325: golang: net/http、x/net/http2: 急速なストリームリセットにより過剰な作業が発生する可能性があります

Migration Toolkit for Containers (MTC) で使用される HTTP/2 プロトコルでの多重化ストリームの処理に欠陥が見つかりました。 クライアントは、新しい多重化ストリームの要求を繰り返し行い、すぐに RST_STREAM フレームを送信してそれをキャンセルする可能性があります。これにより、接続ごとのアクティブなストリームの最大数に関するサーバー側の制限を回避しながら、ストリームのセットアップと削除に関してサーバーに追加のワークロードが発生し、サーバーリソースの消費によるサービス拒否が発生します。(BZ#2245079)

この問題を解決するには、MTC 1.8.1 以降に更新することを推奨します。

詳細は、(CVE-2023-39325) および (CVE-2023-44487) を参照してください。

2.2.2. 既知の問題

このリリースには重大な既知の問題はありません。

2.3. Migration Toolkit for Containers 1.8 リリースノート

2.3.1. 解決した問題

このリリースでは、次の問題が解決されています。

間接的な移行がバックアップ段階で停止する

以前のリリースでは、InvalidImageName エラーが原因で、間接的な移行がバックアップ段階で停止していました。(BZ#2233097)

PodVolumeRestore は In Progress のままになり、移行が Stage Restore で停止する

以前のリリースでは、間接的な移行を実行すると、移行は Stage Restore ステップで停止し、podvolumerestore が 完了するまで待機していました。(BZ#2233868)

移行されたアプリケーションが、ターゲットクラスターの内部レジストリーからイメージをプルできない

以前のリリースでは、アプリケーションをターゲットクラスターに移行する際に、移行されたアプリケーションが内部イメージレジストリーからイメージをプルできず、その結果 application failure が発生していました。(BZ#2233103)

認可の問題により Azure で移行が失敗する

以前のリリースでは、Azure クラスター上で Azure ストレージにバックアップする際に、Backup 段階で移行が失敗していました。(BZ#2238974)

2.3.2. 既知の問題

本リリースには、以下の既知の問題があります。

MTC 1.7.x から 1.8.x にアップグレードしても古い Restic Pod が削除されない

このリリースでは、MTC Operator を 1.7.x から 1.8.x にアップグレードする際に、古い Restic Pod は削除されません。そのため、アップグレードした後に Restic Pod とノードエージェント Pod の両方が namespace に表示されます。(BZ#2236829)

移行されたビルダー Pod がイメージレジストリーにプッシュできない

このリリースでは、BuildConfig を含むアプリケーションをソースクラスターからターゲットクラスターに移行すると、ビルダー Pod で error が発生し、イメージをイメージレジストリーにプッシュできません。(BZ#2234781)

[UI] CA バンドルファイルのフィールドが適切にクリアされない

このリリースでは、Require SSL verification を有効にし、MigStorage 内の MCG NooBaa バケットの CA バンドルファイルにコンテンツを追加すると、想定どおり接続が失敗します。しかし、CA バンドルのコンテンツを削除し、Require SSL verification をオフにしてこれらの変更を元に戻しても、接続は依然として失敗します。この問題は、リポジトリーを削除して再追加しなければ解決できません。(BZ#2240052)

カスタム CA レプリケーションリポジトリーの設定後にバックアップフェーズが失敗します

(MTC) では、レプリケーションリポジトリーを編集し、カスタム CA 証明書を追加し、リポジトリーに正常に接続して移行をトリガーした後、バックアップフェーズ中にエラーが発生しました。

この問題は MTC 1.8.2 で解決されています。

CVE-2023-26136: 4.1.3 より前の tough-cookie パッケージはプロトタイプ汚染に対して脆弱です

MTC で使用される tough-cookie パッケージの 4.1.3 より前のバージョンは、プロトタイプ汚染に対して脆弱です。この脆弱性は、rejectPublicSuffixes の値が false に設定されている場合に CookieJar が cookie を適切に処理しないために発生します。

この問題は MTC 1.8.2 で解決されています。

詳細は、(CVE-2023-26136) を参照してください。

CVE-2022-25883 openshift-migration-ui-container: nodejs-semver: 正規表現によるサービス拒否

以前の (MTC) リリースでは、MTC で使用されている semver パッケージの 7.5.2 より前のバージョンは、信頼できないユーザーデータが範囲として指定された場合、関数 newRange からの Regular Expression Denial of Service (ReDoS) に対して脆弱です。

この問題は MTC 1.8.2 で解決されています。

詳細は、(CVE-2022-25883) を参照してください。

2.3.3. 技術上の変更点

本リリースには、以下の技術上の変更点があります。

- OpenShift Container Platform 3 から OpenShift Container Platform 4 に以降する場合は、レガシー Migration Toolkit for Containers (MTC) Operator と MTC 1.7.x が必要です。

- MTC 1.7.x から MTC 1.8.x への移行はサポートされていません。

OpenShift Container Platform 4.9 以前から移行する場合は、MTC 1.7.x を使用する必要があります。

- MTC 1.7.x は、移行前と移行後の両方で使用する必要があります。

MTC 1.8.x は、OpenShift Container Platform 4.10 以降から OpenShift Container Platform 4.10 以降への移行のみサポートします。移行に含まれるクラスターのバージョンが 4.10 以降のみの場合、1.7.x または 1.8.x のいずれかを使用できます。ただし、移行前と移行後の MTC 1.Y.z が同じである必要があります。

- MTC 1.7.x から MTC 1.8.x への移行はサポートされていません。

- MTC 1.8.x から MTC 1.7.x への移行はサポートされていません。

- MTC 1.7.x から MTC 1.7.x への移行はサポートされています。

- MTC 1.8.x から MTC 1.8.x への移行はサポートされています。

- MTC 1.8.x は、デフォルトで OADP 1.2.x をインストールします。

- MTC 1.7.x から MTC 1.8.0 にアップグレードするには、OADP チャネルを手動で 1.2 に変更する必要があります。これを行わないと、Operator のアップグレードは失敗します。

2.4. Migration Toolkit for Containers 1.7.14 リリースノート

2.4.1. 解決した問題

このリリースでは、次の問題が解決されています。

CVE-2023-39325 CVE-2023-44487: さまざまな不具合

Migration Toolkit for Containers (MTC) で使用される HTTP/2 プロトコルでの多重化ストリームの処理に不具合が見つかりました。 クライアントは、新しい多重化ストリームのリクエストを繰り返し作成し、すぐに RST_STREAM フレームを送信してそれらのリクエストをキャンセルする可能性があります。このアクティビティーにより、ストリームのセットアップと削除に関してサーバーに追加のワークロードが発生しましたが、接続ごとのアクティブなストリームの最大数に関するサーバー側の制限は回避されました。その結果、サーバーリソースの消費によりサービス拒否が発生しました。

この問題を解決するには、MTC 1.7.14 にアップグレードします。

詳細は、(CVE-2023-44487) および (CVE-2023-39325) を参照してください。

CVE-2023-39318 CVE-2023-39319 CVE-2023-39321: さまざまな不具合

(CVE-2023-39318): MTC が使用する Golang に不具合が検出される。

html/templateパッケージは、<script>コンテキスト内のコメントトークンで、HTML のような""コメントトークンやハッシュバン"#!"を適切に処理しませんでした。この欠陥により、テンプレートパーサーが<script>コンテキストの内容を不適切に解釈し、アクションが不適切にエスケープされる可能性があります。(CVE-2023-39319): MTC が使用する Golang に不具合が検出される。

html/templateパッケージは、<script> コンテキストの JavaScript リテラル内の"<script"、"<!--"、および"</script"の出現を処理するための適切なルールを適用していませんでした。これにより、テンプレートパーサーがスクリプトコンテキストが早期に終了すると誤って判断し、アクションが不適切にエスケープされる可能性があります。(CVE-2023-39321): MTC が使用する Golang に不具合が検出される。QUIC 接続の不完全なポストハンドシェイクメッセージを処理すると、パニックが発生する可能性があります。

(CVE-2023-3932):MTC が使用する Golang に不具合が検出される。QUIC トランスポートプロトコルを使用した接続では、ハンドシェイク後のメッセージを読み取るときにバッファーされるデータ量に上限が設定されていなかったため、悪意のある QUIC 接続によって無制限のメモリー増加が発生する可能性がありました。

これらの問題を解決するには、MTC 1.7.14 にアップグレードします。

詳細は、(CVE-2023-39318)、(CVE-2023-39319)、および (CVE-2023-39321) を参照してください。

2.4.2. 既知の問題

このリリースには重大な既知の問題はありません。

2.5. Migration Toolkit for Containers 1.7.13 リリースノート

2.5.1. 解決した問題

このリリースでは解決された主要な問題はありません。

2.5.2. 既知の問題

このリリースには重大な既知の問題はありません。

2.6. Migration Toolkit for Containers 1.7.12 リリースノート

2.6.1. 解決した問題

このリリースでは解決された主要な問題はありません。

2.6.2. 既知の問題

本リリースには、以下の既知の問題があります。

Migration details ページにエラーコード 504 が表示される

Migration details ページでは、最初は問題なく migration details が表示されます。しかし、しばらくすると詳細が表示されなくなり、504 エラーが返されます。(BZ#2231106)

MTC 1.7.x から MTC 1.8 にアップグレードする際に古い Restic Pod が削除されない

MTC Operator を 1.7.x から 1.8.x にアップグレードしても、古い Restic Pod は削除されません。アップグレード後、Restic Pod とノードエージェント Pod の両方が namespace に表示されます。(BZ#2236829)

2.7. Migration Toolkit for Containers 1.7.11 リリースノート

2.7.1. 解決した問題

このリリースでは解決された主要な問題はありません。

2.7.2. 既知の問題

このリリースに既知の問題はありません。

2.8. Migration Toolkit for Containers 1.7.10 リリースノート

2.8.1. 解決した問題

このリリースでは、次の主要な問題が解決されています。

DVM での rsync オプションを調整する

このリリースでは、ダイレクトボリュームマイグレーション (DVM) の過程で Rsync による絶対シンボリックリンクの操作を阻止できます。DVM を特権モードで実行すると、永続ボリューム要求 (PVC) 内の絶対シンボリックリンクが保持されます。特権モードに切り替えるには、MigrationController CR で migration_rsync_privileged 仕様を true に設定します。(BZ#2204461)

2.8.2. 既知の問題

このリリースに既知の問題はありません。

2.9. Migration Toolkit for Containers 1.7.9 リリースノート

2.9.1. 解決した問題

このリリースでは解決された主要な問題はありません。

2.9.2. 既知の問題

このリリースには、以下の既知の問題があります。

DVM での rsync オプションを調整する

このリリースでは、ユーザーは、ダイレクトボリュームマイグレーション (DVM) 中に絶対シンボリックリンクが rsync によって操作されることを防げません。(BZ#2204461)

2.10. Migration Toolkit for Containers 1.7.8 リリースノート

2.10.1. 解決した問題

このリリースでは、次の主要な問題が解決されています。

Velero イメージを MTC Operator でオーバーライドできない

以前のリリースでは、MigrationController カスタムリソース (CR) の velero_image_fqin パラメーターを使用して velero イメージをオーバーライドできませんでした。(BZ#2143389)

ドメイン名が 6 文字を超える場合、UI から MigCluster を追加すると失敗する

以前のリリースでは、ドメイン名が 6 文字を超えると、UI から MigCluster を追加できませんでした。UI コードでは、2 - 6 文字のドメイン名が必要でした。(BZ#2152149)

UI が Migrations ページのレンダリングに失敗する: Cannot read properties of undefined (reading 'name')

以前のリリースでは、UI は Migrations ページのレンダリングに失敗し、 Cannot readproperties of unknown (reading 'name') を返していました。(BZ#2163485)

Red Hat OpenShift Container Platform 4.6 クラスターで DPA リソースの作成に失敗する

以前のリリースでは、{OCP} 4.6 クラスターに MTC をデプロイすると、ログに従って DPA が作成されなかったため、一部の Pod が欠落していました。OCP 4.6 クラスターの migration-controller のログには、予期しない null 値が渡され、それがエラーの原因であることが示されています。(BZ#2173742)

2.10.2. 既知の問題

このリリースに既知の問題はありません。

2.11. Migration Toolkit for Containers 1.7.7 リリースノート

2.11.1. 解決した問題

このリリースでは解決された主要な問題はありません。

2.11.2. 既知の問題

このリリースに既知の問題はありません。

2.12. Migration Toolkit for Containers 1.7.6 リリースノート

2.12.1. 新機能

Red Hat OpenShift Container Platform 4.12 で PSA を使用した DVM サポートに関して提案された変更が実装された

{OCP} 4.12 での Pod Security Admission (PSA)の受信適用により、デフォルトの Pod は restricted プロファイルで実行されます。この restricted プロファイルは、移行するワークロードがこのポリシーに違反し、現時点では機能しないことを意味します。次の機能拡張では、OCP 4.12 との互換性を維持するために必要な変更の概要を説明します。(MIG-1240)

2.12.2. 解決した問題

このリリースでは、次の主要な問題が解決されています。

Red Hat OpenShift Platform 4.12 で cronjob が見つからないエラーにより、ストレージクラス変換プランを作成できない

以前のリリースでは、CronJob が batch/v1beta1 バージョンで使用できないエラーが persistent volumes ページでスローされ、Cancel をクリックすると、migplan が Notready ステータスで作成されていました。(BZ#2143628)

2.12.3. 既知の問題

このリリースには、以下の既知の問題があります。

競合状態が、作成後に短時間で解消される

新しい状態移行プランを作成すると競合エラーが発生し、そのエラーは表示された直後に解消されます。(BZ#2144299)

2.13. Migration Toolkit for Containers 1.7.5 リリースノート

2.13.1. 解決した問題

このリリースでは、次の主要な問題が解決されています。

ソースクラスター上の rsync Pod がエラー状態に移行するため、ボリュームの直接移行が失敗する

以前のリリースでは、移行は警告付きで成功しましたが、ソース namespace の rsync Pod がエラー状態に遷移してボリュームの直接移行に失敗していました。(*BZ#2132978)

2.13.2. 既知の問題

本リリースには、以下の既知の問題があります。

Velero イメージを MTC Operator でオーバーライドできない

以前のリリースでは、MigrationController カスタムリソース (CR) の velero_image_fqin パラメーターを使用して velero イメージをオーバーライドできませんでした。(BZ#2143389)

UI で MigHook を編集すると、ページのリロードに失敗する場合がある

ネットワーク接続に問題がある場合、フックを編集する際に UI のリロードに失敗することがあります。ネットワーク接続が復元された後、キャッシュがクリアされるまでページはリロードできません。(BZ#2140208)

2.14. Migration Toolkit for Containers 1.7.4 リリースノート

2.14.1. 解決した問題

このリリースでは解決された主要な問題はありません。

2.14.2. 既知の問題

ロールバックでターゲットクラスターから一部のリソースが削除されない

MTC UI からアプリケーションのロールバックを実行すると、一部のリソースがターゲットクラスターから削除されず、ステータスにはロールバックが正常に完了したことが表示されます。(BZ#2126880)

2.15. Migration Toolkit for Containers 1.7.3 リリースノート

2.15.1. 解決した問題

このリリースでは、次の主要な問題が解決されています。

宛先 namespace の正しい DNS 検証

以前のリリースでは、宛先の namespace がアルファベット以外の文字で始まっている場合、MigPlan を検証できませんでした。(BZ#2102231)

UI からすべての PVC の選択を解除しても、PVC 転送が試行される

以前のリリースでは、完全移行の実行中に永続ボリューム要求 (PVC) の選択を解除しても、PVC の選択がスキップされず、引き続き移行が試行されていました。 (BZ#2106073)

宛先 namespace の間違った DNS 検証

以前のリリースでは、宛先の namespace がアルファベット以外の文字で始まっていたため、MigPlan を検証できませんでした。 (BZ#2102231)

2.15.2. 既知の問題

このリリースに既知の問題はありません。

2.16. Migration Toolkit for Containers 1.7.2 リリースノート

2.16.1. 解決した問題

このリリースでは、次の主要な問題が解決されています。

MTC UI でログが正しく表示されない

以前のリリースでは、MTC UI でログが正しく表示されませんでした。(BZ#2062266)

StorageClass 変換プランで migplan に migstorage 参照が追加されている

以前のリリースでは、StorageClass 変換プランには、使用されていない場合でも migstorage 参照が含まれていました。(BZ#2078459)

ダウンロードされたログに Velero Pod のログがない

以前のリリースでは、すべてのログの圧縮 (.zip) フォルダーをダウンロードしても、velero Pod がありませんでした。(BZ#2076599)

Velero Pod のログが UI ドロップダウンに表示されない

以前のリリースでは、移行を実行した後、ドロップダウンリストに表示されるログの中に velero Pod ログがありませんでした。(BZ#2076593)

Rsync オプションのログが log-reader Pod に表示されない

以前のリリースでは、migrationcontroller で有効または無効な rsync オプションを設定しようとすると、log-reader に無効なオプションや使用されている rsync コマンドに関するログが表示されませんでした。(BZ#2079252)

Velero/Restic のデフォルトの CPU リクエストは要求が高すぎるため、特定の環境で失敗する

以前のリリースでは、Velero/Restic のデフォルトの CPU リクエストは要求が高すぎて、特定の環境では失敗していました。Velero および Restic Pod のデフォルトの CPU リクエストは 500m に設定されています。この値は高すぎます。(BZ#2088022)

2.16.2. 既知の問題

本リリースには、以下の既知の問題があります。

レプリケーションリポジトリーを別のストレージプロバイダータイプに更新すると、UI は無視される

レプリケーションリポジトリーを別のタイプに更新して Update Repository をクリックすると、接続に成功したことが表示されますが、UI は正しい詳細で更新されません。Edit ボタンを再クリックすると、古いレプリケーションリポジトリー情報が引き続き表示されます。

さらに、レプリケーションリポジトリーを再度更新しようとすると、古いレプリケーションの詳細が引き続き表示されます。新しいリポジトリーを選択すると、同様に以前に入力したすべての情報が表示され、送信する変更がない場合と同様に Update repository が有効になりません。(BZ#2102020)

バックアップが見つからないため移行が失敗する

初期バックアップが見つからないため、復元段階で移行が失敗します。(BZ#2104874)

Azure リソースグループを更新する際に Update Cluster ボタンが有効にならない

リモートクラスターを更新する際に、Azure resource group チェックボックスを選択してリソースグループを追加しても、Update cluster オプションが有効になりません。(BZ#2098594)

migstorage リソースを削除する際にエラーポップアップが UI に表示される

{OCP} で backupStorage 認証情報シークレットを作成する場合に migstorage が UI から削除されると、404 エラーが返され、基礎となるシークレットは削除されません。(BZ#2100828)

UI で Miganalytic リソースのリソース数が 0 と表示される

バックエンドから migplan を作成した後、UI で Miganalytic リソースのリソース数が 0 と表示されます。(BZ#2102139)

イメージレジストリーへの公開ルートホストの末尾にスラッシュを 2 つ追加すると、レジストリーの検証が失敗する

公開レジストリールートの末尾にスラッシュを 2 つ (//) 追加すると、MigCluster リソースのステータスが connected と表示されます。DIM を使用してバックエンドから migplan を作成すると、プランのステータスは unready に遷移します。(BZ#2104864)

ソースクラスターの編集中にサービスアカウントトークンが表示されない

追加された Connected 状態のソースクラスターを編集する際に、UI でフィールドにサービスアカウントトークンが表示されません。ウィザードを保存するには、トークンを再度取得し、フィールド内に詳細を入力する必要があります。(BZ#2097668)

2.17. Migration Toolkit for Containers 1.7.1 リリースノート

2.17.1. 解決した問題

このリリースでは解決された主要な問題はありません。

2.17.2. 既知の問題

本リリースには、以下の既知の問題があります。

宛先 namespace の間違った DNS 検証

宛先 namespace がアルファベット以外の文字で始まっているため、MigPlan を検証できません。(BZ#2102231)

Velero Pod にラベルがないため、移行コントローラーのクラウド伝播フェーズが機能しない

Velero Pod にラベルがないため、移行コントローラーのクラウド伝播フェーズが機能しません。移行コントローラーの EnsureCloudSecretPropagated フェーズは、レプリケーションリポジトリーのシークレットが両側に伝播されるまで待機します。このラベルが Velero Pod にないため、フェーズは期待どおりに機能しません。(BZ#2088026)

Velero/Restic のデフォルトの CPU リクエストの要求は高すぎるため、特定の環境でスケジュールの作成に失敗

Velero/Restic のデフォルトの CPU リクエストの要求は高すぎるため、特定の環境でスケジュールの作成に失敗します。Velero および Restic Pod のデフォルトの CPU リクエストは 500m に設定されています。この値は高すぎます。リソースは、Velero と Restic の podConfig フィールドを使用して DPA で設定できます。Migration Operator は、MTC の実行場所になることが多いリソース制約がある環境で Velero Pod と Restic Pod をスケジュールできるようにするために、CPU リクエストを 100m などの低い値に設定する必要があります。(BZ#2088022)

ストレージクラス変換プランを編集すると、persistentVolumes ページに警告が表示される

ストレージクラス変換プランを編集すると、、PersistentVolumes ページに警告が表示されます。既存の移行プランを編集すると、UI にAt least one PVC must be selected for Storage Class Conversion の警告が表示されます。(BZ#2079549)

ダウンロードされたログに Velero Pod のログがない

すべてのログの圧縮 (.zip) フォルダーをダウンロードしても、velero Pod はありません。(BZ#2076599)

Velero Pod のログが UI ドロップダウンに表示されない

移行を実行した後、ドロップダウンリストに表示されるログの中に velero Pod ログがありません。(BZ#2076593)

2.18. MTC (Migration Toolkit for Containers 1.7) リリースノート

2.18.1. 新機能および機能拡張

本リリースには、以下の新機能および機能拡張が含まれています。

- MTC (Migration Toolkit for Containers) Operator が OpenShift API for Data Protection (OADP) Operator に依存するようになりました。MTC Operator をインストールすると、Operator Lifecycle Manager (OLM) は同じ namespace に OADP Operator を自動的にインストールします。

-

crane tunnel-apiコマンドを使用して 2 つのクラスター間にネットワークトンネルを確立することにより、ファイアウォールの背後にあるソースクラスターからクラウドベースの宛先クラスターに移行できます。 - MTC の Web コンソールでのストレージクラスの変換: 永続ボリューム (PV) のストレージクラスを、同じクラスター内で移行して変換できます。

2.18.2. 既知の問題

本リリースには、以下の既知の問題があります。

-

AWS gp2 PVC に利用可能な領域がない場合に、

MigPlanカスタムリソースには警告は表示されません。(BZ#1963927) - 宛先ストレージが AWS Elastic File System (EFS) によって動的にプロビジョニングされる PV の場合に、直接および間接データ転送は機能しません。これは、AWS EFS Container Storage Interface (CSI) ドライバーの制限が原因です。(BZ#2085097)

- IBM Cloud のブロックストレージは、同じアベイラビリティーゾーンに所属している必要があります。仮想プライベートクラウドのブロックストレージに関する IBM FAQ を参照してください。

2.19. MTC(Migration Toolkit for Containers 1.6) リリースノート

2.19.1. 新機能および機能拡張

本リリースには、以下の新機能および機能拡張が含まれています。

- 状態の移行: 特定の永続ボリューム要求 (PVC) を選択して、反復可能な状態のみの移行を実行できます。

- "New operator version available" の通知: MTC の Web コンソールのクラスターページには、新しい Migration Toolkit for Containers Operator が利用可能になると通知が表示されます。

2.19.2. 非推奨の機能

以下の機能が非推奨になりました。

- MTC バージョン 1.4 はサポートされなくなりました。

2.19.3. 既知の問題

本リリースには、以下の既知の問題があります。

-

OpenShift Container Platform 3.10 では、

MigrationControllerPod の再起動に過剰に時間を要します。Bugzilla レポートには回避策が含まれています。(BZ#1986796) -

段階Pod は、IBM Cloud の従来の OpenShift Container Platform ソースクラスターからボリュームの直接移行時に失敗します。IBM ブロックストレージプラグインでは、同じノードの複数の Pod に、同じボリュームをマウントすることはできません。その結果、PVC は Rsync Pod およびアプリケーション Pod を同時にマウントすることはできません。この問題を解決するには、移行前にアプリケーション Pod を停止します。(BZ#1887526) -

AWS gp2 PVC に利用可能な領域がない場合に、

MigPlanカスタムリソースには警告は表示されません。(BZ#1963927) - IBM Cloud のブロックストレージは、同じアベイラビリティーゾーンに所属している必要があります。仮想プライベートクラウドのブロックストレージに関する IBM FAQ を参照してください。

2.20. Migration Toolkit for Containers 1.5 リリースノート

2.20.1. 新機能および機能拡張

本リリースには、以下の新機能および機能拡張が含まれています。

- Web コンソールの Migration 詳細 ページの Migration リソースツリーが、追加のリソース、Kubernetes イベント、および移行の監視およびデバッグ用のライブステータス情報と共に強化されました。

- Web コンソールは、数百もの移行プランをサポートできます。

- ソース名前空間は、移行計画で別のターゲット名前空間にマッピングすることができます。以前のバージョンでは、ソース名前空間は同じ名前を持つターゲット名前空間にマップされていました。

- ステータス情報を含むフックフェーズは、移行時に Web コンソールに表示されます。

- Rsync 再試行試行の数は、ボリュームの直接移行時に Web コンソールに表示されます。

- 永続ボリューム (PV) のサイズ変更は、ターゲットクラスターがディスク領域不足しないように、ボリュームの直接移行用に有効にできます。

- PV のサイズ変更をトリガーするしきい値は設定可能です。以前のバージョンでは、ディスクの使用状況が 97% を超えると PV のサイズ変更が発生していました。

- Velero がバージョン 1.6 にアップグレードされ、多くの修正および機能強化が数多く追加されました。

- キャッシュされた Kubernetes クライアントを有効にして、パフォーマンスを向上させることができます。

2.20.2. 非推奨の機能

以下の機能が非推奨になりました。

- MTC バージョン 1.2 および 1.3 はサポートされなくなりました。

-

oc convertコマンドが非推奨になるため、非推奨の API の更新手順は、ドキュメントのトラブルシューティングセクションから削除されました。

2.20.3. 既知の問題

本リリースには、以下の既知の問題があります。

-

400 を超える移行プランを作成する場合、Microsoft Azure ストレージは利用できません。

MigStorageカスタムリソースは、以下のメッセージを表示します。The request is being throttled as the limit has been reached for operation type(このリクエストは、操作タイプの制限に達したため、スロットルされています)。(BZ#1977226) - 移行に失敗すると、移行計画は休止状態の Pod のカスタム永続ボリューム (PV) 設定を保持しません。移行を手動でロールバックし、移行計画を削除し、PV 設定で新たな移行計画を作成する必要があります。(BZ#1784899)

-

PV のサイズ変更は、

pv_resizing_thresholdが 42% 以上でない限り、AWS gp2 ストレージでは期待どおりに動作しません。(BZ#1973148) PV のサイズ変更は、以下のシナリオでは OpenShift Container Platform 3.7 および 3.9 ソースクラスターでは機能しません。

- アプリケーションは、MTC のインストール後にインストールされている。

アプリケーション Pod は MTC のインストール後に別のノードで再スケジュールされました。

OpenShift Container Platform 3.7 および 3.9 では、Velero が

ResticPod に PV を自動的にマウントできるようにする Mount Propagation 機能をサポートしません。MigAnalyticカスタムリソース (CR) は、ResticPod から PV データを収集できず、リソースを0として報告します。MigPlanCR は以下のようなステータスを表示します。出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow PV のサイズ変更を有効にするには、ソースクラスターで Restic daemonset を手動で再起動するか、アプリケーションと同じノードで

ResticPod を再起動します。Restic を再起動しない場合、PV のサイズ変更なしにボリュームの直接移行を実行できます。(BZ#1982729)

2.20.4. 技術上の変更点

本リリースには、以下の技術上の変更点があります。

- OpenShift Container Platform バージョン 3.7 から 4.5 では、従来の Migration Toolkit for Containers Operator バージョン 1.5.1 は手動でインストールします。

- OpenShift Container Platform バージョン 4.6 以降では、Migration Toolkit for Containers Operator バージョン 1.5.1 は、Operator Lifecycle Manager を使用してインストールします。

第3章 MTC (Migration Toolkit for Containers) のインストール

MTC (Migration Toolkit for Containers) を OpenShift Container Platform 4 にインストールできます。

OpenShift Container Platform 3 に MTC をインストールするには、OpenShift Container Platform 3 へのコンテナーオペレーター用のレガシー Migration Toolkit のインストール を参照してください。

デフォルトで、MTC Web コンソールおよび Migration Controller Pod はターゲットクラスターで実行されます。Migration Controller カスタムリソースマニフェストを、MTC の Web コンソールおよび Migration Controller Pod を リモートクラスター で実行するように設定できます。

MTC をインストールした後、オブジェクトストレージをレプリケーションリポジトリーとして使用するように設定する必要があります。

MTC をアンインストールするには、MTC のアンインストールとリソースの削除 を参照してください。

3.1. 互換性のガイドライン

OpenShift Container Platform バージョンと互換性がある MTC (Migration Toolkit for Containers) Operator をインストールする必要があります。

定義

- レガシープラットフォーム

- OpenShift Container Platform 4.5 以前。

- 最新プラットフォーム

- OpenShift Container Platform 4.6 以降。

- レガシー operator

- レガシープラットフォーム用に設計された MTC Operator。

- 最新 operator

- 最新のプラットフォーム用に設計された MTC Operator。

- コントロールクラスター

- MTC コントローラーと GUI を実行するクラスター。

- リモートクラスター

- Velero を実行する移行のソースクラスターまたは宛先クラスター。コントロールクラスターは、Velero API を介してリモートクラスターと通信し、移行を促進します。

OpenShift Container Platform クラスターの移行には、互換性のある MTC バージョンを使用する必要があります。移行を成功させるには、ソースクラスターと宛先クラスターの両方が同じバージョンの MTC を使用する必要があります。

MTC 1.7 は、OpenShift Container Platform 3.11 から 4.8 への移行をサポートしています。

MTC 1.8 は、OpenShift Container Platform 4.9 以降からの移行のみをサポートします。

| 詳細 | OpenShift Container Platform 3.11 | OpenShift Container Platform 4.8 から 4.10 | OpenShift Container Platform 4.8 から 4.10 | OpenShift Container Platform 4.12 以降 |

|---|---|---|---|---|

| 安定した MTC バージョン | MTC v.1.7.z | MTC v.1.7.z | MTC v.1.7.z | MTC v.1.8.z |

| インストール |

レガシー MTC v.1.7.z Operator: [IMPORTANT] このクラスターは制御クラスターにすることはできません。 |

OLM を使用してインストール、リリースチャネル |

OLM を使用してインストール、リリースチャネル |

ネットワークの制限により、最新のクラスターが移行に関与する他のクラスターに接続できないというエッジケースが存在します。たとえば、オンプレミスの OpenShift Container Platform 3.11 クラスターからクラウド内の最新の OpenShift Container Platform クラスターに移行する場合、最新のクラスターは OpenShift Container Platform 3.11 クラスターに接続できません。

MTC 1.8 では、ネットワーク制限が原因で、いずれかのリモートクラスターがコントロールクラスターと通信できない場合は、crane tunnel-api コマンドを使用します。

安定した MTC リリースでは、常に最新のクラスターを制御クラスターとして指定する必要がありますが、この特定のケースでは、レガシークラスターを制御クラスターとして指定し、ワークロードをリモートクラスターにプッシュすることができます。

3.2. OpenShift Container Platform 4.2 での従来の Migration Toolkit for Containers Operator の 4.5 へのインストール

レガシー Migration Toolkit for Containers Operator を手動で OpenShift Container Platform バージョン 4.2 から 4.5 にインストールできます。

前提条件

-

cluster-admin権限を持つユーザーとしてすべてのクラスターにログインしている必要があります。 -

registry.redhat.ioにアクセスできる必要があります。 -

podmanがインストールされている必要があります。

手順

Red Hat カスタマーポータルの認証情報を使用して

registry.redhat.ioにログインします。podman login registry.redhat.io

$ podman login registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

operator.ymlファイルをダウンロードします。podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/operator.yml ./

podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/operator.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

controller.ymlファイルをダウンロードします。podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/controller.yml ./

podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/controller.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow - OpenShift Container Platform ソースクラスターにログインします。

クラスターが

registry.redhat.ioで認証できることを確認します。oc run test --image registry.redhat.io/ubi8 --command sleep infinity

$ oc run test --image registry.redhat.io/ubi8 --command sleep infinityCopy to Clipboard Copied! Toggle word wrap Toggle overflow Migration Toolkit for Containers Operator オブジェクトを作成します。

oc create -f operator.yml

$ oc create -f operator.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

Error from server (AlreadyExists)メッセージは無視できます。これらは、以降のリソースで提供される OpenShift Container Platform 4 以前のバージョン用にリソースを作成する Migration Toolkit for Containers Operator が原因です。

MigrationControllerオブジェクトを作成します。oc create -f controller.yml

$ oc create -f controller.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow MTC Pod が実行されていることを確認します。

oc get pods -n openshift-migration

$ oc get pods -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3. Migration Toolkit for Containers Operator の OpenShift Container Platform 4.11 へのインストール

Operator Lifecycle Manager を使用して OpenShift Container Platform 4.11 に Migration Toolkit for Containers Operator をインストールします。

前提条件

-

cluster-admin権限を持つユーザーとしてすべてのクラスターにログインしている必要があります。

手順

- OpenShift Container Platform Web コンソールで、Operators → OperatorHub をクリックします。

- Filter by keyword フィールドを使用して、 Migration Toolkit for Containers Operator を見つけます。

- Migration Toolkit for Containers Operator を選択し、Install をクリックします。

Install をクリックします。

Installed Operators ページで、Migration Toolkit for Containers Operator は、Succeeded のステータスで openshift-migration プロジェクトに表示されます。

- Migration Toolkit for Containers Operator をクリックします。

- Provided APIs の下で Migration Controller タイルを見つけ、Create Instance をクリックします。

- Create をクリックします。

- Workloads → Pods をクリックし、MTC Pod が実行されていることを確認します。

3.4. プロキシー設定

OpenShift Container Platform 4.1 以前のバージョンでは、これらのバージョンはクラスター全体の proxy オブジェクトをサポートしないため、Migration Toolkit for Containers Operator のインストール後に、MigrationController カスタムリソース (CR) マニフェストでプロキシーを設定する必要があります。

OpenShift Container Platform 4.2 から 4.11 の場合、MTC (Migration Toolkit for Containers) はクラスター全体のプロキシー設定を継承します。クラスター全体のプロキシー設定を上書きする場合は、プロキシーパラメーターを変更できます。

3.4.1. ボリュームの直接移行

MTC 1.4.2 で、ボリュームの直接移行 (DVM) が導入されました。DVM は 1 つのプロキシーのみをサポートします。ターゲットクラスターもプロキシーの背後にある場合、ソースクラスターはターゲットクラスターのルートにアクセスできません。

プロキシーの背後にあるソースクラスターから DVM を実行する場合には、トランスポート層で機能する TCP プロキシーを設定して、SSL 接続を独自の SSL 証明書で復号化および再暗号化せずに透過的に転送する必要があります。Stunnel プロキシーは、このようなプロキシーの例です。

3.4.1.1. DVM の TCP プロキシー設定

TCP プロキシー経由でソースとターゲットクラスターの間に直接接続を設定し、プロキシーを使用できるように MigrationController CR の stunnel_tcp_proxy 変数を設定できます。

ボリュームの直接移行 (DVM) は、プロキシーの Basic 認証のみをサポートします。さらに、DVM は、TCP 接続を透過的にトンネルできるプロキシーの背後でのみ機能します。中間者モードの HTTP/HTTPS プロキシーは機能しません。既存のクラスター全体にわたるプロキシーはこの動作をサポートしない可能性があります。その結果、DVM のプロキシー設定は、MTC の通常のプロキシー設定とは異なる状態に保たれます。

3.4.1.2. HTTP/HTTPS プロキシーの代わりに TCP プロキシーを使用する理由

DVM を有効にするには、OpenShift ルートを介してソースおよびターゲットクラスター間で Rsync を実行します。トラフィックは、TCP プロキシーである Stunnel を使用して暗号化されます。ソースクラスターで実行している Stunnel は、ターゲット Stunnel との TLS 接続を開始し、暗号化されたチャネルでデータを転送します。

OpenShift のクラスター全体の HTTP/HTTPS プロキシーは通常、外部サーバーで独自の TLS セッションをネゴシエートする中間者モードで設定されます。ただし、これは Stunnel では機能しません。Stunnel では、プロキシーによって TLS セッションが変更されないようにする必要があります。基本的には、プロキシーを透過的なトンネルにし、単純に TCP 接続をそのまま転送する必要があります。したがって、TCP プロキシーを使用する必要があります。

3.4.1.3. 既知の問題

移行が Upgrade request required エラーで失敗する

移行コントローラーは SPDY プロトコルを使用してリモート Pod 内でコマンドを実行します。リモートクラスターがプロキシーまたは、SPDY プロトコルをサポートしないファイアウォールの背後にある場合には、移行コントローラーはリモートコマンドの実行に失敗します。移行に失敗し、Upgrade request required というエラーメッセージが表示されます。回避策: SPDY プロトコルをサポートするプロキシーを使用します。

SPDY プロトコルのサポートに加えて、このプロキシーまたはファイアウォールでは、Upgrade HTTP ヘッダーを API サーバーに渡す必要もあります。クライアントはこのヘッダーを使用して API サーバーと Websocket 接続を開きます。Upgrade ヘッダーがプロキシーまたはファイアウォールでブロックされると、移行に失敗し、Upgrade request required というエラーメッセージが表示されます。回避策: プロキシーで Upgrade ヘッダーが転送されるようにしてください。

3.4.2. 移行用のネットワークポリシーのチューニング

OpenShift は、クラスターで使用されるネットワークプラグインに基づいて NetworkPolicy または EgressFirewalls を使用した Pod との間のトラフィックの制限をサポートします。移行に関連するソース namespace のいずれかがこのようなメカニズムを使用して Pod へのネットワークトラフィックを制限する場合には、この制限により移行時に Rsync Pod へのトラフィックが誤って停止される可能性があります。

ソースおよびターゲットクラスターの両方で実行される Rsync Pod は OpenShift Route 経由で相互に接続する必要があります。既存の NetworkPolicy または EgressNetworkPolicy オブジェクトは、これらのトラフィックの制限が課されないように Rsync Pod を自動的に取り除くように設定できます。

3.4.2.1. NetworkPolicy の設定

3.4.2.1.1. Rsync Pod からの egress トラフィック

Rsync Pod の一意のラベルを使用し、同期元または同期先 namespace の NetworkPolicy 設定がこのタイプのトラフィックをブロックする場合に egress トラフィックがそれらを通過することを許可できます。以下のポリシーは、namespace の Rsync Pod からの 全 egress トラフィックを許可します。

3.4.2.1.2. Rsync Pod への ingress トラフィック

3.4.2.2. EgressNetworkPolicy 設定

EgressNetworkPolicy オブジェクトまたは Egress ファイアウォール は、egress トラフィックをクラスターからブロックするために設計された OpenShift コンストラクトです。

NetworkPolicy オブジェクトとは異なり、Egress ファイアウォールは namespace のすべての Pod に適用されるためにプロジェクトレベルで機能します。そのため、Rsync Pod の一意のラベルを使用すると、この制限から除外するのは Rsync Pod だけではありません。ただし、ソースおよびターゲットクラスターの CIDR 範囲をポリシーの Allow ルールに追加して、2 つのクラスター間で直接接続を設定できます。

Egress ファイアウォールが存在するクラスターに基づいて、他のクラスターの CIDR 範囲を追加して、2 つの間の egress トラフィックを許可できます。

3.4.2.3. データ転送用の代替エンドポイントの選択

デフォルトでは、DVM は OpenShift Container Platform ルートをエンドポイントとして使用して、PV データを宛先クラスターに転送します。クラスタートポロジーで許可されている場合は、サポートされている別の種類のエンドポイントを選択できます。

クラスターごとに、MigrationController CR で適切な 宛先 クラスターに rsync_endpoint_type 変数を設定することで、エンドポイントを設定できます。

3.4.2.4. RsyncPod の補足グループの設定

PVC が共有ストレージを使用する場合、Pod がアクセスを許可するように RsyncPod 定義に補足グループを追加して、そのストレージへのアクセスを設定できます。

| 変数 | タイプ | デフォルト | 説明 |

|---|---|---|---|

|

| string | 設定されていません | ソース Rsync Pod の補足グループのコンマ区切りリスト |

|

| string | 設定されていません | ターゲット Rsync Pod の補足グループのコンマ区切りリスト |

使用例

MigrationController CR を更新して、これらの補足グループの値を設定できます。

spec: src_supplemental_groups: "1000,2000" target_supplemental_groups: "2000,3000"

spec:

src_supplemental_groups: "1000,2000"

target_supplemental_groups: "2000,3000"3.4.3. プロキシーの設定

前提条件

-

cluster-admin権限を持つユーザーとしてすべてのクラスターにログインしている必要があります。

手順

MigrationControllerCR マニフェストを取得します。oc get migrationcontroller <migration_controller> -n openshift-migration

$ oc get migrationcontroller <migration_controller> -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow プロキシーパラメーターを更新します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow サブドメインのみと一致するように、ドメインの前に

.を付けます。たとえば、.y.comはx.y.comに一致しますが、y.comには一致しません。*を使用し、すべての宛先のプロキシーをバイパスします。インストール設定でnetworking.machineNetwork[].cidrフィールドで定義されるネットワークに含まれていないワーカーをスケールアップする場合、それらをこのリストに追加し、接続の問題を防ぐ必要があります。httpProxyまたはhttpsProxyフィールドのいずれも設定されていない場合、このフィールドは無視されます。-

マニフェストを

migration-controller.yamlとして保存します。 更新したマニフェストを適用します。

oc replace -f migration-controller.yaml -n openshift-migration

$ oc replace -f migration-controller.yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

詳細は、Configuring the cluster-wide proxy を参照してください。

3.4.4. root または非 root として Rsync を実行する

このセクションは、Web コンソールではなく、OpenShift API を使用している場合にのみ適用されます。

OpenShift 環境では、PodSecurityAdmission コントローラーがデフォルトで有効になっています。このコントローラーでは、クラスター管理者がネームスペースラベルを使用して Pod セキュリティー標準を適用する必要があります。クラスター内のすべてのワークロードは、次の Pod セキュリティー標準レベルのいずれかを実行することが期待されます: Privileged、Baseline または Restricted。すべてのクラスターには、独自のデフォルトポリシーセットがあります。

すべての環境で正常なデータ転送を保証するために、Migration Toolkit for Containers (MTC) 1.7.5 では Rsync Pod に変更が導入されました。これには、デフォルトで非ルートユーザーとして Rsync Pod を実行することが含まれます。これにより、必ずしもより高い特権を必要としないワークロードでもデータ転送が可能になります。この変更が行われたのは、可能な限り低いレベルの特権でワークロードを実行するのが最善であるためです。

3.4.4.1. データ転送のデフォルトの非 root 操作を手動でオーバーライドする

ほとんどの場合、非 root ユーザーとして Rsync Pod を実行すると機能しますが、ソース側で root ユーザーとしてワークロードを実行すると、データ転送が失敗することがあります。MTC は、データ転送のデフォルトの非ルート操作を手動でオーバーライドする 2 つの方法を提供します。

- すべての移行の宛先クラスターで Rsync Pod をルートとして実行するように、すべての移行を設定します。

- 移行ごとに宛先クラスターで Rsync Pod をルートとして実行します。

どちらの場合も、移行前に、より高い権限でワークロードを実行している namespace のソース側に、enforce、audit、および warn のラベルを設定する必要があります。

Pod セキュリティーアドミッションとラベルの設定値の詳細は、Pod セキュリティーアドミッションの同期の制御 を参照してください。

3.4.4.2. すべての移行で MigrationController CR をルートまたは非ルートとして設定する

デフォルトでは、Rsync は非ルートとして実行されます。

宛先クラスターで、Rsync をルートとして実行するように MigrationController CR を設定できます。

手順

MigrationControllerCR を次のように設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow この設定は、今後のすべての移行に適用されます。

3.4.4.3. 移行ごとにルートまたは非ルートとして MigMigration CR を設定する

移行先クラスターでは、MigMigration CR を設定して、次の非ルートオプションを使用して、ルートまたは非ルートとして Rsync を実行できます。

- 特定のユーザー ID (UID) として

- 特定のグループ ID (GID) として

手順

Rsync をルートとして実行するには、次の例に従って

MigMigrationCR を設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow Rsync を特定のユーザー ID (UID) または特定のグループ ID (GID) として実行するには、次の例に従って

MigMigrationCR を設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5. レプリケーションリポジトリーの設定

オブジェクトストレージをレプリケーションリポジトリーとして使用するように設定する必要があります。MTC (Migration Toolkit for Containers) は、データをソースクラスターからレプリケーションリポジトリーにコピーしてから、レプリケーションリポジトリーからターゲットクラスターにコピーします。

MTC は、ソースクラスターからターゲットクラスターにデータを移行するために、ファイルシステムおよびスナップショットによるデータのコピー方法 をサポートします。ご使用の環境に適しており、ストレージプロバイダーでサポートされる方法を選択します。

MTC は、以下のストレージプロバイダーをサポートしています。

- Multicloud Object Gateway

- Amazon Web Services S3

- Google Cloud Platform

- Microsoft Azure Blob

- 汎用 S3 オブジェクトストレージ (例: Minio または Ceph S3)

3.5.1. 前提条件

- すべてのクラスターには、レプリケーションリポジトリーへの中断されないネットワークアクセスが必要です。

- 内部でホストされるレプリケーションリポジトリーでプロキシーサーバーを使用する場合は、プロキシーがレプリケーションリポジトリーへのアクセスを許可することを確認する必要があります。

3.5.2. Multicloud Object Gateway の認証情報の取得

MCG を Migration Toolkit for Containers (MTC) のレプリケーションリポジトリーとして設定するには、Multicloud Object Gateway (MCG) 認証情報と S3 エンドポイントを取得する必要があります。OpenShift API for Data Protection (OADP) の Secret カスタムリソース (CR) を作成するには、Multicloud Object Gateway (MCG) 認証情報を取得する必要があります。

MCG は、OpenShift Data Foundation のコンポーネントです。

前提条件

- 適切な OpenShift Data Foundation deployment guide を使用して、OpenShift Data Foundation をデプロイする必要があります。

手順

NooBaaカスタムリソースでdescribeコマンドを実行して、S3 エンドポイントであるAWS_ACCESS_KEY_IDおよびAWS_SECRET_ACCESS_KEYを取得します。これらの認証情報を使用して、MCG をレプリケーションリポジトリーとして追加します。

3.5.3. Amazon Web Services の設定

Amazon Web Services (AWS) S3 オブジェクトストレージを、Migration Toolkit for Containers (MTC) のレプリケーションリポジトリーとして設定します。

前提条件

- AWS CLI がインストールされていること。

- AWS S3 ストレージバケットは、ソースクラスターおよびターゲットクラスターからアクセスできる必要があります。

スナップショットのコピー方法を使用する場合は、以下の条件を満たす必要があります。

- EC2 Elastic Block Storage (EBS) にアクセスできる必要があります。

- ソースおよびターゲットクラスターが同じリージョンにある必要があります。

- ソースおよびターゲットクラスターには、同じストレージクラスがある必要があります。

- ストレージクラスはスナップショットと互換性がある必要があります。

手順

BUCKET変数を設定します。BUCKET=<your_bucket>

$ BUCKET=<your_bucket>Copy to Clipboard Copied! Toggle word wrap Toggle overflow REGION変数を設定します。REGION=<your_region>

$ REGION=<your_region>Copy to Clipboard Copied! Toggle word wrap Toggle overflow AWS S3 バケットを作成します。

aws s3api create-bucket \ --bucket $BUCKET \ --region $REGION \ --create-bucket-configuration LocationConstraint=$REGION$ aws s3api create-bucket \ --bucket $BUCKET \ --region $REGION \ --create-bucket-configuration LocationConstraint=$REGION1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

us-east-1はLocationConstraintをサポートしていません。お住まいの地域がus-east-1の場合は、--create-bucket-configuration LocationConstraint=$REGIONを省略してください。

IAM ユーザーを作成します。

aws iam create-user --user-name velero

$ aws iam create-user --user-name velero1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Velero を使用して複数の S3 バケットを持つ複数のクラスターをバックアップする場合は、クラスターごとに一意のユーザー名を作成します。

velero-policy.jsonファイルを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow ポリシーを添付して、

veleroユーザーに必要最小限の権限を付与します。aws iam put-user-policy \ --user-name velero \ --policy-name velero \ --policy-document file://velero-policy.json

$ aws iam put-user-policy \ --user-name velero \ --policy-name velero \ --policy-document file://velero-policy.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow veleroユーザーのアクセスキーを作成します。aws iam create-access-key --user-name velero

$ aws iam create-access-key --user-name veleroCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow AWS_SECRET_ACCESS_KEYとAWS_ACCESS_KEY_IDを記録します。認証情報を使用して、AWS をレプリケーションリポジトリーとして追加します。

3.5.4. Google Cloud Provider の設定

Google Cloud Provider (GCP) ストレージバケットを MTC (Migration Toolkit for Containers) のレプリケーションリポジトリーとして設定します。

前提条件

-

gcloudおよびgsutilCLI ツールがインストールされている必要があります。詳細は、Google Cloud のドキュメント をご覧ください。 - GCP ストレージバケットは、ソースクラスターおよびターゲットクラスターからアクセスできる必要があります。

スナップショットのコピー方法を使用する場合は、以下の条件を満たす必要があります。

- ソースおよびターゲットクラスターが同じリージョンにある必要があります。

- ソースおよびターゲットクラスターには、同じストレージクラスがある必要があります。

- ストレージクラスはスナップショットと互換性がある必要があります。

手順

GCP にログインします。

gcloud auth login

$ gcloud auth loginCopy to Clipboard Copied! Toggle word wrap Toggle overflow BUCKET変数を設定します。BUCKET=<bucket>

$ BUCKET=<bucket>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- バケット名を指定します。

ストレージバケットを作成します。

gsutil mb gs://$BUCKET/

$ gsutil mb gs://$BUCKET/Copy to Clipboard Copied! Toggle word wrap Toggle overflow PROJECT_ID変数をアクティブなプロジェクトに設定します。PROJECT_ID=$(gcloud config get-value project)

$ PROJECT_ID=$(gcloud config get-value project)Copy to Clipboard Copied! Toggle word wrap Toggle overflow サービスアカウントを作成します。

gcloud iam service-accounts create velero \ --display-name "Velero service account"$ gcloud iam service-accounts create velero \ --display-name "Velero service account"Copy to Clipboard Copied! Toggle word wrap Toggle overflow サービスアカウントをリスト表示します。

gcloud iam service-accounts list

$ gcloud iam service-accounts listCopy to Clipboard Copied! Toggle word wrap Toggle overflow emailの値と一致するようにSERVICE_ACCOUNT_EMAIL変数を設定します。SERVICE_ACCOUNT_EMAIL=$(gcloud iam service-accounts list \ --filter="displayName:Velero service account" \ --format 'value(email)')$ SERVICE_ACCOUNT_EMAIL=$(gcloud iam service-accounts list \ --filter="displayName:Velero service account" \ --format 'value(email)')Copy to Clipboard Copied! Toggle word wrap Toggle overflow ポリシーを添付して、

veleroユーザーに必要最小限の権限を付与します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow velero.serverカスタムロールを作成します。gcloud iam roles create velero.server \ --project $PROJECT_ID \ --title "Velero Server" \ --permissions "$(IFS=","; echo "${ROLE_PERMISSIONS[*]}")"$ gcloud iam roles create velero.server \ --project $PROJECT_ID \ --title "Velero Server" \ --permissions "$(IFS=","; echo "${ROLE_PERMISSIONS[*]}")"Copy to Clipboard Copied! Toggle word wrap Toggle overflow IAM ポリシーバインディングをプロジェクトに追加します。

gcloud projects add-iam-policy-binding $PROJECT_ID \ --member serviceAccount:$SERVICE_ACCOUNT_EMAIL \ --role projects/$PROJECT_ID/roles/velero.server$ gcloud projects add-iam-policy-binding $PROJECT_ID \ --member serviceAccount:$SERVICE_ACCOUNT_EMAIL \ --role projects/$PROJECT_ID/roles/velero.serverCopy to Clipboard Copied! Toggle word wrap Toggle overflow IAM サービスアカウントを更新します。

gsutil iam ch serviceAccount:$SERVICE_ACCOUNT_EMAIL:objectAdmin gs://${BUCKET}$ gsutil iam ch serviceAccount:$SERVICE_ACCOUNT_EMAIL:objectAdmin gs://${BUCKET}Copy to Clipboard Copied! Toggle word wrap Toggle overflow IAM サービスアカウントのキーを現在のディレクトリーにある

credentials-veleroファイルに保存します。gcloud iam service-accounts keys create credentials-velero \ --iam-account $SERVICE_ACCOUNT_EMAIL$ gcloud iam service-accounts keys create credentials-velero \ --iam-account $SERVICE_ACCOUNT_EMAILCopy to Clipboard Copied! Toggle word wrap Toggle overflow credentials-veleroファイルを使用して、GCP をレプリケーションリポジトリーとして追加します。

3.5.5. Microsoft Azure の設定

Microsoft Azure Blob ストレージコンテナーを MTC (Migration Toolkit for Containers) のレプリケーションリポジトリーとして設定します。

前提条件

- Azure CLI がインストールされていること。

- Azure Blob ストレージコンテナーがソースクラスターおよびターゲットクラスターからアクセスできること。

スナップショットのコピー方法を使用する場合は、以下の条件を満たす必要があります。

- ソースおよびターゲットクラスターが同じリージョンにある必要があります。

- ソースおよびターゲットクラスターには、同じストレージクラスがある必要があります。

- ストレージクラスはスナップショットと互換性がある必要があります。

手順

Azure にログインします。

az login

$ az loginCopy to Clipboard Copied! Toggle word wrap Toggle overflow AZURE_RESOURCE_GROUP変数を設定します。AZURE_RESOURCE_GROUP=Velero_Backups

$ AZURE_RESOURCE_GROUP=Velero_BackupsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Azure リソースグループを作成します。

az group create -n $AZURE_RESOURCE_GROUP --location CentralUS

$ az group create -n $AZURE_RESOURCE_GROUP --location CentralUS1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 場所を指定します。

AZURE_STORAGE_ACCOUNT_ID変数を設定します。AZURE_STORAGE_ACCOUNT_ID="velero$(uuidgen | cut -d '-' -f5 | tr '[A-Z]' '[a-z]')"

$ AZURE_STORAGE_ACCOUNT_ID="velero$(uuidgen | cut -d '-' -f5 | tr '[A-Z]' '[a-z]')"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Azure ストレージアカウントを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow BLOB_CONTAINER変数を設定します。BLOB_CONTAINER=velero

$ BLOB_CONTAINER=veleroCopy to Clipboard Copied! Toggle word wrap Toggle overflow Azure Blob ストレージコンテナーを作成します。

az storage container create \ -n $BLOB_CONTAINER \ --public-access off \ --account-name $AZURE_STORAGE_ACCOUNT_ID

$ az storage container create \ -n $BLOB_CONTAINER \ --public-access off \ --account-name $AZURE_STORAGE_ACCOUNT_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow veleroのサービスプリンシパルおよび認証情報を作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow サービスプリンシパルの認証情報を

credentials-veleroファイルに保存します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow credentials-veleroファイルを使用して、Azure をレプリケーションリポジトリーとして追加します。

3.6. MTC のアンインストールおよびリソースの削除

MTC (Migration Toolkit for Containers) をアンインストールし、そのリソースを削除してクラスターをクリーンアップできます。

velero CRD を削除すると、Velero がクラスターから削除されます。

前提条件

-

cluster-admin権限を持つユーザーとしてログインしている。

手順

すべてのクラスターで

MigrationControllerカスタムリソース (CR) を削除します。oc delete migrationcontroller <migration_controller>

$ oc delete migrationcontroller <migration_controller>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Operator Lifecycle Manager を使用して OpenShift Container Platform 4 の Migration Toolkit for Containers Operator をアンインストールします。

以下のコマンドを実行して、すべてのクラスターでクラスタースコープのリソースを削除します。

migrationカスタムリソース定義 (CRDs):oc delete $(oc get crds -o name | grep 'migration.openshift.io')

$ oc delete $(oc get crds -o name | grep 'migration.openshift.io')Copy to Clipboard Copied! Toggle word wrap Toggle overflow VeleroCRD:oc delete $(oc get crds -o name | grep 'velero')

$ oc delete $(oc get crds -o name | grep 'velero')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migrationクラスターロール:oc delete $(oc get clusterroles -o name | grep 'migration.openshift.io')

$ oc delete $(oc get clusterroles -o name | grep 'migration.openshift.io')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migration-operatorクラスターロール:oc delete clusterrole migration-operator

$ oc delete clusterrole migration-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Veleroクラスターロール:oc delete $(oc get clusterroles -o name | grep 'velero')

$ oc delete $(oc get clusterroles -o name | grep 'velero')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migrationクラスターのロールバインディング:oc delete $(oc get clusterrolebindings -o name | grep 'migration.openshift.io')

$ oc delete $(oc get clusterrolebindings -o name | grep 'migration.openshift.io')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migration-operatorクラスターロールバインディング:oc delete clusterrolebindings migration-operator

$ oc delete clusterrolebindings migration-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Veleroクラスターのロールバインディング:oc delete $(oc get clusterrolebindings -o name | grep 'velero')

$ oc delete $(oc get clusterrolebindings -o name | grep 'velero')Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第4章 ネットワークの制限された環境での Migration Toolkit for Containers Operator のインストール

以下の手順を実行して、ネットワークが制限された環境で OpenShift Container Platform 4 に MTC (Migration Toolkit for Containers) をインストールすることができます。

ミラーリングされた Operator カタログ を作成します。

このプロセスは、

registry.redhat.ioイメージとミラーレジストリーイメージ間のマッピングを含むmapping.txtファイルを作成します。mapping.txtファイルは、レガシーの Migration Toolkit for Containers Operator を OpenShift Container Platform 4.2 から 4.5 ソースクラスターにインストールするために必要です。Operator Lifecycle Manager を使用して OpenShift Container Platform 4.11 ターゲットクラスターに Migration Toolkit for Containers Operator をインストールします。

デフォルトで、MTC Web コンソールおよび

Migration ControllerPod はターゲットクラスターで実行されます。Migration Controllerカスタムリソースマニフェストを、MTC の Web コンソールおよびMigration ControllerPod を リモートクラスター で実行するように設定できます。Migration Toolkit for Containers Operator をソースクラスターにインストールします。

- OpenShift Container Platform 4.6 以降: Operator Lifecycle Manager を使用して Migration Toolkit for Containers Operator をインストールします。

- OpenShift Container Platform 4.2 から 4.5: コマンドラインインターフェイスからレガシー Migration Toolkit for Containers Operator をインストールします。

- オブジェクトストレージをレプリケーションリポジトリーとして使用するように設定します。

OpenShift Container Platform 3 に MTC をインストールするには、OpenShift Container Platform 3 へのコンテナーオペレーター用のレガシー Migration Toolkit のインストール を参照してください。

MTC をアンインストールするには、MTC のアンインストールとリソースの削除 を参照してください。

4.1. 互換性のガイドライン

OpenShift Container Platform バージョンと互換性がある MTC (Migration Toolkit for Containers) Operator をインストールする必要があります。

定義

- レガシープラットフォーム

- OpenShift Container Platform 4.5 以前。

- 最新プラットフォーム

- OpenShift Container Platform 4.6 以降。

- レガシー operator

- レガシープラットフォーム用に設計された MTC Operator。

- 最新 operator

- 最新のプラットフォーム用に設計された MTC Operator。

- コントロールクラスター

- MTC コントローラーと GUI を実行するクラスター。

- リモートクラスター

- Velero を実行する移行のソースクラスターまたは宛先クラスター。コントロールクラスターは、Velero API を介してリモートクラスターと通信し、移行を促進します。

OpenShift Container Platform クラスターの移行には、互換性のある MTC バージョンを使用する必要があります。移行を成功させるには、ソースクラスターと宛先クラスターの両方が同じバージョンの MTC を使用する必要があります。

MTC 1.7 は、OpenShift Container Platform 3.11 から 4.8 への移行をサポートしています。

MTC 1.8 は、OpenShift Container Platform 4.9 以降からの移行のみをサポートします。

| 詳細 | OpenShift Container Platform 3.11 | OpenShift Container Platform 4.8 から 4.10 | OpenShift Container Platform 4.8 から 4.10 | OpenShift Container Platform 4.12 以降 |

|---|---|---|---|---|

| 安定した MTC バージョン | MTC v.1.7.z | MTC v.1.7.z | MTC v.1.7.z | MTC v.1.8.z |

| インストール |

レガシー MTC v.1.7.z Operator: [IMPORTANT] このクラスターは制御クラスターにすることはできません。 |

OLM を使用してインストール、リリースチャネル |

OLM を使用してインストール、リリースチャネル |

ネットワークの制限により、最新のクラスターが移行に関与する他のクラスターに接続できないというエッジケースが存在します。たとえば、オンプレミスの OpenShift Container Platform 3.11 クラスターからクラウド内の最新の OpenShift Container Platform クラスターに移行する場合、最新のクラスターは OpenShift Container Platform 3.11 クラスターに接続できません。

MTC 1.8 では、ネットワーク制限が原因で、いずれかのリモートクラスターがコントロールクラスターと通信できない場合は、crane tunnel-api コマンドを使用します。

安定した MTC リリースでは、常に最新のクラスターを制御クラスターとして指定する必要がありますが、この特定のケースでは、レガシークラスターを制御クラスターとして指定し、ワークロードをリモートクラスターにプッシュすることができます。

4.2. Migration Toolkit for Containers Operator の OpenShift Container Platform 4.11 へのインストール

Operator Lifecycle Manager を使用して OpenShift Container Platform 4.11 に Migration Toolkit for Containers Operator をインストールします。

前提条件

-

cluster-admin権限を持つユーザーとしてすべてのクラスターにログインしている必要があります。 - ローカルレジストリーのミラーイメージで Operator カタログを作成する必要があります。

手順

- OpenShift Container Platform Web コンソールで、Operators → OperatorHub をクリックします。

- Filter by keyword フィールドを使用して、 Migration Toolkit for Containers Operator を見つけます。

- Migration Toolkit for Containers Operator を選択し、Install をクリックします。

Install をクリックします。

Installed Operators ページで、Migration Toolkit for Containers Operator は、Succeeded のステータスで openshift-migration プロジェクトに表示されます。

- Migration Toolkit for Containers Operator をクリックします。

- Provided APIs の下で Migration Controller タイルを見つけ、Create Instance をクリックします。

- Create をクリックします。

- Workloads → Pods をクリックし、MTC Pod が実行されていることを確認します。

4.3. OpenShift Container Platform 4.2 での従来の Migration Toolkit for Containers Operator の 4.5 へのインストール

レガシー Migration Toolkit for Containers Operator を手動で OpenShift Container Platform バージョン 4.2 から 4.5 にインストールできます。

前提条件

-

cluster-admin権限を持つユーザーとしてすべてのクラスターにログインしている必要があります。 -

registry.redhat.ioにアクセスできる必要があります。 -

podmanがインストールされている必要があります。 -

registry.redhat.ioからファイルをダウンロードするには、ネットワークアクセスのある Linux ワークステーションが必要です。 - Operator カタログのミラーイメージを作成する必要があります。

- ミラーリングされた Operator カタログから Migration Toolkit for Containers Operator を OpenShift Container Platform 4.11 にインストールする必要があります。

手順

Red Hat カスタマーポータルの認証情報を使用して

registry.redhat.ioにログインします。podman login registry.redhat.io

$ podman login registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

operator.ymlファイルをダウンロードします。podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/operator.yml ./

podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/operator.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

controller.ymlファイルをダウンロードします。podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/controller.yml ./

podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/controller.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して、Operator イメージマッピングを取得します。

grep openshift-migration-legacy-rhel8-operator ./mapping.txt | grep rhmtc

$ grep openshift-migration-legacy-rhel8-operator ./mapping.txt | grep rhmtcCopy to Clipboard Copied! Toggle word wrap Toggle overflow mapping.txtファイルは Operator カタログのミラーリング時に作成されました。出力には、registry.redhat.ioイメージとミラーレジストリーイメージ間のマッピングが表示されます。出力例

registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator@sha256:468a6126f73b1ee12085ca53a312d1f96ef5a2ca03442bcb63724af5e2614e8a=<registry.apps.example.com>/rhmtc/openshift-migration-legacy-rhel8-operator

registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator@sha256:468a6126f73b1ee12085ca53a312d1f96ef5a2ca03442bcb63724af5e2614e8a=<registry.apps.example.com>/rhmtc/openshift-migration-legacy-rhel8-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow ansibleおよびoperatorコンテナーのimage値、およびoperator.ymlファイルのREGISTRY値を更新します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - OpenShift Container Platform ソースクラスターにログインします。

Migration Toolkit for Containers Operator オブジェクトを作成します。

oc create -f operator.yml

$ oc create -f operator.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

Error from server (AlreadyExists)メッセージは無視できます。これらは、以降のリソースで提供される OpenShift Container Platform 4 以前のバージョン用にリソースを作成する Migration Toolkit for Containers Operator が原因です。

MigrationControllerオブジェクトを作成します。oc create -f controller.yml

$ oc create -f controller.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow MTC Pod が実行されていることを確認します。

oc get pods -n openshift-migration

$ oc get pods -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4. プロキシー設定

OpenShift Container Platform 4.1 以前のバージョンでは、これらのバージョンはクラスター全体の proxy オブジェクトをサポートしないため、Migration Toolkit for Containers Operator のインストール後に、MigrationController カスタムリソース (CR) マニフェストでプロキシーを設定する必要があります。

OpenShift Container Platform 4.2 から 4.11 の場合、MTC (Migration Toolkit for Containers) はクラスター全体のプロキシー設定を継承します。クラスター全体のプロキシー設定を上書きする場合は、プロキシーパラメーターを変更できます。

4.4.1. ボリュームの直接移行

MTC 1.4.2 で、ボリュームの直接移行 (DVM) が導入されました。DVM は 1 つのプロキシーのみをサポートします。ターゲットクラスターもプロキシーの背後にある場合、ソースクラスターはターゲットクラスターのルートにアクセスできません。

プロキシーの背後にあるソースクラスターから DVM を実行する場合には、トランスポート層で機能する TCP プロキシーを設定して、SSL 接続を独自の SSL 証明書で復号化および再暗号化せずに透過的に転送する必要があります。Stunnel プロキシーは、このようなプロキシーの例です。

4.4.1.1. DVM の TCP プロキシー設定

TCP プロキシー経由でソースとターゲットクラスターの間に直接接続を設定し、プロキシーを使用できるように MigrationController CR の stunnel_tcp_proxy 変数を設定できます。

ボリュームの直接移行 (DVM) は、プロキシーの Basic 認証のみをサポートします。さらに、DVM は、TCP 接続を透過的にトンネルできるプロキシーの背後でのみ機能します。中間者モードの HTTP/HTTPS プロキシーは機能しません。既存のクラスター全体にわたるプロキシーはこの動作をサポートしない可能性があります。その結果、DVM のプロキシー設定は、MTC の通常のプロキシー設定とは異なる状態に保たれます。

4.4.1.2. HTTP/HTTPS プロキシーの代わりに TCP プロキシーを使用する理由

DVM を有効にするには、OpenShift ルートを介してソースおよびターゲットクラスター間で Rsync を実行します。トラフィックは、TCP プロキシーである Stunnel を使用して暗号化されます。ソースクラスターで実行している Stunnel は、ターゲット Stunnel との TLS 接続を開始し、暗号化されたチャネルでデータを転送します。

OpenShift のクラスター全体の HTTP/HTTPS プロキシーは通常、外部サーバーで独自の TLS セッションをネゴシエートする中間者モードで設定されます。ただし、これは Stunnel では機能しません。Stunnel では、プロキシーによって TLS セッションが変更されないようにする必要があります。基本的には、プロキシーを透過的なトンネルにし、単純に TCP 接続をそのまま転送する必要があります。したがって、TCP プロキシーを使用する必要があります。

4.4.1.3. 既知の問題

移行が Upgrade request required エラーで失敗する

移行コントローラーは SPDY プロトコルを使用してリモート Pod 内でコマンドを実行します。リモートクラスターがプロキシーまたは、SPDY プロトコルをサポートしないファイアウォールの背後にある場合には、移行コントローラーはリモートコマンドの実行に失敗します。移行に失敗し、Upgrade request required というエラーメッセージが表示されます。回避策: SPDY プロトコルをサポートするプロキシーを使用します。

SPDY プロトコルのサポートに加えて、このプロキシーまたはファイアウォールでは、Upgrade HTTP ヘッダーを API サーバーに渡す必要もあります。クライアントはこのヘッダーを使用して API サーバーと Websocket 接続を開きます。Upgrade ヘッダーがプロキシーまたはファイアウォールでブロックされると、移行に失敗し、Upgrade request required というエラーメッセージが表示されます。回避策: プロキシーで Upgrade ヘッダーが転送されるようにしてください。

4.4.2. 移行用のネットワークポリシーのチューニング

OpenShift は、クラスターで使用されるネットワークプラグインに基づいて NetworkPolicy または EgressFirewalls を使用した Pod との間のトラフィックの制限をサポートします。移行に関連するソース namespace のいずれかがこのようなメカニズムを使用して Pod へのネットワークトラフィックを制限する場合には、この制限により移行時に Rsync Pod へのトラフィックが誤って停止される可能性があります。

ソースおよびターゲットクラスターの両方で実行される Rsync Pod は OpenShift Route 経由で相互に接続する必要があります。既存の NetworkPolicy または EgressNetworkPolicy オブジェクトは、これらのトラフィックの制限が課されないように Rsync Pod を自動的に取り除くように設定できます。

4.4.2.1. NetworkPolicy の設定

4.4.2.1.1. Rsync Pod からの egress トラフィック

Rsync Pod の一意のラベルを使用し、同期元または同期先 namespace の NetworkPolicy 設定がこのタイプのトラフィックをブロックする場合に egress トラフィックがそれらを通過することを許可できます。以下のポリシーは、namespace の Rsync Pod からの 全 egress トラフィックを許可します。

4.4.2.1.2. Rsync Pod への ingress トラフィック

4.4.2.2. EgressNetworkPolicy 設定

EgressNetworkPolicy オブジェクトまたは Egress ファイアウォール は、egress トラフィックをクラスターからブロックするために設計された OpenShift コンストラクトです。

NetworkPolicy オブジェクトとは異なり、Egress ファイアウォールは namespace のすべての Pod に適用されるためにプロジェクトレベルで機能します。そのため、Rsync Pod の一意のラベルを使用すると、この制限から除外するのは Rsync Pod だけではありません。ただし、ソースおよびターゲットクラスターの CIDR 範囲をポリシーの Allow ルールに追加して、2 つのクラスター間で直接接続を設定できます。

Egress ファイアウォールが存在するクラスターに基づいて、他のクラスターの CIDR 範囲を追加して、2 つの間の egress トラフィックを許可できます。

4.4.2.3. データ転送用の代替エンドポイントの選択

デフォルトでは、DVM は OpenShift Container Platform ルートをエンドポイントとして使用して、PV データを宛先クラスターに転送します。クラスタートポロジーで許可されている場合は、サポートされている別の種類のエンドポイントを選択できます。

クラスターごとに、MigrationController CR で適切な 宛先 クラスターに rsync_endpoint_type 変数を設定することで、エンドポイントを設定できます。

4.4.2.4. RsyncPod の補足グループの設定

PVC が共有ストレージを使用する場合、Pod がアクセスを許可するように RsyncPod 定義に補足グループを追加して、そのストレージへのアクセスを設定できます。

| 変数 | タイプ | デフォルト | 説明 |

|---|---|---|---|

|

| string | 設定されていません | ソース Rsync Pod の補足グループのコンマ区切りリスト |

|

| string | 設定されていません | ターゲット Rsync Pod の補足グループのコンマ区切りリスト |

使用例

MigrationController CR を更新して、これらの補足グループの値を設定できます。

spec: src_supplemental_groups: "1000,2000" target_supplemental_groups: "2000,3000"

spec:

src_supplemental_groups: "1000,2000"

target_supplemental_groups: "2000,3000"4.4.3. プロキシーの設定

前提条件

-

cluster-admin権限を持つユーザーとしてすべてのクラスターにログインしている必要があります。

手順

MigrationControllerCR マニフェストを取得します。oc get migrationcontroller <migration_controller> -n openshift-migration

$ oc get migrationcontroller <migration_controller> -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow プロキシーパラメーターを更新します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow サブドメインのみと一致するように、ドメインの前に

.を付けます。たとえば、.y.comはx.y.comに一致しますが、y.comには一致しません。*を使用し、すべての宛先のプロキシーをバイパスします。インストール設定でnetworking.machineNetwork[].cidrフィールドで定義されるネットワークに含まれていないワーカーをスケールアップする場合、それらをこのリストに追加し、接続の問題を防ぐ必要があります。httpProxyまたはhttpsProxyフィールドのいずれも設定されていない場合、このフィールドは無視されます。-

マニフェストを

migration-controller.yamlとして保存します。 更新したマニフェストを適用します。

oc replace -f migration-controller.yaml -n openshift-migration

$ oc replace -f migration-controller.yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

詳細は、Configuring the cluster-wide proxy を参照してください。

4.5. root または非 root として Rsync を実行する

このセクションは、Web コンソールではなく、OpenShift API を使用している場合にのみ適用されます。

OpenShift 環境では、PodSecurityAdmission コントローラーがデフォルトで有効になっています。このコントローラーでは、クラスター管理者がネームスペースラベルを使用して Pod セキュリティー標準を適用する必要があります。クラスター内のすべてのワークロードは、次の Pod セキュリティー標準レベルのいずれかを実行することが期待されます: Privileged、Baseline または Restricted。すべてのクラスターには、独自のデフォルトポリシーセットがあります。

すべての環境で正常なデータ転送を保証するために、Migration Toolkit for Containers (MTC) 1.7.5 では Rsync Pod に変更が導入されました。これには、デフォルトで非ルートユーザーとして Rsync Pod を実行することが含まれます。これにより、必ずしもより高い特権を必要としないワークロードでもデータ転送が可能になります。この変更が行われたのは、可能な限り低いレベルの特権でワークロードを実行するのが最善であるためです。

4.5.1. データ転送のデフォルトの非 root 操作を手動でオーバーライドする

ほとんどの場合、非 root ユーザーとして Rsync Pod を実行すると機能しますが、ソース側で root ユーザーとしてワークロードを実行すると、データ転送が失敗することがあります。MTC は、データ転送のデフォルトの非ルート操作を手動でオーバーライドする 2 つの方法を提供します。

- すべての移行の宛先クラスターで Rsync Pod をルートとして実行するように、すべての移行を設定します。

- 移行ごとに宛先クラスターで Rsync Pod をルートとして実行します。

どちらの場合も、移行前に、より高い権限でワークロードを実行している namespace のソース側に、enforce、audit、および warn のラベルを設定する必要があります。

Pod セキュリティーアドミッションとラベルの設定値の詳細は、Pod セキュリティーアドミッションの同期の制御 を参照してください。

4.5.2. すべての移行で MigrationController CR をルートまたは非ルートとして設定する

デフォルトでは、Rsync は非ルートとして実行されます。

宛先クラスターで、Rsync をルートとして実行するように MigrationController CR を設定できます。

手順

MigrationControllerCR を次のように設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow この設定は、今後のすべての移行に適用されます。

4.5.3. 移行ごとにルートまたは非ルートとして MigMigration CR を設定する

移行先クラスターでは、MigMigration CR を設定して、次の非ルートオプションを使用して、ルートまたは非ルートとして Rsync を実行できます。

- 特定のユーザー ID (UID) として

- 特定のグループ ID (GID) として

手順

Rsync をルートとして実行するには、次の例に従って

MigMigrationCR を設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow Rsync を特定のユーザー ID (UID) または特定のグループ ID (GID) として実行するには、次の例に従って

MigMigrationCR を設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.6. レプリケーションリポジトリーの設定

Multicloud Object Gateway は、ネットワークが制限された環境で唯一サポートされるオプションです。

MTC は、ソースクラスターからターゲットクラスターにデータを移行するために、ファイルシステムおよびスナップショットによるデータのコピー方法 をサポートします。ご使用の環境に適した方法で、ストレージプロバイダーでサポートされる方法を選択できます。

4.6.1. 前提条件

- すべてのクラスターには、レプリケーションリポジトリーへの中断されないネットワークアクセスが必要です。

- 内部でホストされるレプリケーションリポジトリーでプロキシーサーバーを使用する場合は、プロキシーがレプリケーションリポジトリーへのアクセスを許可することを確認する必要があります。

4.6.2. Multicloud Object Gateway の認証情報の取得

OpenShift API for Data Protection (OADP) の Secret カスタムリソース (CR) を作成するには、Multicloud Object Gateway (MCG) 認証情報を取得する必要があります。

MCG は、OpenShift Data Foundation のコンポーネントです。

前提条件

- 適切な OpenShift Data Foundation deployment guide を使用して、OpenShift Data Foundation をデプロイする必要があります。

手順

-

NooBaaカスタムリソースでdescribeコマンドを実行して、S3 エンドポイントであるAWS_ACCESS_KEY_IDおよびAWS_SECRET_ACCESS_KEYを取得します。

4.7. MTC のアンインストールおよびリソースの削除

MTC (Migration Toolkit for Containers) をアンインストールし、そのリソースを削除してクラスターをクリーンアップできます。

velero CRD を削除すると、Velero がクラスターから削除されます。

前提条件

-

cluster-admin権限を持つユーザーとしてログインしている。

手順

すべてのクラスターで

MigrationControllerカスタムリソース (CR) を削除します。oc delete migrationcontroller <migration_controller>

$ oc delete migrationcontroller <migration_controller>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - Operator Lifecycle Manager を使用して OpenShift Container Platform 4 の Migration Toolkit for Containers Operator をアンインストールします。

以下のコマンドを実行して、すべてのクラスターでクラスタースコープのリソースを削除します。

migrationカスタムリソース定義 (CRDs):oc delete $(oc get crds -o name | grep 'migration.openshift.io')

$ oc delete $(oc get crds -o name | grep 'migration.openshift.io')Copy to Clipboard Copied! Toggle word wrap Toggle overflow VeleroCRD:oc delete $(oc get crds -o name | grep 'velero')

$ oc delete $(oc get crds -o name | grep 'velero')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migrationクラスターロール:oc delete $(oc get clusterroles -o name | grep 'migration.openshift.io')

$ oc delete $(oc get clusterroles -o name | grep 'migration.openshift.io')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migration-operatorクラスターロール:oc delete clusterrole migration-operator

$ oc delete clusterrole migration-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Veleroクラスターロール:oc delete $(oc get clusterroles -o name | grep 'velero')

$ oc delete $(oc get clusterroles -o name | grep 'velero')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migrationクラスターのロールバインディング:oc delete $(oc get clusterrolebindings -o name | grep 'migration.openshift.io')

$ oc delete $(oc get clusterrolebindings -o name | grep 'migration.openshift.io')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migration-operatorクラスターロールバインディング:oc delete clusterrolebindings migration-operator

$ oc delete clusterrolebindings migration-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow Veleroクラスターのロールバインディング:oc delete $(oc get clusterrolebindings -o name | grep 'velero')

$ oc delete $(oc get clusterrolebindings -o name | grep 'velero')Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第5章 Migration Toolkit for Containers のアップグレード

Migration Toolkit for Containers (MTC) は Operator Lifecycle Manager を使用して OpenShift Container Platform 4.11 でアップグレードできます。

従来の Migration Toolkit for Containers Operator を再インストールすることにより、OpenShift Container Platform 4.5 以前のバージョンで MTC をアップグレードできます。

MTC バージョン 1.3 からアップグレードする場合、MigPlan カスタムリソース (CR) を更新する追加の手順を実行する必要があります。

5.1. OpenShift Container Platform 4.11 での MTC(Migration Toolkit for Containers) のアップグレード

Migration Toolkit for Containers (MTC) は Operator Lifecycle Manager を使用して OpenShift Container Platform 4.11 でアップグレードできます。

Operator Lifecycle Manager を使用して MTC をアップグレードする場合は、サポートされている移行パスを使用する必要があります。

移行パス

- OpenShift Container Platform 3 から OpenShift Container Platform 4 に移行するには、レガシー MTC Operator と MTC 1.7.x が必要です。

- MTC 1.7.x から MTC 1.8.x への移行はサポートされていません。

OpenShift Container Platform 4.9 以前から移行する場合は、MTC 1.7.x を使用する必要があります。

- MTC 1.7.x は、移行前と移行後の両方で使用する必要があります。

MTC 1.8.x は、OpenShift Container Platform 4.10 以降から OpenShift Container Platform 4.10 以降への移行のみサポートします。移行に含まれるクラスターのバージョンが 4.10 以降のみの場合は、1.7.x または 1.8.x のいずれかを使用できます。ただし、MTC バージョンは移行前と移行後の両方で同じである必要があります。

- MTC 1.7.x から MTC 1.8.x への移行はサポートされていません。

- MTC 1.8.x から MTC 1.7.x への移行はサポートされていません。

- MTC 1.7.x から MTC 1.7.x への移行はサポートされています。

- MTC 1.8.x から MTC 1.8.x への移行はサポートされています

前提条件

-

cluster-admin権限を持つユーザーとしてログインしている。

手順

OpenShift Container Platform コンソールで、Operators → Installed Operators に移動します。

更新が保留中の Operator は Upgrade available のステータスを表示します。

- Migration Toolkit for Containers Operator をクリックします。

- Subscription タブをクリックします。アップグレードの承認を必要とするアップグレードは、Upgrade Status の横に表示されます。たとえば、1 requires approval が表示される可能性があります。

- 1 requires approval をクリックしてから、Preview Install Plan をクリックします。

- アップグレードに利用可能なリソースとしてリスト表示されているリソースを確認し、Approve をクリックします。

- Operators → Installed Operators ページに戻り、アップグレードの進捗をモニターします。完了時に、ステータスは Succeeded および Up to date に変更されます。

- Workloads → Pods をクリックし、MTC Pod が実行されていることを確認します。

5.2. Migration Toolkit for Containers 1.8.0 へのアップグレード

Migration Toolkit for Containers を 1.8.0 にアップグレードするには、次の手順を実行します。

手順

次のいずれかの方法で、アップグレードに使用するサブスクリプション名と現在のチャネルを確認します。

次のコマンドを実行して、サブスクリプション名とチャネルを確認します。

oc -n openshift-migration get sub

$ oc -n openshift-migration get subCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME PACKAGE SOURCE CHANNEL mtc-operator mtc-operator mtc-operator-catalog release-v1.7 redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace redhat-oadp-operator mtc-operator-catalog stable-1.0

NAME PACKAGE SOURCE CHANNEL mtc-operator mtc-operator mtc-operator-catalog release-v1.7 redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace redhat-oadp-operator mtc-operator-catalog stable-1.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow または、次のコマンドを実行して、サブスクリプション名とチャネルを JSON で返します。

oc -n openshift-migration get sub -o json | jq -r '.items[] | { name: .metadata.name, package: .spec.name, channel: .spec.channel }'$ oc -n openshift-migration get sub -o json | jq -r '.items[] | { name: .metadata.name, package: .spec.name, channel: .spec.channel }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

サブスクリプションごとに次のコマンドを実行して、MTC 1.7 チャネルから MTC 1.8 チャネルに移動するようにパッチを適用します。

oc -n openshift-migration patch subscription mtc-operator --type merge --patch '{"spec": {"channel": "release-v1.8"}}'$ oc -n openshift-migration patch subscription mtc-operator --type merge --patch '{"spec": {"channel": "release-v1.8"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

subscription.operators.coreos.com/mtc-operator patched

subscription.operators.coreos.com/mtc-operator patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2.1. Migration Toolkit for Containers 1.8.0 用の OADP 1.0 を 1.2 にアップグレードする

Migration Toolkit for Containers 1.8.0 用の OADP 1.0 を 1.2 にアップグレードするには、次の手順を実行します。

手順

サブスクリプションごとに次のコマンドを実行し、OADP Operator に OADP 1.0 から OADP 1.2 へのパッチを適用します。

oc -n openshift-migration patch subscription redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace --type merge --patch '{"spec": {"channel":"stable-1.2"}}'$ oc -n openshift-migration patch subscription redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace --type merge --patch '{"spec": {"channel":"stable-1.2"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記MTC と OADP のインストールにそれぞれ使用する、ユーザー固有の戻り値である

NAME値を示すセクション。出力例

subscription.operators.coreos.com/redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace patched

subscription.operators.coreos.com/redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記戻り値は、この例で使用されている

redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplaceに似た値になります。-

installPlanApprovalパラメーターがAutomaticに設定されている場合、Operator Lifecycle Manager (OLM) はアップグレードプロセスを開始します。 -

installPlanApprovalパラメーターがManualに設定されている場合、OLM がアップグレードを開始する前に、各installPlanを承認する必要があります。

-

検証

次のコマンドを実行して、OLM が OADP と MTC のアップグレードを完了したことを確認します。

oc -n openshift-migration get subscriptions.operators.coreos.com mtc-operator -o json | jq '.status | (."state"=="AtLatestKnown")'

$ oc -n openshift-migration get subscriptions.operators.coreos.com mtc-operator -o json | jq '.status | (."state"=="AtLatestKnown")'Copy to Clipboard Copied! Toggle word wrap Toggle overflow trueの値が返された場合は、次のコマンドを実行して、各サブスクリプションに使用されるチャネルを確認します。oc -n openshift-migration get sub -o json | jq -r '.items[] | {name: .metadata.name, channel: .spec.channel }'$ oc -n openshift-migration get sub -o json | jq -r '.items[] | {name: .metadata.name, channel: .spec.channel }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Confirm that the `mtc-operator.v1.8.0` and `oadp-operator.v1.2.x` packages are installed by running the following command:

Confirm that the `mtc-operator.v1.8.0` and `oadp-operator.v1.2.x` packages are installed by running the following command:Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc -n openshift-migration get csv

$ oc -n openshift-migration get csvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME DISPLAY VERSION REPLACES PHASE mtc-operator.v1.8.0 Migration Toolkit for Containers Operator 1.8.0 mtc-operator.v1.7.13 Succeeded oadp-operator.v1.2.2 OADP Operator 1.2.2 oadp-operator.v1.0.13 Succeeded

NAME DISPLAY VERSION REPLACES PHASE mtc-operator.v1.8.0 Migration Toolkit for Containers Operator 1.8.0 mtc-operator.v1.7.13 Succeeded oadp-operator.v1.2.2 OADP Operator 1.2.2 oadp-operator.v1.0.13 SucceededCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3. OpenShift Container Platform バージョン 4.2 の MTC (Migration Toolkit for Containers) 4.5 へのアップグレード

MTC (Migration Toolkit for Containers) は、レガシーの Migration Toolkit for Containers Operator を手動でインストールすることで、OpenShift Container Platform バージョン 4.2 で 4.5 にアップグレードできます。

前提条件

-

cluster-admin権限を持つユーザーとしてログインしている。 -

registry.redhat.ioにアクセスできる必要があります。 -

podmanがインストールされている必要があります。

手順

以下のコマンドを実行して、Red Hat Customer Portal の認証情報で

registry.redhat.ioにログインします。podman login registry.redhat.io

$ podman login registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

operator.ymlファイルをダウンロードします。podman cp $(podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.8):/operator.yml ./

$ podman cp $(podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.8):/operator.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、Migration Toolkit for Containers Operator を置き換えます。

oc replace --force -f operator.yml

$ oc replace --force -f operator.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

migration-operatorデプロイメントを0にスケールし、デプロイメントを停止します。oc scale -n openshift-migration --replicas=0 deployment/migration-operator

$ oc scale -n openshift-migration --replicas=0 deployment/migration-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow migration-operatorデプロイメントを1にスケーリングしてデプロイメントを開始し、次のコマンドを実行して変更を適用します。oc scale -n openshift-migration --replicas=1 deployment/migration-operator

$ oc scale -n openshift-migration --replicas=1 deployment/migration-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

migration-operatorがアップグレードされたことを確認します。oc -o yaml -n openshift-migration get deployment/migration-operator | grep image: | awk -F ":" '{ print $NF }'$ oc -o yaml -n openshift-migration get deployment/migration-operator | grep image: | awk -F ":" '{ print $NF }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

controller.ymlファイルをダウンロードします。podman cp $(podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.8):/controller.yml ./

$ podman cp $(podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.8):/controller.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

migration-controllerオブジェクトを作成します。oc create -f controller.yml

$ oc create -f controller.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、MTC Pod が実行されていることを確認します。

oc get pods -n openshift-migration

$ oc get pods -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4. MTC 1.3 から 1.8 へのアップグレード

MTC (Migration Toolkit for Containers) バージョン 1.3.x を 1.8 にアップグレードする場合、MigrationController Pod が実行されているクラスターで MigPlan カスタムリソース (CR) マニフェストを更新する必要があります。

indirectImageMigration および indirectVolumeMigration パラメーターは MTC 1.3 に存在しないため、バージョン 1.4 のそれらのデフォルト値は false になります。つまり、イメージの直接移行およびボリュームの直接移行が有効にされます。直接移行の要件が満たされないため、これらのパラメーターの値が true に変更されない限り、移行計画は Ready 状態になりません。

- OpenShift Container Platform 3 から OpenShift Container Platform 4 に移行するには、レガシー MTC Operator と MTC 1.7.x が必要です。

-

MTC 1.7.x から 1.8.x にアップグレードする場合は、OADP チャネルを

stable-1.0からstable-1.2に手動で更新しなければ、アップグレードは正常に完了しません。

前提条件

-

cluster-admin権限を持つユーザーとしてログインしている。

手順

-

MigrationControllerPod が実行されるクラスターにログインします。 MigPlanCR マニフェストを取得します。oc get migplan <migplan> -o yaml -n openshift-migration

$ oc get migplan <migplan> -o yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のパラメーター値を更新し、ファイルを

migplan.yamlとして保存します。... spec: indirectImageMigration: true indirectVolumeMigration: true

... spec: indirectImageMigration: true indirectVolumeMigration: trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow MigPlanCR マニフェストを置き換えて変更を適用します。oc replace -f migplan.yaml -n openshift-migration

$ oc replace -f migplan.yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow 更新された

MigPlanCR マニフェストを取得して変更を確認します。oc get migplan <migplan> -o yaml -n openshift-migration

$ oc get migplan <migplan> -o yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第6章 移行前のチェックリスト

MTC (Migration Toolkit for Containers) を使用してアプリケーションのワークロードを移行する前に、以下のチェックリストを確認してください。

6.1. クラスターヘルスチェックリスト

- ❏ クラスターが特定のプラットフォームおよびインストール方法についての最小ハードウェア要件を満たしている (ベアメタル など)。

- ❏ すべての MTC の前提条件を満たしている。

- ❏ すべてのノードに有効な OpenShift Container Platform サブスクリプションがある。

- ❏ ノードの正常性を確認している。

- ❏ アイデンティティープロバイダー が機能している。

- ❏ 移行ネットワークの最小スループットは 10 Gbps である。

❏ クラスターには移行用に十分なリソースがある。

注記クラスターには、通常のワークロードにほかに移行を実行するために、追加のメモリー、CPU、およびストレージが必要です。実際のリソース要件は、単一の移行計画で移行される Kubernetes リソースの数によって異なります。リソース要件を見積もるため、非実稼働環境で移行をテストする必要があります。

-

❏ クラスターの etcd ディスクのパフォーマンス が

fioで確認されている。

6.2. ソースクラスターのチェックリスト

❏ 以下のコマンドを実行して、異常な設定のある永続ボリューム (PV) が Terminating 状態のままであるかを確認している。

oc get pv

$ oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow ❏ 以下のコマンドを実行して、ステータスが Running または Completed 以外の Pod の有無について確認している。

oc get pods --all-namespaces | egrep -v 'Running | Completed'

$ oc get pods --all-namespaces | egrep -v 'Running | Completed'Copy to Clipboard Copied! Toggle word wrap Toggle overflow ❏ 以下のコマンドを実行して、再起動数の高い Pod の有無について確認している。

oc get pods --all-namespaces --field-selector=status.phase=Running \ -o json | jq '.items[]|select(any( .status.containerStatuses[]; \ .restartCount > 3))|.metadata.name'