アプリケーションのビルド

OpenShift Container Platform でのアプリケーションの作成および管理

概要

第1章 アプリケーションのビルドの概要

OpenShift Container Platform を使用すると、Web コンソールまたはコマンドラインインターフェイス (CLI) を使用してアプリケーションを作成、編集、削除、および管理できます。

1.1. プロジェクトの使用

プロジェクトを使用すると、アプリケーションを分離して編成および管理できます。OpenShift Container Platform で、プロジェクトの作成、表示、削除 などを含め、プロジェクトライフサイクル全体を管理できます。

プロジェクトを作成したら、Developer パースペクティブを使用して、ユーザーに対して プロジェクトへのアクセス権の付与または取り消し と クラスターロールの管理 を行えます。また、新規プロジェクトの自動プロビジョニングに使用されるプロジェクトテンプレートを作成する際に、プロジェクト設定リソースの編集 も行えます。

CLI を使用して、OpenShift Container Platform API へのリクエストを借用して 別のユーザーとしてプロジェクトを作成 できます。新規プロジェクトの作成をリクエストすると、OpenShift Container Platform はエンドポイントを使用して、カスタマイズ可能なテンプレートに従ってプロジェクトをプロビジョニングします。クラスター管理者は、認証されたユーザーグループによる新規プロジェクトのセルフプロビジョニングを阻止 することを選択できます。

1.2. アプリケーションの使用

1.2.1. アプリケーションの作成

アプリケーションを作成するには、プロジェクトを作成しているか、適切なロールとパーミッションでプロジェクトにアクセスできるようになっている必要があります。Web コンソールの Developer パースペクティブ、インストール済みの Operator、OpenShift CLI (oc) のいずれかを使用して、アプリケーションを作成できます。プロジェクトに追加するアプリケーションは、Git、JAR ファイル、devfile、または開発者カタログから入手できます。

ソースまたはバイナリーコード、イメージ、およびテンプレートを含むコンポーネントを使用し、OpenShift CLI (oc) を使用してアプリケーションを作成することもできます。OpenShift Container Platform Web コンソールを使用すると、クラスター管理者によってインストールされた Operator からアプリケーションを作成できます。

1.2.2. アプリケーションの保守

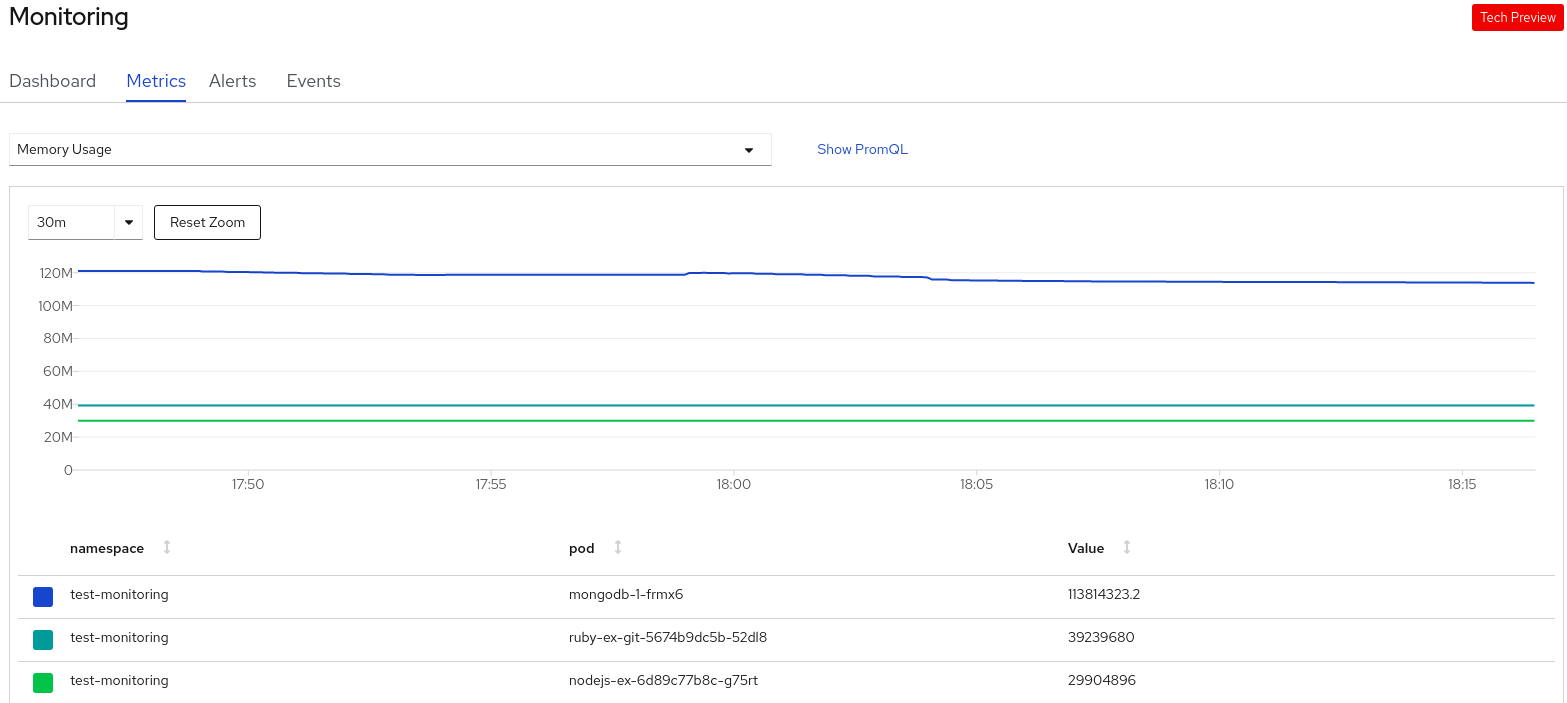

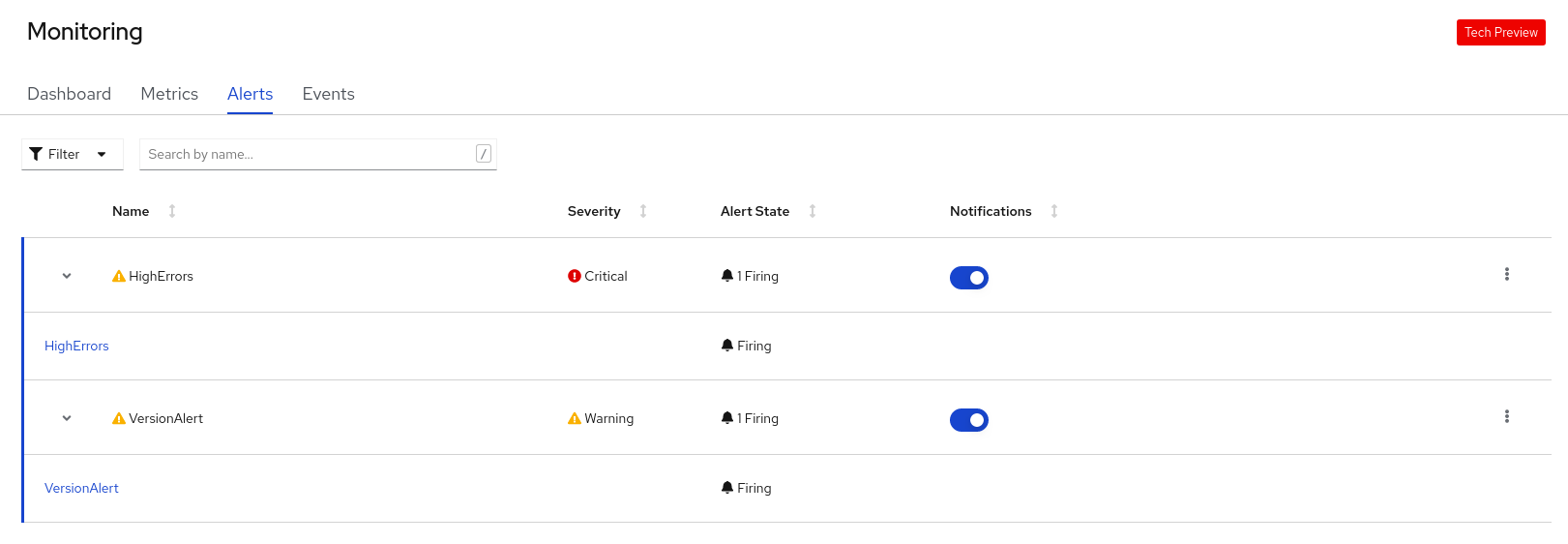

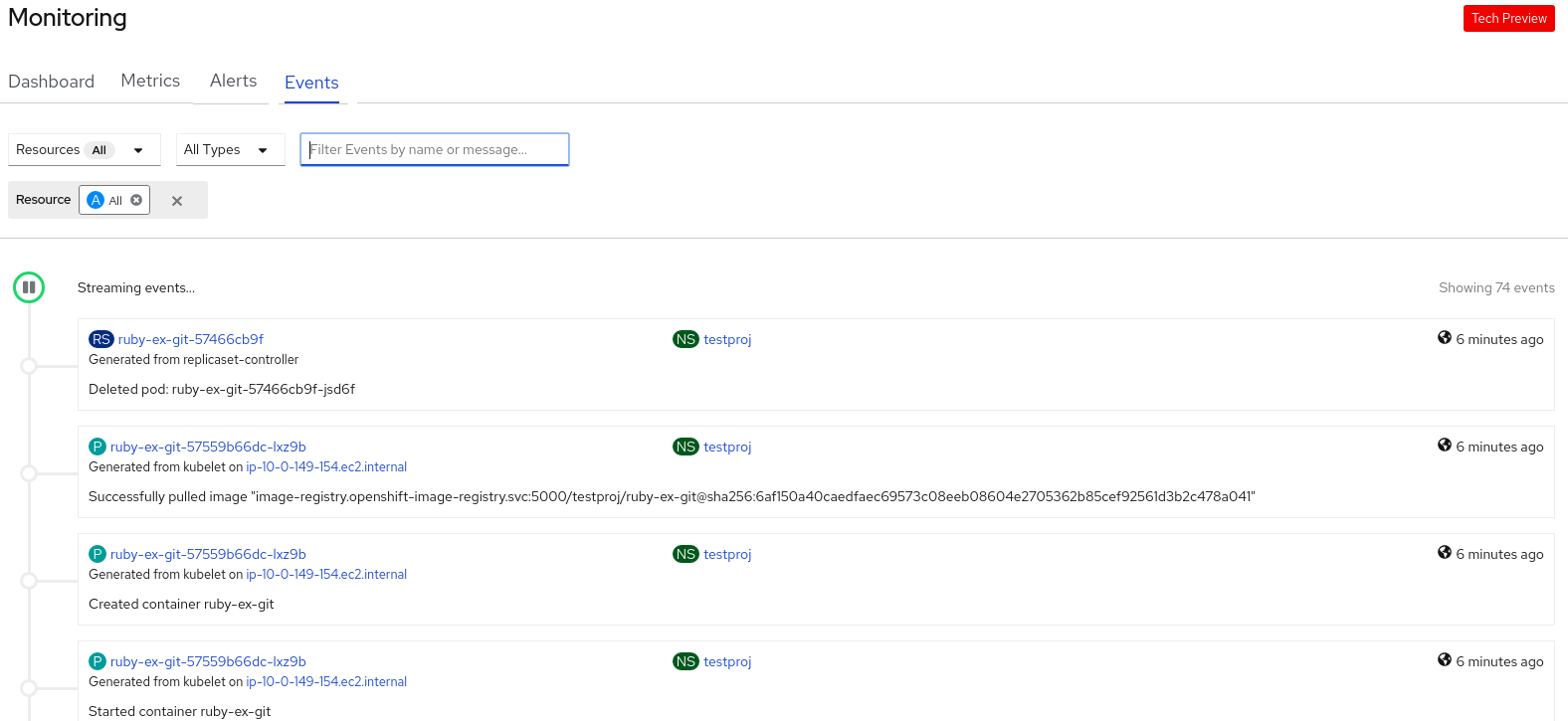

アプリケーションを作成したら、Web コンソールを使用して プロジェクトまたはアプリケーションのメトリクスを監視 できます。Web コンソールを使用して、アプリケーションを 編集 または 削除 することもできます。

アプリケーションの実行中は、すべてのアプリケーションリソースが使用されるわけではありません。クラスター管理者は、スケーラブルなリソースをアイドル状態 にして、リソースの消費を減らすことができます。

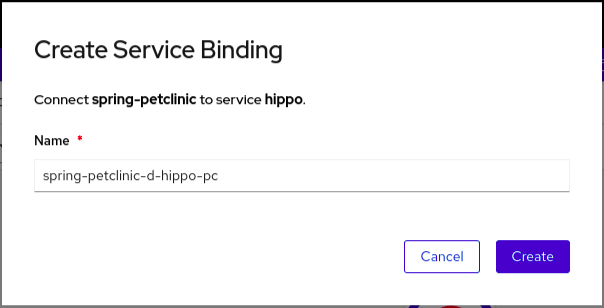

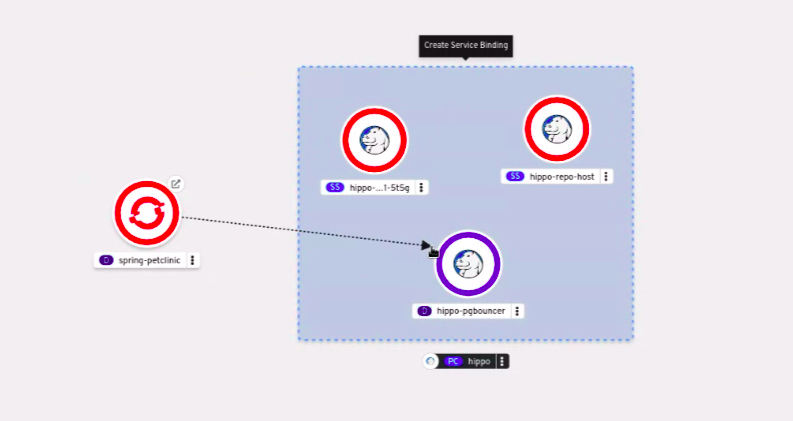

1.2.3. アプリケーションのサービスへの接続

アプリケーションはバッキングサービスを使用して、サービスプロバイダーに応じて異なるワークロードを構築および接続します。開発者として Service Binding Operator を使用すると、手作業でバインディング接続を設定する手順なしに、Operator が管理するバッキングサービスとワークロードを簡単にバインドできます。IBM Power Systems、IBM Z、および LinuxONE 環境 にもサービスバインディングを適用できます。

1.2.4. アプリケーションのデプロイ

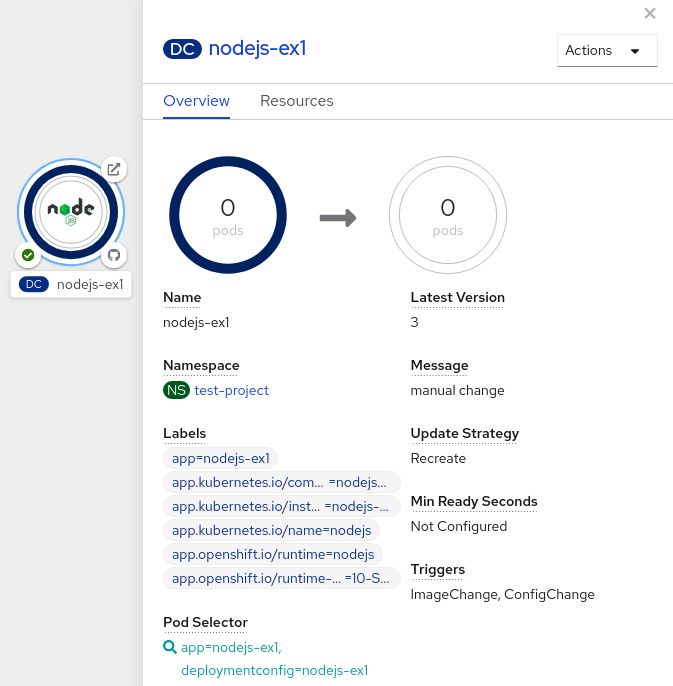

Deployment または DeploymentConfig オブジェクトを使用してアプリケーションをデプロイし、Web コンソールからそれらを 管理 できます。アプリケーションの変更またはアップグレード中のダウンタイムを短縮するのに役立つ デプロイメントストラテジー を作成できます。

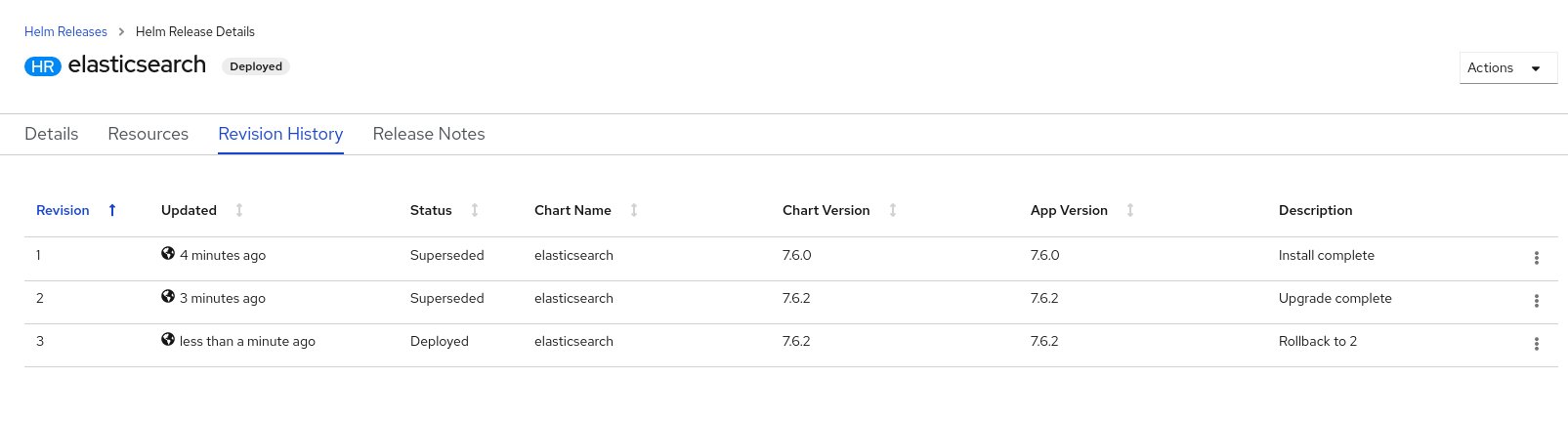

アプリケーションやサービスの OpenShift Container Platform クラスターへのデプロイメントを単純化するソフトウェアパッケージマネージャーである Helm も使用できます。

1.3. Red Hat Marketplace の使用

Red Hat Marketplace は、パブリッククラウドやオンプレミスで実行されるコンテナーベースの環境向けの認定ソフトウェアを見つけてアクセスできるオープンクラウドマーケットプレイスです。

第2章 プロジェクト

2.1. プロジェクトの使用

プロジェクト を使用することにより、あるユーザーコミュニティーは、他のコミュニティーと切り離された状態で独自のコンテンツを整理し、管理することができます。

openshift- および kube- で始まる名前のプロジェクトは デフォルトプロジェクト です。これらのプロジェクトは、Pod として実行されるクラスターコンポーネントおよび他のインフラストラクチャーコンポーネントをホストします。そのため、OpenShift Container Platform では oc new-project コマンドを使用して openshift- または kube- で始まる名前のプロジェクトを作成することができません。クラスター管理者は、oc adm new-project コマンドを使用してこれらのプロジェクトを作成できます。

デフォルトプロジェクトでワークロードを実行したり、デフォルトプロジェクトへのアクセスを共有したりしないでください。デフォルトのプロジェクトは、コアクラスターコンポーネントを実行するために予約されています。

デフォルトプロジェクトである default、kube-public、kube-system、openshift、openshift-infra、openshift-node、および openshift.io/run-level ラベルが 0 または 1 に設定されているその他のシステム作成プロジェクトは、高い特権があるとみなされます。Pod セキュリティーアドミッション、Security Context Constraints、クラスターリソースクォータ、イメージ参照解決などのアドミッションプラグインに依存する機能は、高い特権を持つプロジェクトでは機能しません。

2.1.1. プロジェクトの作成

OpenShift Container Platform Web コンソールまたは OpenShift CLI (oc) を使用して、クラスター内にプロジェクトを作成できます。

2.1.1.1. Web コンソールを使用したプロジェクトの作成

OpenShift Container Platform Web コンソールを使用して、クラスター内にプロジェクトを作成できます。

openshift- および kube- で始まる名前のプロジェクトは OpenShift Container Platform によって重要 (Critical) と見なされます。そのため、OpenShift Container Platform では、Web コンソールを使用して openshift- で始まるプロジェクトを作成することはできません。

前提条件

- OpenShift Container Platform のプロジェクト、アプリケーション、および他のワークロードを作成するために適切なロールおよびパーミッションがあることを確認します。

手順

Administrator パースペクティブを使用している場合は、以下を行います。

- Home → Projects に移動します。

Create Project をクリックします。

-

Create Project ダイアログボックスで、Name フィールドに、

myprojectなどの一意の名前を入力します。 - オプション: プロジェクトの Display name および Description の詳細を追加します。

Create をクリックします。

プロジェクトのダッシュボードが表示されます。

-

Create Project ダイアログボックスで、Name フィールドに、

- オプション: Details タブを選択して、プロジェクトの詳細を表示します。

- オプション: プロジェクトに対する適切なパーミッションがある場合は、Project Access タブを使用して、プロジェクトの admin、edit、および view 権限を付与または取り消すことができます。

Developer パースペクティブを使用している場合は、以下を行います。

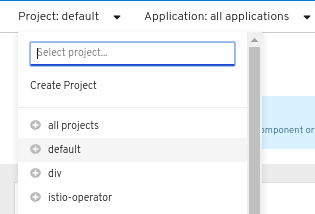

Project メニューをクリックし、Create Project を選択します。

図2.1 Create project

-

Create Project ダイアログボックスで、Name フィールドに、

myprojectなどの一意の名前を入力します。 - オプション: プロジェクトの Display name および Description の詳細を追加します。

- Create をクリックします。

-

Create Project ダイアログボックスで、Name フィールドに、

- オプション: 左側のナビゲーションパネルを使用して Project ビューに移動し、プロジェクトのダッシュボードを表示します。

- オプション: プロジェクトダッシュボードで Details タブを選択し、プロジェクトの詳細を表示します。

- オプション: プロジェクトに対する適切なパーミッションがある場合は、プロジェクトダッシュボードの Project Access タブを使用して、プロジェクトの admin、edit、および view 権限を付与または取り消すことができます。

2.1.1.2. CLI を使用したプロジェクトの作成

クラスター管理者が許可する場合、新規プロジェクトを作成できます。

openshift- および kube- で始まる名前のプロジェクトは OpenShift Container Platform によって重要 (Critical) と見なされます。そのため、OpenShift Container Platform では oc new-project コマンドを使用して openshift- または kube- で始まる名前のプロジェクトを作成することができません。クラスター管理者は、oc adm new-project コマンドを使用してこれらのプロジェクトを作成できます。

手順

以下を実行します。

oc new-project <project_name> \ --description="<description>" --display-name="<display_name>"$ oc new-project <project_name> \ --description="<description>" --display-name="<display_name>"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

oc new-project hello-openshift \ --description="This is an example project" \ --display-name="Hello OpenShift"$ oc new-project hello-openshift \ --description="This is an example project" \ --display-name="Hello OpenShift"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

作成できるプロジェクトの数は、システム管理者により制限される場合があります。上限に達すると、新規プロジェクトを作成できるように、既存プロジェクトの削除が必要になる場合があります。

2.1.2. プロジェクトの表示

OpenShift Container Platform Web コンソールまたは OpenShift CLI (oc) を使用して、クラスター内のプロジェクトを表示できます。

2.1.2.1. Web コンソールを使用してプロジェクトを表示する

OpenShift Container Platform Web コンソールを使用して、アクセス権のあるプロジェクトを表示できます。

手順

Administrator パースペクティブを使用している場合は、以下を行います。

- ナビゲーションメニューで Home → Projects に移動します。

- 表示するプロジェクトを選択します。Overview タブには、プロジェクトのダッシュボードが含まれています。

- Details タブを選択して、プロジェクトの詳細を表示します。

- YAML タブを選択して、プロジェクトリソースの YAML 設定を表示および更新します。

- Workloads タブを選択して、プロジェクト内のワークロードを表示します。

- RoleBindings タブを選択して、プロジェクトのロールバインディングを表示および作成します。

Developer パースペクティブを使用している場合は、以下を行います。

- ナビゲーションメニューの Project ページに移動します。

- 画面上部の Project ドロップダウンメニューから All Projects を選択し、クラスター内のすべてのプロジェクトをリスト表示します。

- 表示するプロジェクトを選択します。Overview タブには、プロジェクトのダッシュボードが含まれています。

- Details タブを選択して、プロジェクトの詳細を表示します。

- プロジェクトに対する適切なパーミッションがある場合は、Project access タブビューを選択し、プロジェクトの権限を更新します。

2.1.2.2. CLI を使用したプロジェクトの表示

プロジェクトを表示する際は、認証ポリシーに基づいて、表示アクセスのあるプロジェクトだけを表示できるように制限されます。

手順

プロジェクトのリストを表示するには、以下を実行します。

oc get projects

$ oc get projectsCopy to Clipboard Copied! Toggle word wrap Toggle overflow CLI 操作で、現在のプロジェクトから別のプロジェクトに切り換えることができます。その後の操作にはすべて指定のプロジェクトが使用され、プロジェクトスコープのコンテンツの操作が実行されます。

oc project <project_name>

$ oc project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.3. Developer パースペクティブを使用したプロジェクトに対するアクセスパーミッションの提供

Developer パースペクティブで Project ビューを使用し、プロジェクトに対するアクセスを付与したり、取り消したりできます。

前提条件

- プロジェクトを作成している。

手順

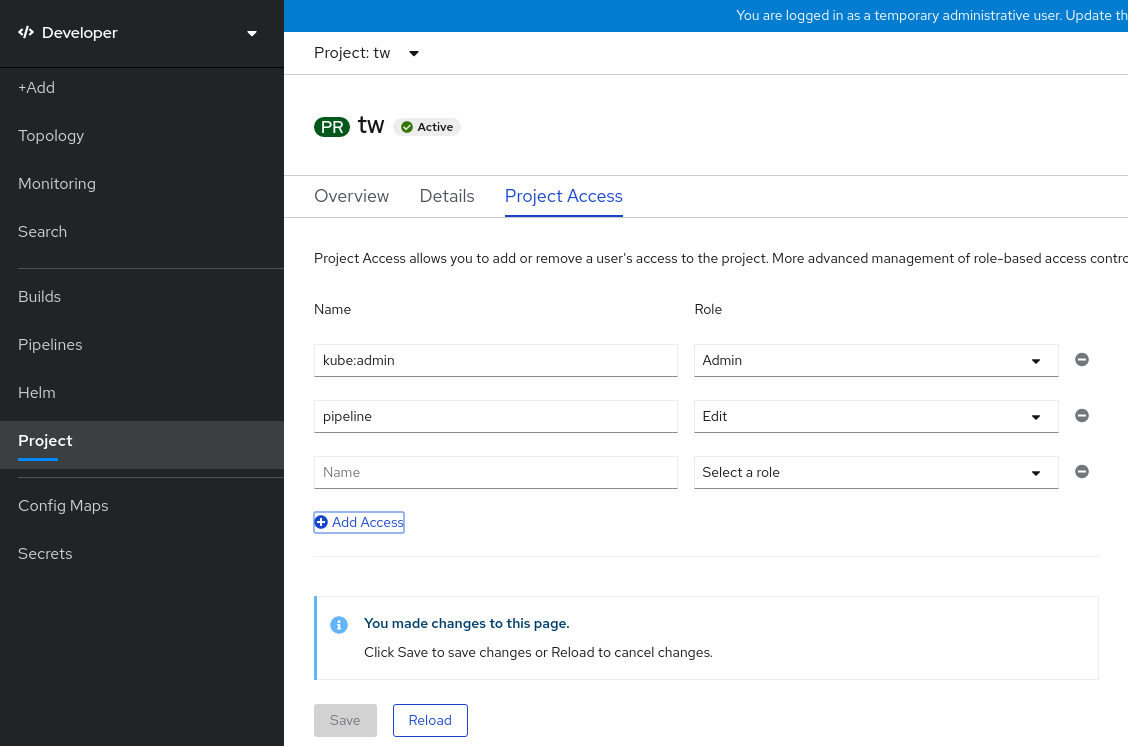

ユーザーをプロジェクトに追加し、Admin、Edit、または View アクセスをユーザーに付与するには、以下を実行します。

- Developer パースペクティブで、Project ページに移動します。

- Project メニューからプロジェクトを選択します。

- Project Access タブを選択します。

Add access をクリックして、パーミッションの新規の行をデフォルトのパーミッションに追加します。

図2.2 プロジェクトパーミッション

- ユーザー名を入力し、Select a role ドロップダウンリストをクリックし、適切なロールを選択します。

- Save をクリックして新規パーミッションを追加します。

以下を使用することもできます。

- Select a role ドロップダウンリストを使用して、既存ユーザーのアクセスパーミッションを変更できます。

- Remove Access アイコンを使用して、既存ユーザーのプロジェクトへのアクセスパーミッションを完全に削除できます。

高度なロールベースのアクセス制御は、Administrator パースペクティブの Roles および Roles Binding ビューで管理されます。

2.1.4. Web コンソールを使用した利用可能なクラスターのロールのカスタマイズ

Web コンソールの Developer パースペクティブでは、Project → Project access ページを使用して、プロジェクト管理者がプロジェクト内のユーザーにロールを付与できるようにします。デフォルトでは、プロジェクト内のユーザーに付与できるクラスターロールは、admin、edit、および view です。

クラスター管理者は、クラスター全体のすべてのプロジェクトに対して Project access ページでどのクラスターロールを使用できるかを定義できます。Console 設定リソースの spec.customization.projectAccess.availableClusterRoles オブジェクトをカスタマイズすることで、使用可能なロールを指定できます。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。

手順

- Administrator パースペクティブで、Administration → Cluster settings に移動します。

- Configuration タブをクリックします。

-

Configuration resource リストから、Console

operator.openshift.ioを選択します。 - YAML タブに移動し、YAML コードを表示し、編集します。

specの YAML コードで、プロジェクトアクセスに使用可能なクラスターロールのリストをカスタマイズします。次の例では、デフォルトのadmin、edit、およびviewロールを指定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

Save をクリックして、

Console設定リソースへの変更を保存します。

検証

- Developer パースペクティブで、Project ページに移動します。

- Project メニューからプロジェクトを選択します。

- Project access タブを選択します。

-

Role 列のメニューをクリックし、使用可能なロールが

Consoleリソース設定に適用した設定と一致することを確認します。

2.1.5. プロジェクトへの追加

Developer パースペクティブの +Add ページを使用して、プロジェクトに項目を追加できます。

前提条件

- プロジェクトを作成している。

手順

- Developer パースペクティブで、+Add ページに移動します。

- Project メニューからプロジェクトを選択します。

- +Add ページで項目をクリックし、ワークフローに従います。

また、Add* ページの検索機能を使用して、プロジェクトに追加する追加アイテムを見つけます。画面上部の Add の下にある * をクリックし、検索フィールドにコンポーネントの名前を入力します。

2.1.6. プロジェクトのステータスの確認

OpenShift Container Platform Web コンソールまたは OpenShift CLI (oc) を使用して、プロジェクトのステータスを表示できます。

2.1.6.1. Web コンソールを使用したプロジェクトのステータスの確認

Web コンソールを使用して、プロジェクトのステータスを確認できます。

前提条件

- プロジェクトを作成している。

手順

Administrator パースペクティブを使用している場合は、以下を行います。

- Home → Projects に移動します。

- 一覧からプロジェクトを選択します。

- Overview ページで、プロジェクトのステータスを確認します。

Developer パースペクティブを使用している場合は、以下を行います。

- Project ページに移動します。

- Project メニューからプロジェクトを選択します。

- Overview ページで、プロジェクトのステータスを確認します。

2.1.6.2. CLI を使用したプロジェクトのステータスの確認

OpenShift CLI (oc) を使用して、プロジェクトのステータスを確認できます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 - プロジェクトを作成している。

手順

プロジェクトに切り替えます。

oc project <project_name>

$ oc project <project_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<project_name>は、プロジェクトの名前に置き換えます。

プロジェクトの概要を取得します。

oc status

$ oc statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.7. プロジェクトの削除

OpenShift Container Platform Web コンソールまたは OpenShift CLI (oc) を使用して、プロジェクトを削除できます。

プロジェクトを削除する際に、サーバーはプロジェクトのステータスを Active から Terminating に更新します。その後、サーバーは Terminating 状態のプロジェクトからすべてのコンテンツをクリアしてから、プロジェクトを削除します。プロジェクトのステータスが Terminating の場合は、新規のコンテンツをプロジェクトに追加することができません。プロジェクトは CLI または Web コンソールから削除できます。

2.1.7.1. Web コンソールを使用したプロジェクトの削除

Web コンソールを使用してプロジェクトを削除できます。

前提条件

- プロジェクトを作成している。

- プロジェクトを削除するために必要なパーミッションを持っている。

手順

Administrator パースペクティブを使用している場合は、以下を行います。

- Home → Projects に移動します。

- 一覧からプロジェクトを選択します。

プロジェクトの Actions ドロップダウンメニューをクリックし、Delete Project を選択します。

注記プロジェクトを削除するために必要なパーミッションがない場合は、Delete Project オプションは選択できません。

- Delete Project? ペインで、プロジェクトの名前を入力して削除を確認します。

- Delete をクリックします。

Developer パースペクティブを使用している場合は、以下を行います。

- Project ページに移動します。

- Project メニューから削除するプロジェクトを選択します。

プロジェクトの Actions ドロップダウンメニューをクリックし、Delete Project を選択します。

注記プロジェクトを削除するために必要なパーミッションがないと、Delete Project オプションを選択できません。

- Delete Project? ペインで、プロジェクトの名前を入力して削除を確認します。

- Delete をクリックします。

2.1.7.2. CLI を使用したプロジェクトの削除

OpenShift CLI (oc) を使用してプロジェクトを削除できます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 - プロジェクトを作成している。

- プロジェクトを削除するために必要なパーミッションを持っている。

手順

プロジェクトを削除します。

oc delete project <project_name>

$ oc delete project <project_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<project_name>を、削除するプロジェクトの名前に置き換えます。

2.2. 別のユーザーとしてのプロジェクトの作成

権限の借用機能により、別のユーザーとしてプロジェクトを作成することができます。

2.2.1. API の権限借用

OpenShift Container Platform API への要求を、別のユーザーから発信されているかのように設定できます。詳細は、Kubernetes ドキュメントの User impersonation を参照してください。

2.2.2. プロジェクト作成時のユーザー権限の借用

プロジェクト要求を作成する際に別のユーザーの権限を借用できます。system:authenticated:oauth はプロジェクト要求を作成できる唯一のブートストラップグループであるため、そのグループの権限を借用する必要があります。

手順

別のユーザーの代わりにプロジェクト要求を作成するには、以下を実行します。

oc new-project <project> --as=<user> \ --as-group=system:authenticated --as-group=system:authenticated:oauth$ oc new-project <project> --as=<user> \ --as-group=system:authenticated --as-group=system:authenticated:oauthCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. プロジェクト作成の設定

OpenShift Container Platform では、プロジェクト は関連するオブジェクトをグループ分けし、分離するために使用されます。Web コンソールまたは oc new-project コマンドを使用して新規プロジェクトの作成要求が実行されると、OpenShift Container Platform のエンドポイントは、カスタマイズ可能なテンプレートに応じてプロジェクトをプロビジョニングするために使用されます。

クラスター管理者は、開発者やサービスアカウントが独自のプロジェクトを作成し、プロジェクトの セルフプロビジョニング を実行することを許可し、その方法を設定できます。

2.3.1. プロジェクト作成について

OpenShift Container Platform API サーバーは、クラスターのプロジェクト設定リソースの projectRequestTemplate パラメーターで識別されるプロジェクトテンプレートに基づいて新規プロジェクトを自動的にプロビジョニングします。パラメーターが定義されない場合、API サーバーは要求される名前でプロジェクトを作成するデフォルトテンプレートを作成し、要求するユーザーをプロジェクトの admin (管理者) ロールに割り当てます。

プロジェクト要求が送信されると、API はテンプレートで以下のパラメーターを置き換えます。

| パラメーター | 説明 |

|---|---|

|

| プロジェクトの名前。必須。 |

|

| プロジェクトの表示名。空にできます。 |

|

| プロジェクトの説明。空にできます。 |

|

| 管理ユーザーのユーザー名。 |

|

| 要求するユーザーのユーザー名。 |

API へのアクセスは、self-provisioner ロールと self-provisioners のクラスターロールバインディングで開発者に付与されます。デフォルトで、このロールはすべての認証された開発者が利用できます。

2.3.2. 新規プロジェクトのテンプレートの変更

クラスター管理者は、デフォルトのプロジェクトテンプレートを変更し、新規プロジェクトをカスタム要件に基づいて作成できます。

独自のカスタムプロジェクトテンプレートを作成するには、以下を実行します。

前提条件

-

cluster-adminパーミッションを持つアカウントを使用して OpenShift Container Platform クラスターにアクセスできる。

手順

-

cluster-admin権限を持つユーザーとしてログインします。 デフォルトのプロジェクトテンプレートを生成します。

oc adm create-bootstrap-project-template -o yaml > template.yaml

$ oc adm create-bootstrap-project-template -o yaml > template.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

オブジェクトを追加するか、既存オブジェクトを変更することにより、テキストエディターで生成される

template.yamlファイルを変更します。 プロジェクトテンプレートは、

openshift-confignamespace に作成する必要があります。変更したテンプレートを読み込みます。oc create -f template.yaml -n openshift-config

$ oc create -f template.yaml -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Web コンソールまたは CLI を使用し、プロジェクト設定リソースを編集します。

Web コンソールの使用

- Administration → Cluster Settings ページに移動します。

- Configuration をクリックし、すべての設定リソースを表示します。

- Project のエントリーを見つけ、Edit YAML をクリックします。

CLI の使用

project.config.openshift.io/clusterリソースを編集します。oc edit project.config.openshift.io/cluster

$ oc edit project.config.openshift.io/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow

specセクションを、projectRequestTemplateおよびnameパラメーターを組み込むように更新し、アップロードされたプロジェクトテンプレートの名前を設定します。デフォルト名はproject-requestです。カスタムプロジェクトテンプレートを含むプロジェクト設定リソース

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を保存した後、変更が正常に適用されたことを確認するために、新しいプロジェクトを作成します。

2.3.3. プロジェクトのセルフプロビジョニングの無効化

認証されたユーザーグループによる新規プロジェクトのセルフプロビジョニングを禁止できます。

手順

-

cluster-admin権限を持つユーザーとしてログインします。 以下のコマンドを実行して、

self-provisionersクラスターロールバインディングの使用を確認します。oc describe clusterrolebinding.rbac self-provisioners

$ oc describe clusterrolebinding.rbac self-provisionersCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow self-provisionersセクションのサブジェクトを確認します。self-provisionerクラスターロールをグループsystem:authenticated:oauthから削除します。self-provisionersクラスターロールバインディングがself-provisionerロールのみをsystem:authenticated:oauthグループにバインドする場合は、以下のコマンドを実行します。oc patch clusterrolebinding.rbac self-provisioners -p '{"subjects": null}'$ oc patch clusterrolebinding.rbac self-provisioners -p '{"subjects": null}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow self-provisionersクラスターロールバインディングがself-provisionerロールをsystem:authenticated:oauthグループ以外のユーザー、グループまたはサービスアカウントにバインドする場合は、以下のコマンドを実行します。oc adm policy \ remove-cluster-role-from-group self-provisioner \ system:authenticated:oauth$ oc adm policy \ remove-cluster-role-from-group self-provisioner \ system:authenticated:oauthCopy to Clipboard Copied! Toggle word wrap Toggle overflow

ロールへの自動更新を防ぐには、

self-provisionersクラスターロールバインディングを編集します。自動更新により、クラスターロールがデフォルトの状態にリセットされます。CLI を使用してロールバインディングを更新するには、以下を実行します。

以下のコマンドを実行します。

oc edit clusterrolebinding.rbac self-provisioners

$ oc edit clusterrolebinding.rbac self-provisionersCopy to Clipboard Copied! Toggle word wrap Toggle overflow 表示されるロールバインディングで、以下の例のように

rbac.authorization.kubernetes.io/autoupdateパラメーター値をfalseに設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

単一コマンドを使用してロールバインディングを更新するには、以下を実行します。

oc patch clusterrolebinding.rbac self-provisioners -p '{ "metadata": { "annotations": { "rbac.authorization.kubernetes.io/autoupdate": "false" } } }'$ oc patch clusterrolebinding.rbac self-provisioners -p '{ "metadata": { "annotations": { "rbac.authorization.kubernetes.io/autoupdate": "false" } } }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

認証されたユーザーとしてログインし、プロジェクトのセルフプロビジョニングを実行できないことを確認します。

oc new-project test

$ oc new-project testCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Error from server (Forbidden): You may not request a new project via this API.

Error from server (Forbidden): You may not request a new project via this API.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 組織に固有のより有用な説明を提供できるように、このプロジェクト要求メッセージをカスタマイズすることを検討します。

2.3.4. プロジェクト要求メッセージのカスタマイズ

プロジェクトのセルフプロビジョニングを実行できない開発者またはサービスアカウントが Web コンソールまたは CLI を使用してプロジェクト作成要求を行う場合は、以下のエラーメッセージがデフォルトで返されます。

You may not request a new project via this API.

You may not request a new project via this API.クラスター管理者はこのメッセージをカスタマイズできます。これを、組織に固有の新規プロジェクトの要求方法の情報を含むように更新することを検討します。以下に例を示します。

-

プロジェクトを要求するには、システム管理者 (

projectname@example.com) に問い合わせてください。 -

新規プロジェクトを要求するには、

https://internal.example.com/openshift-project-requestにあるプロジェクト要求フォームに記入します。

プロジェクト要求メッセージをカスタマイズするには、以下を実行します。

手順

Web コンソールまたは CLI を使用し、プロジェクト設定リソースを編集します。

Web コンソールの使用

- Administration → Cluster Settings ページに移動します。

- Configuration をクリックし、すべての設定リソースを表示します。

- Project のエントリーを見つけ、Edit YAML をクリックします。

CLI の使用

-

cluster-admin権限を持つユーザーとしてログインします。 project.config.openshift.io/clusterリソースを編集します。oc edit project.config.openshift.io/cluster

$ oc edit project.config.openshift.io/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow

-

specセクションを、projectRequestMessageパラメーターを含むように更新し、値をカスタムメッセージに設定します。カスタムプロジェクト要求メッセージを含むプロジェクト設定リソース

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を保存した後に、プロジェクトをセルフプロビジョニングできない開発者またはサービスアカウントとして新規プロジェクトの作成を試行し、変更が正常に適用されていることを確認します。

第3章 アプリケーションの作成

3.1. テンプレートの使用

以下のセクションでは、テンプレートの概要と共に、それらを使用し、作成する方法に関する概要を説明します。

3.1.1. テンプレートについて

テンプレートでは、パラメーター化や処理が可能な一連のオブジェクトを記述し、OpenShift Container Platform で作成するためのオブジェクトのリストを生成します。テンプレートは、サービス、ビルド設定およびデプロイメント設定など、プロジェクト内で作成パーミッションがあるすべてのものを作成するために処理できます。また、テンプレートではラベルのセットを定義して、これをテンプレート内に定義されたすべてのオブジェクトに適用できます。

オブジェクトのリストは CLI を使用してテンプレートから作成できます。また、テンプレートがプロジェクトまたはグローバルテンプレートライブラリーにアップロードされている場合は Web コンソールを使用することもできます。

3.1.2. テンプレートのアップロード

テンプレートを定義する JSON または YAML ファイルがある場合は、CLI を使用してテンプレートをプロジェクトにアップロードできます。こうすることで、プロジェクトにテンプレートが保存され、対象のプロジェクトに対して適切なアクセス権があるユーザーがこれを繰り返し使用できます。独自のテンプレートの記述方法は、このトピックの後半で説明します。

手順

次のいずれかの方法を使用してテンプレートをアップロードします。

現在のプロジェクトのテンプレートライブラリーにテンプレートをアップロードするには、JSON または YAML ファイルを以下のコマンドで渡します。

oc create -f <filename>

$ oc create -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -nオプションを使用してプロジェクト名を指定することで、別のプロジェクトにテンプレートをアップロードできます。oc create -f <filename> -n <project>

$ oc create -f <filename> -n <project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

テンプレートは、Web コンソールまたは CLI を使用して選択できるようになりました。

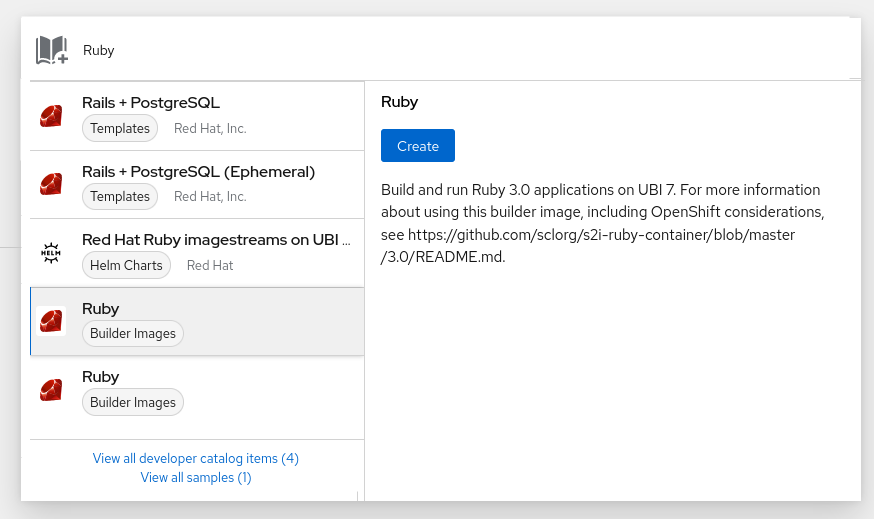

3.1.3. Web コンソールを使用したアプリケーションの作成

Web コンソールを使用して、テンプレートからアプリケーションを作成できます。

手順

- Web コンソールのナビゲーションメニューの上部にあるコンテキストセレクターから Developer を選択します。

- 目的のプロジェクト内で、+Add をクリックします。

- Developer Catalog タイルの All services をクリックします。

Type の下の Builder Images をクリックして、利用可能なビルダーイメージを表示します。

注記以下に示すように、

builderタグがアノテーションにリスト表示されているイメージストリームタグのみがリストに表示されます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ここに

builderを含めると、このイメージストリームがビルダーとして Web コンソールに表示されます。

- 新規アプリケーション画面で設定を変更し、オブジェクトをアプリケーションをサポートするように設定します。

3.1.4. CLI を使用してテンプレートからオブジェクトを作成する手順

CLI を使用して、テンプレートを処理し、オブジェクトを作成するために生成された設定を使用できます。

3.1.4.1. ラベルの追加

ラベルは、Pod などの生成されたオブジェクトを管理し、整理するために使用されます。テンプレートで指定されるラベルは、テンプレートから生成されるすべてのオブジェクトに適用されます。

手順

コマンドラインからテンプレートにラベルを追加します。

oc process -f <filename> -l name=otherLabel

$ oc process -f <filename> -l name=otherLabelCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.1.4.2. パラメーターのリスト表示

上書きできるパラメーターのリストは、テンプレートの parameters セクションに表示されます。

手順

CLI で以下のコマンドを使用し、使用するファイルを指定して、パラメーターをリスト表示することができます。

oc process --parameters -f <filename>

$ oc process --parameters -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow または、テンプレートがすでにアップロードされている場合には、以下を実行します。

oc process --parameters -n <project> <template_name>

$ oc process --parameters -n <project> <template_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow たとえば、デフォルトの

openshiftプロジェクトにあるクイックスタートテンプレートのいずれかに対してパラメーターを一覧表示する場合に、以下のような出力が表示されます。oc process --parameters -n openshift rails-postgresql-example

$ oc process --parameters -n openshift rails-postgresql-exampleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow この出力から、テンプレートの処理時に正規表現のようなジェネレーターで生成された複数のパラメーターを特定できます。

3.1.4.3. オブジェクトリストの生成

CLI を使用して、標準出力にオブジェクトリストを返すテンプレートを定義するファイルを処理できます。

手順

標準出力にオブジェクトリストを返すテンプレートを定義するファイルを処理します。

oc process -f <filename>

$ oc process -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow または、テンプレートがすでに現在のプロジェクトにアップロードされている場合には以下を実行します。

oc process <template_name>

$ oc process <template_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow テンプレートを処理し、

oc createの出力をパイプして、テンプレートからオブジェクトを作成します。oc process -f <filename> | oc create -f -

$ oc process -f <filename> | oc create -f -Copy to Clipboard Copied! Toggle word wrap Toggle overflow または、テンプレートがすでに現在のプロジェクトにアップロードされている場合には以下を実行します。

oc process <template> | oc create -f -

$ oc process <template> | oc create -f -Copy to Clipboard Copied! Toggle word wrap Toggle overflow 上書きする

<name>=<value>の各ペアに、-pオプションを追加することで、ファイルに定義されたパラメーターの値を上書きできます。パラメーター参照は、テンプレートアイテム内のテキストフィールドに表示されます。たとえば、テンプレートの以下の

POSTGRESQL_USERおよびPOSTGRESQL_DATABASEパラメーターを上書きし、カスタマイズされた環境変数の設定を出力します。テンプレートからのオブジェクトリストの作成

oc process -f my-rails-postgresql \ -p POSTGRESQL_USER=bob \ -p POSTGRESQL_DATABASE=mydatabase$ oc process -f my-rails-postgresql \ -p POSTGRESQL_USER=bob \ -p POSTGRESQL_DATABASE=mydatabaseCopy to Clipboard Copied! Toggle word wrap Toggle overflow JSON ファイルは、ファイルにリダイレクトすることも、

oc createコマンドで処理済みの出力をパイプして、テンプレートをアップロードせずに直接適用することも可能です。oc process -f my-rails-postgresql \ -p POSTGRESQL_USER=bob \ -p POSTGRESQL_DATABASE=mydatabase \ | oc create -f -$ oc process -f my-rails-postgresql \ -p POSTGRESQL_USER=bob \ -p POSTGRESQL_DATABASE=mydatabase \ | oc create -f -Copy to Clipboard Copied! Toggle word wrap Toggle overflow 多数のパラメーターがある場合は、それらをファイルに保存してからそのファイルを

oc processに渡すことができます。cat postgres.env POSTGRESQL_USER=bob POSTGRESQL_DATABASE=mydatabase

$ cat postgres.env POSTGRESQL_USER=bob POSTGRESQL_DATABASE=mydatabaseCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc process -f my-rails-postgresql --param-file=postgres.env

$ oc process -f my-rails-postgresql --param-file=postgres.envCopy to Clipboard Copied! Toggle word wrap Toggle overflow --param-fileの引数として"-"を使用して、標準入力から環境を読み込むこともできます。sed s/bob/alice/ postgres.env | oc process -f my-rails-postgresql --param-file=-

$ sed s/bob/alice/ postgres.env | oc process -f my-rails-postgresql --param-file=-Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.1.5. アップロードしたテンプレートの変更

すでにプロジェクトにアップロードされているテンプレートを編集できます。

手順

すでにアップロードされているテンプレートを変更します。

oc edit template <template>

$ oc edit template <template>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.1.6. インスタントアプリとクイックスタートテンプレートの使用

OpenShift Container Platform では、デフォルトで、インスタントアプリとクイックスタートテンプレートを複数提供しており、各種言語で簡単に新規アプリの構築を開始できます。Rails (Ruby)、Django (Python)、Node.js、CakePHP (PHP) および Dancer (Perl) 用のテンプレートを利用できます。クラスター管理者は、これらのテンプレートを利用できるようにデフォルトのグローバル openshift プロジェクトにこれらのテンプレートを作成している必要があります。

デフォルトで、テンプレートビルドは必要なアプリケーションコードが含まれる GitHub の公開ソースリポジトリーを使用して行われます。

手順

以下のように、利用可能なデフォルトのインスタントアプリとクイックスタートテンプレートをリスト表示できます。

oc get templates -n openshift

$ oc get templates -n openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow ソースを変更し、アプリケーションの独自のバージョンをビルドするには、以下を実行します。

-

テンプレートのデフォルト

SOURCE_REPOSITORY_URLパラメーターが参照するリポジトリーをフォークします。 テンプレートから作成する場合には、

SOURCE_REPOSITORY_URLパラメーターの値を上書きします。デフォルト値ではなく、フォークを指定してください。これにより、テンプレートで作成したビルド設定はアプリケーションコードのフォークを参照するようになり、コードを変更し、アプリケーションを自由に再ビルドできます。

-

テンプレートのデフォルト

一部のインスタンスアプリおよびクイックスタートのテンプレートで、データベースのデプロイメント設定を定義します。テンプレートが定義する設定では、データベースコンテンツ用に一時ストレージを使用します。データベース Pod が何らかの理由で再起動されると、データベースの全データが失われてしまうので、これらのテンプレートはデモ目的でのみ使用する必要があります。

3.1.6.1. クイックスタートテンプレート

クイックスタートテンプレートは、OpenShift Container Platform で実行されるアプリケーションの基本的な例です。クイックスタートはさまざまな言語やフレームワークが含まれており、サービスのセット、ビルド設定およびデプロイメント設定などで設定されるテンプレートで定義されています。このテンプレートは、必要なイメージやソースリポジトリーを参照して、アプリケーションをビルドし、デプロイします。

クイックスタートを確認するには、テンプレートからアプリケーションを作成します。管理者がこれらのテンプレートを OpenShift Container Platform クラスターにすでにインストールしている必要がありますが、その場合には、Web コンソールからこれを簡単に選択できます。

クイックスタートは、アプリケーションのソースコードを含むソースリポジトリーを参照します。クイックスタートをカスタマイズするには、リポジトリーをフォークし、テンプレートからアプリケーションを作成する時に、デフォルトのソースリポジトリー名をフォークしたリポジトリーに置き換えます。これにより、提供されたサンプルのソースではなく、独自のソースコードを使用してビルドが実行されます。ソースリポジトリーでコードを更新し、新しいビルドを起動して、デプロイされたアプリケーションで変更が反映されていることを確認できます。

3.1.6.1.1. Web フレームワーククイックスタートテンプレート

以下のクイックスタートテンプレートでは、指定のフレームワークおよび言語の基本アプリケーションを提供します。

- CakePHP: PHP Web フレームワーク (MySQL データベースを含む)

- Dancer: Perl Web フレームワーク (MySQL データベースを含む)

- Django: Python Web フレームワーク (PostgreSQL データベースを含む)

- NodeJS: NodeJS web アプリケーション (MongoDB データベースを含む)

- Rails: Ruby Web フレームワーク (PostgreSQL データベースを含む)

3.1.7. テンプレートの作成

アプリケーションの全オブジェクトを簡単に再作成するために、新規テンプレートを定義できます。テンプレートでは、作成するオブジェクトと、これらのオブジェクトの作成をガイドするメタデータを定義します。

以下は、単純なテンプレートオブジェクト定義 (YAML) の例です。

3.1.7.1. テンプレート記述の作成

テンプレートの記述により、テンプレートの内容に関する情報を提供でき、Web コンソールでの検索時に役立ちます。テンプレート名以外のメタデータは任意ですが、使用できると便利です。メタデータには、一般的な説明などの情報以外にタグのセットも含まれます。便利なタグにはテンプレートで使用する言語名などがあります (例: Java、PHP、Ruby)。

以下は、テンプレート記述メタデータの例です。

- 1

- テンプレートの一意の名前。

- 2

- ユーザーインターフェイスで利用できるように、ユーザーに分かりやすく、簡単な名前。

- 3

- テンプレートの説明。デプロイされる内容、デプロイ前に知っておく必要のある注意点をユーザーが理解できるように詳細を追加します。README ファイルなど、追加情報へのリンクも追加します。パラグラフを作成するには、改行を追加できます。

- 4

- 追加の説明。たとえば、サービスカタログに表示されます。

- 5

- 検索およびグループ化を実行するためにテンプレートに関連付けられるタグ。これを指定されるカタログカテゴリーのいずれかに組み込むタグを追加します。コンソールの定数ファイルの

CATALOG_CATEGORIESでidおよびcategoryAliasesを参照してください。カテゴリーはクラスター全体に対してカスタマイズすることもできます。 - 6

- Web コンソールでテンプレートと一緒に表示されるアイコン。

例3.1 利用可能なアイコン

-

icon-3scale -

icon-aerogear -

icon-amq -

icon-angularjs -

icon-ansible -

icon-apache -

icon-beaker -

icon-camel -

icon-capedwarf -

icon-cassandra -

icon-catalog-icon -

icon-clojure -

icon-codeigniter -

icon-cordova -

icon-datagrid -

icon-datavirt -

icon-debian -

icon-decisionserver -

icon-django -

icon-dotnet -

icon-drupal -

icon-eap -

icon-elastic -

icon-erlang -

icon-fedora -

icon-freebsd -

icon-git -

icon-github -

icon-gitlab -

icon-glassfish -

icon-go-gopher -

icon-golang -

icon-grails -

icon-hadoop -

icon-haproxy -

icon-helm -

icon-infinispan -

icon-jboss -

icon-jenkins -

icon-jetty -

icon-joomla -

icon-jruby -

icon-js -

icon-knative -

icon-kubevirt -

icon-laravel -

icon-load-balancer -

icon-mariadb -

icon-mediawiki -

icon-memcached -

icon-mongodb -

icon-mssql -

icon-mysql-database -

icon-nginx -

icon-nodejs -

icon-openjdk -

icon-openliberty -

icon-openshift -

icon-openstack -

icon-other-linux -

icon-other-unknown -

icon-perl -

icon-phalcon -

icon-php -

icon-play -

iconpostgresql -

icon-processserver -

icon-python -

icon-quarkus -

icon-rabbitmq -

icon-rails -

icon-redhat -

icon-redis -

icon-rh-integration -

icon-rh-spring-boot -

icon-rh-tomcat -

icon-ruby -

icon-scala -

icon-serverlessfx -

icon-shadowman -

icon-spring-boot -

icon-spring -

icon-sso -

icon-stackoverflow -

icon-suse -

icon-symfony -

icon-tomcat -

icon-ubuntu -

icon-vertx -

icon-wildfly -

icon-windows -

icon-wordpress -

icon-xamarin -

icon-zend

-

- 7

- テンプレートを提供する人または組織の名前

- 8

- テンプレートに関する他のドキュメントを参照する URL

- 9

- テンプレートに関するサポートを取得できる URL

- 10

- テンプレートがインスタンス化された時に表示される説明メッセージ。このフィールドで、新規作成されたリソースの使用方法をユーザーに通知します。生成された認証情報や他のパラメーターを出力に追加できるように、メッセージの表示前にパラメーターの置換が行われます。ユーザーが従うべき次の手順が記載されたドキュメントへのリンクを追加してください。

3.1.7.2. テンプレートラベルの作成

テンプレートにはラベルのセットを追加できます。これらのラベルは、テンプレートがインスタンス化される時に作成されるオブジェクトごとに追加します。このようにラベルを定義すると、特定のテンプレートから作成された全オブジェクトの検索、管理が簡単になります。

以下は、テンプレートオブジェクトのラベルの例です。

3.1.7.3. テンプレートパラメーターの作成

パラメーターにより、テンプレートがインスタンス化される時に値を生成するか、ユーザーが値を指定できるようになります。パラメーターが参照されると、値が置換されます。参照は、オブジェクト一覧フィールドであればどこでも定義できます。これは、無作為にパスワードを作成したり、テンプレートのカスタマイズに必要なユーザー固有の値やホスト名を指定したりできるので便利です。パラメーターは、2 種類の方法で参照可能です。

-

文字列の値として、テンプレートの文字列フィールドに

${PARAMETER_NAME}の形式で配置する -

JSON/YAML の値として、テンプレートのフィールドに

${{PARAMETER_NAME}}の形式で配置する

${PARAMETER_NAME} 構文を使用すると、複数のパラメーター参照を 1 つのフィールドに統合でき、"http://${PARAMETER_1}${PARAMETER_2}" などのように、参照を固定データ内に埋め込むことができます。どちらのパラメーター値も置換されて、引用された文字列が最終的な値になります。

${{PARAMETER_NAME}} 構文のみを使用する場合は、単一のパラメーター参照のみが許可され、先頭文字や終了文字は使用できません。結果の値は、置換後に結果が有効な JSON オブジェクトの場合は引用されません。結果が有効な JSON 値でない場合に、結果の値は引用され、標準の文字列として処理されます。

単一のパラメーターは、テンプレート内で複数回参照でき、1 つのテンプレート内で両方の置換構文を使用して参照することができます。

デフォルト値を指定でき、ユーザーが別の値を指定していない場合に使用されます。

以下は、明示的な値をデフォルト値として設定する例です。

parameters:

- name: USERNAME

description: "The user name for Joe"

value: joe

parameters:

- name: USERNAME

description: "The user name for Joe"

value: joeパラメーター値は、パラメーター定義に指定したルールを基に生成することも可能です。以下は、パラメーター値の生成例です。

parameters:

- name: PASSWORD

description: "The random user password"

generate: expression

from: "[a-zA-Z0-9]{12}"

parameters:

- name: PASSWORD

description: "The random user password"

generate: expression

from: "[a-zA-Z0-9]{12}"上記の例では、処理後に、英字の大文字、小文字、数字をすべて含む 12 文字長のパスワードが無作為に作成されます。

利用可能な構文は、完全な正規表現構文ではありません。ただし、\w、\d、\a、および \A 修飾子を使用できます。

-

[\w]{10}は、10 桁の英字、数字、およびアンダースコアを生成します。これは PCRE 標準に準拠し、[a-zA-Z0-9_]{10}に相当します。 -

[\d]{10}は 10 桁の数字を生成します。これは[0-9]{10}に相当します。 -

[\a]{10}は 10 桁の英字を生成します。これは[a-zA-Z]{10}に相当します。 -

[\A]{10}は 10 の句読点または記号文字を生成します。これは[~!@#$%\^&*()\-_+={}\[\]\\|<,>.?/"';:`]{10}に相当します。

テンプレートが YAML または JSON で記述されているかどうか、また修飾子が組み込まれている文字列のタイプによっては、2 番目のバックスラッシュでバックスラッシュをエスケープする必要がある場合があります。以下は例になります。

修飾子を含む YAML テンプレートの例

修飾子を含む JSON テンプレートの例

以下は、パラメーター定義と参照を含む完全なテンプレートの例です。

- 1

- この値は、テンプレートがインスタンス化された時点で

SOURCE_REPOSITORY_URLパラメーターに置き換えられます。 - 2

- この値は、テンプレートがインスタンス化された時点で、

REPLICA_COUNTパラメーターの引用なしの値に置き換えられます。 - 3

- パラメーター名。この値は、テンプレート内でパラメーターを参照するのに使用します。

- 4

- 分かりやすいパラメーターの名前。これは、ユーザーに表示されます。

- 5

- パラメーターの説明。期待値に対する制約など、パラメーターの目的を詳細にわたり説明します。説明には、コンソールのテキスト標準に従い、完結した文章を使用するようにしてください。表示名と同じ内容を使用しないでください。

- 6

- テンプレートをインスタンス化する時に、ユーザーにより値が上書きされない場合に使用されるパラメーターのデフォルト値。パスワードなどのデフォルト値の使用を避けるようにしてください。シークレットと組み合わせた生成パラメーターを使用するようにしてください。

- 7

- このパラメーターが必須であることを示します。つまり、ユーザーは空の値で上書きできません。パラメーターでデフォルト値または生成値が指定されていない場合には、ユーザーは値を指定する必要があります。

- 8

- 値が生成されるパラメーター

- 9

- ジェネレーターへの入力。この場合、ジェネレーターは、大文字、小文字を含む 40 桁の英数字の値を生成します。

- 10

- パラメーターはテンプレートメッセージに含めることができます。これにより、生成された値がユーザーに通知されます。

3.1.7.4. テンプレートオブジェクトリストの作成

テンプレートの主な部分は、テンプレートがインスタンス化される時に作成されるオブジェクトのリストです。これには、ビルド設定、デプロイメント設定、またはサービスなどの有効な API オブジェクトを使用できます。オブジェクトはここで定義された通りに作成され、パラメーターの値は作成前に置換されます。これらのオブジェクトの定義では、以前に定義したパラメーターを参照できます。

以下は、オブジェクトリストの例です。

- 1

- サービスの定義。このテンプレートにより作成されます。

オブジェクト定義のメタデータに namespace フィールドの固定値が含まれる場合、フィールドはテンプレートのインスタンス化の際に定義から取り除かれます。namespace フィールドにパラメーター参照が含まれる場合には、通常のパラメーター置換が行われ、パラメーターの置換による値の解決が実行された namespace で、オブジェクトが作成されます。この場合、ユーザーは対象の namespace でオブジェクトを作成するパーミッションがあることが前提になります。

3.1.7.5. テンプレートをバインド可能としてマーキングする

テンプレートサービスブローカーは、認識されているテンプレートオブジェクトごとに、カタログ内にサービスを 1 つ公開します。デフォルトでは、これらのサービスはそれぞれバインド可能として公開され、エンドユーザーがプロビジョニングしたサービスに対してバインドできるようにします。

手順

テンプレートの作成者は、エンドユーザーが指定テンプレートからプロビジョニングされたサービスに対してバインディングすることを防ぐことができます。

-

template.openshift.io/bindable: "false"のアノテーションをテンプレートに追加して、エンドユーザーが指定のテンプレートからプロビジョニングされるサービスをバインドできないようにできます。

3.1.7.6. テンプレートオブジェクトフィールドの公開

テンプレートの作成者は、テンプレートに含まれる特定のオブジェクトのフィールドを公開すべきかどうかを指定できます。テンプレートサービスブローカーは、ConfigMap、Secret、Service、および Route オブジェクトに公開されたフィールドを認識し、ユーザーがブローカーでサポートされているサービスをバインドする際に公開されたフィールドの値を返します。

オブジェクトのフィールドを 1 つまたは複数公開するには、テンプレート内のオブジェクトに、接頭辞が template.openshift.io/expose- または template.openshift.io/base64-expose- のアノテーションを追加します。

各アノテーションキーは、bind 応答のキーになるように、接頭辞が削除されてパススルーされます。

各アノテーションの値は Kubernetes JSONPath 式の値であり、バインド時に解決され、bind 応答で返される値が含まれるオブジェクトフィールドを指定します。

Bind 応答のキーと値のペアは、環境変数として、システムの他の場所で使用できます。そのため、アノテーションキーで接頭辞を取り除いた値を有効な環境変数名として使用することが推奨されます。先頭に A-Z、a-z または _ を指定して、その後に、ゼロか、他の文字 A-Z、a-z、0-9 または _ を指定してください。

バックスラッシュでエスケープしない限り、Kubernetes の JSONPath 実装は表現内のどの場所に使用されていても、.、@ などはメタ文字として解釈します。そのため、たとえば、my.key という名前の ConfigMap のデータを参照するには、JSONPath 式は {.data['my\.key']} とする必要があります。JSONPath 式が YAML でどのように記述されているかによって、"{.data['my\\.key']}" などのように、追加でバックスラッシュが必要になる場合があります。

以下は、公開されるさまざまなオブジェクトのフィールドの例です。

上記の部分的なテンプレートでの bind 操作に対する応答例は以下のようになります。

手順

-

template.openshift.io/expose-アノテーションを使用して、値を文字列として返します。これは、任意のバイナリーデータを処理しないものの、便利な方法です。 -

バイナリーデータを返す必要がある場合、

template.openshift.io/base64-expose-アノテーションを使用して、データが返される前にデータを base64 でエンコードします。

3.1.7.7. テンプレートの準備ができるまで待機する

テンプレートの作成者は、テンプレート内の特定のオブジェクトがサービスカタログ、Template Service Broker または TemplateInstance API によるテンプレートのインスタンス化が完了したとされるまで待機する必要があるかを指定できます。

手順を開始する前に、以下の考慮事項をお読みください。

- アプリケーションにスムーズに実行するのに十分なリソースが提供されるようにメモリー、CPU、およびストレージのデフォルトサイズを設定します。

-

latestタグが複数のメジャーバージョンで使用されている場合には、イメージからこのタグを参照しないようにします。新規イメージがそのタグにプッシュされると、実行中のアプリケーションが破損してしまう可能性があります。 - 適切なテンプレートの場合、テンプレートのデプロイ後に変更する必要なしに、ビルドおよびデプロイが正常に行われます。

手順

テンプレート機能を使用するには、テンプレート内の

Build、BuildConfig、Deployment、DeploymentConfig、Job、またはStatefulSetのオブジェクト 1 つ以上に、次のアノテーションでマークを付けます。"template.alpha.openshift.io/wait-for-ready": "true"

"template.alpha.openshift.io/wait-for-ready": "true"Copy to Clipboard Copied! Toggle word wrap Toggle overflow テンプレートのインスタンス化は、アノテーションのマークが付けられたすべてのオブジェクトが準備できたと報告されるまで、完了しません。同様に、アノテーションが付けられたオブジェクトが失敗したと報告されるか、固定タイムアウトである 1 時間以内にテンプレートの準備が整わなかった場合に、テンプレートのインスタンス化は失敗します。

インスタンス化の目的で、各オブジェクトの種類の準備状態および失敗は以下のように定義されます。

Expand 種類 準備状態 (Readiness) 失敗 (Failure) Buildオブジェクトが Complete フェーズを報告する

オブジェクトが Canceled、Error、または Failed を報告する

BuildConfig関連付けられた最新のビルドオブジェクトが Complete フェーズを報告する

関連付けられた最新のビルドオブジェクトが Canceled、Error、または Failed を報告する

Deploymentオブジェクトは、新しいレプリカセットとデプロイメントが利用可能であると報告する。これにより、オブジェクトで定義される readiness プローブが有効になります。

オブジェクトで、Progressing の状態が false であると報告される

DeploymentConfigオブジェクトは新規レプリケーションコントローラーおよびデプロイメントが利用可能であると報告する。これにより、オブジェクトで定義される readiness プローブが有効になります。

オブジェクトで、Progressing の状態が false であると報告される

Jobオブジェクトが完了 (completion) を報告する

オブジェクトが 1 つ以上の失敗が発生したことを報告する

StatefulSetオブジェクトはすべてのレプリカが Ready であることを報告するこれにより、オブジェクトで定義される readiness プローブが有効になります。

該当なし

以下は、テンプレートサンプルを一部抜粋したものです。この例では、

wait-for-readyアノテーションが使用されています。他のサンプルは、OpenShift Container Platform クイックスタートテンプレートにあります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.1.7.8. 既存オブジェクトからのテンプレートの作成

テンプレートをゼロから作成するのではなく、プロジェクトから既存のオブジェクトを YAML 形式でエクスポートして、パラメーターを追加したり、テンプレート形式としてカスタマイズしたりして、YAML 形式を変更することもできます。

手順

オブジェクトを YAML 形式でプロジェクトにエクスポートします。

oc get -o yaml all > <yaml_filename>

$ oc get -o yaml all > <yaml_filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow allではなく、特定のリソースタイプや複数のリソースを置き換えることも可能です。他の例は、oc get -hを実行してください。oc get -o yaml allに含まれるオブジェクトタイプは以下の通りです。-

BuildConfig -

Build -

DeploymentConfig -

ImageStream -

Pod -

ReplicationController -

Route -

Service

-

コンテンツはクラスターやバージョンによって異なる可能性があるため、all エイリアスの使用は推奨されません。代わりに、必要なすべてのリソースを指定してください。

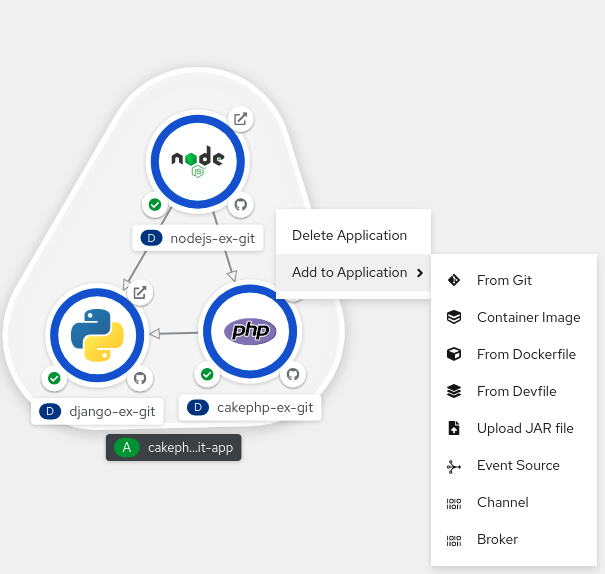

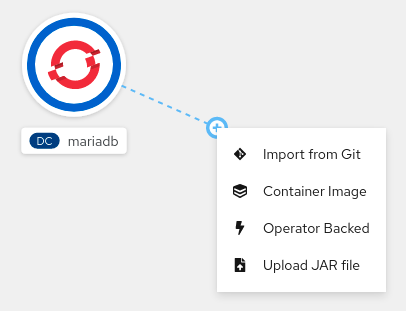

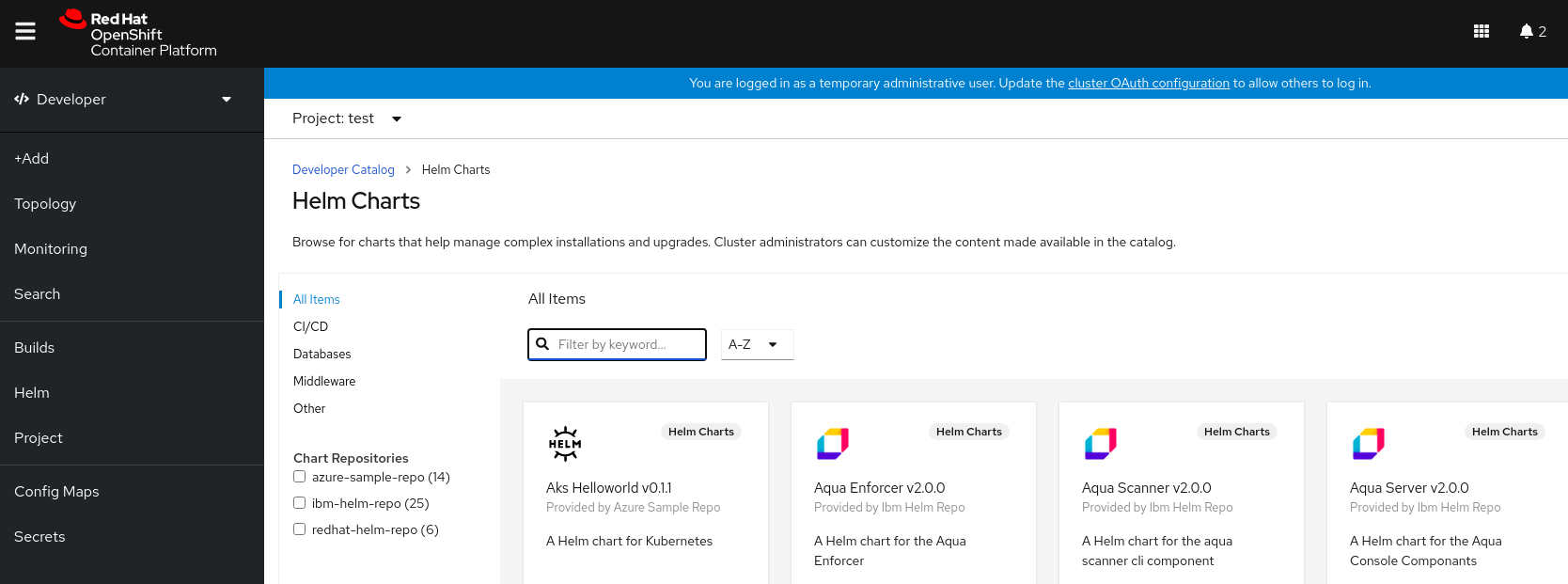

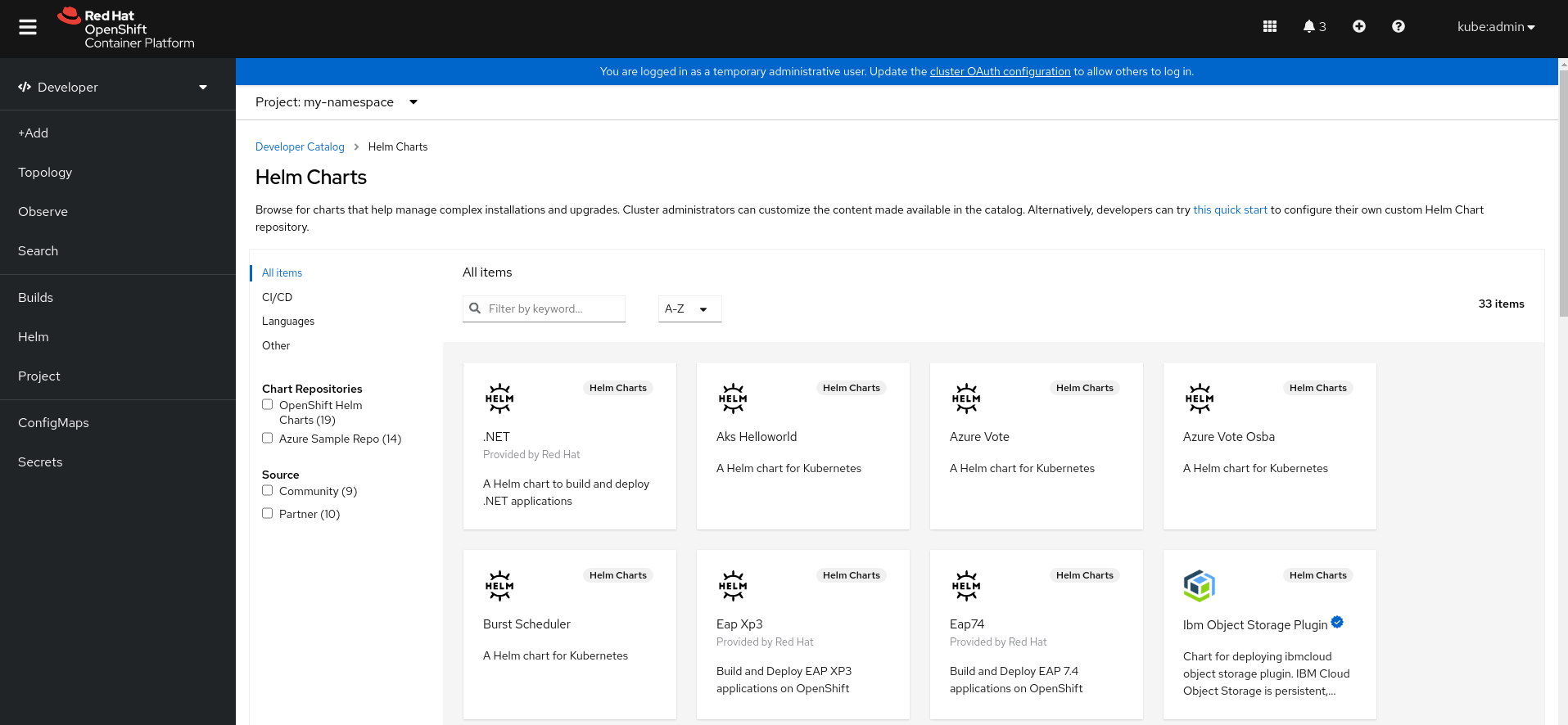

3.2. Developer パースペクティブを使用したアプリケーションの作成

Web コンソールの Developer パースペクティブでは、+Add ビューからアプリケーションおよび関連サービスを作成し、それらを OpenShift Container Platform にデプロイするための以下のオプションが提供されます。

リソースの使用: 開発者コンソールを使い始めるには、これらのリソースを使用します。Options メニュー

を使用してヘッダーを非表示にすることができます。

を使用してヘッダーを非表示にすることができます。

- サンプルを使用したアプリケーションの作成: 既存のコードサンプルを使用して、OpenShift Container Platform でアプリケーションの作成を開始します。

- ガイド付きドキュメントを使用してビルド: ガイド付きドキュメントを参照してアプリケーションを構築し、主なコンセプトや用語に慣れてください。

- 新規開発者機能の確認: Developer パースペクティブの新機能およびリソースを紹介します。

Developer catalog: Developer Catalog で、イメージビルダーに必要なアプリケーション、サービス、またはソースを選択し、プロジェクトに追加します。

- All Services: カタログを参照し、OpenShift Container Platform 全体でサービスを検出します。

- Database: 必要なデータベースサービスを選択し、アプリケーションに追加します。

- Operator Backed: 必要な Operator 管理サービスを選択し、デプロイします。

- Helm chart: 必要な Helm チャートを選択し、アプリケーションおよびサービスのデプロイメントを単純化します。

- Devfile: Devfile レジストリー から devfile を選択して、開発環境を宣言的に定義します。

Event Source: 特定のシステムからイベントソースを選択し、関心のあるイベントクラスを登録します。

注記RHOAS Operator がインストールされている場合には、マネージドサービスオプションも利用できます。

- Git repository: From Git、From Devfile または From Dockerfile オプションを使用して Git リポジトリーから既存のコードベース、Devfile、または Dockerfile をインポートし、OpenShift Container Platform でアプリケーションをビルドしてデプロイします。

- Container Image: イメージストリームまたはレジストリーからの既存イメージを使用し、これを OpenShift Container Platform にデプロイします。

- Pipelines: Tekton パイプラインを使用して OpenShift Container Platform でソフトウェア配信プロセスの CI/CD パイプラインを作成します。

Serverless: Serverless オプションを検査して、OpenShift Container Platform でステートレスおよびサーバーレスアプリケーションを作成、ビルド、デプロイします。

- Channel: Knative チャネルを作成し、インメモリーの信頼性の高い実装を備えたイベント転送および永続化層を作成します。

- Samples: 利用可能なサンプルアプリケーションを確認して、アプリケーションをすばやく作成、ビルド、デプロイします。

- Quick Starts: アプリケーションを作成、インポート、および実行するためのクイックスタートオプションを調べて、ステップバイステップの手順とタスクを使用します。

From Local Machine: From Local Machine タイルを確認して、ローカルマシンのファイルをインポートまたはアップロードし、簡単にアプリケーションをビルドしてデプロイします。

- Import YAML: YAML ファイルをアップロードし、アプリケーションをビルドしてデプロイするためのリソースを定義します。

- Upload JAR file: JAR ファイルをアップロードして Java アプリケーションをビルドおよびデプロイします。

- Share my Project: このオプションを使用して、プロジェクトにユーザーを追加または削除し、アクセシビリティオプションを提供します。

- Helm Chart リポジトリー: このオプションを使用して、namespace に Helm Chart リポジトリーを追加します。

- リソースの並べ替え: これらのリソースを使用して、ナビゲーションペインに追加済みのピン留めされたリソースを並べ替えます。ナビゲーションウィンドウでピン留めされたリソースにカーソルを合わせると、その左側にドラッグアンドドロップアイコンが表示されます。ドラッグしたリソースは、それが属するセクションにのみドロップできます。

Pipelines、Event Source、Import Virtual Machines などの特定のオプションは、OpenShift Pipelines Operator、OpenShift Serverless Operator、および OpenShift Virtualization Operator がインストールされる場合にのみそれぞれ表示されることに注意してください。

3.2.1. 前提条件

Developer パースペクティブを使用してアプリケーションを作成するには、以下を確認してください。

- Web コンソールにログイン している。

- OpenShift Container Platform でアプリケーションおよび他のワークロードを作成するために、プロジェクトを作成しているか、適切な ロールおよびパーミッション を持つプロジェクトにアクセスできる。

前述の前提条件に加えてサーバーレスアプリケーションを作成するには、以下を確認します。

3.2.2. サンプルアプリケーションの作成

Developer パースペクティブの +Add フローでサンプルアプリケーションを使用し、アプリケーションをすぐに作成し、ビルドし、デプロイできます。

前提条件

- OpenShift Container Platform Web コンソールにログインしており、Developer パースペクティブにいます。

手順

- +Add ビューで、Samples タイルをクリックして Samples ページを表示します。

- Samples ページで、利用可能なサンプルアプリケーションの 1 つを選択し、Create Sample Application フォームを表示します。

Create Sample Application Form:

- Name フィールドには、デフォルトでデプロイメント名が表示されます。この名前は必要に応じて変更できます。

- Builder Image Version では、ビルダーイメージがデフォルトで選択されます。Builder Image Version ドロップダウンリストを使用してイメージバージョンを変更できます。

- Git リポジトリー URL のサンプルは、デフォルトで追加されます。

- Create をクリックしてサンプルアプリケーションを作成します。サンプルアプリケーションのビルドステータスが Topology ビューに表示されます。サンプルアプリケーションの作成後、デプロイメントがアプリケーションに追加されていることを確認できます。

3.2.3. Quick Starts を使用したアプリケーションの作成

Quick Starts ページでは、OpenShift Container Platform でアプリケーションを作成、インポート、および実行する方法を、段階的な手順とタスクとともに示します。

前提条件

- OpenShift Container Platform Web コンソールにログインしており、Developer パースペクティブにいます。

手順

- +Add ビューで、Getting Started resources → Build with guided documentation → View all quick starts リンクをクリックして、Quick Starts ページを表示します。

- Quick Starts ページで、使用するクイックスタートのタイルをクリックします。

- Start をクリックして、クイックスタートを開始します。

- 表示される手順を実行します。

3.2.4. Git のコードベースのインポートおよびアプリケーションの作成

Developer パースペクティブを使用し、GitHub で既存のコードベースを使用して OpenShift Container Platform でアプリケーションを作成し、ビルドし、デプロイすることができます。

以下の手順では、Developer パースペクティブの From Git オプションを使用してアプリケーションを作成します。

手順

- +Add ビューで、Git Repository タイルの From Git をクリックし、Import from git フォームを表示します。

-

Git セクションで、アプリケーションの作成に使用するコードベースの Git リポジトリー URL を入力します。たとえば、このサンプル nodejs アプリケーションの URL

https://github.com/sclorg/nodejs-exを入力します。その後、URL は検証されます。 オプション: Show Advanced Git Options をクリックし、以下のような詳細を追加できます。

- Git Reference: アプリケーションのビルドに使用する特定のブランチ、タグ、またはコミットのコードを参照します。

- Context Dir: アプリケーションのビルドに使用するアプリケーションのソースコードのサブディレクトリーを指定します。

- Source Secret: プライベートリポジトリーからソースコードをプルするための認証情報で Secret Name を作成します。

オプション:

Devfile、Dockerfile、Builder Image、またはServerless Functionが Git リポジトリーからインポートして、デプロイをさらにカスタマイズできます。-

Git リポジトリーに

Devfile、Dockerfile、Builder Image、またはfunc.yamlが含まれている場合は自動的に検出され、それぞれのパスフィールドに入力されます。 -

Devfile、Dockerfile、またはBuilder Imageが同じリポジトリーで検出された場合は、デフォルトでDevfileが選択されます。 -

Git リポジトリーで

func.yamlが検出されると、Import Strategy がServerless Functionに変更になります。 - または、Git リポジトリー URL を使用して +Add ビューでサーバー Create Serverless function をクリックして、サーバーレス関数を作成することもできます。

- ファイルのインポートタイプを編集して、別のストラテジーを選択し、Edit import strategy オプションをクリックします。

-

複数の

Devfiles、Dockerfiles、またはBuilder Imagesが検出された場合、特定のインスタンスをインポートするには、コンテキストディレクトリーからの相対パスをそれぞれ指定します。

-

Git リポジトリーに

Git URL の検証後に、推奨されるビルダーイメージが選択されて星マークが付けられます。ビルダーイメージが自動検出されていない場合は、ビルダーイメージを選択します。

https://github.com/sclorg/nodejs-exGit URL の場合、Node.js ビルダーイメージがデフォルトで選択されます。- オプション:Builder Image Version ドロップダウンリストを使用してバージョンを指定します。

- オプション:Edit import strategy を使用して、別のストラテジーを選択します。

- オプション:Node.js ビルダーイメージの場合、Run command フィールドを使用して、アプリケーションを実行するためにコマンドを上書きします。

General セクションで、以下を実行します。

-

Application フィールドに、アプリケーションを分類するために一意の名前 (

myappなど) を入力します。アプリケーション名が namespace で一意であることを確認します。 Name フィールドで、既存のアプリケーションが存在しない場合に、このアプリケーション用に作成されたリソースが Git リポジトリー URL をベースとして自動的に設定されることを確認します。既存のアプリケーションがある場合には、既存のアプリケーション内でそのコンポーネントをデプロイしたり、新しいアプリケーションを作成したり、またはコンポーネントをいずれにも割り当てない状態にしたりすることができます。

注記リソース名は namespace で一意である必要があります。エラーが出る場合はリソース名を変更します。

-

Application フィールドに、アプリケーションを分類するために一意の名前 (

Resources セクションで、以下を選択します。

- Deployment: 単純な Kubernetes スタイルのアプリケーションを作成します。

- Deployment Config: OpenShift Container Platform スタイルのアプリケーションを作成します。

Serverless Deployment: Knative サービスを作成します。

注記アプリケーションをインポートするためのデフォルトのリソース設定を設定するには、User Preferences → Applications → Resource type フィールドに移動します。Serverless Deployment オプションは、OpenShift Serverless Operator がクラスターにインストールされている場合にのみ、Import from Git フォームに表示されます。Resources セクションは、サーバーレス関数の作成時には利用できません。詳細は、OpenShift Serverless のドキュメントを参照してください。

Pipelines セクションで、Add Pipeline を選択してから Show Pipeline Visualization をクリックし、アプリケーションのパイプラインを表示します。デフォルトのパイプラインが選択されますが、アプリケーションで利用可能なパイプラインの一覧から必要なパイプラインを選択できます。

注記次の基準が満たされている場合、Add pipeline チェックボックスがオンになり、Configure PAC がデフォルトで選択されます。

- パイプラインオペレーターがインストールされています

-

pipelines-as-codeが有効になっています -

.tektonディレクトリーが Git リポジトリーで検出される

Webhook をリポジトリーに追加します。Configure PAC がオンになっており、GitHub アプリがセットアップされている場合は、Use GitHub App と Setup a webhook オプションが表示されます。GitHub アプリケーションがセットアップされていない場合は、Setup a webhook オプションのみが表示されます。

- Settings → Webhooks に移動し、Add webhook をクリックします。

- Payload URL を Pipelines as Code コントローラーのパブリック URL に設定します。

- コンテンツタイプを application/json として選択します。

-

Webhook シークレットを追加し、別の場所に書き留めます。

opensslがローカルマシンにインストールされた状態で、ランダムなシークレットを生成します。 - Let me select individual events をクリックし、Commit comments、Issue comments、Pull request、および Pushes のイベントを選択します。

- Add webhook をクリックします。

オプション: Advanced Options セクションでは、Target port および Create a route to the application がデフォルトで選択されるため、公開されている URL を使用してアプリケーションにアクセスできます。

アプリケーションがデフォルトのパブリックポート 80 でデータを公開しない場合は、チェックボックスの選択を解除し、公開する必要のあるターゲットポート番号を設定します。

オプション: 以下の高度なオプションを使用してアプリケーションをさらにカスタマイズできます。

- Routing

Routing のリンクをクリックして、以下のアクションを実行できます。

- ルートのホスト名をカスタマイズします。

- ルーターが監視するパスを指定します。

- ドロップダウンリストから、トラフィックのターゲットポートを選択します。

Secure Route チェックボックスを選択してルートを保護します。必要な TLS 終端タイプを選択し、各ドロップダウンリストから非セキュアなトラフィックに関するポリシーを設定します。

注記サーバーレスアプリケーションの場合、Knative サービスが上記のすべてのルーティングオプションを管理します。ただし、必要に応じて、トラフィックのターゲットポートをカスタマイズできます。ターゲットポートが指定されていない場合、デフォルトポートの

8080が使用されます。

- ドメインマッピング

Serverless Deployment を作成する場合、作成時に Knative サービスにカスタムドメインマッピングを追加できます。

Advanced options セクションで、Show advanced Routing options をクリックします。

- サービスにマッピングするドメインマッピング CR がすでに存在する場合は、Domain mapping のドロップダウンメニューから選択できます。

-

新規ドメインマッピング CR を作成する場合は、ドメイン名をボックスに入力し、Create オプションを選択します。たとえば、

example.comと入力すると、Create オプションは Create "example.com" になります。

- ヘルスチェック

Health Checks リンクをクリックして、Readiness、Liveness、および Startup プローブをアプリケーションに追加します。すべてのプローブに事前に設定されたデフォルトデータが実装され、必要に応じてデフォルトデータでプローブを追加したり、必要に応じてこれをカスタマイズしたりできます。

ヘルスプローブをカスタマイズするには、以下を実行します。

- Add Readiness Probe をクリックし、必要に応じてコンテナーが要求を処理する準備ができているかどうかを確認するためにパラメーターを変更し、チェックマークを選択してプローブを追加します。

- Add Liveness Probe をクリックし、必要に応じてコンテナーが実行中かどうかを確認するためにパラメーターを変更し、チェックマークを選択してプローブを追加します。

Add Startup Probe をクリックし、必要に応じてコンテナー内のアプリケーションが起動しているかどうかを確認するためにパラメーターを変更し、チェックマークを選択してプローブを追加します。

それぞれのプローブについて、ドロップダウンリストから要求タイプ (HTTP GET、Container Command、TCP Socket) を指定できます。選択した要求タイプに応じてフォームが変更されます。次に、プローブの成功および失敗のしきい値、コンテナーの起動後の最初のプローブ実行までの秒数、プローブの頻度、タイムアウト値など、他のパラメーターのデフォルト値を変更できます。

- ビルド設定およびデプロイメント

Build Configuration および Deployment リンクをクリックして、それぞれの設定オプションを表示します。オプションの一部はデフォルトで選択されています。必要なトリガーおよび環境変数を追加して、オプションをさらにカスタマイズできます。

サーバーレスアプリケーションの場合、Deployment オプションは表示されません。これは、Knative 設定リソースが

DeploymentConfigリソースの代わりにデプロイメントの必要な状態を維持するためです。

- スケーリング

Scaling リンクをクリックして、最初にデプロイするアプリケーションの Pod 数またはインスタンス数を定義します。

サーバーレスデプロイメントを作成する場合、以下の設定を行うこともできます。

-

Min Pods は、Knative サービスである時点で実行する必要がある Pod 数の下限を決定します。これは、

minScale設定としても知られています。 -

Max Pods は、Knative サービスである時点で実行できる Pod 数の上限を決定します。これは、

maxScale設定としても知られています。 - Concurrency target は、ある時点でアプリケーションの各インスタンスに対して必要な同時リクエストの数を決定します。

- Concurrency limit は、ある時点でアプリケーションの各インスタンスに対して許容される同時リクエストの数の制限を決定します。

- Concurrency utilization は、Knative が追加のトラフィックを処理するために追加の Pod をスケールアップする際に満たす必要のある同時リクエストの制限のパーセンテージを決定します。

-

Autoscale window は、Autoscaler がパニックモードではない場合に、スケーリングの決定を行う際のインプットを提供するためにメトリクスの平均値を計算する期間を定義します。この期間中にリクエストが受信されなかった場合、サービスはゼロにスケーリングされます。Autoscale window のデフォルト期間は

60sです。これは stable window としても知られています。

-

Min Pods は、Knative サービスである時点で実行する必要がある Pod 数の下限を決定します。これは、

- リソースの制限

- Resource Limit リンクをクリックして、コンテナーが実行時に保証または使用が許可されている CPU および メモリー リソースの量を設定します。

- ラベル

- Labels リンクをクリックして、カスタムラベルをアプリケーションに追加します。

- Create をクリックしてアプリケーションを作成し、成功の通知が表示されます。Topology ビューでアプリケーションのビルドステータスを確認できます。

3.2.5. コンテナーイメージをデプロイしてアプリケーションを作成

外部イメージレジストリーまたは内部レジストリーのイメージストリームタグを使用して、アプリケーションをクラスターにデプロイできます。

前提条件

- OpenShift Container Platform Web コンソールにログインしており、Developer パースペクティブにいます。

手順

- +Add ビューで、Container images をクリックして、Deploy Images ページを表示します。

Image セクションで以下を行います。

- Image name from external registry を選択してパブリックレジストリーまたはプライベートレジストリーからイメージをデプロイメントするか、Image stream tag from internal registry を選択して内部レジストリーからイメージをデプロイメントします。

- Runtime icon タブでイメージのアイコンを選択します。

General セクションで、以下を実行します。

- Application name フィールドに、アプリケーションを分類するための一意の名前を入力します。

- Name フィールドに、このコンポーネント用に作成されたリソースを識別するための一意の名前を入力します。

Resource type セクションで、生成するリソースタイプを選択します。

-

Deployment を選択して、

PodおよびReplicaSetオブジェクトの宣言的更新を有効にします。 -

DeploymentConfig を選択して、

Podオブジェクトのテンプレートを定義し、新しいイメージと設定ソースのデプロイを管理します。 - アイドル時にゼロへのスケーリングを有効にするには、Serverless Deployment を選択します。

-

Deployment を選択して、

- Create をクリックします。Topology ビューでアプリケーションのビルドステータスを確認できます。

3.2.6. JAR ファイルをアップロードして Java アプリケーションをデプロイする

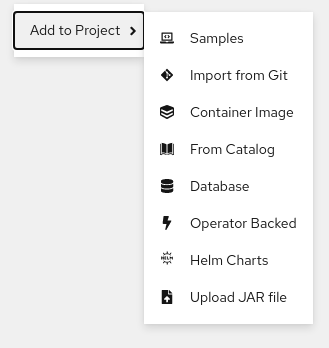

Web コンソールの Developer パースペクティブで、以下のオプションを使用して JAR ファイルをアップロードできます。

- Developer パースペクティブの +Add ビューに移動し、From Local Machine タイルで Upload JAR file をクリックします。JAR ファイルを参照および選択するか、JAR ファイルをドラッグしてアプリケーションをデプロイします。

- Topology ビューに移動し、Upload JAR file オプションを使用するか、JAR ファイルをドラッグしてアプリケーションをデプロイします。

- Topology ビューのコンテキストメニューで Upload JAR file オプションを使用して JAR ファイルをアップロードしてアプリケーションをデプロイします。

前提条件

- クラスター管理者が Cluster Samples Operator をインストールしている。

- OpenShift Container Platform Web コンソールにアクセスでき、Developer パースペクティブを使用している。

手順

- Topology ビューで、任意の場所を右クリックして Add to Project メニューを表示します。

- Add to Project メニューにカーソルを置いてメニューオプションを表示し、Upload JAR file オプションを選択して Upload JAR file フォームを確認します。または、JAR ファイルを Topology ビューにドラッグできます。

- JAR file フィールドで、ローカルマシンで必要な JAR ファイルを参照し、これをアップロードします。または、JAR ファイルをフィールドにドラッグできます。互換性のないタイプのファイルが Topology ビューにドラッグされると、トーストアラートが右側に表示されます。互換性のないファイルタイプがアップロードフォームのフィールドにドロップされると、フィールドエラーが表示されます。

- デフォルトで、ランタイムアイコンとビルダーイメージが選択されています。ビルダーイメージが自動検出されていない場合は、ビルダーイメージを選択します。必要に応じて、Builder Image Version のドロップダウンリストを使用してバージョンを変更できます。

- オプション: Application Name フィールドに、リソースのラベル付けに使用する一意のアプリケーション名を入力します。

- Name フィールドに、関連付けられたリソースに名前を付けるために一意のコンポーネント名を入力します。

- オプション: Resource type ドロップダウンリストを使用して、リソースタイプを変更します。

- Advanced options メニューで Create a Route to the Application をクリックし、デプロイされたアプリケーションのパブリック URL を設定します。

- Create をクリックしてアプリケーションをデプロイします。JAR ファイルがアップロードされたことを通知するトースト通知が表示されます。トースト通知には、ビルドログを表示するリンクも含まれます。

ビルドの実行中にブラウザータブを閉じようとすると、Web アラートが表示されます。

JAR ファイルのアップロードとアプリケーションのデプロイメントが完了すると、Topology ビューにアプリケーションが表示されます。

3.2.7. Devfile レジストリーを使用した devfile へのアクセス

Developer パースペクティブの +Add フローで devfile を使用して、アプリケーションを作成できます。+Add フローは、devfile コミュニティーレジストリー との完全なインテグレーションを提供します。devfile は、ゼロから設定せずに開発環境を記述できる移植可能な YAML ファイルです。Devfile レジストリー を使用すると、事前に設定された devfile を使用してアプリケーションを作成できます。

手順

- Developer Perspective → +Add → Developer Catalog → All Services に移動します。Developer Catalog で利用可能なすべてのサービスの一覧が表示されます。

- Type で、Devfiles をクリックして、特定の言語またはフレームワークをサポートする devfiles を参照します。あるいは、キーワードフィルターを使用して、名前、タグ、または説明を使用して特定の devfile を検索できます。

- アプリケーションの作成に使用する devfile をクリックします。devfile タイルに、devfile の名前、説明、プロバイダー、ドキュメントなど、devfile の詳細が表示されます。

- Create をクリックしてアプリケーションを作成し、Topology ビューでアプリケーションを表示します。

3.2.8. Developer Catalog を使用したサービスまたはコンポーネントのアプリケーションへの追加

Developer Catalog を使用して、データベース、ビルダーイメージ、Helm チャートなどの Operator がサポートするサービスに基づいてアプリケーションとサービスをデプロイします。Developer Catalog には、プロジェクトに追加できるアプリケーションコンポーネント、サービス、イベントソース、または Source-to-Image ビルダーのコレクションが含まれます。クラスター管理者は、カタログで利用可能なコンテンツをカスタマイズできます。

手順

- Developer パースペクティブで、+Add に移動して、Developer Catalog タイルから All Services をクリックし、Developer Catalog で利用可能なすべてのサービスを表示します。

- All Services で、サービスの種類またはプロジェクトに追加する必要のあるコンポーネントを選択します。この例では、Databases を選択してすべてのデータベースサービスを一覧表示し、MariaDB をクリックしてサービスの詳細を表示します。

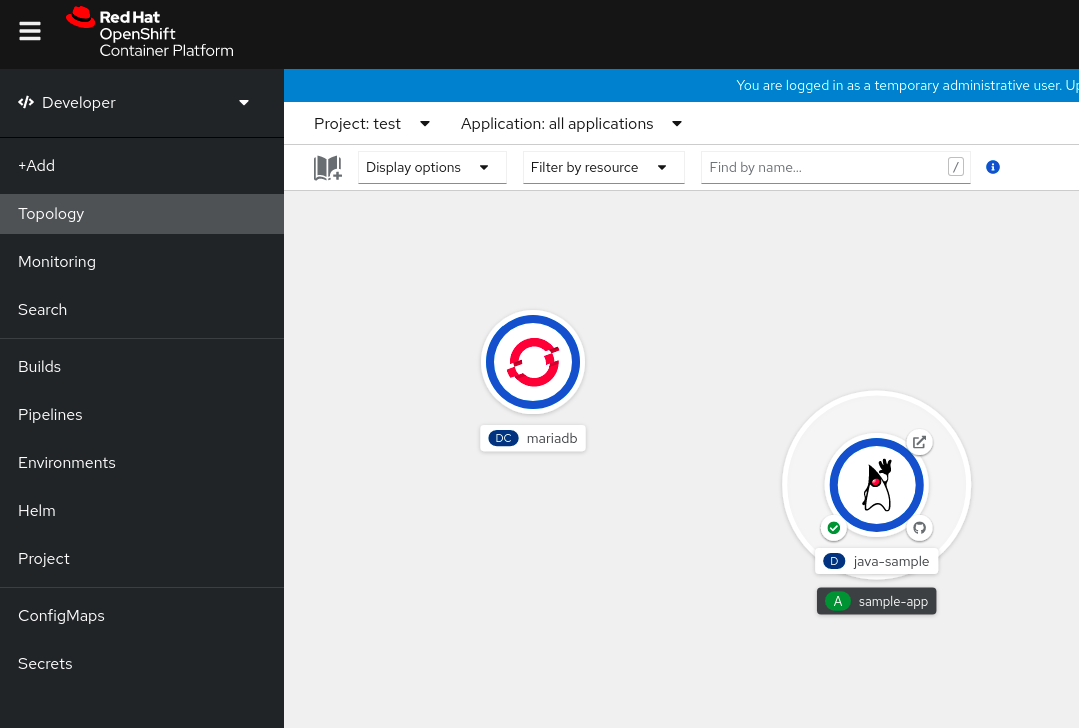

Instantiate Template をクリックして、MariaDB サービスの詳細情報を含む自動的に設定されたテンプレートを表示し、Create をクリックして Topology ビューで MariaDB サービスを作成し、これを表示します。

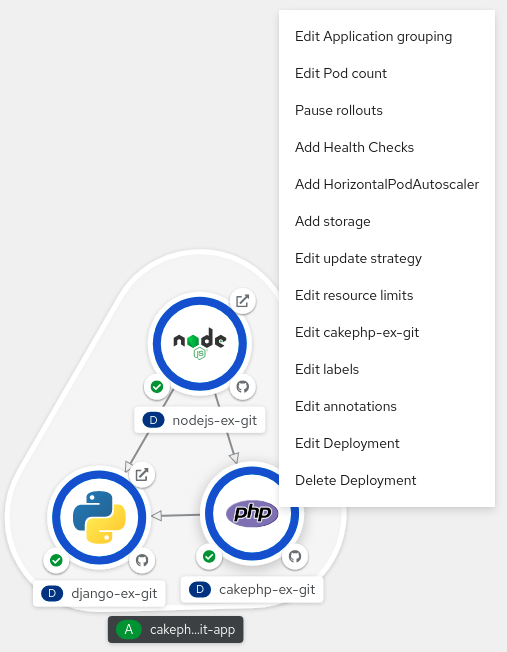

図3.1 トポロジーの MariaDB

3.3. インストールされた Operator からのアプリケーションの作成

Operator は、Kubernetes アプリケーションをパッケージ化し、デプロイし、管理する方法です。クラスター管理者によってインストールされる Operator を使用して、アプリケーションを OpenShift Container Platform で作成できます。

以下では、開発者を対象に、OpenShift Container Platform Web コンソールを使用して、インストールされた Operator からアプリケーションを作成する例を示します。

3.3.1. Operator を使用した etcd クラスターの作成

この手順では、Operator Lifecycle Manager (OLM) で管理される etcd Operator を使用した新規 etcd クラスターの作成を説明します。

前提条件

- OpenShift Container Platform 4.15 クラスターにアクセスできる。

- 管理者によってクラスター全体に etcd Operator がすでにインストールされている。

手順

-

この手順を実行するために OpenShift Container Platform Web コンソールで新規プロジェクトを作成します。この例では、

my-etcdというプロジェクトを使用します。 Operators → Installed Operators ページに移動します。クラスター管理者によってクラスターにインストールされ、使用可能にされた Operator がクラスターサービスバージョン (CSV) のリストとしてここに表示されます。CSV は Operator によって提供されるソフトウェアを起動し、管理するために使用されます。

ヒント以下を使用して、CLI でこのリストを取得できます。

oc get csv

$ oc get csvCopy to Clipboard Copied! Toggle word wrap Toggle overflow Installed Operators ページで、etcd Operator をクリックして詳細情報および選択可能なアクションを表示します。

Provided APIs に表示されているように、この Operator は 3 つの新規リソースタイプを利用可能にします。これには、etcd クラスター (

EtcdClusterリソース) のタイプが含まれます。これらのオブジェクトは、DeploymentまたはReplicaSetなどの組み込み済みのネイティブ Kubernetes オブジェクトと同様に機能しますが、これらには etcd を管理するための固有のロジックが含まれます。新規 etcd クラスターを作成します。

- etcd Cluster API ボックスで、Create instance をクリックします。

-

次のページでは、

EtcdClusterオブジェクト (クラスターのサイズなど) のテンプレートを起動する最小条件を変更できます。ここでは Create をクリックして確定します。これにより、Operator がトリガーされ、Pod、サービス、および新規 etcd クラスターの他のコンポーネントが起動します。

example etcd クラスター、Resources タブの順にクリックし、Operator が自動的に作成および設定した多数のリソースが含まれていることを確認します。

Kubernetes サービスが作成され、プロジェクトの他の Pod からデータベースにアクセスできることを確認します。

所定プロジェクトで

editロールを持つすべてのユーザーは、クラウドサービスのようにセルフサービス方式でプロジェクトにすでに作成されている Operators によって管理されるアプリケーションのインスタンス (この例では etcd クラスター) を作成し、管理し、削除することができます。この機能を持つ追加のユーザーを有効にする必要がある場合、プロジェクト管理者は以下のコマンドを使用してこのロールを追加できます。oc policy add-role-to-user edit <user> -n <target_project>

$ oc policy add-role-to-user edit <user> -n <target_project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

これで、etcd クラスターは Pod が正常でなくなったり、クラスターのノード間で移行する際の障害に対応し、データのリバランスを行います。最も重要な点として、適切なアクセスを持つクラスター管理者または開発者は独自のアプリケーションでデータベースを簡単に使用できるようになります。

3.4. CLI を使用したアプリケーションの作成

OpenShift Container Platform CLI を使用して、ソースまたはバイナリーコード、イメージおよびテンプレートを含むコンポーネントから OpenShift Container Platform アプリケーションを作成できます。

new-app で作成したオブジェクトのセットは、ソースリポジトリー、イメージまたはテンプレートなどのインプットとして渡されるアーティファクトによって異なります。

3.4.1. ソースコードからのアプリケーションの作成

new-app コマンドを使用して、ローカルまたはリモート Git リポジトリーのソースコードからアプリケーションを作成できます。

new-app コマンドは、ビルド設定を作成し、これはソースコードから新規のアプリケーションイメージを作成します。new-app コマンドは通常、Deployment オブジェクトを作成して新規のイメージをデプロイするほか、サービスを作成してイメージを実行するデプロイメントへの負荷分散したアクセスを提供します。

OpenShift Container Platform は、パイプライン、ソース、または docker ビルドストラテジーのいずれを使用すべきかを自動的に検出します。また、ソースビルドの場合は、適切な言語のビルダーイメージを検出します。

3.4.1.1. Local

ローカルディレクトリーの Git リポジトリーを使用してアプリケーションを作成するには、以下を実行します。

oc new-app /<path to source code>

$ oc new-app /<path to source code>

ローカル Git リポジトリーを使用する場合には、リポジトリーで OpenShift Container Platform クラスターがアクセス可能な URL を参照する origin という名前のリモートリポジトリーが必要です。認識されているリモートがない場合は、new-app コマンドを実行してバイナリービルドを作成します。

3.4.1.2. リモート

リモート Git リポジトリーを使用してアプリケーションを作成するには、以下を実行します。

oc new-app https://github.com/sclorg/cakephp-ex

$ oc new-app https://github.com/sclorg/cakephp-exプライベートのリモート Git リポジトリーを使用してアプリケーションを作成するには、以下を実行します。

oc new-app https://github.com/youruser/yourprivaterepo --source-secret=yoursecret

$ oc new-app https://github.com/youruser/yourprivaterepo --source-secret=yoursecret

プライベートリモート Git リポジトリーを使用する場合には、--source-secret フラグを使用して、既存のソースクローンのシークレットを指定できます。このシークレットは、ビルド設定に挿入され、リポジトリーにアクセスできるようになります。

--context-dir フラグを指定することで、ソースコードリポジトリーのサブディレクトリーを使用できます。リモート Git リポジトリーおよびコンテキストサブディレクトリーを使用してアプリケーションを作成する場合は、以下を実行します。

oc new-app https://github.com/sclorg/s2i-ruby-container.git \

--context-dir=2.0/test/puma-test-app

$ oc new-app https://github.com/sclorg/s2i-ruby-container.git \

--context-dir=2.0/test/puma-test-app

また、リモート URL を指定する場合は、以下のように URL の最後に #<branch_name> を追加することで、使用する Git ブランチを指定できます。

oc new-app https://github.com/openshift/ruby-hello-world.git#beta4

$ oc new-app https://github.com/openshift/ruby-hello-world.git#beta43.4.1.3. ビルドストラテジーの検出

OpenShift Container Platform は、特定のファイルを検出し、使用するビルドストラテジーを自動的に判別します。

新規アプリケーションの作成時に Jenkins ファイルがソースリポジトリーのルートまたは指定されたコンテキストディレクトリーに存在する場合に、OpenShift Container Platform はパイプラインビルドストラテジーを生成します。

注記pipelineビルドストラテジーは非推奨になりました。代わりに Red Hat OpenShift Pipelines を使用することを検討してください。- 新規アプリケーションの作成時に Dockerfile がソースリポジトリーのルートまたは指定されたコンテキストディレクトリーに存在する場合に、OpenShift Container Platform は docker ビルドストラテジーを生成します。

- Jenkins ファイルも Dockerfile も検出されない場合、OpenShift Container Platform はソースビルドストラテジーを生成します。

--strategy フラグを docker、pipeline、または source に設定して、自動的に検出されたビルドストラテジーを上書きします。

oc new-app /home/user/code/myapp --strategy=docker

$ oc new-app /home/user/code/myapp --strategy=docker

oc コマンドを使用するには、ビルドソースを含むファイルがリモートの git リポジトリーで利用可能である必要があります。すべてのソースビルドには、git remote -v を使用する必要があります。

3.4.1.4. 言語の検出

ソースビルドストラテジーを使用する場合に、new-app はリポジトリーのルートまたは指定したコンテキストディレクトリーに特定のファイルが存在するかどうかで、使用する言語ビルダーを判別しようとします。

| 言語 | ファイル |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

言語の検出後、new-app は OpenShift Container Platform サーバーで、検出言語と一致して supports アノテーションが指定されたイメージストリームタグか、検出された言語の名前に一致するイメージストリームの有無を検索します。一致するものが見つからない場合には、new-app は Docker Hub レジストリー で名前をベースにした検出言語と一致するイメージの検索を行います。

~ をセパレーターとして使用し、イメージ (イメージストリームまたはコンテナーの仕様) とリポジトリーを指定して、ビルダーが特定のソースリポジトリーを使用するようにイメージを上書きすることができます。この方法を使用すると、ビルドストラテジーの検出および言語の検出は実行されない点に留意してください。

たとえば、リモートリポジトリーのソースを使用して myproject/my-ruby イメージストリームを作成する場合は、以下を実行します。

oc new-app myproject/my-ruby~https://github.com/openshift/ruby-hello-world.git

$ oc new-app myproject/my-ruby~https://github.com/openshift/ruby-hello-world.git

ローカルリポジトリーのソースを使用して openshift/ruby-20-centos7:latest コンテナーのイメージストリームを作成するには、以下を実行します。

oc new-app openshift/ruby-20-centos7:latest~/home/user/code/my-ruby-app

$ oc new-app openshift/ruby-20-centos7:latest~/home/user/code/my-ruby-app

言語の検出では、リポジトリーのクローンを作成し、検査できるように Git クライアントをローカルにインストールする必要があります。Git が使用できない場合、<image>~<repository> 構文を指定し、リポジトリーで使用するビルダーイメージを指定して言語の検出手順を回避することができます。

-i <image> <repository> 呼び出しでは、アーティファクトのタイプを判別するために new-app が repository のクローンを試行する必要があります。そのため、これは Git が利用できない場合には失敗します。

-i <image> --code <repository> 呼び出しでは、image がソースコードのビルダーとして使用されるか、データベースイメージの場合のように別個にデプロイされる必要があるかどうかを判別するために、new-app が repository のクローンを作成する必要があります。

3.4.2. イメージからアプリケーションを作成する方法

既存のイメージからアプリケーションのデプロイが可能です。イメージは、OpenShift Container Platform サーバー内のイメージストリーム、指定したレジストリー内のイメージ、またはローカルの Docker サーバー内のイメージから取得できます。

new-app コマンドは、渡された引数に指定されたイメージの種類を判断しようとします。ただし、イメージが、--docker-image 引数を使用したコンテナーイメージなのか、-i|--image-stream 引数を使用したイメージストリームなのかを、new-app に明示的に指示できます。

ローカル Docker リポジトリーからイメージを指定した場合、同じイメージが OpenShift Container Platform のクラスターノードでも利用できることを確認する必要があります。

3.4.2.1. Docker Hub MySQL イメージ

たとえば、Docker Hub MySQL イメージからアプリケーションを作成するには、以下を実行します。

oc new-app mysql

$ oc new-app mysql3.4.2.2. プライベートレジストリーのイメージ

プライベートのレジストリーのイメージを使用してアプリケーションを作成し、コンテナーイメージの仕様全体を以下のように指定します。

oc new-app myregistry:5000/example/myimage

$ oc new-app myregistry:5000/example/myimage3.4.2.3. 既存のイメージストリームおよびオプションのイメージストリームタグ

既存のイメージストリームおよび任意のイメージストリームタグでアプリケーションを作成します。

oc new-app my-stream:v1

$ oc new-app my-stream:v13.4.3. テンプレートからのアプリケーションの作成

テンプレート名を引数として指定することで、事前に保存したテンプレートまたはテンプレートファイルからアプリケーションを作成することができます。たとえば、サンプルアプリケーションテンプレートを保存し、これを利用してアプリケーションを作成できます。

現在のプロジェクトのテンプレートライブラリーにアプリケーションテンプレートをアップロードします。以下の例では、examples/sample-app/application-template-stibuild.json というファイルからアプリケーションテンプレートをアップロードします。

oc create -f examples/sample-app/application-template-stibuild.json

$ oc create -f examples/sample-app/application-template-stibuild.json

次に、アプリケーションテンプレートを参照して新規アプリケーションを作成します。この例では、テンプレート名は ruby-helloworld-sample です。

oc new-app ruby-helloworld-sample

$ oc new-app ruby-helloworld-sample

OpenShift Container Platform にテンプレートファイルを保存せずに、ローカルファイルシステムでテンプレートファイルを参照して新規アプリケーションを作成するには、-f|--file 引数を使用します。以下に例を示します。

oc new-app -f examples/sample-app/application-template-stibuild.json

$ oc new-app -f examples/sample-app/application-template-stibuild.json3.4.3.1. テンプレートパラメーター

テンプレートをベースとするアプリケーションを作成する場合、以下の -p|--param 引数を使用してテンプレートで定義したパラメーター値を設定します。

oc new-app ruby-helloworld-sample \

-p ADMIN_USERNAME=admin -p ADMIN_PASSWORD=mypassword

$ oc new-app ruby-helloworld-sample \

-p ADMIN_USERNAME=admin -p ADMIN_PASSWORD=mypassword

パラメーターをファイルに保存しておいて、--param-file を指定して、テンプレートをインスタンス化する時にこのファイルを使用することができます。標準入力からパラメーターを読み込む必要がある場合は、以下のように --param-file=- を使用します。以下は、helloworld.params というファイルの例です。

ADMIN_USERNAME=admin ADMIN_PASSWORD=mypassword

ADMIN_USERNAME=admin

ADMIN_PASSWORD=mypasswordテンプレートをインスタンス化する時に、ファイルのパラメーターを参照します。

oc new-app ruby-helloworld-sample --param-file=helloworld.params

$ oc new-app ruby-helloworld-sample --param-file=helloworld.params3.4.4. アプリケーション作成の変更

new-app コマンドは、OpenShift Container Platform オブジェクトを生成します。このオブジェクトにより、作成されるアプリケーションがビルドされ、デプロイされ、実行されます。通常、これらのオブジェクトは現在のプロジェクトに作成され、これらのオブジェクトには入力ソースリポジトリーまたはインプットイメージから派生する名前が割り当てられます。ただし、new-app でこの動作を変更することができます。

| オブジェクト | 説明 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

| その他 | テンプレートのインスタンスを作成する際に、他のオブジェクトをテンプレートに基づいて生成できます。 |

3.4.4.1. 環境変数の指定

テンプレート、ソースまたはイメージからアプリケーションを生成する場合、-e|--env 引数を使用し、ランタイムに環境変数をアプリケーションコンテナーに渡すことができます。

oc new-app openshift/postgresql-92-centos7 \

-e POSTGRESQL_USER=user \

-e POSTGRESQL_DATABASE=db \

-e POSTGRESQL_PASSWORD=password

$ oc new-app openshift/postgresql-92-centos7 \

-e POSTGRESQL_USER=user \

-e POSTGRESQL_DATABASE=db \

-e POSTGRESQL_PASSWORD=password

変数は、--env-file 引数を使用してファイルから読み取ることもできます。以下は、postgresql.env というファイルの例です。

POSTGRESQL_USER=user POSTGRESQL_DATABASE=db POSTGRESQL_PASSWORD=password

POSTGRESQL_USER=user

POSTGRESQL_DATABASE=db

POSTGRESQL_PASSWORD=passwordファイルから変数を読み取ります。

oc new-app openshift/postgresql-92-centos7 --env-file=postgresql.env

$ oc new-app openshift/postgresql-92-centos7 --env-file=postgresql.env

さらに --env-file=- を使用することで、標準入力で環境変数を指定することもできます。

cat postgresql.env | oc new-app openshift/postgresql-92-centos7 --env-file=-

$ cat postgresql.env | oc new-app openshift/postgresql-92-centos7 --env-file=-

-e|--env または --env-file 引数で渡される環境変数では、new-app 処理の一環として作成される BuildConfig オブジェクトは更新されません。

3.4.4.2. ビルド環境変数の指定

テンプレート、ソースまたはイメージからアプリケーションを生成する場合、--build-env 引数を使用し、ランタイムに環境変数をビルドコンテナーに渡すことができます。

oc new-app openshift/ruby-23-centos7 \

--build-env HTTP_PROXY=http://myproxy.net:1337/ \

--build-env GEM_HOME=~/.gem

$ oc new-app openshift/ruby-23-centos7 \

--build-env HTTP_PROXY=http://myproxy.net:1337/ \

--build-env GEM_HOME=~/.gem

変数は、--build-env-file 引数を使用してファイルから読み取ることもできます。以下は、ruby.env というファイルの例です。

HTTP_PROXY=http://myproxy.net:1337/ GEM_HOME=~/.gem

HTTP_PROXY=http://myproxy.net:1337/

GEM_HOME=~/.gemファイルから変数を読み取ります。

oc new-app openshift/ruby-23-centos7 --build-env-file=ruby.env

$ oc new-app openshift/ruby-23-centos7 --build-env-file=ruby.env

さらに --build-env-file=- を使用して、環境変数を標準入力で指定することもできます。

cat ruby.env | oc new-app openshift/ruby-23-centos7 --build-env-file=-

$ cat ruby.env | oc new-app openshift/ruby-23-centos7 --build-env-file=-3.4.4.3. ラベルの指定

ソース、イメージ、またはテンプレートからアプリケーションを生成する場合、-l|--label 引数を使用し、作成されたオブジェクトにラベルを追加できます。ラベルを使用すると、アプリケーションに関連するオブジェクトを一括で選択、設定、削除することが簡単になります。

oc new-app https://github.com/openshift/ruby-hello-world -l name=hello-world

$ oc new-app https://github.com/openshift/ruby-hello-world -l name=hello-world3.4.4.4. 作成前の出力の表示

new-app コマンドの実行に関するドライランを確認するには、yaml または json の値と共に -o|--output 引数を使用できます。次にこの出力を使用して、作成されるオブジェクトのプレビューまたは編集可能なファイルへのリダイレクトを実行できます。問題がなければ、oc create を使用して OpenShift Container Platform オブジェクトを作成できます。

new-app アーティファクトをファイルに出力するには、以下を実行します。

oc new-app https://github.com/openshift/ruby-hello-world \

-o yaml > myapp.yaml

$ oc new-app https://github.com/openshift/ruby-hello-world \

-o yaml > myapp.yamlファイルを編集します。

vi myapp.yaml

$ vi myapp.yamlファイルを参照して新規アプリケーションを作成します。

oc create -f myapp.yaml

$ oc create -f myapp.yaml3.4.4.5. 別名でのオブジェクトの作成

通常 new-app で作成されるオブジェクトの名前はソースリポジトリーまたは生成に使用されたイメージに基づいて付けられます。コマンドに --name フラグを追加することで、生成されたオブジェクトの名前を設定できます。

oc new-app https://github.com/openshift/ruby-hello-world --name=myapp

$ oc new-app https://github.com/openshift/ruby-hello-world --name=myapp3.4.4.6. 別のプロジェクトでのオブジェクトの作成

通常 new-app は現在のプロジェクトにオブジェクトを作成します。ただし、-n|--namespace 引数を使用して、別のプロジェクトにオブジェクトを作成することができます。

oc new-app https://github.com/openshift/ruby-hello-world -n myproject

$ oc new-app https://github.com/openshift/ruby-hello-world -n myproject3.4.4.7. 複数のオブジェクトの作成

new-app コマンドは、複数のパラメーターを new-app に指定して複数のアプリケーションを作成できます。コマンドラインで指定するラベルは、単一コマンドで作成されるすべてのオブジェクトに適用されます。環境変数は、ソースまたはイメージから作成されたすべてのコンポーネントに適用されます。

ソースリポジトリーおよび Docker Hub イメージからアプリケーションを作成するには、以下を実行します。

oc new-app https://github.com/openshift/ruby-hello-world mysql

$ oc new-app https://github.com/openshift/ruby-hello-world mysql

ソースコードリポジトリーおよびビルダーイメージが別個の引数として指定されている場合、new-app はソースコードリポジトリーのビルダーとしてそのビルダーイメージを使用します。これを意図していない場合は、~ セパレーターを使用してソースに必要なビルダーイメージを指定します。

3.4.4.8. 単一 Pod でのイメージとソースのグループ化

new-app コマンドにより、単一 Pod に複数のイメージをまとめてデプロイできます。グループ化するイメージを指定するには + セパレーターを使用します。--group コマンドライン引数をグループ化する必要のあるイメージを指定する際に使用することもできます。ソースリポジトリーからビルドされたイメージを別のイメージと共にグループ化するには、そのビルダーイメージをグループで指定します。

oc new-app ruby+mysql

$ oc new-app ruby+mysqlソースからビルドされたイメージと外部のイメージをまとめてデプロイするには、以下を実行します。

oc new-app \

ruby~https://github.com/openshift/ruby-hello-world \

mysql \

--group=ruby+mysql

$ oc new-app \

ruby~https://github.com/openshift/ruby-hello-world \

mysql \

--group=ruby+mysql3.4.4.9. イメージ、テンプレート、および他の入力の検索

イメージ、テンプレート、および oc new-app コマンドの他の入力内容を検索するには、--search フラグおよび --list フラグを追加します。たとえば、PHP を含むすべてのイメージまたはテンプレートを検索するには、以下を実行します。

oc new-app --search php

$ oc new-app --search php3.4.4.10. インポートモードの設定

oc new-app を使用するときにインポートモードを設定するには、--import-mode フラグを追加します。このフラグには Legacy または PreserveOriginal を追加できます。これにより、それぞれ単一のサブマニフェストまたはすべてのマニフェストを使用してイメージストリームを作成するオプションがユーザーに提供されます。

oc new-app --image=registry.redhat.io/ubi8/httpd-24:latest --import-mode=Legacy --name=test

$ oc new-app --image=registry.redhat.io/ubi8/httpd-24:latest --import-mode=Legacy --name=testoc new-app --image=registry.redhat.io/ubi8/httpd-24:latest --import-mode=PreserveOriginal --name=test

$ oc new-app --image=registry.redhat.io/ubi8/httpd-24:latest --import-mode=PreserveOriginal --name=test3.5. Ruby on Rails を使用したアプリケーションの作成

Ruby on Rails は Ruby で記述される Web フレームワークです。このガイドでは、OpenShift Container Platform での Rails 4 の使用を扱います。

チュートリアル全体をチェックして、OpenShift Container Platform でアプリケーションを実行するために必要なすべての手順を概観してください。問題に直面した場合には、チュートリアル全体を振り返り、もう一度問題に対応してください。またチュートリアルは、実行済みの手順を確認し、すべての手順が適切に実行されていることを確認するのに役立ちます。

3.5.1. 前提条件

- Ruby および Rails の基本知識

- Ruby 2.0.0+、Rubygems、Bundler のローカルにインストールされたバージョン

- Git の基本知識

- OpenShift Container Platform v4 の実行インスタンス

-

OpenShift Container Platform のインスタンスが実行中であり、利用可能であることを確認してください。さらに、

ocCLI クライアントがインストールされており、コマンドがコマンドシェルからアクセスできることを確認し、メールアドレスおよびパスワードを使用してログインする際にこれを使用できるようにします。

3.5.2. データベースの設定

Rails アプリケーションはほぼ常にデータベースと併用されます。ローカル開発の場合は、PostgreSQL データベースを使用します。

手順

データベースをインストールします。

sudo yum install -y postgresql postgresql-server postgresql-devel

$ sudo yum install -y postgresql postgresql-server postgresql-develCopy to Clipboard Copied! Toggle word wrap Toggle overflow データベースを初期化します。

sudo postgresql-setup initdb

$ sudo postgresql-setup initdbCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドで

/var/lib/pgsql/dataディレクトリーが作成され、このディレクトリーにデータが保存されます。データベースを起動します。

sudo systemctl start postgresql.service

$ sudo systemctl start postgresql.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow データベースが実行されたら、

railsユーザーを作成します。sudo -u postgres createuser -s rails

$ sudo -u postgres createuser -s railsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 作成をしたユーザーのパスワードは作成されていない点に留意してください。

3.5.3. アプリケーションの作成

Rails アプリケーションをゼロからビルドするには、Rails gem を先にインストールする必要があります。その後に、アプリケーションを作成することができます。

手順

Rails gem をインストールします。

gem install rails

$ gem install railsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Successfully installed rails-4.3.0 1 gem installed

Successfully installed rails-4.3.0 1 gem installedCopy to Clipboard Copied! Toggle word wrap Toggle overflow Rails gem のインストール後に、PostgreSQL をデータベースとして指定して新規アプリケーションを作成します。

rails new rails-app --database=postgresql

$ rails new rails-app --database=postgresqlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 新規アプリケーションディレクトリーに切り替えます。

cd rails-app

$ cd rails-appCopy to Clipboard Copied! Toggle word wrap Toggle overflow アプリケーションがすでにある場合には

pg(postgresql) gem がGemfileに配置されていることを確認します。配置されていない場合には、gem を追加してGemfileを編集します。gem 'pg'

gem 'pg'Copy to Clipboard Copied! Toggle word wrap Toggle overflow すべての依存関係を含む

Gemfile.lockを新たに生成します。bundle install

$ bundle installCopy to Clipboard Copied! Toggle word wrap Toggle overflow pggem でpostgresqlデータベースを使用するほか、config/database.ymlがpostgresqlアダプターを使用していることを確認する必要があります。config/database.ymlファイルのdefaultセクションを以下のように更新するようにしてください。Copy to Clipboard Copied! Toggle word wrap Toggle overflow アプリケーションの開発およびテスト用のデータベースを作成します。

rake db:create

$ rake db:createCopy to Clipboard Copied! Toggle word wrap Toggle overflow これで PostgreSQL サーバーに

developmentおよびtestデータベースが作成されます。

3.5.3.1. Welcome ページの作成

Rails 4 では静的な public/index.html ページが実稼働環境で提供されなくなったので、新たに root ページを作成する必要があります。

Welcome ページをカスタマイズするには、以下の手順を実行する必要があります。

- index アクションでコントローラーを作成します。

- welcome コントローラーの index アクションの view ページを作成します。

- 作成したコントローラーとビューと共にアプリケーションの root ページを提供するルートを作成します。

Rails には、これらの必要な手順をすべて実行するジェネレーターがあります。

手順

Rails ジェネレーターを実行します。

rails generate controller welcome index

$ rails generate controller welcome indexCopy to Clipboard Copied! Toggle word wrap Toggle overflow すべての必要なファイルが作成されます。

以下のように

config/routes.rbファイルの 2 行目を編集します。root 'welcome#index'

root 'welcome#index'Copy to Clipboard Copied! Toggle word wrap Toggle overflow rails server を実行して、ページが利用できることを確認します。

rails server

$ rails serverCopy to Clipboard Copied! Toggle word wrap Toggle overflow ブラウザーで http://localhost:3000 に移動してページを表示してください。このページが表示されない場合は、サーバーに出力されるログを確認してデバッグを行ってください。

3.5.3.2. OpenShift Container Platform のアプリケーションの設定

アプリケーションが OpenShift Container Platform で実行中の PostgreSQL データベースサービスと通信できるようにするには、後のデータベースサービスの作成時に定義する必要のある環境変数を使用できるように config/database.yml の default セクションを編集する必要があります。

手順

以下のように事前に定義した変数で、

config/database.ymlのdefaultセクションを編集します。config/databaseYAML ファイルのサンプルCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5.3.3. アプリケーションの Git への保存

通常 OpenShift Container Platform でアプリケーションをビルドする場合、ソースコードを git リポジトリーに保存する必要があるため、git がない場合にはインストールしてください。

前提条件

- git をインストールします。

手順

ls -1コマンドを実行して、Rails アプリケーションのディレクトリーで操作を行っていることを確認します。コマンドの出力は以下のようになります。ls -1

$ ls -1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Rails app ディレクトリーで以下のコマンドを実行して、コードを初期化し、git にコミットします。

git init

$ git initCopy to Clipboard Copied! Toggle word wrap Toggle overflow git add .

$ git add .Copy to Clipboard Copied! Toggle word wrap Toggle overflow git commit -m "initial commit"

$ git commit -m "initial commit"Copy to Clipboard Copied! Toggle word wrap Toggle overflow アプリケーションがコミットされたら、これをリモートリポジトリーにプッシュする必要があります。新規リポジトリーを作成する GitHub アカウントです。

お使いの

gitリポジトリーを参照するリモートを設定します。git remote add origin git@github.com:<namespace/repository-name>.git

$ git remote add origin git@github.com:<namespace/repository-name>.gitCopy to Clipboard Copied! Toggle word wrap Toggle overflow アプリケーションをリモートの git リポジトリーにプッシュします。

git push

$ git pushCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5.4. アプリケーションの OpenShift Container Platform へのデプロイ

OpenShift Container Platform にアプリケーションをデプロイすることができます。

rails-app プロジェクトの作成後、新規プロジェクトの namespace に自動的に切り替えられます。

OpenShift Container Platform へのアプリケーションのデプロイでは 3 つの手順を実行します。

- OpenShift Container Platform の PostgreSQL イメージからデータベースサービスを作成します。

- データベースサービスと連動する OpenShift Container Platform の Ruby 2.0 ビルダーイメージおよび Ruby on Rails ソースコードのフロントエンドサービスを作成します。

- アプリケーションのルートを作成します。

手順

Ruby on Rails アプリケーションをデプロイするには、アプリケーション用に新規のプロジェクトを作成します。

oc new-project rails-app --description="My Rails application" --display-name="Rails Application"

$ oc new-project rails-app --description="My Rails application" --display-name="Rails Application"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5.4.1. データベースサービスの作成

Rails アプリケーションには実行中のデータベースサービスが必要です。このサービスには、PostgreSQL データベースイメージを使用します。

データベースサービスを作成するために、oc new-app コマンドを使用します。このコマンドには、必要な環境変数を渡す必要があります。この環境変数は、データベースコンテナー内で使用します。これらの環境変数は、ユーザー名、パスワード、およびデータベースの名前を設定するために必要です。これらの環境変数の値を任意の値に変更できます。変数は以下のようになります。

- POSTGRESQL_DATABASE

- POSTGRESQL_USER

- POSTGRESQL_PASSWORD

これらの変数を設定すると、以下を確認できます。

- 指定の名前のデータベースが存在する

- 指定の名前のユーザーが存在する

- ユーザーは指定のパスワードで指定のデータベースにアクセスできる

手順

データベースサービスを作成します。

oc new-app postgresql -e POSTGRESQL_DATABASE=db_name -e POSTGRESQL_USER=username -e POSTGRESQL_PASSWORD=password

$ oc new-app postgresql -e POSTGRESQL_DATABASE=db_name -e POSTGRESQL_USER=username -e POSTGRESQL_PASSWORD=passwordCopy to Clipboard Copied! Toggle word wrap Toggle overflow データベース管理者のパスワードを設定するには、直前のコマンドに以下を追加します。

-e POSTGRESQL_ADMIN_PASSWORD=admin_pw

-e POSTGRESQL_ADMIN_PASSWORD=admin_pwCopy to Clipboard Copied! Toggle word wrap Toggle overflow 進行状況を確認します。

oc get pods --watch

$ oc get pods --watchCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5.4.2. フロントエンドサービスの作成

アプリケーションを OpenShift Container Platform にデプロイするには、アプリケーションが置かれるリポジトリーを指定する必要があります。

手順

フロントエンドサービスを作成し、データベースサービスの作成時に設定されたデータベース関連の環境変数を指定します。

oc new-app path/to/source/code --name=rails-app -e POSTGRESQL_USER=username -e POSTGRESQL_PASSWORD=password -e POSTGRESQL_DATABASE=db_name -e DATABASE_SERVICE_NAME=postgresql

$ oc new-app path/to/source/code --name=rails-app -e POSTGRESQL_USER=username -e POSTGRESQL_PASSWORD=password -e POSTGRESQL_DATABASE=db_name -e DATABASE_SERVICE_NAME=postgresqlCopy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンドでは、OpenShift Container Platform は指定された環境変数を使用してソースコードの取得、ビルダーのセットアップ、アプリケーションイメージのビルド、新規に作成されたイメージのデプロイを実行します。このアプリケーションには

rails-appという名前を指定します。rails-appデプロイメント設定の JSON ドキュメントを参照して、環境変数が追加されたかどうかを確認できます。oc get dc rails-app -o json

$ oc get dc rails-app -o jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のセクションが表示されるはずです。

出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ビルドプロセスを確認します。

oc logs -f build/rails-app-1

$ oc logs -f build/rails-app-1Copy to Clipboard Copied! Toggle word wrap Toggle overflow ビルドが完了すると、OpenShift Container Platform で Pod が実行されていることを確認します。

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow myapp-<number>-<hash>で始まる行が表示されますが、これは OpenShift Container Platform で実行中のアプリケーションです。データベースの移行スクリプトを実行してデータベースを初期化してからでないと、アプリケーションは機能しません。これを実行する 2 種類の方法があります。

実行中のフロントエンドコンテナーから手動で実行する

rshコマンドでフロントエンドコンテナーに exec を実行します。oc rsh <frontend_pod_id>

$ oc rsh <frontend_pod_id>Copy to Clipboard Copied! Toggle word wrap Toggle overflow コンテナー内から移行を実行します。

RAILS_ENV=production bundle exec rake db:migrate

$ RAILS_ENV=production bundle exec rake db:migrateCopy to Clipboard Copied! Toggle word wrap Toggle overflow developmentまたはtest環境で Rails アプリケーションを実行する場合には、RAILS_ENVの環境変数を指定する必要はありません。

- デプロイメント前のライフサイクルフックをテンプレートに追する

3.5.4.3. アプリケーションのルートの作成

アプリケーションのルートを作成するためにサービスを公開できます。

手順

www.example.comなどの外部からアクセスできるホスト名を指定してサービスを公開するには、OpenShift Container Platform のルートを使用します。この場合は、以下を入力してフロントエンドサービスを公開する必要があります。oc expose service rails-app --hostname=www.example.com

$ oc expose service rails-app --hostname=www.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow

指定するホスト名がルーターの IP アドレスに解決することを確認します。

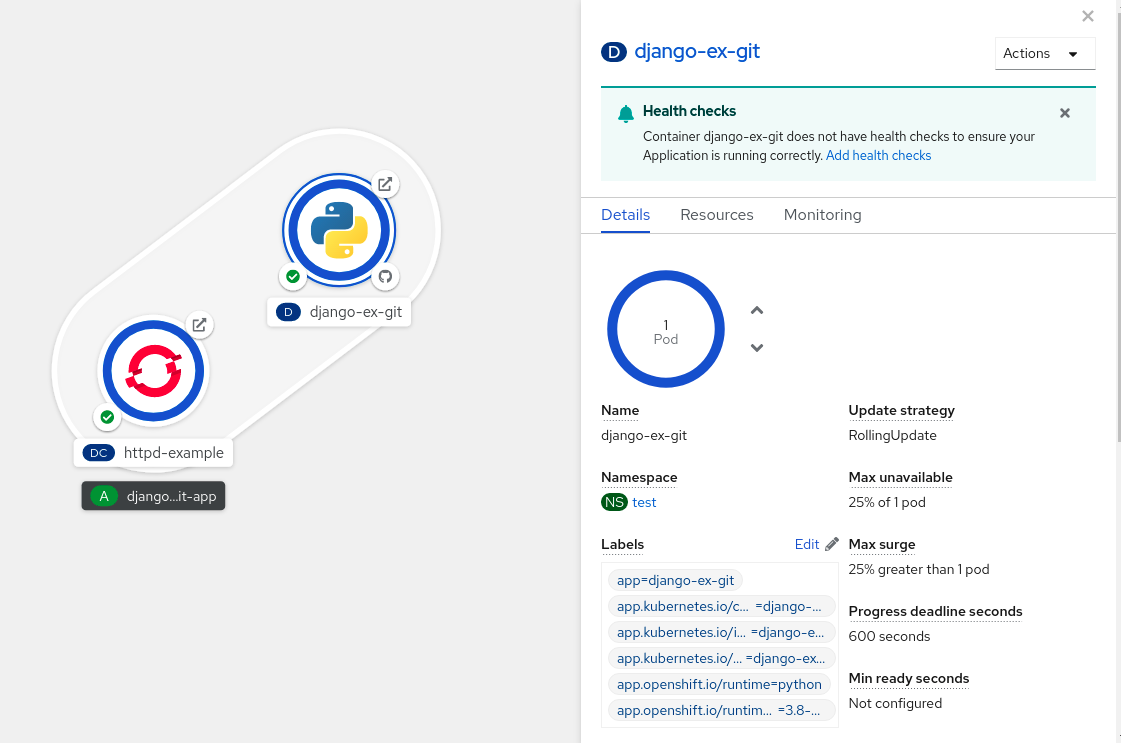

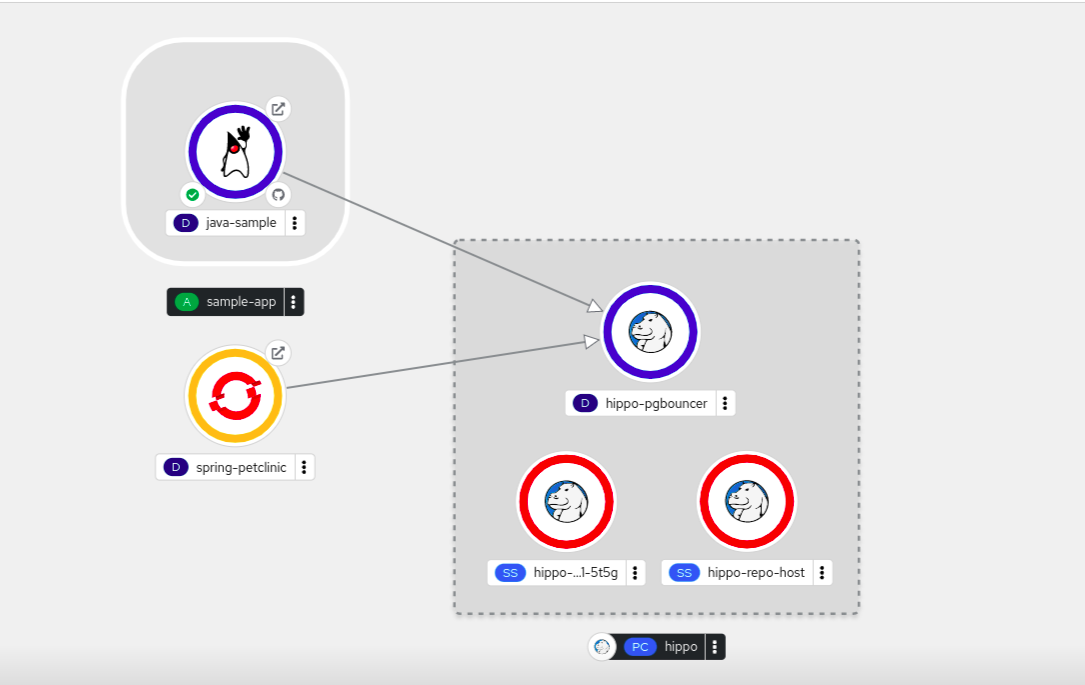

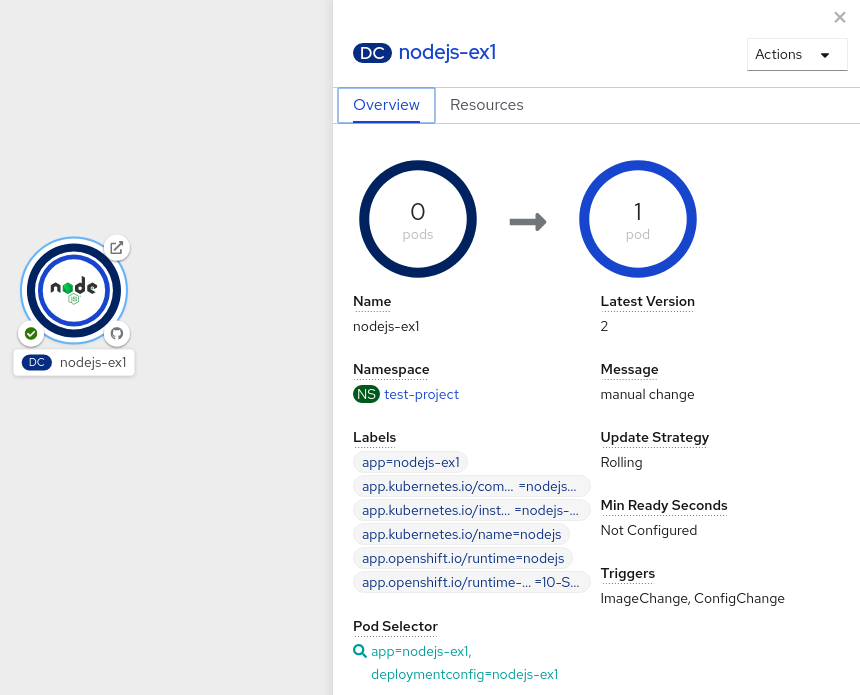

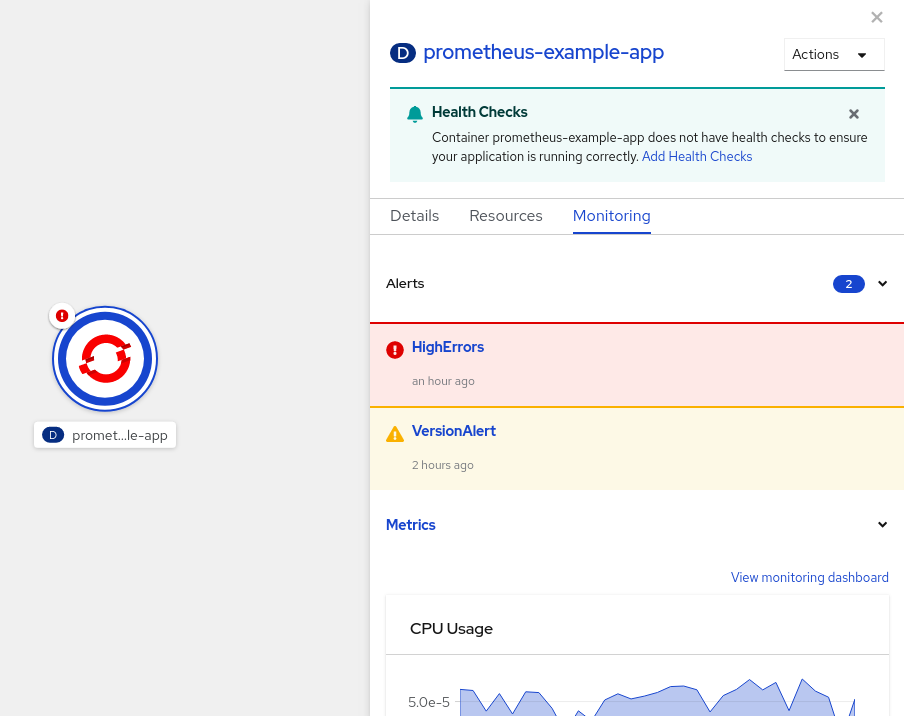

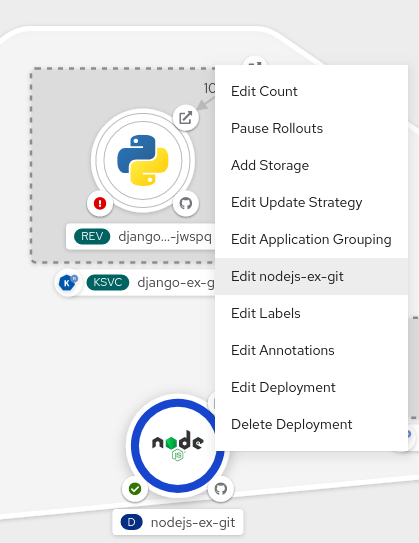

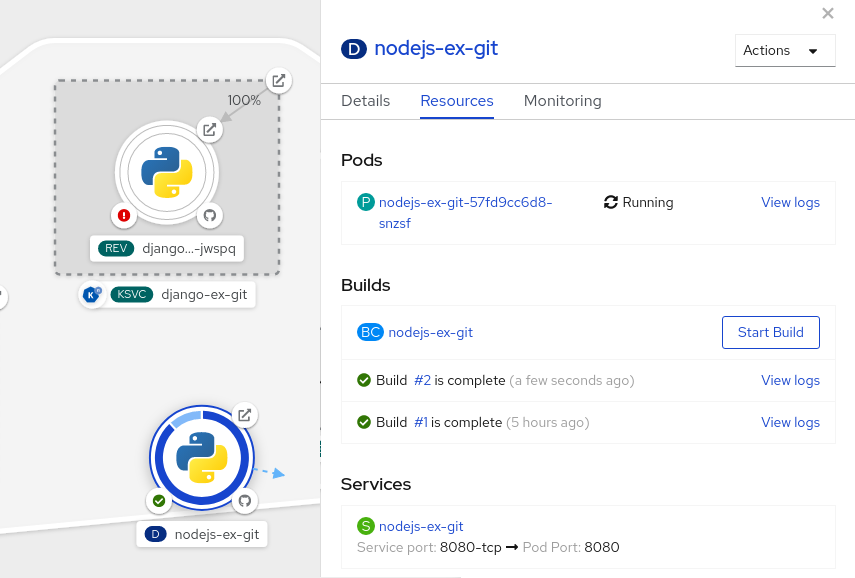

第4章 Topology ビューを使用したアプリケーション構成の表示

Web コンソールの Developer パースペクティブにある Topology ビューは、プロジェクト内のすべてのアプリケーション、それらのビルドステータスおよびアプリケーションに関連するコンポーネントとサービスを視覚的に表示します。

4.1. 前提条件

Topology ビューでアプリケーションを表示し、それらと対話するには、以下を確認します。

- Web コンソールにログイン している。

- OpenShift Container Platform でアプリケーションおよび他のワークロードを作成するための適切なプロジェクト内の ロールおよび権限 がある。

- Developer パースペクティブを使用して OpenShift Container Platform でアプリケーションを作成し、デプロイしている。

- Developer パースペクティブを使用している。

4.2. アプリケーションのトポロジーの表示

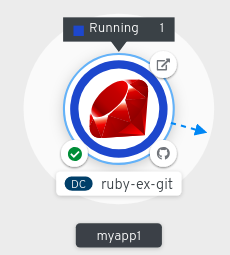

Developer パースペクティブの左側のナビゲーションパネルを使用すると、Topology ビューに移動できます。アプリケーションをデプロイしたら、Graph view に自動的に移動します。ここでは、アプリケーション Pod のステータスの確認、パブリック URL でのアプリケーションへの迅速なアクセス、ソースコードへのアクセスとその変更、最終ビルドのステータスの確認ができます。ズームインおよびズームアウトにより、特定のアプリケーションの詳細を表示することができます。

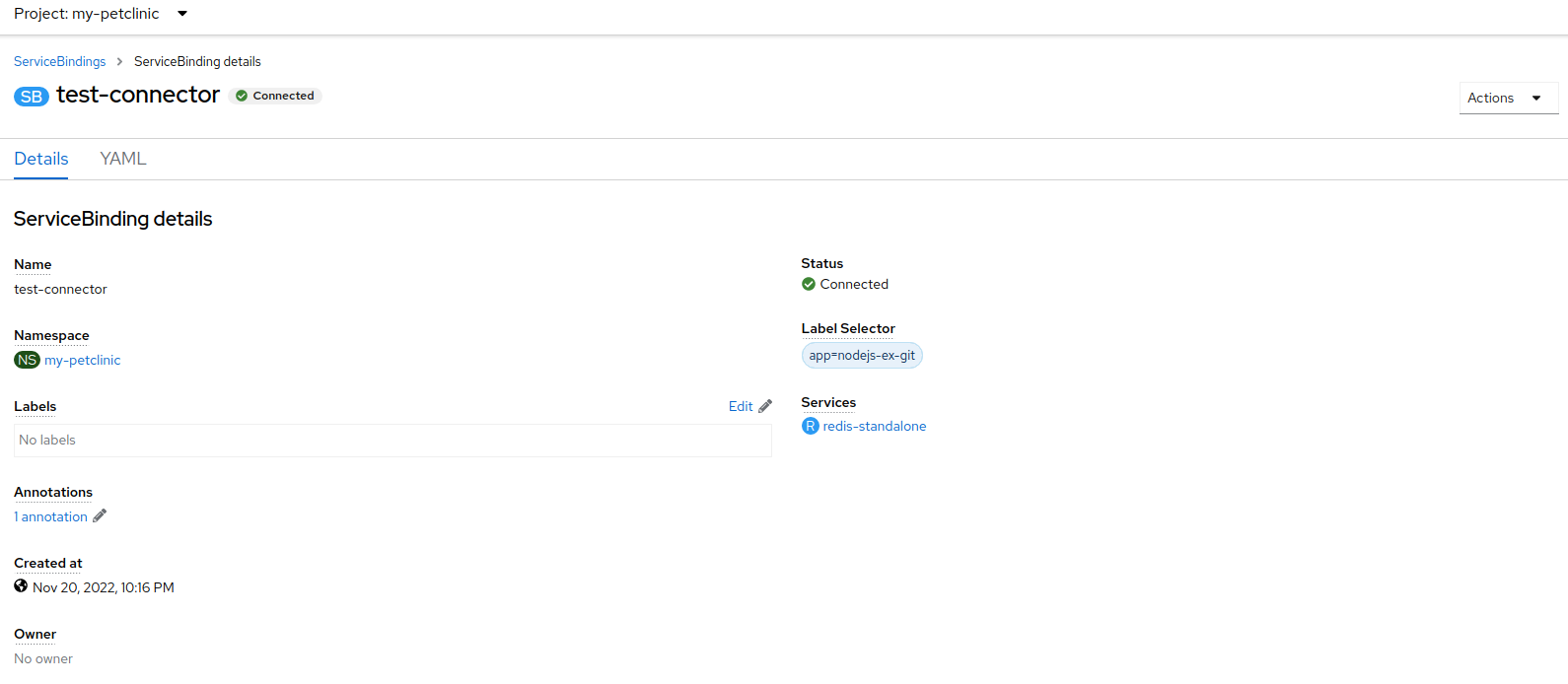

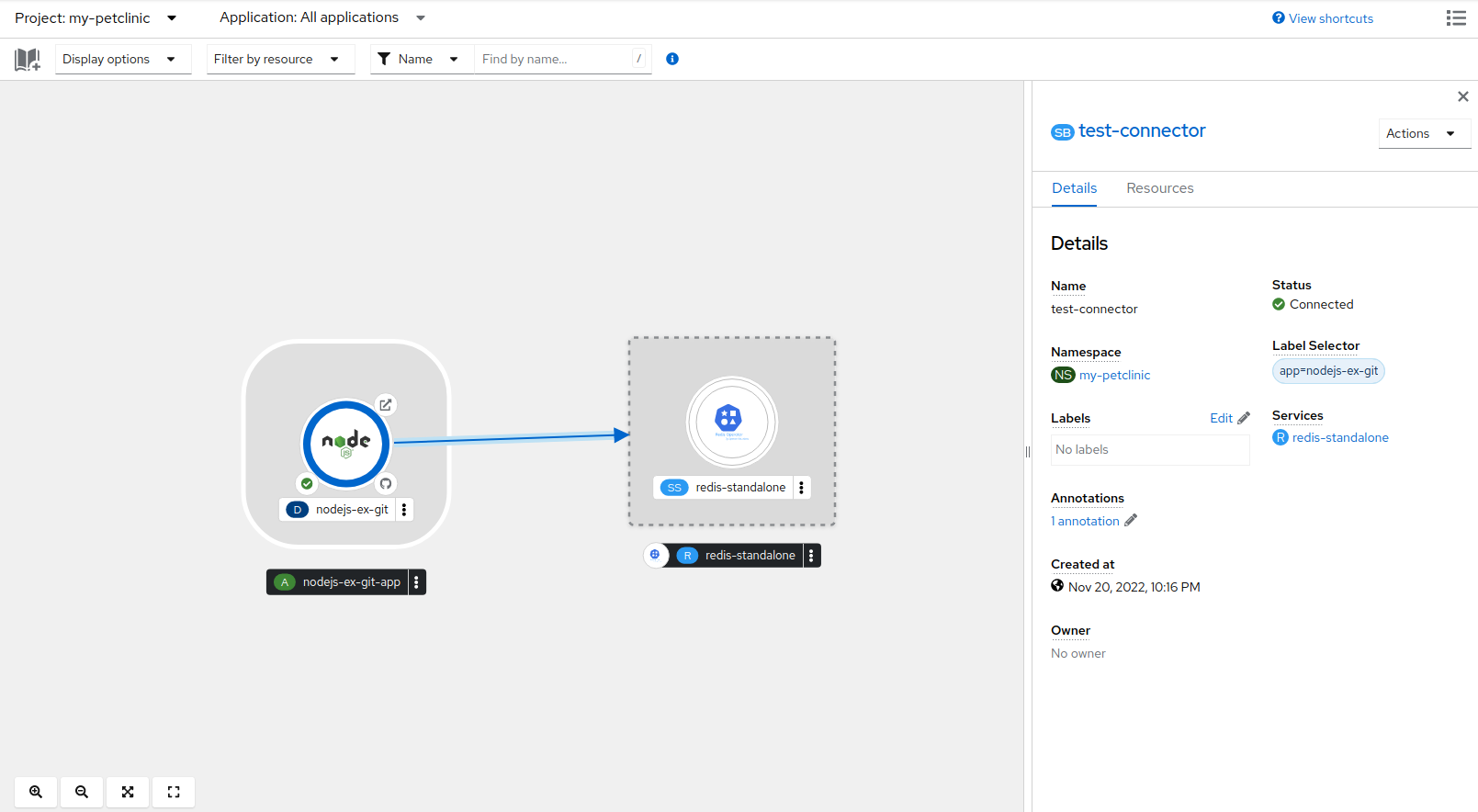

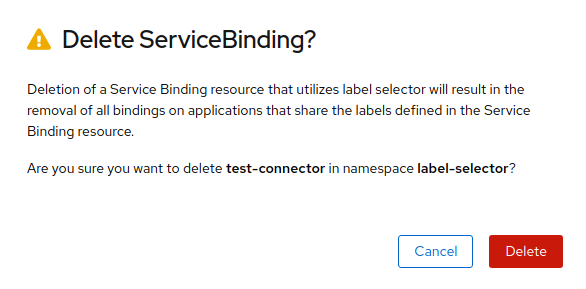

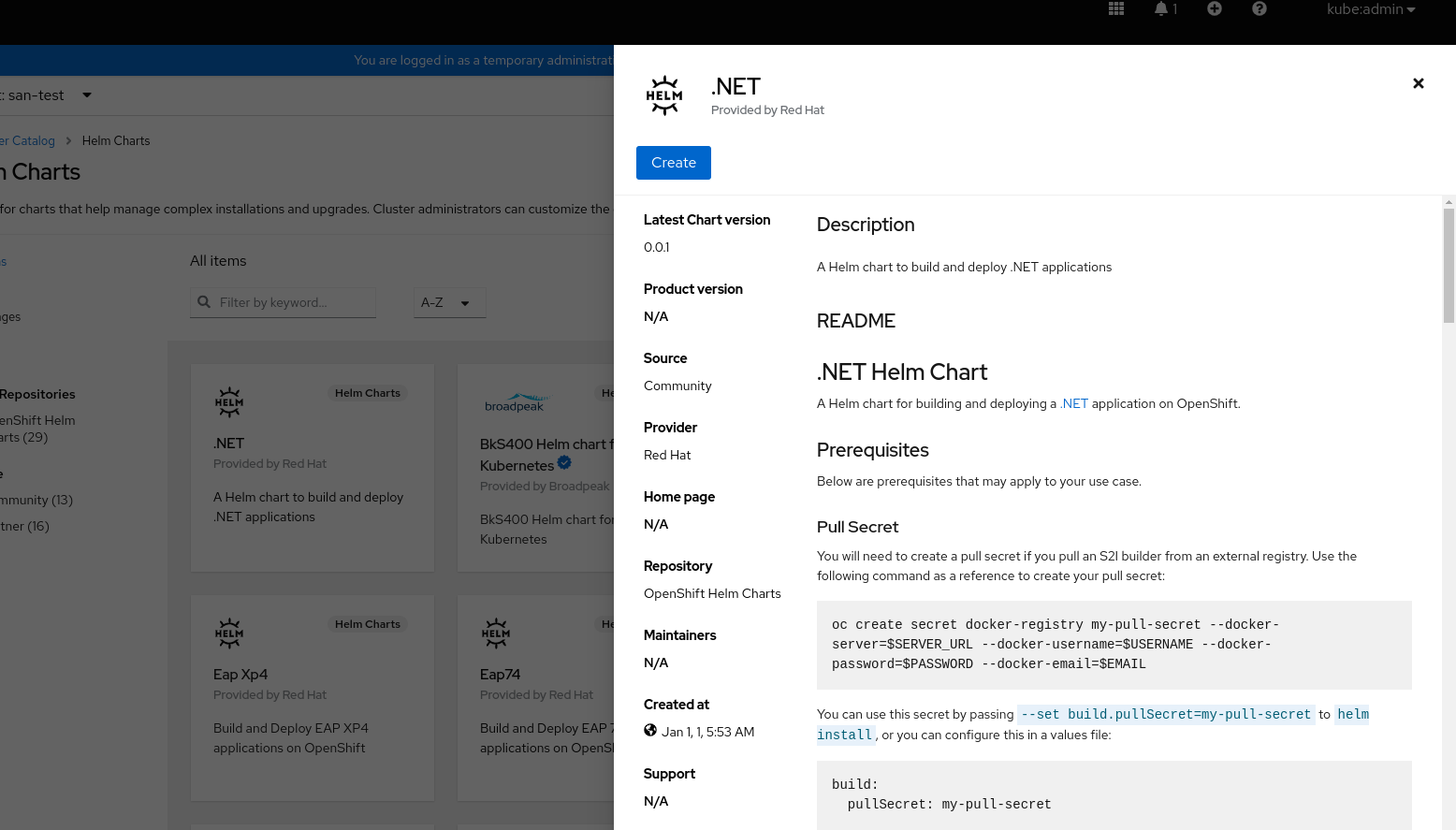

Topology ビューは、List ビューを使用してアプリケーションを監視するオプションも提供します。List view アイコン (