CLI ツール

OpenShift Container Platform コマンドラインツールの使用方法

概要

第1章 OpenShift Container Platform CLI ツールの概要

OpenShift Container Platform での作業中に、次のようなさまざまな操作を実行します。

- クラスターの管理

- アプリケーションのビルド、デプロイ、および管理

- デプロイメントプロセスの管理

- Operator の開発

- Operator カタログの作成と保守

OpenShift Container Platform には、一連のコマンドラインインターフェイス (CLI) ツールが同梱されており、ユーザーがターミナルからさまざまな管理および開発操作を実行できるようにしてこれらのタスクを簡素化します。これらのツールでは、アプリケーションの管理だけでなく、システムの各コンポーネントを操作する簡単なコマンドを利用できます。

1.1. CLI ツールのリスト

OpenShift Container Platform では、以下の CLI ツールのセットを使用できます。

-

OpenShift CLI (

oc): これは OpenShift Container Platform ユーザーが最も一般的に使用する CLI ツールです。これは、クラスター管理者と開発者の両方が、ターミナルを使用して OpenShift Container Platform 全体でエンドツーエンドの操作が行えるようにします。Web コンソールとは異なり、ユーザーはコマンドスクリプトを使用してプロジェクトのソースコードを直接操作できます。 -

Knative CLI (kn): (

kn) CLI ツールは、Knative Serving や Eventing などの OpenShift サーバーレスコンポーネントの操作に使用できるシンプルで直感的なターミナルコマンドを提供します。 -

Pipelines CLI (tkn):OpenShift Pipelines は、内部で Tekton を使用する OpenShift Container Platform の継続的インテグレーションおよび継続的デリバリー (CI / CD) ソリューションです。

tknCLI ツールには、シンプルで直感的なコマンドが同梱されており、ターミナルを使用して OpenShift パイプラインを操作できます。 -

opm CLI:

opmCLI ツールは、Operator 開発者とクラスター管理者がターミナルから Operator のカタログを作成および保守するのに役立ちます。 - Operator SDK: Operator Framework のコンポーネントである Operator SDK は、Operator 開発者がターミナルから Operator のビルド、テストおよびデプロイに使用できる CLI ツールを提供します。これにより、Kubernetes ネイティブアプリケーションを構築するプロセスが簡素化されます。これには、アプリケーション固有の深い運用知識が必要になる場合があります。

第2章 OpenShift CLI (oc)

2.1. OpenShift CLI のスタートガイド

2.1.1. OpenShift CLI について

OpenShift CLI (oc) を使用すると、ターミナルからアプリケーションを作成し、OpenShift Container Platform プロジェクトを管理できます。OpenShift CLI は以下の状況に適しています。

- プロジェクトソースコードを直接使用している。

- OpenShift Container Platform 操作をスクリプト化する。

- 帯域幅リソースによる制限があり、Web コンソールが利用できない状況でのプロジェクトの管理

2.1.2. OpenShift CLI のインストール

OpenShift CLI(oc) をインストールするには、バイナリーをダウンロードするか、RPM を使用します。

2.1.2.1. バイナリーのダウンロードによる OpenShift CLI のインストール

コマンドラインインターフェイスを使用して OpenShift Container Platform と対話するために CLI (oc) をインストールすることができます。oc は Linux、Windows、または macOS にインストールできます。

以前のバージョンの oc をインストールしている場合、これを使用して OpenShift Container Platform 4.15 のすべてのコマンドを実行することはできません。新規バージョンの oc をダウンロードし、インストールします。

2.1.2.1.1. Linux への OpenShift CLI のインストール

以下の手順を使用して、OpenShift CLI (oc) バイナリーを Linux にインストールできます。

手順

- Red Hat カスタマーポータルの OpenShift Container Platform ダウンロードページ に移動します。

- Product Variant ドロップダウンリストからアーキテクチャーを選択します。

- バージョン ドロップダウンリストから適切なバージョンを選択します。

- OpenShift v4.15 Linux Clients エントリーの横にある Download Now をクリックして、ファイルを保存します。

アーカイブを展開します。

tar xvf <file>

$ tar xvf <file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ocバイナリーを、PATHにあるディレクトリーに配置します。PATHを確認するには、以下のコマンドを実行します。echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

OpenShift CLI のインストール後に、

ocコマンドを使用して利用できます。oc <command>

$ oc <command>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.2.1.2. Windows への OpenShift CLI のインストール

以下の手順を使用して、OpenShift CLI (oc) バイナリーを Windows にインストールできます。

手順

- Red Hat カスタマーポータルの OpenShift Container Platform ダウンロードページ に移動します。

- バージョン ドロップダウンリストから適切なバージョンを選択します。

- OpenShift v4.15 Windows Client エントリーの横にある Download Now をクリックして、ファイルを保存します。

- ZIP プログラムでアーカイブを展開します。

ocバイナリーを、PATHにあるディレクトリーに移動します。PATHを確認するには、コマンドプロンプトを開いて以下のコマンドを実行します。path

C:\> pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

OpenShift CLI のインストール後に、

ocコマンドを使用して利用できます。oc <command>

C:\> oc <command>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.2.1.3. macOS への OpenShift CLI のインストール

以下の手順を使用して、OpenShift CLI (oc) バイナリーを macOS にインストールできます。

手順

- Red Hat カスタマーポータルの OpenShift Container Platform ダウンロードページ に移動します。

- バージョン ドロップダウンリストから適切なバージョンを選択します。

OpenShift v4.15 macOS Clients エントリーの横にある Download Now をクリックして、ファイルを保存します。

注記macOS arm64 の場合は、OpenShift v4.15 macOS arm64 Client エントリーを選択します。

- アーカイブを展開し、解凍します。

ocバイナリーをパスにあるディレクトリーに移動します。PATHを確認するには、ターミナルを開き、以下のコマンドを実行します。echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

ocコマンドを使用してインストールを確認します。oc <command>

$ oc <command>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

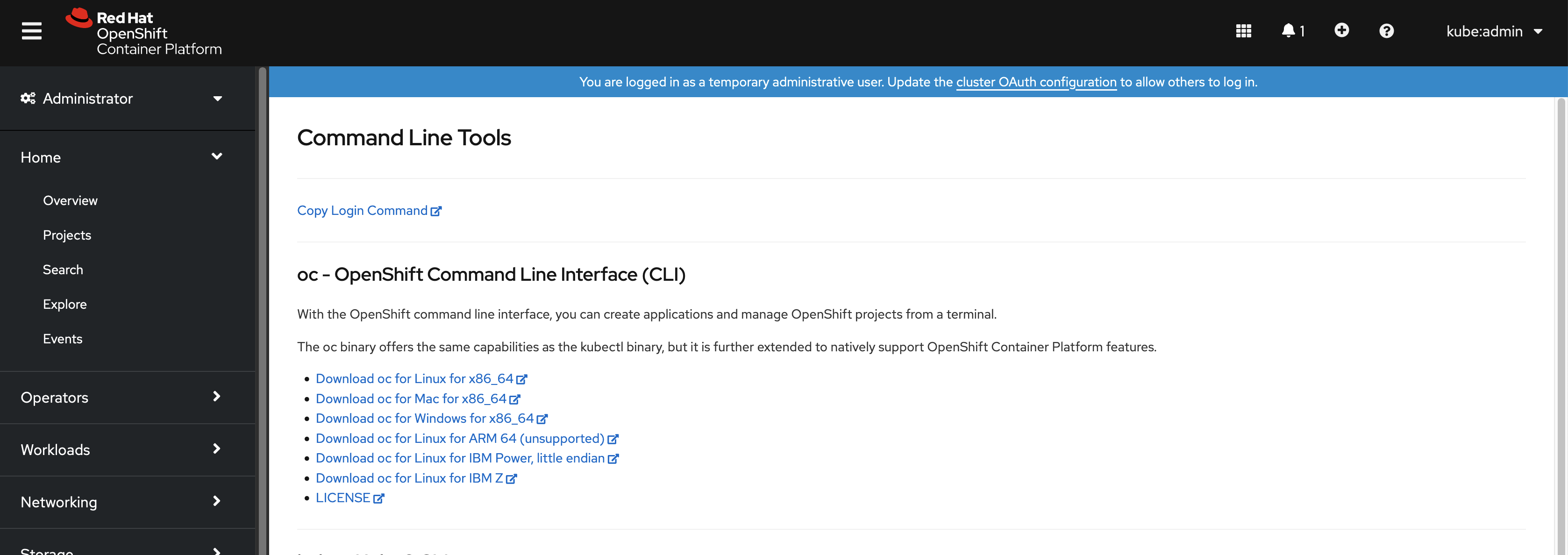

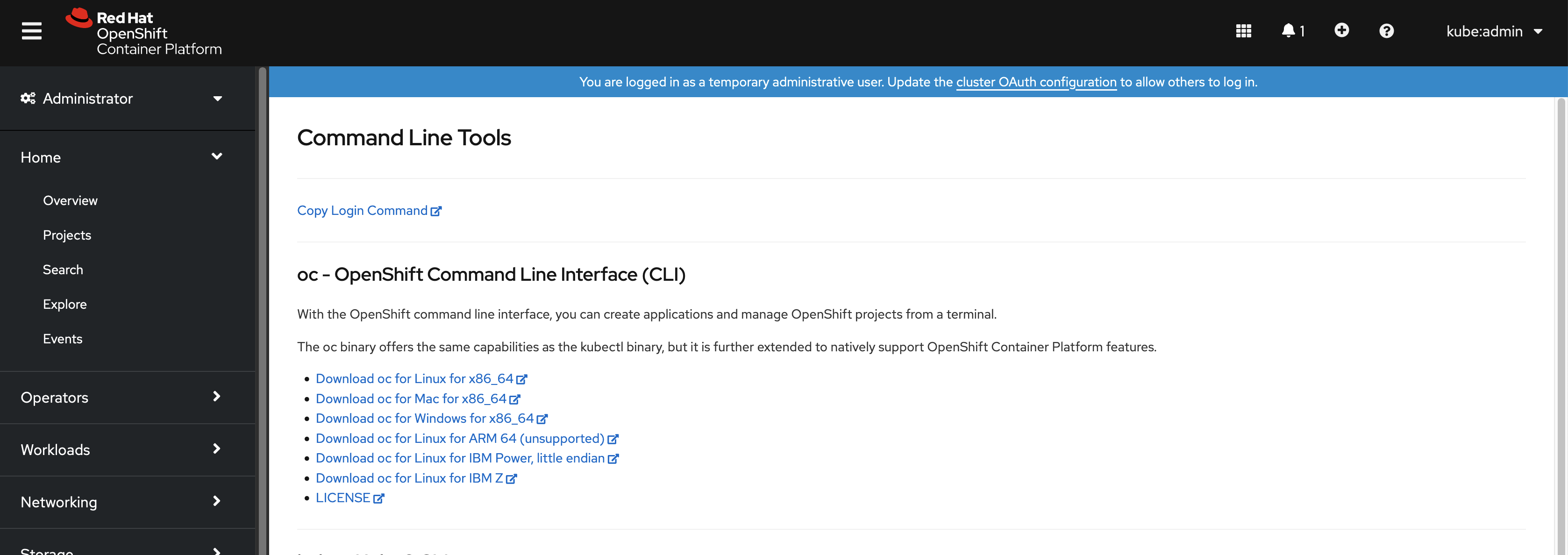

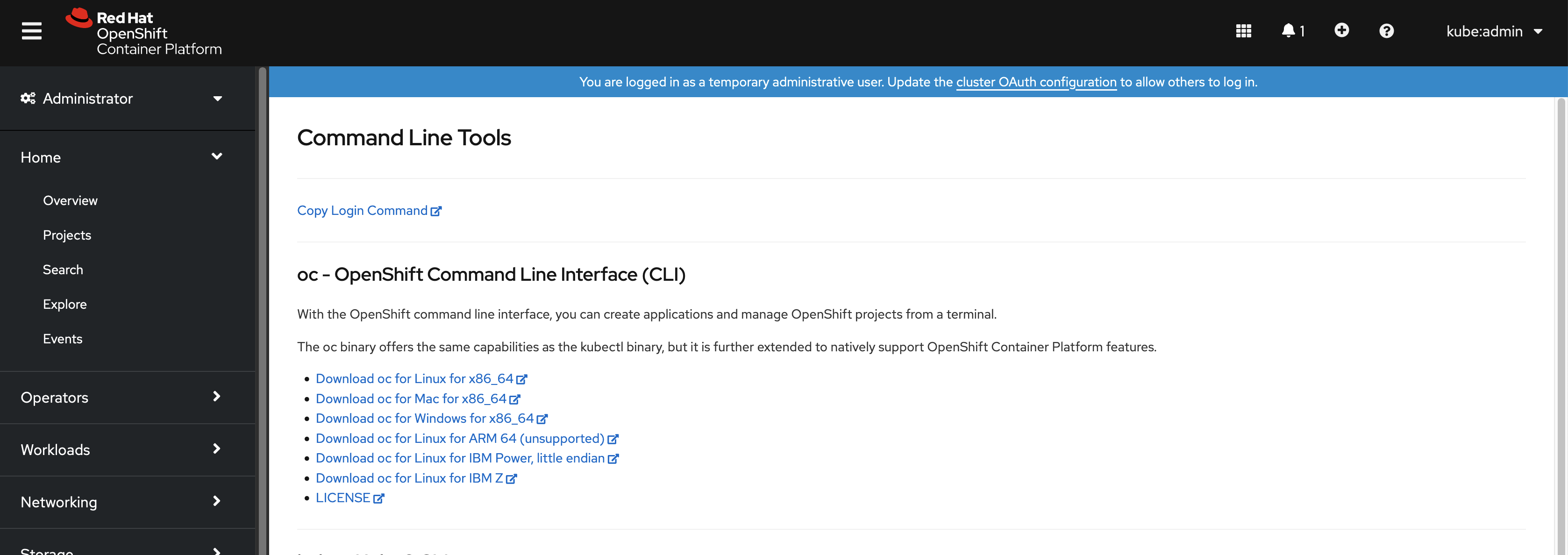

2.1.2.2. Web コンソールを使用した OpenShift CLI のインストール

OpenShift CLI(oc) をインストールして、Web コンソールから OpenShift Container Platform と対話できます。oc は Linux、Windows、または macOS にインストールできます。

以前のバージョンの oc をインストールしている場合、これを使用して OpenShift Container Platform 4.15 のすべてのコマンドを実行することはできません。新しいバージョンの oc をダウンロードしてインストールしてください。

2.1.2.2.1. Web コンソールを使用した Linux への OpenShift CLI のインストール

以下の手順を使用して、OpenShift CLI (oc) バイナリーを Linux にインストールできます。

手順

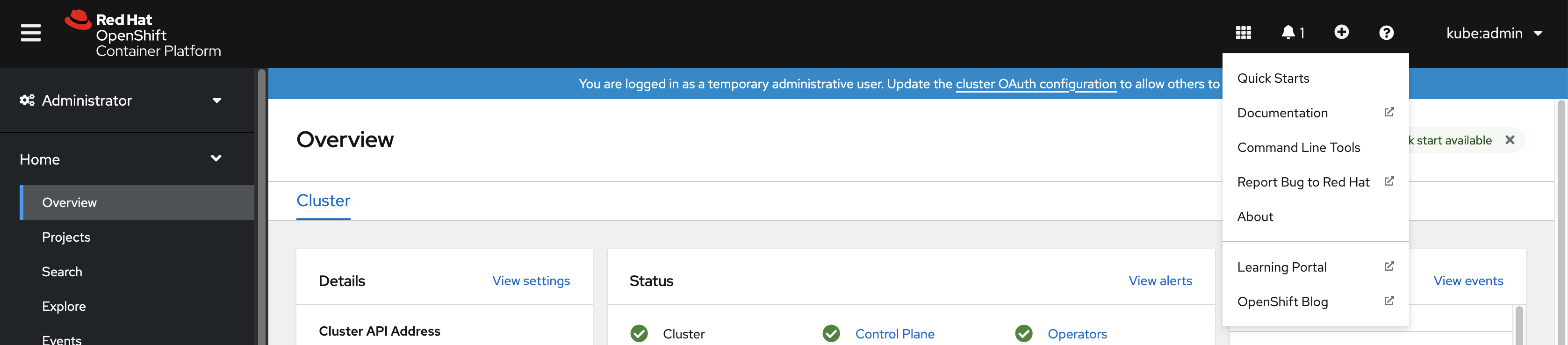

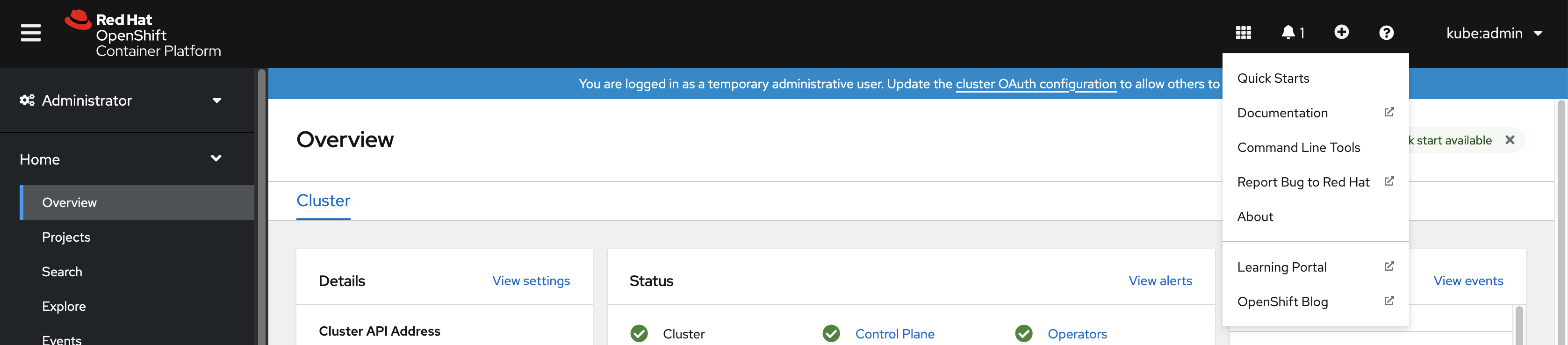

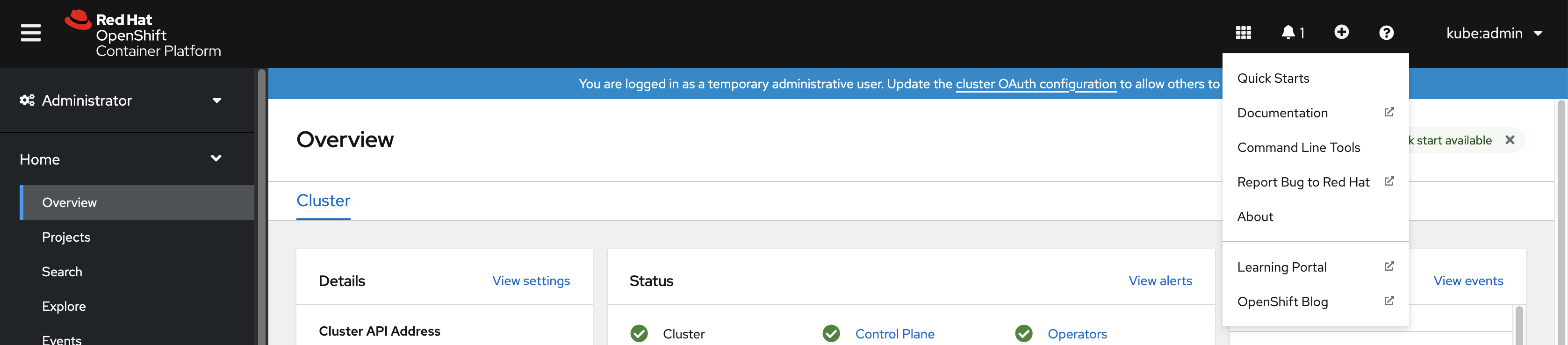

Web コンソールで ? をクリックします。

コマンドラインツール をクリックします。

-

Linux プラットフォームに適した

ocbinary を選択してから、Download oc for Linux をクリックします。 - ファイルを保存します。

アーカイブを展開します。

tar xvf <file>

$ tar xvf <file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ocバイナリーを、PATHにあるディレクトリーに移動します。PATHを確認するには、以下のコマンドを実行します。echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

OpenShift CLI のインストール後に、oc コマンドを使用して利用できます。

oc <command>

$ oc <command>2.1.2.2.2. Web コンソールを使用した Windows への OpenShift CLI のインストール

以下の手順を使用して、OpenShift CLI (oc) バイナリーを Windows にインストールできます。

手順

Web コンソールで ? をクリックします。

コマンドラインツール をクリックします。

-

Windows プラットフォームの

ocバイナリーを選択してから、Download oc for Windows for x86_64 をクリックします。 - ファイルを保存します。

- ZIP プログラムでアーカイブを展開します。

ocバイナリーを、PATHにあるディレクトリーに移動します。PATHを確認するには、コマンドプロンプトを開いて以下のコマンドを実行します。path

C:\> pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow

OpenShift CLI のインストール後に、oc コマンドを使用して利用できます。

oc <command>

C:\> oc <command>2.1.2.2.3. Web コンソールを使用した macOS への OpenShift CLI のインストール

以下の手順を使用して、OpenShift CLI (oc) バイナリーを macOS にインストールできます。

手順

Web コンソールで ? をクリックします。

コマンドラインツール をクリックします。

macOS プラットフォームの

ocバイナリーを選択し、Download oc for Mac for x86_64 をクリックします。注記macOS arm64 の場合は、Download oc for Mac for ARM 64 をクリックします。

- ファイルを保存します。

- アーカイブを展開し、解凍します。

ocバイナリーをパスにあるディレクトリーに移動します。PATHを確認するには、ターミナルを開き、以下のコマンドを実行します。echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

OpenShift CLI のインストール後に、oc コマンドを使用して利用できます。

oc <command>

$ oc <command>2.1.2.3. RPM を使用した OpenShift CLI のインストール

Red Hat Enterprise Linux (RHEL) の場合、Red Hat アカウントに有効な OpenShift Container Platform サブスクリプションがある場合は、OpenShift CLI (oc) を RPM としてインストールできます。

バイナリーをダウンロードして、RHEL 9 用の oc をインストールする必要があります。RPM パッケージを使用した oc のインストールは、Red Hat Enterprise Linux (RHEL) 9 ではサポートされていません。

前提条件

- root または sudo の権限がある。

手順

Red Hat Subscription Manager に登録します。

subscription-manager register

# subscription-manager registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 最新のサブスクリプションデータをプルします。

subscription-manager refresh

# subscription-manager refreshCopy to Clipboard Copied! Toggle word wrap Toggle overflow 利用可能なサブスクリプションをリストします。

subscription-manager list --available --matches '*OpenShift*'

# subscription-manager list --available --matches '*OpenShift*'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 直前のコマンドの出力で、OpenShift Container Platform サブスクリプションのプール ID を見つけ、これを登録されたシステムにアタッチします。

subscription-manager attach --pool=<pool_id>

# subscription-manager attach --pool=<pool_id>Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform 4.15 で必要なリポジトリーを有効にします。

subscription-manager repos --enable="rhocp-4.15-for-rhel-8-x86_64-rpms"

# subscription-manager repos --enable="rhocp-4.15-for-rhel-8-x86_64-rpms"Copy to Clipboard Copied! Toggle word wrap Toggle overflow openshift-clientsパッケージをインストールします。yum install openshift-clients

# yum install openshift-clientsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

-

ocコマンドを使用してインストールを確認します。

oc <command>

$ oc <command>2.1.2.4. Homebrew を使用した OpenShift CLI のインストール

macOS の場合は、Homebrew パッケージマネージャーを使用して OpenShift CLI (oc) をインストールできます。

前提条件

-

Homebrew (

brew) がインストールされている。

手順

以下のコマンドを実行して openshift-cli パッケージをインストールします。

brew install openshift-cli

$ brew install openshift-cliCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

-

ocコマンドを使用してインストールを確認します。

oc <command>

$ oc <command>2.1.3. OpenShift CLI へのログイン

OpenShift CLI (oc) にログインしてクラスターにアクセスし、これを管理できます。

前提条件

- OpenShift Container Platform クラスターへのアクセス。

-

OpenShift CLI (

oc) がインストールされている。

HTTP プロキシーサーバー上でのみアクセスできるクラスターにアクセスするには、HTTP_PROXY、HTTPS_PROXY および NO_PROXY 変数を設定できます。これらの環境変数は、クラスターとのすべての通信が HTTP プロキシーを経由するように oc CLI で使用されます。

認証ヘッダーは、HTTPS トランスポートを使用する場合にのみ送信されます。

手順

oc loginコマンドを入力し、ユーザー名を渡します。oc login -u user1

$ oc login -u user1Copy to Clipboard Copied! Toggle word wrap Toggle overflow プロンプトが表示されたら、必要な情報を入力します。

出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Web コンソールにログインしている場合には、トークンおよびサーバー情報を含む oc login コマンドを生成できます。このコマンドを使用して、対話プロンプトなしに OpenShift Container Platform CLI にログインできます。コマンドを生成するには、Web コンソールの右上にあるユーザー名のドロップダウンメニューから Copy login command を選択します。

これで、プロジェクトを作成でき、クラスターを管理するための他のコマンドを実行することができます。

2.1.4. Web ブラウザーを使用した OpenShift CLI へのログイン

Web ブラウザーを使用して OpenShift CLI (oc) にログインし、クラスターにアクセスして管理できます。これにより、ユーザーはアクセストークンをコマンドラインに挿入する必要がなくなります。

Web ブラウザー経由で CLI にログインすると、HTTPS ではなく HTTP を使用してローカルホスト上のサーバーが実行します。マルチユーザーワークステーションでは注意して使用してください。

前提条件

- OpenShift Container Platform クラスターへのアクセス。

-

OpenShift CLI (

oc) がインストールされている。 - ブラウザーがインストールされている。

手順

--webフラグを指定してoc loginコマンドを入力します。oc login <cluster_url> --web

$ oc login <cluster_url> --web1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- オプションで、サーバー URL とコールバックポートを指定できます。たとえば、

oc login <cluster_url> --web --callback-port 8280 localhost:8443です。

Web ブラウザーが自動的に開きます。表示されない場合は、コマンド出力内のリンクをクリックします。OpenShift Container Platform サーバーを指定しない場合、

ocは現在のoc設定ファイルで指定されているクラスターの Web コンソールを開こうとします。oc設定が存在しない場合、ocはサーバー URL を対話的に要求します。出力例

Opening login URL in the default browser: https://openshift.example.com Opening in existing browser session.

Opening login URL in the default browser: https://openshift.example.com Opening in existing browser session.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 複数の認証プロバイダーが使用できる場合は、提供されるオプションから選択します。

-

ユーザー名とパスワードをブラウザーの対応するフィールドに入力します。ログインすると、ブラウザーには

access token received successfully; please return to your terminalと表示されます。 CLI でログイン確認を確認します。

出力例

Login successful. You don't have any projects. You can try to create a new project, by running oc new-project <projectname>Login successful. You don't have any projects. You can try to create a new project, by running oc new-project <projectname>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Web コンソールのデフォルトは、前のセッションで使用されたプロファイルになります。管理者プロファイルと開発者プロファイルを切り替えるには、OpenShift Container Platform Web コンソールからログアウトし、キャッシュをクリアします。

これで、プロジェクトを作成でき、クラスターを管理するための他のコマンドを実行することができます。

2.1.5. OpenShift CLI の使用

以下のセクションで、CLI を使用して一般的なタスクを実行する方法を確認します。

2.1.5.1. プロジェクトの作成

新規プロジェクトを作成するには、oc new-project コマンドを使用します。

oc new-project my-project

$ oc new-project my-project出力例

Now using project "my-project" on server "https://openshift.example.com:6443".

Now using project "my-project" on server "https://openshift.example.com:6443".2.1.5.2. 新しいアプリケーションの作成

新規アプリケーションを作成するには、oc new-app コマンドを使用します。

oc new-app https://github.com/sclorg/cakephp-ex

$ oc new-app https://github.com/sclorg/cakephp-ex出力例

--> Found image 40de956 (9 days old) in imagestream "openshift/php" under tag "7.2" for "php"

...

Run 'oc status' to view your app.

--> Found image 40de956 (9 days old) in imagestream "openshift/php" under tag "7.2" for "php"

...

Run 'oc status' to view your app.2.1.5.3. Pod の表示

現在のプロジェクトの Pod を表示するには、oc get pods コマンドを使用します。

Pod 内で oc を実行し、namespace を指定しない場合は、Pod の namespace がデフォルトで使用されます。

oc get pods -o wide

$ oc get pods -o wide出力例

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE cakephp-ex-1-build 0/1 Completed 0 5m45s 10.131.0.10 ip-10-0-141-74.ec2.internal <none> cakephp-ex-1-deploy 0/1 Completed 0 3m44s 10.129.2.9 ip-10-0-147-65.ec2.internal <none> cakephp-ex-1-ktz97 1/1 Running 0 3m33s 10.128.2.11 ip-10-0-168-105.ec2.internal <none>

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE

cakephp-ex-1-build 0/1 Completed 0 5m45s 10.131.0.10 ip-10-0-141-74.ec2.internal <none>

cakephp-ex-1-deploy 0/1 Completed 0 3m44s 10.129.2.9 ip-10-0-147-65.ec2.internal <none>

cakephp-ex-1-ktz97 1/1 Running 0 3m33s 10.128.2.11 ip-10-0-168-105.ec2.internal <none>2.1.5.4. Pod ログの表示

特定の Pod のログを表示するには、oc logs コマンドを使用します。

oc logs cakephp-ex-1-deploy

$ oc logs cakephp-ex-1-deploy出力例

--> Scaling cakephp-ex-1 to 1 --> Success

--> Scaling cakephp-ex-1 to 1

--> Success2.1.5.5. 現在のプロジェクトの表示

現在のプロジェクトを表示するには、oc project コマンドを使用します。

oc project

$ oc project出力例

Using project "my-project" on server "https://openshift.example.com:6443".

Using project "my-project" on server "https://openshift.example.com:6443".2.1.5.6. 現在のプロジェクトのステータスの表示

サービス、デプロイメント、およびビルド設定などの現在のプロジェクトに関する情報を表示するには、oc status コマンドを使用します。

oc status

$ oc status出力例

2.1.5.7. サポートされる API のリソースのリスト表示

サーバー上でサポートされる API リソースのリストを表示するには、oc api-resources コマンドを使用します。

oc api-resources

$ oc api-resources出力例

NAME SHORTNAMES APIGROUP NAMESPACED KIND bindings true Binding componentstatuses cs false ComponentStatus configmaps cm true ConfigMap ...

NAME SHORTNAMES APIGROUP NAMESPACED KIND

bindings true Binding

componentstatuses cs false ComponentStatus

configmaps cm true ConfigMap

...2.1.6. ヘルプの表示

CLI コマンドおよび OpenShift Container Platform リソースに関するヘルプを以下の方法で表示することができます。

利用可能なすべての CLI コマンドのリストおよび説明を表示するには、

oc helpを使用します。例: CLI に関する一般的なヘルプの表示

oc help

$ oc helpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 特定の CLI コマンドに関するヘルプを表示するには、

--helpフラグを使用します。例:

oc createコマンドに関するヘルプの表示oc create --help

$ oc create --helpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 特定リソースに関する説明およびフィールドを表示するには、

oc explainコマンドを使用します。例:

Podリソースのドキュメントの表示oc explain pods

$ oc explain podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.1.7. OpenShift CLI からのログアウト

OpenShift CLI からログアウトし、現在のセッションを終了することができます。

oc logoutコマンドを使用します。oc logout

$ oc logoutCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Logged "user1" out on "https://openshift.example.com"

Logged "user1" out on "https://openshift.example.com"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

これにより、サーバーから保存された認証トークンが削除され、設定ファイルから除去されます。

2.2. OpenShift CLI の設定

2.2.1. タブ補完の有効化

Bash または Zsh シェルのタブ補完を有効にできます。

2.2.1.1. Bash のタブ補完の有効化

OpenShift CLI (oc) ツールをインストールした後に、タブ補完を有効にして oc コマンドの自動補完を実行するか、Tab キーを押す際にオプションの提案が表示されるようにできます。次の手順では、Bash シェルのタブ補完を有効にします。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

bash-completionパッケージがインストールされている。

手順

Bash 補完コードをファイルに保存します。

oc completion bash > oc_bash_completion

$ oc completion bash > oc_bash_completionCopy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを

/etc/bash_completion.d/にコピーします。sudo cp oc_bash_completion /etc/bash_completion.d/

$ sudo cp oc_bash_completion /etc/bash_completion.d/Copy to Clipboard Copied! Toggle word wrap Toggle overflow さらにファイルをローカルディレクトリーに保存した後に、これを

.bashrcファイルから取得できるようにすることができます。

タブ補完は、新規ターミナルを開くと有効になります。

2.2.1.2. Zsh のタブ補完の有効化

OpenShift CLI (oc) ツールをインストールした後に、タブ補完を有効にして oc コマンドの自動補完を実行するか、Tab キーを押す際にオプションの提案が表示されるようにできます。次の手順では、Zsh シェルのタブ補完を有効にします。

前提条件

-

OpenShift CLI (

oc) がインストールされている。

手順

ocのタブ補完を.zshrcファイルに追加するには、次のコマンドを実行します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

タブ補完は、新規ターミナルを開くと有効になります。

2.3. oc および kubectl コマンドの使用

Kubernetes のコマンドラインインターフェイス (CLI) kubectl は、Kubernetes クラスターに対してコマンドを実行するのに使用されます。OpenShift Container Platform は認定 Kubernetes ディストリビューションであるため、OpenShift Container Platform に同梱されるサポート対象の kubectl バイナリーを使用するか、または oc バイナリーを使用して拡張された機能を取得できます。

2.3.1. oc バイナリー

oc バイナリーは kubectl バイナリーと同じ機能を提供しますが、これは、以下を含む OpenShift Container Platform 機能をネイティブにサポートするように拡張されています。

OpenShift Container Platform リソースの完全サポート

DeploymentConfig、BuildConfig、Route、ImageStream、およびImageStreamTagオブジェクトなどのリソースは OpenShift Container Platform ディストリビューションに固有のリソースであり、標準の Kubernetes プリミティブにビルドされます。認証

ocバイナリーは、認証用の組み込みloginコマンドを提供し、Kubernetes namespace を認証済みユーザーにマップするプロジェクトを操作できるようにします。詳細は、認証について を参照してください。追加コマンド

追加コマンドの

oc new-appなどは、既存のソースコードまたは事前にビルドされたイメージを使用して新規アプリケーションを起動することを容易にします。同様に、追加コマンドのoc new-projectにより、デフォルトとして切り替えることができるプロジェクトを簡単に開始できるようになります。

以前のバージョンの oc バイナリーをインストールしている場合、これを使用して OpenShift Container Platform 4.15 のすべてのコマンドを実行することはできません。最新の機能が必要な場合は、お使いの OpenShift Container Platform サーバーバージョンに対応する最新バージョンの oc バイナリーをダウンロードし、インストールする必要があります。

セキュリティー以外の API の変更は、古い oc バイナリーの更新を可能にするために、2 つ以上のマイナーリリース (例: 4.1 から 4.2、そして 4.3 へ) が必要です。新機能を使用するには新規の oc バイナリーが必要になる場合があります。4.3 サーバーには、4.2 oc バイナリーが使用できない機能が追加されている場合や、4.3 oc バイナリーには 4.2 サーバーでサポートされていない追加機能が含まれる場合があります。

|

X.Y ( |

X.Y+N footnote:versionpolicyn[N は 1 以上の数値です] ( | |

| X.Y (サーバー) |

|

|

| X.Y+N footnote:versionpolicyn[] (サーバー) |

|

|

完全に互換性がある。

完全に互換性がある。

oc クライアントは、サーバー機能にアクセスできない場合があります。

oc クライアントは、アクセスされるサーバーと互換性のないオプションおよび機能を提供する可能性があります。

2.3.2. kubectl バイナリー

kubectl バイナリーは、標準の Kubernetes 環境を使用する新規 OpenShift Container Platform ユーザー、または kubectl CLI を優先的に使用するユーザーの既存ワークフローおよびスクリプトをサポートする手段として提供されます。kubectl の既存ユーザーはバイナリーを引き続き使用し、OpenShift Container Platform クラスターへの変更なしに Kubernetes のプリミティブと対話できます。

OpenShift CLI のインストール 手順に従って、サポートされている kubectl バイナリーをインストールできます。kubectl バイナリーは、バイナリーをダウンロードする場合にアーカイブに含まれます。または RPM を使用して CLI のインストール時にインストールされます。

詳細は、kubectl のドキュメント を参照してください。

2.4. CLI プロファイルの管理

CLI 設定ファイルでは、CLI ツールの概要 で使用するさまざまなプロファイルまたはコンテキストを設定できます。コンテキストは、ユーザー認証 および ニックネーム と関連付けられた OpenShift Container Platform サーバー情報から構成されます。

2.4.1. CLI プロファイル間のスイッチについて

CLI 操作を使用する場合に、コンテキストを使用すると、複数の OpenShift Container Platform サーバーまたはクラスターにまたがって、複数ユーザー間の切り替えが簡単になります。ニックネームを使用すると、コンテキスト、ユーザーの認証情報およびクラスターの詳細情報の省略された参照を提供することで、CLI 設定の管理が容易になります。ユーザーが oc CLI を使用して初めてログインした後、OpenShift Container Platform は ~/.kube/config ファイルを作成します (まだ存在しない場合)。oc login 操作中に自動的に、または CLI プロファイルを手動で設定することにより、より多くの認証と接続の詳細が CLI に提供されると、更新された情報が設定ファイルに保存されます。

CLI 設定ファイル

- 1

clustersセクションは、マスターサーバーのアドレスを含む OpenShift Container Platform クラスターの接続の詳細を定義します。この例では、1 つのクラスターのニックネームはopenshift1.example.com:8443で、もう 1 つのクラスターのニックネームはopenshift2.example.com:8443となっています。- 2

- この

contextsセクションでは、2 つのコンテキストを定義します。1 つはalice-project/openshift1.example.com:8443/aliceというニックネームで、alice-projectプロジェクト、openshift1.example.com:8443クラスター、およびaliceユーザーを使用します。もう 1 つはjoe-project/openshift1.example.com:8443/aliceというニックネームで、joe-projectプロジェクト、openshift1.example.com:8443クラスター、およびaliceユーザーを使用します。 - 3

current-contextパラメーターは、joe-project/openshift1.example.com:8443/aliceコンテキストが現在使用中であることを示しています。これにより、aliceユーザーはopenshift1.example.com:8443クラスターのjoe-projectプロジェクトで作業することが可能になります。- 4

usersセクションは、ユーザーの認証情報を定義します。この例では、ユーザーニックネームalice/openshift1.example.com:8443は、アクセストークンを使用します。

CLI は、実行時にロードされ、コマンドラインから指定されたオーバーライドオプションとともにマージされる複数の設定ファイルをサポートできます。ログイン後に、oc status または oc project コマンドを使用して、現在の作業環境を確認できます。

現在の作業環境の確認

oc status

$ oc status出力例

現在のプロジェクトのリスト表示

oc project

$ oc project出力例

Using project "joe-project" from context named "joe-project/openshift1.example.com:8443/alice" on server "https://openshift1.example.com:8443".

Using project "joe-project" from context named "joe-project/openshift1.example.com:8443/alice" on server "https://openshift1.example.com:8443".

oc login コマンドを再度実行し、対話式プロセス中に必要な情報を指定して、ユーザー認証情報およびクラスターの詳細の他の組み合わせを使用してログインできます。コンテキストが存在しない場合は、コンテキストが指定される情報に基づいて作成されます。すでにログインしている場合で、現行ユーザーがアクセス可能な別のプロジェクトに切り替える場合には、oc project コマンドを使用してプロジェクトの名前を入力します。

oc project alice-project

$ oc project alice-project出力例

Now using project "alice-project" on server "https://openshift1.example.com:8443".

Now using project "alice-project" on server "https://openshift1.example.com:8443".

出力に示されるように、いつでも oc config view コマンドを使用して、現在の CLI 設定を表示できます。高度な使用方法で利用できる CLI 設定コマンドが他にもあります。

管理者の認証情報にアクセスできるが、デフォルトのシステムユーザー system:admin としてログインしていない場合は、CLI 設定ファイルに認証情報が残っている限り、いつでもこのユーザーとして再度ログインできます。以下のコマンドはログインを実行し、デフォルトプロジェクトに切り替えます。

oc login -u system:admin -n default

$ oc login -u system:admin -n default2.4.2. CLI プロファイルの手動設定

このセクションでは、CLI 設定の高度な使用方法を説明します。ほとんどの場合、oc login コマンドおよび oc project コマンドを使用してログインし、コンテキスト間とプロジェクト間の切り替えを実行できます。

CLI 設定ファイルを手動で設定する必要がある場合は、ファイルを直接変更せずに oc config コマンドを使用することができます。oc config コマンドには、この目的で役立ついくつかのサブコマンドが含まれています。

| サブコマンド | 使用法 |

|---|---|

|

| CLI 設定ファイルにクラスターエントリーを設定します。参照されるクラスターのニックネームがすでに存在する場合、指定情報はマージされます。 oc config set-cluster <cluster_nickname> [--server=<master_ip_or_fqdn>] [--certificate-authority=<path/to/certificate/authority>] [--api-version=<apiversion>] [--insecure-skip-tls-verify=true] |

|

| CLI 設定ファイルにコンテキストエントリーを設定します。参照されるコンテキストのニックネームがすでに存在する場合、指定情報はマージされます。 oc config set-context <context_nickname> [--cluster=<cluster_nickname>] [--user=<user_nickname>] [--namespace=<namespace>] |

|

| 指定されたコンテキストのニックネームを使用して、現在のコンテキストを設定します。 oc config use-context <context_nickname> |

|

| CLI 設定ファイルに個別の値を設定します。 oc config set <property_name> <property_value>

|

|

| CLI 設定ファイルでの個別の値の設定を解除します。 oc config unset <property_name>

|

|

| 現在使用中のマージされた CLI 設定を表示します。 oc config view 指定された CLI 設定ファイルの結果を表示します。 oc config view --config=<specific_filename> |

使用例

-

アクセストークンを使用するユーザーとしてログインします。このトークンは

aliceユーザーによって使用されます。

oc login https://openshift1.example.com --token=ns7yVhuRNpDM9cgzfhhxQ7bM5s7N2ZVrkZepSRf4LC0

$ oc login https://openshift1.example.com --token=ns7yVhuRNpDM9cgzfhhxQ7bM5s7N2ZVrkZepSRf4LC0- 自動的に作成されたクラスターエントリーを表示します。

oc config view

$ oc config view出力例

- 現在のコンテキストを更新して、ユーザーが必要な namespace にログインできるようにします。

oc config set-context `oc config current-context` --namespace=<project_name>

$ oc config set-context `oc config current-context` --namespace=<project_name>- 現在のコンテキストを調べて、変更が実装されていることを確認します。

oc whoami -c

$ oc whoami -c後続のすべての CLI 操作は、オーバーライドする CLI オプションにより特に指定されていない限り、またはコンテキストが切り替わるまで、新しいコンテキストを使用します。

2.4.3. ルールの読み込みおよびマージ

CLI 設定のロードおよびマージ順序の CLI 操作を実行する際に、以下のルールを実行できます。

CLI 設定ファイルは、以下の階層とマージルールを使用してワークステーションから取得されます。

-

--configオプションが設定されている場合、そのファイルのみが読み込まれます。フラグは一度設定され、マージは実行されません。 -

$KUBECONFIG環境変数が設定されている場合は、これが使用されます。変数はパスの一覧である可能性があり、その場合、パスは 1 つにマージされます。値が変更される場合は、スタンザを定義するファイルで変更されます。値が作成される場合は、存在する最初のファイルで作成されます。ファイルがチェーン内に存在しない場合は、一覧の最後のファイルが作成されます。 -

または、

~/.kube/configファイルが使用され、マージは実行されません。

-

使用するコンテキストは、以下のフローの最初の一致に基づいて決定されます。

-

--contextオプションの値。 -

CLI 設定ファイルの

current-context値。 - この段階では空の値が許可されます。

-

使用するユーザーおよびクラスターが決定されます。この時点では、コンテキストがある場合とない場合があります。コンテキストは、以下のフローの最初の一致に基づいて作成されます。このフローは、ユーザー用に 1 回、クラスター用に 1 回実行されます。

-

ユーザー名の

--userの値、およびクラスター名の--clusterオプション。 -

--contextオプションがある場合は、コンテキストの値を使用します。 - この段階では空の値が許可されます。

-

ユーザー名の

使用する実際のクラスター情報が決定されます。この時点では、クラスター情報がある場合とない場合があります。各クラスター情報は、以下のフローの最初の一致に基づいて構築されます。

以下のコマンドラインオプションのいずれかの値。

-

--server -

--api-version -

--certificate-authority -

--insecure-skip-tls-verify

-

- クラスター情報および属性の値がある場合は、それを使用します。

- サーバーロケーションがない場合は、エラーが生じます。

使用する実際のユーザー情報が決定されます。ユーザーは、クラスターと同じルールを使用して作成されます。ただし、複数の手法が競合することによって操作が失敗することから、ユーザーごとの 1 つの認証手法のみを使用できます。コマンドラインのオプションは、設定ファイルの値よりも優先されます。以下は、有効なコマンドラインのオプションです。

-

--auth-path -

--client-certificate -

--client-key -

--token

-

- 欠落している情報がある場合には、デフォルト値が使用され、追加情報を求めるプロンプトが出されます。

2.5. プラグインによる OpenShift CLI の拡張

デフォルトの oc コマンドを拡張するためにプラグインを作成およびインストールし、これを使用して OpenShift Container Platform CLI で新規および追加の複雑なタスクを実行できます。

2.5.1. CLI プラグインの作成

コマンドラインのコマンドを作成できる任意のプログラミング言語またはスクリプトで、OpenShift Container Platform CLI のプラグインを作成できます。既存の oc コマンドを上書きするプラグインを使用することはできない点に注意してください。

手順

以下の手順では、oc foo コマンドの実行時にターミナルにメッセージを出力する単純な Bash プラグインを作成します。

oc-fooというファイルを作成します。プラグインファイルの名前を付ける際には、以下の点に留意してください。

-

プログインとして認識されるように、ファイルの名前は

oc-またはkubectl-で開始する必要があります。 -

ファイル名は、プラグインを起動するコマンドを判別するものとなります。たとえば、ファイル名が

oc-foo-barのプラグインは、oc foo barのコマンドで起動します。また、コマンドにダッシュを含める必要がある場合には、アンダースコアを使用することもできます。たとえば、ファイル名がoc-foo_barのプラグインは、oc foo-barのコマンドで起動します。

-

プログインとして認識されるように、ファイルの名前は

以下の内容をファイルに追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

OpenShift Container Platform CLI のこのプラグインをインストールした後に、oc foo コマンドを使用してこれを起動できます。

2.5.2. CLI プラグインのインストールおよび使用

OpenShift Container Platform CLI のカスタムプラグインを作成した後、使用する前にプラグインをインストールする必要があります。

前提条件

-

ocCLI ツールをインストールしていること。 -

oc-またはkubectl-で始まる CLI プラグインファイルがあること。

手順

必要に応じて、プラグインファイルを更新して実行可能にします。

chmod +x <plugin_file>

$ chmod +x <plugin_file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ファイルを

PATHの任意の場所に置きます (例:/usr/local/bin/)。sudo mv <plugin_file> /usr/local/bin/.

$ sudo mv <plugin_file> /usr/local/bin/.Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc plugin listを実行し、プラグインが一覧表示されることを確認します。oc plugin list

$ oc plugin listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

The following compatible plugins are available: /usr/local/bin/<plugin_file>

The following compatible plugins are available: /usr/local/bin/<plugin_file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow プラグインがここに一覧表示されていない場合、ファイルが

oc-またはkubectl-で開始されるものであり、実行可能な状態でPATH上にあることを確認します。プラグインによって導入される新規コマンドまたはオプションを起動します。

たとえば、

kubectl-nsプラグインを サンプルのプラグインリポジトリー からビルドし、インストールしている場合、以下のコマンドを使用して現在の namespace を表示できます。oc ns

$ oc nsCopy to Clipboard Copied! Toggle word wrap Toggle overflow プラグインを呼び出すコマンドは、プラグインのファイル名に依存することに注意してください。たとえば、ファイル名が

oc-foo-barのプラグインはoc foo barコマンドによって起動します。

2.6. Krew を使用した CLI プラグインの管理

Krew を使用して、OpenShift CLI (oc) のプラグインをインストールおよび管理できます。

Krew を使用して OpenShift CLI のプラグインをインストールおよび管理することは、テクノロジープレビュー機能のみです。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は、実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行い、フィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

2.6.1. Krew を使用した CLI プラグインのインストール

Krew を使用して、OpenShift CLI (oc) のプラグインをインストールできます。

前提条件

- Krew のドキュメントの インストール手順 に従って、Krew をインストールしました。

手順

使用可能なすべてのプラグインを一覧表示するには、次のコマンドを実行します。

oc krew search

$ oc krew searchCopy to Clipboard Copied! Toggle word wrap Toggle overflow プラグインに関する情報を取得するには、次のコマンドを実行します。

oc krew info <plugin_name>

$ oc krew info <plugin_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow プラグインをインストールするには、次のコマンドを実行します。

oc krew install <plugin_name>

$ oc krew install <plugin_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Krew によってインストールされたすべてのプラグインを一覧表示するには、次のコマンドを実行します。

oc krew list

$ oc krew listCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6.2. Krew を使用した CLI プラグインの更新

OpenShift CLI (oc) 用にインストールされたプラグインを Krew で更新できます。

前提条件

- Krew のドキュメントの インストール手順 に従って、Krew をインストールしました。

- Krew を使用して OpenShift CLI のプラグインをインストールしました。

手順

単一のプラグインを更新するには、次のコマンドを実行します。

oc krew upgrade <plugin_name>

$ oc krew upgrade <plugin_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Krew によってインストールされたすべてのプラグインを更新するには、次のコマンドを実行します。

oc krew upgrade

$ oc krew upgradeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6.3. Krew を使用した CLI プラグインのアンインストール

Krew を使用して、OpenShift CLI (oc) 用にインストールされたプラグインをアンインストールできます。

前提条件

- Krew のドキュメントの インストール手順 に従って、Krew をインストールしました。

- Krew を使用して OpenShift CLI のプラグインをインストールしました。

手順

プラグインをアンインストールするには、次のコマンドを実行します。

oc krew uninstall <plugin_name>

$ oc krew uninstall <plugin_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.7. OpenShift CLI 開発者コマンドリファレンス

このリファレンスは、OpenShift CLI (oc) 開発者コマンドの説明とコマンド例を示しています。管理者コマンドは、OpenShift CLI 管理者コマンドリファレンス を参照してください。

oc help を実行して、すべてのコマンドを表示するか、oc <command> --help を実行して、特定のコマンドに関する追加情報を取得します。

2.7.1. OpenShift CLI (oc) 開発者コマンド

2.7.1.1. oc annotate

リソースへのアノテーションを更新します。

使用例

2.7.1.2. oc api-resources

サーバー上のサポートされている API リソースを出力します。

使用例

2.7.1.3. oc api-versions

"group/version" という形式で、サーバー上でサポートされる API バージョンを出力します。

使用例

# Print the supported API versions oc api-versions

# Print the supported API versions

oc api-versions2.7.1.4. oc apply

設定をファイル名または標準入力 (stdin) 別のリソースに適用します。

使用例

2.7.1.5. oc apply edit-last-applied

リソース/オブジェクトの最新の last-applied-configuration アノテーションを編集します。

使用例

# Edit the last-applied-configuration annotations by type/name in YAML oc apply edit-last-applied deployment/nginx # Edit the last-applied-configuration annotations by file in JSON oc apply edit-last-applied -f deploy.yaml -o json

# Edit the last-applied-configuration annotations by type/name in YAML

oc apply edit-last-applied deployment/nginx

# Edit the last-applied-configuration annotations by file in JSON

oc apply edit-last-applied -f deploy.yaml -o json2.7.1.6. oc apply set-last-applied

ファイルの内容に一致するように、ライブオブジェクトに last-applied-configuration アノテーションを設定します。

使用例

2.7.1.7. oc apply view-last-applied

リソース/オブジェクトの最新の last-applied-configuration アノテーションを表示します。

使用例

# View the last-applied-configuration annotations by type/name in YAML oc apply view-last-applied deployment/nginx # View the last-applied-configuration annotations by file in JSON oc apply view-last-applied -f deploy.yaml -o json

# View the last-applied-configuration annotations by type/name in YAML

oc apply view-last-applied deployment/nginx

# View the last-applied-configuration annotations by file in JSON

oc apply view-last-applied -f deploy.yaml -o json2.7.1.8. oc attach

実行中のコンテナーに割り当てます。

使用例

2.7.1.9. oc auth can-i

アクションが可能かどうかを確認します。

使用例

2.7.1.10. oc auth reconcile

RBAC ロール、ロールバインディング、クラスターロール、およびクラスターロールバインディングオブジェクトのルールを調整します。

使用例

# Reconcile RBAC resources from a file oc auth reconcile -f my-rbac-rules.yaml

# Reconcile RBAC resources from a file

oc auth reconcile -f my-rbac-rules.yaml2.7.1.11. oc auth whoami

実験的: 自己サブジェクトの属性を確認します。

使用例

# Get your subject attributes. oc auth whoami # Get your subject attributes in JSON format. oc auth whoami -o json

# Get your subject attributes.

oc auth whoami

# Get your subject attributes in JSON format.

oc auth whoami -o json2.7.1.12. oc autoscale

デプロイメント設定、デプロイメント、レプリカセット、ステートフルセット、またはレプリケーションコントローラーを自動スケーリングします。

使用例

# Auto scale a deployment "foo", with the number of pods between 2 and 10, no target CPU utilization specified so a default autoscaling policy will be used oc autoscale deployment foo --min=2 --max=10 # Auto scale a replication controller "foo", with the number of pods between 1 and 5, target CPU utilization at 80% oc autoscale rc foo --max=5 --cpu-percent=80

# Auto scale a deployment "foo", with the number of pods between 2 and 10, no target CPU utilization specified so a default autoscaling policy will be used

oc autoscale deployment foo --min=2 --max=10

# Auto scale a replication controller "foo", with the number of pods between 1 and 5, target CPU utilization at 80%

oc autoscale rc foo --max=5 --cpu-percent=802.7.1.13. oc cancel-build

実行中、保留中、または新規のビルドを取り消します。

使用例

2.7.1.14. oc cluster-info

クラスター情報を表示します。

使用例

# Print the address of the control plane and cluster services oc cluster-info

# Print the address of the control plane and cluster services

oc cluster-info2.7.1.15. oc cluster-info dump

デバッグおよび診断に関する関連情報をダンプします。

使用例

2.7.1.16. oc completion

指定されたシェル (bash、zsh、fish、または powershell) のシェル補完コードを出力します。

使用例

2.7.1.17. oc config current-context

current-context を表示します。

使用例

# Display the current-context oc config current-context

# Display the current-context

oc config current-context2.7.1.18. oc config delete-cluster

kubeconfig から指定されたクラスターを削除します。

使用例

# Delete the minikube cluster oc config delete-cluster minikube

# Delete the minikube cluster

oc config delete-cluster minikube2.7.1.19. oc config delete-context

kubeconfig から指定されたコンテキストを削除します。

使用例

# Delete the context for the minikube cluster oc config delete-context minikube

# Delete the context for the minikube cluster

oc config delete-context minikube2.7.1.20. oc config delete-user

kubeconfig から指定されたユーザーを削除します。

使用例

# Delete the minikube user oc config delete-user minikube

# Delete the minikube user

oc config delete-user minikube2.7.1.21. oc config get-clusters

kubeconfig に定義されるクラスターを表示します。

使用例

# List the clusters that oc knows about oc config get-clusters

# List the clusters that oc knows about

oc config get-clusters2.7.1.22. oc config get-contexts

コンテキストを 1 つまたは複数記述します。

使用例

# List all the contexts in your kubeconfig file oc config get-contexts # Describe one context in your kubeconfig file oc config get-contexts my-context

# List all the contexts in your kubeconfig file

oc config get-contexts

# Describe one context in your kubeconfig file

oc config get-contexts my-context2.7.1.23. oc config get-users

kubeconfig で定義されるユーザーを表示します。

使用例

# List the users that oc knows about oc config get-users

# List the users that oc knows about

oc config get-users2.7.1.24. oc config new-admin-kubeconfig

新しい admin.kubeconfig を生成してサーバーを信頼させ、表示します。

使用例

# Generate a new admin kubeconfig oc config new-admin-kubeconfig

# Generate a new admin kubeconfig

oc config new-admin-kubeconfig2.7.1.25. oc config new-kubelet-bootstrap-kubeconfig

新しい kubelet /etc/kubernetes/kubeconfig を生成し、サーバーを信頼させて表示します。

使用例

# Generate a new kubelet bootstrap kubeconfig oc config new-kubelet-bootstrap-kubeconfig

# Generate a new kubelet bootstrap kubeconfig

oc config new-kubelet-bootstrap-kubeconfig2.7.1.26. oc config refresh-ca-bundle

apiserver に接続して、OpenShift CA バンドルを更新します。

使用例

2.7.1.27. oc config rename-context

kubeconfig ファイルからのコンテキストの名前を変更します。

使用例

# Rename the context 'old-name' to 'new-name' in your kubeconfig file oc config rename-context old-name new-name

# Rename the context 'old-name' to 'new-name' in your kubeconfig file

oc config rename-context old-name new-name2.7.1.28. oc config set

kubeconfig ファイルに個別の値を設定します。

使用例

2.7.1.29. oc config set-cluster

kubeconfig でクラスターエントリーを設定します。

使用例

2.7.1.30. oc config set-context

kubeconfig のコンテキストエントリーを設定します。

使用例

# Set the user field on the gce context entry without touching other values oc config set-context gce --user=cluster-admin

# Set the user field on the gce context entry without touching other values

oc config set-context gce --user=cluster-admin2.7.1.31. oc config set-credentials

kubeconfig のユーザーエントリーを設定します。

使用例

2.7.1.32. oc config unset

kubeconfig ファイルの個別の値の設定を解除します。

使用例

# Unset the current-context oc config unset current-context # Unset namespace in foo context oc config unset contexts.foo.namespace

# Unset the current-context

oc config unset current-context

# Unset namespace in foo context

oc config unset contexts.foo.namespace2.7.1.33. oc config use-context

kubeconfig ファイルで current-context を設定します。

使用例

# Use the context for the minikube cluster oc config use-context minikube

# Use the context for the minikube cluster

oc config use-context minikube2.7.1.34. oc config view

マージされた kubeconfig 設定または指定された kubeconfig ファイルを表示します。

使用例

2.7.1.35. oc cp

ファイルおよびディレクトリーのコンテナーへの/からのコピーを実行します。

使用例

2.7.1.36. oc create

ファイルまたは標準入力 (stdin) からリソースを作成します。

使用例

2.7.1.37. oc create build

新規ビルドを作成します。

使用例

# Create a new build oc create build myapp

# Create a new build

oc create build myapp2.7.1.38. oc create clusterresourcequota

クラスターリソースクォータを作成します。

使用例

# Create a cluster resource quota limited to 10 pods oc create clusterresourcequota limit-bob --project-annotation-selector=openshift.io/requester=user-bob --hard=pods=10

# Create a cluster resource quota limited to 10 pods

oc create clusterresourcequota limit-bob --project-annotation-selector=openshift.io/requester=user-bob --hard=pods=102.7.1.39. oc create clusterrole

クラスターロールを作成します。

使用例

2.7.1.40. oc create clusterrolebinding

特定のクラスターロールのクラスターロールバインディングを作成します。

使用例

# Create a cluster role binding for user1, user2, and group1 using the cluster-admin cluster role oc create clusterrolebinding cluster-admin --clusterrole=cluster-admin --user=user1 --user=user2 --group=group1

# Create a cluster role binding for user1, user2, and group1 using the cluster-admin cluster role

oc create clusterrolebinding cluster-admin --clusterrole=cluster-admin --user=user1 --user=user2 --group=group12.7.1.41. oc create configmap

ローカルファイル、ディレクトリー、またはリテラル値から config map を作成します。

使用例

2.7.1.42. oc create cronjob

指定の名前で cron job を作成します。

使用例

# Create a cron job oc create cronjob my-job --image=busybox --schedule="*/1 * * * *" # Create a cron job with a command oc create cronjob my-job --image=busybox --schedule="*/1 * * * *" -- date

# Create a cron job

oc create cronjob my-job --image=busybox --schedule="*/1 * * * *"

# Create a cron job with a command

oc create cronjob my-job --image=busybox --schedule="*/1 * * * *" -- date2.7.1.43. oc create deployment

指定の名前のデプロイメントを作成します。

使用例

2.7.1.44. oc create deploymentconfig

デフォルトのオプションを指定して特定のイメージを使用するデプロイメント設定を作成します。

使用例

# Create an nginx deployment config named my-nginx oc create deploymentconfig my-nginx --image=nginx

# Create an nginx deployment config named my-nginx

oc create deploymentconfig my-nginx --image=nginx2.7.1.45. oc create identity

アイデンティティーを手動で作成します (自動作成が無効になっている場合のみが必要)。

使用例

# Create an identity with identity provider "acme_ldap" and the identity provider username "adamjones" oc create identity acme_ldap:adamjones

# Create an identity with identity provider "acme_ldap" and the identity provider username "adamjones"

oc create identity acme_ldap:adamjones2.7.1.46. oc create imagestream

空のイメージストリームを新たに作成します。

使用例

# Create a new image stream oc create imagestream mysql

# Create a new image stream

oc create imagestream mysql2.7.1.47. oc create imagestreamtag

新規イメージストリームタグを作成します。

使用例

# Create a new image stream tag based on an image in a remote registry oc create imagestreamtag mysql:latest --from-image=myregistry.local/mysql/mysql:5.0

# Create a new image stream tag based on an image in a remote registry

oc create imagestreamtag mysql:latest --from-image=myregistry.local/mysql/mysql:5.02.7.1.48. oc create ingress

指定の名前で Ingress を作成します。

使用例

2.7.1.49. oc create job

指定の名前でジョブを作成します。

使用例

2.7.1.50. oc create namespace

指定の名前で namespace を作成します。

使用例

# Create a new namespace named my-namespace oc create namespace my-namespace

# Create a new namespace named my-namespace

oc create namespace my-namespace2.7.1.51. oc create poddisruptionbudget

指定の名前で Pod Disruption Budget を作成します。

使用例

2.7.1.52. oc create priorityclass

指定の名前で priority class を作成します。

使用例

2.7.1.53. oc create quota

指定の名前でクォータを作成します。

使用例

# Create a new resource quota named my-quota oc create quota my-quota --hard=cpu=1,memory=1G,pods=2,services=3,replicationcontrollers=2,resourcequotas=1,secrets=5,persistentvolumeclaims=10 # Create a new resource quota named best-effort oc create quota best-effort --hard=pods=100 --scopes=BestEffort

# Create a new resource quota named my-quota

oc create quota my-quota --hard=cpu=1,memory=1G,pods=2,services=3,replicationcontrollers=2,resourcequotas=1,secrets=5,persistentvolumeclaims=10

# Create a new resource quota named best-effort

oc create quota best-effort --hard=pods=100 --scopes=BestEffort2.7.1.54. oc create role

単一ルールでロールを作成します。

使用例

2.7.1.55. oc create rolebinding

特定のロールまたはクラスターロールのロールバインディングを作成します。

使用例

# Create a role binding for user1, user2, and group1 using the admin cluster role oc create rolebinding admin --clusterrole=admin --user=user1 --user=user2 --group=group1 # Create a role binding for serviceaccount monitoring:sa-dev using the admin role oc create rolebinding admin-binding --role=admin --serviceaccount=monitoring:sa-dev

# Create a role binding for user1, user2, and group1 using the admin cluster role

oc create rolebinding admin --clusterrole=admin --user=user1 --user=user2 --group=group1

# Create a role binding for serviceaccount monitoring:sa-dev using the admin role

oc create rolebinding admin-binding --role=admin --serviceaccount=monitoring:sa-dev2.7.1.56. oc create route edge

edge TLS termination を使用するルートを作成します。

使用例

2.7.1.57. oc create route passthrough

passthrough TLS Termination を使用するルートを作成します。

使用例

2.7.1.58. oc create route reencrypt

reencrypt TLS Termination を使用するルートを作成します。

使用例

2.7.1.59. oc create secret docker-registry

Docker レジストリーで使用するシークレットを作成します。

使用例

# If you do not already have a .dockercfg file, create a dockercfg secret directly oc create secret docker-registry my-secret --docker-server=DOCKER_REGISTRY_SERVER --docker-username=DOCKER_USER --docker-password=DOCKER_PASSWORD --docker-email=DOCKER_EMAIL # Create a new secret named my-secret from ~/.docker/config.json oc create secret docker-registry my-secret --from-file=.dockerconfigjson=path/to/.docker/config.json

# If you do not already have a .dockercfg file, create a dockercfg secret directly

oc create secret docker-registry my-secret --docker-server=DOCKER_REGISTRY_SERVER --docker-username=DOCKER_USER --docker-password=DOCKER_PASSWORD --docker-email=DOCKER_EMAIL

# Create a new secret named my-secret from ~/.docker/config.json

oc create secret docker-registry my-secret --from-file=.dockerconfigjson=path/to/.docker/config.json2.7.1.60. oc create secret generic

ローカルファイル、ディレクトリー、またはリテラル値からシークレットを作成します。

使用例

2.7.1.61. oc create secret tls

TLS シークレットを作成します。

使用例

# Create a new TLS secret named tls-secret with the given key pair oc create secret tls tls-secret --cert=path/to/tls.cert --key=path/to/tls.key

# Create a new TLS secret named tls-secret with the given key pair

oc create secret tls tls-secret --cert=path/to/tls.cert --key=path/to/tls.key2.7.1.62. oc create service clusterip

ClusterIP サービスを作成します。

使用例

# Create a new ClusterIP service named my-cs oc create service clusterip my-cs --tcp=5678:8080 # Create a new ClusterIP service named my-cs (in headless mode) oc create service clusterip my-cs --clusterip="None"

# Create a new ClusterIP service named my-cs

oc create service clusterip my-cs --tcp=5678:8080

# Create a new ClusterIP service named my-cs (in headless mode)

oc create service clusterip my-cs --clusterip="None"2.7.1.63. oc create service externalname

ExternalName サービスを作成します。

使用例

# Create a new ExternalName service named my-ns oc create service externalname my-ns --external-name bar.com

# Create a new ExternalName service named my-ns

oc create service externalname my-ns --external-name bar.com2.7.1.64. oc create service loadbalancer

LoadBalancer サービスを作成します。

使用例

# Create a new LoadBalancer service named my-lbs oc create service loadbalancer my-lbs --tcp=5678:8080

# Create a new LoadBalancer service named my-lbs

oc create service loadbalancer my-lbs --tcp=5678:80802.7.1.65. oc create service nodeport

NodePort サービスを作成します。

使用例

# Create a new NodePort service named my-ns oc create service nodeport my-ns --tcp=5678:8080

# Create a new NodePort service named my-ns

oc create service nodeport my-ns --tcp=5678:80802.7.1.66. oc create serviceaccount

指定の名前でサービスアカウントを作成します。

使用例

# Create a new service account named my-service-account oc create serviceaccount my-service-account

# Create a new service account named my-service-account

oc create serviceaccount my-service-account2.7.1.67. oc create token

サービスアカウントトークンをリクエストします。

使用例

2.7.1.68. oc create user

ユーザーを手動で作成します (自動作成が無効になっている場合のみ必要)。

使用例

# Create a user with the username "ajones" and the display name "Adam Jones" oc create user ajones --full-name="Adam Jones"

# Create a user with the username "ajones" and the display name "Adam Jones"

oc create user ajones --full-name="Adam Jones"2.7.1.69. oc create useridentitymapping

アイデンティティーをユーザーに手動でマップします。

使用例

# Map the identity "acme_ldap:adamjones" to the user "ajones" oc create useridentitymapping acme_ldap:adamjones ajones

# Map the identity "acme_ldap:adamjones" to the user "ajones"

oc create useridentitymapping acme_ldap:adamjones ajones2.7.1.70. oc debug

デバッグ用に Pod の新規インスタンスを起動します。

使用例

2.7.1.71. oc delete

ファイル名、stdin、リソースおよび名前、またはリソースおよびラベルセレクター別にリソースを削除します。

使用例

2.7.1.72. oc describe

特定のリソースまたはリソースのグループの詳細を表示します。

使用例

2.7.1.73. oc diff

ライブバージョンと適用バージョンとの差異を確認します。

使用例

# Diff resources included in pod.json oc diff -f pod.json # Diff file read from stdin cat service.yaml | oc diff -f -

# Diff resources included in pod.json

oc diff -f pod.json

# Diff file read from stdin

cat service.yaml | oc diff -f -2.7.1.74. oc edit

サーバーのリソースを編集します。

使用例

2.7.1.75. oc events

イベントを一覧表示します。

使用例

2.7.1.76. oc exec

コンテナーでコマンドを実行します。

使用例

2.7.1.77. oc explain

リソースのドキュメントを取得します。

使用例

2.7.1.78. oc expose

複製されたアプリケーションをサービスまたはルートとして公開します。

使用例

2.7.1.79. oc extract

シークレットまたは config map をディスクに抽出します。

使用例

2.7.1.80. oc get

1 つ以上のリソースを表示します。

使用例

2.7.1.81. oc get-token

実験的機能: 認証情報実行プラグインとして外部の OIDC 発行者からトークンを取得します。

使用例

# Starts an auth code flow to the issuer url with the client id and the given extra scopes oc get-token --client-id=client-id --issuer-url=test.issuer.url --extra-scopes=email,profile # Starts an authe code flow to the issuer url with a different callback address. oc get-token --client-id=client-id --issuer-url=test.issuer.url --callback-address=127.0.0.1:8343

# Starts an auth code flow to the issuer url with the client id and the given extra scopes

oc get-token --client-id=client-id --issuer-url=test.issuer.url --extra-scopes=email,profile

# Starts an authe code flow to the issuer url with a different callback address.

oc get-token --client-id=client-id --issuer-url=test.issuer.url --callback-address=127.0.0.1:83432.7.1.82. oc idle

スケーラブルなリソースをアイドリングします。

使用例

# Idle the scalable controllers associated with the services listed in to-idle.txt $ oc idle --resource-names-file to-idle.txt

# Idle the scalable controllers associated with the services listed in to-idle.txt

$ oc idle --resource-names-file to-idle.txt2.7.1.83. oc image append

イメージにレイヤーを追加してレジストリーにプッシュします。

使用例

2.7.1.84. oc image extract

イメージからファイルシステムにファイルをコピーします。

使用例

2.7.1.85. oc image info

イメージに関する情報を表示します。

使用例

2.7.1.86. oc image mirror

別のリポジトリーにイメージをミラーリングします。

次の例には、OpenShift Container Platform on AWS に固有の値がいくつか含まれています。

使用例

2.7.1.87. oc import-image

コンテナーイメージレジストリーからイメージをインポートします。

使用例

2.7.1.88. oc kustomize

ディレクトリーまたは URL から kustomization ターゲットをビルドします。

使用例

2.7.1.89. oc label

リソースのラベルを更新します。

使用例

2.7.1.90. oc login

サーバーにログインします。

使用例

2.7.1.91. oc logout

現在のサーバーセッションを終了します。

使用例

# Log out oc logout

# Log out

oc logout2.7.1.92. oc logs

Pod 内のコンテナーのログを出力します。

使用例

2.7.1.93. oc new-app

新規アプリケーションを作成します。

使用例

2.7.1.94. oc new-build

新規ビルド設定を作成します。

使用例

2.7.1.95. oc new-project

新規プロジェクトを要求します。

使用例

# Create a new project with minimal information oc new-project web-team-dev # Create a new project with a display name and description oc new-project web-team-dev --display-name="Web Team Development" --description="Development project for the web team."

# Create a new project with minimal information

oc new-project web-team-dev

# Create a new project with a display name and description

oc new-project web-team-dev --display-name="Web Team Development" --description="Development project for the web team."2.7.1.96. oc observe

リソースの変更を確認し、リソースに対応します (実験的)。

使用例

2.7.1.97. oc patch

リソースのフィールドを更新します。

使用例

2.7.1.98. oc plugin list

ユーザーの PATH にあるすべての表示可能なプラグイン実行可能ファイルをリスト表示します。

使用例

# List all available plugins oc plugin list

# List all available plugins

oc plugin list2.7.1.99. oc policy add-role-to-user

現在のプロジェクトのユーザーまたはサービスアカウントをロールに追加します。

使用例

# Add the 'view' role to user1 for the current project oc policy add-role-to-user view user1 # Add the 'edit' role to serviceaccount1 for the current project oc policy add-role-to-user edit -z serviceaccount1

# Add the 'view' role to user1 for the current project

oc policy add-role-to-user view user1

# Add the 'edit' role to serviceaccount1 for the current project

oc policy add-role-to-user edit -z serviceaccount12.7.1.100. oc policy scc-review

Pod を作成できるサービスアカウントを確認します。

使用例

2.7.1.101. oc policy scc-subject-review

ユーザーまたはサービスアカウントが Pod を作成できるかどうかを確認します。

使用例

2.7.1.102. oc port-forward

1 つ以上のローカルポートを Pod に転送します。

使用例

2.7.1.103. oc process

リソースのリストに対してテンプレートを処理します。

使用例

2.7.1.104. oc project

別のプロジェクトに切り替えます。

使用例

# Switch to the 'myapp' project oc project myapp # Display the project currently in use oc project

# Switch to the 'myapp' project

oc project myapp

# Display the project currently in use

oc project2.7.1.105. oc projects

既存プロジェクトを表示します。

使用例

# List all projects oc projects

# List all projects

oc projects2.7.1.106. oc proxy

Kubernetes API サーバーに対してプロキシーを実行します。

使用例

2.7.1.107. oc registry login

統合レジストリーにログインします。

使用例

# Log in to the integrated registry oc registry login # Log in to different registry using BASIC auth credentials oc registry login --registry quay.io/myregistry --auth-basic=USER:PASS

# Log in to the integrated registry

oc registry login

# Log in to different registry using BASIC auth credentials

oc registry login --registry quay.io/myregistry --auth-basic=USER:PASS2.7.1.108. oc replace

リソースをファイル名または標準入力 (stdin) に置き換えます。

使用例

2.7.1.109. oc rollback

アプリケーションの一部を以前のデプロイメントに戻します。

使用例

2.7.1.110. oc rollout cancel

進行中のデプロイメントをキャンセルします。

使用例

# Cancel the in-progress deployment based on 'nginx' oc rollout cancel dc/nginx

# Cancel the in-progress deployment based on 'nginx'

oc rollout cancel dc/nginx2.7.1.111. oc rollout history

ロールアウト履歴を表示します。

使用例

# View the rollout history of a deployment oc rollout history dc/nginx # View the details of deployment revision 3 oc rollout history dc/nginx --revision=3

# View the rollout history of a deployment

oc rollout history dc/nginx

# View the details of deployment revision 3

oc rollout history dc/nginx --revision=32.7.1.112. oc rollout latest

トリガーからの最新状態を使用して、デプロイメント設定の新規ロールアウトを開始します。

使用例

# Start a new rollout based on the latest images defined in the image change triggers oc rollout latest dc/nginx # Print the rolled out deployment config oc rollout latest dc/nginx -o json

# Start a new rollout based on the latest images defined in the image change triggers

oc rollout latest dc/nginx

# Print the rolled out deployment config

oc rollout latest dc/nginx -o json2.7.1.113. oc rollout pause

提供されたリソースを一時停止としてマークします。

使用例

# Mark the nginx deployment as paused. Any current state of # the deployment will continue its function, new updates to the deployment will not # have an effect as long as the deployment is paused oc rollout pause dc/nginx

# Mark the nginx deployment as paused. Any current state of

# the deployment will continue its function, new updates to the deployment will not

# have an effect as long as the deployment is paused

oc rollout pause dc/nginx2.7.1.114. oc rollout restart

リソースを再起動します。

使用例

2.7.1.115. oc rollout resume

一時停止したリソースを再開します。

使用例

# Resume an already paused deployment oc rollout resume dc/nginx

# Resume an already paused deployment

oc rollout resume dc/nginx2.7.1.116. oc rollout retry

失敗したロールアウトを再試行します。

使用例

# Retry the latest failed deployment based on 'frontend' # The deployer pod and any hook pods are deleted for the latest failed deployment oc rollout retry dc/frontend

# Retry the latest failed deployment based on 'frontend'

# The deployer pod and any hook pods are deleted for the latest failed deployment

oc rollout retry dc/frontend2.7.1.117. oc rollout status

ロールアウトのステータスを表示します。

使用例

# Watch the status of the latest rollout oc rollout status dc/nginx

# Watch the status of the latest rollout

oc rollout status dc/nginx2.7.1.118. oc rollout undo

以前のロールアウトを元に戻します。

使用例

# Roll back to the previous deployment oc rollout undo dc/nginx # Roll back to deployment revision 3. The replication controller for that version must exist oc rollout undo dc/nginx --to-revision=3

# Roll back to the previous deployment

oc rollout undo dc/nginx

# Roll back to deployment revision 3. The replication controller for that version must exist

oc rollout undo dc/nginx --to-revision=32.7.1.119. oc rsh

コンテナーでシェルセッションを開始します。

使用例

2.7.1.120. oc rsync

ローカルファイルシステムと Pod 間でファイルをコピーします。

使用例

# Synchronize a local directory with a pod directory oc rsync ./local/dir/ POD:/remote/dir # Synchronize a pod directory with a local directory oc rsync POD:/remote/dir/ ./local/dir

# Synchronize a local directory with a pod directory

oc rsync ./local/dir/ POD:/remote/dir

# Synchronize a pod directory with a local directory

oc rsync POD:/remote/dir/ ./local/dir2.7.1.121. oc run

クラスターで特定のイメージを実行します。

使用例

2.7.1.122. oc scale

デプロイメント、レプリカセット、またはレプリケーションコントローラーに新規サイズを設定します。

使用例

2.7.1.123. oc secrets link

サービスアカウントにシークレットをリンクします。

使用例

# Add an image pull secret to a service account to automatically use it for pulling pod images oc secrets link serviceaccount-name pull-secret --for=pull # Add an image pull secret to a service account to automatically use it for both pulling and pushing build images oc secrets link builder builder-image-secret --for=pull,mount

# Add an image pull secret to a service account to automatically use it for pulling pod images

oc secrets link serviceaccount-name pull-secret --for=pull

# Add an image pull secret to a service account to automatically use it for both pulling and pushing build images

oc secrets link builder builder-image-secret --for=pull,mount2.7.1.124. oc secrets unlink

サービスアカウントからシークレットをデタッチします。

使用例

# Unlink a secret currently associated with a service account oc secrets unlink serviceaccount-name secret-name another-secret-name ...

# Unlink a secret currently associated with a service account

oc secrets unlink serviceaccount-name secret-name another-secret-name ...2.7.1.125. oc set build-hook

ビルド設定のビルドフックを更新します。

使用例

2.7.1.126. oc set build-secret

ビルド設定のビルドシークレットを更新します。

使用例

2.7.1.127. oc set data

config map またはシークレット内のデータを更新します。

使用例

2.7.1.128. oc set deployment-hook

デプロイメント設定のデプロイメントフックを更新します。

使用例

2.7.1.129. oc set env

Pod テンプレートの環境変数を更新します。

使用例

2.7.1.130. oc set image

Pod テンプレートのイメージを更新します。

使用例

2.7.1.131. oc set image-lookup

アプリケーションのデプロイ時にイメージを解決する方法を変更します。

使用例

2.7.1.132. oc set probe

Pod テンプレートでプローブを更新します。

使用例

2.7.1.133. oc set resources

オブジェクトのリソース要求/制限を Pod テンプレートで更新します。

使用例

2.7.1.134. oc set route-backends

ルートのバックエンドを更新します。

使用例

2.7.1.135. oc set selector

リソースにセレクターを設定します。

使用例

# Set the labels and selector before creating a deployment/service pair. oc create service clusterip my-svc --clusterip="None" -o yaml --dry-run | oc set selector --local -f - 'environment=qa' -o yaml | oc create -f - oc create deployment my-dep -o yaml --dry-run | oc label --local -f - environment=qa -o yaml | oc create -f -

# Set the labels and selector before creating a deployment/service pair.

oc create service clusterip my-svc --clusterip="None" -o yaml --dry-run | oc set selector --local -f - 'environment=qa' -o yaml | oc create -f -

oc create deployment my-dep -o yaml --dry-run | oc label --local -f - environment=qa -o yaml | oc create -f -2.7.1.136. oc set serviceaccount

リソースのサービスアカウントを更新します。

使用例

# Set deployment nginx-deployment's service account to serviceaccount1 oc set serviceaccount deployment nginx-deployment serviceaccount1 # Print the result (in YAML format) of updated nginx deployment with service account from a local file, without hitting the API server oc set sa -f nginx-deployment.yaml serviceaccount1 --local --dry-run -o yaml

# Set deployment nginx-deployment's service account to serviceaccount1

oc set serviceaccount deployment nginx-deployment serviceaccount1

# Print the result (in YAML format) of updated nginx deployment with service account from a local file, without hitting the API server

oc set sa -f nginx-deployment.yaml serviceaccount1 --local --dry-run -o yaml2.7.1.137. oc set subject

ロールバインディングまたはクラスターロールバインディングでユーザー、グループ、またはサービスアカウントを更新します。

使用例

2.7.1.138. oc set triggers

1 つ以上のオブジェクトでトリガーを更新します。

使用例

2.7.1.139. oc set volumes

Pod テンプレートでボリュームを更新します。

使用例

2.7.1.140. oc start-build

新しいビルドを開始します。

使用例

2.7.1.141. oc status

現在のプロジェクトの概要を表示します。

使用例

2.7.1.142. oc tag

既存のイメージをイメージストリームにタグ付けします。

使用例

2.7.1.143. oc version

クライアントおよびサーバーのバージョン情報を出力します。

使用例

2.7.1.144. oc wait

実験的: 1 つ以上のリソースの特定の条件を待機します。

使用例

2.7.1.145. oc whoami

現行セッションに関する情報を返します。

使用例

# Display the currently authenticated user oc whoami

# Display the currently authenticated user

oc whoami2.8. OpenShift CLI 管理者コマンドリファレンス

このリファレンスは、OpenShift CLI (oc) 管理者コマンドの説明およびコマンド例を示しています。これらのコマンドを使用するには、cluster-admin または同等のパーミッションが必要です。

開発者コマンドは、OpenShift CLI 開発者コマンドリファレンス を参照してください。

oc adm -h を実行して、すべての管理者コマンドを表示するか、oc <command> --help を実行して、特定のコマンドに関する追加情報を取得します。

2.8.1. OpenShift CLI (oc) 管理者コマンド

2.8.1.1. oc adm build-chain

ビルドの入力と依存関係を出力します。

使用例

2.8.1.2. oc adm catalog mirror

operator-registry カタログをミラーリングします。

使用例

2.8.1.3. oc adm certificate approve

証明書署名リクエストを承認します。

使用例

# Approve CSR 'csr-sqgzp' oc adm certificate approve csr-sqgzp

# Approve CSR 'csr-sqgzp'

oc adm certificate approve csr-sqgzp2.8.1.4. oc adm certificate deny

証明書署名リクエストを拒否します。

使用例

# Deny CSR 'csr-sqgzp' oc adm certificate deny csr-sqgzp

# Deny CSR 'csr-sqgzp'

oc adm certificate deny csr-sqgzp2.8.1.5. oc adm copy-to-node

指定されたファイルをノードにコピーします。

2.8.1.6. oc adm cordon

ノードにスケジュール対象外 (unschedulable) のマークを付けます。

使用例

# Mark node "foo" as unschedulable oc adm cordon foo

# Mark node "foo" as unschedulable

oc adm cordon foo2.8.1.7. oc adm create-bootstrap-project-template

ブートストラッププロジェクトテンプレートを作成します。

使用例

# Output a bootstrap project template in YAML format to stdout oc adm create-bootstrap-project-template -o yaml

# Output a bootstrap project template in YAML format to stdout

oc adm create-bootstrap-project-template -o yaml2.8.1.8. oc adm create-error-template

エラーページのテンプレートを作成します。

使用例

# Output a template for the error page to stdout oc adm create-error-template

# Output a template for the error page to stdout

oc adm create-error-template2.8.1.9. oc adm create-login-template

ログインテンプレートを作成します。

使用例

# Output a template for the login page to stdout oc adm create-login-template

# Output a template for the login page to stdout

oc adm create-login-template2.8.1.10. oc adm create-provider-selection-template

プロバイダー選択のテンプレートを作成します。

使用例

# Output a template for the provider selection page to stdout oc adm create-provider-selection-template

# Output a template for the provider selection page to stdout

oc adm create-provider-selection-template2.8.1.11. oc adm drain

ノードをドレイン (解放) してメンテナンスを準備します。

使用例

# Drain node "foo", even if there are pods not managed by a replication controller, replica set, job, daemon set, or stateful set on it oc adm drain foo --force # As above, but abort if there are pods not managed by a replication controller, replica set, job, daemon set, or stateful set, and use a grace period of 15 minutes oc adm drain foo --grace-period=900

# Drain node "foo", even if there are pods not managed by a replication controller, replica set, job, daemon set, or stateful set on it

oc adm drain foo --force

# As above, but abort if there are pods not managed by a replication controller, replica set, job, daemon set, or stateful set, and use a grace period of 15 minutes

oc adm drain foo --grace-period=9002.8.1.12. oc adm groups add-users

ユーザーをグループに追加します。

使用例

# Add user1 and user2 to my-group oc adm groups add-users my-group user1 user2

# Add user1 and user2 to my-group

oc adm groups add-users my-group user1 user22.8.1.13. oc adm groups new

新規グループを作成します。

使用例

2.8.1.14. oc adm groups prune

外部プロバイダーから欠落しているレコードを参照する以前の OpenShift グループを削除します。

使用例

2.8.1.15. oc adm groups remove-users

グループからユーザーを削除します。

使用例

# Remove user1 and user2 from my-group oc adm groups remove-users my-group user1 user2

# Remove user1 and user2 from my-group

oc adm groups remove-users my-group user1 user22.8.1.16. oc adm groups sync

OpenShift グループと外部プロバイダーからのレコードを同期します。

使用例

2.8.1.17. oc adm inspect

指定のリソースのデバッグデータを収集します。

使用例

2.8.1.18. oc adm migrate icsp

imagecontentsourcepolicy ファイルを imagedigestmirrorset ファイルに更新します。

使用例

# Update the imagecontentsourcepolicy.yaml file to a new imagedigestmirrorset file under the mydir directory oc adm migrate icsp imagecontentsourcepolicy.yaml --dest-dir mydir

# Update the imagecontentsourcepolicy.yaml file to a new imagedigestmirrorset file under the mydir directory

oc adm migrate icsp imagecontentsourcepolicy.yaml --dest-dir mydir2.8.1.19. oc adm migrate template-instances

テンプレートインスタンスを更新して、最新の group-version-kinds を参照するようにします。

使用例

# Perform a dry-run of updating all objects oc adm migrate template-instances # To actually perform the update, the confirm flag must be appended oc adm migrate template-instances --confirm

# Perform a dry-run of updating all objects

oc adm migrate template-instances

# To actually perform the update, the confirm flag must be appended

oc adm migrate template-instances --confirm2.8.1.20. oc adm must-gather

Pod の新規インスタンスを起動してデバッグ情報を収集します。

使用例

2.8.1.21. oc adm new-project

新規プロジェクトを作成します。

使用例

# Create a new project using a node selector oc adm new-project myproject --node-selector='type=user-node,region=east'

# Create a new project using a node selector

oc adm new-project myproject --node-selector='type=user-node,region=east'2.8.1.22. oc adm node-logs

ノードのログを表示し、フィルターします。

使用例

2.8.1.23. oc adm ocp-certificates monitor-certificates

プラットフォーム証明書を監視します。

使用例

# Watch platform certificates. oc adm ocp-certificates monitor-certificates

# Watch platform certificates.

oc adm ocp-certificates monitor-certificates2.8.1.24. oc adm ocp-certificates regenerate-leaf

OpenShift クラスターのクライアント証明書とサービング証明書を再生成する

2.8.1.25. oc adm ocp-certificates regenerate-machine-config-server-serving-cert

OpenShift クラスターで Machine Config Operator 証明書を再生成する

2.8.1.26. oc adm ocp-certificates regenerate-top-level

OpenShift クラスター内のトップレベルの証明書を再生成する

2.8.1.27. oc adm ocp-certificates remove-old-trust

OpenShift クラスター内のプラットフォーム信頼バンドルを表す ConfigMap から古い CA を削除する

使用例

# Remove only CA certificates created before a certain date from all trust bundles oc adm ocp-certificates remove-old-trust configmaps -A --all --created-before 2023-06-05T14:44:06Z

# Remove only CA certificates created before a certain date from all trust bundles

oc adm ocp-certificates remove-old-trust configmaps -A --all --created-before 2023-06-05T14:44:06Z2.8.1.28. oc adm ocp-certificates update-ignition-ca-bundle-for-machine-config-server

更新された MCO 証明書を使用するように OpenShift クラスター内のユーザーデータシークレットを更新する

使用例

# Regenerate the MCO certs without modifying user-data secrets oc adm certificates regenerate-machine-config-server-serving-cert --update-ignition=false # Update the user-data secrets to use new MCS certs oc adm certificates update-ignition-ca-bundle-for-machine-config-server

# Regenerate the MCO certs without modifying user-data secrets

oc adm certificates regenerate-machine-config-server-serving-cert --update-ignition=false

# Update the user-data secrets to use new MCS certs

oc adm certificates update-ignition-ca-bundle-for-machine-config-server2.8.1.29. oc adm pod-network isolate-projects

プロジェクトネットワークを分離します。

使用例

# Provide isolation for project p1 oc adm pod-network isolate-projects <p1> # Allow all projects with label name=top-secret to have their own isolated project network oc adm pod-network isolate-projects --selector='name=top-secret'

# Provide isolation for project p1

oc adm pod-network isolate-projects <p1>

# Allow all projects with label name=top-secret to have their own isolated project network

oc adm pod-network isolate-projects --selector='name=top-secret'2.8.1.30. oc adm pod-network join-projects

プロジェクトネットワークに参加します。

使用例

# Allow project p2 to use project p1 network oc adm pod-network join-projects --to=<p1> <p2> # Allow all projects with label name=top-secret to use project p1 network oc adm pod-network join-projects --to=<p1> --selector='name=top-secret'

# Allow project p2 to use project p1 network

oc adm pod-network join-projects --to=<p1> <p2>

# Allow all projects with label name=top-secret to use project p1 network

oc adm pod-network join-projects --to=<p1> --selector='name=top-secret'2.8.1.31. oc adm pod-network make-projects-global

プロジェクトネットワークをグローバルにします。

使用例

# Allow project p1 to access all pods in the cluster and vice versa oc adm pod-network make-projects-global <p1> # Allow all projects with label name=share to access all pods in the cluster and vice versa oc adm pod-network make-projects-global --selector='name=share'

# Allow project p1 to access all pods in the cluster and vice versa

oc adm pod-network make-projects-global <p1>

# Allow all projects with label name=share to access all pods in the cluster and vice versa

oc adm pod-network make-projects-global --selector='name=share'2.8.1.32. oc adm policy add-role-to-user

現在のプロジェクトのユーザーまたはサービスアカウントをロールに追加します。

使用例

# Add the 'view' role to user1 for the current project oc adm policy add-role-to-user view user1 # Add the 'edit' role to serviceaccount1 for the current project oc adm policy add-role-to-user edit -z serviceaccount1

# Add the 'view' role to user1 for the current project

oc adm policy add-role-to-user view user1

# Add the 'edit' role to serviceaccount1 for the current project

oc adm policy add-role-to-user edit -z serviceaccount12.8.1.33. oc adm policy add-scc-to-group

Security Context Constraint オブジェクトをグループに追加します。

使用例

# Add the 'restricted' security context constraint to group1 and group2 oc adm policy add-scc-to-group restricted group1 group2

# Add the 'restricted' security context constraint to group1 and group2

oc adm policy add-scc-to-group restricted group1 group22.8.1.34. oc adm policy add-scc-to-user

Security Context Constraint をユーザーまたはサービスアカウントに追加します。

使用例

# Add the 'restricted' security context constraint to user1 and user2 oc adm policy add-scc-to-user restricted user1 user2 # Add the 'privileged' security context constraint to serviceaccount1 in the current namespace oc adm policy add-scc-to-user privileged -z serviceaccount1

# Add the 'restricted' security context constraint to user1 and user2

oc adm policy add-scc-to-user restricted user1 user2

# Add the 'privileged' security context constraint to serviceaccount1 in the current namespace

oc adm policy add-scc-to-user privileged -z serviceaccount12.8.1.35. oc adm policy scc-review

Pod を作成できるサービスアカウントを確認します。

使用例

2.8.1.36. oc adm policy scc-subject-review

ユーザーまたはサービスアカウントが Pod を作成できるかどうかを確認します。

使用例

2.8.1.37. oc adm prune builds

以前の完了済みおよび失敗したビルドを削除します。

使用例

2.8.1.38. oc adm prune deployments

以前の完了済みおよび失敗したデプロイメント設定を削除します。

使用例

# Dry run deleting all but the last complete deployment for every deployment config oc adm prune deployments --keep-complete=1 # To actually perform the prune operation, the confirm flag must be appended oc adm prune deployments --keep-complete=1 --confirm

# Dry run deleting all but the last complete deployment for every deployment config

oc adm prune deployments --keep-complete=1

# To actually perform the prune operation, the confirm flag must be appended

oc adm prune deployments --keep-complete=1 --confirm2.8.1.39. oc adm prune groups

外部プロバイダーから欠落しているレコードを参照する以前の OpenShift グループを削除します。

使用例

2.8.1.40. oc adm prune images

参照されていないイメージを削除します。

使用例

2.8.1.41. oc adm reboot-machine-config-pool

指定された MachineConfigPool の再起動を開始します。

使用例

2.8.1.42. oc adm release extract

更新ペイロードの内容をディスクに抽出します。

次の例には、OpenShift Container Platform on AWS に固有の値がいくつか含まれています。

使用例

2.8.1.43. oc adm release info

リリースに関する情報を表示します。

使用例

2.8.1.44. oc adm release mirror

リリースを別のイメージレジストリーの場所にミラーリングします。

使用例

2.8.1.45. oc adm release new

新しい OpenShift リリースを作成します。

使用例

2.8.1.46. oc adm restart-kubelet

指定されたノードで kubelet を再起動します

使用例

2.8.1.47. oc adm taint

1 つ以上のノードでテイントを更新します。

使用例

2.8.1.48. oc adm top images

イメージの使用状況の統計を表示します。

使用例

# Show usage statistics for images oc adm top images

# Show usage statistics for images

oc adm top images2.8.1.49. oc adm top imagestreams

イメージストリームの使用状況の統計を表示します。

使用例

# Show usage statistics for image streams oc adm top imagestreams

# Show usage statistics for image streams

oc adm top imagestreams2.8.1.50. oc adm top node

ノードのリソース (CPU/メモリー) の使用状況を表示します。

使用例

# Show metrics for all nodes oc adm top node # Show metrics for a given node oc adm top node NODE_NAME

# Show metrics for all nodes

oc adm top node

# Show metrics for a given node

oc adm top node NODE_NAME2.8.1.51. oc adm top pod

Pod のリソース (CPU/メモリー) の使用状況を表示します。

使用例

2.8.1.52. oc adm uncordon

ノードにスケジュール対象 (schedulable) のマークを付けます。

使用例

# Mark node "foo" as schedulable oc adm uncordon foo

# Mark node "foo" as schedulable

oc adm uncordon foo2.8.1.53. oc adm upgrade

クラスターをアップグレードするか、アップグレードチャネルを調整する

使用例

# View the update status and available cluster updates oc adm upgrade # Update to the latest version oc adm upgrade --to-latest=true

# View the update status and available cluster updates

oc adm upgrade

# Update to the latest version

oc adm upgrade --to-latest=true2.8.1.54. oc adm verify-image-signature

イメージ署名に含まれるイメージ ID を確認します。

使用例

2.8.1.55. oc adm wait-for-node-reboot

oc adm reboot-machine-config-pool の実行後、ノードが再起動するまで待ちます。

使用例

2.8.1.56. oc adm wait-for-stable-cluster

プラットフォーム Operator が安定するまで待機します。

使用例

# Wait for all clusteroperators to become stable oc adm wait-for-stable-cluster # Consider operators to be stable if they report as such for 5 minutes straight oc adm wait-for-stable-cluster --minimum-stable-period 5m

# Wait for all clusteroperators to become stable

oc adm wait-for-stable-cluster

# Consider operators to be stable if they report as such for 5 minutes straight

oc adm wait-for-stable-cluster --minimum-stable-period 5m第3章 odoでの重要な更新

Red Hat は、OpenShift Container Platform ドキュメントサイトで odo に関する情報を提供していません。odo に関連するドキュメント情報は、Red Hat およびアップストリームコミュニティーによって管理されている ドキュメント を参照してください。

アップストリームコミュニティーによって維持される資料は、Red Hat は Cooperative Community Support の下でサポートを提供します。

第4章 OpenShift Serverless で使用する Knative CLI

Knative (kn) CLI は、OpenShift Container Platform の Knative コンポーネントとの簡単な対話を有効にします。

4.1. 主な特長

Knative (kn) CLI は、サーバーレスコンピューティングタスクを単純かつ簡潔にするように設計されています。Knative CLI の主な機能は次のとおりです。

- コマンドラインからサーバーレスアプリケーションをデプロイします。

- サービス、リビジョン、およびトラフィック分割などの Knative Serving の機能を管理します。

- イベントソースおよびトリガーなどの Knative Eventing コンポーネントを作成し、管理します。

- 既存の Kubernetes アプリケーションおよび Knative サービスを接続するために、sink binding を作成します。

-

kubectlCLI と同様に、柔軟性のあるプラグインアーキテクチャーで Knative CLI を拡張します。 - Knative サービスの自動スケーリングパラメーターを設定します。

- 操作の結果を待機したり、カスタムロールアウトおよびロールバックストラテジーのデプロイなどのスクリプト化された使用。

4.2. Knative CLI のインストール

Knative CLI のインストール を参照してください。

第5章 Pipelines CLI (tkn)

5.1. tkn のインストール

CLI ツールを使用して、ターミナルから Red Hat OpenShift Pipeline を管理します。以下のセクションでは、各種の異なるプラットフォームに CLI ツール をインストールする方法を説明します。

また、OpenShift Container Platform Web コンソールから最新のバイナリーへの URL を見つけるには、右上隅の ? アイコンをクリックし、Command Line Tools を選択します。

アーカイブと RPM の両方に、次の実行可能ファイルが含まれています。

-

tkn -

tkn-pac -

opc

opc CLI ツールを使用した Red Hat OpenShift Pipelines の実行は、テクノロジープレビュー機能です。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は、実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行い、フィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

5.1.1. Linux への Red Hat OpenShift Pipelines CLI のインストール

Linux ディストリビューションの場合は、CLI を tar.gz アーカイブとしてダウンロードできます。

手順

関連する CLI ツールをダウンロードします。

アーカイブを展開します。

tar xvzf <file>

$ tar xvzf <file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

tkn、tkn-pac、およびopcファイルの場所をPATH環境変数に追加します。 PATHを確認するには、以下のコマンドを実行します。echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.1.2. RPM を使用した Linux への Red Hat OpenShift Pipelines CLI のインストール

Red Hat Enterprise Linux (RHEL) バージョン 8 の場合は、Red Hat OpenShift Pipelines CLI を RPM としてインストールできます。

前提条件

- お使いの Red Hat アカウントに有効な OpenShift Container Platform サブスクリプションがある。

- ローカルシステムに root または sudo 権限がある。

手順

Red Hat Subscription Manager に登録します。

subscription-manager register

# subscription-manager registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 最新のサブスクリプションデータをプルします。

subscription-manager refresh

# subscription-manager refreshCopy to Clipboard Copied! Toggle word wrap Toggle overflow 利用可能なサブスクリプションをリストします。

subscription-manager list --available --matches '*pipelines*'

# subscription-manager list --available --matches '*pipelines*'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 直前のコマンドの出力で、OpenShift Container Platform サブスクリプションのプール ID を見つけ、これを登録されたシステムにアタッチします。

subscription-manager attach --pool=<pool_id>

# subscription-manager attach --pool=<pool_id>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat OpenShift Pipelines で必要なリポジトリーを有効にします。

Linux (x86_64, amd64)

subscription-manager repos --enable="pipelines-1.18-for-rhel-8-x86_64-rpms"

# subscription-manager repos --enable="pipelines-1.18-for-rhel-8-x86_64-rpms"Copy to Clipboard Copied! Toggle word wrap Toggle overflow IBM Z® および IBM® LinuxONE (s390x) 上の Linux

subscription-manager repos --enable="pipelines-1.18-for-rhel-8-s390x-rpms"