モニタリング

OpenShift Container Platform でのモニタリングスタックの設定および使用

概要

第1章 OpenShift Container Platform モニタリングについて

1.1. OpenShift Container Platform モニタリングについて

OpenShift Container Platform には、コアプラットフォームコンポーネントのモニタリングを提供する事前に設定され、事前にインストールされた自己更新型のモニタリングスタックが含まれます。また、ユーザー定義プロジェクトのモニタリングを有効 にするオプションもあります。

クラスター管理者は、サポートされている設定で モニタリングスタックを設定 できます。OpenShift Container Platform は、追加設定が不要のモニタリングのベストプラクティスを提供します。

クラスターの問題を管理者に即座に通知するアラートのセットがデフォルトで含まれています。OpenShift Container Platform Web コンソールのデフォルトのダッシュボードには、クラスターの状態をすぐに理解できるようにするクラスターのメトリクスの視覚的な表示が含まれます。OpenShift Container Platform Web コンソールを使用すると、メトリクスにアクセス し、アラートを管理 できます。

OpenShift Container Platform のインストール後に、クラスター管理者はオプションでユーザー定義プロジェクトのモニタリングを有効にできます。この機能を使用することで、クラスター管理者、開発者、および他のユーザーは、サービスと Pod を独自のプロジェクトでモニターする方法を指定できます。クラスター管理者は、Troubleshooting monitoring issues で、Prometheus によるユーザーメトリクスの使用不可やディスクスペースの大量消費などの一般的な問題に対する回答を見つけることができます。

1.2. モニタリングスタックアーキテクチャー

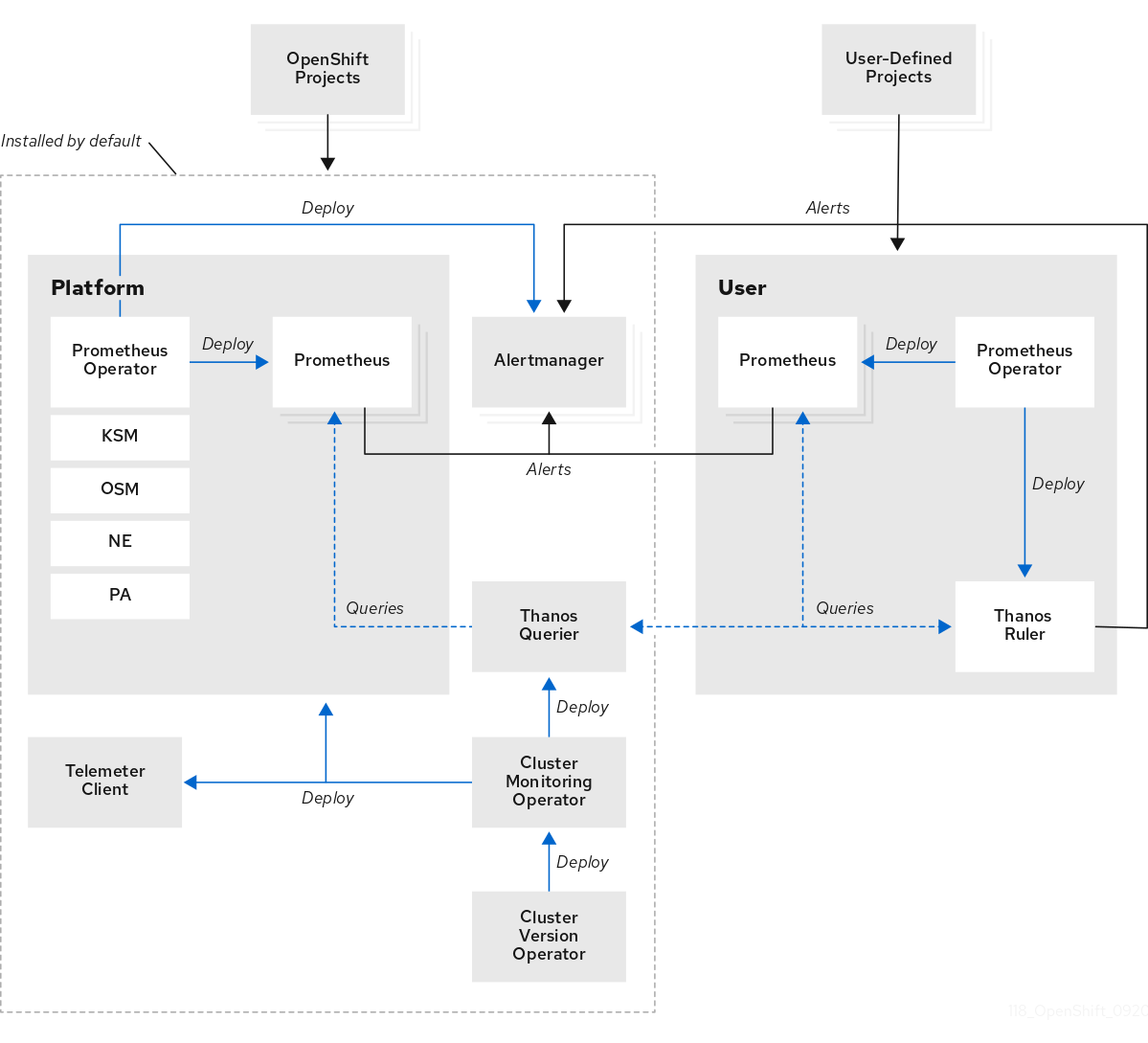

OpenShift Container Platform モニタリングスタックは、Prometheus オープンソースプロジェクトおよびその幅広いエコシステムをベースとしています。ここでは、モニタリングスタックアーキテクチャーを説明します。これには、デフォルトのモニタリングコンポーネントおよびユーザー定義プロジェクトのモニタリング用のコンポーネントが含まれます。

1.2.1. モニタリングスタックについて

モニタリングスタックには、以下のコンポーネントが含まれます。

- デフォルトのプラットフォームモニタリングコンポーネント

プラットフォームモニタリングコンポーネントのセットは、OpenShift Container Platform のインストール時にデフォルトで

openshift-monitoringプロジェクトにインストールされます。これにより、Kubernetes サービスを含むコアクラスターコンポーネントのモニタリングが可能になります。デフォルトのモニタリングスタックは、クラスターのリモートのヘルスモニタリングも有効にします。これらのコンポーネントは、以下の図の Installed by default セクションに表示されます。

- ユーザー定義プロジェクトをモニターするためのコンポーネント

ユーザー定義プロジェクトのモニタリングを有効にすると、追加のモニタリングコンポーネントは

openshift-user-workload-monitoringプロジェクトにインストールされます。これにより、ユーザー定義プロジェクトのオプションのモニタリング機能が提供されます。これらのコンポーネントは、以下の図の User セクションに表示されます。

1.2.2. デフォルトのモニタリングコンポーネント

デフォルトで、OpenShift Container Platform 4.19 モニタリングスタックには以下のコンポーネントが含まれます。

| コンポーネント | 説明 |

|---|---|

| Cluster Monitoring Operator | Cluster Monitoring Operator (CMO) は、モニタリングスタックの中心的なコンポーネントです。Prometheus および Alertmanager インスタンス、Thanos Querier、Telemeter Client、およびメトリクスターゲットをデプロイ、管理、および自動更新します。CMO は Cluster Version Operator (CVO) によってデプロイされます。 |

| Prometheus Operator |

|

| Prometheus | OpenShift Container Platform モニタリングスタックは、Prometheus モニタリングシステムをベースにしています。Prometheus は時系列データベースであり、メトリクスのルール評価エンジンです。Prometheus は処理のためにアラートを Alertmanager に送信します。 |

| Prometheus アダプター |

Prometheus アダプター (上記の図の PA) は、Prometheus で使用する Kubernetes ノードおよび Pod クエリーを変換します。変換されるリソースメトリクスには、CPU およびメモリーの使用率メトリクスが含まれます。Prometheus アダプターは、Horizontal Pod Autoscaling のクラスターリソースメトリクス API を公開します。Prometheus アダプターは |

| Metrics Server (テクノロジープレビュー) |

有効にすると、Metrics Server コンポーネントはリソースメトリクスを収集し、他のツールや API で使用できるように

|

| Alertmanager | Alertmanager サービスは、Prometheus から送信されるアラートを処理します。また、Alertmanager は外部の通知システムにアラートを送信します。 |

| kube-state-metrics エージェント | kube-state-metrics エクスポーターエージェント (上記の図の KSM) は、Kubernetes オブジェクトを Prometheus が使用できるメトリクスに変換します。 |

| monitoring-plugin | monitoring-plugin 動的プラグインコンポーネントは、OpenShift Container Platform Web コンソールの Observe セクションにモニタリングページをデプロイします。Cluster Monitoring Operator config map 設定を使用すると、Web コンソールページの monitoring-plugin リソースを管理できます。 |

| openshift-state-metrics エージェント | openshift-state-metrics エクスポーター (上記の図の OSM) は、OpenShift Container Platform 固有のリソースのメトリクスを追加して、kube-state-metrics を拡張します。 |

| node-exporter エージェント | ノードエクスポーターエージェント (上記の図の NE) は、クラスター内のすべてのノードに関するメトリクスを収集します。node-exporter エージェントはすべてのノードにデプロイされます。 |

| Thanos Querier | Thanos Querier は、単一のマルチテナントインターフェイスで、OpenShift Container Platform のコアメトリクスおよびユーザー定義プロジェクトのメトリクスを集約し、オプションでこれらの重複を排除します。 |

| Telemeter クライアント | Telemeter Client は、プラットフォームの Prometheus インスタンスから Red Hat にデータのサブセクションを送信し、クラスターのリモートヘルスモニタリングを有効にします。 |

モニタリングスタックは、スタック内のすべてのコンポーネントを監視します。このコンポーネントは、OpenShift Container Platform の更新時に自動的に更新されます。

1.2.2.1. デフォルトのモニタリングターゲット

スタック自体のコンポーネントに加えて、デフォルトのモニタリングスタックは追加のプラットフォームコンポーネントを監視します。

以下は、モニタリングターゲットの例です。

- CoreDNS

- etcd

- HAProxy

- イメージレジストリー

- Kubelets

- Kubernetes API サーバー

- Kubernetes コントローラーマネージャー

- Kubernetes スケジューラー

- OpenShift API サーバー

- OpenShift Controller Manager

- Operator Lifecycle Manager (OLM)

- ターゲットの正確なリストは、クラスターの機能とインストールされているコンポーネントによって異なる場合があります。

- 各 OpenShift Container Platform コンポーネントはそれぞれのモニタリング設定を行います。OpenShift Container Platform コンポーネントのモニタリングに関する問題は、Jira 問題 で一般的なモニタリングコンポーネントではなく、特定のコンポーネントに対してバグを報告してください。

他の OpenShift Container Platform フレームワークのコンポーネントもメトリクスを公開する場合があります。詳細は、それぞれのドキュメントを参照してください。

1.2.3. ユーザー定義プロジェクトをモニターするためのコンポーネント

OpenShift Container Platform には、ユーザー定義プロジェクトでサービスおよび Pod を監視する際に役立つモニタリングスタックのオプションの機能拡張が含まれています。この機能には、以下のコンポーネントが含まれます。

| コンポーネント | 説明 |

|---|---|

| Prometheus Operator |

|

| Prometheus | Prometheus は、ユーザー定義プロジェクトのモニタリングを提供するモニタリングシステムです。Prometheus は処理のためにアラートを Alertmanager に送信します。 |

| Thanos Ruler | Thanos Ruler は、別のプロセスとしてデプロイされる Prometheus のルール評価エンジンです。OpenShift Container Platform では、Thanos Ruler はユーザー定義プロジェクトをモニタリングするためのルールおよびアラート評価を提供します。 |

| Alertmanager | Alertmanager サービスは、Prometheus および Thanos Ruler から送信されるアラートを処理します。Alertmanager はユーザー定義のアラートを外部通知システムに送信します。このサービスのデプロイは任意です。 |

上記の表のコンポーネントは、ユーザー定義プロジェクトのモニタリングを有効にした後にデプロイされます。

モニタリングスタックは、ユーザー定義プロジェクトのすべてのコンポーネントを監視します。このコンポーネントは、OpenShift Container Platform の更新時に自動的に更新されます。

1.2.3.1. ユーザー定義プロジェクトのターゲットのモニタリング

ユーザー定義プロジェクトのモニタリングを有効にすると、以下を監視できます。

- ユーザー定義プロジェクトのサービスエンドポイント経由で提供されるメトリクス。

- ユーザー定義プロジェクトで実行される Pod。

1.2.4. 高可用性クラスターでのモニタリングスタック

マルチノードクラスターでは、データの損失やサービスの停止を防ぐために、次のコンポーネントがデフォルトで高可用性 (HA) モードで実行されます。

- Prometheus

- Alertmanager

- Thanos Ruler

- Thanos Querier

- Prometheus アダプター

- モニタリングプラグイン

コンポーネントは 2 つの Pod にレプリケートされ、それぞれが別のノードで実行されます。そのため、モニタリングスタックは 1 つの Pod の損失に耐えることができます。

- HA モードの Prometheus

- 両方のレプリカが独立して同じターゲットをスクレイピングし、同じルールを評価します。

- レプリカは相互に通信しません。したがって、Pod 間でデータが異なる場合があります。

- HA モードの Alertmanager

- 2 つのレプリカが通知とサイレンス状態を相互に同期します。これにより、各通知が少なくとも 1 回は送信されます。

- レプリカが通信に失敗した場合、または受信側に問題がある場合、通知は送信されますが、重複する可能性があります。

Prometheus、Alertmanager、Thanos Ruler はステートフルコンポーネントです。高可用性を実現するには、これらのコンポーネントを永続ストレージを使用して設定する必要があります。

1.2.5. モニタリングスタックにおける TLS セキュリティーとローテーション

通信をセキュアに保つために、OpenShift Container Platform モニタリングスタックで TLS プロファイルと証明書のローテーションがどのように機能するか説明します。

- 監視コンポーネントの TLS セキュリティープロファイル

-

モニタリングスタックのすべてのコンポーネントは、クラスター管理者が一元的に設定する TLS セキュリティープロファイル設定を使用します。モニタリングスタックコンポーネントは、グローバル OpenShift Container Platform

apiservers.config.openshift.io/clusterリソースのtlsSecurityProfileフィールドにすでに存在する TLS セキュリティープロファイル設定を使用します。 - TLS 証明書のローテーションと自動再起動

Cluster Monitoring Operator は、モニタリングコンポーネントの内部 TLS 証明書のライフサイクルを管理します。これらの証明書は、モニタリングコンポーネント間の内部通信を保護します。

証明書のローテーション中に、CMO はシークレットと config map を更新し、影響を受ける Pod の自動再起動をトリガーします。これは想定された動作であり、Pod は自動的に回復します。

次の例は、証明書のローテーション中に発生するイベントを示しています。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

1.2.6. OpenShift Container Platform モニタリングの一般用語集

この用語集では、OpenShift Container Platform アーキテクチャーで使用される一般的な用語を定義します。

- Alertmanager

- Alertmanager は、Prometheus から受信したアラートを処理します。また、Alertmanager は外部の通知システムにアラートを送信します。

- アラートルール

- アラートルールには、クラスター内の特定の状態を示す一連の条件が含まれます。アラートは、これらの条件が true の場合にトリガーされます。アラートルールには、アラートのルーティング方法を定義する重大度を割り当てることができます。

- Cluster Monitoring Operator

- Cluster Monitoring Operator (CMO) は、モニタリングスタックの中心的なコンポーネントです。Thanos Querier、Telemeter Client、メトリクスターゲットなどの Prometheus インスタンスをデプロイおよび管理して、それらが最新であることを確認します。CMO は Cluster Version Operator (CVO) によってデプロイされます。

- Cluster Version Operator

- Cluster Version Operator (CVO) は Cluster Operator のライフサイクルを管理し、その多くはデフォルトで OpenShift Container Platform にインストールされます。

- config map

-

config map は、設定データを Pod に注入する方法を提供します。タイプ

ConfigMapのボリューム内の config map に格納されたデータを参照できます。Pod で実行しているアプリケーションは、このデータを使用できます。 - コンテナー

- コンテナーは、ソフトウェアとそのすべての依存関係を含む軽量で実行可能なイメージです。コンテナーは、オペレーティングシステムを仮想化します。そのため、コンテナーはデータセンターからパブリッククラウド、プライベートクラウド、開発者のラップトップなどまで、場所を問わずコンテナーを実行できます。

- カスタムリソース (CR)

- CR は Kubernetes API のエクステンションです。カスタムリソースを作成できます。

- etcd

- etcd は OpenShift Container Platform のキーと値のストアであり、すべてのリソースオブジェクトの状態を保存します。

- Fluentd

Fluentd は、各 OpenShift Container Platform ノードに常駐するログコレクターです。アプリケーション、インフラストラクチャー、および監査ログを収集し、それらをさまざまな出力に転送します。

注記Fluentd は非推奨となっており、今後のリリースで削除される予定です。Red Hat は、現在のリリースのライフサイクル中にこの機能のバグ修正とサポートを提供しますが、この機能は拡張されなくなりました。Fluentd の代わりに、Vector を使用できます。

- Kubelets

- ノード上で実行され、コンテナーマニフェストを読み取ります。定義されたコンテナーが開始され、実行されていることを確認します。

- Kubernetes API サーバー

- Kubernetes API サーバーは、API オブジェクトのデータを検証して設定します。

- Kubernetes コントローラーマネージャー

- Kubernetes コントローラーマネージャーは、クラスターの状態を管理します。

- Kubernetes スケジューラー

- Kubernetes スケジューラーは Pod をノードに割り当てます。

- ラベル

- ラベルは、Pod などのオブジェクトのサブセットを整理および選択するために使用できるキーと値のペアです。

- node

- OpenShift Container Platform クラスター内のコンピュートマシン。ノードは、仮想マシン (VM) または物理マシンのいずれかです。

- Operator

- OpenShift Container Platform クラスターで Kubernetes アプリケーションをパッケージ化、デプロイ、および管理するための推奨される方法。Operator は、人間による操作に関する知識を取り入れて、簡単にパッケージ化してお客様と共有できるソフトウェアにエンコードします。

- Operator Lifecycle Manager (OLM)

- OLM は、Kubernetes ネイティブアプリケーションのライフサイクルをインストール、更新、および管理するのに役立ちます。OLM は、Operator を効果的かつ自動化されたスケーラブルな方法で管理するために設計されたオープンソースのツールキットです。

- 永続ストレージ

- デバイスがシャットダウンされた後でもデータを保存します。Kubernetes は永続ボリュームを使用して、アプリケーションデータを保存します。

- 永続ボリューム要求 (PVC)

- PVC を使用して、PersistentVolume を Pod にマウントできます。クラウド環境の詳細を知らなくてもストレージにアクセスできます。

- Pod

- Pod は、Kubernetes における最小の論理単位です。Pod は、ワーカーノードで実行される 1 つ以上のコンテナーで構成されます。

- Prometheus

- Prometheus は、OpenShift Container Platform モニタリングスタックのベースとなるモニタリングシステムです。Prometheus は時系列データベースであり、メトリクスのルール評価エンジンです。Prometheus は処理のためにアラートを Alertmanager に送信します。

- Prometheus アダプター

- Prometheus アダプターは、Prometheus で使用するために Kubernetes ノードと Pod のクエリーを変換します。変換されるリソースメトリクスには、CPU およびメモリーの使用率が含まれます。Prometheus アダプターは、Horizontal Pod Autoscaling のクラスターリソースメトリクス API を公開します。

- Prometheus Operator

-

openshift-monitoringプロジェクトの Prometheus Operator は、プラットフォーム Prometheus インスタンスおよび Alertmanager インスタンスを作成、設定、および管理します。また、Kubernetes ラベルのクエリーに基づいてモニタリングターゲットの設定を自動生成します。 - サイレンス

- サイレンスをアラートに適用し、アラートの条件が true の場合に通知が送信されることを防ぐことができます。初期通知後はアラートをミュートにして、根本的な問題の解決に取り組むことができます。

- ストレージ

- OpenShift Container Platform は、オンプレミスおよびクラウドプロバイダーの両方で、多くのタイプのストレージをサポートします。OpenShift Container Platform クラスターで、永続データおよび非永続データ用のコンテナーストレージを管理できます。

- Thanos Ruler

- Thanos Ruler は、別のプロセスとしてデプロイされる Prometheus のルール評価エンジンです。OpenShift Container Platform では、Thanos Ruler はユーザー定義プロジェクトをモニタリングするためのルールおよびアラート評価を提供します。

- Vector

- Vector は、各 OpenShift Container Platform ノードにデプロイするログコレクターです。各ノードからログデータを収集し、データを変換して、設定された出力に転送します。

- Web コンソール

- OpenShift Container Platform を管理するためのユーザーインターフェイス (UI)。

1.3. モニタリングスタックについて - 主な概念

OpenShift Container Platform のモニタリングの概念と用語を解説します。クラスターのパフォーマンスとスケールを向上させる方法、データを保存および記録する方法、メトリクスとアラートを管理する方法などを説明します。

1.3.1. パフォーマンスとスケーラビリティーについて

クラスターのパフォーマンスとスケールを最適化できます。次のアクションを実行して、デフォルトのモニタリングスタックを設定できます。

モニタリングコンポーネントの配置と分散を制御します。

- ノードセレクターを使用して、コンポーネントを特定のノードに移動します。

- taint されたノードにコンポーネントを移動できるように toleration を割り当てます。

- Pod トポロジー分散制約を使用します。

- メトリクススクレイピングのボディーサイズ制限を設定します。

- CPU とメモリーのリソースを管理します。

- メトリクス収集プロファイルを使用します。

1.3.1.1. ノードセレクターを使用したモニタリングコンポーネントの移動

ラベル付きノードで nodeSelector 制約を使用すると、任意のモニタリングスタックコンポーネントを特定ノードに移動できます。これにより、クラスター全体のモニタリングコンポーネントの配置と分散を制御できます。

モニタリングコンポーネントの配置と分散を制御して、システムリソースの使用を最適化し、パフォーマンスを高め、特定の要件やポリシーに基づいてワークロードを分離できます。

ノードセレクターと他の制約の連携

ノードセレクターの制約を使用してモニタリングコンポーネントを移動する場合、クラスターに Pod のスケジューリングを制御するための他の制約があることに注意してください。

- Pod の配置を制御するために、トポロジー分散制約が設定されている可能性があります。

- Prometheus、Alertmanager、およびその他のモニタリングコンポーネントでは、コンポーネントの複数の Pod が必ず異なるノードに分散されて高可用性が常に確保されるように、ハードなアンチアフィニティールールが設定されています。

ノード上で Pod をスケジュールする場合、Pod スケジューラーは既存の制約をすべて満たすように Pod の配置を決定します。つまり、Pod スケジューラーがどの Pod をどのノードに配置するかを決定する際に、すべての制約が組み合わされます。

そのため、ノードセレクター制約を設定しても既存の制約をすべて満たすことができない場合、Pod スケジューラーはすべての制約をマッチさせることができず、ノードへの Pod 配置をスケジュールしません。

モニタリングコンポーネントの耐障害性と高可用性を維持するには、コンポーネントを移動するノードセレクター制約を設定する際に、十分な数のノードが利用可能で、すべての制約がマッチすることを確認してください。

1.3.1.2. モニタリングのための Pod トポロジー分散制約について

OpenShift Container Platform Pod が複数のアベイラビリティーゾーンにデプロイされている場合は、Pod トポロジーの分散制約を使用して、モニタリング Pod がネットワークトポロジー全体にどのように分散されるかを制御できます。

Pod トポロジーの分散制約は、ノードがリージョンやリージョン内のゾーンなど、さまざまなインフラストラクチャーレベルに分散している階層トポロジー内で Pod のスケジューリングを制御するのに適しています。さらに、さまざまなゾーンで Pod をスケジュールできるため、特定のシナリオでネットワーク遅延を改善できます。

Cluster Monitoring Operator によってデプロイされたすべての Pod に対して Pod トポロジーの分散制約を設定し、ゾーン全体のノードに Pod レプリカをスケジュールする方法を制御できます。これにより、ワークロードが異なるデータセンターまたは階層型インフラストラクチャーゾーンのノードに分散されるため、Pod の可用性が高まり、より効率的に実行されるようになります。

1.3.1.3. モニタリングコンポーネントの制限と要求の指定について

次のコアプラットフォームモニタリングコンポーネントのリソース制限と要求を設定できます。

- Alertmanager

- kube-state-metrics

- monitoring-plugin

- node-exporter

- openshift-state-metrics

- Prometheus

- Prometheus アダプター

- Prometheus Operator とそのアドミッション Webhook サービス

- Telemeter クライアント

- Thanos Querier

ユーザー定義プロジェクトを監視する以下のコンポーネントのリソース制限および要求を設定できます。

- Alertmanager

- Prometheus

- Thanos Ruler

リソース制限を定義することで、コンテナーのリソース使用量を制限し、コンテナーが CPU およびメモリーリソースの指定された最大値を超えないようにします。

リソース要求を定義することで、要求されたリソースに一致するのに十分な CPU およびメモリーリソースがあるノードでのみコンテナーをスケジュールできることを指定します。

1.3.1.4. メトリクス収集プロファイルについて

メトリクス収集プロファイルはテクノロジープレビュー機能です。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は、実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行い、フィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

デフォルトでは、Prometheus は OpenShift Container Platform コンポーネントのすべてのデフォルトのメトリクスターゲットによって公開されたメトリクスを収集します。ただし、特定のシナリオでは、Prometheus がクラスターから収集するメトリクスを少なくしたい場合があります。

- クラスター管理者がアラート、テレメトリー、およびコンソールメトリクスのみを必要とし、他のメトリクスを使用可能にする必要がない場合。

- クラスターのサイズが大きくなり、収集されるデフォルトのメトリクスデータのサイズが大きくなった場合、CPU とメモリーリソースを大幅に増やす必要があります。

メトリクス収集プロファイルを使用して、デフォルトの量のメトリクスデータまたは最小量のメトリクスデータを収集できます。最小限のメトリクスデータを収集すると、アラートなどの基本的なモニタリング機能は引き続き機能します。同時に、Prometheus が必要とする CPU およびメモリーリソースが減少します。

次の 2 つのメトリクス収集プロファイルのいずれかを有効にできます。

- full: Prometheus は、すべてのプラットフォームコンポーネントによって公開されるメトリクスデータを収集します。この設定がデフォルトです。

- minimal: Prometheus は、プラットフォームアラート、記録ルール、テレメトリー、およびコンソールダッシュボードに必要なメトリクスデータのみを収集します。

1.3.2. データの保存と記録について

データを保存および記録することで、データを保護し、トラブルシューティングに役立てることができます。次のアクションを実行して、デフォルトのモニタリングスタックを設定できます。

永続ストレージを設定します。

- メトリクスとアラートデータを永続ボリューム (PV) に保存することで、データ損失から保護します。その結果、Pod が再起動または再作成されても存続できます。

- Alertmanager Pod が再起動したときに、重複した通知を受信したり、アラートのサイレンスが失われたりするのを回避します。

- Prometheus および Thanos Ruler メトリクスデータの保持時間とサイズを変更します。

クラスターの問題のトラブルシューティングに役立つロギングを設定します。

- Metrics Server の監査ログを設定します。

- モニタリングのログレベルを設定します。

- Prometheus および Thanos Querier のクエリーロギングを有効にします。

1.3.2.1. Prometheus メトリクスの保持時間とサイズ

デフォルトで、Prometheus がメトリクスデータを保持する期間のデフォルトは以下のとおりです。

- コアプラットフォームのモニタリング: 15 日間

- ユーザー定義プロジェクトの監視: 24 時間

Prometheus インスタンスの保持時間を変更して、データが削除されるまでの時間を変更できます。保持されるメトリクスデータが使用するディスク容量の最大量を設定することもできます。データがこのサイズ制限に達すると、使用するディスク領域が上限を下回るまで、Prometheus は最も古いデータを削除します。

これらのデータ保持設定は、以下の挙動に注意してください。

-

サイズベースのリテンションポリシーは、

/prometheusディレクトリー内のすべてのデータブロックディレクトリーに適用され、永続ブロック、ライトアヘッドログ (WAL) データ、および m-mapped チャンクも含まれます。 -

/walおよび/head_chunksディレクトリー内のデータは保持サイズ制限にカウントされますが、Prometheus がサイズまたは時間ベースの保持ポリシーに基づいてこれらのディレクトリーからデータをパージすることはありません。したがって、/walディレクトリーおよび/head_chunksディレクトリーに設定された最大サイズよりも低い保持サイズ制限を設定すると、/prometheusデータディレクトリーにデータブロックを保持しないようにシステムを設定している。 - サイズベースの保持ポリシーは、Prometheus が新規データブロックをカットする場合にのみ適用されます。これは、WAL に少なくとも 3 時間のデータが含まれてから 2 時間ごとに実行されます。

-

retentionまたはretentionSizeの値を明示的に定義しない場合、保持期間のデフォルトは、コアプラットフォームの監視は 15 日間、ユーザー定義プロジェクトの監視は 24 時間です。保持サイズは設定されていません。 -

retentionおよびretentionSizeの両方に値を定義すると、両方の値が適用されます。データブロックが定義された保持時間または定義されたサイズ制限を超える場合、Prometheus はこれらのデータブロックをパージします。 -

retentionSizeの値を定義してretentionを定義しない場合、retentionSize値のみが適用されます。 -

retentionSizeの値を定義しておらず、pretentionの値のみを定義する場合、retention値のみが適用されます。 -

retentionSizeまたはretentionの値を0に設定すると、デフォルト設定が適用されます。保持期間のデフォルト設定は、コアプラットフォームの監視の場合は 15 日間、ユーザー定義プロジェクトの監視の場合は 24 時間です。デフォルトでは、保持サイズは設定されていません。

データコンパクションは 2 時間ごとに実行されます。そのため、コンパクションが実行される前に永続ボリューム (PV) がいっぱいになり、retentionSize 制限を超える可能性があります。その場合、PV 上のスペースが retentionSize 制限を下回るまで、KubePersistentVolumeFillingUp アラートが発生します。

1.3.3. メトリクスについて

OpenShift Container Platform 4.15 では、クラスターコンポーネントはサービスエンドポイントで公開されるメトリクスを収集することによりモニターされます。ユーザー定義プロジェクトのメトリクスのコレクションを設定することもできます。メトリクスを使用すると、クラスターコンポーネントおよび独自のワークロードの実行方法をモニターできます。

Prometheus クライアントライブラリーをアプリケーションレベルで使用することで、独自のワークロードに指定するメトリクスを定義できます。

OpenShift Container Platform では、メトリクスは /metrics の正規名の下に HTTP サービスエンドポイント経由で公開されます。curl クエリーを http://<endpoint>/metrics に対して実行して、サービスの利用可能なすべてのメトリクスをリスト表示できます。たとえば、prometheus-example-app サンプルアプリケーションへのルートを公開し、以下のコマンドを実行して利用可能なすべてのメトリクスを表示できます。

curl http://<example_app_endpoint>/metrics

$ curl http://<example_app_endpoint>/metrics出力例

1.3.3.1. ユーザー定義プロジェクトでバインドされていないメトリクス属性の影響の制御

開発者は、キーと値のペアの形式でメトリクスの属性を定義するためにラベルを作成できます。使用できる可能性のあるキーと値のペアの数は、属性に使用できる可能性のある値の数に対応します。数が無制限の値を持つ属性は、バインドされていない属性と呼ばれます。たとえば、customer_id 属性は、使用できる値が無限にあるため、バインドされていない属性になります。

割り当てられるキーと値のペアにはすべて、一意の時系列があります。ラベルに多数のバインドされていない値を使用すると、作成される時系列の数が指数関数的に増加する可能性があります。これは Prometheus のパフォーマンスに影響する可能性があり、多くのディスク領域を消費する可能性があります。

クラスター管理者は、以下の手段を使用して、ユーザー定義プロジェクトでのバインドされていないメトリクス属性の影響を制御できます。

- ユーザー定義プロジェクトでターゲットスクレイピングごとの許容可能なサンプル数を制限する

- 収集されたラベルの数、ラベル名の長さ、およびラベル値の長さを制限します。

- 収集サンプルのしきい値に達するか、ターゲットを収集できない場合に実行されるアラートを作成します。

スクレイピングサンプル数を制限すると、ラベルにバインドされない属性を多数追加することによって発生する問題を防ぐことができます。さらに開発者は、メトリクスに定義するバインドされていない属性の数を制限することにより、根本的な原因を防ぐことができます。使用可能な値の制限されたセットにバインドされる属性を使用すると、可能なキーと値のペアの組み合わせの数が減ります。

1.3.3.2. クラスター ID ラベルのメトリクスへの追加

複数の OpenShift Container Platform クラスターを管理し、リモート書き込み機能を使用してメトリクスデータをこれらのクラスターから外部ストレージの場所に送信する場合、クラスター ID ラベルを追加して、異なるクラスターから送られるメトリクスデータを特定できます。次に、これらのラベルをクエリーし、メトリクスのソースクラスターを特定し、そのデータを他のクラスターによって送信される同様のメトリクスデータと区別することができます。

これにより、複数の顧客に対して多数のクラスターを管理し、メトリクスデータを単一の集中ストレージシステムに送信する場合、クラスター ID ラベルを使用して特定のクラスターまたはお客様のメトリクスをクエリーできます。

クラスター ID ラベルの作成および使用には、以下の 3 つの一般的な手順が必要です。

- リモート書き込みストレージの書き込みラベルの設定。

- クラスター ID ラベルをメトリクスに追加します。

- これらのラベルを取得し、メトリクスのソースクラスターまたはカスタマーを特定します。

1.3.4. モニタリングダッシュボードについて

OpenShift Container Platform は、クラスターコンポーネントとユーザー定義のワークロードの状態を理解するのに役立つ一連のモニタリングダッシュボードを提供します。

1.3.4.1. Administrator パースペクティブでのダッシュボードの監視

Administrator パースペクティブを使用して、以下を含む OpenShift Container Platform のコアコンポーネントのダッシュボードにアクセスします。

- API パフォーマンス

- etcd

- Kubernetes コンピュートリソース

- Kubernetes ネットワークリソース

- Prometheus

- クラスターおよびノードのパフォーマンスに関連する USE メソッドダッシュボード

- ノードのパフォーマンスメトリクス

図1.1 Administrator パースペクティブのダッシュボードの例

1.3.4.2. Developer パースペクティブでのダッシュボードの監視

Developer パースペクティブを使用して、選択されたプロジェクトの以下のアプリケーションメトリクスを提供する Kubernetes コンピュートリソースダッシュボードにアクセスします。

- CPU usage (CPU の使用率)

- メモリー使用量

- 帯域幅に関する情報

- パケットレート情報

図1.2 Developer パースペクティブのダッシュボードの例

1.3.5. アラートの管理

OpenShift Container Platform では、アラート UI を使用してアラート、サイレンス、およびアラートルールを管理できます。

- アラートルール。アラートルールには、クラスター内の特定の状態を示す一連の条件が含まれます。アラートは、これらの条件が true の場合にトリガーされます。アラートルールには、アラートのルーティング方法を定義する重大度を割り当てることができます。

- アラート。アラートは、アラートルールで定義された条件が true の場合に発生します。アラートは、一連の状況が OpenShift Container Platform クラスター内で明確であることを示す通知を提供します。

- サイレンス。サイレンスをアラートに適用し、アラートの条件が true の場合に通知が送信されることを防ぐことができます。最初の通知の後、問題の解決に取り組んでいる間は、アラートをミュートすることができます。

アラート UI で利用可能なアラート、サイレンス、およびアラートルールは、アクセス可能なプロジェクトに関連付けられます。たとえば、cluster-admin ロールを持つユーザーとしてログインしている場合は、すべてのアラート、サイレント、およびアラートルールにアクセスできます。

1.3.5.1. サイレンスの管理

OpenShift Container Platform Web コンソールの Administrator パースペクティブと Developer パースペクティブの両方で、アラートのサイレンスを作成できます。サイレンスを作成すると、アラートが発生したときにアラートに関する通知を受信しなくなります。

サイレントの作成は、最初のアラート通知を受信し、アラートの発生の原因となっている根本的な問題を解決するまでの間、さらなる通知を受け取りたくないシナリオで役立ちます。

サイレンスの作成時に、サイレンスをすぐにアクティブにするか、後にアクティブにするかを指定する必要があります。また、サイレンスの有効期限を設定する必要もあります。

サイレンスを作成した後、それらを表示、編集、および期限切れにすることができます。

サイレンスを作成すると、それらは Alertmanager Pod 全体に複製されます。ただし、Alertmanager の永続ストレージを設定しないと、サイレンスが失われる可能性があります。これは、たとえば、すべての Alertmanager Pod が同時に再起動した場合に発生する可能性があります。

1.3.5.2. コアプラットフォームモニタリングのアラートルールの管理

OpenShift Container Platform のモニタリングには、プラットフォームメトリクス用のデフォルトのアラートルールが多数用意されています。クラスター管理者は、このルールセットを 2 つの方法でカスタマイズできます。

-

しきい値を調整するか、ラベルを追加および変更して、既存のプラットフォームのアラートルールの設定を変更します。たとえば、アラートの

severityラベルをwarningからcriticalに変更すると、アラートのフラグが付いた問題のルーティングおよびトリアージに役立ちます。 -

openshift-monitoringnamespace のコアプラットフォームメトリクスに基づいてクエリー式を作成することにより、新しいカスタムアラートルールを定義して追加します。

コアプラットフォームのアラートルールの考慮事項

- 新規のアラートルールはデフォルトの OpenShift Container Platform モニタリングメトリクスをベースとする必要があります。

-

openshift-monitoringnamespace にAlertingRuleオブジェクトとAlertRelabelConfigオブジェクトを作成する必要があります。 - アラートルールのみを追加および変更できます。新しい記録ルールを作成したり、既存の記録ルールを変更したりすることはできません。

-

AlertRelabelConfigオブジェクトを使用して既存のプラットフォームのアラートルールを変更する場合、変更は Prometheus アラート API に反映されません。そのため、削除されたアラートは Alertmanager に転送されていなくても OpenShift Container Platform Web コンソールに表示されます。さらに、severityラベルの変更など、アラートへの変更は Web コンソールには表示されません。

1.3.5.3. コアプラットフォームモニタリングのアラートルールを最適化するためのヒント

組織の特定のニーズに合わせてコアプラットフォームのアラートルールをカスタマイズする場合は、次のガイドラインに従って、カスタマイズされたルールが効率的かつ効果的であることを確認してください。

- 新しいルールの数を最小限に抑えます。特定の要件に不可欠なルールのみを作成します。ルールの数を最小限に抑えることで、より管理しやすく、焦点を絞ったアラートシステムをモニタリング環境に作成できます。

- 原因ではなく症状に焦点を当てます。根本的な原因ではなく症状をユーザーに通知するルールを作成します。このアプローチにより、関連する症状がユーザーに即座に通知され、アラートがトリガーされた後に根本原因を調査できるようになります。この戦略により、作成する必要があるルールの総数も大幅に削減されます。

- 変更を実装する前に、ニーズを計画し、評価します。まず、どの症状が重要であり、これらの症状が発生した場合にユーザーにどのようなアクションをとってもらいたいかを決定します。次に、既存のルールを評価し、症状ごとにまったく新しいルールを作成するのではなく、ニーズを満たすためにルールを変更できるかどうかを判断します。既存のルールを変更し、新しいルールを慎重に作成することで、アラートシステムを合理化できます。

- クリアなアラートメッセージングを提供します。アラートメッセージを作成するときは、症状、考えられる原因、推奨されるアクションを説明します。明確で簡潔な説明と、トラブルシューティング手順または詳細情報へのリンクを含めます。そうすることで、ユーザーは状況を迅速に評価し、適切に対応することができます。

- 重大度レベルを含めます。ルールに重大度レベルを割り当てて、症状が発生してアラートがトリガーされたときにユーザーがどのように反応する必要があるかを示します。たとえば、アラートを Critical として分類すると、個人または重要な対応チームが直ちに対応する必要があることを示します。重大度レベルを定義することで、ユーザーがアラートへの対応方法を理解し、最も緊急性の高い問題に迅速な対応を確実に受けられるようになります。

1.3.5.4. ユーザー定義プロジェクトのアラートルールの作成

ユーザー定義プロジェクトのアラートルールを作成する場合は、新しいルールを定義する際に次の主要な動作と重要な制限事項を考慮してください。

ユーザー定義のアラートルールには、コアプラットフォームのモニタリングからのデフォルトメトリクスに加えて、独自のプロジェクトが公開したメトリクスを含めることができます。別のユーザー定義プロジェクトのメトリクスを含めることはできません。

たとえば、

ns1ユーザー定義プロジェクトのアラートルールでは、CPU やメモリーメトリクスなどのコアプラットフォームメトリクスに加えて、ns1プロジェクトが公開したメトリクスも使用できます。ただし、ルールには、別のns2ユーザー定義プロジェクトからのメトリクスを含めることはできません。レイテンシーを短縮し、コアプラットフォームモニタリングコンポーネントの負荷を最小限に抑えるために、ルールに

openshift.io/prometheus-rule-evaluation-scope: leaf-prometheusラベルを追加できます。このラベルは、openshift-user-workload-monitoringプロジェクトにデプロイされた Prometheus インスタンスのみにアラートルールの評価を強制し、Thanos Ruler インスタンスによる評価を防ぎます。重要アラートルールにこのラベルが付いている場合、そのアラートルールはユーザー定義プロジェクトが公開するメトリクスのみを使用できます。デフォルトのプラットフォームメトリクスに基づいて作成したアラートルールでは、アラートがトリガーされない場合があります。

1.3.5.5. ユーザー定義プロジェクトのアラートルールの管理

OpenShift Container Platform では、ユーザー定義プロジェクト内のアラートルールを表示、編集、削除できます。

アラートルールに関する考慮事項

- デフォルトのアラートルールは OpenShift Container Platform クラスター用に使用され、それ以外の目的では使用されません。

- 一部のアラートルールには、複数の意図的に同じ名前が含まれます。それらは同じイベントに関するアラートを送信しますが、それぞれ異なるしきい値、重大度およびそれらの両方が設定されます。

- 抑制 (inhibition) ルールは、高い重大度のアラートが実行される際に実行される低い重大度のアラートの通知を防ぎます。

1.3.5.6. ユーザー定義プロジェクトのアラートの最適化

アラートルールの作成時に以下の推奨事項を考慮して、独自のプロジェクトのアラートを最適化できます。

- プロジェクト用に作成するアラートルールの数を最小限にします。影響を与える状況を通知するアラートルールを作成します。影響を与えない条件に対して多数のアラートを生成すると、関連するアラートに気づくのがさらに困難になります。

- 原因ではなく現象に関するアラートルールを作成します。根本的な原因に関係なく、状態を通知するアラートルールを作成します。次に、原因を調査できます。アラートルールのそれぞれが特定の原因にのみ関連する場合に、さらに多くのアラートルールが必要になります。そのため、いくつかの原因は見落される可能性があります。

- アラートルールを作成する前にプランニングを行います。重要な現象と、その発生時に実行するアクションを決定します。次に、現象別にアラートルールをビルドします。

- クリアなアラートメッセージングを提供します。アラートメッセージに現象および推奨されるアクションを記載します。

- アラートルールに重大度レベルを含めます。アラートの重大度は、報告される現象が生じた場合に取るべき対応によって異なります。たとえば、現象に個人または緊急対策チーム (Critical Response Team) による早急な対応が必要な場合は、重大アラートをトリガーする必要があります。

1.3.5.7. アラート、サイレンスおよびアラートルールの検索およびフィルター

アラート UI に表示されるアラート、サイレンス、およびアラートルールをフィルターできます。このセクションでは、利用可能な各フィルターオプションを説明します。

1.3.5.7.1. アラートフィルターについて

Administrator パースペクティブでは、アラート UI の Alerts ページに、デフォルトの OpenShift Container Platform プロジェクトおよびユーザー定義プロジェクトに関連するアラートの詳細が提供されます。このページには、各アラートの重大度、状態、およびソースの概要が含まれます。アラートが現在の状態に切り替わった時間も表示されます。

アラートの状態、重大度、およびソースでフィルターできます。デフォルトでは、Firing の Platform アラートのみが表示されます。以下では、それぞれのアラートフィルターオプションを説明します。

State フィルター:

-

Firing。アラート条件が true で、オプションの

forの期間を経過しているためにアラートが実行されます。条件が true である間、アラートの発生が続きます。 - Pending。アラートはアクティブですが、アラート実行前のアラートルールに指定される期間待機します。

- Silenced。指定の期間、アラートがサイレントになります。定義するラベルセレクターのセットに基づいてアラートを一時的にミュートします。リストされたすべての値または正規表現に一致するアラートの土は送信されません。

-

Firing。アラート条件が true で、オプションの

Severity フィルター:

- Critical。アラートをトリガーした状態は重大な影響を与える可能性があります。このアラートには、実行時に早急な対応が必要となり、通常は個人または緊急対策チーム (Critical Response Team) に送信先が設定されます。

- Warning。アラートは、問題の発生を防ぐために注意が必要になる可能性のある問題に関する警告通知を提供します。通常、警告は早急な対応を要さないレビュー用にチケットシステムにルート指定されます。

- Info。アラートは情報提供のみを目的として提供されます。

- None。アラートには重大度が定義されていません。

- また、ユーザー定義プロジェクトに関連するアラートの重大度の定義を作成することもできます。

Source フィルター:

- Platform。プラットフォームレベルのアラートは、デフォルトの OpenShift Container Platform プロジェクトにのみ関連します。これらのプロジェクトは OpenShift Container Platform のコア機能を提供します。

- User。ユーザーアラートはユーザー定義のプロジェクトに関連します。これらのアラートはユーザーによって作成され、カスタマイズ可能です。ユーザー定義のワークロードモニタリングはインストール後に有効にでき、独自のワークロードへの可観測性を提供します。

1.3.5.7.2. サイレンスフィルターについて

Administrator パースペクティブでは、アラート UI の Silences ページには、デフォルトの OpenShift Container Platform およびユーザー定義プロジェクトのアラートに適用されるサイレンスに関する詳細が示されます。このページには、それぞれのサイレンスの状態の概要とサイレンスが終了する時間の概要が含まれます。

サイレンス状態でフィルターを実行できます。デフォルトでは、Active および Pending のサイレンスのみが表示されます。以下は、それぞれのサイレンス状態のフィルターオプションを説明しています。

State フィルター:

- Active。サイレンスはアクティブで、アラートはサイレンスが期限切れになるまでミュートされます。

- Pending。サイレンスがスケジュールされており、アクティブな状態ではありません。

- Expiredアラートの条件が true の場合は、サイレンスが期限切れになり、通知が送信されます。

1.3.5.7.3. アラートルールフィルターについて

Administrator パースペクティブでは、アラート UI の Alerting rules ページに、デフォルトの OpenShift Container Platform およびユーザー定義プロジェクトに関連するアラートルールの詳細が示されます。このページには、各アラートルールの状態、重大度およびソースの概要が含まれます。

アラート状態、重大度、およびソースを使用してアラートルールをフィルターできます。デフォルトでは、プラットフォーム のアラートルールのみが表示されます。以下では、それぞれのアラートルールのフィルターオプションを説明します。

Alert state フィルター:

-

Firing。アラート条件が true で、オプションの

forの期間を経過しているためにアラートが実行されます。条件が true である間、アラートの発生が続きます。 - Pending。アラートはアクティブですが、アラート実行前のアラートルールに指定される期間待機します。

- Silenced。指定の期間、アラートがサイレントになります。定義するラベルセレクターのセットに基づいてアラートを一時的にミュートします。リストされたすべての値または正規表現に一致するアラートの土は送信されません。

- Not Firingアラートは実行されません。

-

Firing。アラート条件が true で、オプションの

Severity フィルター:

- Critical。アラートルールで定義される状態は重大な影響を与える可能性があります。true の場合は、この状態に早急な対応が必要です。通常、ルールに関連するアラートは個別または緊急対策チーム (Critical Response Team) に送信先が設定されます。

- Warning。アラートルールで定義される状態は、問題の発生を防ぐために注意を要する場合があります。通常、ルールに関連するアラートは早急な対応を要さないレビュー用にチケットシステムにルート指定されます。

- Info。アラートルールは情報アラートのみを提供します。

- None。アラートルールには重大度が定義されていません。

- ユーザー定義プロジェクトに関連するアラートルールのカスタム重大度定義を作成することもできます。

Source フィルター:

- Platform。プラットフォームレベルのアラートルールは、デフォルトの OpenShift Container Platform プロジェクトにのみ関連します。これらのプロジェクトは OpenShift Container Platform のコア機能を提供します。

- User。ユーザー定義のワークロードアラートルールは、ユーザー定義プロジェクトに関連します。これらのアラートルールはユーザーによって作成され、カスタマイズ可能です。ユーザー定義のワークロードモニタリングはインストール後に有効にでき、独自のワークロードへの可観測性を提供します。

1.3.5.7.4. Developer パースペクティブでのアラート、サイレンスおよびアラートルールの検索およびフィルター

Developer パースペクティブでは、アラート UI の Alerts ページに、選択したプロジェクトに関連するアラートとサイレンスを組み合わせたビューが提供されています。規定するアラートルールへのリンクが表示されるアラートごとに提供されます。

このビューでは、アラートの状態と重大度でフィルターを実行できます。デフォルトで、プロジェクトへのアクセス権限がある場合は、選択されたプロジェクトのすべてのアラートが表示されます。これらのフィルターは Administrator パースペクティブについて記載されているフィルターと同じです。

1.3.6. ユーザー定義プロジェクトのアラートルーティングについて

クラスター管理者は、ユーザー定義プロジェクトのアラートルーティングを有効にできます。この機能を使用すると、alert-routing-edit クラスターロールを持つユーザーが、ユーザー定義プロジェクトのアラート通知ルーティングとレシーバーを設定できるようになります。これらの通知は、デフォルトの Alertmanager インスタンスで指定されるか、有効にされている場合にユーザー定義のモニタリング専用のオプションの Alertmanager インスタンスによってルーティングされます。

次に、ユーザーはユーザー定義プロジェクトの AlertmanagerConfig オブジェクトを作成または編集して、ユーザー定義のアラートルーティングを作成し、設定できます。

ユーザーがユーザー定義のプロジェクトのアラートルーティングを定義した後に、ユーザー定義のアラート通知は以下のようにルーティングされます。

-

デフォルトのプラットフォーム Alertmanager インスタンスを使用する場合、

openshift-monitoringnamespace のalertmanager-mainPod に対してこれを実行します。 -

ユーザー定義プロジェクトの Alertmanager の別のインスタンスを有効にしている場合に、

openshift-user-workload-monitoringnamespace でalertmanager-user-workloadPod を行うには、以下を実行します。

ユーザー定義プロジェクトのアラートルーティングに関する次の制限事項を確認してください。

-

ユーザー定義のアラートルールの場合、ユーザー定義のルーティングはリソースが定義される namespace に対してスコープ指定されます。たとえば、namespace

ns1のルーティング設定は、同じ namespace のPrometheusRulesリソースにのみ適用されます。 -

namespace がユーザー定義のモニタリングから除外される場合、namespace の

AlertmanagerConfigリソースは、Alertmanager 設定の一部ではなくなります。

1.3.7. 外部システムへの通知の送信

OpenShift Container Platform 4.15 では、実行するアラートをアラート UI に表示できます。アラートは、デフォルトでは通知システムに送信されるように設定されません。以下のレシーバータイプにアラートを送信するように OpenShift Container Platform を設定できます。

- PagerDuty

- Webhook

- Slack

- Microsoft Teams

レシーバーへのアラートのルートを指定することにより、障害が発生する際に適切なチームに通知をタイムリーに送信できます。たとえば、重大なアラートには早急な対応が必要となり、通常は個人または緊急対策チーム (Critical Response Team) に送信先が設定されます。重大ではない警告通知を提供するアラートは、早急な対応を要さないレビュー用にチケットシステムにルート指定される可能性があります。

Watchdog アラートの使用によるアラートが機能することの確認

OpenShift Container Platform モニタリングには、継続的に実行される Watchdog アラートが含まれます。Alertmanager は、Watchdog のアラート通知を設定された通知プロバイダーに繰り返し送信します。通常、プロバイダーは watchdog アラートの受信を停止する際に管理者に通知するように設定されます。このメカニズムは、Alertmanager と通知プロバイダー間の通信に関連する問題を迅速に特定するのに役立ちます。

第2章 スタートガイド

2.1. モニタリングのメンテナンスおよびサポート

モニタリングスタックのすべての設定オプションが公開されているわけではありません。唯一サポートされている OpenShift Container Platform モニタリング設定方法は、Cluster Monitoring Operator (CMO) の Config map リファレンス で説明されているオプションを使用して Cluster Monitoring Operator を設定する方法です。サポートされていない他の設定は使用しないでください。

設定のパラダイムが Prometheus リリース間で変更される可能性があり、このような変更には、設定のすべての可能性が制御されている場合のみ適切に対応できます。Cluster Monitoring Operator の Config map リファレンス で説明されている設定以外の設定を使用すると、デフォルトおよび設計により、CMO が自動的に差異を調整し、サポートされていない変更を元の定義済みの状態にリセットするため、変更は消えてしまいます。

2.1.1. モニタリングのサポートに関する考慮事項

メトリクス、記録ルールまたはアラートルールの後方互換性を保証されません。

以下の変更は明示的にサポートされていません。

-

追加の

ServiceMonitor、PodMonitor、およびPrometheusRuleオブジェクトをopenshift-*およびkube-*プロジェクトに作成します。 openshift-monitoringまたはopenshift-user-workload-monitoringプロジェクトにデプロイされるリソースまたはオブジェクト変更OpenShift Container Platform モニタリングスタックによって作成されるリソースは、後方互換性の保証がないために他のリソースで使用されることは意図されていません。注記Alertmanager 設定は、

openshift-monitoringnamespace のalertmanager-mainシークレットリソースとしてデプロイされます。ユーザー定義のアラートルーティング用に別の Alertmanager インスタンスを有効にしている場合、Alertmanager 設定もopenshift-user-workload-monitoringnamespace のalertmanager-user-workloadシークレットリソースとしてデプロイされます。Alertmanager のインスタンスの追加ルートを設定するには、そのシークレットをデコードし、変更し、エンコードする必要があります。この手順は、前述のステートメントに対してサポートされる例外です。- スタックのリソースの変更。OpenShift Container Platform モニタリングスタックは、そのリソースが常に期待される状態にあることを確認します。これらが変更される場合、スタックはこれらをリセットします。

-

ユーザー定義ワークロードの

openshift-*、およびkube-*プロジェクトへのデプロイ。これらのプロジェクトは Red Hat が提供するコンポーネント用に予約され、ユーザー定義のワークロードに使用することはできません。 -

Prometheus Operator での

Probeカスタムリソース定義 (CRD) による現象ベースのモニタリングの有効化。 -

openshift.io/cluster-monitoring: "true"ラベルを持つ namespace にモニタリングリソースを手動でデプロイ。 -

namespace に

openshift.io/cluster-monitoring: "true"ラベルを追加。このラベルは、コア OpenShift Container Platform コンポーネントと Red Hat 認定コンポーネントを含む namespace 用に予約されています。 - カスタム Prometheus インスタンスの OpenShift Container Platform へのインストール。カスタムインスタンスは、Prometheus Operator によって管理される Prometheus カスタムリソース (CR) です。

2.1.2. Operator のモニタリングに関するサポートポリシー

モニタリング Operator により、OpenShift Container Platform モニタリングリソースの設定およびテスト通りに機能することを確認できます。Operator の Cluster Version Operator (CVO) コントロールがオーバーライドされる場合、Operator は設定の変更に対応せず、クラスターオブジェクトの意図される状態を調整したり、更新を受信したりしません。

Operator の CVO コントロールのオーバーライドはデバッグ時に役立ちますが、これはサポートされず、クラスター管理者は個々のコンポーネントの設定およびアップグレードを完全に制御することを前提としています。

Cluster Version Operator のオーバーライド

spec.overrides パラメーターを CVO の設定に追加すると、管理者はコンポーネントに関する CVO の動作にオーバーライドのリストを追加できます。コンポーネントの spec.overrides[].unmanaged パラメーターを true に設定すると、クラスターのアップグレードがブロックされ、CVO のオーバーライドが設定された後に管理者にアラートが送信されます。

Disabling ownership via cluster version overrides prevents upgrades. Please remove overrides before continuing.

Disabling ownership via cluster version overrides prevents upgrades. Please remove overrides before continuing.CVO のオーバーライドを設定すると、クラスター全体がサポートされていない状態になり、モニタリングスタックをその意図された状態に調整されなくなります。これは Operator に組み込まれた信頼性の機能に影響を与え、更新が受信されなくなります。サポートを継続するには、オーバーライドを削除した後に、報告された問題を再現する必要があります。

2.1.3. モニタリングコンポーネントのサポートバージョンマトリックス

以下のマトリックスには、OpenShift Container Platform 4.12 以降のリリースのモニタリングコンポーネントのバージョンに関する情報が含まれています。

| OpenShift Container Platform | Prometheus Operator | Prometheus | Prometheus アダプター | Metrics Server (テクノロジープレビュー) | Alertmanager | kube-state-metrics エージェント | monitoring-plugin | node-exporter エージェント | Thanos |

|---|---|---|---|---|---|---|---|---|---|

| 4.15 | 0.70.0 | 2.48.0 | 0.11.2 | 0.6.4 | 0.26.0 | 2.10.1 | 1.0.0 | 1.7.0 | 0.32.5 |

| 4.14 | 0.67.1 | 2.46.0 | 0.10.0 | 該当なし | 0.25.0 | 2.9.2 | 1.0.0 | 1.6.1 | 0.30.2 |

| 4.13 | 0.63.0 | 2.42.0 | 0.10.0 | 該当なし | 0.25.0 | 2.8.1 | 該当なし | 1.5.0 | 0.30.2 |

| 4.12 | 0.60.1 | 2.39.1 | 0.10.0 | 該当なし | 0.24.0 | 2.6.0 | 該当なし | 1.4.0 | 0.28.1 |

openshift-state-metrics エージェントと Telemeter Client は、OpenShift 固有のコンポーネントです。したがって、それらのバージョンは OpenShift Container Platform のバージョンに対応します。

2.2. コアプラットフォームモニタリングの最初のステップ

OpenShift Container Platform がインストールされると、コアプラットフォームモニタリングコンポーネントは、照会と表示が可能なメトリクスの収集をすぐに開始します。デフォルトのクラスター内モニタリングスタックには、クラスターからメトリクスを収集するコアプラットフォーム Prometheus インスタンスや、アラートをルーティングするコア Alertmanager インスタンスなどのコンポーネントが含まれます。モニタリングスタックを誰がどのような目的で使用するかに応じて、クラスター管理者は、さまざまな状況で各ユーザーのニーズに合わせてこれらのモニタリングコンポーネントをさらに設定できます。

2.2.1. コアプラットフォームモニタリングの設定: インストール後の手順

OpenShift Container Platform がインストールされた後、クラスター管理者は通常、ニーズに合わせてコアプラットフォームのモニタリングを設定します。これらのアクティビティーには、ストレージのセットアップや、Prometheus、Alertmanager、その他のモニタリングコンポーネントのオプションの設定が含まれます。

デフォルトでは、新しくインストールされた OpenShift Container Platform システムで、ユーザーは収集されたメトリクスを照会および表示できます。ユーザーにアラート通知を受信させる場合にのみ、アラートレシーバーを設定する必要があります。ここにリストされているその他の設定オプションはすべて任意です。

-

cluster-monitoring-configConfigMapオブジェクト が存在しない場合は作成します。 - Alertmanager がメール、Slack、PagerDuty などの外部通知システムにアラートを送信できるように、デフォルトのプラットフォームアラートの通知を設定 します。

より短期間のデータ保持の場合は、Prometheus と Alertmanager の 永続ストレージを設定 して、メトリクスとアラートデータを保存してください。Prometheus および Thanos Ruler のメトリクスデータ保持パラメーターを指定します。

重要- マルチノードクラスターでは、高可用性を実現するために、Prometheus、Alertmanager、および Thanos Ruler の永続ストレージを設定する必要があります。

-

デフォルトでは、新しくインストールされた OpenShift Container Platform システムでは、モニタリングの

ClusterOperatorリソースがPrometheusDataPersistenceNotConfiguredステータスメッセージを報告し、ストレージが設定されていないことを通知します。

データをより長期間保持するには、リモート書き込み機能を設定 して、取り込んだメトリクスを Prometheus がリモートシステムに送信して保存できるようにします。

重要リモート書き込みストレージ設定で使用するために、メトリクスにクラスター ID ラベルを必ず追加 してください。

- 特定のモニタリング機能にアクセスする必要がある管理者以外のユーザーに モニタリングクラスターロールを付与 します。

- 管理者が taint されたノードに移動できるように、モニタリングスタックコンポーネントに toleration を割り当て ます。

- メトリクス収集の ボディーサイズ制限を設定 すると、スクレイピングされたターゲットが大量のデータを含む応答を返すときに Prometheus が過剰にメモリーを消費する状況を回避できます。

- クラスターの アラートルールを変更または作成 します。これらのルールは、CPU またはメモリーの使用率が高い、ネットワークの遅延など、アラートをトリガーする条件を指定します。

- モニタリングコンポーネントを実行するコンテナーに十分な CPU およびメモリーリソースを確保するために、モニタリングコンポーネントのリソース制限および要求を指定 します。

モニタリングスタックがニーズに合わせて設定されると、Prometheus は指定されたサービスからメトリクスを収集し、設定に従ってこれらのメトリクスを保存します。OpenShift Container Platform Web コンソールの Observe ページに移動して、収集されたメトリクスの表示とクエリー、アラートの管理、パフォーマンスのボトルネックの特定、必要に応じてリソースのスケーリングを行うことができます。

- ダッシュボードを表示 して、収集されたメトリクスを視覚化し、アラートをトラブルシューティングし、クラスターに関するその他の情報を監視します。

- PromQL クエリーを作成するか、定義済みクエリーを使用して、収集されたメトリクスを照会 します。

2.3. ユーザーワークロードモニタリングの最初のステップ

クラスター管理者は、コアプラットフォームのモニタリングに加えて、オプションでユーザー定義プロジェクトの監視を有効にできます。開発者などの管理者以外のユーザーは、コアプラットフォームモニタリングの外部で独自のプロジェクトを監視できます。

クラスター管理者は通常、ユーザーが収集されたメトリクスを表示し、これらのメトリクスを照会し、自分のプロジェクトに関するアラートを受信できるように、ユーザー定義プロジェクトを設定するために次のアクティビティーを実行します。

- ユーザーワークロードモニタリングを有効にします。

-

管理者以外のユーザーに、

monitoring-rules-view、monitoring-rules-edit、またはmonitoring-editクラスターロールを割り当てることで、ユーザー定義プロジェクトを監視する権限を付与 します。 -

管理者以外のユーザーに、

user-workload-monitoring-config-editロールを割り当て、ユーザー定義プロジェクトを設定する権限を付与します。 - ユーザー定義のプロジェクトのアラートルーティングを有効にして、開発者やその他のユーザーがプロジェクトのカスタムアラートとアラートルーティングを設定できるようにします。

- 必要に応じて、ユーザー定義プロジェクト専用のオプションの Alertmanager インスタンスを使用 するように、ユーザー定義プロジェクトのアラートルーティングを設定します。

- ユーザー定義のアラートの通知を設定 します。

- ユーザー定義のアラートルーティングにプラットフォーム Alertmanager インスタンスを使用する場合は、デフォルトのプラットフォームアラートとユーザー定義のアラートに 異なるアラートレシーバーを設定 します。

2.4. 開発者および非管理者の手順

ユーザー定義プロジェクトのモニタリングを有効にして設定したら、開発者やその他の管理者以外のユーザーは、次のアクティビティーを実行して、独自のプロジェクトのモニタリングを設定および使用できるようになります。

- サービスをデプロイおよび監視 します。

- アラートルールを作成および管理 します。

- プロジェクトの アラートを受信して管理 します。

-

alert-routing-editクラスターロールが付与されている場合は、アラートルーティングを設定 します。 - OpenShift Container Platform Web コンソールを使用して ダッシュボードを表示 します。

- PromQL クエリーを作成するか、定義済みクエリーを使用して、収集されたメトリクスを照会 します。

第3章 コアプラットフォームモニタリングの設定

3.1. コアプラットフォームモニタリングスタックを設定する準備

OpenShift Container Platform インストールプログラムは、インストール前の少数の設定オプションのみを提供します。ほとんどの OpenShift Container Platform フレームワークコンポーネント (クラスターモニタリングスタックを含む) の設定はインストール後に行われます。

このセクションでは、設定できるモニタリングコンポーネントと、モニタリングスタックを設定するための準備方法を説明します。

- モニタリングスタックのすべての設定パラメーターが公開されるわけではありません。設定では、Cluster Monitoring Operator の config map 参照 にリストされているパラメーターとフィールドのみがサポートされます。

- モニタリングスタックには、追加のリソース要件があります。Cluster Monitoring Operator のスケーリング でコンピューティングリソースに関する推奨事項を参照し、十分なリソースがあることを確認してください。

3.1.1. 設定可能なモニタリングコンポーネント

次の表に、設定できるモニタリングコンポーネントと、cluster-monitoring-config config map でコンポーネントを指定するために使用するキーを示します。

| Component | cluster-monitoring-config config map キー |

|---|---|

| Prometheus Operator |

|

| Prometheus |

|

| Alertmanager |

|

| Thanos Querier |

|

| kube-state-metrics |

|

| monitoring-plugin |

|

| openshift-state-metrics |

|

| Telemeter クライアント |

|

| Prometheus アダプター |

|

ConfigMap オブジェクトの設定変更によって、結果も異なります。

- Pod は再デプロイされません。したがって、サービスの停止はありません。

変更された Pod が再デプロイされます。

- 単一ノードクラスターの場合、一時的なサービスが停止します。

- マルチノードクラスターの場合、高可用性であるため、影響を受ける Pod は徐々にロールアウトされ、モニタリングスタックは引き続き利用可能です。

- 永続ボリュームの設定およびサイズ変更を行うと、高可用性であるかどうかに関係なく、常にサービスが停止します。

config map の変更を必要とする手順にはそれぞれ、想定される結果が含まれます。

3.1.2. クラスターモニタリング config map の作成

openshift-monitoring プロジェクトで cluster-monitoring-config config map を作成および更新することで、OpenShift Container Platform のコアモニタリングコンポーネントを設定できます。その後、Cluster Monitoring Operator (CMO) がモニタリングスタックのコアコンポーネントを設定します。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

OpenShift CLI (

oc) がインストールされている。

手順

cluster-monitoring-configConfigMapオブジェクトが存在するかどうかを確認します。oc -n openshift-monitoring get configmap cluster-monitoring-config

$ oc -n openshift-monitoring get configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow ConfigMapオブジェクトが存在しない場合:以下の YAML マニフェストを作成します。以下の例では、このファイルは

cluster-monitoring-config.yamlという名前です。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 設定を適用して

ConfigMapを作成します。oc apply -f cluster-monitoring-config.yaml

$ oc apply -f cluster-monitoring-config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.1.3. ユーザーへのコアプラットフォームモニタリング権限の付与

クラスター管理者は、すべての OpenShift Container Platform のコアプロジェクトおよびユーザー定義プロジェクトを監視できます。

開発者や他のユーザーに、コアプラットフォームモニタリングに関するさまざまな権限を付与することもできます。次のいずれかのモニタリングロールまたはクラスターロールを割り当てることで、権限を付与できます。

| 名前 | 説明 | プロジェクト |

|---|---|---|

|

| このロールを持つユーザーは、Thanos Querier API エンドポイントにアクセスできます。さらに、コアプラットフォームの Prometheus API とユーザー定義の Thanos Ruler API エンドポイントへのアクセスが許可されます。 |

|

|

|

このロールを持つユーザーは、コアプラットフォームモニタリング用の |

|

|

| このロールを持つユーザーは、コアプラットフォームモニタリング用の Alertmanager API を管理できます。また、OpenShift Container Platform Web コンソールの Administrator パースペクティブでアラートサイレンスを管理することもできます。 |

|

|

| このロールを持つユーザーは、コアプラットフォームモニタリング用の Alertmanager API を監視できます。OpenShift Container Platform Web コンソールの Administrator パースペクティブでアラートサイレンスを表示することもできます。 |

|

|

|

このクラスターロールを持つユーザーには、 |

ユーザー定義の Prometheus の |

3.1.3.1. Web コンソールを使用したユーザー権限の付与

OpenShift Container Platform Web コンソールを使用して、openshift-monitoring プロジェクトまたはユーザー自身のプロジェクトに対する権限をユーザーに付与できます。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 - ロールを割り当てるユーザーアカウントがすでに存在している。

手順

- OpenShift Container Platform Web コンソールの Administrator パースペクティブで、User Management → RoleBindings → Create binding に移動します。

- Binding Type セクションで、Namespace Role Binding タイプを選択します。

- Name フィールドに、ロールバインディングの名前を入力します。

Namespace フィールドで、アクセスを許可するプロジェクトを選択します。

重要この手順を使用してユーザーに付与するモニタリングロールまたはクラスターロールの権限は、Namespace フィールドで選択したプロジェクトにのみ適用されます。

- Role Name リストからモニタリングロールまたはクラスターロールを選択します。

- Subject セクションで、User を選択します。

- Subject Name フィールドにユーザーの名前を入力します。

- Create を選択して、ロールバインディングを適用します。

3.1.3.2. CLI を使用したユーザー権限の付与

OpenShift CLI (oc) を使用して、openshift-monitoring プロジェクトまたはユーザー自身のプロジェクトに対する権限をユーザーに付与できます。

どちらのロールまたはクラスターロールを選択する場合でも、クラスター管理者が特定のプロジェクトにバインドする必要があります。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 - ロールを割り当てるユーザーアカウントがすでに存在している。

-

OpenShift CLI (

oc) がインストールされている。

手順

プロジェクトのユーザーにモニタリングロールを割り当てるには、次のコマンドを入力します。

oc adm policy add-role-to-user <role> <user> -n <namespace> --role-namespace <namespace>

$ oc adm policy add-role-to-user <role> <user> -n <namespace> --role-namespace <namespace>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<role>は必要なモニタリングロールに、<user>はロールを割り当てるユーザーに、<namespace>はアクセスを許可するプロジェクトに置き換えます。

プロジェクトのユーザーにモニタリングクラスターロールを割り当てるには、次のコマンドを入力します。

oc adm policy add-cluster-role-to-user <cluster-role> <user> -n <namespace>

$ oc adm policy add-cluster-role-to-user <cluster-role> <user> -n <namespace>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<cluster-role>は必要なモニタリングクラスターロールに、<user>はクラスターロールを割り当てるユーザーに、<namespace>はアクセスを許可するプロジェクトに置き換えます。

3.2. コアプラットフォームモニタリングのパフォーマンスとスケーラビリティーの設定

モニタリングスタックを設定して、クラスターのパフォーマンスとスケールを最適化できます。次のドキュメントでは、モニタリングコンポーネントを分散する方法と、モニタリングスタックが CPU およびメモリーリソースに与える影響を制御する方法を説明します。

3.2.1. モニタリングコンポーネントの配置と分散の制御

次の方法で、モニタリングスタックコンポーネントを特定のノードに移動できます。

-

ラベル付きノードで

nodeSelector制約を使用して、任意のモニタリングスタックコンポーネントを特定のノードに移動します。 - taint されたノードにコンポーネントを移動できるように toleration を割り当てます。

これにより、クラスター全体のモニタリングコンポーネントの配置と分散を制御できます。

モニタリングコンポーネントの配置と分散を制御して、システムリソースの使用を最適化し、パフォーマンスを高め、特定の要件やポリシーに基づいてワークロードを分離できます。

3.2.1.1. モニタリングコンポーネントの異なるノードへの移動

モニタリングスタックコンポーネントを実行するクラスター内のノードを指定するには、ノードに割り当てられたラベルと一致するように、cluster-monitoring-config config map 内のコンポーネントの nodeSelector 制約を設定します。

ノードセレクター制約を既存のスケジュール済み Pod に直接追加することはできません。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 -

OpenShift CLI (

oc) がインストールされている。

手順

まだの場合は、モニタリングコンポーネントを実行するノードにラベルを追加します。

oc label nodes <node_name> <node_label>

$ oc label nodes <node_name> <node_label>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<node_name>は、ラベルを追加するノードの名前に置き換えます。<node_label>は、必要なラベルの名前に置き換えます。

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yamlでコンポーネントのnodeSelector制約のノードラベルを指定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記nodeSelectorの制約を設定した後もモニタリングコンポーネントがPending状態のままになっている場合は、Pod イベントで taint および toleration に関連するエラーの有無を確認します。- 変更を適用するためにファイルを保存します。新しい設定で指定されたコンポーネントは自動的に新しいノードに移動され、新しい設定の影響を受ける Pod は再デプロイされます。

3.2.1.2. モニタリングコンポーネントへの toleration の割り当て

toleration をモニタリングスタックのコンポーネントに割り当て、それらを taint されたノードに移動することができます。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 -

OpenShift CLI (

oc) がインストールされている。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configconfig map を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンポーネントの

tolerationsを指定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow <component>および<toleration_specification>を随時置き換えます。たとえば、

oc adm taint nodes node1 key1=value1:NoScheduleは、キーがkey1で、値がvalue1のnode1に taint を追加します。これにより、モニタリングコンポーネントがnode1に Pod をデプロイするのを防ぎます。ただし、その taint に対して toleration が設定されている場合を除きます。以下の例は、サンプルの taint を容認するようにalertmanagerMainコンポーネントを設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。新しい設定の影響を受ける Pod は自動的に再デプロイされます。

3.2.2. メトリクススクレイピング (収集) のボディーサイズ制限の設定

デフォルトでは、スクレイピングされたメトリクスターゲットから返されるデータの非圧縮のボディーサイズに制限はありません。スクレイピングされたターゲットが大量のデータを含む応答を返すときに Prometheus が過剰にメモリーを消費する状況を回避するために、ボディーサイズの制限を設定できます。さらに、ボディーサイズ制限を設定することで、悪意のあるターゲットが Prometheus およびクラスター全体に与える影響を軽減できます。

enforcedBodySizeLimit の値を設定した後、少なくとも 1 つの Prometheus スクレイプターゲットが、設定された値より大きいレスポンスボディーで応答すると、アラート PrometheusScrapeBodySizeLimitHit が発生します。

ターゲットからスクレイピングされたメトリクスデータの非圧縮ボディーサイズが、設定されたサイズ制限を超えていると、スクレイピングは失敗します。次に、Prometheus はこのターゲットがダウンしていると見なし、その up メトリクス値を 0 に設定します。これにより、TargetDown アラートをトリガーできます。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

OpenShift CLI (

oc) がインストールされている。

手順

openshift-monitoringnamespace でcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow enforcedBodySizeLimitの値をdata/config.yaml/prometheusK8sに追加して、ターゲットスクレイプごとに受け入れ可能なボディーサイズを制限します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- スクレイピングされたメトリクスターゲットの最大ボディーサイズを指定します。この

enforcedBodySizeLimitの例では、ターゲットスクレイプごとの非圧縮サイズを 40 メガバイトに制限しています。有効な数値は、B (バイト)、KB (キロバイト)、MB (メガバイト)、GB (ギガバイト)、TB (テラバイト)、PB (ペタバイト)、および EB (エクサバイト) の Prometheus データサイズ形式を使用します。デフォルト値は0で、制限は指定されません。値をautomaticに設定して、クラスターの容量に基づいて制限を自動的に計算することもできます。

- 変更を適用するためにファイルを保存します。新しい設定は自動的に適用されます。

3.2.3. モニタリングコンポーネントの CPU およびメモリーリソースの管理

モニタリングコンポーネントを実行するコンテナーに十分な CPU リソースとメモリーリソースを確保するには、これらのコンポーネントのリソース制限および要求の値を指定します。

openshift-monitoring namespace で、コアプラットフォームモニタリングコンポーネントのリソース制限および要求を設定できます。

3.2.3.1. 制限および要求の指定

CPU およびメモリーリソースを設定するには、openshift-monitoring namespace の cluster-monitoring-config ConfigMap オブジェクトでリソース制限および要求の値を指定します。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configという名前のConfigMapオブジェクトを作成した。 -

OpenShift CLI (

oc) がインストールされている。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configconfig map を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 値を追加して、設定する各コンポーネントのリソース制限および要求を定義します。

重要制限に設定した値が常に要求に設定された値よりも大きくなることを確認してください。そうでない場合、エラーが発生し、コンテナーは実行されません。

リソース制限とリクエストの設定例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。新しい設定の影響を受ける Pod は自動的に再デプロイされます。

3.2.4. メトリクス収集プロファイルの選択

メトリクス収集プロファイルはテクノロジープレビュー機能です。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は、実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行い、フィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

コア OpenShift Container Platform モニタリングコンポーネントのメトリクス収集プロファイルを選択するには、cluster-monitoring-config ConfigMap オブジェクトを編集します。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

FeatureGateカスタムリソース (CR) を使用して、テクノロジープレビュー機能を有効にしました。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 -

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yaml/prometheusK8sの下にメトリクス収集プロファイル設定を追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- メトリクス収集プロファイルの名前。使用可能な値は

fullまたはminimalです。値を指定しない場合、またはcollectionProfileキー名が config map に存在しない場合は、デフォルト設定のfullが使用されます。

次の例では、Prometheus のコアプラットフォームインスタンスのメトリクスコレクションプロファイルを

minimalに設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。新しい設定は自動的に適用されます。

3.2.5. Pod トポロジー分散制約の設定

Cluster Monitoring Operator によってデプロイされたすべての Pod に対して Pod トポロジーの分散制約を設定し、ゾーン全体のノードに Pod レプリカをスケジュールする方法を制御できます。これにより、ワークロードが異なるデータセンターまたは階層型インフラストラクチャーゾーンのノードに分散されるため、Pod の可用性が高まり、より効率的に実行されるようになります。

cluster-monitoring-config config map を使用して、Pod を監視するための Pod トポロジーの分散制約を設定できます。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 -

OpenShift CLI (

oc) がインストールされている。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configconfig map を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod トポロジーの分散制約を設定するには、

data/config.yamlフィールドの下に次の設定を追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Pod トポロジーの分散制約を設定するコンポーネントの名前を指定します。

- 2

maxSkewの数値を指定します。これは、どの程度まで Pod が不均等に分散されることを許可するか定義します。- 3

topologyKeyにノードラベルのキーを指定します。このキーと同じ値のラベルを持つノードは、同じトポロジーにあると見なされます。スケジューラーは、各ドメインにバランスの取れた数の Pod を配置しようとします。- 4

whenUnsatisfiableの値を指定します。利用可能なオプションはDoNotScheduleとScheduleAnywayです。maxSkew値で、ターゲットトポロジー内の一致する Pod の数とグローバル最小値との間で許容される最大差を定義する場合は、DoNotScheduleを指定します。スケジューラーが引き続き Pod をスケジュールするが、スキューを減らす可能性のあるノードにより高い優先度を与える場合は、ScheduleAnywayを指定します。- 5

- 一致する Pod を見つけるには、

labelSelectorを指定します。このラベルセレクターに一致する Pod は、対応するトポロジードメイン内の Pod の数を決定するためにカウントされます。

Prometheus の設定例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。新しい設定の影響を受ける Pod は自動的に再デプロイされます。

3.3. コアプラットフォームモニタリングのデータの保存と記録

メトリクスとアラートデータの保存および記録、ログの設定と記録するアクティビティーの指定、Prometheus が保存されたデータを保持する期間の制御、データの最大ディスク領域の設定を行います。これらのアクションは、データを保護し、データをトラブルシューティングに使用するのに役立ちます。

3.3.1. 永続ストレージの設定

永続ストレージを使用してクラスターモニタリングを実行すると、次の利点が得られます。

- メトリクスとアラートデータを永続ボリューム (PV) に保存することで、データ損失から保護します。その結果、Pod が再起動または再作成されても存続できます。

- Alertmanager Pod が再起動したときに、重複した通知を受信したり、アラートのサイレンスが失われたりするのを回避します。

マルチノードクラスターでは、高可用性を確保するために Prometheus および Alertmanager の永続ストレージを設定する必要があります。

実稼働環境では、永続ストレージを設定することを強く推奨します。

3.3.1.1. 永続ストレージの前提条件

- ディスクが一杯にならないように十分な永続ストレージを確保します。

永続ボリュームを設定する際に、

volumeModeパラメーターのストレージタイプ値としてFilesystemを使用します。重要-

PersistentVolumeリソースでvolumeMode: Blockで記述されている生のブロックボリュームを使用しないでください。Prometheus は raw ブロックボリュームを使用できません。 - Prometheus は、POSIX に準拠していないファイルシステムをサポートしません。たとえば、一部の NFS ファイルシステム実装は POSIX に準拠していません。ストレージに NFS ファイルシステムを使用する場合は、NFS 実装が完全に POSIX に準拠していることをベンダーに確認してください。

-

3.3.1.2. 永続ボリューム要求の設定

コンポーネントの監視に永続ボリューム (PV) を使用するには、永続ボリューム要求 (PVC) を設定する必要があります。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 -

OpenShift CLI (

oc) がインストールされている。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configconfig map を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンポーネントの PVC 設定を

data/config.yamlの下に追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次の例では、Prometheus の永続ストレージを要求する PVC を設定します。

PVC 設定の例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 変更を適用するためにファイルを保存します。新しい設定の影響を受ける Pod は自動的に再デプロイされ、新しいストレージ設定が適用されます。

警告PVC 設定で config map を更新すると、影響を受ける

StatefulSetオブジェクトが再作成され、一時的なサービス停止が発生します。

3.3.1.3. 永続ボリュームのサイズ変更

モニタリングコンポーネント (Prometheus や Alertmanager など) の永続ボリューム (PV) のサイズを変更できます。永続ボリューム要求 (PVC) を手動で拡張し、コンポーネントが設定されている config map を更新する必要があります。

PVC のサイズのみ拡張可能です。ストレージサイズを縮小することはできません。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 - コア OpenShift Container Platform モニタリングコンポーネント用に少なくとも 1 つの PVC を設定しました。

-

OpenShift CLI (

oc) がインストールされている。

手順

- 更新されたストレージ要求を使用して PVC を手動で拡張します。詳細は、永続ボリュームの拡張 の「ファイルシステムを使用した永続ボリューム要求 (PVC) の拡張」を参照してください。

openshift-monitoringプロジェクトでcluster-monitoring-configconfig map を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yamlの下に、コンポーネントの PVC 設定用の新しいストレージサイズを追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次の例では、Prometheus インスタンスの新しい PVC 要求を 100 ギガバイトに設定します。

prometheusK8sのストレージ設定例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 変更を適用するためにファイルを保存します。新しい設定の影響を受ける Pod は自動的に再デプロイされます。

警告新しいストレージサイズで config map を更新すると、影響を受ける

StatefulSetオブジェクトが再作成され、サービスが一時的に停止します。

3.3.2. Prometheus メトリクスデータの保持期間およびサイズの変更

デフォルトでは、Prometheus はコアプラットフォームモニタリングのメトリクスデータを 15 日間保持します。データの削除時に Prometheus インスタンスが変更する保持時間を変更できます。保持されるメトリクスデータが使用するディスク容量の最大量を設定することもできます。

データコンパクションは 2 時間ごとに実行されます。そのため、コンパクションが実行される前に永続ボリューム (PV) がいっぱいになり、retentionSize 制限を超える可能性があります。その場合、PV 上のスペースが retentionSize 制限を下回るまで、KubePersistentVolumeFillingUp アラートが発生します。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 -

OpenShift CLI (

oc) がインストールされている。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configconfig map を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 保持期間およびサイズ設定を

data/config.yamlに追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次の例では、Prometheus インスタンスの保持時間を 24 時間、保持サイズを 10 ギガバイトに設定します。

Prometheus の保持期間を設定する例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。新しい設定の影響を受ける Pod は自動的に再デプロイされます。

3.3.3. Prometheus アダプターの監査ログレベルの設定

デフォルトのプラットフォームモニタリングでは、Prometheus アダプターの監査ログレベルを設定できます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。

手順

デフォルトの openshift-monitoring プロジェクトで Prometheus アダプターの監査ログレベルを設定できます。

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow k8sPrometheusAdapter/auditセクションにprofile:をdata/config.yamlの下に追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Prometheus アダプターに適用する監査ログレベル。

profile:パラメーターに以下のいずれかの値を使用して、監査ログレベルを設定します。-

None: イベントをログに記録しません。 -

Metadata: ユーザー、タイムスタンプなど、リクエストのメタデータのみをログに記録します。リクエストテキストと応答テキストはログに記録しないでください。metadataはデフォルトの監査ログレベルです。 -

Request: メタデータと要求テキストのみをログに記録しますが、応答テキストはログに記録しません。このオプションは、リソース以外の要求には適用されません。 -

RequestResponse: イベントのメタデータ、要求テキスト、および応答テキストをログに記録します。このオプションは、リソース以外の要求には適用されません。

-

- 変更を適用するためにファイルを保存します。新しい設定の影響を受ける Pod は自動的に再デプロイされます。

検証

-

config map の

k8sPrometheusAdapter/audit/profileで、ログレベルをRequestに設定し、ファイルを保存します。 Prometheus アダプターの Pod が実行されていることを確認します。以下の例は、

openshift-monitoringプロジェクトの Pod のステータスを一覧表示します。oc -n openshift-monitoring get pods

$ oc -n openshift-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 監査ログレベルと監査ログファイルのパスが正しく設定されていることを確認します。

oc -n openshift-monitoring get deploy prometheus-adapter -o yaml

$ oc -n openshift-monitoring get deploy prometheus-adapter -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

... - --audit-policy-file=/etc/audit/request-profile.yaml - --audit-log-path=/var/log/adapter/audit.log

... - --audit-policy-file=/etc/audit/request-profile.yaml - --audit-log-path=/var/log/adapter/audit.logCopy to Clipboard Copied! Toggle word wrap Toggle overflow 正しいログレベルが

openshift-monitoringプロジェクトのprometheus-adapterデプロイメントに適用されていることを確認します。oc -n openshift-monitoring exec deploy/prometheus-adapter -c prometheus-adapter -- cat /etc/audit/request-profile.yaml

$ oc -n openshift-monitoring exec deploy/prometheus-adapter -c prometheus-adapter -- cat /etc/audit/request-profile.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記ConfigMapオブジェクトで Prometheus アダプターに認識されないprofile値を入力すると、Prometheus アダプターには変更が加えられず、Cluster Monitoring Operator によってエラーがログに記録されます。Prometheus アダプターの監査ログを確認します。

oc -n openshift-monitoring exec -c <prometheus_adapter_pod_name> -- cat /var/log/adapter/audit.log

$ oc -n openshift-monitoring exec -c <prometheus_adapter_pod_name> -- cat /var/log/adapter/audit.logCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.4. モニタリングコンポーネントのログレベルの設定

Alertmanager、Prometheus Operator、Prometheus、および Thanos Querier のログレベルを設定できます。

cluster-monitoring-config ConfigMap オブジェクト内の関連コンポーネントには、次のログレベルを適用できます。

-

debug:デバッグ、情報、警告、およびエラーメッセージをログに記録します。 -

info:情報、警告およびエラーメッセージをログに記録します。 -

warn:警告およびエラーメッセージのみをログに記録します。 -

error:エラーメッセージのみをログに記録します。

デフォルトのログレベルは info です。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 -

OpenShift CLI (

oc) がインストールされている。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configconfig map を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンポーネントの

logLevel: <log_level>をdata/config.yamlの下に追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。新しい設定の影響を受ける Pod は自動的に再デプロイされます。

関連するプロジェクトでデプロイメントまたは Pod 設定を確認し、ログレベルが適用されていることを確認します。以下の例では、

prometheus-operatorデプロイメントのログレベルを確認します。oc -n openshift-monitoring get deploy prometheus-operator -o yaml | grep "log-level"

$ oc -n openshift-monitoring get deploy prometheus-operator -o yaml | grep "log-level"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

- --log-level=debug

- --log-level=debugCopy to Clipboard Copied! Toggle word wrap Toggle overflow コンポーネントの Pod が実行中であることを確認します。次の例では、Pod のステータスをリスト表示します。

oc -n openshift-monitoring get pods

$ oc -n openshift-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記認識されない

logLevel値がConfigMapオブジェクトに含まれる場合は、コンポーネントの Pod が正常に再起動しない可能性があります。

3.3.5. Prometheus のクエリーログファイルの有効化

エンジンによって実行されたすべてのクエリーをログファイルに書き込むように Prometheus を設定できます。

ログローテーションはサポートされていないため、問題のトラブルシューティングが必要な場合にのみ、この機能を一時的に有効にします。トラブルシューティングが終了したら、ConfigMap オブジェクトに加えた変更を元に戻してクエリーログを無効にし、機能を有効にします。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 -

OpenShift CLI (

oc) がインストールされている。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configconfig map を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow Prometheus の

queryLogFileパラメーターをdata/config.yamlの下に追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- クエリーが記録されるファイルへの完全なパスを追加します。

- 変更を適用するためにファイルを保存します。新しい設定の影響を受ける Pod は自動的に再デプロイされます。

コンポーネントの Pod が実行中であることを確認します。次のコマンド例は、Pod のステータスを表示します。

oc -n openshift-monitoring get pods

$ oc -n openshift-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow クエリーログを読みます。

oc -n openshift-monitoring exec prometheus-k8s-0 -- cat <path>

$ oc -n openshift-monitoring exec prometheus-k8s-0 -- cat <path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要ログに記録されたクエリー情報を確認した後、config map の設定を元に戻します。

3.3.6. Thanos Querier のクエリーロギングの有効化

openshift-monitoring プロジェクトのデフォルトのプラットフォームモニタリングの場合、Cluster Monitoring Operator (CMO) を有効にして Thanos Querier によって実行されるすべてのクエリーをログに記録できます。

ログローテーションはサポートされていないため、問題のトラブルシューティングが必要な場合にのみ、この機能を一時的に有効にします。トラブルシューティングが終了したら、ConfigMap オブジェクトに加えた変更を元に戻してクエリーログを無効にし、機能を有効にします。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。

手順

openshift-monitoring プロジェクトで Thanos Querier のクエリーロギングを有効にすることができます。

openshift-monitoringプロジェクトでcluster-monitoring-configConfigMapオブジェクトを編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例のように

thanosQuerierセクションをdata/config.yamlに追加し、値を追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。新しい設定の影響を受ける Pod は自動的に再デプロイされます。

検証

Thanos Querier Pod が実行されていることを確認します。次のコマンドの例は、

openshift-monitoringプロジェクトの Pod のステータスを一覧表示します。oc -n openshift-monitoring get pods

$ oc -n openshift-monitoring get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のサンプルコマンドをモデルとして使用して、テストクエリーを実行します。

token=`oc create token prometheus-k8s -n openshift-monitoring`

$ token=`oc create token prometheus-k8s -n openshift-monitoring`Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc -n openshift-monitoring exec -c prometheus prometheus-k8s-0 -- curl -k -H "Authorization: Bearer $token" 'https://thanos-querier.openshift-monitoring.svc:9091/api/v1/query?query=cluster_version'

$ oc -n openshift-monitoring exec -c prometheus prometheus-k8s-0 -- curl -k -H "Authorization: Bearer $token" 'https://thanos-querier.openshift-monitoring.svc:9091/api/v1/query?query=cluster_version'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行してクエリーログを読み取ります。

oc -n openshift-monitoring logs <thanos_querier_pod_name> -c thanos-query

$ oc -n openshift-monitoring logs <thanos_querier_pod_name> -c thanos-queryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記thanos-querierPod は高可用性 (HA) Pod であるため、1 つの Pod でのみログを表示できる可能性があります。-

ログに記録されたクエリー情報を確認したら、config map で

enableRequestLoggingの値をfalseに変更してクエリーロギングを無効にします。

3.4. コアプラットフォームモニタリングのメトリクスの設定

クラスターコンポーネントと独自のワークロードのパフォーマンスを監視するためのメトリクスのコレクションを設定します。

取り込んだメトリクスをリモートシステムに送信して長期保存したり、別のクラスターからのデータを識別するためにメトリクスにクラスター ID ラベルを追加したりできます。

3.4.1. リモート書き込みストレージの設定

リモート書き込みストレージを設定して、Prometheus が取り込んだメトリクスをリモートシステムに送信して長期保存できるようにします。これを行っても、Prometheus がメトリクスを保存する方法や期間には影響はありません。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 -

OpenShift CLI (

oc) がインストールされている。 リモート書き込み互換性のあるエンドポイント (Thanos) を設定し、エンドポイント URL を把握している。リモート書き込み機能と互換性のないエンドポイントの情報ては、Prometheus リモートエンドポイントおよびストレージに関するドキュメント を参照してください。

重要Red Hat は、リモート書き込み送信側の設定に関する情報のみを提供し、受信側エンドポイントの設定に関するガイダンスは提供しません。お客様は、リモート書き込みと互換性のある独自のエンドポイントを設定する責任があります。エンドポイントレシーバー設定に関する問題は、Red Hat 製品サポートには含まれません。

リモート書き込みエンドポイントの

Secretオブジェクトに認証クレデンシャルを設定している。openshift-monitoringnamespace にシークレットを作成する必要があります。警告セキュリティーリスクを軽減するには、HTTPS および認証を使用してメトリクスをエンドポイントに送信します。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configconfig map を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例のように、

data/config.yaml/prometheusK8sの下にremoteWrite:セクションを追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 認証クレデンシャルの後に、書き込みの再ラベル設定値を追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- リモートエンドポイントに送信するメトリクスの設定を追加します。

my_metricという単一メトリクスを転送する例Copy to Clipboard Copied! Toggle word wrap Toggle overflow my_namespacenamespace にmy_metric_1およびmy_metric_2というメトリクスを転送する例Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。新しい設定は自動的に適用されます。

3.4.1.1. サポート対象のリモート書き込み認証設定

異なる方法を使用して、リモート書き込みエンドポイントとの認証を行うことができます。現時点でサポートされている認証方法は AWS 署名バージョン 4、Basic 認証、認可、OAuth 2.0、および TLS クライアントです。以下の表は、リモート書き込みで使用するサポート対象の認証方法の詳細を示しています。

| 認証方法 | config map フィールド | 説明 |

|---|---|---|

| AWS 署名バージョン 4 |

| この方法では、AWS Signature Version 4 認証を使用して要求を署名します。この方法は、認可、OAuth 2.0、または Basic 認証と同時に使用することはできません。 |

| Basic 認証 |

| Basic 認証は、設定されたユーザー名とパスワードを使用してすべてのリモート書き込み要求に承認ヘッダーを設定します。 |

| 認可 |

|

Authorization は、設定されたトークンを使用して、すべてのリモート書き込みリクエストに |

| OAuth 2.0 |

|

OAuth 2.0 設定は、クライアントクレデンシャル付与タイプを使用します。Prometheus は、リモート書き込みエンドポイントにアクセスするために、指定されたクライアント ID およびクライアントシークレットを使用して |

| TLS クライアント |

| TLS クライアント設定は、TLS を使用してリモート書き込みエンドポイントサーバーで認証するために使用される CA 証明書、クライアント証明書、およびクライアントキーファイル情報を指定します。設定例は、CA 証明書ファイル、クライアント証明書ファイル、およびクライアントキーファイルがすでに作成されていることを前提としています。 |

3.4.1.2. リモート書き込み認証の設定例

次のサンプルは、リモート書き込みエンドポイントに接続するために使用できるさまざまな認証設定を示しています。各サンプルでは、認証情報やその他の関連設定を含む対応する Secret オブジェクトを設定する方法も示しています。それぞれのサンプルは、openshift-monitoring namespace でデフォルトのプラットフォームモニタリングで使用する認証を設定します。

3.4.1.2.1. AWS 署名バージョン 4 認証のサンプル YAML

以下は、openshift-monitoring namespace の sigv4-credentials という名前の sigv4 シークレットの設定を示しています。

以下は、openshift-monitoring namespace の sigv4-credentials という名前の Secret オブジェクトを使用する AWS Signature Version 4 リモート書き込み認証のサンプルを示しています。

3.4.1.2.2. Basic 認証用のサンプル YAML

以下に、openshift-monitoring namespace 内の rw-basic-auth という名前の Secret オブジェクトの基本認証設定のサンプルを示します。

以下の例は、openshift-monitoring namespace の rw-basic-auth という名前の Secret オブジェクトを使用する basicAuth リモート書き込み設定を示しています。これは、エンドポイントの認証認証情報がすでに設定されていることを前提としています。

3.4.1.2.3. Secret オブジェクトを使用したベアラートークンによる認証のサンプル YAML

以下は、openshift-monitoring namespace の rw-bearer-auth という名前の Secret オブジェクトのベアラートークン設定を示しています。

- 1

- 認証トークン。

以下は、openshift-monitoring namespace の rw-bearer-auth という名前の Secret オブジェクトを使用するベアラートークン config map の設定例を示しています。

3.4.1.2.4. OAuth 2.0 認証のサンプル YAML

以下は、openshift-monitoring namespace の oauth2-credentials という名前の Secret オブジェクトの OAuth 2.0 設定のサンプルを示しています。

以下は、openshift-monitoring namespace の oauth2-credentials という Secret オブジェクトを使用した oauth2 リモート書き込み認証のサンプル設定です。

- 1 3

- 対応する

Secretオブジェクトの名前。ClientIdはConfigMapオブジェクトを参照することもできますが、clientSecretはSecretオブジェクトを参照する必要があることに注意してください。 - 2 4

- 指定された

Secretオブジェクトの OAuth 2.0 認証情報が含まれるキー。 - 5

- 指定された

clientIdおよびclientSecretでトークンを取得するために使用される URL。 - 6

- 認可要求の OAuth 2.0 スコープ。これらのスコープは、トークンがアクセスできるデータを制限します。

- 7

- 認可サーバーに必要な OAuth 2.0 認可要求パラメーター。

3.4.1.2.5. TLS クライアント認証のサンプル YAML

以下は、openshift-monitoring namespace 内の mtls-bundle という名前の tls Secret オブジェクトに対する TLS クライアント設定のサンプルです。

以下の例は、mtls-bundle という名前の TLS Secret オブジェクトを使用する tlsConfig リモート書き込み認証設定を示しています。

3.4.1.3. リモート書き込みキューの設定例

リモート書き込み用の queueConfig オブジェクトを使用して、リモート書き込みキューパラメーターを調整できます。次の例は、openshift-monitoring namespace のデフォルトプラットフォームモニタリングのキューパラメーターとそのデフォルト値を示しています。

デフォルト値を使用したリモート書き込みパラメーターの設定例

3.4.1.4. リモート書き込みメトリクスの表

次の表に、リモート書き込みおよびリモート書き込み関連のメトリクスと、リモート書き込みの設定時に発生する問題を解決するのに役立つ詳細な説明を記載します。

| メトリクス | 説明 |

|---|---|

|

| 任意のサンプルについて、Prometheus が先行書き込みログ (WAL) に保存した最新のタイムスタンプを表示します。 |

|

| リモート書き込みキューが正常に送信した最新のタイムスタンプを表示します。 |

|

| リモート書き込みが送信に失敗し、リモートストレージに再送信する必要があったサンプルの数。このメトリクスの値が一定して高い場合は、ネットワークまたはリモートストレージエンドポイントに問題があります。 |

|

| 各リモートエンドポイントで現在実行されているシャードの数を示します。 |

|

| 現在の書き込みスループットと、受信サンプルと送信サンプルの比率に基づいて計算された必要なシャードの数を示します。 |

|

| 現在の設定に基づくシャードの最大数を示します。 |

|

| 現在の設定に基づくシャードの最小数を示します。 |

|

| Prometheus が現在新しいデータを書き込んでいる WAL セグメントファイル。 |

|

| 各リモート書き込みインスタンスが現在読み取っている WAL セグメントファイル。 |

3.4.2. メトリクスのクラスター ID ラベルの作成

openshift-monitoring namespace の cluster-monitoring-config config map にリモート書き込みストレージ用の write_relabel 設定を追加することで、メトリクスのクラスター ID ラベルを作成できます。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 -

OpenShift CLI (

oc) がインストールされている。 - リモート書き込みストレージを設定している。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configconfig map を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yaml/prometheusK8s/remoteWriteの下にあるwriteRelabelConfigs:セクションで、クラスター ID の再ラベル付け設定値を追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のサンプルは、クラスター ID ラベル

cluster_idを使用してメトリクスを転送する方法を示しています。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- システムは最初に

__tmp_openshift_cluster_id__という名前の一時的なクラスター ID ソースラベルを適用します。この一時的なラベルは、指定するクラスター ID ラベル名に置き換えられます。 - 2

- リモート書き込みストレージに送信されるメトリクスのクラスター ID ラベルの名前を指定します。メトリクスにすでに存在するラベル名を使用する場合、その値はこのクラスター ID ラベルの名前でオーバーライドされます。ラベル名には

__tmp_openshift_cluster_id__は使用しないでください。最後の再ラベル手順では、この名前を使用するラベルを削除します。 - 3

replace置き換えラベルの再設定アクションは、一時ラベルを送信メトリクスのターゲットラベルに置き換えます。このアクションはデフォルトであり、アクションが指定されていない場合に適用されます。

- 変更を適用するためにファイルを保存します。新しい設定は自動的に適用されます。

3.5. コアプラットフォームモニタリングのアラートと通知の設定

ローカルまたは外部の Alertmanager インスタンスを設定して、Prometheus からエンドポイントレシーバーにアラートをルーティングできます。すべての時系列とアラートにカスタムラベルを割り当てて、便利なメタデータ情報を追加することもできます。

3.5.1. 外部 Alertmanager インスタンスの設定

OpenShift Container Platform モニタリングスタックには、Prometheus からのアラートのルートなど、ローカルの Alertmanager インスタンスが含まれます。

外部の Alertmanager インスタンスを追加すると、OpenShift Container Platform コアプロジェクトのアラートをルーティングできます。

複数のクラスターに同じ外部 Alertmanager 設定を追加し、クラスターごとにローカルインスタンスを無効にする場合には、単一の外部 Alertmanager インスタンスを使用して複数のクラスターのアラートルーティングを管理できます。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 -

OpenShift CLI (

oc) がインストールされている。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configconfig map を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yaml/prometheusK8sの下に、設定の詳細を含むadditionalAlertmanagerConfigsセクションを追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<alertmanager_specification>は、追加の Alertmanager インスタンスの認証やその他の設定の詳細に置き換えます。現時点で、サポートされている認証方法はベアラートークン (bearerToken) およびクライアント TLS(tlsConfig) です。

次のサンプル config map は、クライアント TLS 認証でベアラートークンを使用して、Prometheus 用の追加の Alertmanager を設定します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。新しい設定の影響を受ける Pod は自動的に再デプロイされます。

3.5.1.1. ローカル Alertmanager の無効化

Prometheus インスタンスからのアラートをルーティングするローカル Alertmanager は、OpenShift Container Platform モニタリングスタックの openshift-monitoring プロジェクトではデフォルトで有効になっています。

ローカル Alertmanager を必要としない場合、openshift-monitoring プロジェクトで cluster-monitoring-config config map を指定して無効にできます。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configconfig map を作成している。 -

OpenShift CLI (

oc) がインストールされている。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configconfig map を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yamlの下に、alertmanagerMainコンポーネントのenabled: falseを追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。Alertmanager インスタンスは、この変更を適用すると自動的に無効にされます。

3.5.2. Alertmanager のシークレットの設定

OpenShift Container Platform モニタリングスタックには、アラートを Prometheus からエンドポイントレシーバーにルーティングする Alertmanager が含まれています。Alertmanager がアラートを送信できるようにレシーバーで認証する必要がある場合は、レシーバーの認証認証情報を含むシークレットを使用するように Alertmanager を設定できます。

たとえば、シークレットを使用して、プライベート認証局 (CA) によって発行された証明書を必要とするエンドポイント受信者を認証するように Alertmanager を設定できます。また、基本 HTTP 認証用のパスワードファイルを必要とする受信者で認証するためにシークレットを使用するように Alertmanager を設定することもできます。いずれの場合も、認証の詳細は、ConfigMap オブジェクトではなく Secret オブジェクトに含まれています。

3.5.2.1. Alertmanager 設定へのシークレットの追加

openshift-monitoring プロジェクトの cluster-monitoring-config config map を編集することで、Alertmanager 設定にシークレットを追加できます。

config map にシークレットを追加すると、シークレットは、Alertmanager Pod の alertmanager コンテナー内の /etc/alertmanager/secrets/<secret_name> にボリュームとしてマウントされます。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configconfig map を作成している。 -

openshift-monitoringプロジェクトの Alertmanager で設定するシークレットを作成しました。 -

OpenShift CLI (

oc) がインストールされている。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configconfig map を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yaml/alertmanagerMainの下にsecrets:セクションを次の設定で追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次の config map 設定の例では、

test-secret-basic-authおよびtest-secret-api-tokenという名前の 2 つのSecretオブジェクトを使用するように Alertmanager を設定します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。新しい設定は自動的に適用されます。

3.5.3. 追加ラベルの時系列 (time series) およびアラートへの割り当て

Prometheus の外部ラベル機能を使用して、Prometheus から送信されるすべての時系列とアラートにカスタムラベルを付けることができます。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

cluster-monitoring-configConfigMapオブジェクトを作成している。 -

OpenShift CLI (

oc) がインストールされている。

手順

openshift-monitoringプロジェクトでcluster-monitoring-configconfig map を編集します。oc -n openshift-monitoring edit configmap cluster-monitoring-config

$ oc -n openshift-monitoring edit configmap cluster-monitoring-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow data/config.yamlの下の各メトリクスに追加するラベルを定義します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<key>: <value>をキーと値のペアに置き換えます。<key>は新しいラベルの一意の名前、<value>はその値です。

警告-

prometheusまたはprometheus_replicaは予約され、オーバーライドされるため、これらをキー名として使用しないでください。 -

キー名に

clusterを使用しないでください。これを使用すると、開発者ダッシュボードでデータが表示されない問題が発生する可能性があります。

たとえば、リージョンと環境に関するメタデータをすべての時系列とアラートに追加するには、次の例を使用します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。新しい設定の影響を受ける Pod は自動的に再デプロイされます。

3.5.4. アラート通知の設定

OpenShift Container Platform 4.20 では、アラート UI でアラートの発生を確認できます。アラートレシーバーを設定することで、デフォルトのプラットフォームアラートに関する通知を送信するように Alertmanager を設定できます。

Alertmanager はデフォルトでは通知を送信しません。Web コンソールまたは alertmanager-main シークレットを通じてアラートレシーバーを設定して、通知を受信するように Alertmanager を設定することを強く推奨します。

3.5.4.1. デフォルトのプラットフォームアラートのアラートルーティングを設定する

クラスターからの重要なアラートを受信するために通知を送信するように Alertmanager を設定できます。Alertmanager からデフォルトのプラットフォームアラートに関する通知を送信する場所と方法をカスタマイズするには、openshift-monitoring namespace の alertmanager-main シークレットのデフォルト設定を編集します。

サポート対象のアップストリームバージョンの Alertmanager 機能はすべて、OpenShift Container Platform の Alertmanager 設定でもサポートされます。サポート対象のアップストリーム Alertmanager バージョンのあらゆる設定オプションを確認するには、Alertmanager configuration (Prometheus ドキュメント) を参照してください。

前提条件

-

cluster-adminクラスターロールを持つユーザーとしてクラスターにアクセスできる。 -

OpenShift CLI (

oc) がインストールされている。

手順

現在アクティブな Alertmanager 設定を

alertmanager-mainシークレットから展開し、ローカルのalertmanager.yamlファイルとして保存します。oc -n openshift-monitoring get secret alertmanager-main --template='{{ index .data "alertmanager.yaml" }}' | base64 --decode > alertmanager.yaml$ oc -n openshift-monitoring get secret alertmanager-main --template='{{ index .data "alertmanager.yaml" }}' | base64 --decode > alertmanager.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

alertmanager.yamlファイルを開きます。 Alertmanager の設定を編集します。

オプション: デフォルトの Alertmanager 設定を変更します。

デフォルトの Alertmanager シークレット YAML の例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Alertmanager が通知を送信する前に、アラートグループの初期アラートを収集するまで待機する時間を指定します。

- 2

- 最初の通知がすでに送信されているアラートグループに追加された新しいアラートに関する通知を Alertmanager が送信するまでの時間を指定します。

- 3

- アラート通知を繰り返すまでの最小時間を指定します。各グループの間隔で通知を繰り返す場合は、

repeat_intervalの値をgroup_intervalの値よりも小さく設定します。ただし、特定の Alertmanager Pod が再起動または再スケジュールされた場合などには、通知の繰り返しが遅れる可能性があります。

アラートレシーバーの設定を追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow PagerDuty をアラートレシーバーとして設定する例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- PagerDuty 統合キーを定義します。

メールアドレスをアラートレシーバーとして設定する例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要Alertmanager には、メールアラートを送信するために外部 SMTP サーバーが必要です。メールアラートのレシーバーを設定する際には、外部 SMTP サーバーの必要な接続の詳細情報があることを確認してください。

ルーティング設定を追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 警告match、match_re、target_match、target_match_re、source_match、source_match_reのキー名は使用しないでください。これらは非推奨であり、今後のリリースで削除される予定です。アラートルーティングの例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 前の例では、

example-appサービスによって発生した重大度がcriticalのアラートが、team-frontend-pageレシーバーにルーティングされます。通常、このタイプのアラートは、個人または緊急対応チームに通知します。

新規設定をファイルで適用します。

oc -n openshift-monitoring create secret generic alertmanager-main --from-file=alertmanager.yaml --dry-run=client -o=yaml | oc -n openshift-monitoring replace secret --filename=-

$ oc -n openshift-monitoring create secret generic alertmanager-main --from-file=alertmanager.yaml --dry-run=client -o=yaml | oc -n openshift-monitoring replace secret --filename=-Copy to Clipboard Copied! Toggle word wrap Toggle overflow ルーティングツリーを可視化してルーティング設定を確認します。