スケーラビリティーおよびパフォーマンス

実稼働環境における OpenShift Container Platform クラスターのスケーリングおよびパフォーマンスチューニング

概要

第1章 OpenShift Container Platform スケーラビリティーおよびパフォーマンスの概要

OpenShift Container Platform は、クラスターのパフォーマンスとスケーリングを最適化するのに役立つベストプラクティスとツールを提供します。次のドキュメントでは、推奨されるパフォーマンスとスケーラビリティーのプラクティス、リファレンス設計仕様、最適化、低レイテンシーのチューニングに関する情報を提供します。

Red Hat サポートへの問い合わせは、サポート を参照してください。

一部のパフォーマンス Operator およびスケーラビリティー Operator には、OpenShift Container Platform のリリースサイクルとは独立したリリースサイクルがあります。詳細は、OpenShift Operators を参照してください。

1.1. パフォーマンスとスケーラビリティの推奨プラクティス

1.2. 通信事業者向けリファレンス設計仕様

1.3. 計画、最適化、測定

IBM Z および IBM LinuxONE の推奨プラクティス

CPU マネージャーおよび Topology Manager の使用

ストレージ、ルーティング、ネットワーク、CPU 使用率の最適化

huge page の機能およびそれらがアプリケーションによって消費される仕組み

クラスターの安定性とパーティションワークロードを改善するための低レイテンシーチューニング

第2章 パフォーマンスとスケーラビリティの推奨プラクティス

2.1. コントロールプレーンの推奨プラクティス

このトピックでは、OpenShift Container Platform のコントロールプレーンに関するパフォーマンスとスケーラビリティーの推奨プラクティスを説明します。

2.1.1. クラスターのスケーリングに関する推奨プラクティス

このセクションのガイダンスは、クラウドプロバイダーの統合によるインストールにのみ関連します。

以下のベストプラクティスを適用して、OpenShift Container Platform クラスター内のワーカーマシンの数をスケーリングします。ワーカーのマシンセットで定義されるレプリカ数を増やしたり、減らしたりしてワーカーマシンをスケーリングします。

クラスターをノード数のより高い値にスケールアップする場合:

- 高可用性を確保するために、ノードを利用可能なすべてのゾーンに分散します。

- 一度に 25 台から 50 台までの範囲でマシンをスケールアップします。

- 定期的なプロバイダーの容量関連の制約を軽減するために、同様のサイズの別のインスタンスタイプを使用して、利用可能なゾーンごとに新規のコンピュートマシンセットを作成することを検討してください。たとえば、AWS で、m5.large および m5d.large を使用します。

クラウドプロバイダーは API サービスのクォータを実装する可能性があります。そのため、クラスターは段階的にスケーリングします。

コンピュートマシンセット内のレプリカがすべて一度に高い数値に設定されると、コントローラーがマシンを作成できない可能性があります。このプロセスには、OpenShift Container Platform がデプロイされているクラウドプラットフォームが処理できる要求の数が影響します。コントローラーは、該当するステータスのマシンの作成、確認、および更新を試行する間に、追加のクエリーを開始します。OpenShift Container Platform がデプロイされるクラウドプラットフォームには API 要求の制限があり、過剰なクエリーが生じると、クラウドプラットフォームの制限によりマシンの作成が失敗する場合があります。

大規模なノード数にスケーリングする際にマシンヘルスチェックを有効にします。障害が発生する場合、ヘルスチェックは状態を監視し、正常でないマシンを自動的に修復します。

大規模で高密度なクラスターをスケールダウンしてノード数を減らす場合、長い時間がかかることがあります。このプロセスでは、終了するノードで実行されているオブジェクトを並行して drain または退避させる必要があるためです。また、退避させるオブジェクトが多すぎる場合、クライアントがリクエストのスロットリングを開始する可能性があります。デフォルトの 1 秒あたりのクライアントクエリー数 (QPS) とバーストレートは、現在それぞれ 50 と 100 に設定されています。これらの値は、OpenShift Container Platform では変更できません。

2.1.2. コントロールプレーンノードのサイジング

コントロールプレーンノードのリソース要件は、クラスター内のノードとオブジェクトの数とタイプによって異なります。次のコントロールプレーンノードサイズの推奨事項は、コントロールプレーン密度に焦点を当てたテストまたは クラスター密度 の結果に基づいています。このテストでは、指定された数の namespace にわたって次のオブジェクトを作成します。

- 1 イメージストリーム

- 1 ビルド

-

5 つのデプロイメント、

sleep状態の 2 つの Pod レプリカ、4 つのシークレット、4 つの config map、およびそれぞれ 1 つの下位 API ボリュームのマウント - 5 つのサービス。それぞれが以前のデプロイメントの 1 つの TCP/8080 および TCP/8443 ポートを指します。

- 以前のサービスの最初を指す 1 つのルート

- 2048 個のランダムな文字列文字を含む 10 個のシークレット

- 2048 個のランダムな文字列文字を含む 10 個の config map

| ワーカーノードの数 | クラスター密度 (namespace) | CPU コア数 | メモリー (GB) |

|---|---|---|---|

| 24 | 500 | 4 | 16 |

| 120 | 1000 | 8 | 32 |

| 252 | 4000 | 16、ただし OVN-Kubernetes ネットワークプラグインを使用する場合は 24 | 64、ただし OVN-Kubernetes ネットワークプラグインを使用する場合は 128 |

| 501、ただし OVN-Kubernetes ネットワークプラグインではテストされていません | 4000 | 16 | 96 |

上の表のデータは、r5.4xlarge インスタンスをコントロールプレーンノードとして使用し、m5.2xlarge インスタンスをワーカーノードとして使用する、AWS 上で実行される OpenShift Container Platform をベースとしています。

3 つのコントロールプレーンノードを持つ大規模で高密度なクラスターでは、いずれかのノードが停止、再起動、または障害が発生すると、CPU とメモリーの使用量が急増します。障害は、電源、ネットワーク、または基礎となるインフラストラクチャーの予期しない問題、またはコストを節約するためにシャットダウンした後にクラスターが再起動する意図的なケースが原因である可能性があります。残りの 2 つのコントロールプレーンノードは、高可用性を維持するために負荷を処理する必要があります。これにより、リソースの使用量が増えます。この動作はアップグレード時にも予想されます。オペレーティングシステムの更新とコントロールプレーン Operator の更新を適用するために、コントロールプレーンノードに cordon (スケジューリング対象からの除外) と drain (Pod の退避) が実行され、ノードが順次再起動されるためです。障害が繰り返し発生しないようにするには、コントロールプレーンノードでの全体的な CPU およびメモリーリソース使用状況を、利用可能な容量の最大 60% に維持し、使用量の急増に対応できるようにします。リソース不足による潜在的なダウンタイムを回避するために、コントロールプレーンノードの CPU およびメモリーを適宜増やします。

ノードのサイジングは、クラスター内のノードおよびオブジェクトの数によって異なります。また、オブジェクトがそのクラスター上でアクティブに作成されるかどうかによっても異なります。オブジェクトの作成時に、コントロールプレーンは、オブジェクトが running フェーズにある場合と比較し、リソースの使用状況においてよりアクティブな状態になります。

Operator Lifecycle Manager (OLM) はコントロールプレーンノードで実行され、OLM のメモリーフットプリントは OLM がクラスター上で管理する必要のある namespace およびユーザーによってインストールされる Operator の数によって異なります。OOM による強制終了を防ぐには、コントロールプレーンノードのサイズを適切に設定する必要があります。以下のデータポイントは、クラスター最大のテストの結果に基づいています。

| namespace 数 | アイドル状態の OLM メモリー (GB) | ユーザー Operator が 5 つインストールされている OLM メモリー (GB) |

|---|---|---|

| 500 | 0.823 | 1.7 |

| 1000 | 1.2 | 2.5 |

| 1500 | 1.7 | 3.2 |

| 2000 | 2 | 4.4 |

| 3000 | 2.7 | 5.6 |

| 4000 | 3.8 | 7.6 |

| 5000 | 4.2 | 9.02 |

| 6000 | 5.8 | 11.3 |

| 7000 | 6.6 | 12.9 |

| 8000 | 6.9 | 14.8 |

| 9000 | 8 | 17.7 |

| 10,000 | 9.9 | 21.6 |

以下の設定でのみ、実行中の OpenShift Container Platform 4.16 クラスターでコントロールプレーンのノードサイズを変更できます。

- ユーザーがプロビジョニングしたインストール方法でインストールされたクラスター。

- installer-provisioned infrastructure インストール方法でインストールされた AWS クラスター。

- コントロールプレーンマシンセットを使用してコントロールプレーンマシンを管理するクラスター。

他のすべての設定では、合計ノード数を見積もり、インストール時に推奨されるコントロールプレーンノードサイズを使用する必要があります。

この推奨事項は、ネットワークプラグインとして OpenShift SDN を使用して OpenShift Container Platform クラスターでキャプチャーされたデータポイントに基づいています。

OpenShift Container Platform 3.11 以前のバージョンと比較すると、OpenShift Container Platform 4.16 ではデフォルトで CPU コア (500 ミリコア) の半分がシステムによって予約されるようになりました。サイズはこれを考慮に入れて決定されます。

2.1.2.1. コントロールプレーンマシン用により大きな Amazon Web Services インスタンスタイプを選択する

Amazon Web Services (AWS) クラスター内のコントロールプレーンマシンがより多くのリソースを必要とする場合は、コントロールプレーンマシンが使用するより大きな AWS インスタンスタイプを選択できます。

コントロールプレーンマシンセットを使用するクラスターの手順は、コントロールプレーンマシンセットを使用しないクラスターの手順とは異なります。

クラスター内の ControlPlaneMachineSet CR の状態が不明な場合は、CR のステータスを確認 できます。

2.1.2.1.1. コントロールプレーンマシンセットを使用して Amazon Web Services インスタンスタイプを変更する

コントロールプレーンマシンセットのカスタムリソース (CR) の仕様を更新することで、コントロールプレーンマシンが使用する Amazon Web Services (AWS) インスタンスタイプを変更できます。

前提条件

- AWS クラスターは、コントロールプレーンマシンセットを使用します。

手順

次のコマンドを実行して、コントロールプレーンマシンセットの CR を編集します。

oc --namespace openshift-machine-api edit controlplanemachineset.machine.openshift.io cluster

$ oc --namespace openshift-machine-api edit controlplanemachineset.machine.openshift.io clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow providerSpecフィールドの下で以下の行を編集します。providerSpec: value: ... instanceType: <compatible_aws_instance_type>providerSpec: value: ... instanceType: <compatible_aws_instance_type>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 前の選択と同じベースで、より大きな AWS インスタンスタイプを指定します。たとえば、

m6i.xlargeをm6i.2xlargeまたはm6i.4xlargeに変更できます。

変更を保存します。

-

デフォルトの

RollingUpdate更新戦略を使用するクラスターの場合、Operator は自動的に変更をコントロールプレーン設定に伝達します。 -

OnDelete更新戦略を使用するように設定されているクラスターの場合、コントロールプレーンマシンを手動で置き換える必要があります。

-

デフォルトの

2.1.2.1.2. AWS コンソールを使用して Amazon Web Services インスタンスタイプを変更する

AWS コンソールでインスタンスタイプを更新することにより、コントロールプレーンマシンが使用するアマゾンウェブサービス (AWS) インスタンスタイプを変更できます。

前提条件

- クラスターの EC2 インスタンスを変更するために必要なアクセス許可を持つ AWS コンソールにアクセスできます。

-

cluster-adminロールを持つユーザーとして OpenShift Container Platform クラスターにアクセスできます。

手順

- AWS コンソールを開き、コントロールプレーンマシンのインスタンスを取得します。

コントロールプレーンマシンインスタンスを 1 つ選択します。

- 選択したコントロールプレーンマシンについて、etcd スナップショットを作成して etcd データをバックアップします。詳細は、「etcd のバックアップ」を参照してください。

- AWS コンソールで、コントロールプレーンマシンインスタンスを停止します。

- 停止したインスタンスを選択し、Actions → Instance Settings → Change instance type をクリックします。

-

インスタンスをより大きなタイプに変更し、タイプが前の選択と同じベースであることを確認して、変更を適用します。たとえば、

m6i.xlargeをm6i.2xlargeまたはm6i.4xlargeに変更できます。 - インスタンスを起動します。

-

OpenShift Container Platform クラスターにインスタンスに対応する

Machineオブジェクトがある場合、AWS コンソールで設定されたインスタンスタイプと一致するようにオブジェクトのインスタンスタイプを更新します。

- コントロールプレーンマシンごとにこのプロセスを繰り返します。

2.2. インフラストラクチャーの推奨プラクティス

このトピックでは、OpenShift Container Platform のインフラストラクチャーに関するパフォーマンスとスケーラビリティーの推奨プラクティスを説明します。

2.2.1. インフラストラクチャーノードのサイジング

インフラストラクチャーノード は、OpenShift Container Platform 環境の各部分を実行するようにラベル付けされたノードです。インフラストラクチャーノードのリソース要件は、クラスターの稼働時間、ノード、およびクラスター内のオブジェクトによって異なります。これらの要因により、Prometheus のメトリクスまたは時系列の数が増える可能性があるためです。次のインフラストラクチャーノードサイズの推奨事項は、コントロールプレーンノードのサイジング セクションで詳しく説明されているクラスター密度テストで観察された結果に基づいています。モニタリングスタックとデフォルトの Ingress コントローラーは、これらのノードに移動されています。

| ワーカーノードの数 | クラスター密度または namespace の数 | CPU コア数 | メモリー (GB) |

|---|---|---|---|

| 27 | 500 | 4 | 24 |

| 120 | 1000 | 8 | 48 |

| 252 | 4000 | 16 | 128 |

| 501 | 4000 | 32 | 128 |

通常、3 つのインフラストラクチャーノードはクラスターごとに推奨されます。

これらのサイジングの推奨事項は、ガイドラインとして使用する必要があります。Prometheus はメモリー集約型のアプリケーションであり、リソースの使用率はノード数、オブジェクト数、Prometheus メトリクスの収集間隔、メトリクスまたは時系列、クラスターの使用年数などのさまざまな要素によって異なります。さらに、ルーターのリソース使用量は、ルートの数とインバウンド要求の量/タイプによっても影響を受ける可能性があります。

これらの推奨事項は、クラスターの作成時にインストールされたモニタリング、イングレス、およびレジストリーインフラストラクチャーコンポーネントをホストするインフラストラクチャーノードにのみ適用されます。

OpenShift Container Platform 3.11 以前のバージョンと比較すると、OpenShift Container Platform 4.16 ではデフォルトで CPU コア (500 ミリコア) の半分がシステムによって予約されるようになりました。これは、上記のサイジングの推奨内容に影響します。

2.2.2. Cluster Monitoring Operator のスケーリング

OpenShift Container Platform は、Cluster Monitoring Operator (CMO) が収集し、Prometheus ベースのモニタリングスタックに保存するメトリクスを公開します。管理者は、Observe → Dashboards に移動して、OpenShift Container Platform Web コンソールでシステムリソース、コンテナー、およびコンポーネントメトリックスのダッシュボードを表示できます。

2.2.3. Prometheus データベースのストレージ要件

Red Hat は、スケールサイズに応じて各種のテストを実行しました。

- 次の Prometheus ストレージ要件は規定されていないため、参考として使用してください。ワークロードのアクティビティーおよびリソースの密度に応じて、クラスターでより多くのリソース消費が観察される可能性があります。これには、Pod、コンテナー、ルート、Prometheus により収集されるメトリクスを公開する他のリソースの数が含まれます。

- ストレージ要件に合わせて、サイズベースのデータ保持ポリシーを設定できます。

| ノード数 | Pod 数 (Pod あたり 2 コンテナー) | 1 日あたりの Prometheus ストレージの増加量 | 15 日ごとの Prometheus ストレージの増加量 | ネットワーク (tsdb チャンクに基づく) |

|---|---|---|---|---|

| 50 | 1800 | 6.3 GB | 94 GB | 16 MB |

| 100 | 3600 | 13 GB | 195 GB | 26 MB |

| 150 | 5400 | 19 GB | 283 GB | 36 MB |

| 200 | 7200 | 25 GB | 375 GB | 46 MB |

ストレージ要件が計算値を超過しないようにするために、オーバーヘッドとして予期されたサイズのおよそ 20% が追加されています。

上記の計算は、デフォルトの OpenShift Container Platform Cluster Monitoring Operator に関する計算です。

CPU の使用率による影響は大きくありません。比率は、およそ 50 ノードおよび 1800 Pod ごとに 40 分の 1 コアです。

OpenShift Container Platform に関する推奨事項

- 少なくとも 2 つのインフラストラクチャー (infra) ノードを使用してください。

- Non-Volatile Memory Express (SSD または NVMe) ドライブを備えた少なくとも 3 つの openshift-container-storage ノードを使用します。

2.2.4. クラスターモニタリングの設定

クラスターモニタリングスタック内の Prometheus コンポーネントのストレージ容量を増やすことができます。

手順

Prometheus のストレージ容量を拡張するには、以下を実行します。

YAML 設定ファイル

cluster-monitoring-config.yamlを作成します。以下に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Prometheus の保持のデフォルト値は

PROMETHEUS_RETENTION_PERIOD=15dです。時間は、接尾辞 s、m、h、d のいずれかを使用する単位で測定されます。 - 2 4

- クラスターのストレージクラス。

- 3

- 標準の値は

PROMETHEUS_STORAGE_SIZE=2000Giです。ストレージの値には、接尾辞 E、P、T、G、M、K のいずれかを使用した単純な整数または固定小数点整数を使用できます。また、2 のべき乗の値 (Ei、Pi、Ti、Gi、Mi、Ki) を使用することもできます。 - 5

- 標準の値は

ALERTMANAGER_STORAGE_SIZE=20Giです。ストレージの値には、接尾辞 E、P、T、G、M、K のいずれかを使用した単純な整数または固定小数点整数を使用できます。また、2 のべき乗の値 (Ei、Pi、Ti、Gi、Mi、Ki) を使用することもできます。

- 保存期間、ストレージクラス、およびストレージサイズの値を追加します。

- ファイルを保存します。

以下を実行して変更を適用します。

oc create -f cluster-monitoring-config.yaml

$ oc create -f cluster-monitoring-config.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. etcd に関する推奨されるプラクティス

このトピックでは、OpenShift Container Platform の etcd に関するパフォーマンスとスケーラビリティーの推奨プラクティスを説明します。

2.3.1. etcd に関する推奨されるプラクティス

etcd はデータをディスクに書き込み、プロポーザルをディスクに保持するため、そのパフォーマンスはディスクのパフォーマンスに依存します。etcd は特に I/O を集中的に使用するわけではありませんが、最適なパフォーマンスと安定性を得るには、低レイテンシーのブロックデバイスが必要です。etcd のコンセンサスプロトコルは、メタデータをログ (WAL) に永続的に保存することに依存しているため、etcd はディスク書き込みの遅延に敏感です。遅いディスクと他のプロセスからのディスクアクティビティーは、長い fsync 待ち時間を引き起こす可能性があります。

これらの待ち時間により、etcd はハートビートを見逃し、新しいプロポーザルを時間どおりにディスクにコミットせず、最終的にリクエストのタイムアウトと一時的なリーダーの喪失を経験する可能性があります。書き込みレイテンシーが高いと、OpenShift API の速度も低下し、クラスターのパフォーマンスに影響します。これらの理由により、I/O を区別する、または集約型であり、同一基盤として I/O インフラストラクチャーを共有する他のワークロードをコントロールプレーンノードに併置することは避けてください。

レイテンシーに関しては、8000 バイト長の 50 IOPS 以上を連続して書き込むことができるブロックデバイス上で etcd を実行します。つまり、レイテンシーが 10 ミリ秒の場合、fdatasync を使用して WAL の各書き込みを同期することに注意してください。負荷の高いクラスターの場合、8000 バイト (2 ミリ秒) の連続 500 IOPS が推奨されます。これらの数値を測定するには、fio などのベンチマークツールを使用できます。

このようなパフォーマンスを実現するには、低レイテンシーで高スループットの SSD または NVMe ディスクに支えられたマシンで etcd を実行します。シングルレベルセル (SLC) ソリッドステートドライブ (SSD) を検討してください。これは、メモリーセルごとに 1 ビットを提供し、耐久性と信頼性が高く、書き込みの多いワークロードに最適です。

etcd の負荷は、ノードや Pod の数などの静的要因と、Pod の自動スケーリング、Pod の再起動、ジョブの実行、その他のワークロード関連イベントが原因となるエンドポイントの変更などの動的要因から生じます。etcd セットアップのサイズを正確に設定するには、ワークロードの具体的な要件を分析する必要があります。etcd の負荷に影響を与えるノード、Pod、およびその他の関連要素の数を考慮してください。

最適な etcd パフォーマンスを得るには、ハードドライブで以下を適用します。

- 専用の etcd ドライブを使用します。iSCSI などのネットワーク経由で通信するドライブは回避します。etcd ドライブにログファイルやその他の重いワークロードを配置しないでください。

- 読み取りおよび書き込みを高速化するために、低レイテンシードライブを優先的に使用します。

- 圧縮と最適化を高速化するために、高帯域幅の書き込みを優先的に使用します。

- 障害からの回復を高速化するために、高帯域幅の読み取りを優先的に使用します。

- 最小の選択肢としてソリッドステートドライブを使用します。実稼働環境には NVMe ドライブの使用が推奨されます。

- 高い信頼性を確保するためには、サーバーグレードのハードウェアを使用します。

NAS または SAN のセットアップ、および回転するドライブは避けてください。Ceph Rados Block Device (RBD) およびその他のタイプのネットワーク接続ストレージでは、予測できないネットワークレイテンシーが発生する可能性があります。etcd ノードに大規模な高速ストレージを提供するには、PCI パススルーを使用して NVM デバイスをノードに直接渡します。

fio などのユーティリティーを使用して、常にベンチマークを行ってください。このようなユーティリティーを使用すると、クラスターのパフォーマンスが向上するにつれて、そのパフォーマンスを継続的に監視できます。

ネットワークファイルシステム (NFS) プロトコルまたはその他のネットワークベースのファイルシステムの使用は避けてください。

デプロイされた OpenShift Container Platform クラスターでモニターする主要なメトリクスの一部は、etcd ディスクの write ahead log 期間の p99 と etcd リーダーの変更数です。Prometheus を使用してこれらのメトリクスを追跡します。

etcd メンバーデータベースのサイズは、通常の運用時にクラスター内で異なる場合があります。この違いは、リーダーのサイズが他のメンバーと異なっていても、クラスターのアップグレードには影響しません。

OpenShift Container Platform クラスターの作成前または作成後に etcd のハードウェアを検証するには、fio を使用できます。

前提条件

- Podman や Docker などのコンテナーランタイムが、テストしているマシンにインストールされている。

-

データは

/var/lib/etcdパスに書き込まれます。

手順

fio を実行し、結果を分析します。

Podman を使用する場合は、次のコマンドを実行します。

sudo podman run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/cloud-bulldozer/etcd-perf

$ sudo podman run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/cloud-bulldozer/etcd-perfCopy to Clipboard Copied! Toggle word wrap Toggle overflow Docker を使用する場合は、次のコマンドを実行します。

sudo docker run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/cloud-bulldozer/etcd-perf

$ sudo docker run --volume /var/lib/etcd:/var/lib/etcd:Z quay.io/cloud-bulldozer/etcd-perfCopy to Clipboard Copied! Toggle word wrap Toggle overflow

この出力では、実行からキャプチャーされた fsync メトリクスの 99 パーセンタイルの比較でディスクが 10 ms 未満かどうかを確認して、ディスクの速度が etcd をホストするのに十分であるかどうかを報告します。I/O パフォーマンスの影響を受ける可能性のある最も重要な etcd メトリックのいくつかを以下に示します。

-

etcd_disk_wal_fsync_duration_seconds_bucketメトリックは、etcd の WAL fsync 期間を報告します。 -

etcd_disk_backend_commit_duration_seconds_bucketメトリクスは、etcd バックエンドコミットの待機時間を報告します。 -

etcd_server_leader_changes_seen_totalメトリクスは、リーダーの変更を報告します。

etcd はすべてのメンバー間で要求を複製するため、そのパフォーマンスはネットワーク入出力 (I/O) のレイテンシーによって大きく変わります。ネットワークのレイテンシーが高くなると、etcd のハートビートの時間は選択のタイムアウトよりも長くなり、その結果、クラスターに中断をもたらすリーダーの選択が発生します。デプロイされた OpenShift Container Platform クラスターでのモニターの主要なメトリクスは、各 etcd クラスターメンバーの etcd ネットワークピアレイテンシーの 99 番目のパーセンタイルになります。Prometheus を使用してメトリクスを追跡します。

histogram_quantile(0.99, rate(etcd_network_peer_round_trip_time_seconds_bucket[2m])) メトリクスは、etcd がメンバー間におけるクライアント要求のレプリケートを完了するまでの往復時間を報告します。50 ミリ秒未満であることを確認してください。

2.3.2. etcd を別のディスクに移動する

etcd を共有ディスクから別のディスクに移動して、パフォーマンスの問題を防止または解決できます。

Machine Config Operator (MCO) は、OpenShift Container Platform 4.16 コンテナーストレージのセカンダリーディスクをマウントします。

このエンコードされたスクリプトは、次のデバイスタイプのデバイス名のみをサポートします。

- SCSI または SATA

-

/dev/sd* - 仮想デバイス

-

/dev/vd* - NVMe

-

/dev/nvme*[0-9]*n*

制限事項

-

新しいディスクがクラスターに接続されると、etcd データベースがルートマウントの一部になります。プライマリーノードが再作成されるとき、ルートマウントはセカンダリーディスクまたは目的のディスクの一部ではありません。そのため、プライマリーノードは個別の

/var/lib/etcdマウントを作成しません。

前提条件

- クラスターの etcd データのバックアップを作成している。

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-admin権限でクラスターにアクセスできる。 - マシン設定をアップロードする前に、追加のディスクを追加する。

-

MachineConfigPoolはmetadata.labels[machineconfiguration.openshift.io/role]と一致する必要があります。これは、コントローラー、ワーカー、またはカスタムプールに適用されます。

この手順では、/var/ などのルートファイルシステムの一部を、インストール済みノードの別のディスクまたはパーティションに移動しません。

コントロールプレーンマシンセットを使用する場合は、この手順がサポートされません。

手順

新しいディスクをクラスターに接続し、デバッグシェルで

lsblkコマンドを実行して、ディスクがノード内で検出されることを確認します。oc debug node/<node_name>

$ oc debug node/<node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow lsblk

# lsblkCopy to Clipboard Copied! Toggle word wrap Toggle overflow lsblkコマンドで報告された新しいディスクのデバイス名をメモします。次のスクリプトを作成し、名前を

etcd-find-secondary-device.shにします。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<device_type_glob>は、ブロックデバイスタイプのシェル glob に置き換えます。SCSI または SATA ドライブの場合は/dev/sd*を使用し、仮想ドライブの場合は/dev/vd*を使用し、NVMe ドライブの場合は/dev/nvme*[0-9]*n*を使用します。

etcd-find-secondary-device.shスクリプトから base64 でエンコードされた文字列を作成し、その内容をメモします。base64 -w0 etcd-find-secondary-device.sh

$ base64 -w0 etcd-find-secondary-device.shCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のような内容を含む

etcd-mc.ymlという名前のMachineConfigYAML ファイルを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<encoded_etcd_find_secondary_device_script>を、メモしておいたエンコードされたスクリプトの内容に置き換えます。

検証手順

ノードのデバッグシェルで

grep /var/lib/etcd /proc/mountsコマンドを実行して、ディスクがマウントされていることを確認します。oc debug node/<node_name>

$ oc debug node/<node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow grep -w "/var/lib/etcd" /proc/mounts

# grep -w "/var/lib/etcd" /proc/mountsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

/dev/sdb /var/lib/etcd xfs rw,seclabel,relatime,attr2,inode64,logbufs=8,logbsize=32k,noquota 0 0

/dev/sdb /var/lib/etcd xfs rw,seclabel,relatime,attr2,inode64,logbufs=8,logbsize=32k,noquota 0 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.3. etcd データのデフラグ

大規模で密度の高いクラスターの場合、キースペースが大きくなりすぎてスペースのクォータを超えると、etcd のパフォーマンスが低下する可能性があります。定期的に etcd をメンテナンスしてデフラグし、データストアの領域を解放してください。Prometheus で etcd メトリクスを監視し、必要に応じてデフラグしてください。そうしないと、etcd がクラスター全体のアラームを発し、クラスターがキーの読み取りと削除しか受け付けないメンテナンスモードになる可能性があります。

以下の主要なメトリクスを監視してください。

-

etcd_server_quota_backend_bytes。これは現在のクォータ制限です。 -

etcd_mvcc_db_total_size_in_use_in_bytes。履歴圧縮後の実際のデータベース使用量を示します。 -

etcd_mvcc_db_total_size_in_bytes。デフラグ待ちの空き領域を含むデータベースのサイズを示します。

etcd データをデフラグし、etcd 履歴の圧縮などのディスクの断片化を引き起こすイベント後にディスク領域を回収します。

履歴の圧縮は 5 分ごとに自動的に行われ、これによりバックエンドデータベースにギャップが生じます。この断片化された領域は etcd が使用できますが、ホストファイルシステムでは利用できません。ホストファイルシステムでこの領域を使用できるようにするには、etcd をデフラグする必要があります。

デフラグは自動的に行われますが、手動でトリガーすることもできます。

etcd Operator はクラスター情報を使用してユーザーの最も効率的な操作を決定するため、ほとんどの場合、自動デフラグが適しています。

2.3.3.1. 自動デフラグ

etcd Operator はディスクを自動的にデフラグします。手動による介入は必要ありません。

以下のログのいずれかを表示して、デフラグプロセスが成功したことを確認します。

- etcd ログ

- cluster-etcd-operator Pod

- Operator ステータスのエラーログ

自動デフラグにより、Kubernetes コントローラーマネージャーなどのさまざまな OpenShift コアコンポーネントでリーダー選出の失敗が発生し、失敗したコンポーネントの再起動がトリガーされる可能性があります。再起動は無害であり、次に実行中のインスタンスへのフェイルオーバーをトリガーするか、再起動後にコンポーネントが再び作業を再開します。

デフラグ成功時のログ出力例

etcd member has been defragmented: <member_name>, memberID: <member_id>

etcd member has been defragmented: <member_name>, memberID: <member_id>デフラグ失敗時のログ出力例

failed defrag on member: <member_name>, memberID: <member_id>: <error_message>

failed defrag on member: <member_name>, memberID: <member_id>: <error_message>2.3.3.2. 手動デフラグ

Prometheus アラートは、手動でのデフラグを使用する必要がある場合を示します。アラートは次の 2 つの場合に表示されます。

- etcd が使用可能なスペースの 50% 以上を 10 分を超過して使用する場合

- etcd が合計データベースサイズの 50% 未満を 10 分を超過してアクティブに使用している場合

また、デフラグによって解放される etcd データベースのサイズ (MB 単位) を確認することで、デフラグが必要かどうかを判断することもできます。これは (etcd_mvcc_db_total_size_in_bytes - etcd_mvcc_db_total_size_in_use_in_bytes)/1024/1024 という PromQL 式を使用して確認できます。

etcd のデフラグはプロセスを阻止するアクションです。etcd メンバーはデフラグが完了するまで応答しません。このため、各 Pod のデフラグアクションごとに少なくとも 1 分間待機し、クラスターが回復できるようにします。

以下の手順に従って、各 etcd メンバーで etcd データをデフラグします。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。

手順

リーダーを最後にデフラグする必要があるため、どの etcd メンバーがリーダーであるかを判別します。

etcd Pod のリストを取得します。

oc -n openshift-etcd get pods -l k8s-app=etcd -o wide

$ oc -n openshift-etcd get pods -l k8s-app=etcd -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

etcd-ip-10-0-159-225.example.redhat.com 3/3 Running 0 175m 10.0.159.225 ip-10-0-159-225.example.redhat.com <none> <none> etcd-ip-10-0-191-37.example.redhat.com 3/3 Running 0 173m 10.0.191.37 ip-10-0-191-37.example.redhat.com <none> <none> etcd-ip-10-0-199-170.example.redhat.com 3/3 Running 0 176m 10.0.199.170 ip-10-0-199-170.example.redhat.com <none> <none>

etcd-ip-10-0-159-225.example.redhat.com 3/3 Running 0 175m 10.0.159.225 ip-10-0-159-225.example.redhat.com <none> <none> etcd-ip-10-0-191-37.example.redhat.com 3/3 Running 0 173m 10.0.191.37 ip-10-0-191-37.example.redhat.com <none> <none> etcd-ip-10-0-199-170.example.redhat.com 3/3 Running 0 176m 10.0.199.170 ip-10-0-199-170.example.redhat.com <none> <none>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Pod を選択し、以下のコマンドを実行して、どの etcd メンバーがリーダーであるかを判別します。

oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.com etcdctl endpoint status --cluster -w table

$ oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.com etcdctl endpoint status --cluster -w tableCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow この出力の

IS LEADER列に基づいて、https://10.0.199.170:2379エンドポイントがリーダーになります。このエンドポイントを直前の手順の出力に一致させると、リーダーの Pod 名はetcd-ip-10-0-199-170.example.redhat.comになります。

etcd メンバーのデフラグ。

実行中の etcd コンテナーに接続し、リーダーでは ない Pod の名前を渡します。

oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.com

$ oc rsh -n openshift-etcd etcd-ip-10-0-159-225.example.redhat.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow ETCDCTL_ENDPOINTS環境変数の設定を解除します。unset ETCDCTL_ENDPOINTS

sh-4.4# unset ETCDCTL_ENDPOINTSCopy to Clipboard Copied! Toggle word wrap Toggle overflow etcd メンバーのデフラグを実行します。

etcdctl --command-timeout=30s --endpoints=https://localhost:2379 defrag

sh-4.4# etcdctl --command-timeout=30s --endpoints=https://localhost:2379 defragCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Finished defragmenting etcd member[https://localhost:2379]

Finished defragmenting etcd member[https://localhost:2379]Copy to Clipboard Copied! Toggle word wrap Toggle overflow タイムアウトエラーが発生した場合は、コマンドが正常に実行されるまで

--command-timeoutの値を増やします。データベースサイズが縮小されていることを確認します。

etcdctl endpoint status -w table --cluster

sh-4.4# etcdctl endpoint status -w table --clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、この etcd メンバーのデータベースサイズは、開始時のサイズの 104 MB ではなく 41 MB です。

これらの手順を繰り返して他の etcd メンバーのそれぞれに接続し、デフラグします。常に最後にリーダーをデフラグします。

etcd Pod が回復するように、デフラグアクションごとに 1 分以上待機します。etcd Pod が回復するまで、etcd メンバーは応答しません。

領域のクォータの超過により

NOSPACEアラームがトリガーされる場合、それらをクリアします。NOSPACEアラームがあるかどうかを確認します。etcdctl alarm list

sh-4.4# etcdctl alarm listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

memberID:12345678912345678912 alarm:NOSPACE

memberID:12345678912345678912 alarm:NOSPACECopy to Clipboard Copied! Toggle word wrap Toggle overflow アラームをクリアします。

etcdctl alarm disarm

sh-4.4# etcdctl alarm disarmCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.4. etcd のチューニングパラメーターの設定

コントロールプレーンのハードウェア速度を "Standard"、"Slower"、またはデフォルトの "" に設定できます。

デフォルト設定では、使用する速度をシステムが決定できます。システムは以前のバージョンから値を選択できるため、この値により、この機能が存在しないバージョンからのアップグレードが可能になります。

他の値のいずれかを選択すると、デフォルトがオーバーライドされます。タイムアウトまたはハートビートの欠落が原因でリーダーの選出が多数発生し、システムが "" または "Standard" に設定されている場合は、ハードウェア速度を "Slower" に設定して、レイテンシーの増加に対するシステムの耐性を高めます。

2.3.4.1. ハードウェア速度許容値の変更

etcd のハードウェア速度許容値を変更するには、次の手順を実行します。

手順

次のコマンドを入力して、現在の値を確認します。

oc describe etcd/cluster | grep "Control Plane Hardware Speed"

$ oc describe etcd/cluster | grep "Control Plane Hardware Speed"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Control Plane Hardware Speed: <VALUE>

Control Plane Hardware Speed: <VALUE>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記出力が空の場合、フィールドは設定されていないため、デフォルト ("") として考慮される必要があります。

次のコマンドを入力して値を変更します。

<value>を有効な値のいずれかに置き換えます (""、"Standard"、または"Slower")。oc patch etcd/cluster --type=merge -p '{"spec": {"controlPlaneHardwareSpeed": "<value>"}}'$ oc patch etcd/cluster --type=merge -p '{"spec": {"controlPlaneHardwareSpeed": "<value>"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次の表は、各プロファイルのハートビート間隔とリーダー選出タイムアウトを示しています。これらの値は変更になる可能性があります。

Expand プロファイル

ETCD_HEARTBEAT_INTERVAL

ETCD_LEADER_ELECTION_TIMEOUT

""プラットフォームによって異なる

プラットフォームによって異なる

Standard100

1000

Slower500

2500

出力を確認します。

出力例

etcd.operator.openshift.io/cluster patched

etcd.operator.openshift.io/cluster patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 有効な値以外の値を入力すると、エラー出力が表示されます。たとえば、

"Faster"値を入力すると、出力は次のようになります。出力例

The Etcd "cluster" is invalid: spec.controlPlaneHardwareSpeed: Unsupported value: "Faster": supported values: "", "Standard", "Slower"

The Etcd "cluster" is invalid: spec.controlPlaneHardwareSpeed: Unsupported value: "Faster": supported values: "", "Standard", "Slower"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、値が変更したことを確認します。

oc describe etcd/cluster | grep "Control Plane Hardware Speed"

$ oc describe etcd/cluster | grep "Control Plane Hardware Speed"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Control Plane Hardware Speed: ""

Control Plane Hardware Speed: ""Copy to Clipboard Copied! Toggle word wrap Toggle overflow etcd Pod がロールアウトされるまで待ちます。

oc get pods -n openshift-etcd -w

$ oc get pods -n openshift-etcd -wCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次の出力は、master-0 の予期されるエントリーを示しています。続行する前に、すべてのマスターのステータスが

4/4 Runningになるまで待ちます。出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して値を確認します。

oc describe -n openshift-etcd pod/<ETCD_PODNAME> | grep -e HEARTBEAT_INTERVAL -e ELECTION_TIMEOUT

$ oc describe -n openshift-etcd pod/<ETCD_PODNAME> | grep -e HEARTBEAT_INTERVAL -e ELECTION_TIMEOUTCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記これらの値はデフォルトから変更されていない可能性があります。

2.3.5. etcd のデータベースサイズを増やす

各 etcd インスタンスのディスククォータをギビバイト (GiB) 単位で設定できます。etcd インスタンスにディスククォータを設定する場合は、8 から 32 までの整数値を指定できます。デフォルト値は 8 です。増加値のみ指定できます。

low space アラートが表示された場合は、ディスククォータを増やすことを推奨します。このアラートは、自動コンパクションおよびデフラグにもかかわらず、クラスターが大きすぎて etcd に収まらないことを示します。このアラートが表示された場合、etcd のスペースが不足すると書き込みが失敗するため、すぐにディスククォータを増やす必要があります。

ディスククォータを増やすことが推奨されるもう 1 つのシナリオは、excessive database growth アラートが発生した場合です。このアラートは、今後 4 時間以内にデータベースが大きくなりすぎる可能性があることを警告しています。このシナリオでは、最終的に low space アラートが表示されたり、書き込みが失敗したりしないように、ディスククォータを増やすことを検討してください。

ディスククォータを増やしても、指定したディスク領域はすぐには予約されません。代わりに、etcd は必要に応じてそのサイズまで拡張できます。etcd が、ディスククォータに指定した値よりも大きい専用ディスク上で実行されていることを確認します。

大規模な etcd データベースの場合、コントロールプレーンノードに追加のメモリーとストレージが必要です。API サーバーキャッシュを考慮する必要があるため、最小メモリー要件は etcd データベースの設定サイズの 3 倍以上になります。

etcd のデータベースサイズを増やす機能は、テクノロジープレビュー機能のみです。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は、実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行い、フィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、以下のリンクを参照してください。

2.3.5.1. etcd データベースのサイズを変更する

etcd のデータベースサイズを変更するには、次の手順を実行します。

手順

次のコマンドを入力して、各 etcd インスタンスのディスククォータの現在の値を確認します。

oc describe etcd/cluster | grep "Backend Quota"

$ oc describe etcd/cluster | grep "Backend Quota"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Backend Quota Gi B: <value>

Backend Quota Gi B: <value>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、ディスククォータの値を変更します。

oc patch etcd/cluster --type=merge -p '{"spec": {"backendQuotaGiB": <value>}}'$ oc patch etcd/cluster --type=merge -p '{"spec": {"backendQuotaGiB": <value>}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

etcd.operator.openshift.io/cluster patched

etcd.operator.openshift.io/cluster patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

次のコマンドを入力して、ディスククォータの新しい値が設定されていることを確認します。

oc describe etcd/cluster | grep "Backend Quota"

$ oc describe etcd/cluster | grep "Backend Quota"Copy to Clipboard Copied! Toggle word wrap Toggle overflow etcd Operator は、新しい値を使用して etcd インスタンスを自動的にロールアウトします。

次のコマンドを入力して、etcd Pod が起動して実行されていることを確認します。

oc get pods -n openshift-etcd

$ oc get pods -n openshift-etcdCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次の出力は、予想されるエントリーを示しています。

出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、etcd Pod のディスククォータ値が更新されていることを確認します。

oc describe -n openshift-etcd pod/<etcd_podname> | grep "ETCD_QUOTA_BACKEND_BYTES"

$ oc describe -n openshift-etcd pod/<etcd_podname> | grep "ETCD_QUOTA_BACKEND_BYTES"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 値はデフォルト値の

8から変更されていない可能性があります。出力例

ETCD_QUOTA_BACKEND_BYTES: 8589934592

ETCD_QUOTA_BACKEND_BYTES: 8589934592Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記設定する値は GiB 単位の整数ですが、出力に表示される値はバイトに変換されます。

2.3.5.2. トラブルシューティング

etcd のデータベースサイズを増やそうとしたときに問題が発生した場合、次のトラブルシューティング手順が役立つ場合があります。

2.3.5.2.1. 値が小さすぎる

指定した値が 8 未満の場合、次のエラーメッセージが表示されます。

oc patch etcd/cluster --type=merge -p '{"spec": {"backendQuotaGiB": 5}}'

$ oc patch etcd/cluster --type=merge -p '{"spec": {"backendQuotaGiB": 5}}'エラーメッセージの例

The Etcd "cluster" is invalid: * spec.backendQuotaGiB: Invalid value: 5: spec.backendQuotaGiB in body should be greater than or equal to 8 * spec.backendQuotaGiB: Invalid value: "integer": etcd backendQuotaGiB may not be decreased

The Etcd "cluster" is invalid:

* spec.backendQuotaGiB: Invalid value: 5: spec.backendQuotaGiB in body should be greater than or equal to 8

* spec.backendQuotaGiB: Invalid value: "integer": etcd backendQuotaGiB may not be decreased

この問題を解決するには、8 - 32 の間の整数を指定します。

2.3.5.2.2. 値が大きすぎる

指定した値が 32 より大きい場合、次のエラーメッセージが表示されます。

oc patch etcd/cluster --type=merge -p '{"spec": {"backendQuotaGiB": 64}}'

$ oc patch etcd/cluster --type=merge -p '{"spec": {"backendQuotaGiB": 64}}'エラーメッセージの例

The Etcd "cluster" is invalid: spec.backendQuotaGiB: Invalid value: 64: spec.backendQuotaGiB in body should be less than or equal to 32

The Etcd "cluster" is invalid: spec.backendQuotaGiB: Invalid value: 64: spec.backendQuotaGiB in body should be less than or equal to 32

この問題を解決するには、8 - 32 の間の整数を指定します。

2.3.5.2.3. 価値が下がっている

値が 8 - 32 の有効な値に設定されている場合、値を減らすことはできません。減らそうとすると、エラーメッセージが表示されます。

次のコマンドを入力して現在の値を確認します。

oc describe etcd/cluster | grep "Backend Quota"

$ oc describe etcd/cluster | grep "Backend Quota"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Backend Quota Gi B: 10

Backend Quota Gi B: 10Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力してディスククォータ値を減らします。

oc patch etcd/cluster --type=merge -p '{"spec": {"backendQuotaGiB": 8}}'$ oc patch etcd/cluster --type=merge -p '{"spec": {"backendQuotaGiB": 8}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow エラーメッセージの例

The Etcd "cluster" is invalid: spec.backendQuotaGiB: Invalid value: "integer": etcd backendQuotaGiB may not be decreased

The Etcd "cluster" is invalid: spec.backendQuotaGiB: Invalid value: "integer": etcd backendQuotaGiB may not be decreasedCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

この問題を解決するには、

10より大きい整数を指定します。

第3章 リファレンス設計仕様

3.1. 通信事業者向けコアおよび RAN DU リファレンス設計仕様

通信事業者コアリファレンスデザイン仕様 (RDS) では、コントロールプレーンや一部の集中型データプレーン機能を含む大規模な通信アプリケーションをサポートできるコモディティーハードウェア上で実行する OpenShift Container Platform 4.16 クラスターを説明します。

通信事業者の RAN RDS は、無線アクセスネットワーク (RAN) で 5G ワークロードをホストするために、コモディティーハードウェア上で実行するクラスターの設定を説明します。

3.1.1. 通信事業者向け 5G デプロイメントのリファレンス設計仕様

Red Hat と認定パートナーは、OpenShift Container Platform 4.16 クラスター上で通信アプリケーションを実行するために必要なネットワークと運用機能に関する深い技術的専門知識とサポートを提供します。

Red Hat の通信パートナーは、エンタープライズ 5G ソリューション向けに大規模に複製できる、十分に統合され、十分にテストされた安定した環境を必要としています。通信事業者コアおよび RAN DU リファレンス設計仕様 (RDS) では、OpenShift Container Platform の特定のバージョンに基づいて推奨されるソリューションアーキテクチャーの概要が示されています。各 RDS は、通信事業者コアおよび RAN DU 使用モデル向けにテストおよび検証されたプラットフォーム設定を表したものです。RDS は、通信事業者の 5G コアと RAN DU の重要な KPI セットを定義することで、アプリケーションを実行する際の最適なエクスペリエンスを保証します。RDS に従うことで、重大度の高いエスカレーションが最小限に抑えられ、アプリケーションの安定性が向上します。

5G のユースケースは進化しており、ワークロードは継続的に変化しています。Red Hat は、顧客とパートナーからのフィードバックに基づいて進化する要件をサポートするために、通信事業者向けコアと RAN DU RDS を継続的に改善することに取り組んでいます。

3.1.2. リファレンス設計の範囲

通信事業者コアおよび通信事業者 RAN リファレンス設計仕様 (RDS) は、通信事業者コアおよび通信事業者 RAN プロファイルを実行するクラスターで信頼性が高く再現性のあるパフォーマンスを実現するために推奨され、テストされ、サポートされている設定をキャプチャーします。

各 RDS には、クラスターが個々のプロファイルを実行するために設計および検証された、リリースされた機能とサポートされている設定が含まれています。設定により、機能と KPI ターゲットを満たすベースラインの OpenShift Container Platform インストールが提供されます。各 RDS では、個々の設定ごとに予想される変動も説明します。各 RDS の検証には、長期間にわたる大規模なテストが多数含まれます。

検証済みのリファレンス設定は、OpenShift Container Platform のメジャー Y-stream リリースごとに更新されます。Z-stream パッチリリースは、リファレンス設定に照らして定期的に再テストされます。

3.1.3. リファレンス設計からの逸脱

検証済みの通信事業者コアおよび通信事業者 RAN DU リファレンス設計仕様 (RDS) から逸脱すると、変更した特定のコンポーネントや機能を超えた大きな影響が生じる可能性があります。逸脱には、完全なソリューションのコンテキストでの分析とエンジニアリングが必要です。

RDS からのすべての逸脱は、明確なアクション追跡情報とともに分析され、文書化される必要があります。パートナーには、逸脱をリファレンス設計に合わせる方法を理解するためのデューデリジェンスが求められます。これには、パートナーが Red Hat と連携して、プラットフォームでユースケースがクラス最高の結果を達成できるようにするための関連情報を提供することが必要になる場合があります。これは、ソリューションのサポート可能性と、Red Hat 全体およびパートナーとの整合性を確保するために重要です。

RDS からの逸脱は、次の結果の一部またはすべてを引き起こす可能性があります。

- 問題の解決にはさらに時間がかかる場合があります。

- プロジェクトのサービスレベル契約 (SLA)、プロジェクトの期限、エンドプロバイダーのパフォーマンス要件などが満たされないリスクがあります。

承認されていない逸脱には、経営幹部レベルでのエスカレーションが必要になる場合があります。

注記Red Hat は、パートナーのエンゲージメントの優先順位に基づいて、逸脱のリクエストへの対応を優先します。

3.2. 通信事業者向け RAN DU リファレンス設計仕様

3.2.1. 通信事業者向け RAN DU 4.16 参照デザインの概要

Telco RAN 分散ユニット (DU) 4.16 リファレンスデザインは、コモディティーハードウェア上で実行している OpenShift Container Platform 4.16 クラスターを設定して、通信事業者向け RAN DU ワークロードをホストします。通信事業者向け RAN DU プロファイルを実行するクラスターで信頼性が高く再現性のあるパフォーマンスを得るために、推奨され、テストされ、サポートされている設定をキャプチャーします。

3.2.1.1. デプロイメントアーキテクチャーの概要

集中管理された RHACM ハブクラスターから、管理対象クラスターに通信事業者向け RAN DU 4.16 参照設定を展開します。リファレンスデザイン仕様 (RDS) には、管理対象クラスターとハブクラスターコンポーネントの設定が含まれます。

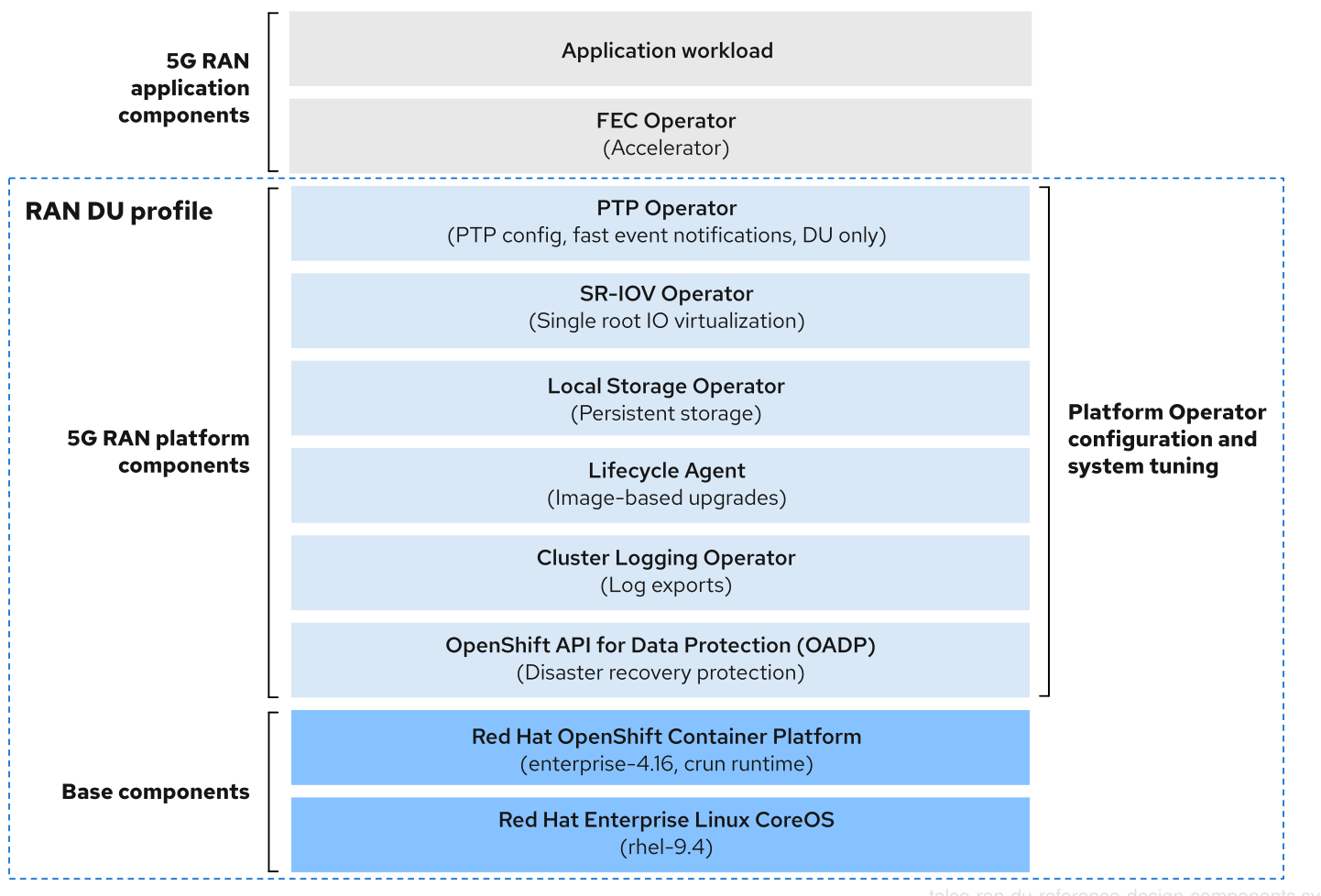

図3.1 通信事業者向け RAN DU デプロイメントアーキテクチャーの概要

3.2.2. 通信事業者向け RAN DU 使用モデルの概要

次の情報を使用して、ハブクラスターと管理対象シングルノード OpenShift クラスターの通信事業者向け RAN DU ワークロード、クラスターリソース、およびハードウェア仕様を計画します。

3.2.2.1. 通信事業者 RAN DU アプリケーションワークロード

DU ワーカーノードには、最大のパフォーマンスが得られるようにファームウェアが調整された、第 3 世代 Xeon (Ice Lake) 2.20 GHz 以上の CPU が必要です。

5G RAN DU ユーザーアプリケーションとワークロードは、次のベストプラクティスとアプリケーション制限に準拠する必要があります。

- CNF ベストプラクティスガイド の最新バージョンに準拠したクラウドネイティブネットワーク機能 (CNF) を開発します。

- 高性能ネットワークには SR-IOV を使用します。

exec プローブは控えめに使用し、他の適切なオプションが利用できない場合にのみ使用してください。

-

CNF が CPU ピンニングを使用する場合は、exec プローブを使用しないでください。

httpGetやtcpSocketなどの他のプローブ実装を使用します。 - exec プローブを使用する必要がある場合は、exec プローブの頻度と量を制限します。exec プローブの最大数は 10 未満に維持し、頻度は 10 秒以上にする必要があります。

-

CNF が CPU ピンニングを使用する場合は、exec プローブを使用しないでください。

- 絶対に実行可能な代替手段がない限り、exec プローブの使用は避けてください。

起動プローブは、定常状態の動作中に最小限のリソースしか必要としません。exec プローブの制限は、主に liveness および readiness プローブに適用されます。

3.2.2.2. 通信事業者向け RAN DU の代表的な参照アプリケーションワークロード特性

代表的な参照アプリケーションワークロードには、次の特性があります。

- 管理および制御機能を含む vRAN アプリケーション用に最大 15 個の Pod と 30 個のコンテナーを備えています。

-

Pod ごとに最大 2 つの

ConfigMapと 4 つのSecretCR を使用します。 - 10 秒以上の頻度で最大 10 個の exec プローブを使用します。

kube-apiserverの増分アプリケーション負荷は、クラスタープラットフォーム使用量の 10% 未満です。注記プラットフォームメトリクスから CPU 負荷を抽出できます。以下に例を示します。

query=avg_over_time(pod:container_cpu_usage:sum{namespace="openshift-kube-apiserver"}[30m])query=avg_over_time(pod:container_cpu_usage:sum{namespace="openshift-kube-apiserver"}[30m])Copy to Clipboard Copied! Toggle word wrap Toggle overflow - アプリケーションログはプラットフォームログコレクターにより収集されません

- プライマリー CNI 上の総トラフィックは 1 MBps 未満です

3.2.2.3. 通信事業者向け RAN DU ワーカーノードクラスターリソース使用率

システム内で実行している Pod の最大数 (アプリケーションワークロードと OpenShift Container Platform Pod を含む) は 120 です。

- リソース利用

OpenShift Container Platform のリソース使用率は、次のようなアプリケーションのワークロード特性を含む多くの要因によって異なります。

- Pod 数

- プローブの種類と頻度

- カーネルネットワークを使用したプライマリー CNI またはセカンダリー CNI 上のメッセージングレート

- API アクセス率

- ロギングレート

- ストレージ IOPS

クラスターリソース要件は、次の条件で適用されます。

- クラスターは、説明した代表的なアプリケーションワークロードを実行しています。

- クラスターは、「通信事業者向け RAN DU ワーカーノードクラスターリソース使用率」で説明されている制約に従って管理されます。

- RAN DU 使用モデル設定でオプションとして記載されているコンポーネントは適用されません。

通信事業者向け RAN DU 参照デザインの範囲外の設定は、リソース使用率への影響と KPI 目標達成能力を判断するために、追加の分析を行う必要があります。要件に応じて、クラスターに関連情報を割り当てることが求められる場合があります。

3.2.2.4. ハブクラスター管理特性

推奨されるクラスター管理ソリューションは、Red Hat Advanced Cluster Management (RHACM) です。ハブクラスターで次の制限を設定します。

- 準拠した評価間隔が少なくとも 10 分である最大 5 つの RHACM ポリシーを設定します。

- ポリシーでは最大 10 個のマネージドクラスターテンプレートを使用します。可能な場合は、ハブ側のテンプレートを使用します。

policy-controllerおよびobservability-controllerアドオンを除くすべての RHACM アドオンを無効にします。Observabilityをデフォルト設定に設定します。重要オプションのコンポーネントを設定したり、追加機能を有効にしたりすると、追加のリソースが使用され、システム全体のパフォーマンスが低下する可能性があります。

詳細は、参照設計のデプロイメントコンポーネント を参照してください。

| メトリクス | Limit | 注記 |

|---|---|---|

| CPU の使用率 | 4000 mc 未満 - 2 コア (4 ハイパースレッド) | プラットフォーム CPU は、各予約済みコアの両方のハイパースレッドを含む予約済みコアに固定されます。このシステムは、定期的なシステムタスクとスパイクに対応できるように、定常状態で 3 つの CPU (3000mc) を使用するように設計されています。 |

| 使用されているメモリー | 16G 未満 |

3.2.2.5. 通信事業者向け RAN DU RDS コンポーネント

以下のセクションでは、通信事業者向け RAN DU ワークロードを実行するためにクラスターを設定およびデプロイするのに使用するさまざまな OpenShift Container Platform コンポーネントと設定を説明します。

図3.2 通信事業者向け RAN DU 参照設計コンポーネント

通信事業者向け RAN DU プロファイルに含まれていないコンポーネントが、ワークロードアプリケーションに割り当てられた CPU リソースに影響を与えないことを確認します。

ツリー外のドライバーはサポートされていません。

3.2.3. 通信事業者向け RAN DU 4.16 参照デザインコンポーネント

以下のセクションでは、RAN DU ワークロードを実行するためにクラスターを設定およびデプロイするのに使用するさまざまな OpenShift Container Platform コンポーネントと設定を説明します。

3.2.3.1. ホストファームウェアのチューニング

- このリリースの変更点

- このリリースではリファレンス設計の更新はありません。

- 説明

システムレベルのパフォーマンスを設定します。推奨設定は、低遅延と高パフォーマンスを実現するホストファームウェアの設定 を参照してください。

Ironic 検査が有効になっていると、ファームウェア設定値はハブクラスター上のクラスターごとの

BareMetalHostCR から入手できます。クラスターのインストールに使用するSiteConfigCR のspec.clusters.nodesフィールドのラベルを使用して、Ironic 検査を有効にします。以下に例を示します。nodes: - hostName: "example-node1.example.com" ironicInspect: "enabled"nodes: - hostName: "example-node1.example.com" ironicInspect: "enabled"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記通信事業者向け RAN DU 参照

SiteConfigでは、ironicInspectフィールドはデフォルトで有効になりません。- 制限と要件

- ハイパースレッディングを有効にする必要がある

- エンジニアリングに関する考慮事項

パフォーマンスを最大限に高めるためにすべての設定を調整する

注記必要に応じて、パフォーマンスを犠牲にして電力を節約するためにファームウェアの選択を調整できます。

3.2.3.2. Node Tuning Operator

- このリリースの新機能

-

このリリースでは、Node Tuning Operator は、予約済みおよび分離されたコア CPU の

PerformanceProfileで CPU 周波数の設定をサポートします。これは、特定の周波数を定義するために使用できるオプションの機能です。この機能を使用して、Intel ハードウェアのintel_pstateCPUFreqドライバーを有効にし、特定の周波数を設定します。FlexRAN のようなアプリケーションの周波数については、Intel の推奨事項に従う必要があります。このようなアプリケーションでは、デフォルトの CPU 周波数をデフォルトの実行周波数よりも低い値に設定する必要があります。 -

以前は、RAN DU プロファイルの場合、

PerformanceProfileでrealTimeワークロードヒントをtrueに設定すると、常にintel_pstateが無効になりました。このリリースでは、Node Tuning Operator はTuneDを使用して基盤となる Intel ハードウェアを検出し、プロセッサーの世代に基づいてintel_pstateカーネルパラメーターを適切に設定します。 - このリリースでは、パフォーマンスプロファイルを持つ OpenShift Container Platform デプロイメントでは、基盤となるリソース管理レイヤーとして cgroups v2 がデフォルトで使用されるようになりました。この変更に対応していないワークロードを実行する場合でも、古い cgroups v1 メカニズムに戻すことができます。

-

このリリースでは、Node Tuning Operator は、予約済みおよび分離されたコア CPU の

- 説明

パフォーマンスプロファイルを作成して、クラスターのパフォーマンスを調整します。パフォーマンスプロファイルで設定する設定には次のものが含まれます。

- リアルタイムカーネルまたは非リアルタイムカーネルを選択します。

-

予約済みまたは分離された

cpusetにコアを割り当てます。管理ワークロードパーティションに割り当てられた OpenShift Container Platform プロセスは、予約セットに固定されます。 - kubelet 機能 (CPU マネージャー、トポロジーマネージャー、メモリーマネージャー) を有効にします。

- Huge Page の設定

- 追加のカーネル引数を設定します。

- コアごとの電力調整と最大 CPU 周波数を設定します。

- 予約済みおよび分離されたコア周波数チューニング。

- 制限と要件

Node Tuning Operator は、

PerformanceProfileCR を使用してクラスターを設定します。RAN DU プロファイルPerformanceProfileCR で次の設定を設定する必要があります。- 予約済みおよび分離されたコアを選択し、最大のパフォーマンスが得られるようにファームウェアが調整された Intel 第 3 世代 Xeon (Ice Lake) 2.20 GHz CPU 以上に少なくとも 4 つのハイパースレッド (2 つのコアに相当) を割り当てるようにします。

-

予約済みの

cpusetを設定して、含まれる各コアの両方のハイパースレッドシブリングを含めます。予約されていないコアは、ワークロードのスケジュールに割り当て可能な CPU として使用できます。ハイパースレッドシブリングが予約済みコアと分離コアに分割されていないことを確認します。 - 予約済みおよび分離された CPU として設定した内容に基づいて、すべてのコアのすべてのスレッドを含めるように予約済みおよび分離された CPU を設定します。

- 各 NUMA ノードのコア 0 を予約済み CPU セットに含めるように設定します。

- huge page のサイズを 1G に設定します。

管理パーティションにワークロードをさらに追加しないでください。OpenShift 管理プラットフォームの一部である Pod のみを管理パーティションにアノテーション付けする必要があります。

- エンジニアリングに関する考慮事項

パフォーマンス要件を満たすには、RT カーネルを使用する必要があります。

注記必要に応じて、非 RT カーネルを使用できます。

- 設定する huge page の数は、アプリケーションのワークロード要件によって異なります。このパラメーターの変動は予想され、許容されます。

- 選択されたハードウェアとシステムで使用されている追加コンポーネントに基づいて、予約済みおよび分離された CPU セットの設定に変化が生じることが予想されます。変動は指定された制限を満たす必要があります。

- IRQ アフィニティーをサポートしていないハードウェアは、分離された CPU に影響します。CPU 全体の QoS が保証された Pod が割り当てられた CPU を最大限に活用できるようにするには、サーバー内のすべてのハードウェアが IRQ アフィニティーをサポートする必要があります。詳細は、IRQ アフィニティー設定のサポートについて を参照してください。

cgroup v1 は非推奨の機能です。非推奨の機能は依然として OpenShift Container Platform に含まれており、引き続きサポートされますが、この製品の今後のリリースで削除されるため、新規デプロイメントでの使用は推奨されません。

OpenShift Container Platform で非推奨となったか、削除された主な機能の最新の一覧は、OpenShift Container Platform リリースノートの 非推奨および削除された機能 セクションを参照してください。

3.2.3.3. PTP Operator

- このリリースの新機能

- デュアル Intel E810 Westport Channel NIC のグランドマスタークロック (T-GM) として linuxptp サービスを設定する機能が、一般に利用可能になりました。

-

linuxptpサービスptp4lおよびphc2sysを、デュアル PTP 境界クロック (T-BC) の高可用性 (HA) システムクロックとして設定できます。

- 説明

クラスターノードでの PTP のサポートと設定の詳細は、PTP タイミング を参照してください。DU ノードは次のモードで実行できます。

- グランドマスタークロックまたは境界クロック (T-BC) に同期された通常のクロック (OC) として

- シングルまたはデュアルカード E810 Westport Channel NIC をサポートする、GPS から同期されるグランドマスタークロックとして

- E810 Westport Channel NIC をサポートするデュアル境界クロック (NIC ごとに 1 つ)

- 異なる NIC 上に複数の時間ソースがある場合に、システムクロックの高可用性を実現します。

- オプション: 無線ユニット (RU) の境界クロックとして

グランドマスタークロックのイベントとメトリクスは、4.14 通信事業者向け RAN DU RDS で追加されたテクニカルプレビュー機能です。詳細は、PTP ハードウェア高速イベント通知フレームワークの使用 を参照してください。

DU アプリケーションが実行しているノードで発生する PTP イベントにアプリケーションをサブスクライブできます。

- 制限と要件

- デュアル NIC および HA の場合、境界クロックは 2 つに制限されます。

- T-GM の WPC カード設定は 2 枚までに制限される

- エンジニアリングに関する考慮事項

- 通常のクロック、境界クロック、グランドマスタークロック、または PTP-HA の設定が提供されます。

-

PTP 高速イベント通知は

ConfigMapCR を使用して PTP イベントサブスクリプションを保存します。 - GPS タイミングを備えた PTP グランドマスタークロックには、Intel E810-XXV-4T Westport Channel NIC を使用します (最小ファームウェアバージョン 4.40)。

3.2.3.4. SR-IOV Operator

- このリリースの新機能

-

このリリースでは、SR-IOV Network Operator を使用して QinQ (802.1ad および 802.1q) タグ付けを設定できます。QinQ タグ付けは、内部 VLAN タグと外部 VLAN タグの両方の使用を可能にすることで、効率的なトラフィック管理を実現します。外部 VLAN タグ付けはハードウェアアクセラレーションされており、ネットワークパフォーマンスが向上します。この更新は SR-IOV Network Operator 自体を超えて拡張されます。

nmstateを使用して外部 VLAN タグを設定することで、外部のマネージド VF 上で QinQ を設定できるようになりました。QinQ のサポートは NIC によって異なります。特定の NIC モデルの既知の制限事項の包括的なリストについては、関連情報 セクションの SR-IOV 対応ワークロードに対する QinQ サポートの設定 を参照してください。 - このリリースでは、ネットワークポリシーの更新中にノードを並行してドレインするように SR-IOV Network Operator を設定できるため、セットアッププロセスが大幅に高速化されます。これは、特に以前は完了までに数時間、場合によっては数日かかっていた大規模なクラスターのデプロイメントにおいて、大幅な時間の節約につながります。

-

このリリースでは、SR-IOV Network Operator を使用して QinQ (802.1ad および 802.1q) タグ付けを設定できます。QinQ タグ付けは、内部 VLAN タグと外部 VLAN タグの両方の使用を可能にすることで、効率的なトラフィック管理を実現します。外部 VLAN タグ付けはハードウェアアクセラレーションされており、ネットワークパフォーマンスが向上します。この更新は SR-IOV Network Operator 自体を超えて拡張されます。

- 説明

-

SR-IOV Operator は、SR-IOV CNI およびデバイスプラグインをプロビジョニングおよび設定します。

netdevice(カーネル VF) とvfio(DPDK) デバイスの両方がサポートされています。 - 制限と要件

- OpenShift Container Platform 対応デバイスを使用する

- BIOS での SR-IOV および IOMMU の有効化: SR-IOV Network Operator は、カーネルコマンドラインで IOMMU を自動的に有効にします。

- SR-IOV VF は PF からリンク状態の更新を受信しません。リンクダウン検出が必要な場合は、プロトコルレベルでこれを設定する必要があります。

-

マルチネットワークポリシーは、

netdeviceドライバータイプにのみ適用できます。マルチネットワークポリシーにはiptablesツールが必要ですが、このツールではvfioドライバータイプを管理できません。

- エンジニアリングに関する考慮事項

-

vfioドライバータイプの SR-IOV インターフェイスは通常、高スループットまたは低レイテンシーを必要とするアプリケーションで追加のセカンダリーネットワークを有効にするために使用されます。 -

SriovNetworkおよびSriovNetworkNodePolicyカスタムリソース (CR) の設定と数は、顧客によって異なることが予想されます。 -

IOMMU カーネルのコマンドライン設定は、インストール時に

MachineConfigCR で適用されます。これにより、SriovOperatorCR がノードを追加するときにノードの再起動が発生しなくなります。 - 並列でノードをドレインするための SR-IOV サポートは、シングルノードの OpenShift クラスターには適用されません。

-

デプロイメントから

SriovOperatorConfigCR を除外すると、CR は自動的に作成されません。 - ワークロードを特定のノードにピン留めまたは制限するシナリオでは、SR-IOV 並列ノードドレイン機能によって Pod の再スケジュールは行われません。このようなシナリオでは、SR-IOV Operator は並列ノードドレイン機能を無効にします。

-

3.2.3.5. ロギング

- このリリースの新機能

- Cluster Logging Operator 6.0 はこのリリースの新機能です。既存の実装を更新して、新しいバージョンの API に適応させます。ポリシーを使用して、古い Operator アーティファクトを削除する必要があります。詳細は、関連情報 を参照してください。

- 説明

- ロギングを使用して、リモート分析のためにファーエッジのノードからログを収集します。推奨されるログコレクターは Vector です。

- エンジニアリングに関する考慮事項

- たとえば、インフラストラクチャー以外のログや、アプリケーションワークロードからの監査ログを処理するには、ロギングレートの増加に応じて CPU とネットワーク帯域幅の追加が必要になります。

OpenShift Container Platform 4.14 以降では、Vector が参照ログコレクターになります。

注記RAN 使用モデルでの fluentd の使用は非推奨です。

3.2.3.6. SRIOV-FEC Operator

- このリリースの変更点

- このリリースではリファレンス設計の更新はありません。

- 説明

- SRIOV-FEC Operator は、FEC アクセラレーターハードウェアをサポートするオプションのサードパーティー認定 Operator です。

- 制限と要件

FEC Operator v2.7.0 以降:

-

SecureBootがサポートされている -

PFのvfioドライバーでは、Pod に挿入されるvfio-tokenを使用する必要があります。Pod 内のアプリケーションは、EAL パラメーター--vfio-vf-tokenを使用してVFトークンを DPDK に渡すことができます。

-

- エンジニアリングに関する考慮事項

-

SRIOV-FEC Operator は、

isolatedCPU セットの CPU コアを使用します。 - たとえば、検証ポリシーを拡張することによって、アプリケーションデプロイメントの事前チェックの一部として FEC の準備を検証できます。

-

SRIOV-FEC Operator は、

3.2.3.7. Local Storage Operator

- このリリースの変更点

- このリリースではリファレンス設計の更新はありません。

- 説明

-

Local Storage Operator を使用して、アプリケーションで

PVCリソースとして使用できる永続ボリュームを作成できます。作成するPVリソースの数とタイプは、要件によって異なります。 - エンジニアリングに関する考慮事項

-

PVを作成する前に、PVCR のバッキングストレージを作成します。これは、パーティション、ローカルボリューム、LVM ボリューム、または完全なディスクにすることができます。 ディスクとパーティションの正しい割り当てを確認するには、各デバイスへのアクセスに使用されるハードウェアパス別に

LocalVolumeCR 内のデバイスリストを参照してください。論理名 (例:/dev/sda) は、ノードの再起動後も一貫性が保たれるとは限りません。詳細は、デバイス識別子に関する RHEL 9 のドキュメント を参照してください。

-

3.2.3.8. LVMS Operator

- このリリースの新機能

- このリリースではリファレンスデザインの更新はありません。

LVMS Operator はオプションのコンポーネントです。

LVMS Operator をストレージソリューションとして使用すると、Local Storage Operator が置き換えられ、必要な CPU がプラットフォームのオーバーヘッドとして管理パーティションに割り当てられます。参照設定には、これらのストレージソリューションのいずれか 1 つを含める必要がありますが、両方を含めることはできません。

- 説明

LVMS Operator は、ブロックおよびファイルストレージの動的なプロビジョニングを提供します。LVMS Operator は、アプリケーションが

PVCリソースとして使用できるローカルデバイスから論理ボリュームを作成します。ボリューム拡張やスナップショットも可能です。次の設定例では、インストールディスクを除くノード上の使用可能なすべてのディスクを活用する

vg1ボリュームグループを作成します。StorageLVMCluster.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 制限と要件

- シングルノードの OpenShift クラスターでは、永続ストレージは LVMS またはローカルストレージのいずれかによって提供される必要があり、両方によって提供される必要はありません。

- エンジニアリングに関する考慮事項

- ストレージ要件を満たす十分なディスクまたはパーティションが利用可能であることを確認します。

3.2.3.9. ワークロードパーティショニング

- このリリースの変更点

- このリリースではリファレンス設計の更新はありません。

- 説明

ワークロードパーティショニングは、DU プロファイルの一部である OpenShift プラットフォームと Day 2 Operator Pod を予約済み

cpusetに固定し、予約済み CPU をノードアカウンティングから削除します。これにより、予約されていないすべての CPU コアがユーザーのワークロードに使用できるようになります。OpenShift Container Platform 4.14 では、ワークロードパーティショニングを有効にして設定する方法が変更されました。

- 4.14 以降

インストールパラメーターを設定してパーティションを設定します。

cpuPartitioningMode: AllNodes

cpuPartitioningMode: AllNodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

PerformanceProfileCR で予約された CPU セットを使用して管理パーティションコアを設定する

- 4.13 以前

-

インストール時に追加の

MachineConfigurationCR を適用してパーティションを設定する

-

インストール時に追加の

- 制限と要件

-

Pod を管理パーティションに適用できるようにするには、

NamespaceとPodCR にアノテーションを付ける必要がある - CPU 制限のある Pod をパーティションに割り当てることはできません。これは、ミューテーションによって Pod の QoS が変わる可能性があるためです。

- 管理パーティションに割り当てることができる CPU の最小数の詳細は、ノードチューニング Operator を参照してください。

-

Pod を管理パーティションに適用できるようにするには、

- エンジニアリングに関する考慮事項

- ワークロードパーティショニングでは、すべての管理 Pod を予約済みコアにピン固定します。オペレーティングシステム、管理 Pod、およびワークロードの開始、ノードの再起動、またはその他のシステムイベントの発生時に発生する CPU 使用率の予想される急増を考慮して、予約セットに十分な数のコアを割り当てる必要があります。

3.2.3.10. クラスターのチューニング

- このリリースの変更点

- このリリースではリファレンス設計の更新はありません。

- 説明

- インストール前に有効または無効にするオプションのコンポーネントの完全なリストについては、クラスター機能 セクションを参照してください。

- 制限と要件

- インストーラーによるプロビジョニングのインストール方法では、クラスター機能は使用できません。

すべてのプラットフォームチューニング設定を適用する必要があります。次の表に、必要なプラットフォームチューニング設定を示します。

Expand 表3.2 クラスター機能の設定 機能 説明 オプションのクラスター機能を削除する

シングルノードの OpenShift クラスターでのみオプションのクラスター Operator を無効にすることで、OpenShift Container Platform のフットプリントを削減します。

- Marketplace および Node Tuning Operator を除くすべてのオプションの Operator を削除します。

クラスター監視を設定する

次の手順を実行して、フットプリントを削減するようにモニタリングスタックを設定します。

-

ローカルの

alertmanagerコンポーネントおよびtelemeterコンポーネントを無効にします。 -

RHACM の可観測性を使用する際、アラートをハブクラスターに転送するには、適切な

additionalAlertManagerConfigsCR で CR を拡張する必要があります。 Prometheusの保持期間を 24 時間に短縮します。注記RHACM ハブクラスターは、マネージドクラスターメトリクスを集約します。

ネットワーク診断を無効にする

シングルノード OpenShift のネットワーク診断は必要ないため無効にします。

単一の OperatorHub カタログソースを設定する

RAN DU デプロイメントに必要な Operator のみを含む単一のカタログソースを使用するようにクラスターを設定します。各カタログソースにより、クラスター上の CPU 使用率が増加します。単一の

CatalogSourceを使用すると、プラットフォームの CPU 予算内に収まります。

- エンジニアリングに関する考慮事項

- このリリースでは、OpenShift Container Platform デプロイメントはデフォルトで Control Groups バージョン 2 (cgroup v2) を使用します。その結果、クラスター内のパフォーマンスプロファイルは、基盤となるリソース管理レイヤーに cgroups v2 を使用します。クラスター上で実行しているワークロードに cgroups v1 が必要な場合は、cgroups v1 を使用するようにノードを設定できます。この設定は、初期クラスターデプロイメントの一部として行うことができます。

3.2.3.11. マシン設定

- このリリースの変更点

- このリリースではリファレンス設計の更新はありません。

- 制限と要件

CRI-O ワイプ無効化

MachineConfigは、定義されたメンテナンスウィンドウ内のスケジュールされたメンテナンス時以外は、ディスク上のイメージが静的であると想定します。イメージが静的であることを保証するには、Pod のimagePullPolicyフィールドをAlwaysに設定しないでください。Expand 表3.3 マシン設定オプション 機能 説明 コンテナーランタイム

すべてのノードロールのコンテナーランタイムを

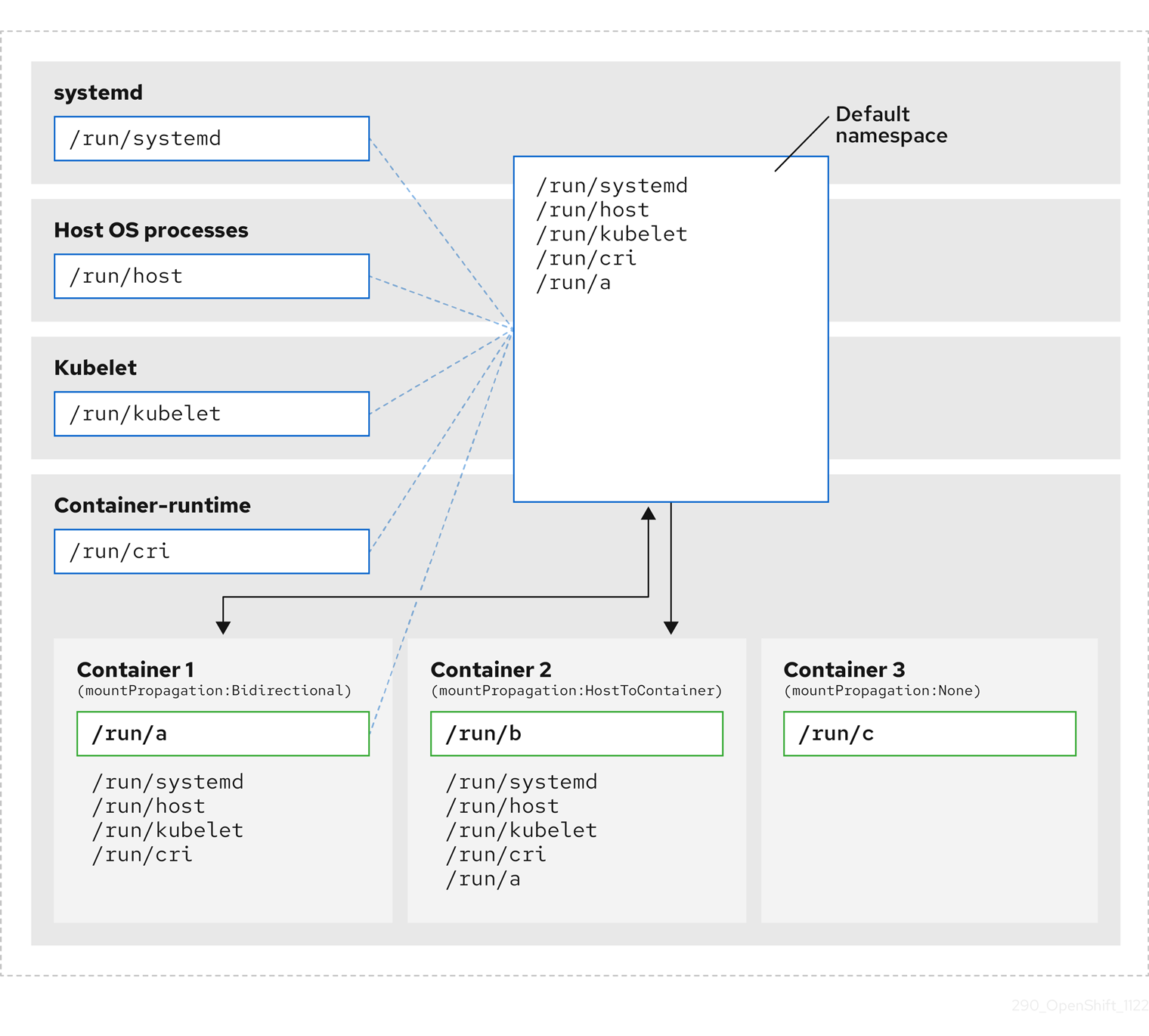

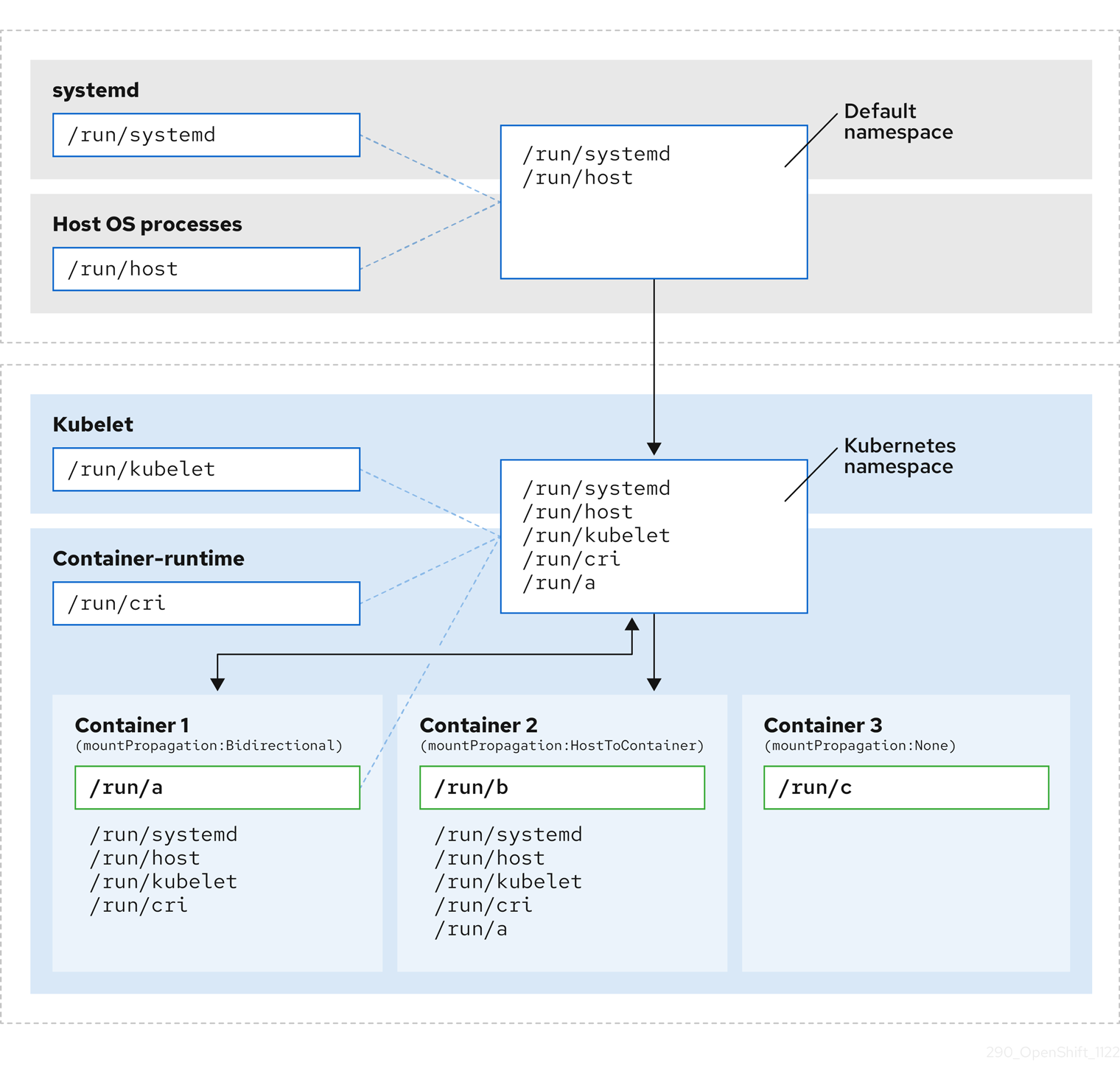

crunに設定します。kubelet の設定とコンテナーマウントの非表示

kubelet ハウスキーピングとエビクションモニタリングの頻度を減らして、CPU 使用量を削減します。システムマウントスキャンのリソース使用量を削減するために、kubelet と CRI-O に表示されるコンテナーマウント namespace を作成します。

SCTP

オプション設定 (デフォルトで有効): SCTP を有効にします。SCTP は RAN アプリケーションで必要ですが、RHCOS ではデフォルトで無効になっています。

kdump

オプション設定 (デフォルトで有効): カーネルパニックが発生したときに kdump がデバッグ情報をキャプチャーできるようにします。

CRI-O ワイプ無効化

不正なシャットダウン後の CRI-O イメージキャッシュの自動消去を無効にします。

SR-IOV 関連のカーネル引数

カーネルコマンドラインに SR-IOV 関連の追加引数を含めます。

RCU 通常の systemd サービス

システムが完全に起動した後に

rcu_normalを設定します。ワンショット時間同期

コントロールプレーンまたはワーカーノードに対して、1 回限りのシステム時間同期ジョブを実行します。

3.2.3.12. Lifecycle Agent

- このリリースの新機能

- Lifecycle Agent を使用して、シングルノードの OpenShift クラスターのイメージベースのアップグレードを有効にします。

- 説明

- Lifecycle Agent は、シングルノードの OpenShift クラスターにローカルのライフサイクル管理サービスを提供します。

- 制限と要件

- Lifecycle Agent は、マルチノードクラスターまたは追加のワーカーを持つシングルノードの OpenShift クラスターには適用されません。

- 永続ボリュームが必要です。

3.2.3.13. 参照設計のデプロイメントコンポーネント

次のセクションでは、Red Hat Advanced Cluster Management (RHACM) を使用してハブクラスターを設定するために使用するさまざまな OpenShift Container Platform コンポーネントと設定を説明します。

3.2.3.13.1. Red Hat Advanced Cluster Management (RHACM)

- このリリースの新機能

-

PolicyGeneratorリソースと Red Hat Advanced Cluster Management (RHACM) を使用して、GitOps ZTP でマネージドクラスターのポリシーをデプロイできるようになりました。これはテクノロジープレビューの機能です。

-

- 説明

RHACM は、デプロイされたクラスターに対して、Multi Cluster Engine (MCE) のインストールと継続的なライフサイクル管理機能を提供します。

PolicyCR を使用して設定とアップグレードを宣言的に指定し、Topology Aware Lifecycle Manager が管理する RHACM ポリシーコントローラーを使用してクラスターにポリシーを適用します。- GitOps Zero Touch Provisioning (ZTP) は、RHACM の MCE 機能を使用します

- 設定、アップグレード、クラスターステータスは RHACM ポリシーコントローラーで管理されます。

インストール中に、RHACM は

SiteConfigカスタムリソース (CR) で設定されたとおりに個々のノードにラベルを適用できます。- 制限と要件

-

単一のハブクラスターは、各クラスターに 5 つの

PolicyCR がバインドされた、最大 3500 個のデプロイされたシングルノード OpenShift クラスターをサポートします。

-

単一のハブクラスターは、各クラスターに 5 つの

- エンジニアリングに関する考慮事項

- RHACM ポリシーハブ側テンプレートを使用して、クラスター設定をより適切にスケーリングします。グループおよびクラスターごとの値がテンプレートに置き換えられる単一のグループポリシーまたは少数の一般的なグループポリシーを使用することで、ポリシーの数を大幅に削減できます。

-

クラスター固有の設定: マネージドクラスターには通常、個々のクラスターに固有の設定値がいくつかあります。これらの設定は、クラスター名に基づいて

ConfigMapCR から取得された値を使用して、RHACM ポリシーハブ側テンプレートを使用して管理する必要があります。 - マネージドクラスターの CPU リソースを節約するには、クラスターの GitOps ZTP インストール後に、静的設定を適用するポリシーをマネージドクラスターからアンバインドする必要があります。

3.2.3.13.2. Topology Aware Lifecycle Manager (TALM)

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

- 説明

- 管理された更新

TALM は、ハブクラスター上でのみ実行し、変更 (クラスターおよび Operator のアップグレード、設定などを含む) がネットワークに展開される方法を管理するための Operator です。TALM は次のことを行います。

-

PolicyCR を使用して、ユーザーが設定可能なバッチでクラスターのフリートに更新を段階的に適用します。 -

クラスターごとに

ztp-doneラベルまたはその他のユーザー設定可能なラベルを追加します。

-

- シングルノード OpenShift クラスターの事前キャッシュ

TALM は、アップグレードを開始する前に、OpenShift Container Platform、OLM Operator、および追加のユーザーイメージをシングルノードの OpenShift クラスターに事前キャッシュするオプションをサポートします。

- 制限と要件

- TALM は 400 のバッチでの同時クラスターデプロイメントをサポートします

- 事前キャッシュおよびバックアップ機能は、シングルノードの OpenShift クラスターのみを対象としています。

- エンジニアリングに関する考慮事項

-

PreCachingConfigCR はオプションであり、プラットフォーム関連 (OpenShift および OLM Operator) イメージを事前キャッシュするだけの場合は作成する必要はありません。ClusterGroupUpgradeCR で参照する前に、PreCachingConfigCR を適用する必要があります。

-

3.2.3.13.3. GitOps および GitOps ZTP プラグイン

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

- 説明

GitOps および GitOps ZTP プラグインは、クラスターのデプロイメントと設定を管理するための GitOps ベースのインフラストラクチャーを提供します。クラスターの定義と設定は、Git で宣言的な状態として維持されます。ZTP プラグインは、

SiteConfigCR からインストール CR を生成することと、PolicyGenTemplateCR に基づいてポリシーに設定 CR を自動的にラップすることをサポートします。ベースライン参照設定 CR を使用して、マネージドクラスターに OpenShift Container Platform の複数のバージョンをデプロイおよび管理できます。ベースライン CR と並行してカスタム CR を使用することもできます。

- 制限

-

ArgoCD アプリケーションごとに 300 個の

SiteConfigCR。複数のアプリケーションを使用することで、単一のハブクラスターでサポートされるクラスターの最大数を実現できます。 -

Git の

/source-crsフォルダー内のコンテンツは、GitOps ZTP プラグインコンテナーで提供されるコンテンツを上書きします。検索パスでは Git が優先されます。 kustomization.yamlファイルと同じディレクトリーに/source-crsフォルダーを追加します。このフォルダーには、ジェネレーターとしてPolicyGenTemplateが含まれています。注記このコンテキストでは、

/source-crsディレクトリーの代替の場所はサポートされていません。

-

ArgoCD アプリケーションごとに 300 個の

- エンジニアリングに関する考慮事項

-

コンテンツを更新するときに混乱や意図しないファイルの上書きを避けるため、

/source-crsフォルダー内のユーザー指定の CR と Git 内の追加マニフェストには、一意で区別できる名前を使用します。 -

SiteConfigCR では、複数の追加マニフェストパスが許可されます。複数のディレクトリーパスで同じ名前のファイルが見つかった場合は、最後に見つかったファイルが優先されます。これにより、バージョン固有の Day 0 マニフェスト (追加マニフェスト) の完全なセットを Git に配置し、SiteConfigCR から参照できるようになります。この機能を使用すると、複数の OpenShift Container Platform バージョンをマネージドクラスターに同時にデプロイできます。 -

SiteConfigCR のextraManifestPathフィールドは、OpenShift Container Platform 4.15 以降では非推奨です。代わりに新しいextraManifests.searchPathsフィールドを使用してください。

-

コンテンツを更新するときに混乱や意図しないファイルの上書きを避けるため、

3.2.3.13.4. Agent-based Installer

- このリリースの変更点

- このリリースではリファレンス設計の更新はありません。

- 説明

Agent-based Installer (ABI) は、集中型インフラストラクチャーなしでインストール機能を提供します。インストールプログラムは、サーバーにマウントする ISO イメージを作成します。サーバーが起動すると、OpenShift Container Platform と提供された追加のマニフェストがインストールされます。

注記ABI を使用して、ハブクラスターなしで OpenShift Container Platform クラスターをインストールすることもできます。このように ABI を使用する場合でも、イメージレジストリーは必要です。

Agent-based Installer (ABI) はオプションのコンポーネントです。

- 制限と要件

- インストール時に、追加のマニフェストの限定されたセットを提供できます。

-

RAN DU ユースケースに必要な

MachineConfigurationCR を含める必要があります。

- エンジニアリングに関する考慮事項

- ABI は、ベースラインの OpenShift Container Platform インストールを提供します。

- インストール後に、Day 2 Operator と残りの RAN DU ユースケース設定をインストールします。

3.2.4. 通信事業者向け RAN 分散ユニット (DU) 参照設定 CR

次のカスタムリソース (CR) を使用して、通信事業者向け RAN DU プロファイルを使用して OpenShift Container Platform クラスターを設定およびデプロイします。一部の CR は、要件に応じてオプションになります。変更できる CR フィールドは、CR 内で YAML コメントによってアノテーションが付けられます。

ztp-site-generate コンテナーイメージから RAN DU CR の完全なセットを抽出できます。詳細は、GitOps ZTP サイト設定リポジトリーの準備 を参照してください。

3.2.4.1. Day 2 Operator 参照 CR

| コンポーネント | 参照 CR | 任意 | このリリースの新機能 |

|---|---|---|---|

| クラスターロギング | いいえ | いいえ | |

| クラスターロギング | いいえ | いいえ | |

| クラスターロギング | いいえ | いいえ | |

| クラスターロギング | いいえ | いいえ | |

| クラスターロギング | いいえ | いいえ | |

| Lifecycle Agent | はい | はい | |

| Lifecycle Agent | はい | はい | |

| Lifecycle Agent | はい | はい | |

| Lifecycle Agent | はい | はい | |

| Local Storage Operator | はい | いいえ | |

| Local Storage Operator | はい | いいえ | |

| Local Storage Operator | はい | いいえ | |

| Local Storage Operator | はい | いいえ | |

| Local Storage Operator | はい | いいえ | |

| LVM Storage | いいえ | はい | |

| LVM Storage | いいえ | はい | |

| LVM Storage | いいえ | はい | |

| LVM Storage | いいえ | はい | |

| LVM Storage | いいえ | はい | |

| Node Tuning Operator | いいえ | いいえ | |

| Node Tuning Operator | いいえ | いいえ | |

| PTP 高速イベント通知 | はい | はい | |

| PTP 高速イベント通知 | はい | はい | |

| PTP 高速イベント通知 | はい | はい | |

| PTP 高速イベント通知 | はい | はい | |

| PTP 高速イベント通知 | はい | いいえ | |

| PTP Operator | いいえ | いいえ | |

| PTP Operator | いいえ | いいえ | |

| PTP Operator | いいえ | いいえ | |

| PTP Operator | いいえ | はい | |

| PTP Operator | いいえ | いいえ | |

| PTP Operator | いいえ | いいえ | |

| PTP Operator | いいえ | いいえ | |

| PTP Operator | いいえ | いいえ | |

| PTP Operator | いいえ | いいえ | |

| PTP Operator | いいえ | いいえ | |

| SR-IOV FEC Operator | はい | いいえ | |

| SR-IOV FEC Operator | はい | いいえ | |

| SR-IOV FEC Operator | はい | いいえ | |

| SR-IOV FEC Operator | はい | いいえ | |

| SR-IOV Operator | いいえ | いいえ | |

| SR-IOV Operator | いいえ | いいえ | |

| SR-IOV Operator | いいえ | いいえ | |

| SR-IOV Operator | いいえ | はい | |

| SR-IOV Operator | いいえ | いいえ | |

| SR-IOV Operator | いいえ | いいえ | |

| SR-IOV Operator | いいえ | いいえ |

3.2.4.2. クラスターチューニング参照 CR

| コンポーネント | 参照 CR | 任意 | このリリースの新機能 |

|---|---|---|---|

| クラスター機能 | いいえ | いいえ | |

| ネットワーク診断を無効にする | いいえ | いいえ | |

| モニタリング設定 | いいえ | いいえ | |

| OperatorHub | いいえ | いいえ | |

| OperatorHub | いいえ | いいえ | |

| OperatorHub | いいえ | いいえ | |

| OperatorHub | いいえ | いいえ | |

| OperatorHub | はい | いいえ |

3.2.4.3. マシン設定のリファレンス CR

| コンポーネント | 参照 CR | 任意 | このリリースの新機能 |

|---|---|---|---|

| コンテナーランタイム (crun) | いいえ | いいえ | |

| コンテナーランタイム (crun) | いいえ | いいえ | |

| CRI-O ワイプを無効にする | いいえ | いいえ | |

| CRI-O ワイプを無効にする | いいえ | いいえ | |

| kdump の有効化 | いいえ | いいえ | |

| kdump の有効化 | いいえ | いいえ | |

| Kubelet の設定とコンテナーマウントの非表示 | いいえ | いいえ | |

| Kubelet の設定とコンテナーマウントの非表示 | いいえ | いいえ | |

| ワンショット時間同期 | いいえ | いいえ | |

| ワンショット時間同期 | いいえ | いいえ | |

| SCTP | いいえ | いいえ | |

| SCTP | いいえ | いいえ | |

| RCU を通常に設定 | いいえ | いいえ | |

| RCU を通常に設定 | いいえ | いいえ | |

| SR-IOV 関連のカーネル引数 | いいえ | はい | |

| SR-IOV 関連のカーネル引数 | いいえ | いいえ |

3.2.4.4. YAML リファレンス

以下は、通信事業者向け RAN DU 4.16 参照設定を構成するすべてのカスタムリソース (CR) の完全な参照です。

3.2.4.4.1. Day 2 Operator 参照 YAML

ClusterLogForwarder.yaml

ClusterLogging.yaml

ClusterLogNS.yaml

ClusterLogOperGroup.yaml

ClusterLogSubscription.yaml

ImageBasedUpgrade.yaml

LcaSubscription.yaml

LcaSubscriptionNS.yaml

LcaSubscriptionOperGroup.yaml

StorageClass.yaml

StorageLV.yaml

StorageNS.yaml

StorageOperGroup.yaml

StorageSubscription.yaml

LVMOperatorStatus.yaml

StorageLVMCluster.yaml

StorageLVMSubscription.yaml

StorageLVMSubscriptionNS.yaml

StorageLVMSubscriptionOperGroup.yaml

PerformanceProfile.yaml

TunedPerformancePatch.yaml

PtpConfigBoundaryForEvent.yaml

PtpConfigForHAForEvent.yaml

PtpConfigMasterForEvent.yaml

PtpConfigSlaveForEvent.yaml

PtpOperatorConfigForEvent.yaml

PtpConfigBoundary.yaml

PtpConfigDualCardGmWpc.yaml

PtpConfigThreeCardGmWpc.yaml

PtpConfigForHA.yaml

PtpConfigGmWpc.yaml

PtpConfigSlave.yaml

PtpOperatorConfig.yaml

PtpSubscription.yaml

PtpSubscriptionNS.yaml

PtpSubscriptionOperGroup.yaml

AcceleratorsNS.yaml

apiVersion: v1

kind: Namespace

metadata:

name: vran-acceleration-operators

annotations: {}

apiVersion: v1

kind: Namespace

metadata:

name: vran-acceleration-operators

annotations: {}AcceleratorsOperGroup.yaml

AcceleratorsSubscription.yaml

SriovFecClusterConfig.yaml

SriovNetwork.yaml

SriovNetworkNodePolicy.yaml

SriovOperatorConfig.yaml

SriovOperatorConfigForSNO.yaml

SriovSubscription.yaml

SriovSubscriptionNS.yaml

SriovSubscriptionOperGroup.yaml

3.2.4.4.2. クラスターチューニング参照 YAML

example-sno.yaml

DisableSnoNetworkDiag.yaml

ReduceMonitoringFootprint.yaml

09-openshift-marketplace-ns.yaml

DefaultCatsrc.yaml

DisableOLMPprof.yaml

DisconnectedICSP.yaml

OperatorHub.yaml

3.2.4.4.3. マシン設定参照 YAML

enable-crun-master.yaml

enable-crun-worker.yaml

99-crio-disable-wipe-master.yaml

99-crio-disable-wipe-worker.yaml

06-kdump-master.yaml

06-kdump-worker.yaml

01-container-mount-ns-and-kubelet-conf-master.yaml

01-container-mount-ns-and-kubelet-conf-worker.yaml

99-sync-time-once-master.yaml

99-sync-time-once-worker.yaml

03-sctp-machine-config-master.yaml

03-sctp-machine-config-worker.yaml

08-set-rcu-normal-master.yaml

08-set-rcu-normal-worker.yaml

3.2.5. 通信事業者向け RAN DU 参照設定ソフトウェア仕様

以下の情報は、通信事業者向け RAN DU 参照デザイン仕様 (RDS) 検証済みソフトウェアバージョンを説明しています。

3.2.5.1. Telco RAN DU 4.16 の検証済みソフトウェアコンポーネント

Red Hat telco RAN DU 4.16 ソリューションは、次に示す OpenShift Container Platform のマネージドクラスターおよびハブクラスター用の Red Hat ソフトウェア製品を使用して検証されています。

| コンポーネント | ソフトウェアバージョン |

|---|---|

| マネージドクラスターのバージョン | 4.16 |

| Cluster Logging Operator | 6.0 |

| Local Storage Operator | 4.16 |

| PTP Operator | 4.16 |

| SRIOV Operator | 4.16 |

| Node Tuning Operator | 4.16 |

| Logging Operator | 4.16 |

| SRIOV-FEC Operator | 2.9 |

| コンポーネント | ソフトウェアバージョン |

|---|---|

| ハブクラスターのバージョン | 4.16 |

| GitOps ZTP プラグイン | 4.16 |

| Red Hat Advanced Cluster Management (RHACM) | 2.10, 2.11 |

| Red Hat OpenShift GitOps | 1.16 |

| Topology Aware Lifecycle Manager (TALM) | 4.16 |

3.3. 通信事業者コアリファレンス設計仕様

3.3.1. Telco core 4.18 リファレンス設計の概要

通信事業者向けコア参照デザイン仕様 (RDS) は、通信事業者向けコアワークロードをホストするために、コモディティーハードウェア上で実行する OpenShift Container Platform クラスターを設定します。

3.3.2. 通信事業者向けコア 4.16 使用モデルの概要

通信事業者向けコア参照デザイン仕様 (RDS) では、シグナリングや集約などのコントロールプレーン機能を含む大規模な通信アプリケーションをサポートするプラットフォームを説明します。また、ユーザープレーン機能 (UPF) などの集中型データプレーン機能もいくつか含まれています。これらの機能には通常、スケーラビリティー、複雑なネットワークサポート、耐障害性の高いソフトウェア定義ストレージ、および RAN などの遠端デプロイメントよりも厳格で制約の少ないパフォーマンス要件のサポートが必要です。

通信事業者向けコア使用モデルアーキテクチャー

通信事業者向けコア機能のネットワークの前提条件は多岐にわたり、さまざまなネットワーク属性とパフォーマンスベンチマークが含まれます。IPv6 は必須であり、デュアルスタック設定が普及しています。特定の機能では、最大のスループットとトランザクションレートが要求されるため、DPDK などのユーザープレーンネットワークサポートが必要になります。その他の機能は従来のクラウドネイティブパターンに準拠しており、OVN-K、カーネルネットワーキング、負荷分散などのソリューションを使用できます。

Telco コアクラスターは、標準の 3 つのコントロールプレーンクラスターとして設定され、ワーカーノードは標準の非リアルタイム (RT) カーネルで設定します。さまざまなネットワークとパフォーマンスの要件を持つワークロードをサポートするために、ワーカーノードは MachineConfigPool CR を使用してセグメント化されます。たとえば、これは非ユーザーデータプレーンノードを高スループットノードから分離するために行われます。必要な通信事業者向け運用機能をサポートするために、クラスターには Operator Lifecycle Manager (OLM) Day 2 Operator の標準セットがインストールされています。

3.3.2.1. 共通ベースラインモデル

以下の設定と使用モデルの説明は、すべての通信事業者向けコア使用事例に適用できます。

- クラスター

クラスターは次の要件に準拠しています。

- 高可用性 (3 つ以上のスーパーバイザノード) コントロールプレーン

- スケジュールできないスーパーバイザーノード

-

複数の

MachineConfigPoolリソース

- ストレージ

- コアユースケースでは、外部の OpenShift Data Foundation によって提供される永続ストレージが必要です。詳細は、「参照コア設計コンポーネント」の「ストレージ」を参照してください。

- ネットワーク

通信事業者向けコアクラスターネットワークは次の要件に準拠します。

- デュアルスタック IPv4/IPv6

- 完全に切断されています。クラスターは、ライフサイクルのどの時点でもパブリックネットワークにアクセスできません。

- 複数のネットワーク: セグメント化されたネットワークにより、OAM、シグナリング、およびストレージトラフィックが分離されます。

- クラスターネットワークタイプ: IPv6 のサポートには OVN-Kubernetes が必要です。

コアクラスターには、基盤となる RHCOS、SR-IOV Operator、ロードバランサー、および次の「ネットワーク」セクションで詳述するその他のコンポーネントによってサポートされる複数のネットワークレイヤーがあります。大まかに言えば、これらのレイヤーには次のものが含まれます。

クラスターネットワーク: クラスターネットワーク設定は、インストール設定を通じて定義および適用されます。設定の更新は、NMState Operator を通じて 2 日目に実行できます。初期設定では次のことを確立できます。

- ホストインターフェイスの設定

- アクティブ/アクティブボンディング (リンクアグリゲーション制御プロトコル (LACP))

セカンダリーまたは追加のネットワーク: OpenShift CNI は、Network

additionalNetworksまたは NetworkAttachmentDefinition CR を通じて設定されます。- MACVLAN

- アプリケーションワークロード: ユーザープレーンネットワークは、Cloud-native Network Functions (CNF) で実行しています。

- Service Mesh

- 通信事業者向け CNF による Service Mesh の使用は非常に一般的です。すべてのコアクラスターに Service Mesh 実装が含まれることが予想されます。Service Mesh の実装と設定は、この仕様の範囲外です。

3.3.2.1.1. エンジニアリングの考慮事項共通使用モデル

共通使用モデルには、次のエンジニアリング上の考慮事項が関連します。

- ワーカーノード

- ワーカーノードは、Intel 第 3 世代 Xeon (IceLake) プロセッサー以降で実行します。あるいは、Skylake またはそれ以前のプロセッサーを使用している場合は、Spectre などのシリコンセキュリティー脆弱性の緩和策を無効にする必要があります。無効にしないと、トランザクションパフォーマンスが 40% も大幅に低下する可能性があります。

-

ワーカーノードで IRQ バランシングが有効になっています。

PerformanceProfileは、globallyDisableIrqLoadBalancing: falseを設定します。保証された QoS Pod には、「参照コア設計コンポーネント」セクションの「CPU パーティショニングとパフォーマンスチューニング」サブセクションで説明されているように、分離を保証するためのアノテーションが付けられます。

- 全ノード

- ハイパースレッディングがすべてのノードで有効になっている

-

CPU アーキテクチャーは

x86_64のみ - ノードは標準 (非 RT) カーネルを実行している

- ノードはワークロード分割用に設定されていない

電源管理と最大パフォーマンスの間のノード設定のバランスは、クラスター内の MachineConfigPools によって異なります。この設定は、MachineConfigPool 内のすべてのノードに対して一貫しています。

- CPU パーティション設定

-

CPU パーティショニングは PerformanceProfile を使用して設定され、

MachineConfigPoolごとに適用されます。「参照コア設計コンポーネント」の「CPU パーティショニングとパフォーマンスチューニング」サブセクションを参照してください。

3.3.2.1.2. アプリケーションワークロード

コアクラスターで実行しているアプリケーションワークロードには、高性能ネットワーク CNF と従来のベストエフォート型またはバースト可能な Pod ワークロードが混在している場合があります。

保証された QoS スケジューリングは、パフォーマンスまたはセキュリティーの要件により CPU を排他的または専用に使用する必要がある Pod で利用できます。通常、DPDK を使用したユーザープレーンネットワークを利用する、高性能で低レイテンシーに敏感なクラウドネイティブ関数 (CNF) をホストする Pod では、CPU 全体を排他的に使用する必要があります。これは、ノードのチューニングと保証されたサービス品質 (QoS) スケジューリングを通じて実現されます。CPU の排他的使用を必要とする Pod の場合は、ハイパースレッドシステムの潜在的な影響に注意し、コア全体 (2 つのハイパースレッド) を Pod に割り当てる必要がある場合は 2 の倍数の CPU を要求するように設定します。

高スループットと低レイテンシーのネットワークを必要としないネットワーク機能を実行する Pod は、通常、ベストエフォートまたはバースト可能な QoS でスケジュールされ、専用または分離された CPU コアを必要としません。

- 制限の説明

- CNF アプリケーションは、Red Hat Best Practices for Kubernetes ガイドの最新バージョンに準拠する必要があります。

ベストエフォート型とバースト型 QoS Pod の組み合わせ用。

-

保証された QoS Pod が使用される可能性がありますが、

PerformanceProfileで予約済みおよび分離された CPU を正しく設定する必要があります。 - 保証された QoS Pod には、CPU を完全に分離するためのアノテーションを含める必要があります。

- ベストエフォートおよびバースト可能な Pod では、CPU の排他的使用は保証されません。ワークロードは、他のワークロード、オペレーティングシステムデーモン、またはカーネルタスクによってプリエンプトされる可能性があります。

-

保証された QoS Pod が使用される可能性がありますが、

実行可能な代替手段がない限り、exec プローブは回避する必要があります。

- CNF が CPU ピンニングを使用している場合は、exec プローブを使用しないでください。

-

httpGet/tcpSocketなどの他のプローブ実装を使用する必要があります。

注記起動プローブは、定常状態の動作中に最小限のリソースしか必要としません。exec プローブの制限は、主に liveness および readiness プローブに適用されます。

- シグナリング作業負荷

- シグナリングワークロードでは通常、SCTP、REST、gRPC、または同様の TCP プロトコルまたは UDP プロトコルが使用されます。

- MACVLAN または SR-IOV として設定されたセカンダリー CNI (multus) を使用すると、1 秒あたりのトランザクション数 (TPS) は数十万単位になります。

- シグナリングワークロードは、保証された QoS またはバースト可能な QoS のいずれかを備えた Pod で実行されます。

3.3.3. 通信事業者向けコア参照設計コンポーネント

以下のセクションでは、通信事業者向けコアワークロードを実行するためにクラスターを設定およびデプロイするために使用するさまざまな OpenShift Container Platform コンポーネントと設定を説明します。

3.3.3.1. CPU パーティショニングとパフォーマンスチューニング

- このリリースの新機能

- このリリースでは、OpenShift Container Platform デプロイメントはデフォルトで Control Groups バージョン 2 (cgroup v2) を使用します。その結果、クラスター内のパフォーマンスプロファイルは、基盤となるリソース管理レイヤーに cgroups v2 を使用します。

- 説明

-

CPU パーティショニングにより、機密性の高いワークロードを一般的な目的、補助プロセス、割り込み、およびドライバー作業キューから分離して、パフォーマンスとレイテンシーを向上させることができます。これらの補助プロセスに割り当てられた CPU は、次のセクションでは

reservedと呼ばれます。ハイパースレッドシステムでは、CPU は 1 つのハイパースレッドです。 - 制限と要件

オペレーティングシステムでは、カーネルネットワークを含むすべてのサポートタスクを実行するために、一定量の CPU が必要です。

- ユーザープレーンネットワーキングアプリケーション (DPDK) のみを備えたシステムでは、オペレーティングシステムとインフラストラクチャーコンポーネント用に少なくとも 1 つのコア (有効な場合は 2 つのハイパースレッド) が予約されている必要があります。

- ハイパースレッディングが有効になっているシステムでは、常にすべてのコアシブリングスレッドを同じ CPU プールに配置する必要があります。

- 予約済みコアと分離されたコアのセットには、すべての CPU コアが含まれている必要があります。

- 各 NUMA ノードのコア 0 は、予約済み CPU セットに含める必要があります。

分離されたコアは割り込みによって影響を受ける可能性があります。保証された QoS Pod で CPU をフルに使用する必要がある場合は、次のアノテーションを Pod に添付する必要があります。

cpu-load-balancing.crio.io: "disable" cpu-quota.crio.io: "disable" irq-load-balancing.crio.io: "disable"

cpu-load-balancing.crio.io: "disable" cpu-quota.crio.io: "disable" irq-load-balancing.crio.io: "disable"Copy to Clipboard Copied! Toggle word wrap Toggle overflow PerformanceProfile.workloadHints.perPodPowerManagementを使用して Pod ごとの電源管理を有効にすると、保証された QoS Pod で CPU をフルに使用する必要がある場合は、次のアノテーションも Pod に添付する必要があります。cpu-c-states.crio.io: "disable" cpu-freq-governor.crio.io: "performance"

cpu-c-states.crio.io: "disable" cpu-freq-governor.crio.io: "performance"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- エンジニアリングに関する考慮事項

-

必要な最小予約容量 (

systemReserved) は、"Which amount of CPU and memory are recommended to reserve for the system in OpenShift 4 nodes?" のガイダンスに従ってください。 - 実際に必要な予約済み CPU 容量は、クラスターの設定とワークロードの属性によって異なります。

- この予約済み CPU 値は、フルコア (2 ハイパースレッド) の配置に切り上げられる必要があります。

- CPU パーティショニングを変更すると、MCP 内のノードがドレインされ、再起動されます。

- 予約された CPU は OpenShift ノードの割り当て可能な容量から削除されるため、Pod 密度が低下します。

- ワークロードがリアルタイム対応である場合は、リアルタイムワークロードヒントを有効にする必要があります。

- Interrupt Request (IRQ) アフィニティーをサポートしていないハードウェアは、分離された CPU に影響を与えます。CPU QoS が保証された Pod が割り当てられた CPU を最大限に活用できるようにするには、サーバー内のすべてのハードウェアが IRQ アフィニティーをサポートする必要があります。

-

OVS は、ネットワークトラフィックのニーズに合わせて

cpuset設定を動的に管理します。プライマリー CNI で高いネットワークスループットを処理するために追加の CPU を予約する必要はありません。 - クラスター上で実行しているワークロードに cgroups v1 が必要な場合は、cgroups v1 を使用するようにノードを設定できます。この設定は、初期クラスターデプロイメントの一部として行うことができます。詳細は、関連情報 セクションの インストール中に Linux cgroup v1 を有効にする を参照してください。

-

必要な最小予約容量 (

3.3.3.2. Service Mesh

- 説明

- 通常、通信事業者向けコア CNF にはサービスメッシュの実装が必要です。必要な特定の機能とパフォーマンスはアプリケーションによって異なります。Service Mesh の実装と設定の選択は、このドキュメントの範囲外です。Pod ネットワーキングに導入される追加のレイテンシーなど、Service Mesh がクラスターリソースの使用率とパフォーマンスに与える影響は、全体的なソリューションエンジニアリングで考慮する必要があります。

3.3.3.3. ネットワーク

OpenShift Container Platform のネットワーキングは、1 つまたは複数のハイブリッドクラスターのネットワークトラフィックを管理するためにクラスターが必要とする高度なネットワーク関連機能で Kubernetes ネットワーキングを拡張する機能、プラグイン、高度なネットワーク機能のエコシステムです。

3.3.3.3.1. Cluster Network Operator

- このリリースの変更点

- このリリースではリファレンス設計の更新はありません。

- 説明

Cluster Network Operator (CNO) は、クラスターのインストール中に、デフォルトの OVN-Kubernetes ネットワークプラグインを含むクラスターネットワークコンポーネントをデプロイおよび管理します。CNO を使用すると、プライマリーインターフェイスの MTU 設定、Pod の Egress にノードルーティングテーブルを使用するための OVN ゲートウェイ設定、および MACVLAN などの追加のセカンダリーネットワークを設定できます。

ネットワークトラフィックの分離をサポートするために、CNO を通じて複数のネットワークインターフェイスが設定されます。これらのインターフェイスへのトラフィックステアリングは、NMState Operator を使用して適用される静的ルートを通じて設定されます。Pod トラフィックが適切にルーティングされるように、OVN-K は

routingViaHostオプションを有効にして設定されます。この設定では、Pod の Egress トラフィックに OVN ではなくカーネルルーティングテーブルと適用された静的ルートを使用します。Whereabouts CNI プラグインは、DHCP サーバーを使用せずに、追加の Pod ネットワークインターフェイスに動的な IPv4 および IPv6 アドレス指定を提供するために使用されます。

- 制限と要件

- IPv6 サポートには OVN-Kubernetes が必要です。

- 大規模 MTU クラスターをサポートするには、接続されたネットワーク機器を同じ値またはそれ以上の値に設定する必要があります。

-

MACVLAN と IPVLAN は、同じ基礎カーネルメカニズム、具体的には

rx_handlerに依存しているため、同じメインインターフェイス上に配置できません。このハンドラーを使用すると、ホストが受信パケットを処理する前にサードパーティーモジュールが受信パケットを処理できるようになります。このようなハンドラーは、ネットワークインターフェイスごとに 1 つだけ登録できます。MACVLAN と IPVLAN は両方とも、機能するために独自のrx_handlerを登録する必要があるため、競合が発生し、同じインターフェイス上で共存することはできません。詳細は、ipvlan/ipvlan_main.c#L82 および net/macvlan.c#L1260 を参照してください。 代替の NIC 設定としては、共有 NIC を複数の NIC に分割したり、単一のデュアルポート NIC を使用したりすることが挙げられます。

重要共有 NIC を複数の NIC に分割したり、単一のデュアルポート NIC を使用したりすることは、通信事業者向けコアリファレンス設計では検証されていません。

- シングルスタック IP クラスターは検証されていません。

- エンジニアリングに関する考慮事項

-

Pod の Egress トラフィックは、

routingViaHostオプションを使用してカーネルルーティングテーブルによって処理されます。ホストに適切な静的ルートを設定する必要があります。

-

Pod の Egress トラフィックは、

3.3.3.3.2. ロードバランサー

- このリリースの新機能

-

OpenShift Container Platform 4.17 では、

frr-k8sがデフォルトで完全にサポートされる Border Gateway Protocol (BGP) バックエンドになりました。非推奨となったfrrBGP モードは引き続き利用可能です。frr-k8sバックエンドを使用するには、クラスターをアップグレードする必要があります。

-

OpenShift Container Platform 4.17 では、

- 説明

MetalLB は、ベアメタルクラスター用の標準ルーティングプロトコルを使用するロードバランサー実装です。これにより、Kubernetes サービスは外部 IP アドレスを取得できるようになり、その IP アドレスはクラスターのホストネットワークにも追加されます。

注記一部のユースケースでは、ステートフルロードバランシングなど、MetalLB では利用できない機能が必要になる場合があります。必要に応じて、外部のサードパーティーロードバランサーを使用します。外部ロードバランサーの選択と設定は、このドキュメントの対象外となります。外部のサードパーティーロードバランサーを使用する場合は、パフォーマンスとリソース使用率のすべての要件を満たしていることを確認してください。

- 制限と要件

- ステートフルロードバランシングは MetalLB ではサポートされていません。これがワークロード CNF の要件である場合は、代替ロードバランサー実装を使用する必要があります。

- ネットワークインフラストラクチャーでは、外部 IP アドレスがクライアントからクラスターのホストネットワークにルーティング可能であることを保証する必要があります。

- エンジニアリングに関する考慮事項

- MetalLB は、コアユースケースモデルの BGP モードでのみ使用されます。

-

通信コア使用モデルの場合、MetalLB は、OVN-Kubernetes ネットワークプラグインの

ovnKubernetesConfig.gatewayConfig仕様でroutingViaHost=trueを設定した場合にのみサポートされます。 - MetalLB での BGP 設定は、ネットワークとピアの要件によって異なります。

- アドレスプールは必要に応じて設定でき、アドレス、集約長、自動割り当て、その他の関連パラメーターを変更できます。

-

MetalLB はルートのアナウンスにのみ BGP を使用します。このモードでは、

transmitIntervalおよびminimumTtlパラメーターのみが関連します。BFD プロファイル内の他のパラメーターは、デフォルト設定に近いままにしておく必要があります。値が短いとエラーが発生し、パフォーマンスに影響する可能性があります。

3.3.3.3.3. SR-IOV

- このリリースの新機能

-

このリリースでは、SR-IOV Network Operator を使用して QinQ (802.1ad および 802.1q) タグ付けを設定できます。QinQ タグ付けは、内部 VLAN タグと外部 VLAN タグの両方の使用を可能にすることで、効率的なトラフィック管理を実現します。外部 VLAN タグ付けはハードウェアアクセラレーションされており、ネットワークパフォーマンスが向上します。この更新は SR-IOV Network Operator 自体を超えて拡張されます。

nmstateを使用して外部 VLAN タグを設定することで、外部のマネージド VF 上で QinQ を設定できるようになりました。QinQ のサポートは NIC によって異なります。特定の NIC モデルの既知の制限事項の包括的なリストについては、公式ドキュメントを参照してください。 - このリリースでは、ネットワークポリシーの更新中にノードを並行してドレインするように SR-IOV Network Operator を設定できるため、セットアッププロセスが大幅に高速化されます。これは、特に以前は完了までに数時間、場合によっては数日かかっていた大規模なクラスターのデプロイメントにおいて、大幅な時間の節約につながります。

-

このリリースでは、SR-IOV Network Operator を使用して QinQ (802.1ad および 802.1q) タグ付けを設定できます。QinQ タグ付けは、内部 VLAN タグと外部 VLAN タグの両方の使用を可能にすることで、効率的なトラフィック管理を実現します。外部 VLAN タグ付けはハードウェアアクセラレーションされており、ネットワークパフォーマンスが向上します。この更新は SR-IOV Network Operator 自体を超えて拡張されます。

- 説明

- SR-IOV を使用すると、物理ネットワークインターフェイス (PF) を複数の Virtual Function (VF) に分割できます。その後、VF を複数の Pod に割り当てることで、Pod を分離したまま、より高いスループットパフォーマンスを実現できます。SR-IOV Network Operator は、SR-IOV CNI、ネットワークデバイスプラグイン、および SR-IOV スタックのその他のコンポーネントをプロビジョニングおよび管理します。

- 制限と要件

- サポートされているネットワークインターフェイスコントローラーは、サポートされているデバイス に記載されています。

- BIOS での SR-IOV および IOMMU の有効化: SR-IOV Network Operator は、カーネルコマンドラインで IOMMU を自動的に有効にします。

- SR-IOV VF は PF からリンク状態の更新を受信しません。リンクダウンの検出が必要な場合は、プロトコルレベルで実行する必要があります。

-

MultiNetworkPolicyCR は、netdeviceネットワークにのみ適用できます。これは、実装ではvfioインターフェイスを管理できないiptablesツールが使用されるためです。

- エンジニアリングに関する考慮事項

-

vfioモードの SR-IOV インターフェイスは通常、高スループットまたは低レイテンシーを必要とするアプリケーション用に追加のセカンダリーネットワークを有効にするために使用されます。 -

デプロイメントから

SriovOperatorConfigCR を除外すると、CR は自動的に作成されません。

-

3.3.3.3.4. NMState Operator

- このリリースの変更点

- このリリースではリファレンス設計の更新はありません。

- 説明

- NMState Operator は、クラスターのノード全体でネットワーク設定を実行するための Kubernetes API を提供します。これにより、ネットワークインターフェイス設定、静的 IP と DNS、VLAN、トランク、ボンディング、静的ルート、MTU、およびセカンダリーインターフェイスでの無差別モードの有効化が可能になります。クラスターノードは、各ノードのネットワークインターフェイスの状態を API サーバーに定期的に報告します。

- 制限と要件

- 該当なし

- エンジニアリングに関する考慮事項

-

初期ネットワーク設定は、インストール CR の

NMStateConfigコンテンツを使用して適用されます。NMState Operator は、ネットワーク更新に必要な場合にのみ使用されます。 -

SR-IOV Virtual Function がホストネットワークに使用される場合は、

NodeNetworkConfigurationPolicyを使用する NMState Operator を使用して、VLAN や MTU などの VF インターフェイスが設定されます。

-

初期ネットワーク設定は、インストール CR の

3.3.3.4. ロギング

- このリリースの新機能

- Cluster Logging Operator 6.0 はこのリリースの新機能です。既存の実装を更新して、新しいバージョンの API に適応させます。ポリシーを使用して、古い Operator アーティファクトを削除する必要があります。詳細は、関連情報 を参照してください。

- 説明

- Cluster Logging Operator を使用すると、リモートアーカイブと分析のために、ノードからログを収集して送信できます。参照設定では、Kafka を使用して監査ログとインフラストラクチャーログをリモートアーカイブに送信します。

- 制限と要件

- 該当なし

- エンジニアリングに関する考慮事項

- クラスターの CPU 使用率の影響は、生成されるログの数またはサイズと、設定されたログフィルタリングの量によって決まります。

- 参照設定には、アプリケーションログの送信は含まれません。設定にアプリケーションログを含めるには、アプリケーションのログ記録レートを評価し、予約セットに十分な追加の CPU リソースを割り当てる必要があります。

3.3.3.5. 電源管理

- このリリースの変更点

- このリリースではリファレンス設計の更新はありません。

- 説明

パフォーマンスプロファイル を使用して、クラスターを高電力モード、低電力モード、または混合モードで設定できます。電源モードの選択は、クラスター上で実行しているワークロードの特性、特にレイテンシーに対する敏感さによって異なります。Pod ごとの電源管理 C ステート機能を使用して、低レイテンシー Pod の最大遅延を設定します。

詳細は、ノードの省電力設定 を参照してください。

- 制限と要件

- 電源設定は、C ステートや P ステートの有効化など、適切な BIOS 設定に依存します。設定はハードウェアベンダーによって異なります。

- エンジニアリングに関する考慮事項

-

レイテンシー: レイテンシーの影響を受けやすいワークロードが要件を満たすようにするには、高電力設定または Pod ごとの電源管理設定のいずれかが必要になります。Pod ごとの電源管理は、専用の固定 CPU を備えた

GuaranteedQoS Pod でのみ使用できます。

-

レイテンシー: レイテンシーの影響を受けやすいワークロードが要件を満たすようにするには、高電力設定または Pod ごとの電源管理設定のいずれかが必要になります。Pod ごとの電源管理は、専用の固定 CPU を備えた

3.3.3.6. ストレージ

- 概要

クラウドネイティブストレージサービスは、Red Hat またはサードパーティーの OpenShift Data Foundation を含む複数のソリューションによって提供できます。

OpenShift Data Foundation は、コンテナー向けの Ceph ベースのソフトウェア定義ストレージソリューションです。ブロックストレージ、ファイルシステムストレージ、オンプレミスオブジェクトストレージを提供し、永続的および非永続的なデータ要件の両方に合わせて動的にプロビジョニングできます。通信事業者向けコアアプリケーションには永続的なストレージが必要です。

注記すべてのストレージデータが転送中に暗号化されるとは限りません。リスクを軽減するには、ストレージネットワークを他のクラスターネットワークから分離します。ストレージネットワークは、他のクラスターネットワークからアクセス可能またはルーティング可能であってはなりません。ストレージネットワークに直接接続されているノードのみがストレージネットワークにアクセスできるようにする必要があります。

3.3.3.6.1. OpenShift Data Foundation

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

- 説明

- Red Hat OpenShift Data Foundation は、コンテナー向けのソフトウェア定義ストレージサービスです。通信事業者向けコアクラスターの場合、ストレージサポートは、アプリケーションワークロードクラスターの外部で実行する OpenShift Data Foundation ストレージサービスによって提供されます。OpenShift Data Foundation は、セカンダリー CNI ネットワークを使用したストレージトラフィックの分離をサポートします。

- 制限と要件

- IPv4/IPv6 デュアルスタックネットワーク環境では、OpenShift Data Foundation は IPv4 アドレスを使用します。詳細は、IPv4 を使用した OpenShift Data Foundation による OpenShift デュアルスタックのサポート を参照してください。

- エンジニアリングに関する考慮事項

- OpenShift Data Foundation ネットワークトラフィックは、VLAN 分離などを使用して、専用ネットワーク上の他のトラフィックから分離する必要があります。

3.3.3.6.2. その他のストレージ

他のストレージソリューションを使用して、コアクラスターに永続的なストレージを提供することもできます。これらのソリューションの設定と統合は、通信事業者向けコア RDS の範囲外です。ストレージソリューションをコアクラスターに統合する場合は、ストレージが全体的なパフォーマンスとリソース使用率の要件を満たしていることを確認するために、適切なサイズ設定とパフォーマンス分析を行う必要があります。

3.3.3.7. モニタリング

- このリリースの変更点

- このリリースではリファレンス設計の更新はありません。

- 説明

Cluster Monitoring Operator (CMO) は、すべての OpenShift クラスターにデフォルトで含まれており、プラットフォームコンポーネントとオプションでユーザープロジェクトのモニタリング (メトリクス、ダッシュボード、アラート) を提供します。

モニタリング Operator の設定では、次のようなカスタマイズが可能です。

- デフォルトの保存期間

- カスタムアラートルール

Pod の CPU とメモリーのメトリクスのデフォルトの処理は、アップストリームの Kubernetes