노드

OpenShift Container Platform에서 노드 구성 및 관리

초록

1장. 노드 개요

1.1. 노드 정보

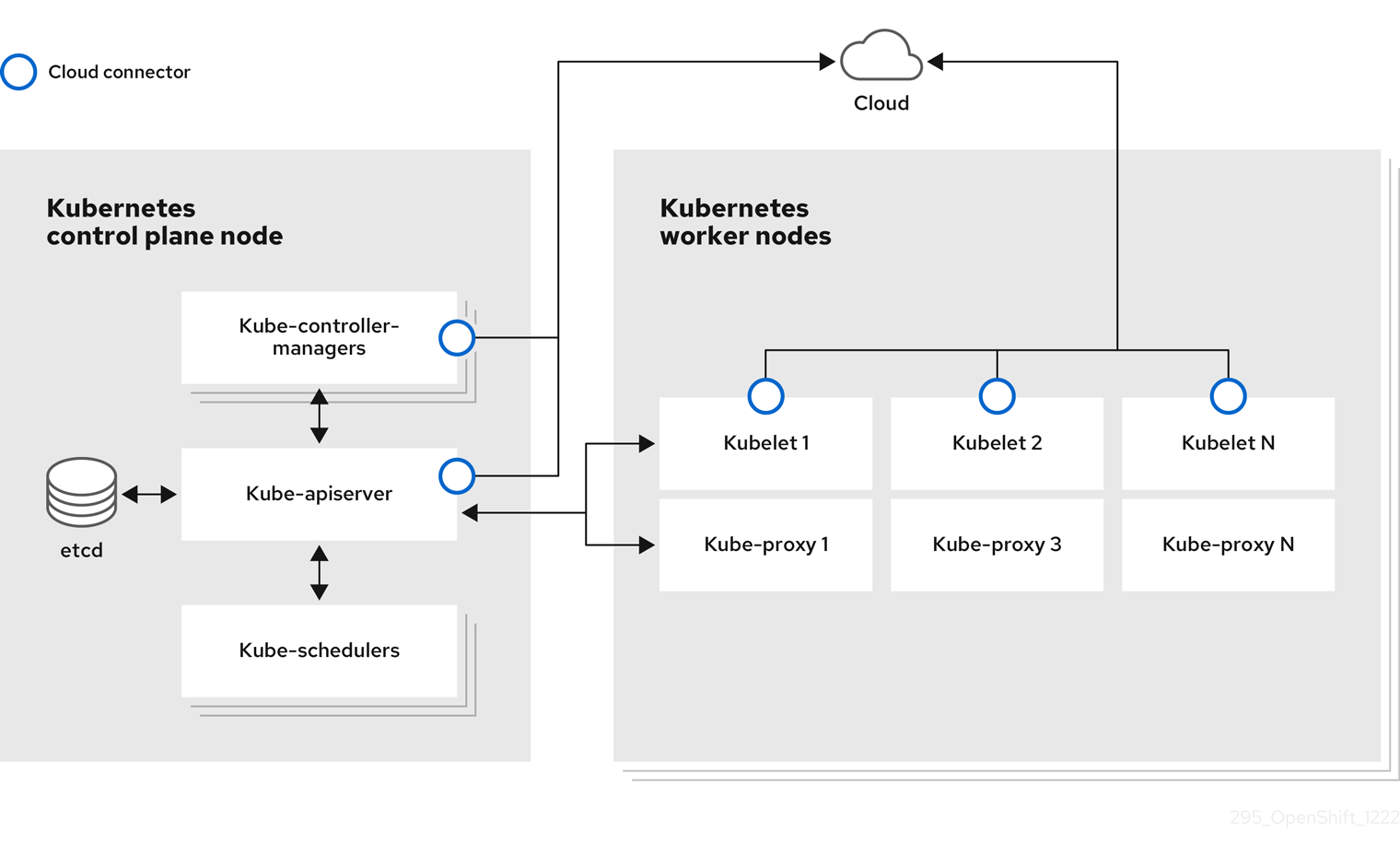

노드는 Kubernetes 클러스터의 가상 또는 베어 메탈 머신입니다. 작업자 노드는 포드로 그룹화된 애플리케이션 컨테이너를 호스팅합니다. 컨트롤 플레인 노드는 Kubernetes 클러스터를 제어하는 데 필요한 서비스를 실행합니다. OpenShift Container Platform에서 컨트롤 플레인 노드에는 OpenShift Container Platform 클러스터를 관리하기 위한 Kubernetes 서비스 이상이 포함되어 있습니다.

클러스터에서 안정적이고 정상적인 노드를 보유하는 것은 호스팅된 애플리케이션의 원활한 작동을 위한 필수 요소입니다. OpenShift Container Platform에서는 노드를 나타내는 Node 오브젝트를 통해 노드에 액세스, 관리 및 모니터링할 수 있습니다. OpenShift CLI(oc) 또는 웹 콘솔을 사용하여 노드에서 다음 작업을 수행할 수 있습니다.

노드의 다음 구성 요소는 Pod의 실행을 유지 관리하고 Kubernetes 런타임 환경을 제공합니다.

- 컨테이너 런타임

- 컨테이너 런타임은 컨테이너 실행을 담당합니다. Kubernetes는 containerd, cri-o, rktlet 및 Docker와 같은 여러 런타임을 제공합니다.

- kubelet

- kubelet은 노드에서 실행되며 컨테이너 매니페스트를 읽습니다. 이렇게 하면 정의된 컨테이너가 시작되어 실행 중인지 확인합니다. kubelet 프로세스는 작업 상태와 노드 서버를 유지 관리합니다. kubelet은 네트워크 규칙 및 포트 전달을 관리합니다. kubelet은 Kubernetes에서만 생성된 컨테이너를 관리합니다.

- kube-proxy

- kube-proxy는 클러스터의 모든 노드에서 실행되며 Kubernetes 리소스 간의 네트워크 트래픽을 유지합니다. Kube-proxy를 사용하면 네트워킹 환경이 분리되어 액세스할 수 있습니다.

- DNS

- 클러스터 DNS는 Kubernetes 서비스에 대한 DNS 레코드를 제공하는 DNS 서버입니다. Kubernetes로 시작한 컨테이너는 DNS 검색에 이 DNS 서버를 자동으로 포함합니다.

읽기 작업

읽기 작업을 사용하면 관리자 또는 개발자가 OpenShift Container Platform 클러스터의 노드에 대한 정보를 가져올 수 있습니다.

- 클러스터의 모든 노드를 나열합니다.

- 메모리 및 CPU 사용량, 상태, 기간과 같은 노드에 대한 정보를 가져옵니다.

- 노드에서 실행 중인 Pod를 나열합니다.

관리 작업

관리자는 여러 작업을 통해 OpenShift Container Platform 클러스터에서 노드를 쉽게 관리할 수 있습니다.

-

노드 레이블을 추가하거나 업데이트합니다. 레이블은

Node오브젝트에 적용되는 키-값 쌍입니다. 라벨을 사용하여 Pod 예약을 제어할 수 있습니다. -

CRD(사용자 정의 리소스 정의) 또는

kubeletConfig오브젝트를 사용하여 노드 구성을 변경합니다. -

Pod 예약을 허용하거나 허용하지 않도록 노드를 구성합니다. 정상 상태의 작업자 노드는 컨트롤 플레인 노드가 없는 동안 기본적으로 Pod 배치를 허용합니다. 작업자 노드를 예약할 수 없고 컨트롤 플레인 노드를 예약할 수 없도록 구성하여 이 기본 동작을 변경할 수 있습니다.

-

system-reserved설정을 사용하여 노드에 리소스를 할당합니다. OpenShift Container Platform에서 노드에 대한 최적의system-reservedCPU 및 메모리 리소스를 자동으로 결정하도록 허용하거나 노드에 가장 적합한 리소스를 수동으로 결정하고 설정할 수 있습니다. - 노드의 프로세서 코어 수, 하드 제한 또는 둘 다에 따라 노드에서 실행할 수 있는 Pod 수를 구성합니다.

- Pod 유사성 방지를 사용하여 노드를 정상적으로 재부팅합니다.

- 컴퓨팅 머신 세트를 사용하여 클러스터를 축소하여 클러스터에서 노드를 삭제합니다. 베어 메탈 클러스터에서 노드를 삭제하려면 먼저 노드의 모든 Pod를 드레이닝한 다음 수동으로 노드를 삭제해야 합니다.

기능 개선 작업

OpenShift Container Platform을 사용하면 노드에만 액세스하고 관리할 수 있습니다. 관리자는 노드에서 다음 작업을 수행하여 클러스터를 보다 효율적이고 애플리케이션 친화적인 상태로 만들고 개발자에게 더 나은 환경을 제공할 수 있습니다.

- Node Tuning Operator를 사용하여 일정 수준의 커널 튜닝이 필요한 고성능 애플리케이션에 대한 노드 수준 튜닝을 관리합니다.

- 노드에서 TLS 보안 프로필을 활성화하여 kubelet과 Kubernetes API 서버 간의 통신을 보호합니다.

- 데몬 세트를 사용하여 노드에서 백그라운드 작업을 자동으로 실행합니다. 데몬 세트를 생성하고 사용하여 공유 스토리지를 생성하거나, 모든 노드에서 로깅 Pod를 실행하거나, 모든 노드에 모니터링 에이전트를 배포할 수 있습니다.

- 가비지 컬렉션을 사용하여 노드 리소스를 확보합니다. 종료된 컨테이너와 실행 중인 Pod에서 참조하지 않는 이미지를 제거하여 노드가 효율적으로 실행되고 있는지 확인할 수 있습니다.

- 노드 집합에 커널 인수를 추가합니다.

- 네트워크 엣지(원격 작업자 노드)에 작업자 노드를 갖도록 OpenShift Container Platform 클러스터를 구성합니다. OpenShift Container Platform 클러스터의 원격 작업자 노드 및 원격 작업자 노드에서 Pod를 관리하는 데 권장되는 몇 가지 접근 방식에 대한 자세한 내용은 네트워크 에지에서 원격 작업자 노드 사용을 참조하십시오.

1.2. Pod 정보

Pod는 노드에 함께 배포되는 하나 이상의 컨테이너입니다. 클러스터 관리자는 Pod를 정의하고 예약할 준비가 된 정상 노드에서 실행하도록 할당할 수 있습니다. Pod는 컨테이너가 실행되는 동안 실행됩니다. Pod가 정의되고 실행되면 변경할 수 없습니다. Pod로 작업할 때 수행할 수 있는 일부 작업은 다음과 같습니다.

읽기 작업

관리자는 다음 작업을 통해 프로젝트의 Pod에 대한 정보를 가져올 수 있습니다.

- 복제본 수 및 재시작, 현재 상태 및 경과와 같은 정보를 포함하여 프로젝트와 연결된 Pod를 나열합니다.

- CPU, 메모리, 스토리지 소비와 같은 Pod 사용량 통계를 확인합니다.

관리 작업

다음 작업 목록은 관리자가 OpenShift Container Platform 클러스터에서 Pod를 관리하는 방법에 대한 개요를 제공합니다.

OpenShift Container Platform에서 사용할 수 있는 고급 스케줄링 기능을 사용하여 Pod 예약을 제어합니다.

- Pod 유사성, 노드 유사성 및 유사성 방지와 같은node -to- pod 바인딩 규칙입니다.

- 노드 레이블 및 선택기.

- 테인트 및 허용 오차.

- Pod 토폴로지 분배 제약 조건.

- 보조 예약.

- 스케줄러 가 더 적절한 노드로 Pod를 다시 예약하도록 특정 전략에 따라 Pod를 제거하도록 Descheduler를 구성합니다.

- Pod 컨트롤러를 사용하여 재시작하고 정책을 다시 시작한 후 Pod가 작동하는 방식을 구성합니다.

- Pod에서 송신 및 수신 트래픽을 모두 제한합니다.

- Pod 템플릿이 있는 모든 오브젝트에 볼륨을 추가하고 제거합니다. 볼륨은 Pod의 모든 컨테이너에서 사용할 수 있는 마운트된 파일 시스템입니다. 컨테이너 스토리지는 임시 스토리지입니다. 볼륨을 사용하여 컨테이너 데이터를 유지할 수 있습니다.

기능 개선 작업

OpenShift Container Platform에서 사용할 수 있는 다양한 툴 및 기능을 사용하여 Pod를 보다 쉽고 효율적으로 사용할 수 있습니다. 다음 작업에는 Pod를 더 잘 관리하기 위해 해당 툴과 기능을 사용하는 작업이 포함됩니다.

| 작업 | 사용자 | 더 많은 정보 |

|---|---|---|

| 수평 Pod 자동 스케일러를 생성하고 사용합니다. | 개발자 | 수평 Pod 자동 스케일러를 사용하여 실행할 최소 및 최대 Pod 수와 Pod에서 대상으로 하는 CPU 사용률 또는 메모리 사용률을 지정할 수 있습니다. 수평 Pod 자동 스케일러를 사용하면 Pod 를 자동으로 스케일링 할 수 있습니다. |

| 관리자 및 개발자 | 관리자는 수직 Pod 자동 스케일러를 사용하여 리소스의 리소스 및 워크로드의 리소스 요구 사항을 모니터링하여 클러스터 리소스를 보다 효과적으로 사용합니다. 개발자는 각 Pod에 충분한 리소스가 있는 노드에 Pod를 예약하여 수요가 많은 기간 동안 수직 Pod 자동 스케일러를 사용하여 Pod를 유지합니다. | |

| 장치 플러그인을 사용하여 외부 리소스에 대한 액세스를 제공합니다. | 시스템 관리자 | 장치 플러그인 은 특정 하드웨어 리소스를 관리하는 노드( kubelet 외부)에서 실행되는 gRPC 서비스입니다. 장치 플러그인을 배포하여 클러스터 전체에서 하드웨어 장치를 소비하는 일관되고 이식 가능한 솔루션을 제공할 수 있습니다. |

|

| 시스템 관리자 |

일부 애플리케이션에는 암호 및 사용자 이름과 같은 민감한 정보가 필요합니다. |

1.3. 컨테이너 정보

컨테이너는 OpenShift Container Platform 애플리케이션의 기본 단위로, 종속 항목, 라이브러리 및 바이너리와 함께 패키지된 애플리케이션 코드로 구성됩니다. 컨테이너에서는 물리 서버, 가상 머신(VM) 및 프라이빗 또는 퍼블릭 클라우드와 같은 환경 및 여러 배치 대상 사이에 일관성을 제공합니다.

Linux 컨테이너 기술은 실행 중인 프로세스를 격리하고 지정된 리소스로만 액세스를 제한하는 간단한 메커니즘입니다. 관리자는 다음과 같은 Linux 컨테이너에서 다양한 작업을 수행할 수 있습니다.

OpenShift Container Platform은 Init 컨테이너라는 특수 컨테이너를 제공합니다. Init 컨테이너는 애플리케이션 컨테이너보다 먼저 실행되며 애플리케이션 이미지에 없는 유틸리티 또는 설정 스크립트를 포함할 수 있습니다. Init 컨테이너를 사용하여 나머지 Pod를 배포하기 전에 작업을 수행할 수 있습니다.

노드, Pod 및 컨테이너에서 특정 작업을 수행하는 것 외에도 전체 OpenShift Container Platform 클러스터에서 작업하여 클러스터를 효율적으로 유지하고 애플리케이션 Pod를 고가용성으로 유지할 수 있습니다.

1.4. 노드에서 Pod 자동 스케일링 정보

OpenShift Container Platform에서는 노드의 Pod 수와 Pod에 할당된 리소스를 자동으로 확장하는 데 사용할 수 있는 세 가지 툴을 제공합니다.

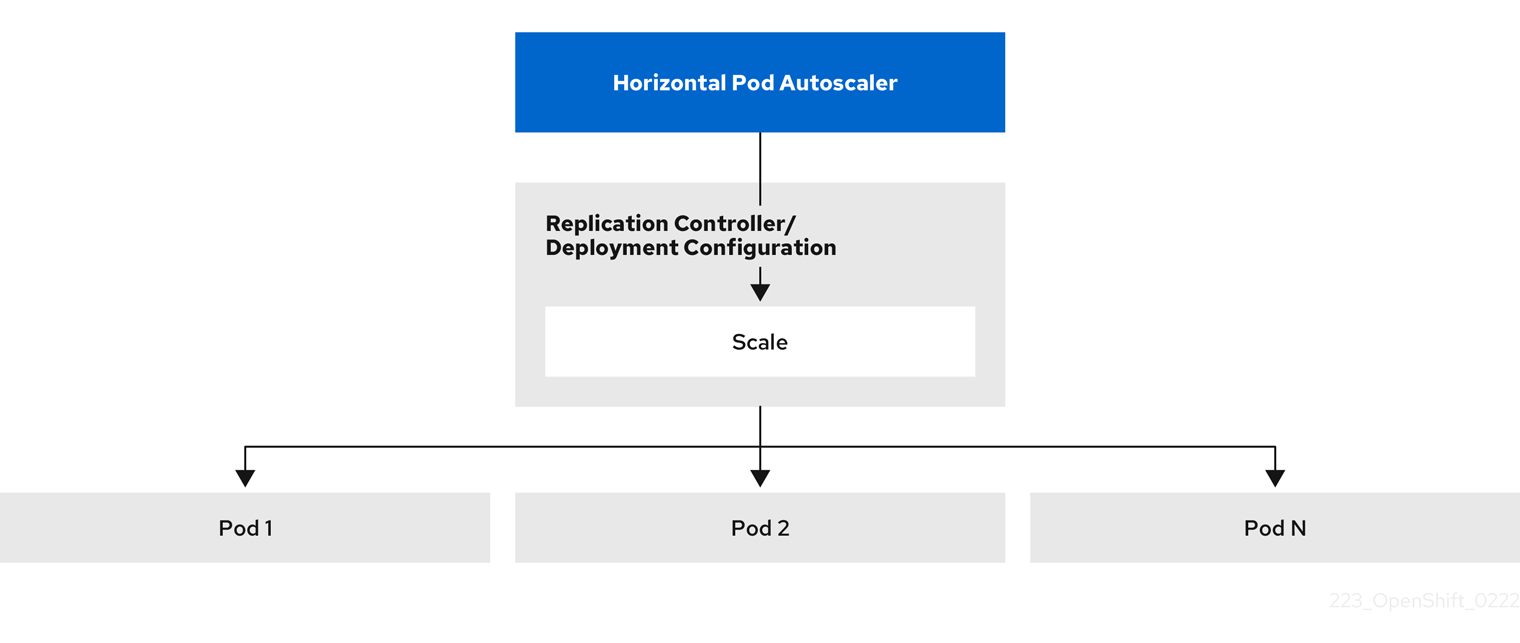

- 수평 Pod 자동 스케일러

HPA(horizontal Pod Autoscaler)는 복제 컨트롤러 또는 배포 구성에 속하는 Pod에서 수집한 메트릭에 따라 복제 컨트롤러 또는 배포 구성의 규모를 자동으로 늘리거나 줄일 수 있습니다.

자세한 내용은 수평 Pod 자동 스케일러를 사용하여 Pod 자동 스케일링을 참조하십시오.

- 사용자 정의 지표 자동 스케일러

사용자 정의 메트릭 자동 스케일러는 CPU 또는 메모리를 기반으로 하지 않는 사용자 정의 메트릭을 기반으로 배포, 상태 저장 세트, 사용자 정의 리소스 또는 작업의 Pod 수를 자동으로 늘리거나 줄일 수 있습니다.

자세한 내용은 Custom Metrics Autoscaler Operator 개요 를 참조하십시오.

- Vertical Pod Autoscaler

VPA(Vertical Pod Autoscaler)는 Pod에서 컨테이너의 기록 및 현재 CPU 및 메모리 리소스를 자동으로 확인하고 학습한 사용량 값에 따라 리소스 제한 및 요청을 업데이트할 수 있습니다.

자세한 내용은 수직 Pod 자동 스케일러를 사용하여 Pod 리소스 수준 자동 조정을 참조하십시오.

1.5. OpenShift Container Platform 노드의 일반 용어집

이 용어집은 노드 콘텐츠에 사용되는 일반적인 용어를 정의합니다.

- 컨테이너

- 이는 소프트웨어와 모든 종속 항목을 포함하는 가볍고 실행 가능한 이미지입니다. 따라서 컨테이너는 운영 체제를 가상화하므로 데이터 센터에서 퍼블릭 또는 프라이빗 클라우드, 개발자의 노트북까지 컨테이너를 실행할 수 있습니다.

- 데몬 세트

- Pod 복제본이 OpenShift Container Platform 클러스터의 적합한 노드에서 실행되도록 합니다.

- egress

- Pod의 네트워크 아웃 바운드 트래픽을 통해 외부적으로 데이터 공유 프로세스.

- 가비지 컬렉션

- 실행 중인 Pod에서 참조하지 않는 종료된 컨테이너 및 이미지와 같은 클러스터 리소스를 정리하는 프로세스입니다.

- 수평 Pod 자동 스케일러(HPA)

- Kubernetes API 리소스 및 컨트롤러로 구현됩니다. HPA를 사용하여 실행할 최소 및 최대 Pod 수를 지정할 수 있습니다. Pod에서 대상으로 해야 하는 CPU 또는 메모리 사용률을 지정할 수도 있습니다. 지정된 CPU 또는 메모리 임계값이 교차되면 HPA는 Pod에서 확장되고 확장됩니다.

- Ingress

- Pod로 들어오는 트래픽입니다.

- 작업

- 완료까지 실행되는 프로세스입니다. 작업은 하나 이상의 Pod 오브젝트를 생성하고 지정된 Pod가 성공적으로 완료되었는지 확인합니다.

- 라벨

- 키-값 쌍인 레이블을 사용하여 Pod와 같은 오브젝트 하위 집합을 구성하고 선택할 수 있습니다.

- 노드

- OpenShift Container Platform 클러스터의 작업자 시스템입니다. 노드는 VM(가상 머신) 또는 물리적 머신일 수 있습니다.

- Node Tuning Operator

- Node Tuning Operator를 사용하여 TuneD 데몬을 사용하여 노드 수준 튜닝을 관리할 수 있습니다. 이렇게 하면 데몬이 이해할 수 있는 형식으로 클러스터에서 실행되는 모든 컨테이너화된 TuneD 데몬에 사용자 정의 튜닝 사양이 전달됩니다. 데몬은 클러스터의 모든 노드에서 노드당 하나씩 실행됩니다.

- Self Node Remediation Operator

- Operator는 클러스터 노드에서 실행되며 비정상인 노드를 식별하고 재부팅합니다.

- Pod

- OpenShift Container Platform 클러스터에서 실행되는 볼륨 및 IP 주소와 같은 공유 리소스가 있는 하나 이상의 컨테이너입니다. Pod는 정의, 배포 및 관리되는 최소 컴퓨팅 단위입니다.

- 톨러레이션

- 일치하는 테인트가 있는 노드 또는 노드 그룹에 Pod를 예약할 수 있지만 필요하지는 않음을 나타냅니다. 허용 오차를 사용하여 스케줄러에서 일치하는 테인트로 Pod를 예약할 수 있습니다.

- taint

- key,value 및 effect로 구성된 코어 오브젝트입니다. 테인트 및 허용 오차가 함께 작동하여 관련 노드에서 Pod를 예약하지 않도록 합니다.

2장. 노드 작업

2.1. Pod 사용

Pod는 하나의 호스트에 함께 배포되는 하나 이상의 컨테이너이자 정의, 배포, 관리할 수 있는 최소 컴퓨팅 단위입니다.

2.1.1. Pod 이해

Pod는 컨테이너에 대한 머신 인스턴스(실제 또는 가상)와 대략적으로 동일합니다. 각 Pod에는 자체 내부 IP 주소가 할당되므로 해당 Pod가 전체 포트 공간을 소유하고 Pod 내의 컨테이너는 로컬 스토리지와 네트워킹을 공유할 수 있습니다.

Pod에는 라이프사이클이 정의되어 있으며 노드에서 실행되도록 할당된 다음 컨테이너가 종료되거나 기타 이유로 제거될 때까지 실행됩니다. Pod는 정책 및 종료 코드에 따라 종료 후 제거되거나 컨테이너 로그에 대한 액세스를 활성화하기 위해 유지될 수 있습니다.

OpenShift Container Platform에서는 대체로 Pod를 변경할 수 없는 것으로 취급합니다. 실행 중에는 Pod 정의를 변경할 수 없습니다. OpenShift Container Platform은 기존 Pod를 종료한 후 수정된 구성이나 기본 이미지 또는 둘 다 사용하여 Pod를 다시 생성하는 방식으로 변경 사항을 구현합니다. Pod를 다시 생성하면 확장 가능한 것으로 취급되고 상태가 유지되지 않습니다. 따라서 일반적으로 Pod는 사용자가 직접 관리하는 대신 상위 수준의 컨트롤러에서 관리해야 합니다.

OpenShift Container Platform 노드 호스트당 최대 Pod 수는 클러스터 제한을 참조하십시오.

복제 컨트롤러에서 관리하지 않는 베어 Pod는 노드 중단 시 다시 예약되지 않습니다.

2.1.2. Pod 구성의 예

OpenShift Container Platform에서는 하나의 호스트에 함께 배포되는 하나 이상의 컨테이너이자 정의, 배포, 관리할 수 있는 최소 컴퓨팅 단위인 Pod의 Kubernetes 개념을 활용합니다.

다음은 Pod 정의의 예입니다. 이 예제에서는 Pod의 다양한 기능을 보여줍니다. 대부분 다른 주제에서 설명하므로 여기에서는 간단히 언급합니다.

Pod 오브젝트 정의(YAML)

- 1

- Pod는 단일 작업에서 Pod 그룹을 선택하고 관리하는 데 사용할 수 있는 라벨을 하나 이상 사용하여 "태그를 지정"할 수 있습니다. 라벨은

metadata해시의 키/값 형식으로 저장됩니다. - 2

- Pod는 가능한 값

Always,OnFailure,Never를 사용하여 정책을 재시작합니다. 기본값은Always입니다. - 3

- OpenShift Container Platform은 컨테이너에 대한 보안 컨텍스트를 정의합니다. 보안 컨텍스트는 권한 있는 컨테이너로 실행하거나 선택한 사용자로 실행할 수 있는지의 여부 등을 지정합니다. 기본 컨텍스트는 매우 제한적이지만 필요에 따라 관리자가 수정할 수 있습니다.

- 4

containers는 하나 이상의 컨테이너 정의로 이루어진 배열을 지정합니다.- 5

- 이 컨테이너는 컨테이너 내에서 외부 스토리지 볼륨이 마운트되는 위치를 지정합니다.

- 6

- Pod에 제공할 볼륨을 지정합니다. 지정된 경로에 볼륨을 마운트합니다. 컨테이너 루트,

/또는 호스트와 컨테이너에서 동일한 경로에 마운트하지 마십시오. 컨테이너가 호스트/dev/pts파일과 같이 충분한 권한이 있는 경우 호스트 시스템이 손상될 수 있습니다./host를 사용하여 호스트를 마운트하는 것이 안전합니다. - 7

- Pod의 각 컨테이너는 자체 컨테이너 이미지에서 인스턴스화됩니다.

- 8

- Pod는 사용할 컨테이너에서 사용할 수 있는 스토리지 볼륨을 정의합니다.

파일 수가 많은 영구 볼륨을 Pod에 연결하면 해당 Pod가 실패하거나 시작하는 데 시간이 오래 걸릴 수 있습니다. 자세한 내용은 OpenShift에서 파일 수가 많은 영구 볼륨을 사용하는 경우 Pod를 시작하지 못하거나 "Ready" 상태를 달성하는 데 과도한 시간이 걸리는 이유를 참조하십시오.

이 Pod 정의에는 Pod가 생성되고 해당 라이프사이클이 시작된 후 OpenShift Container Platform에 의해 자동으로 채워지는 특성은 포함되지 않습니다. Kubernetes Pod 설명서에는 Pod의 기능 및 용도에 대한 세부 정보가 있습니다.

2.2. Pod 보기

관리자는 클러스터의 Pod를 보고 해당 Pod 및 클러스터의 상태를 전체적으로 확인할 수 있습니다.

2.2.1. Pod 정보

OpenShift Container Platform에서는 하나의 호스트에 함께 배포되는 하나 이상의 컨테이너이자 정의, 배포, 관리할 수 있는 최소 컴퓨팅 단위인 Pod의 Kubernetes 개념을 활용합니다. Pod는 컨테이너에 대한 머신 인스턴스(실제 또는 가상)와 대략적으로 동일합니다.

특정 프로젝트와 연결된 Pod 목록을 확인하거나 Pod 관련 사용량 통계를 볼 수 있습니다.

2.2.2. 프로젝트의 Pod 보기

Pod의 복제본 수, 현재 상태, 재시작 횟수, 수명 등을 포함하여 현재 프로젝트와 관련된 Pod 목록을 확인할 수 있습니다.

프로세스

프로젝트의 Pod를 보려면 다음을 수행합니다.

프로젝트로 변경합니다.

oc project <project-name>

$ oc project <project-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행합니다.

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들면 다음과 같습니다.

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME READY STATUS RESTARTS AGE console-698d866b78-bnshf 1/1 Running 2 165m console-698d866b78-m87pm 1/1 Running 2 165m

NAME READY STATUS RESTARTS AGE console-698d866b78-bnshf 1/1 Running 2 165m console-698d866b78-m87pm 1/1 Running 2 165mCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod IP 주소와 Pod가 있는 노드를 보려면

-o wide플래그를 추가합니다.oc get pods -o wide

$ oc get pods -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE console-698d866b78-bnshf 1/1 Running 2 166m 10.128.0.24 ip-10-0-152-71.ec2.internal <none> console-698d866b78-m87pm 1/1 Running 2 166m 10.129.0.23 ip-10-0-173-237.ec2.internal <none>

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE console-698d866b78-bnshf 1/1 Running 2 166m 10.128.0.24 ip-10-0-152-71.ec2.internal <none> console-698d866b78-m87pm 1/1 Running 2 166m 10.129.0.23 ip-10-0-173-237.ec2.internal <none>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.3. Pod 사용량 통계 보기

컨테이너의 런타임 환경을 제공하는 Pod에 대한 사용량 통계를 표시할 수 있습니다. 이러한 사용량 통계에는 CPU, 메모리, 스토리지 사용량이 포함됩니다.

사전 요구 사항

-

사용량 통계를 보려면

cluster-reader권한이 있어야 합니다. - 사용량 통계를 보려면 메트릭이 설치되어 있어야 합니다.

프로세스

사용량 통계를 보려면 다음을 수행합니다.

다음 명령을 실행합니다.

oc adm top pods

$ oc adm top podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들면 다음과 같습니다.

oc adm top pods -n openshift-console

$ oc adm top pods -n openshift-consoleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME CPU(cores) MEMORY(bytes) console-7f58c69899-q8c8k 0m 22Mi console-7f58c69899-xhbgg 0m 25Mi downloads-594fcccf94-bcxk8 3m 18Mi downloads-594fcccf94-kv4p6 2m 15Mi

NAME CPU(cores) MEMORY(bytes) console-7f58c69899-q8c8k 0m 22Mi console-7f58c69899-xhbgg 0m 25Mi downloads-594fcccf94-bcxk8 3m 18Mi downloads-594fcccf94-kv4p6 2m 15MiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 라벨이 있는 Pod의 사용량 통계를 확인합니다.

oc adm top pod --selector=''

$ oc adm top pod --selector=''Copy to Clipboard Copied! Toggle word wrap Toggle overflow 필터링할 선택기(라벨 쿼리)를 선택해야 합니다.

=,==,!=가 지원됩니다.예를 들면 다음과 같습니다.

oc adm top pod --selector='name=my-pod'

$ oc adm top pod --selector='name=my-pod'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.4. 리소스 로그 보기

OpenShift CLI(oc) 및 웹 콘솔에서 다양한 리소스의 로그를 볼 수 있습니다. 로그는 로그의 말미 또는 끝에서 읽습니다.

사전 요구 사항

-

OpenShift CLI(

oc)에 액세스합니다.

프로세스(UI)

OpenShift Container Platform 콘솔에서 워크로드 → Pod로 이동하거나 조사하려는 리소스를 통해 Pod로 이동합니다.

참고빌드와 같은 일부 리소스에는 직접 쿼리할 Pod가 없습니다. 이러한 인스턴스에서 리소스의 세부 정보 페이지에서 로그 링크를 찾을 수 있습니다.

- 드롭다운 메뉴에서 프로젝트를 선택합니다.

- 조사할 Pod 이름을 클릭합니다.

- 로그를 클릭합니다.

프로세스(CLI)

특정 Pod의 로그를 확인합니다.

oc logs -f <pod_name> -c <container_name>

$ oc logs -f <pod_name> -c <container_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

-f- 선택 사항: 출력에서 로그에 기록되는 내용을 따르도록 지정합니다.

<pod_name>- pod 이름을 지정합니다.

<container_name>- 선택 사항: 컨테이너의 이름을 지정합니다. Pod에 여러 컨테이너가 있는 경우 컨테이너 이름을 지정해야 합니다.

예를 들면 다음과 같습니다.

oc logs ruby-58cd97df55-mww7r

$ oc logs ruby-58cd97df55-mww7rCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc logs -f ruby-57f7f4855b-znl92 -c ruby

$ oc logs -f ruby-57f7f4855b-znl92 -c rubyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 로그 파일의 내용이 출력됩니다.

특정 리소스의 로그를 확인합니다.

oc logs <object_type>/<resource_name>

$ oc logs <object_type>/<resource_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 리소스 유형 및 이름을 지정합니다.

예를 들면 다음과 같습니다.

oc logs deployment/ruby

$ oc logs deployment/rubyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 로그 파일의 내용이 출력됩니다.

2.3. Pod에 대한 OpenShift Container Platform 클러스터 구성

관리자는 Pod에 효율적인 클러스터를 생성하고 유지 관리할 수 있습니다.

클러스터를 효율적으로 유지하면 Pod가 종료될 때 수행하는 작업과 같은 툴을 사용하여 개발자에게 더 나은 환경을 제공할 수 있습니다. 즉 필요한 수의 Pod가 항상 실행되고 있는지 확인하여 한 번만 실행되도록 설계된 Pod를 재시작하는 경우 Pod에 사용할 수 있는 대역폭을 제한하고, 중단 중 Pod를 계속 실행하는 방법을 제공합니다.

2.3.1. 재시작 후 Pod 작동 방식 구성

Pod 재시작 정책에 따라 해당 Pod의 컨테이너가 종료될 때 OpenShift Container Platform에서 응답하는 방법이 결정됩니다. 정책은 해당 Pod의 모든 컨테이너에 적용됩니다.

가능한 값은 다음과 같습니다.

-

Always- 기하급수적 백오프 지연(10s, 20s, 40s)이 5분으로 제한되어 Pod에서 성공적으로 종료된 컨테이너를 지속적으로 재시작합니다. 기본값은Always입니다. -

OnFailure- 급격한 백오프 지연(10초, 20초, 40초)을 5분으로 제한하여 Pod에서 실패한 컨테이너를 재시작합니다. -

Never- Pod에서 종료되거나 실패한 컨테이너를 재시작하지 않습니다. Pod가 즉시 실패하고 종료됩니다.

Pod가 특정 노드에 바인딩된 후에는 다른 노드에 바인딩되지 않습니다. 따라서 노드 장애 시 Pod가 작동하려면 컨트롤러가 필요합니다.

| 상태 | 컨트롤러 유형 | 재시작 정책 |

|---|---|---|

| 종료할 것으로 예상되는 Pod(예: 일괄 계산) | Job |

|

| 종료되지 않을 것으로 예상되는 Pod(예: 웹 서버) | 복제 컨트롤러 |

|

| 머신당 하나씩 실행해야 하는 Pod | 데몬 세트 | Any |

Pod의 컨테이너가 실패하고 재시작 정책이 OnFailure로 설정된 경우 Pod가 노드에 남아 있고 컨테이너가 재시작됩니다. 컨테이너를 재시작하지 않으려면 재시작 정책 Never를 사용하십시오.

전체 Pod가 실패하면 OpenShift Container Platform에서 새 Pod를 시작합니다. 개발자는 애플리케이션이 새 Pod에서 재시작될 수 있는 가능성을 고려해야 합니다. 특히 애플리케이션에서는 이전 실행으로 발생한 임시 파일, 잠금, 불완전한 출력 등을 처리해야 합니다.

Kubernetes 아키텍처에서는 클라우드 공급자의 끝점이 안정적인 것으로 예상합니다. 클라우드 공급자가 중단되면 kubelet에서 OpenShift Container Platform이 재시작되지 않습니다.

기본 클라우드 공급자 끝점이 안정적이지 않은 경우 클라우드 공급자 통합을 사용하여 클러스터를 설치하지 마십시오. 클라우드가 아닌 환경에서처럼 클러스터를 설치합니다. 설치된 클러스터에서 클라우드 공급자 통합을 설정하거나 해제하는 것은 권장되지 않습니다.

OpenShift Container Platform에서 실패한 컨테이너에 재시작 정책을 사용하는 방법에 대한 자세한 내용은 Kubernetes 설명서의 예제 상태를 참조하십시오.

2.3.2. Pod에서 사용할 수 있는 대역폭 제한

Pod에 서비스 품질 트래픽 조절 기능을 적용하고 사용 가능한 대역폭을 효과적으로 제한할 수 있습니다. Pod에서 송신하는 트래픽은 구성된 속도를 초과하는 패킷을 간단히 삭제하는 정책에 따라 처리합니다. Pod에 수신되는 트래픽은 데이터를 효과적으로 처리하기 위해 대기 중인 패킷을 구성하여 처리합니다. 특정 Pod에 대한 제한 사항은 다른 Pod의 대역폭에 영향을 미치지 않습니다.

프로세스

Pod의 대역폭을 제한하려면 다음을 수행합니다.

오브젝트 정의 JSON 파일을 작성하고

kubernetes.io/ingress-bandwidth및kubernetes.io/egress-bandwidth주석을 사용하여 데이터 트래픽 속도를 지정합니다. 예를 들어 Pod 송신 및 수신 대역폭을 둘 다 10M/s로 제한하려면 다음을 수행합니다.제한된

Pod오브젝트 정의Copy to Clipboard Copied! Toggle word wrap Toggle overflow 오브젝트 정의를 사용하여 Pod를 생성합니다.

oc create -f <file_or_dir_path>

$ oc create -f <file_or_dir_path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.3. Pod 중단 예산을 사용하여 실행 중인 pod 수를 지정하는 방법

Pod 중단 예산을 사용하면 유지보수를 위해 노드를 드레이닝하는 등 작업 중에 Pod에 대한 보안 제약 조건을 지정할 수 있습니다.

PodDisruptionBudget은 동시에 작동해야 하는 최소 복제본 수 또는 백분율을 지정하는 API 오브젝트입니다. 프로젝트에서 이러한 설정은 노드 유지 관리 (예: 클러스터 축소 또는 클러스터 업그레이드) 중에 유용할 수 있으며 (노드 장애 시가 아니라) 자발적으로 제거된 경우에만 적용됩니다.

PodDisruptionBudget 오브젝트의 구성은 다음과 같은 주요 부분으로 구성되어 있습니다.

- 일련의 pod에 대한 라벨 쿼리 기능인 라벨 선택기입니다.

동시에 사용할 수 있어야 하는 최소 pod 수를 지정하는 가용성 수준입니다.

-

minAvailable은 중단 중에도 항상 사용할 수 있어야하는 pod 수입니다. -

maxUnavailable은 중단 중에 사용할 수없는 pod 수입니다.

-

available 은 조건이 Ready=True 인 Pod 수를 나타냅니다. ready=True 는 요청을 제공할 수 있는 Pod를 나타내며 일치하는 모든 서비스의 로드 밸런싱 풀에 추가해야 합니다.

maxUnavailable 0 % 또는 0이나 minAvailable의 100 % 혹은 복제본 수와 동일한 값은 허용되지만 이로 인해 노드가 드레인되지 않도록 차단할 수 있습니다.

maxUnavailable 의 기본 설정은 OpenShift Container Platform의 모든 머신 구성 풀에 대해 1 입니다. 이 값을 변경하지 않고 한 번에 하나의 컨트롤 플레인 노드를 업데이트하는 것이 좋습니다. 컨트롤 플레인 풀의 경우 이 값을 3 으로 변경하지 마십시오.

다음을 사용하여 모든 프로젝트에서 pod 중단 예산을 확인할 수 있습니다.

oc get poddisruptionbudget --all-namespaces

$ oc get poddisruptionbudget --all-namespaces다음 예제에는 AWS의 OpenShift Container Platform과 관련된 몇 가지 값이 포함되어 있습니다.

출력 예

PodDisruptionBudget은 시스템에서 최소 minAvailable pod가 실행중인 경우 정상으로 간주됩니다. 이 제한을 초과하는 모든 pod는 제거할 수 있습니다.

Pod 우선 순위 및 선점 설정에 따라 우선 순위가 낮은 pod는 pod 중단 예산 요구 사항을 무시하고 제거될 수 있습니다.

2.3.3.1. Pod 중단 예산을 사용하여 실행해야 할 pod 수 지정

PodDisruptionBudget 오브젝트를 사용하여 동시에 가동되어야 하는 최소 복제본 수 또는 백분율을 지정할 수 있습니다.

프로세스

pod 중단 예산을 구성하려면 다음을 수행합니다.

다음과 같은 오브젝트 정의를 사용하여 YAML 파일을 만듭니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 또는 다음을 수행합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 오브젝트를 프로젝트에 추가합니다.

oc create -f </path/to/file> -n <project_name>

$ oc create -f </path/to/file> -n <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.3.2. 비정상 Pod의 제거 정책 지정

PDB(Pod 중단 예산)를 사용하여 동시에 사용할 수 있는 Pod 수를 지정하는 경우 비정상 Pod를 제거로 간주하는 방법에 대한 기준을 정의할 수도 있습니다.

다음 정책 중 하나를 선택할 수 있습니다.

- IfHealthyBudget

- 아직 정상이 아닌 실행 중인 Pod는 보호된 애플리케이션이 중단되지 않는 경우에만 제거할 수 있습니다.

- AlwaysAllow

아직 정상이 아닌 Pod 실행은 Pod 중단 예산의 기준이 충족되었는지 여부와 관계없이 제거할 수 있습니다. 이 정책은

CrashLoopBackOff상태에 있거나Ready상태를 보고하지 못하는 Pod와 같은 오작동 애플리케이션을 제거하는 데 도움이 될 수 있습니다.참고노드 드레이닝 중 잘못된 애플리케이션 제거를 지원하기 위해

PodDisruptionBudget오브젝트에서unhealthyPodEvictionPolicy필드를AlwaysAllow로 설정하는 것이 좋습니다. 기본 동작은 드레이닝을 진행하기 전에 애플리케이션 Pod가 정상 상태가 될 때까지 기다리는 것입니다.

프로세스

PodDisruptionBudget오브젝트를 정의하는 YAML 파일을 생성하고 비정상 Pod 제거 정책을 지정합니다.pod-disruption-budget.yaml파일의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 비정상 Pod 제거 정책으로

IfHealthyBudget또는AlwaysAllow중 하나를 선택합니다.unhealthyPodEvictionPolicy필드가 비어 있는 경우 기본값은IfHealthyBudget입니다.

다음 명령을 실행하여

PodDisruptionBudget오브젝트를 생성합니다.oc create -f pod-disruption-budget.yaml

$ oc create -f pod-disruption-budget.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

AlwaysAllow 비정상적인 Pod 제거 정책이 설정된 PDB를 사용하면 노드를 드레이닝하고 이 PDB에 의해 보호되는 오작동 애플리케이션에 대한 Pod를 제거할 수 있습니다.

2.3.4. 중요 Pod를 사용하여 Pod 제거 방지

완전히 작동하는 클러스터에 중요하지만 마스터가 아닌 일반 클러스터 노드에서 실행되는 다양한 핵심 구성 요소가 있습니다. 중요한 추가 기능이 제거되면 클러스터가 제대로 작동하지 않을 수 있습니다.

중요로 표시된 Pod는 제거할 수 없습니다.

프로세스

Pod를 중요로 설정하려면 다음을 수행합니다.

Pod사양을 생성하거나system-cluster-critical우선순위 클래스를 포함하도록 기존 Pod를 편집합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 노드에서 제거해서는 안 되는 Pod의 기본 우선순위 클래스입니다.

또는 클러스터에 중요한 Pod에 대해

system-node-critical을 지정할 수 있지만 필요한 경우 제거할 수도 있습니다.Pod를 생성합니다.

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.5. 파일 수가 많은 영구 볼륨을 사용할 때 Pod 시간 초과 감소

스토리지 볼륨에 여러 파일(~1,000,000 이상)이 포함된 경우 Pod 시간 초과가 발생할 수 있습니다.

이는 볼륨이 마운트되면 OpenShift Container Platform에서 Pod의 securityContext 에 지정된 fsGroup 과 일치하도록 각 볼륨의 내용의 소유권과 권한을 재귀적으로 변경하기 때문에 발생할 수 있습니다. 대규모 볼륨의 경우 소유권 및 권한을 확인하고 변경하는 데 시간이 오래 걸릴 수 있으므로 Pod 시작 속도가 매우 느려집니다.

다음 해결 방법 중 하나를 적용하여 이 지연을 줄일 수 있습니다.

- SCC(보안 컨텍스트 제약 조건)를 사용하여 볼륨의 SELinux 레이블 재지정을 건너뜁니다.

-

SCC 내에서

fsGroupChangePolicy필드를 사용하여 OpenShift Container Platform이 볼륨에 대한 소유권 및 권한을 확인하고 관리하는 방법을 제어합니다. - Cluster Resource Override Operator를 사용하여 SELinux 레이블 재지정을 건너뛰도록 SCC를 자동으로 적용합니다.

- 런타임 클래스를 사용하여 볼륨의 SELinux 레이블 재레이블을 건너뜁니다.

자세한 내용은 OpenShift에서 파일 수가 많은 영구 볼륨을 사용하는 경우 Pod를 시작하지 못하거나 "Ready" 상태를 달성하는 데 과도한 시간이 걸리는 이유를 참조하십시오.

2.4. 수평 Pod 자동 스케일러를 사용하여 Pod 자동 스케일링

개발자는 HPA(수평 Pod 자동 스케일러)를 사용하여 해당 복제 컨트롤러 또는 배포 구성에 속하는 Pod에서 수집한 메트릭을 기반으로 OpenShift Container Platform에서 복제 컨트롤러 또는 배포 구성의 규모를 자동으로 늘리거나 줄이는 방법을 지정할 수 있습니다. 배포, 배포 구성, 복제본 세트, 복제 컨트롤러 또는 상태 저장 세트에 대해 HPA를 생성할 수 있습니다.

사용자 정의 메트릭을 기반으로 Pod 스케일링에 대한 자세한 내용은 사용자 정의 메트릭을 기반으로 Pod 자동 스케일링을 참조하십시오.

다른 오브젝트에서 제공하는 특정 기능 또는 동작이 필요하지 않은 경우 Deployment 오브젝트 또는 ReplicaSet 오브젝트를 사용하는 것이 좋습니다. 이러한 오브젝트에 대한 자세한 내용은 배포 이해 를 참조하십시오.

2.4.1. 수평 Pod 자동 스케일러 이해

수평 Pod 자동 스케일러를 생성하여 실행하려는 최소 및 최대 Pod 수와 Pod에서 목표로 하는 CPU 사용률 또는 메모리 사용률을 지정할 수 있습니다.

수평 Pod 자동 스케일러를 생성하면 OpenShift Container Platform에서 Pod의 CPU 및/또는 메모리 리소스 메트릭을 쿼리합니다. 이러한 메트릭을 사용할 수 있는 경우 수평 Pod 자동 스케일러에서 현재 메트릭 사용률과 원하는 메트릭 사용률의 비율을 계산하고 그에 따라 확장 또는 축소합니다. 쿼리 및 스케일링은 정기적으로 수행되지만 메트릭을 사용할 수 있을 때까지 1~2분이 걸릴 수 있습니다.

복제 컨트롤러의 경우 이러한 스케일링은 복제 컨트롤러의 복제본과 직접적으로 일치합니다. 배포 구성의 경우 스케일링은 배포 구성의 복제본 수와 직접적으로 일치합니다. 자동 스케일링은 Complete 단계에서 최신 배포에만 적용됩니다.

OpenShift Container Platform은 리소스를 자동으로 차지하여 시작하는 동안과 같이 리소스가 급증하는 동안 불필요한 자동 스케일링을 방지합니다. unready 상태의 Pod는 확장 시 CPU 사용량이 0이고, 축소 시에는 자동 스케일러에서 Pod를 무시합니다. 알려진 메트릭이 없는 Pod는 확장 시 CPU 사용량이 0%이고, 축소 시에는 100%입니다. 이를 통해 HPA를 결정하는 동안 안정성이 향상됩니다. 이 기능을 사용하려면 준비 상태 점검을 구성하여 새 Pod를 사용할 준비가 되었는지 확인해야 합니다.

수평 Pod 자동 스케일러를 사용하려면 클러스터 관리자가 클러스터 메트릭을 올바르게 구성해야 합니다.

2.4.1.1. 지원되는 메트릭

수평 Pod 자동 스케일러에서는 다음 메트릭을 지원합니다.

| 메트릭 | 설명 | API 버전 |

|---|---|---|

| CPU 사용 | 사용되는 CPU 코어의 수입니다. Pod에서 요청하는 CPU의 백분율을 계산하는 데 사용할 수 있습니다. |

|

| 메모리 사용률 | 사용되는 메모리의 양입니다. Pod에서 요청하는 메모리의 백분율을 계산하는 데 사용할 수 있습니다. |

|

메모리 기반 자동 스케일링의 경우 메모리 사용량이 복제본 수에 비례하여 증가 및 감소해야 합니다. 평균적으로 다음과 같습니다.

- 복제본 수가 증가하면 Pod당 메모리(작업 집합) 사용량이 전반적으로 감소해야 합니다.

- 복제본 수가 감소하면 Pod별 메모리 사용량이 전반적으로 증가해야 합니다.

메모리 기반 자동 스케일링을 사용하기 전에 OpenShift Container Platform 웹 콘솔을 사용하여 애플리케이션의 메모리 동작을 확인하고 애플리케이션이 해당 요구 사항을 충족하는지 확인하십시오.

다음 예제에서는 image-registry Deployment 오브젝트에 대한 자동 스케일링을 보여줍니다. 초기 배포에는 Pod 3개가 필요합니다. HPA 오브젝트는 최소 5개로 증가합니다. Pod의 CPU 사용량이 75%에 도달하면 Pod가 7로 증가합니다.

oc autoscale deployment/image-registry --min=5 --max=7 --cpu-percent=75

$ oc autoscale deployment/image-registry --min=5 --max=7 --cpu-percent=75출력 예

horizontalpodautoscaler.autoscaling/image-registry autoscaled

horizontalpodautoscaler.autoscaling/image-registry autoscaledminReplicas 가 3으로 설정된 image-registry Deployment 오브젝트의 샘플 HPA

배포의 새 상태를 확인합니다.

oc get deployment image-registry

$ oc get deployment image-registryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이제 배포에 Pod 5개가 있습니다.

출력 예

NAME REVISION DESIRED CURRENT TRIGGERED BY image-registry 1 5 5 config

NAME REVISION DESIRED CURRENT TRIGGERED BY image-registry 1 5 5 configCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.2. HPA는 어떻게 작동합니까?

HPA(수평 Pod 자동 스케일러)는 Pod 자동 확장 개념을 확장합니다. HPA를 사용하면 부하 분산 노드 그룹을 생성하고 관리할 수 있습니다. 지정된 CPU 또는 메모리 임계값을 초과하면 HPA에서 Pod 수를 자동으로 늘리거나 줄입니다.

그림 2.1. HPA의 상위 수준 워크플로

HPA는 Kubernetes 자동 스케일링 API 그룹의 API 리소스입니다. 자동 스케일러는 동기화 기간 동안 기본값인 15초와 함께 컨트롤 루프로 작동합니다. 이 기간 동안 컨트롤러 관리자는 HPA의 YAML 파일에 정의된 CPU, 메모리 사용률 또는 둘 다에 대해 쿼리합니다. 컨트롤러 관리자는 HPA에서 대상으로 하는 각 Pod에 대해 CPU 또는 메모리와 같은 Pod별 Pod에 대한 리소스 지표 API에서 사용률 지표를 가져옵니다.

사용률 값 target이 설정되면 컨트롤러에서 사용률 값을 각 Pod의 컨테이너에서 동등한 리소스 요청의 백분율로 계산합니다. 그런 다음 컨트롤러는 모든 대상 Pod에서 평균 사용률을 사용하고 원하는 복제본 수를 확장하는 데 사용되는 비율을 생성합니다. HPA는 지표 서버에서 제공하는 metrics.k8s.io 에서 메트릭을 가져오도록 구성됩니다. 지표 평가의 동적 특성으로 인해 복제본 그룹의 스케일링 중에 복제본 수가 변동될 수 있습니다.

HPA를 구현하려면 모든 대상 Pod에 컨테이너에 리소스 요청이 설정되어 있어야 합니다.

2.4.3. 요청 및 제한 정보

스케줄러는 Pod의 컨테이너에 지정하는 리소스 요청을 사용하여 Pod를 배치할 노드를 결정합니다. kubelet은 컨테이너에 지정하는 리소스 제한을 적용하여 컨테이너가 지정된 제한을 초과하여 사용할 수 없도록 합니다. kubelet은 해당 컨테이너에서 사용할 시스템 리소스의 요청 양도 특별히 예약합니다.

리소스 메트릭을 사용하는 방법은 무엇입니까?

Pod 사양에서는 CPU 및 메모리와 같은 리소스 요청을 지정해야 합니다. HPA는 이 사양을 사용하여 리소스 사용률을 확인한 다음 대상을 확장하거나 축소합니다.

예를 들어 HPA 오브젝트는 다음 메트릭 소스를 사용합니다.

이 예에서 HPA는 스케일링 대상에서 Pod의 평균 사용률을 60%로 유지합니다. 사용률은 Pod의 현재 리소스 사용량과 요청된 리소스 사이의 비율입니다.

2.4.4. 모범 사례

모든 Pod에는 리소스 요청이 구성되어 있어야 합니다.

HPA는 OpenShift Container Platform 클러스터에서 Pod의 모니터링된 CPU 또는 메모리 사용률 값을 기반으로 스케일링 결정을 내립니다. 사용률 값은 각 Pod의 리소스 요청 백분율로 계산됩니다. 누락된 리소스 요청 값은 HPA의 최적 성능에 영향을 미칠 수 있습니다.

혼합된 다운 기간 구성

수평 Pod 자동 스케일링 중에 시간 간격 없이 이벤트를 빠르게 스케일링할 수 있습니다. 빈번한 복제본 변동을 방지하도록 차림 다운 기간을 구성합니다. stabilizationWindowSeconds 필드를 구성하여 차기 기간을 지정할 수 있습니다. 안정화 창은 확장에 사용되는 메트릭이 계속 변동될 때 복제본 수의 변동을 제한하는 데 사용됩니다. 자동 스케일링 알고리즘은 이 창을 사용하여 이전 원하는 상태를 유추하고 워크로드 규모에 대한 원치 않는 변경을 방지합니다.

예를 들어 scaleDown 필드에 stabilization 창이 지정됩니다.

behavior:

scaleDown:

stabilizationWindowSeconds: 300

behavior:

scaleDown:

stabilizationWindowSeconds: 300위 예제에서는 지난 5분 동안 원하는 모든 상태를 고려합니다. 이는 롤링 최대값과 근접하며 스케일링 알고리즘이 Pod를 자주 제거하여 나중에 동일한 Pod를 다시 생성하는 것을 트리거하지 않습니다.

2.4.4.1. 스케일링 정책

autoscaling/v2 API를 사용하면 수평 Pod 자동 스케일러에 스케일링 정책을 추가할 수 있습니다. 스케일링 정책은 OpenShift Container Platform HPA(수평 Pod 자동 스케일러)에서 Pod를 스케일링하는 방법을 제어합니다. 스케일링 정책을 사용하면 지정된 기간에 스케일링할 특정 수 또는 특정 백분율을 설정하여 HPA에서 Pod를 확장 또는 축소하는 비율을 제한할 수 있습니다. 또한 메트릭이 계속 변동하는 경우 이전에 계산한 원하는 상태를 사용하여 스케일링을 제어하는 안정화 기간을 정의할 수 있습니다. 동일한 스케일링 방향(확장 또는 축소)에 대해 여러 정책을 생성하여 변경 정도에 따라 사용할 정책을 결정할 수 있습니다. 반복 시간을 지정하여 스케일링을 제한할 수도 있습니다. HPA는 반복 중 Pod를 스케일링한 다음 필요에 따라 추가 반복에서 스케일링을 수행합니다.

스케일링 정책이 포함된 HPA 오브젝트 샘플

- 1

- 스케일링 정책의 방향, 즉

scaleDown또는scaleUp을 지정합니다. 이 예제에서는 축소 정책을 생성합니다. - 2

- 스케일링 정책을 정의합니다.

- 3

- 정책이 각 반복에서 특정 Pod 수 또는 Pod 백분율로 스케일링하는지의 여부를 결정합니다. 기본값은

pods입니다. - 4

- 각 반복 중에 Pod 수 또는 Pod 백분율 중 하나의 스케일링 양을 제한합니다. Pod 수에 따라 축소할 기본값은 없습니다.

- 5

- 스케일링 반복의 길이를 결정합니다. 기본값은

15초입니다. - 6

- 백분율로 된 축소 기본값은 100%입니다.

- 7

- 여러 정책이 정의된 경우 먼저 사용할 정책을 결정합니다. 가장 많은 변경을 허용하는 정책을 사용하려면

Max를 지정하고, 최소 변경을 허용하는 정책을 사용하려면Min을 지정합니다. HPA에서 해당 정책 방향으로 스케일링하지 않도록 하려면Disabled를 지정합니다. 기본값은Max입니다. - 8

- HPA에서 원하는 상태를 검토해야 하는 기간을 결정합니다. 기본값은

0입니다. - 9

- 이 예제에서는 확장 정책을 생성합니다.

- 10

- Pod 수에 따라 확장되는 양을 제한합니다. Pod 수 확장 기본값은 4%입니다.

- 11

- Pod 백분율에 따라 확장되는 양을 제한합니다. 백분율로 된 확장 기본값은 100%입니다.

축소 정책의 예

이 예제에서 Pod 수가 40개를 초과하면 selectPolicy에서 요구하는 대로 해당 정책으로 인해 상당한 변경이 발생하므로 축소에 백분율 기반 정책이 사용됩니다.

Pod 복제본이 80개 있는 경우 HPA는 첫 번째 반복에서 1분(periodSeconds: 60)에 걸쳐 (type: Percent 및 value: 10 매개변수에 따라) Pod 80개 중 10%에 해당하는 8개의 Pod를 줄입니다. 다음 반복에서는 Pod가 72개입니다. HPA는 나머지 Pod의 10%를 계산한 7.2개를 8개로 올림하여 Pod 8개를 축소합니다. 이후 반복할 때마다 나머지 Pod 수에 따라 스케일링할 Pod 수가 다시 계산됩니다. Pod 수가 40개 미만으로 줄어들면 Pod 기반 숫자가 백분율 기반 숫자보다 크기 때문에 Pod 기반 정책이 적용됩니다. HPA는 20개의 복제본(minReplicas)이 남아 있을 때까지 30초(periodSeconds: 30)에 걸쳐 한 번에 Pod를 4개씩 줄입니다(type: Pods 및 value: 4).

selectPolicy: Disabled 매개변수를 사용하면 HPA에서 Pod를 확장하지 못합니다. 필요한 경우 복제본 세트 또는 배포 세트의 복제본 수를 조정하여 수동으로 확장할 수 있습니다.

설정되어 있는 경우 oc edit 명령을 사용하여 스케일링 정책을 확인할 수 있습니다.

oc edit hpa hpa-resource-metrics-memory

$ oc edit hpa hpa-resource-metrics-memory출력 예

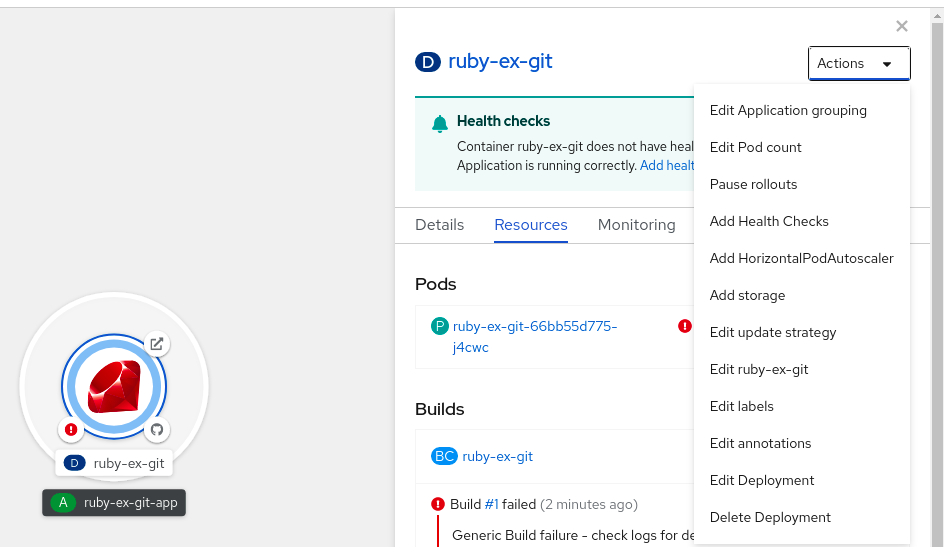

2.4.5. 웹 콘솔을 사용하여 수평 Pod 자동 스케일러 생성

웹 콘솔에서 Deployment 또는 DeploymentConfig 오브젝트에서 실행할 최소 및 최대 Pod 수를 지정하는 HPA(수평 Pod 자동 스케일러)를 생성할 수 있습니다. Pod에서 대상으로 해야 하는 CPU 또는 메모리 사용량의 양을 정의할 수도 있습니다.

HPA는 Operator 지원 서비스, Knative 서비스 또는 Helm 차트의 일부인 배포에 추가할 수 없습니다.

프로세스

웹 콘솔에서 HPA를 생성하려면 다음을 수행합니다.

- 토폴로지 보기에서 노드를 클릭하여 측면 창을 표시합니다.

작업 드롭다운 목록에서 HorizontalPodAutoscaler 추가 를 선택하여 HorizontalPodAutoscaler 추가 양식을 엽니다.

그림 2.2. Add HorizontalPodAutoscaler

HorizontalPodAutoscaler 추가 양식에서 이름, 최소 및 최대 Pod 제한, CPU 및 메모리 사용량을 정의하고 저장을 클릭합니다.

참고CPU 및 메모리 사용량에 대한 값이 없는 경우 경고가 표시됩니다.

웹 콘솔에서 HPA를 편집하려면 다음을 수행합니다.

- 토폴로지 보기에서 노드를 클릭하여 측면 창을 표시합니다.

- 작업 드롭다운 목록에서 HorizontalPodAutoscaler 편집을 선택하여 Horizontal Pod Autoscaler 편집 양식을 엽니다.

- Horizontal Pod Autoscaler 편집 양식에서 최소 및 최대 Pod 제한과 CPU 및 메모리 사용량을 편집한 다음 저장을 클릭합니다.

웹 콘솔에서 수평 Pod 자동 스케일러를 생성하거나 편집하는 동안 양식 보기에서 YAML 보기로 전환할 수 있습니다.

웹 콘솔에서 HPA를 제거하려면 다음을 수행합니다.

- 토폴로지 보기에서 노드를 클릭하여 측면 창을 표시합니다.

- 작업 드롭다운 목록에서 HorizontalPodAutoscaler 제거를 선택합니다.

- 확인 팝업 창에서 제거를 클릭하여 HPA를 제거합니다.

2.4.6. CLI를 사용하여 CPU 사용률에 대한 수평 Pod 자동 스케일러 생성

OpenShift Container Platform CLI를 사용하여 HPA(수평 Pod 자동 스케일러)를 생성하여 기존 Deployment,DeploymentConfig,ReplicaSet,ReplicationController 또는 StatefulSet 오브젝트를 자동으로 스케일링할 수 있습니다. HPA는 지정한 CPU 사용량을 유지하기 위해 해당 오브젝트와 연결된 Pod를 스케일링합니다.

다른 오브젝트에서 제공하는 특정 기능 또는 동작이 필요하지 않은 경우 Deployment 오브젝트 또는 ReplicaSet 오브젝트를 사용하는 것이 좋습니다.

HPA는 최소 및 최대 개수 사이에서 복제본 수를 늘리거나 줄여 전체 Pod에서 지정된 CPU 사용률을 유지합니다.

CPU 사용률을 자동 스케일링할 때는 oc autoscale 명령을 사용하여 언제든지 실행하려는 최소 및 최대 Pod 수와 Pod에서 목표로 하는 평균 CPU 사용률을 지정할 수 있습니다. 최솟값을 지정하지 않으면 Pod에 OpenShift Container Platform 서버의 기본값이 지정됩니다.

특정 CPU 값을 자동 스케일링하려면 대상 CPU 및 Pod 제한을 사용하여 HorizontalPodAutoscaler 오브젝트를 생성합니다.

사전 요구 사항

수평 Pod 자동 스케일러를 사용하려면 클러스터 관리자가 클러스터 메트릭을 올바르게 구성해야 합니다. oc describe PodMetrics <pod-name> 명령을 사용하여 메트릭이 구성되어 있는지 확인할 수 있습니다. 메트릭이 구성된 경우 출력이 다음과 유사하게 표시되고 Usage에 Cpu 및 Memory가 표시됩니다.

oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internal

$ oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internal출력 예

프로세스

CPU 사용률에 대한 수평 Pod 자동 스케일러를 생성하려면 다음을 수행합니다.

다음 중 하나를 수행합니다.

CPU 사용률 백분율에 따라 스케일링하려면 기존 오브젝트에 대한

HorizontalPodAutoscaler오브젝트를 생성합니다.oc autoscale <object_type>/<name> \ --min <number> \ --max <number> \ --cpu-percent=<percent>

$ oc autoscale <object_type>/<name> \1 --min <number> \2 --max <number> \3 --cpu-percent=<percent>4 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들어 다음 명령은

image-registryDeployment오브젝트에 대한 자동 스케일링을 보여줍니다. 초기 배포에는 Pod 3개가 필요합니다. HPA 오브젝트는 최소 5개로 증가합니다. Pod의 CPU 사용량이 75%에 도달하면 Pod가 7로 증가합니다.oc autoscale deployment/image-registry --min=5 --max=7 --cpu-percent=75

$ oc autoscale deployment/image-registry --min=5 --max=7 --cpu-percent=75Copy to Clipboard Copied! Toggle word wrap Toggle overflow 특정 CPU 값을 스케일링하려면 기존 오브젝트에 대해 다음과 유사한 YAML 파일을 생성합니다.

다음과 유사한 YAML 파일을 생성합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

autoscaling/v2API를 사용합니다.- 2

- 이 수평 Pod 자동 스케일러 오브젝트의 이름을 지정합니다.

- 3

- 스케일링할 오브젝트의 API 버전을 지정합니다.

-

Deployment,ReplicaSet,Statefulset오브젝트의 경우apps/v1을 사용합니다. -

ReplicationController의 경우v1을 사용합니다. -

DeploymentConfig의 경우apps.openshift.io/v1을 사용합니다.

-

- 4

- 오브젝트 유형을 지정합니다. 오브젝트는

Deployment,DeploymentConfig/dc,ReplicaSet/rs,ReplicationController/rc또는StatefulSet이어야 합니다. - 5

- 스케일링할 오브젝트의 이름을 지정합니다. 오브젝트가 있어야 합니다.

- 6

- 축소 시 최소 복제본 수를 지정합니다.

- 7

- 확장 시 최대 복제본 수를 지정합니다.

- 8

- 메모리 사용률에

metrics매개변수를 사용합니다. - 9

- CPU 사용률에

cpu를 지정합니다. - 10

AverageValue로 설정합니다.- 11

- 대상 CPU 값을 사용하여

averageValue로 설정합니다.

수평 Pod 자동 스케일러를 생성합니다.

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

수평 Pod 자동 스케일러가 생성되었는지 확인합니다.

oc get hpa cpu-autoscale

$ oc get hpa cpu-autoscaleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE cpu-autoscale Deployment/example 173m/500m 1 10 1 20m

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE cpu-autoscale Deployment/example 173m/500m 1 10 1 20mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.7. CLI를 사용하여 메모리 사용률에 대한 수평 Pod 자동 스케일러 오브젝트 생성

OpenShift Container Platform CLI를 사용하여 HPA(수평 Pod 자동 스케일러)를 생성하여 기존 Deployment,DeploymentConfig,ReplicaSet,ReplicationController 또는 StatefulSet 오브젝트를 자동으로 스케일링할 수 있습니다. HPA는 해당 오브젝트와 연결된 Pod를 스케일링하여 사용자가 지정하는 평균 메모리 사용률(직접 값 또는 요청된 메모리의 백분율)을 유지합니다.

다른 오브젝트에서 제공하는 특정 기능 또는 동작이 필요하지 않은 경우 Deployment 오브젝트 또는 ReplicaSet 오브젝트를 사용하는 것이 좋습니다.

HPA는 최소 및 최대 개수 사이에서 복제본 수를 늘리거나 줄여 전체 Pod에서 지정된 메모리 사용률을 유지합니다.

메모리 사용률의 경우 최소 및 최대 Pod 수와 Pod에서 목표로 해야 하는 평균 메모리 사용률을 지정할 수 있습니다. 최솟값을 지정하지 않으면 Pod에 OpenShift Container Platform 서버의 기본값이 지정됩니다.

사전 요구 사항

수평 Pod 자동 스케일러를 사용하려면 클러스터 관리자가 클러스터 메트릭을 올바르게 구성해야 합니다. oc describe PodMetrics <pod-name> 명령을 사용하여 메트릭이 구성되어 있는지 확인할 수 있습니다. 메트릭이 구성된 경우 출력이 다음과 유사하게 표시되고 Usage에 Cpu 및 Memory가 표시됩니다.

oc describe PodMetrics openshift-kube-scheduler-ip-10-0-129-223.compute.internal -n openshift-kube-scheduler

$ oc describe PodMetrics openshift-kube-scheduler-ip-10-0-129-223.compute.internal -n openshift-kube-scheduler출력 예

프로세스

메모리 사용률에 대한 수평 Pod 자동 스케일러를 생성하려면 다음을 수행합니다.

다음 중 하나에 대한 YAML 파일을 생성합니다.

특정 메모리 값을 스케일링하려면 기존 오브젝트에 대해 다음과 유사한

HorizontalPodAutoscaler오브젝트를 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

autoscaling/v2API를 사용합니다.- 2

- 이 수평 Pod 자동 스케일러 오브젝트의 이름을 지정합니다.

- 3

- 스케일링할 오브젝트의 API 버전을 지정합니다.

-

Deployment,ReplicaSet또는Statefulset오브젝트의 경우apps/v1을 사용합니다. -

ReplicationController의 경우v1을 사용합니다. -

DeploymentConfig의 경우apps.openshift.io/v1을 사용합니다.

-

- 4

- 오브젝트 유형을 지정합니다. 오브젝트는

Deployment,DeploymentConfig,ReplicaSet,ReplicationController또는StatefulSet이어야 합니다. - 5

- 스케일링할 오브젝트의 이름을 지정합니다. 오브젝트가 있어야 합니다.

- 6

- 축소 시 최소 복제본 수를 지정합니다.

- 7

- 확장 시 최대 복제본 수를 지정합니다.

- 8

- 메모리 사용률에

metrics매개변수를 사용합니다. - 9

- 메모리 사용률에 대한

메모리를 지정합니다. - 10

- 유형을

AverageValue로 설정합니다. - 11

averageValue및 특정 메모리 값을 지정합니다.- 12

- 선택 사항: 스케일링 정책을 지정하여 확장 또는 축소비율을 제어합니다.

백분율로 스케일링하려면 기존 오브젝트에 대해 다음과 유사한

HorizontalPodAutoscaler오브젝트를 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

autoscaling/v2API를 사용합니다.- 2

- 이 수평 Pod 자동 스케일러 오브젝트의 이름을 지정합니다.

- 3

- 스케일링할 오브젝트의 API 버전을 지정합니다.

-

ReplicationController의 경우

v1을 사용합니다. -

DeploymentConfig의 경우

apps.openshift.io/v1을 사용합니다. -

Deployment, ReplicaSet, Statefulset 오브젝트의 경우

apps/v1을 사용합니다.

-

ReplicationController의 경우

- 4

- 오브젝트 유형을 지정합니다. 오브젝트는

Deployment,DeploymentConfig,ReplicaSet,ReplicationController또는StatefulSet이어야 합니다. - 5

- 스케일링할 오브젝트의 이름을 지정합니다. 오브젝트가 있어야 합니다.

- 6

- 축소 시 최소 복제본 수를 지정합니다.

- 7

- 확장 시 최대 복제본 수를 지정합니다.

- 8

- 메모리 사용률에

metrics매개변수를 사용합니다. - 9

- 메모리 사용률에 대한

메모리를 지정합니다. - 10

Utilization으로 설정합니다.- 11

averageUtilization및 전체 Pod에 대한 대상 평균 메모리 사용률(요청 메모리의 백분율로 표시)을 지정합니다. 대상 Pod에 메모리 요청이 구성되어 있어야 합니다.- 12

- 선택 사항: 스케일링 정책을 지정하여 확장 또는 축소비율을 제어합니다.

수평 Pod 자동 스케일러를 생성합니다.

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들면 다음과 같습니다.

oc create -f hpa.yaml

$ oc create -f hpa.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

horizontalpodautoscaler.autoscaling/hpa-resource-metrics-memory created

horizontalpodautoscaler.autoscaling/hpa-resource-metrics-memory createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow 수평 Pod 자동 스케일러가 생성되었는지 확인합니다.

oc get hpa hpa-resource-metrics-memory

$ oc get hpa hpa-resource-metrics-memoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE hpa-resource-metrics-memory Deployment/example 2441216/500Mi 1 10 1 20m

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE hpa-resource-metrics-memory Deployment/example 2441216/500Mi 1 10 1 20mCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc describe hpa hpa-resource-metrics-memory

$ oc describe hpa hpa-resource-metrics-memoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.8. CLI를 사용하여 수평 Pod 자동 스케일러 상태 조건 이해

일련의 상태 조건을 사용하여 HPA(수평 Pod 자동 스케일러)에서 스케일링할 수 있는지 그리고 HPA가 현재 제한되어 있는지의 여부를 결정할 수 있습니다.

HPA 상태 조건은 자동 스케일링 API의 v2 버전에서 사용할 수 있습니다.

HPA는 다음과 같은 상태 조건을 통해 응답합니다.

AbleToScale상태는 HPA에서 메트릭을 가져오고 업데이트할 수 있는지의 여부 및 백오프 관련 상태로 스케일링을 방지할 수 있는지의 여부를 나타냅니다.-

True조건은 스케일링이 허용되었음을 나타냅니다. -

False조건은 지정된 이유로 스케일링이 허용되지 않음을 나타냅니다.

-

ScalingActive조건은 HPA가 활성화되어 있고(예: 대상의 복제본 수가 0이 아님) 원하는 메트릭을 계산할 수 있는지의 여부를 나타냅니다.-

True조건은 메트릭이 제대로 작동함을 나타냅니다. -

False조건은 일반적으로 메트릭을 가져오는 데 문제가 있음을 나타냅니다.

-

ScalingLimited조건은 원하는 스케일링이 수평 Pod 자동 스케일러의 최댓값 또는 최솟값으로 제한되었음을 나타냅니다.-

True조건은 스케일링을 위해 최소 또는 최대 복제본 수를 늘리거나 줄여야 함을 나타냅니다. False조건은 요청된 스케일링이 허용됨을 나타냅니다.oc describe hpa cm-test

$ oc describe hpa cm-testCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 수평 Pod 자동 스케일러의 상태 메시지입니다.

-

다음은 스케일링할 수 없는 Pod의 예입니다.

출력 예

다음은 스케일링에 필요한 메트릭을 가져올 수 없는 Pod의 예입니다.

출력 예

Conditions: Type Status Reason Message ---- ------ ------ ------- AbleToScale True SucceededGetScale the HPA controller was able to get the target's current scale ScalingActive False FailedGetResourceMetric the HPA was unable to compute the replica count: failed to get cpu utilization: unable to get metrics for resource cpu: no metrics returned from resource metrics API

Conditions:

Type Status Reason Message

---- ------ ------ -------

AbleToScale True SucceededGetScale the HPA controller was able to get the target's current scale

ScalingActive False FailedGetResourceMetric the HPA was unable to compute the replica count: failed to get cpu utilization: unable to get metrics for resource cpu: no metrics returned from resource metrics API다음은 요청된 자동 스케일링이 필요한 최솟값보다 적은 Pod의 예입니다.

출력 예

2.4.8.1. CLI를 사용하여 수평 Pod 자동 스케일러 상태 조건 보기

HPA(수평 Pod 자동 스케일러)를 통해 Pod에 설정된 상태 조건을 볼 수 있습니다.

수평 Pod 자동 스케일러 상태 조건은 자동 스케일링 API의 v2 버전에서 사용할 수 있습니다.

사전 요구 사항

수평 Pod 자동 스케일러를 사용하려면 클러스터 관리자가 클러스터 메트릭을 올바르게 구성해야 합니다. oc describe PodMetrics <pod-name> 명령을 사용하여 메트릭이 구성되어 있는지 확인할 수 있습니다. 메트릭이 구성된 경우 출력이 다음과 유사하게 표시되고 Usage에 Cpu 및 Memory가 표시됩니다.

oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internal

$ oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internal출력 예

프로세스

Pod의 상태 조건을 보려면 Pod 이름과 함께 다음 명령을 사용합니다.

oc describe hpa <pod-name>

$ oc describe hpa <pod-name>예를 들면 다음과 같습니다.

oc describe hpa cm-test

$ oc describe hpa cm-test

상태가 출력의 Conditions 필드에 나타납니다.

출력 예

2.5. 수직 Pod 자동 스케일러를 사용하여 Pod 리소스 수준 자동 조정

OpenShift Container Platform VPA(Vertical Pod Autoscaler Operator)는 Pod의 컨테이너에 대한 과거 및 현재의 CPU 및 메모리 리소스를 자동으로 검토한 후 확인한 사용량 값에 따라 리소스 제한 및 요청을 업데이트할 수 있습니다. VPA는 개별 CR(사용자 정의 리소스)을 사용하여 Deployment, Deployment Config, StatefulSet, Job, DaemonSet, ReplicaSet 또는 ReplicationController와 같은 워크로드 오브젝트와 연결된 모든 Pod를 프로젝트에서 업데이트합니다.

VPA를 사용하면 Pod의 최적 CPU 및 메모리 사용량을 이해하고 Pod의 라이프사이클 내내 Pod 리소스를 자동으로 유지 관리할 수 있습니다.

2.5.1. Vertical Pod Autoscaler Operator 정보

VPA(Vertical Pod Autoscaler Operator)는 API 리소스 및 CR(사용자 정의 리소스)로 구현됩니다. CR은 VPA Operator가 데몬 세트, 복제 컨트롤러 등과 같은 특정 워크로드 오브젝트와 연결된 Pod와 함께 수행해야 하는 작업을 프로젝트에서 결정합니다.

VPA Operator는 세 가지 구성 요소로 구성되며 각각 VPA 네임스페이스에 자체 Pod가 있습니다.

- 권장 사항

- VPA 권장 사항은 현재 및 과거 리소스 사용을 모니터링하고 이 데이터를 기반으로 관련 워크로드 오브젝트의 Pod에 대한 최적 CPU 및 메모리 리소스를 결정합니다.

- Updater

- VPA 업데이트자는 관련 워크로드 오브젝트의 Pod에 올바른 리소스가 있는지 확인합니다. 리소스가 올바르면 업데이트 프로그램이 작업을 수행하지 않습니다. 리소스가 올바르지 않으면 업데이트 프로그램이 Pod를 종료하여 업데이트된 요청을 통해 컨트롤러에서 다시 생성할 수 있습니다.

- 허용 컨트롤러

- VPA 승인 컨트롤러는 VPA updater 작업으로 인해 Pod가 새로 생성되었는지 또는 컨트롤러에서 재생성했는지와 관계없이 관련 워크로드 오브젝트의 각 새 Pod에 올바른 리소스 요청을 설정합니다.

기본 권장자를 사용하거나 자체 대체 권장 프로그램을 사용하여 자체 알고리즘에 따라 자동 스케일링할 수 있습니다.

기본 권장 사항은 해당 Pod의 컨테이너 및 현재 CPU 및 메모리 사용량을 자동으로 계산하고 이 데이터를 사용하여 최적화된 리소스 제한 및 요청을 확인하여 이러한 Pod가 항상 효율적으로 작동하는지 확인합니다. 예를 들어 기본 권장 사항에서는 사용 중인 리소스보다 더 많은 리소스를 요청하는 Pod의 리소스가 줄어들고 충분히 요청하지 않는 Pod의 리소스를 늘릴 것을 제안합니다.

그런 다음 VPA는 애플리케이션이 다운타임 없이 요청을 계속 제공할 수 있도록 이러한 권장 사항과 일치하지 않는 모든 Pod를 한 번에 하나씩 자동으로 삭제합니다. 그런 다음 워크로드 오브젝트는 원래 리소스 제한 및 요청을 사용하여 Pod를 재배포합니다. VPA는 변경 승인 Webhook를 사용하여 Pod가 노드에 승인되기 전에 최적화된 리소스 제한 및 요청을 사용하여 Pod를 업데이트합니다. VPA에서 Pod를 삭제하지 않으려면 필요에 따라 VPA 리소스 제한 및 요청 및 수동으로 Pod를 업데이트할 수 있습니다.

기본적으로 워크로드 오브젝트는 VPA에서 Pod를 자동으로 삭제하려면 최소 두 개의 복제본을 지정해야 합니다. 이 최소값보다 더 적은 복제본을 지정하는 워크로드 오브젝트는 삭제되지 않습니다. 이러한 Pod를 수동으로 삭제하면 워크로드 오브젝트가 Pod를 재배포하면 VPA에서 새 Pod를 권장 사항으로 업데이트합니다. VPA 최소 값 변경에 표시된 대로 VerticalPodAutoscalerController 오브젝트를 수정하여 이 최소값을 변경할 수 있습니다.

예를 들어 CPU의 50%를 사용하면서 10%만 요청하는 Pod가 있는 경우, VPA는 요청하는 것보다 더 많은 CPU를 사용하고 있는 것으로 판단하고 Pod를 삭제합니다. 복제본 세트와 같은 워크로드 오브젝트는 Pod를 재시작하고 VPA는 권장 리소스로 새 Pod를 업데이트합니다.

개발자의 경우 VPA를 사용하면 각 Pod에 적절한 리소스를 제공하도록 노드에 Pod를 예약하여 수요가 많은 기간에도 Pod가 유지되도록 할 수 있습니다.

관리자는 VPA를 사용하여 Pod에서 필요 이상의 CPU 리소스를 예약하지 않도록 클러스터 리소스를 더 효율적으로 활용할 수 있습니다. VPA는 워크로드에서 실제로 사용 중인 리소스를 모니터링하고 다른 워크로드에서 용량을 사용할 수 있도록 리소스 요구 사항을 조정합니다. 또한 VPA는 초기 컨테이너 구성에 지정된 제한 및 요청 간 비율도 유지합니다.

VPA 실행을 중지하거나 클러스터에서 특정 VPA CR을 삭제하는 경우 VPA에서 이미 수정한 Pod에 대한 리소스 요청은 변경되지 않습니다. 새 Pod에서는 모두 VPA에서 설정한 이전의 권장 사항 대신 워크로드 오브젝트에 정의된 리소스를 가져옵니다.

2.5.2. Vertical Pod Autoscaler Operator 설치

OpenShift Container Platform 웹 콘솔을 사용하여 VPA(Vertical Pod Autoscaler Operator)를 설치할 수 있습니다.

프로세스

- OpenShift Container Platform 웹 콘솔에서 Operator → OperatorHub를 클릭합니다.

- 사용 가능한 Operator 목록에서 VerticalPodAutoscaler를 선택한 다음 설치를 클릭합니다.

-

Operator 설치 페이지에서 Operator 권장 네임스페이스 옵션이 선택되어 있는지 확인합니다. 그러면 필수

openshift-vertical-pod-autoscaler네임스페이스에 Operator가 설치됩니다. 해당 네임스페이스가 존재하지 않는 경우 자동으로 생성됩니다. - 설치를 클릭합니다.

Verifiction

VPA Operator 구성 요소를 나열하여 설치를 확인합니다.

- 워크로드 → Pod로 이동합니다.

-

드롭다운 메뉴에서

openshift-vertical-pod-autoscaler프로젝트를 선택하고 Pod 4개가 실행되고 있는지 확인합니다. - 워크로드 → 배포로 이동하여 배포 4개가 실행되고 있는지 확인합니다.

선택 사항: 다음 명령을 사용하여 OpenShift Container Platform CLI에서 설치를 확인합니다.

oc get all -n openshift-vertical-pod-autoscaler

$ oc get all -n openshift-vertical-pod-autoscalerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력에는 Pod 4개와 배포 4개가 표시됩니다.

출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.3. Vertical Pod Autoscaler Operator 구성 요소 이동

VPA(Vertical Pod Autoscaler Operator) 및 각 구성 요소에는 컨트롤 플레인 노드의 VPA 네임스페이스에 자체 Pod가 있습니다. VPA 서브스크립션 및 VerticalPodAutoscalerController CR에 노드 선택기를 추가하여 VPA Operator 및 구성 요소 Pod를 인프라 또는 작업자 노드로 이동할 수 있습니다.

인프라 노드를 생성하고 사용하여 기본 라우터, 통합 컨테이너 이미지 레지스트리 및 클러스터 지표 및 모니터링 구성 요소와 같은 인프라 구성 요소만 호스팅할 수 있습니다. 이러한 인프라 노드는 환경을 실행하는 데 필요한 총 서브스크립션 수에 포함되지 않습니다. 자세한 내용은 인프라 머신 세트 생성 을 참조하십시오.

구성 요소를 조직에 적절하게 동일한 노드 또는 별도의 노드로 이동할 수 있습니다.

다음 예제에서는 컨트롤 플레인 노드에 VPA Pod의 기본 배포를 보여줍니다.

출력 예

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES vertical-pod-autoscaler-operator-6c75fcc9cd-5pb6z 1/1 Running 0 7m59s 10.128.2.24 c416-tfsbj-master-1 <none> <none> vpa-admission-plugin-default-6cb78d6f8b-rpcrj 1/1 Running 0 5m37s 10.129.2.22 c416-tfsbj-master-1 <none> <none> vpa-recommender-default-66846bd94c-dsmpp 1/1 Running 0 5m37s 10.129.2.20 c416-tfsbj-master-0 <none> <none> vpa-updater-default-db8b58df-2nkvf 1/1 Running 0 5m37s 10.129.2.21 c416-tfsbj-master-1 <none> <none>

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

vertical-pod-autoscaler-operator-6c75fcc9cd-5pb6z 1/1 Running 0 7m59s 10.128.2.24 c416-tfsbj-master-1 <none> <none>

vpa-admission-plugin-default-6cb78d6f8b-rpcrj 1/1 Running 0 5m37s 10.129.2.22 c416-tfsbj-master-1 <none> <none>

vpa-recommender-default-66846bd94c-dsmpp 1/1 Running 0 5m37s 10.129.2.20 c416-tfsbj-master-0 <none> <none>

vpa-updater-default-db8b58df-2nkvf 1/1 Running 0 5m37s 10.129.2.21 c416-tfsbj-master-1 <none> <none>프로세스

VPA Operator의

SubscriptionCR(사용자 정의 리소스)에 노드 선택기를 추가하여 VPA Operator Pod를 이동합니다.CR을 편집합니다.

oc edit Subscription vertical-pod-autoscaler -n openshift-vertical-pod-autoscaler

$ oc edit Subscription vertical-pod-autoscaler -n openshift-vertical-pod-autoscalerCopy to Clipboard Copied! Toggle word wrap Toggle overflow VPA Operator Pod를 설치하려는 노드의 노드 역할 레이블과 일치하도록 노드 선택기를 추가합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고인프라 노드에서 taint를 사용하는 경우

서브스크립션CR에 허용 오차를 추가해야 합니다.예를 들면 다음과 같습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- VPA Operator Pod를 이동하려는 노드에서 테인트에 대한 허용 오차를 지정합니다.

VerticalPodAutoscalerCR(사용자 정의 리소스)에 노드 선택기를 추가하여 각 VPA 구성 요소를 이동합니다.CR을 편집합니다.

oc edit VerticalPodAutoscalerController default -n openshift-vertical-pod-autoscaler

$ oc edit VerticalPodAutoscalerController default -n openshift-vertical-pod-autoscalerCopy to Clipboard Copied! Toggle word wrap Toggle overflow VPA 구성 요소를 설치하려는 노드의 노드 역할 레이블과 일치하도록 노드 선택기를 추가합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고대상 노드에서 테인트를 사용하는 경우

VerticalPodAutoscalerControllerCR에 허용 오차를 추가해야 합니다.예를 들면 다음과 같습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

다음 명령을 사용하여 Pod가 이동했는지 확인할 수 있습니다.

oc get pods -n openshift-vertical-pod-autoscaler -o wide

$ oc get pods -n openshift-vertical-pod-autoscaler -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod는 더 이상 컨트롤 플레인 노드에 배포되지 않습니다.

출력 예

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES vertical-pod-autoscaler-operator-6c75fcc9cd-5pb6z 1/1 Running 0 7m59s 10.128.2.24 c416-tfsbj-infra-eastus3-2bndt <none> <none> vpa-admission-plugin-default-6cb78d6f8b-rpcrj 1/1 Running 0 5m37s 10.129.2.22 c416-tfsbj-infra-eastus1-lrgj8 <none> <none> vpa-recommender-default-66846bd94c-dsmpp 1/1 Running 0 5m37s 10.129.2.20 c416-tfsbj-infra-eastus1-lrgj8 <none> <none> vpa-updater-default-db8b58df-2nkvf 1/1 Running 0 5m37s 10.129.2.21 c416-tfsbj-infra-eastus1-lrgj8 <none> <none>

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES vertical-pod-autoscaler-operator-6c75fcc9cd-5pb6z 1/1 Running 0 7m59s 10.128.2.24 c416-tfsbj-infra-eastus3-2bndt <none> <none> vpa-admission-plugin-default-6cb78d6f8b-rpcrj 1/1 Running 0 5m37s 10.129.2.22 c416-tfsbj-infra-eastus1-lrgj8 <none> <none> vpa-recommender-default-66846bd94c-dsmpp 1/1 Running 0 5m37s 10.129.2.20 c416-tfsbj-infra-eastus1-lrgj8 <none> <none> vpa-updater-default-db8b58df-2nkvf 1/1 Running 0 5m37s 10.129.2.21 c416-tfsbj-infra-eastus1-lrgj8 <none> <none>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

추가 리소스

2.5.4. Vertical Pod Autoscaler Operator 사용 정보

VPA(Vertical Pod Autoscaler Operator)를 사용하려면 클러스터에서 워크로드 오브젝트에 대한 VPA CR(사용자 정의 리소스)을 생성합니다. VPA는 해당 워크로드 오브젝트와 연결된 Pod에 가장 적합한 CPU 및 메모리 리소스를 확인하고 적용합니다. 배포, 상태 저장 세트, 작업, 데몬 세트, 복제본 세트 또는 복제 컨트롤러 워크로드 오브젝트에 VPA를 사용할 수 있습니다. VPA CR은 모니터링할 Pod와 동일한 프로젝트에 있어야 합니다.

VPA CR을 사용하여 워크로드 오브젝트를 연결하고 VPA가 작동하는 모드를 지정합니다.

-

Auto및Recreate모드는 Pod 수명 동안 VPA CPU 및 메모리 권장 사항을 자동으로 적용합니다. VPA는 권장 사항과 일치하지 않는 프로젝트의 모든 Pod를 삭제합니다. 워크로드 오브젝트에서 재배포하면 VPA는 새 Pod를 권장 사항으로 업데이트합니다. -

Initial모드는 Pod 생성 시에만 VPA 권장 사항을 자동으로 적용합니다. -

Off모드는 권장되는 리소스 제한 및 요청만 제공하며 권장 사항을 수동으로 적용할 수 있습니다.off모드에서는 Pod를 업데이트하지 않습니다.

CR을 사용하여 VPA 평가 및 업데이트에서 특정 컨테이너를 옵트아웃할 수도 있습니다.

예를 들어 Pod에 다음과 같은 제한 및 요청이 있습니다.

auto로 설정된 VPA를 생성하면 VPA에서 리소스 사용량을 확인하고 Pod를 삭제합니다. 재배포되면 Pod는 새 리소스 제한 및 요청을 사용합니다.

다음 명령을 사용하여 VPA 권장 사항을 볼 수 있습니다.

oc get vpa <vpa-name> --output yaml

$ oc get vpa <vpa-name> --output yaml몇 분 후 출력에는 CPU 및 메모리 요청에 대한 권장 사항이 표시되며 다음과 유사합니다.

출력 예

출력에는 권장 리소스(target), 최소 권장 리소스(lowerBound), 최고 권장 리소스(upperBound), 최신 리소스 권장 사항(uncappedTarget)이 표시됩니다.

VPA는 lowerBound 및 upperBound 값을 사용하여 Pod를 업데이트해야 하는지 확인합니다. Pod에 lowerBound 값보다 작거나 upperBound 값을 초과하는 리소스 요청이 있는 경우 VPA는 Pod를 종료하고 target 값을 사용하여 Pod를 다시 생성합니다.

2.5.4.1. VPA 최소 값 변경

기본적으로 워크로드 오브젝트는 VPA에서 Pod를 자동으로 삭제하고 업데이트하려면 최소 두 개의 복제본을 지정해야 합니다. 결과적으로 두 개 미만의 복제본을 지정하는 워크로드 오브젝트는 VPA에서 자동으로 작동하지 않습니다. VPA는 Pod가 VPA 외부 일부 프로세스에서 재시작되는 경우 이러한 워크로드 오브젝트에서 새 Pod를 업데이트합니다. VerticalPodAutoscalerController CR(사용자 정의 리소스)에서 minReplicas 매개변수를 수정하여 클러스터 전체 최소 값을 변경할 수 있습니다.

예를 들어 minReplicas 를 3 으로 설정하면 VPA에서 복제본 3개 미만을 지정하는 워크로드 오브젝트의 Pod를 삭제하고 업데이트하지 않습니다.

minReplicas 를 1 로 설정하면 VPA에서 하나의 복제본만 지정하는 워크로드 오브젝트에 대한 유일한 Pod를 삭제할 수 있습니다. VPA에서 Pod를 삭제하여 리소스를 조정할 때마다 워크로드에서 다운타임을 허용할 수 있는 경우에만 이 설정을 one-replica 오브젝트에 사용해야 합니다. one-replica 오브젝트를 사용하여 원하지 않는 다운 타임을 방지하려면 podUpdatePolicy 를 Initial 로 설정하여 VPA CR을 구성합니다. 이 CR은 VPA 외부의 일부 프로세스에 의해 재시작되는 경우에만 Pod를 업데이트하거나 애플리케이션에 적절한 시점에 Pod를 수동으로 업데이트할 수 있습니다.

VerticalPodAutoscalerController 오브젝트의 예

- 1

- VPA가 작동할 수 있도록 워크로드 오브젝트에서 최소 복제본 수를 지정합니다. 최소 복제본보다 적은 모든 오브젝트는 VPA에서 자동으로 삭제되지 않습니다.

2.5.4.2. VPA 권장 사항 자동 적용

VPA를 사용하여 Pod를 자동으로 업데이트하려면 updateMode를 Auto 또는 Recreate로 설정하여 특정 워크로드 오브젝트에 대한 VPA CR을 생성합니다.

워크로드 오브젝트에 대한 Pod가 생성되면 VPA에서 컨테이너를 지속적으로 모니터링하여 CPU 및 메모리 요구 사항을 분석합니다. VPA는 CPU 및 메모리에 대한 VPA 권장 사항을 충족하지 않는 모든 Pod를 삭제합니다. 재배포되면 Pod는 VPA 권장 사항에 따라 새 리소스 제한 및 요청을 사용하여 애플리케이션에 대해 설정된 모든 Pod 중단 예산을 준수합니다. 권장 사항은 참조를 위해 VPA CR의 status 필드에 추가되어 있습니다.

기본적으로 워크로드 오브젝트는 VPA에서 Pod를 자동으로 삭제하려면 최소 두 개의 복제본을 지정해야 합니다. 이 최소값보다 더 적은 복제본을 지정하는 워크로드 오브젝트는 삭제되지 않습니다. 이러한 Pod를 수동으로 삭제하면 워크로드 오브젝트가 Pod를 재배포하면 VPA에서 새 Pod를 권장 사항으로 업데이트합니다. VPA 최소 값 변경에 표시된 대로 VerticalPodAutoscalerController 오브젝트를 수정하여 이 최소값을 변경할 수 있습니다.

Auto 모드 VPA CR의 예

- 1

- 이 VPA CR에서 관리할 워크로드 오브젝트의 유형입니다.

- 2

- 이 VPA CR에서 관리할 워크로드 오브젝트의 이름입니다.

- 3

- 모드를

Auto또는Recreate로 설정합니다.-

Auto. VPA는 Pod 생성 시 리소스 요청을 할당하고 요청된 리소스가 새 권장 사항과 크게 다른 경우 기존 Pod를 종료하여 업데이트합니다. -

Recreate. VPA는 Pod 생성 시 리소스 요청을 할당하고 요청된 리소스가 새 권장 사항과 크게 다른 경우 기존 Pod를 종료하여 업데이트합니다. 이 모드는 리소스 요청이 변경될 때마다 Pod를 재시작해야 하는 경우에만 사용해야 합니다.

-

VPA에서 리소스에 대한 권장 사항을 결정하고 권장 리소스를 새 Pod에 적용하려면 작동 중인 Pod가 있어야 하며 프로젝트에서 실행 중이어야 합니다.

CPU 및 메모리와 같은 워크로드의 리소스 사용량이 일관되게 유지되면 VPA에서 몇 분 내에 리소스에 대한 권장 사항을 확인할 수 있습니다. 워크로드의 리소스 사용량이 일치하지 않는 경우 VPA는 정확한 권장 사항을 수행하기 위해 VPA의 다양한 리소스 사용량 간격으로 지표를 수집해야 합니다.

2.5.4.3. Pod 생성에 VPA 권장 사항 자동 적용

VPA를 사용하여 Pod를 처음 배포할 때만 권장 리소스를 적용하려면 updateMode를 Initial로 설정하여 특정 워크로드 오브젝트에 대한 VPA CR을 생성합니다.

그런 다음 VPA 권장 사항을 사용하려는 워크로드 오브젝트와 연결된 모든 Pod를 수동으로 삭제합니다. Initial 모드에서 VPA는 새 리소스 권장 사항을 확인할 때 Pod를 삭제하지 않고 Pod을 업데이트하지도 않습니다.

Initial 모드 VPA CR의 예

VPA에서 권장 리소스를 결정하고 새 Pod에 권장 사항을 적용하려면 운영 Pod가 있어야 하며 프로젝트에서 실행 중이어야 합니다.

VPA에서 가장 정확한 권장 사항을 얻으려면 Pod가 실행되고 VPA가 안정될 때까지 최소 8일 동안 기다립니다.

2.5.4.4. VPA 권장 사항 수동 적용

VPA를 권장 CPU 및 메모리 값을 확인하는 데에만 사용하려면 updateMode를 off로 설정하여 특정 워크로드 오브젝트에 대한 VPA CR을 생성합니다.

해당 워크로드 오브젝트에 대한 Pod가 생성되면 VPA는 컨테이너의 CPU 및 메모리 요구 사항을 분석하고 VPA CR의 status 필드에 해당 권장 사항을 기록합니다. VPA는 새 리소스 권장 사항을 확인할 때 Pod를 업데이트하지 않습니다.

Off 모드 VPA CR의 예

다음 명령을 사용하여 권장 사항을 볼 수 있습니다.

oc get vpa <vpa-name> --output yaml

$ oc get vpa <vpa-name> --output yaml권장 사항에 따라 워크로드 오브젝트를 편집하여 CPU 및 메모리 요청을 추가한 다음 권장 리소스를 사용하여 Pod를 삭제하고 재배포할 수 있습니다.

VPA에서 권장 리소스를 결정하고 새 Pod에 권장 사항을 적용하려면 운영 Pod가 있어야 하며 프로젝트에서 실행 중이어야 합니다.

VPA에서 가장 정확한 권장 사항을 얻으려면 Pod가 실행되고 VPA가 안정될 때까지 최소 8일 동안 기다립니다.

2.5.4.5. VPA 권장 사항 적용에서 컨테이너 제외

워크로드 오브젝트에 컨테이너가 여러 개 있고 VPA에서 모든 컨테이너를 평가하고 해당 컨테이너에 대해 작동하지 않도록 하려면 특정 워크로드 오브젝트에 대한 VPA CR을 생성하고 resourcePolicy를 추가하여 특정 컨테이너를 옵트아웃합니다.

VPA에서 권장 리소스를 사용하여 Pod를 업데이트하면 resourcePolicy가 포함된 모든 컨테이너가 업데이트되지 않으며 VPA는 Pod의 해당 컨테이너에 대한 권장 사항을 제공하지 않습니다.

예를 들면 Pod에 다음과 같이 리소스 요청 및 제한이 동일한 두 개의 컨테이너가 있습니다.

backend 컨테이너를 옵트아웃으로 설정하여 VPA CR을 시작하면 VPA에서 Pod를 종료한 후 frontend 컨테이너에만 적용되는 권장 리소스를 사용하여 Pod를 다시 생성합니다.

2.5.4.6. VPA Operator 성능 튜닝

클러스터 관리자는 VPA가 Kubernetes API 서버의 요청을 요청하는 속도를 제한하고 VPA 권장, 업데이트자, 승인 컨트롤러 구성 요소 Pod에 대한 CPU 및 메모리 리소스를 지정하도록 VPA(Vertical Pod Autoscaler Operator)의 성능을 조정할 수 있습니다.

또한 VPA CR(사용자 정의 리소스)에서 관리하는 워크로드만 모니터링하도록 VPA Operator를 구성할 수 있습니다. 기본적으로 VPA Operator는 클러스터의 모든 워크로드를 모니터링합니다. 이를 통해 VPA Operator는 모든 워크로드에 대해 8일의 기록 데이터를 작성하고 저장할 수 있습니다. 이 데이터는 Operator가 워크로드에 대해 새 VPA CR을 생성하는 경우 사용할 수 있습니다. 그러나 이로 인해 VPA Operator에서 상당한 CPU 및 메모리를 사용하므로 특히 대규모 클러스터에서 Operator가 실패할 수 있습니다. VPA CR을 사용하여 워크로드만 모니터링하도록 VPA Operator를 구성하면 CPU 및 메모리 리소스에 저장할 수 있습니다. 한 가지 단점은 실행 중인 워크로드가 있고 VPA CR을 생성하여 해당 워크로드를 관리하는 경우 VPA Operator에 해당 워크로드에 대한 기록 데이터가 없다는 것입니다. 결과적으로 초기 권장 사항은 워크로드가 잠시 실행된 후만큼 유용하지 않습니다.

이러한 튜닝을 사용하면 VPA에 최대 효율성으로 작동할 수 있는 충분한 리소스가 있고 Pod 승인이 제한되고 지연되는 것을 방지할 수 있습니다.

VerticalPodAutoscalerController CR(사용자 정의 리소스)을 편집하여 VPA 구성 요소에서 다음 튜닝을 수행할 수 있습니다.

-

제한 및 Pod 승인 지연을 방지하려면

kube-api-qps및kube-api-burst매개변수를 사용하여 Kubernetes API 서버의 VPA 요청에 대한 queries-per-second(QPS) 및 버스트 속도를 설정합니다. -

충분한 CPU 및 메모리를 확인하려면 표준

cpu및 memory 리소스 요청을 사용하여 VPA 구성 요소 Pod에 대한 CPU 및메모리요청을 설정합니다. -

VPA CR에서 관리하는 워크로드만 모니터링하도록 VPA Operator를 구성하려면 권장 구성 요소에 대해

memory-saver매개변수를true로 설정합니다.

다음 예제 VPA 컨트롤러 CR은 VPA API QPS 및 버스트 속도를 설정하고, 구성 요소 Pod 리소스 요청을 구성하고, 권장자에 대해 memory-saver 를 true 로 설정합니다.

VerticalPodAutoscalerController CR의 예

- 1

- VPA 승인 컨트롤러의 튜닝 매개변수를 지정합니다.

- 2

- VPA 승인 컨트롤러의 API QPS 및 버스트 속도를 지정합니다.

-

kube-api-qps: Kubernetes API 서버에 요청할 때 초당 쿼리(QPS) 제한을 지정합니다. 기본값은5.0입니다. -

kube-api-burst: Kubernetes API 서버에 요청할 때 burst 제한을 지정합니다. 기본값은10.0입니다.

-

- 3

- VPA 승인 컨트롤러 Pod에 대한 CPU 및 메모리 요청을 지정합니다.

- 4

- VPA 권장 사항에 대한 튜닝 매개변수를 지정합니다.

- 5

- VPA Operator가 VPA CR을 사용하여 워크로드만 모니터링하도록 지정합니다. 기본값은

false입니다. - 6

- VPA 업데이트 프로그램의 튜닝 매개변수를 지정합니다.

설정이 각 VPA 구성 요소 Pod에 적용되었는지 확인할 수 있습니다.

updater Pod의 예

승인 컨트롤러 Pod의 예

recommender Pod의 예

2.5.4.7. 대체 권장 사항 사용

자체 권장 사항을 사용하여 자체 알고리즘에 따라 자동 스케일링할 수 있습니다. 대체 권장 사항을 지정하지 않는 경우 OpenShift Container Platform은 기본 권장 사항을 사용합니다. 이 권장 사항은 이전 사용량을 기반으로 CPU 및 메모리 요청을 제안합니다. 모든 유형의 워크로드에 적용되는 범용 권장 정책은 없으므로 특정 워크로드에 대해 다른 권장 사항을 생성하고 배포해야 할 수 있습니다.

예를 들어, 기본 권장 사항은 컨테이너가 애플리케이션 모니터링에 사용되는 사용량 급증과 유휴 상태 지정 또는 딥 러닝 애플리케이션에 사용되는 패턴을 반복하고 반복하는 것과 같이 특정 리소스 동작을 표시하는 경우 향후 리소스 사용량을 정확하게 예측하지 못할 수 있습니다. 이러한 사용 동작과 함께 기본 권장 사항을 사용하면 애플리케이션에 대해 상당한 초과 프로비저닝 및 OOM(메모리 부족)이 종료될 수 있습니다.

추천자를 만드는 방법에 대한 지침은 이 문서의 범위를 벗어납니다.

프로세스

Pod에 대체 권장자를 사용하려면 다음을 수행합니다.

대체 권장 사항에 대한 서비스 계정을 생성하고 해당 서비스 계정을 필수 클러스터 역할에 바인딩합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 클러스터에 대체 권장자를 추가하려면 다음과 유사한 Deployment 오브젝트를 생성합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 동일한 네임스페이스의 대체 권장 사항에 대한 새 Pod가 생성됩니다.

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME READY STATUS RESTARTS AGE frontend-845d5478d-558zf 1/1 Running 0 4m25s frontend-845d5478d-7z9gx 1/1 Running 0 4m25s frontend-845d5478d-b7l4j 1/1 Running 0 4m25s vpa-alt-recommender-55878867f9-6tp5v 1/1 Running 0 9s

NAME READY STATUS RESTARTS AGE frontend-845d5478d-558zf 1/1 Running 0 4m25s frontend-845d5478d-7z9gx 1/1 Running 0 4m25s frontend-845d5478d-b7l4j 1/1 Running 0 4m25s vpa-alt-recommender-55878867f9-6tp5v 1/1 Running 0 9sCopy to Clipboard Copied! Toggle word wrap Toggle overflow alternative recommender

Deployment오브젝트의 이름이 포함된 VPA CR을 구성합니다.alternative recommender를 포함하는 VPA CR의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.5. Vertical Pod Autoscaler Operator 사용

VPA(Vertical Pod Autoscaler Operator) CR(사용자 정의 리소스)을 생성하여 VPA를 사용할 수 있습니다. CR은 VPA에서 해당 Pod에 수행할 작업을 분석하고 결정해야 하는 Pod를 나타냅니다.

사전 요구 사항

- 자동 스케일링할 워크로드 오브젝트가 있어야 합니다.

- 대체 권장자를 사용하려면 해당 권장자를 포함한 배포가 있어야 합니다.

프로세스

특정 워크로드 오브젝트에 대한 VPA CR을 생성하려면 다음을 수행합니다.

스케일링할 워크로드 오브젝트가 있는 프로젝트로 변경합니다.

VPA CR YAML 파일을 생성합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 이 VPA에서 관리할 워크로드 오브젝트 유형(

Deployment,StatefulSet,Job,DaemonSet,ReplicaSet또는ReplicationController)을 지정합니다. - 2

- 이 VPA에서 관리할 기존 워크로드 오브젝트의 이름을 지정합니다.

- 3

- 다음과 같이 VPA 모드를 지정합니다.

-

auto: 컨트롤러와 연결된 Pod에 권장 리소스를 자동으로 적용합니다. VPA는 기존 Pod를 종료하고 권장 리소스 제한 및 요청을 사용하여 새 Pod를 생성합니다. -

recreate: 워크로드 오브젝트와 연결된 Pod에 권장 리소스를 자동으로 적용합니다. VPA는 기존 Pod를 종료하고 권장 리소스 제한 및 요청을 사용하여 새 Pod를 생성합니다.recreate모드는 리소스 요청이 변경될 때마다 Pod를 재시작해야 하는 경우에만 사용해야 합니다. -

initial: 워크로드 오브젝트와 연결된 Pod가 생성될 때 권장 리소스를 자동으로 적용합니다. VPA는 새 리소스 권장 사항을 확인할 때 Pod를 업데이트하지 않습니다. -

off: 워크로드 오브젝트와 연결된 Pod의 리소스 권장 사항만 생성합니다. VPA는 새 리소스 권장 사항을 확인할 때 Pod를 업데이트하지 않고 해당 권장 사항을 새 Pod에 적용하지도 않습니다.

-

- 4

- 선택 사항: 옵트아웃할 컨테이너를 지정하고 모드를

Off로 설정합니다. - 5

- 선택 사항: alternative recommender를 지정합니다.

VPA CR을 생성합니다.

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 잠시 후 VPA는 워크로드 오브젝트와 연결된 Pod에서 컨테이너의 리소스 사용량을 확인합니다.

다음 명령을 사용하여 VPA 권장 사항을 볼 수 있습니다.

oc get vpa <vpa-name> --output yaml

$ oc get vpa <vpa-name> --output yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력에는 CPU 및 메모리 요청에 대한 권장 사항이 표시되며 다음과 유사합니다.

출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.6. Vertical Pod Autoscaler Operator 설치 제거

OpenShift Container Platform 클러스터에서 VPA(Vertical Pod Autoscaler Operator)를 제거할 수 있습니다. 설치 제거해도 기존 VPA CR에 의해 이미 수정된 Pod의 리소스 요청은 변경되지 않습니다. 새 Pod에서는 모두 Vertical Pod Autoscaler Operator에서 설정한 권장 사항 대신 워크로드 오브젝트에 정의된 리소스를 가져옵니다.

oc delete vpa <vpa-name > 명령을 사용하여 특정 VPA CR을 제거할 수 있습니다. 리소스 요청에는 수직 Pod 자동 스케일러를 설치 제거할 때와 동일한 작업이 적용됩니다.

VPA Operator를 제거한 후 잠재적인 문제를 방지하려면 Operator와 관련된 다른 구성 요소를 제거하는 것이 좋습니다.

사전 요구 사항

- Vertical Pod Autoscaler Operator를 설치해야 합니다.

프로세스

- OpenShift Container Platform 웹 콘솔에서 Operator → 설치된 Operator를 클릭합니다.

- openshift-vertical-pod-autoscaler 프로젝트로 전환합니다.

-

VerticalPodAutoscaler Operator의 경우 옵션 메뉴

를 클릭하고 Operator 설치 제거를 선택합니다.

를 클릭하고 Operator 설치 제거를 선택합니다.

- 선택 사항: Operator와 연결된 모든 피연산자를 제거하려면 대화 상자에서 이 Operator의 모든 피연산자 인스턴스 삭제를 선택합니다.

- 제거를 클릭합니다.

선택 사항: OpenShift CLI를 사용하여 VPA 구성 요소를 제거합니다.

VPA 네임스페이스를 삭제합니다.

oc delete namespace openshift-vertical-pod-autoscaler

$ oc delete namespace openshift-vertical-pod-autoscalerCopy to Clipboard Copied! Toggle word wrap Toggle overflow VPA CRD(사용자 정의 리소스 정의) 오브젝트를 삭제합니다.

oc delete crd verticalpodautoscalercheckpoints.autoscaling.k8s.io

$ oc delete crd verticalpodautoscalercheckpoints.autoscaling.k8s.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete crd verticalpodautoscalercontrollers.autoscaling.openshift.io

$ oc delete crd verticalpodautoscalercontrollers.autoscaling.openshift.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete crd verticalpodautoscalers.autoscaling.k8s.io

$ oc delete crd verticalpodautoscalers.autoscaling.k8s.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow CRD를 삭제하면 연결된 역할, 클러스터 역할 및 역할 바인딩이 제거됩니다.

참고이 작업은 모든 사용자가 생성한 VPA CR 클러스터에서 제거합니다. VPA를 다시 설치하는 경우 이러한 오브젝트를 다시 생성해야 합니다.

다음 명령을 실행하여

MutatingWebhookConfiguration오브젝트를 삭제합니다.oc delete MutatingWebhookConfiguration vpa-webhook-config

$ oc delete MutatingWebhookConfiguration vpa-webhook-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow VPA Operator를 삭제합니다.

oc delete operator/vertical-pod-autoscaler.openshift-vertical-pod-autoscaler

$ oc delete operator/vertical-pod-autoscaler.openshift-vertical-pod-autoscalerCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6. 보안을 사용하여 Pod에 민감한 데이터 제공

일부 애플리케이션에는 개발자에게 제공하길 원하지 않는 민감한 정보(암호 및 사용자 이름 등)가 필요합니다.

관리자는 Secret 오브젝트를 사용하여 이러한 정보를 명확한 텍스트로 공개하지 않고도 제공할 수 있습니다.

2.6.1. 보안 이해

Secret 오브젝트 유형에서는 암호, OpenShift Container Platform 클라이언트 구성 파일, 개인 소스 리포지토리 자격 증명 등과 같은 중요한 정보를 보유하는 메커니즘을 제공합니다. 보안은 Pod에서 중요한 콘텐츠를 분리합니다. 볼륨 플러그인을 사용하여 컨테이너에 보안을 마운트하거나 시스템에서 시크릿을 사용하여 Pod 대신 작업을 수행할 수 있습니다.

주요 속성은 다음과 같습니다.

- 보안 데이터는 정의와는 별도로 참조할 수 있습니다.

- 보안 데이터 볼륨은 임시 파일 저장 기능(tmpfs)에 의해 지원되며 노드에 저장되지 않습니다.

- 보안 데이터는 네임스페이스 내에서 공유할 수 있습니다.

YAML Secret 오브젝트 정의

먼저 보안을 생성한 후 해당 보안을 사용하는 Pod를 생성해야 합니다.

보안 생성 시 다음을 수행합니다.

- 보안 데이터를 사용하여 보안 오브젝트를 생성합니다.

- Pod 서비스 계정을 업데이트하여 보안에 대한 참조를 허용합니다.

-

보안을 환경 변수로 사용하거나

secret볼륨을 사용하여 파일로 사용하는 Pod를 생성합니다.

2.6.1.1. 보안 유형

type 필드의 값은 보안의 키 이름과 값의 구조를 나타냅니다. 유형을 사용하면 보안 오브젝트에 사용자 이름과 키를 적용할 수 있습니다. 검증을 수행하지 않으려면 기본값인 opaque 유형을 사용합니다.

보안 데이터에 특정 키 이름이 있는지 확인하기 위해 서버 측 최소 검증을 트리거하려면 다음 유형 중 하나를 지정합니다.

-

kubernetes.io/basic-auth: 기본 인증으로 사용 -

kubernetes.io/dockercfg: 이미지 풀 시크릿으로 사용 -

kubernetes.io/dockerconfigjson: 이미지 풀 시크릿으로 사용 -

kubernetes.io/service-account-token: 기존 서비스 계정 API 토큰을 얻으려면 사용 -

kubernetes.io/ssh-auth: SSH 키 인증과 함께 사용 -

kubernetes.io/tls: TLS 인증 기관과 함께 사용

검증을 수행하지 않으려면 typ: Opaque를 지정합니다. 즉 보안에서 키 이름 또는 값에 대한 규칙을 준수하도록 요청하지 않습니다. opaque 보안에는 임의의 값을 포함할 수 있는 비정형 key:value 쌍을 사용할 수 있습니다.

example.com/my-secret-type과 같은 다른 임의의 유형을 지정할 수 있습니다. 이러한 유형은 서버 측에 적용되지 않지만 보안 생성자가 해당 유형의 키/값 요구 사항을 준수하도록 의도했음을 나타냅니다.

다양한 유형의 시크릿 생성 예를 보려면 시크릿을 생성하는 방법 이해 를 참조하십시오.

2.6.1.2. 보안 데이터 키

보안키는 DNS 하위 도메인에 있어야 합니다.

2.6.1.3. 자동으로 생성된 이미지 풀 시크릿

기본적으로 OpenShift Container Platform은 각 서비스 계정에 대한 이미지 풀 시크릿을 생성합니다.

OpenShift Container Platform 4.16 이전에는 생성된 각 서비스 계정에 대해 장기 서비스 계정 API 토큰 시크릿도 생성되었습니다. OpenShift Container Platform 4.16부터 이 서비스 계정 API 토큰 시크릿은 더 이상 생성되지 않습니다.

4.16으로 업그레이드한 후 장기 서비스 계정 API 토큰 시크릿은 삭제되지 않으며 계속 작동합니다. 클러스터에서 사용 중인 장기 API 토큰을 감지하거나 필요하지 않은 경우 삭제하는 방법에 대한 자세한 내용은 OpenShift Container Platform의 장기 서비스 계정 API 토큰을 참조하십시오.

이 이미지 풀 시크릿은 OpenShift 이미지 레지스트리를 클러스터의 사용자 인증 및 권한 부여 시스템에 통합하기 위해 필요합니다.

그러나 ImageRegistry 기능을 활성화하지 않거나 Cluster Image Registry Operator 구성에서 통합 OpenShift 이미지 레지스트리를 비활성화하면 각 서비스 계정에 대해 이미지 풀 시크릿이 생성되지 않습니다.

이전에 활성화된 클러스터에서 통합 OpenShift 이미지 레지스트리가 비활성화되면 이전에 생성된 이미지 가져오기 보안이 자동으로 삭제됩니다.

2.6.2. 보안 생성 방법 이해

관리자는 개발자가 해당 보안을 사용하는 Pod를 생성하기 전에 보안을 생성해야 합니다.

보안 생성 시 다음을 수행합니다.

보안을 유지하려는 데이터가 포함된 보안 오브젝트를 생성합니다. 각 보안 유형에 필요한 특정 데이터는 다음 섹션에서 축소됩니다.

불투명 보안을 생성하는 YAML 오브젝트의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 둘 다 아닌

data또는stringdata필드를 사용합니다.Pod의 서비스 계정을 업데이트하여 보안을 참조합니다.

보안을 사용하는 서비스 계정의 YAML

apiVersion: v1 kind: ServiceAccount ... secrets: - name: test-secret

apiVersion: v1 kind: ServiceAccount ... secrets: - name: test-secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow 보안을 환경 변수로 사용하거나

secret볼륨을 사용하여 파일로 사용하는 Pod를 생성합니다.보안 데이터로 볼륨의 파일을 채우는 Pod의 YAML

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 보안 데이터로 환경 변수를 채우는 Pod의 YAML

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 시크릿 키를 사용하는 환경 변수를 지정합니다.

보안 데이터로 환경 변수를 채우는 빌드 구성의 YAML

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 시크릿 키를 사용하는 환경 변수를 지정합니다.

2.6.2.1. 보안 생성 제한 사항

보안을 사용하려면 Pod에서 보안을 참조해야 합니다. 보안은 다음 세 가지 방법으로 Pod에서 사용할 수 있습니다.

- 컨테이너에 환경 변수를 채우기 위해 사용.

- 하나 이상의 컨테이너에 마운트된 볼륨에서 파일로 사용.

- Pod에 대한 이미지를 가져올 때 kubelet으로 사용.

볼륨 유형 보안은 볼륨 메커니즘을 사용하여 데이터를 컨테이너에 파일로 작성합니다. 이미지 가져오기 보안은 서비스 계정을 사용하여 네임스페이스의 모든 Pod에 보안을 자동으로 삽입합니다.

템플릿에 보안 정의가 포함된 경우 템플릿에 제공된 보안을 사용할 수 있는 유일한 방법은 보안 볼륨 소스를 검증하고 지정된 오브젝트 참조가 Secret 오브젝트를 실제로 가리키는 것입니다. 따라서 보안을 생성한 후 해당 보안을 사용하는 Pod를 생성해야 합니다. 가장 효과적인 방법은 서비스 계정을 사용하여 자동으로 삽입되도록 하는 것입니다.

Secret API 오브젝트는 네임스페이스에 있습니다. 동일한 네임스페이스에 있는 Pod만 참조할 수 있습니다.

개별 보안은 1MB로 제한됩니다. 이는 대규모 보안이 생성되어 apiserver 및 kubelet 메모리가 소모되는 것을 막기 위한 것입니다. 그러나 작은 보안을 많이 생성해도 메모리가 소모될 수 있습니다.

2.6.2.2. 불투명 보안 생성

관리자는 임의의 값을 포함할 수 있는 구조화되지 않은 키:값 쌍을 저장할 수 있는 opaque 보안을 생성할 수 있습니다.

프로세스

컨트롤 플레인 노드의 YAML 파일에

Secret오브젝트를 생성합니다.예를 들면 다음과 같습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 불투명 보안을 지정합니다.

다음 명령을 사용하여

Secret오브젝트를 생성합니다.oc create -f <filename>.yaml

$ oc create -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod에서 보안을 사용하려면 다음을 수행합니다.

- "보안을 생성하는 방법 이해" 섹션에 표시된 대로 Pod의 서비스 계정을 업데이트하여 보안을 참조합니다.

-

"보안 생성 방법 이해" 섹션에 표시된 대로

보안을 환경 변수 또는 파일로 사용하는 Pod를 생성합니다.

2.6.2.3. 레거시 서비스 계정 토큰 시크릿 생성

관리자는 레거시 서비스 계정 토큰 시크릿을 생성할 수 있으므로 API에 인증해야 하는 애플리케이션에 서비스 계정 토큰을 배포할 수 있습니다.

기존 서비스 계정 토큰 시크릿을 사용하는 대신 TokenRequest API를 사용하여 바인딩된 서비스 계정 토큰을 가져오는 것이 좋습니다. TokenRequest API를 사용할 수 없고 읽을 수 있는 API 오브젝트에서 만료되지 않은 토큰의 보안 노출이 허용되는 경우에만 서비스 계정 토큰 시크릿을 생성해야 합니다.

바인딩된 서비스 계정 토큰은 다음과 같은 이유로 서비스 계정 토큰 시크릿보다 안전합니다.

- 바인딩된 서비스 계정 토큰은 수명이 바인딩되어 있습니다.

- 바인딩된 서비스 계정 토큰에는 대상자가 포함됩니다.

- 바인딩된 서비스 계정 토큰은 Pod 또는 보안에 바인딩될 수 있으며 바인딩된 오브젝트가 제거되면 바인딩된 토큰이 무효화됩니다.

바인딩된 서비스 계정 토큰을 얻기 위해 예상 볼륨과 함께 워크로드가 자동으로 삽입됩니다. 워크로드에 추가 서비스 계정 토큰이 필요한 경우 워크로드 매니페스트에 예상 볼륨을 추가합니다.

자세한 내용은 "볼륨 프로젝션을 사용하여 바인딩된 서비스 계정 토큰 구성"을 참조하십시오.

프로세스

컨트롤 플레인 노드의 YAML 파일에

Secret오브젝트를 생성합니다.Secret오브젝트의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 사용하여

Secret오브젝트를 생성합니다.oc create -f <filename>.yaml

$ oc create -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod에서 보안을 사용하려면 다음을 수행합니다.

- "보안을 생성하는 방법 이해" 섹션에 표시된 대로 Pod의 서비스 계정을 업데이트하여 보안을 참조합니다.

-

"보안 생성 방법 이해" 섹션에 표시된 대로

보안을 환경 변수 또는 파일로 사용하는 Pod를 생성합니다.

2.6.2.4. 기본 인증 보안 생성

관리자는 기본 인증에 필요한 인증 정보를 저장할 수 있는 기본 인증 보안을 생성할 수 있습니다. 이 보안 유형을 사용하는 경우 Secret 오브젝트의 data 매개변수에는 base64 형식으로 인코딩된 다음 키가 포함되어야 합니다.

-

username: 인증을 위한 사용자 이름 -

암호: 인증을 위한 암호 또는 토큰

stringData 매개변수를 사용하여 일반 텍스트 콘텐츠를 사용할 수 있습니다.

프로세스

컨트롤 플레인 노드의 YAML 파일에

Secret오브젝트를 생성합니다.보안 오브젝트의예Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 사용하여

Secret오브젝트를 생성합니다.oc create -f <filename>.yaml

$ oc create -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod에서 보안을 사용하려면 다음을 수행합니다.

- "보안을 생성하는 방법 이해" 섹션에 표시된 대로 Pod의 서비스 계정을 업데이트하여 보안을 참조합니다.

-

"보안 생성 방법 이해" 섹션에 표시된 대로

보안을 환경 변수 또는 파일로 사용하는 Pod를 생성합니다.

2.6.2.5. SSH 인증 보안 생성

관리자는 SSH 인증에 사용되는 데이터를 저장할 수 있는 SSH 인증 보안을 생성할 수 있습니다. 이 보안 유형을 사용하는 경우 Secret 오브젝트의 data 매개변수에 사용할 SSH 인증 정보가 포함되어야 합니다.

프로세스

컨트롤 플레인 노드의 YAML 파일에

Secret오브젝트를 생성합니다.보안오브젝트의 예:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 사용하여

Secret오브젝트를 생성합니다.oc create -f <filename>.yaml

$ oc create -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod에서 보안을 사용하려면 다음을 수행합니다.

- "보안을 생성하는 방법 이해" 섹션에 표시된 대로 Pod의 서비스 계정을 업데이트하여 보안을 참조합니다.

-

"보안 생성 방법 이해" 섹션에 표시된 대로

보안을 환경 변수 또는 파일로 사용하는 Pod를 생성합니다.

2.6.2.6. Docker 구성 보안 생성

관리자는 컨테이너 이미지 레지스트리에 액세스하기 위한 인증 정보를 저장할 수 있는 Docker 구성 시크릿을 생성할 수 있습니다.

-

kubernetes.io/dockercfg. 로컬 Docker 구성 파일을 저장하려면 이 시크릿 유형을 사용합니다.보안오브젝트의data매개변수에는 base64 형식으로 인코딩된.dockercfg파일의 내용이 포함되어야 합니다. -

kubernetes.io/dockerconfigjson. 이 시크릿 유형을 사용하여 로컬 Docker 구성 JSON 파일을 저장합니다.보안오브젝트의data매개변수에는 base64 형식으로 인코딩된.docker/config.json파일의 내용이 포함되어야 합니다.

프로세스

컨트롤 플레인 노드의 YAML 파일에

Secret오브젝트를 생성합니다.Docker 구성

시크릿오브젝트의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow Docker 구성 JSON

시크릿오브젝트의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 사용하여

Secret오브젝트를 생성합니다.oc create -f <filename>.yaml

$ oc create -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Pod에서 보안을 사용하려면 다음을 수행합니다.

- "보안을 생성하는 방법 이해" 섹션에 표시된 대로 Pod의 서비스 계정을 업데이트하여 보안을 참조합니다.

-

"보안 생성 방법 이해" 섹션에 표시된 대로

보안을 환경 변수 또는 파일로 사용하는 Pod를 생성합니다.

2.6.2.7. 웹 콘솔을 사용하여 보안 생성

웹 콘솔을 사용하여 보안을 생성할 수 있습니다.

프로세스

- 워크로드 → 시크릿으로 이동합니다.

생성 → YAML 을 클릭합니다.

사양에 맞게 YAML을 수동으로 편집하거나 파일을 YAML 편집기로 끌어서 놓습니다. 예를 들면 다음과 같습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- 생성을 클릭합니다.

워크로드에 시크릿 추가를 클릭합니다.

- 드롭다운 메뉴에서 추가할 워크로드를 선택합니다.

- 저장을 클릭합니다.

2.6.3. 보안 업데이트 방법 이해

보안 값을 수정해도 이미 실행 중인 Pod에서 사용하는 값은 동적으로 변경되지 않습니다. 보안을 변경하려면 원래 Pod를 삭제하고 새 Pod를 생성해야 합니다(대개 동일한 PodSpec 사용).

보안 업데이트 작업에서는 새 컨테이너 이미지를 배포하는 것과 동일한 워크플로를 따릅니다. kubectl rolling-update 명령을 사용할 수 있습니다.

보안의 resourceVersion 값은 참조 시 지정되지 않습니다. 따라서 Pod가 시작되는 동시에 보안이 업데이트되는 경우 Pod에 사용되는 보안의 버전이 정의되지 않습니다.

현재는 Pod가 생성될 때 사용된 보안 오브젝트의 리소스 버전을 확인할 수 없습니다. 컨트롤러에서 이전 resourceVersion 을 사용하여 재시작할 수 있도록 Pod에서 이 정보를 보고하도록 계획되어 있습니다. 그동안 기존 보안 데이터를 업데이트하지 말고 고유한 이름으로 새 보안을 생성하십시오.

2.6.4. 보안 생성 및 사용

관리자는 서비스 계정 토큰 시크릿을 생성할 수 있습니다. 이를 통해 API에 인증해야 하는 애플리케이션에 서비스 계정 토큰을 배포할 수 있습니다.

프로세스

다음 명령을 실행하여 네임스페이스에 서비스 계정을 생성합니다.

oc create sa <service_account_name> -n <your_namespace>

$ oc create sa <service_account_name> -n <your_namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 YAML 예제를

service-account-token-secret.yaml이라는 파일에 저장합니다. 예제에는 서비스 계정 토큰을 생성하는 데 사용할 수 있는Secret오브젝트 구성이 포함되어 있습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 파일을 적용하여 서비스 계정 토큰을 생성합니다.

oc apply -f service-account-token-secret.yaml

$ oc apply -f service-account-token-secret.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 시크릿에서 서비스 계정 토큰을 가져옵니다.

oc get secret <sa_token_secret> -o jsonpath='{.data.token}' | base64 --decode$ oc get secret <sa_token_secret> -o jsonpath='{.data.token}' | base64 --decode1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

ayJhbGciOiJSUzI1NiIsImtpZCI6IklOb2dtck1qZ3hCSWpoNnh5YnZhSE9QMkk3YnRZMVZoclFfQTZfRFp1YlUifQ.eyJpc3MiOiJrdWJlcm5ldGVzL3NlcnZpY2VhY2NvdW50Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9uYW1lc3BhY2UiOiJkZWZhdWx0Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9zZWNyZXQubmFtZSI6ImJ1aWxkZXItdG9rZW4tdHZrbnIiLCJrdWJlcm5ldGVzLmlvL3NlcnZpY2VhY2NvdW50L3NlcnZpY2UtYWNjb3VudC5uYW1lIjoiYnVpbGRlciIsImt1YmVybmV0ZXMuaW8vc2VydmljZWFjY291bnQvc2VydmljZS1hY2NvdW50LnVpZCI6IjNmZGU2MGZmLTA1NGYtNDkyZi04YzhjLTNlZjE0NDk3MmFmNyIsInN1YiI6InN5c3RlbTpzZXJ2aWNlYWNjb3VudDpkZWZhdWx0OmJ1aWxkZXIifQ.OmqFTDuMHC_lYvvEUrjr1x453hlEEHYcxS9VKSzmRkP1SiVZWPNPkTWlfNRp6bIUZD3U6aN3N7dMSN0eI5hu36xPgpKTdvuckKLTCnelMx6cxOdAbrcw1mCmOClNscwjS1KO1kzMtYnnq8rXHiMJELsNlhnRyyIXRTtNBsy4t64T3283s3SLsancyx0gy0ujx-Ch3uKAKdZi5iT-I8jnnQ-ds5THDs2h65RJhgglQEmSxpHrLGZFmyHAQI-_SjvmHZPXEc482x3SkaQHNLqpmrpJorNqh1M8ZHKzlujhZgVooMvJmWPXTb2vnvi3DGn2XI-hZxl1yD2yGH1RBpYUHA

ayJhbGciOiJSUzI1NiIsImtpZCI6IklOb2dtck1qZ3hCSWpoNnh5YnZhSE9QMkk3YnRZMVZoclFfQTZfRFp1YlUifQ.eyJpc3MiOiJrdWJlcm5ldGVzL3NlcnZpY2VhY2NvdW50Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9uYW1lc3BhY2UiOiJkZWZhdWx0Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9zZWNyZXQubmFtZSI6ImJ1aWxkZXItdG9rZW4tdHZrbnIiLCJrdWJlcm5ldGVzLmlvL3NlcnZpY2VhY2NvdW50L3NlcnZpY2UtYWNjb3VudC5uYW1lIjoiYnVpbGRlciIsImt1YmVybmV0ZXMuaW8vc2VydmljZWFjY291bnQvc2VydmljZS1hY2NvdW50LnVpZCI6IjNmZGU2MGZmLTA1NGYtNDkyZi04YzhjLTNlZjE0NDk3MmFmNyIsInN1YiI6InN5c3RlbTpzZXJ2aWNlYWNjb3VudDpkZWZhdWx0OmJ1aWxkZXIifQ.OmqFTDuMHC_lYvvEUrjr1x453hlEEHYcxS9VKSzmRkP1SiVZWPNPkTWlfNRp6bIUZD3U6aN3N7dMSN0eI5hu36xPgpKTdvuckKLTCnelMx6cxOdAbrcw1mCmOClNscwjS1KO1kzMtYnnq8rXHiMJELsNlhnRyyIXRTtNBsy4t64T3283s3SLsancyx0gy0ujx-Ch3uKAKdZi5iT-I8jnnQ-ds5THDs2h65RJhgglQEmSxpHrLGZFmyHAQI-_SjvmHZPXEc482x3SkaQHNLqpmrpJorNqh1M8ZHKzlujhZgVooMvJmWPXTb2vnvi3DGn2XI-hZxl1yD2yGH1RBpYUHACopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- <sa_token_secret>을 서비스 토큰 시크릿의 이름으로 바꿉니다.

서비스 계정 토큰을 사용하여 클러스터의 API로 인증합니다.

curl -X GET <openshift_cluster_api> --header "Authorization: Bearer <token>"

$ curl -X GET <openshift_cluster_api> --header "Authorization: Bearer <token>"1 2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6.5. 보안이 포함된 서명된 인증서 사용 정보

서비스에 대한 통신을 보호하려면 프로젝트의 보안에 추가할 수 있는 서명된 제공 인증서/키 쌍을 생성하도록 OpenShift Container Platform을 구성하면 됩니다.

서비스 제공 인증서 보안은 즉시 사용 가능한 인증서가 필요한 복잡한 미들웨어 애플리케이션을 지원하기 위한 것입니다. 해당 설정은 관리자 툴에서 노드 및 마스터에 대해 생성하는 서버 인증서와 동일합니다.

서비스 Pod 사양은 서비스 제공 인증서 보안에 대해 구성됩니다.

- 1

- 인증서 이름을 지정합니다.

기타 Pod는 해당 Pod에 자동으로 마운트되는 /var/run/secrets/kubernetes.io/serviceaccount/service-ca.crt 파일의 CA 번들을 사용하여 내부 DNS 이름에만 서명되는 클러스터 생성 인증서를 신뢰할 수 있습니다.

이 기능의 서명 알고리즘은 x509.SHA256WithRSA입니다. 직접 교대하려면 생성된 보안을 삭제합니다. 새 인증서가 생성됩니다.

2.6.5.1. 보안과 함께 사용할 서명된 인증서 생성

Pod에서 서명된 제공 인증서/키 쌍을 사용하려면 서비스를 생성하거나 편집하여 service.beta.openshift.io/serving-cert-secret-name 주석을 추가한 다음 Pod에 보안을 추가합니다.

프로세스

서비스 제공 인증서 보안을 생성하려면 다음을 수행합니다.

-

서비스에 대한

Pod사양을 편집합니다. 보안에 사용할 이름과 함께

service.beta.openshift.io/serving-cert-secret-name주석을 추가합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 인증서 및 키는 PEM 형식이며 각각

tls.crt및tls.key에 저장됩니다.서비스를 생성합니다.

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 보안이 생성되었는지 확인합니다.

모든 보안 목록을 확인합니다.

oc get secrets

$ oc get secretsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME TYPE DATA AGE my-cert kubernetes.io/tls 2 9m

NAME TYPE DATA AGE my-cert kubernetes.io/tls 2 9mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 보안에 대한 세부 정보를 확인합니다.

oc describe secret my-cert

$ oc describe secret my-certCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

해당 보안을 사용하여

Pod사양을 편집합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 사용 가능한 경우 Pod가 실행됩니다. 인증서는 내부 서비스 DNS 이름인

<service.name>.<service.namespace>.svc에 적합합니다.인증서/키 쌍은 만료 시기가 다가오면 자동으로 교체됩니다. 시크릿의

service.beta.openshift.io/expiry주석에서 RFC3339 형식으로 된 만료 날짜를 확인합니다.참고대부분의 경우 서비스 DNS 이름

<service.name>.<service.namespace>.svc는 외부에서 라우팅할 수 없습니다.<service.name>.<service.namespace>.svc는 주로 클러스터 내 또는 서비스 내 통신과 경로 재암호화에 사용됩니다.

2.6.6. 보안 문제 해결

서비스 인증서 생성에 실패하는 경우(서비스의 service.beta.openshift.io/serving-cert-generation-error 주석에는 다음이 포함됩니다.

secret/ssl-key references serviceUID 62ad25ca-d703-11e6-9d6f-0e9c0057b608, which does not match 77b6dd80-d716-11e6-9d6f-0e9c0057b60

secret/ssl-key references serviceUID 62ad25ca-d703-11e6-9d6f-0e9c0057b608, which does not match 77b6dd80-d716-11e6-9d6f-0e9c0057b60

인증서를 생성한 서비스가 더 이상 존재하지 않거나 serviceUID가 다릅니다. 이전 보안을 제거하고 서비스 service.beta.openshift.io/serving-cert-generation-error , 주석을 지워 인증서를 강제로 다시 생성해야 합니다.

service.beta.openshift.io/serving-cert-generation-error -num

보안을 삭제합니다.

oc delete secret <secret_name>

$ oc delete secret <secret_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 주석을 지웁니다.

oc annotate service <service_name> service.beta.openshift.io/serving-cert-generation-error-

$ oc annotate service <service_name> service.beta.openshift.io/serving-cert-generation-error-Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc annotate service <service_name> service.beta.openshift.io/serving-cert-generation-error-num-

$ oc annotate service <service_name> service.beta.openshift.io/serving-cert-generation-error-num-Copy to Clipboard Copied! Toggle word wrap Toggle overflow

주석을 제거하는 명령에는 제거할 주석 이름 뒤에 -가 있습니다.

2.7. 외부 시크릿 저장소를 사용하여 Pod에 민감한 데이터 제공

일부 애플리케이션에는 개발자에게 제공하길 원하지 않는 민감한 정보(암호 및 사용자 이름 등)가 필요합니다.

중요한 정보를 제공하기 위해 Kubernetes Secret 오브젝트를 사용하는 대신 외부 시크릿 저장소를 사용하여 중요한 정보를 저장할 수 있습니다. Secrets Store CSI Driver Operator를 사용하여 외부 시크릿 저장소와 통합하고 보안 콘텐츠를 Pod 볼륨으로 마운트할 수 있습니다.

Secrets Store CSI Driver Operator는 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 기술 프리뷰 기능 지원 범위를 참조하십시오.

2.7.1. Secrets Store CSI Driver Operator 정보

Kubernetes 시크릿은 Base64 인코딩으로 저장됩니다. etcd는 이러한 시크릿을 위해 미사용 암호화를 제공하지만 시크릿이 검색되면 암호 해독되어 사용자에게 제공됩니다. 클러스터에서 역할 기반 액세스 제어가 제대로 구성되지 않은 경우 API 또는 etcd 액세스 권한이 있는 모든 사용자가 시크릿을 검색하거나 수정할 수 있습니다. 또한 네임스페이스에서 Pod를 생성할 권한이 있는 사용자는 해당 액세스 권한을 사용하여 해당 네임스페이스의 보안을 읽을 수 있습니다.

보안을 안전하게 저장하고 관리하려면 공급자 플러그인을 사용하여 OpenShift Container Platform Store Container Storage Interface (CSI) Driver Operator를 구성하여 Azure Key Vault와 같은 외부 시크릿 관리 시스템에서 시크릿을 마운트할 수 있습니다. 그러면 애플리케이션에서 시크릿을 사용할 수 있지만 애플리케이션 pod를 삭제한 후에는 시스템에서 시크릿이 유지되지 않습니다.

Secrets Store CSI Driver Operator, secrets-store.csi.k8s.io 를 사용하면 OpenShift Container Platform에서 엔터프라이즈급 외부 시크릿 저장소에 저장된 여러 시크릿, 키 및 인증서를 볼륨으로 마운트할 수 있습니다. Secrets Store CSI Driver Operator는 gRPC를 사용하여 공급자와 통신하여 지정된 외부 시크릿 저장소에서 마운트 콘텐츠를 가져옵니다. 볼륨이 연결되면 해당 데이터가 컨테이너의 파일 시스템에 마운트됩니다. 시크릿 저장소 볼륨은 인라인으로 마운트됩니다.

2.7.1.1. 보안 저장소 공급자

Secrets Store CSI Driver Operator와 함께 다음 보안 저장소 공급자를 사용할 수 있습니다.

- AWS Secrets Manager

- AWS Systems Manager 매개변수 저장소

- Azure Key Vault

- HashiCorp Vault

2.7.1.2. 자동 교체

Secrets Store CSI 드라이버는 마운트된 볼륨의 콘텐츠를 외부 시크릿 저장소의 콘텐츠로 주기적으로 순환합니다. 외부 시크릿 저장소에서 보안이 업데이트되면 마운트된 볼륨에서 보안이 업데이트됩니다. Secrets Store CSI Driver Operator는 2분마다 업데이트를 폴링합니다.

마운트된 콘텐츠의 동기화를 Kubernetes 시크릿으로 활성화한 경우 Kubernetes 시크릿도 순환됩니다.

시크릿 데이터를 사용하는 애플리케이션은 시크릿 업데이트를 감시해야 합니다.

2.7.2. Secrets Store CSI 드라이버 설치

사전 요구 사항

- OpenShift Container Platform 웹 콘솔에 액세스합니다.

- 클러스터에 대한 관리자 액세스 권한

프로세스

Secrets Store CSI 드라이버를 설치하려면 다음을 수행합니다.

Secrets Store CSI Driver Operator를 설치합니다.

- 웹 콘솔에 로그인합니다.

- Operators → OperatorHub를 클릭합니다.

- 필터 상자에 "Secrets Store CSI"를 입력하여 Secrets Store CSI 드라이버 Operator를 찾습니다.

- Secrets Store CSI Driver Operator 버튼을 클릭합니다.