지원

OpenShift Container Platform 지원 요청

초록

1장. 지원 개요

Red Hat은 클러스터, 모니터링 및 문제 해결을 위한 클러스터 관리자 툴을 제공합니다.

1.1. 지원 받기

지원 받기: Red Hat 고객 포털을 방문하여 지식 베이스 문서를 검토하고, 지원 케이스를 제출하고, 추가 제품 설명서 및 리소스를 검토하십시오.

1.2. HO원격 상태 모니터링 문제

원격 상태 모니터링 문제: OpenShift Container Platform은 클러스터에 대한 Telemetry 및 구성 데이터를 수집하여 Telemeter Client 및 Insights Operator를 사용하여 Red Hat에 보고합니다. Red Hat은 이 데이터를 사용하여 연결된 클러스터 의 문제를 이해하고 해결합니다. 연결된 클러스터와 유사하게 제한된 네트워크에서 원격 상태 모니터링을 사용할 수 있습니다. OpenShift Container Platform은 다음을 사용하여 데이터를 수집하고 상태를 모니터링합니다.

Telemetry: Telemetry 클라이언트는 4분 30초마다 지표 값을 수집하여 Red Hat에 업로드합니다. Red Hat은 이 데이터를 사용하여 다음을 수행합니다.

- 클러스터를 모니터링합니다.

- OpenShift Container Platform 업그레이드를 롤아웃합니다.

- 업그레이드 환경을 개선합니다.

Insights Operator: 기본적으로 OpenShift Container Platform은 2시간마다 구성 및 구성 요소 실패 상태를 보고하는 Insights Operator를 설치하고 활성화합니다. Insights Operator는 다음을 지원합니다.

- 잠재적인 클러스터 문제를 사전에 파악합니다.

- Red Hat OpenShift Cluster Manager에서 솔루션 및 예방 조치를 제공합니다.

Telemetry 정보를 검토 할 수 있습니다.

원격 상태 보고를 활성화한 경우 Insights를 사용하여 클러스터 문제를 식별합니다. 선택적으로 원격 상태 보고를 비활성화할 수 있습니다.

1.3. 클러스터에 대한 데이터 수집

클러스터에 대한 데이터 수집: 지원 케이스를 열 때 디버깅 정보를 수집할 것을 권장합니다. 이를 통해 Red Hat 지원은 근본 원인 분석을 수행할 수 있습니다. 클러스터 관리자는 다음을 사용하여 클러스터에 대한 데이터를 수집할 수 있습니다.

-

must-gather 툴:

must-gather툴을 사용하여 클러스터에 대한 정보를 수집하고 문제를 디버깅합니다. -

sosreport: 디버깅을 위해

sosreport툴을 사용하여 구성 세부 정보, 시스템 정보 및 진단 데이터를 수집합니다. - 클러스터 ID: Red Hat 지원에 정보를 제공할 때 클러스터의 고유 식별자를 가져옵니다.

-

부트스트랩 노드 저널 로그: 부트 스트랩 노드에서

bootkube.servicejournald장치 로그 및 컨테이너 로그를 수집하여 부트스트랩 관련 문제를 해결합니다. -

클러스터 노드 저널 로그: 노드 관련 문제를 해결하기 위해 개별 클러스터 노드의

/var/log내에 있는journald장치 로그 및 로그입니다. - 네트워크 추적: 특정 OpenShift Container Platform 클러스터 노드 또는 컨테이너에서 Red Hat 지원으로 네트워크 패킷 추적을 제공하여 네트워크 관련 문제를 해결합니다.

-

진단 데이터:

redhat-support-tool명령을 사용하여 클러스터에 대한 진단 데이터를 수집합니다.

1.4. 문제 해결

클러스터 관리자는 다음 OpenShift Container Platform 구성 요소 문제를 모니터링하고 해결할 수 있습니다.

설치 문제: OpenShift Container Platform 설치는 다양한 단계로 진행됩니다. 다음을 수행할 수 있습니다.

- 설치 단계를 모니터링합니다.

- 어떤 단계에서 설치 문제가 발생하는지 확인합니다.

- 여러 설치 문제를 조사합니다.

- 실패한 설치에서 로그를 수집합니다.

노드 문제: 클러스터 관리자는 노드의 상태, 리소스 사용량 및 구성을 검토하여 노드 관련 문제를 확인하고 해결할 수 있습니다. 다음을 쿼리할 수 있습니다.

- 노드의 kubelet 상태입니다.

- 클러스터 노드 저널 로그입니다.

crio 문제: 클러스터 관리자는 각 클러스터 노드에서 CRI-O 컨테이너 런타임 엔진 상태를 확인할 수 있습니다. 컨테이너 런타임 문제가 발생하는 경우 다음을 수행합니다.

- CRI-O journald 장치 로그를 수집합니다.

- CRI-O 스토리지 정리.

운영 체제 문제: OpenShift Container Platform은 Red Hat Enterprise Linux CoreOS에서 실행됩니다. 운영 체제 문제가 발생하는 경우 커널 충돌 절차를 조사할 수 있습니다. 다음을 확인하십시오.

- kdump를 활성화합니다.

- kdump 설정을 테스트합니다.

- 코어 덤프를 분석합니다.

네트워크 문제: Open vSwitch 문제를 해결하기 위해 클러스터 관리자는 다음을 수행할 수 있습니다.

- Open vSwitch 로그 수준을 일시적으로 구성합니다.

- Open vSwitch 로그 수준을 영구적으로 구성합니다.

- Open vSwitch 로그를 표시합니다.

Operator 문제: 클러스터 관리자는 다음을 수행하여 Operator 문제를 해결할 수 있습니다.

- Operator 서브스크립션 상태를 확인합니다.

- Operator Pod 상태를 확인합니다.

- Operator 로그를 수집합니다.

Pod 문제: 클러스터 관리자는 Pod 상태를 검토하고 다음을 완료하여 Pod 관련 문제를 해결할 수 있습니다.

- Pod 및 컨테이너 로그를 검토합니다.

- root 액세스 권한으로 디버그 Pod를 시작합니다.

S2I 프로세스에서 오류가 발생한 위치를 확인하기 위해 클러스터 관리자는 S2I 단계를 관찰할 수 있습니다. 다음을 수집하여 S2I(Source-to-Image) 문제를 해결합니다.

- S2I(Source-to-Image) 진단 데이터입니다.

- 애플리케이션 오류를 조사하기 위한 애플리케이션 진단 데이터입니다.

스토리지 문제: 실패한 노드가 연결된 볼륨을 마운트 해제할 수 없기 때문에 새 노드의 마운트 볼륨이 불가능한 경우 다중 연결 스토리지 오류가 발생합니다. 클러스터 관리자는 다음을 수행하여 다중 연결 스토리지 문제를 해결할 수 있습니다.

- RWX 볼륨을 사용하여 여러 연결을 활성화합니다.

- RWO 볼륨을 사용할 때 오류가 발생한 노드를 복구하거나 삭제합니다.

모니터링 문제: 클러스터 관리자는 모니터링을 위해 문제 해결 페이지의 절차를 따를 수 있습니다. 사용자 정의 프로젝트의 지표를 사용할 수 없거나 Prometheus가 많은 디스크 공간을 사용하는 경우 다음을 확인하십시오.

- 사용자 정의 메트릭을 사용할 수 없는 이유를 조사합니다.

- Prometheus가 많은 디스크 공간을 소비하는 이유를 확인합니다.

로깅 문제: 클러스터 관리자는 "지원" 및 "Troubleshooting logging" 섹션의 절차를 따라 로깅 문제를 해결할 수 있습니다.

-

OpenShift CLI(

oc) 문제: 로그 수준을 늘려 OpenShift CLI(oc) 문제 조사

2장. 클러스터 리소스 관리

OpenShift Container Platform에서 글로벌 구성 옵션을 적용할 수 있습니다. Operator는 이러한 구성 설정을 클러스터 전체에 적용합니다.

2.1. 클러스터 리소스와 상호 작용

OpenShift Container Platform에서 OpenShift CLI(oc) 툴을 사용하여 클러스터 리소스와 상호 작용할 수 있습니다. oc api-resources 명령을 실행한 후 표시되는 클러스터 리소스를 편집할 수 있습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다. -

웹 콘솔에 액세스하거나

ocCLI 툴을 설치했습니다.

프로세스

적용된 구성 Operator를 보려면 다음 명령을 실행합니다.

oc api-resources -o name | grep config.openshift.io

$ oc api-resources -o name | grep config.openshift.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 구성할 수 있는 클러스터 리소스를 보려면 다음 명령을 실행합니다.

oc explain <resource_name>.config.openshift.io

$ oc explain <resource_name>.config.openshift.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 클러스터에서 CRD(사용자 정의 리소스 정의) 오브젝트의 구성을 보려면 다음 명령을 실행합니다.

oc get <resource_name>.config -o yaml

$ oc get <resource_name>.config -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 클러스터 리소스 구성을 편집하려면 다음 명령을 실행합니다.

oc edit <resource_name>.config -o yaml

$ oc edit <resource_name>.config -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3장. 지원 요청

3.1. 지원 요청

이 문서에 설명된 절차 또는 일반적으로 OpenShift Container Platform에 문제가 발생하는 경우 Red Hat 고객 포털에 액세스하십시오.

고객 포털에서 다음을 수행할 수 있습니다.

- Red Hat 제품과 관련된 기사 및 솔루션에 대한 Red Hat 지식베이스를 검색하거나 살펴볼 수 있습니다.

- Red Hat 지원에 대한 지원 케이스 제출할 수 있습니다.

- 다른 제품 설명서에 액세스 가능합니다.

클러스터 문제를 식별하기 위해 OpenShift Cluster Manager 에서 Insights를 사용할 수 있습니다. Insights는 문제에 대한 세부 정보 및 문제 해결 방법에 대한 정보를 제공합니다.

이 문서를 개선하기 위한 제안이 있거나 오류를 발견한 경우 가장 관련 문서 구성 요소에 대해 Jira 문제를 제출합니다. 섹션 이름 및 OpenShift Container Platform 버전과 같은 구체적인 정보를 제공합니다.

3.2. Red Hat 지식베이스 정보

Red Hat 지식베이스는 Red Hat의 제품과 기술을 최대한 활용할 수 있도록 풍부한 콘텐츠를 제공합니다. Red Hat 지식베이스는 Red Hat 제품 설치, 설정 및 사용에 대한 기사, 제품 문서 및 동영상으로 구성되어 있습니다. 또한 알려진 문제에 대한 솔루션을 검색할 수 있으며, 간결한 근본 원인 설명 및 해결 단계를 제공합니다.

3.3. Red Hat 지식베이스 검색

OpenShift Container Platform 문제가 발생한 경우 초기 검색을 수행하여 솔루션이 이미 Red Hat Knowledgebase 내에 존재하는지 확인할 수 있습니다.

사전 요구 사항

- Red Hat 고객 포털 계정이 있어야 합니다.

프로세스

- Red Hat 고객 포털에 로그인합니다.

- Search를 클릭합니다

검색 필드에서 다음을 포함하여 문제와 관련된 키워드 및 문자열을 입력합니다.

- OpenShift Container Platform 구성 요소 (etcd 등)

- 관련 절차 (예: installation 등)

- 명시적 실패와 관련된 경고, 오류 메시지 및 기타 출력

- Enter 키를 클릭합니다.

- 선택 사항: OpenShift Container Platform 제품 필터를 선택합니다.

- 선택 사항: 문서 콘텐츠 유형 필터를 선택합니다.

3.4. 지원 케이스 제출

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다. -

OpenShift CLI(

oc)가 설치되어 있습니다. - Red Hat 고객 포털 계정이 있어야 합니다.

- Red Hat Standard 또는 Premium 서브스크립션이 있어야 합니다.

프로세스

- Red Hat 고객 포털의 고객 지원 페이지에 로그인합니다.

- 지원 받기를 클릭합니다.

고객 지원 페이지의 케이스 탭에서 다음을 수행합니다.

- 선택 사항: 필요한 경우 미리 채워진 계정 및 소유자 세부 정보를 변경합니다.

- Bug 또는 Defect 와 같은 문제에 대한 적절한 카테고리를 선택하고 Continue 를 클릭합니다.

다음 정보를 입력합니다.

- 요약 필드에 간결하지만 설명적인 문제 요약을 입력하고 경험되는 증상에 대한 자세한 내용과 기대치를 입력합니다.

- 제품 드롭다운 메뉴에서 OpenShift Container Platform 을 선택합니다.

- 버전 드롭다운에서 4.16 을 선택합니다.

- 보고되는 문제와 관련이 있을 수 있는 권장 Red Hat 지식베이스 솔루션 목록을 확인합니다. 제안된 문서로 문제가 해결되지 않으면 Continue을 클릭합니다.

- 보고되는 문제와 관련있는 제안된 Red Hat 지식베이스 솔루션 목록을 확인하십시오. 케이스 작성 과정에서 더 많은 정보를 제공하면 목록이 구체화됩니다. 제안된 문서로 문제가 해결되지 않으면 Continue을 클릭합니다.

- 제시된 계정 정보가 정확한지 확인하고 필요한 경우 적절하게 수정합니다.

자동 입력된 OpenShift Container Platform 클러스터 ID가 올바른지 확인합니다. 그렇지 않은 경우 클러스터 ID를 수동으로 가져옵니다.

OpenShift Container Platform 웹 콘솔을 사용하여 클러스터 ID를 수동으로 가져오려면 다음을 수행합니다.

- 홈 → 개요 로 이동합니다.

- Details 섹션의 Cluster ID 필드에서 값을 찾습니다.

또는 OpenShift Container Platform 웹 콘솔을 통해 새 지원 케이스를 열고 클러스터 ID를 자동으로 입력할 수 있습니다.

- 툴바에서 (?) Help → Open Support Case로 이동합니다.

- Cluster ID 값이 자동으로 입력됩니다.

OpenShift CLI (

oc)를 사용하여 클러스터 ID를 얻으려면 다음 명령을 실행합니다.oc get clusterversion -o jsonpath='{.items[].spec.clusterID}{"\n"}'$ oc get clusterversion -o jsonpath='{.items[].spec.clusterID}{"\n"}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

프롬프트가 표시되면 다음 질문을 입력한 후 Continue를 클릭합니다.

- 무엇을 경험하고 있습니까? 어떤 일이 발생할 것으로 예상하십니까?

- 귀하 또는 비즈니스에 미치는 영향 또는 가치를 정의합니다.

- 이 동작을 어디에서 경험하고 있습니까? 어떤 시스템 환경을 사용하고 있습니까?

- 이 동작이 언제 발생합니까? 발생 빈도는 어떻게 됩니까? 반복적으로 발생합니까? 특정 시간에만 발생합니까?

-

관련 진단 데이터 파일을 업로드하고 Continue를 클릭합니다.

oc adm must-gather명령을 사용하여 수집된 데이터와 해당 명령으로 수집되지 않은 특정 문제와 관련된 데이터를 제공하는 것이 좋습니다 - 관련 케이스 관리 세부 정보를 입력하고 Continue를 클릭합니다.

- 케이스 세부 정보를 미리보고 Submit을 클릭합니다.

4장. 클러스터에 연결하여 원격 상태 모니터링

4.1. 원격 상태 모니터링 정보

OpenShift Container Platform은 클러스터에 대한 Telemetry 및 구성 데이터를 수집하고 Telemeter Client 및 Insights Operator를 사용하여 Red Hat에 보고합니다. Red Hat에 제공되는 데이터는 이 문서에 설명된 장점을 사용할 수 있습니다.

Telemetry 및 Insights Operator를 통해 Red Hat에 데이터를 보고하는 클러스터는 연결 클러스터(connected cluster)라고 합니다.

Telemetry는 OpenShift Container Platform Telemeter Client에서 Red Hat으로 전송되는 정보를 설명하는 데 사용하는 용어입니다. 경량 속성은 연결된 클러스터에서 Red Hat으로 전송되어 서브스크립션 관리 자동화를 활성화하고, 클러스터의 상태를 모니터링하며, 지원 및 고객 환경을 개선합니다.

Insights Operator는 OpenShift Container Platform 구성 데이터를 수집하여 Red Hat으로 전송합니다. 데이터는 클러스터가 노출될 수 있는 문제에 대한 통찰력을 생성하는 데 사용됩니다. 이러한 통찰력은 OpenShift Cluster Manager 에서 클러스터 관리자에게 전달됩니다.

이 두 프로세스에 대한 자세한 내용은 이 문서에 기재되어 있습니다.

Telemetry 및 Insights Operator의 이점

Telemetry 및 Insights Operator는 최종 사용자에게 다음과 같은 이점을 제공합니다.

- 문제 확인 및 해결 방법을 강화 Red Hat은 최종 사용자에 정상적으로 표시될 수 있는 이벤트를 클러스터 단위로 보다 광범위한 관점에서 확인할 수 있습니다. 일부 문제는 이러한 관점에서 보다 신속하게 확인하고 Jira 문제를 열거나 지원 케이스를 열 필요없이 최종 사용자가 해결 할 수 있습니다.

-

고급 릴리스 관리 OpenShift Container Platform은

candidate,fast,stable릴리스 채널을 제공하므로 이를 통해 업데이트 전략을 선택할 수 있습니다. 릴리스를fast버전에서stable버전으로 업그레이드하는 것은 업데이트의 성공률 및 업그레이드 중에 발생하는 이벤트에 따라 달라집니다. 연결된 클러스터에서 제공하는 정보를 통해 Red Hat은 릴리스 품질을stable채널로 개선하고fast채널에 있는 문제에 신속하게 대응할 수 있습니다. - 새로운 기능 및 기능의 우선 순위를 지정 수집된 데이터는 OpenShift Container Platform의 가장 많이 사용되는 영역에 대한 정보를 제공합니다. 이러한 정보를 통해 Red Hat은 고객에게 가장 큰 영향을 미치는 새로운 기능 및 기능을 개발하는 데 중점을 둘 수 있습니다.

- 간소화된 지원 환경 제공 Red Hat 고객 포털에서 지원 티켓을 생성할 때 연결된 클러스터의 클러스터 ID를 지정할 수 있습니다. 이를 통해 Red Hat은 연결된 정보를 사용하여 클러스터 고유의 간소화된 지원 환경을 제공할 수 있습니다. 이 문서에서는 향상된 지원 환경에 대한 자세한 정보를 제공합니다.

- 예측 분석 OpenShift Cluster Manager 의 클러스터에 대해 표시되는 Insights는 연결된 클러스터에서 수집한 정보로 활성화됩니다. Red Hat은 OpenShift Container Platform 클러스터가 노출되는 문제를 식별하는 데 도움이 되도록 딥 러닝, 머신 러닝, 인공지능 자동화에 중점을 두고 있습니다.

4.1.1. Telemetry 정보

Telemetry는 엄선된 클러스터 모니터링 지표의 일부를 Red Hat으로 보냅니다. Telemeter Client는 4분 30초마다 메트릭 값을 가져와 Red Hat에 데이터를 업로드합니다. 이러한 메트릭에 대한 설명은 이 설명서에서 제공됩니다.

Red Hat은 이러한 데이터 스트림을 사용하여 클러스터를 실시간으로 모니터링하고 필요에 따라 고객에게 영향을 미치는 문제에 대응합니다. 또한 Red Hat은 OpenShift Container Platform 업그레이드를 고객에게 제공하여 서비스 영향을 최소화하고 지속적으로 업그레이드 환경을 개선할 수 있습니다.

이러한 디버깅 정보는 Red Hat 지원 및 엔지니어링 팀에 제공되며, 지원 사례를 통해 보고된 데이터에 액세스하는 것과 동일한 제한 사항이 적용됩니다. Red Hat은 연결된 모든 클러스터 정보를 사용하여 OpenShift Container Platform을 개선하고 사용 편의성을 높입니다.

4.1.1.1. Telemetry에서 수집하는 정보

Telemetry에서 수집되는 정보는 다음과 같습니다.

4.1.1.1.1. 시스템 정보

- OpenShift Container Platform 클러스터 버전 및 업데이트 버전 가용성 확인에 사용되는 업데이트 세부 정보와 같은 버전 정보

- 클러스터당 사용 가능한 업데이트 수, 업데이트 진행 정보, 업데이트 진행 정보에 사용되는 채널 및 이미지 리포지터리, 업데이트에 발생하는 오류 수를 포함한 업데이트 정보

- 설치 중 생성된 임의의 고유 식별자

- Red Hat 지원이 클라우드 인프라 수준, 호스트 이름, IP 주소, Kubernetes Pod 이름, 네임스페이스 및 서비스의 노드 구성을 포함하여 고객에게 유용한 지원을 제공하는 데 도움이 되는 구성 세부 정보

- 클러스터 및 해당 조건 및 상태에 설치된 OpenShift Container Platform 프레임워크 구성 요소

- 성능이 저하된 Operator에 대해 "관련 개체"로 나열된 모든 네임스페이스에 대한 이벤트

- 성능 저하 소프트웨어에 대한 정보

- 인증서의 유효성에 대한 정보

- OpenShift Container Platform이 배포된 공급자 플랫폼의 이름 및 데이터 센터 위치

4.1.1.1.2. 크기 조정 정보

- CPU 코어 수 및 각각에 사용된 RAM 용량을 포함한 클러스터, 시스템 유형 및 머신 크기에 대한 정보

- etcd 멤버 수 및 etcd 클러스터에 저장된 오브젝트 수

- 빌드 전략 유형별 애플리케이션 빌드 수

4.1.1.1.3. 사용 정보

- 구성 요소, 기능 및 확장에 대한 사용 정보

- 기술 프리뷰 및 지원되지 않는 구성에 대한 사용량 세부 정보

Telemetry에서는 사용자 이름 또는 암호와 같은 식별 정보를 수집하지 않습니다. Red Hat은 개인 정보를 수집하지 않습니다. 개인 정보가 의도하지 않게 Red Hat에 수신된 경우 Red Hat은 이러한 정보를 삭제합니다. Telemetry 데이터가 개인 정보를 구성하는 범위까지, Red Hat의 개인정보 보호정책에 대한 자세한 내용은 Red Hat 개인정보처리방침을 참조하십시오.

4.1.2. Insights Operator 정보

Insights Operator는 구성 및 구성 요소 오류 상태를 주기적으로 수집하고 기본적으로 이러한 데이터를 두 시간마다 Red Hat에 보고합니다. 이 정보를 통해 Red Hat은 구성 및 Telemetry를 통해 보고된 것보다 더 깊은 오류 데이터를 평가할 수 있습니다.

OpenShift Container Platform 사용자는 Red Hat Hybrid Cloud Console의 Insights Advisor 서비스에 각 클러스터의 보고서를 표시할 수 있습니다. 문제가 확인된 경우 Insights는 추가 세부 정보와 가능한 경우 문제 해결 방법에 대한 단계를 제공합니다.

Insights Operator는 사용자 이름, 암호 또는 인증서와 같은 식별 정보를 수집하지 않습니다. Red Hat Insights 데이터 수집 및 제어에 대한 정보는 Red Hat Insights Data & Application Security를 참조하십시오.

Red Hat은 연결된 모든 클러스터 정보를 사용하여 다음을 수행합니다.

- 잠재적인 클러스터 문제를 확인하고 Red Hat Hybrid Cloud Console의 Insights Advisor 서비스에서 솔루션 및 예방 조치 제공

- 제품 및 지원팀에 집계되는 중요한 정보를 제공하여 OpenShift Container Platform 개선

- OpenShift Container Platform의 직관성 향상

4.1.2.1. Insights Operator에 의해 수집되는 정보

Insights Operator에서 수집되는 정보는 다음과 같습니다.

- OpenShift Container Platform 버전 및 환경과 관련된 문제를 확인하는 클러스터 및 해당 구성 요소에 대한 일반 정보

- 설정한 매개변수와 관련된 잘못된 설정 및 문제를 확인하는 클러스터 구성 파일(예: 이미지 레지스트리 구성)

- 클러스터 구성 요소에서 발생하는 오류

- 실행 중인 업데이트의 진행 상태 정보 및 구성 요소의 업그레이드 상태

- OpenShift Container Platform이 배포된 플랫폼 및 클러스터가 있는 리전의 세부 정보

- 별도의 TLS(Secure Hash Algorithm) 값으로 변환된 클러스터 워크로드 정보는 Red Hat이 중요한 세부 사항을 분리하지 않고 보안 및 버전 취약점에 대한 워크로드를 평가할 수 있습니다.

-

Operator가 문제를 보고하면

openshift-*및kube-*프로젝트의 코어 OpenShift Container Platform Pod에 대한 정보가 수집됩니다. 여기에는 상태, 리소스, 보안 컨텍스트, 볼륨 정보 등이 포함됩니다.

4.1.3. Telemetry 및 Insights Operator 데이터 흐름 이해

Telemeter Client는 Prometheus API에서 선택한 시계열 데이터를 수집합니다. 시계열 데이터는 처리하기 위해 4분 30초 마다 api.openshift.com에 업로드됩니다.

Insights Operator는 선택한 데이터를 Kubernetes API 및 Prometheus API에서 아카이브로 수집합니다. 아카이브는 처리를 위해 2시간마다 OpenShift Cluster Manager 에 업로드됩니다. Insights Operator는 OpenShift Cluster Manager 에서도 최신 Insights 분석을 다운로드합니다. OpenShift Container Platform 웹 콘솔의 Overview 페이지에 있는 Insights status 팝업을 설정하는 데 사용됩니다.

Red Hat과의 모든 통신은 TLS(Transport Layer Security) 및 상호 인증서 인증을 사용하여 암호화된 채널을 통해 이루어집니다. 모든 데이터는 전송 및 정지 상태에서 암호화됩니다.

고객 데이터를 처리하는 시스템에 대한 액세스는 다단계 인증 및 엄격한 인증 권한에 의해 제어됩니다. 필요에 따라 액세스 권한이 부여되며 필수 작업으로 제한됩니다.

Telemetry 및 Insights Operator 데이터 흐름

4.1.4. 원격 상태 모니터링 데이터 사용 방법에 대한 추가 정보

원격 상태 모니터링을 사용하도록 수집된 정보는 Telemetry에 의해 수집된 정보 및 Insights Operator에 의해 수집된 정보에서 참조하십시오.

이 문서의 이전 섹션에 설명되어 있듯이 Red Hat은 지원 및 업그레이드, 성능 또는 구성 최적화, 서비스에 미치는 영향을 최소화, 위협 식별 및 문제 해결, 문제에 대한 대응 및 청구 등의 목적으로 Red Hat 제품 사용에 대한 데이터를 수집합니다.

수집 보안 조치

Red Hat은 Telemetry 및 구성 데이터를 보호하기 위해 설계된 기술 및 제도 상의 조치를 사용합니다.

공유

Red Hat은 사용자 환경을 개선하기 위해 Telemetry 및 Insights Operator에서 수집한 데이터를 내부적으로 공유할 수 있습니다. Red Hat은 Red Hat 제품 사용 및 고객의 사용을 보다 잘 이해할 수 있도록 돕거나 또는 파트너가 협력하여 제품의 지원을 성공적으로 통합하는 데 도움이 되는 집계 양식에서 Telemetry 및 설정 데이터를 공유할 수 있습니다.

타사

Red Hat은 Telemetry 및 구성 데이터의 수집, 분석 및 저장을 지원하기 위해 특정 타사와 협력할 수 있습니다.

사용자 컨트롤 / Telemetry 및 설정 데이터 수집 활성화 및 비활성화

4.2. 원격 상태 모니터링으로 수집된 데이터 표시

관리자는 Telemetry 및 Insights Operator에서 수집한 메트릭을 검토할 수 있습니다.

4.2.1. Telemetry로 수집한 데이터 표시

Telemetry에서 캡처한 클러스터 및 구성 요소 시계열 데이터를 볼 수 있습니다.

사전 요구 사항

-

OpenShift Container Platform CLI(

oc)를 설치했습니다. -

cluster-admin역할 또는cluster-monitoring-view역할의 사용자로 클러스터에 액세스할 수 있습니다.

프로세스

- 클러스터에 로그인합니다.

- 다음 명령을 실행하여 클러스터의 Prometheus 서비스를 쿼리하고 Telemetry에서 캡처한 전체 시계열 데이터 세트를 반환합니다.

다음 예제에는 AWS의 OpenShift Container Platform과 관련된 몇 가지 값이 포함되어 있습니다.

4.2.2. Insights Operator에 의해 수집된 데이터의 표시

Insights Operator가 수집한 데이터를 검토할 수 있습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

프로세스

Insights Operator에 대해 현재 실행 중인 Pod의 이름을 검색합니다.

INSIGHTS_OPERATOR_POD=$(oc get pods --namespace=openshift-insights -o custom-columns=:metadata.name --no-headers --field-selector=status.phase=Running)

$ INSIGHTS_OPERATOR_POD=$(oc get pods --namespace=openshift-insights -o custom-columns=:metadata.name --no-headers --field-selector=status.phase=Running)Copy to Clipboard Copied! Toggle word wrap Toggle overflow Insights Operator가 수집한 최근 데이터 아카이브를 복사합니다.

oc cp openshift-insights/$INSIGHTS_OPERATOR_POD:/var/lib/insights-operator ./insights-data

$ oc cp openshift-insights/$INSIGHTS_OPERATOR_POD:/var/lib/insights-operator ./insights-dataCopy to Clipboard Copied! Toggle word wrap Toggle overflow

최신 Insights Operator 아카이브는 이제 insights-data 디렉토리에서 사용할 수 있습니다.

4.3. 원격 상태 보고

클러스터 의 상태 및 사용량 데이터를 선택, 활성화 또는 비활성화, 보고, 보고할 수 있습니다.

4.3.1. 원격 상태 보고 활성화

사용자 또는 조직에서 원격 상태 보고를 비활성화한 경우 이 기능을 다시 활성화할 수 있습니다. OpenShift Container Platform 웹 콘솔 개요 페이지의 상태 타일에서 Insights를 사용할 수 없는 메시지에서 원격 상태 보고가 비활성화되어 있음을 확인할 수 있습니다.

원격 상태 보고를 활성화하려면 새 권한 부여 토큰을 사용하여 글로벌 클러스터 풀 시크릿을 변경해야 합니다. 원격 상태 보고를 활성화하면 Insights Operator 및 Telemetry를 모두 사용할 수 있습니다.

4.3.2. 원격 상태 보고를 활성화하려면 글로벌 클러스터 풀 시크릿 변경

기존 글로벌 클러스터 풀 시크릿을 변경하여 원격 상태 보고를 활성화할 수 있습니다. 원격 상태 모니터링을 비활성화한 경우 Red Hat OpenShift Cluster Manager에서 console.openshift.com 액세스 토큰을 사용하여 새 풀 시크릿을 다운로드해야 합니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다. - OpenShift Cluster Manager에 액세스합니다.

프로세스

- Red Hat Hybrid Cloud Console의 다운로드 페이지로 이동합니다.

토큰 → 가져오기 보안 에서 다운로드 버튼을 클릭합니다.

pull-secret파일에는 JSON 형식의cloud.openshift.com액세스 토큰이 포함되어 있습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 로컬 파일 시스템에 글로벌 클러스터 풀 시크릿을 다운로드합니다.

oc get secret/pull-secret -n openshift-config --template='{{index .data ".dockerconfigjson" | base64decode}}' > pull-secret$ oc get secret/pull-secret -n openshift-config --template='{{index .data ".dockerconfigjson" | base64decode}}' > pull-secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow 풀 시크릿의 백업 사본을 만듭니다.

cp pull-secret pull-secret-backup

$ cp pull-secret pull-secret-backupCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

텍스트 편집기에서

pull-secret파일을 엽니다. -

이전에 다운로드한

pull-secret파일의cloud.openshift.comJSON 항목을auths파일에 추가합니다. - 파일을 저장합니다.

다음 명령을 실행하여 클러스터의 시크릿을 업데이트합니다.

oc set data secret/pull-secret -n openshift-config --from-file=.dockerconfigjson=pull-secret

oc set data secret/pull-secret -n openshift-config --from-file=.dockerconfigjson=pull-secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow 시크릿이 업데이트되고 클러스터가 보고를 시작할 때까지 몇 분 정도 기다려야 할 수 있습니다.

검증

OpenShift Container Platform 웹 콘솔의 확인 확인을 위해 다음 단계를 완료합니다.

- OpenShift Container Platform 웹 콘솔의 개요 페이지로 이동합니다.

- 발견된 문제 수를 보고하는 상태 타일에서 Insights 섹션을 확인합니다.

OpenShift CLI(

oc)의 확인 확인을 위해 다음 명령을 입력하고status매개변수의 값이false로 되어 있는지 확인합니다.oc get co insights -o jsonpath='{.status.conditions[?(@.type=="Disabled")]}'$ oc get co insights -o jsonpath='{.status.conditions[?(@.type=="Disabled")]}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3.3. 원격 상태 보고를 비활성화한 경우의 영향

OpenShift Container Platform에서 고객은 사용 정보를 보고하지 않도록 비활성화할 수 있습니다.

원격 상태 보고를 비활성화하기 전에 연결된 클러스터의 다음 이점을 확인하십시오.

- Red Hat은 문제에 보다 신속하게 대응하고 고객에게 더 나은 지원을 제공할 수 있습니다.

- Red Hat은 제품 업그레이드가 클러스터에 미치는 영향을 더 잘 이해할 수 있습니다.

- 연결된 클러스터를 사용하면 서브스크립션 및 인타이틀먼트 프로세스를 단순화할 수 있습니다.

- 연결된 클러스터를 사용하면 OpenShift Cluster Manager 서비스가 클러스터 및 해당 서브스크립션 상태에 대한 개요를 제공할 수 있습니다.

사전 프로덕션, 테스트 및 프로덕션 클러스터에 대해 상태 및 사용량 보고를 활성화한 것이 좋습니다. 즉, Red Hat은 사용자 환경에서 OpenShift Container Platform을 검증하고 제품 문제에 보다 신속하게 대응할 수 있습니다.

다음은 연결된 클러스터에서 원격 상태 보고를 비활성화한 몇 가지 결과를 보여줍니다.

- Red Hat은 오픈 지원 케이스 없이 제품 업그레이드 성공 또는 클러스터 상태를 볼 수 없습니다.

- Red Hat은 구성 데이터를 사용하여 고객 지원 케이스를 보다 효과적으로 분류하고 고객이 중요하게 생각하는 구성을 식별할 수 없습니다.

- OpenShift Cluster Manager는 상태 및 사용 정보가 포함된 클러스터에 대한 데이터를 표시할 수 없습니다.

-

사용 자동 보고 기능 없이

console.redhat.com웹 콘솔에 서브스크립션 정보를 수동으로 입력해야 합니다.

제한된 네트워크에서 Telemetry 및 Insights 데이터는 여전히 프록시의 적절한 구성을 통해 수집됩니다.

4.3.4. 원격 상태 보고 비활성화

기존 글로벌 클러스터 풀 시크릿을 변경하여 원격 상태 보고를 비활성화할 수 있습니다. 이 설정은 Telemetry 및 Insights Operator를 모두 비활성화합니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

프로세스

로컬 파일 시스템에 글로벌 클러스터 풀 시크릿을 다운로드합니다.

oc extract secret/pull-secret -n openshift-config --to=.

$ oc extract secret/pull-secret -n openshift-config --to=.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 텍스트 편집기에서

cloud.openshift.comJSON 항목을 제거하여 다운로드한.dockerconfigjson파일을 편집합니다."cloud.openshift.com":{"auth":"<hash>","email":"<email_address>"}"cloud.openshift.com":{"auth":"<hash>","email":"<email_address>"}Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 파일을 저장합니다.

클러스터에서 시크릿을 업데이트합니다. 자세한 내용은 "글로벌 클러스터 풀 시크릿 업그레이드"를 참조하십시오.

클러스터에서 시크릿이 업데이트될 때까지 몇 분 정도 기다려야 할 수 있습니다.

4.3.5. 연결이 끊긴 클러스터 등록

원격 상태 보고를 비활성화하여 클러스터가 영향을 받지 않도록 Red Hat Hybrid Cloud Console에 연결이 끊긴 OpenShift Container Platform 클러스터를 등록합니다. 자세한 내용은 "원격 상태 보고 비활성화"를 참조하십시오.

연결이 끊긴 클러스터를 등록하면 Red Hat에 서브스크립션 사용량을 계속 보고할 수 있습니다. Red Hat은 서브스크립션과 관련된 정확한 사용량 및 용량 추세를 반환하여 반환된 정보를 사용하여 모든 리소스에서 서브스크립션 할당을 보다 효과적으로 구성할 수 있습니다.

사전 요구 사항

-

OpenShift Container Platform 웹 콘솔에

cluster-admin역할로 로그인했습니다. - Red Hat Hybrid Cloud Console에 로그인할 수 있습니다.

프로세스

- Red Hat Hybrid Cloud Console의 연결이 끊긴 클러스터 웹 페이지로 이동합니다.

- 선택 사항: Red Hat Hybrid Cloud Console의 홈 페이지에서 연결이 끊긴 클러스터 웹 페이지에 액세스하려면 Cluster List 탐색 메뉴 항목으로 이동한 다음 Register cluster 버튼을 선택합니다.

- 등록 연결이 끊긴 클러스터 페이지의 제공된 필드에 클러스터의 세부 정보를 입력합니다.

- 페이지의 서브스크립션 설정 섹션에서 Red Hat 서브스크립션 제품에 적용되는 서브스크립션 설정을 선택합니다.

- 연결이 끊긴 클러스터를 등록하려면 클러스터 동록 버튼을 선택합니다.

- 서브스크립션 서비스에 서브스크립션 데이터가 어떻게 표시됩니까?(서브스크립션 서비스 시작하기)

4.3.6. 글로벌 클러스터 풀 시크릿 업데이트

현재 풀 시크릿을 교체하거나 새 풀 시크릿을 추가하여 클러스터의 글로벌 풀 시크릿을 업데이트할 수 있습니다.

설치 중에 사용된 레지스트리보다 이미지를 저장하기 위해 별도의 레지스트리가 필요한 경우 절차를 사용하십시오.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

프로세스

선택 사항: 기존 풀 시크릿에 새 풀 시크릿을 추가하려면 다음 단계를 완료합니다.

다음 명령을 입력하여 풀 시크릿을 다운로드합니다.

oc get secret/pull-secret -n openshift-config --template='{{index .data ".dockerconfigjson" | base64decode}}' > <pull_secret_location>$ oc get secret/pull-secret -n openshift-config --template='{{index .data ".dockerconfigjson" | base64decode}}' > <pull_secret_location>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<pull_secret_location> : 풀 시크릿 파일의 경로를 포함합니다.

다음 명령을 입력하여 새 풀 시크릿을 추가합니다.

oc registry login --registry="<registry>" \ --auth-basic="<username>:<password>" \ --to=<pull_secret_location>

$ oc registry login --registry="<registry>" \1 --auth-basic="<username>:<password>" \2 --to=<pull_secret_location>3 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 풀 시크릿 파일에 대한 수동 업데이트를 수행할 수도 있습니다.

다음 명령을 입력하여 클러스터의 글로벌 풀 시크릿을 업데이트합니다.

oc set data secret/pull-secret -n openshift-config --from-file=.dockerconfigjson=<pull_secret_location>

$ oc set data secret/pull-secret -n openshift-config --from-file=.dockerconfigjson=<pull_secret_location>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<pull_secret_location>: 새 풀 시크릿 파일의 경로를 추가합니다.

이번 업데이트에서는 모든 노드에 롤아웃되며 클러스터 크기에 따라 다소 시간이 걸릴 수 있습니다.

참고OpenShift Container Platform 4.7.4부터 글로벌 풀 시크릿을 변경해도 더 이상 노드 드레이닝 또는 재부팅이 트리거되지 않습니다.

추가 리소스

4.4. Insights를 사용하여 클러스터의 문제 식별

Insights는 Insights Operator가 전송하는 데이터를 반복적으로 분석합니다. 여기에는 Deployment Validation Operator(DVO)의 워크로드 권장 사항이 포함됩니다. OpenShift Container Platform 사용자는 Red Hat Hybrid Cloud Console의 Insights Advisor 서비스에 결과를 표시할 수 있습니다.

4.4.1. OpenShift Container Platform 용 Red Hat Insights Advisor 정보

Insights 권고 서비스를 사용하여 OpenShift Container Platform 클러스터의 상태를 평가하고 모니터링할 수 있습니다. 개별 클러스터에 대한 관심이 있거나 전체 인프라에 관계없이 서비스 가용성, 내결함성, 성능 또는 보안에 영향을 줄 수 있는 문제에 대한 클러스터 인프라 노출을 인식하는 것이 중요합니다.

클러스터에 DVO(Deployment Validation Operator)가 설치된 경우 권장 사항은 구성이 클러스터 상태 문제로 이어질 수 있는 워크로드도 강조 표시합니다.

Insights 분석 결과는 Red Hat Hybrid Cloud Console의 Insights 권고 서비스에서 확인할 수 있습니다. Red Hat Hybrid Cloud Console에서는 다음 작업을 수행할 수 있습니다.

- 특정 권장 사항의 영향을 받는 클러스터 및 워크로드를 확인합니다.

- 강력한 필터링 기능을 사용하여 결과를 해당 권장 사항으로 구체화합니다.

- 개별 권장 사항, 존재하는 위험에 대한 세부 정보, 개별 클러스터에 맞게 조정된 해결 방법에 대해 자세히 알아보십시오.

- 다른 이해 관계자와 결과를 공유하십시오.

4.4.2. Insights Advisor 권장 사항 이해

Insights 서비스는 클러스터 및 워크로드의 서비스 가용성, 내결함성, 성능 또는 보안에 부정적인 영향을 미칠 수 있는 다양한 클러스터 상태 및 구성 요소 구성에 대한 정보를 제공합니다. 이 정보 세트를 Insights 조언 서비스의 권장 사항이라고 합니다. 클러스터의 권장 사항에는 다음 정보가 포함됩니다.

- 이름: 권장 사항에 대한 간결한 설명

- 추가됨: Insights Advisor 서비스 아카이브에 권장 사항이 게시되었을 때

- 카테고리: 문제가 서비스 가용성, 내결함성, 성능 또는 보안에 부정적인 영향을 미칠 수 있는지 여부

- 총 위험: 조건이 클러스터 또는 워크로드에 부정적인 영향을 미칠 가능성 에서 파생된 값 및 이러한 상황이 발생할 경우 운영에 미치는 영향

- 클러스터: 권장 사항이 감지되는 클러스터 목록

- 설명: 클러스터에 미치는 영향을 포함하여 문제에 대한 간략한 개요

4.4.3. 클러스터와 관련된 잠재적인 문제 표시

이 섹션에서는 OpenShift Cluster Manager 의 Insights 권고에 Insights 보고서를 표시하는 방법을 설명합니다.

Insights는 반복적으로 클러스터를 분석하여 최신 결과를 표시합니다. 예를 들어 문제를 해결하거나 새로운 문제가 발견된 경우 이러한 결과가 변경될 수 있습니다.

사전 요구 사항

- 클러스터는 OpenShift Cluster Manager 에 등록되어 있습니다.

- 원격 상태 보고가 활성화되어 있습니다 (기본값).

- OpenShift Cluster Manager 에 로그인되어 있습니다.

프로세스

OpenShift Cluster Manager 에서 Advisor → Recommendations 로 이동합니다.

결과에 따라 Insights 권고 서비스에 다음 중 하나가 표시됩니다.

- Insights에서 문제를 식별하지 않은 경우 일치하는 권장 사항을 찾을 수 없습니다.

- Insights가 감지한 문제 목록으로 위험(낮음, 중간, 중요 및 심각)으로 그룹화되어 있습니다.

- Insights 가 아직 클러스터를 분석하지 않은 경우 아직 클러스터가 없습니다. 클러스터가 설치, 등록 및 인터넷에 연결된 직후 분석이 시작됩니다.

문제가 표시되면 항목 앞의 > 아이콘을 클릭하여 자세한 내용을 확인합니다.

문제에 따라 세부 정보에는 문제에 대한 Red Hat의 자세한 정보 링크가 포함될 수 있습니다.

4.4.4. Insights 조언자 서비스 권장 사항 표시

기본적으로 권장 사항 보기는 클러스터에서 탐지된 권장 사항만 표시합니다. 그러나 advisor 서비스의 아카이브에 있는 모든 권장 사항을 볼 수 있습니다.

사전 요구 사항

- 원격 상태 보고가 활성화되어 있습니다 (기본값).

- 클러스터는 Red Hat Hybrid Cloud Console에 등록되어 있습니다.

- OpenShift Cluster Manager 에 로그인되어 있습니다.

프로세스

- OpenShift Cluster Manager 에서 Advisor → Recommendations 로 이동합니다.

영향을 받는 클러스터 및 상태 필터 옆에 있는 X 아이콘을 클릭합니다.

이제 클러스터에 대한 모든 잠재적인 권장 사항을 확인할 수 있습니다.

4.4.5. Advisor 권장 필터

Insights 권고 서비스는 많은 권장 사항을 반환할 수 있습니다. 가장 중요한 권장 사항에 중점을 두려면 Advisor 권장 사항 목록에 필터를 적용하여 우선순위가 낮은 권장 사항을 제거할 수 있습니다.

기본적으로 필터는 하나 이상의 클러스터에 영향을 미치는 활성화된 권장 사항만 표시하도록 설정됩니다. Insights 라이브러리의 모든 또는 비활성화된 권장 사항을 보려면 필터를 사용자 지정할 수 있습니다.

필터를 적용하려면 필터 유형을 선택한 다음 드롭다운 목록에서 사용할 수 있는 옵션을 기반으로 값을 설정합니다. 권장 사항 목록에 여러 필터를 적용할 수 있습니다.

다음 필터 유형을 설정할 수 있습니다.

- name: 이름으로 권장 사항을 검색합니다.

- 총 위험: 심각,중요,보통 및 낮음에서 하나 이상의 값을 선택하여 클러스터에 미치는 부정적인 영향을 미치는 가능성과 심각도를 나타냅니다.

- 영향: 클러스터 작업의 연속성에 미치는 영향을 나타내는 심각,높음,중간 및 낮음 에서 하나 이상의 값을 선택합니다.

- 가능성: 심각,높음,중간, 낮음 에서 하나 이상의 값을 선택하여 클러스터에 부정적인 영향을 미칠 가능성이 있는지 여부를 나타냅니다.

- 범주: Service Availability,Performance,Fault Tolerance,Security, Best Practice 에서 하나 이상의 카테고리를 선택하여 집중할 수 있습니다.

- 상태: 활성화된 권장 사항(기본값), 비활성화된 권장 사항 또는 모든 권장 사항을 표시하려면 라디오 버튼을 클릭합니다.

- 영향을 받는 클러스터: 현재 하나 이상의 클러스터, 영향을 받지 않는 권장 사항 또는 모든 권장 사항에 영향을 미치는 권장 사항을 표시하도록 필터를 설정합니다.

- 변경 위험: High,Moderate,Low y low 에서 하나 이상의 값을 선택하여 해상도 구현이 클러스터 작업에 미칠 수 있는 위험을 나타냅니다.

4.4.5.1. Insights 권고 서비스 권장 사항 필터링

OpenShift Container Platform 클러스터 관리자는 권장 사항 목록에 표시되는 권장 사항을 필터링할 수 있습니다. 필터를 적용하면 보고된 권장 사항 수를 줄이고 가장 높은 우선 순위 권장 사항에 집중할 수 있습니다.

다음 절차에서는 카테고리 필터를 설정하고 제거하는 방법을 보여줍니다. 그러나 절차는 모든 필터 유형과 각 값에 적용할 수 있습니다.

사전 요구 사항

하이브리드 클라우드 콘솔의 OpenShift Cluster Manager 에 로그인되어 있습니다.

프로세스

- OpenShift > Advisor > Recommendations로 이동합니다.

- 기본 필터 유형 드롭다운 목록에서 카테고리 필터 유형을 선택합니다.

- filter-value 드롭다운 목록을 펼치고 보려는 각 범주의 권장 사항 옆에 있는 확인란을 선택합니다. 불필요한 카테고리에 대해 확인란을 지웁니다.

- 선택 사항: 목록을 추가로 구체화하려면 필터를 추가합니다.

선택한 범주의 권장 사항만 목록에 표시됩니다.

검증

- 필터를 적용한 후 업데이트된 권장 사항 목록을 볼 수 있습니다. 적용된 필터는 기본 필터 옆에 추가됩니다.

4.4.5.2. Insights 조언 서비스 권장 사항에서 필터 제거

권장 사항 목록에 여러 필터를 적용할 수 있습니다. 준비가 되면 개별적으로 제거하거나 완전히 재설정할 수 있습니다.

개별적으로 필터 제거

- 기본 필터를 포함하여 각 필터 옆에 있는 X 아이콘을 클릭하여 개별적으로 제거합니다.

기본이 아닌 모든 필터 제거

- 새로 고침 필터 를 클릭하여 적용한 필터만 제거하고 기본 필터를 그대로 둡니다.

4.4.6. Insights 권고 서비스 권장 사항 비활성화

보고서에 더 이상 표시되지 않도록 클러스터에 영향을 미치는 특정 권장 사항을 비활성화할 수 있습니다. 단일 클러스터 또는 모든 클러스터에 대한 권장 사항을 비활성화할 수 있습니다.

모든 클러스터에 대한 권장 사항을 비활성화하는 것은 향후 클러스터에도 적용됩니다.

사전 요구 사항

- 원격 상태 보고가 활성화되어 있습니다 (기본값).

- 클러스터는 OpenShift Cluster Manager 에 등록되어 있습니다.

- OpenShift Cluster Manager 에 로그인되어 있습니다.

프로세스

- OpenShift Cluster Manager 에서 Advisor → Recommendations 로 이동합니다.

- 선택 사항: 필요에 따라 클러스터에 영향을 미치는 상태 필터를 사용합니다.

다음 방법 중 하나를 사용하여 경고를 비활성화합니다.

경고를 비활성화하려면 다음을 수행합니다.

-

해당 경고에 대한 옵션 메뉴

를 클릭한 다음 권장 사항 비활성화 를 클릭합니다.

를 클릭한 다음 권장 사항 비활성화 를 클릭합니다.

- 확인 참고 사항을 입력하고 저장을 클릭합니다.

-

해당 경고에 대한 옵션 메뉴

경고를 비활성화하기 전에 이 경고의 영향을 받는 클러스터를 보려면 다음을 수행합니다.

- 비활성화할 권장 사항 이름을 클릭합니다. 단일 권장 사항 페이지로 이동합니다.

- 영향을 받는 클러스터 섹션의 클러스터 목록을 검토합니다.

- 동작 → 권장 사항 비활성화 를 클릭하여 모든 클러스터에 대한 경고를 비활성화합니다.

- 확인 참고 사항을 입력하고 저장을 클릭합니다.

4.4.7. 이전에 비활성화된 Insights 조언 서비스 권장 사항 활성화

모든 클러스터에 대해 권장 사항이 비활성화되면 더 이상 Insights 권고 서비스에 권장 사항이 표시되지 않습니다. 이 동작을 변경할 수 있습니다.

사전 요구 사항

- 원격 상태 보고가 활성화되어 있습니다 (기본값).

- 클러스터는 OpenShift Cluster Manager 에 등록되어 있습니다.

- OpenShift Cluster Manager 에 로그인되어 있습니다.

프로세스

- OpenShift Cluster Manager 에서 Advisor → Recommendations 로 이동합니다.

비활성화된 권장 사항에 표시할 권장 사항을 필터링합니다.

- Status 드롭다운 메뉴에서 Status 를 선택합니다.

- Filter by status 드롭다운 메뉴에서 Disabled 를 선택합니다.

- 선택 사항: 영향을 받는 클러스터 필터를 지웁니다.

- 활성화할 권장 사항을 찾습니다.

-

옵션 메뉴

를 클릭한 다음 권장 사항 사용을 클릭합니다.

를 클릭한 다음 권장 사항 사용을 클릭합니다.

4.4.8. 워크로드에 대한 Insights 조언 서비스 권장 사항 정보

OpenShift 어드바이저 서비스에 Red Hat Insights를 사용하여 클러스터뿐만 아니라 워크로드에 영향을 미치는 권장 사항에 대한 정보를 보고 관리할 수 있습니다. 권고 서비스는 배포 검증을 활용하고 OpenShift 클러스터 관리자가 배포 정책의 모든 런타임 위반을 확인할 수 있도록 지원합니다. OpenShift > Advisor > Red Hat Hybrid Cloud Console에서 워크로드에 대한 권장 사항을 확인할 수 있습니다. 자세한 내용은 다음 추가 리소스를 참조하십시오.

4.4.9. 웹 콘솔에 Insights 상태 표시

Insights는 클러스터를 반복적으로 분석하고 OpenShift Container Platform 웹 콘솔에서 확인된 잠재적 클러스터 문제의 상태를 표시할 수 있습니다. 이 상태에는 다양한 카테고리의 문제 수가 표시되고 자세한 내용은 OpenShift Cluster Manager 의 보고서에 대한 링크입니다.

사전 요구 사항

- 클러스터는 OpenShift Cluster Manager 에 등록되어 있습니다.

- 원격 상태 보고가 활성화되어 있습니다 (기본값).

- OpenShift Container Platform 웹 콘솔에 로그인되어 있습니다.

프로세스

- OpenShift Container Platform 웹 콘솔에서 홈 → 개요로 이동합니다.

상태 카드에서 Insights를 클릭합니다.

팝업 창에 잠재적인 문제가 위험으로 그룹화되어 나열됩니다. 개별 카테고리를 클릭하거나 Insights Advisor의 모든 권장 사항 보기를 클릭하여 자세한 내용을 표시합니다.

4.5. Insights Operator 사용

Insights Operator는 구성 및 구성 요소 오류 상태를 주기적으로 수집하고 기본적으로 이러한 데이터를 두 시간마다 Red Hat에 보고합니다. 이 정보를 통해 Red Hat은 구성 및 Telemetry를 통해 보고된 것보다 더 깊은 오류 데이터를 평가할 수 있습니다. OpenShift Container Platform 사용자는 Red Hat Hybrid Cloud Console의 Insights Advisor 서비스에 보고서를 표시할 수 있습니다.

4.5.1. Insights Operator 구성

Insights Operator 구성은 기본 Operator 구성과 openshift-insights 네임스페이스의 insights-config ConfigMap 오브젝트에 저장된 구성 또는 openshift-config 네임스페이스의 support 시크릿에 저장된 구성의 조합입니다.

ConfigMap 오브젝트 또는 지원 시크릿이 있는 경우 포함된 특성 값이 기본 Operator 구성 값을 재정의합니다. ConfigMap 오브젝트 와 지원 시크릿이 둘 다 있는 경우 Operator는 ConfigMap 오브젝트를 읽습니다.

ConfigMap 오브젝트는 기본적으로 존재하지 않으므로 OpenShift Container Platform 클러스터 관리자가 이를 생성해야 합니다.

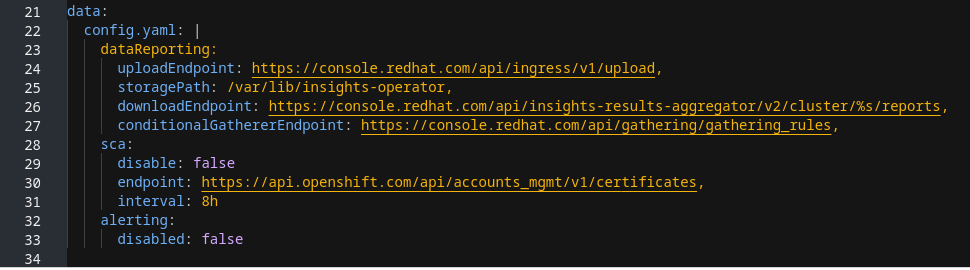

ConfigMap 오브젝트 구성 구조

insights-config ConfigMap 오브젝트(config.yaml 구성)의 예에서는 표준 YAML 형식을 사용하여 구성 옵션을 보여줍니다.

구성 가능한 속성 및 기본값

다음 표에서는 사용 가능한 구성 속성을 설명합니다.

insights-config ConfigMap 오브젝트는 표준 YAML 형식을 따릅니다. 여기서 하위 값은 상위 속성 아래에 있고 두 개의 공백을 들여씁니다. Obfuscation 속성의 경우 부모 속성의 공지된 하위 항목으로 값을 입력합니다.

| 특성 이름 | 설명 | 값 유형 | 기본값 |

|---|---|---|---|

alerting:

disabled: false

| 클러스터 Prometheus 인스턴스에 대한 Insights Operator 경고를 비활성화합니다. | 부울 |

|

clusterTransfer:

endpoint: <url>

| 클러스터 전송 데이터를 확인하고 다운로드하는 끝점입니다. | URL | https://api.openshift.com/api/accounts_mgmt/v1/cluster_transfers/ |

clusterTransfer:

interval: 1h0m0s

| 사용 가능한 클러스터 전송을 확인하는 빈도를 설정합니다. | 시간 간격 |

|

dataReporting:

interval: 30m0s

| 데이터 수집 및 업로드 빈도를 설정합니다. | 시간 간격 |

|

dataReporting:

uploadEndpoint: <url>

| 업로드 끝점을 설정합니다. | URL | |

dataReporting:

storagePath: <path>

| 보관된 데이터가 저장되는 경로를 구성합니다. | 파일 경로 | /var/lib/insights-operator |

dataReporting:

downloadEndpoint: <url>

| 최신 Insights 분석을 다운로드하기 위한 끝점을 지정합니다. | URL | |

dataReporting:

conditionalGathererEndpoint: <url>

| 조건부 수집 규칙 정의를 제공하기 위한 끝점을 설정합니다. | URL | |

dataReporting:

obfuscation:

- networking

| IP 주소 및 클러스터 도메인 이름을 전역 난독 처리를 활성화합니다. | 문자열 | 해당 없음 |

dataReporting:

obfuscation:

- workload_names

| Data Validation Operator 데이터의 난독 처리를 활성화합니다. 리소스 ID가 리소스 이름이 아닌 아카이브 파일에만 표시되는 클러스터 리소스입니다. | 문자열 | 해당 없음 |

proxy:

httpProxy: http://example.com,

httpsProxy: http://example.com,

noProxy: test.org

| Insights Operator에 대한 사용자 정의 프록시를 설정합니다. | URL | 기본값이 없음 |

sca:

interval: 8h0m0s

| SCA(Simple Content Access) 인타이틀먼트 다운로드 빈도를 지정합니다. | 시간 간격 |

|

sca:

endpoint: <url>

| SCA(Simple Content Access) 인타이틀먼트를 다운로드하는 끝점을 지정합니다. | URL | https://api.openshift.com/api/accounts_mgmt/v1/entitlement_certificates |

sca:

disabled: false

| 간단한 콘텐츠 액세스 권한 다운로드를 비활성화합니다. | 부울 |

|

4.5.1.1. insights-config ConfigMap 오브젝트 생성

다음 절차에서는 Insights Operator에 대한 insights-config ConfigMap 오브젝트를 생성하여 사용자 정의 구성을 설정하는 방법을 설명합니다.

기본 Insights Operator 구성을 변경하기 전에 Red Hat 지원을 참조하는 것이 좋습니다.

사전 요구 사항

- 원격 상태 보고가 활성화되어 있습니다 (기본값).

-

cluster-admin역할의 사용자로 OpenShift Container Platform 웹 콘솔에 로그인되어 있습니다.

프로세스

- 워크로드 → ConfigMaps 로 이동하여 Project: openshift-insights 를 선택합니다.

- ConfigMap 생성을 클릭합니다.

Configure via: YAML view 를 선택하고 구성 기본 설정을 입력합니다. 예를 들면 다음과 같습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 선택 사항: 양식 보기를 선택하고 해당 방식으로 필요한 정보를 입력합니다.

- ConfigMap 이름 필드에 insights-config 를 입력합니다.

- 키 필드에 config.yaml 을 입력합니다.

- Value 필드의 경우 필드로 드래그 앤 드롭할 파일을 검색하거나 구성 매개변수를 수동으로 입력합니다.

-

생성 을 클릭하면

ConfigMap오브젝트 및 구성 정보가 표시됩니다.

4.5.2. Insights Operator 경고 이해

Insights Operator는 Prometheus 모니터링 시스템을 통해 Alertmanager에 경고를 선언합니다. 다음 방법 중 하나를 사용하여 OpenShift Container Platform 웹 콘솔의 경고 UI에서 이러한 경고를 볼 수 있습니다.

- 관리자 화면에서 모니터링 → 경고를 클릭합니다.

- 개발자 화면에서 모니터링 → <project_name> → 경고 탭을 클릭합니다.

현재 조건이 충족되면 Insights Operator에서 다음 경고를 보냅니다.

| 경고 | 설명 |

|---|---|

|

| Insights Operator가 비활성화되어 있습니다. |

|

| Red Hat 서브스크립션 관리에서는 간단한 컨텐츠 액세스가 허용되지 않습니다. |

|

| Insights에는 클러스터에 대한 활성 권장 사항이 있습니다. |

4.5.2.1. Insights Operator 경고 비활성화

Insights Operator가 클러스터 Prometheus 인스턴스에 경고를 보내지 못하도록 insights-config ConfigMap 오브젝트를 생성하거나 편집합니다.

이전에는 클러스터 관리자가 openshift-config 네임스페이스의 support 시크릿 을 사용하여 Insights Operator 구성을 생성하거나 편집했습니다. Red Hat Insights는 Operator를 구성하기 위해 ConfigMap 오브젝트 생성을 지원합니다. Operator는 둘 다 있는 경우 지원 시크릿을 통해 구성 맵 구성에 우선 순위를 부여합니다.

insights-config ConfigMap 오브젝트가 없는 경우 사용자 정의 구성을 처음 추가할 때 생성해야 합니다. ConfigMap 오브젝트 내의 구성은 config/pod.yaml 파일에 정의된 기본 설정보다 우선합니다.

사전 요구 사항

- 원격 상태 보고가 활성화되어 있습니다 (기본값).

-

cluster-admin으로 OpenShift Container Platform 웹 콘솔에 로그인되어 있습니다. -

insights-config

ConfigMap오브젝트는openshift-insights네임스페이스에 있습니다.

프로세스

- 워크로드 → ConfigMaps 로 이동하여 Project: openshift-insights 를 선택합니다.

-

insights-config

ConfigMap오브젝트를 클릭하여 엽니다. - 작업을 클릭하고 ConfigMap 편집을 선택합니다.

- YAML 보기 라디오 버튼을 클릭합니다.

파일에서

alerting속성을disabled: true로 설정합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 저장을 클릭합니다. insights-config config-map 세부 정보 페이지가 열립니다.

-

config.yamlalerting속성 값이disabled: true로 설정되어 있는지 확인합니다.

변경 사항을 저장하면 Insights Operator에서 더 이상 클러스터 Prometheus 인스턴스에 경고를 보내지 않습니다.

4.5.2.2. Insights Operator 경고 활성화

경고가 비활성화되면 Insights Operator에서 더 이상 클러스터 Prometheus 인스턴스로 경고를 보내지 않습니다. 다시 활성화할 수 있습니다.

이전에는 클러스터 관리자가 openshift-config 네임스페이스의 support 시크릿 을 사용하여 Insights Operator 구성을 생성하거나 편집했습니다. Red Hat Insights는 Operator를 구성하기 위해 ConfigMap 오브젝트 생성을 지원합니다. Operator는 둘 다 있는 경우 지원 시크릿을 통해 구성 맵 구성에 우선 순위를 부여합니다.

사전 요구 사항

- 원격 상태 보고가 활성화되어 있습니다 (기본값).

-

cluster-admin으로 OpenShift Container Platform 웹 콘솔에 로그인되어 있습니다. -

insights-config

ConfigMap오브젝트는openshift-insights네임스페이스에 있습니다.

프로세스

- 워크로드 → ConfigMaps 로 이동하여 Project: openshift-insights 를 선택합니다.

-

insights-config

ConfigMap오브젝트를 클릭하여 엽니다. - 작업을 클릭하고 ConfigMap 편집을 선택합니다.

- YAML 보기 라디오 버튼을 클릭합니다.

파일에서

alerting속성을disabled: false로 설정합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 저장을 클릭합니다. insights-config config-map 세부 정보 페이지가 열립니다.

-

config.yamlalerting속성 값이disabled: false로 설정되어 있는지 확인합니다.

변경 사항을 저장하면 Insights Operator에서 클러스터 Prometheus 인스턴스에 경고를 다시 보냅니다.

4.5.3. Insights Operator 아카이브 다운로드

Insights Operator는 클러스터의 openshift-insights 네임스페이스에 있는 아카이브에 수집된 데이터를 저장합니다. Insights Operator가 수집한 데이터를 다운로드하여 검토할 수 있습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

프로세스

Insights Operator에 대해 실행 중인 Pod의 이름을 찾습니다.

oc get pods --namespace=openshift-insights -o custom-columns=:metadata.name --no-headers --field-selector=status.phase=Running

$ oc get pods --namespace=openshift-insights -o custom-columns=:metadata.name --no-headers --field-selector=status.phase=RunningCopy to Clipboard Copied! Toggle word wrap Toggle overflow Insights Operator가 수집한 최근 데이터 아카이브를 복사합니다.

oc cp openshift-insights/<insights_operator_pod_name>:/var/lib/insights-operator ./insights-data

$ oc cp openshift-insights/<insights_operator_pod_name>:/var/lib/insights-operator ./insights-data1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<insights_operator_pod_name>을 이전 명령의 Pod 이름 출력으로 바꿉니다.

최신 Insights Operator 아카이브는 이제 insights-data 디렉토리에서 사용할 수 있습니다.

4.5.4. Insights Operator 수집 작업 실행

필요에 따라 Insights Operator 데이터 수집 작업을 실행할 수 있습니다. 다음 절차에서는 OpenShift 웹 콘솔 또는 CLI를 사용하여 기본 수집 작업 목록을 실행하는 방법을 설명합니다. on demand gather 함수를 사용자 지정하여 선택한 수집 작업을 제외할 수 있습니다. 기본 목록에서 수집 작업을 비활성화하면 Insights Advisor에서 클러스터에 대한 효과적인 권장 사항을 제공하는 기능이 저하됩니다. 이전에 Insights Operator가 클러스터에서 작업을 수집하지 않은 경우 이 절차에서는 해당 매개변수를 재정의합니다.

DataGather 사용자 정의 리소스는 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 다음 링크를 참조하십시오.

클러스터에서 기술 프리뷰를 활성화하면 Insights Operator가 개별 Pod에서 작업을 실행합니다. 이는 Insights Operator에 대한 기술 프리뷰 기능 세트의 일부이며 새로운 데이터 수집 기능을 지원합니다.

4.5.4.1. Insights Operator 수집 기간 보기

Insights Operator에서 아카이브에 포함된 정보를 수집하는 데 걸리는 시간을 볼 수 있습니다. 이를 통해 Insights Operator 리소스 사용량 및 Insights 권고 문제를 이해하는 데 도움이 됩니다.

사전 요구 사항

- Insights Operator 아카이브의 최근 사본.

프로세스

아카이브에서

/insights-operator/gathers.json을 엽니다.파일에는 Insights Operator 수집 작업 목록이 포함되어 있습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

duration_in_ms는 각 수집 작업의 시간(밀리초)입니다.

- 비정상적인 상태에 대한 각 수집 작업을 검사합니다.

4.5.4.2. 웹 콘솔에서 Insights Operator 수집 작업 실행

데이터를 수집하기 위해 OpenShift Container Platform 웹 콘솔을 사용하여 Insights Operator 수집 작업을 실행할 수 있습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 OpenShift Container Platform 웹 콘솔에 로그인되어 있습니다.

프로세스

- 콘솔에서 Administration → CustomResourceDefinitions 를 선택합니다.

- CustomResourceDefinitions 페이지의 이름으로 검색 필드에서 DataGather 리소스 정의를 찾은 다음 클릭합니다.

- 사용자 정의 리소스 정의 세부 정보 페이지에서 인스턴스 탭을 클릭합니다.

- DataGather 만들기를 클릭합니다.

새

DataGather작업을 생성하려면 다음 구성 파일을 편집하고 변경 사항을 저장합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

이 문자열이 다른 관리 작업을 위해 예약되고 의도된 수집 작업에 영향을 미칠 수 있으므로 gather 작업 이름에 periodic-gathering- 접두사를 추가하지 마십시오.

검증

- 콘솔에서 워크로드 → Pod 로 선택합니다.

- Pod 페이지에서 프로젝트 풀다운 메뉴로 이동한 다음 기본 프로젝트 표시를 선택합니다.

-

프로젝트 풀다운 메뉴에서

openshift-insights프로젝트를 선택합니다. -

openshift-insights프로젝트의 Pod 목록에서 선택한 이름으로 새 수집 작업에 접두어가 있는지 확인합니다. 완료되면 Insights Operator가 처리를 위해 Red Hat에 데이터를 자동으로 업로드합니다.

4.5.4.3. OpenShift CLI에서 Insights Operator 수집 작업 실행

OpenShift Container Platform 명령줄 인터페이스를 사용하여 Insights Operator 수집 작업을 실행할 수 있습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 OpenShift Container Platform에 로그인되어 있습니다.

프로세스

다음 명령을 입력하여 수집 작업을 실행합니다.

oc apply -f <your_datagather_definition>.yaml

$ oc apply -f <your_datagather_definition>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow &

lt;your_datagather_definition>.yaml을 다음 매개변수가 포함된 구성 파일로 바꿉니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

이 문자열이 다른 관리 작업을 위해 예약되고 의도된 수집 작업에 영향을 미칠 수 있으므로 gather 작업 이름에 periodic-gathering- 접두사를 추가하지 마십시오.

검증

-

openshift-insights프로젝트의 Pod 목록에서 선택한 이름으로 새 수집 작업에 접두어가 있는지 확인합니다. 완료되면 Insights Operator가 처리를 위해 Red Hat에 데이터를 자동으로 업로드합니다.

4.5.4.4. Insights Operator 수집 작업 비활성화

Insights Operator 수집 작업을 비활성화할 수 있습니다. 수집 작업을 비활성화하면 Insights Operator가 더 이상 Insights 클러스터 보고서를 Red Hat에 전송하지 않으므로 조직의 개인 정보를 향상시킬 수 있습니다. 이렇게 하면 클러스터 전송과 같은 Red Hat과 통신해야 하는 다른 핵심 기능에 영향을 주지 않고 클러스터의 Insights 분석 및 권장 사항이 비활성화됩니다. Insights Operator 아카이브의 /insights-operator/gathers.json 파일에서 시도한 클러스터 수집 작업 목록을 볼 수 있습니다. 일부 수집 작업은 특정 조건이 충족되고 가장 최근 아카이브에 표시되지 않을 때만 발생합니다.

InsightsDataGather 사용자 정의 리소스는 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 다음 링크를 참조하십시오.

클러스터에서 기술 프리뷰를 활성화하면 Insights Operator가 개별 Pod에서 작업을 실행합니다. 이는 Insights Operator에 대한 기술 프리뷰 기능 세트의 일부이며 새로운 데이터 수집 기능을 지원합니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 OpenShift Container Platform 웹 콘솔에 로그인되어 있습니다.

프로세스

- 관리 → 클러스터 리소스 정의로 이동합니다.

- 클러스터 리소스 정의 페이지에서 이름으로 검색 필드를 사용하여 InsightsDataGather 리소스 정의를 찾아 클릭합니다.

- 사용자 정의 리소스 정의 세부 정보 페이지에서 인스턴스 탭을 클릭합니다.

- 클러스터를 클릭한 다음 YAML 탭을 클릭합니다.

InsightsDataGather구성 파일에 다음 편집 중 하나를 수행하여 수집 작업을 비활성화합니다.저장을 클릭합니다.

변경 사항을 저장하면 Insights Operator 수집 구성이 업데이트되고 작업이 더 이상 발생하지 않습니다.

수집 작업을 비활성화하면 Insights 조언 서비스에서 클러스터에 대한 효과적인 권장 사항을 제공할 수 있는 기능이 저하됩니다.

4.5.4.5. Insights Operator 수집 작업 활성화

수집 작업이 비활성화된 경우 Insights Operator 수집 작업을 활성화할 수 있습니다.

InsightsDataGather 사용자 정의 리소스는 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 다음 링크를 참조하십시오.

사전 요구 사항

-

cluster-admin역할의 사용자로 OpenShift Container Platform 웹 콘솔에 로그인되어 있습니다.

프로세스

- 관리 → 클러스터 리소스 정의로 이동합니다.

- 클러스터 리소스 정의 페이지에서 이름으로 검색 필드를 사용하여 InsightsDataGather 리소스 정의를 찾아 클릭합니다.

- 사용자 정의 리소스 정의 세부 정보 페이지에서 인스턴스 탭을 클릭합니다.

- 클러스터를 클릭한 다음 YAML 탭을 클릭합니다.

다음 편집 중 하나를 수행하여 수집 작업을 활성화합니다.

저장을 클릭합니다.

변경 사항을 저장하면 Insights Operator가 구성을 업데이트하고 영향을 받는 수집 작업이 시작됩니다.

수집 작업을 비활성화하면 Insights Advisor의 기능이 클러스터에 대한 효과적인 권장 사항을 제공하는 성능이 저하됩니다.

4.5.5. Deployment Validation Operator 데이터 난독 처리

기본적으로 Deployment Validation Operator(DVO)를 설치할 때 리소스의 이름 및 고유 식별자(UID)는 OpenShift Container Platform용 Insights Operator가 캡처 및 처리하는 데이터에 포함됩니다. 클러스터 관리자인 경우 DVO(Deployment Validation Operator)의 데이터를 난독화하도록 Insights Operator를 구성할 수 있습니다. 예를 들어, Red Hat으로 전송되는 아카이브 파일에서 워크로드 이름을 난독화할 수 있습니다.

리소스 이름을 난독화하려면 다음 절차에 설명된 대로 insights-config ConfigMap 오브젝트 의 난독화 속성을 수동으로 설정해야 합니다.

사전 요구 사항

- 원격 상태 보고가 활성화되어 있습니다 (기본값).

- "cluster-admin" 역할을 사용하여 OpenShift Container Platform 웹 콘솔에 로그인되어 있습니다.

-

insights-config

ConfigMap오브젝트는openshift-insights네임스페이스에 있습니다. - 클러스터가 자체 관리되고 Deployment Validation Operator가 설치됩니다.

프로세스

- 워크로드 → ConfigMaps 로 이동하여 Project: openshift-insights 를 선택합니다.

-

insights-configConfigMap오브젝트를 클릭하여 엽니다. - 작업을 클릭하고 ConfigMap 편집을 선택합니다.

- YAML 보기 라디오 버튼을 클릭합니다.

파일에서

workload_names값을 사용하여난독 처리속성을 설정합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 저장을 클릭합니다. insights-config config-map 세부 정보 페이지가 열립니다.

-

config.yaml난독 처리속성 값이- workload_names로 설정되어 있는지 확인합니다.

4.6. 네트워크가 제한된 환경에서 원격 상태 보고 사용

Insights Operator 아카이브를 수동으로 수집 및 업로드하여 제한된 네트워크에서 문제를 진단할 수 있습니다.

제한된 네트워크에서 Insights Operator를 사용하려면 다음을 수행해야 합니다.

- Insights Operator 아카이브 사본을 만듭니다.

- Insights Operator 아카이브를 console.redhat.com에 업로드합니다.

또한 업로드하기 전에 Insights Operator 데이터를 난독화 하도록 선택할 수 있습니다.

4.6.1. Insights Operator 수집 작업 실행

Insights Operator 아카이브를 생성하려면 수집 작업을 실행해야 합니다.

사전 요구 사항

-

cluster-admin으로 OpenShift Container Platform 클러스터에 로그인되어 있습니다.

프로세스

이 템플릿을 사용하여

gather-job.yaml이라는 파일을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow insights-operator이미지 버전을 복사합니다.oc get -n openshift-insights deployment insights-operator -o yaml

$ oc get -n openshift-insights deployment insights-operator -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

insights-operator이미지 버전을 지정합니다.

gather-job.yaml에 이미지 버전을 붙여 넣습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 기존 값을

insights-operator이미지 버전으로 교체합니다.

수집 작업을 생성합니다.

oc apply -n openshift-insights -f gather-job.yaml

$ oc apply -n openshift-insights -f gather-job.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 작업 Pod의 이름을 찾습니다.

oc describe -n openshift-insights job/insights-operator-job

$ oc describe -n openshift-insights job/insights-operator-jobCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 다음과 같습니다.

-

insights-operator-job-<your_job>은 Pod의 이름입니다.

작업이 완료되었는지 확인합니다.

oc logs -n openshift-insights insights-operator-job-<your_job> insights-operator

$ oc logs -n openshift-insights insights-operator-job-<your_job> insights-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

I0407 11:55:38.192084 1 diskrecorder.go:34] Wrote 108 records to disk in 33ms

I0407 11:55:38.192084 1 diskrecorder.go:34] Wrote 108 records to disk in 33msCopy to Clipboard Copied! Toggle word wrap Toggle overflow 생성된 아카이브를 저장합니다.

oc cp openshift-insights/insights-operator-job-<your_job>:/var/lib/insights-operator ./insights-data

$ oc cp openshift-insights/insights-operator-job-<your_job>:/var/lib/insights-operator ./insights-dataCopy to Clipboard Copied! Toggle word wrap Toggle overflow 작업을 정리합니다.

oc delete -n openshift-insights job insights-operator-job

$ oc delete -n openshift-insights job insights-operator-jobCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.6.2. Insights Operator 아카이브 업로드

Insights Operator 아카이브를 console.redhat.com에 수동으로 업로드하여 잠재적인 문제를 진단할 수 있습니다.

사전 요구 사항

-

cluster-admin으로 OpenShift Container Platform 클러스터에 로그인되어 있습니다. - 무제한 인터넷 액세스가 가능한 워크스테이션이 있습니다.

- Insights Operator 아카이브 사본을 생성했습니다.

프로세스

dockerconfig.json파일을 다운로드합니다.oc extract secret/pull-secret -n openshift-config --to=.

$ oc extract secret/pull-secret -n openshift-config --to=.Copy to Clipboard Copied! Toggle word wrap Toggle overflow dockerconfig.json파일에서"cloud.openshift.com""auth"토큰을 복사합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow console.redhat.com에 아카이브를 업로드합니다.

curl -v -H "User-Agent: insights-operator/one10time200gather184a34f6a168926d93c330 cluster/<cluster_id>" -H "Authorization: Bearer <your_token>" -F "upload=@<path_to_archive>; type=application/vnd.redhat.openshift.periodic+tar" https://console.redhat.com/api/ingress/v1/upload

$ curl -v -H "User-Agent: insights-operator/one10time200gather184a34f6a168926d93c330 cluster/<cluster_id>" -H "Authorization: Bearer <your_token>" -F "upload=@<path_to_archive>; type=application/vnd.redhat.openshift.periodic+tar" https://console.redhat.com/api/ingress/v1/uploadCopy to Clipboard Copied! Toggle word wrap Toggle overflow 여기서

<cluster_id>는 클러스터 ID이며<your_token>은 풀 시크릿의 토큰이며<path_to_archive>는 Insights Operator 아카이브의 경로입니다.작업이 성공하면 명령은

"request_id"및"account_number"를 반환합니다.출력 예

* Connection #0 to host console.redhat.com left intact {"request_id":"393a7cf1093e434ea8dd4ab3eb28884c","upload":{"account_number":"6274079"}}%* Connection #0 to host console.redhat.com left intact {"request_id":"393a7cf1093e434ea8dd4ab3eb28884c","upload":{"account_number":"6274079"}}%Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증 단계

- https://console.redhat.com/openshift로 로그인합니다.

- 왼쪽 창에서 Cluster List 메뉴를 클릭합니다.

- 클러스터 이름을 클릭하여 클러스터의 세부 사항을 표시합니다.

클러스터의 Insights 권고 탭을 엽니다.

업로드에 성공하면 탭에 다음 중 하나가 표시됩니다.

- 클러스터에서 모든 권장 사항을 통과: Insights 권고에서 문제가 발견되지 않은 경우 표시됩니다.

- Insights 권고에서 감지한 문제 목록으로 위험 (낮음, 중간, 중요 및 심각)에 따라 우선 순위가 지정됩니다.

4.6.3. Insights Operator 데이터 난독 처리

난독성을 활성화하여 Insights Operator가 console.redhat.com에 전송하는 중요하고 식별 가능한 IPv4 주소 및 클러스터 기본 도메인을 마스킹할 수 있습니다.

이 기능을 사용할 수 있지만 Red Hat은 더욱 효과적인 지원 환경을 위해 난독 처리를 비활성할 것을 권장합니다.

난독 처리는 클러스터 IPv4 주소에 고유하지 않은 값을 할당하고, 메모리에 유지되는 변환 테이블을 사용하여 데이터를 console.redhat.com에 업로드하기 전에 Insights Operator 아카이브 전체의 난독 처리된 버전으로 IP 주소를 변경합니다.

클러스터 기본 도메인의 경우 난독 처리는 기본 도메인을 하드 코딩된 하위 문자열로 변경합니다. 예를 들어 cluster-api.openshift.example.com은 cluster-api.<CLUSTER_BASE_DOMAIN>이 됩니다.

다음 절차에서는 openshift-config 네임스페이스의 support 시크릿을 사용하여 난독화를 활성화합니다.

사전 요구 사항

-

cluster-admin으로 OpenShift Container Platform 웹 콘솔에 로그인되어 있습니다.

프로세스

- 워크로드 → 시크릿으로 이동합니다.

- openshift-config 프로젝트를 선택합니다.

- 이름으로 검색 필드를 사용하여 지원 시크릿을 검색합니다. 존재하지 않는 경우 생성 → 키/값 시크릿을 클릭하여 생성합니다.

-

옵션 메뉴를

클릭한 다음 시크릿 편집을 클릭합니다.

클릭한 다음 시크릿 편집을 클릭합니다.

- 키/값 추가 클릭

-

값이

true인enableGlobalObfuscation이라는 키를 생성하고 저장을 클릭합니다. - 워크로드 → Pod로 이동합니다.

-

openshift-insights프로젝트를 선택합니다. -

insights-operatorpod를 찾습니다. -

insights-operatorpod를 다시 시작하려면 옵션 메뉴 를 클릭한 다음 Pod 삭제를 클릭합니다.

를 클릭한 다음 Pod 삭제를 클릭합니다.

검증

- 워크로드 → 시크릿으로 이동합니다.

- openshift-insights 프로젝트를 선택합니다.

- 이름으로 검색 필드를 사용하여 난독화-translation-table 시크릿을 검색합니다.

obfuscation-translation-table 시크릿이 있으면 난독이 활성화되고 작동합니다.

또는 Insights Operator 아카이브의 /insights-operator/gathers.json 값을 "is_global_obfuscation_enabled": true로 검사할 수 있습니다.

4.7. Insights Operator를 사용하여 간단한 콘텐츠 액세스 인타이틀먼트 가져오기

Insights Operator는 OpenShift Cluster Manager 에서 간단한 콘텐츠 액세스 권한을 주기적으로 가져와 openshift-config-managed 네임스페이스의 etc-pki-entitlement 시크릿에 저장합니다. 간단한 컨텐츠 액세스는 인타이틀먼트 도구의 동작을 단순화하는 Red Hat 서브스크립션 도구의 기능입니다. 이 기능을 사용하면 서브스크립션 툴링을 구성하는 복잡성 없이 Red Hat 서브스크립션에서 제공하는 컨텐츠를 더 쉽게 사용할 수 있습니다.

이전에는 클러스터 관리자가 openshift-config 네임스페이스의 support 시크릿 을 사용하여 Insights Operator 구성을 생성하거나 편집했습니다. Red Hat Insights는 Operator를 구성하기 위해 ConfigMap 오브젝트 생성을 지원합니다. Operator는 둘 다 있는 경우 지원 시크릿을 통해 구성 맵 구성에 우선 순위를 부여합니다.

Insights Operator는 8시간마다 간단한 콘텐츠 액세스 인타이틀먼트를 가져오지만 openshift-insights 네임스페이스에서 insights-config ConfigMap 오브젝트를 사용하여 구성하거나 비활성화할 수 있습니다.

가져오기 기능을 사용하려면 Red Hat 서브스크립션 관리에서 간단한 컨텐츠 액세스를 활성화해야 합니다.

4.7.1. 간단한 콘텐츠 액세스 가져오기 간격 구성

openshift-insights 네임스페이스에서 insights-config ConfigMap 오브젝트를 사용하여 Insights Operator에서 간단한 콘텐츠 액세스(sca) 인타이틀먼트를 가져오는 빈도를 구성할 수 있습니다. 인타이틀먼트 가져오기는 일반적으로 8시간마다 발생하지만 insights-config ConfigMap 오브젝트에서 간단한 콘텐츠 액세스 구성을 업데이트하는 경우 이 sca 간격을 단축할 수 있습니다.

이 절차에서는 가져오기 간격을 2시간(2h)으로 업데이트하는 방법을 설명합니다. 시간(h) 또는 시간 및 분을 지정할 수 있습니다(예: 2h30m).

사전 요구 사항

- 원격 상태 보고가 활성화되어 있습니다 (기본값).

-

cluster-admin역할의 사용자로 OpenShift Container Platform 웹 콘솔에 로그인되어 있습니다. -

insights-config

ConfigMap오브젝트는openshift-insights네임스페이스에 있습니다.

프로세스

- 워크로드 → ConfigMaps 로 이동하여 Project: openshift-insights 를 선택합니다.

-

insights-config

ConfigMap오브젝트를 클릭하여 엽니다. - 작업을 클릭하고 ConfigMap 편집을 선택합니다.

- YAML 보기 라디오 버튼을 클릭합니다.

파일의

sca특성을interval: 2h로 설정하여 2시간마다 콘텐츠를 가져옵니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 저장을 클릭합니다. insights-config config-map 세부 정보 페이지가 열립니다.

-

config.yamlsca속성 값이interval: 2h로 설정되어 있는지 확인합니다.

4.7.2. 간단한 콘텐츠 액세스 가져오기 비활성화

openshift-insights 네임스페이스에서 insights-config ConfigMap 오브젝트를 사용하여 간단한 콘텐츠 액세스 인타이틀먼트 가져오기를 비활성화할 수 있습니다.

사전 요구 사항

- 원격 상태 보고가 활성화되어 있습니다 (기본값).

-

cluster-admin으로 OpenShift Container Platform 웹 콘솔에 로그인되어 있습니다. -

insights-config

ConfigMap오브젝트는openshift-insights네임스페이스에 있습니다.

프로세스

- 워크로드 → ConfigMaps 로 이동하여 Project: openshift-insights 를 선택합니다.

-

insights-config

ConfigMap오브젝트를 클릭하여 엽니다. - 작업을 클릭하고 ConfigMap 편집을 선택합니다.

- YAML 보기 라디오 버튼을 클릭합니다.

파일에서

sca속성을disabled: true로 설정합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 저장을 클릭합니다. insights-config config-map 세부 정보 페이지가 열립니다.

-

config.yamlsca속성 값이disabled: true로 설정되어 있는지 확인합니다.

4.7.3. 이전에 비활성화된 간단한 콘텐츠 액세스 가져오기 활성화

간단한 콘텐츠 액세스 인타이틀먼트를 가져올 수 없는 경우 Insights Operator는 간단한 콘텐츠 액세스 인타이틀먼트를 가져오지 않습니다. 이 동작을 변경할 수 있습니다.

사전 요구 사항

- 원격 상태 보고가 활성화되어 있습니다 (기본값).

-

cluster-admin역할의 사용자로 OpenShift Container Platform 웹 콘솔에 로그인되어 있습니다. -

insights-config

ConfigMap오브젝트는openshift-insights네임스페이스에 있습니다.

프로세스

- 워크로드 → ConfigMaps 로 이동하여 Project: openshift-insights 를 선택합니다.

-

insights-config

ConfigMap오브젝트를 클릭하여 엽니다. - 작업을 클릭하고 ConfigMap 편집을 선택합니다.

- YAML 보기 라디오 버튼을 클릭합니다.

파일에서

sca속성을disabled: false로 설정합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 저장을 클릭합니다. insights-config config-map 세부 정보 페이지가 열립니다.

-

config.yamlsca속성 값이disabled: false로 설정되어 있는지 확인합니다.

5장. 클러스터에 대한 데이터 수집

지원 사례를 여는 경우 클러스터에 대한 디버깅 정보를 Red Hat 지원에 제공하면 도움이 됩니다.

다음을 제공하는 것이 좋습니다.

5.1. must-gather 툴 정보

oc adm must-gather CLI 명령은 다음을 포함하여 문제를 디버깅하는 데 필요할 가능성이 높은 클러스터에서 정보를 수집합니다.

- 리소스 정의

- 서비스 로그

기본적으로 oc adm must-gather 명령은 기본 플러그인 이미지를 사용하고 ./must-gather.local 에 씁니다.

또는 다음 섹션에 설명된 대로 적절한 인수로 명령을 실행하여 특정 정보를 수집할 수 있습니다.

하나 이상의 특정 기능과 관련된 데이터를 수집하려면 다음 섹션에 나열된 대로 이미지와 함께

--image인수를 사용합니다.예를 들면 다음과 같습니다.

oc adm must-gather \ --image=registry.redhat.io/container-native-virtualization/cnv-must-gather-rhel9:v4.16.21

$ oc adm must-gather \ --image=registry.redhat.io/container-native-virtualization/cnv-must-gather-rhel9:v4.16.21Copy to Clipboard Copied! Toggle word wrap Toggle overflow 감사 로그를 수집하려면 다음 섹션에 설명된 대로

-- /usr/bin/gather_audit_logs인수를 사용하십시오.예를 들면 다음과 같습니다.

oc adm must-gather -- /usr/bin/gather_audit_logs

$ oc adm must-gather -- /usr/bin/gather_audit_logsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고- 감사 로그는 파일 크기를 줄이기 위해 기본 정보 세트의 일부로 수집되지 않습니다.

-

Windows 운영 체제에서

cwRsync클라이언트를 설치하고oc rsync명령과 함께 사용할PATH변수에 추가합니다.

oc adm must-gather 를 실행하면 클러스터의 새 프로젝트에 임의의 이름이 있는 새 Pod가 생성됩니다. 해당 Pod에서 데이터가 수집되어 현재 작업 디렉터리에 must-gather.local 로 시작하는 새 디렉터리에 저장됩니다.

예를 들면 다음과 같습니다.

NAMESPACE NAME READY STATUS RESTARTS AGE ... openshift-must-gather-5drcj must-gather-bklx4 2/2 Running 0 72s openshift-must-gather-5drcj must-gather-s8sdh 2/2 Running 0 72s ...

NAMESPACE NAME READY STATUS RESTARTS AGE

...

openshift-must-gather-5drcj must-gather-bklx4 2/2 Running 0 72s

openshift-must-gather-5drcj must-gather-s8sdh 2/2 Running 0 72s

...

필요한 경우 --run-namespace 옵션을 사용하여 특정 네임스페이스에서 oc adm must-gather 명령을 실행할 수 있습니다.

예를 들면 다음과 같습니다.

oc adm must-gather --run-namespace <namespace> \ --image=registry.redhat.io/container-native-virtualization/cnv-must-gather-rhel9:v4.16.21

$ oc adm must-gather --run-namespace <namespace> \

--image=registry.redhat.io/container-native-virtualization/cnv-must-gather-rhel9:v4.16.215.1.1. Red Hat 지원을 위한 클러스터에 대한 데이터 수집

oc adm must-gather CLI 명령을 사용하여 클러스터에 대한 디버깅 정보를 수집할 수 있습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다. -

OpenShift Container Platform CLI(

oc)가 설치되어 있습니다.

프로세스

must-gather데이터를 저장하려는 디렉터리로 이동합니다.참고클러스터가 연결이 끊긴 환경에 있는 경우 추가 단계를 수행해야 합니다. 미러 레지스트리에 신뢰할 수 있는 CA가 있는 경우 먼저 신뢰할 수 있는 CA를 클러스터에 추가해야 합니다. 연결이 끊긴 환경의 모든 클러스터에 대해 기본

must-gather이미지를 이미지 스트림으로 가져와야 합니다.oc import-image is/must-gather -n openshift

$ oc import-image is/must-gather -n openshiftCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc adm must-gather명령을 실행합니다.oc adm must-gather

$ oc adm must-gatherCopy to Clipboard Copied! Toggle word wrap Toggle overflow 중요연결이 끊긴 환경에 있는 경우

--image플래그를 must-gather의 일부로 사용하여 페이로드 이미지를 가리킵니다.참고이 명령은 기본적으로 임의의 컨트롤 플레인 노드를 선택하므로 Pod가

NotReady및SchedulingDisabled상태인 컨트롤 플레인 노드로 예약할 수 있습니다.예를 들어 클러스터에서 Pod를 예약할 수 없는 경우와 같이 명령이 실패하면

oc adm inspect명령을 사용하여 특정 리소스에 대한 정보를 수집합니다.참고권장되는 리소스를 얻으려면 Red Hat 지원에 문의하십시오.

작업 디렉토리에서 생성된

must-gather디렉토리에서 압축 파일을 만듭니다. 고유한 must-gather 데이터에 대한 날짜 및 클러스터 ID를 제공해야 합니다. 클러스터 ID를 찾는 방법에 대한 자세한 내용은 OpenShift 클러스터에서 클러스터 ID 또는 이름을 찾는 방법을 참조하십시오. 예를 들어 Linux 운영 체제를 사용하는 컴퓨터에서 다음 명령을 실행합니다.tar cvaf must-gather-`date +"%m-%d-%Y-%H-%M-%S"`-<cluster_id>.tar.gz <must_gather_local_dir>

$ tar cvaf must-gather-`date +"%m-%d-%Y-%H-%M-%S"`-<cluster_id>.tar.gz <must_gather_local_dir>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- &

lt;must_gather_local_dir>을 실제 디렉터리 이름으로 바꿉니다.

- 압축 파일을 Red Hat 고객 포털 의 고객 지원 페이지의 지원 케이스에 첨부합니다.

5.1.2. 특정 기능에 대한 데이터 수집

oc adm must-gather CLI 명령을 --image 또는 --image-stream 인수와 함께 사용하여 특정 기능에 대한 디버깅 정보를 수집할 수 있습니다. must-gather 툴은 여러 이미지를 지원하므로 단일 명령을 실행하여 둘 이상의 기능에 대한 데이터를 수집할 수 있습니다.

| 이미지 | 목적 |

|---|---|

|

| OpenShift Virtualization의 데이터 수집. |

|

| OpenShift Serverless의 데이터 수집. |

|

| Red Hat OpenShift Service Mesh의 데이터 수집 |

|

| 호스팅된 컨트롤 플레인의 데이터 수집 |

|

| Migration Toolkit for Containers의 데이터 수집 |

|

| Red Hat OpenShift Data Foundation의 데이터 수집 |

|

| 로깅을 위한 데이터 수집 |

|

| Network Observability Operator의 데이터 수집 |

|

| OpenShift Shared Resource CSI 드라이버의 데이터 수집 |

|

| Local Storage Operator의 데이터 수집 |

|

| OpenShift 샌드박스 컨테이너의 데이터 수집 |

|

| Self Node Remediation (SNR) Operator, Fence Agents Remediation (FAR) Operator, Machine Deletion Remediation (MDR) Operator, Node Health Check (NHC) Operator 및 Node Health Check Operator (NMO)를 포함하여 Red Hat Workload Availability Operator의 데이터 수집 NHC Operator 버전이 0.9.0 이전 버전인 경우 이 이미지를 사용합니다. 자세한 내용은 수정, 펜싱 및 유지 관리의 특정 Operator에 대한 "Gathering data" 섹션을 참조하십시오(Red Hat OpenShift의 워크로드 가용성 설명서). |

|

| Self Node Remediation (SNR) Operator, Fence Agents Remediation (FAR) Operator, Machine Deletion Remediation (MDR) Operator, Node Health Check (NHC) Operator 및 Node Health Check Operator (NMO)를 포함하여 Red Hat Workload Availability Operator의 데이터 수집 NHC Operator 버전이 0.9.0 이상인 경우 이 이미지를 사용하십시오. 자세한 내용은 수정, 펜싱 및 유지 관리의 특정 Operator에 대한 "Gathering data" 섹션을 참조하십시오(Red Hat OpenShift의 워크로드 가용성 설명서). |

|

| NUMA Resources Operator(NRO)의 데이터 수집 |

|

| PTP Operator의 데이터 수집 |

|

| Red Hat OpenShift GitOps의 데이터 수집 |

|

| Secrets Store CSI Driver Operator의 데이터 수집 |

|

| LVM Operator의 데이터 수집 |

|

| Compliance Operator의 데이터 수집 |

OpenShift Container Platform 구성 요소의 최신 버전을 확인하려면 Red Hat Customer Portal의 OpenShift Operator 라이프 사이클 웹 페이지를 참조하십시오.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다. -

OpenShift Container Platform CLI(

oc)가 설치되어 있습니다.

프로세스

-

must-gather데이터를 저장하려는 디렉터리로 이동합니다. --image또는--image-stream인수를 하나 이상 사용하여oc adm must-gather명령을 실행합니다.참고-

특정 기능 데이터 외에도 기본

must-gather데이터를 수집하려면--image-stream=openshift/must-gather인수를 추가하십시오. - 사용자 지정 지표 자동 스케일러에 대한 데이터 수집에 대한 자세한 내용은 다음의 추가 리소스 섹션을 참조하십시오.

예를 들어 다음 명령은 기본 클러스터 데이터와 OpenShift Virtualization 관련 정보를 모두 수집합니다.

oc adm must-gather \ --image-stream=openshift/must-gather \ --image=registry.redhat.io/container-native-virtualization/cnv-must-gather-rhel9:v4.16.21

$ oc adm must-gather \ --image-stream=openshift/must-gather \1 --image=registry.redhat.io/container-native-virtualization/cnv-must-gather-rhel9:v4.16.212 Copy to Clipboard Copied! Toggle word wrap Toggle overflow must-gather툴을 추가 인수와 함께 사용하여 클러스터의 OpenShift 로깅 및 Red Hat OpenShift Logging Operator와 관련된 데이터를 수집할 수 있습니다. OpenShift 로깅의 경우 다음 명령을 실행합니다.oc adm must-gather --image=$(oc -n openshift-logging get deployment.apps/cluster-logging-operator \ -o jsonpath='{.spec.template.spec.containers[?(@.name == "cluster-logging-operator")].image}')$ oc adm must-gather --image=$(oc -n openshift-logging get deployment.apps/cluster-logging-operator \ -o jsonpath='{.spec.template.spec.containers[?(@.name == "cluster-logging-operator")].image}')Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예 5.1. OpenShift 로깅의

must-gather출력 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

특정 기능 데이터 외에도 기본

--image또는--image-stream인수를 하나 이상 사용하여oc adm must-gather명령을 실행합니다. 예를 들어 다음 명령은 기본 클러스터 데이터와 KubeVirt 관련 정보를 모두 수집합니다.oc adm must-gather \ --image-stream=openshift/must-gather \ --image=quay.io/kubevirt/must-gather

$ oc adm must-gather \ --image-stream=openshift/must-gather \1 --image=quay.io/kubevirt/must-gather2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow 작업 디렉토리에서 생성된

must-gather디렉토리에서 압축 파일을 만듭니다. 고유한 must-gather 데이터에 대한 날짜 및 클러스터 ID를 제공해야 합니다. 클러스터 ID를 찾는 방법에 대한 자세한 내용은 OpenShift 클러스터에서 클러스터 ID 또는 이름을 찾는 방법을 참조하십시오. 예를 들어 Linux 운영 체제를 사용하는 컴퓨터에서 다음 명령을 실행합니다.tar cvaf must-gather-`date +"%m-%d-%Y-%H-%M-%S"`-<cluster_id>.tar.gz <must_gather_local_dir>

$ tar cvaf must-gather-`date +"%m-%d-%Y-%H-%M-%S"`-<cluster_id>.tar.gz <must_gather_local_dir>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- &

lt;must_gather_local_dir>을 실제 디렉터리 이름으로 바꿉니다.

- 압축 파일을 Red Hat 고객 포털 의 고객 지원 페이지의 지원 케이스에 첨부합니다.

5.2. 추가 리소스

- 사용자 정의 지표 자동 스케일러의 디버깅 데이터 수집입니다.

- Red Hat OpenShift Container Platform 라이프 사이클 정책

5.2.1. 네트워크 로그 수집

클러스터의 모든 노드에서 네트워크 로그를 수집할 수 있습니다.

프로세스

-- gather_network_logs를 사용하여oc adm must-gather명령을 실행합니다.oc adm must-gather -- gather_network_logs

$ oc adm must-gather -- gather_network_logsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고기본적으로

must-gather툴은 클러스터의 모든 노드에서 OVNnbdb및sbdb데이터베이스를 수집합니다. OVNnbdb데이터베이스에 대한 OVN-Kubernetes 트랜잭션이 포함된 추가 로그를 포함하도록-- gather_network_logs옵션을 추가합니다.작업 디렉토리에서 생성된

must-gather디렉토리에서 압축 파일을 만듭니다. 고유한 must-gather 데이터에 대한 날짜 및 클러스터 ID를 제공해야 합니다. 클러스터 ID를 찾는 방법에 대한 자세한 내용은 OpenShift 클러스터에서 클러스터 ID 또는 이름을 찾는 방법을 참조하십시오. 예를 들어 Linux 운영 체제를 사용하는 컴퓨터에서 다음 명령을 실행합니다.tar cvaf must-gather-`date +"%m-%d-%Y-%H-%M-%S"`-<cluster_id>.tar.gz <must_gather_local_dir>

$ tar cvaf must-gather-`date +"%m-%d-%Y-%H-%M-%S"`-<cluster_id>.tar.gz <must_gather_local_dir>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- &

lt;must_gather_local_dir>을 실제 디렉터리 이름으로 바꿉니다.

- 압축 파일을 Red Hat 고객 포털 의 고객 지원 페이지의 지원 케이스에 첨부합니다.

5.2.2. must-gather 스토리지 제한 변경

oc adm must-gather 명령을 사용하여 데이터를 수집할 때 정보의 기본 최대 스토리지는 컨테이너의 스토리지 용량의 30%입니다. 30% 제한에 도달하면 컨테이너가 종료되고 수집 프로세스가 중지됩니다. 이미 수집된 정보는 로컬 스토리지에 다운로드되어 있습니다. must-gather 명령을 다시 실행하려면 스토리지 용량이 더 많은 컨테이너를 사용하거나 최대 볼륨 백분율을 조정해야 합니다.

컨테이너가 스토리지 제한에 도달하면 다음 예와 유사한 오류 메시지가 생성됩니다.

출력 예

Disk usage exceeds the volume percentage of 30% for mounted directory. Exiting...

Disk usage exceeds the volume percentage of 30% for mounted directory. Exiting...사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다. -

OpenShift CLI(

oc)가 설치되어 있어야 합니다.

프로세스

volume-percentage플래그를 사용하여oc adm must-gather명령을 실행합니다. 새 값은 100을 초과할 수 없습니다.oc adm must-gather --volume-percentage <storage_percentage>

$ oc adm must-gather --volume-percentage <storage_percentage>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.3. 클러스터 ID 검색

Red Hat 지원에 정보를 제공할 때 클러스터의 고유 식별자를 제공하는 것이 유용합니다. OpenShift Container Platform 웹 콘솔을 사용하여 클러스터 ID를 자동으로 입력할 수 있습니다. 웹 콘솔 또는 OpenShift CLI (oc)를 사용하여 클러스터 ID를 수동으로 검색할 수 있습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다. -

설치된 웹 콘솔 또는 OpenShift CLI(

oc)에 액세스할 수 있습니다.

프로세스

웹 콘솔을 사용하여 지원 케이스를 열고 클러스터 ID를 자동으로 입력하려면 다음을 수행합니다.

- 툴바에서 (?) Help 를 선택하고 목록에서 피드백 공유를 선택합니다.

- Tell us about your experience 창에서 지원 케이스 열기 를 클릭합니다.

웹 콘솔을 사용하여 클러스터 ID를 수동으로 가져오려면 다음을 수행합니다.

- 홈 → 개요 로 이동합니다.

- 값은 Details 섹션의 Cluster ID 필드에서 사용 가능합니다.

OpenShift CLI (

oc)를 사용하여 클러스터 ID를 얻으려면 다음 명령을 실행합니다.oc get clusterversion -o jsonpath='{.items[].spec.clusterID}{"\n"}'$ oc get clusterversion -o jsonpath='{.items[].spec.clusterID}{"\n"}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4. sosreport 정보

sosreport는 RHEL(Red Hat Enterprise Linux) 및 RHCOS(Red Hat Enterprise Linux CoreOS) 시스템에서 구성 세부 정보, 시스템 정보, 진단 데이터를 수집하는 툴입니다. sosreport는 노드와 관련된 진단 정보를 수집하는 표준화된 방법을 제공합니다. 이러한 정보는 문제 진단을 위해 Red Hat 지원팀에 제공할 수 있습니다.

경우에 따라 Red Hat 지원팀에서 특정 OpenShift Container Platform 노드에 대한 sosreport 아카이브를 수집하도록 요청할 수 있습니다. 예를 들어, oc adm must-gather의 출력에 포함되지 않은 시스템 로그 또는 기타 노드 별 데이터를 확인해야 하는 경우가 있습니다.

5.5. OpenShift Container Platform 클러스터 노드의 sosreport 아카이브 생성

OpenShift Container Platform 4.16 클러스터 노드에 sosreport 를 생성하는 방법으로 디버그 Pod를 사용하는 것이 좋습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다. - 호스트에 대한 SSH 액세스 권한이 있어야 합니다.

-

OpenShift CLI(

oc)가 설치되어 있습니다. - Red Hat 표준 또는 프리미엄 서브스크립션이 있습니다.

- Red Hat 고객 포털 계정이 있어야 합니다.

- 기존 Red Hat 지원 케이스 ID가 있습니다.

프로세스

클러스터 노드 목록을 가져옵니다.

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 대상 노드에서 디버그 세션으로 들어갑니다. 이 단계는

<node_name>-debug라는 디버그 Pod를 인스턴스화합니다.oc debug node/my-cluster-node

$ oc debug node/my-cluster-nodeCopy to Clipboard Copied! Toggle word wrap Toggle overflow NoExecute효과로 테인트된 대상 노드에서 디버그 세션에 들어가려면 더미 네임스페이스에 허용 오차를 추가하고 더미 네임스페이스에서 디버그 Pod를 시작합니다.oc new-project dummy

$ oc new-project dummyCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc patch namespace dummy --type=merge -p '{"metadata": {"annotations": { "scheduler.alpha.kubernetes.io/defaultTolerations": "[{\"operator\": \"Exists\"}]"}}}'$ oc patch namespace dummy --type=merge -p '{"metadata": {"annotations": { "scheduler.alpha.kubernetes.io/defaultTolerations": "[{\"operator\": \"Exists\"}]"}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc debug node/my-cluster-node

$ oc debug node/my-cluster-nodeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 디버그 쉘 내에서

/host를 root 디렉터리로 설정합니다. 디버그 Pod는 Pod 내의/host에 호스트의 루트 파일 시스템을 마운트합니다. root 디렉토리를/host로 변경하면 호스트의 실행 경로에 포함된 바이너리를 실행할 수 있습니다.chroot /host

# chroot /hostCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고RHCOS(Red Hat Enterprise Linux CoreOS)를 실행하는 OpenShift Container Platform 4.16 클러스터 노드는 변경할 수 없으며 Operator를 사용하여 클러스터 변경 사항을 적용합니다. SSH를 사용하여 클러스터 노드에 액세스하는 것은 권장되지 않습니다. 그러나 OpenShift Container Platform API를 사용할 수 없거나 kubelet이 대상 노드에서 제대로 작동하지 않는 경우

oc작업이 영향을 받습니다. 이러한 상황에서 대신ssh core @ <node>.<cluster_name>.<base_domain>을 사용하여 노드에 액세스할 수 있습니다.sosreport를 실행하는 데 필요한 바이너리 및 플러그인이 포함된toolbox컨테이너를 시작합니다.toolbox

# toolboxCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고기존

toolboxPod가 이미 실행 중인 경우toolbox명령은'toolbox-' already exists를 출력합니다. Trying to start…를 출력합니다.podman rm toolbox-에서 실행중인 toolbox 컨테이너를 제거하고 새 toolbox 컨테이너를 생성하여sosreport플러그인 문제를 방지합니다.sosreport아카이브를 수집합니다.sos report명령을 실행하여crio및podman에서 필요한 문제 해결 데이터를 수집합니다.sos report -k crio.all=on -k crio.logs=on -k podman.all=on -k podman.logs=on

# sos report -k crio.all=on -k crio.logs=on -k podman.all=on -k podman.logs=on1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

-k를 사용하면 기본값 외부에서sosreport플러그인 매개 변수를 정의할 수 있습니다.

선택 사항: 보고서에 있는 노드의 OVN-Kubernetes 네트워킹 구성에 대한 정보를 포함하려면 다음 명령을 실행합니다.

sos report --all-logs

# sos report --all-logsCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 프롬프트가 표시되면 Enter를 눌러 계속 진행합니다.

-

Red Hat 지원 사례 ID를 제공합니다.

sosreport는 아카이브의 파일 이름에 ID를 추가합니다. sosreport출력은 아카이브의 위치와 체크섬을 제공합니다. 다음 예에서는 케이스 ID01234567을 참조합니다.Your sosreport has been generated and saved in: /host/var/tmp/sosreport-my-cluster-node-01234567-2020-05-28-eyjknxt.tar.xz The checksum is: 382ffc167510fd71b4f12a4f40b97a4e

Your sosreport has been generated and saved in: /host/var/tmp/sosreport-my-cluster-node-01234567-2020-05-28-eyjknxt.tar.xz1 The checksum is: 382ffc167510fd71b4f12a4f40b97a4eCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- toolbox 컨테이너가 호스트의 root 디렉토리를

/host에 마운트하기 때문에sosreport아카이브의 파일 경로는chroot환경 외부에 있습니다.

다음 방법 중 하나를 사용하여 분석을 위해 Red Hat 지원에

sosreport아카이브를 제공합니다.기존 Red Hat 지원 케이스에 파일을 업로드합니다.

oc debug node/<node_name>명령을 실행하여sosreport아카이브를 연결하고 출력을 파일로 리디렉션합니다. 이 명령은 이전oc debug세션을 종료했다고 가정합니다.oc debug node/my-cluster-node -- bash -c 'cat /host/var/tmp/sosreport-my-cluster-node-01234567-2020-05-28-eyjknxt.tar.xz' > /tmp/sosreport-my-cluster-node-01234567-2020-05-28-eyjknxt.tar.xz

$ oc debug node/my-cluster-node -- bash -c 'cat /host/var/tmp/sosreport-my-cluster-node-01234567-2020-05-28-eyjknxt.tar.xz' > /tmp/sosreport-my-cluster-node-01234567-2020-05-28-eyjknxt.tar.xz1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 디버그 컨테이너는

/host에 호스트의 root 디렉토리를 마운트합니다. 연결할 대상 파일을 지정할 때/host를 포함하여 디버그 컨테이너의 root 디렉토리에서 절대 경로를 참조합니다.

참고RHCOS(Red Hat Enterprise Linux CoreOS)를 실행하는 OpenShift Container Platform 4.16 클러스터 노드는 변경할 수 없으며 Operator를 사용하여 클러스터 변경 사항을 적용합니다.

scp를 사용하여 클러스터 노드에서sosreport아카이브를 전송하는 것은 권장되지 않습니다. 그러나 OpenShift Container Platform API를 사용할 수 없거나 kubelet이 대상 노드에서 제대로 작동하지 않는 경우oc작업이 영향을 받습니다. 이러한 상황에서는scp core@<node>.<cluster_name>.<base_domain>:<file_path> <local_path>를 실행하여 노드에서sosreport아카이브를 복사할 수 있습니다.- Red Hat 고객 포털 의 고객 지원 페이지에서 기존 지원 케이스로 이동합니다.

- Attach files를 선택하고 메시지에 따라 파일을 업로드합니다.

5.6. 부트 스트랩 노드의 저널 로그 쿼리

부트 스트랩 관련 문제가 발생하는 경우 부트 스트랩 노드에서 bootkube.service journald 장치 로그 및 컨테이너 로그를 수집할 수 있습니다.

사전 요구 사항

- 부트 스트랩 노드에 대한 SSH 액세스 권한이 있어야 합니다.

- 부트 스트랩 노드의 정규화된 도메인 이름이 있어야 합니다.

프로세스

OpenShift Container Platform 설치 중에 부트 스트랩 노드에서

bootkube.servicejournald장치 로그를 쿼리합니다.<bootstrap_fqdn>을 부트 스트랩 노드의 정규화된 도메인 이름으로 바꿉니다.ssh core@<bootstrap_fqdn> journalctl -b -f -u bootkube.service

$ ssh core@<bootstrap_fqdn> journalctl -b -f -u bootkube.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고부트스트랩 노드의

bootkube.service로그는 etcdconnectionrejectd 오류를 출력하고 부트스트랩 서버가 컨트롤 플레인 노드의 etcd에 연결할 수 없음을 나타냅니다. 각 컨트롤 플레인 노드에서 etcd를 시작하고 노드가 클러스터에 가입되면 오류가 중지됩니다.부트 스트랩 노드에서

podman을 사용하여 부트 스트랩 노드 컨테이너에서 로그를 수집합니다.<bootstrap_fqdn>을 부트 스트랩 노드의 정규화된 도메인 이름으로 바꿉니다.ssh core@<bootstrap_fqdn> 'for pod in $(sudo podman ps -a -q); do sudo podman logs $pod; done'

$ ssh core@<bootstrap_fqdn> 'for pod in $(sudo podman ps -a -q); do sudo podman logs $pod; done'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.7. 클러스터 노드의 저널 로그 쿼리

개별 클러스터 노드의 /var/log 내에 journald 장치 로그 및 기타 로그를 수집할 수 있습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다. -

OpenShift CLI(

oc)가 설치되어 있습니다. - API 서비스가 작동하고 있어야 합니다.

- 호스트에 대한 SSH 액세스 권한이 있어야 합니다.

프로세스

OpenShift Container Platform 클러스터 노드에서

kubeletjournald장치 로그를 쿼리합니다. 다음 예제에서는 컨트롤 플레인 노드만 쿼리합니다.oc adm node-logs --role=worker -u kubelet

$ oc adm node-logs --role=worker -u kubeletCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

kubelet: 다른 장치 로그를 쿼리하려면 적절하게 바꿉니다.

-

클러스터 노드의

/var/log/아래에있는 특정 하위 디렉터리에서 로그를 수집합니다./var/log/하위 디렉토리에 포함된 로그 목록을 검색합니다. 다음 예제는 모든 컨트롤 플레인 노드의/var/log/openshift-apiserver/에 있는 파일을 나열합니다.oc adm node-logs --role=master --path=openshift-apiserver

$ oc adm node-logs --role=master --path=openshift-apiserverCopy to Clipboard Copied! Toggle word wrap Toggle overflow /var/log/하위 디렉터리 내의 특정 로그를 확인합니다. 다음 예제는 모든 컨트롤 플레인 노드에서/var/log/openshift-apiserver/audit.log내용을 출력합니다.oc adm node-logs --role=master --path=openshift-apiserver/audit.log

$ oc adm node-logs --role=master --path=openshift-apiserver/audit.logCopy to Clipboard Copied! Toggle word wrap Toggle overflow API가 작동하지 않는 경우 SSH를 사용하여 각 노드의 로그를 확인합니다. 다음은

/var/log/openshift-apiserver/audit.log예제입니다.ssh core@<master-node>.<cluster_name>.<base_domain> sudo tail -f /var/log/openshift-apiserver/audit.log

$ ssh core@<master-node>.<cluster_name>.<base_domain> sudo tail -f /var/log/openshift-apiserver/audit.logCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고RHCOS(Red Hat Enterprise Linux CoreOS)를 실행하는 OpenShift Container Platform 4.16 클러스터 노드는 변경할 수 없으며 Operator를 사용하여 클러스터 변경 사항을 적용합니다. SSH를 사용하여 클러스터 노드에 액세스하는 것은 권장되지 않습니다. SSH를 통해 진단 데이터를 수집하기 전에

oc adm must gather및 기타oc명령을 실행하여 충분한 데이터를 수집할 수 있는지 확인하십시오. 그러나 OpenShift Container Platform API를 사용할 수 없거나 kubelet이 대상 노드에서 제대로 작동하지 않는 경우oc작업이 영향을 받습니다. 이러한 상황에서ssh core@<node>.<cluster_name>.<base_domain>을 사용하여 노드에 액세스할 수 있습니다.

5.8. 네트워크 추적 방법

패킷 캡처 레코드 형태로 네트워크 추적을 수집하면 네트워크 문제 해결과 관련하여 Red Hat 지원을 지원할 수 있습니다.

OpenShift Container Platform은 네트워크 추적을 수행하는 두 가지 방법을 지원합니다. 다음 표를 검토하고 요구 사항에 맞는 방법을 선택합니다.

| 방법 | 이점 및 기능 |

|---|---|

| 호스트 네트워크 추적 수집 | 하나 이상의 노드에 동시에 지정하는 기간에 대해 패킷 캡처를 수행합니다. 지정된 기간이 충족되면 패킷 캡처 파일이 노드에서 클라이언트 시스템으로 전송됩니다. 특정 작업에서 네트워크 통신 문제를 트리거하는 이유를 해결할 수 있습니다. 패킷 캡처를 실행하고 문제를 트리거하는 작업을 수행하고 로그를 사용하여 문제를 진단합니다. |

| OpenShift Container Platform 노드 또는 컨테이너에서 네트워크 추적 수집 |

하나의 노드 또는 하나의 컨테이너에서 패킷 캡처를 수행합니다. 패킷 캡처를 수동으로 시작하고 네트워크 통신 문제를 트리거한 다음 패킷 캡처를 수동으로 중지할 수 있습니다.

이 방법은 |

5.9. 호스트 네트워크 추적 수집

네트워크 통신을 추적하고 동시에 여러 노드에서 패킷을 캡처하여 네트워크 관련 문제를 해결할 수 있습니다.

oc adm must-gather 명령과 registry.redhat.io/openshift4/network-tools-rhel8 컨테이너 이미지 조합을 사용하여 노드에서 패킷 캡처를 수집할 수 있습니다. 패킷 캡처를 분석하면 네트워크 통신 문제를 해결하는 데 도움이 될 수 있습니다.

oc adm must-gather 명령은 특정 노드의 Pod에서 tcpdump 명령을 실행하는 데 사용됩니다. tcpdump 명령은 Pod에 패킷 캡처를 기록합니다. tcpdump 명령이 종료되면 oc adm must-gather 명령은 Pod에서 패킷 캡처가 있는 파일을 클라이언트 머신으로 전송합니다.

다음 절차의 샘플 명령은 tcpdump 명령을 사용하여 패킷 캡처를 수행하는 방법을 보여줍니다. 그러나 --image 인수에 지정된 컨테이너 이미지에서 모든 명령을 실행하여 여러 노드에서 문제 해결 정보를 동시에 수집할 수 있습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 OpenShift Container Platform에 로그인되어 있습니다. -

OpenShift CLI(

oc)가 설치되어 있습니다.

프로세스

다음 명령을 실행하여 일부 노드에서 호스트 네트워크에서 패킷 캡처를 실행합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow <.>

--dest-dir인수는oc adm must-gather가 클라이언트 머신의/tmp/captures와 관련된 디렉터리에 패킷 캡처를 저장하도록 지정합니다. 쓰기 가능한 디렉터리를 지정할 수 있습니다. <.>oc adm must-gather가 시작되는 디버그 Pod에서tcpdump가 실행될 때--source-dir인수는 패킷 캡처가 Pod의/tmp/tcpdump디렉터리에 일시적으로 저장되도록 지정합니다. <.>--image인수는tcpdump명령을 포함하는 컨테이너 이미지. <.>--node-selector인수 및 예제 값은 작업자 노드에서 패킷 캡처를 수행하도록 지정합니다. 또는 단일 노드에서 패킷 캡처를 실행하도록--node-name인수를 지정할 수 있습니다.--node-selector및--node-name인수를 모두 생략하면 패킷 캡처가 모든 노드에서 수행됩니다. <.> 패킷 캡처가 노드의 네트워크 인터페이스에서 수행되도록--host-network=true인수가 필요합니다. <.>--timeout인수 및 값은 디버그 Pod를 30 초 동안 실행하기 위해 지정합니다.--timeout인수와 기간을 지정하지 않으면 디버그 Pod가 10분 동안 실행됩니다. <.>tcpdump명령의-i any인수는 모든 네트워크 인터페이스에서 패킷을 캡처하도록 지정합니다. 또는 네트워크 인터페이스 이름을 지정할 수 있습니다.- 네트워크 추적에서 패킷을 캡처하는 동안 네트워크 통신 문제를 트리거하는 웹 애플리케이션 액세스와 같은 작업을 수행합니다.

oc adm must-gather가 Pod에서 클라이언트 머신으로 전송된 패킷 캡처 파일을 확인합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

5.10. OpenShift Container Platform 노드 또는 컨테이너에서 네트워크 추적 수집

잠재적인 네트워크 관련 OpenShift Container Platform 문제를 조사할 때 Red Hat 지원은 특정 OpenShift Container Platform 클러스터 노드 또는 특정 컨테이너에서 네트워크 패킷 추적을 요청할 수 있습니다. OpenShift Container Platform에서 네트워크 추적을 캡처하는 데 권장되는 방법은 디버그 Pod를 사용하는 것입니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다. -

OpenShift CLI(

oc)가 설치되어 있습니다. - 기존 Red Hat 지원 케이스 ID가 있습니다.

- Red Hat 표준 또는 프리미엄 서브스크립션이 있습니다.

- Red Hat 고객 포털 계정이 있어야 합니다.

- 호스트에 대한 SSH 액세스 권한이 있어야 합니다.

프로세스

클러스터 노드 목록을 가져옵니다.

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 대상 노드에서 디버그 세션으로 들어갑니다. 이 단계는

<node_name>-debug라는 디버그 Pod를 인스턴스화합니다.oc debug node/my-cluster-node

$ oc debug node/my-cluster-nodeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 디버그 쉘 내에서

/host를 root 디렉터리로 설정합니다. 디버그 Pod는 Pod 내의/host에 호스트의 루트 파일 시스템을 마운트합니다. root 디렉토리를/host로 변경하면 호스트의 실행 경로에 포함된 바이너리를 실행할 수 있습니다.chroot /host

# chroot /hostCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고RHCOS(Red Hat Enterprise Linux CoreOS)를 실행하는 OpenShift Container Platform 4.16 클러스터 노드는 변경할 수 없으며 Operator를 사용하여 클러스터 변경 사항을 적용합니다. SSH를 사용하여 클러스터 노드에 액세스하는 것은 권장되지 않습니다. 그러나 OpenShift Container Platform API를 사용할 수 없거나 kubelet이 대상 노드에서 제대로 작동하지 않는 경우

oc작업이 영향을 받습니다. 이러한 상황에서 대신ssh core @ <node>.<cluster_name>.<base_domain>을 사용하여 노드에 액세스할 수 있습니다.chroot환경 콘솔에서 노드의 인터페이스 이름을 가져옵니다.ip ad

# ip adCopy to Clipboard Copied! Toggle word wrap Toggle overflow sosreport를 실행하는 데 필요한 바이너리 및 플러그인이 포함된toolbox컨테이너를 시작합니다.toolbox

# toolboxCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고기존

toolboxPod가 이미 실행 중인 경우toolbox명령은'toolbox-' already exists를 출력합니다. Trying to start…를 출력합니다.tcpdump문제를 방지하려면podman rm toolbox-에서 실행중인 toolbox 컨테이너를 제거하고 새 toolbox 컨테이너를 생성합니다.클러스터 노드에서

tcpdump세션을 시작하고 출력을 캡처 파일로 리디렉션합니다. 이 예에서는ens5를 인터페이스 이름으로 사용합니다.tcpdump -nn -s 0 -i ens5 -w /host/var/tmp/my-cluster-node_$(date +%d_%m_%Y-%H_%M_%S-%Z).pcap

$ tcpdump -nn -s 0 -i ens5 -w /host/var/tmp/my-cluster-node_$(date +%d_%m_%Y-%H_%M_%S-%Z).pcap1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- toolbox 컨테이너가 호스트의 root 디렉토리를

/host에 마운트하기 때문에tcpdump캡처 파일의 경로는chroot환경 외부에 있습니다.

노드의 특정 컨테이너에

tcpdump캡처가 필요한 경우 다음 단계를 따르십시오.대상 컨테이너 ID를 확인합니다. toolbox 컨테이너가 호스트의 root 디렉토리를

/host에 마운트하기 때문에chroot host명령은 이 단계에서crictl명령 보다 우선합니다.chroot /host crictl ps

# chroot /host crictl psCopy to Clipboard Copied! Toggle word wrap Toggle overflow 컨테이너의 프로세스 ID를 확인합니다. 이 예에서 컨테이너 ID는

a7fe32346b120입니다.chroot /host crictl inspect --output yaml a7fe32346b120 | grep 'pid' | awk '{print $2}'# chroot /host crictl inspect --output yaml a7fe32346b120 | grep 'pid' | awk '{print $2}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 컨테이너에서