Nutanix에 설치

Nutanix에 OpenShift Container Platform 설치

초록

1장. Nutanix에 설치 준비

OpenShift Container Platform 클러스터를 설치하기 전에 Nutanix 환경이 다음 요구사항을 충족하는지 확인하십시오.

1.1. Nutanix 버전 요구 사항

다음 요구 사항을 충족하는 Nutanix 환경에 OpenShift Container Platform 클러스터를 설치해야 합니다.

| Component | 필수 버전 |

|---|---|

| Nutanix AOS | 6.5.2.7 이상 |

| Prism Central | PC.2022.6 이상 |

1.2. 환경 요구사항

OpenShift Container Platform 클러스터를 설치하기 전에 다음 Nutanix AOS 환경 요구 사항을 검토하십시오.

1.2.1. 인프라 요구사항

온프레미스 Nutanix 클러스터, Nutanix 클라우드 클러스터(NC2)에 OpenShift Container Platform을 AWS(Amazon Web Services)에 설치하거나 Microsoft Azure에 OpenShift Container Platform을 설치할 수 있습니다.

자세한 내용은 AWS의 Nutanix 클라우드 클러스터 및 Microsoft Azure의 Nutanix 클라우드 클러스터를 참조하세요.

1.2.2. 필요한 계정 권한

설치 프로그램에서 클러스터를 배포하고 일상적인 작업을 유지하기 위해 필요한 권한으로 Nutanix 계정에 액세스해야 합니다. 다음 옵션을 사용할 수 있습니다.

- 관리 권한으로 로컬 Prism Central 사용자 계정을 사용할 수 있습니다. 로컬 계정을 사용하는 것이 필요한 권한이 있는 계정에 대한 액세스 권한을 부여하는 가장 빠른 방법입니다.

- 조직의 보안 정책에서 보다 제한적인 권한 세트를 사용해야 하는 경우 다음 표에 나열된 권한을 사용하여 Prism Central에서 사용자 지정 Cloud Native 역할을 만듭니다. 그런 다음 Prism Central 인증 디렉터리의 멤버인 사용자 계정에 역할을 할당할 수 있습니다.

이 사용자 계정을 관리할 때는 다음을 고려하십시오.

- 엔터티를 역할에 할당할 때 사용자가 가상 머신을 배포하는 데 필요한 Prism Element 및 subnet에만 액세스할 수 있는지 확인합니다.

- 사용자가 가상 머신을 할당해야 하는 프로젝트의 멤버인지 확인합니다.

자세한 내용은 Custom Cloud Native 역할 생성, 역할 할당 및 프로젝트에 사용자를 추가하는 방법에 대한 Nutanix 설명서를 참조하십시오.

예 1.1. Custom Cloud Native 역할을 생성하는 데 필요한 권한

| Nutanix 오브젝트 | 필요한 경우 | Nutanix API에서 필요한 권한 | 설명 |

|---|---|---|---|

| 카테고리 | Always |

| OpenShift Container Platform 시스템에 할당된 카테고리를 생성, 읽기 및 삭제합니다. |

| 이미지 | Always |

| OpenShift Container Platform 머신에 사용되는 운영 체제 이미지를 생성, 읽기 및 삭제합니다. |

| 가상 머신 | Always |

| OpenShift Container Platform 시스템을 생성, 읽기 및 삭제합니다. |

| 클러스터 | Always |

| OpenShift Container Platform 머신을 호스팅하는 Prism Element 클러스터를 확인합니다. |

| 서브넷 | Always |

| OpenShift Container Platform 머신을 호스팅하는 서브넷을 확인합니다. |

| 프로젝트 | 프로젝트를 컴퓨팅 시스템, 컨트롤 플레인 시스템 또는 모든 시스템과 연결하는 경우. |

| Prism Central에 정의된 프로젝트를 보고 OpenShift Container Platform 머신에 프로젝트를 할당할 수 있습니다. |

| 작업 | Always |

| OpenShift Container Platform 머신 및 노드가 포함된 Prism Element에서 작업을 가져와서 봅니다. |

| 호스트 | 컴퓨팅 시스템과 함께 GPU를 사용하는 경우 |

| GPU가 연결된 Prism Element에서 호스트를 가져와서 봅니다. |

1.2.3. 클러스터 제한

사용 가능한 리소스는 클러스터마다 다릅니다. Nutanix 환경에서 사용 가능한 클러스터 수는 주로 사용 가능한 스토리지 공간 및 클러스터가 생성하는 리소스와 관련된 제한 사항 및 IP 주소 및 네트워크를 배포하는 데 필요한 리소스를 통해 제한됩니다.

1.2.4. 클러스터 리소스

표준 클러스터를 사용하려면 최소 800GB의 스토리지가 필요합니다.

설치 관리자 프로비저닝 인프라를 사용하는 OpenShift Container Platform 클러스터를 배포할 때 설치 프로그램은 Nutanix 인스턴스에 여러 리소스를 생성할 수 있어야 합니다. 이러한 리소스는 856GB의 스토리지를 사용하지만 부트스트랩 노드는 설치 프로세스의 일부로 삭제됩니다.

표준 OpenShift Container Platform 설치는 다음 리소스를 생성합니다.

- 레이블 1개

가상 머신:

- 디스크 이미지 1개

- 임시 부트스트랩 노드 한 개

- 컨트롤 플레인 노드 세 개

- 컴퓨팅 시스템 세 개

1.2.5. 네트워킹 요구사항

네트워크에 AHV IP 주소 관리(IPAM) 또는 DHCP(Dynamic Host Configuration Protocol)를 사용하고 클러스터 시스템에 영구 IP 주소를 제공하도록 구성되어 있는지 확인해야 합니다. 또한 OpenShift Container Platform 클러스터를 설치하기 전에 다음 네트워킹 리소스를 생성합니다.

- IP 주소

- DNS 레코드

새 클러스터 설치에는 Nutanix Flow Virtual Networking이 지원됩니다. 이 기능을 사용하려면 설치하기 전에 AHV 클러스터에서 Flow Virtual Networking을 활성화합니다. 자세한 내용은 Flow Virtual Networking 개요 를 참조하십시오.

클러스터의 각 OpenShift Container Platform 노드는 DHCP를 통해 검색할 수 있는 NTP(Network Time Protocol) 서버에 액세스하는 것이 좋습니다. NTP 서버 없이도 설치할 수 있습니다. 그러나 NTP 서버는 일반적으로 비동기 서버 클록과 관련된 오류를 방지합니다.

1.2.5.1. 필요한 IP 주소

설치 프로그램에서 제공하는 설치에는 두 개의 고정 가상 IP(VIP) 주소가 필요합니다.

- API의 VIP 주소가 필요합니다. 이 주소는 클러스터 API에 액세스하는 데 사용됩니다.

- Ingress의 VIP 주소가 필요합니다. 이 주소는 클러스터 인그레스 트래픽에 사용됩니다.

OpenShift Container Platform 클러스터를 설치할 때 이러한 IP 주소를 지정합니다.

1.2.5.2. DNS 레코드

OpenShift Container Platform 클러스터를 호스팅하는 Nutanix 인스턴스에 적절한 DNS 서버에 두 개의 고정 IP 주소에 대한 DNS 레코드를 생성해야 합니다. 각 레코드에서 <cluster_name>은 클러스터 이름이고 <base_domain>은 클러스터를 설치할 때 지정하는 클러스터 기본 도메인입니다.

자체 DNS 또는 DHCP 서버를 사용하는 경우 부트스트랩, 컨트롤 플레인 및 컴퓨팅 노드를 포함하여 각 노드에 대한 레코드도 생성해야 합니다.

전체 DNS 레코드는 <component>.<cluster_name>.<base_domain> 형식입니다.

| 구성 요소 | 레코드 | 설명 |

|---|---|---|

| API VIP |

| 이 DNS A/AAAA 또는 CNAME 레코드는 컨트롤 플레인 시스템의 로드 밸런서를 가리켜야 합니다. 이 레코드는 클러스터 외부의 클라이언트와 클러스터 내의 모든 노드에서 확인할 수 있어야 합니다. |

| Ingress VIP |

| 기본적으로 작업자 노드인 인그레스 라우터 Pod를 실행하는 시스템을 대상으로 하는 로드 밸런서를 가리키는 와일드카드 DNS A/AAAA 또는 CNAME 레코드입니다. 이 레코드는 클러스터 외부의 클라이언트와 클러스터 내의 모든 노드에서 확인할 수 있어야 합니다. |

1.3. Cloud Credential Operator 유틸리티 구성

CCO(Cloud Credential Operator)는 클라우드 공급자 자격 증명을 Kubernetes CRD(사용자 지정 리소스 정의)로 관리합니다. Nutanix에 클러스터를 설치하려면 설치 프로세스의 일부로 CCO를 수동 모드로 설정해야 합니다.

CCO(Cloud Credential Operator)가 수동 모드에서 작동할 때 클러스터 외부에서 클라우드 인증 정보를 생성하고 관리하려면 CCO 유틸리티(ccoctl) 바이너리를 추출 및 준비합니다.

ccoctl 유틸리티는 Linux 환경에서 실행해야 하는 Linux 바이너리입니다.

사전 요구 사항

- 클러스터 관리자 액세스 권한이 있는 OpenShift Container Platform 계정에 액세스할 수 있습니다.

-

OpenShift CLI(

oc)가 설치되어 있습니다.

프로세스

다음 명령을 실행하여 OpenShift Container Platform 릴리스 이미지의 변수를 설정합니다.

RELEASE_IMAGE=$(./openshift-install version | awk '/release image/ {print $3}')$ RELEASE_IMAGE=$(./openshift-install version | awk '/release image/ {print $3}')Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 OpenShift Container Platform 릴리스 이미지에서 CCO 컨테이너 이미지를 가져옵니다.

CCO_IMAGE=$(oc adm release info --image-for='cloud-credential-operator' $RELEASE_IMAGE -a ~/.pull-secret)

$ CCO_IMAGE=$(oc adm release info --image-for='cloud-credential-operator' $RELEASE_IMAGE -a ~/.pull-secret)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고$RELEASE_IMAGE의 아키텍처가ccoctl툴을 사용할 환경의 아키텍처와 일치하는지 확인합니다.다음 명령을 실행하여 OpenShift Container Platform 릴리스 이미지 내에서

ccoctl바이너리를 추출합니다.oc image extract $CCO_IMAGE \ --file="/usr/bin/ccoctl.<rhel_version>" \ -a ~/.pull-secret

$ oc image extract $CCO_IMAGE \ --file="/usr/bin/ccoctl.<rhel_version>" \1 -a ~/.pull-secretCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- &

lt;rhel_version> 의 경우 호스트가 사용하는 RHEL(Red Hat Enterprise Linux) 버전에 해당하는 값을 지정합니다. 값을 지정하지 않으면 기본적으로ccoctl.rhel8이 사용됩니다. 다음 값이 유효합니다.-

rhel8: RHEL 8을 사용하는 호스트에 대해 이 값을 지정합니다. -

rhel9: RHEL 9를 사용하는 호스트에 대해 이 값을 지정합니다.

-

참고ccoctl바이너리는/usr/bin/에서는 명령을 실행한 디렉터리에 생성됩니다. 디렉터리 이름을 바꾸거나ccoctl.<rhel_version> 바이너리를ccoctl으로 이동해야 합니다.다음 명령을 실행하여

ccoctl을 실행할 수 있도록 권한을 변경합니다.chmod 775 ccoctl

$ chmod 775 ccoctlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

ccoctl을 사용할 준비가 되었는지 확인하려면 도움말 파일을 표시합니다. 명령을 실행할 때 상대 파일 이름을 사용합니다. 예를 들면 다음과 같습니다../ccoctl

$ ./ccoctlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2장. 여러 Prism Cryostat를 사용한 내결함성 배포

기본적으로 설치 프로그램은 컨트롤 플레인 및 컴퓨팅 머신을 단일 Nutanix Prism Element (클러스터)에 설치합니다. OpenShift Container Platform 클러스터의 내결함성을 개선하기 위해 장애 도메인을 구성하여 이러한 머신을 여러 Nutanix 클러스터에 배포하도록 지정할 수 있습니다.

실패 도메인은 설치 중 및 설치 후 OpenShift Container Platform 머신 풀에서 사용할 수 있는 추가 Prism Element 인스턴스를 나타냅니다.

2.1. 설치 방법 및 실패 도메인 구성

OpenShift Container Platform 설치 방법은 장애 도메인을 구성하는 방법과 시기를 결정합니다.

설치 관리자 프로비저닝 인프라를 사용하여 배포하는 경우 클러스터를 배포하기 전에 설치 구성 파일에서 실패 도메인을 구성할 수 있습니다. 자세한 내용은 실패 도메인 구성을 참조하십시오.

클러스터가 배포된 후 실패 도메인을 구성할 수도 있습니다. 설치 후 실패 도메인 구성에 대한 자세한 내용은 기존 Nutanix 클러스터에 장애 도메인 추가를 참조하십시오.

- (사용자 프로비저닝 인프라)를 사용하여 관리하는 인프라를 사용하여 배포하는 경우 추가 구성이 필요하지 않습니다. 클러스터가 배포된 후 장애 도메인에서 컨트롤 플레인과 컴퓨팅 머신을 수동으로 배포할 수 있습니다.

2.2. 기존 Nutanix 클러스터에 장애 도메인 추가

기본적으로 설치 프로그램은 컨트롤 플레인 및 컴퓨팅 머신을 단일 Nutanix Prism Element (클러스터)에 설치합니다. OpenShift Container Platform 클러스터가 배포된 후 실패 도메인을 사용하여 배포에 Prism Element 인스턴스를 추가하여 내결함성을 개선할 수 있습니다.

장애 도메인은 새 컨트롤 플레인 및 컴퓨팅 시스템을 배포하고 기존 컨트롤 플레인 및 컴퓨팅 시스템을 배포할 수 있는 단일 Prism Element 인스턴스를 나타냅니다.

2.2.1. 실패 도메인 요구 사항

실패 도메인을 사용하려는 경우 다음 요구 사항을 고려하십시오.

- 모든 Nutanix Prism Element 인스턴스는 Prism Central의 동일한 인스턴스에서 관리해야 합니다. 여러 Prism Central 인스턴스로 구성된 배포는 지원되지 않습니다.

- Prism Element 클러스터를 구성하는 시스템은 장애 도메인이 서로 통신할 수 있도록 동일한 이더넷 네트워크에 있어야 합니다.

- OpenShift Container Platform 클러스터에서 장애 도메인으로 사용할 각 Prism Element에 서브넷이 필요합니다. 이러한 서브넷을 정의할 때 동일한 IP 주소 접두사(CIDR)를 공유해야 하며 OpenShift Container Platform 클러스터가 사용하는 가상 IP 주소를 포함해야 합니다.

2.2.2. Infrastructure CR에 장애 도메인 추가

Infrastructure CR(사용자 정의 리소스)( infrastructure.config.openshift.io )을 수정하여 기존 Nutanix 클러스터에 장애 도메인을 추가합니다.

고가용성을 보장하기 위해 세 개의 실패 도메인을 구성하는 것이 좋습니다.

프로세스

다음 명령을 실행하여 Infrastructure CR을 편집합니다.

oc edit infrastructures.config.openshift.io cluster

$ oc edit infrastructures.config.openshift.io clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow 실패 도메인을 구성합니다.

Nutanix 실패 도메인이 있는 Infrastructure CR의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

<uuid>- Prism Element의 UUID(Universally unique identifier)를 지정합니다.

<failure_domain_name>-

실패 도메인의 고유한 이름을 지정합니다. 이름은 64자 미만으로 제한되며 소문자, 숫자, 대시(

-)를 포함할 수 있습니다. 대시는 이름의 선행 또는 종료 위치에 있을 수 없습니다. <network_uuid>- Prism Element 서브넷 오브젝트의 UUID를 지정합니다. 서브넷의 CIDR(IP 주소 접두사)에는 OpenShift Container Platform 클러스터가 사용하는 가상 IP 주소가 포함되어야 합니다. OpenShift Container Platform 클러스터에서 장애 도메인(Prism Element)당 하나의 서브넷만 지원됩니다.

- CR을 저장하여 변경 사항을 적용합니다.

2.2.3. 장애 도메인에서 컨트롤 플레인 배포

컨트롤 플레인 머신 세트 CR(사용자 정의 리소스)을 수정하여 Nutanix 장애 도메인에 컨트롤 플레인을 배포합니다.

사전 요구 사항

- 클러스터의 Infrastructure CR(사용자 정의 리소스)에 장애 도메인을 구성했습니다.

- 컨트롤 플레인 머신 세트 CR(사용자 정의 리소스)은 활성 상태입니다.

컨트롤 플레인 머신 세트 사용자 정의 리소스 상태를 확인하는 방법에 대한 자세한 내용은 "추가 리소스"를 참조하십시오.

프로세스

다음 명령을 실행하여 컨트롤 플레인 머신 세트 CR을 편집합니다.

oc edit controlplanemachineset.machine.openshift.io cluster -n openshift-machine-api

$ oc edit controlplanemachineset.machine.openshift.io cluster -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow spec.template.machines_v1beta1_machine_openshift_io.failureDomains스탠자를 추가하여 실패 도메인을 사용하도록 컨트롤 플레인 머신 세트를 구성합니다.Nutanix 장애 도메인이 있는 컨트롤 플레인 머신 세트의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 변경 사항을 저장하십시오.

기본적으로 컨트롤 플레인 머신 세트는 변경 사항을 컨트롤 플레인 구성에 자동으로 전파합니다. 클러스터가 OnDelete 업데이트 전략을 사용하도록 구성된 경우 컨트롤 플레인을 수동으로 교체해야 합니다. 자세한 내용은 "추가 리소스"를 참조하십시오.

2.2.4. 장애 도메인에서 컴퓨팅 머신 배포

다음 방법 중 하나로 Nutanix 장애 도메인에 컴퓨팅 머신을 배포할 수 있습니다.

- 기존 컴퓨팅 머신 세트를 편집하면 Nutanix 장애 도메인에 컴퓨팅 머신을 최소 구성 업데이트로 배포할 수 있습니다.

- 기존 컴퓨팅 머신 세트를 교체 하면 사양을 변경할 수 없으며 모든 머신이 동일합니다.

2.2.4.1. 실패 도메인 구현을 위해 컴퓨팅 머신 세트 편집

기존 컴퓨팅 머신 세트를 사용하여 Nutanix 장애 도메인에 컴퓨팅 머신을 배포하려면 컴퓨팅 머신 세트를 구성으로 업데이트한 다음 스케일링을 사용하여 기존 컴퓨팅 머신을 교체합니다.

사전 요구 사항

- 클러스터의 Infrastructure CR(사용자 정의 리소스)에 장애 도메인을 구성했습니다.

프로세스

다음 명령을 실행하여 클러스터의 Infrastructure CR을 확인합니다.

oc describe infrastructures.config.openshift.io cluster

$ oc describe infrastructures.config.openshift.io clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

각 장애 도메인(

platformSpec.nutanix.failureDomains)에 대해 클러스터의 UUID, 이름 및 서브넷 오브젝트 UUID를 기록해 둡니다. 이러한 값은 컴퓨팅 머신 세트에 실패 도메인을 추가하는 데 필요합니다. 다음 명령을 실행하여 클러스터의 컴퓨팅 머신 세트를 나열합니다.

oc get machinesets -n openshift-machine-api

$ oc get machinesets -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME DESIRED CURRENT READY AVAILABLE AGE <machine_set_name_1> 1 1 1 1 55m <machine_set_name_2> 1 1 1 1 55m

NAME DESIRED CURRENT READY AVAILABLE AGE <machine_set_name_1> 1 1 1 1 55m <machine_set_name_2> 1 1 1 1 55mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 첫 번째 컴퓨팅 머신 세트를 편집합니다.

oc edit machineset <machine_set_name_1> -n openshift-machine-api

$ oc edit machineset <machine_set_name_1> -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음을

spec.template.spec.providerSpec.value스탠자로 업데이트하여 첫 번째 실패 도메인을 사용하도록 컴퓨팅 시스템 세트를 구성합니다.참고cluster및subnets필드에 지정한 값이 클러스터의 Infrastructure CR의failureDomains스탠자에 구성된 값과 일치하는지 확인합니다.Nutanix 실패 도메인이 있는 컴퓨팅 머신 세트의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

변경 사항을 적용하기 위해 컴퓨팅 머신 세트를 스케일링할 때 필요하므로

spec.replicas의 값을 확인합니다. - 변경 사항을 저장하십시오.

다음 명령을 실행하여 업데이트된 컴퓨팅 머신 세트에서 관리하는 머신을 나열합니다.

oc get -n openshift-machine-api machines \ -l machine.openshift.io/cluster-api-machineset=<machine_set_name_1>

$ oc get -n openshift-machine-api machines \ -l machine.openshift.io/cluster-api-machineset=<machine_set_name_1>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME PHASE TYPE REGION ZONE AGE <machine_name_original_1> Running AHV Unnamed Development-STS 4h <machine_name_original_2> Running AHV Unnamed Development-STS 4h

NAME PHASE TYPE REGION ZONE AGE <machine_name_original_1> Running AHV Unnamed Development-STS 4h <machine_name_original_2> Running AHV Unnamed Development-STS 4hCopy to Clipboard Copied! Toggle word wrap Toggle overflow 업데이트된 컴퓨팅 머신 세트에서 관리하는 각 머신에 대해 다음 명령을 실행하여

삭제주석을 설정합니다.oc annotate machine/<machine_name_original_1> \ -n openshift-machine-api \ machine.openshift.io/delete-machine="true"

$ oc annotate machine/<machine_name_original_1> \ -n openshift-machine-api \ machine.openshift.io/delete-machine="true"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 새 구성으로 대체 머신을 생성하려면 다음 명령을 실행하여 컴퓨팅 머신 세트를 복제본 수의 두 배로 스케일링합니다.

oc scale --replicas=<twice_the_number_of_replicas> \ machineset <machine_set_name_1> \ -n openshift-machine-api

$ oc scale --replicas=<twice_the_number_of_replicas> \1 machineset <machine_set_name_1> \ -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 예를 들어 컴퓨팅 시스템 세트의 원래 복제본 수가

2이면 복제본을4로 스케일링합니다.

다음 명령을 실행하여 업데이트된 컴퓨팅 머신 세트에서 관리하는 머신을 나열합니다.

oc get -n openshift-machine-api machines -l machine.openshift.io/cluster-api-machineset=<machine_set_name_1>

$ oc get -n openshift-machine-api machines -l machine.openshift.io/cluster-api-machineset=<machine_set_name_1>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 새 머신이

Running단계에 있는 경우 컴퓨팅 머신 세트를 원래 복제본 수로 확장할 수 있습니다.이전 구성으로 생성된 머신을 제거하려면 다음 명령을 실행하여 컴퓨팅 머신 세트를 원래 복제본 수로 확장합니다.

oc scale --replicas=<original_number_of_replicas> \ machineset <machine_set_name_1> \ -n openshift-machine-api

$ oc scale --replicas=<original_number_of_replicas> \1 machineset <machine_set_name_1> \ -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 예를 들어 컴퓨팅 시스템 세트의 원래 복제본 수가

2인 경우 복제본을2로 확장합니다.

- 필요에 따라 배포에 사용할 수 있는 추가 실패 도메인을 참조하도록 머신 세트를 계속 수정합니다.

2.2.4.2. 실패 도메인 구현을 위해 컴퓨팅 머신 세트 교체

컴퓨팅 머신 세트를 교체하여 Nutanix 장애 도메인에 컴퓨팅 머신을 배포하려면 구성으로 새 컴퓨팅 머신 세트를 생성하고 생성된 시스템이 시작될 때까지 기다린 다음 이전 컴퓨팅 머신 세트를 삭제합니다.

사전 요구 사항

- 클러스터의 Infrastructure CR(사용자 정의 리소스)에 장애 도메인을 구성했습니다.

프로세스

다음 명령을 실행하여 클러스터의 Infrastructure CR을 확인합니다.

oc describe infrastructures.config.openshift.io cluster

$ oc describe infrastructures.config.openshift.io clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

각 장애 도메인(

platformSpec.nutanix.failureDomains)에 대해 클러스터의 UUID, 이름 및 서브넷 오브젝트 UUID를 기록해 둡니다. 이러한 값은 컴퓨팅 머신 세트에 실패 도메인을 추가하는 데 필요합니다. 다음 명령을 실행하여 클러스터의 컴퓨팅 머신 세트를 나열합니다.

oc get machinesets -n openshift-machine-api

$ oc get machinesets -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME DESIRED CURRENT READY AVAILABLE AGE <original_machine_set_name_1> 1 1 1 1 55m <original_machine_set_name_2> 1 1 1 1 55m

NAME DESIRED CURRENT READY AVAILABLE AGE <original_machine_set_name_1> 1 1 1 1 55m <original_machine_set_name_2> 1 1 1 1 55mCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 기존 컴퓨팅 머신 세트의 이름을 확인합니다.

다음 방법 중 하나를 사용하여 새 컴퓨팅 머신 세트 CR(사용자 정의 리소스)의 값이 포함된 YAML 파일을 생성합니다.

다음 명령을 실행하여 기존 컴퓨팅 머신 세트 구성을 새 파일에 복사합니다.

oc get machineset <original_machine_set_name_1> \ -n openshift-machine-api -o yaml > <new_machine_set_name_1>.yaml

$ oc get machineset <original_machine_set_name_1> \ -n openshift-machine-api -o yaml > <new_machine_set_name_1>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 기본 텍스트 편집기를 사용하여 이 YAML 파일을 편집할 수 있습니다.

원하는 텍스트 편집기를 사용하여 <

new_machine_set_name_1>.yaml이라는 빈 YAML 파일을 생성하고 새 컴퓨팅 머신 세트에 필요한 값을 포함합니다.특정 필드에 설정할 값이 확실하지 않은 경우 다음 명령을 실행하여 기존 컴퓨팅 머신 세트 CR의 값을 볼 수 있습니다.

oc get machineset <original_machine_set_name_1> \ -n openshift-machine-api -o yaml

$ oc get machineset <original_machine_set_name_1> \ -n openshift-machine-api -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

<new_machine_set_name_1>.yaml파일의spec.template.spec.providerSpec.value스탠자에 다음을 업데이트하여 첫 번째 실패 도메인을 사용하도록 새 컴퓨팅 머신 세트를 구성합니다.참고cluster및subnets필드에 지정한 값이 클러스터의 Infrastructure CR의failureDomains스탠자에 구성된 값과 일치하는지 확인합니다.Nutanix 실패 도메인이 있는 컴퓨팅 머신 세트의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 변경 사항을 저장하십시오.

다음 명령을 실행하여 컴퓨팅 머신 세트 CR을 생성합니다.

oc create -f <new_machine_set_name_1>.yaml

$ oc create -f <new_machine_set_name_1>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 필요에 따라 배포에 사용할 수 있는 추가 장애 도메인을 참조하는 컴퓨팅 머신 세트를 계속 생성합니다.

새 컴퓨팅 머신 세트마다 다음 명령을 실행하여 새 컴퓨팅 머신 세트에서 관리하는 머신을 나열합니다.

oc get -n openshift-machine-api machines -l machine.openshift.io/cluster-api-machineset=<new_machine_set_name_1>

$ oc get -n openshift-machine-api machines -l machine.openshift.io/cluster-api-machineset=<new_machine_set_name_1>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME PHASE TYPE REGION ZONE AGE <machine_from_new_1> Provisioned AHV Unnamed Development-STS 25s <machine_from_new_2> Provisioning AHV Unnamed Development-STS 25s

NAME PHASE TYPE REGION ZONE AGE <machine_from_new_1> Provisioned AHV Unnamed Development-STS 25s <machine_from_new_2> Provisioning AHV Unnamed Development-STS 25sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 새 머신이

Running단계에 있을 때 실패 도메인 구성이 포함되지 않은 이전 컴퓨팅 머신 세트를 삭제할 수 있습니다.새 머신이

Running단계에 있음을 확인한 경우 각각에 대해 다음 명령을 실행하여 이전 컴퓨팅 머신 세트를 삭제합니다.oc delete machineset <original_machine_set_name_1> -n openshift-machine-api

$ oc delete machineset <original_machine_set_name_1> -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

업데이트된 구성이 없는 컴퓨팅 머신 세트가 삭제되었는지 확인하려면 다음 명령을 실행하여 클러스터의 컴퓨팅 머신 세트를 나열합니다.

oc get machinesets -n openshift-machine-api

$ oc get machinesets -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

NAME DESIRED CURRENT READY AVAILABLE AGE <new_machine_set_name_1> 1 1 1 1 4m12s <new_machine_set_name_2> 1 1 1 1 4m12s

NAME DESIRED CURRENT READY AVAILABLE AGE <new_machine_set_name_1> 1 1 1 1 4m12s <new_machine_set_name_2> 1 1 1 1 4m12sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 업데이트된 구성이 없는 컴퓨팅 머신이 삭제되었는지 확인하려면 다음 명령을 실행하여 클러스터의 시스템을 나열합니다.

oc get -n openshift-machine-api machines

$ oc get -n openshift-machine-api machinesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 삭제가 진행되는 동안 출력 예

NAME PHASE TYPE REGION ZONE AGE <machine_from_new_1> Running AHV Unnamed Development-STS 5m41s <machine_from_new_2> Running AHV Unnamed Development-STS 5m41s <machine_from_original_1> Deleting AHV Unnamed Development-STS 4h <machine_from_original_2> Deleting AHV Unnamed Development-STS 4h

NAME PHASE TYPE REGION ZONE AGE <machine_from_new_1> Running AHV Unnamed Development-STS 5m41s <machine_from_new_2> Running AHV Unnamed Development-STS 5m41s <machine_from_original_1> Deleting AHV Unnamed Development-STS 4h <machine_from_original_2> Deleting AHV Unnamed Development-STS 4hCopy to Clipboard Copied! Toggle word wrap Toggle overflow 삭제가 완료되면 출력 예

NAME PHASE TYPE REGION ZONE AGE <machine_from_new_1> Running AHV Unnamed Development-STS 6m30s <machine_from_new_2> Running AHV Unnamed Development-STS 6m30s

NAME PHASE TYPE REGION ZONE AGE <machine_from_new_1> Running AHV Unnamed Development-STS 6m30s <machine_from_new_2> Running AHV Unnamed Development-STS 6m30sCopy to Clipboard Copied! Toggle word wrap Toggle overflow 새 컴퓨팅 머신 세트로 생성한 머신에 올바른 구성이 있는지 확인하려면 다음 명령을 실행하여 새 머신 중 하나에 대해 CR의 관련 필드를 검사합니다.

oc describe machine <machine_from_new_1> -n openshift-machine-api

$ oc describe machine <machine_from_new_1> -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3장. Nutanix에 클러스터 설치

OpenShift Container Platform 버전 4.17에서는 다음 옵션 중 하나를 선택하여 Nutanix 인스턴스에 클러스터를 설치할 수 있습니다.

설치 관리자 프로비저닝 인프라 사용: 다음 섹션의 절차를 사용하여 설치 관리자 프로비저닝 인프라를 사용합니다. 설치 관리자 프로비저닝 인프라는 연결되거나 연결이 끊긴 네트워크 환경에 설치하는 데 이상적입니다. 설치 프로그램에서 제공하는 인프라에는 클러스터의 기본 인프라를 프로비저닝하는 설치 프로그램이 포함되어 있습니다.

지원 설치 관리자 사용: console.redhat.com 에서 호스팅되는 지원 설치 관리자 입니다. 지원 설치 프로그램은 연결이 끊긴 환경에서 사용할 수 없습니다. 지원 설치 프로그램은 클러스터의 기본 인프라를 프로비저닝하지 않으므로 지원 설치 관리자를 실행하기 전에 인프라를 프로비저닝해야 합니다. 지원 설치 관리자를 사용하여 설치하면 Nutanix와의 통합도 제공되므로 자동 스케일링이 가능합니다. 자세한 내용은 지원 설치 관리자를 사용하여 온프레미스 클러스터 설치를 참조하십시오.

사용자 프로비저닝 인프라 사용: 모든 플랫폼 설명서에서 클러스터 설치에 설명된 관련 단계를 완료합니다.

3.1. 사전 요구 사항

- OpenShift Container Platform 설치 및 업데이트 프로세스에 대한 세부 사항을 검토했습니다.

- 설치 프로그램은 Prism Central 및 Prism Element의 포트 9440에 액세스해야 합니다. 포트 9440에 액세스할 수 있는지 확인합니다.

방화벽을 사용하는 경우 다음 사전 요구 사항을 충족했습니다.

- 포트 9440에 액세스할 수 있음을 확인했습니다. 컨트롤 플레인 노드는 설치에 성공하려면 포트 9440에서 Prism Central 및 Prism Element에 도달할 수 있어야 합니다.

- OpenShift Container Platform에 필요한 사이트에 대한 액세스 권한을 부여 하도록 방화벽을 구성하셨습니다. 여기에는 Telemetry 사용이 포함됩니다.

Nutanix 환경에서 자체 서명된 기본 SSL 인증서를 사용하는 경우 CA에서 서명한 인증서로 교체합니다. 설치 프로그램에는 Prism Central API에 액세스하려면 유효한 CA 서명 인증서가 필요합니다. 자체 서명된 인증서 교체에 대한 자세한 내용은 Nutanix AOS 보안 가이드를 참조하십시오.

Nutanix 환경에서 내부 CA를 사용하여 인증서를 발급하는 경우 클러스터 전체 프록시를 설치 프로세스의 일부로 구성해야 합니다. 자세한 내용은 사용자 정의 PKI 구성을 참조하십시오.

중요2048비트 인증서를 사용합니다. Prism Central 2022.x와 함께 4096비트 인증서를 사용하는 경우 설치에 실패합니다.

3.2. OpenShift Container Platform 용 인터넷 액세스

OpenShift Container Platform 4.17에서 클러스터를 설치하려면 인터넷 액세스가 필요합니다.

다음 작업을 수행하려면 인터넷 액세스가 있어야 합니다.

- OpenShift Cluster Manager 에 액세스하여 설치 프로그램을 다운로드하고 서브스크립션 관리를 수행합니다. 클러스터가 인터넷에 액세스할 수 있고 Telemetry 서비스를 비활성화하지 않은 경우, 클러스터에 자동으로 권한이 부여됩니다.

- Quay.io에 액세스. 클러스터를 설치하는 데 필요한 패키지를 받을 수 있습니다.

- 클러스터 업데이트를 수행하는 데 필요한 패키지를 받을 수 있습니다.

클러스터가 직접 인터넷에 액세스할 수 없는 경우, 프로비저닝하는 일부 유형의 인프라에서 제한된 네트워크 설치를 수행할 수 있습니다. 이 프로세스 동안 필요한 콘텐츠를 다운로드하고 이를 사용하여 설치 패키지로 미러 레지스트리를 채웁니다. 설치 유형에 따라서는 클러스터를 설치하는 환경에 인터넷 액세스가 필요하지 않을 수도 있습니다. 클러스터를 업데이트하기 전에 미러 레지스트리의 내용을 업데이트합니다.

3.3. Prism Central에 대한 인터넷 액세스

Prism Central은 클러스터를 설치하는 데 필요한 RHCOS(Red Hat Enterprise Linux CoreOS) 이미지를 가져오려면 인터넷 액세스가 필요합니다. Nutanix용 RHCOS 이미지는 rhcos.mirror.openshift.com 에서 사용할 수 있습니다.

3.4. 클러스터 노드 SSH 액세스를 위한 키 쌍 생성

OpenShift Container Platform을 설치하는 동안 SSH 공개 키를 설치 프로그램에 지정할 수 있습니다. 키는 Ignition 구성 파일을 통해 RHCOS(Red Hat Enterprise Linux CoreOS) 노드에 전달되며 노드에 대한 SSH 액세스를 인증하는 데 사용됩니다. 키는 각 노드에서 core 사용자의 ~/.ssh/authorized_keys 목록에 추가되어 암호 없는 인증을 활성화합니다.

키가 노드에 전달되면 키 쌍을 사용하여 사용자 core로 RHCOS 노드에 SSH로 SSH 연결을 수행할 수 있습니다 . SSH를 통해 노드에 액세스하려면 로컬 사용자의 SSH에서 개인 키 ID를 관리해야 합니다.

설치 디버깅 또는 재해 복구를 수행하기 위해 클러스터 노드에 SSH를 실행하려면 설치 프로세스 중에 SSH 공용 키를 지정해야 합니다. ./openshift-install gather 명령에도 SSH 공개 키가 클러스터 노드에 있어야 합니다.

재해 복구 및 디버깅이 필요한 프로덕션 환경에서는이 단계를 생략하지 마십시오.

AWS 키 쌍과 같이 플랫폼 고유의 방식으로 구성된 키가 아닌 로컬 키를 사용해야 합니다.

프로세스

로컬 시스템에 클러스터 노드의 인증에 사용할 기존 SSH 키 쌍이 없는 경우 새로 생성합니다. 예를 들어 Linux 운영 체제를 사용하는 컴퓨터에서 다음 명령을 실행합니다.

ssh-keygen -t ed25519 -N '' -f <path>/<file_name>

$ ssh-keygen -t ed25519 -N '' -f <path>/<file_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 새 SSH 키의 경로 및 파일 이름(예:

~/.ssh/id_ed25519)을 지정합니다. 기존 키 쌍이 있는 경우 공개 키가'~/.ssh디렉터리에 있는지 확인하십시오.

참고x86_64,ppc64le,s390x아키텍처에서만 FIPS 140-2/140-3 Validation에 대해 NIST에 제출된 RHEL 암호화 라이브러리를 사용하는 OpenShift Container Platform 클러스터를 설치하려면ed25519알고리즘을 사용하는 키를 생성하지 마십시오. 대신rsa또는ecdsa알고리즘을 사용하는 키를 생성합니다.공개 SSH 키를 확인합니다.

cat <path>/<file_name>.pub

$ cat <path>/<file_name>.pubCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들어 다음을 실행하여

~/.ssh/id_ed25519.pub공개 키를 확인합니다.cat ~/.ssh/id_ed25519.pub

$ cat ~/.ssh/id_ed25519.pubCopy to Clipboard Copied! Toggle word wrap Toggle overflow 아직 추가되지 않은 경우 로컬 사용자의 SSH 에이전트에 SSH 개인 키 ID를 추가합니다. 키의 SSH 에이전트 관리는 클러스터 노드에 암호 없는 SSH 인증을 수행하거나

./openshift-install gather명령을 사용하려는 경우 필요합니다.참고일부 배포에서는

~/.ssh/id_rsa및~/.ssh/id_dsa와 같은 기본 SSH 개인 키 ID가 자동으로 관리됩니다.ssh-agent프로세스가 로컬 사용자에 대해 실행되지 않은 경우 백그라운드 작업으로 시작합니다.eval "$(ssh-agent -s)"

$ eval "$(ssh-agent -s)"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Agent pid 31874

Agent pid 31874Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고클러스터가 FIPS 모드인 경우 FIPS 호환 알고리즘만 사용하여 SSH 키를 생성합니다. 키는 RSA 또는 ECDSA여야 합니다.

ssh-agent에 SSH 개인 키를 추가합니다.ssh-add <path>/<file_name>

$ ssh-add <path>/<file_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- SSH 개인 키의 경로와 파일 이름을 지정합니다(예:

~/.ssh/id_ed25519).

출력 예

Identity added: /home/<you>/<path>/<file_name> (<computer_name>)

Identity added: /home/<you>/<path>/<file_name> (<computer_name>)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

다음 단계

- OpenShift Container Platform을 설치할 때 SSH 공개 키를 설치 프로그램에 지정합니다.

3.5. 설치 프로그램 받기

OpenShift Container Platform을 설치하기 전에 설치에 사용하는 호스트에 설치 파일을 다운로드합니다.

사전 요구 사항

- 500MB의 로컬 디스크 공간이 있는 Linux 또는 macOS를 실행하는 컴퓨터가 있습니다.

프로세스

Red Hat Hybrid Cloud Console의 Cluster Type 페이지로 이동합니다. Red Hat 계정이 있는 경우 인증 정보를 사용하여 로그인합니다. 계정이 없으면 계정을 만드십시오.

작은 정보- 페이지의 자체 실행 섹션에서 인프라 공급자를 선택합니다.

- OpenShift 설치 관리자의 드롭다운 메뉴에서 호스트 운영 체제 및 아키텍처를 선택하고 설치 프로그램 다운로드를 클릭합니다.

다운로드한 파일을 설치 구성 파일을 저장할 디렉터리에 배치합니다.

중요- 설치 프로그램은 클러스터를 설치하는 데 사용하는 컴퓨터에 여러 파일을 만듭니다. 클러스터 설치를 마친 후 설치 프로그램과 설치 프로그램으로 생성되는 파일을 보관해야 합니다. 클러스터를 삭제하려면 두 파일이 모두 필요합니다.

- 클러스터 설치에 실패하거나 설치 프로그램으로 만든 파일을 삭제해도 클러스터는 제거되지 않습니다. 클러스터를 제거하려면 해당 클라우드 공급자에 적용되는 OpenShift Container Platform 설치 제거 절차를 완료해야 합니다.

설치 프로그램 파일의 압축을 풉니다. 예를 들어 Linux 운영 체제를 사용하는 컴퓨터에서 다음 명령을 실행합니다.

tar -xvf openshift-install-linux.tar.gz

$ tar -xvf openshift-install-linux.tar.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Red Hat OpenShift Cluster Manager에서 설치 풀 시크릿을 다운로드합니다. 이 풀 시크릿을 사용하면 OpenShift Container Platform 구성 요소에 대한 컨테이너 이미지를 제공하는 Quay.io를 포함하여 인증 기관에서 제공하는 서비스로 인증할 수 있습니다.

또는 다운로드할 설치 프로그램 버전을 지정할 수 있는 Red Hat 고객 포털에서 설치 프로그램을 검색할 수 있습니다. 그러나 이 페이지에 액세스하려면 활성 서브스크립션이 있어야 합니다.

3.6. 시스템 신뢰에 Nutanix 루트 CA 인증서 추가

설치 프로그램에서 Prism Central API에 액세스해야 하므로 OpenShift Container Platform 클러스터를 설치하기 전에 Nutanix 신뢰할 수 있는 루트 CA 인증서를 시스템 신뢰에 추가해야 합니다.

프로세스

- Prism Central 웹 콘솔에서 Nutanix 루트 CA 인증서를 다운로드합니다.

- Nutanix 루트 CA 인증서가 포함된 압축 파일을 추출합니다.

운영 체제 파일을 시스템 신뢰에 추가합니다. 예를 들어 Fedora 운영 체제에서는 다음 명령을 실행합니다.

cp certs/lin/* /etc/pki/ca-trust/source/anchors

# cp certs/lin/* /etc/pki/ca-trust/source/anchorsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 시스템 신뢰를 업데이트합니다. 예를 들어 Fedora 운영 체제에서는 다음 명령을 실행합니다.

update-ca-trust extract

# update-ca-trust extractCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.7. 설치 구성 파일 만들기

Nutanix에 설치하는 OpenShift Container Platform 클러스터를 사용자 지정할 수 있습니다.

사전 요구 사항

- OpenShift Container Platform 설치 프로그램과 클러스터의 풀 시크릿이 있습니다.

- Nutanix 네트워킹 요구 사항을 충족하는지 확인했습니다. 자세한 내용은 " Nutanix에 설치 준비"를 참조하십시오.

프로세스

install-config.yaml파일을 생성합니다.설치 프로그램이 포함된 디렉터리로 변경하고 다음 명령을 실행합니다.

./openshift-install create install-config --dir <installation_directory>

$ ./openshift-install create install-config --dir <installation_directory>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<installation_directory>는 설치 프로그램이 생성하는 파일을 저장할 디렉터리 이름을 지정합니다.

디렉터리를 지정할 때 다음을 수행합니다.

-

디렉터리에

execute권한이 있는지 확인합니다. 설치 디렉토리에서 Terraform 바이너리를 실행하려면 이 권한이 필요합니다. - 빈 디렉터리를 사용합니다. 부트스트랩 X.509 인증서와 같은 일부 설치 자산은 단기간에 만료되므로 설치 디렉터리를 재사용해서는 안 됩니다. 다른 클러스터 설치의 개별 파일을 재사용하려면 해당 파일을 사용자 디렉터리에 복사하면 됩니다. 그러나 설치 자산의 파일 이름은 릴리스간에 변경될 수 있습니다. 따라서 이전 OpenShift Container Platform 버전에서 설치 파일을 복사할 때는 주의하십시오.

화면에 나타나는 지시에 따라 클라우드에 대한 구성 세부 사항을 입력합니다.

선택사항: 클러스터 시스템에 액세스하는 데 사용할 SSH 키를 선택합니다.

참고설치 디버깅 또는 재해 복구를 수행하려는 프로덕션 OpenShift Container Platform 클러스터의 경우

ssh-agent프로세스가 사용하는 SSH 키를 지정합니다.- 대상 플랫폼으로 nutanix 를 선택합니다.

- Prism Central 도메인 이름 또는 IP 주소를 입력합니다.

- Prism Central에 로그인하는 데 사용되는 포트를 입력합니다.

Prism Central에 로그인하는 데 사용되는 인증 정보를 입력합니다.

설치 프로그램은 Prism Central에 연결됩니다.

- OpenShift Container Platform 클러스터를 관리할 Prism Element를 선택합니다.

- 사용할 네트워크 서브넷을 선택합니다.

- 컨트롤 플레인 API 액세스를 위해 구성한 가상 IP 주소를 입력합니다.

- 클러스터 인그레스용으로 구성한 가상 IP 주소를 입력합니다.

- 기본 도메인을 입력합니다. 이 기본 도메인은 DNS 레코드에서 구성한 것과 동일해야 합니다.

클러스터를 설명할 수 있는 이름을 입력합니다.

입력한 클러스터 이름은 DNS 레코드를 구성할 때 지정한 클러스터 이름과 일치해야 합니다.

선택 사항:

install.config.yaml파일에서 기본 구성 매개변수 중 하나 이상을 업데이트하여 설치를 사용자 지정합니다.매개변수에 대한 자세한 내용은 "설치 구성 매개변수"를 참조하십시오.

참고3-노드 클러스터를 설치하는 경우

compute.replicas매개변수를0으로 설정해야 합니다. 이렇게 하면 클러스터의 컨트롤 플레인을 예약할 수 있습니다. 자세한 내용은 "Nutanix에 3노드 클러스터 설치"를 참조하세요.여러 클러스터를 설치하는 데 사용할 수 있도록

install-config.yaml파일을 백업합니다.중요install-config.yaml파일은 설치 과정에서 사용됩니다. 이 파일을 재사용하려면 지금 백업해야 합니다.

3.7.1. Nutanix용 샘플 사용자 지정 install-config.yaml 파일

install-config.yaml 파일을 사용자 지정하여 OpenShift Container Platform 클러스터 플랫폼에 대한 자세한 정보를 지정하거나 필수 매개변수 값을 수정할 수 있습니다.

이 샘플 YAML 파일은 참조용으로만 제공됩니다. 설치 프로그램을 사용하여 install-config.yaml 파일을 받아서 수정해야 합니다.

- 1 10 12 15 16 17 18 19 21

- 필수 항목입니다. 설치 프로그램에서 이 값을 입력하라는 메시지를 표시합니다.

- 2 6

controlPlane섹션은 단일 매핑이지만 compute 섹션은 일련의 매핑입니다. 서로 다른 데이터 구조의 요구사항을 충족하도록compute섹션의 첫 번째 줄은 하이픈(-)으로 시작해야 하며controlPlane섹션의 첫 번째 줄은 하이픈으로 시작할 수 없습니다. 현재 두 섹션이 모두 단일 시스템 풀을 정의하지만 향후 출시되는 OpenShift Container Platform 버전은 설치 과정에서 여러 컴퓨팅 풀 정의를 지원할 수 있습니다. 하나의 컨트롤 플레인 풀만 사용됩니다.- 3 7

- 동시 멀티스레딩 또는

hyperthreading활성화/비활성화 여부를 지정합니다. 시스템 코어의 성능을 높이기 위해 기본적으로 동시 멀티스레딩이 활성화됩니다. 매개변수 값을Disabled로 설정하여 비활성화할 수 있습니다. 일부 클러스터 시스템에서 동시 멀티스레딩을 비활성화할 경우에는 해당 멀티스레딩을 모든 클러스터 시스템에서 비활성화해야 합니다.중요동시 멀티스레딩을 비활성화하는 경우 용량 계획에서 시스템 성능이 크게 저하될 수 있는 문제를 고려해야 합니다.

- 4 8

- 선택사항: 컴퓨팅 및 컨트롤 플레인 시스템의 시스템 풀 매개변수에 대한 추가 구성을 제공하십시오.

- 5 9 13

- 선택 사항: prism 카테고리 키와 prism 카테고리 값 중 하나 이상의 쌍을 제공합니다. 이러한 카테고리 키-값 쌍은 Prism Central에 있어야 합니다. 컴퓨팅 시스템, 컨트롤 플레인 시스템 또는 모든 시스템에 별도의 카테고리를 제공할 수 있습니다.

- 11

- 설치할 클러스터 네트워크 플러그인입니다. 기본 값

OVNKubernetes는 지원되는 유일한 값입니다. - 14

- 선택 사항: VM이 연결된 프로젝트를 지정합니다. 프로젝트 유형에

name또는uuid를 지정한 다음 해당 UUID 또는 프로젝트 이름을 입력합니다. 프로젝트를 컴퓨팅 시스템, 컨트롤 플레인 시스템 또는 모든 시스템에 연결할 수 있습니다. - 20

- 선택 사항: 기본적으로 설치 프로그램은 RHCOS(Red Hat Enterprise Linux CoreOS) 이미지를 다운로드하여 설치합니다. Prism Central이 인터넷에 액세스할 수 없는 경우 모든 HTTP 서버에서 RHCOS 이미지를 호스팅하고 설치 프로그램을 이미지로 가리켜 기본 동작을 재정의할 수 있습니다.

- 22

- FIPS 모드 활성화 또는 비활성화 여부입니다. 기본적으로 FIPS 모드는 비활성화됩니다. FIPS 모드가 활성화되면 OpenShift Container Platform이 실행되는 RHCOS(Red Hat Enterprise Linux CoreOS) 시스템에서 기본 Kubernetes 암호화 제품군은 우회하고 RHCOS와 함께 제공되는 암호화 모듈을 대신 사용합니다.중요

FIPS 모드에서 부팅된 RHEL(Red Hat Enterprise Linux CoreOS) 또는 RHCOS(Red Hat Enterprise Linux CoreOS)를 실행하는 경우 OpenShift Container Platform 코어 구성 요소는 x86_64, ppc64le 및 s390x 아키텍처에서만 FIPS 140-2/140-3 Validation에 대해 NIST에 제출된 RHEL 암호화 라이브러리를 사용합니다.

- 23

- 선택 사항: 클러스터의 시스템에 액세스하는 데 사용하는

sshKey값을 제공할 수 있습니다.참고설치 디버깅 또는 재해 복구를 수행하려는 프로덕션 OpenShift Container Platform 클러스터의 경우

ssh-agent프로세스가 사용하는 SSH 키를 지정합니다.

3.7.2. 실패 도메인 구성

장애 도메인은 여러 Nutanix Prism Cryostat (클러스터)에 컨트롤 플레인 및 컴퓨팅 머신을 배포하여 OpenShift Container Platform 클러스터의 내결함성을 향상시킵니다.

고가용성을 보장하기 위해 세 개의 실패 도메인을 구성하는 것이 좋습니다.

사전 요구 사항

-

설치 구성 파일(

install-config.yaml)이 있습니다.

프로세스

install-config.yaml파일을 편집하고 다음 스탠자를 추가하여 첫 번째 실패 도메인을 구성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

<failure_domain_name>-

실패 도메인의 고유한 이름을 지정합니다. 이름은 64자 미만으로 제한되며 소문자, 숫자, 대시(

-)를 포함할 수 있습니다. 대시는 이름의 선행 또는 종료 위치에 있을 수 없습니다. <prism_element_name>- 선택 사항: Prism Element의 이름을 지정합니다.

<prism_element_uuid>- Prism Element의 UUID를 지정합니다.

<network_uuid>- Prism Element 서브넷 오브젝트의 UUID를 지정합니다. 서브넷의 CIDR(IP 주소 접두사)에는 OpenShift Container Platform 클러스터가 사용하는 가상 IP 주소가 포함되어야 합니다. OpenShift Container Platform 클러스터에서 장애 도메인(Prism Element)당 하나의 서브넷만 지원됩니다.

- 필요에 따라 추가 실패 도메인을 구성합니다.

장애 도메인에서 컨트롤 플레인 및 컴퓨팅 시스템을 배포하려면 다음 중 하나를 수행하십시오.

컴퓨팅 및 컨트롤 플레인 시스템이 동일한 장애 도메인 세트를 공유할 수 있는 경우 클러스터의 기본 머신 구성에 장애 도메인 이름을 추가합니다.

장애 도메인 세트를 공유하는 컨트롤 플레인 및 컴퓨팅 머신의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 컴퓨팅 및 컨트롤 플레인 시스템에서 다른 장애 도메인을 사용해야 하는 경우 해당 시스템 풀 아래에 실패 도메인 이름을 추가합니다.

다른 장애 도메인을 사용하는 컨트롤 플레인 및 컴퓨팅 머신의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- 파일을 저장합니다.

3.7.3. 설치 중 클러스터 단위 프록시 구성

프로덕션 환경에서는 인터넷에 대한 직접 액세스를 거부하고 대신 HTTP 또는 HTTPS 프록시를 사용할 수 있습니다. install-config.yaml 파일에서 프록시 설정을 구성하여 프록시가 사용되도록 새 OpenShift Container Platform 클러스터를 구성할 수 있습니다.

사전 요구 사항

-

기존

install-config.yaml파일이 있습니다. 클러스터에서 액세스해야 하는 사이트를 검토하고 프록시를 바이패스해야 하는지 확인했습니다. 기본적으로 호스팅 클라우드 공급자 API에 대한 호출을 포함하여 모든 클러스터 발신(Egress) 트래픽이 프록시됩니다. 필요한 경우 프록시를 바이패스하기 위해

Proxy오브젝트의spec.noProxy필드에 사이트를 추가했습니다.참고Proxy오브젝트의status.noProxy필드는 설치 구성에 있는networking.machineNetwork[].cidr,networking.clusterNetwork[].cidr,networking.serviceNetwork[]필드의 값으로 채워집니다.AWS(Amazon Web Services), Google Cloud, Microsoft Azure 및 RHOSP(Red Hat OpenStack Platform)에 설치하는 경우

프록시오브젝트status.noProxy필드도 인스턴스 메타데이터 끝점(169.254.169.254)으로 채워집니다.

프로세스

install-config.yaml파일을 편집하고 프록시 설정을 추가합니다. 예를 들면 다음과 같습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 클러스터 외부에서 HTTP 연결을 구축하는 데 사용할 프록시 URL입니다. URL 스키마는

http여야 합니다. - 2

- 클러스터 외부에서 HTTPS 연결을 구축하는 데 사용할 프록시 URL입니다.

- 3

- 대상 도메인 이름, IP 주소 또는 프록시에서 제외할 기타 네트워크 CIDR로 이루어진 쉼표로 구분된 목록입니다. 하위 도메인과 일치하려면 도메인 앞에

.을 입력합니다. 예를 들어,.y.com은x.y.com과 일치하지만y.com은 일치하지 않습니다.*를 사용하여 모든 대상에 대해 프록시를 바이패스합니다. - 4

- 이 값을 제공하면 설치 프로그램에서 HTTPS 연결을 프록시하는 데 필요한 추가 CA 인증서가 하나 이상 포함된

openshift-config네임스페이스에user-ca-bundle이라는 이름으로 구성 맵을 생성합니다. 그러면 CNO(Cluster Network Operator)에서 이러한 콘텐츠를 RHCOS(Red Hat Enterprise Linux CoreOS) 신뢰 번들과 병합하는trusted-ca-bundle구성 맵을 생성합니다. 이 구성 맵은Proxy오브젝트의trustedCA필드에서 참조됩니다. 프록시의 ID 인증서를 RHCOS 트러스트 번들에 있는 기관에서 서명하지 않은 경우additionalTrustBundle필드가 있어야 합니다. - 5

- 선택 사항:

trustedCA필드에서user-ca-bundle구성 맵을 참조할프록시오브젝트의 구성을 결정하는 정책입니다. 허용되는 값은Proxyonly및Always입니다.http/https프록시가 구성된 경우에만user-ca-bundle구성 맵을 참조하려면Proxyonly를 사용합니다.Always를 사용하여user-ca-bundle구성 맵을 항상 참조합니다. 기본값은Proxyonly입니다.

참고설치 프로그램에서 프록시

adinessEndpoints필드를 지원하지 않습니다.참고설치 프로그램이 시간 초과되면 설치 프로그램의

wait-for명령을 사용하여 배포를 다시 시작한 다음 완료합니다. 예를 들면 다음과 같습니다../openshift-install wait-for install-complete --log-level debug

$ ./openshift-install wait-for install-complete --log-level debugCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 파일을 저장해 놓고 OpenShift Container Platform을 설치할 때 참조하십시오.

제공되는 install-config.yaml 파일의 프록시 설정을 사용하는 cluster라는 이름의 클러스터 전체 프록시가 설치 프로그램에 의해 생성됩니다. 프록시 설정을 제공하지 않아도 cluster Proxy 오브젝트는 계속 생성되지만 spec은 nil이 됩니다.

cluster라는 Proxy 오브젝트만 지원되며 추가 프록시는 생성할 수 없습니다.

3.8. OpenShift CLI 설치

명령줄 인터페이스를 사용하여 OpenShift Container Platform과 상호 작용하기 위해 OpenShift CLI(oc)를 설치할 수 있습니다. Linux, Windows 또는 macOS에 oc를 설치할 수 있습니다.

이전 버전의 oc 를 설치한 경우 OpenShift Container Platform 4.17의 모든 명령을 완료하는 데 해당 버전을 사용할 수 없습니다. 새 버전의 oc를 다운로드하여 설치합니다.

3.8.1. Linux에서 OpenShift CLI 설치

다음 절차를 사용하여 Linux에서 OpenShift CLI(oc) 바이너리를 설치할 수 있습니다.

프로세스

- Red Hat 고객 포털에서 OpenShift Container Platform 다운로드 페이지로 이동합니다.

- 제품 변형 드롭다운 목록에서 아키텍처를 선택합니다.

- 버전 드롭다운 목록에서 적절한 버전을 선택합니다.

- OpenShift v4.17 Linux Clients 항목 옆에 있는 지금 다운로드를 클릭하고 파일을 저장합니다.

아카이브의 압축을 풉니다.

tar xvf <file>

$ tar xvf <file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc바이너리를PATH에 있는 디렉터리에 배치합니다.PATH를 확인하려면 다음 명령을 실행합니다.echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

OpenShift CLI를 설치한 후

oc명령을 사용할 수 있습니다.oc <command>

$ oc <command>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.8.2. Windows에서 OpenSfhit CLI 설치

다음 절차에 따라 Windows에 OpenShift CLI(oc) 바이너리를 설치할 수 있습니다.

프로세스

- Red Hat 고객 포털에서 OpenShift Container Platform 다운로드 페이지로 이동합니다.

- 버전 드롭다운 목록에서 적절한 버전을 선택합니다.

- OpenShift v4.17 Windows Client 항목 옆에 있는 지금 다운로드를 클릭하고 파일을 저장합니다.

- ZIP 프로그램으로 아카이브의 압축을 풉니다.

oc바이너리를PATH에 있는 디렉터리로 이동합니다.PATH를 확인하려면 명령 프롬프트를 열고 다음 명령을 실행합니다.path

C:\> pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

OpenShift CLI를 설치한 후

oc명령을 사용할 수 있습니다.oc <command>

C:\> oc <command>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.8.3. macOS에 OpenShift CLI 설치

다음 절차에 따라 macOS에서 OpenShift CLI(oc) 바이너리를 설치할 수 있습니다.

프로세스

- Red Hat 고객 포털에서 OpenShift Container Platform 다운로드 페이지로 이동합니다.

- 버전 드롭다운 목록에서 적절한 버전을 선택합니다.

OpenShift v4.17 macOS Clients 항목 옆에 있는 지금 다운로드를 클릭하고 파일을 저장합니다.

참고macOS arm64의 경우 OpenShift v4.17 macOS arm64 Client 항목을 선택합니다.

- 아카이브의 압축을 해제하고 압축을 풉니다.

oc바이너리 PATH의 디렉터리로 이동합니다.PATH를 확인하려면 터미널을 열고 다음 명령을 실행합니다.echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

oc명령을 사용하여 설치를 확인합니다.oc <command>

$ oc <command>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.9. Nutanix의 IAM 구성

클러스터를 설치하려면 CCO(Cloud Credential Operator)가 수동 모드에서 작동해야 합니다. 설치 프로그램은 수동 모드에 대한 CCO를 구성하는 동안 ID 및 액세스 관리 보안을 지정해야 합니다.

사전 요구 사항

-

ccoctl바이너리를 구성했습니다. -

install-config.yaml파일이 있습니다.

프로세스

다음 형식으로 자격 증명 데이터가 포함된 YAML 파일을 생성합니다.

인증 정보 데이터 형식

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 설치 파일의 릴리스 이미지로

$RELEASE_IMAGE변수를 설정합니다.RELEASE_IMAGE=$(./openshift-install version | awk '/release image/ {print $3}')$ RELEASE_IMAGE=$(./openshift-install version | awk '/release image/ {print $3}')Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 OpenShift Container Platform 릴리스 이미지에서

CredentialsRequestCR(사용자 정의 리소스) 목록을 추출합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 샘플

CredentialsRequest개체Copy to Clipboard Copied! Toggle word wrap Toggle overflow ccoctl툴을 사용하여 다음 명령을 실행하여 모든CredentialsRequest오브젝트를 처리합니다.ccoctl nutanix create-shared-secrets \ --credentials-requests-dir=<path_to_credentials_requests_directory> \ --output-dir=<ccoctl_output_dir> \ --credentials-source-filepath=<path_to_credentials_file>

$ ccoctl nutanix create-shared-secrets \ --credentials-requests-dir=<path_to_credentials_requests_directory> \1 --output-dir=<ccoctl_output_dir> \2 --credentials-source-filepath=<path_to_credentials_file>3 Copy to Clipboard Copied! Toggle word wrap Toggle overflow credentialsMode매개변수가Manual로 설정되도록install-config.yaml구성 파일을 편집합니다.install-config.yaml설정 파일 예apiVersion: v1 baseDomain: cluster1.example.com credentialsMode: Manual ...

apiVersion: v1 baseDomain: cluster1.example.com credentialsMode: Manual1 ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 이 행을 추가하여

credentialsMode매개변수를Manual로 설정합니다.

다음 명령을 실행하여 설치 매니페스트를 생성합니다.

openshift-install create manifests --dir <installation_directory>

$ openshift-install create manifests --dir <installation_directory>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 클러스터의

install-config.yaml파일이 포함된 디렉터리의 경로를 지정합니다.

다음 명령을 실행하여 생성된 인증 정보 파일을 대상 매니페스트 디렉터리에 복사합니다.

cp <ccoctl_output_dir>/manifests/*credentials.yaml ./<installation_directory>/manifests

$ cp <ccoctl_output_dir>/manifests/*credentials.yaml ./<installation_directory>/manifestsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

매니페스트디렉터리에 적절한 시크릿이 있는지 확인합니다.ls ./<installation_directory>/manifests

$ ls ./<installation_directory>/manifestsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.10. Nutanix CCM에 필요한 구성 맵 및 시크릿 리소스 추가

Nutanix에 설치하려면 Nutanix Cloud Controller Manager (CCM)와 통합하기 위해 추가 ConfigMap 및 Secret 리소스가 필요합니다.

사전 요구 사항

-

설치 디렉터리에

매니페스트디렉터리가 생성되어 있습니다.

프로세스

manifests디렉터리로 이동합니다.cd <path_to_installation_directory>/manifests

$ cd <path_to_installation_directory>/manifestsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이름이

openshift-cloud-controller-manager-cloud-config.yaml인cloud-confConfigMap파일을 생성하고 다음 정보를 추가합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Prism Central FQDN/IP를 지정합니다.

cluster-infrastructure-02-config.yml파일이 존재하고 다음 정보가 있는지 확인합니다.spec: cloudConfig: key: config name: cloud-provider-configspec: cloudConfig: key: config name: cloud-provider-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.11. 사용자 관리 로드 밸런서의 서비스

기본 로드 밸런서 대신 사용자 관리 로드 밸런서를 사용하도록 OpenShift Container Platform 클러스터를 구성할 수 있습니다.

사용자 관리 로드 밸런서 구성은 벤더의 로드 밸런서에 따라 다릅니다.

이 섹션의 정보와 예제는 지침용으로만 사용됩니다. 벤더의 로드 밸런서에 대한 자세한 내용은 벤더 설명서를 참조하십시오.

Red Hat은 사용자 관리 로드 밸런서에 대해 다음 서비스를 지원합니다.

- Ingress 컨트롤러

- OpenShift API

- OpenShift MachineConfig API

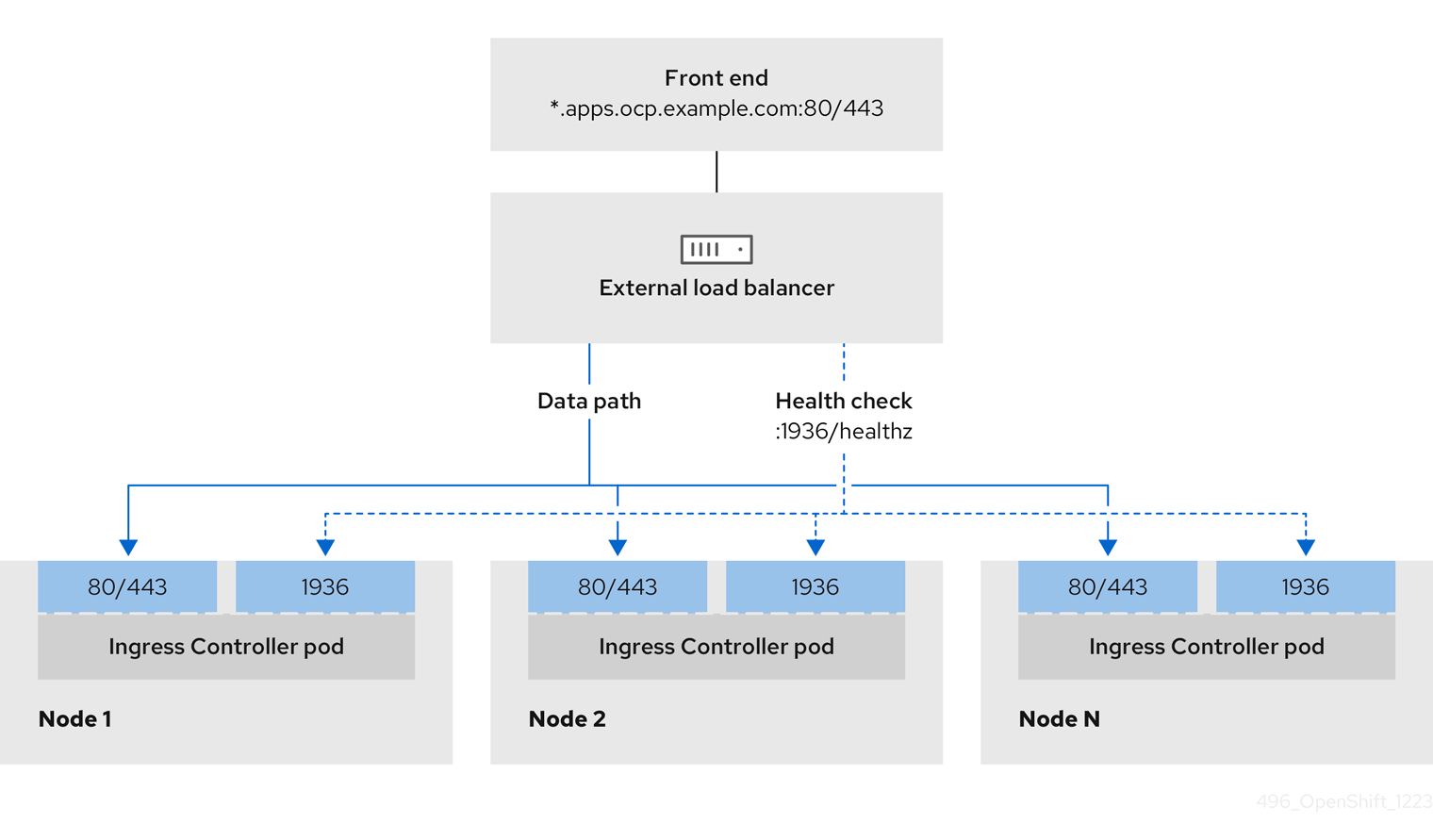

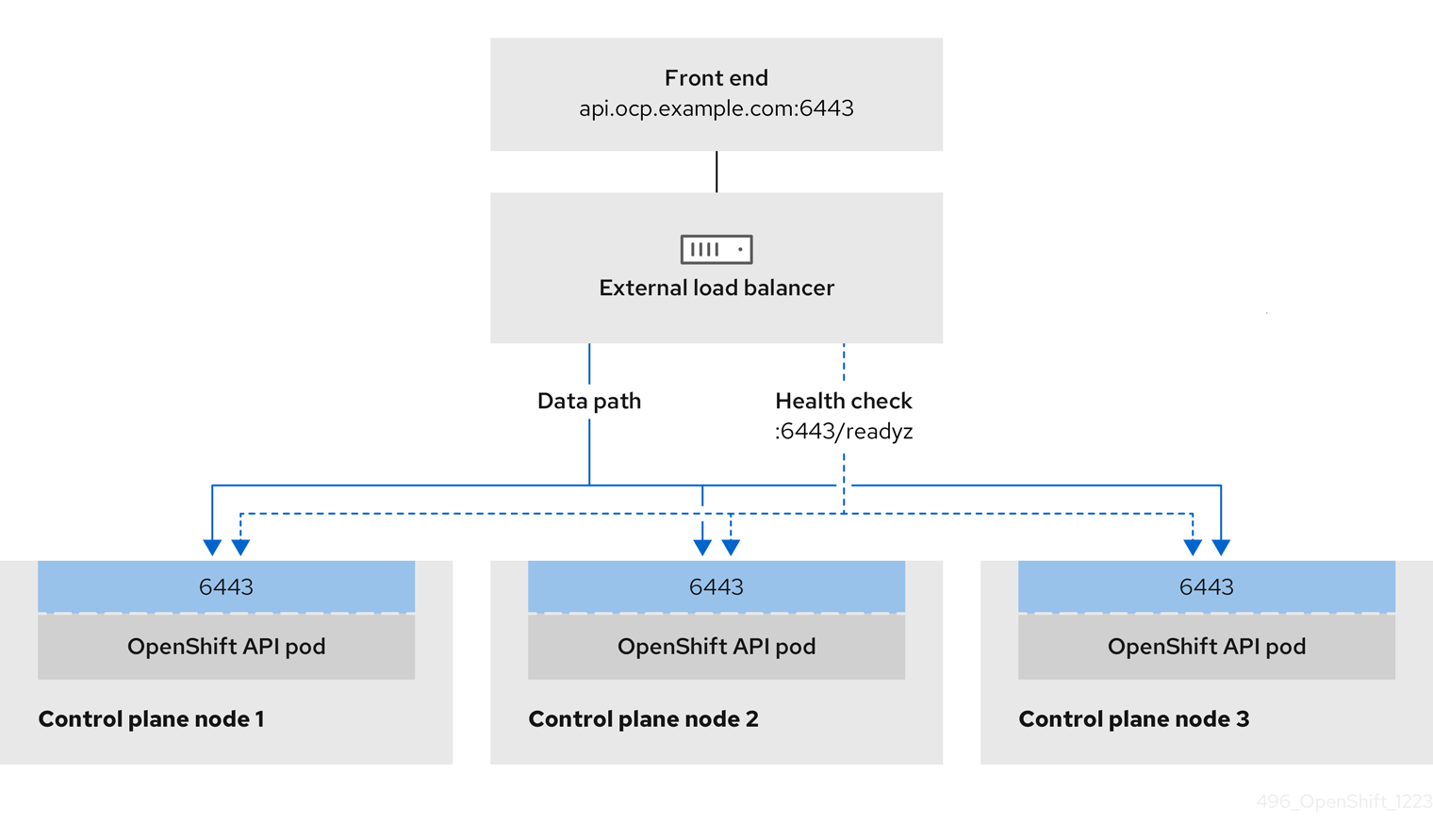

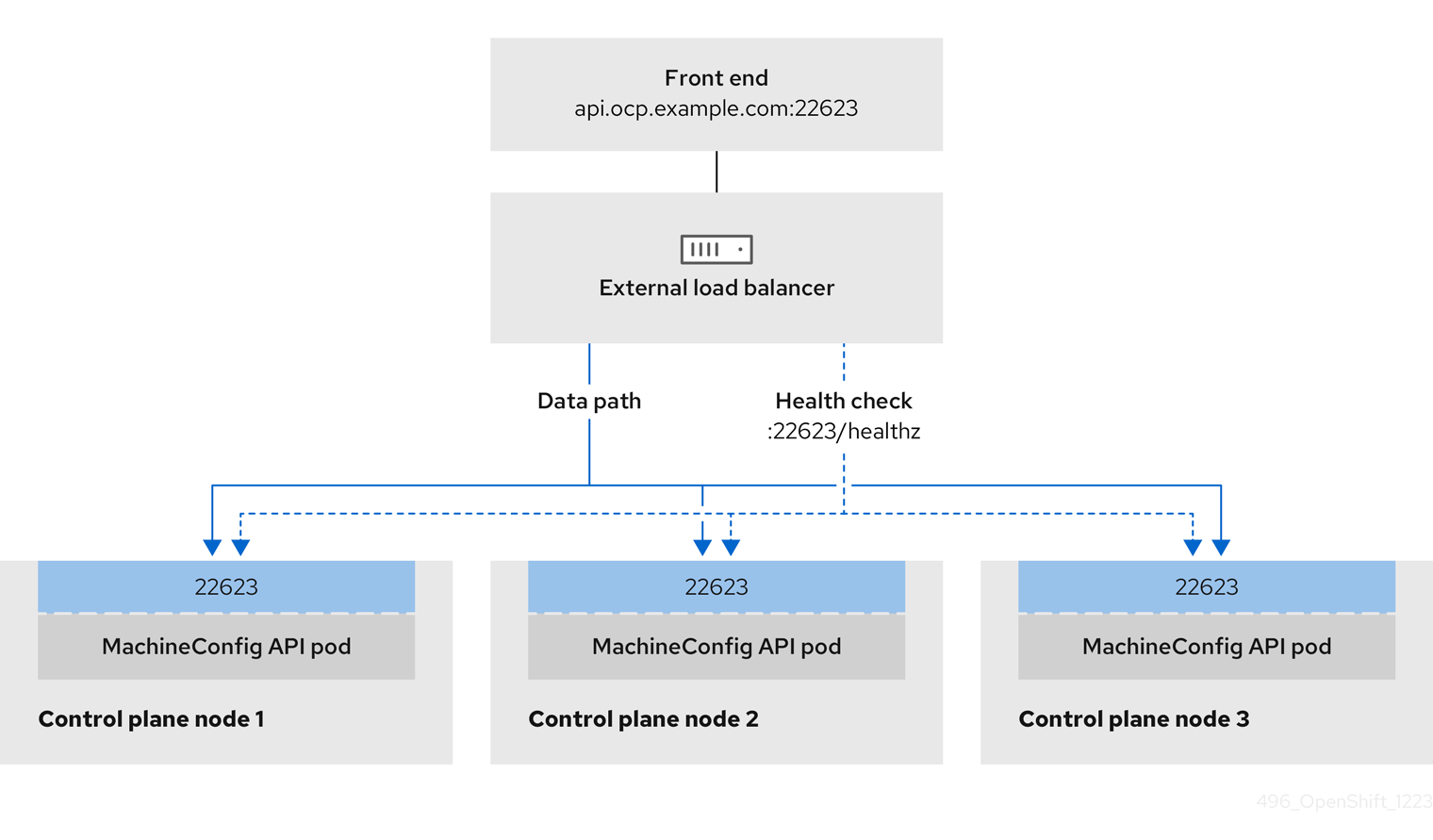

사용자 관리 로드 밸런서에 대해 이러한 서비스 중 하나 또는 모두를 구성할지 여부를 선택할 수 있습니다. Ingress 컨트롤러 서비스만 구성하는 것은 일반적인 구성 옵션입니다. 각 서비스를 더 잘 이해하려면 다음 다이어그램을 참조하십시오.

그림 3.1. OpenShift Container Platform 환경에서 작동하는 Ingress 컨트롤러를 보여주는 네트워크 워크플로의 예

그림 3.2. OpenShift Container Platform 환경에서 작동하는 OpenShift API를 보여주는 네트워크 워크플로우의 예

그림 3.3. OpenShift Container Platform 환경에서 작동하는 OpenShift MachineConfig API를 보여주는 네트워크 워크플로우의 예

사용자 관리 로드 밸런서에 대해 지원되는 구성 옵션은 다음과 같습니다.

- 노드 선택기를 사용하여 Ingress 컨트롤러를 특정 노드 세트에 매핑합니다. 이 세트의 각 노드에 고정 IP 주소를 할당하거나 DHCP(Dynamic Host Configuration Protocol)에서 동일한 IP 주소를 수신하도록 각 노드를 구성해야 합니다. 인프라 노드는 일반적으로 이러한 유형의 구성을 수신합니다.

서브넷의 모든 IP 주소를 대상으로 지정합니다. 이 구성은 로드 밸런서 대상을 재구성하지 않고 해당 네트워크 내에서 노드를 생성하고 삭제할 수 있으므로 유지 관리 오버헤드를 줄일 수 있습니다.

/27또는/28과 같은 작은 네트워크에 머신 세트를 사용하여 Ingress Pod를 배포하는 경우 로드 밸런서 대상을 단순화할 수 있습니다.작은 정보머신 구성 풀의 리소스를 확인하여 네트워크에 존재하는 모든 IP 주소를 나열할 수 있습니다.

OpenShift Container Platform 클러스터에 대한 사용자 관리 로드 밸런서를 구성하기 전에 다음 정보를 고려하십시오.

- 프런트 엔드 IP 주소의 경우 프런트 엔드 IP 주소, Ingress 컨트롤러의 로드 밸런서 및 API 로드 밸런서에 동일한 IP 주소를 사용할 수 있습니다. 이 기능에 대해서는 벤더의 설명서를 확인하십시오.

백엔드 IP 주소의 경우 사용자 관리 로드 밸런서의 수명 동안 OpenShift Container Platform 컨트롤 플레인 노드의 IP 주소가 변경되지 않아야 합니다. 다음 작업 중 하나를 완료하여 이 작업을 수행할 수 있습니다.

- 각 컨트롤 플레인 노드에 고정 IP 주소를 할당합니다.

- 노드가 DHCP 리스를 요청할 때마다 DHCP에서 동일한 IP 주소를 수신하도록 각 노드를 구성합니다. 공급 업체에 따라 DHCP 리스를 IP 예약 또는 정적 DHCP 할당의 형태로 될 수 있습니다.

- Ingress 컨트롤러 백엔드 서비스의 사용자 관리 로드 밸런서에서 Ingress 컨트롤러를 실행하는 각 노드를 수동으로 정의합니다. 예를 들어 Ingress 컨트롤러가 정의되지 않은 노드로 이동하는 경우 연결 중단이 발생할 수 있습니다.

3.11.1. 사용자 관리 로드 밸런서 구성

기본 로드 밸런서 대신 사용자 관리 로드 밸런서를 사용하도록 OpenShift Container Platform 클러스터를 구성할 수 있습니다.

사용자 관리 로드 밸런서를 구성하기 전에 "사용자 관리 로드 밸런서의 서비스" 섹션을 읽으십시오.

사용자 관리 로드 밸런서에 대해 구성할 서비스에 적용되는 다음 사전 요구 사항을 읽으십시오.

클러스터에서 실행되는 MetalLB는 사용자 관리 로드 밸런서로 작동합니다.

OpenShift API 사전 요구 사항

- 프런트 엔드 IP 주소를 정의했습니다.

TCP 포트 6443 및 22623은 로드 밸런서의 프런트 엔드 IP 주소에 노출됩니다. 다음 항목을 확인합니다.

- 포트 6443은 OpenShift API 서비스에 대한 액세스를 제공합니다.

- 포트 22623은 노드에 Ignition 시작 구성을 제공할 수 있습니다.

- 프런트 엔드 IP 주소와 포트 6443은 OpenShift Container Platform 클러스터 외부의 위치로 시스템의 모든 사용자가 연결할 수 있습니다.

- 프런트 엔드 IP 주소와 포트 22623은 OpenShift Container Platform 노드에서만 연결할 수 있습니다.

- 로드 밸런서 백엔드는 포트 6443 및 22623의 OpenShift Container Platform 컨트롤 플레인 노드와 통신할 수 있습니다.

Ingress 컨트롤러 사전 요구 사항

- 프런트 엔드 IP 주소를 정의했습니다.

- TCP 포트 443 및 80은 로드 밸런서의 프런트 엔드 IP 주소에 노출됩니다.

- 프런트 엔드 IP 주소, 포트 80 및 포트 443은 OpenShift Container Platform 클러스터 외부에 있는 위치로 시스템의 모든 사용자가 연결할 수 있습니다.

- 프런트 엔드 IP 주소, 포트 80 및 포트 443은 OpenShift Container Platform 클러스터에서 작동하는 모든 노드에 연결할 수 있습니다.

- 로드 밸런서 백엔드는 포트 80, 443, 1936에서 Ingress 컨트롤러를 실행하는 OpenShift Container Platform 노드와 통신할 수 있습니다.

상태 점검 URL 사양의 사전 요구 사항

서비스를 사용할 수 없거나 사용할 수 없는지 결정하는 상태 점검 URL을 설정하여 대부분의 로드 밸런서를 구성할 수 있습니다. OpenShift Container Platform은 OpenShift API, 머신 구성 API 및 Ingress 컨트롤러 백엔드 서비스에 대한 이러한 상태 점검을 제공합니다.

다음 예제에서는 이전에 나열된 백엔드 서비스의 상태 점검 사양을 보여줍니다.

Kubernetes API 상태 점검 사양의 예

Path: HTTPS:6443/readyz Healthy threshold: 2 Unhealthy threshold: 2 Timeout: 10 Interval: 10

Path: HTTPS:6443/readyz

Healthy threshold: 2

Unhealthy threshold: 2

Timeout: 10

Interval: 10Machine Config API 상태 점검 사양의 예

Path: HTTPS:22623/healthz Healthy threshold: 2 Unhealthy threshold: 2 Timeout: 10 Interval: 10

Path: HTTPS:22623/healthz

Healthy threshold: 2

Unhealthy threshold: 2

Timeout: 10

Interval: 10Ingress 컨트롤러 상태 점검 사양의 예

Path: HTTP:1936/healthz/ready Healthy threshold: 2 Unhealthy threshold: 2 Timeout: 5 Interval: 10

Path: HTTP:1936/healthz/ready

Healthy threshold: 2

Unhealthy threshold: 2

Timeout: 5

Interval: 10프로세스

포트 6443, 22623, 443 및 80의 로드 밸런서에서 클러스터에 액세스할 수 있도록 HAProxy Ingress 컨트롤러를 구성합니다. 필요에 따라 HAProxy 구성에 있는 여러 서브넷의 IP 주소 또는 단일 서브넷의 IP 주소를 지정할 수 있습니다.

나열된 서브넷이 있는 HAProxy 구성 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 나열된 여러 서브넷이 있는 HAProxy 구성의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow curlCLI 명령을 사용하여 사용자 관리 로드 밸런서 및 해당 리소스가 작동하는지 확인합니다.다음 명령을 실행하고 응답을 관찰하여 Kubernetes API 서버 리소스에서 클러스터 머신 구성 API에 액세스할 수 있는지 확인합니다.

curl https://<loadbalancer_ip_address>:6443/version --insecure

$ curl https://<loadbalancer_ip_address>:6443/version --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 구성이 올바르면 응답으로 JSON 오브젝트가 표시됩니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하고 출력을 관찰하여 클러스터 머신 구성 API에 머신 구성 서버 리소스에 액세스할 수 있는지 확인합니다.

curl -v https://<loadbalancer_ip_address>:22623/healthz --insecure

$ curl -v https://<loadbalancer_ip_address>:22623/healthz --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 구성이 올바르면 명령의 출력에 다음 응답이 표시됩니다.

HTTP/1.1 200 OK Content-Length: 0

HTTP/1.1 200 OK Content-Length: 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하고 출력을 관찰하여 포트 80의 Ingress 컨트롤러 리소스에서 컨트롤러에 액세스할 수 있는지 확인합니다.

curl -I -L -H "Host: console-openshift-console.apps.<cluster_name>.<base_domain>" http://<load_balancer_front_end_IP_address>

$ curl -I -L -H "Host: console-openshift-console.apps.<cluster_name>.<base_domain>" http://<load_balancer_front_end_IP_address>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 구성이 올바르면 명령의 출력에 다음 응답이 표시됩니다.

HTTP/1.1 302 Found content-length: 0 location: https://console-openshift-console.apps.ocp4.private.opequon.net/ cache-control: no-cache

HTTP/1.1 302 Found content-length: 0 location: https://console-openshift-console.apps.ocp4.private.opequon.net/ cache-control: no-cacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하고 출력을 관찰하여 포트 443의 Ingress 컨트롤러 리소스에서 컨트롤러에 액세스할 수 있는지 확인합니다.

curl -I -L --insecure --resolve console-openshift-console.apps.<cluster_name>.<base_domain>:443:<Load Balancer Front End IP Address> https://console-openshift-console.apps.<cluster_name>.<base_domain>

$ curl -I -L --insecure --resolve console-openshift-console.apps.<cluster_name>.<base_domain>:443:<Load Balancer Front End IP Address> https://console-openshift-console.apps.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 구성이 올바르면 명령의 출력에 다음 응답이 표시됩니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

사용자 관리 로드 밸런서의 프런트 엔드 IP 주소를 대상으로 하도록 클러스터의 DNS 레코드를 구성합니다. 로드 밸런서를 통해 클러스터 API 및 애플리케이션의 DNS 서버로 레코드를 업데이트해야 합니다.

수정된 DNS 레코드 예

<load_balancer_ip_address> A api.<cluster_name>.<base_domain> A record pointing to Load Balancer Front End

<load_balancer_ip_address> A api.<cluster_name>.<base_domain> A record pointing to Load Balancer Front EndCopy to Clipboard Copied! Toggle word wrap Toggle overflow <load_balancer_ip_address> A apps.<cluster_name>.<base_domain> A record pointing to Load Balancer Front End

<load_balancer_ip_address> A apps.<cluster_name>.<base_domain> A record pointing to Load Balancer Front EndCopy to Clipboard Copied! Toggle word wrap Toggle overflow 중요DNS 전파는 각 DNS 레코드를 사용할 수 있을 때까지 약간의 시간이 걸릴 수 있습니다. 각 레코드를 검증하기 전에 각 DNS 레코드가 전파되는지 확인합니다.

OpenShift Container Platform 클러스터가 사용자 관리 로드 밸런서를 사용하려면 클러스터의

install-config.yaml파일에 다음 구성을 지정해야 합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

type매개변수에 대해UserManaged를 설정하여 클러스터의 사용자 관리 로드 밸런서를 지정합니다. 매개변수의 기본값은 기본 내부 로드 밸런서를 나타내는OpenShiftManagedDefault입니다.openshift-kni-infra네임스페이스에 정의된 서비스의 경우 사용자 관리 로드 밸런서는coredns서비스를 클러스터의 Pod에 배포할 수 있지만keepalived및haproxy서비스를 무시합니다.- 2

- 사용자 관리 로드 밸런서를 지정할 때 필수 매개변수입니다. Kubernetes API가 사용자 관리 로드 밸런서와 통신할 수 있도록 사용자 관리 로드 밸런서의 공용 IP 주소를 지정합니다.

- 3

- 사용자 관리 로드 밸런서를 지정할 때 필수 매개변수입니다. 사용자 관리 로드 밸런서에서 클러스터의 인그레스 트래픽을 관리할 수 있도록 사용자 관리 로드 밸런서의 공용 IP 주소를 지정합니다.

검증

curlCLI 명령을 사용하여 사용자 관리 로드 밸런서 및 DNS 레코드 구성이 작동하는지 확인합니다.다음 명령을 실행하고 출력을 관찰하여 클러스터 API에 액세스할 수 있는지 확인합니다.

curl https://api.<cluster_name>.<base_domain>:6443/version --insecure

$ curl https://api.<cluster_name>.<base_domain>:6443/version --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 구성이 올바르면 응답으로 JSON 오브젝트가 표시됩니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하고 출력을 관찰하여 클러스터 머신 구성에 액세스할 수 있는지 확인합니다.

curl -v https://api.<cluster_name>.<base_domain>:22623/healthz --insecure

$ curl -v https://api.<cluster_name>.<base_domain>:22623/healthz --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 구성이 올바르면 명령의 출력에 다음 응답이 표시됩니다.

HTTP/1.1 200 OK Content-Length: 0

HTTP/1.1 200 OK Content-Length: 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하고 출력을 관찰하여 포트의 각 클러스터 애플리케이션에 액세스할 수 있는지 확인합니다.

curl http://console-openshift-console.apps.<cluster_name>.<base_domain> -I -L --insecure

$ curl http://console-openshift-console.apps.<cluster_name>.<base_domain> -I -L --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 구성이 올바르면 명령의 출력에 다음 응답이 표시됩니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하고 출력을 관찰하여 포트 443에서 각 클러스터 애플리케이션에 액세스할 수 있는지 확인합니다.

curl https://console-openshift-console.apps.<cluster_name>.<base_domain> -I -L --insecure

$ curl https://console-openshift-console.apps.<cluster_name>.<base_domain> -I -L --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 구성이 올바르면 명령의 출력에 다음 응답이 표시됩니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.12. 클러스터 배포

호환되는 클라우드 플랫폼에 OpenShift Container Platform을 설치할 수 있습니다.

최초 설치 과정에서 설치 프로그램의 create cluster 명령을 한 번만 실행할 수 있습니다.

사전 요구 사항

- OpenShift Container Platform 설치 프로그램과 클러스터의 풀 시크릿이 있습니다.

- 호스트의 클라우드 공급자 계정에 클러스터를 배포할 수 있는 올바른 권한이 있는지 확인했습니다. 잘못된 권한이 있는 계정으로 인해 누락된 권한이 표시되는 오류 메시지와 함께 설치 프로세스가 실패합니다.

프로세스

설치 프로그램이 포함된 디렉터리에서 다음 명령을 실행하여 클러스터 배포를 초기화합니다.

./openshift-install create cluster --dir <installation_directory> \ --log-level=info$ ./openshift-install create cluster --dir <installation_directory> \1 --log-level=info2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

클러스터 배포가 성공적으로 완료되면 다음을 수행합니다.

-

터미널에는 웹 콘솔에 대한 링크 및

kubeadmin사용자의 인증 정보를 포함하여 클러스터에 액세스하는 지침이 표시됩니다. -

인증 정보도 <

installation_directory>/.openshift_install.log로 출력합니다.

설치 프로그램 또는 설치 프로그램이 생성하는 파일을 삭제하지 마십시오. 클러스터를 삭제하려면 두 가지가 모두 필요합니다.

출력 예

-

설치 프로그램에서 생성하는 Ignition 구성 파일에 24시간 후에 만료되는 인증서가 포함되어 있습니다. 이 인증서는 그 후에 갱신됩니다. 인증서를 갱신하기 전에 클러스터가 종료되고 24시간이 지난 후에 클러스터가 다시 시작되면 클러스터는 만료된 인증서를 자동으로 복구합니다. 예외적으로 kubelet 인증서를 복구하려면 대기 중인

node-bootstrapper인증서 서명 요청(CSR)을 수동으로 승인해야 합니다. 자세한 내용은 만료된 컨트롤 플레인 인증서에서 복구 문서를 참조하십시오. - 24 시간 인증서는 클러스터를 설치한 후 16시간에서 22시간으로 인증서가 교체되기 때문에 생성된 후 12시간 이내에 Ignition 구성 파일을 사용하는 것이 좋습니다. 12시간 이내에 Ignition 구성 파일을 사용하면 설치 중에 인증서 업데이트가 실행되는 경우 설치 실패를 방지할 수 있습니다.

3.13. 기본 스토리지 컨테이너 구성

클러스터를 설치한 후 Nutanix CSI Operator를 설치하고 클러스터의 기본 스토리지 컨테이너를 구성해야 합니다.

자세한 내용은 CSI Operator 설치 및 레지스트리 스토리지 구성 을 위한 Nutanix 설명서를 참조하십시오.

3.14. OpenShift Container Platform의 Telemetry 액세스

OpenShift Container Platform 4.17에서 클러스터 상태 및 업데이트 진행에 대한 메트릭을 제공하기 위해 기본적으로 실행되는 Telemetry 서비스에는 인터넷 액세스가 필요합니다. 클러스터가 인터넷에 연결되어 있으면 Telemetry가 자동으로 실행되고 OpenShift Cluster Manager에 클러스터가 자동으로 등록됩니다.

OpenShift Cluster Manager 인벤토리가 올바르거나 OpenShift Cluster Manager를 사용하여 자동으로 또는 OpenShift Cluster Manager를 사용하여 수동으로 유지 관리되는지 확인한 후 subscription watch를 사용하여 계정 또는 다중 클러스터 수준에서 OpenShift Container Platform 서브스크립션을 추적합니다.

3.16. 다음 단계

4장. 제한된 네트워크에서 Nutanix에 클러스터 설치

OpenShift Container Platform 4.17에서는 설치 릴리스 콘텐츠의 내부 미러를 생성하여 제한된 네트워크의 Nutanix 인프라에 클러스터를 설치할 수 있습니다.

4.1. 사전 요구 사항

- OpenShift Container Platform 설치 및 업데이트 프로세스에 대한 세부 사항을 검토했습니다.

- 설치 프로그램은 Prism Central 및 Prism Element의 포트 9440에 액세스해야 합니다. 포트 9440에 액세스할 수 있는지 확인합니다.

방화벽을 사용하는 경우 다음 사전 요구 사항을 충족했습니다.

- 포트 9440에 액세스할 수 있음을 확인했습니다. 컨트롤 플레인 노드는 설치에 성공하려면 포트 9440에서 Prism Central 및 Prism Element에 도달할 수 있어야 합니다.

- OpenShift Container Platform에 필요한 사이트에 대한 액세스 권한을 부여 하도록 방화벽을 구성하셨습니다. 여기에는 Telemetry 사용이 포함됩니다.

Nutanix 환경에서 기본 자체 서명된 SSL/TLS 인증서를 사용하는 경우 CA에서 서명한 인증서로 교체합니다. 설치 프로그램에는 Prism Central API에 액세스하려면 유효한 CA 서명 인증서가 필요합니다. 자체 서명된 인증서 교체에 대한 자세한 내용은 Nutanix AOS 보안 가이드를 참조하십시오.

Nutanix 환경에서 내부 CA를 사용하여 인증서를 발급하는 경우 클러스터 전체 프록시를 설치 프로세스의 일부로 구성해야 합니다. 자세한 내용은 사용자 정의 PKI 구성을 참조하십시오.

중요2048비트 인증서를 사용합니다. Prism Central 2022.x와 함께 4096비트 인증서를 사용하는 경우 설치에 실패합니다.

- Red Hat Quay와 같은 컨테이너 이미지 레지스트리가 있습니다. 레지스트리가 없는 경우 Red Hat OpenShift 용 미러 레지스트리를 사용하여 미러 레지스트리 를 생성할 수 있습니다.

oc-mirror OpenShift CLI(oc) 플러그인 을 사용하여 Nutanix CSI Operator를 포함한 모든 필수 OpenShift Container Platform 콘텐츠 및 기타 이미지를 미러 레지스트리에 미러링했습니다.

중요미러 호스트에 설치 미디어가 있으므로 해당 컴퓨터를 사용하여 모든 설치 단계를 완료하십시오.

4.2. 네트워크가 제한된 환경에서의 설치 정보

OpenShift Container Platform 4.17에서는 소프트웨어 구성 요소를 받기 위한 인터넷 접속이 필요하지 않은 설치를 수행할 수 있습니다. 제한된 네트워크 설치는 클러스터를 설치하는 클라우드 플랫폼에 따라 설치 관리자 프로비저닝 인프라 또는 사용자 프로비저닝 인프라를 사용하여 완료할 수 있습니다.

클라우드 플랫폼에 제한된 네트워크 설치를 수행하는 방법을 선택해도 클라우드 API에 액세스는 가능해야 합니다. Amazon Web Service의 Route 53 DNS 및 IAM 서비스와 같은 일부 클라우드 기능에는 인터넷 액세스가 필요합니다. 네트워크에 따라 베어 메탈 하드웨어, Nutanix 또는 VMware vSphere에 설치하기 위해 인터넷 액세스가 줄어들 수 있습니다.

제한된 네트워크 설치를 완료하려면 OpenShift 이미지 레지스트리의 콘텐츠를 미러링하고 설치 미디어를 포함하는 레지스트리를 생성해야 합니다. 인터넷과 폐쇄 네트워크에 모두 액세스하거나 제한 사항을 따르는 다른 방법을 통해 미러 호스트에 레지스트리를 생성할 수 있습니다.

4.2.1. 추가 제한

제한된 네트워크의 클러스터에는 다음과 같은 추가 제한이 있습니다.

-

ClusterVersion상태에사용 가능한 업데이트를 검색할 수 없음오류가 포함되어 있습니다. - 기본적으로 필요한 이미지 스트림 태그에 액세스할 수 없기 때문에 개발자 카탈로그의 내용을 사용할 수 없습니다.

4.3. 클러스터 노드 SSH 액세스를 위한 키 쌍 생성

OpenShift Container Platform을 설치하는 동안 SSH 공개 키를 설치 프로그램에 지정할 수 있습니다. 키는 Ignition 구성 파일을 통해 RHCOS(Red Hat Enterprise Linux CoreOS) 노드에 전달되며 노드에 대한 SSH 액세스를 인증하는 데 사용됩니다. 키는 각 노드에서 core 사용자의 ~/.ssh/authorized_keys 목록에 추가되어 암호 없는 인증을 활성화합니다.

키가 노드에 전달되면 키 쌍을 사용하여 사용자 core로 RHCOS 노드에 SSH로 SSH 연결을 수행할 수 있습니다 . SSH를 통해 노드에 액세스하려면 로컬 사용자의 SSH에서 개인 키 ID를 관리해야 합니다.

설치 디버깅 또는 재해 복구를 수행하기 위해 클러스터 노드에 SSH를 실행하려면 설치 프로세스 중에 SSH 공용 키를 지정해야 합니다. ./openshift-install gather 명령에도 SSH 공개 키가 클러스터 노드에 있어야 합니다.

재해 복구 및 디버깅이 필요한 프로덕션 환경에서는이 단계를 생략하지 마십시오.

AWS 키 쌍과 같이 플랫폼 고유의 방식으로 구성된 키가 아닌 로컬 키를 사용해야 합니다.

프로세스

로컬 시스템에 클러스터 노드의 인증에 사용할 기존 SSH 키 쌍이 없는 경우 새로 생성합니다. 예를 들어 Linux 운영 체제를 사용하는 컴퓨터에서 다음 명령을 실행합니다.

ssh-keygen -t ed25519 -N '' -f <path>/<file_name>

$ ssh-keygen -t ed25519 -N '' -f <path>/<file_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 새 SSH 키의 경로 및 파일 이름(예:

~/.ssh/id_ed25519)을 지정합니다. 기존 키 쌍이 있는 경우 공개 키가'~/.ssh디렉터리에 있는지 확인하십시오.

참고x86_64,ppc64le,s390x아키텍처에서만 FIPS 140-2/140-3 Validation에 대해 NIST에 제출된 RHEL 암호화 라이브러리를 사용하는 OpenShift Container Platform 클러스터를 설치하려면ed25519알고리즘을 사용하는 키를 생성하지 마십시오. 대신rsa또는ecdsa알고리즘을 사용하는 키를 생성합니다.공개 SSH 키를 확인합니다.

cat <path>/<file_name>.pub

$ cat <path>/<file_name>.pubCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예를 들어 다음을 실행하여

~/.ssh/id_ed25519.pub공개 키를 확인합니다.cat ~/.ssh/id_ed25519.pub

$ cat ~/.ssh/id_ed25519.pubCopy to Clipboard Copied! Toggle word wrap Toggle overflow 아직 추가되지 않은 경우 로컬 사용자의 SSH 에이전트에 SSH 개인 키 ID를 추가합니다. 키의 SSH 에이전트 관리는 클러스터 노드에 암호 없는 SSH 인증을 수행하거나

./openshift-install gather명령을 사용하려는 경우 필요합니다.참고일부 배포에서는

~/.ssh/id_rsa및~/.ssh/id_dsa와 같은 기본 SSH 개인 키 ID가 자동으로 관리됩니다.ssh-agent프로세스가 로컬 사용자에 대해 실행되지 않은 경우 백그라운드 작업으로 시작합니다.eval "$(ssh-agent -s)"

$ eval "$(ssh-agent -s)"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Agent pid 31874

Agent pid 31874Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고클러스터가 FIPS 모드인 경우 FIPS 호환 알고리즘만 사용하여 SSH 키를 생성합니다. 키는 RSA 또는 ECDSA여야 합니다.

ssh-agent에 SSH 개인 키를 추가합니다.ssh-add <path>/<file_name>

$ ssh-add <path>/<file_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- SSH 개인 키의 경로와 파일 이름을 지정합니다(예:

~/.ssh/id_ed25519).

출력 예

Identity added: /home/<you>/<path>/<file_name> (<computer_name>)

Identity added: /home/<you>/<path>/<file_name> (<computer_name>)Copy to Clipboard Copied! Toggle word wrap Toggle overflow

다음 단계

- OpenShift Container Platform을 설치할 때 SSH 공개 키를 설치 프로그램에 지정합니다.

4.4. 시스템 신뢰에 Nutanix 루트 CA 인증서 추가

설치 프로그램에서 Prism Central API에 액세스해야 하므로 OpenShift Container Platform 클러스터를 설치하기 전에 Nutanix 신뢰할 수 있는 루트 CA 인증서를 시스템 신뢰에 추가해야 합니다.

프로세스

- Prism Central 웹 콘솔에서 Nutanix 루트 CA 인증서를 다운로드합니다.

- Nutanix 루트 CA 인증서가 포함된 압축 파일을 추출합니다.

운영 체제 파일을 시스템 신뢰에 추가합니다. 예를 들어 Fedora 운영 체제에서는 다음 명령을 실행합니다.

cp certs/lin/* /etc/pki/ca-trust/source/anchors

# cp certs/lin/* /etc/pki/ca-trust/source/anchorsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 시스템 신뢰를 업데이트합니다. 예를 들어 Fedora 운영 체제에서는 다음 명령을 실행합니다.

update-ca-trust extract

# update-ca-trust extractCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5. RHCOS 클러스터 이미지 다운로드

Prism Central은 클러스터를 설치하려면 RHCOS(Red Hat Enterprise Linux CoreOS) 이미지에 액세스해야 합니다. 설치 프로그램을 사용하여 RHCOS 이미지를 찾아서 다운로드하여 내부 HTTP 서버 또는 Nutanix 개체를 통해 사용할 수 있도록 할 수 있습니다.

사전 요구 사항

- OpenShift Container Platform 설치 프로그램과 클러스터의 풀 시크릿을 받습니다. 제한된 네트워크 설치의 경우, 해당 파일은 미러 호스트에 있습니다.

프로세스

설치 프로그램이 포함된 디렉터리로 변경하고 다음 명령을 실행합니다.

./openshift-install coreos print-stream-json

$ ./openshift-install coreos print-stream-jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 명령 출력을 사용하여 Nutanix 이미지의 위치를 찾고 링크를 클릭하여 다운로드합니다.

출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 내부 HTTP 서버 또는 Nutanix 개체를 통해 이미지를 사용할 수 있도록 합니다.

-

다운로드한 이미지의 위치를 기록해 둡니다. 클러스터를 배포하기 전에 설치 구성 파일(

install-config.yaml)의platform섹션을 이미지 위치로 업데이트합니다.

RHCOS 이미지를 지정하는 install-config.yaml 파일의 스니펫

platform:

nutanix:

clusterOSImage: http://example.com/images/rhcos-411.86.202210041459-0-nutanix.x86_64.qcow2

platform:

nutanix:

clusterOSImage: http://example.com/images/rhcos-411.86.202210041459-0-nutanix.x86_64.qcow24.6. 설치 구성 파일 만들기

Nutanix에 설치하는 OpenShift Container Platform 클러스터를 사용자 지정할 수 있습니다.

사전 요구 사항

- OpenShift Container Platform 설치 프로그램과 클러스터의 풀 시크릿이 있습니다. 제한된 네트워크 설치의 경우, 해당 파일은 미러 호스트에 있습니다.

-

레지스트리를 미러링할 때 생성된

imageContentSourcePolicy.yaml파일이 있습니다. - 다운로드한 RHCOS(Red Hat Enterprise Linux CoreOS) 이미지의 위치가 있습니다.

- 미러 레지스트리에 대한 인증서의 콘텐츠를 가져왔습니다.

- RHCOS(Red Hat Enterprise Linux CoreOS) 이미지를 검색하여 액세스 가능한 위치에 업로드했습니다.

- Nutanix 네트워킹 요구 사항을 충족하는지 확인했습니다. 자세한 내용은 " Nutanix에 설치 준비"를 참조하십시오.

프로세스

install-config.yaml파일을 생성합니다.설치 프로그램이 포함된 디렉터리로 변경하고 다음 명령을 실행합니다.

./openshift-install create install-config --dir <installation_directory>

$ ./openshift-install create install-config --dir <installation_directory>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<installation_directory>는 설치 프로그램이 생성하는 파일을 저장할 디렉터리 이름을 지정합니다.

디렉터리를 지정할 때 다음을 수행합니다.

-

디렉터리에

실행권한이 있는지 확인합니다. 설치 디렉토리에서 Terraform 바이너리를 실행하려면 이 권한이 필요합니다. - 빈 디렉터리를 사용합니다. 부트스트랩 X.509 인증서와 같은 일부 설치 자산은 단기간에 만료되므로 설치 디렉터리를 재사용해서는 안 됩니다. 다른 클러스터 설치의 개별 파일을 재사용하려면 해당 파일을 사용자 디렉터리에 복사하면 됩니다. 그러나 설치 자산의 파일 이름은 릴리스간에 변경될 수 있습니다. 따라서 이전 OpenShift Container Platform 버전에서 설치 파일을 복사할 때는 주의하십시오.

화면에 나타나는 지시에 따라 클라우드에 대한 구성 세부 사항을 입력합니다.

선택사항: 클러스터 시스템에 액세스하는 데 사용할 SSH 키를 선택합니다.

참고설치 디버깅 또는 재해 복구를 수행하려는 프로덕션 OpenShift Container Platform 클러스터의 경우

ssh-agent프로세스가 사용하는 SSH 키를 지정합니다.- 대상 플랫폼으로 nutanix 를 선택합니다.

- Prism Central 도메인 이름 또는 IP 주소를 입력합니다.

- Prism Central에 로그인하는 데 사용되는 포트를 입력합니다.

Prism Central에 로그인하는 데 사용되는 인증 정보를 입력합니다.

설치 프로그램은 Prism Central에 연결됩니다.

- OpenShift Container Platform 클러스터를 관리할 Prism Element를 선택합니다.

- 사용할 네트워크 서브넷을 선택합니다.

- 컨트롤 플레인 API 액세스를 위해 구성한 가상 IP 주소를 입력합니다.

- 클러스터 인그레스용으로 구성한 가상 IP 주소를 입력합니다.

- 기본 도메인을 입력합니다. 이 기본 도메인은 DNS 레코드에서 구성한 것과 동일해야 합니다.

클러스터를 설명할 수 있는 이름을 입력합니다.

입력한 클러스터 이름은 DNS 레코드를 구성할 때 지정한 클러스터 이름과 일치해야 합니다.

install-config.yaml파일에서platform.nutanix.clusterOSImage값을 이미지 위치 또는 이름으로 설정합니다. 예를 들면 다음과 같습니다.platform: nutanix: clusterOSImage: http://mirror.example.com/images/rhcos-47.83.202103221318-0-nutanix.x86_64.qcow2platform: nutanix: clusterOSImage: http://mirror.example.com/images/rhcos-47.83.202103221318-0-nutanix.x86_64.qcow2Copy to Clipboard Copied! Toggle word wrap Toggle overflow install-config.yaml파일을 편집하여 제한된 네트워크에 설치하는 데 필요한 추가 정보를 제공합니다.레지스트리의 인증 정보를 포함하도록

pullSecret값을 업데이트합니다.pullSecret: '{"auths":{"<mirror_host_name>:5000": {"auth": "<credentials>","email": "you@example.com"}}}'pullSecret: '{"auths":{"<mirror_host_name>:5000": {"auth": "<credentials>","email": "you@example.com"}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow <mirror_host_name>의 경우 미러 레지스트리의 인증서에 지정한 레지스트리 도메인 이름을 지정하고<credentials>의 경우 미러 레지스트리에 base64로 인코딩된 사용자 이름 및 암호를 지정합니다.additionalTrustBundle매개변수와 값을 추가합니다.additionalTrustBundle: | -----BEGIN CERTIFICATE----- ZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZ -----END CERTIFICATE-----

additionalTrustBundle: | -----BEGIN CERTIFICATE----- ZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZZ -----END CERTIFICATE-----Copy to Clipboard Copied! Toggle word wrap Toggle overflow 값은 미러 레지스트리에 사용한 인증서 파일의 내용이어야 합니다. 인증서 파일은 신뢰할 수 있는 기존 인증 기관 또는 미러 레지스트리에 대해 생성한 자체 서명 인증서일 수 있습니다.

다음 YAML 발췌와 유사한 이미지 콘텐츠 리소스를 추가합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이러한 값의 경우 레지스트리를 미러링할 때 생성된

imageContentSourcePolicy.yaml파일을 사용합니다.선택사항: 게시 전략을

Internal로 설정합니다.publish: Internal

publish: InternalCopy to Clipboard Copied! Toggle word wrap Toggle overflow 이 옵션을 설정하여 내부 Ingress Controller 및 프라이빗 로드 밸런서를 생성합니다.

선택 사항:

install.config.yaml파일에서 기본 구성 매개변수 중 하나 이상을 업데이트하여 설치를 사용자 지정합니다.매개변수에 대한 자세한 내용은 "설치 구성 매개변수"를 참조하십시오.

참고3-노드 클러스터를 설치하는 경우

compute.replicas매개변수를0으로 설정해야 합니다. 이렇게 하면 클러스터의 컨트롤 플레인을 예약할 수 있습니다. 자세한 내용은 " {platform}에 3-노드 클러스터 설치"를 참조하십시오.여러 클러스터를 설치하는 데 사용할 수 있도록

install-config.yaml파일을 백업합니다.중요install-config.yaml파일은 설치 과정에서 사용됩니다. 이 파일을 재사용하려면 지금 백업해야 합니다.

4.6.1. Nutanix용 샘플 사용자 지정 install-config.yaml 파일

install-config.yaml 파일을 사용자 지정하여 OpenShift Container Platform 클러스터 플랫폼에 대한 자세한 정보를 지정하거나 필수 매개변수 값을 수정할 수 있습니다.

이 샘플 YAML 파일은 참조용으로만 제공됩니다. 설치 프로그램을 사용하여 install-config.yaml 파일을 받아서 수정해야 합니다.

- 1 10 12 13 16 17 18 19

- 필수 항목입니다. 설치 프로그램에서 이 값을 입력하라는 메시지를 표시합니다.

- 2 6

controlPlane섹션은 단일 매핑이지만 compute 섹션은 일련의 매핑입니다. 서로 다른 데이터 구조의 요구사항을 충족하도록compute섹션의 첫 번째 줄은 하이픈(-)으로 시작해야 하며controlPlane섹션의 첫 번째 줄은 하이픈으로 시작할 수 없습니다. 현재 두 섹션이 모두 단일 시스템 풀을 정의하지만 향후 출시되는 OpenShift Container Platform 버전은 설치 과정에서 여러 컴퓨팅 풀 정의를 지원할 수 있습니다. 하나의 컨트롤 플레인 풀만 사용됩니다.- 3 7

- 동시 멀티스레딩 또는

hyperthreading활성화/비활성화 여부를 지정합니다. 시스템 코어의 성능을 높이기 위해 기본적으로 동시 멀티스레딩이 활성화됩니다. 매개변수 값을Disabled로 설정하여 비활성화할 수 있습니다. 일부 클러스터 시스템에서 동시 멀티스레딩을 비활성화할 경우에는 해당 멀티스레딩을 모든 클러스터 시스템에서 비활성화해야 합니다.중요동시 멀티스레딩을 비활성화하는 경우 용량 계획에서 시스템 성능이 크게 저하될 수 있는 문제를 고려해야 합니다.

- 4 8

- 선택사항: 컴퓨팅 및 컨트롤 플레인 시스템의 시스템 풀 매개변수에 대한 추가 구성을 제공하십시오.

- 5 9 14

- 선택 사항: prism 카테고리 키와 prism 카테고리 값 중 하나 이상의 쌍을 제공합니다. 이러한 카테고리 키-값 쌍은 Prism Central에 있어야 합니다. 컴퓨팅 시스템, 컨트롤 플레인 시스템 또는 모든 시스템에 별도의 카테고리를 제공할 수 있습니다.

- 11

- 설치할 클러스터 네트워크 플러그인입니다. 기본 값

OVNKubernetes는 지원되는 유일한 값입니다. - 15

- 선택 사항: VM이 연결된 프로젝트를 지정합니다. 프로젝트 유형에

name또는uuid를 지정한 다음 해당 UUID 또는 프로젝트 이름을 입력합니다. 프로젝트를 컴퓨팅 시스템, 컨트롤 플레인 시스템 또는 모든 시스템에 연결할 수 있습니다. - 20

- 선택 사항: 기본적으로 설치 프로그램은 RHCOS(Red Hat Enterprise Linux CoreOS) 이미지를 다운로드하여 설치합니다. Prism Central이 인터넷에 액세스할 수 없는 경우 HTTP 서버 또는 Nutanix 개체에서 RHCOS 이미지를 호스팅하고 설치 프로그램을 이미지를 가리켜 기본 동작을 재정의할 수 있습니다.

- 21

<local_registry>는 미러 레지스트리가 해당 내용을 제공하는 데 사용하는 레지스트리 도메인 이름과 포트(선택사항)를 지정합니다. 예:registry.example.com또는registry.example.com:5000.<credentials>는 미러 레지스트리의 base64 인코딩 사용자 이름과 암호를 지정합니다.- 22

- FIPS 모드 활성화 또는 비활성화 여부입니다. 기본적으로 FIPS 모드는 비활성화됩니다. FIPS 모드가 활성화되면 OpenShift Container Platform이 실행되는 RHCOS(Red Hat Enterprise Linux CoreOS) 시스템에서 기본 Kubernetes 암호화 제품군은 우회하고 RHCOS와 함께 제공되는 암호화 모듈을 대신 사용합니다.중요

FIPS 모드에서 부팅된 RHEL(Red Hat Enterprise Linux CoreOS) 또는 RHCOS(Red Hat Enterprise Linux CoreOS)를 실행하는 경우 OpenShift Container Platform 코어 구성 요소는 x86_64, ppc64le 및 s390x 아키텍처에서만 FIPS 140-2/140-3 Validation에 대해 NIST에 제출된 RHEL 암호화 라이브러리를 사용합니다.

- 23

- 선택 사항: 클러스터의 시스템에 액세스하는 데 사용하는

sshKey값을 제공할 수 있습니다.참고설치 디버깅 또는 재해 복구를 수행하려는 프로덕션 OpenShift Container Platform 클러스터의 경우

ssh-agent프로세스가 사용하는 SSH 키를 지정합니다. - 24

- 미러 레지스트리에 사용한 인증서 파일의 내용을 제공하십시오.

- 25

- 레지스트리를 미러링할 때 생성된

imageContentSourcePolicy.yaml파일의metadata.name: release-0섹션에서 이러한 값을 제공합니다.

4.6.2. 실패 도메인 구성

장애 도메인은 여러 Nutanix Prism Cryostat (클러스터)에 컨트롤 플레인 및 컴퓨팅 머신을 배포하여 OpenShift Container Platform 클러스터의 내결함성을 향상시킵니다.

고가용성을 보장하기 위해 세 개의 실패 도메인을 구성하는 것이 좋습니다.

사전 요구 사항

-

설치 구성 파일(

install-config.yaml)이 있습니다.

프로세스

install-config.yaml파일을 편집하고 다음 스탠자를 추가하여 첫 번째 실패 도메인을 구성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음과 같습니다.

<failure_domain_name>-

실패 도메인의 고유한 이름을 지정합니다. 이름은 64자 미만으로 제한되며 소문자, 숫자, 대시(

-)를 포함할 수 있습니다. 대시는 이름의 선행 또는 종료 위치에 있을 수 없습니다. <prism_element_name>- 선택 사항: Prism Element의 이름을 지정합니다.

<prism_element_uuid>- Prism Element의 UUID를 지정합니다.

<network_uuid>- Prism Element 서브넷 오브젝트의 UUID를 지정합니다. 서브넷의 CIDR(IP 주소 접두사)에는 OpenShift Container Platform 클러스터가 사용하는 가상 IP 주소가 포함되어야 합니다. OpenShift Container Platform 클러스터에서 장애 도메인(Prism Element)당 하나의 서브넷만 지원됩니다.

- 필요에 따라 추가 실패 도메인을 구성합니다.

장애 도메인에서 컨트롤 플레인 및 컴퓨팅 시스템을 배포하려면 다음 중 하나를 수행하십시오.

컴퓨팅 및 컨트롤 플레인 시스템이 동일한 장애 도메인 세트를 공유할 수 있는 경우 클러스터의 기본 머신 구성에 장애 도메인 이름을 추가합니다.

장애 도메인 세트를 공유하는 컨트롤 플레인 및 컴퓨팅 머신의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 컴퓨팅 및 컨트롤 플레인 시스템에서 다른 장애 도메인을 사용해야 하는 경우 해당 시스템 풀 아래에 실패 도메인 이름을 추가합니다.

다른 장애 도메인을 사용하는 컨트롤 플레인 및 컴퓨팅 머신의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

- 파일을 저장합니다.

4.6.3. 설치 중 클러스터 단위 프록시 구성

프로덕션 환경에서는 인터넷에 대한 직접 액세스를 거부하고 대신 HTTP 또는 HTTPS 프록시를 사용할 수 있습니다. install-config.yaml 파일에서 프록시 설정을 구성하여 프록시가 사용되도록 새 OpenShift Container Platform 클러스터를 구성할 수 있습니다.

사전 요구 사항

-

기존

install-config.yaml파일이 있습니다. 클러스터에서 액세스해야 하는 사이트를 검토하고 프록시를 바이패스해야 하는지 확인했습니다. 기본적으로 호스팅 클라우드 공급자 API에 대한 호출을 포함하여 모든 클러스터 발신(Egress) 트래픽이 프록시됩니다. 필요한 경우 프록시를 바이패스하기 위해

Proxy오브젝트의spec.noProxy필드에 사이트를 추가했습니다.참고Proxy오브젝트의status.noProxy필드는 설치 구성에 있는networking.machineNetwork[].cidr,networking.clusterNetwork[].cidr,networking.serviceNetwork[]필드의 값으로 채워집니다.AWS(Amazon Web Services), Google Cloud, Microsoft Azure 및 RHOSP(Red Hat OpenStack Platform)에 설치하는 경우

프록시오브젝트status.noProxy필드도 인스턴스 메타데이터 끝점(169.254.169.254)으로 채워집니다.

프로세스

install-config.yaml파일을 편집하고 프록시 설정을 추가합니다. 예를 들면 다음과 같습니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 클러스터 외부에서 HTTP 연결을 구축하는 데 사용할 프록시 URL입니다. URL 스키마는

http여야 합니다. - 2

- 클러스터 외부에서 HTTPS 연결을 구축하는 데 사용할 프록시 URL입니다.

- 3

- 대상 도메인 이름, IP 주소 또는 프록시에서 제외할 기타 네트워크 CIDR로 이루어진 쉼표로 구분된 목록입니다. 하위 도메인과 일치하려면 도메인 앞에

.을 입력합니다. 예를 들어,.y.com은x.y.com과 일치하지만y.com은 일치하지 않습니다.*를 사용하여 모든 대상에 대해 프록시를 바이패스합니다. - 4

- 이 값을 제공하면 설치 프로그램에서 HTTPS 연결을 프록시하는 데 필요한 추가 CA 인증서가 하나 이상 포함된

openshift-config네임스페이스에user-ca-bundle이라는 이름으로 구성 맵을 생성합니다. 그러면 CNO(Cluster Network Operator)에서 이러한 콘텐츠를 RHCOS(Red Hat Enterprise Linux CoreOS) 신뢰 번들과 병합하는trusted-ca-bundle구성 맵을 생성합니다. 이 구성 맵은Proxy오브젝트의trustedCA필드에서 참조됩니다. 프록시의 ID 인증서를 RHCOS 트러스트 번들에 있는 기관에서 서명하지 않은 경우additionalTrustBundle필드가 있어야 합니다. - 5

- 선택 사항:

trustedCA필드에서user-ca-bundle구성 맵을 참조할프록시오브젝트의 구성을 결정하는 정책입니다. 허용되는 값은Proxyonly및Always입니다.http/https프록시가 구성된 경우에만user-ca-bundle구성 맵을 참조하려면Proxyonly를 사용합니다.Always를 사용하여user-ca-bundle구성 맵을 항상 참조합니다. 기본값은Proxyonly입니다.

참고설치 프로그램에서 프록시

adinessEndpoints필드를 지원하지 않습니다.참고설치 프로그램이 시간 초과되면 설치 프로그램의

wait-for명령을 사용하여 배포를 다시 시작한 다음 완료합니다. 예를 들면 다음과 같습니다../openshift-install wait-for install-complete --log-level debug

$ ./openshift-install wait-for install-complete --log-level debugCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 파일을 저장해 놓고 OpenShift Container Platform을 설치할 때 참조하십시오.

제공되는 install-config.yaml 파일의 프록시 설정을 사용하는 cluster라는 이름의 클러스터 전체 프록시가 설치 프로그램에 의해 생성됩니다. 프록시 설정을 제공하지 않아도 cluster Proxy 오브젝트는 계속 생성되지만 spec은 nil이 됩니다.

cluster라는 Proxy 오브젝트만 지원되며 추가 프록시는 생성할 수 없습니다.

4.7. OpenShift CLI 설치

명령줄 인터페이스를 사용하여 OpenShift Container Platform과 상호 작용하기 위해 OpenShift CLI(oc)를 설치할 수 있습니다. Linux, Windows 또는 macOS에 oc를 설치할 수 있습니다.

이전 버전의 oc 를 설치한 경우 OpenShift Container Platform 4.17의 모든 명령을 완료하는 데 해당 버전을 사용할 수 없습니다. 새 버전의 oc를 다운로드하여 설치합니다.

4.7.1. Linux에서 OpenShift CLI 설치

다음 절차를 사용하여 Linux에서 OpenShift CLI(oc) 바이너리를 설치할 수 있습니다.

프로세스

- Red Hat 고객 포털에서 OpenShift Container Platform 다운로드 페이지로 이동합니다.

- 제품 변형 드롭다운 목록에서 아키텍처를 선택합니다.

- 버전 드롭다운 목록에서 적절한 버전을 선택합니다.

- OpenShift v4.17 Linux Clients 항목 옆에 있는 지금 다운로드를 클릭하고 파일을 저장합니다.

아카이브의 압축을 풉니다.

tar xvf <file>

$ tar xvf <file>Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc바이너리를PATH에 있는 디렉터리에 배치합니다.PATH를 확인하려면 다음 명령을 실행합니다.echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

OpenShift CLI를 설치한 후

oc명령을 사용할 수 있습니다.oc <command>

$ oc <command>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7.2. Windows에서 OpenSfhit CLI 설치

다음 절차에 따라 Windows에 OpenShift CLI(oc) 바이너리를 설치할 수 있습니다.

프로세스

- Red Hat 고객 포털에서 OpenShift Container Platform 다운로드 페이지로 이동합니다.

- 버전 드롭다운 목록에서 적절한 버전을 선택합니다.

- OpenShift v4.17 Windows Client 항목 옆에 있는 지금 다운로드를 클릭하고 파일을 저장합니다.

- ZIP 프로그램으로 아카이브의 압축을 풉니다.

oc바이너리를PATH에 있는 디렉터리로 이동합니다.PATH를 확인하려면 명령 프롬프트를 열고 다음 명령을 실행합니다.path

C:\> pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

OpenShift CLI를 설치한 후

oc명령을 사용할 수 있습니다.oc <command>

C:\> oc <command>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7.3. macOS에 OpenShift CLI 설치

다음 절차에 따라 macOS에서 OpenShift CLI(oc) 바이너리를 설치할 수 있습니다.

프로세스

- Red Hat 고객 포털에서 OpenShift Container Platform 다운로드 페이지로 이동합니다.

- 버전 드롭다운 목록에서 적절한 버전을 선택합니다.

OpenShift v4.17 macOS Clients 항목 옆에 있는 지금 다운로드를 클릭하고 파일을 저장합니다.

참고macOS arm64의 경우 OpenShift v4.17 macOS arm64 Client 항목을 선택합니다.

- 아카이브의 압축을 해제하고 압축을 풉니다.

oc바이너리 PATH의 디렉터리로 이동합니다.PATH를 확인하려면 터미널을 열고 다음 명령을 실행합니다.echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

oc명령을 사용하여 설치를 확인합니다.oc <command>

$ oc <command>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.8. Nutanix의 IAM 구성

클러스터를 설치하려면 CCO(Cloud Credential Operator)가 수동 모드에서 작동해야 합니다. 설치 프로그램은 수동 모드에 대한 CCO를 구성하는 동안 ID 및 액세스 관리 보안을 지정해야 합니다.

사전 요구 사항

-

ccoctl바이너리를 구성했습니다. -

install-config.yaml파일이 있습니다.

프로세스

다음 형식으로 자격 증명 데이터가 포함된 YAML 파일을 생성합니다.

인증 정보 데이터 형식

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 설치 파일의 릴리스 이미지로

$RELEASE_IMAGE변수를 설정합니다.RELEASE_IMAGE=$(./openshift-install version | awk '/release image/ {print $3}')$ RELEASE_IMAGE=$(./openshift-install version | awk '/release image/ {print $3}')Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 OpenShift Container Platform 릴리스 이미지에서

CredentialsRequestCR(사용자 정의 리소스) 목록을 추출합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 샘플

CredentialsRequest개체Copy to Clipboard Copied! Toggle word wrap Toggle overflow ccoctl툴을 사용하여 다음 명령을 실행하여 모든CredentialsRequest오브젝트를 처리합니다.ccoctl nutanix create-shared-secrets \ --credentials-requests-dir=<path_to_credentials_requests_directory> \ --output-dir=<ccoctl_output_dir> \ --credentials-source-filepath=<path_to_credentials_file>

$ ccoctl nutanix create-shared-secrets \ --credentials-requests-dir=<path_to_credentials_requests_directory> \1 --output-dir=<ccoctl_output_dir> \2 --credentials-source-filepath=<path_to_credentials_file>3 Copy to Clipboard Copied! Toggle word wrap Toggle overflow credentialsMode매개변수가Manual로 설정되도록install-config.yaml구성 파일을 편집합니다.install-config.yaml설정 파일 예apiVersion: v1 baseDomain: cluster1.example.com credentialsMode: Manual ...

apiVersion: v1 baseDomain: cluster1.example.com credentialsMode: Manual1 ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 이 행을 추가하여

credentialsMode매개변수를Manual로 설정합니다.

다음 명령을 실행하여 설치 매니페스트를 생성합니다.

openshift-install create manifests --dir <installation_directory>

$ openshift-install create manifests --dir <installation_directory>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 클러스터의

install-config.yaml파일이 포함된 디렉터리의 경로를 지정합니다.

다음 명령을 실행하여 생성된 인증 정보 파일을 대상 매니페스트 디렉터리에 복사합니다.

cp <ccoctl_output_dir>/manifests/*credentials.yaml ./<installation_directory>/manifests

$ cp <ccoctl_output_dir>/manifests/*credentials.yaml ./<installation_directory>/manifestsCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

매니페스트디렉터리에 적절한 시크릿이 있는지 확인합니다.ls ./<installation_directory>/manifests

$ ls ./<installation_directory>/manifestsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.9. 클러스터 배포

호환되는 클라우드 플랫폼에 OpenShift Container Platform을 설치할 수 있습니다.

최초 설치 과정에서 설치 프로그램의 create cluster 명령을 한 번만 실행할 수 있습니다.

사전 요구 사항

- OpenShift Container Platform 설치 프로그램과 클러스터의 풀 시크릿이 있습니다.

- 호스트의 클라우드 공급자 계정에 클러스터를 배포할 수 있는 올바른 권한이 있는지 확인했습니다. 잘못된 권한이 있는 계정으로 인해 누락된 권한이 표시되는 오류 메시지와 함께 설치 프로세스가 실패합니다.

프로세스

설치 프로그램이 포함된 디렉터리에서 다음 명령을 실행하여 클러스터 배포를 초기화합니다.

./openshift-install create cluster --dir <installation_directory> \ --log-level=info$ ./openshift-install create cluster --dir <installation_directory> \1 --log-level=info2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

클러스터 배포가 성공적으로 완료되면 다음을 수행합니다.

-

터미널에는 웹 콘솔에 대한 링크 및

kubeadmin사용자의 인증 정보를 포함하여 클러스터에 액세스하는 지침이 표시됩니다. -

인증 정보도 <

installation_directory>/.openshift_install.log로 출력합니다.

설치 프로그램 또는 설치 프로그램이 생성하는 파일을 삭제하지 마십시오. 클러스터를 삭제하려면 두 가지가 모두 필요합니다.

출력 예

-

설치 프로그램에서 생성하는 Ignition 구성 파일에 24시간 후에 만료되는 인증서가 포함되어 있습니다. 이 인증서는 그 후에 갱신됩니다. 인증서를 갱신하기 전에 클러스터가 종료되고 24시간이 지난 후에 클러스터가 다시 시작되면 클러스터는 만료된 인증서를 자동으로 복구합니다. 예외적으로 kubelet 인증서를 복구하려면 대기 중인

node-bootstrapper인증서 서명 요청(CSR)을 수동으로 승인해야 합니다. 자세한 내용은 만료된 컨트롤 플레인 인증서에서 복구 문서를 참조하십시오. - 24 시간 인증서는 클러스터를 설치한 후 16시간에서 22시간으로 인증서가 교체되기 때문에 생성된 후 12시간 이내에 Ignition 구성 파일을 사용하는 것이 좋습니다. 12시간 이내에 Ignition 구성 파일을 사용하면 설치 중에 인증서 업데이트가 실행되는 경우 설치 실패를 방지할 수 있습니다.

4.10. 설치 후

클러스터 구성을 완료하려면 다음 단계를 완료합니다.

4.10.1. 기본 OperatorHub 카탈로그 소스 비활성화

Red Hat 및 커뮤니티 프로젝트에서 제공하는 콘텐츠를 소싱하는 Operator 카탈로그는 OpenShift Container Platform을 설치하는 동안 기본적으로 OperatorHub용으로 구성됩니다. 제한된 네트워크 환경에서는 클러스터 관리자로서 기본 카탈로그를 비활성화해야 합니다.

프로세스

OperatorHub오브젝트에disableAllDefaultSources: true를 추가하여 기본 카탈로그의 소스를 비활성화합니다.oc patch OperatorHub cluster --type json \ -p '[{"op": "add", "path": "/spec/disableAllDefaultSources", "value": true}]'$ oc patch OperatorHub cluster --type json \ -p '[{"op": "add", "path": "/spec/disableAllDefaultSources", "value": true}]'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

또는 웹 콘솔을 사용하여 카탈로그 소스를 관리할 수 있습니다. 관리 → 클러스터 설정 → 구성 → OperatorHub 페이지에서 개별 소스 를 생성, 업데이트, 삭제, 비활성화 및 활성화할 수 있는 소스 탭을 클릭합니다.

4.10.2. 클러스터에 정책 리소스 설치

oc-mirror OpenShift CLI(oc) 플러그인을 사용하여 OpenShift Container Platform 콘텐츠를 미러링하면 catalogSource- certified-operator-index.yaml 및 imageContentSourcePolicy.yaml 이 포함된 리소스가 생성됩니다.

-

ImageContentSourcePolicy리소스는 미러 레지스트리를 소스 레지스트리와 연결하고 온라인 레지스트리에서 미러 레지스트리로 이미지 가져오기 요청을 리디렉션합니다. -

CatalogSource리소스는 OLM(Operator Lifecycle Manager)에서 미러 레지스트리에서 사용 가능한 Operator에 대한 정보를 검색하는 데 사용되며, 이를 통해 사용자가 Operator를 검색하고 설치할 수 있습니다.

클러스터를 설치한 후 이러한 리소스를 클러스터에 설치해야 합니다.

사전 요구 사항

- 연결이 끊긴 환경에서 레지스트리 미러로 이미지를 미러링했습니다.

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

프로세스

-

cluster-admin역할의 사용자로 OpenShift CLI에 로그인합니다. 결과 디렉터리의 YAML 파일을 클러스터에 적용합니다.

oc apply -f ./oc-mirror-workspace/results-<id>/

$ oc apply -f ./oc-mirror-workspace/results-<id>/Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

ImageContentSourcePolicy리소스가 성공적으로 설치되었는지 확인합니다.oc get imagecontentsourcepolicy

$ oc get imagecontentsourcepolicyCopy to Clipboard Copied! Toggle word wrap Toggle overflow CatalogSource리소스가 성공적으로 설치되었는지 확인합니다.oc get catalogsource --all-namespaces

$ oc get catalogsource --all-namespacesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.10.3. 기본 스토리지 컨테이너 구성

클러스터를 설치한 후 Nutanix CSI Operator를 설치하고 클러스터의 기본 스토리지 컨테이너를 구성해야 합니다.

자세한 내용은 CSI Operator 설치 및 레지스트리 스토리지 구성 을 위한 Nutanix 설명서를 참조하십시오.

4.11. OpenShift Container Platform의 Telemetry 액세스

OpenShift Container Platform 4.17에서 클러스터 상태 및 업데이트 진행에 대한 메트릭을 제공하기 위해 기본적으로 실행되는 Telemetry 서비스에는 인터넷 액세스가 필요합니다. 클러스터가 인터넷에 연결되어 있으면 Telemetry가 자동으로 실행되고 OpenShift Cluster Manager에 클러스터가 자동으로 등록됩니다.

OpenShift Cluster Manager 인벤토리가 올바르거나 OpenShift Cluster Manager를 사용하여 자동으로 또는 OpenShift Cluster Manager를 사용하여 수동으로 유지 관리되는지 확인한 후 subscription watch를 사용하여 계정 또는 다중 클러스터 수준에서 OpenShift Container Platform 서브스크립션을 추적합니다.

4.13. 다음 단계

- 필요한 경우 원격 상태 보고를 참조하십시오.

- 필요한 경우 연결이 끊긴 클러스터 등록을참조하십시오.

- 클러스터 사용자 정의