容器迁移工具套件(MTC)

迁移到 OpenShift Container Platform 4

摘要

第 1 章 关于 Migration Toolkit for Containers(MTC)

MTC(Migration Toolkit for Containers)可让您按照命名空间将有状态应用程序工作负载在不同 OpenShift Container Platform 4 集群间进行迁移。

如果要从 OpenShift Container Platform 3 迁移,请参阅关于从 OpenShift Container Platform 3 迁移到 4以及在 OpenShift Container Platform 3 上安装旧的 MTC Operator。

您可以使用状态迁移,在同一集群或不同集群间迁移应用程序。

MTC 提供了一个基于 Kubernetes 自定义资源的 web 控制台和 API,可帮助您控制迁移并最小化应用程序停机时间。

MTC 控制台默认安装在目标集群中。您可以配置 MTC Operator,以便在远程集群中安装控制台。

有关以下主题的详情,请参阅高级迁移选项:

- 使用迁移 hook 和 MTC API 自动迁移。

- 配置迁移计划以排除资源,支持大规模迁移,并为直接卷迁移启用自动 PV 大小调整。

1.1. MTC 1.8 支持

- 所有 {OCP-short} 版本 4.15 及更早版本都支持使用 OADP 1.3.z 的 MTC 1.8.3 和更早的版本。

- MTC 1.8.4 及更新版本使用 OADP 1.3.z,目前在所有 {OCP-short} 版本 4.15 及更早版本上被支持。

- MTC 1.8.4 及更新的版本使用 OADP 1.4.z,所有支持的 {OCP-short} 版本 4.13 及更新的版本都被支持。

1.2. 术语

| 术语 | 定义 |

|---|---|

| 源集群 | 从中迁移应用程序的集群。 |

| 目标集群[1] | 将应用程序迁移到的集群。 |

| 复制软件仓库 | 用于在间接迁移过程中复制镜像、卷和 Kubernetes 对象的对象存储,或者用于直接卷迁移或直接镜像迁移期间 Kubernetes 对象的对象存储。 复制存储库必须可以被所有集群访问。 |

| 主机集群 |

运行 主机集群不需要公开的 registry 路由来直接迁移镜像。 |

| 远程集群 | 远程集群通常是源集群,但这不是必需的。

远程集群需要一个包含 远程集群需要一个公开的安全 registry 路由来直接迁移镜像。 |

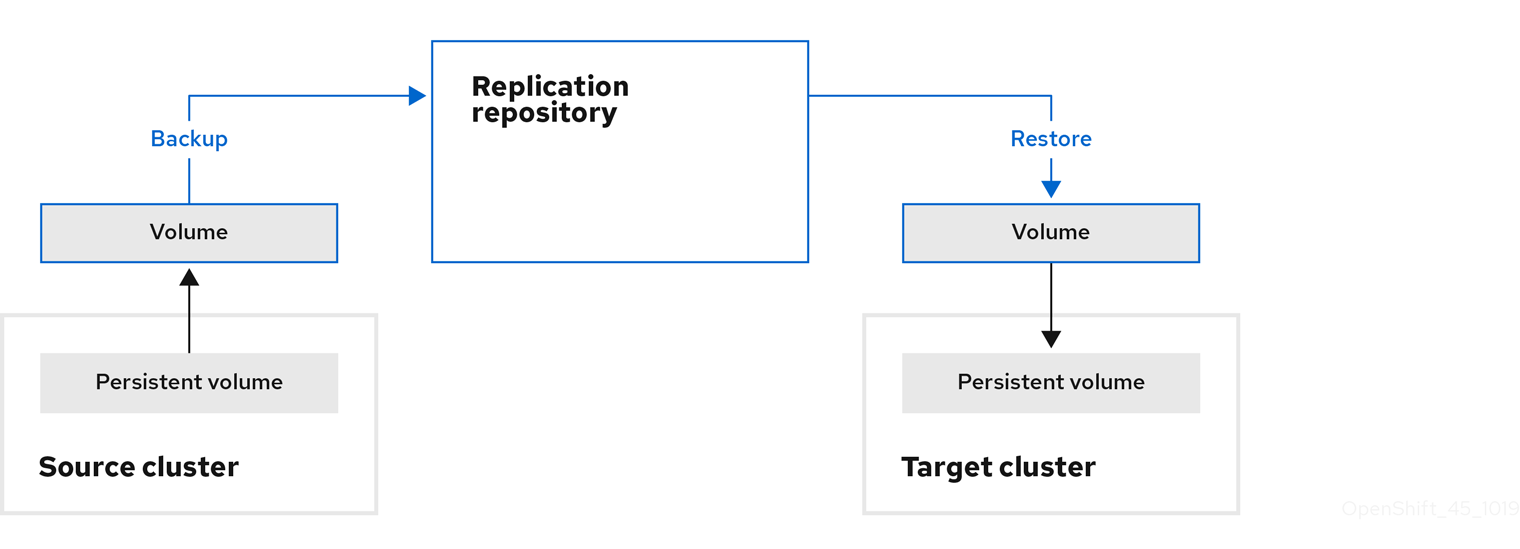

| 间接迁移 | 镜像、卷和 Kubernetes 对象从源集群复制到复制存储库,然后从复制存储库复制到目标集群。 |

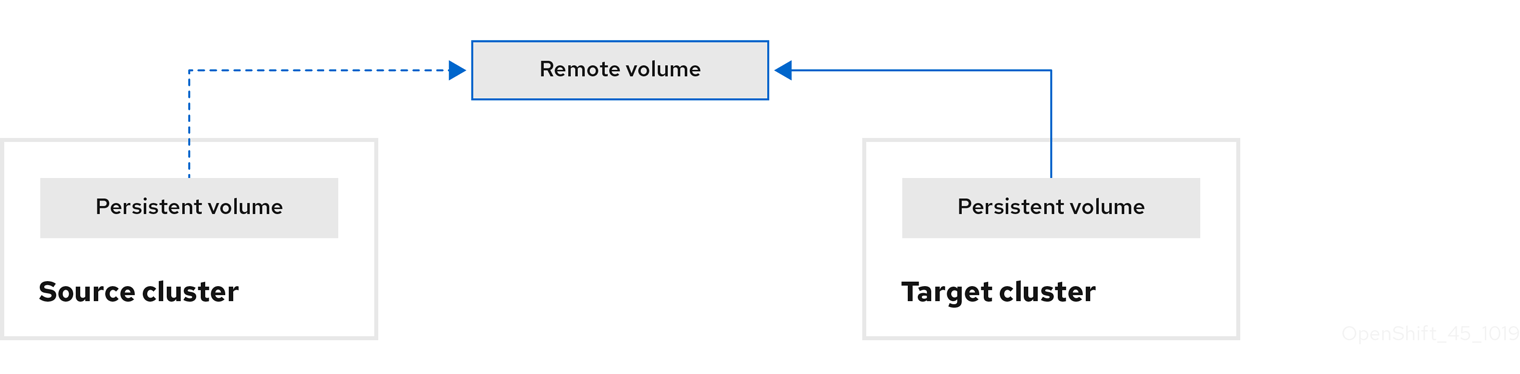

| 直接卷迁移 | 持久性卷直接从源集群复制到目标集群。 |

| 直接镜像迁移 | 镜像直接从源集群复制到目标集群。 |

| 阶段迁移 | 在不停止应用程序的情况下,数据将复制到目标集群。 多次运行阶段迁移会缩短迁移的持续时间。 |

| 剪切迁移 | 应用在源集群中停止,其资源迁移到目标集群。 |

| 状态迁移 | 通过将特定的持久性卷声明复制到目标集群来迁移应用程序状态。 |

| 回滚迁移 | 回滚迁移会回滚一个已完成的迁移。 |

1 在 MTC web 控制台中称为 目标集群。

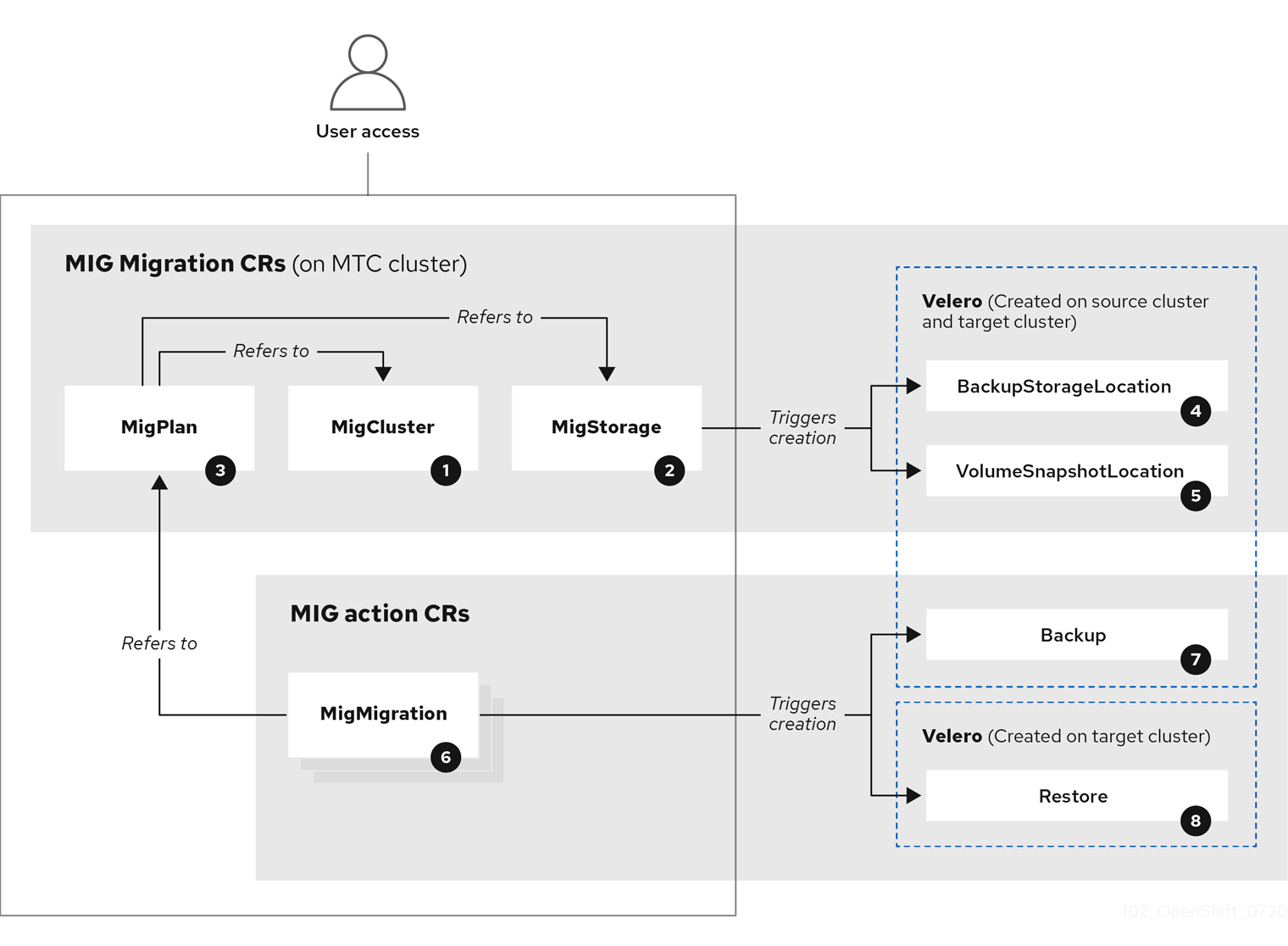

1.3. MTC 工作流

您可以使用 MTC web 控制台或 Kubernetes API 将 Kubernetes 资源、持久性卷数据和内部容器镜像迁移到 OpenShift Container Platform 4.13。

MTC 迁移以下资源:

- 在迁移计划中指定的命名空间。

命名空间范围的资源:当 MTC 迁移命名空间时,它会迁移与该命名空间关联的所有对象和资源,如服务或 Pod。另外,如果一个资源在命名空间中存在但不在集群级别,这个资源依赖于集群级别存在的另外一个资源,MTC 会迁移这两个资源。

例如,安全性上下文约束(SCC)是一个存在于集群级别的资源,服务帐户(SA)是存在于命名空间级别的资源。如果 MTC 迁移的命名空间中存在 SA,MTC 会自动找到链接到 SA 的所有 SCC,并迁移这些 SCC。同样,MTC 会迁移链接到命名空间持久性卷声明的持久性卷。

注意根据资源,可能需要手动迁移集群范围的资源。

- 自定义资源 (CR) 和自定义资源定义 (CRD):MTC 在命名空间级别自动迁移 CR 和 CRD。

使用 MTC Web 控制台迁移应用程序涉及以下步骤:

在所有集群中安装 MTC Operator。

您可以在有限的或没有互联网访问的受限环境中为 Containers Operator 安装 Migration Toolkit。源和目标集群必须可以在相互间进行访问,而需要可以访问 registry 的镜像(mirror).

配置复制存储库,这是 MTC 用来迁移数据的中间对象存储。

源和目标集群必须有对复制仓库的不受限制的网络访问权限。如果使用代理服务器,您必须将其配置为允许复制仓库和集群间的网络流量。

- 在 MTC web 控制台中添加源集群。

- 在 MTC web 控制台中添加复制存储库。

创建迁移计划,包含以下数据迁移选项之一:

Copy:MTC 将数据从源集群复制到复制存储库,再从复制存储库把数据复制到目标集群。

注意如果您使用直接镜像迁移或直接卷迁移,则镜像或卷会直接从源集群复制到目标集群。

Move:MTC 从源集群中卸载一个远程卷(例如 NFS),在目标集群上创建一个指向这个远程卷的 PV 资源,然后在目标集群中挂载远程卷。在目标集群中运行的应用程序使用源集群使用的同一远程卷。远程卷必须可以被源集群和目标集群访问。

注意虽然复制仓库没有出现在此图表中,但迁移需要它。

运行迁移计划,使用以下选项之一:

stage 在不停止应用程序的情况下将数据复制到目标集群。

阶段迁移可以多次运行,以便在迁移前将大多数数据复制到目标。运行一个或多个阶段迁移可缩短迁移的持续时间。

cutover 会停止源集群上的应用程序,并将资源移到目标集群。

可选:您可以清除 Halt transactions on the source cluster during migration 多选设置。

1.4. 关于数据复制方法

Migration Toolkit for Containers (MTC) 支持将数据从源集群迁移到目标集群的文件系统和快照数据复制方法。您可以选择适合于您的环境并受您的存储供应商支持的方法。

1.4.1. 文件系统复制方法

MTC 工具将数据文件从源集群复制到复制存储库,并从那里复制到目标集群。

文件系统复制方法使用 Restic 进行间接迁移,或使用 Rsync 进行直接卷迁移。

| 优点 | 限制 |

|---|---|

|

|

Restic 和 Rsync PV 迁移假设支持的 PV 仅是 volumeMode=filesystem。不支持在文件系统迁移中使用 volumeMode=Block。

1.4.2. 快照复制方法

MTC 将源集群数据的快照复制到云供应商的复制仓库。数据在目标集群上恢复。

快照复制方法可用于 Amazon Web Services、Google Cloud Provider 和 Microsoft Azure。

| 优点 | 限制 |

|---|---|

|

|

1.5. 直接卷迁移和直接镜像迁移

您可以使用直接镜像迁移(DIM)和直接卷迁移(DVM)将镜像和数据直接从源集群迁移到目标集群。

如果您使用位于不同可用区的节点运行 DVM,迁移可能会失败,因为迁移的 pod 无法访问持久性卷声明。

DIM 和 DVM 具有显著的性能优势,因为跳过将文件从源集群备份到复制存储库以及从复制存储库恢复到目标集群的中间步骤。使用 Rsync 传输数据。

DIM 和 DVM 还有其他先决条件。

第 2 章 MTC 发行注记

2.1. Migration Toolkit for Containers 1.8 发行注记

该版本的 Migration Toolkit for Containers 发行注记介绍了新的功能和增强功能、已弃用的功能以及已知的问题。

MTC(Migration Toolkit for Containers)可让您按照命名空间将应用程序工作负载在不同 OpenShift Container Platform 集群间进行迁移。

MTC 提供了一个基于 Kubernetes 自定义资源的 web 控制台和 API,可帮助您控制迁移并最小化应用程序停机时间。

有关 MTC 支持政策的信息,请参阅 OpenShift Application and Cluster Migration Solutions,它是 Red Hat OpenShift Container Platform 生命周期政策的一部分。

2.1.1. Migration Toolkit for Containers 1.8.4 发行注记

2.1.1.1. 技术变化

Migration Toolkit for Containers (MTC) 1.8.4 有以下技术更改:

- MTC 1.8.4 扩展其依赖项解析,使其包含对使用 OpenShift API for Data Protection (OADP) 1.4 的支持。

支持带有 DirectVolumeMigration 的 KubeVirt 虚拟机

MTC 1.8.4 添加了对带有直接卷迁移(DVM)的 KubeVirt 虚拟机(VM)的支持。

2.1.1.2. 已解决的问题

MTC 1.8.4 包括以下主要解决的问题:

安装 OpenShift Virtualization 时 Ansible Operator 无法正常工作

安装 OpenShift Virtualization 的 python3-openshift 软件包中有一个错误,在处理任务的过程中会返回一个例外 ValueError: too many values to unpack。早期版本的 MTC 会受到影响,MTC 1.8.4 提供了一个临时解决方案。更新至 MTC 1.8.4 代表您不再会受到此问题的影响。(OCPBUGS-38116)

在创建迁移计划时,UI 会在 Namespaces 步骤中卡住

当尝试从 MTC UI 创建迁移计划时,迁移计划向导会停留在 Namespaces 步骤中。这个问题已在 MTC 1.8.4 中解决。(MIG-1597)

迁移失败,并显示版本 kubevirt/v1 中没有匹配的虚拟机类型

在应用程序迁移过程中,所有必要的步骤(包括备份、DVM 和恢复)都会成功完成。但是,迁移被标记为未成功并带有错误信息 no matches for kind Virtual machine in version kubevirt/v1。(MIG-1594)

当迁移到与源命名空间不同的命名空间时,直接卷迁移会失败

在执行从源集群到目标集群的迁移时,如果目标命名空间与源命名空间不同,DVM 会失败。(MIG-1592)

直接镜像迁移不遵循 migplan 中的标签选择器

使用 Direct Image Migration (DIM) 时,如果在迁移计划上设置了标签选择器,DIM 并不会遵循它,并尝试迁移命名空间中的所有镜像流。(MIG-1533)

2.1.1.3. 已知问题

MTC 1.8.4 包括以下已知的问题:

在 OpenShift Container Platform 4.12 中无法迁移服务帐户关联的 SCC

无法迁移 OpenShift Container Platform 4.12 中服务帐户的相关安全性上下文约束 (SCC)。计划在以后的 MTC 版本中解决这个问题。(MIG-1454)

rsync pod 无法启动,导致 DVM 阶段失败

因为权限问题,Rsync pod 无法启动会导致 DVM 阶段失败。

迁移的构建器 pod 无法推送到镜像 registry

在将包含 BuildConfig 的应用程序迁移到目标集群时,构建器 Pod 会导致错误,无法将镜像推送到镜像 registry。

在创建后,冲突条件会在短暂的时间段内被清除

在创建会导致冲突错误的新状态迁移计划时,这个错误会在显示后被清除。

在设置 pv_resizing_threshold 后,PvCapacityAdjustmentRequired 警告信息没有显示

在调整 pv_resizing_threshold 后,PvCapacityAdjustmentRequired 警告信息将不会出现在迁移计划中。

2.1.2. Migration Toolkit for Containers 1.8.3 发行注记

2.1.2.1. 技术变化

Migration Toolkit for Containers (MTC) 1.8.3 有以下技术变化:

现在支持 OADP 1.3

MTC 1.8.3 添加了对 OpenShift API for Data Protection (OADP) 的支持,作为 MTC 1.8.z 的依赖。

2.1.2.2. 已解决的问题

MTC 1.8.3 包括以下主要解决的问题:

CVE-2024-24786: Golang protobuf 模块中的一个错误会导致 unmarshal 函数进入死循环

在以前的 MTC 版本中,在 Golang 的 protobuf 模块中发现了一个漏洞,在处理某些无效输入时,unmarshal 函数会进入一个死循环。因此,攻击者可以利用这个漏洞,通过一个精心构建的无效输入,会导致这个函数进入死循环。

在这个版本中,unmarshal 功能可以正常工作。

如需更多信息,请参阅 CVE-2024-24786。

CVE-2023-45857: Axios Cross-Site Request Forgery 安全漏洞

在以前的 MTC 版本中,在 Axios 1.5.1 中发现了一个漏洞,它会被利用来发现存储在 Cookie 中的敏感的 XSRF-TOKEN,方法是在向主机发出的每个请求的 HTTP 标头 X-XSRF-TOKEN 中包括它。

如需更多信息,请参阅 CVE-2023-45857。

当源工作负载没有静止时,Restic 备份无法正常工作

在以前的 MTC 版本中,当使用路由部署应用程序时,一些文件不会被迁移。当源工作负载取消选择 quiesce 选项时,Restic 备份无法正常工作。

这个问题已在 MTC 1.8.3 中解决。

如需更多信息,请参阅 BZ#2242064。

因为 Velero 中的一个不被支持的值错误,Migration Controller 无法安装

因为 Velero 不支持的值错误,MigrationController 无法安装。将 OADP 1.3.0 更新至 OADP 1.3.1 可解决这个问题。如需更多信息,请参阅 BZ#2267018。

这个问题已在 MTC 1.8.3 中解决。

有关所有已解决的问题的完整列表,请参阅 JIRA 中的 MTC 1.8.3 解决的问题 列表。

2.1.2.3. 已知问题

MTC (Migration Toolkit for Containers) 1.8.3 有以下已知问题:

安装 OpenShift Virtualization 时 Ansible Operator 无法正常工作

安装 OpenShift Virtualization 的 python3-openshift 软件包中有一个错误,在处理任务的过程中会返回一个例外 ValueError: too many values to unpack。MTC 1.8.4 实施了一个临时解决方案。更新至 MTC 1.8.4 代表您不再会受到此问题的影响。(OCPBUGS-38116)

在 OpenShift Container Platform 4.12 中无法迁移服务帐户关联的 SCC

OpenShift Container Platform 版本 4.12 中服务帐户的相关安全性上下文约束 (SCC) 无法迁移。计划在以后的 MTC 版本中解决这个问题。(MIG-1454)

有关所有已知问题的完整列表,请参阅 JIRA 中的 MTC 1.8.3 已知问题列表。

2.1.3. Migration Toolkit for Containers 1.8.2 发行注记

2.1.3.1. 已解决的问题

此发行版本有以下主要解决的问题:

在设置自定义 CA 复制存储库后备份阶段失败

在以前的 MTC 版本中,在编辑复制存储库后,添加自定义 CA 证书、成功连接仓库并触发迁移,在备份阶段出现问题。

CVE-2023-26136: 在 4.1.3 之前使用 tough-cookie 软件包会受到 Prototype Pollution 的攻击

在以前的 (MTC) 版本中,MTC 中使用的 tough-cookie 软件包版本 4.1.3 会被受到原型处理的影响。发生此漏洞的原因是,当 rejectPublicSuffixes 的值设置为 false 时,CookieJar 无法正确处理 Cookie。

如需了解更多详细信息,请参阅 (CVE-2023-26136)

CVE-2022-25883 openshift-migration-ui-container: nodejs-semver: Regular expression 拒绝服务

在以前的(MTC)版本中,当不受信任的用户数据作为 newRange 提供时,MTC 中使用的 7.5.2 之前的 semver 软件包版本容易受到 Regular Expression Denial 的 Service (ReDoS)的攻击。

如需了解更多详细信息,请参阅 (CVE-2022-25883)

2.1.3.2. 已知问题

MTC 1.8.2 包括以下已知的问题:

安装 OpenShift Virtualization 时 Ansible Operator 无法正常工作

安装 OpenShift Virtualization 的 python3-openshift 软件包中有一个错误,在处理任务的过程中会返回一个例外 ValueError: too many values to unpack。MTC 1.8.4 实施了一个临时解决方案。更新至 MTC 1.8.4 代表您不再会受到此问题的影响。(OCPBUGS-38116)

2.1.4. Migration Toolkit for Containers 1.8.1 发行注记

2.1.4.1. 已解决的问题

MTC (Migration Toolkit for Containers) 1.8.1 解决了以下主要问题:

CVE-2023-39325: golang: net/http, x/net/http2: 快速流重置可能会导致过量工作

在处理 HTTP/2 协议(被 MTC 使用)中的多路流中发现了一个安全漏洞。 客户端可以重复请求新的多路流,并立即发送 RST_STREAM 帧来取消它。这在设置和分离流方面为服务器创建额外的工作负载,同时避免每个连接的最大活跃流数量的服务器端限制,从而导致因为服务器资源消耗而拒绝服务。(BZ#2245079)

建议升级到 MTC 1.8.1 或更高版本,从而解决了这个问题。

如需了解更多详细信息,请参阅 (CVE-2023-39325) 和 (CVE-2023-44487)

2.1.4.2. 已知问题

MTC (Migration Toolkit for Containers) 1.8.1 有以下已知问题:

安装 OpenShift Virtualization 时 Ansible Operator 无法正常工作

安装 OpenShift Virtualization 的 python3-openshift 软件包中存在一个错误。在任务执行期间会返回一个例外 ValueError: too too value to unpack。MTC 1.8.4 实施了一个临时解决方案。更新至 MTC 1.8.4 代表您不再会受到此问题的影响。(OCPBUGS-38116)

2.1.5. Migration Toolkit for Containers 1.8.0 发行注记

2.1.5.1. 已解决的问题

MTC (Migration Toolkit for Containers) 1.8.0 解决了以下问题:

间接迁移会一直处于备份阶段

在以前的版本中,因为 InvalidImageName 错误,间接迁移会卡住在备份阶段。 ((BZ#2233097))

PodVolumeRestore 会保留在 In Progress 状态,使迁移一直处于 Stage Restore 状态

在以前的版本中,在执行间接迁移时,迁移会停留在 Stage Restore 步骤中,等待 podvolumerestore 完成。 ((BZ#2233868))

迁移的应用程序无法从目标集群上的内部 registry 中拉取镜像

在以前的版本中,在将应用程序迁移到目标集群时,迁移的应用程序无法从内部镜像 registry 中拉取镜像,从而导致 应用程序失败。 ((BZ#2233103))

由于授权问题,在 Azure 上迁移失败

在以前的版本中,在 Azure 集群中,当备份到 Azure 存储时,迁移会在 Backup 阶段失败。((BZ#2238974))

2.1.5.2. 已知问题

MTC 1.8.0 包括以下已知的问题:

安装 OpenShift Virtualization 时 Ansible Operator 无法正常工作

安装 OpenShift Virtualization 的 python3-openshift 软件包中有一个错误,在处理任务的过程中会返回一个例外 ValueError: too many values to unpack。MTC 1.8.4 实施了一个临时解决方案。更新至 MTC 1.8.4 代表您不再会受到此问题的影响。(OCPBUGS-38116)

升级 MTC 1.7.x → 1.8.x 时不会删除旧的 Restic pod

在这个发行版本中,当将 MTC Operator 从 1.7.x 升级到 1.8.x 时,旧的 Restic pod 不会被删除。因此,在升级后,Restic 和 node-agent pod 仍然可以在命名空间中看见。((BZ#2236829))

迁移的构建器 pod 无法推送到镜像 registry

在本发行版本中,在将包含 BuildConfig 的应用程序从源迁移到目标集群时,builder pod 会导致错误,无法将镜像推送到镜像 registry。((BZ#2234781))

[UI] CA 捆绑包文件字段没有被正确清除

在本发行版本中,在启用 Require SSL 验证 并将内容添加到 MigStorage 的 MCG NooBaa 存储桶的 CA 捆绑包文件中后,连接会如预期失败。但是,通过删除 CA 捆绑包内容并清除 Require SSL 验证 来恢复这些更改时,连接仍会失败。该问题仅通过删除和重新添加存储库来解决。((BZ#2240052))

在设置自定义 CA 复制存储库后备份阶段失败

在(MTC)编辑复制存储库后,添加自定义 CA 证书、成功连接仓库并触发迁移,在备份阶段出现问题。

这个问题已在 MTC 1.8.2 中解决。

CVE-2023-26136: 在 4.1.3 之前使用 tough-cookie 软件包会受到 Prototype Pollution 的攻击

MTC 中使用的 4.1.3 tough-cookie 软件包版本之前(在 MTC 中使用)容易受到对轮询建模的攻击。此漏洞发生,因为当 rejectPublicSuffixes 的值设置为 false 时,CookieJar 无法正确处理 Cookie。

这个问题已在 MTC 1.8.2 中解决。

如需了解更多详细信息,请参阅 (CVE-2023-26136)

CVE-2022-25883 openshift-migration-ui-container: nodejs-semver: Regular expression 拒绝服务

在以前的(MTC)版本中,当不受信任的用户数据作为 newRange 提供时,MTC 中使用的 7.5.2 之前的 semver 软件包版本容易受到 Regular Expression Denial 的 Service (ReDoS)的攻击。

这个问题已在 MTC 1.8.2 中解决。

如需了解更多详细信息,请参阅 (CVE-2022-25883)

2.1.5.3. 技术变化

此发行版本有以下技术更改:

- 从 OpenShift Container Platform 3 迁移到 OpenShift Container Platform 4 需要旧的 MTC Operator 和 MTC 1.7.x 的 Migration Toolkit。

- 不支持从 MTC 1.7.x 迁移到 MTC 1.8.x。

您必须使用 MTC 1.7.x 来迁移使用 OpenShift Container Platform 4.9 或更早版本源的任何内容。

- MTC 1.7.x 必须在源和目标中使用。

Migration Toolkit for Containers (MTC) 1.8.x 仅支持从 OpenShift Container Platform 4.10 或更高版本迁移到 OpenShift Container Platform 4.10 或更高版本。对于仅涉及集群版本 4.10 或更高版本的迁移,可以使用 1.7.x 或 1.8.x。但是,在源和目标上 MTC 1.Y.z 必须相同。

- 不支持从源 MTC 1.7.x 迁移到目标 MTC 1.8.x。

- 不支持从源 MTC 1.8.x 迁移到目标 MTC 1.7.x。

- 支持从源 MTC 1.7.x 迁移到目标 MTC 1.7.x。

- 支持从源 MTC 1.8.x 迁移到目标 MTC 1.8.x。

- MTC 1.8.x 默认会安装 OADP 1.2.x。

- 从 MTC 1.7.x 升级到 MTC 1.8.0,需要手动将 OADP 频道改为 1.2。如果没有这样做,Operator 升级会失败。

2.2. Migration Toolkit for Containers 1.7 发行注记

该版本的 Migration Toolkit for Containers 发行注记介绍了新的功能和增强功能、已弃用的功能以及已知的问题。

MTC(Migration Toolkit for Containers)可让您按照命名空间将应用程序工作负载在不同 OpenShift Container Platform 集群间进行迁移。

您可以从 OpenShift Container Platform 3 迁移到 4.13,也可以在 OpenShift Container Platform 4 集群之间迁移。

MTC 提供了一个基于 Kubernetes 自定义资源的 web 控制台和 API,可帮助您控制迁移并最小化应用程序停机时间。

有关 MTC 支持政策的信息,请参阅 OpenShift Application and Cluster Migration Solutions,它是 Red Hat OpenShift Container Platform 生命周期政策的一部分。

2.2.1. Migration Toolkit for Containers 1.7.17 发行注记

Migration Toolkit for Containers (MTC) 1.7.17 只是一个 Container Grade (CGO) 版本,用于刷新容器的健康状态等级,与 MTC 1.7.16 相比,不会对产品本身中的任何代码进行更改。

2.2.2. Migration Toolkit for Containers 1.7.16 发行注记

2.2.2.1. 已解决的问题

此发行版本有以下解决的问题:

CVE-2023-45290: Golang: net/http: Memory exhaustion in the Request.ParseMultipartForm method

net/http Golang 标准库软件包中发现了一个安全漏洞,它会影响 MTC 的早期版本。在以前的版本中,当解析 multipart 表单时,可以明确使用 Request.ParseMultipartForm,或使用 Request.FormValue, Request.PostFormValue, 或 Request.FormFile 方法隐式应用,解析表单的总大小限制不适用于在读单一表单行时消耗的内存。这可能会允许在恶意设计的输入中包含非常长的行,从而导致分配大量内存,这可能会导致内存耗尽。

要解决这个问题,升级到 MTC 1.7.16。

如需了解更多详细信息,请参阅 CVE-2023-45290

CVE-2024-24783: Golang: crypto/x509: Verify panics on certificates with an unknown public key algorithm

在 crypto/x509 Golang 标准库软件包中发现了一个安全漏洞,它会影响 MTC 的早期版本。验证包含带有未知公钥算法的证书的证书链会导致 Certificate.Verify panic。这会影响将 Config.ClientAuth 设置为 VerifyClientCertIfGiven 或 RequireAndVerifyClientCert 的所有 crypto/tls 客户端和服务器。默认行为是 TLS 服务器无法验证客户端证书。

要解决这个问题,升级到 MTC 1.7.16。

如需了解更多详细信息,请参阅 CVE-2024-24783。

CVE-2024-24784: Golang: net/mail: 显示名称中的注释被错误处理

net/mail Golang 标准库软件包中发现了一个安全漏洞,它会影响 MTC 的早期版本。ParseAddressList 函数错误地处理注释、文本(括号中的文本)和显示名称。由于这与地址解析程序不匹配,因此可能会导致使用不同解析器的程序进行不同的信任决策。

要解决这个问题,升级到 MTC 1.7.16。

如需了解更多详细信息,请参阅 CVE-2024-24784。

CVE-2024-24785: Golang: html/template: Errors returned from MarshalJSON methods may break template escaping

在 html/template Golang 标准库软件包中发现了一个安全漏洞,它会影响 MTC 的早期版本。 如果来自 MarshalJSON 方法返回的错误包含用户控制的数据,则它们可能会用来破坏 html/template 软件包的上下文自动转义行为,以便后续操作将意外内容注入模板。

要解决这个问题,升级到 MTC 1.7.16。

如需了解更多详细信息,请参阅 CVE-2024-24785。

CVE-2024-29180: webpack-dev-middleware: Lack of URL validation may lead to file leak

webpack-dev-middleware 软件包 中发现了一个安全漏洞,它会影响 MTC 的早期版本。在返回本地文件前,这个缺陷无法验证提供的 URL 地址,这可让攻击者编写 URL 来从开发人员机器返回任意本地文件。

要解决这个问题,升级到 MTC 1.7.16。

如需了解更多详细信息,请参阅 CVE-2024-29180。

CVE-2024-30255: envoy: HTTP/2 CPU exhaustion due to CONTINUATION frame flood

在 envoy 代理如何实现 HTTP/2 codec 中发现了一个安全漏洞,这会影响早期版本的 MTC。对可在单一流内发送的 CONTINUATION 帧数量有不足的限制,即使超过 envoy 的标题映射限制。这个漏洞可能会允许未经身份验证的远程攻击者向存在安全漏洞的服务器发送数据包。这些数据包可能会消耗计算资源并导致拒绝服务(DoS)。

要解决这个问题,升级到 MTC 1.7.16。

如需了解更多详细信息,请参阅 CVE-2024-30255。

2.2.2.2. 已知问题

这个版本有以下已知问题:

直接卷迁移失败,因为源集群中的 Rsync pod 进入 Error 状态

在使用持久性卷声明(PVC)迁移任何应用程序时,Stage migration 操作会成功显示警告,而直接卷迁移(DVM)会失败,源命名空间中的 rsync pod 会进入 error 状态。(BZ#2256141)

冲突条件会在创建后被清除

在创建导致冲突错误消息的新状态迁移计划时,错误消息会在显示后很快清除。(BZ#2144299)

当集群中配置了不同提供程序类型的多个卷快照位置时,迁移会失败

当具有不同供应商类型的集群中有多个卷快照位置(VSL)时,但没有将任何它们设置为默认的 VSL,Velero 会导致迁移操作失败。(BZ#2180565)

2.2.3. Migration Toolkit for Containers 1.7.15 发行注记

2.2.3.1. 已解决的问题

此发行版本有以下解决的问题:

CVE-2024-24786: 在 Golang 的 protobuf 模块中发现了一个安全漏洞,unmarshal 功能可以进入一个死循环

在 protojson.Unmarshal 函数中发现了一个安全漏洞,它可能会导致函数在 unmarshaling 特定的无效 JSON 消息时进入死循环。当 unmarshaling 到一个包括了 google.protobuf.Any 值的信息或在 JSON 格式的消息中设置了 UnmarshalOptions.DiscardUnknown 选项时,这个条件会发生。

要解决这个问题,升级到 MTC 1.7.15。

如需了解更多详细信息,请参阅 (CVE-2024-24786)。

CVE-2024-28180: jose-go 错误处理高度压缩的数据

在 Jose 中发现了一个因为处理高压缩数据不当造成的漏洞。攻击者可以发送一个 JSON Web 加密(JWE)加密消息,其中包含在解压缩 Decrypt 或 DecryptMulti 功能时使用的大量内存和 CPU 的压缩数据。

要解决这个问题,升级到 MTC 1.7.15。

如需了解更多详细信息,请参阅 (CVE-2024-28180)。

2.2.3.2. 已知问题

这个版本有以下已知问题:

直接卷迁移失败,因为源集群中的 Rsync pod 进入 Error 状态

在使用持久性卷声明(PVC)迁移任何应用程序时,Stage migration 操作会成功显示警告,而直接卷迁移(DVM)会失败,源命名空间中的 rsync pod 会进入 error 状态。(BZ#2256141)

冲突条件会在创建后被清除

在创建导致冲突错误消息的新状态迁移计划时,错误消息会在显示后很快清除。(BZ#2144299)

当集群中配置了多个不同提供程序类型的卷快照位置(VSL)时,迁移会失败,且没有指定默认 VSL。

当集群中具有不同提供程序类型的集群中有多个 VSL,并且没有设置它们作为默认的 VSL,Velero 会产生一个验证错误,导致迁移操作失败。(BZ#2180565)

2.2.4. Migration Toolkit for Containers 1.7.14 发行注记

2.2.4.1. 已解决的问题

此发行版本有以下解决的问题:

CVE-2023-39325 CVE-2023-44487: 各种安全漏洞

在处理 HTTP/2 协议(被 MTC 使用)中的多路流中发现了一个安全漏洞。 客户端可以重复请求新的多路流,然后立即发送 RST_STREAM 帧来取消这些请求。对于设置和分离流,这个活动会为服务器创建额外的工作负载,但避免了每个连接的最大活跃流数量的服务器端限制。这会导致因为服务器的资源被耗尽而出现拒绝服务的问题。

要解决这个问题,升级到 MTC 1.7.14。

如需了解更多详细信息,请参阅 (CVE-2023-44487) 和 (CVE-2023-39325)。

CVE-2023-39318 CVE-2023-39319 CVE-2023-39321: 各种安全漏洞

(CVE-2023-39318): 在 Golang 中发现了一个安全漏洞,它被 MTC 使用。

html/template软件包没有正确处理类似 HTML 的""注释令牌,或者在<script>上下文中正确处理 hashbang"#!"注释令牌。此漏洞可能会导致模板解析器错误地解释<script>上下文的内容,从而导致操作被不当转义。(CVE-2023-39319): 在 Golang 中发现了一个安全漏洞,它被 MTC 使用。对于 <script> 中的 JavaScript 代码,

html/template软件包没有应用正确的规则来处理同时存在的"<script","<!--", 和"</script"。这可能会导致模板解析器错误地认为脚本已结束,从而导致操作被不当转义。(CVE-2023-39321): 在 Golang 中发现了一个安全漏洞,它被 MTC 使用。为 QUIC 连接处理不完整的 post-handshake 消息可能会导致 panic。

(CVE-2023-3932): 在 Golang 中发现了一个安全漏洞,它被 MTC 使用。使用 QUIC 传输协议进行连接时,当在读取握手后消息时对缓冲区的数据量没有设置上限,从而使恶意的 QUIC 连接可以导致内存的使用大量增加。

要解决这个问题,升级到 MTC 1.7.14。

如需了解更多详细信息,请参阅 (CVE-2023-39318), (CVE-2023-39319) 和 (CVE-2023-39321)。

2.2.4.2. 已知问题

这个版本没有主要已知的问题。

2.2.5. Migration Toolkit for Containers 1.7.13 发行注记

2.2.5.1. 已解决的问题

这个版本没有主要解决的问题。

2.2.5.2. 已知问题

这个版本没有主要已知的问题。

2.2.6. Migration Toolkit for Containers 1.7.12 发行注记

2.2.6.1. 已解决的问题

这个版本没有主要解决的问题。

2.2.6.2. 已知问题

这个版本有以下已知问题:

Migration details 页面中会显示错误代码 504

在 Migration details 页面中,首先会显示 迁移详情,且没有任何问题。但是,在一段时间后,详情会消失,并返回 504 错误。(BZ#2231106)

当将 MTC 1.7.x 升级到 MTC 1.8 时,旧的 restic pod 不会被删除

在将 MTC operator 从 1.7.x 升级到 1.8.x 时,旧的 restic pod 不会被删除。升级后,restic 和 node-agent pod 在命名空间中可见。(BZ#2236829)

2.2.7. Migration Toolkit for Containers 1.7.11 发行注记

2.2.7.1. 已解决的问题

这个版本没有主要解决的问题。

2.2.7.2. 已知问题

这个版本没有已知的问题。

2.2.8. Migration Toolkit for Containers 1.7.10 发行注记

2.2.8.1. 已解决的问题

此发行版本包括以下已解决的问题:

调整 DVM 中的 rsync 选项

在这个发行版本中,您可以防止在直接卷迁移 (DVM) 过程中使用 Rsync 对绝对符号链接进行操作。以特权模式运行 DVM 会在持久性卷声明 (PVC) 内保留绝对符号链接。要切换到特权模式,在 MigrationController CR 中,将 migration_rsync_privileged spec 设置为 true。(BZ#2204461)

2.2.8.2. 已知问题

这个版本没有已知的问题。

2.2.9. Migration Toolkit for Containers 1.7.9 发行注记

2.2.9.1. 已解决的问题

这个版本没有主要解决的问题。

2.2.9.2. 已知问题

此发行版本有以下已知问题:

调整 DVM 中的 rsync 选项

在这个发行版本中,用户无法防止在直接卷迁移(DVM)期间通过 rsync 操作绝对符号链接。(BZ#2204461)

2.2.10. Migration Toolkit for Containers 1.7.8 发行注记

2.2.10.1. 已解决的问题

此发行版本有以下主要解决的问题:

在 MTC operator 中无法覆盖 Velero 镜像

在以前的版本中,无法使用 MigrationController 自定义资源(CR)中的 velero_image_fqin 参数覆盖 velero 镜像。(BZ#2143389)

当域名有超过 6 个字符时,从 UI 添加一个 MigCluster 会失败

在以前的版本中,当域名有超过 6 个字符时,从 UI 添加一个 MigCluster 会失败。UI 代码预期有两个到六个字符之间的域名。(BZ#2152149)

UI 无法呈现 Migrations' 页面: Cannot read properties of undefined (reading 'name')

在以前的版本中,UI 无法呈现 Migrations' 页面,返回 Cannot read properties of undefined (reading 'name')。(BZ#2163485)

在 Red Hat OpenShift Container Platform 4.6 集群中创建 DPA 资源失败

在以前的版本中,当在 OpenShift Container Platform 4.6 集群上部署 MTC 时,根据日志创建 DPA 会失败,这会导致一些 pod 缺少。从 OpenShift Container Platform 4.6 集群中的 migration-controller 日志中,这表示传递了一个意外的 null 值,这会导致错误。(BZ#2173742)

2.2.10.2. 已知问题

这个版本没有已知的问题。

2.2.11. Migration Toolkit for Containers 1.7.7 发行注记

2.2.11.1. 已解决的问题

这个版本没有主要解决的问题。

2.2.11.2. 已知问题

这个版本没有已知的问题。

2.2.12. Migration Toolkit for Containers 1.7.6 发行注记

2.2.12.1. 新功能

在 Red Hat OpenShift Container Platform 4.12 中使用 PSA 实现 DVM 支持的建议更改

随着 OpenShift Container Platform 4.12 中的 Pod Security Admission (PSA)的传入强制,默认 pod 会使用 restricted 配置集运行。这个 restricted 配置集意味着要迁移的工作负载将违反此策略,且现在不再可以正常工作。以下功能增强概述了与 OCP 4.12 兼容所需的更改。(MIG-1240)

2.2.12.2. 已解决的问题

此发行版本有以下主要解决的问题:

由于 Red Hat OpenShift Platform 4.12 中缺少 cronjob 错误,则无法创建存储类 Conversion 计划

在以前的版本中,在持久性卷页面中,抛出一个错误,即 CronJob 在版本 batch/v1beta1 中不可用,并在点 cancel 时创建 migplan,其状态为 Not ready。(BZ#2143628)

2.2.12.3. 已知问题

此发行版本有以下已知问题:

冲突条件会在创建后被清除

在创建会导致冲突错误的新状态迁移计划时,这个错误会在显示后被清除。(BZ#2144299)

2.2.13. Migration Toolkit for Containers 1.7.5 发行注记

2.2.13.1. 已解决的问题

此发行版本包括以下已解决的问题:

直接卷迁移作为源集群上的 rsync pod 失败,进入 Error 状态

在以前的版本中,迁移成功并显示警告,但使用源命名空间中的 rsync pod 进入错误状态的直接卷迁移失败。(*BZ#2132978)

2.2.13.2. 已知问题

这个版本有以下已知问题:

在 MTC operator 中无法覆盖 Velero 镜像

在以前的版本中,无法使用 MigrationController 自定义资源(CR)中的 velero_image_fqin 参数覆盖 velero 镜像。(BZ#2143389)

在 UI 中编辑 MigHook 时,页面可能无法重新加载

如果出现网络连接问题,则 UI 在编辑 hook 时可能无法重新加载。恢复网络连接后,页面将无法重新加载,直到缓存被清除为止。(BZ#2140208)

2.2.14. Migration Toolkit for Containers 1.7.4 发行注记

2.2.14.1. 已解决的问题

这个版本没有主要解决的问题。

2.2.14.2. 已知问题

回滚没有从目标集群中删除某些资源

在从 MTC UI 执行应用程序回滚时,一些资源不会从目标集群中删除,回滚会显示成功的状态。(BZ#2126880)

2.2.15. Migration Toolkit for Containers 1.7.3 发行注记

2.2.15.1. 已解决的问题

此发行版本有以下主要解决的问题:

目标命名空间的正确 DNS 验证

在以前的版本中,如果目标命名空间使用非字母字符启动,则 MigPlan 无法验证。(BZ#2102231)

从 UI 取消选择所有 PVC 仍然会导致尝试的 PVC 传输

在以前的版本中,在进行完整迁移时,取消选择持久性卷声明(PVC)不会跳过选择 PVC,并仍然尝试迁移它们。 (BZ#2106073)

目标命名空间的 DNS 验证不正确

在以前的版本中,MigPlan 无法验证,因为目标命名空间使用非字母字符启动。 (BZ#2102231)

2.2.15.2. 已知问题

这个版本没有已知的问题。

2.2.16. Migration Toolkit for Containers 1.7.2 发行注记

2.2.16.1. 已解决的问题

此发行版本有以下主要解决的问题:

MTC UI 无法正确显示日志

在以前的版本中,MTC UI 没有正确显示日志。(BZ#2062266)

StorageClass 转换计划在 migplan 中添加 migstorage 参考

在以前的版本中,StorageClass 转换计划有一个 migstorage 引用,即使还没有使用它。(BZ#2078459)

下载的日志中缺少 Velero pod 日志

在以前的版本中,当为所有日志下载压缩(.zip)文件夹时,会缺少 velero pod。(BZ#2076599)

UI 下拉菜单中缺少 Velero pod 日志

在以前的版本中,在执行迁移后,velero pod 日志没有包含在下拉列表中提供的日志中。(BZ#2076593)

rsync 选项日志无法在 log-reader pod 中看到

在以前的版本中,当试图在 migrationcontroller 中设置任何有效或无效的 rsync 选项时,log-reader 不会显示有关无效选项或正在使用的 rsync 命令的任何日志。(BZ#2079252)

Velero/Restic 上的默认 CPU 请求过于要求,在某些情况下会失败

在以前的版本中,Velero/Restic 上的默认 CPU 请求过于要求并在某些环境中失败。Velero 和 Restic Pod 的默认 CPU 请求被设置为 500m。这些值非常高。(BZ#2088022)

2.2.16.2. 已知问题

这个版本有以下已知问题:

UI 不遵守将复制存储库更新到不同的存储供应商类型

将复制存储库更新为不同的类型并点 Update Repository 后,它会显示连接成功,但不会使用正确的详情更新 UI。当再次点 Edit 按钮时,它仍然会显示旧的复制存储库信息。

另外,当尝试再次更新复制存储库时,它仍然会显示旧的复制详情。在选择新存储库时,它还会显示您之前输入的所有信息,并且没有启用 Update repository,因为没有提交更改。(BZ#2102020)

迁移失败,因为没有找到备份

因为没有找到初始备份,迁移在恢复阶段失败。(BZ#2104874)

更新 Azure 资源组时不会启用更新 Cluster 按钮

在更新远程集群时,选择 Azure 资源组 复选框,添加资源组不会启用 Update cluster 选项。(BZ#2098594)

删除 migstorage 资源的 UI 中的弹出错误

在 OpenShift Container Platform 中创建 backupStorage 凭证 secret 时,如果从 UI 中删除 migstorage,则返回 404 错误,且不会删除底层 secret。(BZ#2100828)

MigAnalytic 资源在 UI 中显示资源数为 0

从后端创建 migplan 后,Miganalytic 资源会在 UI 中显示为 0。(BZ#2102139)

当将两个尾部斜杠添加到公开路由主机到镜像 registry 时,registry 验证会失败

在向公开的 registry 路由中添加两个尾部斜杠(即 // )后,MigCluster 资源会显示为 已连接 的状态。当使用 DIM 从后端创建 migplan 时,计划将移至 未就绪 状态。(BZ#2104864)

在编辑源集群时,Service Account Token 不可见

在编辑添加并处于 Connected 状态的源集群时,在 UI 中无法看到服务帐户令牌。要保存向导,您必须再次获取令牌,并在字段内提供详情。(BZ#2097668)

2.2.17. Migration Toolkit for Containers 1.7.1 发行注记

2.2.17.1. 已解决的问题

这个版本没有主要解决的问题。

2.2.17.2. 已知问题

这个版本有以下已知问题:

目标命名空间的 DNS 验证不正确

PlanPlan 无法被验证,因为目标命名空间以非字母字符开头。(BZ#2102231)

因为 Velero pod 中缺少标签,迁移控制器中的云传播阶段无法正常工作

因为 Velero pod 中缺少标签,迁移控制器中的 Cloud propagation 阶段无法正常工作。迁移控制器中的 EnsureCloudSecretPropagated 阶段会等待两个端传播复制存储库 secret。因为 Velero pod 缺少该标签,所以该阶段无法正常工作。(BZ#2088026)

在某些环境中进行调度失败时,Velero/Restic 上的默认 CPU 请求过于要求

在某些环境中进行调度失败时,Velero/Restic 上的默认 CPU 请求过于要求。Velero 和 Restic Pod 的默认 CPU 请求被设置为 500m。这些值非常高。可以使用 Velero 和 Restic 的 podConfig 字段在 DPA 中配置资源。迁移 Operator 应该将 CPU 请求设置为较低值,如 100m,以便 Velero 和 Restic pod 可以在资源受限环境中调度,这通常运行。(BZ#2088022)

编辑存储类转换计划后,PersistentVolumeVolumes 页面中会显示警告

编辑存储类转换计划后,persistentVolumes 页面中会显示警告信息。在编辑现有迁移计划时,在 UI 上会显示一个警告,At least one PVC must be selected for Storage Class Conversion。(BZ#2079549)

下载的日志中缺少 Velero pod 日志

当为所有日志下载压缩(.zip)文件夹时,velero pod 缺失。(BZ#2076599)

UI 下拉菜单中缺少 Velero pod 日志

执行迁移后,velero pod 日志不会包含在下拉列表中提供的日志中。(BZ#2076593)

2.2.18. Migration Toolkit for Containers 1.7.0 发行注记

2.2.18.1. 新功能及功能增强

此发行版本有以下新功能和增强:

- Migration Toolkit for Containers(MTC)Operator 现在依赖于 OpenShift API for Data Protection(OADP)Operator。安装 MTC Operator 时,Operator Lifecycle Manager(OLM)会自动在同一命名空间中安装 OADP Operator。

-

您可以使用

crane tunnel-api命令在两个集群间建立网络隧道,从位于防火墙后的源集群迁移到基于云的目标集群。 - 在 MTC web 控制台中转换存储类:您可以通过在同一集群中迁移持久性卷(PV)的存储类来转换它。

2.2.18.2. 已知问题

这个版本有以下已知问题:

-

当 AWS gp2 PVC 没有可用空间时,

MigPlan自定义资源不会显示警告。(BZ#1963927) - 如果目标存储是由 AWS Elastic 文件系统(EFS)动态置备的 PV,则直接和间接数据传输无法正常工作。这是因为 AWS EFS Container Storage Interface(CSI)驱动程序的限制。(BZ#2085097)

- IBM Cloud 的块存储必须位于同一可用区中。请参阅针对虚拟私有云块存储的 IBM 常见问题解答。

-

MTC 1.7.6 无法将支持

v1beta1cron 作业的源集群迁移到 OpenShift Container Platform 4.12 及更新的版本,不支持v1beta1cron 作业。(BZ#2149119)

2.3. 容器迁移工具 1.6 发行注记

该版本的 Migration Toolkit for Containers 发行注记介绍了新的功能和增强功能、已弃用的功能以及已知的问题。

MTC(Migration Toolkit for Containers)可让您按照命名空间将应用程序工作负载在不同 OpenShift Container Platform 集群间进行迁移。

您可以从 OpenShift Container Platform 3 迁移到 4.13,也可以在 OpenShift Container Platform 4 集群之间迁移。

MTC 提供了一个基于 Kubernetes 自定义资源的 web 控制台和 API,可帮助您控制迁移并最小化应用程序停机时间。

有关 MTC 支持政策的信息,请参阅 OpenShift Application and Cluster Migration Solutions,它是 Red Hat OpenShift Container Platform 生命周期政策的一部分。

2.3.1. 容器迁移工具 1.6 发行注记

2.3.1.1. 新功能及功能增强

此发行版本有以下新功能和增强:

- 状态迁移:您可以选择特定的持久性卷声明 (PVC) 来执行可重复的、仅限状态的迁移。

- "new operator version available"通知:MTC web 控制台的 Clusters 页面在有新的 MTC Operator 可用时显示通知。

2.3.1.2. 已弃用的功能

以下功能已弃用:

- MTC 版本 1.4 不再被支持。

2.3.1.3. 已知问题

这个版本有以下已知问题:

-

在 OpenShift Container Platform 3.10 中,

MigrationControllerpod 重启用时过长。Bugzilla 报告包含临时解决方案。(BZ#1986796) -

在从 IBM Cloud 上的典型 OpenShift Container Platform 源集群直接迁移卷时,

Stagepod 会失败。IBM 块存储插件不允许将同一卷挂载到同一节点的多个 pod。因此,PVC 无法同时挂载到 Rsync pod 和应用程序 pod 上。要解决这个问题,请在迁移前停止应用程序 pod。(BZ#1887526) -

当 AWS gp2 PVC 没有可用空间时,

MigPlan自定义资源不会显示警告。(BZ#1963927) - IBM Cloud 的块存储必须位于同一可用区中。请参阅针对虚拟私有云块存储的 IBM 常见问题解答。

2.4. Migration Toolkit for Containers 1.5 发行注记

该版本的 Migration Toolkit for Containers 发行注记介绍了新的功能和增强功能、已弃用的功能以及已知的问题。

MTC(Migration Toolkit for Containers)可让您按照命名空间将应用程序工作负载在不同 OpenShift Container Platform 集群间进行迁移。

您可以从 OpenShift Container Platform 3 迁移到 4.13,也可以在 OpenShift Container Platform 4 集群之间迁移。

MTC 提供了一个基于 Kubernetes 自定义资源的 web 控制台和 API,可帮助您控制迁移并最小化应用程序停机时间。

有关 MTC 支持政策的信息,请参阅 OpenShift Application and Cluster Migration Solutions,它是 Red Hat OpenShift Container Platform 生命周期政策的一部分。

2.4.1. Migration Toolkit for Containers 1.5 发行注记

2.4.1.1. 新功能及功能增强

此发行版本有以下新功能和增强:

- Web 控制台的 Migration 详情页面中的 Migration 资源树通过用于监控和调试迁移的其他资源、Kubernetes 事件和实时状态信息进行了增强。

- Web 控制台支持数百个迁移计划。

- 源命名空间可以在迁移计划中映射到不同的目标命名空间。在以前的版本中,源命名空间映射到名称相同的目标命名空间。

- 在迁移过程中,Web 控制台中会显示带有状态信息的 hook 阶段。

- 在直接卷迁移过程中,web 控制台中会显示 Rsync 重试尝试的数量。

- 可以为直接卷迁移启用持久性卷 (PV) 大小,以确保目标集群不会出现磁盘空间不足的问题。

- 触发 PV 重新定义大小的阈值可以配置。在以前的版本中,当磁盘用量超过 97% 时,PV 会重新定义大小。

- Velero 已更新至 1.6 版本,它提供了大量修复和增强。

- 可以启用缓存的 Kubernetes 客户端来提高性能。

2.4.1.2. 已弃用的功能

以下功能已弃用:

- MTC 版本 1.2 和 1.3 不再被支持。

-

更新已弃用 API 的步骤已从文档的故障排除部分中删除,因为

oc convert命令已弃用。

2.4.1.3. 已知问题

这个版本有以下已知问题:

-

如果您创建超过 400 个迁移计划,则 Microsoft Azure 存储不可用。

MigStorage自定义资源显示以下消息:The request is being throttled as the limit has been reached for operation type。(BZ#1977226) - 如果迁移失败,迁移计划不会为静默的 pod 保留自定义持久性卷 (PV) 设置。您必须手动回滚,删除迁移计划,并使用 PV 设置创建新的迁移计划。(BZ#1784899)

-

对于 AWS gp2 存储,PV 大小重新定义无法正常工作,除非

pv_resizing_threshold为 42% 或更高。(BZ#1973148) 在以下情况下,PV 重新定义大小不适用于 OpenShift Container Platform 3.7 和 3.9 源集群:

- 应用程序是在安装 MTC 后安装的。

安装 MTC 后,应用程序 pod 会被重新调度到其他节点上。

OpenShift Container Platform 3.7 和 3.9 不支持 Mount Propagation 功能,它允许 Velero 在

Resticpod 中自动挂载 PV。MigAnalytic自定义资源 (CR) 无法从Resticpod 收集 PV 数据,并将资源报告为0。MigPlanCR 显示类似如下的状态:输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要启用 PV 大小调整,您可以在源集群中手动重启 Restic daemonset,或者在与应用程序相同的节点上重启

Resticpod。如果没有重启 Restic,在没有调整 PV 的情况下运行直接卷迁移。(BZ#1982729)

2.4.1.4. 技术变化

此发行版本有以下技术更改:

- 旧的 MTC Operator 版本 1.5.1 在 OpenShift Container Platform 版本 3.7 到 4.5 中手动安装。

- Migration Toolkit for Containers Operator 版本 1.5.1 在 OpenShift Container Platform 版本 4.6 及更新的版本中使用 Operator Lifecycle Manager 安装。

第 3 章 安装 MTC

您可以在 OpenShift Container Platform 4 上安装 MTC。

要在 OpenShift Container Platform 3 上安装 MTC ,请参阅在 OpenShift Container Platform 3 上安装旧的 MTC。

默认情况下,MTC web 控制台和 Migration Controller pod 在目标集群中运行。您可以配置 Migration Controller 自定义资源清单在远程集群中运行 MTC web 控制台和 Migration Controller pod。

安装 MTC 后,您必须配置对象存储以用作复制存储库。

要卸载 MTC,请参阅卸载 MTC 并删除资源。

3.1. 兼容性指南

您必须安装与 OpenShift Container Platform 版本兼容的 MTC。

定义

- 旧平台

- OpenShift Container Platform 4.5 及更早版本。

- 现代平台

- OpenShift Container Platform 4.6 及更新的版本。

- 旧 Operator

- 针对传统平台设计的 MTC Operator。

- 现代 operator

- 针对现代平台设计的 MTC Operator。

- 控制集群

- 运行 MTC 控制器和 GUI 的集群。

- 远程集群

- 运行 Velero 的迁移的源或目标集群。Control Cluster 通过 Velero API 与远程集群通信,以驱动迁移。

您必须使用兼容的 MTC 版本来迁移 OpenShift Container Platform 集群。要使迁移成功源集群和目标集群,必须使用相同的 MTC 版本。

MTC 1.7 支持从 OpenShift Container Platform 3.11 迁移到 4.9。

MTC 1.8 仅支持从 OpenShift Container Platform 4.10 及更新的版本进行迁移。

| 详情 | OpenShift Container Platform 3.11 | OpenShift Container Platform 4.0 到 4.5 | OpenShift Container Platform 4.6 到 4.9 | OpenShift Container Platform 4.10 或更高版本 |

|---|---|---|---|---|

| 稳定 MTC 版本 | MTC v.1.7.z | MTC v.1.7.z | MTC v.1.7.z | MTC v.1.8.z |

| 安装 |

旧版 MTC v.1.7.z operator:使用 [重要信息] 此集群不能是控制集群。 |

使用 OLM 安装,发行频道 |

使用 OLM 安装,发行频道 |

在某些情况下,网络的限制可能会阻止现代集群连接到迁移中需要涉及的其他集群。例如,当从内部的 OpenShift Container Platform 3.11 集群迁移到云环境中的现代 OpenShift Container Platform 集群时,,现代集群无法连接到 OpenShift Container Platform 3.11 集群。

在 MTC v.1.7.z 中,如果其中一个远程集群因为网络限制而无法与控制集群通信,请使用 crane tunnel-api 命令。

对于稳定(stable)的 MTC 发行版本,虽然您应该始终将最现代化的集群指定为控制集群,但是在这种情况下,可能需要将旧的集群指定为控制集群,并将工作负载推送到远程集群。

您可以在 OpenShift Container Platform 版本 4.2 到 4.5 中手动安装旧的 MTC Operator。

先决条件

-

必须使用在所有集群中具有

cluster-admin权限的用户登录。 -

您必须有权访问

registry.redhat.io。 -

必须安装

podman。

流程

使用您的红帽客户门户网站账户登陆到

registry.redhat.io:podman login registry.redhat.io

$ podman login registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令下载

operator.yml文件:podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/operator.yml ./

podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/operator.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令下载

controller.yml文件:podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/controller.yml ./

podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/controller.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 登录您的 OpenShift Container Platform 源集群。

验证集群可以在

registry.redhat.io中进行身份验证:oc run test --image registry.redhat.io/ubi9 --command sleep infinity

$ oc run test --image registry.redhat.io/ubi9 --command sleep infinityCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 MTC Operator 对象的 Migration Toolkit:

oc create -f operator.yml

$ oc create -f operator.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 您可以忽略

Error from server (AlreadyExists)信息。它们是由 MTC Operator 为早期版本的 OpenShift Container Platform 4 创建资源造成的,这些资源在以后的版本中已提供。

创建

MigrationController对象:oc create -f controller.yml

$ oc create -f controller.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证 MTC Pod 是否正在运行:

oc get pods -n openshift-migration

$ oc get pods -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

您可以使用 Operator Lifecycle Manager 在 OpenShift Container Platform 4.13 上安装 MTC Operator。

先决条件

-

必须使用在所有集群中具有

cluster-admin权限的用户登录。

流程

- 在 OpenShift Container Platform Web 控制台中,点击 Operators → OperatorHub。

- 使用 Filter by keyword 字段查找 MTCs Operator。

- 选择 Migration Toolkit for Containers Operator 并点 Install。

点击 Install。

在 Installed Operators 页中,openshift-migration 项目中会出现状态为 Succeeded 的 Migration Toolkit for Containers Operator。

- 点 Migration Toolkit for Containers Operator。

- 在 Provided APIs 下,找到 Migration Controller 标题,再点 Create Instance。

- 点击 Create。

- 点 Workloads → Pods 来验证 MTC pod 正在运行 。

3.4. 代理配置

对于 OpenShift Container Platform 4.1 及更早的版本,您必须在安装 Migration Toolkit for Containers Operator 后,在 MigrationController 自定义资源 (CR) 清单中配置代理,因为这些版本不支持集群范围的 proxy 对象。

对于 OpenShift Container Platform 4.2 到 4.13,MTC 会继承集群范围的代理设置。如果要覆盖集群范围的代理设置,可以更改代理参数。

3.4.1. 直接卷迁移

MTC 1.4.2 中引入了直接卷迁移(DVM)。DVM 只支持一个代理。如果目标集群也位于代理后面,则源集群无法访问目标集群的路由。

如果要从代理后面的源集群执行 DVM,您必须配置一个 TCP 代理,该代理可在传输层进行透明处理,并在不使用自己的 SSL 证书的情况下转发 SSL 连接。Stunnel 代理是此类代理的示例。

3.4.1.1. DVM 的 TCP 代理设置

您可以通过 TCP 代理在源和目标集群之间设置直接连接,并在 MigrationController CR 中配置 stunnel_tcp_proxy 变量来使用代理:

直接卷迁移(DVM)只支持代理的基本身份验证。此外,DVM 仅适用于可透明地传输 TCP 连接的代理。在 man-in-the-middle 模式中的 HTTP/HTTPS 代理无法正常工作。现有的集群范围的代理可能不支持此行为。因此,DVM 的代理设置意与 MTC 中常见的代理配置不同。

3.4.1.2. 为什么使用 TCP 代理而不是 HTTP/HTTPS 代理?

您可以通过 OpenShift 路由在源和目标集群之间运行 Rsync 来启用 DVM。流量通过 TCP 代理(Stunnel)加密。在源集群上运行的 Stunnel 会启动与目标 Stunnel 的 TLS 连接,并通过加密频道来传输数据。

OpenShift 中的集群范围 HTTP/HTTPS 代理通常在 man-in-the-middle 模式进行配置,其中它们将自己的 TLS 会话与外部服务器协商。但是,这不适用于 Stunnel。Stunnel 要求代理不处理它的 TLS 会话,基本上使代理成为一个透明的隧道,只需按原样转发 TCP 连接。因此,您必须使用 TCP 代理。

3.4.1.3. 已知问题

迁移失败并显示 Upgrade request required 错误

迁移控制器使用 SPDY 协议在远程 pod 中执行命令。如果远程集群位于代理或不支持 SPDY 协议的防火墙后,迁移控制器将无法执行远程命令。迁移失败并显示出错信息 Upgrade request required。临时解决方案: 使用支持 SPDY 协议的代理。

除了支持 SPDY 协议外,代理或防火墙还必须将 Upgrade HTTP 标头传递给 API 服务器。客户端使用此标头打开与 API 服务器的 websocket 连接。如果代理或防火墙阻止 Upgrade 标头,则迁移会失败,并显示出错信息 Upgrade request required。临时解决方案:确保代理转发 Upgrade 标头。

3.4.2. 为迁移调优网络策略

OpenShift 支持根据集群使用的网络插件,限制使用 NetworkPolicy 或 EgressFirewalls 的流量。如果任何涉及迁移的源命名空间使用此类机制将网络流量限制到 pod,限制可能会在迁移过程中停止到 Rsync pod 的流量。

在源和目标集群上运行的 rsync pod 必须通过 OpenShift Route 相互连接。可将现有的 NetworkPolicy 或 EgressNetworkPolicy 对象配置为从这些流量限制自动排除 Rsync pod。

3.4.2.1. NetworkPolicy 配置

3.4.2.1.1. 来自 Rsync pod 的出口流量

如果源或目标命名空间中的 NetworkPolicy 配置阻止这种类型的流量,您可以使用 Rsync pod 的唯一标签来允许出口流量从它们传递。以下策略允许来自命名空间中 Rsync pod 的所有出口流量:

3.4.2.1.2. 到 Rsync pod 的入口流量

3.4.2.2. EgressNetworkPolicy 配置

EgressNetworkPolicy 对象或 Egress Firewalls 是 OpenShift 构造,用于阻止离开集群的出口流量。

与 NetworkPolicy 对象不同,egress Firewall 在项目级别工作,因为它适用于命名空间中的所有 pod。因此,Rsync pod 的唯一标签不会使只有 Rsync pod 的 Rsync pod 冲突。但是,您可以将源集群或目标集群的 CIDR 范围添加到策略的 Allow 规则中,以便可以在两个集群之间设置直接连接。

根据存在 Egress Firewall 的集群,您可以添加其他集群的 CIDR 范围来允许两者间的出口流量:

3.4.2.3. 为数据传输选择备用端点

默认情况下,DVM 使用 OpenShift Container Platform 路由作为端点,将 PV 数据传送到目标集群。如果集群拓扑允许,您可以选择其他类型的支持的端点。

对于每个集群,您可以通过在 MigrationController CR 中适当的 目标集群上设置 rsync_endpoint_type 变量来配置端点:

3.4.2.4. 为 Rsync pod 配置补充组

当 PVC 使用共享存储时,您可以通过将 supplemental 组添加到 Rsync pod 定义来配置对存储的访问,以便 pod 允许访问:

| 变量 | 类型 | Default(默认) | 描述 |

|---|---|---|---|

|

| string | 未设置 | 用于源 Rsync pod 的以逗号分隔的补充组列表 |

|

| string | 未设置 | 目标 Rsync pod 的,以逗号分隔的补充组列表 |

用法示例

可以更新 MigrationController CR,以便为这些补充组设置值:

spec: src_supplemental_groups: "1000,2000" target_supplemental_groups: "2000,3000"

spec:

src_supplemental_groups: "1000,2000"

target_supplemental_groups: "2000,3000"3.4.3. 配置代理

先决条件

-

必须使用在所有集群中具有

cluster-admin权限的用户登录。

流程

获取

MigrationControllerCR 清单:oc get migrationcontroller <migration_controller> -n openshift-migration

$ oc get migrationcontroller <migration_controller> -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow 更新代理参数:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在域前面加

.来仅匹配子域。例如:.y.com匹配x.y.com,但不匹配y.com。使用*可对所有目的地绕过所有代理。如果您扩展了未包含在安装配置中networking.machineNetwork[].cidr字段定义的 worker,您必须将它们添加到此列表中,以防止连接问题。如果未设置

httpProxy和httpsProxy字段,则此字段将被忽略。-

将清单保存为

migration-controller.yaml。 应用更新的清单:

oc replace -f migration-controller.yaml -n openshift-migration

$ oc replace -f migration-controller.yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

如需更多信息,请参阅配置集群范围代理。

3.4.4. 以 root 或非 root 身份运行 Rsync

OpenShift Container Platform 环境默认启用 PodSecurityAdmission 控制器。此控制器要求集群管理员通过命名空间标签强制实施 Pod 安全标准。集群中的所有工作负载都应该运行以下 Pod 安全标准级别之一: Privileged、Baseline 或 Restricted。每个集群都有自己的默认策略集。

为了保证在所有环境中成功进行数据传输,MTC 1.7.5 引入了 Rsync pod 中的更改,包括默认以非 root 用户身份运行 Rsync pod。这样可确保即使不一定需要更高特权的工作负载也可以进行数据传输。这个更改是进行的,因为它最适合运行具有最低级别权限的工作负载。

3.4.4.1. 为数据 trannsfer 手动覆盖默认非 root 操作

虽然在大多数情况下,以非 root 用户身份运行 Rsync pod 可以正常工作,但当您以 root 用户身份在源端运行工作负载时,数据传输可能会失败。MTC 提供了为数据传输手动覆盖默认非 root 操作的方法:

- 将所有迁移配置为作为 root 在目标集群上针对所有迁移运行 Rsync pod。

- 对于每个迁移,在目标集群上以 root 用户身份运行 Rsync pod。

在这两种情况下,您必须在迁移前运行具有较高特权的工作负载的命名空间源上设置以下标签: enforce、audit 和 warn。

要了解更多有关标签的 Pod Security Admission 和设置值的信息,请参阅控制 pod 安全准入同步。

3.4.4.2. 将所有迁移的 MigrationController CR 配置为 root 或非 root

默认情况下,Rsync 作为非 root 运行。

在目标集群中,您可以将 MigrationController CR 配置为以 root 用户身份运行 Rsync。

流程

配置

MigrationControllerCR,如下所示:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 此配置将适用于所有将来的迁移。

3.4.4.3. 将 MigMigration CR 配置为每个迁移的根或非 root

在目标集群中,您可以使用以下非 root 选项将 MigMigration CR 配置为以 root 或非 root 身份运行 Rsync:

- 作为特定用户 ID (UID)

- 作为一个特定组 ID (GID)

流程

要以 root 用户身份运行 Rsync,请根据本例配置

MigMigrationCR:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要将 Rsync 作为特定用户 ID (UID)或特定组 ID (GID)运行,请根据本例配置

MigMigrationCR:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5. 配置复制存储库

您必须将对象存储配置为用作复制存储库。MTC 将数据从源集群复制到复制存储库,然后从复制存储库复制到目标集群。

MTC 支持使用文件系统和快照数据复制的方法将数据从源集群迁移到目标集群。您可以选择适合于您的环境并受您的存储供应商支持的方法。

MTC 支持以下存储供应商:

- 多云对象网关

- Amazon Web Services S3

- Google Cloud Platform

- Microsoft Azure Blob

- 通用 S3 对象存储,例如 Minio 或 Ceph S3

3.5.1. 先决条件

- 所有集群都必须具有对复制存储库的不间断网络访问权限。

- 如果您将代理服务器与内部托管的复制存储库搭配使用,您必须确保代理允许访问复制存储库。

3.5.2. 检索多云对象网关凭证

您必须检索 Multicloud Object Gateway(MCG)凭证和 S3 端点,以便将 MCG 配置为 MTC 的 Migration Toolkit for Containers(MTC)的复制仓库。

您必须检索 Multicloud Object Gateway (MCG)凭证,您需要为 MTC 创建一个 Secret 自定义资源 (CR)。

虽然 MCG Operator 已被弃用,但 MCG 插件仍可用于 OpenShift Data Foundation。要下载插件,请访问下载 Red Hat OpenShift Data Foundation,并为您的操作系统下载适当的 MCG 插件。

先决条件

- 请根据相关的 Red Hat OpenShift Data Foundation 部署指南部署 OpenShift Data Foundation。

流程

通过对

NooBaa自定义资源运行describe命令,获取 S3 端点、AWS_ACCESS_KEY_ID和AWS_SECRET_ACCESS_KEY。您可以使用这些凭证将 MCG 作为复制存储库来添加。

3.5.3. 配置 Amazon Web Services

您可以将 Amazon Web Services(AWS)S3 对象存储配置为 MTC 的 Migration Toolkit for Containers(MTC)的复制仓库。

先决条件

- 已安装 AWS CLI。

- AWS S3 存储桶必须可以被源和目标集群访问。

如果您使用快照复制方法:

- 您必须有权访问 EC2 Elastic Block Storage (EBS)。

- 源和目标集群必须位于同一区域。

- 源和目标集群必须具有相同的存储类。

- 存储类必须与快照兼容。

流程

设置

BUCKET变量:BUCKET=<your_bucket>

$ BUCKET=<your_bucket>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 设置

REGION变量:REGION=<your_region>

$ REGION=<your_region>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 AWS S3 存储桶:

aws s3api create-bucket \ --bucket $BUCKET \ --region $REGION \ --create-bucket-configuration LocationConstraint=$REGION$ aws s3api create-bucket \ --bucket $BUCKET \ --region $REGION \ --create-bucket-configuration LocationConstraint=$REGION1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

us-east-1不支持LocationConstraint。如果您的区域是us-east-1,忽略--create-bucket-configuration LocationConstraint=$REGION。

创建一个 IAM 用户:

aws iam create-user --user-name velero

$ aws iam create-user --user-name velero1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 如果要使用 Velero 备份具有多个 S3 存储桶的集群,请为每个集群创建一个唯一用户名。

创建

velero-policy.json文件:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 附加策略,为

velero用户提供所需的最低权限:aws iam put-user-policy \ --user-name velero \ --policy-name velero \ --policy-document file://velero-policy.json

$ aws iam put-user-policy \ --user-name velero \ --policy-name velero \ --policy-document file://velero-policy.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 为

velero用户创建访问密钥:aws iam create-access-key --user-name velero

$ aws iam create-access-key --user-name veleroCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 记录

AWS_SECRET_ACCESS_KEY和AWS_ACCESS_KEY_ID。您可以使用凭证将 AWS 添加为复制存储库。

3.5.4. 配置 Google Cloud Platform

您可以将 Google Cloud Platform(GCP)存储桶配置为 Migration Toolkit for Containers(MTC)的复制仓库。

先决条件

-

您必须安装了

gcloud和gsutilCLI 工具。详情请查看 Google 云文档。 - GCP 存储桶必须可以被源和目标集群访问。

如果您使用快照复制方法:

- 源和目标集群必须位于同一区域。

- 源和目标集群必须具有相同的存储类。

- 存储类必须与快照兼容。

流程

登录到 GCP:

gcloud auth login

$ gcloud auth loginCopy to Clipboard Copied! Toggle word wrap Toggle overflow 设置

BUCKET变量:BUCKET=<bucket>

$ BUCKET=<bucket>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定存储桶名称。

创建存储桶:

gsutil mb gs://$BUCKET/

$ gsutil mb gs://$BUCKET/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将

PROJECT_ID变量设置为您的活跃项目:PROJECT_ID=$(gcloud config get-value project)

$ PROJECT_ID=$(gcloud config get-value project)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建服务帐户:

gcloud iam service-accounts create velero \ --display-name "Velero service account"$ gcloud iam service-accounts create velero \ --display-name "Velero service account"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 列出服务帐户:

gcloud iam service-accounts list

$ gcloud iam service-accounts listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 设置

SERVICE_ACCOUNT_EMAIL变量,使其与email值匹配:SERVICE_ACCOUNT_EMAIL=$(gcloud iam service-accounts list \ --filter="displayName:Velero service account" \ --format 'value(email)')$ SERVICE_ACCOUNT_EMAIL=$(gcloud iam service-accounts list \ --filter="displayName:Velero service account" \ --format 'value(email)')Copy to Clipboard Copied! Toggle word wrap Toggle overflow 附加策略,为

velero用户提供所需的最低权限:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建

velero.server自定义角色:gcloud iam roles create velero.server \ --project $PROJECT_ID \ --title "Velero Server" \ --permissions "$(IFS=","; echo "${ROLE_PERMISSIONS[*]}")"$ gcloud iam roles create velero.server \ --project $PROJECT_ID \ --title "Velero Server" \ --permissions "$(IFS=","; echo "${ROLE_PERMISSIONS[*]}")"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 为项目添加 IAM 策略绑定:

gcloud projects add-iam-policy-binding $PROJECT_ID \ --member serviceAccount:$SERVICE_ACCOUNT_EMAIL \ --role projects/$PROJECT_ID/roles/velero.server$ gcloud projects add-iam-policy-binding $PROJECT_ID \ --member serviceAccount:$SERVICE_ACCOUNT_EMAIL \ --role projects/$PROJECT_ID/roles/velero.serverCopy to Clipboard Copied! Toggle word wrap Toggle overflow 更新 IAM 服务帐户:

gsutil iam ch serviceAccount:$SERVICE_ACCOUNT_EMAIL:objectAdmin gs://${BUCKET}$ gsutil iam ch serviceAccount:$SERVICE_ACCOUNT_EMAIL:objectAdmin gs://${BUCKET}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 将 IAM 服务帐户的密钥保存到当前目录中的

credentials-velero文件中:gcloud iam service-accounts keys create credentials-velero \ --iam-account $SERVICE_ACCOUNT_EMAIL$ gcloud iam service-accounts keys create credentials-velero \ --iam-account $SERVICE_ACCOUNT_EMAILCopy to Clipboard Copied! Toggle word wrap Toggle overflow 您可以使用

credentials-velero文件将 GCP 添加为复制存储库。

3.5.5. 配置 Microsoft Azure

您可以将 Microsoft Azure Blob 存储容器配置为 Migration Toolkit for Containers(MTC)的复制仓库。

先决条件

- 已安装 Azure CLI。

- Azure Blob 存储容器必须可以被源和目标集群访问。

如果您使用快照复制方法:

- 源和目标集群必须位于同一区域。

- 源和目标集群必须具有相同的存储类。

- 存储类必须与快照兼容。

流程

登录到 Azure:

az login

$ az loginCopy to Clipboard Copied! Toggle word wrap Toggle overflow 设置

AZURE_RESOURCE_GROUP变量:AZURE_RESOURCE_GROUP=Velero_Backups

$ AZURE_RESOURCE_GROUP=Velero_BackupsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 Azure 资源组:

az group create -n $AZURE_RESOURCE_GROUP --location CentralUS

$ az group create -n $AZURE_RESOURCE_GROUP --location CentralUS1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定位置。

设置

AZURE_STORAGE_ACCOUNT_ID变量:AZURE_STORAGE_ACCOUNT_ID="velero$(uuidgen | cut -d '-' -f5 | tr '[A-Z]' '[a-z]')"

$ AZURE_STORAGE_ACCOUNT_ID="velero$(uuidgen | cut -d '-' -f5 | tr '[A-Z]' '[a-z]')"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 Azure 存储帐户:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 设置

BLOB_CONTAINER变量:BLOB_CONTAINER=velero

$ BLOB_CONTAINER=veleroCopy to Clipboard Copied! Toggle word wrap Toggle overflow 创建 Azure Blob 存储容器:

az storage container create \ -n $BLOB_CONTAINER \ --public-access off \ --account-name $AZURE_STORAGE_ACCOUNT_ID

$ az storage container create \ -n $BLOB_CONTAINER \ --public-access off \ --account-name $AZURE_STORAGE_ACCOUNT_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 为

velero创建服务主体和凭证:AZURE_SUBSCRIPTION_ID=`az account list --query '[?isDefault].id' -o tsv` AZURE_TENANT_ID=`az account list --query '[?isDefault].tenantId' -o tsv`

$ AZURE_SUBSCRIPTION_ID=`az account list --query '[?isDefault].id' -o tsv` AZURE_TENANT_ID=`az account list --query '[?isDefault].tenantId' -o tsv`Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建一个带有

Contributor角色的服务主体,分配一个特定的--role和--scopes:AZURE_CLIENT_SECRET=`az ad sp create-for-rbac --name "velero" \ --role "Contributor" \ --query 'password' -o tsv \ --scopes /subscriptions/$AZURE_SUBSCRIPTION_ID/resourceGroups/$AZURE_RESOURCE_GROUP`$ AZURE_CLIENT_SECRET=`az ad sp create-for-rbac --name "velero" \ --role "Contributor" \ --query 'password' -o tsv \ --scopes /subscriptions/$AZURE_SUBSCRIPTION_ID/resourceGroups/$AZURE_RESOURCE_GROUP`Copy to Clipboard Copied! Toggle word wrap Toggle overflow CLI 为您生成一个密码。确保您记录了密码。

创建服务主体后,获取客户端 ID。

AZURE_CLIENT_ID=`az ad app credential list --id <your_app_id>`

$ AZURE_CLIENT_ID=`az ad app credential list --id <your_app_id>`Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意要成功完成此操作,您必须知道您的 Azure 应用程序 ID。

在

credentials-velero文件中保存服务主体的凭证:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 您可以使用

credentials-velero文件将 Azure 添加为复制存储库。

3.6. 卸载 MTC 并删除资源

您可以卸载 MTC,并删除其资源来清理集群。

删除 velero CRD 会从集群中移除 Velero。

先决条件

-

您必须以具有

cluster-admin权限的用户身份登录。

流程

删除所有集群中的

MigrationController自定义资源 (CR):oc delete migrationcontroller <migration_controller>

$ oc delete migrationcontroller <migration_controller>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 使用 Operator Lifecycle Manager 在 OpenShift Container Platform 4 上卸载 MTC Operator。

运行以下命令,删除所有集群中的集群范围资源:

migration自定义资源定义 (CRDs):oc delete $(oc get crds -o name | grep 'migration.openshift.io')

$ oc delete $(oc get crds -o name | grep 'migration.openshift.io')Copy to Clipboard Copied! Toggle word wrap Toggle overflow VeleroCRD:oc delete $(oc get crds -o name | grep 'velero')

$ oc delete $(oc get crds -o name | grep 'velero')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migration集群角色:oc delete $(oc get clusterroles -o name | grep 'migration.openshift.io')

$ oc delete $(oc get clusterroles -o name | grep 'migration.openshift.io')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migration-operator集群角色:oc delete clusterrole migration-operator

$ oc delete clusterrole migration-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow velero集群角色:oc delete $(oc get clusterroles -o name | grep 'velero')

$ oc delete $(oc get clusterroles -o name | grep 'velero')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migration集群角色绑定:oc delete $(oc get clusterrolebindings -o name | grep 'migration.openshift.io')

$ oc delete $(oc get clusterrolebindings -o name | grep 'migration.openshift.io')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migration-operator集群角色绑定:oc delete clusterrolebindings migration-operator

$ oc delete clusterrolebindings migration-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow velero集群角色绑定:oc delete $(oc get clusterrolebindings -o name | grep 'velero')

$ oc delete $(oc get clusterrolebindings -o name | grep 'velero')Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 4 章 在受限网络环境中安装 MTC

您可以通过执行以下步骤在受限网络环境中的 OpenShift Container Platform 4 上安装 MTC:

创建一个已镜像的 Operator 目录。

此过程会创建一个

mapping.txt文件,其中包含registry.redhat.io镜像和您的镜像 registry 镜像之间的映射。mapping.txt文件是在 OpenShift Container Platform 4.2 到 4.5 源集群中安装 旧的 MTC Operator 所需要的。使用 Operator Lifecycle Manager 在 OpenShift Container Platform 4.13 目标集群上安装 MTC。

默认情况下,MTC web 控制台和

Migration Controllerpod 在目标集群中运行。您可以配置Migration Controller自定义资源清单在远程集群中运行 MTC web 控制台和Migration Controllerpod。在源集群中安装 MTC Operator:

- OpenShift Container Platform 4.6 或更高版本: 使用 Operator Lifecycle Manager 安装 MTC Operator。

- OpenShift Container Platform 4.2 到 4.5: 使用命令行界面安装传统的 MTC Operator。

- 配置对象存储,以用作复制存储库。

要在 OpenShift Container Platform 3 上安装 MTC ,请参阅在 OpenShift Container Platform 3 上安装旧的 MTC。

要卸载 MTC,请参阅卸载 MTC 并删除资源。

4.1. 兼容性指南

您必须安装与 OpenShift Container Platform 版本兼容的 MTC。

定义

- 旧平台

- OpenShift Container Platform 4.5 及更早版本。

- 现代平台

- OpenShift Container Platform 4.6 及更新的版本。

- 旧 Operator

- 针对传统平台设计的 MTC Operator。

- 现代 operator

- 针对现代平台设计的 MTC Operator。

- 控制集群

- 运行 MTC 控制器和 GUI 的集群。

- 远程集群

- 运行 Velero 的迁移的源或目标集群。Control Cluster 通过 Velero API 与远程集群通信,以驱动迁移。

您必须使用兼容的 MTC 版本来迁移 OpenShift Container Platform 集群。要使迁移成功源集群和目标集群,必须使用相同的 MTC 版本。

MTC 1.7 支持从 OpenShift Container Platform 3.11 迁移到 4.9。

MTC 1.8 仅支持从 OpenShift Container Platform 4.10 及更新的版本进行迁移。

| 详情 | OpenShift Container Platform 3.11 | OpenShift Container Platform 4.0 到 4.5 | OpenShift Container Platform 4.6 到 4.9 | OpenShift Container Platform 4.10 或更高版本 |

|---|---|---|---|---|

| 稳定 MTC 版本 | MTC v.1.7.z | MTC v.1.7.z | MTC v.1.7.z | MTC v.1.8.z |

| 安装 |

旧版 MTC v.1.7.z operator:使用 [重要信息] 此集群不能是控制集群。 |

使用 OLM 安装,发行频道 |

使用 OLM 安装,发行频道 |

在某些情况下,网络的限制可能会阻止现代集群连接到迁移中需要涉及的其他集群。例如,当从内部的 OpenShift Container Platform 3.11 集群迁移到云环境中的现代 OpenShift Container Platform 集群时,,现代集群无法连接到 OpenShift Container Platform 3.11 集群。

在 MTC v.1.7.z 中,如果其中一个远程集群因为网络限制而无法与控制集群通信,请使用 crane tunnel-api 命令。

对于稳定(stable)的 MTC 发行版本,虽然您应该始终将最现代化的集群指定为控制集群,但是在这种情况下,可能需要将旧的集群指定为控制集群,并将工作负载推送到远程集群。

您可以使用 Operator Lifecycle Manager 在 OpenShift Container Platform 4.13 上安装 MTC Operator。

先决条件

-

必须使用在所有集群中具有

cluster-admin权限的用户登录。 - 您必须从本地 registry 中的镜像创建 Operator 目录。

流程

- 在 OpenShift Container Platform Web 控制台中,点击 Operators → OperatorHub。

- 使用 Filter by keyword 字段查找 MTCs Operator。

- 选择 Migration Toolkit for Containers Operator 并点 Install。

点击 Install。

在 Installed Operators 页中,openshift-migration 项目中会出现状态为 Succeeded 的 Migration Toolkit for Containers Operator。

- 点 Migration Toolkit for Containers Operator。

- 在 Provided APIs 下,找到 Migration Controller 标题,再点 Create Instance。

- 点击 Create。

- 点 Workloads → Pods 来验证 MTC pod 正在运行 。

您可以在 OpenShift Container Platform 版本 4.2 到 4.5 中手动安装旧的 MTC Operator。

先决条件

-

必须使用在所有集群中具有

cluster-admin权限的用户登录。 -

您必须有权访问

registry.redhat.io。 -

必须安装

podman。 -

您必须有一个有网络访问权限的 Linux 工作站才能从

registry.redhat.io下载文件。 - 您必须创建 Operator 目录的镜像镜像。

- 您必须从 OpenShift Container Platform 4.13 上镜像的 Operator 目录安装 MTC Operator。

流程

使用您的红帽客户门户网站账户登陆到

registry.redhat.io:podman login registry.redhat.io

$ podman login registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令下载

operator.yml文件:podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/operator.yml ./

podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/operator.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令下载

controller.yml文件:podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/controller.yml ./

podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/controller.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来获取 Operator 镜像映射:

grep openshift-migration-legacy-rhel8-operator ./mapping.txt | grep rhmtc

$ grep openshift-migration-legacy-rhel8-operator ./mapping.txt | grep rhmtcCopy to Clipboard Copied! Toggle word wrap Toggle overflow mapping.txt文件是在对 Operator 目录进行镜像时创建的。输出显示了registry.redhat.io镜像和您的镜像 registry 镜像之间的映射。输出示例

registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator@sha256:468a6126f73b1ee12085ca53a312d1f96ef5a2ca03442bcb63724af5e2614e8a=<registry.apps.example.com>/rhmtc/openshift-migration-legacy-rhel8-operator

registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator@sha256:468a6126f73b1ee12085ca53a312d1f96ef5a2ca03442bcb63724af5e2614e8a=<registry.apps.example.com>/rhmtc/openshift-migration-legacy-rhel8-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

operator.yml文件中,为ansible和operator容器更新image值,并更新REGISTRY值:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 登录您的 OpenShift Container Platform 源集群。

创建 MTC Operator 对象的 Migration Toolkit:

oc create -f operator.yml

$ oc create -f operator.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 您可以忽略

Error from server (AlreadyExists)信息。它们是由 MTC Operator 为早期版本的 OpenShift Container Platform 4 创建资源造成的,这些资源在以后的版本中已提供。

创建

MigrationController对象:oc create -f controller.yml

$ oc create -f controller.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证 MTC Pod 是否正在运行:

oc get pods -n openshift-migration

$ oc get pods -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4. 代理配置

对于 OpenShift Container Platform 4.1 及更早的版本,您必须在安装 Migration Toolkit for Containers Operator 后,在 MigrationController 自定义资源 (CR) 清单中配置代理,因为这些版本不支持集群范围的 proxy 对象。

对于 OpenShift Container Platform 4.2 到 4.13,MTC 会继承集群范围的代理设置。如果要覆盖集群范围的代理设置,可以更改代理参数。

4.4.1. 直接卷迁移

MTC 1.4.2 中引入了直接卷迁移(DVM)。DVM 只支持一个代理。如果目标集群也位于代理后面,则源集群无法访问目标集群的路由。

如果要从代理后面的源集群执行 DVM,您必须配置一个 TCP 代理,该代理可在传输层进行透明处理,并在不使用自己的 SSL 证书的情况下转发 SSL 连接。Stunnel 代理是此类代理的示例。

4.4.1.1. DVM 的 TCP 代理设置

您可以通过 TCP 代理在源和目标集群之间设置直接连接,并在 MigrationController CR 中配置 stunnel_tcp_proxy 变量来使用代理:

直接卷迁移(DVM)只支持代理的基本身份验证。此外,DVM 仅适用于可透明地传输 TCP 连接的代理。在 man-in-the-middle 模式中的 HTTP/HTTPS 代理无法正常工作。现有的集群范围的代理可能不支持此行为。因此,DVM 的代理设置意与 MTC 中常见的代理配置不同。

4.4.1.2. 为什么使用 TCP 代理而不是 HTTP/HTTPS 代理?

您可以通过 OpenShift 路由在源和目标集群之间运行 Rsync 来启用 DVM。流量通过 TCP 代理(Stunnel)加密。在源集群上运行的 Stunnel 会启动与目标 Stunnel 的 TLS 连接,并通过加密频道来传输数据。

OpenShift 中的集群范围 HTTP/HTTPS 代理通常在 man-in-the-middle 模式进行配置,其中它们将自己的 TLS 会话与外部服务器协商。但是,这不适用于 Stunnel。Stunnel 要求代理不处理它的 TLS 会话,基本上使代理成为一个透明的隧道,只需按原样转发 TCP 连接。因此,您必须使用 TCP 代理。

4.4.1.3. 已知问题

迁移失败并显示 Upgrade request required 错误

迁移控制器使用 SPDY 协议在远程 pod 中执行命令。如果远程集群位于代理或不支持 SPDY 协议的防火墙后,迁移控制器将无法执行远程命令。迁移失败并显示出错信息 Upgrade request required。临时解决方案: 使用支持 SPDY 协议的代理。

除了支持 SPDY 协议外,代理或防火墙还必须将 Upgrade HTTP 标头传递给 API 服务器。客户端使用此标头打开与 API 服务器的 websocket 连接。如果代理或防火墙阻止 Upgrade 标头,则迁移会失败,并显示出错信息 Upgrade request required。临时解决方案:确保代理转发 Upgrade 标头。

4.4.2. 为迁移调优网络策略

OpenShift 支持根据集群使用的网络插件,限制使用 NetworkPolicy 或 EgressFirewalls 的流量。如果任何涉及迁移的源命名空间使用此类机制将网络流量限制到 pod,限制可能会在迁移过程中停止到 Rsync pod 的流量。

在源和目标集群上运行的 rsync pod 必须通过 OpenShift Route 相互连接。可将现有的 NetworkPolicy 或 EgressNetworkPolicy 对象配置为从这些流量限制自动排除 Rsync pod。

4.4.2.1. NetworkPolicy 配置

4.4.2.1.1. 来自 Rsync pod 的出口流量

如果源或目标命名空间中的 NetworkPolicy 配置阻止这种类型的流量,您可以使用 Rsync pod 的唯一标签来允许出口流量从它们传递。以下策略允许来自命名空间中 Rsync pod 的所有出口流量:

4.4.2.1.2. 到 Rsync pod 的入口流量

4.4.2.2. EgressNetworkPolicy 配置

EgressNetworkPolicy 对象或 Egress Firewalls 是 OpenShift 构造,用于阻止离开集群的出口流量。

与 NetworkPolicy 对象不同,egress Firewall 在项目级别工作,因为它适用于命名空间中的所有 pod。因此,Rsync pod 的唯一标签不会使只有 Rsync pod 的 Rsync pod 冲突。但是,您可以将源集群或目标集群的 CIDR 范围添加到策略的 Allow 规则中,以便可以在两个集群之间设置直接连接。

根据存在 Egress Firewall 的集群,您可以添加其他集群的 CIDR 范围来允许两者间的出口流量:

4.4.2.3. 为数据传输选择备用端点

默认情况下,DVM 使用 OpenShift Container Platform 路由作为端点,将 PV 数据传送到目标集群。如果集群拓扑允许,您可以选择其他类型的支持的端点。

对于每个集群,您可以通过在 MigrationController CR 中适当的 目标集群上设置 rsync_endpoint_type 变量来配置端点:

4.4.2.4. 为 Rsync pod 配置补充组

当 PVC 使用共享存储时,您可以通过将 supplemental 组添加到 Rsync pod 定义来配置对存储的访问,以便 pod 允许访问:

| 变量 | 类型 | Default(默认) | 描述 |

|---|---|---|---|

|

| string | 未设置 | 用于源 Rsync pod 的以逗号分隔的补充组列表 |

|

| string | 未设置 | 目标 Rsync pod 的,以逗号分隔的补充组列表 |

用法示例

可以更新 MigrationController CR,以便为这些补充组设置值:

spec: src_supplemental_groups: "1000,2000" target_supplemental_groups: "2000,3000"

spec:

src_supplemental_groups: "1000,2000"

target_supplemental_groups: "2000,3000"4.4.3. 配置代理

先决条件

-

必须使用在所有集群中具有

cluster-admin权限的用户登录。

流程

获取

MigrationControllerCR 清单:oc get migrationcontroller <migration_controller> -n openshift-migration

$ oc get migrationcontroller <migration_controller> -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow 更新代理参数:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 在域前面加

.来仅匹配子域。例如:.y.com匹配x.y.com,但不匹配y.com。使用*可对所有目的地绕过所有代理。如果您扩展了未包含在安装配置中networking.machineNetwork[].cidr字段定义的 worker,您必须将它们添加到此列表中,以防止连接问题。如果未设置

httpProxy和httpsProxy字段,则此字段将被忽略。-

将清单保存为

migration-controller.yaml。 应用更新的清单:

oc replace -f migration-controller.yaml -n openshift-migration

$ oc replace -f migration-controller.yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

如需更多信息,请参阅配置集群范围代理。

4.5. 以 root 或非 root 身份运行 Rsync

本节仅在使用 OpenShift API 而不是 Web 控制台时应用。

OpenShift 环境默认启用 PodSecurityAdmission 控制器。此控制器要求集群管理员通过命名空间标签强制实施 Pod 安全标准。集群中的所有工作负载都应该运行以下 Pod 安全标准级别之一: Privileged、Baseline 或 Restricted。每个集群都有自己的默认策略集。

为了保证在所有环境中成功进行数据传输,MTC 1.7.5 引入了 Rsync pod 中的更改,包括默认以非 root 用户身份运行 Rsync pod。这样可确保即使不一定需要更高特权的工作负载也可以进行数据传输。这个更改是进行的,因为它最适合运行具有最低级别权限的工作负载。

为数据 trannsfer 手动覆盖默认非 root 操作

虽然在大多数情况下,以非 root 用户身份运行 Rsync pod 可以正常工作,但当您以 root 用户身份在源端运行工作负载时,数据传输可能会失败。MTC 提供了为数据传输手动覆盖默认非 root 操作的方法:

- 将所有迁移配置为作为 root 在目标集群上针对所有迁移运行 Rsync pod。

- 对于每个迁移,在目标集群上以 root 用户身份运行 Rsync pod。

在这两种情况下,您必须在迁移前运行具有较高权限的工作负载的命名空间源上设置以下标签: enforce、audit 和 warn。

要了解更多有关标签的 Pod Security Admission 和设置值的信息,请参阅控制 pod 安全准入同步。

4.5.1. 将所有迁移的 MigrationController CR 配置为 root 或非 root

默认情况下,Rsync 作为非 root 运行。

在目标集群中,您可以将 MigrationController CR 配置为以 root 用户身份运行 Rsync。

流程

配置

MigrationControllerCR,如下所示:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 此配置将适用于所有将来的迁移。

4.5.2. 将 MigMigration CR 配置为每个迁移的根或非 root

在目标集群中,您可以使用以下非 root 选项将 MigMigration CR 配置为以 root 或非 root 身份运行 Rsync:

- 作为特定用户 ID (UID)

- 作为一个特定组 ID (GID)

流程

要以 root 用户身份运行 Rsync,请根据本例配置

MigMigrationCR:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要将 Rsync 作为特定用户 ID (UID)或特定组 ID (GID)运行,请根据本例配置

MigMigrationCR:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.6. 配置复制存储库

Multicloud 对象网关是受限网络环境唯一支持的选项。

MTC 支持使用文件系统和快照数据复制的方法将数据从源集群迁移到目标集群。您可以选择适合于您的环境并受您的存储供应商支持的方法。

4.6.1. 先决条件

- 所有集群都必须具有对复制存储库的不间断网络访问权限。

- 如果您将代理服务器与内部托管的复制存储库搭配使用,您必须确保代理允许访问复制存储库。

4.6.2. 检索多云对象网关凭证

虽然 MCG Operator 已被弃用,但 MCG 插件仍可用于 OpenShift Data Foundation。要下载插件,请访问下载 Red Hat OpenShift Data Foundation,并为您的操作系统下载适当的 MCG 插件。

先决条件

- 请根据相关的 Red Hat OpenShift Data Foundation 部署指南部署 OpenShift Data Foundation。

4.7. 卸载 MTC 并删除资源

您可以卸载 MTC,并删除其资源来清理集群。

删除 velero CRD 会从集群中移除 Velero。

先决条件

-

您必须以具有

cluster-admin权限的用户身份登录。

流程

删除所有集群中的

MigrationController自定义资源 (CR):oc delete migrationcontroller <migration_controller>

$ oc delete migrationcontroller <migration_controller>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 使用 Operator Lifecycle Manager 在 OpenShift Container Platform 4 上卸载 MTC Operator。

运行以下命令,删除所有集群中的集群范围资源:

migration自定义资源定义 (CRDs):oc delete $(oc get crds -o name | grep 'migration.openshift.io')

$ oc delete $(oc get crds -o name | grep 'migration.openshift.io')Copy to Clipboard Copied! Toggle word wrap Toggle overflow VeleroCRD:oc delete $(oc get crds -o name | grep 'velero')

$ oc delete $(oc get crds -o name | grep 'velero')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migration集群角色:oc delete $(oc get clusterroles -o name | grep 'migration.openshift.io')

$ oc delete $(oc get clusterroles -o name | grep 'migration.openshift.io')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migration-operator集群角色:oc delete clusterrole migration-operator

$ oc delete clusterrole migration-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow velero集群角色:oc delete $(oc get clusterroles -o name | grep 'velero')

$ oc delete $(oc get clusterroles -o name | grep 'velero')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migration集群角色绑定:oc delete $(oc get clusterrolebindings -o name | grep 'migration.openshift.io')

$ oc delete $(oc get clusterrolebindings -o name | grep 'migration.openshift.io')Copy to Clipboard Copied! Toggle word wrap Toggle overflow migration-operator集群角色绑定:oc delete clusterrolebindings migration-operator

$ oc delete clusterrolebindings migration-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow velero集群角色绑定:oc delete $(oc get clusterrolebindings -o name | grep 'velero')

$ oc delete $(oc get clusterrolebindings -o name | grep 'velero')Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 5 章 升级 MTC

您可以使用 Operator Lifecycle Manager 在 OpenShift Container Platform 4.13 上升级 MTC。

您可以通过重新安装 Containers Operator 的传统 Migration Toolkit for Containers Operator,在 OpenShift Container Platform 4.5 及更早的版本上升级 MTC。

如果要升级到 MTC 1.3,您必须执行额外步骤来更新 MigPlan 自定义资源(CR)。

5.1. 在 OpenShift Container Platform 4.13 中升级 MTC

您可以使用 Operator Lifecycle Manager 在 OpenShift Container Platform 4.13 上升级 MTC。

当使用 Operator Lifecycle Manager 升级 MTC 时,必须使用受支持的迁移路径。

迁移路径

- 从 OpenShift Container Platform 3 迁移到 OpenShift Container Platform 4 需要旧的 MTC Operator 和 MTC 1.7.x。

- 不支持从 MTC 1.7.x 迁移到 MTC 1.8.x。

您必须使用 MTC 1.7.x 来迁移使用 OpenShift Container Platform 4.9 或更早版本源的任何内容。

- MTC 1.7.x 必须在源和目标中使用。

MTC 1.8.x 仅支持从 OpenShift Container Platform 4.10 或更高版本迁移到 OpenShift Container Platform 4.10 或更高版本。对于仅涉及集群版本 4.10 或更高版本的迁移,可以使用 1.7.x 或 1.8.x。但是,它必须与源和目标上的 MTC 版本相同。

- 不支持从源 MTC 1.7.x 迁移到目标 MTC 1.8.x。

- 不支持从源 MTC 1.8.x 迁移到目标 MTC 1.7.x。

- 支持从源 MTC 1.7.x 迁移到目标 MTC 1.7.x。

- 支持从源 MTC 1.8.x 迁移到目标 MTC 1.8.x

先决条件

-

您必须以具有

cluster-admin权限的用户身份登录。

流程

在 OpenShift Container Platform 控制台中导航至 Operators → Installed Operators。

处于待定升级的 operator 会显示 Upgrade available 状态。

- 点 Migration Toolkit for Containers Operator。

- 点 Subscription 标签页。任何需要批准的升级都会在 Upgrade Status 旁边显示。例如:它可能会显示 1 requires approval。

- 点 1 requires approval,然后点 Preview Install Plan。

- 查看列出可用于升级的资源,并点 Approve。

- 返回 Operators → Installed Operators 页面来监控升级的过程。完成后,状态会变为 Succeeded 和 Up to date。

- 点 Workloads → Pods 来验证 MTC pod 正在运行 。

5.2. 将 MTC 升级到 1.8.0

要将 MTC 升级到 1.8.0,请完成以下步骤。

流程

使用以下方法之一确定要升级的订阅名称和当前频道:

运行以下命令确定订阅名称和频道:

oc -n openshift-migration get sub

$ oc -n openshift-migration get subCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME PACKAGE SOURCE CHANNEL mtc-operator mtc-operator mtc-operator-catalog release-v1.7 redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace redhat-oadp-operator mtc-operator-catalog stable-1.0

NAME PACKAGE SOURCE CHANNEL mtc-operator mtc-operator mtc-operator-catalog release-v1.7 redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace redhat-oadp-operator mtc-operator-catalog stable-1.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 或者运行以下命令来返回 JSON 中的订阅名称和频道:

oc -n openshift-migration get sub -o json | jq -r '.items[] | { name: .metadata.name, package: .spec.name, channel: .spec.channel }'$ oc -n openshift-migration get sub -o json | jq -r '.items[] | { name: .metadata.name, package: .spec.name, channel: .spec.channel }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

对于每个订阅,运行以下命令来从 MTC 1.7 频道迁移到 MTC 1.8 频道:

oc -n openshift-migration patch subscription mtc-operator --type merge --patch '{"spec": {"channel": "release-v1.8"}}'$ oc -n openshift-migration patch subscription mtc-operator --type merge --patch '{"spec": {"channel": "release-v1.8"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

subscription.operators.coreos.com/mtc-operator patched

subscription.operators.coreos.com/mtc-operator patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.2.1. 将 OADP 1.0 升级到 1.2 for Containers 1.8.0

要将 OADP 1.0 升级到 1.2 for Containers 1.8.0,请完成以下步骤。

流程

对于每个订阅,运行以下命令,将 OADP operator 从 OADP 1.0 修补到 OADP 1.2:

oc -n openshift-migration patch subscription redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace --type merge --patch '{"spec": {"channel":"stable-1.2"}}'$ oc -n openshift-migration patch subscription redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace --type merge --patch '{"spec": {"channel":"stable-1.2"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意指示用户特定返回的

NAME值分别用于安装 MTC 和 OADP 的部分。输出示例

subscription.operators.coreos.com/redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace patched

subscription.operators.coreos.com/redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意返回的值与

redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace类似,在本示例中使用。-

如果

installPlanApproval参数设置为Automatic,Operator Lifecycle Manager (OLM)将开始升级过程。 -

如果将

installPlanApproval参数设置为Manual,则必须在 OLM 开始升级前批准每个installPlan。

-

如果

验证

运行以下命令,验证 OLM 是否已完成 OADP 和 MTC 的升级:

oc -n openshift-migration get subscriptions.operators.coreos.com mtc-operator -o json | jq '.status | (."state"=="AtLatestKnown")'

$ oc -n openshift-migration get subscriptions.operators.coreos.com mtc-operator -o json | jq '.status | (."state"=="AtLatestKnown")'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 当返回

true值时,运行以下命令来验证每个订阅使用的频道:oc -n openshift-migration get sub -o json | jq -r '.items[] | {name: .metadata.name, channel: .spec.channel }'$ oc -n openshift-migration get sub -o json | jq -r '.items[] | {name: .metadata.name, channel: .spec.channel }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Confirm that the `mtc-operator.v1.8.0` and `oadp-operator.v1.2.x` packages are installed by running the following command:

Confirm that the `mtc-operator.v1.8.0` and `oadp-operator.v1.2.x` packages are installed by running the following command:Copy to Clipboard Copied! Toggle word wrap Toggle overflow oc -n openshift-migration get csv

$ oc -n openshift-migration get csvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME DISPLAY VERSION REPLACES PHASE mtc-operator.v1.8.0 Migration Toolkit for Containers Operator 1.8.0 mtc-operator.v1.7.13 Succeeded oadp-operator.v1.2.2 OADP Operator 1.2.2 oadp-operator.v1.0.13 Succeeded

NAME DISPLAY VERSION REPLACES PHASE mtc-operator.v1.8.0 Migration Toolkit for Containers Operator 1.8.0 mtc-operator.v1.7.13 Succeeded oadp-operator.v1.2.2 OADP Operator 1.2.2 oadp-operator.v1.0.13 SucceededCopy to Clipboard Copied! Toggle word wrap Toggle overflow

您可以通过手动安装旧的 MTC Operator,将 OpenShift Container Platform 版本 4.2 上的 MTC 升级到 4.5。

先决条件

-

您必须以具有

cluster-admin权限的用户身份登录。 -

您必须有权访问

registry.redhat.io。 -

必须安装

podman。

流程

输入以下命令,使用您的红帽客户门户网站凭证登录到

registry.redhat.io:podman login registry.redhat.io

$ podman login registry.redhat.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令下载

operator.yml文件:podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7:/operator.yml ./

$ podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7:/operator.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令替换 Containers Operator 的 Migration Toolkit:

oc replace --force -f operator.yml

$ oc replace --force -f operator.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令将

migration-operator部署扩展到0以停止部署:oc scale -n openshift-migration --replicas=0 deployment/migration-operator

$ oc scale -n openshift-migration --replicas=0 deployment/migration-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令将

migration-operator部署扩展到1以启动部署并应用更改:oc scale -n openshift-migration --replicas=1 deployment/migration-operator

$ oc scale -n openshift-migration --replicas=1 deployment/migration-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令验证

migration-operator是否已升级:oc -o yaml -n openshift-migration get deployment/migration-operator | grep image: | awk -F ":" '{ print $NF }'$ oc -o yaml -n openshift-migration get deployment/migration-operator | grep image: | awk -F ":" '{ print $NF }'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令下载

controller.yml文件:podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/operator.yml ./

$ podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/operator.yml ./Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建

migration-controller对象:oc create -f controller.yml

$ oc create -f controller.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令验证 MTC pod 是否正在运行:

oc get pods -n openshift-migration

$ oc get pods -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4. 将 MTC 1.3 升级到 1.8

如果要将 MTC 版本 1.3.x 升级到 1.8,您必须更新运行 MigrationController Pod 的集群中的 MigPlan 自定义资源(CR)清单。

由于 MTC 1.3 中不存在 indirectImageMigration 和 indirectVolumeMigration 参数,它们在 1.4 版中的默认值会为 false,这意味着启用了直接镜像迁移和直接卷迁移。由于没有满足直接迁移要求,迁移计划无法变为 Ready 状态,除非将这些参数值改为 true。

- 从 OpenShift Container Platform 3 迁移到 OpenShift Container Platform 4 需要旧的 MTC Operator 和 MTC 1.7.x。

-

将 MTC 1.7.x 升级到 1.8.x 需要手动将 OADP 频道从

stable-1.0更新至stable-1.2,以便成功完成从 1.7.x 升级到 1.8.x。

先决条件

-

您必须以具有

cluster-admin权限的用户身份登录。

流程

-

登录到运行

MigrationControllerPod 的集群。 获取

MigPlanCR 清单:oc get migplan <migplan> -o yaml -n openshift-migration

$ oc get migplan <migplan> -o yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow 更新以下参数值,并将文件保存为

migplan.yaml:... spec: indirectImageMigration: true indirectVolumeMigration: true

... spec: indirectImageMigration: true indirectVolumeMigration: trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 替换

MigPlanCR 清单以应用更改:oc replace -f migplan.yaml -n openshift-migration

$ oc replace -f migplan.yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow 获取更新的

MigPlanCR 清单以验证更改:oc get migplan <migplan> -o yaml -n openshift-migration

$ oc get migplan <migplan> -o yaml -n openshift-migrationCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第 6 章 预迁移检查列表

在使用 Migration Toolkit for Containers(MTC)迁移应用程序工作负载前,请查看以下检查列表。

6.1. 集群健康检查清单

- 集群满足特定平台和安装方法(例如 在裸机上 )的最低硬件要求。

- ❏ 满足所有 MTC 的先决条件。

- ❏ 所有节点都有一个有效的 OpenShift Container Platform 订阅。

- ❏ 已验证节点健康状况。

- ❏ 身份提供程序可以正常工作。

- ❏ 迁移网络的最小吞吐量为 10 Gbps。

❏ 集群有足够的资源进行迁移。

注意集群需要额外的内存、CPU 和存储,以便在正常工作负载之上运行迁移。实际的资源要求取决于单个迁移计划中迁移的 Kubernetes 资源数量。您必须在非生产环境中测试迁移,以便估计资源要求。

-

❏ 已使用

fio检查了集群的 etcd 磁盘性能。

6.2. 源集群检查列表

❏ 您已通过运行以下命令检查是否有异常配置的处于 Terminating 状态的持久性卷(PV):

oc get pv

$ oc get pvCopy to Clipboard Copied! Toggle word wrap Toggle overflow ❏ 您已通过运行以下命令检查了状态不是 Running 或 Completed 的 pod:

oc get pods --all-namespaces | egrep -v 'Running | Completed'

$ oc get pods --all-namespaces | egrep -v 'Running | Completed'Copy to Clipboard Copied! Toggle word wrap Toggle overflow ❏ 您已通过运行以下命令来检查有高重启次数的 pod:

oc get pods --all-namespaces --field-selector=status.phase=Running \ -o json | jq '.items[]|select(any( .status.containerStatuses[]; \ .restartCount > 3))|.metadata.name'

$ oc get pods --all-namespaces --field-selector=status.phase=Running \ -o json | jq '.items[]|select(any( .status.containerStatuses[]; \ .restartCount > 3))|.metadata.name'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 即使 pod 处于 Running 状态,具有高的重启次数可能表示底层有问题。

- ❏ 集群证书在迁移过程中是有效的。

❏ 您已通过运行以下命令检查是否有待处理的证书签名请求:

oc get csr -A | grep pending -i

$ oc get csr -A | grep pending -iCopy to Clipboard Copied! Toggle word wrap Toggle overflow - ❏ registry 使用推荐的存储类型。

- ❏ 您可以将镜像读取和写入到 registry。

- ❏ etcd 集群是健康的。

- ❏ 源集群中的平均 API 服务器响应时间小于 50 ms。

6.3. 目标集群清单

- ❏ 集群具有访问外部服务(如数据库、源代码存储库、容器镜像 registry 和 CI/CD 工具)的正确网络配置和权限。

- ❏ 使用集群提供的服务的外部应用程序和服务具有访问集群的正确网络配置和权限。

- ❏ 满足内部容器镜像所需的依赖项要求。

- ❏ 目标集群和复制存储库有足够的存储空间。

第 7 章 网络注意事项

检查迁移后用于重定向应用程序网络流量的策略。

7.1. DNS 注意事项

目标集群的 DNS 域与源集群的域不同。默认情况下,应用程序在迁移后获取目标集群的 FQDN。

要保留迁移的应用程序的源 DNS 域,请选择下面描述的两个选项之一。

7.1.1. 将目标集群的 DNS 域与客户端隔离

您可以允许发送到源集群的 DNS 域的客户端请求访问目标集群的 DNS 域,而无需将目标集群公开给客户端。

流程

- 将外部网络组件(如应用程序负载均衡器或反向代理)放在客户端和目标集群之间。

- 更新 DNS 服务器上的源集群中的应用程序 FQDN,以返回 exterior 网络组件的 IP 地址。

- 配置网络组件,将源域中为应用接收的请求发送到目标集群域中的负载均衡器。

-

为

*.apps.source.example.com域创建一个通配符 DNS 记录,指向源集群的负载均衡器的 IP 地址。 - 为每个应用程序创建一个 DNS 记录,指向目标集群前面的 exterior 网络组件的 IP 地址。特定的 DNS 记录的优先级高于通配符记录,因此在解决应用 FQDN 时不会发生冲突。

- 外部网络组件必须终止所有安全的 TLS 连接。如果连接传递给目标集群负载均衡器,目标应用程序的 FQDN 会公开给客户端,证书发生错误。

- 应用程序不得将引用目标集群域的链接返回给客户端。否则,应用的某些部分可能无法加载或正常工作。

7.1.2. 设置目标集群以接受源 DNS 域

您可以设置目标集群,以接受源集群的 DNS 域中迁移的应用程序的请求。

流程

对于非安全 HTTP 访问和安全 HTTPS 访问,请执行以下步骤:

在目标集群的项目中创建一个路由,该路由配置为接受源集群中处理的应用程序 FQDN 的请求:

oc expose svc <app1-svc> --hostname <app1.apps.source.example.com> \ -n <app1-namespace>

$ oc expose svc <app1-svc> --hostname <app1.apps.source.example.com> \ -n <app1-namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 新路由就位后,服务器接受对该 FQDN 的任何请求,并将它发送到对应的应用容器集。另外,当迁移应用程序时,会在目标集群域中创建另一个路由。请求会使用这些主机名之一到达迁移的应用。

使用您的 DNS 供应商创建 DNS 记录,将源集群中的应用的 FQDN 指向目标集群的默认负载均衡器的 IP 地址。这会将来自源集群的流量重定向到目标集群。

应用程序的 FQDN 解析到目标集群的负载均衡器。默认入口控制器路由器接受对该 FQDN 的请求,因为公开了该主机名的路由。

对于安全 HTTPS 访问,请执行以下步骤:

- 将在安装过程中创建的默认入口控制器的 x509 证书替换为自定义证书。

将这个证书配置为在

subjectAltName字段中为源和目标集群包含通配符 DNS 域。新证书对于保护使用 DNS 域进行的连接有效。

7.2. 网络流量重定向策略

迁移成功后,您必须将无状态应用的网络流量从源集群重定向到目标集群。

重定向网络流量的策略基于以下假设:

- 应用程序 pod 在源集群和目标集群上运行。

- 每个应用都有一个包含源集群主机名的路由。

- 源集群主机名的路由包含 CA 证书。

- 对于 HTTPS,目标路由器 CA 证书包含用于源集群的通配符 DNS 记录的 Subject 备用名称。

考虑以下策略并选择符合您目标的策略。

同时重定向所有应用的所有网络流量

更改源集群的通配符 DNS 记录,使其指向目标集群路由器的虚拟 IP 地址 (VIP)。

此策略适用于简单应用程序或小型环境的迁移。

为单个应用重定向网络流量

使用指向目标集群路由器 VIP 的源集群主机名为每个应用程序创建一个 DNS 记录。这个 DNS 记录优先于源集群通配符 DNS 记录。

为单个应用逐步重定向网络流量

- 创建一个代理,用于将流量定向到每个应用程序的源集群路由器的 VIP 和目标集群路由器的 VIP。

- 使用指向代理的源集群主机名为每个应用程序创建一个 DNS 记录。

- 配置应用的代理条目,将流量百分比路由到目标集群路由器的 VIP,并将其余流量路由到源集群路由器的 VIP。

- 逐渐增加您路由到目标集群路由器 VIP 的流量百分比,直到所有网络流量被重定向为止。

基于用户的单个应用程序流量重定向

使用此策略,您可以过滤用户请求的 TCP/IP 标头,以便为预定义的用户组重定向网络流量。这允许您在重定向整个网络流量之前测试用户特定版本的重定向过程。

- 创建一个代理,用于将流量定向到每个应用程序的源集群路由器的 VIP 和目标集群路由器的 VIP。

- 使用指向代理的源集群主机名为每个应用程序创建一个 DNS 记录。

-

配置应用的代理条目,将匹配给定标头模式的流量(如

测试客户)路由到目标集群路由器的 VIP,并将其余流量路由到源集群路由器的 VIP。 - 将流量分阶段重定向到目标集群路由器的 VIP,直到所有流量都位于目标集群路由器的 VIP 上。

第 8 章 直接迁移要求

Migration Toolkit for Containers (MTC) 1.4.0 或更高版本提供直接迁移。

直接迁移有两个部分:

- 直接卷迁移

- 直接镜像迁移

直接迁移启用持久性卷和内部镜像直接从源集群迁移到目标集群,而无需中间的复制存储库(对象存储)。

8.1. 先决条件

- 为外部流量迁移涉及的集群(源和目标)公开内部 registry。

- 确保远程源和目标集群可以使用端口 443 上的 OpenShift Container Platform 路由进行通信。

在源和目标集群集群中配置公开的 registry 路由;通过指定

spec.exposedRegistryPath字段或从 MTC UI 完成此操作。注意- 如果目标集群与主机集群(迁移控制器存在)相同,则不需要为该特定 MTC 集群配置公开的 registry 路由。

-

spec.exposedRegistryPath只适用于直接镜像迁移,而不是直接卷迁移。

-

确保

MigPlan自定义资源 (CR)indirectImageMigration和indirectVolumeMigration中的两个 spec 标志被设置为false,以便直接执行 Migration。这些标志的默认值为false。

MTC 的直接迁移功能使用 Rsync 工具。