网络

配置和管理集群网络

摘要

第 1 章 关于网络

Red Hat OpenShift 网络是一个功能生态系统、插件和高级网络功能,它使用高级网络相关功能来扩展 Kubernetes 网络,集群需要为其一个或多个混合集群管理网络流量。这个网络功能生态系统集成了入口、出口、负载均衡、高性能吞吐量、安全性和集群内部流量管理,并提供基于角色的可观察工具来减少其自然复杂性。

以下列表重点介绍集群中可用的一些最常用的 Red Hat OpenShift Networking 功能:

由以下 Container Network Interface (CNI) 插件之一提供的主要集群网络:

- 经认证的第三方替代主网络插件

- 用于网络插件管理的 Cluster Network Operator

- 用于 TLS 加密 Web 流量的 Ingress Operator

- 用于名称分配的 DNS Operator

- 用于裸机集群上的流量负载均衡的 MetalLB Operator

- 对高可用性的 IP 故障转移支持

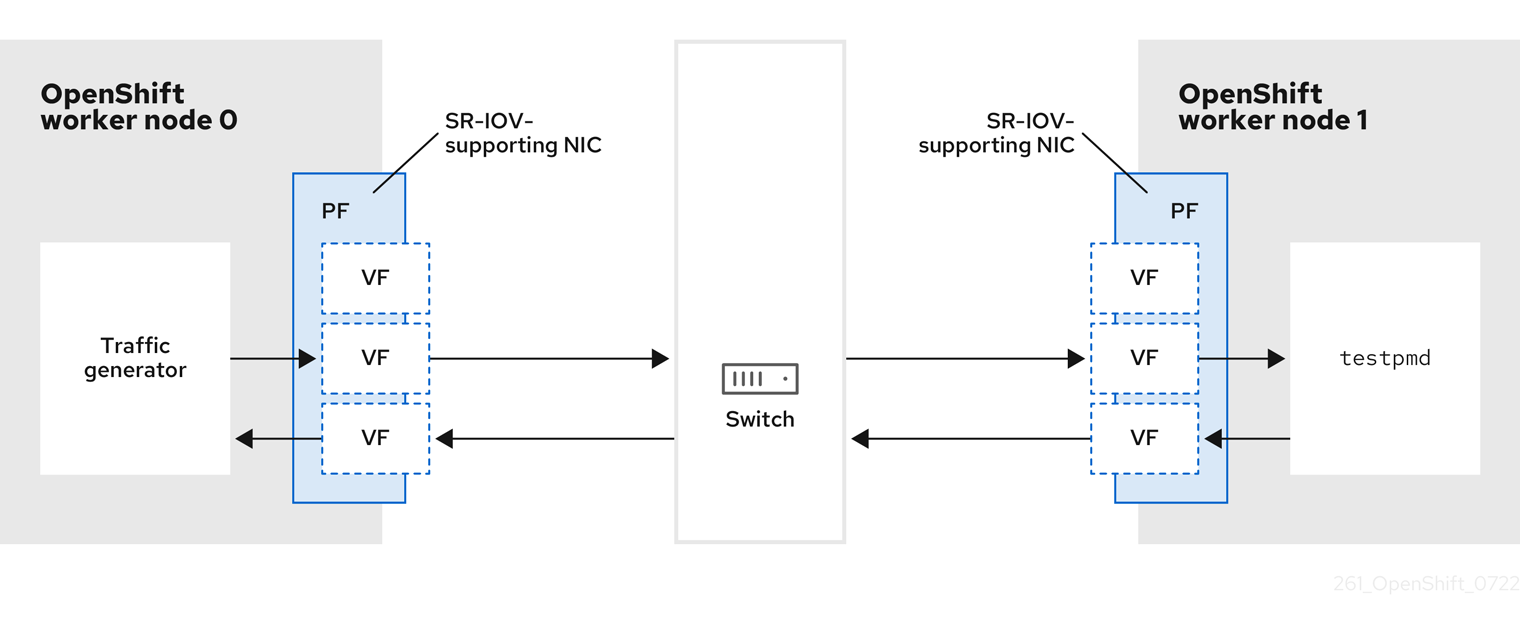

- 通过多个 CNI 插件支持额外的硬件网络,包括 macvlan、ipvlan 和 SR-IOV 硬件网络

- IPv4、IPv6 和双堆栈寻址

- 用于基于 Windows 的工作负载的混合 Linux-Windows 主机集群

- Red Hat OpenShift Service Mesh 用于发现、负载均衡、服务对服务身份验证、故障恢复、指标和监控服务

- 单节点 OpenShift

- Network Observability Operator 用于网络调试和见解

- Submariner 用于 inter-cluster 网络

- Red Hat Service Interconnect 用于第 7 层 inter-cluster 网络

第 2 章 了解网络

集群管理员有几个选项用于公开集群内的应用程序到外部流量并确保网络连接:

- 服务类型,如节点端口或负载均衡器

-

API 资源,如

Ingress和Route

默认情况下,Kubernetes 为 pod 内运行的应用分配内部 IP 地址。Pod 及其容器可以网络,但集群外的客户端无法访问网络。当您将应用公开给外部流量时,为每个容器集指定自己的 IP 地址意味着 pod 在端口分配、网络、命名、服务发现、负载平衡、应用配置和迁移方面可被视为物理主机或虚拟机。

一些云平台提供侦听 169.254.169.254 IP 地址的元数据 API,它是 IPv4 169.254.0.0/16 CIDR 块中的 连接内部 IP 地址。

此 CIDR 块无法从 pod 网络访问。需要访问这些 IP 地址的 Pod 必须通过将 pod spec 中的 spec.hostnetwork 字段设置为 true 来获得主机网络访问。

如果允许 pod 主机网络访问,则将授予 pod 对底层网络基础架构的访问权限。

2.1. OpenShift Container Platform DNS

如果您运行多个服务,比如使用多个 pod 的前端和后端服务,则要为用户名和服务 IP 等创建环境变量,使前端 pod 可以跟后端服务通信。如果删除并重新创建服务,可以为该服务分配一个新的 IP 地址,而且需要重新创建前端 pod 来获取服务 IP 环境变量的更新值。另外,必须在任何前端 pod 之前创建后端服务,以确保正确生成服务 IP,并将它作为环境变量提供给前端 pod。

因此,OpenShift Container Platform 具有一个内置 DNS,以便服务 DNS 以及服务 IP/端口能够访问这些服务。

2.2. OpenShift Container Platform Ingress Operator

在创建 OpenShift Container Platform 集群时,在集群中运行的 Pod 和服务会各自分配自己的 IP 地址。IP 地址可供附近运行的其他容器集和服务访问,但外部客户端无法访问这些 IP 地址。Ingress Operator 实现 IngressController API,是负责启用对 OpenShift Container Platform 集群服务的外部访问的组件。

Ingress Operator 通过部署和管理一个或多个基于 HAProxy 的 Ingress Controller 来处理路由,使外部客户端可以访问您的服务。您可以通过指定 OpenShift Container Platform Route 和 Kubernetes Ingress 资源,来使用 Ingress Operator 路由流量。Ingress Controller 中的配置(如定义 endpointPublishingStrategy 类型和内部负载平衡)提供了发布 Ingress Controller 端点的方法。

2.2.1. 路由和 Ingress 的比较

OpenShift Container Platform 中的 Kubernetes Ingress 资源通过作为集群内 pod 运行的共享路由器服务来实现 Ingress Controller。管理 Ingress 流量的最常见方法是使用 Ingress Controller。您可以像任何其他常规 pod 一样扩展和复制此 pod。此路由器服务基于 HAProxy,后者是一个开源负载均衡器解决方案。

OpenShift Container Platform 路由为集群中的服务提供入口流量。路由提供了标准 Kubernetes Ingress Controller 可能不支持的高级功能,如 TLS 重新加密、TLS 直通和为蓝绿部署分割流量。

入口流量通过路由访问集群中的服务。路由和入口是处理入口流量的主要资源。Ingress 提供类似于路由的功能,如接受外部请求并根据路由委派它们。但是,对于 Ingress,您只能允许某些类型的连接:HTTP/2、HTTPS 和服务器名称识别(SNI),以及 TLS(证书)。在 OpenShift Container Platform 中,生成路由以满足 Ingress 资源指定的条件。

2.3. OpenShift Container Platform 网络的常见术语表

该术语表定义了在网络内容中使用的常用术语。

- 身份验证

- 为了控制对 OpenShift Container Platform 集群的访问,集群管理员可以配置用户身份验证,并确保只有批准的用户访问集群。要与 OpenShift Container Platform 集群交互,您必须对 OpenShift Container Platform API 进行身份验证。您可以通过在您对 OpenShift Container Platform API 的请求中提供 OAuth 访问令牌或 X.509 客户端证书来进行身份验证。

- AWS Load Balancer Operator

-

AWS Load Balancer (ALB) Operator 部署和管理

aws-load-balancer-controller的实例。 - Cluster Network Operator

- Cluster Network Operator(CNO)在 OpenShift Container Platform 集群中部署和管理集群网络组件。这包括在安装过程中为集群选择的 Container Network Interface (CNI) 网络插件部署。

- 配置映射

-

配置映射提供将配置数据注入 pod 的方法。您可以在类型为

ConfigMap的卷中引用存储在配置映射中的数据。在 pod 中运行的应用程序可以使用这个数据。 - 自定义资源 (CR)

- CR 是 Kubernetes API 的扩展。您可以创建自定义资源。

- DNS

- 集群 DNS 是一个 DNS 服务器,它为 Kubernetes 服务提供 DNS 记录。由 Kubernetes 启动的容器会在其 DNS 搜索中自动包含此 DNS 服务器。

- DNS Operator

- DNS Operator 部署并管理 CoreDNS,以便为 pod 提供名称解析服务。这会在 OpenShift Container Platform 中启用基于 DNS 的 Kubernetes 服务发现。

- 部署

- 维护应用程序生命周期的 Kubernetes 资源对象。

- domain

- Domain(域)是 Ingress Controller 提供的 DNS 名称。

- egress

- 通过来自 pod 的网络出站流量进行外部数据共享的过程。

- 外部 DNS Operator

- External DNS Operator 部署并管理 ExternalDNS,以便为从外部 DNS 供应商到 OpenShift Container Platform 的服务和路由提供名称解析。

- 基于 HTTP 的路由

- 基于 HTTP 的路由是一个不受保护的路由,它使用基本的 HTTP 路由协议,并在未安全的应用程序端口上公开服务。

- 入口

- OpenShift Container Platform 中的 Kubernetes Ingress 资源通过作为集群内 pod 运行的共享路由器服务来实现 Ingress Controller。

- Ingress Controller

- Ingress Operator 管理 Ingress Controller。使用 Ingress Controller 是允许从外部访问 OpenShift Container Platform 集群的最常用方法。

- 安装程序置备的基础架构

- 安装程序部署并配置运行集群的基础架构。

- kubelet

- 在集群的每个节点上运行的一个主节点代理,以确保容器在 pod 中运行。

- Kubernetes NMState Operator

- Kubernetes NMState Operator 提供了一个 Kubernetes API,用于使用 NMState 在 OpenShift Container Platform 集群的节点上执行状态驱动的网络配置。

- kube-proxy

- kube-proxy 是一个代理服务,在每个节点上运行,有助于为外部主机提供服务。它有助于将请求转发到正确的容器,并且能够执行原语负载平衡。

- 负载均衡器

- OpenShift Container Platform 使用负载均衡器从集群外部与集群中运行的服务进行通信。

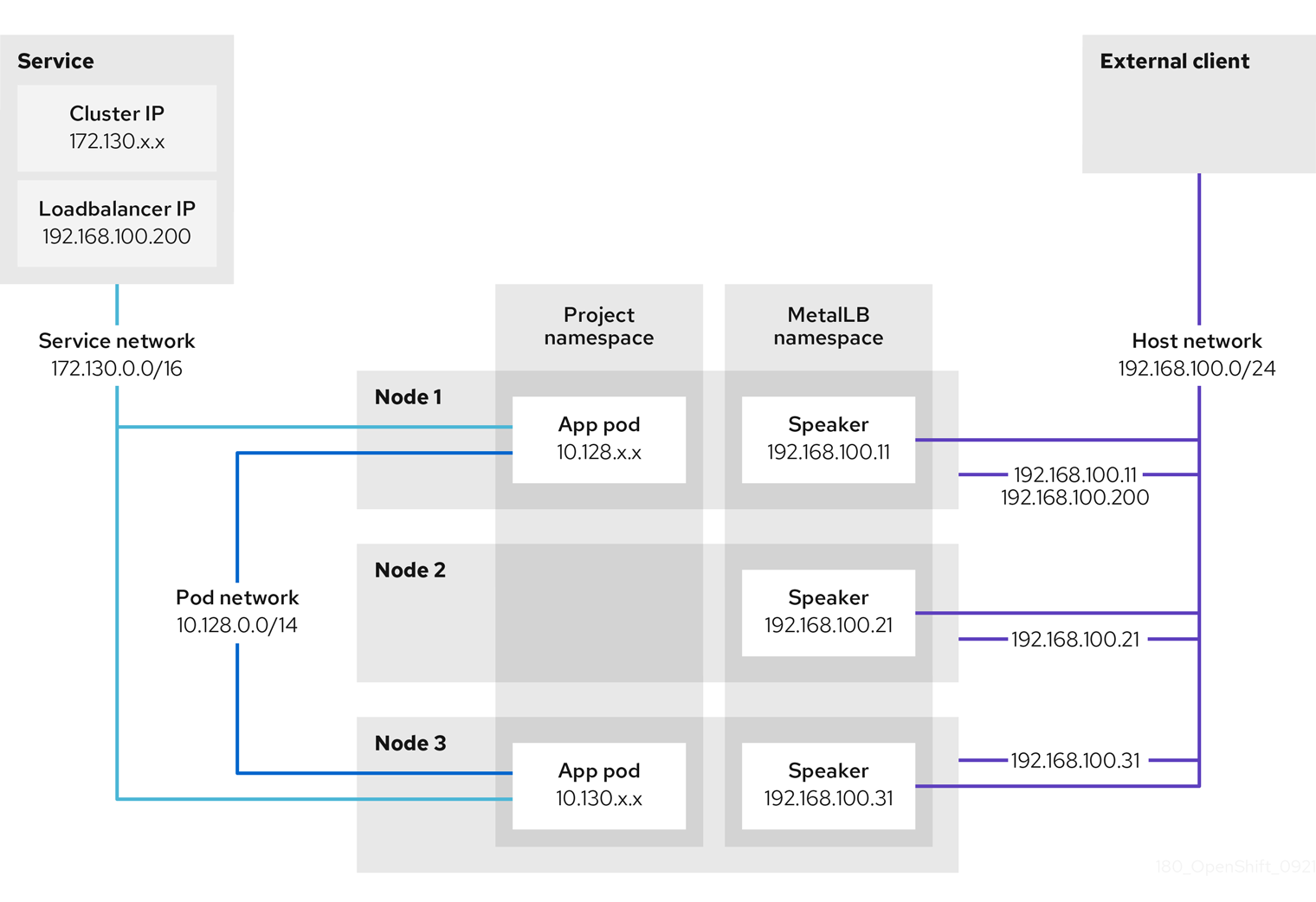

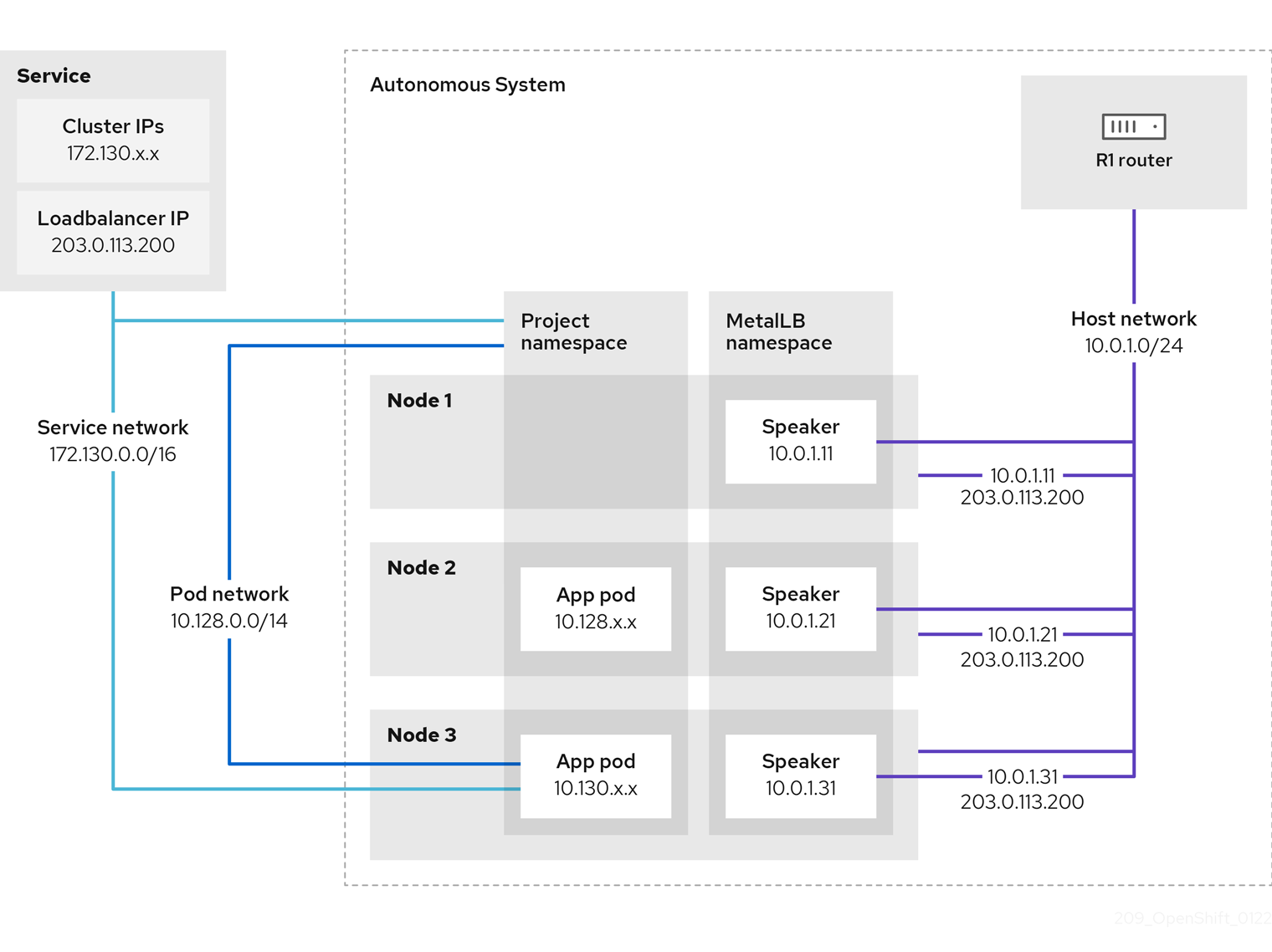

- MetalLB Operator

-

作为集群管理员,您可以将 MetalLB Operator 添加到集群中,以便在将

LoadBalancer类型服务添加到集群中时,MetalLB 可为该服务添加外部 IP 地址。 - multicast

- 通过使用 IP 多播,数据可同时广播到许多 IP 地址。

- 命名空间

- 命名空间隔离所有进程可见的特定系统资源。在一个命名空间中,只有属于该命名空间的进程才能看到这些资源。

- networking

- OpenShift Container Platform 集群的网络信息。

- node

- OpenShift Container Platform 集群中的 worker 机器。节点是虚拟机 (VM) 或物理计算机。

- OpenShift Container Platform Ingress Operator

-

Ingress Operator 实现

IngressControllerAPI,是负责启用对 OpenShift Container Platform 服务的外部访问的组件。 - pod

- 一个或多个带有共享资源(如卷和 IP 地址)的容器,在 OpenShift Container Platform 集群中运行。pod 是定义、部署和管理的最小计算单元。

- PTP Operator

-

PTP Operator 会创建和管理

linuxptp服务。 - route

- OpenShift Container Platform 路由为集群中的服务提供入口流量。路由提供了标准 Kubernetes Ingress Controller 可能不支持的高级功能,如 TLS 重新加密、TLS 直通和为蓝绿部署分割流量。

- 扩展

- 增加或减少资源容量。

- service

- 在一组 pod 上公开正在运行的应用程序。

- 单根 I/O 虚拟化 (SR-IOV) Network Operator

- Single Root I/O Virtualization(SR-IOV)Network Operator 管理集群中的 SR-IOV 网络设备和网络附加。

- 软件定义型网络 (SDN)

- OpenShift Container Platform 使用软件定义网络 (SDN) 方法来提供一个统一的集群网络,它允许 OpenShift Container Platform 集群中的不同 pod 相互间进行通信。

- 流控制传输协议 (SCTP)

- SCTP 是基于信息的可靠协议,可在 IP 网络之上运行。

- taint

- 污点和容限可确保将 pod 调度到适当的节点上。您可以在节点上应用一个或多个污点。

- 容限 (tolerations)

- 您可以将容限应用到 pod。容限 (toleration) 允许调度程序调度具有匹配污点的 pod。

- Web 控制台

- 用于管理 OpenShift Container Platform 的用户界面(UI)。

第 3 章 访问主机

了解如何创建堡垒主机来访问 OpenShift Container Platform 实例,以及使用安全 shell (SSH) 访问 control plane 节点。

3.1. 访问安装程序置备的基础架构集群中 Amazon Web Services 上的主机

OpenShift Container Platform 安装程序不会为任何置备 OpenShift Container Platform 集群的 Amazon Elastic Compute Cloud (Amazon EC2) 实例创建公共 IP 地址。为了可以 SSH 到 OpenShift Container Platform 主机,您必须按照以下步骤操作。

流程

-

创建一个安全组,允许 SSH 访问由

openshift-install命令创建的虚拟私有云 (VPC) 。 - 在安装程序创建的某个公共子网中创建 Amazon EC2 实例。

将公共 IP 地址与您创建的 Amazon EC2 实例相关联。

与 OpenShift Container Platform 安装不同,您应该将您创建的 Amazon EC2 实例与 SSH 密钥对关联。这与您为这个实例选择的操作系统无关,因为它只是一个 SSH 堡垒将互联网桥接到 OpenShift Container Platform 集群的 VPC。它与您使用的 Amazon Machine Image (AMI) 相关。例如,在 Red Hat Enterprise Linux CoreOS(RHCOS) 中,您可以像安装程序一样通过 Ignition 提供密钥。

一旦置备了 Amazon EC2 实例并可以 SSH 到它,您必须添加与 OpenShift Container Platform 安装关联的 SSH 密钥。这个密钥可以与堡垒实例的密钥不同,也可以相同。

注意直接通过 SSH 访问仅建议在灾难恢复时使用。当 Kubernetes API 正常工作时,应该使用特权 Pod。

-

运行

oc get nodes,查看输出结果,然后选择一个 master 节点。主机名类似于ip-10-0-1-163.ec2.internal。 从您手动部署到 Amazon EC2 的堡垒 SSH 主机中,SSH 部署到该 control plane 主机。确定您使用了在安装过程中指定的相同的 SSH 密钥:

ssh -i <ssh-key-path> core@<master-hostname>

$ ssh -i <ssh-key-path> core@<master-hostname>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第 4 章 网络 Operator 概述

OpenShift Container Platform 支持多种类型的网络 Operator。您可以使用这些网络 Operator 管理集群网络。

4.1. Cluster Network Operator

Cluster Network Operator(CNO)在 OpenShift Container Platform 集群中部署和管理集群网络组件。这包括在安装过程中为集群选择的 Container Network Interface (CNI) 网络插件部署。如需更多信息,请参阅 OpenShift Container Platform 中的 Cluster Network Operator。

4.2. DNS Operator

DNS Operator 部署并管理 CoreDNS,以便为 pod 提供名称解析服务。这会在 OpenShift Container Platform 中启用基于 DNS 的 Kubernetes 服务发现。如需更多信息,请参阅 OpenShift Container Platform 中的 DNS Operator。

4.3. Ingress Operator

创建 OpenShift Container Platform 集群时,集群中运行的 pod 和服务将为每个分配的 IP 地址。IP 地址可以被其他 pod 和服务访问,但外部客户端无法访问。Ingress Operator 实现 Ingress Controller API,并负责启用对 OpenShift Container Platform 集群服务的外部访问。如需更多信息,请参阅 OpenShift Container Platform 中的 Ingress Operator。

4.4. 外部 DNS Operator

External DNS Operator 部署并管理 ExternalDNS,以便为从外部 DNS 供应商到 OpenShift Container Platform 的服务和路由提供名称解析。如需更多信息,请参阅了解外部 DNS Operator。

4.5. Ingress Node Firewall Operator

Ingress Node Firewall Operator 使用扩展的 Berkley Packet Filter (eBPF) 和 eXpress Data Path (XDP) 插件来处理节点防火墙规则,更新统计信息并为丢弃的流量生成事件。Operator 管理入口节点防火墙资源,验证防火墙配置,不允许错误配置规则来防止集群访问,并将 ingress 节点防火墙 XDP 程序加载到规则对象中的所选接口。如需更多信息,请参阅了解 Ingress Node Firewall Operator

4.6. Network Observability Operator

Network Observability Operator 是一个可选 Operator,它允许集群管理员观察 OpenShift Container Platform 集群的网络流量。Network Observability Operator 使用 eBPF 技术创建网络流。然后,OpenShift Container Platform 信息会增强网络流,并存储在 Loki 中。您可以在 OpenShift Container Platform 控制台中查看和分析所存储的 netflow 信息,以进一步洞察和故障排除。如需更多信息,请参阅关于 Network Observability Operator。

Cluster Network Operator (CNO)在 OpenShift Container Platform 集群上部署和管理集群网络组件,包括在安装过程中为集群选择的 Container Network Interface (CNI) 网络插件。

5.1. Cluster Network Operator

Cluster Network Operator 从 operator.openshift.io API 组实现 network API。Operator 通过使用守护进程集部署 OVN-Kubernetes 网络插件,或部署您在集群安装过程中选择的网络供应商插件。

流程

Cluster Network Operator 在安装过程中被部署为一个 Kubernetes 部署。

运行以下命令,以查看部署状态:

oc get -n openshift-network-operator deployment/network-operator

$ oc get -n openshift-network-operator deployment/network-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY UP-TO-DATE AVAILABLE AGE network-operator 1/1 1 1 56m

NAME READY UP-TO-DATE AVAILABLE AGE network-operator 1/1 1 1 56mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,以查看 Cluster Network Operator 的状态:

oc get clusteroperator/network

$ oc get clusteroperator/networkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE network 4.5.4 True False False 50m

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE network 4.5.4 True False False 50mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下字段提供有关 Operator 状态的信息:

AVAILABLE、Progressing和DEGRADED。当 Cluster Network Operator 报告可用状态条件时,AVAILABLE字段为True。

5.2. 查看集群网络配置

每个 OpenShift Container Platform 新安装都有一个名为 cluster 的 network.config 对象。

5.3. 查看 Cluster Network Operator 状态

您可以使用 oc describe 命令来检查状态并查看 Cluster Network Operator 的详情。

流程

运行以下命令,以查看 Cluster Network Operator 的状态:

oc describe clusteroperators/network

$ oc describe clusteroperators/networkCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.4. 查看 Cluster Network Operator 日志

您可以使用 oc logs 命令来查看 Cluster Network Operator 日志。

流程

运行以下命令,以查看 Cluster Network Operator 的日志:

oc logs --namespace=openshift-network-operator deployment/network-operator

$ oc logs --namespace=openshift-network-operator deployment/network-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.5. Cluster Network Operator 配置

集群网络的配置作为 Cluster Network Operator(CNO)配置的一部分指定,并存储在名为 cluster 的自定义资源(CR)对象中。CR 指定 operator.openshift.io API 组中的 Network API 的字段。

CNO 配置在集群安装过程中从 Network. config.openshift.io API 组中的 Network API 继承以下字段,且这些字段无法更改:

clusterNetwork- 从中分配 Pod IP 地址的 IP 地址池。

serviceNetwork- 服务的 IP 地址池.

defaultNetwork.type- 集群网络插件,如 OpenShift SDN 或 OVN-Kubernetes。

在集群安装后,您无法修改上一节中列出的字段。

您可以通过在名为 cluster 的 CNO 对象中设置 defaultNetwork 对象的字段来为集群指定集群网络插件配置。

5.5.1. Cluster Network Operator 配置对象

下表中描述了 Cluster Network Operator(CNO)的字段:

| 字段 | 类型 | 描述 |

|---|---|---|

|

|

|

CNO 对象的名称。这个名称始终是 |

|

|

| 用于指定从哪些 IP 地址块分配 Pod IP 地址以及集群中每个节点的子网前缀长度的列表。例如:

此值是只读的,在集群安装过程中从名为 |

|

|

| 服务的 IP 地址块。OpenShift SDN 和 OVN-Kubernetes 网络插件只支持服务网络的一个 IP 地址块。例如: spec: serviceNetwork: - 172.30.0.0/14

此值是只读的,在集群安装过程中从名为 |

|

|

| 为集群网络配置网络插件。 |

|

|

| 此对象的字段指定 kube-proxy 配置。如果使用 OVN-Kubernetes 集群网络供应商,则 kube-proxy 配置不会起作用。 |

对于需要在多个网络间部署对象的集群,请确保为 install-config.yaml 文件中定义的每种网络类型指定与 clusterNetwork.hostPrefix 参数相同的值。为每个 clusterNetwork.hostPrefix 参数设置不同的值可能会影响 OVN-Kubernetes 网络插件,其中插件无法有效地在不同节点间路由对象流量。

defaultNetwork 对象配置

下表列出了 defaultNetwork 对象的值:

| 字段 | 类型 | 描述 |

|---|---|---|

|

|

|

注意 OpenShift Container Platform 默认使用 OVN-Kubernetes 网络插件。 |

|

|

| 此对象仅对 OpenShift SDN 网络插件有效。 |

|

|

| 此对象仅对 OVN-Kubernetes 网络插件有效。 |

配置 OpenShift SDN 网络插件

下表描述了 OpenShift SDN 网络插件的配置字段:

| 字段 | 类型 | 描述 |

|---|---|---|

|

|

| OpenShift SDN 的网络隔离模式。 |

|

|

| VXLAN 覆盖网络的最大传输单元(MTU)。这个值通常是自动配置的。 |

|

|

|

用于所有 VXLAN 数据包的端口。默认值为 |

您只能在集群安装过程中更改集群网络插件的配置。

OpenShift SDN 配置示例

配置 OVN-Kubernetes 网络插件

下表描述了 OVN-Kubernetes 网络插件的配置字段:

| 字段 | 类型 | 描述 |

|---|---|---|

|

|

| Geneve(通用网络虚拟化封装)覆盖网络的最大传输单元(MTU)。这个值通常是自动配置的。 |

|

|

| Geneve 覆盖网络的 UDP 端口。 |

|

|

| 如果存在该字段,则会为集群启用 IPsec。 |

|

|

| 指定用于自定义网络策略审计日志的配置对象。如果未设置,则使用默认的审计日志设置。 |

|

|

| 可选:指定一个配置对象来自定义如何将出口流量发送到节点网关。 注意 在迁移出口流量时,工作负载和服务流量会受到一定影响,直到 Cluster Network Operator (CNO) 成功推出更改。 |

|

|

如果您的现有网络基础架构与 在安装后无法更改此字段。 |

默认值为 |

|

|

如果您的现有网络基础架构与 在安装后无法更改此字段。 |

默认值为 |

| 字段 | 类型 | 描述 |

|---|---|---|

|

| 整数 |

每个节点每秒生成一次的消息数量上限。默认值为每秒 |

|

| 整数 |

审计日志的最大大小,以字节为单位。默认值为 |

|

| 整数 | 保留的日志文件的最大数量。 |

|

| 字符串 | 以下附加审计日志目标之一:

|

|

| 字符串 |

syslog 工具,如 as |

| 字段 | 类型 | 描述 |

|---|---|---|

|

|

|

将此字段设置为

此字段与 Open vSwitch 硬件卸载功能有交互。如果将此字段设置为 |

您只能在集群安装过程中更改集群网络插件的配置,但 gatewayConfig 字段可作为安装后活动在运行时更改。

启用 IPSec 的 OVN-Kubernetes 配置示例

kubeProxyConfig object configuration

kubeProxyConfig 对象的值在下表中定义:

| 字段 | 类型 | 描述 |

|---|---|---|

|

|

|

注意

由于 OpenShift Container Platform 4.3 及更高版本中引进了性能改进,不再需要调整 |

|

|

|

刷新 kubeProxyConfig:

proxyArguments:

iptables-min-sync-period:

- 0s

|

5.5.2. Cluster Network Operator 配置示例

以下示例中指定了完整的 CNO 配置:

Cluster Network Operator 对象示例

第 6 章 OpenShift Container Platform 中的 DNS Operator

DNS Operator 部署并管理 CoreDNS,以为 pod 提供名称解析服务。它在 OpenShift Container Platform 中启用了基于 DNS 的 Kubernetes 服务发现。

6.1. DNS Operator

DNS Operator 从 operator.openshift.io API 组实现 dns API。Operator 使用守护进程集部署 CoreDNS,为守护进程集创建一个服务,并将 kubelet 配置为指示 pod 使用 CoreDNS 服务 IP 地址进行名称解析。

流程

在安装过程中使用 Deployment 对象部署 DNS Operator。

使用

oc get命令查看部署状态:oc get -n openshift-dns-operator deployment/dns-operator

$ oc get -n openshift-dns-operator deployment/dns-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY UP-TO-DATE AVAILABLE AGE dns-operator 1/1 1 1 23h

NAME READY UP-TO-DATE AVAILABLE AGE dns-operator 1/1 1 1 23hCopy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

oc get命令来查看 DNS Operator 的状态:oc get clusteroperator/dns

$ oc get clusteroperator/dnsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE dns 4.1.0-0.11 True False False 92m

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE dns 4.1.0-0.11 True False False 92mCopy to Clipboard Copied! Toggle word wrap Toggle overflow AVAILABLE、PROGRESSING和DEGRADED提供了有关 Operator 状态的信息。当 CoreDNS 守护进程中至少有 1 个 pod 被设置为Available状态时,AVAILABLE为True。

6.2. 更改 DNS Operator managementState

DNS 管理 CoreDNS 组件,为集群中的 pod 和服务提供名称解析服务。默认情况下,DNS Operator 的 managementState 设置为 Managed,这意味着 DNS Operator 会主动管理其资源。您可以将其更改为 Unmanaged,这意味着 DNS Operator 不管理其资源。

以下是更改 DNS Operator managementState 的用例:

-

您是一个开发者,希望测试配置更改来查看它是否解决了 CoreDNS 中的问题。您可以通过将

managementState设置为Unmanaged来停止 DNS Operator 覆盖更改。 -

您是一个集群管理员,报告了 CoreDNS 的问题,但在解决这个问题前需要应用一个临时解决方案。您可以将 DNS Operator 的

managementState字段设置为Unmanaged以应用临时解决方案。

流程

修改

managementStateDNS Operator:oc patch dns.operator.openshift.io default --type merge --patch '{"spec":{"managementState":"Unmanaged"}}'oc patch dns.operator.openshift.io default --type merge --patch '{"spec":{"managementState":"Unmanaged"}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.3. 控制 DNS pod 放置

DNS Operator 有两个守护进程集:一个用于 CoreDNS,另一个用于管理 /etc/hosts 文件。/etc/hosts 的守护进程集必须在每个节点主机上运行,以便为集群镜像 registry 添加条目来支持拉取镜像。安全策略可以禁止节点对之间的通信,这会阻止 CoreDNS 的守护进程集在每个节点上运行。

作为集群管理员,您可以使用自定义节点选择器将 CoreDNS 的守护进程集配置为在某些节点上运行或不运行。

先决条件

-

已安装

ocCLI。 -

使用具有

cluster-admin权限的用户登陆到集群。

流程

要防止某些节点间的通信,请配置

spec.nodePlacement.nodeSelectorAPI 字段:修改名为

default的 DNS Operator 对象:oc edit dns.operator/default

$ oc edit dns.operator/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 指定在

spec.nodePlacement.nodeSelectorAPI 字段中只包含 control plane 节点的节点选择器:spec: nodePlacement: nodeSelector: node-role.kubernetes.io/worker: ""spec: nodePlacement: nodeSelector: node-role.kubernetes.io/worker: ""Copy to Clipboard Copied! Toggle word wrap Toggle overflow

要允许 CoreDNS 的守护进程集在节点上运行,请配置污点和容限:

修改名为

default的 DNS Operator 对象:oc edit dns.operator/default

$ oc edit dns.operator/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 为污点指定污点键和一个容忍度:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 如果污点是

dns-only,它可以无限期地被容许。您可以省略tolerationSeconds。

6.4. 查看默认 DNS

每个 OpenShift Container Platform 新安装都有一个名为 default 的 dns.operator。

流程

使用

oc describe命令来查看默认dns:oc describe dns.operator/default

$ oc describe dns.operator/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要查找集群的服务 CIDR,使用

oc get命令:oc get networks.config/cluster -o jsonpath='{$.status.serviceNetwork}'$ oc get networks.config/cluster -o jsonpath='{$.status.serviceNetwork}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

输出示例

[172.30.0.0/16]

[172.30.0.0/16]6.5. 使用 DNS 转发

您可以使用以下方法使用 DNS 转发来覆盖 /etc/resolv.conf 文件中的默认转发配置:

- 为每个区指定名称服务器。如果转发区是 OpenShift Container Platform 管理的 Ingress 域,那么上游名称服务器必须为域授权。

- 提供上游 DNS 服务器列表。

- 更改默认转发策略。

默认域的 DNS 转发配置可以同时在 /etc/resolv.conf 文件和上游 DNS 服务器中指定默认服务器。

流程

修改名为

default的 DNS Operator 对象:oc edit dns.operator/default

$ oc edit dns.operator/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 发出上一命令后,Operator 会根据

Server创建并更新名为dns-default的配置映射,并带有额外的服务器配置块。如果任何服务器都没有与查询匹配的区域,则名称解析会返回上游 DNS 服务器。配置 DNS 转发

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 必须符合

rfc6335服务名称语法。 - 2

- 必须符合

rfc1123服务名称语法中的子域的定义。集群域cluster.local是对zones字段的无效子域。 - 3

- 定义用于选择上游解析器的策略。默认值为

Random。您还可以使用RoundRobin, 和Sequential值。 - 4

- 每个

forwardPlugin最多允许 15 个upstreams。 - 5

- 可选。您可以使用它来覆盖默认策略,并将 DNS 解析转发到默认域的指定 DNS 解析器(上游解析器)。如果没有提供任何上游解析器,DNS 名称查询将进入

/etc/resolv.conf中的服务器。 - 6

- 决定选择上游服务器进行查询的顺序。您可以指定这些值之一:

Random、RoundRobin或Sequential。默认值为Sequential。 - 7

- 可选。您可以使用它提供上游解析器。

- 8

- 您可以指定

上游的两种类型 -SystemResolvConf和Network。SystemResolvConf将上游配置为使用/etc/resolv.conf和Network定义一个Networkresolver。您可以指定其中一个或两者都指定。 - 9

- 如果指定类型是

Network,则必须提供 IP 地址。address字段必须是有效的 IPv4 或 IPv6 地址。 - 10

- 如果指定类型是

Network,您可以选择性地提供端口。port字段必须是1到65535之间的值。如果您没有为上游指定端口,则会尝试默认端口 853。

可选:在高度监管的环境中工作时,您可能需要在将请求转发到上游解析器时保护 DNS 流量,以便您可以确保额外的 DNS 流量和数据隐私。集群管理员可以配置传输层安全(TLS)来转发 DNS 查询。

使用 TLS 配置 DNS 转发

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 必须符合

rfc6335服务名称语法。 - 2

- 必须符合

rfc1123服务名称语法中的子域的定义。集群域cluster.local是对zones字段的无效子域。集群域cluster.local不是zones中的一个有效的subdomain。 - 3

- 在为转发 DNS 查询配置 TLS 时,将

transport字段设置为具有值TLS。默认情况下,CoreDNS 缓存在 10 秒内转发连接。如果没有请求,CoreDNS 将为该 10 秒打开 TCP 连接。对于大型集群,请确保您的 DNS 服务器知道可能有多个新的连接来保存打开,因为您可以在每个节点上启动连接。相应地设置 DNS 层次结构以避免性能问题。 - 4

- 当为转发 DNS 查询配置 TLS 时,这是用作服务器名称的一部分(SNI)的强制服务器名称来验证上游 TLS 服务器证书。

- 5

- 定义用于选择上游解析器的策略。默认值为

Random。您还可以使用RoundRobin, 和Sequential值。 - 6

- 必需。您可以使用它提供上游解析器。每个

forwardPlugin条目最多允许 15 个upstreams条目。 - 7

- 可选。您可以使用它来覆盖默认策略,并将 DNS 解析转发到默认域的指定 DNS 解析器(上游解析器)。如果没有提供任何上游解析器,DNS 名称查询将进入

/etc/resolv.conf中的服务器。 - 8

网络类型表示,该上游解析器应该独立于/etc/resolv.conf中列出的上游解析器单独处理转发请求。在使用 TLS 时,只允许网络类型,且您必须提供 IP 地址。- 9

address字段必须是有效的 IPv4 或 IPv6 地址。- 10

- 您可以选择提供端口。

port必须是1到65535之间的值。如果您没有为上游指定端口,则会尝试默认端口 853。

注意如果

servers未定义或无效,则配置映射只包括默认服务器。

验证

查看配置映射:

oc get configmap/dns-default -n openshift-dns -o yaml

$ oc get configmap/dns-default -n openshift-dns -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 基于以上 DNS 示例的 DNS ConfigMap 示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 对

forwardPlugin的更改会触发 CoreDNS 守护进程集的滚动更新。

6.6. DNS Operator 状态

您可以使用 oc describe 命令来检查状态并查看 DNS Operator 的详情。

流程

查看 DNS Operator 的状态:

oc describe clusteroperators/dns

$ oc describe clusteroperators/dns6.7. DNS Operator 日志

您可以使用 oc logs 命令来查看 DNS Operator 日志。

流程

查看 DNS Operator 的日志:

oc logs -n openshift-dns-operator deployment/dns-operator -c dns-operator

$ oc logs -n openshift-dns-operator deployment/dns-operator -c dns-operator6.8. 设置 CoreDNS 日志级别

您可以配置 CoreDNS 日志级别来确定日志记录错误信息中的详情量。CoreDNS 日志级别的有效值为 Normal、Debug 和 Trace。默认 logLevel 为 Normal。

错误插件会始终被启用。以下 logLevel 设置会报告不同的错误响应:

-

logLevel:Normal启用 "errors" 类:log . { class error }. -

loglevel:Debug启用 "denial" 类:log . { class denial error }。 -

logLevel:Trace启用 "all" 类:log . { class all }.

流程

要将

logLevel设置为Debug,输入以下命令:oc patch dnses.operator.openshift.io/default -p '{"spec":{"logLevel":"Debug"}}' --type=merge$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"logLevel":"Debug"}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要将

logLevel设置为Trace,输入以下命令:oc patch dnses.operator.openshift.io/default -p '{"spec":{"logLevel":"Trace"}}' --type=merge$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"logLevel":"Trace"}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

要确保设置了所需的日志级别,请检查配置映射:

oc get configmap/dns-default -n openshift-dns -o yaml

$ oc get configmap/dns-default -n openshift-dns -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.9. 查看 CoreDNS 日志

您可以使用 oc logs 命令查看 CoreDNS 日志。

流程

输入以下命令来查看特定 CoreDNS pod 的日志:

oc -n openshift-dns logs -c dns <core_dns_pod_name>

$ oc -n openshift-dns logs -c dns <core_dns_pod_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令遵循所有 CoreDNS pod 的日志:

oc -n openshift-dns logs -c dns -l dns.operator.openshift.io/daemonset-dns=default -f --max-log-requests=<number>

$ oc -n openshift-dns logs -c dns -l dns.operator.openshift.io/daemonset-dns=default -f --max-log-requests=<number>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 指定要流传输日志的 DNS pod 数量。最大值为 6。

6.10. 设置 CoreDNS Operator 的日志级别

集群管理员可以配置 Operator 日志级别来更快地跟踪 OpenShift DNS 问题。operatorLogLevel 的有效值为 Normal、Debug 和 Trace。Trace 具有更详细的信息。默认 operatorlogLevel 为 Normal。问题有七个日志记录级别: Trace、debug、info、warning、Error、Fatal 和 Panic。设置了日志级别后,具有该严重性级别或以上级别的所有内容都会记录为日志条目。

-

operatorLogLevel: "Normal"设置logrus.SetLogLevel("Info")。 -

operatorLogLevel: "Debug"设置logrus.SetLogLevel("Debug")。 -

operatorLogLevel: "Trace"设置logrus.SetLogLevel("Trace")。

流程

要将

operatorLogLevel设置为Debug,请输入以下命令:oc patch dnses.operator.openshift.io/default -p '{"spec":{"operatorLogLevel":"Debug"}}' --type=merge$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"operatorLogLevel":"Debug"}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要将

operatorLogLevel设置为Trace,请输入以下命令:oc patch dnses.operator.openshift.io/default -p '{"spec":{"operatorLogLevel":"Trace"}}' --type=merge$ oc patch dnses.operator.openshift.io/default -p '{"spec":{"operatorLogLevel":"Trace"}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.11. 调整 CoreDNS 缓存

您可以配置成功或失败缓存的最长持续时间(分别也称为正缓存或负缓存),由 CoreDNS 执行。调整 DNS 查询响应缓存持续时间可减少任何上游 DNS 解析器的负载。

流程

运行以下命令来编辑名为

default的 DNS Operator 对象:oc edit dns.operator.openshift.io/default

$ oc edit dns.operator.openshift.io/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 修改生存时间 (TTL) 缓存值:

配置 DNS 缓存

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 警告将 TTL 字段设为低值可能会导致集群、任何上游解析器或两者中负载的增加。

第 7 章 OpenShift Container Platform 中的 Ingress Operator

7.1. OpenShift Container Platform Ingress Operator

在创建 OpenShift Container Platform 集群时,在集群中运行的 Pod 和服务会各自分配自己的 IP 地址。IP 地址可供附近运行的其他容器集和服务访问,但外部客户端无法访问这些 IP 地址。Ingress Operator 实现 IngressController API,是负责启用对 OpenShift Container Platform 集群服务的外部访问的组件。

Ingress Operator 通过部署和管理一个或多个基于 HAProxy 的 Ingress Controller 来处理路由,使外部客户端可以访问您的服务。您可以通过指定 OpenShift Container Platform Route 和 Kubernetes Ingress 资源,来使用 Ingress Operator 路由流量。Ingress Controller 中的配置(如定义 endpointPublishingStrategy 类型和内部负载平衡)提供了发布 Ingress Controller 端点的方法。

7.2. Ingress 配置资产

安装程序在 config.openshift.io API 组中生成带有 Ingress 资源的资产,cluster-ingress-02-config.yml。

Ingress 资源的 YAML 定义

安装程序将这个资产保存在 manifests/ 目录下的 cluster-ingress-02-config.yml 文件中。此 Ingress 资源定义 Ingress 的集群范围配置。此 Ingress 配置的用法如下所示:

- Ingress Operator 使用集群 Ingress 配置中的域,作为默认 Ingress Controller 的域。

-

OpenShift API Server Operator 使用集群 Ingress 配置中的域。在为未指定显式主机的

Route资源生成默认主机时,还会使用此域。

7.3. Ingress Controller 配置参数

IngressController 自定义资源(CR) 包含可选配置参数,您可以配置它们来满足您的机构的特定需求。

| 参数 | 描述 |

|---|---|

|

|

如果为空,默认值为 |

|

|

|

|

|

对于云环境,使用

在 Google Cloud、AWS 和 Azure 上,您可以配置以下

如果没有设置,则默认值基于

对于大多数平台,可以更新

对于非云环境,如裸机平台,请使用

如果您没有在这些字段中设置值,则默认值基于

如果需要在集群部署后更新

|

|

|

secret 必须包含以下密钥和数据:*

如果没有设置,则自动生成和使用通配符证书。该证书对 Ingress Controller 的 内部证书(无论是生成的证书还是用户指定的证书)自动与 OpenShift Container Platform 内置的 OAuth 服务器集成。 |

|

|

|

|

|

|

|

|

如果没有设置,则使用默认值。 注意

|

|

|

如果没有设置,则默认值基于

当使用

Ingress Controller 的最低 TLS 版本是 注意

加密器和配置的安全配置集的最小 TLS 版本反映在 重要

Ingress Operator 将 |

|

|

|

|

|

|

|

|

|

|

|

通过为

默认情况下,策略设置为

通过设置 这些调整仅应用于明文、边缘终止和重新加密路由,且仅在使用 HTTP/1 时有效。

对于请求标头,这些调整仅适用于具有 |

|

|

|

|

|

|

|

|

对于您要捕获的任何 Cookie,以下参数必须位于

例如: httpCaptureCookies:

- matchType: Exact

maxLength: 128

name: MYCOOKIE

|

|

|

|

|

|

|

|

|

|

|

|

这些连接来自负载均衡器健康探测或 Web 浏览器规范连接(预连接),可以安全地忽略。但是,这些请求可能是由网络错误造成的,因此将此字段设置为 |

7.3.1. Ingress Controller TLS 安全配置集

TLS 安全配置文件为服务器提供了一种方式,以规范连接的客户端在连接服务器时可以使用哪些密码。

7.3.1.1. 了解 TLS 安全配置集

您可以使用 TLS(Transport Layer Security)安全配置集来定义各种 OpenShift Container Platform 组件需要哪些 TLS 密码。OpenShift Container Platform TLS 安全配置集基于 Mozilla 推荐的配置。

您可以为每个组件指定以下 TLS 安全配置集之一:

| profile | 描述 |

|---|---|

|

| 此配置集用于旧的客户端或库。该配置集基于旧的向后兼容性建议配置。

注意 对于 Ingress Controller,最小 TLS 版本从 1.0 转换为 1.1。 |

|

| 此配置集是 Ingress Controller、kubelet 和 control plane 的默认 TLS 安全配置集。该配置集基于 Intermediate 兼容性推荐的配置。

注意 这个配置集是大多数客户端的建议配置。 |

|

| 此配置集主要用于不需要向后兼容的现代客户端。这个配置集基于 Modern 兼容性推荐的配置。

|

|

| 此配置集允许您定义要使用的 TLS 版本和密码。 警告

使用 |

当使用预定义的配置集类型时,有效的配置集配置可能会在发行版本之间有所改变。例如,使用在版本 X.Y.Z 中部署的 Intermediate 配置集指定了一个规格,升级到版本 X.Y.Z+1 可能会导致应用新的配置集配置,从而导致推出部署。

7.3.1.2. 为 Ingress Controller 配置 TLS 安全配置集

要为 Ingress Controller 配置 TLS 安全配置集,请编辑 IngressController 自定义资源(CR)来指定预定义或自定义 TLS 安全配置集。如果没有配置 TLS 安全配置集,则默认值基于为 API 服务器设置的 TLS 安全配置集。

配置 Old TLS 安全配置集的 IngressController CR 示例

TLS 安全配置集定义 Ingress Controller 的 TLS 连接的最低 TLS 版本和 TLS 密码。

您可以在 Status.Tls Profile 和 Spec.Tls Security Profile 下看到 IngressController 自定义资源(CR)中配置的 TLS 安全配置集的密码和最小 TLS 版本。对于 Custom TLS 安全配置集,这两个参数下列出了特定的密码和最低 TLS 版本。

HAProxy Ingress Controller 镜像支持 TLS 1.3 和 Modern 配置集。

Ingress Operator 还会将 Old 或 Custom 配置集的 TLS 1.0 转换为 1.1。

先决条件

-

您可以使用具有

cluster-admin角色的用户访问集群。

流程

编辑

openshift-ingress-operator项目中的IngressControllerCR,以配置 TLS 安全配置集:oc edit IngressController default -n openshift-ingress-operator

$ oc edit IngressController default -n openshift-ingress-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 添加

spec.tlsSecurityProfile字段:Custom配置集的IngressControllerCR 示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存文件以使改变生效。

验证

验证

IngressControllerCR 中是否设置了配置集:oc describe IngressController default -n openshift-ingress-operator

$ oc describe IngressController default -n openshift-ingress-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.3.1.3. 配置 mutual TLS 身份验证

您可以通过设置 spec.clientTLS 值,将 Ingress Controller 配置为启用 mutual TLS (mTLS) 身份验证。clientTLS 值将 Ingress Controller 配置为验证客户端证书。此配置包括设置 clientCA 值,这是对配置映射的引用。配置映射包含 PEM 编码的 CA 证书捆绑包,用于验证客户端的证书。另外,您还可以配置证书主题过滤器列表。

如果 clientCA 值指定了 X509v3 证书撤销列表 (CRL) 分发点,Ingress Operator 会下载并管理基于每个提供的证书中指定的 HTTP URI X509v3 CRL 分发点的 CRL 配置映射。Ingress Controller 在 mTLS/TLS 协商过程中使用此配置映射。不提供有效证书的请求将被拒绝。

先决条件

-

您可以使用具有

cluster-admin角色的用户访问集群。 - 您有一个 PEM 编码的 CA 证书捆绑包。

如果您的 CA 捆绑包引用 CRL 发布点,还必须将最终用户或叶证书包含在客户端 CA 捆绑包中。此证书必须在

CRL 分发点下包含 HTTP URI,如 RFC 5280 所述。例如:Issuer: C=US, O=Example Inc, CN=Example Global G2 TLS RSA SHA256 2020 CA1 Subject: SOME SIGNED CERT X509v3 CRL Distribution Points: Full Name: URI:http://crl.example.com/example.crlIssuer: C=US, O=Example Inc, CN=Example Global G2 TLS RSA SHA256 2020 CA1 Subject: SOME SIGNED CERT X509v3 CRL Distribution Points: Full Name: URI:http://crl.example.com/example.crlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

流程

在

openshift-config命名空间中,从 CA 捆绑包创建配置映射:oc create configmap \ router-ca-certs-default \ --from-file=ca-bundle.pem=client-ca.crt \ -n openshift-config

$ oc create configmap \ router-ca-certs-default \ --from-file=ca-bundle.pem=client-ca.crt \1 -n openshift-configCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 配置映射数据键必须是

ca-bundle.pem,数据值必须是 PEM 格式的 CA 证书。

编辑

openshift-ingress-operator项目中的IngressController资源:oc edit IngressController default -n openshift-ingress-operator

$ oc edit IngressController default -n openshift-ingress-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow 添加

spec.clientTLS字段和子字段来配置 mutual TLS:指定过滤模式的

clientTLS配置集的IngressControllerCR 示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

可选,输入以下命令获取

allowedSubjectPatterns的可辨识名称 (DN)。

openssl x509 -in custom-cert.pem -noout -subject subject= /CN=example.com/ST=NC/C=US/O=Security/OU=OpenShift

$ openssl x509 -in custom-cert.pem -noout -subject

subject= /CN=example.com/ST=NC/C=US/O=Security/OU=OpenShift7.4. 查看默认的 Ingress Controller

Ingress Operator 是 OpenShift Container Platform 的一个核心功能,开箱即用。

每个 OpenShift Container Platform 新安装都有一个名为 default 的 ingresscontroller。它可以通过额外的 Ingress Controller 来补充。如果删除了默认的 ingresscontroller,Ingress Operator 会在一分钟内自动重新创建。

流程

查看默认的 Ingress Controller:

oc describe --namespace=openshift-ingress-operator ingresscontroller/default

$ oc describe --namespace=openshift-ingress-operator ingresscontroller/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.5. 查看 Ingress Operator 状态

您可以查看并检查 Ingress Operator 的状态。

流程

查看您的 Ingress Operator 状态:

oc describe clusteroperators/ingress

$ oc describe clusteroperators/ingressCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.6. 查看 Ingress Controller 日志

您可以查看 Ingress Controller 日志。

流程

查看 Ingress Controller 日志:

oc logs --namespace=openshift-ingress-operator deployments/ingress-operator -c <container_name>

$ oc logs --namespace=openshift-ingress-operator deployments/ingress-operator -c <container_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.7. 查看 Ingress Controller 状态

您可以查看特定 Ingress Controller 的状态。

流程

查看 Ingress Controller 的状态:

oc describe --namespace=openshift-ingress-operator ingresscontroller/<name>

$ oc describe --namespace=openshift-ingress-operator ingresscontroller/<name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8. 配置 Ingress Controller

7.8.1. 设置自定义默认证书

作为管理员,您可以通过创建 Secret 资源并编辑 IngressController 自定义资源 (CR),将 Ingress Controller 配置为使用自定义证书。

先决条件

- 您必须在 PEM 编码文件中有一个证书/密钥对,其中该证书由可信证书认证机构签名,或者由您在一个自定义 PKI 中配置的私有可信证书认证机构签名。

您的证书满足以下要求:

- 该证书对入口域有效。

-

证书使用

subjectAltName扩展来指定通配符域,如*.apps.ocp4.example.com。

您必须有一个

IngressControllerCR。您可以使用默认值:oc --namespace openshift-ingress-operator get ingresscontrollers

$ oc --namespace openshift-ingress-operator get ingresscontrollersCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME AGE default 10m

NAME AGE default 10mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

如果您有中间证书,则必须将其包含在包含自定义默认证书的 secret 的 tls.crt 文件中。指定证书时指定的顺序是相关的; 在任意服务器证书后列出您的中间证书。

流程

以下步骤假定自定义证书和密钥对位于当前工作目录下的 tls.crt 和 tls.key 文件中。替换 tls.crt 和 tls.key 的实际路径名。在创建 Secret 资源并在 IngressController CR 中引用它时,您也可以将 custom-certs-default 替换成另一名称。

此操作会导致使用滚动部署策略重新部署 Ingress Controller。

使用

tls.crt和tls.key文件,创建在openshift-ingress命名空间中包含自定义证书的 Secret 资源。oc --namespace openshift-ingress create secret tls custom-certs-default --cert=tls.crt --key=tls.key

$ oc --namespace openshift-ingress create secret tls custom-certs-default --cert=tls.crt --key=tls.keyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 更新 IngressController CR,以引用新的证书 Secret:

oc patch --type=merge --namespace openshift-ingress-operator ingresscontrollers/default \ --patch '{"spec":{"defaultCertificate":{"name":"custom-certs-default"}}}'$ oc patch --type=merge --namespace openshift-ingress-operator ingresscontrollers/default \ --patch '{"spec":{"defaultCertificate":{"name":"custom-certs-default"}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 验证更新是否已生效:

echo Q |\ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null |\ openssl x509 -noout -subject -issuer -enddate

$ echo Q |\ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null |\ openssl x509 -noout -subject -issuer -enddateCopy to Clipboard Copied! Toggle word wrap Toggle overflow 其中:

<domain>- 指定集群的基域名。

输出示例

subject=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = *.apps.example.com issuer=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = example.com notAfter=May 10 08:32:45 2022 GM

subject=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = *.apps.example.com issuer=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = example.com notAfter=May 10 08:32:45 2022 GMCopy to Clipboard Copied! Toggle word wrap Toggle overflow 提示您还可以应用以下 YAML 来设置自定义默认证书:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 证书 Secret 名称应该与用来更新 CR 的值匹配。

修改了 IngressController CR 后,Ingress Operator 将更新 Ingress Controller 的部署以使用自定义证书。

7.8.2. 删除自定义默认证书

作为管理员,您可以删除配置了 Ingress Controller 的自定义证书。

先决条件

-

您可以使用具有

cluster-admin角色的用户访问集群。 -

已安装 OpenShift CLI(

oc)。 - 您之前为 Ingress Controller 配置了自定义默认证书。

流程

要删除自定义证书并恢复 OpenShift Container Platform 附带的证书,请输入以下命令:

oc patch -n openshift-ingress-operator ingresscontrollers/default \ --type json -p $'- op: remove\n path: /spec/defaultCertificate'

$ oc patch -n openshift-ingress-operator ingresscontrollers/default \ --type json -p $'- op: remove\n path: /spec/defaultCertificate'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 集群协调新证书配置时可能会有延迟。

验证

要确认原始集群证书已被恢复,请输入以下命令:

echo Q | \ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null | \ openssl x509 -noout -subject -issuer -enddate

$ echo Q | \ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null | \ openssl x509 -noout -subject -issuer -enddateCopy to Clipboard Copied! Toggle word wrap Toggle overflow 其中:

<domain>- 指定集群的基域名。

输出示例

subject=CN = *.apps.<domain> issuer=CN = ingress-operator@1620633373 notAfter=May 10 10:44:36 2023 GMT

subject=CN = *.apps.<domain> issuer=CN = ingress-operator@1620633373 notAfter=May 10 10:44:36 2023 GMTCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8.3. 自动扩展 Ingress Controller

您可以自动缩放 Ingress Controller 以动态满足路由性能或可用性要求,如提高吞吐量的要求。

以下流程提供了一个扩展默认 Ingress Controller 的示例。

先决条件

-

已安装 OpenShift CLI (

oc)。 -

您可以使用具有

cluster-admin角色的用户访问 OpenShift Container Platform 集群。 已安装自定义 Metrics Autoscaler Operator 和关联的 KEDA Controller。

-

您可以在 Web 控制台中使用 OperatorHub 安装 Operator。安装 Operator 后,您可以创建

KedaController实例。

-

您可以在 Web 控制台中使用 OperatorHub 安装 Operator。安装 Operator 后,您可以创建

流程

运行以下命令,创建一个服务帐户来与 Thanos 进行身份验证:

oc create -n openshift-ingress-operator serviceaccount thanos && oc describe -n openshift-ingress-operator serviceaccount thanos

$ oc create -n openshift-ingress-operator serviceaccount thanos && oc describe -n openshift-ingress-operator serviceaccount thanosCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用以下命令手动创建服务帐户令牌:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用服务帐户的令牌,在

openshift-ingress-operator命名空间中定义一个TriggerAuthentication对象。运行以下命令,定义包含 secret 的

secret变量:secret=$(oc get secret -n openshift-ingress-operator | grep thanos-token | head -n 1 | awk '{ print $1 }')$ secret=$(oc get secret -n openshift-ingress-operator | grep thanos-token | head -n 1 | awk '{ print $1 }')Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建

TriggerAuthentication对象,并将secret变量的值传递给TOKEN参数:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

创建并应用角色以从 Thanos 读取指标:

创建一个新角色

thanos-metrics-reader.yaml,从 pod 和节点读取指标:thanos-metrics-reader.yaml

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来应用新角色:

oc apply -f thanos-metrics-reader.yaml

$ oc apply -f thanos-metrics-reader.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

输入以下命令在服务帐户中添加新角色:

oc adm policy -n openshift-ingress-operator add-role-to-user thanos-metrics-reader -z thanos --role-namespace=openshift-ingress-operator

$ oc adm policy -n openshift-ingress-operator add-role-to-user thanos-metrics-reader -z thanos --role-namespace=openshift-ingress-operatorCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc adm policy -n openshift-ingress-operator add-cluster-role-to-user cluster-monitoring-view -z thanos

$ oc adm policy -n openshift-ingress-operator add-cluster-role-to-user cluster-monitoring-view -z thanosCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意只有在使用跨命名空间查询时,才需要参数

add-cluster-role-to-user。以下步骤使用kube-metrics命名空间中的查询,该命名空间需要此参数。创建一个新的

ScaledObjectYAML 文件ingress-autoscaler.yaml,该文件以默认 Ingress Controller 部署为目标:ScaledObject定义示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要如果使用跨命名空间查询,您必须在

serverAddress字段中目标端口 9091 而不是端口 9092。您还必须有升级的特权,才能从此端口读取指标。运行以下命令来应用自定义资源定义:

oc apply -f ingress-autoscaler.yaml

$ oc apply -f ingress-autoscaler.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

运行以下命令,验证默认 Ingress Controller 是否已扩展以匹配

kube-state-metrics查询返回的值:使用

grep命令搜索 Ingress Controller YAML 文件以查找副本:oc get -n openshift-ingress-operator ingresscontroller/default -o yaml | grep replicas:

$ oc get -n openshift-ingress-operator ingresscontroller/default -o yaml | grep replicas:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

replicas: 3

replicas: 3Copy to Clipboard Copied! Toggle word wrap Toggle overflow 获取

openshift-ingress项目中的 pod:oc get pods -n openshift-ingress

$ oc get pods -n openshift-ingressCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY STATUS RESTARTS AGE router-default-7b5df44ff-l9pmm 2/2 Running 0 17h router-default-7b5df44ff-s5sl5 2/2 Running 0 3d22h router-default-7b5df44ff-wwsth 2/2 Running 0 66s

NAME READY STATUS RESTARTS AGE router-default-7b5df44ff-l9pmm 2/2 Running 0 17h router-default-7b5df44ff-s5sl5 2/2 Running 0 3d22h router-default-7b5df44ff-wwsth 2/2 Running 0 66sCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8.4. 扩展 Ingress Controller

手动扩展 Ingress Controller 以满足路由性能或可用性要求,如提高吞吐量的要求。oc 命令用于扩展 IngressController 资源。以下流程提供了扩展默认 IngressController 的示例。

扩展不是立刻就可以完成的操作,因为它需要时间来创建所需的副本数。

流程

查看默认

IngressController的当前可用副本数:oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'$ oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

2

2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

oc patch命令,将默认IngressController扩展至所需的副本数。以下示例将默认IngressController扩展至 3 个副本:oc patch -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"replicas": 3}}' --type=merge$ oc patch -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"replicas": 3}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

ingresscontroller.operator.openshift.io/default patched

ingresscontroller.operator.openshift.io/default patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 验证默认

IngressController是否已扩展至您指定的副本数:oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'$ oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

3

3Copy to Clipboard Copied! Toggle word wrap Toggle overflow 提示您还可以应用以下 YAML 将 Ingress Controller 扩展为三个副本:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 如果需要不同数量的副本,请更改

replicas值。

7.8.5. 配置 Ingress 访问日志

您可以配置 Ingress Controller 以启用访问日志。如果您的集群没有接收许多流量,那么您可以将日志记录到 sidecar。如果您的集群接收大量流量,为了避免超出日志记录堆栈的容量,或与 OpenShift Container Platform 之外的日志记录基础架构集成,您可以将日志转发到自定义 syslog 端点。您还可以指定访问日志的格式。

当不存在 Syslog 日志记录基础架构时,容器日志记录可用于在低流量集群中启用访问日志,或者在诊断 Ingress Controller 时进行简短使用。

对于访问日志可能会超过 OpenShift Logging 堆栈容量的高流量集群,或需要任何日志记录解决方案与现有 Syslog 日志记录基础架构集成的环境,则需要 syslog。Syslog 用例可能会相互重叠。

先决条件

-

以具有

cluster-admin特权的用户身份登录。

流程

配置 Ingress 访问日志到 sidecar。

要配置 Ingress 访问日志记录,您必须使用

spec.logging.access.destination指定一个目的地。要将日志记录指定到 sidecar 容器,您必须指定Containerspec.logging.access.destination.type。以下示例是将日志记录到Container目的地的 Ingress Controller 定义:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 当将 Ingress Controller 配置为日志记录到 sidecar 时,Operator 会在 Ingress Controller Pod 中创建一个名为

logs的容器:oc -n openshift-ingress logs deployment.apps/router-default -c logs

$ oc -n openshift-ingress logs deployment.apps/router-default -c logsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

2020-05-11T19:11:50.135710+00:00 router-default-57dfc6cd95-bpmk6 router-default-57dfc6cd95-bpmk6 haproxy[108]: 174.19.21.82:39654 [11/May/2020:19:11:50.133] public be_http:hello-openshift:hello-openshift/pod:hello-openshift:hello-openshift:10.128.2.12:8080 0/0/1/0/1 200 142 - - --NI 1/1/0/0/0 0/0 "GET / HTTP/1.1"

2020-05-11T19:11:50.135710+00:00 router-default-57dfc6cd95-bpmk6 router-default-57dfc6cd95-bpmk6 haproxy[108]: 174.19.21.82:39654 [11/May/2020:19:11:50.133] public be_http:hello-openshift:hello-openshift/pod:hello-openshift:hello-openshift:10.128.2.12:8080 0/0/1/0/1 200 142 - - --NI 1/1/0/0/0 0/0 "GET / HTTP/1.1"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

配置 Ingress 访问日志记录到 Syslog 端点。

要配置 Ingress 访问日志记录,您必须使用

spec.logging.access.destination指定一个目的地。要将日志记录指定到 Syslog 端点目的地,您必须为spec.logging.access.destination.type指定Syslog。如果目的地类型是Syslog,则必须使用spec.logging.access.destination.syslog.endpoint指定一个目的地端点,并可使用spec.logging.access.destination.syslog.facility指定一个工具。以下示例是将日志记录到Syslog目的地的 Ingress Controller 定义:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意Syslog目的地端口必须是 UDP。

使用特定的日志格式配置 Ingress 访问日志。

您可以指定

spec.logging.access.httpLogFormat来自定义日志格式。以下示例是一个 Ingress Controller 定义,它将日志记录到 IP 地址为 1.2.3.4、端口为 10514 的syslog端点:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

禁用 Ingress 访问日志。

要禁用 Ingress 访问日志,请保留

spec.logging或spec.logging.access为空:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8.6. 设置 Ingress Controller 线程数

集群管理员可设置线程数,以增加集群可以处理的入站的连接量。您可以修补现有的 Ingress Controller 来增加线程量。

先决条件

- 以下假设您已创建了 Ingress Controller。

流程

更新 Ingress Controller 以增加线程数量:

oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"threadCount": 8}}}'$ oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"threadCount": 8}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意如果您的节点有能力运行大量资源,您可以使用与预期节点容量匹配的标签配置

spec.nodePlacement.nodeSelector,并将spec.tuningOptions.threadCount配置为一个适当的高值。

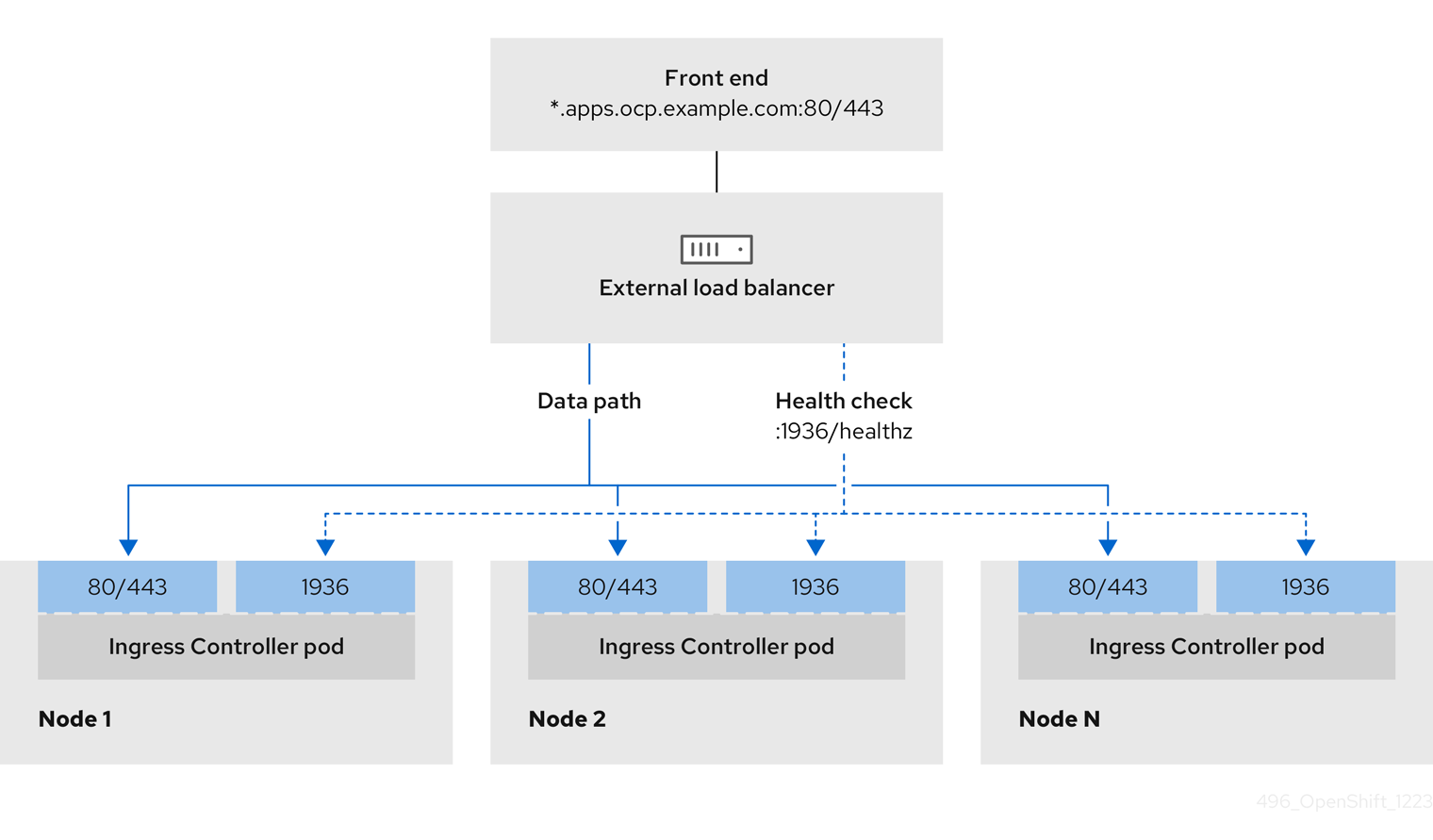

7.8.7. 配置 Ingress Controller 以使用内部负载均衡器

当在云平台上创建 Ingress Controller 时,Ingress Controller 默认由一个公共云负载均衡器发布。作为管理员,您可以创建一个使用内部云负载均衡器的 Ingress Controller。

如果云供应商是 Microsoft Azure,则必须至少有一个指向节点的公共负载均衡器。如果不这样做,所有节点都将丢失到互联网的出站连接。

如果要更改 IngressController 的 scope,您可以在创建自定义资源(CR)后更改 .spec.endpointPublishingStrategy.loadBalancer.scope 参数。

图 7.1. LoadBalancer 图表

上图显示了与 OpenShift Container Platform Ingress LoadBalancerService 端点发布策略相关的以下概念:

- 您可以使用 OpenShift Ingress Controller Load Balancer 在外部使用云供应商负载均衡器或内部加载负载。

- 您可以使用负载均衡器的单个 IP 地址以及更熟悉的端口,如 8080 和 4200,如图形中所述的集群所示。

- 来自外部负载均衡器的流量定向到 pod,并由负载均衡器管理,如下节点的实例中所述。有关实现详情请查看 Kubernetes 服务文档 。

先决条件

-

安装 OpenShift CLI(

oc)。 -

以具有

cluster-admin特权的用户身份登录。

流程

在名为

<name>-ingress-controller.yaml的文件中创建IngressController自定义资源 (CR) ,如下例所示:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,创建上一步中定义的 Ingress Controller:

oc create -f <name>-ingress-controller.yaml

$ oc create -f <name>-ingress-controller.yaml1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

<name>替换为IngressController对象的名称。

可选:通过运行以下命令确认创建了 Ingress Controller:

oc --all-namespaces=true get ingresscontrollers

$ oc --all-namespaces=true get ingresscontrollersCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8.8. 在 Google Cloud 上为 Ingress Controller 配置全局访问

在带有内部负载均衡器的 Google Cloud 上创建的 Ingress Controller 会为该服务生成内部 IP 地址。集群管理员可指定全局访问选项,该选项可启用同一 VPC 网络内任何区域中的客户端作为负载均衡器,以访问集群上运行的工作负载。

如需更多信息,请参阅 Google Cloud 文档以了解 全局访问。

先决条件

- 您已在 Google Cloud 基础架构上部署了 OpenShift Container Platform 集群。

- 已将 Ingress Controller 配置为使用内部负载均衡器。

-

已安装 OpenShift CLI(

oc)。

流程

配置 Ingress Controller 资源,以允许全局访问。

注意您还可以创建 Ingress Controller 并指定全局访问选项。

配置 Ingress Controller 资源:

oc -n openshift-ingress-operator edit ingresscontroller/default

$ oc -n openshift-ingress-operator edit ingresscontroller/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 编辑 YAML 文件:

clientAccess配置为Global的示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

gcp.clientAccess设置为Global。

- 保存文件以使改变生效。

运行以下命令,以验证该服务是否允许全局访问:

oc -n openshift-ingress edit svc/router-default -o yaml

$ oc -n openshift-ingress edit svc/router-default -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出显示,使用注解

networking.gke.io/internal-load-balancer-allow-global-access的 Google Cloud 启用了全局访问。

7.8.9. 设置 Ingress Controller 健康检查间隔

集群管理员可以设置健康检查间隔,以定义路由器在两个连续健康检查之间等待的时间。这个值会作为所有路由的默认值进行全局应用。默认值为 5 秒。

先决条件

- 以下假设您已创建了 Ingress Controller。

流程

更新 Ingress Controller,以更改后端健康检查之间的间隔:

oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"healthCheckInterval": "8s"}}}'$ oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"healthCheckInterval": "8s"}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注意要覆盖单个路由的

healthCheckInterval,请使用路由注解router.openshift.io/haproxy.health.check.interval

7.8.10. 将集群的默认 Ingress Controller 配置为内部

您可以通过删除并重新它来将默认 Ingress Controller 配置为内部。

如果云供应商是 Microsoft Azure,则必须至少有一个指向节点的公共负载均衡器。如果不这样做,所有节点都将丢失到互联网的出站连接。

如果要更改 IngressController 的 scope,您可以在创建自定义资源(CR)后更改 .spec.endpointPublishingStrategy.loadBalancer.scope 参数。

先决条件

-

安装 OpenShift CLI(

oc)。 -

以具有

cluster-admin特权的用户身份登录。

流程

通过删除并重新创建集群,将

默认Ingress Controller 配置为内部。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

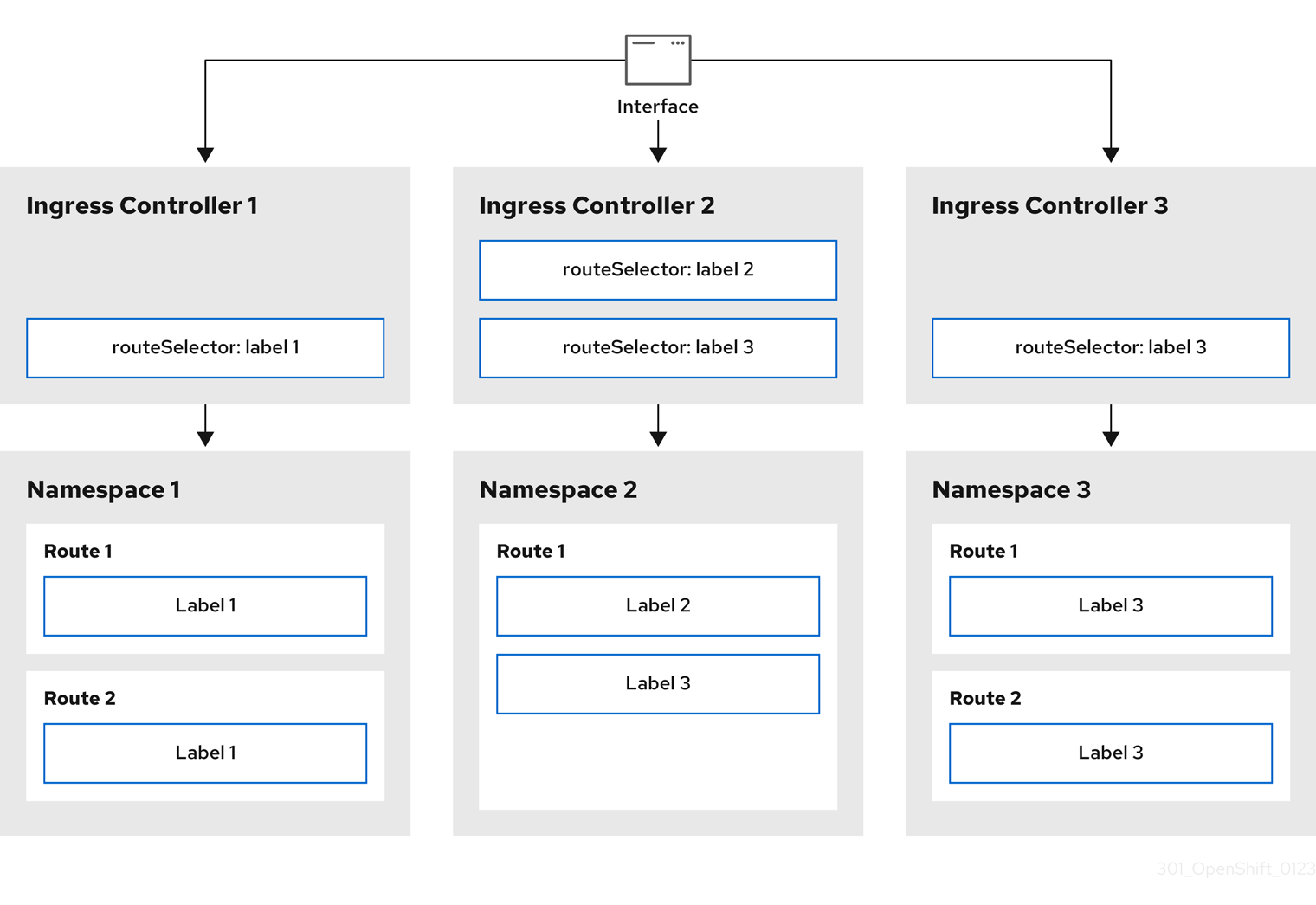

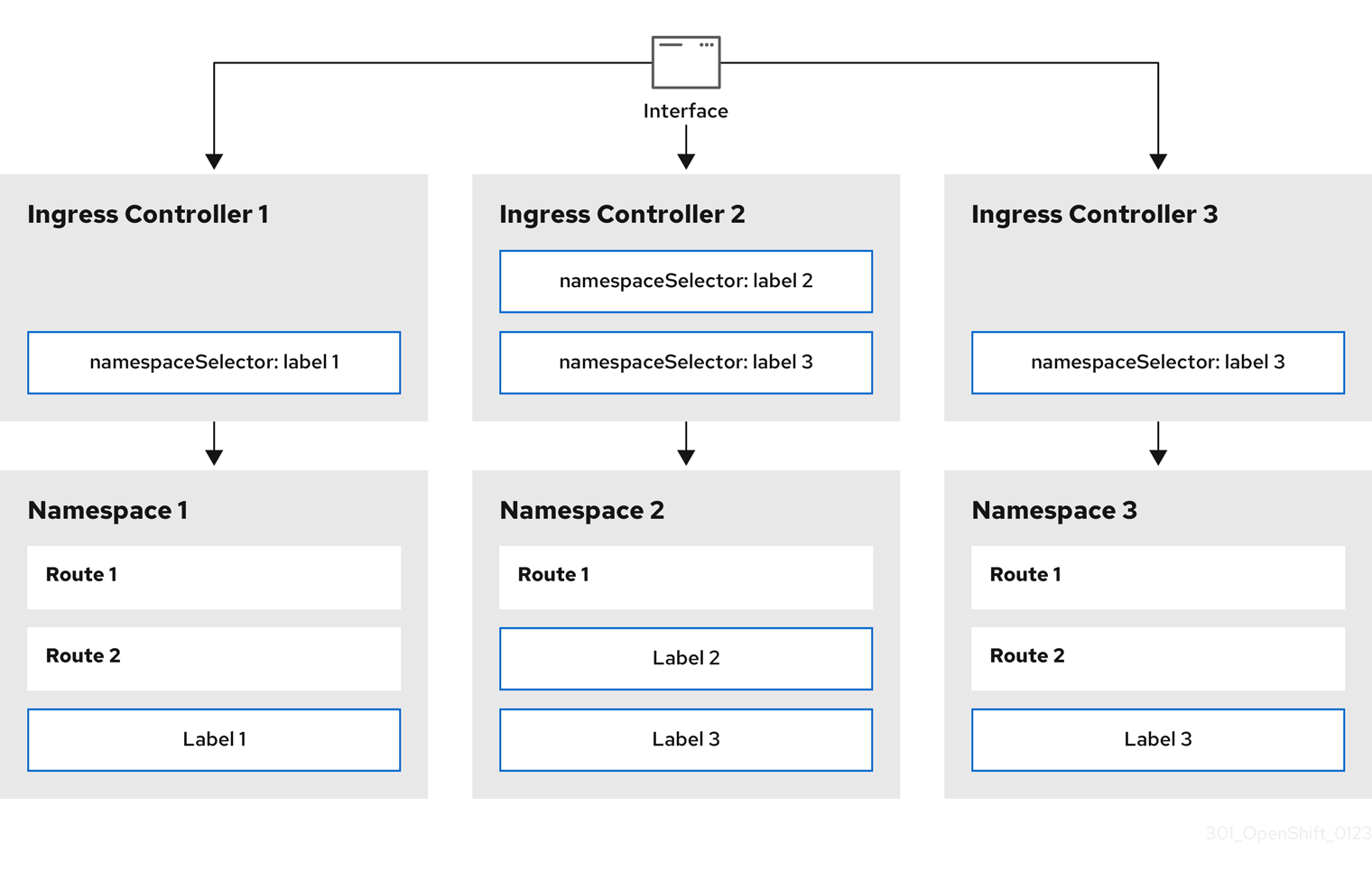

7.8.11. 配置路由准入策略

管理员和应用程序开发人员可在多个命名空间中运行具有相同域名的应用程序。这是针对多个团队开发的、在同一个主机名上公开的微服务的机构。

只有在命名空间间有信任的集群才会启用跨命名空间之间的声明,否则恶意用户可能会接管主机名。因此,默认的准入策略不允许在命名空间间声明主机名。

先决条件

- 必须具有集群管理员权限。

流程

使用以下命令编辑

ingresscontroller资源变量的.spec.routeAdmission 字段:oc -n openshift-ingress-operator patch ingresscontroller/default --patch '{"spec":{"routeAdmission":{"namespaceOwnership":"InterNamespaceAllowed"}}}' --type=merge$ oc -n openshift-ingress-operator patch ingresscontroller/default --patch '{"spec":{"routeAdmission":{"namespaceOwnership":"InterNamespaceAllowed"}}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress 控制器配置参数

spec: routeAdmission: namespaceOwnership: InterNamespaceAllowed ...spec: routeAdmission: namespaceOwnership: InterNamespaceAllowed ...Copy to Clipboard Copied! Toggle word wrap Toggle overflow 提示您还可以应用以下 YAML 来配置路由准入策略:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8.12. 使用通配符路由

HAProxy Ingress Controller 支持通配符路由。Ingress Operator 使用 wildcardPolicy 来配置 Ingress Controller 的 ROUTER_ALLOW_WILDCARD_ROUTES 环境变量。

Ingress Controller 的默认行为是接受采用 None 通配符策略的路由,该策略与现有 IngressController 资源向后兼容。

流程

配置通配符策略。

使用以下命令来编辑

IngressController资源:oc edit IngressController

$ oc edit IngressControllerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

spec下,将wildcardPolicy字段设置为 WildcardsDisallowed或WildcardsAllowed:spec: routeAdmission: wildcardPolicy: WildcardsDisallowed # or WildcardsAllowedspec: routeAdmission: wildcardPolicy: WildcardsDisallowed # or WildcardsAllowedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8.13. 使用 X-Forwarded 标头

您可以将 HAProxy Ingress Controller 配置为指定如何处理 HTTP 标头的策略,其中包括 Forwarded 和 X-Forwarded-For。Ingress Operator 使用 HTTPHeaders 字段配置 Ingress Controller 的 ROUTER_SET_FORWARDED_HEADERS 环境变量。

流程

为 Ingress Controller 配置

HTTPHeaders字段。使用以下命令来编辑

IngressController资源:oc edit IngressController

$ oc edit IngressControllerCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

spec下,将HTTPHeaders策略字段设置为Append、Replace、IfNone或Never:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

使用案例示例

作为集群管理员,您可以:

配置将

X-Forwarded-For标头注入每个请求的外部代理,然后将其转发到 Ingress Controller。要将 Ingress Controller 配置为通过未修改的标头传递,您需要指定

never策略。然后,Ingress Controller 不会设置标头,应用程序只接收外部代理提供的标头。将 Ingress Controller 配置为通过未修改的外部代理在外部集群请求上设置

X-Forwarded-For标头。要将 Ingress Controller 配置为在不通过外部代理的内部集群请求上设置

X-Forwarded-For标头,请指定if-none策略。如果 HTTP 请求已经通过外部代理设置了标头,则 Ingress Controller 会保留它。如果缺少标头,因为请求没有通过代理,Ingress Controller 会添加标头。

作为应用程序开发人员,您可以:

配置特定于应用程序的外部代理来注入

X-Forwarded-For标头。要配置 Ingress Controller,以便在不影响其他路由策略的情况下将标头传递到应用程序的路由,请在应用程序的路由上添加注解

haproxy.router.openshift.io/set-forwarded-headers: if-none或haproxy.router.openshift.io/set-forwarded-headers: never。注意您可以根据每个路由设置

haproxy.router.openshift.io/set-forwarded-headers注解,独立于 Ingress Controller 的全局设置值。

7.8.14. 启用 HTTP/2 入口连接

您可以在 HAProxy 中启用透明端到端的 HTTP/2 连接。此功能使应用程序所有者利用 HTTP/2 协议功能,包括单一连接、标头压缩、二 进制流等等。

您可以为单独的 Ingress Controller 或整个集群启用 HTTP/2 连接。

要在从客户端到 HAProxy 的连接中启用 HTTP/2,路由必须指定一个自定义证书。使用默认证书的路由无法使用 HTTP/2。这一限制是避免连接并发问题(如客户端为使用相同证书的不同路由重新使用连接)所必需的。

从 HAProxy 到应用程序 pod 的连接只能将 HTTP/2 用于 re-encrypt 路由,而不适用于 edge-terminated 或 insecure 路由。存在这个限制的原因是,在与后端协商使用 HTTP/2 时,HAProxy 要使用 ALPN(Application-Level Protocol Negotiation),它是一个 TLS 的扩展。这意味着,端到端的 HTTP/2 适用于 passthrough 和 re-encrypt 路由,而不适用于 nsecure 或 edge-terminated 路由。

使用带有重新加密路由的 WebSockets,并在 Ingress Controller 上启用 HTTP/2 需要 WebSocket 支持 HTTP/2。通过 HTTP/2 的 websocket 是 HAProxy 2.4 的 Websocket 功能,目前在 OpenShift Container Platform 中不支持它。

对于非 passthrough 路由,Ingress Controller 会独立于客户端的连接来协商它与应用程序的连接。这意味着,客户端可以连接到 Ingress Controller 并协商 HTTP/1.1,Ingress Controller 可连接到应用程序,协商 HTTP/2 并使用 HTTP/2 连接将客户端 HTTP/1.1 连接转发请求。如果客户端随后试图将其连接从 HTTP/1.1 升级到 WebSocket 协议,这会导致问题。因为 Ingress Controller 无法将 WebSocket 转发到 HTTP/2,也无法将其 HTTP/2 的连接升级到 WebSocket。因此,如果您有一个应用程序旨在接受 WebSocket 连接,则必须允许使用 HTTP/2 协议,或者其它客户端将无法升级到 WebSocket 协议。

流程

在单一 Ingress Controller 上启用 HTTP/2。

要在 Ingress Controller 上启用 HTTP/2,请输入

oc annotate命令:oc -n openshift-ingress-operator annotate ingresscontrollers/<ingresscontroller_name> ingress.operator.openshift.io/default-enable-http2=true

$ oc -n openshift-ingress-operator annotate ingresscontrollers/<ingresscontroller_name> ingress.operator.openshift.io/default-enable-http2=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 将

<ingresscontroller_name>替换为要注解的 Ingress Controller 的名称。

在整个集群中启用 HTTP/2。

要为整个集群启用 HTTP/2,请输入

oc annotate命令:oc annotate ingresses.config/cluster ingress.operator.openshift.io/default-enable-http2=true

$ oc annotate ingresses.config/cluster ingress.operator.openshift.io/default-enable-http2=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 提示您还可以应用以下 YAML 来添加注解:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8.15. 为 Ingress Controller 配置 PROXY 协议

当 Ingress Controller 使用 HostNetwork 或 NodePortService 端点发布策略类型时,集群管理员可配置 PROXY 协议。PROXY 协议使负载均衡器能够为 Ingress Controller 接收的连接保留原始客户端地址。原始客户端地址可用于记录、过滤和注入 HTTP 标头。在默认配置中,Ingress Controller 接收的连接只包含与负载均衡器关联的源地址。

云部署不支持此功能。具有这个限制的原因是,当 OpenShift Container Platform 在云平台中运行时,IngressController 指定应使用服务负载均衡器,Ingress Operator 会配置负载均衡器服务,并根据保留源地址的平台要求启用 PROXY 协议。

您必须将 OpenShift Container Platform 和外部负载均衡器配置为使用 PROXY 协议或使用 TCP。

在使用 Keepalived Ingress VIP 的非云平台上带有安装程序置备的集群的默认 Ingress Controller 不支持 PROXY 协议。

先决条件

- 已创建一个 Ingress Controller。

流程

编辑 Ingress Controller 资源:

oc -n openshift-ingress-operator edit ingresscontroller/default

$ oc -n openshift-ingress-operator edit ingresscontroller/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 设置 PROXY 配置:

如果您的 Ingress Controller 使用 hostNetwork 端点发布策略类型,将

spec.endpointPublishingStrategy.hostNetwork.protocol子字段设置为PROXY:hostNetwork配置为PROXY的示例spec: endpointPublishingStrategy: hostNetwork: protocol: PROXY type: HostNetworkspec: endpointPublishingStrategy: hostNetwork: protocol: PROXY type: HostNetworkCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果您的 Ingress Controller 使用 NodePortService 端点发布策略类型,将

spec.endpointPublishingStrategy.nodePort.protocol子字段设置为PROXY:nodePort配置为PROXY示例spec: endpointPublishingStrategy: nodePort: protocol: PROXY type: NodePortServicespec: endpointPublishingStrategy: nodePort: protocol: PROXY type: NodePortServiceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8.16. 使用 appsDomain 选项指定备选集群域

作为集群管理员,您可以通过配置 appsDomain 字段来为用户创建的路由指定默认集群域替代内容。appsDomain 字段是 OpenShift Container Platform 使用的可选域,而不是默认值,它在 domain 字段中指定。如果您指定了其它域,它会覆盖为新路由确定默认主机的目的。

例如,您可以将您公司的 DNS 域用作集群中运行的应用程序的路由和入口的默认域。

先决条件

- 已部署 OpenShift Container Platform 集群。

-

已安装

oc命令行界面。

流程

通过为用户创建的路由指定备选默认域来配置

appsDomain字段。编辑 ingress

集群资源 :oc edit ingresses.config/cluster -o yaml

$ oc edit ingresses.config/cluster -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 编辑 YAML 文件:

示例

appsDomain配置为test.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow

通过公开路由并验证路由域更改,验证现有路由是否包含

appsDomain字段中指定的域名:注意在公开路由前,等待

openshift-apiserver完成滚动更新。公开路由:

oc expose service hello-openshift route.route.openshift.io/hello-openshift exposed

$ oc expose service hello-openshift route.route.openshift.io/hello-openshift exposedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例:

oc get routes NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD hello-openshift hello_openshift-<my_project>.test.example.com hello-openshift 8080-tcp None

$ oc get routes NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD hello-openshift hello_openshift-<my_project>.test.example.com hello-openshift 8080-tcp NoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8.17. 转换 HTTP 标头的大小写

默认情况下,HAProxy HTTP 的标头名称是小写的,例如,会将 Host: xyz.com 更改为 host: xyz.com。如果旧应用程序对 HTTP 标头名称中使用大小写敏感,请使用 Ingress Controller spec.httpHeaders.headerNameCaseAdjustments API 字段进行调整来适应旧的应用程序,直到它们被改变。

OpenShift Container Platform 包括 HAProxy 2.2。如果要更新基于 web 的负载均衡器的这个版本,请确保将 spec.httpHeaders.headerNameCaseAdjustments 部分添加到集群的配置文件中。

作为集群管理员,您可以使用 oc patch 命令,或设置 Ingress Controller YAML 文件中的 HeaderNameCaseAdjustments 字段来转换 HTTP 标头的大小写。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

您可以使用具有

cluster-admin角色的用户访问集群。

流程

使用

oc patch命令大写 HTTP 标头。运行以下命令,将 HTTP 标头从

host更改为Host:oc -n openshift-ingress-operator patch ingresscontrollers/default --type=merge --patch='{"spec":{"httpHeaders":{"headerNameCaseAdjustments":["Host"]}}}'$ oc -n openshift-ingress-operator patch ingresscontrollers/default --type=merge --patch='{"spec":{"httpHeaders":{"headerNameCaseAdjustments":["Host"]}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 创建

Route资源 YAML 文件,以便注解可应用到应用程序。名为

my-application的路由示例Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 设置

haproxy.router.openshift.io/h1-adjust-case,以便 Ingress Controller 能够调整指定的host请求标头。

通过在 Ingress Controller YAML 配置文件中配置

HeaderNameCaseAdjustments字段指定调整。以下示例 Ingress Controller YAML 文件将 HTTP/1 请求的

host标头调整为Host,以适当地注解路由:Ingress Controller YAML 示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下示例路由中,使用

haproxy.router.openshift.io/h1-adjust-case注解启用对 HTTP 响应标头名称的大小写调整:路由 YAML 示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

haproxy.router.openshift.io/h1-adjust-case设置为 true。

7.8.18. 使用路由器压缩

您可以将 HAProxy Ingress Controller 配置为为特定 MIME 类型全局指定路由器压缩。您可以使用 mimeTypes 变量定义压缩应用到的 MIME 类型的格式。类型包括:application, image, message, multipart, text, video, 或带有一个 "X-" 前缀的自定义类型。要查看 MIME 类型和子类型的完整表示法,请参阅 RFC1341。

为压缩分配的内存可能会影响最大连接。此外,对大型缓冲区的压缩可能导致延迟,如非常复杂的正则表达式或较长的正则表达式列表。

并非所有 MIME 类型从压缩中受益,但 HAProxy 仍然使用资源在指示时尝试压缩。通常而言,文本格式(如 html、css 和 js)与压缩格式获益,但已经压缩的格式(如图像、音频和视频)可能会因为需要压缩操作而无法获得太多的好处。

流程

为 Ingress Controller 配置

httpCompression字段。使用以下命令来编辑

IngressController资源:oc edit -n openshift-ingress-operator ingresscontrollers/default

$ oc edit -n openshift-ingress-operator ingresscontrollers/defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在

spec下,将httpCompression策略字段设置为mimeTypes,并指定应该应用压缩的 MIME 类型列表:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8.19. 公开路由器指标

您可以在默认统计端口 1936 上以 Prometheus 格式公开 HAProxy 路由器指标。外部指标收集和聚合系统(如 Prometheus)可以访问 HAProxy 路由器指标。您可以在浏览器中以 HTML 的形式和以逗号分隔的值 (CSV) 格式查看 HAProxy 路由器指标。

先决条件

- 您已将防火墙配置为访问默认统计数据端口 1936。

流程

运行以下命令来获取路由器 pod 名称:

oc get pods -n openshift-ingress

$ oc get pods -n openshift-ingressCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY STATUS RESTARTS AGE router-default-76bfffb66c-46qwp 1/1 Running 0 11h

NAME READY STATUS RESTARTS AGE router-default-76bfffb66c-46qwp 1/1 Running 0 11hCopy to Clipboard Copied! Toggle word wrap Toggle overflow 获取路由器的用户名和密码,路由器 Pod 存储在

/var/lib/haproxy/conf/metrics-auth/statsUsername和/var/lib/haproxy/conf/metrics-auth/statsPassword文件中:运行以下命令来获取用户名:

oc rsh <router_pod_name> cat metrics-auth/statsUsername

$ oc rsh <router_pod_name> cat metrics-auth/statsUsernameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来获取密码:

oc rsh <router_pod_name> cat metrics-auth/statsPassword

$ oc rsh <router_pod_name> cat metrics-auth/statsPasswordCopy to Clipboard Copied! Toggle word wrap Toggle overflow

运行以下命令,获取路由器 IP 和指标证书:

oc describe pod <router_pod>

$ oc describe pod <router_pod>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,以 Prometheus 格式获取原始统计信息:

curl -u <user>:<password> http://<router_IP>:<stats_port>/metrics

$ curl -u <user>:<password> http://<router_IP>:<stats_port>/metricsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来安全地访问指标:

curl -u user:password https://<router_IP>:<stats_port>/metrics -k

$ curl -u user:password https://<router_IP>:<stats_port>/metrics -kCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,访问默认的 stats 端口 1936:

curl -u <user>:<password> http://<router_IP>:<stats_port>/metrics

$ curl -u <user>:<password> http://<router_IP>:<stats_port>/metricsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例 7.1. 输出示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 通过在浏览器中输入以下 URL 来启动 stats 窗口:

http://<user>:<password>@<router_IP>:<stats_port>

http://<user>:<password>@<router_IP>:<stats_port>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 可选:通过在浏览器中输入以下 URL 来获取 CSV 格式的统计信息:

http://<user>:<password>@<router_ip>:1936/metrics;csv

http://<user>:<password>@<router_ip>:1936/metrics;csvCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8.20. 自定义 HAProxy 错误代码响应页面

作为集群管理员,您可以为 503、404 或两个错误页面指定自定义错误代码响应页面。当应用 Pod 没有运行时,HAProxy 路由器会提供一个 503 错误页面,如果请求的 URL 不存在,则 HAProxy 路由器会提供 404 错误页面。例如,如果您自定义 503 错误代码响应页面,则应用 Pod 未运行时会提供页面,并且 HAProxy 路由器为不正确的路由或不存在的路由提供默认的 404 错误代码 HTTP 响应页面。

自定义错误代码响应页面在配置映射中指定,然后修补至 Ingress Controller。配置映射键有两个可用的文件名,如下所示:error-page-503.http 和 error-page-404.http。

自定义 HTTP 错误代码响应页面必须遵循 HAProxy HTTP 错误页面配置指南。以下是默认 OpenShift Container Platform HAProxy 路由器 http 503 错误代码响应页面的示例。您可以使用默认内容作为模板来创建自己的自定义页面。

默认情况下,当应用没有运行或者路由不正确或不存在时,HAProxy 路由器仅提供一个 503 错误页面。此默认行为与 OpenShift Container Platform 4.8 及更早版本中的行为相同。如果没有提供用于自定义 HTTP 错误代码响应的配置映射,且您使用的是自定义 HTTP 错误代码响应页面,路由器会提供默认的 404 或 503 错误代码响应页面。

如果您使用 OpenShift Container Platform 默认 503 错误代码页面作为自定义的模板,文件中的标头需要编辑器而不是使用 CRLF 行结尾。

流程

在

openshift-config命名空间中创建一个名为my-custom-error-code-pages的配置映射:oc -n openshift-config create configmap my-custom-error-code-pages \ --from-file=error-page-503.http \ --from-file=error-page-404.http

$ oc -n openshift-config create configmap my-custom-error-code-pages \ --from-file=error-page-503.http \ --from-file=error-page-404.httpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要如果没有为自定义错误代码响应页面指定正确的格式,则会出现路由器 pod 中断。要解决此中断,您必须删除或更正配置映射并删除受影响的路由器 pod,以便使用正确的信息重新创建它们。

对 Ingress Controller 进行补丁以根据名称引用

my-custom-error-code-pages配置映射:oc patch -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"httpErrorCodePages":{"name":"my-custom-error-code-pages"}}}' --type=merge$ oc patch -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"httpErrorCodePages":{"name":"my-custom-error-code-pages"}}}' --type=mergeCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress Operator 将

my-custom-error-code-pages配置映射从openshift-config命名空间复制到openshift-ingress命名空间。Operator 根据openshift-ingress命名空间中的模式<your_ingresscontroller_name>-errorpages命名配置映射。显示副本:

oc get cm default-errorpages -n openshift-ingress

$ oc get cm default-errorpages -n openshift-ingressCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME DATA AGE default-errorpages 2 25s

NAME DATA AGE default-errorpages 2 25s1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 配置映射名称示例为

default-errorpages,因为defaultIngress Controller 自定义资源 (CR) 已被修补。

确认包含自定义错误响应页面的配置映射挂载到路由器卷中,其中配置映射键是具有自定义 HTTP 错误代码响应的文件名:

对于 503 自定义 HTTP 自定义错误代码响应:

oc -n openshift-ingress rsh <router_pod> cat /var/lib/haproxy/conf/error_code_pages/error-page-503.http

$ oc -n openshift-ingress rsh <router_pod> cat /var/lib/haproxy/conf/error_code_pages/error-page-503.httpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 对于 404 自定义 HTTP 自定义错误代码响应:

oc -n openshift-ingress rsh <router_pod> cat /var/lib/haproxy/conf/error_code_pages/error-page-404.http

$ oc -n openshift-ingress rsh <router_pod> cat /var/lib/haproxy/conf/error_code_pages/error-page-404.httpCopy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

验证自定义错误代码 HTTP 响应:

创建测试项目和应用程序:

oc new-project test-ingress

$ oc new-project test-ingressCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc new-app django-psql-example

$ oc new-app django-psql-exampleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 对于 503 自定义 http 错误代码响应:

- 停止应用的所有容器集。

运行以下 curl 命令或在浏览器中访问路由主机名:

curl -vk <route_hostname>

$ curl -vk <route_hostname>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

对于 404 自定义 http 错误代码响应:

- 访问不存在的路由或路由不正确。

运行以下 curl 命令或在浏览器中访问路由主机名:

curl -vk <route_hostname>

$ curl -vk <route_hostname>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

检查

haproxy.config文件中的errorfile属性是否正确:oc -n openshift-ingress rsh <router> cat /var/lib/haproxy/conf/haproxy.config | grep errorfile

$ oc -n openshift-ingress rsh <router> cat /var/lib/haproxy/conf/haproxy.config | grep errorfileCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8.21. 设置 Ingress Controller 最大连接数

集群管理员可以设置 OpenShift 路由器部署的最大同时连接数。您可以修补现有的 Ingress Controller 来提高最大连接数。

先决条件

- 以下假设您已创建了 Ingress Controller

流程

更新 Ingress Controller,以更改 HAProxy 的最大连接数:

oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"maxConnections": 7500}}}'$ oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"maxConnections": 7500}}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 警告如果您设置了大于当前操作系统的

spec.tuningOptions.maxConnections值,则 HAProxy 进程不会启动。有关这个参数的更多信息,请参阅"Ingress Controller 配置参数"部分中的表。

Ingress Node Firewall Operator 提供了一个无状态的、基于 eBPF 的防火墙,用于管理 OpenShift Container Platform 中的节点级别的入口流量。

8.1. Ingress Node Firewall Operator

Ingress Node Firewall Operator 通过将守护进程集部署到您在防火墙配置中指定和管理的节点,在节点级别提供入口防火墙规则。要部署守护进程集,请创建一个 IngressNodeFirewallConfig 自定义资源 (CR)。Operator 应用 IngressNodeFirewallConfig CR 来创建入口节点防火墙守护进程集 daemon,它在与 nodeSelector 匹配的所有节点上运行。

您可以配置 IngressNodeFirewall CR 的规则,并使用 nodeSelector 将值设置为 "true" 的集群。

Ingress Node Firewall Operator 仅支持无状态防火墙规则。

最大传输单元 (MTU) 参数是 OpenShift Container Platform 4.13 中的 4Kb (kilobytes)。

不支持原生 XDP 驱动程序的网络接口控制器 (NIC) 将以较低性能运行。

带有默认 OpenShift 安装或 Red Hat OpenShift Service on AWS (ROSA)的 Amazon Web Services (AWS)不支持 Ingress Node Firewall Operator。如需有关 Red Hat OpenShift Service on AWS 支持和入口的更多信息,请参阅 Red Hat OpenShift Service on AWS 中的 Ingress Operator。

8.2. 安装 Ingress Node Firewall Operator

作为集群管理员,您可以使用 OpenShift Container Platform CLI 或 Web 控制台安装 Ingress Node Firewall Operator。

8.2.1. 使用 CLI 安装 Ingress Node Firewall Operator

作为集群管理员,您可以使用 CLI 安装 Operator。

先决条件

-

已安装 OpenShift CLI(

oc)。 - 有管理员特权的帐户。

流程

运行以下命令来创建

openshift-ingress-node-firewall命名空间:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令来创建

OperatorGroupCR:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 订阅 Ingress Node Firewall Operator。

要为 Ingress Node Firewall Operator 创建

SubscriptionCR,请输入以下命令:Copy to Clipboard Copied! Toggle word wrap Toggle overflow

要验证是否已安装 Operator,请输入以下命令:

oc get ip -n openshift-ingress-node-firewall

$ oc get ip -n openshift-ingress-node-firewallCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME CSV APPROVAL APPROVED install-5cvnz ingress-node-firewall.4.13.0-202211122336 Automatic true

NAME CSV APPROVAL APPROVED install-5cvnz ingress-node-firewall.4.13.0-202211122336 Automatic trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要验证 Operator 的版本,请输入以下命令:

oc get csv -n openshift-ingress-node-firewall

$ oc get csv -n openshift-ingress-node-firewallCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME DISPLAY VERSION REPLACES PHASE ingress-node-firewall.4.13.0-202211122336 Ingress Node Firewall Operator 4.13.0-202211122336 ingress-node-firewall.4.13.0-202211102047 Succeeded

NAME DISPLAY VERSION REPLACES PHASE ingress-node-firewall.4.13.0-202211122336 Ingress Node Firewall Operator 4.13.0-202211122336 ingress-node-firewall.4.13.0-202211102047 SucceededCopy to Clipboard Copied! Toggle word wrap Toggle overflow

8.2.2. 使用 Web 控制台安装 Ingress Node Firewall Operator

作为集群管理员,您可以使用 Web 控制台安装 Operator。

先决条件

-

已安装 OpenShift CLI(

oc)。 - 有管理员特权的帐户。

流程

安装 Ingress Node Firewall Operator:

- 在 OpenShift Container Platform Web 控制台中,点击 Operators → OperatorHub。

- 从可用的 Operator 列表中选择 Ingress Node Firewall Operator,然后点 Install。

- 在 Install Operator 页面中,在 Installed Namespace 下选择 Operator recommended Namespace。

- 点 Install。

验证 Ingress Node Firewall Operator 是否已成功安装:

- 导航到 Operators → Installed Operators 页面。

确保 openshift-ingress-node-firewall 项目中列出的 Ingress Node Firewall Operator 的 Status 为 InstallSucceeded。

注意在安装过程中,Operator 可能会显示 Failed 状态。如果安装过程结束后有 InstallSucceeded 信息,您可以忽略这个 Failed 信息。

如果 Operator 没有 InstallSucceeded 状态,请按照以下步骤进行故障排除:

- 检查 Operator Subscriptions 和 Install Plans 选项卡中的 Status 项中是否有任何错误。

-

进入到 Workloads → Pods 页面,在

openshift-ingress-node-firewall项目中检查 pod 的日志。 检查 YAML 文件的命名空间。如果缺少注解,您可以使用以下命令将注解

workload.openshift.io/allowed=management添加到 Operator 命名空间中:oc annotate ns/openshift-ingress-node-firewall workload.openshift.io/allowed=management

$ oc annotate ns/openshift-ingress-node-firewall workload.openshift.io/allowed=managementCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意对于单节点 OpenShift 集群,

openshift-ingress-node-firewall命名空间需要workload.openshift.io/allowed=management注解。

8.3. 部署 Ingress Node Firewall Operator

前提条件

- 已安装 Ingress Node Firewall Operator。

流程

要拒绝 Ingress Node Firewall Operator,请创建一个 IngressNodeFirewallConfig 自定义资源,该资源将部署 Operator 的守护进程集。您可以通过应用防火墙规则,将一个或多个 IngressNodeFirewall CRD 部署到节点。

-

在

openshift-ingress-node-firewall命名空间中创建IngressNodeFirewallConfig,名为ingressnodefirewallconfig。 运行以下命令来部署 Ingress Node Firewall Operator 规则:

oc apply -f rule.yaml

$ oc apply -f rule.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

8.3.1. Ingress 节点防火墙配置对象

下表中描述了 Ingress Node Firewall 配置对象的字段:

| 字段 | 类型 | 描述 |

|---|---|---|

|

|

|

CR 对象的名称。防火墙规则对象的名称必须是 |

|

|

|

Ingress Firewall Operator CR 对象的命名空间。 |

|

|

| 通过指定节点标签 (label) 用于目标节点的节点选择约束。例如: spec:

nodeSelector:

node-role.kubernetes.io/worker: ""

注意

|

Operator 使用 CR,并在与 nodeSelector 匹配的所有节点上创建一个入口节点防火墙守护进程集。

Ingress Node Firewall Operator 示例配置

以下示例中指定了完整的 Ingress Node 防火墙配置:

Ingress 节点防火墙配置对象示例

Operator 使用 CR,并在与 nodeSelector 匹配的所有节点上创建一个入口节点防火墙守护进程集。

8.3.2. Ingress 节点防火墙规则对象

下表中描述了 Ingress Node Firewall 规则对象的字段:

| 字段 | 类型 | 描述 |

|---|---|---|

|

|

| CR 对象的名称。 |

|

|

|

此对象的字段指定要应用防火墙规则的接口。例如, |

|

|

|

您可以使用 |

|

|

|

|

8.3.2.1. Ingress 对象配置

ingress 对象的值在下表中定义:

| 字段 | 类型 | 描述 |

|---|---|---|

|

|

| 允许您设置 CIDR 块。您可以从不同地址系列配置多个 CIDR。 注意

不同的 CIDR 允许您使用相同的顺序规则。如果同一节点有多个 |

|

|

|

对于每个

将 注意 Ingress 防火墙规则使用阻止任何无效配置的验证 Webhook 进行验证。验证 Webhook 会阻止阻塞任何关键集群服务,如 API 服务器或 SSH。 |

8.3.2.2. Ingress 节点防火墙规则对象示例

以下示例中指定了完整的 Ingress Node 防火墙配置:

Ingress 节点防火墙配置示例

- 1

- 节点上必须存在 <label_name> 和 <label_value>,且必须与应用到您希望

ingressfirewallconfigCR 运行的节点的nodeselector标签和值匹配。<label_value> 可以是true或false。通过使用nodeSelector标签,您可以针对单独的节点组为目标,以使用ingressfirewallconfigCR 应用不同的规则。

8.3.2.3. 零信任 Ingress Node Firewall 规则对象示例

零信任 Ingress 节点防火墙规则可为多接口集群提供额外的安全性。例如,您可以使用零信任 Ingress Node Firewall 规则来丢弃除 SSH 之外的特定接口上的网络流量。

以下示例中指定了零信任 Ingress Node Firewall 规则集的完整配置:

用户需要为其提供应用程序使用的所有端口添加到允许列表,以确保正常工作。

零信任 Ingress 节点防火墙规则示例

8.4. 查看 Ingress Node Firewall Operator 规则

流程

运行以下命令来查看所有当前规则:

oc get ingressnodefirewall

$ oc get ingressnodefirewallCopy to Clipboard Copied! Toggle word wrap Toggle overflow 选择返回的

<resource>名称之一,并运行以下命令来查看规则或配置:oc get <resource> <name> -o yaml

$ oc get <resource> <name> -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

8.5. 对 Ingress Node Firewall Operator 进行故障排除

运行以下命令列出已安装的 Ingress Node Firewall 自定义资源定义 (CRD):

oc get crds | grep ingressnodefirewall

$ oc get crds | grep ingressnodefirewallCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY UP-TO-DATE AVAILABLE AGE ingressnodefirewallconfigs.ingressnodefirewall.openshift.io 2022-08-25T10:03:01Z ingressnodefirewallnodestates.ingressnodefirewall.openshift.io 2022-08-25T10:03:00Z ingressnodefirewalls.ingressnodefirewall.openshift.io 2022-08-25T10:03:00Z

NAME READY UP-TO-DATE AVAILABLE AGE ingressnodefirewallconfigs.ingressnodefirewall.openshift.io 2022-08-25T10:03:01Z ingressnodefirewallnodestates.ingressnodefirewall.openshift.io 2022-08-25T10:03:00Z ingressnodefirewalls.ingressnodefirewall.openshift.io 2022-08-25T10:03:00ZCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令,以查看 Ingress Node Firewall Operator 的状态:

oc get pods -n openshift-ingress-node-firewall

$ oc get pods -n openshift-ingress-node-firewallCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME READY STATUS RESTARTS AGE ingress-node-firewall-controller-manager 2/2 Running 0 5d21h ingress-node-firewall-daemon-pqx56 3/3 Running 0 5d21h

NAME READY STATUS RESTARTS AGE ingress-node-firewall-controller-manager 2/2 Running 0 5d21h ingress-node-firewall-daemon-pqx56 3/3 Running 0 5d21hCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下字段提供有关 Operator 状态的信息:

READY、STATUS、AGE、和RESTARTS。当 Ingress Node Firewall Operator 将守护进程集部署到分配的节点时,STATUS字段为Running。运行以下命令来收集所有入口防火墙节点 pod 的日志:

oc adm must-gather – gather_ingress_node_firewall

$ oc adm must-gather – gather_ingress_node_firewallCopy to Clipboard Copied! Toggle word wrap Toggle overflow 在 sos 节点的报告中,其中包含位于

/sos_commands/ebpf的 eBPFbpftool输出的报告。这些报告包括用于或作为入口防火墙 XDP 处理数据包处理、更新统计信息和发出事件的查找表。

第 9 章 为手动 DNS Management 配置 Ingress Controller

作为集群管理员,在创建 Ingress Controller 时,Operator 会自动管理 DNS 记录。当所需的 DNS 区域与集群 DNS 区域不同或 DNS 区域被托管在云供应商时,这有一些限制。

作为集群管理员,您可以将 Ingress Controller 配置为停止自动 DNS 管理并启动手动 DNS 管理。将 dnsManagementPolicy 设置为指定应自动或手动管理的时间。

当您将 Ingress Controller 从 Managed 改为 Unmanaged DNS 管理策略时,Operator 不会清理在云中置备的以前的通配符 DNS 记录。当您将 Ingress Controller 从 Unmanaged 改为 Managed DNS 管理策略时,Operator 会尝试在云供应商上创建 DNS 记录(如果不存在),或更新 DNS 记录(如果已存在)。

当您将 dnsManagementPolicy 设置为 unmanaged 时,您必须手动管理云供应商上的通配符 DNS 记录的生命周期。

9.1. Managed DNS 管理策略

Ingress Controller 的 Managed DNS 管理策略可确保云供应商上通配符 DNS 记录的生命周期由 Operator 自动管理。

9.2. Unmanaged DNS 管理策略

Ingress Controller 的 Unmanaged DNS 管理策略可确保云供应商上通配符 DNS 记录的生命周期不会自动管理,而是由集群管理员负责。

在 AWS 云平台中,如果 Ingress Controller 上的域与 dnsConfig.Spec.BaseDomain 不匹配,则 DNS 管理策略会自动设置为 Unmanaged。

9.3. 使用 Unmanaged DNS 管理策略创建自定义 Ingress Controller

作为集群管理员,您可以使用 Unmanaged DNS 管理策略创建新的自定义 Ingress Controller。

先决条件

-

安装 OpenShift CLI(

oc)。 -

以具有

cluster-admin特权的用户身份登录。

流程

创建名为

sample-ingress.yaml的自定义资源 (CR) 文件,包含以下内容:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 保存文件以使改变生效。

oc apply -f <name>.yaml

oc apply -f <name>.yaml1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow

9.4. 修改现有 Ingress Controller

作为集群管理员,您可以修改现有 Ingress Controller 以手动管理 DNS 记录生命周期。

先决条件

-

安装 OpenShift CLI(

oc)。 -

以具有

cluster-admin特权的用户身份登录。

流程

修改所选