Authentification et autorisation

La sécurisation d’OpenShift Dédié.

Résumé

Chapitre 1. Aperçu de l’authentification et de l’autorisation

1.1. Glossaire des termes communs pour OpenShift Authentification et autorisation dédiées

Ce glossaire définit les termes communs qui sont utilisés dans OpenShift Dedicated Authentification et autorisation.

- authentification

- L’authentification détermine l’accès à un cluster dédié OpenShift et garantit que seuls les utilisateurs authentifiés accèdent au cluster dédié OpenShift.

- autorisation

- L’autorisation détermine si l’utilisateur identifié dispose d’autorisations pour effectuer l’action demandée.

- jeton au porteur

- Le jeton porteur est utilisé pour s’authentifier en API avec l’en-tête Autorisation: Bearer <token>.

- configuration de la carte

- La carte de configuration fournit un moyen d’injecter des données de configuration dans les pods. Les données stockées dans une carte de configuration peuvent être référencées dans un volume de type ConfigMap. Les applications qui s’exécutent dans un pod peuvent utiliser ces données.

- conteneurs

- Des images légères et exécutables qui sont constituées de logiciels et de toutes ses dépendances. Comme les conteneurs virtualisent le système d’exploitation, vous pouvez exécuter des conteneurs dans un centre de données, un cloud public ou privé ou votre hôte local.

- Les ressources personnalisées (CR)

- A CR est une extension de l’API Kubernetes.

- groupe de travail

- Le groupe est un ensemble d’utilisateurs. Le groupe est utile pour accorder des autorisations à plusieurs utilisateurs une fois.

- Htpasswd

- Htpasswd met à jour les fichiers qui stockent les noms d’utilisateur et le mot de passe pour l’authentification des utilisateurs HTTP.

- Keystone

- Keystone est un projet Red Hat OpenStack Platform (RHOSP) qui fournit des services d’identité, de jeton, de catalogue et de politique.

- Le protocole d’accès à l’annuaire léger (LDAP)

- LDAP est un protocole qui interroge les informations de l’utilisateur.

- espace de noms

- L’espace de noms isole des ressources système spécifiques qui sont visibles pour tous les processus. À l’intérieur d’un espace de noms, seuls les processus qui sont membres de cet espace de noms peuvent voir ces ressources.

- le nœud

- Le nœud est une machine ouvrier dans le cluster dédié OpenShift. Le nœud est soit une machine virtuelle (VM) soit une machine physique.

- Client OAuth

- Le client OAuth est utilisé pour obtenir un jeton au porteur.

- Le serveur OAuth

- Le plan de contrôle dédié OpenShift comprend un serveur OAuth intégré qui détermine l’identité de l’utilisateur à partir du fournisseur d’identité configuré et crée un jeton d’accès.

- Connexion d’OpenID

- L’OpenID Connect est un protocole permettant d’authentifier les utilisateurs à l’aide d’une connexion unique (SSO) pour accéder aux sites qui utilisent les fournisseurs OpenID.

- la pod

- La gousse est la plus petite unité logique de Kubernetes. La gousse est composée d’un ou de plusieurs contenants à utiliser dans un nœud ouvrier.

- les utilisateurs réguliers

- Les utilisateurs qui sont créés automatiquement dans le cluster lors de la première connexion ou via l’API.

- en-tête de demande

- L’en-tête de requête est un en-tête HTTP qui est utilisé pour fournir des informations sur le contexte de requête HTTP, afin que le serveur puisse suivre la réponse de la requête.

- contrôle d’accès basé sur le rôle (RBAC)

- Contrôle de sécurité clé pour s’assurer que les utilisateurs de clusters et les charges de travail n’ont accès qu’aux ressources nécessaires à l’exécution de leurs rôles.

- comptes de services

- Les comptes de service sont utilisés par les composants ou applications du cluster.

- les utilisateurs du système

- Les utilisateurs qui sont créés automatiquement lorsque le cluster est installé.

- les utilisateurs

- Les utilisateurs sont une entité qui peut faire des demandes à l’API.

1.2. À propos de l’authentification dans OpenShift Dedicated

Afin de contrôler l’accès à un cluster dédié OpenShift, un administrateur doté du rôle administrateur dédié peut configurer l’authentification de l’utilisateur et s’assurer que seuls les utilisateurs approuvés accèdent au cluster.

Afin d’interagir avec un cluster dédié OpenShift, les utilisateurs doivent d’abord s’authentifier auprès de l’API dédiée OpenShift d’une manière ou d’une autre. Dans vos demandes, vous pouvez vous authentifier en fournissant un jeton d’accès OAuth ou un certificat client X.509 à l’API dédiée OpenShift.

En cas de non-présentation d’un jeton d’accès valide ou d’un certificat, votre demande n’est pas authentifiée et vous recevez une erreur HTTP 401.

L’administrateur peut configurer l’authentification en configurant un fournisseur d’identité. Dans OpenShift Dedicated, vous pouvez définir n’importe quel fournisseur d’identité pris en charge et l’ajouter à votre cluster.

1.3. À propos de l’autorisation dans OpenShift Dedicated

L’autorisation consiste à déterminer si l’utilisateur identifié dispose d’autorisations pour effectuer l’action demandée.

Les administrateurs peuvent définir des autorisations et les attribuer aux utilisateurs en utilisant les objets RBAC, tels que les règles, les rôles et les liaisons. Afin de comprendre comment fonctionne l’autorisation dans OpenShift Dedicated, voir Évaluer l’autorisation.

Il est également possible de contrôler l’accès à un cluster dédié OpenShift par le biais de projets et d’espaces de noms.

En plus de contrôler l’accès de l’utilisateur à un cluster, vous pouvez également contrôler les actions qu’un pod peut effectuer et les ressources auxquelles il peut accéder en utilisant des contraintes de contexte de sécurité (SCC).

Il est possible de gérer l’autorisation d’OpenShift Dédiée à travers les tâches suivantes:

- Affichage des rôles et des liens locaux et de cluster.

- Créer un rôle local et l’attribuer à un utilisateur ou à un groupe.

- Attribution d’un rôle de cluster à un utilisateur ou à un groupe : OpenShift Dedicated inclut un ensemble de rôles de cluster par défaut. Il est possible de les ajouter à un utilisateur ou à un groupe.

- Accorder des privilèges d’administrateur aux utilisateurs : Vous pouvez accorder des privilèges d’administration dédiés aux utilisateurs.

- Création de comptes de service : Les comptes de service offrent un moyen flexible de contrôler l’accès à l’API sans partager les informations d’identification d’un utilisateur régulier. L’utilisateur peut créer et utiliser un compte de service dans des applications et aussi en tant que client OAuth.

- Jetons de portée : Un jeton à portée de main est un jeton qui s’identifie comme un utilisateur spécifique qui ne peut effectuer que des opérations spécifiques. Il est possible de créer des jetons expansés pour déléguer certaines de vos autorisations à un autre utilisateur ou à un compte de service.

- La synchronisation des groupes LDAP : Vous pouvez gérer les groupes d’utilisateurs en un seul endroit en synchronisant les groupes stockés dans un serveur LDAP avec les groupes d’utilisateurs dédiés OpenShift.

Chapitre 2. Comprendre l’authentification

Afin que les utilisateurs interagissent avec OpenShift Dedicated, ils doivent d’abord s’authentifier au cluster. La couche d’authentification identifie l’utilisateur associé aux requêtes à l’API dédiée OpenShift. La couche d’autorisation utilise ensuite des informations sur l’utilisateur demandeur pour déterminer si la demande est autorisée.

2.1. Les utilisateurs

L’utilisateur dans OpenShift Dedicated est une entité qui peut faire des demandes à l’API dédiée OpenShift. L’objet utilisateur dédié OpenShift représente un acteur qui peut recevoir des autorisations dans le système en ajoutant des rôles à eux ou à leurs groupes. En règle générale, cela représente le compte d’un développeur ou d’un administrateur qui interagit avec OpenShift Dedicated.

Différents types d’utilisateurs peuvent exister:

| Le type d’utilisateur | Description |

|---|---|

|

| C’est la façon dont les utilisateurs dédiés OpenShift les plus interactifs sont représentés. Les utilisateurs réguliers sont créés automatiquement dans le système lors de la première connexion ou peuvent être créés via l’API. Les utilisateurs réguliers sont représentés avec l’objet Utilisateur. Exemples: joe alice |

|

| Beaucoup d’entre eux sont créés automatiquement lorsque l’infrastructure est définie, principalement dans le but de permettre à l’infrastructure d’interagir en toute sécurité avec l’API. Ils comprennent un administrateur de cluster (avec accès à tout), un utilisateur par nœud, des utilisateurs pour les routeurs et les registres, et divers autres. Enfin, il y a un utilisateur système anonyme qui est utilisé par défaut pour les demandes non authentifiées. Exemples: system:admin system:openshift-registry system:node:node1.example.com |

|

| Il s’agit d’utilisateurs système spéciaux associés à des projets; certains sont créés automatiquement lorsque le projet est créé pour la première fois, tandis que les administrateurs de projet peuvent en créer davantage dans le but de définir l’accès au contenu de chaque projet. Les comptes de service sont représentés avec l’objet ServiceAccount. Exemples: system:serviceaccount:default:deployer system:serviceaccount:foo:builder |

Chaque utilisateur doit s’authentifier d’une manière ou d’une autre pour accéder à OpenShift Dedicated. Les requêtes API sans authentification ou authentification invalide sont authentifiées en tant que requêtes de l’utilisateur du système anonyme. Après l’authentification, la stratégie détermine ce que l’utilisateur est autorisé à faire.

2.2. Groupes

L’utilisateur peut être affecté à un ou plusieurs groupes, chacun représentant un certain ensemble d’utilisateurs. Les groupes sont utiles lors de la gestion des stratégies d’autorisation pour accorder des autorisations à plusieurs utilisateurs à la fois, par exemple permettre l’accès à des objets dans un projet, plutôt que de les accorder aux utilisateurs individuellement.

En plus des groupes explicitement définis, il y a aussi des groupes système, ou des groupes virtuels, qui sont automatiquement mis à disposition par le cluster.

Les groupes virtuels par défaut suivants sont les plus importants:

| Groupe virtuel | Description |

|---|---|

|

| Automatiquement associé à tous les utilisateurs authentifiés. |

|

| Automatiquement associé à tous les utilisateurs authentifiés avec un jeton d’accès OAuth. |

|

| Automatiquement associé à tous les utilisateurs non authentifiés. |

2.3. Authentification de l’API

Les demandes à l’API dédiée OpenShift sont authentifiées en utilisant les méthodes suivantes:

- Jetons d’accès OAuth

- Obtenu à partir du serveur OpenShift Dedicated OAuth à l’aide des points de terminaison <namespace_route>/oauth/autorisation et <namespace_route>/oauth/token.

- Envoyé en tant qu’autorisation: Bearer… en-tête.

- Envoyé comme un en-tête de sous-protocole websocket dans le formulaire base64url.bearer.authorization.k8s.io.<base64url-encoded-token> pour les requêtes websocket.

- Certificats de client x.509

- Nécessite une connexion HTTPS au serveur API.

- Vérifié par le serveur API par rapport à un ensemble d’autorités de certification de confiance.

- Le serveur API crée et distribue des certificats aux contrôleurs pour s’authentifier.

Chaque demande avec un jeton d’accès invalide ou un certificat invalide est rejetée par le calque d’authentification avec une erreur 401.

En l’absence de jeton d’accès ou de certificat, la couche d’authentification attribue le système: utilisateur virtuel anonyme et le groupe virtuel système:non authentifié à la demande. Cela permet à la couche d’autorisation de déterminer quelles requêtes, le cas échéant, un utilisateur anonyme est autorisé à faire.

2.3.1. Le serveur OAuth dédié à OpenShift

Le maître dédié OpenShift inclut un serveur OAuth intégré. Les utilisateurs obtiennent des jetons d’accès OAuth pour s’authentifier à l’API.

Lorsqu’une personne demande un nouveau jeton OAuth, le serveur OAuth utilise le fournisseur d’identité configuré pour déterminer l’identité de la personne qui fait la demande.

Il détermine ensuite à quel utilisateur cette identité cartographie, crée un jeton d’accès pour cet utilisateur, et retourne le jeton pour utilisation.

2.3.1.1. Demandes de jetons OAuth

Chaque demande de jeton OAuth doit spécifier le client OAuth qui recevra et utilisera le jeton. Les clients OAuth suivants sont automatiquement créés lors du démarrage de l’API dédiée OpenShift:

| Client OAuth | L’utilisation |

|---|---|

|

| Demande des jetons à <namespace_route>/oauth/token/request avec un agent utilisateur capable de gérer les connexions interactives. [1] |

|

| Demandes de jetons avec un agent utilisateur capable de gérer les défis WWW-Authenticate. |

<namespace_route> fait référence à la route de l’espace de noms. Ceci est trouvé en exécutant la commande suivante:

oc get route oauth-openshift -n openshift-authentication -o json | jq .spec.host

$ oc get route oauth-openshift -n openshift-authentication -o json | jq .spec.hostCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Les demandes de jetons OAuth impliquent une demande de <namespace_route>/oauth/autorisation. La plupart des intégrations d’authentification placent un proxy authentifiant devant ce point de terminaison, ou configurent OpenShift Dedicated pour valider les informations d’identification par rapport à un fournisseur d’identité de support. Les demandes de <namespace_route>/oauth/autorisation peuvent provenir d’agents utilisateurs qui ne peuvent pas afficher des pages de connexion interactives, telles que le CLI. Ainsi, OpenShift Dedicated prend en charge l’authentification à l’aide d’un défi WWW-Authenticate en plus des flux de connexion interactifs.

Lorsqu’un proxy authentifiant est placé devant le point de terminaison <namespace_route>/oauth/autoriser, il envoie des défis WWW-Authenticate non authentiques et non navigateurs, plutôt que d’afficher une page de connexion interactive ou de rediriger vers un flux de connexion interactif.

Afin d’éviter les attaques de faux de requêtes intersites (CSRF) contre les clients du navigateur, n’envoyer des défis d’authentification de base que si un en-tête X-CSRF-Token est sur la demande. Les clients qui s’attendent à recevoir les défis de base WWW-Authenticate doivent définir cette en-tête à une valeur non vide.

Lorsque le proxy d’authentification ne peut pas prendre en charge les défis WWW-Authenticate, ou si OpenShift Dedicated est configuré pour utiliser un fournisseur d’identité qui ne prend pas en charge les défis WWW-Authenticate, vous devez utiliser un navigateur pour obtenir manuellement un jeton à partir de <namespace_route>/oauth/token/request.

Chapitre 3. Gestion des jetons d’accès OAuth appartenant à l’utilisateur

Les utilisateurs peuvent revoir leurs propres jetons d’accès OAuth et supprimer tout ce qui n’est plus nécessaire.

3.1. Liste des jetons d’accès OAuth appartenant à l’utilisateur

Il est possible de répertorier vos jetons d’accès OAuth appartenant à l’utilisateur. Les noms de jetons ne sont pas sensibles et ne peuvent pas être utilisés pour se connecter.

Procédure

Liste de tous les jetons d’accès OAuth appartenant à l’utilisateur:

oc get useroauthaccesstokens

$ oc get useroauthaccesstokensCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME CLIENT NAME CREATED EXPIRES REDIRECT URI SCOPES <token1> openshift-challenging-client 2021-01-11T19:25:35Z 2021-01-12 19:25:35 +0000 UTC https://oauth-openshift.apps.example.com/oauth/token/implicit user:full <token2> openshift-browser-client 2021-01-11T19:27:06Z 2021-01-12 19:27:06 +0000 UTC https://oauth-openshift.apps.example.com/oauth/token/display user:full <token3> console 2021-01-11T19:26:29Z 2021-01-12 19:26:29 +0000 UTC https://console-openshift-console.apps.example.com/auth/callback user:full

NAME CLIENT NAME CREATED EXPIRES REDIRECT URI SCOPES <token1> openshift-challenging-client 2021-01-11T19:25:35Z 2021-01-12 19:25:35 +0000 UTC https://oauth-openshift.apps.example.com/oauth/token/implicit user:full <token2> openshift-browser-client 2021-01-11T19:27:06Z 2021-01-12 19:27:06 +0000 UTC https://oauth-openshift.apps.example.com/oauth/token/display user:full <token3> console 2021-01-11T19:26:29Z 2021-01-12 19:26:29 +0000 UTC https://console-openshift-console.apps.example.com/auth/callback user:fullCopy to Clipboard Copied! Toggle word wrap Toggle overflow Liste des jetons d’accès OAuth appartenant à l’utilisateur pour un client particulier OAuth:

oc get useroauthaccesstokens --field-selector=clientName="console"

$ oc get useroauthaccesstokens --field-selector=clientName="console"Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME CLIENT NAME CREATED EXPIRES REDIRECT URI SCOPES <token3> console 2021-01-11T19:26:29Z 2021-01-12 19:26:29 +0000 UTC https://console-openshift-console.apps.example.com/auth/callback user:full

NAME CLIENT NAME CREATED EXPIRES REDIRECT URI SCOPES <token3> console 2021-01-11T19:26:29Z 2021-01-12 19:26:29 +0000 UTC https://console-openshift-console.apps.example.com/auth/callback user:fullCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.2. Affichage des détails d’un jeton d’accès OAuth appartenant à l’utilisateur

Consultez les détails d’un jeton d’accès OAuth appartenant à l’utilisateur.

Procédure

Décrire les détails d’un jeton d’accès OAuth appartenant à l’utilisateur:

oc describe useroauthaccesstokens <token_name>

$ oc describe useroauthaccesstokens <token_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Le nom du jeton, qui est le hachage sha256 du jeton. Les noms de jetons ne sont pas sensibles et ne peuvent pas être utilisés pour se connecter.

- 2

- Le nom du client, qui décrit d’où provient le jeton.

- 3

- La valeur en secondes du temps de création avant l’expiration de ce jeton.

- 4

- En cas d’inactivité du serveur OAuth, c’est la valeur en secondes du temps de création avant que ce jeton ne puisse plus être utilisé.

- 5

- Les portées de ce jeton.

- 6

- Le nom d’utilisateur associé à ce jeton.

3.3. La suppression des jetons d’accès OAuth appartenant à l’utilisateur

La commande oc logout invalide uniquement le jeton OAuth pour la session active. Il est possible d’utiliser la procédure suivante pour supprimer les jetons OAuth appartenant à l’utilisateur qui ne sont plus nécessaires.

La suppression d’un jeton d’accès OAuth déconnecte l’utilisateur de toutes les sessions qui utilisent le jeton.

Procédure

Effacer le jeton d’accès OAuth appartenant à l’utilisateur:

oc delete useroauthaccesstokens <token_name>

$ oc delete useroauthaccesstokens <token_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

useroauthaccesstoken.oauth.openshift.io "<token_name>" deleted

useroauthaccesstoken.oauth.openshift.io "<token_name>" deletedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. Ajout de groupes non authentifiés aux rôles de cluster

En tant qu’administrateur de cluster, vous pouvez ajouter des utilisateurs non authentifiés aux rôles de cluster suivants dans OpenShift Dedicated en créant une liaison de rôle de cluster. Les utilisateurs non authentifiés n’ont pas accès à des rôles de cluster non publics. Cela ne devrait être fait que dans des cas d’utilisation spécifiques lorsque cela est nécessaire.

Il est possible d’ajouter des utilisateurs non authentifiés aux rôles de cluster suivants:

-

le système:scope-impersonation -

le système:webhook -

le système:oauth-token-deleter -

auto-réviseur d’accès

Assurez-vous toujours de respecter les normes de sécurité de votre organisation lors de la modification de l’accès non authentifié.

Conditions préalables

- En tant qu’utilisateur, vous avez accès au cluster avec le rôle cluster-admin.

- L’OpenShift CLI (oc) a été installé.

Procédure

Créez un fichier YAML nommé add-<cluster_role>-unauth.yaml et ajoutez le contenu suivant:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Appliquer la configuration en exécutant la commande suivante:

oc apply -f add-<cluster_role>.yaml

$ oc apply -f add-<cluster_role>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Chapitre 4. Configuration des fournisseurs d’identité

Après la création de votre cluster OpenShift Dedicated, vous devez configurer des fournisseurs d’identité pour déterminer comment les utilisateurs se connectent pour accéder au cluster.

4.1. Comprendre les fournisseurs d’identité

Le serveur OpenShift Dedicated inclut un serveur OAuth intégré. Les développeurs et les administrateurs obtiennent des jetons d’accès OAuth pour s’authentifier à l’API. En tant qu’administrateur, vous pouvez configurer OAuth pour spécifier un fournisseur d’identité après avoir installé votre cluster. La configuration des fournisseurs d’identité permet aux utilisateurs de se connecter et d’accéder au cluster.

4.1.1. Fournisseurs d’identité pris en charge

Les types de fournisseurs d’identité suivants peuvent être configurés:

| Fournisseur d’identité | Description |

|---|---|

| GitHub ou GitHub Enterprise | Configurez un fournisseur d’identité GitHub pour valider les noms d’utilisateur et les mots de passe contre le serveur d’authentification OAuth de GitHub ou GitHub Enterprise. |

| GitLab | Configurez un fournisseur d’identité GitLab pour utiliser GitLab.com ou toute autre instance GitLab en tant que fournisseur d’identité. |

| | Configurez un fournisseur d’identité Google en utilisant l’intégration OpenID Connect de Google. |

| LDAP | Configurez un fournisseur d’identité LDAP pour valider les noms d’utilisateur et les mots de passe contre un serveur LDAPv3, en utilisant une simple authentification de liaison. |

| Connexion d’OpenID | Configurez un fournisseur d’identité OpenID Connect (OIDC) pour s’intégrer à un fournisseur d’identité OIDC à l’aide d’un flux de code d’autorisation. |

| htpasswd | Configurez un fournisseur d’identité htpasswd pour un seul utilisateur d’administration statique. En tant qu’utilisateur, vous pouvez vous connecter au cluster pour résoudre les problèmes. Important L’option fournisseur d’identité htpasswd n’est incluse que pour activer la création d’un seul utilisateur d’administration statique. htpasswd n’est pas pris en charge en tant que fournisseur d’identité à usage général pour OpenShift Dedicated. Les étapes pour configurer l’utilisateur unique, voir Configuration d’un fournisseur d’identité htpasswd. |

4.1.2. Les paramètres du fournisseur d’identité

Les paramètres suivants sont communs à tous les fournisseurs d’identité:

| Le paramètre | Description |

|---|---|

|

| Le nom du fournisseur est préfixé aux noms d’utilisateur du fournisseur pour former un nom d’identité. |

|

| Définit comment les nouvelles identités sont cartographiées aux utilisateurs lorsqu’ils se connectent. Entrez l’une des valeurs suivantes:

|

Lorsque vous ajoutez ou modifiez des fournisseurs d’identité, vous pouvez cartographier les identités du nouveau fournisseur aux utilisateurs existants en définissant le paramètre mappingMethod à ajouter.

4.2. Configuration d’un fournisseur d’identité GitHub

Configurez un fournisseur d’identité GitHub pour valider les noms d’utilisateur et les mots de passe contre le serveur d’authentification OAuth de GitHub ou GitHub Enterprise et accédez à votre cluster dédié OpenShift. L’OAuth facilite un flux d’échange de jetons entre OpenShift Dedicated et GitHub ou GitHub Enterprise.

La configuration de l’authentification GitHub permet aux utilisateurs de se connecter à OpenShift Dedicated avec leurs identifiants GitHub. Afin d’empêcher toute personne disposant d’un identifiant utilisateur GitHub de se connecter à votre cluster dédié OpenShift, vous devez restreindre l’accès à ceux qui se trouvent dans des organisations ou des équipes GitHub spécifiques.

Conditions préalables

- L’application OAuth doit être créée directement dans les paramètres d’organisation GitHub par l’administrateur de l’organisation GitHub.

- Les organisations ou les équipes GitHub sont configurées dans votre compte GitHub.

Procédure

- À partir d’OpenShift Cluster Manager, accédez à la page Liste des clusters et sélectionnez le cluster pour lequel vous devez configurer les fournisseurs d’identité.

- Cliquez sur l’onglet Contrôle d’accès.

Cliquez sur Ajouter un fournisseur d’identité.

NoteIl est également possible de cliquer sur le lien de configuration Ajouter Oauth dans le message d’avertissement affiché après la création du cluster pour configurer vos fournisseurs d’identité.

- Choisissez GitHub dans le menu déroulant.

Entrez un nom unique pour le fournisseur d’identité. Ce nom ne peut pas être changé plus tard.

L’URL de rappel OAuth est automatiquement générée dans le champ fourni. Ceci vous permettra d’enregistrer l’application GitHub.

https://oauth-openshift.apps.<cluster_name>.<cluster_domain>/oauth2callback/<idp_provider_name>

https://oauth-openshift.apps.<cluster_name>.<cluster_domain>/oauth2callback/<idp_provider_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow À titre d’exemple:

https://oauth-openshift.apps.openshift-cluster.example.com/oauth2callback/github

https://oauth-openshift.apps.openshift-cluster.example.com/oauth2callback/githubCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- Enregistrez une demande sur GitHub.

- Cliquez sur OpenShift Dedicated et sélectionnez une méthode de cartographie dans le menu déroulant. La réclamation est recommandée dans la plupart des cas.

- Entrez l’ID Client et le secret du client fournis par GitHub.

- Entrez un nom d’hôte. Le nom d’hôte doit être saisi lors de l’utilisation d’une instance hébergée de GitHub Enterprise.

- Facultatif : Vous pouvez utiliser un fichier d’autorité de certification (CA) pour valider les certificats de serveur pour l’URL GitHub Enterprise configurée. Cliquez sur Parcourir pour localiser et joindre un fichier CA au fournisseur d’identité.

- Choisissez Utilisez des organisations ou Utilisez les équipes pour restreindre l’accès à une organisation GitHub particulière ou à une équipe GitHub.

- Entrez le nom de l’organisation ou de l’équipe à laquelle vous souhaitez restreindre l’accès. Cliquez sur Ajouter plus pour spécifier plusieurs organisations ou équipes dont les utilisateurs peuvent être membres.

- Cliquez sur Confirmer.

La vérification

- Le fournisseur d’identité configuré est maintenant visible dans l’onglet Contrôle d’accès de la page Liste des clusters.

4.3. Configuration d’un fournisseur d’identité GitLab

Configurez un fournisseur d’identité GitLab pour utiliser GitLab.com ou toute autre instance GitLab en tant que fournisseur d’identité.

Conditions préalables

- Lorsque vous utilisez la version 7.7.0 à 11.0 de GitLab, vous vous connectez à l’intégration OAuth. En utilisant la version 11.1 ou ultérieure de GitLab, vous pouvez utiliser OpenID Connect (OIDC) pour vous connecter au lieu d’OAuth.

Procédure

- À partir d’OpenShift Cluster Manager, accédez à la page Liste des clusters et sélectionnez le cluster pour lequel vous devez configurer les fournisseurs d’identité.

- Cliquez sur l’onglet Contrôle d’accès.

Cliquez sur Ajouter un fournisseur d’identité.

NoteIl est également possible de cliquer sur le lien de configuration Ajouter Oauth dans le message d’avertissement affiché après la création du cluster pour configurer vos fournisseurs d’identité.

- Choisissez GitLab dans le menu déroulant.

Entrez un nom unique pour le fournisseur d’identité. Ce nom ne peut pas être changé plus tard.

L’URL de rappel OAuth est automatiquement générée dans le champ fourni. Cette URL est fournie à GitLab.

https://oauth-openshift.apps.<cluster_name>.<cluster_domain>/oauth2callback/<idp_provider_name>

https://oauth-openshift.apps.<cluster_name>.<cluster_domain>/oauth2callback/<idp_provider_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow À titre d’exemple:

https://oauth-openshift.apps.openshift-cluster.example.com/oauth2callback/gitlab

https://oauth-openshift.apps.openshift-cluster.example.com/oauth2callback/gitlabCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- Ajouter une nouvelle application dans GitLab.

- Cliquez sur OpenShift Dedicated et sélectionnez une méthode de cartographie dans le menu déroulant. La réclamation est recommandée dans la plupart des cas.

- Entrez l’ID Client et le secret client fournis par GitLab.

- Entrez l’URL de votre fournisseur GitLab.

- Facultatif : Vous pouvez utiliser un fichier d’autorité de certification (CA) pour valider les certificats de serveur pour l’URL GitLab configurée. Cliquez sur Parcourir pour localiser et joindre un fichier CA au fournisseur d’identité.

- Cliquez sur Confirmer.

La vérification

- Le fournisseur d’identité configuré est maintenant visible dans l’onglet Contrôle d’accès de la page Liste des clusters.

4.4. Configuration d’un fournisseur d’identité Google

Configurez un fournisseur d’identité Google pour permettre aux utilisateurs de s’authentifier avec leurs identifiants Google.

L’utilisation de Google comme fournisseur d’identité permet à tout utilisateur de Google de s’authentifier auprès de votre serveur. Il est possible de limiter l’authentification aux membres d’un domaine hébergé spécifique avec l’attribut de configuration hostDomain.

Procédure

- À partir d’OpenShift Cluster Manager, accédez à la page Liste des clusters et sélectionnez le cluster pour lequel vous devez configurer les fournisseurs d’identité.

- Cliquez sur l’onglet Contrôle d’accès.

Cliquez sur Ajouter un fournisseur d’identité.

NoteIl est également possible de cliquer sur le lien de configuration Ajouter Oauth dans le message d’avertissement affiché après la création du cluster pour configurer vos fournisseurs d’identité.

- Choisissez Google dans le menu déroulant.

Entrez un nom unique pour le fournisseur d’identité. Ce nom ne peut pas être changé plus tard.

L’URL de rappel OAuth est automatiquement générée dans le champ fourni. Cette URL sera fournie à Google.

https://oauth-openshift.apps.<cluster_name>.<cluster_domain>/oauth2callback/<idp_provider_name>

https://oauth-openshift.apps.<cluster_name>.<cluster_domain>/oauth2callback/<idp_provider_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow À titre d’exemple:

https://oauth-openshift.apps.openshift-cluster.example.com/oauth2callback/google

https://oauth-openshift.apps.openshift-cluster.example.com/oauth2callback/googleCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- Configurez un fournisseur d’identité Google en utilisant l’intégration OpenID Connect de Google.

- Cliquez sur OpenShift Dedicated et sélectionnez une méthode de cartographie dans le menu déroulant. La réclamation est recommandée dans la plupart des cas.

- Entrez l’ID Client d’un projet Google enregistré et le secret client émis par Google.

- Entrez un domaine hébergé pour restreindre les utilisateurs à un domaine Google Apps.

- Cliquez sur Confirmer.

La vérification

- Le fournisseur d’identité configuré est maintenant visible dans l’onglet Contrôle d’accès de la page Liste des clusters.

4.5. Configuration d’un fournisseur d’identité LDAP

Configurez le fournisseur d’identité LDAP pour valider les noms d’utilisateur et les mots de passe contre un serveur LDAPv3, en utilisant une simple authentification de liaison.

Conditions préalables

Lorsque vous configurez un fournisseur d’identité LDAP, vous devrez entrer une URL LDAP configurée. L’URL configurée est une URL RFC 2255, qui spécifie l’hôte LDAP et les paramètres de recherche à utiliser. La syntaxe de l’URL est:

ldap://host:port/basedn?attribute?scope?filter

ldap://host:port/basedn?attribute?scope?filterCopy to Clipboard Copied! Toggle word wrap Toggle overflow Expand Composant URL Description LDAPDans le cas d’un LDAP régulier, utilisez la corde ldap. Dans le cas d’un LDAP sécurisé (LDAPS), utilisez plutôt ldaps.

hôte:portLe nom et le port du serveur LDAP. Défaut à localhost:389 pour ldap et localhost:636 pour LDAPS.

baseDNLe DN de la branche du répertoire où toutes les recherches devraient commencer. À tout le moins, cela doit être le haut de votre arbre de répertoire, mais il pourrait également spécifier un sous-arbre dans le répertoire.

attributL’attribut à rechercher. Bien que la RFC 2255 autorise une liste d’attributs séparés par des virgules, seul le premier attribut sera utilisé, peu importe le nombre d’attributs fournis. En l’absence d’attributs, la valeur par défaut est d’utiliser uid. Il est recommandé de choisir un attribut qui sera unique dans toutes les entrées dans le sous-arbre que vous utiliserez.

champ d’applicationLa portée de la recherche. Il peut être un ou sous. Dans le cas où la portée n’est pas fournie, la valeur par défaut est d’utiliser une portée de sub.

filtrerFiltre de recherche LDAP valide. Dans le cas contraire, par défaut (objectClass=*)

Lorsque vous effectuez des recherches, l’attribut, le filtre et le nom d’utilisateur fourni sont combinés pour créer un filtre de recherche qui ressemble à:

(&(<filter>)(<attribute>=<username>))

(&(<filter>)(<attribute>=<username>))Copy to Clipboard Copied! Toggle word wrap Toggle overflow ImportantLorsque le répertoire LDAP nécessite une authentification pour rechercher, spécifiez un bindDN et bindPassword à utiliser pour effectuer la recherche d’entrée.

Procédure

- À partir d’OpenShift Cluster Manager, accédez à la page Liste des clusters et sélectionnez le cluster pour lequel vous devez configurer les fournisseurs d’identité.

- Cliquez sur l’onglet Contrôle d’accès.

Cliquez sur Ajouter un fournisseur d’identité.

NoteIl est également possible de cliquer sur le lien de configuration Ajouter Oauth dans le message d’avertissement affiché après la création du cluster pour configurer vos fournisseurs d’identité.

- Choisissez LDAP dans le menu déroulant.

- Entrez un nom unique pour le fournisseur d’identité. Ce nom ne peut pas être changé plus tard.

- Choisissez une méthode de cartographie dans le menu déroulant. La réclamation est recommandée dans la plupart des cas.

- Entrez une URL LDAP pour spécifier les paramètres de recherche LDAP à utiliser.

- Facultatif: Entrez un mot de passe Bind DN et Bind.

Entrez les attributs qui mapperont les attributs LDAP aux identités.

- Entrez un attribut ID dont la valeur doit être utilisée comme ID utilisateur. Cliquez sur Ajouter plus pour ajouter plusieurs attributs d’identification.

- Facultatif: Entrez un attribut de nom d’utilisateur préféré dont la valeur doit être utilisée comme nom d’affichage. Cliquez sur Ajouter plus pour ajouter plusieurs attributs de nom d’utilisateur préférés.

- Facultatif: Entrez un attribut Email dont la valeur doit être utilisée comme adresse e-mail. Cliquez sur Ajouter plus pour ajouter plusieurs attributs de messagerie.

- Facultatif: Cliquez sur Afficher les options avancées pour ajouter un fichier d’autorité de certificat (CA) à votre fournisseur d’identité LDAP pour valider les certificats de serveur pour l’URL configurée. Cliquez sur Parcourir pour localiser et joindre un fichier CA au fournisseur d’identité.

Facultatif: Dans le cadre des options avancées, vous pouvez choisir de rendre le fournisseur LDAP non sécurisé. Dans le cas où vous sélectionnez cette option, un fichier CA ne peut pas être utilisé.

ImportantLorsque vous utilisez une connexion LDAP non sécurisée (ldap:/ ou port 389), vous devez vérifier l’option Insecure dans l’assistant de configuration.

- Cliquez sur Confirmer.

La vérification

- Le fournisseur d’identité configuré est maintenant visible dans l’onglet Contrôle d’accès de la page Liste des clusters.

4.6. Configuration d’un fournisseur d’identité OpenID

Configurez un fournisseur d’identité OpenID pour s’intégrer à un fournisseur d’identité OpenID Connect à l’aide d’un flux de code d’autorisation.

L’opérateur d’authentification dans OpenShift Dedicated exige que le fournisseur d’identité OpenID Connect configuré implémente la spécification OpenID Connect Discovery.

Les réclamations sont lues à partir du JWT id_token retourné par le fournisseur d’identité OpenID et, si spécifié, à partir du JSON retourné par l’URL de l’émetteur.

Au moins une revendication doit être configurée pour être utilisée comme identité de l’utilisateur.

Il est également possible d’indiquer les revendications à utiliser comme nom d’utilisateur, nom d’affichage et adresse e-mail préférés de l’utilisateur. Lorsque plusieurs revendications sont spécifiées, la première avec une valeur non vide est utilisée. Les revendications standard sont les suivantes:

| Demande d ' indemnisation | Description |

|---|---|

|

| Le nom d’utilisateur préféré lors du provisionnement d’un utilisateur. C’est un nom abrégé que l’utilisateur veut appeler, tel que janedoe. Généralement une valeur correspondant au nom d’utilisateur ou au nom d’utilisateur dans le système d’authentification, tel que le nom d’utilisateur ou l’email. |

|

| Adresse e-mail. |

|

| Afficher le nom. |

Consultez la documentation sur les demandes OpenID pour plus d’informations.

Conditions préalables

- Avant de configurer OpenID Connect, vérifiez les prérequis d’installation pour tout produit ou service Red Hat que vous souhaitez utiliser avec votre cluster OpenShift Dedicated.

Procédure

- À partir d’OpenShift Cluster Manager, accédez à la page Liste des clusters et sélectionnez le cluster pour lequel vous devez configurer les fournisseurs d’identité.

- Cliquez sur l’onglet Contrôle d’accès.

Cliquez sur Ajouter un fournisseur d’identité.

NoteIl est également possible de cliquer sur le lien de configuration Ajouter Oauth dans le message d’avertissement affiché après la création du cluster pour configurer vos fournisseurs d’identité.

- Choisissez OpenID dans le menu déroulant.

Entrez un nom unique pour le fournisseur d’identité. Ce nom ne peut pas être changé plus tard.

L’URL de rappel OAuth est automatiquement générée dans le champ fourni.

https://oauth-openshift.apps.<cluster_name>.<cluster_domain>/oauth2callback/<idp_provider_name>

https://oauth-openshift.apps.<cluster_name>.<cluster_domain>/oauth2callback/<idp_provider_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow À titre d’exemple:

https://oauth-openshift.apps.openshift-cluster.example.com/oauth2callback/openid

https://oauth-openshift.apps.openshift-cluster.example.com/oauth2callback/openidCopy to Clipboard Copied! Toggle word wrap Toggle overflow

- Enregistrez un nouveau client OpenID Connect dans le fournisseur d’identité OpenID en suivant les étapes pour créer une demande d’autorisation.

- Cliquez sur OpenShift Dedicated et sélectionnez une méthode de cartographie dans le menu déroulant. La réclamation est recommandée dans la plupart des cas.

- Entrez un identifiant client et un secret client fourni à partir d’OpenID.

- Entrez une URL de l’émetteur. C’est l’URL que le fournisseur OpenID affirme comme l’identifiant de l’émetteur. Il doit utiliser le schéma https sans paramètres de requête d’URL ou fragments.

- Entrez un attribut Email dont la valeur doit être utilisée comme adresse e-mail. Cliquez sur Ajouter plus pour ajouter plusieurs attributs de messagerie.

- Entrez un attribut Nom dont la valeur doit être utilisée comme nom d’utilisateur préféré. Cliquez sur Ajouter plus pour ajouter plusieurs noms d’utilisateur préférés.

- Entrez un attribut de nom d’utilisateur préféré dont la valeur doit être utilisée comme nom d’affichage. Cliquez sur Ajouter plus pour ajouter plusieurs noms d’affichage.

- Facultatif: Cliquez sur Afficher les options avancées pour ajouter un fichier d’autorité de certificat (CA) à votre fournisseur d’identité OpenID.

- Facultatif: Sous les options avancées, vous pouvez ajouter des zones supplémentaires. La portée OpenID est demandée par défaut.

- Cliquez sur Confirmer.

La vérification

- Le fournisseur d’identité configuré est maintenant visible dans l’onglet Contrôle d’accès de la page Liste des clusters.

4.7. Configuration d’un fournisseur d’identité htpasswd

Configurez un fournisseur d’identité htpasswd pour créer un seul utilisateur statique avec des privilèges d’administration de clusters. Connectez-vous à votre cluster en tant qu’utilisateur pour résoudre les problèmes.

L’option fournisseur d’identité htpasswd n’est incluse que pour activer la création d’un seul utilisateur d’administration statique. htpasswd n’est pas pris en charge en tant que fournisseur d’identité à usage général pour OpenShift Dedicated.

Procédure

- À partir d’OpenShift Cluster Manager, accédez à la page Liste des clusters et sélectionnez votre cluster.

- Choisissez Contrôle d’accès → Fournisseurs d’identité.

- Cliquez sur Ajouter un fournisseur d’identité.

- Choisissez HTPasswd dans le menu déroulant fournisseur d’identité.

- Ajoutez un nom unique dans le champ Nom du fournisseur d’identité.

Utilisez le nom d’utilisateur et le mot de passe suggérés pour l’utilisateur statique, ou créez le vôtre.

NoteLes informations d’identification définies dans cette étape ne sont pas visibles après avoir sélectionné Ajouter à l’étape suivante. Lorsque vous perdez les informations d’identification, vous devez recréer le fournisseur d’identité et définir à nouveau les informations d’identification.

- Cliquez sur Ajouter pour créer le fournisseur d’identité htpasswd et l’utilisateur unique et statique.

Accordez l’autorisation de l’utilisateur statique pour gérer le cluster:

- Dans Contrôle d’accès → Rôles de cluster et Accès, sélectionnez Ajouter un utilisateur.

- Entrez l’identifiant utilisateur de l’utilisateur statique que vous avez créé à l’étape précédente.

- Choisissez Ajouter un utilisateur pour accorder les privilèges d’administration à l’utilisateur.

La vérification

Le fournisseur d’identité htpasswd configuré est visible sur la page Contrôle d’accès → Fournisseurs d’identité.

NoteAprès avoir créé le fournisseur d’identité, la synchronisation se termine généralement en deux minutes. Lorsque le fournisseur d’identité htpasswd est disponible, vous pouvez vous connecter au cluster en tant qu’utilisateur.

- Le seul utilisateur administratif est visible sur la page Access Control → Cluster Roles and Access. L’adhésion du groupe d’administration de l’utilisateur est également affichée.

4.8. Accéder à votre cluster

Après avoir configuré vos fournisseurs d’identité, les utilisateurs peuvent accéder au cluster à partir de Red Hat OpenShift Cluster Manager.

Conditions préalables

- Connectez-vous à OpenShift Cluster Manager.

- Création d’un cluster OpenShift dédié.

- Configuration d’un fournisseur d’identité pour votre cluster.

- Ajout de votre compte utilisateur au fournisseur d’identité configuré.

Procédure

- À partir d’OpenShift Cluster Manager, cliquez sur le cluster auquel vous souhaitez accéder.

- Cliquez sur Ouvrir la console.

- Cliquez sur votre fournisseur d’identité et fournissez vos informations d’identification pour vous connecter au cluster.

- Cliquez sur Ouvrir la console pour ouvrir la console Web de votre cluster.

- Cliquez sur votre fournisseur d’identité et fournissez vos informations d’identification pour vous connecter au cluster. Complétez toute demande d’autorisation présentée par votre fournisseur.

Chapitre 5. Annuler les privilèges et l’accès à un cluster dédié OpenShift

En tant que propriétaire de cluster, vous pouvez révoquer les privilèges d’administrateur et l’accès de l’utilisateur à un cluster dédié OpenShift.

5.1. Annuler les privilèges d’administrateur d’un utilisateur

Suivez les étapes de cette section pour révoquer les privilèges d’administration dédié d’un utilisateur.

Conditions préalables

- Connectez-vous à OpenShift Cluster Manager.

- Création d’un cluster OpenShift dédié.

- « vous avez configuré un fournisseur d’identité GitHub pour votre cluster et ajouté un utilisateur de fournisseur d’identité.

- « vous avez accordé des privilèges dédiés à l’administration à un utilisateur.

Procédure

- Accédez à OpenShift Cluster Manager et sélectionnez votre cluster.

- Cliquez sur l’onglet Contrôle d’accès.

- Dans l’onglet Rôles de cluster et Accès, sélectionnez à côté d’un utilisateur et cliquez sur Supprimer.

La vérification

- Après avoir révoqué les privilèges, l’utilisateur n’est plus listé dans le groupe admins dédiés sous Contrôle d’accès → Rôles de cluster et Accès sur la page OpenShift Cluster Manager pour votre cluster.

5.2. Annuler l’accès de l’utilisateur à un cluster

Il est possible de révoquer l’accès au cluster d’un utilisateur du fournisseur d’identité en les supprimant de votre fournisseur d’identité configuré.

Il est possible de configurer différents types de fournisseurs d’identité pour votre cluster OpenShift dédié. L’exemple suivant révoque l’accès au cluster pour un membre d’une organisation ou d’une équipe GitHub qui est configuré pour la fourniture d’identité au cluster.

Conditions préalables

- Il y a un cluster dédié OpenShift.

- Il y a un compte utilisateur GitHub.

- « vous avez configuré un fournisseur d’identité GitHub pour votre cluster et ajouté un utilisateur de fournisseur d’identité.

Procédure

- Accédez à github.com et connectez-vous à votre compte GitHub.

Enlevez l’utilisateur de votre organisation ou équipe GitHub:

- Lorsque la configuration de votre fournisseur d’identité utilise une organisation GitHub, suivez les étapes de la suppression d’un membre de votre organisation dans la documentation GitHub.

- Lorsque la configuration de votre fournisseur d’identité utilise une équipe au sein d’une organisation GitHub, suivez les étapes dans Retirer les membres de l’organisation d’une équipe dans la documentation GitHub.

La vérification

- Après avoir retiré l’utilisateur de votre fournisseur d’identité, l’utilisateur ne peut pas s’authentifier dans le cluster.

Chapitre 6. Gestion des rôles d’administration et des utilisateurs

6.1. Comprendre les rôles administratifs

6.1.1. Le rôle de cluster-admin

En tant qu’administrateur d’un cluster dédié OpenShift avec abonnements cloud client (CCS), vous avez accès au rôle cluster-admin. L’utilisateur qui a créé le cluster peut ajouter le rôle d’utilisateur cluster-admin à un compte pour avoir le maximum de privilèges d’administrateur. Ces privilèges ne sont pas automatiquement attribués à votre compte utilisateur lorsque vous créez le cluster. Alors qu’ils sont connectés à un compte avec le rôle de cluster-admin, les utilisateurs ont pour la plupart un accès illimité au contrôle et à la configuration du cluster. Il y a certaines configurations qui sont bloquées avec des webhooks pour empêcher la déstabilisation du cluster, ou parce qu’elles sont gérées dans OpenShift Cluster Manager et tout changement dans l’inclusion serait écrasé. L’utilisation du rôle de cluster-admin est soumise aux restrictions énumérées dans votre accord de l’Annexe 4 avec Red Hat. En tant que meilleure pratique, limiter le nombre d’utilisateurs de cluster-admin au plus petit nombre possible.

6.1.2. Le rôle dédié-admin

En tant qu’administrateur d’un cluster dédié OpenShift, votre compte dispose d’autorisations supplémentaires et d’un accès à tous les projets créés par l’utilisateur dans le cluster de votre organisation. Alors qu’il est connecté à un compte avec le rôle dédié-admin, les commandes CLI développeur (sous la commande oc) vous permettent d’augmenter la visibilité et les capacités de gestion sur les objets à travers les projets, tandis que les commandes CLI administrateur (sous la commande oc adm) vous permettent de compléter des opérations supplémentaires.

Bien que votre compte ait ces autorisations accrues, la maintenance réelle du cluster et la configuration de l’hôte sont toujours effectuées par l’équipe des opérations OpenShift.

6.2. Gestion des administrateurs dédiés à OpenShift

Les rôles d’administrateur sont gérés à l’aide d’un cluster-admin ou d’un groupe dédié-admin sur le cluster. Les membres existants de ce groupe peuvent modifier l’adhésion via OpenShift Cluster Manager.

6.2.1. Ajout d’un utilisateur

Procédure

- Accédez à la page Détails du cluster et à l’onglet Contrôle d’accès.

- Choisissez l’onglet Rôles de cluster et Accès et cliquez sur Ajouter un utilisateur.

- Entrez le nom d’utilisateur et sélectionnez le groupe.

- Cliquez sur Ajouter un utilisateur.

L’ajout d’un utilisateur au groupe cluster-admin peut prendre plusieurs minutes.

6.2.2. La suppression d’un utilisateur

Procédure

- Accédez à la page Détails du cluster et à l’onglet Contrôle d’accès.

- Cliquez sur le menu Options à droite de la combinaison utilisateur et groupe et cliquez sur Supprimer.

Chapitre 7. En utilisant RBAC pour définir et appliquer des autorisations

7.1. Aperçu du RBAC

Les objets de contrôle d’accès basés sur les rôles (RBAC) déterminent si un utilisateur est autorisé à effectuer une action donnée au sein d’un projet.

Les administrateurs dotés du rôle d’administrateur dédié peuvent utiliser les rôles de cluster et les liaisons pour contrôler qui a différents niveaux d’accès à la plate-forme OpenShift Dedicated elle-même et à tous les projets.

Les développeurs peuvent utiliser des rôles et des liens locaux pour contrôler qui a accès à leurs projets. À noter que l’autorisation est une étape distincte de l’authentification, qui consiste davantage à déterminer l’identité de qui prend l’action.

L’autorisation est gérée en utilisant:

| L’objet d’autorisation | Description |

|---|---|

| Les règles | Ensembles de verbes autorisés sur un ensemble d’objets. À titre d’exemple, si un compte d’utilisateur ou de service peut créer des pods. |

| Les rôles | Collections de règles. Il est possible d’associer ou de lier des utilisateurs et des groupes à plusieurs rôles. |

| Fixations | Associations entre utilisateurs et/ou groupes ayant un rôle. |

Il y a deux niveaux de rôles et de liaisons RBAC qui contrôlent l’autorisation:

| Le niveau RBAC | Description |

|---|---|

| Cluster RBAC | Les rôles et les liens qui s’appliquent à tous les projets. Les rôles de cluster existent à l’échelle du groupe, et les liens de rôle de cluster ne peuvent référencer que les rôles de cluster. |

| Local RBAC | Les rôles et les liens qui s’appliquent à un projet donné. Bien que les rôles locaux n’existent que dans un seul projet, les liens de rôle locaux peuvent référencer à la fois les rôles de cluster et les rôles locaux. |

La liaison entre les rôles de cluster est une obligation qui existe au niveau des clusters. Il existe un rôle contraignant au niveau du projet. La vue de rôle de cluster doit être liée à un utilisateur en utilisant une liaison de rôle locale pour que cet utilisateur puisse voir le projet. Créer des rôles locaux uniquement si un rôle de cluster ne fournit pas l’ensemble des autorisations nécessaires à une situation particulière.

Cette hiérarchie à deux niveaux permet de réutiliser plusieurs projets via les rôles de cluster tout en permettant la personnalisation à l’intérieur des projets individuels via des rôles locaux.

Au cours de l’évaluation, on utilise à la fois les liaisons de rôle de groupe et les liaisons locales pour les rôles. À titre d’exemple:

- Les règles «permis» à l’échelle du cluster sont vérifiées.

- Les règles "d’autorisation" locales sont vérifiées.

- Déni par défaut.

7.1.1. Les rôles de cluster par défaut

Le programme OpenShift Dedicated inclut un ensemble de rôles de cluster par défaut que vous pouvez lier aux utilisateurs et aux groupes à l’échelle du cluster ou localement.

Il n’est pas recommandé de modifier manuellement les rôles de cluster par défaut. Les modifications apportées à ces rôles du système peuvent empêcher un cluster de fonctionner correctement.

| Le rôle du cluster par défaut | Description |

|---|---|

|

| Chef de projet. En cas d’utilisation dans une liaison locale, un administrateur a le droit de visualiser toute ressource dans le projet et de modifier toute ressource dans le projet, à l’exception du quota. |

|

| D’un utilisateur qui peut obtenir des informations de base sur les projets et les utilisateurs. |

|

| C’est un super-utilisateur qui peut effectuer n’importe quelle action dans n’importe quel projet. Lorsqu’ils sont liés à un utilisateur avec une liaison locale, ils ont un contrôle total sur le quota et chaque action sur chaque ressource du projet. |

|

| D’un utilisateur qui peut obtenir des informations de base sur l’état du cluster. |

|

| D’un utilisateur qui peut obtenir ou visualiser la plupart des objets, mais qui ne peut pas les modifier. |

|

| L’utilisateur qui peut modifier la plupart des objets d’un projet mais qui n’a pas le pouvoir d’afficher ou de modifier des rôles ou des liaisons. |

|

| L’utilisateur qui peut créer ses propres projets. |

|

| L’utilisateur qui ne peut apporter aucune modification, mais qui peut voir la plupart des objets dans un projet. Ils ne peuvent pas voir ou modifier les rôles ou les liaisons. |

Gardez à l’esprit la différence entre les liaisons locales et les regroupements. À titre d’exemple, si vous liez le rôle cluster-admin à un utilisateur en utilisant une liaison de rôle locale, il peut sembler que cet utilisateur a les privilèges d’un administrateur de cluster. Ce n’est pas le cas. Lier le cluster-admin à un utilisateur dans un projet accorde des privilèges de super administrateur pour seulement ce projet à l’utilisateur. Cet utilisateur a les autorisations de l’administrateur de rôle de cluster, plus quelques permissions supplémentaires comme la possibilité de modifier les limites de taux, pour ce projet. Cette liaison peut être déroutante via l’interface utilisateur de la console Web, qui ne répertorie pas les liaisons de rôle de cluster qui sont liées à de vrais administrateurs de clusters. Cependant, il répertorie les liaisons de rôle locales que vous pouvez utiliser pour lier localement cluster-admin.

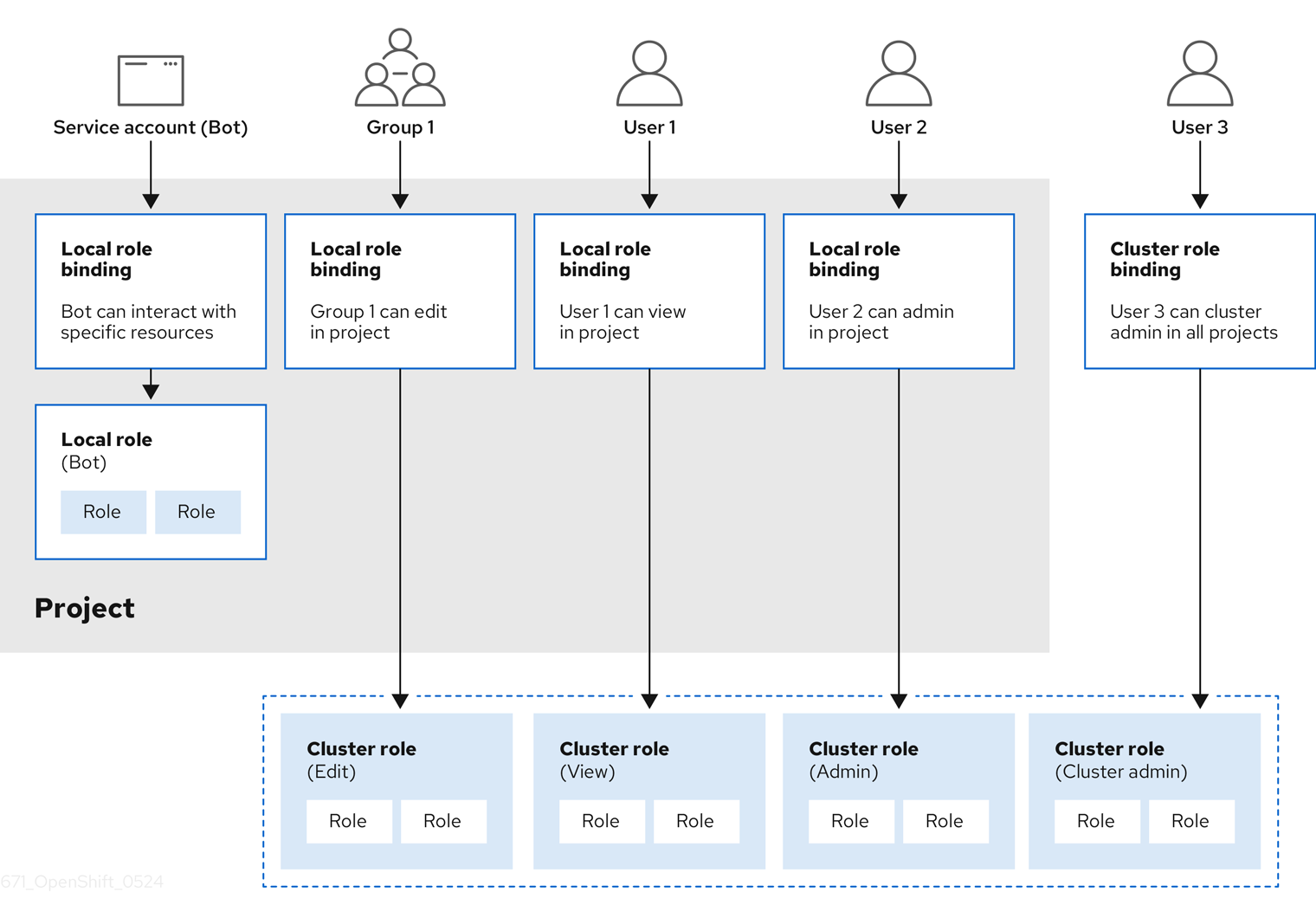

Les relations entre les rôles de cluster, les rôles locaux, les liens de rôle de cluster, les liens locaux de rôle, les utilisateurs, les groupes et les comptes de services sont illustrés ci-dessous.

Les get pods/exec, get pods/*, et obtenir * règles accordent des privilèges d’exécution lorsqu’ils sont appliqués à un rôle. Appliquez le principe du moindre privilège et n’attribuez que les droits minimaux RBAC requis pour les utilisateurs et les agents. Les règles RBAC autorisent les privilèges d’exécution.

7.1.2. Évaluation de l’autorisation

La société OpenShift Dedicated évalue l’autorisation en utilisant:

- Identité

- Le nom d’utilisateur et la liste des groupes auxquels l’utilisateur appartient.

- À l’action

L’action que vous effectuez. Dans la plupart des cas, il s’agit de:

- Le projet auquel vous accédez. Il s’agit d’un espace de noms Kubernetes avec des annotations supplémentaires qui permet à une communauté d’utilisateurs d’organiser et de gérer leur contenu indépendamment des autres communautés.

- L’action elle-même : obtenir, répertorier, créer, mettre à jour, supprimer, supprimer, supprimer ou regarder.

- Le nom de la ressource : le point de terminaison API auquel vous accédez.

- Fixations

- La liste complète des liens, les associations entre utilisateurs ou groupes ayant un rôle.

La société OpenShift Dedicated évalue l’autorisation en utilisant les étapes suivantes:

- L’identité et l’action à portée de projet sont utilisées pour trouver toutes les liaisons qui s’appliquent à l’utilisateur ou à ses groupes.

- Les liaisons sont utilisées pour localiser tous les rôles qui s’appliquent.

- Les rôles sont utilisés pour trouver toutes les règles qui s’appliquent.

- L’action est vérifiée par rapport à chaque règle pour trouver un match.

- En cas d’absence de règle de correspondance, l’action est alors refusée par défaut.

Gardez à l’esprit que les utilisateurs et les groupes peuvent être associés ou liés à plusieurs rôles en même temps.

Les administrateurs de projet peuvent utiliser le CLI pour afficher les rôles et les liens locaux, y compris une matrice des verbes et des ressources auxquels chacun est associé.

Le rôle de cluster lié à l’administrateur du projet est limité dans un projet par le biais d’une liaison locale. Il n’est pas lié à l’ensemble du cluster comme les rôles de cluster attribués au cluster-admin ou system:admin.

Les rôles de cluster sont des rôles définis au niveau du cluster, mais peuvent être liés soit au niveau du cluster, soit au niveau du projet.

7.1.2.1. Agrégation des rôles de cluster

L’administrateur, l’édition, la vue et les rôles de cluster par défaut prennent en charge l’agrégation des rôles de cluster, où les règles de cluster pour chaque rôle sont mises à jour dynamiquement à mesure que de nouvelles règles sont créées. Cette fonctionnalité n’est pertinente que si vous étendez l’API Kubernetes en créant des ressources personnalisées.

7.2. Les projets et espaces de noms

L’espace de noms Kubernetes fournit un mécanisme permettant d’étendre les ressources d’un cluster. La documentation Kubernetes contient plus d’informations sur les espaces de noms.

Les espaces de noms offrent une possibilité unique pour:

- Les ressources nommées pour éviter les collisions de base.

- Délégation du pouvoir de gestion aux utilisateurs de confiance.

- La capacité de limiter la consommation de ressources communautaires.

La plupart des objets du système sont encadrés par l’espace de noms, mais certains sont exceptés et n’ont pas d’espace de noms, y compris les nœuds et les utilisateurs.

Le projet est un espace de noms Kubernetes avec des annotations supplémentaires et est le véhicule central par lequel l’accès aux ressources pour les utilisateurs réguliers est géré. Le projet permet à une communauté d’utilisateurs d’organiser et de gérer leur contenu indépendamment des autres communautés. Les utilisateurs doivent avoir accès aux projets par les administrateurs ou, s’ils sont autorisés à créer des projets, ont automatiquement accès à leurs propres projets.

Les projets peuvent avoir un nom, un nom d’affichage et une description séparés.

- Le nom obligatoire est un identifiant unique pour le projet et est plus visible lors de l’utilisation des outils CLI ou API. La longueur maximale du nom est de 63 caractères.

- Le nom optionnel d’affichage est la façon dont le projet est affiché dans la console Web (par défaut de nom).

- La description optionnelle peut être une description plus détaillée du projet et est également visible dans la console Web.

Chaque projet porte sur son propre ensemble de:

| L’objet | Description |

|---|---|

|

| Des pods, des services, des contrôleurs de réplication, etc. |

|

| Les règles pour lesquelles les utilisateurs peuvent ou ne peuvent pas effectuer des actions sur des objets. |

|

| Quotas pour chaque type d’objet qui peut être limité. |

|

| Les comptes de service agissent automatiquement avec l’accès désigné aux objets du projet. |

Les administrateurs ayant le rôle d’administrateur dédié peuvent créer des projets et déléguer des droits administratifs pour le projet à tout membre de la communauté d’utilisateurs. Les administrateurs ayant un rôle d’administrateur dédié peuvent également permettre aux développeurs de créer leurs propres projets.

Les développeurs et les administrateurs peuvent interagir avec des projets en utilisant le CLI ou la console Web.

7.3. Les projets par défaut

Les projets OpenShift Dedicated sont livrés avec un certain nombre de projets par défaut, et les projets commençant par openshift- sont les plus essentiels pour les utilisateurs. Ces projets hébergent des composants maîtres qui fonctionnent comme des pods et d’autres composants d’infrastructure. Les pods créés dans ces espaces de noms qui ont une annotation critique de pod sont considérés comme critiques, et l’admission garantie par kubelet. Les pods créés pour les composants maîtres dans ces espaces de noms sont déjà marqués comme critiques.

Évitez d’exécuter des charges de travail ou de partager l’accès aux projets par défaut. Les projets par défaut sont réservés à l’exécution de composants de cluster de base.

Les projets par défaut suivants sont considérés comme hautement privilégiés: par défaut, kube-public, kube-system, openshift, openshift-infra, openshift-node, et d’autres projets créés par système qui ont l’étiquette openshift.io / run-level définie à 0 ou 1. La fonctionnalité qui repose sur des plugins d’admission, tels que l’admission de sécurité pod, les contraintes de contexte de sécurité, les quotas de ressources de cluster et la résolution de référence d’image, ne fonctionne pas dans des projets hautement privilégiés.

7.4. Affichage des rôles et des liens de cluster

Il est possible d’utiliser le CLI oc pour afficher les rôles et les liaisons de cluster à l’aide de la commande de description oc.

Conditions préalables

- Installez le CLI oc.

- Demandez l’autorisation d’afficher les rôles et les liaisons du cluster.

Procédure

Afficher les rôles de cluster et leurs ensembles de règles associés:

oc describe clusterrole.rbac

$ oc describe clusterrole.rbacCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Afficher l’ensemble actuel de liaisons de rôles de cluster, qui montre les utilisateurs et les groupes qui sont liés à divers rôles:

oc describe clusterrolebinding.rbac

$ oc describe clusterrolebinding.rbacCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.5. Affichage des rôles et des liens locaux

Il est possible d’utiliser le CLI oc pour afficher les rôles et les liaisons locaux à l’aide de la commande de description oc.

Conditions préalables

- Installez le CLI oc.

Obtenir la permission d’afficher les rôles et les liens locaux:

- Les utilisateurs avec le rôle de cluster par défaut d’administrateur lié localement peuvent afficher et gérer les rôles et les liaisons dans ce projet.

Procédure

Afficher l’ensemble actuel de liaisons de rôles locales, qui montrent les utilisateurs et les groupes qui sont liés à divers rôles pour le projet en cours:

oc describe rolebinding.rbac

$ oc describe rolebinding.rbacCopy to Clipboard Copied! Toggle word wrap Toggle overflow Afin d’afficher les liaisons de rôle locales pour un projet différent, ajoutez le drapeau -n à la commande:

oc describe rolebinding.rbac -n joe-project

$ oc describe rolebinding.rbac -n joe-projectCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

7.6. Ajout de rôles aux utilisateurs

Il est possible d’utiliser l’administrateur oc adm CLI pour gérer les rôles et les liaisons.

La liaison ou l’ajout d’un rôle aux utilisateurs ou aux groupes donne à l’utilisateur ou au groupe l’accès accordé par le rôle. Il est possible d’ajouter et de supprimer des rôles vers et à partir d’utilisateurs et de groupes à l’aide de commandes de stratégie adm oc.

Il est possible de lier n’importe lequel des rôles de cluster par défaut aux utilisateurs locaux ou aux groupes de votre projet.

Procédure

Ajouter un rôle à un utilisateur dans un projet spécifique:

oc adm policy add-role-to-user <role> <user> -n <project>

$ oc adm policy add-role-to-user <role> <user> -n <project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow À titre d’exemple, vous pouvez ajouter le rôle d’administrateur à l’utilisateur alice dans le projet joe en exécutant:

oc adm policy add-role-to-user admin alice -n joe

$ oc adm policy add-role-to-user admin alice -n joeCopy to Clipboard Copied! Toggle word wrap Toggle overflow AstuceAlternativement, vous pouvez appliquer le YAML suivant pour ajouter le rôle à l’utilisateur:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Consultez les liaisons locales des rôles et vérifiez l’ajout dans la sortie:

oc describe rolebinding.rbac -n <project>

$ oc describe rolebinding.rbac -n <project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow À titre d’exemple, voir les liens de rôle locaux pour le projet joe:

oc describe rolebinding.rbac -n joe

$ oc describe rolebinding.rbac -n joeCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- L’utilisateur alice a été ajouté aux administrateurs RoleBinding.

7.7. Créer un rôle local

Il est possible de créer un rôle local pour un projet, puis de le lier à un utilisateur.

Procédure

Afin de créer un rôle local pour un projet, exécutez la commande suivante:

oc create role <name> --verb=<verb> --resource=<resource> -n <project>

$ oc create role <name> --verb=<verb> --resource=<resource> -n <project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Dans cette commande, spécifiez:

- <nom>, le nom du rôle local

- <verb>, une liste séparée par virgule des verbes à appliquer au rôle

- <Resource>, les ressources auxquelles le rôle s’applique

- <projet>, le nom du projet

À titre d’exemple, pour créer un rôle local qui permet à un utilisateur d’afficher des pods dans le projet bleu, exécutez la commande suivante:

oc create role podview --verb=get --resource=pod -n blue

$ oc create role podview --verb=get --resource=pod -n blueCopy to Clipboard Copied! Toggle word wrap Toggle overflow Afin de lier le nouveau rôle à un utilisateur, exécutez la commande suivante:

oc adm policy add-role-to-user podview user2 --role-namespace=blue -n blue

$ oc adm policy add-role-to-user podview user2 --role-namespace=blue -n blueCopy to Clipboard Copied! Toggle word wrap Toggle overflow

7.8. Commandes locales de liaison des rôles

Lorsque vous gérez les rôles associés d’un utilisateur ou d’un groupe pour les liaisons de rôles locales en utilisant les opérations suivantes, un projet peut être spécifié avec l’indicateur -n. Dans le cas contraire, le projet en cours est utilisé.

Les commandes suivantes peuvent être utilisées pour la gestion RBAC locale.

| Commande | Description |

|---|---|

|

| Indique quels utilisateurs peuvent effectuer une action sur une ressource. |

|

| Lie un rôle spécifié aux utilisateurs spécifiés dans le projet en cours. |

|

| Élimine un rôle donné des utilisateurs spécifiés dans le projet en cours. |

|

| Élimine les utilisateurs spécifiés et tous leurs rôles dans le projet en cours. |

|

| Lie un rôle donné à des groupes spécifiés dans le projet en cours. |

|

| Élimine un rôle donné des groupes spécifiés dans le projet en cours. |

|

| Élimine les groupes spécifiés et tous leurs rôles dans le projet en cours. |

7.9. Commandes de liaison de rôle de cluster

En outre, vous pouvez gérer les liaisons de rôles de cluster à l’aide des opérations suivantes. Le drapeau -n n’est pas utilisé pour ces opérations parce que les liaisons de rôle de cluster utilisent des ressources non-nombrées.

| Commande | Description |

|---|---|

|

| Lie un rôle donné aux utilisateurs spécifiés pour tous les projets du cluster. |

|

| Élimine un rôle donné des utilisateurs spécifiés pour tous les projets du cluster. |

|

| Lie un rôle donné à des groupes spécifiés pour tous les projets du cluster. |

|

| Élimine un rôle donné des groupes spécifiés pour tous les projets du cluster. |

7.10. Accorder des privilèges d’administrateur à un utilisateur

Après avoir configuré un fournisseur d’identité pour votre cluster et ajouté un utilisateur au fournisseur d’identité, vous pouvez accorder des privilèges de cluster dédié-admin à l’utilisateur.

Conditions préalables

- Connectez-vous à OpenShift Cluster Manager.

- Création d’un cluster OpenShift dédié.

- Configuration d’un fournisseur d’identité pour votre cluster.

Procédure

- Accédez à OpenShift Cluster Manager et sélectionnez votre cluster.

- Cliquez sur l’onglet Contrôle d’accès.

- Dans l’onglet Rôles de cluster et Accès, cliquez sur Ajouter un utilisateur.

- Entrez l’identifiant utilisateur d’un utilisateur fournisseur d’identité.

- Cliquez sur Ajouter un utilisateur pour accorder des privilèges de cluster dédié-admin à l’utilisateur.

La vérification

- Après avoir accordé les privilèges, l’utilisateur est listé dans le groupe admins dédié sous Contrôle d’accès → Rôles de cluster et Accès sur la page OpenShift Cluster Manager pour votre cluster.

7.11. Liaisons de rôles de cluster pour les groupes non authentifiés

Avant OpenShift Dedicated 4.17, les groupes non authentifiés étaient autorisés à accéder à certains rôles de cluster. Les clusters mis à jour à partir des versions avant OpenShift Dedicated 4.17 conservent cet accès pour les groupes non authentifiés.

Et pour des raisons de sécurité, OpenShift Dedicated 4 ne permet pas aux groupes non authentifiés d’avoir un accès par défaut aux rôles de cluster.

Il y a des cas d’utilisation où il pourrait être nécessaire d’ajouter system:inauthenticated à un rôle de cluster.

Les administrateurs de clusters peuvent ajouter des utilisateurs non authentifiés aux rôles de cluster suivants:

-

le système:scope-impersonation -

le système:webhook -

le système:oauth-token-deleter -

auto-réviseur d’accès

Assurez-vous toujours de respecter les normes de sécurité de votre organisation lors de la modification de l’accès non authentifié.

Chapitre 8. Comprendre et créer des comptes de services

8.1. Aperçu des comptes de services

Le compte de service est un compte dédié OpenShift qui permet à un composant d’accéder directement à l’API. Les comptes de service sont des objets API qui existent dans chaque projet. Les comptes de service offrent un moyen flexible de contrôler l’accès à l’API sans partager les informations d’identification d’un utilisateur régulier.

Lorsque vous utilisez le CLI dédié OpenShift ou la console Web, votre jeton API vous authentifie vers l’API. Il est possible d’associer un composant à un compte de service afin qu’il puisse accéder à l’API sans utiliser les informations d’identification d’un utilisateur régulier.

Le nom d’utilisateur de chaque compte de service est dérivé de son projet et de son nom:

system:serviceaccount:<project>:<name>

system:serviceaccount:<project>:<name>Chaque compte de service est également membre de deux groupes:

| Groupe de travail | Description |

|---|---|

| le système:comptes de service | Inclut tous les comptes de service dans le système. |

| les comptes de service:<projet> | Inclut tous les comptes de service dans le projet spécifié. |

8.1.1. Les secrets d’attraction d’image générés automatiquement

Par défaut, OpenShift Dedicated crée un secret d’attraction d’image pour chaque compte de service.

Avant OpenShift Dedicated 4.16, un secret de jeton API de compte de service de longue durée a également été généré pour chaque compte de service créé. À partir de OpenShift Dedicated 4.16, le secret de jetons de compte de service n’est plus créé.

Après la mise à niveau à 4, tous les secrets de jetons de compte de service de longue durée existants ne sont pas supprimés et continueront à fonctionner. Afin d’obtenir des informations sur la détection des jetons API de longue durée qui sont utilisés dans votre cluster ou de les supprimer s’ils ne sont pas nécessaires, consultez l’article Red Hat Knowledgebase des jetons API de compte de service longue durée dans OpenShift Container Platform.

Ce secret d’attraction d’image est nécessaire pour intégrer le registre d’images OpenShift dans le système d’authentification et d’autorisation de l’utilisateur du cluster.

Cependant, si vous n’activez pas la fonction ImageRegistry ou si vous désactivez le registre d’images OpenShift intégré dans la configuration de l’opérateur de registre d’images du cluster, un secret d’attraction d’image n’est pas généré pour chaque compte de service.

Lorsque le registre d’images OpenShift intégré est désactivé sur un cluster qui l’avait précédemment activé, les secrets d’extraction d’images générés précédemment sont supprimés automatiquement.

8.2. Création de comptes de service

Il est possible de créer un compte de service dans un projet et de lui accorder des autorisations en le liant à un rôle.

Procédure

Facultatif: Pour visualiser les comptes de service dans le projet en cours:

oc get sa

$ oc get saCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

NAME SECRETS AGE builder 1 2d default 1 2d deployer 1 2d

NAME SECRETS AGE builder 1 2d default 1 2d deployer 1 2dCopy to Clipboard Copied! Toggle word wrap Toggle overflow Créer un nouveau compte de service dans le projet en cours:

oc create sa <service_account_name>

$ oc create sa <service_account_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Afin de créer un compte de service dans un projet différent, spécifiez -n <project_name>.

Exemple de sortie

serviceaccount "robot" created

serviceaccount "robot" createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow AstuceAlternativement, vous pouvez appliquer le YAML suivant pour créer le compte de service:

apiVersion: v1 kind: ServiceAccount metadata: name: <service_account_name> namespace: <current_project>

apiVersion: v1 kind: ServiceAccount metadata: name: <service_account_name> namespace: <current_project>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Facultatif: Voir les secrets pour le compte de service:

oc describe sa robot

$ oc describe sa robotCopy to Clipboard Copied! Toggle word wrap Toggle overflow Exemple de sortie

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

8.3. Accorder des rôles aux comptes de services

Il est possible d’accorder des rôles aux comptes de service de la même manière que vous accordez des rôles à un compte utilisateur régulier.

Il est possible de modifier les comptes de service pour le projet en cours. À titre d’exemple, ajouter le rôle de vue au compte de service robot dans le projet top-secret:

oc policy add-role-to-user view system:serviceaccount:top-secret:robot

$ oc policy add-role-to-user view system:serviceaccount:top-secret:robotCopy to Clipboard Copied! Toggle word wrap Toggle overflow AstuceAlternativement, vous pouvez appliquer le YAML suivant pour ajouter le rôle:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Il est également possible d’accorder l’accès à un compte de service spécifique dans un projet. À partir du projet auquel appartient le compte de service, utilisez le drapeau -z et spécifiez le <service_account_name>

oc policy add-role-to-user <role_name> -z <service_account_name>

$ oc policy add-role-to-user <role_name> -z <service_account_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ImportantDans le cas où vous souhaitez autoriser l’accès à un compte de service spécifique dans un projet, utilisez le drapeau -z. L’utilisation de ce drapeau permet d’éviter les typos et garantit que l’accès est accordé uniquement au compte de service spécifié.

AstuceAlternativement, vous pouvez appliquer le YAML suivant pour ajouter le rôle:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Afin de modifier un espace de noms différent, vous pouvez utiliser l’option -n pour indiquer l’espace de noms du projet auquel il s’applique, comme indiqué dans les exemples suivants.

À titre d’exemple, permettre à tous les comptes de services de tous les projets d’afficher les ressources du projet de mon projet:

oc policy add-role-to-group view system:serviceaccounts -n my-project

$ oc policy add-role-to-group view system:serviceaccounts -n my-projectCopy to Clipboard Copied! Toggle word wrap Toggle overflow AstuceAlternativement, vous pouvez appliquer le YAML suivant pour ajouter le rôle:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow De permettre à tous les comptes de services du projet des gestionnaires d’éditer des ressources dans le projet de mon projet:

oc policy add-role-to-group edit system:serviceaccounts:managers -n my-project

$ oc policy add-role-to-group edit system:serviceaccounts:managers -n my-projectCopy to Clipboard Copied! Toggle word wrap Toggle overflow AstuceAlternativement, vous pouvez appliquer le YAML suivant pour ajouter le rôle:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

Chapitre 9. L’utilisation des comptes de service dans les applications