インストール後の設定

OpenShift Container Platform の Day 2 オペレーション

概要

第1章 インストール後の設定の概要

OpenShift Container Platform のインストール後に、クラスター管理者は以下のコンポーネントを設定し、カスタマイズできます。

- マシン

- ベアメタル

- クラスター

- ノード

- ネットワーク

- ストレージ

- ユーザー

- アラートおよび通知

1.1. インストール後の設定タスク

インストール後の設定タスクを実行して、ニーズに合わせて環境を設定できます。

次のリストにインストール後の設定の詳細を示します。

-

オペレーティングシステム機能の設定: Machine Config Operator (MCO) は

MachineConfigオブジェクトを管理します。MCO を使用すると、ノードとカスタムリソースを設定できます。 ベアメタルノードの設定: Bare Metal Operator (BMO) を使用してベアメタルホストを管理できます。BMO は次の操作を完了できます。

- ホストのハードウェアの詳細を検査し、ベアメタルホストに報告します。

- ファームウェアを検査し、BIOS を設定します。

- 必要なイメージでホストをプロビジョニングします。

- ホストをプロビジョニングする前または後に、ホストのディスクの内容をクリーンアップします。

クラスター機能の設定: OpenShift Container Platform クラスターの以下の機能を変更できます。

- イメージレジストリー

- ネットワーク設定

- イメージビルドの動作

- アイデンティティープロバイダー

- etcd の設定

- ワークロードを処理するマシンセットの作成

- クラウドプロバイダーの認証情報の管理

プライベートクラスターの設定: デフォルトでは、インストールプログラムはパブリックにアクセス可能な DNS とエンドポイントを使用して、OpenShift Container Platform をプロビジョニングします。内部ネットワーク内からのみクラスターにアクセスできるようにするには、次のコンポーネントを設定してプライベートにします。

- DNS

- Ingress コントローラー

- API サーバー

ノード操作の実施: デフォルトでは、OpenShift Container Platform は Red Hat Enterprise Linux CoreOS (RHCOS) コンピュートマシンを使用します。次のノード操作を実行できます。

- コンピュートマシンの追加および削除

- taint および toleration 追加および削除

- ノードあたりの Pod の最大数の設定

- Device Manager の有効化

ユーザーの設定: ユーザーは、OAuth アクセストークンを使用して API に対して認証を行うことができます。次のタスクを実行するように OAuth を設定できます。

- アイデンティティープロバイダーを指定します。

- ロールベースのアクセス制御を使用して、ユーザーにパーミッションを定義し付与します。

- OperatorHub から Operator をインストールします。

- アラート通知の設定: デフォルトでは、発生中のアラートは Web コンソールのアラート UI に表示されます。外部システムにアラート通知を送信するように OpenShift Container Platform を設定することもできます。

第2章 プライベートクラスターの設定

OpenShift Container Platform バージョン 4.16 クラスターのインストール後に、そのコアコンポーネントの一部を private に設定できます。

2.1. プライベートクラスター

デフォルトで、OpenShift Container Platform は一般にアクセス可能な DNS およびエンドポイントを使用してプロビジョニングされます。プライベートクラスターのデプロイ後に DNS、Ingress コントローラー、および API サーバーを private に設定できます。

クラスターにパブリックサブネットがある場合、管理者により作成されたロードバランサーサービスはパブリックにアクセスできる可能性があります。クラスターのセキュリティーを確保するには、これらのサービスに明示的にプライベートアノテーションが付けられていることを確認してください。

2.1.1. DNS

OpenShift Container Platform を installer-provisioned infrastructure にインストールする場合、インストールプログラムは既存のパブリックゾーンにレコードを作成し、可能な場合はクラスター独自の DNS 解決用のプライベートゾーンを作成します。パブリックゾーンおよびプライベートゾーンの両方で、インストールプログラムまたはクラスターが Ingress オブジェクトの *.apps、および API サーバーの api の DNS エントリーを作成します。

*.apps レコードはパブリックゾーンとプライベートゾーンのどちらでも同じであるため、パブリックゾーンを削除する際に、プライベートゾーンではクラスターのすべての DNS 解決をシームレスに提供します。

2.1.2. Ingress コントローラー

デフォルトの Ingress オブジェクトはパブリックとして作成されるため、ロードバランサーはインターネットに接続され、パブリックサブネットで使用されます。

Ingress Operator は、カスタムのデフォルト証明書を設定するまで、プレースホルダーとして機能する Ingress コントローラーのデフォルト証明書を生成します。実稼働クラスターで Operator が生成するデフォルト証明書は使用しないでください。Ingress Operator は、独自の署名証明書または生成するデフォルト証明書をローテーションしません。Operator が生成するデフォルト証明書は、設定するカスタムデフォルト証明書のプレースホルダーとして使用されます。

2.1.3. API サーバー

デフォルトでは、インストールプログラムは内部トラフィックと外部トラフィックの両方で使用するための API サーバーの適切なネットワークロードバランサーを作成します。

Amazon Web Services (AWS) では、個別のパブリックロードバランサーおよびプライベートロードバランサーが作成されます。ロードバランサーは、クラスター内で使用するために追加ポートが内部で利用可能な場合を除き、常に同一です。インストールプログラムは API サーバー要件に基づいてロードバランサーを自動的に作成または破棄しますが、クラスターはそれらを管理または維持しません。クラスターの API サーバーへのアクセスを保持する限り、ロードバランサーを手動で変更または移動できます。パブリックロードバランサーの場合、ポート 6443 は開放され、ヘルスチェックが HTTPS について /readyz パスに対して設定されます。

Google Cloud では、内部 API トラフィックと外部 API トラフィックの両方を管理するために単一のロードバランサーが作成されるため、ロードバランサーを変更する必要はありません。

Microsoft Azure では、パブリックおよびプライベートロードバランサーの両方が作成されます。ただし、現在の実装には制限があるため、プライベートクラスターで両方のロードバランサーを保持します。

2.2. プライベートゾーンで公開する DNS レコードの設定

すべての OpenShift Container Platform クラスターでは、パブリックかプライベートかにかかわらず、DNS レコードはデフォルトでパブリックゾーンに公開されます。

DNS レコードをパブリックに公開しない場合は、クラスター DNS 設定からパブリックゾーンを削除できます。内部ドメイン名、内部 IP アドレス、組織内のクラスターの数などの機密情報を公開しない場合や、レコードを公開する必要がない場合もあります。クラスター内のサービスに接続できるすべてのクライアントが、プライベートゾーンの DNS レコードを持つプライベート DNS サービスを使用する場合、クラスターのパブリック DNS レコードは必要ありません。

クラスターをデプロイした後、DNS カスタムリソース (CR) を変更して、プライベートゾーンのみを使用するように DNS を変更できます。このように DNS CR を変更すると、その後に作成される DNS レコードはパブリック DNS サーバーに公開されなくなり、DNS レコードに関する情報は内部ユーザーだけに限定されます。これは、クラスターをプライベートに設定する場合、または DNS レコードをパブリックに解決する必要がない場合に適用できます。

または、プライベートクラスターでも DNS レコード用のパブリックゾーンを保持し、クライアントがそのクラスターで実行されているアプリケーションの DNS 名を解決できるようにすることも可能です。たとえば組織は、パブリックインターネットに接続するマシンを所有し、特定のプライベート IP 範囲に対して VPN 接続を確立してプライベート IP アドレスに接続することができます。これらのマシンからの DNS ルックアップでは、パブリック DNS を使用してそれらのサービスのプライベートアドレスを判断し、VPN 経由でプライベートアドレスに接続します。

手順

次のコマンドを実行して出力を確認し、クラスターの

DNSCR を確認します。oc get dnses.config.openshift.io/cluster -o yaml

$ oc get dnses.config.openshift.io/cluster -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow specセクションには、プライベートゾーンとパブリックゾーンの両方が含まれることに注意してください。次のコマンドを実行して、

DNSCR にパッチを適用し、パブリックゾーンを削除します。oc patch dnses.config.openshift.io/cluster --type=merge --patch='{"spec": {"publicZone": null}}'$ oc patch dnses.config.openshift.io/cluster --type=merge --patch='{"spec": {"publicZone": null}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

dns.config.openshift.io/cluster patched

dns.config.openshift.io/cluster patchedCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ingress Operator は、

IngressControllerオブジェクトの DNS レコード作成時にDNSCR 定義を参照します。プライベートゾーンのみ指定されている場合、プライベートレコードのみが作成されます。重要パブリックゾーンを削除しても、既存の DNS レコードは変更されません。以前に公開したパブリック DNS レコードで、パブリックに公開する必要がなくなったものは、手動で削除する必要があります。

検証

次のコマンドを実行し、出力でクラスターの

DNSCR を確認してパブリックゾーンが削除されたことを確認します。oc get dnses.config.openshift.io/cluster -o yaml

$ oc get dnses.config.openshift.io/cluster -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. Ingress コントローラーをプライベートに設定する

クラスターのデプロイ後に、その Ingress コントローラーをプライベートゾーンのみを使用するように変更できます。

手順

内部エンドポイントのみを使用するようにデフォルト Ingress コントローラーを変更します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

ingresscontroller.operator.openshift.io "default" deleted ingresscontroller.operator.openshift.io/default replaced

ingresscontroller.operator.openshift.io "default" deleted ingresscontroller.operator.openshift.io/default replacedCopy to Clipboard Copied! Toggle word wrap Toggle overflow パブリック DNS エントリーが削除され、プライベートゾーンエントリーが更新されます。

2.4. API サーバーをプライベートに制限する

クラスターを Amazon Web Services (AWS) または Microsoft Azure にデプロイした後に、プライベートゾーンのみを使用するように API サーバーを再設定することができます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

admin権限を持つユーザーとして Web コンソールにアクセスできること。

手順

クラウドプロバイダーの Web ポータルまたはコンソールで、次の操作を行います。

適切なロードバランサーコンポーネントを見つけて削除します。

- AWS の場合は、外部ロードバランサーを削除します。プライベートゾーンの API DNS エントリーは、同一の設定を使用する内部ロードバランサーをすでに参照するため、内部ロードバランサーを変更する必要はありません。

-

Azure の場合は、パブリックロードバランサーの

api-internal-v4ルールを削除します。

-

Azure の場合、Ingress Controller エンドポイントの公開スコープを

Internalに設定します。詳細は、「Ingress Controller エンドポイント公開スコープを内部に設定」を参照してください。 -

Azure パブリックロードバランサーの場合は、Ingress Controller エンドポイントの公開スコープを

Internalに設定し、パブリックロードバランサーに既存の受信規則がない場合は、バックエンドアドレスプールに送信トラフィックを提供するための送信規則を明示的に作成する必要があります。詳細は、送信ルールの追加に関する Microsoft Azure のドキュメントを参照してください。 -

パブリックゾーンの

api.$clustername.$yourdomainまたはapi.$clusternameDNS エントリーを削除します。

AWS クラスター: 外部ロードバランサーを削除します。

重要以下の手順は、installer-provisioned infrastructure (IPI) のクラスターでのみ実行できます。user-provisioned infrastructure (UPI) のクラスターの場合は、外部ロードバランサーを手動で削除するか、無効にする必要があります。

クラスターがコントロールプレーンマシンセットを使用する場合は、コントロールプレーンマシンセットのカスタムリソースで、パブリックまたは外部ロードバランサーを設定する行を削除します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターがコントロールプレーンマシンセットを使用しない場合は、各コントロールプレーンマシンから外部ロードバランサーを削除する必要があります。

ターミナルから、次のコマンドを実行してクラスターマシンを一覧表示します。

oc get machine -n openshift-machine-api

$ oc get machine -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow コントロールプレーンマシンの名前には

masterが含まれています。各コントロールプレーンマシンから外部ロードバランサーを削除します。

次のコマンドを実行して、コントロールプレーンマシンオブジェクトを編集します。

oc edit machines -n openshift-machine-api <control_plane_name>

$ oc edit machines -n openshift-machine-api <control_plane_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 変更するコントロールプレーンマシンオブジェクトの名前を指定します。

次の例でマークされている、外部ロードバランサーを説明する行を削除します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を保存して、オブジェクト仕様を終了します。

- コントロールプレーンマシンごとに、このプロセスを繰り返します。

2.5. Azure 上でプライベートストレージエンドポイントを設定する

Image Registry Operator を利用すると、Azure 上でプライベートエンドポイントを使用できます。これにより、OpenShift Container Platform がプライベート Azure クラスターにデプロイされている場合に、プライベートストレージアカウントのシームレスな設定が可能になります。これにより、パブリック向けのストレージエンドポイントを公開せずにイメージレジストリーをデプロイできます。

Microsoft Azure Red Hat OpenShift (ARO) でプライベートストレージエンドポイントを設定しないでください。エンドポイントによって、Microsoft Azure Red Hat OpenShift クラスターが回復不能な状態になる可能性があります。

次のどちらかの方法で、Azure 上のプライベートストレージエンドポイントを使用するように Image Registry Operator を設定できます。

- Image Registry Operator を設定して VNet 名とサブネット名を検出する

- ユーザーが指定した Azure 仮想ネットワーク (VNet) 名とサブネット名を使用する

2.5.1. Azure 上でプライベートストレージエンドポイントを設定する場合の制限事項

Azure 上でプライベートストレージエンドポイントを設定する場合は、次の制限が適用されます。

-

プライベートストレージエンドポイントを使用するように Image Registry Operator を設定すると、ストレージアカウントへのパブリックネットワークアクセスが無効になります。したがって、OpenShift Container Platform の外部のレジストリーからイメージをプルするには、レジストリーの Operator 設定で

disableRedirect: trueを設定する必要があります。リダイレクトが有効になっていると、ストレージアカウントからイメージを直接プルするように、レジストリーによってクライアントがリダイレクトされますが、これは機能しません。パブリックネットワークアクセスが無効になっているためです。詳細は、「Azure でプライベートストレージエンドポイントを使用する場合にリダイレクトを無効にする」を参照してください。 - この操作は、Image Registry Operator によって元に戻すことはできません。

2.5.2. Image Registry Operator による VNet 名とサブネット名の検出を有効にして Azure 上でプライベートストレージエンドポイントを設定する

次の手順では、VNet 名とサブネット名を検出するように Image Registry Operator を設定して、Azure 上でプライベートストレージエンドポイントを設定する方法を示します。

前提条件

- Azure 上で動作するようにイメージレジストリーを設定している。

ネットワークが、Installer Provisioned Infrastructure インストール方法を使用してセットアップされている。

カスタムネットワーク設定を使用するユーザーの場合は、「ユーザー指定の VNet 名とサブネット名を使用して Azure 上でプライベートストレージエンドポイントを設定する」を参照してください。

手順

Image Registry Operator の

configオブジェクトを編集し、networkAccess.typeをInternalに設定します。oc edit configs.imageregistry/cluster

$ oc edit configs.imageregistry/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: 次のコマンドを入力して、Operator がプロビジョニングを完了したことを確認します。これには数分かかる場合があります。

oc get configs.imageregistry/cluster -o=jsonpath="{.spec.storage.azure.privateEndpointName}" -w$ oc get configs.imageregistry/cluster -o=jsonpath="{.spec.storage.azure.privateEndpointName}" -wCopy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: レジストリーがルートによって公開されており、ストレージアカウントをプライベートに設定する場合、クラスターの外部へのプルを引き続き機能させるには、リダイレクトを無効にする必要があります。次のコマンドを入力して、Image Operator 設定のリダイレクトを無効にします。

oc patch configs.imageregistry cluster --type=merge -p '{"spec":{"disableRedirect": true}}'$ oc patch configs.imageregistry cluster --type=merge -p '{"spec":{"disableRedirect": true}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記リダイレクトが有効になっていると、クラスターの外部からのイメージのプルが機能しなくなります。

検証

次のコマンドを実行して、レジストリーサービス名を取得します。

oc registry info --internal=true

$ oc registry info --internal=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

image-registry.openshift-image-registry.svc:5000

image-registry.openshift-image-registry.svc:5000Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行してデバッグモードに入ります。

oc debug node/<node_name>

$ oc debug node/<node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 推奨される

chrootコマンドを実行します。以下に例を示します。chroot /host

$ chroot /hostCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、コンテナーレジストリーにログインします。

podman login --tls-verify=false -u unused -p $(oc whoami -t) image-registry.openshift-image-registry.svc:5000

$ podman login --tls-verify=false -u unused -p $(oc whoami -t) image-registry.openshift-image-registry.svc:5000Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Login Succeeded!

Login Succeeded!Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、レジストリーからイメージをプルできることを確認します。

podman pull --tls-verify=false image-registry.openshift-image-registry.svc:5000/openshift/tools

$ podman pull --tls-verify=false image-registry.openshift-image-registry.svc:5000/openshift/toolsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.3. ユーザー指定の VNet 名とサブネット名を使用して Azure 上でプライベートストレージエンドポイントを設定する

次の手順を使用して、パブリックネットワークアクセスが無効な、Azure 上のプライベートストレージエンドポイントの背後で公開されるストレージアカウントを設定します。

前提条件

- Azure 上で動作するようにイメージレジストリーを設定している。

- Azure 環境で使用する VNet 名とサブネット名を把握している。

- ネットワークが Azure の別のリソースグループに設定されている場合は、そのリソースグループの名前も把握している。

手順

Image Registry Operator の

configオブジェクトを編集し、VNet 名とサブネット名を使用してプライベートエンドポイントを設定します。oc edit configs.imageregistry/cluster

$ oc edit configs.imageregistry/clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow Copy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: 次のコマンドを入力して、Operator がプロビジョニングを完了したことを確認します。これには数分かかる場合があります。

oc get configs.imageregistry/cluster -o=jsonpath="{.spec.storage.azure.privateEndpointName}" -w$ oc get configs.imageregistry/cluster -o=jsonpath="{.spec.storage.azure.privateEndpointName}" -wCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記リダイレクトが有効になっていると、クラスターの外部からのイメージのプルが機能しなくなります。

検証

次のコマンドを実行して、レジストリーサービス名を取得します。

oc registry info --internal=true

$ oc registry info --internal=trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

image-registry.openshift-image-registry.svc:5000

image-registry.openshift-image-registry.svc:5000Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行してデバッグモードに入ります。

oc debug node/<node_name>

$ oc debug node/<node_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 推奨される

chrootコマンドを実行します。以下に例を示します。chroot /host

$ chroot /hostCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、コンテナーレジストリーにログインします。

podman login --tls-verify=false -u unused -p $(oc whoami -t) image-registry.openshift-image-registry.svc:5000

$ podman login --tls-verify=false -u unused -p $(oc whoami -t) image-registry.openshift-image-registry.svc:5000Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Login Succeeded!

Login Succeeded!Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、レジストリーからイメージをプルできることを確認します。

podman pull --tls-verify=false image-registry.openshift-image-registry.svc:5000/openshift/tools

$ podman pull --tls-verify=false image-registry.openshift-image-registry.svc:5000/openshift/toolsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.4. オプション: Azure でプライベートストレージエンドポイントを使用する場合にリダイレクトを無効にする

デフォルトでは、イメージレジストリーを使用する場合、リダイレクトが有効になります。リダイレクトにより、レジストリー Pod からオブジェクトストレージへのトラフィックのオフロードが可能になり、プルが高速化されます。リダイレクトが有効で、ストレージアカウントがプライベートである場合、クラスターの外部のユーザーはレジストリーからイメージをプルできません。

場合によっては、クラスターの外部のユーザーがレジストリーからイメージをプルできるように、リダイレクトを無効にする必要があります。

リダイレクトを無効にするには、次の手順を実行します。

前提条件

- Azure 上で動作するようにイメージレジストリーを設定している。

- ルートを設定している。

手順

次のコマンドを入力して、イメージレジストリー設定のリダイレクトを無効にします。

oc patch configs.imageregistry cluster --type=merge -p '{"spec":{"disableRedirect": true}}'$ oc patch configs.imageregistry cluster --type=merge -p '{"spec":{"disableRedirect": true}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

次のコマンドを実行して、レジストリーサービス名を取得します。

oc registry info

$ oc registry infoCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

default-route-openshift-image-registry.<cluster_dns>

default-route-openshift-image-registry.<cluster_dns>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、コンテナーレジストリーにログインします。

podman login --tls-verify=false -u unused -p $(oc whoami -t) default-route-openshift-image-registry.<cluster_dns>

$ podman login --tls-verify=false -u unused -p $(oc whoami -t) default-route-openshift-image-registry.<cluster_dns>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Login Succeeded!

Login Succeeded!Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、レジストリーからイメージをプルできることを確認します。

podman pull --tls-verify=false default-route-openshift-image-registry.<cluster_dns> /openshift/tools

$ podman pull --tls-verify=false default-route-openshift-image-registry.<cluster_dns> /openshift/toolsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

第3章 ベアメタルの設定

ベアメタルホストに OpenShift Container Platform をデプロイする場合、プロビジョニングの前後にホストに変更を加える必要がある場合があります。これには、ホストのハードウェア、ファームウェア、ファームウェアの詳細の検証が含まれます。また、ディスクのフォーマットや、変更可能なファームウェア設定の変更も含まれます。

3.1. ユーザー管理ロードバランサーのサービス

デフォルトのロードバランサーの代わりに、ユーザーが管理するロードバランサーを使用するように OpenShift Container Platform クラスターを設定できます。

ユーザー管理ロードバランサーの設定は、ベンダーのロードバランサーによって異なります。

このセクションの情報と例は、ガイドラインのみを目的としています。ベンダーのロードバランサーに関する詳細は、ベンダーのドキュメントを参照してください。

Red Hat は、ユーザー管理ロードバランサーに対して次のサービスをサポートしています。

- Ingress Controller

- OpenShift API

- OpenShift MachineConfig API

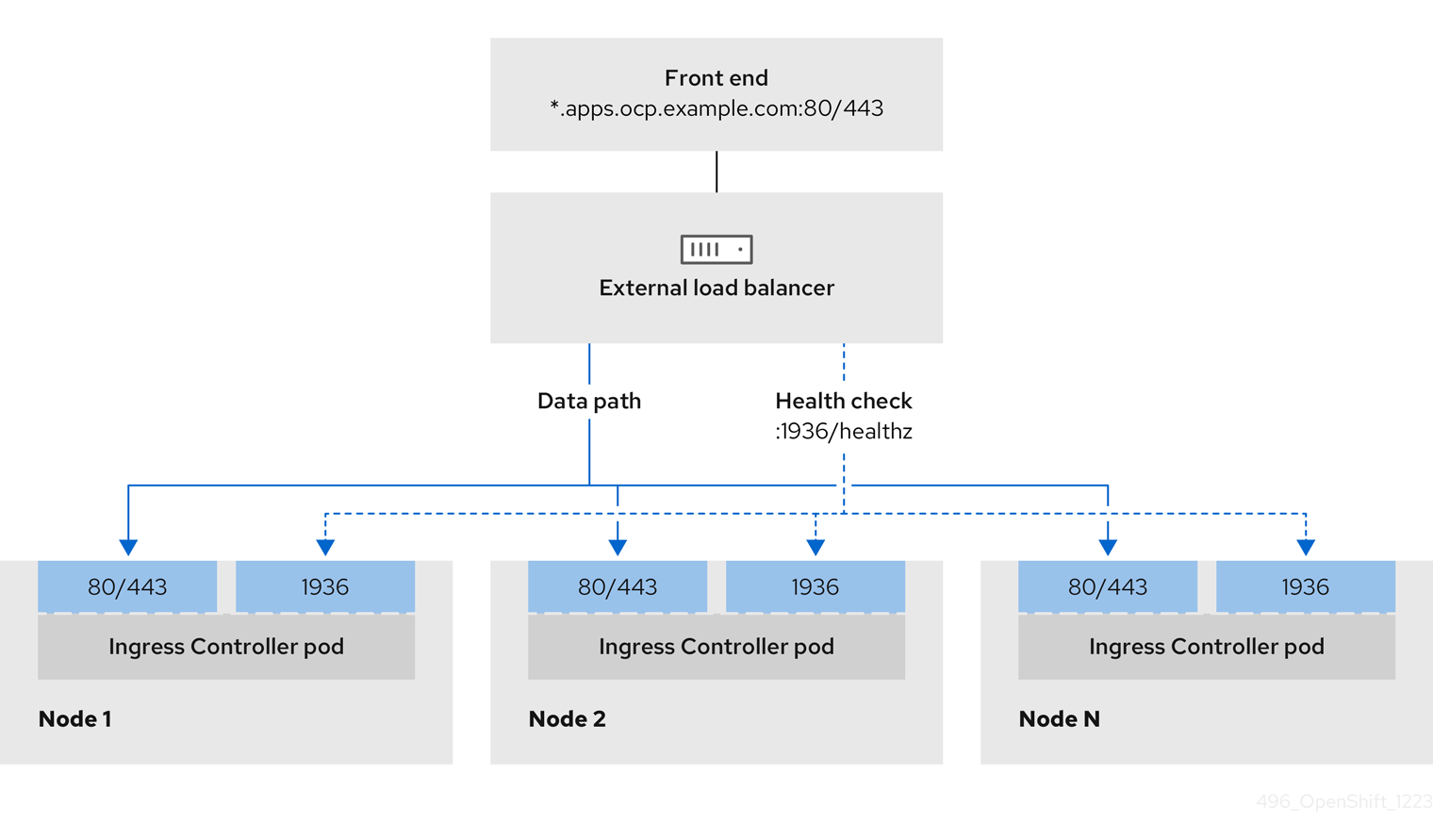

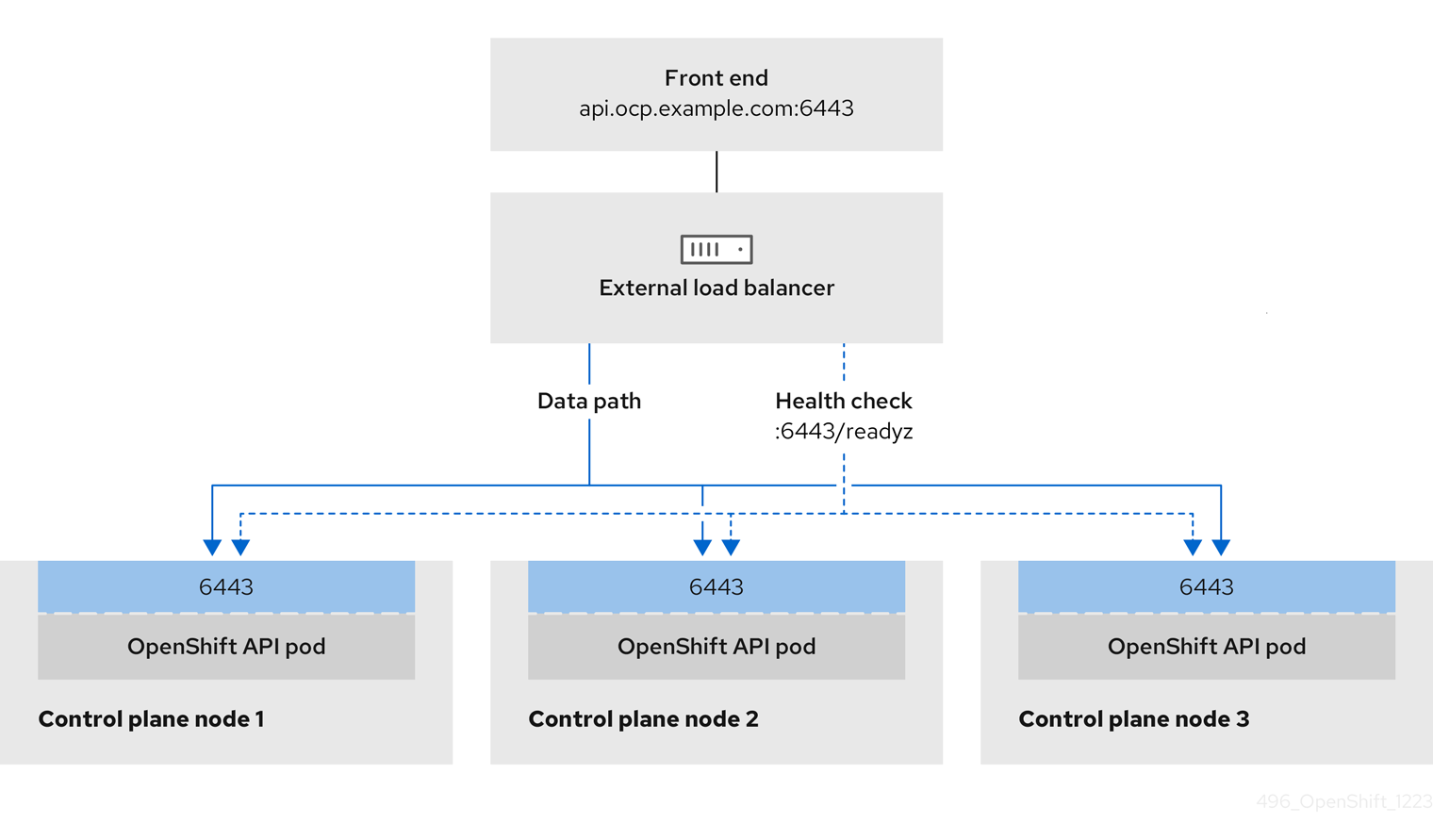

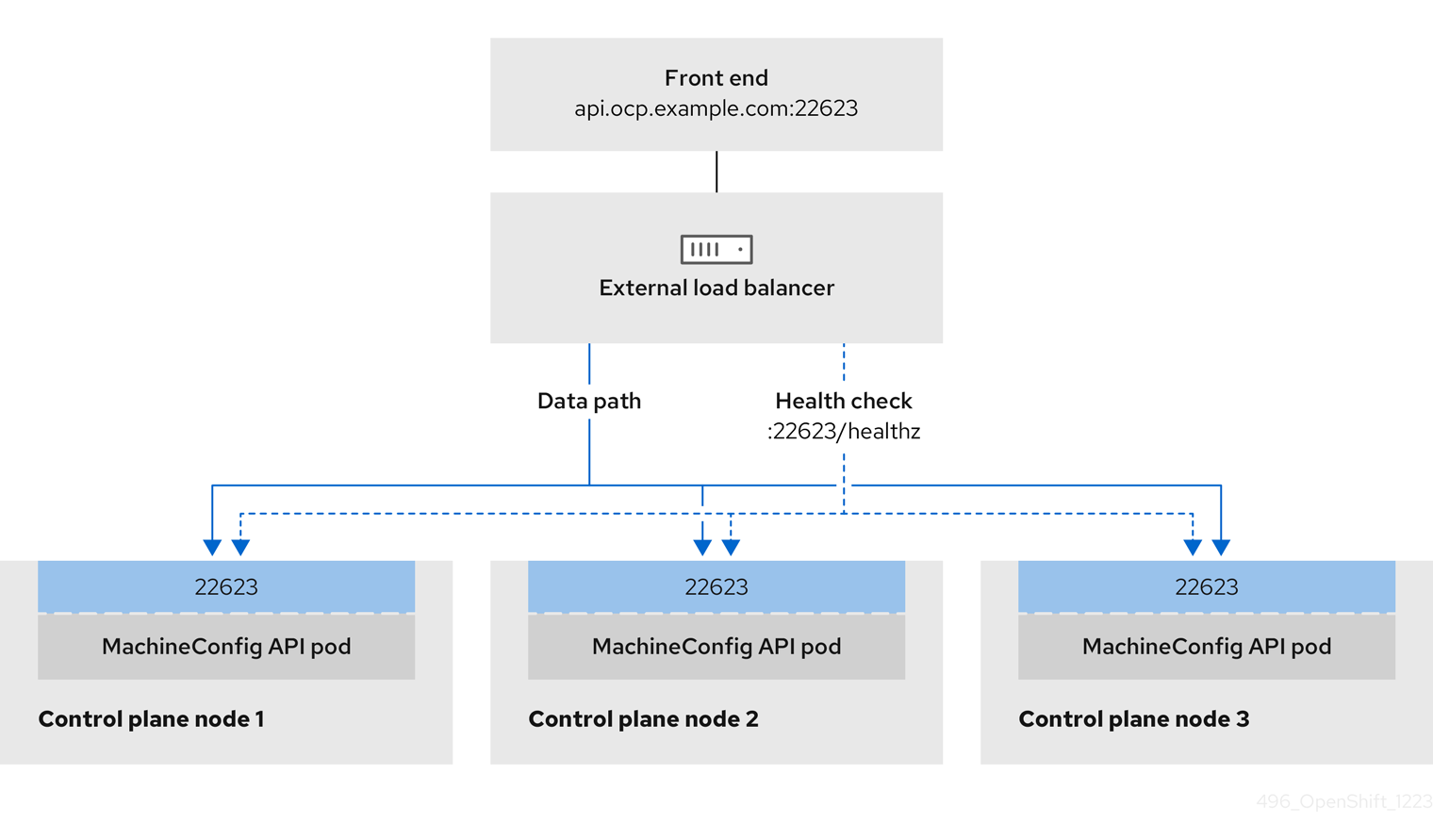

ユーザー管理ロードバランサーに対して、これらのサービスの 1 つを設定するか、すべてを設定するかを選択できます。一般的な設定オプションは、Ingress Controller サービスのみを設定することです。次の図は、各サービスの詳細を示しています。

図3.1 OpenShift Container Platform 環境で動作する Ingress Controller を示すネットワークワークフローの例

図3.2 OpenShift Container Platform 環境で動作する OpenShift API を示すネットワークワークフローの例

図3.3 OpenShift Container Platform 環境で動作する OpenShift MachineConfig API を示すネットワークワークフローの例

ユーザー管理ロードバランサーでは、次の設定オプションがサポートされています。

- ノードセレクターを使用して、Ingress Controller を特定のノードのセットにマッピングします。このセットの各ノードに静的 IP アドレスを割り当てるか、Dynamic Host Configuration Protocol (DHCP) から同じ IP アドレスを受け取るように各ノードを設定する必要があります。インフラストラクチャーノードは通常、このタイプの設定を受け取ります。

サブネット上のすべての IP アドレスをターゲットにします。この設定では、ロードバランサーターゲットを再設定せずにネットワーク内でノードを作成および破棄できるため、メンテナンスオーバーヘッドを削減できます。

/27や/28などの小規模なネットワーク上に設定されたマシンを使用して Ingress Pod をデプロイする場合、ロードバランサーのターゲットを簡素化できます。ヒントマシン config プールのリソースを確認することで、ネットワーク内に存在するすべての IP アドレスをリスト表示できます。

OpenShift Container Platform クラスターのユーザー管理ロードバランサーを設定する前に、以下の情報を考慮してください。

- フロントエンド IP アドレスの場合、フロントエンド IP アドレス、Ingress Controller のロードバランサー、および API ロードバランサーに同じ IP アドレスを使用できます。この機能は、ベンダーのドキュメントを確認してください。

バックエンド IP アドレスの場合、ユーザー管理ロードバランサーの有効期間中に OpenShift Container Platform コントロールプレーンノードの IP アドレスが変更されないことを確認します。次のいずれかのアクションを実行すると、これを実現できます。

- 各コントロールプレーンノードに静的 IP アドレスを割り当てます。

- ノードが DHCP リースを要求するたびに、DHCP から同じ IP アドレスを受信するように各ノードを設定します。ベンダーによっては、DHCP リースは IP 予約または静的 DHCP 割り当ての形式になる場合があります。

- Ingress Controller バックエンドサービスのユーザー管理ロードバランサーで Ingress Controller を実行する各ノードを手動で定義します。たとえば、Ingress Controller が未定義のノードに移動すると、接続が停止する可能性があります。

3.1.1. ユーザー管理ロードバランサーの設定

デフォルトのロードバランサーの代わりに、ユーザーが管理するロードバランサーを使用するように OpenShift Container Platform クラスターを設定できます。

ユーザー管理ロードバランサーを設定する前に、「ユーザー管理ロードバランサーのサービス」セクションを必ずお読みください。

ユーザー管理ロードバランサー用に設定するサービスに適用される次の前提条件をお読みください。

クラスター上で実行される MetalLB は、ユーザー管理ロードバランサーとして機能します。

OpenShift API の前提条件

- フロントエンド IP アドレスを定義している。

TCP ポート 6443 および 22623 は、ロードバランサーのフロントエンド IP アドレスで公開されている。以下の項目を確認します。

- ポート 6443 が OpenShift API サービスにアクセスできる。

- ポート 22623 が Ignition 起動設定をノードに提供できる。

- フロントエンド IP アドレスとポート 6443 へは、OpenShift Container Platform クラスターの外部の場所にいるシステムのすべてのユーザーがアクセスできる。

- フロントエンド IP アドレスとポート 22623 は、OpenShift Container Platform ノードからのみ到達できる。

- ロードバランサーバックエンドは、ポート 6443 および 22623 の OpenShift Container Platform コントロールプレーンノードと通信できる。

Ingress Controller の前提条件

- フロントエンド IP アドレスを定義している。

- TCP ポート 443 および 80 はロードバランサーのフロントエンド IP アドレスで公開されている。

- フロントエンドの IP アドレス、ポート 80、ポート 443 へは、OpenShift Container Platform クラスターの外部の場所にあるシステムの全ユーザーがアクセスできる。

- フロントエンドの IP アドレス、ポート 80、ポート 443 は、OpenShift Container Platform クラスターで動作するすべてのノードから到達できる。

- ロードバランサーバックエンドは、ポート 80、443、および 1936 で Ingress Controller を実行する OpenShift Container Platform ノードと通信できる。

ヘルスチェック URL 仕様の前提条件

ほとんどのロードバランサーは、サービスが使用可能か使用不可かを判断するヘルスチェック URL を指定して設定できます。OpenShift Container Platform は、OpenShift API、Machine Configuration API、および Ingress Controller バックエンドサービスのこれらのヘルスチェックを提供します。

次の例は、前にリスト表示したバックエンドサービスのヘルスチェック仕様を示しています。

Kubernetes API ヘルスチェック仕様の例

Path: HTTPS:6443/readyz Healthy threshold: 2 Unhealthy threshold: 2 Timeout: 10 Interval: 10

Path: HTTPS:6443/readyz

Healthy threshold: 2

Unhealthy threshold: 2

Timeout: 10

Interval: 10Machine Config API ヘルスチェック仕様の例

Path: HTTPS:22623/healthz Healthy threshold: 2 Unhealthy threshold: 2 Timeout: 10 Interval: 10

Path: HTTPS:22623/healthz

Healthy threshold: 2

Unhealthy threshold: 2

Timeout: 10

Interval: 10Ingress Controller のヘルスチェック仕様の例

Path: HTTP:1936/healthz/ready Healthy threshold: 2 Unhealthy threshold: 2 Timeout: 5 Interval: 10

Path: HTTP:1936/healthz/ready

Healthy threshold: 2

Unhealthy threshold: 2

Timeout: 5

Interval: 10手順

HAProxy Ingress Controller を設定して、ポート 6443、22623、443、および 80 でロードバランサーからクラスターへのアクセスを有効化できるようにします。必要に応じて、HAProxy 設定で単一のサブネットの IP アドレスまたは複数のサブネットの IP アドレスを指定できます。

1 つのサブネットをリストした HAProxy 設定の例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 複数のサブネットをリストした HAProxy 設定の例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow curlCLI コマンドを使用して、ユーザー管理ロードバランサーとそのリソースが動作していることを確認します。次のコマンドを実行して応答を観察し、クラスターマシン設定 API が Kubernetes API サーバーリソースにアクセスできることを確認します。

curl https://<loadbalancer_ip_address>:6443/version --insecure

$ curl https://<loadbalancer_ip_address>:6443/version --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 設定が正しい場合は、応答として JSON オブジェクトを受信します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して出力を確認し、クラスターマシン設定 API がマシン設定サーバーリソースからアクセスできることを確認します。

curl -v https://<loadbalancer_ip_address>:22623/healthz --insecure

$ curl -v https://<loadbalancer_ip_address>:22623/healthz --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 設定が正しい場合、コマンドの出力には次の応答が表示されます。

HTTP/1.1 200 OK Content-Length: 0

HTTP/1.1 200 OK Content-Length: 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して出力を確認し、コントローラーがポート 80 の Ingress Controller リソースにアクセスできることを確認します。

curl -I -L -H "Host: console-openshift-console.apps.<cluster_name>.<base_domain>" http://<load_balancer_front_end_IP_address>

$ curl -I -L -H "Host: console-openshift-console.apps.<cluster_name>.<base_domain>" http://<load_balancer_front_end_IP_address>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 設定が正しい場合、コマンドの出力には次の応答が表示されます。

HTTP/1.1 302 Found content-length: 0 location: https://console-openshift-console.apps.ocp4.private.opequon.net/ cache-control: no-cache

HTTP/1.1 302 Found content-length: 0 location: https://console-openshift-console.apps.ocp4.private.opequon.net/ cache-control: no-cacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して出力を確認し、コントローラーがポート 443 の Ingress Controller リソースにアクセスできることを確認します。

curl -I -L --insecure --resolve console-openshift-console.apps.<cluster_name>.<base_domain>:443:<Load Balancer Front End IP Address> https://console-openshift-console.apps.<cluster_name>.<base_domain>

$ curl -I -L --insecure --resolve console-openshift-console.apps.<cluster_name>.<base_domain>:443:<Load Balancer Front End IP Address> https://console-openshift-console.apps.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 設定が正しい場合、コマンドの出力には次の応答が表示されます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

ユーザー管理ロードバランサーのフロントエンド IP アドレスをターゲットにするようにクラスターの DNS レコードを設定します。ロードバランサー経由で、クラスター API およびアプリケーションの DNS サーバーのレコードを更新する必要があります。

変更された DNS レコードの例

<load_balancer_ip_address> A api.<cluster_name>.<base_domain> A record pointing to Load Balancer Front End

<load_balancer_ip_address> A api.<cluster_name>.<base_domain> A record pointing to Load Balancer Front EndCopy to Clipboard Copied! Toggle word wrap Toggle overflow <load_balancer_ip_address> A apps.<cluster_name>.<base_domain> A record pointing to Load Balancer Front End

<load_balancer_ip_address> A apps.<cluster_name>.<base_domain> A record pointing to Load Balancer Front EndCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要DNS の伝播では、各 DNS レコードが使用可能になるまでに時間がかかる場合があります。各レコードを検証する前に、各 DNS レコードが伝播されることを確認してください。

OpenShift Container Platform クラスターでユーザー管理ロードバランサーを使用するには、クラスターの

install-config.yamlファイルで次の設定を指定する必要があります。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- クラスターのユーザー管理ロードバランサーを指定するには、

typeパラメーターにUserManagedを設定します。パラメーターのデフォルトはOpenShiftManagedDefaultで、これはデフォルトの内部ロードバランサーを示します。openshift-kni-infranamespace で定義されたサービスの場合、ユーザー管理ロードバランサーはcorednsサービスをクラスター内の Pod にデプロイできますが、keepalivedおよびhaproxyサービスは無視します。 - 2

- ユーザー管理ロードバランサーを指定する場合に必須のパラメーターです。Kubernetes API がユーザー管理ロードバランサーと通信できるように、ユーザー管理ロードバランサーのパブリック IP アドレスを指定します。

- 3

- ユーザー管理ロードバランサーを指定する場合に必須のパラメーターです。ユーザー管理ロードバランサーのパブリック IP アドレスを指定して、ユーザー管理ロードバランサーがクラスターの Ingress トラフィックを管理できるようにします。

検証

curlCLI コマンドを使用して、ユーザー管理ロードバランサーと DNS レコード設定が動作していることを確認します。次のコマンドを実行して出力を確認し、クラスター API にアクセスできることを確認します。

curl https://api.<cluster_name>.<base_domain>:6443/version --insecure

$ curl https://api.<cluster_name>.<base_domain>:6443/version --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 設定が正しい場合は、応答として JSON オブジェクトを受信します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して出力を確認し、クラスターマシン設定にアクセスできることを確認します。

curl -v https://api.<cluster_name>.<base_domain>:22623/healthz --insecure

$ curl -v https://api.<cluster_name>.<base_domain>:22623/healthz --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 設定が正しい場合、コマンドの出力には次の応答が表示されます。

HTTP/1.1 200 OK Content-Length: 0

HTTP/1.1 200 OK Content-Length: 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して出力を確認し、ポートで各クラスターアプリケーションにアクセスできることを確認します。

curl http://console-openshift-console.apps.<cluster_name>.<base_domain> -I -L --insecure

$ curl http://console-openshift-console.apps.<cluster_name>.<base_domain> -I -L --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 設定が正しい場合、コマンドの出力には次の応答が表示されます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して出力を確認し、ポート 443 で各クラスターアプリケーションにアクセスできることを確認します。

curl https://console-openshift-console.apps.<cluster_name>.<base_domain> -I -L --insecure

$ curl https://console-openshift-console.apps.<cluster_name>.<base_domain> -I -L --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 設定が正しい場合、コマンドの出力には次の応答が表示されます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

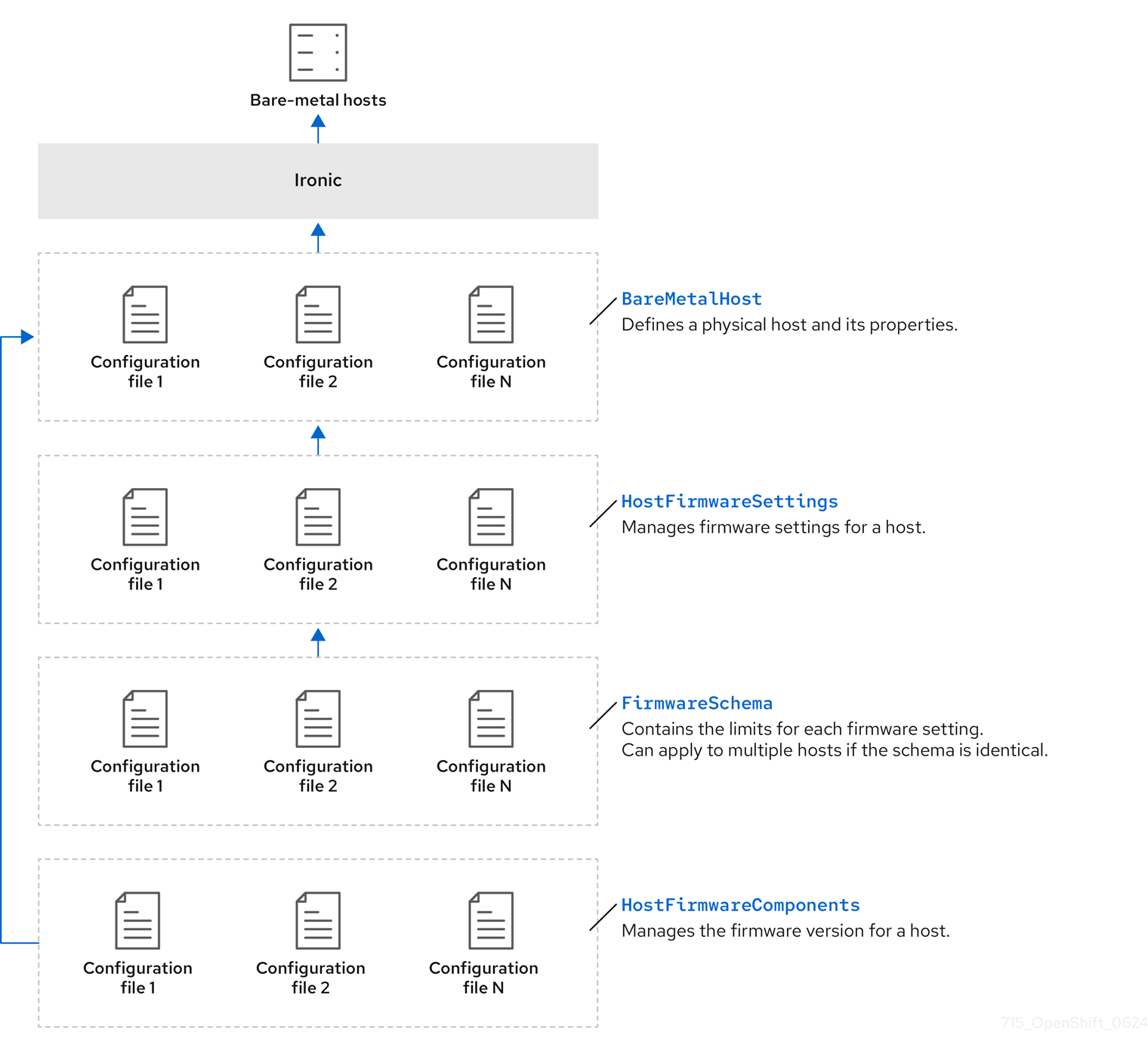

3.2. Bare Metal Operator について

Bare Metal Operator (BMO) を使用して、クラスター内のベアメタルホストをプロビジョニング、管理、検査します。

BMO はこれらのタスクを完了するために次のリソースを使用します。

-

BareMetalHost -

HostFirmwareSettings -

FirmwareSchema -

HostFirmwareComponents

BMO は、各ベアメタルホストを BareMetalHost カスタムリソース定義のインスタンスにマッピングすることにより、クラスター内の物理ホストのインベントリーを維持します。各 BareMetalHost リソースには、ハードウェア、ソフトウェア、およびファームウェアの詳細が含まれています。BMO は、クラスター内のベアメタルホストを継続的に検査して、各 BareMetalHost リソースが対応するホストのコンポーネントを正確に詳述していることを確認します。

BMO は、HostFirmwareSettings リソース、FirmwareSchema リソース、および HostFirmwareComponents リソースを使用して、ファームウェア仕様の詳細を指定し、ベアメタルホストのファームウェアをアップグレードまたはダウングレードします。

BMO は、Ironic API サービスを使用してクラスター内のベアメタルホストと接続します。Ironic サービスは、ホスト上のベースボード管理コントローラー (BMC) を使用して、マシンと接続します。

BMO を使用して実行できる一般的なタスクには、次のようなものがあります。

- 特定のイメージを使用したクラスターへのベアメタルホストのプロビジョニング

- プロビジョニング前またはプロビジョニング解除後におけるホストのディスクコンテンツのフォーマット

- ホストのオン/オフの切り替え

- ファームウェア設定の変更

- ホストのハードウェア詳細の表示

- ホストのファームウェアを特定のバージョンにアップグレードまたはダウングレードする

3.2.1. Bare Metal Operator のアーキテクチャー

Bare Metal Operator (BMO) は、次のリソースを使用して、クラスター内のベアメタルホストをプロビジョニング、管理、検査します。次の図は、これらのリソースのアーキテクチャーを示しています。

BareMetalHost

BareMetalHost リソースは、物理ホストとそのプロパティーを定義します。ベアメタルホストをクラスターにプロビジョニングするときは、そのホストの BareMetalHost リソースを定義する必要があります。ホストの継続的な管理のために、BareMetalHost の情報を調べたり、この情報を更新したりできます。

BareMetalHost リソースには、次のようなプロビジョニング情報が含まれます。

- オペレーティングシステムのブートイメージやカスタム RAM ディスクなどのデプロイメント仕様

- プロビジョニング状態

- ベースボード管理コントローラー (BMC) アドレス

- 目的の電源状態

BareMetalHost リソースには、次のようなハードウェア情報が含まれます。

- CPU 数

- NIC の MAC アドレス

- ホストのストレージデバイスのサイズ

- 現在の電源状態

HostFirmwareSettings

HostFirmwareSettings リソースを使用して、ホストのファームウェア設定を取得および管理できます。ホストが Available 状態に移行すると、Ironic サービスはホストのファームウェア設定を読み取り、HostFirmwareSettings リソースを作成します。BareMetalHost リソースと HostFirmwareSettings リソースの間には 1 対 1 のマッピングがあります。

HostFirmwareSettings リソースを使用して、ホストのファームウェア仕様を調べたり、ホストのファームウェア仕様を更新したりできます。

HostFirmwareSettings リソースの spec フィールドを編集するときは、ベンダーファームウェアに固有のスキーマに従う必要があります。このスキーマは、読み取り専用の FirmwareSchema リソースで定義されます。

FirmwareSchema

ファームウェア設定は、ハードウェアベンダーやホストモデルによって異なります。FirmwareSchema リソースは、各ホストモデル上の各ファームウェア設定のタイプおよび制限が含まれる読み取り専用リソースです。データは、Ironic サービスを使用して BMC から直接取得されます。FirmwareSchema リソースを使用すると、HostFirmwareSettings リソースの spec フィールドに指定できる有効な値を特定できます。

スキーマが同じであれば、FirmwareSchema リソースは多くの BareMetalHost リソースに適用できます。

HostFirmwareComponents

Metal3 は、BIOS およびベースボード管理コントローラー (BMC) ファームウェアのバージョンを記述する HostFirmwareComponents リソースを提供します。HostFirmwareComponents リソースの spec フィールドを編集することで、ホストのファームウェアを特定のバージョンにアップグレードまたはダウングレードできます。これは、特定のファームウェアバージョンに対してテストされた検証済みパターンを使用してデプロイする場合に便利です。

3.3. カスタマイズした br-ex ブリッジを含むマニフェストオブジェクトの作成

カスタマイズした br-ex ブリッジを含むマニフェストオブジェクトを作成する場合は、次のユースケースを検討してください。

-

Open vSwitch (OVS) または OVN-Kubernetes

br-exブリッジネットワークの変更など、ブリッジにインストール後の変更を加えたい場合。configure-ovs.shシェルスクリプトは、ブリッジへのインストール後の変更をサポートしていません。 - ホストまたはサーバーの IP アドレスで使用可能なインターフェイスとは異なるインターフェイスにブリッジをデプロイします。

-

configure-ovs.shシェルスクリプトでは不可能な、ブリッジの高度な設定を実行したいと考えています。これらの設定にスクリプトを使用すると、ブリッジが複数のネットワークインターフェイスに接続できず、インターフェイス間のデータ転送が促進されない可能性があります。

前提条件

-

configure-ovsの代替方法を使用して、カスタマイズされたbr-exを設定している。 - Kubernetes NMState Operator がインストールされている。

手順

NodeNetworkConfigurationPolicy(NNCP) CR を作成し、カスタマイズされたbr-exブリッジネットワーク設定を定義します。br-exNNCP CR には、ネットワークの OVN-Kubernetes マスカレード IP アドレスとサブネットが含まれている必要があります。サンプルの NNCP CR には、ipv4.address.ipおよびipv6.address.ipパラメーターにデフォルト値が含まれます。ipv4.address.ip、ipv6.address.ip、またはその両方で masquerade IP アドレスを設定できます。重要インストール後のタスクとして、カスタマイズした

br-exブリッジのプライマリー IP アドレスを変更できません。シングルスタッククラスターネットワークをデュアルスタッククラスターネットワークに変換する場合、NNCP CR でセカンダリー IPv6 アドレスは追加または変更できますが、既存のプライマリー IP アドレスは変更できません。Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは、以下のようになります。

metadata.name- ポリシーの名前。

interfaces.name- インターフェイスの名前。

interfaces.type- イーサネットのタイプ。

interfaces.state- 作成後のインターフェイスの要求された状態。

ipv4.enabled- この例では、IPv4 と IPv6 を無効にします。

port.name- ブリッジが接続されているノード NIC。

address.ip- デフォルトの IPv4 および IPv6 の IP アドレスを表示します。ネットワークの masquerade IPv4 および IPv6 の IP アドレスを設定するようにしてください。

auto-route-metric-

br-exデフォルトルートに常に最高の優先度 (最も低いメトリック値) を付与するには、パラメーターを48に設定します。この設定により、NetworkManagerサービスによって自動的に設定される他のインターフェイスとのルーティングの競合が防止されます。

次のステップ

-

コンピュートノードをスケーリングして、クラスター内に存在する各コンピュートノードに、カスタマイズされた

br-exブリッジを含むマニフェストオブジェクトを適用します。詳細は、関連情報 セクションの「クラスターの拡張」を参照してください。

3.4. BareMetalHost リソースについて

Metal3 で、物理ホストとそのプロパティーを定義する BareMetalHost リソースの概念が導入されました。BareMetalHost リソースには、2 つのセクションが含まれます。

-

BareMetalHostspec -

BareMetalHoststatus

3.4.1. BareMetalHost spec

BareMetalHost リソースの spec セクションは、ホストの必要な状態を定義します。

| パラメーター | 説明 |

|---|---|

|

|

プロビジョニングおよびプロビジョニング解除時の自動クリーニングを有効または無効にするインターフェイス。 |

bmc: address: credentialsName: disableCertificateVerification: |

|

|

| ホストのプロビジョニングに使用する NIC の MAC アドレス。 |

|

|

ホストのブートモード。デフォルトは |

|

|

ホストを使用している別のリソースへの参照。別のリソースが現在ホストを使用していない場合は、空になることがあります。たとえば、 |

|

| ホストの特定に役立つ、人間が提供した文字列。 |

|

| ホストのプロビジョニングとプロビジョニング解除が外部で管理されるかどうかを示すブール値。設定される場合:

|

|

|

ベアメタルホストの BIOS 設定に関する情報が含まれます。現在、

|

image: url: checksum: checksumType: format: |

|

|

| ネットワーク設定データおよびその namespace が含まれるシークレットへの参照。したがって、ホストが起動してネットワークをセットアップする前にホストに接続することができます。 |

|

|

ホストの電源を入れる ( |

raid: hardwareRAIDVolumes: softwareRAIDVolumes: | (オプション) ベアメタルホストの RAID 設定に関する情報が含まれます。指定しない場合は、現在の設定を保持します。 注記 OpenShift Container Platform 4.20 は、BMC のインストールドライブ上で以下のハードウェア RAID をサポートします。

OpenShift Container Platform 4.20 は、インストールドライブ上のソフトウェア RAID をサポートしていません。 次の構成設定を参照してください。

spec:

raid:

hardwareRAIDVolume: []

ドライバーが RAID に対応していないことを示すエラーメッセージが表示された場合は、 |

|

|

|

3.4.2. BareMetalHost status

BareMetalHost status は、ホストの現在の状態を表し、テスト済みの認証情報、現在のハードウェアの詳細などの情報が含まれます。

| パラメーター | 説明 |

|---|---|

|

| シークレットおよびその namespace の参照で、システムが動作中と検証できるベースボード管理コントローラー (BMC) 認証情報のセットが保持されています。 |

|

| プロビジョニングバックエンドが報告する最後のエラーの詳細 (ある場合)。 |

|

| ホストがエラー状態になった原因となった問題のクラスを示します。エラータイプは以下のとおりです。

|

|

|

|

hardware: firmware: | BIOS ファームウェア情報が含まれます。たとえば、ハードウェアベンダーおよびバージョンなどです。 |

|

|

|

hardware: ramMebibytes: | ホストのメモリー容量 (MiB 単位)。 |

|

|

|

hardware:

systemVendor:

manufacturer:

productName:

serialNumber:

|

ホストの |

|

| ホストのステータスの最終更新時のタイムスタンプ。 |

|

| サーバーのステータス。ステータスは以下のいずれかになります。

|

|

| ホストの電源が入っているかどうかを示すブール値。 |

|

|

|

|

| プロビジョニングバックエンドに送信された BMC 認証情報の最後のセットを保持するシークレットおよびその namespace への参照。 |

3.5. BareMetalHost リソースの取得

BareMetalHost リソースには、物理ホストのプロパティーが含まれます。物理ホストのプロパティーをチェックするには、その BareMetalHost リソースを取得する必要があります。

手順

BareMetalHostリソースの一覧を取得します。oc get bmh -n openshift-machine-api -o yaml

$ oc get bmh -n openshift-machine-api -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記oc getコマンドで、bmhの長い形式として、baremetalhostを使用できます。ホストのリストを取得します。

oc get bmh -n openshift-machine-api

$ oc get bmh -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 特定のホストの

BareMetalHostリソースを取得します。oc get bmh <host_name> -n openshift-machine-api -o yaml

$ oc get bmh <host_name> -n openshift-machine-api -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ここで、

<host_name>はホストの名前です。出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6. BareMetalHost リソースの編集

OpenShift Container Platform クラスターをベアメタルにデプロイした後、ノードの BareMetalHost リソースを編集する必要がある場合があります。たとえば、次のような例が考えられます。

- Assisted Installer を使用してクラスターをデプロイし、ベースボード管理コントローラー (BMC) のホスト名または IP アドレスを追加または編集する必要がある。

- ノードをプロビジョニング解除せずに、あるクラスターから別のクラスターに移動する必要がある。

前提条件

-

ノードが

Provisioned、ExternallyProvisioned、またはAvailable状態であることを確認する。

手順

ノードのリストを取得します。

oc get bmh -n openshift-machine-api

$ oc get bmh -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow ノードの

BareMetalHostリソースを編集する前に、次のコマンドを実行してノードを Ironic からデタッチします。oc annotate baremetalhost <node_name> -n openshift-machine-api 'baremetalhost.metal3.io/detached=true'

$ oc annotate baremetalhost <node_name> -n openshift-machine-api 'baremetalhost.metal3.io/detached=true'1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<node_name>はノード名に置き換えてください。

次のコマンドを実行して、

BareMetalHostリソースを編集します。oc edit bmh <node_name> -n openshift-machine-api

$ oc edit bmh <node_name> -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、ノードを Ironic に再アタッチします。

oc annotate baremetalhost <node_name> -n openshift-machine-api 'baremetalhost.metal3.io/detached'-

$ oc annotate baremetalhost <node_name> -n openshift-machine-api 'baremetalhost.metal3.io/detached'-Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.7. BareMetalHost リソースを削除する際の遅延のトラブルシューティング

Bare Metal Operator (BMO) が BareMetalHost リソースを削除すると、Ironic がベアメタルホストのプロビジョニングを解除します。これは、たとえばマシンセットを縮小するときに発生する可能性があります。プロビジョニング解除には、"クリーニング" と呼ばれるプロセスが含まれます。このプロセスでは、次の手順が実行されます。

- ベアメタルホストの電源をオフにする

- ベアメタルホスト上のサービス RAM ディスクを起動する

- すべてのディスクからパーティションメタデータを削除する

- ベアメタルホストの電源を再度オフにする

クリーニングが成功しない場合は、BareMetalHost リソースの削除に長い時間がかかり、削除が完了しないことがあります。

BareMetalHost リソースを強制的に削除するためにファイナライザーを削除しないでください。プロビジョニングバックエンドには、ホストレコードを保持する独自のデータベースがあります。ファイナライザーを削除して強制的に削除しようとしても、実行中のアクションは引き続き実行されます。後でベアメタルホストを追加しようとしたときに、予期しない問題が発生する可能性があります。

手順

- クリーニングプロセスが回復できる場合は、プロセスが完了するまで待ちます。

-

クリーニングが回復できない場合は、

BareMetalHostリソースを変更し、automaticCleaningModeフィールドをdisabledに設定して、クリーニングプロセスを無効にします。

詳細は、「BareMetalHost リソースの編集」を参照してください。

3.8. ブータブルでない ISO をベアメタルノードにアタッチする

DataImage リソースを使用すると、ブータブルでない汎用の ISO 仮想メディアイメージを、プロビジョニングされたノードにアタッチできます。リソースを適用すると、起動後にオペレーティングシステムから ISO イメージにアクセスできるようになります。これは、オペレーティングシステムをプロビジョニングした後、ノードが初めて起動する前にノードを設定する場合に便利です。

前提条件

- この機能をサポートするために、ノードが Redfish またはそれから派生したドライバーを使用している。

-

ノードが

ProvisionedまたはExternallyProvisioned状態である。 -

nameが、BareMetalHostリソースで定義されているノードの名前と同じである。 -

ISO イメージへの有効な

urlがある。

手順

DataImageリソースを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

DataImageリソースをファイルに保存します。vim <node_name>-dataimage.yaml

$ vim <node_name>-dataimage.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

DataImageリソースを適用します。oc apply -f <node_name>-dataimage.yaml -n <node_namespace>

$ oc apply -f <node_name>-dataimage.yaml -n <node_namespace>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- namespace が

BareMetalHostリソースの namespace と一致するように<node_namespace>を置き換えます。たとえば、openshift-machine-apiです。

ノードを再起動します。

注記ノードを再起動するには、

reboot.metal3.ioアノテーションを割り当てるか、BareMetalHostリソースでonlineステータスをリセットします。ベアメタルノードを強制的に再起動すると、ノードの状態がしばらくの間NotReadyに変わります。具体的には、5 分以上変わります。次のコマンドを実行して、

DataImageリソースを表示します。oc get dataimage <node_name> -n openshift-machine-api -o yaml

$ oc get dataimage <node_name> -n openshift-machine-api -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.9. HostFirmwareSettings リソースについて

HostFirmwareSettings リソースを使用して、ホストの BIOS 設定を取得および管理できます。ホストが Available 状態に移行すると、Ironic はホストの BIOS 設定を読み取り、HostFirmwareSettings リソースを作成します。リソースには、ベースボード管理コントローラー (BMC) から返される完全な BIOS 設定が含まれます。BareMetalHost リソースの firmware フィールドは、ベンダーに依存しない 3 つのフィールドを返しますが、HostFirmwareSettings リソースは、通常ホストごとにベンダー固有のフィールドの多数の BIOS 設定で構成されます。

HostFirmwareSettings リソースには、以下の 2 つのセクションが含まれます。

-

HostFirmwareSettingsspec -

HostFirmwareSettingsstatus

3.9.1. HostFirmwareSettings spec

HostFirmwareSettings リソースの spec セクションは、ホストの BIOS の必要な状態を定義し、デフォルトでは空です。Ironic は spec.settings セクションの設定を使用して、ホストが Preparing 状態の場合、ベースボード管理コントローラー (BMC) を更新します。FirmwareSchema リソースを使用して、無効な名前と値のペアをホストに送信しないようにします。詳細は、「FirmwareSchema リソースについて」を参照してください。

例

spec:

settings:

ProcTurboMode: Disabled

spec:

settings:

ProcTurboMode: Disabled- 1

- 前述の例では、

spec.settingsセクションには、ProcTurboModeBIOS 設定をDisabledに設定する名前/値のペアが含まれます。

status セクションに一覧表示される整数パラメーターは文字列として表示されます。たとえば、"1" と表示されます。spec.settings セクションで整数を設定する場合、値は引用符なしの整数として設定する必要があります。たとえば、1 と設定します。

3.9.2. HostFirmwareSettings status

status は、ホストの BIOS の現在の状態を表します。

| パラメーター | 説明 |

|---|---|

|

|

|

status:

schema:

name:

namespace:

lastUpdated:

|

ファームウェア設定の

|

status: settings: |

|

3.10. HostFirmwareSettings リソースの取得

HostFirmwareSettings リソースには、物理ホストのベンダー固有の BIOS プロパティーが含まれます。物理ホストの BIOS プロパティーをチェックするには、その HostFirmwareSettings リソースを取得する必要があります。

手順

HostFirmwareSettingsリソースの詳細な一覧を取得します。oc get hfs -n openshift-machine-api -o yaml

$ oc get hfs -n openshift-machine-api -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注記oc getコマンドで、hfsの長い形式として、hostfirmwaresettingsを使用できます。HostFirmwareSettingsリソースの一覧を取得します。oc get hfs -n openshift-machine-api

$ oc get hfs -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 特定のホストの

HostFirmwareSettingsリソースを取得します。oc get hfs <host_name> -n openshift-machine-api -o yaml

$ oc get hfs <host_name> -n openshift-machine-api -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ここで、

<host_name>はホストの名前です。

3.11. HostFirmwareSettings リソースの編集

プロビジョニングされたホストの HostFirmwareSettings を編集できます。

読み取り専用の値を除き、ホストが プロビジョニング された状態にある場合にのみ、ホストを編集できます。externally provisioned 状態のホストは編集できません。

手順

HostFirmwareSettingsリソースの一覧を取得します。oc get hfs -n openshift-machine-api

$ oc get hfs -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホストの

HostFirmwareSettingsリソースを編集します。oc edit hfs <host_name> -n openshift-machine-api

$ oc edit hfs <host_name> -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow ここで、

<host_name>はプロビジョニングされたホストの名前です。HostFirmwareSettingsリソースは、ターミナルのデフォルトエディターで開きます。spec.settingsセクションに、名前と値のペアを追加します。例

spec: settings: name: valuespec: settings: name: value1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

FirmwareSchemaリソースを使用して、ホストで利用可能な設定を特定します。読み取り専用の値は設定できません。

- 変更を保存し、エディターを終了します。

ホストのマシン名を取得します。

oc get bmh <host_name> -n openshift-machine name

$ oc get bmh <host_name> -n openshift-machine nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow ここで、

<host_name>はホストの名前です。マシン名はCONSUMERフィールドの下に表示されます。マシンにアノテーションを付け、マシンセットから削除します。

oc annotate machine <machine_name> machine.openshift.io/delete-machine=true -n openshift-machine-api

$ oc annotate machine <machine_name> machine.openshift.io/delete-machine=true -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow ここで、

<machine_name>は削除するマシンの名前です。ノードのリストを取得し、ワーカーノードの数をカウントします。

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow マシンセットを取得します。

oc get machinesets -n openshift-machine-api

$ oc get machinesets -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow マシンセットをスケーリングします。

oc scale machineset <machineset_name> -n openshift-machine-api --replicas=<n-1>

$ oc scale machineset <machineset_name> -n openshift-machine-api --replicas=<n-1>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここで、

<machineset_name>はマシンセットの名前で、<n-1>は減少させたワーカーノードの数です。ホストが

Availableの状態になったら、machineset をスケールアップして、HostFirmwareSettingsリソースの変更を反映させます。oc scale machineset <machineset_name> -n openshift-machine-api --replicas=<n>

$ oc scale machineset <machineset_name> -n openshift-machine-api --replicas=<n>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここで、

<machineset_name>はマシンセットの名前で、<n>はワーカーノードの数です。

3.12. HostFirmware Settings リソースが有効であることの確認

ユーザーが spec.settings セクションを編集して HostFirmwareSetting (HFS) リソースに変更を加えると、Bare Metal Operator (BMO) は読み取り専用リソースである FimwareSchema リソースに対して変更を検証します。この設定が無効な場合、BMO は status.Condition 設定の Type の値を False に設定し、イベントを生成して HFS リソースに保存します。以下の手順を使用して、リソースが有効であることを確認します。

手順

HostFirmwareSettingリソースの一覧を取得します。oc get hfs -n openshift-machine-api

$ oc get hfs -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 特定のホストの

HostFirmwareSettingsリソースが有効であることを確認します。oc describe hfs <host_name> -n openshift-machine-api

$ oc describe hfs <host_name> -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow ここで、

<host_name>はホストの名前です。出力例

Events: Type Reason Age From Message ---- ------ ---- ---- ------- Normal ValidationFailed 2m49s metal3-hostfirmwaresettings-controller Invalid BIOS setting: Setting ProcTurboMode is invalid, unknown enumeration value - Foo

Events: Type Reason Age From Message ---- ------ ---- ---- ------- Normal ValidationFailed 2m49s metal3-hostfirmwaresettings-controller Invalid BIOS setting: Setting ProcTurboMode is invalid, unknown enumeration value - FooCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要応答が

ValidationFailedを返す場合、リソース設定にエラーがあり、FirmwareSchemaリソースに準拠するよう値を更新する必要があります。

3.13. FirmwareSchema リソースについて

BIOS 設定は、ハードウェアベンダーやホストモデルによって異なります。FirmwareSchema リソースは、各ホストモデル上の各 BIOS 設定のタイプおよび制限が含まれる読み取り専用リソースです。データは BMC から Ironic に直接取得されます。FirmwareSchema を使用すると、HostFirmwareSettings リソースの spec フィールドに指定できる有効な値を特定できます。FirmwareSchema リソースには、その設定および制限から派生する一意の識別子があります。同じホストモデルは同じ FirmwareSchema 識別子を使用します。HostFirmwareSettings の複数のインスタンスが同じ FirmwareSchema を使用する可能性が高いです。

| パラメーター | 説明 |

|---|---|

|

|

|

3.14. FirmwareSchema リソースの取得

各ベンダーの各ホストモデルの BIOS 設定は、それぞれ異なります。HostFirmwareSettings リソースの spec セクションを編集する際に、設定する名前/値のペアはそのホストのファームウェアスキーマに準拠している必要があります。有効な名前と値のペアを設定するには、ホストの FirmwareSchema を取得して確認します。

手順

FirmwareSchemaリソースインスタンスの一覧を取得するには、以下を実行します。oc get firmwareschema -n openshift-machine-api

$ oc get firmwareschema -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 特定の

FirmwareSchemaインスタンスを取得するには、以下を実行します。oc get firmwareschema <instance_name> -n openshift-machine-api -o yaml

$ oc get firmwareschema <instance_name> -n openshift-machine-api -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ここで、

<instance_name>は、HostFirmwareSettingsリソース (表 3 を参照) に記載されているスキーマインスタンスの名前です。

3.15. HostFirmwareComponents リソースについて

Metal3 は、BIOS およびベースボード管理コントローラー (BMC) ファームウェアのバージョンを記述する HostFirmwareComponents リソースを提供します。HostFirmwareComponents リソースには 2 つのセクションが含まれています。

-

HostFirmwareComponentsspec -

HostFirmwareComponentsstatus

3.15.1. HostFirmwareComponents spec

HostFirmwareComponents リソースの spec セクションでは、ホストの BIOS および BMC バージョンの目的の状態を定義します。

| パラメーター | 説明 |

|---|---|

updates: component: url: |

|

3.15.2. HostFirmwareComponents status

HostFirmwareComponents リソースの status セクションは、ホストの BIOS および BMC バージョンの現在のステータスを返します。

| パラメーター | 説明 |

|---|---|

|

|

|

updates: component: url: |

|

3.16. HostFirmwareComponents リソースの取得

HostFirmwareComponents リソースには、物理ホストの BIOS およびベースボード管理コントローラー (BMC) の特定のファームウェアバージョンが含まれています。ファームウェアのバージョンとステータスを確認するには、物理ホストの HostFirmwareComponents リソースを取得する必要があります。

手順

HostFirmwareComponentsリソースの詳細なリストを取得します。oc get hostfirmwarecomponents -n openshift-machine-api -o yaml

$ oc get hostfirmwarecomponents -n openshift-machine-api -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow HostFirmwareComponentsリソースのリストを取得します。oc get hostfirmwarecomponents -n openshift-machine-api

$ oc get hostfirmwarecomponents -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 特定のホストの

HostFirmwareComponentsリソースを取得します。oc get hostfirmwarecomponents <host_name> -n openshift-machine-api -o yaml

$ oc get hostfirmwarecomponents <host_name> -n openshift-machine-api -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ここで、

<host_name>はホストの名前です。出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.17. HostFirmwareComponents リソースの編集

ノードの HostFirmwareComponents リソースを編集できます。

手順

HostFirmwareComponentsリソースの詳細なリストを取得します。oc get hostfirmwarecomponents -n openshift-machine-api -o yaml

$ oc get hostfirmwarecomponents -n openshift-machine-api -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ホストの

HostFirmwareComponentsリソースを編集します。oc edit <host_name> hostfirmwarecomponents -n openshift-machine-api

$ oc edit <host_name> hostfirmwarecomponents -n openshift-machine-api1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ここで、

<host_name>はホストの名前です。HostFirmwareComponentsリソースが、ターミナルのデフォルトのエディターで開きます。

出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を保存し、エディターを終了します。

ホストのマシン名を取得します。

oc get bmh <host_name> -n openshift-machine name

$ oc get bmh <host_name> -n openshift-machine name1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ここで、

<host_name>はホストの名前です。マシン名はCONSUMERフィールドの下に表示されます。

マシンにアノテーションを付け、マシンセットから削除します。

oc annotate machine <machine_name> machine.openshift.io/delete-machine=true -n openshift-machine-api

$ oc annotate machine <machine_name> machine.openshift.io/delete-machine=true -n openshift-machine-api1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ここで、

<machine_name>は削除するマシンの名前です。

ノードのリストを取得し、ワーカーノードの数をカウントします。

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow マシンセットを取得します。

oc get machinesets -n openshift-machine-api

$ oc get machinesets -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow マシンセットをスケーリングします。

oc scale machineset <machineset_name> -n openshift-machine-api --replicas=<n-1>

$ oc scale machineset <machineset_name> -n openshift-machine-api --replicas=<n-1>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<machineset_name>はマシンセットの名前です。<n-1>は減少させたワーカーノードの数です。

ホストが

Available状態になったら、マシンセットをスケールアップして、HostFirmwareComponentsリソースの変更を有効にします。oc scale machineset <machineset_name> -n openshift-machine-api --replicas=<n>

$ oc scale machineset <machineset_name> -n openshift-machine-api --replicas=<n>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<machineset_name>はマシンセットの名前です。<n>はワーカーノードの数です。

第4章 OpenShift クラスターでのマルチアーキテクチャーのコンピュートマシンの設定

4.1. マルチアーキテクチャーのコンピュートマシンを含むクラスターについて

マルチアーキテクチャー計算マシンを使用する OpenShift Container Platform クラスターは、異なるアーキテクチャーのコンピュートマシンをサポートするクラスターです。

マルチアーキテクチャーコンピュートマシンの設定には、さらにいくつかの点を考慮する必要があります。

- クラスター内に複数のアーキテクチャーを持つノードがある場合、ノードにデプロイするコンテナーイメージのアーキテクチャーは、そのノードのアーキテクチャーと一致している必要があります。Pod が適切なアーキテクチャーを持つノードに割り当てられていること、およびそれがコンテナーイメージのアーキテクチャーと一致していることを確認する必要があります。ノードへの Pod の割り当ての詳細は、ノードへの Pod の割り当て を参照してください。

- インストーラーでプロビジョニングされるインストールでは、単一クラウドプロバイダーによって提供されるインフラストラクチャーの使用に制限されます。アーキテクチャーに関係なく、これらのクラスターに外部ノードを追加することはサポートされていません。

プラットフォームタイプ

noneでインストールされたクラスターは、Machine API を使用したコンピュートマシンの管理など、一部の機能を使用できません。この制限は、クラスターに接続されている計算マシンが、通常はこの機能をサポートするプラットフォームにインストールされている場合でも適用されます。このパラメーターは、インストール後に変更することはできません。重要仮想化またはクラウド環境で OpenShift Container Platform クラスターのインストールを試行する前に、guidelines for deploying OpenShift Container Platform on non-tested platforms にある情報を確認してください。

- Cluster Samples Operator は、マルチアーキテクチャーのコンピュートマシンを含むクラスターではサポートされません。この機能がなくてもクラスターを作成できます。詳細は、クラスターの機能 を参照してください。

- 単一アーキテクチャーのクラスターを、マルチアーキテクチャーのコンピュートマシンをサポートするクラスターに移行する方法は、マルチアーキテクチャーのコンピュートマシンを含むクラスターへの移行 を参照してください。

4.1.1. マルチアーキテクチャーのコンピュートマシンを使用したクラスターの設定

各種のインストールオプションとプラットフォームを使用してマルチアーキテクチャーコンピュートマシンを含むクラスターを作成するには、次の表のドキュメントを使用してください。

| ドキュメントのセクション | プラットフォーム | user-provisioned installation | installer-provisioned installation | コントロールプレーン | コンピュートノード |

|---|---|---|---|---|---|

| Microsoft Azure | ✓ | ✓ |

|

| |

| Amazon Web Services (AWS) | ✓ | ✓ |

|

| |

| Google Cloud | ✓ |

|

| ||

| ベアメタル、IBM Power、または IBM Z 上でマルチアーキテクチャーのコンピュートマシンを含むクラスターを作成する | ベアメタル | ✓ |

|

| |

| IBM Power | ✓ |

|

| ||

| IBM Z | ✓ |

|

| ||

| z/VM を使用した IBM Z® および IBM® LinuxONE 上でマルチアーキテクチャーのコンピュートマシンを含むクラスターを作成する | IBM Z® および IBM® LinuxONE | ✓ |

|

| |

| RHEL KVM を使用した IBM Z® および IBM® LinuxONE 上でマルチアーキテクチャーのコンピュートマシンを含むクラスターを作成する | IBM Z® および IBM® LinuxONE | ✓ |

|

| |

| IBM Power® | ✓ |

|

|

現在、Google Cloud ではゼロからの自動スケーリングはサポートされていません。

4.2. Azure 上でマルチアーキテクチャーのコンピュートマシンを含むクラスターを作成する

マルチアーキテクチャーのコンピュートマシンを含む Azure クラスターをデプロイするには、まず、マルチアーキテクチャーインストーラーバイナリーを使用して、Azure インストーラーによってプロビジョニングされたシングルアーキテクチャーのクラスターを作成する必要があります。Azure へのインストールの詳細は、カスタマイズを使用した Azure へのクラスターのインストール を参照してください。

シングルアーキテクチャーのコンピュートマシンを含む現在のクラスターを、マルチアーキテクチャーのコンピュートマシンを含むクラスターに移行することもできます。詳細は、マルチアーキテクチャーのコンピュートマシンを備えたクラスターへの移行 を参照してください。

マルチアーキテクチャークラスターを作成した後、異なるアーキテクチャーのノードをクラスターに追加できます。

4.2.1. クラスターの互換性の確認

異なるアーキテクチャーのコンピュートノードをクラスターに追加する前に、クラスターがマルチアーキテクチャー互換であることを確認する必要があります。

前提条件

-

OpenShift CLI (

oc) がインストールされている。

手順

-

OpenShift CLI (

oc) にログインします。 次のコマンドを実行すると、クラスターがアーキテクチャーペイロードを使用していることを確認できます。

oc adm release info -o jsonpath="{ .metadata.metadata}"$ oc adm release info -o jsonpath="{ .metadata.metadata}"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

次の出力が表示された場合、クラスターはマルチアーキテクチャーペイロードを使用しています。

{ "release.openshift.io/architecture": "multi", "url": "https://access.redhat.com/errata/<errata_version>" }{ "release.openshift.io/architecture": "multi", "url": "https://access.redhat.com/errata/<errata_version>" }Copy to Clipboard Copied! Toggle word wrap Toggle overflow その後、クラスターへのマルチアーキテクチャーコンピュートノードの追加を開始できます。

次の出力が表示された場合、クラスターはマルチアーキテクチャーペイロードを使用していません。

{ "url": "https://access.redhat.com/errata/<errata_version>" }{ "url": "https://access.redhat.com/errata/<errata_version>" }Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要クラスターを、マルチアーキテクチャーコンピュートマシンをサポートするクラスターに移行するには、マルチアーキテクチャーコンピュートマシンを含むクラスターへの移行 の手順に従ってください。

4.2.2. Azure イメージギャラリーを使用して 64 ビット ARM ブートイメージを作成する

次の手順では、64 ビット ARM ブートイメージを手動で生成する方法を説明します。

前提条件

-

Azure CLI (

az) をインストールしている。 - マルチアーキテクチャーインストーラーバイナリーを使用して、単一アーキテクチャーの Azure インストーラープロビジョニングクラスターを作成している。

手順

Azure アカウントにログインします。

az login

$ az loginCopy to Clipboard Copied! Toggle word wrap Toggle overflow ストレージアカウントを作成し、

aarch64仮想ハードディスク (VHD) をストレージアカウントにアップロードします。OpenShift Container Platform インストールプログラムはリソースグループを作成しますが、ブートイメージをカスタムの名前付きリソースグループにアップロードすることもできます。az storage account create -n ${STORAGE_ACCOUNT_NAME} -g ${RESOURCE_GROUP} -l westus --sku Standard_LRS$ az storage account create -n ${STORAGE_ACCOUNT_NAME} -g ${RESOURCE_GROUP} -l westus --sku Standard_LRS1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

westusオブジェクトはリージョンの例です。

生成したストレージアカウントを使用してストレージコンテナーを作成します。

az storage container create -n ${CONTAINER_NAME} --account-name ${STORAGE_ACCOUNT_NAME}$ az storage container create -n ${CONTAINER_NAME} --account-name ${STORAGE_ACCOUNT_NAME}Copy to Clipboard Copied! Toggle word wrap Toggle overflow URL と

aarch64VHD 名を抽出するには、OpenShift Container Platform インストールプログラムの JSON ファイルを使用する必要があります。次のコマンドを実行して、

URLフィールドを抽出し、ファイル名としてRHCOS_VHD_ORIGIN_URLに設定します。RHCOS_VHD_ORIGIN_URL=$(oc -n openshift-machine-config-operator get configmap/coreos-bootimages -o jsonpath='{.data.stream}' | jq -r '.architectures.aarch64."rhel-coreos-extensions"."azure-disk".url')$ RHCOS_VHD_ORIGIN_URL=$(oc -n openshift-machine-config-operator get configmap/coreos-bootimages -o jsonpath='{.data.stream}' | jq -r '.architectures.aarch64."rhel-coreos-extensions"."azure-disk".url')Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

aarch64VHD 名を抽出し、ファイル名としてBLOB_NAMEに設定します。BLOB_NAME=rhcos-$(oc -n openshift-machine-config-operator get configmap/coreos-bootimages -o jsonpath='{.data.stream}' | jq -r '.architectures.aarch64."rhel-coreos-extensions"."azure-disk".release')-azure.aarch64.vhd$ BLOB_NAME=rhcos-$(oc -n openshift-machine-config-operator get configmap/coreos-bootimages -o jsonpath='{.data.stream}' | jq -r '.architectures.aarch64."rhel-coreos-extensions"."azure-disk".release')-azure.aarch64.vhdCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Shared Access Signature (SAS) トークンを生成します。このトークンを使用して、次のコマンドで RHCOS VHD をストレージコンテナーにアップロードします。

end=`date -u -d "30 minutes" '+%Y-%m-%dT%H:%MZ'`

$ end=`date -u -d "30 minutes" '+%Y-%m-%dT%H:%MZ'`Copy to Clipboard Copied! Toggle word wrap Toggle overflow sas=`az storage container generate-sas -n ${CONTAINER_NAME} --account-name ${STORAGE_ACCOUNT_NAME} --https-only --permissions dlrw --expiry $end -o tsv`$ sas=`az storage container generate-sas -n ${CONTAINER_NAME} --account-name ${STORAGE_ACCOUNT_NAME} --https-only --permissions dlrw --expiry $end -o tsv`Copy to Clipboard Copied! Toggle word wrap Toggle overflow RHCOS VHD をストレージコンテナーにコピーします。

az storage blob copy start --account-name ${STORAGE_ACCOUNT_NAME} --sas-token "$sas" \ --source-uri "${RHCOS_VHD_ORIGIN_URL}" \ --destination-blob "${BLOB_NAME}" --destination-container ${CONTAINER_NAME}$ az storage blob copy start --account-name ${STORAGE_ACCOUNT_NAME} --sas-token "$sas" \ --source-uri "${RHCOS_VHD_ORIGIN_URL}" \ --destination-blob "${BLOB_NAME}" --destination-container ${CONTAINER_NAME}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを使用して、コピープロセスのステータスを確認できます。

az storage blob show -c ${CONTAINER_NAME} -n ${BLOB_NAME} --account-name ${STORAGE_ACCOUNT_NAME} | jq .properties.copy$ az storage blob show -c ${CONTAINER_NAME} -n ${BLOB_NAME} --account-name ${STORAGE_ACCOUNT_NAME} | jq .properties.copyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- status パラメーターに

successオブジェクトが表示されたら、コピープロセスは完了です。

次のコマンドを使用してイメージギャラリーを作成します。

az sig create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME}$ az sig create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME}Copy to Clipboard Copied! Toggle word wrap Toggle overflow イメージギャラリーを使用してイメージ定義を作成します。次のコマンド例では、

rhcos-arm64がイメージ定義の名前です。az sig image-definition create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME} --gallery-image-definition rhcos-arm64 --publisher RedHat --offer arm --sku arm64 --os-type linux --architecture Arm64 --hyper-v-generation V2$ az sig image-definition create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME} --gallery-image-definition rhcos-arm64 --publisher RedHat --offer arm --sku arm64 --os-type linux --architecture Arm64 --hyper-v-generation V2Copy to Clipboard Copied! Toggle word wrap Toggle overflow VHD の URL を取得してファイル名として

RHCOS_VHD_URLに設定するには、次のコマンドを実行します。RHCOS_VHD_URL=$(az storage blob url --account-name ${STORAGE_ACCOUNT_NAME} -c ${CONTAINER_NAME} -n "${BLOB_NAME}" -o tsv)$ RHCOS_VHD_URL=$(az storage blob url --account-name ${STORAGE_ACCOUNT_NAME} -c ${CONTAINER_NAME} -n "${BLOB_NAME}" -o tsv)Copy to Clipboard Copied! Toggle word wrap Toggle overflow RHCOS_VHD_URLファイル、ストレージアカウント、リソースグループ、およびイメージギャラリーを使用して、イメージバージョンを作成します。次の例では、1.0.0がイメージバージョンです。az sig image-version create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME} --gallery-image-definition rhcos-arm64 --gallery-image-version 1.0.0 --os-vhd-storage-account ${STORAGE_ACCOUNT_NAME} --os-vhd-uri ${RHCOS_VHD_URL}$ az sig image-version create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME} --gallery-image-definition rhcos-arm64 --gallery-image-version 1.0.0 --os-vhd-storage-account ${STORAGE_ACCOUNT_NAME} --os-vhd-uri ${RHCOS_VHD_URL}Copy to Clipboard Copied! Toggle word wrap Toggle overflow arm64ブートイメージが生成されました。次のコマンドを使用して、イメージの ID にアクセスできます。az sig image-version show -r $GALLERY_NAME -g $RESOURCE_GROUP -i rhcos-arm64 -e 1.0.0

$ az sig image-version show -r $GALLERY_NAME -g $RESOURCE_GROUP -i rhcos-arm64 -e 1.0.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次の例のイメージ ID は、コンピュートマシンセットの

recourseIDパラメーターで使用されます。resourceIDの例/resourceGroups/${RESOURCE_GROUP}/providers/Microsoft.Compute/galleries/${GALLERY_NAME}/images/rhcos-arm64/versions/1.0.0/resourceGroups/${RESOURCE_GROUP}/providers/Microsoft.Compute/galleries/${GALLERY_NAME}/images/rhcos-arm64/versions/1.0.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.3. Azure イメージギャラリーを使用して 64 ビット x86 ブートイメージを作成する

次の手順では、64 ビット x86 ブートイメージを手動で生成する方法を説明します。

前提条件

-

Azure CLI (

az) をインストールしている。 - マルチアーキテクチャーインストーラーバイナリーを使用して、単一アーキテクチャーの Azure インストーラープロビジョニングクラスターを作成している。

手順

次のコマンドを実行して、Azure アカウントにログインします。

az login

$ az loginCopy to Clipboard Copied! Toggle word wrap Toggle overflow ストレージアカウントを作成し、次のコマンドを実行して

x86_64仮想ハードディスク (VHD) をストレージアカウントにアップロードします。OpenShift Container Platform インストールプログラムがリソースグループを作成します。なお、ブートイメージは、カスタム名のリソースグループにアップロードすることもできます。az storage account create -n ${STORAGE_ACCOUNT_NAME} -g ${RESOURCE_GROUP} -l westus --sku Standard_LRS$ az storage account create -n ${STORAGE_ACCOUNT_NAME} -g ${RESOURCE_GROUP} -l westus --sku Standard_LRS1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

westusオブジェクトはリージョンの例です。

次のコマンドを実行して、生成したストレージアカウントを使用してストレージコンテナーを作成します。

az storage container create -n ${CONTAINER_NAME} --account-name ${STORAGE_ACCOUNT_NAME}$ az storage container create -n ${CONTAINER_NAME} --account-name ${STORAGE_ACCOUNT_NAME}Copy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Container Platform インストールプログラムの JSON ファイルを使用して、URL と

x86_64VHD 名を抽出します。次のコマンドを実行して、

URLフィールドを抽出し、ファイル名としてRHCOS_VHD_ORIGIN_URLに設定します。RHCOS_VHD_ORIGIN_URL=$(oc -n openshift-machine-config-operator get configmap/coreos-bootimages -o jsonpath='{.data.stream}' | jq -r '.architectures.x86_64."rhel-coreos-extensions"."azure-disk".url')$ RHCOS_VHD_ORIGIN_URL=$(oc -n openshift-machine-config-operator get configmap/coreos-bootimages -o jsonpath='{.data.stream}' | jq -r '.architectures.x86_64."rhel-coreos-extensions"."azure-disk".url')Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

x86_64VHD 名を抽出し、ファイル名としてBLOB_NAMEに設定します。BLOB_NAME=rhcos-$(oc -n openshift-machine-config-operator get configmap/coreos-bootimages -o jsonpath='{.data.stream}' | jq -r '.architectures.x86_64."rhel-coreos-extensions"."azure-disk".release')-azure.x86_64.vhd$ BLOB_NAME=rhcos-$(oc -n openshift-machine-config-operator get configmap/coreos-bootimages -o jsonpath='{.data.stream}' | jq -r '.architectures.x86_64."rhel-coreos-extensions"."azure-disk".release')-azure.x86_64.vhdCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Shared Access Signature (SAS) トークンを生成します。このトークンを使用して、次のコマンドを実行し、RHCOS VHD をストレージコンテナーにアップロードします。

end=`date -u -d "30 minutes" '+%Y-%m-%dT%H:%MZ'`

$ end=`date -u -d "30 minutes" '+%Y-%m-%dT%H:%MZ'`Copy to Clipboard Copied! Toggle word wrap Toggle overflow sas=`az storage container generate-sas -n ${CONTAINER_NAME} --account-name ${STORAGE_ACCOUNT_NAME} --https-only --permissions dlrw --expiry $end -o tsv`$ sas=`az storage container generate-sas -n ${CONTAINER_NAME} --account-name ${STORAGE_ACCOUNT_NAME} --https-only --permissions dlrw --expiry $end -o tsv`Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、RHCOS VHD をストレージコンテナーにコピーします。

az storage blob copy start --account-name ${STORAGE_ACCOUNT_NAME} --sas-token "$sas" \ --source-uri "${RHCOS_VHD_ORIGIN_URL}" \ --destination-blob "${BLOB_NAME}" --destination-container ${CONTAINER_NAME}$ az storage blob copy start --account-name ${STORAGE_ACCOUNT_NAME} --sas-token "$sas" \ --source-uri "${RHCOS_VHD_ORIGIN_URL}" \ --destination-blob "${BLOB_NAME}" --destination-container ${CONTAINER_NAME}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行すると、コピープロセスのステータスを確認できます。

az storage blob show -c ${CONTAINER_NAME} -n ${BLOB_NAME} --account-name ${STORAGE_ACCOUNT_NAME} | jq .properties.copy$ az storage blob show -c ${CONTAINER_NAME} -n ${BLOB_NAME} --account-name ${STORAGE_ACCOUNT_NAME} | jq .properties.copyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

statusパラメーターにsuccessオブジェクトが表示されたら、コピープロセスは完了です。

次のコマンドを実行してイメージギャラリーを作成します。

az sig create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME}$ az sig create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME}Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、イメージギャラリーを使用してイメージ定義を作成します。

az sig image-definition create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME} --gallery-image-definition rhcos-x86_64 --publisher RedHat --offer x86_64 --sku x86_64 --os-type linux --architecture x64 --hyper-v-generation V2$ az sig image-definition create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME} --gallery-image-definition rhcos-x86_64 --publisher RedHat --offer x86_64 --sku x86_64 --os-type linux --architecture x64 --hyper-v-generation V2Copy to Clipboard Copied! Toggle word wrap Toggle overflow このコマンド例の

rhcos-x86_64は、イメージ定義の名前です。VHD の URL を取得してファイル名として

RHCOS_VHD_URLに設定するには、次のコマンドを実行します。RHCOS_VHD_URL=$(az storage blob url --account-name ${STORAGE_ACCOUNT_NAME} -c ${CONTAINER_NAME} -n "${BLOB_NAME}" -o tsv)$ RHCOS_VHD_URL=$(az storage blob url --account-name ${STORAGE_ACCOUNT_NAME} -c ${CONTAINER_NAME} -n "${BLOB_NAME}" -o tsv)Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

RHCOS_VHD_URLファイル、ストレージアカウント、リソースグループ、イメージギャラリーを使用してイメージバージョンを作成します。az sig image-version create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME} --gallery-image-definition rhcos-arm64 --gallery-image-version 1.0.0 --os-vhd-storage-account ${STORAGE_ACCOUNT_NAME} --os-vhd-uri ${RHCOS_VHD_URL}$ az sig image-version create --resource-group ${RESOURCE_GROUP} --gallery-name ${GALLERY_NAME} --gallery-image-definition rhcos-arm64 --gallery-image-version 1.0.0 --os-vhd-storage-account ${STORAGE_ACCOUNT_NAME} --os-vhd-uri ${RHCOS_VHD_URL}Copy to Clipboard Copied! Toggle word wrap Toggle overflow この例では、

1.0.0がイメージバージョンです。オプション: 次のコマンドを実行して、生成された

x86_64ブートイメージの ID にアクセスします。az sig image-version show -r $GALLERY_NAME -g $RESOURCE_GROUP -i rhcos-x86_64 -e 1.0.0

$ az sig image-version show -r $GALLERY_NAME -g $RESOURCE_GROUP -i rhcos-x86_64 -e 1.0.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次の例のイメージ ID は、コンピュートマシンセットの

recourseIDパラメーターで使用されます。resourceIDの例/resourceGroups/${RESOURCE_GROUP}/providers/Microsoft.Compute/galleries/${GALLERY_NAME}/images/rhcos-x86_64/versions/1.0.0/resourceGroups/${RESOURCE_GROUP}/providers/Microsoft.Compute/galleries/${GALLERY_NAME}/images/rhcos-x86_64/versions/1.0.0Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.2.4. Azure クラスターにマルチアーキテクチャーコンピュートマシンセットを追加する

マルチアーキテクチャークラスターを作成した後、異なるアーキテクチャーのノードを追加できます。

マルチアーキテクチャーコンピュートマシンをマルチアーキテクチャークラスターに追加する方法には、次のものがあります。

- 64 ビット ARM コントロールプレーンマシンを使用し、すでに 64 ビット ARM コンピュートマシンが含まれているクラスターに 64 ビット x86 コンピュートマシンを追加します。この場合、64 ビット x86 がセカンダリーアーキテクチャーと見なされます。

- 64 ビット x86 コントロールプレーンマシンを使用し、すでに 64 ビット x86 コンピュートマシンが含まれているクラスターに 64 ビット ARM コンピュートマシンを追加します。この場合、64 ビット ARM がセカンダリーアーキテクチャーと見なされます。

Azure でカスタムコンピュートマシンセットを作成するには、「Azure でのコンピュートマシンセットの作成」を参照してください。

セカンダリーアーキテクチャーノードをクラスターに追加する前に、Multiarch Tuning Operator をインストールし、ClusterPodPlacementConfig カスタムリソースをデプロイすることを推奨します。詳細は、「Multiarch Tuning Operator を使用してマルチアーキテクチャークラスター上のワークロードを管理する」を参照してください。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 - 64 ビット ARM または 64 ビット x86 ブートイメージを作成した。

- インストールプログラムを使用し、マルチアーキテクチャーインストーラーバイナリーを使用して、64 ビット ARM または 64 ビット x86 から成るシングルアーキテクチャーの Azure クラスターを作成した。

手順

-

OpenShift CLI (

oc) にログインします。 YAML ファイルを作成し、設定を追加して、クラスター内の 64 ビット ARM または 64 ビット x86 コンピュートノードを制御するコンピュートマシンセットを作成します。

Azure の 64 ビット ARM または 64 ビット x86 コンピュートノードの

MachineSetオブジェクトの例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行してコンピュートマシンセットを作成します。

oc create -f <file_name>

$ oc create -f <file_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<file_name>は、コンピュートマシン設定を含む YAML ファイルの名前に置き換えます。たとえば、arm64-machine-set-0.yaml、またはamd64-machine-set-0.yamlです。

検証

次のコマンドを実行して、新しいマシンが実行中であることを確認します。

oc get machineset -n openshift-machine-api

$ oc get machineset -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力に、作成したマシンセットが含まれている必要があります。

出力例

NAME DESIRED CURRENT READY AVAILABLE AGE <infrastructure_id>-machine-set-0 2 2 2 2 10m

NAME DESIRED CURRENT READY AVAILABLE AGE <infrastructure_id>-machine-set-0 2 2 2 2 10mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行すると、ノードが準備完了状態でスケジュール可能かどうかを確認できます。

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3. AWS 上でマルチアーキテクチャーのコンピュートマシンを含むクラスターを作成する

マルチアーキテクチャーのコンピュートマシンを含む AWS クラスターを作成するには、まず、マルチアーキテクチャーインストーラーバイナリーを使用して、AWS インストーラーによってプロビジョニングされたシングルアーキテクチャーのクラスターを作成する必要があります。AWS へのインストールの詳細は、カスタマイズを使用した AWS へのクラスターのインストール を参照してください。

シングルアーキテクチャーのコンピュートマシンを含む現在のクラスターを、マルチアーキテクチャーのコンピュートマシンを含むクラスターに移行することもできます。詳細は、マルチアーキテクチャーのコンピュートマシンを備えたクラスターへの移行 を参照してください。

マルチアーキテクチャークラスターを作成した後、異なるアーキテクチャーのノードをクラスターに追加できます。

4.3.1. クラスターの互換性の確認

異なるアーキテクチャーのコンピュートノードをクラスターに追加する前に、クラスターがマルチアーキテクチャー互換であることを確認する必要があります。

前提条件

-

OpenShift CLI (

oc) がインストールされている。

手順

-

OpenShift CLI (

oc) にログインします。 次のコマンドを実行すると、クラスターがアーキテクチャーペイロードを使用していることを確認できます。

oc adm release info -o jsonpath="{ .metadata.metadata}"$ oc adm release info -o jsonpath="{ .metadata.metadata}"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

次の出力が表示された場合、クラスターはマルチアーキテクチャーペイロードを使用しています。

{ "release.openshift.io/architecture": "multi", "url": "https://access.redhat.com/errata/<errata_version>" }{ "release.openshift.io/architecture": "multi", "url": "https://access.redhat.com/errata/<errata_version>" }Copy to Clipboard Copied! Toggle word wrap Toggle overflow その後、クラスターへのマルチアーキテクチャーコンピュートノードの追加を開始できます。

次の出力が表示された場合、クラスターはマルチアーキテクチャーペイロードを使用していません。

{ "url": "https://access.redhat.com/errata/<errata_version>" }{ "url": "https://access.redhat.com/errata/<errata_version>" }Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要クラスターを、マルチアーキテクチャーコンピュートマシンをサポートするクラスターに移行するには、マルチアーキテクチャーコンピュートマシンを含むクラスターへの移行 の手順に従ってください。

4.3.2. AWS クラスターにマルチアーキテクチャーコンピュートマシンセットを追加する

マルチアーキテクチャークラスターを作成した後、異なるアーキテクチャーのノードを追加できます。

マルチアーキテクチャーコンピュートマシンをマルチアーキテクチャークラスターに追加する方法には、次のものがあります。

- 64 ビット ARM コントロールプレーンマシンを使用し、すでに 64 ビット ARM コンピュートマシンが含まれているクラスターに 64 ビット x86 コンピュートマシンを追加します。この場合、64 ビット x86 がセカンダリーアーキテクチャーと見なされます。

- 64 ビット x86 コントロールプレーンマシンを使用し、すでに 64 ビット x86 コンピュートマシンが含まれているクラスターに 64 ビット ARM コンピュートマシンを追加します。この場合、64 ビット ARM がセカンダリーアーキテクチャーと見なされます。

セカンダリーアーキテクチャーノードをクラスターに追加する前に、Multiarch Tuning Operator をインストールし、ClusterPodPlacementConfig カスタムリソースをデプロイすることを推奨します。詳細は、「Multiarch Tuning Operator を使用してマルチアーキテクチャークラスター上のワークロードを管理する」を参照してください。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 - インストールプログラムを使用し、マルチアーキテクチャーインストーラーバイナリーを使用して、64 ビット ARM または 64 ビット x86 から成るシングルアーキテクチャーの AWS クラスターを作成した。

手順

-

OpenShift CLI (

oc) にログインします。 YAML ファイルを作成し、設定を追加して、クラスター内の 64 ビット ARM または 64 ビット x86 コンピュートノードを制御するコンピュートマシンセットを作成します。

AWS の 64 ビット ARM または x86 コンピュートノードの

MachineSetオブジェクトの例Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1 2 3 9 13 14

- クラスターのプロビジョニング時に設定したクラスター ID を基にするインフラストラクチャー ID を指定します。OpenShift CLI (

oc) がインストールされている場合は、以下のコマンドを実行してインフラストラクチャー ID を取得できます。oc get -o jsonpath="{.status.infrastructureName}{'\n'}" infrastructure cluster$ oc get -o jsonpath="{.status.infrastructureName}{'\n'}" infrastructure clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 4 7

- インフラストラクチャー ID、ロールノードラベル、およびゾーンを指定します。

- 5 6

- 追加するロールノードラベルを指定します。

- 8

- ノードの AWS リージョンに Red Hat Enterprise Linux CoreOS (RHCOS) Amazon Machine Image (AMI) を指定します。RHCOS AMI はマシンのアーキテクチャーと互換性がある必要があります。

oc get configmap/coreos-bootimages \ -n openshift-machine-config-operator \ -o jsonpath='{.data.stream}' | jq \ -r '.architectures.<arch>.images.aws.regions."<region>".image'$ oc get configmap/coreos-bootimages \ -n openshift-machine-config-operator \ -o jsonpath='{.data.stream}' | jq \ -r '.architectures.<arch>.images.aws.regions."<region>".image'Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 10

- 選択した AMI の CPU アーキテクチャーに合ったマシンタイプを指定します。詳細は、「AWS 64 ビット ARM のテスト済みインスタンスタイプ」を参照してください。

- 11

- ゾーンを指定します。たとえば、

us-east-1aです。選択したゾーンに必要なアーキテクチャーを備えたマシンがあることを確認してください。 - 12

- リージョンを指定します。たとえば、

us-east-1などです。選択したゾーンに必要なアーキテクチャーを備えたマシンがあることを確認してください。

次のコマンドを実行してコンピュートマシンセットを作成します。

oc create -f <file_name>

$ oc create -f <file_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<file_name>は、コンピュートマシン設定を含む YAML ファイルの名前に置き換えます。たとえば、aws-arm64-machine-set-0.yaml、またはaws-amd64-machine-set-0.yamlです。

検証

次のコマンドを実行して、コンピュートマシンセットのリストを表示します。

oc get machineset -n openshift-machine-api

$ oc get machineset -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力に、作成したマシンセットが含まれている必要があります。

出力例

NAME DESIRED CURRENT READY AVAILABLE AGE <infrastructure_id>-aws-machine-set-0 2 2 2 2 10m

NAME DESIRED CURRENT READY AVAILABLE AGE <infrastructure_id>-aws-machine-set-0 2 2 2 2 10mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行すると、ノードが準備完了状態でスケジュール可能かどうかを確認できます。

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.4. Google Cloud 上でマルチアーキテクチャーのコンピュートマシンを含むクラスターを作成する

マルチアーキテクチャーのコンピュートマシンを含む Google Cloud クラスターを作成するには、まず、マルチアーキテクチャーインストーラーバイナリーを使用して、Google Cloud インストーラーによってプロビジョニングされたシングルアーキテクチャーのクラスターを作成する必要があります。AWS へのインストールの詳細は、カスタマイズを使用した GCP へのクラスターのインストール を参照してください。

シングルアーキテクチャーのコンピュートマシンを含む現在のクラスターを、マルチアーキテクチャーのコンピュートマシンを含むクラスターに移行することもできます。詳細は、マルチアーキテクチャーのコンピュートマシンを備えたクラスターへの移行 を参照してください。

マルチアーキテクチャークラスターを作成した後、異なるアーキテクチャーのノードをクラスターに追加できます。

Google Cloud の 64 ビット ARM マシンでは、セキュアブートは現在サポートされていません。

4.4.1. クラスターの互換性の確認

異なるアーキテクチャーのコンピュートノードをクラスターに追加する前に、クラスターがマルチアーキテクチャー互換であることを確認する必要があります。

前提条件

-

OpenShift CLI (

oc) がインストールされている。

手順

-

OpenShift CLI (

oc) にログインします。 次のコマンドを実行すると、クラスターがアーキテクチャーペイロードを使用していることを確認できます。

oc adm release info -o jsonpath="{ .metadata.metadata}"$ oc adm release info -o jsonpath="{ .metadata.metadata}"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

次の出力が表示された場合、クラスターはマルチアーキテクチャーペイロードを使用しています。

{ "release.openshift.io/architecture": "multi", "url": "https://access.redhat.com/errata/<errata_version>" }{ "release.openshift.io/architecture": "multi", "url": "https://access.redhat.com/errata/<errata_version>" }Copy to Clipboard Copied! Toggle word wrap Toggle overflow その後、クラスターへのマルチアーキテクチャーコンピュートノードの追加を開始できます。

次の出力が表示された場合、クラスターはマルチアーキテクチャーペイロードを使用していません。

{ "url": "https://access.redhat.com/errata/<errata_version>" }{ "url": "https://access.redhat.com/errata/<errata_version>" }Copy to Clipboard Copied! Toggle word wrap Toggle overflow 重要クラスターを、マルチアーキテクチャーコンピュートマシンをサポートするクラスターに移行するには、マルチアーキテクチャーコンピュートマシンを含むクラスターへの移行 の手順に従ってください。

4.4.2. Google Cloud クラスターにマルチアーキテクチャーコンピュートマシンセットを追加する

マルチアーキテクチャークラスターを作成した後、異なるアーキテクチャーのノードを追加できます。

マルチアーキテクチャーコンピュートマシンをマルチアーキテクチャークラスターに追加する方法には、次のものがあります。

- 64 ビット ARM コントロールプレーンマシンを使用し、すでに 64 ビット ARM コンピュートマシンが含まれているクラスターに 64 ビット x86 コンピュートマシンを追加します。この場合、64 ビット x86 がセカンダリーアーキテクチャーと見なされます。

- 64 ビット x86 コントロールプレーンマシンを使用し、すでに 64 ビット x86 コンピュートマシンが含まれているクラスターに 64 ビット ARM コンピュートマシンを追加します。この場合、64 ビット ARM がセカンダリーアーキテクチャーと見なされます。

セカンダリーアーキテクチャーノードをクラスターに追加する前に、Multiarch Tuning Operator をインストールし、ClusterPodPlacementConfig カスタムリソースをデプロイすることを推奨します。詳細は、「Multiarch Tuning Operator を使用してマルチアーキテクチャークラスター上のワークロードを管理する」を参照してください。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 - インストールプログラムを使用し、マルチアーキテクチャーインストーラーバイナリーを使用して、64 ビット x86 または 64 ビット ARM から成るシングルアーキテクチャーの Google Cloud クラスターを作成した。

手順

-

OpenShift CLI (

oc) にログインします。 YAML ファイルを作成し、設定を追加して、クラスター内の 64 ビット ARM または 64 ビット x86 コンピュートノードを制御するコンピュートマシンセットを作成します。

Google Cloud の 64 ビット ARM または 64 ビット x86 コンピュートノードの

MachineSetオブジェクトの例Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- クラスターのプロビジョニング時に設定したクラスター ID を基にするインフラストラクチャー ID を指定します。以下のコマンドを実行してインフラストラクチャー ID を取得できます。

oc get -o jsonpath='{.status.infrastructureName}{"\n"}' infrastructure cluster$ oc get -o jsonpath='{.status.infrastructureName}{"\n"}' infrastructure clusterCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 2

- 追加するロールノードラベルを指定します。

- 3

- 現在のコンピュートマシンセットで使用されるイメージへのパスを指定します。イメージへのパスにはプロジェクトとイメージ名が必要です。

プロジェクトとイメージ名にアクセスするには、次のコマンドを実行します。

oc get configmap/coreos-bootimages \ -n openshift-machine-config-operator \ -o jsonpath='{.data.stream}' | jq \ -r '.architectures.aarch64.images.gcp'$ oc get configmap/coreos-bootimages \ -n openshift-machine-config-operator \ -o jsonpath='{.data.stream}' | jq \ -r '.architectures.aarch64.images.gcp'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

"gcp": { "release": "415.92.202309142014-0", "project": "rhcos-cloud", "name": "rhcos-415-92-202309142014-0-gcp-aarch64" }"gcp": { "release": "415.92.202309142014-0", "project": "rhcos-cloud", "name": "rhcos-415-92-202309142014-0-gcp-aarch64" }Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力の

projectパラメーターとnameパラメーターを使用して、マシンセット内のイメージフィールドへのパスを作成します。イメージへのパスは次の形式に従う必要があります。projects/<project>/global/images/<image_name>

$ projects/<project>/global/images/<image_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 4

- オプション:

key:valueのペアの形式でカスタムメタデータを指定します。ユースケースの例は、カスタムメタデータの設定 に関する Google Cloud のドキュメントを参照してください。 - 5

- 選択した OS イメージの CPU アーキテクチャーに合ったマシンタイプを指定します。詳細は、「64 ビット ARM インフラストラクチャー上の Google Cloud のテスト済みのインスタンスタイプ」を参照してください。

- 6

- クラスターに使用する Google Cloud プロジェクトの名前を指定します。

- 7

- リージョンを指定します。たとえば、

us-central1です。選択したゾーンに必要なアーキテクチャーを備えたマシンがあることを確認してください。

次のコマンドを実行してコンピュートマシンセットを作成します。

oc create -f <file_name>

$ oc create -f <file_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

<file_name>は、コンピュートマシン設定を含む YAML ファイルの名前に置き換えます。たとえば、gcp-arm64-machine-set-0.yaml、またはgcp-amd64-machine-set-0.yamlです。

検証

次のコマンドを実行して、コンピュートマシンセットのリストを表示します。

oc get machineset -n openshift-machine-api

$ oc get machineset -n openshift-machine-apiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力に、作成したマシンセットが含まれている必要があります。

出力例

NAME DESIRED CURRENT READY AVAILABLE AGE <infrastructure_id>-gcp-machine-set-0 2 2 2 2 10m

NAME DESIRED CURRENT READY AVAILABLE AGE <infrastructure_id>-gcp-machine-set-0 2 2 2 2 10mCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行すると、ノードが準備完了状態でスケジュール可能かどうかを確認できます。

oc get nodes

$ oc get nodesCopy to Clipboard Copied! Toggle word wrap Toggle overflow