ノード

Red Hat OpenShift Service on AWS のノード

概要

第1章 ノードの概要

1.1. ノードについて

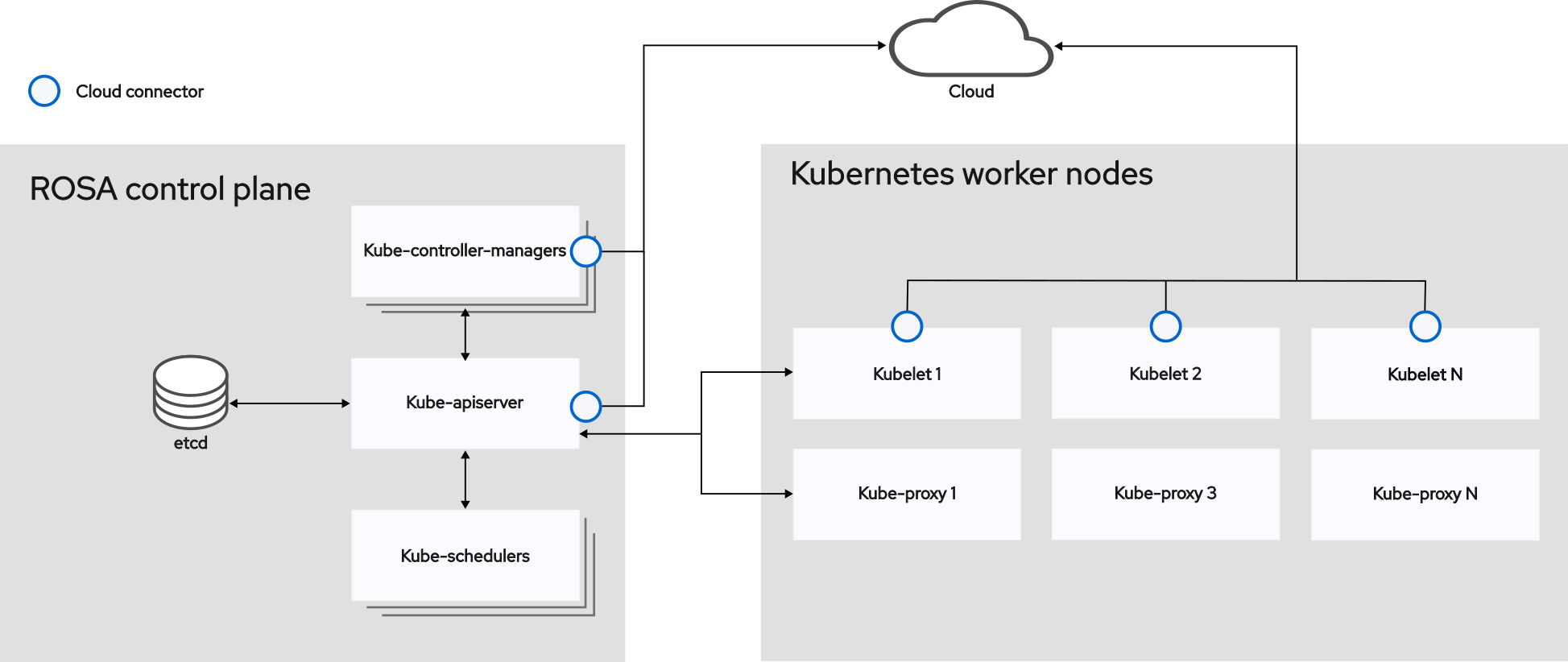

ノードは、Kubernetes クラスター内の仮想マシンまたはベアメタルマシンです。ワーカーノードは、Pod としてグループ化されたアプリケーションコンテナーをホストします。コントロールプレーンノードは、Kubernetes クラスターを制御するために必要なサービスを実行します。Red Hat OpenShift Service on AWS では、コントロールプレーンノードは Red Hat が所有する AWS アカウントでホストされます。Red Hat が、お客様の代わりにコントロールプレーンのインフラストラクチャーを完全に管理します。

ワーカーノードは永続性が保証されておらず、OpenShift の通常の運用および管理の一環として、いつでも置き換えられる可能性があります。詳細は、ノードのライフサイクル を参照してください。

クラスター内に安定した正常なノードを持つことは、ホストされたアプリケーションがスムーズに機能するための基本です。Red Hat OpenShift Service on AWS では、ノードを表す Node オブジェクトを介してノードにアクセス、管理、およびモニターできます。OpenShift CLI (oc) または Web コンソールを使用して、ノードで以下の操作を実行できます。

ノードの次のコンポーネントは、Pod の実行を維持し、Kubernetes ランタイム環境を提供するロールを果たします。

- コンテナーランタイム

- コンテナーランタイムはコンテナーの実行を担当します。Red Hat OpenShift Service on AWS は、クラスター内の各 Red Hat Enterprise Linux CoreOS (RHCOS) ノードに CRI-O コンテナーランタイムをデプロイします。Windows Machine Config Operator (WMCO) は、Windows ノードに containerd ランタイムをデプロイします。

- Kubelet

- Kubelet はノード上で実行され、コンテナーマニフェストを読み取ります。定義されたコンテナーが開始され、実行されていることを確認します。kubelet プロセスは、作業の状態とノードサーバーを維持します。Kubelet は、ネットワークルールとポートフォワーディングを管理します。kubelet は、Kubernetes によってのみ作成されたコンテナーを管理します。

- DNS

- クラスター DNS は、Kubernetes サービスの DNS レコードを提供する DNS サーバーです。Kubernetes により開始したコンテナーは、DNS 検索にこの DNS サーバーを自動的に含めます。

1.1.1. 読み取り操作

読み取り操作により、管理者または開発者は Red Hat OpenShift Service on AWS クラスター内のノードに関する情報を取得できます。

- クラスター内のすべてのノードを一覧表示します。

- メモリーと CPU の使用率、ヘルス、ステータス、経過時間など、ノードに関する情報を取得します。

- ノードで実行されている Pod を一覧表示します。

1.1.2. エンハンスメント操作

Red Hat OpenShift Service on AWS で可能なことは、ノードへのアクセスと管理だけではありません。管理者は、ノードで次のタスクを実行して、クラスターをより効率的でアプリケーションに適したものにし、開発者により良い環境を提供できます。

- Node Tuning Operator を使用して、ある程度のカーネルチューニングを必要とする高性能アプリケーションのノードレベルのチューニングを管理します。

- デーモンセットを使用して、ノードでバックグラウンドタスクを自動的に実行します。デーモンセットを作成して使用し、共有ストレージを作成したり、すべてのノードでロギング Pod を実行したり、すべてのノードに監視エージェントをデプロイしたりできます。

1.2. Pod について

Pod は、ノードに一緒にデプロイされる 1 つ以上のコンテナーです。クラスター管理者は、Pod を定義し、スケジューリングの準備ができている正常なノードで実行するように割り当て、管理することができます。コンテナーが実行されている限り、Pod は実行されます。Pod を定義して実行すると、Pod を変更することはできません。Pod を操作するときに実行できる操作は次のとおりです。

1.2.1. 読み取り操作

管理者は、次のタスクを通じてプロジェクト内の Pod に関する情報を取得できます。

- レプリカと再起動の数、現在のステータス、経過時間などの情報を含む、プロジェクトに関連付けられている Pod を一覧表示 します。

- CPU、メモリー、ストレージ消費量などの Pod 使用状況の統計を表示 します。

1.2.2. 管理操作

次のタスクのリストは、管理者が Red Hat OpenShift Service on AWS で Pod を管理する方法の概要を示しています。

Red Hat OpenShift Service on AWS で利用可能な高度なスケジューリング機能を使用して、Pod のスケジューリングを制御します。

- Pod アフィニティー、ノードアフィニティー、アンチ アフィニティーなどのノードから Pod へのバインディングルール。

- ノードラベルとセレクター。

- Pod トポロジー分散制約。

- Pod コントローラーと再起動ポリシーを使用して、再起動後の Pod の動作を設定します。

- Pod で送信トラフィックと受信トラフィックの両方を制限 します。

- Pod テンプレートを持つ任意のオブジェクトにボリュームを追加および削除します。ボリュームは、Pod 内のすべてのコンテナーで使用できるマウントされたファイルシステムです。コンテナーストレージは一時的なものです。ボリュームを使用すると、コンテナーデータを永続化できます。

1.2.3. エンハンスメント操作

Red Hat OpenShift Service on AWS で利用可能なさまざまなツールと機能を使用して、Pod をより簡単かつ効率的に操作できます。次の操作では、これらのツールと機能を使用して Pod をより適切に管理します。

-

Secrets: 一部のアプリケーションでは、パスワードやユーザー名などの機密情報が必要です。管理者は

Secretオブジェクトを使用して、Secretオブジェクトを使用する Pod に機密データを提供できます。

1.3. コンテナーについて

コンテナーは、Red Hat OpenShift Service on AWS アプリケーションの基本ユニットであり、依存関係、ライブラリー、およびバイナリーとともにパッケージ化されたアプリケーションコードで構成されます。コンテナーは、複数の環境、および物理サーバー、仮想マシン (VM)、およびプライベートまたはパブリッククラウドなどの複数のデプロイメントターゲット間に一貫性をもたらします。

Linux コンテナーテクノロジーは、実行中のプロセスを分離し、指定されたリソースのみへのアクセスを制限するための軽量メカニズムです。管理者は、Linux コンテナーで次のようなさまざまなタスクを実行できます。

Red Hat OpenShift Service on AWS は、Init コンテナー と呼ばれる特殊なコンテナーを提供します。Init コンテナーは、アプリケーションコンテナーの前に実行され、アプリケーションイメージに存在しないユーティリティーまたはセットアップスクリプトを含めることができます。Pod の残りの部分がデプロイされる前に、Init コンテナーを使用してタスクを実行できます。

ノード、Pod、およびコンテナーで特定のタスクを実行する以外に、Red Hat OpenShift Service on AWS クラスター全体を操作して、クラスターの効率とアプリケーション Pod の高可用性を維持できます。

1.4. Red Hat OpenShift Service on AWS ノードの一般用語集

この用語集では、ノード のコンテンツで使用される一般的な用語を定義しています。

- コンテナー

- これは、ソフトウェアとそのすべての依存関係を構成する軽量で実行可能なイメージです。コンテナーはオペレーティングシステムを仮想化するため、データセンターからパブリックまたはプライベートクラウド、さらには開発者のラップトップまで、どこでもコンテナーを実行できます。

- デーモンセット

- Pod のレプリカが Red Hat OpenShift Service on AWS クラスター内の対象となるノードで実行されるようにします。

- Egress

- Pod からのネットワークのアウトバウンドトラフィックを介して外部とデータを共有するプロセス。

- ガベージコレクション

- 終了したコンテナーや実行中の Pod によって参照されていないイメージなどのクラスターリソースをクリーンアップするプロセス。

- Ingress

- Pod への着信トラフィック。

- ジョブ

- 完了するまで実行されるプロセス。ジョブは 1 つ以上の Pod オブジェクトを作成し、指定された Pod が正常に完了するようにします。

- ラベル

- キーと値のペアであるラベルを使用して、Pod などのオブジェクトのサブセットを整理および選択できます。

- ノード

- Red Hat OpenShift Service on AWS クラスター内のワーカーマシンです。ノードは、仮想マシン (VM) または物理マシンのいずれかになります。

- Node Tuning Operator

- Node Tuning Operator を使用すると、TuneD デーモンを使用してノードレベルのチューニングを管理できます。これにより、カスタムチューニング仕様が、デーモンが認識する形式でクラスターで実行されるすべてのコンテナー化された TuneD デーモンに渡されます。デーモンは、ノードごとに 1 つずつ、クラスターのすべてのノードで実行されます。

- Self Node Remediation Operator

- Operator はクラスターノードで実行され、異常なノードを特定して再起動します。

- Pod

- Red Hat OpenShift Service on AWS クラスターで実行されている、ボリュームや IP アドレスなどの共有リソースを持つ 1 つ以上のコンテナー。Pod は、定義、デプロイ、および管理される最小のコンピュート単位です。

- toleration

- taint が一致するノードまたはノードグループで Pod をスケジュールできる (必須ではない) ことを示します。toleration を使用して、スケジューラーが一致する taint を持つ Pod をスケジュールできるようにすることができます。

- taint

- キー、値、および Effect で構成されるコアオブジェクト。taint と toleration が連携して、Pod が無関係なノードでスケジュールされないようにします。

第2章 Pod の使用

2.1. Pod の使用

Pod は 1 つのホストにデプロイされる 1 つ以上のコンテナーであり、定義され、デプロイされ、管理される最小のコンピュート単位です。

2.1.1. Pod について

Pod はコンテナーに対してマシンインスタンス (物理または仮想) とほぼ同じ機能を持ちます。各 Pod は独自の内部 IP アドレスで割り当てられるため、そのポートスペース全体を所有し、Pod 内のコンテナーはそれらのローカルストレージおよびネットワークを共有できます。

Pod にはライフサイクルがあります。それらは定義された後にノードで実行されるために割り当てられ、コンテナーが終了するまで実行されるか、その他の理由でコンテナーが削除されるまで実行されます。ポリシーおよび終了コードによっては、Pod は終了後に削除されるか、コンテナーのログへのアクセスを有効にするために保持される可能性があります。

Red Hat OpenShift Service on AWS は Pod をほぼイミュータブルなものとして扱います。Pod の実行中に Pod 定義を変更することはできません。Red Hat OpenShift Service on AWS は、既存の Pod を終了し、変更された設定、ベースイメージ、またはその両方を使用して Pod を再作成することによって変更を実装します。Pod は拡張可能なものとしても処理されますが、再作成時に状態を維持しません。そのため、Pod はユーザーが直接管理するのではなく、通常は上位レベルのコントローラーによって管理される必要があります。

レプリケーションコントローラーによって管理されないベア Pod はノードの中断時に再スケジュールされません。

2.1.2. Pod 設定の例

Red Hat OpenShift Service on AWS は、Kubernetes の Pod の概念を活用しています。Pod は、1 つのホスト上に一緒にデプロイされる 1 つ以上のコンテナーであり、定義、デプロイ、管理できる最小のコンピュート単位です。

以下は Pod の定義例です。これは数多くの Pod の機能を示していますが、それらのほとんどは他のトピックで説明されるため、ここではこれらを簡単に説明します。

Pod オブジェクト定義 (YAML)

- 1

- Pod には 1 つまたは複数のラベルで "タグ付け" することができ、このラベルを使用すると、一度の操作で Pod グループの選択や管理が可能になります。これらのラベルは、キー/値形式で

metadataハッシュに保存されます。 - 2

- Pod 再起動ポリシーと使用可能な値の

Always、OnFailure、およびNeverです。デフォルト値はAlwaysです。 - 3

- Red Hat OpenShift Service on AWS は、コンテナーを特権付きコンテナーとして実行するか、選択したユーザーとして実行するかどうかを指定するセキュリティーコンテキストを定義します。デフォルトのコンテキストには多くの制限がありますが、管理者は必要に応じてこれを変更できます。

- 4

containersは、1 つ以上のコンテナー定義の配列を指定します。- 5

- コンテナーは、コンテナー内に外部ストレージボリュームをマウントする場所を指定します。

- 6

- Pod に提供するボリュームを指定します。ボリュームは指定されたパスにマウントされます。コンテナーのルート (

/) や、ホストとコンテナーで同じパスにはマウントしないでください。これは、コンテナーに十分な特権が付与されている場合に、ホストシステムを破壊する可能性があります (例: ホストの/dev/ptsファイル)。ホストをマウントするには、/hostを使用するのが安全です。 - 7

- Pod 内の各コンテナーは、独自のコンテナーイメージからインスタンス化されます。

- 8

- Pod は、コンテナーで使用できるストレージボリュームを定義します。

ファイル数が多い永続ボリュームを Pod に割り当てる場合、それらの Pod は失敗するか、起動に時間がかかる場合があります。詳細は、When using Persistent Volumes with high file counts in OpenShift, why do pods fail to start or take an excessive amount of time to achieve "Ready" state? を参照してください。

この Pod 定義には、Pod が作成され、ライフサイクルが開始した後に Red Hat OpenShift Service on AWS によって自動的に設定される属性が含まれません。Kubernetes Pod ドキュメント には、Pod の機能および目的の詳細が記載されています。

2.1.3. リソース要求および制限について

Pod の仕様 (「Pod 設定の例」を参照) または Pod の制御オブジェクトの仕様を使用すると、Pod の CPU およびメモリーの要求と制限を指定できます。

CPU およびメモリーの 要求 は、Pod の実行に必要なリソースの最小量を指定するものです。これは、Red Hat OpenShift Service on AWS が十分なリソースを持つノードに Pod をスケジュールするのに役立ちます。

CPU とメモリーの 制限 は、Pod が消費できるリソースの最大量を定義するものです。これは、Pod がリソースを過剰に消費して同じノード上の他の Pod に影響を与える可能性を防ぎます。

CPU およびメモリーの要求と制限は、次の原則に従って処理されます。

CPU 制限は、CPU スロットリングを使用して適用されます。コンテナーが CPU 制限に近づくと、コンテナーの制限として指定された CPU へのアクセスをカーネルが制限します。したがって、CPU 制限はカーネルによって適用されるハード制限です。Red Hat OpenShift Service on AWS では、コンテナーが CPU 制限を長時間超過することが許される場合があります。ただし、コンテナーランタイムは、CPU 使用率が高すぎる場合でも Pod またはコンテナーを終了しません。

CPU の制限と要求は CPU 単位で測定されます。1 つの CPU ユニットは、ノードが物理ホストであるか、物理マシン内で実行されている仮想マシンであるかに応じて、1 つの物理 CPU コアまたは 1 つの仮想コアに相当します。小数の要求も許可されます。たとえば、CPU 要求を

0.5にしてコンテナーを定義すると、1.0CPU を要求した場合の半分の CPU 時間を要求することになります。CPU ユニットの場合、0.1は100mに相当します。これは 100 millicpu または 100 ミリコア として読み取られます。CPU リソースは常に絶対的なリソース量であり、相対的な量ではありません。注記デフォルトでは、Pod に割り当てることができる CPU の最小量は 10 mCPU です。Pod の仕様では、10 mCPU 未満のリソース制限を要求できます。その場合も、Pod には 10 mCPU が割り当てられます。

メモリー制限は、カーネルにより、Out of Memory (OOM) による強制終了を使用して適用されます。コンテナーがメモリー制限を超えるメモリーを使用する場合、カーネルはそのコンテナーを終了できます。ただし、終了はカーネルがメモリーの逼迫を検出した場合にのみ実行されます。そのため、メモリーを過剰に割り当てるコンテナーがすぐに強制終了されないことがあります。つまり、メモリー制限はリアクティブに適用されます。コンテナーはメモリー制限を超えるメモリーを使用することがあります。その場合、コンテナーが強制終了される可能性があります。

メモリーは、数量を表す

E、P、T、G、M、またはkのいずれかの接尾辞を使用して、単純な整数または固定小数点数として表すことができます。対応する 2 のべき乗の単位 (Ei、Pi、Ti、Gi、Mi、またはKi) を使用することもできます。

Pod が実行されているノードに十分なリソースがある場合、コンテナーは要求よりも多くの CPU またはメモリーリソースを使用する可能性があります。ただし、コンテナーは対応する制限を超えることはできません。たとえば、コンテナーのメモリー要求を 256 MiB に設定し、そのコンテナーが 8GiB のメモリーを持つノードにスケジュールされた Pod 内にあり、そのノードに他の Pod がない場合、コンテナーは要求された 256 MiB より多くのメモリーを使用しようとする可能性があります。

この動作は CPU およびメモリーの制限には適用されません。CPU およびメモリーの制限は、kubelet とコンテナーランタイムによって適用され、カーネルによって強制されます。Linux ノードでは、カーネルが cgroups を使用して制限を適用します。

2.2. Pod の表示

管理者は、クラスター Pod を表示し、その健全性をチェックして、クラスターの全体的な健全性を評価できます。特定のプロジェクトに関連付けられている Pod のリストを表示したり、Pod に関する使用状況統計を表示したりすることもできます。Pod を定期的に表示すると、問題を早期に検出し、リソースの使用状況を追跡し、クラスターの安定性を確保するのに役立ちます。

2.2.1. プロジェクトでの Pod の表示

CPU、メモリー、ストレージ消費量などの Pod の使用状況に関する統計情報を表示して、コンテナーのランタイム環境を監視し、効率的なリソース使用を確保できます。

手順

次のコマンドを入力してプロジェクトに変更します。

oc project <project_name>

$ oc project <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して Pod のリストを取得します。

oc get pods

$ oc get podsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME READY STATUS RESTARTS AGE console-698d866b78-bnshf 1/1 Running 2 165m console-698d866b78-m87pm 1/1 Running 2 165m

NAME READY STATUS RESTARTS AGE console-698d866b78-bnshf 1/1 Running 2 165m console-698d866b78-m87pm 1/1 Running 2 165mCopy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: Pod の IP アドレスと Pod が配置されているノードを表示するには、

-o wideフラグを追加します。以下に例を示します。oc get pods -o wide

$ oc get pods -o wideCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE console-698d866b78-bnshf 1/1 Running 2 166m 10.128.0.24 ip-10-0-152-71.ec2.internal <none> console-698d866b78-m87pm 1/1 Running 2 166m 10.129.0.23 ip-10-0-173-237.ec2.internal <none>

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE console-698d866b78-bnshf 1/1 Running 2 166m 10.128.0.24 ip-10-0-152-71.ec2.internal <none> console-698d866b78-m87pm 1/1 Running 2 166m 10.129.0.23 ip-10-0-173-237.ec2.internal <none>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.2. Pod の使用状況に関する統計の表示

コンテナーのランタイム環境を提供する、Pod に関する使用状況の統計を表示できます。これらの使用状況の統計には CPU、メモリー、およびストレージの消費量が含まれます。

前提条件

-

使用状況の統計を表示するには、

cluster-reader権限が必要です。 - 使用状況の統計を表示するには、メトリクスをインストールしている必要があります。

手順

次のコマンドを入力して使用状況の統計情報を表示します。

oc adm top pods -n <namespace>

$ oc adm top pods -n <namespace>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME CPU(cores) MEMORY(bytes) console-7f58c69899-q8c8k 0m 22Mi console-7f58c69899-xhbgg 0m 25Mi downloads-594fcccf94-bcxk8 3m 18Mi downloads-594fcccf94-kv4p6 2m 15Mi

NAME CPU(cores) MEMORY(bytes) console-7f58c69899-q8c8k 0m 22Mi console-7f58c69899-xhbgg 0m 25Mi downloads-594fcccf94-bcxk8 3m 18Mi downloads-594fcccf94-kv4p6 2m 15MiCopy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: ラベル付き Pod の使用状況の統計情報を表示するには、

--selector=''ラベルを追加します。フィルタリングするラベルクエリー (=、==、!=など) を選択する必要があることに注意してください。以下に例を示します。oc adm top pod --selector='<pod_name>'

$ oc adm top pod --selector='<pod_name>'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.3. リソースログの表示

OpenShift CLI (oc) または Web コンソールでリソースのログを表示できます。デフォルトでは、ログは最後 (または末尾) から表示されます。リソースのログを表示すると、問題のトラブルシューティングやリソースの動作の監視に役立ちます。

2.2.3.1. Web コンソールを使用してリソースログを表示する

Red Hat OpenShift Service on AWS Web コンソールを使用してリソースログを表示するには、次の手順を使用します。

手順

Red Hat OpenShift Service on AWS コンソールで Workloads → Pods に移動するか、調査するリソースから Pod に移動します。

注記ビルドなどの一部のリソースには、直接クエリーする Pod がありません。このような場合は、リソースの Details ページで Logs リンクを特定できます。

- ドロップダウンメニューからプロジェクトを選択します。

- 調査する Pod の名前をクリックします。

- Logs をクリックします。

2.2.3.2. CLI を使用してリソースログを表示する

コマンドラインインターフェイス (CLI) を使用してリソースログを表示するには、次の手順を使用します。

前提条件

-

OpenShift CLI (

oc) へのアクセスがある。

手順

次のコマンドを入力して、特定の Pod のログを表示します。

oc logs -f <pod_name> -c <container_name>

$ oc logs -f <pod_name> -c <container_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは、以下のようになります。

-f- オプション: ログに書き込まれている内容に沿って出力することを指定します。

<pod_name>- Pod の名前を指定します。

<container_name>- オプション: コンテナーの名前を指定します。Pod に複数のコンテナーがある場合は、コンテナー名を指定する必要があります。

以下に例を示します。

oc logs -f ruby-57f7f4855b-znl92 -c ruby

$ oc logs -f ruby-57f7f4855b-znl92 -c rubyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを入力して、特定のリソースのログを表示します。

oc logs <object_type>/<resource_name>

$ oc logs <object_type>/<resource_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

oc logs deployment/ruby

$ oc logs deployment/rubyCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3. Pod 用の Red Hat OpenShift Service on AWS の設定

管理者として、Pod に対して効率的なクラスターを作成し、維持することができます。

クラスターの効率性を維持することにより、1 回のみ実行するように設計された Pod をいつ再起動するか、Pod が利用できる帯域幅をいつ制限するか、中断時に Pod をどのように実行させ続けるかなど、Pod が終了するときの動作をツールとして使用して必要な数の Pod が常に実行されるようにし、開発者により良い環境を提供することができます。

2.3.1. 再起動後の Pod の動作方法の設定

Pod 再起動ポリシーは、Pod のコンテナーの終了時に Red Hat OpenShift Service on AWS が応答する方法を決定します。このポリシーは Pod のすべてのコンテナーに適用されます。

以下の値を使用できます。

-

Always- Pod で正常に終了したコンテナーの再起動を継続的に試みます。指数関数的なバックオフ遅延 (10 秒、20 秒、40 秒) は 5 分に制限されています。デフォルトはAlwaysです。 -

OnFailure: Pod で失敗したコンテナーの継続的な再起動を、5 分を上限として指数関数のバックオフ遅延 (10 秒、20 秒、40 秒) で試行します。 -

Never: Pod で終了したコンテナーまたは失敗したコンテナーの再起動を試行しません。Pod はただちに失敗し、終了します。

いったんノードにバインドされた Pod は別のノードにはバインドされなくなります。これは、Pod がノードの失敗後も存続するにはコントローラーが必要であることを示しています。

| 条件 | コントローラーのタイプ | 再起動ポリシー |

|---|---|---|

| 終了することが期待される Pod (バッチ計算など) | ジョブ |

|

| 終了しないことが期待される Pod (Web サーバーなど) | レプリケーションコントローラー |

|

| マシンごとに 1 回実行される Pod | デーモンセット | すべて |

Pod のコンテナーが失敗し、再起動ポリシーが OnFailure に設定される場合、Pod はノード上に留まり、コンテナーが再起動します。コンテナーを再起動させない場合には、再起動ポリシーの Never を使用します。

Pod 全体に障害が発生した場合、Red Hat OpenShift Service on AWS は新しい Pod を起動します。開発者は、アプリケーションが新規 Pod で再起動される可能性に対応しなくてはなりません。とくに、アプリケーションは、一時的なファイル、ロック、以前の実行で生じた未完成の出力などを処理する必要があります。

Kubernetes アーキテクチャーでは、クラウドプロバイダーからの信頼性のあるエンドポイントが必要です。クラウドプロバイダーが停止している場合、kubelet により Red Hat OpenShift Service on AWS の再起動が阻止されます。

基礎となるクラウドプロバイダーのエンドポイントに信頼性がない場合は、クラウドプロバイダー統合を使用してクラスターをインストールしないでください。クラスターを、非クラウド環境で実行する場合のようにインストールします。インストール済みのクラスターで、クラウドプロバイダー統合をオンまたはオフに切り替えることは推奨されていません。

Red Hat OpenShift Service on AWS が失敗したコンテナーに再起動ポリシーを使用する方法の詳細は、Kubernetes ドキュメントの Example States を参照してください。

2.3.2. Pod で利用可能な帯域幅の制限

Quality-of-Service (QoS) トラフィックシェーピングを Pod に適用し、その利用可能な帯域幅を効果的に制限することができます。(Pod からの) Egress トラフィックは、設定したレートを超えるパケットを単純にドロップするポリシングによって処理されます。(Pod への) Ingress トラフィックは、データを効果的に処理できるようシェーピングでパケットをキューに入れて処理されます。Pod に設定する制限は、他の Pod の帯域幅には影響を与えません。

手順

Pod の帯域幅を制限するには、以下を実行します。

オブジェクト定義 JSON ファイルを作成し、

kubernetes.io/ingress-bandwidthおよびkubernetes.io/egress-bandwidthアノテーションを使用してデータトラフィックの速度を指定します。たとえば、Pod の egress および ingress の両方の帯域幅を 10M/s に制限するには、以下を実行します。制限が設定された

Podオブジェクト定義Copy to Clipboard Copied! Toggle word wrap Toggle overflow オブジェクト定義を使用して Pod を作成します。

oc create -f <file_or_dir_path>

$ oc create -f <file_or_dir_path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.3.3. 起動している必要がある Pod の数を Pod Disruption Budget を使用して指定する方法について

Pod Disruption Budget を使用すると、メンテナンスのためにノードの drain (Pod の退避) を実行するなど、運用中の Pod に対して安全上の制約を指定できます。

PodDisruptionBudget は、同時に起動している必要のあるレプリカの最小数またはパーセンテージを指定する API オブジェクトです。これらをプロジェクトに設定することは、ノードのメンテナンス (クラスターのスケールダウンまたはクラスターのアップグレードなどの実行) 時に役立ち、この設定は (ノードの障害時ではなく) 自発的な退避の場合にのみ許可されます。

PodDisruptionBudget オブジェクトの設定は、次の主要な部分で構成されます。

- 一連の Pod に対するラベルのクエリー機能であるラベルセレクター。

同時に利用可能にする必要のある Pod の最小数を指定する可用性レベル。

-

minAvailableは、中断時にも常に利用可能である必要のある Pod 数です。 -

maxUnavailableは、中断時に利用不可にできる Pod 数です。

-

Available は、Ready=True の状態にある Pod 数を指します。Ready=True は、要求に対応でき、一致するすべてのサービスの負荷分散プールに追加する必要がある Pod を指します。

maxUnavailable の 0% または 0 あるいは minAvailable の 100%、ないしはレプリカ数に等しい値は許可されますが、これによりノードが drain されないようにブロックされる可能性があります。

Red Hat OpenShift Service on AWS のすべてのマシン設定プールにおける maxUnavailable のデフォルト設定は 1 です。この値を変更せず、一度に 1 つのコントロールプレーンノードを更新することを推奨します。コントロールプレーンプールのこの値を 3 に変更しないでください。

以下を実行して、Pod の Disruption Budget をすべてのプロジェクトで確認することができます。

oc get poddisruptionbudget --all-namespaces

$ oc get poddisruptionbudget --all-namespaces以下の例には、Red Hat OpenShift Service on AWS に固有の値がいくつか含まれています。

出力例

PodDisruptionBudget は、最低でも minAvailable Pod がシステムで実行されている場合は正常であるとみなされます。この制限を超えるすべての Pod は退避の対象となります。

Pod の優先度とプリエンプションの設定によっては、Pod Disruption Budget の要件にもかかわらず、優先度の低い Pod が削除される可能性があります。

2.3.3.1. 起動している必要がある Pod の数を Pod Disruption Budget を使用して指定する

同時に起動している必要のあるレプリカの最小数またはパーセンテージは、PodDisruptionBudget オブジェクトを使用して指定します。

手順

Pod Disruption Budget を設定するには、次の手順を実行します。

YAML ファイルを以下のようなオブジェクト定義で作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow または、以下を実行します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行してオブジェクトをプロジェクトに追加します。

oc create -f </path/to/file> -n <project_name>

$ oc create -f </path/to/file> -n <project_name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5. 設定マップの作成および使用

以下のセクションでは、設定マップおよびそれらを作成し、使用する方法を定義します。

2.5.1. 設定マップについて

多くのアプリケーションには、設定ファイル、コマンドライン引数、および環境変数の組み合わせを使用した設定が必要です。Red Hat OpenShift Service on AWS では、これらの設定アーティファクトは、コンテナー化されたアプリケーションを移植可能な状態に保つためにイメージコンテンツから切り離されます。

ConfigMap オブジェクトは、コンテナーを Red Hat OpenShift Service on AWS に依存させないようにする一方で、コンテナーに設定データを注入するメカニズムを提供します。設定マップは、個々のプロパティーなどの粒度の細かい情報や、設定ファイル全体または JSON Blob などの粒度の荒い情報を保存するために使用できます。

ConfigMap オブジェクトは、Pod で使用したり、コントローラーなどのシステムコンポーネントの設定データを保存するために使用できる設定データのキーと値のペアを保持します。以下に例を示します。

ConfigMap オブジェクト定義

イメージなどのバイナリーファイルから設定マップを作成する場合に、binaryData フィールドを使用できます。

設定データはさまざまな方法で Pod 内で使用できます。設定マップは以下を実行するために使用できます。

- コンテナーへの環境変数値の設定

- コンテナーのコマンドライン引数の設定

- ボリュームの設定ファイルの設定

ユーザーとシステムコンポーネントの両方が設定データを設定マップに保存できます。

設定マップはシークレットに似ていますが、機密情報を含まない文字列の使用をより効果的にサポートするように設計されています。

2.5.1.1. 設定マップの制限

設定マップは、コンテンツを Pod で使用される前に作成する必要があります。

コントローラーは、設定データが不足していても、その状況を許容して作成できます。ケースごとに設定マップを使用して設定される個々のコンポーネントを参照してください。

ConfigMap オブジェクトはプロジェクト内にあります。

それらは同じプロジェクトの Pod によってのみ参照されます。

Kubelet は、API サーバーから取得する Pod の設定マップの使用のみをサポートします。

これには、CLI を使用して作成された Pod、またはレプリケーションコントローラーから間接的に作成された Pod が含まれます。これには、Red Hat OpenShift Service on AWS ノードの --manifest-url フラグ、--config フラグ、REST API を使用して作成された Pod は含まれません。これらは Pod を作成する一般的な方法ではないためです。

2.5.2. Red Hat OpenShift Service on AWS Web コンソールでの config map の作成

Red Hat OpenShift Service on AWS Web コンソールで config map を作成できます。

手順

クラスター管理者として設定マップを作成するには、以下を実行します。

-

Administrator パースペクティブで

Workloads→Config Mapsを選択します。 - ページの右上にある Create Config Map を選択します。

- 設定マップの内容を入力します。

- Create を選択します。

-

Administrator パースペクティブで

開発者として設定マップを作成するには、以下を実行します。

-

開発者パースペクティブで、

Config Mapsを選択します。 - ページの右上にある Create Config Map を選択します。

- 設定マップの内容を入力します。

- Create を選択します。

-

開発者パースペクティブで、

2.5.3. CLI を使用して設定マップを作成する

以下のコマンドを使用して、ディレクトリー、特定のファイルまたはリテラル値から設定マップを作成できます。

手順

設定マップの作成

oc create configmap <configmap_name> [options]

$ oc create configmap <configmap_name> [options]Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.3.1. ディレクトリーからの設定マップの作成

--from-file フラグを使用すると、ディレクトリーから config map を作成できます。この方法では、ディレクトリー内の複数のファイルを使用して設定マップを作成できます。

ディレクトリー内の各ファイルは、config map にキーを設定するために使用されます。キーの名前はファイル名で、キーの値はファイルの内容です。

たとえば、次のコマンドは、example-files ディレクトリーの内容を使用して config map を作成します。

oc create configmap game-config --from-file=example-files/

$ oc create configmap game-config --from-file=example-files/config map 内のキーを表示します。

oc describe configmaps game-config

$ oc describe configmaps game-config出力例

マップにある 2 つのキーが、コマンドで指定されたディレクトリーのファイル名に基づいて作成されていることに気づかれることでしょう。これらのキーの内容は大きい可能性があるため、oc describe の出力にはキーの名前とそのサイズのみが表示されます。

前提条件

config map に追加するデータを含むファイルを含むディレクトリーが必要です。

次の手順では、サンプルファイル

game.propertiesおよびui.propertiesを使用します。cat example-files/game.properties

$ cat example-files/game.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow cat example-files/ui.properties

$ cat example-files/ui.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

color.good=purple color.bad=yellow allow.textmode=true how.nice.to.look=fairlyNice

color.good=purple color.bad=yellow allow.textmode=true how.nice.to.look=fairlyNiceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

次のコマンドを入力して、このディレクトリー内の各ファイルの内容を保持する設定マップを作成します。

oc create configmap game-config \ --from-file=example-files/$ oc create configmap game-config \ --from-file=example-files/Copy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

-oオプションを使用してオブジェクトのoc getコマンドを入力し、キーの値を表示します。oc get configmaps game-config -o yaml

$ oc get configmaps game-config -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.3.2. ファイルから設定マップを作成する

--from-file フラグを使用すると、ファイルから config map を作成できます。--from-file オプションを CLI に複数回渡すことができます。

key=value 式を --from-file オプションに渡すことで、ファイルからインポートされたコンテンツの config map に設定するキーを指定することもできます。以下に例を示します。

oc create configmap game-config-3 --from-file=game-special-key=example-files/game.properties

$ oc create configmap game-config-3 --from-file=game-special-key=example-files/game.properties

ファイルから設定マップを作成する場合、UTF8 以外のデータを破損することなく、UTF8 以外のデータを含むファイルをこの新規フィールドに配置できます。Red Hat OpenShift Service on AWS はバイナリーファイルを検出し、ファイルを MIME として透過的にエンコーディングします。サーバーでは、データを破損することなく MIME ペイロードがデコーディングされ、保存されます。

前提条件

config map に追加するデータを含むファイルを含むディレクトリーが必要です。

次の手順では、サンプルファイル

game.propertiesおよびui.propertiesを使用します。cat example-files/game.properties

$ cat example-files/game.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow cat example-files/ui.properties

$ cat example-files/ui.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

color.good=purple color.bad=yellow allow.textmode=true how.nice.to.look=fairlyNice

color.good=purple color.bad=yellow allow.textmode=true how.nice.to.look=fairlyNiceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

特定のファイルを指定して設定マップを作成します。

oc create configmap game-config-2 \ --from-file=example-files/game.properties \ --from-file=example-files/ui.properties$ oc create configmap game-config-2 \ --from-file=example-files/game.properties \ --from-file=example-files/ui.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow キーと値のペアを指定して、設定マップを作成します。

oc create configmap game-config-3 \ --from-file=game-special-key=example-files/game.properties$ oc create configmap game-config-3 \ --from-file=game-special-key=example-files/game.propertiesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

-oオプションを使用してオブジェクトのoc getコマンドを入力し、ファイルからキーの値を表示します。oc get configmaps game-config-2 -o yaml

$ oc get configmaps game-config-2 -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -oオプションを使用してオブジェクトのoc getコマンドを入力し、key-value (キー/値) ペアからキーの値を表示します。oc get configmaps game-config-3 -o yaml

$ oc get configmaps game-config-3 -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- これは、先の手順で設定したキーです。

2.5.3.3. リテラル値からの設定マップの作成

設定マップにリテラル値を指定することができます。

--from-literal オプションは、リテラル値をコマンドラインに直接指定できる key=value 構文を取ります。

手順

リテラル値を指定して設定マップを作成します。

oc create configmap special-config \ --from-literal=special.how=very \ --from-literal=special.type=charm$ oc create configmap special-config \ --from-literal=special.how=very \ --from-literal=special.type=charmCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

-oオプションを使用してオブジェクトのoc getコマンドを入力し、キーの値を表示します。oc get configmaps special-config -o yaml

$ oc get configmaps special-config -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.4. ユースケース: Pod で設定マップを使用する

以下のセクションでは、Pod で ConfigMap オブジェクトを使用する際のいくつかのユースケースを説明します。

2.5.4.1. 設定マップの使用によるコンテナーでの環境変数の設定

config map を使用して、コンテナーで個別の環境変数を設定するために使用したり、有効な環境変数名を生成するすべてのキーを使用してコンテナーで環境変数を設定するために使用したりすることができます。

例として、以下の設定マップを見てみましょう。

2 つの環境変数を含む ConfigMap

1 つの環境変数を含む ConfigMap

手順

configMapKeyRefセクションを使用して、Pod のこのConfigMapのキーを使用できます。特定の環境変数を注入するように設定されている

Pod仕様のサンプルCopy to Clipboard Copied! Toggle word wrap Toggle overflow この Pod が実行されると、Pod のログには以下の出力が含まれます。

SPECIAL_LEVEL_KEY=very log_level=INFO

SPECIAL_LEVEL_KEY=very log_level=INFOCopy to Clipboard Copied! Toggle word wrap Toggle overflow

SPECIAL_TYPE_KEY=charm は出力例にリスト表示されません。optional: true が設定されているためです。

2.5.4.2. 設定マップを使用したコンテナーコマンドのコマンドライン引数の設定

config map を使用すると、Kubernetes 置換構文 $(VAR_NAME) を使用してコンテナー内のコマンドまたは引数の値を設定できます。

例として、以下の設定マップを見てみましょう。

手順

コンテナー内のコマンドに値を注入するには、環境変数として使用するキーを使用する必要があります。次に、

$(VAR_NAME)構文を使用してコンテナーのコマンドでそれらを参照することができます。特定の環境変数を注入するように設定されている Pod 仕様のサンプル

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 環境変数として使用するキーを使用して、コンテナーのコマンドに値を挿入します。

この Pod が実行されると、test-container コンテナーで実行される echo コマンドの出力は以下のようになります。

very charm

very charmCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.5.4.3. 設定マップの使用によるボリュームへのコンテンツの挿入

config map を使用して、コンテンツをボリュームに注入することができます。

ConfigMap カスタムリソース (CR) の例

手順

config map を使用してコンテンツをボリュームに注入するには、2 つの異なるオプションを使用できます。

config map を使用してコンテンツをボリュームに注入するための最も基本的な方法は、キーがファイル名であり、ファイルの内容がキーの値になっているファイルでボリュームを設定する方法です。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- キーを含むファイル。

この Pod が実行されると、cat コマンドの出力は以下のようになります。

very

veryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 設定マップキーが投影されるボリューム内のパスを制御することもできます。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 設定マップキーへのパス。

この Pod が実行されると、cat コマンドの出力は以下のようになります。

very

veryCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.6. Pod スケジューリングの決定に Pod の優先順位を含める

クラスターで Pod の優先順位およびプリエンプションを有効にできます。Pod の優先度は、他の Pod との比較した Pod の重要度を示し、その優先度に基づいて Pod をキューに入れます。Pod のプリエンプションは、クラスターが優先順位の低い Pod の退避またはプリエンプションを実行することを可能にするため、適切なノードに利用可能な領域がない場合に優先順位のより高い Pod をスケジュールできます。Pod の優先順位は Pod のスケジューリングの順序にも影響を与え、リソース不足の場合のノード上での退避の順序に影響を与えます。

優先順位とプリエンプションを使用するには、Pod 仕様の優先順位クラスを参照して、その重みをスケジューリングに適用します。

2.6.1. Pod の優先順位について

Pod の優先順位およびプリエンプション機能を使用する場合、スケジューラーは優先順位に基づいて保留中の Pod を順序付け、保留中の Pod はスケジューリングのキューで優先順位のより低い他の保留中の Pod よりも前に置かれます。その結果、より優先順位の高い Pod は、スケジューリングの要件を満たす場合に優先順位の低い Pod よりも早くスケジュールされる可能性があります。Pod をスケジュールできない場合、スケジューラーは引き続き他の優先順位の低い Pod をスケジュールします。

2.6.1.1. Pod の優先順位クラス

Pod には優先順位クラスを割り当てることができます。これは、名前から優先順位の整数値へのマッピングを定義する namespace を使用していないオブジェクトです。値が高いと優先順位が高くなります。

優先順位およびプリエンプションは、1000000000 (10 億) 以下の 32 ビットの整数値を取ることができます。プリエンプションや退避を実行すべきでない Critical Pod 用に 10 億以上の数値を予約する必要があります。デフォルトで、Red Hat OpenShift Service on AWS には予約済みの優先順位クラスが 2 つあります。これらのクラスは、重要なシステム Pod のスケジューリングを保証するために使用されます。

oc get priorityclasses

$ oc get priorityclasses出力例

NAME VALUE GLOBAL-DEFAULT AGE system-node-critical 2000001000 false 72m system-cluster-critical 2000000000 false 72m openshift-user-critical 1000000000 false 3d13h cluster-logging 1000000 false 29s

NAME VALUE GLOBAL-DEFAULT AGE

system-node-critical 2000001000 false 72m

system-cluster-critical 2000000000 false 72m

openshift-user-critical 1000000000 false 3d13h

cluster-logging 1000000 false 29ssystem-node-critical: この優先順位クラスには 2000001000 の値があり、ノードから退避すべきでないすべての Pod に使用されます。この優先順位クラスを持つ Pod の例としては、

ovnkube-nodeなどがあります。数多くの重要なコンポーネントには、デフォルトでsystem-node-criticalの優先順位クラスが含まれます。以下は例になります。- master-api

- master-controller

- master-etcd

- ovn-kubernetes

- sync

system-cluster-critical: この優先順位クラスには 2000000000 (20 億) の値があり、クラスターに重要な Pod に使用されます。この優先順位クラスの Pod は特定の状況でノードから退避される可能性があります。たとえば、

system-node-critical優先順位クラスで設定される Pod が優先される可能性があります。この場合でも、この優先順位クラスではスケジューリングが保証されます。この優先順位クラスを持つ可能性のある Pod の例として、fluentd、descheduler などのアドオンコンポーネントなどがあります。数多くの重要なコンポーネントには、デフォルトでsystem-cluster-critical優先順位クラスが含まれます。以下はその一例です。- fluentd

- metrics-server

- descheduler

-

openshift-user-critical:

priorityClassNameフィールドを、リソース消費をバインドできず、予測可能なリソース消費動作がない重要な Pod で使用できます。openshift-monitoringおよびopenshift-user-workload-monitoringnamespace 下にある Prometheus Pod は、openshift-user-criticalpriorityClassNameを使用します。モニタリングのワークロードはsystem-criticalを最初のpriorityClassとして使用しますが、これにより、モニタリング時にメモリーが過剰に使用され、ノードが退避できない問題が発生します。その結果、モニタリングの優先順位が下がり、スケジューラーに柔軟性が与えられ、重要なノードの動作を維持するために重いワークロード発生します。 - cluster-logging: この優先順位は、Fluentd Pod が他のアプリケーションより優先してノードにスケジュールされるようにするために Fluentd で使用されます。

2.6.1.2. Pod の優先順位名

1 つ以上の優先順位クラスを準備した後に、Pod 仕様に優先順位クラス名を指定する Pod を作成できます。優先順位のアドミッションコントローラーは、優先順位クラス名フィールドを使用して優先順位の整数値を設定します。名前付きの優先順位クラスが見つからない場合、Pod は拒否されます。

2.6.2. Pod のプリエンプションについて

開発者が Pod を作成する場合、Pod はキューに入れられます。開発者が Pod の優先順位またはプリエンプションを設定している場合、スケジューラーはキューから Pod を選択し、Pod をノードにスケジュールしようとします。スケジューラーが Pod に指定されたすべての要件を満たす適切なノードに領域を見つけられない場合、プリエンプションロジックが保留中の Pod にトリガーされます。

スケジューラーがノードで 1 つ以上の Pod のプリエンプションを実行する場合、優先順位の高い Pod 仕様の nominatedNodeName フィールドは、nodename フィールドと共にノードの名前に設定されます。スケジューラーは nominatedNodeName フィールドを使用して Pod の予約されたリソースを追跡し、またクラスターのプリエンプションに関する情報をユーザーに提供します。

スケジューラーが優先順位の低い Pod のプリエンプションを実行した後に、スケジューラーは Pod のグレースフルな終了期間を許可します。スケジューラーが優先順位の低い Pod の終了を待機する間に別のノードが利用可能になると、スケジューラーはそのノードに優先順位の高い Pod をスケジュールできます。その結果、Pod 仕様の nominatedNodeName フィールドおよび nodeName フィールドが異なる可能性があります。

さらに、スケジューラーがノード上で Pod のプリエンプションを実行し、終了を待機している場合で、保留中の Pod よりも優先順位の高い Pod をスケジュールする必要がある場合、スケジューラーは代わりに優先順位の高い Pod をスケジュールできます。その場合、スケジューラーは保留中の Pod の nominatedNodeName をクリアし、その Pod を他のノードの対象とすることができます。

プリエンプションは、ノードから優先順位の低いすべての Pod を削除する訳ではありません。スケジューラーは、優先順位の低い Pod の一部を削除して保留中の Pod をスケジュールできます。

スケジューラーは、保留中の Pod をノードにスケジュールできる場合にのみ、Pod のプリエンプションを実行するノードを考慮します。

2.6.2.1. プリエンプションを実行しない優先順位クラス

プリエンプションポリシーが Never に設定された Pod は優先順位の低い Pod よりも前のスケジューリングキューに置かれますが、他の Pod のプリエンプションを実行することはできません。スケジュールを待機しているプリエンプションを実行しない Pod は、十分なリソースが解放され、これがスケジュールされるまでスケジュールキュー内に留まります。他の Pod などのプリエンプションを実行しない Pod はスケジューラーのバックオフの対象になります。つまり、スケジューラーがこれらの Pod のスケジュールの試行に成功しない場合、低頻度で再試行されるため、優先順位の低い他の Pod をそれらの Pod よりも前にスケジュールできます。

プリエンプションを実行しない Pod には、他の優先順位の高い Pod が依然としてプリエンプションを実行できます。

2.6.2.2. Pod プリエンプションおよび他のスケジューラーの設定

Pod の優先順位およびプリエンプションを有効にする場合、他のスケジューラー設定を考慮します。

- Pod の優先順位および Pod の Disruption Budget (停止状態の予算)

- Pod の Disruption Budget (停止状態の予算) は一度に稼働している必要のあるレプリカの最小数またはパーセンテージを指定します。Pod の Disruption Budget (停止状態の予算) を指定する場合、Red Hat OpenShift Service on AWS は、Best Effort レベルで Pod のプリエンプションを実行する際にそれらを適用します。スケジューラーは、Pod の Disruption Budget (停止状態の予算) に違反しない範囲で Pod のプリエンプションを試行します。該当する Pod が見つからない場合には、Pod の Disruption Budget (停止状態の予算) の要件を無視して優先順位の低い Pod のプリエンプションが実行される可能性があります。

- Pod の優先順位およびアフィニティー

- Pod のアフィニティーは、新規 Pod が同じラベルを持つ他の Pod と同じノードにスケジュールされることを要求します。

保留中の Pod にノード上の 1 つ以上の優先順位の低い Pod との Pod 間のアフィニティーがある場合、スケジューラーはアフィニティーの要件を違反せずに優先順位の低い Pod のプリエンプションを実行することはできません。この場合、スケジューラーは保留中の Pod をスケジュールするための別のノードを探します。ただし、スケジューラーが適切なノードを見つけることは保証できず、保留中の Pod がスケジュールされない可能性があります。

この状態を防ぐには、優先順位が等しい Pod との Pod のアフィニティーの設定を慎重に行ってください。

2.6.2.3. プリエンプションが実行された Pod の正常な終了

Pod のプリエンプションの実行中、スケジューラーは Pod のグレースフルな終了期間が期限切れになるのを待機します。その後、Pod は機能を完了し、終了します。Pod がこの期間後も終了しない場合、スケジューラーは Pod を強制終了します。このようにグレースフルな終了期間が原因で、スケジューラーによる Pod のプリエンプションの実行時と保留中の Pod のノードへのスケジュール時に時間差が出ます。

このギャップを最小限に抑えるには、優先度の低い Pod に対してグレースフルな終了期間を短く設定します。

2.6.3. 優先順位およびプリエンプションの設定

Pod 仕様で priorityClassName を使用して優先順位クラスオブジェクトを作成し、Pod を優先順位に関連付けることで、Pod の優先度およびプリエンプションを適用できます。

優先クラスを既存のスケジュール済み Pod に直接追加することはできません。

手順

優先順位およびプリエンプションを使用するようにクラスターを設定するには、以下を実行します。

次のような YAML ファイルを作成して、優先順位クラスの名前を含む Pod 仕様を定義します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- この Pod で使用する優先順位クラスを指定します。

Pod を作成します。

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 優先順位の名前は Pod 設定または Pod テンプレートに直接追加できます。

2.7. ノードセレクターの使用による特定ノードへの Pod の配置

ノードセレクター は、キーと値のペアのマップを指定します。ルールは、ノード上のカスタムラベルと Pod で指定されたセレクターを使用して定義されます。

Pod がノードで実行する要件を満たすには、Pod はノードのラベルとして示されるキーと値のペアを持っている必要があります。

同じ Pod 設定でノードのアフィニティーとノードセレクターを使用している場合、以下の重要な考慮事項を参照してください。

2.7.1. ノードセレクターの使用による Pod 配置の制御

Pod でノードセレクターを使用し、ノードでラベルを使用して、Pod がスケジュールされる場所を制御できます。ノードセレクターを使用すると、Red Hat OpenShift Service on AWS は一致するラベルが含まれるノード上に Pod をスケジュールします。

ラベルをノード、コンピュートマシンセット、またはマシン設定に追加します。コンピュートマシンセットにラベルを追加すると、ノードまたはマシンが停止した場合に、新規ノードにそのラベルが追加されます。ノードまたはマシン設定に追加されるラベルは、ノードまたはマシンが停止すると維持されません。

ノードセレクターを既存 Pod に追加するには、ノードセレクターを ReplicaSet オブジェクト、DaemonSet オブジェクト、StatefulSet オブジェクト、Deployment オブジェクト、または DeploymentConfig オブジェクトなどの Pod の制御オブジェクトに追加します。制御オブジェクト下の既存 Pod は、一致するラベルを持つノードで再作成されます。新規 Pod を作成する場合、ノードセレクターを Pod 仕様に直接追加できます。Pod に制御オブジェクトがない場合は、Pod を削除し、Pod 仕様を編集して、Pod を再作成する必要があります。

ノードセレクターを既存のスケジュールされている Pod に直接追加することはできません。

前提条件

ノードセレクターを既存 Pod に追加するには、Pod の制御オブジェクトを判別します。たとえば、router-default-66d5cf9464-m2g75 Pod は router-default-66d5cf9464 レプリカセットによって制御されます。

oc describe pod router-default-66d5cf9464-7pwkc

$ oc describe pod router-default-66d5cf9464-7pwkc出力例

Web コンソールでは、Pod YAML の ownerReferences に制御オブジェクトをリスト表示します。

手順

一致するノードセレクターを Pod に追加します。

ノードセレクターを既存 Pod および新規 Pod に追加するには、ノードセレクターを Pod の制御オブジェクトに追加します。

ラベルを含む

ReplicaSetオブジェクトのサンプルCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ノードセレクターを追加します。

ノードセレクターを特定の新規 Pod に追加するには、セレクターを

Podオブジェクトに直接追加します。ノードセレクターを持つ

Podオブジェクトの例Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記ノードセレクターを既存のスケジュールされている Pod に直接追加することはできません。

第3章 Custom Metrics Autoscaler Operator を使用した Pod の自動スケーリング

3.1. リリースノート

3.1.1. Custom Metrics Autoscaler Operator リリースノート

Red Hat OpenShift の Custom Metrics Autoscaler Operator のリリースノートでは、新機能および拡張機能、非推奨となった機能、および既知の問題を説明しています。

Custom Metrics Autoscaler Operator は、Kubernetes ベースの Event Driven Autoscaler (KEDA) を使用し、Red Hat OpenShift Service on AWS の Horizontal Pod Autoscaler (HPA) の上に構築されます。

Red Hat OpenShift の Custom Metrics Autoscaler Operator のロギングサブシステムは、インストール可能なコンポーネントとして提供され、コアの Red Hat OpenShift Service on AWS とは異なるリリースサイクルを備えています。Red Hat OpenShift Container Platform ライフサイクルポリシー はリリースの互換性を概説しています。

3.1.1.1. サポート対象バージョン

次の表は、Red Hat OpenShift Service on AWS の各バージョンの Custom Metrics Autoscaler Operator バージョンを定義しています。

| バージョン | Red Hat OpenShift Service on AWS のバージョン | 一般提供 |

|---|---|---|

| 2.17.2-2 | 4.20 | 一般提供 |

| 2.17.2-2 | 4.19 | 一般提供 |

| 2.17.2-2 | 4.18 | 一般提供 |

| 2.17.2-2 | 4.17 | 一般提供 |

| 2.17.2-2 | 4.16 | 一般提供 |

| 2.17.2-2 | 4.15 | 一般提供 |

| 2.17.2-2 | 4.14 | 一般提供 |

| 2.17.2-2 | 4.13 | 一般提供 |

| 2.17.2-2 | 4.12 | 一般提供 |

3.1.1.2. Custom Metrics Autoscaler Operator 2.17.2-2 リリースノート

発行日: 2025 年 10 月 21 日

この Custom Metrics Autoscaler Operator 2.17.2-2 リリースは、新しいベースイメージと Go コンパイラーを使用して、Custom Metrics Autoscaler Operator のバージョン 2.17.2 を再構築したものです。Custom Metrics Autoscaler Operator のコード変更はありません。Custom Metrics Autoscaler Operator に関しては、次のアドバイザリーが利用可能です。

このバージョンの Custom Metrics Autoscaler Operator をインストールする前に、以前にインストールされたテクノロジープレビューバージョンまたはコミュニティーがサポートするバージョンの Kubernetes ベースの Event Driven Autoscaler (KEDA) を削除します。

3.1.2. Custom Metrics Autoscaler Operator の過去リリースに関するリリースノート

次のリリースノートは、以前の Custom Metrics Autoscaler Operator バージョンを対象としています。

現在のバージョンは、Custom Metrics Autoscaler Operator リリースノート を参照してください。

3.1.2.1. Custom Metrics Autoscaler Operator 2.17.2 リリースノート

発行日: 2025 年 9 月 25 日

Custom Metrics Autoscaler Operator 2.17.2 のこのリリースでは、Common Vulnerabilities and Exposures (CVE) に対処しています。Custom Metrics Autoscaler Operator に関しては、次のアドバイザリーが利用可能です。

このバージョンの Custom Metrics Autoscaler Operator をインストールする前に、以前にインストールされたテクノロジープレビューバージョンまたはコミュニティーがサポートするバージョンの Kubernetes ベースの Event Driven Autoscaler (KEDA) を削除します。

3.1.2.1.1. 新機能および機能拡張

3.1.2.1.1.1. KEDA コントローラーはインストール中に自動的に作成される

Custom Metrics Autoscaler Operator をインストールすると、KEDA コントローラーが自動的に作成されるようになりました。以前は、KEDA コントローラーを手動で作成する必要がありました。必要に応じて、自動作成された KEDA コントローラーを編集できます。

3.1.2.1.1.2. Kubernetes ワークロードトリガーのサポート

Cluster Metrics Autoscaler Operator は、Kubernetes ワークロードトリガーを使用して、特定のラベルセレクターに一致する Pod の数に基づいて Pod をスケーリングできるようになりました。

3.1.2.1.1.3. バインドされたサービスアカウントトークンのサポート

Cluster Metrics Autoscaler Operator は、バインドされたサービスアカウントトークンをサポートするようになりました。これまで、Operator はレガシーサービスアカウントトークンのみをサポートしていましたが、セキュリティー上の理由から、バインドされたサービスアカウントトークンに段階的に移行しています。

3.1.2.1.2. バグ修正

- 以前は、KEDA コントローラーはボリュームマウントをサポートしていませんでした。その結果、Kafka スケーラーで Kerberos を使用できませんでした。この修正により、KEDA コントローラーはボリュームマウントをサポートするようになりました。(OCPBUGS-42559)

-

以前は、

keda-operatorデプロイメントオブジェクトログの KEDA バージョンで、Custom Metrics Autoscaler Operator が誤った KEDA バージョンに基づいていることが報告されていました。この修正により、正しい KEDA バージョンがログに報告されるようになりました。(OCPBUGS-58129)

3.1.2.2. Custom Metrics Autoscaler Operator 2.15.1-4 リリースノート

発行日: 2025 年 3 月 31 日

Custom Metrics Autoscaler Operator 2.15.1-4 のこのリリースでは、Common Vulnerabilities and Exposures (CVE) に対処しています。Custom Metrics Autoscaler Operator に関しては、次のアドバイザリーが利用可能です。

このバージョンの Custom Metrics Autoscaler Operator をインストールする前に、以前にインストールされたテクノロジープレビューバージョンまたはコミュニティーがサポートするバージョンの Kubernetes ベースの Event Driven Autoscaler (KEDA) を削除します。

3.1.2.2.1. 新機能および機能拡張

3.1.2.2.1.1. CMA マルチアーキテクチャービルド

このバージョンの Custom Metrics Autoscaler Operator を使用すると、ARM64 Red Hat OpenShift Service on AWS クラスターに Operator をインストールして実行できるようになりました。

3.1.2.3. Custom Metrics Autoscaler Operator 2.14.1-467 リリースノート

この Custom Metrics Autoscaler Operator 2.14.1-467 リリースでは、Red Hat OpenShift Service on AWS クラスターで Operator を実行するための CVE とバグ修正が提供されます。RHSA-2024:7348 に関する次のアドバイザリーが利用可能です。

このバージョンの Custom Metrics Autoscaler Operator をインストールする前に、以前にインストールされたテクノロジープレビューバージョンまたはコミュニティーがサポートするバージョンの Kubernetes ベースの Event Driven Autoscaler (KEDA) を削除します。

3.1.2.3.1. バグ修正

- 以前は、Custom Metrics Autoscaler Operator Pod のルートファイルシステムが書き込み可能でした。これは不要であり、セキュリティー上の問題を引き起こす可能性がありました。この更新により、Pod のルートファイルシステムが読み取り専用になり、潜在的なセキュリティー問題が解決されました。(OCPBUGS-37989)

3.1.2.4. Custom Metrics Autoscaler Operator 2.14.1-454 リリースノート

この Custom Metrics Autoscaler Operator 2.14.1-454 リリースでは、Red Hat OpenShift Service on AWS クラスターで Operator を実行するための CVE、新機能、およびバグ修正を使用できます。RHBA-2024:5865 に関する次のアドバイザリーが利用可能です。

このバージョンの Custom Metrics Autoscaler Operator をインストールする前に、以前にインストールされたテクノロジープレビューバージョンまたはコミュニティーがサポートするバージョンの Kubernetes ベースの Event Driven Autoscaler (KEDA) を削除します。

3.1.2.4.1. 新機能および機能拡張

3.1.2.4.1.1. Custom Metrics Autoscaler Operator による Cron トリガーのサポート

Custom Metrics Autoscaler Operator が、Cron トリガーを使用して、時間単位のスケジュールに基づいて Pod をスケーリングできるようになりました。指定した時間枠が開始すると、Custom Metrics Autoscaler Operator が Pod を必要な数にスケーリングします。時間枠が終了すると、Operator は以前のレベルまでスケールダウンします。

詳細は、Cron トリガーについて を参照してください。

3.1.2.4.2. バグ修正

-

以前は、

KedaControllerカスタムリソースの監査設定パラメーターに変更を加えても、keda-metrics-server-audit-policyconfig map が更新されませんでした。その結果、Custom Metrics Autoscaler の初期デプロイ後に監査設定パラメーターを変更することができませんでした。この修正により、監査設定への変更が config map に適切に反映されるようになり、インストール後いつでも監査設定を変更できるようになりました。(OCPBUGS-32521)

3.1.2.5. Custom Metrics Autoscaler Operator 2.13.1 リリースノート

Custom Metrics Autoscaler Operator 2.13.1-421 のこのリリースでは、Red Hat OpenShift Service on AWS クラスターで Operator を実行するための新機能およびバグ修正が提供されます。RHBA-2024:4837 に関する次のアドバイザリーが利用可能です。

このバージョンの Custom Metrics Autoscaler Operator をインストールする前に、以前にインストールされたテクノロジープレビューバージョンまたはコミュニティーがサポートするバージョンの Kubernetes ベースの Event Driven Autoscaler (KEDA) を削除します。

3.1.2.5.1. 新機能および機能拡張

3.1.2.5.1.1. Custom Metrics Autoscaler Operator によるカスタム証明書のサポート

Custom Metrics Autoscaler Operator は、カスタムサービス CA 証明書を使用して、外部 Kafka クラスターや外部 Prometheus サービスなどの TLS 対応メトリクスソースにセキュアに接続できるようになりました。デフォルトでは、Operator は自動生成されたサービス証明書を使用して、クラスター上のサービスにのみ接続します。KedaController オブジェクトには、config map を使用して外部サービスに接続するためのカスタムサーバー CA 証明書を読み込むことができる新しいフィールドがあります。

詳細は、Custom Metrics Autoscaler のカスタム CA 証明書 を参照してください。

3.1.2.5.2. バグ修正

-

以前は、

custom-metrics-autoscalerおよびcustom-metrics-autoscaler-adapterイメージにタイムゾーン情報がありませんでした。その結果、コントローラーがタイムゾーン情報を見つけられなかったため、cronトリガーを使用した scaled object は機能しなくなりました。この修正により、イメージビルドが更新され、タイムゾーン情報が含まれるようになりました。その結果、cronトリガーを含む scaled object が正常に機能するようになりました。cronトリガーを含む scaled object は、現在、カスタムメトリクスオートスケーラーではサポートされていません。(OCPBUGS-34018)

3.1.2.6. Custom Metrics Autoscaler Operator 2.12.1-394 リリースノート

Custom Metrics Autoscaler Operator 2.12.1-394 のこのリリースでは、Red Hat OpenShift Service on AWS クラスターで Operator を実行するためのバグ修正が提供されます。RHSA-2024:2901 には、次のアドバイザリーを利用できます。

このバージョンの Custom Metrics Autoscaler Operator をインストールする前に、以前にインストールされたテクノロジープレビューバージョンまたはコミュニティーがサポートするバージョンの Kubernetes ベースの Event Driven Autoscaler (KEDA) を削除します。

3.1.2.6.1. バグ修正

-

以前は、

protojson.Unmarshal関数は、特定の形式の無効な JSON をアンマーシャリングするときに無限ループに入りました。この状態は、google.protobuf.Any値を含むメッセージにアンマーシャリングするとき、またはUnmarshalOptions.DiscardUnknownオプションが設定されているときに発生する可能性があります。このリリースではこの問題が修正されています。(OCPBUGS-30305) -

以前は、

Request.ParseMultipartFormメソッドを使用して明示的に、またはRequest.FormValue、Request.PostFormValue、Request.FormFileメソッドを使用して暗黙的にマルチパートフォームを解析する場合、解析されたフォームの合計サイズの制限は、消費されるメモリーには適用されませんでした。これによりメモリー不足が発生する可能性があります。この修正により、解析プロセスでは、単一のフォーム行を読み取る際に、フォーム行の最大サイズが正しく制限されるようになりました。(OCPBUGS-30360) -

以前は、一致するサブドメイン上または最初のドメインと完全に一致しないドメインへの HTTP リダイレクトに従う場合、HTTP クライアントは

AuthorizationやCookieなどの機密ヘッダーを転送しませんでした。たとえば、example.comからwww.example.comへのリダイレクトではAuthorizationヘッダーが転送されますが、www.example.orgへのリダイレクトではヘッダーは転送されません。このリリースではこの問題が修正されています。(OCPBUGS-30365) -

以前は、不明な公開鍵アルゴリズムを持つ証明書を含む証明書チェーンを検証すると、証明書検証プロセスがパニックに陥っていました。この状況は、

Config.ClientAuthパラメーターをVerifyClientCertIfGivenまたはRequireAndVerifyClientCert値に設定するすべての暗号化および Transport Layer Security (TLS) クライアントとサーバーに影響しました。デフォルトの動作では、TLS サーバーはクライアント証明書を検証しません。このリリースではこの問題が修正されています。(OCPBUGS-30370) -

以前は、

MarshalJSONメソッドから返されるエラーにユーザーが制御するデータが含まれている場合、攻撃者はそのデータを使用して HTML テンプレートパッケージのコンテキスト自動エスケープ動作を破ることができた可能性があります。この条件により、後続のアクションによってテンプレートに予期しないコンテンツが注入される可能性があります。このリリースではこの問題が修正されています。(OCPBUGS-30397) -

以前は、Go パッケージ

net/httpおよびgolang.org/x/net/http2では、HTTP/2 リクエストのCONTINUATIONフレームの数に制限がありませんでした。この状態により、CPU が過剰に消費される可能性があります。このリリースではこの問題が修正されています。(OCPBUGS-30894)

3.1.2.7. Custom Metrics Autoscaler Operator 2.12.1-384 リリースノート

Custom Metrics Autoscaler Operator 2.12.1-384 のこのリリースでは、Red Hat OpenShift Service on AWS クラスターで Operator を実行するためのバグ修正が提供されます。RHBA-2024:2043 に関する次のアドバイザリーが利用可能です。

このバージョンの Custom Metrics Autoscaler Operator をインストールする前に、以前にインストールされたテクノロジープレビューバージョンまたはコミュニティーがサポートするバージョンの KEDA を削除します。

3.1.2.7.1. バグ修正

-

以前は、

custom-metrics-autoscalerおよびcustom-metrics-autoscaler-adapterイメージにタイムゾーン情報がありませんでした。その結果、コントローラーがタイムゾーン情報を見つけられなかったため、cronトリガーを使用した scaled object は機能しなくなりました。この修正により、イメージビルドが更新され、タイムゾーン情報が含まれるようになりました。その結果、cronトリガーを含む scaled object が正常に機能するようになりました。(OCPBUGS-32395)

3.1.2.8. Custom Metrics Autoscaler Operator 2.12.1-376 リリースノート

この Custom Metrics Autoscaler Operator 2.12.1-376 リリースでは、Red Hat OpenShift Service on AWS クラスターで Operator を実行するためのセキュリティー更新とバグ修正を使用できます。RHSA-2024:1812 には、次のアドバイザリーを利用できます。

このバージョンの Custom Metrics Autoscaler Operator をインストールする前に、以前にインストールされたテクノロジープレビューバージョンまたはコミュニティーがサポートするバージョンの KEDA を削除します。

3.1.2.8.1. バグ修正

- 以前は、存在しない namespace などの無効な値が scaled object メタデータに指定されている場合、基盤となるスケーラークライアントはクライアント記述子を解放または終了できず、低速のメモリーリークが発生していました。この修正により、エラーが発生した場合に基礎となるクライアント記述子が適切に終了され、メモリーのリークが防止されます。(OCPBUGS-30145)

-

以前は、

keda-metrics-apiserverPod のServiceMonitorカスタムリソース (CR) が機能していませんでした。これは、CR がhttpという誤ったメトリクスポート名を参照していたためです。この修正により、ServiceMonitorCR が修正され、metricsの適切なポート名が参照されるようになります。その結果、Service Monitor が正常に機能します。(OCPBUGS-25806)

3.1.2.9. Custom Metrics Autoscaler Operator 2.11.2-322 リリースノート

この Custom Metrics Autoscaler Operator 2.11.2-322 リリースでは、Red Hat OpenShift Service on AWS クラスターで Operator を実行するためのセキュリティー更新とバグ修正を使用できます。RHSA-2023:6144 には、次のアドバイザリーを利用できます。

このバージョンの Custom Metrics Autoscaler Operator をインストールする前に、以前にインストールされたテクノロジープレビューバージョンまたはコミュニティーがサポートするバージョンの KEDA を削除します。

3.1.2.9.1. バグ修正

- Custom Metrics Autoscaler Operator バージョン 3.11.2-311 は、Operator デプロイメントで必要なボリュームマウントなしにリリースされたため、Custom Metrics Autoscaler Operator Pod は 15 分ごとに再起動しました。この修正により、必要なボリュームマウントが Operator デプロイメントに追加されました。その結果、Operator は 15 分ごとに再起動しなくなりました。(OCPBUGS-22361)

3.1.2.10. Custom Metrics Autoscaler Operator 2.11.2-311 リリースノート

この Custom Metrics Autoscaler Operator 2.11.2-311 リリースでは、Red Hat OpenShift Service on AWS クラスターで Operator を実行するための新機能とバグ修正を使用できます。Custom Metrics Autoscaler Operator 2.11.2-311 のコンポーネントは RHBA-2023:5981 でリリースされました。

このバージョンの Custom Metrics Autoscaler Operator をインストールする前に、以前にインストールされたテクノロジープレビューバージョンまたはコミュニティーがサポートするバージョンの KEDA を削除します。

3.1.2.10.1. 新機能および機能拡張

3.1.2.10.1.1. Red Hat OpenShift Service on AWS と OpenShift Dedicated がサポートされるようになる

Custom Metrics Autoscaler Operator 2.11.2-311 は、Red Hat OpenShift Service on AWS および OpenShift Dedicated マネージドクラスターにインストールできます。Custom Metrics Autoscaler Operator の以前のバージョンは、openshift-keda namespace にのみインストールできました。これにより、Operator を Red Hat OpenShift Service on AWS および OpenShift Dedicated クラスターにインストールできませんでした。このバージョンの Custom Metrics Autoscaler では、openshift-operators または keda などの他の namespace へのインストールが可能になり、Red Hat OpenShift Service on AWS および OpenShift Dedicated クラスターへのインストールが可能になります。

3.1.2.10.2. バグ修正

-

以前は、Custom Metrics Autoscaler Operator がインストールおよび設定されているが使用されていない場合、OpenShift CLI では、

ocコマンドを入力すると、couldn’t get resource list for external.metrics.k8s.io/v1beta1: Got empty response for: external.metrics.k8s.io/v1beta1エラーが報告されていました。このメッセージは無害ではありますが、混乱を引き起こす可能性がありました。この修正により、Got empty response for: external.metrics…エラーが不適切に表示されなくなりました。(OCPBUGS-15779) - 以前は、設定変更後など、Keda Controller が変更されるたびに、Custom Metrics Autoscaler Operator によって管理されるオブジェクトに対するアノテーションやラベルの変更は、Custom Metrics Autoscaler Operator によって元に戻されました。これにより、オブジェクト内のラベルが継続的に変更されてしまいました。Custom Metrics Autoscaler は、独自のアノテーションを使用してラベルとアノテーションを管理するようになり、アノテーションやラベルが不適切に元に戻されることがなくなりました。(OCPBUGS-15590)

3.1.2.11. Custom Metrics Autoscaler Operator 2.10.1-267 リリースノート

この Custom Metrics Autoscaler Operator 2.10.1-267 リリースでは、Red Hat OpenShift Service on AWS クラスターで Operator を実行するための新機能とバグ修正を使用できます。Custom Metrics Autoscaler Operator 2.10.1-267 のコンポーネントは RHBA-2023:4089 でリリースされました。

このバージョンの Custom Metrics Autoscaler Operator をインストールする前に、以前にインストールされたテクノロジープレビューバージョンまたはコミュニティーがサポートするバージョンの KEDA を削除します。

3.1.2.11.1. バグ修正

-

以前は、

custom-metrics-autoscalerイメージとcustom-metrics-autoscaler-adapterイメージにはタイムゾーン情報が含まれていませんでした。そのため、コントローラーがタイムゾーン情報を検出できないことが原因で、cron トリガーを使用した scaled object が機能していませんでした。今回の修正により、イメージビルドにタイムゾーン情報が含まれるようになりました。その結果、cron トリガーを含む scaled object が正常に機能するようになりました。(OCPBUGS-15264) -

以前のバージョンでは、Custom Metrics Autoscaler Operator は、他の namespace 内のオブジェクトやクラスタースコープのオブジェクトを含む、すべてのマネージドオブジェクトの所有権を取得しようとしていました。このため、Custom Metrics Autoscaler Operator は API サーバーに必要な認証情報を読み取るためのロールバインディングを作成できませんでした。これにより、

kube-systemnamespace でエラーが発生しました。今回の修正により、Custom Metrics Autoscaler Operator は、別の namespace 内のオブジェクトまたはクラスタースコープのオブジェクトへのownerReferenceフィールドの追加をスキップします。その結果、ロールバインディングがエラーなしで作成されるようになりました。(OCPBUGS-15038) -

以前は、Custom Metrics Autoscaler Operator によって、

ownerReferencesフィールドがopenshift-kedanamespace に追加されていました。これによって機能上の問題が発生することはありませんでしたが、このフィールドの存在によりクラスター管理者が混乱する可能性がありました。今回の修正により、Custom Metrics Autoscaler Operator はownerReferenceフィールドをopenshift-kedanamespace に追加しなくなりました。その結果、openshift-kedanamespace には余分なownerReferenceフィールドが含まれなくなりました。(OCPBUGS-15293) -

以前のバージョンでは、Pod ID 以外の認証方法で設定された Prometheus トリガーを使用し、

podIdentityパラメーターがnoneに設定されている場合、トリガーはスケーリングに失敗しました。今回の修正により、OpenShift の Custom Metrics Autoscaler は、Pod ID プロバイダータイプnoneを適切に処理できるようになりました。その結果、Pod ID 以外の認証方法で設定され、podIdentityパラメーターがnoneに設定された Prometheus トリガーが適切にスケーリングされるようになりました。(OCPBUGS-15274)

3.1.2.12. Custom Metrics Autoscaler Operator 2.10.1 リリースノート

この Custom Metrics Autoscaler Operator 2.10.1 リリースでは、Red Hat OpenShift Service on AWS クラスターで Operator を実行するための新機能とバグ修正を使用できます。Custom Metrics Autoscaler Operator 2.10.1 のコンポーネントは RHEA-2023:3199 でリリースされました。

このバージョンの Custom Metrics Autoscaler Operator をインストールする前に、以前にインストールされたテクノロジープレビューバージョンまたはコミュニティーがサポートするバージョンの KEDA を削除します。

3.1.2.12.1. 新機能および機能拡張

3.1.2.12.1.1. Custom Metrics Autoscaler Operator の一般提供

Custom Metrics Autoscaler Operator バージョン 2.10.1 以降で、Custom Metrics Autoscaler Operator の一般提供が開始されました。

スケーリングされたジョブを使用したスケーリングはテクノロジープレビュー機能です。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は、実稼働環境でこれらを使用することを推奨していません。テクノロジープレビュー機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行い、フィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

3.1.2.12.1.2. パフォーマンスメトリクス

Prometheus Query Language (PromQL) を使用して、Custom Metrics Autoscaler Operator でメトリクスのクエリーを行えるようになりました。

3.1.2.12.1.3. スケーリングされたオブジェクトのカスタムメトリクス自動スケーリングの一時停止

必要に応じてスケーリングされたオブジェクトの自動スケーリングを一時停止し、準備ができたら再開できるようになりました。

3.1.2.12.1.4. スケーリングされたオブジェクトのレプリカフォールバック

スケーリングされたオブジェクトがソースからメトリクスを取得できなかった場合に、フォールバックするレプリカの数を指定できるようになりました。

3.1.2.12.1.5. スケーリングされたオブジェクトのカスタマイズ可能な HPA 命名

スケーリングされたオブジェクトで、Horizontal Pod Autoscaler のカスタム名を指定できるようになりました。

3.1.2.12.1.6. アクティブ化およびスケーリングのしきい値

Horizontal Pod Autoscaler (HPA) は 0 レプリカへの、または 0 レプリカからのスケーリングができないため、Custom Metrics Autoscaler Operator がそのスケーリングを実行し、その後 HPA がスケーリングを実行します。レプリカの数に基づき HPA が自動スケーリングを引き継ぐタイミングを指定できるようになりました。これにより、スケーリングポリシーの柔軟性が向上します。

3.1.2.13. Custom Metrics Autoscaler Operator 2.8.2-174 リリースノート

この Custom Metrics Autoscaler Operator 2.8.2-174 リリースでは、Red Hat OpenShift Service on AWS クラスターで Operator を実行するための新機能とバグ修正を使用できます。Custom Metrics Autoscaler Operator 2.8.2-174 のコンポーネントは RHEA-2023:1683 でリリースされました。

Custom Metrics Autoscaler Operator バージョン 2.8.2-174 は、テクノロジープレビュー 機能です。

3.1.2.13.1. 新機能および機能拡張

3.1.2.13.1.1. Operator のアップグレードサポート

以前の Custom Metrics Autoscaler Operator バージョンからアップグレードできるようになりました。Operator のアップグレードの詳細は、「関連情報」の「Operator の更新チャネルの変更」を参照してください。

3.1.2.13.1.2. must-gather サポート

Red Hat OpenShift Service on AWS の must-gather ツールを使用して、Custom Metrics Autoscaler Operator とそのコンポーネントに関するデータを収集できるようになりました。現時点で、Custom Metrics Autoscaler で must-gather ツールを使用するプロセスは、他の Operator とは異なります。詳細は、関連情報の「デバッグデータの収集」を参照してください。

3.1.2.14. Custom Metrics Autoscaler Operator 2.8.2 リリースノート

この Custom Metrics Autoscaler Operator 2.8.2 リリースでは、Operator in an Red Hat OpenShift Service on AWS クラスターで Operator を実行するための新機能とバグ修正を使用できます。Custom Metrics Autoscaler Operator 2.8.2 のコンポーネントは RHSA-2023:1042 でリリースされました。

Custom Metrics Autoscaler Operator バージョン 2.8.2 は テクノロジープレビュー 機能です。

3.1.2.14.1. 新機能および機能拡張

3.1.2.14.1.1. 監査ロギング

Custom Metrics Autoscaler Operator とその関連コンポーネントの監査ログを収集して表示できるようになりました。監査ログは、システムに影響を与えた一連のアクティビティーを個別のユーザー、管理者その他システムのコンポーネント別に記述したセキュリティー関連の時系列のレコードです。

3.1.2.14.1.2. Apache Kafka メトリクスに基づくアプリケーションのスケーリング

KEDA Apache kafka トリガー/スケーラーを使用して、Apache Kafka トピックに基づいてデプロイメントをスケーリングできるようになりました。

3.1.2.14.1.3. CPU メトリクスに基づくアプリケーションのスケーリング

KEDA CPU トリガー/スケーラーを使用して、CPU メトリクスに基づいてデプロイメントをスケーリングできるようになりました。

3.1.2.14.1.4. メモリーメトリクスに基づくアプリケーションのスケーリング

KEDA メモリートリガー/スケーラーを使用して、メモリーメトリクスに基づいてデプロイメントをスケーリングできるようになりました。

3.2. Custom Metrics Autoscaler Operator の概要

開発者は、Red Hat OpenShift の Custom Metrics Autoscaler Operator を使用して、CPU やメモリー以外のものも含むカスタムメトリクスに基づいて、Red Hat OpenShift Service on AWS のデプロイメント、ステートフルセット、カスタムリソース、またはジョブの Pod 数を自動的に増減する方法を指定できます。

Custom Metrics Autoscaler Operator は、Kubernetes Event Driven Autoscaler (KEDA) に基づくオプションの Operator であり、Pod メトリクス以外の追加のメトリクスソースを使用してワークロードをスケーリングできます。

カスタムメトリクスオートスケーラーは現在、Prometheus、CPU、メモリー、および Apache Kafka メトリクスのみをサポートしています。

Custom Metrics Autoscaler Operator は、特定のアプリケーションからのカスタムの外部メトリクスに基づいて、Pod をスケールアップおよびスケールダウンします。他のアプリケーションは引き続き他のスケーリング方法を使用します。スケーラーとも呼ばれる トリガー を設定します。これは、カスタムメトリクスオートスケーラーがスケーリング方法を決定するために使用するイベントとメトリクスのソースです。カスタムメトリクスオートスケーラーはメトリクス API を使用して、外部メトリクスを Red Hat OpenShift Service on AWS が使用できる形式に変換します。カスタムメトリクスオートスケーラーは、実際のスケーリングを実行する Horizontal Pod Autoscaler (HPA) を作成します。

カスタムメトリクスオートスケーラーを使用するには、ワークロード用の ScaledObject または ScaledJob オブジェクトを作成します。これらは、スケーリングメタデータを定義するカスタムリソース (CR) です。スケーリングするデプロイメントまたはジョブ、スケーリングするメトリクスのソース (トリガー)、許可される最小および最大レプリカ数などのその他のパラメーターを指定します。

スケーリングするワークロードごとに、スケーリングされたオブジェクトまたはスケーリングされたジョブを 1 つだけ作成できます。また、スケーリングされたオブジェクトまたはスケーリングされたジョブと Horizontal Pod Autoscaler (HPA) を同じワークロードで使用することはできません。

カスタムメトリクスオートスケーラーは、HPA とは異なり、ゼロにスケーリングできます。カスタムメトリクスオートスケーラー CR の minReplicaCount 値を 0 に設定すると、カスタムメトリクスオートスケーラーはワークロードを 1 レプリカから 0 レプリカにスケールダウンするか、0 レプリカから 1 にスケールアップします。これは、アクティベーションフェーズ として知られています。1 つのレプリカにスケールアップした後、HPA はスケーリングを制御します。これは スケーリングフェーズ として知られています。

一部のトリガーにより、クラスターメトリクスオートスケーラーによってスケーリングされるレプリカの数を変更できます。いずれの場合も、アクティベーションフェーズを設定するパラメーターは、activation で始まる同じフレーズを常に使用します。たとえば、threshold パラメーターがスケーリングを設定する場合、activationThreshold はアクティベーションを設定します。アクティベーションフェーズとスケーリングフェーズを設定すると、スケーリングポリシーの柔軟性が向上します。たとえば、アクティベーションフェーズをより高く設定することで、メトリクスが特に低い場合にスケールアップまたはスケールダウンを防ぐことができます。

それぞれ異なる決定を行う場合は、スケーリングの値よりもアクティベーションの値が優先されます。たとえば、threshold が 10 に設定されていて、activationThreshold が 50 である場合にメトリクスが 40 を報告した場合、スケーラーはアクティブにならず、HPA が 4 つのインスタンスを必要とする場合でも Pod はゼロにスケーリングされます。

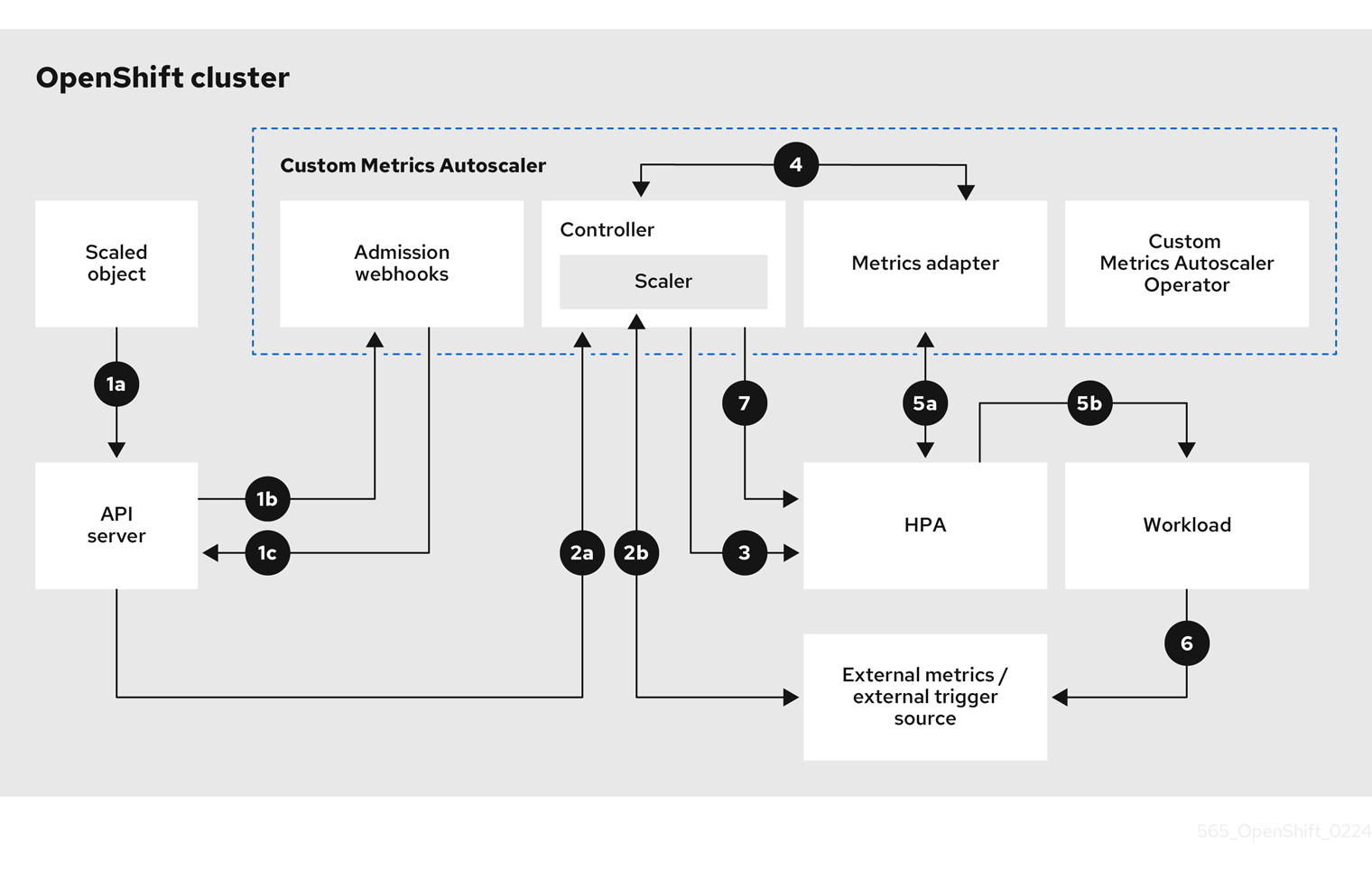

図3.1 カスタムメトリクスオートスケーラーのワークフロー

- クラスター上のワークロード用のスケーリングされたオブジェクトのカスタムリソースを作成または変更します。オブジェクトには、そのワークロードのスケーリング設定を含めます。OpenShift API サーバーは、新しいオブジェクトを受け入れる前に、そのオブジェクトをカスタムメトリクスオートスケーラーのアドミッション Webhook プロセスに送信して、オブジェクトが有効であることを確認します。検証が成功すると、API サーバーはオブジェクトを永続化します。

- カスタムメトリクスオートスケーラーコントローラーが、スケーリングされたオブジェクトの更新または変更を監視します。OpenShift API サーバーがコントローラーに変更を通知すると、コントローラーは、オブジェクト内で指定されている外部トリガーソース (データソースとも呼ばれる) を監視して、メトリクスデータの変更を確認します。1 つ以上のスケーラーが外部トリガーソースからのスケーリングデータを要求します。たとえば、Kafka トリガータイプの場合、コントローラーは Kafka スケーラーを使用して Kafka インスタンスと通信し、トリガーによって要求されたデータを取得します。

- コントローラーが、スケーリングされたオブジェクトの Horizontal Pod Autoscaler オブジェクトを作成します。その結果、Horizontal Pod Autoscaler (HPA) Operator が、トリガーに関連付けられたスケーリングデータの監視を開始します。HPA は、クラスターの OpenShift API サーバーエンドポイントからスケーリングデータを要求します。

- OpenShift API サーバーエンドポイントが、カスタムメトリクスオートスケーラーのメトリクスアダプターによって提供されます。メトリクスアダプターは、カスタムメトリクスの要求を受信すると、コントローラーへの GRPC 接続を使用して、スケーラーから受信した最新のトリガーデータを要求します。

- HPA がメトリクスアダプターから受信したデータに基づいてスケーリングを決定し、レプリカを増減することでワークロードをスケールアップまたはスケールダウンします。

- 運用中に、ワークロードがスケーリングメトリクスに影響を与えることがあります。たとえば、Kafka キュー内の作業を処理するためにワークロードがスケールアップされた場合、ワークロードがすべての作業を処理した後、キューのサイズが減少します。その結果、ワークロードがスケールダウンされます。

-

メトリクスが

minReplicaCount値で指定された範囲内にある場合、カスタムメトリクスオートスケーラーコントローラーがすべてのスケーリングを無効にして、レプリカ数を一定に維持します。メトリクスがその範囲を超える場合、カスタムメトリクスオートスケーラーコントローラーはスケーリングを有効にして、HPA がワークロードをスケーリングできるようにします。スケーリングが無効になっている間、HPA は何もアクションを実行しません。

3.2.1. Custom Metrics Autoscaler 用のカスタム CA 証明書

デフォルトでは、Custom Metrics Autoscaler Operator は、自動的に生成されたサービス CA 証明書を使用して、クラスター上のサービスに接続します。

カスタム CA 証明書を必要とするクラスター外のサービスを使用する場合は、必要な証明書を config map に追加できます。次に、カスタムメトリクスオートスケーラーのインストール の説明に従って、KedaController カスタムリソースに config map を追加します。Operator は起動時にこれらの証明書を読み込み、Operator によって信頼されたものとして登録します。

config map には、1 つ以上の PEM エンコードされた CA 証明書を含む 1 つ以上の証明書ファイルを含めることができます。または、証明書ファイルごとに個別の config map を使用することもできます。

後で config map を更新して追加の証明書を追加する場合は、変更を有効にするために keda-operator-* Pod を再起動する必要があります。

3.3. カスタムメトリクスオートスケーラーのインストール

Custom Metrics Autoscaler Operator は、Red Hat OpenShift Service on AWS Web コンソールを使用してインストールできます。

インストールにより、以下の 5 つの CRD が作成されます。

-

ClusterTriggerAuthentication -

KedaController -

ScaledJob -

ScaledObject -

TriggerAuthentication

インストールプロセスでは、KedaController カスタムリソース (CR) も作成されます。必要に応じて、デフォルトの KedaController CR を変更できます。詳細は、「Keda Controller CR の編集」を参照してください。

2.17.2 より前のバージョンの Custom Metrics Autoscaler Operator をインストールする場合は、Keda Controller CR を手動で作成する必要があります。CR を作成するには、「Keda Controller CR の編集」で説明されている手順を使用できます。

3.3.1. カスタムメトリクスオートスケーラーのインストール

次の手順を使用して、Custom Metrics Autoscaler Operator をインストールできます。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにアクセスできる。 - これまでにインストールしたテクノロジープレビューバージョンの Cluster Metrics Autoscaler Operator を削除する。

コミュニティーベースの KEDA バージョンをすべて削除する。

次のコマンドを実行して、KEDA 1.x カスタムリソース定義を削除する。

oc delete crd scaledobjects.keda.k8s.io

$ oc delete crd scaledobjects.keda.k8s.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc delete crd triggerauthentications.keda.k8s.io

$ oc delete crd triggerauthentications.keda.k8s.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

kedanamespace が存在することを確認します。存在しない場合は、kedanamespace を手動で作成する必要があります。 オプション: Custom Metrics Autoscaler Operator を外部 Kafka クラスターや外部 Prometheus サービスなどのクラスター外のサービスに接続する必要がある場合は、必要なサービス CA 証明書を config map に配置します。config map は、Operator がインストールされているのと同じ namespace に存在する必要があります。以下に例を示します。

oc create configmap -n openshift-keda thanos-cert --from-file=ca-cert.pem

$ oc create configmap -n openshift-keda thanos-cert --from-file=ca-cert.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

- Red Hat OpenShift Service on AWS Web コンソールで、Ecosystem → Software Catalog をクリックします。

- 使用可能な Operator のリストから Custom Metrics Autoscaler を選択し、Install をクリックします。

- Install Operator ページで、Installation Mode に A specific namespace on the cluster オプションが選択されていることを確認します。

- Installed Namespace で、Select a namespace をクリックします。

Select Project をクリックします。

-

kedanamespace が存在する場合は、リストから keda を選択します。 kedanamespace が存在しない場合は、以下を実行します。- Create Project を選択して、Create Project ウィンドウを開きます。

-

Name フィールドに

kedaと入力します。 -

Display Name フィールドに、

kedaなどのわかりやすい名前を入力します。 - オプション: Display Name フィールドに、namespace の説明を追加します。

- Create をクリックします。

-

- Install をクリックします。

Custom Metrics Autoscaler Operator コンポーネントをリスト表示して、インストールを確認します。

- Workloads → Pods に移動します。

-

ドロップダウンメニューから

kedaプロジェクトを選択し、custom-metrics-autoscaler-operator-*Pod が実行されていることを確認します。 -

Workloads → Deployments に移動して、

custom-metrics-autoscaler-operatorデプロイメントが実行されていることを確認します。

オプション: 次のコマンドを使用して、OpenShift CLI でインストールを確認します。

oc get all -n keda

$ oc get all -n kedaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のような出力が表示されます。

出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3.2. Keda Controller CR の編集

Custom Metrics Autoscaler Operator のインストール中に自動的にインストールされる KedaController カスタムリソース (CR) を変更するには、次の手順に従います。

手順

- Red Hat OpenShift Service on AWS Web コンソールで、Ecosystem → Installed Operator をクリックします。

- Custom Metrics Autoscaler をクリックします。

- Operator Details ページで、KedaController タブをクリックします。

KedaController タブで、Create KedaController をクリックしてファイルを編集します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Custom Metrics Autoscaler Operator がアプリケーションをスケーリングする単一の namespace を指定します。空白のままにするか、または空にして、すべての namespace でアプリケーションをスケーリングします。このフィールドは、namespace があるか、空である必要があります。デフォルト値は空です。

- 2

- Custom Metrics Autoscaler Operator ログメッセージの詳細レベルを指定します。許可される値は

debug、info、errorです。デフォルトはinfoです。 - 3

- Custom Metrics Autoscaler Operator ログメッセージのログ形式を指定します。許可される値は

consoleまたはjsonです。デフォルトはconsoleです。 - 4

- オプション: CA 証明書を持つ 1 つ以上の config map を指定します。Custom Metrics Autoscaler Operator はこれを使用して、TLS 対応のメトリクスソースにセキュアに接続できます。

- 5

- オプション: コンテナーのマウントパスを追加します。

- 6

- オプション:

volumesブロックを追加し、各 projected ボリュームのソースをリストします。 - 7

- Custom Metrics Autoscaler Metrics Server のログレベルを指定します。使用可能な値は、

infoの場合は0、debugの場合は4です。デフォルトは0です。 - 8

- Custom Metrics Autoscaler Operator の監査ログをアクティブにして、使用する監査ポリシーを指定します (「監査ログの設定」セクションを参照)。

- Save をクリックして、変更を保存します。

3.4. カスタムメトリクスオートスケーラートリガーについて

スケーラーとも呼ばれるトリガーは、Custom Metrics Autoscaler Operator が Pod をスケーリングするために使用するメトリクスを提供します。

カスタムメトリクスオートスケーラーは現在、Prometheus、CPU、メモリー、Apache Kafka、cron トリガーをサポートしています。

以下のセクションで説明するように、ScaledObject または ScaledJob カスタムリソースを使用して、特定のオブジェクトのトリガーを設定します。

scaled object で使用 する認証局、または クラスター内のすべてのスケーラー用 の認証局を設定できます。

3.4.1. Prometheus トリガーについて

Prometheus メトリクスに基づいて Pod をスケーリングできます。このメトリクスは、インストール済みの Red Hat OpenShift Service on AWS モニタリングまたは外部 Prometheus サーバーをメトリクスソースとして使用できます。Red Hat OpenShift Service on AWS モニタリングをメトリクスのソースとして使用するために必要な設定は、「OpenShift Service on AWS モニタリングを使用するためのカスタムメトリクスオートスケーラーの設定」を参照してください。

カスタムメトリクスオートスケーラーがスケーリングしているアプリケーションから Prometheus がメトリクスを収集している場合は、カスタムリソースで最小レプリカ数を 0 に設定しないでください。アプリケーション Pod がないと、カスタムメトリクスオートスケーラーにスケーリングの基準となるメトリクスが提供されません。

Prometheus ターゲットを使用した scaled object の例

- 1

- Prometheus をトリガータイプとして指定します。

- 2

- Prometheus サーバーのアドレスを指定します。この例では、Red Hat OpenShift Service on AWS モニタリングを使用します。

- 3

- オプション: スケーリングするオブジェクトの namespace を指定します。メトリクスのソースとして Red Hat OpenShift Service on AWS モニタリングを使用する場合、このパラメーターは必須です。

- 4

external.metrics.k8s.ioAPI でメトリクスを識別する名前を指定します。複数のトリガーを使用している場合、すべてのメトリクス名が一意である必要があります。- 5

- スケーリングをトリガーする値を指定します。引用符で囲まれた文字列値として指定する必要があります。

- 6

- 使用する Prometheus クエリーを指定します。

- 7

- 使用する認証方法を指定します。Prometheus スケーラーは、ベアラー認証 (

bearer)、Basic 認証 (basic)、または TLS 認証 (tls) をサポートしています。以下のセクションで説明するように、トリガー認証で特定の認証パラメーターを設定します。必要に応じて、シークレットを使用することもできます。 - 8

- 9

- オプション: Prometheus ターゲットが失われた場合のトリガーの処理方法を指定します。

-

trueの場合、Prometheus ターゲットが失われても、トリガーは動作し続けます。これがデフォルトの動作です。 -

falseの場合、Prometheus ターゲットが失われると、トリガーはエラーを返します。

-

- 10

- オプション: 証明書チェックをスキップするかどうかを指定します。たとえば、テスト環境で実行しており、Prometheus エンドポイントで自己署名証明書を使用している場合は、チェックをスキップできます。

-

falseの場合、証明書のチェックが実行されます。これがデフォルトの動作です。 trueの場合、証明書のチェックは実行されません。重要チェックのスキップは推奨されません。

-

- 11

- オプション: この Prometheus トリガーで使用される HTTP クライアントの HTTP 要求タイムアウトをミリ秒単位で指定します。この値は、グローバルタイムアウト設定をオーバーライドします。

3.4.1.1. Prometheus と DCGM メトリクスを使用した GPU ベースの自動スケーリングの設定

カスタムメトリクスオートスケーラーを NVIDIA データセンター GPU マネージャー (DCGM) メトリクスとともに使用すると、GPU 使用率に基づいてワークロードをスケーリングできます。これは、GPU リソースを必要とする AI および機械学習のワークロードに特に役立ちます。

GPU ベースの自動スケーリングのために Prometheus ターゲットを使用する scaled object の例

- 1

- 維持するレプリカの最小数を指定します。GPU ワークロードの場合は、メトリクスが継続的に収集されるように、これを

0に設定しないください。 - 2

- スケールアップ操作中に許可するレプリカの最大数を指定します。

- 3

- スケーリングをトリガーする GPU 使用率のしきい値をパーセンテージで指定します。GPU の平均使用率が 90% を超えると、オートスケーラーがデプロイメントをスケールアップします。

- 4

- すべての GPU デバイスの GPU 使用率を監視するために、NVIDIA DCGM メトリクスを使用して Prometheus クエリーを指定します。

DCGM_FI_DEV_GPU_UTILメトリクスは、GPU 使用率を提供します。

3.4.1.2. Red Hat OpenShift Service on AWS モニタリングを使用するためのカスタムメトリクスオートスケーラーの設定

カスタムメトリクスオートスケーラーが使用するメトリクスのソースとして、インストール済みの Red Hat OpenShift Service on AWS Prometheus モニタリングを使用できます。ただし、実行する必要がある追加の設定がいくつかあります。

scaled object が Red Hat OpenShift Service on AWS の Prometheus メトリクスを読み取れるように、トリガー認証またはクラスタートリガー認証を使用して、必要な認証情報を提供する必要があります。以下の手順は、使用するトリガー認証方式によって異なります。トリガー認証の詳細は、「カスタムメトリクスオートスケーラーのトリガー認証について」を参照してください。

これらの手順は、外部 Prometheus ソースには必要ありません。

このセクションで説明するように、次のタスクを実行する必要があります。

- サービスアカウントを作成します。

- トリガー認証を作成します。

- ロールを作成します。

- そのロールをサービスアカウントに追加します。

- Prometheus が使用するトリガー認証オブジェクトでトークンを参照します。

前提条件

- Red Hat OpenShift Service on AWS モニタリングをインストールしている。

- ユーザー定義のワークロードのモニタリングを、Red Hat OpenShift Service on AWS モニタリングで有効にしている (ユーザー定義のワークロードモニタリング設定マップの作成 セクションで説明)。

- Custom Metrics Autoscaler Operator をインストールしている。

手順

適切なプロジェクトに切り替えます。

oc project <project_name>

$ oc project <project_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 次のプロジェクトのいずれかを指定します。

- トリガー認証を使用している場合は、スケーリングするオブジェクトを含むプロジェクトを指定します。

-

クラスタートリガー認証を使用している場合は、

openshift-kedaプロジェクトを指定します。

クラスターにサービスアカウントがない場合は作成します。

次のコマンドを使用して、

service accountオブジェクトを作成します。oc create serviceaccount thanos

$ oc create serviceaccount thanos1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- サービスアカウントの名前を指定します。

サービスアカウントトークンを使用してトリガー認証を作成します。

以下のような YAML ファイルを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow CR オブジェクトを作成します。

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Thanos メトリクスを読み取るためのロールを作成します。

次のパラメーターを使用して YAML ファイルを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow CR オブジェクトを作成します。

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Thanos メトリクスを読み取るためのロールバインディングを作成します。

以下のような YAML ファイルを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 次のオブジェクト型のいずれかを指定します。

-

トリガー認証を使用している場合は、

RoleBindingを指定します。 -

クラスタートリガー認証を使用している場合は、

ClusterRoleBindingを指定します。

-

トリガー認証を使用している場合は、

- 2

- 作成したロールの名前を指定します。

- 3

- 次のプロジェクトのいずれかを指定します。

- トリガー認証を使用している場合は、スケーリングするオブジェクトを含むプロジェクトを指定します。

-

クラスタートリガー認証を使用している場合は、

openshift-kedaプロジェクトを指定します。

- 4

- ロールにバインドするサービスアカウントの名前を指定します。

- 5

- サービスアカウントを先に作成したプロジェクトを指定します。

CR オブジェクトを作成します。

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

「カスタムメトリクスオートスケーラーの追加方法について」で説明されているとおり、スケーリングされたオブジェクトまたはスケーリングされたジョブをデプロイして、アプリケーションの自動スケーリングを有効化できます。Red Hat OpenShift Service on AWS モニタリングをソースとして使用するには、トリガーまたはスケーラーに以下のパラメーターを含める必要があります。

-

triggers.typeはprometheusにしてください。 -

triggers.metadata.serverAddressはhttps://thanos-querier.openshift-monitoring.svc.cluster.local:9092にしてください。 -

triggers.metadata.authModesはbearerにしてください。 -

triggers.metadata.namespaceは、スケーリングするオブジェクトの namespace に設定してください。 -

triggers.authenticationRefは、直前の手順で指定されたトリガー認証リソースを指す必要があります。

3.4.2. CPU トリガーについて

CPU メトリクスに基づいて Pod をスケーリングできます。このトリガーは、クラスターメトリクスをメトリクスのソースとして使用します。

カスタムメトリクスオートスケーラーは、オブジェクトに関連付けられた Pod をスケーリングして、指定された CPU 使用率を維持します。オートスケーラーは、すべての Pod で指定された CPU 使用率を維持するために、最小数と最大数の間でレプリカ数を増減します。メモリートリガーは、Pod 全体のメモリー使用率を考慮します。Pod に複数のコンテナーがある場合、メモリートリガーは Pod 内にあるすべてのコンテナーの合計メモリー使用率を考慮します。

-

このトリガーは、

ScaledJobカスタムリソースでは使用できません。 -

メモリートリガーを使用してオブジェクトをスケーリングすると、複数のトリガーを使用している場合でも、オブジェクトは

0にスケーリングされません。

CPU ターゲットを使用した scaled object の例

- 1

- トリガータイプとして CPU を指定します。

- 2

- 使用するメトリクスのタイプ (

UtilizationまたはAverageValueのいずれか) を指定します。 - 3

- スケーリングをトリガーする値を指定します。引用符で囲まれた文字列値として指定する必要があります。

-

Utilizationを使用する場合、ターゲット値は、関連する全 Pod のリソースメトリクスの平均値であり、Pod のリソースの要求値に占めるパーセンテージとして表されます。 -

AverageValueを使用する場合、ターゲット値は、関連する全 Pod のメトリクスの平均値です。

-

- 4

- スケールダウン時のレプリカの最小数を指定します。CPU トリガーの場合は、

1以上の値を入力します。CPU メトリクスのみを使用している場合、HPA はゼロにスケールできないためです。

3.4.3. メモリートリガーについて

メモリーメトリクスに基づいて Pod をスケーリングできます。このトリガーは、クラスターメトリクスをメトリクスのソースとして使用します。

カスタムメトリクスオートスケーラーは、オブジェクトに関連付けられた Pod をスケーリングして、指定されたメモリー使用率を維持します。オートスケーラーは、すべての Pod で指定のメモリー使用率を維持するために、最小数と最大数の間でレプリカ数を増減します。メモリートリガーは、Pod 全体のメモリー使用率を考慮します。Pod に複数のコンテナーがある場合、メモリー使用率はすべてのコンテナーの合計になります。

-

このトリガーは、

ScaledJobカスタムリソースでは使用できません。 -

メモリートリガーを使用してオブジェクトをスケーリングすると、複数のトリガーを使用している場合でも、オブジェクトは

0にスケーリングされません。

メモリーターゲットを使用した scaled object の例

- 1

- トリガータイプとしてメモリーを指定します。

- 2

- 使用するメトリクスのタイプ (

UtilizationまたはAverageValueのいずれか) を指定します。 - 3

- スケーリングをトリガーする値を指定します。引用符で囲まれた文字列値として指定する必要があります。

-

Utilizationを使用する場合、ターゲット値は、関連する全 Pod のリソースメトリクスの平均値であり、Pod のリソースの要求値に占めるパーセンテージとして表されます。 -

AverageValueを使用する場合、ターゲット値は、関連する全 Pod のメトリクスの平均値です。

-

- 4

- オプション: Pod 全体ではなく、そのコンテナーのみのメモリー使用率に基づいて、スケーリングする個々のコンテナーを指定します。この例では、

apiという名前のコンテナーのみがスケーリングされます。

3.4.4. Kafka トリガーについて

Apache Kafka トピックまたは Kafka プロトコルをサポートするその他のサービスに基づいて Pod をスケーリングできます。カスタムメトリクスオートスケーラーは、スケーリングされるオブジェクトまたはスケーリングされるジョブで allowIdleConsumers パラメーターを true に設定しない限り、Kafka パーティションの数を超えてスケーリングしません。

コンシューマーグループの数がトピック内のパーティションの数を超えると、余分なコンシューマーグループはそのままアイドル状態になります。これを回避するために、デフォルトではレプリカの数は次の値を超えません。

- トピックのパーティションの数 (トピックが指定されている場合)。

- コンシューマーグループ内の全トピックのパーティション数 (トピックが指定されていない場合)。

-

スケーリングされるオブジェクトまたはスケーリングされるジョブの CR で指定された

maxReplicaCount。

これらのデフォルトの動作は、allowIdleConsumers パラメーターを使用して無効にすることができます。

Kafka ターゲットを使用した scaled object の例

- 1

- トリガータイプとして Kafka を指定します。

- 2

- Kafka がオフセットラグを処理している Kafka トピックの名前を指定します。

- 3

- 接続する Kafka ブローカーのコンマ区切りリストを指定します。

- 4

- トピックのオフセットの確認と、関連するラグの処理に使用される Kafka コンシューマーグループの名前を指定します。

- 5

- オプション: スケーリングをトリガーする平均ターゲット値を指定します。引用符で囲まれた文字列値として指定する必要があります。デフォルトは

5です。 - 6

- オプション: アクティベーションフェーズのターゲット値を指定します。引用符で囲まれた文字列値として指定する必要があります。

- 7

- オプション: Kafka コンシューマーの Kafka オフセットリセットポリシーを指定します。使用可能な値は

latestおよびearliestです。デフォルトはlatestです。 - 8

- オプション: Kafka レプリカの数がトピックのパーティションの数を超えることを許可するかどうかを指定します。

-

trueの場合、Kafka レプリカの数はトピックのパーティションの数を超えることができます。これにより、Kafka コンシューマーがアイドル状態になることが許容されます。 -

falseの場合、Kafka レプリカの数はトピックのパーティションの数を超えることはできません。これがデフォルトです。

-

- 9

- Kafka パーティションに有効なオフセットがない場合のトリガーの動作を指定します。

-

trueの場合、そのパーティションのコンシューマーはゼロにスケーリングされます。 -

falseの場合、スケーラーはそのパーティションのために 1 つのコンシューマーを保持します。これがデフォルトです。

-

- 10

- オプション: 現在のオフセットが前のポーリングサイクルの現在のオフセットと同じであるパーティションのパーティションラグをトリガーに含めるか除外するかを指定します。

-

trueの場合、スケーラーはこれらのパーティションのパーティションラグを除外します。 -

falseの場合、すべてのパーティションのコンシューマーラグがすべてトリガーに含まれます。これがデフォルトです。

-

- 11

- オプション: Kafka ブローカーのバージョンを指定します。引用符で囲まれた文字列値として指定する必要があります。デフォルトは

1.0.0です。 - 12

- オプション: スケーリングのスコープを適用するパーティション ID のコンマ区切りリストを指定します。指定されている場合、ラグの計算時にリスト内の ID のみが考慮されます。引用符で囲まれた文字列値として指定する必要があります。デフォルトでは、すべてのパーティションが考慮されます。

- 13

- オプション: Kafka に TSL クライアント認証を使用するかどうかを指定します。デフォルトは

disableです。TLS の設定の詳細は、「カスタムメトリクスオートスケーラートリガー認証について」を参照してください。

3.4.5. Cron トリガーについて

Pod は時間範囲に基づいてスケーリングできます。

時間範囲の開始時に、カスタムメトリクスオートスケーラーが、オブジェクトに関連する Pod を、設定された最小 Pod 数から指定された必要な Pod 数にスケーリングします。時間範囲の終了時に、Pod は設定された最小値にスケールダウンされます。期間は cron 形式 で設定する必要があります。

次の例では、この scaled object に関連する Pod を、インド標準時の午前 6 時から午後 6 時 30 分まで 0 から 100 にスケーリングします。

Cron トリガーを使用した scaled object の例

- 1

- 時間枠の終了時にスケールダウンする Pod の最小数を指定します。

- 2

- スケールアップ時のレプリカの最大数を指定します。この値は

desiredReplicasと同じである必要があります。デフォルトは100です。 - 3

- Cron トリガーを指定します。

- 4

- 時間枠のタイムゾーンを指定します。この値は、IANA Time Zone Database から取得する必要があります。

- 5

- 時間枠の始点を指定します。

- 6

- 時間枠の終点を指定します。

- 7

- 時間枠の始点から終点までの間にスケーリングする Pod の数を指定します。この値は

maxReplicaCountと同じである必要があります。

3.4.6. Kubernetes ワークロードトリガーを理解する

特定のラベルセレクターに一致する Pod の数に基づいて Pod をスケーリングできます。

Custom Metrics Autoscaler Operator は、同じ namespace にある特定のラベルが付いた Pod の数を追跡し、ラベル付き Pod の数に基づいて scaled object の Pod との 関係 を計算します。この関係を使用して、Custom Metrics Autoscaler Operator は、ScaledObject または ScaledJob 仕様のスケーリングポリシーに従ってオブジェクトをスケーリングします。

Pod 数には、Succeeded フェーズまたは Failed フェーズの Pod が含まれます。

たとえば、frontend デプロイメントと backend デプロイメントがあるとします。kubernetes-workload トリガーを使用すると、frontend Pod の数に基づいて backend デプロイメントをスケーリングできます。frontend Pod の数が増えると、Operator は指定された比率を維持するために backend Pod をスケーリングします。この例では、app=frontend Pod セレクターを持つ Pod が 10 個ある場合、Operator は、scaled object で設定された 0.5 の比率を維持するために、バックエンド Pod を 5 にスケーリングします。

Kubernetes ワークロードトリガーを使用した scaled object の例

- 1

- Kubernetes ワークロードトリガーを指定します。

- 2

- Pod 数を取得するために使用する 1 つ以上の Pod セレクターやセットベースセレクターをコンマで区切って指定します。

- 3

- スケーリングされたワークロードとセレクターに一致する Pod の数との間のターゲット関係を指定します。この関係は次の式に従って計算されます。

relation = (pods that match the selector) / (scaled workload pods)

relation = (pods that match the selector) / (scaled workload pods)Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 4

- オプション: スケーラーアクティベーションフェーズのターゲット値を指定します。デフォルトは

0です。

3.5. カスタムメトリクスオートスケーラートリガー認証について

トリガー認証を使用すると、関連付けられたコンテナーで使用できるスケーリングされたオブジェクトまたはスケーリングされたジョブに認証情報を含めることができます。トリガー認証を使用して、Red Hat OpenShift Service on AWS シークレット、プラットフォームネイティブの Pod 認証メカニズム、環境変数などを渡すことができます。

スケーリングするオブジェクトと同じ namespace に TriggerAuthentication オブジェクトを定義します。そのトリガー認証は、その namespace 内のオブジェクトによってのみ使用できます。

または、複数の namespace のオブジェクト間で認証情報を共有するには、すべての namespace で使用できる ClusterTriggerAuthentication オブジェクトを作成できます。

トリガー認証とクラスタートリガー認証は同じ設定を使用します。ただし、クラスタートリガー認証では、スケーリングされたオブジェクトの認証参照に追加の kind パラメーターが必要です。

バインドされたサービスアカウントトークンを使用するトリガー認証の例

バインドされたサービスアカウントトークンを使用するクラスタートリガー認証の例

Basic 認証にシークレットを使用するトリガー認証の例

Basic 認証のシークレットの例

- 1

- トリガー認証に提供するユーザー名とパスワード。

dataスタンザ内の値は、Base64 でエンコードされている必要があります。

CA の詳細にシークレットを使用するトリガー認証の例

- 1

- スケーリングするオブジェクトの namespace を指定します。

- 2

- このトリガー認証では、メトリクスエンドポイントに接続するときに、認可にシークレットを使用することを指定します。

- 3

- 使用する認証の種類を指定します。

- 4

- 使用するシークレットの名前を指定します。

- 5

- 指定されたパラメーターで使用するシークレットのキーを指定します。

- 6

- メトリクスエンドポイントに接続するときに、カスタム CA の認証パラメーターを指定します。

- 7

- 使用するシークレットの名前を指定します。認証局 (CA) の詳細を含む次のシークレットの例を参照してください。

- 8

- 指定されたパラメーターで使用するシークレットのキーを指定します。

認証局 (CA) の詳細を含むシークレットの例

ベアラートークンを使用するトリガー認証の例

ベアラートークンのシークレットの例

- 1

- ベアラー認証で使用するベアラートークンを指定します。値は Base64 でエンコードされている必要があります。

環境変数を使用するトリガー認証の例

Pod 認証プロバイダーを使用するトリガー認証の例

3.5.1. トリガー認証の使用

トリガー認証とクラスタートリガー認証は、カスタムリソースを使用して認証を作成し、スケーリングされたオブジェクトまたはスケーリングされたジョブへの参照を追加することで使用します。

前提条件

- Custom Metrics Autoscaler Operator をインストールしている。

- バインドされたサービスアカウントトークンを使用している場合は、サービスアカウントが存在している必要があります。

バインドされたサービスアカウントトークンを使用している場合は、Custom Metrics Autoscaler Operator がサービスアカウントからサービスアカウントトークンを要求できるようにするロールベースのアクセス制御 (RBAC) オブジェクトが存在する必要があります。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

シークレットを使用している場合は、

Secretオブジェクトが存在している必要があります。

手順

TriggerAuthenticationまたはClusterTriggerAuthenticationオブジェクトを作成します。オブジェクトを定義する YAML ファイルを作成します。

バインドされたサービスアカウントトークンを使用したトリガー認証の例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow TriggerAuthenticationオブジェクトを作成します。oc create -f <filename>.yaml

$ oc create -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

トリガー認証を使用する

ScaledObjectYAML ファイルを作成または編集します。次のコマンドを実行して、オブジェクトを定義する YAML ファイルを作成します。

トリガー認証を使用したスケーリングされたオブジェクトの例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow クラスタートリガー認証を使用したスケーリングされたオブジェクトの例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、スケーリングされたオブジェクトを作成します。

oc apply -f <filename>

$ oc apply -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

3.6. カスタムメトリクスオートスケーラーの追加方法について

カスタムメトリクスオートスケーラーを追加するには、デプロイメント、ステートフルセット、またはカスタムリソース用の ScaledObject カスタムリソースを作成します。ジョブの ScaledJob カスタムリソースを作成します。

スケーリングするワークロードごとに、スケーリングされたオブジェクトを 1 つだけ作成できます。スケーリングされたオブジェクトと Horizontal Pod Autoscaler (HPA) は、同じワークロードで使用できません。

3.6.1. ワークロードへのカスタムメトリクスオートスケーラーの追加

Deployment、StatefulSet、または custom resource オブジェクトによって作成されるワークロード用のカスタムメトリクスオートスケーラーを作成できます。

前提条件

- Custom Metrics Autoscaler Operator をインストールしている。

CPU またはメモリーに基づくスケーリングにカスタムメトリクスオートスケーラーを使用する場合:

クラスター管理者は、クラスターメトリクスを適切に設定する必要があります。メトリクスが設定されているかどうかは、

oc describe PodMetrics <pod-name>コマンドを使用して判断できます。メトリクスが設定されている場合、出力は以下の Usage の下にある CPU と Memory のように表示されます。oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internal

$ oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internalCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow スケーリングするオブジェクトに関連付けられた Pod には、指定されたメモリーと CPU の制限が含まれている必要があります。以下に例を示します。

Pod 仕様の例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

手順

以下のような YAML ファイルを作成します。名前

<2>、オブジェクト名<4>、およびオブジェクトの種類<5>のみが必要です。スケーリングされたオブジェクトの例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- オプション: 「ワークロードのカスタムメトリクスオートスケーラーの一時停止」セクションで説明されているように、Custom Metrics Autoscaler Operator がレプリカを指定された値にスケーリングし、自動スケーリングを停止するよう指定します。

- 2

- このカスタムメトリクスオートスケーラーの名前を指定します。

- 3

- オプション: ターゲットリソースの API バージョンを指定します。デフォルトは

apps/v1です。 - 4

- スケーリングするオブジェクトの名前を指定します。

- 5

kindをDeployment、StatefulSetまたはCustomResourceとして指定します。- 6

- オプション: カスタムメトリクスオートスケーラーがシークレットなどを保持する環境変数を取得する、ターゲットリソース内のコンテナーの名前を指定します。デフォルトは

.spec.template.spec.containers[0]です。 - 7

- オプション:

minReplicaCountが0に設定されている場合、最後のトリガーが報告されてからデプロイメントを0にスケールバックするまでの待機時間を秒単位で指定します。デフォルトは300です。 - 8

- オプション: スケールアップ時のレプリカの最大数を指定します。デフォルトは

100です。 - 9

- オプション: スケールダウン時のレプリカの最小数を指定します。

- 10

- オプション: 「監査ログの設定」セクションで説明されているように、監査ログのパラメーターを指定します。

- 11

- オプション:

failureThresholdパラメーターで定義された回数だけスケーラーがソースからメトリクスを取得できなかった場合に、フォールバックするレプリカの数を指定します。フォールバック動作の詳細は、KEDA のドキュメント を参照してください。 - 12

- オプション: フォールバックが発生した場合に使用するレプリカ数を指定します。次のいずれかのオプションを入力するか、パラメーターを省略します。

-

fallback.replicasパラメーターで指定されたレプリカの数を使用するには、staticと入力します。これがデフォルトです。 -

現在のレプリカ数を維持するには、

currentReplicasと入力します。 -

現在のレプリカ数が