仮想化

OpenShift Virtualization のインストールと使用方法。

概要

第1章 概要

1.1. OpenShift Virtualization について

OpenShift Virtualization の機能およびサポート範囲を確認します。

1.1.1. OpenShift Virtualization の機能

OpenShift Virtualization は、Red Hat OpenShift でスケーラブルなエンタープライズグレードの仮想化機能を提供します。これを使用して、仮想マシン (VM) だけを管理することも、またはコンテナーワークロードと合わせて管理することもできます。

OpenShift Virtualization は、Kubernetes カスタムリソースを使用して仮想化タスクを有効にし、Red Hat OpenShift Service on AWS クラスターに新しいオブジェクトを追加します。これらのタスクには、以下が含まれます。

- Linux および Windows 仮想マシンの作成と管理

- クラスター内で Pod と仮想マシンのワークロードの同時実行

- さまざまなコンソールや CLI ツールを介した仮想マシンへの接続

- 既存の仮想マシンのインポートとクローン作成

- 仮想マシンに接続されたネットワークインターフェイスコントローラーとストレージディスクの管理

- ノード間での仮想マシンのライブマイグレーション

Red Hat OpenShift Service on AWS Web コンソールの Virtualization パースペクティブ、および OpenShift CLI (oc) を使用して、クラスターと仮想化リソースを管理できます。

OpenShift Virtualization は OVN-Kubernetes とともに使用できます。

Compliance Operator をインストールし、ocp4-moderate および ocp4-moderate-node を使用してスキャンを実行することにより、OpenShift Virtualization クラスターのコンプライアンスの問題を確認できます。Compliance Operator は、NIST 認定ツール である OpenSCAP を使用して、セキュリティーポリシーをスキャンし、適用します。

特殊なストレージ、ネットワーク、バックアップ、および追加機能に関して、独立系ソフトウェアベンダー (ISV) およびサービスパートナーと連携する方法は、Red Hat Ecosystem Catalog を参照してください。

1.1.2. OpenShift Virtualization と VMware vSphere の比較

VMware vSphere に精通している場合は、以下の表に記載された、同様のタスクを実行できる OpenShift Virtualization コンポーネントを使用できます。

ただし、OpenShift Virtualization は vSphere とは概念的に異なり、その機能の多くは基盤となる Red Hat OpenShift Service on AWS から提供されるため、OpenShift Virtualization には vSphere のすべての概念やコンポーネントに対する直接的な代替が存在するわけではありません。

| vSphere の概念 | OpenShift Virtualization | 詳細 |

|---|---|---|

| Datastore | 永続ボリューム (PV) 永続ボリューム要求 (PVC) |

仮想マシンディスクを保存します。PV は既存のストレージを表し、PVC 経由で仮想マシンに割り当てられます。 |

| Dynamic Resource Scheduling (DRS) | Pod 退避ポリシー descheduler | アクティブなリソースバランシングを提供します。Pod の退避ポリシーと descheduler の組み合わせにより、仮想マシンはより適切なノードへのライブマイグレーションが可能となり、ノードのリソースの使用状況を管理可能な状態に保つことができます。 |

| NSX | Multus OVN-Kubernetes サードパーティーのコンテナーネットワークインターフェイス (CNI) プラグイン | オーバーレイネットワーク設定を提供します。OpenShift Virtualization の NSX と同等のものはありませんが、OVN-Kubernetes ネットワークプロバイダーを使用するか、認定されたサードパーティー CNI プラグインをインストールすることができます。 |

| Storage Policy Based Management (SPBM) | Storage class | ポリシーベースのストレージの選択を提供します。ストレージクラスは、さまざまなストレージタイプを表し、Quality of Service (QoS)、バックアップポリシー、回収ポリシー、ボリューム拡張が許可されるかどうかなどのストレージ機能を記述します。PVC は、アプリケーションの要件を満たすために特定のストレージクラスを要求できます。 |

| vCenter vRealize Operations | OpenShift メトリクスおよびモニタリング | ホストおよび仮想マシンのメトリクスを提供します。Red Hat OpenShift Service on AWS Web コンソールを使用すると、メトリクスを表示し、クラスターと仮想マシンの全体的な健全性を監視できます。 |

| vMotion | ライブマイグレーション |

実行中の仮想マシンを中断せずに別のノードに移動します。ライブマイグレーションを使用できるようにするには、仮想マシンに割り当てられた PVC に |

| vSwitch DvSwitch | NMState Operator Multus | 物理ネットワーク設定を提供します。NMState Operator を使用して、ステートドリブンのネットワーク設定を適用し、Linux ブリッジやネットワークボンディングなど、さまざまなネットワークインターフェイスタイプを管理できます。Multus を使用すると、複数のネットワークインターフェイスを割り当て、仮想マシンを外部ネットワークに接続できます。 |

1.1.3. OpenShift Virtualization でサポートされるクラスターバージョン

OpenShift Virtualization 4.20 は、Red Hat OpenShift Service on AWS 4 クラスターでの使用がサポートされています。OpenShift Virtualization の最新の z-stream リリースを使用するには、まず、Red Hat OpenShift Service on AWS の最新バージョンにアップグレードする必要があります。

OpenShift Virtualization 4.20 の最新の安定リリースは 4.20.1 です。

OpenShift Virtualization は現在、x86-64 CPU で利用可能です。Arm ベースのノードはまだサポートされていません。

1.1.4. 仮想マシンディスクのボリュームとアクセスモードについて

既知のストレージプロバイダーでストレージ API を使用する場合、ボリュームモードとアクセスモードは自動的に選択されます。ただし、ストレージプロファイルのないストレージクラスを使用する場合は、ボリュームとアクセスモードを設定する必要があります。

OpenShift Virtualization に対応している既知のストレージプロバイダーのリストは、Red Hat Ecosystem Catalog を参照してください。

最良の結果を得るには、ReadWriteMany (RWX) アクセスモードと Block ボリュームモードを使用してください。これは、以下の理由により重要です。

-

ライブマイグレーションには

ReadWriteMany(RWX) アクセスモードが必要です。 -

Blockボリュームモードは、Filesystemボリュームモードよりもパフォーマンスが大幅に優れています。これは、Filesystemボリュームモードでは、ファイルシステムレイヤーやディスクイメージファイルなどを含め、より多くのストレージレイヤーが使用されるためです。仮想マシンのディスクストレージに、これらのレイヤーは必要ありません。

次の設定の仮想マシンをライブマイグレーションすることはできません。

-

ReadWriteOnce(RWO) アクセスモードのストレージボリューム - GPU などのパススルー機能

これらの仮想マシンの evictionStrategy フィールドを None に設定します。None ストラテジーでは、ノードの再起動中に仮想マシンの電源がオフになります。

1.2. セキュリティーポリシー

OpenShift Virtualization のセキュリティーと認可を説明します。

主なポイント

-

OpenShift Virtualization は、Pod セキュリティーの現在のベストプラクティスを強制することを目的とした、

restrictedKubernetes pod security standards プロファイルに準拠しています。 - 仮想マシン (VM) のワークロードは、特権のない Pod として実行されます。

-

Security Context Constraints (SCC) は、

kubevirt-controllerサービスアカウントに対して定義されます。 - OpenShift Virtualization コンポーネントの TLS 証明書は更新され、自動的にローテーションされます。

1.2.1. ワークロードのセキュリティーについて

デフォルトでは、OpenShift Virtualization の仮想マシン (VM) ワークロードは root 権限では実行されず、root 権限を必要とするサポート対象の OpenShift Virtualization 機能はありません。

仮想マシンごとに、virt-launcher Pod が libvirt のインスタンスを セッションモード で実行し、仮想マシンプロセスを管理します。セッションモードでは、libvirt デーモンは root 以外のユーザーアカウントとして実行され、同じユーザー識別子 (UID) で実行されているクライアントからの接続のみを許可します。したがって、仮想マシンは権限のない Pod として実行し、最小権限のセキュリティー原則に従います。

1.2.2. TLS 証明書

OpenShift Virtualization コンポーネントの TLS 証明書は更新され、自動的にローテーションされます。手動で更新する必要はありません。

1.2.2.1. 自動更新スケジュール

TLS 証明書は自動的に削除され、以下のスケジュールに従って置き換えられます。

- KubeVirt 証明書は毎日更新されます。

- Containerized Data Importer controller (CDI) 証明書は、15 日ごとに更新されます。

- MAC プール証明書は毎年更新されます。

TLS 証明書の自動ローテーションはいずれの操作も中断しません。たとえば、以下の操作は中断せずに引き続き機能します。

- 移行

- イメージのアップロード

- VNC およびコンソールの接続

1.2.3. 認可

OpenShift Virtualization は、ロールベースのアクセス制御 (RBAC) を使用して、人間のユーザーとサービスアカウントの権限を定義します。サービスアカウントに定義された権限は、OpenShift Virtualization コンポーネントが実行できるアクションを制御します。

RBAC ロールを使用して、仮想化機能へのユーザーアクセスを管理することもできます。たとえば管理者は、仮想マシンの起動に必要な権限を提供する RBAC ロールを作成できます。管理者は、ロールを特定のユーザーにバインドすることでアクセスを制限できます。

1.2.3.1. OpenShift Virtualization のデフォルトのクラスターロール

クラスターロール集約を使用することで、OpenShift Virtualization はデフォルトの Red Hat OpenShift Service on AWS クラスターロールを拡張して、仮想化オブジェクトにアクセスするための権限を組み込みます。OpenShift Virtualization 固有のロールは、Red Hat OpenShift Service on AWS のロールと集約されません。

| デフォルトのクラスターロール | OpenShift Virtualization のクラスターロール | OpenShift Virtualization クラスターロールの説明 |

|---|---|---|

|

|

| クラスター内の OpenShift Virtualization リソースをすべて表示できるユーザー。ただし、リソースの作成、削除、変更、アクセスはできません。たとえば、ユーザーは仮想マシン (VM) が実行中であることを確認できますが、それをシャットダウンしたり、そのコンソールにアクセスしたりすることはできません。 |

|

|

| クラスター内のすべての OpenShift Virtualization リソースを変更できるユーザー。たとえば、ユーザーは仮想マシンの作成、VM コンソールへのアクセス、仮想マシンの削除を行えます。 |

|

|

|

リソースコレクションの削除を含め、すべての OpenShift Virtualization リソースに対する完全な権限を持つユーザー。このユーザーは、 |

|

|

|

namespace 付きの |

1.2.3.2. OpenShift Virtualization のストレージ機能の RBAC ロール

cdi-operator および cdi-controller サービスアカウントを含む、次のパーミッションがコンテナー化データインポーター (CDI) に付与されます。

1.2.3.2.1. クラスター全体の RBAC のロール

| CDI クラスターのロール | リソース | 動詞 |

|---|---|---|

|

|

|

|

|

|

| |

|

|

|

|

|

|

| |

|

|

|

|

|

|

| |

|

|

|

|

| API グループ | リソース | 動詞 |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

許可リスト: |

|

|

|

許可リスト: |

|

|

|

|

|

| API グループ | リソース | 動詞 |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1.2.3.2.2. namespace 付きの RBAC ロール

| API グループ | リソース | 動詞 |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| API グループ | リソース | 動詞 |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1.2.3.3. kubevirt-controller サービスアカウントの追加の SCC とパーミッション

SCC (Security Context Constraints) は Pod のパーミッションを制御します。これらのパーミッションには、コンテナーのコレクションである Pod が実行できるアクションおよびそれがアクセスできるリソース情報が含まれます。SCC を使用して、Pod がシステムに受け入れられるために必要な Pod の実行に関する条件の一覧を定義できます。

virt-controller は、クラスター内の仮想マシンの virt-launcher Pod を作成するクラスターコントローラーです。

デフォルトでは、virt-launcher Pod は namespace 内の default サービスアカウントで実行されます。コンプライアンス制御に一意のサービスアカウントが必要な場合は、仮想マシンに割り当てます。この設定は、VirtualMachineInstance オブジェクトと virt-launcher Pod に適用されます。

kubevirt-controller サービスアカウントには追加の SCC および Linux 機能が付与され、これにより適切なパーミッションを持つ virt-launcher Pod を作成できます。これらの拡張パーミッションにより、仮想マシンは通常の Pod の範囲外の OpenShift Virtualization 機能を利用できます。

kubevirt-controller サービスアカウントには以下の SCC が付与されます。

scc.AllowHostDirVolumePlugin = true- 仮想マシンが hostpath ボリュームプラグインを使用することを許可します。

scc.AllowPrivilegedContainer = false-

virt-launcherPod が特権コンテナーとして実行されないようにします。 scc.AllowedCapabilities = []corev1.Capability{"SYS_NICE", "NET_BIND_SERVICE"}-

SYS_NICEを使用すると、CPU アフィニティーを設定できます。 -

NET_BIND_SERVICEは、DHCP および Slirp 操作を許可します。

-

1.2.3.3.1. kubevirt-controller の SCC および RBAC 定義の表示

oc ツールを使用して kubevirt-controller の SecurityContextConstraints 定義を表示できます。

oc get scc kubevirt-controller -o yaml

$ oc get scc kubevirt-controller -o yaml

oc ツールを使用して kubevirt-controller クラスターロールの RBAC 定義を表示できます。

oc get clusterrole kubevirt-controller -o yaml

$ oc get clusterrole kubevirt-controller -o yaml1.3. OpenShift Virtualization アーキテクチャー

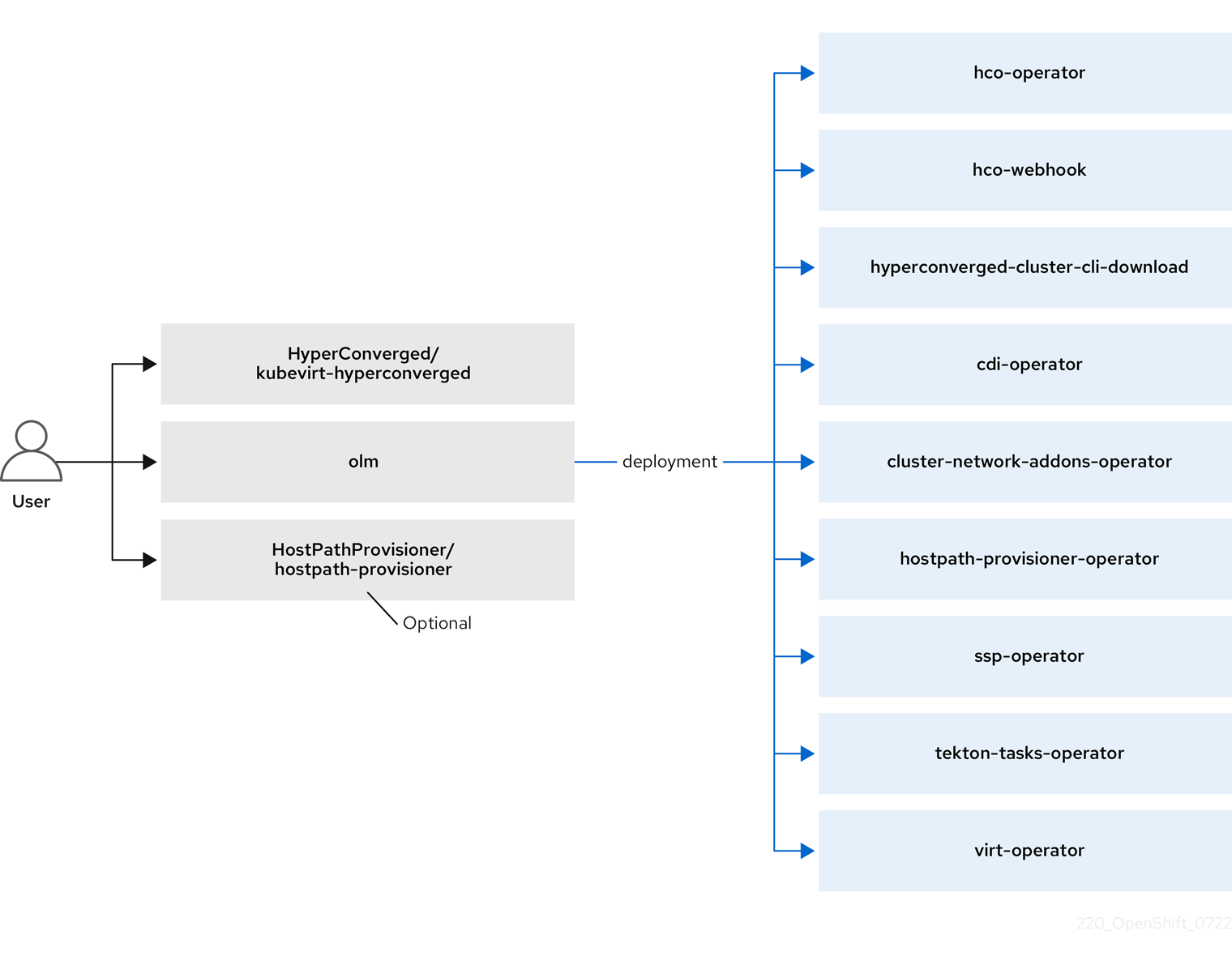

Operator Lifecycle Manager (OLM) は、OpenShift Virtualization の各コンポーネントのオペレーター Pod をデプロイします。

-

コンピューティング:

virt-operator -

ストレージ:

cdi-operator -

ネットワーク:

cluster-network-addons-operator -

スケーリング:

ssp-operator

OLM は、他のコンポーネントのデプロイ、設定、およびライフサイクルを担当する hyperconverged-cluster-operator Pod と、いくつかのヘルパー Pod (hco-webhook および hyperconverged-cluster-cli-download) もデプロイします。

すべての Operator Pod が正常にデプロイされたら、HyperConverged カスタムリソース (CR) を作成する必要があります。HyperConverged CR で設定された設定は、信頼できる唯一の情報源および OpenShift Virtualization のエントリーポイントとして機能し、CR の動作をガイドします。

HyperConverged CR は、リコンシリエーションループに含まれる他の全コンポーネントの Operator に対して対応する CR を作成します。その後、各 Operator は、デーモンセット、config map、および OpenShift Virtualization コントロールプレーン用の追加コンポーネントなどのリソースを作成します。たとえば、HyperConverged Operator (HCO) が KubeVirt CR を作成すると、OpenShift Virtualization Operator がそれを調整し、virt-controller、virt-handler、virt-api などの追加リソースを作成します。

OLM は Hostpath Provisioner (HPP) Operator をデプロイしますが、hostpath-provisioner CR を作成するまで機能しません。

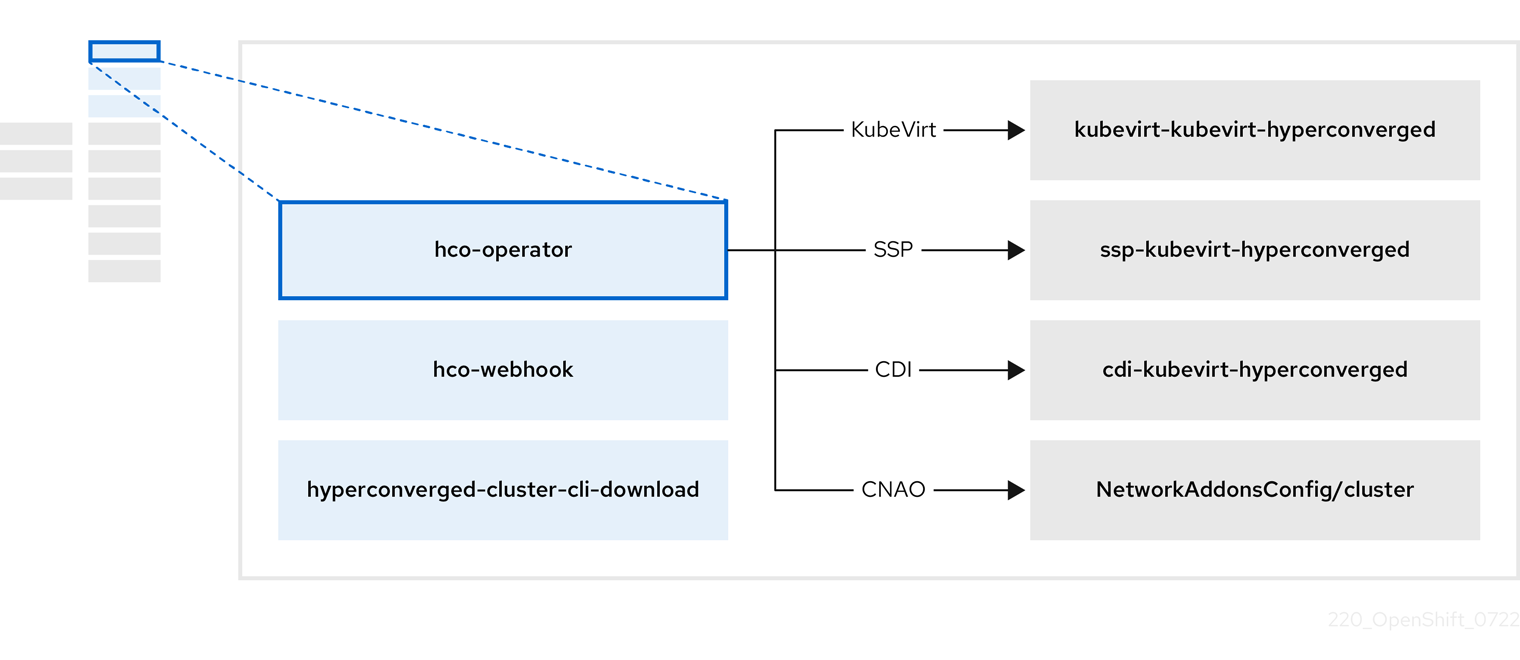

1.3.1. HyperConverged Operator (HCO) について

HCO (hco-operator) は、OpenShift Virtualization と複数のヘルパー Operator を、推奨のデフォルト設定を使用してデプロイおよび管理するための単一のエントリーポイントを提供します。また、これらの Operator のカスタムリソース (CR) も作成します。

| コンポーネント | 説明 |

|---|---|

|

|

|

|

|

クラスターから直接ダウンロードできるように、 |

|

| OpenShift Virtualization に必要なすべての Operator、CR、およびオブジェクトが含まれています。 |

|

| Scheduling, Scale, and Performance (SSP) CR。これは、HCO によって自動的に作成されます。 |

|

| Containerized Data Importer (CDI) CR。これは、HCO によって自動的に作成されます。 |

|

|

|

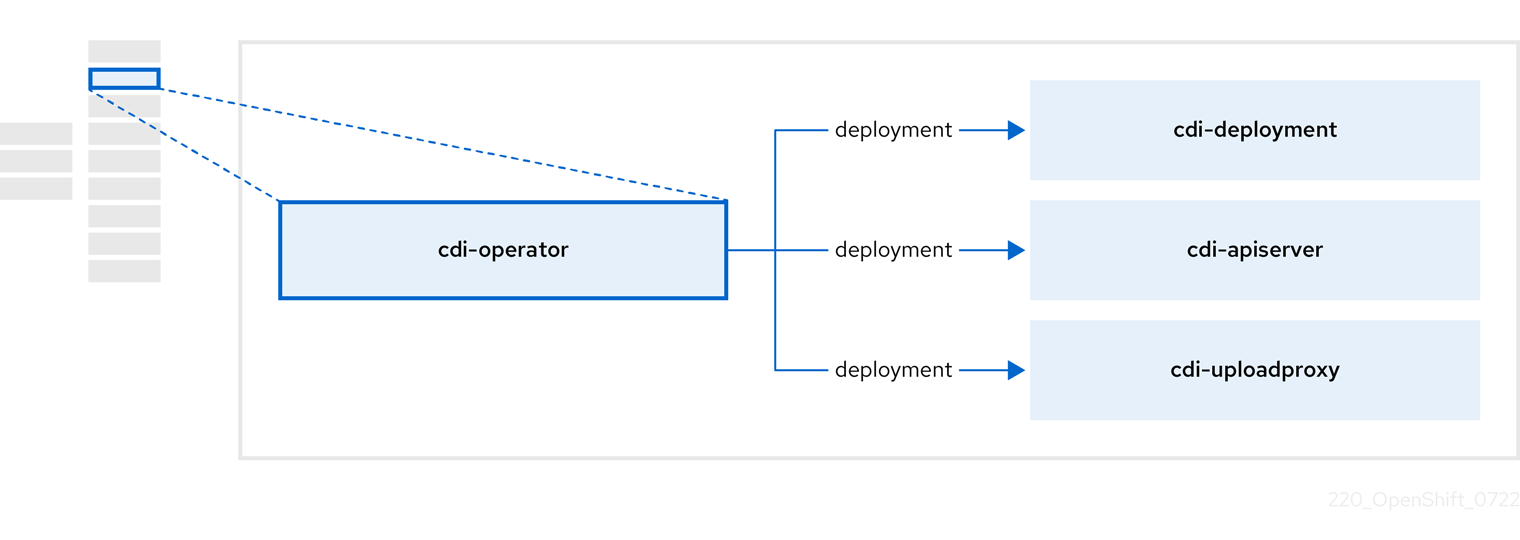

1.3.2. Containerized Data Importer (CDI) Operator について

CDI Operator cdi-operator は、CDI とその関連リソースを管理し、データボリュームを使用して仮想マシンイメージを永続ボリューム要求 (PVC) にインポートします。

| コンポーネント | 説明 |

|---|---|

|

| セキュアなアップロードトークンを発行して、VM ディスクを PVC にアップロードするための承認を管理します。 |

|

| 外部ディスクのアップロードトラフィックを適切なアップロードサーバー Pod に転送して、正しい PVC に書き込むことができるようにします。有効なアップロードトークンが必要です。 |

|

| データボリュームの作成時に仮想マシンイメージを PVC にインポートするヘルパー Pod。 |

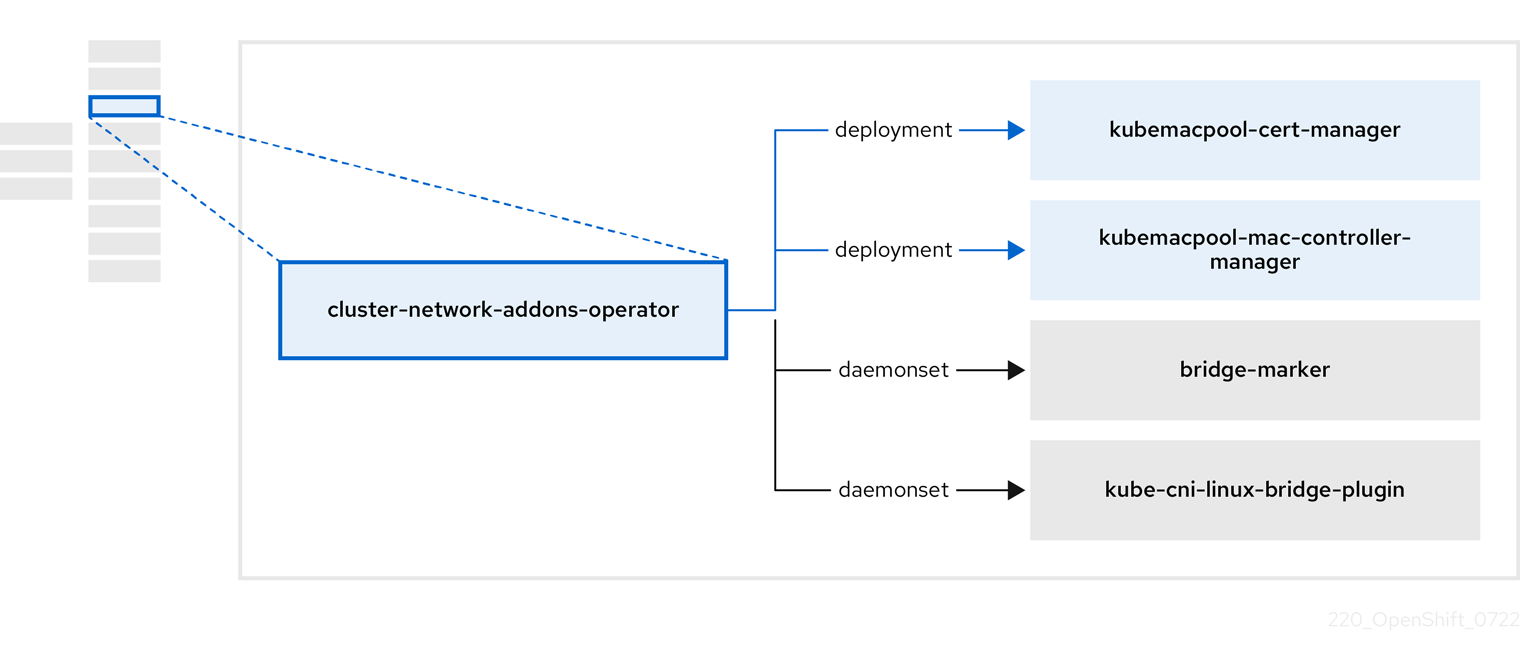

1.3.3. Cluster Network Addons Operator について

Cluster Network Addons Operator (cluster-network-addons-operator) は、クラスターにネットワークコンポーネントをデプロイし、拡張ネットワーク機能の関連リソースを管理します。

| コンポーネント | 説明 |

|---|---|

|

| Kubemacpool の Webhook の TLS 証明書を管理します。 |

|

| 仮想マシン (VM) ネットワークインターフェイスカード (NIC) の MAC アドレスプールサービスを提供します。 |

|

| ノードで使用可能なネットワークブリッジをノードリソースとしてマークします。 |

|

| クラスターノードに Container Network Interface (CNI) プラグインをインストールし、network attachment definition を介して Linux ブリッジに VM を接続できるようにします。 |

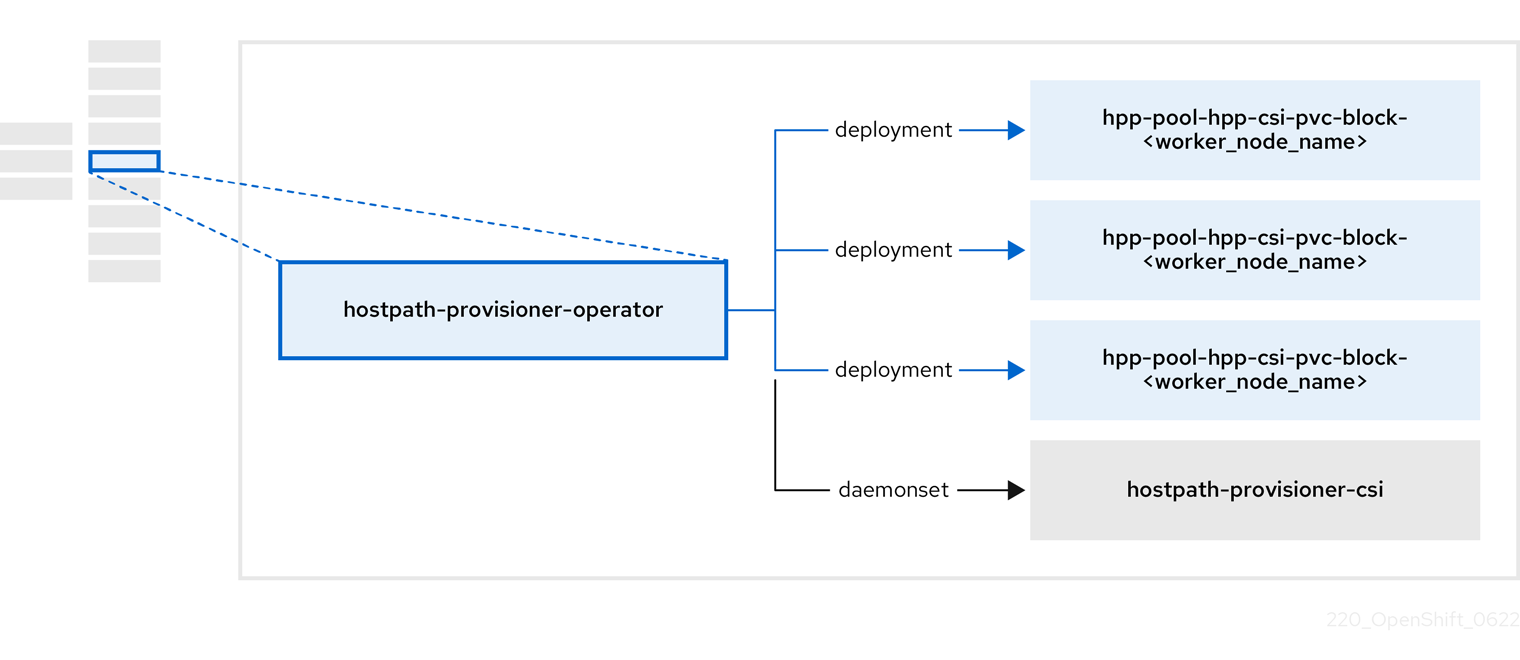

1.3.4. Hostpath Provisioner (HPP) Operator について

HPP オペレーター hostpath-provisioner-operator は、マルチノード HPP および関連リソースをデプロイおよび管理します。

| コンポーネント | 説明 |

|---|---|

|

| HPP の実行が指定されている各ノードにワーカーを提供します。Pod は、指定されたバッキングストレージをノードにマウントします。 |

|

| HPP の Container Storage Interface (CSI) ドライバーインターフェイスを実装します。 |

|

| HPP のレガシードライバーインターフェイスを実装します。 |

1.3.5. Scheduling, Scale, and Performance (SSP) Operator について

SSP オペレーター ssp-operator は、共通テンプレート、関連するデフォルトのブートソース、パイプラインタスク、およびテンプレートバリデーターをデプロイします。

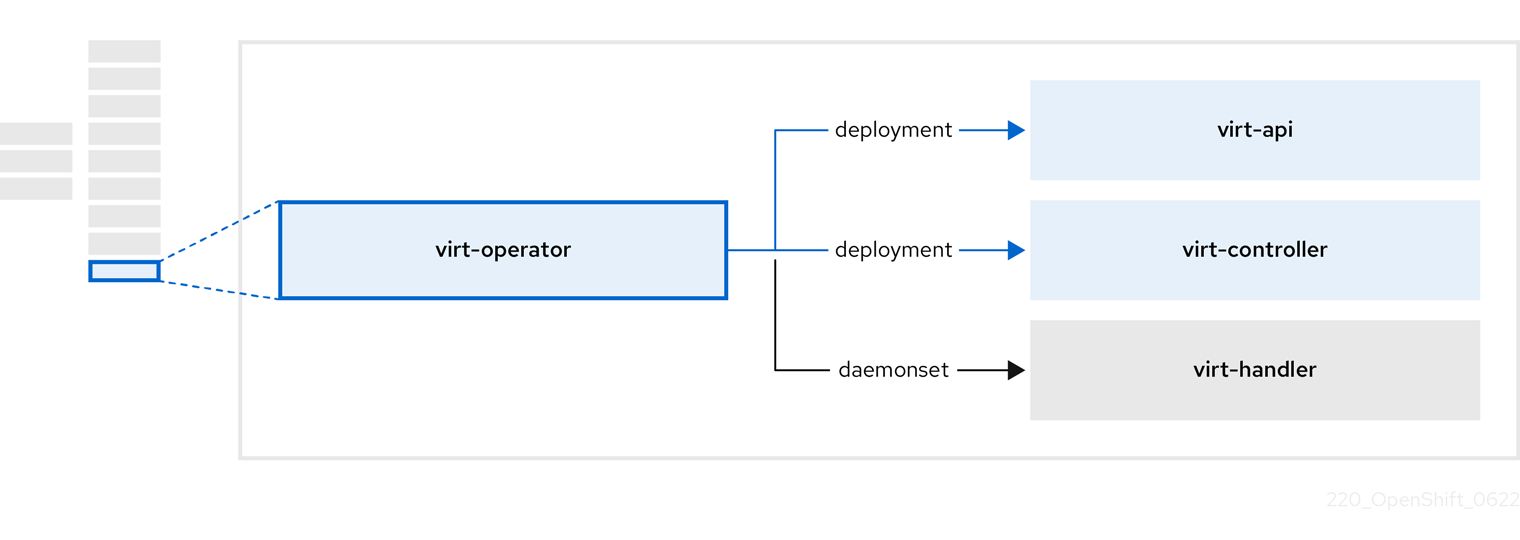

1.3.6. OpenShift Virtualization Operator について

OpenShift Virtualization Operator virt-operator は、現在の仮想マシンワークロードを中断することなく OpenShift Virtualization をデプロイ、アップグレード、管理します。さらに、OpenShift Virtualization Operator は、共通のインスタンスタイプと共通の設定をデプロイします。

| コンポーネント | 説明 |

|---|---|

|

| すべての仮想化関連フローのエントリーポイントとして機能する HTTP API サーバー。 |

|

|

新しい VM インスタンスオブジェクトの作成を監視し、対応する Pod を作成します。Pod がノードでスケジュールされると、 |

|

|

仮想マシンへの変更を監視し、必要な操作を実行するように |

|

|

|

第2章 スタートガイド

2.1. OpenShift Virtualization の開始

基本的な環境をインストールして設定することにより、OpenShift Virtualization の特徴と機能を調べることができます。

クラスター設定手順には、cluster-admin 権限が必要です。

2.1.1. OpenShift Virtualization の計画とインストール

Red Hat OpenShift Service on AWS クラスターに OpenShift Virtualization を計画してインストールします。

計画およびインストールのリソース

2.1.2. 仮想マシンの作成と管理

仮想マシンを作成します。

Red Hat テンプレートを使用して仮想マシンを作成できます。

- 仮想マシンを作成するには、コンテナーレジストリーまたは Web ページからカスタムイメージをインポートするか、ローカルマシンからイメージをアップロードするか、永続ボリューム要求 (PVC) を複製 することによって実行できます。

仮想マシンをセカンダリーネットワークに接続します。

オープン仮想ネットワーク (OVN)- Kubernetes セカンダリーネットワーク。

注記VM はデフォルトで Pod ネットワークに接続されます。

仮想マシンに接続します。

- 仮想マシンの シリアルコンソール または VNC コンソール に接続します。

- SSH を使用して仮想マシンに接続します。

- Windows 仮想マシンのデスクトップビューアーに接続します。

仮想マシンを管理します。

2.1.3. OpenShift Virtualization への移行

VMware vSphere、Red Hat OpenStack Platform (RHOSP)、Red Hat Virtualization、別の Red Hat OpenShift Service on AWS クラスターなどの外部プロバイダーから仮想マシンを移行するには、Migration Toolkit for Virtualization (MTV) を使用します。VMware vSphere によって作成された Open Virtual Appliance (OVA) ファイルも移行できます。

Migration Toolkit for Virtualization は OpenShift Virtualization に含まれていないため、別途インストールする必要があります。そのため、この手順内のすべてのリンクは OpenShift Virtualization ドキュメントの外部につながります。

前提条件

- Migration Toolkit for Virtualization Operator が インストールされている。

2.1.4. 次のステップ

2.2. CLI ツールの使用

virtctl コマンドラインツールを使用して、OpenShift Virtualization リソースを管理できます。

libguestfs コマンドラインツールを使用すると、仮想マシン (VM) のディスクイメージにアクセスして変更できます。libguestfs をデプロイするには、virtctl libguestfs コマンドを使用します。

2.2.1. virtctl のインストール

Red Hat Enterprise Linux (RHEL) 9、Linux、Windows、および MacOS オペレーティングシステムに virtctl をインストールするには、virtctl バイナリーファイルをダウンロードしてインストールします。

RHEL 8 に virtctl をインストールするには、OpenShift Virtualization リポジトリーを有効にしてから、kubevirt-virtctl パッケージをインストールします。

2.2.1.1. RHEL 9、Linux、Windows、macOS への virtctl バイナリーのインストール

Red Hat OpenShift Service on AWS Web コンソールからオペレーティングシステムの virtctl バイナリーをダウンロードしてインストールできます。

手順

- Web コンソールの Virtualization → Overview ページに移動します。

-

Download virtctl リンクをクリックして、オペレーティングシステム用の

virtctlバイナリーをダウンロードします。 virtctlをインストールします。RHEL 9 およびその他の Linux オペレーティングシステムの場合:

アーカイブファイルを解凍します。

tar -xvf <virtctl-version-distribution.arch>.tar.gz

$ tar -xvf <virtctl-version-distribution.arch>.tar.gzCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

virtctlバイナリーを実行可能にします。chmod +x <path/virtctl-file-name>

$ chmod +x <path/virtctl-file-name>Copy to Clipboard Copied! Toggle word wrap Toggle overflow virtctlバイナリーをPATH環境変数内のディレクトリーに移動します。次のコマンドを実行して、パスを確認できます。

echo $PATH

$ echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow KUBECONFIG環境変数を設定します。export KUBECONFIG=/home/<user>/clusters/current/auth/kubeconfig

$ export KUBECONFIG=/home/<user>/clusters/current/auth/kubeconfigCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Windows の場合:

- アーカイブファイルを展開します。

-

展開したフォルダー階層に移動し、

virtctl実行可能ファイルをダブルクリックしてクライアントをインストールします。 virtctlバイナリーをPATH環境変数内のディレクトリーに移動します。次のコマンドを実行して、パスを確認できます。

path

C:\> pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow

macOS の場合:

- アーカイブファイルを展開します。

virtctlバイナリーをPATH環境変数内のディレクトリーに移動します。次のコマンドを実行して、パスを確認できます。

echo $PATH

echo $PATHCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.1.2. RHEL 8 への virtctl RPM のインストール

OpenShift Virtualization リポジトリーを有効にし、kubevirt-virtctl パッケージをインストールすることで、Red Hat Enterprise Linux (RHEL) 8 に virtctl RPM をインストールできます。

前提条件

- クラスター内の各ホストは Red Hat Subscription Manager (RHSM) に登録され、アクティブな Red Hat OpenShift Service on AWS サブスクリプションがある。

手順

subscription-managerCLI ツールを使用して次のコマンドを実行し、OpenShift Virtualization リポジトリーを有効にします。subscription-manager repos --enable cnv-4.20-for-rhel-8-x86_64-rpms

# subscription-manager repos --enable cnv-4.20-for-rhel-8-x86_64-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 次のコマンドを実行して、

kubevirt-virtctlパッケージをインストールします。yum install kubevirt-virtctl

# yum install kubevirt-virtctlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.2.2. virtctl コマンド

virtctl クライアントは、OpenShift Virtualization リソースを管理するためのコマンドラインユーティリティーです。

特に指定がない限り、仮想マシンコマンドは仮想マシンインスタンスにも適用されます。

2.2.2.1. virtctl 情報コマンド

次の virtctl 情報コマンドを使用して、virtctl クライアントに関する情報を表示できます。

| コマンド | 説明 |

|---|---|

|

|

|

|

|

|

|

| 特定のコマンドのオプションのリストを表示します。 |

|

|

任意の |

2.2.2.2. 仮想マシン情報コマンド

virtctl を使用すると、仮想マシンおよび仮想マシンインスタンス (VMI) に関する情報を表示できます。

| コマンド | 説明 |

|---|---|

|

| ゲストマシンで使用可能なファイルシステムを表示します。 |

|

| ゲストマシンのオペレーティングシステムに関する情報を表示します。 |

|

| ゲストマシンにログインしているユーザーを表示します。 |

2.2.2.3. 仮想マシンマニフェスト作成コマンド

以下の virtctl create コマンドを使用して、仮想マシン、インスタンスタイプ、および設定のマニフェストを作成できます。

| コマンド | 説明 |

|---|---|

|

|

|

| 仮想マシンの名前を指定して、仮想マシンのマニフェストを作成します。 |

|

| cloud-init 設定を使用して仮想マシンマニフェストの作成、選択したユーザーの作成を行い、指定された文字列から SSH 公開鍵を追加するか、ファイルからパスワードを追加します。 |

|

| 選択したシークレットから注入されたユーザーとパスワードの組み合わせを使用して仮想マシンマニフェストを作成します。 |

|

| 選択したシークレットから注入された SSH 公開鍵を使用して仮想マシンマニフェストを作成します。 |

|

|

sysprep ボリュームとして使用する config map を指定して、仮想マシンマニフェストを作成します。config map には、 |

|

| 既存のクラスター全体のインスタンスタイプを使用する仮想マシンのマニフェストを作成します。 |

|

| 既存の namespaced 付きのインスタンスタイプを使用する仮想マシンのマニフェストを作成します。 |

|

| クラスター全体のインスタンスタイプのマニフェストを作成します。 |

|

| namespace 付きのインスタンスタイプのマニフェストを作成します。 |

|

| 設定の名前を指定して、クラスター全体の仮想マシン設定のマニフェストを作成します。 |

|

| namespace 付きの仮想マシン設定のマニフェストを作成します。 |

2.2.2.4. 仮想マシン管理コマンド

以下の virtctl コマンドを使用して、仮想マシン (VM) および仮想マシンインスタンス (VMI) を管理および移行できます。

| コマンド | 説明 |

|---|---|

|

| 仮想マシンを開始します。 |

|

| 仮想マシンを一時停止状態で起動します。このオプションを使用すると、VNC コンソールからブートプロセスを中断できます。 |

|

| 仮想マシンを停止します。 |

|

| 仮想マシンを強制停止します。このオプションは、データの不整合またはデータ損失を引き起こす可能性があります。 |

|

| 仮想マシンを一時停止します。マシンの状態がメモリーに保持されます。 |

|

| 仮想マシンの一時停止を解除します。 |

|

| 仮想マシンを移行します。 |

|

| 仮想マシンの移行をキャンセルします。 |

|

| 仮想マシンを再起動します。 |

2.2.2.5. 仮想マシン接続コマンド

次の virtctl コマンドを使用してポートを公開し、仮想マシン (VM) および仮想マシンインスタンス (VMI) に接続できます。

| コマンド | 説明 |

|---|---|

|

| 仮想マシンのシリアルコンソールに接続します。 |

|

| 仮想マシンの指定されたポートを転送するサービスを作成し、ノードの指定されたポートでサービスを公開します。

例: |

|

| マシンから仮想マシンにファイルをコピーします。このコマンドは、SSH 鍵ペアの秘密鍵を使用します。仮想マシンは公開鍵を使用して設定する必要があります。 |

|

| 仮想マシンからマシンにファイルをコピーします。このコマンドは、SSH 鍵ペアの秘密鍵を使用します。仮想マシンは公開鍵を使用して設定する必要があります。 |

|

| 仮想マシンとの SSH 接続を開きます。このコマンドは、SSH 鍵ペアの秘密鍵を使用します。仮想マシンは公開鍵を使用して設定する必要があります。 |

|

| 仮想マシンの VNC コンソールに接続します。

|

|

| ポート番号を表示し、VNC 接続を介してビューアーを使用して手動で VM に接続します。 |

|

| ポートが利用可能な場合、その指定されたポートでプロキシーを実行するためにポート番号を指定します。 ポート番号が指定されていない場合、プロキシーはランダムポートで実行されます。 |

2.2.2.6. 仮想マシンエクスポートコマンド

virtctl vmexport コマンドを使用して、仮想マシン、仮想マシンスナップショット、または永続ボリューム要求 (PVC) からエクスポートされたボリュームを作成、ダウンロード、または削除できます。特定のマニフェストには、OpenShift Virtualization が使用できる形式でディスクイメージをインポートするためのエンドポイントへのアクセスを許可するヘッダーシークレットも含まれています。

| コマンド | 説明 |

|---|---|

|

|

仮想マシン、仮想マシンスナップショット、または PVC からボリュームをエクスポートするには、

|

|

|

|

|

|

オプション:

|

|

|

|

|

| 既存のエクスポートのマニフェストを取得します。マニフェストにはヘッダーシークレットが含まれていません。 |

|

| 仮想マシンサンプルの仮想マシンエクスポートを作成し、マニフェストを取得します。マニフェストにはヘッダーシークレットが含まれていません。 |

|

| 仮想マシンスナップショットの例の仮想マシンエクスポートを作成し、マニフェストを取得します。マニフェストにはヘッダーシークレットが含まれていません。 |

|

| 既存のエクスポートのマニフェストを取得します。マニフェストにはヘッダーシークレットが含まれています。 |

|

| 既存のエクスポートのマニフェストを json 形式で取得します。マニフェストにはヘッダーシークレットが含まれていません。 |

|

| 既存のエクスポートのマニフェストを取得します。マニフェストにはヘッダーシークレットが含まれており、指定されたファイルにそれを書き込みます。 |

2.2.2.7. ホットプラグおよびホットアンプラグコマンド

次の virtctl コマンドを使用して、実行中の仮想マシン (VM) および仮想マシンインスタンス (VMI) にリソースを追加または削除できます。

| コマンド | 説明 |

|---|---|

|

| データボリュームまたは永続ボリューム要求 (PVC) をホットプラグします。 オプション:

|

|

| 仮想ディスクをホットアンプラグします。 |

2.2.2.8. イメージアップロードコマンド

次の virtctl image-upload コマンドを使用して、仮想マシンイメージをデータボリュームにアップロードできます。

| コマンド | 説明 |

|---|---|

|

| VM イメージを既存のデータボリュームにアップロードします。 |

|

| 指定された要求されたサイズの新しいデータボリュームに VM イメージをアップロードします。 |

|

|

仮想マシンイメージを新しいデータボリュームにアップロードし、それに関連付けられた |

2.2.3. virtctl を使用した libguestfs のデプロイ

virtctl guestfs コマンドを使用して、libguestfs-tools および永続ボリューム要求 (PVC) がアタッチされた対話型コンテナーをデプロイできます。

手順

libguestfs-toolsでコンテナーをデプロイして PVC をマウントし、シェルを割り当てるには、以下のコマンドを実行します。virtctl guestfs -n <namespace> <pvc_name>

$ virtctl guestfs -n <namespace> <pvc_name>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- PVC 名は必須の引数です。この引数を追加しないと、エラーメッセージが表示されます。

2.2.3.1. Libguestfs および virtctl guestfs コマンド

Libguestfs ツールは、仮想マシン (VM) のディスクイメージにアクセスして変更するのに役立ちます。libguestfs ツールを使用して、ゲスト内のファイルの表示および編集、仮想マシンのクローンおよびビルド、およびディスクのフォーマットおよびサイズ変更を実行できます。

virtctl guestfs コマンドおよびそのサブコマンドを使用して、PVC で仮想マシンディスクを変更して検査し、デバッグすることもできます。使用可能なサブコマンドの完全なリストを表示するには、コマンドラインで virt- と入力して Tab を押します。以下に例を示します。

| コマンド | 説明 |

|---|---|

|

| ターミナルでファイルを対話的に編集します。 |

|

| ゲストに ssh 鍵を注入し、ログインを作成します。 |

|

| 仮想マシンによって使用されるディスク容量を確認します。 |

|

| 完全なリストを含む出力ファイルを作成して、ゲストにインストールされているすべての RPM の全リストを表示します。 |

|

|

ターミナルで |

|

| テンプレートとして使用する仮想マシンディスクイメージをシールします。 |

デフォルトでは、virtctl guestfs は、仮想ディスク管理に必要な項目を含めてセッションを作成します。ただし、動作をカスタマイズできるように、コマンドは複数のフラグオプションもサポートしています。

| フラグオプション | 説明 |

|---|---|

|

|

|

|

| 特定の namespace から PVC を使用します。

|

|

|

|

|

|

デフォルトでは、

クラスターに

設定されていない場合、 |

|

|

|

このコマンドは、PVC が別の Pod によって使用されているかどうかを確認します。使用されている場合には、エラーメッセージが表示されます。ただし、libguestfs-tools プロセスが開始されると、設定では同じ PVC を使用する新規 Pod を回避できません。同じ PVC にアクセスする仮想マシンを起動する前に、アクティブな virtctl guestfs Pod がないことを確認する必要があります。

virtctl guestfs コマンドは、インタラクティブな Pod に割り当てられている PVC 1 つだけを受け入れます。

2.2.4. Ansible の使用

OpenShift Virtualization 用の Ansible コレクションを使用するには、Red Hat Ansible Automation Hub (Red Hat Hybrid Cloud Console) を参照してください。

第3章 インストール

3.1. OpenShift Virtualization のクラスターの準備

OpenShift Virtualization をインストールする前に、このセクションを参照して、クラスターが要件を満たしていることを確認してください。

3.1.1. Red Hat OpenShift Service on AWS での OpenShift Virtualization

OpenShift Virtualization は、Red Hat OpenShift Service on AWS クラスター上で実行できます。

クラスターを設定する前に、サポート対象の機能と制限に関する以下の要約を確認してください。

- インストール

インストーラーでプロビジョニングされるインフラストラクチャーを使用してクラスターをインストールし、ワーカーノードにベアメタルインスタンスタイプを指定する必要があります。たとえば、x86_64 アーキテクチャーをベースとするマシンの

c5n.metalタイプの値を使用できます。詳細は、AWS へのインストールに関する Red Hat OpenShift Service on AWS のドキュメントを参照してください。

- 仮想マシン (VM) へのアクセス

-

virtctlCLI ツールまたは Red Hat OpenShift Service on AWS Web コンソールを使用して仮想マシンにアクセスする方法に変更はありません。 NodePortまたはLoadBalancerサービスを使用して、仮想マシンを公開できます。注記Red Hat OpenShift Service on AWS は AWS にロードバランサーを自動的に作成し、そのライフサイクルを管理するため、ロードバランサーのアプローチが推奨されます。また、セキュリティーグループはロードバランサー用にも作成され、アノテーションを使用して既存のセキュリティーグループをアタッチできます。サービスを削除すると、Red Hat OpenShift Service on AWS はロードバランサーとそれに関連するリソースを削除します。

- ネットワーク

-

アプリケーションで Egress トラフィックを必要としないフラットなレイヤー 2 ネットワークが必要な場合は、

Layer2トポロジーで OVN-Kubernetes セカンダリーオーバーレイネットワークを使用することを検討してください。

- ストレージ

基盤となるプラットフォームとの連携がストレージベンダーによって認定されている任意のストレージソリューションを使用できます。

重要AWS ベアメタル、Red Hat OpenShift Service on AWS、および Red Hat OpenShift Service on AWS クラシックアーキテクチャーの各クラスターで、サポートされるストレージソリューションが異なる場合があります。ストレージベンダーにサポートを確認してください。

OpenShift Virtualization で Amazon Elastic File System (EFS) または Amazon Elastic Block Store (EBS) を使用すると、次の表に示すようにパフォーマンスと機能の制限が発生する可能性があります。

Expand 表3.1 EFS と EBS のパフォーマンスと機能の制限 機能 EBS ボリューム EFS ボリューム 共有ストレージソリューション gp2

gp3

io2

仮想マシンライブマイグレーション

利用不可

利用不可

利用可能

利用可能

利用可能

クローン作成による高速仮想マシン作成

利用可能

利用不可

利用可能

スナップショットを使用した仮想マシンのバックアップと復元

利用可能

利用不可

利用可能

ライブマイグレーション、高速仮想マシンの作成、仮想マシンスナップショット機能の有効化を行うには、ReadWriteMany (RWX)、クローン作成、スナップショットをサポートする CSI ストレージの使用を検討してください。

3.1.2. ARM64 の互換性

ARM64 システムにインストールされた Red Hat OpenShift Service on AWS クラスターで OpenShift Virtualization を使用する機能が一般提供 (GA) されました。

ARM64 ベースのシステムで OpenShift Virtualization を使用する前に、次の制限に留意してください。

- オペレーティングシステム

- Linux ベースのゲストオペレーティングシステムのみがサポートされます。

- RHEL のすべての仮想化制限は、OpenShift Virtualization にも適用されます。詳細は、RHEL ドキュメントの ARM64 の仮想化と AMD64 および Intel 64 の仮想化の違い を参照してください。

- ライブマイグレーション

- ARM64 ベースの Red Hat OpenShift Service on AWS クラスターではライブマイグレーションは サポートされていません。

- ホットプラグはライブマイグレーションに依存するため、ARM64 ベースのクラスターではサポートされていません。

- 仮想マシンの作成

- RHEL 10 は、インスタンスタイプと設定をサポートしますが、テンプレートはサポートしていません。

- RHEL 9 は、テンプレート、インスタンスタイプ、および設定をサポートします。

3.1.3. ハードウェアとオペレーティングシステムの要件

OpenShift Virtualization の次のハードウェアおよびオペレーティングシステム要件を確認してください。

3.1.3.1. CPU の要件

Red Hat Enterprise Linux (RHEL) 9 でサポート。

サポートされている CPU の Red Hat Ecosystem Catalog を参照してください。

注記ワーカーノードの CPU が異なる場合は、CPU ごとに機能が異なるため、ライブマイグレーションが失敗する可能性があります。この問題は、ワーカーノードに適切な容量の CPU が搭載されていることを確認し、仮想マシンのノードアフィニティールールを設定することで軽減できます。

詳細は、ノードアフィニティーの required (必須) ルールの設定 を参照してください。

-

AMD64、Intel 64 ビット (x86-64-v2)、IBM Z® (

s390x)、または ARM64 ベース (arm64またはaarch64) アーキテクチャーとそれぞれの CPU 拡張機能のサポートがある。 -

Intel VT-x、AMD-V、または ARM 仮想化拡張機能が有効になっているか、

s390x仮想化サポートが有効になっている。 - NX (実行なし) フラグが有効になっている。

-

s390xアーキテクチャーを使用する場合、default CPU model がgen15bに設定されている。

3.1.3.2. オペレーティングシステム要件

- ワーカーノードにインストールされた Red Hat Enterprise Linux CoreOS (RHCOS)。

3.1.3.3. ストレージ要件

- Red Hat OpenShift Service on AWS によってサポートされます。

-

ストレージプロビジョナーがスナップショットをサポートしている場合は、

VolumeSnapshotClassオブジェクトをデフォルトのストレージクラスに関連付ける必要があります。

3.1.3.3.1. 仮想マシンディスクのボリュームとアクセスモードについて

既知のストレージプロバイダーでストレージ API を使用する場合、ボリュームモードとアクセスモードは自動的に選択されます。ただし、ストレージプロファイルのないストレージクラスを使用する場合は、ボリュームとアクセスモードを設定する必要があります。

OpenShift Virtualization に対応している既知のストレージプロバイダーのリストは、Red Hat Ecosystem Catalog を参照してください。

最良の結果を得るには、ReadWriteMany (RWX) アクセスモードと Block ボリュームモードを使用してください。これは、以下の理由により重要です。

-

ライブマイグレーションには

ReadWriteMany(RWX) アクセスモードが必要です。 -

Blockボリュームモードは、Filesystemボリュームモードよりもパフォーマンスが大幅に優れています。これは、Filesystemボリュームモードでは、ファイルシステムレイヤーやディスクイメージファイルなどを含め、より多くのストレージレイヤーが使用されるためです。仮想マシンのディスクストレージに、これらのレイヤーは必要ありません。

次の設定の仮想マシンをライブマイグレーションすることはできません。

-

ReadWriteOnce(RWO) アクセスモードのストレージボリューム - GPU などのパススルー機能

これらの仮想マシンの evictionStrategy フィールドを None に設定します。None ストラテジーでは、ノードの再起動中に仮想マシンの電源がオフになります。

3.1.4. ライブマイグレーションの要件

-

ReadWriteMany(RWX) アクセスモードの共有ストレージ 十分な RAM およびネットワーク帯域幅

注記ノードの drain に伴うライブマイグレーションを実行できるように、クラスター内に十分なメモリーリクエスト容量があることを確認する必要があります。以下の計算を使用して、必要な予備のメモリーを把握できます。

Product of (Maximum number of nodes that can drain in parallel) and (Highest total VM memory request allocations across nodes)

Product of (Maximum number of nodes that can drain in parallel) and (Highest total VM memory request allocations across nodes)Copy to Clipboard Copied! Toggle word wrap Toggle overflow クラスターで 並行して実行できるデフォルトの移行数 は 5 です。

- 仮想マシンがホストモデルの CPU を使用する場合、ノードは仮想マシンのホストモデルの CPU をサポートする必要があります。

ライブマイグレーション 専用の Multus ネットワーク を強く推奨します。専用ネットワークは、移行中のテナントワークロードに対するネットワークの飽和状態の影響を最小限に抑えます。

3.1.5. 物理リソースのオーバーヘッド要件

OpenShift Virtualization は、Red Hat OpenShift Service on AWS へのアドオンであり、クラスターの計画時に考慮する必要があるオーバーヘッドが追加されます。

各クラスターマシンは、Red Hat OpenShift Service on AWS 要件に加えて、次のオーバーヘッド要件に対応する必要があります。クラスター内の物理リソースを過剰にサブスクライブすると、パフォーマンスに影響する可能性があります。

このドキュメントに記載されている数は、Red Hat のテスト方法およびセットアップに基づいています。これらの数は、独自のセットアップおよび環境に応じて異なります。

3.1.5.1. メモリーのオーバーヘッド

以下の式を使用して、OpenShift Virtualization のメモリーオーバーヘッドの値を計算します。

- クラスターメモリーのオーバーヘッド

Memory overhead per infrastructure node ≈ 150 MiB

Memory overhead per infrastructure node ≈ 150 MiBCopy to Clipboard Copied! Toggle word wrap Toggle overflow Memory overhead per worker node ≈ 360 MiB

Memory overhead per worker node ≈ 360 MiBCopy to Clipboard Copied! Toggle word wrap Toggle overflow さらに、OpenShift Virtualization 環境リソースには、すべてのインフラストラクチャーノードに分散される合計 2179 MiB の RAM が必要です。

- 仮想マシンのメモリーオーバーヘッド

Memory overhead per virtual machine ≈ (0.002 × requested memory) \ + 218 MiB \ + 8 MiB × (number of vCPUs) \ + 16 MiB × (number of graphics devices) \ + (additional memory overhead)Memory overhead per virtual machine ≈ (0.002 × requested memory) \ + 218 MiB \1 + 8 MiB × (number of vCPUs) \2 + 16 MiB × (number of graphics devices) \3 + (additional memory overhead)4 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

virt-launcherPod で実行されるプロセスに必要です。- 2

- 仮想マシンが要求する仮想 CPU の数。

- 3

- 仮想マシンが要求する仮想グラフィックスカードの数。

- 4

- 追加のメモリーオーバーヘッド:

- お使いの環境に Single Root I/O Virtualization (SR-IOV) ネットワークデバイスまたは Graphics Processing Unit (GPU) が含まれる場合、それぞれのデバイスに 1 GiB の追加のメモリーオーバーヘッドを割り当てます。

- Secure Encrypted Virtualization (SEV) が有効な場合は、256 MiB を追加します。

- Trusted Platform Module (TPM) が有効な場合は、53 MiB を追加します。

3.1.5.2. CPU オーバーヘッド

以下の式を使用して、OpenShift Virtualization のクラスタープロセッサーのオーバーヘッド要件を計算します。仮想マシンごとの CPU オーバーヘッドは、個々の設定によって異なります。

- クラスターの CPU オーバーヘッド

CPU overhead for infrastructure nodes ≈ 4 cores

CPU overhead for infrastructure nodes ≈ 4 coresCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Virtualization は、ロギング、ルーティング、およびモニタリングなどのクラスターレベルのサービスの全体的な使用率を増加させます。このワークロードに対応するには、インフラストラクチャーコンポーネントをホストするノードに、4 つの追加コア (4000 ミリコア) の容量があり、これがそれらのノード間に分散されていることを確認します。

CPU overhead for worker nodes ≈ 2 cores + CPU overhead per virtual machine

CPU overhead for worker nodes ≈ 2 cores + CPU overhead per virtual machineCopy to Clipboard Copied! Toggle word wrap Toggle overflow 仮想マシンをホストする各ワーカーノードには、仮想マシンのワークロードに必要な CPU に加えて、OpenShift Virtualization 管理ワークロード用に 2 つの追加コア (2000 ミリコア) の容量が必要です。

- 仮想マシンの CPU オーバーヘッド

- 専用の CPU が要求される場合は、仮想マシン 1 台につき CPU 1 つとなり、クラスターの CPU オーバーヘッド要件に影響が出てきます。それ以外の場合は、仮想マシンに必要な CPU の数に関する特別なルールはありません。

3.1.5.3. ストレージのオーバーヘッド

以下のガイドラインを使用して、OpenShift Virtualization 環境のストレージオーバーヘッド要件を見積もります。

- クラスターストレージオーバーヘッド

Aggregated storage overhead per node ≈ 10 GiB

Aggregated storage overhead per node ≈ 10 GiBCopy to Clipboard Copied! Toggle word wrap Toggle overflow 10 GiB は、OpenShift Virtualization のインストール時にクラスター内の各ノードに関するディスク上のストレージの予想される影響に相当します。

- 仮想マシンのストレージオーバーヘッド

- 仮想マシンごとのストレージオーバーヘッドは、仮想マシン内のリソース割り当ての特定の要求により異なります。この要求は、クラスター内の別の場所でホストされるノードまたはストレージリソースの一時ストレージに対するものである可能性があります。OpenShift Virtualization は現在、実行中のコンテナー自体に追加の一時ストレージを割り当てていません。

- 例

- クラスター管理者が、クラスター内の 10 台の (それぞれ 1 GiB の RAM と 2 つの仮想 CPU の) 仮想マシンをホストする予定の場合、クラスター全体で影響を受けるメモリーは 11.68 GiB になります。クラスターの各ノードについて予想されるディスク上のストレージの影響は 10 GiB で示され、仮想マシンのワークロードをホストするワーカーノードに関する CPU の影響は最小 2 コアで示されます。

3.2. OpenShift Virtualization のインストール

OpenShift Virtualization をインストールして、Red Hat OpenShift Service on AWS クラスターに仮想化機能を追加します。

3.2.1. OpenShift Virtualization Operator のインストール

Red Hat OpenShift Service on AWS Web コンソールまたはコマンドラインを使用して、OpenShift Virtualization Operator をインストールします。

3.2.1.1. Web コンソールを使用した OpenShift Virtualization Operator のインストール

Red Hat OpenShift Service on AWS Web コンソールを使用して OpenShift Virtualization Operator をデプロイできます。

前提条件

- Red Hat OpenShift Service on AWS 4 をクラスターにインストールする。

-

cluster-admin権限を持つユーザーとして、Red Hat OpenShift Service on AWS Web コンソールにログインする。 - ベアメタルコンピュートノードインスタンスタイプに基づいてマシンプールを作成する。詳細は、このセクションの関連情報の「マシンプールの作成」を参照してください。

手順

- Administrator パースペクティブから、Ecosystem → Software Catalog をクリックします。

- Filter by keyword に Virtualization と入力します。

- Red Hat ソースラベルが示されている OpenShift Virtualization Operator タイルを選択します。

- Operator の情報を確認してから、Install をクリックします。

Install Operator ページで以下を行います。

- 選択可能な Update Channel オプションの一覧から stable を選択します。これにより、Red Hat OpenShift Service on AWS のバージョンと互換性のある OpenShift Virtualization のバージョンが確実にインストールされます。

インストールされた namespace の場合、Operator recommended namespace オプションが選択されていることを確認します。これにより、Operator が必須の

openshift-cnvnamespace にインストールされます。この namespace は存在しない場合は、自動的に作成されます。警告OpenShift Virtualization Operator を

openshift-cnv以外の namespace にインストールしようとすると、インストールが失敗します。Approval Strategy の場合に、stable 更新チャネルで新しいバージョンが利用可能になったときに OpenShift Virtualization が自動更新されるように、デフォルト値である Automatic を選択することを強く推奨します。

Manual 承認ストラテジーを選択することは、クラスターのサポートと機能に大きなリスクをもたらすため、推奨しません。これらのリスクを完全に理解していて、Automatic を使用できない場合のみ、Manual を選択してください。

警告OpenShift Virtualization は、対応する Red Hat OpenShift Service on AWS バージョンで使用される場合にのみサポートされるため、OpenShift Virtualization の更新が欠落していると、クラスターがサポートされなくなる可能性があります。

-

Install をクリックし、Operator を

openshift-cnvnamespace で利用可能にします。 - Operator が正常にインストールされたら、Create HyperConverged をクリックします。

- オプション: OpenShift Virtualization コンポーネントの Infra および Workloads ノード配置オプションを設定します。

- Create をクリックして OpenShift Virtualization を起動します。

検証

- Workloads → Pods ページに移動して、OpenShift Virtualization Pod がすべて Running 状態になるまでこれらの Pod をモニターします。すべての Pod で Running 状態が表示された後に、OpenShift Virtualization を使用できます。

3.2.1.2. コマンドラインを使用した OpenShift Virtualization Operator のインストール

OpenShift Virtualization カタログをサブスクライブし、クラスターにマニフェストを適用して OpenShift Virtualization Operator をインストールします。

3.2.1.2.1. CLI を使用した OpenShift Virtualization カタログのサブスクライブ

OpenShift Virtualization をインストールする前に、OpenShift Virtualization カタログにサブスクライブする必要があります。サブスクライブにより、openshift-cnv namespace に OpenShift Virtualization Operator へのアクセスが付与されます。

単一マニフェストをクラスターに適用して Namespace、OperatorGroup、および Subscription オブジェクトをサブスクライブし、設定します。

前提条件

- Red Hat OpenShift Service on AWS 4 をクラスターにインストールする。

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-admin権限を持つユーザーとしてログインしている。

手順

以下のマニフェストを含む YAML ファイルを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

stableチャネルを使用することで、Red Hat OpenShift Service on AWS のバージョンと互換性のある OpenShift Virtualization のバージョンが確実にインストールされます。

以下のコマンドを実行して、OpenShift Virtualization に必要な

Namespace、OperatorGroup、およびSubscriptionオブジェクトを作成します。oc apply -f <filename>.yaml

$ oc apply -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

OpenShift Virtualization のインストールに進む前に、サブスクリプションの作成が成功したことを確認する必要があります。

ClusterServiceVersion(CSV) オブジェクトが正常に作成されたことを確認します。次のコマンドを実行し、出力を確認します。oc get csv -n openshift-cnv

$ oc get csv -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow CSV が正常に作成された場合、次の出力例に示すように、出力には

NAME値がkubevirt-hyperconverged-operator-*、DISPLAY値がOpenShift Virtualization、PHASE値がSucceededを含むエントリーが表示されます。出力例

NAME DISPLAY VERSION REPLACES PHASE kubevirt-hyperconverged-operator.v4.20.1 OpenShift Virtualization 4.20.1 kubevirt-hyperconverged-operator.v4.19.0 Succeeded

NAME DISPLAY VERSION REPLACES PHASE kubevirt-hyperconverged-operator.v4.20.1 OpenShift Virtualization 4.20.1 kubevirt-hyperconverged-operator.v4.19.0 SucceededCopy to Clipboard Copied! Toggle word wrap Toggle overflow HyperConvergedカスタムリソース (CR) のバージョンが正しいことを確認します。次のコマンドを実行し、出力を確認します。oc get hco -n openshift-cnv kubevirt-hyperconverged -o json | jq .status.versions

$ oc get hco -n openshift-cnv kubevirt-hyperconverged -o json | jq .status.versionsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

{ "name": "operator", "version": "4.20.1" }{ "name": "operator", "version": "4.20.1" }Copy to Clipboard Copied! Toggle word wrap Toggle overflow HyperConvergedCR の条件を確認します。以下のコマンドを実行して出力を確認します。oc get hco kubevirt-hyperconverged -n openshift-cnv -o json | jq -r '.status.conditions[] | {type,status}'$ oc get hco kubevirt-hyperconverged -n openshift-cnv -o json | jq -r '.status.conditions[] | {type,status}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

YAML ファイルで、証明書のローテーションパラメーターを設定 できます。

3.2.1.2.2. CLI を使用した OpenShift Virtualization Operator のデプロイ

oc CLI を使用して OpenShift Virtualization Operator をデプロイすることができます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

openshift-cnvnamespace の OpenShift Virtualization カタログへのサブスクリプション。 -

cluster-admin権限を持つユーザーとしてログインしている。 - ベアメタルコンピュートノードインスタンスタイプに基づいてマシンプールを作成する。

手順

以下のマニフェストを含む YAML ファイルを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下のコマンドを実行して OpenShift Virtualization Operator をデプロイします。

oc apply -f <file_name>.yaml

$ oc apply -f <file_name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

検証

openshift-cnvnamespace の Cluster Service Version (CSV) のPHASEを監視して、OpenShift Virtualization が正常にデプロイされたことを確認します。以下のコマンドを実行します。watch oc get csv -n openshift-cnv

$ watch oc get csv -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の出力は、デプロイメントに成功したかどうかを表示します。

NAME DISPLAY VERSION REPLACES PHASE kubevirt-hyperconverged-operator.v4.20.1 OpenShift Virtualization 4.20.1 Succeeded

NAME DISPLAY VERSION REPLACES PHASE kubevirt-hyperconverged-operator.v4.20.1 OpenShift Virtualization 4.20.1 SucceededCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.2.2. 次のステップ

- ホストパスプロビジョナー は、OpenShift Virtualization 用に設計されたローカルストレージプロビジョナーです。仮想マシンのローカルストレージを設定する必要がある場合、まずホストパスプロビジョナーを有効にする必要があります。

3.3. OpenShift Virtualization のアンインストール

Web コンソールまたはコマンドラインインターフェイス (CLI) を使用して OpenShift Virtualization をアンインストールし、OpenShift Virtualization のワークロード、Operator、およびそのリソースを削除します。

3.3.1. Web コンソールを使用した OpenShift Virtualization のアンインストール

OpenShift Virtualization をアンインストールするには、Web コンソール を使用して次のタスクを実行します。

まず、すべての 仮想マシン と 仮想マシンインスタンス を削除する必要があります。

ワークロードがクラスターに残っている間は、OpenShift Virtualization をアンインストールできません。

3.3.1.1. HyperConverged カスタムリソースの削除

OpenShift Virtualization をアンインストールするには、最初に HyperConverged カスタムリソース (CR) を削除します。

前提条件

-

cluster-adminパーミッションを持つアカウントを使用して Red Hat OpenShift Service on AWS クラスターにアクセスできる。

手順

- Ecosystem → Installed Operators ページに移動します。

- OpenShift Virtualization Operator を選択します。

- OpenShift Virtualization Deployment タブをクリックします。

-

kubevirt-hyperconvergedの横にある Options メニュー をクリックし、Delete HyperConverged を選択します。

をクリックし、Delete HyperConverged を選択します。

- 確認ウィンドウで Delete をクリックします。

3.3.1.2. Web コンソールの使用によるクラスターからの Operator の削除

クラスター管理者は Web コンソールを使用して、選択した namespace からインストールされた Operators を削除できます。

前提条件

-

dedicated-admin権限を持つアカウントを使用して、Red Hat OpenShift Service on AWS クラスターにアクセスできる。

手順

- Ecosystem → Installed Operators ページに移動します。

- スクロールするか、キーワードを Filter by name フィールドに入力して、削除する Operator を見つけます。次に、それをクリックします。

Operator Details ページの右側で、Actions 一覧から Uninstall Operator を選択します。

Uninstall Operator? ダイアログボックスが表示されます。

Uninstall を選択し、Operator、Operator デプロイメント、および Pod を削除します。このアクションの後には、Operator は実行を停止し、更新を受信しなくなります。

注記このアクションは、カスタムリソース定義 (CRD) およびカスタムリソース (CR) など、Operator が管理するリソースは削除されません。Web コンソールおよび継続して実行されるクラスター外のリソースによって有効にされるダッシュボードおよびナビゲーションアイテムには、手動でのクリーンアップが必要になる場合があります。Operator のアンインストール後にこれらを削除するには、Operator CRD を手動で削除する必要があります。

3.3.1.3. Web コンソールを使用した namespace の削除

Red Hat OpenShift Service on AWS Web コンソールを使用して namespace を削除できます。

前提条件

-

cluster-admin権限を持つアカウントを使用して、Red Hat OpenShift Service on AWS クラスターにアクセスできる。

手順

- Administration → Namespaces に移動します。

- namespace の一覧で削除する必要のある namespace を見つけます。

-

namespace の一覧の右端で、Options メニュー

から Delete Namespace を選択します。

から Delete Namespace を選択します。

- Delete Namespace ペインが表示されたら、フィールドから削除する namespace の名前を入力します。

- Delete をクリックします。

3.3.1.4. OpenShift Virtualization カスタムリソース定義の削除

Web コンソールを使用して、OpenShift Virtualization カスタムリソース定義 (CRD) を削除できます。

前提条件

-

cluster-admin権限を持つアカウントを使用して、Red Hat OpenShift Service on AWS クラスターにアクセスできる。

手順

- Administration → CustomResourceDefinitions に移動します。

-

Label フィルターを選択し、Search フィールドに

operators.coreos.com/kubevirt-hyperconverged.openshift-cnvと入力して OpenShift Virtualization CRD を表示します。 -

各 CRD の横にある Options メニュー

をクリックし、Delete CustomResourceDefinition の削除を選択します。

をクリックし、Delete CustomResourceDefinition の削除を選択します。

3.3.2. CLI を使用した OpenShift Virtualization のアンインストール

OpenShift CLI (oc) を使用して OpenShift Virtualization をアンインストールできます。

前提条件

-

cluster-admin権限を持つアカウントを使用して、Red Hat OpenShift Service on AWS クラスターにアクセスできる。 -

OpenShift CLI (

oc) がインストールされている。 - すべての仮想マシンと仮想マシンインスタンスを削除した。ワークロードがクラスターに残っている間は、OpenShift Virtualization をアンインストールできません。

手順

HyperConvergedカスタムリソースを削除します。oc delete HyperConverged kubevirt-hyperconverged -n openshift-cnv

$ oc delete HyperConverged kubevirt-hyperconverged -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Virtualization Operator サブスクリプションを削除します。

oc delete subscription hco-operatorhub -n openshift-cnv

$ oc delete subscription hco-operatorhub -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Virtualization

ClusterServiceVersionリソースを削除します。oc delete csv -n openshift-cnv -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnv

$ oc delete csv -n openshift-cnv -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow OpenShift Virtualization namespace を削除します。

oc delete namespace openshift-cnv

$ oc delete namespace openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow dry-runオプションを指定してoc delete crdコマンドを実行し、OpenShift Virtualization カスタムリソース定義 (CRD) を一覧表示します。oc delete crd --dry-run=client -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnv

$ oc delete crd --dry-run=client -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow dry-runオプションを指定せずにoc delete crdコマンドを実行して、CRD を削除します。oc delete crd -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnv

$ oc delete crd -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow

第4章 インストール後の設定

4.1. インストール後の設定

通常、以下の手順は OpenShift Virtualization をインストールした後に実行されます。環境に関連するコンポーネントを設定できます。

- OpenShift Virtualization Operator、ワークロード、およびコントローラーのノード配置ルール

- Red Hat OpenShift Service on AWS Web コンソールを使用したロードバランサーサービスの作成の有効化

- Container Storage Interface (CSI) のデフォルトのストレージクラスの定義

- ホストパスプロビジョナー (HPP) を使用したローカルストレージの設定

4.2. OpenShift Virtualization コンポーネントのノードの指定

ベアメタルノード上の仮想マシン (VM) のデフォルトスケジューリングは、そのままでも機能します。任意で、ノードの配置ルールを設定して、OpenShift Virtualization Operator、ワークロード、およびコントローラーをデプロイするノードを指定できます。

OpenShift Virtualization のインストール後に一部のコンポーネントに対してノード配置ルールを設定できますが、ワークロードに対してノード配置ルールを設定する場合は仮想マシンが存在できません。

4.2.1. OpenShift Virtualization コンポーネントのノード配置ルールについて

ノード配置ルールを使用すると、仮想化ワークロード用のノードにのみ仮想マシンをデプロイしたり、インフラストラクチャーノードにのみ Operator をデプロイしたり、ワークロード間の分離を維持したりすることができます。

オブジェクトに応じて、以下のルールタイプを 1 つ以上使用できます。

nodeSelector- このフィールドで指定したキーと値のペアでラベル付けされたノードで Pod をスケジュールできるようにします。ノードには、リスト表示されたすべてのペアに一致するラベルがなければなりません。

affinity- より表現的な構文を使用して、ノードと Pod に一致するルールを設定できます。アフィニティーを使用すると、ルールの適用方法に追加のニュアンスを持たせることができます。たとえば、ルールが要件ではなく設定であると指定できます。ルールが優先の場合、ルールが満たされていない場合でも Pod はスケジュールされます。

tolerations- 一致する taint を持つノードに Pod をスケジュールすることを許容します。ノードに taint が適用されると、そのノードはその taint を許容する Pod のみを受け入れます。

4.2.2. ノード配置ルールの適用

コマンドラインを使用して Subscription、HyperConverged、または HostPathProvisioner オブジェクトを編集することで、ノード配置ルールを適用できます。

前提条件

-

ocCLI ツールがインストールされている。 - クラスター管理者の権限でログインしています。

手順

次のコマンドを実行して、デフォルトのエディターでオブジェクトを編集します。

oc edit <resource_type> <resource_name> -n openshift-cnv

$ oc edit <resource_type> <resource_name> -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 変更を適用するためにファイルを保存します。

4.2.3. ノード配置ルールの例

Subscription、HyperConverged、または HostPathProvisioner オブジェクトを編集することで、OpenShift Virtualization コンポーネントのノード配置ルールを指定できます。

4.2.3.1. サブスクリプションオブジェクトノード配置ルールの例

OLM が OpenShift Virtualization Operator をデプロイするノードを指定するには、OpenShift Virtualization のインストール時に Subscription オブジェクトを編集します。

現時点では、Web コンソールを使用して Subscription オブジェクトのノードの配置ルールを設定することはできません。

Subscription オブジェクトは、affinity ノードの配置ルールをサポートしていません。

nodeSelector ルールを含む Subscription オブジェクトの例:

- 1

- OLM は、

example.io/example-infra-key = example-infra-valueというラベルのノードに OpenShift Virtualization Operator をデプロイします。

tolerations ルールを含む Subscription オブジェクトの例:

- 1

- OLM は、

key = virtualization:NoScheduletaint のラベルが付けられているノードに OpenShift Virtualization Operator をデプロイします。このノードには、一致する toleration を持つ Pod のみがスケジュールされます。

4.2.3.2. HyperConverged オブジェクトノード配置ルールの例

OpenShift Virtualization がそのコンポーネントをデプロイするノードを指定するには、OpenShift Virtualization のインストール時に作成する HyperConverged カスタムリソース (CR) ファイルに nodePlacement オブジェクトを編集できます。

nodeSelector ルールを含む HyperConverged オブジェクトの例:

affinity ルールを含む HyperConverged オブジェクトの例:

tolerations ルールを含む HyperConverged オブジェクトの例:

- 1

- OpenShift Virtualization コンポーネント用に予約されているノードには、

key = virtualization:NoScheduletaint のラベルが付けられています。予約済みノードには、一致する toleration を持つ Pod のみがスケジュールされます。

4.2.3.3. HostPathProvisioner オブジェクトノード配置ルールの例

HostPathProvisioner オブジェクトは、直接編集することも、Web コンソールを使用して編集することもできます。

ホストパスプロビジョナーと OpenShift Virtualization コンポーネントを同じノード上でスケジュールする必要があります。スケジュールしない場合は、ホストパスプロビジョナーを使用する仮想化 Pod を実行できません。仮想マシンを実行することはできません。

ホストパスプロビジョナー (HPP) ストレージクラスを使用して仮想マシン (VM) をデプロイした後、ノードセレクターを使用して同じノードからホストパスプロビジョナー Pod を削除できます。ただし、少なくともその特定のノードは、まずその変更を元に戻し、仮想マシンを削除しようとする前に Pod が実行されるのを待つ必要があります。

ノード配置ルールを設定するには、ホストパスプロビジョナーのインストール時に作成する HostPathProvisioner オブジェクトの spec.workload フィールドに nodeSelector、affinity、または tolerations を指定します。

nodeSelector ルールを含む HostPathProvisioner オブジェクトの例:

- 1

- ワークロードは、

example.io/example-workloads-key = example-workloads-valueというラベルの付いたノードに配置されます。

4.3. インストール後のネットワーク設定

デフォルトでは、OpenShift Virtualization はインストール後に単一の内部 Pod ネットワークを使用します。

4.3.1. ネットワーキングオペレーターのインストール

4.3.2. Linux ブリッジネットワークの設定

Kubernetes NMState Operator をインストールしたら、ライブマイグレーションまたは仮想マシン (VM) への外部アクセス用に Linux ブリッジネットワークを設定できます。

4.3.2.1. Linux ブリッジ NNCP の作成

Linux ブリッジネットワークの NodeNetworkConfigurationPolicy (NNCP) マニフェストを作成できます。

前提条件

- Kubernetes NMState Operator がインストールされている。

手順

NodeNetworkConfigurationPolicyマニフェストを作成します。この例には、独自の情報で置き換える必要のあるサンプルの値が含まれます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記IBM Z® で OSA を使用する Linux ブリッジ用の NNCP マニフェストを作成するには、

NodeNetworkConfigurationPolicyマニフェストでrx-vlan-filterをfalseに設定して VLAN フィルタリングを無効にする必要があります。または、ノードへの SSH アクセス権がある場合は、次のコマンドを実行して VLAN フィルタリングを無効にできます。

sudo ethtool -K <osa-interface-name> rx-vlan-filter off

$ sudo ethtool -K <osa-interface-name> rx-vlan-filter offCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3.2.2. Web コンソールを使用した Linux ブリッジ NAD の作成

Red Hat OpenShift Service on AWS Web コンソールを使用して、ネットワークアタッチメント定義 (NAD) を作成し、Pod と仮想マシンにレイヤー 2 ネットワークを提供できます。

仮想マシンのネットワークアタッチメント定義での IP アドレス管理 (IPAM) の設定はサポートされていません。

手順

- Web コンソールで、Networking → NetworkAttachmentDefinitions をクリックします。

Create Network Attachment Definition をクリックします。

注記network attachment definition は Pod または仮想マシンと同じ namespace にある必要があります。

- 一意の Name およびオプションの Description を入力します。

- Network Type リストから CNV Linux bridge を選択します。

- Bridge Name フィールドにブリッジの名前を入力します。

オプション: リソースに VLAN ID が設定されている場合、VLAN Tag Number フィールドに ID 番号を入力します。

注記IBM Z® 上の OSA インターフェイスは VLAN フィルタリングをサポートしていないため、VLAN タグ付きのトラフィックは破棄されます。OSA インターフェイスでは VLAN タグを使用する NAD を使用しないでください。

- オプション: MAC Spoof Check を選択して、MAC スプーフフィルタリングを有効にします。この機能により、Pod を終了するための MAC アドレスを 1 つだけ許可することで、MAC スプーフィング攻撃に対してセキュリティーを確保します。

- Create をクリックします。

4.3.3. ライブマイグレーション用のネットワークの設定

Linux ブリッジネットワークを設定した後、ライブマイグレーション用の専用ネットワークを設定できます。専用ネットワークは、ライブマイグレーション中のテナントワークロードに対するネットワークの飽和状態の影響を最小限に抑えます。

4.3.3.1. ライブマイグレーション用の専用セカンダリーネットワークの設定

ライブマイグレーション用に専用のセカンダリーネットワークを設定するには、まず CLI を使用してブリッジ network attachment definition (NAD) を作成する必要があります。次に、NetworkAttachmentDefinition オブジェクトの名前を HyperConverged カスタムリソース(CR)に追加できます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-adminロールを持つユーザーとしてクラスターにログインしている。 - 各ノードには少なくとも 2 つのネットワークインターフェイスカード (NIC) があります。

- ライブマイグレーション用の NIC は同じ VLAN に接続されます。

手順

次の例に従って、

NetworkAttachmentDefinitionマニフェストを作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは、以下のようになります。

metadata.name-

NetworkAttachmentDefinitionオブジェクトの名前を指定します。 config.master- ライブマイグレーションに使用する NIC の名前を指定します。

config.type- NAD にネットワークを提供する CNI プラグインの名前を指定します。

config.range- セカンダリーネットワークの IP アドレス範囲を指定します。この範囲は、メインネットワークの IP アドレスと重複してはなりません。

以下のコマンドを実行して、デフォルトのエディターで

HyperConvergedCR を開きます。oc edit hyperconverged kubevirt-hyperconverged -n openshift-cnv

$ oc edit hyperconverged kubevirt-hyperconverged -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow NetworkAttachmentDefinitionオブジェクトの名前をHyperConvergedCR のspec.liveMigrationConfigスタンザに追加します。HyperConvergedマニフェストの例:Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは、以下のようになります。

network-

ライブマイグレーションに使用される Multus

NetworkAttachmentDefinitionオブジェクトの名前を指定します。

-

変更を保存し、エディターを終了します。

virt-handlerPod が再起動し、セカンダリーネットワークに接続されます。

検証

仮想マシンが実行されるノードがメンテナンスモードに切り替えられると、仮想マシンは自動的にクラスター内の別のノードに移行します。仮想マシンインスタンス (VMI) メタデータのターゲット IP アドレスを確認して、デフォルトの Pod ネットワークではなく、セカンダリーネットワーク上で移行が発生したことを確認できます。

oc get vmi <vmi_name> -o jsonpath='{.status.migrationState.targetNodeAddress}'$ oc get vmi <vmi_name> -o jsonpath='{.status.migrationState.targetNodeAddress}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.3.3.2. Web コンソールを使用して専用ネットワークを選択する

Red Hat OpenShift Service on AWS Web コンソールを使用して、ライブマイグレーション用の専用ネットワークを選択できます。

前提条件

- ライブマイグレーション用に Multus ネットワークが設定されている。

- ネットワークの network attachment definition を作成している。

手順

- Red Hat OpenShift Service on AWS Web コンソールで Virtualization > Overview に移動します。

- Settings タブをクリックし、Live migration をクリックします。

- Live migration network リストからネットワークを選択します。

4.3.4. Web コンソールを使用したロードバランサーサービスの作成の有効化

Red Hat OpenShift Service on AWS Web コンソールを使用して、仮想マシン (VM) のロードバランサーサービスの作成を有効にできます。

前提条件

- クラスターのロードバランサーが設定されました。

-

cluster-adminロールを持つユーザーとしてログインしている。 - ネットワークの network attachment definition を作成している。

手順

- Virtualization → Overview に移動します。

- Settings タブで、Cluster をクリックします。

- Expand General settings と SSH configuration を展開します。

- SSH over LoadBalancer service をオンに設定します。

4.3.5. cdi-uploadproxy サービスへの追加ルートの設定

クラスター管理者は、cdi-uploadproxy サービスへの追加ルートを設定し、ユーザーがクラスター外から仮想マシンイメージをアップロードできるようにすることができます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-adminロールを持つユーザーとしてクラスターにログインしている。

手順

次のコマンドを実行して、外部ホストへのルートを設定します。

oc create route reencrypt <route_name> -n openshift-cnv \ --insecure-policy=Redirect \ --hostname=<host_name_or_address> \ --service=cdi-uploadproxy$ oc create route reencrypt <route_name> -n openshift-cnv \ --insecure-policy=Redirect \ --hostname=<host_name_or_address> \ --service=cdi-uploadproxyCopy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは、以下のようになります。

- <route_name>

- このカスタム ルートに割り当てる名前を指定します。

- <host_name_or_address>

- イメージのアップロードアクセスを提供する外部ホストの完全修飾ドメイン名または IP アドレスを指定します。

以下のコマンドを実行してルートにアノテーションを付けます。これにより、証明書がローテーションされる際に、正しい Containerized Data Importer (CDI) CA 証明書が挿入されます。

oc annotate route <route_name> -n openshift-cnv \ operator.cdi.kubevirt.io/injectUploadProxyCert="true"$ oc annotate route <route_name> -n openshift-cnv \ operator.cdi.kubevirt.io/injectUploadProxyCert="true"Copy to Clipboard Copied! Toggle word wrap Toggle overflow ここでは、以下のようになります。

- <route_name>

- 作成したルートの名前。

4.4. インストール後のストレージ設定

次のストレージ設定タスクは必須です。

- ストレージプロバイダーが Containerized Data Importer (CDI) によって認識されない場合は、ストレージプロファイル を設定する必要があります。ストレージプロファイルは、関連付けられたストレージクラスに基づいて推奨されるストレージ設定を提供します。

オプション: ホストパスプロビジョナー (HPP) を使用して、ローカルストレージを設定できます。

CDI、データボリューム、自動ブートソース更新の設定など、その他のオプションは、ストレージ設定の概要 を参照してください。

4.4.1. HPP を使用したローカルストレージの設定

OpenShift Virtualization Operator のインストール時に、Hostpath Provisioner (HPP) Operator は自動的にインストールされます。HPP Operator は HPP プロビジョナーを作成します。

HPP は、OpenShift Virtualization 用に設計されたローカルストレージプロビジョナーです。HPP を使用するには、HPP カスタムリソース (CR) を作成する必要があります。

HPP ストレージプールは、オペレーティングシステムと同じパーティションにあってはなりません。そうしないと、ストレージプールがオペレーティングシステムパーティションをいっぱいにする可能性があります。オペレーティングシステムのパーティションがいっぱいになると、パフォーマンスに悪影響が生じたり、ノードが不安定になったり使用できなくなったりする可能性があります。

4.4.1.1. storagePools スタンザを使用した CSI ドライバーのストレージクラスの作成

ホストパスプロビジョナー (HPP) を使用するには、コンテナーストレージインターフェイス (CSI) ドライバーに関連するストレージクラスを作成する必要があります。

ストレージクラスの作成時に、ストレージクラスに属する永続ボリューム (PV) の動的プロビジョニングに影響するパラメーターを設定します。StorageClass オブジェクトの作成後には、このオブジェクトのパラメーターを更新できません。

仮想マシンは、ローカル PV に基づくデータボリュームを使用します。ローカル PV は特定のノードにバインドされます。ディスクイメージは仮想マシンで使用するために準備されますが、ローカルストレージ PV がすでに固定されたノードに仮想マシンをスケジュールすることができない可能性があります。

この問題を解決するには、Kubernetes Pod スケジューラーを使用して、永続ボリューム要求 (PVC) を正しいノードの PV にバインドします。volumeBindingMode パラメーターが WaitForFirstConsumer に設定された StorageClass 値を使用することにより、PV のバインディングおよびプロビジョニングは、Pod が PVC を使用して作成されるまで遅延します。

手順

storageclass_csi.yamlファイルを作成して、ストレージクラスを定義します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

reclaimPolicyには、DeleteおよびRetainの 2 つの値があります。値を指定しない場合、デフォルト値はDeleteです。- 2

volumeBindingModeパラメーターは、動的プロビジョニングとボリュームのバインディングが実行されるタイミングを決定します。WaitForFirstConsumerを指定して、永続ボリューム要求 (PVC) を使用する Pod が作成されるまで PV のバインディングおよびプロビジョニングを遅延させます。これにより、PV が Pod のスケジュール要件を満たすようになります。- 3

- HPP CR で定義されているストレージプールの名前を指定します。

- ファイルを保存して終了します。

次のコマンドを実行して、

StorageClassオブジェクトを作成します。oc create -f storageclass_csi.yaml

$ oc create -f storageclass_csi.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5. 証明書ローテーションの設定

証明書ローテーションパラメーターを設定して、既存の証明書を置き換えます。

4.5.1. 証明書ローテーションの設定

これは、Web コンソールでの OpenShift Virtualization のインストール時に、または HyperConverged カスタムリソース (CR) でインストール後に実行することができます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。

手順

以下のコマンドを実行して

HyperConvergedCR を開きます。oc edit hyperconverged kubevirt-hyperconverged -n openshift-cnv

$ oc edit hyperconverged kubevirt-hyperconverged -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例のように

spec.certConfigフィールドを編集します。システムのオーバーロードを避けるには、すべての値が 10 分以上であることを確認します。golangParseDuration形式 に準拠する文字列として、すべての値を表現します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

ca.renewBeforeの値はca.durationの値以下である必要があります。 -

server.durationの値はca.durationの値以下である必要があります。 -

server.renewBeforeの値はserver.durationの値以下である必要があります。

-

以下のコマンドを実行して、

HyperConvergedCR に更新を適用します。oc apply -f <filename>.yaml

$ oc apply -f <filename>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

oc apply -f kubevirt-hyperconverged.yaml

$ oc apply -f kubevirt-hyperconverged.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5.2. 証明書ローテーションパラメーターのトラブルシューティング

HyperConverged カスタムリソース(CR)で 1 つ以上の certConfig 値を削除すると、certConfig 値はデフォルト値に戻ります。

デフォルト値が以下のいずれかの条件と競合する場合は、代わりにエラーメッセージが表示されます。

-

ca.renewBeforeの値はca.durationの値以下である必要があります。 -

server.durationの値はca.durationの値以下である必要があります。 -

server.renewBeforeの値はserver.durationの値以下である必要があります。

たとえば、server.duration 値を削除すると、デフォルト値の 24h0m0s は ca.duration の値よりも大きく、指定された条件と競合します。

これにより、以下のエラーメッセージが表示されます。

error: hyperconvergeds.hco.kubevirt.io "kubevirt-hyperconverged" could not be patched: admission webhook "validate-hco.kubevirt.io" denied the request: spec.certConfig: ca.duration is smaller than server.duration

error: hyperconvergeds.hco.kubevirt.io "kubevirt-hyperconverged" could not be patched: admission webhook "validate-hco.kubevirt.io" denied the request: spec.certConfig: ca.duration is smaller than server.duration

エラーメッセージには、最初の競合のみが記載されます。続行する前に、すべての certConfig の値を確認します。

第5章 更新

5.1. OpenShift Virtualization の更新

OpenShift Virtualization を最新の状態に保ち、Red Hat OpenShift Service on AWS との互換性を維持する方法について説明します。

5.1.1. OpenShift Virtualization の更新について

OpenShift Virtualization をインストールするときに、更新チャネルと承認ストラテジーを選択します。更新チャネルによって、OpenShift Virtualization が更新されるバージョンが決まります。承認ストラテジー設定により、更新が自動的に行われるか、手動の承認が必要かどうかが決まります。

どちらの設定もサポート性に影響を与える可能性があります。

5.1.1.1. 推奨設定

サポート可能な環境を維持するには、次の設定を使用します。

- 更新チャネル: stable

- 承認ストラテジー: Automatic

これらの設定により、Operator の新しいバージョンが stable チャネルで利用可能になると、更新プロセスが自動的に開始されます。これにより、OpenShift Virtualization と Red Hat OpenShift Service on AWS のバージョンの互換性が確保され、OpenShift Virtualization のバージョンが実稼働環境に適したものになります。

OpenShift Virtualization の各マイナーバージョンは、対応する Red Hat OpenShift Service on AWS バージョンを実行している場合にのみサポートされます。たとえば、Red Hat OpenShift Service on AWS 4.20 で OpenShift Virtualization 4.20 を実行する必要があります。

5.1.1.2. 予想されること

- 更新の完了までにかかる時間は、ネットワーク接続によって異なります。ほとんどの自動更新は 15 分以内に完了します。

- OpenShift Virtualization を更新しても、ネットワーク接続が中断されることはありません。

- データボリュームとそれに関連付けられた永続ボリューム要求は、更新中に保持されます。

AWS Elastic Block Store (EBS) ストレージを使用する仮想マシンを実行している場合、ライブマイグレーションができないため、Red Hat OpenShift Service on AWS クラスター更新がブロックされる可能性があります。

回避策として、仮想マシンを再設定し、クラスターの更新時にそれらの電源を自動的にオフになるようにできます。evictionStrategy フィールドを None に、runStrategy フィールドを Always に設定します。

5.1.1.3. 更新の仕組み

- Operator Lifecycle Manager(OLM) は OpenShift Virtualization Operator のライフサイクルを管理します。Red Hat OpenShift Service on AWS のインストール中にデプロイされる Marketplace Operator により、クラスターで外部 Operators を使用できるようになります。

- OLM は、OpenShift Virtualization の z-stream およびマイナーバージョンの更新を提供します。Red Hat OpenShift Service on AWS を次のマイナーバージョンに更新すると、マイナーバージョンの更新が利用可能になります。最初に Red Hat OpenShift Service on AWS を更新しない限り、OpenShift Virtualization を次のマイナーバージョンに更新できません。

5.1.1.4. RHEL 9 の互換性

OpenShift Virtualization 4.20 は、Red Hat Enterprise Linux (RHEL) 9 をベースにしています。標準の OpenShift Virtualization 更新手順に従って、RHEL 8 をベースとするバージョンから OpenShift Virtualization 4.20 に更新できます。追加の手順は必要ありません。

以前のバージョンと同様に、実行中のワークロードを中断することなく更新を実行できます。OpenShift Virtualization 4.20 では、RHEL 8 ノードから RHEL 9 ノードへのライブマイグレーションがサポートされています。

5.1.1.4.1. RHEL 9 マシンタイプ

OpenShift Virtualization に含まれるすべての仮想マシンテンプレートは、デフォルトで RHEL 9 マシンタイプ machineType: pc-q35-rhel9.<y>.0 を使用するようになりました。この場合の <y> は RHEL 9 の最新のマイナーバージョンに対応する 1 桁の数字です。たとえば、RHEL 9.2 の場合は pc-q35-rhel9.2.0 の値が使用されます。

OpenShift Virtualization を更新しても、既存仮想マシンの machineType 値は変更されません。これらの仮想マシンは、引き続き更新前と同様に機能します。RHEL 9 での改良を反映するために、オプションで仮想マシンのマシンタイプを変更できます。

仮想マシンの machineType 値を変更する前に、仮想マシンをシャットダウンする必要があります。

5.1.2. 更新ステータスの監視

OpenShift Virtualization Operator の更新のステータスをモニターするには、クラスターサービスバージョン (CSV) PHASE を監視します。Web コンソールを使用するか、ここに提供されているコマンドを実行して CSV の状態をモニターすることもできます。

PHASE および状態の値は利用可能な情報に基づく近似値になります。

前提条件

-

cluster-adminロールを持つユーザーとしてクラスターにログインしている。 -

OpenShift CLI (

oc) がインストールされている。

手順

以下のコマンドを実行します。

oc get csv -n openshift-cnv

$ oc get csv -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力を確認し、

PHASEフィールドをチェックします。以下に例を示します。VERSION REPLACES PHASE 4.9.0 kubevirt-hyperconverged-operator.v4.8.2 Installing 4.9.0 kubevirt-hyperconverged-operator.v4.9.0 Replacing

VERSION REPLACES PHASE 4.9.0 kubevirt-hyperconverged-operator.v4.8.2 Installing 4.9.0 kubevirt-hyperconverged-operator.v4.9.0 ReplacingCopy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: 以下のコマンドを実行して、すべての OpenShift Virtualization コンポーネントの状態の集約されたステータスをモニターします。

oc get hyperconverged kubevirt-hyperconverged -n openshift-cnv \ -o=jsonpath='{range .status.conditions[*]}{.type}{"\t"}{.status}{"\t"}{.message}{"\n"}{end}'$ oc get hyperconverged kubevirt-hyperconverged -n openshift-cnv \ -o=jsonpath='{range .status.conditions[*]}{.type}{"\t"}{.status}{"\t"}{.message}{"\n"}{end}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow アップグレードが成功すると、以下の出力が得られます。

ReconcileComplete True Reconcile completed successfully Available True Reconcile completed successfully Progressing False Reconcile completed successfully Degraded False Reconcile completed successfully Upgradeable True Reconcile completed successfully

ReconcileComplete True Reconcile completed successfully Available True Reconcile completed successfully Progressing False Reconcile completed successfully Degraded False Reconcile completed successfully Upgradeable True Reconcile completed successfullyCopy to Clipboard Copied! Toggle word wrap Toggle overflow

5.1.3. 仮想マシンワークロードの更新

OpenShift Virtualization を更新すると、ライブマイグレーションをサポートしている場合には libvirt、virt-launcher、および qemu などの仮想マシンのワークロードが自動的に更新されます。

各仮想マシンには、仮想マシンインスタンス (VMI) を実行する virt-launcher Pod があります。virt-launcher Pod は、仮想マシン (VM) のプロセスを管理するために使用される libvirt のインスタンスを実行します。

HyperConverged カスタムリソース (CR) の spec.workloadUpdateStrategy スタンザを編集して、ワークロードの更新方法を設定できます。ワークロードの更新方法として、LiveMigrate と Evict の 2 つが利用可能です。

Evict メソッドは VMI Pod をシャットダウンするため、デフォルトでは LiveMigrate 更新ストラテジーのみが有効になっています。

LiveMigrate が有効な唯一の更新ストラテジーである場合:

- ライブマイグレーションをサポートする VMI は更新プロセス時に移行されます。VM ゲストは、更新されたコンポーネントが有効になっている新しい Pod に移動します。

ライブマイグレーションをサポートしない VMI は中断または更新されません。

-

VMI に

LiveMigrate退避ストラテジーがあるが、ライブマイグレーションをサポートしていない場合、VMI は更新されません。

-

VMI に

LiveMigrate と Evict の両方を有効にした場合:

-

ライブマイグレーションをサポートする VMI は、

LiveMigrate更新ストラテジーを使用します。 -

ライブマイグレーションをサポートしない VMI は、

Evict更新ストラテジーを使用します。VMI がrunStrategy: Alwaysに設定されたVirtualMachineオブジェクトによって制御される場合、新規の VMI は、更新されたコンポーネントを使用して新規 Pod に作成されます。

5.1.3.1. 移行の試行とタイムアウト

ワークロードを更新するときに、Pod が次の期間 Pending 状態の場合、ライブマイグレーションは失敗します。

- 5 分間

-

Pod が

Unschedulableであるために保留中の場合。 - 15 分

- 何らかの理由で Pod が保留状態のままになっている場合。

VMI が移行に失敗すると、virt-controller は VMI の移行を再試行します。すべての移行可能な VMI が新しい virt-launcher Pod で実行されるまで、このプロセスが繰り返されます。ただし、VMI が不適切に設定されている場合、これらの試行は無限に繰り返される可能性があります。

各試行は、移行オブジェクトに対応します。直近の 5 回の試行のみがバッファーに保持されます。これにより、デバッグ用の情報を保持しながら、移行オブジェクトがシステムに蓄積されるのを防ぎます。

5.1.3.2. ワークロードの更新方法の設定

HyperConverged カスタムリソース (CR) を編集することにより、ワークロードの更新方法を設定できます。

前提条件

ライブマイグレーションを更新方法として使用するには、まずクラスターでライブマイグレーションを有効にする必要があります。

注記VirtualMachineInstanceCR にevictionStrategy: LiveMigrateが含まれており、仮想マシンインスタンス (VMI) がライブマイグレーションをサポートしない場合には、VMI は更新されません。-

OpenShift CLI (

oc) がインストールされている。

手順

デフォルトエディターで

HyperConvergedCR を作成するには、以下のコマンドを実行します。oc edit hyperconverged kubevirt-hyperconverged -n openshift-cnv

$ oc edit hyperconverged kubevirt-hyperconverged -n openshift-cnvCopy to Clipboard Copied! Toggle word wrap Toggle overflow HyperConvergedCR のworkloadUpdateStrategyスタンザを編集します。以下に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ワークロードの自動更新を実行するのに使用できるメソッド。設定可能な値は

LiveMigrateおよびEvictです。上記の例のように両方のオプションを有効にした場合に、ライブマイグレーションをサポートする VMI にはLiveMigrateを、ライブマイグレーションをサポートしない VMI にはEvictを、更新に使用します。ワークロードの自動更新を無効にするには、workloadUpdateStrategyスタンザを削除するか、workloadUpdateMethods: []を設定して配列を空のままにします。 - 2

- 中断を最小限に抑えた更新メソッド。ライブマイグレーションをサポートする VMI は、仮想マシン (VM) ゲストを更新されたコンポーネントが有効なっている新規 Pod に移行することで更新されます。

LiveMigrateがリストされている唯一のワークロード更新メソッドである場合には、ライブマイグレーションをサポートしない VMI は中断または更新されません。 - 3

- アップグレード時に VMI Pod をシャットダウンする破壊的な方法。

Evictは、ライブマイグレーションがクラスターで有効でない場合に利用可能な唯一の更新方法です。VMI がrunStrategy: Alwaysに設定されたVirtualMachineオブジェクトによって制御される場合には、新規の VMI は、更新されたコンポーネントを使用して新規 Pod に作成されます。 - 4

Evictメソッドを使用して一度に強制的に更新できる VMI の数。これは、LiveMigrateメソッドには適用されません。- 5

- 次のワークロードバッチを退避するまで待機する間隔。これは、

LiveMigrateメソッドには適用されません。

注記HyperConvergedCR のspec.liveMigrationConfigスタンザを編集することにより、ライブマイグレーションの制限とタイムアウトを設定できます。- 変更を適用するには、エディターを保存し、終了します。

5.1.3.3. 古くなった仮想マシンワークロードの表示

CLI を使用して、古くなった仮想マシン (VM) ワークロードのリストを表示できます。

クラスターに以前の仮想化 Pod がある場合には、OutdatedVirtualMachineInstanceWorkloads アラートが実行されます。

前提条件

-

OpenShift CLI (

oc) がインストールされている。

手順

以前の仮想マシンインスタンス (VMI) の一覧を表示するには、以下のコマンドを実行します。

oc get vmi -l kubevirt.io/outdatedLauncherImage --all-namespaces

$ oc get vmi -l kubevirt.io/outdatedLauncherImage --all-namespacesCopy to Clipboard Copied! Toggle word wrap Toggle overflow

VMI が自動的に更新されるようにするには、ワークロードの更新を設定します。

5.1.4. 高度なオプション

ほとんどの OpenShift Virtualization インストールでは、stable リリースチャネルと Automatic 承認ストラテジーが推奨されます。リスクを理解している場合にのみ、他の設定を使用してください。

5.1.4.1. 更新設定の変更

Web コンソールを使用して、OpenShift Virtualization Operator サブスクリプションの更新チャネルと承認ストラテジーを変更できます。

前提条件

- OpenShift Virtualization Operator がインストールされている。

- 管理者権限がある。

手順

- Ecosystem → Installed Operators をクリックします。

- リストから OpenShift Virtualization を選択します。

- Subscription タブをクリックします。

- Subscription details セクションで、変更する設定をクリックします。たとえば、承認ストラテジーを Manual から Automatic に変更するには、Manual をクリックします。

- 開いたウィンドウで、新しい更新チャネルまたは承認ストラテジーを選択します。

- Save をクリックします。

5.1.4.2. 手動承認ストラテジー

Manual 承認ストラテジーを使用する場合は、すべての保留中の更新を手動で承認する必要があります。Red Hat OpenShift Service on AWS と OpenShift Virtualization の更新が同期していない場合、クラスターはサポートされなくなります。

クラスターのサポート性と機能性を危険にさらさないようにするには、Automatic 承認ストラテジーを使用します。Manual 承認ストラテジーを使用する必要がある場合は、保留中の Operator 更新が利用可能になり次第承認し、サポート可能なクラスターを維持します。

5.1.4.3. 保留中の Operator 更新の手動による承認

インストールされた Operator のサブスクリプションの承認ストラテジーが Manual に設定されている場合、新規の更新が現在の更新チャネルにリリースされると、インストールを開始する前に更新を手動で承認する必要があります。

前提条件

- Operator Lifecycle Manager (OLM) を使用して以前にインストールされている Operator。

手順

- Red Hat OpenShift Service on AWS Web コンソールで、Ecosystem → Installed Operators に移動します。

- 更新が保留中の Operators は Upgrade available のステータスを表示します。更新する Operator の名前をクリックします。

- Subscription タブをクリックします。承認が必要な更新は、Upgrade status の横に表示されます。たとえば、1 requires approval が表示される可能性があります。

- 1 requires approval をクリックしてから、Preview Install Plan をクリックします。

- 更新に利用可能なリソースとして一覧表示されているリソースを確認します。問題がなければ、Approve をクリックします。

- Ecosystem → Installed Operators ページに戻って、更新の進行状況を監視します。完了時に、ステータスは Succeeded および Up to date に変更されます。

5.1.5. 早期アクセスリリース

ご使用の OpenShift Virtualization バージョンの candidate 更新チャネルをサブスクライブすると、開発中のビルドにアクセスできます。

早期アクセスリリースは、Red Hat によって完全にテストされておらず、サポート対象でもありませんが、そのバージョン用に開発している機能やバグ修正をテストするために、非実稼働クラスターで使用することができます。

stable チャネルは実稼働システムに適しています。このチャネルは基盤となる Red Hat OpenShift Service on AWS のバージョンと一致し、完全にテストされています。Operator Hub で stable チャネルと candidate チャネルを切り替えることができます。ただし、candidate チャネルリリースから stable チャネルリリースへの更新は Red Hat によってテストされていません。

一部の candidate リリースは stable チャネルに昇格されます。ただし、candidate チャネルにのみ存在するリリースには、一般提供 (GA) されるすべての機能が含まれていない可能性があります。また、candidate ビルドの一部の機能は GA の前に削除される可能性があります。さらに、candidate リリースには、後の GA リリースへの更新パスがない場合があります。

candidate チャネルは、クラスターの破棄と再作成が許容されるテスト目的にのみ適しています。

第6章 仮想マシンの作成

6.1. インスタンスタイプからの仮想マシンの作成

Red Hat OpenShift Service on AWS Web コンソールまたは CLI を使用して仮想マシンを作成する場合でも、インスタンスタイプを使用することで仮想マシン (仮想マシン) の作成を簡素化できます。

Red Hat OpenShift Service on AWS クラスターでは、OpenShift Virtualization 4.15 のインスタンスタイプから仮想マシンを作成することがサポートされています。OpenShift Virtualization 4.14 では、インスタンスタイプからの仮想マシンの作成はテクノロジープレビュー機能であり、Red Hat OpenShift Service on AWS クラスターでの使用はサポートされていません。

6.1.1. インスタンスタイプについて

インスタンスタイプは、新しい仮想マシンに適用するリソースと特性を定義できる再利用可能なオブジェクトです。カスタムインスタンスタイプを定義したり、OpenShift Virtualization のインストール時に含まれるさまざまなインスタンスタイプを使用したりできます。

新しいインスタンスタイプを作成するには、まず手動で、または virtctl CLI ツールを使用してマニフェストを作成する必要があります。次に、マニフェストをクラスターに適用してインスタンスタイプオブジェクトを作成します。

OpenShift Virtualization は、インスタンスタイプを設定するための 2 つの CRD を提供します。

-

namespace 付きのオブジェクト:

VirtualMachineInstancetype -

クラスター全体のオブジェクト:

VirtualMachineClusterInstancetype

これらのオブジェクトは同じ VirtualMachineInstancetypeSpec を使用します。

6.1.1.1. 必須の属性

インスタンスタイプを設定するときは、cpu および memory 属性を定義する必要があります。その他の属性はオプションです。

インスタンスタイプから仮想マシンを作成する場合は、インスタンスタイプで定義されているパラメーターをオーバーライドすることはできません。

インスタンスタイプには定義された CPU およびメモリー属性が必要であるため、OpenShift Virtualization は、インスタンスタイプから仮想マシンを作成するときに、これらのリソースに対する追加の要求を常に拒否します。

インスタンスタイプマニフェストを手動で作成できます。以下に例を示します。

virtctl CLI ユーティリティーを使用してインスタンスタイプマニフェストを作成できます。以下に例を示します。

virtctl create instancetype --cpu 2 --memory 256Mi

$ virtctl create instancetype --cpu 2 --memory 256Miここでは、以下のようになります。

--cpu <value>- ゲストに割り当てる仮想 CPU の数を指定します。必須。

--memory <value>- ゲストに割り当てるメモリーの量を指定します。必須。

次のコマンドを実行すると、新しいマニフェストからオブジェクトをすぐに作成できます。

virtctl create instancetype --cpu 2 --memory 256Mi | oc apply -f -

$ virtctl create instancetype --cpu 2 --memory 256Mi | oc apply -f -6.1.1.2. オプション属性

必須の cpu および memory 属性に加えて、VirtualMachineInstancetypeSpec に次のオプション属性を含めることができます。

annotations- 仮想マシンに適用するアノテーションをリスト表示します。

gpus- パススルー用の仮想 GPU をリスト表示します。

hostDevices- パススルー用のホストデバイスをリスト表示します。

ioThreadsPolicy- 専用ディスクアクセスを管理するための IO スレッドポリシーを定義します。

launchSecurity- セキュア暗号化仮想化 (SEV) を設定します。

nodeSelector- この仮想マシンがスケジュールされているノードを制御するためのノードセレクターを指定します。

schedulerName- デフォルトのスケジューラーの代わりに、この仮想マシンに使用するカスタムスケジューラーを定義します。

6.1.1.3. コントローラーリビジョン

インスタンスタイプを使用して仮想マシンを作成すると、ControllerRevision オブジェクトにインスタンスタイプオブジェクトのイミュータブルなスナップショットが保持されます。このスナップショットにより、必要なゲスト CPU やメモリーなど、インスタンスタイプオブジェクトで定義されているリソース関連の特性が固定されます。また、仮想マシンのステータスに、ControllerRevision オブジェクトへの参照が含まれます。

このスナップショットはバージョン管理に不可欠です。このスナップショットにより、仮想マシンの実行中にその元になったインスタンスタイプオブジェクトが更新されても、仮想マシンの起動時に作成される仮想マシンインスタンスが変更されないことが保証されます。

6.1.2. 定義済みのインスタンスタイプ

OpenShift Virtualization には、common-instancetypes と呼ばれる事前定義されたインスタンスタイプのセットが含まれています。特定のワークロードに特化したものもあれば、ワークロードに依存しないものもあります。

これらのインスタンスタイプリソースは、シリーズ、バージョン、サイズに応じて名前が付けられます。サイズの値は . 区切り文字に続き、範囲は nano から 8xlarge です。

| ユースケース | シリーズ | 特徴 | 仮想 CPU とメモリーの比率 | リソースの例 |

|---|---|---|---|---|

| ネットワーク | N |

| 1:2 |

|

| 過剰コミットメント | O |

| 1:4 |

|

| コンピュート専用 | CX |

| 1:2 |

|

| 一般的用途 | U |

| 1:4 |

|

| メモリー集約型 | M |

| 1:8 |

|

6.1.3. インスタンスタイプまたは設定の指定

インスタンスタイプまたは優先度、またはその両方を指定して、複数の仮想マシンで再利用するためのワークロードサイジングとランタイム特性を定義できます。

6.1.3.1. フラグを使用したインスタンスタイプと設定の指定

フラグを使用してインスタンスタイプと設定を指定できます。

前提条件

- クラスターにインスタンスタイプ、プリファレンス、またはその両方がある。

手順

仮想マシンを作成するときにインスタンスタイプを指定するには、

--instancetypeフラグを使用します。設定を指定するには、--preferenceフラグを使用します。次の例には両方のフラグが含まれています。virtctl create vm --instancetype <my_instancetype> --preference <my_preference>

$ virtctl create vm --instancetype <my_instancetype> --preference <my_preference>Copy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: namespace 付きのインスタンスタイプまたは設定を指定するには、

--instancetypeまたは--preferenceフラグコマンドに渡される値にkindを含めます。namespace 付きのインスタンスタイプまたは設定は、仮想マシンを作成するのと同じ namespace に存在する必要があります。次の例には、namespace 付きインスタンスタイプと namespace 付き設定のフラグが含まれています。virtctl create vm --instancetype virtualmachineinstancetype/<my_instancetype> --preference virtualmachinepreference/<my_preference>

$ virtctl create vm --instancetype virtualmachineinstancetype/<my_instancetype> --preference virtualmachinepreference/<my_preference>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.1.3.2. インスタンスタイプまたは設定の推測

インスタンスタイプの推論、設定、またはその両方がデフォルトで有効になっており、inferFromVolume 属性の inferFromVolumeFailure ポリシーは Ignore に設定されています。ブートボリュームから推測する場合、エラーは無視され、インスタンスタイプと設定が未設定のままで仮想マシンが作成されます。

ただし、フラグが適用されると、inferFromVolumeFailure ポリシーはデフォルトで Reject に設定されます。ブートボリュームから推測する場合、エラーが発生すると、その仮想マシンの作成が拒否されます。

--infer-instancetype フラグと --infer-preference フラグを使用すると、仮想マシンのワークロードのサイズ設定と実行時特性を定義するために使用するインスタンスタイプ、設定、またはその両方を推測できます。

前提条件

-

virtctlツールがインストールされている。

手順

仮想マシンの起動に使用されるボリュームから明示的にインスタンスタイプを推測するには、

--infer-instancetypeフラグを使用します。設定を明示的に推測するには、--infer-preferenceフラグを使用します。次のコマンドには両方のフラグが含まれます。virtctl create vm --volume-import type:pvc,src:my-ns/my-pvc --infer-instancetype --infer-preference

$ virtctl create vm --volume-import type:pvc,src:my-ns/my-pvc --infer-instancetype --infer-preferenceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 仮想マシンのブートに使用されるボリューム以外のボリュームからインスタンスタイプまたは設定を推測するには、

--infer-instancetype-fromおよび--infer-preference-fromフラグを使用して、仮想マシンのボリュームのいずれかを指定します。以下の例では、仮想マシンはvolume-aから起動しますが、volume-bからインスタンスタイプと設定を推測しています。virtctl create vm \ --volume-import=type:pvc,src:my-ns/my-pvc-a,name:volume-a \ --volume-import=type:pvc,src:my-ns/my-pvc-b,name:volume-b \ --infer-instancetype-from volume-b \ --infer-preference-from volume-b

$ virtctl create vm \ --volume-import=type:pvc,src:my-ns/my-pvc-a,name:volume-a \ --volume-import=type:pvc,src:my-ns/my-pvc-b,name:volume-b \ --infer-instancetype-from volume-b \ --infer-preference-from volume-bCopy to Clipboard Copied! Toggle word wrap Toggle overflow

6.1.3.3. inferFromVolume ラベルの設定

PVC、データソース、またはデータボリュームで次のラベルを使用して、ボリュームから起動するときに使用するインスタンスタイプ、設定、またはその両方を推論メカニズムに指示します。

-

クラスター全体のインスタンスのタイプ:

instancetype.kubevirt.io/default-instancetypeラベル。 -

namespace 付きのインスタンスタイプ:

instancetype.kubevirt.io/default-instancetype-kindラベル。空のままにすると、デフォルトでVirtualMachineClusterInstancetypeラベルになります。 -

クラスター全体の設定:

instancetype.kubevirt.io/default-preferenceラベル。 -

namespace 付きの設定:

instancetype.kubevirt.io/default-preference-kindラベル。空のままにすると、デフォルトでVirtualMachineClusterPreferenceラベルになります。

前提条件

- クラスターにインスタンスタイプ、プリファレンス、またはその両方がある。

-

OpenShift CLI (

oc) がインストールされている。

手順

データソースにラベルを適用するには、

oc labelを使用します。次のコマンドは、クラスター全体のインスタンスタイプを指すラベルを適用します。oc label DataSource foo instancetype.kubevirt.io/default-instancetype=<my_instancetype>

$ oc label DataSource foo instancetype.kubevirt.io/default-instancetype=<my_instancetype>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.1.4. Web コンソールを使用したインスタンスタイプからの仮想マシンの作成

Red Hat OpenShift Service on AWS Web コンソールを使用して、インスタンスタイプから仮想マシン (VM) を作成できます。Web コンソールを使用して、既存のスナップショットをコピーするか仮想マシンを複製して、仮想マシンを作成することもできます。

使用可能な起動可能なボリュームのリストから仮想マシンを作成できます。Linux ベースまたは Windows ベースのボリュームをリストに追加できます。

手順

Web コンソールで、Virtualization → Catalog に移動します。

InstanceTypes タブがデフォルトで開きます。

注記仮想マシン設定を使用する IBM Z® システムで downward-metrics デバイスを設定する場合は、

spec.preference.name値をrhel.9.s390xに設定するか、*.s390xという形式の使用可能な別の設定を指定する必要があります。- 異種クラスターのみ: 提供されているオプションを使用して起動可能なボリュームをフィルタリングするには、Architecture をクリックします。

次のオプションのいずれかを選択します。

リストから適切な起動可能なボリュームを選択します。リストが切り捨てられている場合は、Show all ボタンをクリックしてリスト全体を表示します。

注記ブート可能ボリュームテーブルには、

openshift-virtualization-os-imagesnamespace 内のinstancetype.kubevirt.io/default-preferenceラベルを持つボリュームのみリストされます。- オプション: 星アイコンをクリックして、ブート可能ボリュームをお気に入りとして指定します。星付きのブート可能ボリュームは、ボリュームリストの最初に表示されます。

新しいボリュームをアップロードするか、既存の永続ボリューム要求 (PVC)、ボリュームスナップショット、または

containerDiskボリュームを使用するには Add volume をクリックします。Save をクリックします。クラスターで使用できないオペレーティングシステムのロゴは、リストの下部に表示されます。Add volume リンクをクリックすると、必要なオペレーティングシステムのボリュームを追加できます。

さらに、Windows の起動可能なボリュームを作成する クイックスタートへのリンクもあります。Select volume to boot from の横にある疑問符アイコンの上にポインターを置くと、ポップオーバーに同じリンクが表示されます。

環境をインストールした直後、または環境が切断された直後は、起動元のボリュームのリストは空になります。その場合、Windows、RHEL、Linux の 3 つのオペレーティングシステムのロゴが表示されます。Add volume ボタンをクリックすると、要件を満たす新しいボリュームを追加できます。

- インスタンスタイプのタイルをクリックし、ワークロードに適したリソースサイズを選択します。Red Hat が提供する M および CX シリーズのインスタンスタイプでは、huge page を選択できます。huge page オプションは、1gi で終わる名前で識別されます。

オプション: 起動元のボリュームに適用される仮想マシンの詳細 (仮想マシンの名前を含む) を選択します。

Linux ベースのボリュームの場合は、次の手順に従って SSH を設定します。

- プロジェクトに SSH 公開鍵をまだ追加していない場合は、VirtualMachine details セクションの Authorized SSH key の横にある編集アイコンをクリックします。

以下のオプションのいずれかを選択します。

- Use existing: シークレットリストからシークレットを選択します。

Add new: 以下の手順に従ってください。

- SSH 公開鍵ファイルを参照するか、ファイルを鍵のフィールドに貼り付けます。

- シークレット名を入力します。

- オプション: Automatically apply this key to any new VirtualMachine you create in this project を選択します。

- Save をクリックします。

Windows ボリュームの場合は、次のいずれかの手順に従って sysprep オプションを設定します。

Windows ボリュームに sysprep オプションをまだ追加していない場合は、次の手順に従います。

- VirtualMachine details セクションの Sysprep の横にある編集アイコンをクリックします。

- Autoattend.xml アンサーファイルを追加します。

- Unattend.xml アンサーファイルを追加します。

- Save をクリックします。

Windows ボリュームに既存の sysprep オプションを使用する場合は、次の手順に従います。

- 既存の sysprep を添付 をクリックします。

- 既存の sysprep Unattend.xml アンサーファイルの名前を入力します。

- Save をクリックします。

オプション: Windows 仮想マシンを作成する場合は、Windows ドライバーディスクをマウントできます。

- Customize VirtualMachine ボタンをクリックします。

- VirtualMachine details ページで、Storage をクリックします。

- Mount Windows drivers disk チェックボックスを選択します。