4.3. 测试模型 API

现在,您已部署了模型,您可以测试其 API 端点。

流程

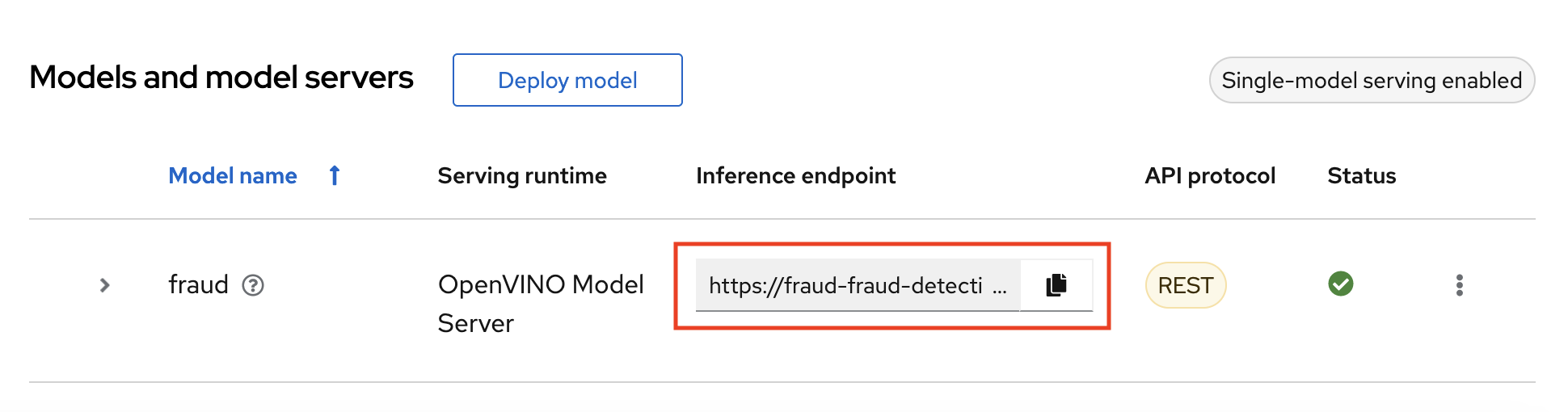

- 在 OpenShift AI 仪表板中,导航到项目详情页面,再点 Models 选项卡。

记录模型的 Inference 端点。测试模型 API 时需要此信息。

返回到 Jupyter 环境,再尝试您的新端点。

如果您使用多型号服务部署模型,请按照

3_rest_requests_multi_model.ipynb中的指示尝试 REST API 调用和4_grpc_requests_multi_model.ipynb尝试 gRPC API 调用。如果您使用单模式服务部署模型,请按照

5_rest_requests_single_model.ipynb中的指示操作来尝试 REST API 调用。

后续步骤