19.3. カスタマイズによる OpenStack へのクラスターのインストール

OpenShift Container Platform バージョン 4.16 では、Red Hat OpenStack Platform (RHOSP) にカスタマイズしたクラスターをインストールできます。インストールをカスタマイズするには、クラスターをインストールする前に install-config.yaml でパラメーターを変更します。

19.3.1. 前提条件

- OpenShift Container Platform のインストールおよび更新 プロセスの詳細を確認した。

- クラスターインストール方法の選択およびそのユーザー向けの準備 を確認した。

- OpenShift クラスターでサポートされるプラットフォーム セクションを使用して、OpenShift Container Platform 4.16 が RHOSP バージョンと互換性があることを確認した。RHOSP サポートマトリックスの OpenShift Container Platform を参照して、プラットフォームのサポートを異なるバージョン間で比較することもできます。

- ブロックストレージ (Cinder) またはオブジェクトストレージ (Swift) などのストレージサービスが RHOSP にインストールされている。オブジェクトストレージは、OpenShift Container Platform レジストリークラスターデプロイメントに推奨されるストレージ技術です。詳細は、ストレージの最適化 を参照してください。

- クラスターのスケーリング、コントロールプレーンのサイジング、および etcd のパフォーマンスおよびスケーラビリティーに関する理解がある。詳細は、クラスターのスケーリングに関する推奨プラクティス を参照してください。

- RHOSP でメタデータサービスが有効化されている。

19.3.2. OpenShift Container Platform を RHOSP にインストールするリソースのガイドライン

OpenShift Container Platform のインストールをサポートするために、Red Hat OpenStack Platform (RHOSP) クォータは以下の要件を満たす必要があります。

| リソース | 値 |

|---|---|

| Floating IP アドレス | 3 |

| ポート | 15 |

| ルーター | 1 |

| サブネット | 1 |

| RAM | 88 GB |

| vCPU | 22 |

| ボリュームストレージ | 275 GB |

| インスタンス | 7 |

| セキュリティーグループ | 3 |

| セキュリティーグループルール | 60 |

| サーバーグループ | 2 - 各マシンプールの追加のアベイラビリティーゾーンごとに 1 つ追加 |

クラスターは推奨されるリソースよりもリソースが少ない場合にも機能する場合がありますが、その場合のパフォーマンスは保証されません。

RHOSP オブジェクトストレージ (Swift) が利用可能で、swiftoperator ロールを持つユーザーアカウントによって操作されている場合、これは OpenShift Container Platform イメージレジストリーのデフォルトバックエンドとして使用されます。この場合、ボリュームストレージ要件は 175 GB です。Swift 領域要件は、イメージレジストリーのサイズによって異なります。

デフォルトで、セキュリティーグループおよびセキュリティーグループルールのクォータは低く設定される可能性があります。問題が生じた場合には、管理者として openstack quota set --secgroups 3 --secgroup-rules 60 <project> を実行して値を増やします。

OpenShift Container Platform デプロイメントは、コントロールプレーンマシン、コンピュートマシン、およびブートストラップマシンで構成されます。

19.3.2.1. コントロールプレーンマシン

デフォルトでは、OpenShift Container Platform インストールプロセスは 3 つのコントロールプレーンマシンを作成します。

それぞれのマシンには以下が必要です。

- RHOSP クォータからのインスタンス

- RHOSP クォータからのポート

- 少なくとも 16 GB のメモリーと 4 つの vCPU を備えたフレーバー

- RHOSP クォータから少なくとも 100 GB のストレージ容量

19.3.2.2. コンピュートマシン

デフォルトでは、OpenShift Container Platform インストールプロセスは 3 つのコンピューティングマシンを作成します。

それぞれのマシンには以下が必要です。

- RHOSP クォータからのインスタンス

- RHOSP クォータからのポート

- 少なくとも 8 GB のメモリーと 2 つの vCPU を備えたフレーバー

- RHOSP クォータから少なくとも 100 GB のストレージ容量

コンピュートマシンは、OpenShift Container Platform で実行されるアプリケーションをホストします。できるだけ多くのアプリケーションを実行することが意図されています。

19.3.2.3. ブートストラップマシン

インストール時に、ブートストラップマシンは一時的にプロビジョニングされ、コントロールプレーンを初期化します。実稼働環境用のコントロールプレーンの準備ができた後に、ブートストラップマシンのプロビジョニングは解除されます。

ブートストラップマシンには以下が必要です。

- RHOSP クォータからのインスタンス

- RHOSP クォータからのポート

- 少なくとも 16 GB のメモリーと 4 つの vCPU を備えたフレーバー

- RHOSP クォータから少なくとも 100 GB のストレージ容量

19.3.2.4. user-provisioned infrastructure の負荷分散要件

OpenShift Container Platform をインストールする前に、デフォルトの内部ロードバランシングソリューションの代わりに使用する独自の API およびアプリケーション Ingress ロードバランシングインフラストラクチャーをプロビジョニングできます。実稼働のシナリオでは、API およびアプリケーション Ingress ロードバランサーを個別にデプロイし、それぞれのロードバランサーインフラストラクチャーを分離してスケーリングすることができます。

Red Hat Enterprise Linux (RHEL) インスタンスを使用して API およびアプリケーションイングレスロードバランサーをデプロイする場合は、RHEL サブスクリプションを別途購入する必要があります。

負荷分散インフラストラクチャーは以下の要件を満たす必要があります。

API ロードバランサー: プラットフォームと対話およびプラットフォームを設定するためのユーザー向けの共通のエンドポイントを提供します。以下の条件を設定します。

- Layer 4 の負荷分散のみ。これは、Raw TCP または SSL パススルーモードと呼ばれます。

- ステートレス負荷分散アルゴリズム。オプションは、ロードバランサーの実装によって異なります。

重要API ロードバランサーのセッションの永続性は設定しないでください。Kubernetes API サーバーのセッション永続性を設定すると、OpenShift Container Platform クラスターとクラスター内で実行される Kubernetes API の過剰なアプリケーショントラフィックによりパフォーマンスの問題が発生する可能性があります。

ロードバランサーのフロントとバックの両方で以下のポートを設定します。

表19.2 API ロードバランサー ポート バックエンドマシン (プールメンバー) 内部 外部 説明 6443ブートストラップおよびコントロールプレーン。ブートストラップマシンがクラスターのコントロールプレーンを初期化した後に、ブートストラップマシンをロードバランサーから削除します。API サーバーのヘルスチェックプローブの

/readyzエンドポイントを設定する必要があります。X

X

Kubernetes API サーバー

22623ブートストラップおよびコントロールプレーン。ブートストラップマシンがクラスターのコントロールプレーンを初期化した後に、ブートストラップマシンをロードバランサーから削除します。

X

マシン設定サーバー

注記ロードバランサーは、API サーバーが

/readyzエンドポイントをオフにしてからプールから API サーバーインスタンスを削除するまで最大 30 秒かかるように設定する必要があります。/readyzの後の時間枠内でエラーが返されたり、正常になったりする場合は、エンドポイントが削除または追加されているはずです。5 秒または 10 秒ごとにプローブし、2 つの正常な要求が正常な状態になり、3 つの要求が正常な状態になりません。これらは十分にテストされた値です。Application Ingress ロードバランサー: クラスター外から送られるアプリケーショントラフィックの Ingress ポイントを提供します。Ingress ルーターの作業用の設定が OpenShift Container Platform クラスターに必要です。

以下の条件を設定します。

- Layer 4 の負荷分散のみ。これは、Raw TCP または SSL パススルーモードと呼ばれます。

- 選択可能なオプションやプラットフォーム上でホストされるアプリケーションの種類に基づいて、接続ベースの永続化またはセッションベースの永続化が推奨されます。

ヒントクライアントの実際の IP アドレスがアプリケーション Ingress ロードバランサーによって確認できる場合、ソースの IP ベースのセッション永続化を有効にすると、エンドツーエンドの TLS 暗号化を使用するアプリケーションのパフォーマンスを強化できます。

ロードバランサーのフロントとバックの両方で以下のポートを設定します。

表19.3 アプリケーション Ingress ロードバランサー ポート バックエンドマシン (プールメンバー) 内部 外部 説明 443デフォルトで Ingress コントローラー Pod、コンピュート、またはワーカーを実行するマシン。

X

X

HTTPS トラフィック

80デフォルトで Ingress コントローラー Pod、コンピュート、またはワーカーを実行するマシン。

X

X

HTTP トラフィック

注記ゼロ (0) コンピュートノードで 3 ノードクラスターをデプロイする場合、Ingress コントローラー Pod はコントロールプレーンノードで実行されます。3 ノードクラスターデプロイメントでは、HTTP および HTTPS トラフィックをコントロールプレーンノードにルーティングするようにアプリケーション Ingress ロードバランサーを設定する必要があります。

19.3.2.4.1. ユーザー管理のロードバランサーを使用してデプロイされたクラスターのロードバランサー設定の例

このセクションでは、ユーザー管理のロードバランサーを使用してデプロイされたクラスターのロードバランシング要件を満たす API およびアプリケーションの Ingress load balancer 設定の例を示します。この例は、HAProxy ロードバランサーの /etc/haproxy/haproxy.cfg 設定です。この例では、特定の負荷分散ソリューションを選択するためのアドバイスを提供することを目的としていません。

この例では、同じロードバランサーが Kubernetes API およびアプリケーションの Ingress トラフィックに使用されます。実稼働のシナリオでは、API およびアプリケーション Ingress ロードバランサーを個別にデプロイし、それぞれのロードバランサーインフラストラクチャーを分離してスケーリングすることができます。

HAProxy をロードバランサーとして使用し、SELinux が enforcing に設定されている場合は、setsebool -P haproxy_connect_any=1 を実行して、HAProxy サービスが設定済みの TCP ポートにバインドできることを確認する必要があります。

例19.1 API およびアプリケーション Ingress ロードバランサーの設定例

global log 127.0.0.1 local2 pidfile /var/run/haproxy.pid maxconn 4000 daemon defaults mode http log global option dontlognull option http-server-close option redispatch retries 3 timeout http-request 10s timeout queue 1m timeout connect 10s timeout client 1m timeout server 1m timeout http-keep-alive 10s timeout check 10s maxconn 3000 listen api-server-6443 1 bind *:6443 mode tcp option httpchk GET /readyz HTTP/1.0 option log-health-checks balance roundrobin server bootstrap bootstrap.ocp4.example.com:6443 verify none check check-ssl inter 10s fall 2 rise 3 backup 2 server master0 master0.ocp4.example.com:6443 weight 1 verify none check check-ssl inter 10s fall 2 rise 3 server master1 master1.ocp4.example.com:6443 weight 1 verify none check check-ssl inter 10s fall 2 rise 3 server master2 master2.ocp4.example.com:6443 weight 1 verify none check check-ssl inter 10s fall 2 rise 3 listen machine-config-server-22623 3 bind *:22623 mode tcp server bootstrap bootstrap.ocp4.example.com:22623 check inter 1s backup 4 server master0 master0.ocp4.example.com:22623 check inter 1s server master1 master1.ocp4.example.com:22623 check inter 1s server master2 master2.ocp4.example.com:22623 check inter 1s listen ingress-router-443 5 bind *:443 mode tcp balance source server compute0 compute0.ocp4.example.com:443 check inter 1s server compute1 compute1.ocp4.example.com:443 check inter 1s listen ingress-router-80 6 bind *:80 mode tcp balance source server compute0 compute0.ocp4.example.com:80 check inter 1s server compute1 compute1.ocp4.example.com:80 check inter 1s

- 1

- ポート

6443は Kubernetes API トラフィックを処理し、コントロールプレーンマシンを参照します。 - 2 4

- ブートストラップエントリーは、OpenShift Container Platform クラスターのインストール前に有効にし、ブートストラッププロセスの完了後にそれらを削除する必要があります。

- 3

- ポート

22623はマシン設定サーバートラフィックを処理し、コントロールプレーンマシンを参照します。 - 5

- ポート

443は HTTPS トラフィックを処理し、Ingress コントローラー Pod を実行するマシンを参照します。Ingress コントローラー Pod はデフォルトでコンピュートマシンで実行されます。 - 6

- ポート

80は HTTP トラフィックを処理し、Ingress コントローラー Pod を実行するマシンを参照します。Ingress コントローラー Pod はデフォルトでコンピュートマシンで実行されます。注記ゼロ (0) コンピュートノードで 3 ノードクラスターをデプロイする場合、Ingress コントローラー Pod はコントロールプレーンノードで実行されます。3 ノードクラスターデプロイメントでは、HTTP および HTTPS トラフィックをコントロールプレーンノードにルーティングするようにアプリケーション Ingress ロードバランサーを設定する必要があります。

HAProxy をロードバランサーとして使用する場合は、HAProxy ノードで netstat -nltupe を実行して、ポート 6443、22623、443、および 80 で haproxy プロセスがリッスンしていることを確認することができます。

19.3.3. OpenShift Container Platform のインターネットアクセス

OpenShift Container Platform 4.16 では、クラスターをインストールするためにインターネットアクセスが必要になります。

インターネットへのアクセスは以下を実行するために必要です。

- OpenShift Cluster Manager にアクセスし、インストールプログラムをダウンロードし、サブスクリプション管理を実行します。クラスターにインターネットアクセスがあり、Telemetry を無効にしない場合、そのサービスは有効なサブスクリプションでクラスターを自動的に使用します。

- クラスターのインストールに必要なパッケージを取得するために Quay.io にアクセスします。

- クラスターの更新を実行するために必要なパッケージを取得します。

クラスターでインターネットに直接アクセスできない場合、プロビジョニングする一部のタイプのインフラストラクチャーでネットワークが制限されたインストールを実行できます。このプロセスで、必要なコンテンツをダウンロードし、これを使用してミラーレジストリーにインストールパッケージを設定します。インストールタイプによっては、クラスターのインストール環境でインターネットアクセスが不要となる場合があります。クラスターを更新する前に、ミラーレジストリーのコンテンツを更新します。

19.3.4. RHOSP での Swift の有効化

Swift は、swiftoperator ロールのあるユーザーアカウントによって操作されます。インストールプログラムを実行する前に、ロールをアカウントに追加します。

Swift として知られる Red Hat OpenStack Platform (RHOSP) オブジェクトストレージサービス が利用可能な場合、OpenShift Container Platform はこれをイメージレジストリーストレージとして使用します。利用できない場合、インストールプログラムは Cinder として知られる RHOSP ブロックストレージサービスに依存します。

Swift が存在し、これを使用する必要がある場合は、Swift へのアクセスを有効にする必要があります。これが存在しない場合や使用する必要がない場合は、このセクションを省略してください。

RHOSP 17 では、Ceph RGW の rgw_max_attr_size パラメーターが 256 文字に設定されます。この設定は、コンテナーイメージを OpenShift Container Platform レジストリーにアップロードする際に問題を引き起こします。rgw_max_attr_size の値は、1024 文字以上に設定する必要があります。

インストールする前に、RHOSP のデプロイメントがこの問題の影響を受けるかどうか確認してください。影響を受ける場合は、Ceph RGW を再設定します。

前提条件

- ターゲット環境に RHOSP 管理者アカウントがあります。

- Swift サービスがインストールされています。

-

Ceph RGW で、

account in urlオプションが有効化されています。

手順

RHOSP 上で Swift を有効にするには、以下を実行します。

RHOSP CLI の管理者として、

swiftoperatorロールを Swift にアクセスするアカウントに追加します。$ openstack role add --user <user> --project <project> swiftoperator

RHOSP デプロイメントでは、イメージレジストリーに Swift を使用することができます。

19.3.5. RHOSP で実行されるクラスター上のカスタムストレージを使用したイメージレジストリーの設定

Red Hat OpenStack Platform (RHOSP) にクラスターをインストールした後に、特定のアベイラビリティーゾーンにある Cinder ボリュームをレジストリーストレージとして使用できます。

手順

YAML ファイルを作成して、使用するストレージクラスとアベイラビリティーゾーンを指定します。以下に例を示します。

apiVersion: storage.k8s.io/v1 kind: StorageClass metadata: name: custom-csi-storageclass provisioner: cinder.csi.openstack.org volumeBindingMode: WaitForFirstConsumer allowVolumeExpansion: true parameters: availability: <availability_zone_name>

注記OpenShift Container Platform では、選択したアベイラビリティーゾーンが存在するかどうかは確認されません。設定を適用する前に、アベイラビリティーゾーンの名前を確認してください。

コマンドラインから設定を適用します。

$ oc apply -f <storage_class_file_name>

出力例

storageclass.storage.k8s.io/custom-csi-storageclass created

ストレージクラスと

openshift-image-registrynamespace を使用する永続ボリュームクレーム (PVC) を指定する YAML ファイルを作成します。以下に例を示します。apiVersion: v1 kind: PersistentVolumeClaim metadata: name: csi-pvc-imageregistry namespace: openshift-image-registry 1 annotations: imageregistry.openshift.io: "true" spec: accessModes: - ReadWriteOnce volumeMode: Filesystem resources: requests: storage: 100Gi 2 storageClassName: <your_custom_storage_class> 3

コマンドラインから設定を適用します。

$ oc apply -f <pvc_file_name>

出力例

persistentvolumeclaim/csi-pvc-imageregistry created

イメージレジストリー設定の元の永続ボリューム要求は、新しい要求に置き換えます。

$ oc patch configs.imageregistry.operator.openshift.io/cluster --type 'json' -p='[{"op": "replace", "path": "/spec/storage/pvc/claim", "value": "csi-pvc-imageregistry"}]'出力例

config.imageregistry.operator.openshift.io/cluster patched

数分すると、設定が更新されます。

検証

レジストリーが定義したリソースを使用していることを確認するには、以下を実行します。

PVC クレーム値が PVC 定義で指定した名前と同じであることを確認します。

$ oc get configs.imageregistry.operator.openshift.io/cluster -o yaml

出力例

... status: ... managementState: Managed pvc: claim: csi-pvc-imageregistry ...PVC のステータスが

Boundであることを確認します。$ oc get pvc -n openshift-image-registry csi-pvc-imageregistry

出力例

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE csi-pvc-imageregistry Bound pvc-72a8f9c9-f462-11e8-b6b6-fa163e18b7b5 100Gi RWO custom-csi-storageclass 11m

19.3.6. 外部ネットワークアクセスの確認

OpenShift Container Platform インストールプロセスでは、外部ネットワークへのアクセスが必要です。外部ネットワーク値をこれに指定する必要があります。指定しない場合には、デプロイメントは失敗します。このプロセスを実行する前に、外部ルータータイプのネットワークが Red Hat OpenStack Platform (RHOSP) に存在することを確認します。

手順

RHOSP CLI を使用して、'External' ネットワークの名前と ID を確認します。

$ openstack network list --long -c ID -c Name -c "Router Type"

出力例

+--------------------------------------+----------------+-------------+ | ID | Name | Router Type | +--------------------------------------+----------------+-------------+ | 148a8023-62a7-4672-b018-003462f8d7dc | public_network | External | +--------------------------------------+----------------+-------------+

外部ルータータイプのあるネットワークがネットワークリストに表示されます。1 つ以上のネットワークが表示されない場合は、デフォルトの Floating IP ネットワークの作成 および デフォルトのプロバイダーネットワークの作成 を参照してください。

外部ネットワークの CIDR 範囲がデフォルトのネットワーク範囲のいずれかと重複している場合、インストールプロセスを開始する前に、install-config.yaml ファイルで一致するネットワーク範囲を変更する必要があります。

デフォルトのネットワーク範囲は以下のとおりです。

| ネットワーク | 範囲 |

|---|---|

|

| 10.0.0.0/16 |

|

| 172.30.0.0/16 |

|

| 10.128.0.0/14 |

インストールプログラムにより同じ名前を持つ複数のネットワークが見つかる場合、それらのネットワークのいずれかがランダムに設定されます。この動作を回避するには、RHOSP でリソースの一意の名前を作成します。

Neutron トランクサービスプラグインが有効にされると、トランクポートがデフォルトで作成されます。詳細は、Neutron trunk port を参照してください。

19.3.7. インストールプログラムのパラメーターの定義

OpenShift Container Platform インストールプログラムは、clouds.yaml というファイルを使用します。このファイルは、プロジェクト名、ログイン情報、認可サービスの URL を含む Red Hat OpenStack Platform (RHOSP) 設定パラメーターを説明します。

手順

clouds.yamlファイルを作成します。RHOSP ディストリビューションに Horizon Web UI が含まれる場合には、そこに

clouds.yamlファイルを生成します。重要パスワードを必ず

authフィールドに追加してください。シークレットは、clouds.yamlの 別のファイル に保持できます。RHOSP ディストリビューションに Horizon Web UI が含まれない場合や Horizon を使用する必要がない場合には、このファイルを独自に作成します。

clouds.yamlの詳細は、RHOSP ドキュメントの Config files を参照してください。clouds: shiftstack: auth: auth_url: http://10.10.14.42:5000/v3 project_name: shiftstack username: <username> password: <password> user_domain_name: Default project_domain_name: Default dev-env: region_name: RegionOne auth: username: <username> password: <password> project_name: 'devonly' auth_url: 'https://10.10.14.22:5001/v2.0'

RHOSP インストールでエンドポイント認証用に自己署名認証局 (CA) を使用する場合、以下を実行します。

- 認証局ファイルをマシンにコピーします。

cacertsキーをclouds.yamlファイルに追加します。この値は、CA 証明書への絶対的な root 以外によるアクセスが可能なパスである必要があります。clouds: shiftstack: ... cacert: "/etc/pki/ca-trust/source/anchors/ca.crt.pem"ヒントカスタム CA 証明書を使用してインストーラーを実行した後に、

cloud-provider-configキーマップのca-cert.pemキーの値を編集して証明書を更新できます。コマンドラインで、以下を実行します。$ oc edit configmap -n openshift-config cloud-provider-config

clouds.yamlファイルを以下の場所のいずれかに置きます。-

OS_CLIENT_CONFIG_FILE環境変数の値 - 現行ディレクトリー

-

Unix 固有のユーザー設定ディレクトリー (例:

~/.config/openstack/clouds.yaml) Unix 固有のサイト設定ディレクトリー (例:

/etc/openstack/clouds.yaml)インストールプログラムはこの順序で

clouds.yamlを検索します。

-

19.3.8. OpenStack Cloud Controller Manager のオプション設定

オプションで、クラスターの OpenStack Cloud Controller Manager (CCM) 設定を編集できます。この設定は、OpenShift Container Platform が Red Hat OpenStack Platform (RHOSP) と対話する方法を制御します。

設定パラメーターの完全なリストは、「OpenStack のインストール」ドキュメントの「OpenStack Cloud Controller Manager リファレンスガイド」を参照してください。

手順

クラスター用に生成されたマニフェストファイルがない場合は、以下のコマンドを実行して生成します。

$ openshift-install --dir <destination_directory> create manifests

テキストエディターで、cloud-provider 設定マニフェストファイルを開きます。以下に例を示します。

$ vi openshift/manifests/cloud-provider-config.yaml

CCM リファレンスガイドに従ってオプションを変更します。

負荷分散のために Octavia を設定することが一般的です。以下に例を示します。

#... [LoadBalancer] lb-provider = "amphora" 1 floating-network-id="d3deb660-4190-40a3-91f1-37326fe6ec4a" 2 create-monitor = True 3 monitor-delay = 10s 4 monitor-timeout = 10s 5 monitor-max-retries = 1 6 #...

- 1

- このプロパティーは、ロードバランサーが使用する Octavia プロバイダーを設定します。

"ovn"または"amphora"を値として受け入れます。OVN の使用を選択する場合は、lb-methodをSOURCE_IP_PORT。 - 2

- このプロパティーは、複数の外部ネットワークをクラスターで使用する場合に必要です。クラウドプロバイダーは、ここで指定するネットワーク上に Floating IP アドレスを作成します。

- 3

- このプロパティーは、クラウドプロバイダーが Octavia ロードバランサーのヘルスモニターを作成するかどうかを制御します。ヘルスモニターを作成するには、値を

Trueに設定します。RHOSP 16.2 の時点で、この機能は Amphora プロバイダーでのみ利用できます。 - 4

- このプロパティーは、監視されるエンドポイントの頻度を設定します。値は

time.ParseDuration()形式である必要があります。このプロパティーは、create-monitorプロパティーの値がTrueの場合に必要です。 - 5

- このプロパティーは、タイムアウトする前に監視要求が開く時間を設定します。値は

time.ParseDuration()形式である必要があります。このプロパティーは、create-monitorプロパティーの値がTrueの場合に必要です。 - 6

- このプロパティーは、ロードバランサーがオンラインとしてマークされる前に必要なモニタリング要求の数を定義します。値は整数でなければなりません。このプロパティーは、

create-monitorプロパティーの値がTrueの場合に必要です。

重要変更を保存する前に、ファイルが正しく構造化されていることを確認します。プロパティーが適切なセクションに置かれていないと、クラスターが失敗することがあります。

重要.spec.externalTrafficPolicyプロパティーの値がLocalに設定されたサービスを使用する場合は、create-monitorプロパティーの値をTrueに設定する必要があります。RHOSP 16.2 の OVN Octavia プロバイダーは、ヘルスモニターをサポートしません。そのため、lb-providerの値が"ovn"に設定されている場合、ETPパラメーターの値がLocalに設定されたサービスは応答しない可能性があります。変更をファイルに保存し、インストールを続行します。

ヒントインストーラーの実行後に、クラウドプロバイダー設定を更新できます。コマンドラインで、以下を実行します。

$ oc edit configmap -n openshift-config cloud-provider-config

変更を保存した後、クラスターの再設定には多少時間がかかります。ノードが

SchedulingDisabledのままの場合は、プロセスが完了します。

19.3.9. インストールプログラムの取得

OpenShift Container Platform をインストールする前に、インストールに使用しているホストにインストールファイルをダウンロードします。

前提条件

- 500 MB のローカルディスク領域がある Linux または macOS を実行するコンピューターが必要です。

手順

- OpenShift Cluster Manager サイトの インフラストラクチャープロバイダー ページにアクセスします。Red Hat アカウントがある場合は、認証情報を使用してログインします。アカウントがない場合はこれを作成します。

- インフラストラクチャープロバイダーを選択します。

インストールタイプのページに移動し、ホストオペレーティングシステムとアーキテクチャーに対応するインストールプログラムをダウンロードして、インストール設定ファイルを保存するディレクトリーにファイルを配置します。

重要インストールプログラムは、クラスターのインストールに使用するコンピューターにいくつかのファイルを作成します。クラスターのインストール完了後は、インストールプログラムおよびインストールプログラムが作成するファイルを保持する必要があります。ファイルはいずれもクラスターを削除するために必要になります。

重要インストールプログラムで作成されたファイルを削除しても、クラスターがインストール時に失敗した場合でもクラスターは削除されません。クラスターを削除するには、特定のクラウドプロバイダー用の OpenShift Container Platform のアンインストール手順を実行します。

インストールプログラムを展開します。たとえば、Linux オペレーティングシステムを使用するコンピューターで以下のコマンドを実行します。

$ tar -xvf openshift-install-linux.tar.gz

- Red Hat OpenShift Cluster Manager からインストールプルシークレット をダウンロードします。このプルシークレットを使用し、OpenShift Container Platform コンポーネントのコンテナーイメージを提供する Quay.io など、組み込まれた各種の認証局によって提供されるサービスで認証できます。

19.3.10. インストール設定ファイルの作成

Red Hat OpenStack Platform (RHOSP) にインストールする OpenShift Container Platform クラスターをカスタマイズできます。

前提条件

- OpenShift Container Platform インストールプログラムおよびクラスターのプルシークレットがある。

手順

install-config.yamlファイルを作成します。インストールプログラムが含まれるディレクトリーに切り替え、以下のコマンドを実行します。

$ ./openshift-install create install-config --dir <installation_directory> 1- 1

<installation_directory>の場合、インストールプログラムが作成するファイルを保存するためにディレクトリー名を指定します。

ディレクトリーを指定する場合:

-

ディレクトリーに

execute権限があることを確認します。この権限は、インストールディレクトリーで Terraform バイナリーを実行するために必要です。 - 空のディレクトリーを使用します。ブートストラップ X.509 証明書などの一部のインストールアセットは有効期限が短いため、インストールディレクトリーを再利用しないでください。別のクラスターインストールの個別のファイルを再利用する必要がある場合は、それらをディレクトリーにコピーすることができます。ただし、インストールアセットのファイル名はリリース間で変更される可能性があります。インストールファイルを以前のバージョンの OpenShift Container Platform からコピーする場合は注意してコピーを行ってください。

プロンプト時に、クラウドの設定の詳細情報を指定します。

オプション: クラスターマシンにアクセスするために使用する SSH キーを選択します。

注記インストールのデバッグまたは障害復旧を実行する必要のある実稼働用の OpenShift Container Platform クラスターでは、

ssh-agentプロセスが使用する SSH キーを指定します。- ターゲットに設定するプラットフォームとして openstack を選択します。

- クラスターのインストールに使用する Red Hat OpenStack Platform (RHOSP) の外部ネットワーク名を指定します。

- OpenShift API への外部アクセスに使用する floating IP アドレスを指定します。

- コントロールプレーンノードに使用する少なくとも 16 GB の RAM とコンピュートノードに使用する 8 GB の RAM を持つ RHOSP フレーバーを指定します。

- クラスターをデプロイするベースドメインを選択します。すべての DNS レコードはこのベースのサブドメインとなり、クラスター名も含まれます。

- クラスターの名前を入力します。名前は 14 文字以下でなければなりません。

-

install-config.yamlファイルを変更します。利用可能なパラメーターの詳細は、「インストール設定パラメーター」のセクションを参照してください。 install-config.yamlファイルをバックアップし、複数のクラスターをインストールするのに使用できるようにします。重要install-config.yamlファイルはインストールプロセス時に使用されます。このファイルを再利用する必要がある場合は、この段階でこれをバックアップしてください。

19.3.10.1. インストール時のクラスター全体のプロキシーの設定

実稼働環境では、インターネットへの直接アクセスを拒否し、代わりに HTTP または HTTPS プロキシーを使用することができます。プロキシー設定を install-config.yaml ファイルで行うことにより、新規の OpenShift Container Platform クラスターをプロキシーを使用するように設定できます。

前提条件

-

既存の

install-config.yamlファイルがある。 クラスターがアクセスする必要のあるサイトを確認済みで、それらのいずれかがプロキシーをバイパスする必要があるかどうかを判別している。デフォルトで、すべてのクラスター Egress トラフィック (クラスターをホストするクラウドに関するクラウドプロバイダー API に対する呼び出しを含む) はプロキシーされます。プロキシーを必要に応じてバイパスするために、サイトを

Proxyオブジェクトのspec.noProxyフィールドに追加している。注記Proxyオブジェクトのstatus.noProxyフィールドには、インストール設定のnetworking.machineNetwork[].cidr、networking.clusterNetwork[].cidr、およびnetworking.serviceNetwork[]フィールドの値が設定されます。Amazon Web Services (AWS)、Google Cloud Platform (GCP)、Microsoft Azure、および Red Hat OpenStack Platform (RHOSP) へのインストールの場合、

Proxyオブジェクトのstatus.noProxyフィールドには、インスタンスメタデータのエンドポイント (169.254.169.254) も設定されます。

手順

install-config.yamlファイルを編集し、プロキシー設定を追加します。以下に例を示します。apiVersion: v1 baseDomain: my.domain.com proxy: httpProxy: http://<username>:<pswd>@<ip>:<port> 1 httpsProxy: https://<username>:<pswd>@<ip>:<port> 2 noProxy: example.com 3 additionalTrustBundle: | 4 -----BEGIN CERTIFICATE----- <MY_TRUSTED_CA_CERT> -----END CERTIFICATE----- additionalTrustBundlePolicy: <policy_to_add_additionalTrustBundle> 5

- 1

- クラスター外の HTTP 接続を作成するために使用するプロキシー URL。URL スキームは

httpである必要があります。 - 2

- クラスター外で HTTPS 接続を作成するために使用するプロキシー URL。

- 3

- プロキシーから除外するための宛先ドメイン名、IP アドレス、または他のネットワーク CIDR のコンマ区切りのリスト。サブドメインのみと一致するように、ドメインの前に

.を付けます。たとえば、.y.comはx.y.comに一致しますが、y.comには一致しません。*を使用し、すべての宛先のプロキシーをバイパスします。 - 4

- 指定されている場合、インストールプログラムは HTTPS 接続のプロキシーに必要な 1 つ以上の追加の CA 証明書が含まれる

user-ca-bundleという名前の設定マップをopenshift-confignamespace に生成します。次に Cluster Network Operator は、これらのコンテンツを Red Hat Enterprise Linux CoreOS (RHCOS) 信頼バンドルにマージするtrusted-ca-bundle設定マップを作成し、この設定マップはProxyオブジェクトのtrustedCAフィールドで参照されます。additionalTrustBundleフィールドは、プロキシーのアイデンティティー証明書が RHCOS 信頼バンドルからの認証局によって署名されない限り必要になります。 - 5

- オプション:

trustedCAフィールドのuser-ca-bundle設定マップを参照するProxyオブジェクトの設定を決定するポリシー。許可される値はProxyonlyおよびAlwaysです。Proxyonlyを使用して、http/httpsプロキシーが設定されている場合にのみuser-ca-bundle設定マップを参照します。Alwaysを使用して、常にuser-ca-bundle設定マップを参照します。デフォルト値はProxyonlyです。

注記インストールプログラムは、プロキシーの

readinessEndpointsフィールドをサポートしません。注記インストーラーがタイムアウトした場合は、インストーラーの

wait-forコマンドを使用してデプロイメントを再起動してからデプロイメントを完了します。以下に例を示します。$ ./openshift-install wait-for install-complete --log-level debug

- ファイルを保存し、OpenShift Container Platform のインストール時にこれを参照します。

インストールプログラムは、指定の install-config.yaml ファイルのプロキシー設定を使用する cluster という名前のクラスター全体のプロキシーを作成します。プロキシー設定が指定されていない場合、cluster Proxy オブジェクトが依然として作成されますが、これには spec がありません。

cluster という名前の Proxy オブジェクトのみがサポートされ、追加のプロキシーを作成することはできません。

19.3.10.2. RHOSP デプロイメントでのカスタムサブネット

オプションで、選択する Red Hat OpenStack Platform (RHOSP) サブネットにクラスターをデプロイすることができます。サブネットの GUID は、install-config.yaml ファイルの platform.openstack.machinesSubnet の値として渡されます。

このサブネットはクラスターのプライマリーサブネットとして使用されます。デフォルトで、ノードおよびポートはこの上に作成されます。platform.openstack.machinesSubnet プロパティーの値をサブネットの UUID に設定すると、異なる RHOSP サブネットにノードおよびポートを作成することができます。

カスタムサブネットを使用して OpenShift Container Platform インストーラーを実行する前に、設定が以下の要件を満たしていることを確認してください。

-

platform.openstack.machinesSubnetで使用されるサブネットで DHCP が有効にされている。 -

platform.openstack.machinesSubnetの CIDR はnetworking.machineNetworkの CIDR に一致する。 - インストールプログラムのユーザーには、固定 IP アドレスを持つポートなど、このネットワークでポートを作成するパーミッションがある。

カスタムサブネットを使用するクラスターには、以下の制限があります。

-

Floating IP アドレスを使用するクラスターをインストールする予定の場合には、

platform.openstack.machinesSubnetサブネットをexternalNetworkネットワークに接続されているルーターに接続する必要があります。 -

platform.openstack.machinesSubnetの値がinstall-config.yamlファイルに設定されている場合、インストールプログラムは RHOSP マシンのプライベートネットワークまたはサブネットを作成しません。 -

platform.openstack.externalDNSプロパティーは、カスタムサブネットと同時に使用することはできません。カスタムサブネットを使用するクラスターに DNS を追加するには、RHOSP ネットワークで DNS を設定します。

デフォルトでは、API VIP は x.x.x.5 を取得し、Ingress VIP はネットワークの CIDR ブロックから x.x.x.7 を取得します。これらのデフォルト値を上書きするには、DHCP 割り当てプール外の platform.openstack.apiVIPs および platform.openstack.ingressVIPs の値を設定します。

ネットワークの CIDR 範囲は、クラスターのインストール後に調整できません。Red Hat は、namespace ごとに作成される Pod の数を慎重に検討する必要があるため、クラスターのインストール時に範囲を決定するための直接的なガイダンスを提供していません。

19.3.10.3. ベアメタルマシンを使用したクラスターのデプロイ

クラスターでベアメタルマシンを使用する必要がある場合は、install-config.yaml ファイルを変更します。クラスターには、ベアメタル上でコントロールプレーンとコンピュートマシンの両方を実行させることも、コンピュートマシンのみを実行させることもできます。

install-config.yaml ファイルで、ベアメタルワーカーに使用する RHOSP ネットワークが Floating IP アドレスをサポートするかどうかが反映されていることを確認します。

前提条件

- RHOSP の ベアメタルサービス (Ironic) は有効にされており、RHOSP Compute API でアクセスできる。

- ベアメタルは RHOSP フレーバー として利用可能である。

- クラスターが 16.1.6 以降、16.2.4 未満の RHOSP バージョンで実行している場合は、メタデータサービスが OpenShift Container Platform ノード上のサービスで使用できなくなる 既知の問題 により、ベアメタルワーカーは機能しません。

- RHOSP ネットワークは、仮想マシンとベアメタルサーバー接続の両方をサポートする。

- マシンを既存のネットワークにデプロイする必要がある場合、RHOSP サブネットがプロビジョニングされる。

- マシンを installer-provisioned ネットワークに場合、RHOSP ベアメタルサービス (Ironic) はテナントネットワークで実行される Preboot eXecution Environment (PXE) ブートマシンをリッスンし、これと対話できます。

-

install-config.yamlファイルを OpenShift Container Platform インストールプログラムの一部として作成している。

手順

install-config.yamlファイルで、マシンのフレーバーを編集します。-

ベアメタルのコントロールプレーンマシンを使用する必要がある場合は、

controlPlane.platform.openstack.typeの値をベアメタルフレーバーに変更します。 -

compute.platform.openstack.typeの値をベアメタルフレーバーに変更します。 既存のネットワークにマシンをデプロイする場合は、

platform.openstack.machinesSubnetの値をネットワークの RHOSP サブネット UUID に変更します。コントロールプレーンおよびコンピュートマシンは同じサブネットを使用する必要があります。ベアメタルの

install-config.yamlのサンプルファイルcontrolPlane: platform: openstack: type: <bare_metal_control_plane_flavor> 1 ... compute: - architecture: amd64 hyperthreading: Enabled name: worker platform: openstack: type: <bare_metal_compute_flavor> 2 replicas: 3 ... platform: openstack: machinesSubnet: <subnet_UUID> 3 ...

-

ベアメタルのコントロールプレーンマシンを使用する必要がある場合は、

更新された install-config.yaml ファイルを使用してインストールプロセスを完了します。デプロイメント時に作成されるコンピュートマシンは、ファイルに追加したフレーバーを使用します。

インストーラーは、ベアメタルマシンの起動中にタイムアウトする可能性があります。

インストーラーがタイムアウトした場合は、インストーラーの wait-for コマンドを使用してデプロイメントを再起動してからデプロイメントを完了します。以下に例を示します。

$ ./openshift-install wait-for install-complete --log-level debug

19.3.10.4. RHOSP プロバイダーネットワーク上のクラスターデプロイメント

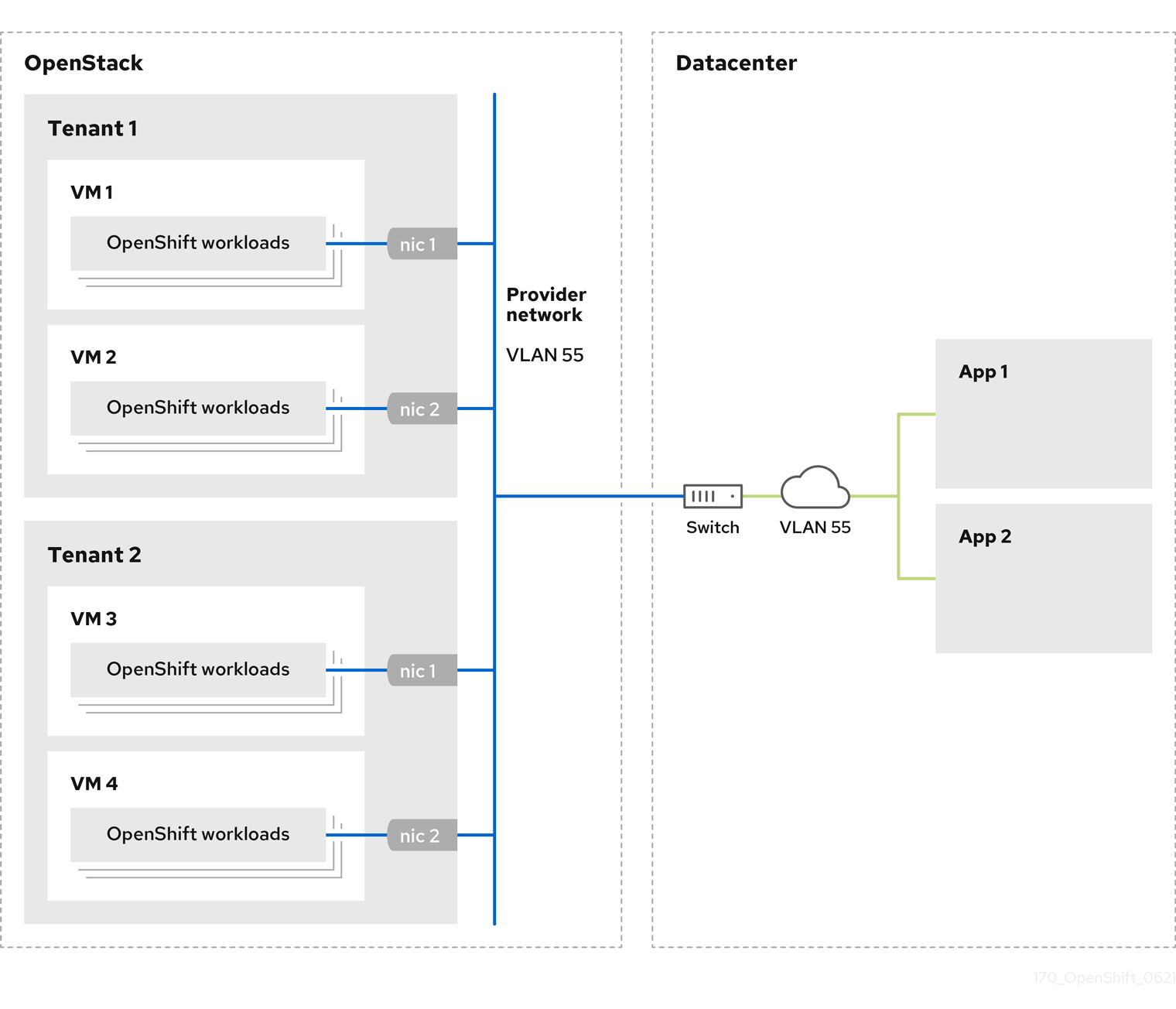

プロバイダーネットワーク上のプライマリーネットワークインターフェイスを使用して、OpenShift Container Platform クラスターを Red Hat OpenStack Platform (RHOSP) にデプロイできます。プロバイダーネットワークは一般的に、インターネットへの到達に使用可能なパブリックネットワークに、プロジェクトが直接アクセスできるように使用します。ネットワーク作成プロセスの一環として、プロバイダーネットワークをプロジェクト間で共有することもできます。

RHOSP プロバイダーネットワークは、データセンター内の既存の物理ネットワークに直接マップします。RHOSP 管理者はこれらを作成する必要があります。

以下の例では、OpenShift Container Platform ワークロードはプロバイダーネットワークを使用してデータセンターに接続されます。

プロバイダーネットワークにインストールされている OpenShift Container Platform クラスターは、テナントネットワークまたは Floating IP アドレスを必要としません。インストーラーは、インストール中にこれらのリソースを作成しません。

プロバイダーネットワークタイプの例には、フラット (タグなし) および VLAN (802.1Q タグ付き) が含まれます。

クラスターは、ネットワークタイプが許可する限り多くのプロバイダーネットワーク接続をサポートできます。たとえば、VLAN ネットワークは、通常最大 4096 の接続をサポートします。

プロバイダーネットワークおよびテナントネットワークの詳細は、RHOSP のドキュメント を参照してください。

19.3.10.4.1. クラスターのインストールにおける RHOSP プロバイダーネットワーク要件

OpenShift Container Platform クラスターをインストールする前に、Red Hat OpenStack Platform (RHOSP) のデプロイメントおよびプロバイダーネットワークは、さまざまな条件を満たす必要があります。

- RHOSP ネットワークサービス (Neutron) が有効化され、RHOSP ネットワーク API 経由でアクセス可能であること。

- RHOSP ネットワークサービスでは、ポートセキュリティーと許可するアドレスペアの機能拡張が有効化 されていること。

プロバイダーネットワークは他のテナントと共有できます。

ヒント--shareフラグを指定してopenstack network createコマンドを使用して、共有できるネットワークを作成します。クラスターのインストールに使用する RHOSP プロジェクトは、プロバイダーネットワークと適切なサブネットを所有する必要があります。

ヒント- "openshift" という名前のプロジェクトのネットワークを作成するには、以下のコマンドを入力します。

$ openstack network create --project openshift

- "openshift" という名前のプロジェクトのサブネットを作成するには、以下のコマンドを入力します。

$ openstack subnet create --project openshift

RHOSP でのネットワークの作成に関する詳細は、プロバイダーネットワークに関するドキュメント を参照してください。

クラスターが

adminユーザーによって所有されている場合、そのユーザーとしてインストーラーを実行してネットワーク上でポートを作成する必要があります。重要プロバイダーネットワークは、クラスターの作成に使用される RHOSP プロジェクトによって所有されている必要があります。所有されていない場合は、RHOSP Compute サービス (Nova) はそのネットワークからポートを要求できません。

プロバイダーネットワークが、デフォルトで

169.254.169.254である RHOSP メタデータサービスの IP アドレスに到達できることを確認します。RHOSP SDN とネットワークサービス設定によっては、サブネットを作成する際に、ルートを提供しなければならない場合があります。以下に例を示します。

$ openstack subnet create --dhcp --host-route destination=169.254.169.254/32,gateway=192.0.2.2 ...

- オプション: ネットワークのセキュリティーを保護するには、単一のプロジェクトへのネットワークアクセスを制限する ロールベースのアクセス制御 (RBAC) ルールを作成します。

19.3.10.4.2. プロバイダーネットワークにプライマリーインターフェイスを持つクラスターのデプロイ

Red Hat OpenStack Platform (RHOSP) プロバイダーネットワーク上にプライマリーネットワークインターフェイスを持つ OpenShift Container Platform クラスターをデプロイすることができます。

前提条件

- 「クラスターのインストールにおける RHOSP プロバイダーネットワーク要件」に記載されているとおりに、お使いの Red Hat OpenStack Platform (RHOSP) のデプロイメントが設定されています。

手順

-

テキストエディターで

install-config.yamlファイルを開きます。 -

platform.openstack.apiVIPsプロパティーの値を API VIP の IP アドレスに設定します。 -

platform.openstack.ingressVIPsプロパティーの値を Ingress VIP の IP アドレスに設定します。 -

platform.openstack.machinesSubnetプロパティーの値をプロバイダーネットワークサブネットの UUID に設定します。 -

networking.machineNetwork.cidrプロパティーの値をプロバイダーネットワークサブネットの CIDR ブロックに設定します。

platform.openstack.apiVIPs プロパティーおよび platform.openstack.ingressVIPs プロパティーはいずれも、networking.machineNetwork.cidr ブロックから割り当てられていない IP アドレスである必要があります。

RHOSP プロバイダーネットワークに依存するクラスターのインストール設定ファイルのセクション

...

platform:

openstack:

apiVIPs: 1

- 192.0.2.13

ingressVIPs: 2

- 192.0.2.23

machinesSubnet: fa806b2f-ac49-4bce-b9db-124bc64209bf

# ...

networking:

machineNetwork:

- cidr: 192.0.2.0/24

プライマリーネットワークインターフェイスにプロバイダーネットワークを使用している間は、platform.openstack.externalNetwork パラメーターまたは platform.openstack.externalDNS パラメーターを設定することはできません。

クラスターをデプロイする際に、インストーラーは install-config.yaml ファイルを使用してプロバイダーネットワークにクラスターをデプロイします。

プロバイダーネットワークを含むネットワークを platform.openstack.additionalNetworkIDs リストに追加できます。

クラスターのデプロイ後に、Pod を追加のネットワークに接続することができます。詳細は、複数ネットワークについて を参照してください。

19.3.10.5. RHOSP のカスタマイズされた install-config.yaml ファイルのサンプル

次の install-config.yaml ファイルの例は、すべての可能な Red Hat OpenStack Platform (RHOSP) カスタマイズオプションを示しています。

このサンプルファイルは参照用にのみ提供されます。インストールプログラムを使用して install-config.yaml ファイルを取得する必要があります。

例19.2 シングルスタックの install-config.yaml ファイルの例

apiVersion: v1

baseDomain: example.com

controlPlane:

name: master

platform: {}

replicas: 3

compute:

- name: worker

platform:

openstack:

type: ml.large

replicas: 3

metadata:

name: example

networking:

clusterNetwork:

- cidr: 10.128.0.0/14

hostPrefix: 23

machineNetwork:

- cidr: 10.0.0.0/16

serviceNetwork:

- 172.30.0.0/16

networkType: OVNKubernetes

platform:

openstack:

cloud: mycloud

externalNetwork: external

computeFlavor: m1.xlarge

apiFloatingIP: 128.0.0.1

fips: false

pullSecret: '{"auths": ...}'

sshKey: ssh-ed25519 AAAA...例19.3 デュアルスタックの install-config.yaml ファイルの例

apiVersion: v1

baseDomain: example.com

controlPlane:

name: master

platform: {}

replicas: 3

compute:

- name: worker

platform:

openstack:

type: ml.large

replicas: 3

metadata:

name: example

networking:

clusterNetwork:

- cidr: 10.128.0.0/14

hostPrefix: 23

- cidr: fd01::/48

hostPrefix: 64

machineNetwork:

- cidr: 192.168.25.0/24

- cidr: fd2e:6f44:5dd8:c956::/64

serviceNetwork:

- 172.30.0.0/16

- fd02::/112

networkType: OVNKubernetes

platform:

openstack:

cloud: mycloud

externalNetwork: external

computeFlavor: m1.xlarge

apiVIPs:

- 192.168.25.10

- fd2e:6f44:5dd8:c956:f816:3eff:fec3:5955

ingressVIPs:

- 192.168.25.132

- fd2e:6f44:5dd8:c956:f816:3eff:fe40:aecb

controlPlanePort:

fixedIPs:

- subnet:

name: openshift-dual4

- subnet:

name: openshift-dual6

network:

name: openshift-dual

fips: false

pullSecret: '{"auths": ...}'

sshKey: ssh-ed25519 AAAA...19.3.10.6. デュアルスタックネットワークを使用したクラスターの設定

RHOSP 上にデュアルスタッククラスターを作成できます。ただし、デュアルスタック設定は、IPv4 および IPv6 サブネットを持つ RHOSP ネットワークを使用している場合にのみ有効になります。

RHOSP は、IPv4 シングルスタッククラスターからデュアルスタッククラスターネットワークへの変換をサポートしていません。

19.3.10.6.1. デュアルスタッククラスターの導入

手順

IPv4 および IPv6 サブネットを含むネットワークを作成します。

ipv6-ra-modeおよびipv6-address-modeフィールドで使用可能なアドレスモードは、dhcpv6-stateful、dhcpv6-stateless、およびslaacです。注記デュアルスタックネットワーク MTU は、IPv6 の最小 MTU (1280) と OVN-Kubernetes カプセル化オーバーヘッド (100) の両方に対応する必要があります。

注記DHCP はサブネット上で有効にする必要があります。

- API ポートと Ingress VIP ポートを作成します。

- IPv6 サブネットをルーターに追加して、ルーターのアドバタイズメントを有効にします。プロバイダーネットワークを使用している場合は、ネットワークを外部ゲートウェイとして追加することでルーターのアドバタイズメントを有効にすることができ、これにより外部接続も有効になります。

クラスターノードの IPv4 および IPv6 アドレスエンドポイントを設定するには、

install-config.yamlファイルを編集します。以下は、install-config.yamlファイルの例です。install-config.yamlの例apiVersion: v1 baseDomain: mydomain.test compute: - name: worker platform: openstack: type: m1.xlarge replicas: 3 controlPlane: name: master platform: openstack: type: m1.xlarge replicas: 3 metadata: name: mycluster networking: machineNetwork: 1 - cidr: "192.168.25.0/24" - cidr: "fd2e:6f44:5dd8:c956::/64" clusterNetwork: 2 - cidr: 10.128.0.0/14 hostPrefix: 23 - cidr: fd01::/48 hostPrefix: 64 serviceNetwork: 3 - 172.30.0.0/16 - fd02::/112 platform: openstack: ingressVIPs: ['192.168.25.79', 'fd2e:6f44:5dd8:c956:f816:3eff:fef1:1bad'] 4 apiVIPs: ['192.168.25.199', 'fd2e:6f44:5dd8:c956:f816:3eff:fe78:cf36'] 5 controlPlanePort: 6 fixedIPs: 7 - subnet: 8 name: subnet-v4 id: subnet-v4-id - subnet: 9 name: subnet-v6 id: subnet-v6-id network: 10 name: dualstack id: network-id- 1 2 3

- IPv4 と IPv6 の両方のアドレスファミリーの IP アドレス範囲を指定する必要があります。

- 4

- クラスターにインターフェイスを提供するための Ingress VIP サービスの仮想 IP (VIP) アドレスエンドポイントを指定します。

- 5

- API VIP サービスの仮想 IP (VIP) アドレスエンドポイントを指定して、クラスターにインターフェイスを提供します。

- 6

- クラスター内のすべてのノードで使用されるデュアルスタックネットワークの詳細を指定します。

- 7

- このフィールドで指定されたサブネットの CIDR は、

network.machineNetworkにリストされている CIDR と一致する必要があります。 - 8 9

nameまたはidのいずれか、または両方の値を指定できます。- 10

ControlPlanePortフィールドでのnetworkの指定は任意です。

あるいは、IPv6 プライマリーデュアルスタッククラスターが必要な場合は、以下の例に従って

install-config.yamlファイルを編集します。install-config.yamlの例apiVersion: v1 baseDomain: mydomain.test compute: - name: worker platform: openstack: type: m1.xlarge replicas: 3 controlPlane: name: master platform: openstack: type: m1.xlarge replicas: 3 metadata: name: mycluster networking: machineNetwork: 1 - cidr: "fd2e:6f44:5dd8:c956::/64" - cidr: "192.168.25.0/24" clusterNetwork: 2 - cidr: fd01::/48 hostPrefix: 64 - cidr: 10.128.0.0/14 hostPrefix: 23 serviceNetwork: 3 - fd02::/112 - 172.30.0.0/16 platform: openstack: ingressVIPs: ['fd2e:6f44:5dd8:c956:f816:3eff:fef1:1bad', '192.168.25.79'] 4 apiVIPs: ['fd2e:6f44:5dd8:c956:f816:3eff:fe78:cf36', '192.168.25.199'] 5 controlPlanePort: 6 fixedIPs: 7 - subnet: 8 name: subnet-v6 id: subnet-v6-id - subnet: 9 name: subnet-v4 id: subnet-v4-id network: 10 name: dualstack id: network-id- 1 2 3

- IPv4 と IPv6 の両方のアドレスファミリーの IP アドレス範囲を指定する必要があります。

- 4

- クラスターにインターフェイスを提供するための Ingress VIP サービスの仮想 IP (VIP) アドレスエンドポイントを指定します。

- 5

- API VIP サービスの仮想 IP (VIP) アドレスエンドポイントを指定して、クラスターにインターフェイスを提供します。

- 6

- クラスター内のすべてのノードで使用されるデュアルスタックネットワークの詳細を指定します。

- 7

- このフィールドで指定されたサブネットの CIDR は、

network.machineNetworkにリストされている CIDR と一致する必要があります。 - 8 9

nameまたはidのいずれか、または両方の値を指定できます。- 10

ControlPlanePortフィールドでのnetworkの指定は任意です。

隔離されたデュアルスタックネットワークでインストールホストを使用する場合、再起動時に IPv6 アドレスが正しく再割り当てされない場合があります。

Red Hat Enterprise Linux (RHEL) 8 でこの問題を解決するには、次の設定を含む /etc/NetworkManager/system-connections/required-rhel8-ipv6.conf という名前のファイルを作成します。

[connection] type=ethernet [ipv6] addr-gen-mode=eui64 method=auto

RHEL 9 でこの問題を解決するには、次の設定を含む /etc/NetworkManager/conf.d/required-rhel9-ipv6.conf という名前のファイルを作成します。

[connection] ipv6.addr-gen-mode=0

ファイルを作成して編集したら、インストールホストを再起動します。

19.3.10.7. ユーザー管理のロードバランサーを使用した OpenStack 上のクラスターのインストール設定

次の install-config.yaml ファイルの例は、デフォルトの内部ロードバランサーではなく、ユーザー管理の外部ロードバランサーを使用するクラスターを設定する方法を示しています。

apiVersion: v1

baseDomain: mydomain.test

compute:

- name: worker

platform:

openstack:

type: m1.xlarge

replicas: 3

controlPlane:

name: master

platform:

openstack:

type: m1.xlarge

replicas: 3

metadata:

name: mycluster

networking:

clusterNetwork:

- cidr: 10.128.0.0/14

hostPrefix: 23

machineNetwork:

- cidr: 192.168.10.0/24

platform:

openstack:

cloud: mycloud

machinesSubnet: 8586bf1a-cc3c-4d40-bdf6-c243decc603a 1

apiVIPs:

- 192.168.10.5

ingressVIPs:

- 192.168.10.7

loadBalancer:

type: UserManaged 219.3.11. クラスターノードの SSH アクセス用のキーペアの生成

OpenShift Container Platform をインストールする際に、SSH パブリックキーをインストールプログラムに指定できます。キーは、Ignition 設定ファイルを介して Red Hat Enterprise Linux CoreOS (RHCOS) ノードに渡され、ノードへの SSH アクセスを認証するために使用されます。このキーは各ノードの core ユーザーの ~/.ssh/authorized_keys リストに追加され、パスワードなしの認証が可能になります。

キーがノードに渡されると、キーペアを使用して RHCOS ノードにユーザー core として SSH を実行できます。SSH 経由でノードにアクセスするには、秘密鍵のアイデンティティーをローカルユーザーの SSH で管理する必要があります。

インストールのデバッグまたは障害復旧を実行するためにクラスターノードに対して SSH を実行する場合は、インストールプロセスの間に SSH 公開鍵を指定する必要があります。./openshift-install gather コマンドでは、SSH 公開鍵がクラスターノードに配置されている必要もあります。

障害復旧およびデバッグが必要な実稼働環境では、この手順を省略しないでください。

手順

クラスターノードへの認証に使用するローカルマシンに既存の SSH キーペアがない場合は、これを作成します。たとえば、Linux オペレーティングシステムを使用するコンピューターで以下のコマンドを実行します。

$ ssh-keygen -t ed25519 -N '' -f <path>/<file_name> 1- 1

- 新しい SSH キーのパスとファイル名 (

~/.ssh/id_ed25519など) を指定します。既存のキーペアがある場合は、公開鍵が~/.sshディレクトリーにあることを確認します。

注記x86_64、ppc64le、およびs390xアーキテクチャーのみで FIPS 140-2/140-3 検証のために NIST に提出された RHEL 暗号化ライブラリーを使用する OpenShift Container Platform クラスターをインストールする予定がある場合は、ed25519アルゴリズムを使用するキーを作成しないでください。代わりに、rsaアルゴリズムまたはecdsaアルゴリズムを使用するキーを作成します。公開 SSH キーを表示します。

$ cat <path>/<file_name>.pub

たとえば、次のコマンドを実行して

~/.ssh/id_ed25519.pub公開鍵を表示します。$ cat ~/.ssh/id_ed25519.pub

ローカルユーザーの SSH エージェントに SSH 秘密鍵 ID が追加されていない場合は、それを追加します。キーの SSH エージェント管理は、クラスターノードへのパスワードなしの SSH 認証、または

./openshift-install gatherコマンドを使用する場合は必要になります。注記一部のディストリビューションでは、

~/.ssh/id_rsaおよび~/.ssh/id_dsaなどのデフォルトの SSH 秘密鍵のアイデンティティーは自動的に管理されます。ssh-agentプロセスがローカルユーザーに対して実行されていない場合は、バックグラウンドタスクとして開始します。$ eval "$(ssh-agent -s)"

出力例

Agent pid 31874

注記クラスターが FIPS モードにある場合は、FIPS 準拠のアルゴリズムのみを使用して SSH キーを生成します。鍵は RSA または ECDSA のいずれかである必要があります。

SSH プライベートキーを

ssh-agentに追加します。$ ssh-add <path>/<file_name> 1- 1

~/.ssh/id_ed25519などの、SSH プライベートキーのパスおよびファイル名を指定します。

出力例

Identity added: /home/<you>/<path>/<file_name> (<computer_name>)

次のステップ

- OpenShift Container Platform をインストールする際に、SSH パブリックキーをインストールプログラムに指定します。

19.3.12. 環境へのアクセスの有効化

デプロイ時に、OpenShift Container Platform マシンはすべて Red Hat OpenStack Platform (RHOSP) テナントネットワークに作成されます。したがって、ほとんどの RHOSP デプロイメントでは直接アクセスできません。

インストール時に Floating IP アドレス (FIP) を使用して OpenShift Container Platform API およびアプリケーションのアクセスを設定できます。FIP を設定せずにインストールを完了することもできますが、インストーラーは API またはアプリケーションを外部からアクセスする方法を設定しません。

19.3.12.1. floating IP アドレスを使用したアクセスの有効化

OpenShift Container Platform API およびクラスターアプリケーションへの外部アクセス用に Floating IP (FIP) アドレスを作成します。

手順

Red Hat OpenStack Platform (RHOSP) CLI を使用して、API FIP を作成します。

$ openstack floating ip create --description "API <cluster_name>.<base_domain>" <external_network>

Red Hat OpenStack Platform (RHOSP) CLI を使用して、apps (アプリ)、または Ingress、FIP を作成します。

$ openstack floating ip create --description "Ingress <cluster_name>.<base_domain>" <external_network>

API および Ingress FIP の DNS サーバーに、これらのパターンに準拠するレコードを追加します。

api.<cluster_name>.<base_domain>. IN A <API_FIP> *.apps.<cluster_name>.<base_domain>. IN A <apps_FIP>

注記DNS サーバーを制御していない場合は、次のようなクラスタードメイン名を

/etc/hostsファイルに追加することで、クラスターにアクセスできます。-

<api_floating_ip> api.<cluster_name>.<base_domain> -

<application_floating_ip> grafana-openshift-monitoring.apps.<cluster_name>.<base_domain> -

<application_floating_ip> prometheus-k8s-openshift-monitoring.apps.<cluster_name>.<base_domain> -

<application_floating_ip> oauth-openshift.apps.<cluster_name>.<base_domain> -

<application_floating_ip> console-openshift-console.apps.<cluster_name>.<base_domain> -

application_floating_ip integrated-oauth-server-openshift-authentication.apps.<cluster_name>.<base_domain>

/etc/hostsファイル内のクラスタードメイン名により、クラスターの Web コンソールおよび監視インターフェイスへのローカルアクセスが許可されます。kubectlまたはocを使用することもできます。<application_floating_ip> を指す追加のエントリーを使用して、ユーザーアプリケーションにアクセスできます。このアクションにより、API およびアプリケーションは他のユーザーがアクセスできない状態になり、この状態は実稼働デプロイメントには適していませんが、開発およびテスト目的のインストールが可能になります。-

FIP を、以下のパラメーターの値として

install-config.yamlファイルに追加します。-

platform.openstack.ingressFloatingIP -

platform.openstack.apiFloatingIP

-

これらの値を使用する場合には、install-config.yaml ファイルの platform.openstack.externalNetwork パラメーターの値として外部ネットワークを入力する必要もあります。

Floating IP アドレスを割り当て、ファイアウォール設定を更新することで、OpenShift Container Platform リソースがクラスター外で利用できる状態にすることができます。

19.3.12.2. Floating IP アドレスなしでのインストールの完了

Floating IP アドレスを指定せずに OpenShift Container Platform を Red Hat OpenStack Platform (RHOSP) にインストールすることができます。

install-config.yaml ファイルで以下のパラメーターを定義しないでください。

-

platform.openstack.ingressFloatingIP -

platform.openstack.apiFloatingIP

外部ネットワークを提供できない場合は、platform.openstack.externalNetwork を空白のままにすることもできます。platform.openstack.externalNetwork の値を指定しない場合はルーターが作成されず、追加のアクションがない場合は、インストーラーは Glance からのイメージの取得に失敗します。外部接続を独自に設定する必要があります。

Floating IP アドレスまたは名前解決がないために、クラスター API に到達できないシステムからインストーラーを実行すると、インストールに失敗します。このような場合にインストールが失敗するのを防ぐために、プロキシーネットワークを使用するか、マシンと同じネットワークにあるシステムからインストーラーを実行できます。

API および Ingress ポートの DNS レコードを作成して、名前解決を有効にできます。以下に例を示します。

api.<cluster_name>.<base_domain>. IN A <api_port_IP> *.apps.<cluster_name>.<base_domain>. IN A <ingress_port_IP>

DNS サーバーを制御しない場合は、/etc/hosts ファイルにレコードを追加できます。このアクションにより、API は他者のアクセスできない状態になり、この状態は実稼働デプロイメントには適していませんが、開発およびテスト目的のインストールが可能になります。

19.3.13. クラスターのデプロイ

互換性のあるクラウドプラットフォームに OpenShift Container Platform をインストールできます。

インストールプログラムの create cluster コマンドは、初期インストール時に 1 回だけ実行できます。

前提条件

- OpenShift Container Platform インストールプログラムおよびクラスターのプルシークレットがある。

- ホスト上のクラウドプロバイダーアカウントに、クラスターをデプロイするための適切な権限があることが確認されました。アカウントの権限が正しくないと、インストールプロセスが失敗し、不足している権限を示すエラーメッセージが表示されます。

手順

インストールプログラムが含まれるディレクトリーに切り替え、クラスターのデプロイメントを初期化します。

$ ./openshift-install create cluster --dir <installation_directory> \ 1 --log-level=info 2

検証

クラスターのデプロイが正常に完了すると、次のようになります。

-

ターミナルには、Web コンソールへのリンクや

kubeadminユーザーの認証情報など、クラスターにアクセスするための指示が表示されます。 -

認証情報は

<installation_directory>/.openshift_install.logにも出力されます。

インストールプログラム、またはインストールプログラムが作成するファイルを削除することはできません。これらはいずれもクラスターを削除するために必要になります。

出力例

... INFO Install complete! INFO To access the cluster as the system:admin user when using 'oc', run 'export KUBECONFIG=/home/myuser/install_dir/auth/kubeconfig' INFO Access the OpenShift web-console here: https://console-openshift-console.apps.mycluster.example.com INFO Login to the console with user: "kubeadmin", and password: "password" INFO Time elapsed: 36m22s

-

インストールプログラムが生成する Ignition 設定ファイルには、24 時間が経過すると期限切れになり、その後に更新される証明書が含まれます。証明書を更新する前にクラスターが停止し、24 時間経過した後にクラスターを再起動すると、クラスターは期限切れの証明書を自動的に復元します。例外として、kubelet 証明書を回復するために保留状態の

node-bootstrapper証明書署名要求 (CSR) を手動で承認する必要があります。詳細は、コントロールプレーン証明書の期限切れの状態からのリカバリー に関するドキュメントを参照してください。 - 24 時間証明書はクラスターのインストール後 16 時間から 22 時間にローテーションするため、Ignition 設定ファイルは、生成後 12 時間以内に使用することを推奨します。12 時間以内に Ignition 設定ファイルを使用することにより、インストール中に証明書の更新が実行された場合のインストールの失敗を回避できます。

19.3.14. クラスターステータスの確認

インストール時またはインストール後に OpenShift Container Platform クラスターのステータスを確認することができます。

手順

クラスター環境で、管理者の kubeconfig ファイルをエクスポートします。

$ export KUBECONFIG=<installation_directory>/auth/kubeconfig 1- 1

<installation_directory>には、インストールファイルを保存したディレクトリーへのパスを指定します。

kubeconfigファイルには、クライアントを正しいクラスターおよび API サーバーに接続するために CLI で使用されるクラスターに関する情報が含まれます。デプロイメント後に作成されたコントロールプレーンおよびコンピュートマシンを表示します。

$ oc get nodes

クラスターのバージョンを表示します。

$ oc get clusterversion

Operator のステータスを表示します。

$ oc get clusteroperator

クラスター内のすべての実行中の Pod を表示します。

$ oc get pods -A

19.3.15. CLI の使用によるクラスターへのログイン

クラスター kubeconfig ファイルをエクスポートし、デフォルトシステムユーザーとしてクラスターにログインできます。kubeconfig ファイルには、クライアントを正しいクラスターおよび API サーバーに接続するために CLI で使用されるクラスターに関する情報が含まれます。このファイルはクラスターに固有のファイルであり、OpenShift Container Platform のインストール時に作成されます。

前提条件

- OpenShift Container Platform クラスターをデプロイしていること。

-

ocCLI をインストールしていること。

手順

kubeadmin認証情報をエクスポートします。$ export KUBECONFIG=<installation_directory>/auth/kubeconfig 1- 1

<installation_directory>には、インストールファイルを保存したディレクトリーへのパスを指定します。

エクスポートされた設定を使用して、

ocコマンドを正常に実行できることを確認します。$ oc whoami

出力例

system:admin

関連情報

- OpenShift Container Platform Web コンソールへのアクセスと理解に関する詳細は、Web コンソールへのアクセス を参照してください。

19.3.16. OpenShift Container Platform の Telemetry アクセス

OpenShift Container Platform 4.16 では、Telemetry サービスにもインターネットアクセスが必要です。Telemetry サービスは、クラスターの健全性と更新の成功に関するメトリクスを提供するためにデフォルトで実行されます。クラスターがインターネットに接続されている場合、Telemetry は自動的に実行され、クラスターは OpenShift Cluster Manager に登録されます。

OpenShift Cluster Manager インベントリーが正常である (Telemetry によって自動的に維持、または OpenShift Cluster Manager を使用して手動で維持) ことを確認した後に、subscription watch を使用 して、アカウントまたはマルチクラスターレベルで OpenShift Container Platform サブスクリプションを追跡します。

関連情報

- Telemetry サービスの詳細は、リモートヘルスモニタリング を参照してください。

19.3.17. 次のステップ

- クラスターをカスタマイズ します。

- 必要に応じて、リモートヘルスレポートをオプトアウト できます。

- ノードポートへの外部アクセスを有効にする必要がある場合は、ノードポートを使用して Ingress クラスタートラフィックを設定 します。

- Floating IP アドレス上でアプリケーショントラフィックを受け入れるように RHOSP を設定していない場合は、Floating IP アドレスを使用して RHOSP アクセスを設定 します。