2.4. 使用自定义在 vSphere 上安装集群

在 OpenShift Container Platform 版本 4.15 中,您可以使用安装程序置备的基础架构在 VMware vSphere 实例上安装集群。要自定义安装,请在安装集群前修改 install-config.yaml 文件中的参数。

OpenShift Container Platform 支持将集群部署到单个 VMware vCenter 中。不支持在多个 vCenter 上使用机器/机器集部署集群。

2.4.1. 先决条件

- 您已完成了 准备使用安装程序置备的基础架构安装集群 中的任务。

- 您检查了 VMware 平台许可证。红帽不会对 VMware 许可证产生任何限制,但有些 VMware 基础架构组件需要许可。

- 您可以参阅有关 OpenShift Container Platform 安装和更新 流程的详细信息。

- 您可以阅读有关 选择集群安装方法的文档,并为用户准备它。

-

已为集群置备了 持久性存储。要部署私有镜像 registry,您的存储必须提供

ReadWriteMany访问模式。 - OpenShift Container Platform 安装程序需要访问 vCenter 和 ESXi 主机上的端口 443。您确认可以访问端口 443。

- 如果您使用防火墙,您与管理员确认可以访问端口 443。control plane 节点必须能够通过端口 443 访问 vCenter 和 ESXi 主机,才能成功安装。

如果使用防火墙,则会 将其配置为允许集群需要访问的站点。

注意如果要配置代理,请务必查看此站点列表。

2.4.2. OpenShift Container Platform 互联网访问

在 OpenShift Container Platform 4.15 中,您需要访问互联网来安装集群。

您必须具有以下互联网访问权限:

- 访问 OpenShift Cluster Manager 以下载安装程序并执行订阅管理。如果集群可以访问互联网,并且没有禁用 Telemetry,该服务会自动授权您的集群。

- 访问 Quay.io,以获取安装集群所需的软件包。

- 获取执行集群更新所需的软件包。

如果您的集群无法直接访问互联网,则可以在置备的某些类型的基础架构上执行受限网络安装。在此过程中,您可以下载所需的内容,并使用它为镜像 registry 填充安装软件包。对于某些安装类型,集群要安装到的环境不需要访问互联网。在更新集群前,您要更新镜像 registry 的内容。

2.4.3. VMware vSphere 区域和区启用

您可以将 OpenShift Container Platform 集群部署到在单个 VMware vCenter 中运行的多个 vSphere 数据中心。每个数据中心都可以运行多个集群。此配置降低了导致集群失败的硬件故障或网络中断的风险。要启用区域和区域,您必须为 OpenShift Container Platform 集群定义多个故障域。

VMware vSphere 区域和区启用功能需要 vSphere Container Storage Interface (CSI) 驱动程序作为集群中的默认存储驱动程序。因此,这个功能只在新安装的集群中可用。

对于从上一版本升级的集群,您必须为集群启用 CSI 自动迁移。然后,您可以为升级的集群配置多个区域和区域。

默认安装配置将集群部署到单个 vSphere 数据中心。如果要将集群部署到多个 vSphere 数据中心,您必须创建一个启用地区和区功能的安装配置文件。

默认 install-config.yaml 文件包含 vcenters 和 failureDomains 字段,您可以在其中为 OpenShift Container Platform 集群指定多个 vSphere 数据中心和集群。如果要在由单个数据中心组成的 vSphere 环境中安装 OpenShift Container Platform 集群,您可以将这些字段留空。

以下列表描述了为集群定义区和区域相关的术语:

-

故障域:建立地区和区域之间的关系。您可以使用 vCenter 对象(如

datastore对象)定义故障域。故障域定义 OpenShift Container Platform 集群节点的 vCenter 位置。 -

Region :指定 vCenter 数据中心。您可以使用

openshift-region标签类别中的标签来定义区域。 -

Zone:指定一个 vCenter 集群。您可以使用

openshift-zone标签类别中的标签来定义区。

如果您计划在 install-config.yaml 文件中指定多个故障域,则必须在创建配置文件前创建标签类别、区域标签和区域标签。

您必须为每个代表一个区域的 vCenter 数据中心创建一个 vCenter 标签。另外,您必须为比数据中心(代表一个区)中运行的每个集群创建一个 vCenter 标签。创建标签后,您必须将每个标签附加到对应的数据中心和集群。

下表概述了在单个 VMware vCenter 中运行的多个 vSphere 数据中心的区域、区域和标签之间的关系示例。

| 数据中心(区域) | 集群(区) | Tags |

|---|---|---|

| us-east | us-east-1 | us-east-1a |

| us-east-1b | ||

| us-east-2 | us-east-2a | |

| us-east-2b | ||

| us-west | us-west-1 | us-west-1a |

| us-west-1b | ||

| us-west-2 | us-west-2a | |

| us-west-2b |

2.4.4. 创建安装配置文件

您可以自定义在 VMware vSphere 上安装的 OpenShift Container Platform 集群。

先决条件

- 您有 OpenShift Container Platform 安装程序和集群的 pull secret。

流程

创建

install-config.yaml文件。进入包含安装程序的目录并运行以下命令:

./openshift-install create install-config --dir <installation_directory>

$ ./openshift-install create install-config --dir <installation_directory>1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 对于

<installation_directory>,请指定要存储安装程序创建的文件的目录名称。

在指定目录时:

-

验证该目录是否具有

执行权限。在安装目录中运行 Terraform 二进制文件需要这个权限。 - 使用空目录。有些安装资产,如 bootstrap X.509 证书的过期间隔较短,因此不得重复使用安装目录。如果要重复使用另一个集群安装中的单个文件,您可以将它们复制到您的目录中。但是,安装资产的文件名可能会在发行版本间有所变化。从以前的 OpenShift Container Platform 版本中复制安装文件时请小心。

在提示符处,提供云的配置详情:

可选: 选择用于访问集群机器的 SSH 密钥。

注意对于您要在其上执行安装调试或灾难恢复的生产环境 OpenShift Container Platform 集群,请指定

ssh-agent进程使用的 SSH 密钥。- Select vsphere 作为目标平台。

- 指定 vCenter 实例的名称。

指定创建集群所需的权限的 vCenter 帐户的用户名和密码。

安装程序连接到您的 vCenter 实例。

选择要连接的 vCenter 实例中的数据中心。

注意创建安装配置文件后,您可以修改该文件以创建多个 vSphere 数据中心环境。这意味着您可以将 OpenShift Container Platform 集群部署到在单个 VMware vCenter 中运行的多个 vSphere 数据中心。有关创建此环境的更多信息,请参阅名为 VMware vSphere 区域和区启用的部分。

选择要使用的默认 vCenter 数据存储。

警告您可以指定数据存储集群中存在的任何数据存储路径。默认情况下,使用 Storage vMotion 的存储分布式资源调度程序(SDRS)会自动为数据存储集群启用。红帽不支持 Storage vMotion,因此您必须禁用 Storage DRS 以避免 OpenShift Container Platform 集群的数据丢失问题。

您不能指定多个数据存储路径。如果需要在多个数据存储间指定虚拟机,请使用

数据存储对象在集群install-config.yaml配置文件中指定故障域。如需更多信息,请参阅"VMware vSphere 区域和区启用"。- 选择要在其中安装 OpenShift Container Platform 集群的 vCenter 集群。安装程序使用 vSphere 集群的 root 资源池作为默认资源池。

- 选择包含您配置的虚拟 IP 地址和 DNS 记录的 vCenter 实例中的网络。

- 输入您为 control plane API 访问配置的虚拟 IP 地址。

- 输入您为集群入口配置的虚拟 IP 地址。

- 输入基域。这个基域必须与您配置的 DNS 记录中使用的域相同。

为集群输入描述性名称。

您输入的集群名称必须与您在配置 DNS 记录时指定的集群名称匹配。

修改

install-config.yaml文件。您可以在"安装配置参数"部分找到有关可用参数的更多信息。注意如果要安装三节点集群,请确保将

compute.replicas参数设置为0。这样可确保集群的 control plane 可以调度。如需更多信息,请参阅"在 vSphere 上安装三节点集群"。备份

install-config.yaml文件,以便您可以使用它安装多个集群。重要install-config.yaml文件会在安装过程中消耗掉。如果要重复使用此文件,必须现在备份。

您可以自定义 install-config.yaml 文件,以指定有关 OpenShift Container Platform 集群平台的更多详情,或修改所需参数的值。

- 1

- 集群的基域。所有 DNS 记录都必须是这个基域的子域,并包含集群名称。

- 2 3

controlPlane部分是一个单个映射,但compute部分是一系列映射。为满足不同数据结构的要求,compute部分的第一行必须以连字符-开头,controlPlane部分的第一行则不以连字符开头。仅使用一个 control plane 池。- 4

- 您在 DNS 记录中指定的集群名称。

- 5

- 可选:为 compute 和 control plane 机器提供额外的机器池参数配置。

- 6

- 建立地区和区域之间的关系。您可以使用 vCenter 对象(如

datastore对象)定义故障域。故障域定义 OpenShift Container Platform 集群节点的 vCenter 位置。 - 7

- 保存虚拟机文件、模板和 ISO 镜像的 vSphere 数据存储路径。重要

您可以指定数据存储集群中存在的任何数据存储路径。默认情况下,Storage vMotion 会自动为数据存储集群启用。红帽不支持 Storage vMotion,因此您必须禁用 Storage vMotion 以避免 OpenShift Container Platform 集群的数据丢失问题。

如果需要在多个数据存储间指定虚拟机,请使用

数据存储对象在集群install-config.yaml配置文件中指定故障域。如需更多信息,请参阅"VMware vSphere 区域和区启用"。 - 8

- 可选:为创建机器提供现有资源池。如果没有指定值,安装程序将使用 vSphere 集群的 root 资源池。

- 9

- vSphere 磁盘置备方法。

在 OpenShift Container Platform 4.12 及更新的版本中,apiVIP 和 ingressVIP 配置设置已弃用。反之,使用列表格式在 apiVIPs 和 ingressVIPs 配置设置中输入值。

2.4.4.2. 在安装过程中配置集群范围的代理

生产环境可能会拒绝直接访问互联网,而是提供 HTTP 或 HTTPS 代理。您可以通过在 install-config.yaml 文件中配置代理设置,将新的 OpenShift Container Platform 集群配置为使用代理。

先决条件

-

您有一个现有的

install-config.yaml文件。 您检查了集群需要访问的站点,并确定它们中的任何站点是否需要绕过代理。默认情况下,所有集群出口流量都经过代理,包括对托管云供应商 API 的调用。如果需要,您将在

Proxy 对象的spec.noProxy字段中添加站点来绕过代理。注意Proxy对象status.noProxy字段使用安装配置中的networking.machineNetwork[].cidr、networking.clusterNetwork[].cidr和networking.serviceNetwork[]字段的值填充。对于在 Amazon Web Services (AWS)、Google Cloud、Microsoft Azure 和 Red Hat OpenStack Platform (RHOSP)上安装,

Proxy对象status.noProxy字段也会填充实例元数据端点(169.254.169.254)。

流程

编辑

install-config.yaml文件并添加代理设置。例如:Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 用于创建集群外 HTTP 连接的代理 URL。URL 方案必须是

http。 - 2

- 用于创建集群外 HTTPS 连接的代理 URL。

- 3

- 要从代理中排除的目标域名、IP 地址或其他网络 CIDR 的逗号分隔列表。在域前面加上

.以仅匹配子域。例如,.y.com匹配x.y.com,但不匹配y.com。使用*绕过所有目的地的代理。您必须包含 vCenter 的 IP 地址以及用于其机器的 IP 范围。 - 4

- 如果提供,安装程序会在

openshift-config命名空间中生成名为user-ca-bundle的配置映射,其包含代理 HTTPS 连接所需的一个或多个额外 CA 证书。然后,Cluster Network Operator 会创建trusted-ca-bundle配置映射,将这些内容与 Red Hat Enterprise Linux CoreOS(RHCOS)信任捆绑包合并,Proxy对象的trustedCA字段中也会引用此配置映射。additionalTrustBundle字段是必需的,除非代理的身份证书由来自 RHCOS 信任捆绑包的颁发机构签名。 - 5

- 可选:决定

Proxy对象的配置以引用trustedCA字段中user-ca-bundle配置映射的策略。允许的值是Proxyonly和Always。仅在配置了http/https代理时,使用Proxyonly引用user-ca-bundle配置映射。使用Always始终引用user-ca-bundle配置映射。默认值为Proxyonly。

注意安装程序不支持代理的

readinessEndpoints字段。注意如果安装程序超时,重启并使用安装程序的

wait-for命令完成部署。例如:./openshift-install wait-for install-complete --log-level debug

$ ./openshift-install wait-for install-complete --log-level debugCopy to Clipboard Copied! Toggle word wrap Toggle overflow - 保存该文件并在安装 OpenShift Container Platform 时引用。

安装程序会创建一个名为 cluster 的集群范围代理,该代理 使用 提供的 install-config.yaml 文件中的代理设置。如果没有提供代理设置,仍然会创建一个 cluster Proxy 对象,但它会有一个空 spec。

只支持名为 cluster 的 Proxy 对象,且无法创建额外的代理。

2.4.4.3. 为 VMware vCenter 配置区域和区域

您可以修改默认安装配置文件,以便您可以将 OpenShift Container Platform 集群部署到在单个 VMware vCenter 中运行的多个 vSphere 数据中心。

之前版本的 OpenShift Container Platform 的默认 install-config.yaml 文件配置已弃用。您可以继续使用已弃用的默认配置,但 openshift-installer 会提示您显示在配置文件中已弃用字段的警告信息。

这个示例使用 govc 命令。govc 命令是 VMware 提供的开源命令;它不是红帽提供的。红帽支持团队不维护 govc 命令。有关下载和安装 govc 的说明,请参阅 VMware 文档网站

先决条件

您有一个现有的

install-config.yaml安装配置文件。重要您必须为 OpenShift Container Platform 集群指定一个故障域,以便您可以为 VMware vCenter 服务器置备数据中心对象。如果您需要在不同的数据中心、集群、数据存储和其他组件中置备虚拟机节点,请考虑指定多个故障域。要启用区域和区域,您必须为 OpenShift Container Platform 集群定义多个故障域。

流程

输入以下

govc命令行工具命令,以创建openshift-region和openshift-zonevCenter 标签类别:重要如果为

openshift-region和openshift-zonevCenter 标签类别指定不同的名称,OpenShift Container Platform 集群的安装会失败。govc tags.category.create -d "OpenShift region" openshift-region

$ govc tags.category.create -d "OpenShift region" openshift-regionCopy to Clipboard Copied! Toggle word wrap Toggle overflow govc tags.category.create -d "OpenShift zone" openshift-zone

$ govc tags.category.create -d "OpenShift zone" openshift-zoneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 要为您要部署集群的每个区域 vSphere 数据中心创建一个 region 标签,请在终端中输入以下命令:

govc tags.create -c <region_tag_category> <region_tag>

$ govc tags.create -c <region_tag_category> <region_tag>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 要为您要部署集群的每个 vSphere 集群创建一个区标签,请输入以下命令:

govc tags.create -c <zone_tag_category> <zone_tag>

$ govc tags.create -c <zone_tag_category> <zone_tag>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令将区域标签附加到每个 vCenter 数据中心对象:

govc tags.attach -c <region_tag_category> <region_tag_1> /<datacenter_1>

$ govc tags.attach -c <region_tag_category> <region_tag_1> /<datacenter_1>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令将区标签附加到每个 vCenter 数据中心对象:

govc tags.attach -c <zone_tag_category> <zone_tag_1> /<datacenter_1>/host/vcs-mdcnc-workload-1

$ govc tags.attach -c <zone_tag_category> <zone_tag_1> /<datacenter_1>/host/vcs-mdcnc-workload-1Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 进入包含安装程序的目录,并根据您选择的安装要求初始化集群部署。

在 vSphere 数据中心中定义的多个数据中心的 install-config.yaml 文件示例

2.4.5. 部署集群

您可以在兼容云平台上安装 OpenShift Container Platform。

在初始安装过程中,您只能运行安装程序的 create cluster 命令一次。

先决条件

- 您有 OpenShift Container Platform 安装程序和集群的 pull secret。

- 已确认主机上的云供应商帐户具有部署集群的正确权限。权限不正确的帐户会导致安装过程失败,并显示包括缺失权限的错误消息。

可选:在创建集群时,配置外部负载均衡器来代替默认负载均衡器。

重要您不需要为安装程序指定 API 和 Ingress 静态地址。如果选择此配置,则必须采取额外的操作来定义接受每个引用的 vSphere 子网的 IP 地址的网络目标。请参阅"配置外部负载均衡器"一节。

流程

进入包含安装程序的目录并初始化集群部署:

./openshift-install create cluster --dir <installation_directory> \ --log-level=info$ ./openshift-install create cluster --dir <installation_directory> \1 --log-level=info2 Copy to Clipboard Copied! Toggle word wrap Toggle overflow

验证

当集群部署成功完成时:

-

终端会显示用于访问集群的说明,包括指向 Web 控制台和

kubeadmin用户的凭证的链接。 -

凭证信息还会输出到

<installation_directory>/.openshift_install.log.

不要删除安装程序或安装程序所创建的文件。需要这两者才能删除集群。

输出示例

-

安装程序生成的 Ignition 配置文件包含在 24 小时后过期的证书,然后在过期时进行续订。如果在更新证书前关闭集群,且集群在 24 小时后重启,集群会自动恢复过期的证书。一个例外是,您必须手动批准待处理的

node-bootstrapper证书签名请求(CSR)来恢复 kubelet 证书。如需更多信息,请参阅从过期的 control plane 证书 中恢复的文档。 - 建议您在 Ignition 配置文件生成后的 12 小时内使用它们,因为 24 小时的证书会在集群安装后的 16 小时到 22 小时间进行轮转。通过在 12 小时内使用 Ignition 配置文件,您可以避免在安装过程中因为执行了证书更新而导致安装失败的问题。

2.4.6. 使用 CLI 登录集群

您可以通过导出集群 kubeconfig 文件,以默认系统用户身份登录集群。kubeconfig 文件包含有关集群的信息,供 CLI 用于将客户端连接到正确的集群和 API 服务器。该文件特定于集群,在 OpenShift Container Platform 安装过程中创建。

先决条件

- 已部署 OpenShift Container Platform 集群。

-

已安装

ocCLI。

流程

导出

kubeadmin凭证:export KUBECONFIG=<installation_directory>/auth/kubeconfig

$ export KUBECONFIG=<installation_directory>/auth/kubeconfig1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 对于

<installation_directory>,请指定安装文件保存到的目录的路径。

验证您可以使用导出的配置成功运行

oc命令:oc whoami

$ oc whoamiCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

system:admin

system:adminCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.7. 创建 registry 存储

安装集群后,必须为 registry Operator 创建存储。

2.4.7.1. 安装过程中删除的镜像 registry

在不提供可共享对象存储的平台上,OpenShift Image Registry Operator bootstraps 本身为 Removed。这允许 openshift-installer 在这些平台类型上完成安装。

安装后,您必须编辑 Image Registry Operator 配置,将 managementState 从 Removed 切换到 Managed。完成此操作后,您必须配置存储。

2.4.7.2. 镜像 registry 存储配置

对于不提供默认存储的平台,Image Registry Operator 最初不可用。安装后,您必须将 registry 配置为使用存储,以便 Registry Operator 可用。

显示配置生产集群所需的持久性卷的说明。如果适用,显示有关将空目录配置为存储位置的说明,这仅适用于非生产集群。

提供了在升级过程中使用 Recreate rollout 策略来允许镜像 registry 使用块存储类型的说明。

2.4.7.2.1. 为 VMware vSphere 配置 registry 存储

作为集群管理员,在安装后需要配置 registry 来使用存储。

先决条件

- 集群管理员权限。

- VMware vSphere 上有一个集群。

为集群置备的持久性存储,如 Red Hat OpenShift Data Foundation。

重要当您只有一个副本时,OpenShift Container Platform 支持对镜像 registry 存储的

ReadWriteOnce访问。ReadWriteOnce访问还要求 registry 使用Recreaterollout 策略。要部署支持高可用性的镜像 registry,需要两个或多个副本,ReadWriteMany访问。- 必须具有"100Gi"容量.

测试显示在 RHEL 中使用 NFS 服务器作为核心服务的存储后端的问题。这包括 OpenShift Container Registry 和 Quay,Prometheus 用于监控存储,以及 Elasticsearch 用于日志存储。因此,不建议使用 RHEL NFS 作为 PV 后端用于核心服务。

市场上的其他 NFS 实现可能没有这些问题。如需了解更多与此问题相关的信息,请联络相关的 NFS 厂商。

流程

要将 registry 配置为使用存储,修改

configs.imageregistry/cluster资源中的spec.storage.pvc。注意使用共享存储时,请查看您的安全设置以防止外部访问。

验证您没有 registry pod:

oc get pod -n openshift-image-registry -l docker-registry=default

$ oc get pod -n openshift-image-registry -l docker-registry=defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

No resourses found in openshift-image-registry namespace

No resourses found in openshift-image-registry namespaceCopy to Clipboard Copied! Toggle word wrap Toggle overflow 注意如果您的输出中有一个 registry pod,则不需要继续这个过程。

检查 registry 配置:

oc edit configs.imageregistry.operator.openshift.io

$ oc edit configs.imageregistry.operator.openshift.ioCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

storage: pvc: claim:storage: pvc: claim:1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 将

claim字段留空以允许自动创建image-registry-storage持久性卷声明(PVC)。PVC 基于默认存储类生成。但请注意,默认存储类可能会提供 ReadWriteOnce (RWO)卷,如 RADOS 块设备(RBD),这可能会在复制到多个副本时导致问题。

检查

clusteroperator状态:oc get clusteroperator image-registry

$ oc get clusteroperator image-registryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE MESSAGE image-registry 4.7 True False False 6h50m

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE MESSAGE image-registry 4.7 True False False 6h50mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.7.2.2. 为 VMware vSphere 配置块 registry 存储

要允许镜像 registry 在作为集群管理员升级过程中使用块存储类型,如 vSphere Virtual Machine Disk(VMDK),您可以使用 Recreate rollout 策略。

支持块存储卷,但不建议在生产环境中用于镜像 registry。在块存储上配置 registry 的安装不具有高可用性,因为 registry 无法具有多个副本。

流程

输入以下命令将镜像 registry 存储设置为块存储类型,对 registry 进行补丁,使其使用

Recreaterollout 策略,并只使用一个副本运行:oc patch config.imageregistry.operator.openshift.io/cluster --type=merge -p '{"spec":{"rolloutStrategy":"Recreate","replicas":1}}'$ oc patch config.imageregistry.operator.openshift.io/cluster --type=merge -p '{"spec":{"rolloutStrategy":"Recreate","replicas":1}}'Copy to Clipboard Copied! Toggle word wrap Toggle overflow 为块存储设备置备 PV,并为该卷创建 PVC。请求的块卷使用 ReadWriteOnce(RWO)访问模式。

创建包含以下内容的

pvc.yaml文件以定义 VMware vSpherePersistentVolumeClaim对象:Copy to Clipboard Copied! Toggle word wrap Toggle overflow 输入以下命令从文件创建

PersistentVolumeClaim对象:oc create -f pvc.yaml -n openshift-image-registry

$ oc create -f pvc.yaml -n openshift-image-registryCopy to Clipboard Copied! Toggle word wrap Toggle overflow

输入以下命令编辑 registry 配置,使其引用正确的 PVC:

oc edit config.imageregistry.operator.openshift.io -o yaml

$ oc edit config.imageregistry.operator.openshift.io -o yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 输出示例

storage: pvc: claim:storage: pvc: claim:1 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 通过创建自定义 PVC,您可以将

claim字段留空,以便默认自动创建image-registry-storagePVC。

有关配置 registry 存储以便引用正确的 PVC 的说明,请参阅 为 vSphere 配置 registry。

2.4.8. OpenShift Container Platform 的 Telemetry 访问

在 OpenShift Container Platform 4.15 中,默认运行的 Telemetry 服务提供有关集群健康状况和成功更新的指标,需要访问互联网。如果您的集群连接到互联网,Telemetry 会自动运行,而且集群会注册到 OpenShift Cluster Manager。

确认 OpenShift Cluster Manager 清单正确后,可以由 Telemetry 自动维护,也可以使用 OpenShift Cluster Manager 手动维护,使用订阅监控来跟踪帐户或多集群级别的 OpenShift Container Platform 订阅。

2.4.9. 外部负载均衡器的服务

您可以将 OpenShift Container Platform 集群配置为使用外部负载均衡器来代替默认负载均衡器。

配置外部负载均衡器取决于您的供应商的负载均衡器。

本节中的信息和示例仅用于指导目的。有关供应商负载均衡器的更多信息,请参阅供应商文档。

红帽支持外部负载均衡器的以下服务:

- Ingress Controller

- OpenShift API

- OpenShift MachineConfig API

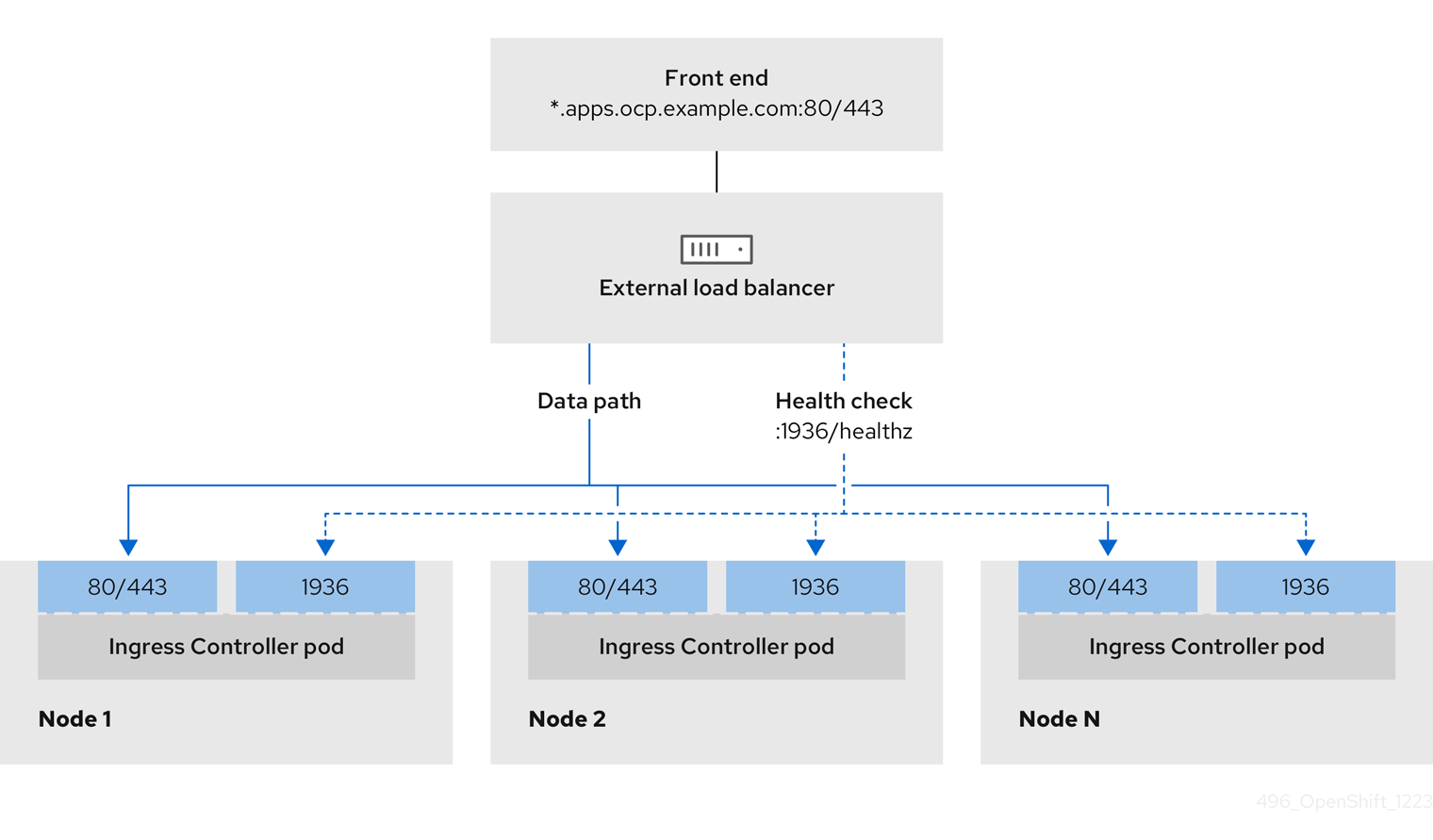

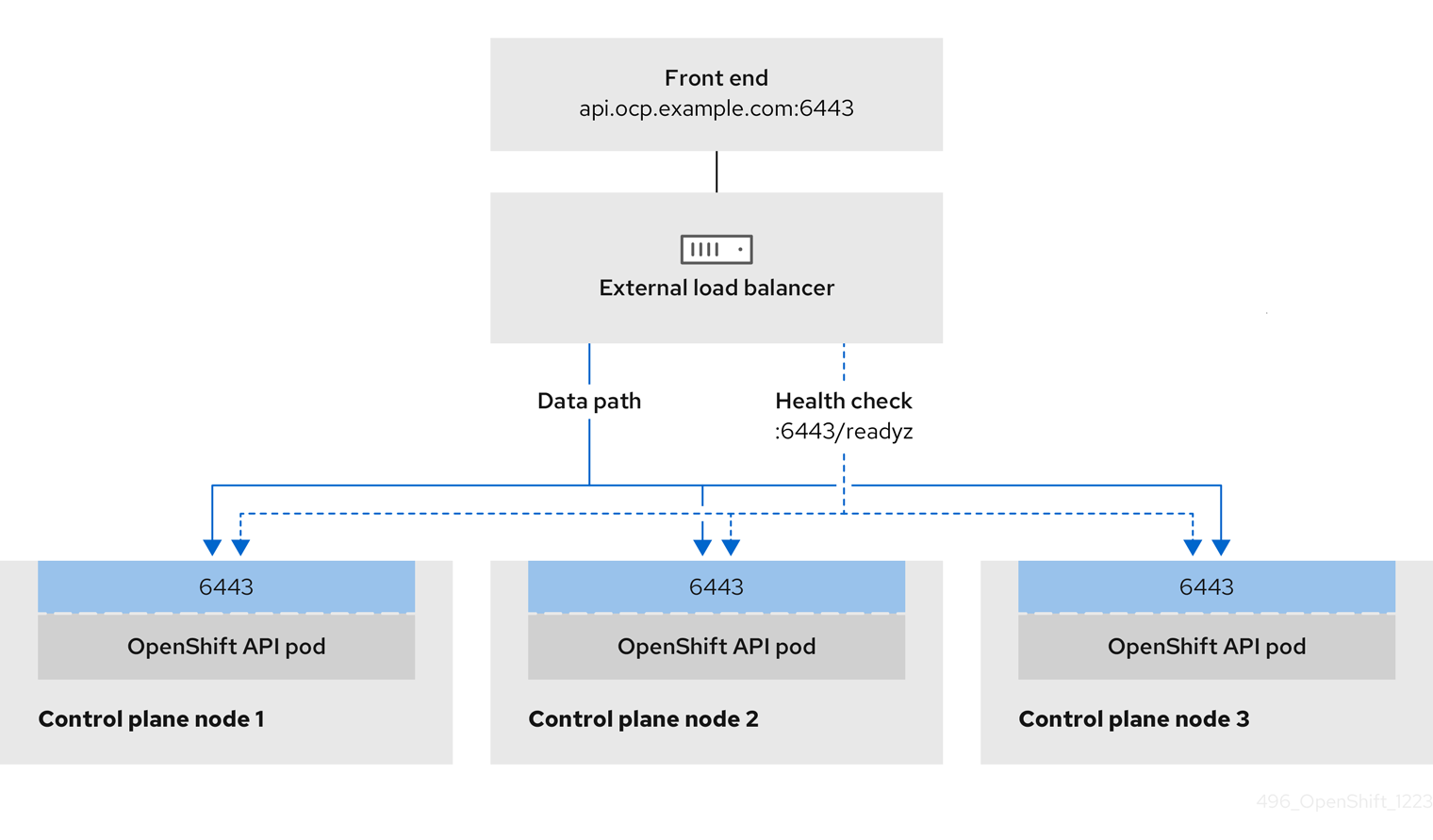

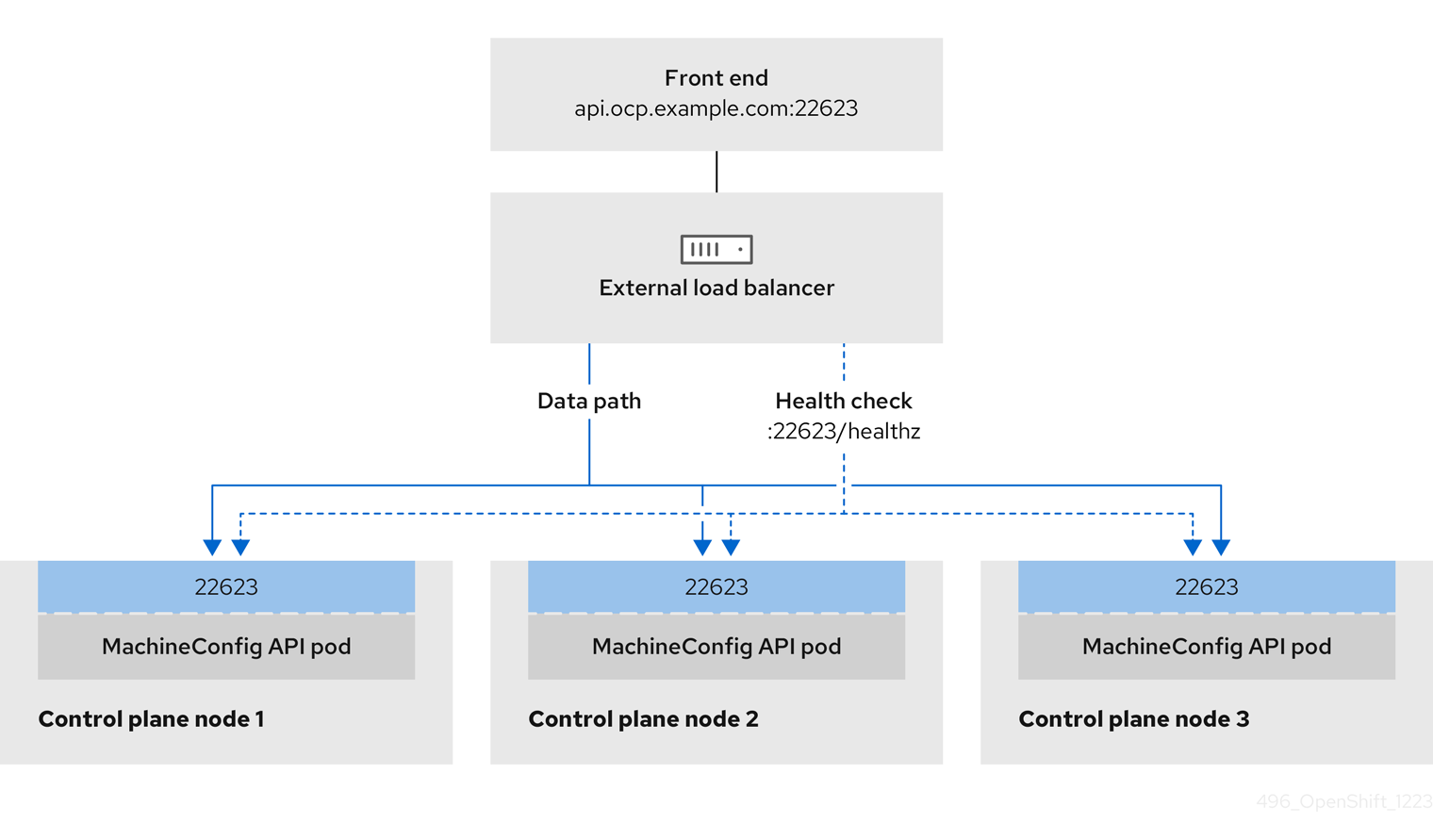

您可以选择是否为外部负载均衡器配置一个或多个所有服务。仅配置 Ingress Controller 服务是一个通用的配置选项。要更好地了解每个服务,请查看以下图表:

图 2.1. 显示 OpenShift Container Platform 环境中运行的 Ingress Controller 的网络工作流示例

图 2.2. 显示 OpenShift Container Platform 环境中运行的 OpenShift API 的网络工作流示例

图 2.3. 显示 OpenShift Container Platform 环境中运行的 OpenShift MachineConfig API 的网络工作流示例

外部负载均衡器支持以下配置选项:

- 使用节点选择器将 Ingress Controller 映射到一组特定的节点。您必须为这个集合中的每个节点分配一个静态 IP 地址,或者将每个节点配置为从动态主机配置协议(DHCP)接收相同的 IP 地址。基础架构节点通常接收这种类型的配置。

以子网上的所有 IP 地址为目标。此配置可减少维护开销,因为您可以在这些网络中创建和销毁节点,而无需重新配置负载均衡器目标。如果您使用较小的网络上的机器集来部署入口 pod,如

/27或/28,您可以简化负载均衡器目标。提示您可以通过检查机器配置池的资源来列出网络中存在的所有 IP 地址。

在为 OpenShift Container Platform 集群配置外部负载均衡器前,请考虑以下信息:

- 对于前端 IP 地址,您可以对前端 IP 地址、Ingress Controller 的负载均衡器和 API 负载均衡器使用相同的 IP 地址。查看厂商的文档以获取此功能的相关信息。

对于后端 IP 地址,请确保 OpenShift Container Platform control plane 节点的 IP 地址在外部负载均衡器的生命周期内不会改变。您可以通过完成以下操作之一来实现此目的:

- 为每个 control plane 节点分配一个静态 IP 地址。

- 将每个节点配置为在每次节点请求 DHCP 租期时从 DHCP 接收相同的 IP 地址。根据供应商,DHCP 租期可能采用 IP 保留或静态 DHCP 分配的形式。

- 在 Ingress Controller 后端服务的外部负载均衡器中手动定义运行 Ingress Controller 的每个节点。例如,如果 Ingress Controller 移到未定义节点,则可能会出现连接中断。

2.4.9.1. 配置外部负载均衡器

您可以将 OpenShift Container Platform 集群配置为使用外部负载均衡器来代替默认负载均衡器。

在配置外部负载均衡器前,请确定您阅读了外部负载均衡器的"服务"部分。

阅读适用于您要为外部负载均衡器配置的服务的以下先决条件。

MetalLB,在集群中运行,充当外部负载均衡器。

OpenShift API 的先决条件

- 您定义了前端 IP 地址。

TCP 端口 6443 和 22623 在负载均衡器的前端 IP 地址上公开。检查以下项:

- 端口 6443 提供对 OpenShift API 服务的访问。

- 端口 22623 可以为节点提供 ignition 启动配置。

- 前端 IP 地址和端口 6443 可以被您的系统的所有用户访问,其位置为 OpenShift Container Platform 集群外部。

- 前端 IP 地址和端口 22623 只能被 OpenShift Container Platform 节点访问。

- 负载均衡器后端可以在端口 6443 和 22623 上与 OpenShift Container Platform control plane 节点通信。

Ingress Controller 的先决条件

- 您定义了前端 IP 地址。

- TCP 端口 443 和 80 在负载均衡器的前端 IP 地址上公开。

- 前端 IP 地址、端口 80 和端口 443 可以被您的系统所有用户访问,以及 OpenShift Container Platform 集群外部的位置。

- 前端 IP 地址、端口 80 和端口 443 可被 OpenShift Container Platform 集群中运行的所有节点访问。

- 负载均衡器后端可以在端口 80、443 和 1936 上与运行 Ingress Controller 的 OpenShift Container Platform 节点通信。

健康检查 URL 规格的先决条件

您可以通过设置健康检查 URL 来配置大多数负载均衡器,以确定服务是否可用或不可用。OpenShift Container Platform 为 OpenShift API、Machine Configuration API 和 Ingress Controller 后端服务提供这些健康检查。

以下示例演示了以前列出的后端服务的健康检查规格:

Kubernetes API 健康检查规格示例

Path: HTTPS:6443/readyz Healthy threshold: 2 Unhealthy threshold: 2 Timeout: 10 Interval: 10

Path: HTTPS:6443/readyz

Healthy threshold: 2

Unhealthy threshold: 2

Timeout: 10

Interval: 10Machine Config API 健康检查规格示例

Path: HTTPS:22623/healthz Healthy threshold: 2 Unhealthy threshold: 2 Timeout: 10 Interval: 10

Path: HTTPS:22623/healthz

Healthy threshold: 2

Unhealthy threshold: 2

Timeout: 10

Interval: 10Ingress Controller 健康检查规格示例

Path: HTTP:1936/healthz/ready Healthy threshold: 2 Unhealthy threshold: 2 Timeout: 5 Interval: 10

Path: HTTP:1936/healthz/ready

Healthy threshold: 2

Unhealthy threshold: 2

Timeout: 5

Interval: 10流程

配置 HAProxy Ingress Controller,以便您可以在端口 6443、443 和 80 上从负载均衡器访问集群:

HAProxy 配置示例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 使用

curlCLI 命令验证外部负载均衡器及其资源是否正常运行:运行以下命令并查看响应,验证集群机器配置 API 是否可以被 Kubernetes API 服务器资源访问:

curl https://<loadbalancer_ip_address>:6443/version --insecure

$ curl https://<loadbalancer_ip_address>:6443/version --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果配置正确,您会收到 JSON 对象的响应:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令并观察输出,验证集群机器配置 API 是否可以被 Machine 配置服务器资源访问:

curl -v https://<loadbalancer_ip_address>:22623/healthz --insecure

$ curl -v https://<loadbalancer_ip_address>:22623/healthz --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果配置正确,命令的输出会显示以下响应:

HTTP/1.1 200 OK Content-Length: 0

HTTP/1.1 200 OK Content-Length: 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令并观察输出,验证控制器是否可以被端口 80 上的 Ingress Controller 资源访问:

curl -I -L -H "Host: console-openshift-console.apps.<cluster_name>.<base_domain>" http://<load_balancer_front_end_IP_address>

$ curl -I -L -H "Host: console-openshift-console.apps.<cluster_name>.<base_domain>" http://<load_balancer_front_end_IP_address>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果配置正确,命令的输出会显示以下响应:

HTTP/1.1 302 Found content-length: 0 location: https://console-openshift-console.apps.ocp4.private.opequon.net/ cache-control: no-cache

HTTP/1.1 302 Found content-length: 0 location: https://console-openshift-console.apps.ocp4.private.opequon.net/ cache-control: no-cacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令并观察输出,验证控制器是否可以被端口 443 上的 Ingress Controller 资源访问:

curl -I -L --insecure --resolve console-openshift-console.apps.<cluster_name>.<base_domain>:443:<Load Balancer Front End IP Address> https://console-openshift-console.apps.<cluster_name>.<base_domain>

$ curl -I -L --insecure --resolve console-openshift-console.apps.<cluster_name>.<base_domain>:443:<Load Balancer Front End IP Address> https://console-openshift-console.apps.<cluster_name>.<base_domain>Copy to Clipboard Copied! Toggle word wrap Toggle overflow 如果配置正确,命令的输出会显示以下响应:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

为您的集群配置 DNS 记录,以外部负载均衡器的前端 IP 地址为目标。您必须在负载均衡器上将记录更新为集群 API 和应用程序的 DNS 服务器。

修改 DNS 记录示例

<load_balancer_ip_address> A api.<cluster_name>.<base_domain> A record pointing to Load Balancer Front End

<load_balancer_ip_address> A api.<cluster_name>.<base_domain> A record pointing to Load Balancer Front EndCopy to Clipboard Copied! Toggle word wrap Toggle overflow <load_balancer_ip_address> A apps.<cluster_name>.<base_domain> A record pointing to Load Balancer Front End

<load_balancer_ip_address> A apps.<cluster_name>.<base_domain> A record pointing to Load Balancer Front EndCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要DNS 传播可能需要一些时间才能获得每个 DNS 记录。在验证每个记录前,请确保每个 DNS 记录传播。

使用

curlCLI 命令验证外部负载均衡器和 DNS 记录配置是否正常运行:运行以下命令并查看输出,验证您可以访问集群 API:

curl https://api.<cluster_name>.<base_domain>:6443/version --insecure

$ curl https://api.<cluster_name>.<base_domain>:6443/version --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果配置正确,您会收到 JSON 对象的响应:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令并查看输出,验证您可以访问集群机器配置:

curl -v https://api.<cluster_name>.<base_domain>:22623/healthz --insecure

$ curl -v https://api.<cluster_name>.<base_domain>:22623/healthz --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果配置正确,命令的输出会显示以下响应:

HTTP/1.1 200 OK Content-Length: 0

HTTP/1.1 200 OK Content-Length: 0Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令并查看输出,验证您可以在端口上访问每个集群应用程序:

curl http://console-openshift-console.apps.<cluster_name>.<base_domain> -I -L --insecure

$ curl http://console-openshift-console.apps.<cluster_name>.<base_domain> -I -L --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果配置正确,命令的输出会显示以下响应:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 运行以下命令并查看输出,验证您可以在端口 443 上访问每个集群应用程序:

curl https://console-openshift-console.apps.<cluster_name>.<base_domain> -I -L --insecure

$ curl https://console-openshift-console.apps.<cluster_name>.<base_domain> -I -L --insecureCopy to Clipboard Copied! Toggle word wrap Toggle overflow 如果配置正确,命令的输出会显示以下响应:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.10. 后续步骤

- 自定义集群。

- 如果需要,您可以 远程健康报告。

- 设置 registry 并配置 registry 存储。

- 可选: 查看 vSphere 问题检测器 Operator 中的事件,以确定集群是否有权限或存储配置问题。