4.7. Ceph Object Gateway の高可用性

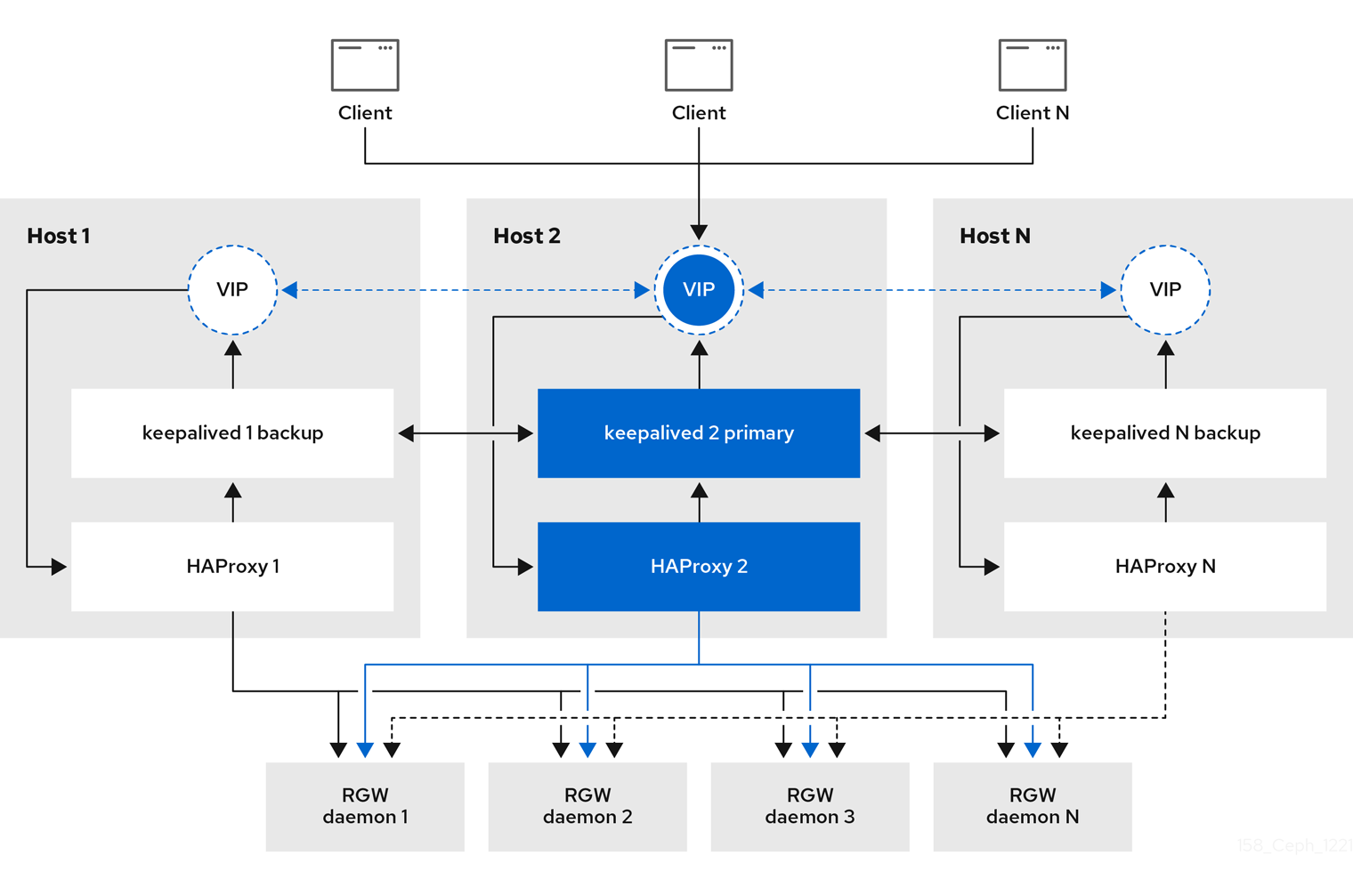

ストレージ管理者は、Ceph Object Gateway のインスタンス数を単一のゾーンに割り当てることができます。これにより、負荷の増加 (つまり同じゾーングループおよびゾーン) としてスケールアウトすることができます。ただし、高可用性プロキシーを使用するためにフェデレーションされたアーキテクチャーは必要ありません。各 Ceph Object Gateway デーモンには独自の IP アドレスがあるため、Ingress サービスを使用して、多数の Ceph Object Gateway デーモンまたはノードで負荷を分散できます。Ingress サービスは、Ceph Object Gateway 環境の HAProxy および keepalived デーモンを管理します。HAProxy サーバーで HTTPS トラフィックを終了し、HAProxy サーバーと Ceph Object Gateway の Beast フロントエンド Web サーバーインスタンスの間に HTTP を使用することもできます。

4.7.1. 前提条件

- 異なるホストで実行している 2 つ以上の Ceph Object Gateway デーモン。

-

異なるホストで実行されている

Ingressサービスの 2 つ以上のインスタンスの容量。

4.7.2. 高可用性サービス

Ingress サービスは、Ceph Object Gateway に可用性の高いエンドポイントを提供します。Ingress サービスは、必要に応じて任意の数のホストにデプロイできます。Red Hat では、それぞれが ingress サービスで設定されている Red Hat Enterprise Linux 8 サーバーを少なくとも 2 つ用意することを推奨しています。最小限の設定オプションを使用して、高可用性 (HA) サービスを実行できます。Ceph オーケストレーターは、フローティング仮想 IP アドレスで負荷分散を提供することで haproxy および keepalived デーモンを管理する ingress サービスをデプロイします。アクティブな haproxy は、利用可能なすべての Ceph Object Gateway デーモンに、すべての Ceph Object Gateway 要求を配布します。

仮想 IP アドレスは、いずれかの Ingress ホスト (プライマリーホスト) でまとめて自動的に設定されます。Ceph オーケストレーターは、同じサブネットの一部として設定された既存の IP アドレスに基づいて最初のネットワークインターフェイスを選択します。仮想 IP アドレスが同じサブネットに属さない場合、既存の IP アドレスに一致するように Ceph オーケストレーターのサブネットリストを定義することができます。keepalived デーモンとアクティブな haproxy がプライマリーホストで応答しない場合、仮想 IP アドレスはバックアップホストに移動します。このバックアップホストが新しいプライマリーホストになります。

現在、IP アドレスが設定されていないネットワークインターフェイスに仮想 IP アドレスを設定することはできません。

セキュアソケットレイヤー (SSL) を使用するには、Ceph Object Gateway ではなく Ingress サービスによって SSL を終了する必要があります。

4.7.3. Ceph Object Gateway の高可用性の設定

Ceph Object Gateway の高可用性 (HA) を設定するには、YAML 設定ファイルを作成します。また、Ceph オーケストレーターが Ingress サービスのインストール、設定、および管理を行います。Ingress サービスは haproxy および keepalived デーモンを使用して Ceph Object Gateway の高可用性を提供します。

前提条件

-

Ingressサービスをインストールするための、Red Hat Enterprise Linux 8 以降を実行する 2 つ以上のホスト。 - 正常かつ実行中の Red Hat Ceph Storage クラスター

- 異なるホストで実行されている 2 つ以上の Ceph Object Gateway デーモン。

-

Ingressサービスを実行しているホストへのルートレベルのアクセス。 - ファイアウォールを使用している場合は、HTTP 用にポート 80 を開き、HTTPS トラフィック用にポート 443 を開きます。

手順

新規

ingress.yamlファイルを作成します。例

[root@host01 ~] touch ingress.yaml

[root@host01 ~] touch ingress.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow ingress.yamlファイルを開いて編集します。以下のオプションを追加し、環境に適した値を追加します。構文

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Cephadm シェルを起動します。

例

cephadm shell --mount ingress.yaml:/var/lib/ceph/radosgw/igress.yaml

[root@host01 ~]# cephadm shell --mount ingress.yaml:/var/lib/ceph/radosgw/igress.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 最新の

haproxyイメージおよびkeepalivedイメージを設定します。構文

ceph config set mgr mgr/cephadm/container_image_haproxy HAPROXY_IMAGE_ID ceph config set mgr mgr/cephadm/container_image_keepalived KEEPALIVED_IMAGE_ID

ceph config set mgr mgr/cephadm/container_image_haproxy HAPROXY_IMAGE_ID ceph config set mgr mgr/cephadm/container_image_keepalived KEEPALIVED_IMAGE_IDCopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

[ceph: root@host01 /]# ceph config set mgr mgr/cephadm/container_image_haproxy registry.redhat.io/rhceph/rhceph-haproxy-rhel8:latest [ceph: root@host01 /]# ceph config set mgr mgr/cephadm/container_image_keepalived registry.redhat.io/rhceph/keepalived-rhel8:latest

[ceph: root@host01 /]# ceph config set mgr mgr/cephadm/container_image_haproxy registry.redhat.io/rhceph/rhceph-haproxy-rhel8:latest [ceph: root@host01 /]# ceph config set mgr mgr/cephadm/container_image_keepalived registry.redhat.io/rhceph/keepalived-rhel8:latestCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph オーケストレーターを使用して新規

Ingressサービスをインストールおよび設定します。[ceph: root@host01 /]# ceph orch apply -i ingress.yaml

[ceph: root@host01 /]# ceph orch apply -i ingress.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph オーケストレーターが完了したら、HA 設定を確認します。

Ingressサービスを実行しているホストで、仮想 IP アドレスが表示されることを確認します。例

ip addr show

[root@host01 ~]# ip addr showCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph クライアントから Ceph Object Gateway にアクセスしてみてください。

構文

wget HOST_NAME

wget HOST_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 例

wget host01.example.com

[root@client ~]# wget host01.example.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の例のような内容を含む

index.htmlが返される場合、Ceph Object Gateway の HA 設定は正常に機能しています。例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7.4. HAProxy および Keepalived

ストレージ管理者は、Ceph Object Gateway のインスタンス数を単一のゾーンに割り当てることができます。これにより、負荷の増加 (つまり同じゾーングループおよびゾーン) としてスケールアウトすることができます。ただし、HAProxy および keepalived を使用するためにフェデレーションされたアーキテクチャーは必要ありません。各オブジェクトゲートウェイは独自の IP アドレスを持つため、HAProxy および keepalived を使用して Ceph Object Gateway サーバー全体で負荷を分散できます。

HAProxy および keepalived のもう 1 つのユースケースは、HAProxy サーバーで HTTPS を終了することです。HAProxy サーバーを使用して HAProxy サーバーで HTTPS を終了でき、HAProxy サーバーと Beast Web サーバーインスタンスの間で HTTP を使用できます。

4.7.4.1. HAProxy/keepalived の前提条件

Ceph Object Gateway で HA プロキシーを設定するには、以下が必要です。

- 稼働中の Red Hat Ceph Storage クラスターがある。

- ポート 80 で実行されるよう設定された同じゾーン内の Ceph Object Gateway サーバー 2 台以上簡単なインストール手順に従うと、ゲートウェイインスタンスはデフォルトで同じゾーングループおよびゾーンに置かれます。フェデレーションアーキテクチャーを使用している場合は、インスタンスが同じゾーングループとゾーンにあることを確認してください。

-

HAProxy および

keepalivedの 2 台以上の Red Hat Enterprise Linux 8 サーバー

本セクションでは、少なくとも 2 つの Ceph Object Gateway サーバーが実行されていることを前提とし、ポート 80 でテストスクリプトを実行する際に、このいずれかのサーバーからの有効な応答を取得していることを前提としています。

4.7.4.2. HAProxy ノードの準備

以下の設定は、haproxy と haproxy2 という名前の 2 つの HAProxy ノードと、rgw1 と rgw2 という名前の 2 台の Ceph Object Gateway サーバーを前提としています。優先する命名規則を使用する場合があります。少なくとも 2 つの HAProxy ノードで以下の手順を実行します。

- Install Red Hat Enterprise Linux 8.x

ノードを登録します。

subscription-manager register

[root@haproxy]# subscription-manager registerCopy to Clipboard Copied! Toggle word wrap Toggle overflow RHEL サーバーリポジトリーを有効にします。

Red Hat Enterprise Linux 9

subscription-manager repos --enable=rhel-9-server-rpms

[root@haproxy]# subscription-manager repos --enable=rhel-9-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Enterprise Linux 8

subscription-manager repos --enable=rhel-8-server-rpms

[root@haproxy]# subscription-manager repos --enable=rhel-8-server-rpmsCopy to Clipboard Copied! Toggle word wrap Toggle overflow サーバーを更新します。

dnf update -y

[root@haproxy]# dnf update -yCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

必要に応じて管理ツール (

wget、vimなど) をインストールします。 ポート

80を開きます。firewall-cmd --zone=public --add-port 80/tcp --permanent firewall-cmd --reload

[root@haproxy]# firewall-cmd --zone=public --add-port 80/tcp --permanent [root@haproxy]# firewall-cmd --reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow HTTPS の場合は、ポート

443を開きます。firewall-cmd --zone=public --add-port 443/tcp --permanent firewall-cmd --reload

[root@haproxy]# firewall-cmd --zone=public --add-port 443/tcp --permanent [root@haproxy]# firewall-cmd --reloadCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7.4.3. keepalived のインストールと設定

少なくとも 2 つの HAProxy ノードで以下の手順を実行します。

前提条件

- 少なくとも 2 つの HAProxy ノード

- 少なくとも 2 つの Object Gateway ノード

手順

keepalivedをインストールします。yum install -y keepalived

[root@haproxy]# yum install -y keepalivedCopy to Clipboard Copied! Toggle word wrap Toggle overflow 両方の HAProxy ノードで

keepalivedを設定します。vim /etc/keepalived/keepalived.conf

[root@haproxy]# vim /etc/keepalived/keepalived.confCopy to Clipboard Copied! Toggle word wrap Toggle overflow 設定ファイルには、

haproxyプロセスを確認するスクリプトがあります。vrrp_script chk_haproxy { script "killall -0 haproxy" # check the haproxy process interval 2 # every 2 seconds weight 2 # add 2 points if OK }vrrp_script chk_haproxy { script "killall -0 haproxy" # check the haproxy process interval 2 # every 2 seconds weight 2 # add 2 points if OK }Copy to Clipboard Copied! Toggle word wrap Toggle overflow 次に、プライマリーロードバランサーとバックアップロードバランサーのインスタンスは、ネットワークインターフェイスとして

eno1を使用します。また、仮想 IP アドレス (192.168.1.20) も割り当てます。プライマリーロードバランサーノード

Copy to Clipboard Copied! Toggle word wrap Toggle overflow バックアップロードバランサーノード

Copy to Clipboard Copied! Toggle word wrap Toggle overflow keepalivedサービスを有効にして開始します。systemctl enable keepalived systemctl start keepalived

[root@haproxy]# systemctl enable keepalived [root@haproxy]# systemctl start keepalivedCopy to Clipboard Copied! Toggle word wrap Toggle overflow

関連情報

-

keepalivedの使用に関する詳細は、Red Hat カスタマーポータルの Setting up a Linux cluster with Keepalived: Basic configuration の記事を参照してください。

4.7.4.4. HAProxy のインストールおよび設定

少なくとも 2 つの HAProxy ノードで以下の手順を実行します。

haproxyをインストールします。dnf install haproxy

[root@haproxy]# dnf install haproxyCopy to Clipboard Copied! Toggle word wrap Toggle overflow SELinux および HTTP に対して

haproxyを設定します。vim /etc/firewalld/services/haproxy-http.xml

[root@haproxy]# vim /etc/firewalld/services/haproxy-http.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の行を追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow rootとして、正しい SELinux コンテキストとファイルパーミッションをhaproxy-http.xmlファイルに割り当てます。cd /etc/firewalld/services restorecon haproxy-http.xml chmod 640 haproxy-http.xml

[root@haproxy]# cd /etc/firewalld/services [root@haproxy]# restorecon haproxy-http.xml [root@haproxy]# chmod 640 haproxy-http.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow HTTPS を使用する場合は、SELinux および HTTPS に対して

haproxyを設定します。vim /etc/firewalld/services/haproxy-https.xml

[root@haproxy]# vim /etc/firewalld/services/haproxy-https.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の行を追加します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow rootで、正しい SELinux コンテキストとファイルパーミッションをhaproxy-https.xmlファイルに割り当てます。cd /etc/firewalld/services restorecon haproxy-https.xml chmod 640 haproxy-https.xml

# cd /etc/firewalld/services # restorecon haproxy-https.xml # chmod 640 haproxy-https.xmlCopy to Clipboard Copied! Toggle word wrap Toggle overflow HTTPS を使用する場合は、SSL のキーを生成します。証明書がない場合は、自己署名証明書を使用できます。

最後に、証明書と鍵を PEM ファイルに格納します。

[root@haproxy]# cat example.com.crt example.com.key > example.com.pem [root@haproxy]# cp example.com.pem /etc/ssl/private/

[root@haproxy]# cat example.com.crt example.com.key > example.com.pem [root@haproxy]# cp example.com.pem /etc/ssl/private/Copy to Clipboard Copied! Toggle word wrap Toggle overflow haproxyを設定します。vim /etc/haproxy/haproxy.cfg

[root@haproxy]# vim /etc/haproxy/haproxy.cfgCopy to Clipboard Copied! Toggle word wrap Toggle overflow globalおよびdefaultsは変更しない可能性があります。defaultsセクションの後に、frontendセクションおよびbackendセクションを設定する必要があります。以下に例を示します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow HAProxy 設定の詳細は、Red Hat Update Infrastructure System 管理者ガイドの HAProxy ロードバランサー―の追加 を参照してください。

haproxyの有効化/起動systemctl enable haproxy systemctl start haproxy

[root@haproxy]# systemctl enable haproxy [root@haproxy]# systemctl start haproxyCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7.4.5. HAProxy 設定のテスト

HAProxy ノードで、

keepalived設定の仮想 IP アドレスが表示されることを確認します。ip addr show

[root@haproxy]# ip addr showCopy to Clipboard Copied! Toggle word wrap Toggle overflow Red Hat Ceph Dashboard コンテナーをホストするノードで、ロードバランサー設定を使用して Ceph Object Gateway ノードに到達できるかどうかを確認します。以下に例を示します。

wget haproxy

[root@haproxy]# wget haproxyCopy to Clipboard Copied! Toggle word wrap Toggle overflow 上記のコマンドの結果は以下のコマンドと同じになるはずです。

wget rgw1

[root@haproxy]# wget rgw1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 以下の内容を含む

index.htmlファイルを返す場合は、次のコマンドを実行します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow その後、設定が正常に機能します。