6.2. Knative Kafka 구성

Knative Kafka는 OpenShift Serverless에서 지원되는 Apache Kafka 메시지 스트리밍 플랫폼을 사용할 수 있는 통합 옵션을 제공합니다. Kafka는 이벤트 소스, 채널, 브로커 및 이벤트 싱크 기능에 대한 옵션을 제공합니다.

클러스터 관리자는 핵심 OpenShift Serverless 설치의 일부로 제공되는 Knative Eventing 구성 요소 외에도 KnativeKafka 사용자 정의 리소스(CR)를 설치할 수 있습니다.

Knative Kafka는 현재 IBM Z 및 IBM Power Systems에서 지원되지 않습니다.

KnativeKafka CR은 사용자에게 다음과 같은 추가 옵션을 제공합니다.

- Kafka 소스

- Kafka 채널

- Kafka 브로커

- Kafka 싱크

6.2.1. Knative Kafka 설치

Knative Kafka는 OpenShift Serverless에서 지원되는 Apache Kafka 메시지 스트리밍 플랫폼을 사용할 수 있는 통합 옵션을 제공합니다. Knative Kafka 기능은 KnativeKafka 사용자 정의 리소스를 설치한 경우 OpenShift Serverless 설치에서 사용할 수 있습니다.

사전 요구 사항

- OpenShift Serverless Operator 및 Knative Eventing을 클러스터에 설치했습니다.

- Red Hat AMQ Streams 클러스터에 액세스할 수 있습니다.

-

확인 단계를 사용하려면 OpenShift CLI(

oc)를 설치합니다. - OpenShift Container Platform에 대한 클러스터 관리자 권한이 있습니다.

- OpenShift Container Platform 웹 콘솔에 로그인되어 있습니다.

절차

-

관리자 화면에서 Operator

설치된 Operator로 이동합니다. - 페이지 상단에 있는 프로젝트 드롭다운이 Project: knative-eventing으로 설정되어 있는지 확인합니다.

- OpenShift Serverless Operator의 Provided APIs 목록에서 Knative Kafka를 검색하여 Create Instance를 클릭합니다.

Knative Kafka 생성 페이지에서 KnativeKafka 오브젝트를 구성합니다.

중요클러스터에서 Kafka 채널, 소스, 브로커 또는 싱크를 사용하려면 사용할 옵션에 대해 활성화된 스위치를 true 로 전환해야 합니다. 이러한 스위치는 기본적으로 false로 설정됩니다. 또한 Kafka 채널, 브로커 또는 싱크를 사용하려면 부트스트랩 서버를 지정해야 합니다.

KnativeKafka사용자 정의 리소스의 예Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 개발자가 클러스터에서

KafkaChannel채널 유형을 사용할 수 있습니다. - 2

- AMQ Streams 클러스터에 있는 쉼표로 구분된 부트스트랩 서버 목록입니다.

- 3

- 개발자가 클러스터에서

KafkaSource이벤트 소스 유형을 사용할 수 있습니다. - 4

- 개발자가 클러스터에서 Knative Kafka 브로커 구현을 사용할 수 있습니다.

- 5

- Red Hat AMQ Streams 클러스터에서 쉼표로 구분된 부트스트랩 서버 목록입니다.

- 6

Broker오브젝트에서 지원하는 Kafka 주제의 파티션 수를 정의합니다. 기본값은10입니다.- 7

Broker오브젝트에서 지원하는 Kafka 주제의 복제 요소를 정의합니다. 기본값은3입니다.- 8

- 개발자가 클러스터에서 Kafka 싱크를 사용할 수 있습니다.

참고replication factor값은 Red Hat AMQ Streams 클러스터의 노드 수보다 작거나 같아야 합니다.- 해당 양식은 KnativeKafka 오브젝트 생성을 완전히 제어할 필요가 없는 단순한 구성에 사용하는 것이 좋습니다.

- KnativeKafka 오브젝트 생성을 완전히 제어해야 하는 복잡한 구성의 경우 YAML을 편집하는 것이 좋습니다. Knative Kafka 생성 페이지의 오른쪽 상단에 있는 YAML 편집 링크를 클릭하여 YAML에 액세스할 수 있습니다.

- Kafka에 대한 선택적 구성을 완료한 후 생성을 클릭합니다. 그러면 리소스 목록에 knative-kafka가 있는 Knative Kafka 탭으로 자동으로 이동합니다.

검증

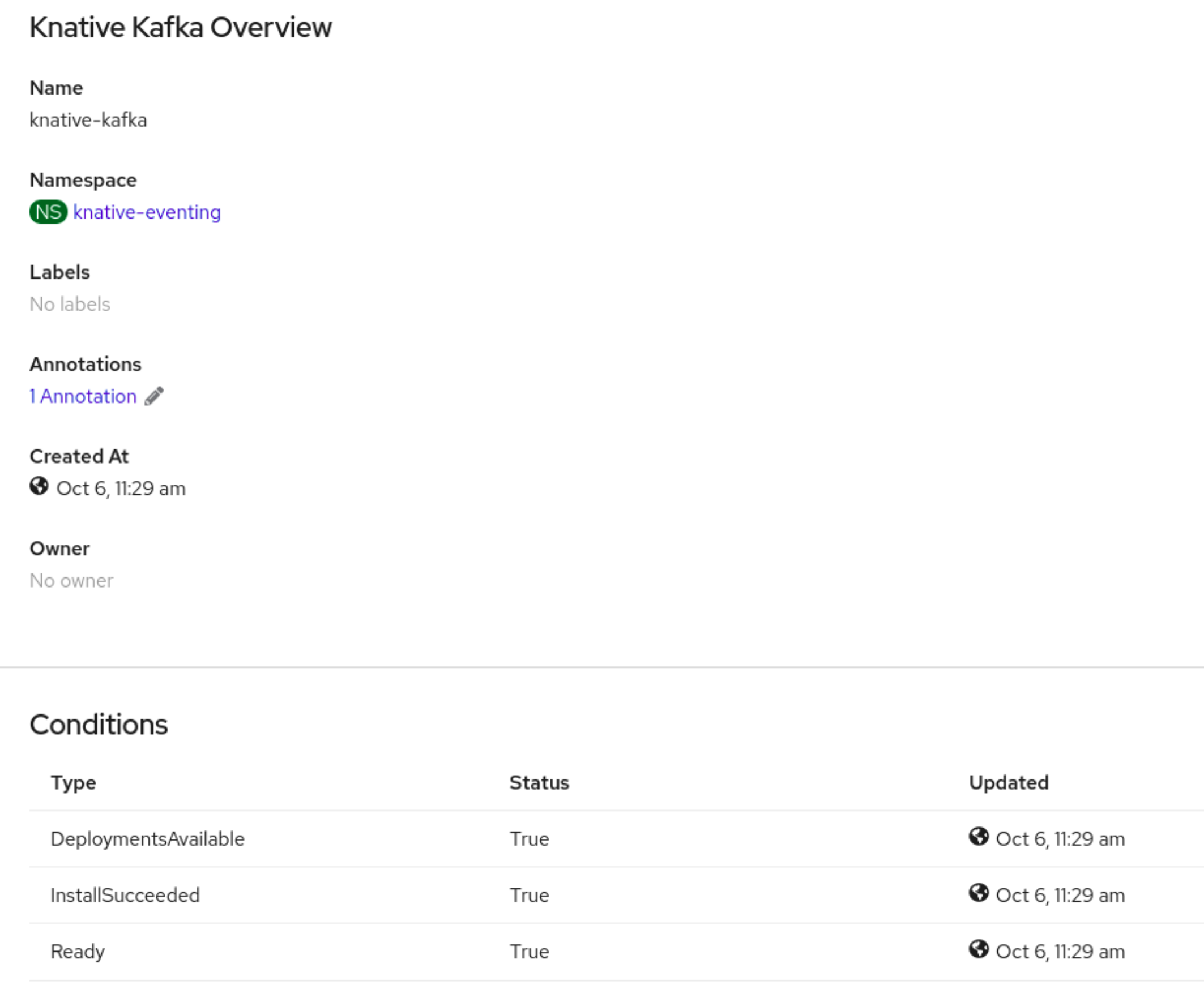

- Knative Kafka 탭에서 knative-kafka 리소스를 클릭합니다. 그러면 자동으로 Knative Kafka 개요 페이지로 이동합니다.

리소스에 대한 조건 목록을 확인하고 상태가 True인지 확인합니다.

조건 상태가 알 수 없음 또는 False인 경우 몇 분 정도 기다린 후 페이지를 새로 고칩니다.

Knative Kafka 리소스가 생성되었는지 확인합니다.

oc get pods -n knative-eventing

$ oc get pods -n knative-eventingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.2. Knative Kafka의 보안 구성

Kafka 클러스터는 일반적으로 TLS 또는 SASL 인증 방법을 사용하여 보호됩니다. TLS 또는 SASL을 사용하여 보호된 Red Hat AMQ Streams 클러스터에서 작동하도록 Kafka 브로커 또는 채널을 구성할 수 있습니다.

SASL과 TLS를 모두 함께 활성화하는 것이 좋습니다.

6.2.2.1. Kafka 브로커의 TLS 인증 구성

TLS( Transport Layer Security )는 Apache Kafka 클라이언트와 서버에서 Knative와 Kafka 간의 트래픽 암호화 및 인증에 사용됩니다. TLS는 Knative Kafka에서 지원되는 유일한 트래픽 암호화 방법입니다.

사전 요구 사항

- OpenShift Container Platform에 대한 클러스터 관리자 권한이 있습니다.

-

OpenShift Serverless Operator, Knative Eventing,

KnativeKafkaCR이 OpenShift Container Platform 클러스터에 설치되어 있습니다. - 프로젝트를 생성했거나 OpenShift Container Platform에서 애플리케이션 및 기타 워크로드를 생성하는 데 적절한 역할 및 권한이 있는 프로젝트에 액세스할 수 있습니다.

-

Kafka 클러스터 CA 인증서가

.pem파일로 저장되어 있습니다. -

Kafka 클러스터 클라이언트 인증서와

.pem파일로 저장된 키가 있습니다. -

OpenShift CLI(

oc)를 설치합니다.

절차

knative-eventing네임스페이스에서 인증서 파일을 시크릿으로 생성합니다.oc create secret -n knative-eventing generic <secret_name> \ --from-literal=protocol=SSL \ --from-file=ca.crt=caroot.pem \ --from-file=user.crt=certificate.pem \ --from-file=user.key=key.pem

$ oc create secret -n knative-eventing generic <secret_name> \ --from-literal=protocol=SSL \ --from-file=ca.crt=caroot.pem \ --from-file=user.crt=certificate.pem \ --from-file=user.key=key.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 중요키 이름

ca.crt,user.crt,user.key를 사용합니다. 이 값은 변경하지 마십시오.KnativeKafkaCR을 편집하고broker사양에 보안에 대한 참조를 추가합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.2.2. Kafka 브로커에 대한 SASL 인증 구성

SASL( Simple Authentication and Security Layer )은 Apache Kafka에서 인증에 사용됩니다. 클러스터에서 SASL 인증을 사용하는 경우 사용자는 Kafka 클러스터와 통신하기 위해 Knative에 인증 정보를 제공해야 합니다. 그러지 않으면 이벤트를 생성하거나 사용할 수 없습니다.

사전 요구 사항

- OpenShift Container Platform에 대한 클러스터 관리자 권한이 있습니다.

-

OpenShift Serverless Operator, Knative Eventing,

KnativeKafkaCR이 OpenShift Container Platform 클러스터에 설치되어 있습니다. - 프로젝트를 생성했거나 OpenShift Container Platform에서 애플리케이션 및 기타 워크로드를 생성하는 데 적절한 역할 및 권한이 있는 프로젝트에 액세스할 수 있습니다.

- Kafka 클러스터의 사용자 이름과 암호가 있습니다.

-

사용할 SASL 메커니즘을 선택했습니다(예:

PLAIN,SCRAM-SHA-256또는SCRAM-SHA-512). -

TLS가 활성화된 경우 Kafka 클러스터의

ca.crt인증서 파일도 필요합니다. -

OpenShift CLI(

oc)를 설치합니다.

프로세스

knative-eventing네임스페이스에서 인증서 파일을 시크릿으로 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

키 이름

ca.crt,암호,sasl.mechanism을 사용합니다. 이 값은 변경하지 마십시오. 공용 CA 인증서와 함께 SASL을 사용하려면 시크릿을 생성할 때

ca.crt인수 대신tls.enabled=true플래그를 사용해야 합니다. 예를 들면 다음과 같습니다.oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-literal=tls.enabled=true \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \ --from-literal=user="my-sasl-user"

$ oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-literal=tls.enabled=true \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \ --from-literal=user="my-sasl-user"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

키 이름

KnativeKafkaCR을 편집하고broker사양에 보안에 대한 참조를 추가합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.2.3. Kafka 채널의 TLS 인증 구성

TLS( Transport Layer Security )는 Apache Kafka 클라이언트와 서버에서 Knative와 Kafka 간의 트래픽 암호화 및 인증에 사용됩니다. TLS는 Knative Kafka에서 지원되는 유일한 트래픽 암호화 방법입니다.

사전 요구 사항

- OpenShift Container Platform에 대한 클러스터 관리자 권한이 있습니다.

-

OpenShift Serverless Operator, Knative Eventing,

KnativeKafkaCR이 OpenShift Container Platform 클러스터에 설치되어 있습니다. - 프로젝트를 생성했거나 OpenShift Container Platform에서 애플리케이션 및 기타 워크로드를 생성하는 데 적절한 역할 및 권한이 있는 프로젝트에 액세스할 수 있습니다.

-

Kafka 클러스터 CA 인증서가

.pem파일로 저장되어 있습니다. -

Kafka 클러스터 클라이언트 인증서와

.pem파일로 저장된 키가 있습니다. -

OpenShift CLI(

oc)를 설치합니다.

절차

선택한 네임스페이스에서 인증서 파일을 시크릿으로 생성합니다.

oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-file=ca.crt=caroot.pem \ --from-file=user.crt=certificate.pem \ --from-file=user.key=key.pem

$ oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-file=ca.crt=caroot.pem \ --from-file=user.crt=certificate.pem \ --from-file=user.key=key.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 중요키 이름

ca.crt,user.crt,user.key를 사용합니다. 이 값은 변경하지 마십시오.KnativeKafka사용자 정의 리소스 편집을 시작합니다.oc edit knativekafka

$ oc edit knativekafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 시크릿 및 시크릿의 네임스페이스를 참조합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고부트스트랩 서버에서 일치하는 포트를 지정해야 합니다.

예를 들면 다음과 같습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.2.4. Kafka 채널의 SASL 인증 구성

SASL( Simple Authentication and Security Layer )은 Apache Kafka에서 인증에 사용됩니다. 클러스터에서 SASL 인증을 사용하는 경우 사용자는 Kafka 클러스터와 통신하기 위해 Knative에 인증 정보를 제공해야 합니다. 그러지 않으면 이벤트를 생성하거나 사용할 수 없습니다.

사전 요구 사항

- OpenShift Container Platform에 대한 클러스터 관리자 권한이 있습니다.

-

OpenShift Serverless Operator, Knative Eventing,

KnativeKafkaCR이 OpenShift Container Platform 클러스터에 설치되어 있습니다. - 프로젝트를 생성했거나 OpenShift Container Platform에서 애플리케이션 및 기타 워크로드를 생성하는 데 적절한 역할 및 권한이 있는 프로젝트에 액세스할 수 있습니다.

- Kafka 클러스터의 사용자 이름과 암호가 있습니다.

-

사용할 SASL 메커니즘을 선택했습니다(예:

PLAIN,SCRAM-SHA-256또는SCRAM-SHA-512). -

TLS가 활성화된 경우 Kafka 클러스터의

ca.crt인증서 파일도 필요합니다. -

OpenShift CLI(

oc)를 설치합니다.

프로세스

선택한 네임스페이스에서 인증서 파일을 시크릿으로 생성합니다.

oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-file=ca.crt=caroot.pem \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \ --from-literal=user="my-sasl-user"

$ oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-file=ca.crt=caroot.pem \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \ --from-literal=user="my-sasl-user"Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

키 이름

ca.crt,암호,sasl.mechanism을 사용합니다. 이 값은 변경하지 마십시오. 공용 CA 인증서와 함께 SASL을 사용하려면 시크릿을 생성할 때

ca.crt인수 대신tls.enabled=true플래그를 사용해야 합니다. 예를 들면 다음과 같습니다.oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-literal=tls.enabled=true \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \ --from-literal=user="my-sasl-user"

$ oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-literal=tls.enabled=true \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \ --from-literal=user="my-sasl-user"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

키 이름

KnativeKafka사용자 정의 리소스 편집을 시작합니다.oc edit knativekafka

$ oc edit knativekafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow 시크릿 및 시크릿의 네임스페이스를 참조합니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고부트스트랩 서버에서 일치하는 포트를 지정해야 합니다.

예를 들면 다음과 같습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.2.5. Kafka 소스에 대한 SASL 인증 구성

SASL( Simple Authentication and Security Layer )은 Apache Kafka에서 인증에 사용됩니다. 클러스터에서 SASL 인증을 사용하는 경우 사용자는 Kafka 클러스터와 통신하기 위해 Knative에 인증 정보를 제공해야 합니다. 그러지 않으면 이벤트를 생성하거나 사용할 수 없습니다.

사전 요구 사항

- OpenShift Container Platform에 대한 클러스터 또는 전용 관리자 권한이 있어야 합니다.

-

OpenShift Serverless Operator, Knative Eventing,

KnativeKafkaCR이 OpenShift Container Platform 클러스터에 설치되어 있습니다. - 프로젝트를 생성했거나 OpenShift Container Platform에서 애플리케이션 및 기타 워크로드를 생성하는 데 적절한 역할 및 권한이 있는 프로젝트에 액세스할 수 있습니다.

- Kafka 클러스터의 사용자 이름과 암호가 있습니다.

-

사용할 SASL 메커니즘을 선택했습니다(예:

PLAIN,SCRAM-SHA-256또는SCRAM-SHA-512). -

TLS가 활성화된 경우 Kafka 클러스터의

ca.crt인증서 파일도 필요합니다. -

OpenShift(

oc) CLI를 설치했습니다.

프로세스

선택한 네임스페이스에서 인증서 파일을 시크릿으로 생성합니다.

oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-file=ca.crt=caroot.pem \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \ --from-literal=user="my-sasl-user"

$ oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-file=ca.crt=caroot.pem \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \1 --from-literal=user="my-sasl-user"Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- SASL 유형은

PLAIN,SCRAM-SHA-256또는SCRAM-SHA-512일 수 있습니다.

다음

사양구성이 포함되도록 Kafka 소스를 생성하거나 수정합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Apache Kafka용 Red Hat OpenShift Streams와 같은 퍼블릭 클라우드 Kafka 서비스를 사용하는 경우에는

caCert사양이 필요하지 않습니다.

6.2.2.6. Kafka 싱크에 대한 보안 구성

TLS( Transport Layer Security )는 Apache Kafka 클라이언트와 서버에서 Knative와 Kafka 간의 트래픽 암호화 및 인증에 사용됩니다. TLS는 Knative Kafka에서 지원되는 유일한 트래픽 암호화 방법입니다.

SASL( Simple Authentication and Security Layer )은 Apache Kafka에서 인증에 사용됩니다. 클러스터에서 SASL 인증을 사용하는 경우 사용자는 Kafka 클러스터와 통신하기 위해 Knative에 인증 정보를 제공해야 합니다. 그러지 않으면 이벤트를 생성하거나 사용할 수 없습니다.

사전 요구 사항

-

OpenShift Serverless Operator, Knative Eventing,

KnativeKafka사용자 정의 리소스(CR)가 OpenShift Container Platform 클러스터에 설치되어 있습니다. -

Kafka 싱크는

KnativeKafkaCR에서 활성화되어 있습니다. - 프로젝트를 생성했거나 OpenShift Container Platform에서 애플리케이션 및 기타 워크로드를 생성하는 데 적절한 역할 및 권한이 있는 프로젝트에 액세스할 수 있습니다.

-

Kafka 클러스터 CA 인증서가

.pem파일로 저장되어 있습니다. -

Kafka 클러스터 클라이언트 인증서와

.pem파일로 저장된 키가 있습니다. -

OpenShift(

oc) CLI를 설치했습니다. -

사용할 SASL 메커니즘을 선택했습니다(예:

PLAIN,SCRAM-SHA-256또는SCRAM-SHA-512).

절차

KafkaSink오브젝트와 동일한 네임스페이스에 인증서 파일을 시크릿으로 생성합니다.중요인증서 및 키는 PEM 형식이어야 합니다.

암호화 없이 SASL을 사용한 인증의 경우:

oc create secret -n <namespace> generic <secret_name> \ --from-literal=protocol=SASL_PLAINTEXT \ --from-literal=sasl.mechanism=<sasl_mechanism> \ --from-literal=user=<username> \ --from-literal=password=<password>

$ oc create secret -n <namespace> generic <secret_name> \ --from-literal=protocol=SASL_PLAINTEXT \ --from-literal=sasl.mechanism=<sasl_mechanism> \ --from-literal=user=<username> \ --from-literal=password=<password>Copy to Clipboard Copied! Toggle word wrap Toggle overflow TLS를 사용한 SASL 및 암호화를 사용한 인증의 경우:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 퍼블릭 클라우드 관리 Kafka 서비스를 사용하는 경우 시스템의 루트 CA 세트(예: Red Hat OpenShift Streams for Apache Kafka)를 사용하도록

ca.crt를 생략할 수 있습니다.

TLS를 사용한 인증 및 암호화의 경우:

oc create secret -n <namespace> generic <secret_name> \ --from-literal=protocol=SSL \ --from-file=ca.crt=<my_caroot.pem_file_path> \ --from-file=user.crt=<my_cert.pem_file_path> \ --from-file=user.key=<my_key.pem_file_path>

$ oc create secret -n <namespace> generic <secret_name> \ --from-literal=protocol=SSL \ --from-file=ca.crt=<my_caroot.pem_file_path> \1 --from-file=user.crt=<my_cert.pem_file_path> \ --from-file=user.key=<my_key.pem_file_path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 퍼블릭 클라우드 관리 Kafka 서비스를 사용하는 경우 시스템의 루트 CA 세트(예: Red Hat OpenShift Streams for Apache Kafka)를 사용하도록

ca.crt를 생략할 수 있습니다.

KafkaSink오브젝트를 생성하거나 수정하고auth사양에서 보안에 대한 참조를 추가합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow KafkaSink오브젝트를 적용합니다.oc apply -f <filename>

$ oc apply -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.3. Kafka 브로커 설정 구성

Kafka Broker 오브젝트에서 구성 맵을 생성하고 이 구성 맵을 참조하여 Kafka 브로커의 복제 요소, 부트스트랩 서버 및 Kafka 브로커의 주제 파티션 수를 구성할 수 있습니다.

사전 요구 사항

- OpenShift Container Platform에 대한 클러스터 또는 전용 관리자 권한이 있어야 합니다.

-

OpenShift Serverless Operator, Knative Eventing,

KnativeKafka사용자 정의 리소스(CR)가 OpenShift Container Platform 클러스터에 설치되어 있습니다. - 프로젝트를 생성하거나 OpenShift Container Platform에서 애플리케이션 및 기타 워크로드를 생성하는 데 적절한 역할 및 권한이 있는 프로젝트에 액세스할 수 있습니다.

-

OpenShift CLI(

oc)가 설치되어 있습니다.

절차

kafka-broker-config구성 맵을 수정하거나 다음 구성이 포함된 자체 구성 맵을 생성합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 구성 맵 이름입니다.

- 2

- 구성 맵이 존재하는 네임스페이스입니다.

- 3

- Kafka 브로커의 주제 파티션 수입니다. 이렇게 하면 이벤트를 브로커로 얼마나 빨리 보낼 수 있는지가 제어됩니다. 파티션 수가 많을 경우 더 많은 컴퓨팅 리소스가 필요합니다.

- 4

- 주제 메시지의 복제 요소. 이는 데이터 손실을 방지합니다. 복제 요인이 증가하려면 더 많은 컴퓨팅 리소스와 더 많은 스토리지가 필요합니다.

- 5

- 쉼표로 구분된 부트스트랩 서버 목록입니다. 이는 OpenShift Container Platform 클러스터 내부 또는 외부에 있을 수 있으며 브로커가 이벤트를 수신하고 이벤트를 보내는 Kafka 클러스터 목록입니다.

중요default.topic.replication.factor값은 클러스터의 Kafka 브로커 인스턴스 수보다 작거나 같아야 합니다. 예를 들어 Kafka 브로커가 하나만 있는 경우default.topic.replication.factor값은"1"을 초과해서는 안 됩니다.Kafka 브로커 구성 맵의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 구성 맵을 적용합니다.

$ oc apply -f <config_map_filename>

$ oc apply -f <config_map_filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Kafka

Broker오브젝트의 구성 맵을 지정합니다.Broker 오브젝트의 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 브로커를 적용합니다.

$ oc apply -f <broker_filename>

$ oc apply -f <broker_filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow