24.2. OVN-Kubernetes 아키텍처

24.2.1. OVN-Kubernetes 아키텍처 소개

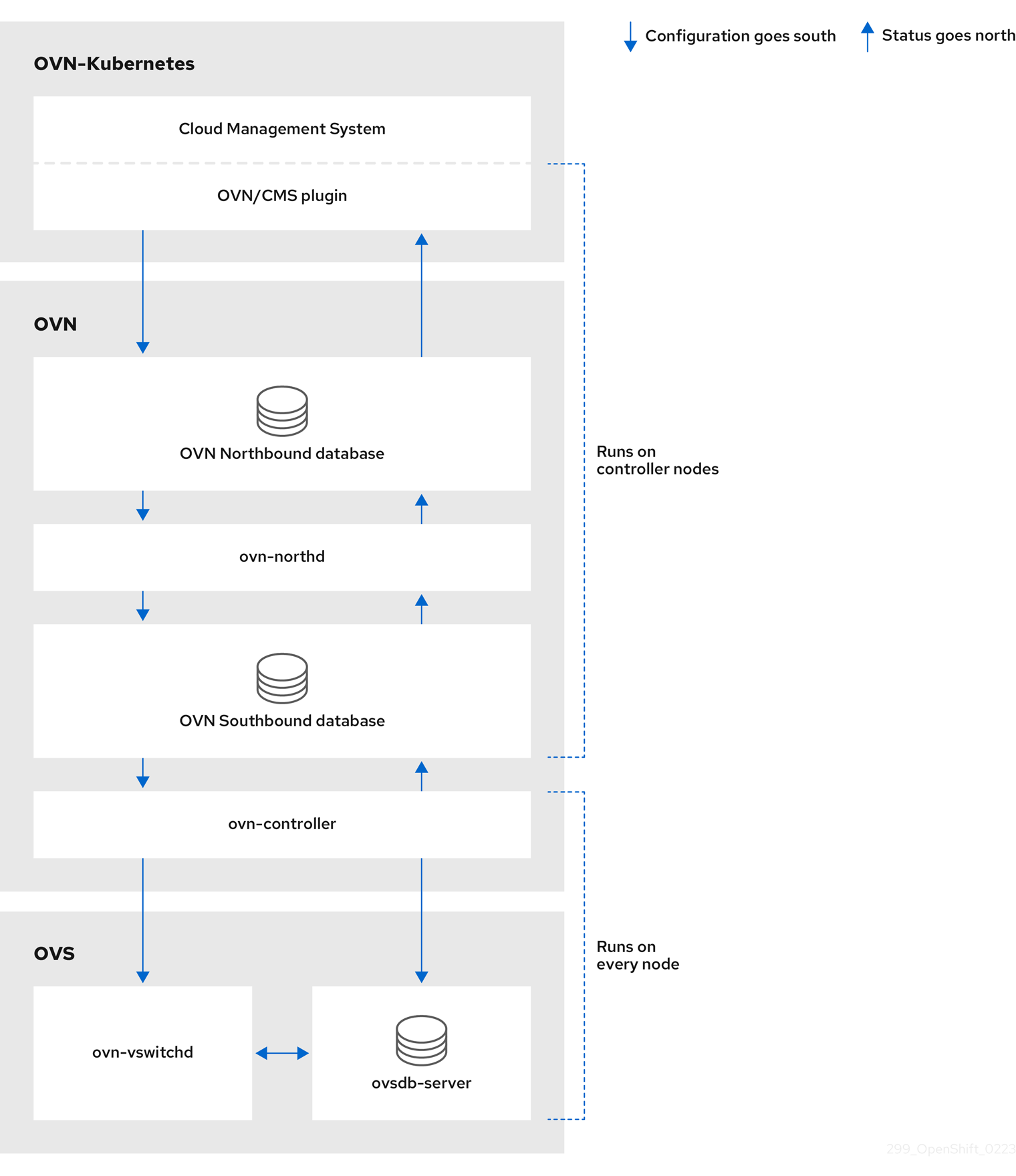

다음 다이어그램은 OVN-Kubernetes 아키텍처를 보여줍니다.

그림 24.1. OVK-Kubernetes 아키텍처

주요 구성 요소는 다음과 같습니다.

- Cloud Management System (CMS) - OVN 통합을 위한 CMS 특정 플러그인을 제공하는 OVN용 플랫폼 특정 클라이언트입니다. 플러그인은 CMS 구성 데이터베이스에 저장된 논리적 네트워크 구성에 대한 클라우드 관리 시스템의 개념을 OVN에 의해 이해되는 중간 표현으로 변환합니다.

-

OVN Northbound 데이터베이스(

nbdb) - CMS 플러그인에 의해 전달된 논리 네트워크 구성을 저장합니다. -

OVN Southbound 데이터베이스(

sbdb) - OpenVswitch(OVS) 시스템의 물리적 및 논리적 네트워크 구성 상태를 각 노드에서 바인딩하는 테이블을 포함하여 저장합니다. -

OVN-northd -

nbdb와sbdb간의 중간 클라이언트입니다.nbdb에서 가져온 기존 네트워크 개념의 관점에서 논리 네트워크 구성을sbdb아래의 논리 데이터 경로 흐름으로 변환합니다. 컨테이너 이름은northd이고ovnkube-masterPod에서 실행됩니다. -

OVN-controller -

sbdb에 필요한 모든 정보 또는 업데이트에 대해 OVS 및 하이퍼바이저와 상호 작용하는 OVN 에이전트입니다.ovn-controller는sbdb에서 논리 흐름을 읽고OpenFlow흐름으로 변환한 후 노드의 OVS 데몬으로 보냅니다. 컨테이너 이름은ovn-controller이며ovnkube-nodePod에서 실행됩니다.

OVN northbound 데이터베이스에는 클라우드 관리 시스템(CMS)에 의해 전달된 논리적 네트워크 구성이 있습니다. OVN northbound 데이터베이스에는 논리 포트, 논리 스위치, 논리 라우터 등의 컬렉션으로 제공되는 현재 원하는 네트워크의 상태가 포함되어 있습니다. ovn-northd (northd 컨테이너)는 OVN northbound 데이터베이스 및 OVN southbound 데이터베이스에 연결됩니다. OVN northbound 데이터베이스에서 가져온 기존 네트워크 개념과 관련하여 논리적 네트워크 구성을 OVN southbound 데이터베이스의 논리 데이터 경로 흐름으로 변환합니다.

OVN southbound 데이터베이스에는 서로 연결하는 네트워크 및 바인딩 테이블에 대한 물리적 표현과 논리적 표현이 있습니다. 클러스터의 모든 노드는 southbound 데이터베이스에 표시되며 연결된 포트를 확인할 수 있습니다. 또한 모든 논리 흐름이 포함되어 있으며 논리 흐름은 각 노드에서 실행되는 ovn-controller 프로세스와 공유되며 ovn-controller 는 해당 규칙을 OpenFlow 규칙으로 Open vSwitch 로 변환합니다.

Kubernetes 컨트롤 플레인 노드에는 각각 OVN northbound 및 southbound 데이터베이스의 컨테이너를 호스팅하는 ovnkube-master Pod가 포함되어 있습니다. 모든 OVN northbound 데이터베이스는 Raft 클러스터를 구성하고 모든 southbound 데이터베이스는 별도의 Raft 클러스터를 형성합니다. 언제든지 단일 ovnkube-master 가 리더이고 다른 ovnkube-master Pod는 우선합니다.

24.2.2. OVN-Kubernetes 프로젝트의 모든 리소스 나열

OVN-Kubernetes 프로젝트에서 실행되는 리소스와 컨테이너를 찾는 것이 OVN-Kubernetes 네트워킹 구현을 이해하는 데 중요합니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스합니다. -

OpenShift CLI(

oc)가 설치되어 있어야 합니다.

프로세스

다음 명령을 실행하여 OVN-Kubernetes 프로젝트에서 모든 리소스, 끝점 및

ConfigMap을 가져옵니다.oc get all,ep,cm -n openshift-ovn-kubernetes

$ oc get all,ep,cm -n openshift-ovn-kubernetesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 컨트롤 플레인 노드에서 실행되는

ovnkube-masterovnkube-nodePod를 배포하는 데 사용되는 두 개의 데몬 세트가 있습니다. 클러스터의 각 노드에 대해 하나의ovnkube-nodePod가 있습니다. 이 예제에는 5개가 있으며 클러스터에 노드당 하나의ovnkube-node가 있으므로 클러스터에 5개의 노드가 있습니다.ovnkube-configConfigMap에는 온라인 마스터 및ovnkube-node에서 OpenShift Container Platform OVN-Kubernetes 구성이 시작됩니다.ovn-kubernetes-masterConfigMap에는 현재 온라인 마스터 리더의 정보가 있습니다.다음 명령을 실행하여

ovnkube-masterPod의 모든 컨테이너를 나열합니다.oc get pods ovnkube-master-9g7zt \ -o jsonpath='{.spec.containers[*].name}' -n openshift-ovn-kubernetes$ oc get pods ovnkube-master-9g7zt \ -o jsonpath='{.spec.containers[*].name}' -n openshift-ovn-kubernetesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예상 출력

northd nbdb kube-rbac-proxy sbdb ovnkube-master ovn-dbchecker

northd nbdb kube-rbac-proxy sbdb ovnkube-master ovn-dbcheckerCopy to Clipboard Copied! Toggle word wrap Toggle overflow ovnkube-masterPod는 여러 컨테이너로 구성됩니다. Pod, egressIP, 네임스페이스, 서비스, 송신 방화벽 및 네트워크 정책에 대한 클러스터 이벤트를 감시하고 northbound 데이터베이스(ovnkube-masterPod)에 작성하고 노드에 대한 Pod 서브넷 할당을 관리합니다.다음 명령을 실행하여

ovnkube-nodePod의 모든 컨테이너를 나열합니다.oc get pods ovnkube-node-jg52r \ -o jsonpath='{.spec.containers[*].name}' -n openshift-ovn-kubernetes$ oc get pods ovnkube-node-jg52r \ -o jsonpath='{.spec.containers[*].name}' -n openshift-ovn-kubernetesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예상 출력

ovn-controller ovn-acl-logging kube-rbac-proxy kube-rbac-proxy-ovn-metrics ovnkube-node

ovn-controller ovn-acl-logging kube-rbac-proxy kube-rbac-proxy-ovn-metrics ovnkube-nodeCopy to Clipboard Copied! Toggle word wrap Toggle overflow ovnkube-nodePod에는 각 OpenShift Container Platform 노드에 상주하는 컨테이너(ovn-controller)가 있습니다. 각 노드의ovn-controller는 OVN northbound를 OVN southbound 데이터베이스에 연결하여 OVN 구성에 대해 알아봅니다.ovn-controller는 southbound를ovs-vswitchd에 OpenFlow 컨트롤러로, 네트워크 트래픽을 제어하며 로컬ovsdb-server에 연결하여 Open vSwitch 구성을 모니터링하고 제어할 수 있습니다.

24.2.3. OVN-Kubernetes northbound 데이터베이스 콘텐츠 나열

논리 흐름 규칙을 이해하려면 northbound 데이터베이스를 검사하고 오브젝트가 논리 흐름 규칙으로 어떻게 변환되는지 이해해야 합니다. 이 절차에서는 OVN Raft 리더에 최신 정보가 있으며, 이 절차에서는 Raft 리더를 찾고 나중에 OVN northbound 데이터베이스 콘텐츠를 나열하도록 쿼리하는 방법을 설명합니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스합니다. -

OpenShift CLI(

oc)가 설치되어 있어야 합니다.

프로세스

northbound 데이터베이스의 OVN Raft 리더를 찾습니다.

참고Raft 리더는 최신 정보를 저장합니다.

다음 명령을 실행하여 Pod를 나열합니다.

oc get po -n openshift-ovn-kubernetes

$ oc get po -n openshift-ovn-kubernetesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 임의의 마스터 Pod 중 하나를 선택하고 다음 명령을 실행합니다.

oc exec -n openshift-ovn-kubernetes ovnkube-master-7j97q \ -- /usr/bin/ovn-appctl -t /var/run/ovn/ovnnb_db.ctl \ --timeout=3 cluster/status OVN_Northbound

$ oc exec -n openshift-ovn-kubernetes ovnkube-master-7j97q \ -- /usr/bin/ovn-appctl -t /var/run/ovn/ovnnb_db.ctl \ --timeout=3 cluster/status OVN_NorthboundCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 사용하여 IP 주소

10.0.242.240에서 실행 중인ovnkube-masterPod를 찾습니다.oc get po -o wide -n openshift-ovn-kubernetes | grep 10.0.242.240 | grep -v ovnkube-node

$ oc get po -o wide -n openshift-ovn-kubernetes | grep 10.0.242.240 | grep -v ovnkube-nodeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

ovnkube-master-gt4ms 6/6 Running 1 (143m ago) 150m 10.0.242.240 ip-10-0-242-240.ec2.internal <none> <none>

ovnkube-master-gt4ms 6/6 Running 1 (143m ago) 150m 10.0.242.240 ip-10-0-242-240.ec2.internal <none> <none>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ovnkube-master-gt4ms포드는 IP 주소 10.0.242.240에서 실행됩니다.

다음 명령을 실행하여 northbound 데이터베이스의 모든 오브젝트를 표시합니다.

oc exec -n openshift-ovn-kubernetes -it ovnkube-master-gt4ms \ -c northd -- ovn-nbctl show

$ oc exec -n openshift-ovn-kubernetes -it ovnkube-master-gt4ms \ -c northd -- ovn-nbctl showCopy to Clipboard Copied! Toggle word wrap Toggle overflow 여기에 나열하기에는 출력이 너무 길습니다. 목록에는 NAT 규칙, 논리 스위치, 로드 밸런서 등이 포함됩니다.

다음 명령을 실행하여

ovn-nbctl명령으로 사용 가능한 옵션을 표시합니다.oc exec -n openshift-ovn-kubernetes -it ovnkube-master-mk6p6 \ -c northd ovn-nbctl --help

$ oc exec -n openshift-ovn-kubernetes -it ovnkube-master-mk6p6 \ -c northd ovn-nbctl --helpCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령 중 일부를 사용하여 특정 구성 요소를 축소하고 집중할 수 있습니다.

다음 명령을 실행하여 논리 라우터 목록을 표시합니다.

oc exec -n openshift-ovn-kubernetes -it ovnkube-master-gt4ms \ -c northd -- ovn-nbctl lr-list

$ oc exec -n openshift-ovn-kubernetes -it ovnkube-master-gt4ms \ -c northd -- ovn-nbctl lr-listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고이 출력에서 각 노드에

ovn_cluster_router가 추가되었음을 확인할 수 있습니다.다음 명령을 실행하여 논리 스위치 목록을 표시합니다.

oc exec -n openshift-ovn-kubernetes -it ovnkube-master-gt4ms \ -c northd -- ovn-nbctl ls-list

$ oc exec -n openshift-ovn-kubernetes -it ovnkube-master-gt4ms \ -c northd -- ovn-nbctl ls-listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고이 출력에서 노드 이름 자체와 조인 스위치를 사용하여 각 노드와 스위치에 대해 ext 스위치가 있음을 확인할 수 있습니다.

다음 명령을 실행하여 로드 밸런서 목록을 표시합니다.

oc exec -n openshift-ovn-kubernetes -it ovnkube-master-gt4ms \ -c northd -- ovn-nbctl lb-list

$ oc exec -n openshift-ovn-kubernetes -it ovnkube-master-gt4ms \ -c northd -- ovn-nbctl lb-listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고이 잘린 출력에서는 많은 OVN-Kubernetes 로드 밸런서가 있음을 확인할 수 있습니다. OVN-Kubernetes의 로드 밸런서는 서비스를 나타냅니다.

24.2.4. ovn-nbctl에서 northbound 데이터베이스 콘텐츠를 검사하는 명령줄 인수

다음 표에서는 ovn-nbctl 과 함께 사용하여 northbound 데이터베이스의 내용을 검사할 수 있는 명령줄 인수를 설명합니다.

| 인수 | 설명 |

|---|---|

|

| northbound 데이터베이스 콘텐츠의 개요입니다. |

|

| 지정된 스위치 또는 라우터와 연결된 세부 정보를 표시합니다. |

|

| 논리 라우터를 표시합니다. |

|

|

|

|

| 지정된 라우터에 대한 네트워크 주소 변환 세부 정보를 표시합니다. |

|

| 논리 스위치 표시 |

|

|

|

|

| 논리 포트의 유형을 가져옵니다. |

|

| 로드 밸런서를 표시합니다. |

24.2.5. OVN-Kubernetes southbound 데이터베이스 콘텐츠 나열

논리 흐름 규칙은 인프라를 나타내는 southbound 데이터베이스에 저장됩니다. 이 절차에서는 OVN Raft 리더에 최신 정보가 있으며 이 절차에서는 Raft 리더를 찾아 OVN southbound 데이터베이스 콘텐츠를 나열하는 방법을 설명합니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스합니다. -

OpenShift CLI(

oc)가 설치되어 있어야 합니다.

프로세스

southbound 데이터베이스의 OVN Raft 리더를 찾습니다.

참고Raft 리더는 최신 정보를 저장합니다.

다음 명령을 실행하여 Pod를 나열합니다.

oc get po -n openshift-ovn-kubernetes

$ oc get po -n openshift-ovn-kubernetesCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 임의로 마스터 Pod 중 하나를 선택하고 다음 명령을 실행하여 OVN southbound Raft 리더를 찾습니다.

oc exec -n openshift-ovn-kubernetes ovnkube-master-7j97q \ -- /usr/bin/ovn-appctl -t /var/run/ovn/ovnsb_db.ctl \ --timeout=3 cluster/status OVN_Southbound

$ oc exec -n openshift-ovn-kubernetes ovnkube-master-7j97q \ -- /usr/bin/ovn-appctl -t /var/run/ovn/ovnsb_db.ctl \ --timeout=3 cluster/status OVN_SouthboundCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 사용하여 IP 주소

10.0.163.212에서 실행 중인ovnkube-masterPod를 찾습니다.oc get po -o wide -n openshift-ovn-kubernetes | grep 10.0.163.212 | grep -v ovnkube-node

$ oc get po -o wide -n openshift-ovn-kubernetes | grep 10.0.163.212 | grep -v ovnkube-nodeCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

ovnkube-master-mk6p6 6/6 Running 0 136m 10.0.163.212 ip-10-0-163-212.ec2.internal <none> <none>

ovnkube-master-mk6p6 6/6 Running 0 136m 10.0.163.212 ip-10-0-163-212.ec2.internal <none> <none>Copy to Clipboard Copied! Toggle word wrap Toggle overflow ovnkube-master-mk6p6포드는 IP 주소 10.0.163.212에서 실행됩니다.

다음 명령을 실행하여 southbound 데이터베이스에 저장된 모든 정보를 표시합니다.

oc exec -n openshift-ovn-kubernetes -it ovnkube-master-mk6p6 \ -c northd -- ovn-sbctl show

$ oc exec -n openshift-ovn-kubernetes -it ovnkube-master-mk6p6 \ -c northd -- ovn-sbctl showCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 이 상세 출력은 섀시와 섀시에 연결된 포트를 보여줍니다. 이 경우 모든 라우터 포트와 호스트 네트워킹과 같이 실행되는 모든 포트입니다. 모든 pod는 소스 네트워크 주소 변환(SNAT)을 사용하여 더 광범위한 네트워크에 통신합니다. 해당 IP 주소는 Pod가 실행 중인 노드의 IP 주소로 변환된 다음 네트워크로 전송됩니다.

southbound 데이터베이스에는 모든 논리 흐름이 있으며 이러한 논리 흐름은 각 노드에서 실행되는

ovn-controller로 전송됩니다.ovn-controller는 논리 흐름을 오픈 흐름 규칙 및 궁극적으로OpenvSwitch프로그램으로 변환하여 Pod가 오픈 흐름 규칙을 따르고 네트워크를 벗어나게 할 수 있도록 합니다.다음 명령을 실행하여

ovn-sbctl명령으로 사용 가능한 옵션을 표시합니다.oc exec -n openshift-ovn-kubernetes -it ovnkube-master-mk6p6 \ -c northd -- ovn-sbctl --help

$ oc exec -n openshift-ovn-kubernetes -it ovnkube-master-mk6p6 \ -c northd -- ovn-sbctl --helpCopy to Clipboard Copied! Toggle word wrap Toggle overflow

24.2.6. ovn-sbctl에 대한 명령행 인수로 southbound 데이터베이스 콘텐츠를 검사합니다.

다음 표에서는 ovn-sbctl 에서 southbound 데이터베이스의 콘텐츠를 검사하는 데 사용할 수 있는 명령줄 인수를 설명합니다.

| 인수 | 설명 |

|---|---|

|

| southbound 데이터베이스 콘텐츠 개요. |

|

| 지정된 포트에 대한 southbound 데이터베이스의 내용을 나열합니다. |

|

| 논리 흐름을 나열합니다. |

24.2.7. OVN-Kubernetes 논리 아키텍처

OVN은 네트워크 가상화 솔루션입니다. 논리 스위치 및 라우터를 생성합니다. 이러한 스위치 및 라우터는 모든 네트워크 토폴로지를 생성하기 위해 고충됩니다. 로그 수준이 2 또는 5로 설정된 ovnkube-trace 를 실행하면 OVN-Kubernetes 논리 구성 요소가 노출됩니다. 다음 다이어그램에서는 OpenShift Container Platform에서 라우터 및 스위치가 연결된 방법을 보여줍니다.

그림 24.2. OVN-Kubernetes 라우터 및 스위치 구성 요소

패킷 처리와 관련된 주요 구성 요소는 다음과 같습니다.

- 게이트웨이 라우터

-

L3 게이트웨이 라우터라고도 하는 게이트웨이 라우터는 일반적으로 분산 라우터와 물리적 네트워크 간에 사용됩니다. 논리 패치 포트를 포함한 게이트웨이 라우터는 물리적 위치(분산되지 않음) 또는 섀시에 바인딩됩니다. 이 라우터의 패치 포트는 ovn-southbound 데이터베이스(

ovn-sbdb)에서 l3gateway 포트라고 합니다. - 분산 논리 라우터

- 분산 논리 라우터와 그 뒤에 논리 스위치, 가상 시스템 및 컨테이너가 연결되는 논리 스위치는 각 하이퍼바이저에 효과적으로 상주합니다.

- 로컬 스위치에 가입

- 조인 로컬 스위치는 분산 라우터 및 게이트웨이 라우터를 연결하는 데 사용됩니다. 분산 라우터에 필요한 IP 주소 수를 줄입니다.

- 패치 포트가 있는 논리 스위치

- 패치 포트가 있는 논리 스위치는 네트워크 스택을 가상화하는 데 사용됩니다. 원격 논리 포트를 터널을 통해 연결합니다.

- localnet 포트가 있는 논리 스위치

- localnet 포트가 있는 논리 스위치는 OVN을 물리적 네트워크에 연결하는 데 사용됩니다. localnet 포트를 사용하여 직접 연결된 물리적 L2 세그먼트에 패킷을 브리징하여 원격 논리 포트를 연결합니다.

- 패치 포트

- 패치 포트는 논리 스위치와 논리 라우터와 피어 논리 라우터 간의 연결을 나타냅니다. 단일 연결에는 이러한 연결 시점에 각각 하나씩의 패치 포트가 있습니다.

- l3gateway 포트

-

l3gateway 포트는 게이트웨이 라우터에서 사용되는 논리 패치 포트에 대한

ovn-sbdb의 포트 바인딩 항목입니다. 이러한 포트는 게이트웨이 라우터 자체와 마찬가지로 섀시에 바인딩된다는 사실을 나타내기 위해 패치 포트가 아닌 l3gateway 포트라고 합니다. - Localnet 포트

-

로컬net 포트는 브리지된 논리 스위치에 있으며 각

ovn-controller인스턴스에서 로컬에 액세스할 수 있는 네트워크에 연결할 수 있습니다. 이를 통해 논리 스위치에서 물리적 네트워크에 직접 연결할 수 있습니다. 논리 스위치에는 하나의 localnet 포트만 연결할 수 있습니다.

24.2.7.1. 로컬 호스트에 network-tools 설치

로컬 호스트에 network-tools 를 설치하여 OpenShift Container Platform 클러스터 네트워크 문제를 디버깅하는 데 사용할 수 있는 툴 컬렉션을 만듭니다.

프로세스

다음 명령을 사용하여

network-tools리포지토리를 워크스테이션에 복제합니다.git clone git@github.com:openshift/network-tools.git

$ git clone git@github.com:openshift/network-tools.gitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 방금 복제한 리포지토리의 디렉터리로 변경합니다.

cd network-tools

$ cd network-toolsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 선택 사항: 사용 가능한 모든 명령을 나열합니다.

./debug-scripts/network-tools -h

$ ./debug-scripts/network-tools -hCopy to Clipboard Copied! Toggle word wrap Toggle overflow

24.2.7.2. network-tools 실행

network-tools 를 실행하여 논리 스위치 및 라우터에 대한 정보를 가져옵니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin권한이 있는 사용자로 클러스터에 로그인합니다. -

로컬 호스트에

network-tools를 설치했습니다.

프로세스

다음 명령을 실행하여 라우터를 나열합니다.

./debug-scripts/network-tools ovn-db-run-command ovn-nbctl lr-list

$ ./debug-scripts/network-tools ovn-db-run-command ovn-nbctl lr-listCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 localnet 포트를 나열합니다.

./debug-scripts/network-tools ovn-db-run-command \ ovn-sbctl find Port_Binding type=localnet

$ ./debug-scripts/network-tools ovn-db-run-command \ ovn-sbctl find Port_Binding type=localnetCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여

l3gateway포트를 나열합니다../debug-scripts/network-tools ovn-db-run-command \ ovn-sbctl find Port_Binding type=l3gateway

$ ./debug-scripts/network-tools ovn-db-run-command \ ovn-sbctl find Port_Binding type=l3gatewayCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 명령을 실행하여 패치 포트를 나열합니다.

./debug-scripts/network-tools ovn-db-run-command \ ovn-sbctl find Port_Binding type=patch

$ ./debug-scripts/network-tools ovn-db-run-command \ ovn-sbctl find Port_Binding type=patchCopy to Clipboard Copied! Toggle word wrap Toggle overflow 출력 예

Copy to Clipboard Copied! Toggle word wrap Toggle overflow