1.4. 新功能及功能增强

此版本对以下方面进行了改进。

1.4.1. Red Hat Enterprise Linux CoreOS (RHCOS)

1.4.1.1. RHCOS 现在使用 RHEL 8.4

RHCOS 现在在 OpenShift Container Platform 4.8 中使用 Red Hat Enterprise Linux (RHEL) 8.4,以及 OpenShift Container Platform 4.7.24 及更高版本。这可让您获得最新的修复、功能和增强,以及最新的硬件支持和驱动程序更新。OpenShift Container Platform 4.6 是一个延长更新支持(EUS)版本,其整个生命周期中将继续使用 RHEL 8.2 EUS 软件包。

1.4.1.2. 使用流元数据改进引导镜像自动化

流元数据提供标准化的 JSON 格式,用于在 OpenShift Container Platform 安装过程中将元数据注入集群中。为改进自动化,新的 openshift-install coreos print-stream-json 命令提供了一种以可脚本、机器可读格式打印流元数据的方法。

对于用户置备的安装,openshift-install 二进制文件包含对经过测试用于 OpenShift Container Platform 的 RHCOS 引导镜像版本的引用,如 AWS AMI。现在,您可以使用 https://github.com/coreos/stream-metadata-go 官方 stream-metadata-go 库从 Go 程序解析流元数据。

如需更多信息,请参阅使用流元数据访问 RHCOS AMI。

OpenShift Container Platform 现在包含 Butane config transpiler,可协助生成和验证机器配置。现在,文档建议使用 Butane 为 LUKS 磁盘加密、引导磁盘镜像和自定义内核模块创建机器配置。

如需更多信息,请参阅使用 Butane 创建机器配置。

1.4.1.4. 在云平台上进入自定义 chrony.conf 默认

如果云管理员已经设置了自定义 /etc/chrony.conf 配置,RHCOS 不再默认在云平台上设置 PEERNTP=no 选项。否则,默认仍会设置 PEERNTP=no 选项。如需更多信息,请参阅 BZ#1924869。

1.4.1.5. 在裸机安装时启用多路径

现在,OpenShift Container Platform 4.8 或更高版本置备的节点支持在裸机安装过程中启用多路径。您可以通过在 coreos-installer install 命令中附加内核参数来启用多路径,以便安装的系统本身从第一次引导开始使用多路径。虽然安装后支持仍可通过机器配置激活多路径,但建议在安装过程中为从 OpenShift Container Platform 4.8 开始置备的节点启用多路径。

如需更多信息,请参阅在 RHCOS 上启用使用内核参数的多路径。

1.4.2. 安装和升级

1.4.2.1. 将集群安装到 Azure 上的现有空资源组

现在,您可以通过在 install-config.yaml 文件中定义 platform.azure.resourceGroupName 字段来定义一个已存在的资源组,以便在 Azure 上安装集群。此资源组必须为空,且仅适用于单个集群 ; 集群组件假定资源组中所有资源的所有权。

如果您将安装程序的服务主体范围限制到这个资源组,您必须确保您的环境中安装程序使用的所有其他资源都有必要的权限,如公共 DNS 区和虚拟网络。使用安装程序销毁集群会删除用户定义的资源组。

1.4.2.2. 为 AWS 上的集群使用现有 IAM 角色

现在,您可以通过在 install-config.yaml 文件中设置 compute.platform.aws.iamRole 和 controlPlane.platform.aws.iamRole 字段来为机器实例配置集定义预先存在的 Amazon Web Services(AWS)IAM 角色。这可让您为 IAM 角色执行以下操作:

- 匹配命名方案

- 包括预定义的权限边界

1.4.2.3. 在 AWS 中使用预先存在的 Route53 托管私有区

现在,您可以通过在 install-config.yaml 文件中设置 platform.aws.hostedZone 字段来为集群定义一个现有 Route 53 私有托管区。您只能在提供自己的 VPC 时使用已存在的托管区。

1.4.2.4. 在机器 CIDR 中增大 GCP 子网的大小

Google Cloud Platform(GCP)的 OpenShift Container Platform 安装程序现在在机器 CIDR 中尽可能多地创建子网。这允许集群使用机器 CIDR 大小来容纳集群中的节点数量。

1.4.2.5. 改进了升级持续时间

在这个版本中,将守护进程集部署到所有节点的集群 Operator 的升级周期会被显著降低。例如,一个 250 个节点的测试集群的升级持续时间从 7.5 小时减少到 1.5 小时,这代表为每个额外节点进行升级的时间被缩减为少于一分钟。

这个更改不会影响机器配置池推出部署的时间。

1.4.2.6. MCO 在报告更新完成前等待所有机器配置池进行更新

更新时,如果任何机器配置池没有完成更新,Machine Config Operator(MCO)现在会在 machine-config Cluster Operator 中报告 Upgradeable=False 条件。这个状态会阻止将来的次要更新,但不会阻止将来的补丁更新或当前更新。在以前的版本中,MCO 仅根据 control plane 机器配置池的状态报告 Upgradeable 状态,即使 worker 池没有更新。

1.4.2.7. 使用 Fujitsu iRMC 在裸机节点上安装

在 OpenShift Container Platform 4.8 中,您可以在裸机上部署安装程序置备的集群时,使用 Fujitsu 硬件和 Fujitsu iRMC 基本管理控制器协议。目前,Fujitsu 支持 iRMC S5 固件版本 3.05P 及更高版本,用于裸机上的安装程序置备安装。OpenShift Container Platform 4.8 的改进和程序错误修复包括:

- 支持 iRMC 硬件上的软电源关闭。

- 安装程序在裸机节点上部署 control plane 后停止调配服务。如需更多信息,请参阅 BZ#1949859。

-

在 bootstrap

keepalived检查中添加 Ironic 健康检查。如需更多信息,请参阅 BZ#1949859。 - 验证 control plane 节点上的单播 peers 列表不是空的。如需更多信息,请参阅 BZ#1957708。

- 更新 Bare Metal Operator 以匹配 iRMC PowerInterface。如需更多信息,请参阅 BZ#1957869。

-

更新

pyghmi库版本。如需更多信息,请参阅 BZ#1920294。 - 更新 Bare Metal Operator 以解决缺少的 IPMI 凭证。如需更多信息,请参阅 BZ#1965182。

-

从

enabled_bios_interfaces中删除 iRMC。如需更多信息,请参阅 BZ#1969212。 -

在裸机 pod 定义中添加

ironicTlsMount和inspectorTlsMount。如需更多信息,请参阅 BZ#1968701。 - 为 iRMC 服务器禁用 RAID 功能。如需更多信息,请参阅 BZ#1969487。

- 为所有驱动程序禁用 RAID。如需更多信息,请参阅 BZ#1969487。

1.4.2.8. RHOSP 上带有安装程序置备基础架构的集群的 SR-IOV 网络支持

现在,您可以在 RHOSP 上部署集群,这些集群使用单根 I/O 虚拟化(SR-IOV)网络用于计算机器。

如需更多信息,请参阅在支持 SR-IOV 连接计算机器的 OpenStack 上安装集群 。

1.4.2.9. ironic Python 代理支持 VLAN 接口

在这个版本中,Ironic Python 代理会在内省期间在接口列表中报告 VLAN 接口。此外,IP 地址包含在接口中,允许正确创建 CSR。因此,可以为所有接口(包括 VLAN 接口)获取 CSR。如需更多信息,请参阅 BZ#1888712。

1.4.2.10. 使用 OpenShift 更新服务进行无线更新

OpenShift 更新服务(OpenShift Update Service,简称 OSUS)为 OpenShift Container Platform(包括 Red Hat Enterprise Linux CoreOS(RHCOS))提供了无线更新(over-the air update)功能。它以前只能作为红帽托管服务(位于公共 API 后面)进行访问,但现在可以在本地安装。OpenShift Update Service 由 Operator 和一个或多个应用程序实例组成,现在在 OpenShift Container Platform 4.6 及更高版本中正式发布。

如需更多信息,请参阅了解 OpenShift Update Service。

1.4.3. Web 控制台

1.4.3.1. 自定义控制台路由现在使用新的 CustomDomains 集群 API

对于 console 和 downloads 路由,自定义路由功能现在会使用新的 ingress 配置路由配置 API spec.componentRoutesConsole Operator 配置已包含自定义路由自定义,但仅适用于 console 路由。通过 console-operator 配置的路由配置已弃用。因此,如果 console 自定义路由在 ingress 配置和 console-operator 配置中都设置时,新的 ingress 配置自定义路由配置有高的优先级。

如需更多信息,请参阅自定义控制台路由。

1.4.3.2. 从快速入门访问代码片段

现在,您可以在 web 控制台的 Quick Start 中包含 CLI 片段时执行它。要使用这个功能,您必须首先安装 Web Terminal Operator。如果您没有安装 Web Terminal Operator,则 web 终端中执行的 web 终端和代码片段操作将不存在。另外,无论您是否安装了 Web Terminal Operator,您都可以将代码片段复制到剪贴板中。

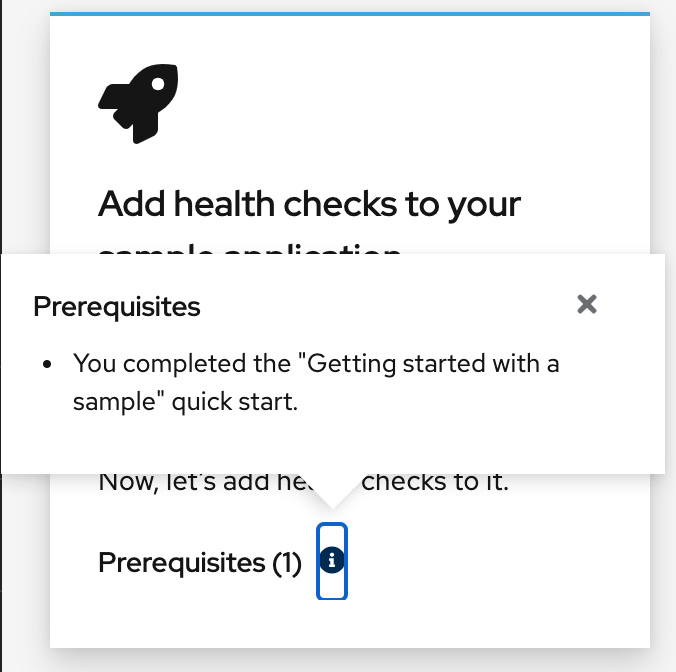

1.4.3.3. 改进了快速入门先决条件的介绍

在以前的版本中,快速入门先决条件以组合文本而不是 Quick Start 卡中的列表显示。考虑到可扩展性,现在会在弹出窗口中显示先决条件,而不是在卡中显示。

1.4.3.4. Developer Perspective (开发者视角)

在这个版本中,您可以:

- 使用自定义管道模板从 Git 存储库创建和部署应用程序。这些模板覆盖 OpenShift Pipelines 1.5 及之后的版本提供的默认管道模板。

- 根据它们的认证级别过滤 Helm chart,并在 Developer Catalog 中查看所有 Helm chart。

- 使用 Add 页面中的选项来创建应用程序和相关服务,并在 OpenShift Container Platform 上部署这些应用程序和服务。Add 页选项包括:Getting started resources, Creating applications using samples, Build with guided documentation, 和 Explore new developer features。

- 在管道构建器中创建管道时使用工作区。您还可以在管道中添加触发器,以便您可以使用任务支持管道中的工作区。

- 使用 Developer 视角的 Topology 视图中的 JAR 文件来部署 Java 应用程序。

- 在 OpenShift Container Platform 中创建多个事件源类型,并将这些源类型连接到 sink。您可以在 OpenShift Container Platform 集群中将功能部署为 Knative 服务,并将它们连接到 sink。

-

使用管道中的

finally任务并行执行命令。 - 使用 Add Task 表单中的代码帮助来访问任务参数值。要查看管道参数,以及引用该特定管道参数的正确语法,请转至相应的文本字段。

-

仅在满足特定条件后运行一个

Task。使用when字段配置任务的执行,并列出对when表达式的一系列引用。

1.4.4. IBM Z 和 LinuxONE

在这个版本中,IBM Z 和 LinuxONE 与 OpenShift Container Platform 4.8 兼容。可以使用 z/VM 或 RHEL KVM 进行安装。有关安装说明,请参阅以下文档:

主要改进

IBM Z 和 LinuxONE 中的 OpenShift Container Platform 4.8 支持以下新功能:

- IBM Z 和 LinuxONE 上的、用户置备安装的 OpenShift Container Platform 4.8 支持 RHEL 8.3 或更高版本的 KVM 作为的虚拟机监控程序(hypervisor)。现在还支持使用静态 IP 地址安装并在受限网络中安装。

- 加密存储在 etcd 中的数据.

- 4K FCP 块设备.

- 三节点集群支持.

支持的功能

IBM Z 和 LinuxONE 也支持以下功能:

- 多路径(Multipathing)

- 使用 iSCSI 的持久性存储

- 使用本地卷的持久性存储(本地存储 Operator)

- 使用 hostPath 的持久性存储

- 使用 Fibre Channel 持久性存储

- 使用 Raw Block 的持久性存储

- 初始安装 OpenShift Container Platform 4.8 的 OVN-Kubernetes

- SCSI 磁盘中的 z/VM 模拟 FBA 设备

以下功能仅适用于 IBM Z 上的 OpenShift Container Platform 4.8:

- IBM Z /LinuxONE 为附加的 ECKD 存储的虚拟机启用了 HyperPAV

限制

请注意,OpenShift Container Platform 对 IBM Z 和 LinuxONE 有如下限制:

用于 IBM Z 的 OpenShift Container Platform 不包括以下技术预览功能:

- 精度时间协议 (PTP) 硬件

以下 OpenShift Container Platform 功能不被支持:

- 使用机器健康检查功能自动修复损坏的机器

- CodeReady Containers (CRC)

- 在节点上控制过量使用和管理容器密度

- CSI 卷克隆

- CSI 卷快照

- FIPS 加密

- Helm 命令行界面 (CLI) 工具

- Multus CNI 插件

- NVMe

- OpenShift Metering

- OpenShift Virtualization

- 在 OpenShift Container Platform 部署过程中启用 Tang 模式磁盘加密。

- worker 节点必须运行 Red Hat Enterprise Linux CoreOS(RHCOS)

- 必须使用 NFS 或其他支持的存储协议来置备持久性共享存储

- 必须使用本地存储(如 iSCSI、FC 或者带有 DASD、FCP 或 EDEV/FBA 的 LSO)置备持久性非共享存储

1.4.5. IBM Power 系统

在这个版本中,IBM Power Systems 与 OpenShift Container Platform 4.8 兼容。有关安装说明,请参阅以下文档:

主要改进

使用 OpenShift Container Platform 4.8 的 IBM Power Systems 支持以下新功能:

- 加密数据存储在 etcd 中

- 三节点集群支持

- Multus SR-IOV

支持的功能

IBM Power 系统还支持以下功能:

目前,支持五个 Operator:

- Cluster-Logging-Operator

- Cluster-NFD-Operator

- Elastic Search-Operator

- Local Storage Operator

- Cluster Network Operator

- 多路径(Multipathing)

- 使用 iSCSI 的持久性存储

- 使用本地卷的持久性存储(本地存储 Operator)

- 使用 hostPath 的持久性存储

- 使用 Fibre Channel 持久性存储

- 使用 Raw Block 的持久性存储

- 初始安装 OpenShift Container Platform 4.8 的 OVN-Kubernetes

- 4K 磁盘支持

- NVMe

限制

OpenShift Container Platform 在 IBM Power 上会有以下限制:

用于 IBM Power 系统的 OpenShift Container Platform 不包括以下技术预览功能:

- 精度时间协议 (PTP) 硬件

以下 OpenShift Container Platform 功能不被支持:

- 使用机器健康检查功能自动修复损坏的机器

- CodeReady Containers (CRC)

- 在节点上控制过量使用和管理容器密度

- FIPS 加密

- Helm 命令行界面 (CLI) 工具

- OpenShift Metering

- OpenShift Virtualization

- 在 OpenShift Container Platform 部署过程中启用 Tang 模式磁盘加密。

- worker 节点必须运行 Red Hat Enterprise Linux CoreOS(RHCOS)

- 持久性存储必须是使用本地卷、网络文件系统(NFS)或 Container Storage Interface(CSI)的 Filesystem 类型

1.4.6. 安全性与合规性

1.4.6.1. Audit 会将 OAuth 访问令牌登出请求记录在日志中

现在, Default 审计日志策略会记录 OAuth 访问令牌创建(登录)和删除(注销)请求的请求正文。在以前的版本中,删除请求正文不会被记录。

有关审计日志策略的更多信息,请参阅配置节点审计日志策略。

1.4.6.2. 无头服务的服务证书的通配符主题

为无头服务生成服务服务证书现在包括一个通配符主题,格式为 *.<service.name>.<service.namespace>.svc。这允许 TLS 保护连接到单个有状态集 pod,而无需为这些 pod 手动生成证书。

因为生成的证书包含无头服务的通配符主题,因此如果您的客户端必须区分不同的 pod,则不得使用服务 CA。在这种情况下:

- 使用其他 CA 生成各个 TLS 证书。

- 对于定向到单个 pod 且不得被其他 pod 模拟的连接,不接受服务 CA 作为可信 CA。这些连接必须配置为信任用于生成单个 TLS 证书的 CA。

如需更多信息,请参阅添加服务证书。

1.4.6.3. oc-compliance 插件现在可用

Compliance Operator 为 OpenShift Container Platform 集群自动执行许多检查和补救。但是,使集群进入合规的完整过程通常需要管理员与 Compliance Operator API 和其他组件进行交互。oc-compliance 插件现在可用,并使进程变得更加容易。

如需更多信息,请参阅使用 oc-compliance 插件

1.4.6.4. Kubernetes control plane 的 TLS 安全配置集

Kubernetes API 服务器 TLS 安全配置集设置现在也被 Kubernetes 调度程序和 Kubernetes 控制器管理器实现。

如需更多信息,请参阅配置 TLS 安全配置集。

1.4.6.5. kubelet 的 TLS 安全配置集作为服务器

现在,当作为 Kubernetes API 服务器的 HTTP 服务器时,您可以为 kubelet 设置 TLS 安全配置集。

如需更多信息,请参阅配置 TLS 安全配置集。

1.4.6.6. 支持 bcrypt 密码哈希

在以前的版本中, oauth-proxy 命令只允许在用于身份验证的 htpasswd 文件中使用 SHA-1 哈希密码。OAuth-proxy 现在包含对使用 bcrypt 密码散列的 htpasswd 条目的支持。如需更多信息,请参阅 BZ#1874322。

1.4.6.7. 使用安装程序置备的集群启用受管的安全引导

OpenShift Container Platform 4.8 支持为置备的 control plane 和 worker 节点自动打开 UEFI 安全引导(Secure Boot)模式,并在删除节点时将其关闭。要使用这个功能,在 install-config.yaml 文件中将节点的 bootMode 配置设置为 UEFISecureBoot。红帽仅在第 10 代 HPE 硬件上支持带有管理的安全引导机制的安装程序置备安装,第 13 代的 Dell 硬件运行固件版本 2.75.75.75 或更高版本。如需了解更多详细信息,请参阅 install-config.yaml 文件中配置受管安全引导。

1.4.7. 网络

1.4.7.1. 在带有 OVN-Kubernetes 集群网络供应商的安装程序置备的裸机基础架构上支持双栈

对于安装程序置备的裸机基础架构上的集群,OVN-Kubernetes 集群网络供应商支持 IPv4 和 IPv6 地址系列。

对于安装程序置备的裸机集群从以前的 OpenShift Container Platform 版本升级,您必须转换集群来支持双栈网络。如需更多信息,请参阅转换到 IPv4/IPv6 双栈网络。

1.4.7.2. 在用户置备的基础架构上从 OpenShift SDN 迁移到 OVN-Kubernetes

用户置备的集群支持 OpenShift SDN 集群网络供应商迁移到 OVN-Kubernetes 集群网络供应商。如需更多信息,请参阅从 OpenShift SDN 集群网络供应商迁移。

1.4.7.3. OpenShift SDN 集群网络供应商出口 IP 功能在节点间平衡

现在,当命名空间被分配了多个出口 IP(egress IP)地址时, OpenShift SDN 的 egress IP 功能会以大致相等的方式在命名空间的节点间平衡网络流量。每个 IP 地址必须位于不同的节点上。如需更多信息,请参阅为 OpenShift SDN 配置项目的出口 IP。

1.4.7.4. 网络策略支持选择主机网络 Ingress Controller

使用 OpenShift SDN 或 OVN-Kubernetes 集群网络供应商时,您可以在网络策略规则中选择来自 Ingress Controller 的流量,无论 Ingress Controller 在集群网络还是主机网络上运行。在网络策略规则中,policy-group.network.openshift.io/ingress: "" 命名空间选择器标签与来自 Ingress Controller 的流量匹配。您可以继续使用 network.openshift.io/policy-group: ingress 命名空间选择器标签,但在以后的 OpenShift Container Platform 发行版本中可能会删除这个旧标签。

在以前的 OpenShift Container Platform 版本中,存在以下限制:

-

使用 OpenShift SDN 集群网络供应商的集群只能通过将

network.openshift.io/policy-group: ingress标签应用到default命名空间来选择来自主机网络上的 Ingress Controller 的流量。 - 使用 OVN-Kubernetes 集群网络供应商的集群无法从主机网络上的 Ingress Controller 选择流量。

如需更多信息,请参阅关于网络策略。

1.4.7.5. 网络策略支持选择主机网络流量

使用 OVN-Kubernetes 集群网络供应商或 OpenShift SDN 集群网络供应商时,您可以使用 policy-group.network.openshift.io/host-network: "" 命名空间选择器在网络策略规则中选择主机网络流量。

1.4.7.6. 网络策略审计日志

如果使用 OVN-Kubernetes 集群网络供应商,您可以为命名空间中的网络策略启用审计日志。日志采用 syslog 兼容格式,可以保存在本地、通过 UDP 连接发送或定向到 UNIX 域套接字。您可以指定是否记录允许、丢弃的连接,以及是否允许和丢弃的连接。如需更多信息,请参阅日志记录网络策略事件。

1.4.7.7. 对 macvlan 额外网络的网络策略支持

您可以使用实现 NetworkPolicy API 的 MultiNetworkPolicy API 创建适用于 macvlan 额外网络的网络策略。如需更多信息,请参阅配置多网络策略。

1.4.7.8. SR-IOV 支持的硬件

OpenShift Container Platform 4.8 添加了对额外的 Intel 和 Mellanox 网络接口控制器的支持。

- Intel X710、XL710 和 E810

- Mellanox ConnectX-5 Ex

如需更多信息,请参阅支持的设备。

1.4.7.9. SR-IOV Network Operator 的改进

使用 Operator 部署的 Network Resources Injector 被改进,以通过 Downward API 来公开有关巨页请求和限制的信息。当 pod 规格包含巨页请求或限制时,信息会在 /etc/podnetinfo 路径中公开。

如需更多信息,请参阅 Downward API 的 Huge page 资源注入。

1.4.7.10. 跟踪网络流

OpenShift Container Platform 4.8 添加了对将 pod 网络上网络流的元数据发送到网络流收集器的支持。支持以下协议:

- NetFlow

- sFlow

- IPFIX

数据包数据不会发送到网络流收集器。数据包级元数据(如协议、源地址、目标地址、端口号、字节数和其他数据包级别信息)将发送到网络流收集器。

如需更多信息,请参阅跟踪网络流。

1.4.7.11. CoreDNS-mDNS 不再用来将节点名称解析为 IP 地址

OpenShift Container Platform 4.8 及更新的版本包括使用集群成员资格信息生成 A/AAAA 记录的功能。这会将节点名称解析为其 IP 地址。使用 API 注册节点后,集群就可以分布节点信息,而无需使用 CoreDNS-mDNS。这可消除与多播 DNS 关联的网络流量。

OpenShift Container Platform 更新至 HAProxy 2.2,它默认将 HTTP 标头名称更改为小写,例如将 Host: xyz.com 改为 host: xyz.com。对于对 HTTP 标头名称大小写敏感的传统应用程序,请使用 Ingress Controller spec.httpHeaders.headerNameCaseAdjustments API 字段来适应旧的应用程序,直到它们被修复为止。当 HAProxy 2.2 可用时,在升级 OpenShift Container Platform 前,确保使用 spec.httpHeaders.headerNameCaseAdjustments 来添加必要的配置。

如需更多信息,请参阅转换 HTTP 标头问题单。

OpenShift Container Platform 更新至 HAProxy 2.2,它对 HTTP 标头强制执行一些额外的限制。这些限制旨在缓解应用中可能存在的安全性弱点。特别是,如果一个请求没有在请求行和 HTTP host 标头中同时指定或忽略端口号,则可能拒绝 HTTP 请求行中指定主机名的 HTTP 客户端请求。例如,带有标头 host: hostname 的请求 GET http://hostname:80/path 将被拒绝并带有 HTTP 400 "Bad request" 响应,因为请求行指定了端口号,而 host 标头没有指定端口号。这个限制的目的是减少 request smuggling 攻击。

在启用了 HTTP/2 时,在以前的 OpenShift Container Platform 版本中也可以启用了这个严格的 HTTP 标头验证。这意味着,您可以通过在 OpenShift Container Platform 4.7 集群中启用 HTTP/2 并检查 HTTP 400 错误来测试有问题的客户端请求。有关如何启用 HTTP/2 的详情,请参考启用 HTTP/2 Ingress 连接。

1.4.7.14. 在 GCP 上为 Ingress Controller 配置全局访问

OpenShift Container Platform 4.8 添加了对使用内部负载均衡器在 GCP 上创建的 Ingress Controller 的全局访问选项的支持。启用全局访问选项后,同一 VPC 网络和计算区域内任何区域中的客户端都可以访问集群中运行的工作负载。

如需更多信息,请参阅为 GCP 上的 Ingress Controller 配置全局访问。

1.4.7.15. 设置 Ingress Controller 线程数

OpenShift Container Platform 4.8 添加了对设置线程数的支持,以增加集群可以处理的进入连接量。

如需更多信息,请参阅设置 Ingress Controller 线程计数。

1.4.7.16. 为 Ingress Controller 配置 PROXY 协议

OpenShift Container Platform 4.8 添加了对在非云平台上为 Ingress Controller 配置 PROXY 协议的支持,特别是 HostNetwork 或 NodePortService 端点发布策略类型。

如需更多信息,请参阅为 Ingress Controller 配置 PROXY 协议。

1.4.7.17. control plane 节点上的 NTP 服务器

在 OpenShift Container Platform 4.8 中,安装程序置备的集群可以在 control plane 节点上配置和部署网络时间协议(NTP)服务器,并在 worker 节点上配置和部署 NTP 客户端。这可让 worker 从 control plane 节点上的 NTP 服务器检索日期和时间,即使从可路由的网络断开连接。您也可以在部署后配置和部署 NTP 服务器和 NTP 客户端。

1.4.7.18. Kuryr 的默认 API 负载均衡器管理更改

在带有 Kuryr-Kubernetes 的 Red Hat OpenStack Platform(RHOSP)上的 OpenShift Container Platform 4.8 部署中,default/kubernetes 服务的 API 负载均衡器不再由 Cluster Network Operator(CNO)管理,而是由 kuryr-controller 本身管理。这意味着:

升级到 OpenShift Container Platform 4.8 时,

default/kubernetes服务会停机。注意在没有 Open Virtual Network(OVN)Octavia 的部署中,应该有更多停机时间。

-

default/kubernetes负载均衡器不再需要使用 Octavia Amphora 驱动程序。如果 OpenStack 云中有default/kubernetes服务,则 OVN Octavia 将使用它来实现。

1.4.7.19. 安装后启用置备网络

通过为裸机集群提供支持的安装程序和安装程序置备安装,可以在没有 provisioning 网络的情况下部署集群。在 OpenShift Container Platform 4.8 及更新版本中,您可以使用 Cluster Baremetal Operator(CBO)在安装后启用 provisioning 网络。

1.4.7.20. 配置要在 control plane 上运行的网络组件

如果您需要在裸机安装中的 control plane 节点上运行虚拟 IP(VIP)地址,您必须将 apiVIP 和 ingressVIP VIP 地址配置为仅在 control plane 节点上运行。默认情况下,OpenShift Container Platform 允许 worker 机器配置池中的任何节点托管 apiVIP 和 ingressVIP VIP 地址。由于许多裸机环境在与 control plane 节点独立的子网中部署 worker 节点,因此将 apiVIP 和 ingressVIP 虚拟 IP 地址配置为完全在 control plane 节点上运行,从而防止在不同的子网中部署 worker 节点导致问题。如需了解更多详细信息,请参阅配置在 control plane 上运行的网络组件。

1.4.7.21. 为 apiVIP 和 ingressVIP 流量配置外部负载均衡器

在 OpenShift Container Platform 4.8 中,您可以配置一个外部负载均衡器来处理 Red Hat OpenStack Platform (RHOSP) 和裸机安装程序置备的集群的 apiVIP 和 ingressVIP 流量。当使用 VLAN 在负载均衡服务和 control plane 节点之间路由流量时,外部负载平衡服务和 control plane 节点必须在同一个 L2 网络上运行,并使用 VLAN 来路由负载平衡服务和 control plane 节点之间的流量。

VMware 安装程序置备的集群不支持将负载均衡器来处理 apiVIP 和 ingressVIP 流量。

1.4.7.22. OVN-Kubernetes IPsec 支持双栈网络

OpenShift Container Platform 4.8 为配置为使用双栈网络的集群添加了 OVN-Kubernetes IPsec 支持。

1.4.7.23. OVN-Kubernetes 的出口路由器 CNI

egress router CNI 插件已正式发布。Cluster Network Operator 被改进以支持 EgressRouter API 对象。在使用 OVN-Kubernetes 的集群中添加出口路由器的过程已被简化。当您创建出口路由器对象时,Operator 会自动添加网络附加定义和部署。部署的容器集充当出口路由器。

如需更多信息,请参阅使用出口路由器 pod 的注意事项。

1.4.7.24. OpenShift Container Platform 上的 IP 故障切换支持

现在,裸机上的 OpenShift Container Platform 集群支持 IP 故障切换。IP 故障转移使用 keepalived 在一组主机上托管一组外部访问的 VIP 地址。在一个时间点上,每个 VIP 仅由一个主机提供服务。keepalived 使用虚拟路由器冗余协议(VRRP)决定在主机集合中使用哪个主机提供 VIP 服务。如果主机不可用,或者 keepalived 正在监视的服务没有响应,则 VIP 会切换到主机集中的另外一个主机。这意味着只要主机可用,便始终可以提供 VIP 服务。

如需更多信息,请参阅配置 IP 故障切换。

1.4.7.25. 控制 DNS pod 放置

在 OpenShift Container Platform 4.8 中,您可以使用自定义节点选择器和容限配置 CoreDNS 的守护进程集,使其在特定节点上运行。

以前的 OpenShift Container Platform 版本使用一个针对所有污点的容限配置了 CoreDNS 守护进程集,DNS pod 可以在集群的所有节点上运行,而不会考虑节点污点的情况。OpenShift Container Platform 4.8 默认不再为所有污点配置这个容限。相反,默认为仅为 node-role.kubernetes.io/master 污点设置容限。要使 DNS pod 在带有其他污点的节点上运行,您必须配置自定义容限。

如需更多信息,请参阅控制 DNS pod 放置。

1.4.7.26. 在 RHOSP 上运行的集群的供应商网络支持

Red Hat OpenStack Platform(RHOSP)上的 OpenShift Container Platform 集群现在支持所有部署类型的供应商网络。

1.4.7.27. HAProxy 可配置的 tune.maxrewrite 和 tune.bufsize

集群管理员现在可以设置 headerBufferMaxRewriteByte 和 headerBufferBytes Ingress Controller 调整参数,以配置每个 Ingress Controller 的 tune.maxrewrite 和 tune.bufsize HAProxy 内存选项。

如需更多信息,请参阅 Ingress Controller 配置参数。

1.4.8. 存储

1.4.8.1. 使用 GCP PD CSI 驱动程序 operator 的持久性存储已正式发布

Google Cloud Platform(GCP)持久性磁盘(PD)Container Storage Interface(CSI)驱动程序会在 GCP 环境中自动部署和管理,允许您动态置备这些卷,而无需手动安装驱动程序。此功能以前在 OpenShift Container Platform 4.7 中作为技术预览功能,现在在 OpenShift Container Platform 4.8 中正式发布并启用。

如需更多信息,请参阅 GCP PD CSI Driver Operator。

1.4.8.2. 使用 Azure Disk CSI Driver Operator 的持久性存储(技术预览)

Azure Disk CSI Driver Operator 默认提供一个存储类,您可以使用它来创建持久性卷声明(PVC)。管理此驱动程序的 Azure Disk CSI Driver Operator 只是一个技术预览。

如需更多信息,请参阅 Azure Disk CSI Driver Operator。

1.4.8.3. 使用 vSphere CSI Driver Operator 的持久性存储(技术预览)

vSphere CSI Driver Operator 默认提供一个存储类,您可以使用它来创建持久性卷声明(PVC)。管理此驱动程序的 vSphere CSI Driver Operator 只是一个技术预览。

如需更多信息,请参阅 vSphere CSI Driver Operator。

1.4.8.4. 自动 CSI 迁移(技术预览)

从 OpenShift Container Platform 4.8 开始,以下树内(in-tree)卷插件自动迁移到对应的 CSI 驱动程序作为技术预览功能:

- Amazon Web Services(AWS)Elastic Block Storage(EBS)

- OpenStack Cinder

如需更多信息,请参阅自动 CSI 迁移。

1.4.8.5. 已删除 AWS EFS(技术预览)功能的外部置备程序

Amazon Web Services(AWS)Elastic File System(EFS)技术预览功能已被删除,且不再被支持。

1.4.8.6. 改进了对 RHOSP 上运行的集群 Cinder 卷可用性区的控制

现在,您可以在安装过程中为 Cinder 卷选择可用性区域。您还可以将特定可用区中的 Cinder 卷用于镜像 registry。

1.4.9. Registry

1.4.10. Operator 生命周期

1.4.10.1. 增强了针对管理员的错误报告

使用 Operator Lifecycle Manager(OLM)安装 Operator 的集群管理员可能会遇到与当前 API 或低级别 API 相关的错误条件。在以前的版本中,很难了解 OLM 无法履行安装或更新 Operator 的请求。这些错误的范围包括一些微不足道的问题(如对象属性中的拼写错误或缺少 RBAC 等)以及一些比较复杂的问题(如因为元数据解析而无法从目录中加载项目)。

对于管理员,应该可以在不需要了解各种低级别 API 的交互过程或访问 OLM pod 日志的情况下,就可以成功调试这些问题,所以 OpenShift Container Platform 4.8 在 OLM 中引入了以下增强功能,以便为管理员提供更易理解的错误报告和消息:

1.4.10.2. 重试安装计划

安装计划由 InstallPlan 对象定义,可能会遇到临时错误,例如,因为 API 服务器可用性或其他写入器冲突。在以前的版本中,这些错误会导致部分应用的安装计划终止需要手动清理。在这个版本中, Catalog Operator 在安装计划执行过程中重试错误最多一分钟。新的 .status.message 字段在进行重试时提供人类可读指示。

1.4.10.3. 它代表无效的 Operator 组

在没有 Operator 组或多个 Operator 组的命名空间中创建订阅会导致 Operator 安装停止,并永久保留在 phase=Installing 中。在这个版本中,安装计划会立即转换为 phase=Failed,以便管理员可以更正无效的 Operator 组,然后删除并重新创建订阅。

1.4.10.4. 当找不到候选 Operator 时报告

当命名空间中依赖项解析失败时创建的 ResolutionFailed 事件现在在命名空间包含引用的目录源中不存在的软件包或频道的订阅时提供更具体的文本。在以前的版本中,这个消息比较通用:

no candidate operators found matching the spec of subscription '<name>'

no candidate operators found matching the spec of subscription '<name>'在这个版本中,信息更为具体:

Operator 不存在

no operators found in package <name> in the catalog referenced by subscription <name>

no operators found in package <name> in the catalog referenced by subscription <name>目录(Catalog)不存在

no operators found from catalog <name> in namespace openshift-marketplace referenced by subscription <name>

no operators found from catalog <name> in namespace openshift-marketplace referenced by subscription <name>频道不存在

no operators found in channel <name> of package <name> in the catalog referenced by subscription <name>

no operators found in channel <name> of package <name> in the catalog referenced by subscription <name>集群服务版本(CSV)不存在

no operators found with name <name>.<version> in channel <name> of package <name> in the catalog referenced by subscription <name>

no operators found with name <name>.<version> in channel <name> of package <name> in the catalog referenced by subscription <name>1.4.11. Operator 开发

1.4.11.1. 将 Operator 项目从软件包清单格式迁移到捆绑包格式

OpenShift Container Platform 4.8 及更高版本中删除了对 Operator 的传统软件包清单格式的支持。从 OpenShift Container Platform 4.6 开始,捆绑包格式是 Operator Lifecycle Manager(OLM)的首选 Operator 打包格式。如果您有一个 Operator 项目最初以软件包清单格式创建(已弃用),则可以使用 Operator SDK pkgman-to-bundle 命令将项目迁移到捆绑包格式。

如需更多信息,请参阅迁移软件包清单项目到捆绑包格式。

1.4.11.2. 发布包含捆绑 Operator 的目录

要安装和管理 Operator,Operator Lifecycle Manager(OLM)要求 Operator 捆绑包列在索引镜像中,该镜像由集群中的目录引用。作为 Operator 作者,您可以使用 Operator SDK 为 Operator 及其所有依赖项创建一个包含捆绑包的索引。这可用于测试远程集群并发布到容器 registry。

如需更多信息,请参阅发布包含捆绑的 Operator 的目录。

1.4.11.3. 增强的 Operator 升级测试

Operator SDK 的 run bundle-upgrade 子命令通过为以后的版本指定捆绑包镜像来自动触发已安装的 Operator 以升级到更新的版本。在以前的版本中,子命令只能升级最初使用 run bundle 子命令安装的 Operator。在这个版本中,run bundle-upgrade 还可用于最初与传统 Operator Lifecycle Manager(OLM)工作流一起安装的 Operator。

如需更多信息,请参阅在 Operator Lifecycle Manager 上测试 Operator 升级。

当从 OpenShift Container Platform 版本中删除 API 时,在该集群版本上运行的仍使用删除的 API 的 Operator 将不再正常工作。作为 Operator 作者,您应该计划更新 Operator 项目,以适应 API 弃用和删除情况,以避免 Operator 用户中断。

如需了解更多与 OpenShift Container Platform 版本的Operator 兼容性,请参阅控制与 OpenShift Container Platform 版本的 Operator 兼容性。

Builds

1.4.11.5. 按策略划分的构建数量的新 Telemetry 指标

Telemetry 包括一个新的 openshift:build_by_strategy:sum 量表指标,它将按照策略类型向 Telemeter 客户端发送构建数量。此指标可让站点可靠性工程师(SRE)和产品经理查看在 OpenShift Container Platform 集群上运行的构建类型。

1.4.11.6. 挂载自定义 PKI 证书颁发机构

在以前的版本中,构建无法使用有时需要的集群 PKI 证书颁发机构来访问公司工件存储库。现在,您可以通过将 mountTrustedCA 设置为 true,将 BuildConfig 对象配置为挂载集群自定义 PKI 证书颁发机构。

1.4.12. 镜像

1.4.13. 机器 API

1.4.13.1. 使用集群自动扩展将 vSphere 中运行的机器扩展到零,并从零扩展

在 vSphere 中运行机器时,您可以在 MachineAutoscaler 资源定义中将 minReplicas 值设置为 0。当将此值设置为 0 时,取决于机器是否在使用,集群自动扩展器会将机器集缩到零,或从零进行扩展。如需更多信息,请参阅 MachineAutoscaler 资源定义。

1.4.13.2. 自动轮转 kubelet-ca.crt 不需要节点排空或重启

自动轮转 /etc/kubernetes/kubelet-ca.crt 证书颁发机构(CA)不再需要 Machine Config Operator(MCO)来排空节点或重启集群。

作为这一更改的一部分,以下修改不需要 MCO 排空节点:

-

在机器配置的

spec.config.ignition.passwd.users.sshAuthorizedKeys参数中更改 SSH 密钥 -

在

openshift-config命名空间中更改全局 pull secret 或 pull secret

当 MCO 检测到任何这些更改时,它会应用更改并取消记录节点。

如需更多信息,请参阅了解 Machine Config Operator。

1.4.13.3. 机器集策略增强

在以前的版本中,创建机器集需要用户手动配置 CPU 固定设置、NUMA 固定设置和 CPU 拓扑更改,以便从主机获得更好的性能。在这个版本中,用户可以在 MachineSet 资源中选择一个策略来自动填充设置。如需更多信息,请参阅BZ#1941334。

1.4.13.4. 机器集巨页增强

现在,可以在 MachineSet 资源中提供 hugepages 属性。此增强使用 oVirt 中的自定义属性创建 MachineSet 资源的节点,并指示这些节点使用虚拟机监控程序的巨页(hugepage)。如需更多信息,请参阅 BZ#1948963。

OpenShift Container Platform 4.8 避免了所选 ImageContentSourcePolicy 对象更改的工作负载中断。此功能帮助用户和团队在不中断工作负载的情况下添加额外的镜像和 registry。因此,/etc/containers/registries.conf 文件中的以下更改将不再发生工作负载分离:

-

添加一个带有

mirror-by-digest-only=true的 registry -

在带有

mirror-by-digest-only=true的 registry 中添加镜像 -

在

unqualified-search-registries列表中附加项目

对于 /etc/containers/registries.conf 文件中的任何其他更改,Machine Config Operator 默认排空节点以应用更改。如需更多信息,请参阅BZ#1943315。

1.4.14. 节点

1.4.14.1. Descheduler operator.openshift.io/v1 API 组现在可用

现在,descheduler 可以使用 operator.openshift.io/v1 API 组。在以后的发行版本,可能会删除对 descheduler 使用 operator.openshift.io/v1beta1 API 组的支持。

1.4.14.2. descheduler 的 Prometheus 指标

现在,您可以把 openshift.io/cluster-monitoring=true 标识添加到您安装 descheduler 的 openshift-kube-descheduler-operator 命令空间中来启用 descheduler 的 Prometheus 指标功能。

可用的 descheduler 指标如下:

-

descheduler_build_info- 提供 descheduler 的构建信息。 -

descheduler_pods_evicted- 提供为每个策略、命名空间和结果组合被驱除的 pod 数量。必须至少有一个被驱除的 pod 才能显示此指标。

1.4.14.3. 支持使用 Downward API 的巨页

在这个版本中,当您为 pod 规格中的巨页设置请求和限值时,您可以使用 Downward API 从容器中查看 pod 的分配。这个改进依赖于 DownwardAPIHugePages 功能门。OpenShift Container Platform 4.8 启用功能门。

如需更多信息,请参阅使用 Downward API 消耗巨页资源。

1.4.14.4. Node Feature Discovery Operator 的新标签

Node Feature Discovery(NFD)Operator 会检测 OpenShift Container Platform 集群中每个节点上可用的硬件功能。然后,它会使用节点标签修改节点对象。这可让 NFD Operator 公告特定节点的功能。OpenShift Container Platform 4.8 支持 NFD Operator 的三个额外标签。

-

pstate intel-pstate:当 Intelpstate驱动程序被启用和使用时,pstate intel-pstate标签反映了 Intelpstate驱动程序的状态。它的状态可以是active或passive。 -

pstate scaling_governor:当 Intelpstate驱动程序状态为active时,pstate scaling_governor标签反映扩展监管器算法。该算法可以是powerave或performance。 -

cstate status:如果intel_idle驱动程序具有 C-states 或 idle 状态,则cstate status标签为true。否则,为false。

1.4.14.5. 使用 Poison Pill Operator 修复不健康节点

您可以使用 Poison Pill Operator 来允许不健康的节点自动重新引导。这可最小化有状态应用程序和 ReadWriteOnce (RWO) 卷的停机时间,并在发生临时故障时恢复计算容量。

Poison Pill Operator 适用于所有集群和硬件类型。

如需更多信息,请参阅使用 Poison Pill Operator 修复节点。

1.4.14.6. 自动轮转 kubelet-ca.crt 不需要重启

自动轮转 /etc/kubernetes/kubelet-ca.crt 证书颁发机构(CA)不再需要 Machine Config Operator(MCO)来排空节点或重启集群。

作为这一更改的一部分,以下修改不需要 MCO 排空节点:

-

在机器配置的

spec.config.ignition.passwd.users.sshAuthorizedKeys参数中更改 SSH 密钥 -

在

openshift-config命名空间中更改全局 pull secret 或 pull secret

当 MCO 检测到任何这些更改时,它会应用更改并取消记录节点。

如需更多信息,请参阅了解 Machine Config Operator。

1.4.14.7. 垂直 pod 自动扩展通常可用

OpenShift Container Platform 垂直 pod 自动扩展(VPA)现已正式发布。VPA 会自动检查 pod 中容器的运行状况和当前的 CPU 和内存资源,并根据它所了解的用量值更新资源限值和请求。

您还可以通过修改 VerticalPodAutoscalerController 对象,将 VPA 与只需要一个副本的 pod 搭配使用,如下所述。在以前的版本中,VPA 只适用于需要两个或多个副本的 pod。

如需更多信息,请参阅使用垂直 pod 自动扩展自动调整 pod 资源级别。

1.4.14.8. 可以配置垂直 pod 自动扩展最小

默认情况下,工作负载对象必须至少指定两个副本,以便 VPA 自动更新 pod。因此,VPA 不会对指定少于两个副本的工作负载对象执行操作。您可以通过修改 VerticalPodAutoscalerController 对象来添加 minReplicas 参数,用来更改这个集群范围的最小值。

如需更多信息,请参阅使用垂直 pod 自动扩展自动调整 pod 资源级别。

1.4.14.9. 为节点自动分配 CPU 和内存资源

当节点启动时,OpenShift Container Platform 可以自动决定 system-reserved 设置的最佳大小调整值。在以前的版本中,system-reserved 设置中的 CPU 和内存分配是手动决定和设置所需的固定限制。

启用自动资源分配后,每个节点上的脚本会根据节点上安装的 CPU 和内存容量来计算相应保留资源的优化值。

如需更多信息,请参阅自动为节点分配资源。

1.4.14.10. 添加特定的软件仓库来拉取镜像

现在,您可以在创建允许和阻止的 registry 列表来拉取和推送镜像时,在 registry 中指定单独的存储库。在以前的版本中,您只能指定 registry。

如需更多信息,请参阅添加特定 registry 和阻塞特定的 registry。

1.4.14.11. Cron Job 正式发布

Cron Job 自定义资源现已正式发布。作为这一变化的一部分,新的控制器已实施以显著提高 cron 作业的性能。如需有关 cron 作业的更多信息,请参阅了解作业和 cron 作业。

1.4.15. Red Hat OpenShift Logging

在 OpenShift Container Platform 4.7 中,Cluster Logging 变为了 Red Hat OpenShift Logging。如需更多信息,请参阅 Red Hat OpenShift Logging 的发行注记。

1.4.16. 监控

1.4.16.1. 对规则更改的警报

OpenShift Container Platform 4.8 包括以下警报规则更改:

例 1.1. 对规则更改的警报

-

ThanosSidecarPrometheusDown警报的严重性从 critical 更新为 warning。 -

ThanosSidecarUnhealthy警报的严重性从 critical 更新为 warning。 -

ThanosQueryHttpRequestQueryErrorRateHigh警报的严重性从 critical 更新为 warning。 -

ThanosQueryHttpRequestQueryRangeErrorRateHigh警报的严重性从 critical 更新为 warning。 -

ThanosQueryInstantLatencyHigh严重警报已被删除。如果 Thanos Querier 有一个高延迟进行即时查询,则会触发此警报。 -

ThanosQueryRangeLatencyHigh严重警报被删除。如果 Thanos Querier 存在较高的范围查询延迟,则会触发此警报。 -

对于所有 Thanos Querier 警报,

for持续时间增加到 1 小时。 -

对于所有 Thanos sidecar 警报,

for持续时间增加到 1 小时。

红帽不保证指标、记录规则或警报规则的向后兼容。

1.4.16.2. 在下一个发行版本中,将删除使用的 API 的警报和信息

OpenShift Container Platform 4.8 引入了两个新警报,它们会在使用了下一发行版本中将被删除的 API 时触发:

-

APIRemovedInNextReleaseInUse- 针对将在下一个 OpenShift Container Platform 发行版本中删除的 API。 -

APIRemovedInNextEUSReleaseInUse- 针对将在下一个 OpenShift Container Platform 扩展更新支持(EUS)版本中删除的 API。

您可以使用新的 APIRequestCount API 来跟踪使用已弃用 API 的内容。这可让您规划在升级到下一版本时是否需要进行一些相关的操作。

1.4.16.3. 监控堆栈组件和依赖项的版本更新

OpenShift Container Platform 4.8 包括对以下监控堆栈组件和依赖项的版本更新:

- Prometheus Operator 现在为 0.48.1 版本。

- Prometheus 现在是 2.26.1 版本。

-

node-exporter代理现在基于 1.1.2 版本。 - Thanos 现在为 0.20.2 版本。

- Grafana 现在是版本 7.5.5。

1.4.16.4. kube-state-metrics 升级到版本 2.0.0

kube-state-metrics 升级到 2.0.0 版本。kube-state-metrics 版本 1.9 中弃用了以下指标,并在 2.0.0 版本中实际删除:

pod 的非通用资源指标:

- kube_pod_container_resource_requests_cpu_cores

- kube_pod_container_resource_limits_cpu_cores

- kube_pod_container_resource_requests_memory_bytes

- kube_pod_container_resource_limits_memory_bytes

节点的非通用资源指标:

- kube_node_status_capacity_pods

- kube_node_status_capacity_cpu_cores

- kube_node_status_capacity_memory_bytes

- kube_node_status_allocatable_pods

- kube_node_status_allocatable_cpu_cores

- kube_node_status_allocatable_memory_bytes

1.4.16.5. 删除了 Grafana 和 Alertmanager UI 链接

第三方 Alertmanager UI 的链接已从 OpenShift Container Platform Web 控制台的 Monitoring openshift-monitoring 项目中的 Networking

1.4.16.6. Web 控制台中的监控仪表板增强

OpenShift Container Platform Web 控制台的 Monitoring

- 当您通过用鼠标选择一个区域来缩放单个图形时,所有其他图形现在都会更新,以反映相同的时间范围。

- 现在,仪表板面板被组织成组,您可以展开和折叠这些组。

- 单值面板现在支持根据颜色的值更改颜色。

- 现在,仪表板标签会显示在 Dashboard 下拉列表中。

- 现在,您可以通过在 Time Range 下拉列表中选择 Custom time rang 来为仪表板指定自定义时间范围。

- 现在,您可以在仪表板过滤器下拉菜单中选择 All 选项,以显示该过滤器中所有选项的数据。

1.4.17. Metering

Metering Operator 在 OpenShift Container Platform 4.6 中弃用,并计划在下一个 OpenShift Container Platform 发行版本中删除。

1.4.18. 扩展

1.4.18.1. 在单一节点集群中运行

在单一节点集群中运行测试会导致特定测试的超时时间较长,包括 SR-IOV 和 SCTP 测试,并跳过需要 control plane 和 worker 节点的测试。需要节点重启的重新配置会导致重启整个环境,包括 OpenShift control plane,因此完成时间较长。所有需要 control plane 节点和 worker 节点的 PTP 测试都会跳过。不需要额外的配置,因为测试会在启动时检查节点数量并相应地调整测试行为。

PTP 测试可在发现模式下运行。测试会查找在集群外配置的 PTP control plane。需要以下参数:

-

ROLE_WORKER_CNF=master- 必需,因为 control plane(master)是唯一的、节点将属于的机器池。 -

XT_U32TEST_HAS_NON_CNF_WORKERS=false- 需要指示xt_u32负测试跳过,因为只有加载模块的节点。 -

SCTPTEST_HAS_NON_CNF_WORKERS=false- 需要指示 SCTP 负测试跳过,因为只有加载模块的节点。

1.4.18.2. 使用 Performance Addon Operator 减少 NIC

Performance Addon Operator 允许您配置性能配置集来调整每个网络设备的网络接口卡(NIC)队列数量。设备网络队列允许数据包分布到不同的物理队列中,每个队列获得用于数据包处理的独立线程。

对于基于 Data Plane Development Kit(DPDK)的工作负载,务必要将 NIC 队列减少到仅保留或托管 CPU 的数量,以确保实现所需的低延迟。

如需更多信息,请参阅使用 Performance Addon Operator 缩减 NIC 队列。

1.4.18.3. 集群最大限制

针对 OpenShift Container Platform 4.8 的集群最大限制指导信息已更新。

此发行版本没有针对 OVN-Kubernetes 测试执行大规模测试。

使用 OpenShift Container Platform Limit Calculator 可以估算出您的环境的集群限制。

1.4.18.4. 创建性能配置集

现在,您可以使用 Performance Profile Creator(PPC)工具创建性能配置集。该工具会消耗来自集群和几个用户提供的配置集参数的 must-gather 数据,并使用这些信息生成适合您的硬件和拓扑的性能配置集。

如需更多信息,请参阅创建性能配置集。

1.4.18.5. Node Feature Discovery Operator

Node Feature Discovery(NFD)Operator 现已可用。使用它来通过编排节点功能发现(用于检测硬件功能和系统配置的 Kubernetes 附加组件)来公开节点级信息。

1.4.18.6. Driver Toolkit(技术预览)

现在,您可以使用 Driver Toolkit 作为驱动程序容器的基础镜像,以便您可以在 Kubernetes 上启用特殊软件和硬件设备。目前,这是一个技术预览功能。

1.4.19. 备份和恢复

1.4.19.1. etcd 快照增强

一个新的改进会在备份后并在恢复前验证 etcd 快照的状态。在以前的版本中,备份过程无法验证所执行的快照是否已完成,恢复过程也不会验证正在恢复的快照是否有效,没有损坏。现在,如果磁盘在备份或恢复过程中被破坏,则错误会明确报告给管理员。如需更多信息,请参阅 BZ#1965024。

1.4.20. Insights Operator

1.4.20.1. 有关受限网络的见解顾问建议

在 OpenShift Container Platform 4.8 中,在受限网络中运行的用户可以收集 Insights Operator 存档并上传到 Insights 顾问,以诊断潜在的问题。另外,用户也可以在上传前模糊处理 Insights Operator 归档中包含的敏感数据。

如需更多信息,请参阅在受限网络中使用远程健康报告。

1.4.20.2. Insights Advisor 的改进

OpenShift Container Platform Web 控制台中的 insights Advisor 现在可以正确地报告有 0 个问题。在以前的版本中,在这种情况下,Insights Advisor 没有提供任何信息。

1.4.20.3. 深入了解 Operator 数据收集功能的增强

在 OpenShift Container Platform 4.8 中,Insights Operator 会收集以下附加信息:

- 无法识别的集群工作负载信息来查找已知的安全性和版本问题。

-

MachineHealthCheck和MachineAutoscaler定义。 -

virt_platform和vsphere_node_hw_version_total指标。 - 有关不健康 SAP pod 的信息,以帮助安装 SAP 智能数据集成。

-

datahubs.installers.datahub.sap.com资源用于识别 SAP 集群。 -

一个失败的

PodNetworkConnectivityCheck的摘要,用于增强网络。 -

有关

openshift-cluster-operator命名空间中的cluster-versionpod 和事件的信息,以调试cluster-versionOperator 的问题。

通过这些附加信息,红帽可在 Insights Advisor 中提供改进的补救步骤。

1.4.20.4. 对不健康的 SAP pod 的深入了解 Operator 的增强

Insights Operator 现在可以为不健康的 SAP pod 收集数据。当 SDI 安装失败时,可以通过查看哪个初始化 pod 失败来检测到问题。Insights Operator 现在会在 SAP/SDI 命名空间中收集有关失败 pod 的信息。如需更多信息,请参阅 BZ#1930393。

1.4.20.5. 了解 Operator 的增强以收集 SAP pod 数据

Insights Operator 现在可以从 SAP 集群收集 Datahubs 资源。通过这些数据,SAP 集群可以被与 Insights Operator 归档中的非 SAP 集群区分开,即使缺少所有从 SAP 集群收集的数据,否则就无法确定集群是否有 SDI 安装。如需更多信息,请参阅 BZ#1940432。

1.4.21. 认证和授权

现在,您可以使用 Cloud Credential Operator(CCO)实用程序(ccoctl)将 CCO 配置为使用 Amazon Web Services Security Token Service(AWS STS)。当 CCO 配置为使用 STS 时,它会分配 IAM 角色,它提供短暂的、有限制权限的安全凭证。

此功能以前作为技术预览功能在 OpenShift Container Platform 4.7 中引入,现在正式包括在 OpenShift Container Platform 4.8 中。

如需更多信息,请参阅在 STS 中使用手动模式。

1.4.22. OpenShift 沙盒容器

要查看 OpenShift 沙盒容器新功能、程序错误修复、已知问题和异步勘误更新,请参阅 OpenShift 沙盒容器 1.0 发行注记。