11.16. 推奨される設定: 障害の発生したボリューム

ブリック設定

以下の表は、分散および分散されるボリューム向けの複数のサーバー/ディスク設定のブリックレイアウトの詳細を示しています。

| 冗長性レベル | サポートされる構成 | サブボリュームごとにサーバーごとのブリック | ノードの損失 | サブボリューム内の最大ブリック失敗数 | 互換性のあるサーバーノードの数 | サイズの増加 (ノードのなし) | サブボリュームの最小数 | 合計スピンドル | 許容される HDD 失敗の割合 |

|---|---|---|---|---|---|---|---|---|---|

| 12 HDD シャーシ | |||||||||

| 2 | 4 + 2 | 2 | 1 | 2 | 3 | 3 | 6 | 36 | 33.33% |

| 1 | 2 | 2 | 6 | 6 | 12 | 72 | 33.33% | ||

| 2 | 8+2 | 2 | 1 | 2 | 5 | 5 | 6 | 60 | 20.00% |

| 1 | 2 | 2 | 10 | 10 | 12 | 120 | 20.00% | ||

| 3 | 8 + 3 | 1-2 | 1 | 3 | 6 | 6 | 6 | 72 | 25.00% |

| 4 | 8 + 4 | 4 | 1 | 4 | 3 | 3 | 3 | 36 | 33.33% |

| 2 | 2 | 4 | 6 | 6 | 6 | 72 | 33.33% | ||

| 1 | 4 | 4 | 12 | 12 | 12 | 144 | 33.33% | ||

| 4 | 16 + 4 | 4 | 1 | 4 | 5 | 5 | 3 | 60 | 20.00% |

| 2 | 2 | 4 | 10 | 10 | 6 | 120 | 20.00% | ||

| 1 | 4 | 4 | 20 | 20 | 12 | 240 | 20.00% | ||

| 24 HDD シャーシ | |||||||||

| 2 | 4 + 2 | 2 | 1 | 2 | 3 | 3 | 12 | 72 | 33.33% |

| 1 | 2 | 2 | 6 | 6 | 24 | 144 | 33.33% | ||

| 2 | 8+ 2 | 2 | 1 | 2 | 5 | 5 | 12 | 120 | 20.00% |

| 1 | 2 | 2 | 10 | 10 | 24 | 240 | 20.00% | ||

| 4 | 8 + 4 | 4 | 1 | 4 | 3 | 3 | 6 | 72 | 33.33% |

| 2 | 2 | 4 | 6 | 6 | 12 | 144 | 33.33% | ||

| 1 | 4 | 4 | 12 | 12 | 24 | 288 | 33.33% | ||

| 4 | 16 + 4 | 4 | 1 | 4 | 5 | 5 | 6 | 120 | 20.00% |

| 2 | 2 | 4 | 10 | 10 | 12 | 240 | 20.00% | ||

| 1 | 4 | 4 | 20 | 20 | 24 | 480 | 20.00% | ||

| 36 HDD シャーシ | |||||||||

| 2 | 4 + 2 | 2 | 1 | 2 | 3 | 3 | 18 | 108 | 33.33% |

| 1 | 2 | 2 | 6 | 6 | 36 | 216 | 33.33% | ||

| 2 | 8 + 2 | 2 | 1 | 1 | 5 | 5 | 18 | 180 | 20.00% |

| 1 | 2 | 2 | 10 | 10 | 36 | 360 | 20.00% | ||

| 3 | 8 + 3 | 1-2 | 1 | 3 | 6 | 6 | 19 | 216 | 26.39% |

| 4 | 8 + 4 | 4 | 1 | 4 | 3 | 3 | 9 | 108 | 33.33% |

| 2 | 2 | 4 | 6 | 6 | 18 | 216 | 33.33% | ||

| 1 | 4 | 4 | 12 | 12 | 36 | 432 | 33.33% | ||

| 4 | 16 + 4 | 4 | 1 | 4 | 5 | 5 | 9 | 180 | 20.00% |

| 2 | 2 | 4 | 10 | 10 | 18 | 360 | 20.00% | ||

| 1 | 4 | 4 | 20 | 20 | 36 | 720 | 20.00% | ||

| 60 HDD シャーシ | |||||||||

| 2 | 4 + 2 | 2 | 1 | 2 | 3 | 3 | 30 | 180 | 33.33% |

| 1 | 2 | 2 | 6 | 6 | 60 | 360 | 33.33% | ||

| 2 | 8 + 2 | 2 | 1 | 2 | 5 | 5 | 30 | 300 | 20.00% |

| 1 | 2 | 2 | 10 | 10 | 60 | 600 | 20.00% | ||

| 3 | 8 + 3 | 1-2 | 1 | 3 | 6 | 6 | 32 | 360 | 26.67% |

| 4 | 8 + 4 | 4 | 1 | 4 | 3 | 3 | 15 | 180 | 33.33% |

| 2 | 2 | 4 | 6 | 6 | 30 | 360 | 33.33% | ||

| 1 | 4 | 4 | 12 | 12 | 60 | 720 | 33.33% | ||

| 4 | 16 + 4 | 4 | 1 | 4 | 5 | 5 | 15 | 300 | 20.00% |

| 2 | 2 | 4 | 10 | 10 | 30 | 600 | 20.00% | ||

| 1 | 4 | 4 | 20 | 20 | 60 | 1200 | 20.00% | ||

例 1: 3 台のサーバーで 4+2 設定の無効化

この例では、3 台のサーバーのコンパクトな設定を説明し、各サーバーが 12 HDD シャーシに接続して分散ボリュームを作成します。この例では、各 HDD には単一のブリックが含まれていることが前提となります。

gluster volume create test_vol disperse-data 4 redundancy 2 transport tcp server1:/rhgs/brick1 server1:/rhgs/brick2 server2:/rhgs/brick3 server2:/rhgs/brick4 server3:/rhgs/brick5 server3:/rhgs/brick6 --force

# gluster volume create test_vol disperse-data 4 redundancy 2 transport tcp server1:/rhgs/brick1 server1:/rhgs/brick2 server2:/rhgs/brick3 server2:/rhgs/brick4 server3:/rhgs/brick5 server3:/rhgs/brick6 --force--force パラメーターが必要な点に注意してください。各サーバーは 2 つのブリックを提供するため、各ブリックが別のサーバーによって提供された場合、サーバーがオフラインになる場合、この構成ではデータの可用性がより高くなります。

gluster volume add-brick test_vol server1:/rhgs/brick7 server1:/rhgs/brick8 server2:/rhgs/brick9 server2:/rhgs/brick10 server3:/rhgs/brick11 server3:/rhgs/brick12

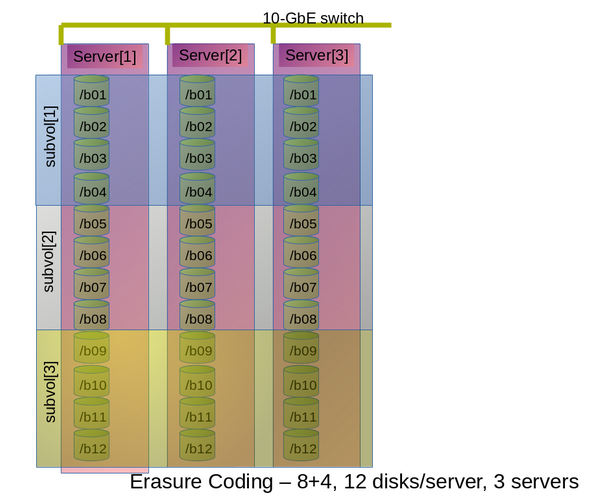

# gluster volume add-brick test_vol server1:/rhgs/brick7 server1:/rhgs/brick8 server2:/rhgs/brick9 server2:/rhgs/brick10 server3:/rhgs/brick11 server3:/rhgs/brick12例 2: 3 台のサーバーで 8+4 設定の無効化

以下の図は、表11.3「Dispersed および Distributed Dispersed ボリュームのブリック設定」 の行 3 の行 3 で説明したように、3 つのサーバーで分散された 8+4 設定を示しています。このコマンドでは、この設定の分散ボリュームを作成します。

gluster volume create test_vol disperse-data 8 redundancy 4 transport tcp server1:/rhgs/brick1 server1:/rhgs/brick2 server1:/rhgs/brick3 server1:/rhgs/brick4 server2:/rhgs/brick1 server2:/rhgs/brick2 server2:/rhgs/brick3 server2:/rhgs/brick4 server3:/rhgs/brick1 server3:/rhgs/brick2 server3:/rhgs/brick3 server3:/rhgs/brick4 server1:/rhgs/brick5 server1:/rhgs/brick6 server1:/rhgs/brick7 server1:/rhgs/brick8 server2:/rhgs/brick5 server2:/rhgs/brick6 server2:/rhgs/brick7 server2:/rhgs/brick8 server3:/rhgs/brick5 server3:/rhgs/brick6 server3:/rhgs/brick7 server3:/rhgs/brick8 server1:/rhgs/brick9 server1:/rhgs/brick10 server1:/rhgs/brick11 server1:/rhgs/brick12 server2:/rhgs/brick9 server2:/rhgs/brick10 server2:/rhgs/brick11 server2:/rhgs/brick12 server3:/rhgs/brick9 server3:/rhgs/brick10 server3:/rhgs/brick11 server3:/rhgs/brick12 --force

# gluster volume create test_vol disperse-data 8 redundancy 4 transport tcp server1:/rhgs/brick1 server1:/rhgs/brick2 server1:/rhgs/brick3 server1:/rhgs/brick4 server2:/rhgs/brick1 server2:/rhgs/brick2 server2:/rhgs/brick3 server2:/rhgs/brick4 server3:/rhgs/brick1 server3:/rhgs/brick2 server3:/rhgs/brick3 server3:/rhgs/brick4 server1:/rhgs/brick5 server1:/rhgs/brick6 server1:/rhgs/brick7 server1:/rhgs/brick8 server2:/rhgs/brick5 server2:/rhgs/brick6 server2:/rhgs/brick7 server2:/rhgs/brick8 server3:/rhgs/brick5 server3:/rhgs/brick6 server3:/rhgs/brick7 server3:/rhgs/brick8 server1:/rhgs/brick9 server1:/rhgs/brick10 server1:/rhgs/brick11 server1:/rhgs/brick12 server2:/rhgs/brick9 server2:/rhgs/brick10 server2:/rhgs/brick11 server2:/rhgs/brick12 server3:/rhgs/brick9 server3:/rhgs/brick10 server3:/rhgs/brick11 server3:/rhgs/brick12 --force--force パラメーターが必要な点に注意してください。各サーバーには複数のブリックがあるため、別のサーバーで各ブリックが提供されている場合に、サーバーがオフラインの場合、この構成ではデータの可用性がより高くなります。

図11.1 8+4 分散ボリューム設定例

m ブリックがあります (詳細は n = k+m 式の情報の 「分散ボリュームの作成」 セクションを参照)。サーバー S の分散されたサブボリュームからm のブリックを追加して、サーバー S がダウンした場合には、データは利用できません。

S (上記の図の単一列) がダウンすると、データの損失はありません。ただし、ハードウェアに障害が発生しても、別のノードが停止またはストレージデバイスの障害が即座になくなると、データがすぐに失われます。

例 3: 6 台のサーバーでの分散 4+2 設定

以下の図は、6 台のサーバーで分散した 4+2 の構成と、表11.3「Dispersed および Distributed Dispersed ボリュームのブリック設定」 の行 2 で説明されているように 12-disk-per-server 設定を持つ各サーバーを示しています。この設定用に分散ボリュームを作成するコマンド:

gluster volume create test_vol disperse-data 4 redundancy 2 transport tcp server1:/rhgs/brick1 server2:/rhgs/brick1 server3:/rhgs/brick1 server4:/rhgs/brick1 server5:/rhgs/brick1 server6:/rhgs/brick1server1:/rhgs/brick2 server2:/rhgs/brick2 server3:/rhgs/brick2 server4:/rhgs/brick2 server5:/rhgs/brick2 server6:/rhgs/brick2 server1:/rhgs/brick3 server2:/rhgs/brick3 server3:/rhgs/brick3 server4:/rhgs/brick3 server5:/rhgs/brick3 server6:/rhgs/brick3 server1:/rhgs/brick4 server2:/rhgs/brick4 server3:/rhgs/brick4 server4:/rhgs/brick4 server5:/rhgs/brick4 server6:/rhgs/brick4 server1:/rhgs/brick5 server2:/rhgs/brick5 server3:/rhgs/brick5 server4:/rhgs/brick5 server5:/rhgs/brick5 server6:/rhgs/brick5 server1:/rhgs/brick6 server2:/rhgs/brick6 server3:/rhgs/brick6 server4:/rhgs/brick6 server5:/rhgs/brick6 server6:/rhgs/brick6 server1:/rhgs/brick7 server2:/rhgs/brick7 server3:/rhgs/brick7 server4:/rhgs/brick7 server5:/rhgs/brick7 server6:/rhgs/brick7 server1:/rhgs/brick8 server2:/rhgs/brick8 server3:/rhgs/brick8 server4:/rhgs/brick8 server5:/rhgs/brick8 server6:/rhgs/brick8 server1:/rhgs/brick9 server2:/rhgs/brick9 server3:/rhgs/brick9 server4:/rhgs/brick9 server5:/rhgs/brick9 server6:/rhgs/brick9 server1:/rhgs/brick10 server2:/rhgs/brick10 server3:/rhgs/brick10 server4:/rhgs/brick10 server5:/rhgs/brick10 server6:/rhgs/brick10 server1:/rhgs/brick11 server2:/rhgs/brick11 server3:/rhgs/brick11 server4:/rhgs/brick11 server5:/rhgs/brick11 server6:/rhgs/brick11 server1:/rhgs/brick12 server2:/rhgs/brick12 server3:/rhgs/brick12 server4:/rhgs/brick12 server5:/rhgs/brick12 server6:/rhgs/brick12

# gluster volume create test_vol disperse-data 4 redundancy 2 transport tcp server1:/rhgs/brick1 server2:/rhgs/brick1 server3:/rhgs/brick1 server4:/rhgs/brick1 server5:/rhgs/brick1 server6:/rhgs/brick1server1:/rhgs/brick2 server2:/rhgs/brick2 server3:/rhgs/brick2 server4:/rhgs/brick2 server5:/rhgs/brick2 server6:/rhgs/brick2 server1:/rhgs/brick3 server2:/rhgs/brick3 server3:/rhgs/brick3 server4:/rhgs/brick3 server5:/rhgs/brick3 server6:/rhgs/brick3 server1:/rhgs/brick4 server2:/rhgs/brick4 server3:/rhgs/brick4 server4:/rhgs/brick4 server5:/rhgs/brick4 server6:/rhgs/brick4 server1:/rhgs/brick5 server2:/rhgs/brick5 server3:/rhgs/brick5 server4:/rhgs/brick5 server5:/rhgs/brick5 server6:/rhgs/brick5 server1:/rhgs/brick6 server2:/rhgs/brick6 server3:/rhgs/brick6 server4:/rhgs/brick6 server5:/rhgs/brick6 server6:/rhgs/brick6 server1:/rhgs/brick7 server2:/rhgs/brick7 server3:/rhgs/brick7 server4:/rhgs/brick7 server5:/rhgs/brick7 server6:/rhgs/brick7 server1:/rhgs/brick8 server2:/rhgs/brick8 server3:/rhgs/brick8 server4:/rhgs/brick8 server5:/rhgs/brick8 server6:/rhgs/brick8 server1:/rhgs/brick9 server2:/rhgs/brick9 server3:/rhgs/brick9 server4:/rhgs/brick9 server5:/rhgs/brick9 server6:/rhgs/brick9 server1:/rhgs/brick10 server2:/rhgs/brick10 server3:/rhgs/brick10 server4:/rhgs/brick10 server5:/rhgs/brick10 server6:/rhgs/brick10 server1:/rhgs/brick11 server2:/rhgs/brick11 server3:/rhgs/brick11 server4:/rhgs/brick11 server5:/rhgs/brick11 server6:/rhgs/brick11 server1:/rhgs/brick12 server2:/rhgs/brick12 server3:/rhgs/brick12 server4:/rhgs/brick12 server5:/rhgs/brick12 server6:/rhgs/brick12図11.2 4+2 分散ボリューム設定の例:

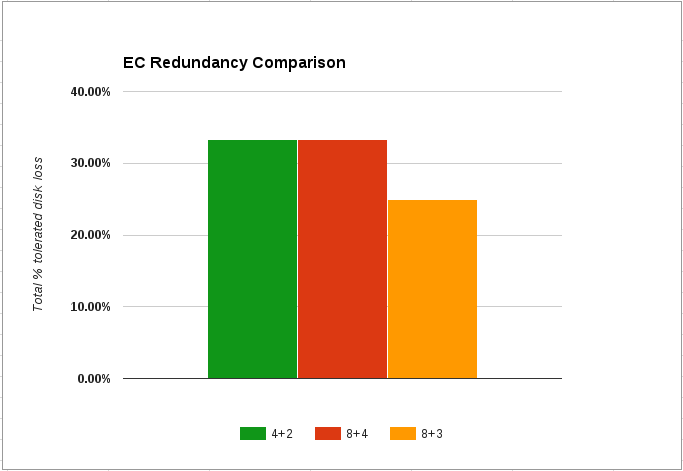

冗長性比較

以下のチャートは、サポートされるすべての分散ボリューム設定の冗長性の比較を示しています。

図11.3 冗長性比較の図