This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.6.2. Knative Kafka の設定

Knative Kafka は、OpenShift Serverless でサポートされているバージョンの Apache Kafka メッセージストリーミングプラットフォームを使用する統合オプションを提供します。Kafka は、イベントソース、チャネル、ブローカー、およびイベントシンク機能のオプションを提供します。

OpenShift Serverless のコアインストールの一部として提供される Knative Eventing コンポーネントの他に、クラスター管理者は KnativeKafka カスタムリソース (CR) をインストールできます。

現時点で、Knative Kafka は IBM Z および IBM Power Systems ではサポートされていません。

KnativeKafka CR は、ユーザーに以下のような追加オプションを提供します。

- Kafka ソース

- Kafka チャネル

- Kafka ブローカー

- Kafka シンク

6.2.1. Knative Kafka のインストール

Knative Kafka は、OpenShift Serverless でサポートされているバージョンの Apache Kafka メッセージストリーミングプラットフォームを使用する統合オプションを提供します。KnativeKafka カスタムリソースをインストールしている場合、Knative Kafka 機能は OpenShift Serverless インストールで使用できます。

前提条件

- OpenShift Serverless Operator および Knative Eventing がクラスターにインストールされていること。

- Red Hat AMQ Streams クラスターにアクセスできる。

-

検証手順を使用する場合は、OpenShift CLI (

oc) をインストールします。 - OpenShift Container Platform のクラスター管理者パーミッションがある。

- OpenShift Container Platform Web コンソールにログインしている。

手順

-

Administrator パースペクティブで、Operators

Installed Operators に移動します。 - ページ上部の Project ドロップダウンメニューが Project: knative-eventing に設定されていることを確認します。

- OpenShift Serverless Operator の Provided APIs の一覧で Knative Kafka ボックスを見つけ、Create Instance をクリックします。

Create Knative Kafka ページで KnativeKafka オブジェクトを設定します。

重要クラスターで Kafka チャネル、ソース、ブローカー、またはシンクを使用するには、使用するオプションの 有効な スイッチを true に切り替える必要があります。これらのスイッチは、デフォルトで false に設定されます。さらに、Kafka チャネル、ブローカー、またはシンクを使用するには、ブートストラップサーバーを指定する必要があります。

KnativeKafkaカスタムリソースの例Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 開発者はクラスターで

KafkaChannelチャネルを使用できます。 - 2

- AMQ Streams クラスターからのブートストラップサーバーのコンマ区切りの一覧。

- 3

- 開発者はクラスターで

KafkaSourceイベントソースタイプを使用できます。 - 4

- 開発者はクラスターで Knative Kafka ブローカー実装を使用できます。

- 5

- Red Hat AMQ Streams クラスターからのブートストラップサーバーのコンマ区切りリスト。

- 6

Brokerオブジェクトでサポートされる Kafka トピックのパーティション数を定義します。デフォルトは10です。- 7

Brokerオブジェクトでサポートされる Kafka トピックのレプリケーション係数を定義します。デフォルトは3です。- 8

- 開発者がクラスター内で Kafka シンクを使用できるようにします。

注記replicationFactorの値は、Red Hat AMQ Streams クラスターのノード数以下である必要があります。- KnativeKafka オブジェクトの作成を完全に制御する必要がない単純な設定に、このフォームの使用が推奨されます。

- KnativeKafka オブジェクトの作成を完全に制御する必要のあるより複雑な設定には、YAML の編集が推奨されます。YAML にアクセスするには、Create Knative Kafka ページの右上にある Edit YAML リンクをクリックします。

- Kafka のオプションの設定が完了したら、Create をクリックします。Knative Kafka タブに自動的にダイレクトされます。ここで、knative-kafka はリソースの一覧にあります。

検証

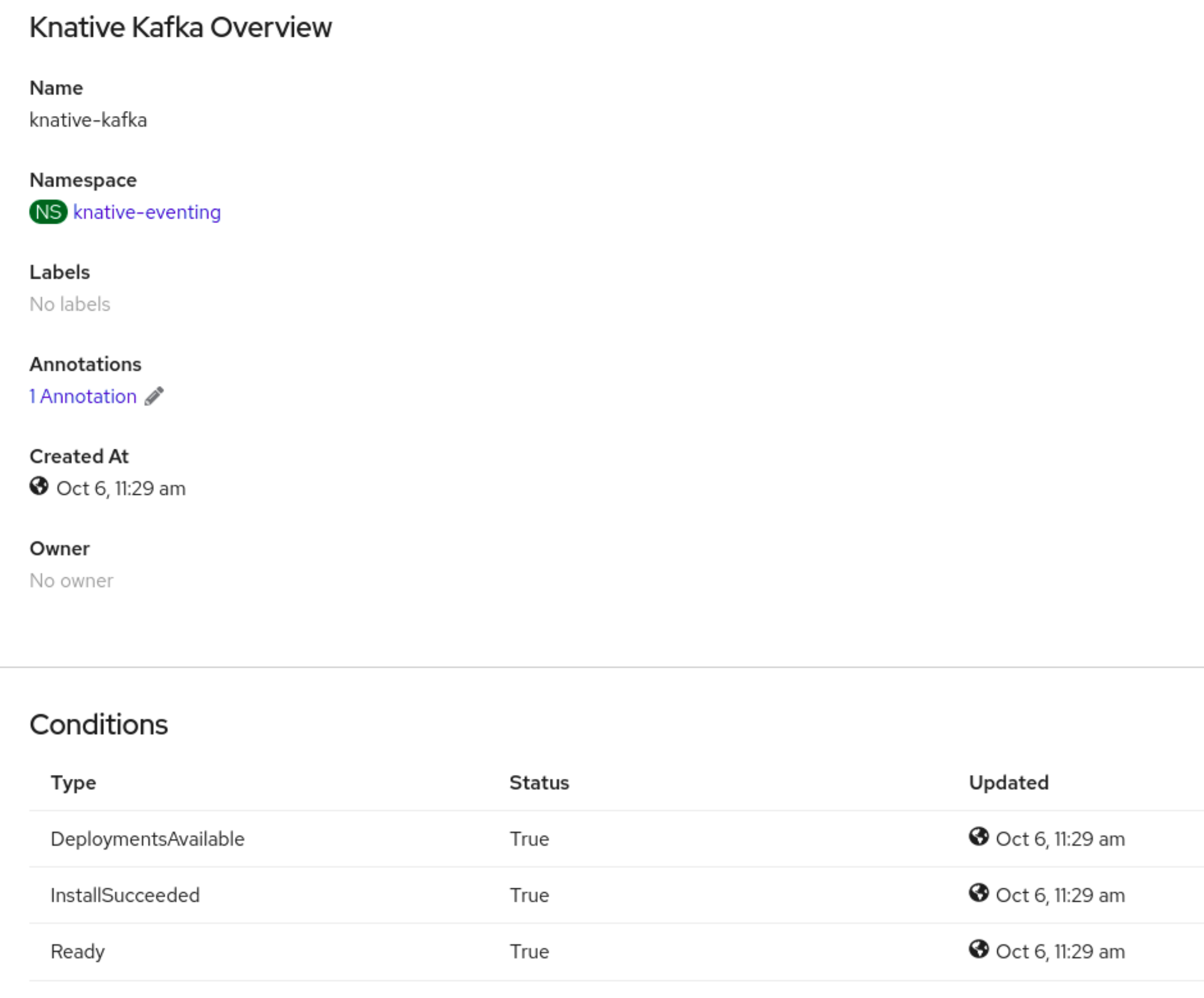

- Knative Kafka タブで knative-kafka リソースをクリックします。Knative Kafka Overview ページに自動的にダイレクトされます。

リソースの Conditions (状態) の一覧を表示し、それらのステータスが True であることを確認します。

状態のステータスが Unknown または False である場合は、ページを更新するためにしばらく待機します。

Knative Eventing リソースが作成されていることを確認します。

oc get pods -n knative-eventing

$ oc get pods -n knative-eventingCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.2. Knative Kafka のセキュリティー設定

Kafka クラスターは、通常、TLS または SASL 認証方法を使用して保護されます。TLS または SASL を使用して、保護された Red Hat AMQ Streams クラスターに対して動作するように Kafka ブローカーまたはチャネルを設定できます。

Red Hat は、SASL と TLS の両方を一緒に有効にすることをお勧めします。

6.2.2.1. Kafka ブローカーの TLS 認証の設定

Transport Layer Security (TLS) は、Apache Kafka クライアントおよびサーバーによって、Knative と Kafka 間のトラフィックを暗号化するため、および認証のために使用されます。TLS は、Knative Kafka のトラフィック暗号化でサポートされている唯一の方法です。

前提条件

- OpenShift Container Platform のクラスター管理者パーミッションがある。

-

OpenShift Serverless Operator、Knative Eventing、および

KnativeKafkaCR は OpenShift Container Platform クラスターにインストールされます。 - OpenShift Container Platform でアプリケーションおよび他のワークロードを作成するために、プロジェクトを作成しているか、適切なロールおよびパーミッションを持つプロジェクトにアクセスできる。

-

.pemファイルとして Kafka クラスター CA 証明書が保存されている。 -

Kafka クラスタークライアント証明書とキーが

.pemファイルとして保存されている。 -

OpenShift CLI (

oc) をインストールしている。

手順

証明書ファイルを

knative-eventingnamespace にシークレットファイルとして作成します。oc create secret -n knative-eventing generic <secret_name> \ --from-literal=protocol=SSL \ --from-file=ca.crt=caroot.pem \ --from-file=user.crt=certificate.pem \ --from-file=user.key=key.pem

$ oc create secret -n knative-eventing generic <secret_name> \ --from-literal=protocol=SSL \ --from-file=ca.crt=caroot.pem \ --from-file=user.crt=certificate.pem \ --from-file=user.key=key.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要キー名に

ca.crt、user.crt、およびuser.keyを使用します。これらの値は変更しないでください。KnativeKafkaCR を編集し、broker仕様にシークレットへの参照を追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.2.2. Kafka ブローカーの SASL 認証の設定

Simple Authentication and Security Layer (SASL) は、Apache Kafka が認証に使用します。クラスターで SASL 認証を使用する場合、ユーザーは Kafka クラスターと通信するために Knative に認証情報を提供する必要があります。そうしないと、イベントを生成または消費できません。

前提条件

- OpenShift Container Platform のクラスター管理者パーミッションがある。

-

OpenShift Serverless Operator、Knative Eventing、および

KnativeKafkaCR は OpenShift Container Platform クラスターにインストールされます。 - OpenShift Container Platform でアプリケーションおよび他のワークロードを作成するために、プロジェクトを作成しているか、適切なロールおよびパーミッションを持つプロジェクトにアクセスできる。

- Kafka クラスターのユーザー名およびパスワードがある。

-

使用する SASL メカニズムを選択している (例:

PLAIN、SCRAM-SHA-256、またはSCRAM-SHA-512)。 -

TLS が有効にされている場合、Kafka クラスターの

ca.crt証明書ファイルも必要になります。 -

OpenShift CLI (

oc) をインストールしている。

手順

証明書ファイルを

knative-eventingnamespace にシークレットファイルとして作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

キー名に

ca.crt、password、およびsasl.mechanismを使用します。これらの値は変更しないでください。 パブリック CA 証明書で SASL を使用する場合は、シークレットの作成時に

ca.crt引数ではなくtls.enabled=trueフラグを使用する必要があります。以下に例を示します。oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-literal=tls.enabled=true \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \ --from-literal=user="my-sasl-user"

$ oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-literal=tls.enabled=true \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \ --from-literal=user="my-sasl-user"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

キー名に

KnativeKafkaCR を編集し、broker仕様にシークレットへの参照を追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.2.3. Kafka チャネルの TLS 認証の設定

Transport Layer Security (TLS) は、Apache Kafka クライアントおよびサーバーによって、Knative と Kafka 間のトラフィックを暗号化するため、および認証のために使用されます。TLS は、Knative Kafka のトラフィック暗号化でサポートされている唯一の方法です。

前提条件

- OpenShift Container Platform のクラスター管理者パーミッションがある。

-

OpenShift Serverless Operator、Knative Eventing、および

KnativeKafkaCR は OpenShift Container Platform クラスターにインストールされます。 - OpenShift Container Platform でアプリケーションおよび他のワークロードを作成するために、プロジェクトを作成しているか、適切なロールおよびパーミッションを持つプロジェクトにアクセスできる。

-

.pemファイルとして Kafka クラスター CA 証明書が保存されている。 -

Kafka クラスタークライアント証明書とキーが

.pemファイルとして保存されている。 -

OpenShift CLI (

oc) をインストールしている。

手順

選択された namespace にシークレットとして証明書ファイルを作成します。

oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-file=ca.crt=caroot.pem \ --from-file=user.crt=certificate.pem \ --from-file=user.key=key.pem

$ oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-file=ca.crt=caroot.pem \ --from-file=user.crt=certificate.pem \ --from-file=user.key=key.pemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 重要キー名に

ca.crt、user.crt、およびuser.keyを使用します。これらの値は変更しないでください。KnativeKafkaカスタムリソースの編集を開始します。oc edit knativekafka

$ oc edit knativekafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットおよびシークレットの namespace を参照します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記ブートストラップサーバーで一致するポートを指定するようにしてください。

以下に例を示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.2.4. Kafka チャネルの SASL 認証の設定

Simple Authentication and Security Layer (SASL) は、Apache Kafka が認証に使用します。クラスターで SASL 認証を使用する場合、ユーザーは Kafka クラスターと通信するために Knative に認証情報を提供する必要があります。そうしないと、イベントを生成または消費できません。

前提条件

- OpenShift Container Platform のクラスター管理者パーミッションがある。

-

OpenShift Serverless Operator、Knative Eventing、および

KnativeKafkaCR は OpenShift Container Platform クラスターにインストールされます。 - OpenShift Container Platform でアプリケーションおよび他のワークロードを作成するために、プロジェクトを作成しているか、適切なロールおよびパーミッションを持つプロジェクトにアクセスできる。

- Kafka クラスターのユーザー名およびパスワードがある。

-

使用する SASL メカニズムを選択している (例:

PLAIN、SCRAM-SHA-256、またはSCRAM-SHA-512)。 -

TLS が有効にされている場合、Kafka クラスターの

ca.crt証明書ファイルも必要になります。 -

OpenShift CLI (

oc) をインストールしている。

手順

選択された namespace にシークレットとして証明書ファイルを作成します。

oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-file=ca.crt=caroot.pem \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \ --from-literal=user="my-sasl-user"

$ oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-file=ca.crt=caroot.pem \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \ --from-literal=user="my-sasl-user"Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

キー名に

ca.crt、password、およびsasl.mechanismを使用します。これらの値は変更しないでください。 パブリック CA 証明書で SASL を使用する場合は、シークレットの作成時に

ca.crt引数ではなくtls.enabled=trueフラグを使用する必要があります。以下に例を示します。oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-literal=tls.enabled=true \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \ --from-literal=user="my-sasl-user"

$ oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-literal=tls.enabled=true \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \ --from-literal=user="my-sasl-user"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

-

キー名に

KnativeKafkaカスタムリソースの編集を開始します。oc edit knativekafka

$ oc edit knativekafkaCopy to Clipboard Copied! Toggle word wrap Toggle overflow シークレットおよびシークレットの namespace を参照します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 注記ブートストラップサーバーで一致するポートを指定するようにしてください。

以下に例を示します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.2.5. Kafka ソースの SASL 認証の設定

Simple Authentication and Security Layer (SASL) は、Apache Kafka が認証に使用します。クラスターで SASL 認証を使用する場合、ユーザーは Kafka クラスターと通信するために Knative に認証情報を提供する必要があります。そうしないと、イベントを生成または消費できません。

前提条件

- OpenShift Container Platform でクラスターまたは専用の管理者パーミッションを持っている。

-

OpenShift Serverless Operator、Knative Eventing、および

KnativeKafkaCR は、OpenShift Container Platform クラスターにインストールされている。 - OpenShift Container Platform でアプリケーションおよび他のワークロードを作成するために、プロジェクトを作成しているか、適切なロールおよびパーミッションを持つプロジェクトにアクセスできる。

- Kafka クラスターのユーザー名およびパスワードがある。

-

使用する SASL メカニズムを選択している (例:

PLAIN、SCRAM-SHA-256、またはSCRAM-SHA-512)。 -

TLS が有効にされている場合、Kafka クラスターの

ca.crt証明書ファイルも必要になります。 -

OpenShift (

oc) CLI がインストールされている。

手順

選択された namespace にシークレットとして証明書ファイルを作成します。

oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-file=ca.crt=caroot.pem \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \ --from-literal=user="my-sasl-user"

$ oc create secret -n <namespace> generic <kafka_auth_secret> \ --from-file=ca.crt=caroot.pem \ --from-literal=password="SecretPassword" \ --from-literal=saslType="SCRAM-SHA-512" \1 --from-literal=user="my-sasl-user"Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- SASL タイプは

PLAIN、SCRAM-SHA-256、またはSCRAM-SHA-512です。

Kafka ソースを作成または変更して、次の

spec設定が含まれるようにします。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Red Hat OpenShift Streams for Apache Kafka などのパブリッククラウド Kafka サービスを使用している場合は、

caCert仕様は必要ありません。

6.2.2.6. Kafka シンクのセキュリティーの設定

Transport Layer Security (TLS) は、Apache Kafka クライアントおよびサーバーによって、Knative と Kafka 間のトラフィックを暗号化するため、および認証のために使用されます。TLS は、Knative Kafka のトラフィック暗号化でサポートされている唯一の方法です。

Simple Authentication and Security Layer (SASL) は、Apache Kafka が認証に使用します。クラスターで SASL 認証を使用する場合、ユーザーは Kafka クラスターと通信するために Knative に認証情報を提供する必要があります。そうしないと、イベントを生成または消費できません。

前提条件

-

OpenShift Serverless Operator、Knative Eventing、および

KnativeKafkaカスタムリソース (CR) は OpenShift Container Platform クラスターにインストールされます。 -

Kafka シンクは

KnativeKafkaCR で有効になっています。 - OpenShift Container Platform でアプリケーションおよび他のワークロードを作成するために、プロジェクトを作成しているか、適切なロールおよびパーミッションを持つプロジェクトにアクセスできる。

-

.pemファイルとして Kafka クラスター CA 証明書が保存されている。 -

Kafka クラスタークライアント証明書とキーが

.pemファイルとして保存されている。 -

OpenShift (

oc) CLI がインストールされている。 -

使用する SASL メカニズムを選択している (例:

PLAIN、SCRAM-SHA-256、またはSCRAM-SHA-512)。

手順

KafkaSinkオブジェクトと同じ namespace に証明書ファイルをシークレットとして作成します。重要証明書とキーは PEM 形式である必要があります。

暗号化なしで SASL を使用した認証の場合:

oc create secret -n <namespace> generic <secret_name> \ --from-literal=protocol=SASL_PLAINTEXT \ --from-literal=sasl.mechanism=<sasl_mechanism> \ --from-literal=user=<username> \ --from-literal=password=<password>

$ oc create secret -n <namespace> generic <secret_name> \ --from-literal=protocol=SASL_PLAINTEXT \ --from-literal=sasl.mechanism=<sasl_mechanism> \ --from-literal=user=<username> \ --from-literal=password=<password>Copy to Clipboard Copied! Toggle word wrap Toggle overflow SASL を使用した認証と TLS を使用した暗号化の場合:

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Red Hat OpenShift Streams for Apache Kafka などのパブリッククラウドで管理される Kafka サービスを使用している場合は、システムのルート CA セットを使用するために

ca.crtを省略できます。

TLS を使用した認証と暗号化の場合:

oc create secret -n <namespace> generic <secret_name> \ --from-literal=protocol=SSL \ --from-file=ca.crt=<my_caroot.pem_file_path> \ --from-file=user.crt=<my_cert.pem_file_path> \ --from-file=user.key=<my_key.pem_file_path>

$ oc create secret -n <namespace> generic <secret_name> \ --from-literal=protocol=SSL \ --from-file=ca.crt=<my_caroot.pem_file_path> \1 --from-file=user.crt=<my_cert.pem_file_path> \ --from-file=user.key=<my_key.pem_file_path>Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Red Hat OpenShift Streams for Apache Kafka などのパブリッククラウドで管理される Kafka サービスを使用している場合は、システムのルート CA セットを使用するために

ca.crtを省略できます。

KafkaSinkオブジェクトを作成または変更し、auth仕様にシークレットへの参照を追加します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow KafkaSinkオブジェクトを適用します。oc apply -f <filename>

$ oc apply -f <filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow

6.2.3. Kafka ブローカー構成の設定

設定マップを作成し、Kafka Broker オブジェクトでこの ConfigMap を参照することで、レプリケーション係数、ブートストラップサーバー、および Kafka ブローカーのトピックパーティションの数を設定できます。

前提条件

- OpenShift Container Platform でクラスターまたは専用の管理者パーミッションを持っている。

-

OpenShift Serverless Operator、Knative Eventing、および

KnativeKafkaカスタムリソース (CR) は OpenShift Container Platform クラスターにインストールされます。 - OpenShift Container Platform でアプリケーションおよび他のワークロードを作成するために、プロジェクトを作成しているか、適切なロールおよびパーミッションを持つプロジェクトにアクセスできる。

-

OpenShift CLI (

oc) がインストールされている。

手順

kafka-broker-configConfigMap を変更するか、以下の設定が含まれる独自の ConfigMap を作成します。Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- ConfigMap 名。

- 2

- ConfigMap が存在する namespace。

- 3

- Kafka ブローカーのトピックパーティションの数。これは、イベントをブローカーに送信する速度を制御します。パーティションが多い場合には、コンピュートリソースが多く必要です。

- 4

- トピックメッセージのレプリケーション係数。これにより、データ損失を防ぐことができます。レプリケーション係数を増やすには、より多くのコンピュートリソースとストレージが必要になります。

- 5

- ブートストラップサーバーのコンマ区切りリスト。これは、OpenShift Container Platform クラスターの内部または外部にある可能性があり、ブローカーがイベントを受信してイベントを送信する Kafka クラスターのリストです。

重要default.topic.replication.factorの値は、クラスター内の Kafka ブローカーインスタンスの数以下である必要があります。たとえば、Kafka ブローカーが 1 つしかない場合には、default.topic.replication.factorの値は"1"を超える値にすることはできません。Kafka ブローカーの ConfigMap の例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ConfigMap を適用します。

$ oc apply -f <config_map_filename>

$ oc apply -f <config_map_filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow Kafka

Brokerオブジェクトの ConfigMap を指定します。Broker オブジェクトの例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow ブローカーを適用します。

$ oc apply -f <broker_filename>

$ oc apply -f <broker_filename>Copy to Clipboard Copied! Toggle word wrap Toggle overflow