7.3. デプロイメントストラテジーの使用

デプロイメントストラテジー は、アプリケーションを変更またはアップグレードする 1 つの方法です。この目的は、ユーザーには改善が加えられていることが分からないように、ダウンタイムなしに変更を加えることにあります。

エンドユーザーは通常ルーターによって処理されるルート経由でアプリケーションにアクセスするため、デプロイメントストラテジーは、 DeploymentConfig オブジェクト機能またはルーティング機能に重点を置きます。デプロイメントに重点を置くストラテジーは、アプリケーションを使用するすべてのルートに影響を与えます。ルーター機能を使用するストラテジーは個別のルートにターゲットを設定します。

デプロイメントストラテジーの多くは、DeploymentConfig オブジェクトでサポートされ、追加のストラテジーはルーター機能でサポートされます。このセクションでは、デプロイメントストラテジーについて説明します。

デプロイメントストラテジーの選択

デプロイメントストラテジーを選択する場合に、以下を考慮してください。

- 長期間実行される接続は正しく処理される必要があります。

- データベースの変換は複雑になる可能性があり、アプリケーションと共に変換し、ロールバックする必要があります。

- アプリケーションがマイクロサービスと従来のコンポーネントを使用するハイブリッドの場合には、移行の完了時にダウンタイムが必要になる場合があります。

- これを実行するためのインフラストラクチャーが必要です。

- テスト環境が分離されていない場合は、新規バージョンと以前のバージョン両方が破損してしまう可能性があります。

デプロイメントストラテジーは、readiness チェックを使用して、新しい Pod の使用準備ができているかを判断します。readiness チェックに失敗すると、DeploymentConfig オブジェクトは、タイムアウトするまで Pod の実行を再試行します。デフォルトのタイムアウトは、10m で、値は dc.spec.strategy.*params の TimeoutSeconds で設定します。

7.3.1. ローリングストラテジー

ローリングデプロイメントは、以前のバージョンのアプリケーションインスタンスを、新しいバージョンのアプリケーションインスタンスに徐々に置き換えます。ローリングストラテジーは、DeploymentConfig オブジェクトにストラテジーが指定されていない場合に使用されるデフォルトのデプロイメントストラテジーです。

ローリングデプロイメントは通常、新規 Pod が readiness チェックによって ready になるのを待機してから、古いコンポーネントをスケールダウンします。重大な問題が生じる場合、ローリングデプロイメントは中止される場合があります。

ローリングデプロイメントの使用のタイミング

- ダウンタイムを発生させずに、アプリケーションの更新を行う場合

- 以前のコードと新しいコードの同時実行がアプリケーションでサポートされている場合

ローリングデプロイメントとは、以前のバージョンと新しいバージョンのコードを同時に実行するという意味です。これは通常、アプリケーションで N-1 互換性に対応する必要があります。

ローリングストラテジー定義の例

- 1

- 各 Pod が次に更新されるまで待機する時間。指定されていない場合、デフォルト値は

1となります。 - 2

- 更新してからデプロイメントステータスをポーリングするまでの間待機する時間。指定されていない場合、デフォルト値は

1となります。 - 3

- イベントのスケーリングを中断するまでの待機時間。この値はオプションです。デフォルトは

600です。ここでの 中断 とは、自動的に以前の完全なデプロイメントにロールバックされるという意味です。 - 4

maxSurgeはオプションで、指定されていない場合には、デフォルト値は25%となります。以下の手順の次にある情報を参照してください。- 5

maxUnavailableはオプションで、指定されていない場合には、デフォルト値は25%となります。以下の手順の次にある情報を参照してください。- 6

preおよびpostはどちらもライフサイクルフックです。

ローリングストラテジー:

-

preライフサイクルフックを実行します。 - サージ数に基づいて新しいレプリケーションコントローラーをスケールアップします。

- 最大利用不可数に基づいて以前のレプリケーションコントローラーをスケールダウンします。

- 新しいレプリケーションコントローラーが希望のレプリカ数に到達して、以前のレプリケーションコントローラーの数がゼロになるまで、このスケーリングを繰り返します。

-

postライフサイクルフックを実行します。

スケールダウン時には、ローリングストラテジーは Pod の準備ができるまで待機し、スケーリングを行うことで可用性に影響が出るかどうかを判断します。Pod をスケールアップしたにもかかわらず、準備が整わない場合には、デプロイメントプロセスは最終的にタイムアウトして、デプロイメントに失敗します。

maxUnavailable パラメーターは、更新時に利用できない Pod の最大数です。maxSurge パラメーターは、元の Pod 数を超えてスケジュールできる Pod の最大数です。どちらのパラメーターも、パーセント (例: 10%) または絶対値 (例: 2) のいずれかに設定できます。両方のデフォルト値は 25% です。

以下のパラメーターを使用して、デプロイメントの可用性やスピードを調整できます。以下に例を示します。

-

maxUnavailable*=0およびmaxSurge*=20%が指定されていると、更新時および急速なスケールアップ時に完全なキャパシティーが維持されるようになります。 -

maxUnavailable*=10%およびmaxSurge*=0が指定されていると、追加のキャパシティーを使用せずに更新を実行します (インプレース更新)。 -

maxUnavailable*=10%およびmaxSurge*=10%の場合は、キャパシティーが失われる可能性がありますが、迅速にスケールアップおよびスケールダウンします。

一般的に、迅速にロールアウトする場合は maxSurge を使用します。リソースのクォータを考慮して、一部に利用不可の状態が発生してもかまわない場合には、maxUnavailable を使用します。

7.3.1.1. カナリアデプロイメント

OpenShift Container Platform におけるすべてのローリングデプロイメントは カナリアデプロイメント です。新規バージョン (カナリア) はすべての古いインスタンスが置き換えられる前にテストされます。readiness チェックが成功しない場合、カナリアインスタンスは削除され、DeploymentConfig オブジェクトは自動的にロールバックされます。

readiness チェックはアプリケーションコードの一部であり、新規インスタンスが使用できる状態にするために必要に応じて高度な設定をすることができます。(実際のユーザーワークロードを新規インスタンスに送信するなどの) アプリケーションのより複雑なチェックを実装する必要がある場合、カスタムデプロイメントや blue-green デプロイメントストラテジーの実装を検討してください。

7.3.1.2. ローリングデプロイメントの作成

ローリングデプロイメントは OpenShift Container Platform のデフォルトタイプです。CLI を使用してローリングデプロイメントを作成できます。

手順

Quay.io にあるデプロイメントイメージのサンプルに基づいてアプリケーションを作成します。

oc new-app quay.io/openshifttest/deployment-example:latest

$ oc new-app quay.io/openshifttest/deployment-example:latestCopy to Clipboard Copied! Toggle word wrap Toggle overflow ルーターをインストールしている場合は、ルートを使用してアプリケーションを利用できるようにするか、または、サービス IP を直接使用してください。

oc expose svc/deployment-example

$ oc expose svc/deployment-exampleCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

deployment-example.<project>.<router_domain>でアプリケーションを参照し、v1イメージが表示されることを確認します。 レプリカが最大 3 つになるまで、

DeploymentConfigオブジェクトをスケーリングします。oc scale dc/deployment-example --replicas=3

$ oc scale dc/deployment-example --replicas=3Copy to Clipboard Copied! Toggle word wrap Toggle overflow 新しいバージョンの例を

latestとタグ付けして、新規デプロイメントを自動的にトリガーします。oc tag deployment-example:v2 deployment-example:latest

$ oc tag deployment-example:v2 deployment-example:latestCopy to Clipboard Copied! Toggle word wrap Toggle overflow -

ブラウザーで、

v2イメージが表示されるまでページを更新します。 CLI を使用している場合は、以下のコマンドで、バージョン 1 に Pod がいくつあるか、バージョン 2 にはいくつあるかを表示します。Web コンソールでは、Pod が徐々に v2 に追加され、v1 から削除されます。

oc describe dc deployment-example

$ oc describe dc deployment-exampleCopy to Clipboard Copied! Toggle word wrap Toggle overflow

デプロイメントプロセスで、新しいレプリケーションコントローラーが漸増的にスケールアップします。(rediness チェックをパスした後に) 新規 Pod に ready のマークが付けられると、デプロイメントプロセスは継続されます。

Pod が準備状態にならない場合、プロセスは中止し、デプロイメントは直前のバージョンにロールバックします。

7.3.1.3. 開発者パースペクティブを使用したローリングデプロイメントの開始

前提条件

- Web コンソールの Developer パースペクティブにいることを確認します。

- Add ビューを使用してアプリケーションを作成し、これが Topology ビューにデプロイされていることを確認します。

手順

ローリングデプロイメントを開始し、アプリケーションをアップグレードするには、以下を実行します。

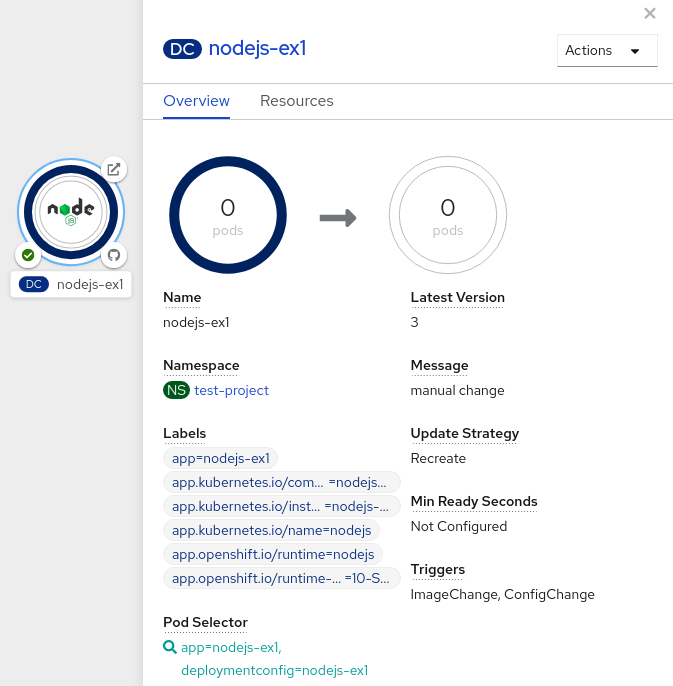

- Developer パースペクティブの Topology ビューで、アプリケーションノードをクリックし、Overview タブをパネル内に表示します。Update Strategy がデフォルトの Rolling ストラテジーに設定されていることに注意してください。

Actions ドロップダウンメニューで、Start Rollout を選択し、ローリング更新を開始します。ローリングデプロイメントは、新しいバージョンのアプリケーションを起動してから、古いバージョンを終了します。

図7.1 ローリング更新

7.3.2. 再作成ストラテジー

再作成ストラテジーは、基本的なロールアウト動作で、デプロイメントプロセスにコードを挿入するためのライフサイクルフックをサポートします。

再作成ストラテジー定義の例

再作成ストラテジー:

-

preライフサイクルフックを実行します。 - 以前のデプロイメントをゼロにスケールダウンします。

-

任意の

midライフサイクルフックを実行します。 - 新規デプロイメントをスケールアップします。

-

postライフサイクルフックを実行します。

スケールアップ中に、デプロイメントのレプリカ数が複数ある場合は、デプロイメントの最初のレプリカが準備できているかどうかが検証されてから、デプロイメントが完全にスケールアップされます。最初のレプリカの検証に失敗した場合には、デプロイメントは失敗とみなされます。

再作成デプロイメントの使用のタイミング:

- 新規コードを起動する前に、移行または他のデータの変換を行う必要がある場合

- 以前のバージョンと新しいバージョンのアプリケーションコードの同時使用をサポートしていない場合

- 複数のレプリカ間での共有がサポートされていない、RWO ボリュームを使用する場合

再作成デプロイメントでは、短い期間にアプリケーションのインスタンスが実行されなくなるので、ダウンタイムが発生します。ただし、以前のコードと新しいコードは同時には実行されません。

7.3.3. 開発者パースペクティブを使用した再作成デプロイメントの開始

Web コンソールの Developer パースペクティブを使用して、デプロイメントストラテジーをデフォルトのローリング更新から再作成更新に切り替えることができます。

前提条件

- Web コンソールの Developer パースペクティブにいることを確認します。

- Add ビューを使用してアプリケーションを作成し、これが Topology ビューにデプロイされていることを確認します。

手順

再作成更新ストラテジーに切り替え、アプリケーションをアップグレードするには、以下を実行します。

- Actions ドロップダウンメニューで、Edit Deployment Config を選択し、アプリケーションのデプロイメント設定の詳細を確認します。

-

YAML エディターで

spec.strategy.typeをRecreateに変更し、Save をクリックします。 - Topology ビューでノードを選択し、サイドパネルの Overview タブを表示します。これで、Update Strategy は Recreate に設定されます。

Actions ドロップダウンメニューを使用し、Start Rollout を選択し、再作成ストラテジーを使用して更新を開始します。再作成ストラテジーはまず、アプリケーションの古いバージョンの Pod を終了してから、新規バージョンの Pod を起動します。

図7.2 再作成更新

7.3.4. カスタムストラテジー

カスタムストラテジーでは、独自のデプロイメントの動作を提供できるようになります。

カスタムストラテジー定義の例

上記の例では、organization/strategy コンテナーイメージにより、デプロイメントの動作が提供されます。オプションの command 配列は、イメージの Dockerfile で指定した CMD ディレクティブを上書きします。指定したオプションの環境変数は、ストラテジープロセスの実行環境に追加されます。

さらに、OpenShift Container Platform は以下の環境変数をデプロイメントプロセスに提供します。

| 環境変数 | 説明 |

|---|---|

|

| 新規デプロイメント名 (レプリケーションコントローラー) |

|

| 新規デプロイメントの namespace |

新規デプロイメントのレプリカ数は最初はゼロです。ストラテジーの目的は、ユーザーのニーズに最適な仕方で対応するロジックを使用して新規デプロイメントをアクティブにすることにあります。

または customParams オブジェクトを使用して、カスタムのデプロイメントロジックを、既存のデプロイメントストラテジーに挿入します。カスタムのシェルスクリプトロジックを指定して、openshift-deploy バイナリーを呼び出します。カスタムのデプロイヤーコンテナーイメージを用意する必要はありません。ここでは、代わりにデフォルトの OpenShift Container Platform デプロイヤーイメージが使用されます。

この設定により、以下のようなデプロイメントになります。

カスタムデプロイメントストラテジーのプロセスでは、OpenShift Container Platform API または Kubernetes API へのアクセスが必要な場合には、ストラテジーを実行するコンテナーは、認証用のコンテナーで利用可能なサービスアカウントのトークンを使用できます。

7.3.5. ライフサイクルフック

ローリングおよび再作成ストラテジーは、ストラテジーで事前に定義したポイントでデプロイメントプロセスに動作を挿入できるようにする ライフサイクルフック またはデプロイメントフックをサポートします。

pre ライフサイクルフックの例

pre:

failurePolicy: Abort

execNewPod: {}

pre:

failurePolicy: Abort

execNewPod: {} - 1

execNewPodは Pod ベースのライフサイクルフックです。

フックにはすべて、フックに問題が発生した場合にストラテジーが取るべきアクションを定義する 失敗ポリシー が含まれます。

|

| フックに失敗すると、デプロイメントプロセスも失敗とみなされます。 |

|

| フックの実行は、成功するまで再試行されます。 |

|

| フックの失敗は無視され、デプロイメントは続行されます。 |

フックには、フックの実行方法を記述するタイプ固有のフィールドがあります。現在、フックタイプとしてサポートされているのは Pod ベースのフックのみで、このフックは execNewPod フィールドで指定されます。

Pod ベースのライフサイクルフック

Pod ベースのライフサイクルフックは、DeploymentConfig オブジェクトのテンプレートをベースとする新しい Pod でフックコードを実行します。

以下のデプロイメントの例は簡素化されており、この例ではローリングストラテジーを使用します。簡潔にまとめられるように、トリガーおよびその他の詳細は省略しています。

この例では、pre フックは、helloworld コンテナーからの openshift/origin-ruby-sample イメージを使用して新規 Pod で実行されます。フック Pod には以下のプロパティーが設定されます。

-

フックコマンドは

/usr/bin/command arg1 arg2です。 -

フックコンテナーには、

CUSTOM_VAR1=custom_value1環境変数が含まれます。 -

フックの失敗ポリシーは

Abortで、フックが失敗するとデプロイメントプロセスも失敗します。 -

フック Pod は、

DeploymentConfigオブジェクト Pod からdataボリュームを継承します。

7.3.5.1. ライフサイクルフックの設定

CLI を使用してデプロイメント用に、ライフサイクルフックまたはデプロイメントフックを設定できます。

手順

oc set deployment-hookコマンドを使用して、必要なフックのタイプを設定します (--pre、--mid、または--post)。たとえば、デプロイメント前のフックを設定するには、以下を実行します。oc set deployment-hook dc/frontend \ --pre -c helloworld -e CUSTOM_VAR1=custom_value1 \ --volumes data --failure-policy=abort -- /usr/bin/command arg1 arg2$ oc set deployment-hook dc/frontend \ --pre -c helloworld -e CUSTOM_VAR1=custom_value1 \ --volumes data --failure-policy=abort -- /usr/bin/command arg1 arg2Copy to Clipboard Copied! Toggle word wrap Toggle overflow