3.2. 通信事業者向け RAN DU リファレンス設計仕様

3.2.1. 通信事業者向け RAN DU 4.17 参照デザインの概要

Telco RAN 分散ユニット (DU) 4.17 リファレンス設計は、コモディティーハードウェア上で実行している OpenShift Container Platform 4.17 クラスターを設定して、通信事業者向け RAN DU ワークロードをホストします。通信事業者向け RAN DU プロファイルを実行するクラスターで信頼性が高く再現性のあるパフォーマンスを得るために、推奨され、テストされ、サポートされている設定をキャプチャーします。

3.2.1.1. デプロイメントアーキテクチャーの概要

集中管理された RHACM ハブクラスターから、管理対象クラスターに通信事業者向け RAN DU 4.17 参照設定を展開します。リファレンス設計仕様 (RDS) には、管理対象クラスターとハブクラスターコンポーネントの設定が含まれます。

図3.1 通信事業者向け RAN DU デプロイメントアーキテクチャーの概要

3.2.2. 通信事業者向け RAN DU 使用モデルの概要

次の情報を使用して、ハブクラスターと管理対象シングルノード OpenShift クラスターの通信事業者向け RAN DU ワークロード、クラスターリソース、およびハードウェア仕様を計画します。

3.2.2.1. 通信事業者 RAN DU アプリケーションワークロード

DU ワーカーノードには、最大のパフォーマンスが得られるようにファームウェアが調整された、第 3 世代 Xeon (Ice Lake) 2.20 GHz 以上の CPU が必要です。

5G RAN DU ユーザーアプリケーションとワークロードは、次のベストプラクティスとアプリケーション制限に準拠する必要があります。

- 最新バージョンの Red Hat Best Practices for Kubernetes に準拠した Cloud-native Network Functions (CNF) を開発します。

- 高性能ネットワークには SR-IOV を使用します。

exec プローブは控えめに使用し、他の適切なオプションが利用できない場合にのみ使用してください。

-

CNF が CPU ピンニングを使用する場合は、exec プローブを使用しないでください。

httpGetやtcpSocketなどの他のプローブ実装を使用します。 - exec プローブを使用する必要がある場合は、exec プローブの頻度と量を制限します。exec プローブの最大数は 10 未満に維持し、頻度は 10 秒以上にする必要があります。

-

CNF が CPU ピンニングを使用する場合は、exec プローブを使用しないでください。

絶対に実行可能な代替手段がない限り、exec プローブの使用は避けてください。

注記起動プローブは、定常状態の動作中に最小限のリソースしか必要としません。exec プローブの制限は、主に liveness および readiness プローブに適用されます。

この仕様で説明されているリファレンス DU アプリケーションワークロードのディメンションに準拠するテストワークロードは、openshift-kni/du-test-workloads にあります。

3.2.2.2. 通信事業者向け RAN DU の代表的な参照アプリケーションワークロード特性

代表的な参照アプリケーションワークロードには、次の特性があります。

- 管理および制御機能を含む vRAN アプリケーション用に最大 15 個の Pod と 30 個のコンテナーを備えています。

-

Pod ごとに最大 2 つの

ConfigMapと 4 つのSecretCR を使用します。 - 10 秒以上の頻度で最大 10 個の exec プローブを使用します。

kube-apiserverの増分アプリケーション負荷は、クラスタープラットフォーム使用量の 10% 未満です。注記プラットフォームメトリクスから CPU 負荷を抽出できます。以下に例を示します。

query=avg_over_time(pod:container_cpu_usage:sum{namespace="openshift-kube-apiserver"}[30m])query=avg_over_time(pod:container_cpu_usage:sum{namespace="openshift-kube-apiserver"}[30m])Copy to Clipboard Copied! Toggle word wrap Toggle overflow - アプリケーションログはプラットフォームログコレクターにより収集されません

- プライマリー CNI 上の総トラフィックは 1 MBps 未満です

3.2.2.3. 通信事業者向け RAN DU ワーカーノードクラスターリソース使用率

システム内で実行している Pod の最大数 (アプリケーションワークロードと OpenShift Container Platform Pod を含む) は 120 です。

- リソース利用

OpenShift Container Platform のリソース使用率は、次のようなアプリケーションのワークロード特性を含む多くの要因によって異なります。

- Pod 数

- プローブの種類と頻度

- カーネルネットワークを使用したプライマリー CNI またはセカンダリー CNI 上のメッセージングレート

- API アクセス率

- ロギング率

- ストレージ IOPS

クラスターリソース要件は、次の条件で適用されます。

- クラスターは、説明した代表的なアプリケーションワークロードを実行しています。

- クラスターは、「通信事業者向け RAN DU ワーカーノードクラスターリソース使用率」で説明されている制約に従って管理されます。

- RAN DU 使用モデル設定でオプションとして記載されているコンポーネントは適用されません。

通信事業者向け RAN DU 参照デザインの範囲外の設定は、リソース使用率への影響と KPI 目標達成能力を判断するために、追加の分析を行う必要があります。要件に応じて、クラスターに関連情報を割り当てることが求められる場合があります。

3.2.2.4. ハブクラスター管理特性

推奨されるクラスター管理ソリューションは、Red Hat Advanced Cluster Management (RHACM) です。ハブクラスターで次の制限を設定します。

- 準拠した評価間隔が少なくとも 10 分である最大 5 つの RHACM ポリシーを設定します。

- ポリシーでは最大 10 個のマネージドクラスターテンプレートを使用します。可能な場合は、ハブ側のテンプレートを使用します。

policy-controllerおよびobservability-controllerアドオンを除くすべての RHACM アドオンを無効にします。Observabilityをデフォルト設定に設定します。重要オプションのコンポーネントを設定したり、追加機能を有効にしたりすると、追加のリソースが使用され、システム全体のパフォーマンスが低下する可能性があります。

詳細は、参照設計のデプロイメントコンポーネント を参照してください。

| メトリクス | Limit | 注記 |

|---|---|---|

| CPU の使用率 | 4000 mc 未満 - 2 コア (4 ハイパースレッド) | プラットフォーム CPU は、各予約済みコアの両方のハイパースレッドを含む予約済みコアに固定されます。このシステムは、定期的なシステムタスクとスパイクに対応できるように、定常状態で 3 つの CPU (3000mc) を使用するように設計されています。 |

| 使用されているメモリー | 16G 未満 |

3.2.2.5. 通信事業者向け RAN DU RDS コンポーネント

以下のセクションでは、通信事業者向け RAN DU ワークロードを実行するためにクラスターを設定およびデプロイするのに使用するさまざまな OpenShift Container Platform コンポーネントと設定を説明します。

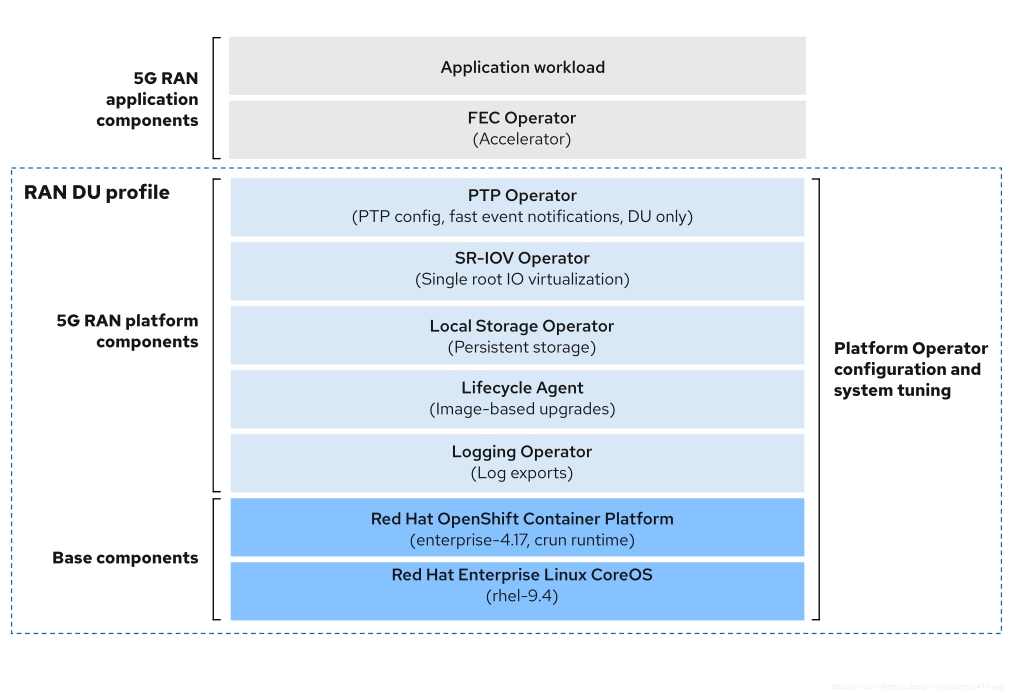

図3.2 通信事業者向け RAN DU 参照設計コンポーネント

通信事業者向け RAN DU プロファイルに含まれていないコンポーネントが、ワークロードアプリケーションに割り当てられた CPU リソースに影響を与えないことを確認します。

ツリー外のドライバーはサポートされていません。

3.2.3. 通信事業者向け RAN DU 4.17 参照デザインコンポーネント

以下のセクションでは、RAN DU ワークロードを実行するためにクラスターを設定およびデプロイするのに使用するさまざまな OpenShift Container Platform コンポーネントと設定を説明します。

3.2.3.1. ホストファームウェアのチューニング

- このリリースの新機能

- GitOps ZTP を使用してデプロイしたマネージドクラスターのホストファームウェア設定を行えるようになりました。

- 説明

-

初期クラスターデプロイメント中に最適なパフォーマンスが得られるようにホストファームウェア設定を調整します。マネージドクラスターホストのファームウェア設定は、

SiteConfigCR と GitOps ZTP を使用してマネージドクラスターをデプロイするときに作成されるBareMetalHostカスタムリソース (CR) としてハブクラスターで使用できます。 - 制限と要件

- ハイパースレッディングを有効にする必要がある

- エンジニアリングに関する考慮事項

- パフォーマンスを最大限に高めるためにすべての設定を調整します。

- 省電力用に調整されていない限り、すべての設定は最大のパフォーマンスが得られるものと予想されます。

- 必要に応じて、省電力用にパフォーマンスを犠牲にしてホストファームウェアを調整できます。

- Secure Boot を有効にします。セキュアブートを有効にすると、署名されたカーネルモジュールのみがカーネルによってロードされます。ツリー外のドライバーはサポートされていません。

3.2.3.2. Node Tuning Operator

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

- 説明

パフォーマンスプロファイルを作成して、クラスターのパフォーマンスをチューニングします。

重要RAN DU ユースケースでは、低レイテンシーのパフォーマンスを実現するためにクラスターをチューニングする必要があります。

- 制限と要件

Node Tuning Operator は、

PerformanceProfileCR を使用してクラスターを設定します。RAN DU プロファイルPerformanceProfileCR で次の設定を設定する必要があります。- 予約済みおよび分離されたコアを選択し、最大のパフォーマンスが得られるようにファームウェアが調整された Intel 第 3 世代 Xeon (Ice Lake) 2.20 GHz CPU 以上に少なくとも 4 つのハイパースレッド (2 つのコアに相当) を割り当てるようにします。

-

予約済みの

cpusetを設定して、含まれる各コアの両方のハイパースレッドシブリングを含めます。予約されていないコアは、ワークロードのスケジュールに割り当て可能な CPU として使用できます。ハイパースレッドシブリングが予約済みコアと分離コアに分割されていないことを確認します。 - 予約済みおよび分離された CPU として設定した内容に基づいて、すべてのコアのすべてのスレッドを含めるように予約済みおよび分離された CPU を設定します。

- 各 NUMA ノードのコア 0 を予約済み CPU セットに含めるように設定します。

- huge page のサイズを 1G に設定します。

管理パーティションにワークロードをさらに追加しないでください。OpenShift 管理プラットフォームの一部である Pod のみを管理パーティションにアノテーション付けする必要があります。

- エンジニアリングに関する考慮事項

- パフォーマンス要件を満たすには、RT カーネルを使用する必要があります。ただし、必要に応じて、クラスターのパフォーマンスに相応の影響を及ぼしますが、非 RT カーネルを使用することもできます。

- 設定する huge page の数は、アプリケーションのワークロード要件によって異なります。このパラメーターの変動は予想され、許容されます。

- 選択されたハードウェアとシステムで使用されている追加コンポーネントに基づいて、予約済みおよび分離された CPU セットの設定に変化が生じることが予想されます。変動は指定された制限を満たす必要があります。

- IRQ アフィニティーをサポートしていないハードウェアは、分離された CPU に影響します。CPU 全体の QoS が保証された Pod が割り当てられた CPU を最大限に活用できるようにするには、サーバー内のすべてのハードウェアが IRQ アフィニティーをサポートする必要があります。詳細は、「ノードの有効な IRQ アフィニティー設定の検索」を参照してください。

cpuPartitioningMode: AllNodes 設定を使用してクラスターのデプロイメント中にワークロードのパーティショニングを有効にする場合、PerformanceProfile CR で予約された CPU セットには、オペレーティングシステム、割り込み、および OpenShift プラットフォーム Pod に十分な CPU が含まれている必要があります。

cgroups v1 は非推奨の機能です。非推奨の機能は依然として OpenShift Container Platform に含まれており、引き続きサポートされますが、この製品の今後のリリースで削除されるため、新規デプロイメントでの使用は推奨されません。

OpenShift Container Platform で非推奨となったか、削除された主な機能の最新の一覧は、OpenShift Container Platform リリースノートの 非推奨および削除された機能セクションを参照してください。

3.2.3.3. PTP Operator

- このリリースの新機能

-

Precision Time Protocol (PTP) 高速イベント REST API の新しいバージョン 2 が利用可能になりました。コンシューマーアプリケーションは、PTP イベントプロデューサーサイドカーのイベント REST API に直接サブスクライブできるようになりました。PTP 高速イベント REST API v2 は、O-RAN O-Cloud Notification API Specification for Event Consumers 3.0 に準拠しています。

PtpOperatorConfigリソースのptpEventConfig.apiVersionフィールドを設定することで、API バージョンを変更できます。

-

Precision Time Protocol (PTP) 高速イベント REST API の新しいバージョン 2 が利用可能になりました。コンシューマーアプリケーションは、PTP イベントプロデューサーサイドカーのイベント REST API に直接サブスクライブできるようになりました。PTP 高速イベント REST API v2 は、O-RAN O-Cloud Notification API Specification for Event Consumers 3.0 に準拠しています。

- 説明

クラスターノードでの PTP のサポートと設定に関する詳細は、「vDU アプリケーションのワークロードに推奨されるシングルノード OpenShift クラスター設定」を参照してください。DU ノードは次のモードで実行できます。

- グランドマスタークロックまたは境界クロック (T-BC) に同期された通常のクロック (OC) として実行。

- シングルまたはデュアルカード E810 NIC をサポートする、GPS から同期されるグランドマスタークロック (T-GM) として実行。

- E810 NIC をサポートするデュアル境界クロック (NIC ごとに 1 つ) として実行。

- 異なる NIC に複数のタイムソースがある場合に、高可用性 (HA) システムクロックを備えた T-BC として実行。

- オプション: 無線ユニット (RU) の境界クロックとして実行。

- 制限と要件

- デュアル NIC および HA の場合、境界クロックは 2 つに制限されます。

- T-GM の場合、E810 カード設定は 2 枚に制限されます。

- エンジニアリングに関する考慮事項

- 通常クロック、境界クロック、高可用性システムクロックを備えた境界クロック、およびグランドマスタークロックの設定が提供されます。

-

PTP 高速イベント通知は

ConfigMapCR を使用して PTP イベントサブスクリプションを保存します。 - PTP イベント REST API v2 には、リソースパスに含まれるすべての下位階層リソースに対するグローバルサブスクリプションがありません。利用可能なさまざまなイベントタイプのコンシューマーアプリケーションを、個別にサブスクライブします。

3.2.3.4. SR-IOV Operator

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

- 説明

-

SR-IOV Operator は、SR-IOV CNI およびデバイスプラグインをプロビジョニングおよび設定します。

netdevice(カーネル VF) デバイスとvfio(DPDK) デバイスの両方がサポートされており、RAN 使用モデルに適用できます。 - 制限と要件

- OpenShift Container Platform 対応デバイスを使用する

- BIOS での SR-IOV および IOMMU の有効化: SR-IOV Network Operator は、カーネルコマンドラインで IOMMU を自動的に有効にします。

- SR-IOV VF は PF からリンク状態の更新を受信しません。リンクダウン検出が必要な場合は、プロトコルレベルでこれを設定する必要があります。

セキュアブートまたはカーネルロックダウンを使用したファームウェア更新をサポートしていない NIC は、アプリケーションワークロードに必要な Virtual Function (VF) の数をサポートするために十分な VF で事前に設定されている必要があります。

注記文書化されていない

disablePluginsオプションを使用して、サポートされていない NIC の SR-IOV Operator プラグインを無効化することを推奨します。

- エンジニアリングに関する考慮事項

-

vfioドライバータイプの SR-IOV インターフェイスは通常、高スループットまたは低レイテンシーを必要とするアプリケーションで追加のセカンダリーネットワークを有効にするために使用されます。 -

SriovNetworkおよびSriovNetworkNodePolicyカスタムリソース (CR) の設定と数は、顧客によって異なることが予想されます。 -

IOMMU カーネルのコマンドライン設定は、インストール時に

MachineConfigCR で適用されます。これにより、SriovOperatorCR がノードを追加するときにノードの再起動が発生しなくなります。 - 並列でノードをドレインするための SR-IOV サポートは、シングルノードの OpenShift クラスターには適用されません。

-

デプロイメントから

SriovOperatorConfigCR を除外すると、CR は自動的に作成されません。 - ワークロードを特定のノードにピン留めまたは制限するシナリオでは、SR-IOV 並列ノードドレイン機能によって Pod の再スケジュールは行われません。このようなシナリオでは、SR-IOV Operator は並列ノードドレイン機能を無効にします。

-

3.2.3.5. ロギング

- このリリースの新機能

- Cluster Logging Operator 6.0 はこのリリースの新機能です。既存の実装を更新して、新しいバージョンの API に適応させます。

- 説明

- ログ記録を使用して、リモート分析のために遠端のエッジノードからログを収集します。推奨されるログコレクターは Vector です。

- エンジニアリングに関する考慮事項

- たとえば、インフラストラクチャーを超えたログや、アプリケーションワークロードからの監査ログを処理するには、追加のログ記録レートに基づいて追加の CPU とネットワーク帯域幅が必要になります。

OpenShift Container Platform 4.14 以降では、Vector が参照ログコレクターになります。

注記RAN 使用モデルでの fluentd の使用は非推奨です。

3.2.3.6. SRIOV-FEC Operator

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

- 説明

- SRIOV-FEC Operator は、FEC アクセラレーターハードウェアをサポートするオプションのサードパーティー認定 Operator です。

- 制限と要件

FEC Operator v2.7.0 以降:

-

SecureBootがサポートされている -

PFのvfioドライバーでは、Pod に挿入されるvfio-tokenを使用する必要があります。Pod 内のアプリケーションは、EAL パラメーター--vfio-vf-tokenを使用してVFトークンを DPDK に渡すことができます。

-

- エンジニアリングに関する考慮事項

-

SRIOV-FEC Operator は、

isolatedCPU セットの CPU コアを使用します。 - たとえば、検証ポリシーを拡張することによって、アプリケーションデプロイメントの事前チェックの一部として FEC の準備を検証できます。

-

SRIOV-FEC Operator は、

3.2.3.7. Lifecycle Agent

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

- 説明

- Lifecycle Agent は、シングルノードの OpenShift クラスターにローカルのライフサイクル管理サービスを提供します。

- 制限と要件

- Lifecycle Agent は、マルチノードクラスターまたは追加のワーカーを持つシングルノードの OpenShift クラスターには適用されません。

- クラスターのインストール時に作成する永続ボリュームが必要です。パーティション要件は、「GitOps ZTP を使用する場合の ostree stateroot 間の共有コンテナーディレクトリーの設定」を参照してください。

3.2.3.8. Local Storage Operator

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

- 説明

-

Local Storage Operator を使用して、アプリケーションで

PVCリソースとして使用できる永続ボリュームを作成できます。作成するPVリソースの数とタイプは、要件によって異なります。 - エンジニアリングに関する考慮事項

-

PVを作成する前に、PVCR のバッキングストレージを作成します。これは、パーティション、ローカルボリューム、LVM ボリューム、または完全なディスクにすることができます。 ディスクとパーティションの正しい割り当てを確認するには、各デバイスへのアクセスに使用されるハードウェアパス別に

LocalVolumeCR 内のデバイスリストを参照してください。論理名 (例:/dev/sda) は、ノードの再起動後も一貫性が保たれるとは限りません。詳細は、デバイス識別子に関する RHEL 9 のドキュメント を参照してください。

-

3.2.3.9. LVM Storage

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

論理ボリュームマネージャー (LVM) ストレージはオプションのコンポーネントです。

ストレージソリューションとして LVM Storage を使用すると、Local Storage Operator が置き換えられます。CPU リソースは、プラットフォームのオーバーヘッドとして管理パーティションに割り当てられます。リファレンス設定には、これらのストレージソリューションのいずれか 1 つを含める必要がありますが、両方を含めることはできません。

- 説明

-

LVM Storage は、ブロックおよびファイルストレージの動的なプロビジョニングを提供します。LVM Storage は、アプリケーションが

PVCリソースとして使用できるローカルデバイスから論理ボリュームを作成します。ボリューム拡張やスナップショットも可能です。 - 制限と要件

- シングルノードの OpenShift クラスターでは、永続ストレージは LVM ストレージまたはローカルストレージのいずれかによって提供される必要があり、両方によって提供される必要はありません。

- ボリュームスナップショットはリファレンス設定から除外されます。

- エンジニアリングに関する考慮事項

- LVM Storage は、RAN DU ユースケースのローカルストレージ実装として使用できます。LVM Storage をストレージソリューションとして使用すると、Local Storage Operator が置き換えられ、必要な CPU がプラットフォームのオーバーヘッドとして管理パーティションに割り当てられます。参照設定には、これらのストレージソリューションのいずれか 1 つを含める必要がありますが、両方を含めることはできません。

- ストレージ要件を満たす十分なディスクまたはパーティションが利用可能であることを確認します。

3.2.3.10. ワークロードの分割

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

- 説明

- ワークロードパーティショニングは、DU プロファイルの一部である OpenShift プラットフォームと Day 2 Operator Pod を予約済み CPU セットに固定し、予約済み CPU をノードアカウンティングから削除します。これにより、予約されていないすべての CPU コアがユーザーのワークロードに使用できるようになります。

- 制限と要件

-

Pod を管理パーティションに適用できるようにするには、

NamespaceとPodCR にアノテーションを付ける必要がある - CPU 制限のある Pod をパーティションに割り当てることはできません。これは、ミューテーションによって Pod の QoS が変わる可能性があるためです。

- 管理パーティションに割り当てることができる CPU の最小数の詳細は、ノードチューニング Operator を参照してください。

-

Pod を管理パーティションに適用できるようにするには、

- エンジニアリングに関する考慮事項

- ワークロードパーティショニングでは、すべての管理 Pod を予約済みコアにピン固定します。オペレーティングシステム、管理 Pod、およびワークロードの開始、ノードの再起動、またはその他のシステムイベントの発生時に発生する CPU 使用率の予想される急増を考慮して、予約セットに十分な数のコアを割り当てる必要があります。

3.2.3.11. クラスターのチューニング

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

- 説明

- インストール前に有効または無効にできるオプションのコンポーネントの完全なリストは、「クラスター機能」を参照してください。

- 制限と要件

- インストーラーによるプロビジョニングのインストール方法では、クラスター機能は使用できません。

すべてのプラットフォームチューニング設定を適用する必要があります。次の表に、必要なプラットフォームチューニング設定を示します。

Expand 表3.2 クラスター機能の設定 機能 説明 オプションのクラスター機能を削除する

シングルノードの OpenShift クラスターでのみオプションのクラスター Operator を無効にすることで、OpenShift Container Platform のフットプリントを削減します。

- Marketplace および Node Tuning Operator を除くすべてのオプションの Operator を削除します。

クラスター監視を設定する

次の手順を実行して、フットプリントを削減するようにモニタリングスタックを設定します。

-

ローカルの

alertmanagerコンポーネントおよびtelemeterコンポーネントを無効にします。 -

RHACM の可観測性を使用する際、アラートをハブクラスターに転送するには、適切な

additionalAlertManagerConfigsCR で CR を拡張する必要があります。 Prometheusの保持期間を 24 時間に短縮します。注記RHACM ハブクラスターは、マネージドクラスターメトリクスを集約します。

ネットワーク診断を無効にする

シングルノード OpenShift のネットワーク診断は必要ないため無効にします。

単一の OperatorHub カタログソースを設定する

RAN DU デプロイメントに必要な Operator のみを含む単一のカタログソースを使用するようにクラスターを設定します。各カタログソースにより、クラスター上の CPU 使用率が増加します。単一の

CatalogSourceを使用すると、プラットフォームの CPU 予算内に収まります。Console Operator を無効にする

コンソールが無効になっている状態でクラスターがデプロイされた場合、

ConsoleCR (ConsoleOperatorDisable.yaml) は必要ありません。コンソールが有効になっている状態でクラスターがデプロイされた場合、ConsoleCR を適用する必要があります。

- エンジニアリングに関する考慮事項

OpenShift Container Platform 4.16 以降では、

PerformanceProfileCR が適用されても、クラスターは自動的に cgroups v1 に戻りません。クラスター上で実行されているワークロードに cgroups v1 が必要な場合は、cgroups v1 を使用するようにクラスターを設定する必要があります。注記cgroups v1 を設定する必要がある場合は、初期クラスターデプロイメントの一部として設定を行います。

3.2.3.12. マシン設定

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

- 制限と要件

CRI-O ワイプ無効化

MachineConfigは、定義されたメンテナンスウィンドウ内のスケジュールされたメンテナンス時以外は、ディスク上のイメージが静的であると想定します。イメージが静的であることを保証するには、Pod のimagePullPolicyフィールドをAlwaysに設定しないでください。Expand 表3.3 マシン設定オプション 機能 説明 コンテナーランタイム

すべてのノードロールのコンテナーランタイムを

crunに設定します。kubelet の設定とコンテナーマウントの非表示

kubelet ハウスキーピングとエビクションモニタリングの頻度を減らして、CPU 使用量を削減します。システムマウントスキャンのリソース使用量を削減するために、kubelet と CRI-O に表示されるコンテナーマウント namespace を作成します。

SCTP

オプション設定 (デフォルトで有効): SCTP を有効にします。SCTP は RAN アプリケーションで必要ですが、RHCOS ではデフォルトで無効になっています。

kdump

オプション設定 (デフォルトで有効): カーネルパニックが発生したときに kdump がデバッグ情報をキャプチャーできるようにします。

注記kdump を有効にするリファレンス CR では、リファレンス設定に含まれるドライバーとカーネルモジュールのセットに基づいて、メモリー予約が増加します。

CRI-O ワイプ無効化

不正なシャットダウン後の CRI-O イメージキャッシュの自動消去を無効にします。

SR-IOV 関連のカーネル引数

カーネルコマンドラインに SR-IOV 関連の追加引数を含めます。

RCU 通常の systemd サービス

システムが完全に起動した後に

rcu_normalを設定します。ワンショット時間同期

コントロールプレーンまたはワーカーノードに対して 1 回限りの NTP システム時間同期ジョブを実行します。

3.2.3.13. 通信事業者向け RAN DU デプロイメントコンポーネント

次のセクションでは、Red Hat Advanced Cluster Management (RHACM) を使用してハブクラスターを設定するために使用するさまざまな OpenShift Container Platform コンポーネントと設定を説明します。

3.2.3.13.1. Red Hat Advanced Cluster Management

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

- 説明

Red Hat Advanced Cluster Management (RHACM) は、デプロイされたクラスターに対して Multi Cluster Engine (MCE) のインストールと継続的なライフサイクル管理機能を提供します。メンテナンス期間中に

Policyカスタムリソース (CR) をクラスターに適用することで、クラスターの設定とアップグレードを宣言的に管理します。Topology Aware Lifecycle Manager (TALM) によって管理される RHACM ポリシーコントローラーを使用してポリシーを適用します。ポリシーコントローラーは、設定、アップグレード、およびクラスターのステータスを処理します。

マネージドクラスターをインストールすると、RHACM は、カスタムディスクパーティション分割、ロールの割り当て、マシン設定プールへの割り当てをサポートするために、個々のノードにラベルと初期イグニッション設定を適用します。これらの設定は、

SiteConfigまたはClusterInstanceCR を使用して定義します。- 制限と要件

-

ArgoCD アプリケーションごとに 300 個の

SiteConfigCR。複数のアプリケーションを使用することで、単一のハブクラスターでサポートされるクラスターの最大数を実現できます。 -

単一のハブクラスターは、各クラスターに 5 つの

PolicyCR がバインドされた、最大 3500 個のデプロイされたシングルノード OpenShift クラスターをサポートします。

-

ArgoCD アプリケーションごとに 300 個の

- エンジニアリングに関する考慮事項

- RHACM ポリシーハブ側テンプレートを使用して、クラスター設定をより適切にスケーリングします。グループおよびクラスターごとの値がテンプレートに置き換えられる単一のグループポリシーまたは少数の一般的なグループポリシーを使用することで、ポリシーの数を大幅に削減できます。

-

クラスター固有の設定: マネージドクラスターには通常、個々のクラスターに固有の設定値がいくつかあります。これらの設定は、クラスター名に基づいて

ConfigMapCR から取得された値を使用して、RHACM ポリシーハブ側テンプレートを使用して管理する必要があります。 - マネージドクラスターの CPU リソースを節約するには、クラスターの GitOps ZTP インストール後に、静的設定を適用するポリシーをマネージドクラスターからアンバインドする必要があります。

3.2.3.13.2. Topology Aware Lifecycle Manager

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

- 説明

- Topology Aware Lifecycle Manager (TALM) は、ハブクラスター上でのみ実行され、変更 (クラスターおよび Operator のアップグレード、設定などを含む) がネットワークにロールアウトされる方法を管理するための Operator です。

- 制限と要件

- TALM は 400 のバッチでの同時クラスターデプロイメントをサポートします。

- 事前キャッシュおよびバックアップ機能は、シングルノードの OpenShift クラスターのみを対象としています。

- エンジニアリングに関する考慮事項

-

ran.openshift.io/ztp-deploy-waveアノテーションを持つポリシーのみが、クラスターの初期インストール時に TALM によって自動的に適用されます。 -

さらに

ClusterGroupUpgradeCR を作成して、TALM が修復するポリシーを制御できます。

-

3.2.3.13.3. GitOps および GitOps ZTP プラグイン

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

- 説明

GitOps および GitOps ZTP プラグインは、クラスターのデプロイメントと設定を管理するための GitOps ベースのインフラストラクチャーを提供します。クラスターの定義と設定は、Git で宣言的な状態として維持されます。

ClusterInstanceCR をハブクラスターに適用すると、SiteConfigOperator がそれをインストール CR としてレンダリングします。または、GitOps ZTP プラグインを使用して、SiteConfigCR から直接インストール CR を生成することもできます。GitOps ZTP プラグインは、PolicyGenTemplateCR に基づいて、ポリシー内の設定 CR を自動的にラップすることをサポートします。注記ベースライン参照設定 CR を使用して、マネージドクラスターに OpenShift Container Platform の複数のバージョンをデプロイおよび管理できます。ベースライン CR と並行してカスタム CR を使用できます。

複数のバージョンごとのポリシーを同時に維持するには、Git を使用してソース CR とポリシー CR (

PolicyGenTemplateまたはPolicyGenerator) のバージョンを管理します。参照 CR とカスタム CR を別のディレクトリーに保存します。これを行うと、カスタム CR に触れることなく、ディレクトリーのすべてのコンテンツを簡単に置き換えるだけで、参照 CR にパッチを適用して更新できます。

- 制限

-

ArgoCD アプリケーションごとに 300 個の

SiteConfigCR。複数のアプリケーションを使用することで、単一のハブクラスターでサポートされるクラスターの最大数を実現できます。 -

Git の

/source-crsフォルダー内のコンテンツは、GitOps ZTP プラグインコンテナーで提供されるコンテンツを上書きします。検索パスでは Git が優先されます。 kustomization.yamlファイルと同じディレクトリーに/source-crsフォルダーを追加します。このフォルダーには、ジェネレーターとしてPolicyGenTemplateが含まれています。注記このコンテキストでは、

/source-crsディレクトリーの代替の場所はサポートされていません。-

SiteConfigCR のextraManifestPathフィールドは、OpenShift Container Platform 4.15 以降では非推奨です。代わりに新しいextraManifests.searchPathsフィールドを使用してください。

-

ArgoCD アプリケーションごとに 300 個の

- エンジニアリングに関する考慮事項

-

マルチノードクラスターのアップグレードの場合、

pausedフィールドをtrueに設定することで、メンテナンスウィンドウ中にMachineConfigPool(MCP) CR を一時停止できます。MCPCR でmaxUnavailable設定を設定することで、同時に更新されるMCPごとのノード数を増やすことができます。MaxUnavailableフィールドは、MachineConfigの更新中に同時に使用できなくなるプール内のノードのパーセンテージを定義します。maxUnavailableを最大許容値に設定します。これにより、アップグレード中にクラスター内で再起動する回数が減り、アップグレード時間が短縮されます。最終的にMCPCR の一時停止を解除すると、変更されたすべての設定が 1 回の再起動で適用されます。 -

クラスターのインストール中に、

pausedフィールドをtrueに設定し、maxUnavailableを 100% に設定することで、カスタムMCPCR を一時停止し、インストール時間を短縮できます。 -

コンテンツを更新するときに混乱や意図しないファイルの上書きを避けるため、

/source-crsフォルダー内のユーザー指定の CR と Git 内の追加マニフェストには、一意で区別できる名前を使用します。 -

SiteConfigCR では、複数の追加マニフェストパスが許可されます。複数のディレクトリーパスで同じ名前のファイルが見つかった場合は、最後に見つかったファイルが優先されます。これにより、バージョン固有の Day 0 マニフェスト (追加マニフェスト) の完全なセットを Git に配置し、SiteConfigCR から参照できるようになります。この機能を使用すると、複数の OpenShift Container Platform バージョンをマネージドクラスターに同時にデプロイできます。

-

マルチノードクラスターのアップグレードの場合、

3.2.3.13.4. Agent-based Installer

- このリリースの新機能

- このリリースではリファレンス設計の更新はありません。

- 説明

Agent-based Installer (ABI) は、集中型インフラストラクチャーなしでインストール機能を提供します。インストールプログラムは、サーバーにマウントする ISO イメージを作成します。サーバーが起動すると、OpenShift Container Platform と提供された追加のマニフェストがインストールされます。

注記ABI を使用して、ハブクラスターなしで OpenShift Container Platform クラスターをインストールすることもできます。このように ABI を使用する場合でも、イメージレジストリーは必要です。

Agent-based Installer (ABI) はオプションのコンポーネントです。

- 制限と要件

- インストール時に、追加のマニフェストの限定されたセットを提供できます。

-

RAN DU ユースケースに必要な

MachineConfigurationCR を含める必要があります。

- エンジニアリングに関する考慮事項

- ABI は、ベースラインの OpenShift Container Platform インストールを提供します。

- インストール後に、Day 2 Operator と残りの RAN DU ユースケース設定をインストールします。

3.2.4. 通信事業者向け RAN 分散ユニット (DU) 参照設定 CR

次のカスタムリソース (CR) を使用して、通信事業者向け RAN DU プロファイルを使用して OpenShift Container Platform クラスターを設定およびデプロイします。一部の CR は、要件に応じてオプションになります。変更できる CR フィールドは、CR 内で YAML コメントによってアノテーションが付けられます。

ztp-site-generate コンテナーイメージから RAN DU CR の完全なセットを抽出できます。詳細は、GitOps ZTP サイト設定リポジトリーの準備 を参照してください。

3.2.4.1. Day 2 Operator 参照 CR

| コンポーネント | 参照 CR | 任意 | このリリースの新機能 |

|---|---|---|---|

| クラスターロギング | いいえ | いいえ | |

| クラスターロギング | いいえ | いいえ | |

| クラスターロギング | いいえ | いいえ | |

| クラスターロギング | いいえ | はい | |

| クラスターロギング | いいえ | はい | |

| クラスターロギング | いいえ | はい | |

| クラスターロギング | いいえ | いいえ | |

| LifeCycle Agent Operator | はい | いいえ | |

| LifeCycle Agent Operator | はい | いいえ | |

| LifeCycle Agent Operator | はい | いいえ | |

| LifeCycle Agent Operator | はい | いいえ | |

| Local Storage Operator | はい | いいえ | |

| Local Storage Operator | はい | いいえ | |

| Local Storage Operator | はい | いいえ | |

| Local Storage Operator | はい | いいえ | |

| Local Storage Operator | はい | いいえ | |

| LVM Operator | はい | いいえ | |

| LVM Operator | はい | いいえ | |

| LVM Operator | はい | いいえ | |

| LVM Operator | はい | いいえ | |

| LVM Operator | はい | いいえ | |

| Node Tuning Operator | いいえ | いいえ | |

| Node Tuning Operator | いいえ | いいえ | |

| PTP 高速イベント通知 | はい | いいえ | |

| PTP 高速イベント通知 | はい | いいえ | |

| PTP 高速イベント通知 | はい | いいえ | |

| PTP 高速イベント通知 | はい | いいえ | |

| PTP Operator - 高可用性 | いいえ | いいえ | |

| PTP Operator - 高可用性 | いいえ | いいえ | |

| PTP Operator | いいえ | いいえ | |

| PTP Operator | いいえ | いいえ | |

| PTP Operator | いいえ | いいえ | |

| PTP Operator | いいえ | いいえ | |

| PTP Operator | いいえ | いいえ | |

| PTP Operator | いいえ | いいえ | |

| PTP Operator | いいえ | いいえ | |

| PTP Operator | いいえ | いいえ | |

| SR-IOV FEC Operator | はい | いいえ | |

| SR-IOV FEC Operator | はい | いいえ | |

| SR-IOV FEC Operator | はい | いいえ | |

| SR-IOV FEC Operator | はい | いいえ | |

| SR-IOV Operator | いいえ | いいえ | |

| SR-IOV Operator | いいえ | いいえ | |

| SR-IOV Operator | いいえ | いいえ | |

| SR-IOV Operator | いいえ | いいえ | |

| SR-IOV Operator | いいえ | いいえ | |

| SR-IOV Operator | いいえ | いいえ | |

| SR-IOV Operator | いいえ | いいえ |

3.2.4.2. クラスターチューニング参照 CR

| コンポーネント | 参照 CR | 任意 | このリリースの新機能 |

|---|---|---|---|

| コンポーザブル OpenShift | いいえ | いいえ | |

| コンソールの無効化 | はい | いいえ | |

| 非接続レジストリー | いいえ | いいえ | |

| 非接続レジストリー | いいえ | いいえ | |

| 非接続レジストリー | いいえ | いいえ | |

| 非接続レジストリー | いいえ | いいえ | |

| 非接続レジストリー | OperatorHub は、シングルノード OpenShift では必須であり、マルチノードクラスターではオプションです。 | いいえ | |

| モニタリング設定 | いいえ | いいえ | |

| ネットワーク診断の無効化 | いいえ | いいえ |

3.2.4.3. マシン設定参照 CR

| コンポーネント | 参照 CR | 任意 | このリリースの新機能 |

|---|---|---|---|

| コンテナーランタイム (crun) | いいえ | いいえ | |

| コンテナーランタイム (crun) | いいえ | いいえ | |

| CRI-O ワイプを無効にする | いいえ | いいえ | |

| CRI-O ワイプを無効にする | いいえ | いいえ | |

| Kdump を有効にする | いいえ | いいえ | |

| Kdump を有効にする | いいえ | いいえ | |

| Kubelet 設定/コンテナーマウントの非表示 | いいえ | いいえ | |

| Kubelet 設定/コンテナーマウントの非表示 | いいえ | いいえ | |

| ワンショット時間同期 | いいえ | いいえ | |

| ワンショット時間同期 | いいえ | いいえ | |

| SCTP | はい | いいえ | |

| SCTP | はい | いいえ | |

| RCU を通常に設定する | いいえ | いいえ | |

| RCU を通常に設定する | いいえ | いいえ | |

| SR-IOV 関連のカーネル引数 | いいえ | いいえ | |

| SR-IOV 関連のカーネル引数 | いいえ | いいえ |

3.2.4.4. YAML リファレンス

以下は、通信事業者向け RAN DU 4.17 参照設定を構成するすべてのカスタムリソース (CR) の完全な参照です。

3.2.4.4.1. Day 2 Operator 参照 YAML

ClusterLogForwarder.yaml

ClusterLogNS.yaml

ClusterLogOperGroup.yaml

ClusterLogServiceAccount.yaml

ClusterLogServiceAccountAuditBinding.yaml

ClusterLogServiceAccountInfrastructureBinding.yaml

ClusterLogSubscription.yaml

ImageBasedUpgrade.yaml

LcaSubscription.yaml

LcaSubscriptionNS.yaml

LcaSubscriptionOperGroup.yaml

StorageClass.yaml

StorageLV.yaml

StorageNS.yaml

StorageOperGroup.yaml

StorageSubscription.yaml

LVMOperatorStatus.yaml

StorageLVMCluster.yaml

StorageLVMSubscription.yaml

StorageLVMSubscriptionNS.yaml

StorageLVMSubscriptionOperGroup.yaml

PerformanceProfile.yaml

TunedPerformancePatch.yaml

PtpConfigBoundaryForEvent.yaml

PtpConfigForHAForEvent.yaml

PtpConfigMasterForEvent.yaml

PtpConfigSlaveForEvent.yaml

PtpConfigBoundary.yaml

PtpConfigForHA.yaml

PtpConfigDualCardGmWpc.yaml

PtpConfigGmWpc.yaml

PtpConfigSlave.yaml

PtpOperatorConfig.yaml

PtpOperatorConfigForEvent.yaml

PtpSubscription.yaml

PtpSubscriptionNS.yaml

PtpSubscriptionOperGroup.yaml

AcceleratorsNS.yaml

apiVersion: v1

kind: Namespace

metadata:

name: vran-acceleration-operators

annotations: {}

apiVersion: v1

kind: Namespace

metadata:

name: vran-acceleration-operators

annotations: {}AcceleratorsOperGroup.yaml

AcceleratorsSubscription.yaml

SriovFecClusterConfig.yaml

SriovNetwork.yaml

SriovNetworkNodePolicy.yaml

SriovOperatorConfig.yaml

SriovOperatorConfigForSNO.yaml

SriovSubscription.yaml

SriovSubscriptionNS.yaml

SriovSubscriptionOperGroup.yaml

3.2.4.4.2. クラスターチューニング参照 YAML

example-sno.yaml

ConsoleOperatorDisable.yaml

09-openshift-marketplace-ns.yaml

DefaultCatsrc.yaml

DisableOLMPprof.yaml

DisconnectedICSP.yaml

OperatorHub.yaml

ReduceMonitoringFootprint.yaml

DisableSnoNetworkDiag.yaml

3.2.4.4.3. マシン設定参照 YAML

enable-crun-master.yaml

enable-crun-worker.yaml

99-crio-disable-wipe-master.yaml

99-crio-disable-wipe-worker.yaml

06-kdump-master.yaml

06-kdump-worker.yaml

01-container-mount-ns-and-kubelet-conf-master.yaml

01-container-mount-ns-and-kubelet-conf-worker.yaml

99-sync-time-once-master.yaml

99-sync-time-once-worker.yaml

03-sctp-machine-config-master.yaml

03-sctp-machine-config-worker.yaml

08-set-rcu-normal-master.yaml

08-set-rcu-normal-worker.yaml

3.2.5. 通信事業者向け RAN DU 参照設定ソフトウェア仕様

以下の情報は、通信事業者向け RAN DU リファレンス設計仕様 (RDS) 検証済みソフトウェアバージョンを説明しています。

3.2.5.1. Telco RAN DU 4.17 の検証済みソフトウェアコンポーネント

Red Hat telco RAN DU 4.17 ソリューションは、次に示す OpenShift Container Platform のマネージドクラスターおよびハブクラスター用の Red Hat ソフトウェア製品を使用して検証されています。

| コンポーネント | ソフトウェアバージョン |

|---|---|

| マネージドクラスターのバージョン | 4.17 |

| Cluster Logging Operator | 6.0 |

| Local Storage Operator | 4.17 |

| OpenShift API for Data Protection (OADP) | 1.4.1 |

| PTP Operator | 4.17 |

| SRIOV Operator | 4.17 |

| SRIOV-FEC Operator | 2.9 |

| Lifecycle Agent | 4.17 |

| コンポーネント | ソフトウェアバージョン |

|---|---|

| ハブクラスターのバージョン | 4.17 |

| Red Hat Advanced Cluster Management (RHACM) | 2.11 |

| GitOps ZTP プラグイン | 4.17 |

| Red Hat OpenShift GitOps | 1.13 |

| Topology Aware Lifecycle Manager (TALM) | 4.17 |