This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.2.4. Horizontal Pod Autoscaler での Pod の自動スケーリング

開発者として、Horizontal Pod Autoscaler (HPA) を使って、レプリケーションコントローラーに属する Pod から収集されるメトリクスまたはデプロイメント設定に基づき、OpenShift Container Platform がレプリケーションコントローラーまたはデプロイメント設定のスケールを自動的に増減する方法を指定できます。

2.4.1. Horizontal Pod Autoscaler について

Horizontal Pod Autoscaler を作成することで、実行する Pod の最小数と最大数を指定するだけでなく、Pod がターゲットに設定する CPU の使用率またはメモリー使用率を指定することができます。

Horizontal Pod Autoscaler を作成すると、OpenShift Container Platform は Pod で CPU またはメモリーリソースのメトリクスのクエリーを開始します。メトリクスが利用可能になると、Horizontal Pod Autoscaler は必要なメトリクスの使用率に対する現在のメトリクスの使用率の割合を計算し、随時スケールアップまたはスケールダウンを実行します。クエリーとスケーリングは一定間隔で実行されますが、メトリクスが利用可能になるでに 1 分から 2 分の時間がかかる場合があります。

レプリケーションコントローラーの場合、このスケーリングはレプリケーションコントローラーのレプリカに直接対応します。デプロイメント設定の場合、スケーリングはデプロイメント設定のレプリカ数に直接対応します。自動スケーリングは Complete フェーズの最新デプロイメントにのみ適用されることに注意してください。

OpenShift Container Platform はリソースに自動的に対応し、起動時などのリソースの使用が急増した場合など必要のない自動スケーリングを防ぎます。unready 状態の Pod には、スケールアップ時の使用率が 0 CPU と指定され、Autoscaler はスケールダウン時にはこれらの Pod を無視します。既知のメトリクスのない Pod にはスケールアップ時の使用率が 0% CPU、スケールダウン時に 100% CPU となります。これにより、HPA の決定時に安定性が増します。この機能を使用するには、readiness チェックを設定して新規 Pod が使用可能であるかどうかを判別します。

Horizontal Pod Autoscaler を使用するには、クラスターの管理者はクラスターメトリクスを適切に設定している必要があります。

2.4.1.1. サポートされるメトリクス

以下のメトリクスは Horizontal Pod Autoscaler でサポートされています。

| メトリクス | 説明 | API バージョン |

|---|---|---|

| CPU の使用率 | 使用されている CPU コアの数。Pod の要求される CPU の割合の計算に使用されます。 |

|

| メモリーの使用率 | 使用されているメモリーの量。Pod の要求されるメモリーの割合の計算に使用されます。 |

|

メモリーベースの自動スケーリングでは、メモリー使用量がレプリカ数と比例して増減する必要があります。平均的には以下のようになります。

- レプリカ数が増えると、Pod ごとのメモリー (作業セット) の使用量が全体的に減少します。

- レプリカ数が減ると、Pod ごとのメモリー使用量が全体的に増加します。

OpenShift Container Platform Web コンソールを使用して、アプリケーションのメモリー動作を確認し、メモリーベースの自動スケーリングを使用する前にアプリケーションがそれらの要件を満たしていることを確認します。

以下の例は、image-registry DeploymentConfig オブジェクトの自動スケーリングを示しています。最初のデプロイメントでは 3 つの Pod が必要です。HPA オブジェクトは最小で 5 まで増加され、Pod 上の CPU 使用率が 75% に達すると、Pod を最大 7 まで増やします。

oc autoscale dc/image-registry --min=5 --max=7 --cpu-percent=75

$ oc autoscale dc/image-registry --min=5 --max=7 --cpu-percent=75出力例

horizontalpodautoscaler.autoscaling/image-registry autoscaled

horizontalpodautoscaler.autoscaling/image-registry autoscaledminReplicas が 3 に設定された image-registryDeploymentConfig オブジェクトのサンプル HPA

デプロイメントの新しい状態を表示します。

oc get dc image-registry

$ oc get dc image-registryCopy to Clipboard Copied! Toggle word wrap Toggle overflow デプロイメントには 5 つの Pod があります。

出力例

NAME REVISION DESIRED CURRENT TRIGGERED BY image-registry 1 5 5 config

NAME REVISION DESIRED CURRENT TRIGGERED BY image-registry 1 5 5 configCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.1.2. スケーリングポリシー

autoscaling/v2beta2 API を使用すると、スケーリングポリシー を Horizontal Pod Autoscaler に追加できます。スケーリングポリシーは、OpenShift Container Platform の Horizontal Pod Autoscaler (HPA) が Pod をスケーリングする方法を制御します。スケーリングポリシーにより、特定の期間にスケーリングするように特定の数または特定のパーセンテージを設定して、HPA が Pod をスケールアップまたはスケールダウンするレートを制限できます。固定化ウィンドウ (stabilization window) を定義することもできます。これはメトリクスが変動する場合に、先に計算される必要な状態を使用してスケーリングを制御します。同じスケーリングの方向に複数のポリシーを作成し、変更の量に応じて使用するポリシーを判別することができます。タイミングが調整された反復によりスケーリングを制限することもできます。HPA は反復時に Pod をスケーリングし、その後の反復で必要に応じてスケーリングを実行します。

スケーリングポリシーを適用するサンプル HPA オブジェクト

- 1

scaleDownまたはscaleUpのいずれかのスケーリングポリシーの方向を指定します。この例では、スケールダウンのポリシーを作成します。- 2

- スケーリングポリシーを定義します。

- 3

- ポリシーが反復時に特定の Pod の数または Pod のパーセンテージに基づいてスケーリングするかどうかを決定します。デフォルト値は

podsです。 - 4

- 反復ごとに Pod の数または Pod のパーセンテージのいずれかでスケーリングの量を決定します。Pod 数でスケールダウンする際のデフォルト値はありません。

- 5

- スケーリングの反復の長さを決定します。デフォルト値は

15秒です。 - 6

- パーセンテージでのスケールダウンのデフォルト値は 100% です。

- 7

- 複数のポリシーが定義されている場合は、最初に使用するポリシーを決定します。最大限の変更を許可するポリシーを使用するように

Maxを指定するか、最小限の変更を許可するポリシーを使用するようにMinを指定するか、または HPA がポリシーの方向でスケーリングしないようにDisabledを指定します。デフォルト値はMaxです。 - 8

- HPA が必要とされる状態で遡る期間を決定します。デフォルト値は

0です。 - 9

- この例では、スケールアップのポリシーを作成します。

- 10

- Pod 数によるスケールアップの量。Pod 数をスケールアップするためのデフォルト値は 4% です。

- 11

- Pod のパーセンテージによるスケールアップの量。パーセンテージでスケールアップするためのデフォルト値は 100% です。

スケールダウンポリシーの例

この例では、Pod の数が 40 より大きい場合、パーセントベースのポリシーがスケールダウンに使用されます。このポリシーでは、 selectPolicy による要求により、より大きな変更が生じるためです。

80 の Pod レプリカがある場合、初回の反復で HPA は Pod を 8 Pod 減らします。これは、1 分間 (periodSeconds: 60) の (type: Percent および value: 10 パラメーターに基づく) 80 Pod の 10% に相当します。次回の反復では、Pod 数は 72 になります。HPA は、残りの Pod の 10% が 7.2 であると計算し、これを 8 に丸め、8 Pod をスケールダウンします。後続の反復ごとに、スケーリングされる Pod 数は残りの Pod 数に基づいて再計算されます。Pod の数が 40 未満の場合、Pod ベースの数がパーセントベースの数よりも大きくなるため、Pod ベースのポリシーが適用されます。HPA は、残りのレプリカ (minReplicas) が 20 になるまで、30 秒 (periodSeconds: 30) で一度に 4 Pod (type: Pods および value: 4) を減らします。

selectPolicy: Disabled パラメーターは HPA による Pod のスケールアップを防ぎます。必要な場合は、レプリカセットまたはデプロイメントセットでレプリカの数を調整して手動でスケールアップできます。

設定されている場合、oc edit コマンドを使用してスケーリングポリシーを表示できます。

oc edit hpa hpa-resource-metrics-memory

$ oc edit hpa hpa-resource-metrics-memory出力例

2.4.2. Web コンソールを使用した Horizontal Pod Autoscaler の作成

Web コンソールから、デプロイメントで実行する Pod の最小および最大数を指定する Horizontal Pod Autoscaler (HPA) を作成できます。Pod がターゲットに設定する CPU またはメモリー使用量を定義することもできます。

HPA は、Operator がサポートするサービス、Knative サービス、または Helm チャートの一部であるデプロイメントに追加することはできません。

手順

Web コンソールで HPA を作成するには、以下を実行します。

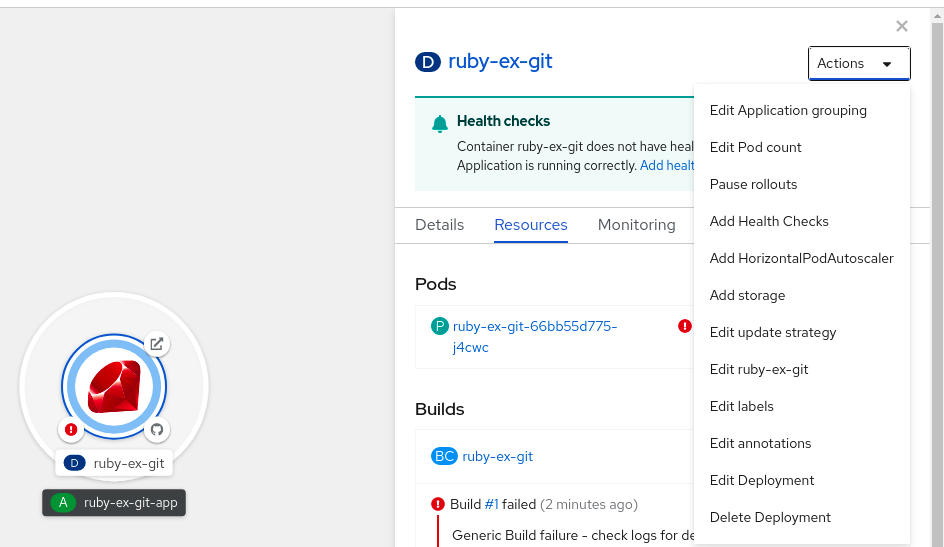

- Topology ビューで、ノードをクリックしてサイドペインを表示します。

Actions ドロップダウンリストから、Add HorizontalPodAutoscaler を選択して Add HorizontalPodAutoscaler フォームを開きます。

図2.1 Horizontal Pod Autoscaler の追加

Add HorizontalPodAutoscaler フォームから、名前、最小および最大の Pod 制限、CPU およびメモリーの使用状況を定義し、Save をクリックします。

注記CPU およびメモリー使用量の値のいずれかが見つからない場合は、警告が表示されます。

Web コンソールで HPA を編集するには、以下を実行します。

- Topology ビューで、ノードをクリックしてサイドペインを表示します。

- Actions ドロップダウンリストから、Edit HorizontalPodAutoscaler を選択し、 Horizontal Pod Autoscaler フォームを開きます。

- Edit Horizontal Pod Autoscaler フォームから、最小および最大の Pod 制限および CPU およびメモリー使用量を編集し、Save をクリックします。

Web コンソールで Horizontal Pod Autoscaler を作成または編集する際に、Form view から YAML viewに切り替えることができます。

Web コンソールで HPA を削除するには、以下を実行します。

- Topology ビューで、ノードをクリックし、サイドパネルを表示します。

- Actions ドロップダウンリストから、Remove HorizontalPodAutoscaler を選択します。

- 確認のポップアップウィンドウで、Remove をクリックして HPA を削除します。

2.4.3. CLI を使用した CPU 使用率向けの Horizontal Pod Autoscaler の作成

既存の Deployment、DeploymentConfig、ReplicaSet、ReplicationController 、または StatefulSet オブジェクトの水平 Pod オートスケーラー (HPA) を作成して、そのオブジェクトに関連付けられた Pod を自動的にスケーリングし、指定した CPU 使用率を維持できます。

HPA は、すべての Pod で指定された CPU 使用率を維持するために、最小数と最大数の間でレプリカ数を増減します。

CPU 使用率について自動スケーリングを行う際に、oc autoscale コマンドを使用し、実行する必要のある Pod の最小数および最大数と Pod がターゲットとして設定する必要のある平均 CPU 使用率を指定することができます。最小値を指定しない場合、Pod には OpenShift Container Platform サーバーからのデフォルト値が付与されます。特定の CPU 値について自動スケーリングを行うには、ターゲット CPU および Pod の制限のある HorizontalPodAutoscaler オブジェクトを作成します。

前提条件

Horizontal Pod Autoscaler を使用するには、クラスターの管理者はクラスターメトリクスを適切に設定している必要があります。メトリクスが設定されているかどうかは、oc describe PodMetrics <pod-name> コマンドを使用して判断できます。メトリクスが設定されている場合、出力は以下の Usage の下にある Cpu と Memory のように表示されます。

oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internal

$ oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internal出力例

手順

CPU 使用率のための Horizontal Pod Autoscaler を作成するには、以下を実行します。

以下のいずれかを実行します。

CPU 使用率のパーセントに基づいてスケーリングするには、既存のオブジェクトとして

HorizontalPodAutoscalerオブジェクトを作成します。oc autoscale <object_type>/<name> \ --min <number> \ --max <number> \ --cpu-percent=<percent>

$ oc autoscale <object_type>/<name> \1 --min <number> \2 --max <number> \3 --cpu-percent=<percent>4 Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- 自動スケーリングするオブジェクトのタイプと名前を指定します。オブジェクトが存在し、

Deployment、DeploymentConfig/dc、ReplicaSet/rs、ReplicationController/rc、またはStatefulSetである必要があります。 - 2

- オプションで、スケールダウン時のレプリカの最小数を指定します。

- 3

- スケールアップ時のレプリカの最大数を指定します。

- 4

- 要求された CPU のパーセントで表示された、すべての Pod に対する目標の平均 CPU 使用率を指定します。指定しない場合または負の値の場合、デフォルトの自動スケーリングポリシーが使用されます。

たとえば、次のコマンドが示すように、

image-registryDeploymentConfigオブジェクトの自動スケーリング。最初のデプロイメントでは 3 つの Pod が必要です。HPA オブジェクトは最小で 5 まで増加され、Pod 上の CPU 使用率が 75% に達すると、Pod を最大 7 まで増やします。oc autoscale dc/image-registry --min=5 --max=7 --cpu-percent=75

$ oc autoscale dc/image-registry --min=5 --max=7 --cpu-percent=75Copy to Clipboard Copied! Toggle word wrap Toggle overflow 特定の CPU 値に合わせてスケーリングするには、既存のオブジェクトに対して次のような YAML ファイルを作成します。

以下のような YAML ファイルを作成します。

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

autoscaling/v2beta2API を使用します。- 2

- この Horizontal Pod Autoscaler オブジェクトの名前を指定します。

- 3

- スケーリングするオブジェクトの API バージョンを指定します。

-

ReplicationControllerの場合は、v1を使用します。 -

DeploymentConfigの場合は、apps.openshift.io/v1を使用します。 -

Deployment、ReplicaSet、Statefulsetオブジェクトの場合は、apps/v1を使用します。

-

- 4

- オブジェクトのタイプを指定します。オブジェクトは、

Deployment、DeploymentConfig/dc、ReplicaSet/rs、ReplicationController/rc、またはStatefulSetである必要があります。 - 5

- スケーリングするオブジェクトの名前を指定します。オブジェクトが存在する必要があります。

- 6

- スケールダウン時のレプリカの最小数を指定します。

- 7

- スケールアップ時のレプリカの最大数を指定します。

- 8

- メモリー使用率に

metricsパラメーターを使用します。 - 9

- CPU 使用率に

cpuを指定します。 - 10

AverageValueに設定します。- 11

- ターゲットに設定された CPU 値で

averageValueに設定します。

Horizontal Pod Autoscaler を作成します。

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Horizontal Pod Autoscaler が作成されていることを確認します。

oc get hpa cpu-autoscale

$ oc get hpa cpu-autoscaleCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE cpu-autoscale ReplicationController/example 173m/500m 1 10 1 20m

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE cpu-autoscale ReplicationController/example 173m/500m 1 10 1 20mCopy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.4. CLI を使用したメモリー使用率向けの Horizontal Pod Autoscaler オブジェクトの作成

直接の値または要求されるメモリーのパーセンテージのいずれかで指定する平均のメモリー使用率を維持するために、オブジェクトに関連付けられた Pod を自動的にスケーリングする既存の DeploymentConfig オブジェクトまたは ReplicationController オブジェクトの Horizontal Pod Autoscaler (HPA) を作成できます。

HPA は、すべての Pod で指定のメモリー使用率を維持するために、最小数と最大数の間のレプリカ数を増減します。

メモリー使用率については、Pod の最小数および最大数と、Pod がターゲットとする平均のメモリー使用率を指定することができます。最小値を指定しない場合、Pod には OpenShift Container Platform サーバーからのデフォルト値が付与されます。

前提条件

Horizontal Pod Autoscaler を使用するには、クラスターの管理者はクラスターメトリクスを適切に設定している必要があります。メトリクスが設定されているかどうかは、oc describe PodMetrics <pod-name> コマンドを使用して判断できます。メトリクスが設定されている場合、出力は以下の Usage の下にある Cpu と Memory のように表示されます。

oc describe PodMetrics openshift-kube-scheduler-ip-10-0-129-223.compute.internal -n openshift-kube-scheduler

$ oc describe PodMetrics openshift-kube-scheduler-ip-10-0-129-223.compute.internal -n openshift-kube-scheduler出力例

手順

メモリー使用率の Horizontal Pod Autoscaler を作成するには、以下を実行します。

以下のいずれか 1 つを含む YAML ファイルを作成します。

特定のメモリー値に合わせてスケーリングするには、既存の

ReplicationControllerオブジェクトまたはレプリケーションコントローラーに対して、次のようなHorizontalPodAutoscalerオブジェクトを作成します。出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

autoscaling/v2beta2API を使用します。- 2

- この Horizontal Pod Autoscaler オブジェクトの名前を指定します。

- 3

- スケーリングするオブジェクトの API バージョンを指定します。

-

レプリケーションコントローラーについては、

v1を使用します。 -

DeploymentConfigオブジェクトについては、apps.openshift.io/v1を使用します。

-

レプリケーションコントローラーについては、

- 4

- スケーリングするオブジェクトの種類 (

ReplicationControllerまたはDeploymentConfigのいずれか) を指定します。 - 5

- スケーリングするオブジェクトの名前を指定します。オブジェクトが存在する必要があります。

- 6

- スケールダウン時のレプリカの最小数を指定します。

- 7

- スケールアップ時のレプリカの最大数を指定します。

- 8

- メモリー使用率に

metricsパラメーターを使用します。 - 9

- メモリー使用率の

memoryを指定します。 - 10

- タイプを

AverageValueに設定します。 - 11

averageValueおよび特定のメモリー値を指定します。- 12

- オプション: スケールアップまたはスケールダウンのレートを制御するスケーリングポリシーを指定します。

パーセンテージについてスケーリングするには、以下のように

HorizontalPodAutoscalerオブジェクトを作成します。出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

autoscaling/v2beta2API を使用します。- 2

- この Horizontal Pod Autoscaler オブジェクトの名前を指定します。

- 3

- スケーリングするオブジェクトの API バージョンを指定します。

-

レプリケーションコントローラーについては、

v1を使用します。 -

DeploymentConfigオブジェクトについては、apps.openshift.io/v1を使用します。

-

レプリケーションコントローラーについては、

- 4

- スケーリングするオブジェクトの種類 (

ReplicationControllerまたはDeploymentConfigのいずれか) を指定します。 - 5

- スケーリングするオブジェクトの名前を指定します。オブジェクトが存在する必要があります。

- 6

- スケールダウン時のレプリカの最小数を指定します。

- 7

- スケールアップ時のレプリカの最大数を指定します。

- 8

- メモリー使用率に

metricsパラメーターを使用します。 - 9

- メモリー使用率の

memoryを指定します。 - 10

Utilizationに設定します。- 11

averageUtilizationおよび ターゲットに設定する平均メモリー使用率をすべての Pod に対して指定します (要求されるメモリーのパーセントで表す)。ターゲット Pod にはメモリー要求が設定されている必要があります。- 12

- オプション: スケールアップまたはスケールダウンのレートを制御するスケーリングポリシーを指定します。

Horizontal Pod Autoscaler を作成します。

oc create -f <file-name>.yaml

$ oc create -f <file-name>.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 以下に例を示します。

oc create -f hpa.yaml

$ oc create -f hpa.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

horizontalpodautoscaler.autoscaling/hpa-resource-metrics-memory created

horizontalpodautoscaler.autoscaling/hpa-resource-metrics-memory createdCopy to Clipboard Copied! Toggle word wrap Toggle overflow Horizontal Pod Autoscaler が作成されていることを確認します。

oc get hpa hpa-resource-metrics-memory

$ oc get hpa hpa-resource-metrics-memoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE hpa-resource-metrics-memory ReplicationController/example 2441216/500Mi 1 10 1 20m

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE hpa-resource-metrics-memory ReplicationController/example 2441216/500Mi 1 10 1 20mCopy to Clipboard Copied! Toggle word wrap Toggle overflow oc describe hpa hpa-resource-metrics-memory

$ oc describe hpa hpa-resource-metrics-memoryCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

2.4.5. CLI を使用した Horizontal Pod Autoscaler の状態条件について

状態条件セットを使用して、Horizontal Pod Autoscaler (HPA) がスケーリングできるかどうかや、現時点でこれがいずれかの方法で制限されているかどうかを判別できます。

HPA の状態条件は、自動スケーリング API の v2beta1 バージョンで利用できます。

HPA は、以下の状態条件で応答します。

AbleToScale条件では、HPA がメトリクスを取得して更新できるか、またバックオフ関連の条件によりスケーリングが回避されるかどうかを指定します。-

True条件はスケーリングが許可されることを示します。 -

False条件は指定される理由によりスケーリングが許可されないことを示します。

-

ScalingActive条件は、HPA が有効にされており (ターゲットのレプリカ数がゼロでない)、必要なメトリクスを計算できるかどうかを示します。-

True条件はメトリクスが適切に機能していることを示します。 -

False条件は通常フェッチするメトリクスに関する問題を示します。

-

ScalingLimited条件は、必要とするスケールが Horizontal Pod Autoscaler の最大値または最小値によって制限されていたことを示します。-

True条件は、スケーリングするためにレプリカの最小または最大数を引き上げるか、または引き下げる必要があることを示します。 False条件は、要求されたスケーリングが許可されることを示します。oc describe hpa cm-test

$ oc describe hpa cm-testCopy to Clipboard Copied! Toggle word wrap Toggle overflow 出力例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

- Horizontal Pod Autoscaler の状況メッセージです。

-

以下は、スケーリングできない Pod の例です。

出力例

以下は、スケーリングに必要なメトリクスを取得できなかった Pod の例です。

出力例

Conditions: Type Status Reason Message ---- ------ ------ ------- AbleToScale True SucceededGetScale the HPA controller was able to get the target's current scale ScalingActive False FailedGetResourceMetric the HPA was unable to compute the replica count: failed to get cpu utilization: unable to get metrics for resource cpu: no metrics returned from resource metrics API

Conditions:

Type Status Reason Message

---- ------ ------ -------

AbleToScale True SucceededGetScale the HPA controller was able to get the target's current scale

ScalingActive False FailedGetResourceMetric the HPA was unable to compute the replica count: failed to get cpu utilization: unable to get metrics for resource cpu: no metrics returned from resource metrics API以下は、要求される自動スケーリングが要求される最小数よりも小さい場合の Pod の例です。

出力例

2.4.5.1. CLI を使用した Horizontal Pod Autoscaler の状態条件の表示

Pod に設定された状態条件は、Horizontal Pod Autoscaler (HPA) で表示することができます。

Horizontal Pod Autoscaler の状態条件は、自動スケーリング API の v2beta1 バージョンで利用できます。

前提条件

Horizontal Pod Autoscaler を使用するには、クラスターの管理者はクラスターメトリクスを適切に設定している必要があります。メトリクスが設定されているかどうかは、oc describe PodMetrics <pod-name> コマンドを使用して判断できます。メトリクスが設定されている場合、出力は以下の Usage の下にある Cpu と Memory のように表示されます。

oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internal

$ oc describe PodMetrics openshift-kube-scheduler-ip-10-0-135-131.ec2.internal出力例

手順

Pod の状態条件を表示するには、Pod の名前と共に以下のコマンドを使用します。

oc describe hpa <pod-name>

$ oc describe hpa <pod-name>以下に例を示します。

oc describe hpa cm-test

$ oc describe hpa cm-test

条件は、出力の Conditions フィールドに表示されます。

出力例