This documentation is for a release that is no longer maintained

See documentation for the latest supported version 3 or the latest supported version 4.5.15.2. Kafka ソース

Apache Kafka クラスターからイベントを読み取り、これらのイベントをシンクに渡す Kafka ソースを作成できます。Kafka ソースを作成するには、OpenShift Container Platform Web コンソールの Knative (kn)CLI を使用するか、KafkaSource オブジェクトを YAML ファイルとして直接作成し、OpenShift CLI (oc) を使用して適用します。

5.15.2.1. Web コンソールを使用した Kafka イベントソースの作成

Knative Kafka をクラスターにインストールした後、Web コンソールを使用して Kafka ソースを作成できます。OpenShift Container Platform Web コンソールを使用すると、Kafka ソースを作成するための合理的で直感的なユーザーインターフェイスが提供されます。

前提条件

-

OpenShift Serverless Operator、Knative Serving、および

KnativeKafkaカスタムリソースがクラスターにインストールされている。 - Web コンソールにログインしている。

- インポートする Kafka メッセージを生成する Red Hat AMQ Streams (Kafka) クラスターにアクセスできる。

- OpenShift Container Platform でアプリケーションおよび他のワークロードを作成するために、プロジェクトを作成しているか、適切なロールおよびパーミッションを持つプロジェクトにアクセスできる。

手順

- Developer パースペクティブで、Add ページに移動し、Event Source を選択します。

- Event Sources ページで、Type セクションの Kafka Source を選択します。

Kafka Source 設定を設定します。

- ブートストラップサーバー のコンマ区切りの一覧を追加します。

- トピック のコンマ区切りの一覧を追加します。

- コンシューマーグループ を追加します。

- 作成したサービスアカウントの Service Account Name を選択します。

- イベントソースの Sink を選択します。Sink は、チャネル、ブローカー、またはサービスなどの Resource、または URI のいずれかになります。

- Kafka イベントソースの Name を入力します。

- Create をクリックします。

検証

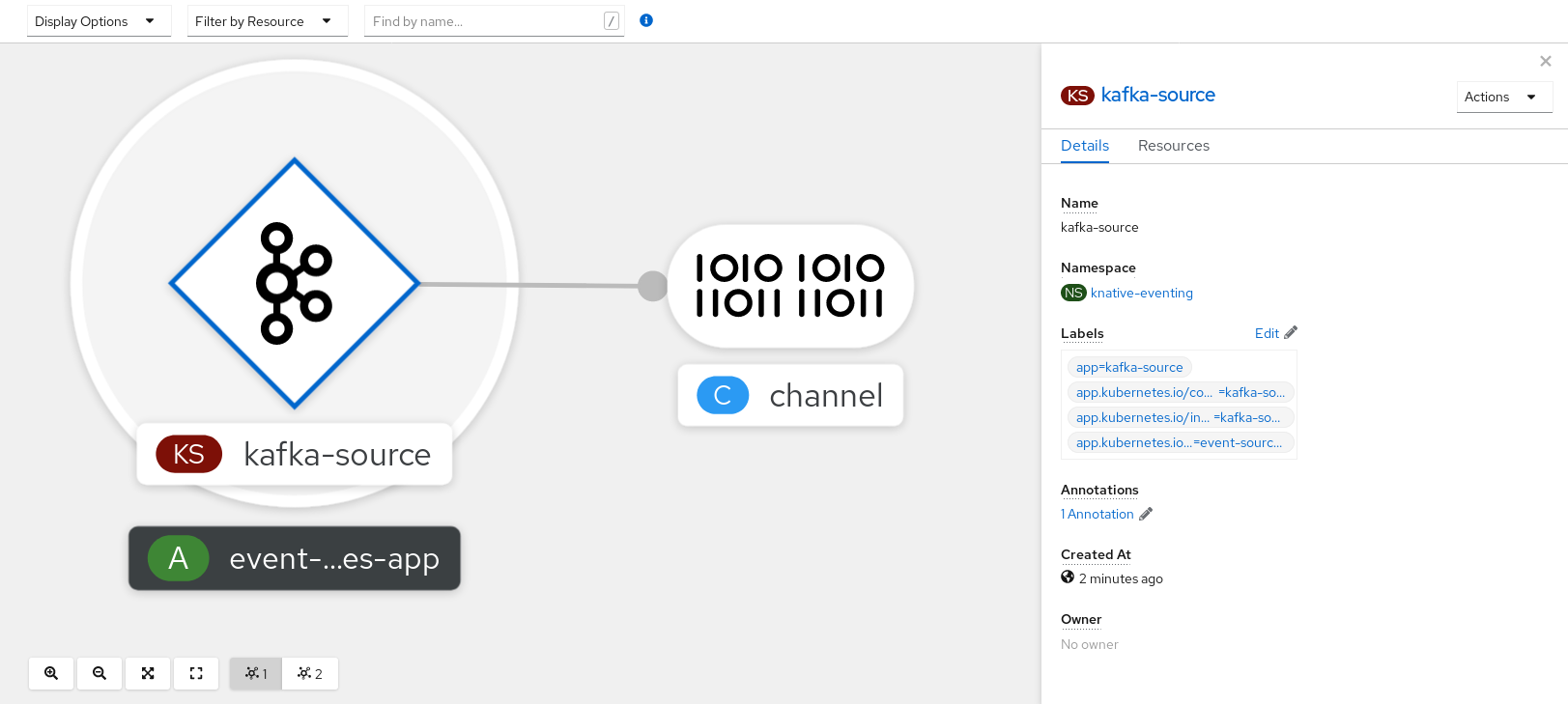

Topology ページを表示して、Kafka イベントソースが作成され、シンクに接続されていることを確認できます。

- Developer パースペクティブで、Topology に移動します。

Kafka イベントソースおよびシンクを表示します。