第12章 Agent-based Installer を使用したオンプレミスクラスターのインストール

12.1. Agent-based Installer を使用したインストールの準備

12.1.1. Agent-based Installer について

エージェントベースのインストール方法では、選択した任意の方法でオンプレミスサーバーを柔軟に起動できます。Assisted Installation サービスの使いやすさと、エアギャップ環境を含むオフラインでの実行機能を兼ね備えています。エージェントベースのインストールは、OpenShift Container Platform インストーラーのサブコマンドです。OpenShift Container Platform クラスターをデプロイするために必要なすべての情報を含む起動可能な ISO イメージを、利用可能なリリースイメージと共に生成します。

設定は、installer-provisioned infrastructure および user-provisioned infrastructure のインストール方法と同じ形式です。Agent-based Installer は、必要に応じてゼロタッチプロビジョニング (ZTP) カスタムリソースを生成または受け入れることもできます。ZTP を使用すると、ベアメタル機器の宣言型設定で新しいエッジサイトをプロビジョニングできます。

12.1.2. エージェントベースのインストーラーについて

OpenShift Container Platform ユーザーは、切断された環境で Assisted Installer のホストサービスの利点を活用できます。

エージェントベースのインストールは、Assisted Discovery Agent と Assisted Service を含む起動可能な ISO で構成されます。クラスターのインストールを実行するには両方が必要ですが、後者はいずれかのホストでのみ実行されます。

openshift-install agent create image サブコマンドは、指定した入力をもとに一時 ISO を生成します。以下のマニフェストで入力を指定できます。

推奨:

-

install-config.yaml -

agent-config.yaml

または

オプション: ZTP マニフェスト

-

cluster-manifests/cluster-deployment.yaml -

cluster-manifests/agent-cluster-install.yaml -

cluster-manifests/pull-secret.yaml -

cluster-manifests/infraenv.yaml -

cluster-manifests/cluster-image-set.yaml -

cluster-manifests/nmstateconfig.yaml -

mirror/registries.conf -

mirror/ca-bundle.crt

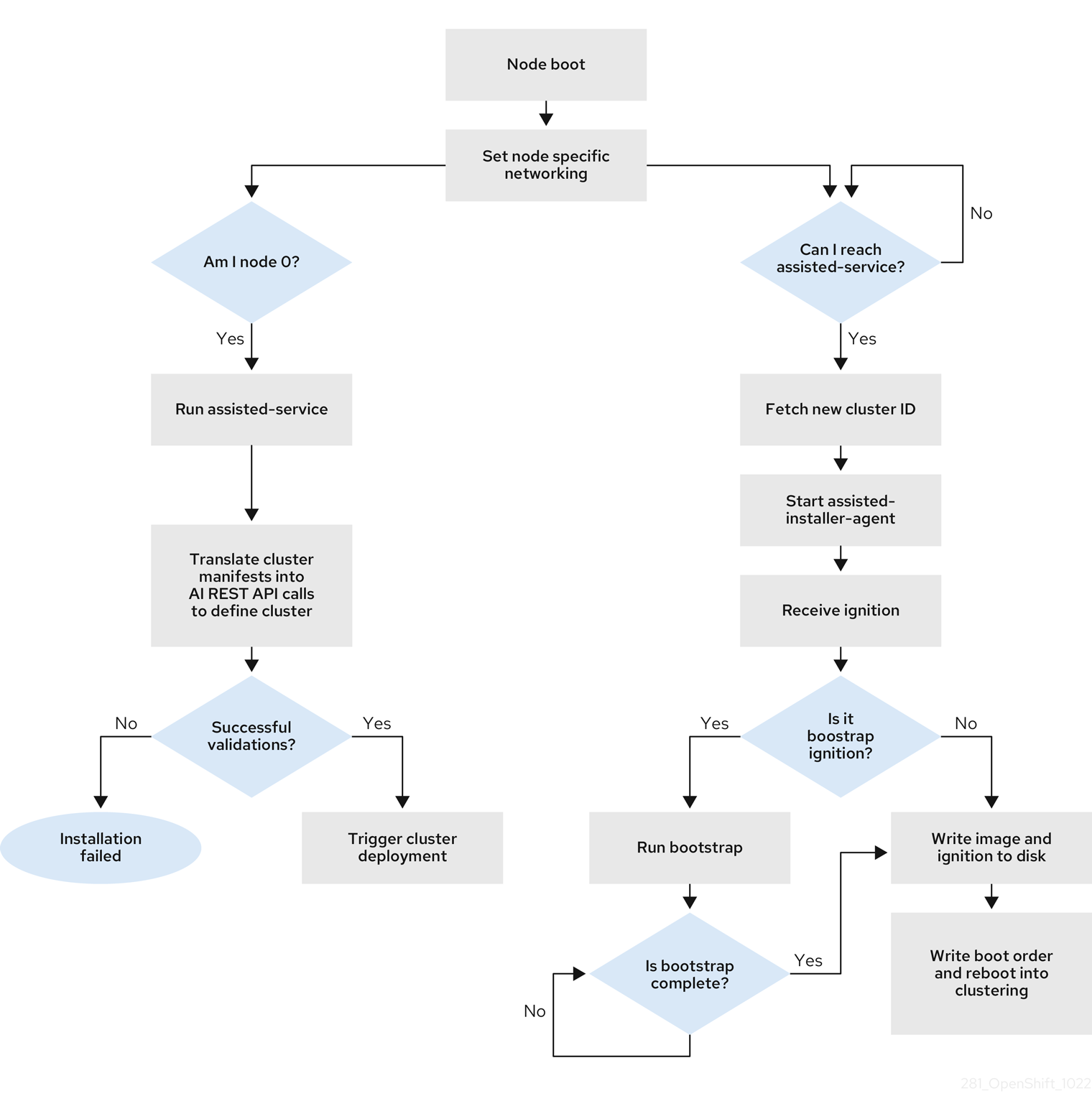

12.1.2.1. Agent-based Installer のワークフロー

コントロールプレーンホストの 1 つは、ブートプロセスの開始時に Assisted Service を実行し、最終的にブートストラップホストになります。このノードを ランデブーホスト (ノード 0) と呼びます。Assisted Service は、すべてのホストが要件を満たしていることを確認し、OpenShift Container Platform クラスターのデプロイをトリガーします。すべてのノードで Red Hat Enterprise Linux CoreOS (RHCOS) イメージがディスクに書き込まれます。ブートストラップ以外のノードは再起動し、クラスターデプロイメントを開始します。ノードが再起動されると、ランデブーホストが再起動し、クラスターに参加します。ブートストラップが完了し、クラスターがデプロイされます。

図12.1 ノードのインストールワークフロー

以下のトポロジーでは、openshift-install agent create image サブコマンドを使用して、ネットワークに接続されていない OpenShift Container Platform クラスターをインストールできます。

- 単一ノードの OpenShift Container Platform クラスター (SNO): マスターとワーカーの両方であるノード。

- 3 ノードの OpenShift Container Platform クラスター: ワーカーノードでもある 3 つのマスターノードを持つコンパクトなクラスター。

- 高可用性 OpenShift Container Platform クラスター (HA): 任意の数のワーカーノードを持つ 3 つのマスターノード。

12.1.2.2. 各トポロジーに推奨されるリソース

以下の各トポロジーに推奨されるクラスターリソースを示します。

| トポロジー | マスターノードの数 | ワーカーノードの数 | vCPU | メモリー | ストレージ |

|---|---|---|---|---|---|

| シングルノードクラスター | 1 | 0 | 仮想 CPU 8 個 | 16GB の RAM | 120GB |

| コンパクトなクラスター | 3 | 0 または 1 | 仮想 CPU 8 個 | 16GB の RAM | 120GB |

| HA クラスター | 3 | 2 以降 | 仮想 CPU 8 個 | 16GB の RAM | 120GB |

以下のプラットフォームがサポートされます。

-

baremetal -

vsphere none重要プラットフォームが

noneの場合:-

noneオプションでは、クラスター内に DNS 名前解決と負荷分散インフラストラクチャーをプロビジョニングする必要があります。詳細は、「関連情報」セクションの プラットフォーム "none" オプションを使用するクラスターの要件 参照してください。 - 仮想化またはクラウド環境で OpenShift Container Platform クラスターのインストールを試行する前に、Deploying OpenShift 4.x on non-tested platforms using the bare metal install method にある情報を確認してください。

-

12.1.3. FIPS 準拠について

多くの OpenShift Container Platform のお客様においては、システムが実稼働環境で使用される前に、一定レベルでの規制への対応またはコンプライアンスが必要になります。この規制対応は、国家標準、業界標準または組織の企業ガバナンスフレームワークによって課せられます。FIPS (Federal Information Processing Standards) コンプライアンスは、安全な環境で必要とされる最も重要なコンポーネントの 1 つであり、サポートされている暗号化技術のみがノード上で許可されるようにします。

クラスターで FIPS モードを有効にするには、FIPS モードで動作するように設定された Red Hat Enterprise Linux (RHEL) コンピューターからインストールプログラムを実行する必要があります。RHEL での FIPS モードの設定の詳細は、FIPS モードでのシステムのインストール を参照してください。FIPS モードでブートされた Red Hat Enterprise Linux (RHEL) または Red Hat Enterprise Linux CoreOS (RHCOS) を実行する場合、OpenShift Container Platform コアコンポーネントは、x86_64、ppc64le、および s390x アーキテクチャーのみで、FIPS 140-2/140-3 検証のために NIST に提出された RHEL 暗号化ライブラリーを使用します。

12.1.4. Agent-based Installer による FIPS の設定

クラスターのデプロイ中に、Red Hat Enterprise Linux CoreOS (RHCOS) マシンがクラスターにデプロイされると、連邦情報処理標準 (FIPS) の変更が適用されます。Red Hat Enterprise Linux (RHEL) マシンでは、ワーカーマシンとして使用する予定のマシンにオペレーティングシステムをインストールする場合に FIPS モードを有効にする必要があります。

install-config.yaml および agent-config.yaml の推奨される方法で FIPS モードを有効にできます。

install-config.yamlファイルでfipsフィールドの値をTrueに設定する必要があります。サンプル install-config.yaml.file

apiVersion: v1 baseDomain: test.example.com metadata: name: sno-cluster fips: True

apiVersion: v1 baseDomain: test.example.com metadata: name: sno-cluster fips: TrueCopy to Clipboard Copied! Toggle word wrap Toggle overflow オプション: GitOps ZTP マニフェストを使用している場合、

agent-cluster-install.yamlファイルのAgent-install.openshift.io/install-config-overridesフィールドでfipsの値をTrueに設定する必要があります。サンプルの agent-cluster-install.yaml ファイル

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

12.1.5. ホストの設定

クラスター上の各ホストの agent-config.yaml ファイルで、ネットワーク設定やルートデバイスのヒントなど追加設定を行うことができます。

設定するホストごとに、ホスト上のインターフェイスの MAC アドレスで、設定するホストを指定する必要があります。

12.1.5.1. ホストのロール

クラスター内の各ホストには、master または worker のいずれかのロールが割り当てられます。role パラメーターを使用して、agent-config.yaml ファイルで各ホストのロールを定義できます。ホストにロールを割り当てない場合、インストール時にロールがランダムに割り当てられます。

そのため、ホストのロールは明示的に定義することが推奨されます。

rendezvousIP は、master ロールを持つホストに割り当てる必要があります。これは、手動で、または Agent-based Installer によるロールの割り当てを許可することで行えます。

ランデブーホストの master ロールを明示的に定義する必要はありませんが、この割り当てと競合する設定は作成できません。

たとえば、ホストが 4 台あり、そのうち 3 台が master ロールを持つように明示的に定義されている場合、最後の 1 台にはインストール時に worker ロールが自動的に割り当てられ、ランデブーホストには設定できません。

agent-config.yaml のサンプルファイル

12.1.5.2. ルートデバイスヒントについて

rootDeviceHints パラメーターは、インストーラーが Red Hat Enterprise Linux CoreOS (RHCOS) イメージを特定のデバイスにプロビジョニングできるようにします。インストーラーは、検出順にデバイスを検査し、検出された値をヒントの値と比較します。インストーラーは、ヒント値に一致する最初に検出されたデバイスを使用します。この設定は複数のヒントを組み合わせることができますが、デバイスは、インストーラーがこれを選択できるようにすべてのヒントに一致する必要があります。

| サブフィールド | 説明 |

|---|---|

|

|

|

|

|

|

|

| ベンダー固有のデバイス識別子を含む文字列。ヒントは、実際の値のサブ文字列になります。 |

|

| デバイスのベンダーまたは製造元の名前が含まれる文字列。ヒントは、実際の値のサブ文字列になります。 |

|

| デバイスのシリアル番号を含む文字列。ヒントは、実際の値と完全に一致する必要があります。 |

|

| デバイスの最小サイズ (ギガバイト単位) を表す整数。 |

|

| 一意のストレージ ID を含む文字列。ヒントは、実際の値と完全に一致する必要があります。 |

|

| デバイスがローテーションするディスクである (true) か、そうでないか (false) を示すブール値。 |

使用例

- name: master-0

role: master

rootDeviceHints:

deviceName: "/dev/sda"

- name: master-0

role: master

rootDeviceHints:

deviceName: "/dev/sda"12.1.6. ネットワークの概要

最初の起動時にすべてのホストが支援サービスにチェックインできるように、ランデブー IP はエージェント ISO の生成時に認識されている必要があります。IP アドレスが動的ホスト設定プロトコル (DHCP) サーバーを使用して割り当てられている場合、rendezvousIP フィールドは、デプロイメントされたコントロールプレーンの一部になるホストの 1 つの IP アドレスに設定する必要があります。DHCP サーバーがない環境では、IP アドレスを静的に定義できます。

静的 IP アドレスに加えて、NMState 形式の任意のネットワーク設定を適用できます。これには、VLAN と NIC ボンディングが含まれます。

12.1.6.1. DHCP

推奨される方法: install-config.yaml および agent-config.yaml

rendezvousIP フィールドの値を指定する必要があります。networkConfig フィールドは空白のままにすることができます。

agent-config.yaml.file のサンプル

apiVersion: v1alpha1 kind: AgentConfig metadata: name: sno-cluster rendezvousIP: 192.168.111.80

apiVersion: v1alpha1

kind: AgentConfig

metadata:

name: sno-cluster

rendezvousIP: 192.168.111.80 - 1

- ランデブーホストの IP アドレス。

12.1.6.2. 静的ネットワーキング

推奨される方法:

install-config.yamlおよびagent-config.yamlagent-config.yaml.file のサンプル

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 1

rendezvousIPフィールドに値が指定されていない場合、networkConfigフィールドで指定された静的 IP アドレスから 1 つのアドレスが選択されます。- 2

- 設定を適用するホストを決定するために使用される、ホスト上のインターフェイスの MAC アドレス。

- 3

- ターゲットのベアメタルホストの静的 IP アドレス。

- 4

- ターゲットのベアメタルホストの静的 IP アドレスのサブネット接頭辞。

- 5

- ターゲットのベアメタルホストの DNS サーバー。

- 6

- ノードトラフィックのネクストホップアドレス。これは、指定されたインターフェイスに設定される IP アドレスと同じサブネットにある必要があります。

オプションの方法: GitOps ZTP マニフェスト

GitOps ZTP カスタムリソースのオプションの方法は、6 つのカスタムリソースで構成されます。静的 IP は

nmstateconfig.yamlで設定できます。Copy to Clipboard Copied! Toggle word wrap Toggle overflow

ランデブー IP は、config フィールドで指定された静的 IP アドレスから選択されます。

12.1.7. プラットフォーム "none" オプションを使用するクラスターの要件

このセクションでは、プラットフォーム none オプションを使用するように設定されたエージェントベースの OpenShift Container Platform インストールの要件を説明します。

仮想化またはクラウド環境で OpenShift Container Platform クラスターのインストールを試行する前に、Deploying OpenShift 4.x on non-tested platforms using the bare metal install method にある情報を確認してください。

12.1.7.1. プラットフォーム "none" の DNS 要件

OpenShift Container Platform のデプロイメントでは、以下のコンポーネントに DNS 名前解決が必要です。

- The Kubernetes API

- OpenShift Container Platform のアプリケーションワイルドカード

- コントロールプレーンおよびコンピュートマシン

逆引き DNS 解決は、Kubernetes API、コントロールプレーンマシン、およびコンピュートマシンにも必要です。

DNS A/AAAA または CNAME レコードは名前解決に使用され、PTR レコードは逆引き名前解決に使用されます。ホスト名が DHCP によって提供されていない場合は、Red Hat Enterprise Linux CoreOS (RHCOS) は逆引きレコードを使用してすべてのノードのホスト名を設定するため、逆引きレコードは重要です。さらに、逆引きレコードは、OpenShift Container Platform が動作するために必要な証明書署名要求 (CSR) を生成するために使用されます。

各クラスターノードにホスト名を提供するために DHCP サーバーを使用することが推奨されます。

以下の DNS レコードは、プラットフォーム none オプションを使用する OpenShift Container Platform クラスターに必要であり、インストール前に設定されている必要があります。各レコードで、<cluster_name> はクラスター名で、<base_domain> は、install-config.yaml ファイルに指定するベースドメインです。完全な DNS レコードは <component>.<cluster_name>.<base_domain>. の形式を取ります。

| コンポーネント | レコード | 説明 |

|---|---|---|

| Kubernetes API |

| API ロードバランサーを特定するための DNS A/AAAA または CNAME レコード、および DNS PTR レコード。これらのレコードは、クラスター外のクライアントおよびクラスター内のすべてのノードで解決できる必要があります。 |

|

| API ロードバランサーを内部的に識別するための DNS A/AAAA または CNAME レコード、および DNS PTR レコード。これらのレコードは、クラスター内のすべてのノードで解決できる必要があります。 重要 API サーバーは、Kubernetes に記録されるホスト名でワーカーノードを解決できる必要があります。API サーバーがノード名を解決できない場合、プロキシーされる API 呼び出しが失敗し、Pod からログを取得できなくなる可能性があります。 | |

| ルート |

| アプリケーション Ingress ロードバランサーを参照するワイルドカード DNS A/AAAA または CNAME レコード。アプリケーション Ingress ロードバランサーは、Ingress コントローラー Pod を実行するマシンをターゲットにします。Ingress コントローラー Pod はデフォルトでコンピュートマシンで実行されます。これらのレコードは、クラスター外のクライアントおよびクラスター内のすべてのノードで解決できる必要があります。

たとえば、 |

| コントロールプレーンマシン |

| ワーカーノードの各マシンを特定するための DNS A/AAAA または CNAME レコードおよび DNS PTR レコードこれらのレコードは、クラスター内のノードで解決できる必要があります。 |

| コンピュートマシン |

| ワーカーノードの各マシンを特定するための DNS A/AAAA または CNAME レコード、および DNS PTR レコード。これらのレコードは、クラスター内のノードで解決できる必要があります。 |

OpenShift Container Platform 4.4 以降では、DNS 設定で etcd ホストおよび SRV レコードを指定する必要はありません。

dig コマンドを使用して、名前および逆引き名前解決を確認することができます。

12.1.7.1.1. プラットフォーム "none" クラスターの DNS 設定例

このセクションでは、プラットフォーム none オプションを使用して OpenShift Container Platform をデプロイするための DNS 要件を満たす A および PTR レコード設定サンプルを提供します。サンプルは、特定の DNS ソリューションを選択するためのアドバイスを提供することを目的としていません。

この例では、クラスター名は ocp4 で、ベースドメインは example.com です。

プラットフォーム "none" クラスターの DNS A レコード設定の例

次の例は、プラットフォーム none オプションを使用したクラスター内の名前解決のサンプル A レコードを示す BIND ゾーンファイルです。

例12.1 DNS ゾーンデータベースのサンプル

- 1

- Kubernetes API の名前解決を提供します。レコードは API ロードバランサーの IP アドレスを参照します。

- 2

- Kubernetes API の名前解決を提供します。レコードは API ロードバランサーの IP アドレスを参照し、内部クラスター通信に使用されます。

- 3

- ワイルドカードルートの名前解決を提供します。レコードは、アプリケーション Ingress ロードバランサーの IP アドレスを参照します。アプリケーション Ingress ロードバランサーは、Ingress コントローラー Pod を実行するマシンをターゲットにします。Ingress コントローラー Pod はデフォルトでコンピュートマシンで実行されます。注記

この例では、同じロードバランサーが Kubernetes API およびアプリケーションの Ingress トラフィックに使用されます。実稼働のシナリオでは、API およびアプリケーション Ingress ロードバランサーを個別にデプロイし、それぞれのロードバランサーインフラストラクチャーを分離してスケーリングすることができます。

- 4 5 6

- コントロールプレーンマシンの名前解決を提供します。

- 7 8

- コンピュートマシンの名前解決を提供します。

プラットフォーム "none" クラスターの DNS PTR レコード設定の例

次の BIND ゾーンファイルの例は、プラットフォーム none オプションを使用したクラスターでの逆名前解決のサンプル PTR レコードを示しています。

例12.2 逆引きレコードの DNS ゾーンデータベースの例

PTR レコードは、OpenShift Container Platform アプリケーションのワイルドカードには必要ありません。

12.1.7.2. プラットフォーム "none" 負荷分散要件

OpenShift Container Platform をインストールする前に、API およびアプリケーションの Ingress 負荷分散インフラストラクチャーをプロビジョニングする必要があります。実稼働のシナリオでは、API およびアプリケーション Ingress ロードバランサーを個別にデプロイし、それぞれのロードバランサーインフラストラクチャーを分離してスケーリングすることができます。

これらの要件は、プラットフォーム none オプションを使用する単一ノード OpenShift クラスターには適用されません。

Red Hat Enterprise Linux (RHEL) インスタンスを使用して API およびアプリケーションイングレスロードバランサーをデプロイする場合は、RHEL サブスクリプションを別途購入する必要があります。

負荷分散インフラストラクチャーは以下の要件を満たす必要があります。

API ロードバランサー: プラットフォームと対話およびプラットフォームを設定するためのユーザー向けの共通のエンドポイントを提供します。以下の条件を設定します。

- Layer 4 の負荷分散のみ。これは、Raw TCP、SSL パススルー、または SSL ブリッジモードと呼ばれます。SSL ブリッジモードを使用する場合は、API ルートの Server Name Indication (SNI) を有効にする必要があります。

- ステートレス負荷分散アルゴリズム。オプションは、ロードバランサーの実装によって異なります。

重要API ロードバランサーのセッションの永続性は設定しないでください。

ロードバランサーのフロントとバックの両方で以下のポートを設定します。

Expand 表12.4 API ロードバランサー ポート バックエンドマシン (プールメンバー) 内部 外部 説明 6443コントロールプレーンAPI サーバーのヘルスチェックプローブの

/readyzエンドポイントを設定する必要があります。X

X

Kubernetes API サーバー

22623コントロールプレーン

X

マシン設定サーバー

注記ロードバランサーは、API サーバーが

/readyzエンドポイントをオフにしてからプールから API サーバーインスタンスを削除するまで最大 30 秒かかるように設定する必要があります。/readyzの後の時間枠内でエラーが返されたり、正常になったりする場合は、エンドポイントが削除または追加されているはずです。5 秒または 10 秒ごとにプローブし、2 つの正常な要求が正常な状態になり、3 つの要求が正常な状態になりません。これらは十分にテストされた値です。Application Ingress ロードバランサー: クラスター外から送られるアプリケーショントラフィックの Ingress ポイントを提供します。Ingress ルーターの作業用の設定が OpenShift Container Platform クラスターに必要です。

以下の条件を設定します。

- Layer 4 の負荷分散のみ。これは、Raw TCP、SSL パススルー、または SSL ブリッジモードと呼ばれます。SSL ブリッジモードを使用する場合は、Ingress ルートの Server Name Indication (SNI) を有効にする必要があります。

- 選択可能なオプションやプラットフォーム上でホストされるアプリケーションの種類に基づいて、接続ベースの永続化またはセッションベースの永続化が推奨されます。

ヒントクライアントの実際の IP アドレスがアプリケーション Ingress ロードバランサーによって確認できる場合、ソースの IP ベースのセッション永続化を有効にすると、エンドツーエンドの TLS 暗号化を使用するアプリケーションのパフォーマンスを強化できます。

ロードバランサーのフロントとバックの両方で以下のポートを設定します。

Expand 表12.5 アプリケーション Ingress ロードバランサー ポート バックエンドマシン (プールメンバー) 内部 外部 説明 443デフォルトで Ingress コントローラー Pod、コンピュート、またはワーカーを実行するマシン。

X

X

HTTPS トラフィック

80デフォルトで Ingress コントローラー Pod、コンピュート、またはワーカーを実行するマシン。

X

X

HTTP トラフィック

注記ゼロ (0) コンピュートノードで 3 ノードクラスターをデプロイする場合、Ingress コントローラー Pod はコントロールプレーンノードで実行されます。3 ノードクラスターデプロイメントでは、HTTP および HTTPS トラフィックをコントロールプレーンノードにルーティングするようにアプリケーション Ingress ロードバランサーを設定する必要があります。

12.1.7.2.1. プラットフォーム "none" クラスターのロードバランサー設定の例

このセクションでは、プラットフォーム none オプションを使用してクラスターのロードバランシング要件を満たす API とアプリケーションの Ingress ロードバランサー設定の例を示します。この例は、HAProxy ロードバランサーの /etc/haproxy/haproxy.cfg 設定です。この例では、特定の負荷分散ソリューションを選択するためのアドバイスを提供することを目的としていません。

この例では、同じロードバランサーが Kubernetes API およびアプリケーションの Ingress トラフィックに使用されます。実稼働のシナリオでは、API およびアプリケーション Ingress ロードバランサーを個別にデプロイし、それぞれのロードバランサーインフラストラクチャーを分離してスケーリングすることができます。

HAProxy をロードバランサーとして使用し、SELinux が enforcing に設定されている場合は、setsebool -P haproxy_connect_any=1 を実行して、HAProxy サービスが設定済みの TCP ポートにバインドできることを確認する必要があります。

例12.3 API およびアプリケーション Ingress ロードバランサーの設定例

- 1

- ポート

6443は Kubernetes API トラフィックを処理し、コントロールプレーンマシンを参照します。 - 2

- ポート

22623はマシン設定サーバートラフィックを処理し、コントロールプレーンマシンを参照します。 - 3

- ポート

443は HTTPS トラフィックを処理し、Ingress コントローラー Pod を実行するマシンを参照します。Ingress コントローラー Pod はデフォルトでコンピュートマシンで実行されます。 - 4

- ポート

80は HTTP トラフィックを処理し、Ingress コントローラー Pod を実行するマシンを参照します。Ingress コントローラー Pod はデフォルトでコンピュートマシンで実行されます。注記ゼロ (0) コンピュートノードで 3 ノードクラスターをデプロイする場合、Ingress コントローラー Pod はコントロールプレーンノードで実行されます。3 ノードクラスターデプロイメントでは、HTTP および HTTPS トラフィックをコントロールプレーンノードにルーティングするようにアプリケーション Ingress ロードバランサーを設定する必要があります。

HAProxy をロードバランサーとして使用する場合は、HAProxy ノードで netstat -nltupe を実行して、ポート 6443、22623、443、および 80 で haproxy プロセスがリッスンしていることを確認することができます。

12.1.8. 例: ボンディングと VLAN インターフェイスノードのネットワーク設定

次の agent-config.yaml ファイルは、ボンディングおよび VLAN インターフェイスのマニフェストの例です。

- 1 3

- インターフェイスの名前。

- 2

- インターフェイスのタイプ。以下の例では VLAN を作成します。

- 4

- インターフェイスのタイプ。この例では、ボンドを作成します。

- 5

- インターフェイスの MAC アドレス。

- 6

mode属性は、ボンドモードを指定します。- 7

- MII リンクの監視頻度をミリ秒単位で指定します。この例では、ボンディングリンクを 150 ミリ秒ごとに検査します。

- 8

- オプション:DNS サーバーの検索およびサーバー設定を指定します。

- 9

- ノードトラフィックのネクストホップアドレス。これは、指定されたインターフェイスに設定される IP アドレスと同じサブネットにある必要があります。

- 10

- ノードトラフィックのネクストホップインターフェイス。

12.1.9. 例: ボンディングと SR-IOV デュアル NIC ノードのネットワーク設定

SR-IOV デバイスの NIC パーティショニングの有効化に関連する Day 1 操作のサポートは、テクノロジープレビュー機能のみです。テクノロジープレビュー機能は、Red Hat 製品のサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではないことがあります。Red Hat は、実稼働環境でこれらを使用することを推奨していません。テクノロジープレビューの機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

次の agent-config.yaml ファイルは、ボンドと SR-IOV インターフェイスを備えたデュアルポート NIC のマニフェストの例です。

- 1

networkConfigフィールドには、ホストのネットワーク設定に関する情報が含まれ、サブフィールドには、interfaces、dns-resolver、およびroutesが含まれます。- 2

interfacesフィールドは、ホスト用に定義されたネットワークインターフェイスの配列です。- 3

- インターフェイスの名前。

- 4

- インターフェイスのタイプ。この例では、イーサネットインターフェイスを作成します。

- 5

- 厳密に必要ではない場合、物理機能 (PF) の DHCP を無効にするには、これを

falseに設定します。 - 6

- これを、インスタンス化する SR-IOV 仮想機能 (VF) の数に設定します。

- 7

- これを

upに設定します。 - 8

- ボンドに接続された VF の IPv4 アドレス指定を無効にするには、これを

falseに設定します。 - 9

- VF の最小伝送速度 (Mbps) を設定します。このサンプル値は、100 Mbps のレートを設定します。

- この値は、最大伝送レート以下である必要があります。

-

Intel NIC は

min-tx-rateパラメーターをサポートしていません。詳細は、BZ#1772847 を参照してください。

- 10

- VF の最大伝送速度 (Mbps) を設定します。このサンプル値は、200 Mbps のレートを設定します。

- 11

- 目的のボンディングモードを設定します。

- 12

- ボンディングインターフェイスの優先ポートを設定します。プライマリーデバイスは、最初に使用されるボンディングインターフェイスであり、障害が発生しないかぎり、破棄されません。この設定が特に役立つのは、ボンディングインターフェイスの NIC の 1 つが高速なため、大規模な負荷に対応できる場合です。この設定は、ボンディングインターフェイスが

active-backupモード (モード 1) およびbalance-tlb(モード 5) の場合のみに有効です。 - 13

- ボンドインターフェイスの静的 IP アドレスを設定します。これはノードの IP アドレスです。

- 14

- デフォルトルートのゲートウェイとして

bond0を設定します。

12.1.10. ベアメタルのサンプル install-config.yaml ファイル

install-config.yaml ファイルをカスタマイズして、OpenShift Container Platform クラスターのプラットフォームに関する詳細を指定するか、必要なパラメーターの値を変更することができます。

- 1

- クラスターのベースドメイン。すべての DNS レコードはこのベースのサブドメインである必要があり、クラスター名が含まれる必要があります。

- 2 4

controlPlaneセクションは単一マッピングですが、computeセクションはマッピングのシーケンスになります。複数の異なるデータ構造の要件を満たすには、computeセクションの最初の行はハイフン-で始め、controlPlaneセクションの最初の行はハイフンで始めることができません。1 つのコントロールプレーンプールのみが使用されます。- 3

- このパラメーターは、インストールプロセスをトリガーする前に、エージェントベースのインストールが検出を待機するコンピュートマシンの数を制御します。これは、生成された ISO で起動する必要があるコンピューティングマシンの数です。注記

3 ノードクラスターをインストールする場合は、Red Hat Enterprise Linux CoreOS (RHCOS) マシンをインストールする際にコンピュートマシンをデプロイしないでください。

- 5

- クラスターに追加するコントロールプレーンマシンの数。クラスターをこれらの値をクラスターの etcd エンドポイント数として使用するため、値はデプロイするコントロールプレーンマシンの数に一致する必要があります。

- 6

- DNS レコードに指定したクラスター名。

- 7

- Pod IP アドレスの割り当てに使用する IP アドレスのブロック。このブロックは既存の物理ネットワークと重複できません。これらの IP アドレスは Pod ネットワークに使用されます。外部ネットワークから Pod にアクセスする必要がある場合、ロードバランサーおよびルーターを、トラフィックを管理するように設定する必要があります。注記

クラス E の CIDR 範囲は、将来の使用のために予約されています。クラス E CIDR 範囲を使用するには、ネットワーク環境がクラス E CIDR 範囲内の IP アドレスを受け入れるようにする必要があります。

- 8

- それぞれの個別ノードに割り当てるサブネット接頭辞長。たとえば、

hostPrefixが23に設定されている場合、各ノードに指定のcidrから/23サブネットが割り当てられます。これにより、510 (2^(32 - 23) - 2) Pod IP アドレスが許可されます。外部ネットワークからのノードへのアクセスを提供する必要がある場合には、ロードバランサーおよびルーターを、トラフィックを管理するように設定します。 - 9

- インストールするクラスターネットワークプラグイン。サポートされている値は

OVNKubernetes(デフォルト値) とOpenShiftSDNです。 - 10

- サービス IP アドレスに使用する IP アドレスプール。1 つの IP アドレスプールのみを入力できます。このブロックは既存の物理ネットワークと重複できません。外部ネットワークからサービスにアクセスする必要がある場合、ロードバランサーおよびルーターを、トラフィックを管理するように設定します。

- 11

- 単一ノードクラスターの場合は、プラットフォームを

noneに設定しなくてはなりません。マルチノードクラスターの場合は、プラットフォームをvsphere、baremetal、またはnoneに設定できます。注記プラットフォームを

vsphereまたはbaremetalに設定すると、次の 3 つの方法でクラスターノードの IP アドレスエンドポイントを設定できます。- IPv4

- IPv6

- IPv4 と IPv6 の並列 (デュアルスタック)

デュアルスタックネットワーキングの例

Copy to Clipboard Copied! Toggle word wrap Toggle overflow - 12

- FIPS モードを有効または無効にするかどうか。デフォルトでは、FIPS モードは有効にされません。FIPS モードが有効にされている場合、OpenShift Container Platform が実行される Red Hat Enterprise Linux CoreOS (RHCOS) マシンがデフォルトの Kubernetes 暗号スイートをバイパスし、代わりに RHCOS で提供される暗号モジュールを使用します。重要

FIPS モードでブートされた Red Hat Enterprise Linux (RHEL) または Red Hat Enterprise Linux CoreOS (RHCOS) を実行する場合、OpenShift Container Platform コアコンポーネントは、x86_64、ppc64le、および s390x アーキテクチャーのみで、FIPS 140-2/140-3 検証のために NIST に提出された RHEL 暗号化ライブラリーを使用します。

- 13

- このプルシークレットを使用し、OpenShift Container Platform コンポーネントのコンテナーイメージを提供する Quay.io など、組み込まれた各種の認証局によって提供されるサービスで認証できます。

- 14

- Red Hat Enterprise Linux CoreOS (RHCOS) の

coreユーザーの SSH 公開鍵。注記インストールのデバッグまたは障害復旧を実行する必要のある実稼働用の OpenShift Container Platform クラスターでは、

ssh-agentプロセスが使用する SSH キーを指定します。

12.1.11. agent.ISO の作成前の検証チェック

Agent-based Installer は、ISO が作成される前に、ユーザー定義の YAML ファイルに対して検証チェックを実行します。検証に成功すると、agent.ISO が作成されます。

install-config.yaml

-

baremetal、vsphere、およびnoneプラットフォームがサポートされています。 -

noneプラットフォームの場合、networkTypeパラメーターはOVNKubernetesである必要があります。 -

apiVIPsおよびingressVIPsパラメーターは、ベアメタルおよび vSphere プラットフォームに設定する必要があります。 -

agent-config.yamlファイルに相当するベアメタルプラットフォーム設定の一部のホスト固有フィールドは無視されます。これらのフィールドが設定されている場合、警告メッセージがログに記録されます。

agent-config.yaml

- 各インターフェイスには、定義された MAC アドレスが必要です。また、すべてのインターフェイスに異なる MAC アドレスが必要です。

- ホストごとに少なくとも 1 つのインターフェイスを定義する必要があります。

- World Wide Name (WWN) ベンダーエクステンションは、ルートデバイスのヒントではサポートされません。

-

hostオブジェクトのroleパラメーターの値はmasterまたはworkerのいずれかである必要があります。

12.1.11.1. ZTP マニフェスト

agent-cluster-install.yaml

-

IPv6 の場合、

networkTypeパラメーターでサポートされる唯一の値はOVNKubernetesです。OpenShiftSDN値は、IPv4 にのみ使用できます。

cluster-image-set.yaml

-

ReleaseImageパラメーターは、インストーラーで定義されるリリースと一致する必要があります。